java爬虫抓取网页数据

java爬虫抓取网页数据(什么是网络爬虫从功能上来讲架构的四大组件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-01-16 08:08

什么是网络爬虫

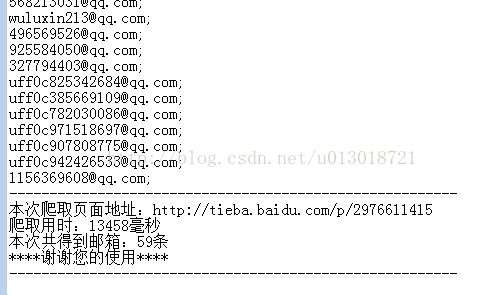

从功能上来说,爬虫一般分为数据采集、处理、存储三部分。爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。

网络爬虫常用技术的底层实现是HttpClient + Jsoup

HttpClient 是 Apache Jakarta Common 下的一个子项目,用于提供高效、最新、功能丰富的支持 HTTP 协议的客户端编程工具包,支持最新版本和推荐的 HTTP 协议。HttpClient 已经在很多项目中使用,比如 Cactus 和 HTMLUnit,Apache Jakarta 上另外两个知名的开源项目,都使用了 HttpClient。关注了解更多信息。

Jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的 API,用于通过 DOM、CSS 和类似 jQuery 的操作方法获取和操作数据。

HttpClient用于下载网页源代码,Jsoup用于从网页源代码中解析出需要的内容。

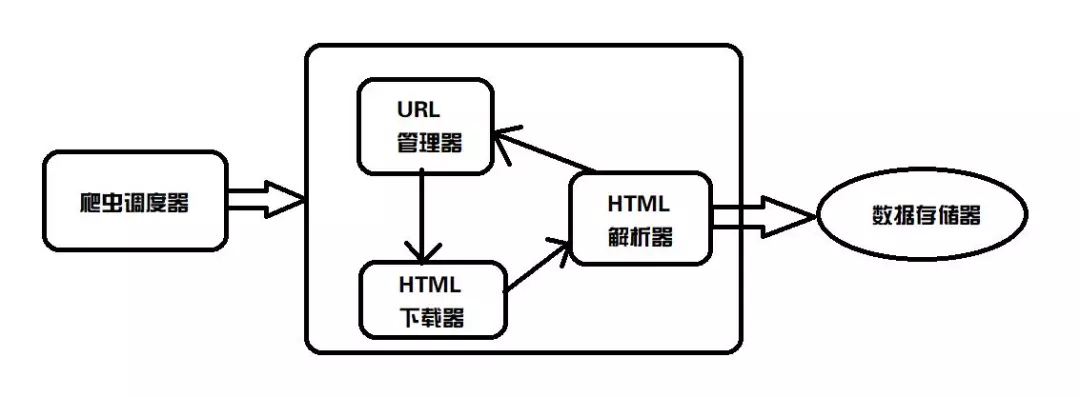

Webmagic 框架

webmagic 是一个开源的 Java 爬虫框架,其目标是简化爬虫开发过程,让开发者专注于逻辑功能的开发。webmagic的核心很简单,但是涵盖了爬虫的全过程,也是学习爬虫开发的好资料。

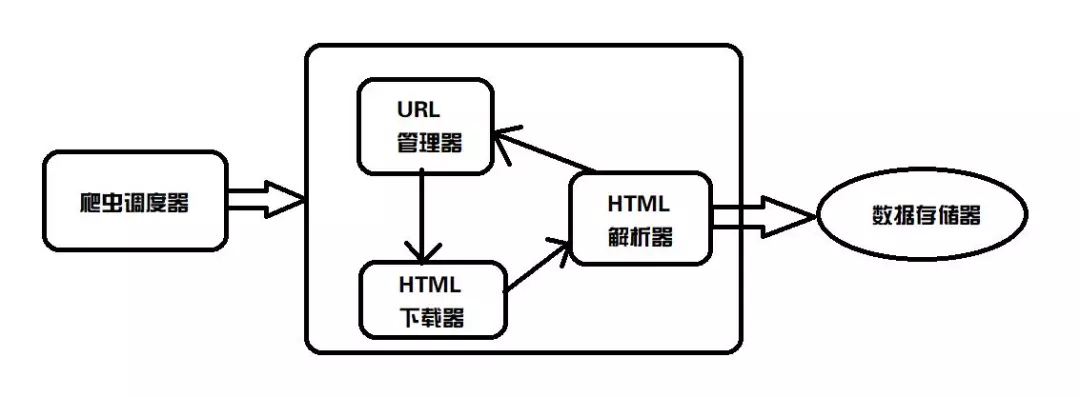

爬虫框架Webmagic介绍架构的四大组件

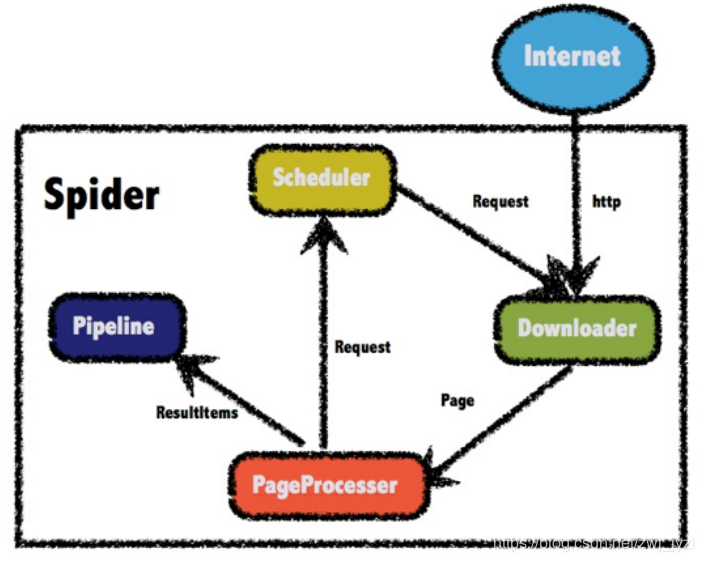

WebMagic 的结构分为四大组件:Downloader、PageProcessor、Scheduler 和 Pipeline,它们由 Spider 组织。这四个组件分别对应了爬虫生命周期中的下载、处理、管理和持久化的功能。Spider 组织这些组件,以便它们可以相互交互并处理执行。可以认为Spider是一个大容器,也是WebMagic逻辑的核心。

简单说明:Downloader负责爬取网页的源码,PageProcesser指定爬取的规则(即指定要爬取什么内容),然后交给Pipeline来存储爬取的内容,并交给用于管理的Scheduler URL,防止Downloader再次爬取该页面,防止爬取重复内容。

PageProcessor 爬取页面的全部内容

需求:编写爬虫程序,爬取csdn中博客的内容

1)引入依赖

us.codecraft

webmagic-core

0.7.3

us.codecraft

webmagic-extension

0.7.3

2)编写类来抓取网页内容

public class MyProcessor implements PageProcessor {

public void process(Page page) {

// 将爬取的网页源代码输出到控制台

System.out.println(page.getHtml().toString());

}

public Site getSite() {

return Site.me().setSleepTime(100).setRetryTimes(3);

}

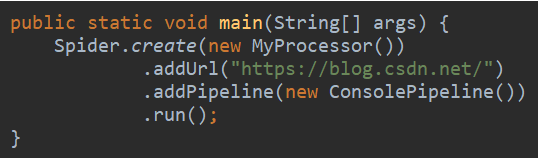

public static void main(String[] args) {

Spider.create(new MyProcessor())

.addUrl("https://blog.csdn.net/")

.run();

}

}

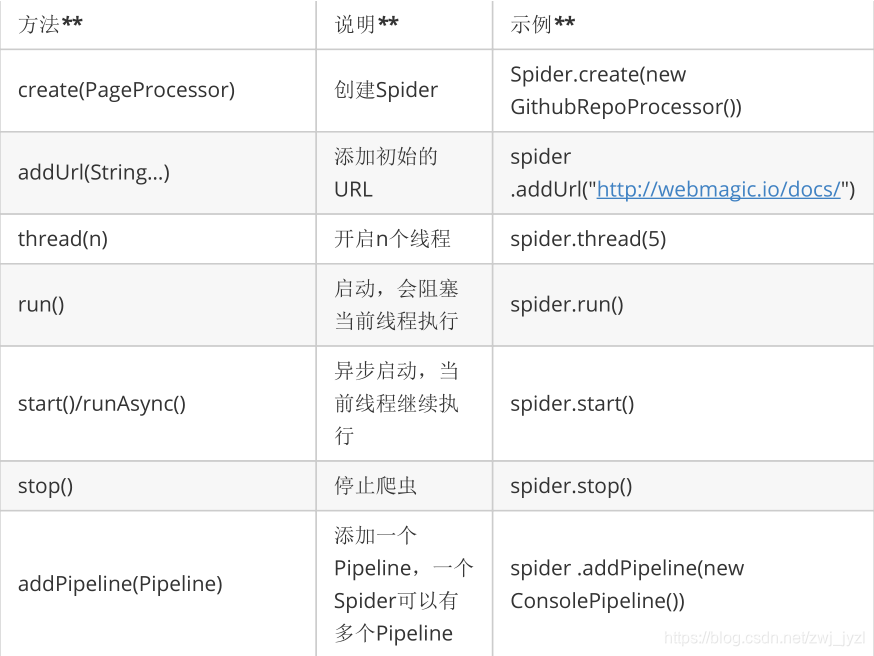

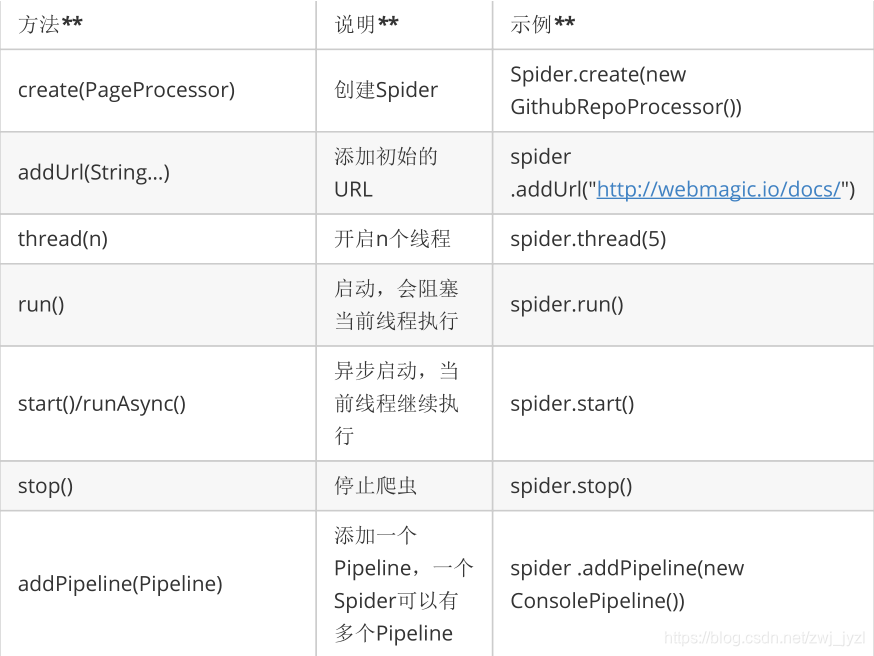

Spider 是爬虫启动的入口点。在启动爬虫之前,我们需要使用 PageProcessor 创建一个 Spider 对象,然后使用 run() 来启动它。

蜘蛛的一些方法:

同时可以通过set方法设置Spider的其他组件(Downloader、Scheduler、Pipeline)。

Page 代表从 Downloader 下载的页面 - 它可能是 HTML、JSON 或其他文本内容。页面是WebMagic抽取过程的核心对象,它提供了一些抽取、结果保存等方法。

Site用于定义站点本身的一些配置信息,如编码、HTTP头、超时、重试策略等,代理等,可以通过设置Site对象来配置。

网站的一些方法:

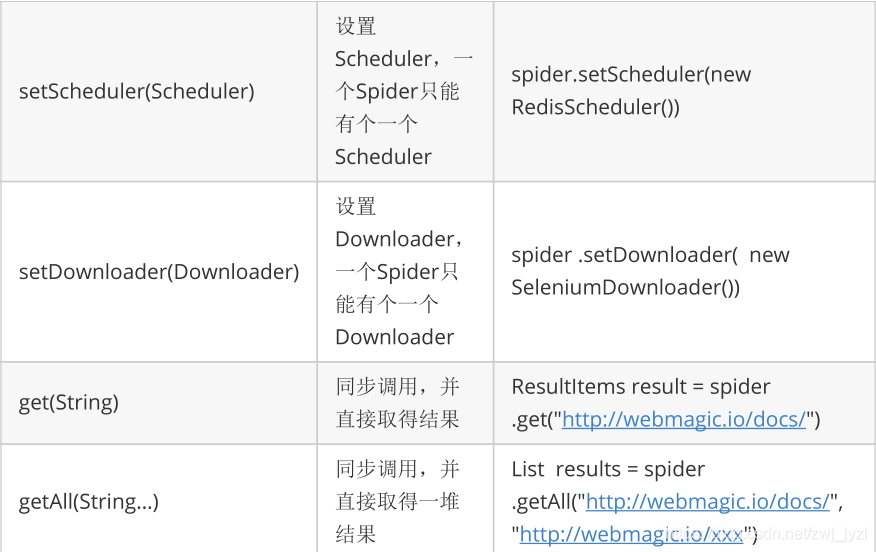

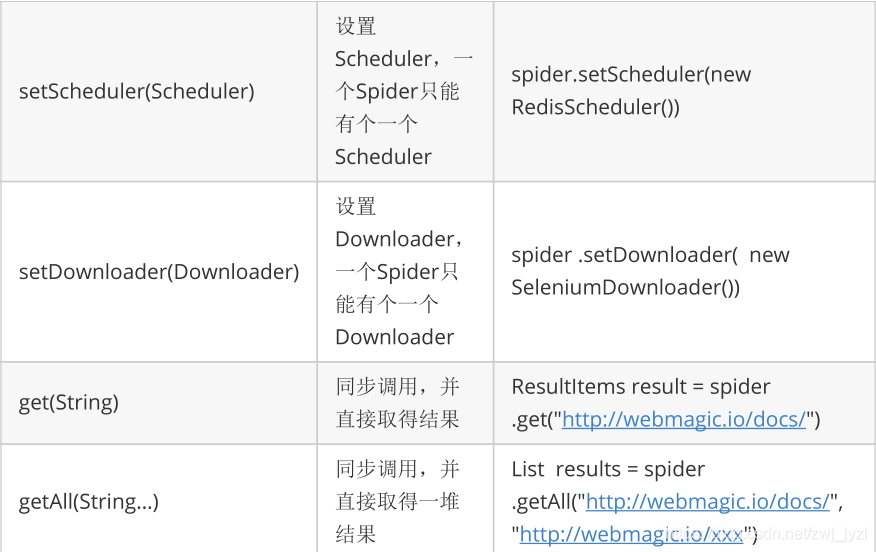

爬取指定内容(Xpath)

如果我们要爬取网页的部分内容,需要指定xpath。XPath,即 XML 路径语言 (XMLPathLanguage),是一种用于确定 XML 文档的某个部分的位置的语言。XPath 使用路径表达式来选择 XML 文档中的节点或节点集。这些路径表达式与我们在常规计算机文件系统中看到的表达式非常相似。

我们通过指定 xpath 来抓取网页的一部分:

System.out.println(page.getHtml().xpath("//*[@id=\"mainBox\"]/main/div[1]/div/div/div[1]/h1").toString());

获取xpath的简单方法:打开网页,按F12

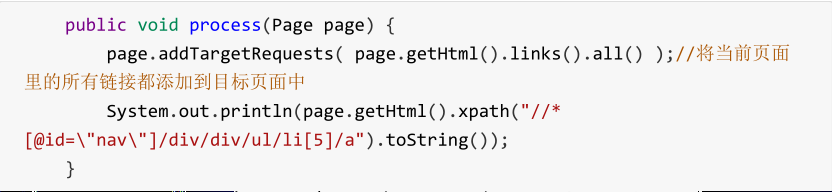

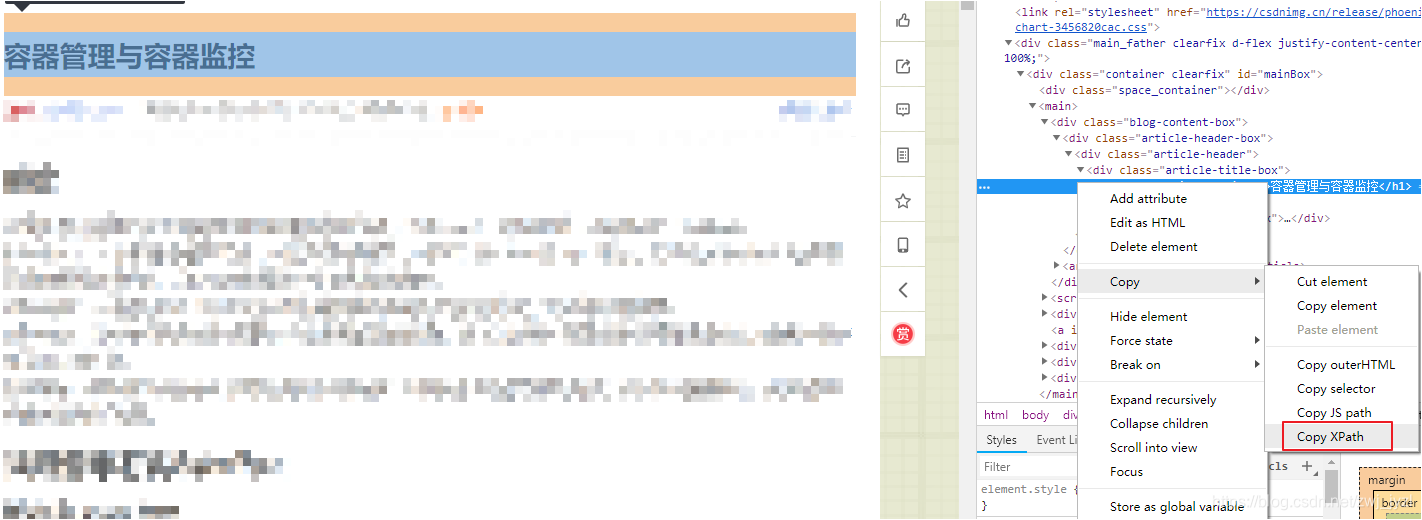

添加目标地址

我们可以通过添加目标地址从种子页面爬取更多页面:

目标地址正则表达式

有时我们只需要将当前页面中符合要求的链接添加到目标页面即可。这时候,我们可以使用正则表达式来过滤链接:

// 添加目标地址,从一个页面爬到另一个页面

page.addTargetRequests(page.getHtml().links().regex("https://blog.csdn.net/[a-z 0-9 _]+/article/details/[0-9]{8}").all());

System.out.println(page.getHtml().xpath("//*[@id=\"mainBox\"]/main/div[1]/div/div/div[1]/h1").toString());

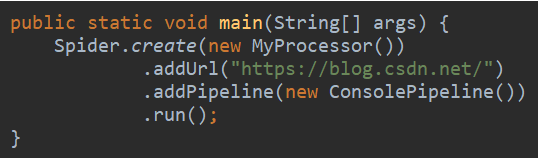

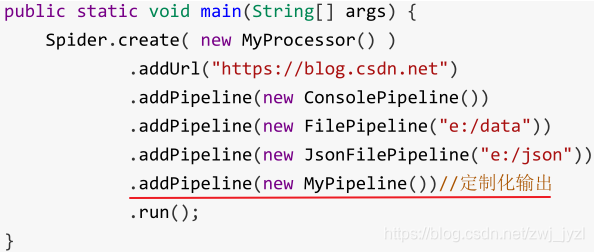

管道控制台管道控制台输出

将处理结果输出到控制台

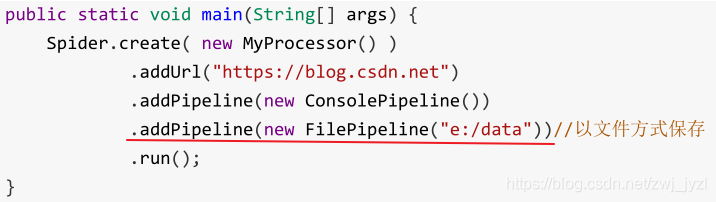

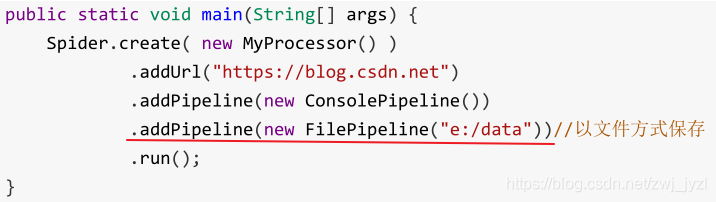

FilePipeline 文件保存

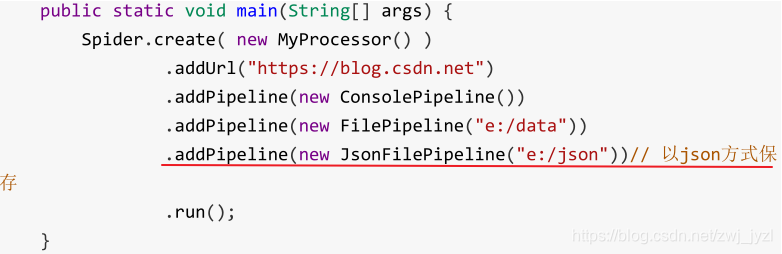

另存为 json

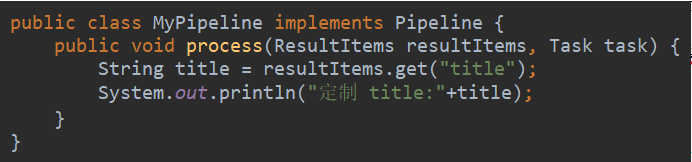

自定义管道

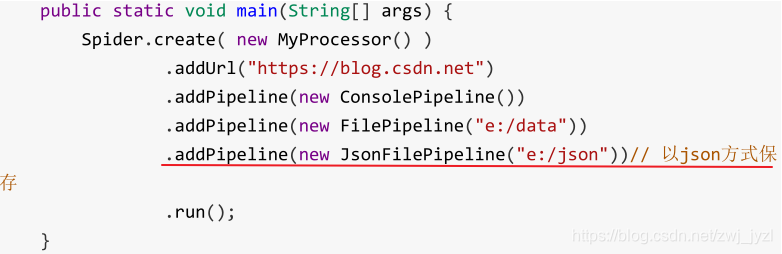

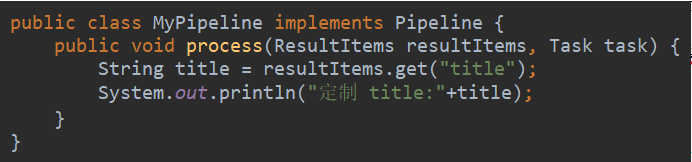

一般我们需要把爬取的数据放到数据库中,这个时候我们可以自定义Pipeline

创建一个实现 Pipeline 接口的类:

修改主方法:

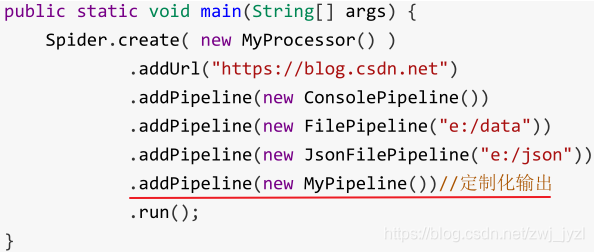

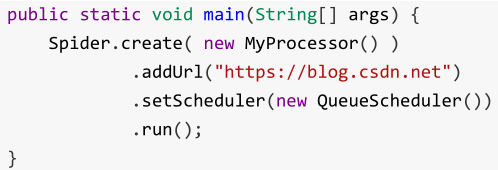

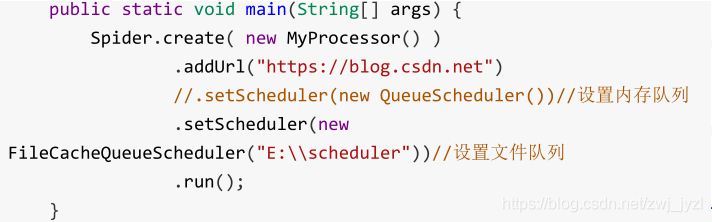

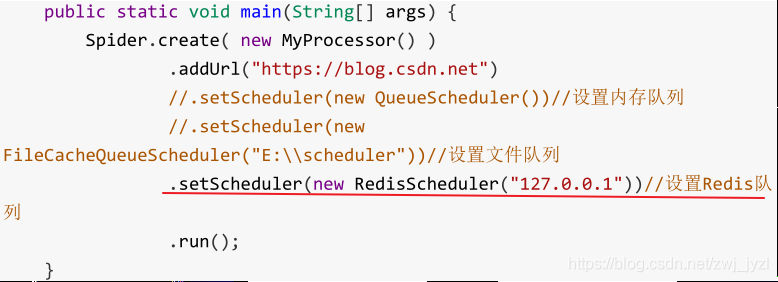

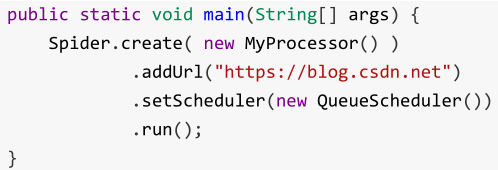

调度器

我们刚刚完成的功能,每次运行可能会爬取重复页面,这是没有意义的。Scheduler(URL管理)最基本的功能就是对已经爬取的URL进行标记。可以实现 URL 的增量重复数据删除。

目前scheduler的实现主要有3种:

内存队列

使用 setScheduler 设置调度器:

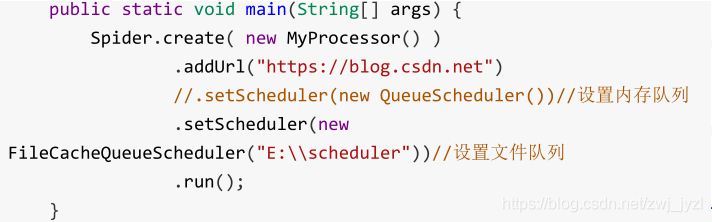

文件队列

使用文件保存爬取的URL,在关闭程序下一次开始时,可以从之前获取的URL继续爬取

但是,要使用这种方法,首先要保证文件目录存在,所以先创建一个文件存放目录:

运行后文件夹E:\scheduler会生成两个文件.urls.txt和.cursor.txt

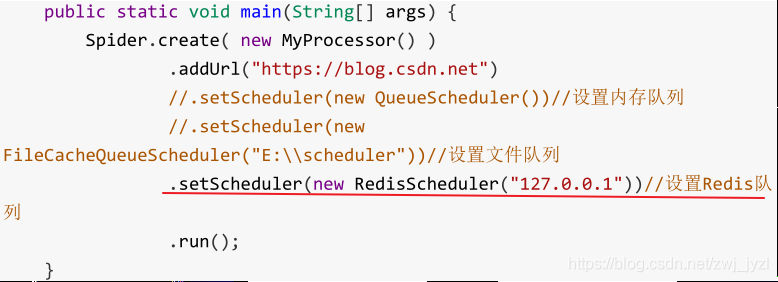

Redis 队列

使用Redis保存抓取队列,可用于多台机器同时协同抓取

首先运行redis服务器

示例(爬取csdn博客的用户昵称和头像)

1)引入依赖

2)创建配置文件

server:

port: 9014

spring:

application:

name: tensquare-article-crawler #指定服务名

datasource:

driverClassName: com.mysql.jdbc.Driver

url: jdbc:mysql://192.168.227.129:3306/tensquare_article?characterEncoding=UTF8

username: root

password: 123456

jpa:

database: MySQL

show-sql: true

redis:

host: 192.168.227.129

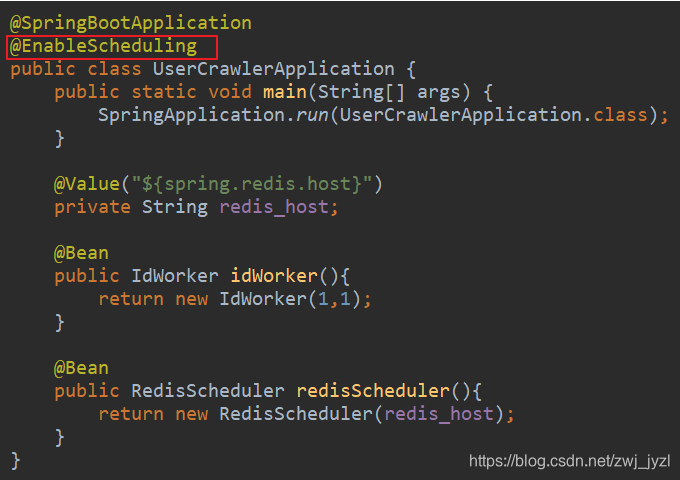

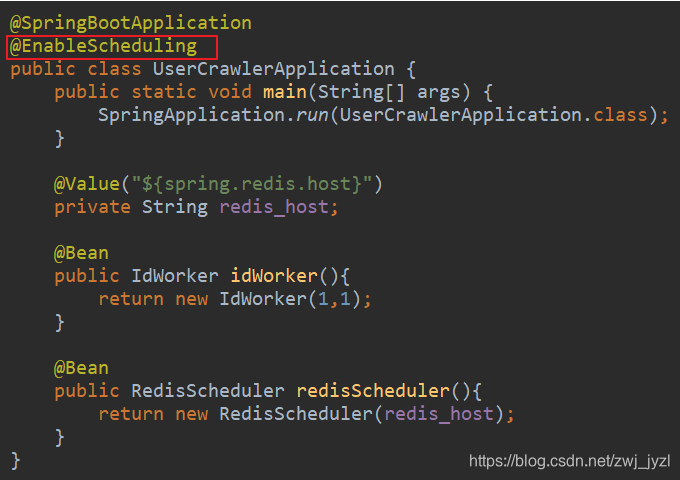

3)创建一个启动类

@SpringBootApplication

public class ArticleCrawlerApplication {

public static void main(String[] args) {

SpringApplication.run(ArticleCrawlerApplication.class);

}

@Value("${spring.redis.host}")

private String redis_host;

@Bean

public IdWorker idWorker(){

return new IdWorker(1,1);

}

@Bean

public RedisScheduler redisScheduler(){

return new RedisScheduler(redis_host);

}

}

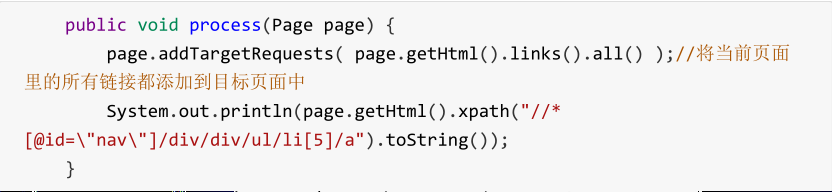

4)创建爬虫类

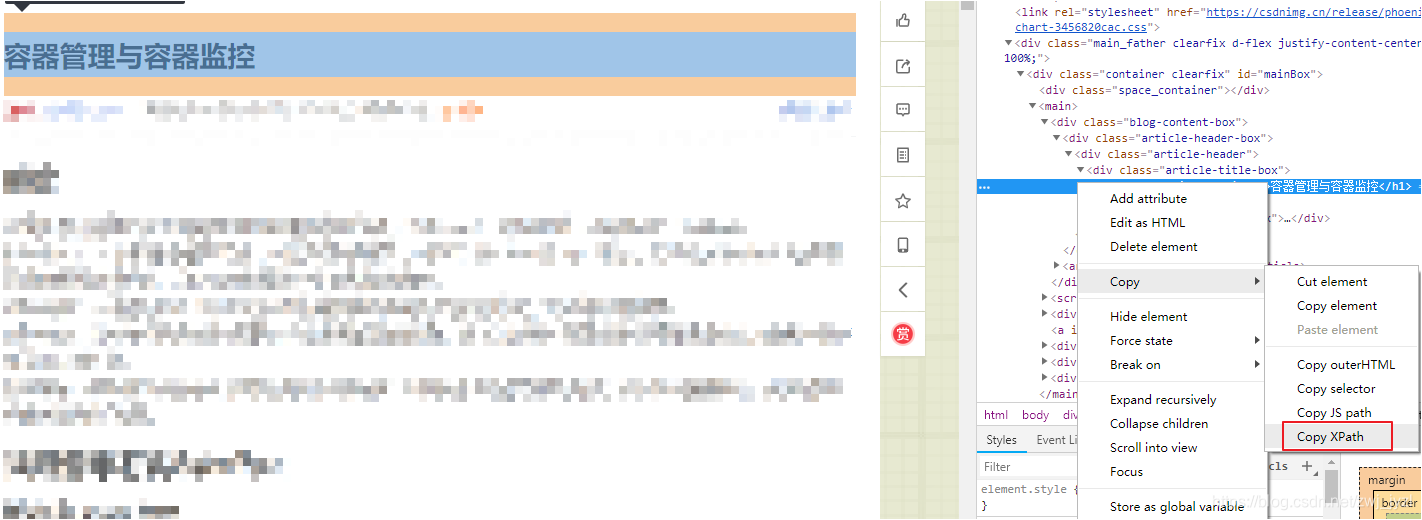

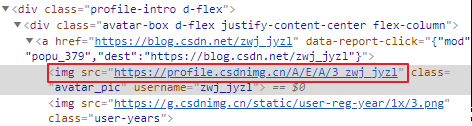

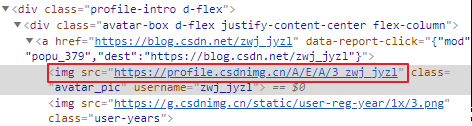

打开网页,按F12,找到头像和昵称

如上图:头像是标签中的一个属性,如何获取呢?

@Component

public class UserProcessor implements PageProcessor {

@Override

public void process(Page page) {

// 添加目标地址,从一个页面爬到另一个页面

page.addTargetRequests(page.getHtml().links().regex("https://blog.csdn.net/[a-z 0-9 _]+/article/details/[0-9]{8}").all());

// 添加字段,代码结构化,可多次使用

String nickName = page.getHtml().xpath("//*[@id=\"uid\"]/text()").get();

String image = page.getHtml().xpath("//*[@id=\"asideProfile\"]/div[1]/div[1]/a/img[1]/@src").get();

if (nickName != null && image != null){

page.putField("nickName",nickName);

page.putField("image",image);

} else {

// 不执行后面的步骤

page.setSkip(true);

}

}

@Override

public Site getSite() {

return Site.me().setSleepTime(100).setRetryTimes(3);

}

}

只需在对应的 xpath 路径后添加 /@property 名称即可

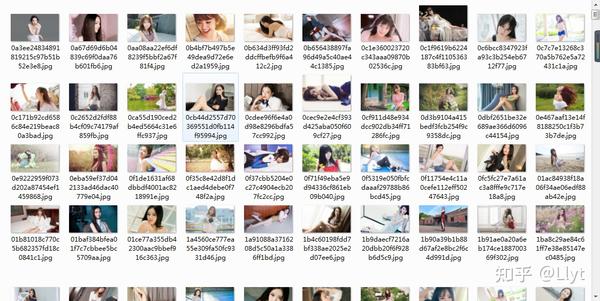

我们拿到头像的存储地址后,需要下载到本地,然后上传到我们自己的图片服务器,所以我们还需要一个下载工具类

package util;

import java.io.*;

import java.net.URL;

import java.net.URLConnection;

/**

* 下载工具类

*/

public class DownloadUtil {

public static void download(String urlStr,String filename,String savePath) throws IOException {

URL url = new URL(urlStr);

//打开url连接

URLConnection connection = url.openConnection();

//请求超时时间

connection.setConnectTimeout(5000);

//输入流

InputStream in = connection.getInputStream();

//缓冲数据

byte [] bytes = new byte[1024];

//数据长度

int len;

//文件

File file = new File(savePath);

if(!file.exists())

file.mkdirs();

OutputStream out = new FileOutputStream(file.getPath()+"\\"+filename);

//先读到bytes中

while ((len=in.read(bytes))!=-1){

//再从bytes中写入文件

out.write(bytes,0,len);

}

//关闭IO

out.close();

in.close();

}

}

5)创建存储类

@Component

public class UserPipeline implements Pipeline {

@Autowired

private IdWorker idWorker;

@Autowired

private UserDao userDao;

@Override

public void process(ResultItems resultItems, Task task) {

String nickName = resultItems.get("nickName");

String image = resultItems.get("image");

String imageName = image.substring(image.lastIndexOf("/") + 1) + ".jpg";

User user = new User();

user.setId(idWorker.nextId()+"");

user.setAvatar(imageName);

user.setNickname(nickName);

// 将用户存入数据库

userDao.save(user);

// 将图片下载下载

try {

DownloadUtil.download(image,imageName,"E:/tensquare/userimage");

} catch (IOException e) {

e.printStackTrace();

}

}

}

6)创建任务类

@Component

public class UserTask {

@Autowired

private UserProcessor userProcessor;

@Autowired

private UserPipeline userPipeline;

@Autowired

private RedisScheduler redisScheduler;

@Scheduled(cron = "0 57 22 * * ?")

public void UserTask(){

Spider spider = Spider.create(userProcessor);

spider.addUrl("https://blog.csdn.net/");

spider.addPipeline(userPipeline);

spider.setScheduler(redisScheduler);

spider.start();

}

}

7)为启动类添加注解

8)运行这个模块,数据会在指定时间自动爬取 查看全部

java爬虫抓取网页数据(什么是网络爬虫从功能上来讲架构的四大组件)

什么是网络爬虫

从功能上来说,爬虫一般分为数据采集、处理、存储三部分。爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。

网络爬虫常用技术的底层实现是HttpClient + Jsoup

HttpClient 是 Apache Jakarta Common 下的一个子项目,用于提供高效、最新、功能丰富的支持 HTTP 协议的客户端编程工具包,支持最新版本和推荐的 HTTP 协议。HttpClient 已经在很多项目中使用,比如 Cactus 和 HTMLUnit,Apache Jakarta 上另外两个知名的开源项目,都使用了 HttpClient。关注了解更多信息。

Jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的 API,用于通过 DOM、CSS 和类似 jQuery 的操作方法获取和操作数据。

HttpClient用于下载网页源代码,Jsoup用于从网页源代码中解析出需要的内容。

Webmagic 框架

webmagic 是一个开源的 Java 爬虫框架,其目标是简化爬虫开发过程,让开发者专注于逻辑功能的开发。webmagic的核心很简单,但是涵盖了爬虫的全过程,也是学习爬虫开发的好资料。

爬虫框架Webmagic介绍架构的四大组件

WebMagic 的结构分为四大组件:Downloader、PageProcessor、Scheduler 和 Pipeline,它们由 Spider 组织。这四个组件分别对应了爬虫生命周期中的下载、处理、管理和持久化的功能。Spider 组织这些组件,以便它们可以相互交互并处理执行。可以认为Spider是一个大容器,也是WebMagic逻辑的核心。

简单说明:Downloader负责爬取网页的源码,PageProcesser指定爬取的规则(即指定要爬取什么内容),然后交给Pipeline来存储爬取的内容,并交给用于管理的Scheduler URL,防止Downloader再次爬取该页面,防止爬取重复内容。

PageProcessor 爬取页面的全部内容

需求:编写爬虫程序,爬取csdn中博客的内容

1)引入依赖

us.codecraft

webmagic-core

0.7.3

us.codecraft

webmagic-extension

0.7.3

2)编写类来抓取网页内容

public class MyProcessor implements PageProcessor {

public void process(Page page) {

// 将爬取的网页源代码输出到控制台

System.out.println(page.getHtml().toString());

}

public Site getSite() {

return Site.me().setSleepTime(100).setRetryTimes(3);

}

public static void main(String[] args) {

Spider.create(new MyProcessor())

.addUrl("https://blog.csdn.net/";)

.run();

}

}

Spider 是爬虫启动的入口点。在启动爬虫之前,我们需要使用 PageProcessor 创建一个 Spider 对象,然后使用 run() 来启动它。

蜘蛛的一些方法:

同时可以通过set方法设置Spider的其他组件(Downloader、Scheduler、Pipeline)。

Page 代表从 Downloader 下载的页面 - 它可能是 HTML、JSON 或其他文本内容。页面是WebMagic抽取过程的核心对象,它提供了一些抽取、结果保存等方法。

Site用于定义站点本身的一些配置信息,如编码、HTTP头、超时、重试策略等,代理等,可以通过设置Site对象来配置。

网站的一些方法:

爬取指定内容(Xpath)

如果我们要爬取网页的部分内容,需要指定xpath。XPath,即 XML 路径语言 (XMLPathLanguage),是一种用于确定 XML 文档的某个部分的位置的语言。XPath 使用路径表达式来选择 XML 文档中的节点或节点集。这些路径表达式与我们在常规计算机文件系统中看到的表达式非常相似。

我们通过指定 xpath 来抓取网页的一部分:

System.out.println(page.getHtml().xpath("//*[@id=\"mainBox\"]/main/div[1]/div/div/div[1]/h1").toString());

获取xpath的简单方法:打开网页,按F12

添加目标地址

我们可以通过添加目标地址从种子页面爬取更多页面:

目标地址正则表达式

有时我们只需要将当前页面中符合要求的链接添加到目标页面即可。这时候,我们可以使用正则表达式来过滤链接:

// 添加目标地址,从一个页面爬到另一个页面

page.addTargetRequests(page.getHtml().links().regex("https://blog.csdn.net/[a-z 0-9 _]+/article/details/[0-9]{8}").all());

System.out.println(page.getHtml().xpath("//*[@id=\"mainBox\"]/main/div[1]/div/div/div[1]/h1").toString());

管道控制台管道控制台输出

将处理结果输出到控制台

FilePipeline 文件保存

另存为 json

自定义管道

一般我们需要把爬取的数据放到数据库中,这个时候我们可以自定义Pipeline

创建一个实现 Pipeline 接口的类:

修改主方法:

调度器

我们刚刚完成的功能,每次运行可能会爬取重复页面,这是没有意义的。Scheduler(URL管理)最基本的功能就是对已经爬取的URL进行标记。可以实现 URL 的增量重复数据删除。

目前scheduler的实现主要有3种:

内存队列

使用 setScheduler 设置调度器:

文件队列

使用文件保存爬取的URL,在关闭程序下一次开始时,可以从之前获取的URL继续爬取

但是,要使用这种方法,首先要保证文件目录存在,所以先创建一个文件存放目录:

运行后文件夹E:\scheduler会生成两个文件.urls.txt和.cursor.txt

Redis 队列

使用Redis保存抓取队列,可用于多台机器同时协同抓取

首先运行redis服务器

示例(爬取csdn博客的用户昵称和头像)

1)引入依赖

2)创建配置文件

server:

port: 9014

spring:

application:

name: tensquare-article-crawler #指定服务名

datasource:

driverClassName: com.mysql.jdbc.Driver

url: jdbc:mysql://192.168.227.129:3306/tensquare_article?characterEncoding=UTF8

username: root

password: 123456

jpa:

database: MySQL

show-sql: true

redis:

host: 192.168.227.129

3)创建一个启动类

@SpringBootApplication

public class ArticleCrawlerApplication {

public static void main(String[] args) {

SpringApplication.run(ArticleCrawlerApplication.class);

}

@Value("${spring.redis.host}")

private String redis_host;

@Bean

public IdWorker idWorker(){

return new IdWorker(1,1);

}

@Bean

public RedisScheduler redisScheduler(){

return new RedisScheduler(redis_host);

}

}

4)创建爬虫类

打开网页,按F12,找到头像和昵称

如上图:头像是标签中的一个属性,如何获取呢?

@Component

public class UserProcessor implements PageProcessor {

@Override

public void process(Page page) {

// 添加目标地址,从一个页面爬到另一个页面

page.addTargetRequests(page.getHtml().links().regex("https://blog.csdn.net/[a-z 0-9 _]+/article/details/[0-9]{8}").all());

// 添加字段,代码结构化,可多次使用

String nickName = page.getHtml().xpath("//*[@id=\"uid\"]/text()").get();

String image = page.getHtml().xpath("//*[@id=\"asideProfile\"]/div[1]/div[1]/a/img[1]/@src").get();

if (nickName != null && image != null){

page.putField("nickName",nickName);

page.putField("image",image);

} else {

// 不执行后面的步骤

page.setSkip(true);

}

}

@Override

public Site getSite() {

return Site.me().setSleepTime(100).setRetryTimes(3);

}

}

只需在对应的 xpath 路径后添加 /@property 名称即可

我们拿到头像的存储地址后,需要下载到本地,然后上传到我们自己的图片服务器,所以我们还需要一个下载工具类

package util;

import java.io.*;

import java.net.URL;

import java.net.URLConnection;

/**

* 下载工具类

*/

public class DownloadUtil {

public static void download(String urlStr,String filename,String savePath) throws IOException {

URL url = new URL(urlStr);

//打开url连接

URLConnection connection = url.openConnection();

//请求超时时间

connection.setConnectTimeout(5000);

//输入流

InputStream in = connection.getInputStream();

//缓冲数据

byte [] bytes = new byte[1024];

//数据长度

int len;

//文件

File file = new File(savePath);

if(!file.exists())

file.mkdirs();

OutputStream out = new FileOutputStream(file.getPath()+"\\"+filename);

//先读到bytes中

while ((len=in.read(bytes))!=-1){

//再从bytes中写入文件

out.write(bytes,0,len);

}

//关闭IO

out.close();

in.close();

}

}

5)创建存储类

@Component

public class UserPipeline implements Pipeline {

@Autowired

private IdWorker idWorker;

@Autowired

private UserDao userDao;

@Override

public void process(ResultItems resultItems, Task task) {

String nickName = resultItems.get("nickName");

String image = resultItems.get("image");

String imageName = image.substring(image.lastIndexOf("/") + 1) + ".jpg";

User user = new User();

user.setId(idWorker.nextId()+"");

user.setAvatar(imageName);

user.setNickname(nickName);

// 将用户存入数据库

userDao.save(user);

// 将图片下载下载

try {

DownloadUtil.download(image,imageName,"E:/tensquare/userimage");

} catch (IOException e) {

e.printStackTrace();

}

}

}

6)创建任务类

@Component

public class UserTask {

@Autowired

private UserProcessor userProcessor;

@Autowired

private UserPipeline userPipeline;

@Autowired

private RedisScheduler redisScheduler;

@Scheduled(cron = "0 57 22 * * ?")

public void UserTask(){

Spider spider = Spider.create(userProcessor);

spider.addUrl("https://blog.csdn.net/";);

spider.addPipeline(userPipeline);

spider.setScheduler(redisScheduler);

spider.start();

}

}

7)为启动类添加注解

8)运行这个模块,数据会在指定时间自动爬取

java爬虫抓取网页数据(自动在工程下创建Pictures文件夹)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-15 20:14

为达到效果,在项目下自动创建Pictures文件夹,根据网站URL爬取图片,逐层获取。图片下的分层URL为网站的文件夹命名,用于安装该层URL下的图片。同时将文件名、路径、URL插入数据库,方便索引。

第一步是创建持久层类来存储文件名、路径和URL。

package org.amuxia.demo;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

public class JDBCHelper {

private static final String driver = "com.mysql.jdbc.Driver";

private static final String DBurl = "jdbc:mysql://127.0.0.1:3306/edupic";

private static final String user = "root";

private static final String password = "root";

private PreparedStatement pstmt = null;

private Connection spiderconn = null;

public void insertFilePath(String fileName, String filepath, String url) {

try {

Class.forName(driver);

spiderconn = DriverManager.getConnection(DBurl, user, password);

String sql = "insert into FilePath (filename,filepath,url) values (?,?,?)";

pstmt = spiderconn.prepareStatement(sql);

pstmt.setString(1, fileName);

pstmt.setString(2, filepath);

pstmt.setString(3, url);

pstmt.executeUpdate();

} catch (ClassNotFoundException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (SQLException e) {

e.printStackTrace();

} finally {

try {

pstmt.close();

spiderconn.close();

} catch (Exception e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

}

第二步,创建一个解析URL并爬取的类

<p> package org.amuxia.demo;

import java.io.BufferedReader;

import java.io.File;

import java.io.FileOutputStream;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.PrintWriter;

import java.net.URL;

import java.net.URLConnection;

import java.util.ArrayList;

import java.util.Hashtable;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class GetWeb {

private int webDepth = 5; // 爬虫深度

private int intThreadNum = 1; // 线程数

private String strHomePage = ""; // 主页地址

private String myDomain; // 域名

private String fPath = "CSDN"; // 储存网页文件的目录名

private ArrayList arrUrls = new ArrayList(); // 存储未处理URL

private ArrayList arrUrl = new ArrayList(); // 存储所有URL供建立索引

private Hashtable allUrls = new Hashtable(); // 存储所有URL的网页号

private Hashtable deepUrls = new Hashtable(); // 存储所有URL深度

private int intWebIndex = 0; // 网页对应文件下标,从0开始

private long startTime;

private int webSuccessed = 0;

private int webFailed = 0;

public static void main(String[] args) {

GetWeb gw = new GetWeb("http://www.csdn.net/");

gw.getWebByHomePage();

}

public GetWeb(String s) {

this.strHomePage = s;

}

public GetWeb(String s, int i) {

this.strHomePage = s;

this.webDepth = i;

}

public synchronized void addWebSuccessed() {

webSuccessed++;

}

public synchronized void addWebFailed() {

webFailed++;

}

public synchronized String getAUrl() {

String tmpAUrl = arrUrls.get(0);

arrUrls.remove(0);

return tmpAUrl;

}

public synchronized String getUrl() {

String tmpUrl = arrUrl.get(0);

arrUrl.remove(0);

return tmpUrl;

}

public synchronized Integer getIntWebIndex() {

intWebIndex++;

return intWebIndex;

}

/**

* 由用户提供的域名站点开始,对所有链接页面进行抓取

*/

public void getWebByHomePage() {

startTime = System.currentTimeMillis();

this.myDomain = getDomain();

if (myDomain == null) {

System.out.println("Wrong input!");

return;

}

System.out.println("Homepage = " + strHomePage);

System.out.println("Domain = " + myDomain);

arrUrls.add(strHomePage);

arrUrl.add(strHomePage);

allUrls.put(strHomePage, 0);

deepUrls.put(strHomePage, 1);

File fDir = new File(fPath);

if (!fDir.exists()) {

fDir.mkdir();

}

System.out.println("开始工作");

String tmp = getAUrl(); // 取出新的URL

this.getWebByUrl(tmp, allUrls.get(tmp) + ""); // 对新URL所对应的网页进行抓取

int i = 0;

for (i = 0; i < intThreadNum; i++) {

new Thread(new Processer(this)).start();

}

while (true) {

if (arrUrls.isEmpty() && Thread.activeCount() == 1) {

long finishTime = System.currentTimeMillis();

long costTime = finishTime - startTime;

System.out.println("\n\n\n\n\n完成");

System.out.println(

"开始时间 = " + startTime + " " + "结束时间 = " + finishTime + " " + "爬取总时间= " + costTime + "ms");

System.out.println("爬取的URL总数 = " + (webSuccessed + webFailed) + " 成功的URL总数: " + webSuccessed

+ " 失败的URL总数: " + webFailed);

String strIndex = "";

String tmpUrl = "";

while (!arrUrl.isEmpty()) {

tmpUrl = getUrl();

strIndex += "Web depth:" + deepUrls.get(tmpUrl) + " Filepath: " + fPath + "/web"

+ allUrls.get(tmpUrl) + ".htm" + "url:" + tmpUrl + "\n\n";

}

System.out.println(strIndex);

try {

PrintWriter pwIndex = new PrintWriter(new FileOutputStream("fileindex.txt"));

pwIndex.println(strIndex);

pwIndex.close();

} catch (Exception e) {

System.out.println("生成索引文件失败!");

}

break;

}

}

}

/**

* 对后续解析的网站进行爬取

*

* @param strUrl

* @param fileIndex

*/

public void getWebByUrl(String strUrl, String fileIndex) {

try {

System.out.println("通过URL得到网站: " + strUrl);

URL url = new URL(strUrl);

URLConnection conn = url.openConnection();

conn.setDoOutput(true);

InputStream is = null;

is = url.openStream();

String filename = strUrl.replaceAll("/", "_");

filename = filename.replace(":", ".");

if (filename.indexOf("*") > 0) {

filename = filename.replaceAll("*", ".");

}

if (filename.indexOf("?") > 0) {

filename = filename.replaceAll("?", ".");

}

if (filename.indexOf("\"") > 0) {

filename = filename.replaceAll("\"", ".");

}

if (filename.indexOf(">") > 0) {

filename = filename.replaceAll(">", ".");

}

if (filename.indexOf(" 查看全部

java爬虫抓取网页数据(自动在工程下创建Pictures文件夹)

为达到效果,在项目下自动创建Pictures文件夹,根据网站URL爬取图片,逐层获取。图片下的分层URL为网站的文件夹命名,用于安装该层URL下的图片。同时将文件名、路径、URL插入数据库,方便索引。

第一步是创建持久层类来存储文件名、路径和URL。

package org.amuxia.demo;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

public class JDBCHelper {

private static final String driver = "com.mysql.jdbc.Driver";

private static final String DBurl = "jdbc:mysql://127.0.0.1:3306/edupic";

private static final String user = "root";

private static final String password = "root";

private PreparedStatement pstmt = null;

private Connection spiderconn = null;

public void insertFilePath(String fileName, String filepath, String url) {

try {

Class.forName(driver);

spiderconn = DriverManager.getConnection(DBurl, user, password);

String sql = "insert into FilePath (filename,filepath,url) values (?,?,?)";

pstmt = spiderconn.prepareStatement(sql);

pstmt.setString(1, fileName);

pstmt.setString(2, filepath);

pstmt.setString(3, url);

pstmt.executeUpdate();

} catch (ClassNotFoundException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (SQLException e) {

e.printStackTrace();

} finally {

try {

pstmt.close();

spiderconn.close();

} catch (Exception e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

}

第二步,创建一个解析URL并爬取的类

<p> package org.amuxia.demo;

import java.io.BufferedReader;

import java.io.File;

import java.io.FileOutputStream;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.PrintWriter;

import java.net.URL;

import java.net.URLConnection;

import java.util.ArrayList;

import java.util.Hashtable;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class GetWeb {

private int webDepth = 5; // 爬虫深度

private int intThreadNum = 1; // 线程数

private String strHomePage = ""; // 主页地址

private String myDomain; // 域名

private String fPath = "CSDN"; // 储存网页文件的目录名

private ArrayList arrUrls = new ArrayList(); // 存储未处理URL

private ArrayList arrUrl = new ArrayList(); // 存储所有URL供建立索引

private Hashtable allUrls = new Hashtable(); // 存储所有URL的网页号

private Hashtable deepUrls = new Hashtable(); // 存储所有URL深度

private int intWebIndex = 0; // 网页对应文件下标,从0开始

private long startTime;

private int webSuccessed = 0;

private int webFailed = 0;

public static void main(String[] args) {

GetWeb gw = new GetWeb("http://www.csdn.net/";);

gw.getWebByHomePage();

}

public GetWeb(String s) {

this.strHomePage = s;

}

public GetWeb(String s, int i) {

this.strHomePage = s;

this.webDepth = i;

}

public synchronized void addWebSuccessed() {

webSuccessed++;

}

public synchronized void addWebFailed() {

webFailed++;

}

public synchronized String getAUrl() {

String tmpAUrl = arrUrls.get(0);

arrUrls.remove(0);

return tmpAUrl;

}

public synchronized String getUrl() {

String tmpUrl = arrUrl.get(0);

arrUrl.remove(0);

return tmpUrl;

}

public synchronized Integer getIntWebIndex() {

intWebIndex++;

return intWebIndex;

}

/**

* 由用户提供的域名站点开始,对所有链接页面进行抓取

*/

public void getWebByHomePage() {

startTime = System.currentTimeMillis();

this.myDomain = getDomain();

if (myDomain == null) {

System.out.println("Wrong input!");

return;

}

System.out.println("Homepage = " + strHomePage);

System.out.println("Domain = " + myDomain);

arrUrls.add(strHomePage);

arrUrl.add(strHomePage);

allUrls.put(strHomePage, 0);

deepUrls.put(strHomePage, 1);

File fDir = new File(fPath);

if (!fDir.exists()) {

fDir.mkdir();

}

System.out.println("开始工作");

String tmp = getAUrl(); // 取出新的URL

this.getWebByUrl(tmp, allUrls.get(tmp) + ""); // 对新URL所对应的网页进行抓取

int i = 0;

for (i = 0; i < intThreadNum; i++) {

new Thread(new Processer(this)).start();

}

while (true) {

if (arrUrls.isEmpty() && Thread.activeCount() == 1) {

long finishTime = System.currentTimeMillis();

long costTime = finishTime - startTime;

System.out.println("\n\n\n\n\n完成");

System.out.println(

"开始时间 = " + startTime + " " + "结束时间 = " + finishTime + " " + "爬取总时间= " + costTime + "ms");

System.out.println("爬取的URL总数 = " + (webSuccessed + webFailed) + " 成功的URL总数: " + webSuccessed

+ " 失败的URL总数: " + webFailed);

String strIndex = "";

String tmpUrl = "";

while (!arrUrl.isEmpty()) {

tmpUrl = getUrl();

strIndex += "Web depth:" + deepUrls.get(tmpUrl) + " Filepath: " + fPath + "/web"

+ allUrls.get(tmpUrl) + ".htm" + "url:" + tmpUrl + "\n\n";

}

System.out.println(strIndex);

try {

PrintWriter pwIndex = new PrintWriter(new FileOutputStream("fileindex.txt"));

pwIndex.println(strIndex);

pwIndex.close();

} catch (Exception e) {

System.out.println("生成索引文件失败!");

}

break;

}

}

}

/**

* 对后续解析的网站进行爬取

*

* @param strUrl

* @param fileIndex

*/

public void getWebByUrl(String strUrl, String fileIndex) {

try {

System.out.println("通过URL得到网站: " + strUrl);

URL url = new URL(strUrl);

URLConnection conn = url.openConnection();

conn.setDoOutput(true);

InputStream is = null;

is = url.openStream();

String filename = strUrl.replaceAll("/", "_");

filename = filename.replace(":", ".");

if (filename.indexOf("*") > 0) {

filename = filename.replaceAll("*", ".");

}

if (filename.indexOf("?") > 0) {

filename = filename.replaceAll("?", ".");

}

if (filename.indexOf("\"") > 0) {

filename = filename.replaceAll("\"", ".");

}

if (filename.indexOf(">") > 0) {

filename = filename.replaceAll(">", ".");

}

if (filename.indexOf("

java爬虫抓取网页数据( ,实例分析了java爬虫的两种实现技巧具有一定参考借鉴价值)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-14 02:05

,实例分析了java爬虫的两种实现技巧具有一定参考借鉴价值)

JAVA使用爬虫爬取网站网页内容

更新时间:2015-07-24 09:36:05 转载:fzhlee

本文文章主要介绍JAVA使用爬虫爬取网站网页内容的方法,并结合实例分析java爬虫的两种实现技术,具有一定的参考价值,有需要的朋友需要的可以参考下一个

本文的例子描述了JAVA使用爬虫爬取网站网页内容的方法。分享给大家,供大家参考。详情如下:

最近在用JAVA研究爬网,呵呵,进门了,和大家分享一下我的经验

提供了以下两种方法,一种是使用apache提供的包。另一种是使用JAVA自带的。

代码如下:

<p>

// 第一种方法

//这种方法是用apache提供的包,简单方便

//但是要用到以下包:commons-codec-1.4.jar

// commons-httpclient-3.1.jar

// commons-logging-1.0.4.jar

public static String createhttpClient(String url, String param) {

HttpClient client = new HttpClient();

String response = null;

String keyword = null;

PostMethod postMethod = new PostMethod(url);

// try {

// if (param != null)

// keyword = new String(param.getBytes("gb2312"), "ISO-8859-1");

// } catch (UnsupportedEncodingException e1) {

// // TODO Auto-generated catch block

// e1.printStackTrace();

// }

// NameValuePair[] data = { new NameValuePair("keyword", keyword) };

// // 将表单的值放入postMethod中

// postMethod.setRequestBody(data);

// 以上部分是带参数抓取,我自己把它注销了.大家可以把注销消掉研究下

try {

int statusCode = client.executeMethod(postMethod);

response = new String(postMethod.getResponseBodyAsString()

.getBytes("ISO-8859-1"), "gb2312");

//这里要注意下 gb2312要和你抓取网页的编码要一样

String p = response.replaceAll("//&[a-zA-Z]{1,10};", "")

.replaceAll("]*>", "");//去掉网页中带有html语言的标签

System.out.println(p);

} catch (Exception e) {

e.printStackTrace();

}

return response;

}

// 第二种方法

// 这种方法是JAVA自带的URL来抓取网站内容

public String getPageContent(String strUrl, String strPostRequest,

int maxLength) {

// 读取结果网页

StringBuffer buffer = new StringBuffer();

System.setProperty("sun.net.client.defaultConnectTimeout", "5000");

System.setProperty("sun.net.client.defaultReadTimeout", "5000");

try {

URL newUrl = new URL(strUrl);

HttpURLConnection hConnect = (HttpURLConnection) newUrl

.openConnection();

// POST方式的额外数据

if (strPostRequest.length() > 0) {

hConnect.setDoOutput(true);

OutputStreamWriter out = new OutputStreamWriter(hConnect

.getOutputStream());

out.write(strPostRequest);

out.flush();

out.close();

}

// 读取内容

BufferedReader rd = new BufferedReader(new InputStreamReader(

hConnect.getInputStream()));

int ch;

for (int length = 0; (ch = rd.read()) > -1

&& (maxLength 查看全部

java爬虫抓取网页数据(

,实例分析了java爬虫的两种实现技巧具有一定参考借鉴价值)

JAVA使用爬虫爬取网站网页内容

更新时间:2015-07-24 09:36:05 转载:fzhlee

本文文章主要介绍JAVA使用爬虫爬取网站网页内容的方法,并结合实例分析java爬虫的两种实现技术,具有一定的参考价值,有需要的朋友需要的可以参考下一个

本文的例子描述了JAVA使用爬虫爬取网站网页内容的方法。分享给大家,供大家参考。详情如下:

最近在用JAVA研究爬网,呵呵,进门了,和大家分享一下我的经验

提供了以下两种方法,一种是使用apache提供的包。另一种是使用JAVA自带的。

代码如下:

<p>

// 第一种方法

//这种方法是用apache提供的包,简单方便

//但是要用到以下包:commons-codec-1.4.jar

// commons-httpclient-3.1.jar

// commons-logging-1.0.4.jar

public static String createhttpClient(String url, String param) {

HttpClient client = new HttpClient();

String response = null;

String keyword = null;

PostMethod postMethod = new PostMethod(url);

// try {

// if (param != null)

// keyword = new String(param.getBytes("gb2312"), "ISO-8859-1");

// } catch (UnsupportedEncodingException e1) {

// // TODO Auto-generated catch block

// e1.printStackTrace();

// }

// NameValuePair[] data = { new NameValuePair("keyword", keyword) };

// // 将表单的值放入postMethod中

// postMethod.setRequestBody(data);

// 以上部分是带参数抓取,我自己把它注销了.大家可以把注销消掉研究下

try {

int statusCode = client.executeMethod(postMethod);

response = new String(postMethod.getResponseBodyAsString()

.getBytes("ISO-8859-1"), "gb2312");

//这里要注意下 gb2312要和你抓取网页的编码要一样

String p = response.replaceAll("//&[a-zA-Z]{1,10};", "")

.replaceAll("]*>", "");//去掉网页中带有html语言的标签

System.out.println(p);

} catch (Exception e) {

e.printStackTrace();

}

return response;

}

// 第二种方法

// 这种方法是JAVA自带的URL来抓取网站内容

public String getPageContent(String strUrl, String strPostRequest,

int maxLength) {

// 读取结果网页

StringBuffer buffer = new StringBuffer();

System.setProperty("sun.net.client.defaultConnectTimeout", "5000");

System.setProperty("sun.net.client.defaultReadTimeout", "5000");

try {

URL newUrl = new URL(strUrl);

HttpURLConnection hConnect = (HttpURLConnection) newUrl

.openConnection();

// POST方式的额外数据

if (strPostRequest.length() > 0) {

hConnect.setDoOutput(true);

OutputStreamWriter out = new OutputStreamWriter(hConnect

.getOutputStream());

out.write(strPostRequest);

out.flush();

out.close();

}

// 读取内容

BufferedReader rd = new BufferedReader(new InputStreamReader(

hConnect.getInputStream()));

int ch;

for (int length = 0; (ch = rd.read()) > -1

&& (maxLength

java爬虫抓取网页数据(JavaHTML解析器的具体思路:1.调用url网页信息2.解析 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-01-13 09:06

)

想找一些图片作为桌面背景,又不想一张一张下载,于是想到了爬虫。. .

没有具体用过爬虫,在网上搜索后写了一个小demo。

爬虫的具体思路是:

1.调用url抓取网页信息

2.解析网页信息

3.保存数据

一开始是用regex来匹配获取img标签中的src地址,但是发现有很多不便(主要是我对regex不太了解),后来才发现神器jsoup。jsoup 是一个 Java HTML 解析器,可以直接解析一个 URL 地址和 HTML 文本内容。它提供了一个非常省力的 API,用于通过 DOM、CSS 和类似 jQuery 的操作方法获取和操作数据。

下面是一个爬取图片的例子:

import com.crawler.domain.PictureInfo;

import org.bson.types.ObjectId;

import org.springframework.data.mongodb.core.MongoTemplate;

import org.springframework.data.mongodb.gridfs.GridFsTemplate;

import org.springframework.stereotype.Service;

import org.apache.commons.io.FileUtils;

import org.apache.http.HttpEntity;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import org.springframework.util.DigestUtils;

import org.springframework.util.StringUtils;

import javax.annotation.Resource;

import java.io.*;

import java.net.HttpURLConnection;

import java.net.MalformedURLException;

import java.net.URL;

import java.net.URLConnection;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

* 爬虫实现

*@program: crawler

* @description

* @author: wl

* @create: 2021-01-12 17:56

**/

@Service

public class CrawlerService {

/**

* @param url 要抓取的网页地址

* @param encoding 要抓取网页编码

* @return

*/

public String getHtmlResourceByUrl(String url, String encoding) {

URL urlObj = null;

HttpURLConnection uc = null;

InputStreamReader isr = null;

BufferedReader reader = null;

StringBuffer buffer = new StringBuffer();

// 建立网络连接

try {

urlObj = new URL(url);

// 打开网络连接

uc =(HttpURLConnection) urlObj.openConnection();

// 模拟浏览器请求

uc.setRequestProperty("User-Agent", "Mozilla/4.0 (compatible; MSIE 5.0; Windows NT; DigExt)");

// 建立文件输入流

isr = new InputStreamReader(uc.getInputStream(), encoding);

// 建立缓存导入 将网页源代码下载下来

reader = new BufferedReader(isr);

// 临时

String temp = null;

while ((temp = reader.readLine()) != null) {// System.out.println(temp+"\n");

buffer.append(temp + "\n");

}

System.out.println("爬取结束:"+buffer.toString());

} catch (Exception e) {

e.printStackTrace();

} finally {

// 关流

if (isr != null) {

try {

isr.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

return buffer.toString();

}

/**

* 下载图片

*

* @param listImgSrc

*/

public void Download(List listImgSrc) {

int count = 0;

try {

for (int i = 0; i < listImgSrc.size(); i++) {

try {

PictureInfo pictureInfo = listImgSrc.get(i);

String url=pictureInfo.getSrc();

String imageName = url.substring(url.lastIndexOf("/") + 1, url.length());

URL uri = new URL(url);

// 打开连接

URLConnection con = uri.openConnection();

//设置请求超时为

con.setConnectTimeout(5 * 1000);

con.setRequestProperty("User-Agent", "Mozilla/4.0 (compatible; MSIE 5.0; Windows NT; DigExt)");

// 输入流

InputStream is = con.getInputStream();

// 1K的数据缓冲

byte[] bs = new byte[1024];

// 读取到的数据长度

int len;

// 输出的文件流

String src = url.substring(URL.length());

int index = src.lastIndexOf('/');

String fileName = src.substring(0, index + 1);

File sf = new File(SAVE_PATH + fileName);

if (!sf.exists()) {

sf.mkdirs();

}

OutputStream os = new FileOutputStream(sf.getPath() + "\\" + imageName);

System.out.println(++count + ".开始下载:" + url);

// 开始读取

while ((len = is.read(bs)) != -1) {

os.write(bs, 0, len);

}

// 完毕,关闭所有链接

os.close();

is.close();

System.out.println(imageName + ":--下载完成");

} catch (IOException e) {

System.out.println("下载错误"+e);

}

}

} catch (Exception e) {

e.printStackTrace();

System.out.println("下载失败"+e);

}

}

/**

* 得到网页中图片的地址-推荐

* 使用jsoup

* @param htmlStr html字符串

* @return List

*/

public List getImgStrJsoup(String htmlStr) {

List pics = new ArrayList();

//获取网页的document树

Document imgDoc = Jsoup.parse(htmlStr);

//获取所有的img

Elements alts = imgDoc.select("img[src]");

for (Element alt : alts) {

PictureInfo p=new PictureInfo();

p.setSrc(alt.attr("src"));

p.setAlt(alt.attr("alt"));

p.setTitle(alt.attr("title"));

pics.add(p);

}

return pics;

}

}

这些是主要的方法。只要爬取的网页信息中收录img标签,就可以去除对应的图片。

查看全部

java爬虫抓取网页数据(JavaHTML解析器的具体思路:1.调用url网页信息2.解析

)

想找一些图片作为桌面背景,又不想一张一张下载,于是想到了爬虫。. .

没有具体用过爬虫,在网上搜索后写了一个小demo。

爬虫的具体思路是:

1.调用url抓取网页信息

2.解析网页信息

3.保存数据

一开始是用regex来匹配获取img标签中的src地址,但是发现有很多不便(主要是我对regex不太了解),后来才发现神器jsoup。jsoup 是一个 Java HTML 解析器,可以直接解析一个 URL 地址和 HTML 文本内容。它提供了一个非常省力的 API,用于通过 DOM、CSS 和类似 jQuery 的操作方法获取和操作数据。

下面是一个爬取图片的例子:

import com.crawler.domain.PictureInfo;

import org.bson.types.ObjectId;

import org.springframework.data.mongodb.core.MongoTemplate;

import org.springframework.data.mongodb.gridfs.GridFsTemplate;

import org.springframework.stereotype.Service;

import org.apache.commons.io.FileUtils;

import org.apache.http.HttpEntity;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import org.springframework.util.DigestUtils;

import org.springframework.util.StringUtils;

import javax.annotation.Resource;

import java.io.*;

import java.net.HttpURLConnection;

import java.net.MalformedURLException;

import java.net.URL;

import java.net.URLConnection;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

* 爬虫实现

*@program: crawler

* @description

* @author: wl

* @create: 2021-01-12 17:56

**/

@Service

public class CrawlerService {

/**

* @param url 要抓取的网页地址

* @param encoding 要抓取网页编码

* @return

*/

public String getHtmlResourceByUrl(String url, String encoding) {

URL urlObj = null;

HttpURLConnection uc = null;

InputStreamReader isr = null;

BufferedReader reader = null;

StringBuffer buffer = new StringBuffer();

// 建立网络连接

try {

urlObj = new URL(url);

// 打开网络连接

uc =(HttpURLConnection) urlObj.openConnection();

// 模拟浏览器请求

uc.setRequestProperty("User-Agent", "Mozilla/4.0 (compatible; MSIE 5.0; Windows NT; DigExt)");

// 建立文件输入流

isr = new InputStreamReader(uc.getInputStream(), encoding);

// 建立缓存导入 将网页源代码下载下来

reader = new BufferedReader(isr);

// 临时

String temp = null;

while ((temp = reader.readLine()) != null) {// System.out.println(temp+"\n");

buffer.append(temp + "\n");

}

System.out.println("爬取结束:"+buffer.toString());

} catch (Exception e) {

e.printStackTrace();

} finally {

// 关流

if (isr != null) {

try {

isr.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

return buffer.toString();

}

/**

* 下载图片

*

* @param listImgSrc

*/

public void Download(List listImgSrc) {

int count = 0;

try {

for (int i = 0; i < listImgSrc.size(); i++) {

try {

PictureInfo pictureInfo = listImgSrc.get(i);

String url=pictureInfo.getSrc();

String imageName = url.substring(url.lastIndexOf("/") + 1, url.length());

URL uri = new URL(url);

// 打开连接

URLConnection con = uri.openConnection();

//设置请求超时为

con.setConnectTimeout(5 * 1000);

con.setRequestProperty("User-Agent", "Mozilla/4.0 (compatible; MSIE 5.0; Windows NT; DigExt)");

// 输入流

InputStream is = con.getInputStream();

// 1K的数据缓冲

byte[] bs = new byte[1024];

// 读取到的数据长度

int len;

// 输出的文件流

String src = url.substring(URL.length());

int index = src.lastIndexOf('/');

String fileName = src.substring(0, index + 1);

File sf = new File(SAVE_PATH + fileName);

if (!sf.exists()) {

sf.mkdirs();

}

OutputStream os = new FileOutputStream(sf.getPath() + "\\" + imageName);

System.out.println(++count + ".开始下载:" + url);

// 开始读取

while ((len = is.read(bs)) != -1) {

os.write(bs, 0, len);

}

// 完毕,关闭所有链接

os.close();

is.close();

System.out.println(imageName + ":--下载完成");

} catch (IOException e) {

System.out.println("下载错误"+e);

}

}

} catch (Exception e) {

e.printStackTrace();

System.out.println("下载失败"+e);

}

}

/**

* 得到网页中图片的地址-推荐

* 使用jsoup

* @param htmlStr html字符串

* @return List

*/

public List getImgStrJsoup(String htmlStr) {

List pics = new ArrayList();

//获取网页的document树

Document imgDoc = Jsoup.parse(htmlStr);

//获取所有的img

Elements alts = imgDoc.select("img[src]");

for (Element alt : alts) {

PictureInfo p=new PictureInfo();

p.setSrc(alt.attr("src"));

p.setAlt(alt.attr("alt"));

p.setTitle(alt.attr("title"));

pics.add(p);

}

return pics;

}

}

这些是主要的方法。只要爬取的网页信息中收录img标签,就可以去除对应的图片。

java爬虫抓取网页数据( 这是Java网络爬虫系列文章的第一篇(图),需要哪些基础知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-13 06:02

这是Java网络爬虫系列文章的第一篇(图),需要哪些基础知识)

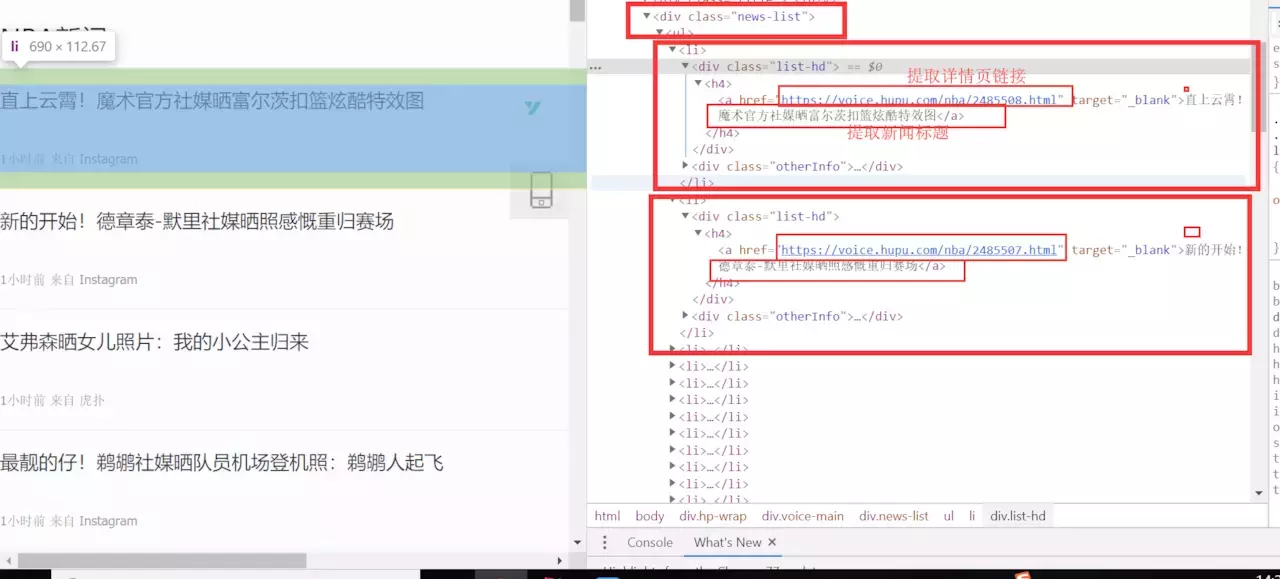

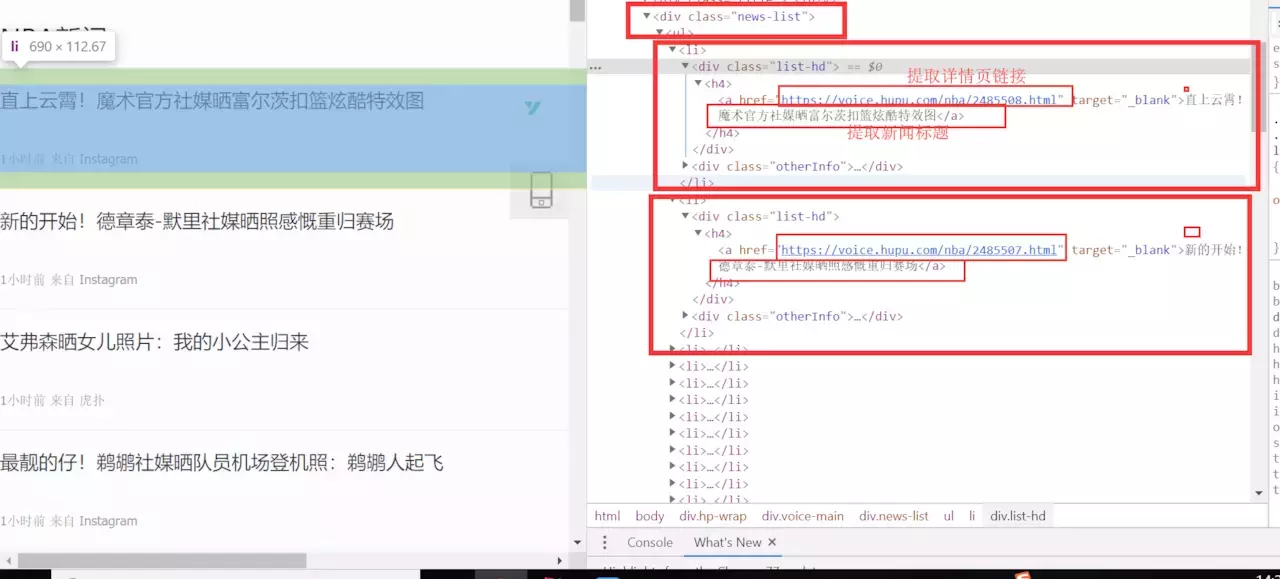

这是Java网络爬虫系列的第一篇文章。如果您不了解Java网络爬虫系列文章,请参阅学习Java网络爬虫需要哪些基础知识。第一篇是关于Java网络爬虫的介绍。在本文中,我们以 采集hupu 列表新闻的新闻标题和详情页为例。需要提取的内容如下图所示:

我们需要提取图中圈出的文字及其对应的链接。在提取过程中,我们会使用两种方法进行提取,一种是Jsoup方法,另一种是httpclient+正则表达式方法。它们也是Java网络爬虫常用的两种方法。这两种方法你不懂也没关系。后面会有相应的说明书。在正式写解压程序之前,先解释一下Java爬虫系列博文的环境。本系列博文中的所有demo都是使用SpringBoot搭建的。无论使用哪种环境,只需要正确导入对应的包即可。

通过 Jsoup 提取信息

我们先用Jsoup来提取新闻信息。如果你还不了解Jsoup,请参考/

首先创建一个Springboot项目,名称可选,在pom.xml中引入Jsoup的依赖

好,我们一起来分析一下页面,想必你还没有浏览过,点击这里浏览虎扑新闻。在列表页面中,我们使用F12评论元素查看页面结构,经过我们的分析,我们发现列表新闻在

标签下,每条新闻都是一个li标签,分析结果如下图所示:

既然我们已经知道了css选择器,我们结合浏览器的Copy功能,为我们的a标签编写了css选择器代码: div.news-list > ul > li > div.list-hd > h4 > a ,一切准备就绪,让我们编写Jsoup方式提取信息的代码:

使用Jsoup提取非常简单,只需5、6行代码即可完成。更多Jsoup如何提取节点信息,请参考jsoup官网教程。我们编写main方法执行jsoupList方法,看看jsoupList方法是否正确。

执行main方法,得到如下结果:

从结果可以看出,我们已经正确地提取到了我们想要的信息。如果要采集详情页的信息,只需要写一个采集详情页的方法,在方法中提取详情页对应的节点信息,然后通过将列表页面中的链接提取到详细信息页面的提取方法中。httpclient + 正则表达式

上面,我们使用了Jsoup方法正确提取了虎扑列表新闻。接下来我们使用httpclient+正则表达式的方式进行提取,看看这种方式会涉及哪些问题? httpclient+正则表达式方式涉及的知识点相当多,涉及到正则表达式、Java正则表达式、httpclient。如果你不知道这些知识,可以点击下面的链接了解一下:

正则表达式:正则表达式

Java 正则表达式:Java 正则表达式 查看全部

java爬虫抓取网页数据(

这是Java网络爬虫系列文章的第一篇(图),需要哪些基础知识)

这是Java网络爬虫系列的第一篇文章。如果您不了解Java网络爬虫系列文章,请参阅学习Java网络爬虫需要哪些基础知识。第一篇是关于Java网络爬虫的介绍。在本文中,我们以 采集hupu 列表新闻的新闻标题和详情页为例。需要提取的内容如下图所示:

我们需要提取图中圈出的文字及其对应的链接。在提取过程中,我们会使用两种方法进行提取,一种是Jsoup方法,另一种是httpclient+正则表达式方法。它们也是Java网络爬虫常用的两种方法。这两种方法你不懂也没关系。后面会有相应的说明书。在正式写解压程序之前,先解释一下Java爬虫系列博文的环境。本系列博文中的所有demo都是使用SpringBoot搭建的。无论使用哪种环境,只需要正确导入对应的包即可。

通过 Jsoup 提取信息

我们先用Jsoup来提取新闻信息。如果你还不了解Jsoup,请参考/

首先创建一个Springboot项目,名称可选,在pom.xml中引入Jsoup的依赖

好,我们一起来分析一下页面,想必你还没有浏览过,点击这里浏览虎扑新闻。在列表页面中,我们使用F12评论元素查看页面结构,经过我们的分析,我们发现列表新闻在

标签下,每条新闻都是一个li标签,分析结果如下图所示:

既然我们已经知道了css选择器,我们结合浏览器的Copy功能,为我们的a标签编写了css选择器代码: div.news-list > ul > li > div.list-hd > h4 > a ,一切准备就绪,让我们编写Jsoup方式提取信息的代码:

使用Jsoup提取非常简单,只需5、6行代码即可完成。更多Jsoup如何提取节点信息,请参考jsoup官网教程。我们编写main方法执行jsoupList方法,看看jsoupList方法是否正确。

执行main方法,得到如下结果:

从结果可以看出,我们已经正确地提取到了我们想要的信息。如果要采集详情页的信息,只需要写一个采集详情页的方法,在方法中提取详情页对应的节点信息,然后通过将列表页面中的链接提取到详细信息页面的提取方法中。httpclient + 正则表达式

上面,我们使用了Jsoup方法正确提取了虎扑列表新闻。接下来我们使用httpclient+正则表达式的方式进行提取,看看这种方式会涉及哪些问题? httpclient+正则表达式方式涉及的知识点相当多,涉及到正则表达式、Java正则表达式、httpclient。如果你不知道这些知识,可以点击下面的链接了解一下:

正则表达式:正则表达式

Java 正则表达式:Java 正则表达式

java爬虫抓取网页数据(Java爬虫采集网页数据(简单介绍)(1)_ )

网站优化 • 优采云 发表了文章 • 0 个评论 • 230 次浏览 • 2022-01-12 00:08

)

Java爬虫采集网页数据一、爬虫简介

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动从万维网上爬取信息的程序或脚本。

学过爬虫的同学都知道,目前80%的爬虫都是用Python写的:

原因一:由于目前大部分网络协议都是基于HTTP/HTTPS的,而java的基础框架支持TCP/IP网络协议,构建爬虫时需要导入大量底层库;

原因2:Python有很多开源爬虫库,好用,也有Java的,但是Java入门比较难;

理由三:Python语言简单难懂。相比之下,Java语言更复杂,理解难度也增加了;

好了,这次回到我们的话题,修改后的例子是一个基于JavaClient加正则化的爬虫来简单实现Java Maven项目采集的图片数据!

二、必需的 pom.xml 依赖项

org.jsoup

jsoup

1.8.3

commons-io

commons-io

2.5

org.apache.httpcomponents

httpclient

4.5.5

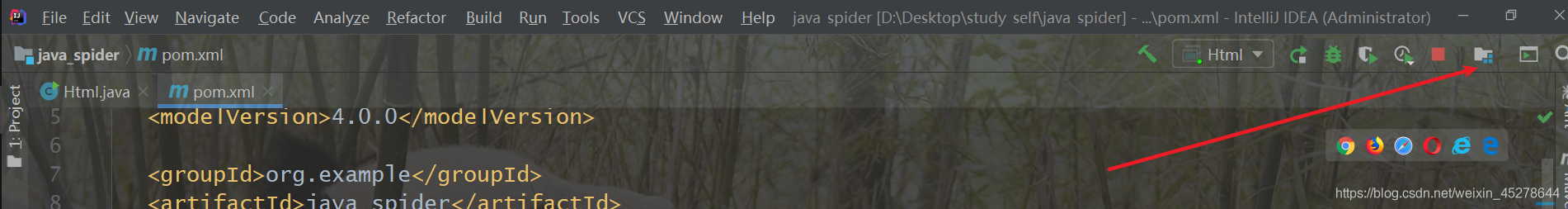

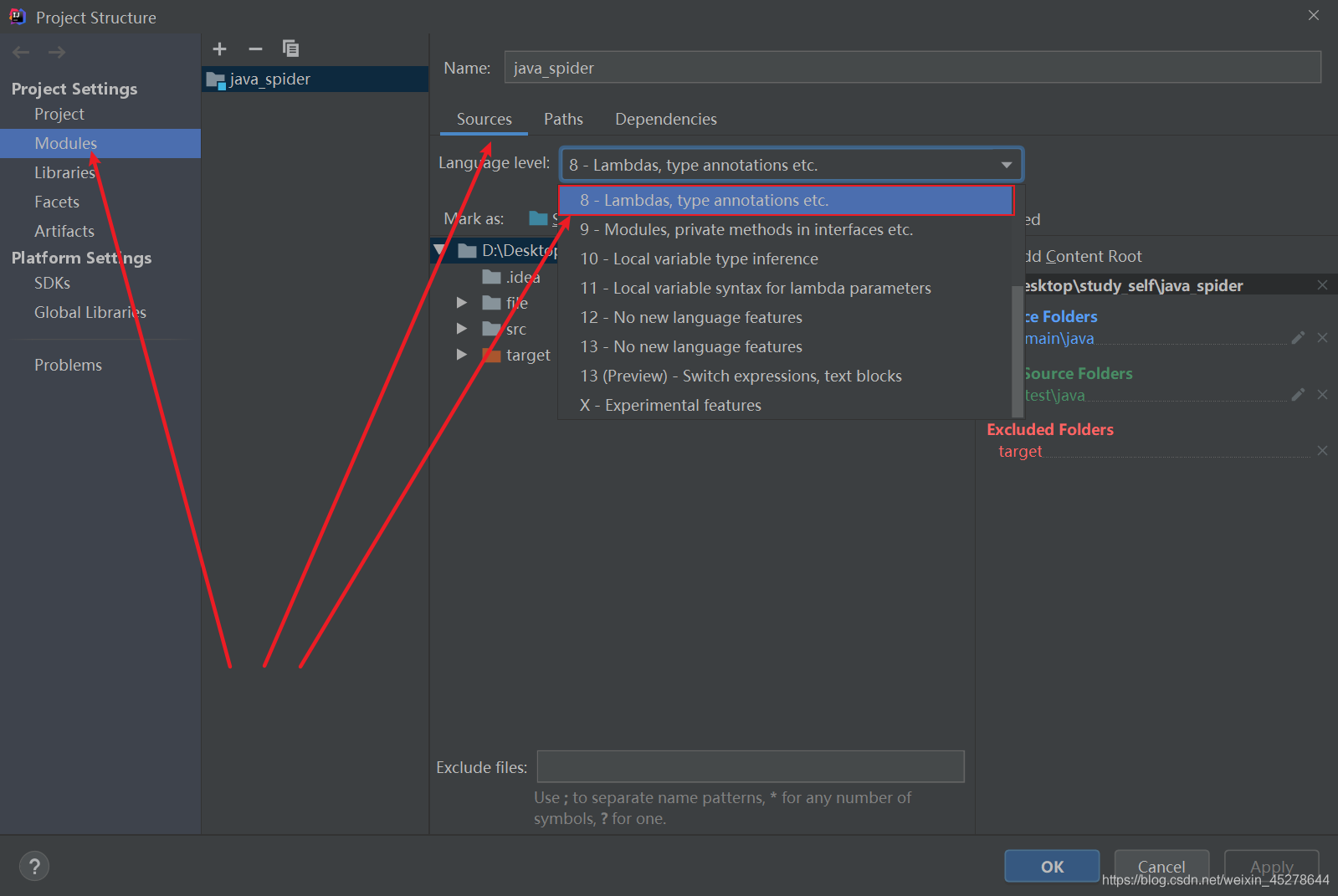

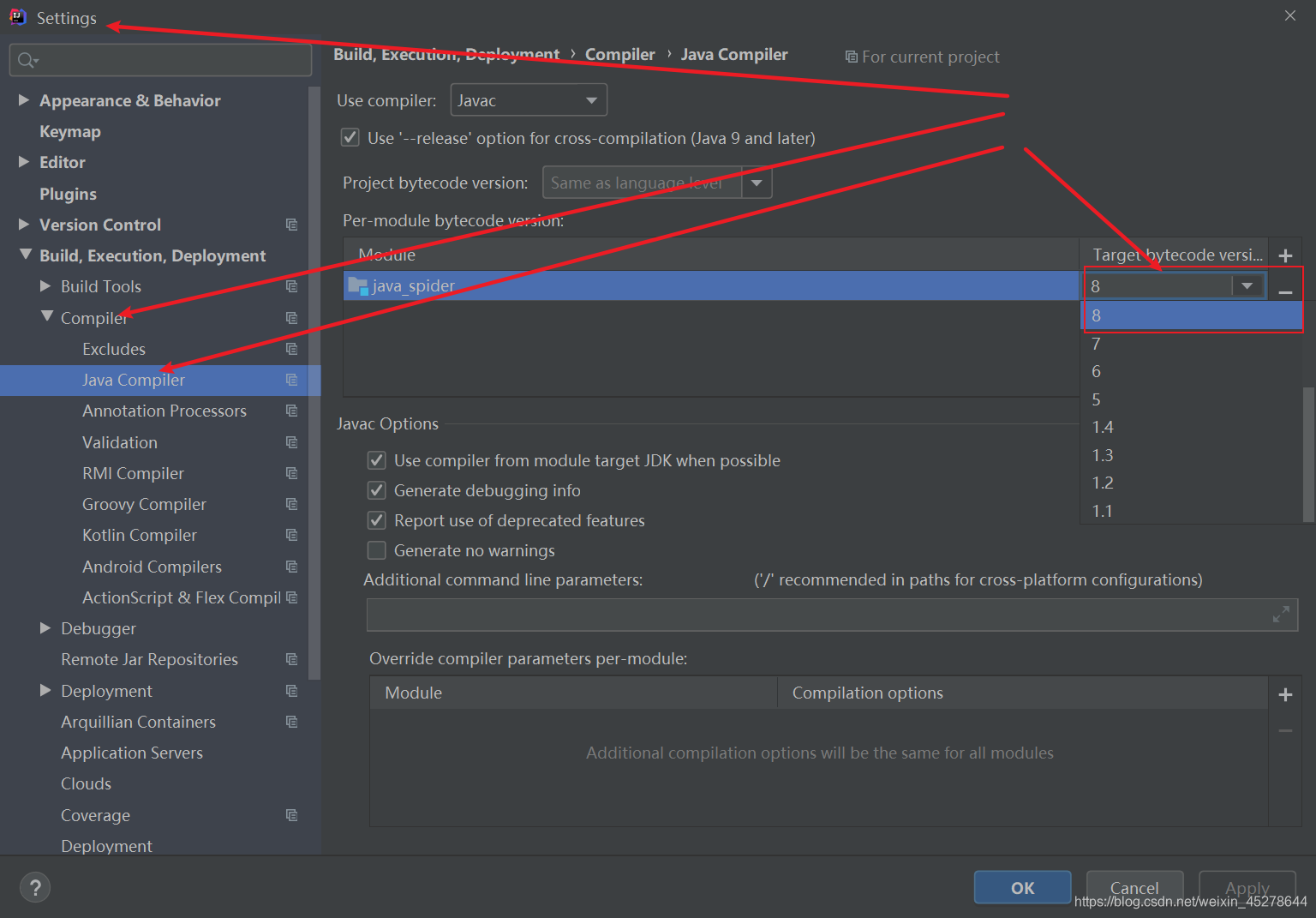

有同学创建Maven项目后,程序还是跑错了!只要三点修改,就会更宽!(基于 JDK1.8)

1.修改pom.xml依赖中的JDK版本号

UTF-8

1.8

1.8

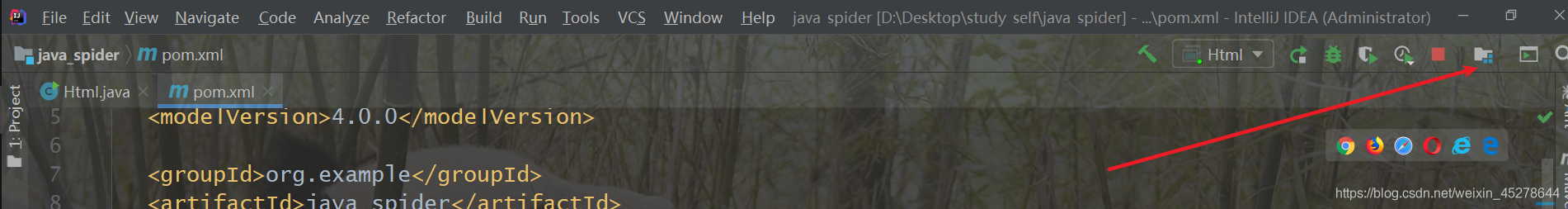

2.根据下图找到项目结构图标,进入Project Settings --> Modules -->Souces->Language level:设置为8;

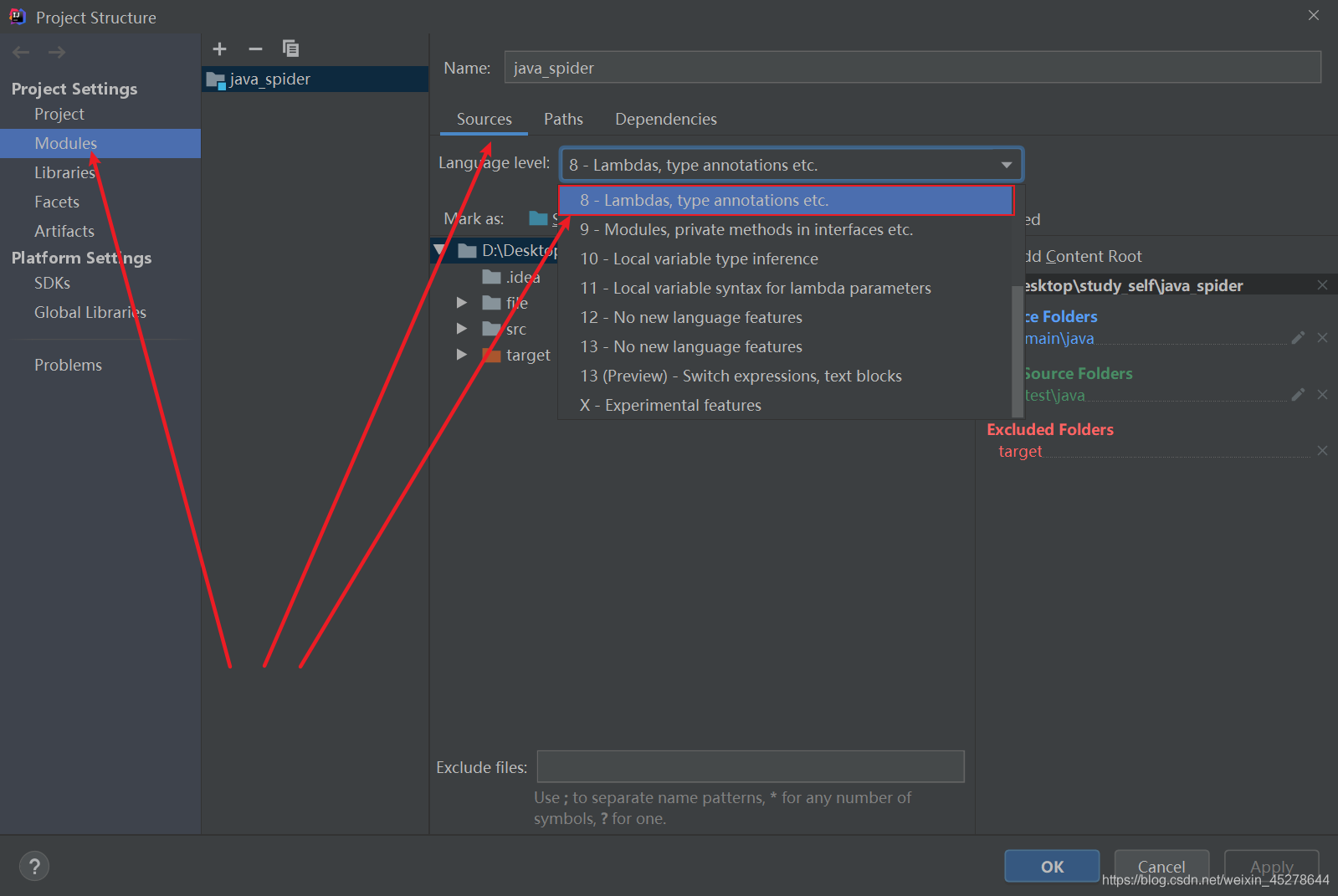

3 进入项目设置文件,Settings–>Build, Execution, Deployment–>Compiler–>Java Compiler–>Moudle:配置JDK版本为8;

三点后就可以配置了

三.java代码(附详细注释)

因为我这里是一个简单的java爬虫,所以我只用了一个java文件写成静态方法,方便调用

爬取图片下载到本地

html.java

<p>import org.apache.http.HttpEntity;

import org.apache.http.HttpStatus;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import java.io.*;

import java.util.Scanner;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class scenery {

//编码格式

private static final String ENCODING = "UTF-8";

//保存地址

private static final String SAVE_PATH = "file/background";

/**

* 获取到指定网址的网页源码并返回

* @param url 爬取网址

* @return html

*/

public static String getHtmlResourceByUrl(String url) {

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet httpGet = new HttpGet(url);

HttpEntity httpEntity = null;

String html = null;

// 设置长连接

httpGet.setHeader("Connection", "keep-alive");

// 设置代理(模拟浏览器版本)

httpGet.setHeader("User-Agent", "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36");

CloseableHttpResponse httpResponse = null;

System.out.println("开始请求网页!!!!!!!!");

try {

// 请求并获得响应结果

httpResponse = httpClient.execute(httpGet);

httpEntity = httpResponse.getEntity();

// 输出请求结果

html = EntityUtils.toString(httpEntity);

} catch (IOException e) {

e.printStackTrace();

}

return html;

}

/**

* 获取网页的链接与标题,并追加到list中,从而返回list

* @param html 网页地址

* @return list

*/

public static List getTitleUrl(String html){

String regex_img_url = "<img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

String regex_img_title span class="token operator"=/span span class="token string""div class=\"tits\"(.*?)b class=hightlight"/spanspan class="token punctuation";/span

ArrayListspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建pattern对象/span

Pattern img_url_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_urlspan class="token punctuation")/spanspan class="token punctuation";/span

Pattern img_title_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_titlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_url_m span class="token operator"=/span img_url_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

Matcher img_title_m span class="token operator"=/span img_title_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_url_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/span span class="token operator"&&/span img_title_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

String url span class="token operator"=/span img_url_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanurlspan class="token punctuation")/spanspan class="token punctuation";/span

String title span class="token operator"=/span img_title_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spantitlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 获取image url 追加到List中,并返回List

* @param details_html 详情页网址

* @return List

*//span

span class="token keyword"public/span span class="token keyword"static/span Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span span class="token function"getImageSrc/spanspan class="token punctuation"(/spanString details_htmlspan class="token punctuation")/spanspan class="token punctuation"{/span

Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

String imgRegex span class="token operator"=/span span class="token string""img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

span class="token comment"//创建Pattern对象/span

Pattern img_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanimgRegexspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_m span class="token operator"=/span img_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spandetails_htmlspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""开始解析..."/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 下载图片

* @param imgUrl img网址

* @param filePath 图片报错地址

* @param title 图片系列

* @param imageName 图片名

* @param page 页数

* @param count 每页的图片计数

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"downLoad/spanspan class="token punctuation"(/spanString imgUrlspan class="token punctuation",/spanString filePathspan class="token punctuation",/span String titlespan class="token punctuation",/span String imageNamespan class="token punctuation",/spanspan class="token keyword"int/span pagespan class="token punctuation",/span span class="token keyword"int/span countspan class="token punctuation")/span span class="token punctuation"{/span

CloseableHttpClient httpClient span class="token operator"=/span HttpClientsspan class="token punctuation"./spanspan class="token function"createDefault/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

HttpGet httpGet span class="token operator"=/span span class="token keyword"new/span span class="token class-name"HttpGet/spanspan class="token punctuation"(/spanimgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"try/span span class="token punctuation"{/span

CloseableHttpResponse response span class="token operator"=/span httpClientspan class="token punctuation"./spanspan class="token function"execute/spanspan class="token punctuation"(/spanhttpGetspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""第"/span span class="token operator"+/spanpagespan class="token operator"+/span span class="token string""页的"/span span class="token operator"+/span title span class="token operator"+/span span class="token string""系列图片开始下载:"/span span class="token operator"+/span imgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"if/span span class="token punctuation"(/spanHttpStatusspan class="token punctuation"./spanSC_OK span class="token operator"==/span responsespan class="token punctuation"./spanspan class="token function"getStatusLine/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation"./spanspan class="token function"getStatusCode/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

HttpEntity entity span class="token operator"=/span responsespan class="token punctuation"./spanspan class="token function"getEntity/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

InputStream imgContent span class="token operator"=/span entityspan class="token punctuation"./spanspan class="token function"getContent/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token function"saveImage/spanspan class="token punctuation"(/spanimgContentspan class="token punctuation",/span filePathspan class="token punctuation",/spanimageNamespan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""第"/span span class="token operator"+/span span class="token punctuation"(/spancount span class="token operator"+/span span class="token number"1/spanspan class="token punctuation")/span span class="token operator"+/span span class="token string""张图片下载完成名为:"/span span class="token operator"+/span imageNamespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"ClientProtocolException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token comment"/**

* 保存图片

* @param is 输入数据流

* @param filePath 文件目录Path

* @param imageName image名

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"saveImage/spanspan class="token punctuation"(/spanInputStream isspan class="token punctuation",/span String filePathspan class="token punctuation",/span String imageNamespan class="token punctuation")/spanspan class="token punctuation"{/span

span class="token keyword"try/span span class="token punctuation"{/span

span class="token comment"//创建图片文件/span

String imgSavePath span class="token operator"=/span filePathspan class="token punctuation"./spanspan class="token function"concat/spanspan class="token punctuation"(/spanspan class="token string""/"/span span class="token operator"+/span imageName span class="token operator"+/span span class="token string"".jpg"/spanspan class="token punctuation")/spanspan class="token punctuation";/span

File imgPath span class="token operator"=/span span class="token keyword"new/span span class="token class-name"File/spanspan class="token punctuation"(/spanimgSavePathspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"if/span span class="token punctuation"(/spanspan class="token operator"!/spanimgPathspan class="token punctuation"./spanspan class="token function"exists/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

imgPathspan class="token punctuation"./spanspan class="token function"createNewFile/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

FileOutputStream fos span class="token operator"=/span span class="token keyword"new/span span class="token class-name"FileOutputStream/spanspan class="token punctuation"(/spanimgPathspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"byte/spanspan class="token punctuation"[/spanspan class="token punctuation"]/span bytes span class="token operator"=/span span class="token keyword"new/span span class="token class-name"byte/spanspan class="token punctuation"[/spanspan class="token number"1024/span span class="token operator"*/span span class="token number"1024/span span class="token operator"*/span span class="token number"1024/spanspan class="token punctuation"]/spanspan class="token punctuation";/span

span class="token keyword"int/span len span class="token operator"=/span span class="token number"0/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanspan class="token punctuation"(/spanlen span class="token operator"=/span isspan class="token punctuation"./spanspan class="token function"read/spanspan class="token punctuation"(/spanbytesspan class="token punctuation")/spanspan class="token punctuation")/span span class="token operator"!=/span span class="token operator"-/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

fosspan class="token punctuation"./spanspan class="token function"write/spanspan class="token punctuation"(/spanbytesspan class="token punctuation",/span span class="token number"0/spanspan class="token punctuation",/span lenspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

fosspan class="token punctuation"./spanspan class="token function"flush/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

fosspan class="token punctuation"./spanspan class="token function"close/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/spanspan class="token keyword"finally/span span class="token punctuation"{/span

span class="token keyword"try/spanspan class="token punctuation"{/span

isspan class="token punctuation"./spanspan class="token function"close/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"run/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

span class="token comment"//循环获取列表页的html/span

String title span class="token operator"=/span span class="token string"""/spanspan class="token punctuation";/span

span class="token comment"//采集类型大家阔以自行发挥!!!/span

Scanner input span class="token operator"=/span span class="token keyword"new/span span class="token class-name"Scanner/spanspan class="token punctuation"(/spanSystemspan class="token punctuation"./spaninspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""*********************欢迎来到洋群满满壁纸下载地,请选择你想要下载序列的序号!*********************"/spanspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""1>>>风景|2>>>美女|3>>>汽车|4>>>动漫|5>>>二次元|6>>>森林|7>>>明星|8>>>猜你喜欢(You Know!!!)");

System.out.print("请选择:");

int choose = input.nextInt();

switch (choose){

case 1:

title = "风景";

break;

case 2:

title = "美女";

break;

case 3:

title = "汽车";

break;

case 4:

title = "动漫";

break;

case 5:

title = "二次元";

break;

case 6:

title = "森林";

break;

case 7:

title = "明星";

break;

case 8:

title = "性感";

break;

default:

title = "风景";

System.out.println("选择错误,默认采集风景系列图片!!!");

break;

}

int page = 1;

for (; page 查看全部

java爬虫抓取网页数据(Java爬虫采集网页数据(简单介绍)(1)_

)

Java爬虫采集网页数据一、爬虫简介

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动从万维网上爬取信息的程序或脚本。

学过爬虫的同学都知道,目前80%的爬虫都是用Python写的:

原因一:由于目前大部分网络协议都是基于HTTP/HTTPS的,而java的基础框架支持TCP/IP网络协议,构建爬虫时需要导入大量底层库;

原因2:Python有很多开源爬虫库,好用,也有Java的,但是Java入门比较难;

理由三:Python语言简单难懂。相比之下,Java语言更复杂,理解难度也增加了;

好了,这次回到我们的话题,修改后的例子是一个基于JavaClient加正则化的爬虫来简单实现Java Maven项目采集的图片数据!

二、必需的 pom.xml 依赖项

org.jsoup

jsoup

1.8.3

commons-io

commons-io

2.5

org.apache.httpcomponents

httpclient

4.5.5

有同学创建Maven项目后,程序还是跑错了!只要三点修改,就会更宽!(基于 JDK1.8)

1.修改pom.xml依赖中的JDK版本号

UTF-8

1.8

1.8

2.根据下图找到项目结构图标,进入Project Settings --> Modules -->Souces->Language level:设置为8;

3 进入项目设置文件,Settings–>Build, Execution, Deployment–>Compiler–>Java Compiler–>Moudle:配置JDK版本为8;

三点后就可以配置了

三.java代码(附详细注释)

因为我这里是一个简单的java爬虫,所以我只用了一个java文件写成静态方法,方便调用

爬取图片下载到本地

html.java

<p>import org.apache.http.HttpEntity;

import org.apache.http.HttpStatus;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import java.io.*;

import java.util.Scanner;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class scenery {

//编码格式

private static final String ENCODING = "UTF-8";

//保存地址

private static final String SAVE_PATH = "file/background";

/**

* 获取到指定网址的网页源码并返回

* @param url 爬取网址

* @return html

*/

public static String getHtmlResourceByUrl(String url) {

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet httpGet = new HttpGet(url);

HttpEntity httpEntity = null;

String html = null;

// 设置长连接

httpGet.setHeader("Connection", "keep-alive");

// 设置代理(模拟浏览器版本)

httpGet.setHeader("User-Agent", "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36");

CloseableHttpResponse httpResponse = null;

System.out.println("开始请求网页!!!!!!!!");

try {

// 请求并获得响应结果

httpResponse = httpClient.execute(httpGet);

httpEntity = httpResponse.getEntity();

// 输出请求结果

html = EntityUtils.toString(httpEntity);

} catch (IOException e) {

e.printStackTrace();

}

return html;

}

/**

* 获取网页的链接与标题,并追加到list中,从而返回list

* @param html 网页地址

* @return list

*/

public static List getTitleUrl(String html){

String regex_img_url = "<img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

String regex_img_title span class="token operator"=/span span class="token string""div class=\"tits\"(.*?)b class=hightlight"/spanspan class="token punctuation";/span

ArrayListspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建pattern对象/span

Pattern img_url_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_urlspan class="token punctuation")/spanspan class="token punctuation";/span

Pattern img_title_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_titlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_url_m span class="token operator"=/span img_url_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

Matcher img_title_m span class="token operator"=/span img_title_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_url_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/span span class="token operator"&&/span img_title_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

String url span class="token operator"=/span img_url_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanurlspan class="token punctuation")/spanspan class="token punctuation";/span

String title span class="token operator"=/span img_title_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spantitlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 获取image url 追加到List中,并返回List

* @param details_html 详情页网址

* @return List

*//span

span class="token keyword"public/span span class="token keyword"static/span Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span span class="token function"getImageSrc/spanspan class="token punctuation"(/spanString details_htmlspan class="token punctuation")/spanspan class="token punctuation"{/span

Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

String imgRegex span class="token operator"=/span span class="token string""img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

span class="token comment"//创建Pattern对象/span

Pattern img_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanimgRegexspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_m span class="token operator"=/span img_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spandetails_htmlspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""开始解析..."/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 下载图片

* @param imgUrl img网址

* @param filePath 图片报错地址

* @param title 图片系列

* @param imageName 图片名

* @param page 页数

* @param count 每页的图片计数

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"downLoad/spanspan class="token punctuation"(/spanString imgUrlspan class="token punctuation",/spanString filePathspan class="token punctuation",/span String titlespan class="token punctuation",/span String imageNamespan class="token punctuation",/spanspan class="token keyword"int/span pagespan class="token punctuation",/span span class="token keyword"int/span countspan class="token punctuation")/span span class="token punctuation"{/span

CloseableHttpClient httpClient span class="token operator"=/span HttpClientsspan class="token punctuation"./spanspan class="token function"createDefault/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

HttpGet httpGet span class="token operator"=/span span class="token keyword"new/span span class="token class-name"HttpGet/spanspan class="token punctuation"(/spanimgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"try/span span class="token punctuation"{/span

CloseableHttpResponse response span class="token operator"=/span httpClientspan class="token punctuation"./spanspan class="token function"execute/spanspan class="token punctuation"(/spanhttpGetspan class="token punctuation")/spanspan class="token punctuation";/span