java爬虫抓取网页数据(一下使用ja来写作一个爬虫功能强大的方法分享)

优采云 发布时间: 2022-01-07 08:11java爬虫抓取网页数据(一下使用ja来写作一个爬虫功能强大的方法分享)

一般来说,当我们说到爬虫程序时,我们总会想到python爬虫。但是,python 爬虫有一些固有的缺点。python的具体实现基本是固定的,底层实现我们也看不懂,导致很多网站可以反爬虫,今天给大家介绍一下用ja写爬虫,ja的爬虫功能相当强大,目前我还没有发现任何可以用来对抗ja爬虫的网站。

1 首先先介绍一下我们需要导入的jar包:.jsoup,这是一个ja解析html包,它的作用就是解析网页的代码,这个功能强大到没有网站可以做反分析。2.j a.io,这部分其实是没有必要的。我使用这个只是因为我在分析网页代码之前将网页保存在本地。至于为什么要这样做,后面的说明中会提到。3.j 这个包是ja的网络包,我们必须依赖这个包才能使用ja连接网络。

2 我们先说明一下如何将在线的html保存到本地。我们首先创建我们的输入和输出流缓冲区,然后创建一个url来获取我们需要抓取的网页。注意我们使用ipad的动态访问来实现 防止反爬虫对我们的阻碍。最后,我们在 uffer 中生成了我们的 html 代码,然后将其保存在本地。

3 现在让我告诉你为什么它存储在本地。在网页上反复爬取我们需要的数据,难免会导致服务器警觉。就像你看到一个漂亮的女孩一样,你总是盯着别人看。总会找到的,不过偷个图慢慢看也无妨。啊哈哈,这是个玩笑,但这是大体的想法。

4 这部分解释了如何获取html文件中的有用信息。众所周知,html中的代码占了很大一部分,我们需要得到对我们有用的文本才是我们需要做的。并且这段代码分析html中的标签,比如这些标签,分析出复杂代码中有价值的文本信息和超链接。当然,您可以选择要获取的内容。

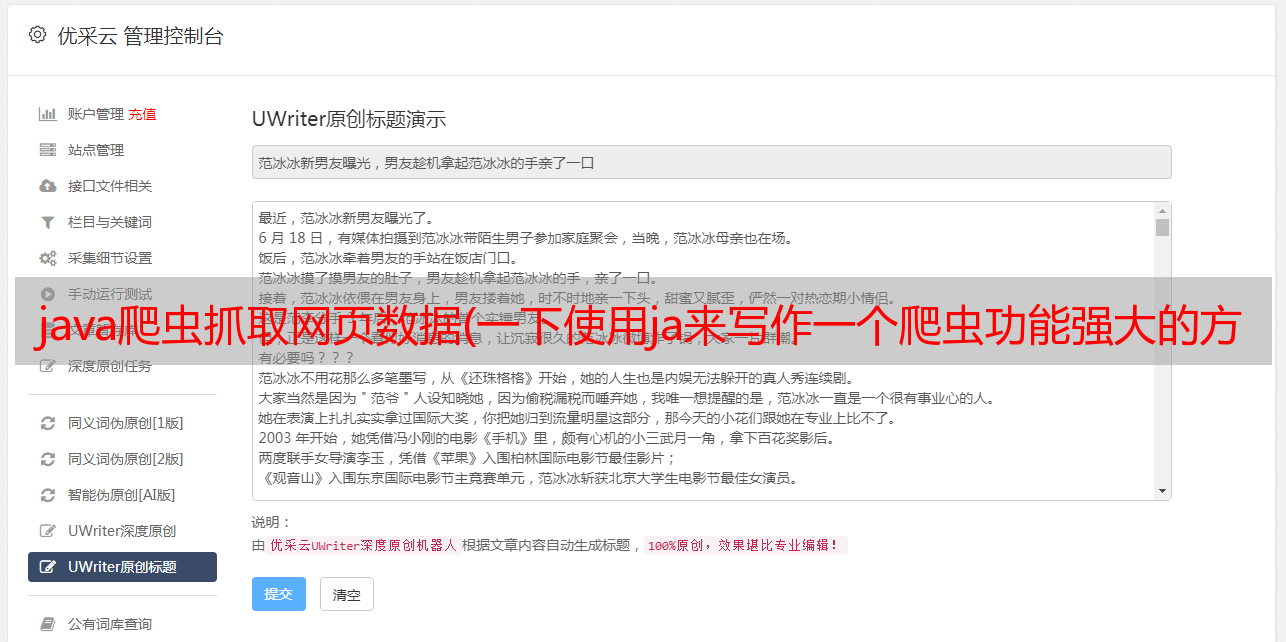

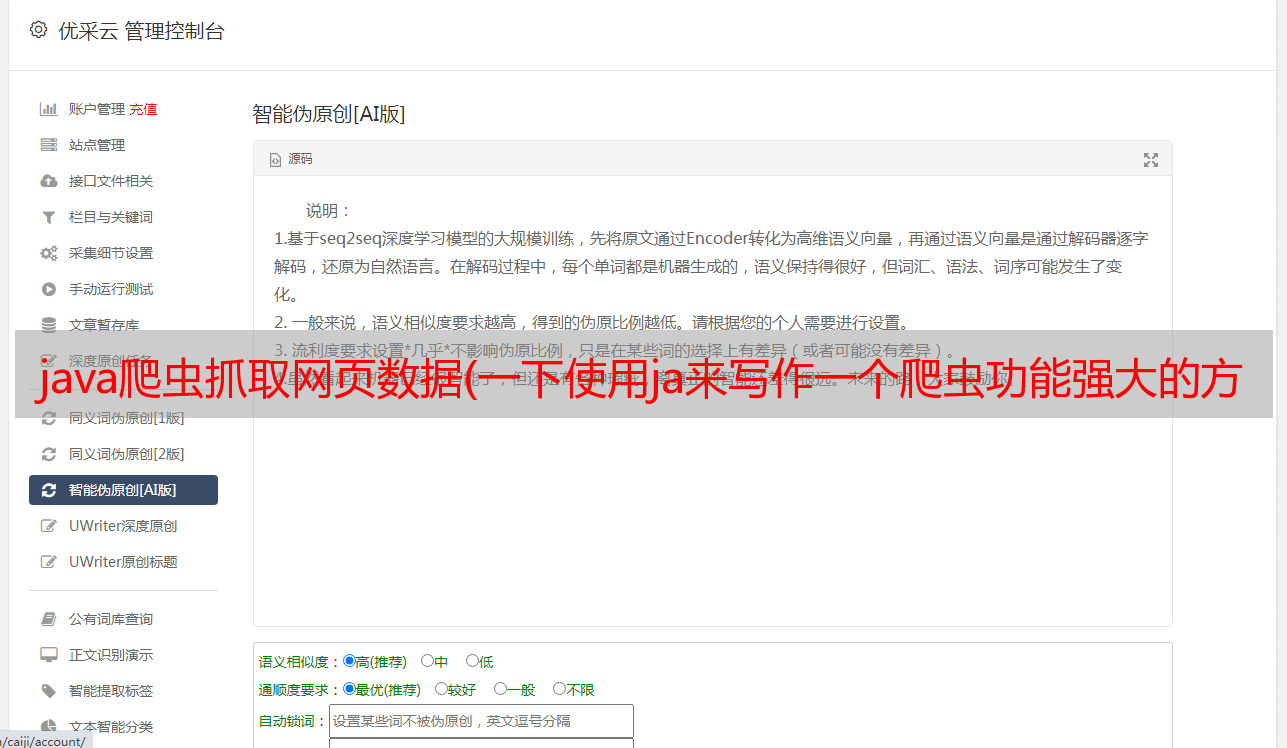

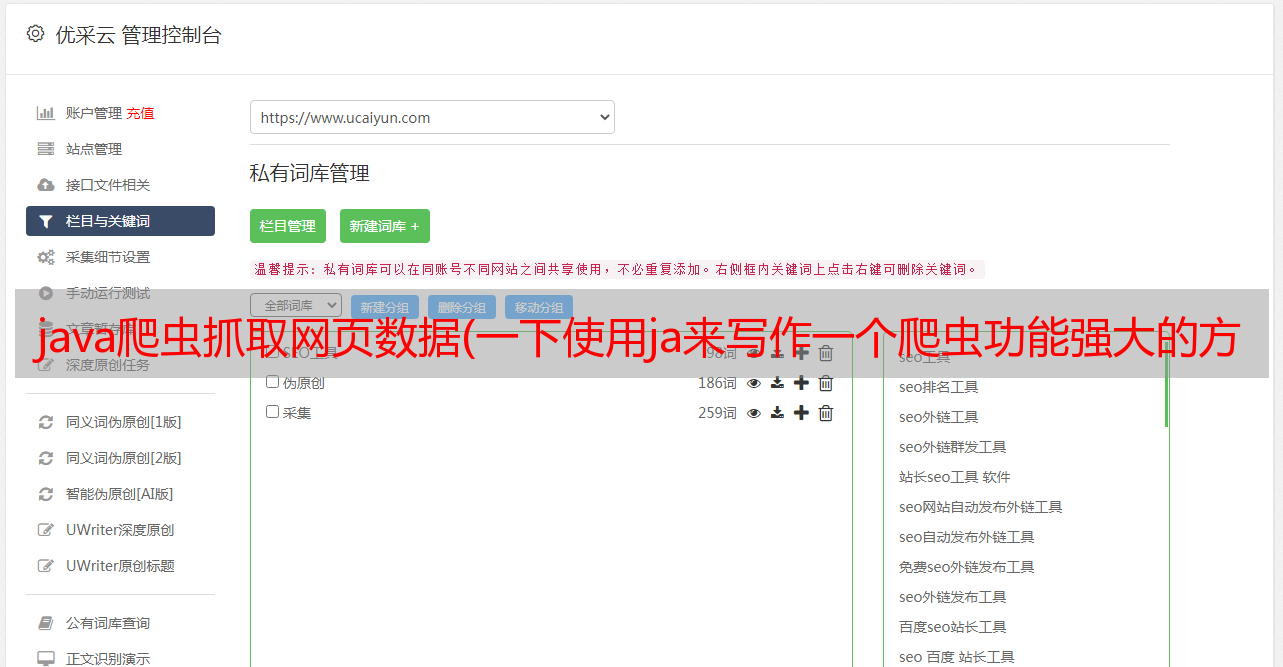

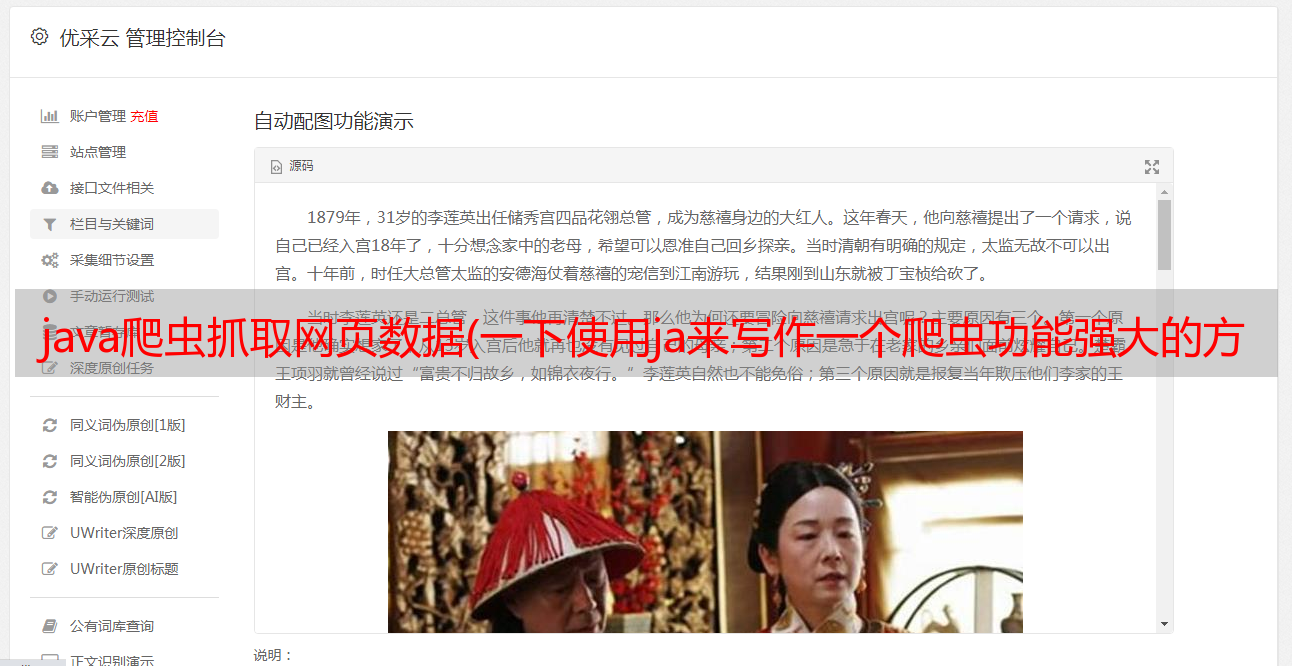

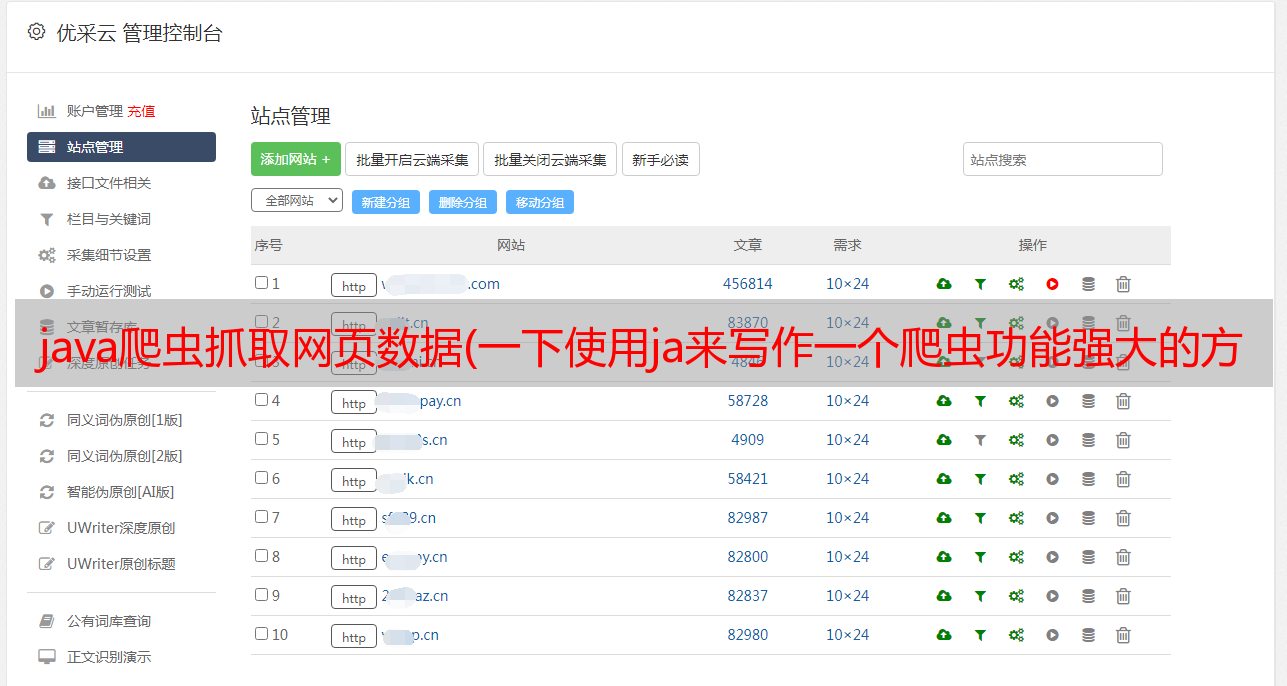

5最后,让我们尝试爬取我们需要的网站: 下图展示了操作方法和爬虫网页。我们要抓取的是这个网页的header:

6 我们的爬虫结果如下: 嗯,看来爬虫还是挺成功的。有兴趣的可以自己试试ja爬虫。相信我,这个功能真的很强大也很简单。

jsoup包需要网上下载或者使用men下载

建议爬取大量网页后删除一个,否则会不断积累本地网页