java爬虫抓取网页数据

java爬虫抓取网页数据(网络爬虫(又被称为网页蜘蛛,网络机器人() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 332 次浏览 • 2022-03-26 00:18

)

网络爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常称为网络追逐者)是根据一定规则自动从万维网上爬取信息的程序或脚本。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。网络蜘蛛通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,阅读

网页的内容,找到网页中的其他链接地址,然后通过这些链接地址寻找下一个网页,如此循环下去,直到这个网站的所有网页都被爬取完毕。如果整个

互联网被视为一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了抓取网络上的数据,不仅需要爬虫,还需要

由“爬虫”发回的数据进行处理和过滤的服务器,爬虫爬取的数据量越大,对服务器的性能要求就越高。

1 重点介绍爬虫的工作原理及关键技术概述

网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页的信息。

在抓取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂,需要根据某个网页进行分析

算法过滤掉主题链接,保留有用的链接并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,重复上述操作

停止上述过程,直到达到系统的某个条件。此外,所有被爬虫爬取的网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;

对于焦爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程起到反馈和指导作用。

与通用网络爬虫相比,聚焦爬虫还需要解决三个主要问题:

(1) 获取目标的描述或定义;

(2) 网页或数据的分析和过滤;

(3) URL 的搜索策略。

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:通用网络爬虫、重点网络爬虫、

增量网络爬虫,深度网络爬虫。实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。刚从网上

网站获取的URL进一步循环获取数据,提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的网站爬虫远比这个复杂,深入的讨论太多了。

. 除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个Java模拟的提取新浪网页链接并存储的程序

在一个文件中

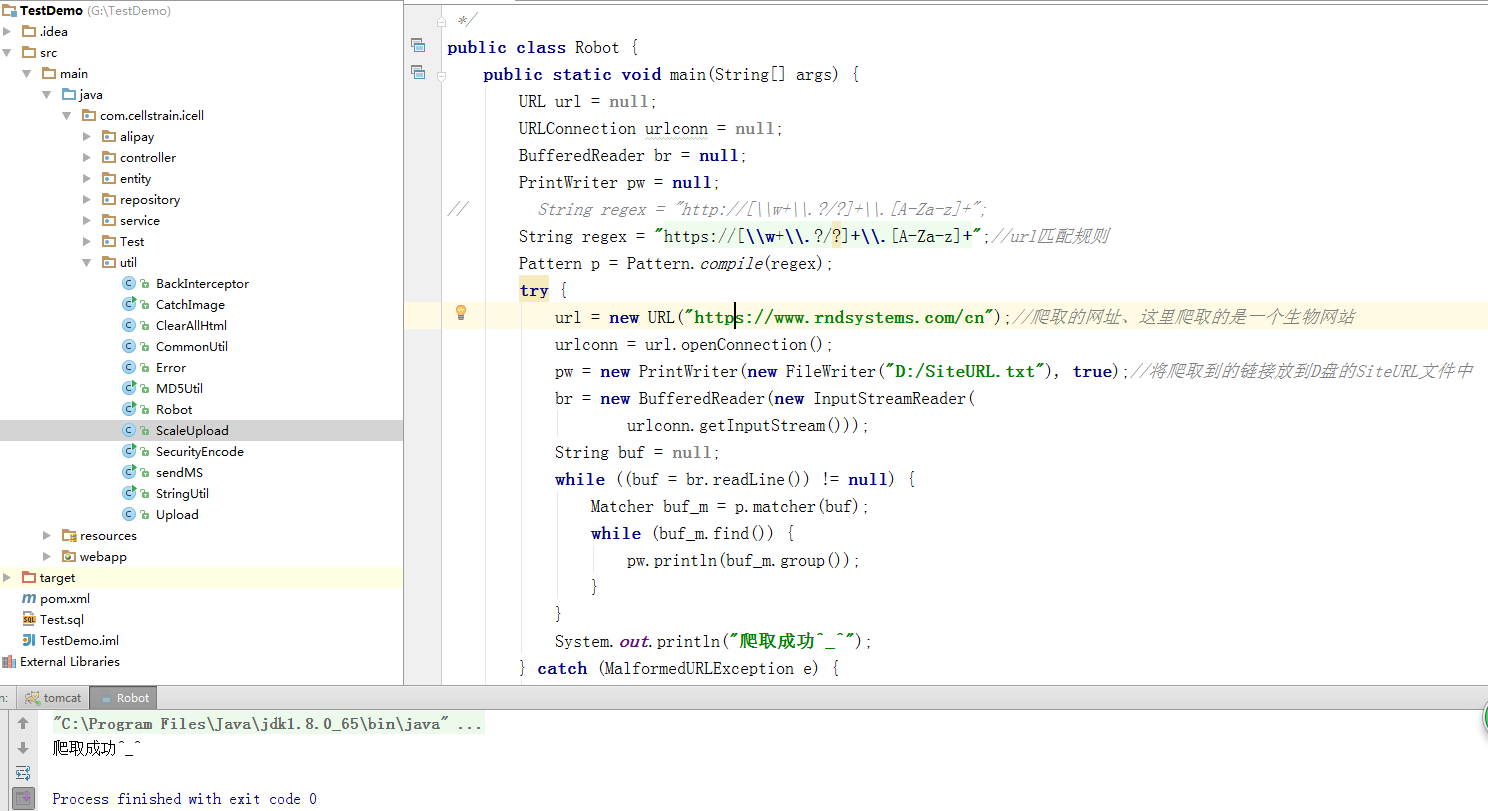

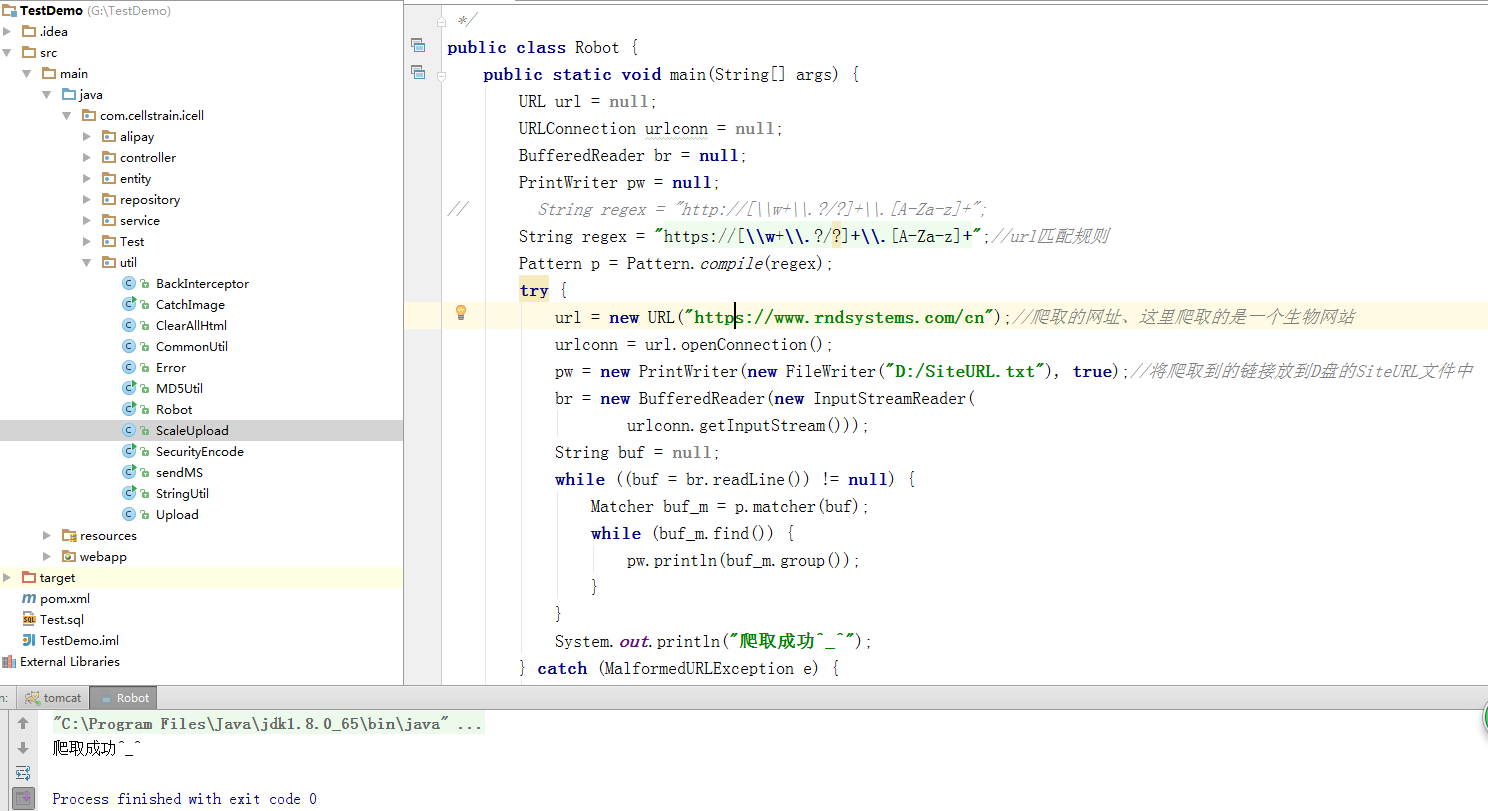

源代码如下

package com.cellstrain.icell.util;

import java.io.*;

import java.net.*;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

* java实现爬虫

*/

public class Robot {

public static void main(String[] args) {

URL url = null;

URLConnection urlconn = null;

BufferedReader br = null;

PrintWriter pw = null;

// String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";

String regex = "https://[\\w+\\.?/?]+\\.[A-Za-z]+";//url匹配规则

Pattern p = Pattern.compile(regex);

try {

url = new URL("https://www.rndsystems.com/cn");//爬取的网址、这里爬取的是一个生物网站

urlconn = url.openConnection();

pw = new PrintWriter(new FileWriter("D:/SiteURL.txt"), true);//将爬取到的链接放到D盘的SiteURL文件中

br = new BufferedReader(new InputStreamReader(

urlconn.getInputStream()));

String buf = null;

while ((buf = br.readLine()) != null) {

Matcher buf_m = p.matcher(buf);

while (buf_m.find()) {

pw.println(buf_m.group());

}

}

System.out.println("爬取成功^_^");

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

br.close();

} catch (IOException e) {

e.printStackTrace();

}

pw.close();

}

}

}

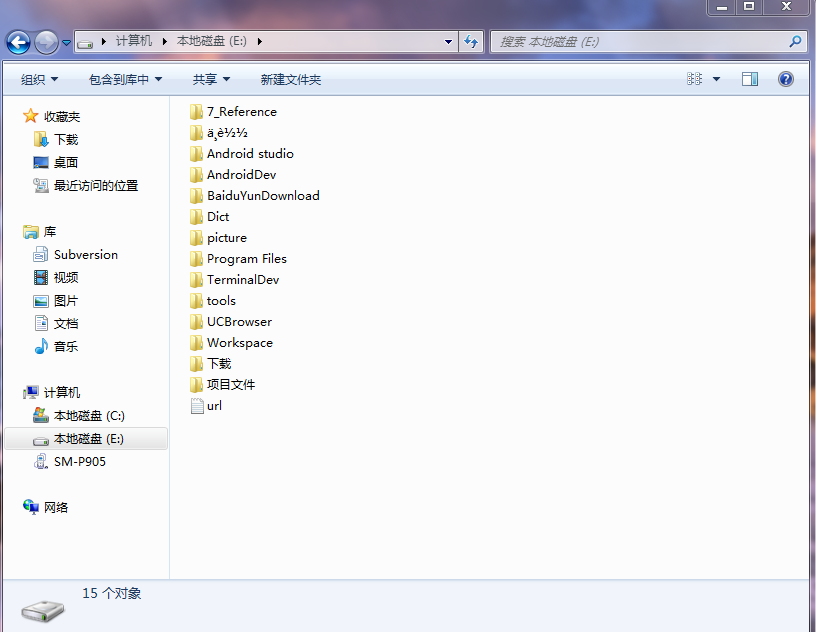

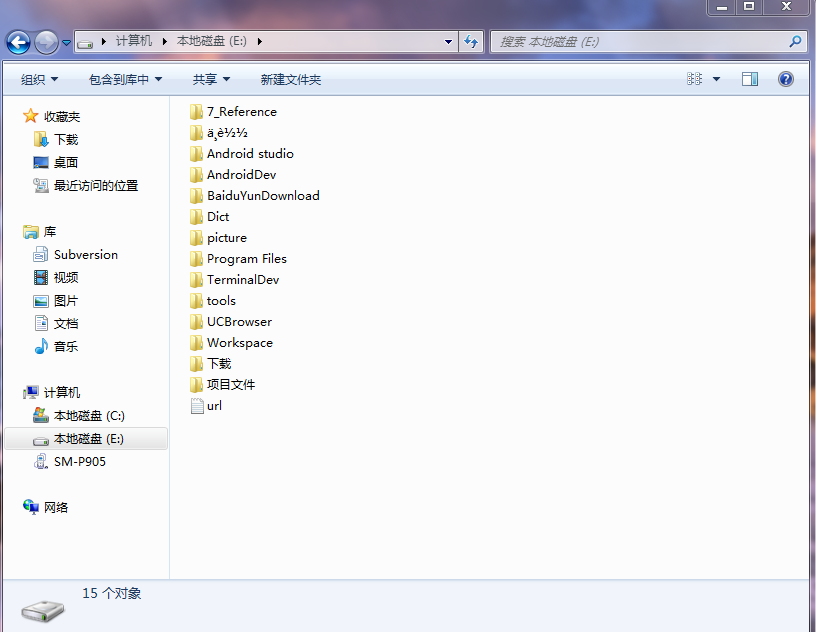

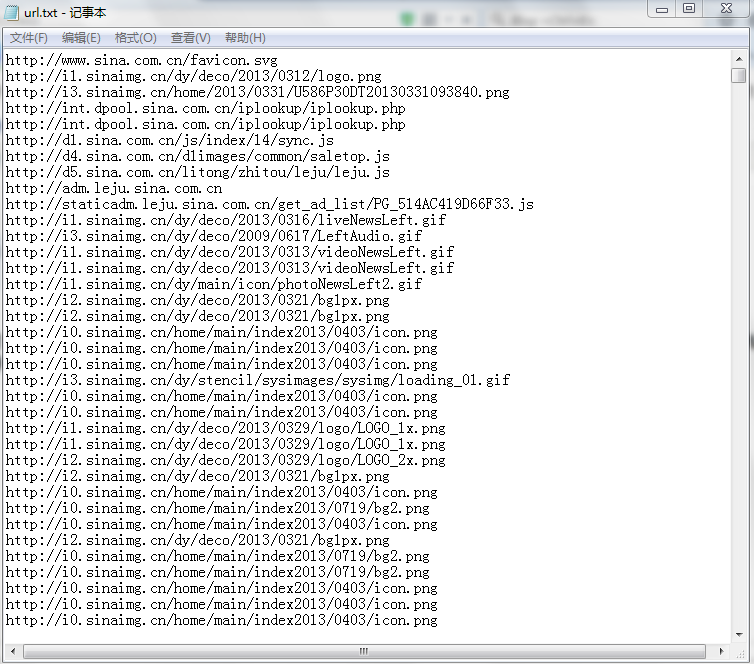

运行idea的结果如下:

检查D盘是否有SiteURL.txt文件

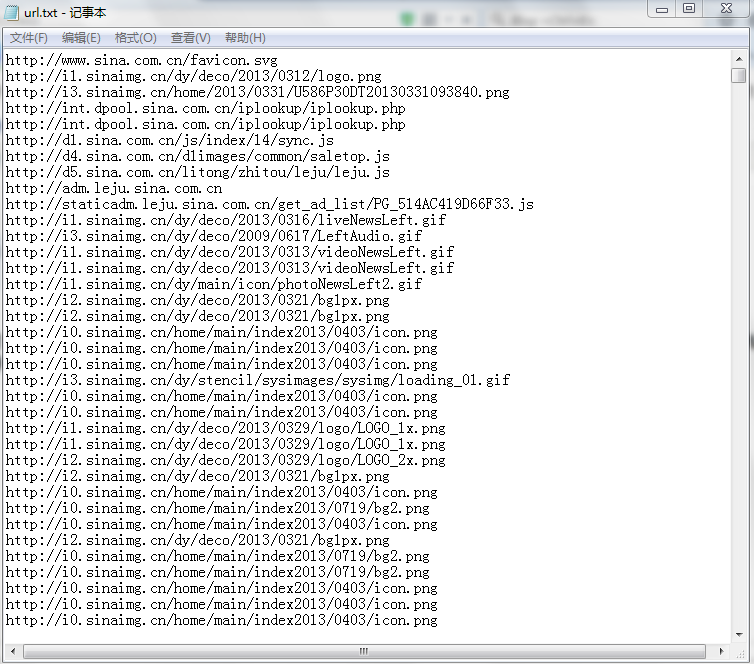

已经成功生成SiteURL文件,打开就可以看到所有抓到的url

查看全部

java爬虫抓取网页数据(网络爬虫(又被称为网页蜘蛛,网络机器人()

)

网络爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常称为网络追逐者)是根据一定规则自动从万维网上爬取信息的程序或脚本。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。网络蜘蛛通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,阅读

网页的内容,找到网页中的其他链接地址,然后通过这些链接地址寻找下一个网页,如此循环下去,直到这个网站的所有网页都被爬取完毕。如果整个

互联网被视为一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了抓取网络上的数据,不仅需要爬虫,还需要

由“爬虫”发回的数据进行处理和过滤的服务器,爬虫爬取的数据量越大,对服务器的性能要求就越高。

1 重点介绍爬虫的工作原理及关键技术概述

网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页的信息。

在抓取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂,需要根据某个网页进行分析

算法过滤掉主题链接,保留有用的链接并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,重复上述操作

停止上述过程,直到达到系统的某个条件。此外,所有被爬虫爬取的网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;

对于焦爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程起到反馈和指导作用。

与通用网络爬虫相比,聚焦爬虫还需要解决三个主要问题:

(1) 获取目标的描述或定义;

(2) 网页或数据的分析和过滤;

(3) URL 的搜索策略。

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:通用网络爬虫、重点网络爬虫、

增量网络爬虫,深度网络爬虫。实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。刚从网上

网站获取的URL进一步循环获取数据,提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的网站爬虫远比这个复杂,深入的讨论太多了。

. 除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个Java模拟的提取新浪网页链接并存储的程序

在一个文件中

源代码如下

package com.cellstrain.icell.util;

import java.io.*;

import java.net.*;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

* java实现爬虫

*/

public class Robot {

public static void main(String[] args) {

URL url = null;

URLConnection urlconn = null;

BufferedReader br = null;

PrintWriter pw = null;

// String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";

String regex = "https://[\\w+\\.?/?]+\\.[A-Za-z]+";//url匹配规则

Pattern p = Pattern.compile(regex);

try {

url = new URL("https://www.rndsystems.com/cn";);//爬取的网址、这里爬取的是一个生物网站

urlconn = url.openConnection();

pw = new PrintWriter(new FileWriter("D:/SiteURL.txt"), true);//将爬取到的链接放到D盘的SiteURL文件中

br = new BufferedReader(new InputStreamReader(

urlconn.getInputStream()));

String buf = null;

while ((buf = br.readLine()) != null) {

Matcher buf_m = p.matcher(buf);

while (buf_m.find()) {

pw.println(buf_m.group());

}

}

System.out.println("爬取成功^_^");

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

br.close();

} catch (IOException e) {

e.printStackTrace();

}

pw.close();

}

}

}

运行idea的结果如下:

检查D盘是否有SiteURL.txt文件

已经成功生成SiteURL文件,打开就可以看到所有抓到的url

java爬虫抓取网页数据(博客系列Java爬虫入门简介(一)——HttpClient请求 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-22 20:42

)

博客系列

Java爬虫简介(一)——HttpClient请求(本文)

Java爬虫简介(二)——Jsoup解析HTML页面(本文)

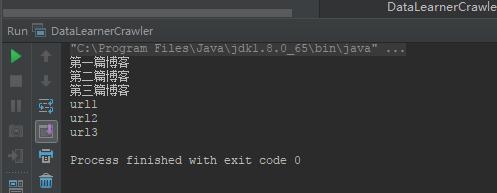

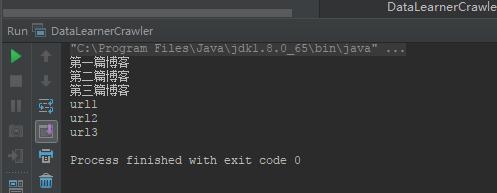

在上一篇博客中,我们已经介绍了如何使用 HttpClient 来模拟客户端请求页面。在本篇博客中,我们将介绍如何解析获取的页面内容。

在上一节中,我们获得了页面的 HTML 源代码,但是这些源代码是提供给浏览器进行解析的。我们需要的数据其实就是页面上博客的标题、作者、简介、发布日期等。我们需要一种方法来从 HTML 源代码中解析这些信息,将其提取出来,并将其存储在文本或数据库中。在本篇博客中,我们将介绍使用 Jsoup 包来帮助我们解析页面和提取数据。

Jsoup是一个Java HTML解析器,可以直接解析一个URL地址或者解析HTML内容。它的主要功能包括解析 HTML 页面、通过 DOM 或 CSS 选择器查找和提取数据以及更改 HTML 内容。Jsoup的使用也很简单。使用Jsoup.parse(String str)方法解析我们之前获取的HTML内容得到一个Document类,剩下的工作就是从Document中选择我们需要的数据。例如,假设我们有一个收录以下内容的 HTML 页面:

第一篇博客

第二篇博客

第三篇博客

通过Jsoup,我们可以将以上三个博客的标题提取成一个List。使用方法如下:

首先,我们通过maven来介绍Jsoup

org.jsoup

jsoup

1.10.3

然后写Java来解析。

package org.hfutec.example;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.util.ArrayList;

import java.util.List;

/*******

* created by DuFei at 2017.08.25 21:00

* web crawler example

* ******/

public class DataLearnerCrawler {

public static void main(String[] args) {

List titles = new ArrayList();

List urls = new ArrayList();

//假设我们获取的HTML的字符内容如下

String html = "<a href=\"url1\">第一篇博客</a><a href=\"url2\">第二篇博客</a><a href=\"url3\">第三篇博客</a>";

//第一步,将字符内容解析成一个Document类

Document doc = Jsoup.parse(html);

//第二步,根据我们需要得到的标签,选择提取相应标签的内容

Elements elements = doc.select("div[id=blog_list]").select("div[class=blog_title]");

for( Element element : elements ){

String title = element.text();

titles.add(title);

urls.add(element.select("a").attr("href"));

}

//输出测试

for( String title : titles ){

System.out.println(title);

}

for( String url : urls ){

System.out.println(url);

}

}

}

下面简单介绍一下Jsoup的解析过程。第一步是调用parse()方法把字符对象变成Document对象,然后我们对这个对象进行操作。一般来说,提取数据就是根据标签选择数据。select() 方法的语法格式与 javascript/css 选择器的语法格式相同。一般抽取一个标签,其属性值为指定的内容。得到的结果是一个Elements的集合,也就是Elements(因为可能有很多符合条件的标签,所以结果就是一个集合)。select() 方法可以一直持续到我们想要的标签集被选中(注意我们不必从标签层级中逐层选择,我们可以直接将 select() 方法写到我们需要的标签中,例如, 这里的示例代码可以直接写成 Elements elements = doc.select("div[class=blog_title]"); 效果是一样的)。对于选定的一组元素,我们可以通过循环提取每个所需的数据。例如,如果我们需要获取标签的文本信息,可以使用 text() 方法。如果我们需要获取对应的 HTML 属性信息,可以使用 attr() 方法。我们可以看到上述方法的输出如下:

更多Jsoup解析操作请参考以下内容:

1、

2、

一个实例

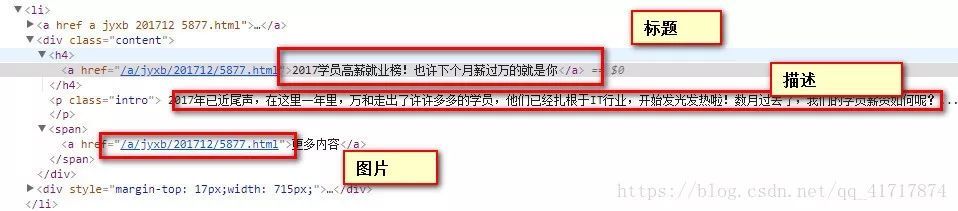

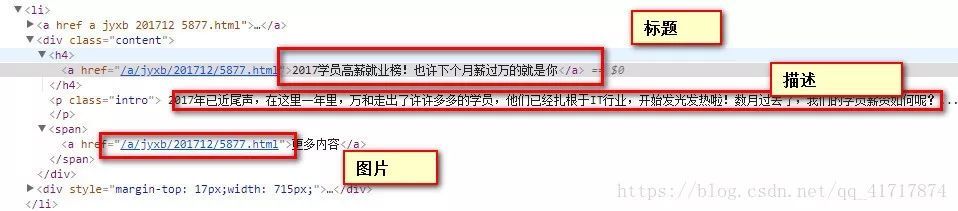

让我们继续上一个爬取数据的例子来学习官方的网站博客列表来解释一个例子。我们已经知道可以使用 Jsoup 来解析爬取的 HTML 页面内容。那么我们如何查看我们需要的内容对应的标签呢?以Chrome浏览器为例,我们需要爬取这个页面的博客。首先用Chrome浏览器打开网址,然后右击博客标题,点击“Inspect”,得到HTML页面。如下所示。

图2 右击标题

图3 点击元素父元素侧边的小三角关闭代码查看

图4 确认当前博客HTML代码的一致性

经过上面的操作,我们已经可以看到所有的博客标题等信息都存放在class=card div中了。所以,我们只需要注意这个标签中的内容是如何组织的,仅此而已。如下图所示,我们需要的信息所属的标签可以通过点击小三角展开得到。

因此,解析博客列表的代码可以写成如下。

package org.hfutec.example;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

/*******

* created by DuFei at 2017.08.25 21:00

* web crawler example

* ******/

public class DataLearnerCrawler {

public static void main(String[] args) {

String url = "http://www.datalearner.com/blog_list";

String rawHTML = null;

try {

rawHTML = getHTMLContent(url);

} catch (IOException e) {

e.printStackTrace();

}

//将当前页面转换成Jsoup的Document对象

Document doc = Jsoup.parse(rawHTML);

//获取所有的博客列表集合

Elements blogList = doc.select("div[class=card]");

//针对每个博客内容进行解析,并输出

for( Element element : blogList ){

String title = element.select("h4[class=card-title]").text();

String introduction = element.select("p[class=card-text]").text();

String author = element.select("span[class=fa fa-user]").text();

System.out.println("Title:\t"+title);

System.out.println("introduction:\t"+introduction);

System.out.println("Author:\t"+author);

System.out.println("--------------------------");

}

}

//根据url地址获取对应页面的HTML内容,我们将上一节中的内容打包成了一个方法,方便调用

private static String getHTMLContent( String url ) throws IOException {

//建立一个新的请求客户端

CloseableHttpClient httpClient = HttpClients.createDefault();

//使用HttpGet方式请求网址

HttpGet httpGet = new HttpGet(url);

//获取网址的返回结果

CloseableHttpResponse response = httpClient.execute(httpGet);

//获取返回结果中的实体

HttpEntity entity = response.getEntity();

String content = EntityUtils.toString(entity);

//关闭HttpEntity流

EntityUtils.consume(entity);

return content;

}

}

最终输出如下图所示:

查看全部

java爬虫抓取网页数据(博客系列Java爬虫入门简介(一)——HttpClient请求

)

博客系列

Java爬虫简介(一)——HttpClient请求(本文)

Java爬虫简介(二)——Jsoup解析HTML页面(本文)

在上一篇博客中,我们已经介绍了如何使用 HttpClient 来模拟客户端请求页面。在本篇博客中,我们将介绍如何解析获取的页面内容。

在上一节中,我们获得了页面的 HTML 源代码,但是这些源代码是提供给浏览器进行解析的。我们需要的数据其实就是页面上博客的标题、作者、简介、发布日期等。我们需要一种方法来从 HTML 源代码中解析这些信息,将其提取出来,并将其存储在文本或数据库中。在本篇博客中,我们将介绍使用 Jsoup 包来帮助我们解析页面和提取数据。

Jsoup是一个Java HTML解析器,可以直接解析一个URL地址或者解析HTML内容。它的主要功能包括解析 HTML 页面、通过 DOM 或 CSS 选择器查找和提取数据以及更改 HTML 内容。Jsoup的使用也很简单。使用Jsoup.parse(String str)方法解析我们之前获取的HTML内容得到一个Document类,剩下的工作就是从Document中选择我们需要的数据。例如,假设我们有一个收录以下内容的 HTML 页面:

第一篇博客

第二篇博客

第三篇博客

通过Jsoup,我们可以将以上三个博客的标题提取成一个List。使用方法如下:

首先,我们通过maven来介绍Jsoup

org.jsoup

jsoup

1.10.3

然后写Java来解析。

package org.hfutec.example;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.util.ArrayList;

import java.util.List;

/*******

* created by DuFei at 2017.08.25 21:00

* web crawler example

* ******/

public class DataLearnerCrawler {

public static void main(String[] args) {

List titles = new ArrayList();

List urls = new ArrayList();

//假设我们获取的HTML的字符内容如下

String html = "<a href=\"url1\">第一篇博客</a><a href=\"url2\">第二篇博客</a><a href=\"url3\">第三篇博客</a>";

//第一步,将字符内容解析成一个Document类

Document doc = Jsoup.parse(html);

//第二步,根据我们需要得到的标签,选择提取相应标签的内容

Elements elements = doc.select("div[id=blog_list]").select("div[class=blog_title]");

for( Element element : elements ){

String title = element.text();

titles.add(title);

urls.add(element.select("a").attr("href"));

}

//输出测试

for( String title : titles ){

System.out.println(title);

}

for( String url : urls ){

System.out.println(url);

}

}

}

下面简单介绍一下Jsoup的解析过程。第一步是调用parse()方法把字符对象变成Document对象,然后我们对这个对象进行操作。一般来说,提取数据就是根据标签选择数据。select() 方法的语法格式与 javascript/css 选择器的语法格式相同。一般抽取一个标签,其属性值为指定的内容。得到的结果是一个Elements的集合,也就是Elements(因为可能有很多符合条件的标签,所以结果就是一个集合)。select() 方法可以一直持续到我们想要的标签集被选中(注意我们不必从标签层级中逐层选择,我们可以直接将 select() 方法写到我们需要的标签中,例如, 这里的示例代码可以直接写成 Elements elements = doc.select("div[class=blog_title]"); 效果是一样的)。对于选定的一组元素,我们可以通过循环提取每个所需的数据。例如,如果我们需要获取标签的文本信息,可以使用 text() 方法。如果我们需要获取对应的 HTML 属性信息,可以使用 attr() 方法。我们可以看到上述方法的输出如下:

更多Jsoup解析操作请参考以下内容:

1、

2、

一个实例

让我们继续上一个爬取数据的例子来学习官方的网站博客列表来解释一个例子。我们已经知道可以使用 Jsoup 来解析爬取的 HTML 页面内容。那么我们如何查看我们需要的内容对应的标签呢?以Chrome浏览器为例,我们需要爬取这个页面的博客。首先用Chrome浏览器打开网址,然后右击博客标题,点击“Inspect”,得到HTML页面。如下所示。

图2 右击标题

图3 点击元素父元素侧边的小三角关闭代码查看

图4 确认当前博客HTML代码的一致性

经过上面的操作,我们已经可以看到所有的博客标题等信息都存放在class=card div中了。所以,我们只需要注意这个标签中的内容是如何组织的,仅此而已。如下图所示,我们需要的信息所属的标签可以通过点击小三角展开得到。

因此,解析博客列表的代码可以写成如下。

package org.hfutec.example;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

/*******

* created by DuFei at 2017.08.25 21:00

* web crawler example

* ******/

public class DataLearnerCrawler {

public static void main(String[] args) {

String url = "http://www.datalearner.com/blog_list";

String rawHTML = null;

try {

rawHTML = getHTMLContent(url);

} catch (IOException e) {

e.printStackTrace();

}

//将当前页面转换成Jsoup的Document对象

Document doc = Jsoup.parse(rawHTML);

//获取所有的博客列表集合

Elements blogList = doc.select("div[class=card]");

//针对每个博客内容进行解析,并输出

for( Element element : blogList ){

String title = element.select("h4[class=card-title]").text();

String introduction = element.select("p[class=card-text]").text();

String author = element.select("span[class=fa fa-user]").text();

System.out.println("Title:\t"+title);

System.out.println("introduction:\t"+introduction);

System.out.println("Author:\t"+author);

System.out.println("--------------------------");

}

}

//根据url地址获取对应页面的HTML内容,我们将上一节中的内容打包成了一个方法,方便调用

private static String getHTMLContent( String url ) throws IOException {

//建立一个新的请求客户端

CloseableHttpClient httpClient = HttpClients.createDefault();

//使用HttpGet方式请求网址

HttpGet httpGet = new HttpGet(url);

//获取网址的返回结果

CloseableHttpResponse response = httpClient.execute(httpGet);

//获取返回结果中的实体

HttpEntity entity = response.getEntity();

String content = EntityUtils.toString(entity);

//关闭HttpEntity流

EntityUtils.consume(entity);

return content;

}

}

最终输出如下图所示:

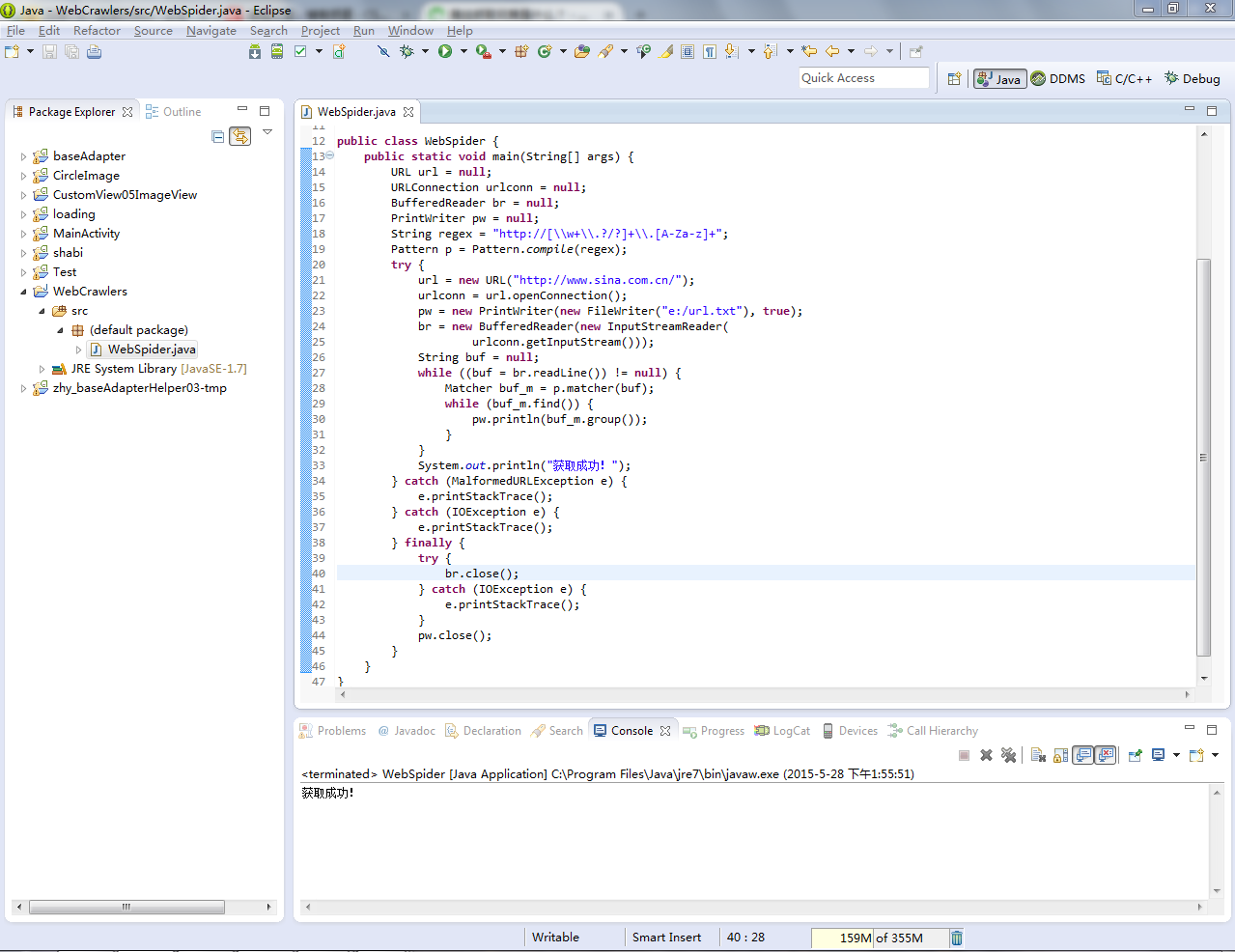

java爬虫抓取网页数据(一共需要做四个规则:第一个规则“第二个规则图” )

网站优化 • 优采云 发表了文章 • 0 个评论 • 264 次浏览 • 2022-03-22 20:41

)

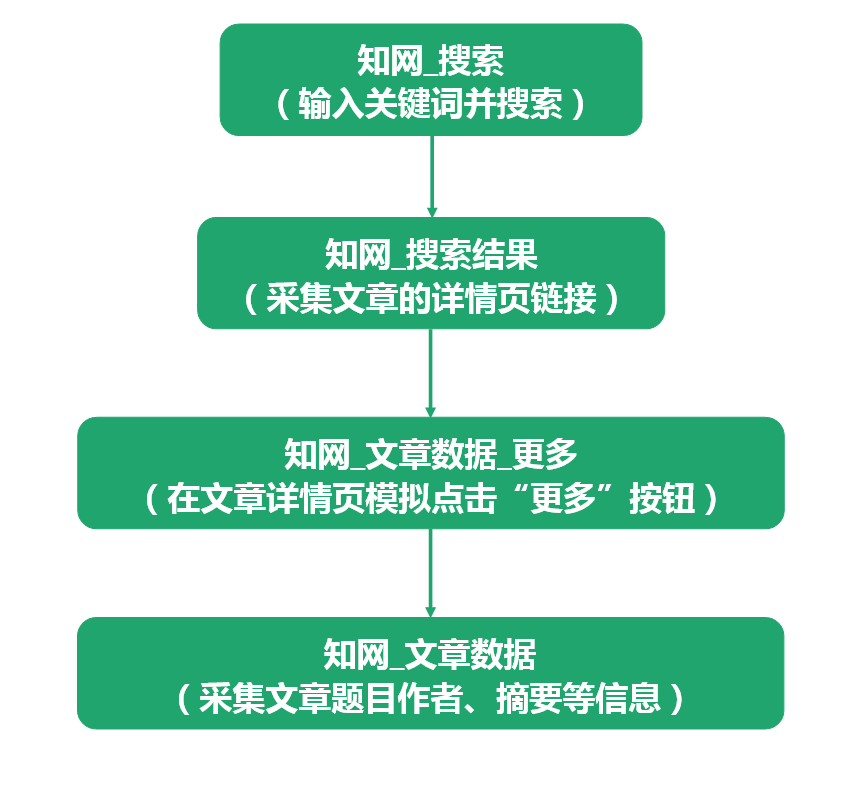

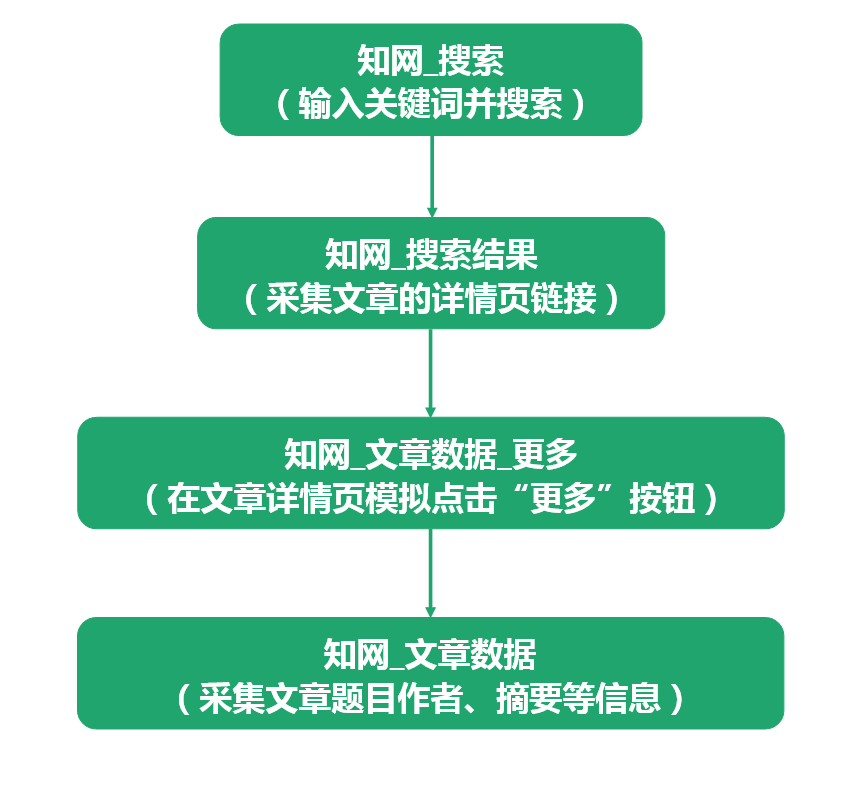

2.如何使用快捷键采集:如何使用快捷键采集

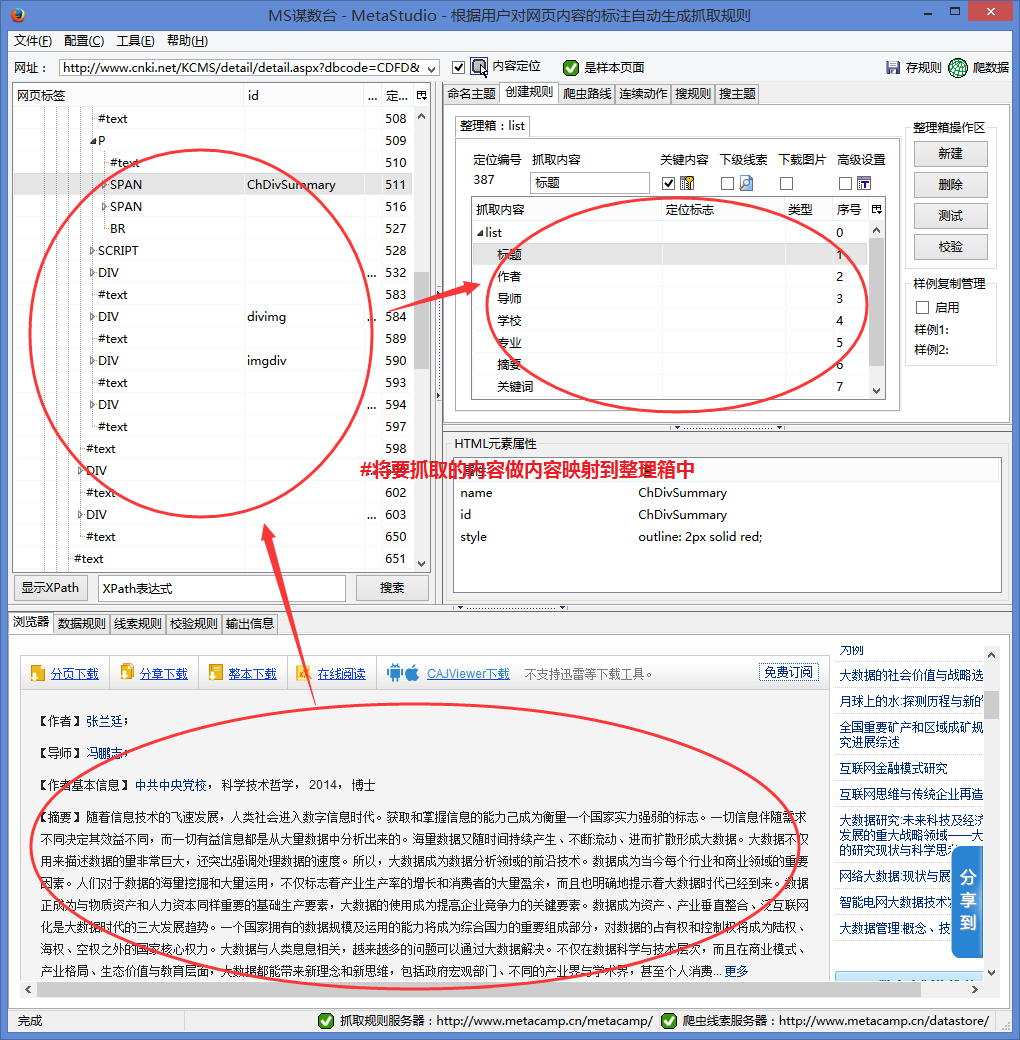

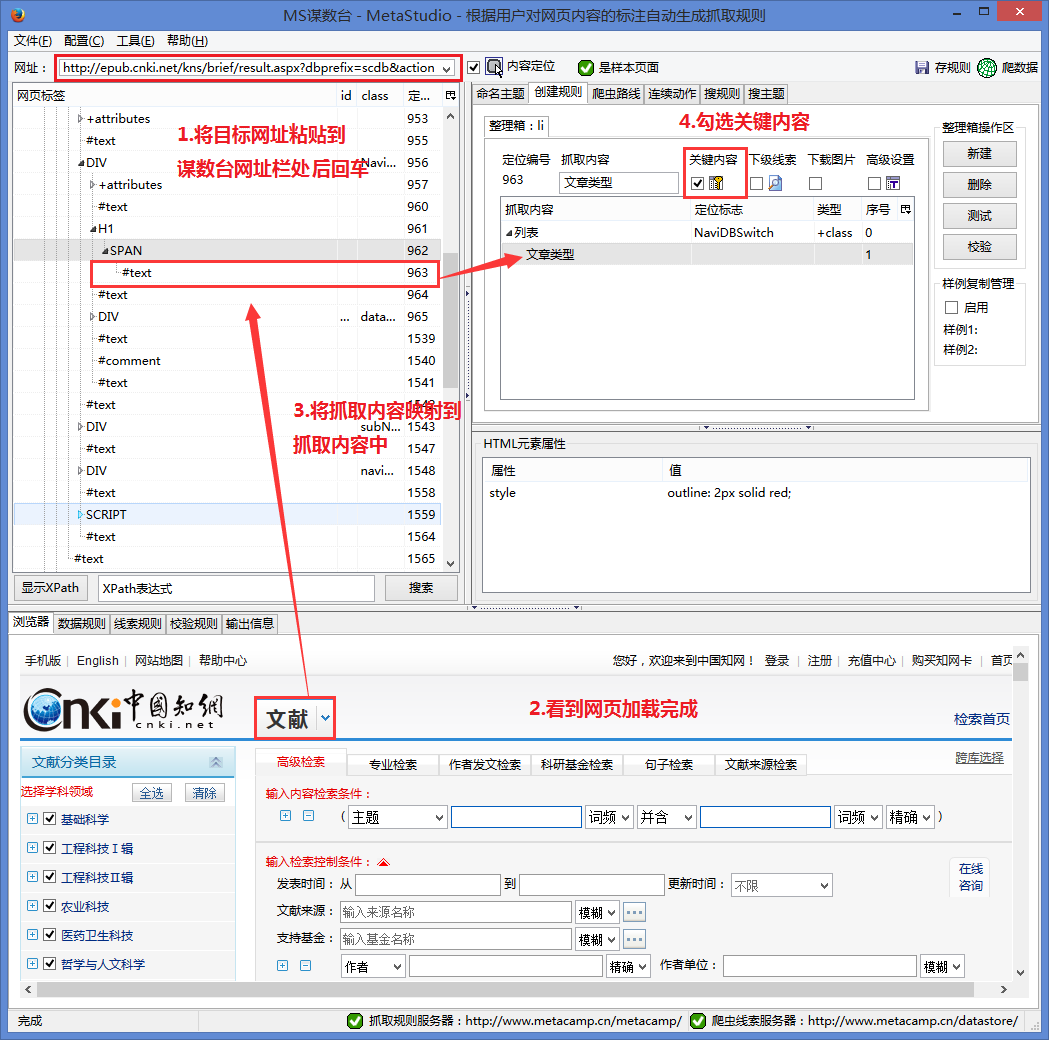

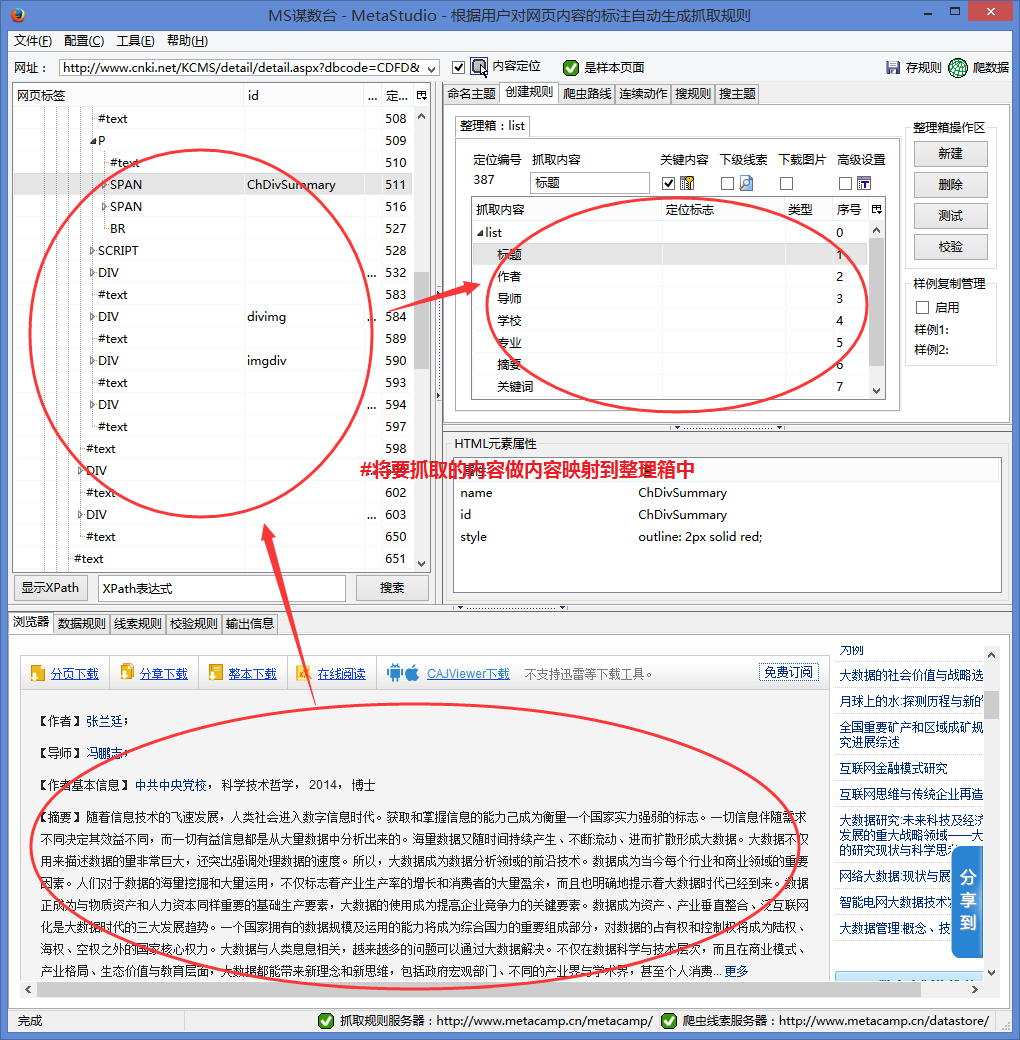

通过CNKI高级搜索,输入关键词,即可获取相关的文章标题、作者、摘要、关键词等信息。但是CNKI在输入关键词进行搜索后并没有改变URL,所以在爬取的时候,我们需要爬虫自动输入目标关键词来搜索并开始爬取数据。

要获取标题、作者、摘要、关键词等信息,我们一共需要制定四个规则:

第一条规则”

第二条规则”

提示:文章的部分摘要需要点击“更多”才能全部显示。为了抓取完整的摘要,我们需要制定一个规则来点击这个“更多”。

第三条规则”

第四条规则”

图1

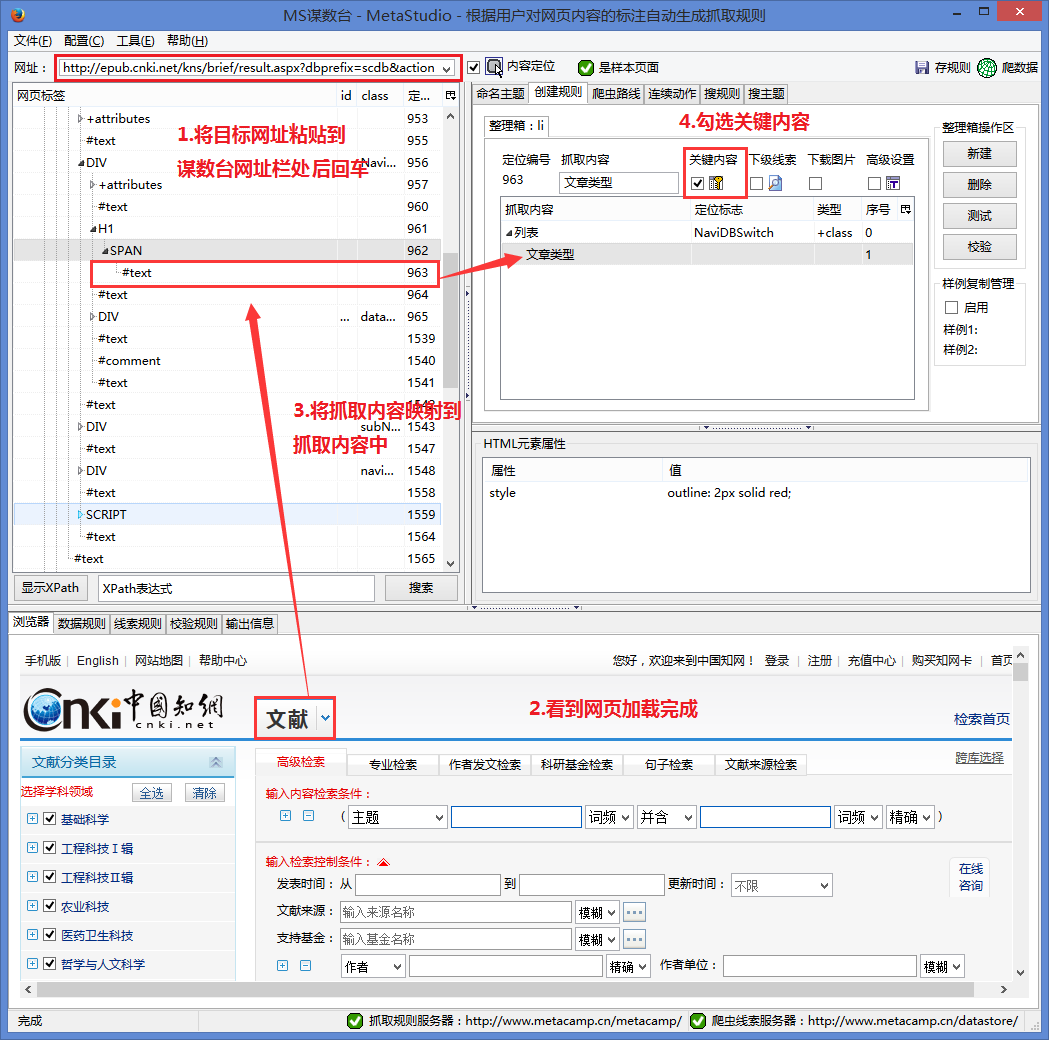

一、第一条规则 - 知网搜索

1.以CNKI高级检索文献文章为例,将高级文献检索链接粘贴到某手。

第一条规则的主要工作是搜索关键词,但是为了有效地执行规则,我们在规则中抓取文章的类型。这里以文献为例,我们抓取的内容为“文献”,并勾选关键内容。

图 2

如图2所示,具体操作如下:

#1.将目标爬取网页粘贴到猫鼠台网址栏,回车。

#2.看到页面加载完毕。

#3.将抓取的内容“文档”映射到排序框中。

#4.选择文献的重点内容。

2.跳转到连续动作工作台输入关键词及其动作

关键词 的自动输入点是建立两个步骤。第一步是通过输入框的定位表达式找到输入框,然后输入关键词。第二步,通过定位表达式找到搜索按钮,然后爬虫自行点击按钮。

2.1 创建输入步骤

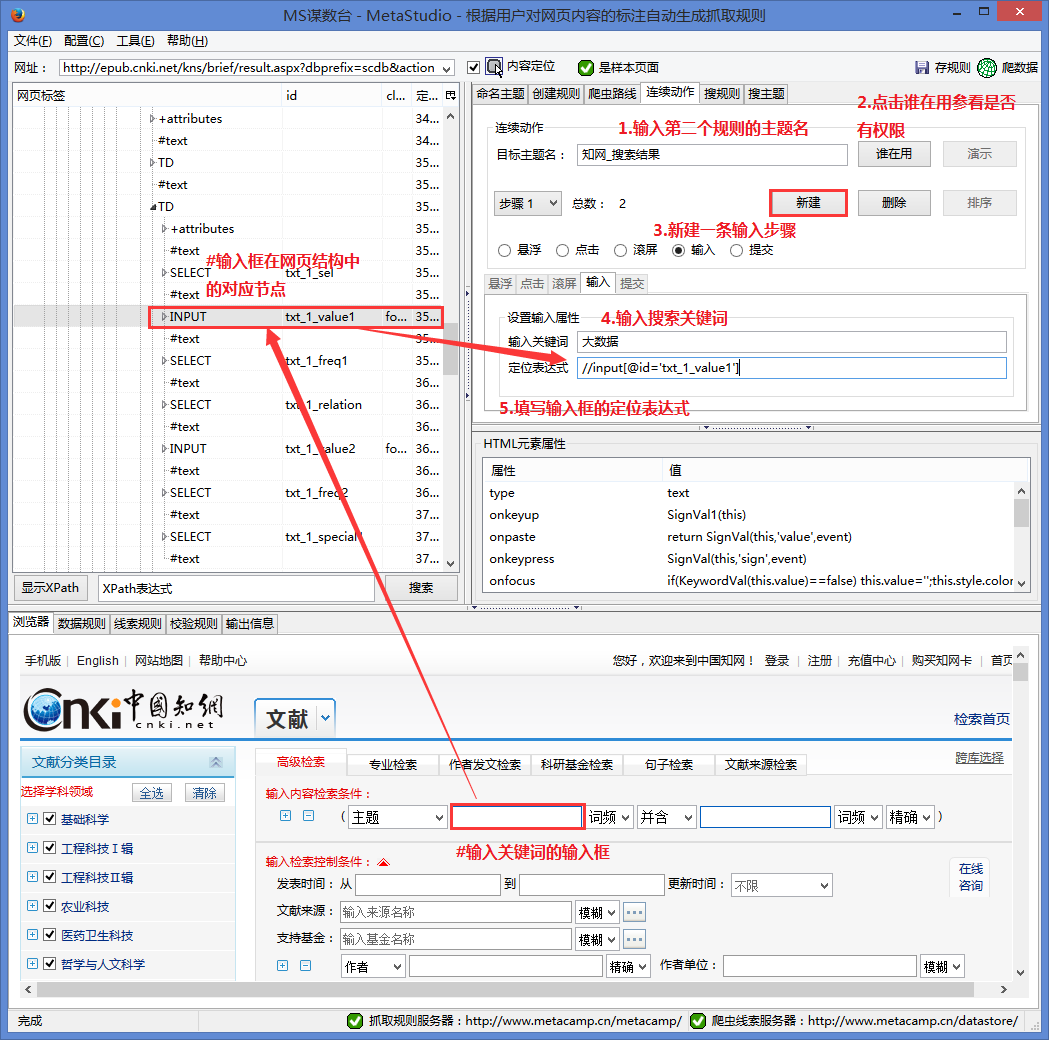

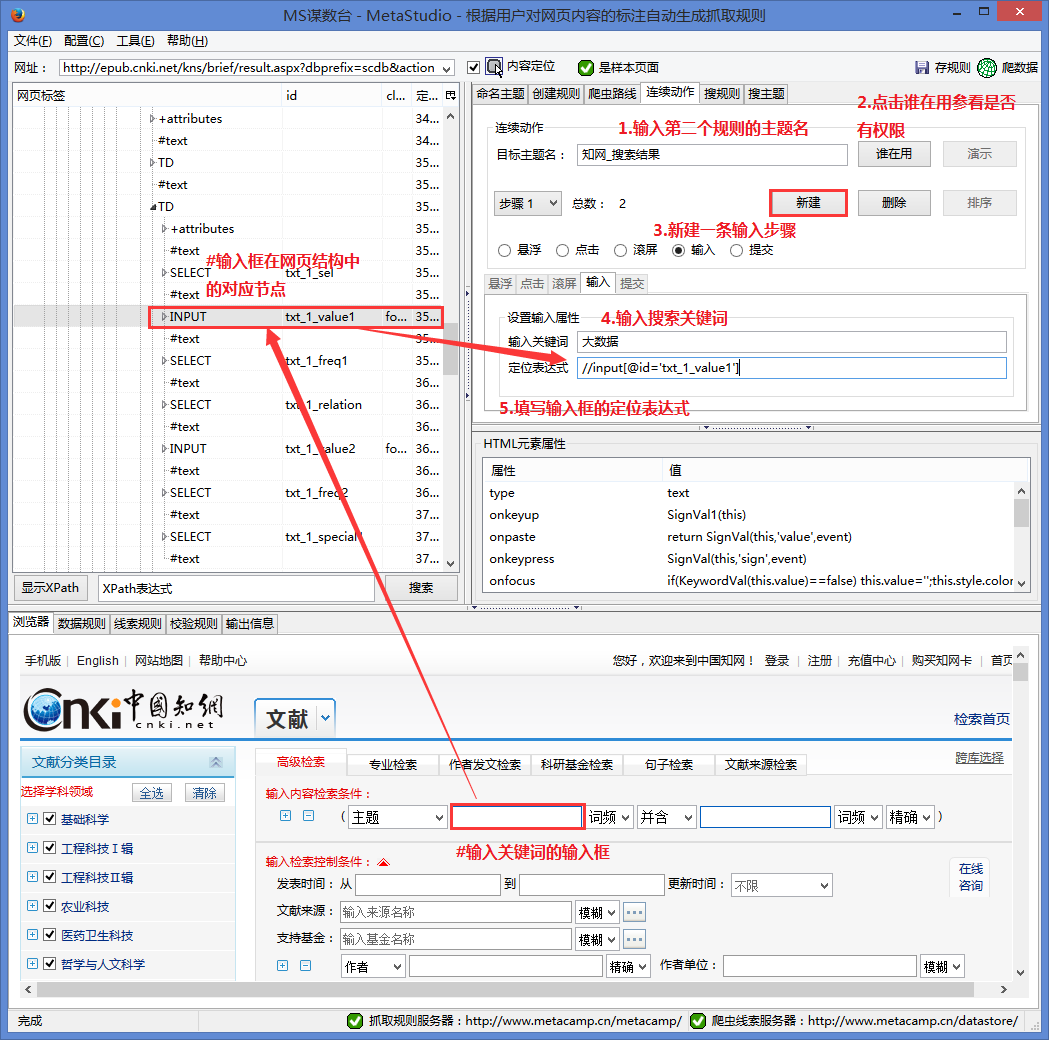

图 3

如图3所示,具体操作如下:

#1.输入目标主题名,即第二条规则主题名,表示第二条规则搜索到关键词后会执行爬取

#2.点击谁在使用,查看输入的主题名是否被其他人占用。如果已经被其他人占用,则需要更改另一个主题名称。

#3.创建一个新的输入步骤。如上所述,首先是执行输入动作,所以这里是一个新的输入步骤。

#4.输入 关键词 进行搜索。

#5.根据网页结构填写输入框的定位表达式,即网页上能定位输入框的XPath表达式。写好表达式后,可以使用MS的搜索功能进行验证。定位是否准确,详见网页内容搜索方法。

2.2 构建和提交步骤

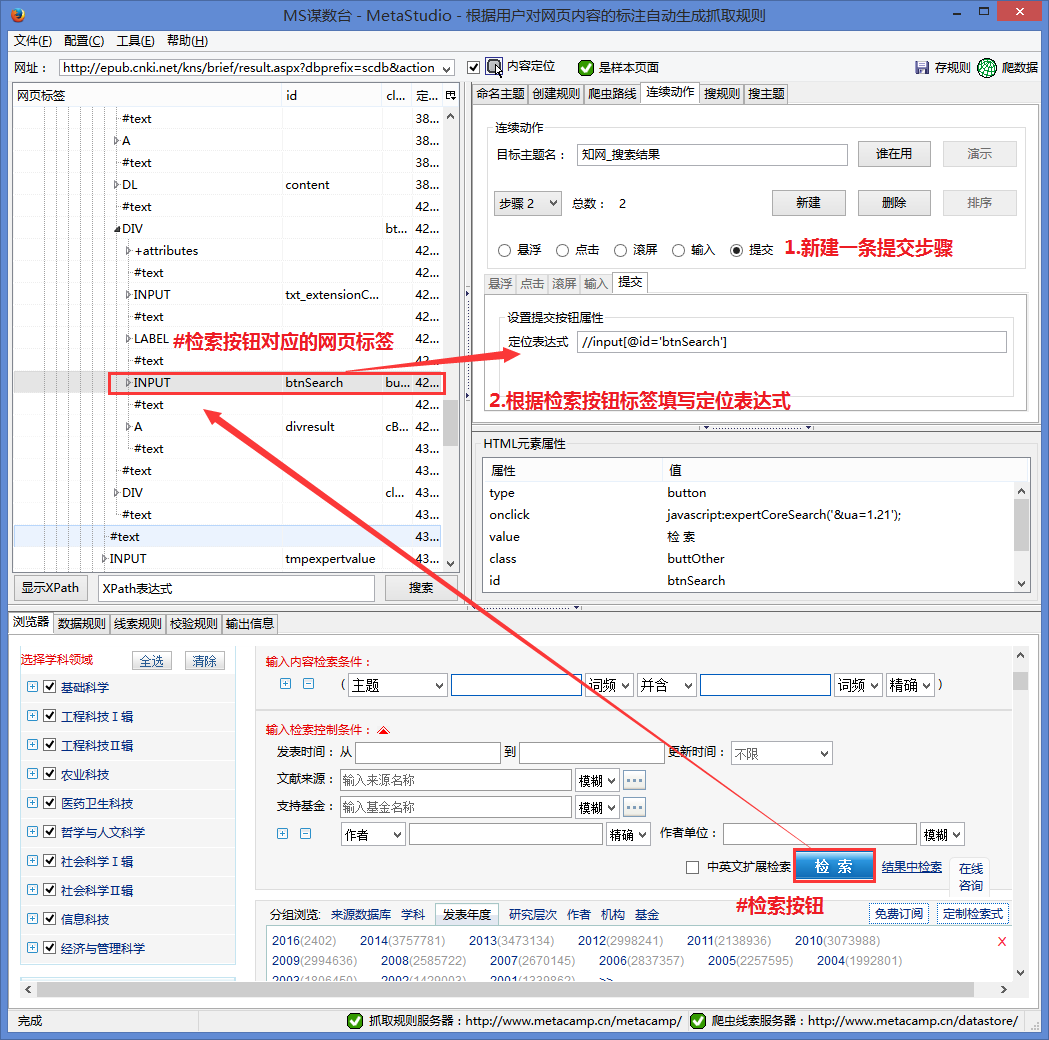

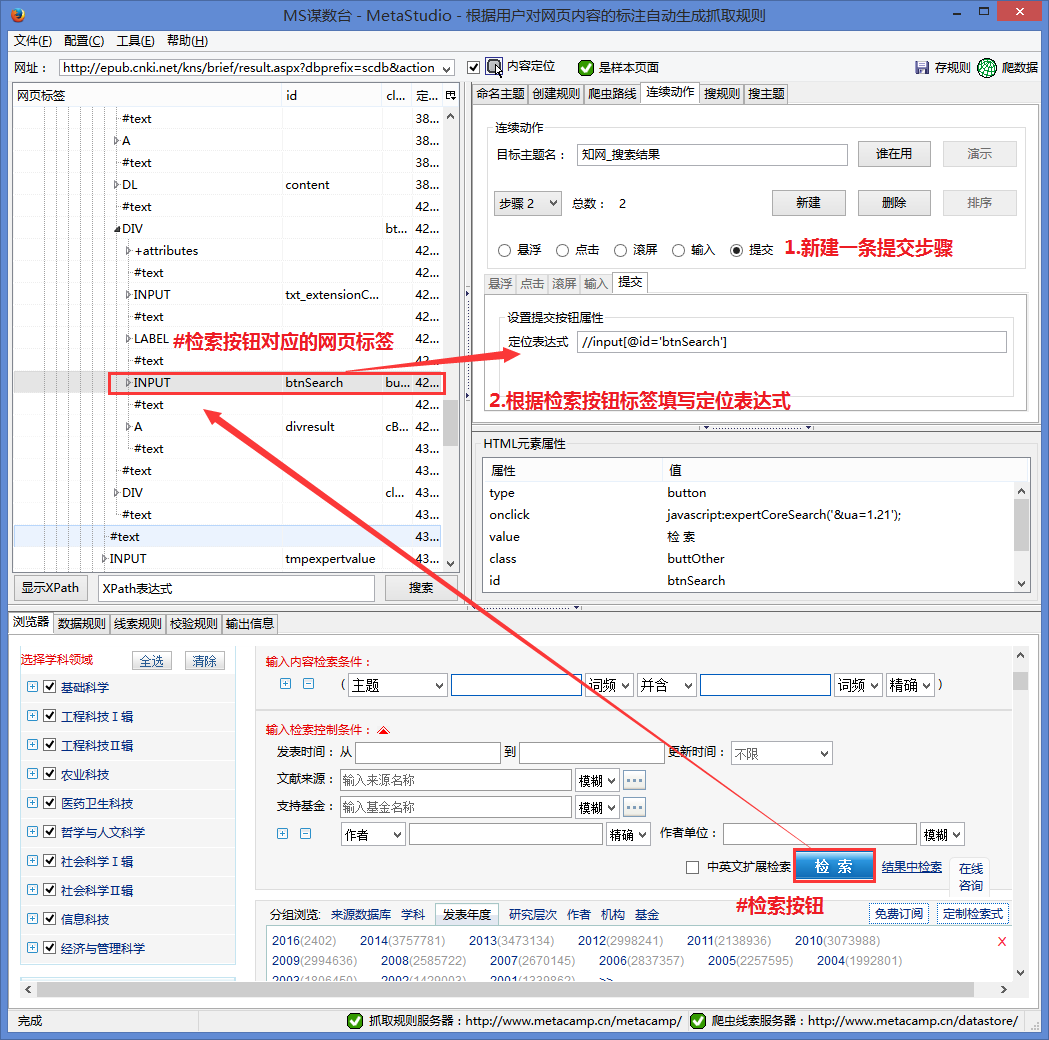

图 4

如图4所示,具体操作如下:

#1.根据网页结构填写检索定位表达式,即网页上能定位输入框的XPath表达式。写好表达式后,可以使用MS的搜索功能来验证是否定位准确。详情请参阅搜索网页内容的使用方法。

保存规则后,知网搜索就完成了。

二、第二条规则——知网搜索结果

该规则负责通过知网搜索对 关键词 搜索到的页面进行爬取。此规则与定义普通规则相同。

将要爬取的内容映射到排序框中。如果我们想要捕获每个文章的详细数据抽象作者,我们需要建立一个分层捕获,在当前规则中捕获每个文章的细节。为CNKI_文章数据生成线索的数据页的URL。

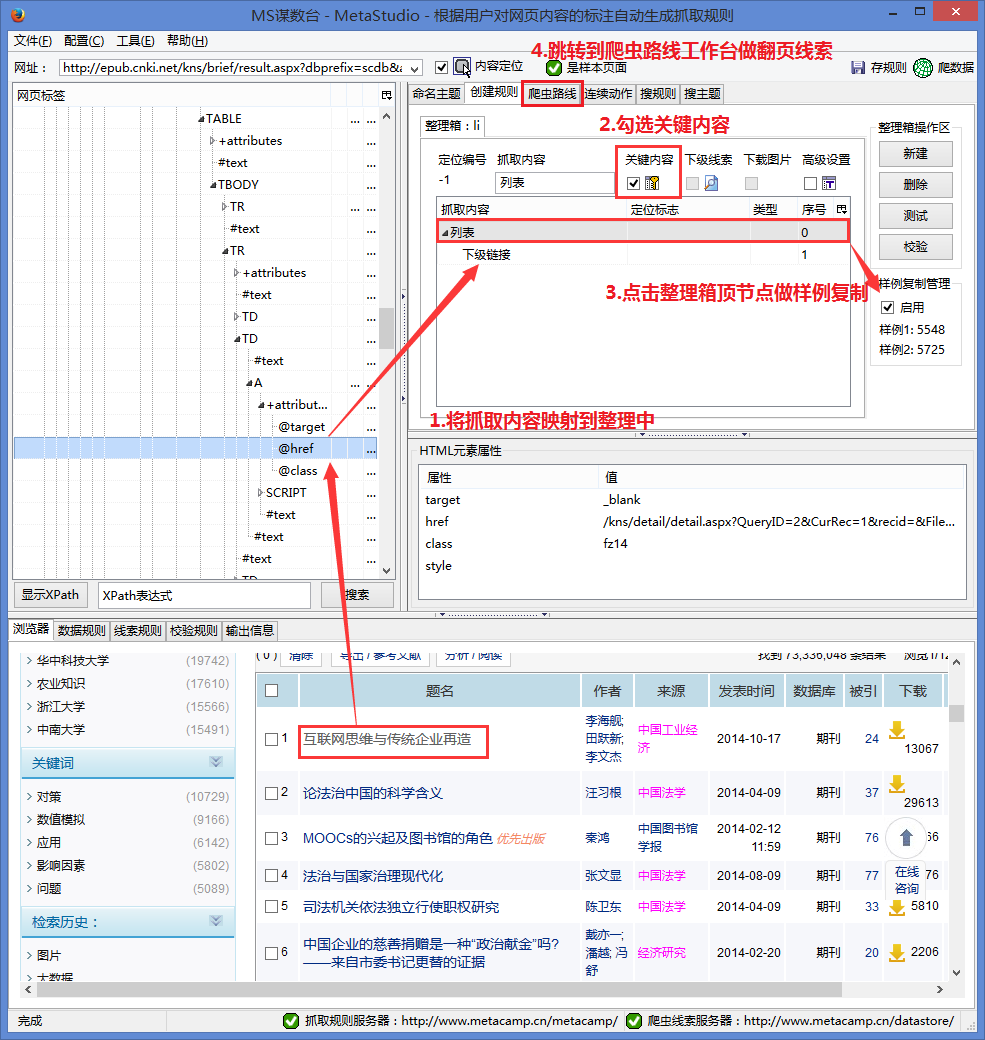

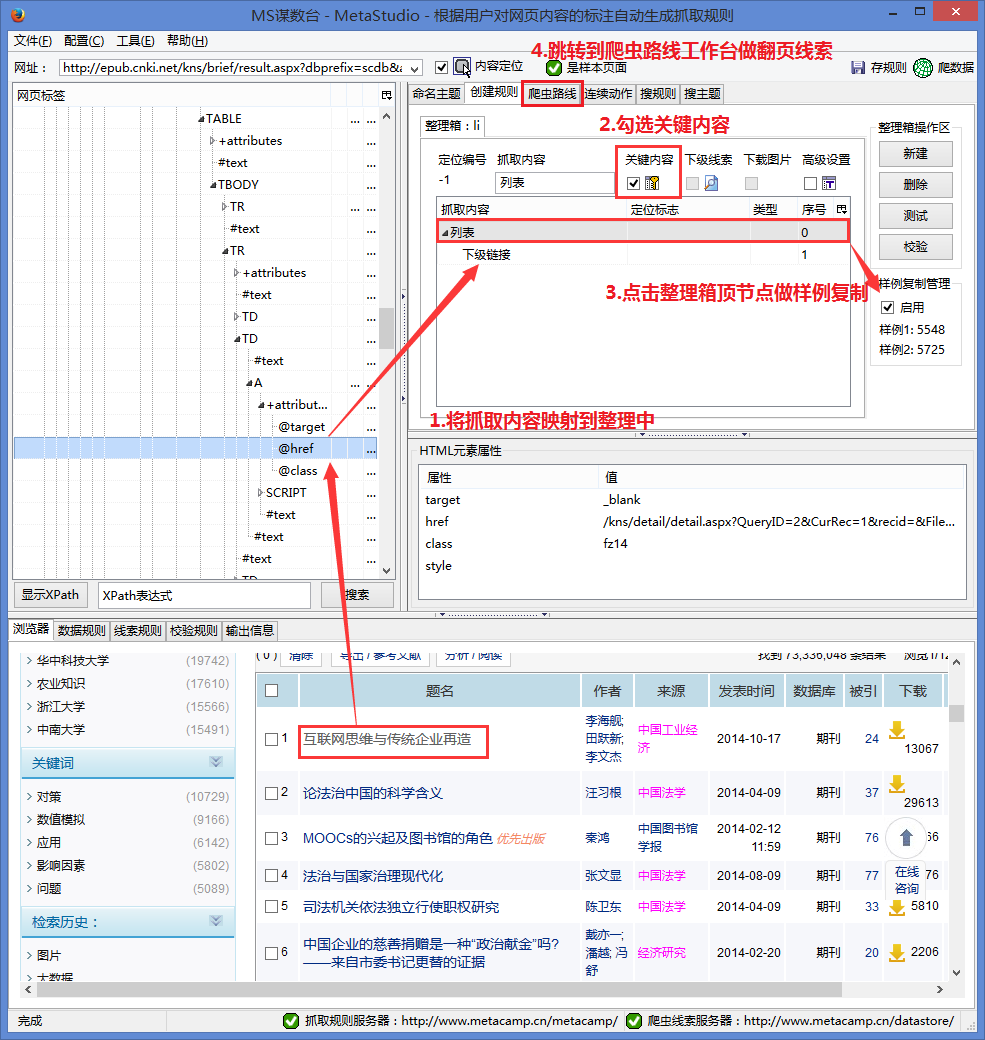

图 5

如图5所示,具体操作如下:

#1.将要爬取的下级链接映射到排序框中

#2.查看关键内容

#3.点击排序框顶部节点复制样本。要抓取当前页面文章的所有下级链接,需要复制样本。详情请参考教程:

#4.跳转到爬虫路由工作台做翻页线索。要抓取翻页的文章,需要做翻页线索。详情请参考教程:

保存规则后,CNKI_search结果规则就完成了,接下来需要做文章详细页面的爬取规则。

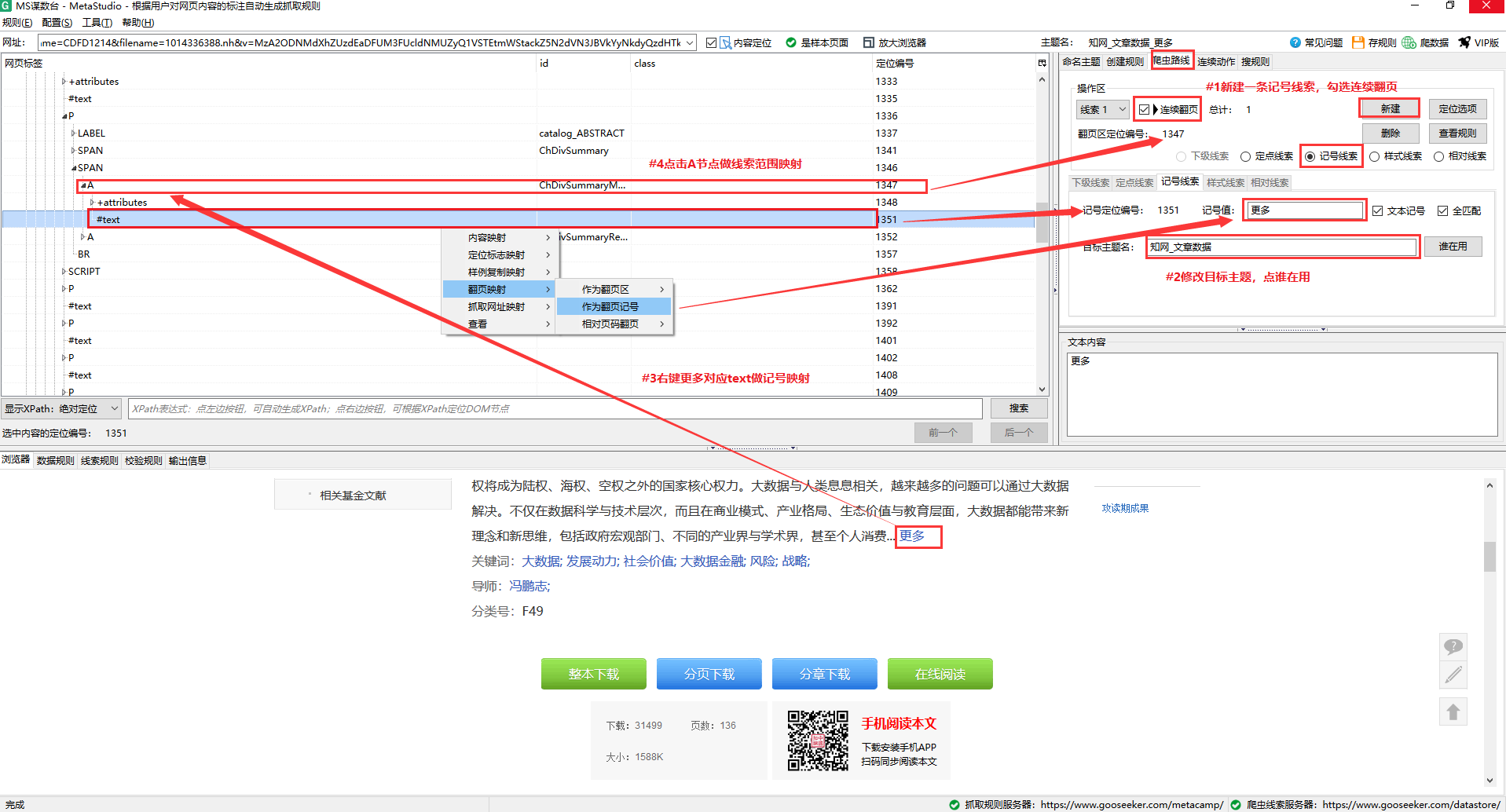

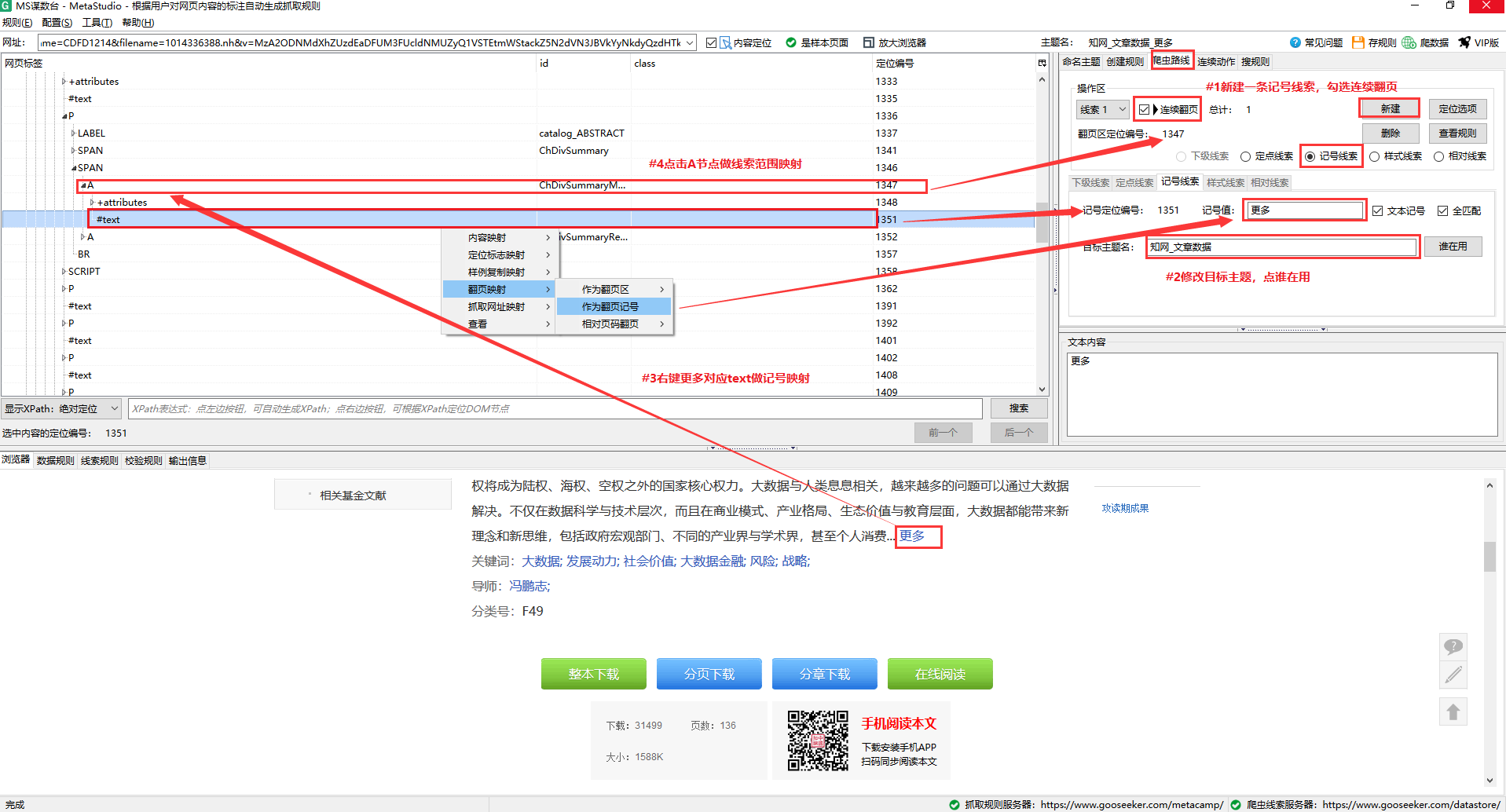

三、第三条规则——知网_文章数据_more

1.将网页上的“更多”按钮映射到排序框作为内容映射,查看重点内容。

2.在爬虫路由工作台上做一个模拟点击,即为“更多”做一个标记轨迹作为标记。

图 6

如图6所示,具体操作如下:

#1.新建一个标记线索,勾选Consecutive fetching,意思是爬虫在执行抓取任务时,在同一个DS计数器窗口抓取到当前页面后,可以直接跳转到下一页。抓住。

#2.点击“更多”按钮,自动定位页面标签节点,展开节点,找到收录“更多”的文本节点。

#3.在文本节点上右键,Clue Mapping → Mark Clue,可以看到“more”自动填入了mark值。

#4.将节点映射到线索范围,右击翻页块节点,选择线索映射→定位→线索1,完成后定位号会显示页面的定位号-转块节点。

保存规则后,知网_文章Data_More规则就完成了,接下来需要完成一些“更多”知网来执行抓取的规则——知网_文章Data。

提示:第三条和第四条规则演示模拟点击。不明白的可以参考教程:

四、第四条规则——知网_文章数据。

这个规则是最简单的类型,将需要爬取的内容映射到一个bin中。

图 7

如图7所示,具体操作如下: #1. 将要抓取的内容映射到排序框中。

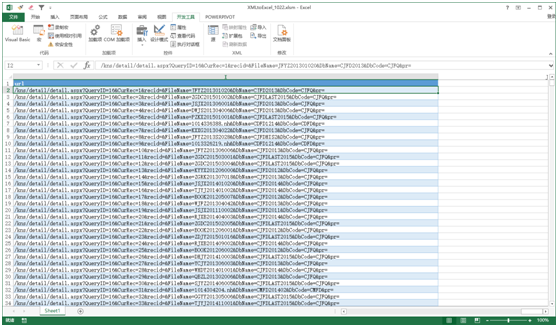

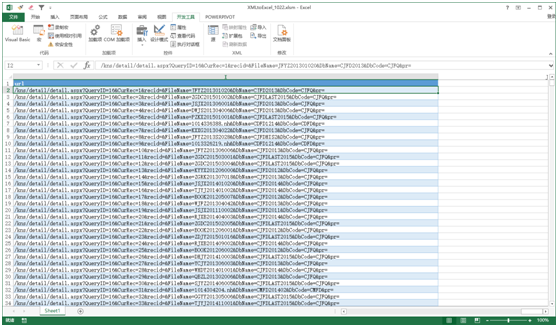

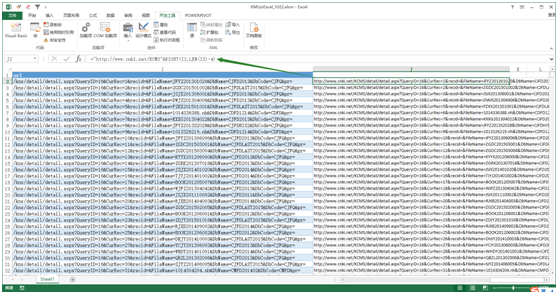

五、修改文章详细页面URL参数,构造新URL,生成第三条规则线索——hownet_文章data_more

将第二条规则采集的详情页的链接导入excel。

图 8

可以发现不是完整的URL,DS计数器也无法构造URL直接生成可访问的URL,需要用excel手动修改。

对比详情页的完整网址,如下:

可以发现采集的链接缺少了之前的域名,增加了“/kns”部分。您可以使用该功能修改链接。

图 9

在J2单元格中输入公式=""&RIGHT(I2,LEN(I2)-4)获取可访问的URL并填写,这样就可以将获取的URL作为第三个批量添加规则的线索。

如有疑问,您可以或

查看全部

java爬虫抓取网页数据(一共需要做四个规则:第一个规则“第二个规则图”

)

2.如何使用快捷键采集:如何使用快捷键采集

通过CNKI高级搜索,输入关键词,即可获取相关的文章标题、作者、摘要、关键词等信息。但是CNKI在输入关键词进行搜索后并没有改变URL,所以在爬取的时候,我们需要爬虫自动输入目标关键词来搜索并开始爬取数据。

要获取标题、作者、摘要、关键词等信息,我们一共需要制定四个规则:

第一条规则”

第二条规则”

提示:文章的部分摘要需要点击“更多”才能全部显示。为了抓取完整的摘要,我们需要制定一个规则来点击这个“更多”。

第三条规则”

第四条规则”

图1

一、第一条规则 - 知网搜索

1.以CNKI高级检索文献文章为例,将高级文献检索链接粘贴到某手。

第一条规则的主要工作是搜索关键词,但是为了有效地执行规则,我们在规则中抓取文章的类型。这里以文献为例,我们抓取的内容为“文献”,并勾选关键内容。

图 2

如图2所示,具体操作如下:

#1.将目标爬取网页粘贴到猫鼠台网址栏,回车。

#2.看到页面加载完毕。

#3.将抓取的内容“文档”映射到排序框中。

#4.选择文献的重点内容。

2.跳转到连续动作工作台输入关键词及其动作

关键词 的自动输入点是建立两个步骤。第一步是通过输入框的定位表达式找到输入框,然后输入关键词。第二步,通过定位表达式找到搜索按钮,然后爬虫自行点击按钮。

2.1 创建输入步骤

图 3

如图3所示,具体操作如下:

#1.输入目标主题名,即第二条规则主题名,表示第二条规则搜索到关键词后会执行爬取

#2.点击谁在使用,查看输入的主题名是否被其他人占用。如果已经被其他人占用,则需要更改另一个主题名称。

#3.创建一个新的输入步骤。如上所述,首先是执行输入动作,所以这里是一个新的输入步骤。

#4.输入 关键词 进行搜索。

#5.根据网页结构填写输入框的定位表达式,即网页上能定位输入框的XPath表达式。写好表达式后,可以使用MS的搜索功能进行验证。定位是否准确,详见网页内容搜索方法。

2.2 构建和提交步骤

图 4

如图4所示,具体操作如下:

#1.根据网页结构填写检索定位表达式,即网页上能定位输入框的XPath表达式。写好表达式后,可以使用MS的搜索功能来验证是否定位准确。详情请参阅搜索网页内容的使用方法。

保存规则后,知网搜索就完成了。

二、第二条规则——知网搜索结果

该规则负责通过知网搜索对 关键词 搜索到的页面进行爬取。此规则与定义普通规则相同。

将要爬取的内容映射到排序框中。如果我们想要捕获每个文章的详细数据抽象作者,我们需要建立一个分层捕获,在当前规则中捕获每个文章的细节。为CNKI_文章数据生成线索的数据页的URL。

图 5

如图5所示,具体操作如下:

#1.将要爬取的下级链接映射到排序框中

#2.查看关键内容

#3.点击排序框顶部节点复制样本。要抓取当前页面文章的所有下级链接,需要复制样本。详情请参考教程:

#4.跳转到爬虫路由工作台做翻页线索。要抓取翻页的文章,需要做翻页线索。详情请参考教程:

保存规则后,CNKI_search结果规则就完成了,接下来需要做文章详细页面的爬取规则。

三、第三条规则——知网_文章数据_more

1.将网页上的“更多”按钮映射到排序框作为内容映射,查看重点内容。

2.在爬虫路由工作台上做一个模拟点击,即为“更多”做一个标记轨迹作为标记。

图 6

如图6所示,具体操作如下:

#1.新建一个标记线索,勾选Consecutive fetching,意思是爬虫在执行抓取任务时,在同一个DS计数器窗口抓取到当前页面后,可以直接跳转到下一页。抓住。

#2.点击“更多”按钮,自动定位页面标签节点,展开节点,找到收录“更多”的文本节点。

#3.在文本节点上右键,Clue Mapping → Mark Clue,可以看到“more”自动填入了mark值。

#4.将节点映射到线索范围,右击翻页块节点,选择线索映射→定位→线索1,完成后定位号会显示页面的定位号-转块节点。

保存规则后,知网_文章Data_More规则就完成了,接下来需要完成一些“更多”知网来执行抓取的规则——知网_文章Data。

提示:第三条和第四条规则演示模拟点击。不明白的可以参考教程:

四、第四条规则——知网_文章数据。

这个规则是最简单的类型,将需要爬取的内容映射到一个bin中。

图 7

如图7所示,具体操作如下: #1. 将要抓取的内容映射到排序框中。

五、修改文章详细页面URL参数,构造新URL,生成第三条规则线索——hownet_文章data_more

将第二条规则采集的详情页的链接导入excel。

图 8

可以发现不是完整的URL,DS计数器也无法构造URL直接生成可访问的URL,需要用excel手动修改。

对比详情页的完整网址,如下:

可以发现采集的链接缺少了之前的域名,增加了“/kns”部分。您可以使用该功能修改链接。

图 9

在J2单元格中输入公式=""&RIGHT(I2,LEN(I2)-4)获取可访问的URL并填写,这样就可以将获取的URL作为第三个批量添加规则的线索。

如有疑问,您可以或

java爬虫抓取网页数据(目标网络爬虫的是做什么的?手动写一个简单的网络 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-03-22 20:40

)

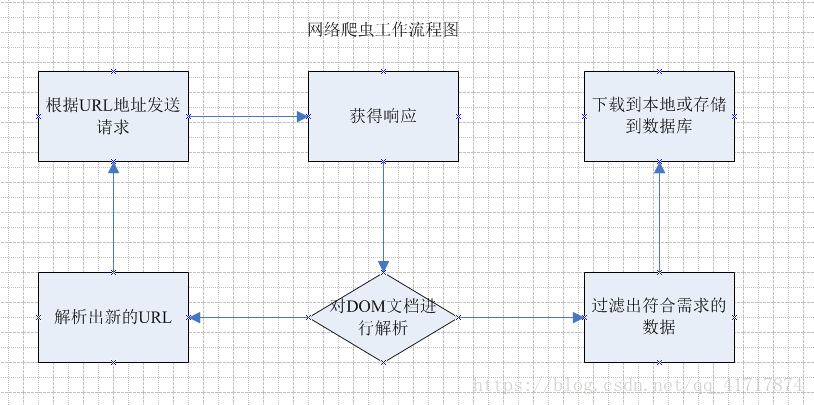

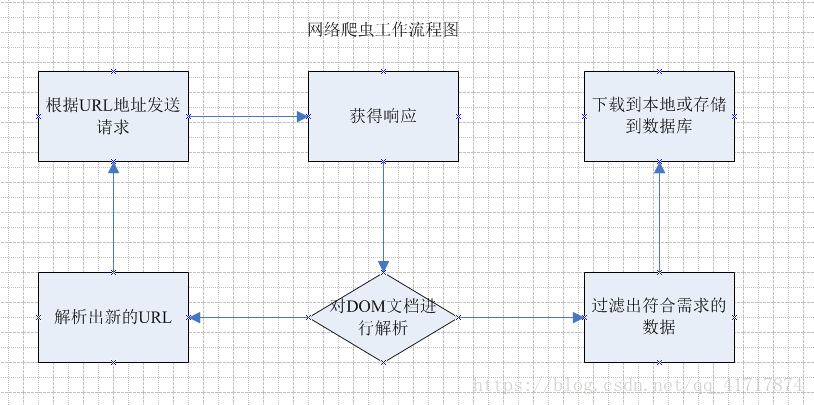

目标网络爬虫做什么?手动编写一个简单的网络爬虫;1.网络爬虫1.1.名称1.2.简要说明2.流程

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

简单爬虫所需:

发送请求和获取响应的功能;解析响应的功能;存储过滤数据的功能;处理解析后的URL路径的功能;2.1. 关注

3. 分类

4. 思想分析

首先观察我们爬虫的起始页是:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式写代码实现了

5. 代码实现

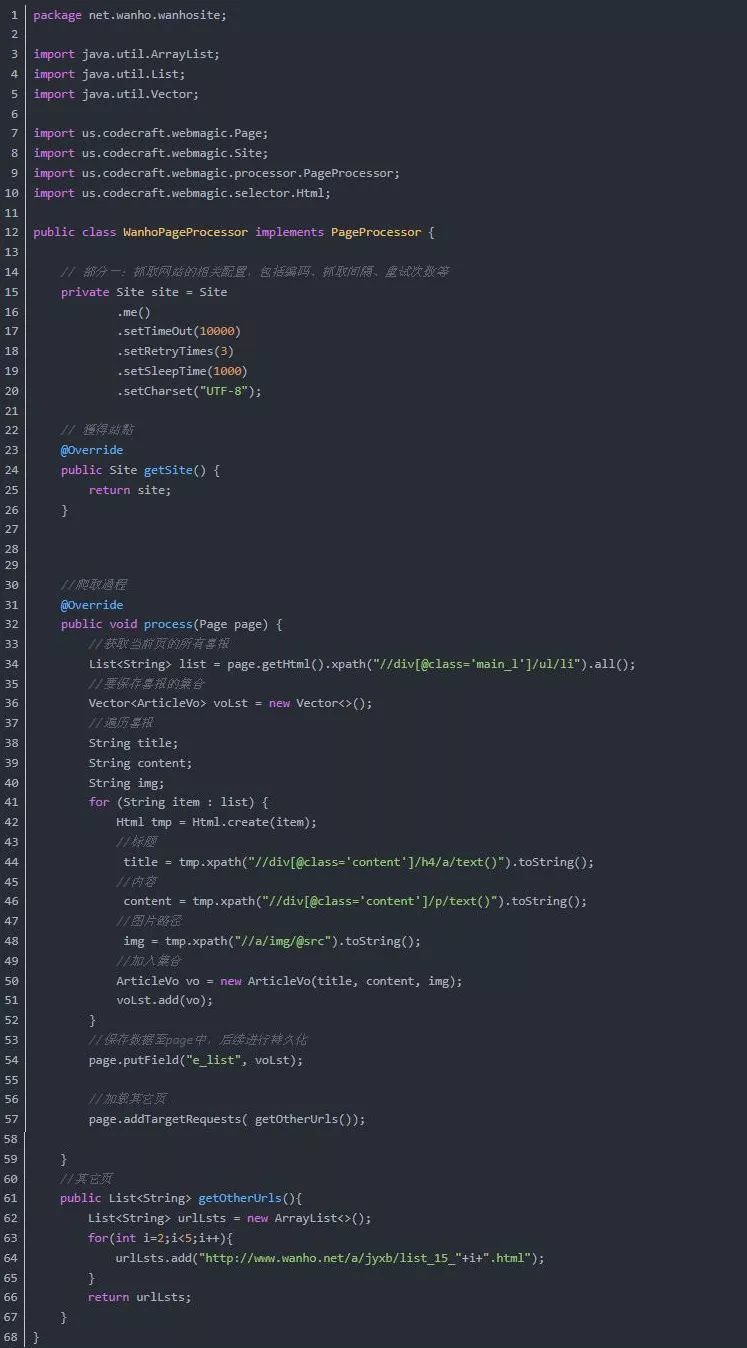

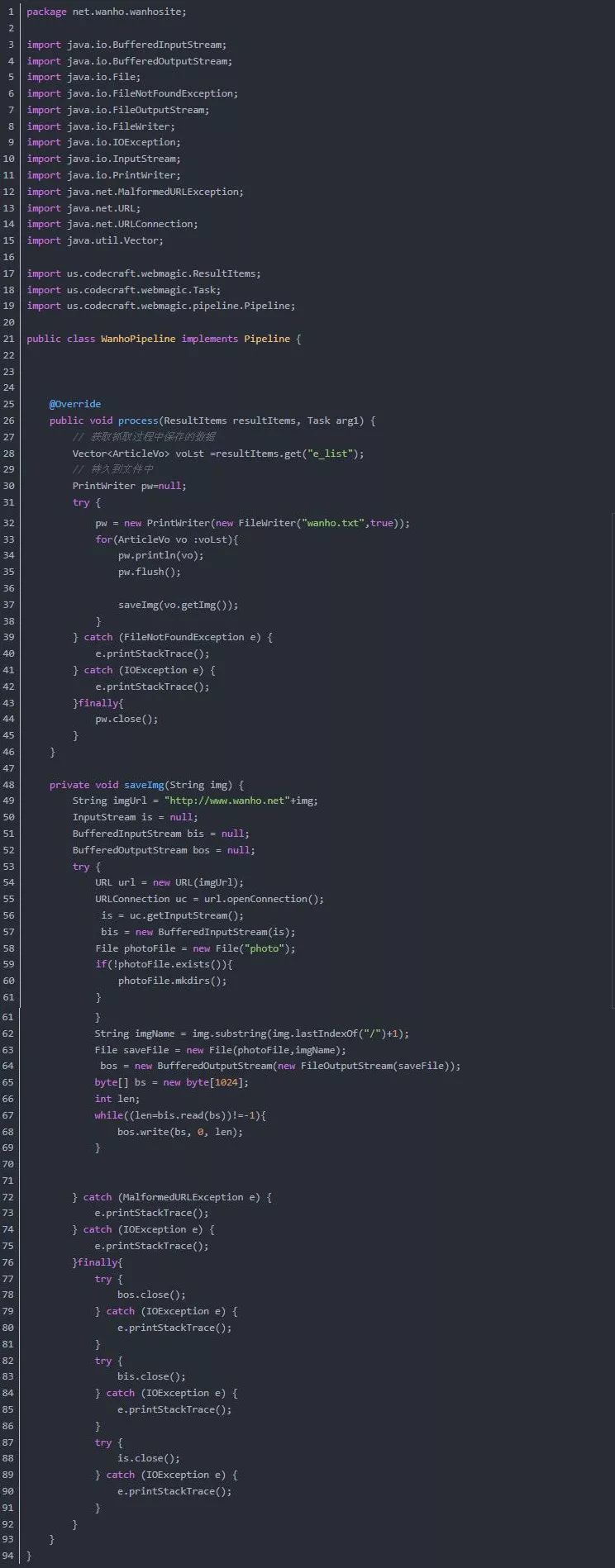

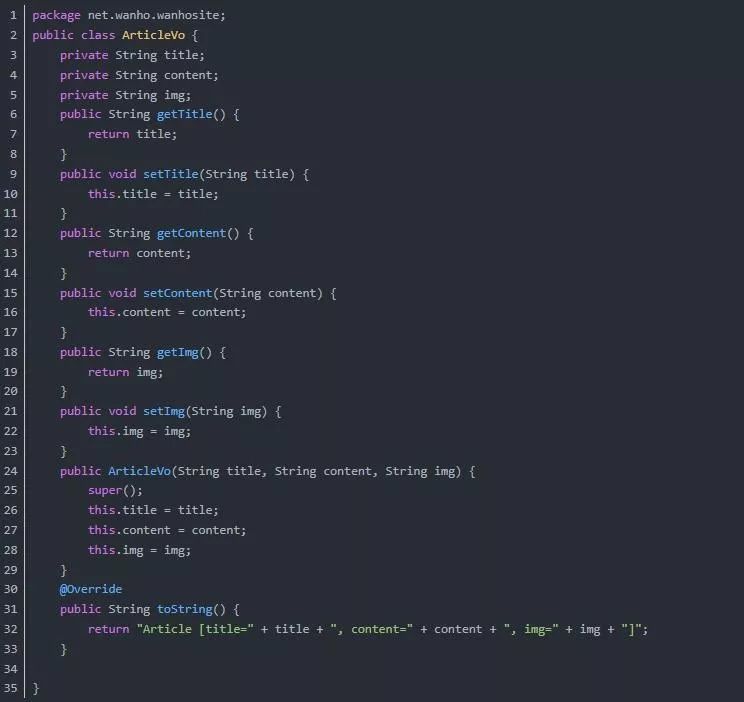

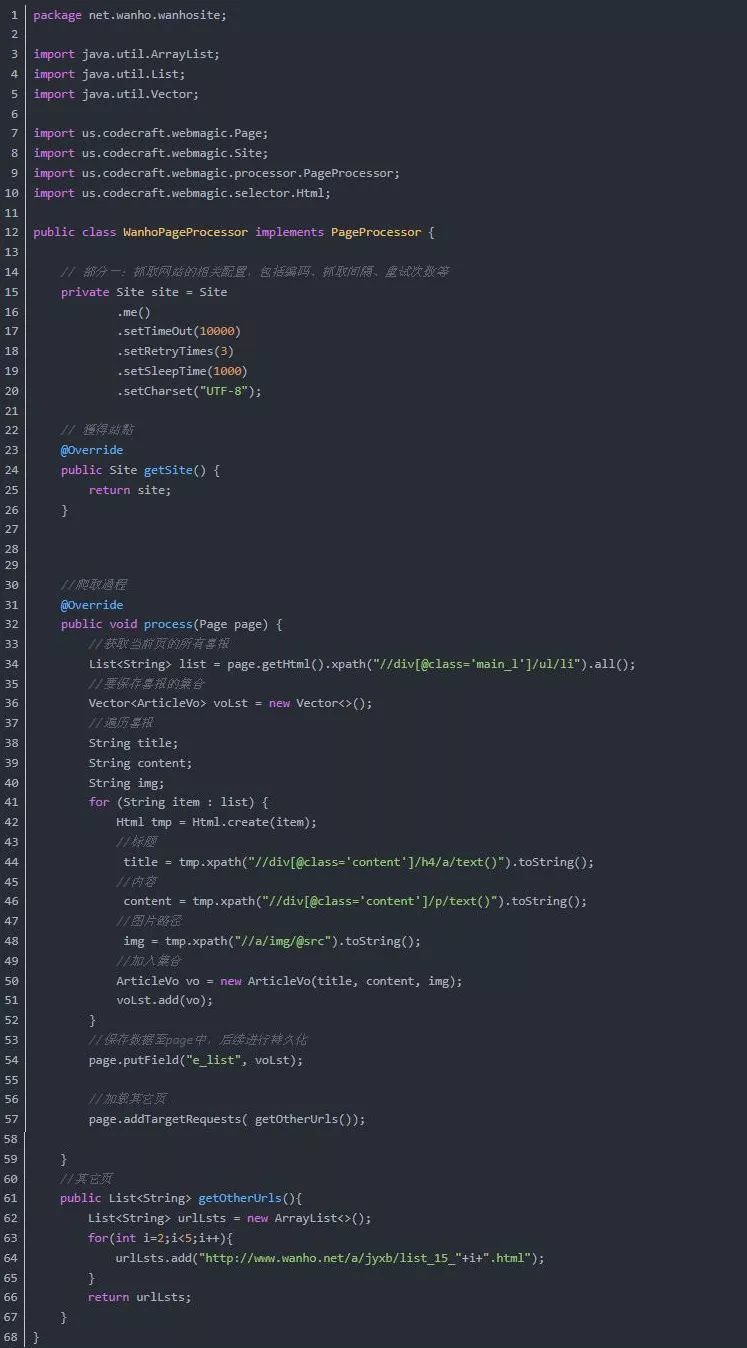

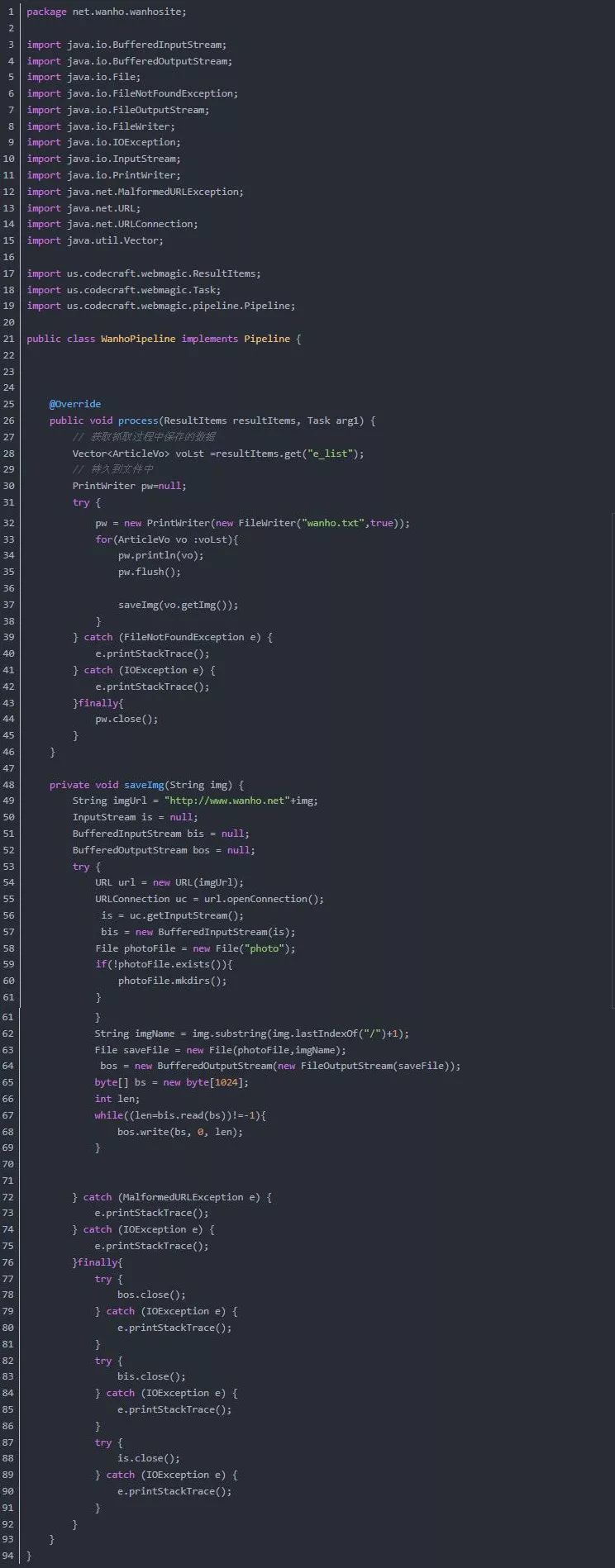

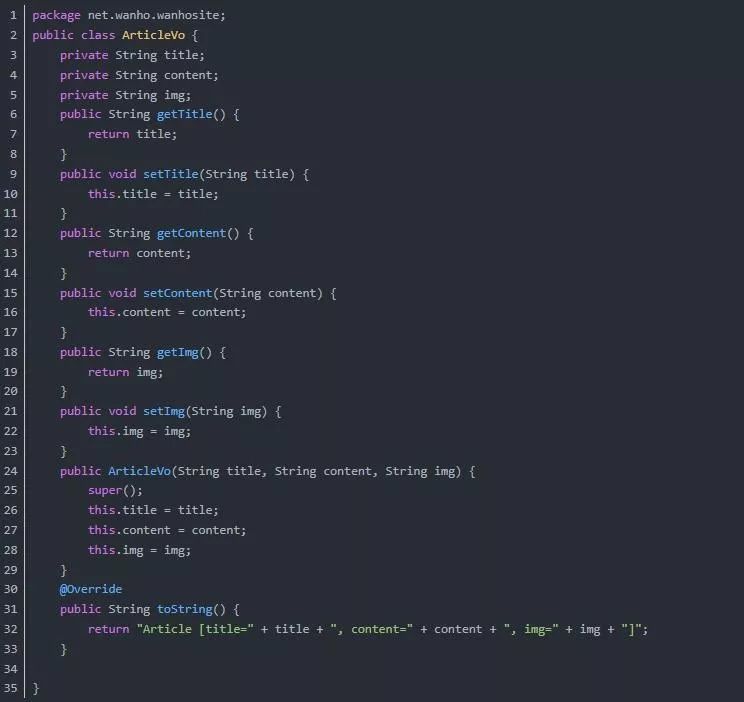

代码实现部分使用了webmagic框架,因为它比使用基础Java网络编程要简单很多注:webmagic框架可以看下面的讲义

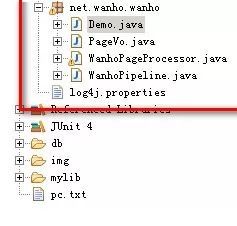

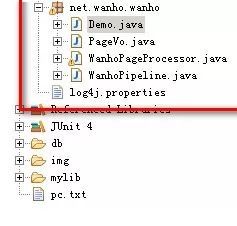

5.1. 代码结构

5.2. 程序入口

演示.java

/**

* 程序入口

*/

public class Demo {

public static void main(String[] args) {

// 爬取开始

Spider

// 爬取过程

.create(new WanhoPageProcessor())

// 爬取结果保存

.addPipeline(new WanhoPipeline())

// 爬取的第一个页面

.addUrl("http://www.wanho.net/a/jyxb/")

// 启用的线程数

.thread(5).run();

}

}

5.3. 爬取过程

<p>package net.wanho.wanhosite;

import java.util.ArrayList;

import java.util.List;

import java.util.Vector;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.processor.PageProcessor;

import us.codecraft.webmagic.selector.Html;

public class WanhoPageProcessor implements PageProcessor {

// 部分一:抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site

.me()

.setTimeOut(10000)

.setRetryTimes(3)

.setSleepTime(1000)

.setCharset("UTF-8");

// 獲得站點

@Override

public Site getSite() {

return site;

}

//爬取過程

@Override

public void process(Page page) {

//获取当前页的所有喜报

List list = page.getHtml().xpath("//div[@class='main_l']/ul/li").all();

//要保存喜报的集合

Vector voLst = new Vector();

//遍历喜报

String title;

String content;

String img;

for (String item : list) {

Html tmp = Html.create(item);

//标题

title = tmp.xpath("//div[@class='content']/h4/a/text()").toString();

//内容

content = tmp.xpath("//div[@class='content']/p/text()").toString();

//图片路径

img = tmp.xpath("//a/img/@src").toString();

//加入集合

ArticleVo vo = new ArticleVo(title, content, img);

voLst.add(vo);

}

//保存数据至page中,后续进行持久化

page.putField("e_list", voLst);

//加载其它页

page.addTargetRequests( getOtherUrls());

}

//其它页

public List getOtherUrls(){

List urlLsts = new ArrayList();

for(int i=2;i 查看全部

java爬虫抓取网页数据(目标网络爬虫的是做什么的?手动写一个简单的网络

)

目标网络爬虫做什么?手动编写一个简单的网络爬虫;1.网络爬虫1.1.名称1.2.简要说明2.流程

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

简单爬虫所需:

发送请求和获取响应的功能;解析响应的功能;存储过滤数据的功能;处理解析后的URL路径的功能;2.1. 关注

3. 分类

4. 思想分析

首先观察我们爬虫的起始页是:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式写代码实现了

5. 代码实现

代码实现部分使用了webmagic框架,因为它比使用基础Java网络编程要简单很多注:webmagic框架可以看下面的讲义

5.1. 代码结构

5.2. 程序入口

演示.java

/**

* 程序入口

*/

public class Demo {

public static void main(String[] args) {

// 爬取开始

Spider

// 爬取过程

.create(new WanhoPageProcessor())

// 爬取结果保存

.addPipeline(new WanhoPipeline())

// 爬取的第一个页面

.addUrl("http://www.wanho.net/a/jyxb/";)

// 启用的线程数

.thread(5).run();

}

}

5.3. 爬取过程

<p>package net.wanho.wanhosite;

import java.util.ArrayList;

import java.util.List;

import java.util.Vector;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.processor.PageProcessor;

import us.codecraft.webmagic.selector.Html;

public class WanhoPageProcessor implements PageProcessor {

// 部分一:抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site

.me()

.setTimeOut(10000)

.setRetryTimes(3)

.setSleepTime(1000)

.setCharset("UTF-8");

// 獲得站點

@Override

public Site getSite() {

return site;

}

//爬取過程

@Override

public void process(Page page) {

//获取当前页的所有喜报

List list = page.getHtml().xpath("//div[@class='main_l']/ul/li").all();

//要保存喜报的集合

Vector voLst = new Vector();

//遍历喜报

String title;

String content;

String img;

for (String item : list) {

Html tmp = Html.create(item);

//标题

title = tmp.xpath("//div[@class='content']/h4/a/text()").toString();

//内容

content = tmp.xpath("//div[@class='content']/p/text()").toString();

//图片路径

img = tmp.xpath("//a/img/@src").toString();

//加入集合

ArticleVo vo = new ArticleVo(title, content, img);

voLst.add(vo);

}

//保存数据至page中,后续进行持久化

page.putField("e_list", voLst);

//加载其它页

page.addTargetRequests( getOtherUrls());

}

//其它页

public List getOtherUrls(){

List urlLsts = new ArrayList();

for(int i=2;i

java爬虫抓取网页数据(什么是网络爬虫?网络蜘蛛的实现原理根据这种原理 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-19 04:12

)

什么是网络爬虫?网络爬虫也称为蜘蛛。网络蜘蛛通过网页的链接地址搜索网页,从网站的一个页面(通常是首页)开始,读取网页内容,找到网页中的其他链接地址,然后通过这些链接地址找到下一个网页,以此类推,直到这个网站的所有网页都被爬取完毕。如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发回的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

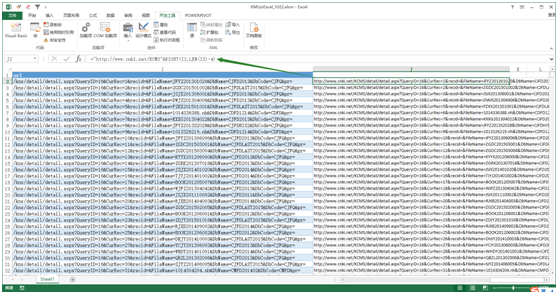

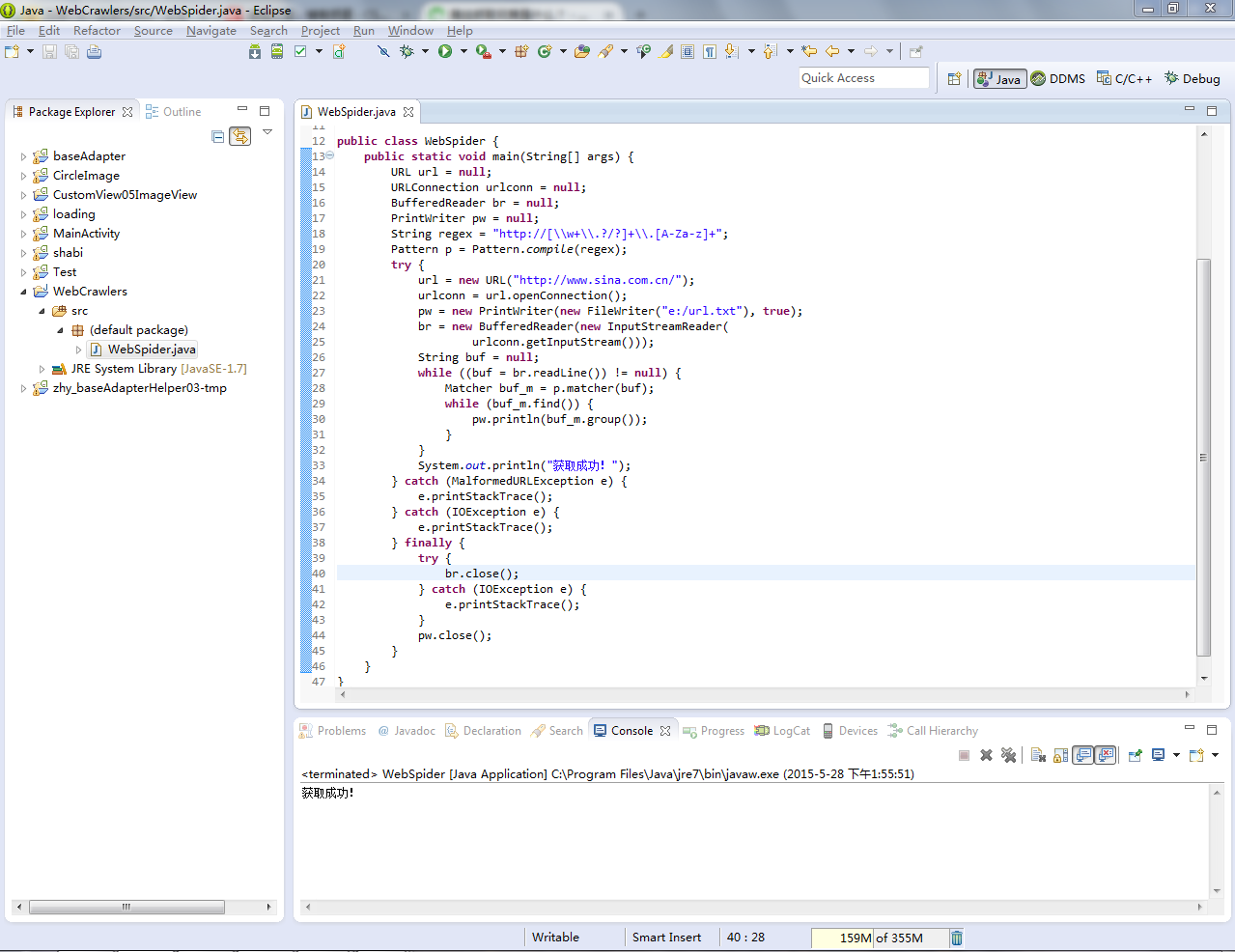

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。只需从 网站 获得的 URL 进一步循环,即可获取数据并从中提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的 网站 爬虫远比这复杂。太多了,无法深入讨论。除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个用Java模拟的程序,用来提取新浪网页上的链接,并保存在一个文件中

源代码

import java.io.BufferedReader;

import java.io.FileWriter;

import java.io.IOException;

import java.io.InputStreamReader;

import java.io.PrintWriter;

import java.net.MalformedURLException;

import java.net.URL;

import java.net.URLConnection;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class WebSpider {

public static void main(String[] args) {

URL url = null;

URLConnection urlconn = null;

BufferedReader br = null;

PrintWriter pw = null;

String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";

Pattern p = Pattern.compile(regex);

try {

url = new URL("http://www.sina.com.cn/");

urlconn = url.openConnection();

pw = new PrintWriter(new FileWriter("e:/url.txt"), true);//这里我们把收集到的链接存储在了E盘底下的一个叫做url的txt文件中

br = new BufferedReader(new InputStreamReader(

urlconn.getInputStream()));

String buf = null;

while ((buf = br.readLine()) != null) {

Matcher buf_m = p.matcher(buf);

while (buf_m.find()) {

pw.println(buf_m.group());

}

}

System.out.println("获取成功!");

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

br.close();

} catch (IOException e) {

e.printStackTrace();

}

pw.close();

}

}

}

在 Eclipse 中运行的结果

底部显示收购成功!接下来我们到E盘根目录下找到url.txt。看看有没有这个文件

接下来,我们打开txt文件,找到一系列URL链接。这些都是我们爬取新浪首页得到的网址

查看全部

java爬虫抓取网页数据(什么是网络爬虫?网络蜘蛛的实现原理根据这种原理

)

什么是网络爬虫?网络爬虫也称为蜘蛛。网络蜘蛛通过网页的链接地址搜索网页,从网站的一个页面(通常是首页)开始,读取网页内容,找到网页中的其他链接地址,然后通过这些链接地址找到下一个网页,以此类推,直到这个网站的所有网页都被爬取完毕。如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发回的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。只需从 网站 获得的 URL 进一步循环,即可获取数据并从中提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的 网站 爬虫远比这复杂。太多了,无法深入讨论。除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个用Java模拟的程序,用来提取新浪网页上的链接,并保存在一个文件中

源代码

import java.io.BufferedReader;

import java.io.FileWriter;

import java.io.IOException;

import java.io.InputStreamReader;

import java.io.PrintWriter;

import java.net.MalformedURLException;

import java.net.URL;

import java.net.URLConnection;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class WebSpider {

public static void main(String[] args) {

URL url = null;

URLConnection urlconn = null;

BufferedReader br = null;

PrintWriter pw = null;

String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";

Pattern p = Pattern.compile(regex);

try {

url = new URL("http://www.sina.com.cn/";);

urlconn = url.openConnection();

pw = new PrintWriter(new FileWriter("e:/url.txt"), true);//这里我们把收集到的链接存储在了E盘底下的一个叫做url的txt文件中

br = new BufferedReader(new InputStreamReader(

urlconn.getInputStream()));

String buf = null;

while ((buf = br.readLine()) != null) {

Matcher buf_m = p.matcher(buf);

while (buf_m.find()) {

pw.println(buf_m.group());

}

}

System.out.println("获取成功!");

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

br.close();

} catch (IOException e) {

e.printStackTrace();

}

pw.close();

}

}

}

在 Eclipse 中运行的结果

底部显示收购成功!接下来我们到E盘根目录下找到url.txt。看看有没有这个文件

接下来,我们打开txt文件,找到一系列URL链接。这些都是我们爬取新浪首页得到的网址

java爬虫抓取网页数据(一下关于网络爬虫的入门知识入门教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-03-18 05:11

经常听到“爬行动物”这个词,但它是什么意思呢?它是干什么用的?下面是万和专业老师为大家分享网络爬虫的入门知识。

0 1

网络爬虫

1.1. 名称

网络爬虫(也称为网络蜘蛛或网络机器人)是一种程序或脚本,它根据一定的规则自动爬取万维网上的信息。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。

1.2. 简要说明

网络爬虫通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,读取网页的内容,寻找网页中的其他链接地址,然后通过这些链接地址寻找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取。

如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。

因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发回的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

0 2

过程

网络爬虫有什么作用?他的主要工作是根据指定的url地址发送请求,得到响应,然后解析响应。新的URL路径,然后继续访问,继续解析;继续寻找需要的数据,继续解析出新的URL路径。

这是网络爬虫的主要工作。以下是流程图:

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

一个简单爬虫的必要功能包括:

发送请求和获取响应的函数;

解析响应的函数;

存储过滤数据的功能;

处理解析后的URL路径的函数;

2.1. 专注

爬虫需要注意的三点:

抓取目标的描述或定义;

网页或数据的分析和过滤;

URL 的搜索策略。

0 3

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:

通用网络爬虫

专注的网络爬虫

增量网络爬虫

深网爬虫。

实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

0 4

思想分析

接下来,我将通过我们的官网来和大家一起分析一下如何实现这样的爬虫:

首先观察我们爬虫的起始页是:

分析页面:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据:

标题:由 XPath 表达式表示 //div[@class='content']/h4/a/text()

说明:使用XPath表达式表示 //div[@class='content']/p/text()

图片://a/img/@src 作为 XPath 表达式

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式编写代码来实现了。

0 5

代码

代码实现部分使用了webmagic框架,因为它比使用基本的Java网络编程要简单得多。

5.1. 代码结构

5.2. 程序入口

演示.java

5.3. 爬取过程

WanhoPageProcessor.java

5.4. 结果保存

WanhoPipeline.java

5.5. 模型对象

ArticleVo.java

如果你想了解更多关于网络爬虫的知识,可以去万和官网,注册后可以免费学习Java爬虫项目。

面对面专业指导

白手起家

进入IT高薪圈

从这里开始 查看全部

java爬虫抓取网页数据(一下关于网络爬虫的入门知识入门教程)

经常听到“爬行动物”这个词,但它是什么意思呢?它是干什么用的?下面是万和专业老师为大家分享网络爬虫的入门知识。

0 1

网络爬虫

1.1. 名称

网络爬虫(也称为网络蜘蛛或网络机器人)是一种程序或脚本,它根据一定的规则自动爬取万维网上的信息。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。

1.2. 简要说明

网络爬虫通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,读取网页的内容,寻找网页中的其他链接地址,然后通过这些链接地址寻找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取。

如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。

因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发回的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

0 2

过程

网络爬虫有什么作用?他的主要工作是根据指定的url地址发送请求,得到响应,然后解析响应。新的URL路径,然后继续访问,继续解析;继续寻找需要的数据,继续解析出新的URL路径。

这是网络爬虫的主要工作。以下是流程图:

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

一个简单爬虫的必要功能包括:

发送请求和获取响应的函数;

解析响应的函数;

存储过滤数据的功能;

处理解析后的URL路径的函数;

2.1. 专注

爬虫需要注意的三点:

抓取目标的描述或定义;

网页或数据的分析和过滤;

URL 的搜索策略。

0 3

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:

通用网络爬虫

专注的网络爬虫

增量网络爬虫

深网爬虫。

实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

0 4

思想分析

接下来,我将通过我们的官网来和大家一起分析一下如何实现这样的爬虫:

首先观察我们爬虫的起始页是:

分析页面:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据:

标题:由 XPath 表达式表示 //div[@class='content']/h4/a/text()

说明:使用XPath表达式表示 //div[@class='content']/p/text()

图片://a/img/@src 作为 XPath 表达式

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式编写代码来实现了。

0 5

代码

代码实现部分使用了webmagic框架,因为它比使用基本的Java网络编程要简单得多。

5.1. 代码结构

5.2. 程序入口

演示.java

5.3. 爬取过程

WanhoPageProcessor.java

5.4. 结果保存

WanhoPipeline.java

5.5. 模型对象

ArticleVo.java

如果你想了解更多关于网络爬虫的知识,可以去万和官网,注册后可以免费学习Java爬虫项目。

面对面专业指导

白手起家

进入IT高薪圈

从这里开始

java爬虫抓取网页数据(爬虫爬虫处理html格式返回就需要用到)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-03-18 05:09

爬虫

爬虫可以理解为一种从第三方网站获取数据的技术。

关于爬虫语言

Java对网页数据的爬取必须涉及到.URL和从URL读取的数据(本文使用字符流获取url返回),需要经过转换才能被我们使用。目前大部分都是json格式。相比html格式,json格式更简单。本文介绍返回的html格式。

汤

需要 Jsoup 来处理 html 格式的返回。jsoup 是一个 Java html 解析器,可以直接解析一个 URL 地址和 HTML 文本内容。具体的jar包可以自己下载。

我们可以通过如下方式模拟这样的请求,然后从请求的返回中解析出我们需要的数据。

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

/**

* Created by wingzing on 2018/8/8.

*/

public class WingZingDemo {

public static void main(String[] args) {

String httpUrl = "http://bestcbooks.com/"; //需要爬的网址

String html;

try {

StringBuffer sbf = new StringBuffer();

URL url = new URL(httpUrl);

HttpURLConnection connection = (HttpURLConnection) url

.openConnection();

connection.setRequestMethod("GET"); //设置请求方式 可设置POST 注意一定要大写

//connection.setRequestProperty("Cookie", cookie); //设置请求头参数 如Cookie、Host等等

connection.connect(); //开启连接

InputStream is = connection.getInputStream();

BufferedReader reader = new BufferedReader(new InputStreamReader(is, "UTF-8"));

String strRead = null;

while ((strRead = reader.readLine()) != null) { //读取返回

sbf.append(strRead);

sbf.append("\r\n");

}

reader.close();//关闭缓冲字符流

html = sbf.toString();

//System.out.println(html);

Document doc = Jsoup.parse(html);//将爬来的html格式的字符串转成Document从而获取其中需要的数据

Element ul = doc.getElementById("category-list");//取得ID为category-list的元素

Elements liList = ul.getElementsByTag("li");//取得其中的li标签 为一个集合

for(Element li:liList){ //循环该li集合

System.out.println(li.getElementsByTag("a").get(0).text());//取得每个li中的a标签的值 进行输出

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

代码中的注释写得很清楚。可以自己复制代码运行,通过debug一步步看值。

一般来说,首先获取页面加载或执行时发送的请求,判断是否需要参数,需要哪些参数,进行模拟,然后获取请求的返回,解析请求,获取我们的数据需要。

以上是一个用Java实现的简单爬虫,仅供没有接触过Java的朋友学习爬虫。后续我会写一些Java中稍微麻烦一点的爬虫,比如抓取数据到自己的数据库,对模拟网页进行一些操作等等。 查看全部

java爬虫抓取网页数据(爬虫爬虫处理html格式返回就需要用到)

爬虫

爬虫可以理解为一种从第三方网站获取数据的技术。

关于爬虫语言

Java对网页数据的爬取必须涉及到.URL和从URL读取的数据(本文使用字符流获取url返回),需要经过转换才能被我们使用。目前大部分都是json格式。相比html格式,json格式更简单。本文介绍返回的html格式。

汤

需要 Jsoup 来处理 html 格式的返回。jsoup 是一个 Java html 解析器,可以直接解析一个 URL 地址和 HTML 文本内容。具体的jar包可以自己下载。

我们可以通过如下方式模拟这样的请求,然后从请求的返回中解析出我们需要的数据。

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

/**

* Created by wingzing on 2018/8/8.

*/

public class WingZingDemo {

public static void main(String[] args) {

String httpUrl = "http://bestcbooks.com/"; //需要爬的网址

String html;

try {

StringBuffer sbf = new StringBuffer();

URL url = new URL(httpUrl);

HttpURLConnection connection = (HttpURLConnection) url

.openConnection();

connection.setRequestMethod("GET"); //设置请求方式 可设置POST 注意一定要大写

//connection.setRequestProperty("Cookie", cookie); //设置请求头参数 如Cookie、Host等等

connection.connect(); //开启连接

InputStream is = connection.getInputStream();

BufferedReader reader = new BufferedReader(new InputStreamReader(is, "UTF-8"));

String strRead = null;

while ((strRead = reader.readLine()) != null) { //读取返回

sbf.append(strRead);

sbf.append("\r\n");

}

reader.close();//关闭缓冲字符流

html = sbf.toString();

//System.out.println(html);

Document doc = Jsoup.parse(html);//将爬来的html格式的字符串转成Document从而获取其中需要的数据

Element ul = doc.getElementById("category-list");//取得ID为category-list的元素

Elements liList = ul.getElementsByTag("li");//取得其中的li标签 为一个集合

for(Element li:liList){ //循环该li集合

System.out.println(li.getElementsByTag("a").get(0).text());//取得每个li中的a标签的值 进行输出

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

代码中的注释写得很清楚。可以自己复制代码运行,通过debug一步步看值。

一般来说,首先获取页面加载或执行时发送的请求,判断是否需要参数,需要哪些参数,进行模拟,然后获取请求的返回,解析请求,获取我们的数据需要。

以上是一个用Java实现的简单爬虫,仅供没有接触过Java的朋友学习爬虫。后续我会写一些Java中稍微麻烦一点的爬虫,比如抓取数据到自己的数据库,对模拟网页进行一些操作等等。

java爬虫抓取网页数据( 有没有什么轻便的框架供我们使用?什么框架?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-03-18 05:08

有没有什么轻便的框架供我们使用?什么框架?)

Java 爬虫 (二)

前言:在上一篇博客中,我们使用了基于HttpURLConnection的方法进行数据爬取

Java爬虫(一),但是里面没有框架,通过原生http爬取,那么问题来了,有没有轻量级的框架给我们用?

Jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的API,可以通过DOM、CSS和类似jQuery的操作方法来检索和操作数据。本篇博客将主要介绍jsoup技术进行数据爬取,为了提高效率,我们将使用多线程的方式读取数据

爬进入口

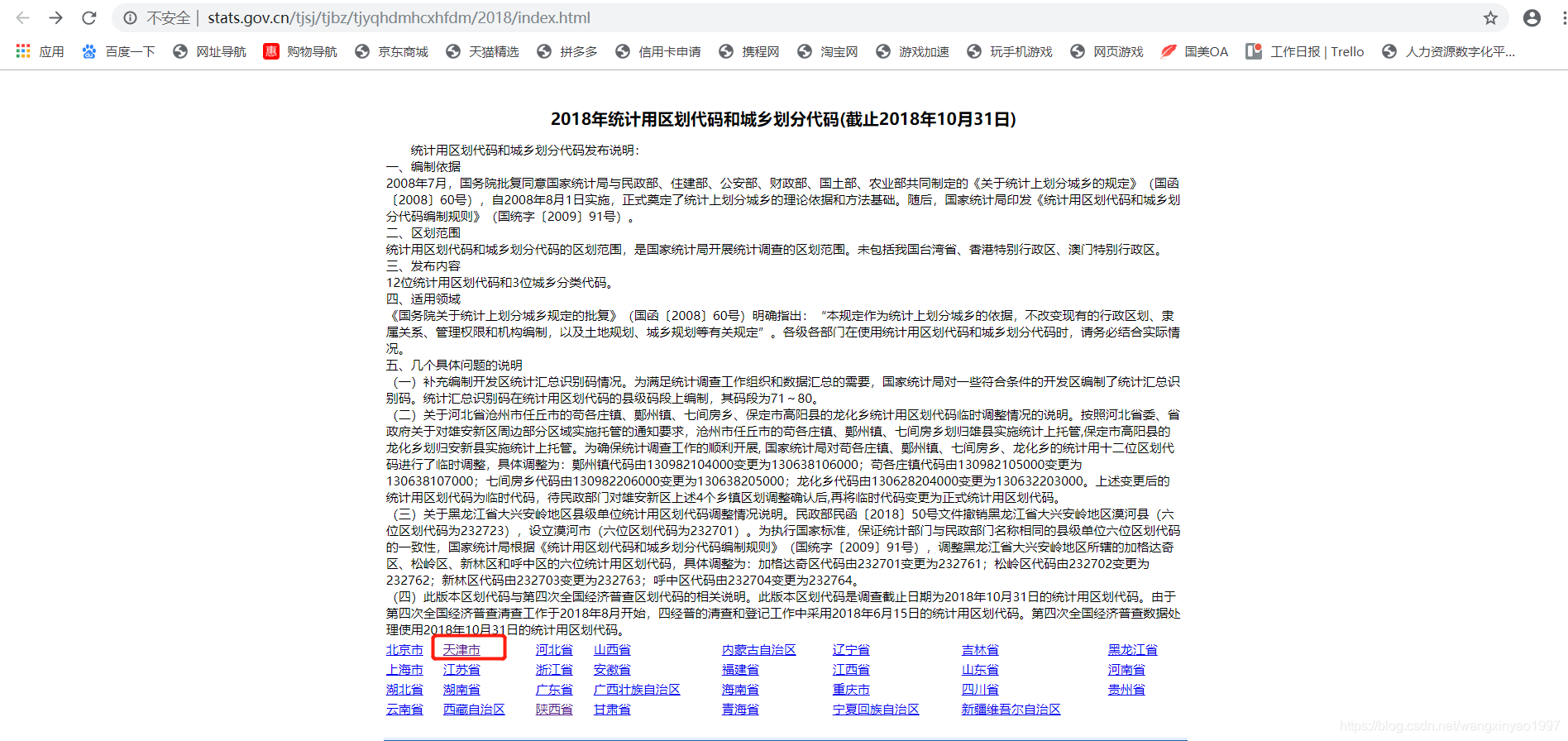

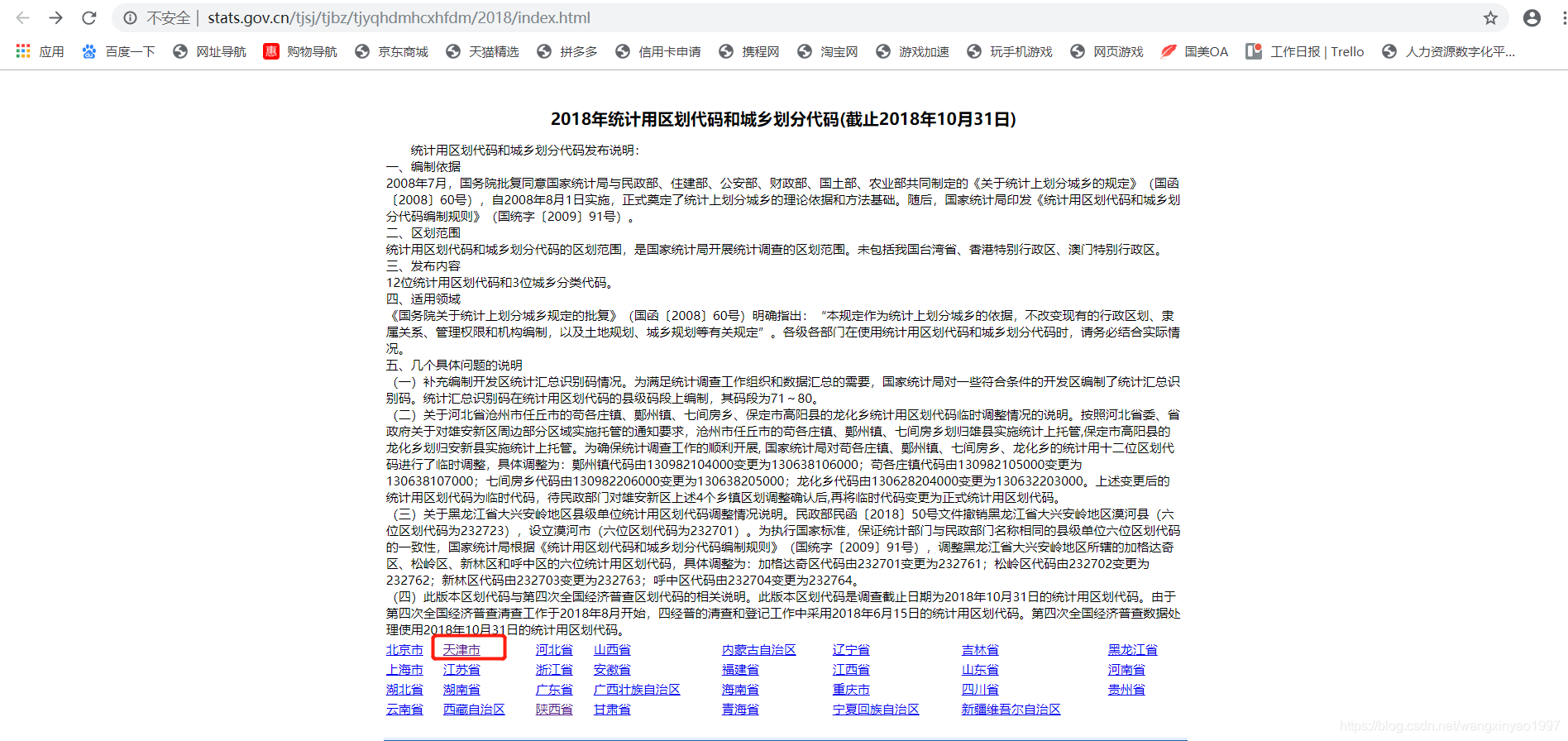

我们随便找一个网站来爬取,原理是一样的,比如我们爬取一个国家统计局的数据,首先找到爬取到的网站的页面如下:

比如我爬取天津的数据,找到要爬取的网站页面入口:

http://www.stats.gov.cn/tjsj/t ... .html

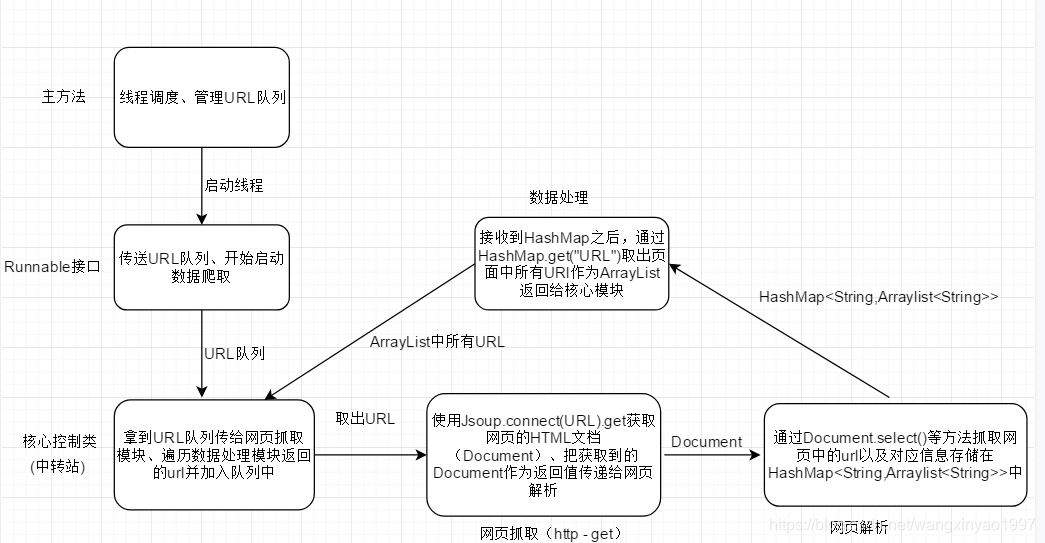

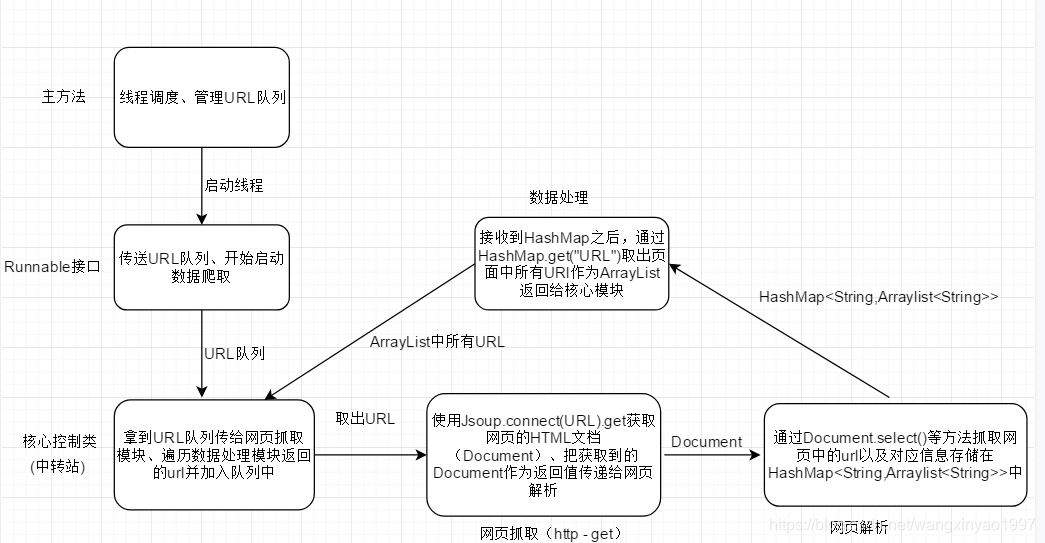

爬行的想法

其实爬虫的代码不用太在意。首先我们理清思路,上图:

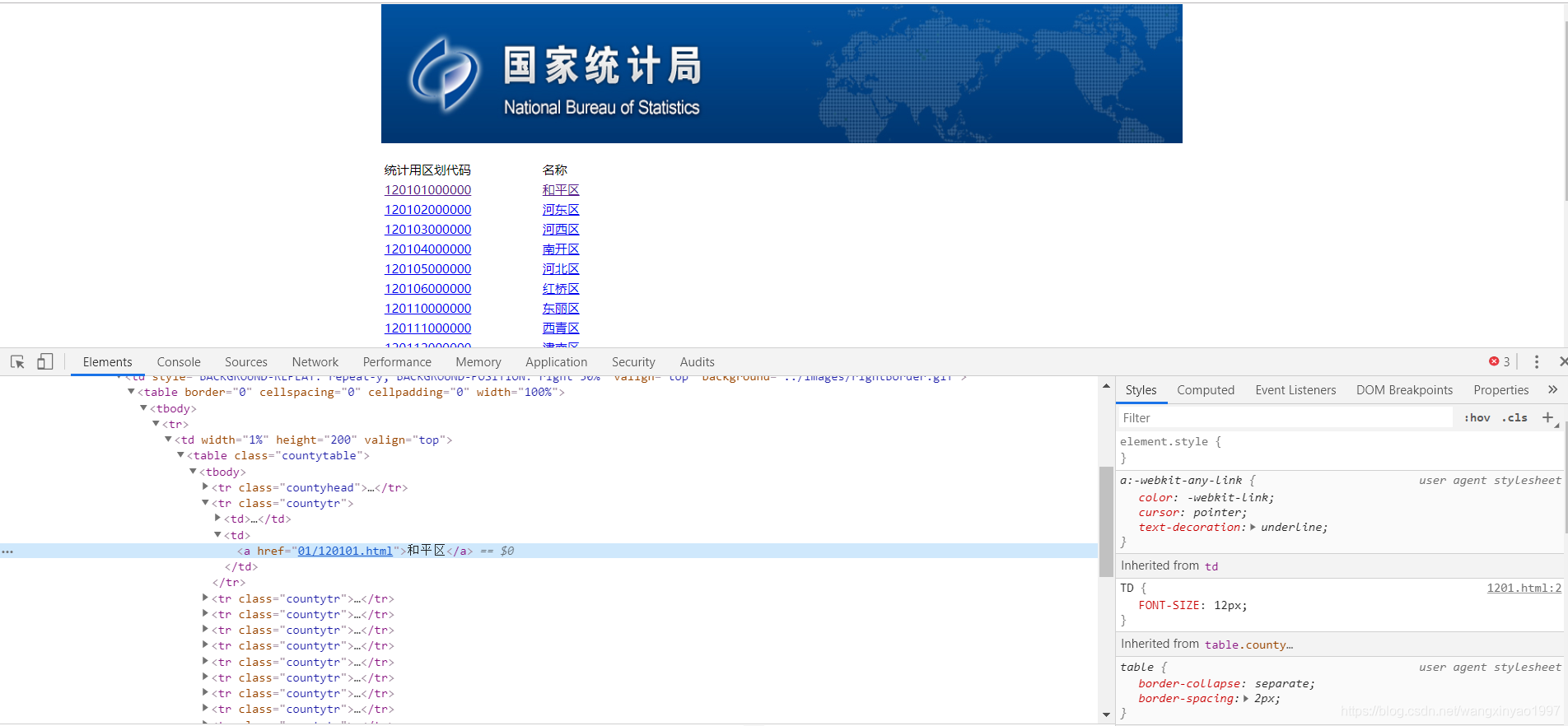

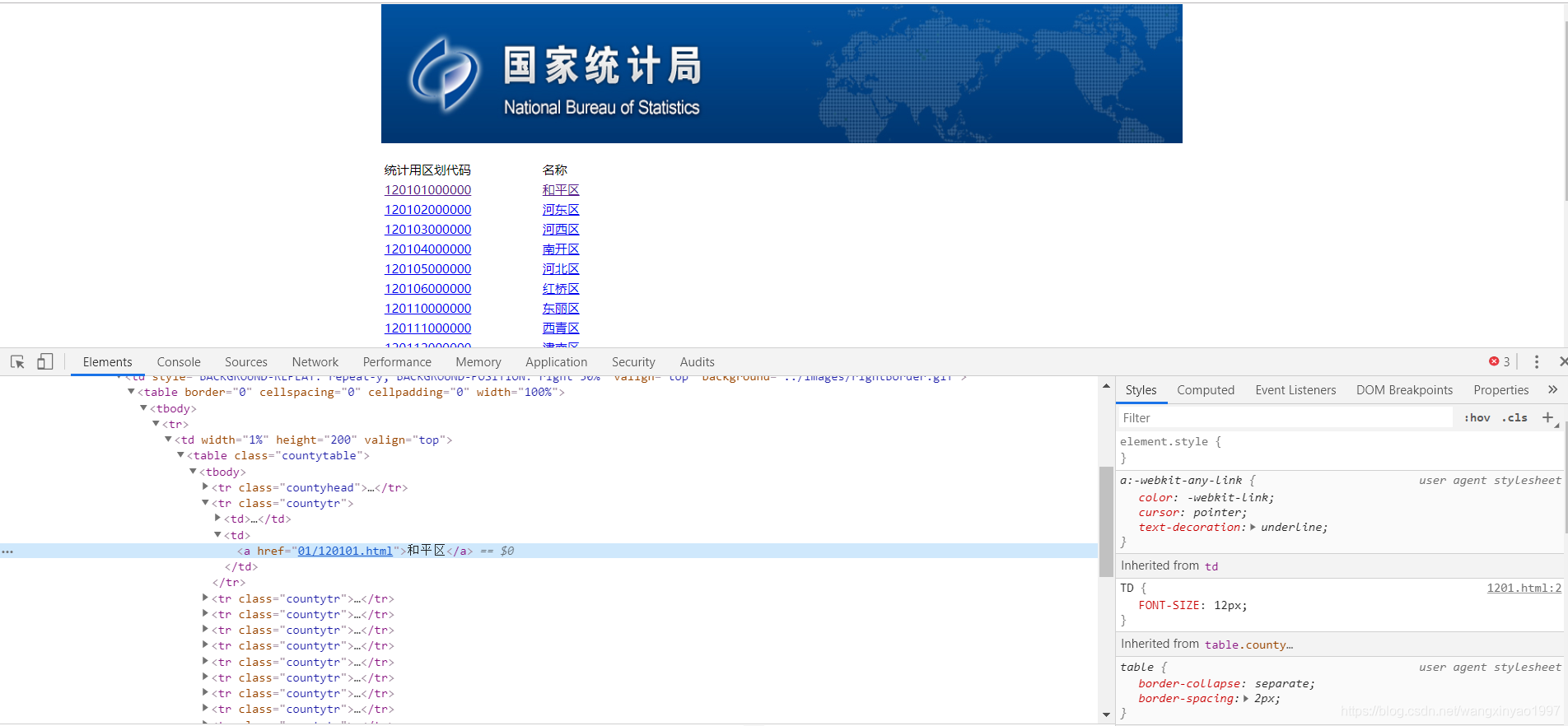

从上图可以看出我们的基本思路和流程,但是由于网站的可变性,我们不能贸然爬取,造成数据冗余。这个网页的最后一层只有文字信息,其余网页一条短信对应一条短信到一个URL地址,而在最后一层之外,每一层的数字和短信都有相同的URL,所以我们只需要爬取名字,如下:

开始爬行

请注意,我们的以下文档包路径是:

import org.jsoup.nodes.Document;

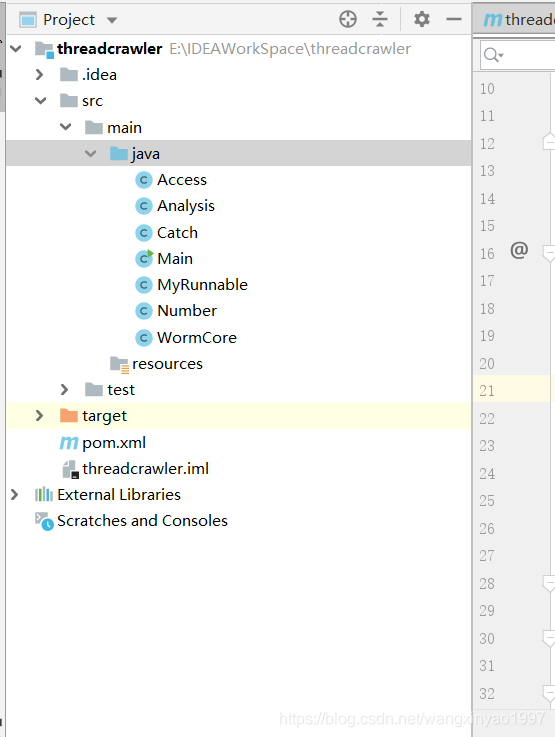

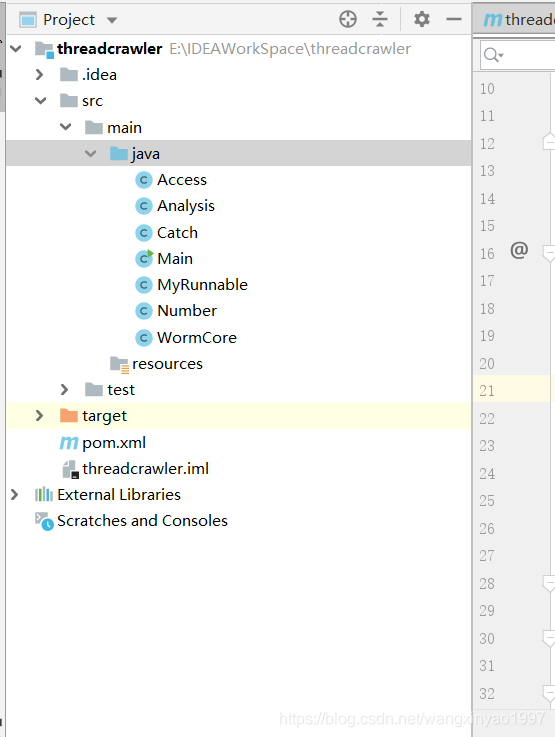

最终的项目目录结构如下:

1.只需创建一个maven项目

2.在pom.xml文件中添加如下依赖

org.jsoup

jsoup

1.11.3

3.创建主类

public class Main {

//待抓取的Url队列,全局共享

public static final LinkedBlockingQueue UrlQueue = new LinkedBlockingQueue();

public static final WormCore wormCore = new WormCore();

public static void main(String[] args) {

//要抓取的根URL

String rootUrl = "http://www.stats.gov.cn/tjsj/t ... 3B%3B

//先把根URL加入URL队列

UrlQueue.offer(rootUrl);

Runnable runnable = new MyRunnable();

//开启固定大小的线程池,线程数为10

ExecutorService Fixed = Executors.newFixedThreadPool(10);

//开始爬取

for (int i = 0;i 3) {

System.out.println(element.text());

}

Flag++;

}

//普通页面的处理

}else {

for (Element element : elements) {

if (!Number.IsNumber(element.text())) {

Text.add(element.text());

System.out.println(element.text());

Urls.add(Before_Url + element.attr("href"));

}

}

}

//把文本集合和URL集合装到Map中返回

Message.put("text",Text);

Message.put("Url",Urls);

return Message;

}

}

由于最后一页与上一页不同,需要因地制宜地调整措施。我们把前面提到的统计划分码号扔掉了,只要名字是必填的,所以博主通过下面Number类中的方法来判断

8.判断是否为数字

<p>public class Number {

public static boolean IsNumber(String str){

for(int i=0;i=48 && c 查看全部

java爬虫抓取网页数据(

有没有什么轻便的框架供我们使用?什么框架?)

Java 爬虫 (二)

前言:在上一篇博客中,我们使用了基于HttpURLConnection的方法进行数据爬取

Java爬虫(一),但是里面没有框架,通过原生http爬取,那么问题来了,有没有轻量级的框架给我们用?

Jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的API,可以通过DOM、CSS和类似jQuery的操作方法来检索和操作数据。本篇博客将主要介绍jsoup技术进行数据爬取,为了提高效率,我们将使用多线程的方式读取数据

爬进入口

我们随便找一个网站来爬取,原理是一样的,比如我们爬取一个国家统计局的数据,首先找到爬取到的网站的页面如下:

比如我爬取天津的数据,找到要爬取的网站页面入口:

http://www.stats.gov.cn/tjsj/t ... .html

爬行的想法

其实爬虫的代码不用太在意。首先我们理清思路,上图:

从上图可以看出我们的基本思路和流程,但是由于网站的可变性,我们不能贸然爬取,造成数据冗余。这个网页的最后一层只有文字信息,其余网页一条短信对应一条短信到一个URL地址,而在最后一层之外,每一层的数字和短信都有相同的URL,所以我们只需要爬取名字,如下:

开始爬行

请注意,我们的以下文档包路径是:

import org.jsoup.nodes.Document;

最终的项目目录结构如下:

1.只需创建一个maven项目

2.在pom.xml文件中添加如下依赖

org.jsoup

jsoup

1.11.3

3.创建主类

public class Main {

//待抓取的Url队列,全局共享

public static final LinkedBlockingQueue UrlQueue = new LinkedBlockingQueue();

public static final WormCore wormCore = new WormCore();

public static void main(String[] args) {

//要抓取的根URL

String rootUrl = "http://www.stats.gov.cn/tjsj/t ... 3B%3B

//先把根URL加入URL队列

UrlQueue.offer(rootUrl);

Runnable runnable = new MyRunnable();

//开启固定大小的线程池,线程数为10

ExecutorService Fixed = Executors.newFixedThreadPool(10);

//开始爬取

for (int i = 0;i 3) {

System.out.println(element.text());

}

Flag++;

}

//普通页面的处理

}else {

for (Element element : elements) {

if (!Number.IsNumber(element.text())) {

Text.add(element.text());

System.out.println(element.text());

Urls.add(Before_Url + element.attr("href"));

}

}

}

//把文本集合和URL集合装到Map中返回

Message.put("text",Text);

Message.put("Url",Urls);

return Message;

}

}

由于最后一页与上一页不同,需要因地制宜地调整措施。我们把前面提到的统计划分码号扔掉了,只要名字是必填的,所以博主通过下面Number类中的方法来判断

8.判断是否为数字

<p>public class Number {

public static boolean IsNumber(String str){

for(int i=0;i=48 && c

java爬虫抓取网页数据(内容简明扼要能使你眼前一亮,通过这篇文章的详细介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-16 12:24

这篇文章文章教你如何使用JAVA编写爬虫。内容简洁易懂,一定会让你眼前一亮。通过这次对文章的详细介绍,希望你能有所收获。

这篇文章文章其实是我很久以前写的,所以这次重新整理一下。很多朋友可能没有尝试过用Java写爬虫。可能是因为这方面的资料比较少,也可能是用Python写爬虫太方便了。

基本概念

jsoupi 是一个用于处理实际 HTML 的 Java 库。它提供了一个非常方便的 API,用于提取和操作数据,使用 DOM、CSS 和类似 jquery 的最佳方法。

以上是jsoup的官方解释,意思是jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的 API,用于通过 DOM、CSS 和类似 jQuery 的操作方法获取和操作数据。

一般来说,它可以帮助我们解析HTML页面,抓取HTML中的内容。

开始写代码

我们的目标是抓取菜鸟笔记上的信息(文章标题和链接)

public static void main(String[] args) { try { //下面这行代码是连接我们的目标站点,并且get到他的静态HTML代码 Document document=Jsoup.connect("http://www.runoob.com/w3cnote").get(); //我们把获取到的document打印一下,看看里面到底是啥? System.out.println(document); } catch (IOException e) { e.printStackTrace(); } }

看看我们代码运行的结果:

你会发现我们通过这句话获得了网站《菜鸟笔记》的HTML源码

我们来分析一下这串html源码

发现这两个正是我们要获取的数据,我们继续爬取

<p>public static void main(String[] args) { try { Document document=Jsoup.connect("http://www.runoob.com/w3cnote").get(); //底下一行代码是我们进一步抓取到具体的HTML模块,div表示标签, //后面的post-intro表示的是div的class //由于div.post-intro这个标签有多个(每个标题有一个),所以我们先获取到它的所有 Elements elements=document.select("div.post-intro"); //我们来遍历一下,因为div.post-intro有很多个 for(int i=0;i 查看全部

java爬虫抓取网页数据(内容简明扼要能使你眼前一亮,通过这篇文章的详细介绍)

这篇文章文章教你如何使用JAVA编写爬虫。内容简洁易懂,一定会让你眼前一亮。通过这次对文章的详细介绍,希望你能有所收获。

这篇文章文章其实是我很久以前写的,所以这次重新整理一下。很多朋友可能没有尝试过用Java写爬虫。可能是因为这方面的资料比较少,也可能是用Python写爬虫太方便了。

基本概念

jsoupi 是一个用于处理实际 HTML 的 Java 库。它提供了一个非常方便的 API,用于提取和操作数据,使用 DOM、CSS 和类似 jquery 的最佳方法。

以上是jsoup的官方解释,意思是jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的 API,用于通过 DOM、CSS 和类似 jQuery 的操作方法获取和操作数据。

一般来说,它可以帮助我们解析HTML页面,抓取HTML中的内容。

开始写代码

我们的目标是抓取菜鸟笔记上的信息(文章标题和链接)

public static void main(String[] args) { try { //下面这行代码是连接我们的目标站点,并且get到他的静态HTML代码 Document document=Jsoup.connect("http://www.runoob.com/w3cnote";).get(); //我们把获取到的document打印一下,看看里面到底是啥? System.out.println(document); } catch (IOException e) { e.printStackTrace(); } }

看看我们代码运行的结果:

你会发现我们通过这句话获得了网站《菜鸟笔记》的HTML源码

我们来分析一下这串html源码

发现这两个正是我们要获取的数据,我们继续爬取

<p>public static void main(String[] args) { try { Document document=Jsoup.connect("http://www.runoob.com/w3cnote";).get(); //底下一行代码是我们进一步抓取到具体的HTML模块,div表示标签, //后面的post-intro表示的是div的class //由于div.post-intro这个标签有多个(每个标题有一个),所以我们先获取到它的所有 Elements elements=document.select("div.post-intro"); //我们来遍历一下,因为div.post-intro有很多个 for(int i=0;i

java爬虫抓取网页数据(java爬虫抓取网页数据主要分为两个流程:)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-03-14 05:00

java爬虫抓取网页数据主要分为两个流程:1.选择想要爬取的网站2.爬取网站数据,存放到本地存储场景:分享海量的数据给一个社区里面的陌生人,让他们来看,分享这些数据给其他人。推荐大家用solr语法:1.要爬取哪个网站。2.抓取数据保存存储到哪个位置。3.请求数据。大小限制4.请求方式可以是https,socket。

5.爬取耗时等。详细点去这个站点cnblogs-分享无限新鲜资讯,爬爬爬~附带我们公司之前爬虫获取的数据。-我们公司是做职业考试服务的,上有时候会有到对于考试难度的职业考试信息,可以通过抓包来获取考试信息(相关文章:王奋斗:cpa考试包过二本学校研究生取得高薪就业凭什么?)。目前,我们不是所有学校考试都有抓包。

我们目前可以抓取所有考试的相关信息。考生信息。部分考试抓包获取一级、二级及以上考试的考试信息部分考试抓包获取一级、二级及以上考试的考试信息结果统计在最新的一些情况下,做个数据整理,可以比较直观的了解考试信息的变化情况,这样做的好处:方便考试管理人员掌握当前国家出题情况,及时调整考试方向及难度等。更新考试政策,及时跟踪考试大纲变化。欢迎交流。 查看全部

java爬虫抓取网页数据(java爬虫抓取网页数据主要分为两个流程:)

java爬虫抓取网页数据主要分为两个流程:1.选择想要爬取的网站2.爬取网站数据,存放到本地存储场景:分享海量的数据给一个社区里面的陌生人,让他们来看,分享这些数据给其他人。推荐大家用solr语法:1.要爬取哪个网站。2.抓取数据保存存储到哪个位置。3.请求数据。大小限制4.请求方式可以是https,socket。

5.爬取耗时等。详细点去这个站点cnblogs-分享无限新鲜资讯,爬爬爬~附带我们公司之前爬虫获取的数据。-我们公司是做职业考试服务的,上有时候会有到对于考试难度的职业考试信息,可以通过抓包来获取考试信息(相关文章:王奋斗:cpa考试包过二本学校研究生取得高薪就业凭什么?)。目前,我们不是所有学校考试都有抓包。

我们目前可以抓取所有考试的相关信息。考生信息。部分考试抓包获取一级、二级及以上考试的考试信息部分考试抓包获取一级、二级及以上考试的考试信息结果统计在最新的一些情况下,做个数据整理,可以比较直观的了解考试信息的变化情况,这样做的好处:方便考试管理人员掌握当前国家出题情况,及时调整考试方向及难度等。更新考试政策,及时跟踪考试大纲变化。欢迎交流。

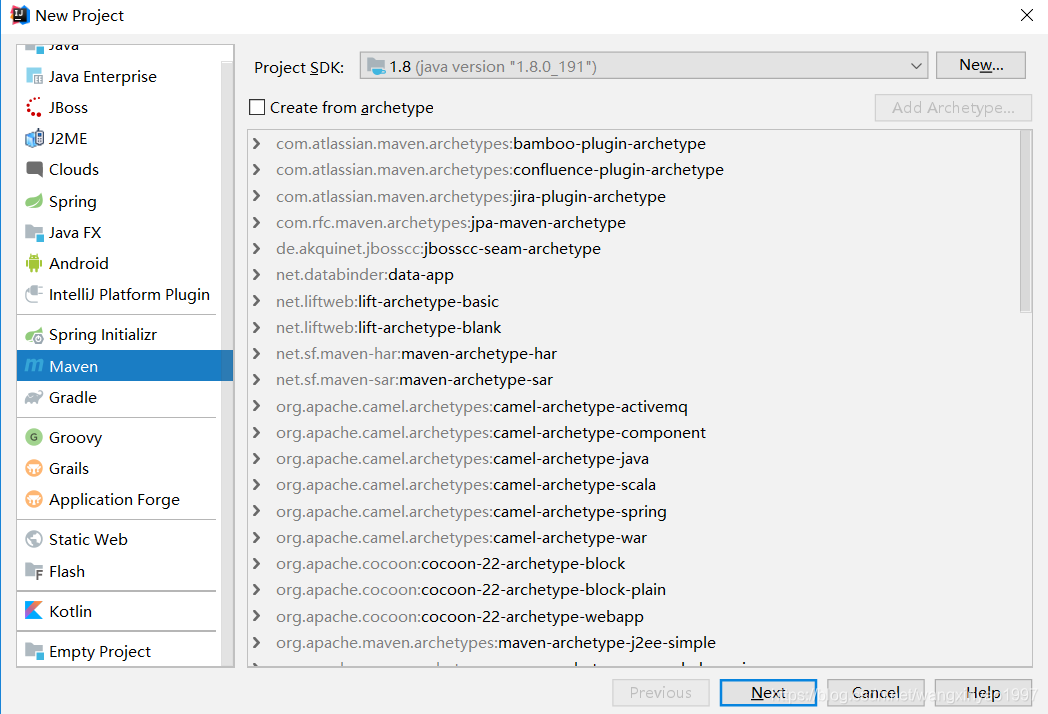

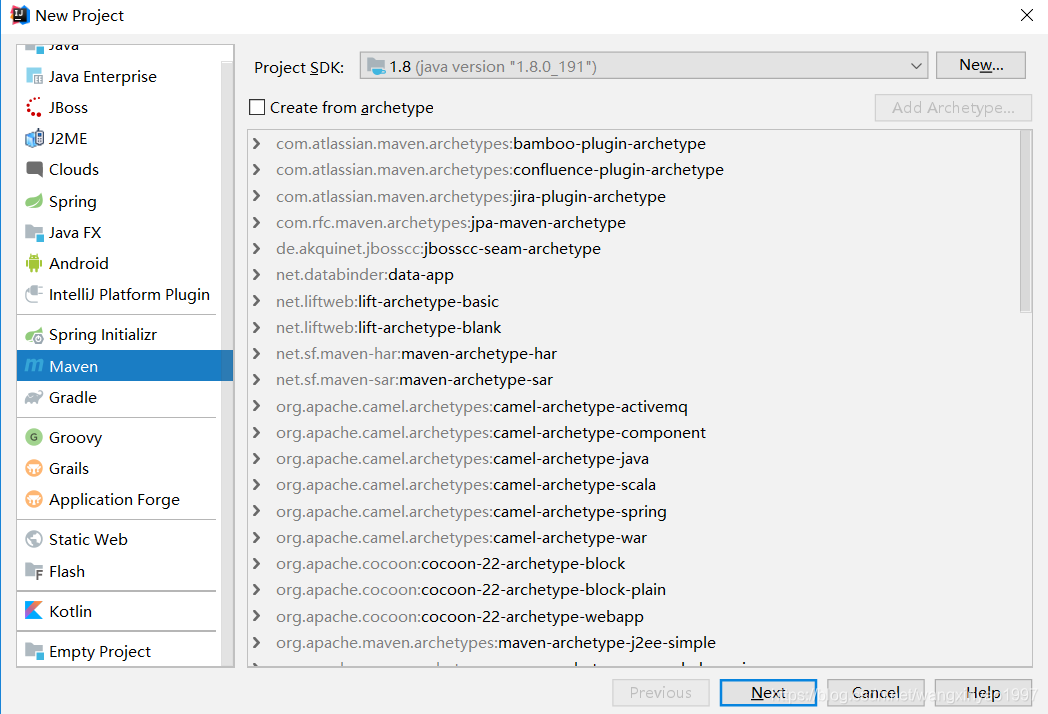

java爬虫抓取网页数据(主流java爬虫框架有哪些?(1)框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 240 次浏览 • 2022-03-12 07:02

文字

一、目前主流的java爬虫框架包括

Python中有Scrapy和Pyspider;

Java 有 Nutch、WebMagic、WebCollector、heritrix3、Crawler4j

这些框架的优缺点是什么?

(1), Scrapy:

Scrapy,一个用 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。 Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。

Scrapy 的吸引力在于它是一个任何人都可以根据自己的需要轻松修改的框架。还提供了各种爬虫的基类,如BaseSpider、sitemap爬虫等。最新版本提供了对web2.0爬虫的支持。

Scrap 意味着碎片化。这个 Python 爬虫框架叫做 Scrapy。

优点:

1.极其灵活的自定义抓取。

2.社区比较大,文档比较齐全。

3.URL去重采用Bloom filter方案。

4.可以处理不完整的HTML,Scrapy已经提供了选择器(基于lxml的更高级的接口),

可以有效地处理不完整的 HTML 代码。

缺点:

1.对新生不友好,需要一定的新手期

(2), Pyspider:

pyspider 是一个用python实现的强大的网络爬虫系统。它可以在浏览器界面上实时编写脚本、调度函数和查看爬取结果。后端使用通用数据库来爬取结果。它还可以定期设置任务和任务优先级。

优点:

1.支持分布式部署。

2.完全可视化,非常人性化:WEB界面编写调试脚本,启动和停止脚本,监控执行状态,查看活动历史,获取结果。

3.五分钟即可轻松上手。脚本规则简单,开发效率高。支持抓取 JavaScript 页面。

简而言之,Pyspider 非常强大,比框架更强大。

缺点:

1.URL去重使用数据库而不是Bloom过滤器,十亿级存储的db io会导致效率急剧下降。

2.使用的人性化牺牲了灵活性,降低了定制能力。

(3)Apache Nutch(高)

Nutch 是专为搜索引擎设计的爬虫。大多数用户需要一个爬虫来进行准确的数据爬取(精细提取)。 Nutch 运行的三分之二的流程是为搜索引擎设计的。 .

Nutch 框架需要 Hadoop 运行,Hadoop 需要开启集群。我不希望快速开始使用爬虫...

这里列出了一些资源地址,以后可能会学到。

Nutch 官网

1.Nutch 支持分布式爬取,拥有Hadoop 支持多机分布式爬取、存储和索引。另一个非常吸引人的地方是它提供了一个插件框架,可以很容易地扩展它的功能,例如解析各种网页内容、采集、查询、聚类、过滤各种数据。因为这个框架,Nutch的插件开发非常容易,第三方插件层出不穷,大大提升了Nutch的功能和知名度。

缺点

1.Nutch的爬虫定制能力比较弱

(4), WebMagic

WebMagic 是一个简单灵活的 Java 爬虫框架。基于WebMagic,您可以快速开发一个高效且易于维护的爬虫。

优点:

1.简单的API,快速上手

2.模块化结构,方便扩展

3.多线程和分布式支持

缺点:

1.不支持JS页面爬取

(5), 网络采集器

WebCollector是一个无需配置,方便二次开发的JAVA爬虫框架(内核)。它提供了精简的API,只需少量代码即可实现强大的爬虫。 WebCollector-Hadoop 是 WebCollector 的 Hadoop 版本,支持分布式爬取。

优点:

1.根据文字密度自动提取网页文字

2.支持断点重爬

3.支持代理

缺点:

1.不支持分布式,只支持单机

2.无 URL 优先级调度

3.不是很活跃

(6), Heritrix3

Heritrix是java开发的开源网络爬虫,用户可以使用它从互联网上爬取想要的资源

优势

Heritrix 的爬虫有很多自定义参数

缺点

1.单实例爬虫无法合作。

2.机器资源有限的复杂操作。

3.仅官方支持,仅在 Linux 上测试。

4.每个爬虫单独工作,无需修改更新。

5.在发生硬件和系统故障时恢复能力很差。

6.优化性能的时间非常少。

7.相比Nutch,Heritrix只是一个爬虫工具,不提供搜索引擎。如果要对爬取的网站进行排名,就必须实现类似于Pagerank的复杂算法。

(7), Crawler4j

Crawler4j是一个基于Java的轻量级独立开源爬虫框架

优势

1.多线程采集

2.内置的Url过滤机制使用BerkeleyDB进行url过滤。

3.可扩展支持结构化提取网页字段,可作为垂直采集使用

缺点

1.不支持动态网页抓取,例如网页的 ajax 部分

2.不支持分布式采集,可以认为是分布式爬虫的一部分,客户端采集部分

为了让这7个爬虫框架更直观,小编做了一个框架优缺点对比图,如下:

Jsoup(经典,适合静态网友)

这个框架很经典,也是我们暑期培训老师讲解的框架。有一个近乎完整的文档介绍。

同HtmlUnit,只能获取静态内容。

不过,这个框架的优势在于解析网页非常强大。

Jsoup中文教程

selenium(多位谷歌领导参与开发)

感觉很棒,但实际上真的很棒。看官网和其他人的介绍,都说是真实的浏览器模拟。 GitHub1.4w+star,你没看错,上万。但我就是不适应环境。介绍Demo就是跑不成功,所以放弃了。

selenium 官方 GitHub

cdp4j(方便快捷,但需要依赖谷歌浏览器)

先决条件:

安装 Chrome 浏览器就完成了。

简介:

HtmlUnit的优点是可以轻松爬取静态网友;缺点是只能抓取静态网页。

selenium 的优点是可以爬取渲染好的网页;缺点是需要配置环境变量等。

两者结合,取长补短,就有了cdp4j。

之所以选择它,是因为它真的很方便好用,而且官方文档详细,Demo程序基本可以运行,类名熟悉。我想我在学习软件工程的时候一直在想,如果我的程序能实现这个功能,为什么还要写文档呢?现在,看着这么详细的文件,激动和遗憾的泪流满面……

cdp4j 有很多特点:

一个。获取渲染后的网页源代码

b.模拟浏览器点击事件

c。下载可以从网页下载的文件

d。截取网页截图或转换为 PDF 打印

e。等等

更详细的信息可以到以下三个地址去探索发现:

[cdp4j官网地址]

[Github 仓库]

[演示列表]

总结

上述框架各有优缺点。其中cdp4j方便,功能齐全,但我个人觉得唯一的缺点就是需要依赖谷歌浏览器。

以后打算用手动的方法:httpclient +jsoup+selenium实现java爬虫功能用httpclient爬取,jsoup解析页面,90%的页面可以做,剩下的用selenium;

参考链接: 查看全部

java爬虫抓取网页数据(主流java爬虫框架有哪些?(1)框架)

文字

一、目前主流的java爬虫框架包括

Python中有Scrapy和Pyspider;

Java 有 Nutch、WebMagic、WebCollector、heritrix3、Crawler4j

这些框架的优缺点是什么?

(1), Scrapy:

Scrapy,一个用 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。 Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。

Scrapy 的吸引力在于它是一个任何人都可以根据自己的需要轻松修改的框架。还提供了各种爬虫的基类,如BaseSpider、sitemap爬虫等。最新版本提供了对web2.0爬虫的支持。

Scrap 意味着碎片化。这个 Python 爬虫框架叫做 Scrapy。

优点:

1.极其灵活的自定义抓取。

2.社区比较大,文档比较齐全。

3.URL去重采用Bloom filter方案。

4.可以处理不完整的HTML,Scrapy已经提供了选择器(基于lxml的更高级的接口),

可以有效地处理不完整的 HTML 代码。

缺点:

1.对新生不友好,需要一定的新手期

(2), Pyspider:

pyspider 是一个用python实现的强大的网络爬虫系统。它可以在浏览器界面上实时编写脚本、调度函数和查看爬取结果。后端使用通用数据库来爬取结果。它还可以定期设置任务和任务优先级。

优点:

1.支持分布式部署。

2.完全可视化,非常人性化:WEB界面编写调试脚本,启动和停止脚本,监控执行状态,查看活动历史,获取结果。

3.五分钟即可轻松上手。脚本规则简单,开发效率高。支持抓取 JavaScript 页面。

简而言之,Pyspider 非常强大,比框架更强大。

缺点:

1.URL去重使用数据库而不是Bloom过滤器,十亿级存储的db io会导致效率急剧下降。

2.使用的人性化牺牲了灵活性,降低了定制能力。

(3)Apache Nutch(高)

Nutch 是专为搜索引擎设计的爬虫。大多数用户需要一个爬虫来进行准确的数据爬取(精细提取)。 Nutch 运行的三分之二的流程是为搜索引擎设计的。 .

Nutch 框架需要 Hadoop 运行,Hadoop 需要开启集群。我不希望快速开始使用爬虫...

这里列出了一些资源地址,以后可能会学到。

Nutch 官网

1.Nutch 支持分布式爬取,拥有Hadoop 支持多机分布式爬取、存储和索引。另一个非常吸引人的地方是它提供了一个插件框架,可以很容易地扩展它的功能,例如解析各种网页内容、采集、查询、聚类、过滤各种数据。因为这个框架,Nutch的插件开发非常容易,第三方插件层出不穷,大大提升了Nutch的功能和知名度。

缺点

1.Nutch的爬虫定制能力比较弱

(4), WebMagic

WebMagic 是一个简单灵活的 Java 爬虫框架。基于WebMagic,您可以快速开发一个高效且易于维护的爬虫。

优点:

1.简单的API,快速上手

2.模块化结构,方便扩展

3.多线程和分布式支持

缺点:

1.不支持JS页面爬取

(5), 网络采集器

WebCollector是一个无需配置,方便二次开发的JAVA爬虫框架(内核)。它提供了精简的API,只需少量代码即可实现强大的爬虫。 WebCollector-Hadoop 是 WebCollector 的 Hadoop 版本,支持分布式爬取。

优点:

1.根据文字密度自动提取网页文字

2.支持断点重爬

3.支持代理

缺点:

1.不支持分布式,只支持单机

2.无 URL 优先级调度

3.不是很活跃

(6), Heritrix3

Heritrix是java开发的开源网络爬虫,用户可以使用它从互联网上爬取想要的资源

优势

Heritrix 的爬虫有很多自定义参数

缺点

1.单实例爬虫无法合作。

2.机器资源有限的复杂操作。

3.仅官方支持,仅在 Linux 上测试。

4.每个爬虫单独工作,无需修改更新。

5.在发生硬件和系统故障时恢复能力很差。

6.优化性能的时间非常少。

7.相比Nutch,Heritrix只是一个爬虫工具,不提供搜索引擎。如果要对爬取的网站进行排名,就必须实现类似于Pagerank的复杂算法。

(7), Crawler4j

Crawler4j是一个基于Java的轻量级独立开源爬虫框架

优势

1.多线程采集

2.内置的Url过滤机制使用BerkeleyDB进行url过滤。

3.可扩展支持结构化提取网页字段,可作为垂直采集使用

缺点

1.不支持动态网页抓取,例如网页的 ajax 部分

2.不支持分布式采集,可以认为是分布式爬虫的一部分,客户端采集部分

为了让这7个爬虫框架更直观,小编做了一个框架优缺点对比图,如下:

Jsoup(经典,适合静态网友)

这个框架很经典,也是我们暑期培训老师讲解的框架。有一个近乎完整的文档介绍。

同HtmlUnit,只能获取静态内容。

不过,这个框架的优势在于解析网页非常强大。

Jsoup中文教程

selenium(多位谷歌领导参与开发)

感觉很棒,但实际上真的很棒。看官网和其他人的介绍,都说是真实的浏览器模拟。 GitHub1.4w+star,你没看错,上万。但我就是不适应环境。介绍Demo就是跑不成功,所以放弃了。

selenium 官方 GitHub

cdp4j(方便快捷,但需要依赖谷歌浏览器)

先决条件:

安装 Chrome 浏览器就完成了。

简介:

HtmlUnit的优点是可以轻松爬取静态网友;缺点是只能抓取静态网页。

selenium 的优点是可以爬取渲染好的网页;缺点是需要配置环境变量等。

两者结合,取长补短,就有了cdp4j。

之所以选择它,是因为它真的很方便好用,而且官方文档详细,Demo程序基本可以运行,类名熟悉。我想我在学习软件工程的时候一直在想,如果我的程序能实现这个功能,为什么还要写文档呢?现在,看着这么详细的文件,激动和遗憾的泪流满面……

cdp4j 有很多特点:

一个。获取渲染后的网页源代码

b.模拟浏览器点击事件

c。下载可以从网页下载的文件

d。截取网页截图或转换为 PDF 打印

e。等等

更详细的信息可以到以下三个地址去探索发现:

[cdp4j官网地址]

[Github 仓库]

[演示列表]

总结

上述框架各有优缺点。其中cdp4j方便,功能齐全,但我个人觉得唯一的缺点就是需要依赖谷歌浏览器。

以后打算用手动的方法:httpclient +jsoup+selenium实现java爬虫功能用httpclient爬取,jsoup解析页面,90%的页面可以做,剩下的用selenium;

参考链接:

java爬虫抓取网页数据(爬虫+基于接口的网络爬虫上一篇讲了(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2022-03-10 18:13

爬虫+基于界面的网络爬虫

上一篇讲了【java爬虫】---爬虫+jsoup轻松爬取博客。这种方式有个很大的限制,就是通过jsoup爬虫只能爬取静态网页,所以只能爬取当前页面的所有新闻。如果需要爬取一个网站的所有信息,就得通过界面反复调整网站的界面,通过改变参数,爬到网站的所有数据信息。 @网站。

本博客旨在抓取黄金财经新闻资讯,抓取网站自建站以来发布的所有新闻资讯。下面将逐步解释。我这里重点讲一下思路,最后提供完整的源码。

第一步:找到接口

如果要获取网站的所有新闻数据,第一步当然是获取接口,通过接口获取所有信息。

F12-->Network-->all,找到接口:limit=23&information_id=56630&flag=down&version=9.9.9

这三个参数的说明:

limit=23 表示每次调用接口返回23条数据。

information_id=56630 表示下面返回的23条数据是由大于56630或小于56630的ID返回的。

flag=down 表示向下翻页,即23条ID小于56630的数据。

通过邮递员测试

输入:limit=2&information_id=0&flag=down&version=9.9.9(这里返回两个,这里id=0代表最新的两个数据)

返回json数据格式:

{

"news": 2,

"count": 2,

"total": null,

"top_id": 58300,

"bottom_id": 58325,

"list": [

{

"id": 58300,

"title": "跨越牛熊的摆渡人:看金融IT服务如何助力加密货币交易",

"short_title": "当传统金融IT服务商进入加密货币时代",

"type": 1,

"order": 0,

"is_top": false,

"extra": {

"version": "9.9.9",

"summary": "存量资金与投资者日渐枯竭,如何获取新用户和新资金入场,成为大小交易所都在考虑的问题。而交易深度有限、流动性和行情稳定性不佳,也成为横亘在牛熊之间的一道障碍。",

"published_at": 1532855806,

"author": "临渊",

"author_avatar": "https://img.jinse.com/753430_image20.png",

"author_id": 127939,

"author_level": 1,

"read_number": 27064,

"read_number_yuan": "2.7万",

"thumbnail_pic": "https://img.jinse.com/996033_image1.png",

"thumbnails_pics": [

"https://img.jinse.com/996033"

],

"thumbnail_type": 1,

"source": "金色财经",

"topic_url": "https://m.jinse.com/news/block ... ot%3B,

"attribute_exclusive": "",

"attribute_depth": "深度",

"attribute_spread": ""

}

},

{

"id": 58325,

"title": "各路大佬怎样看待区块链:技术新武器应寻找新战场",

"short_title": "各路大佬怎样看待区块链:技术新武器应寻找新战场",

"type": 1,

"order": 0,

"is_top": false,

"extra": {

"version": "9.9.9",

"summary": "今年年初由区块链社区引发的讨论热潮,成为全民一时热议的话题,罕有一项技术,能像区块链这样——在其应用还未大范围铺开、被大众直观感知时,就搅起舆论风暴,扰动民众情绪。",

"published_at": 1532853425,

"author": "新浪财经",

"author_avatar": "https://img.jinse.com/581794_image20.png",

"author_id": 94556,

"author_level": 5,

"read_number": 33453,

"read_number_yuan": "3.3万",

"thumbnail_pic": "https://img.jinse.com/995994_image1.png",

"thumbnails_pics": [

"https://img.jinse.com/995994"

],

"thumbnail_type": 1,

"source": "新浪财经",

"topic_url": "https://m.jinse.com/blockchain/219934.html",

"attribute_exclusive": "",

"attribute_depth": "",

"attribute_spread": ""

}

}

]

}

接口返回信息

第 2 步:通过定时任务开始爬虫工作

@Slf4j

@Component

public class SchedulePressTrigger {

@Autowired

private CrawlerJinSeLivePressService crawlerJinSeLivePressService;

/**

* 定时抓取金色财经的新闻

*/

@Scheduled(initialDelay = 1000, fixedRate = 600 * 1000)

public void doCrawlJinSeLivePress() {

// log.info("开始抓取金色财经新闻, time:" + new Date());

try {

crawlerJinSeLivePressService.start();

} catch (Exception e) {

// log.error("本次抓取金色财经新闻异常", e);

}

// log.info("结束抓取金色财经新闻, time:" + new Date());

}

}

第三步:主要实现类

/**

* 抓取金色财经快讯

* @author xub

* @since 2018/6/29

*/

@Slf4j

@Service

public class CrawlerJinSeLivePressServiceImpl extends AbstractCrawlLivePressService implements

CrawlerJinSeLivePressService {

//这个参数代表每一次请求获得多少个数据

private static final int PAGE_SIZE = 15;

//这个是真正翻页参数,每一次找id比它小的15个数据(有写接口是通过page=1,2来进行翻页所以比较好理解一点,其实它们性质一样)

private long bottomId;

//这个这里没有用到,但是如果有数据层,就需要用到,这里我只是把它答应到控制台

@Autowired

private LivePressService livePressService;

//定时任务运行这个方法,doTask没有被重写,所有运行父类的方法

@Override

public void start() {

try {

doTask(CoinPressConsts.CHAIN_FOR_LIVE_PRESS_DATA_URL_FORMAT);

} catch (IOException e) {

// log.error("抓取金色财经新闻异常", e);

}

}

@Override

protected List crawlPage(int pageNum) throws IOException {

// 最多抓取100页,多抓取也没有特别大的意思。

if (pageNum >= 100) {

return Collections.emptyList();

}

// 格式化翻页参数(第一次bottomId为0,第二次就是这次爬到的最小bottomId值)

String requestUrl = String.format(CoinPressConsts.CHAIN_FOR_LIVE_PRESS_DATA_URL_FORMAT, PAGE_SIZE, bottomId);<br />

Response response = OkHttp.singleton().newCall(

new Request.Builder().url(requestUrl).addHeader("referer", CoinPressConsts.CHAIN_FOR_LIVE_URL).get().build())

.execute();

if (response.isRedirect()) {

// 如果请求发生了跳转,说明请求不是原来的地址了,返回空数据。

return Collections.emptyList();

}

//先获得json数据格式

String responseText = response.body().string();

//在通过工具类进行数据赋值

JinSePressResult jinSepressResult = JsonUtils.objectFromJson(responseText, JinSePressResult.class);

if (null == jinSepressResult) {

// 反序列化失败

System.out.println("抓取金色财经新闻列表反序列化异常");

return Collections.emptyList();

}

// 取金色财经最小的记录id,来进行翻页

bottomId = jinSepressResult.getBottomId();

//这个是谷歌提供了guava包里的工具类,Lists这个集合工具,对list集合操作做了些优化提升。

List pageListPresss = Lists.newArrayListWithExpectedSize(PAGE_SIZE);

for (JinSePressResult.DayData dayData : jinSepressResult.getList()) {

JinSePressData data = dayData.getExtra();

//新闻发布时间(时间戳格式)这里可以来判断只爬多久时间以内的新闻

long createTime = data.getPublishedAt() * 1000;

Long timemill=System.currentTimeMillis();

// if (System.currentTimeMillis() - createTime > CoinPressConsts.MAX_CRAWLER_TIME) {

// // 快讯过老了,放弃

// continue;

// }

SimpleDateFormat sdf=new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

String sd = sdf.format(new Date(createTime)); // 时间戳转换成时间

Date newsCreateTime=new Date();

try {

//获得新闻发布时间

newsCreateTime = sdf.parse(sd);

} catch (ParseException e) {

e.printStackTrace();

}

//具体文章页面路径(这里可以通过这个路径+jsoup就可以爬新闻正文所有信息了)

String href = data.getTopicUrl();

//新闻摘要

String summary = data.getSummary();

//新闻阅读数量

String pressreadcount = data.getReadNumber();

//新闻标题

String title = dayData.getTitle();

pageListPresss.add(new PageListPress(href,title, Integer.parseInt(pressreadcount),

newsCreateTime , summary));

}

return pageListPresss;

}

}

AbstractCrawlLivePressService 类

public abstract class AbstractCrawlLivePressService {

String url;

public void doTask(String url) throws IOException {

this.url = url;

int pageNum = 1;

//通过 while (true)会一直循环调取接口,直到数据为空或者时间过老跳出循环

while (true) {

List newsList = crawlPage(pageNum++);

// 抓取不到新的内容本次抓取结束

if (CollectionUtils.isEmpty(newsList)) {

break;

}

//这里并没有把数据放到数据库,而是直接从控制台输出

for (int i = newsList.size() - 1; i >= 0; i--) {

PageListPress pageListNews = newsList.get(i);

System.out.println(pageListNews.toString());

}

}

}

//这个由具体实现类实现

protected abstract List crawlPage(int pageNum) throws IOException;

@Data

@AllArgsConstructor

@NoArgsConstructor

public static class PageListPress {

//新闻详情页面url

private String href;

//新闻标题

private String title;

//新闻阅读数量

private int readCounts;

//新闻发布时间

private Date createTime;

//新闻摘要

private String summary;

}

}

JinSePress结果

/**

*在创建对象的时候一定要分析好json格式的类型

*金色新闻的返回格式就是第一层有普通属性和一个list集合

*在list集合中又有普通属性和一个extra的对象。

*/

@JsonIgnoreProperties(ignoreUnknown = true)

@Data

public class JinSePressResult {

private int news;

private int count;

@JsonProperty("top_id")

private long topId;

@JsonProperty("bottom_id")

private long bottomId;

//list的名字也要和json数据的list名字一致,否则无用

private List list;

@Data

@JsonIgnoreProperties(ignoreUnknown = true)

public static class DayData {

private String title;

//这里对象的属性名extra也要和json的extra名字一致

private JinSePressData extra;

@JsonProperty("topic_url")

private String topicUrl;

}

}

这里需要注意两点

(1)在创建对象的时候,首先要弄清楚json格式类型是否收录对象中的集合,或者集合中是否存在对象等。

(2) 只能定义自己需要的属性字段,当无法匹配json的属性名但类型不一致时。比如上面改成Listextra,会导致序列化失败,因为json的extra显然是一个对象,这里接受的确实是一个集合,关键是

性别名称相同,所以赋值时会报错,序列化会失败。

第四步:查看运行结果

这里只是控制台输出的部分信息,这样就可以获得网站的所有新闻信息。同时我们已经获取到了具体新闻的URL,那么我们就可以通过JSOup获取该新闻的所有具体信息了。(完美的)

第 5 步:数据库重复数据删除思路

因为你不可能每次都直接爬取播放数据到数据库中,所以必须对比新闻数据库是否已经存在,不存在才放入数据库。思路如下:

(1)在数据库表中添加唯一属性字段,可以识别新闻,比如jinse+bottomId形成唯一属性,或者新闻特定页面路径URI,形成唯一属性。

(2)创建地图集合,通过URI检查数据库是否存在,如果存在,如果不存在。

(3) 在通过 map.get(URI) 存储之前,如果为 false,则存储在数据库中。

Git 源代码

首先,源代码本身是通过Idea测试运行的。这里使用龙目岛。现在需要在idea或者eclipse中配置Lombok。

源地址:

想的太多,做的太少,中间的差距就是麻烦。如果你想没有麻烦,要么别想,要么做更多。中校【9】

转载于: 查看全部

java爬虫抓取网页数据(爬虫+基于接口的网络爬虫上一篇讲了(组图))

爬虫+基于界面的网络爬虫

上一篇讲了【java爬虫】---爬虫+jsoup轻松爬取博客。这种方式有个很大的限制,就是通过jsoup爬虫只能爬取静态网页,所以只能爬取当前页面的所有新闻。如果需要爬取一个网站的所有信息,就得通过界面反复调整网站的界面,通过改变参数,爬到网站的所有数据信息。 @网站。

本博客旨在抓取黄金财经新闻资讯,抓取网站自建站以来发布的所有新闻资讯。下面将逐步解释。我这里重点讲一下思路,最后提供完整的源码。

第一步:找到接口

如果要获取网站的所有新闻数据,第一步当然是获取接口,通过接口获取所有信息。

F12-->Network-->all,找到接口:limit=23&information_id=56630&flag=down&version=9.9.9

这三个参数的说明:

limit=23 表示每次调用接口返回23条数据。

information_id=56630 表示下面返回的23条数据是由大于56630或小于56630的ID返回的。

flag=down 表示向下翻页,即23条ID小于56630的数据。

通过邮递员测试

输入:limit=2&information_id=0&flag=down&version=9.9.9(这里返回两个,这里id=0代表最新的两个数据)

返回json数据格式:

{

"news": 2,

"count": 2,

"total": null,

"top_id": 58300,

"bottom_id": 58325,

"list": [

{

"id": 58300,

"title": "跨越牛熊的摆渡人:看金融IT服务如何助力加密货币交易",

"short_title": "当传统金融IT服务商进入加密货币时代",

"type": 1,

"order": 0,

"is_top": false,

"extra": {

"version": "9.9.9",

"summary": "存量资金与投资者日渐枯竭,如何获取新用户和新资金入场,成为大小交易所都在考虑的问题。而交易深度有限、流动性和行情稳定性不佳,也成为横亘在牛熊之间的一道障碍。",

"published_at": 1532855806,

"author": "临渊",

"author_avatar": "https://img.jinse.com/753430_image20.png",

"author_id": 127939,

"author_level": 1,

"read_number": 27064,

"read_number_yuan": "2.7万",

"thumbnail_pic": "https://img.jinse.com/996033_image1.png",

"thumbnails_pics": [

"https://img.jinse.com/996033"

],

"thumbnail_type": 1,

"source": "金色财经",

"topic_url": "https://m.jinse.com/news/block ... ot%3B,

"attribute_exclusive": "",

"attribute_depth": "深度",

"attribute_spread": ""

}

},

{

"id": 58325,

"title": "各路大佬怎样看待区块链:技术新武器应寻找新战场",

"short_title": "各路大佬怎样看待区块链:技术新武器应寻找新战场",

"type": 1,

"order": 0,

"is_top": false,

"extra": {

"version": "9.9.9",

"summary": "今年年初由区块链社区引发的讨论热潮,成为全民一时热议的话题,罕有一项技术,能像区块链这样——在其应用还未大范围铺开、被大众直观感知时,就搅起舆论风暴,扰动民众情绪。",

"published_at": 1532853425,

"author": "新浪财经",

"author_avatar": "https://img.jinse.com/581794_image20.png",

"author_id": 94556,

"author_level": 5,

"read_number": 33453,

"read_number_yuan": "3.3万",

"thumbnail_pic": "https://img.jinse.com/995994_image1.png",

"thumbnails_pics": [

"https://img.jinse.com/995994"

],

"thumbnail_type": 1,

"source": "新浪财经",

"topic_url": "https://m.jinse.com/blockchain/219934.html",

"attribute_exclusive": "",

"attribute_depth": "",

"attribute_spread": ""

}

}

]

}

接口返回信息

第 2 步:通过定时任务开始爬虫工作

@Slf4j

@Component

public class SchedulePressTrigger {

@Autowired

private CrawlerJinSeLivePressService crawlerJinSeLivePressService;

/**

* 定时抓取金色财经的新闻

*/

@Scheduled(initialDelay = 1000, fixedRate = 600 * 1000)

public void doCrawlJinSeLivePress() {

// log.info("开始抓取金色财经新闻, time:" + new Date());

try {

crawlerJinSeLivePressService.start();

} catch (Exception e) {

// log.error("本次抓取金色财经新闻异常", e);

}

// log.info("结束抓取金色财经新闻, time:" + new Date());

}

}

第三步:主要实现类

/**

* 抓取金色财经快讯

* @author xub

* @since 2018/6/29

*/

@Slf4j

@Service

public class CrawlerJinSeLivePressServiceImpl extends AbstractCrawlLivePressService implements

CrawlerJinSeLivePressService {

//这个参数代表每一次请求获得多少个数据

private static final int PAGE_SIZE = 15;

//这个是真正翻页参数,每一次找id比它小的15个数据(有写接口是通过page=1,2来进行翻页所以比较好理解一点,其实它们性质一样)

private long bottomId;

//这个这里没有用到,但是如果有数据层,就需要用到,这里我只是把它答应到控制台

@Autowired

private LivePressService livePressService;

//定时任务运行这个方法,doTask没有被重写,所有运行父类的方法

@Override

public void start() {

try {

doTask(CoinPressConsts.CHAIN_FOR_LIVE_PRESS_DATA_URL_FORMAT);

} catch (IOException e) {

// log.error("抓取金色财经新闻异常", e);

}

}

@Override

protected List crawlPage(int pageNum) throws IOException {

// 最多抓取100页,多抓取也没有特别大的意思。

if (pageNum >= 100) {

return Collections.emptyList();

}

// 格式化翻页参数(第一次bottomId为0,第二次就是这次爬到的最小bottomId值)

String requestUrl = String.format(CoinPressConsts.CHAIN_FOR_LIVE_PRESS_DATA_URL_FORMAT, PAGE_SIZE, bottomId);<br />

Response response = OkHttp.singleton().newCall(

new Request.Builder().url(requestUrl).addHeader("referer", CoinPressConsts.CHAIN_FOR_LIVE_URL).get().build())

.execute();

if (response.isRedirect()) {

// 如果请求发生了跳转,说明请求不是原来的地址了,返回空数据。

return Collections.emptyList();

}

//先获得json数据格式

String responseText = response.body().string();

//在通过工具类进行数据赋值

JinSePressResult jinSepressResult = JsonUtils.objectFromJson(responseText, JinSePressResult.class);

if (null == jinSepressResult) {

// 反序列化失败

System.out.println("抓取金色财经新闻列表反序列化异常");

return Collections.emptyList();

}

// 取金色财经最小的记录id,来进行翻页

bottomId = jinSepressResult.getBottomId();

//这个是谷歌提供了guava包里的工具类,Lists这个集合工具,对list集合操作做了些优化提升。

List pageListPresss = Lists.newArrayListWithExpectedSize(PAGE_SIZE);

for (JinSePressResult.DayData dayData : jinSepressResult.getList()) {

JinSePressData data = dayData.getExtra();

//新闻发布时间(时间戳格式)这里可以来判断只爬多久时间以内的新闻

long createTime = data.getPublishedAt() * 1000;

Long timemill=System.currentTimeMillis();

// if (System.currentTimeMillis() - createTime > CoinPressConsts.MAX_CRAWLER_TIME) {

// // 快讯过老了,放弃

// continue;

// }

SimpleDateFormat sdf=new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

String sd = sdf.format(new Date(createTime)); // 时间戳转换成时间

Date newsCreateTime=new Date();

try {

//获得新闻发布时间

newsCreateTime = sdf.parse(sd);

} catch (ParseException e) {

e.printStackTrace();

}

//具体文章页面路径(这里可以通过这个路径+jsoup就可以爬新闻正文所有信息了)

String href = data.getTopicUrl();

//新闻摘要

String summary = data.getSummary();

//新闻阅读数量

String pressreadcount = data.getReadNumber();

//新闻标题

String title = dayData.getTitle();

pageListPresss.add(new PageListPress(href,title, Integer.parseInt(pressreadcount),

newsCreateTime , summary));

}

return pageListPresss;

}

}

AbstractCrawlLivePressService 类

public abstract class AbstractCrawlLivePressService {

String url;

public void doTask(String url) throws IOException {

this.url = url;

int pageNum = 1;

//通过 while (true)会一直循环调取接口,直到数据为空或者时间过老跳出循环

while (true) {

List newsList = crawlPage(pageNum++);

// 抓取不到新的内容本次抓取结束

if (CollectionUtils.isEmpty(newsList)) {

break;

}

//这里并没有把数据放到数据库,而是直接从控制台输出

for (int i = newsList.size() - 1; i >= 0; i--) {

PageListPress pageListNews = newsList.get(i);

System.out.println(pageListNews.toString());

}

}

}

//这个由具体实现类实现

protected abstract List crawlPage(int pageNum) throws IOException;

@Data

@AllArgsConstructor

@NoArgsConstructor

public static class PageListPress {

//新闻详情页面url

private String href;

//新闻标题

private String title;

//新闻阅读数量

private int readCounts;

//新闻发布时间

private Date createTime;

//新闻摘要

private String summary;

}

}

JinSePress结果

/**

*在创建对象的时候一定要分析好json格式的类型

*金色新闻的返回格式就是第一层有普通属性和一个list集合

*在list集合中又有普通属性和一个extra的对象。

*/

@JsonIgnoreProperties(ignoreUnknown = true)

@Data

public class JinSePressResult {

private int news;

private int count;

@JsonProperty("top_id")

private long topId;

@JsonProperty("bottom_id")

private long bottomId;

//list的名字也要和json数据的list名字一致,否则无用

private List list;

@Data

@JsonIgnoreProperties(ignoreUnknown = true)

public static class DayData {

private String title;

//这里对象的属性名extra也要和json的extra名字一致

private JinSePressData extra;

@JsonProperty("topic_url")

private String topicUrl;

}

}

这里需要注意两点

(1)在创建对象的时候,首先要弄清楚json格式类型是否收录对象中的集合,或者集合中是否存在对象等。

(2) 只能定义自己需要的属性字段,当无法匹配json的属性名但类型不一致时。比如上面改成Listextra,会导致序列化失败,因为json的extra显然是一个对象,这里接受的确实是一个集合,关键是

性别名称相同,所以赋值时会报错,序列化会失败。

第四步:查看运行结果

这里只是控制台输出的部分信息,这样就可以获得网站的所有新闻信息。同时我们已经获取到了具体新闻的URL,那么我们就可以通过JSOup获取该新闻的所有具体信息了。(完美的)

第 5 步:数据库重复数据删除思路

因为你不可能每次都直接爬取播放数据到数据库中,所以必须对比新闻数据库是否已经存在,不存在才放入数据库。思路如下:

(1)在数据库表中添加唯一属性字段,可以识别新闻,比如jinse+bottomId形成唯一属性,或者新闻特定页面路径URI,形成唯一属性。

(2)创建地图集合,通过URI检查数据库是否存在,如果存在,如果不存在。

(3) 在通过 map.get(URI) 存储之前,如果为 false,则存储在数据库中。

Git 源代码

首先,源代码本身是通过Idea测试运行的。这里使用龙目岛。现在需要在idea或者eclipse中配置Lombok。

源地址:

想的太多,做的太少,中间的差距就是麻烦。如果你想没有麻烦,要么别想,要么做更多。中校【9】

转载于:

java爬虫抓取网页数据(Java开发的爬虫框架很容易上手,输出结果:如果你和我一样)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-03-10 18:11

爬虫初学者,WebMagic作为Java开发的爬虫框架很容易上手,下面看一个简单的例子。

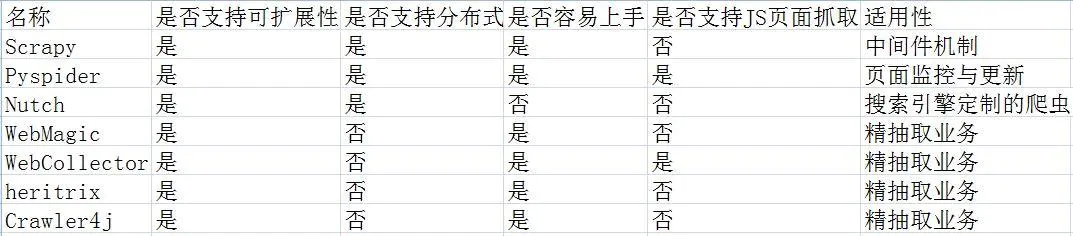

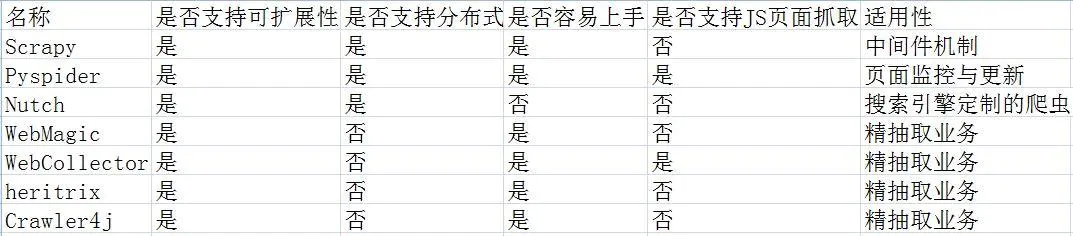

WebMagic 框架简介

WebMagic 框架由四个组件组成,PageProcessor、Scheduler、Downloader 和 Pipeline。

这四个组件分别对应了爬虫生命周期中的处理、管理、下载和持久化的功能。

这四个组件是Spider中的属性,爬虫框架是通过Spider来启动和管理的。

WebMagic的整体架构图如下:

四个组件

PageProcessor 负责解析页面、提取有用信息和发现新链接。你需要定义自己。

Scheduler 负责管理要爬取的 URL,以及一些去重工作。一般不需要自己自定义Scheduler。

Pipeline 负责提取结果的处理,包括计算、持久化到文件、数据库等。

下载器负责从 Internet 下载页面以进行后续处理。通常你不需要自己实现它。

数据流对象

Request是对URL地址的一层封装,一个Request对应一个URL地址。

Page 表示从 Downloader 下载的页面 - 它可能是 HTML、JSON 或其他文本内容。

ResultItems相当于一个Map,它保存了PageProcessor处理的结果,供Pipeline使用。

环境配置

使用Maven添加依赖jar包。

us.codecraft

webmagic-core

0.7.3

us.codecraft

webmagic-extension

0.7.3

org.slf4j

slf4j-log4j12

或者直接点我下载。

添加jar包后,所有的准备工作就完成了,是不是很简单。

让我们测试一下。

package edu.heu.spider;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.Spider;

import us.codecraft.webmagic.pipeline.ConsolePipeline;

import us.codecraft.webmagic.processor.PageProcessor;

/**

* @ClassName: MyCnblogsSpider

* @author LJH

* @date 2017年11月26日 下午4:41:40

*/

public class MyCnblogsSpider implements PageProcessor {

private Site site = Site.me().setRetryTimes(3).setSleepTime(100);

public Site getSite() {

return site;

}

public void process(Page page) {

if (!page.getUrl().regex("http://www.cnblogs.com/[a-z 0-9 -]+/p/[0-9]{7}.html").match()) {

page.addTargetRequests(

page.getHtml().xpath("//*[@id=\"mainContent\"]/div/div/div[@class=\"postTitle\"]/a/@href").all());

} else {

page.putField(page.getHtml().xpath("//*[@id=\"cb_post_title_url\"]/text()").toString(),

page.getHtml().xpath("//*[@id=\"cb_post_title_url\"]/@href").toString());

}

}<br />public static void main(String[] args) {

Spider.create(new MyCnblogsSpider()).addUrl("http://www.cnblogs.com/justcooooode/")

.addPipeline(new ConsolePipeline()).run();

}

}

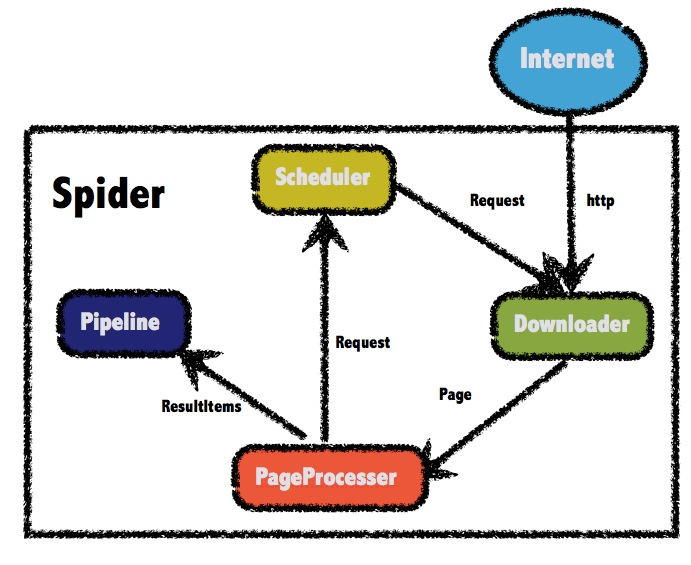

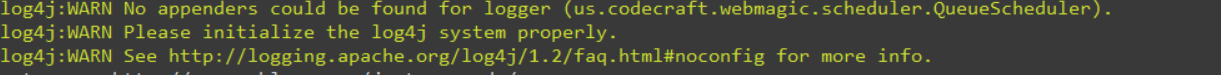

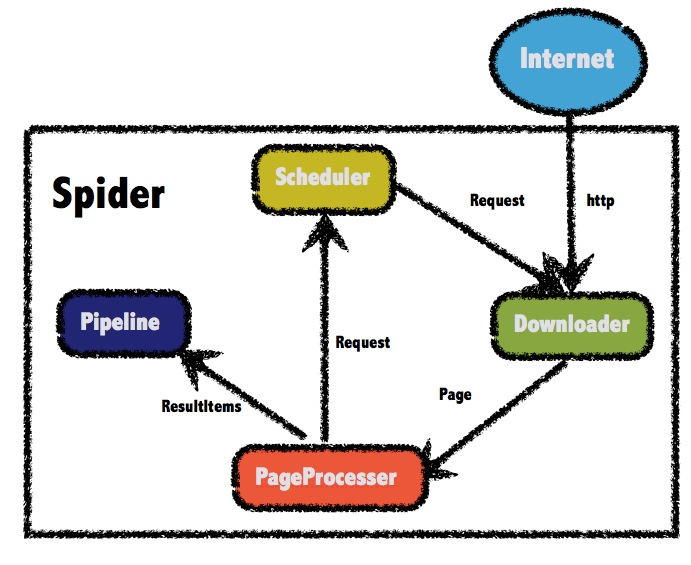

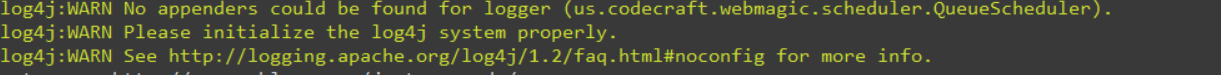

输出结果:

如果你和我一样,之前没有使用过 log4j,可能会出现以下警告:

这是因为没有配置文件。在资源目录下新建一个log4j.properties文件,粘贴如下配置信息。

目录可以定义为您自己的文件夹。

# 全局日志级别设定 ,file

log4j.rootLogger=INFO, stdout, file

# 自定义包路径LOG级别

log4j.logger.org.quartz=WARN, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d{MM-dd HH:mm:ss}[%p]%m%n

# Output to the File

log4j.appender.file=org.apache.log4j.FileAppender

log4j.appender.file.File=D:\\MyEclipse2017Workspaces\\webmagic\\webmagic.log

log4j.appender.file.layout=org.apache.log4j.PatternLayout

log4j.appender.file.layout.ConversionPattern=%n%-d{MM-dd HH:mm:ss}-%C.%M()%n[%p]%m%n

立即尝试,没有警告?

爬取列表类 网站 示例

列表爬取的思路很相似。首先判断是否为列表页。如果是这样,请将 文章url 添加到爬取队列中。如果不是,则说明此时是一个文章页面,直接爬取你想要的。内容可以。

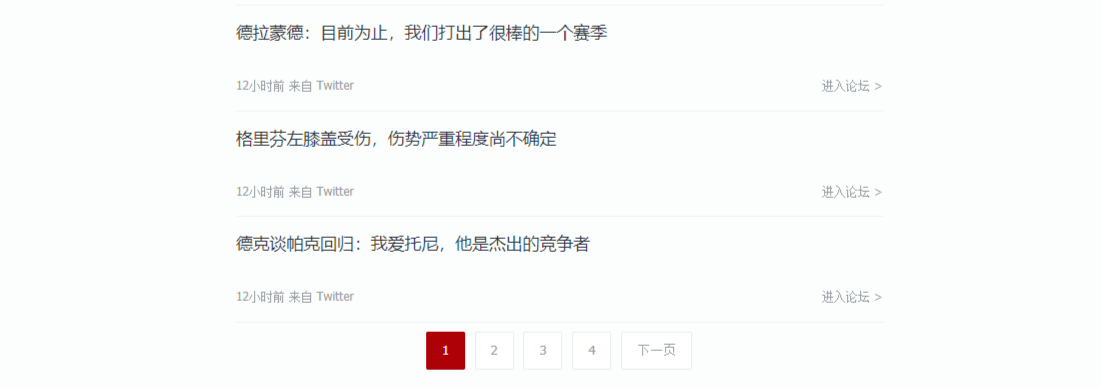

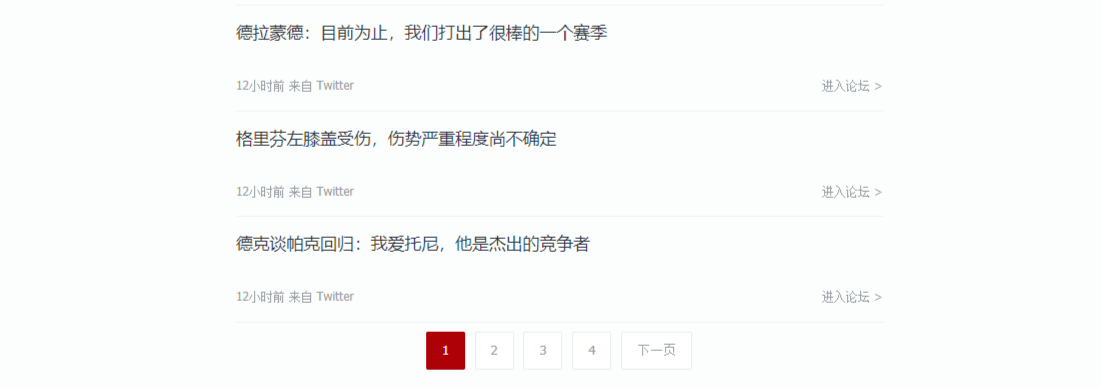

选择列表类 文章 的 网站:

首先判断是文章还是列表。查看几页后,您可以找到规则并使用正则表达式来区分它们。

page.getUrl().regex("https://voice\\.hupu\\.com/nba/[0-9]{7}\\.html").match()

如果满足上述正则表达式,则url对应一个文章页面。

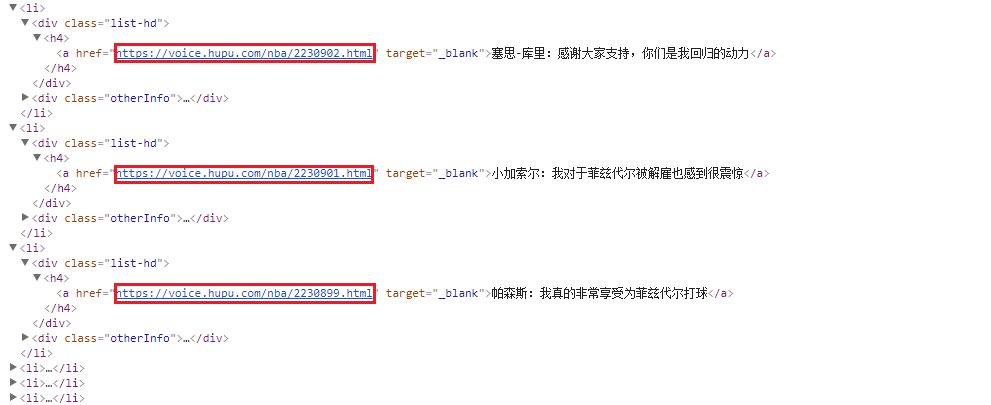

接下来提取需要爬取的内容,我选择了xPath(浏览器直接粘贴即可)。

WebMagic框架支持多种提取方式,包括xPath、css选择器、正则表达式,所有的链接都可以通过links()方法来选择。

提取前记得通过getHtml()获取html对象,通过html对象使用提取方法。

ps:WebMagic 似乎不支持 xPath 中的 last() 方法。如果您使用它,您可以考虑其他方法。

然后使用 page.putFiled(String key, Object field) 方法将你想要的内容放入一个键值对中。

page.putField("Title", page.getHtml().xpath("/html/body/div[4]/div[1]/div[1]/h1/text()").toString());

page.putField("Content", page.getHtml().xpath("/html/body/div[4]/div[1]/div[2]/div/div[2]/p/text()").all().toString());

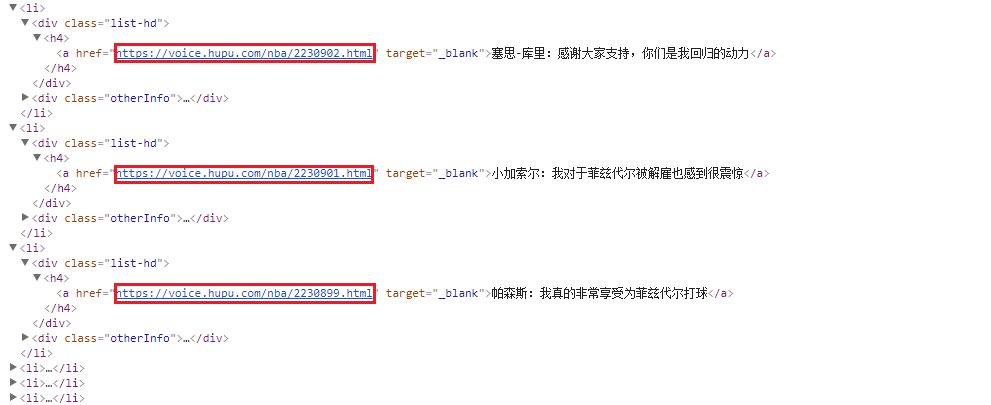

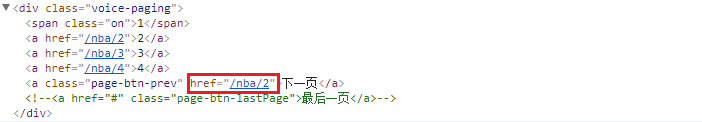

如果文章页面的规律性不满足,说明这是一个列表页面,页面中文章的url应该是通过xPath定位的。

page.getHtml().xpath("/html/body/div[3]/div[1]/div[2]/ul/li/div[1]/h4/a/@href").all();

至此,你已经得到了要爬取的url列表,你可以通过addTargetRequests方法将它们添加到队列中。

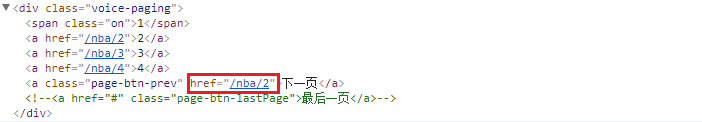

最后实现翻页。同样,WebMagic 会自动加入到爬取队列中。

page.getHtml().xpath("/html/body/div[3]/div[1]/div[3]/a[@class='page-btn-prev']/@href").all()

以下是完整的代码。我实现了一个MysqlPipeline类,使用Mybatis将爬取的数据直接持久化到数据库中。

您还可以使用内置的 ConsolePipeline 或 FilePipeline。

package edu.heu.spider;

import java.io.IOException;

import java.io.InputStream;

import java.util.Iterator;

import java.util.Map;

import java.util.Map.Entry;

import org.apache.ibatis.io.Resources;

import org.apache.ibatis.session.SqlSession;

import org.apache.ibatis.session.SqlSessionFactory;

import org.apache.ibatis.session.SqlSessionFactoryBuilder;

import edu.heu.domain.News;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.ResultItems;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.Spider;

import us.codecraft.webmagic.Task;

import us.codecraft.webmagic.pipeline.Pipeline;

import us.codecraft.webmagic.processor.PageProcessor;

/**

* @ClassName: HupuNewsSpider

* @author LJH

* @date 2017年11月27日 下午4:54:48

*/

public class HupuNewsSpider implements PageProcessor {

// 抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site.me().setRetryTimes(3).setSleepTime(100);

public Site getSite() {

return site;

}

public void process(Page page) {

// 文章页,匹配 https://voice.hupu.com/nba/七位数字.html

if (page.getUrl().regex("https://voice\\.hupu\\.com/nba/[0-9]{7}\\.html").match()) {

page.putField("Title", page.getHtml().xpath("/html/body/div[4]/div[1]/div[1]/h1/text()").toString());

page.putField("Content",

page.getHtml().xpath("/html/body/div[4]/div[1]/div[2]/div/div[2]/p/text()").all().toString());

}

// 列表页

else {

// 文章url

page.addTargetRequests(

page.getHtml().xpath("/html/body/div[3]/div[1]/div[2]/ul/li/div[1]/h4/a/@href").all());

// 翻页url

page.addTargetRequests(

page.getHtml().xpath("/html/body/div[3]/div[1]/div[3]/a[@class='page-btn-prev']/@href").all());

}

}<br />public static void main(String[] args) {

Spider.create(new HupuNewsSpider()).addUrl("https://voice.hupu.com/nba/1").addPipeline(new MysqlPipeline())

.thread(3).run();

}

}

// 自定义实现Pipeline接口

class MysqlPipeline implements Pipeline {

public MysqlPipeline() {

}

public void process(ResultItems resultitems, Task task) {

Map mapResults = resultitems.getAll();

Iterator iter = mapResults.entrySet().iterator();

Map.Entry entry;

// 输出到控制台

while (iter.hasNext()) {

entry = iter.next();

System.out.println(entry.getKey() + ":" + entry.getValue());

}

// 持久化

News news = new News();

if (!mapResults.get("Title").equals("")) {

news.setTitle((String) mapResults.get("Title"));

news.setContent((String) mapResults.get("Content"));

}

try {

InputStream is = Resources.getResourceAsStream("conf.xml");

SqlSessionFactory sessionFactory = new SqlSessionFactoryBuilder().build(is);

SqlSession session = sessionFactory.openSession();

session.insert("add", news);

session.commit();

session.close();

} catch (IOException e) {

e.printStackTrace();

}

}