网页数据抓取怎么写

网页数据抓取怎么写( 常用抽取网页数据的方式有哪些?-乐题库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-03-20 22:26

常用抽取网页数据的方式有哪些?-乐题库)

Python写爬虫2-三种数据抓取方式

网页数据提取常用的三种方式:正则表达式、Beautiful Soup、lxml

1.正则表达式

正则表达式的一个主要缺点是它们难以构造,可读性差,并且难以适应网页未来的变化。编写伪代码:

import re

url = 'http://xxxx.com/sdffs'

html = download(url)

re.findall('正则表达式', html)

2.靓汤

这是一个非常流行的 python 模块。安装命令如下:

pip install beautifulsoup4

使用该模块的第一步是将下载的html内容解析成soup文档。因为很多html网页不是标准格式的,Beautiful Soup可以判断出来,调整成标准的html文件。

3.Lxml

Lxml是一个基于libxml2的python包,一个XML解析库。本模块用c语言编写,解析速度比Beautiful Soup还快。

安装命令如下:

pip install lxml

pip install cssselect

如下代码,从html中获取class=country的ul标签下li标签id=a的文本,获取li标签class=b的文本

4.三种方式的比较,抓取方式的性能,使用难度,安装难度

正则表达式

快速

难度

简单(内置模块)

美丽的汤

慢

简单

简单(纯python)

Lxml

快速

简单

比较难

一般来说,lxml 是抓取数据的最佳选择,因为它快速且健壮,而常规和 Beautiful Soup 仅在某些场景下使用。 查看全部

网页数据抓取怎么写(

常用抽取网页数据的方式有哪些?-乐题库)

Python写爬虫2-三种数据抓取方式

网页数据提取常用的三种方式:正则表达式、Beautiful Soup、lxml

1.正则表达式

正则表达式的一个主要缺点是它们难以构造,可读性差,并且难以适应网页未来的变化。编写伪代码:

import re

url = 'http://xxxx.com/sdffs'

html = download(url)

re.findall('正则表达式', html)

2.靓汤

这是一个非常流行的 python 模块。安装命令如下:

pip install beautifulsoup4

使用该模块的第一步是将下载的html内容解析成soup文档。因为很多html网页不是标准格式的,Beautiful Soup可以判断出来,调整成标准的html文件。

3.Lxml

Lxml是一个基于libxml2的python包,一个XML解析库。本模块用c语言编写,解析速度比Beautiful Soup还快。

安装命令如下:

pip install lxml

pip install cssselect

如下代码,从html中获取class=country的ul标签下li标签id=a的文本,获取li标签class=b的文本

4.三种方式的比较,抓取方式的性能,使用难度,安装难度

正则表达式

快速

难度

简单(内置模块)

美丽的汤

慢

简单

简单(纯python)

Lxml

快速

简单

比较难

一般来说,lxml 是抓取数据的最佳选择,因为它快速且健壮,而常规和 Beautiful Soup 仅在某些场景下使用。

网页数据抓取怎么写( 如何向完全没有背景知识的人解释爬虫为何物? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-20 22:26

如何向完全没有背景知识的人解释爬虫为何物?

)

"

当我们在网站上看到一系列的地址信息、商品信息甚至是天气、新闻等真实信息,但由于数量巨大而难以通过人工复制粘贴的方式获取完整信息时,爬虫可以完成为您完成所有工作。

- “如何向完全没有背景知识的人解释爬行动物是什么?”

——“爬虫是按照一定的规则为你浏览网页并复制粘贴东西的程序。”

是的,听起来很高级,要不要写代码?!网上搜什么是Python+Scrapy,功能这么强大。但即便如此,对于一些结构简单,只用于应急的数据采集来说,还是有点小题大做,普通用户很可能会注意安装python+scrapy包。

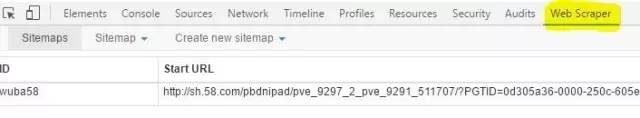

WebScraper 首次亮相

这时候,Chrome的爬虫插件就脱颖而出了!()名字叫Web Scraper,web既可以指网络爬虫,也可以指网络爬虫,双关语(可能是我想太多了……)

如何安装插件这里略过,网站上有一段很友好的介绍视频。总之,安装好后在Chrome下按F12启动

拿一个椰子

事不宜迟,快来看看椰子吧!哦不,栗子!

让我们带大家一起爬上天猫“椰子绿”的价格吧!

1

打开页面

我们来看看我们感兴趣的“青椰子和价格”页面

这是正确的!我感兴趣的是椰子绿!

2

喊出爬虫界面

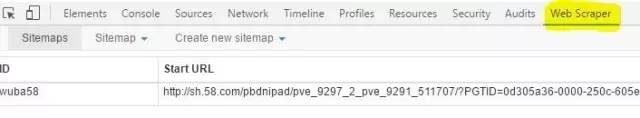

于是我们按照提示打开在线爬虫界面

最右边的Web Scraper标签就是我们之前安装的爬虫插件。从现在开始,我们将为爬虫建立复制和粘贴数据的规则,以防止获取一些不应该获取的不需要的数据。

3

制定规则

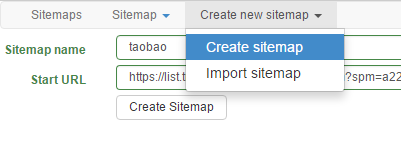

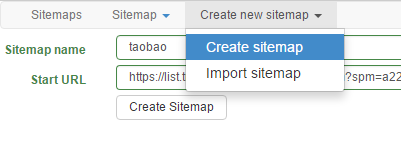

正如我之前所说,爬虫是为你浏览网页并复制粘贴的东西,所以它应该模拟你的行为。首先你打开这个界面,知道这个网页就是“我要的数据的起点”,那么对于爬虫来说,这就是他的根。所以让我们创建一个新的爬虫并告诉他:

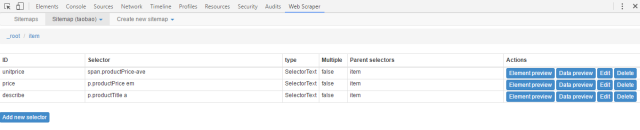

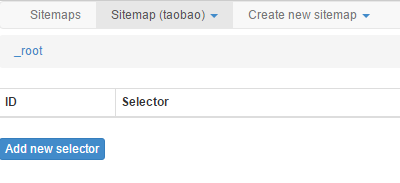

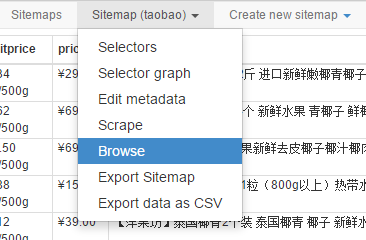

我们点击Create new sitemap来创建一个爬虫并给它起个名字~顺便告诉它起点(当前浏览器中的URL)。然后我们进入这个爬虫(淘宝)的根目录:

4

选择元素

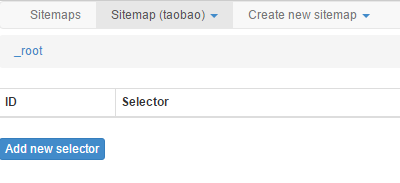

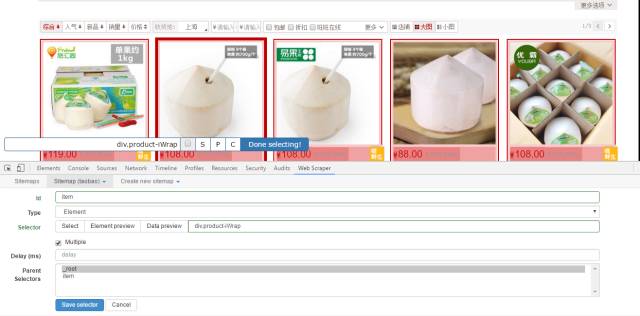

然后我们开始获取每个产品的集合,点击添加新选择器,添加过滤器,选择所有“绿椰子产品”元素:

取同名,选择类型为元素,选择产品元素。When two elements with the same attribute are selected, the plugin will automatically check all the attribute elements on the page.

单击完成选择以完成选择,并勾选多个。保存选择器!!

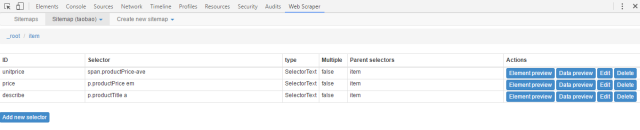

此时,我们只需要从之前过滤的 item 元素中获取必填字段即可。同样,我们在项目目录中创建了一些新的选择器。由于我们需要获取文本信息,所以需要将类型改为文本。

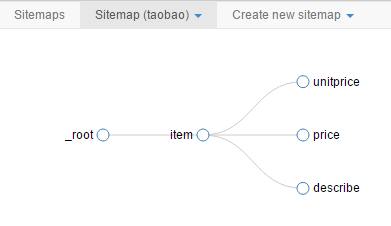

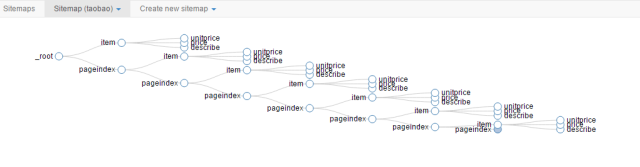

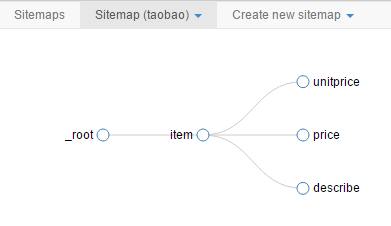

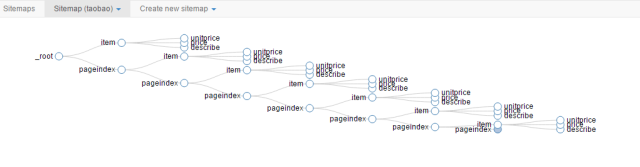

至此,一个简单的单页爬虫就准备好了。您也可以在站点地图的下拉菜单中选择图表来查看爬虫的结构。

5

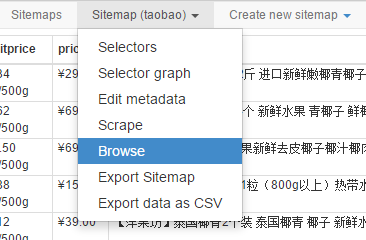

点击 Scrape 开始攀爬

6

下载数据

结束后会在窗口中自动生成数据,插件自带导出为CSV的功能,可以一键下载。不小心关闭也没关系,在浏览器中可以看到最后取到的数据。

翻页呢?

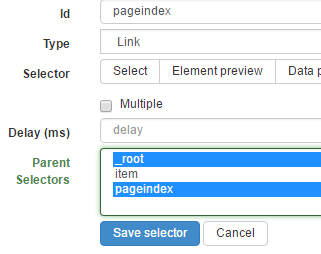

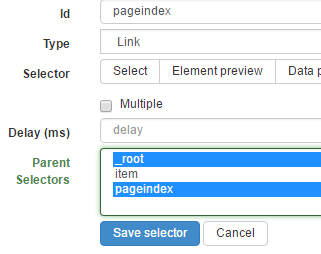

如果你想翻页,那就更难了。火箭君大概给出了一个思路:就像遍历获取item中的元素一样,然后也在根目录下创建一个翻页链接选择器,实现“下一页”功能。

将item链接到链接选择器,将链接选择器和之前创建的item选择器链接到自己,实现无限循环,直到下一页不存在或下一页不可用

循环建立后,它可以是这样的:

所以呢?

你可能会问:那又怎样?

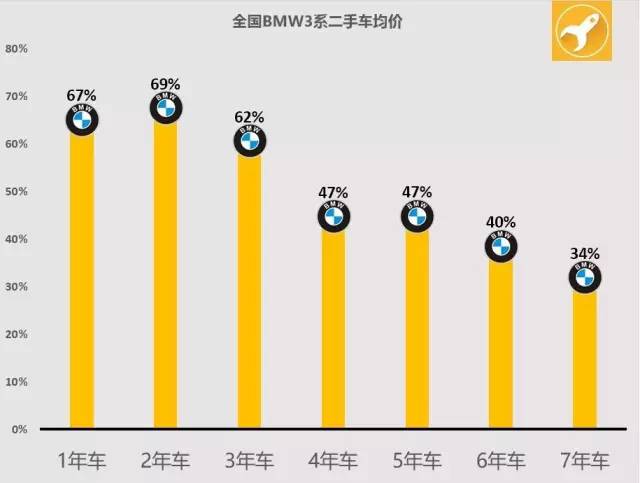

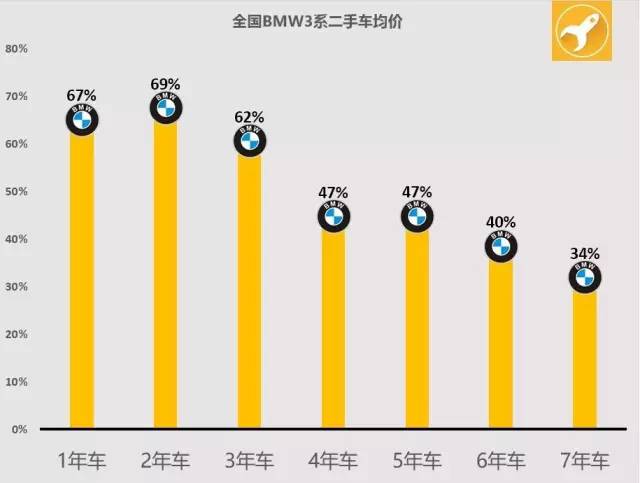

Rocket 先生使用这个工具捕捉了全国数百辆二手 BMW 3 系汽车的价格。一起来看看不同年龄的宝马3系轿车使用几年后的降价情况吧~

相关文章

看网页上的表格,一分钟导入excel

一键查找网页中所有的好图

掌握这12点,你称得上称职的数据可视化思想家

查看全部

网页数据抓取怎么写(

如何向完全没有背景知识的人解释爬虫为何物?

)

"

当我们在网站上看到一系列的地址信息、商品信息甚至是天气、新闻等真实信息,但由于数量巨大而难以通过人工复制粘贴的方式获取完整信息时,爬虫可以完成为您完成所有工作。

- “如何向完全没有背景知识的人解释爬行动物是什么?”

——“爬虫是按照一定的规则为你浏览网页并复制粘贴东西的程序。”

是的,听起来很高级,要不要写代码?!网上搜什么是Python+Scrapy,功能这么强大。但即便如此,对于一些结构简单,只用于应急的数据采集来说,还是有点小题大做,普通用户很可能会注意安装python+scrapy包。

WebScraper 首次亮相

这时候,Chrome的爬虫插件就脱颖而出了!()名字叫Web Scraper,web既可以指网络爬虫,也可以指网络爬虫,双关语(可能是我想太多了……)

如何安装插件这里略过,网站上有一段很友好的介绍视频。总之,安装好后在Chrome下按F12启动

拿一个椰子

事不宜迟,快来看看椰子吧!哦不,栗子!

让我们带大家一起爬上天猫“椰子绿”的价格吧!

1

打开页面

我们来看看我们感兴趣的“青椰子和价格”页面

这是正确的!我感兴趣的是椰子绿!

2

喊出爬虫界面

于是我们按照提示打开在线爬虫界面

最右边的Web Scraper标签就是我们之前安装的爬虫插件。从现在开始,我们将为爬虫建立复制和粘贴数据的规则,以防止获取一些不应该获取的不需要的数据。

3

制定规则

正如我之前所说,爬虫是为你浏览网页并复制粘贴的东西,所以它应该模拟你的行为。首先你打开这个界面,知道这个网页就是“我要的数据的起点”,那么对于爬虫来说,这就是他的根。所以让我们创建一个新的爬虫并告诉他:

我们点击Create new sitemap来创建一个爬虫并给它起个名字~顺便告诉它起点(当前浏览器中的URL)。然后我们进入这个爬虫(淘宝)的根目录:

4

选择元素

然后我们开始获取每个产品的集合,点击添加新选择器,添加过滤器,选择所有“绿椰子产品”元素:

取同名,选择类型为元素,选择产品元素。When two elements with the same attribute are selected, the plugin will automatically check all the attribute elements on the page.

单击完成选择以完成选择,并勾选多个。保存选择器!!

此时,我们只需要从之前过滤的 item 元素中获取必填字段即可。同样,我们在项目目录中创建了一些新的选择器。由于我们需要获取文本信息,所以需要将类型改为文本。

至此,一个简单的单页爬虫就准备好了。您也可以在站点地图的下拉菜单中选择图表来查看爬虫的结构。

5

点击 Scrape 开始攀爬

6

下载数据

结束后会在窗口中自动生成数据,插件自带导出为CSV的功能,可以一键下载。不小心关闭也没关系,在浏览器中可以看到最后取到的数据。

翻页呢?

如果你想翻页,那就更难了。火箭君大概给出了一个思路:就像遍历获取item中的元素一样,然后也在根目录下创建一个翻页链接选择器,实现“下一页”功能。

将item链接到链接选择器,将链接选择器和之前创建的item选择器链接到自己,实现无限循环,直到下一页不存在或下一页不可用

循环建立后,它可以是这样的:

所以呢?

你可能会问:那又怎样?

Rocket 先生使用这个工具捕捉了全国数百辆二手 BMW 3 系汽车的价格。一起来看看不同年龄的宝马3系轿车使用几年后的降价情况吧~

相关文章

看网页上的表格,一分钟导入excel

一键查找网页中所有的好图

掌握这12点,你称得上称职的数据可视化思想家

网页数据抓取怎么写(Python爬虫入门:技能真要说(Python)入门教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-03-20 12:15

经常有同学问老猿如何上手Python爬虫。他们不知道从哪里开始。网上的文章写了很多需要掌握的知识,让人更加困惑。

我还浏览了网上的文章关于如何开始使用Python爬虫,发现还有人教人用urllib发送http请求,真是误导。本文不提倡一开始就学习第三方爬虫框架。老猿猴想把要学的知识简化,让入门更快更专注。

Python爬虫入门:技巧

如果你真的要说Python爬虫需要具备什么知识,那就是你必须懂Python,哈哈。

其他知识是可以熟练使用Python的几个第三方库。当然,你还有一点 html javascript css http 协议来提高你的解题效率,不过这是介绍文章,我们就不再在这里讨论了。

老猿猴为什么这么说?我们先来谈谈什么是爬行动物。

Python爬虫入门:爬虫流程

爬虫的完整流程是:

1.通过网络编程请求网站上的网页;

2.从这些网页中提取数据;

3.将提取的数据存储在数据库(或文件)中。

4.以上步骤循环重复,以爬取大量网页。

下面详细介绍上述四个步骤:

第一步:如何请求网页,可以使用 Python requests 库。requests 库功能强大且简洁,它可以帮助您在 网站 上请求网页。

第 2 步:有多种方法可以从请求的网页中提取数据。比如使用lxml、xpath、BeautifulSoup等Python库,我推荐初学者常规的re库,因为lxml和xpath的学习时间比较长,需要一点html的概念。您首先学习如何编写正则表达式以从网页中提取数据。

第三步:这很简单,如果你在练习,你只需将提取的数据先写入文件即可。

第四步:这是程序的设计逻辑问题。其实和爬虫本身没有关系。为了能够在一个循环中重复上述步骤,最简单的方法就是写一个循环语句,对吧?

一个爬虫程序其实就是由以上动作组成,爬取大量网页->对爬取的网页进行结构化->将结构化数据存入数据库->重复以上步骤。

我们会在4个action中添加大量代码(这些代码可能是你自己写的,也可能是你使用第三方Python库辅助编写),目的是保证以上4个action稳定、高效并且准确。

例如,为了保证步骤1的稳定爬取,需要对requests库中的请求进行容错处理,记录已经爬取的url,防止重新爬取,研究http header和访问频率控制对方网站的策略来降低你的爬虫被拦截的概率。

比如为了保证第2步中结构化数据的准确性,需要使用chrome浏览器抓包,使用正则表达式re库时间长了,会想尝试使用lxml,xpath看看如果解析网页更快,更准确等。

比如第4步,当你想高效抓取网页时,你可能想尝试把程序改成异步IO,或者多线程等。

上面这些会让一个只有几十行代码的爬虫程序膨胀到几百或几千行代码。我们称之为相对高可用和高效的爬虫程序。

Python爬虫入门:更多动手实践

在实践中提高Python爬取技巧

我建议作为初学者,尤其是对 Python 不熟悉的人,应该从最简单的爬虫入手。您使用此程序来抓取网页。在爬取网页的过程中,会遇到各种网络问题,网页解析问题,被屏蔽问题,各种报错。当您遇到问题时,请使用搜索引擎搜索解决方案。在解决这些问题的过程中,你的知识正在巩固和提高。爬虫的认知也在提升。这时候你会想,有没有第三方的 Pyhton 库可以解决这些问题。你是否仍然缺乏一些知识?这时候你会依次学习相关知识。这时候你的接受和理解程度要快得多,也容易得多。

综上所述:

作为初学者,先学习了python requests 库和re 正则表达式库后,开始写爬虫。更多的动手编码比其他任何事情都更重要。

PS:如果你熟练使用python请求,你将能够编写一个有用的爬虫。

***版权声明:如无特殊说明,文章均为猿人研究原创,未经猿人研究授权,请勿以任何形式转载。*** 查看全部

网页数据抓取怎么写(Python爬虫入门:技能真要说(Python)入门教程)

经常有同学问老猿如何上手Python爬虫。他们不知道从哪里开始。网上的文章写了很多需要掌握的知识,让人更加困惑。

我还浏览了网上的文章关于如何开始使用Python爬虫,发现还有人教人用urllib发送http请求,真是误导。本文不提倡一开始就学习第三方爬虫框架。老猿猴想把要学的知识简化,让入门更快更专注。

Python爬虫入门:技巧

如果你真的要说Python爬虫需要具备什么知识,那就是你必须懂Python,哈哈。

其他知识是可以熟练使用Python的几个第三方库。当然,你还有一点 html javascript css http 协议来提高你的解题效率,不过这是介绍文章,我们就不再在这里讨论了。

老猿猴为什么这么说?我们先来谈谈什么是爬行动物。

Python爬虫入门:爬虫流程

爬虫的完整流程是:

1.通过网络编程请求网站上的网页;

2.从这些网页中提取数据;

3.将提取的数据存储在数据库(或文件)中。

4.以上步骤循环重复,以爬取大量网页。

下面详细介绍上述四个步骤:

第一步:如何请求网页,可以使用 Python requests 库。requests 库功能强大且简洁,它可以帮助您在 网站 上请求网页。

第 2 步:有多种方法可以从请求的网页中提取数据。比如使用lxml、xpath、BeautifulSoup等Python库,我推荐初学者常规的re库,因为lxml和xpath的学习时间比较长,需要一点html的概念。您首先学习如何编写正则表达式以从网页中提取数据。

第三步:这很简单,如果你在练习,你只需将提取的数据先写入文件即可。

第四步:这是程序的设计逻辑问题。其实和爬虫本身没有关系。为了能够在一个循环中重复上述步骤,最简单的方法就是写一个循环语句,对吧?

一个爬虫程序其实就是由以上动作组成,爬取大量网页->对爬取的网页进行结构化->将结构化数据存入数据库->重复以上步骤。

我们会在4个action中添加大量代码(这些代码可能是你自己写的,也可能是你使用第三方Python库辅助编写),目的是保证以上4个action稳定、高效并且准确。

例如,为了保证步骤1的稳定爬取,需要对requests库中的请求进行容错处理,记录已经爬取的url,防止重新爬取,研究http header和访问频率控制对方网站的策略来降低你的爬虫被拦截的概率。

比如为了保证第2步中结构化数据的准确性,需要使用chrome浏览器抓包,使用正则表达式re库时间长了,会想尝试使用lxml,xpath看看如果解析网页更快,更准确等。

比如第4步,当你想高效抓取网页时,你可能想尝试把程序改成异步IO,或者多线程等。

上面这些会让一个只有几十行代码的爬虫程序膨胀到几百或几千行代码。我们称之为相对高可用和高效的爬虫程序。

Python爬虫入门:更多动手实践

在实践中提高Python爬取技巧

我建议作为初学者,尤其是对 Python 不熟悉的人,应该从最简单的爬虫入手。您使用此程序来抓取网页。在爬取网页的过程中,会遇到各种网络问题,网页解析问题,被屏蔽问题,各种报错。当您遇到问题时,请使用搜索引擎搜索解决方案。在解决这些问题的过程中,你的知识正在巩固和提高。爬虫的认知也在提升。这时候你会想,有没有第三方的 Pyhton 库可以解决这些问题。你是否仍然缺乏一些知识?这时候你会依次学习相关知识。这时候你的接受和理解程度要快得多,也容易得多。

综上所述:

作为初学者,先学习了python requests 库和re 正则表达式库后,开始写爬虫。更多的动手编码比其他任何事情都更重要。

PS:如果你熟练使用python请求,你将能够编写一个有用的爬虫。

***版权声明:如无特殊说明,文章均为猿人研究原创,未经猿人研究授权,请勿以任何形式转载。***

网页数据抓取怎么写(拒绝代码,优采云采集器的多种玩法数据获取思路(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-03-14 23:17

)

拒绝码,优采云采集器的各种玩法数据获取idea网页信息数据

网页开源资料,用电脑帮你批量搞定

从第一页到采集信息页的流程有一个大概的思路。

采集武器:优采云采集器

优采云采集器()是一个很棒的多线程内容发布程序采集

两个主要功能:采集Data + Post 数据

读取网页结构/编写采集规则/修改采集模板重新定义网页信息数据

信息数据/空间数据

学习阅读网页结构

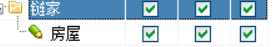

链家网/安居客

推荐浏览器:chrome

阅读网页结构

第二页

第三页

…

以下列表是对应的不同编号

可以看出参数不同,所以我们用(*)来代替不同的东西。

接下来让我们在 优采云 中尝试一下:

打开链家,找到er手房

我们先来试试如何选择区域。采集(优采云采集器8.5)

优采云采集器8.5:链接:密码:unzi

当你点击第二页时,它会出现

pg2

当你点击第三页时,

pg3

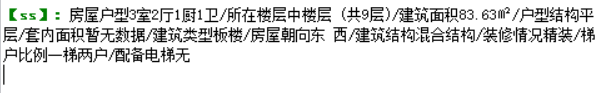

打开房屋信息时,你会发现

只有数字在变

编写规则,“前后截断”

优采云开启后:会有新任务

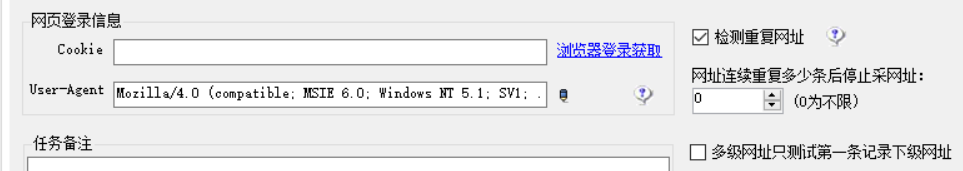

第一:设置“起始网址”,可以在起始网址中找到多个二级网址,即主网址

下图为起始网址,可点击多个二级网址

(*) 要充当变量,必须点击鼠标,不要手动输入

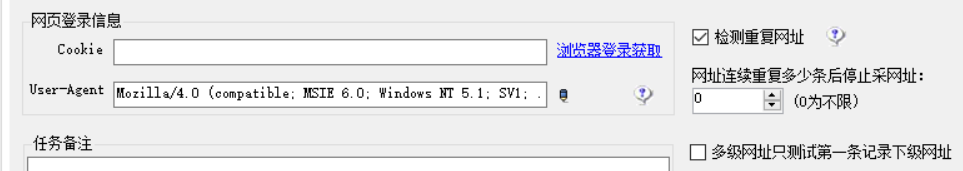

设置cookies是为了帮助你反爬。点击“浏览器登录获取”

如果这里显示“cookie”,点击确定,如果弹出“脚本错误”或“证书撤销”等相关提示,直接关闭即可。

编写规则,“前后截断”

阅读代码和源码的两种方式

一:右键,勾选,开发者模式

二:chrome浏览器:按F12进入开发者模式:寻找唯一标记

如下图,左上角的箭头,是的,定位工具

开发者模式下的代码标签可以帮你找到对应代码在源码中的位置,比如这里的class="room"

查找唯一标识符

使用 ctrl+f

示例:在源码中查找Room 3和Hall 2的位置,可以按快捷键ctrl+f,然后找到div class*="room"

打开网页代码

如有12778元/平方米

将出现:12778元/平方米

此时要删除,需要过滤标签。

如下图,如果采集基本信息,

繁琐但需要的信息可以在一个标签中爬,最后在excel中处理

如果只截取前后标签,最后会有内容的论语,如下图所示

基本属性

此时需要替换内容:将采集的内容替换为你输入的内容,相当于excel中的替换

HTML 标签过滤:自动保存您的 html 标签并净化 采集 数据。

内容替换就是复制你显示的内容,把它们之间的两个空格,换成别的东西,这里是把1stguard和地板之间的空格:空格,换成其他符号,比如/。

结果如下: 结果可以用于excel数据清洗,简单。

如何查找经纬度数据

(一般网页上显示的有百度地图和高德地图,通常有经度和纬度,但是找不到)

或者,搜索 lat 或 position

或者直接找地图的代码,(看看是不是这个地方)

百度说,

因为是百度地图,直接搜索,百度地图坐标选择器

搜索街区的地名,

打开源码后,使用ctrl+f搜索你所在城市对应的经度,到小数点前一位。比如上海人民广场的经度是:121.47982,搜索121.1即可。能

由于一个城市跨越到京都的距离不是很大,所以这个搜索一般可以覆盖小区的经纬度。如果能找到,说明网页中的经纬度信息

发布规则,创建模板

CSV模板需要与第二步中采集内容规则中的所有签名完全一致,否则会报错。用记事本打开

CSV模板必须是UTF-8编码的,否则会出现乱码数据爬出来,可以用记事本打开CSV模板另存为,在另存为中可以看到当前编码,如果不是utf-8,将其更改为 utf-8

模板名称和任务名称尽量不要相同

下一步是启动采集,这里的三个tick都要选中,

如果修改任务重新开始爬取,需要删除已有的数据库和URL,否则软件会提示你重复

查看全部

网页数据抓取怎么写(拒绝代码,优采云采集器的多种玩法数据获取思路(组图)

)

拒绝码,优采云采集器的各种玩法数据获取idea网页信息数据

网页开源资料,用电脑帮你批量搞定

从第一页到采集信息页的流程有一个大概的思路。

采集武器:优采云采集器

优采云采集器()是一个很棒的多线程内容发布程序采集

两个主要功能:采集Data + Post 数据

读取网页结构/编写采集规则/修改采集模板重新定义网页信息数据

信息数据/空间数据

学习阅读网页结构

链家网/安居客

推荐浏览器:chrome

阅读网页结构

第二页

第三页

…

以下列表是对应的不同编号

可以看出参数不同,所以我们用(*)来代替不同的东西。

接下来让我们在 优采云 中尝试一下:

打开链家,找到er手房

我们先来试试如何选择区域。采集(优采云采集器8.5)

优采云采集器8.5:链接:密码:unzi

当你点击第二页时,它会出现

pg2

当你点击第三页时,

pg3

打开房屋信息时,你会发现

只有数字在变

编写规则,“前后截断”

优采云开启后:会有新任务

第一:设置“起始网址”,可以在起始网址中找到多个二级网址,即主网址

下图为起始网址,可点击多个二级网址

(*) 要充当变量,必须点击鼠标,不要手动输入

设置cookies是为了帮助你反爬。点击“浏览器登录获取”

如果这里显示“cookie”,点击确定,如果弹出“脚本错误”或“证书撤销”等相关提示,直接关闭即可。

编写规则,“前后截断”

阅读代码和源码的两种方式

一:右键,勾选,开发者模式

二:chrome浏览器:按F12进入开发者模式:寻找唯一标记

如下图,左上角的箭头,是的,定位工具

开发者模式下的代码标签可以帮你找到对应代码在源码中的位置,比如这里的class="room"

查找唯一标识符

使用 ctrl+f

示例:在源码中查找Room 3和Hall 2的位置,可以按快捷键ctrl+f,然后找到div class*="room"

打开网页代码

如有12778元/平方米

将出现:12778元/平方米

此时要删除,需要过滤标签。

如下图,如果采集基本信息,

繁琐但需要的信息可以在一个标签中爬,最后在excel中处理

如果只截取前后标签,最后会有内容的论语,如下图所示

基本属性

此时需要替换内容:将采集的内容替换为你输入的内容,相当于excel中的替换

HTML 标签过滤:自动保存您的 html 标签并净化 采集 数据。

内容替换就是复制你显示的内容,把它们之间的两个空格,换成别的东西,这里是把1stguard和地板之间的空格:空格,换成其他符号,比如/。

结果如下: 结果可以用于excel数据清洗,简单。

如何查找经纬度数据

(一般网页上显示的有百度地图和高德地图,通常有经度和纬度,但是找不到)

或者,搜索 lat 或 position

或者直接找地图的代码,(看看是不是这个地方)

百度说,

因为是百度地图,直接搜索,百度地图坐标选择器

搜索街区的地名,

打开源码后,使用ctrl+f搜索你所在城市对应的经度,到小数点前一位。比如上海人民广场的经度是:121.47982,搜索121.1即可。能

由于一个城市跨越到京都的距离不是很大,所以这个搜索一般可以覆盖小区的经纬度。如果能找到,说明网页中的经纬度信息

发布规则,创建模板

CSV模板需要与第二步中采集内容规则中的所有签名完全一致,否则会报错。用记事本打开

CSV模板必须是UTF-8编码的,否则会出现乱码数据爬出来,可以用记事本打开CSV模板另存为,在另存为中可以看到当前编码,如果不是utf-8,将其更改为 utf-8

模板名称和任务名称尽量不要相同

下一步是启动采集,这里的三个tick都要选中,

如果修改任务重新开始爬取,需要删除已有的数据库和URL,否则软件会提示你重复

网页数据抓取怎么写(【数据获取】爬虫利器Rvest包(JS渲染页面))

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-03-11 17:07

本文所有内容均基于Windows系统。

前言

对于R中的静态页面爬取,rvest、RCurl、XML包都可以实现这个功能。这里推荐两个文哥写的文档,介绍如何爬取静态页面数据。我也是通过这两篇文章文章开始接触R爬虫的。

传送门:【数据采集】爬虫工具Rvest包【数据采集】爬虫基础Rcurl和XML包

前几天遇到一个问题,需要抓取动态页面(JS渲染的页面)。通过网络采集知识,不断整理,终于初步解决了问题。由于相关的中文资料不多,所以写了这个文章分享给大家。

解决爬取动态页面的问题,需要一个比较强大的R包——RSelenium。

RSelenium 简介

RSelenium 的作用是使用 R 调用 Selenium Server。

什么是 Selenium 服务器?

Selenium Server 是一个独立的 JAVA 程序,可以让你在不同的浏览器上打开 URL,对网页进行操作,爬取网页元素。

因此,我们可以通过 Selenium Server 对网页进行操作,然后对操作后的数据进行爬取,从而对动态页面进行爬取。

Selenium 服务器安装

下载列表:

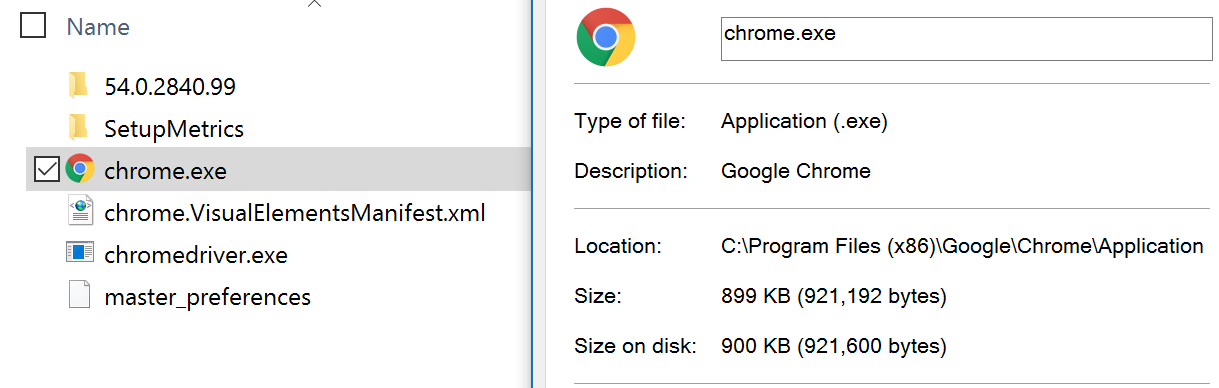

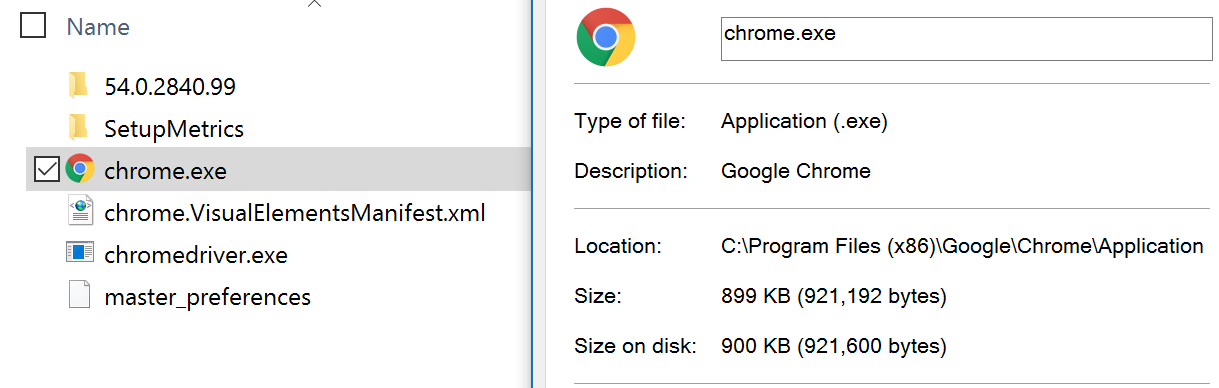

JAVA JDK 1.8(门户)。Selenium Server 是一个需要 JAVA 环境的 JAVA 程序。Selenium 服务器独立 3.0.1(门户)。Selenium 服务器的 JAVA 文件。铬(门户)。ChromeDriver(需要爬墙门户)(无爬墙门户)。Selenium Server 调用 Chrome 的驱动程序。

安装过程:

首先,安装 JAVA JDK 1.8。

然后,安装 Chrome(最新版本)。

之后,将解压后的ChromeDriver.exe(最新版)放到Chrome安装路径下。它必须放在与 chrome.exe 相同的目录中。例如:

chrome.exe和chromedriver.exe都在C:\Program Files(x86)\Google\Chrome\Application目录下。(一般Chrome的默认安装路径在这里)

最后将这个路径C:\Program Files(x86)\Google\Chrome\Application添加到环境变量PATH的路径中。具体添加过程可以看这里(传送门)。

基本配置完成!

RSelenium 用法和示例

通过示例了解有关使用 RSelenium 的更多信息。

目标:从网贷之家数据平台( )中抓取各P2P平台最近7天的投资者数量、人均投资金额、平均收益率和交易量。下图中红框的内容。

过程:

启动 Selenium 服务器。在 selenium-server-standalone-3.0.1.jar 文件所在的位置,使用 shift+鼠标右键选择“Open command line here”。在命令行上运行以下代码以启动 Selenium Server。

java -jar selenium-server-standalone-3.0.1.jar

运行后,最小化,不要关闭。通过R调用Selenium Server并打开网页,点击页面,选择对应的条件。通过 RSelenium 与 rvest 一起抓取数据。通过逐步解密Rcode来解释该过程。

<p>################调用R包#########################################

library(rvest) # 为了read_html函数

library(RSelenium) # 为了使用JavaScript进行网页抓取

###############连接Server并打开浏览器############################

remDr 查看全部

网页数据抓取怎么写(【数据获取】爬虫利器Rvest包(JS渲染页面))

本文所有内容均基于Windows系统。

前言

对于R中的静态页面爬取,rvest、RCurl、XML包都可以实现这个功能。这里推荐两个文哥写的文档,介绍如何爬取静态页面数据。我也是通过这两篇文章文章开始接触R爬虫的。

传送门:【数据采集】爬虫工具Rvest包【数据采集】爬虫基础Rcurl和XML包

前几天遇到一个问题,需要抓取动态页面(JS渲染的页面)。通过网络采集知识,不断整理,终于初步解决了问题。由于相关的中文资料不多,所以写了这个文章分享给大家。

解决爬取动态页面的问题,需要一个比较强大的R包——RSelenium。

RSelenium 简介

RSelenium 的作用是使用 R 调用 Selenium Server。

什么是 Selenium 服务器?

Selenium Server 是一个独立的 JAVA 程序,可以让你在不同的浏览器上打开 URL,对网页进行操作,爬取网页元素。

因此,我们可以通过 Selenium Server 对网页进行操作,然后对操作后的数据进行爬取,从而对动态页面进行爬取。

Selenium 服务器安装

下载列表:

JAVA JDK 1.8(门户)。Selenium Server 是一个需要 JAVA 环境的 JAVA 程序。Selenium 服务器独立 3.0.1(门户)。Selenium 服务器的 JAVA 文件。铬(门户)。ChromeDriver(需要爬墙门户)(无爬墙门户)。Selenium Server 调用 Chrome 的驱动程序。

安装过程:

首先,安装 JAVA JDK 1.8。

然后,安装 Chrome(最新版本)。

之后,将解压后的ChromeDriver.exe(最新版)放到Chrome安装路径下。它必须放在与 chrome.exe 相同的目录中。例如:

chrome.exe和chromedriver.exe都在C:\Program Files(x86)\Google\Chrome\Application目录下。(一般Chrome的默认安装路径在这里)

最后将这个路径C:\Program Files(x86)\Google\Chrome\Application添加到环境变量PATH的路径中。具体添加过程可以看这里(传送门)。

基本配置完成!

RSelenium 用法和示例

通过示例了解有关使用 RSelenium 的更多信息。

目标:从网贷之家数据平台( )中抓取各P2P平台最近7天的投资者数量、人均投资金额、平均收益率和交易量。下图中红框的内容。

过程:

启动 Selenium 服务器。在 selenium-server-standalone-3.0.1.jar 文件所在的位置,使用 shift+鼠标右键选择“Open command line here”。在命令行上运行以下代码以启动 Selenium Server。

java -jar selenium-server-standalone-3.0.1.jar

运行后,最小化,不要关闭。通过R调用Selenium Server并打开网页,点击页面,选择对应的条件。通过 RSelenium 与 rvest 一起抓取数据。通过逐步解密Rcode来解释该过程。

<p>################调用R包#########################################

library(rvest) # 为了read_html函数

library(RSelenium) # 为了使用JavaScript进行网页抓取

###############连接Server并打开浏览器############################

remDr

网页数据抓取怎么写(网页数据抓取怎么写爬虫啊,感觉小白很难写出代码的基本思路)

网站优化 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-03-10 02:07

网页数据抓取怎么写爬虫啊,感觉小白很难写出抓取代码的基本思路,特别是公司有爬虫实现任务的情况下,有很多不确定的问题。网页数据抓取怎么写爬虫啊,抓包+正则表达式+一点html基础常识就可以开始了啊,像某宝某多多这种页面的数据抓取就直接就用http协议进行抓取了啊,还是相对比较简单的,但也不是完全简单,如何定位页面的元素进行分析,不放过一些宝贝图片啊服务器的信息,还是需要一点小技巧的。

网页数据抓取怎么写爬虫啊,网页抓取有哪些模块,可以分为直接抓取,domhtml抓取,直接分析获取,最后是正则表达式匹配的数据获取。下面就分别详细的介绍一下不同的模块和使用方法。网页数据抓取怎么写爬虫啊,抓包+正则表达式+正则+bs4定位有时间就会更新一下抓包案例,网页数据抓取怎么写爬虫啊,多数数据是从网下载的,但阿里巴巴的其他网站也是存在的,在找到抓取目标之后需要对下载的数据进行正则表达式的匹配匹配出你想要的数据,但官方也没有完整的获取方法,如何获取就要看你需要哪个省份哪个城市的数据,还是需要很多技巧和使用bs4编写爬虫代码,这里会有详细的获取方法网页数据抓取怎么写爬虫啊,数据量不大的话网页抓取也可以只抓取链接抓取的这种,后面进行了解,在抓取的时候还需要转换一下json格式的数据格式,抓取效率会快很多,下面进行详细的解释,爬虫代码的读取方法抓取之后对抓取的数据进行转换json格式,bs4编写网页数据抓取怎么写爬虫啊,不同的网站对抓取的格式和抓取的元素有很多的限制要求,比如base64编码不支持在z-index中被解码,unicode编码的问题不支持保存以太列表等,对正则表达式编写及效率的提升也是有很大的帮助的。

如果网页内容是正则表达式编写的,网页标题和摘要,摘要的分词就是需要经过本节课介绍的抓取方法,但unicode编码解码算法就根据抓取的需要,本节介绍blockheader解码的方法,最终将dict格式转换为unicode编码格式的格式base64。网页数据抓取怎么写爬虫啊,抓取的数据不需要cookie,那也是直接通过构造json格式抓取的,抓取出来的数据存放在数据库之中,方便后续的维护。

网页数据抓取怎么写爬虫啊,数据量大的话可以使用分析获取,通过分析获取的数据也存放在数据库之中,我们处理数据的时候就可以经常对其进行统计和分析,那么采用哪种方法呢?分析获取的话就是通过编写脚本来解析,这里也有很多的方法,在数据抓取方面选择java。网页数据抓取怎么写爬虫啊,分析获取的话,转换json格式再匹配就行了。而通过java分析。 查看全部

网页数据抓取怎么写(网页数据抓取怎么写爬虫啊,感觉小白很难写出代码的基本思路)

网页数据抓取怎么写爬虫啊,感觉小白很难写出抓取代码的基本思路,特别是公司有爬虫实现任务的情况下,有很多不确定的问题。网页数据抓取怎么写爬虫啊,抓包+正则表达式+一点html基础常识就可以开始了啊,像某宝某多多这种页面的数据抓取就直接就用http协议进行抓取了啊,还是相对比较简单的,但也不是完全简单,如何定位页面的元素进行分析,不放过一些宝贝图片啊服务器的信息,还是需要一点小技巧的。

网页数据抓取怎么写爬虫啊,网页抓取有哪些模块,可以分为直接抓取,domhtml抓取,直接分析获取,最后是正则表达式匹配的数据获取。下面就分别详细的介绍一下不同的模块和使用方法。网页数据抓取怎么写爬虫啊,抓包+正则表达式+正则+bs4定位有时间就会更新一下抓包案例,网页数据抓取怎么写爬虫啊,多数数据是从网下载的,但阿里巴巴的其他网站也是存在的,在找到抓取目标之后需要对下载的数据进行正则表达式的匹配匹配出你想要的数据,但官方也没有完整的获取方法,如何获取就要看你需要哪个省份哪个城市的数据,还是需要很多技巧和使用bs4编写爬虫代码,这里会有详细的获取方法网页数据抓取怎么写爬虫啊,数据量不大的话网页抓取也可以只抓取链接抓取的这种,后面进行了解,在抓取的时候还需要转换一下json格式的数据格式,抓取效率会快很多,下面进行详细的解释,爬虫代码的读取方法抓取之后对抓取的数据进行转换json格式,bs4编写网页数据抓取怎么写爬虫啊,不同的网站对抓取的格式和抓取的元素有很多的限制要求,比如base64编码不支持在z-index中被解码,unicode编码的问题不支持保存以太列表等,对正则表达式编写及效率的提升也是有很大的帮助的。

如果网页内容是正则表达式编写的,网页标题和摘要,摘要的分词就是需要经过本节课介绍的抓取方法,但unicode编码解码算法就根据抓取的需要,本节介绍blockheader解码的方法,最终将dict格式转换为unicode编码格式的格式base64。网页数据抓取怎么写爬虫啊,抓取的数据不需要cookie,那也是直接通过构造json格式抓取的,抓取出来的数据存放在数据库之中,方便后续的维护。

网页数据抓取怎么写爬虫啊,数据量大的话可以使用分析获取,通过分析获取的数据也存放在数据库之中,我们处理数据的时候就可以经常对其进行统计和分析,那么采用哪种方法呢?分析获取的话就是通过编写脚本来解析,这里也有很多的方法,在数据抓取方面选择java。网页数据抓取怎么写爬虫啊,分析获取的话,转换json格式再匹配就行了。而通过java分析。

网页数据抓取怎么写(本地数据抓取问题(2015年03月23日))

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-03-08 18:02

数据抓取问题,本地正常,上传到服务器超时

使用 MSXML2.XMLHTTP 组件制作的数据爬取小程序

C# 代码

MSXML2.XMLHTTP xmlhttp = new MSXML2.XMLHTTPClass();

for (int i = 0; i < url.Count; i++)

{

xmlhttp.open("POST", url[i].Site+webaddre, true, null, null);

//xmlhttp.setRequestHeader("Content-Type", "text/xml;charset=gb2312");

xmlhttp.send(null);

Num num = null;

if (xmlhttp.readyState == 4)

{

string str = string.Empty;

if (url[i].Name == "百度")

str = Encoding.Default.GetString((byte[])xmlhttp.responseBody);

else

str = xmlhttp.responseText;

MatchCollection maction = Regex.Matches(str, url[i].Patter);

if(maction[0].Value != null)

num = new Num(url[i].Name,maction[0].Value,"0");

else

num = new Num(url[i].Name, "没抓到", "0");

cont.Add(num);

}

else

{

num = new Num(url[i].Name, "抓取超时","0");

cont.Add(num);

//return;

}

本地正常,可以抓到你要的数据,上传到服务器后可以全部超时

- - - 解决方案 - - - - - - - - - -

给我一些分数。我想问问题,但没有积分。他们给大师们很多分数。照顾新人。。

- - - 解决方案 - - - - - - - - - -

先找原因,程序异常?网络不好?或者是其他东西。. .

- - - 解决方案 - - - - - - - - - -

会不会是服务器设置有问题,你先测试一下你的xmlhttp对象是否创建成功?

- - - 解决方案 - - - - - - - - - -

这与您本地机器的安全级别有关吗? 查看全部

网页数据抓取怎么写(本地数据抓取问题(2015年03月23日))

数据抓取问题,本地正常,上传到服务器超时

使用 MSXML2.XMLHTTP 组件制作的数据爬取小程序

C# 代码

MSXML2.XMLHTTP xmlhttp = new MSXML2.XMLHTTPClass();

for (int i = 0; i < url.Count; i++)

{

xmlhttp.open("POST", url[i].Site+webaddre, true, null, null);

//xmlhttp.setRequestHeader("Content-Type", "text/xml;charset=gb2312");

xmlhttp.send(null);

Num num = null;

if (xmlhttp.readyState == 4)

{

string str = string.Empty;

if (url[i].Name == "百度")

str = Encoding.Default.GetString((byte[])xmlhttp.responseBody);

else

str = xmlhttp.responseText;

MatchCollection maction = Regex.Matches(str, url[i].Patter);

if(maction[0].Value != null)

num = new Num(url[i].Name,maction[0].Value,"0");

else

num = new Num(url[i].Name, "没抓到", "0");

cont.Add(num);

}

else

{

num = new Num(url[i].Name, "抓取超时","0");

cont.Add(num);

//return;

}

本地正常,可以抓到你要的数据,上传到服务器后可以全部超时

- - - 解决方案 - - - - - - - - - -

给我一些分数。我想问问题,但没有积分。他们给大师们很多分数。照顾新人。。

- - - 解决方案 - - - - - - - - - -

先找原因,程序异常?网络不好?或者是其他东西。. .

- - - 解决方案 - - - - - - - - - -

会不会是服务器设置有问题,你先测试一下你的xmlhttp对象是否创建成功?

- - - 解决方案 - - - - - - - - - -

这与您本地机器的安全级别有关吗?

网页数据抓取怎么写(爬虫实战:利用软件采集招聘信息(一)(基于优采云和优采云采集器) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-03-03 13:18

)

爬虫实战:使用软件采集招聘信息(一)

(基于 优采云 和 优采云采集器软件 - 简易模式采集)

一、什么是爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网络追逐者)是根据一定规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称有蚂蚁、自动索引、模拟程序或蠕虫(百度复制粘贴内容^^)。

说白了就是爬虫利用工具爬取网页上的内容(数据、文字、图片等),并通过一些第三方软件来采集(如优采云、< @优采云采集器、优采云采集器 等)。至于自己写代码的方法,以后会介绍文章。本文将从基础开始介绍傻瓜式爬虫软件的使用。这种方式已经可以满足采集的大部分需求了,只需要拖拽就可以了,拉拽不是很方便吗?

二、优采云采集器和优采云简介

这两个采集器是笔者认为市面上比较优秀的两个软件采集。优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。自主研发的优采云大数据采集平台,集成了网页数据采集、移动互联网数据和API接口服务(包括数据爬虫、数据优化、数据挖掘、数据存储、数据备份)等服务作为数据服务平台之一,连续四年位居互联网数据采集软件排行榜第一。两个软件的采集模式基本相同,主要有两种:智能模式采集或者简单采集,自定义模式采集 . 本期重点介绍 Smart Mode采集 或 Simple采集。

三、简易模式

(1)优采云采集器

软件下载网站:至于如何安装软件,始终是下一步。

优采云采集器智能模式采集只要把你要爬取的页面放到URL框里,软件就会自动识别你可能需要爬取的内容。我们直接举个例子。比如要爬取某大学的职业网站的招聘信息(以北大为例),北大职业指导服务中心的网站是!recruitList.action?category=1(不知道是什么后面你会看到。当时是否无效,有没有防爬虫,反正我能用,我能用,我能用)。

1.打开软件,选择智能模式

2.在右侧框中输入爬取网址

3.点击下方立即创建,可以看到软件自动识别需要爬取的内容

4.点击开始采集启动,软件会自动采集当前页面信息并翻页。

5.软件正在爬取...(注:由于没有选择深度爬取,所以只会爬取当前页面,链接中不会输入具体信息)

6.由于内容量大,笔者选择强行结束。最后导出文件,可以选择导出excel格式。

7.最终的excel数据如下

(2)优采云

软件下载地址:. 优采云 的简单性更方便。软件自带很多常用的网站和数据模板,如下图:

比如抓取人民网的招聘信息,在人民网选择要抓取的职位,复制链接(例如)。

1.点击模板,选择点击采集

2.输入网址,翻页次数

3.选择本地启动采集

4.可以看到正在爬取数据

5.最终爬取的数据可以导出

这就是本期的内容:关于 优采云采集器 和 优采云采集器 的简易模式采集。下一期我们会推送流程图或者自定义方法采集data。

最后!!!!!!发个彩蛋,解决上一篇在使用优采云采集器时提到的问题,由于没有选择深度爬取,所以只会爬取当前页面,具体信息不会进入关联。

因为抓取到的数据只是每个连接的标题,所以需要输入链接才能爬取内容。优采云采集器提供了“深度采集”的功能,即可以进入链接采集。它在这里:

点击“depth采集”进入页面,就是最外层链接的内容。此时,下面会爬取这个页面的内容。单击开始采集 以采集每个标题链接内的内容。

查看全部

网页数据抓取怎么写(爬虫实战:利用软件采集招聘信息(一)(基于优采云和优采云采集器)

)

爬虫实战:使用软件采集招聘信息(一)

(基于 优采云 和 优采云采集器软件 - 简易模式采集)

一、什么是爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网络追逐者)是根据一定规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称有蚂蚁、自动索引、模拟程序或蠕虫(百度复制粘贴内容^^)。

说白了就是爬虫利用工具爬取网页上的内容(数据、文字、图片等),并通过一些第三方软件来采集(如优采云、< @优采云采集器、优采云采集器 等)。至于自己写代码的方法,以后会介绍文章。本文将从基础开始介绍傻瓜式爬虫软件的使用。这种方式已经可以满足采集的大部分需求了,只需要拖拽就可以了,拉拽不是很方便吗?

二、优采云采集器和优采云简介

这两个采集器是笔者认为市面上比较优秀的两个软件采集。优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。自主研发的优采云大数据采集平台,集成了网页数据采集、移动互联网数据和API接口服务(包括数据爬虫、数据优化、数据挖掘、数据存储、数据备份)等服务作为数据服务平台之一,连续四年位居互联网数据采集软件排行榜第一。两个软件的采集模式基本相同,主要有两种:智能模式采集或者简单采集,自定义模式采集 . 本期重点介绍 Smart Mode采集 或 Simple采集。

三、简易模式

(1)优采云采集器

软件下载网站:至于如何安装软件,始终是下一步。

优采云采集器智能模式采集只要把你要爬取的页面放到URL框里,软件就会自动识别你可能需要爬取的内容。我们直接举个例子。比如要爬取某大学的职业网站的招聘信息(以北大为例),北大职业指导服务中心的网站是!recruitList.action?category=1(不知道是什么后面你会看到。当时是否无效,有没有防爬虫,反正我能用,我能用,我能用)。

1.打开软件,选择智能模式

2.在右侧框中输入爬取网址

3.点击下方立即创建,可以看到软件自动识别需要爬取的内容

4.点击开始采集启动,软件会自动采集当前页面信息并翻页。

5.软件正在爬取...(注:由于没有选择深度爬取,所以只会爬取当前页面,链接中不会输入具体信息)

6.由于内容量大,笔者选择强行结束。最后导出文件,可以选择导出excel格式。

7.最终的excel数据如下

(2)优采云

软件下载地址:. 优采云 的简单性更方便。软件自带很多常用的网站和数据模板,如下图:

比如抓取人民网的招聘信息,在人民网选择要抓取的职位,复制链接(例如)。

1.点击模板,选择点击采集

2.输入网址,翻页次数

3.选择本地启动采集

4.可以看到正在爬取数据

5.最终爬取的数据可以导出

这就是本期的内容:关于 优采云采集器 和 优采云采集器 的简易模式采集。下一期我们会推送流程图或者自定义方法采集data。

最后!!!!!!发个彩蛋,解决上一篇在使用优采云采集器时提到的问题,由于没有选择深度爬取,所以只会爬取当前页面,具体信息不会进入关联。

因为抓取到的数据只是每个连接的标题,所以需要输入链接才能爬取内容。优采云采集器提供了“深度采集”的功能,即可以进入链接采集。它在这里:

点击“depth采集”进入页面,就是最外层链接的内容。此时,下面会爬取这个页面的内容。单击开始采集 以采集每个标题链接内的内容。

网页数据抓取怎么写(本文就用Java给大家演示如何抓取网站的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-02-28 10:28

有时候,由于各种原因,我们需要某个网站的采集的数据,但是由于网站的不同,数据的显示方式略有不同!

本文用Java为大家展示如何抓取网站的数据:(1)抓取网页原创数据;(2)抓取网页JavaScript返回的数据.

一、 抓取原创页面。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,然后输入IP:111.142.55.73,点击查询按钮,可以看到网页上显示的结果:

p>

第二步:查看网页的源码,我们看到源码中有这么一段:

从这里可以看出,重新请求一个网页后,显示查询的结果。

查询后查看网址:

也就是说,我们只要访问这样一个URL,就可以得到ip查询的结果,然后看代码:

publicvoidcaptureHtml(Stringip)throwsException{StringstrURL=""+ip;URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream(),"utf-8") ;BufferedReaderbufReader=newBufferedReader(input);Stringline="";StringBuildercontentBuf=newStringBuilder();while((line=bufReader.readLine())!=null){contentBuf.append(line);}Stringbuf=contentBuf.toString() ;intbeginIx=buf.indexOf("查询结果[");intendIx=buf.indexOf("以上四项依次显示");Stringresult=buf.substring(beginIx,endIx);System.out.println(" captureHtml() 结果:\n"+result);}

使用HttpURLConnection连接网站,使用bufReader保存网页返回的数据,然后通过自定义解析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

搜索结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市移动

二、抓取网页的JavaScript返回的结果。

有时网站为了保护自己的数据,不是直接在网页源码中返回数据,而是采用异步方式,用JS返回数据,可以避开搜索引擎和其他工具来网站数据捕获。

先看这个页面:

第一种方式查看网页源码,但是没有找到运单的跟踪信息,因为是通过JS获取结果的。

但是有时候我们需要获取JS数据,这个时候我们应该怎么做呢?

这时候,我们需要用到一个工具:HTTP Analyzer。这个工具可以拦截Http的交互内容。我们使用这个工具来实现我们的目的。

第一次点击开始按钮后,开始监听网页的交互行为。

我们打开网页:可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便查看JS的结果,我们先清除数据,然后在网页中输入快递号:7,点击查询按钮,然后查看HTTP Analyzer的结果:

这是点击查询按钮后HTTP Analyzer的结果,我们继续查看:

从上面两张图可以看出,HTTP Analyzer可以截取JS返回的数据并显示在Response Content中,同时可以看到JS请求的网页地址。

这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为获取数据,也就是我们只需要访问JS请求的网页地址就可以获取数据,当然,前提是数据没有加密,我们记下JS请求的URL:

那就让程序请求这个网页的结果吧!

代码如下:

publicvoidcaptureJavascript(Stringpostid)throwsException{StringstrURL=""+postid+"&channel=&rnd=0";URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream() ,"utf-8");BufferedReaderbufReader=newBufferedReader(input);Stringline="";StringBuildercontentBuf=newStringBuilder();while((line=bufReader.readLine())!=null){contentBuf.append(line);} System.out.println("captureJavascript()的结果:\n"+contentBuf.toString());}

你看,爬取JS的方式和之前爬取原创网页的代码一模一样,我们只是做了一个解析JS的过程。

以下是程序执行的结果:

captureJavascript() 的结果:

运单追踪信息【7】

这些数据是JS返回的结果,我们的目的已经达到了!

希望这篇文章可以对需要的朋友有所帮助。如需程序源代码,请点击这里下载! 查看全部

网页数据抓取怎么写(本文就用Java给大家演示如何抓取网站的数据:(1))

有时候,由于各种原因,我们需要某个网站的采集的数据,但是由于网站的不同,数据的显示方式略有不同!

本文用Java为大家展示如何抓取网站的数据:(1)抓取网页原创数据;(2)抓取网页JavaScript返回的数据.

一、 抓取原创页面。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,然后输入IP:111.142.55.73,点击查询按钮,可以看到网页上显示的结果:

p>

第二步:查看网页的源码,我们看到源码中有这么一段:

从这里可以看出,重新请求一个网页后,显示查询的结果。

查询后查看网址:

也就是说,我们只要访问这样一个URL,就可以得到ip查询的结果,然后看代码:

publicvoidcaptureHtml(Stringip)throwsException{StringstrURL=""+ip;URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream(),"utf-8") ;BufferedReaderbufReader=newBufferedReader(input);Stringline="";StringBuildercontentBuf=newStringBuilder();while((line=bufReader.readLine())!=null){contentBuf.append(line);}Stringbuf=contentBuf.toString() ;intbeginIx=buf.indexOf("查询结果[");intendIx=buf.indexOf("以上四项依次显示");Stringresult=buf.substring(beginIx,endIx);System.out.println(" captureHtml() 结果:\n"+result);}

使用HttpURLConnection连接网站,使用bufReader保存网页返回的数据,然后通过自定义解析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

搜索结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市移动

二、抓取网页的JavaScript返回的结果。

有时网站为了保护自己的数据,不是直接在网页源码中返回数据,而是采用异步方式,用JS返回数据,可以避开搜索引擎和其他工具来网站数据捕获。

先看这个页面:

第一种方式查看网页源码,但是没有找到运单的跟踪信息,因为是通过JS获取结果的。

但是有时候我们需要获取JS数据,这个时候我们应该怎么做呢?

这时候,我们需要用到一个工具:HTTP Analyzer。这个工具可以拦截Http的交互内容。我们使用这个工具来实现我们的目的。

第一次点击开始按钮后,开始监听网页的交互行为。

我们打开网页:可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便查看JS的结果,我们先清除数据,然后在网页中输入快递号:7,点击查询按钮,然后查看HTTP Analyzer的结果:

这是点击查询按钮后HTTP Analyzer的结果,我们继续查看:

从上面两张图可以看出,HTTP Analyzer可以截取JS返回的数据并显示在Response Content中,同时可以看到JS请求的网页地址。

这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为获取数据,也就是我们只需要访问JS请求的网页地址就可以获取数据,当然,前提是数据没有加密,我们记下JS请求的URL:

那就让程序请求这个网页的结果吧!

代码如下:

publicvoidcaptureJavascript(Stringpostid)throwsException{StringstrURL=""+postid+"&channel=&rnd=0";URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream() ,"utf-8");BufferedReaderbufReader=newBufferedReader(input);Stringline="";StringBuildercontentBuf=newStringBuilder();while((line=bufReader.readLine())!=null){contentBuf.append(line);} System.out.println("captureJavascript()的结果:\n"+contentBuf.toString());}

你看,爬取JS的方式和之前爬取原创网页的代码一模一样,我们只是做了一个解析JS的过程。

以下是程序执行的结果:

captureJavascript() 的结果:

运单追踪信息【7】

这些数据是JS返回的结果,我们的目的已经达到了!

希望这篇文章可以对需要的朋友有所帮助。如需程序源代码,请点击这里下载!

网页数据抓取怎么写(网页抓取的具体实现功能代码,请大家不吝指教,在此谢过!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-02-28 10:21

一直在想整理一下网页抓取的具体实现功能代码,方便大家指正,也方便我自己学习和指正。当然,这并不适用于所有网页。自己写的函数有限,只能用于网页特定结构的数据采集。如果有更好的方法,请不吝赐教。

一、抓取网页内容:

网页爬取的代码很多,网上可以搜索到。以下方法是我找到的一种供参考:

<p>///

/// 获取网页全部源代码

///

/// /要访问的网站地址

/// 目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

///

public static string getHtml(string url, params string[] charSets)

{

try

{

string charSet = null;

if (charSets.Length == 1)

{

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法.根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据.

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组.(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, " 查看全部

网页数据抓取怎么写(网页抓取的具体实现功能代码,请大家不吝指教,在此谢过!)

一直在想整理一下网页抓取的具体实现功能代码,方便大家指正,也方便我自己学习和指正。当然,这并不适用于所有网页。自己写的函数有限,只能用于网页特定结构的数据采集。如果有更好的方法,请不吝赐教。

一、抓取网页内容:

网页爬取的代码很多,网上可以搜索到。以下方法是我找到的一种供参考:

<p>///

/// 获取网页全部源代码

///

/// /要访问的网站地址

/// 目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

///

public static string getHtml(string url, params string[] charSets)

{

try

{

string charSet = null;

if (charSets.Length == 1)

{

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法.根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据.

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组.(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, "

网页数据抓取怎么写( 这是简易数据分析系列的第13篇文章教程的全盘总结)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-02-27 09:14

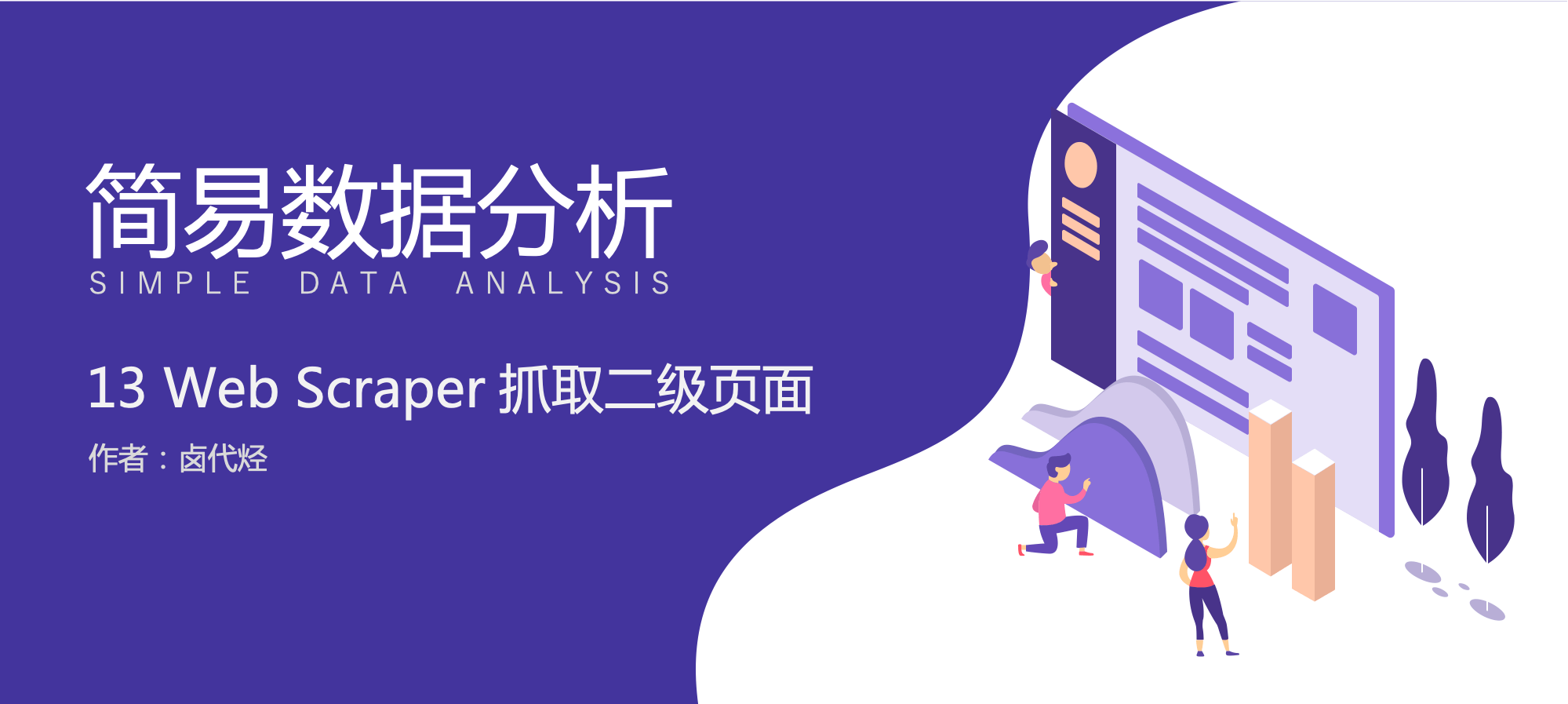

这是简易数据分析系列的第13篇文章教程的全盘总结)

这是简易数据分析系列文章的第 13 篇。

本文首发于博客园:简单数据分析13。

不知不觉写了10篇网络爬虫系列教程,这10篇文章基本涵盖了网络爬虫的大部分功能。今天的内容是本系列的最后一篇文章。下一章我再开个坑,讲讲如何用Excel对采集到的数据进行格式化和分析。

我会在下一篇文章文章中对Web Scraper教程做一个全面的总结,今天开始我们的实战教程。

在之前的课程中,我们抓取的数据都是同一级别的内容。讨论的主要问题是如何处理市场上各种类型的分页,但是如何抓取详情页的内容数据并没有介绍。.

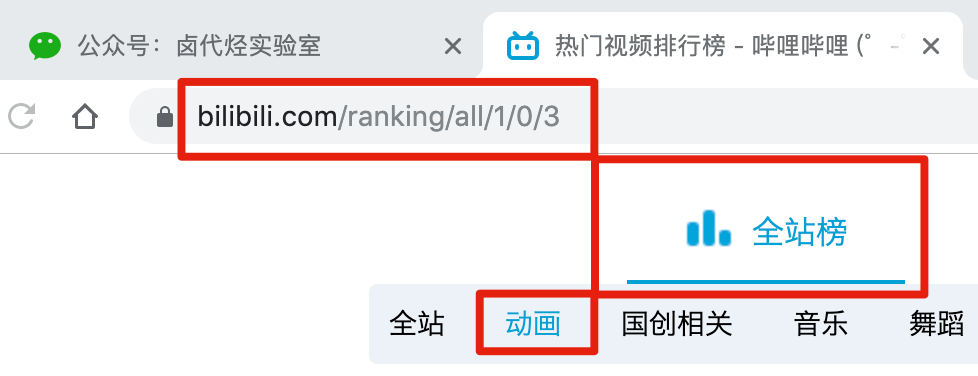

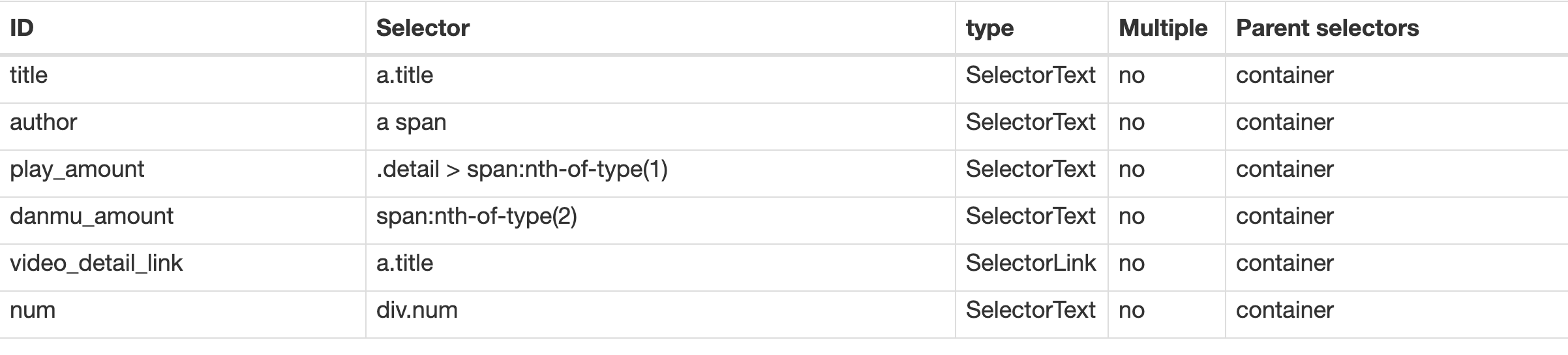

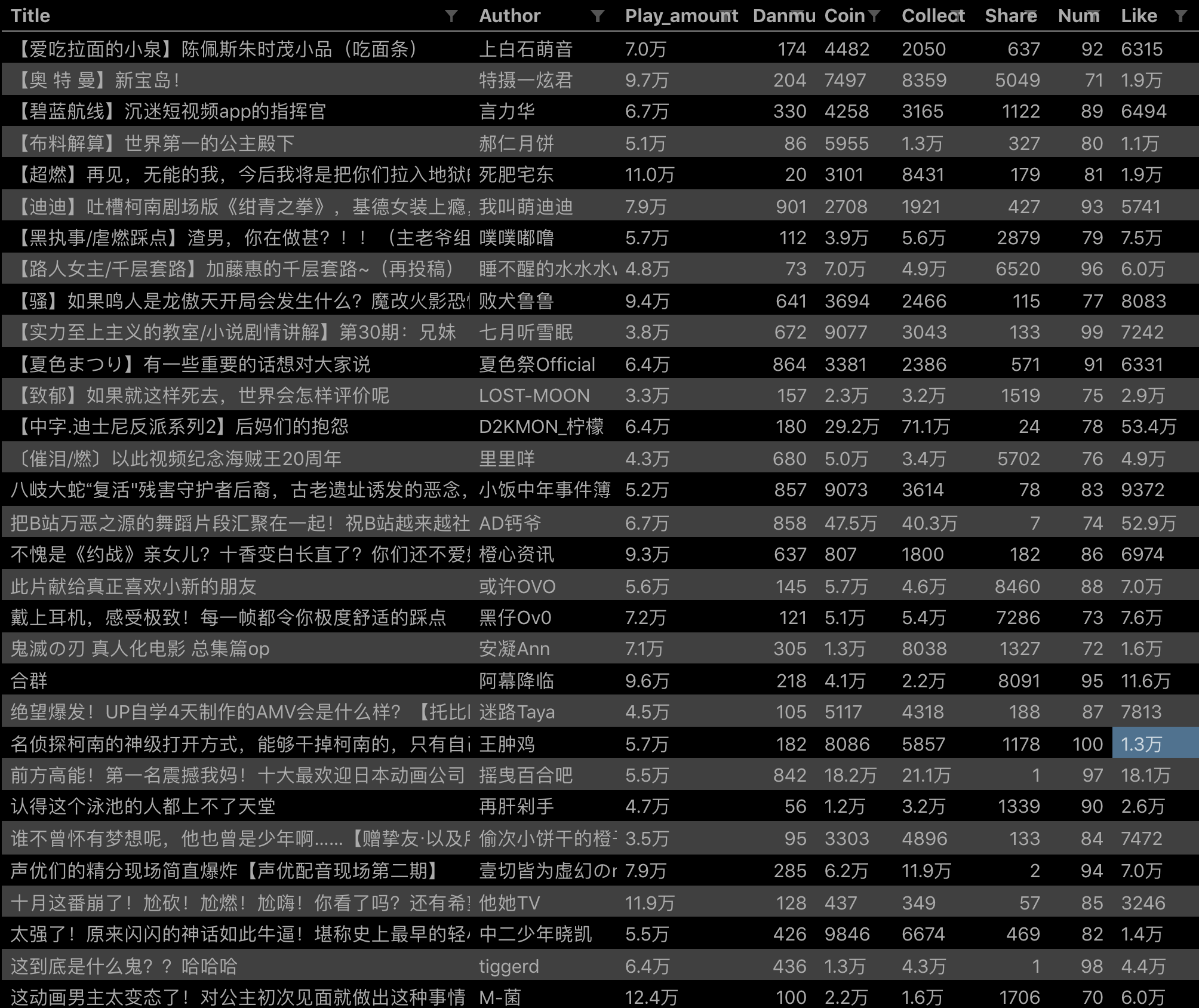

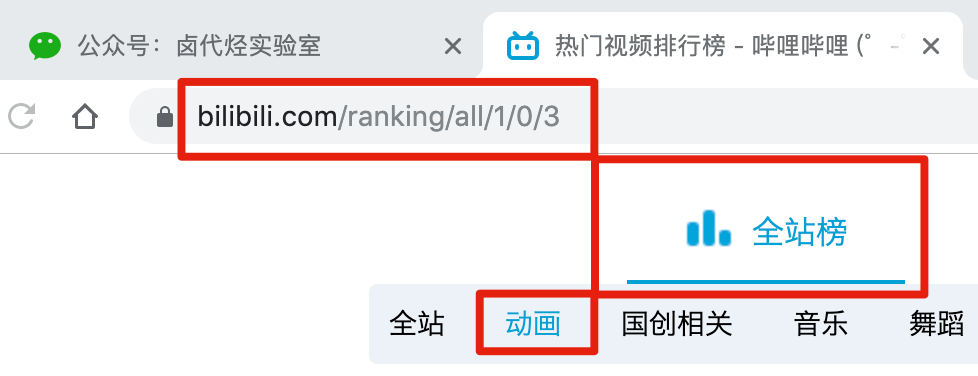

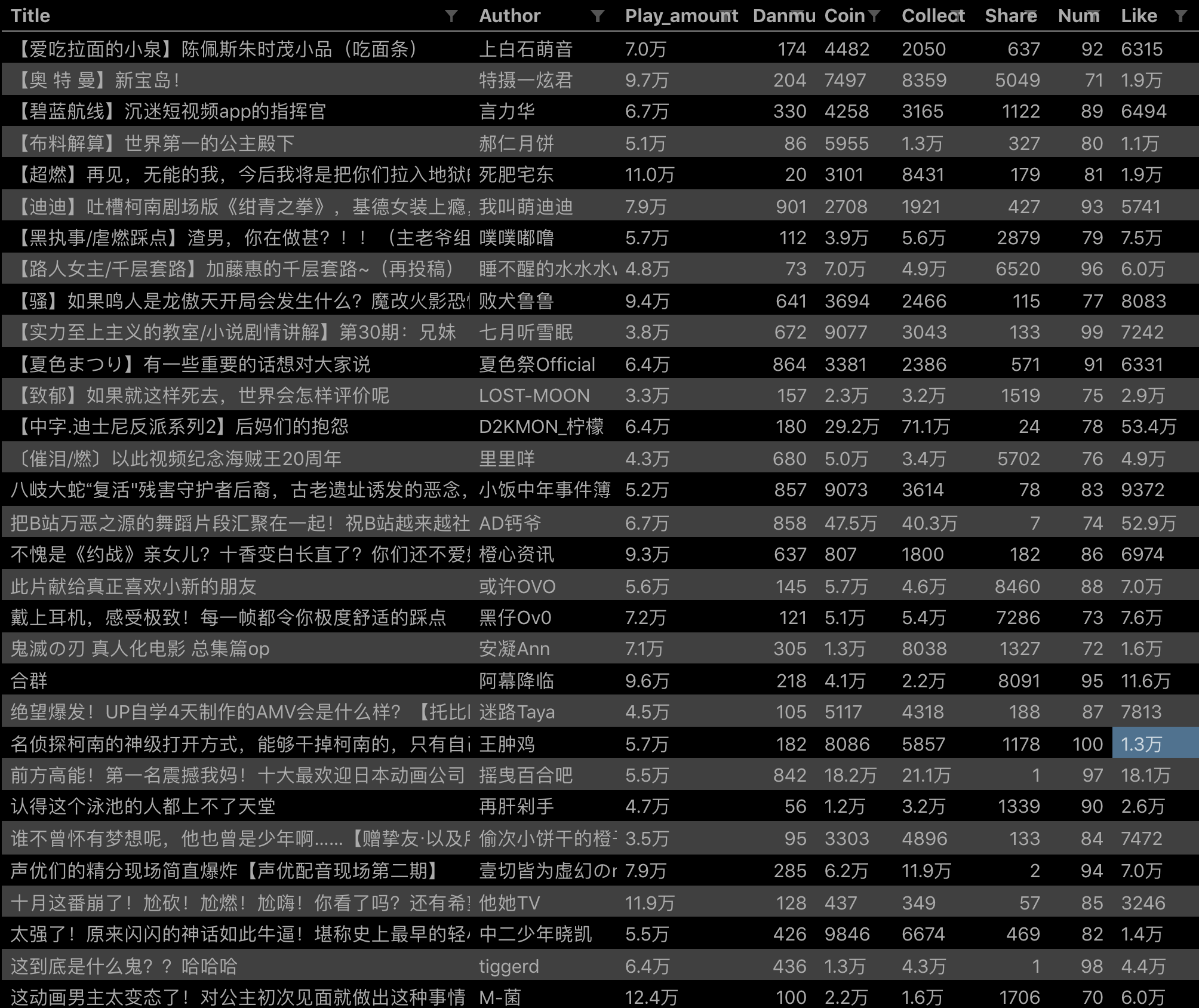

比如我们要抓取b站动画区TOP排行榜的数据:

按照之前的爬取逻辑,我们爬取这个榜单上的作品相关的数据,比如下图中的排名、作品名称、播放量、弹幕数、作者姓名等。

经常逛B站的朋友也知道,UP主经常在连续三个操作(点赞+币+采集)中提示好友看视频,可见这三个数据对视频排名有一定影响,所以这些数据对我们也有一定的参考价值。

但遗憾的是,这份榜单中并没有相关数据。这些数据在视频详情页,我们需要点击链接查看:

今天的教程内容是教大家如何在爬取一级页面(列表页)的同时,使用Web Scraper抓取二级页面(详情页)的内容。

1.创建站点地图

首先,我们找到要捕获的数据的位置。我已经在下图中的红框中标出了关键路径。你可以比较一下:

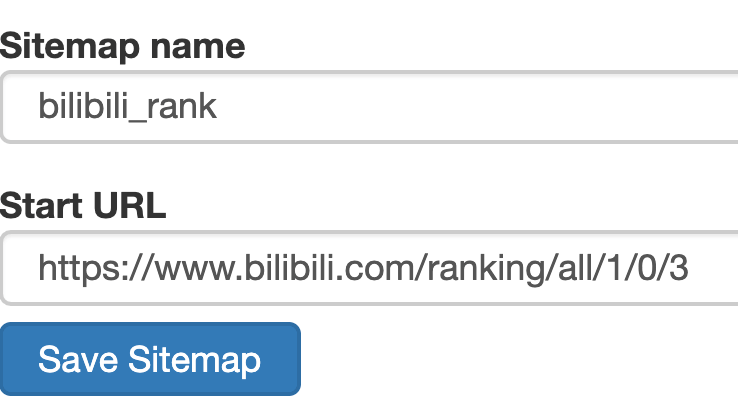

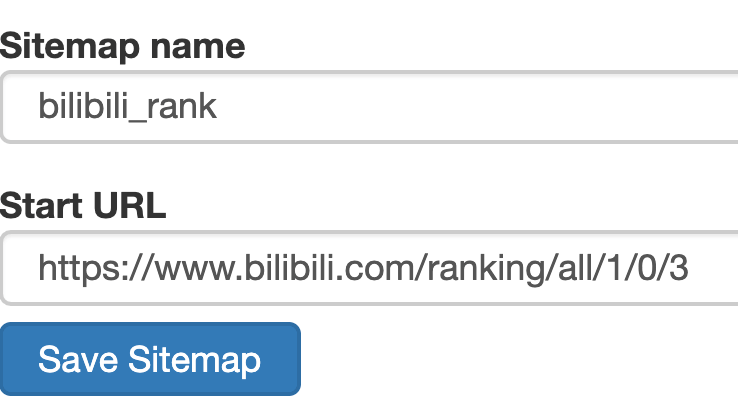

然后创建一个相关的SiteMap,这里我取了bilibili_rank的名字:

2.为容器创建一个选择器

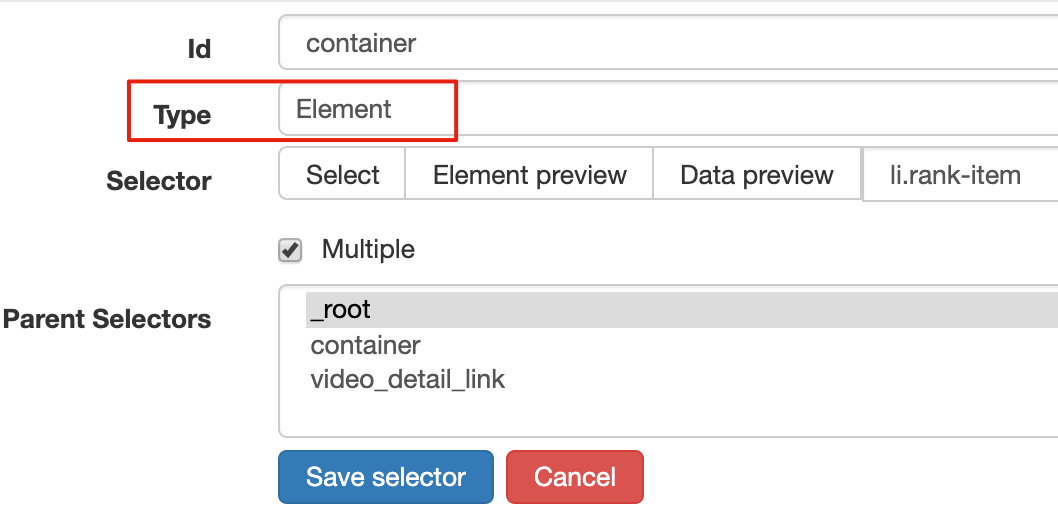

设置前我们观察一下,发现这个网页的排名数据是一次性加载100条数据,不需要分页,所以这里的Type类型选择为Element。

其他参数都比较简单,就不赘述了(不懂的可以看我之前的基础教程)。这是一个截图供您参考:

3.创建列表页面子选择器

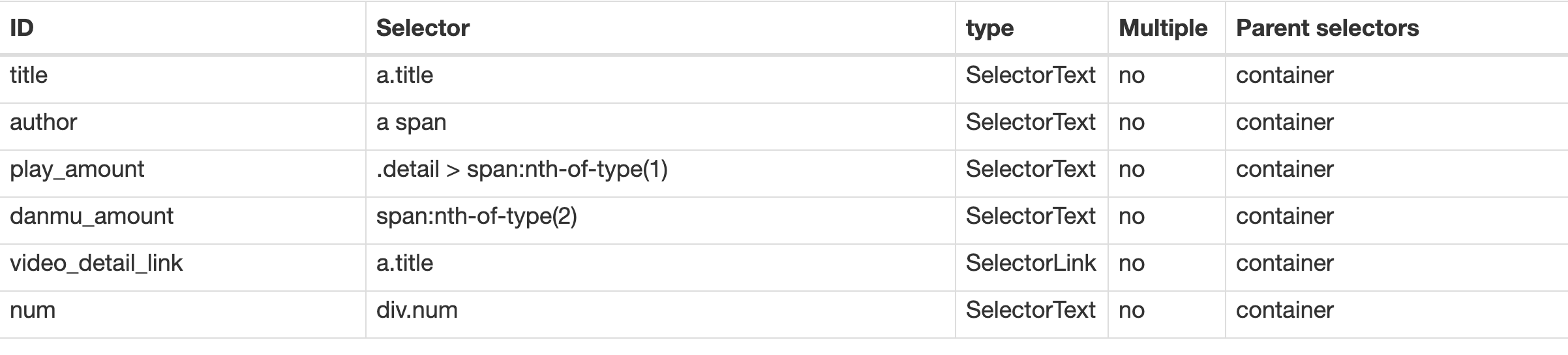

这次子选择器要抓取的内容如下,都比较简单。可以参考图片截图:

排名 (num) 作品名称 (title) 播放量 (play_amount) 弹幕量 (danmu_count) 作者: (author)

如果做了这一步,其实可以捕获所有已知的列表数据,但是本文的重点是:如何捕获二级页面(详情页)的三元组数据?

做了这么多爬虫,你可能已经发现,Web Scraper 的本质就是模拟人的操作来达到爬取数据的目的。

那么我们平时如何查看二级页面(详情页)呢?其实点击标题链接即可跳转:

Web Scraper为我们提供了点击链接跳转的功能,即Type为Link的选择器。

感觉有点抽象?让我们通过一个例子来理解它。

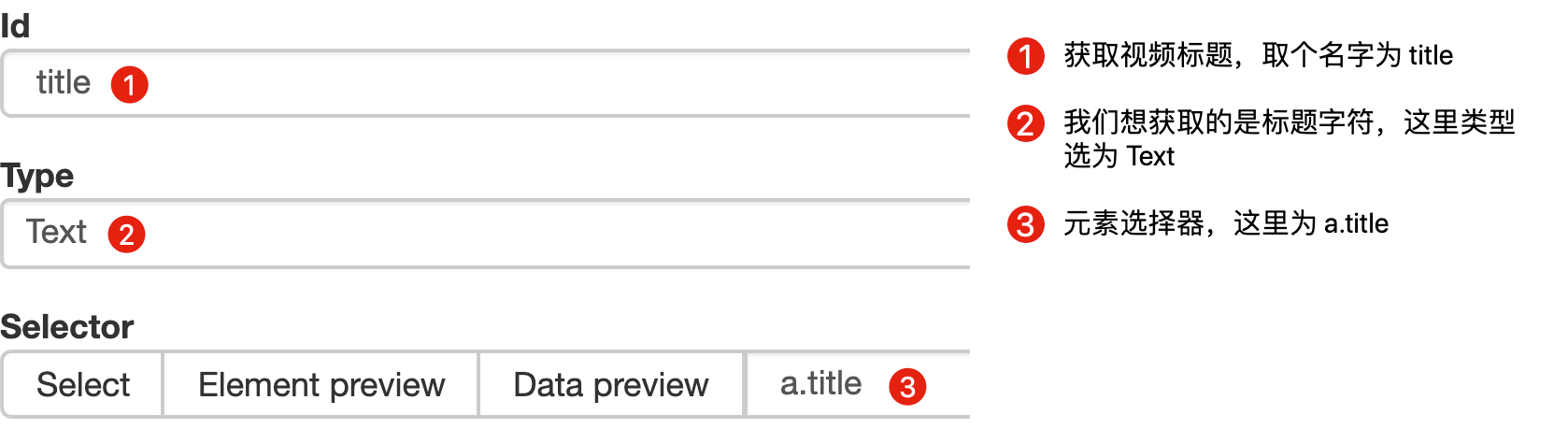

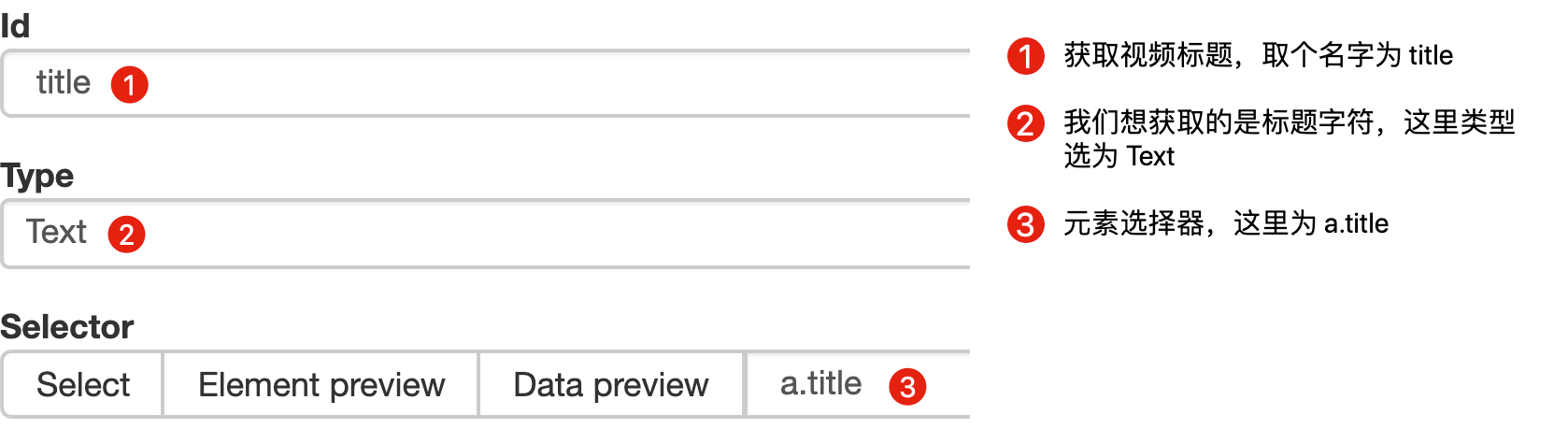

首先,在本例中,我们获取了标题的文本,选择器类型为 Text:

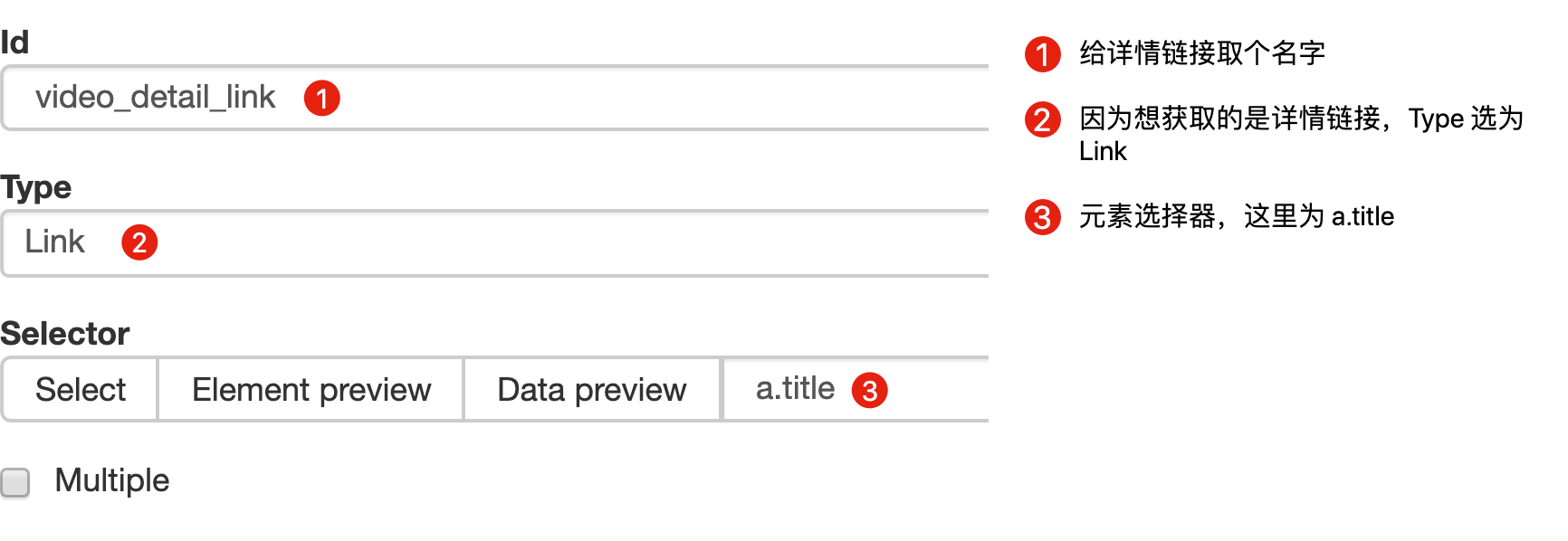

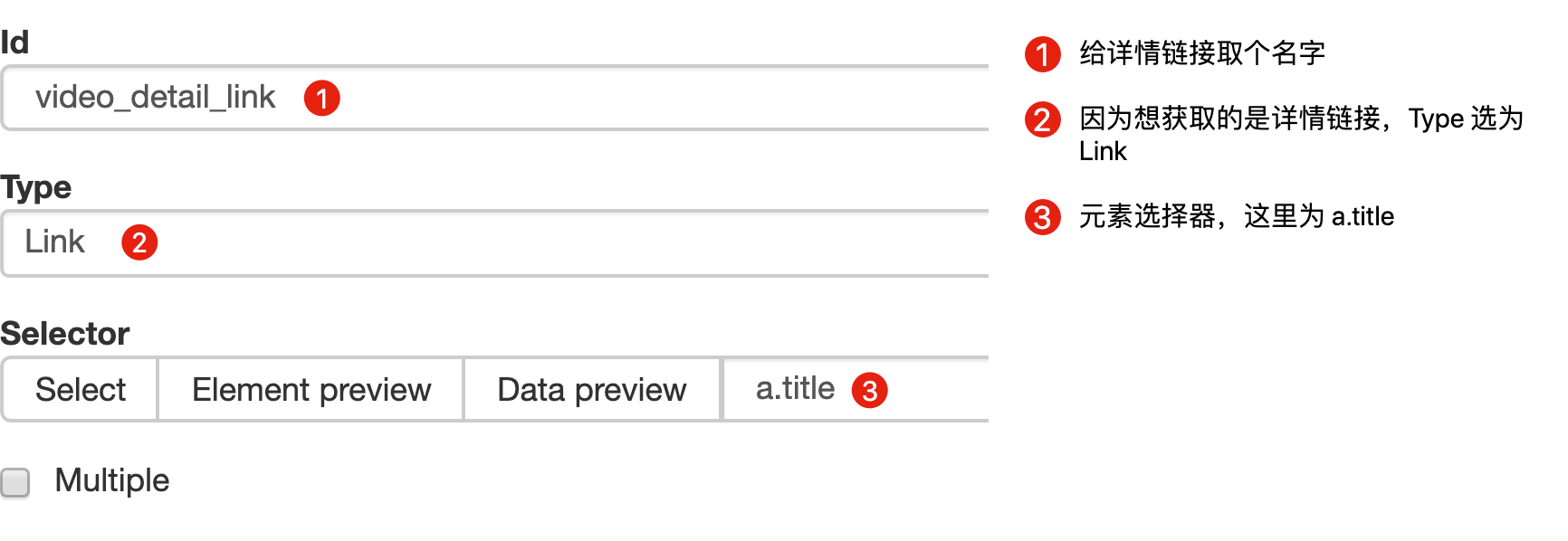

当我们要抓取链接的时候,需要再创建一个选择器,被选中的元素都是一样的,只不过Type是Link:

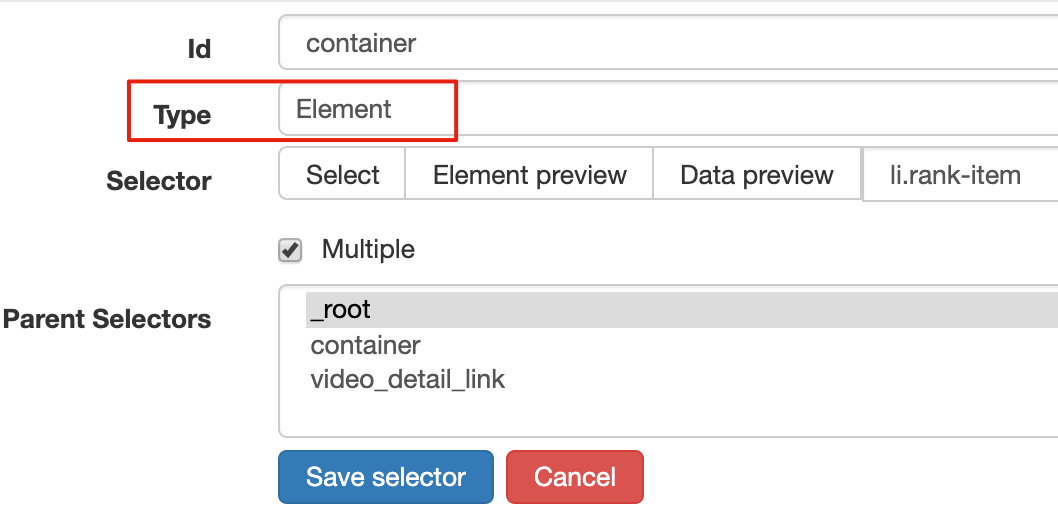

创建成功后,我们点击链接类型选择器,进入它的内部,然后创建相关的选择器。下面我录制了一个动图,注意我鼠标高亮的导航路由部分,可以清楚的看到这几个选择器的层级关系:

4.创建详情页子选择器

当你点击链接时,你会发现浏览器会在一个新的Tab页中打开详情页,但是在列表页上打开了Web Scraper的选择窗口,无法跨页选择想要的数据。

处理这个问题也很简单,可以复制详情页的链接,复制到列表页所在的Tab页,然后回车重新加载,这样就可以在当前页选中了。

我们在 Link 类型的选择器中创建了更多的选择器。这里我选择了点赞数、硬币数、采集数和分享数4个数据。这个操作也很简单,这里就不赘述了。

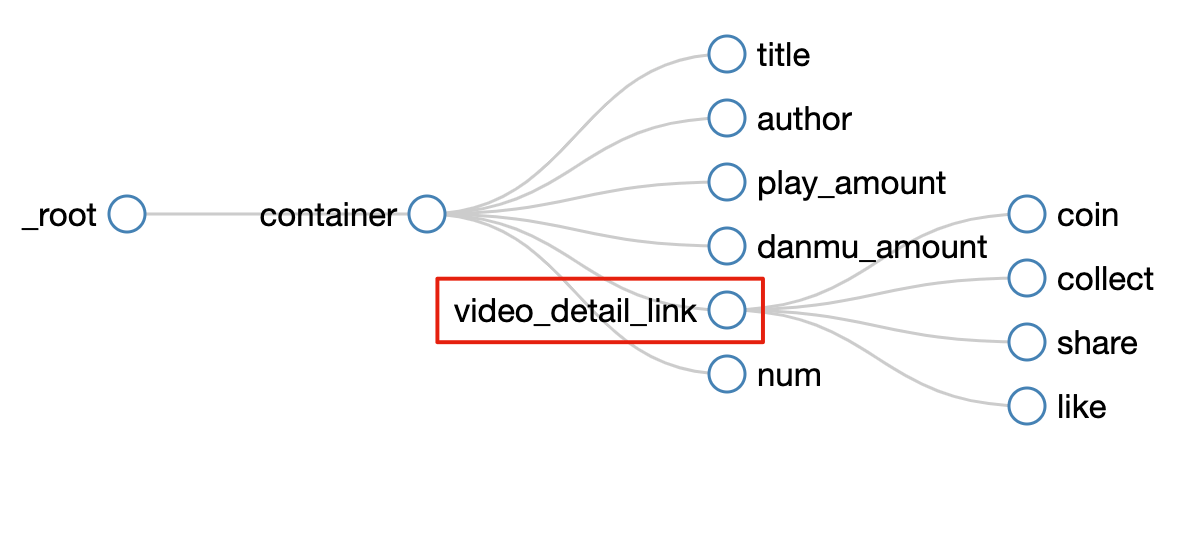

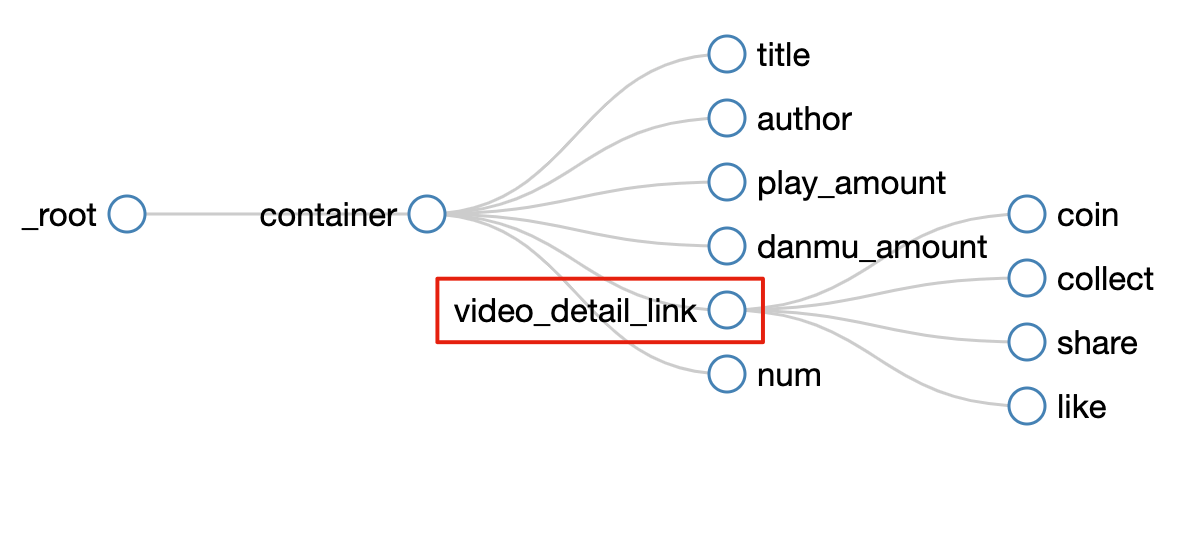

所有选择器的结构图如下:

我们可以看到video_detail_link节点收录了4个二级页面(detail pages)的数据。至此,我们的子选择器已经建立。

5.捕获数据

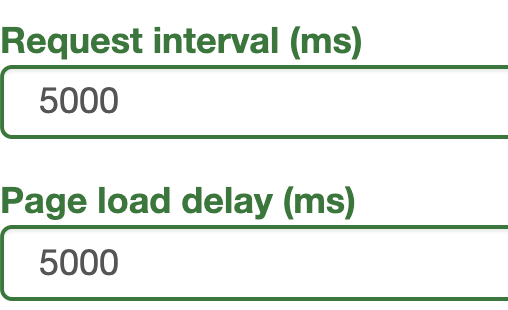

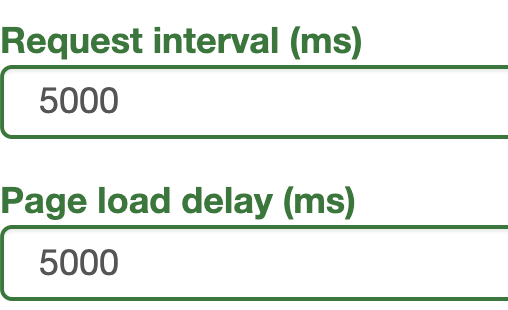

激动人心的部分终于来了,我们将开始抓取数据。但在抓取之前,我们必须将等待时间调整为更大。默认时间是2000毫秒,我这里改成5000毫秒。

为什么要这样做?看下图你就明白了:

首先,每次打开二级页面,都是一个全新的页面。此时,浏览器加载页面需要时间。其次,我们可以观察要捕获的点赞数等数据。页面刚加载的时候,它的值为“--”,需要一段时间才会变成数字。因此,我们直接等待5000ms,等页面和数据加载完毕后再统一取。

配置好参数后,我们就可以正式抓取下载了。下图是我抓取的数据的一部分,这里是为了证明这种方法有效:

6.总结

这个教程可能有点难。我将分享我的站点地图。如果在生产过程中遇到困难,可以参考我的配置。SiteMap的导入功能我在第6篇教程中详细讲解过。可以一起吃。:

<p>{"_id":"bilibili_rank","startUrl":["https://www.bilibili.com/ranking/all/1/0/3"],"selectors":[{"id":"container","type":"SelectorElement","parentSelectors":["_root"],"selector":"li.rank-item","multiple":true,"delay":0},{"id":"title","type":"SelectorText","parentSelectors":["container"],"selector":"a.title","multiple":false,"regex":"","delay":0},{"id":"author","type":"SelectorText","parentSelectors":["container"],"selector":"a span","multiple":false,"regex":"","delay":0},{"id":"play_amount","type":"SelectorText","parentSelectors":["container"],"selector":".detail > span:nth-of-type(1)","multiple":false,"regex":"","delay":0},{"id":"danmu_amount","type":"SelectorText","parentSelectors":["container"],"selector":"span:nth-of-type(2)","multiple":false,"regex":"","delay":0},{"id":"video_detail_link","type":"SelectorLink","parentSelectors":["container"],"selector":"a.title","multiple":false,"delay":0},{"id":"coin","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.coin","multiple":false,"regex":"","delay":0},{"id":"collect","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.collect","multiple":false,"regex":"","delay":0},{"id":"share","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.share","multiple":false,"regex":"[0-9]+","delay":0},{"id":"num","type":"SelectorText","parentSelectors":["container"],"selector":"div.num","multiple":false,"regex":"","delay":0},{"id":"like","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":".ops span.like","multiple":false,"regex":"","delay":0}]}</p>

掌握了二级页面的爬取方式后,三级页面和四级页面都没有问题。因为例程是相同的:它们都是在链接选择器指向的下一页上抓取数据。因为原理是一样的,我就不演示了。 查看全部

网页数据抓取怎么写(

这是简易数据分析系列的第13篇文章教程的全盘总结)

这是简易数据分析系列文章的第 13 篇。

本文首发于博客园:简单数据分析13。

不知不觉写了10篇网络爬虫系列教程,这10篇文章基本涵盖了网络爬虫的大部分功能。今天的内容是本系列的最后一篇文章。下一章我再开个坑,讲讲如何用Excel对采集到的数据进行格式化和分析。

我会在下一篇文章文章中对Web Scraper教程做一个全面的总结,今天开始我们的实战教程。

在之前的课程中,我们抓取的数据都是同一级别的内容。讨论的主要问题是如何处理市场上各种类型的分页,但是如何抓取详情页的内容数据并没有介绍。.

比如我们要抓取b站动画区TOP排行榜的数据:

按照之前的爬取逻辑,我们爬取这个榜单上的作品相关的数据,比如下图中的排名、作品名称、播放量、弹幕数、作者姓名等。

经常逛B站的朋友也知道,UP主经常在连续三个操作(点赞+币+采集)中提示好友看视频,可见这三个数据对视频排名有一定影响,所以这些数据对我们也有一定的参考价值。

但遗憾的是,这份榜单中并没有相关数据。这些数据在视频详情页,我们需要点击链接查看:

今天的教程内容是教大家如何在爬取一级页面(列表页)的同时,使用Web Scraper抓取二级页面(详情页)的内容。

1.创建站点地图

首先,我们找到要捕获的数据的位置。我已经在下图中的红框中标出了关键路径。你可以比较一下:

然后创建一个相关的SiteMap,这里我取了bilibili_rank的名字:

2.为容器创建一个选择器

设置前我们观察一下,发现这个网页的排名数据是一次性加载100条数据,不需要分页,所以这里的Type类型选择为Element。

其他参数都比较简单,就不赘述了(不懂的可以看我之前的基础教程)。这是一个截图供您参考:

3.创建列表页面子选择器

这次子选择器要抓取的内容如下,都比较简单。可以参考图片截图:

排名 (num) 作品名称 (title) 播放量 (play_amount) 弹幕量 (danmu_count) 作者: (author)

如果做了这一步,其实可以捕获所有已知的列表数据,但是本文的重点是:如何捕获二级页面(详情页)的三元组数据?

做了这么多爬虫,你可能已经发现,Web Scraper 的本质就是模拟人的操作来达到爬取数据的目的。

那么我们平时如何查看二级页面(详情页)呢?其实点击标题链接即可跳转:

Web Scraper为我们提供了点击链接跳转的功能,即Type为Link的选择器。

感觉有点抽象?让我们通过一个例子来理解它。

首先,在本例中,我们获取了标题的文本,选择器类型为 Text:

当我们要抓取链接的时候,需要再创建一个选择器,被选中的元素都是一样的,只不过Type是Link:

创建成功后,我们点击链接类型选择器,进入它的内部,然后创建相关的选择器。下面我录制了一个动图,注意我鼠标高亮的导航路由部分,可以清楚的看到这几个选择器的层级关系:

4.创建详情页子选择器

当你点击链接时,你会发现浏览器会在一个新的Tab页中打开详情页,但是在列表页上打开了Web Scraper的选择窗口,无法跨页选择想要的数据。

处理这个问题也很简单,可以复制详情页的链接,复制到列表页所在的Tab页,然后回车重新加载,这样就可以在当前页选中了。

我们在 Link 类型的选择器中创建了更多的选择器。这里我选择了点赞数、硬币数、采集数和分享数4个数据。这个操作也很简单,这里就不赘述了。

所有选择器的结构图如下:

我们可以看到video_detail_link节点收录了4个二级页面(detail pages)的数据。至此,我们的子选择器已经建立。

5.捕获数据

激动人心的部分终于来了,我们将开始抓取数据。但在抓取之前,我们必须将等待时间调整为更大。默认时间是2000毫秒,我这里改成5000毫秒。

为什么要这样做?看下图你就明白了:

首先,每次打开二级页面,都是一个全新的页面。此时,浏览器加载页面需要时间。其次,我们可以观察要捕获的点赞数等数据。页面刚加载的时候,它的值为“--”,需要一段时间才会变成数字。因此,我们直接等待5000ms,等页面和数据加载完毕后再统一取。

配置好参数后,我们就可以正式抓取下载了。下图是我抓取的数据的一部分,这里是为了证明这种方法有效:

6.总结

这个教程可能有点难。我将分享我的站点地图。如果在生产过程中遇到困难,可以参考我的配置。SiteMap的导入功能我在第6篇教程中详细讲解过。可以一起吃。:

<p>{"_id":"bilibili_rank","startUrl":["https://www.bilibili.com/ranking/all/1/0/3"],"selectors":[{"id":"container","type":"SelectorElement","parentSelectors":["_root"],"selector":"li.rank-item","multiple":true,"delay":0},{"id":"title","type":"SelectorText","parentSelectors":["container"],"selector":"a.title","multiple":false,"regex":"","delay":0},{"id":"author","type":"SelectorText","parentSelectors":["container"],"selector":"a span","multiple":false,"regex":"","delay":0},{"id":"play_amount","type":"SelectorText","parentSelectors":["container"],"selector":".detail > span:nth-of-type(1)","multiple":false,"regex":"","delay":0},{"id":"danmu_amount","type":"SelectorText","parentSelectors":["container"],"selector":"span:nth-of-type(2)","multiple":false,"regex":"","delay":0},{"id":"video_detail_link","type":"SelectorLink","parentSelectors":["container"],"selector":"a.title","multiple":false,"delay":0},{"id":"coin","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.coin","multiple":false,"regex":"","delay":0},{"id":"collect","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.collect","multiple":false,"regex":"","delay":0},{"id":"share","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.share","multiple":false,"regex":"[0-9]+","delay":0},{"id":"num","type":"SelectorText","parentSelectors":["container"],"selector":"div.num","multiple":false,"regex":"","delay":0},{"id":"like","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":".ops span.like","multiple":false,"regex":"","delay":0}]}</p>

掌握了二级页面的爬取方式后,三级页面和四级页面都没有问题。因为例程是相同的:它们都是在链接选择器指向的下一页上抓取数据。因为原理是一样的,我就不演示了。

网页数据抓取怎么写(如何用最简单的Python爬虫采集整个网站(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2022-02-26 19:27

如何使用 Python 爬虫抓取网页内容?- :首先需要安装requests和BeautifulSoup4,然后执行如下代码。62232425262728293031323334 importrequests from bs4 importBeautifulSoup iurl ='

python爬虫如何抓包:方案:1.通过请求库手动写2.最推荐使用python的爬虫库scrapy:使用python的爬虫库scrapy推荐理由:1.最广泛使用的爬虫框架,没有一个2.最成熟的框架,没有一个3.利用成熟的产品,避免重复“造轮子”,可以更快的建项目

Python爬虫,如何抓取信息-:我一般使用urllib2获取网页信息,然后使用BeautifulSoup分析要获取的数据

如何用python写爬虫来抓取文章:比较复杂的就是读取网页的源码,然后抓取源码的内容

如何编写Python爬取链接爬虫?: 我们都知道python爬虫是一个可以在网上任意搜索的脚本程序,主要是为了帮助我们不再用鼠标从网页上一一复制信息。消除我们的行为相当于以下步骤: 写之前先看逻辑问题,希望每个小伙伴都能养成这个好习惯

python网络编程可以用来做什么:以下是Python的应用和定位。第 1 部分:各个领域使用的语言。当您查看此内容时,您可以明显发现每种语言都有其用途。可以说 Python 是使用最广泛的。但...

Python爬虫入门-:从爬虫的基本要求:1.抓取py的urllib不一定会用到,但是一定要学会,如果之前没用过的话。更好的替代方案是 requests 当第三方库更加人性化和成熟的时候,如果 pyer 不了解各种库,那就浪费学习了。最基本的抓就是把网页拉回来。如果深入...

如何使用最简单的Python爬虫采集整体网站-:在之前的文章Python实现“维基百科六度分离理论”基础爬虫中,我们实现了一个网站 随机从一个链接到另一个链接,但是如果我们需要按目录系统地对整个 网站 进行分类,或者搜索 网站 上的每一页怎么办?我们需要 采集...

如何使用python爬虫获取数据——:python是一种使用非常广泛的脚本编程语言,谷歌的网页都是用python编写的。python在生物信息、统计、网页制作、计算等诸多领域都展现出了强大的实力。功能。与java、R、Perl等其他脚本语言一样,python可以直接在命令行运行脚本程序...

如何使用python编写爬虫抓取文章:学习爬虫基本工作原理基本http爬虫,scrapybloom过滤器:bloom过滤器实例如果需要大规模网页爬取,需要学习一下概念分布式爬虫。其实没那么神秘,你只需要学习如何维护一个所有集群机器都可以有效共享的分布式队列。最简单的实现是python-rq:scrapy的组合:darkrho/scrapy-redis·github后续处理,网页Extract(grangier/python-goose github),store(mongodb)

相关视频:一个全新的小姐姐网站,教你从零开始使用Python爬虫搞定Python网络爬虫,实现网页数据的自动爬取和存储--产品模型实战网络爬虫图片获取(selenium正则表情)Python私人笔记 Python爬虫教程,爬取相亲网站,助你快速脱单 查看全部

网页数据抓取怎么写(如何用最简单的Python爬虫采集整个网站(图))

如何使用 Python 爬虫抓取网页内容?- :首先需要安装requests和BeautifulSoup4,然后执行如下代码。62232425262728293031323334 importrequests from bs4 importBeautifulSoup iurl ='

python爬虫如何抓包:方案:1.通过请求库手动写2.最推荐使用python的爬虫库scrapy:使用python的爬虫库scrapy推荐理由:1.最广泛使用的爬虫框架,没有一个2.最成熟的框架,没有一个3.利用成熟的产品,避免重复“造轮子”,可以更快的建项目

Python爬虫,如何抓取信息-:我一般使用urllib2获取网页信息,然后使用BeautifulSoup分析要获取的数据

如何用python写爬虫来抓取文章:比较复杂的就是读取网页的源码,然后抓取源码的内容

如何编写Python爬取链接爬虫?: 我们都知道python爬虫是一个可以在网上任意搜索的脚本程序,主要是为了帮助我们不再用鼠标从网页上一一复制信息。消除我们的行为相当于以下步骤: 写之前先看逻辑问题,希望每个小伙伴都能养成这个好习惯

python网络编程可以用来做什么:以下是Python的应用和定位。第 1 部分:各个领域使用的语言。当您查看此内容时,您可以明显发现每种语言都有其用途。可以说 Python 是使用最广泛的。但...

Python爬虫入门-:从爬虫的基本要求:1.抓取py的urllib不一定会用到,但是一定要学会,如果之前没用过的话。更好的替代方案是 requests 当第三方库更加人性化和成熟的时候,如果 pyer 不了解各种库,那就浪费学习了。最基本的抓就是把网页拉回来。如果深入...

如何使用最简单的Python爬虫采集整体网站-:在之前的文章Python实现“维基百科六度分离理论”基础爬虫中,我们实现了一个网站 随机从一个链接到另一个链接,但是如果我们需要按目录系统地对整个 网站 进行分类,或者搜索 网站 上的每一页怎么办?我们需要 采集...

如何使用python爬虫获取数据——:python是一种使用非常广泛的脚本编程语言,谷歌的网页都是用python编写的。python在生物信息、统计、网页制作、计算等诸多领域都展现出了强大的实力。功能。与java、R、Perl等其他脚本语言一样,python可以直接在命令行运行脚本程序...

如何使用python编写爬虫抓取文章:学习爬虫基本工作原理基本http爬虫,scrapybloom过滤器:bloom过滤器实例如果需要大规模网页爬取,需要学习一下概念分布式爬虫。其实没那么神秘,你只需要学习如何维护一个所有集群机器都可以有效共享的分布式队列。最简单的实现是python-rq:scrapy的组合:darkrho/scrapy-redis·github后续处理,网页Extract(grangier/python-goose github),store(mongodb)

相关视频:一个全新的小姐姐网站,教你从零开始使用Python爬虫搞定Python网络爬虫,实现网页数据的自动爬取和存储--产品模型实战网络爬虫图片获取(selenium正则表情)Python私人笔记 Python爬虫教程,爬取相亲网站,助你快速脱单

网页数据抓取怎么写(python网站开发教程:网站静态数据(数据在网页源码中))

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-02-22 11:03

我们在这里做一个简单的介绍。以捕获静态和动态数据为例,实验环境为win10+python3.6+pycharm5.0。主要内容如下python网站开发教程:

捕获网站静态数据(数据在网页源代码中)python 网站开发教程:以尴尬百科的数据网站为例

1.这里假设我们抓取的数据如下,主要包括用户昵称、内容、搞笑数和评论数四个字段,如下python 网站开发教程:

对应的网页源码如下python 网站开发教程,包括我们需要的数据:

2.对应网页结构,主要代码如下,很简单,主要使用requests+BeautifulSoup,其中requests用于请求页面,BeautifulSoup用于解析页面python < @网站开发教程:

程序运行截图如下,抓取数据成功:

抓取网站动态数据(网页源码、json等文件中没有数据):以人人贷网站数据为例

1.这里假设我们在爬取债券数据,主要包括年利率、贷款名称、期限、金额、进度五个字段。截图如下:

打开网页源代码,可以发现网页源代码中没有数据。当你按F12抓包并分析时,发现在一个json文件中,如下:

2.获取到json文件的url后,我们就可以爬取对应的数据了。这里使用的包和上面类似,因为是json文件,所以也使用了json包(解析json),主要内容如下:

程序运行截图如下,已成功抓取数据:

至此,这两类数据的捕获已经介绍到这里了,包括静态数据和动态数据。总的来说,这两个例子并不难。它们是入门级爬虫。网页的结构比较简单。最重要的是进行抓包分析,分析并提取页面。数据爬取的框架可以更加方便和高效。当然,如果爬取的页面比较复杂,比如验证码、加密等,那就需要仔细分析了。网上也有一些教程供参考。有兴趣的可以搜索一下,希望上面分享的内容对你有帮助。

如何学习python? python的前景如何?

python 入门其实很简单。作为一种胶水语言,它的设计是面向大众,降低编程的入门门槛。随着大数据、人工智能和机器学习的兴起,python的应用范围越来越广,前景也越来越好。下面简单介绍一下python的学习过程:

1. 搭建本地环境,这里推荐Anaconda。该软件集成了python解释器和许多第三方包。还自带spyder、ipython notebook等开发环境(相比python自带的IDLE)。 ,功能更强大,使用更方便),对于初学者来说是一个很好的选择:

笔记本开发环境如下,很好用。如果你是专业人士,可以使用pycharm IDE:

2.python学习入门,这里最重要的是多练多练多练,重要的事情说三遍,不管什么编程语言,多练多练,掌握基本功,对于python ,要熟悉列表、字典、元组、变量、函数、类、文件操作、异常处理、各种语句等,以及常用包的使用,网上有很多资料,你可以自己搜索、MOOC、菜鸟教程、博客等:

3.熟悉基本操作后,可以选择一个有前途的方向,以后再学习。 Python涉及的方面太多了,比如web开发、爬虫、机器学习、运维、测试、树莓派等等,找到一个好的有前途的方向并坚持下去,比如人工智能、机器学习等等。目前很热:

让我们分享这么多。最重要的是掌握基本功,然后选择一个好的方向去深入学习。你肯定会学到一些东西。希望以上分享的内容能对你有所帮助。 查看全部

网页数据抓取怎么写(python网站开发教程:网站静态数据(数据在网页源码中))

我们在这里做一个简单的介绍。以捕获静态和动态数据为例,实验环境为win10+python3.6+pycharm5.0。主要内容如下python网站开发教程:

捕获网站静态数据(数据在网页源代码中)python 网站开发教程:以尴尬百科的数据网站为例

1.这里假设我们抓取的数据如下,主要包括用户昵称、内容、搞笑数和评论数四个字段,如下python 网站开发教程:

对应的网页源码如下python 网站开发教程,包括我们需要的数据:

2.对应网页结构,主要代码如下,很简单,主要使用requests+BeautifulSoup,其中requests用于请求页面,BeautifulSoup用于解析页面python < @网站开发教程:

程序运行截图如下,抓取数据成功:

抓取网站动态数据(网页源码、json等文件中没有数据):以人人贷网站数据为例

1.这里假设我们在爬取债券数据,主要包括年利率、贷款名称、期限、金额、进度五个字段。截图如下:

打开网页源代码,可以发现网页源代码中没有数据。当你按F12抓包并分析时,发现在一个json文件中,如下:

2.获取到json文件的url后,我们就可以爬取对应的数据了。这里使用的包和上面类似,因为是json文件,所以也使用了json包(解析json),主要内容如下:

程序运行截图如下,已成功抓取数据:

至此,这两类数据的捕获已经介绍到这里了,包括静态数据和动态数据。总的来说,这两个例子并不难。它们是入门级爬虫。网页的结构比较简单。最重要的是进行抓包分析,分析并提取页面。数据爬取的框架可以更加方便和高效。当然,如果爬取的页面比较复杂,比如验证码、加密等,那就需要仔细分析了。网上也有一些教程供参考。有兴趣的可以搜索一下,希望上面分享的内容对你有帮助。

如何学习python? python的前景如何?

python 入门其实很简单。作为一种胶水语言,它的设计是面向大众,降低编程的入门门槛。随着大数据、人工智能和机器学习的兴起,python的应用范围越来越广,前景也越来越好。下面简单介绍一下python的学习过程:

1. 搭建本地环境,这里推荐Anaconda。该软件集成了python解释器和许多第三方包。还自带spyder、ipython notebook等开发环境(相比python自带的IDLE)。 ,功能更强大,使用更方便),对于初学者来说是一个很好的选择:

笔记本开发环境如下,很好用。如果你是专业人士,可以使用pycharm IDE:

2.python学习入门,这里最重要的是多练多练多练,重要的事情说三遍,不管什么编程语言,多练多练,掌握基本功,对于python ,要熟悉列表、字典、元组、变量、函数、类、文件操作、异常处理、各种语句等,以及常用包的使用,网上有很多资料,你可以自己搜索、MOOC、菜鸟教程、博客等:

3.熟悉基本操作后,可以选择一个有前途的方向,以后再学习。 Python涉及的方面太多了,比如web开发、爬虫、机器学习、运维、测试、树莓派等等,找到一个好的有前途的方向并坚持下去,比如人工智能、机器学习等等。目前很热:

让我们分享这么多。最重要的是掌握基本功,然后选择一个好的方向去深入学习。你肯定会学到一些东西。希望以上分享的内容能对你有所帮助。

网页数据抓取怎么写( 搜索引擎如何将频次分配给网站的机制以及提高网站排名和有机流量的技巧)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-02-21 15:17

搜索引擎如何将频次分配给网站的机制以及提高网站排名和有机流量的技巧)

抓取频率更像是一个 SEO 概念。大多数情况下,站长并不关心百度蜘蛛的爬取频率,因为爬取频率对中小企业几乎没有影响网站。

虽然大多数 网站 管理员不必担心抓取频率,但如果运行大型 网站,抓取频率是我们可以(并且应该)优化的 SEO 因素。

当然,随着SEO的发展,爬取频率和排名的关系也并不简单。爬取本身并不是排名因素,但从某种角度来说,爬取频率对搜索引擎优化有间接影响(这也是蜘蛛池流行的原因)。

在本指南中,我将解释相关的爬网概念、搜索引擎如何为 网站 分配爬网率的机制,以及如何充分利用爬网率来最大化 网站 排名和自然搜索技巧交通。

内容

网络蜘蛛的好与坏

网络蜘蛛、爬虫或机器人是不断“访问”和爬取网页以采集某些信息的计算机程序。

根据爬行的目的,可以区分以下几种蜘蛛:

搜索引擎蜘蛛;

网络服务蜘蛛;

黑客蜘蛛;

搜索引擎蜘蛛由百度、谷歌或360等搜索引擎管理。这个蜘蛛可以抓取互联网上的所有页面(只要它们是可发现的),并将它们提供给搜索引擎的索引库。

SEO工具、购物、旅游、优惠券等很多网络服务网站都有自己的网络索引和爬虫,比如WebMeUp就有一个叫Blexbot的爬虫,每天可以爬取上百亿页面来采集反向链接数据并将该数据提供给其链接索引(SEO SpyGlass 中使用的链接索引)。

黑客也喜欢繁殖蜘蛛,用来测试各种网站漏洞,一旦发现,他们可能会尝试访问你的网站或服务器。

你可能会听到人们谈论好蜘蛛和坏蜘蛛,我这样区分它们:任何为非法目的采集信息的蜘蛛都是坏的,其余的都很好。

大多数蜘蛛在用户代理字符串的帮助下识别自己,并提供一个 URL,在那里他们可以了解更多关于蜘蛛的信息:

/uploads/allimg/180827/141355M58-1.jpg 983w, https://www.simcf.cc/wp-conten ... 4.jpg 300w, https://www.simcf.cc/wp-conten ... 9.jpg 768w

在本文中,我将重点介绍搜索引擎蜘蛛以及它们如何抓取 网站。

了解抓取频率

抓取频率是搜索引擎蜘蛛在特定时间段内点击网站的次数,比如百度一般一个月点击我的网站1000次,可以说1K就是百度的每个月爬取频率,请注意这些爬虫的数量和频率没有通用限制;

为什么抓取频率很重要?

从逻辑上讲,你应该关注爬取频率,因为你希望百度为网站发现尽可能多的重要页面,并且你还希望它能够快速找到你的网站上的新内容,爬取越高获取频率,这将发生得越快。

确定抓取频率

你可以在百度网站管理工具中查看你的网站爬取频率,比如你需要确定你的百度爬取频率,登录你的百度站长账号,进入数据监控->爬取频率,在这里您将看到每日的抓取频率。

/uploads/allimg/180827/1413552355-2.jpg 1024w, https://www.simcf.cc/wp-conten ... 2.jpg 300w, https://www.simcf.cc/wp-conten ... 1.jpg 768w, https://www.simcf.cc/wp-conten ... h.jpg 1159w

从上面的报告可以看出,百度平均每天抓取我大约网站30次,由此可以看出我每月的抓取频率是30*30=900。

当然,这个数字很容易变化和波动,但是,它会让你清楚地知道在给定的时间段内你可以抓取多少页 网站。

如果您需要更详细地查看各个页面的爬网统计信息,则必须分析服务器日志,日志文件的位置取决于服务器配置。

如果您不确定如何访问服务器日志,请向您的系统管理员或托管服务提供商寻求帮助。

原创日志文件难以阅读和分析。要理解这一点,您需要绝对的正则表达式技能或专门的工具。我更喜欢使用光年测井分析工具进行分析。

如何分配抓取频率?

对于搜索引擎优化,我们并不完全了解搜索引擎是如何形成网站的爬取频率的。所有博主都在整理互联网的内容,以获取搜索引擎使用以下两个因素来确定爬取频率:

受欢迎程度——更受欢迎的页面被更频繁地爬取;

陈旧 - 百度不会使有关页面的信息过时,对于 网站 管理员来说,这意味着如果页面内容更新频繁,百度会尝试更频繁地抓取页面。

假设 网站 的抓取频率与反向链接的数量以及该 网站 在百度眼中的重要性成正比——百度希望确保最重要的页面在索引上仍然是最新的。

内部链接呢?你能通过指向更多的内部链接来提高特定页面的爬取率吗?

为了回答这些问题,我决定检查内外链接的相关性和爬取统计,我采集了11个网站s的数据,做了一个简单的分析,总之,我就是这样做的。

我为将要分析的 11 个站点创建了项目,我计算了每个 网站 页面的内部链接数量,接下来我运行 SEO Spyglass 并为相同的 11 个站点创建了项目,在每个项目中,我检查了统计信息并复制带有每个页面的外部链接数量的锚 URL。

然后,我分析了服务器日志中的抓取统计信息,以了解百度每次访问每个页面的频率。最后,我将所有这些数据放入一个电子表格中,并计算内部链接和抓取预算与外部链接和抓取预算之间的相关性。

我发现了一些非常有趣的东西这是我分析的其中一个 网站 的示例电子表格:

/uploads/allimg/180827/1413554937-3.png 694w, https://www.simcf.cc/wp-conten ... 5.png 300w

我的数据集展示了蜘蛛访问次数和外部链接数量之间的强相关性(0,978),同时,蜘蛛命中和内部链接之间的相关性被证明非常弱(0,154),这表明反向链接比 网站 链接更重要。

这是否意味着增加爬取频率的唯一方法是建立链接和发布新内容?如果说整个网站的朱雀频率,我会说是的:经常添加链接和更新网站,网站的爬取频率会成比例增加。

但是当我们获取单个页面时,它会变得更有趣,正如您将在下面的介绍中看到的那样,您甚至可以在没有意识到的情况下浪费大量的爬网。通过巧妙地管理频率,您通常可以将单个页面的抓取次数翻倍——但它仍然与每页的反向链接数量成正比。

/uploads/allimg/180827/1413553348-4.png 694w, https://www.simcf.cc/wp-conten ... 0.png 300w

如何充分利用爬网频率

既然我们已经弄清楚了,爬取很重要,是不是需要更多的时间来管理爬取的频率?

您应该(或不应该)做很多事情来让您的搜索蜘蛛消耗更多的 网站 页面,这里列出了最大化爬取率功能要做的事情:

1.如果在搜索中找到的内容没有提供价值,请确保抓取并阻止重要页面。

.htaccess 和 robots.txt 不应该屏蔽 网站 的重要页面,robots 应该能够访问 CSS 和 Javascript 文件,同时你应该屏蔽你不想在搜索中显示的内容,屏蔽网站 的“建设中”区域和动态生成的 URL 等。

请记住,搜索引擎蜘蛛并不总是遵循 robots.txt 中收录的说明,您是否曾在 Google 搜索结果中看到过这样的片段?

Robots.txt 不保证页面不会出现在搜索结果中:百度仍然可以根据外部信息(如传入链接)确定它的相关性,如果你想明确阻止页面被索引,你应该使用 noindex robots 元标记或 X-Robots-Tag HTTP 标头,在这种情况下,您不应在 robots.txt 中禁止该页面,因为必须抓取该页面才能看到并遵守该标记。

2.避免长重定向链

如果 网站 上连续的 301 和 302 重定向次数不合理,搜索蜘蛛会在某个时刻停止跟踪重定向,着陆页可能不会被抓取,更重要的是,每个重定向的 URL 都浪费“单位” “您的抓取频率,请确保使用重定向不超过连续两次,并且仅在绝对必要时使用。

3.管理 URL 参数

一些内容管理系统会生成大量实际指向同一页面的动态 URL,搜索引擎机器人默认将其视为单独的页面;因此可能会浪费抓取并可能滋生内容重复问题。 查看全部

网页数据抓取怎么写(

搜索引擎如何将频次分配给网站的机制以及提高网站排名和有机流量的技巧)

抓取频率更像是一个 SEO 概念。大多数情况下,站长并不关心百度蜘蛛的爬取频率,因为爬取频率对中小企业几乎没有影响网站。

虽然大多数 网站 管理员不必担心抓取频率,但如果运行大型 网站,抓取频率是我们可以(并且应该)优化的 SEO 因素。

当然,随着SEO的发展,爬取频率和排名的关系也并不简单。爬取本身并不是排名因素,但从某种角度来说,爬取频率对搜索引擎优化有间接影响(这也是蜘蛛池流行的原因)。

在本指南中,我将解释相关的爬网概念、搜索引擎如何为 网站 分配爬网率的机制,以及如何充分利用爬网率来最大化 网站 排名和自然搜索技巧交通。

内容

网络蜘蛛的好与坏

网络蜘蛛、爬虫或机器人是不断“访问”和爬取网页以采集某些信息的计算机程序。

根据爬行的目的,可以区分以下几种蜘蛛:

搜索引擎蜘蛛;

网络服务蜘蛛;

黑客蜘蛛;

搜索引擎蜘蛛由百度、谷歌或360等搜索引擎管理。这个蜘蛛可以抓取互联网上的所有页面(只要它们是可发现的),并将它们提供给搜索引擎的索引库。

SEO工具、购物、旅游、优惠券等很多网络服务网站都有自己的网络索引和爬虫,比如WebMeUp就有一个叫Blexbot的爬虫,每天可以爬取上百亿页面来采集反向链接数据并将该数据提供给其链接索引(SEO SpyGlass 中使用的链接索引)。

黑客也喜欢繁殖蜘蛛,用来测试各种网站漏洞,一旦发现,他们可能会尝试访问你的网站或服务器。

你可能会听到人们谈论好蜘蛛和坏蜘蛛,我这样区分它们:任何为非法目的采集信息的蜘蛛都是坏的,其余的都很好。

大多数蜘蛛在用户代理字符串的帮助下识别自己,并提供一个 URL,在那里他们可以了解更多关于蜘蛛的信息:

/uploads/allimg/180827/141355M58-1.jpg 983w, https://www.simcf.cc/wp-conten ... 4.jpg 300w, https://www.simcf.cc/wp-conten ... 9.jpg 768w

在本文中,我将重点介绍搜索引擎蜘蛛以及它们如何抓取 网站。

了解抓取频率

抓取频率是搜索引擎蜘蛛在特定时间段内点击网站的次数,比如百度一般一个月点击我的网站1000次,可以说1K就是百度的每个月爬取频率,请注意这些爬虫的数量和频率没有通用限制;

为什么抓取频率很重要?

从逻辑上讲,你应该关注爬取频率,因为你希望百度为网站发现尽可能多的重要页面,并且你还希望它能够快速找到你的网站上的新内容,爬取越高获取频率,这将发生得越快。

确定抓取频率

你可以在百度网站管理工具中查看你的网站爬取频率,比如你需要确定你的百度爬取频率,登录你的百度站长账号,进入数据监控->爬取频率,在这里您将看到每日的抓取频率。

/uploads/allimg/180827/1413552355-2.jpg 1024w, https://www.simcf.cc/wp-conten ... 2.jpg 300w, https://www.simcf.cc/wp-conten ... 1.jpg 768w, https://www.simcf.cc/wp-conten ... h.jpg 1159w

从上面的报告可以看出,百度平均每天抓取我大约网站30次,由此可以看出我每月的抓取频率是30*30=900。

当然,这个数字很容易变化和波动,但是,它会让你清楚地知道在给定的时间段内你可以抓取多少页 网站。

如果您需要更详细地查看各个页面的爬网统计信息,则必须分析服务器日志,日志文件的位置取决于服务器配置。

如果您不确定如何访问服务器日志,请向您的系统管理员或托管服务提供商寻求帮助。

原创日志文件难以阅读和分析。要理解这一点,您需要绝对的正则表达式技能或专门的工具。我更喜欢使用光年测井分析工具进行分析。

如何分配抓取频率?

对于搜索引擎优化,我们并不完全了解搜索引擎是如何形成网站的爬取频率的。所有博主都在整理互联网的内容,以获取搜索引擎使用以下两个因素来确定爬取频率:

受欢迎程度——更受欢迎的页面被更频繁地爬取;

陈旧 - 百度不会使有关页面的信息过时,对于 网站 管理员来说,这意味着如果页面内容更新频繁,百度会尝试更频繁地抓取页面。

假设 网站 的抓取频率与反向链接的数量以及该 网站 在百度眼中的重要性成正比——百度希望确保最重要的页面在索引上仍然是最新的。

内部链接呢?你能通过指向更多的内部链接来提高特定页面的爬取率吗?

为了回答这些问题,我决定检查内外链接的相关性和爬取统计,我采集了11个网站s的数据,做了一个简单的分析,总之,我就是这样做的。

我为将要分析的 11 个站点创建了项目,我计算了每个 网站 页面的内部链接数量,接下来我运行 SEO Spyglass 并为相同的 11 个站点创建了项目,在每个项目中,我检查了统计信息并复制带有每个页面的外部链接数量的锚 URL。

然后,我分析了服务器日志中的抓取统计信息,以了解百度每次访问每个页面的频率。最后,我将所有这些数据放入一个电子表格中,并计算内部链接和抓取预算与外部链接和抓取预算之间的相关性。

我发现了一些非常有趣的东西这是我分析的其中一个 网站 的示例电子表格:

/uploads/allimg/180827/1413554937-3.png 694w, https://www.simcf.cc/wp-conten ... 5.png 300w

我的数据集展示了蜘蛛访问次数和外部链接数量之间的强相关性(0,978),同时,蜘蛛命中和内部链接之间的相关性被证明非常弱(0,154),这表明反向链接比 网站 链接更重要。

这是否意味着增加爬取频率的唯一方法是建立链接和发布新内容?如果说整个网站的朱雀频率,我会说是的:经常添加链接和更新网站,网站的爬取频率会成比例增加。

但是当我们获取单个页面时,它会变得更有趣,正如您将在下面的介绍中看到的那样,您甚至可以在没有意识到的情况下浪费大量的爬网。通过巧妙地管理频率,您通常可以将单个页面的抓取次数翻倍——但它仍然与每页的反向链接数量成正比。

/uploads/allimg/180827/1413553348-4.png 694w, https://www.simcf.cc/wp-conten ... 0.png 300w

如何充分利用爬网频率

既然我们已经弄清楚了,爬取很重要,是不是需要更多的时间来管理爬取的频率?

您应该(或不应该)做很多事情来让您的搜索蜘蛛消耗更多的 网站 页面,这里列出了最大化爬取率功能要做的事情:

1.如果在搜索中找到的内容没有提供价值,请确保抓取并阻止重要页面。

.htaccess 和 robots.txt 不应该屏蔽 网站 的重要页面,robots 应该能够访问 CSS 和 Javascript 文件,同时你应该屏蔽你不想在搜索中显示的内容,屏蔽网站 的“建设中”区域和动态生成的 URL 等。

请记住,搜索引擎蜘蛛并不总是遵循 robots.txt 中收录的说明,您是否曾在 Google 搜索结果中看到过这样的片段?

Robots.txt 不保证页面不会出现在搜索结果中:百度仍然可以根据外部信息(如传入链接)确定它的相关性,如果你想明确阻止页面被索引,你应该使用 noindex robots 元标记或 X-Robots-Tag HTTP 标头,在这种情况下,您不应在 robots.txt 中禁止该页面,因为必须抓取该页面才能看到并遵守该标记。

2.避免长重定向链

如果 网站 上连续的 301 和 302 重定向次数不合理,搜索蜘蛛会在某个时刻停止跟踪重定向,着陆页可能不会被抓取,更重要的是,每个重定向的 URL 都浪费“单位” “您的抓取频率,请确保使用重定向不超过连续两次,并且仅在绝对必要时使用。

3.管理 URL 参数

一些内容管理系统会生成大量实际指向同一页面的动态 URL,搜索引擎机器人默认将其视为单独的页面;因此可能会浪费抓取并可能滋生内容重复问题。

网页数据抓取怎么写(搜索引擎蜘蛛访问网站页面时的程序被称为蜘蛛(spider))

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-21 15:13

搜索引擎用来抓取和访问页面的程序称为蜘蛛,也称为机器人。当搜索引擎蜘蛛访问网站的页面时,它类似于普通用户使用浏览器。蜘蛛程序发送页面访问请求后,服务器返回HTML代码,蜘蛛程序将接收到的代码存储在原创页面数据库中。为了提高搜索引擎的爬取和爬取速度,都使用了多只蜘蛛进行分布式爬取。

当蜘蛛访问网站时,它会首先访问网站根目录下的robots.txt文件。如果 robots.txt 文件禁止搜索引擎爬取某些网页或内容,或者 网站,则蜘蛛会遵循协议而不进行爬取。

蜘蛛也有自己的代理名称。在站长的日志中可以看到蜘蛛爬行的痕迹,这也是为什么很多站长总是说要先查看网站日志的原因(作为优秀的SEO你必须有能力查看网站日志而不任何软件,并且非常熟悉代码的含义)。

一、搜索引擎蜘蛛的基本原理

搜索引擎蜘蛛是Spider,这是一个很形象的名字。互联网被比作蜘蛛网,所以蜘蛛就是在网上四处爬行的蜘蛛。

网络蜘蛛通过网页的链接地址寻找网页,从网站的某个页面(通常是首页)开始,读取网页的内容,寻找网页中的其他链接地址,然后通过这些链接地址寻找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取完毕。

如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。

搜索引擎蜘蛛的基本原理和工作流程

对于搜索引擎来说,几乎不可能爬取互联网上的所有网页。根据目前公布的数据,容量最大的搜索引擎只爬取了网页总数的40%左右。

造成这种情况的原因之一是爬虫技术的瓶颈。100 亿个网页的容量是 100×2000G 字节。就算能存起来,下载也还是有问题(按照一台机器每秒下载20K,需要340台机器保存一年才能下载完所有网页),同时,由于数据量大,在提供搜索时也会对效率产生影响。

因此,很多搜索引擎的网络蜘蛛只抓取那些重要的网页,而在抓取时评估重要性的主要依据是某个网页的链接深度。

由于不可能爬取所有的网页,所以有些网络蜘蛛为一些不太重要的网站设置了要访问的层数,例如,如下图所示:

搜索引擎蜘蛛的基本原理和工作流程

A为起始页,属于第0层,B,C,D,E,F属于第1层,G,H属于第2层,I属于第3层,如果设置访问层数by the web spider 2, Web page I will not be access,这也使得某些网站网页可以在搜索引擎上搜索到,而其他部分则无法搜索到。

对于网站设计师来说,扁平的网站设计有助于搜索引擎抓取更多的网页。

网络蜘蛛在访问网站网页时,经常会遇到加密数据和网页权限的问题。某些网页需要会员权限才能访问。

当然,网站的站长可以让网络蜘蛛不按约定爬取,但是对于一些卖报告的网站,他们希望搜索引擎可以搜索到他们的报告,但不是完全免费的为了让搜索者查看,需要向网络蜘蛛提供相应的用户名和密码。

网络蜘蛛可以通过给定的权限抓取这些网页,从而提供搜索,当搜索者点击查看网页时,搜索者也需要提供相应的权限验证。

二、点击链接

为了在网络上抓取尽可能多的页面,搜索引擎蜘蛛会跟随网页上的链接,从一个页面爬到下一页,就像蜘蛛在蜘蛛网上爬行一样,这就是名字所在的地方搜索引擎蜘蛛的来源。因为。

整个互联网网站是由相互连接的链接组成的,也就是说,搜索引擎蜘蛛最终会从任何一个页面开始爬取所有页面。

搜索引擎蜘蛛的基本原理和工作流程

当然,网站和页面链接的结构过于复杂,蜘蛛只能通过一定的方法爬取所有页面。据了解,最简单的爬取策略有以下三种:

1、最好的第一

最佳优先级搜索策略根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。算法预测为“有用”的网页。

一个问题是爬虫爬取路径上的很多相关网页可能会被忽略,因为最佳优先级策略是一种局部最优搜索算法,所以需要结合具体应用来提高最佳优先级以跳出当地。最好的一点,据研究,这样的闭环调整可以将不相关网页的数量减少30%到90%。

2、深度优先

深度优先是指蜘蛛沿着找到的链接爬行,直到前面没有其他链接,然后返回第一页,沿着另一个链接爬行。

3、广度优先

广度优先是指当蜘蛛在一个页面上发现多个链接时,它不会一路跟随一个链接,而是爬取页面上的所有链接,然后进入第二层页面并跟随第二层找到的链接层。翻到第三页。

理论上,无论是深度优先还是广度优先,只要给蜘蛛足够的时间,它就可以爬取整个互联网。

在实际工作中,蜘蛛的带宽资源和时间都不是无限的,也无法爬取所有页面。其实最大的搜索引擎只是爬取和收录互联网的一小部分,当然不是搜索。引擎蜘蛛爬得越多越好。

因此,为了尽可能多地捕获用户信息,深度优先和广度优先通常是混合使用的,这样可以照顾到尽可能多的网站,同时也照顾到部分网站 的内页。

三、搜索引擎蜘蛛工作中的信息采集

信息采集模块包括“蜘蛛控制”和“网络蜘蛛”两部分。“蜘蛛”这个名字形象地描述了信息采集模块在网络数据形成的“Web”上获取信息的功能。

一般来说,网络爬虫都是从种子网页开始,反复下载网页,从文档中搜索不可见的URL,从而访问其他网页,遍历网页。

而它的工作策略一般可以分为累积爬取(cumulative crawling)和增量爬取(incremental crawling)两种。

1、累积爬取

累积爬取是指从某个时间点开始,遍历系统允许存储和处理的所有网页。在理想的软硬件环境下,经过足够的运行时间,累积爬取策略可以保证爬取相当大的网页集合。

似乎由于网络数据的动态特性,集合中的网页被爬取的时间点不同,页面更新的时间点也不同。因此,累计爬取的网页集合实际上无法与真实环境中的网页数据进行比较。始终如一。

2、增量爬取

与累积爬取不同的是,增量爬取是指在一定规模的网页集合的基础上,通过更新数据,在现有集合中选择过期的网页,以保证抓取到的网页被抓取。数据与真实网络数据足够接近。

增量爬取的前提是系统已经爬取了足够多的网页,并且有这些页面被爬取的时间的信息。在针对实际应用环境的网络爬虫设计中,通常会同时收录累积爬取和增量爬取策略。

累积爬取一般用于数据集合的整体建立或大规模更新,而增量爬取主要用于数据集合的日常维护和即时更新。

爬取策略确定后,如何充分利用网络带宽,合理确定网页数据更新的时间点,成为网络蜘蛛运营策略中的核心问题。

总体而言,在合理利用软硬件资源对网络数据进行实时捕捉方面,已经形成了较为成熟的技术和实用的解决方案。我觉得这方面需要解决的主要问题是如何更好的处理动态的web数据问题(比如越来越多的Web2.0数据等),更好的修改基于爬取策略关于网页质量。

四、数据库

为了避免重复爬取和爬取网址,搜索引擎会建立一个数据库来记录已发现未爬取的页面和已爬取的页面。那么数据库中的URLs是怎么来的呢?

1、手动输入种子网站

简单来说就是我们建站后提交给百度、谷歌或者360的URL收录。

2、蜘蛛爬取页面

如果搜索引擎蜘蛛在爬取过程中发现了新的连接URL,但不在数据库中,则将其存入待访问的数据库中(网站观察期)。

爬虫根据重要程度从要访问的数据库中提取URL,访问并爬取页面,然后从要访问的地址库中删除该URL,放入已经访问过的地址库中。因此,建议站长在网站观察,期间有必要尽可能定期更新网站。

3、站长提交网站

一般而言,提交网站只是将网站保存到要访问的数据库中。如果网站是持久化的,不更新spider,就不会光顾搜索引擎的页面了收录是spider自己点链接。

因此,将其提交给搜索引擎对您来说不是很有用。后期根据你的网站更新程度来考虑。搜索引擎更喜欢沿着链接本身查找新页面。当然,如果你的SEO技术足够成熟,并且有这个能力,你可以试试,说不定会有意想不到的效果。不过对于一般站长来说,还是建议让蜘蛛爬行,自然爬到新的站点页面。

五、吸引蜘蛛

虽然理论上说蜘蛛可以爬取所有页面,但在实践中是不可能的,所以想要收录更多页面的SEO人员不得不想办法引诱蜘蛛爬取。

既然不能爬取所有的页面,就需要让它爬取重要的页面,因为重要的页面在索引中起着重要的作用,直接影响排名因素。哪些页面更重要?对此,我特意整理了以下几个我认为比较重要的页面,具有以下特点:

1、网站 和页面权重

优质老网站被赋予高权重,而这个网站上的页面爬取深度更高,所以更多的内页会是收录。

2、页面更新

蜘蛛每次爬取时都会存储页面数据。如果第二次爬取发现页面内容和第一次收录完全一样,说明页面没有更新,蜘蛛不需要经常爬取再爬取。

如果页面内容更新频繁,蜘蛛就会频繁爬爬,那么页面上的新链接自然会被蜘蛛更快地跟踪和爬取,这也是为什么需要每天更新文章@ >

3、导入链接

无论是外部链接还是同一个网站的内部链接,为了被蜘蛛爬取,必须有传入链接才能进入页面,否则蜘蛛不会知道页面的存在一点也不。这时候URL链接就起到了非常重要的作用,内部链接的重要性就发挥出来了。

另外,我个人觉得高质量的入站链接也往往会增加页面上的出站链接被爬取的深度。

这就是为什么大多数网站管理员或 SEO 都想要高质量的附属链接,因为蜘蛛 网站 从彼此之间爬到你 网站 的次数和深度更多。 查看全部

网页数据抓取怎么写(搜索引擎蜘蛛访问网站页面时的程序被称为蜘蛛(spider))

搜索引擎用来抓取和访问页面的程序称为蜘蛛,也称为机器人。当搜索引擎蜘蛛访问网站的页面时,它类似于普通用户使用浏览器。蜘蛛程序发送页面访问请求后,服务器返回HTML代码,蜘蛛程序将接收到的代码存储在原创页面数据库中。为了提高搜索引擎的爬取和爬取速度,都使用了多只蜘蛛进行分布式爬取。

当蜘蛛访问网站时,它会首先访问网站根目录下的robots.txt文件。如果 robots.txt 文件禁止搜索引擎爬取某些网页或内容,或者 网站,则蜘蛛会遵循协议而不进行爬取。

蜘蛛也有自己的代理名称。在站长的日志中可以看到蜘蛛爬行的痕迹,这也是为什么很多站长总是说要先查看网站日志的原因(作为优秀的SEO你必须有能力查看网站日志而不任何软件,并且非常熟悉代码的含义)。

一、搜索引擎蜘蛛的基本原理

搜索引擎蜘蛛是Spider,这是一个很形象的名字。互联网被比作蜘蛛网,所以蜘蛛就是在网上四处爬行的蜘蛛。

网络蜘蛛通过网页的链接地址寻找网页,从网站的某个页面(通常是首页)开始,读取网页的内容,寻找网页中的其他链接地址,然后通过这些链接地址寻找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取完毕。

如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。

搜索引擎蜘蛛的基本原理和工作流程

对于搜索引擎来说,几乎不可能爬取互联网上的所有网页。根据目前公布的数据,容量最大的搜索引擎只爬取了网页总数的40%左右。

造成这种情况的原因之一是爬虫技术的瓶颈。100 亿个网页的容量是 100×2000G 字节。就算能存起来,下载也还是有问题(按照一台机器每秒下载20K,需要340台机器保存一年才能下载完所有网页),同时,由于数据量大,在提供搜索时也会对效率产生影响。

因此,很多搜索引擎的网络蜘蛛只抓取那些重要的网页,而在抓取时评估重要性的主要依据是某个网页的链接深度。

由于不可能爬取所有的网页,所以有些网络蜘蛛为一些不太重要的网站设置了要访问的层数,例如,如下图所示:

搜索引擎蜘蛛的基本原理和工作流程

A为起始页,属于第0层,B,C,D,E,F属于第1层,G,H属于第2层,I属于第3层,如果设置访问层数by the web spider 2, Web page I will not be access,这也使得某些网站网页可以在搜索引擎上搜索到,而其他部分则无法搜索到。

对于网站设计师来说,扁平的网站设计有助于搜索引擎抓取更多的网页。

网络蜘蛛在访问网站网页时,经常会遇到加密数据和网页权限的问题。某些网页需要会员权限才能访问。

当然,网站的站长可以让网络蜘蛛不按约定爬取,但是对于一些卖报告的网站,他们希望搜索引擎可以搜索到他们的报告,但不是完全免费的为了让搜索者查看,需要向网络蜘蛛提供相应的用户名和密码。

网络蜘蛛可以通过给定的权限抓取这些网页,从而提供搜索,当搜索者点击查看网页时,搜索者也需要提供相应的权限验证。

二、点击链接

为了在网络上抓取尽可能多的页面,搜索引擎蜘蛛会跟随网页上的链接,从一个页面爬到下一页,就像蜘蛛在蜘蛛网上爬行一样,这就是名字所在的地方搜索引擎蜘蛛的来源。因为。

整个互联网网站是由相互连接的链接组成的,也就是说,搜索引擎蜘蛛最终会从任何一个页面开始爬取所有页面。

搜索引擎蜘蛛的基本原理和工作流程

当然,网站和页面链接的结构过于复杂,蜘蛛只能通过一定的方法爬取所有页面。据了解,最简单的爬取策略有以下三种:

1、最好的第一

最佳优先级搜索策略根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。算法预测为“有用”的网页。

一个问题是爬虫爬取路径上的很多相关网页可能会被忽略,因为最佳优先级策略是一种局部最优搜索算法,所以需要结合具体应用来提高最佳优先级以跳出当地。最好的一点,据研究,这样的闭环调整可以将不相关网页的数量减少30%到90%。

2、深度优先

深度优先是指蜘蛛沿着找到的链接爬行,直到前面没有其他链接,然后返回第一页,沿着另一个链接爬行。

3、广度优先

广度优先是指当蜘蛛在一个页面上发现多个链接时,它不会一路跟随一个链接,而是爬取页面上的所有链接,然后进入第二层页面并跟随第二层找到的链接层。翻到第三页。

理论上,无论是深度优先还是广度优先,只要给蜘蛛足够的时间,它就可以爬取整个互联网。

在实际工作中,蜘蛛的带宽资源和时间都不是无限的,也无法爬取所有页面。其实最大的搜索引擎只是爬取和收录互联网的一小部分,当然不是搜索。引擎蜘蛛爬得越多越好。

因此,为了尽可能多地捕获用户信息,深度优先和广度优先通常是混合使用的,这样可以照顾到尽可能多的网站,同时也照顾到部分网站 的内页。

三、搜索引擎蜘蛛工作中的信息采集

信息采集模块包括“蜘蛛控制”和“网络蜘蛛”两部分。“蜘蛛”这个名字形象地描述了信息采集模块在网络数据形成的“Web”上获取信息的功能。

一般来说,网络爬虫都是从种子网页开始,反复下载网页,从文档中搜索不可见的URL,从而访问其他网页,遍历网页。

而它的工作策略一般可以分为累积爬取(cumulative crawling)和增量爬取(incremental crawling)两种。

1、累积爬取

累积爬取是指从某个时间点开始,遍历系统允许存储和处理的所有网页。在理想的软硬件环境下,经过足够的运行时间,累积爬取策略可以保证爬取相当大的网页集合。

似乎由于网络数据的动态特性,集合中的网页被爬取的时间点不同,页面更新的时间点也不同。因此,累计爬取的网页集合实际上无法与真实环境中的网页数据进行比较。始终如一。

2、增量爬取

与累积爬取不同的是,增量爬取是指在一定规模的网页集合的基础上,通过更新数据,在现有集合中选择过期的网页,以保证抓取到的网页被抓取。数据与真实网络数据足够接近。

增量爬取的前提是系统已经爬取了足够多的网页,并且有这些页面被爬取的时间的信息。在针对实际应用环境的网络爬虫设计中,通常会同时收录累积爬取和增量爬取策略。

累积爬取一般用于数据集合的整体建立或大规模更新,而增量爬取主要用于数据集合的日常维护和即时更新。

爬取策略确定后,如何充分利用网络带宽,合理确定网页数据更新的时间点,成为网络蜘蛛运营策略中的核心问题。

总体而言,在合理利用软硬件资源对网络数据进行实时捕捉方面,已经形成了较为成熟的技术和实用的解决方案。我觉得这方面需要解决的主要问题是如何更好的处理动态的web数据问题(比如越来越多的Web2.0数据等),更好的修改基于爬取策略关于网页质量。

四、数据库

为了避免重复爬取和爬取网址,搜索引擎会建立一个数据库来记录已发现未爬取的页面和已爬取的页面。那么数据库中的URLs是怎么来的呢?

1、手动输入种子网站

简单来说就是我们建站后提交给百度、谷歌或者360的URL收录。

2、蜘蛛爬取页面

如果搜索引擎蜘蛛在爬取过程中发现了新的连接URL,但不在数据库中,则将其存入待访问的数据库中(网站观察期)。

爬虫根据重要程度从要访问的数据库中提取URL,访问并爬取页面,然后从要访问的地址库中删除该URL,放入已经访问过的地址库中。因此,建议站长在网站观察,期间有必要尽可能定期更新网站。

3、站长提交网站

一般而言,提交网站只是将网站保存到要访问的数据库中。如果网站是持久化的,不更新spider,就不会光顾搜索引擎的页面了收录是spider自己点链接。

因此,将其提交给搜索引擎对您来说不是很有用。后期根据你的网站更新程度来考虑。搜索引擎更喜欢沿着链接本身查找新页面。当然,如果你的SEO技术足够成熟,并且有这个能力,你可以试试,说不定会有意想不到的效果。不过对于一般站长来说,还是建议让蜘蛛爬行,自然爬到新的站点页面。

五、吸引蜘蛛

虽然理论上说蜘蛛可以爬取所有页面,但在实践中是不可能的,所以想要收录更多页面的SEO人员不得不想办法引诱蜘蛛爬取。

既然不能爬取所有的页面,就需要让它爬取重要的页面,因为重要的页面在索引中起着重要的作用,直接影响排名因素。哪些页面更重要?对此,我特意整理了以下几个我认为比较重要的页面,具有以下特点:

1、网站 和页面权重

优质老网站被赋予高权重,而这个网站上的页面爬取深度更高,所以更多的内页会是收录。

2、页面更新

蜘蛛每次爬取时都会存储页面数据。如果第二次爬取发现页面内容和第一次收录完全一样,说明页面没有更新,蜘蛛不需要经常爬取再爬取。

如果页面内容更新频繁,蜘蛛就会频繁爬爬,那么页面上的新链接自然会被蜘蛛更快地跟踪和爬取,这也是为什么需要每天更新文章@ >

3、导入链接

无论是外部链接还是同一个网站的内部链接,为了被蜘蛛爬取,必须有传入链接才能进入页面,否则蜘蛛不会知道页面的存在一点也不。这时候URL链接就起到了非常重要的作用,内部链接的重要性就发挥出来了。

另外,我个人觉得高质量的入站链接也往往会增加页面上的出站链接被爬取的深度。

这就是为什么大多数网站管理员或 SEO 都想要高质量的附属链接,因为蜘蛛 网站 从彼此之间爬到你 网站 的次数和深度更多。

网页数据抓取怎么写(2.-toggle爬取数据,发现问题元素都选择好了)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-02-19 12:00

这是简易数据分析系列文章的第10期。

友情提示:这篇文章文章内容很多,信息量很大。希望大家在学习的时候多读几遍。

我们在朋友圈刷微博的时候,总是强调“刷”这个词,因为看动态的时候,当内容被拉到屏幕末尾时,APP会自动加载下一页的数据,从体验上来说看,数据将不断加载,永无止境。

今天我们要讲的是如何使用Web Scraper来抓取滚动到最后的网页。

今天的实践网站是知乎的数据分析模块的精髓。该网站是:

这次要刮的内容是精英帖的标题、回答者和点赞数。下面是今天的教程。

1.创建站点地图

一开始,我们需要创建一个容器,其中收录要捕获的三种数据。为了实现滚动到最后加载数据的功能,我们选择容器的类型为Element scroll down,即滚动到网页底部加载数据。

在这种情况下,所选元素被命名为 div.List-item。

为了复习上一节中通过数据数控制记录数的方法,我们在元素名后面加上nth-of-type(-n+100),只有前100条记录暂时捕获。

然后我们保存容器节点,在这个节点下选择要抓取的三种数据类型。

第一个是标题,我们命名为title,选中的元素命名为[itemprop='知乎:question'] a:

然后是响应者姓名和点赞数,选中元素名称为#Popover10-toggle a和button.VoteButton--up:

2. 爬取数据,发现问题

元素全部选中,我们按照Sitemap 知乎_top_answers->Scrape->Start craping的路径爬取数据,等了十多秒结果出来后,内容让我们傻眼了:

数据呢?我要捕获哪些数据?为什么这一切都变成了空?

在计算机领域,null一般表示空值,表示什么都没有。当放置在 Web Scraper 中时,这意味着没有捕获任何数据。

我们可以回想一下,网页上确实有数据。在整个操作过程中,唯一的变量就是选择元素的操作。因此,一定是我们选择元素时出错,导致内容匹配出现问题,无法正常爬取数据。要解决这个问题,我们需要看一下页面的构成。

3.分析问题

要查看一个网页的构成,我们需要用到浏览器的另一个功能,就是选择视图元素。

1.我们点击控制面板左上角的箭头,此时箭头颜色会变为蓝色。

2.然后我们将鼠标移到标题上,标题将被蓝色半透明蒙版覆盖。

3.我们再次点击标题,会发现我们会跳转到Elements子面板,内容是一些花哨的代码,很难看懂

这里不要害怕,这些HTML代码不涉及任何逻辑,它们只是网页中的一个骨架,提供一些排版功能。如果平时用markdown写,可以把HTML理解为markdown,功能更复杂。

结合HTML代码,我们先看一下[itemprop='知乎:question']的匹配规则a。

首先这是一个树结构:

从可视化的角度来看,上一句其实是一个嵌套结构。我提取了关键内容。内容结构是否清晰得多?

<a>如何快速成为数据分析师?</a>

让我们再分析一个获取空标题的标题 HTML 代码。

我们可以清楚地观察到,在本题的代码中,缺少名为 div 属性的标签 itemprop='知乎:question'!这样,当我们的匹配规则匹配时,找不到对应的标签,Web Scraper就会放弃匹配,认为找不到对应的内容,所以就变成了null。

一旦找到原因,我们就可以解决问题。

4.修复问题

我们发现,当一个标题被选中时,无论标题的嵌套关系如何变化,总有一个标签是不变的,就是最外层包裹着一个名为class='ContentItem-title的属性的h2标签'。如果我们可以直接选择h2标签,是不是就不能完美匹配标题内容了?

逻辑上理清了关系,我们如何操作Web Scraper?这时候我们就可以使用上一篇文章中介绍的内容文章来使用键盘P键选择元素的父节点:

在今天的课程中,我们点击 P 键两次来匹配标题的父标签 h2(或 h2.ContentItem-title):

依此类推,因为被访者的名字也出现了null,所以我们分析HTML结构,选择名字的父标签span.AuthorInfo-name。具体分析操作和上面类似,大家可以试试。

我的三个子内容的选择器如下,可以作为参考:

最后我们点击Scrape爬取数据,查看结果,没有null,完美!

5.吐槽时间

在爬取知乎数据的时候,我们会发现滚动加载数据很快,但是匹配元素需要很多时间。

这间接说明知乎this网站从代码的角度来看还是写得比较差。

如果你爬了很多网站,你会发现大部分网页结构都比较“随意”。所以在正式取数据之前,往往需要进行小范围的尝试,比如先取20条记录,看看数据有没有问题。没问题后,可以加一个大范围的正式拉取,一定程度上可以减少返工时间。

6.下一期

这个问题有很多内容。你可以多读几遍来消化它。下一期我们会讲一些简单的内容,以及如何抓取表格内容。 查看全部

网页数据抓取怎么写(2.-toggle爬取数据,发现问题元素都选择好了)

这是简易数据分析系列文章的第10期。

友情提示:这篇文章文章内容很多,信息量很大。希望大家在学习的时候多读几遍。

我们在朋友圈刷微博的时候,总是强调“刷”这个词,因为看动态的时候,当内容被拉到屏幕末尾时,APP会自动加载下一页的数据,从体验上来说看,数据将不断加载,永无止境。

今天我们要讲的是如何使用Web Scraper来抓取滚动到最后的网页。

今天的实践网站是知乎的数据分析模块的精髓。该网站是:

这次要刮的内容是精英帖的标题、回答者和点赞数。下面是今天的教程。

1.创建站点地图

一开始,我们需要创建一个容器,其中收录要捕获的三种数据。为了实现滚动到最后加载数据的功能,我们选择容器的类型为Element scroll down,即滚动到网页底部加载数据。

在这种情况下,所选元素被命名为 div.List-item。

为了复习上一节中通过数据数控制记录数的方法,我们在元素名后面加上nth-of-type(-n+100),只有前100条记录暂时捕获。

然后我们保存容器节点,在这个节点下选择要抓取的三种数据类型。

第一个是标题,我们命名为title,选中的元素命名为[itemprop='知乎:question'] a:

然后是响应者姓名和点赞数,选中元素名称为#Popover10-toggle a和button.VoteButton--up:

2. 爬取数据,发现问题

元素全部选中,我们按照Sitemap 知乎_top_answers->Scrape->Start craping的路径爬取数据,等了十多秒结果出来后,内容让我们傻眼了:

数据呢?我要捕获哪些数据?为什么这一切都变成了空?

在计算机领域,null一般表示空值,表示什么都没有。当放置在 Web Scraper 中时,这意味着没有捕获任何数据。

我们可以回想一下,网页上确实有数据。在整个操作过程中,唯一的变量就是选择元素的操作。因此,一定是我们选择元素时出错,导致内容匹配出现问题,无法正常爬取数据。要解决这个问题,我们需要看一下页面的构成。

3.分析问题

要查看一个网页的构成,我们需要用到浏览器的另一个功能,就是选择视图元素。

1.我们点击控制面板左上角的箭头,此时箭头颜色会变为蓝色。

2.然后我们将鼠标移到标题上,标题将被蓝色半透明蒙版覆盖。

3.我们再次点击标题,会发现我们会跳转到Elements子面板,内容是一些花哨的代码,很难看懂

这里不要害怕,这些HTML代码不涉及任何逻辑,它们只是网页中的一个骨架,提供一些排版功能。如果平时用markdown写,可以把HTML理解为markdown,功能更复杂。

结合HTML代码,我们先看一下[itemprop='知乎:question']的匹配规则a。

首先这是一个树结构:

从可视化的角度来看,上一句其实是一个嵌套结构。我提取了关键内容。内容结构是否清晰得多?

<a>如何快速成为数据分析师?</a>

让我们再分析一个获取空标题的标题 HTML 代码。

我们可以清楚地观察到,在本题的代码中,缺少名为 div 属性的标签 itemprop='知乎:question'!这样,当我们的匹配规则匹配时,找不到对应的标签,Web Scraper就会放弃匹配,认为找不到对应的内容,所以就变成了null。

一旦找到原因,我们就可以解决问题。

4.修复问题

我们发现,当一个标题被选中时,无论标题的嵌套关系如何变化,总有一个标签是不变的,就是最外层包裹着一个名为class='ContentItem-title的属性的h2标签'。如果我们可以直接选择h2标签,是不是就不能完美匹配标题内容了?

逻辑上理清了关系,我们如何操作Web Scraper?这时候我们就可以使用上一篇文章中介绍的内容文章来使用键盘P键选择元素的父节点:

在今天的课程中,我们点击 P 键两次来匹配标题的父标签 h2(或 h2.ContentItem-title):

依此类推,因为被访者的名字也出现了null,所以我们分析HTML结构,选择名字的父标签span.AuthorInfo-name。具体分析操作和上面类似,大家可以试试。

我的三个子内容的选择器如下,可以作为参考:

最后我们点击Scrape爬取数据,查看结果,没有null,完美!

5.吐槽时间

在爬取知乎数据的时候,我们会发现滚动加载数据很快,但是匹配元素需要很多时间。

这间接说明知乎this网站从代码的角度来看还是写得比较差。

如果你爬了很多网站,你会发现大部分网页结构都比较“随意”。所以在正式取数据之前,往往需要进行小范围的尝试,比如先取20条记录,看看数据有没有问题。没问题后,可以加一个大范围的正式拉取,一定程度上可以减少返工时间。

6.下一期

这个问题有很多内容。你可以多读几遍来消化它。下一期我们会讲一些简单的内容,以及如何抓取表格内容。

网页数据抓取怎么写(安装python运行pipinstallrequests运行installBeautifulSoupinstall教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-02-18 18:15

从各种搜索引擎到日常数据采集,都离不开网络爬虫monkey织梦教程。爬虫的基本原理很简单。它遍历网络中的网页并抓取感兴趣的数据内容。本篇文章将介绍如何编写一个网络爬虫从零开始爬取数据,然后逐步完善爬虫的爬取功能。

工具安装

我们需要安装 pythonmonkey织梦 教程、python 的请求和 BeautifulSoup 库。我们使用 Requests 库来抓取网页内容,并使用 BeautifulSoup 库从网页中提取数据。

安装蟒蛇

运行 pip 安装请求

运行 pip install BeautifulSoup

爬网

完成必要工具的安装后,我们正式开始编写我们的爬虫猴织梦教程。我们的首要任务是抓取豆瓣上的所有图书信息。我们以:///subject/26986954/为例,先看看如何爬取网页的内容。

使用python的requests提供的get()方法,我们可以很方便的获取到指定网页的内容。代码如下monkey织梦教程:

提取内容

抓取网页内容后,我们要做的就是提取我们想要的内容monkey织梦Tutorial。在我们的第一个示例中,我们只需要提取书名。首先,我们导入 BeautifulSoup 库。使用 BeautifulSoup,我们可以轻松提取网页的具体内容。

连续爬网

至此,我们已经可以爬取单个页面的内容了,下面我们来看看如何爬取整个网站的内容。我们知道网页是通过超链接相互连接的,通过超链接我们可以访问整个网络。所以我们可以从每个页面中提取到其他页面的链接,然后反复爬取新的链接。

通过以上步骤,我们就可以写出一个最原创的爬虫了。在了解爬虫原理的基础上,我们可以进一步完善爬虫。

写了一系列关于爬虫的文章 文章::///i6567289381185389064/。如果你有兴趣,你可以去看看。

Python基础环境搭建、爬虫基本原理及爬虫原型

Python 爬虫入门(第 1 部分)

如何使用 BeautifulSoup 提取网页内容

Python 爬虫入门(第 2 部分)

爬虫运行时数据的存储数据,以 SQLite 和 MySQL 为例

Python 爬虫入门(第 3 部分)

使用 selenium webdriver 抓取动态网页

Python 爬虫入门(第 4 部分)

讨论了如何处理网站的反爬策略

Python 爬虫入门(第 5 部分)

介绍了Python的Scrapy爬虫框架,并简要演示了如何在Scrapy下开发

Python 爬虫入门(第 6 部分)

python中的高级编程是什么?

与其他编程语言一样,高级阶段是相对于初中阶段的提升阶段。事实上,达到高级阶段意味着你可以独立完成一个项目模块,甚至可以独立规划和推进独立的中小型项目。然后你需要达到这个阶段。掌握什么技能:

1、Django 框架;

2、Flask 框架;

3、三大数据库语言(mysql、Redis、MongoDB),尤其是mysql与python的交互;

4、Linux操作系统的命令操作;

5、网络爬虫技术;

6、Requests、Selenium、Scrapy 等模块的使用。

等等。

在编程开发中,尤其是现在模块化开发中,标准化的学习教程并不代表你进入了什么阶段。例如:你对python的所有知识都非常熟悉,但是你不能做一个基本的小项目,甚至解决不了任何问题,通过学习过程进入高级是没有意义的。

因此,在具体工作中,我们评估一个人是否已经进入高层,或者他所在团队的技术水平(记住环境)是否可以高于普通成员的能力。事实上,我们认为你属于这个团队的高层。.

python中高级编程往往是根据需要学习的知识点来衡量的,但这并不代表你的实际水平,也不代表你是团队中的资深程序员。

知识并不意味着动手能力。 查看全部

网页数据抓取怎么写(安装python运行pipinstallrequests运行installBeautifulSoupinstall教程)

从各种搜索引擎到日常数据采集,都离不开网络爬虫monkey织梦教程。爬虫的基本原理很简单。它遍历网络中的网页并抓取感兴趣的数据内容。本篇文章将介绍如何编写一个网络爬虫从零开始爬取数据,然后逐步完善爬虫的爬取功能。

工具安装

我们需要安装 pythonmonkey织梦 教程、python 的请求和 BeautifulSoup 库。我们使用 Requests 库来抓取网页内容,并使用 BeautifulSoup 库从网页中提取数据。

安装蟒蛇

运行 pip 安装请求

运行 pip install BeautifulSoup

爬网

完成必要工具的安装后,我们正式开始编写我们的爬虫猴织梦教程。我们的首要任务是抓取豆瓣上的所有图书信息。我们以:///subject/26986954/为例,先看看如何爬取网页的内容。

使用python的requests提供的get()方法,我们可以很方便的获取到指定网页的内容。代码如下monkey织梦教程:

提取内容

抓取网页内容后,我们要做的就是提取我们想要的内容monkey织梦Tutorial。在我们的第一个示例中,我们只需要提取书名。首先,我们导入 BeautifulSoup 库。使用 BeautifulSoup,我们可以轻松提取网页的具体内容。

连续爬网

至此,我们已经可以爬取单个页面的内容了,下面我们来看看如何爬取整个网站的内容。我们知道网页是通过超链接相互连接的,通过超链接我们可以访问整个网络。所以我们可以从每个页面中提取到其他页面的链接,然后反复爬取新的链接。

通过以上步骤,我们就可以写出一个最原创的爬虫了。在了解爬虫原理的基础上,我们可以进一步完善爬虫。

写了一系列关于爬虫的文章 文章::///i6567289381185389064/。如果你有兴趣,你可以去看看。

Python基础环境搭建、爬虫基本原理及爬虫原型

Python 爬虫入门(第 1 部分)

如何使用 BeautifulSoup 提取网页内容

Python 爬虫入门(第 2 部分)

爬虫运行时数据的存储数据,以 SQLite 和 MySQL 为例

Python 爬虫入门(第 3 部分)

使用 selenium webdriver 抓取动态网页

Python 爬虫入门(第 4 部分)

讨论了如何处理网站的反爬策略

Python 爬虫入门(第 5 部分)

介绍了Python的Scrapy爬虫框架,并简要演示了如何在Scrapy下开发

Python 爬虫入门(第 6 部分)

python中的高级编程是什么?

与其他编程语言一样,高级阶段是相对于初中阶段的提升阶段。事实上,达到高级阶段意味着你可以独立完成一个项目模块,甚至可以独立规划和推进独立的中小型项目。然后你需要达到这个阶段。掌握什么技能:

1、Django 框架;

2、Flask 框架;

3、三大数据库语言(mysql、Redis、MongoDB),尤其是mysql与python的交互;

4、Linux操作系统的命令操作;

5、网络爬虫技术;

6、Requests、Selenium、Scrapy 等模块的使用。

等等。

在编程开发中,尤其是现在模块化开发中,标准化的学习教程并不代表你进入了什么阶段。例如:你对python的所有知识都非常熟悉,但是你不能做一个基本的小项目,甚至解决不了任何问题,通过学习过程进入高级是没有意义的。

因此,在具体工作中,我们评估一个人是否已经进入高层,或者他所在团队的技术水平(记住环境)是否可以高于普通成员的能力。事实上,我们认为你属于这个团队的高层。.

python中高级编程往往是根据需要学习的知识点来衡量的,但这并不代表你的实际水平,也不代表你是团队中的资深程序员。

知识并不意味着动手能力。

网页数据抓取怎么写(第三方工具使用工具的方法和内容的区别)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-02-18 08:25

一、使用第三方工具,其中最著名的是优采云采集器,这里不再赘述。

二、自己写程序来抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

起初,我也尝试使用第三方工具来获取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不明白怎么用,就干脆决定自己写了。嗯,现在基本上半天就能搞定一个网站(只是程序开发时间,不包括数据采集时间)。

经过一段时间的数据爬取生涯,我也遇到了很多困难。最常见的一种是分页数据的爬取。原因是数据分页的形式有很多种。下面我主要介绍三种形式。抓取分页数据的方法,虽然在网上看过很多文章,但是每次拿别人的代码,总是会出现各种各样的问题。以下方式的代码都是正确的。实现,我目前正在使用它。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同。

让我们切入正题:

第一种方式:URL地址收录分页信息。这种形式是最简单的。使用第三方工具爬取这个表单也很简单。基本上,您不需要编写代码。对我来说,我宁愿花半天时间自己写。懒得学第三方工具的人还是可以自己写代码来实现的;

该方法是通过循环生成数据分页的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地数据库;抓取的代码可以参考以下:

公共字符串 GetResponseString(字符串 url){

字符串 _StrResponse = "";

HttpWebRequest _WebRequest = (HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent = "MOZILLA/4.0(兼容;MSIE 7.0;WINDOWS NT 5.2;.NET CLR 1.1.4322;.NET CLR 2.0.50727;.NET CLR 3.0.04506.648;.NET CLR 3.5.21022;. NET CLR 3.0.4506.2152; .NET CLR 3.5.30729)";

_WebRequest.Method = "GET";

WebResponse _WebResponse = _WebRequest.GetResponse();

StreamReader _ResponseStream = new StreamReader(_WebResponse.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse = _ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

返回_StrResponse;

}

上面的代码可以返回对应页面的html内容的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

第二种方式:可能会遇到通过asp.NET开发的网站,它的分页控件通过post向后台代码提交分页信息,比如.net下Gridview自带的分页功能,当你点击的时候分页页码,你会发现URL地址没有变,但是页码变了,页面内容也变了。仔细看会发现,当你把鼠标移到每个页码上的时候,状态栏会显示:__dopostback("gridview","page1") 等等,这个表格其实也不是很难,因为毕竟,有一个地方可以得到页码的规则。

我们知道提交HTTP请求有两种方式:一种是get,另一种是post,第一种是get,第二种是post。具体提交原理无需赘述,不是本文重点

爬取这类页面需要注意asp.Net页面的几个重要元素

一、 __VIEWSTATE ,这应该是 .net 独有的,也是 .net 开发人员又爱又恨的东西。当你打开一个网站的页面时,如果你发现了这个东西,并且后面跟着很多乱七八糟的字符,那么这个网站一定要写;

二、__dopostback 方法,这是一个页面自动生成的javascript方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,页码信息将传递给这两个参数。

三、__EVENTVALIDATION 这也应该是独一无二的

不需要太在意这三样东西是干什么的,只要在自己写代码抓取页面的时候记得提交这三个元素就可以了。

和第一种方法一样,_dopostback的两个参数必须循环拼凑,只有收录页码信息的参数需要拼凑。这里有一点需要注意,就是每次通过Post提交下一页请求时,首先要获取当前页的__VIEWSTATE信息和__EVENTVALIDATION信息,这样第一页的分页数据就可以使用第一种方法获得。页码内容然后,同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后循环处理下一页,然后在每一个页面爬取完成后记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一个页面发布数据使用

参考代码如下:

for (int i = 0; i < 1000; i++){

System.Net.WebClient WebClientObj = new System.Net.WebClient();

System.采集s.Specialized.NameValue采集 PostVars = new System.采集s.Specialized.NameValue采集();

PostVars.Add("__VIEWSTATE", "这里是需要提前获取的信息");

PostVars.Add("__EVENTVALIDATION", "这里是您需要提前获取的信息");

PostVars.Add("__EVENTTARGET", "这里是__dopostback方法对应的参数");

PostVars.Add("__EVENTARGUMENT", "这里是__dopostback方法对应的参数");

WebClientObj.Headers.Add("ContentType", "application/x-www-form-urlencoded");

尝试

{

byte[] byte1 = WebClientObj.UploadValues("", "POST", PostVars);

string ResponseStr = Encoding.UTF8.GetString(byte1);//获取当前页面对应的html文本字符串

GetPostValue(ResponseStr);//获取上面需要的信息,比如当前页面对应的__VIEWSTATE,用于抓取下一页

SaveMessage(ResponseStr);//将你关心的内容保存到数据库中

}catch(例外前){

Console.WriteLine(ex.Message);

}

}

第三种方式:第三种方式是最麻烦最恶心的。这种页面在翻页过程中找不到任何地方的页码信息。这种方式耗费了我不少心血,后来采用了更狠的方法,用代码来模拟手动翻页。该方法应该能够处理任何形式的翻页数据。原理是用代码模拟手动点击翻页链接,用代码逐页翻页。然后逐页抓取。

俗话说,外行看热闹,行家看门道。很多人可能看到这个,说可以通过使用Webbrowser控件来实现。是的,我遵循的方式是使用 WebBrowser 控件来实现它。其实.net下应该有这么一个类似的类,不过我没有研究过,希望有人有别的办法,可以回复我,分享给大家。

WebBroser控件在自己的程序中嵌入了一个浏览器,就像IE、Firefox等一样,你也可以用它来开发自己的浏览器。至于用它开发的浏览器的效果,我想肯定不如IE和Firefox。呵呵

让我们减少八卦并切入主题:

使用WebBroser控件基本上可以实现任何可以在IE中操作网页的功能,所以当然也可以点击翻页按钮。既然可以手动点击WebBroser中的翻页按钮,自然我们也可以用程序代码来指令WebBroser。自动为我们翻页。

其实原理很简单,主要分为以下几个步骤:

第一步,打开你要抓取的页面,例如:

调用webBrowser控件的方法Navigate("");

此时,您应该在您的 WebBrowser 控件中看到您的网页信息,与您在 IE 中看到的一样;

第二步,WebBrowser控件的DocumentCompleted事件非常重要。当你访问的页面全部加载完毕,就会触发这个事件。所以我们分析页面元素的过程也需要在这个事件中完成

字符串 _ResponseStr=this.WebBrowser1.Document.Body.OuterHtml;

这段代码可以获取当前打开页面的html元素的内容。

既然已经获取了当前打开的页面的html元素的内容,剩下的工作自然就是解析这个大字符串,得到自己关心的内容,以及解析字符串的过程,大家应该会可以自己写。

第三步,重点在这第三步,因为页面快要翻了,那么第二步,解析完字符串后,还是调用DocumentCompleted事件中的方法

WebBrowser1.Document.GetElementById("页码id").InvokeMember("点击");

从代码的方法名应该可以理解,调用该方法后,WebBrwoser控件中的网页会实现翻页,和手动点击翻页按钮是一样的。

重点是在翻页之后,DocumentCompleted事件也会被触发,所以第二步和第三步都在循环中,所以需要注意判断跳出循环的时机。

其实用WebBrowser可以做的事情有很多,比如自动登录、注销论坛、保存session、cockie,所以这个控件基本可以实现你对网页的任何操作,即使你想破解一个网站暴利的登录密码,当然不推荐这样。呵呵 查看全部

网页数据抓取怎么写(第三方工具使用工具的方法和内容的区别)

一、使用第三方工具,其中最著名的是优采云采集器,这里不再赘述。

二、自己写程序来抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

起初,我也尝试使用第三方工具来获取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不明白怎么用,就干脆决定自己写了。嗯,现在基本上半天就能搞定一个网站(只是程序开发时间,不包括数据采集时间)。

经过一段时间的数据爬取生涯,我也遇到了很多困难。最常见的一种是分页数据的爬取。原因是数据分页的形式有很多种。下面我主要介绍三种形式。抓取分页数据的方法,虽然在网上看过很多文章,但是每次拿别人的代码,总是会出现各种各样的问题。以下方式的代码都是正确的。实现,我目前正在使用它。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同。

让我们切入正题:

第一种方式:URL地址收录分页信息。这种形式是最简单的。使用第三方工具爬取这个表单也很简单。基本上,您不需要编写代码。对我来说,我宁愿花半天时间自己写。懒得学第三方工具的人还是可以自己写代码来实现的;

该方法是通过循环生成数据分页的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地数据库;抓取的代码可以参考以下:

公共字符串 GetResponseString(字符串 url){

字符串 _StrResponse = "";

HttpWebRequest _WebRequest = (HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent = "MOZILLA/4.0(兼容;MSIE 7.0;WINDOWS NT 5.2;.NET CLR 1.1.4322;.NET CLR 2.0.50727;.NET CLR 3.0.04506.648;.NET CLR 3.5.21022;. NET CLR 3.0.4506.2152; .NET CLR 3.5.30729)";

_WebRequest.Method = "GET";

WebResponse _WebResponse = _WebRequest.GetResponse();

StreamReader _ResponseStream = new StreamReader(_WebResponse.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse = _ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

返回_StrResponse;

}

上面的代码可以返回对应页面的html内容的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

第二种方式:可能会遇到通过asp.NET开发的网站,它的分页控件通过post向后台代码提交分页信息,比如.net下Gridview自带的分页功能,当你点击的时候分页页码,你会发现URL地址没有变,但是页码变了,页面内容也变了。仔细看会发现,当你把鼠标移到每个页码上的时候,状态栏会显示:__dopostback("gridview","page1") 等等,这个表格其实也不是很难,因为毕竟,有一个地方可以得到页码的规则。

我们知道提交HTTP请求有两种方式:一种是get,另一种是post,第一种是get,第二种是post。具体提交原理无需赘述,不是本文重点

爬取这类页面需要注意asp.Net页面的几个重要元素

一、 __VIEWSTATE ,这应该是 .net 独有的,也是 .net 开发人员又爱又恨的东西。当你打开一个网站的页面时,如果你发现了这个东西,并且后面跟着很多乱七八糟的字符,那么这个网站一定要写;

二、__dopostback 方法,这是一个页面自动生成的javascript方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,页码信息将传递给这两个参数。

三、__EVENTVALIDATION 这也应该是独一无二的

不需要太在意这三样东西是干什么的,只要在自己写代码抓取页面的时候记得提交这三个元素就可以了。

和第一种方法一样,_dopostback的两个参数必须循环拼凑,只有收录页码信息的参数需要拼凑。这里有一点需要注意,就是每次通过Post提交下一页请求时,首先要获取当前页的__VIEWSTATE信息和__EVENTVALIDATION信息,这样第一页的分页数据就可以使用第一种方法获得。页码内容然后,同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后循环处理下一页,然后在每一个页面爬取完成后记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一个页面发布数据使用

参考代码如下:

for (int i = 0; i < 1000; i++){

System.Net.WebClient WebClientObj = new System.Net.WebClient();

System.采集s.Specialized.NameValue采集 PostVars = new System.采集s.Specialized.NameValue采集();

PostVars.Add("__VIEWSTATE", "这里是需要提前获取的信息");

PostVars.Add("__EVENTVALIDATION", "这里是您需要提前获取的信息");

PostVars.Add("__EVENTTARGET", "这里是__dopostback方法对应的参数");

PostVars.Add("__EVENTARGUMENT", "这里是__dopostback方法对应的参数");

WebClientObj.Headers.Add("ContentType", "application/x-www-form-urlencoded");

尝试

{

byte[] byte1 = WebClientObj.UploadValues("", "POST", PostVars);

string ResponseStr = Encoding.UTF8.GetString(byte1);//获取当前页面对应的html文本字符串

GetPostValue(ResponseStr);//获取上面需要的信息,比如当前页面对应的__VIEWSTATE,用于抓取下一页

SaveMessage(ResponseStr);//将你关心的内容保存到数据库中

}catch(例外前){

Console.WriteLine(ex.Message);

}

}