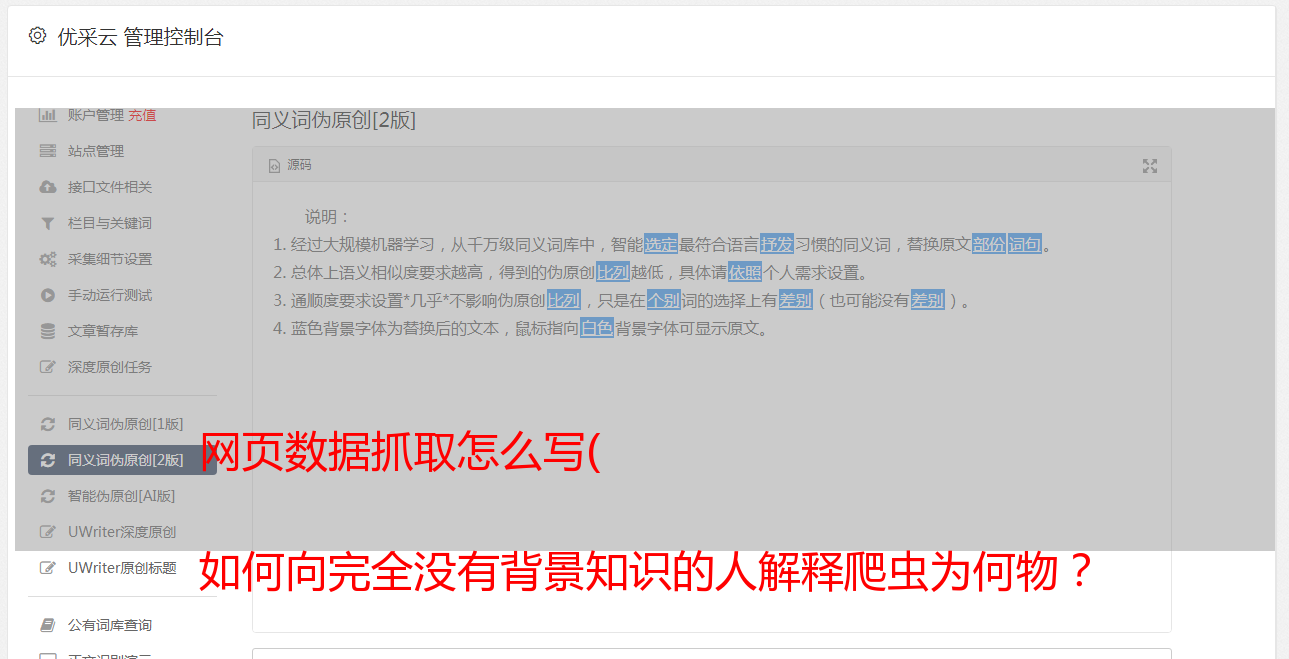

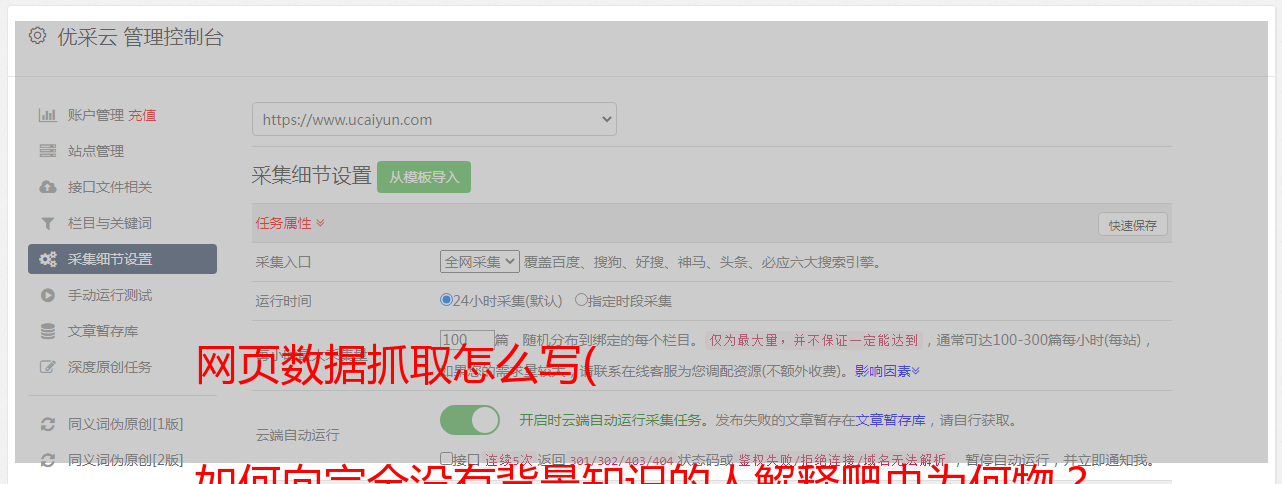

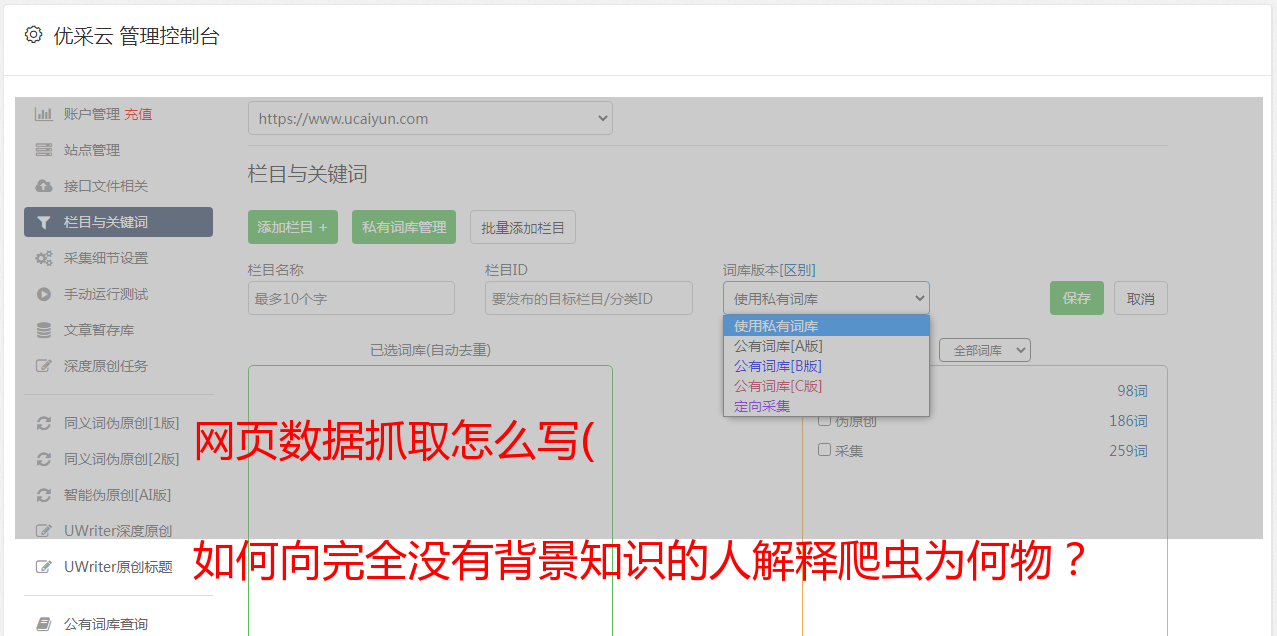

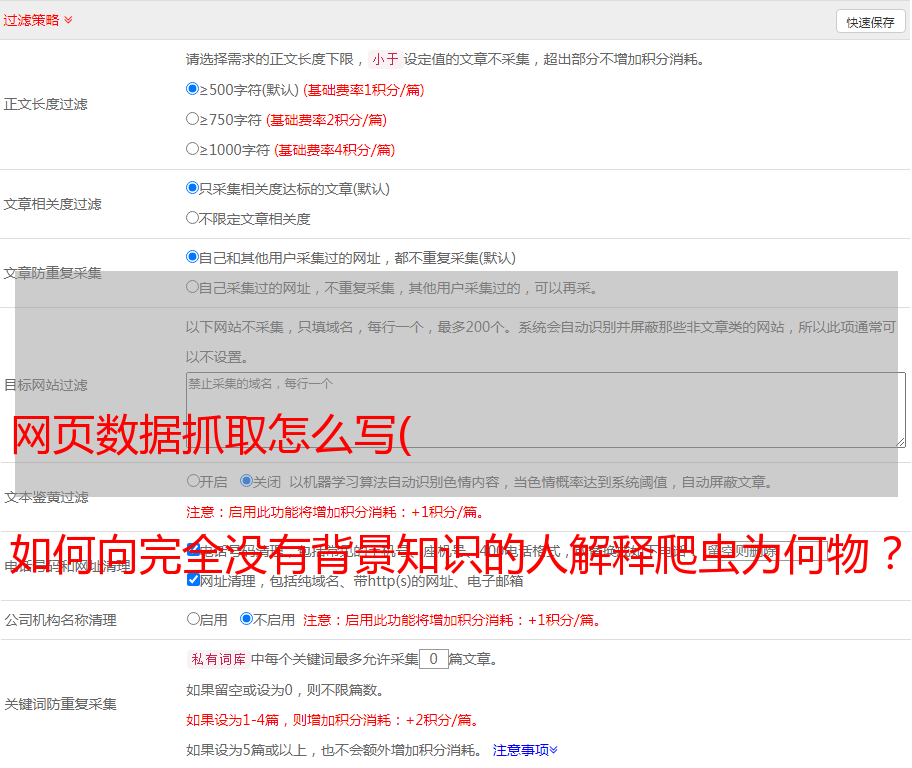

网页数据抓取怎么写( 如何向完全没有背景知识的人解释爬虫为何物? )

优采云 发布时间: 2022-03-20 22:26网页数据抓取怎么写(

如何向完全没有背景知识的人解释爬虫为何物?

)

"

当我们在网站上看到一系列的地址信息、商品信息甚至是天气、新闻等真实信息,但由于数量巨大而难以通过人工复制粘贴的方式获取完整信息时,爬虫可以完成为您完成所有工作。

- “如何向完全没有背景知识的人解释爬行动物是什么?”

——“爬虫是按照一定的规则为你浏览网页并复制粘贴东西的程序。”

是的,听起来很高级,要不要写代码?!网上搜什么是Python+Scrapy,功能这么强大。但即便如此,对于一些结构简单,只用于应急的数据采集来说,还是有点小题大做,普通用户很可能会注意安装python+scrapy包。

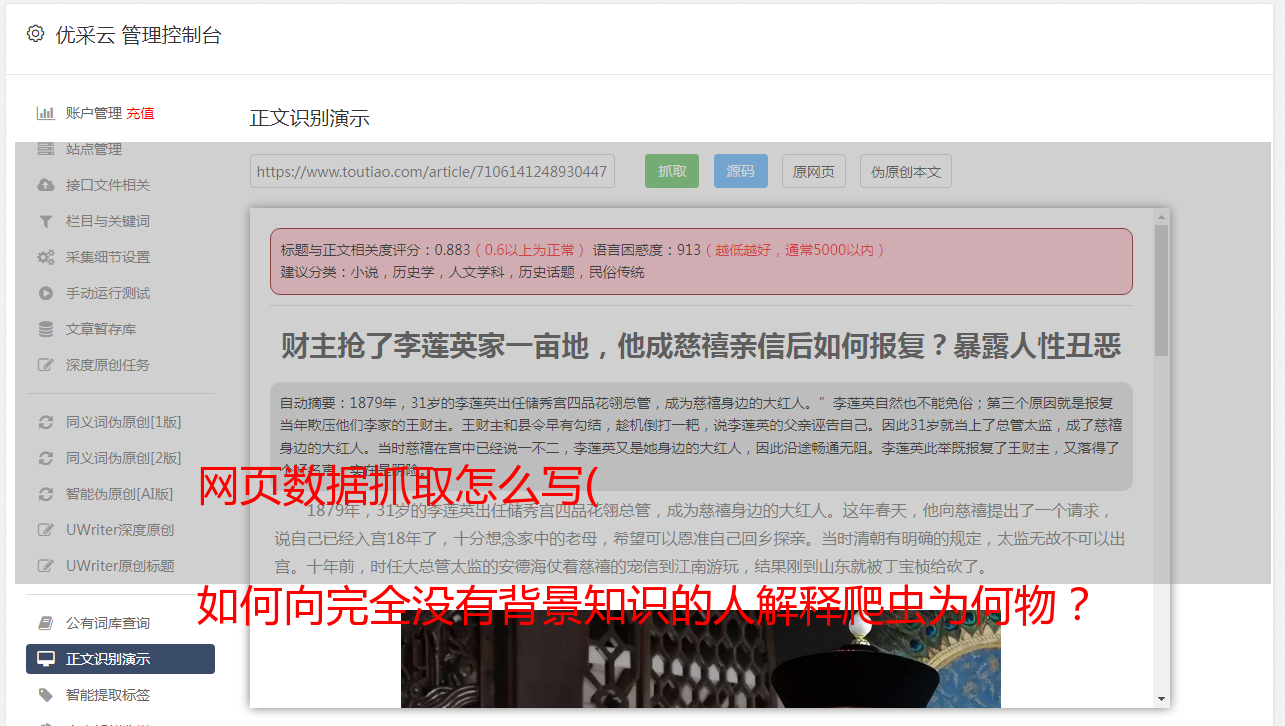

WebScraper 首次亮相

这时候,Chrome的爬虫插件就脱颖而出了!()名字叫Web Scraper,web既可以指网络爬虫,也可以指网络爬虫,双关语(可能是我想太多了……)

如何安装插件这里略过,网站上有一段很友好的介绍视频。总之,安装好后在Chrome下按F12启动

拿一个椰子

事不宜迟,快来看看椰子吧!哦不,栗子!

让我们带大家一起爬上天猫“椰子绿”的价格吧!

1

打开页面

我们来看看我们感兴趣的“青椰子和价格”页面

这是正确的!我感兴趣的是椰子绿!

2

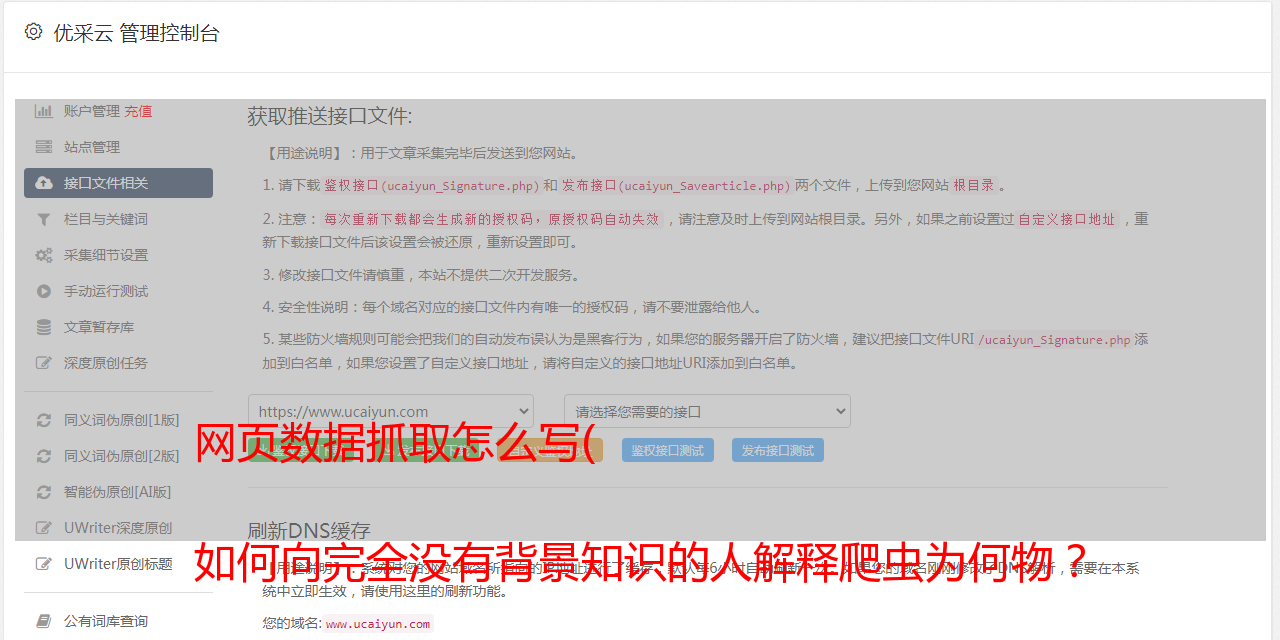

喊出爬虫界面

于是我们按照提示打开在线爬虫界面

最右边的Web Scraper标签就是我们之前安装的爬虫插件。从现在开始,我们将为爬虫建立复制和粘贴数据的规则,以防止获取一些不应该获取的不需要的数据。

3

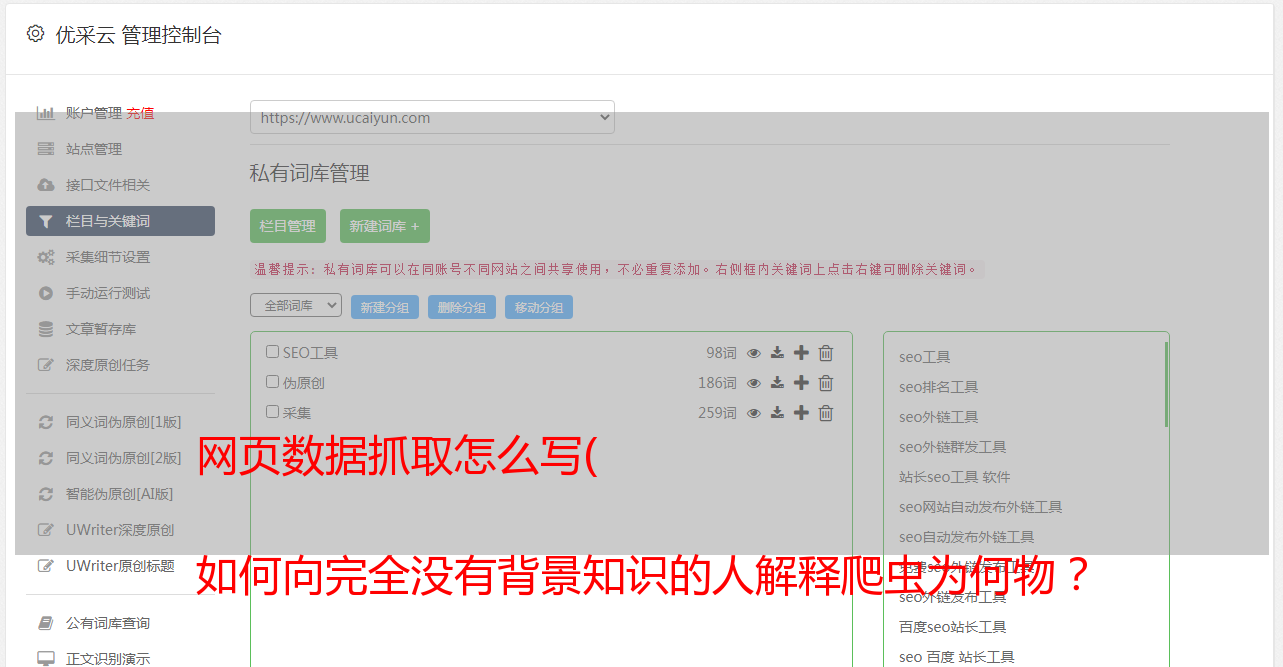

制定规则

正如我之前所说,爬虫是为你浏览网页并复制粘贴的东西,所以它应该模拟你的行为。首先你打开这个界面,知道这个网页就是“我要的数据的起点”,那么对于爬虫来说,这就是他的根。所以让我们创建一个新的爬虫并告诉他:

我们点击Create new sitemap来创建一个爬虫并给它起个名字~顺便告诉它起点(当前浏览器中的URL)。然后我们进入这个爬虫(淘宝)的根目录:

4

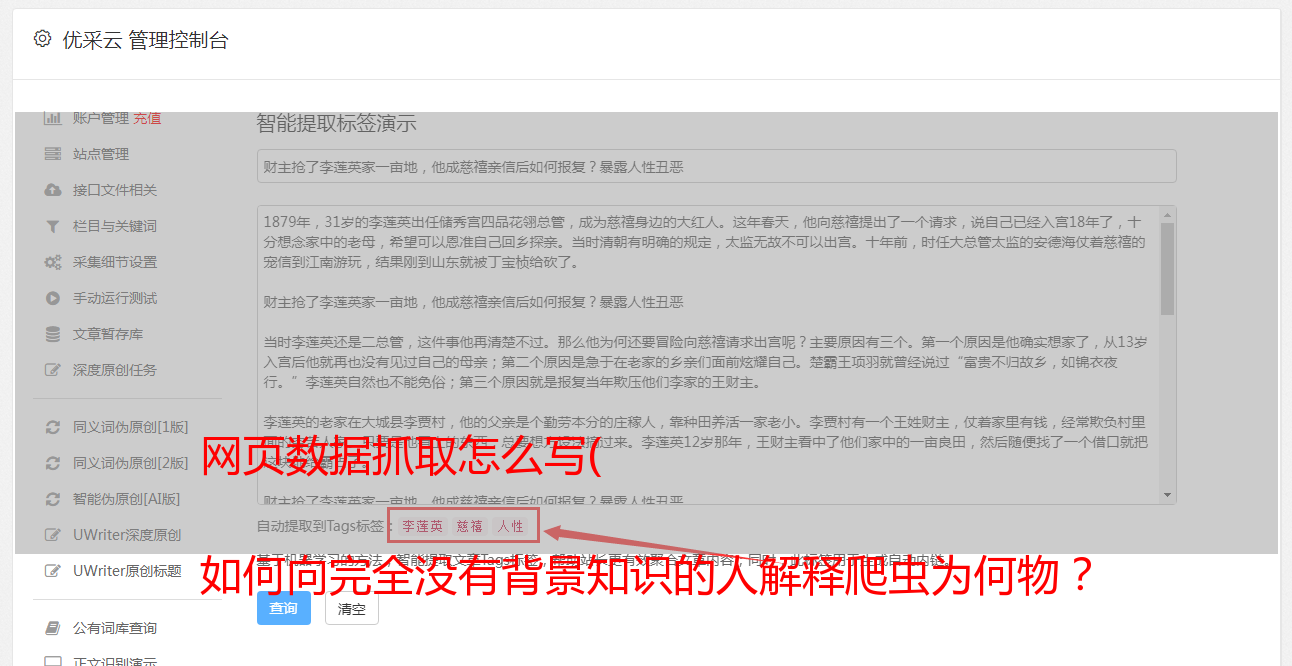

选择元素

然后我们开始获取每个产品的集合,点击添加新选择器,添加过滤器,选择所有“绿椰子产品”元素:

取同名,选择类型为元素,选择产品元素。When two elements with the same attribute are selected, the plugin will automatically check all the attribute elements on the page.

单击完成选择以完成选择,并勾选多个。保存选择器!!

此时,我们只需要从之前过滤的 item 元素中获取必填字段即可。同样,我们在项目目录中创建了一些新的选择器。由于我们需要获取文本信息,所以需要将类型改为文本。

至此,一个简单的单页爬虫就准备好了。您也可以在站点地图的下拉菜单中选择图表来查看爬虫的结构。

5

点击 Scrape 开始攀爬

6

下载数据

结束后会在窗口中自动生成数据,插件自带导出为CSV的功能,可以一键下载。不小心关闭也没关系,在浏览器中可以看到最后取到的数据。

翻页呢?

如果你想翻页,那就更难了。火箭君大概给出了一个思路:就像遍历获取item中的元素一样,然后也在根目录下创建一个翻页链接选择器,实现“下一页”功能。

将item链接到链接选择器,将链接选择器和之前创建的item选择器链接到自己,实现无限循环,直到下一页不存在或下一页不可用

循环建立后,它可以是这样的:

所以呢?

你可能会问:那又怎样?

Rocket 先生使用这个工具捕捉了全国数百辆二手 BMW 3 系汽车的价格。一起来看看不同年龄的宝马3系轿车使用几年后的降价情况吧~

相关文章

看网页上的表格,一分钟导入excel

一键查找网页中所有的好图

掌握这12点,你称得上称职的数据可视化思想家