网页数据抓取怎么写

网页数据抓取怎么写(人人都用得上webscraper进阶教程,人人用得上数据教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-12-21 19:06

如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。

相关文章:

最简单的数据采集教程,大家都可以用

进阶网页爬虫教程,人人都能用

如果你在使用网络爬虫抓取数据,你很可能会遇到以下一个或多个问题,这些问题可能会直接打乱你的计划,甚至让你放弃网络爬虫。

下面列出了您可能遇到的几个问题,并解释了解决方案。

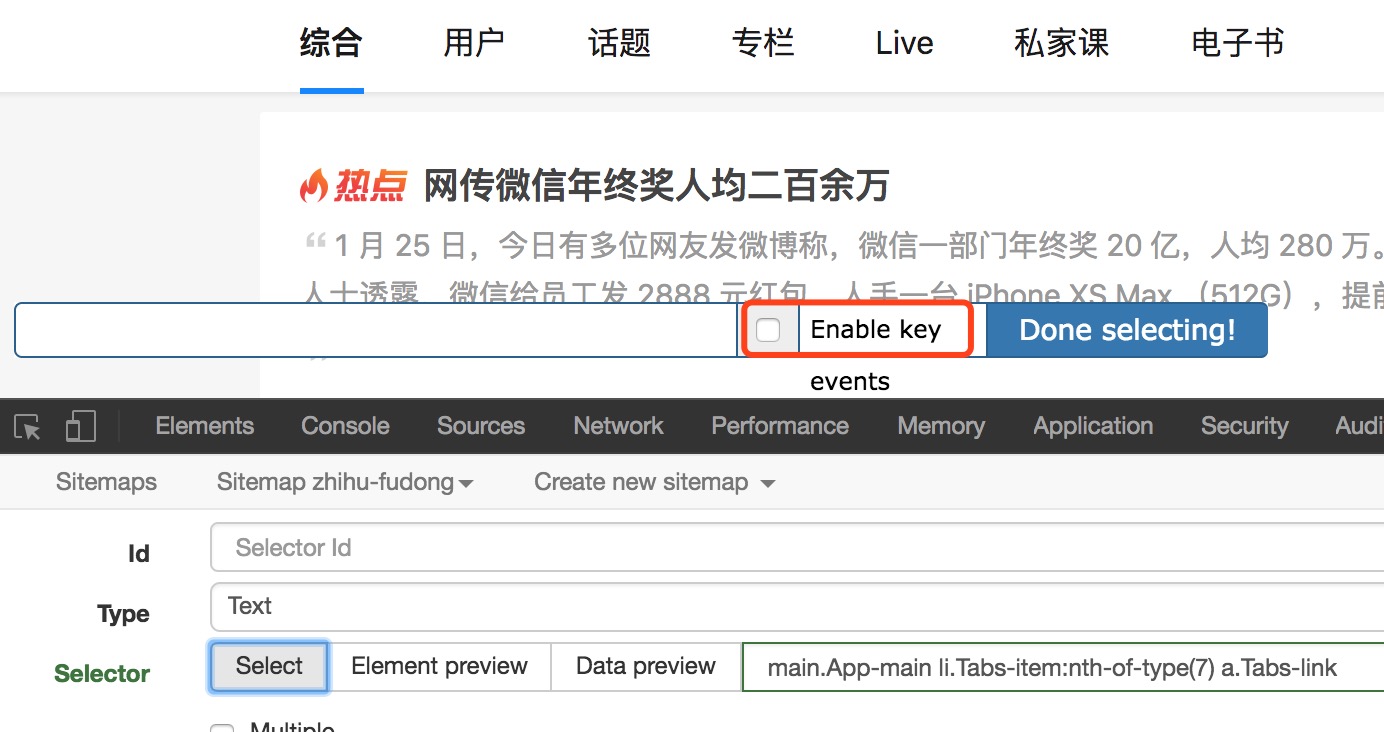

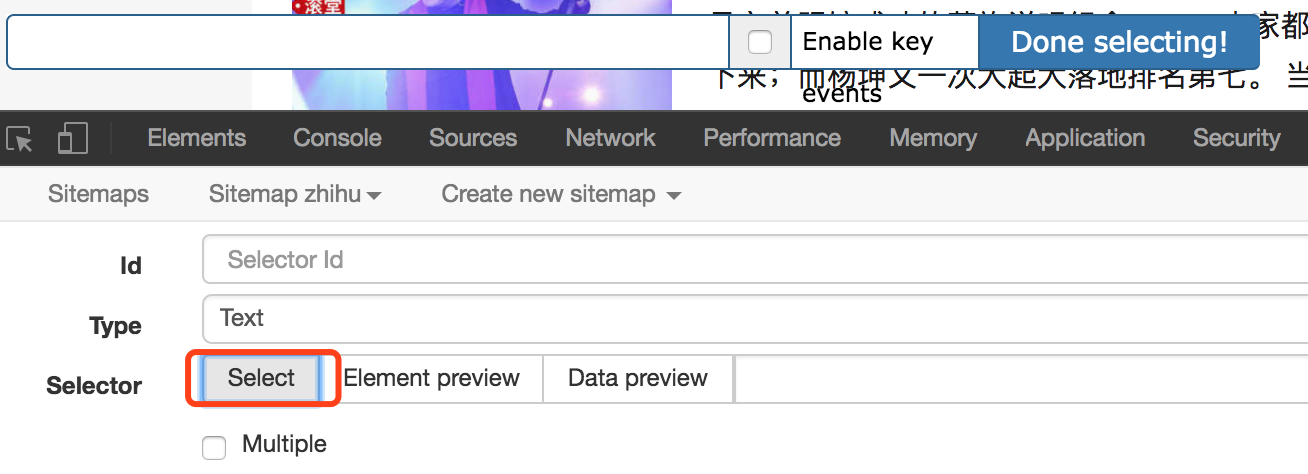

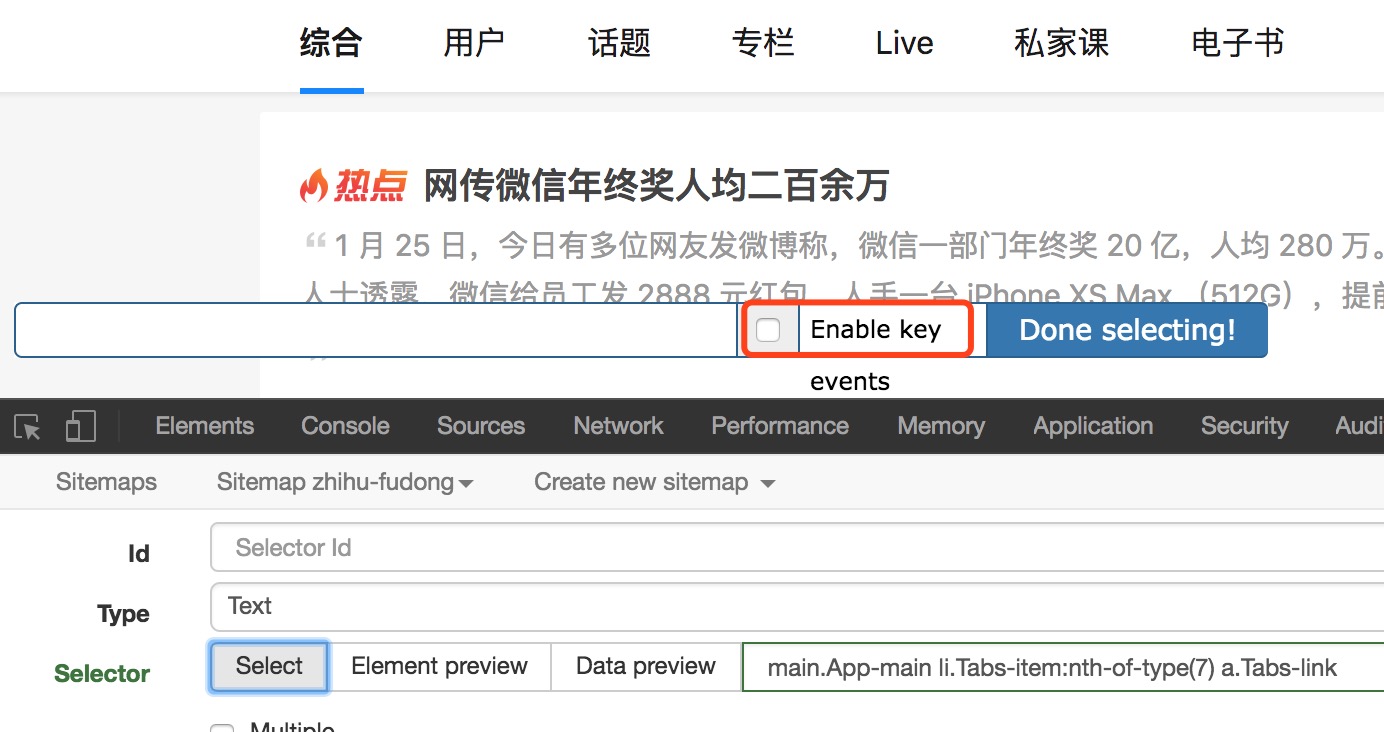

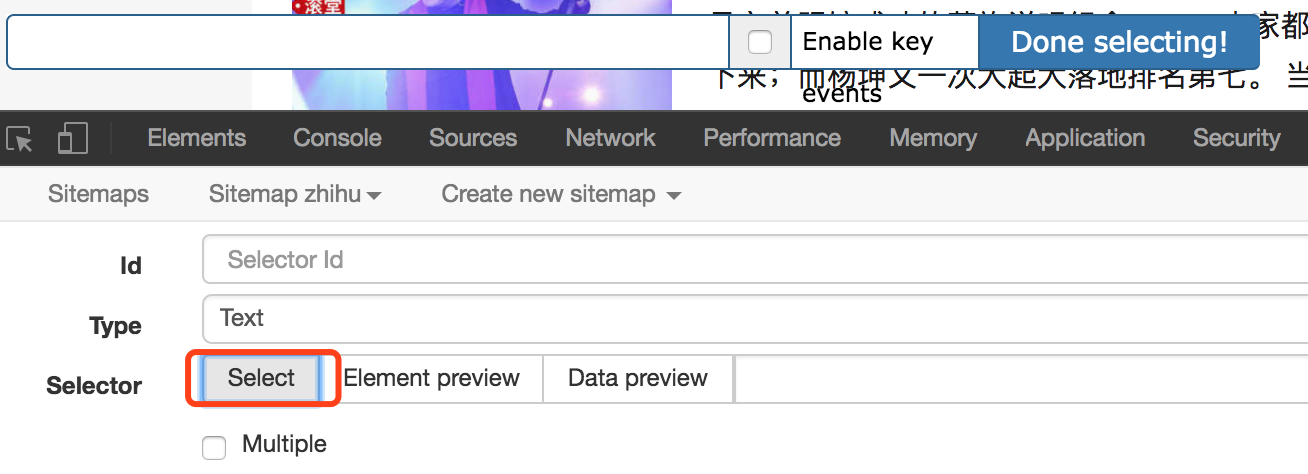

1、有时候我们想选择一个链接,但是鼠标点击会触发页面跳转,如何处理?

当我们选择页面元素时,勾选“启用键”,然后将鼠标移动到要选择的元素上,按S键。

另外勾选“启用键”后,会出现三个字母,分别是S、P、C。按S选择当前元素,按P选择当前元素的父元素,按C选择子元素当前元素的。当前元素是指鼠标所在的元素。

2、 分页数据或滚动加载的数据无法完全抓取,如知乎 和推特等?

出现这种问题多半是网络问题。在数据可以加载之前,网络爬虫开始解析数据,但由于没有及时加载,网络爬虫误认为抓取已经完成。

因此,适当增加延迟大小,延长等待时间,并留出足够的时间来加载数据。默认延迟2000,也就是2秒,可以根据网速调整。

但是,当数据量比较大时,不完整的数据抓取也很常见。因为只要在延迟时间内没有完成翻页或者下拉加载,那么爬取就结束了。

3、获取数据的顺序和网页上的顺序不一致?

webscraper默认是乱序的,可以安装CouchDB保证数据的顺序。

或者使用其他替代方法,我们最终将数据导出为 CSV 格式。CSV在Excel中打开后,可以按照某一列进行排序。比如我们抓取微博数据的时候,可以抓取发布时间,然后在Excel中重新加载。按发布时间排序,或者知乎上的数据按点赞数排序。

4、有些页面元素无法通过网络爬虫提供的选择器进行选择?

出现这种情况的原因可能是网站页面本身不符合页面布局规范,或者你想要的数据是动态的,比如只有鼠标悬停时才会显示的元素。在这些情况下,您也需要使用其他方法。

其实就是通过鼠标操作选择元素,最后找到元素对应的xpath。Xpath对应网页解释,是定位一个元素的路径,通过元素的类型、唯一标识符、样式名称、从属关系来查找某个元素或某种类型的元素。

如果你没有遇到过这个问题,那么就没有必要了解xpath,遇到问题就可以直接开始学习。

这里只列举几个在使用网络爬虫过程中常见的问题。如果遇到其他问题,可以在文章下留言。 查看全部

网页数据抓取怎么写(人人都用得上webscraper进阶教程,人人用得上数据教程)

如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。

相关文章:

最简单的数据采集教程,大家都可以用

进阶网页爬虫教程,人人都能用

如果你在使用网络爬虫抓取数据,你很可能会遇到以下一个或多个问题,这些问题可能会直接打乱你的计划,甚至让你放弃网络爬虫。

下面列出了您可能遇到的几个问题,并解释了解决方案。

1、有时候我们想选择一个链接,但是鼠标点击会触发页面跳转,如何处理?

当我们选择页面元素时,勾选“启用键”,然后将鼠标移动到要选择的元素上,按S键。

另外勾选“启用键”后,会出现三个字母,分别是S、P、C。按S选择当前元素,按P选择当前元素的父元素,按C选择子元素当前元素的。当前元素是指鼠标所在的元素。

2、 分页数据或滚动加载的数据无法完全抓取,如知乎 和推特等?

出现这种问题多半是网络问题。在数据可以加载之前,网络爬虫开始解析数据,但由于没有及时加载,网络爬虫误认为抓取已经完成。

因此,适当增加延迟大小,延长等待时间,并留出足够的时间来加载数据。默认延迟2000,也就是2秒,可以根据网速调整。

但是,当数据量比较大时,不完整的数据抓取也很常见。因为只要在延迟时间内没有完成翻页或者下拉加载,那么爬取就结束了。

3、获取数据的顺序和网页上的顺序不一致?

webscraper默认是乱序的,可以安装CouchDB保证数据的顺序。

或者使用其他替代方法,我们最终将数据导出为 CSV 格式。CSV在Excel中打开后,可以按照某一列进行排序。比如我们抓取微博数据的时候,可以抓取发布时间,然后在Excel中重新加载。按发布时间排序,或者知乎上的数据按点赞数排序。

4、有些页面元素无法通过网络爬虫提供的选择器进行选择?

出现这种情况的原因可能是网站页面本身不符合页面布局规范,或者你想要的数据是动态的,比如只有鼠标悬停时才会显示的元素。在这些情况下,您也需要使用其他方法。

其实就是通过鼠标操作选择元素,最后找到元素对应的xpath。Xpath对应网页解释,是定位一个元素的路径,通过元素的类型、唯一标识符、样式名称、从属关系来查找某个元素或某种类型的元素。

如果你没有遇到过这个问题,那么就没有必要了解xpath,遇到问题就可以直接开始学习。

这里只列举几个在使用网络爬虫过程中常见的问题。如果遇到其他问题,可以在文章下留言。

网页数据抓取怎么写(一下抓取别人网站数据的方式有什么作用?如何抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-12-21 16:07

我相信所有个人网站 站长都有抓取他人数据的经验。目前有两种方式可以抓取别人的网站数据:

一、使用第三方工具,其中最著名的是优采云采集器,这里不再介绍。

二、自己写程序抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

一开始,我尝试使用第三方工具来抓取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不知道怎么用,所以决定自己写。嗯,现在半天基本上可以搞定一个网站(只是程序开发时间,不包括数据抓取时间)。

经过一段时间的数据爬取生涯,遇到了很多困难。最常见的就是抓取分页数据。原因是数据分页的形式很多。下面我主要介绍三种形式。抓取分页数据的方法。虽然我在网上看到过很多这样的文章,但是每次拿别人的代码时总会出现各种各样的问题。以下代码全部正确。实现,我目前正在使用。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同。

让我们切入主题:

第一种方法:url地址收录分页信息,这种形式最简单,这种形式也很简单,使用第三方工具爬取,基本不需要写代码,对我来说,我宁愿花半天时间写自己动手 懒得在代码中学习第三方工具的可以自己写代码;

该方法是通过循环生成数据页面的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地数据库;获取到的代码可以参考如下:

公共字符串 GetResponseString(string url){

字符串_StrResponse =“”;

HttpWebRequest _WebRequest = (HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent = "MOZILLA/4.0 (COMPATIBLE; MSIE 7.0; WINDOWS NT 5.2; .NET CLR 1.1.4322;.NET CLR 2.0.50727;.NET CLR 3.0.04506.648;.NET CLR 3.5.21022;. NET CLR 3.0.4506.2152; .NET CLR 3.5.30729)";

_WebRequest.Method = "GET";

WebResponse _WebResponse = _WebRequest.GetResponse();

StreamReader _ResponseStream = new StreamReader(_WebResponse.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse = _ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

返回_StrResponse;

}

上面的代码可以返回页面html内容对应的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

方式二:通过网站的开发可能经常遇到,它的分页控件通过post方法向后台代码提交分页信息,比如.net下Gridview的分页功能,点击页面时分页号的时候,你会发现url地址没有变,但是页码变了,页面内容也变了。仔细看会发现,当你将鼠标移到每个页码上时,状态栏会显示 javascript:__dopostback("gridview","page1") 等等,这种形式的代码其实并不难,因为毕竟有一个地方可以找到页码的规则。

我们知道有两种方式可以提交 HTTP 请求。一个是get,一个是post,第一个是get,第二个是post。具体的投稿原则无需赘述,也不是本文的重点。

爬取这类页面,需要注意页面的几个重要元素

一、 __VIEWSTATE,这应该是.net独有的,也是.net开发者又爱又恨的东西。当你打开一个网站的页面时,如果你发现这个东西,并且后面有很多乱七八糟的字符,那么这个网站一定要写;

二、__dopostback方法,这是一个javascript自动生成页面的方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,页码信息将发送给这两个参数。

三、__EVENTVALIDATION 这也应该是唯一的

不用太在意这三个东西是干什么的,自己写代码抓取页面的时候记得提交这三个元素就行了。

和第一种方法一样,必须循环拼凑_dopostback的两个参数,只需要拼凑收录页码信息的参数即可。这里需要注意的一点是,每次通过Post提交下一页的请求时,首先要获取当前页面的__VIEWSTATE信息和__EVENTVALIDATION信息,这样就可以通过第一种方式获取到分页数据的第一页. 页码内容 然后,同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后做一个循环处理下一页,然后每抓取一个页面,记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一页发布数据使用

参考代码如下:

for (int i = 0; i <1000; i++){

System.Net.WebClient WebClientObj = new System.Net.WebClient();

System.采集s.Specialized.NameValue采集 PostVars = new System.采集s.Specialized.NameValue采集();

PostVars.Add("__VIEWSTATE", "这里有需要提前获取的信息");

PostVars.Add("__EVENTVALIDATION", "这里是需要提前获取的信息");

PostVars.Add("__EVENTTARGET", "这里是__dopostback方法对应的参数");

PostVars.Add("__EVENTARGUMENT", "这里是__dopostback方法对应的参数");

WebClientObj.Headers.Add("ContentType", "application/x-www-form-urlencoded");

尝试

{

byte[] byte1 = WebClientObj.UploadValues(" ", "POST", PostVars);

string ResponseStr = Encoding.UTF8.GetString(byte1);//获取当前页面对应的html文本字符串

GetPostValue(ResponseStr);//获取当前页面对应的__VIEWSTATE等上面需要的信息,用来抓取下一页

SaveMessage(ResponseStr);//将你关心的内容保存到数据库中

}catch(异常前){

Console.WriteLine(ex.Message);

}

}

第三种方式:第三种方式最麻烦,也最恶心。这种页面在翻页时没有任何地方可以找到页码信息。这种方式需要很大的努力。后来采用了更狠的方法,用代码模拟手动翻页。这种方法应该能够处理任何形式的翻页数据。原理是用代码模拟手动点击翻页链接,并用代码逐页翻页。然后逐页抓取。

所谓门外汉看热闹,高手看门道,可能很多人看到这里就说可以通过Webbrowser的控制来实现,是的,我下面的方式就是利用WebBrowser的控制来实现实现,其实在.net下应该也有这种类似的类,不过我没研究过,希望有人有其他方法可以回复我,分享给大家。

WebBroser控件在自己的程序中嵌入了浏览器,就像IE、Firefox等一样,你也可以用它来开发自己的浏览器。至于用它开发的浏览器的效果,我觉得肯定不如IE和Firefox。呵呵

我们还是八卦一下,切入主题:

基本上,你可以使用WebBroser控件来实现IE中任何操作网页的功能,当然点击翻页按钮也是可以的。既然您可以手动点击WebBroser中的翻页按钮,自然我们也可以使用程序代码来指示WebBroser自动为我们翻页。

其实原理很简单,主要分为以下几个步骤:

第一步,打开你要爬取的页面,比如:

调用webBrowser控件Navigate(" ")的方法;

此时,您应该在您的WebBrowser 控件中看到您的网页信息,这与在IE 中看到的相同;

第二步,WebBrowser控件的这个事件DocumentCompleted很重要。当您访问的所有页面都加载完毕时,将触发此事件。所以分析页面元素的过程也需要在这个事件中完成

字符串 _ResponseStr=this.WebBrowser1.Document.Body.OuterHtml;

这段代码可以获取当前打开页面的html元素的内容。

既然已经获取到了当前打开页面的html元素的内容,接下来的工作自然就是解析这个大字符串,得到自己关心的内容,以及解析字符串的过程。你应该可以自己写。

第三步,重点在这第三步,因为要翻页,按照第二步,解析字符串后,或者在DocumentCompleted事件中,调用方法

WebBrowser1.Document.GetElementById("page id").InvokeMember("click");

从代码的方法名大家应该就可以理解了,那么调用这个方法后,WebBrwoser控件中的网页就实现了翻页,和手动点击翻页按钮的效果是一样的。

重点是翻页后会触发DocumentCompleted事件,所以第二步和第三步都在循环中,所以大家需要注意跳出循环的时机。

它实用的WebBrowser还可以做很多事情,比如自动登录、退出论坛、保存会话、cockie,所以这个控件基本上可以实现你想要在网页上的任何操作,即使你想破解一个网站@ > 以营利为目的登录密码,当然不推荐这个。呵呵

看完这篇文章,我觉得可以解决手头的网站,但是在实际操作中,第二种方法无法完成网页抓取,而第三种方法也不好控制;

个人实践一使用页面添加或修改其中一个标签的属性 查看全部

网页数据抓取怎么写(一下抓取别人网站数据的方式有什么作用?如何抓取)

我相信所有个人网站 站长都有抓取他人数据的经验。目前有两种方式可以抓取别人的网站数据:

一、使用第三方工具,其中最著名的是优采云采集器,这里不再介绍。

二、自己写程序抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

一开始,我尝试使用第三方工具来抓取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不知道怎么用,所以决定自己写。嗯,现在半天基本上可以搞定一个网站(只是程序开发时间,不包括数据抓取时间)。

经过一段时间的数据爬取生涯,遇到了很多困难。最常见的就是抓取分页数据。原因是数据分页的形式很多。下面我主要介绍三种形式。抓取分页数据的方法。虽然我在网上看到过很多这样的文章,但是每次拿别人的代码时总会出现各种各样的问题。以下代码全部正确。实现,我目前正在使用。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同。

让我们切入主题:

第一种方法:url地址收录分页信息,这种形式最简单,这种形式也很简单,使用第三方工具爬取,基本不需要写代码,对我来说,我宁愿花半天时间写自己动手 懒得在代码中学习第三方工具的可以自己写代码;

该方法是通过循环生成数据页面的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地数据库;获取到的代码可以参考如下:

公共字符串 GetResponseString(string url){

字符串_StrResponse =“”;

HttpWebRequest _WebRequest = (HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent = "MOZILLA/4.0 (COMPATIBLE; MSIE 7.0; WINDOWS NT 5.2; .NET CLR 1.1.4322;.NET CLR 2.0.50727;.NET CLR 3.0.04506.648;.NET CLR 3.5.21022;. NET CLR 3.0.4506.2152; .NET CLR 3.5.30729)";

_WebRequest.Method = "GET";

WebResponse _WebResponse = _WebRequest.GetResponse();

StreamReader _ResponseStream = new StreamReader(_WebResponse.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse = _ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

返回_StrResponse;

}

上面的代码可以返回页面html内容对应的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

方式二:通过网站的开发可能经常遇到,它的分页控件通过post方法向后台代码提交分页信息,比如.net下Gridview的分页功能,点击页面时分页号的时候,你会发现url地址没有变,但是页码变了,页面内容也变了。仔细看会发现,当你将鼠标移到每个页码上时,状态栏会显示 javascript:__dopostback("gridview","page1") 等等,这种形式的代码其实并不难,因为毕竟有一个地方可以找到页码的规则。

我们知道有两种方式可以提交 HTTP 请求。一个是get,一个是post,第一个是get,第二个是post。具体的投稿原则无需赘述,也不是本文的重点。

爬取这类页面,需要注意页面的几个重要元素

一、 __VIEWSTATE,这应该是.net独有的,也是.net开发者又爱又恨的东西。当你打开一个网站的页面时,如果你发现这个东西,并且后面有很多乱七八糟的字符,那么这个网站一定要写;

二、__dopostback方法,这是一个javascript自动生成页面的方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,页码信息将发送给这两个参数。

三、__EVENTVALIDATION 这也应该是唯一的

不用太在意这三个东西是干什么的,自己写代码抓取页面的时候记得提交这三个元素就行了。

和第一种方法一样,必须循环拼凑_dopostback的两个参数,只需要拼凑收录页码信息的参数即可。这里需要注意的一点是,每次通过Post提交下一页的请求时,首先要获取当前页面的__VIEWSTATE信息和__EVENTVALIDATION信息,这样就可以通过第一种方式获取到分页数据的第一页. 页码内容 然后,同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后做一个循环处理下一页,然后每抓取一个页面,记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一页发布数据使用

参考代码如下:

for (int i = 0; i <1000; i++){

System.Net.WebClient WebClientObj = new System.Net.WebClient();

System.采集s.Specialized.NameValue采集 PostVars = new System.采集s.Specialized.NameValue采集();

PostVars.Add("__VIEWSTATE", "这里有需要提前获取的信息");

PostVars.Add("__EVENTVALIDATION", "这里是需要提前获取的信息");

PostVars.Add("__EVENTTARGET", "这里是__dopostback方法对应的参数");

PostVars.Add("__EVENTARGUMENT", "这里是__dopostback方法对应的参数");

WebClientObj.Headers.Add("ContentType", "application/x-www-form-urlencoded");

尝试

{

byte[] byte1 = WebClientObj.UploadValues(" ", "POST", PostVars);

string ResponseStr = Encoding.UTF8.GetString(byte1);//获取当前页面对应的html文本字符串

GetPostValue(ResponseStr);//获取当前页面对应的__VIEWSTATE等上面需要的信息,用来抓取下一页

SaveMessage(ResponseStr);//将你关心的内容保存到数据库中

}catch(异常前){

Console.WriteLine(ex.Message);

}

}

第三种方式:第三种方式最麻烦,也最恶心。这种页面在翻页时没有任何地方可以找到页码信息。这种方式需要很大的努力。后来采用了更狠的方法,用代码模拟手动翻页。这种方法应该能够处理任何形式的翻页数据。原理是用代码模拟手动点击翻页链接,并用代码逐页翻页。然后逐页抓取。

所谓门外汉看热闹,高手看门道,可能很多人看到这里就说可以通过Webbrowser的控制来实现,是的,我下面的方式就是利用WebBrowser的控制来实现实现,其实在.net下应该也有这种类似的类,不过我没研究过,希望有人有其他方法可以回复我,分享给大家。

WebBroser控件在自己的程序中嵌入了浏览器,就像IE、Firefox等一样,你也可以用它来开发自己的浏览器。至于用它开发的浏览器的效果,我觉得肯定不如IE和Firefox。呵呵

我们还是八卦一下,切入主题:

基本上,你可以使用WebBroser控件来实现IE中任何操作网页的功能,当然点击翻页按钮也是可以的。既然您可以手动点击WebBroser中的翻页按钮,自然我们也可以使用程序代码来指示WebBroser自动为我们翻页。

其实原理很简单,主要分为以下几个步骤:

第一步,打开你要爬取的页面,比如:

调用webBrowser控件Navigate(" ")的方法;

此时,您应该在您的WebBrowser 控件中看到您的网页信息,这与在IE 中看到的相同;

第二步,WebBrowser控件的这个事件DocumentCompleted很重要。当您访问的所有页面都加载完毕时,将触发此事件。所以分析页面元素的过程也需要在这个事件中完成

字符串 _ResponseStr=this.WebBrowser1.Document.Body.OuterHtml;

这段代码可以获取当前打开页面的html元素的内容。

既然已经获取到了当前打开页面的html元素的内容,接下来的工作自然就是解析这个大字符串,得到自己关心的内容,以及解析字符串的过程。你应该可以自己写。

第三步,重点在这第三步,因为要翻页,按照第二步,解析字符串后,或者在DocumentCompleted事件中,调用方法

WebBrowser1.Document.GetElementById("page id").InvokeMember("click");

从代码的方法名大家应该就可以理解了,那么调用这个方法后,WebBrwoser控件中的网页就实现了翻页,和手动点击翻页按钮的效果是一样的。

重点是翻页后会触发DocumentCompleted事件,所以第二步和第三步都在循环中,所以大家需要注意跳出循环的时机。

它实用的WebBrowser还可以做很多事情,比如自动登录、退出论坛、保存会话、cockie,所以这个控件基本上可以实现你想要在网页上的任何操作,即使你想破解一个网站@ > 以营利为目的登录密码,当然不推荐这个。呵呵

看完这篇文章,我觉得可以解决手头的网站,但是在实际操作中,第二种方法无法完成网页抓取,而第三种方法也不好控制;

个人实践一使用页面添加或修改其中一个标签的属性

网页数据抓取怎么写( 游戏/数码网络2018-06-1314浏览方法/步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2021-12-21 04:25

游戏/数码网络2018-06-1314浏览方法/步骤)

如何用python抓取网页数据

游戏/数字网络2018-06-13 14 浏览次数

可能很多朋友不是很清楚如何使用python来抓取网页数据,那么具体应该怎么做呢?感兴趣的朋友请看小编!方法/步骤在capture网站中有两个基本任务:将网页加载到字符串中。从网页解析 HTML 以定位感兴趣的位置。Python 为上述两项任务提供了两个很好的工具。我将使用请求加载网页并使用 BeautifulSoup 进行分析。我们可以把上面两个包放到一个虚拟环境中: $ mkdir pycon-scraper$ virtualenv venv$ so

可能很多朋友对如何使用python抓取网页数据不是很清楚,那我该怎么办呢?有兴趣的朋友,一起来看看小编吧!

方法/步骤

爬取网站有两个基本任务:

将网页加载到字符串中。

解析网页中的 HTML 以定位感兴趣的位置。

Python 为上述两项任务提供了两个很好的工具。我将使用请求加载网页和 BeautifulSoup 进行解析。

我们可以把上面两个包放到一个虚拟环境中:

$ mkdir pycon-scraper$ virtualenv venv$ source venv/bin/activate(venv) $ pip install requests beautifulsoup4

如果你使用的是Windows操作系统,注意上面虚拟环境的激活命令是不同的,你应该使用venv\Scripts\activate。

基本爬取技术

在编写爬虫脚本时,首先要手动观察要爬取的页面,以确定如何定位数据。

首先,我们来看看 PyCon 会议视频列表。检查这个页面的HTML源代码,我们发现视频列表的结果几乎是这样的:

...

...

...

然后第一个任务是加载这个页面,然后提取每个单独页面的链接,因为 YouTube 视频的链接在这些单独的页面上。

文章 标签:vba抓取网页数据抓取app数据抓取app数据软件python从文件中读取数据,绘制,招募数据抓取 查看全部

网页数据抓取怎么写(

游戏/数码网络2018-06-1314浏览方法/步骤)

如何用python抓取网页数据

游戏/数字网络2018-06-13 14 浏览次数

可能很多朋友不是很清楚如何使用python来抓取网页数据,那么具体应该怎么做呢?感兴趣的朋友请看小编!方法/步骤在capture网站中有两个基本任务:将网页加载到字符串中。从网页解析 HTML 以定位感兴趣的位置。Python 为上述两项任务提供了两个很好的工具。我将使用请求加载网页并使用 BeautifulSoup 进行分析。我们可以把上面两个包放到一个虚拟环境中: $ mkdir pycon-scraper$ virtualenv venv$ so

可能很多朋友对如何使用python抓取网页数据不是很清楚,那我该怎么办呢?有兴趣的朋友,一起来看看小编吧!

方法/步骤

爬取网站有两个基本任务:

将网页加载到字符串中。

解析网页中的 HTML 以定位感兴趣的位置。

Python 为上述两项任务提供了两个很好的工具。我将使用请求加载网页和 BeautifulSoup 进行解析。

我们可以把上面两个包放到一个虚拟环境中:

$ mkdir pycon-scraper$ virtualenv venv$ source venv/bin/activate(venv) $ pip install requests beautifulsoup4

如果你使用的是Windows操作系统,注意上面虚拟环境的激活命令是不同的,你应该使用venv\Scripts\activate。

基本爬取技术

在编写爬虫脚本时,首先要手动观察要爬取的页面,以确定如何定位数据。

首先,我们来看看 PyCon 会议视频列表。检查这个页面的HTML源代码,我们发现视频列表的结果几乎是这样的:

...

...

...

然后第一个任务是加载这个页面,然后提取每个单独页面的链接,因为 YouTube 视频的链接在这些单独的页面上。

文章 标签:vba抓取网页数据抓取app数据抓取app数据软件python从文件中读取数据,绘制,招募数据抓取

网页数据抓取怎么写(网络爬虫的2个功能:取数据和存数据!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-12-18 13:19

很多朋友在开始python的时候都是从爬虫开始的,网络爬虫是这几年比较流行的概念。尤其是大数据分析流行之后,越来越多的人开始学习网络爬虫,哦对了,现在叫数据挖掘!

其实一般爬虫有两个功能:取数据和存储数据!好像是在胡说八道。. .

从这两个功能的扩展来看,需要很多知识:请求数据、反爬虫处理、页面分析、内容匹配、绕过验证码、保持登录、数据库等相关知识。今天我们就来聊一聊。简单爬虫,一般需要的步骤!

保存数据

先说存储数据,因为在最初的学习中,接触很少,不需要过多关注。随着学习的逐渐深入,当我们需要保存大量数据时,就需要学习数据库的相关知识。向上!稍后我们将分别解释这一点。

初期,我们抓到需要的内容后,只需要保存到本地即可。无非是文件、表格(excel)等几种方法。这里只需要掌握with语句就可以基本保证需求。它看起来像这样:

with open (path and file name, save mode) as f:

f.write(数据)#如果是文本,可以直接写入,如果是其他文件,数据最好用二进制方式

当然需要使用xlwt库(excel)和python-docx库(word)保存到excel表格或者word文档中。这个网上很多,可以自己学。

获取数据

说了这么多,终于到了正题,如何抓取我们想要的数据呢?我们一步一步来!

一般所谓的抓取网页内容是指通过Python脚本访问某个URL地址(请求数据),然后获取返回的内容(HTML源代码、Json格式字符串等)。然后通过解析规则(页面解析),对我们需要的数据进行分析和获取(内容匹配)。

在python中实现爬虫非常方便。有大量的库可以满足我们的需求。比如首先使用requests库获取一个url(网页)的源码

导入请求#导入库

url ='您的目标网址'

response = requests.get(url)#请求数据

print(response.text)#打印出数据的文本内容

这几行代码就可以拿到网页的源码了,但是有时候会出现乱码,为什么呢?

由于中文网站收录中文,而终端不支持gbk编码,我们在打印时需要将中文从gbk格式转换为终端支持的编码,一般为utf-8编码。

所有我们需要在打印响应之前指定编码(我们可以直接指定代码显示的编码格式为网页本身的编码格式,比如utf-8,网页的编码格式一般是标签下的charset在源代码属性中指定)。只需添加一行

response.encode ='utf-8'#指定编码格式

至此,我们已经获得了网页的源代码。下一步是在杂乱的源代码中找到我们需要的东西。这里需要用到各种匹配方法。常用的方法有:正则表达式(re库)、bs4(Beautifulsoup4库)、xpath(lxml库)!

建议大家从常规规则开始学习,最后一定要看看xpath,爬虫框架scrapy中用的很多!

通过各种匹配方式找到我们的内容后(注意:一般匹配的是一个列表),我们就到了上面提到的存储数据的阶段。这是一个简单的爬行过程!

当然,我们在写代码的时候,会发现很多上面没有提到的内容,比如

获取源码的时候遇到了反爬,无法获取数据。部分网站需要登录才能获取内容。遇到验证码后,将内容写入文件,出现错误。如何设计获取大量内容乃至全站爬虫的循环

等等,让我们慢慢研究这些!

Python学习群:542110741

总之,学习本身就是一个漫长的过程,需要我们不断的实践来增强学习的兴趣,学到更多扎实的知识!大家来吧! 查看全部

网页数据抓取怎么写(网络爬虫的2个功能:取数据和存数据!)

很多朋友在开始python的时候都是从爬虫开始的,网络爬虫是这几年比较流行的概念。尤其是大数据分析流行之后,越来越多的人开始学习网络爬虫,哦对了,现在叫数据挖掘!

其实一般爬虫有两个功能:取数据和存储数据!好像是在胡说八道。. .

从这两个功能的扩展来看,需要很多知识:请求数据、反爬虫处理、页面分析、内容匹配、绕过验证码、保持登录、数据库等相关知识。今天我们就来聊一聊。简单爬虫,一般需要的步骤!

保存数据

先说存储数据,因为在最初的学习中,接触很少,不需要过多关注。随着学习的逐渐深入,当我们需要保存大量数据时,就需要学习数据库的相关知识。向上!稍后我们将分别解释这一点。

初期,我们抓到需要的内容后,只需要保存到本地即可。无非是文件、表格(excel)等几种方法。这里只需要掌握with语句就可以基本保证需求。它看起来像这样:

with open (path and file name, save mode) as f:

f.write(数据)#如果是文本,可以直接写入,如果是其他文件,数据最好用二进制方式

当然需要使用xlwt库(excel)和python-docx库(word)保存到excel表格或者word文档中。这个网上很多,可以自己学。

获取数据

说了这么多,终于到了正题,如何抓取我们想要的数据呢?我们一步一步来!

一般所谓的抓取网页内容是指通过Python脚本访问某个URL地址(请求数据),然后获取返回的内容(HTML源代码、Json格式字符串等)。然后通过解析规则(页面解析),对我们需要的数据进行分析和获取(内容匹配)。

在python中实现爬虫非常方便。有大量的库可以满足我们的需求。比如首先使用requests库获取一个url(网页)的源码

导入请求#导入库

url ='您的目标网址'

response = requests.get(url)#请求数据

print(response.text)#打印出数据的文本内容

这几行代码就可以拿到网页的源码了,但是有时候会出现乱码,为什么呢?

由于中文网站收录中文,而终端不支持gbk编码,我们在打印时需要将中文从gbk格式转换为终端支持的编码,一般为utf-8编码。

所有我们需要在打印响应之前指定编码(我们可以直接指定代码显示的编码格式为网页本身的编码格式,比如utf-8,网页的编码格式一般是标签下的charset在源代码属性中指定)。只需添加一行

response.encode ='utf-8'#指定编码格式

至此,我们已经获得了网页的源代码。下一步是在杂乱的源代码中找到我们需要的东西。这里需要用到各种匹配方法。常用的方法有:正则表达式(re库)、bs4(Beautifulsoup4库)、xpath(lxml库)!

建议大家从常规规则开始学习,最后一定要看看xpath,爬虫框架scrapy中用的很多!

通过各种匹配方式找到我们的内容后(注意:一般匹配的是一个列表),我们就到了上面提到的存储数据的阶段。这是一个简单的爬行过程!

当然,我们在写代码的时候,会发现很多上面没有提到的内容,比如

获取源码的时候遇到了反爬,无法获取数据。部分网站需要登录才能获取内容。遇到验证码后,将内容写入文件,出现错误。如何设计获取大量内容乃至全站爬虫的循环

等等,让我们慢慢研究这些!

Python学习群:542110741

总之,学习本身就是一个漫长的过程,需要我们不断的实践来增强学习的兴趣,学到更多扎实的知识!大家来吧!

网页数据抓取怎么写(本节书摘来自异步社区《用Python写网络爬虫》第2章)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-12-15 20:19

本节摘自异步社区《Writing Web Crawlers in Python》一书第2章2.2,作者[澳大利亚]理查德劳森(Richard Lawson),李斌译,更多章节内容可在云栖社区“异步社区”公众号查看。

2.2 三种网络爬虫方法

现在我们已经了解了网页的结构,我们将介绍三种捕获其中数据的方法。首先是正则表达式,然后是流行的 BeautifulSoup 模块,最后是强大的 lxml 模块。

2.2.1 正则表达式

如果您对正则表达式不熟悉,或者需要一些提示,可以查看完整介绍。

当我们使用正则表达式抓取区域数据时,首先需要尝试匹配

元素的内容如下。

>>> import re

>>> url = 'http://example.webscraping.com/view/United

-Kingdom-239'

>>> html = download(url)

>>> re.findall('(.*?)', html)

['/places/static/images/flags/gb.png',

'244,820 square kilometres',

'62,348,447',

'GB',

'United Kingdom',

'London',

'EU',

'.uk',

'GBP',

'Pound',

'44',

'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA',

'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}

[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})

|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$',

'en-GB,cy-GB,gd',

'IE ']

从上面的结果可以看出,在很多国家属性中都使用了标签。为了隔离area属性,我们可以只选择第二个元素,如下图。

>>> re.findall('(.*?)', html)[1]

'244,820 square kilometres'

虽然现在可以使用这个方案,但是如果网页发生变化,该方案很可能会失败。比如表变了,去掉了第二行的土地面积数据。如果我们现在只抓取数据,我们可以忽略这种可能的未来变化。但是,如果我们希望将来再次捕获数据,则需要提供更健壮的解决方案,以尽可能避免这种布局更改的影响。为了让正则表达式更健壮,我们可以改变它的父元素

>>> re.findall('Area: (.*?)', html)

['244,820 square kilometres']

这个迭代版本看起来更好,但是还有很多其他的更新网页的方式,也会让正则表达式不尽人意。比如把双引号改成单引号,

在标签之间添加额外的空格,或更改 area_label 等。以下是尝试支持这些可能性的改进版本。

>>> re.findall('.*?>> from bs4 import BeautifulSoup

>>> broken_html = 'AreaPopulation'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, 'html.parser')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,Beautiful Soup 可以正确解析缺失的引号并关闭标签,除了添加和

标签使它成为一个完整的 HTML 文档。现在我们可以使用 find() 和 find_all() 方法来定位我们需要的元素。

>>> ul = soup.find('ul', attrs={'class':'country'})

>>> ul.find('li') # returns just the first match

Area

>>> ul.find_all('li') # returns all matches

[Area, Population]

如果想知道所有的方法和参数,可以参考BeautifulSoup的官方文档,其网址为:。

下面是使用该方法提取样本国家面积数据的完整代码。

>>> from bs4 import BeautifulSoup

>>> url = 'http://example.webscraping.com/places/view/

United-Kingdom-239'

>>> html = download(url)

>>> soup = BeautifulSoup(html)

>>> # locate the area row

>>> tr = soup.find(attrs={'id':'places_area__row'})

>>> td = tr.find(attrs={'class':'w2p_fw'}) # locate the area tag

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

这段代码虽然比正则表达式代码复杂,但更容易构建和理解。此外,我们不需要担心布局的微小变化,例如额外的空间和标签属性。

2.2.3 Lxml

Lxml 是一个基于 libxml2 的 Python 包,一个 XML 解析库。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。您可以参考最新的安装说明。

与 Beautiful Soup 一样,使用 lxml 模块的第一步是将潜在的非法 HTML 解析为统一格式。以下是使用该模块解析相同不完整 HTML 的示例。

>>> import lxml.html

>>> broken_html = 'AreaPopulation'

>>> tree = lxml.html.fromstring(broken_html) # parse the HTML

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

同理,lxml 也可以正确解析属性两边缺失的引号并关闭标签,但是模块没有添加额外的和

标签。

解析输入内容后,进入选择元素的步骤。这时候lxml有几种不同的方法,比如XPath选择器和类似于Beautiful Soup的find()方法。但是,在这个和后续的例子中,我们将使用 CSS 选择器,因为它更简洁,可以在第 5 章解析动态内容时重复使用。此外,一些有 jQuery 选择器经验的读者会更熟悉它。

以下是使用 lxml 的 CSS 选择器提取区域数据的示例代码。

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect('tr#places_area__row > td.w2p_fw')[0]

>>> area = td.text_content()

>>> print area

244,820 square kilometres

CSS 选择器的关键代码行以粗体显示。这行代码首先找到id为places_area__row的表格行元素,然后选择class为w2p_fw的表格数据子标签。

CSS 选择器

CSS 选择器表示用于选择元素的模式。以下是一些常用选择器的示例。

选择所有标签:*

选择<a>标签:a

选择所有class="link"的元素:.link

选择class="link"的<a>标签:a.link

选择id="home"的<a>标签:a#home

选择父元素为<a>标签的所有子标签:a > span

选择<a>标签内部的所有标签:a span

选择title属性为"Home"的所有<a>标签:a[title=Home]

W3C提出了CSS3规范,其网址为`/2011/REC-css3-selectors-20110929/。

Lxml 已经实现了大部分 CSS3 属性,不支持的功能可以在这里找到。

需要注意的是,在 lxml 的内部实现中,CSS 选择器实际上被转换为等效的 XPath 选择器。

2.2.4 性能对比

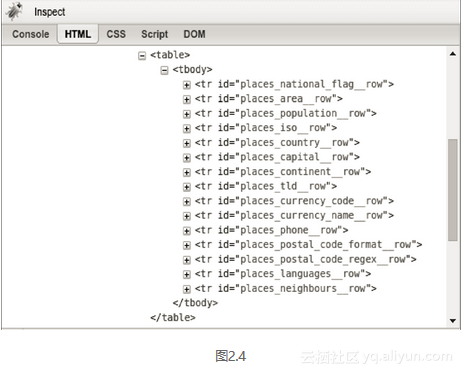

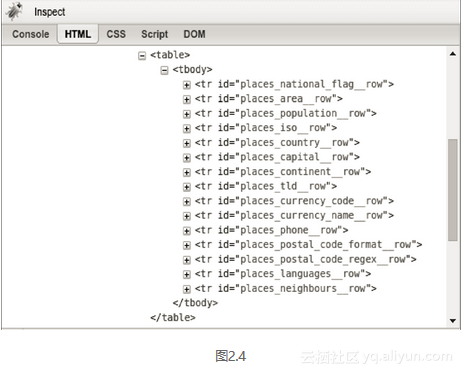

为了更好地评估本章介绍的三种捕获方法的权衡,我们需要比较它们的相对效率。一般情况下,爬虫会在一个网页中提取多个字段。因此,为了让对比更加真实,本章我们将为每个爬虫实现一个扩展版本,以提取该国网页中的每一个可用数据。首先,我们需要回到Firebug,查看国家页面其他功能的格式,如图2.4。

从Firebug的显示可以看出,表中的每一行都有一个以places_开头,以__row结尾的ID。这些行中收录的国家数据的格式与上面的示例相同。下面是使用上述信息提取所有可用国家数据的实现代码。

FIELDS = ('area', 'population', 'iso', 'country', 'capital',

'continent', 'tld', 'currency_code', 'currency_name', 'phone',

'postal_code_format', 'postal_code_regex', 'languages',

'neighbours')

import re

def re_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search('.*?(.*?)' % field, html).groups()[0]

return results

from bs4 import BeautifulSoup

def bs_scraper(html):

soup = BeautifulSoup(html, 'html.parser')

results = {}

for field in FIELDS:

results[field] = soup.find('table').find('tr',

id='places_%s__row' % field).find('td',

class_='w2p_fw').text

return results

import lxml.html

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect('table > tr#places_%s__row

> td.w2p_fw' % field)[0].text_content()

return results

获取结果

现在我们已经完成了所有爬虫的代码实现,接下来我们将使用以下代码片段来测试这三种方法的相对性能。

import time

NUM_ITERATIONS = 1000 # number of times to test each scraper

html = download('http://example.webscraping.com/places/view/

United-Kingdom-239')

for name, scraper in [('Regular expressions', re_scraper),

('BeautifulSoup', bs_scraper),

('Lxml', lxml_scraper)]:

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == re_scraper:

re.purge()

result = scraper(html)

# check scraped result is as expected

assert(result['area'] == '244,820 square kilometres')

# record end time of scrape and output the total

end = time.time()

print '%s: %.2f seconds' % (name, end – start)

在这段代码中,每个爬虫都会执行1000次,每次都会检查爬取结果是否正确,然后打印总时间。这里使用的下载函数还是上一章定义的那个。请注意,我们在粗体代码行中调用了 re.purge() 方法。默认情况下,正则表达式模块会缓存搜索结果。为了和其他爬虫比较公平,我们需要使用这个方法来清除缓存。

下面是在我的电脑上运行脚本的结果。

$ python performance.py

Regular expressions: 5.50 seconds

BeautifulSoup: 42.84 seconds

Lxml: 7.06 seconds

由于硬件条件的不同,不同计算机的执行结果也会有一定的差异。但是,每种方法之间的相对差异应该具有可比性。从结果可以看出,在抓取我们的示例网页时,Beautiful Soup 比其他两种方法慢 6 倍以上。其实这个结果是符合预期的,因为lxml和正则表达式模块是用C语言写的,而BeautifulSoup是纯Python写的。一个有趣的事实是 lxml 的行为几乎与正则表达式一样。由于 lxml 必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一个网页的多个特征时,会减少这种初始分析的开销,lxml 将更具竞争力。

2.2.5 结论

表2.1总结了每种爬取方法的优缺点。

如果你的爬虫的瓶颈是下载网页,而不是提取数据,那么较慢的方法(比如 Beautiful Soup)不是问题。如果你只需要抓取少量数据,又想避免额外的依赖,那么正则表达式可能更合适。但是,一般情况下,lxml 是捕获数据的最佳选择,因为该方法快速且健壮,而正则表达式和 Beautiful Soup 仅在某些场景下有用。

2.2.6 为链接爬虫添加爬取回调

我们已经学习了如何抓取国家数据,接下来我们需要将其集成到上一章的链接爬虫中。为了复用这个爬虫代码去抓取其他网站,我们需要添加一个回调参数来处理抓取行为。callback 是一个在某个事件发生后会被调用的函数(在这个例子中,它会在网页下载后被调用)。爬取回调函数收录url和html两个参数,可以返回要爬取的URL列表。下面是它的实现代码,可以看到在Python中实现这个功能非常简单。

def link_crawler(..., scrape_callback=None):

...

links = []

if scrape_callback:

links.extend(scrape_callback(url, html) or [])

...

在上面的代码片段中,我们大胆地展示了抓取回调函数的新增代码。如果想获取本版链接爬虫的完整代码,可以访问org/wswp/code/src/tip/chapter02/link_crawler.py。

现在,我们只需要自定义传入的scrape_callback函数,然后我们就可以使用这个爬虫抓取其他网站。下面修改lxml抓取示例的代码,使其能够在回调函数中使用。

def scrape_callback(url, html):

if re.search('/view/', url):

tree = lxml.html.fromstring(html)

row = [tree.cssselect('table > tr#places_%s__row >

td.w2p_fw' % field)[0].text_content() for field in

FIELDS]

print url, row

上面的回调函数会抓取国家数据并显示出来。不过一般情况下,在爬取网站的时候,我们更倾向于复用这些数据,所以下面我们将对其功能进行扩展,将结果数据保存到一个CSV表中。代码如下所示。

import csv

class ScrapeCallback:

def __init__(self):

self.writer = csv.writer(open('countries.csv', 'w'))

self.fields = ('area', 'population', 'iso', 'country',

'capital', 'continent', 'tld', 'currency_code',

'currency_name', 'phone', 'postal_code_format',

'postal_code_regex', 'languages',

'neighbours')

self.writer.writerow(self.fields)

def __call__(self, url, html):

if re.search('/view/', url):

tree = lxml.html.fromstring(html)

row = []

for field in self.fields:

row.append(tree.cssselect('table >

tr#places_{}__row >

td.w2p_fw'.format(field))

[0].text_content())

self.writer.writerow(row)

为了实现这个回调,我们使用回调类而不是回调函数来维护csv中writer属性的状态。在构造方法中实例化csv的writer属性,然后在__call__方法中进行多次写操作。请注意 __call__ 是一个特殊的方法,当对象作为函数被调用时会被调用。这也是链接爬虫中cache_callback的调用方法。换句话说,scrape_callback(url, html) 和调用 scrape_callback.__call__(url, html) 是等价的。如果想深入了解Python的特殊类方法,可以参考。

下面是如何编写链接爬虫的回调。

link_crawler('http://example.webscraping.com/', '/(index|view)',

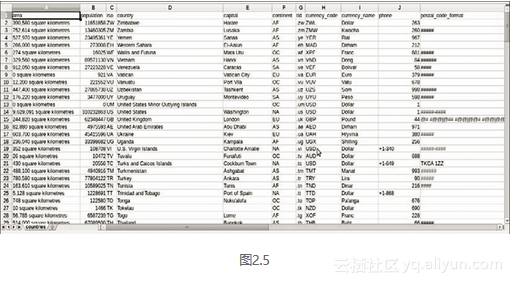

max_depth=-1, scrape_callback=ScrapeCallback())

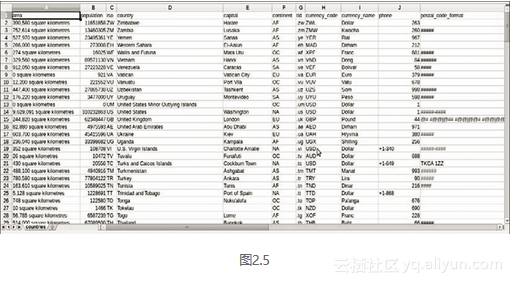

现在,当我们运行这个使用回调的爬虫时,程序会将结果写入CSV文件,我们可以使用Excel或LibreOffice等应用程序查看该文件,如图2.5。

这是成功的!我们完成了第一个工作数据爬虫。 查看全部

网页数据抓取怎么写(本节书摘来自异步社区《用Python写网络爬虫》第2章)

本节摘自异步社区《Writing Web Crawlers in Python》一书第2章2.2,作者[澳大利亚]理查德劳森(Richard Lawson),李斌译,更多章节内容可在云栖社区“异步社区”公众号查看。

2.2 三种网络爬虫方法

现在我们已经了解了网页的结构,我们将介绍三种捕获其中数据的方法。首先是正则表达式,然后是流行的 BeautifulSoup 模块,最后是强大的 lxml 模块。

2.2.1 正则表达式

如果您对正则表达式不熟悉,或者需要一些提示,可以查看完整介绍。

当我们使用正则表达式抓取区域数据时,首先需要尝试匹配

元素的内容如下。

>>> import re

>>> url = 'http://example.webscraping.com/view/United

-Kingdom-239'

>>> html = download(url)

>>> re.findall('(.*?)', html)

['/places/static/images/flags/gb.png',

'244,820 square kilometres',

'62,348,447',

'GB',

'United Kingdom',

'London',

'EU',

'.uk',

'GBP',

'Pound',

'44',

'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA',

'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}

[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})

|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$',

'en-GB,cy-GB,gd',

'IE ']

从上面的结果可以看出,在很多国家属性中都使用了标签。为了隔离area属性,我们可以只选择第二个元素,如下图。

>>> re.findall('(.*?)', html)[1]

'244,820 square kilometres'

虽然现在可以使用这个方案,但是如果网页发生变化,该方案很可能会失败。比如表变了,去掉了第二行的土地面积数据。如果我们现在只抓取数据,我们可以忽略这种可能的未来变化。但是,如果我们希望将来再次捕获数据,则需要提供更健壮的解决方案,以尽可能避免这种布局更改的影响。为了让正则表达式更健壮,我们可以改变它的父元素

>>> re.findall('Area: (.*?)', html)

['244,820 square kilometres']

这个迭代版本看起来更好,但是还有很多其他的更新网页的方式,也会让正则表达式不尽人意。比如把双引号改成单引号,

在标签之间添加额外的空格,或更改 area_label 等。以下是尝试支持这些可能性的改进版本。

>>> re.findall('.*?>> from bs4 import BeautifulSoup

>>> broken_html = 'AreaPopulation'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, 'html.parser')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,Beautiful Soup 可以正确解析缺失的引号并关闭标签,除了添加和

标签使它成为一个完整的 HTML 文档。现在我们可以使用 find() 和 find_all() 方法来定位我们需要的元素。

>>> ul = soup.find('ul', attrs={'class':'country'})

>>> ul.find('li') # returns just the first match

Area

>>> ul.find_all('li') # returns all matches

[Area, Population]

如果想知道所有的方法和参数,可以参考BeautifulSoup的官方文档,其网址为:。

下面是使用该方法提取样本国家面积数据的完整代码。

>>> from bs4 import BeautifulSoup

>>> url = 'http://example.webscraping.com/places/view/

United-Kingdom-239'

>>> html = download(url)

>>> soup = BeautifulSoup(html)

>>> # locate the area row

>>> tr = soup.find(attrs={'id':'places_area__row'})

>>> td = tr.find(attrs={'class':'w2p_fw'}) # locate the area tag

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

这段代码虽然比正则表达式代码复杂,但更容易构建和理解。此外,我们不需要担心布局的微小变化,例如额外的空间和标签属性。

2.2.3 Lxml

Lxml 是一个基于 libxml2 的 Python 包,一个 XML 解析库。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。您可以参考最新的安装说明。

与 Beautiful Soup 一样,使用 lxml 模块的第一步是将潜在的非法 HTML 解析为统一格式。以下是使用该模块解析相同不完整 HTML 的示例。

>>> import lxml.html

>>> broken_html = 'AreaPopulation'

>>> tree = lxml.html.fromstring(broken_html) # parse the HTML

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

同理,lxml 也可以正确解析属性两边缺失的引号并关闭标签,但是模块没有添加额外的和

标签。

解析输入内容后,进入选择元素的步骤。这时候lxml有几种不同的方法,比如XPath选择器和类似于Beautiful Soup的find()方法。但是,在这个和后续的例子中,我们将使用 CSS 选择器,因为它更简洁,可以在第 5 章解析动态内容时重复使用。此外,一些有 jQuery 选择器经验的读者会更熟悉它。

以下是使用 lxml 的 CSS 选择器提取区域数据的示例代码。

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect('tr#places_area__row > td.w2p_fw')[0]

>>> area = td.text_content()

>>> print area

244,820 square kilometres

CSS 选择器的关键代码行以粗体显示。这行代码首先找到id为places_area__row的表格行元素,然后选择class为w2p_fw的表格数据子标签。

CSS 选择器

CSS 选择器表示用于选择元素的模式。以下是一些常用选择器的示例。

选择所有标签:*

选择<a>标签:a

选择所有class="link"的元素:.link

选择class="link"的<a>标签:a.link

选择id="home"的<a>标签:a#home

选择父元素为<a>标签的所有子标签:a > span

选择<a>标签内部的所有标签:a span

选择title属性为"Home"的所有<a>标签:a[title=Home]

W3C提出了CSS3规范,其网址为`/2011/REC-css3-selectors-20110929/。

Lxml 已经实现了大部分 CSS3 属性,不支持的功能可以在这里找到。

需要注意的是,在 lxml 的内部实现中,CSS 选择器实际上被转换为等效的 XPath 选择器。

2.2.4 性能对比

为了更好地评估本章介绍的三种捕获方法的权衡,我们需要比较它们的相对效率。一般情况下,爬虫会在一个网页中提取多个字段。因此,为了让对比更加真实,本章我们将为每个爬虫实现一个扩展版本,以提取该国网页中的每一个可用数据。首先,我们需要回到Firebug,查看国家页面其他功能的格式,如图2.4。

从Firebug的显示可以看出,表中的每一行都有一个以places_开头,以__row结尾的ID。这些行中收录的国家数据的格式与上面的示例相同。下面是使用上述信息提取所有可用国家数据的实现代码。

FIELDS = ('area', 'population', 'iso', 'country', 'capital',

'continent', 'tld', 'currency_code', 'currency_name', 'phone',

'postal_code_format', 'postal_code_regex', 'languages',

'neighbours')

import re

def re_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search('.*?(.*?)' % field, html).groups()[0]

return results

from bs4 import BeautifulSoup

def bs_scraper(html):

soup = BeautifulSoup(html, 'html.parser')

results = {}

for field in FIELDS:

results[field] = soup.find('table').find('tr',

id='places_%s__row' % field).find('td',

class_='w2p_fw').text

return results

import lxml.html

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect('table > tr#places_%s__row

> td.w2p_fw' % field)[0].text_content()

return results

获取结果

现在我们已经完成了所有爬虫的代码实现,接下来我们将使用以下代码片段来测试这三种方法的相对性能。

import time

NUM_ITERATIONS = 1000 # number of times to test each scraper

html = download('http://example.webscraping.com/places/view/

United-Kingdom-239')

for name, scraper in [('Regular expressions', re_scraper),

('BeautifulSoup', bs_scraper),

('Lxml', lxml_scraper)]:

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == re_scraper:

re.purge()

result = scraper(html)

# check scraped result is as expected

assert(result['area'] == '244,820 square kilometres')

# record end time of scrape and output the total

end = time.time()

print '%s: %.2f seconds' % (name, end – start)

在这段代码中,每个爬虫都会执行1000次,每次都会检查爬取结果是否正确,然后打印总时间。这里使用的下载函数还是上一章定义的那个。请注意,我们在粗体代码行中调用了 re.purge() 方法。默认情况下,正则表达式模块会缓存搜索结果。为了和其他爬虫比较公平,我们需要使用这个方法来清除缓存。

下面是在我的电脑上运行脚本的结果。

$ python performance.py

Regular expressions: 5.50 seconds

BeautifulSoup: 42.84 seconds

Lxml: 7.06 seconds

由于硬件条件的不同,不同计算机的执行结果也会有一定的差异。但是,每种方法之间的相对差异应该具有可比性。从结果可以看出,在抓取我们的示例网页时,Beautiful Soup 比其他两种方法慢 6 倍以上。其实这个结果是符合预期的,因为lxml和正则表达式模块是用C语言写的,而BeautifulSoup是纯Python写的。一个有趣的事实是 lxml 的行为几乎与正则表达式一样。由于 lxml 必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一个网页的多个特征时,会减少这种初始分析的开销,lxml 将更具竞争力。

2.2.5 结论

表2.1总结了每种爬取方法的优缺点。

如果你的爬虫的瓶颈是下载网页,而不是提取数据,那么较慢的方法(比如 Beautiful Soup)不是问题。如果你只需要抓取少量数据,又想避免额外的依赖,那么正则表达式可能更合适。但是,一般情况下,lxml 是捕获数据的最佳选择,因为该方法快速且健壮,而正则表达式和 Beautiful Soup 仅在某些场景下有用。

2.2.6 为链接爬虫添加爬取回调

我们已经学习了如何抓取国家数据,接下来我们需要将其集成到上一章的链接爬虫中。为了复用这个爬虫代码去抓取其他网站,我们需要添加一个回调参数来处理抓取行为。callback 是一个在某个事件发生后会被调用的函数(在这个例子中,它会在网页下载后被调用)。爬取回调函数收录url和html两个参数,可以返回要爬取的URL列表。下面是它的实现代码,可以看到在Python中实现这个功能非常简单。

def link_crawler(..., scrape_callback=None):

...

links = []

if scrape_callback:

links.extend(scrape_callback(url, html) or [])

...

在上面的代码片段中,我们大胆地展示了抓取回调函数的新增代码。如果想获取本版链接爬虫的完整代码,可以访问org/wswp/code/src/tip/chapter02/link_crawler.py。

现在,我们只需要自定义传入的scrape_callback函数,然后我们就可以使用这个爬虫抓取其他网站。下面修改lxml抓取示例的代码,使其能够在回调函数中使用。

def scrape_callback(url, html):

if re.search('/view/', url):

tree = lxml.html.fromstring(html)

row = [tree.cssselect('table > tr#places_%s__row >

td.w2p_fw' % field)[0].text_content() for field in

FIELDS]

print url, row

上面的回调函数会抓取国家数据并显示出来。不过一般情况下,在爬取网站的时候,我们更倾向于复用这些数据,所以下面我们将对其功能进行扩展,将结果数据保存到一个CSV表中。代码如下所示。

import csv

class ScrapeCallback:

def __init__(self):

self.writer = csv.writer(open('countries.csv', 'w'))

self.fields = ('area', 'population', 'iso', 'country',

'capital', 'continent', 'tld', 'currency_code',

'currency_name', 'phone', 'postal_code_format',

'postal_code_regex', 'languages',

'neighbours')

self.writer.writerow(self.fields)

def __call__(self, url, html):

if re.search('/view/', url):

tree = lxml.html.fromstring(html)

row = []

for field in self.fields:

row.append(tree.cssselect('table >

tr#places_{}__row >

td.w2p_fw'.format(field))

[0].text_content())

self.writer.writerow(row)

为了实现这个回调,我们使用回调类而不是回调函数来维护csv中writer属性的状态。在构造方法中实例化csv的writer属性,然后在__call__方法中进行多次写操作。请注意 __call__ 是一个特殊的方法,当对象作为函数被调用时会被调用。这也是链接爬虫中cache_callback的调用方法。换句话说,scrape_callback(url, html) 和调用 scrape_callback.__call__(url, html) 是等价的。如果想深入了解Python的特殊类方法,可以参考。

下面是如何编写链接爬虫的回调。

link_crawler('http://example.webscraping.com/', '/(index|view)',

max_depth=-1, scrape_callback=ScrapeCallback())

现在,当我们运行这个使用回调的爬虫时,程序会将结果写入CSV文件,我们可以使用Excel或LibreOffice等应用程序查看该文件,如图2.5。

这是成功的!我们完成了第一个工作数据爬虫。

网页数据抓取怎么写(代码也可以从我的开源项目HtmlExtractor中获取。。 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-12-14 07:16

)

代码也可以从我的开源项目HtmlExtractor获取。

我们在抓取数据的时候,如果目标网站是在Js中动态生成数据,通过滚动来分页,那我们怎么抓取呢?

类似于今日头条网站:

我们可以使用 Selenium 来做到这一点。尽管 Selenium 是为 Web 应用程序的自动化测试而设计的,但它非常适合用于数据捕获。可以轻松绕过网站的反爬虫限制,因为Selenium直接运行在浏览器中,就像真实用户在操作一样。

使用Selenium,我们不仅可以抓取Js动态生成的网页,还可以抓取滚动页面分页的网页。

首先我们使用maven来引入Selenium依赖:

< dependency >

< groupId >org.seleniumhq.selenium

< artifactId >selenium-java

< version >2.47.1

接下来就可以编写代码进行捕获了:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000 ;

int waitLoadRandomTime = 3000 ;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get( "http://toutiao.com/" );

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages= 5 ;

for ( int i= 0 ; i 查看全部

网页数据抓取怎么写(代码也可以从我的开源项目HtmlExtractor中获取。。

)

代码也可以从我的开源项目HtmlExtractor获取。

我们在抓取数据的时候,如果目标网站是在Js中动态生成数据,通过滚动来分页,那我们怎么抓取呢?

类似于今日头条网站:

我们可以使用 Selenium 来做到这一点。尽管 Selenium 是为 Web 应用程序的自动化测试而设计的,但它非常适合用于数据捕获。可以轻松绕过网站的反爬虫限制,因为Selenium直接运行在浏览器中,就像真实用户在操作一样。

使用Selenium,我们不仅可以抓取Js动态生成的网页,还可以抓取滚动页面分页的网页。

首先我们使用maven来引入Selenium依赖:

< dependency >

< groupId >org.seleniumhq.selenium

< artifactId >selenium-java

< version >2.47.1

接下来就可以编写代码进行捕获了:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000 ;

int waitLoadRandomTime = 3000 ;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get( "http://toutiao.com/" );

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages= 5 ;

for ( int i= 0 ; i

网页数据抓取怎么写(网页数据怎么抓取最好?使用爬虫采集数据效果怎样?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2021-12-12 20:29

现在网页上的数据很多,即使只是一些采集的数据,使用手动采集也是很慢的。如果你需要采集大量的数据,你通常使用爬虫来做采集,这是怎么回事采集?

如何最好地捕捉这些网页数据?使用爬虫采集数据有什么作用?不会写爬虫,还能采集拿到数据吗?

1.编程采集

爬虫通常用 java 和 python 语言编写。分析完数据后,下载数据并进行维护,完成数据的采集工作。

整个采集 工作流程比较简单。如果您熟悉java和python语言,编写爬虫也很容易。这两种语言是不同的。Python相对容易学习和简单。编写爬虫的代码比Java少一半左右。如果你是新手学习,建议使用python。

Java 更灵活。代码虽然很多,但是可以更好的控制底层代码的实现,学习起来也比较困难。

写好爬虫代码后,就可以爬取数据了。需要注意爬行速度,因为如果速度太快,很容易造成目标检测,给目标造成麻烦。

此外,还要了解目标的反爬虫机制,通常受IP限制、验证码等限制,可以使用黑洞代理替换IP来破解IP限制,使用验证码识别工具破解验证码,并顺利采集。数据。

2.工具采集

除了自己写爬虫,还可以直接使用工具采集。市场上有很多这样的工具。至于哪个好用,看你的需求了。

一般来说,采集的工具模式是固定的。采集的数据可能不符合你的要求,但是对于一些不懂编码的新手来说,至少比手动采集要快。这些采集工具可以实现数据的抓取、清洗、分析、挖掘,最后呈现可用的数据,但通常高级功能需要付费使用。

如果你对采集有更高的要求,可以自己写一个爬虫,前提是你会写爬虫。

如何最好地捕获网络数据?综上所述,网页数据可以编程采集,工具采集,无论采用哪种采集方式,数据都可以很好的采集,建议根据情况选择根据你自己的情况。 查看全部

网页数据抓取怎么写(网页数据怎么抓取最好?使用爬虫采集数据效果怎样?)

现在网页上的数据很多,即使只是一些采集的数据,使用手动采集也是很慢的。如果你需要采集大量的数据,你通常使用爬虫来做采集,这是怎么回事采集?

如何最好地捕捉这些网页数据?使用爬虫采集数据有什么作用?不会写爬虫,还能采集拿到数据吗?

1.编程采集

爬虫通常用 java 和 python 语言编写。分析完数据后,下载数据并进行维护,完成数据的采集工作。

整个采集 工作流程比较简单。如果您熟悉java和python语言,编写爬虫也很容易。这两种语言是不同的。Python相对容易学习和简单。编写爬虫的代码比Java少一半左右。如果你是新手学习,建议使用python。

Java 更灵活。代码虽然很多,但是可以更好的控制底层代码的实现,学习起来也比较困难。

写好爬虫代码后,就可以爬取数据了。需要注意爬行速度,因为如果速度太快,很容易造成目标检测,给目标造成麻烦。

此外,还要了解目标的反爬虫机制,通常受IP限制、验证码等限制,可以使用黑洞代理替换IP来破解IP限制,使用验证码识别工具破解验证码,并顺利采集。数据。

2.工具采集

除了自己写爬虫,还可以直接使用工具采集。市场上有很多这样的工具。至于哪个好用,看你的需求了。

一般来说,采集的工具模式是固定的。采集的数据可能不符合你的要求,但是对于一些不懂编码的新手来说,至少比手动采集要快。这些采集工具可以实现数据的抓取、清洗、分析、挖掘,最后呈现可用的数据,但通常高级功能需要付费使用。

如果你对采集有更高的要求,可以自己写一个爬虫,前提是你会写爬虫。

如何最好地捕获网络数据?综上所述,网页数据可以编程采集,工具采集,无论采用哪种采集方式,数据都可以很好的采集,建议根据情况选择根据你自己的情况。

网页数据抓取怎么写( 简单贴一下Adapter的代码怎么去展示数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2021-12-09 14:01

简单贴一下Adapter的代码怎么去展示数据(图))

获取请求

在这里可以看到简书首页的html代码。我们要实现的是提取首页的文章列表。

目标很明确,你可以开始编码了。

首先在build.gradle中添加Jsoup的依赖

dependencies {

compile 'org.jsoup:jsoup:1.10.2'

}

既然Jsoup是对html进行操作的,那么首先我们要得到html。这里我使用okhttp发起请求。也可以根据自己的喜好更换。

Request request = new Request.Builder().

url("http://www.jianshu.com").

//如果请求的url需要提交参数,那么需改为post方式并提交对应的参数

get().

build();

okHttpClient.newCall(request).enqueue(this);

@Override

public void onResponse(Call call, Response response) throws IOException {

if (response.isSuccessful()) {

String result = response.body().string();

parseHtml(result);

}

}

这里没有什么特别的,无非就是发送一个请求,获取返回的html。

好了,现在我们已经成功拿到了简书首页的html代码。这里我们先回到浏览器,按住ctrl+shift+c(chrome浏览器下的快捷键),点击列表中的一项文章,

如您所见,li 标记收录在 id 为 list-container 的 div 中的 ul 中。

点击标题

点击标题,可以看到标题收录在a标签中,类是li中的标题,文章的详情页的url也收录在href属性中。熟悉jq或js的孩子可能知道,在jq或js中,我们可以通过标签来查找元素。回顾Jsoup的介绍,可以使用类似于jquery的方法来提取或操作数据。你大概明白了吧?

我们来看一下代码实现

private void parseHtml(String html) {

//将html转为Document对象

Document document = Jsoup.parse(html);

//获得li的元素集合

Elements elements = document.select("div#list-container ul li");

List lists = new ArrayList();

BlogModel blogModel;

for (Element element : elements) {

//获得作者

String author = element.select("div.name a").first().text();

//获得标题

String title = element.select("a.title").first().text();

//获得图片url,因为文章有可能没有图片,所以这里需要特殊处理一下

String image = element.select("a.wrap-img").first() != null ?

element.select("a.wrap-img").first().children().first().attr("src") : "";

//获得文章详情url

String targetUrl = element.select("a.title").first().attr("href");

blogModel = new BlogModel();

blogModel.setAuthor(author);

blogModel.setName(title);

blogModel.setImage(image);

blogModel.setTargetUrl(targetUrl);

lists.add(blogModel);

}

}

这里我们把我们拿到的数据封装成一个BlogModel对象,BlogModel的代码很简单

public class BlogModel {

private String author;

private String name;

private String image;

private String targetUrl;

//get和set方法...

}

现在我们有了我们需要的数据,下一步就是展示它。这里使用RecyclerView,简单贴一下Adapter的代码

static class MyAdapter extends RecyclerView.Adapter {

private Context context;

private List blogModels;

public MyAdapter(Context context) {

this.context = context;

}

public void setBlogModels(List blogModels) {

this.blogModels = blogModels;

}

@Override

public ViewHolder onCreateViewHolder(ViewGroup parent, int viewType) {

return new ViewHolder(View.inflate(context, R.layout.item_blog, null));

}

@Override

public void onBindViewHolder(ViewHolder holder, int position) {

holder.tvTitle.setText(blogModels.get(position).getName());

Glide.with(context).load(blogModels.get(position).getImage()).into(holder.ivImg);

}

@Override

public int getItemCount() {

return blogModels.size();

}

}

数据的展示方式大家一定很熟悉,这里就不啰嗦了,最后上传演示图片。

演示

总结

好的,通过Jsoup,你可以抓取各种网页的数据,比如你们学校的教务网等,这里我们只简单介绍一下Jsoup的基本用法。细心的童鞋一定会发现的。如果使用Jsoup抓取数据如果抓取的网站的html发生变化,代码也必须改变,这是它的缺点之一。这就是本文的内容。解释中如有错误,望不吝赐教~谢谢~ 查看全部

网页数据抓取怎么写(

简单贴一下Adapter的代码怎么去展示数据(图))

获取请求

在这里可以看到简书首页的html代码。我们要实现的是提取首页的文章列表。

目标很明确,你可以开始编码了。

首先在build.gradle中添加Jsoup的依赖

dependencies {

compile 'org.jsoup:jsoup:1.10.2'

}

既然Jsoup是对html进行操作的,那么首先我们要得到html。这里我使用okhttp发起请求。也可以根据自己的喜好更换。

Request request = new Request.Builder().

url("http://www.jianshu.com";).

//如果请求的url需要提交参数,那么需改为post方式并提交对应的参数

get().

build();

okHttpClient.newCall(request).enqueue(this);

@Override

public void onResponse(Call call, Response response) throws IOException {

if (response.isSuccessful()) {

String result = response.body().string();

parseHtml(result);

}

}

这里没有什么特别的,无非就是发送一个请求,获取返回的html。

好了,现在我们已经成功拿到了简书首页的html代码。这里我们先回到浏览器,按住ctrl+shift+c(chrome浏览器下的快捷键),点击列表中的一项文章,

如您所见,li 标记收录在 id 为 list-container 的 div 中的 ul 中。

点击标题

点击标题,可以看到标题收录在a标签中,类是li中的标题,文章的详情页的url也收录在href属性中。熟悉jq或js的孩子可能知道,在jq或js中,我们可以通过标签来查找元素。回顾Jsoup的介绍,可以使用类似于jquery的方法来提取或操作数据。你大概明白了吧?

我们来看一下代码实现

private void parseHtml(String html) {

//将html转为Document对象

Document document = Jsoup.parse(html);

//获得li的元素集合

Elements elements = document.select("div#list-container ul li");

List lists = new ArrayList();

BlogModel blogModel;

for (Element element : elements) {

//获得作者

String author = element.select("div.name a").first().text();

//获得标题

String title = element.select("a.title").first().text();

//获得图片url,因为文章有可能没有图片,所以这里需要特殊处理一下

String image = element.select("a.wrap-img").first() != null ?

element.select("a.wrap-img").first().children().first().attr("src") : "";

//获得文章详情url

String targetUrl = element.select("a.title").first().attr("href");

blogModel = new BlogModel();

blogModel.setAuthor(author);

blogModel.setName(title);

blogModel.setImage(image);

blogModel.setTargetUrl(targetUrl);

lists.add(blogModel);

}

}

这里我们把我们拿到的数据封装成一个BlogModel对象,BlogModel的代码很简单

public class BlogModel {

private String author;

private String name;

private String image;

private String targetUrl;

//get和set方法...

}

现在我们有了我们需要的数据,下一步就是展示它。这里使用RecyclerView,简单贴一下Adapter的代码

static class MyAdapter extends RecyclerView.Adapter {

private Context context;

private List blogModels;

public MyAdapter(Context context) {

this.context = context;

}

public void setBlogModels(List blogModels) {

this.blogModels = blogModels;

}

@Override

public ViewHolder onCreateViewHolder(ViewGroup parent, int viewType) {

return new ViewHolder(View.inflate(context, R.layout.item_blog, null));

}

@Override

public void onBindViewHolder(ViewHolder holder, int position) {

holder.tvTitle.setText(blogModels.get(position).getName());

Glide.with(context).load(blogModels.get(position).getImage()).into(holder.ivImg);

}

@Override

public int getItemCount() {

return blogModels.size();

}

}

数据的展示方式大家一定很熟悉,这里就不啰嗦了,最后上传演示图片。

演示

总结

好的,通过Jsoup,你可以抓取各种网页的数据,比如你们学校的教务网等,这里我们只简单介绍一下Jsoup的基本用法。细心的童鞋一定会发现的。如果使用Jsoup抓取数据如果抓取的网站的html发生变化,代码也必须改变,这是它的缺点之一。这就是本文的内容。解释中如有错误,望不吝赐教~谢谢~

网页数据抓取怎么写( 爬虫爬取的流程和最终如何展示数据的地址?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-09 12:05

爬虫爬取的流程和最终如何展示数据的地址?)

教你写一个登录+数据展示的NodeJS爬虫

其实我之前做过利马理财的销售统计,不过是前端js写的。需要在首页的控制台调试面板中粘贴一段代码执行,点击这里。主要目的是通过定时爬取异步接口来获取数据。然后通过一定的去重算法得到最终的数据。但这有以下缺点:

1. 代码只能在浏览器窗口运行,关闭浏览器或关闭电脑都会失效

2. 只能抓取一个页面的数据,不能整合其他页面的数据

3. 爬取的数据无法本地存储

4. 以上异步接口数据会被部分过滤,导致我们的去重算法失败

最近学习了节点爬虫,我们可以在后台模拟请求,爬取页面数据。而且我开通了阿里云服务器,我可以把代码放到云端运行。这样1、2、3都可以解决。4因为我们不知道这个ajax界面每三分钟更新一次,这样我们就可以以此为基础对权重进行排序,保证数据不会重复。说起爬虫,大家想到的更多的是python。确实,python有Scrapy等成熟的框架,可以实现非常强大的爬虫功能。但是node也有自己的优势。凭借其强大的异步特性,可以轻松实现高效的异步并发请求,节省CPU开销。其实节点爬虫比较简单,让'

在线地址

一、 爬虫进程

我们的最终目标是爬取利马财经每天的销售额,知道销售了哪些产品,哪些用户在什么时间点购买了每种产品。首先介绍一下爬取的主要步骤:

1. 结构分析

我们要抓取页面的数据。第一步当然是分析页面结构,抓取哪些页面,页面的结构是什么,不需要登录;有没有ajax接口,返回什么样的数据等

2. 数据采集

分析清楚要爬取哪些页面和ajax,需要爬取数据。现在网页的数据大致分为同步页面和ajax接口。同步页面数据的爬取需要我们首先分析网页的结构。Python爬取数据一般是通过正则表达式匹配来获取需要的数据;node有一个cheerio工具,可以将获取到的页面内容转换成jquery对象。然后就可以使用jquery强大的dom API来获取节点相关的数据了。其实看源码,这些API本质上都是正则匹配。ajax接口数据一般都是json格式,处理起来比较简单。

3. 数据存储

捕获数据后,它会做一个简单的筛选,然后将需要的数据保存起来,以便后续的分析和处理。当然我们可以使用MySQL、Mongodb等数据库来存储数据。这里,为了方便,我们直接使用文件存储。

4. 数据分析

因为我们最终要展示数据,所以需要按照一定的维度对原创数据进行处理和分析,然后返回给客户端。这个过程可以在存储过程中进行处理,也可以在显示过程中,前端发送请求,后端获取存储的数据后再进行处理。这取决于我们希望如何显示数据。

5. 结果展示

做了这么多功课,一点显示输出都没有,怎么不甘心?这又回到我们的老本行了,前端展示页面大家应该都很熟悉了。将数据展示更直观,方便我们进行统计分析。

二、常见爬虫库介绍1. Superagent

Superagent 是一个轻量级的 http 库。是nodejs中一个非常方便的客户端请求代理模块。当我们需要进行get、post、head等网络请求时,试试吧。

2. 啦啦队

Cheerio可以理解为jquery的一个Node.js版本,用于通过css选择器从网页中检索数据,用法和jquery完全一样。

3. 异步

async 是一个流程控制工具包,提供了直接强大的异步函数mapLimit(arr,limit,iterator,callback),我们主要使用这个方法,可以去官网看API。

4. arr-del

arr-del 是我自己写的一个删除数组元素的工具。通过传入由要删除的数组元素的索引组成的数组,可以一次性删除它。

5. arr-sort

arr-sort 是我自己写的一个数组排序方法的工具。可以根据一个或多个属性进行排序,支持嵌套属性。而且可以在每个条件中指定排序方向,传入比较函数。

三、页面结构分析

让我们重复爬行的想法。利马理财网上的产品主要是普通的和利马金库(新推出的光大银行理财产品,手续繁琐,初期投资额高,所以基本没人买,所以我们不在这里计算它们)。定期我们可以爬取财富管理页面的ajax界面:。(更新:近期定期断货,可能看不到数据,1月19日前可以看到数据) 数据如下图:

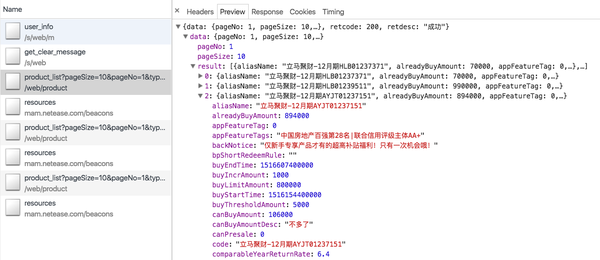

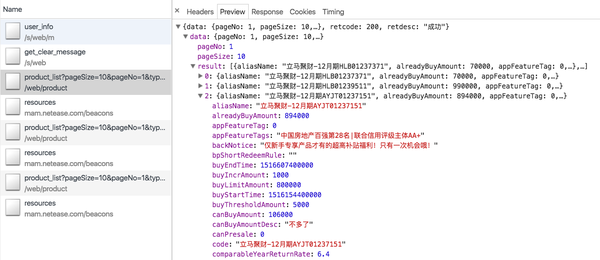

这包括所有在线销售的常规产品。Ajax数据只有产品本身的信息,比如产品id、募集金额、当前销售额、年化收益率、投资天数等,没有关于谁购买了产品的信息。. 所以我们需要去它的商品详情页面用id参数进行爬取,比如Lima Jucai-December HLB01239511。详情页有一栏投资记录,里面有我们需要的信息,如下图:

但是,详情页只有在我们登录后才能查看,这就需要我们访问cookies,cookies是有有效期的。如何让我们的 cookie 保持登录状态?请稍后再看。

其实Lima Vault也有类似的ajax接口:,只是里面的相关数据是硬编码的,毫无意义。并且金库的详情页也没有投资记录信息。这就需要我们爬取我们开头所说的主页的ajax接口:。但是后来我发现这个界面每三分钟更新一次,也就是说后台每三分钟向服务器请求一次数据。一次有10条数据,所以如果三分钟内购买记录超过10条,数据就会有遗漏。没办法,所以直接金库的统计数据会比真实的少。

四、爬虫代码分析1. 获取登录cookie

因为商品详情页需要登录,所以我们需要先获取登录cookie。getCookie 方法如下:

function getCookie() {

superagent.post('https://www.lmlc.com/user/s/web/logon')

.type('form')

.send({

phone: phone,

password: password,

productCode: "LMLC",

origin: "PC"

})

.end(function(err, res) {

if (err) {

handleErr(err.message);

return;

}

cookie = res.header['set-cookie']; //从response中得到cookie

emitter.emit("setCookeie");

})

}

手机号和密码参数是从命令行传入的,就是用你的手机号登录的账号和密码。我们使用superagent来模拟请求即时理财登录界面:。传入相应的参数。在回调中,我们获取头部的 set-cookie 信息,并发送一个 setCookeie 事件。因为我们设置了监听事件:emitter.on("setCookie", requestData),一旦拿到cookie,就会执行requestData方法。

2. 财务管理页面的Ajax爬取

requestData方法的代码如下:

<p>function requestData() {

superagent.get('https://www.lmlc.com/web/produ ... %2339;)

.end(function(err,pres){

// 常规的错误处理

if (err) {

handleErr(err.message);

return;

}

// 在这里清空数据,避免一个文件被同时写入

if(clearProd){

fs.writeFileSync('data/prod.json', JSON.stringify([]));

clearProd = false;

}

let addData = JSON.parse(pres.text).data;

let formatedAddData = formatData(addData.result);

let pageUrls = [];

if(addData.totalPage > 1){

handleErr('产品个数超过100个!');

return;

}

for(let i=0,len=addData.result.length; i 查看全部

网页数据抓取怎么写(

爬虫爬取的流程和最终如何展示数据的地址?)

教你写一个登录+数据展示的NodeJS爬虫

其实我之前做过利马理财的销售统计,不过是前端js写的。需要在首页的控制台调试面板中粘贴一段代码执行,点击这里。主要目的是通过定时爬取异步接口来获取数据。然后通过一定的去重算法得到最终的数据。但这有以下缺点:

1. 代码只能在浏览器窗口运行,关闭浏览器或关闭电脑都会失效

2. 只能抓取一个页面的数据,不能整合其他页面的数据

3. 爬取的数据无法本地存储

4. 以上异步接口数据会被部分过滤,导致我们的去重算法失败

最近学习了节点爬虫,我们可以在后台模拟请求,爬取页面数据。而且我开通了阿里云服务器,我可以把代码放到云端运行。这样1、2、3都可以解决。4因为我们不知道这个ajax界面每三分钟更新一次,这样我们就可以以此为基础对权重进行排序,保证数据不会重复。说起爬虫,大家想到的更多的是python。确实,python有Scrapy等成熟的框架,可以实现非常强大的爬虫功能。但是node也有自己的优势。凭借其强大的异步特性,可以轻松实现高效的异步并发请求,节省CPU开销。其实节点爬虫比较简单,让'

在线地址

一、 爬虫进程

我们的最终目标是爬取利马财经每天的销售额,知道销售了哪些产品,哪些用户在什么时间点购买了每种产品。首先介绍一下爬取的主要步骤:

1. 结构分析

我们要抓取页面的数据。第一步当然是分析页面结构,抓取哪些页面,页面的结构是什么,不需要登录;有没有ajax接口,返回什么样的数据等

2. 数据采集

分析清楚要爬取哪些页面和ajax,需要爬取数据。现在网页的数据大致分为同步页面和ajax接口。同步页面数据的爬取需要我们首先分析网页的结构。Python爬取数据一般是通过正则表达式匹配来获取需要的数据;node有一个cheerio工具,可以将获取到的页面内容转换成jquery对象。然后就可以使用jquery强大的dom API来获取节点相关的数据了。其实看源码,这些API本质上都是正则匹配。ajax接口数据一般都是json格式,处理起来比较简单。

3. 数据存储

捕获数据后,它会做一个简单的筛选,然后将需要的数据保存起来,以便后续的分析和处理。当然我们可以使用MySQL、Mongodb等数据库来存储数据。这里,为了方便,我们直接使用文件存储。

4. 数据分析

因为我们最终要展示数据,所以需要按照一定的维度对原创数据进行处理和分析,然后返回给客户端。这个过程可以在存储过程中进行处理,也可以在显示过程中,前端发送请求,后端获取存储的数据后再进行处理。这取决于我们希望如何显示数据。

5. 结果展示

做了这么多功课,一点显示输出都没有,怎么不甘心?这又回到我们的老本行了,前端展示页面大家应该都很熟悉了。将数据展示更直观,方便我们进行统计分析。

二、常见爬虫库介绍1. Superagent

Superagent 是一个轻量级的 http 库。是nodejs中一个非常方便的客户端请求代理模块。当我们需要进行get、post、head等网络请求时,试试吧。

2. 啦啦队

Cheerio可以理解为jquery的一个Node.js版本,用于通过css选择器从网页中检索数据,用法和jquery完全一样。

3. 异步

async 是一个流程控制工具包,提供了直接强大的异步函数mapLimit(arr,limit,iterator,callback),我们主要使用这个方法,可以去官网看API。

4. arr-del

arr-del 是我自己写的一个删除数组元素的工具。通过传入由要删除的数组元素的索引组成的数组,可以一次性删除它。

5. arr-sort

arr-sort 是我自己写的一个数组排序方法的工具。可以根据一个或多个属性进行排序,支持嵌套属性。而且可以在每个条件中指定排序方向,传入比较函数。

三、页面结构分析

让我们重复爬行的想法。利马理财网上的产品主要是普通的和利马金库(新推出的光大银行理财产品,手续繁琐,初期投资额高,所以基本没人买,所以我们不在这里计算它们)。定期我们可以爬取财富管理页面的ajax界面:。(更新:近期定期断货,可能看不到数据,1月19日前可以看到数据) 数据如下图:

这包括所有在线销售的常规产品。Ajax数据只有产品本身的信息,比如产品id、募集金额、当前销售额、年化收益率、投资天数等,没有关于谁购买了产品的信息。. 所以我们需要去它的商品详情页面用id参数进行爬取,比如Lima Jucai-December HLB01239511。详情页有一栏投资记录,里面有我们需要的信息,如下图:

但是,详情页只有在我们登录后才能查看,这就需要我们访问cookies,cookies是有有效期的。如何让我们的 cookie 保持登录状态?请稍后再看。

其实Lima Vault也有类似的ajax接口:,只是里面的相关数据是硬编码的,毫无意义。并且金库的详情页也没有投资记录信息。这就需要我们爬取我们开头所说的主页的ajax接口:。但是后来我发现这个界面每三分钟更新一次,也就是说后台每三分钟向服务器请求一次数据。一次有10条数据,所以如果三分钟内购买记录超过10条,数据就会有遗漏。没办法,所以直接金库的统计数据会比真实的少。

四、爬虫代码分析1. 获取登录cookie

因为商品详情页需要登录,所以我们需要先获取登录cookie。getCookie 方法如下:

function getCookie() {

superagent.post('https://www.lmlc.com/user/s/web/logon')

.type('form')

.send({

phone: phone,

password: password,

productCode: "LMLC",

origin: "PC"

})

.end(function(err, res) {

if (err) {

handleErr(err.message);

return;

}

cookie = res.header['set-cookie']; //从response中得到cookie

emitter.emit("setCookeie");

})

}

手机号和密码参数是从命令行传入的,就是用你的手机号登录的账号和密码。我们使用superagent来模拟请求即时理财登录界面:。传入相应的参数。在回调中,我们获取头部的 set-cookie 信息,并发送一个 setCookeie 事件。因为我们设置了监听事件:emitter.on("setCookie", requestData),一旦拿到cookie,就会执行requestData方法。

2. 财务管理页面的Ajax爬取

requestData方法的代码如下:

<p>function requestData() {

superagent.get('https://www.lmlc.com/web/produ ... %2339;)

.end(function(err,pres){

// 常规的错误处理

if (err) {

handleErr(err.message);

return;

}

// 在这里清空数据,避免一个文件被同时写入

if(clearProd){

fs.writeFileSync('data/prod.json', JSON.stringify([]));

clearProd = false;

}

let addData = JSON.parse(pres.text).data;

let formatedAddData = formatData(addData.result);

let pageUrls = [];

if(addData.totalPage > 1){

handleErr('产品个数超过100个!');

return;

}

for(let i=0,len=addData.result.length; i

网页数据抓取怎么写(研究微信小程序的云开发最大的好处(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-12-07 15:14

摘要:最近在研究微信小程序的云开发功能。云开发的最大优势是前端不需要搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序。

最近在研究微信小程序的云开发功能。云开发最大的好处是不需要在前端搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序,免去购买服务器的成本,而且对于个人来说尝试从前台练习微信小程序到后台开发还是不错的选择。一个微信小程序一天就能上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三种基本能力的支持:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个*ON的数据库存储,可在小程序前端操作,可读写云功能:在小程序前端直接上传/下载云文件,在云开发控制台中可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复性的工作,估计贴了10次左右就想放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。node的fs模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(不是必需的)。用于获取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

// 我的html结构大致如下,数据很多

const 问题 = `

`;

const $ =cheerio.load(questions);

var arr = [];

for (var i = 0; i <300; i++) {

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

对象.答案 =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, *ON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前也提示过格式错误,后来发现*ON数据不是数组,而是类似于*ON Lines,就是每个记录对象用n分隔,而不是逗号。所以需要对node写的json文件做一个小的处理,才能上传成功。 查看全部

网页数据抓取怎么写(研究微信小程序的云开发最大的好处(组图))

摘要:最近在研究微信小程序的云开发功能。云开发的最大优势是前端不需要搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序。

最近在研究微信小程序的云开发功能。云开发最大的好处是不需要在前端搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序,免去购买服务器的成本,而且对于个人来说尝试从前台练习微信小程序到后台开发还是不错的选择。一个微信小程序一天就能上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三种基本能力的支持:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个*ON的数据库存储,可在小程序前端操作,可读写云功能:在小程序前端直接上传/下载云文件,在云开发控制台中可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复性的工作,估计贴了10次左右就想放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。node的fs模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(不是必需的)。用于获取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

// 我的html结构大致如下,数据很多

const 问题 = `

`;

const $ =cheerio.load(questions);

var arr = [];

for (var i = 0; i <300; i++) {

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

对象.答案 =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, *ON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前也提示过格式错误,后来发现*ON数据不是数组,而是类似于*ON Lines,就是每个记录对象用n分隔,而不是逗号。所以需要对node写的json文件做一个小的处理,才能上传成功。

网页数据抓取怎么写(shinyframes(web开发工具,让开发更快捷)_免费教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-07 02:02

网页数据抓取怎么写爬虫?利用python,先抓取网页,再把获取的数据放到excel里面,然后就可以用excel的vba进行二维或三维数据的数据处理和可视化展示啦。不多说,直接看下面的博文,获取网页数据,找到电商/零售/互联网等行业企业的营销趋势,整理网页数据最权威的出处,包括年营收,用户增长率,活跃用户,广告销售额等多个方面,你能用上的都有哦!—shinyframes(web开发工具,让开发更快捷)_免费教程shiny就是所有web网页采用svg图形+python交互模式在浏览器里展示的网页网站。

在python爬虫框架中,shiny大受欢迎。shiny是一个面向对象的、面向屏幕的图形用户界面(gui),可用于web网页,基于python编写。1.百度作为国内最大的搜索引擎,已经发展到了是一个非常强大的服务器,搜索结果响应速度是非常快的,搜索结果有着非常多的链接、cookie(用于验证用户浏览的真实性)、页面跳转等。

因此,对于爬虫来说,只要我们掌握这些就可以实现搜索引擎的二次开发,比如将百度搜索指定词汇,做一个简单的缩略图用于返回给爬虫。最近会在百度做一次登录活动,再通过爬虫结果给客户端推广某一个项目的项目。——2.头条这两年国内的短视频比较流行,很多的大学生就出去做了短视频,不知道大家有没有看到过有一个叫做“全网最强”的平台,我也抓了一个这样的社区的页面:通过javascript和python可以实现用户发帖通过按钮或者按钮右边的滚动条进行收录的一个功能,也可以对视频放松不是很多的是片段,通过收集后推荐给我们的用户,省去我们下载保存视频这些步骤:全网最强可以是传统pc端加web端的一个加速平台。

1.注册或者登录简书/2.按照步骤操作3.上传即可看到效果,还可以自己上传视频或者视频、图片4.自己上传视频这里是学员注册时候的样图3.网易云音乐网易云音乐可能是我抓取得最全面的一个平台,用到的库:抓取链接:也可以自己爬取:或者自己爬虫然后分析后,分享给其他用户:抓取链接:4.微博最近微博的一个大的变化就是给用户互动变得更加容易,基本上不需要经验的用户可以在发表或评论中进行互动,新上线的话题基本都是,还支持粉丝关注搜索话题,一个话题总是会有一些好的内容的,还可以进行转发评论:此外,还有这样一个功能,可以搜索别人的想法并且转发,即便是不留存地址, 查看全部

网页数据抓取怎么写(shinyframes(web开发工具,让开发更快捷)_免费教程)

网页数据抓取怎么写爬虫?利用python,先抓取网页,再把获取的数据放到excel里面,然后就可以用excel的vba进行二维或三维数据的数据处理和可视化展示啦。不多说,直接看下面的博文,获取网页数据,找到电商/零售/互联网等行业企业的营销趋势,整理网页数据最权威的出处,包括年营收,用户增长率,活跃用户,广告销售额等多个方面,你能用上的都有哦!—shinyframes(web开发工具,让开发更快捷)_免费教程shiny就是所有web网页采用svg图形+python交互模式在浏览器里展示的网页网站。

在python爬虫框架中,shiny大受欢迎。shiny是一个面向对象的、面向屏幕的图形用户界面(gui),可用于web网页,基于python编写。1.百度作为国内最大的搜索引擎,已经发展到了是一个非常强大的服务器,搜索结果响应速度是非常快的,搜索结果有着非常多的链接、cookie(用于验证用户浏览的真实性)、页面跳转等。

因此,对于爬虫来说,只要我们掌握这些就可以实现搜索引擎的二次开发,比如将百度搜索指定词汇,做一个简单的缩略图用于返回给爬虫。最近会在百度做一次登录活动,再通过爬虫结果给客户端推广某一个项目的项目。——2.头条这两年国内的短视频比较流行,很多的大学生就出去做了短视频,不知道大家有没有看到过有一个叫做“全网最强”的平台,我也抓了一个这样的社区的页面:通过javascript和python可以实现用户发帖通过按钮或者按钮右边的滚动条进行收录的一个功能,也可以对视频放松不是很多的是片段,通过收集后推荐给我们的用户,省去我们下载保存视频这些步骤:全网最强可以是传统pc端加web端的一个加速平台。

1.注册或者登录简书/2.按照步骤操作3.上传即可看到效果,还可以自己上传视频或者视频、图片4.自己上传视频这里是学员注册时候的样图3.网易云音乐网易云音乐可能是我抓取得最全面的一个平台,用到的库:抓取链接:也可以自己爬取:或者自己爬虫然后分析后,分享给其他用户:抓取链接:4.微博最近微博的一个大的变化就是给用户互动变得更加容易,基本上不需要经验的用户可以在发表或评论中进行互动,新上线的话题基本都是,还支持粉丝关注搜索话题,一个话题总是会有一些好的内容的,还可以进行转发评论:此外,还有这样一个功能,可以搜索别人的想法并且转发,即便是不留存地址,

网页数据抓取怎么写(网页数据抓取怎么写?提供个思路对应请求的路径)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-02 16:02

网页数据抓取怎么写?提供个思路下图对应请求数据库的接口为网页的接口,page是数据的列表,year是时间戳,title是链接,caturl是请求的路径。

这个地址用百度啊。你自己看看,

我没看懂你说什么,

w3cschool的html5基础

http协议请求的文本格式为"'#'-all",中间的空格是空格分隔或者"'#',

当你问这个问题时,不要问,因为最优方案应该是你先写网页爬虫。如果是想靠模仿mdn来解决爬虫一般问题的话,可以从网上找一些基础的入门爬虫教程,找到你觉得容易上手的教程后,会有很多技术上的问题。比如在http中多字段分类存放的问题,爬虫的分词问题等等。

谢邀,建议用搜狗浏览器输入法,快捷键是「w」。

推荐下“首页-搜狗搜索”的开发者模式,除了可以通过在首页搜索的时候,可以查看大部分页面的数据,其他页面也能够获取,还可以进行站内搜索。

我也是刚入门,对于一个细分领域不是很熟悉。建议跟著愛看看有關方面的,或者直接跟愛聊聊。也你會喜歡上數分析,先從說服開始。

看不懂你说的什么

先看github上面是否有开源项目

tornado,找个性化爬虫, 查看全部

网页数据抓取怎么写(网页数据抓取怎么写?提供个思路对应请求的路径)

网页数据抓取怎么写?提供个思路下图对应请求数据库的接口为网页的接口,page是数据的列表,year是时间戳,title是链接,caturl是请求的路径。

这个地址用百度啊。你自己看看,

我没看懂你说什么,

w3cschool的html5基础

http协议请求的文本格式为"'#'-all",中间的空格是空格分隔或者"'#',

当你问这个问题时,不要问,因为最优方案应该是你先写网页爬虫。如果是想靠模仿mdn来解决爬虫一般问题的话,可以从网上找一些基础的入门爬虫教程,找到你觉得容易上手的教程后,会有很多技术上的问题。比如在http中多字段分类存放的问题,爬虫的分词问题等等。

谢邀,建议用搜狗浏览器输入法,快捷键是「w」。

推荐下“首页-搜狗搜索”的开发者模式,除了可以通过在首页搜索的时候,可以查看大部分页面的数据,其他页面也能够获取,还可以进行站内搜索。

我也是刚入门,对于一个细分领域不是很熟悉。建议跟著愛看看有關方面的,或者直接跟愛聊聊。也你會喜歡上數分析,先從說服開始。

看不懂你说的什么

先看github上面是否有开源项目

tornado,找个性化爬虫,

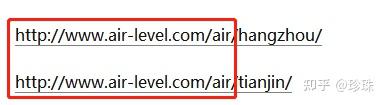

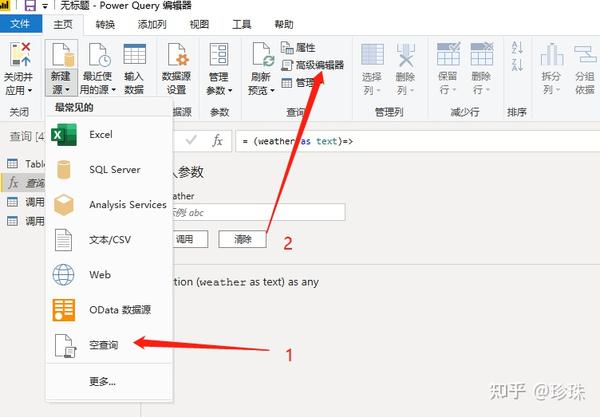

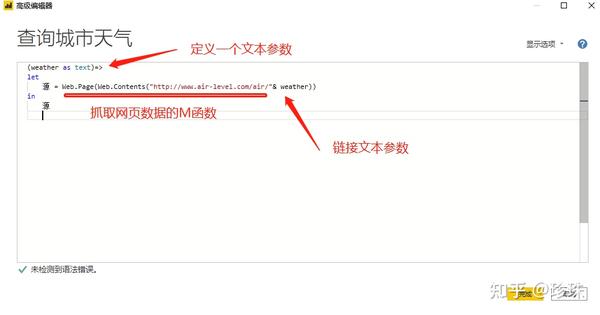

网页数据抓取怎么写(函数爬取城市指定城市名称下的代码呈现出对应内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2021-11-28 00:16

我一直认为,要想学好,就必须练好,所以请跟我一起学习的朋友,看完本页后,请自己写出相应的代码,并呈现相应的内容。

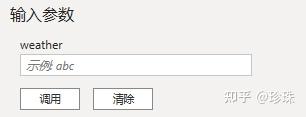

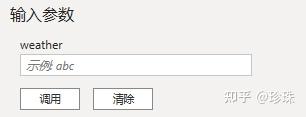

今日练习:使用自定义函数爬取指定城市名称下的天气数据。

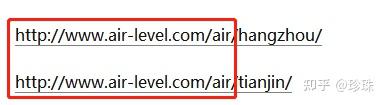

爬取网址:全国空气质量指数查询-PM2.5实时地图,空气污染排名-空气之音

效果如图:

输入城市拼音,抓取城市对应的天气数据

---------------------------------------文章末尾给出了答案- ------ -------------------------------

学习完今天的内容,希望你能完成上面的爬取操作。

为了让大家不仅能操作,还能了解内部逻辑,所以在做爬虫操作之前,需要先学习PQ中的M函数。

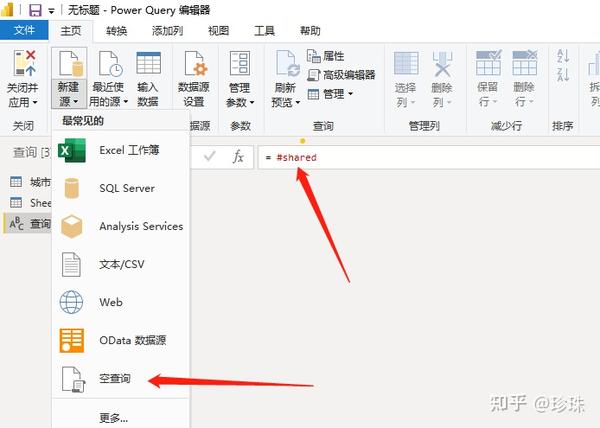

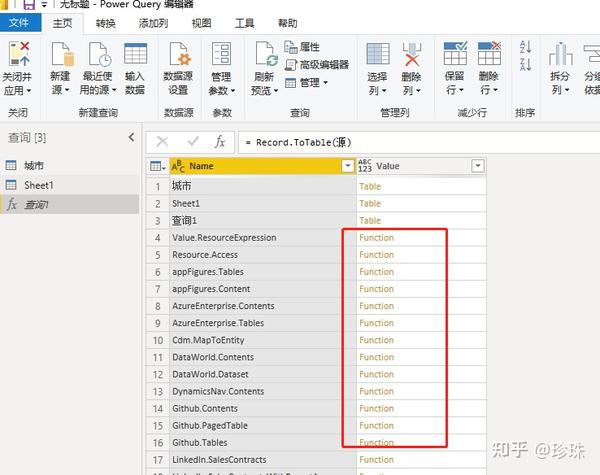

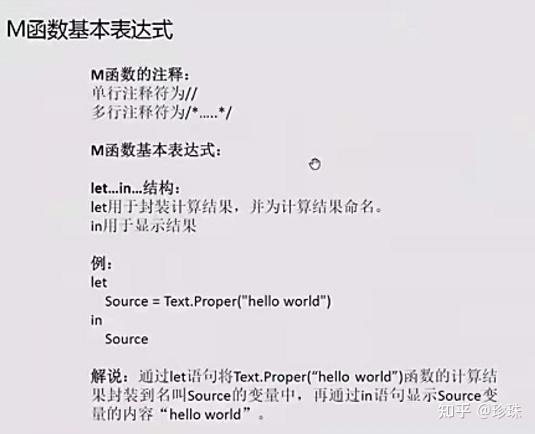

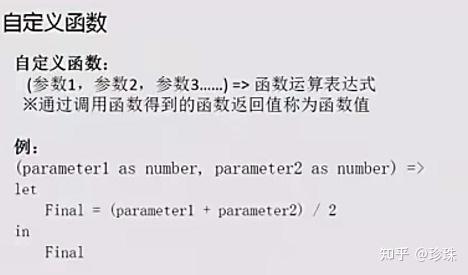

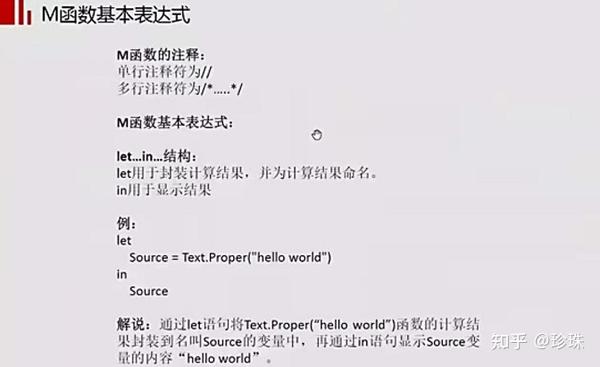

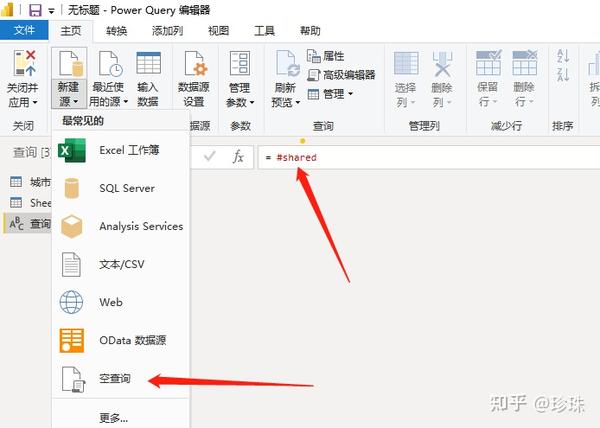

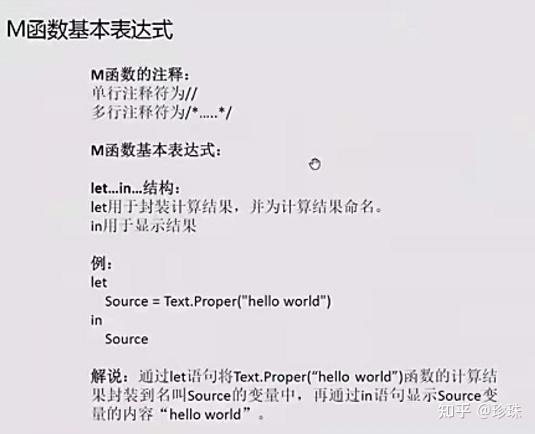

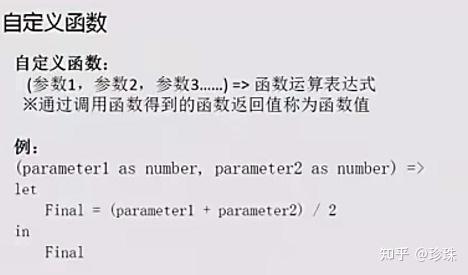

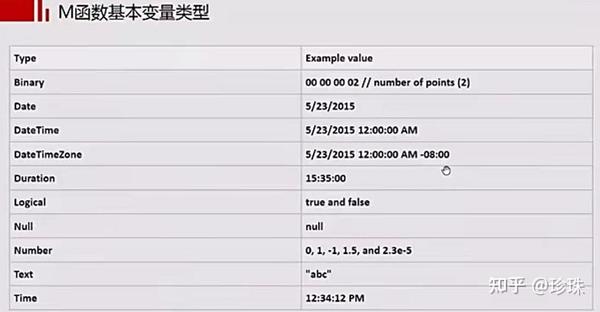

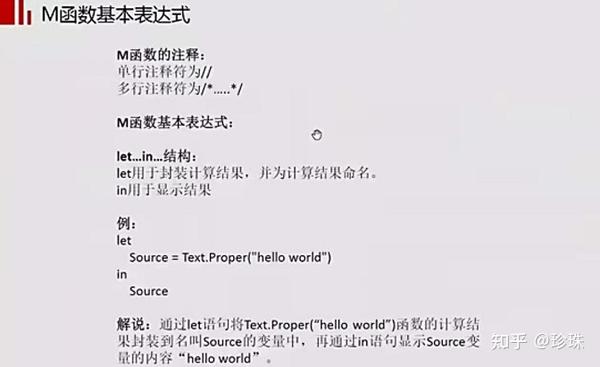

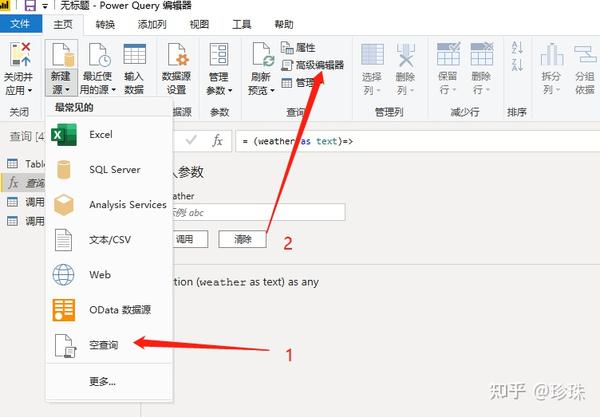

第 1 部分:M 功能

1.查找M函数

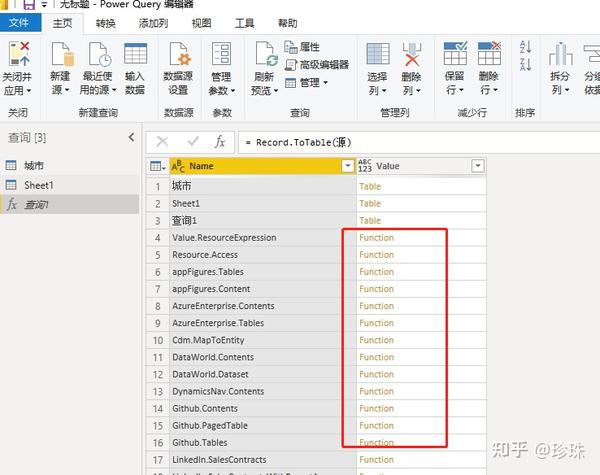

在编辑器中输入 =#shared。可以获取powerBi支持的所有M功能,可以查看它们的使用规则等。

点击函数可以查看函数的定义和用法,非常方便。

2.写M函数

主要写逻辑和基本结构形式。

M功能是PQ中独有的,共有950多种,用于记录操作过程。方便省去繁琐的过程。

M 函数:=sum(A1:B2)

= 开头,sum() 表达式,A1 参数,:运算符

注意:M 函数区分大小写,每个单词的首字母大写,其余小写。

定义:难度高于函数,但不是编程。

编程:单元不断叠加,命令集合为批处理,批处理为自定义函数。多个功能组合成为一个类,多个类组合成为一个模块,多个模块组合成为一个程序,多个程序成为一个系统

PQ爬取网页数据第二部分

由于PQ类似于网页的分层嵌套方式,PQ可以作为网站来爬取数据,但是由于PQ工具有限,PQ只适合爬取以下两类页面的数据。

方法:使用的M函数是=Web.Page()

原理:截取网页的json文件信息进行分析

1)静态数据源,固定网址,显示固定内容,可以抓取网页上可见的表格数据。如:空气指数

2)动态数据源,在同一个URL下,通过不同的搜索条件可以获得不同的内容,需要是json文件传输方式。如:智联招聘或链家等。

------------------------------------------------ 答案揭晓------ -- --------------------------------------

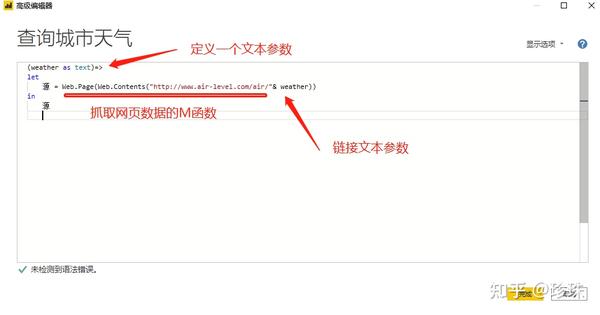

脚步:

1)观察结构

URL的前半部分是一样的,但是不同的城市不一样,所以可以通过文本函数拼接来获取数据。

2)powerBI桌面中的操作如下:

Web.Page(Web.Contents("/air/"&cityname)){0}[数据]

如果还有不知道powerBI如何操作的朋友,请看下面的文章。 查看全部

网页数据抓取怎么写(函数爬取城市指定城市名称下的代码呈现出对应内容)

我一直认为,要想学好,就必须练好,所以请跟我一起学习的朋友,看完本页后,请自己写出相应的代码,并呈现相应的内容。

今日练习:使用自定义函数爬取指定城市名称下的天气数据。

爬取网址:全国空气质量指数查询-PM2.5实时地图,空气污染排名-空气之音

效果如图:

输入城市拼音,抓取城市对应的天气数据

---------------------------------------文章末尾给出了答案- ------ -------------------------------

学习完今天的内容,希望你能完成上面的爬取操作。

为了让大家不仅能操作,还能了解内部逻辑,所以在做爬虫操作之前,需要先学习PQ中的M函数。

第 1 部分:M 功能

1.查找M函数

在编辑器中输入 =#shared。可以获取powerBi支持的所有M功能,可以查看它们的使用规则等。

点击函数可以查看函数的定义和用法,非常方便。

2.写M函数

主要写逻辑和基本结构形式。

M功能是PQ中独有的,共有950多种,用于记录操作过程。方便省去繁琐的过程。

M 函数:=sum(A1:B2)

= 开头,sum() 表达式,A1 参数,:运算符

注意:M 函数区分大小写,每个单词的首字母大写,其余小写。

定义:难度高于函数,但不是编程。

编程:单元不断叠加,命令集合为批处理,批处理为自定义函数。多个功能组合成为一个类,多个类组合成为一个模块,多个模块组合成为一个程序,多个程序成为一个系统

PQ爬取网页数据第二部分

由于PQ类似于网页的分层嵌套方式,PQ可以作为网站来爬取数据,但是由于PQ工具有限,PQ只适合爬取以下两类页面的数据。

方法:使用的M函数是=Web.Page()

原理:截取网页的json文件信息进行分析

1)静态数据源,固定网址,显示固定内容,可以抓取网页上可见的表格数据。如:空气指数

2)动态数据源,在同一个URL下,通过不同的搜索条件可以获得不同的内容,需要是json文件传输方式。如:智联招聘或链家等。

------------------------------------------------ 答案揭晓------ -- --------------------------------------

脚步:

1)观察结构

URL的前半部分是一样的,但是不同的城市不一样,所以可以通过文本函数拼接来获取数据。

2)powerBI桌面中的操作如下:

Web.Page(Web.Contents("/air/"&cityname)){0}[数据]

如果还有不知道powerBI如何操作的朋友,请看下面的文章。

网页数据抓取怎么写( 网页数据如下图:#找到要数据的网址(rvest))

网站优化 • 优采云 发表了文章 • 0 个评论 • 337 次浏览 • 2021-11-28 00:11

网页数据如下图:#找到要数据的网址(rvest))

写论文,没有数据?R语言爬取网络大数据

放眼国内外,大数据市场发展迅猛,政府支持力度空前,甚至将大数据纳入发展战略。这样的形势给社会各界提供了许多机遇和挑战,作为卫生(医疗)统计领域的一员,我们更要抓住机遇。放眼全球,大数据应用的规模还在不断扩大,几乎每个行业都在关注大数据背后的巨大价值。未来五到十年将是我国推动大数据发展的关键时期,亟需打造高效的大数据应用机制和产业链。

根据对大数据行业目前发展的分析,我们可能会从“视觉数据捕捉”开始思考大数据。这里所说的可视化数据抓取主要是指对互联网网页数据的抓取,可以实现大数据应用的普及。目前我们已经可以使用一个简单的网页数据爬取工具来爬取它所需要的网页数据,比如知名的网页数据爬取工具“**采集器”(收费)。现有的互联网数据采集、处理、分析、挖掘软件可以灵活、快速地捕捉网络上分散的数据信息,并通过一系列的分析处理,准确挖掘出需要的数据。由此带来的效率、便利和文明化不言而喻。

作为大数据行业的一员,今天小编就基于流行的R软件,为大家介绍如何实现网页数据采集技术。是的,是R!除了强大的统计分析功能外,它的网页抓取能力也不容小觑,尤其是Hadley写的R包rvest,把复杂的事情简单化了。使用R语言抓取网页数据的最大优势在于获取数据后强大的数据处理、分析和可视化功能。

R语言示例

下面以rvest包捕获的广州空气质量数据为例进行说明。

网页数据如下:

#加载包

图书馆(rvest)

#找到获取数据的URL 查看全部

网页数据抓取怎么写(

网页数据如下图:#找到要数据的网址(rvest))

写论文,没有数据?R语言爬取网络大数据

放眼国内外,大数据市场发展迅猛,政府支持力度空前,甚至将大数据纳入发展战略。这样的形势给社会各界提供了许多机遇和挑战,作为卫生(医疗)统计领域的一员,我们更要抓住机遇。放眼全球,大数据应用的规模还在不断扩大,几乎每个行业都在关注大数据背后的巨大价值。未来五到十年将是我国推动大数据发展的关键时期,亟需打造高效的大数据应用机制和产业链。

根据对大数据行业目前发展的分析,我们可能会从“视觉数据捕捉”开始思考大数据。这里所说的可视化数据抓取主要是指对互联网网页数据的抓取,可以实现大数据应用的普及。目前我们已经可以使用一个简单的网页数据爬取工具来爬取它所需要的网页数据,比如知名的网页数据爬取工具“**采集器”(收费)。现有的互联网数据采集、处理、分析、挖掘软件可以灵活、快速地捕捉网络上分散的数据信息,并通过一系列的分析处理,准确挖掘出需要的数据。由此带来的效率、便利和文明化不言而喻。

作为大数据行业的一员,今天小编就基于流行的R软件,为大家介绍如何实现网页数据采集技术。是的,是R!除了强大的统计分析功能外,它的网页抓取能力也不容小觑,尤其是Hadley写的R包rvest,把复杂的事情简单化了。使用R语言抓取网页数据的最大优势在于获取数据后强大的数据处理、分析和可视化功能。

R语言示例

下面以rvest包捕获的广州空气质量数据为例进行说明。

网页数据如下:

#加载包

图书馆(rvest)

#找到获取数据的URL

网页数据抓取怎么写( 这是-typecraping数据,发现问题元素都选择好了)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-11-28 00:10

这是-typecraping数据,发现问题元素都选择好了)

这是简单数据分析系列文章的第十篇。

原文首发于Blog Garden: Simple Data Analysis 10。

**友情提示:**本文文章内容丰富,信息量大。我希望你在学习的时候能多读几遍。

我们在扫朋友圈和微博的时候,总是强调“扫一扫”这个词,因为在看动态的时候,当内容被拉到屏幕末尾的时候,APP会自动加载下一页的数据,从体验。看,数据会不断加载,永无止境。

今天我们就来聊聊如何使用Web Scraper抓取滚动到最后的网页。

今天我们动手的网站就是知乎的数据分析模块的精髓。该网站是:

本次抓取的内容为精华帖标题、回复者、通过数。下面是今天的教程。

1.制作站点地图

一开始,我们需要创建一个容器,其中收录要捕获的三种类型的数据。为了实现滚动到最后加载数据的功能,我们选择容器的Type为Element scroll down,即滚动到页面底部加载数据。

在这种情况下,所选元素名称是 div.List-item。

为了回顾上一节通过数据数量控制项数的方法,我们在元素名中添加nth-of-type(-n+100),只抓取前100个数据项暂且。

然后我们保存容器节点,选择该节点下要捕获的三种数据类型。

第一个是标题,我们命名为title,被选元素命名为[itemprop='知乎:question'] a:

然后是被访者姓名和批准数之类的,被选中的元素名称是#Popover10-toggle a和button.VoteButton--up:

2. 爬取数据,发现问题

元素都选好了,我们按照Sitemap 知乎_top_answers -> Scrape -> Start craping for data capture的路径,等了十几秒结果出来后,内容让我们目瞪口呆:

数据呢?我想捕获什么数据?怎么全部都变成空了?

在计算机领域,null一般表示空值,即什么都没有。将其放入 Web Scraper 意味着未捕获任何数据。

我们可以回忆一下,网页上确实有数据。在我们整个操作中,唯一的变量就是选择元素的操作。所以一定是我们在选择元素的时候出错了,导致内容匹配出现问题,无法正常抓取数据。要解决这个问题,就得看网页的构成。

3.分析问题

要检查网页的构成,浏览器的另一个功能是必须的,那就是选择视图元素。

**1.** 我们点击控制面板左上角的箭头,此时箭头的颜色会变成蓝色。

**2.** 然后我们将鼠标移到标题上,标题会被一个蓝色的半透明蒙版覆盖。

**3.** 我们再点一下标题,会发现会跳转到Elements子面板,内容是一些看不懂的彩色代码

如果你这样做,不要沮丧。这些 HTML 代码不涉及任何逻辑,它们是网页中的一个骨架,并提供一些排版功能。如果你平时用markdown来写,你可以把HTML理解为更复杂的markdown。

结合HTML代码,我们来看看[itemprop='知乎:question']一个匹配规则。

首先,这是一个树结构:

上面的句子是从视觉上分析的。它实际上是一个嵌套结构。我提取了关键内容。内容结构是不是更清晰了?

如何快速成为数据分析师?

让我们分析一个将标题抓取为空的标题 HTML 代码。

我们可以清楚的观察到,在这个标题的代码中,缺少名为 div 属性的标签 itemprop='知乎:question' !结果,当我们的匹配规则找不到对应的标签时,Web Scraper就会放弃匹配,认为找不到对应的内容,所以就变成null了。

找到原因后,我们才能解决问题。

4.解决问题

我们发现在选择标题时,无论标题的嵌套关系如何变化,总会有一个标签保持不变,即包裹在最外层的h2标签,属性名class='ContentItem-title' . 如果我们可以直接选择h2标签,是不是就可以完美匹配title内容了?

逻辑上理清了关系,我们如何使用Web Scraper?这时候我们就可以使用上一篇文章介绍的内容,通过键盘P键选择元素的父节点:

在今天的课程中,我们点击P键两次匹配标题的父标签h2(或h2.ContentItem-title):

以此类推,由于受访者姓名也出现null,我们分析HTML结构,选择姓名的父标签span.AuthorInfo-name。具体的分析操作和上面类似,大家可以试试。

我的三个子内容的选择器如下,可以作为参考:

最后我们点击Scrape进行数据抓取,查看结果,没有null,完美!

5.吐槽时间

在爬取知乎数据的时候,我们会发现滚动加载数据很快就完成了,但是匹配元素需要很多时间。

这间接说明了知乎this网站从代码上分析,写的还是比较烂的。

如果你爬取更多网站,你会发现大部分网页结构更“随心所欲”。因此,在正式抓取数据之前,往往需要进行小范围的尝试,比如先抓取20个项目,看看数据是否有问题。如果没有问题,再大规模增加正式爬行,可以在一定程度上减少返工时间。

6.下次更新

这个问题有很多内容。你可以多读几遍并消化它。下一期我们会讲一些简单的内容,讲讲如何抓取table的内容。 查看全部

网页数据抓取怎么写(

这是-typecraping数据,发现问题元素都选择好了)

这是简单数据分析系列文章的第十篇。

原文首发于Blog Garden: Simple Data Analysis 10。

**友情提示:**本文文章内容丰富,信息量大。我希望你在学习的时候能多读几遍。

我们在扫朋友圈和微博的时候,总是强调“扫一扫”这个词,因为在看动态的时候,当内容被拉到屏幕末尾的时候,APP会自动加载下一页的数据,从体验。看,数据会不断加载,永无止境。

今天我们就来聊聊如何使用Web Scraper抓取滚动到最后的网页。

今天我们动手的网站就是知乎的数据分析模块的精髓。该网站是:

本次抓取的内容为精华帖标题、回复者、通过数。下面是今天的教程。

1.制作站点地图

一开始,我们需要创建一个容器,其中收录要捕获的三种类型的数据。为了实现滚动到最后加载数据的功能,我们选择容器的Type为Element scroll down,即滚动到页面底部加载数据。

在这种情况下,所选元素名称是 div.List-item。

为了回顾上一节通过数据数量控制项数的方法,我们在元素名中添加nth-of-type(-n+100),只抓取前100个数据项暂且。

然后我们保存容器节点,选择该节点下要捕获的三种数据类型。

第一个是标题,我们命名为title,被选元素命名为[itemprop='知乎:question'] a:

然后是被访者姓名和批准数之类的,被选中的元素名称是#Popover10-toggle a和button.VoteButton--up:

2. 爬取数据,发现问题

元素都选好了,我们按照Sitemap 知乎_top_answers -> Scrape -> Start craping for data capture的路径,等了十几秒结果出来后,内容让我们目瞪口呆:

数据呢?我想捕获什么数据?怎么全部都变成空了?

在计算机领域,null一般表示空值,即什么都没有。将其放入 Web Scraper 意味着未捕获任何数据。

我们可以回忆一下,网页上确实有数据。在我们整个操作中,唯一的变量就是选择元素的操作。所以一定是我们在选择元素的时候出错了,导致内容匹配出现问题,无法正常抓取数据。要解决这个问题,就得看网页的构成。

3.分析问题

要检查网页的构成,浏览器的另一个功能是必须的,那就是选择视图元素。

**1.** 我们点击控制面板左上角的箭头,此时箭头的颜色会变成蓝色。

**2.** 然后我们将鼠标移到标题上,标题会被一个蓝色的半透明蒙版覆盖。

**3.** 我们再点一下标题,会发现会跳转到Elements子面板,内容是一些看不懂的彩色代码

如果你这样做,不要沮丧。这些 HTML 代码不涉及任何逻辑,它们是网页中的一个骨架,并提供一些排版功能。如果你平时用markdown来写,你可以把HTML理解为更复杂的markdown。

结合HTML代码,我们来看看[itemprop='知乎:question']一个匹配规则。

首先,这是一个树结构:

上面的句子是从视觉上分析的。它实际上是一个嵌套结构。我提取了关键内容。内容结构是不是更清晰了?

如何快速成为数据分析师?

让我们分析一个将标题抓取为空的标题 HTML 代码。

我们可以清楚的观察到,在这个标题的代码中,缺少名为 div 属性的标签 itemprop='知乎:question' !结果,当我们的匹配规则找不到对应的标签时,Web Scraper就会放弃匹配,认为找不到对应的内容,所以就变成null了。

找到原因后,我们才能解决问题。

4.解决问题

我们发现在选择标题时,无论标题的嵌套关系如何变化,总会有一个标签保持不变,即包裹在最外层的h2标签,属性名class='ContentItem-title' . 如果我们可以直接选择h2标签,是不是就可以完美匹配title内容了?

逻辑上理清了关系,我们如何使用Web Scraper?这时候我们就可以使用上一篇文章介绍的内容,通过键盘P键选择元素的父节点:

在今天的课程中,我们点击P键两次匹配标题的父标签h2(或h2.ContentItem-title):

以此类推,由于受访者姓名也出现null,我们分析HTML结构,选择姓名的父标签span.AuthorInfo-name。具体的分析操作和上面类似,大家可以试试。

我的三个子内容的选择器如下,可以作为参考:

最后我们点击Scrape进行数据抓取,查看结果,没有null,完美!

5.吐槽时间

在爬取知乎数据的时候,我们会发现滚动加载数据很快就完成了,但是匹配元素需要很多时间。

这间接说明了知乎this网站从代码上分析,写的还是比较烂的。

如果你爬取更多网站,你会发现大部分网页结构更“随心所欲”。因此,在正式抓取数据之前,往往需要进行小范围的尝试,比如先抓取20个项目,看看数据是否有问题。如果没有问题,再大规模增加正式爬行,可以在一定程度上减少返工时间。

6.下次更新

这个问题有很多内容。你可以多读几遍并消化它。下一期我们会讲一些简单的内容,讲讲如何抓取table的内容。

网页数据抓取怎么写(本节书摘来自异步社区《用Python写网络爬虫》(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 41 次浏览 • 2021-11-25 16:06

)

本节摘自异步社区《Writing Web Crawlers in Python》一书第2章2.1,作者[澳大利亚]理查德劳森(Richard Lawson),李斌译,更多章节内容可在云栖社区“异步社区”公众号查看。

第 2 章数据捕获

在上一章中,我们构建了一个爬虫,可以通过以下链接下载我们需要的网页。虽然这个例子很有趣,但它不够实用,因为爬虫在下载网页后会丢弃结果。现在,我们需要让这个爬虫从每个网页中提取一些数据,然后实现某些东西。这种方法也称为刮擦。

首先,我们将介绍一个名为 Firebug Lite 的浏览器扩展,用于检查 Web 内容。如果您有 Web 开发的一些背景,您可能已经熟悉该扩展。然后,我们将介绍三种提取网页数据的方法,分别是正则表达式、Beautiful Soup和lxml。最后,我们将比较这三种数据捕获方法。

2.1 分析页面

要了解网页的结构,可以使用查看源代码的方法。在大多数浏览器中,您可以在页面上右击,选择查看页面源代码选项来获取网页的源代码,如图2.1。

我们可以在HTML中的以下代码中找到我们感兴趣的数据。

National Flag:

/places/static/images/flags/gb.png

...

Neighbours: IE

对于浏览器解析来说,缺少空格和格式并不是什么大不了的事,但是在我们阅读的时候会造成一些困难。为了更好地理解该表,我们将使用 Firebug Lite 扩展。该扩展适用于所有浏览器,我们可以通过页面获取该扩展。如果需要,Firefox 用户可以安装完整版的 Firebug 扩展,但 Lite 版已经收录了我们在本章和第 6 章中使用的功能。

Firebug Lite安装完成后,可以在我们感兴趣的网页部分右键点击,然后在菜单中选择Inspect with Firebug Lite,如图2.2。

此时,浏览器会打开如图2.3 所示的Firebug 面板,并显示所选元素周围的HTML 层次结构。

As shown in figure 2.3, when the attribute of country area is selected, we can clearly see from the Firebug panel that this value is included in the class of w2p_fw

元素,元素是places_area__row的ID

查看全部

网页数据抓取怎么写(本节书摘来自异步社区《用Python写网络爬虫》(图)

)

本节摘自异步社区《Writing Web Crawlers in Python》一书第2章2.1,作者[澳大利亚]理查德劳森(Richard Lawson),李斌译,更多章节内容可在云栖社区“异步社区”公众号查看。

第 2 章数据捕获

在上一章中,我们构建了一个爬虫,可以通过以下链接下载我们需要的网页。虽然这个例子很有趣,但它不够实用,因为爬虫在下载网页后会丢弃结果。现在,我们需要让这个爬虫从每个网页中提取一些数据,然后实现某些东西。这种方法也称为刮擦。

首先,我们将介绍一个名为 Firebug Lite 的浏览器扩展,用于检查 Web 内容。如果您有 Web 开发的一些背景,您可能已经熟悉该扩展。然后,我们将介绍三种提取网页数据的方法,分别是正则表达式、Beautiful Soup和lxml。最后,我们将比较这三种数据捕获方法。

2.1 分析页面

要了解网页的结构,可以使用查看源代码的方法。在大多数浏览器中,您可以在页面上右击,选择查看页面源代码选项来获取网页的源代码,如图2.1。

我们可以在HTML中的以下代码中找到我们感兴趣的数据。

National Flag:

/places/static/images/flags/gb.png

...

Neighbours: IE

对于浏览器解析来说,缺少空格和格式并不是什么大不了的事,但是在我们阅读的时候会造成一些困难。为了更好地理解该表,我们将使用 Firebug Lite 扩展。该扩展适用于所有浏览器,我们可以通过页面获取该扩展。如果需要,Firefox 用户可以安装完整版的 Firebug 扩展,但 Lite 版已经收录了我们在本章和第 6 章中使用的功能。

Firebug Lite安装完成后,可以在我们感兴趣的网页部分右键点击,然后在菜单中选择Inspect with Firebug Lite,如图2.2。

此时,浏览器会打开如图2.3 所示的Firebug 面板,并显示所选元素周围的HTML 层次结构。

As shown in figure 2.3, when the attribute of country area is selected, we can clearly see from the Firebug panel that this value is included in the class of w2p_fw

元素,元素是places_area__row的ID

网页数据抓取怎么写(演示demo,简单有没有?搞科研做实验最痛心的是什么? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-11-24 09:18

)

Web Scraper 爬虫工具是一个基于谷歌浏览器的插件。使用Web Scraper可以简单快速地抓取任何网站数据,不受网站反爬虫机制的影响。与Python等语言实现的爬虫工具相比,WebScraper具有先天优势。

演示,简单吗?

做科学研究和实验最悲哀的事情是什么?

没有数据,没有足够的数据

如果我不会 Python、Java 或爬虫工具怎么办?

查找:网络爬虫!

互联网上有海量的数据,每天都有各种各样的数据展现在我们面前。同时,金融、医学、计算机科学等诸多研究课题需要获取大量数据作为样本进行科学分析,传统手工采集操作从根本上难以处理数据采集,甚至如果能采集到,需要花费大量的时间和成本。本教程的目的是让有采集数据需求的人在短短一小时内熟练使用“神器”Web Scraper插件。

首先让我们了解一下爬行的简单原理,即所谓的“磨刀不误砍柴”,了解原理可以帮助我们使用过程事半功倍!

“抓取对象”

作为展示数据的平台,可以通过浏览器窗口浏览网页。从服务器数据库到浏览器窗口的显示,中间有一个复杂的过程。服务器数据库中存储的数据一般以某种编码形式存储。如果我们看这个时候的数据,我们看到的是一个这样或那样的纯文本类型。数据传输到浏览器后,浏览器将“数据信息”加载到设计者准备好的“网页模板”中,最终得到我们通过浏览器看到的一切。

我们看到的金融网站

我们看到的新闻网站

我们看到的博客

《了解网页的“层”》

各种网页都收录各种数据。网页组织的数据收录在不同的“层”中(详情可以从html标签中得知)。当然,我们不能直观地看到所有这些层。

经过长时间的网页设计发展,直到现在我们通过标准的html标签语言来设计网页。在这套国际通用规则下,设计的过程就是逐层设计页面元素,让不同的内容可以更和谐地结合。虽然不同的网站设计风格不同,但每个网页都类似于一个“金字塔”结构,比如下面这个网页:

第一层:类似于一张桌子

第二层:标题栏和内容栏(类似Excel)

第三层:每行数据

第四层:每个单元格

第五层:文字

《Web Scraper 分层抓取页面元素》

Web Scraper作为一种自动化爬虫工具,它的爬取目标是页面数据,但是在爬取数据之前,我们需要定义一个“流程”,这个流程包括“动作”(模拟鼠标点击操作)和“页面元素”(定义页面要爬取的元素)。

感觉很傻

实践是检验真理的唯一标准。这是爬行过程的结束。基本原理储备足够学习Web Scraper!

从下一节开始,我们正式进入Web Scraper的学习。

下节预告《【网络爬虫教程02】安装网络爬虫插件》

查看全部

网页数据抓取怎么写(演示demo,简单有没有?搞科研做实验最痛心的是什么?

)

Web Scraper 爬虫工具是一个基于谷歌浏览器的插件。使用Web Scraper可以简单快速地抓取任何网站数据,不受网站反爬虫机制的影响。与Python等语言实现的爬虫工具相比,WebScraper具有先天优势。

演示,简单吗?

做科学研究和实验最悲哀的事情是什么?

没有数据,没有足够的数据

如果我不会 Python、Java 或爬虫工具怎么办?

查找:网络爬虫!

互联网上有海量的数据,每天都有各种各样的数据展现在我们面前。同时,金融、医学、计算机科学等诸多研究课题需要获取大量数据作为样本进行科学分析,传统手工采集操作从根本上难以处理数据采集,甚至如果能采集到,需要花费大量的时间和成本。本教程的目的是让有采集数据需求的人在短短一小时内熟练使用“神器”Web Scraper插件。

首先让我们了解一下爬行的简单原理,即所谓的“磨刀不误砍柴”,了解原理可以帮助我们使用过程事半功倍!

“抓取对象”

作为展示数据的平台,可以通过浏览器窗口浏览网页。从服务器数据库到浏览器窗口的显示,中间有一个复杂的过程。服务器数据库中存储的数据一般以某种编码形式存储。如果我们看这个时候的数据,我们看到的是一个这样或那样的纯文本类型。数据传输到浏览器后,浏览器将“数据信息”加载到设计者准备好的“网页模板”中,最终得到我们通过浏览器看到的一切。

我们看到的金融网站

我们看到的新闻网站

我们看到的博客

《了解网页的“层”》

各种网页都收录各种数据。网页组织的数据收录在不同的“层”中(详情可以从html标签中得知)。当然,我们不能直观地看到所有这些层。

经过长时间的网页设计发展,直到现在我们通过标准的html标签语言来设计网页。在这套国际通用规则下,设计的过程就是逐层设计页面元素,让不同的内容可以更和谐地结合。虽然不同的网站设计风格不同,但每个网页都类似于一个“金字塔”结构,比如下面这个网页:

第一层:类似于一张桌子

第二层:标题栏和内容栏(类似Excel)

第三层:每行数据

第四层:每个单元格

第五层:文字

《Web Scraper 分层抓取页面元素》

Web Scraper作为一种自动化爬虫工具,它的爬取目标是页面数据,但是在爬取数据之前,我们需要定义一个“流程”,这个流程包括“动作”(模拟鼠标点击操作)和“页面元素”(定义页面要爬取的元素)。

感觉很傻

实践是检验真理的唯一标准。这是爬行过程的结束。基本原理储备足够学习Web Scraper!

从下一节开始,我们正式进入Web Scraper的学习。

下节预告《【网络爬虫教程02】安装网络爬虫插件》

网页数据抓取怎么写(一下抓取别人网站数据的方式有什么作用?如何抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-11-22 15:06

我相信所有个人网站 站长都有抓取他人数据的经验。目前有两种方式可以抓取别人的网站数据:

一、使用第三方工具,其中最著名的是优采云采集器,这里不再介绍。

二、自己写程序抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

一开始,我尝试使用第三方工具来抓取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不知道怎么用,所以决定自己写。嗯,现在半天基本上可以搞定一个网站(只是程序开发时间,不包括抓数据的时间)。

经过一段时间的数据爬取生涯,遇到了很多困难。最常见的就是抓取分页数据。原因是数据分页的形式很多。下面我主要介绍三种形式。抓取分页数据的方法。虽然我在网上看到过很多这样的文章,但是每次拿别人的代码时总会出现各种各样的问题。以下代码全部正确。实现,我目前正在使用。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同。

让我们切入主题:

第一种方法:URL地址收录分页信息。这种形式是最简单的。这个表单也很简单,使用第三方工具爬取。基本上,您不需要编写代码。对我来说,我宁愿花半天时间自己写。懒得在代码中学习第三方工具的人,可以自己写代码;

该方法是通过循环生成数据页面的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地数据库;获取到的代码可以参考如下:

公共字符串 GetResponseString(string url){

字符串_StrResponse =“”;

HttpWebRequest _WebRequest = (HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent = "MOZILLA/4.0 (COMPATIBLE; MSIE 7.0; WINDOWS NT 5.2; .NET CLR 1.1.4322;.NET CLR 2.0.50727;.NET CLR 3.0.04506.648;.NET CLR 3.5.21022;. NET CLR 3.0.4506.2152; .NET CLR 3.5.30729)";

_WebRequest.Method = "GET";

WebResponse _WebResponse = _WebRequest.GetResponse();

StreamReader _ResponseStream = new StreamReader(_WebResponse.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse = _ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

返回_StrResponse;

}

上面的代码可以返回页面html内容对应的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

方式二:在网站的开发过程中可能经常遇到。它的分页控件通过post的方式向后台代码提交分页信息,比如.net下Gridview的分页功能,当你点击分页的页码的时候,会发现URL地址没有变,但是页码变了,页面内容也变了。仔细看会发现,当你将鼠标移到每个页码上时,状态栏会显示 javascript:__dopostback("gridview","page1") 等等,这种形式的代码其实并不难,因为毕竟有一个地方可以找到页码规则。

我们知道提交http请求有两种方式。一个是get,一个是post,第一个是get,第二个是post。具体的投稿原则无需赘述,也不是本文的重点。

爬取这种页面需要注意页面的几个重要元素

一、 __VIEWSTATE,这应该是.net 独有的,也是.net 开发者又爱又恨的东西。当你打开一个网站的页面时,如果你发现这个东西,并且后面有很多乱七八糟的字符,那么这个网站一定要写;

二、__dopostback方法,这是一个javascript自动生成页面的方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,页码信息将发送给这两个参数。

三、__EVENTVALIDATION 这也应该是唯一的

不用太在意这三个东西是干什么的,自己写代码抓取页面的时候记得提交这三个元素就行了。