网页数据抓取怎么写(安装python运行pipinstallrequests运行installBeautifulSoupinstall教程)

优采云 发布时间: 2022-02-18 18:15网页数据抓取怎么写(安装python运行pipinstallrequests运行installBeautifulSoupinstall教程)

从各种搜索引擎到日常数据采集,都离不开网络爬虫monkey织梦教程。爬虫的基本原理很简单。它遍历网络中的网页并抓取感兴趣的数据内容。本篇文章将介绍如何编写一个网络爬虫从零开始爬取数据,然后逐步完善爬虫的爬取功能。

工具安装

我们需要安装 pythonmonkey织梦 教程、python 的请求和 BeautifulSoup 库。我们使用 Requests 库来抓取网页内容,并使用 BeautifulSoup 库从网页中提取数据。

安装蟒蛇

运行 pip 安装请求

运行 pip install BeautifulSoup

爬网

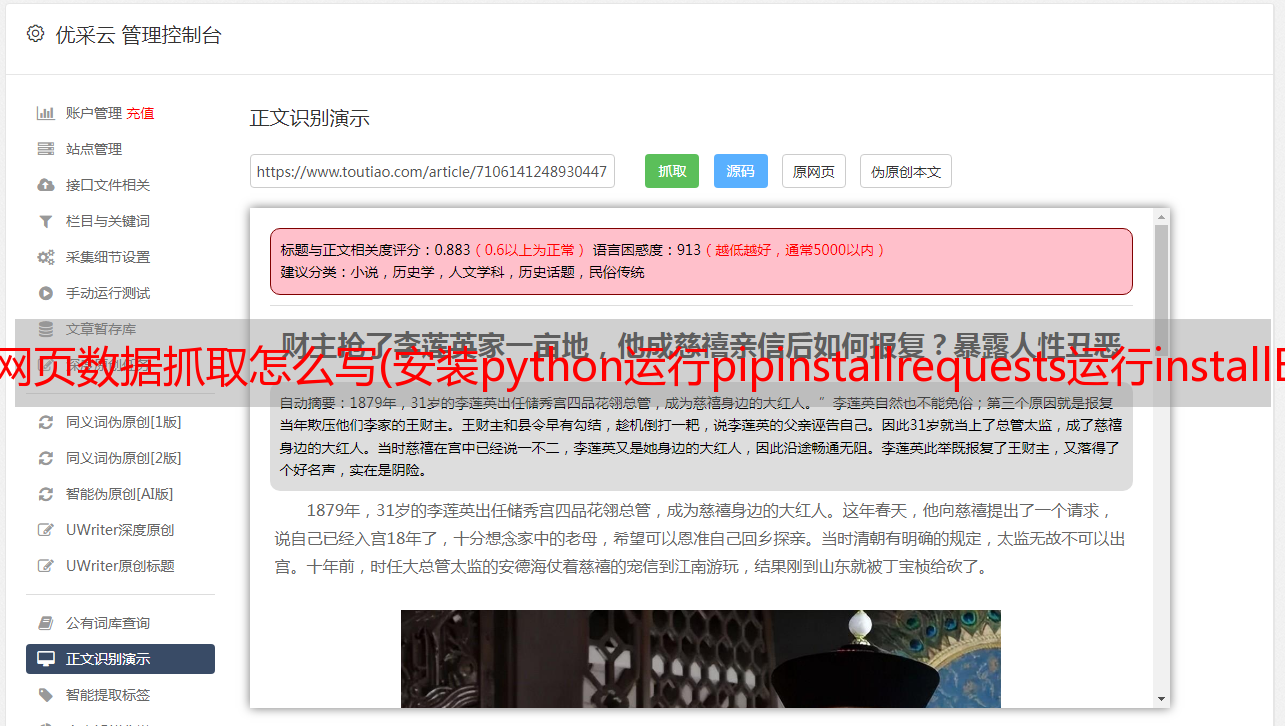

完成必要工具的安装后,我们正式开始编写我们的爬虫猴织梦教程。我们的首要任务是抓取豆瓣上的所有图书信息。我们以:///subject/26986954/为例,先看看如何爬取网页的内容。

使用python的requests提供的get()方法,我们可以很方便的获取到指定网页的内容。代码如下monkey织梦教程:

提取内容

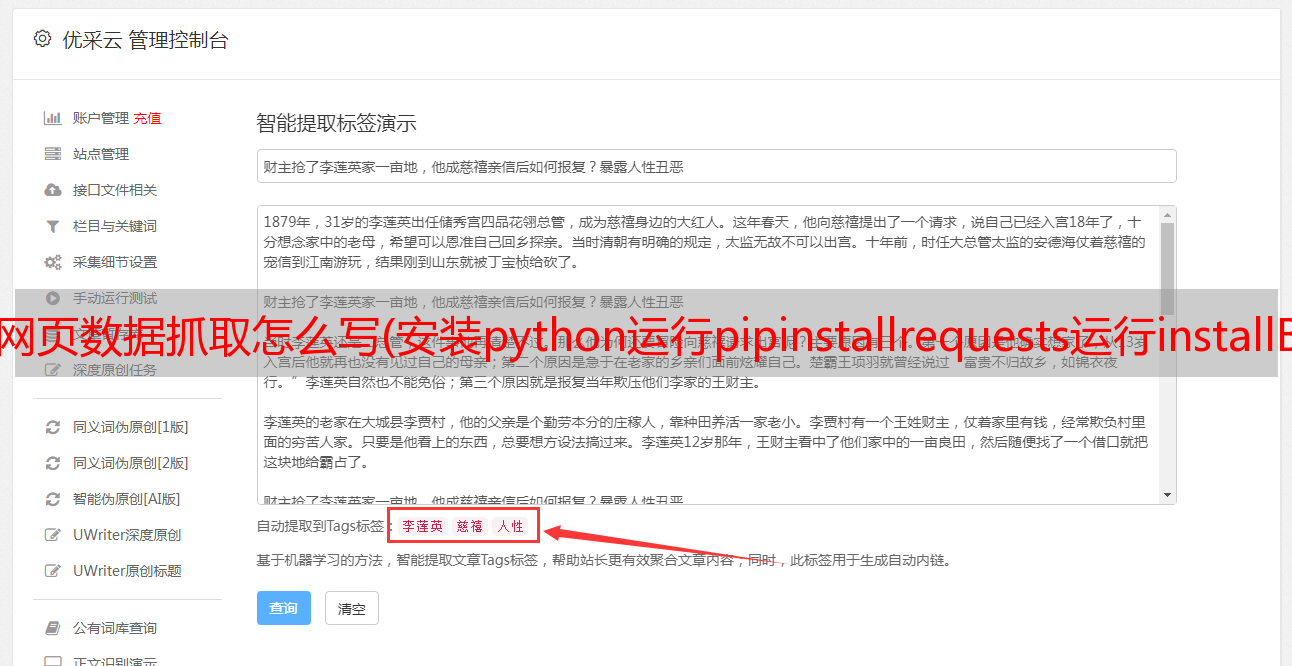

抓取网页内容后,我们要做的就是提取我们想要的内容monkey织梦Tutorial。在我们的第一个示例中,我们只需要提取书名。首先,我们导入 BeautifulSoup 库。使用 BeautifulSoup,我们可以轻松提取网页的具体内容。

连续爬网

至此,我们已经可以爬取单个页面的内容了,下面我们来看看如何爬取整个网站的内容。我们知道网页是通过超链接相互连接的,通过超链接我们可以访问整个网络。所以我们可以从每个页面中提取到其他页面的链接,然后反复爬取新的链接。

通过以上步骤,我们就可以写出一个最原创的爬虫了。在了解爬虫原理的基础上,我们可以进一步完善爬虫。

写了一系列关于爬虫的文章 文章::///i6567289381185389064/。如果你有兴趣,你可以去看看。

Python基础环境搭建、爬虫基本原理及爬虫原型

Python 爬虫入门(第 1 部分)

如何使用 BeautifulSoup 提取网页内容

Python 爬虫入门(第 2 部分)

爬虫运行时数据的存储数据,以 SQLite 和 MySQL 为例

Python 爬虫入门(第 3 部分)

使用 selenium webdriver 抓取动态网页

Python 爬虫入门(第 4 部分)

讨论了如何处理网站的反爬策略

Python 爬虫入门(第 5 部分)

介绍了Python的Scrapy爬虫框架,并简要演示了如何在Scrapy下开发

Python 爬虫入门(第 6 部分)

python中的高级编程是什么?

与其他编程语言一样,高级阶段是相对于初中阶段的提升阶段。事实上,达到高级阶段意味着你可以独立完成一个项目模块,甚至可以独立规划和推进独立的中小型项目。然后你需要达到这个阶段。掌握什么技能:

1、Django 框架;

2、Flask 框架;

3、三大数据库语言(mysql、Redis、MongoDB),尤其是mysql与python的交互;

4、Linux操作系统的命令操作;

5、网络爬虫技术;

6、Requests、Selenium、Scrapy 等模块的使用。

等等。

在编程开发中,尤其是现在模块化开发中,标准化的学习教程并不代表你进入了什么阶段。例如:你对python的所有知识都非常熟悉,但是你不能做一个基本的小项目,甚至解决不了任何问题,通过学习过程进入高级是没有意义的。

因此,在具体工作中,我们评估一个人是否已经进入高层,或者他所在团队的技术水平(记住环境)是否可以高于普通成员的能力。事实上,我们认为你属于这个团队的高层。.

python中高级编程往往是根据需要学习的知识点来衡量的,但这并不代表你的实际水平,也不代表你是团队中的资深程序员。

知识并不意味着动手能力。