爬虫抓取网页数据

爬虫抓取网页数据(Web爬虫与网络爬虫(请记住,抓取与抓取))

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-01-13 15:07

抓取与抓取 - 定义

在我们开始之前,让我们对互联网上的各种“草稿”和“爬虫”以及我们将在本文中使用的内容有一个正确的定义。

通常,有两种类型的划痕。可:

网页抓取

数据抓取

也是同样的爬行:

网络搜索

数据检索

现在,网络和数据的定义非常明确,但为了安全起见,网络是可以在互联网上找到的任何东西,而数据是可以在任何地方(不仅仅是互联网)找到的信息、统计数据和事实。

在我们的 文章 中,我们将介绍什么是网络爬虫与网络爬虫(请记住,数据爬虫和技术上的数据爬虫是相同的,只是它们不在网络上执行)。

正如我们的数据分析师告诉我们的那样,可以通过多种方式区分网络爬虫和网络抓取。所以请注意,我们将介绍一种区分它们的方法。你们中的一些人可能不同意我们,不要!在下面的评论中让我们知道您的想法,这是网络抓取和网络抓取之间的主要区别!

现在我们已经走出了困境,让我们直接跳进去。

网页抓取和抓取#2

什么是网络爬虫?

网络爬虫通常指的是从……你猜对了——万维网采集数据!传统上,需要做很多工作,但不仅限于小工作。爬虫穿过(或像蜘蛛一样爬)许多不同的目标并点击它们。

根据我们的 Python 开发人员的说法,爬虫是“连接到网页并下载其内容的程序”。

他解释说,爬虫程序上网只是为了找到两件事:

用户正在搜索的数据

抓取更多目标

所以如果我们尝试爬取一个真实的网站,过程会是这样的:

爬虫会到达您预定义的目标 -

发现产品页面

然后查找并下载产品数据(价格、标题、描述等)

但是,关于最后一点(我们方便地为您加粗了),我们将其从 Cloud Cube 注释中排除并称之为草稿。

请花点时间查看他关于网络抓取的完整 文章。Cloud Cube 确实详细介绍了网络爬取的工作原理及其不同的爬取阶段,因此,如果您在技术上对此感兴趣,请查看他的个人博客。

什么是网页抓取?

如果网络抓取意味着遍历和点击不同的目标,那么网络抓取就是您获取找到的数据并下载它的部分。网络抓取意味着您在获取之前知道要获取什么(例如,在网络抓取/抓取的情况下,通常可以抓取的是产品数据、价格、标题、描述等)。

因此,正如您可能已经采集到的那样,网络爬虫通常与爬虫齐头并进。网络爬取时,您可以在线下载现成的信息。之后,您将过滤掉不必要的信息,并通过抓取仅选择所需的信息。

然而,网络抓取可以在没有爬虫帮助的情况下手动完成(特别是如果您需要采集少量数据),并且网络爬虫通常会伴随抓取以过滤掉不必要的信息。

网页抓取和抓取

所以,Grab vs Grab——让我们梳理一下这两者之间的所有主要区别,以便清楚地了解两者:

运动的:

网络抓取——仅“抓取”数据(获取选定的数据并下载)。

网络爬虫——仅“爬取”数据(通过选定的目标)。

劳工:

网页抓取 - 可以手动完成。

网络爬虫——只能使用爬虫代理(蜘蛛机器人)来完成。

重复数据删除:

网络抓取——重复数据删除并不总是必要的,因为它可以手动完成,因此规模较小。

网络爬虫——网上很多内容都是重复的,为了不采集太多重复的信息,爬虫会过滤掉这些数据。

综上所述

网络爬虫和网络爬虫之间的区别非常明显——爬虫会爬过互联网上的各种目标,就像蜘蛛爬网一样。一旦爬虫到达目标,它就会被爬取 - 采集并下载所选目标的数据。 查看全部

爬虫抓取网页数据(Web爬虫与网络爬虫(请记住,抓取与抓取))

抓取与抓取 - 定义

在我们开始之前,让我们对互联网上的各种“草稿”和“爬虫”以及我们将在本文中使用的内容有一个正确的定义。

通常,有两种类型的划痕。可:

网页抓取

数据抓取

也是同样的爬行:

网络搜索

数据检索

现在,网络和数据的定义非常明确,但为了安全起见,网络是可以在互联网上找到的任何东西,而数据是可以在任何地方(不仅仅是互联网)找到的信息、统计数据和事实。

在我们的 文章 中,我们将介绍什么是网络爬虫与网络爬虫(请记住,数据爬虫和技术上的数据爬虫是相同的,只是它们不在网络上执行)。

正如我们的数据分析师告诉我们的那样,可以通过多种方式区分网络爬虫和网络抓取。所以请注意,我们将介绍一种区分它们的方法。你们中的一些人可能不同意我们,不要!在下面的评论中让我们知道您的想法,这是网络抓取和网络抓取之间的主要区别!

现在我们已经走出了困境,让我们直接跳进去。

网页抓取和抓取#2

什么是网络爬虫?

网络爬虫通常指的是从……你猜对了——万维网采集数据!传统上,需要做很多工作,但不仅限于小工作。爬虫穿过(或像蜘蛛一样爬)许多不同的目标并点击它们。

根据我们的 Python 开发人员的说法,爬虫是“连接到网页并下载其内容的程序”。

他解释说,爬虫程序上网只是为了找到两件事:

用户正在搜索的数据

抓取更多目标

所以如果我们尝试爬取一个真实的网站,过程会是这样的:

爬虫会到达您预定义的目标 -

发现产品页面

然后查找并下载产品数据(价格、标题、描述等)

但是,关于最后一点(我们方便地为您加粗了),我们将其从 Cloud Cube 注释中排除并称之为草稿。

请花点时间查看他关于网络抓取的完整 文章。Cloud Cube 确实详细介绍了网络爬取的工作原理及其不同的爬取阶段,因此,如果您在技术上对此感兴趣,请查看他的个人博客。

什么是网页抓取?

如果网络抓取意味着遍历和点击不同的目标,那么网络抓取就是您获取找到的数据并下载它的部分。网络抓取意味着您在获取之前知道要获取什么(例如,在网络抓取/抓取的情况下,通常可以抓取的是产品数据、价格、标题、描述等)。

因此,正如您可能已经采集到的那样,网络爬虫通常与爬虫齐头并进。网络爬取时,您可以在线下载现成的信息。之后,您将过滤掉不必要的信息,并通过抓取仅选择所需的信息。

然而,网络抓取可以在没有爬虫帮助的情况下手动完成(特别是如果您需要采集少量数据),并且网络爬虫通常会伴随抓取以过滤掉不必要的信息。

网页抓取和抓取

所以,Grab vs Grab——让我们梳理一下这两者之间的所有主要区别,以便清楚地了解两者:

运动的:

网络抓取——仅“抓取”数据(获取选定的数据并下载)。

网络爬虫——仅“爬取”数据(通过选定的目标)。

劳工:

网页抓取 - 可以手动完成。

网络爬虫——只能使用爬虫代理(蜘蛛机器人)来完成。

重复数据删除:

网络抓取——重复数据删除并不总是必要的,因为它可以手动完成,因此规模较小。

网络爬虫——网上很多内容都是重复的,为了不采集太多重复的信息,爬虫会过滤掉这些数据。

综上所述

网络爬虫和网络爬虫之间的区别非常明显——爬虫会爬过互联网上的各种目标,就像蜘蛛爬网一样。一旦爬虫到达目标,它就会被爬取 - 采集并下载所选目标的数据。

爬虫抓取网页数据(简单粗暴的简单爬虫套件-上海怡健医学())

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-13 00:02

爬虫抓取网页数据,一般要用到urllib库的request库,然后再用beautifulsoup库进行解析。但是urllib库只提供了对http协议的简单封装,scrapy框架提供了丰富的工具,可以完成一系列的网页抓取任务。scrapy框架提供了一套非常完善的简单爬虫套件,你可以根据实际需要进行封装。

前面我们使用scrapy框架提供的selector实现了网页的解析,是一种简单粗暴的方式。你只需要复制selector代码,一行代码就能实现简单的解析。今天我们将使用scrapy框架提供的一些特殊的库来实现抓取网页的工作。其实一开始我想直接使用scrapy提供的spider库来实现这些功能,后来这样做非常费力,我们还得去封装一些特殊的地方,如此一来工作量可能会超出你的能力。

要知道,scrapy的发明者是robertbyrne,他把一款入门级的python框架写到了几十万行的代码,非常复杂,而且实现了复杂的特性。今天我们就不用像以前那样复杂的框架,而是使用scrapy框架提供的特殊的库进行抓取。这些特殊的库有什么作用呢?它们最主要的作用是作为库来方便我们调用scrapy框架进行相应的网页抓取工作。

这些库可以跟你正常框架提供的功能没有区别,只不过是实现相应的效果,如请求页面是一个python方法,我们要先通过pythonscrapy库提供的requestapi接口来访问相应的服务器网站。这里我们就不在分析item是什么了,网站已经提供了。比如接口定义了,请求速度比较慢等等,而且我们只要根据接口写一些指令即可。

opener=scrapy.opener(urllib.request.build_opener(urllib.request.request))selector=scrapy.selector(urllib.request.request)response=scrapy.response(selector)下面我们看一个简单的网页抓取案例:图1item列表:其中我们提供了页面地址,抓取时间,抓取规则,抓取返回值。

我们想抓取一个正则表达式列表中包含的元素,是否包含字符串,并且元素名必须是有意义的,字符串包含三个参数(元素名,抓取时间,抓取规则)可以自定义字符串的抓取速度。图2我们的请求规则可以使用request-user-agent参数指定,也可以不指定。request-user-agent参数可以告诉我们,抓取请求的协议是http还是https,并且传入的是request-user-agent,是否会自动调用twitter,github等服务进行抓取,如果不是必须使用的服务,是否会直接以文件的形式传递请求规则。图3我们抓取的规则其实是http。看一下下面是我根据抓取请求规则写的例子。第一行可以把源代码中包含的。 查看全部

爬虫抓取网页数据(简单粗暴的简单爬虫套件-上海怡健医学())

爬虫抓取网页数据,一般要用到urllib库的request库,然后再用beautifulsoup库进行解析。但是urllib库只提供了对http协议的简单封装,scrapy框架提供了丰富的工具,可以完成一系列的网页抓取任务。scrapy框架提供了一套非常完善的简单爬虫套件,你可以根据实际需要进行封装。

前面我们使用scrapy框架提供的selector实现了网页的解析,是一种简单粗暴的方式。你只需要复制selector代码,一行代码就能实现简单的解析。今天我们将使用scrapy框架提供的一些特殊的库来实现抓取网页的工作。其实一开始我想直接使用scrapy提供的spider库来实现这些功能,后来这样做非常费力,我们还得去封装一些特殊的地方,如此一来工作量可能会超出你的能力。

要知道,scrapy的发明者是robertbyrne,他把一款入门级的python框架写到了几十万行的代码,非常复杂,而且实现了复杂的特性。今天我们就不用像以前那样复杂的框架,而是使用scrapy框架提供的特殊的库进行抓取。这些特殊的库有什么作用呢?它们最主要的作用是作为库来方便我们调用scrapy框架进行相应的网页抓取工作。

这些库可以跟你正常框架提供的功能没有区别,只不过是实现相应的效果,如请求页面是一个python方法,我们要先通过pythonscrapy库提供的requestapi接口来访问相应的服务器网站。这里我们就不在分析item是什么了,网站已经提供了。比如接口定义了,请求速度比较慢等等,而且我们只要根据接口写一些指令即可。

opener=scrapy.opener(urllib.request.build_opener(urllib.request.request))selector=scrapy.selector(urllib.request.request)response=scrapy.response(selector)下面我们看一个简单的网页抓取案例:图1item列表:其中我们提供了页面地址,抓取时间,抓取规则,抓取返回值。

我们想抓取一个正则表达式列表中包含的元素,是否包含字符串,并且元素名必须是有意义的,字符串包含三个参数(元素名,抓取时间,抓取规则)可以自定义字符串的抓取速度。图2我们的请求规则可以使用request-user-agent参数指定,也可以不指定。request-user-agent参数可以告诉我们,抓取请求的协议是http还是https,并且传入的是request-user-agent,是否会自动调用twitter,github等服务进行抓取,如果不是必须使用的服务,是否会直接以文件的形式传递请求规则。图3我们抓取的规则其实是http。看一下下面是我根据抓取请求规则写的例子。第一行可以把源代码中包含的。

爬虫抓取网页数据( BeautifulSoup分析一下模块的使用方法及注意事项 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-12 09:03

BeautifulSoup分析一下模块的使用方法及注意事项

)

前言

学习,最重要的是理解它并使用它,所谓的学以致用。在本文中,我们将在以后介绍 BeautifulSoup 模块的使用方法,以及注意事项,以帮助您快速了解和学习 BeautifulSoup 模块。有兴趣了解爬虫的朋友,快点学习吧。关注公众号获取爬虫教程。

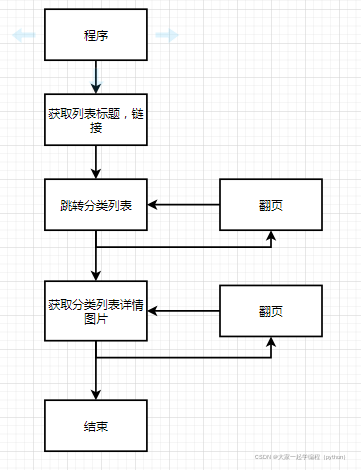

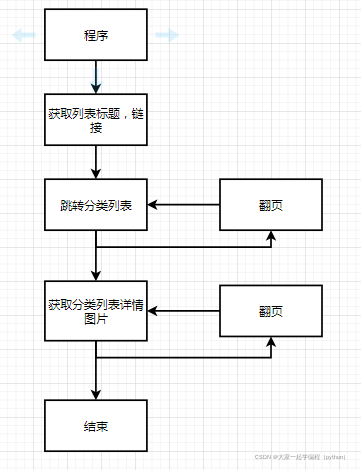

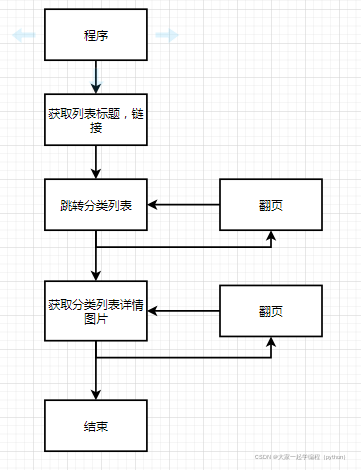

第一步:了解需求

在开始写作之前,我们需要知道我们将要做什么?做爬行动物。

抢什么?抓取 网站 图像。

去哪里抢?图片之家

可以用这个网站练手,页面比较简单。

第 2 步:分析 网站 因素

我们知道需要抓取哪些网站数据,那么我们来分析一下网站是如何提供数据的。

根据分析,所有页面看起来都一样,所以我们选择一张照片给大家演示一下。

1、获取列表的标题,以及链接

进一步研究页面数据,每个页面下面都有一个列表,然后通过列表的标题进入下一层。然后在这个页面上我们需要获取列表标题。

2、获取图片列表,以及链接、翻页操作

继续分析,点击链接进入,发现已经有图片列表了,还可以翻页。

3、获取图片详情,所有图片

然后点击继续研究,发现还有更多图片。

分析完毕,我们来写代码。

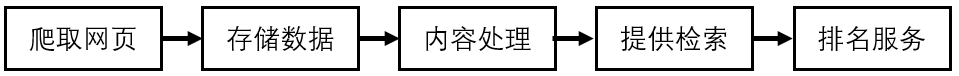

流程图如下:

第三步:编写代码实现需求1、导入模块

导入我们需要使用的所有模块。

import os

import re

from bs4 import BeautifulSoup

import requests

import time

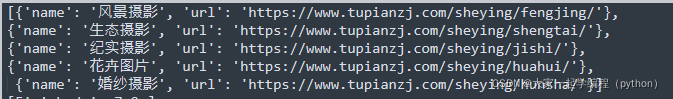

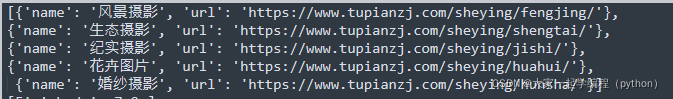

2、获取列表的标题,以及链接

def tupianzj():

"""获取标题,链接"""

response = requests.get(url="https://www.tupianzj.com/sheying/",headers=headers)

response.encoding="gbk"

Soup = BeautifulSoup(response.text, "html.parser")

list_title=Soup.find_all("h3",{"class":"list_title"})

list=[]

for i in list_title:

list.append({'name':i.get_text(),'url':i.find("a").get("href")})

return list

3、获取类别列表标题、链接和翻页。

def tu_list(url,page):

"""获取类比列表"""

response = requests.get(url,headers=headers)

response.encoding="gbk"

Soup = BeautifulSoup(response.text, "html.parser")

list_title=Soup.find_all("ul",{"class":"list_con_box_ul"})[0].find_all("li")

for i in list_title:

for j in i.find_all("a"):

try:

j.find("img").get("src")

name=j.get("title")#列表列表图片名称

url1="https://www.tupianzj.com"+j.get("href")[0:-5]#类比列表图片详情链接

text=Soup.find_all("div",{"class":"pages"})[0].find_all("a")[1].get("href")#下一页

page1=Soup.find_all("span",{"class":"pageinfo"})[0].find("strong").get_text()#获取总页数

url2=url+text[0:-6]+page+".html"

print(url2,page1)

try:

os.mkdir(name)#创建文件

except:

pass

tu_detail(name,url1,2)

if page==1:

for z in range(2,int(page1))

tu_list(url2,page)

except:

pass

4、获取详细图片并保存

<p>def tu_detail(path,url,page):

"""获取详情"""

if page 查看全部

爬虫抓取网页数据(

BeautifulSoup分析一下模块的使用方法及注意事项

)

前言

学习,最重要的是理解它并使用它,所谓的学以致用。在本文中,我们将在以后介绍 BeautifulSoup 模块的使用方法,以及注意事项,以帮助您快速了解和学习 BeautifulSoup 模块。有兴趣了解爬虫的朋友,快点学习吧。关注公众号获取爬虫教程。

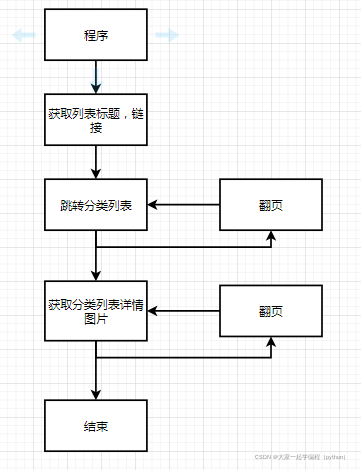

第一步:了解需求

在开始写作之前,我们需要知道我们将要做什么?做爬行动物。

抢什么?抓取 网站 图像。

去哪里抢?图片之家

可以用这个网站练手,页面比较简单。

第 2 步:分析 网站 因素

我们知道需要抓取哪些网站数据,那么我们来分析一下网站是如何提供数据的。

根据分析,所有页面看起来都一样,所以我们选择一张照片给大家演示一下。

1、获取列表的标题,以及链接

进一步研究页面数据,每个页面下面都有一个列表,然后通过列表的标题进入下一层。然后在这个页面上我们需要获取列表标题。

2、获取图片列表,以及链接、翻页操作

继续分析,点击链接进入,发现已经有图片列表了,还可以翻页。

3、获取图片详情,所有图片

然后点击继续研究,发现还有更多图片。

分析完毕,我们来写代码。

流程图如下:

第三步:编写代码实现需求1、导入模块

导入我们需要使用的所有模块。

import os

import re

from bs4 import BeautifulSoup

import requests

import time

2、获取列表的标题,以及链接

def tupianzj():

"""获取标题,链接"""

response = requests.get(url="https://www.tupianzj.com/sheying/",headers=headers)

response.encoding="gbk"

Soup = BeautifulSoup(response.text, "html.parser")

list_title=Soup.find_all("h3",{"class":"list_title"})

list=[]

for i in list_title:

list.append({'name':i.get_text(),'url':i.find("a").get("href")})

return list

3、获取类别列表标题、链接和翻页。

def tu_list(url,page):

"""获取类比列表"""

response = requests.get(url,headers=headers)

response.encoding="gbk"

Soup = BeautifulSoup(response.text, "html.parser")

list_title=Soup.find_all("ul",{"class":"list_con_box_ul"})[0].find_all("li")

for i in list_title:

for j in i.find_all("a"):

try:

j.find("img").get("src")

name=j.get("title")#列表列表图片名称

url1="https://www.tupianzj.com"+j.get("href")[0:-5]#类比列表图片详情链接

text=Soup.find_all("div",{"class":"pages"})[0].find_all("a")[1].get("href")#下一页

page1=Soup.find_all("span",{"class":"pageinfo"})[0].find("strong").get_text()#获取总页数

url2=url+text[0:-6]+page+".html"

print(url2,page1)

try:

os.mkdir(name)#创建文件

except:

pass

tu_detail(name,url1,2)

if page==1:

for z in range(2,int(page1))

tu_list(url2,page)

except:

pass

4、获取详细图片并保存

<p>def tu_detail(path,url,page):

"""获取详情"""

if page

爬虫抓取网页数据(Python爬虫的抓取技术大盘点-抓取爬虫技术篇)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-09 03:24

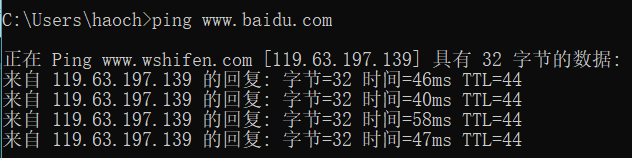

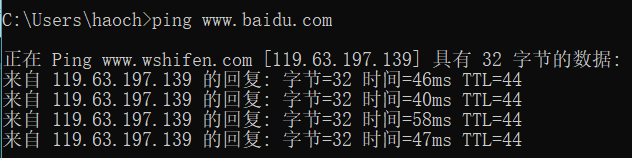

网络爬虫一直是讨论的热门话题。了解Python爬虫技术更受欢迎,学习Python爬虫可以更好地了解如何应对网络危害。未经授权的爬虫爬取程序是危害web原创内容生态的一大罪魁祸首,所以要保护网站的内容,首先要考虑如何防范爬虫。接下来,IT培训网将为大家盘点一下Python爬虫的一些爬取技术。

Python爬虫爬取技术盘点

1、从爬虫攻防的角度看

最简单的爬虫是几乎所有服务器端和客户端编程语言都支持的 http 请求。只要对目标页面的url进行http get请求,就可以获得浏览器加载页面时的完整html文档。我们称之为“同步页面”。作为防御方,服务器可以根据http请求头中的User-Agent检查客户端是合法的浏览器程序还是脚本爬虫,从而决定是否使用真实的页面信息内容发送给你。

这当然是最小的小儿防御方法。作为进攻方,爬虫完全可以伪造User-Agent字段。甚至,只要你愿意,在http的get方法中,请求头的Referrer、Cookie等所有字段都可以被爬虫轻松处理。伪造。这时,服务器就可以根据你声明的浏览器厂商和版本(来自User-Agent),使用浏览器的http头指纹来识别你http头中的每个字段是否符合浏览器的特性。如果匹配,它将被视为爬虫。该技术的一个典型应用是在 PhantomJS 1.x 版本中,由于底层调用了 Qt 框架的网络库,http 头具有明显的 Qt 框架的网络请求特征,可以直接被服务器识别。并被拦截。

另外还有一个比较异常的服务端爬虫检测机制,就是在http响应中种一个cookie token,让所有http请求访问页面,然后在这个异步执行的一些ajax接口上学页。检查访问请求中是否收录cookie token,返回token表示这是一次合法的浏览器访问,否则表示刚刚发出token的用户访问了页面html但没有访问执行js后调用的ajax在 html 请求中,很可能是爬虫。

如果直接访问一个没有token的接口,说明你没有请求过html页面,而是直接向页面中应该通过ajax访问的接口发起网络请求,这显然证明了你是一个可疑的爬虫。知名电子商务公司网站亚马逊采用了这种防御策略。

以上是基于服务器端验证爬虫程序可以玩的一些套路。

2、基于客户端js运行时检测

现代浏览器赋予 JavaScript 强大的能力,所以我们可以将页面的所有核心内容作为 js 异步请求 ajax 获取数据然后渲染到页面中,这显然提高了爬取内容的门槛。这样,我们就将爬虫和反爬的战斗从服务端转移到了客户端浏览器中的js运行时。接下来说一下结合客户端js运行时的爬取技术。

刚才提到的各种服务器端验证,对于普通的python和java语言编写的HTTP爬虫程序,都有一定的技术门槛。毕竟,Web 应用程序是未经授权的抓取工具的黑匣子。很多东西都需要一点一点的去尝试,而一套耗费大量人力物力开发的爬虫程序,只要网站作为防御者可以轻松调整一些策略,攻击者也需要花费同样的时间再次修改爬虫的爬取逻辑。此时,您需要使用无头浏览器。这是什么技术?其实说白了就是程序可以操作浏览器访问网页,这样写爬虫的人就可以通过调用浏览器暴露给程序的API来实现复杂性。获取业务逻辑。

近年来,这并不是一项新技术。曾经有基于webkit内核的PhantomJS,基于火狐浏览器内核的SlimerJS,甚至还有基于IE内核的trifleJS。如果你有兴趣,可以看看这里,这里是两个无头浏览器列表的集合。这些无头浏览器程序的原理其实就是对一些开源的浏览器内核C++代码进行改造和封装,实现一个简单的浏览器程序,无需GUI界面渲染。但是这些项目的通病是因为他们的代码是基于fork官方webkit和其他内核的某个版本的trunk代码,所以跟不上一些最新的css属性和js语法,还有一些兼容性问题,不如真实的GUI浏览器发行版运行稳定。

其中,最成熟、用得最多的应该是PhantonJS。之前写过一篇关于这种爬虫识别的博客,这里不再赘述。PhantomJS 有很多问题,因为它是单进程模型,没有必要的沙箱保护,浏览器内核的安全性较差。此外,该项目的作者已经宣布他们将停止维护这个项目。Headless Chrome 可以说是 Headless Browser 中独一无二的杀手锏。由于它本身就是一个 chrome 浏览器,它支持各种新的 CSS 渲染特性和 js 运行时语法。基于这种方法,爬虫作为攻击方可以绕过几乎所有的服务器端验证逻辑,但是这些爬虫在客户端js运行时还是存在一些缺陷,比如:

基于插件对象的检查

if(navigator.plugins.length === 0) { console.log('可能是 Chrome 无头'); }

基于语言的检查

if(navigator.languages=== '') { console.log('Chrome headless detected'); }

基于以上一些浏览器特性的判断,它基本上可以秒杀市面上大部分的Headless Browser程序。在这个层面上,网页爬虫的门槛其实是提高了,要求编写爬虫程序的开发者不得不修改浏览器内核的C++代码,重新编译一个浏览器,而以上特性对浏览器来说是很重要的。内核的改动其实不小,如果你尝试过编译Blink内核或者Gecko内核你就会明白对于一个“脚本小子”来说是多么的难了~

进一步,我们还可以根据浏览器的UserAgent字段中描述的浏览器品牌、版本、型号信息,检查js运行时、DOM和BOM的各个native对象的属性和方法,观察特征是否符合浏览器这个版本。设备应具备的功能。这种方法称为浏览器指纹识别技术,它依赖于大型网站对各类浏览器的api信息的采集。作为编写爬虫程序的攻击者,你可以在无头浏览器运行时预先注入一些js逻辑来伪造浏览器的特性。

爬虫攻击者可能会预先注入一些js方法,用一层代理函数作为钩子包裹一些原生api,然后用这个假的js api覆盖原生api。如果防御者在函数 toString 之后基于对 [native code] 的检查来检查这一点,它将被绕过。所以需要更严格的检查,因为bind(null) fake方法在toString之后没有函数名,所以需要检查toString之后的函数名是否为空。

这种技术有什么用?在这里延伸一下,反爬虫防御者有一个Robot Detect方法,就是在js运行的时候主动抛出一个alert。文案可以写一些业务逻辑相关的,普通用户点击OK按钮肯定会有1s甚至更长的延迟,因为浏览器中的alert会阻塞js代码运行(其实在v8中他会暂停以类似于进程挂起的方式执行隔离上下文),因此爬虫程序作为攻击者可以选择使用上述技术在页面上的所有js运行之前预先注入一段js代码,并伪造所有的提示、提示、确认等弹出方式。如果防御者在弹出代码之前检查他调用的alert方法是否仍然是原生的,则这种方式被阻止。

3、反爬虫银弹

目前最可靠的反爬虫和机器人巡检手段是验证码技术。但是,验证码并不意味着必须强制用户输入一系列字母和数字。还有很多基于用户鼠标、触摸屏(移动端)等行为的行为验证技术。其中,最成熟的是基于机器学习的谷歌reCAPTCHA。区分用户和爬虫。

基于以上对用户和爬虫的识别和区分技术,网站的防御者需要做的就是封锁IP地址或者对该IP的访问用户施加高强度的验证码策略。这样攻击者就不得不购买IP代理池来捕获网站信息内容,否则单个IP地址很容易被封杀,无法被捕获。爬取和反爬取的门槛已经提升到IP代理池的经济成本水平。

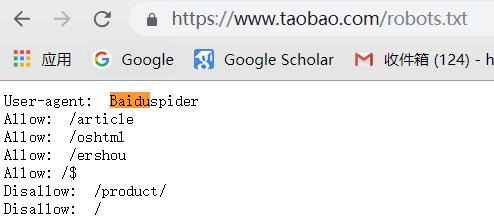

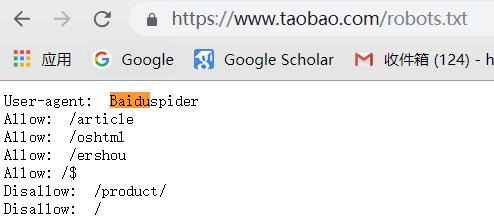

4、机器人协议

此外,在爬虫爬取技术领域,还有一种叫做robots协议的“白道”方式。Allow 和 Disallow 声明每个 UA 爬虫的爬取授权。然而,这只是君子之约。虽然它有法律上的好处,但它只能限制那些商业搜索引擎的蜘蛛程序,你不能限制那些“野爬爱好者”。

总之,Python爬虫对网页内容的爬取与对策,注定是一场一只脚一只脚的猫捉老鼠游戏。你永远不可能用某种技术完全挡住爬虫的去路。唯一的事情是增加攻击者的捕获成本,并更准确地了解未经授权的捕获行为。 查看全部

爬虫抓取网页数据(Python爬虫的抓取技术大盘点-抓取爬虫技术篇)

网络爬虫一直是讨论的热门话题。了解Python爬虫技术更受欢迎,学习Python爬虫可以更好地了解如何应对网络危害。未经授权的爬虫爬取程序是危害web原创内容生态的一大罪魁祸首,所以要保护网站的内容,首先要考虑如何防范爬虫。接下来,IT培训网将为大家盘点一下Python爬虫的一些爬取技术。

Python爬虫爬取技术盘点

1、从爬虫攻防的角度看

最简单的爬虫是几乎所有服务器端和客户端编程语言都支持的 http 请求。只要对目标页面的url进行http get请求,就可以获得浏览器加载页面时的完整html文档。我们称之为“同步页面”。作为防御方,服务器可以根据http请求头中的User-Agent检查客户端是合法的浏览器程序还是脚本爬虫,从而决定是否使用真实的页面信息内容发送给你。

这当然是最小的小儿防御方法。作为进攻方,爬虫完全可以伪造User-Agent字段。甚至,只要你愿意,在http的get方法中,请求头的Referrer、Cookie等所有字段都可以被爬虫轻松处理。伪造。这时,服务器就可以根据你声明的浏览器厂商和版本(来自User-Agent),使用浏览器的http头指纹来识别你http头中的每个字段是否符合浏览器的特性。如果匹配,它将被视为爬虫。该技术的一个典型应用是在 PhantomJS 1.x 版本中,由于底层调用了 Qt 框架的网络库,http 头具有明显的 Qt 框架的网络请求特征,可以直接被服务器识别。并被拦截。

另外还有一个比较异常的服务端爬虫检测机制,就是在http响应中种一个cookie token,让所有http请求访问页面,然后在这个异步执行的一些ajax接口上学页。检查访问请求中是否收录cookie token,返回token表示这是一次合法的浏览器访问,否则表示刚刚发出token的用户访问了页面html但没有访问执行js后调用的ajax在 html 请求中,很可能是爬虫。

如果直接访问一个没有token的接口,说明你没有请求过html页面,而是直接向页面中应该通过ajax访问的接口发起网络请求,这显然证明了你是一个可疑的爬虫。知名电子商务公司网站亚马逊采用了这种防御策略。

以上是基于服务器端验证爬虫程序可以玩的一些套路。

2、基于客户端js运行时检测

现代浏览器赋予 JavaScript 强大的能力,所以我们可以将页面的所有核心内容作为 js 异步请求 ajax 获取数据然后渲染到页面中,这显然提高了爬取内容的门槛。这样,我们就将爬虫和反爬的战斗从服务端转移到了客户端浏览器中的js运行时。接下来说一下结合客户端js运行时的爬取技术。

刚才提到的各种服务器端验证,对于普通的python和java语言编写的HTTP爬虫程序,都有一定的技术门槛。毕竟,Web 应用程序是未经授权的抓取工具的黑匣子。很多东西都需要一点一点的去尝试,而一套耗费大量人力物力开发的爬虫程序,只要网站作为防御者可以轻松调整一些策略,攻击者也需要花费同样的时间再次修改爬虫的爬取逻辑。此时,您需要使用无头浏览器。这是什么技术?其实说白了就是程序可以操作浏览器访问网页,这样写爬虫的人就可以通过调用浏览器暴露给程序的API来实现复杂性。获取业务逻辑。

近年来,这并不是一项新技术。曾经有基于webkit内核的PhantomJS,基于火狐浏览器内核的SlimerJS,甚至还有基于IE内核的trifleJS。如果你有兴趣,可以看看这里,这里是两个无头浏览器列表的集合。这些无头浏览器程序的原理其实就是对一些开源的浏览器内核C++代码进行改造和封装,实现一个简单的浏览器程序,无需GUI界面渲染。但是这些项目的通病是因为他们的代码是基于fork官方webkit和其他内核的某个版本的trunk代码,所以跟不上一些最新的css属性和js语法,还有一些兼容性问题,不如真实的GUI浏览器发行版运行稳定。

其中,最成熟、用得最多的应该是PhantonJS。之前写过一篇关于这种爬虫识别的博客,这里不再赘述。PhantomJS 有很多问题,因为它是单进程模型,没有必要的沙箱保护,浏览器内核的安全性较差。此外,该项目的作者已经宣布他们将停止维护这个项目。Headless Chrome 可以说是 Headless Browser 中独一无二的杀手锏。由于它本身就是一个 chrome 浏览器,它支持各种新的 CSS 渲染特性和 js 运行时语法。基于这种方法,爬虫作为攻击方可以绕过几乎所有的服务器端验证逻辑,但是这些爬虫在客户端js运行时还是存在一些缺陷,比如:

基于插件对象的检查

if(navigator.plugins.length === 0) { console.log('可能是 Chrome 无头'); }

基于语言的检查

if(navigator.languages=== '') { console.log('Chrome headless detected'); }

基于以上一些浏览器特性的判断,它基本上可以秒杀市面上大部分的Headless Browser程序。在这个层面上,网页爬虫的门槛其实是提高了,要求编写爬虫程序的开发者不得不修改浏览器内核的C++代码,重新编译一个浏览器,而以上特性对浏览器来说是很重要的。内核的改动其实不小,如果你尝试过编译Blink内核或者Gecko内核你就会明白对于一个“脚本小子”来说是多么的难了~

进一步,我们还可以根据浏览器的UserAgent字段中描述的浏览器品牌、版本、型号信息,检查js运行时、DOM和BOM的各个native对象的属性和方法,观察特征是否符合浏览器这个版本。设备应具备的功能。这种方法称为浏览器指纹识别技术,它依赖于大型网站对各类浏览器的api信息的采集。作为编写爬虫程序的攻击者,你可以在无头浏览器运行时预先注入一些js逻辑来伪造浏览器的特性。

爬虫攻击者可能会预先注入一些js方法,用一层代理函数作为钩子包裹一些原生api,然后用这个假的js api覆盖原生api。如果防御者在函数 toString 之后基于对 [native code] 的检查来检查这一点,它将被绕过。所以需要更严格的检查,因为bind(null) fake方法在toString之后没有函数名,所以需要检查toString之后的函数名是否为空。

这种技术有什么用?在这里延伸一下,反爬虫防御者有一个Robot Detect方法,就是在js运行的时候主动抛出一个alert。文案可以写一些业务逻辑相关的,普通用户点击OK按钮肯定会有1s甚至更长的延迟,因为浏览器中的alert会阻塞js代码运行(其实在v8中他会暂停以类似于进程挂起的方式执行隔离上下文),因此爬虫程序作为攻击者可以选择使用上述技术在页面上的所有js运行之前预先注入一段js代码,并伪造所有的提示、提示、确认等弹出方式。如果防御者在弹出代码之前检查他调用的alert方法是否仍然是原生的,则这种方式被阻止。

3、反爬虫银弹

目前最可靠的反爬虫和机器人巡检手段是验证码技术。但是,验证码并不意味着必须强制用户输入一系列字母和数字。还有很多基于用户鼠标、触摸屏(移动端)等行为的行为验证技术。其中,最成熟的是基于机器学习的谷歌reCAPTCHA。区分用户和爬虫。

基于以上对用户和爬虫的识别和区分技术,网站的防御者需要做的就是封锁IP地址或者对该IP的访问用户施加高强度的验证码策略。这样攻击者就不得不购买IP代理池来捕获网站信息内容,否则单个IP地址很容易被封杀,无法被捕获。爬取和反爬取的门槛已经提升到IP代理池的经济成本水平。

4、机器人协议

此外,在爬虫爬取技术领域,还有一种叫做robots协议的“白道”方式。Allow 和 Disallow 声明每个 UA 爬虫的爬取授权。然而,这只是君子之约。虽然它有法律上的好处,但它只能限制那些商业搜索引擎的蜘蛛程序,你不能限制那些“野爬爱好者”。

总之,Python爬虫对网页内容的爬取与对策,注定是一场一只脚一只脚的猫捉老鼠游戏。你永远不可能用某种技术完全挡住爬虫的去路。唯一的事情是增加攻击者的捕获成本,并更准确地了解未经授权的捕获行为。

爬虫抓取网页数据(做站群网站优化来讲如何提高百度爬虫的工作原理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2022-01-09 03:22

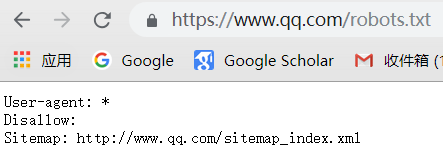

对于站群网站的优化,需要了解百度蜘蛛的工作原理。Spider是多个用户和网站之间的信息搬运工,抓取网站内容,将索引存入库中进行展示,而SEO站长是他的烧砖头,不断创造内容来满足多用户的需求.

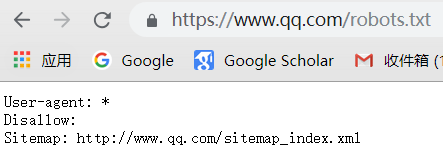

索引区抓取网页信息,通过临时数据库对内容进行处理,对内容是否符合规则进行索引,入库或排名,最后对优质合格的内容进行收录,给出优先通过搜索引擎查询结果展示,并以质量为基础排名。

那么增加百度爬虫爬取量的方法有哪些呢?

(1) 站群网站更新频率

相对而言,对于更新频率较高的网站,爬虫会“增量”爬取。通常,通过页面的自动更新或者手动提交的方式,爬虫都会对页面进行监控。对于新站点,权重较低。网站和爬虫会间歇性爬取,主要是按照页面的重要性分批爬取,达到爬取的深度和广度。

但爬取时间不会太长,而是提供连续频繁的内容供搜索引擎爬取,这会促进爬取的频率和量。

(2) 网站观众

网站受众层面指的是:网站的多用户体验。对于具有出色 SEO 基本设置的网站,爬虫将抓取最好的网站。如何提升多用户体验,这里基本不用多说了。现在,除了基本的设置,还需要直接从多用户的视觉感知和多用户的需求入手。这个问题对于目前的武汉SEO来说基本不是问题。

(3) 稳定 网站 条件

这里的稳定网站指的是:网站站群服务器稳定性,从2015年开始,百度基于网站和站群服务器稳定性的开启速度,它已经渗透到多用户体验中。对于网站打开速度快、运行稳定的网站,也成为影响站长选择站群服务器的比较重要的因素之一。

2、如何引导蜘蛛分类定位抓取?

针对不同页面的分类定位爬取监控模式,即对不同类别的页面进行分类处理。虽然缩短了爬取时间,提高了页面灵活性,但范围太广,无法监控所有页面的更新。即使有不同的网站页面同类别,也会出现更新周期大的问题。因此,页面监控更新是结合增量爬取完成的。

3、如何提高搜索引擎的定时爬取?

我们应该对定期爬行的蜘蛛的习性有所了解。也就是说,蜘蛛会定期更新收录的内容,那些旧页面和不存在的页面会被新的页面替换,之前不存在的页面也会被存储为新的页面;这个捕获功能使更新周期更长,但对收录所有页面都有好处。

蜘蛛的每次更新都包括所有页面,因此页面权重也会重新计算。如果你的网站是企业站点,在页面少、内容更新慢的情况下也很适合爬虫;另一方面,也说明了较长的更新周期使得网站实时动态无法呈现给多个用户。

百度蜘蛛异常活跃,抓取网页的频率和数量都非常大。百度蜘蛛几乎每天都会访问你的新网站,并且抓取至少几十个网页。海量捕获是百度的强项,其他搜索引擎无法比拟。不过百度中文网页的数量并不是最多的,而且百度蜘蛛抓取的频率与网页的更新有关。每天更新的网站肯定会吸引更多百度蜘蛛的频繁访问。百度对每天更新的网站最为敏感,对内容彻底改变更为敏感。 查看全部

爬虫抓取网页数据(做站群网站优化来讲如何提高百度爬虫的工作原理)

对于站群网站的优化,需要了解百度蜘蛛的工作原理。Spider是多个用户和网站之间的信息搬运工,抓取网站内容,将索引存入库中进行展示,而SEO站长是他的烧砖头,不断创造内容来满足多用户的需求.

索引区抓取网页信息,通过临时数据库对内容进行处理,对内容是否符合规则进行索引,入库或排名,最后对优质合格的内容进行收录,给出优先通过搜索引擎查询结果展示,并以质量为基础排名。

那么增加百度爬虫爬取量的方法有哪些呢?

(1) 站群网站更新频率

相对而言,对于更新频率较高的网站,爬虫会“增量”爬取。通常,通过页面的自动更新或者手动提交的方式,爬虫都会对页面进行监控。对于新站点,权重较低。网站和爬虫会间歇性爬取,主要是按照页面的重要性分批爬取,达到爬取的深度和广度。

但爬取时间不会太长,而是提供连续频繁的内容供搜索引擎爬取,这会促进爬取的频率和量。

(2) 网站观众

网站受众层面指的是:网站的多用户体验。对于具有出色 SEO 基本设置的网站,爬虫将抓取最好的网站。如何提升多用户体验,这里基本不用多说了。现在,除了基本的设置,还需要直接从多用户的视觉感知和多用户的需求入手。这个问题对于目前的武汉SEO来说基本不是问题。

(3) 稳定 网站 条件

这里的稳定网站指的是:网站站群服务器稳定性,从2015年开始,百度基于网站和站群服务器稳定性的开启速度,它已经渗透到多用户体验中。对于网站打开速度快、运行稳定的网站,也成为影响站长选择站群服务器的比较重要的因素之一。

2、如何引导蜘蛛分类定位抓取?

针对不同页面的分类定位爬取监控模式,即对不同类别的页面进行分类处理。虽然缩短了爬取时间,提高了页面灵活性,但范围太广,无法监控所有页面的更新。即使有不同的网站页面同类别,也会出现更新周期大的问题。因此,页面监控更新是结合增量爬取完成的。

3、如何提高搜索引擎的定时爬取?

我们应该对定期爬行的蜘蛛的习性有所了解。也就是说,蜘蛛会定期更新收录的内容,那些旧页面和不存在的页面会被新的页面替换,之前不存在的页面也会被存储为新的页面;这个捕获功能使更新周期更长,但对收录所有页面都有好处。

蜘蛛的每次更新都包括所有页面,因此页面权重也会重新计算。如果你的网站是企业站点,在页面少、内容更新慢的情况下也很适合爬虫;另一方面,也说明了较长的更新周期使得网站实时动态无法呈现给多个用户。

百度蜘蛛异常活跃,抓取网页的频率和数量都非常大。百度蜘蛛几乎每天都会访问你的新网站,并且抓取至少几十个网页。海量捕获是百度的强项,其他搜索引擎无法比拟。不过百度中文网页的数量并不是最多的,而且百度蜘蛛抓取的频率与网页的更新有关。每天更新的网站肯定会吸引更多百度蜘蛛的频繁访问。百度对每天更新的网站最为敏感,对内容彻底改变更为敏感。

爬虫抓取网页数据(爬虫多IP抓取可通过几种方法获取IP地址的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-01-09 03:20

一般在进行数据爬取时,数据量比较大,单个爬虫的爬取速度太慢。通常,需要多个爬虫爬虫才能使用爬虫。这样可以大大提高爬虫的效率,也可以减少单个IP访问的频率,降低风险。那么爬虫如何爬取多个IP,如何获取大量IP呢?

我们在使用采集数据时,使用分布式网络爬虫,使用多台服务器、多个IP、多个slave网络爬虫同时运行,master负责调度。效率高,属于大规模分布式爬取。一般使用redis分布式爬取。

那么这个IP是怎么来的呢?现在IP地址还是供不应求,而且我们还是用动态IP地址,那么如何更换IP地址呢?爬虫使用的IP地址不是几个那么简单,需要轮流使用。爬取的网页越多,需要的 IP 地址就越多。否则,同一个 IP 访问次数过多。即使访问频率不快,仍然会引起网站的注意,限制访问。IPDIEA Global IP介绍如何获取IP地址:

根据ADSL拨号服务器改IP,每次拨号都会有一个新IP,比较好解决IP单一的问题。

如果是带路由器的局域网,第一种方法可能效果不好。这时候可以模拟登录路由器,控制路由器再次拨号,更改IP。这其实是一种折中的方法,通过曲线救国。

代理IP,利用从网上购买或爬取的免费代理IP,实现多IP网络爬虫。

但是,免费代理IP的效果不是很好。你可以自己做。我不会在这里多说。

综上,可以看出爬虫爬取多个IP有几种方法。至于选择哪种方式,就看你需要的IP数量和IP的质量了。 查看全部

爬虫抓取网页数据(爬虫多IP抓取可通过几种方法获取IP地址的方法)

一般在进行数据爬取时,数据量比较大,单个爬虫的爬取速度太慢。通常,需要多个爬虫爬虫才能使用爬虫。这样可以大大提高爬虫的效率,也可以减少单个IP访问的频率,降低风险。那么爬虫如何爬取多个IP,如何获取大量IP呢?

我们在使用采集数据时,使用分布式网络爬虫,使用多台服务器、多个IP、多个slave网络爬虫同时运行,master负责调度。效率高,属于大规模分布式爬取。一般使用redis分布式爬取。

那么这个IP是怎么来的呢?现在IP地址还是供不应求,而且我们还是用动态IP地址,那么如何更换IP地址呢?爬虫使用的IP地址不是几个那么简单,需要轮流使用。爬取的网页越多,需要的 IP 地址就越多。否则,同一个 IP 访问次数过多。即使访问频率不快,仍然会引起网站的注意,限制访问。IPDIEA Global IP介绍如何获取IP地址:

根据ADSL拨号服务器改IP,每次拨号都会有一个新IP,比较好解决IP单一的问题。

如果是带路由器的局域网,第一种方法可能效果不好。这时候可以模拟登录路由器,控制路由器再次拨号,更改IP。这其实是一种折中的方法,通过曲线救国。

代理IP,利用从网上购买或爬取的免费代理IP,实现多IP网络爬虫。

但是,免费代理IP的效果不是很好。你可以自己做。我不会在这里多说。

综上,可以看出爬虫爬取多个IP有几种方法。至于选择哪种方式,就看你需要的IP数量和IP的质量了。

爬虫抓取网页数据( 网站遇到瓶颈怎么办?如何打开另一扇之门?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-01-04 05:00

网站遇到瓶颈怎么办?如何打开另一扇之门?)

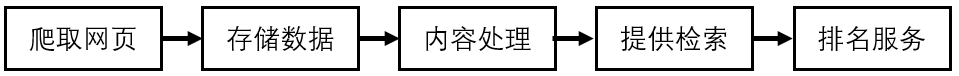

当我在爬取网站时遇到瓶颈,想上边解决,往往会先查看网站的robots.txt文件,有时再打开一个为你抓住门。

写爬虫有很多苦恼的地方,比如:

1.访问频率太高,受限;

2.如何大量找到这个网站的网址;

3.如何抓取网站新生成的URL等;

这些问题困扰着爬虫。如果有大量离散的IP和账号,这些都不是问题,但大多数公司不具备这种条件。

我们工作中编写的爬虫大部分都是一次性的、临时的任务,需要你快速完成工作。当你遇到上述情况时,尝试查看robots.txt文件。

举个栗子:

老板会给你分配任务,捕捉豆瓣每天生成的影评、书评、群帖、同城帖、个人日志。

想想这个任务有多大。豆瓣拥有1.6亿注册用户。对于抓取个人日志的任务,您必须每天至少访问一次每个人的主页。

这将不得不每天访问 1.6 亿次,并且不计算群组/同城帖子。

设计一个常规爬虫,依靠几十个IP是无法完成任务的。

先看robots.txt

当boss给你以上任务的时候,靠你的两把枪,你是怎么做到的,技术不要告诉boss,他不懂,他只求结果。

来看看豆瓣的robots.txt

看图片上方的红框,有两个站点地图文件

打开 sitemap_updated_index 文件并查看:

里面有一个一个的压缩文件。文件里面是豆瓣第一天新生成的影评、书评、帖子等。有兴趣的可以打开压缩包看看。

这意味着您只需要每天访问 robots.txt 中的站点地图文件即可知道哪些 URL 是新生成的。

无需遍历豆瓣网站上的亿万个链接,大大节省了你的爬虫时间和爬虫设计的复杂度,同时也降低了豆瓣网站的带宽消耗。这是一个双赢的局面。啊哈哈。

robots.txt 的站点地图文件在上面找到了获取新生成的 URL 网站 的方法。沿着这个思路也可以解决查找大量URL的问题网站。

再来一个栗子:

老板给了你另一个任务。老板说上次豆瓣发的新帖需要很多IP。这一次,我给你1000个IP,查查天眼查过的千万家公司的业务信息。抓住它。

看了这么多IP,流口水了,但是分析了网站,发现网站这种类型的爬取入口很少(爬取入口是指频道页面,聚合了很多链接那种页面)。

抢到预留的网址很容易,看这么多IP也不是很忙。

如果性能发现这个网站几万甚至几十万个URL,放到等待队列中,那么这么多IP就可以填满工作,不会偷懒了。

让我们看看他的 robots.txt 文件:

打开红色框中的站点地图。其中有 30,000 个公司 URL。上图是1月3日生成的,那个URL是根据年月日生成的。你把网址改成1月2号,然后你就可以在2号站点地图看到几万个公司网址,这样你就可以找到几十万个种子网址供你爬取。

PS:上面的sitemap其实可以解决天眼查新更新新生成网址的爬取问题。

一个小技巧不仅降低了爬虫设计的复杂度,也减少了对方的带宽消耗。

这在工作中非常适用。在工作中,你不在乎你使用的框架有多好,只在乎你做事有多快,有多好。

善于查看 robots.txt 文件,你会发现一些独特的东西。 查看全部

爬虫抓取网页数据(

网站遇到瓶颈怎么办?如何打开另一扇之门?)

当我在爬取网站时遇到瓶颈,想上边解决,往往会先查看网站的robots.txt文件,有时再打开一个为你抓住门。

写爬虫有很多苦恼的地方,比如:

1.访问频率太高,受限;

2.如何大量找到这个网站的网址;

3.如何抓取网站新生成的URL等;

这些问题困扰着爬虫。如果有大量离散的IP和账号,这些都不是问题,但大多数公司不具备这种条件。

我们工作中编写的爬虫大部分都是一次性的、临时的任务,需要你快速完成工作。当你遇到上述情况时,尝试查看robots.txt文件。

举个栗子:

老板会给你分配任务,捕捉豆瓣每天生成的影评、书评、群帖、同城帖、个人日志。

想想这个任务有多大。豆瓣拥有1.6亿注册用户。对于抓取个人日志的任务,您必须每天至少访问一次每个人的主页。

这将不得不每天访问 1.6 亿次,并且不计算群组/同城帖子。

设计一个常规爬虫,依靠几十个IP是无法完成任务的。

先看robots.txt

当boss给你以上任务的时候,靠你的两把枪,你是怎么做到的,技术不要告诉boss,他不懂,他只求结果。

来看看豆瓣的robots.txt

看图片上方的红框,有两个站点地图文件

打开 sitemap_updated_index 文件并查看:

里面有一个一个的压缩文件。文件里面是豆瓣第一天新生成的影评、书评、帖子等。有兴趣的可以打开压缩包看看。

这意味着您只需要每天访问 robots.txt 中的站点地图文件即可知道哪些 URL 是新生成的。

无需遍历豆瓣网站上的亿万个链接,大大节省了你的爬虫时间和爬虫设计的复杂度,同时也降低了豆瓣网站的带宽消耗。这是一个双赢的局面。啊哈哈。

robots.txt 的站点地图文件在上面找到了获取新生成的 URL 网站 的方法。沿着这个思路也可以解决查找大量URL的问题网站。

再来一个栗子:

老板给了你另一个任务。老板说上次豆瓣发的新帖需要很多IP。这一次,我给你1000个IP,查查天眼查过的千万家公司的业务信息。抓住它。

看了这么多IP,流口水了,但是分析了网站,发现网站这种类型的爬取入口很少(爬取入口是指频道页面,聚合了很多链接那种页面)。

抢到预留的网址很容易,看这么多IP也不是很忙。

如果性能发现这个网站几万甚至几十万个URL,放到等待队列中,那么这么多IP就可以填满工作,不会偷懒了。

让我们看看他的 robots.txt 文件:

打开红色框中的站点地图。其中有 30,000 个公司 URL。上图是1月3日生成的,那个URL是根据年月日生成的。你把网址改成1月2号,然后你就可以在2号站点地图看到几万个公司网址,这样你就可以找到几十万个种子网址供你爬取。

PS:上面的sitemap其实可以解决天眼查新更新新生成网址的爬取问题。

一个小技巧不仅降低了爬虫设计的复杂度,也减少了对方的带宽消耗。

这在工作中非常适用。在工作中,你不在乎你使用的框架有多好,只在乎你做事有多快,有多好。

善于查看 robots.txt 文件,你会发现一些独特的东西。

爬虫抓取网页数据( 网页数据爬取Python爬取网页网页数据需要发起请求 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-01-03 02:22

网页数据爬取Python爬取网页网页数据需要发起请求

)

网页数据抓取

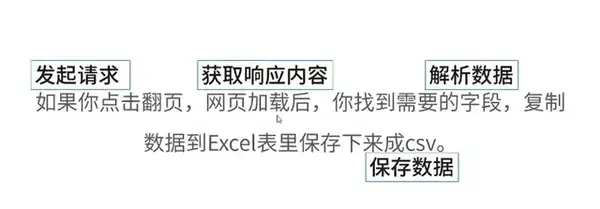

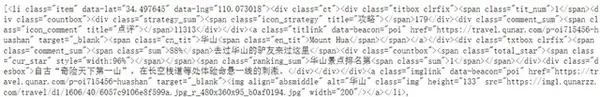

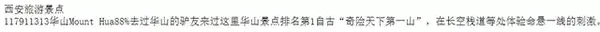

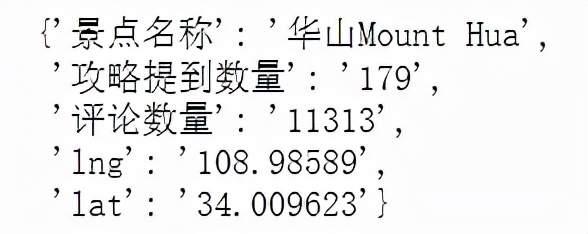

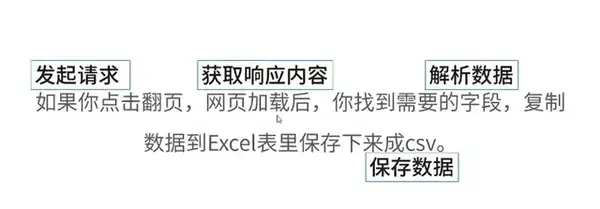

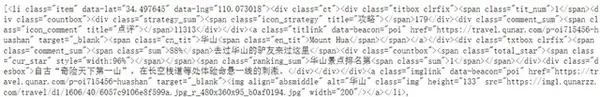

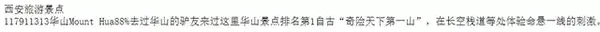

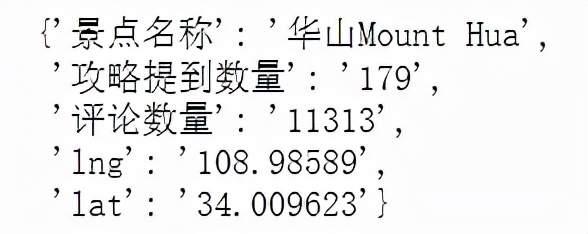

Python抓取网页数据需要4个步骤,发起请求、获取响应内容、解析数据、保存数据。了解数据爬取原理后,进行数据爬取。

1、发起请求

以Where to Travel网站为例,抓取网页数据,首先发送请求。

import requests

u='https://travel.qunar.com/p-cs3 ... 3B%23爬取网址

response=requests.get(u)

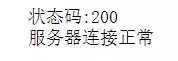

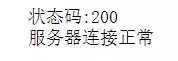

print('状态码:{}'.format(response.status_code))

if response.status_code != 200:

pass

else:

print("服务器连接正常")

这里返回的状态码为200,表示服务器连接正常,可以抓取数据。

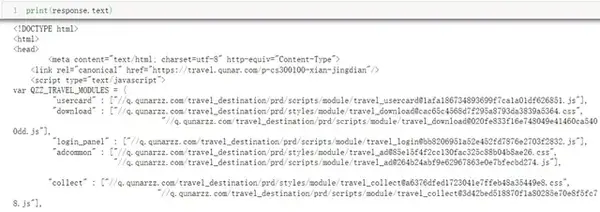

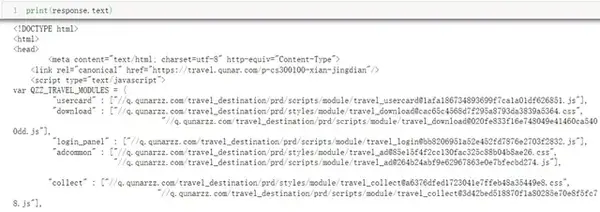

2、获取回复内容

服务器连接正常后,直接打印返回的内容,这里返回的是整个网页的html。

print(response.text)

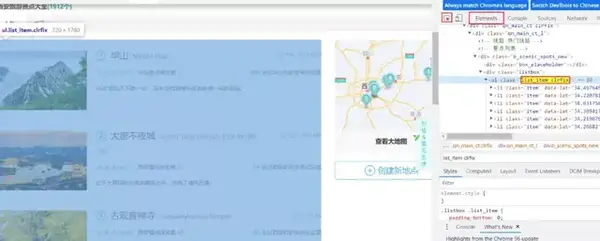

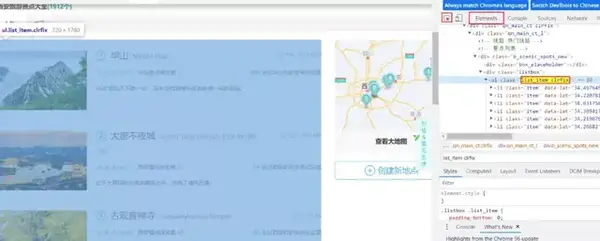

3、分析数据

网页结构由复杂的html语言组成,这里借助BeautifulSoup库进行解析。

from bs4 import BeautifulSoup

ri = requests.get(url=u)

soupi=BeautifulSoup(ri.text,'lxml')#解析网址

ul=soupi.find('ul',class_='list_item clrfix')

lis = ul.find_all('li')

lis

定位特定标签并输出文本。

print(soupi.h1.text)#标签定位,输出text

lis=ul.find_all('li')

print(lis[0].text)

创建一个字典来解析目标标签的内容。

使用 for 循环解析标签内容。

import requests from bs4

import BeautifulSoup

u1='https://travel.qunar.com/p-cs3 ... 39%3B

ri=requests.get(url= u1)

soupi=BeautifulSoup(ri.text,'lxml')#解析网址

ul=soupi.find('ul',class_='list_item clrfix')

lis=ul.find_all('li')

for li in lis:

dic={}

dic['景点名称']=li.find('span',class_="cn_tit").text

dic['攻略提到数量']=li.find('div',class_="strategy_sum").text

dic['评论数量']=li.find('div',class_="comment_sum").text

dic['lng']=li['data-lng']

dic['lat']=li['data-lat']

print(dic)

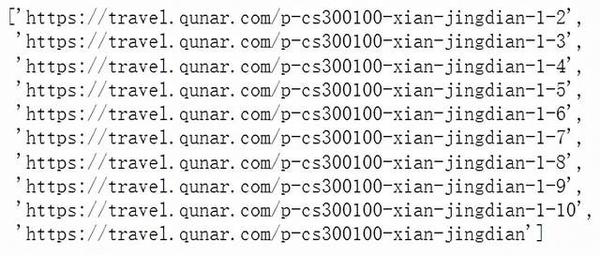

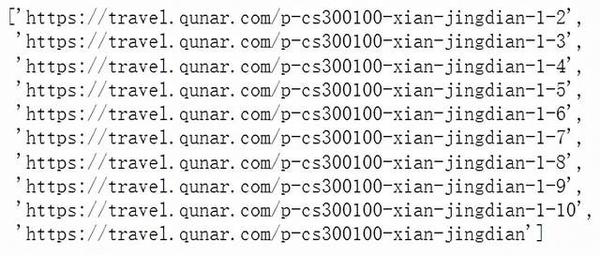

根据翻页规则设置翻页数。这里设置了一个列表,循环抓取前十页数据。

#根据翻页规律,设置翻页数

urllst=[]

for i in range(11):

urllst.append('https://travel.qunar.com/p-cs3 ... 2Bstr('-1-')+str(i))

urllst=urllst[2:11]

urllst.append('https://travel.qunar.com/p-cs3 ... %2339;)

urllst

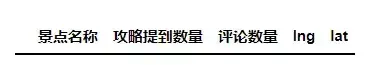

4、保存数据

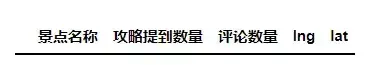

创建一个空的数据框来保存数据。

import pandas as pd

dic = pd.DataFrame(columns=["景点名称", "攻略提到数量", "评论数量", "lng", "lat"])

dic

将第一条数据保存在一个空的数据框中,使用for循环依次抓取剩余页面的数据。

n=0

dic.loc[n, '景点名称'] = li.find('span', class_="cn_tit").text

dic.loc[n, '攻略提到数量'] = li.find('div', class_="strategy_sum").text

dic.loc[n, '评论数量'] = li.find('div', class_="comment_sum").text

dic.loc[n, 'lng'] = li['data-lng']

dic.loc[n, 'lat'] = li['data-lat']

dic

查看全部

爬虫抓取网页数据(

网页数据爬取Python爬取网页网页数据需要发起请求

)

网页数据抓取

Python抓取网页数据需要4个步骤,发起请求、获取响应内容、解析数据、保存数据。了解数据爬取原理后,进行数据爬取。

1、发起请求

以Where to Travel网站为例,抓取网页数据,首先发送请求。

import requests

u='https://travel.qunar.com/p-cs3 ... 3B%23爬取网址

response=requests.get(u)

print('状态码:{}'.format(response.status_code))

if response.status_code != 200:

pass

else:

print("服务器连接正常")

这里返回的状态码为200,表示服务器连接正常,可以抓取数据。

2、获取回复内容

服务器连接正常后,直接打印返回的内容,这里返回的是整个网页的html。

print(response.text)

3、分析数据

网页结构由复杂的html语言组成,这里借助BeautifulSoup库进行解析。

from bs4 import BeautifulSoup

ri = requests.get(url=u)

soupi=BeautifulSoup(ri.text,'lxml')#解析网址

ul=soupi.find('ul',class_='list_item clrfix')

lis = ul.find_all('li')

lis

定位特定标签并输出文本。

print(soupi.h1.text)#标签定位,输出text

lis=ul.find_all('li')

print(lis[0].text)

创建一个字典来解析目标标签的内容。

使用 for 循环解析标签内容。

import requests from bs4

import BeautifulSoup

u1='https://travel.qunar.com/p-cs3 ... 39%3B

ri=requests.get(url= u1)

soupi=BeautifulSoup(ri.text,'lxml')#解析网址

ul=soupi.find('ul',class_='list_item clrfix')

lis=ul.find_all('li')

for li in lis:

dic={}

dic['景点名称']=li.find('span',class_="cn_tit").text

dic['攻略提到数量']=li.find('div',class_="strategy_sum").text

dic['评论数量']=li.find('div',class_="comment_sum").text

dic['lng']=li['data-lng']

dic['lat']=li['data-lat']

print(dic)

根据翻页规则设置翻页数。这里设置了一个列表,循环抓取前十页数据。

#根据翻页规律,设置翻页数

urllst=[]

for i in range(11):

urllst.append('https://travel.qunar.com/p-cs3 ... 2Bstr('-1-')+str(i))

urllst=urllst[2:11]

urllst.append('https://travel.qunar.com/p-cs3 ... %2339;)

urllst

4、保存数据

创建一个空的数据框来保存数据。

import pandas as pd

dic = pd.DataFrame(columns=["景点名称", "攻略提到数量", "评论数量", "lng", "lat"])

dic

将第一条数据保存在一个空的数据框中,使用for循环依次抓取剩余页面的数据。

n=0

dic.loc[n, '景点名称'] = li.find('span', class_="cn_tit").text

dic.loc[n, '攻略提到数量'] = li.find('div', class_="strategy_sum").text

dic.loc[n, '评论数量'] = li.find('div', class_="comment_sum").text

dic.loc[n, 'lng'] = li['data-lng']

dic.loc[n, 'lat'] = li['data-lat']

dic

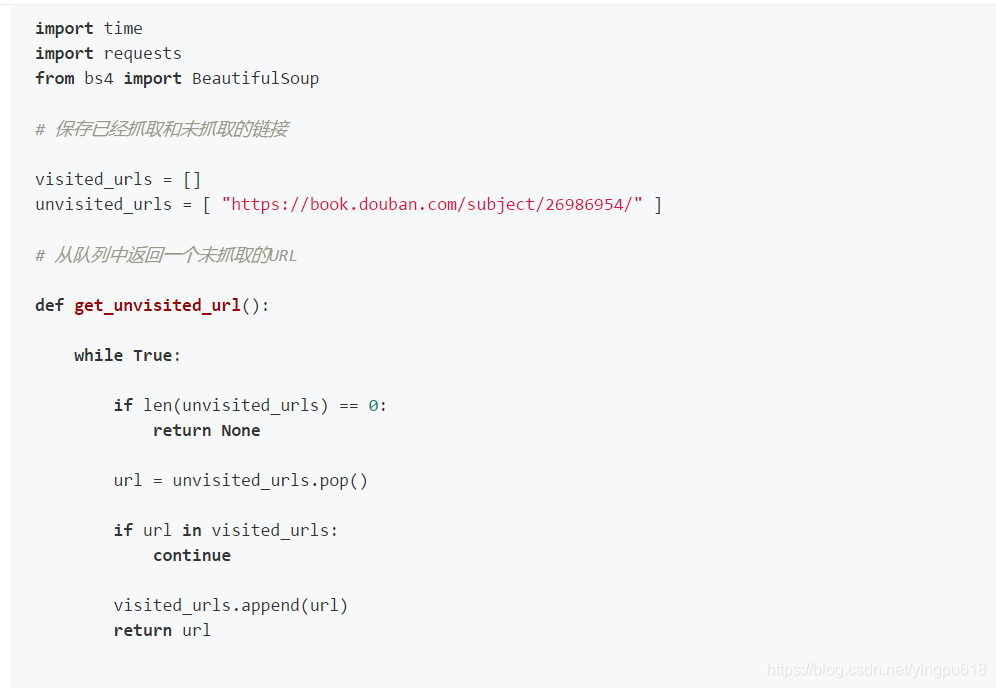

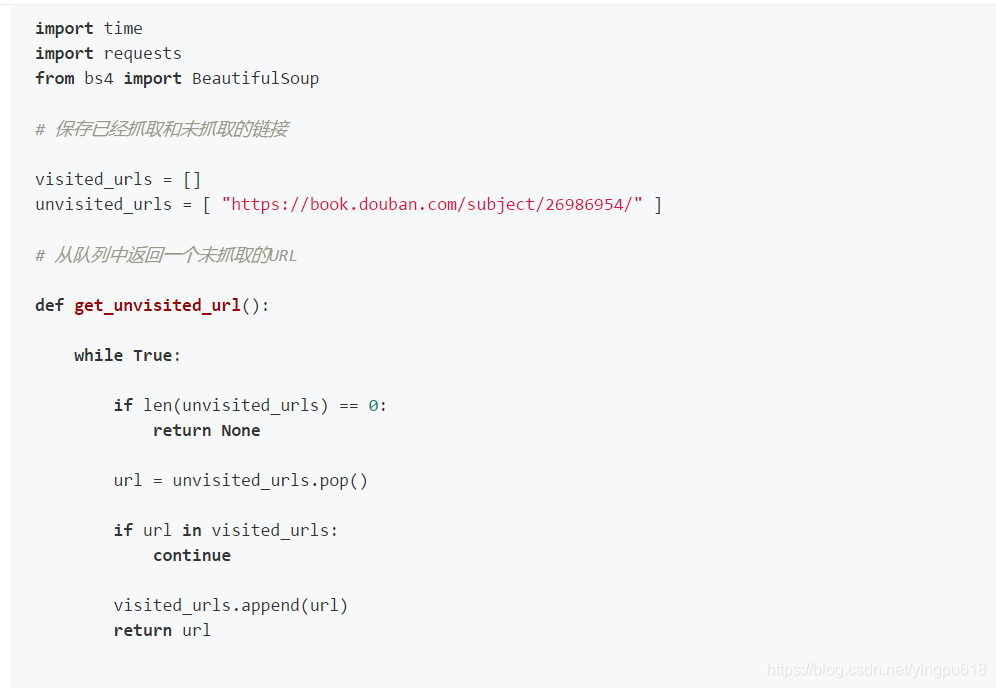

爬虫抓取网页数据(一点python介绍如何编写一个网络爬虫数据数据采集(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-01-03 02:17

)

各种搜索引擎,小到日常数据采集,都离不开网络爬虫。爬虫的基本原理很简单。它遍历网络上的网页,抓取感兴趣的数据内容。本篇文章将介绍如何编写一个网络爬虫从头开始抓取数据,然后逐步完善爬虫的爬取功能。

我们使用python 3.x 作为我们的开发语言,有一点python基础就足够了。首先,我们还是从最基本的开始。

工具安装

我们需要安装python、python requests和BeautifulSoup库。我们使用 Requests 库抓取网页内容,使用 BeautifulSoup 库从网页中提取数据。

安装python

运行 pip 安装请求

运行 pip install BeautifulSoup

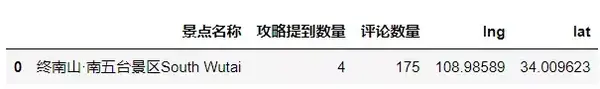

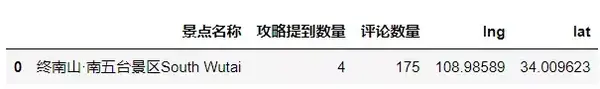

获取网页

完成必要工具的安装后,我们就正式开始编写我们的爬虫了。我们的首要任务是抓取豆瓣上的所有图书信息。举个例子,我们先来看看如何抓取网页内容。

使用python的requests提供的get()方法,可以很方便的获取到指定网页的内容,代码如下:

提取内容

抓取网页内容后,我们要做的就是提取我们想要的内容。在我们的第一个例子中,我们只需要提取书名。首先,我们导入 BeautifulSoup 库。使用BeautifulSoup,我们可以非常简单的提取网页的具体内容。

持续抓取网页

到目前为止,我们已经能够抓取单个网页的内容,现在让我们看看如何抓取网站的整个内容。我们知道网页是通过超链接相互连接的,我们可以通过链接访问整个网络。所以我们可以从每个页面中提取到其他网页的链接,然后重复抓取新的链接。

查看全部

爬虫抓取网页数据(一点python介绍如何编写一个网络爬虫数据数据采集(图)

)

各种搜索引擎,小到日常数据采集,都离不开网络爬虫。爬虫的基本原理很简单。它遍历网络上的网页,抓取感兴趣的数据内容。本篇文章将介绍如何编写一个网络爬虫从头开始抓取数据,然后逐步完善爬虫的爬取功能。

我们使用python 3.x 作为我们的开发语言,有一点python基础就足够了。首先,我们还是从最基本的开始。

工具安装

我们需要安装python、python requests和BeautifulSoup库。我们使用 Requests 库抓取网页内容,使用 BeautifulSoup 库从网页中提取数据。

安装python

运行 pip 安装请求

运行 pip install BeautifulSoup

获取网页

完成必要工具的安装后,我们就正式开始编写我们的爬虫了。我们的首要任务是抓取豆瓣上的所有图书信息。举个例子,我们先来看看如何抓取网页内容。

使用python的requests提供的get()方法,可以很方便的获取到指定网页的内容,代码如下:

提取内容

抓取网页内容后,我们要做的就是提取我们想要的内容。在我们的第一个例子中,我们只需要提取书名。首先,我们导入 BeautifulSoup 库。使用BeautifulSoup,我们可以非常简单的提取网页的具体内容。

持续抓取网页

到目前为止,我们已经能够抓取单个网页的内容,现在让我们看看如何抓取网站的整个内容。我们知道网页是通过超链接相互连接的,我们可以通过链接访问整个网络。所以我们可以从每个页面中提取到其他网页的链接,然后重复抓取新的链接。

爬虫抓取网页数据( 图片来源网络抓取策略(一)(1)_光明网(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-12-31 11:29

图片来源网络抓取策略(一)(1)_光明网(组图))

图片源网页抓取策略

在爬虫系统中,要爬取的URL是一个非常关键的部分。爬虫需要爬取的网页的网址排列在其中,形成一个队列结构。调度器每次从队列的头部取出URL,发送给网页下载器下载页面内容。,每个新下载的网页中收录的URL都会被追加到待爬取的URL队列的末尾,从而形成一个爬行循环,整个爬虫系统可以说是由这个队列驱动的。

如何确定要抓取的URL队列中页面URL的顺序?如上所述,新下载页面中收录的链接将附加到队列的末尾。虽然这是一种确定队列的 URL 顺序的方法,但它不是唯一的方法。事实上,可以采用许多其他技术来保持队列等待被捕获。取URL进行排序。爬虫的不同爬取策略使用不同的方法来确定要爬取的 URL 队列中 URL 的优先级。

爬虫的爬取策略有很多种,但不管采用哪种方式,基本目标都是一样的:首先选择重要的网页进行爬取。在爬虫系统中,所谓的网页重要性可以通过不同的方法来判断,但大多是按照网页的流行程度来定义的。

爬取策略的方法虽然有很多,但这里仅列举被证明有效或具有代表性的解决方案,包括以下四种:广度优先遍历策略、不完全PageRank策略、OPIC策略和大站优先策略。

01 广度优先遍历策略

广度优先遍历策略是一种非常简单直观的遍历方法,历史悠久。搜索引擎爬虫一出现就被采用。新提出的爬取策略往往使用这种方法作为比较的基准。不过,值得注意的是,这种策略也是一种非常强大的方法。很多新方法的实际效果不一定比广度优先遍历策略好。所以这个方法其实是很多爬虫采用的第一种爬虫策略。

如上所述,“新下载的网页中收录的URL会被追加到待抓取的URL队列的末尾”,这就是广度优先遍历的思想。也就是说,该方法并没有明确提出和使用网页的重要性作为衡量标准,而是机械地从新下载的网页中提取链接,作为URL的下载顺序附加到待抓取的URL队列中。下图是这个策略的示意图: 假设队列头部的网页是1号网页,从1号网页中提取3个分别指向2号、3号、4号的链接,因此它们按要捕获的数字顺序排列。在取队列中,图中网页的编号就是这个页面在待取队列中的序号,

实验表明,这种策略非常有效。虽然看起来很机械,但实际的网页抓取顺序基本上是按照网页的重要性排序的。为此,一些研究人员认为,如果一个网页收录许多传入链接,则更容易被广度优先遍历策略及早捕获。传入链接的数量从侧面反映了网页的重要性,即实际的宽度优先遍历策略 以上也暗示了一些网页优先级假设。

广度优先遍历策略 02 Incomplete PageRank 策略

PageRank 是一种著名的链接分析算法,可用于衡量网页的重要性。自然可以想到使用PageRank的思想来对URL优先级进行排序。但是这里有一个问题。PageRank 是一种全局算法,这意味着当所有网页都被下载时,计算结果是可靠的。爬虫的目的是下载网页,运行时只能看到部分网页。,所以在爬行阶段的网页无法获得可靠的PageRank分数。

如果我们仍然坚持在这个不完整的 Internet 页面子集中计算 PageRank 怎么办?这就是不完全PageRank策略的基本思想:对于下载的网页,将要爬取的URL队列中的URL加入到一个网页集合中,在这个集合中进行PageRank计算,计算完成后,待爬取的URL队列 根据PageRank得分从高到低对其中的网页进行排序,形成的顺序就是爬虫接下来要爬取的URL列表。这就是为什么它被称为“不完整的 PageRank”。

如果每次抓取一个新的网页,所有下载的网页都重新计算为一个新的不完整的PageRank值,这显然效率太低,在现实中也不可行。一个折衷的方法是:每当有足够K个新下载的网页时,对所有下载的网页重新计算一个新的不完整PageRank。这种计算效率勉强可以接受,但又带来了一个新问题:在开始下一轮PageRank计算之前,提取新下载网页中收录的链接。这些链接很可能非常重要,应该优先考虑。下载,这种情况怎么解决?不完整的 PageRank 会为这些新提取的没有 PageRank 值的网页分配一个临时的 PageRank 值。本网页所有链内传输的 PageRank 值汇总为临时 PageRank 值。如果这个值大于在要爬取的URL队列中计算出来的值,如果PageRank值高的页面出来,则先下载这个URL。

下图是不完全PageRank策略的示意图。我们为每下载 3 个网页设置一个新的 PageRank 计算。此时本地已经下载了3个网页{P1,P2,P3},这3个网页中收录的链接指向{P4,P5,P6},形成了一个待抓取的URL队列。如何决定下载顺序?将这6个网页组成一个新的集合,并计算该集合的PageRank值,使P4、P5和P6得到各自对应的PageRank值,从大到小排序,即可得到下载顺序. 这里可以假设下载顺序为:P5、P4、P6。下载P5页面时,链接被提取并指向页面P8。此时,P8 被分配了一个临时的 PageRank 值。如果这个值大于 P4 和 P6 如果你有一个 PageRank 值,P8 将首先被下载。这样一个连续的循环就形成了不完全PageRank策略的计算思路。

Incomplete PageRank看起来很复杂,那么效果一定比简单的广度优先遍历策略更好吗?不同的实验结果是有争议的。一些结果表明,不完整的 PageRank 结果稍好一些,而一些实验结果则刚好相反。有研究人员指出,不完整的 PageRank 计算的重要性与完整的 PageRank 计算结果有很大不同。不应作为计算网址在爬取过程中重要性的依据。

不完整的 PageRank 策略 03 OPIC 策略

OPIC字面意思是“在线页面重要性计算”,可以看作是一种改进的PageRank算法。在算法开始之前,每个互联网页面都被给予相同的“现金”。每当某个页面 P 被下载时,P 会将自己拥有的“现金”平均分配给该页面所收录的链接页面,并将自己的“现金”分配给“空”。对于 URL 队列中待抓取的网页,它们根据手头有多少现金进行排序,现金最多的网页先下载。OPIC在其大框架上与PageRank基本相同。区别在于:PageRank每次都需要迭代计算,而OPIC策略不需要迭代过程,所以计算速度比PageRank快很多,适合实时计算。同时,在计算PageRank时,有一个远程跳转到没有链接关系的网页的过程,而OPIC没有这个计算因素。实验结果表明,OPIC是一种较好的重要性度量策略,其效果略好于广度优先遍历策略。

04 大站点优先策略

大站点优先策略很简单:以 网站 为单位衡量网页的重要性。对于URL队列中待抓取的网页,根据各自的网站进行分类,如果等待下载的是哪个网站,如果页面数最多,先下载这些链接。本质思想倾向于优先下载大的网站,因为大的网站往往收录更多的页面。鉴于大型网站往往是知名公司的内容,而且他们的网页一般都是高质量的,这个想法很简单,但是有一定的依据。实验表明,该算法的效果略好于宽度优先遍历策略。

网页更新策略

Internet 的动态特性是其显着特征。随时出现新页面,更改页面内容或删除现有页面。对于爬虫来说,并不是在本地爬取网页,即使完成了任务,也必须体现互联网的动态性。本地下载的页面可以看作是互联网页面的“镜子”,爬虫应该尽量保证一致性。可以假设这样一种情况:某个网页被删除或内容发生了重大变化,搜索引擎仍然对这个引擎一无所知,仍然按照旧内容进行排序,作为搜索结果提供给用户。用户体验还不错。不言而喻。因此,对于已经爬取过的网页,

网页更新策略的任务是决定何时重新抓取下载的网页,尽可能使本地下载的网页内容与互联网上的原创网页一致。常用的网页更新策略有3种:历史参考策略、用户体验策略和聚类抽样策略。

01 历史参考策略

历史参考策略是最直观的更新策略。它基于这样一个假设,即过去经常更新的网页在未来也会经常更新。因此,为了估计某个网页的更新时间,可以参考历史更新情况进行判断。

这种方法经常使用泊松过程来对网页的变化进行建模。根据每个网页过去的变化,该模型用于预测未来内容何时会再次发生变化,以指导爬虫的抓取过程。不同的方法有不同的侧重点。例如,一些研究将网页划分为不同的区域。爬取策略应忽略广告栏或导航栏等不重要区域的频繁变化,专注于内容变化检测和建模。优越的。

02用户体验策略

一般来说,一个搜索引擎用户提交查询后,可能会有上千条相关的搜索结果,用户没有耐心等着看排在后面的搜索结果,可能只看前3页的搜索内容。用户体验策略利用用户的这种特性来设计更新策略。

此更新策略以用户体验为中心。即使本地索引的网页内容已经过时,如果不影响用户体验,那么以后更新这些过时的网页也是可以的。因此,判断网页何时更新取决于网页内容的变化(通常以搜索结果排名的变化来衡量)带来的搜索质量的变化。网页的影响越大,应该更新得越快。

用户体验策略保存网页的多个历史版本,根据过去每次内容变化对搜索质量的影响取平均值,作为判断爬虫重新抓取网页时间的参考依据。网页的影响越严重,就越优先安排重新抓取。

03 整群抽样策略

上面介绍的两种网页更新策略很大程度上依赖于网页的历史更新信息,因为这是后续计算的基础。但在现实中,要为每个网页保存历史信息,搜索系统会增加很多额外的负担。从另一个角度来说,如果是第一个被爬取的网页,因为没有历史信息,无法按照这两个思路来估计更新周期。为了解决上述不足,提出了聚类抽样策略。

聚类抽样策略认为网页具有一些属性,可以根据这些属性预测更新周期。具有相似属性的网页具有相似的更新周期。因此,可以根据这些属性对网页进行分类,同一类别的网页具有相同的更新频率。为了计算某个类别的更新周期,只需对该类别中的网页进行采样,并将这些采样网页的更新周期作为该类别中所有网页的更新周期。与前面介绍的两种方法相比,该策略一方面不需要为每个网页保存历史信息;另一方面,对于新的网页,即使没有历史信息,也可以根据类别进行更新。

下图描述了集群抽样策略的基本流程。首先,根据网页的特点,将它们聚合到不同的类别中,每个类别中的网页都有相似的更新周期。从类别中提取出一部分最具代表性的网页(通常是提取离类别中心最近的网页),计算这些网页的更新周期,然后将该更新周期用于该类别中的所有网页,然后可以基于网页的类别 确定其更新周期。

聚类抽样策略

网页更新周期的属性特征分为静态特征和动态特征两大类。静态特征包括:页面内容、图片数量、页面大小、链接深度、PageRank值等十几种类型;而动态特征则反映了静态特征随时间的变化,比如图片数量的变化、链接的进出变化等。基于这两种特征,可以对网页进行聚类。

上图是一个比较笼统的过程,不同的算法在一些细节上有差异。例如,有的研究直接省略了聚类步骤,而是使用网站作为聚类单元,即假设属于同一网站的网页具有相同的更新周期,则其中的网页网站是Sampling,计算更新周期,然后网站中的所有网页都会以这个更新周期为准。虽然这个假设很粗略,因为很明显同一网站内的网页更新周期变化很大,但是可以省略聚类步骤,这样计算效率会更高。

相关实验表明,聚类采样策略优于前两种更新策略,但对亿万网页进行聚类也非常困难。

如果你对爬虫感兴趣,还可以阅读:

全程干货| 爬虫技术原理入门,看这篇文章就知道了

网络爬虫 | 你不知道的暗网是如何爬行的?

网络爬虫 | 你知道分布式爬虫是如何工作的吗? 查看全部

爬虫抓取网页数据(

图片来源网络抓取策略(一)(1)_光明网(组图))

图片源网页抓取策略

在爬虫系统中,要爬取的URL是一个非常关键的部分。爬虫需要爬取的网页的网址排列在其中,形成一个队列结构。调度器每次从队列的头部取出URL,发送给网页下载器下载页面内容。,每个新下载的网页中收录的URL都会被追加到待爬取的URL队列的末尾,从而形成一个爬行循环,整个爬虫系统可以说是由这个队列驱动的。

如何确定要抓取的URL队列中页面URL的顺序?如上所述,新下载页面中收录的链接将附加到队列的末尾。虽然这是一种确定队列的 URL 顺序的方法,但它不是唯一的方法。事实上,可以采用许多其他技术来保持队列等待被捕获。取URL进行排序。爬虫的不同爬取策略使用不同的方法来确定要爬取的 URL 队列中 URL 的优先级。

爬虫的爬取策略有很多种,但不管采用哪种方式,基本目标都是一样的:首先选择重要的网页进行爬取。在爬虫系统中,所谓的网页重要性可以通过不同的方法来判断,但大多是按照网页的流行程度来定义的。

爬取策略的方法虽然有很多,但这里仅列举被证明有效或具有代表性的解决方案,包括以下四种:广度优先遍历策略、不完全PageRank策略、OPIC策略和大站优先策略。

01 广度优先遍历策略

广度优先遍历策略是一种非常简单直观的遍历方法,历史悠久。搜索引擎爬虫一出现就被采用。新提出的爬取策略往往使用这种方法作为比较的基准。不过,值得注意的是,这种策略也是一种非常强大的方法。很多新方法的实际效果不一定比广度优先遍历策略好。所以这个方法其实是很多爬虫采用的第一种爬虫策略。

如上所述,“新下载的网页中收录的URL会被追加到待抓取的URL队列的末尾”,这就是广度优先遍历的思想。也就是说,该方法并没有明确提出和使用网页的重要性作为衡量标准,而是机械地从新下载的网页中提取链接,作为URL的下载顺序附加到待抓取的URL队列中。下图是这个策略的示意图: 假设队列头部的网页是1号网页,从1号网页中提取3个分别指向2号、3号、4号的链接,因此它们按要捕获的数字顺序排列。在取队列中,图中网页的编号就是这个页面在待取队列中的序号,

实验表明,这种策略非常有效。虽然看起来很机械,但实际的网页抓取顺序基本上是按照网页的重要性排序的。为此,一些研究人员认为,如果一个网页收录许多传入链接,则更容易被广度优先遍历策略及早捕获。传入链接的数量从侧面反映了网页的重要性,即实际的宽度优先遍历策略 以上也暗示了一些网页优先级假设。

广度优先遍历策略 02 Incomplete PageRank 策略

PageRank 是一种著名的链接分析算法,可用于衡量网页的重要性。自然可以想到使用PageRank的思想来对URL优先级进行排序。但是这里有一个问题。PageRank 是一种全局算法,这意味着当所有网页都被下载时,计算结果是可靠的。爬虫的目的是下载网页,运行时只能看到部分网页。,所以在爬行阶段的网页无法获得可靠的PageRank分数。

如果我们仍然坚持在这个不完整的 Internet 页面子集中计算 PageRank 怎么办?这就是不完全PageRank策略的基本思想:对于下载的网页,将要爬取的URL队列中的URL加入到一个网页集合中,在这个集合中进行PageRank计算,计算完成后,待爬取的URL队列 根据PageRank得分从高到低对其中的网页进行排序,形成的顺序就是爬虫接下来要爬取的URL列表。这就是为什么它被称为“不完整的 PageRank”。

如果每次抓取一个新的网页,所有下载的网页都重新计算为一个新的不完整的PageRank值,这显然效率太低,在现实中也不可行。一个折衷的方法是:每当有足够K个新下载的网页时,对所有下载的网页重新计算一个新的不完整PageRank。这种计算效率勉强可以接受,但又带来了一个新问题:在开始下一轮PageRank计算之前,提取新下载网页中收录的链接。这些链接很可能非常重要,应该优先考虑。下载,这种情况怎么解决?不完整的 PageRank 会为这些新提取的没有 PageRank 值的网页分配一个临时的 PageRank 值。本网页所有链内传输的 PageRank 值汇总为临时 PageRank 值。如果这个值大于在要爬取的URL队列中计算出来的值,如果PageRank值高的页面出来,则先下载这个URL。

下图是不完全PageRank策略的示意图。我们为每下载 3 个网页设置一个新的 PageRank 计算。此时本地已经下载了3个网页{P1,P2,P3},这3个网页中收录的链接指向{P4,P5,P6},形成了一个待抓取的URL队列。如何决定下载顺序?将这6个网页组成一个新的集合,并计算该集合的PageRank值,使P4、P5和P6得到各自对应的PageRank值,从大到小排序,即可得到下载顺序. 这里可以假设下载顺序为:P5、P4、P6。下载P5页面时,链接被提取并指向页面P8。此时,P8 被分配了一个临时的 PageRank 值。如果这个值大于 P4 和 P6 如果你有一个 PageRank 值,P8 将首先被下载。这样一个连续的循环就形成了不完全PageRank策略的计算思路。

Incomplete PageRank看起来很复杂,那么效果一定比简单的广度优先遍历策略更好吗?不同的实验结果是有争议的。一些结果表明,不完整的 PageRank 结果稍好一些,而一些实验结果则刚好相反。有研究人员指出,不完整的 PageRank 计算的重要性与完整的 PageRank 计算结果有很大不同。不应作为计算网址在爬取过程中重要性的依据。

不完整的 PageRank 策略 03 OPIC 策略

OPIC字面意思是“在线页面重要性计算”,可以看作是一种改进的PageRank算法。在算法开始之前,每个互联网页面都被给予相同的“现金”。每当某个页面 P 被下载时,P 会将自己拥有的“现金”平均分配给该页面所收录的链接页面,并将自己的“现金”分配给“空”。对于 URL 队列中待抓取的网页,它们根据手头有多少现金进行排序,现金最多的网页先下载。OPIC在其大框架上与PageRank基本相同。区别在于:PageRank每次都需要迭代计算,而OPIC策略不需要迭代过程,所以计算速度比PageRank快很多,适合实时计算。同时,在计算PageRank时,有一个远程跳转到没有链接关系的网页的过程,而OPIC没有这个计算因素。实验结果表明,OPIC是一种较好的重要性度量策略,其效果略好于广度优先遍历策略。

04 大站点优先策略

大站点优先策略很简单:以 网站 为单位衡量网页的重要性。对于URL队列中待抓取的网页,根据各自的网站进行分类,如果等待下载的是哪个网站,如果页面数最多,先下载这些链接。本质思想倾向于优先下载大的网站,因为大的网站往往收录更多的页面。鉴于大型网站往往是知名公司的内容,而且他们的网页一般都是高质量的,这个想法很简单,但是有一定的依据。实验表明,该算法的效果略好于宽度优先遍历策略。

网页更新策略

Internet 的动态特性是其显着特征。随时出现新页面,更改页面内容或删除现有页面。对于爬虫来说,并不是在本地爬取网页,即使完成了任务,也必须体现互联网的动态性。本地下载的页面可以看作是互联网页面的“镜子”,爬虫应该尽量保证一致性。可以假设这样一种情况:某个网页被删除或内容发生了重大变化,搜索引擎仍然对这个引擎一无所知,仍然按照旧内容进行排序,作为搜索结果提供给用户。用户体验还不错。不言而喻。因此,对于已经爬取过的网页,

网页更新策略的任务是决定何时重新抓取下载的网页,尽可能使本地下载的网页内容与互联网上的原创网页一致。常用的网页更新策略有3种:历史参考策略、用户体验策略和聚类抽样策略。

01 历史参考策略

历史参考策略是最直观的更新策略。它基于这样一个假设,即过去经常更新的网页在未来也会经常更新。因此,为了估计某个网页的更新时间,可以参考历史更新情况进行判断。

这种方法经常使用泊松过程来对网页的变化进行建模。根据每个网页过去的变化,该模型用于预测未来内容何时会再次发生变化,以指导爬虫的抓取过程。不同的方法有不同的侧重点。例如,一些研究将网页划分为不同的区域。爬取策略应忽略广告栏或导航栏等不重要区域的频繁变化,专注于内容变化检测和建模。优越的。

02用户体验策略

一般来说,一个搜索引擎用户提交查询后,可能会有上千条相关的搜索结果,用户没有耐心等着看排在后面的搜索结果,可能只看前3页的搜索内容。用户体验策略利用用户的这种特性来设计更新策略。

此更新策略以用户体验为中心。即使本地索引的网页内容已经过时,如果不影响用户体验,那么以后更新这些过时的网页也是可以的。因此,判断网页何时更新取决于网页内容的变化(通常以搜索结果排名的变化来衡量)带来的搜索质量的变化。网页的影响越大,应该更新得越快。

用户体验策略保存网页的多个历史版本,根据过去每次内容变化对搜索质量的影响取平均值,作为判断爬虫重新抓取网页时间的参考依据。网页的影响越严重,就越优先安排重新抓取。

03 整群抽样策略

上面介绍的两种网页更新策略很大程度上依赖于网页的历史更新信息,因为这是后续计算的基础。但在现实中,要为每个网页保存历史信息,搜索系统会增加很多额外的负担。从另一个角度来说,如果是第一个被爬取的网页,因为没有历史信息,无法按照这两个思路来估计更新周期。为了解决上述不足,提出了聚类抽样策略。

聚类抽样策略认为网页具有一些属性,可以根据这些属性预测更新周期。具有相似属性的网页具有相似的更新周期。因此,可以根据这些属性对网页进行分类,同一类别的网页具有相同的更新频率。为了计算某个类别的更新周期,只需对该类别中的网页进行采样,并将这些采样网页的更新周期作为该类别中所有网页的更新周期。与前面介绍的两种方法相比,该策略一方面不需要为每个网页保存历史信息;另一方面,对于新的网页,即使没有历史信息,也可以根据类别进行更新。

下图描述了集群抽样策略的基本流程。首先,根据网页的特点,将它们聚合到不同的类别中,每个类别中的网页都有相似的更新周期。从类别中提取出一部分最具代表性的网页(通常是提取离类别中心最近的网页),计算这些网页的更新周期,然后将该更新周期用于该类别中的所有网页,然后可以基于网页的类别 确定其更新周期。

聚类抽样策略

网页更新周期的属性特征分为静态特征和动态特征两大类。静态特征包括:页面内容、图片数量、页面大小、链接深度、PageRank值等十几种类型;而动态特征则反映了静态特征随时间的变化,比如图片数量的变化、链接的进出变化等。基于这两种特征,可以对网页进行聚类。

上图是一个比较笼统的过程,不同的算法在一些细节上有差异。例如,有的研究直接省略了聚类步骤,而是使用网站作为聚类单元,即假设属于同一网站的网页具有相同的更新周期,则其中的网页网站是Sampling,计算更新周期,然后网站中的所有网页都会以这个更新周期为准。虽然这个假设很粗略,因为很明显同一网站内的网页更新周期变化很大,但是可以省略聚类步骤,这样计算效率会更高。

相关实验表明,聚类采样策略优于前两种更新策略,但对亿万网页进行聚类也非常困难。

如果你对爬虫感兴趣,还可以阅读:

全程干货| 爬虫技术原理入门,看这篇文章就知道了

网络爬虫 | 你不知道的暗网是如何爬行的?

网络爬虫 | 你知道分布式爬虫是如何工作的吗?

爬虫抓取网页数据(动态网页数据抓取什么是AJAX:异步JavaScript和XML的区别)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-31 11:24

什么是 AJAX?

AJAX (Asynchronouse JavaScript And XML) 异步 JavaScript 和 XML。通过在后台与服务器交换少量数据,Ajax 可以使网页异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。如果内容需要更新,传统网页(不使用 Ajax)必须重新加载整个网页。因为传统的数据传输格式是XML语法。所以它被称为 AJAX。其实现在数据交互基本都是用JSON。使用AJAX加载的数据,即使使用JS将数据渲染到浏览器中,在右键->查看网页源代码中仍然看不到通过ajax加载的数据,只能看到使用这个url加载的html代码。

ajax数据的获取方式:直接分析ajax调用的接口。然后通过代码请求这个接口。使用Selenium+chromedriver模拟浏览器行为获取数据。

大大地

优势

缺点

分析界面

可以直接请求数据。无需做一些解析工作。代码量小,性能高。

解析接口比较复杂,尤其是一些被js混淆的接口,必须有一定的js基础。很容易被发现是爬虫。

硒

直接模拟浏览器的行为。浏览器可以请求的内容也可以使用 selenium 请求。爬虫更稳定。

很多代码。低性能。

Selenium+chromedriver 获取动态数据:

Selenium 相当于一个机器人。可以在浏览器上模拟一些人类的行为,在浏览器上自动处理一些行为,比如点击、填充数据、删除cookies等。 chromedriver是一个驱动Chrome浏览器的驱动,可以用来驱动浏览器. 当然,不同的浏览器有不同的驱动程序。下面列出了不同的浏览器及其相应的驱动程序:

Chrome: Firefox: Edge: Safari: Install Selenium: Selenium有多种语言版本,如java、ruby、python等,我们可以下载python版本。pip install selenium install chromedriver:下载完成后,放到一个不需要权限的纯英文目录下。安装 Selenium 和 chromedriver:快速入门:

from selenium import webdriver

# chromedriver的绝对路径

driver_path = r'D:\ProgramApp\chromedriver\chromedriver.exe'

# 初始化一个driver,并且指定chromedriver的路径

driver = webdriver.Chrome(executable_path=driver_path)

# 请求网页

driver.get("https://www.baidu.com/")

# 通过page_source获取网页源代码

print(driver.page_source)

Selenium 常见操作:

更多教程参考:

关闭页面: driver.close():关闭当前页面。driver.quit():退出整个浏览器。定位元素:

需要注意的是find_element是获取第一个满足条件的元素。find_elements 是获取所有满足条件的元素。

find_element_by_id:根据id来查找某个元素。等价于:

submitTag = driver.find_element_by_id('su')

submitTag1 = driver.find_element(By.ID,'su')

find_element_by_class_name:根据类名查找元素。 等价于:

submitTag = driver.find_element_by_class_name('su')

submitTag1 = driver.find_element(By.CLASS_NAME,'su')

find_element_by_name:根据name属性的值来查找元素。等价于:

submitTag = driver.find_element_by_name('email')

submitTag1 = driver.find_element(By.NAME,'email')

find_element_by_tag_name:根据标签名来查找元素。等价于:

submitTag = driver.find_element_by_tag_name('div')

submitTag1 = driver.find_element(By.TAG_NAME,'div')

find_element_by_xpath:根据xpath语法来获取元素。等价于:

submitTag = driver.find_element_by_xpath('//div')

submitTag1 = driver.find_element(By.XPATH,'//div')

find_element_by_css_selector:根据css选择器选择元素。等价于:

submitTag = driver.find_element_by_css_selector('//div')

submitTag1 = driver.find_element(By.CSS_SELECTOR,'//div')

操作表单元素:

操作输入框:分为两步。第一步:找到这个元素。第二步:使用send_keys(value)填写数据。示例代码如下:

inputTag = driver.find_element_by_id('kw')

inputTag.send_keys('python')

使用clear方法清除输入框的内容。示例代码如下:

inputTag.clear()

操作checkbox:因为要选中checkbox标签,所以在网页上用鼠标点击。所以,如果要选中checkbox标签,先选中这个标签,再执行click事件。示例代码如下:

rememberTag = driver.find_element_by_name("rememberMe")

记住Tag.click()

选择选择:不能直接点击选择元素。因为元素需要点击后被选中。这时,selenium 专门为select 标签提供了一个类selenium.webdriver.support.ui.Select。将获取的元素作为参数传递给该类以创建该对象。您可以在将来使用此对象进行选择。示例代码如下:

fromselenium.webdriver.support.ui importSelect

#选中这个标签,然后用Select创建一个对象

selectTag = Select(driver.find_element_by_name("jumpMenu"))

#根据索引选择

selectTag.select_by_index(1)

# 按值选择

selectTag.select_by_value("")

# 根据可见文本选择

selectTag.select_by_visible_text("95 显示客户端")

# 取消所有选项

selectTag.deselect_all()

操作按钮:操作按钮的方式有很多种。比如单击、右键、双击等,这里是最常用的一种。只需点击。直接调用click函数就行了。示例代码如下:

inputTag = driver.find_element_by_id('su')

inputTag.click()

行为链:

有时页面上的操作可能会有很多步骤,这时就可以使用鼠标行为链类ActionChains来完成。例如,现在你想将鼠标移动到一个元素上并执行一个点击事件。那么示例代码如下:

inputTag = driver.find_element_by_id('kw')

submitTag = driver.find_element_by_id('su')

actions = ActionChains(driver)

actions.move_to_element(inputTag)

actions.send_keys_to_element(inputTag,'python')

actions.move_to_element(submitTag)

actions.click(submitTag)

actions.perform()

还有更多与鼠标相关的操作。

饼干操作:

获取所有的cookie:

for cookie in driver.get_cookies():

print(cookie)

根据cookie的key获取value:

value = driver.get_cookie(key)

删除所有的cookie:

driver.delete_all_cookies()

删除某个cookie:

driver.delete_cookie(key)

页面等待:

现在越来越多的网页使用 Ajax 技术,因此程序无法确定元素何时完全加载。如果实际页面等待时间过长,某个dom元素没有出来,而你的代码直接使用了这个WebElement,那么就会抛出NullPointer异常。为了解决这个问题。所以Selenium提供了两种等待方式:一种是隐式等待,一种是显式等待。

隐式等待:调用 driver.implicitly_wait。然后,在获取不可用元素之前,它会等待 10 秒。示例代码如下

driver = webdriver.Chrome(executable_path=driver_path)

driver.implicitly_wait(10)

# 请求网页

driver.get("https://www.douban.com/")

2/显示等待:显示等待是表示在执行获取元素的操作之前已经建立了某种条件。也可以指定等待的最长时间,超过这个时间就会抛出异常。显示等待应在 selenium.webdriver.support.excepted_conditions 和 selenium.webdriver.support.ui.WebDriverWait 的预期条件下完成。示例代码如下:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

driver = webdriver.Firefox()

driver.get("http://somedomain/url_that_delays_loading")

try:

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "myDynamicElement"))

)

finally:

driver.quit()

其他一些等待条件:

更多条件参考:

切换页面:

有时窗口中有很多子标签页。这个时候必须切换。

Selenium 提供了一个 switch_to_window 来切换。要切换到的特定页面可以在 driver.window_handles 中找到。示例代码如下:

# 打开一个新的页面

self.driver.execute_script("window.open('https://www.baidu.com')")

#显示当前页面的url

driver.current_url //还是百度页面

# 切换到这个新的页面中

driver.switch_to_window(driver.window_handles[1])

设置代理ip:

有时会频繁抓取一些网页。服务器发现你是爬虫后会屏蔽你的ip地址。这时候我们就可以更改代理ip了。更改代理ip,不同浏览器实现方式不同。以下是 Chrome 浏览器的示例:

from selenium import webdriver

options = webdriver.ChromeOptions() //设置存储浏览器的信息

//添加代理服务器

options.add_argument("--proxy-server=http://110.73.2.248:8123")

driver_path = r"D:\ProgramApp\chromedriver\chromedriver.exe"

driver = webdriver.Chrome(executable_path=driver_path,chrome_options=options)

driver.get('http://httpbin.org/ip')

WebElement 元素:

from selenium.webdriver.remote.webelement import WebElement 类是获取到的每个元素的类。

有一些常用的属性:

get_attribute:此标签的属性值。

screentshot:获取当前页面的截图。此方法只能在驱动程序上使用。

驱动程序的对象类也继承自 WebElement。

. 查看全部

爬虫抓取网页数据(动态网页数据抓取什么是AJAX:异步JavaScript和XML的区别)

什么是 AJAX?

AJAX (Asynchronouse JavaScript And XML) 异步 JavaScript 和 XML。通过在后台与服务器交换少量数据,Ajax 可以使网页异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。如果内容需要更新,传统网页(不使用 Ajax)必须重新加载整个网页。因为传统的数据传输格式是XML语法。所以它被称为 AJAX。其实现在数据交互基本都是用JSON。使用AJAX加载的数据,即使使用JS将数据渲染到浏览器中,在右键->查看网页源代码中仍然看不到通过ajax加载的数据,只能看到使用这个url加载的html代码。

ajax数据的获取方式:直接分析ajax调用的接口。然后通过代码请求这个接口。使用Selenium+chromedriver模拟浏览器行为获取数据。

大大地

优势

缺点

分析界面

可以直接请求数据。无需做一些解析工作。代码量小,性能高。

解析接口比较复杂,尤其是一些被js混淆的接口,必须有一定的js基础。很容易被发现是爬虫。

硒

直接模拟浏览器的行为。浏览器可以请求的内容也可以使用 selenium 请求。爬虫更稳定。

很多代码。低性能。

Selenium+chromedriver 获取动态数据:

Selenium 相当于一个机器人。可以在浏览器上模拟一些人类的行为,在浏览器上自动处理一些行为,比如点击、填充数据、删除cookies等。 chromedriver是一个驱动Chrome浏览器的驱动,可以用来驱动浏览器. 当然,不同的浏览器有不同的驱动程序。下面列出了不同的浏览器及其相应的驱动程序:

Chrome: Firefox: Edge: Safari: Install Selenium: Selenium有多种语言版本,如java、ruby、python等,我们可以下载python版本。pip install selenium install chromedriver:下载完成后,放到一个不需要权限的纯英文目录下。安装 Selenium 和 chromedriver:快速入门:

from selenium import webdriver

# chromedriver的绝对路径

driver_path = r'D:\ProgramApp\chromedriver\chromedriver.exe'

# 初始化一个driver,并且指定chromedriver的路径

driver = webdriver.Chrome(executable_path=driver_path)

# 请求网页

driver.get("https://www.baidu.com/";)

# 通过page_source获取网页源代码

print(driver.page_source)

Selenium 常见操作:

更多教程参考:

关闭页面: driver.close():关闭当前页面。driver.quit():退出整个浏览器。定位元素:

需要注意的是find_element是获取第一个满足条件的元素。find_elements 是获取所有满足条件的元素。

find_element_by_id:根据id来查找某个元素。等价于:

submitTag = driver.find_element_by_id('su')

submitTag1 = driver.find_element(By.ID,'su')

find_element_by_class_name:根据类名查找元素。 等价于:

submitTag = driver.find_element_by_class_name('su')

submitTag1 = driver.find_element(By.CLASS_NAME,'su')

find_element_by_name:根据name属性的值来查找元素。等价于:

submitTag = driver.find_element_by_name('email')

submitTag1 = driver.find_element(By.NAME,'email')

find_element_by_tag_name:根据标签名来查找元素。等价于:

submitTag = driver.find_element_by_tag_name('div')

submitTag1 = driver.find_element(By.TAG_NAME,'div')

find_element_by_xpath:根据xpath语法来获取元素。等价于:

submitTag = driver.find_element_by_xpath('//div')

submitTag1 = driver.find_element(By.XPATH,'//div')

find_element_by_css_selector:根据css选择器选择元素。等价于:

submitTag = driver.find_element_by_css_selector('//div')

submitTag1 = driver.find_element(By.CSS_SELECTOR,'//div')

操作表单元素:

操作输入框:分为两步。第一步:找到这个元素。第二步:使用send_keys(value)填写数据。示例代码如下:

inputTag = driver.find_element_by_id('kw')

inputTag.send_keys('python')

使用clear方法清除输入框的内容。示例代码如下:

inputTag.clear()

操作checkbox:因为要选中checkbox标签,所以在网页上用鼠标点击。所以,如果要选中checkbox标签,先选中这个标签,再执行click事件。示例代码如下:

rememberTag = driver.find_element_by_name("rememberMe")

记住Tag.click()

选择选择:不能直接点击选择元素。因为元素需要点击后被选中。这时,selenium 专门为select 标签提供了一个类selenium.webdriver.support.ui.Select。将获取的元素作为参数传递给该类以创建该对象。您可以在将来使用此对象进行选择。示例代码如下:

fromselenium.webdriver.support.ui importSelect

#选中这个标签,然后用Select创建一个对象

selectTag = Select(driver.find_element_by_name("jumpMenu"))

#根据索引选择

selectTag.select_by_index(1)

# 按值选择

selectTag.select_by_value("")

# 根据可见文本选择

selectTag.select_by_visible_text("95 显示客户端")

# 取消所有选项

selectTag.deselect_all()

操作按钮:操作按钮的方式有很多种。比如单击、右键、双击等,这里是最常用的一种。只需点击。直接调用click函数就行了。示例代码如下:

inputTag = driver.find_element_by_id('su')

inputTag.click()

行为链:

有时页面上的操作可能会有很多步骤,这时就可以使用鼠标行为链类ActionChains来完成。例如,现在你想将鼠标移动到一个元素上并执行一个点击事件。那么示例代码如下:

inputTag = driver.find_element_by_id('kw')

submitTag = driver.find_element_by_id('su')

actions = ActionChains(driver)

actions.move_to_element(inputTag)

actions.send_keys_to_element(inputTag,'python')

actions.move_to_element(submitTag)

actions.click(submitTag)

actions.perform()

还有更多与鼠标相关的操作。

饼干操作:

获取所有的cookie:

for cookie in driver.get_cookies():

print(cookie)

根据cookie的key获取value:

value = driver.get_cookie(key)

删除所有的cookie:

driver.delete_all_cookies()

删除某个cookie:

driver.delete_cookie(key)

页面等待:

现在越来越多的网页使用 Ajax 技术,因此程序无法确定元素何时完全加载。如果实际页面等待时间过长,某个dom元素没有出来,而你的代码直接使用了这个WebElement,那么就会抛出NullPointer异常。为了解决这个问题。所以Selenium提供了两种等待方式:一种是隐式等待,一种是显式等待。

隐式等待:调用 driver.implicitly_wait。然后,在获取不可用元素之前,它会等待 10 秒。示例代码如下

driver = webdriver.Chrome(executable_path=driver_path)

driver.implicitly_wait(10)

# 请求网页

driver.get("https://www.douban.com/";)

2/显示等待:显示等待是表示在执行获取元素的操作之前已经建立了某种条件。也可以指定等待的最长时间,超过这个时间就会抛出异常。显示等待应在 selenium.webdriver.support.excepted_conditions 和 selenium.webdriver.support.ui.WebDriverWait 的预期条件下完成。示例代码如下:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

driver = webdriver.Firefox()

driver.get("http://somedomain/url_that_delays_loading";)

try:

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "myDynamicElement"))

)

finally:

driver.quit()

其他一些等待条件:

更多条件参考:

切换页面:

有时窗口中有很多子标签页。这个时候必须切换。

Selenium 提供了一个 switch_to_window 来切换。要切换到的特定页面可以在 driver.window_handles 中找到。示例代码如下:

# 打开一个新的页面

self.driver.execute_script("window.open('https://www.baidu.com')")

#显示当前页面的url

driver.current_url //还是百度页面

# 切换到这个新的页面中

driver.switch_to_window(driver.window_handles[1])

设置代理ip:

有时会频繁抓取一些网页。服务器发现你是爬虫后会屏蔽你的ip地址。这时候我们就可以更改代理ip了。更改代理ip,不同浏览器实现方式不同。以下是 Chrome 浏览器的示例:

from selenium import webdriver

options = webdriver.ChromeOptions() //设置存储浏览器的信息

//添加代理服务器

options.add_argument("--proxy-server=http://110.73.2.248:8123";)

driver_path = r"D:\ProgramApp\chromedriver\chromedriver.exe"

driver = webdriver.Chrome(executable_path=driver_path,chrome_options=options)

driver.get('http://httpbin.org/ip')

WebElement 元素:

from selenium.webdriver.remote.webelement import WebElement 类是获取到的每个元素的类。

有一些常用的属性:

get_attribute:此标签的属性值。

screentshot:获取当前页面的截图。此方法只能在驱动程序上使用。

驱动程序的对象类也继承自 WebElement。

.

爬虫抓取网页数据(利用Python网络爬虫抓取微信朋友圈动态——附代码(下))

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-12-31 10:10

前几天跟大家分享了使用Python网络爬虫爬取微信朋友圈的动态(上)和使用Python网络爬虫爬取微信朋友圈的动态-附代码(下),抓取的数据是用Python Word进行的云和艺术字可视化,有兴趣的小伙伴可以戳这个文章:使用Python字云和艺术字可视化工具将朋友圈数据可视化。

今天我们继续关注微信,但这次我们将使用Python网络爬虫来抓取微信好友总数和微信好友的性别分布。代码实现相当简单,具体教程如下。

相信大家都知道直接通过网页抓取微信数据是不可行的,但是强大的Python提供了一个itchat库,搭建了一个链接微信好友信息的友好桥梁,直接上传代码,如图以下。

代码的关键部分做了注释,方便大家理解。程序运行时,会弹出一个微信二维码。这时候需要用手机扫码授权登录。如果当时登录的是微信电脑版,微信会被强制退出再授权。授权成功后,程序会继续执行,过一会就可以返回给你微信好友的数量。

这里以小编的微信好友为例。程序运行后,得到的信息如下图所示:

可以看到,编辑器中有1637个微信好友。相信很多朋友都已经知道,在手机微信页面的第二个标签“联系人”中,可以下拉好友列表,直到最后,就可以看到自己的微信好友数量。你可以试试,对吗?Python 程序捕获的数字是否相同。

接下来小编就继续带大家去发掘微信好友中的男女比例。其实很简单,代码实现也很容易。这里有两种方式,如下图所示。(注:代码是按照前面的程序写的)

可以自定义一个获取性别信息的函数,也可以直接调用value_counts()方法,这样可以更方便的统计每一项出现的次数。我们微信好友的男女人数如下图所示。这里1代表男性,2代表女性,0代表未知性别(因为有些朋友没有设置性别)。

可以看出,编辑有884个男性朋友,655个女性朋友,近100个性别不明的朋友。

至此,使用Python网络爬虫抓取微信好友数量和微信好友男女比例已经完成。朋友可以打开电脑快速试用一下。简单的几行代码就带你微信好友啦~~~

这个文章的主要参考链接在这里:谢谢你的想法和方法。

下一篇文章,小编将继续与大家分享微信好友的那些事儿,带大家使用Python网络爬虫抓取微信好友的省市分布,并进行可视化,敬请期待~ ~

最后,祝大家520假期快乐!有女朋友就抱女朋友,有老婆就抱老婆,没有女朋友就抱女朋友~~ 查看全部

爬虫抓取网页数据(利用Python网络爬虫抓取微信朋友圈动态——附代码(下))

前几天跟大家分享了使用Python网络爬虫爬取微信朋友圈的动态(上)和使用Python网络爬虫爬取微信朋友圈的动态-附代码(下),抓取的数据是用Python Word进行的云和艺术字可视化,有兴趣的小伙伴可以戳这个文章:使用Python字云和艺术字可视化工具将朋友圈数据可视化。

今天我们继续关注微信,但这次我们将使用Python网络爬虫来抓取微信好友总数和微信好友的性别分布。代码实现相当简单,具体教程如下。

相信大家都知道直接通过网页抓取微信数据是不可行的,但是强大的Python提供了一个itchat库,搭建了一个链接微信好友信息的友好桥梁,直接上传代码,如图以下。

代码的关键部分做了注释,方便大家理解。程序运行时,会弹出一个微信二维码。这时候需要用手机扫码授权登录。如果当时登录的是微信电脑版,微信会被强制退出再授权。授权成功后,程序会继续执行,过一会就可以返回给你微信好友的数量。

这里以小编的微信好友为例。程序运行后,得到的信息如下图所示:

可以看到,编辑器中有1637个微信好友。相信很多朋友都已经知道,在手机微信页面的第二个标签“联系人”中,可以下拉好友列表,直到最后,就可以看到自己的微信好友数量。你可以试试,对吗?Python 程序捕获的数字是否相同。

接下来小编就继续带大家去发掘微信好友中的男女比例。其实很简单,代码实现也很容易。这里有两种方式,如下图所示。(注:代码是按照前面的程序写的)

可以自定义一个获取性别信息的函数,也可以直接调用value_counts()方法,这样可以更方便的统计每一项出现的次数。我们微信好友的男女人数如下图所示。这里1代表男性,2代表女性,0代表未知性别(因为有些朋友没有设置性别)。

可以看出,编辑有884个男性朋友,655个女性朋友,近100个性别不明的朋友。

至此,使用Python网络爬虫抓取微信好友数量和微信好友男女比例已经完成。朋友可以打开电脑快速试用一下。简单的几行代码就带你微信好友啦~~~

这个文章的主要参考链接在这里:谢谢你的想法和方法。

下一篇文章,小编将继续与大家分享微信好友的那些事儿,带大家使用Python网络爬虫抓取微信好友的省市分布,并进行可视化,敬请期待~ ~

最后,祝大家520假期快乐!有女朋友就抱女朋友,有老婆就抱老婆,没有女朋友就抱女朋友~~

爬虫抓取网页数据(网页中有哪些URL,然后不断重复的重复了?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-30 12:09

获取一个网站的所有网址,思路很简单,就是反复分析新获取的页面中有哪些网址,然后再重复一遍。

下面是抓CSDN的例子: 首先是一些辅助功能:

1 def getResponse(url):# 使用requests获取Response

2 headers = {

3 'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.182 Safari/537.36'

4 }

5 response = requests.get(url=url, headers=headers)

6 return response

7

8 def getHTMLBySelenium(url):# 使用selenium获取页面的page_text

9 try:

10 chrome_options =Options()

11 chrome_options.add_argument('--headless')

12 browser = webdriver.Chrome(executable_path='C:/Users/Administrator/Desktop/chromedriver_win32/chromedriver.exe', options=chrome_options)

13 browser.get(url)

14 time.sleep(2)

15 page_text = browser.page_source

16 browser.quit()

17 return page_text

18 except Exception as e:

19 return ''

20

21 def getBlog(url):# 获取页面内容

22 try:

23 page_text = getHTMLBySelenium(url)

24 tree = etree.HTML(page_text)

25 allText = tree.xpath('//body//text()')

26 text = '\n'.join(allText)

27 title = url.replace('/', '_')

28 title = title.replace('.', '_')

29 title = title.replace(':', '_')

30 with open('全站/' + title + '.txt', 'w', encoding='utf-8') as fp:

31 fp.write(text)

32 except Exception as e:

33 return

提取一个页面收录

的所有其他页面的URL,具体分析具体的网站,这里是CSDN的获取方式:

def getLinks(url):

try:

page_text = getHTMLBySelenium(url)

tree = etree.HTML(page_text)

all_href = tree.xpath('//a')

links = []

for href in all_href:

link = href.xpath('./@href')

if len(link) == 0:

continue

link = link[0]

if link.startswith('https://blog.csdn.net'):

links.append(link)

return links

except Exception as e:

return []

下面是递归获取页面URL的过程,先看一段简单的代码:

urls = set()# 存储已经被操作过的URL

temp1 = set()# 存储正在被操作的URL

temp2 = set()# 存储新获取的URL

temp1.add('url')# 程序最开始的分析的页面,可以是网站首页URL

while temp1:# temp1不为空则程序一直运行

for url in temp1:

if url in urls:# url在urls 代表这条url已经被处理

continue

doSomeThing(url)# 处理url

for link in getLinks(url):# 分析url表示的页面中有哪些其他的URL

if link in urls:

continue

if link in temp2:

continue

temp2.add(link)

# temp1中url处理完毕

# 将temp2内容赋给temp1,并清空temp2

temp1 = temp2.copy()

temp2.clear()

从上面的代码可以看出整个程序的运行逻辑,但是在具体使用中需要注意一些问题:

首先,我们用什么来保存获得的链接,我首先使用set,分别使用了一个文本文件用于urls,temp1和temp2。

复制,因为不知道程序在哪个节点会出问题。保存为文本后,可以避免从头开始运行代码的问题。这也是

这就是为什么我使用 try...except... 作为上述辅助功能的原因。

按照上面的思路,我完成了第一个版本的代码,set+text file,周末程序跑了两天后,发现程序有

脑内存满了(win10+16G内存),电脑卡死了,然后强制关机重启后,我看了一下存放URL的文件,程序是最多的

外循环大约运行了第四次,temp2中有几十万个URL。

既然内存不够,那我想把url存到数据库里,然后我选择用mysql而不是set来存url,还是用text

备份。

下面是这个版本的代码。如果程序运行两天没有内存问题,本文不再更新:

# ---- 用pymysql 操作数据库

def get_connection():

conn = pymysql.connect(host=host, port=port, db=db, user=user, password=password)

return conn

#打开数据库连接

conn = get_connection()

cnt = 1

循环 = 2

游标 = conn.cursor()

cursor1 = conn.cursor()

cursor2 = conn.cursor()

while True:

print(f'Loop {loop}')

loop += 1

# 遍历temp1

cursor1.execute("select * from csdn_temp1")

while True:

temp1Res = cursor1.fetchone()

# temp1 遍历完成

if temp1Res is None:

#表示已经取完结果集

break

print (temp1Res)

url = temp1Res[0]

url = re.sub('[\u4e00-\u9fa5]', '', url)

cursor.execute("select * from csdn_urls where url = %s", [url])

urlsRes = cursor.fetchone()

# 已经抓过这一条链接 continue

if urlsRes is not None:

continue

#if cnt % 100 == 0:

#print(url)

cnt += 1

sql = "insert ignore into csdn_urls values(%s)"

cursor.execute(sql,(url))

conn.commit()

with open('urls.txt', 'a', encoding='utf-8') as fp:

fp.write(url)

fp.write('\n')

getBlog(url)

links = getLinks(url)

#toTemp2Urls = []

for link in links:

# 已经抓过这一条链接 或者 temp2 已经有了这一链接 continue

cursor.execute("select * from csdn_urls where url = %s", [link])

urlsRes = cursor.fetchone()

if urlsRes is not None:

continue

cursor2.execute("select * from csdn_temp2 where url = %s", [link])

temp2Res = cursor2.fetchone()

if temp2Res is not None:

continue

#toTemp2Urls.append(link)

sql = "insert ignore into csdn_temp2 values(%s)"

link = re.sub('[\u4e00-\u9fa5]', '', link)

cursor2.execute(sql,(link))

conn.commit()

with open('temp2.txt', 'a', encoding='utf-8') as fp:

fp.write(link)

fp.write('\n')

#sql="insert ignore into csdn_temp2 values(%s)"

#cursor2.executemany(sql,toTemp2Urls)

conn.commit()

#toTemp2Urls = []

conn.commit()

cursor.execute("rename table csdn_temp1 to csdn_temp")

conn.commit()

cursor.execute("rename table csdn_temp2 to csdn_temp1")

conn.commit()

cursor.execute("rename table csdn_temp to csdn_temp2")

conn.commit()

# 删除temp2数据

cursor.execute("delete from csdn_temp2")

conn.commit()

os.rename('temp1.txt', 'temp3.txt')

os.rename('temp2.txt', 'temp1.txt')

os.rename('temp3.txt', 'temp2.txt')

with open('temp2.txt', 'w', encoding='utf-8') as fp:

fp.write('')

在写上面的代码时,我遇到了一个问题。表改名后没有及时commit,清空了我在第一个版本抓到的几十万个网址。

它是空的,用于备份的文本文件也被清空。修改后得到上述代码。

整个代码的调试过程和写代码的思路可以在我的GitHub上的jupyter文件中找到。 查看全部

爬虫抓取网页数据(网页中有哪些URL,然后不断重复的重复了?)

获取一个网站的所有网址,思路很简单,就是反复分析新获取的页面中有哪些网址,然后再重复一遍。

下面是抓CSDN的例子: 首先是一些辅助功能:

1 def getResponse(url):# 使用requests获取Response

2 headers = {

3 'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.182 Safari/537.36'

4 }

5 response = requests.get(url=url, headers=headers)

6 return response

7

8 def getHTMLBySelenium(url):# 使用selenium获取页面的page_text

9 try:

10 chrome_options =Options()

11 chrome_options.add_argument('--headless')

12 browser = webdriver.Chrome(executable_path='C:/Users/Administrator/Desktop/chromedriver_win32/chromedriver.exe', options=chrome_options)

13 browser.get(url)

14 time.sleep(2)

15 page_text = browser.page_source

16 browser.quit()

17 return page_text

18 except Exception as e:

19 return ''

20

21 def getBlog(url):# 获取页面内容

22 try:

23 page_text = getHTMLBySelenium(url)

24 tree = etree.HTML(page_text)

25 allText = tree.xpath('//body//text()')

26 text = '\n'.join(allText)

27 title = url.replace('/', '_')

28 title = title.replace('.', '_')

29 title = title.replace(':', '_')

30 with open('全站/' + title + '.txt', 'w', encoding='utf-8') as fp:

31 fp.write(text)

32 except Exception as e:

33 return

提取一个页面收录

的所有其他页面的URL,具体分析具体的网站,这里是CSDN的获取方式:

def getLinks(url):

try:

page_text = getHTMLBySelenium(url)

tree = etree.HTML(page_text)

all_href = tree.xpath('//a')

links = []

for href in all_href:

link = href.xpath('./@href')

if len(link) == 0:

continue

link = link[0]

if link.startswith('https://blog.csdn.net'):

links.append(link)

return links

except Exception as e:

return []

下面是递归获取页面URL的过程,先看一段简单的代码:

urls = set()# 存储已经被操作过的URL

temp1 = set()# 存储正在被操作的URL

temp2 = set()# 存储新获取的URL

temp1.add('url')# 程序最开始的分析的页面,可以是网站首页URL

while temp1:# temp1不为空则程序一直运行

for url in temp1:

if url in urls:# url在urls 代表这条url已经被处理

continue

doSomeThing(url)# 处理url

for link in getLinks(url):# 分析url表示的页面中有哪些其他的URL

if link in urls:

continue

if link in temp2:

continue

temp2.add(link)

# temp1中url处理完毕

# 将temp2内容赋给temp1,并清空temp2

temp1 = temp2.copy()

temp2.clear()

从上面的代码可以看出整个程序的运行逻辑,但是在具体使用中需要注意一些问题:

首先,我们用什么来保存获得的链接,我首先使用set,分别使用了一个文本文件用于urls,temp1和temp2。

复制,因为不知道程序在哪个节点会出问题。保存为文本后,可以避免从头开始运行代码的问题。这也是

这就是为什么我使用 try...except... 作为上述辅助功能的原因。

按照上面的思路,我完成了第一个版本的代码,set+text file,周末程序跑了两天后,发现程序有

脑内存满了(win10+16G内存),电脑卡死了,然后强制关机重启后,我看了一下存放URL的文件,程序是最多的

外循环大约运行了第四次,temp2中有几十万个URL。

既然内存不够,那我想把url存到数据库里,然后我选择用mysql而不是set来存url,还是用text

备份。

下面是这个版本的代码。如果程序运行两天没有内存问题,本文不再更新:

# ---- 用pymysql 操作数据库

def get_connection():

conn = pymysql.connect(host=host, port=port, db=db, user=user, password=password)

return conn

#打开数据库连接

conn = get_connection()

cnt = 1

循环 = 2

游标 = conn.cursor()

cursor1 = conn.cursor()

cursor2 = conn.cursor()

while True:

print(f'Loop {loop}')

loop += 1

# 遍历temp1

cursor1.execute("select * from csdn_temp1")

while True:

temp1Res = cursor1.fetchone()

# temp1 遍历完成

if temp1Res is None:

#表示已经取完结果集

break

print (temp1Res)

url = temp1Res[0]

url = re.sub('[\u4e00-\u9fa5]', '', url)

cursor.execute("select * from csdn_urls where url = %s", [url])

urlsRes = cursor.fetchone()

# 已经抓过这一条链接 continue

if urlsRes is not None:

continue

#if cnt % 100 == 0:

#print(url)

cnt += 1

sql = "insert ignore into csdn_urls values(%s)"

cursor.execute(sql,(url))

conn.commit()

with open('urls.txt', 'a', encoding='utf-8') as fp:

fp.write(url)

fp.write('\n')

getBlog(url)

links = getLinks(url)

#toTemp2Urls = []

for link in links:

# 已经抓过这一条链接 或者 temp2 已经有了这一链接 continue

cursor.execute("select * from csdn_urls where url = %s", [link])

urlsRes = cursor.fetchone()

if urlsRes is not None:

continue

cursor2.execute("select * from csdn_temp2 where url = %s", [link])

temp2Res = cursor2.fetchone()

if temp2Res is not None:

continue

#toTemp2Urls.append(link)

sql = "insert ignore into csdn_temp2 values(%s)"

link = re.sub('[\u4e00-\u9fa5]', '', link)

cursor2.execute(sql,(link))

conn.commit()

with open('temp2.txt', 'a', encoding='utf-8') as fp:

fp.write(link)

fp.write('\n')

#sql="insert ignore into csdn_temp2 values(%s)"

#cursor2.executemany(sql,toTemp2Urls)

conn.commit()

#toTemp2Urls = []

conn.commit()

cursor.execute("rename table csdn_temp1 to csdn_temp")

conn.commit()

cursor.execute("rename table csdn_temp2 to csdn_temp1")

conn.commit()

cursor.execute("rename table csdn_temp to csdn_temp2")

conn.commit()

# 删除temp2数据

cursor.execute("delete from csdn_temp2")

conn.commit()

os.rename('temp1.txt', 'temp3.txt')

os.rename('temp2.txt', 'temp1.txt')

os.rename('temp3.txt', 'temp2.txt')

with open('temp2.txt', 'w', encoding='utf-8') as fp:

fp.write('')

在写上面的代码时,我遇到了一个问题。表改名后没有及时commit,清空了我在第一个版本抓到的几十万个网址。

它是空的,用于备份的文本文件也被清空。修改后得到上述代码。

整个代码的调试过程和写代码的思路可以在我的GitHub上的jupyter文件中找到。

爬虫抓取网页数据(网络爬虫应该怎么实现?(图)Part1理论基础篇)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-12-29 17:15

阿里云>云栖社区>主题图>P>python网络爬虫获取页面内容

推荐活动:

更多优惠>

当前主题:python网络爬虫获取页面内容并添加到采集

夹

相关话题:

Python网络爬虫获取与页面内容相关的博客 查看更多博客

精通Python网络爬虫:核心技术、框架及项目实战。3.1 网络爬虫实现原理详解

作者:华章电脑 3448人浏览评论:04年前

摘要 通过前面几章的学习,我们已经基本了解了网络爬虫,那么网络爬虫应该如何实现呢?核心技术是什么?在本文中,我们将首先介绍网络爬虫的相关实现原理和实现技术;然后,讲解Urllib库的相关实际内容;然后,带领大家一起开发几个典型的网络爬虫,让大家在实战项目中。

阅读全文

《精通Python网络爬虫:核心技术、框架与项目实战》-Part 1 理论基础第1章什么是网络爬虫1.1 初识网络爬虫

作者:华章电脑 2720人浏览评论:04年前

本节摘自华章出版社《精通Python网络爬虫:核心技术、框架与项目实战》一书第1章,1.1节,作者魏伟,更多章节可访问云 在Qi社区查看“华章电脑”的公众号。第一部分1理论基础第一章什么是网络爬虫第二章网络爬虫技能概述

阅读全文

开源python网络爬虫框架Scrapy

作者:shadowcat2385 浏览评论人数:05年前

来源: 简介: 所谓网络爬虫,就是一种在互联网上到处或有针对性地抓取数据的程序。当然,这种说法是不够专业的。更专业的描述是抓取特定网站页面的HTML数据。但因为一个

阅读全文

浅谈Python网络爬虫

作者:小科技专家2076人浏览评论:04年前

相关背景 网络蜘蛛,又称网络蜘蛛或网络机器人,是一种用于自动采集

网站数据的程序。如果把互联网比作蜘蛛网,那么蜘蛛就是在网上爬行的蜘蛛。网络爬虫不仅可以为搜索引擎采集

网络信息,还可以作为定向信息采集

器采集

一定的

阅读全文

Python网络爬虫详细介绍

作者:yunqi2 浏览评论人数:02年前

什么是网络爬虫?网络爬虫又称网络蜘蛛,是指根据一定的规则在网络上爬取所需内容的脚本程序。众所周知,每个网页通常都收录

其他网页的入口,网络爬虫通过一个网站进入其他网站,获取需要的内容。优先声明:我们使用的python编译环境是PyCharm 一、 首先是一个网络爬虫

阅读全文

一篇文章教你使用Python网络爬虫获取电影天堂视频下载链接

作者:pythonAdvanced 1047人浏览评论:01年前

【一、项目背景】相信大家都有头疼的经历。下载电影需要很多努力,对吧?需要一一下载,无法直观的知道最近电影更新的状态。今天以电影天堂为例,更直观的展示给大家看自己喜欢的电影并下载。【二、项目准备】首先,我们的第一步是安装一个Pyc

阅读全文

python网络爬虫(14)使用Scrapy搭建爬虫框架

作者:优惠码收到998人浏览评论:02年前

Python网络爬虫(14)使用Scrapy搭建爬虫框架。阅读目录内容。目的描述创建scrapy项目。一些介绍说明。创建爬虫模块-下载增强爬虫模块-分析增强爬虫模块-打包数据增强爬虫模块-翻页增强爬虫模块-存储增强爬虫模块-图片下载保存开始爬虫

阅读全文

一篇文章教你使用Python网络爬虫实现豆瓣电影采集

作者:pythonadvanced 11人浏览评论:01年前

【一、项目背景】豆瓣影业提供最新的电影介绍和影评,包括正在放映的电影的视频查询和购票服务。顺便可以录下想看的电影和电视剧,看,看,还可以写影评。它极大地方便了人们的生活。今天以电视剧(美剧)为例,批量抓取对应的电影,写入csv文件。用户可以更好的选择

阅读全文 查看全部

爬虫抓取网页数据(网络爬虫应该怎么实现?(图)Part1理论基础篇)

阿里云>云栖社区>主题图>P>python网络爬虫获取页面内容

推荐活动:

更多优惠>

当前主题:python网络爬虫获取页面内容并添加到采集

夹

相关话题:

Python网络爬虫获取与页面内容相关的博客 查看更多博客

精通Python网络爬虫:核心技术、框架及项目实战。3.1 网络爬虫实现原理详解

作者:华章电脑 3448人浏览评论:04年前

摘要 通过前面几章的学习,我们已经基本了解了网络爬虫,那么网络爬虫应该如何实现呢?核心技术是什么?在本文中,我们将首先介绍网络爬虫的相关实现原理和实现技术;然后,讲解Urllib库的相关实际内容;然后,带领大家一起开发几个典型的网络爬虫,让大家在实战项目中。

阅读全文

《精通Python网络爬虫:核心技术、框架与项目实战》-Part 1 理论基础第1章什么是网络爬虫1.1 初识网络爬虫

作者:华章电脑 2720人浏览评论:04年前

本节摘自华章出版社《精通Python网络爬虫:核心技术、框架与项目实战》一书第1章,1.1节,作者魏伟,更多章节可访问云 在Qi社区查看“华章电脑”的公众号。第一部分1理论基础第一章什么是网络爬虫第二章网络爬虫技能概述

阅读全文

开源python网络爬虫框架Scrapy

作者:shadowcat2385 浏览评论人数:05年前

来源: 简介: 所谓网络爬虫,就是一种在互联网上到处或有针对性地抓取数据的程序。当然,这种说法是不够专业的。更专业的描述是抓取特定网站页面的HTML数据。但因为一个

阅读全文

浅谈Python网络爬虫

作者:小科技专家2076人浏览评论:04年前

相关背景 网络蜘蛛,又称网络蜘蛛或网络机器人,是一种用于自动采集

网站数据的程序。如果把互联网比作蜘蛛网,那么蜘蛛就是在网上爬行的蜘蛛。网络爬虫不仅可以为搜索引擎采集

网络信息,还可以作为定向信息采集

器采集

一定的

阅读全文

Python网络爬虫详细介绍

作者:yunqi2 浏览评论人数:02年前

什么是网络爬虫?网络爬虫又称网络蜘蛛,是指根据一定的规则在网络上爬取所需内容的脚本程序。众所周知,每个网页通常都收录

其他网页的入口,网络爬虫通过一个网站进入其他网站,获取需要的内容。优先声明:我们使用的python编译环境是PyCharm 一、 首先是一个网络爬虫

阅读全文

一篇文章教你使用Python网络爬虫获取电影天堂视频下载链接

作者:pythonAdvanced 1047人浏览评论:01年前

【一、项目背景】相信大家都有头疼的经历。下载电影需要很多努力,对吧?需要一一下载,无法直观的知道最近电影更新的状态。今天以电影天堂为例,更直观的展示给大家看自己喜欢的电影并下载。【二、项目准备】首先,我们的第一步是安装一个Pyc

阅读全文

python网络爬虫(14)使用Scrapy搭建爬虫框架

作者:优惠码收到998人浏览评论:02年前

Python网络爬虫(14)使用Scrapy搭建爬虫框架。阅读目录内容。目的描述创建scrapy项目。一些介绍说明。创建爬虫模块-下载增强爬虫模块-分析增强爬虫模块-打包数据增强爬虫模块-翻页增强爬虫模块-存储增强爬虫模块-图片下载保存开始爬虫

阅读全文

一篇文章教你使用Python网络爬虫实现豆瓣电影采集

作者:pythonadvanced 11人浏览评论:01年前

【一、项目背景】豆瓣影业提供最新的电影介绍和影评,包括正在放映的电影的视频查询和购票服务。顺便可以录下想看的电影和电视剧,看,看,还可以写影评。它极大地方便了人们的生活。今天以电视剧(美剧)为例,批量抓取对应的电影,写入csv文件。用户可以更好的选择

阅读全文

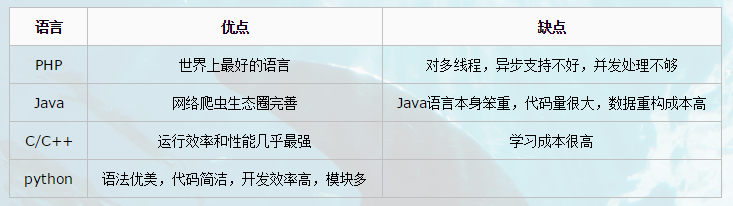

爬虫抓取网页数据(如何有效地提取网络爬虫、监视竞争对手或者获取销售线索)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-29 17:11

互联网已经成为海量信息的载体;互联网目前是分析市场趋势、监控竞争对手或获取销售线索的最佳场所。数据采集

和分析能力已成为推动业务决策的关键技能。

如何有效地提取和利用这些信息成为了一个巨大的挑战,而网络爬虫是一种很好的自动采集

数据的通用手段。本文将介绍爬虫的种类、爬虫的爬取策略以及深度学习爬虫所需的网络基础。

01 什么是爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常见的网络追逐者)是根据某些规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称包括蚂蚁、自动索引、模拟器或蠕虫。

网络爬虫通过抓取 Internet 上网络服务器的内容来工作。它是用计算机语言编写的程序或脚本,用于自动从互联网上获取信息或数据,扫描并抓取每个需要的页面上的一些信息,直到处理完所有可以正常打开的页面。

作为搜索引擎的重要组成部分,爬虫的主要功能是抓取网页数据(如图2-1所示)。目前市场上流行的采集器软件都利用了网络爬虫的原理或功能。

02 爬虫的含义

现在大数据时代已经到来,网络爬虫技术已经成为这个时代不可或缺的一部分。公司需要数据来分析用户行为、其产品的缺陷以及竞争对手的信息。所有这一切的第一个条件是数据。采集

。

网络爬虫的价值其实就是数据的价值。在互联网社会,数据是无价的。一切都是数据。谁拥有大量有用的数据,谁就拥有决策的主动权。网络爬虫的应用领域有很多,比如搜索引擎、数据采集、广告过滤、大数据分析等。

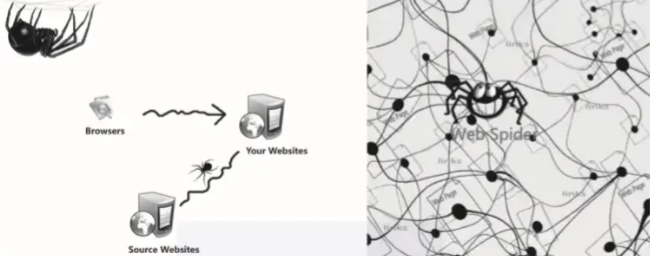

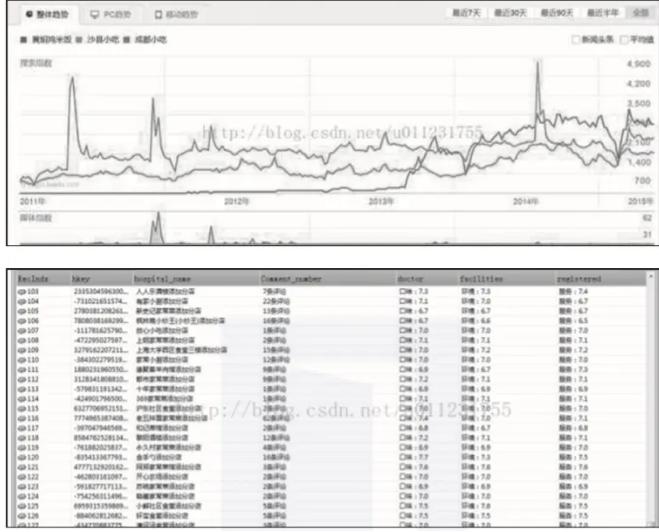

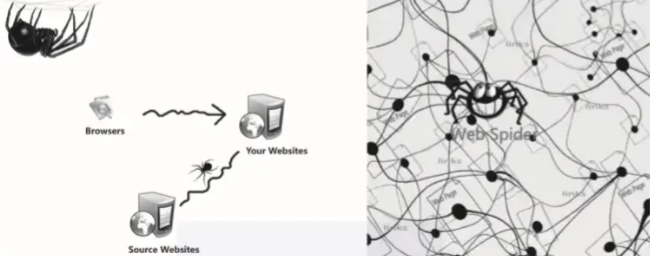

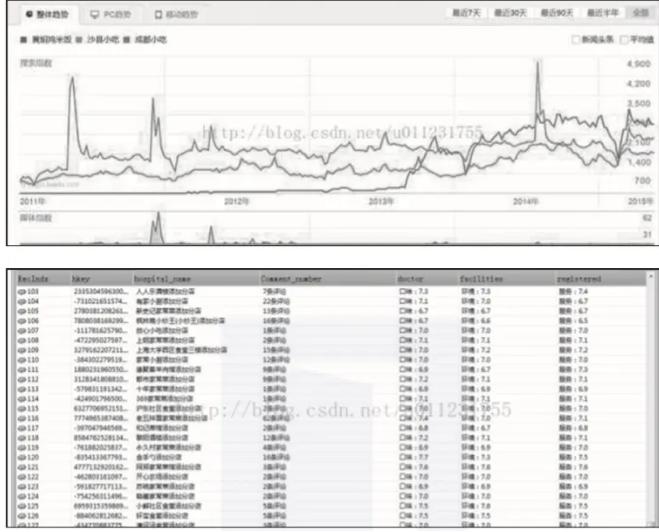

1) 抓取各大电商网站的产品销售信息和用户评论进行分析,如图2-2所示。

▲图2-2 电商网站产品销售信息

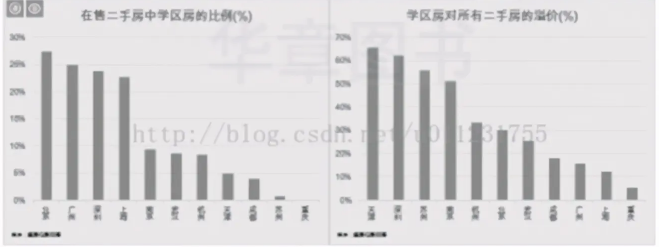

2)分析大众点评、美团等餐饮网站的用户消费、评价和发展趋势,如图2-3所示。

▲图2-3 餐饮网站用户消费信息

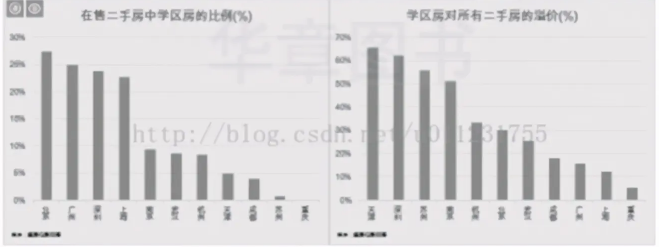

3)分析各城市中学区的房屋比例,学区房的价格比普通二手房高出多少,如图2-4所示。

▲图2-4 学区房占比及价格对比

以上数据是通过ForeSpider数据采集软件爬取的,有兴趣的读者可以尝试自己爬取一些数据。

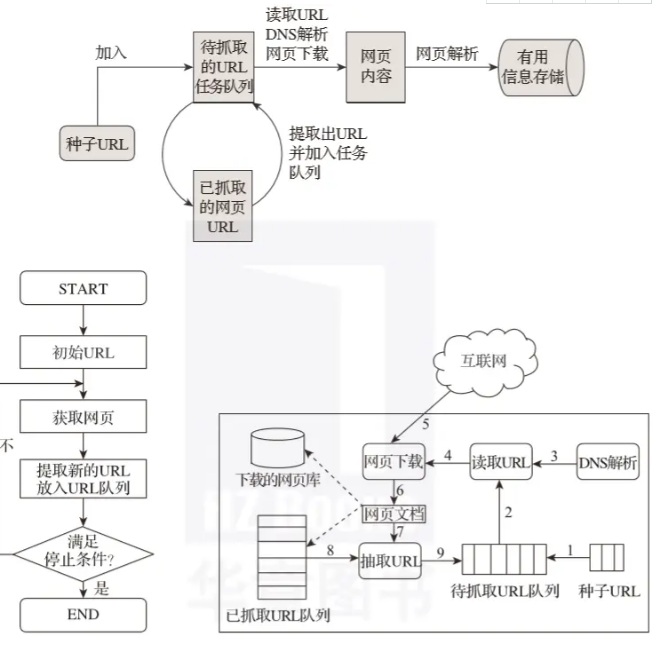

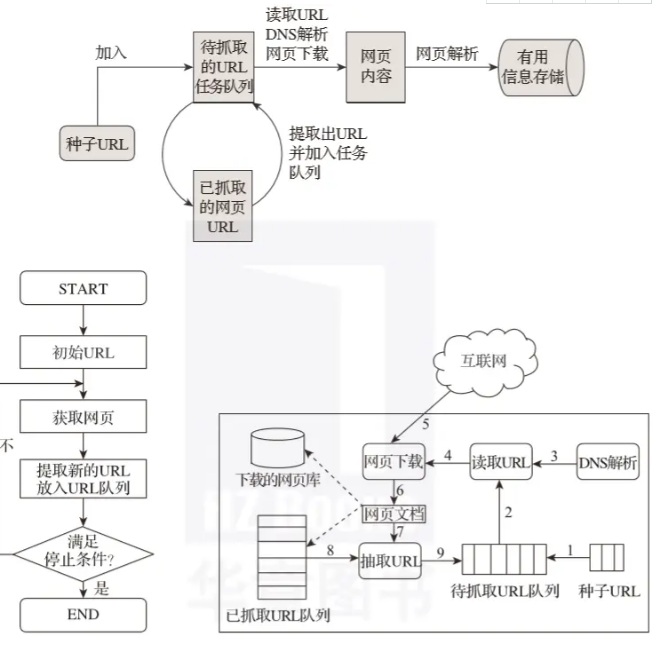

03 爬虫原理

我们通常将网络爬虫的组件模块分为初始链接库、网络爬取模块、网络处理模块、网络分析模块、DNS模块、待爬取的链接队列、网络库等。网络爬虫的每个系统模块可以组成一个循环系统进行持续分析和捕捉。

爬虫的工作原理可以简单的解释为先找到目标信息网络,然后是页面爬取模块,然后是页面分析模块,最后是数据存储模块。具体细节如图2-5所示。

▲图2-5 履带示意图

爬虫工作的基本过程:

首先在互联网上选择一部分网页,将这些网页的链接地址作为种子网址;

将这些种子URL放入待爬取的URL队列,爬虫从待爬取的URL队列中依次读取;

通过DNS解析URL;

将链接地址转换为web服务器对应的IP地址;

网页下载器通过网页服务器下载网页;

下载的网页为网页文件形式;

提取网页文档中的网址;

过滤掉已经爬取过的网址;

没有被爬取的URL继续循环爬取,直到待爬取的URL队列为空。

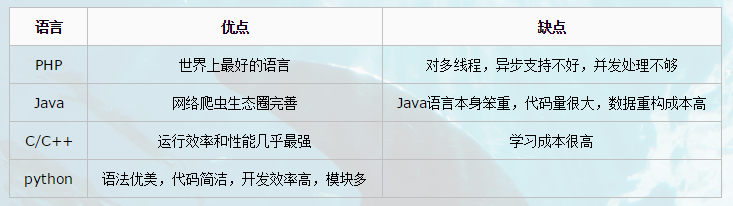

04 履带技术的种类

聚焦网络爬虫是“面向特定学科需求”的爬虫程序,而通用网络爬虫是搜索引擎爬虫系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是将互联网上的网页下载到本地,形成互联网内容的镜像备份。

增量爬取就是对某个站点的数据进行爬取。当网站的新数据或站点数据发生变化时,将自动捕获新的或变化的数据。

网页按其存在方式可分为表面网页(surface Web)和深层网页(又称隐形网页或隐藏网页)。

表面网页是指可以被传统搜索引擎收录的网页,即以超链接可以访问的静态网页为主的网页。

深层网页是那些大部分内容无法通过静态链接获取并隐藏在搜索表单后面的网页。只有用户可以提交一些关键词来获取网页。 查看全部

爬虫抓取网页数据(如何有效地提取网络爬虫、监视竞争对手或者获取销售线索)

互联网已经成为海量信息的载体;互联网目前是分析市场趋势、监控竞争对手或获取销售线索的最佳场所。数据采集

和分析能力已成为推动业务决策的关键技能。

如何有效地提取和利用这些信息成为了一个巨大的挑战,而网络爬虫是一种很好的自动采集

数据的通用手段。本文将介绍爬虫的种类、爬虫的爬取策略以及深度学习爬虫所需的网络基础。

01 什么是爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常见的网络追逐者)是根据某些规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称包括蚂蚁、自动索引、模拟器或蠕虫。

网络爬虫通过抓取 Internet 上网络服务器的内容来工作。它是用计算机语言编写的程序或脚本,用于自动从互联网上获取信息或数据,扫描并抓取每个需要的页面上的一些信息,直到处理完所有可以正常打开的页面。

作为搜索引擎的重要组成部分,爬虫的主要功能是抓取网页数据(如图2-1所示)。目前市场上流行的采集器软件都利用了网络爬虫的原理或功能。

02 爬虫的含义

现在大数据时代已经到来,网络爬虫技术已经成为这个时代不可或缺的一部分。公司需要数据来分析用户行为、其产品的缺陷以及竞争对手的信息。所有这一切的第一个条件是数据。采集

。

网络爬虫的价值其实就是数据的价值。在互联网社会,数据是无价的。一切都是数据。谁拥有大量有用的数据,谁就拥有决策的主动权。网络爬虫的应用领域有很多,比如搜索引擎、数据采集、广告过滤、大数据分析等。

1) 抓取各大电商网站的产品销售信息和用户评论进行分析,如图2-2所示。

▲图2-2 电商网站产品销售信息

2)分析大众点评、美团等餐饮网站的用户消费、评价和发展趋势,如图2-3所示。

▲图2-3 餐饮网站用户消费信息

3)分析各城市中学区的房屋比例,学区房的价格比普通二手房高出多少,如图2-4所示。

▲图2-4 学区房占比及价格对比

以上数据是通过ForeSpider数据采集软件爬取的,有兴趣的读者可以尝试自己爬取一些数据。

03 爬虫原理

我们通常将网络爬虫的组件模块分为初始链接库、网络爬取模块、网络处理模块、网络分析模块、DNS模块、待爬取的链接队列、网络库等。网络爬虫的每个系统模块可以组成一个循环系统进行持续分析和捕捉。

爬虫的工作原理可以简单的解释为先找到目标信息网络,然后是页面爬取模块,然后是页面分析模块,最后是数据存储模块。具体细节如图2-5所示。

▲图2-5 履带示意图

爬虫工作的基本过程:

首先在互联网上选择一部分网页,将这些网页的链接地址作为种子网址;

将这些种子URL放入待爬取的URL队列,爬虫从待爬取的URL队列中依次读取;

通过DNS解析URL;

将链接地址转换为web服务器对应的IP地址;

网页下载器通过网页服务器下载网页;

下载的网页为网页文件形式;

提取网页文档中的网址;

过滤掉已经爬取过的网址;

没有被爬取的URL继续循环爬取,直到待爬取的URL队列为空。

04 履带技术的种类

聚焦网络爬虫是“面向特定学科需求”的爬虫程序,而通用网络爬虫是搜索引擎爬虫系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是将互联网上的网页下载到本地,形成互联网内容的镜像备份。

增量爬取就是对某个站点的数据进行爬取。当网站的新数据或站点数据发生变化时,将自动捕获新的或变化的数据。

网页按其存在方式可分为表面网页(surface Web)和深层网页(又称隐形网页或隐藏网页)。

表面网页是指可以被传统搜索引擎收录的网页,即以超链接可以访问的静态网页为主的网页。

深层网页是那些大部分内容无法通过静态链接获取并隐藏在搜索表单后面的网页。只有用户可以提交一些关键词来获取网页。

爬虫抓取网页数据( 关于python爬虫实现爬取同一个网站的多页数据的实例内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-12-29 07:14

关于python爬虫实现爬取同一个网站的多页数据的实例内容)

python爬虫从同一个网站爬取多页数据的示例说明

更新时间:2021年1月18日14:15:47 作者:宋松

本文小编为大家整理了一个python爬虫从同一个网站爬取多页数据的例子。有兴趣的朋友可以学习参考。

对于一个网站的图片、文字、音频、视频等,如果我们一一下载,不仅浪费时间,还容易出错。Python爬虫帮助我们获取我们需要的数据,这些数据可以批量快速获取。本文小编带领大家通过python爬虫获取获取总页数和更改url的方法,实现对同一网站多页数据的爬取。

一、爬虫的目的

从 Internet 获取您需要的数据

二、爬取过程

1、获取url(网址)。

2、 发出请求并得到响应。

3、 提取数据。

4、保存数据。

三、 爬虫函数

批量快速获取你想要的数据,无需手动一一下载(图片、文字、音频、视频等)

四、 使用python爬虫爬取同一个网站的多页数据

1、需要定位标签,获取总页数

def get_page_size(soup):

pcxt=soup.find('div',{'class':'babynames-term-articles'}).find('nav')

pcxt1=pcxt.find('div',{'class':'nav-links'}).findAll('a')

for i in pcxt1[:-1]:

link=i.get('href')

s=str(i)

page=re.sub('','',page1)

page3=re.sub('','',page2)

pagesize=int(page3)

print(pagesize)

return pagesize

Pass

2、更改url访问网站,也就是写main函数

if __name__ == '__main__':

url="http://www.sheknows.com/baby-names/browse/a/"

soup=get_requests(url)

page=get_page_size(soup)

for i in range(1,page+1):

url1=url+"page/"+str(i)+"/"

soup1=get_requests(url1)

draw_base_list(soup1)

示例扩展:

import requests

from lxml import etree

import re

url="https://movie.douban.com/top250"

header = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.130 Safari/537.36"}

allMovieList=[]

flag = True

while flag:

html = requests.get(url, headers=header).text

list = etree.HTML(html)

lis = list.xpath('//ol[@class="grid_view"]/li')

for oneSelector in lis:

name = oneSelector.xpath("div/div[2]/div[1]/a/span[1]/text()")[0]

score = oneSelector.xpath("div/div[2]/div[2]/div/span[2]/text()")[0]

people = oneSelector.xpath("div/div[2]/div[2]/div/span[4]/text()")[0]

people = re.findall("(.*?)人评价",people)[0]

oneMovieList = [name,score,people]

allMovieList.append(oneMovieList)

#获取下一页地址

try:

next_url = list.xpath('//span[@class="next"]/a/@href')[0]

if next_url:

url = "https://movie.douban.com/top250"+ next_url

except:

flag = False

print(allMovieList)

至此,这篇关于python爬虫爬取同一个网站的多页数据的示例讲解的文章就介绍到这里了。更多相关python爬虫如何从同一个网站爬取多个页面的数据,请搜索脚本之家之前的文章或继续浏览下面的相关文章。希望大家以后多多支持Scripthome! 查看全部

爬虫抓取网页数据(

关于python爬虫实现爬取同一个网站的多页数据的实例内容)

python爬虫从同一个网站爬取多页数据的示例说明

更新时间:2021年1月18日14:15:47 作者:宋松

本文小编为大家整理了一个python爬虫从同一个网站爬取多页数据的例子。有兴趣的朋友可以学习参考。

对于一个网站的图片、文字、音频、视频等,如果我们一一下载,不仅浪费时间,还容易出错。Python爬虫帮助我们获取我们需要的数据,这些数据可以批量快速获取。本文小编带领大家通过python爬虫获取获取总页数和更改url的方法,实现对同一网站多页数据的爬取。

一、爬虫的目的

从 Internet 获取您需要的数据

二、爬取过程

1、获取url(网址)。

2、 发出请求并得到响应。

3、 提取数据。

4、保存数据。

三、 爬虫函数

批量快速获取你想要的数据,无需手动一一下载(图片、文字、音频、视频等)

四、 使用python爬虫爬取同一个网站的多页数据

1、需要定位标签,获取总页数

def get_page_size(soup):

pcxt=soup.find('div',{'class':'babynames-term-articles'}).find('nav')

pcxt1=pcxt.find('div',{'class':'nav-links'}).findAll('a')

for i in pcxt1[:-1]:

link=i.get('href')

s=str(i)

page=re.sub('','',page1)

page3=re.sub('','',page2)

pagesize=int(page3)

print(pagesize)

return pagesize

Pass

2、更改url访问网站,也就是写main函数

if __name__ == '__main__':

url="http://www.sheknows.com/baby-names/browse/a/"

soup=get_requests(url)

page=get_page_size(soup)

for i in range(1,page+1):

url1=url+"page/"+str(i)+"/"

soup1=get_requests(url1)

draw_base_list(soup1)

示例扩展:

import requests

from lxml import etree

import re

url="https://movie.douban.com/top250"

header = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.130 Safari/537.36"}

allMovieList=[]

flag = True

while flag:

html = requests.get(url, headers=header).text

list = etree.HTML(html)

lis = list.xpath('//ol[@class="grid_view"]/li')

for oneSelector in lis:

name = oneSelector.xpath("div/div[2]/div[1]/a/span[1]/text()")[0]