python网页数据抓取

python网页数据抓取(下拉下滑栏时会发送一个新异步发送URL(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-10-25 20:11

)

常见的动态数据是我们下拉滑动条时可以在网页上动态加载的新数据。例如,以下 网站:

我们继续下拉滑动条,新的数据会继续加载。但是网页的 URL 保持不变。但实际上,当我们下拉时,浏览器会发送一个新的异步请求来获取这些新数据,但是新的异步请求的 URL 并没有显示在浏览器上。因此,获取网页中动态数据的关键是获取异步发送的URL,并发现其格式规律。

获取异步发送的 URL

在 Chrome 上打开网页 -> 右键查看 -> 点击网络 -> 点击 XHR -> 下拉网页加载动态数据 -> 获取发送的请求 -> 获取请求头中的请求 URL 信息。

通过以上步骤,我们就获取到了异步请求的URL。通过分析,我们可以发现异步请求URL的区别在于“page=xx”部分。如果我们要抓取10条动态数据,那么我们需要10个URL,其中page的取值范围为1到10。完整的抓取代码如下。爬取的原理和之前一样,唯一不同的是URL是一个异步请求的URL。

from bs4 import BeautifulSoup

import requests

import time

url = 'https://knewone.com/discover?page='

def get_page(url,data=None):

wb_data = requests.get(url)

soup = BeautifulSoup(wb_data.text,'lxml')

imgs = soup.select('a.cover-inner > img')

titles = soup.select('section.content > h4 > a')

links = soup.select('section.content > h4 > a')

if data==None:

for img,title,link in zip(imgs,titles,links):

data = {

'img':img.get('src'),

'title':title.get('title'),

'link':link.get('href')

}

print(data)

def get_more_pages(start,end):

for one in range(start,end):

get_page(url+str(one))

time.sleep(2)

get_more_pages(1,10) 查看全部

python网页数据抓取(下拉下滑栏时会发送一个新异步发送URL(图)

)

常见的动态数据是我们下拉滑动条时可以在网页上动态加载的新数据。例如,以下 网站:

我们继续下拉滑动条,新的数据会继续加载。但是网页的 URL 保持不变。但实际上,当我们下拉时,浏览器会发送一个新的异步请求来获取这些新数据,但是新的异步请求的 URL 并没有显示在浏览器上。因此,获取网页中动态数据的关键是获取异步发送的URL,并发现其格式规律。

获取异步发送的 URL

在 Chrome 上打开网页 -> 右键查看 -> 点击网络 -> 点击 XHR -> 下拉网页加载动态数据 -> 获取发送的请求 -> 获取请求头中的请求 URL 信息。

通过以上步骤,我们就获取到了异步请求的URL。通过分析,我们可以发现异步请求URL的区别在于“page=xx”部分。如果我们要抓取10条动态数据,那么我们需要10个URL,其中page的取值范围为1到10。完整的抓取代码如下。爬取的原理和之前一样,唯一不同的是URL是一个异步请求的URL。

from bs4 import BeautifulSoup

import requests

import time

url = 'https://knewone.com/discover?page='

def get_page(url,data=None):

wb_data = requests.get(url)

soup = BeautifulSoup(wb_data.text,'lxml')

imgs = soup.select('a.cover-inner > img')

titles = soup.select('section.content > h4 > a')

links = soup.select('section.content > h4 > a')

if data==None:

for img,title,link in zip(imgs,titles,links):

data = {

'img':img.get('src'),

'title':title.get('title'),

'link':link.get('href')

}

print(data)

def get_more_pages(start,end):

for one in range(start,end):

get_page(url+str(one))

time.sleep(2)

get_more_pages(1,10)

python网页数据抓取(N-Gram(有时也称为N元模型)(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2021-10-24 07:03

)

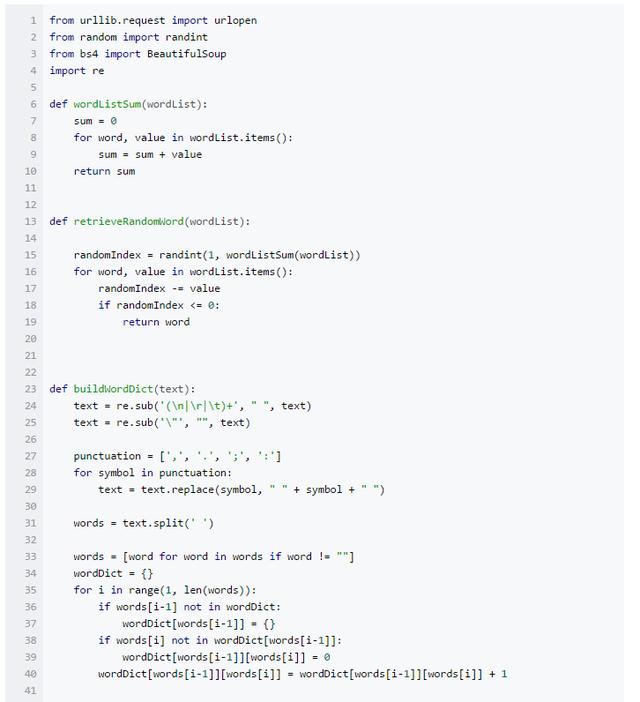

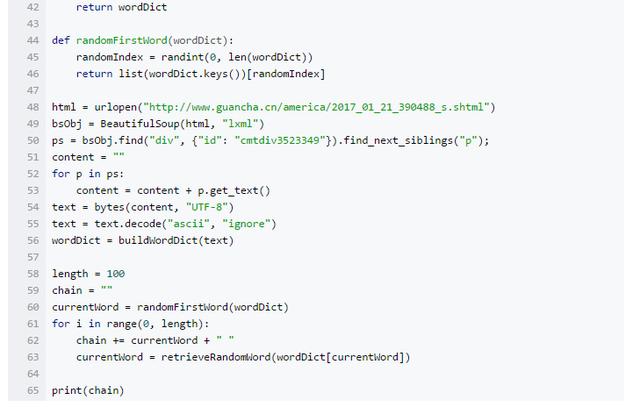

N-Gram

N-Gram(有时也称为 N-gram 模型)是自然语言处理中一个非常重要的概念。通常在 NLP 中,人们可以使用 N-Gram 根据一定的语料库来预测或评估一个句子是否合理。另一方面,N-Gram 的另一个功能是评估两个字符串之间的差异程度。这是模糊匹配中常用的方法。

美汤

简单来说,Beautiful Soup是一个python库,主要功能是抓取网页数据。官方解释如下:

Beautiful Soup 提供了一些简单的、python 风格的函数来处理导航、搜索、修改分析树和其他功能。它是一个工具箱,为用户提供需要通过解析文档来捕获的数据。由于其简单性,无需太多代码即可编写完整的应用程序。

Beautiful Soup 自动将输入文档转换为 Unicode 编码,输出文档为 utf-8 编码。不需要考虑编码方式,除非文档没有指定编码方式,此时Beautiful Soup无法自动识别编码方式。然后,您只需要解释原创编码方法。

Beautiful Soup 已成为与 lxml 和 html6lib 一样优秀的 Python 解释器,灵活地为用户提供不同的解析策略或强大的速度。

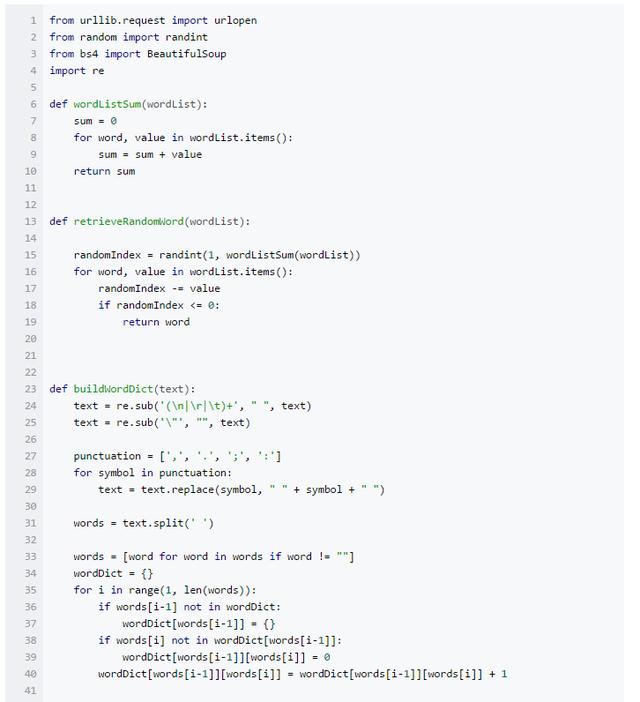

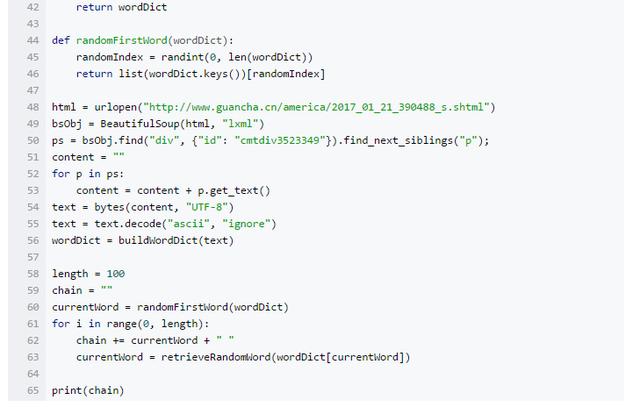

实战

下面的Python程序通过从网页中抓取一段文章,然后根据这个文章生成一个新的文章,其原理是基于概率的文本分析统计数据。小编为大家推荐一个学习交流群:708214004,群里有的人都快满了~遇到任何问题都可以交流!是个学习交流的好地方~如果你想从索欧进~各种PDF等你下载,全部免费,只为帮你快速上手。

过程大概是网络爬取数据->统计分析->生成新的文章。网页抓取数据就是通过BeautifulSoup库抓取网页上的文字内容。统计分析首先需要使用ngram模型对文章进行分段并统计频数。因为文章的生成主要是基于马尔可夫模型,所以使用了2-gram,这样可以统计一个词一个接一个出现的概率。new 文章 的生成基于对大量随机事件进行分析的马尔可夫模型。随机事件的特点是在一个离散事件发生后,在前一个事件的条件下,另一个离散事件会以一定的概率发生。

查看全部

python网页数据抓取(N-Gram(有时也称为N元模型)(组图)

)

N-Gram

N-Gram(有时也称为 N-gram 模型)是自然语言处理中一个非常重要的概念。通常在 NLP 中,人们可以使用 N-Gram 根据一定的语料库来预测或评估一个句子是否合理。另一方面,N-Gram 的另一个功能是评估两个字符串之间的差异程度。这是模糊匹配中常用的方法。

美汤

简单来说,Beautiful Soup是一个python库,主要功能是抓取网页数据。官方解释如下:

Beautiful Soup 提供了一些简单的、python 风格的函数来处理导航、搜索、修改分析树和其他功能。它是一个工具箱,为用户提供需要通过解析文档来捕获的数据。由于其简单性,无需太多代码即可编写完整的应用程序。

Beautiful Soup 自动将输入文档转换为 Unicode 编码,输出文档为 utf-8 编码。不需要考虑编码方式,除非文档没有指定编码方式,此时Beautiful Soup无法自动识别编码方式。然后,您只需要解释原创编码方法。

Beautiful Soup 已成为与 lxml 和 html6lib 一样优秀的 Python 解释器,灵活地为用户提供不同的解析策略或强大的速度。

实战

下面的Python程序通过从网页中抓取一段文章,然后根据这个文章生成一个新的文章,其原理是基于概率的文本分析统计数据。小编为大家推荐一个学习交流群:708214004,群里有的人都快满了~遇到任何问题都可以交流!是个学习交流的好地方~如果你想从索欧进~各种PDF等你下载,全部免费,只为帮你快速上手。

过程大概是网络爬取数据->统计分析->生成新的文章。网页抓取数据就是通过BeautifulSoup库抓取网页上的文字内容。统计分析首先需要使用ngram模型对文章进行分段并统计频数。因为文章的生成主要是基于马尔可夫模型,所以使用了2-gram,这样可以统计一个词一个接一个出现的概率。new 文章 的生成基于对大量随机事件进行分析的马尔可夫模型。随机事件的特点是在一个离散事件发生后,在前一个事件的条件下,另一个离散事件会以一定的概率发生。

python网页数据抓取(python2抓取网页的编码问题及解决办法编码的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2021-10-24 07:00

在使用python2抓取网页时,我们经常会遇到抓取到的内容出现乱码。

出现这种情况的最大可能是编码问题:运行环境的字符编码与网页的字符编码不一致。

例如,我在 windows 控制台 (gbk) 中抓取了一个 utf-8 编码的 网站。或者,在Mac/Linux终端中抓一个gbk编码的网站(utf-8)。因为大多数网站使用的是utf-8编码,而且很多人用的是Windows,所有这种情况相当普遍。

如果你发现你抓取的内容在英文、数字、符号上看起来都是正确的,但是中间出现了一些乱码,你基本可以断定是这样的。

解决这个问题的办法是先按照网页的编码方式将结果解码成unicode,然后输出。如果不确定网页的编码,可以参考以下代码:

导入 urllib

req = urllib.urlopen("")

信息 = ()

charset = info.getparam('charset')

内容 = req.read()

打印 content.decode(charset,'ignore')

'ignore' 参数的作用是忽略无法解码的字符。

然而,这种方法并不总是有效。另一种方式是通过正则化直接匹配网页代码中的编码设置:

除了编码问题导致的乱码外,还有一种情况经常被忽略,那就是登陆页面开启了gzip压缩。压缩后的网页传输的数据更少,打开速度更快。在浏览器中打开时,浏览器会根据网页的header信息自动解压。但是直接用代码去抢就不行了。所以,很可能会疑惑,为什么打开网页地址明了,但是程序爬取却不行。就连我自己也被这个问题愚弄了。

这种情况的表现就是抓取的内容几乎都是乱码,甚至无法显示。

判断网页是否开启压缩并解压,可以参考如下代码:

导入 urllib

导入 gzip

从 StringIO 导入 StringIO

req = urllib.urlopen("")

信息 = ()

encoding = info.getheader('Content-Encoding')

内容 = req.read()

如果编码 =='gzip':

buf = StringIO(内容)

gf = gzip.GzipFile(fileobj=buf)

内容 = gf.read()

印刷内容

在我们课堂上查看天气系列的编程实例中,这两个问题困扰了很多人。这里有一个特别的解释。

最后,还有另一个“武器”要介绍。如果你第一次使用它,你甚至不知道上面两个问题仍然存在。

这是请求模块。

以同样的方式抓取网页,您只需要:

进口请求

打印 requests.get("").text

没有编码问题,没有压缩问题。

这就是我喜欢 Python 的原因。

至于如何安装requests模块,请参考前面的文章: 查看全部

python网页数据抓取(python2抓取网页的编码问题及解决办法编码的方法)

在使用python2抓取网页时,我们经常会遇到抓取到的内容出现乱码。

出现这种情况的最大可能是编码问题:运行环境的字符编码与网页的字符编码不一致。

例如,我在 windows 控制台 (gbk) 中抓取了一个 utf-8 编码的 网站。或者,在Mac/Linux终端中抓一个gbk编码的网站(utf-8)。因为大多数网站使用的是utf-8编码,而且很多人用的是Windows,所有这种情况相当普遍。

如果你发现你抓取的内容在英文、数字、符号上看起来都是正确的,但是中间出现了一些乱码,你基本可以断定是这样的。

解决这个问题的办法是先按照网页的编码方式将结果解码成unicode,然后输出。如果不确定网页的编码,可以参考以下代码:

导入 urllib

req = urllib.urlopen("")

信息 = ()

charset = info.getparam('charset')

内容 = req.read()

打印 content.decode(charset,'ignore')

'ignore' 参数的作用是忽略无法解码的字符。

然而,这种方法并不总是有效。另一种方式是通过正则化直接匹配网页代码中的编码设置:

除了编码问题导致的乱码外,还有一种情况经常被忽略,那就是登陆页面开启了gzip压缩。压缩后的网页传输的数据更少,打开速度更快。在浏览器中打开时,浏览器会根据网页的header信息自动解压。但是直接用代码去抢就不行了。所以,很可能会疑惑,为什么打开网页地址明了,但是程序爬取却不行。就连我自己也被这个问题愚弄了。

这种情况的表现就是抓取的内容几乎都是乱码,甚至无法显示。

判断网页是否开启压缩并解压,可以参考如下代码:

导入 urllib

导入 gzip

从 StringIO 导入 StringIO

req = urllib.urlopen("")

信息 = ()

encoding = info.getheader('Content-Encoding')

内容 = req.read()

如果编码 =='gzip':

buf = StringIO(内容)

gf = gzip.GzipFile(fileobj=buf)

内容 = gf.read()

印刷内容

在我们课堂上查看天气系列的编程实例中,这两个问题困扰了很多人。这里有一个特别的解释。

最后,还有另一个“武器”要介绍。如果你第一次使用它,你甚至不知道上面两个问题仍然存在。

这是请求模块。

以同样的方式抓取网页,您只需要:

进口请求

打印 requests.get("").text

没有编码问题,没有压缩问题。

这就是我喜欢 Python 的原因。

至于如何安装requests模块,请参考前面的文章:

python网页数据抓取( Python/162717和前面一样的网页分析(一)-Python)

网站优化 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2021-10-24 06:20

Python/162717和前面一样的网页分析(一)-Python)

Python进阶多线程爬取网页项目实战

一、网络分析

这次我们选择爬取的网站是水木社区的Python页面

网页:#!board/Python?p=1

按照惯例,我们的第一步是分析页面结构和翻页请求。

分析前三个页面的链接后,我们知道每个页面的链接中最后一个参数是页数,我们可以修改它来获取其他页面的数据。

我们再分析一下,我们需要在id为body的section下拿到帖子的链接,然后一层一层的找到里面的表格,我们就可以遍历这些链接的标题了。

我们点击打开一个帖子:#!article/Python/162717

和之前一样,我们先分析一下网页中标题和内容的结构

不难发现,在subject section中,只需要找到b-head角下的第二个span和id为main的section下的class即可。

主题部分

在内容部分,只需找到类为 a-wrap 角的 div 并找到下面的 a-content。

内容部分

分析完页面的结构,我们就可以开始写代码了!

二、代码实现

首先确定要保存的内容:这次我们保存了水木社区Python版前面10页的所有帖子标题和帖子首页的所有回复。

解析列表页面以获取所有帖子链接

from bs4 import BeautifulSoup

# 解析列表页内容,得到这一页的内容链接

def parse_list_page(text):

soup = BeautifulSoup(text, 'html.parser')

# 下面相当于 soup.find('table', class_='board-list tiz').find('tbody')

tbody = soup.find('table', class_='board-list tiz').tbody

urls = []

for tr in tbody:

td = tr.find('td', class_='title_9')

urls.append(td.a.attrs['href'])

return urls

解析内容页面以获取该页面上的标题和所有帖子内容

# 解析内容页,得到标题和所有帖子内容

def parse_content_page(text):

soup = BeautifulSoup(text, 'html.parser')

title = soup.find('span', class_='n-left').text.strip('文章主题:').strip()

content_div = soup.find('div', class_='b-content corner')

contents = []

for awrap in content_div.find_all('div', class_='a-wrap corner'):

content = awrap.p.text

contents.append(content)

return title, contents

将列表页的链接转换成我们要抓取的链接

def convert_content_url(path):

URL_PREFIX = 'http://www.mysmth.net'

path += '?ajax'

return URL_PREFIX + path

为前 10 页生成列表页面链接

list_urls = []

for i in range(1, 11):

url = 'http://www.mysmth.net/nForum/board/Python?ajax&p='

url += str(i)

list_urls.append(url)

下面是获取前 10 页列表页面中所有文本的链接。这时候我们使用线程池来运行

import requests

from concurrent import futures

session = requests.Session()

executor = futures.ThreadPoolExecutor(max_workers=5)

# 这个函数获取列表页数据,解析出链接,并转换成真实链接

def get_content_urls(list_url):

res = session.get(list_url)

content_urls = parse_list_page(res.text)

real_content_urls = []

for url in content_urls:

url = convert_content_url(url)

real_content_urls.append(url)

return real_content_urls

# 根据刚刚生成的十个列表页链接,开始提交任务

fs = []

for list_url in list_urls:

fs.append(executor.submit(get_content_urls, list_url))

futures.wait(fs)

content_urls = set()

for f in fs:

for url in f.result():

content_urls.add(url)

这里需要注意的是,在第 23 行中我们使用了 set() 函数,该函数用于删除重复值。它的原理是创建一个Set,它是Python中的一种特殊数据类型,可以收录多个元素,但不能重复。我们来看看set()的用法

numbers = [1, 1, 2, 2, 2, 3, 4]

unique = set(numbers)

print(type(unique))

# 输出:

print(unique)

# 输出:{1, 2, 3, 4}

我们看到 set() 将列表编号转换为集合 {1, 2, 3, 4} 而没有重复元素。

我们使用这个特性首先在第 23 行用 content_urls = set() 创建一个空集,然后向它添加链接,它会自动删除多次出现的链接。

得到所有的文本链接后,我们解析文本页面的内容并放入字典中

# 获取正文页内容,解析出标题和帖子

def get_content(url):

r = session.get(url)

title, contents = parse_content_page(r.text)

return title, contents

# 提交解析正文的任务

fs = []

for url in content_urls:

fs.append(executor.submit(get_content, url))

futures.wait(fs)

results = {}

for f in fs:

title, contents = f.result()

results[title] = contents

print(results.keys())

这样,我们就完成了多线程的Mizuki社区爬虫。打印 results.keys() 以查看所有帖子的标题。

这次抓取了前十页的所有主题,以及他们的第一页回复。共解析了 10 个列表页、300 个主题页和 1533 条回复。在网络良好、性能正常的机器上,测试执行只用了大约 13 秒。

完整代码如下

import requests

from concurrent import futures

from bs4 import BeautifulSoup

# 解析列表页内容,得到这一页的内容链接

def parse_list_page(text):

soup = BeautifulSoup(text, 'html.parser')

tbody = soup.find('table', class_='board-list tiz').tbody

urls = []

for tr in tbody:

td = tr.find('td', class_='title_9')

urls.append(td.a.attrs['href'])

return urls

# 解析内容页,得到标题和所有帖子内容

def parse_content_page(text):

soup = BeautifulSoup(text, 'html.parser')

title = soup.find('span', class_='n-left').text.strip('文章主题:').strip()

content_div = soup.find('div', class_='b-content corner')

contents = []

for awrap in content_div.find_all('div', class_='a-wrap corner'):

content = awrap.p.text

contents.append(content)

return title, contents

# 把列表页得到的链接转换成我们要抓取的链接

def convert_content_url(path):

URL_PREFIX = 'http://www.mysmth.net'

path += '?ajax'

return URL_PREFIX + path

# 生成前十页的链接

list_urls = []

for i in range(1, 11):

url = 'http://www.mysmth.net/nForum/board/Python?ajax&p='

url += str(i)

list_urls.append(url)

session = requests.Session()

executor = futures.ThreadPoolExecutor(max_workers=5)

# 这个函数获取列表页数据,解析出链接,并转换成真实链接

def get_content_urls(list_url):

res = session.get(list_url)

content_urls = parse_list_page(res.text)

real_content_urls = []

for url in content_urls:

url = convert_content_url(url)

real_content_urls.append(url)

return real_content_urls

# 根据刚刚生成的十个列表页链接,开始提交任务

fs = []

for list_url in list_urls:

fs.append(executor.submit(get_content_urls, list_url))

futures.wait(fs)

content_urls = set()

for f in fs:

for url in f.result():

content_urls.add(url)

# 获取正文页内容,解析出标题和帖子

def get_content(url):

r = session.get(url)

title, contents = parse_content_page(r.text)

return title, contents

# 提交解析正文的任务

fs = []

for url in content_urls:

fs.append(executor.submit(get_content, url))

futures.wait(fs)

results = {}

for f in fs:

title, contents = f.result()

results[title] = contents

print(results.keys())

本次分享到此结束,感谢阅读!! 查看全部

python网页数据抓取(

Python/162717和前面一样的网页分析(一)-Python)

Python进阶多线程爬取网页项目实战

一、网络分析

这次我们选择爬取的网站是水木社区的Python页面

网页:#!board/Python?p=1

按照惯例,我们的第一步是分析页面结构和翻页请求。

分析前三个页面的链接后,我们知道每个页面的链接中最后一个参数是页数,我们可以修改它来获取其他页面的数据。

我们再分析一下,我们需要在id为body的section下拿到帖子的链接,然后一层一层的找到里面的表格,我们就可以遍历这些链接的标题了。

我们点击打开一个帖子:#!article/Python/162717

和之前一样,我们先分析一下网页中标题和内容的结构

不难发现,在subject section中,只需要找到b-head角下的第二个span和id为main的section下的class即可。

主题部分

在内容部分,只需找到类为 a-wrap 角的 div 并找到下面的 a-content。

内容部分

分析完页面的结构,我们就可以开始写代码了!

二、代码实现

首先确定要保存的内容:这次我们保存了水木社区Python版前面10页的所有帖子标题和帖子首页的所有回复。

解析列表页面以获取所有帖子链接

from bs4 import BeautifulSoup

# 解析列表页内容,得到这一页的内容链接

def parse_list_page(text):

soup = BeautifulSoup(text, 'html.parser')

# 下面相当于 soup.find('table', class_='board-list tiz').find('tbody')

tbody = soup.find('table', class_='board-list tiz').tbody

urls = []

for tr in tbody:

td = tr.find('td', class_='title_9')

urls.append(td.a.attrs['href'])

return urls

解析内容页面以获取该页面上的标题和所有帖子内容

# 解析内容页,得到标题和所有帖子内容

def parse_content_page(text):

soup = BeautifulSoup(text, 'html.parser')

title = soup.find('span', class_='n-left').text.strip('文章主题:').strip()

content_div = soup.find('div', class_='b-content corner')

contents = []

for awrap in content_div.find_all('div', class_='a-wrap corner'):

content = awrap.p.text

contents.append(content)

return title, contents

将列表页的链接转换成我们要抓取的链接

def convert_content_url(path):

URL_PREFIX = 'http://www.mysmth.net'

path += '?ajax'

return URL_PREFIX + path

为前 10 页生成列表页面链接

list_urls = []

for i in range(1, 11):

url = 'http://www.mysmth.net/nForum/board/Python?ajax&p='

url += str(i)

list_urls.append(url)

下面是获取前 10 页列表页面中所有文本的链接。这时候我们使用线程池来运行

import requests

from concurrent import futures

session = requests.Session()

executor = futures.ThreadPoolExecutor(max_workers=5)

# 这个函数获取列表页数据,解析出链接,并转换成真实链接

def get_content_urls(list_url):

res = session.get(list_url)

content_urls = parse_list_page(res.text)

real_content_urls = []

for url in content_urls:

url = convert_content_url(url)

real_content_urls.append(url)

return real_content_urls

# 根据刚刚生成的十个列表页链接,开始提交任务

fs = []

for list_url in list_urls:

fs.append(executor.submit(get_content_urls, list_url))

futures.wait(fs)

content_urls = set()

for f in fs:

for url in f.result():

content_urls.add(url)

这里需要注意的是,在第 23 行中我们使用了 set() 函数,该函数用于删除重复值。它的原理是创建一个Set,它是Python中的一种特殊数据类型,可以收录多个元素,但不能重复。我们来看看set()的用法

numbers = [1, 1, 2, 2, 2, 3, 4]

unique = set(numbers)

print(type(unique))

# 输出:

print(unique)

# 输出:{1, 2, 3, 4}

我们看到 set() 将列表编号转换为集合 {1, 2, 3, 4} 而没有重复元素。

我们使用这个特性首先在第 23 行用 content_urls = set() 创建一个空集,然后向它添加链接,它会自动删除多次出现的链接。

得到所有的文本链接后,我们解析文本页面的内容并放入字典中

# 获取正文页内容,解析出标题和帖子

def get_content(url):

r = session.get(url)

title, contents = parse_content_page(r.text)

return title, contents

# 提交解析正文的任务

fs = []

for url in content_urls:

fs.append(executor.submit(get_content, url))

futures.wait(fs)

results = {}

for f in fs:

title, contents = f.result()

results[title] = contents

print(results.keys())

这样,我们就完成了多线程的Mizuki社区爬虫。打印 results.keys() 以查看所有帖子的标题。

这次抓取了前十页的所有主题,以及他们的第一页回复。共解析了 10 个列表页、300 个主题页和 1533 条回复。在网络良好、性能正常的机器上,测试执行只用了大约 13 秒。

完整代码如下

import requests

from concurrent import futures

from bs4 import BeautifulSoup

# 解析列表页内容,得到这一页的内容链接

def parse_list_page(text):

soup = BeautifulSoup(text, 'html.parser')

tbody = soup.find('table', class_='board-list tiz').tbody

urls = []

for tr in tbody:

td = tr.find('td', class_='title_9')

urls.append(td.a.attrs['href'])

return urls

# 解析内容页,得到标题和所有帖子内容

def parse_content_page(text):

soup = BeautifulSoup(text, 'html.parser')

title = soup.find('span', class_='n-left').text.strip('文章主题:').strip()

content_div = soup.find('div', class_='b-content corner')

contents = []

for awrap in content_div.find_all('div', class_='a-wrap corner'):

content = awrap.p.text

contents.append(content)

return title, contents

# 把列表页得到的链接转换成我们要抓取的链接

def convert_content_url(path):

URL_PREFIX = 'http://www.mysmth.net'

path += '?ajax'

return URL_PREFIX + path

# 生成前十页的链接

list_urls = []

for i in range(1, 11):

url = 'http://www.mysmth.net/nForum/board/Python?ajax&p='

url += str(i)

list_urls.append(url)

session = requests.Session()

executor = futures.ThreadPoolExecutor(max_workers=5)

# 这个函数获取列表页数据,解析出链接,并转换成真实链接

def get_content_urls(list_url):

res = session.get(list_url)

content_urls = parse_list_page(res.text)

real_content_urls = []

for url in content_urls:

url = convert_content_url(url)

real_content_urls.append(url)

return real_content_urls

# 根据刚刚生成的十个列表页链接,开始提交任务

fs = []

for list_url in list_urls:

fs.append(executor.submit(get_content_urls, list_url))

futures.wait(fs)

content_urls = set()

for f in fs:

for url in f.result():

content_urls.add(url)

# 获取正文页内容,解析出标题和帖子

def get_content(url):

r = session.get(url)

title, contents = parse_content_page(r.text)

return title, contents

# 提交解析正文的任务

fs = []

for url in content_urls:

fs.append(executor.submit(get_content, url))

futures.wait(fs)

results = {}

for f in fs:

title, contents = f.result()

results[title] = contents

print(results.keys())

本次分享到此结束,感谢阅读!!

python网页数据抓取(Python爬虫的基本概念性的知识。(一)的概念性)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-10-23 22:14

今天我们将讲解python的基本概念知识。很多刚接触python的朋友有很多疑问,什么是python爬虫?那为什么python被称为爬虫呢?

什么是python爬虫?

在进入文章之前,我们首先要知道什么是爬虫。爬虫,或者网络爬虫,可以理解为在互联网上爬行的蜘蛛。互联网就像一张大网,爬虫就是在这个网上爬来爬去的蜘蛛。如果它遇到自己的猎物(必需资源),那么它就会抓住它。比如它在爬一个网页,他在这个网上找到了一条路,其实就是一个网页的超链接,然后就可以爬到另一个网页上获取数据了。如果不是很容易理解,其实可以通过下图来理解:

由于python的脚本特性,python易于配置,对字符的处理也非常灵活。另外python有丰富的网络捕捉模块,所以两者经常联系在一起。Python爬虫开发工程师,从某个页面(通常是首页)开始,读取网页内容,找到网页中的其他链接地址,然后利用这些链接地址查找下一个网页,等等. , 直到这个网站的所有网页都被抓取完毕。如果把整个互联网看作一个网站,那么网络蜘蛛就可以利用这个原理抓取互联网上的所有网页。

爬虫可以抓取某个网站或某个应用的内容来提取有用的价值。还可以模拟用户在浏览器或App应用上的操作,实现程序自动化。使用爬虫可以实现以下行为:

抢票神器

投票神器

预测(股市预测、票房预测)

民族情绪分析

社交网络

如上所述,我们可以认为爬虫一般指的是对网络资源的爬取。由于python的脚本特性和易于配置,在字符处理上也非常灵活。此外,python还有丰富的网络捕捉模块。所以两者经常联系在一起。这就是为什么python被称为爬虫。

为什么python被称为爬虫?

作为一种编程语言,Python 是纯自由软件。它因其简洁明了的语法以及句子缩进强制使用空格而深受程序员的喜爱。举个例子:完成一个任务,总共需要用C语言写1000行代码,用Java写100行代码,用Python写20行代码。如果你使用python来完成编程任务,你编写的代码量更少,代码简洁、简短、可读性更强。一个团队在开发的时候,读别人的代码会更快,开发效率会更高,工作也会更有效率。

这是一种非常适合开发网络爬虫的编程语言,相比其他静态编程语言,Python 有更简单的抓取网络文档的界面;与其他动态脚本语言相比,Python 的 urllib2 包提供了更完整的 Web 文档访问 API。另外python中有优秀的第三方包,可以高效的实现网页抓取,可以用很短的代码完成网页的标签过滤功能。

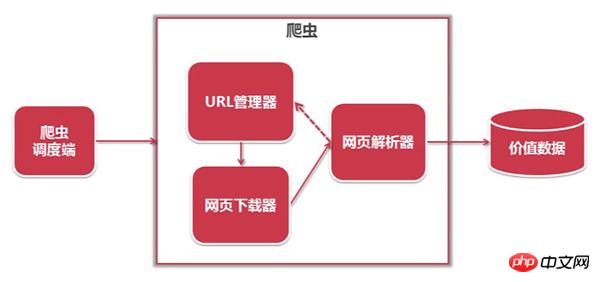

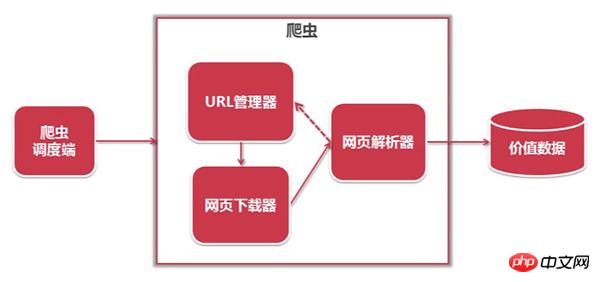

python爬虫的结构如下:

1. 网址管理器:管理待抓取网址的集合和已抓取网址的集合,并将待抓取的网址发送给网页下载器;

2. 网页下载器:抓取url对应的网页,存储为字符串,发送给网页解析器;

3. 网页解析器:解析出有价值的数据并存储,同时将url添加到URL管理器中。

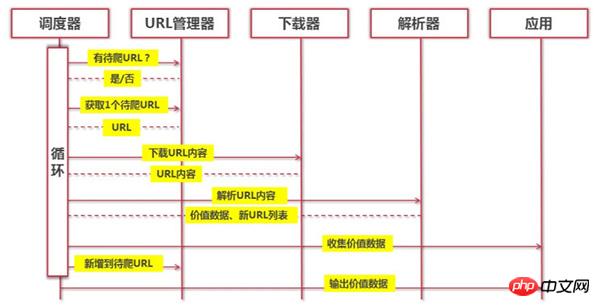

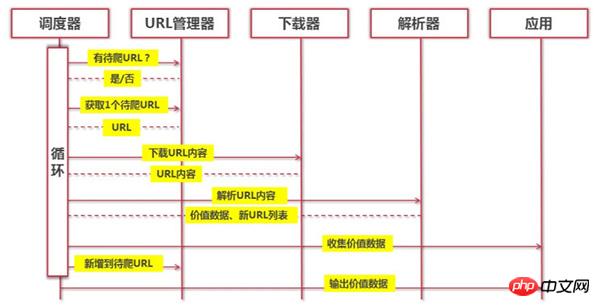

python的工作流程如下:

(Python爬虫通过URL管理器判断是否有需要爬取的URL,如果有需要爬取的URL,则通过dispatcher传递给下载器,下载URL内容,通过Dispatcher,解析 URL 内容,并结合 value 数据和通过 Dispatcher 将新的 URL 列表传递给应用程序并输出 value 信息的过程。)

Python是一种非常适合开发网络爬虫的编程语言。提供了urllib、re、json、pyquery等模块,同时还有很多成型框架,如Scrapy框架、PySpider爬虫系统等,本身就非常简单方便。它是网络爬虫首选的编程语言!希望这篇文章可以为刚接触python语言的朋友提供一些帮助。

以上是什么是python爬虫?为什么python被称为爬虫?更多详情请关注其他相关php中文网文章!

免责声明:本文原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何疑问,请与我们联系 查看全部

python网页数据抓取(Python爬虫的基本概念性的知识。(一)的概念性)

今天我们将讲解python的基本概念知识。很多刚接触python的朋友有很多疑问,什么是python爬虫?那为什么python被称为爬虫呢?

什么是python爬虫?

在进入文章之前,我们首先要知道什么是爬虫。爬虫,或者网络爬虫,可以理解为在互联网上爬行的蜘蛛。互联网就像一张大网,爬虫就是在这个网上爬来爬去的蜘蛛。如果它遇到自己的猎物(必需资源),那么它就会抓住它。比如它在爬一个网页,他在这个网上找到了一条路,其实就是一个网页的超链接,然后就可以爬到另一个网页上获取数据了。如果不是很容易理解,其实可以通过下图来理解:

由于python的脚本特性,python易于配置,对字符的处理也非常灵活。另外python有丰富的网络捕捉模块,所以两者经常联系在一起。Python爬虫开发工程师,从某个页面(通常是首页)开始,读取网页内容,找到网页中的其他链接地址,然后利用这些链接地址查找下一个网页,等等. , 直到这个网站的所有网页都被抓取完毕。如果把整个互联网看作一个网站,那么网络蜘蛛就可以利用这个原理抓取互联网上的所有网页。

爬虫可以抓取某个网站或某个应用的内容来提取有用的价值。还可以模拟用户在浏览器或App应用上的操作,实现程序自动化。使用爬虫可以实现以下行为:

抢票神器

投票神器

预测(股市预测、票房预测)

民族情绪分析

社交网络

如上所述,我们可以认为爬虫一般指的是对网络资源的爬取。由于python的脚本特性和易于配置,在字符处理上也非常灵活。此外,python还有丰富的网络捕捉模块。所以两者经常联系在一起。这就是为什么python被称为爬虫。

为什么python被称为爬虫?

作为一种编程语言,Python 是纯自由软件。它因其简洁明了的语法以及句子缩进强制使用空格而深受程序员的喜爱。举个例子:完成一个任务,总共需要用C语言写1000行代码,用Java写100行代码,用Python写20行代码。如果你使用python来完成编程任务,你编写的代码量更少,代码简洁、简短、可读性更强。一个团队在开发的时候,读别人的代码会更快,开发效率会更高,工作也会更有效率。

这是一种非常适合开发网络爬虫的编程语言,相比其他静态编程语言,Python 有更简单的抓取网络文档的界面;与其他动态脚本语言相比,Python 的 urllib2 包提供了更完整的 Web 文档访问 API。另外python中有优秀的第三方包,可以高效的实现网页抓取,可以用很短的代码完成网页的标签过滤功能。

python爬虫的结构如下:

1. 网址管理器:管理待抓取网址的集合和已抓取网址的集合,并将待抓取的网址发送给网页下载器;

2. 网页下载器:抓取url对应的网页,存储为字符串,发送给网页解析器;

3. 网页解析器:解析出有价值的数据并存储,同时将url添加到URL管理器中。

python的工作流程如下:

(Python爬虫通过URL管理器判断是否有需要爬取的URL,如果有需要爬取的URL,则通过dispatcher传递给下载器,下载URL内容,通过Dispatcher,解析 URL 内容,并结合 value 数据和通过 Dispatcher 将新的 URL 列表传递给应用程序并输出 value 信息的过程。)

Python是一种非常适合开发网络爬虫的编程语言。提供了urllib、re、json、pyquery等模块,同时还有很多成型框架,如Scrapy框架、PySpider爬虫系统等,本身就非常简单方便。它是网络爬虫首选的编程语言!希望这篇文章可以为刚接触python语言的朋友提供一些帮助。

以上是什么是python爬虫?为什么python被称为爬虫?更多详情请关注其他相关php中文网文章!

免责声明:本文原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何疑问,请与我们联系

python网页数据抓取(Python中的正则表达式教程输出结果及总结表(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-10-22 18:16

摘要:本文讲了三种使用Python抓取网页数据的方法;它们是正则表达式 (re)、BeautifulSoup 模块和 lxml 模块。本文所有代码运行在python3.5.

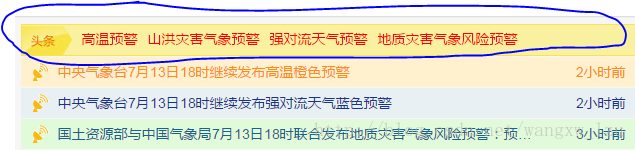

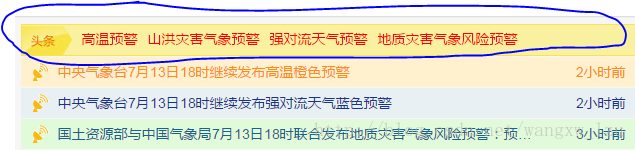

本文抓取的是[中央气象台](http://www.nmc.cn/)首页头条信息:

HTML 层次结构是:

抓取 href、标题和标签的内容。

一、正则表达式

复制外层HTML:

高温预警

代码:

<p># coding=utf-8

import re, urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

html = html.decode('utf-8') #python3版本中需要加入

links = re.findall(' 查看全部

python网页数据抓取(Python中的正则表达式教程输出结果及总结表(一))

摘要:本文讲了三种使用Python抓取网页数据的方法;它们是正则表达式 (re)、BeautifulSoup 模块和 lxml 模块。本文所有代码运行在python3.5.

本文抓取的是[中央气象台](http://www.nmc.cn/)首页头条信息:

HTML 层次结构是:

抓取 href、标题和标签的内容。

一、正则表达式

复制外层HTML:

高温预警

代码:

<p># coding=utf-8

import re, urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

html = html.decode('utf-8') #python3版本中需要加入

links = re.findall('

python网页数据抓取(三种抓取网页数据的方法-2.Beautiful)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-10-21 16:03

下面我们将介绍三种抓取网页数据的方法,首先是正则表达式,然后是流行的BeautifulSoup模块,最后是强大的lxml模块。

1. 正则表达式

如果您对正则表达式不熟悉,或者需要一些提示,可以参考正则表达式 HOWTO 中的完整介绍。

当我们使用正则表达式抓取国家/地区数据时,首先要尽量匹配元素的内容,如下图:

>>> import re

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> re.findall(\'(.*?)\', html)

[\'/places/static/images/flags/gb.png\', \'244,820 square kilometres\', \'62,348,447\', \'GB\', \'United Kingdom\', \'London\', \'EU\', \'.uk\', \'GBP\', \'Pound\', \'44\', \'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA\', \'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$\', \'en-GB,cy-GB,gd\', \'IE \']

>>>

从上面的结果可以看出,在很多国家属性中都使用了标签。为了隔离area属性,我们可以只选择第二个元素,如下图:

>>> re.findall(\'(.*?)\', html)[1]

\'244,820 square kilometres\'

虽然现在可以使用这个方案,但是如果网页发生变化,该方案很可能会失败。比如表变了,去掉了第二行的土地面积数据。如果我们现在只抓取数据,我们可以忽略这种可能的未来变化。但是,如果我们希望将来再次捕获数据,则需要提供更健壮的解决方案,以尽可能避免这种布局更改的影响。为了使正则表达式更加健壮,我们还可以添加其父元素。由于此元素具有 ID 属性,因此它应该是唯一的。

>>> re.findall(\'Area: (.*?)\', html)

[\'244,820 square kilometres\']

这个迭代版本看起来更好,但是还有很多其他的更新网页的方式,也会让正则表达式不尽人意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或者更改 area_label 等。以下是尝试支持这些可能性的改进版本。

>>> re.findall(\'.*?>> from bs4 import BeautifulSoup

>>> broken_html = \'

AreaPopulation\'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, \'html.parser\')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,Beautiful Soup可以正确解析缺失的引号并关闭标签。现在我们可以使用 find() 和 find_all() 方法来定位我们需要的元素。

>>> ul = soup.find(\'ul\', attrs={\'class\':\'country\'})

>>> ul.find(\'li\') # return just the first match

AreaPopulation

>>> ul.find_all(\'li\') # return all matches

[AreaPopulation, Population]

注:由于不同版本的Python内置库容错能力的差异,处理结果可能与上述不同。详情请参考:。如果想知道所有的方法和参数,可以参考Beautiful Soup的官方文档

以下是使用该方法提取样本国家面积数据的完整代码。

>>> from bs4 import BeautifulSoup

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> # locate the area row

>>> tr = soup.find(attrs={\'id\':\'places_area__row\'})

>>> # locate the area tag

>>> td = tr.find(attrs={\'class\':\'w2p_fw\'})

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

这段代码虽然比正则表达式代码复杂,但更容易构建和理解。此外,我们不需要担心布局的微小变化,例如额外的空间和标签属性。

3. Lxml

Lxml 是一个基于 libxml2(一个 XML 解析库)的 Python 包。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。可以参考最新的安装说明。**

与 Beautiful Soup 一样,使用 lxml 模块的第一步是将潜在的非法 HTML 解析为统一格式。以下是使用此模块解析不完整 HTML 的示例:

>>> import lxml.html

>>> broken_html = \'

AreaPopulation\'

>>> # parse the HTML

>>> tree = lxml.html.fromstring(broken_html)

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

同理,lxml 可以正确解析属性两边缺失的引号并关闭标签,但模块不会添加额外的和标签。

解析输入内容后,进入选择元素的步骤。这时候lxml有几种不同的方法,比如XPath选择器和类似于Beautiful Soup的find()方法。但是,我们以后会使用 CSS 选择器,因为它更简洁,可以在解析动态内容时重复使用。另外,一些有jQuery选择器使用经验的读者会比较熟悉。

以下是使用 lxml 的 CSS 选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect(\'tr#places_area__row > td.w2p_fw\')[0] # *行代码

>>> area = td.text_content()

>>> print area

244,820 square kilometres

*行代码会先找到id为places_area__row的表格行元素,然后选择class为w2p_fw的表格数据子标签。

CSS 选择器表示用于选择元素的模式。以下是一些常用选择器的示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link

选择 id="home" 的 标签: a#home

选择父元素为 标签的所有 子标签: a > span

选择 标签内部的所有 标签: a span

选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C 提出了 CSS3 规范,其网站是

Lxml 已经实现了大部分 CSS3 属性,不支持的功能可以在:。

注意:在 lxml 的内部实现中,它实际上是将 CSS 选择器转换为等效的 XPath 选择器。

4. 性能对比

下面的代码中,每个爬虫都会执行1000次,每次都会检查爬取结果是否正确,然后打印总时间。

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re

import timeit

from bs4 import BeautifulSoup

import lxml.html

FIELDS = (\'area\', \'population\', \'iso\', \'country\', \'capital\', \'continent\', \'tld\', \'currency_code\', \'currency_name\', \'phone\', \'postal_code_format\', \'postal_code_regex\', \'languages\', \'neighbours\')

def regex_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search(\'.*?(.*?)\'.format(field), html).groups()[0]

return results

def beautiful_soup_scraper(html):

soup = BeautifulSoup(html, \'html.parser\')

results = {}

for field in FIELDS:

results[field] = soup.find(\'table\').find(\'tr\', id=\'places_{}__row\'.format(field)).find(\'td\', class_=\'w2p_fw\').text

return results

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect(\'table > tr#places_{}__row > td.w2p_fw\'.format(field))[0].text_content()

return results

def main():

times = {}

html = urllib2.urlopen(\'http://example.webscraping.com/view/United-Kingdom-239\').read()

NUM_ITERATIONS = 1000 # number of times to test each scraper

for name, scraper in (\'Regular expressions\', regex_scraper), (\'Beautiful Soup\', beautiful_soup_scraper), (\'Lxml\', lxml_scraper):

times[name] = []

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == regex_scraper:

# the regular expression module will cache results

# so need to purge this cache for meaningful timings

re.purge() # *行代码

result = scraper(html)

# check scraped result is as expected

assert(result[\'area\'] == \'244,820 square kilometres\')

times[name].append(time.time() - start)

# record end time of scrape and output the total

end = time.time()

print \'{}: {:.2f} seconds\'.format(name, end - start)

writer = csv.writer(open(\'times.csv\', \'w\'))

header = sorted(times.keys())

writer.writerow(header)

for row in zip(*[times[scraper] for scraper in header]):

writer.writerow(row)

if __name__ == \'__main__\':

main()

请注意,我们在 * 代码行中调用了 re.purge() 方法。默认情况下,正则表达式将缓存搜索结果。公平地说,我们需要使用这种方法来清除缓存。

这是在我的电脑上运行脚本的结果:

由于硬件条件的不同,不同电脑的执行结果也会有一定的差异。但是,每种方法之间的相对差异应该具有可比性。从结果可以看出,在抓取我们的示例网页时,Beautiful Soup 比其他两种方法慢 7 倍以上。其实这个结果是符合预期的,因为lxml和正则表达式模块都是用C语言写的,而Beautiful Soup是用纯Python写的。一个有趣的事实是 lxml 的性能几乎与正则表达式一样好。由于 lxml 必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当抓取同一个网页的多个特征时,这个初步分析的开销会减少,lxml会更有竞争力。

5. 总结

三种网页抓取方式的优缺点:

抓取方式 性能 使用困难 安装困难

正则表达式

快的

困难

简单(内置模块)

美汤

减缓

简单的

简单(纯 Python)

xml文件

快的

简单的

比较难

如果你的爬虫的瓶颈是下载网页而不是提取数据,那么使用较慢的方法(比如Beautiful Soup)不是问题。正则表达式在一次性提取中非常有用,还可以避免解析整个网页的开销。如果你只需要爬取少量数据,又想避免额外的依赖,那么正则表达式可能更合适。但是,一般情况下,lxml 是捕获数据的最佳选择,因为它不仅速度更快,而且用途更广,而正则表达式和 Beautiful Soup 仅在某些场景下有用。 查看全部

python网页数据抓取(三种抓取网页数据的方法-2.Beautiful)

下面我们将介绍三种抓取网页数据的方法,首先是正则表达式,然后是流行的BeautifulSoup模块,最后是强大的lxml模块。

1. 正则表达式

如果您对正则表达式不熟悉,或者需要一些提示,可以参考正则表达式 HOWTO 中的完整介绍。

当我们使用正则表达式抓取国家/地区数据时,首先要尽量匹配元素的内容,如下图:

>>> import re

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> re.findall(\'(.*?)\', html)

[\'/places/static/images/flags/gb.png\', \'244,820 square kilometres\', \'62,348,447\', \'GB\', \'United Kingdom\', \'London\', \'EU\', \'.uk\', \'GBP\', \'Pound\', \'44\', \'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA\', \'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$\', \'en-GB,cy-GB,gd\', \'IE \']

>>>

从上面的结果可以看出,在很多国家属性中都使用了标签。为了隔离area属性,我们可以只选择第二个元素,如下图:

>>> re.findall(\'(.*?)\', html)[1]

\'244,820 square kilometres\'

虽然现在可以使用这个方案,但是如果网页发生变化,该方案很可能会失败。比如表变了,去掉了第二行的土地面积数据。如果我们现在只抓取数据,我们可以忽略这种可能的未来变化。但是,如果我们希望将来再次捕获数据,则需要提供更健壮的解决方案,以尽可能避免这种布局更改的影响。为了使正则表达式更加健壮,我们还可以添加其父元素。由于此元素具有 ID 属性,因此它应该是唯一的。

>>> re.findall(\'Area: (.*?)\', html)

[\'244,820 square kilometres\']

这个迭代版本看起来更好,但是还有很多其他的更新网页的方式,也会让正则表达式不尽人意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或者更改 area_label 等。以下是尝试支持这些可能性的改进版本。

>>> re.findall(\'.*?>> from bs4 import BeautifulSoup

>>> broken_html = \'

AreaPopulation\'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, \'html.parser\')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,Beautiful Soup可以正确解析缺失的引号并关闭标签。现在我们可以使用 find() 和 find_all() 方法来定位我们需要的元素。

>>> ul = soup.find(\'ul\', attrs={\'class\':\'country\'})

>>> ul.find(\'li\') # return just the first match

AreaPopulation

>>> ul.find_all(\'li\') # return all matches

[AreaPopulation, Population]

注:由于不同版本的Python内置库容错能力的差异,处理结果可能与上述不同。详情请参考:。如果想知道所有的方法和参数,可以参考Beautiful Soup的官方文档

以下是使用该方法提取样本国家面积数据的完整代码。

>>> from bs4 import BeautifulSoup

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> # locate the area row

>>> tr = soup.find(attrs={\'id\':\'places_area__row\'})

>>> # locate the area tag

>>> td = tr.find(attrs={\'class\':\'w2p_fw\'})

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

这段代码虽然比正则表达式代码复杂,但更容易构建和理解。此外,我们不需要担心布局的微小变化,例如额外的空间和标签属性。

3. Lxml

Lxml 是一个基于 libxml2(一个 XML 解析库)的 Python 包。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。可以参考最新的安装说明。**

与 Beautiful Soup 一样,使用 lxml 模块的第一步是将潜在的非法 HTML 解析为统一格式。以下是使用此模块解析不完整 HTML 的示例:

>>> import lxml.html

>>> broken_html = \'

AreaPopulation\'

>>> # parse the HTML

>>> tree = lxml.html.fromstring(broken_html)

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

同理,lxml 可以正确解析属性两边缺失的引号并关闭标签,但模块不会添加额外的和标签。

解析输入内容后,进入选择元素的步骤。这时候lxml有几种不同的方法,比如XPath选择器和类似于Beautiful Soup的find()方法。但是,我们以后会使用 CSS 选择器,因为它更简洁,可以在解析动态内容时重复使用。另外,一些有jQuery选择器使用经验的读者会比较熟悉。

以下是使用 lxml 的 CSS 选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect(\'tr#places_area__row > td.w2p_fw\')[0] # *行代码

>>> area = td.text_content()

>>> print area

244,820 square kilometres

*行代码会先找到id为places_area__row的表格行元素,然后选择class为w2p_fw的表格数据子标签。

CSS 选择器表示用于选择元素的模式。以下是一些常用选择器的示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link

选择 id="home" 的 标签: a#home

选择父元素为 标签的所有 子标签: a > span

选择 标签内部的所有 标签: a span

选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C 提出了 CSS3 规范,其网站是

Lxml 已经实现了大部分 CSS3 属性,不支持的功能可以在:。

注意:在 lxml 的内部实现中,它实际上是将 CSS 选择器转换为等效的 XPath 选择器。

4. 性能对比

下面的代码中,每个爬虫都会执行1000次,每次都会检查爬取结果是否正确,然后打印总时间。

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re

import timeit

from bs4 import BeautifulSoup

import lxml.html

FIELDS = (\'area\', \'population\', \'iso\', \'country\', \'capital\', \'continent\', \'tld\', \'currency_code\', \'currency_name\', \'phone\', \'postal_code_format\', \'postal_code_regex\', \'languages\', \'neighbours\')

def regex_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search(\'.*?(.*?)\'.format(field), html).groups()[0]

return results

def beautiful_soup_scraper(html):

soup = BeautifulSoup(html, \'html.parser\')

results = {}

for field in FIELDS:

results[field] = soup.find(\'table\').find(\'tr\', id=\'places_{}__row\'.format(field)).find(\'td\', class_=\'w2p_fw\').text

return results

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect(\'table > tr#places_{}__row > td.w2p_fw\'.format(field))[0].text_content()

return results

def main():

times = {}

html = urllib2.urlopen(\'http://example.webscraping.com/view/United-Kingdom-239\').read()

NUM_ITERATIONS = 1000 # number of times to test each scraper

for name, scraper in (\'Regular expressions\', regex_scraper), (\'Beautiful Soup\', beautiful_soup_scraper), (\'Lxml\', lxml_scraper):

times[name] = []

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == regex_scraper:

# the regular expression module will cache results

# so need to purge this cache for meaningful timings

re.purge() # *行代码

result = scraper(html)

# check scraped result is as expected

assert(result[\'area\'] == \'244,820 square kilometres\')

times[name].append(time.time() - start)

# record end time of scrape and output the total

end = time.time()

print \'{}: {:.2f} seconds\'.format(name, end - start)

writer = csv.writer(open(\'times.csv\', \'w\'))

header = sorted(times.keys())

writer.writerow(header)

for row in zip(*[times[scraper] for scraper in header]):

writer.writerow(row)

if __name__ == \'__main__\':

main()

请注意,我们在 * 代码行中调用了 re.purge() 方法。默认情况下,正则表达式将缓存搜索结果。公平地说,我们需要使用这种方法来清除缓存。

这是在我的电脑上运行脚本的结果:

由于硬件条件的不同,不同电脑的执行结果也会有一定的差异。但是,每种方法之间的相对差异应该具有可比性。从结果可以看出,在抓取我们的示例网页时,Beautiful Soup 比其他两种方法慢 7 倍以上。其实这个结果是符合预期的,因为lxml和正则表达式模块都是用C语言写的,而Beautiful Soup是用纯Python写的。一个有趣的事实是 lxml 的性能几乎与正则表达式一样好。由于 lxml 必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当抓取同一个网页的多个特征时,这个初步分析的开销会减少,lxml会更有竞争力。

5. 总结

三种网页抓取方式的优缺点:

抓取方式 性能 使用困难 安装困难

正则表达式

快的

困难

简单(内置模块)

美汤

减缓

简单的

简单(纯 Python)

xml文件

快的

简单的

比较难

如果你的爬虫的瓶颈是下载网页而不是提取数据,那么使用较慢的方法(比如Beautiful Soup)不是问题。正则表达式在一次性提取中非常有用,还可以避免解析整个网页的开销。如果你只需要爬取少量数据,又想避免额外的依赖,那么正则表达式可能更合适。但是,一般情况下,lxml 是捕获数据的最佳选择,因为它不仅速度更快,而且用途更广,而正则表达式和 Beautiful Soup 仅在某些场景下有用。

python网页数据抓取(先导入PythonCSV模块的使用方法及获取方法(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-10-21 15:22

获取我们的数据:

# 获取 Class 对应的标签

name_box = soup.find('h1', attrs={'class': 'name'})

一旦我们得到了标签,我们就可以使用 text 方法来获取里面的内容:

name = name_box.text.strip() # strip() 用来移除首尾的空白符

print name

同样,使用以下方法获取价格:

# 获取价格

price_box = soup.find('div', attrs={'class':'price'})

price = price_box.text

print price

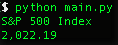

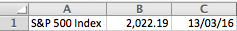

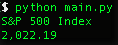

当您运行程序时,您应该能够看到标准普尔 500 指数的价格:

导出为 ExcelCSV 格式

接下来,我们需要导出采集的数据。在导出文件格式的选择上,Excel的CSV逗号分隔文档是一个不错的选择,可以直接通过Excel打开,进行简单的数据处理。

但是我们需要先导入Python CSV模块,请在您的模块导入区添加以下代码:

import csv

from datetime import datetime

在代码的最底部,添加以下代码:

# 添加内容,这样就不会替换掉老数据了

with open('index.csv', 'a') as csv_file:

writer = csv.writer(csv_file)

writer.writerow([name, price, datetime.now()])

现在当你允许该程序时,你可以看到一个 index.csv 文件,用 Excel 打开它,你可以看到类似的数据:

现在您可以使用该程序为您获取标准普尔 500 指数的价格数据。

更近一步(高级用户)

多个索引

抓取索引对您来说还不够有趣,对吧?我们可以尝试同时提取多个索引。

首先,将 quote_page 修改为 URL 数组。

quote_page = ['http://www.bloomberg.com/quote/SPX:IND', 'http://www.bloomberg.com/quote/CCMP:IND']

然后我们将数据抽取代码改成for循环,将这些URL一一处理,将所有数据以元组的形式存储在变量data中。

# for 循环

data = []

for pg in quote_page:

# 查询网站并将返回的 html 赋值给变量 `page`

page = urllib2.urlopen(pg)

# 使用 beautiful soap 解析 html 并存储在变量 `soup` 中。

soup = BeautifulSoup(page, 'html.parser')

# 拿出 标签的 name 并获取它的值

name_box = soup.find('h1', attrs={'class': 'name'})

name = name_box.text.strip() # strip() 用来一处开始和结尾的空白

# 获取索引的 price

price_box = soup.find('div', attrs={'class':'price'})

price = price_box.text

# 保存数据到元组

data.append((name, price))

另外,修改保存部分,逐行保存数据。

# 以添加模式打开一个 csv 文件,这样旧数据会被擦除

with open('index.csv', 'a') as csv_file:

writer = csv.writer(csv_file)

# for 循环

for name, price in data:

writer.writerow([name, price, datetime.now()])

重新运行程序,您应该可以同时提取两个索引!

先进的爬虫技术

BeautifulSoup 非常简单,非常适合小规模的网络爬虫。但是,如果您对更大规模地抓取数据感兴趣,则应该考虑以下其他替代方案:

Scrapy 是一个强大的 Python 爬虫框架,它试图将一些公共 API 集成到您的代码中。数据检索的效率远高于页面爬取的效率。例如,查看 Facebook Graph API,它将帮助您获取 Facebook 页面的隐藏数据。当数据量过大时,可以考虑使用类似于 MySQL 的数据库后端来存储您的数据。采用 DRY 方法

DRY 的意思是“不要重复自己”,并尝试像这个人一样自动化你的日常工作。其他一些有趣的项目可能会考虑跟踪您的 Facebook 好友的活跃时间(当然在他们同意的情况下),或者获取论坛主题列表并尝试自然语言处理(这是当前人工智能的热门话题)!

如果您有任何问题,请随时在下面留言。

参考\

\

本文所有翻译仅供学习交流使用,转载请务必注明译者、出处及本文链接

我们的翻译工作符合 CC 协议。如果我们的工作侵犯了您的权益,请及时与我们联系。 查看全部

python网页数据抓取(先导入PythonCSV模块的使用方法及获取方法(图))

获取我们的数据:

# 获取 Class 对应的标签

name_box = soup.find('h1', attrs={'class': 'name'})

一旦我们得到了标签,我们就可以使用 text 方法来获取里面的内容:

name = name_box.text.strip() # strip() 用来移除首尾的空白符

print name

同样,使用以下方法获取价格:

# 获取价格

price_box = soup.find('div', attrs={'class':'price'})

price = price_box.text

print price

当您运行程序时,您应该能够看到标准普尔 500 指数的价格:

导出为 ExcelCSV 格式

接下来,我们需要导出采集的数据。在导出文件格式的选择上,Excel的CSV逗号分隔文档是一个不错的选择,可以直接通过Excel打开,进行简单的数据处理。

但是我们需要先导入Python CSV模块,请在您的模块导入区添加以下代码:

import csv

from datetime import datetime

在代码的最底部,添加以下代码:

# 添加内容,这样就不会替换掉老数据了

with open('index.csv', 'a') as csv_file:

writer = csv.writer(csv_file)

writer.writerow([name, price, datetime.now()])

现在当你允许该程序时,你可以看到一个 index.csv 文件,用 Excel 打开它,你可以看到类似的数据:

现在您可以使用该程序为您获取标准普尔 500 指数的价格数据。

更近一步(高级用户)

多个索引

抓取索引对您来说还不够有趣,对吧?我们可以尝试同时提取多个索引。

首先,将 quote_page 修改为 URL 数组。

quote_page = ['http://www.bloomberg.com/quote/SPX:IND', 'http://www.bloomberg.com/quote/CCMP:IND']

然后我们将数据抽取代码改成for循环,将这些URL一一处理,将所有数据以元组的形式存储在变量data中。

# for 循环

data = []

for pg in quote_page:

# 查询网站并将返回的 html 赋值给变量 `page`

page = urllib2.urlopen(pg)

# 使用 beautiful soap 解析 html 并存储在变量 `soup` 中。

soup = BeautifulSoup(page, 'html.parser')

# 拿出 标签的 name 并获取它的值

name_box = soup.find('h1', attrs={'class': 'name'})

name = name_box.text.strip() # strip() 用来一处开始和结尾的空白

# 获取索引的 price

price_box = soup.find('div', attrs={'class':'price'})

price = price_box.text

# 保存数据到元组

data.append((name, price))

另外,修改保存部分,逐行保存数据。

# 以添加模式打开一个 csv 文件,这样旧数据会被擦除

with open('index.csv', 'a') as csv_file:

writer = csv.writer(csv_file)

# for 循环

for name, price in data:

writer.writerow([name, price, datetime.now()])

重新运行程序,您应该可以同时提取两个索引!

先进的爬虫技术

BeautifulSoup 非常简单,非常适合小规模的网络爬虫。但是,如果您对更大规模地抓取数据感兴趣,则应该考虑以下其他替代方案:

Scrapy 是一个强大的 Python 爬虫框架,它试图将一些公共 API 集成到您的代码中。数据检索的效率远高于页面爬取的效率。例如,查看 Facebook Graph API,它将帮助您获取 Facebook 页面的隐藏数据。当数据量过大时,可以考虑使用类似于 MySQL 的数据库后端来存储您的数据。采用 DRY 方法

DRY 的意思是“不要重复自己”,并尝试像这个人一样自动化你的日常工作。其他一些有趣的项目可能会考虑跟踪您的 Facebook 好友的活跃时间(当然在他们同意的情况下),或者获取论坛主题列表并尝试自然语言处理(这是当前人工智能的热门话题)!

如果您有任何问题,请随时在下面留言。

参考\

\

本文所有翻译仅供学习交流使用,转载请务必注明译者、出处及本文链接

我们的翻译工作符合 CC 协议。如果我们的工作侵犯了您的权益,请及时与我们联系。

python网页数据抓取(Pandas库有一种内置的方法,可以从名为_html中提取表格数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-10-20 18:21

翻译丨糖水

@ageitgey/quick-tip-the-easiest-way-to-grab-data-out-of-a-web-page-in-python-7153cecfca58

假设您在 Internet 上搜索某个项目所需的原创数据,但坏消息是该数据存在于网络上,并且没有可用的 API 来获取原创数据。

所以现在你不得不浪费 30 分钟编写脚本来获取数据(最后花了 2 小时)。

这并不难,但很浪费时间。

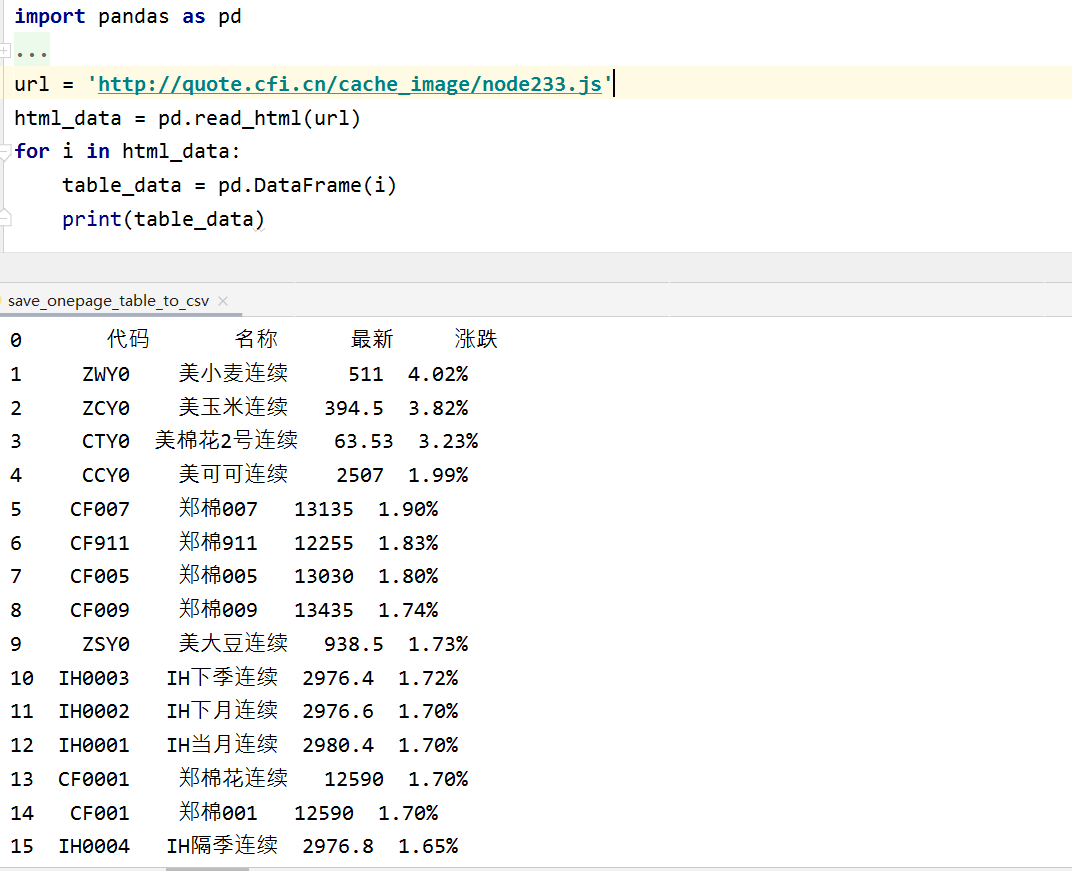

Pandas 库有一个内置方法可以从名为 read_html() 的 html 页面中提取表格数据:

就是这么简单!Pandas 可以找到页面上所有重要的 html 表格,并将它们作为新的 DataFrame 对象返回。

#数据框

输入表单 0 行有列标题,并要求它将基于文本的日期转换为时间对象:

得到:

是一行代码,数据不能作为json记录。

运行以下代码,您将获得漂亮的 json 输出(即使使用正确的 ISO 8601 日期格式):

您甚至可以将数据保存到 CSV 或 XLS 文件中:

运行并双击 call.csv 以在电子表格中打开它:

当然,Pandas 还可以更简单地过滤、分类或处理数据:

推荐↓↓↓

千山万水总相爱,能不能订个“好看” 查看全部

python网页数据抓取(Pandas库有一种内置的方法,可以从名为_html中提取表格数据)

翻译丨糖水

@ageitgey/quick-tip-the-easiest-way-to-grab-data-out-of-a-web-page-in-python-7153cecfca58

假设您在 Internet 上搜索某个项目所需的原创数据,但坏消息是该数据存在于网络上,并且没有可用的 API 来获取原创数据。

所以现在你不得不浪费 30 分钟编写脚本来获取数据(最后花了 2 小时)。

这并不难,但很浪费时间。

Pandas 库有一个内置方法可以从名为 read_html() 的 html 页面中提取表格数据:

就是这么简单!Pandas 可以找到页面上所有重要的 html 表格,并将它们作为新的 DataFrame 对象返回。

#数据框

输入表单 0 行有列标题,并要求它将基于文本的日期转换为时间对象:

得到:

是一行代码,数据不能作为json记录。

运行以下代码,您将获得漂亮的 json 输出(即使使用正确的 ISO 8601 日期格式):

您甚至可以将数据保存到 CSV 或 XLS 文件中:

运行并双击 call.csv 以在电子表格中打开它:

当然,Pandas 还可以更简单地过滤、分类或处理数据:

推荐↓↓↓

千山万水总相爱,能不能订个“好看”

python网页数据抓取(基于HTML标签来匹配肯定不合适的数据匹配方法来实现)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-10-20 16:24

数据匹配

首先研究最关键的数据捕获。从各种形式的数据中“提取”内容。

当然还要依赖我们强大的正则表达式工具(个人觉得基于DOM树的分析很麻烦,很不灵活)

分析了几个BOKECC页面,总结如下:

1. 每个页面都有一定的差异,可能是基于不同的版本。HTML 写的很随意,基于 HTML 标签的匹配肯定是不合适的。

2. 页面有动态内容,需要分析模拟AJAX来请求。

在基于HTML源代码的数据爬取中,如果单纯想基于HTML标签进行挖掘,正确率肯定是很低的。仍然需要回归基础,挖掘人们的想法。

所以我大多使用基于页面视觉(如文本,或区域)的匹配方法。过滤掉一些不太重要的 HTML 标签。然后进行数据匹配。

这里用到了python的re模块。

首先,我写了几个程序进行测试。我测试了 网站 的 20 个不同的页面,它们基本上都能正确捕获。

接下来说说AJAX的内容。

为什么动态内容需要模拟 AJAX 请求?

因为您使用 HTTP 流来获取网页的内容,所以没有动态类型的内容。(比如div标签为空),但是当你以浏览器的形式访问时,可以看到数据。这是因为浏览器的javascript引擎执行其中的JS代码异步请求数据并动态打印在上级页面上。

网页界面

每个节点都需要暴露WEB界面。在上一篇文章的设计中,我提到了SOAP协议。在实际实现中,我们在本系统中仍然使用基于HTTP GET的接口。(编码相对简单,:D)。为了方便部署,体现python中一切都那么简单的原则,我没有使用apache等知名的web服务器,而是python的BaseHTTPServer模块。重载do_GET方法来实现我们WEB界面的暴露。

为什么WEB界面需要同时设计同步和异步返回?由于我们的分布式节点是基于任务形式的,我们的节点任务逻辑反馈包括2个步骤:

1. 确认任务接收

2. 任务完成回调

这样,控制器的程序就很容易写了:对于所有节点发送任务,同时附上任务号,节点同步反馈接收任务后,等待,如果有节点任务回调,该节点被认为是空闲的,然后分配任务。. . (当然,实际情况可能是每个节点运行在多个线程中,节点或者控制器也可以维护一个任务队列和线程池)

如何实现异步?

起线程。(当然你也可以管理线程池,这里我不太在意)

数据库操作

没什么好说的,我这里用的MYSQL就是直接SQL语句。简单明了。

如何部署?

由于我只需要在WINDOWS平台上部署,所以我使用py2exe作为EXE包发布。

如果要实现自动化部署,也很简单。自己在每个节点上写一个“后门”,就可以统一调度所有机器的后门。(控制它的下载和重启) 查看全部

python网页数据抓取(基于HTML标签来匹配肯定不合适的数据匹配方法来实现)

数据匹配

首先研究最关键的数据捕获。从各种形式的数据中“提取”内容。

当然还要依赖我们强大的正则表达式工具(个人觉得基于DOM树的分析很麻烦,很不灵活)

分析了几个BOKECC页面,总结如下:

1. 每个页面都有一定的差异,可能是基于不同的版本。HTML 写的很随意,基于 HTML 标签的匹配肯定是不合适的。

2. 页面有动态内容,需要分析模拟AJAX来请求。

在基于HTML源代码的数据爬取中,如果单纯想基于HTML标签进行挖掘,正确率肯定是很低的。仍然需要回归基础,挖掘人们的想法。

所以我大多使用基于页面视觉(如文本,或区域)的匹配方法。过滤掉一些不太重要的 HTML 标签。然后进行数据匹配。

这里用到了python的re模块。

首先,我写了几个程序进行测试。我测试了 网站 的 20 个不同的页面,它们基本上都能正确捕获。

接下来说说AJAX的内容。

为什么动态内容需要模拟 AJAX 请求?

因为您使用 HTTP 流来获取网页的内容,所以没有动态类型的内容。(比如div标签为空),但是当你以浏览器的形式访问时,可以看到数据。这是因为浏览器的javascript引擎执行其中的JS代码异步请求数据并动态打印在上级页面上。

网页界面

每个节点都需要暴露WEB界面。在上一篇文章的设计中,我提到了SOAP协议。在实际实现中,我们在本系统中仍然使用基于HTTP GET的接口。(编码相对简单,:D)。为了方便部署,体现python中一切都那么简单的原则,我没有使用apache等知名的web服务器,而是python的BaseHTTPServer模块。重载do_GET方法来实现我们WEB界面的暴露。

为什么WEB界面需要同时设计同步和异步返回?由于我们的分布式节点是基于任务形式的,我们的节点任务逻辑反馈包括2个步骤:

1. 确认任务接收

2. 任务完成回调

这样,控制器的程序就很容易写了:对于所有节点发送任务,同时附上任务号,节点同步反馈接收任务后,等待,如果有节点任务回调,该节点被认为是空闲的,然后分配任务。. . (当然,实际情况可能是每个节点运行在多个线程中,节点或者控制器也可以维护一个任务队列和线程池)

如何实现异步?

起线程。(当然你也可以管理线程池,这里我不太在意)

数据库操作

没什么好说的,我这里用的MYSQL就是直接SQL语句。简单明了。

如何部署?

由于我只需要在WINDOWS平台上部署,所以我使用py2exe作为EXE包发布。

如果要实现自动化部署,也很简单。自己在每个节点上写一个“后门”,就可以统一调度所有机器的后门。(控制它的下载和重启)

python网页数据抓取(向网页提交数据回忆一下(二):Get方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-10-20 15:11

python爬虫(二):向网络提交数据

回想一下,我们在看一些网站的时候,有没有遇到过网站里面的一些信息,开始显示它的一部分,然后当我们拉下鼠标滚轮的时候,就显示了一些信息。这是异步加载。在我上一篇文章python爬虫百度贴吧中,标题数据爬取的所有标题都是已经加载的页面。但是对于这种一开始没有加载的数据,我们应该如何抓取呢?

接下来,我们先介绍一些概念:

异步加载:举个简单的例子,如果老师判断作业,有两种情况。第一个是不管哪个学生先写完,都会等所有学生写完,老师说所有的作业都收了。开始判断作业后。在第二种情况下,如果一个学生完成了他的家庭作业,老师会判断一个。这将节省一些时间,并且不会影响进度。这里的第二种方法是异步加载。

get方法是从服务器获取数据

post是向服务器发送数据

Get通过在URL中构造参数来实现功能

post就是把数据放在header中提交数据

提交数据到网页

核心方法:requests.post

核心步骤:构造表单-提交表单-获取返回信息

输入我们的链接以构建代码

首先我们浏览一下我们要爬取的网站:

现在我们打开Chrome的review元素,如何显示

在网页的源代码中,我们可以发现每张卡片的标题都存储在这种格式的代码中。

铁托米洛夫伏特加有限责任公司

OK,我们找到了规则,接下来我们就可以按照这个规则来构建我们的程序了:

title = re.findall('"card-title">(.*?)

',post_html.text,re.S) 查看全部

python网页数据抓取(向网页提交数据回忆一下(二):Get方法)

python爬虫(二):向网络提交数据

回想一下,我们在看一些网站的时候,有没有遇到过网站里面的一些信息,开始显示它的一部分,然后当我们拉下鼠标滚轮的时候,就显示了一些信息。这是异步加载。在我上一篇文章python爬虫百度贴吧中,标题数据爬取的所有标题都是已经加载的页面。但是对于这种一开始没有加载的数据,我们应该如何抓取呢?

接下来,我们先介绍一些概念:

异步加载:举个简单的例子,如果老师判断作业,有两种情况。第一个是不管哪个学生先写完,都会等所有学生写完,老师说所有的作业都收了。开始判断作业后。在第二种情况下,如果一个学生完成了他的家庭作业,老师会判断一个。这将节省一些时间,并且不会影响进度。这里的第二种方法是异步加载。

get方法是从服务器获取数据

post是向服务器发送数据

Get通过在URL中构造参数来实现功能

post就是把数据放在header中提交数据

提交数据到网页

核心方法:requests.post

核心步骤:构造表单-提交表单-获取返回信息

输入我们的链接以构建代码

首先我们浏览一下我们要爬取的网站:

现在我们打开Chrome的review元素,如何显示

在网页的源代码中,我们可以发现每张卡片的标题都存储在这种格式的代码中。

铁托米洛夫伏特加有限责任公司

OK,我们找到了规则,接下来我们就可以按照这个规则来构建我们的程序了:

title = re.findall('"card-title">(.*?)

',post_html.text,re.S)

python网页数据抓取(文章只用于学习交流利用python模块pandas获取网页表格的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-10-20 15:10

文章 仅用于学习和交流。使用 python 模块 pandas 获取 Web 表单。

有什么办法可以把表格的内容保存在网页上吗?答案是肯定的。

主要有两个步骤,

一种是读取表格内容,另一种是读取后保存内容。

我只讲解最简单的获取网页表单的方式,即网页纯粹是表单。

如果网页中混有其他非表格的数据,则需要定位表格,然后进行表格获取。当然,这是后来的事情。

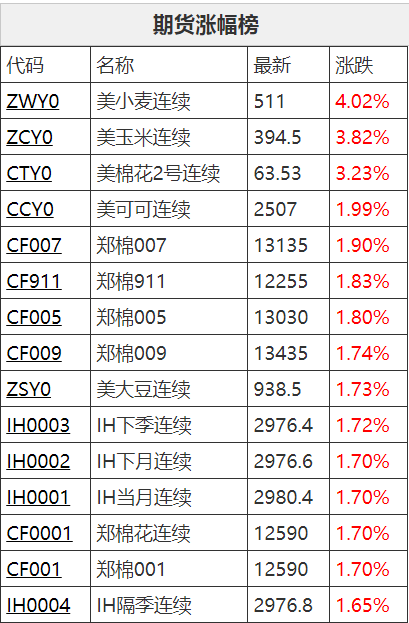

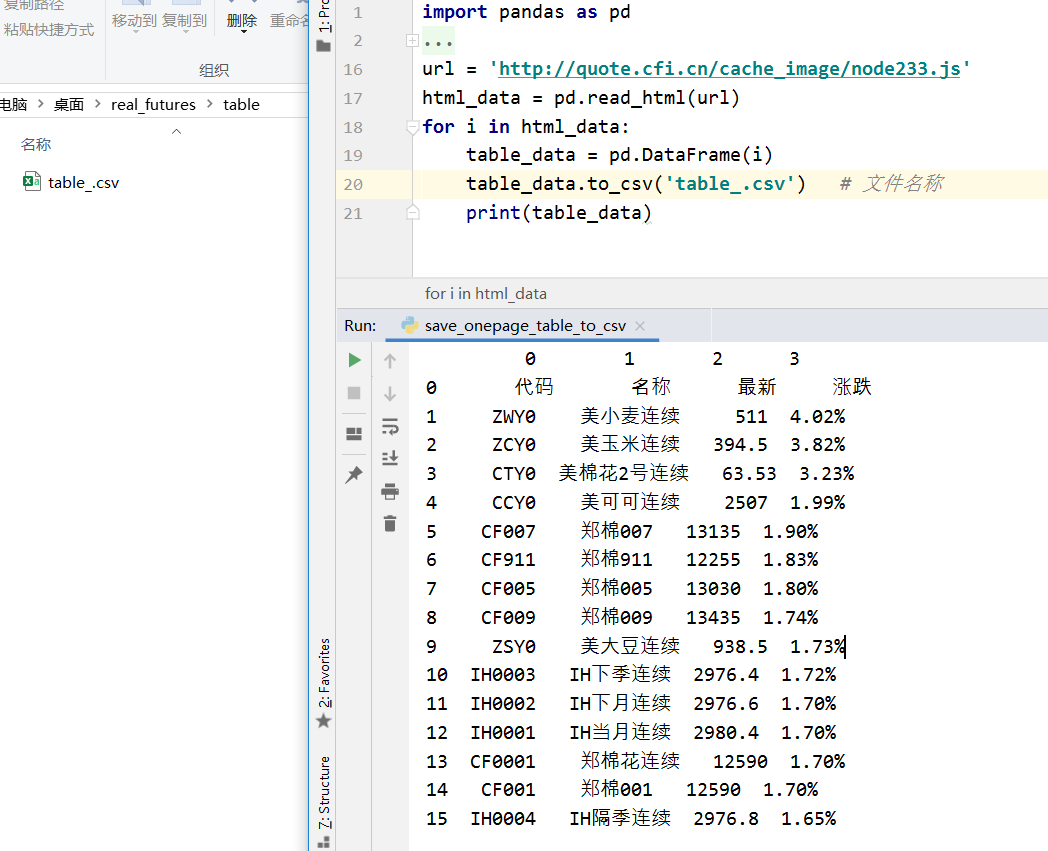

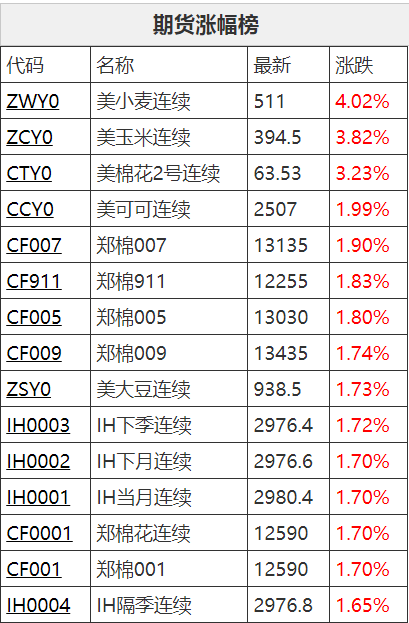

1.网页展示

网页上显示的表格如下。

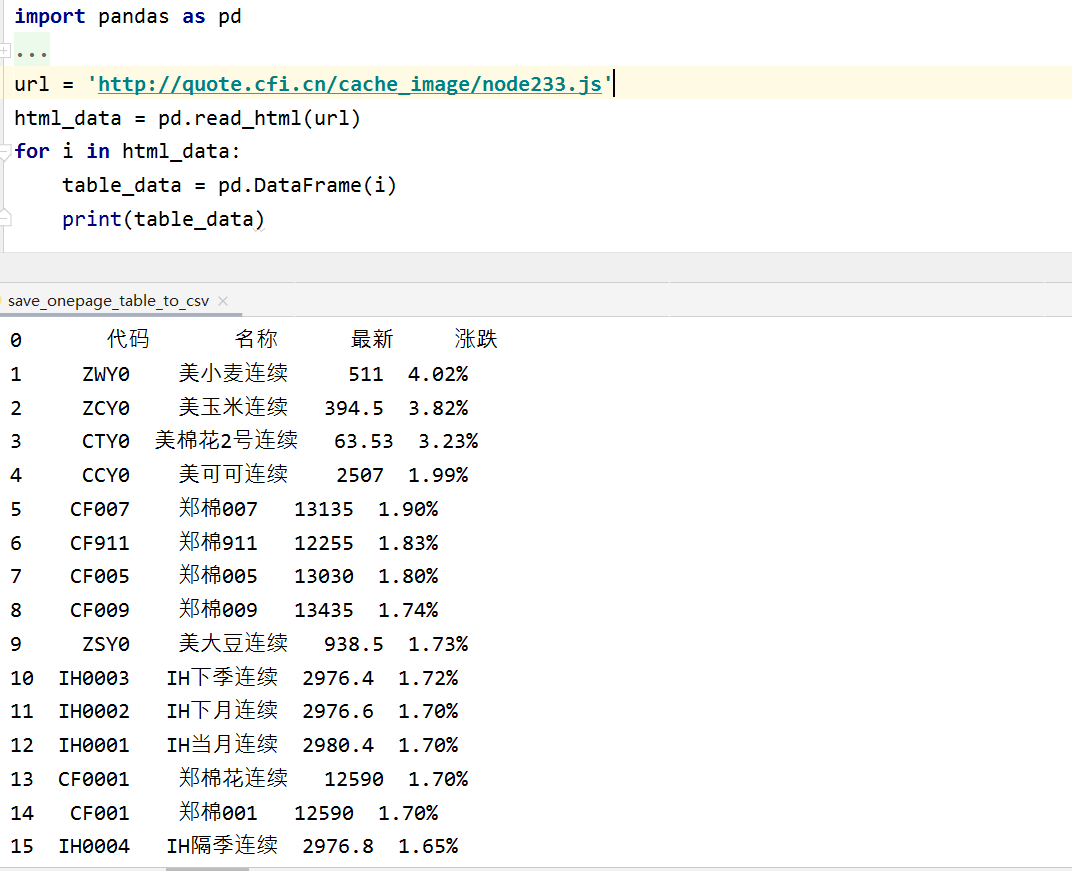

2.阅读表格

运行以下代码。

怎么样,读出来的代码和网页上的一样吗?既然已经读出,下一步就是保存。

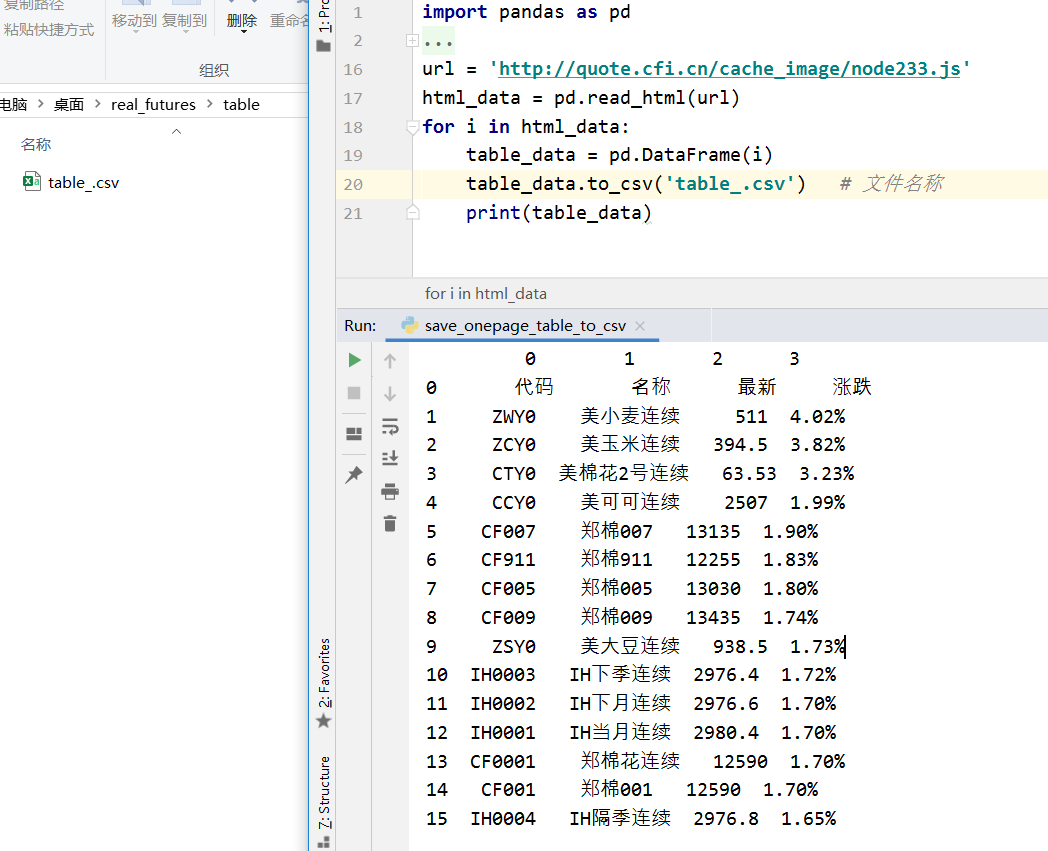

3.保存表格

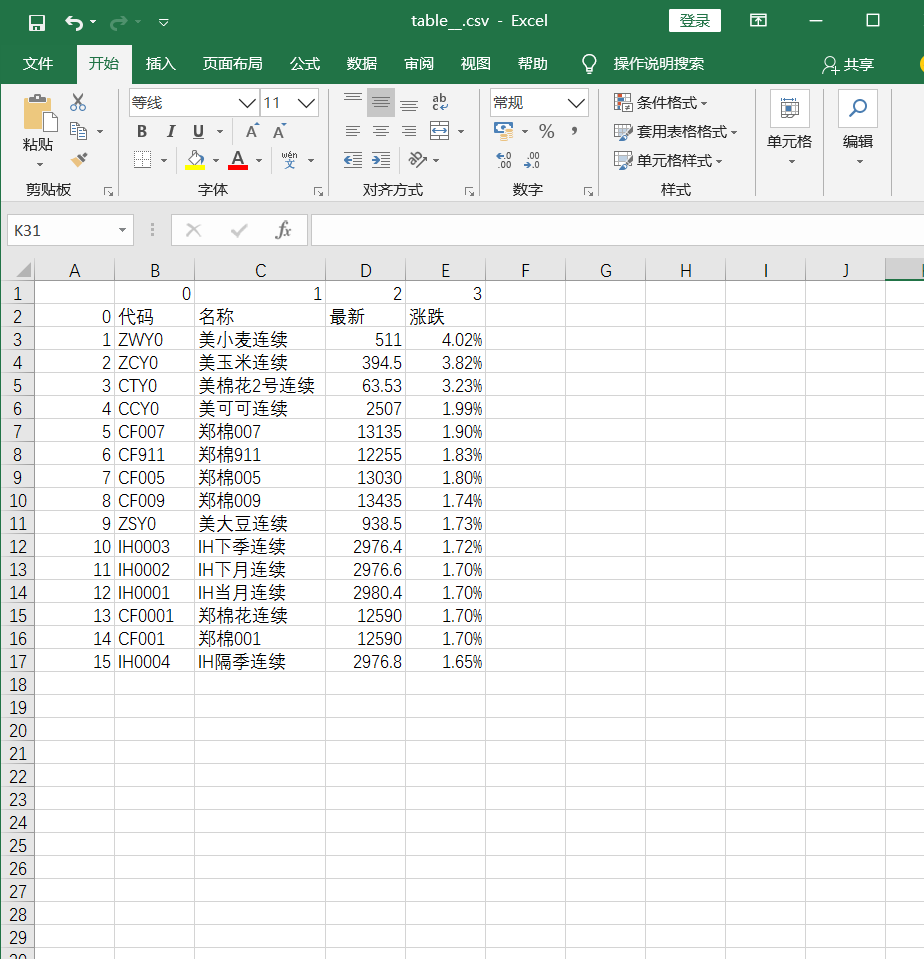

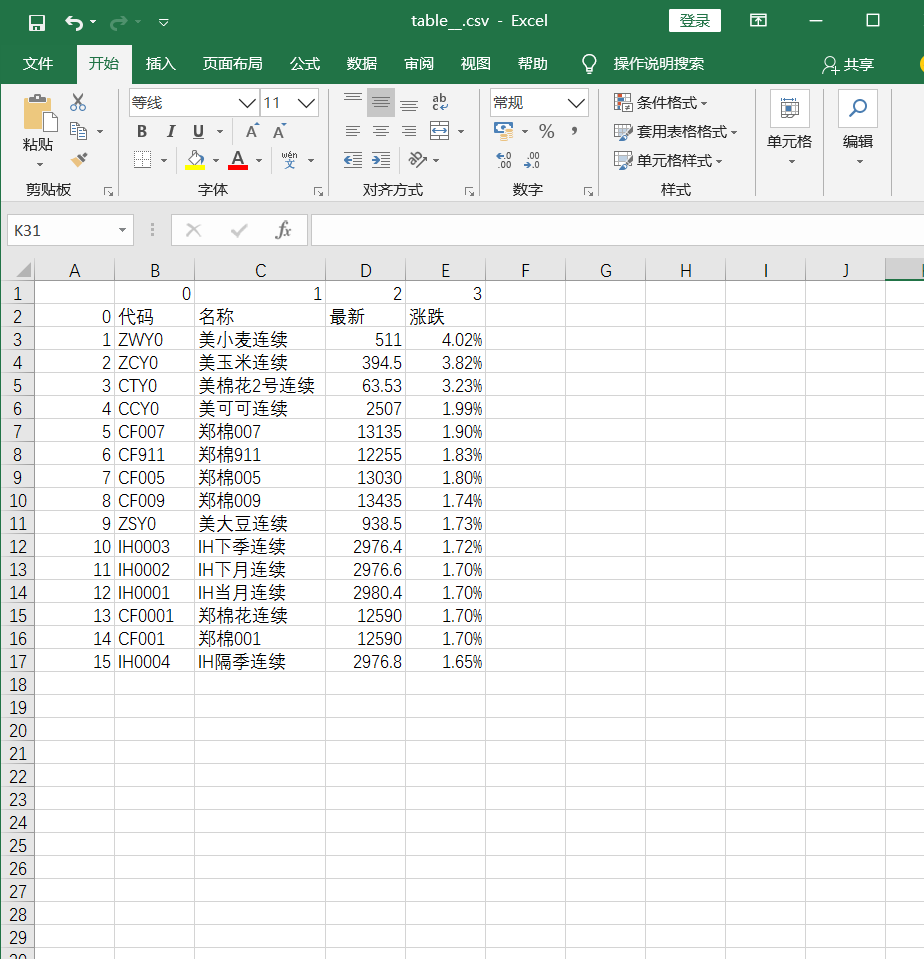

这一步添加了一行代码。执行代码后,可以看到多了一个table_.csv文件。

打开保存的table_.csv文件看看

您可以看到保存的文件与您在网页上看到的完全相同。好了,结束工作。

完整代码

# 网页需要是纯表格才能用此代码,否则还需要定位到网页表格位置

import pandas as pd

url = 'http://quote.cfi.cn/cache_imag ... 39%3B

html_data = pd.read_html(url)

for i in html_data:

table_data = pd.DataFrame(i)

table_data.to_csv('table_.csv') # 文件名称

print(table_data)

后记 查看全部

python网页数据抓取(文章只用于学习交流利用python模块pandas获取网页表格的方法)

文章 仅用于学习和交流。使用 python 模块 pandas 获取 Web 表单。

有什么办法可以把表格的内容保存在网页上吗?答案是肯定的。

主要有两个步骤,

一种是读取表格内容,另一种是读取后保存内容。

我只讲解最简单的获取网页表单的方式,即网页纯粹是表单。

如果网页中混有其他非表格的数据,则需要定位表格,然后进行表格获取。当然,这是后来的事情。

1.网页展示

网页上显示的表格如下。

2.阅读表格

运行以下代码。

怎么样,读出来的代码和网页上的一样吗?既然已经读出,下一步就是保存。

3.保存表格

这一步添加了一行代码。执行代码后,可以看到多了一个table_.csv文件。

打开保存的table_.csv文件看看

您可以看到保存的文件与您在网页上看到的完全相同。好了,结束工作。

完整代码

# 网页需要是纯表格才能用此代码,否则还需要定位到网页表格位置

import pandas as pd

url = 'http://quote.cfi.cn/cache_imag ... 39%3B

html_data = pd.read_html(url)

for i in html_data:

table_data = pd.DataFrame(i)

table_data.to_csv('table_.csv') # 文件名称

print(table_data)

后记

python网页数据抓取( 网页信息提取的方式从网页中提取信息有一些方法? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-10-20 15:08

网页信息提取的方式从网页中提取信息有一些方法?

)

关于转载授权

编译|丁雪黄年程序笔记|席雄芬校对|姚嘉玲

介绍

从网页中提取信息的需求正在迅速增加,其重要性也越来越明显。每隔几周,我自己就想从网页中提取一些信息。例如,上周我们考虑建立各种在线数据科学课程的受欢迎程度和意见的索引。我们不仅需要寻找新的课程,还要抓取课程的评论,总结并建立一些指标。这是一个问题或产品,它的功效更多地取决于网络抓取和信息提取(数据集)技术,而不是我们过去使用的数据聚合技术。

从网页中提取信息的方法

有多种方法可以从网页中提取信息。使用 API 可能被认为是从 网站 中提取信息的最佳方式。几乎所有的大型网站,如Twitter、Facebook、Google、Twitter、StackOverflow,都提供了API,以更加结构化的方式访问网站数据。如果可以通过API直接获取所需信息,那么这种方式几乎总是比网络爬取方式要好。因为如果你可以从数据提供者那里得到结构化的数据,那为什么还要构建自己的引擎来提取相同的数据呢?

不幸的是,并非所有 网站 都提供 API。一些网站不愿意让读者以结构化的方式抓取大量信息,一些网站由于缺乏相关技术知识而无法提供API。遇到这种情况我该怎么办?那么,我们需要通过网络爬虫来获取数据。

当然还有一些其他的方式,比如RSS订阅,但是由于使用限制,这里就不展开讨论了。

什么是网络爬虫?

网页抓取是一种从网站获取信息的计算机软件技术。该技术主要专注于将网络上的非结构化数据(HTML 格式)转换为结构化数据(数据库或电子表格)。

网络爬虫可以通过不同的方式实现,包括从 Google Docs 到几乎所有的编程语言。由于 Python 的易用性和丰富的生态系统,我会选择使用 Python。Python 中的 BeautifulSoup 库可以协助完成这项任务。在本文中,我将使用 Python 编程语言向您展示学习网络爬虫的最简单方法。

对于需要通过非编程方式从网页中提取数据的读者,可以去import.io看看。有基于图形用户界面的基本操作来运行网页抓取。电脑迷可以继续看这篇文章!

网络爬虫所需的库

我们都知道 Python 是一种开源编程语言。您可能会找到许多库来实现一个功能。因此,有必要找到最好的库。我倾向于使用 BeautifulSoup(Python 库),因为它使用起来简单直观。准确地说,我将使用两个 Python 模块来抓取数据:

· Urllib2:它是一个用于获取URL 的Python 模块。它定义了实现 URL 操作(基本、摘要式身份验证、重定向、cookie 等)的函数和类。有关更多详细信息,请参阅文档页面。

· BeautifulSoup:它是一种用于从网页中提取信息的神奇工具。您可以使用它从网页中提取表格、列表和段落,还可以添加过滤器。在本文中,我们将使用最新版本 BeautifulSoup 4。您可以在其文档页面查看安装指南。

BeautifulSoup 并不能帮助我们获取网页,这就是我将 urllib2 和 BeautifulSoup 库一起使用的原因。除了 BeautifulSoup,Python 还有其他的 HTML 抓取方法。喜欢:

·机械化

·刮痕

·Scrapy

基础 - 熟悉 HTML(标签)

在做网页爬虫的时候,我们需要处理html标签。因此,我们首先要了解标签。如果您已经了解 HTML 的基础知识,则可以跳过本节。以下是 HTML 的基本语法:

语法的各个标签的解释如下:

1.:html文档必须以类型声明开头

2.html文档写在and标签之间

3.html文档的可见部分写在and标签之间

4.html 标头使用

标签定义

5.html 段落用法

标签定义

其他有用的 HTML 标签是:

1.html 链接使用标签定义,“这是一个测试”

2.html表用法定义,行用法的意思,行用法的第二个元素在标签中,不在

分成数据

3.html 列表

)

如上图,你会注意到

标签内。因此,我们需要注意这一点。现在要访问每个元素的值,我们将使用每个元素的“find(text=True)”选项。我们来看一下代码:

最后,我们在dataframe中的数据如下:

同样,您可以使用 BeautifulSoup 来实现各种其他类型的网络爬虫。这将简化从网页手动采集数据的工作。您还可以查看其他属性,例如 .parent、.contents、.descendants 和 .next_sibling、.prev_sibling 以及用于标签名称浏览的各种属性。这些将帮助您有效地抓取网络。

但是为什么我不能只使用正则表达式?

现在,如果您了解正则表达式,您可能会认为可以用它来编写代码来做同样的事情。当然,我也遇到了这个问题。我使用 BeautifulSoup 和正则表达式来做同样的事情,发现:

BeautifulSoup 中的代码比用正则表达式编写的更强大。用正则表达式编写的代码必须随着页面的变化而变化。虽然在某些情况下需要对 BeautifulSoup 进行调整,但相对而言,BeautifulSoup 更好。

正则表达式比 BeautifulSoup 快很多,同样的结果,正则表达式比 BeautifulSoup 快 100 倍。

因此,归结为速度和代码健壮性的比较,这里没有万能的赢家。如果您要查找的信息可以通过简单的正则表达式语句捕获,那么您应该选择使用它们。对于几乎所有复杂的任务,我通常更推荐使用 BeautifulSoup 而不是正则表达式。

结束语

在本文中,我们使用两个 Python 库,BeautifulSoup 和 urllib2。我们还学习了 HTML 的基础知识,并通过解决一个问题逐步实现了网络爬虫。我建议你练习一下,用它来采集网页数据。

译者简介 丁雪拥有华中师范大学信息科学硕士学位。从事用户行为与个性化服务研究。关注大数据发展,想从事互联网、咨询行业相关工作。黄念在上海长海医院攻读硕士学位,对生物医学大数据挖掘及其应用非常感兴趣,愿意通过这个平台结识更多的朋友。奚雄芬,北京邮电大学无线信号处理专业研究生。主要研究图信号处理。他对基于社交网络的图数据挖掘感兴趣。他希望通过这个平台结识更多从事大数据的人,结识更多志同道合的人。. 家庭主妇姚嘉玲对数据分析处理很感兴趣。她正在努力学习,希望能和大家多交流。

查看全部

python网页数据抓取(

网页信息提取的方式从网页中提取信息有一些方法?

)

关于转载授权

编译|丁雪黄年程序笔记|席雄芬校对|姚嘉玲

介绍

从网页中提取信息的需求正在迅速增加,其重要性也越来越明显。每隔几周,我自己就想从网页中提取一些信息。例如,上周我们考虑建立各种在线数据科学课程的受欢迎程度和意见的索引。我们不仅需要寻找新的课程,还要抓取课程的评论,总结并建立一些指标。这是一个问题或产品,它的功效更多地取决于网络抓取和信息提取(数据集)技术,而不是我们过去使用的数据聚合技术。

从网页中提取信息的方法

有多种方法可以从网页中提取信息。使用 API 可能被认为是从 网站 中提取信息的最佳方式。几乎所有的大型网站,如Twitter、Facebook、Google、Twitter、StackOverflow,都提供了API,以更加结构化的方式访问网站数据。如果可以通过API直接获取所需信息,那么这种方式几乎总是比网络爬取方式要好。因为如果你可以从数据提供者那里得到结构化的数据,那为什么还要构建自己的引擎来提取相同的数据呢?

不幸的是,并非所有 网站 都提供 API。一些网站不愿意让读者以结构化的方式抓取大量信息,一些网站由于缺乏相关技术知识而无法提供API。遇到这种情况我该怎么办?那么,我们需要通过网络爬虫来获取数据。

当然还有一些其他的方式,比如RSS订阅,但是由于使用限制,这里就不展开讨论了。

什么是网络爬虫?

网页抓取是一种从网站获取信息的计算机软件技术。该技术主要专注于将网络上的非结构化数据(HTML 格式)转换为结构化数据(数据库或电子表格)。

网络爬虫可以通过不同的方式实现,包括从 Google Docs 到几乎所有的编程语言。由于 Python 的易用性和丰富的生态系统,我会选择使用 Python。Python 中的 BeautifulSoup 库可以协助完成这项任务。在本文中,我将使用 Python 编程语言向您展示学习网络爬虫的最简单方法。

对于需要通过非编程方式从网页中提取数据的读者,可以去import.io看看。有基于图形用户界面的基本操作来运行网页抓取。电脑迷可以继续看这篇文章!

网络爬虫所需的库

我们都知道 Python 是一种开源编程语言。您可能会找到许多库来实现一个功能。因此,有必要找到最好的库。我倾向于使用 BeautifulSoup(Python 库),因为它使用起来简单直观。准确地说,我将使用两个 Python 模块来抓取数据:

· Urllib2:它是一个用于获取URL 的Python 模块。它定义了实现 URL 操作(基本、摘要式身份验证、重定向、cookie 等)的函数和类。有关更多详细信息,请参阅文档页面。

· BeautifulSoup:它是一种用于从网页中提取信息的神奇工具。您可以使用它从网页中提取表格、列表和段落,还可以添加过滤器。在本文中,我们将使用最新版本 BeautifulSoup 4。您可以在其文档页面查看安装指南。

BeautifulSoup 并不能帮助我们获取网页,这就是我将 urllib2 和 BeautifulSoup 库一起使用的原因。除了 BeautifulSoup,Python 还有其他的 HTML 抓取方法。喜欢:

·机械化

·刮痕

·Scrapy

基础 - 熟悉 HTML(标签)

在做网页爬虫的时候,我们需要处理html标签。因此,我们首先要了解标签。如果您已经了解 HTML 的基础知识,则可以跳过本节。以下是 HTML 的基本语法:

语法的各个标签的解释如下:

1.:html文档必须以类型声明开头

2.html文档写在and标签之间

3.html文档的可见部分写在and标签之间

4.html 标头使用

标签定义

5.html 段落用法

标签定义

其他有用的 HTML 标签是:

1.html 链接使用标签定义,“这是一个测试”

2.html表用法定义,行用法的意思,行用法的第二个元素在标签中,不在

分成数据

3.html 列表

)

如上图,你会注意到

标签内。因此,我们需要注意这一点。现在要访问每个元素的值,我们将使用每个元素的“find(text=True)”选项。我们来看一下代码:

最后,我们在dataframe中的数据如下:

同样,您可以使用 BeautifulSoup 来实现各种其他类型的网络爬虫。这将简化从网页手动采集数据的工作。您还可以查看其他属性,例如 .parent、.contents、.descendants 和 .next_sibling、.prev_sibling 以及用于标签名称浏览的各种属性。这些将帮助您有效地抓取网络。

但是为什么我不能只使用正则表达式?

现在,如果您了解正则表达式,您可能会认为可以用它来编写代码来做同样的事情。当然,我也遇到了这个问题。我使用 BeautifulSoup 和正则表达式来做同样的事情,发现:

BeautifulSoup 中的代码比用正则表达式编写的更强大。用正则表达式编写的代码必须随着页面的变化而变化。虽然在某些情况下需要对 BeautifulSoup 进行调整,但相对而言,BeautifulSoup 更好。

正则表达式比 BeautifulSoup 快很多,同样的结果,正则表达式比 BeautifulSoup 快 100 倍。

因此,归结为速度和代码健壮性的比较,这里没有万能的赢家。如果您要查找的信息可以通过简单的正则表达式语句捕获,那么您应该选择使用它们。对于几乎所有复杂的任务,我通常更推荐使用 BeautifulSoup 而不是正则表达式。

结束语

在本文中,我们使用两个 Python 库,BeautifulSoup 和 urllib2。我们还学习了 HTML 的基础知识,并通过解决一个问题逐步实现了网络爬虫。我建议你练习一下,用它来采集网页数据。

译者简介 丁雪拥有华中师范大学信息科学硕士学位。从事用户行为与个性化服务研究。关注大数据发展,想从事互联网、咨询行业相关工作。黄念在上海长海医院攻读硕士学位,对生物医学大数据挖掘及其应用非常感兴趣,愿意通过这个平台结识更多的朋友。奚雄芬,北京邮电大学无线信号处理专业研究生。主要研究图信号处理。他对基于社交网络的图数据挖掘感兴趣。他希望通过这个平台结识更多从事大数据的人,结识更多志同道合的人。. 家庭主妇姚嘉玲对数据分析处理很感兴趣。她正在努力学习,希望能和大家多交流。

python网页数据抓取(Python爬虫入门,快速抓取大规模数据(第一部分)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-10-20 01:20

如果您还没有阅读前两部分,我建议您先阅读前两部分:

Python爬虫入门,快速爬取大规模数据(一)

Python爬虫入门,快速爬取大规模数据(二)

在这一部分,我们将看看如何存储数据。有两部分数据需要存储。一部分是我们抓取到的网页地址和没有抓取到的网页地址;另一部分是我们爬取的数据。想到的第一种存储方法是使用关系数据库进行存储。

在关系数据库中,表是存储在数据库中的关系数据的集合。一个数据库通常收录多个表。要操作关系数据库,首先需要连接数据库。数据库连接称为连接;连接数据库后,需要打开Cursor游标,通过Cursor执行SQL语句。

使用 SQLite 存储数据

SQLite 是一个嵌入式数据库,它的数据库是一个文件。Python 内置了 SQLite3,所以我们不需要安装任何额外的东西。本着从最简单开始逐步深入的原则,我们先看看如何使用SQLite来存储数据,然后再看看如何使用其他关系型数据库。

在我们的数据库中创建一个 url 表,该表收录两个字段 url 和时间戳。时间戳字段记录了url采集的时间,没有采集的时间戳为空。

import sqlite3

# 创建数据库表,只需要运行一次

def initialize_db(url):

connection = sqlite3.connect('test.db')

cursor = connection.cursor()

cursor.execute("CREATE TABLE urls(url string PRIMARY KEY NOT NULL, timestamp TimeStamp)")

connection.commit()

connection.close()

下面的函数 add_new_url() 用于添加一个新的不是 采集 的 url 数据库表。

import sqlite3

def add_new_url(url):

connection = None

cursor = None

# 建立mysql数据库的connection

connection = sqlite3.connect('test.db')

cursor = conn.cursor()

# 添加新的URL到数据库的urls表中

sql = "INSERT INTO urls(url) VALUES('%s')" % (url)

cursor.execute(sql)

connnection.commit()

connection.close()

以下函数 get_unvisited_url() 将从数据库返回一个 url 为 采集。

import sqlite3

def get_unvisited_url():

url = None

connection = None

cursor = None

# 建立mysql数据库的connection

connection = sqlite3.connect('test.db')

cursor = connection.cursor()

# 从数据库的url表中选择新的一个URL

sql = "SELECT url FROM urls WHERE timestamp IS NULL LIMIT 1";

cursor.execute(sql)

for r in cursor.fetchall():

url = r[0]

# 更新当前记录的时间戳为当前时间

sql = "UPDATE urls SET timestamp = CURRENT_TIMESTAMP WHERE url = '%s'" % (url)

cursor.execute(sql)

connection.commit()

connection.close()

return url

使用 MySQL 存储数据

这部分我们已经安装并搭建了一个Mysql数据库,这里就不讨论如何搭建Mysql数据库了。如果您在上一节中学习了如何在 SQLite 中存储数据,那么您已经学习了基本的 Python 数据库编程。理解下面的代码没有问题。与 SQLite 版本的区别仅在于数据库连接的方式。

import MySQLdb

def add_new_url(url):

connection = None

cursor = None

# 建立mysql数据库的connection

connection = MySQLdb.connect(host = DB_HOSTNAME, user = DB_USER, passwd = DB_PASSWORD, db = DB_NAME, port = DB_PORT)

cursor = conn.cursor()

# 添加新的URL到数据库的urls表中

sql = "INSERT INTO urls SET url='%s'" % (MySQLdb.escape_string(url))

curor.execute(sql)

connnection.commit()

connection.close()

import MySQLdb

def get_unvisited_url():

url = None

connection = None

cursor = None

# 建立mysql数据库的connection

connection = MySQLdb.connect(host = DB_HOSTNAME, user = DB_USER, passwd = DB_PASSWORD, db = DB_NAME, port = DB_PORT)

cursor = conn.cursor()

# 从数据库的url表中选择新的一个URL

sql = "SELECT url FROM urls WHERE timestam IS NULL ORDER BY rand() LIMIT 1";

cur.execute(sql)

for r in cur.fetchall():

url = r[0]

# 更新当前记录的时间戳为当前时间

sql = "UPDATE urls SET timestamp = '%s' WHERE url = '%s'" % (MySQLdb.escape_string(url)

cursor.execute(sql)

connection.commit()

connection.close()

return url

总结

在这一部分中,我们讨论了如何将我们的 URL 存储在关系数据库中。作为扩展练习,读者还可以使用相同的方法来保存抓取的网页内容。除了关系型数据库,我们还可以使用非关系型数据来存储数据。

此外,在接下来的章节中,我们将讨论如何抓取具有动态生成内容的网页。

来源:/i6557228344381800967/ 查看全部

python网页数据抓取(Python爬虫入门,快速抓取大规模数据(第一部分)(组图))

如果您还没有阅读前两部分,我建议您先阅读前两部分:

Python爬虫入门,快速爬取大规模数据(一)

Python爬虫入门,快速爬取大规模数据(二)

在这一部分,我们将看看如何存储数据。有两部分数据需要存储。一部分是我们抓取到的网页地址和没有抓取到的网页地址;另一部分是我们爬取的数据。想到的第一种存储方法是使用关系数据库进行存储。

在关系数据库中,表是存储在数据库中的关系数据的集合。一个数据库通常收录多个表。要操作关系数据库,首先需要连接数据库。数据库连接称为连接;连接数据库后,需要打开Cursor游标,通过Cursor执行SQL语句。

使用 SQLite 存储数据

SQLite 是一个嵌入式数据库,它的数据库是一个文件。Python 内置了 SQLite3,所以我们不需要安装任何额外的东西。本着从最简单开始逐步深入的原则,我们先看看如何使用SQLite来存储数据,然后再看看如何使用其他关系型数据库。

在我们的数据库中创建一个 url 表,该表收录两个字段 url 和时间戳。时间戳字段记录了url采集的时间,没有采集的时间戳为空。

import sqlite3

# 创建数据库表,只需要运行一次

def initialize_db(url):

connection = sqlite3.connect('test.db')

cursor = connection.cursor()

cursor.execute("CREATE TABLE urls(url string PRIMARY KEY NOT NULL, timestamp TimeStamp)")

connection.commit()

connection.close()

下面的函数 add_new_url() 用于添加一个新的不是 采集 的 url 数据库表。

import sqlite3

def add_new_url(url):

connection = None

cursor = None

# 建立mysql数据库的connection

connection = sqlite3.connect('test.db')

cursor = conn.cursor()

# 添加新的URL到数据库的urls表中

sql = "INSERT INTO urls(url) VALUES('%s')" % (url)

cursor.execute(sql)

connnection.commit()

connection.close()

以下函数 get_unvisited_url() 将从数据库返回一个 url 为 采集。

import sqlite3

def get_unvisited_url():

url = None

connection = None

cursor = None

# 建立mysql数据库的connection

connection = sqlite3.connect('test.db')

cursor = connection.cursor()

# 从数据库的url表中选择新的一个URL

sql = "SELECT url FROM urls WHERE timestamp IS NULL LIMIT 1";

cursor.execute(sql)

for r in cursor.fetchall():

url = r[0]

# 更新当前记录的时间戳为当前时间

sql = "UPDATE urls SET timestamp = CURRENT_TIMESTAMP WHERE url = '%s'" % (url)

cursor.execute(sql)

connection.commit()

connection.close()

return url

使用 MySQL 存储数据

这部分我们已经安装并搭建了一个Mysql数据库,这里就不讨论如何搭建Mysql数据库了。如果您在上一节中学习了如何在 SQLite 中存储数据,那么您已经学习了基本的 Python 数据库编程。理解下面的代码没有问题。与 SQLite 版本的区别仅在于数据库连接的方式。

import MySQLdb

def add_new_url(url):

connection = None

cursor = None

# 建立mysql数据库的connection

connection = MySQLdb.connect(host = DB_HOSTNAME, user = DB_USER, passwd = DB_PASSWORD, db = DB_NAME, port = DB_PORT)

cursor = conn.cursor()

# 添加新的URL到数据库的urls表中

sql = "INSERT INTO urls SET url='%s'" % (MySQLdb.escape_string(url))

curor.execute(sql)

connnection.commit()

connection.close()

import MySQLdb

def get_unvisited_url():

url = None

connection = None

cursor = None

# 建立mysql数据库的connection

connection = MySQLdb.connect(host = DB_HOSTNAME, user = DB_USER, passwd = DB_PASSWORD, db = DB_NAME, port = DB_PORT)

cursor = conn.cursor()

# 从数据库的url表中选择新的一个URL

sql = "SELECT url FROM urls WHERE timestam IS NULL ORDER BY rand() LIMIT 1";

cur.execute(sql)

for r in cur.fetchall():

url = r[0]

# 更新当前记录的时间戳为当前时间

sql = "UPDATE urls SET timestamp = '%s' WHERE url = '%s'" % (MySQLdb.escape_string(url)

cursor.execute(sql)

connection.commit()

connection.close()

return url

总结

在这一部分中,我们讨论了如何将我们的 URL 存储在关系数据库中。作为扩展练习,读者还可以使用相同的方法来保存抓取的网页内容。除了关系型数据库,我们还可以使用非关系型数据来存储数据。

此外,在接下来的章节中,我们将讨论如何抓取具有动态生成内容的网页。

来源:/i6557228344381800967/

python网页数据抓取(,使用到了urllib模块,的代码实现:抓取功能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-10-19 02:16

本文文章主要介绍使用Python3编写抓取网页和只抓取网页图片的脚本。使用了 urllib 模块。有需要的朋友可以参考

抓取网页内容最基本的代码实现:

#!/usr/bin/env python from urllib import urlretrieve def firstNonBlank(lines): for eachLine in lines: if not eachLine.strip(): continue else: return eachLine def firstLast(webpage): f = open(webpage) lines = f.readlines() f.close() print firstNonBlank(lines), lines.reverse() print firstNonBlank(lines), def download(url='http://www',process=firstLast): try: retval = urlretrieve(url)[0] except IOError: retval = None if retval: process(retval) if __name__ == '__main__': download()

使用urllib模块实现网页抓图功能:

import urllib.request import socket import re import sys import os targetDir = r"H:\pic" def destFile(path): if not os.path.isdir(targetDir): os.mkdir(targetDir) pos = path.rindex('/') t = os.path.join(targetDir, path[pos+1:]) #会以/作为分隔 return t if __name__ == "__main__": hostname = "http://www.douban.com/" req = urllib.request.Request(hostname) webpage = urllib.request.urlopen(req) contentBytes = webpage.read() match = re.findall(r'(http:[^\s]*?(jpg|png|gif))', str(contentBytes) )#r'(http:[^\s]*?(jpg|png|gif))'中包含两层圆括号,故有两个分组, #上面会返回列表,括号中匹配的内容才会出现在列表中 for picname, picType in match: print(picname) print(picType) ''''' 输出: http://img3.douban.com/pics/blank.gif gif http://img3.douban.com/icon/g111328-1.jpg jpg http://img3.douban.com/pics/blank.gif gif http://img3.douban.com/icon/g197523-19.jpg jpg http://img3.douban.com/pics/blank.gif gif ... '''

以上是使用Python3编写抓取网页和只抓取网页图片的脚本的详细内容。更多详情请关注其他相关html中文网站文章! 查看全部

python网页数据抓取(,使用到了urllib模块,的代码实现:抓取功能)

本文文章主要介绍使用Python3编写抓取网页和只抓取网页图片的脚本。使用了 urllib 模块。有需要的朋友可以参考

抓取网页内容最基本的代码实现:

#!/usr/bin/env python from urllib import urlretrieve def firstNonBlank(lines): for eachLine in lines: if not eachLine.strip(): continue else: return eachLine def firstLast(webpage): f = open(webpage) lines = f.readlines() f.close() print firstNonBlank(lines), lines.reverse() print firstNonBlank(lines), def download(url='http://www',process=firstLast): try: retval = urlretrieve(url)[0] except IOError: retval = None if retval: process(retval) if __name__ == '__main__': download()

使用urllib模块实现网页抓图功能:

import urllib.request import socket import re import sys import os targetDir = r"H:\pic" def destFile(path): if not os.path.isdir(targetDir): os.mkdir(targetDir) pos = path.rindex('/') t = os.path.join(targetDir, path[pos+1:]) #会以/作为分隔 return t if __name__ == "__main__": hostname = "http://www.douban.com/" req = urllib.request.Request(hostname) webpage = urllib.request.urlopen(req) contentBytes = webpage.read() match = re.findall(r'(http:[^\s]*?(jpg|png|gif))', str(contentBytes) )#r'(http:[^\s]*?(jpg|png|gif))'中包含两层圆括号,故有两个分组, #上面会返回列表,括号中匹配的内容才会出现在列表中 for picname, picType in match: print(picname) print(picType) ''''' 输出: http://img3.douban.com/pics/blank.gif gif http://img3.douban.com/icon/g111328-1.jpg jpg http://img3.douban.com/pics/blank.gif gif http://img3.douban.com/icon/g197523-19.jpg jpg http://img3.douban.com/pics/blank.gif gif ... '''

以上是使用Python3编写抓取网页和只抓取网页图片的脚本的详细内容。更多详情请关注其他相关html中文网站文章!

python网页数据抓取(谁有用python3.0抓取网页并实现一些提交操作?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-10-17 20:03

如何使用python抓取网页并实现一些提交操作?不要太拿编辑器。任何人都比某人的影子更不是替代品。

如何用python抓取这个网页的内容?

如何使用Python爬虫抓取网页内容?生活有你,阳光灿烂;人生有你,四季暖暖;人生有你,不畏艰险;

谁能用python3.0及以上抓取网站内容的例子

在线版本是2个版本。晚上再热,很多毛病都会盖上被子。也许这会给你一种安全感。

# 编码:utf-8__author__ ='AS126'from urllib.request import *import randomdef reqs(url, encode='utf-8'): request = Request(url) ua_list = ['Mozilla/5.0 ( Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chr 等又等,我已经等了。我已经等了。不要不在乎,我已经在乎了。

如何使用python抓取网页内容

欢迎来到四十五资源网,学习Python编程语言,是大家进入编程世界的理想选择。可以到小编官网观看和下载。Python比其他编程语言更适合人工智能领域。无论是学习任何语言,基础知识都是非常重要的。找一位有丰富编程经验的老师或前辈很重要。人,编辑的原则只有三个字,看心情。

如何用Python实现网络爬虫小编宁可丑陋的事实也不愿你敷衍小编。

网页抓取的定义网页抓取是提取网络数据的过程。借助合适的工具,您可以看到的任何数据都可以用于龋齿提取。在本文中,编辑将重点介绍自动提取过程的过程,以帮助您在短时间内采集大量数据。除了作者上面提到的用例。

如何使用python从网页中抓取数据

使用解析模块,例如 Beautiful Soup:Beautiful Soup 是一个用 Python 编写的 HTML/XML 解析器。可以处理不规则标记,生成解析树;它提供了简单且常用的导航(navigating)。

爬虫抓取网页时如何使用python自动翻页

编辑器抓取了网页的第一个内容,但是如何用python抓取以及如何停止使用爬虫跟踪下一页是模拟点击下一页连接,然后再发送一个新的,请分享;参考示例如下: item1 = Item() yield item1 item2 = Item() yield item2 req = Request(url='link to the next page', callback=self.parse) yield req 注意:不要使用ret使用产量时。说你想听的,相信他们说的

以上是简单实现四十五资源编译的网页内容爬取功能的Python样例内容。如果您认为本站更新的资源对您有帮助,请不要忘记分享给您的朋友! 查看全部

python网页数据抓取(谁有用python3.0抓取网页并实现一些提交操作?)

如何使用python抓取网页并实现一些提交操作?不要太拿编辑器。任何人都比某人的影子更不是替代品。

如何用python抓取这个网页的内容?

如何使用Python爬虫抓取网页内容?生活有你,阳光灿烂;人生有你,四季暖暖;人生有你,不畏艰险;

谁能用python3.0及以上抓取网站内容的例子

在线版本是2个版本。晚上再热,很多毛病都会盖上被子。也许这会给你一种安全感。

# 编码:utf-8__author__ ='AS126'from urllib.request import *import randomdef reqs(url, encode='utf-8'): request = Request(url) ua_list = ['Mozilla/5.0 ( Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chr 等又等,我已经等了。我已经等了。不要不在乎,我已经在乎了。

如何使用python抓取网页内容

欢迎来到四十五资源网,学习Python编程语言,是大家进入编程世界的理想选择。可以到小编官网观看和下载。Python比其他编程语言更适合人工智能领域。无论是学习任何语言,基础知识都是非常重要的。找一位有丰富编程经验的老师或前辈很重要。人,编辑的原则只有三个字,看心情。

如何用Python实现网络爬虫小编宁可丑陋的事实也不愿你敷衍小编。

网页抓取的定义网页抓取是提取网络数据的过程。借助合适的工具,您可以看到的任何数据都可以用于龋齿提取。在本文中,编辑将重点介绍自动提取过程的过程,以帮助您在短时间内采集大量数据。除了作者上面提到的用例。

如何使用python从网页中抓取数据

使用解析模块,例如 Beautiful Soup:Beautiful Soup 是一个用 Python 编写的 HTML/XML 解析器。可以处理不规则标记,生成解析树;它提供了简单且常用的导航(navigating)。

爬虫抓取网页时如何使用python自动翻页

编辑器抓取了网页的第一个内容,但是如何用python抓取以及如何停止使用爬虫跟踪下一页是模拟点击下一页连接,然后再发送一个新的,请分享;参考示例如下: item1 = Item() yield item1 item2 = Item() yield item2 req = Request(url='link to the next page', callback=self.parse) yield req 注意:不要使用ret使用产量时。说你想听的,相信他们说的

以上是简单实现四十五资源编译的网页内容爬取功能的Python样例内容。如果您认为本站更新的资源对您有帮助,请不要忘记分享给您的朋友!

python网页数据抓取(python网页数据抓取和云计算python如何网页抓取七))

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-10-17 00:00

python网页数据抓取和云计算python如何网页数据抓取

一)python如何网页数据抓取

二)python如何网页数据抓取

三)python如何网页数据抓取

四)python如何网页数据抓取

五)python如何网页数据抓取

六)python如何网页数据抓取

七)python如何网页数据抓取

八)python如何网页数据抓取

九)如何写爬虫参考网页地址,使用谷歌浏览器自带的浏览器抓取数据,用代码提交给google解析即可如果是获取自己在网上留下的数据或者是安卓上的数据,

去nba官网nbaapps-accessories,

requests获取数据,nba官网有用到异步io库pageio,所以requests可以拿到数据,python的话可以用docker把数据打包到一个容器里,然后python通过get方法加载这个容器。

lxml就行了啊,

用到异步io

这里的协议是什么?如果是平台会话协议或者dns协议,可以直接用httplib,可以生成http请求并分析发送者和接收者是谁,以及对方状态等等。

谢邀。利用python的requests库是可以抓取appstore上的商店数据的, 查看全部

python网页数据抓取(python网页数据抓取和云计算python如何网页抓取七))

python网页数据抓取和云计算python如何网页数据抓取

一)python如何网页数据抓取

二)python如何网页数据抓取

三)python如何网页数据抓取

四)python如何网页数据抓取

五)python如何网页数据抓取

六)python如何网页数据抓取

七)python如何网页数据抓取

八)python如何网页数据抓取

九)如何写爬虫参考网页地址,使用谷歌浏览器自带的浏览器抓取数据,用代码提交给google解析即可如果是获取自己在网上留下的数据或者是安卓上的数据,

去nba官网nbaapps-accessories,

requests获取数据,nba官网有用到异步io库pageio,所以requests可以拿到数据,python的话可以用docker把数据打包到一个容器里,然后python通过get方法加载这个容器。

lxml就行了啊,

用到异步io

这里的协议是什么?如果是平台会话协议或者dns协议,可以直接用httplib,可以生成http请求并分析发送者和接收者是谁,以及对方状态等等。

谢邀。利用python的requests库是可以抓取appstore上的商店数据的,

python网页数据抓取( Web抓取的探险之前,如何得到那些重要数据呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-10-16 10:03

Web抓取的探险之前,如何得到那些重要数据呢?)

随着电子商务的蓬勃发展,作者近年来对比价应用越来越着迷。每次线上(甚至线下)购买,都是对各大电商深度研究的结果网站。

作者常用的比价应用包括:RedLaser、ShopSavvy 和 BuyHatke。这些应用程序有效地提高了价格透明度,从而为消费者节省了大量时间。

但是,您有没有想过这些应用程序是如何获取这些重要数据的?通常,他们使用 Web 抓取技术来完成此任务。

网页抓取的定义

网络抓取是提取网络数据的过程。借助合适的工具,您可以提取任何您能看到的数据。在本文中,我们将重点介绍自动提取过程的过程,以帮助您在短时间内采集大量数据。除了我上面提到的用例,抓取技术的用途还包括:SEO跟踪、工作跟踪、新闻分析,以及我最喜欢的社交媒体情绪分析!

提醒

在开始网络抓取冒险之前,请确保您了解相关的法律问题。许多 网站 在其服务条款中明确禁止抓取其内容。例如,Medium 网站 写道:“按照网站 robots.txt 文件中的规定抓取是可以接受的,但我们禁止抓取。” 爬不准爬的网站可能会把你拉上他们的黑名单!与任何工具一样,网页抓取也可能用于不受欢迎的目的,例如复制 网站 内容。此外,网络爬虫引发的法律诉讼也不少。

设置代码

在完全理解需要谨慎处理之后,让我们开始学习网络抓取。事实上,网页抓取可以用任何编程语言实现。前不久,我们用Node来实现。在本文中,考虑到它的简单性和丰富的包支持,我们将使用 Python 来实现爬虫程序。

网页抓取的基本过程

当您在网络上打开一个站点时,它的 HTML 代码将被下载,您的 Web 浏览器将对其进行分析和显示。HTML 代码收录您看到的所有信息。因此,可以通过分析 HTML 代码获得所需的信息(如价格)。您可以使用正则表达式在数据海洋中搜索您需要的信息,也可以使用函数库来解释HTML,也可以获取您需要的数据。

在 Python 中,我们将使用一个名为 Beautiful Soup 的模块来分析 HTML 数据。您可以借助安装程序(例如 pip)进行安装,只需运行以下代码:

pip install beautifulsoup4

或者,您可以从源代码构建。在本模块中,您可以看到详细的安装步骤。

安装完成后,我们一般会按照以下步骤来实现网页抓取:

作为演示,我们将使用作者的博客作为目标 URL。

前两步比较简单,可以这样完成:

from urllib import urlopen#Sending the http requestwebpage = urlopen('http://my_website.com/').read()

接下来,将响应传递给之前安装的模块:

from bs4 import BeautifulSoup#making the soup! yummy ;)soup = BeautifulSoup(webpage, "html5lib")

请注意,这里我们选择了 html5lib 作为解析器。根据它,您还可以为其选择不同的解析器。

解析 HTML

将 HTML 传递给 BeautifulSoup 后,我们可以尝试一些命令。例如,要检查 HTML 标记代码是否正确,您可以验证页面的标题(在 Python 解释器中):

>>> soup.titleTranscendental Tech Talk>>> soup.title.text

u'Transcendental Tech Talk'

>>>

接下来,开始提取页面中的特定元素。例如,我想提取博客中的 文章 标题列表。为此,我需要分析 HTML 的结构,这可以在 Chrome 检查器的帮助下完成。其他浏览器也提供了类似的工具。

使用 Chrome 检查器检查页面的 HTML 结构

如您所见,所有 文章 标题都有 h3 标签和两个类属性:post-title 和 entry-title 类。因此,搜索所有带有 post-title 类的 h3 元素,以获取页面的 文章 标题列表。在这个例子中,我们使用了 BeautifulSoup 提供的 find_all 函数,并使用 class_ 参数来确定所需的类:

>>> titles = soup.find_all('h3', class_ = 'post-title') #Getting all titles>>> titles[0].textu'\nKolkata #BergerXP IndiBlogger meet, Marketing Insights, and some Blogging Tips\n'>>>

您应该通过仅通过 post-title 类搜索项目来获得相同的结果:

>>> titles = soup.find_all(class_ = 'post-title') #Getting all items with class post-title>>> titles[0].textu'\nKolkata #BergerXP IndiBlogger meet, Marketing Insights, and some Blogging Tips\n'>>>

如果您想了解有关条目引用的链接的更多信息,可以运行以下代码:

>>> for title in titles:... # Each title is in the form of Post Title<a/>... print title.find("a").get("href")...http://dada.theblogbowl.in/201 ... .html

http://dada.theblogbowl.in/201 ... .html

http://dada.theblogbowl.in/201 ... .html

http://dada.theblogbowl.in/201 ... gt%3B

BeautifulSoup 有许多内置方法可以帮助您玩转 HTML。下面列出了其中一些方法:

>>> titles[0].contents

[u'\n', Kolkata #BergerXP IndiBlogger meet, Marketing Insights, and some Blogging Tips</a>, u'\n']>>>

请注意,您也可以使用 children 属性,但它有点像生成器:

>>> titles[0].parent\n</a>\n\nKolkata #BergerXP IndiBlogger ...

>>>

为此,您还可以使用正则表达式来搜索 CSS 类。

使用 Mechanize 模拟登录

到目前为止,我们所做的只是下载页面并分析其内容。但是,Web 开发者可能会阻塞非浏览器请求,或者某些网站 内容只有登录后才能读取。那么,我们如何处理这些情况呢?

对于第一种情况,我们需要在向页面发送请求时模拟浏览器。每个 HTTP 请求都收录一些相关的数据头,其中收录访问者的浏览器、操作系统和屏幕大小等信息。我们可以改变这些数据头,冒充浏览器发送请求。

对于第二种情况,为了访问有访问者限制的内容,我们需要登录网站并使用cookies来维护会话。接下来,让我们看看如何在冒充浏览器的情况下完成此操作。

我们将使用 cookielib 模块来管理使用 cookie 的会话。此外,我们还将使用 mechanize,它可以使用 pip 等安装程序进行安装。

我们将通过博客碗页面登录并访问通知页面。以下代码由内联注释解释:

import mechanize

import cookielib

from urllib import urlopen

from bs4 import BeautifulSoup# Cookie Jarcj = cookielib.LWPCookieJar()

browser = mechanize.Browser()

browser.set_cookiejar(cj)

browser.set_handle_robots(False)

browser.set_handle_redirect(True)# Solving issue #1 by emulating a browser by adding HTTP headersbrowser.addheaders = [('User-agent', 'Mozilla/5.0 (X11; U; Linux i686; en-US; rv:1.9.0.1) Gecko/2008071615 Fedora/3.0.1-1.fc9 Firefox/3.0.1')]# Open Login Pagebrowser.open("http://theblogbowl.in/login/")# Select Login form (1st form of the page)browser.select_form(nr = 0)# Alternate syntax - browser.select_form(name = "form_name")# The first tag of the form is a CSRF token# Setting the 2nd and 3rd tags to email and passwordbrowser.form.set_value("email@example.com", nr=1)

browser.form.set_value("password", nr=2)# Logging inresponse = browser.submit()# Opening new page after loginsoup = BeautifulSoup(browser.open('http://theblogbowl.in/notifications/').read(), "html5lib")

通知页面的结构

# Print notificationsprint soup.find(class_ = "search_results").text

登录通知页面后的结果

结束语

很多开发者会告诉你:你在网上看到的任何信息都可以被抓取。通过这个文章,你学会了如何轻松提取登录后才能看到的内容。另外,如果你的IP被屏蔽了,你可以屏蔽你的IP地址(或选择其他地址)。同时,为了看起来像一个人在访问,你应该在请求之间保持一定的时间间隔。

随着人们对数据的需求不断增长,网络抓取(无论出于好坏的原因)只会在未来得到更广泛的应用。因此,了解其原理非常重要,无论您是要有效地使用该技术还是避免其陷入困境。

OneAPM 可以帮助您查看 Python 应用程序的各个方面。它不仅可以监控终端的用户体验,还可以监控服务器的性能。它还支持跟踪数据库、第三方 API 和 Web 服务器问题。阅读更多技术文章,请访问OneAPM官方技术博客。 查看全部

python网页数据抓取(

Web抓取的探险之前,如何得到那些重要数据呢?)

随着电子商务的蓬勃发展,作者近年来对比价应用越来越着迷。每次线上(甚至线下)购买,都是对各大电商深度研究的结果网站。

作者常用的比价应用包括:RedLaser、ShopSavvy 和 BuyHatke。这些应用程序有效地提高了价格透明度,从而为消费者节省了大量时间。

但是,您有没有想过这些应用程序是如何获取这些重要数据的?通常,他们使用 Web 抓取技术来完成此任务。

网页抓取的定义

网络抓取是提取网络数据的过程。借助合适的工具,您可以提取任何您能看到的数据。在本文中,我们将重点介绍自动提取过程的过程,以帮助您在短时间内采集大量数据。除了我上面提到的用例,抓取技术的用途还包括:SEO跟踪、工作跟踪、新闻分析,以及我最喜欢的社交媒体情绪分析!

提醒

在开始网络抓取冒险之前,请确保您了解相关的法律问题。许多 网站 在其服务条款中明确禁止抓取其内容。例如,Medium 网站 写道:“按照网站 robots.txt 文件中的规定抓取是可以接受的,但我们禁止抓取。” 爬不准爬的网站可能会把你拉上他们的黑名单!与任何工具一样,网页抓取也可能用于不受欢迎的目的,例如复制 网站 内容。此外,网络爬虫引发的法律诉讼也不少。

设置代码

在完全理解需要谨慎处理之后,让我们开始学习网络抓取。事实上,网页抓取可以用任何编程语言实现。前不久,我们用Node来实现。在本文中,考虑到它的简单性和丰富的包支持,我们将使用 Python 来实现爬虫程序。

网页抓取的基本过程

当您在网络上打开一个站点时,它的 HTML 代码将被下载,您的 Web 浏览器将对其进行分析和显示。HTML 代码收录您看到的所有信息。因此,可以通过分析 HTML 代码获得所需的信息(如价格)。您可以使用正则表达式在数据海洋中搜索您需要的信息,也可以使用函数库来解释HTML,也可以获取您需要的数据。

在 Python 中,我们将使用一个名为 Beautiful Soup 的模块来分析 HTML 数据。您可以借助安装程序(例如 pip)进行安装,只需运行以下代码:

pip install beautifulsoup4

或者,您可以从源代码构建。在本模块中,您可以看到详细的安装步骤。

安装完成后,我们一般会按照以下步骤来实现网页抓取:

作为演示,我们将使用作者的博客作为目标 URL。

前两步比较简单,可以这样完成:

from urllib import urlopen#Sending the http requestwebpage = urlopen('http://my_website.com/').read()

接下来,将响应传递给之前安装的模块:

from bs4 import BeautifulSoup#making the soup! yummy ;)soup = BeautifulSoup(webpage, "html5lib")

请注意,这里我们选择了 html5lib 作为解析器。根据它,您还可以为其选择不同的解析器。

解析 HTML

将 HTML 传递给 BeautifulSoup 后,我们可以尝试一些命令。例如,要检查 HTML 标记代码是否正确,您可以验证页面的标题(在 Python 解释器中):

>>> soup.titleTranscendental Tech Talk>>> soup.title.text

u'Transcendental Tech Talk'

>>>

接下来,开始提取页面中的特定元素。例如,我想提取博客中的 文章 标题列表。为此,我需要分析 HTML 的结构,这可以在 Chrome 检查器的帮助下完成。其他浏览器也提供了类似的工具。

使用 Chrome 检查器检查页面的 HTML 结构

如您所见,所有 文章 标题都有 h3 标签和两个类属性:post-title 和 entry-title 类。因此,搜索所有带有 post-title 类的 h3 元素,以获取页面的 文章 标题列表。在这个例子中,我们使用了 BeautifulSoup 提供的 find_all 函数,并使用 class_ 参数来确定所需的类:

>>> titles = soup.find_all('h3', class_ = 'post-title') #Getting all titles>>> titles[0].textu'\nKolkata #BergerXP IndiBlogger meet, Marketing Insights, and some Blogging Tips\n'>>>

您应该通过仅通过 post-title 类搜索项目来获得相同的结果:

>>> titles = soup.find_all(class_ = 'post-title') #Getting all items with class post-title>>> titles[0].textu'\nKolkata #BergerXP IndiBlogger meet, Marketing Insights, and some Blogging Tips\n'>>>

如果您想了解有关条目引用的链接的更多信息,可以运行以下代码: