网页中flash数据抓取

网页中flash数据抓取(一下营销型网站建设的动态页面和静态页面最简单最直接的区分)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-20 16:05

很多人认为动态网页比静态网页好看。其实这里有两个误解:动态网页和静态网页的定义混淆了,选择动态网页还是静态网页取决于我们网站的基本功能需求。考虑。今天小编就来分析一下营销网站搭建的动静态页面。

动态页面和静态页面最简单、最直接的区别就是看是否从数据库中检索到数据。每次打开一个网页,必须从数据库中检索数据为动态页面,不需要从数据库中检索数据的为静态页面;有flash动画的网页一定是动态页面,静态页面也可以用flash动画制作,也可以很漂亮。

营销型网站的构建应该选择动态页面还是静态页面,还要从网站的功能和各自的关注点出发。

1、营销网站和普通网站最大的区别就是SEO

我们在做营销类型网站的时候,首先考虑的是如何更好的让搜索引擎抓取我们网站的内容,我们网站的内容被搜索引擎抓取的越多,那么排名我们的网站在搜索引擎中的效果会更好。动态页面的所有数据都必须从数据库中检索,搜索引擎无法抓取和存储,因此搜索引擎在找到此类信息时会直接放弃。以HTML格式存储的静态页面易于存储和抓取,因此更适合搜索引擎和收录习惯。专业来讲,静态页面对搜索引擎更友好,所以静态页面网站排名效果一般要好于动态页面。

2、从用户体验的角度

每次打开动态页面时,都必须从数据库中检索信息。网页打开速度会很慢,不利于阅读。静态页面打开速度快很多,用户体验好;动态页面只能提升用户体验文章从自己的服务器和宽带做起,但是这方面的投入会很大,效果会比静态网页好,因为它取决于用户的硬件配置和网络;

3、安全视角

静态页面源代码固定,不可恶意篡改,跳转速度快,不易被黑客攻击;而动态页面每次跳转和内容更新都需要从数据库中检索数据,打开速度慢。过程复杂,容易招致黑客攻击

4、网站 论坛、留言板、会员注册页面等必备功能,数据要时时更新保存

静态页面无法实现这些功能,所以这些地方必须动态化。因此,面向营销的网站建设要以静态页面为主,动态页面设置在各个位置,利用静态页面和动态页面各自的优势,实现优势互补。

希望以上营销型网站动态页面和静态页面的分析对大家有所帮助。 查看全部

网页中flash数据抓取(一下营销型网站建设的动态页面和静态页面最简单最直接的区分)

很多人认为动态网页比静态网页好看。其实这里有两个误解:动态网页和静态网页的定义混淆了,选择动态网页还是静态网页取决于我们网站的基本功能需求。考虑。今天小编就来分析一下营销网站搭建的动静态页面。

动态页面和静态页面最简单、最直接的区别就是看是否从数据库中检索到数据。每次打开一个网页,必须从数据库中检索数据为动态页面,不需要从数据库中检索数据的为静态页面;有flash动画的网页一定是动态页面,静态页面也可以用flash动画制作,也可以很漂亮。

营销型网站的构建应该选择动态页面还是静态页面,还要从网站的功能和各自的关注点出发。

1、营销网站和普通网站最大的区别就是SEO

我们在做营销类型网站的时候,首先考虑的是如何更好的让搜索引擎抓取我们网站的内容,我们网站的内容被搜索引擎抓取的越多,那么排名我们的网站在搜索引擎中的效果会更好。动态页面的所有数据都必须从数据库中检索,搜索引擎无法抓取和存储,因此搜索引擎在找到此类信息时会直接放弃。以HTML格式存储的静态页面易于存储和抓取,因此更适合搜索引擎和收录习惯。专业来讲,静态页面对搜索引擎更友好,所以静态页面网站排名效果一般要好于动态页面。

2、从用户体验的角度

每次打开动态页面时,都必须从数据库中检索信息。网页打开速度会很慢,不利于阅读。静态页面打开速度快很多,用户体验好;动态页面只能提升用户体验文章从自己的服务器和宽带做起,但是这方面的投入会很大,效果会比静态网页好,因为它取决于用户的硬件配置和网络;

3、安全视角

静态页面源代码固定,不可恶意篡改,跳转速度快,不易被黑客攻击;而动态页面每次跳转和内容更新都需要从数据库中检索数据,打开速度慢。过程复杂,容易招致黑客攻击

4、网站 论坛、留言板、会员注册页面等必备功能,数据要时时更新保存

静态页面无法实现这些功能,所以这些地方必须动态化。因此,面向营销的网站建设要以静态页面为主,动态页面设置在各个位置,利用静态页面和动态页面各自的优势,实现优势互补。

希望以上营销型网站动态页面和静态页面的分析对大家有所帮助。

网页中flash数据抓取(谭云财SEO顾问:sitemap蜘蛛抓取原理详解百度蜘蛛)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-20 16:04

(谭云才SEO顾问)在互联网上,我们经常会涉及到各种搜索引擎的爬取算法,所有的搜索引擎都必须经过爬取和过滤。五个主要的搜索引擎是百度、搜狗、360、谷歌和必应。抓取的原理是什么?一个存储到展示的过程。当然,他们都会抓取robots文件,具体抓取时间和频率根据网站的更新频率+站点地图更新确定。

详解sitemap蜘蛛爬行的原理

百度蜘蛛抓取原理

爬取:百度蜘蛛会先分析网站的robots文件,然后读取网站的哪些目录可以爬取,哪些信息不加权重。百度蜘蛛抓取的信息属于广义模式,会抓取一个链接目录下的所有子链接,或者抓取一个页面上的所有链接进行存储。

百度蜘蛛也会根据爬取频率和时间来判断一个网站的性能。网站服务器在一定单位时间内(天级别)的总爬取次数,如果搜索引擎爬取该站点的频率太高,很可能导致服务器不稳定。当网站出现延迟时,将暂停当天内网站内容的获取。

还要注意网站各个页面之间的权重转换以及面包屑的合理布局。

具体的爬取频率和爬取时间需要根据网站服务器的性能来判断,对网站的内容重复进行过滤。

百度蜘蛛通常最热衷于静态目录形式的链接:

如同:

所有的域名都会有pr的权重参数,所以在网站的布局中,所有的列都需要根据蜘蛛爬取的信息进行排序,即“信息在先,功能在后”的布局被俘。

过滤:百度蜘蛛不会抓取JS脚本、iframe框架、网页需要登录的信息、flash视频。(这些都是禁忌!)

正常情况下,百度蜘蛛会从每天提交的新内容中识别并抓取内容网站;然后过滤内容,过滤掉发现不舒服的内容;

惩罚:如果在网站上发现大量类似内容,直接过滤掉。如果采集的内容严重的话,网站可能会被黑1-2个月收录内没有给出,结果是网站进入沙盒期并且它的排名下降了。

存储:百度蜘蛛会过滤数据,保留符合条件的内容,存储在临时索引库中,进行分类存储。

显示:库中存储的内容,我们将通过站点命令查看索引。当用户搜索内容时,百度蜘蛛会选择符合用户习惯并需要展示的内容。

对抗采集站的算法:此外,百度会定期发布相应算法对抗采集网站,保护原创。采集不同文章的多篇文章拼接在一起,整体内容没有形成完整的逻辑,存在阅读不一致、文章不连贯等问题,并且当内容不能满足用户需求,百度也将严打,收录网站的内容在一段时间内将无法使用。

搜狗搜索引擎抓取原理

搜狗的搜索引擎采用目录爬取,即注重深度索引。(批量推送时,会选择性抓取内部链接)

一个内容好、内容独特的页面,如果你的页面内容与互联网上已经存在的其他页面的相似度高,可能不是搜狗收录。

1、 链接级别浅的页面,以及链接级别太深的页面,尤其是动态网页的链接,将被丢弃而不是 收录。

2、 如果是动态网页,请控制参数个数和URL长度。搜狗更喜欢 收录 静态网页。

搜狗搜索引擎主要抓取微信内容。

360搜索引擎抓取原理

360搜索引擎主要抓取网站的ALT图片,是一款专业的图片搜索引擎工具。通常,站长也会将图片提交给360进行抓取,并有选择地存储和构建索引库。

360搜索引擎主要抓取网站图片。

谷歌搜索引擎抓取原理

谷歌搜索引擎又称通用搜索引擎,分为索引蜘蛛爬行和目录蜘蛛爬行,爬取网络上的所有链接。【做站群时需要禁止谷歌抓取】

Bing搜索引擎抓取原理

主要用在手机端的UC浏览器,差点挂了。(武汉seo优化) 查看全部

网页中flash数据抓取(谭云财SEO顾问:sitemap蜘蛛抓取原理详解百度蜘蛛)

(谭云才SEO顾问)在互联网上,我们经常会涉及到各种搜索引擎的爬取算法,所有的搜索引擎都必须经过爬取和过滤。五个主要的搜索引擎是百度、搜狗、360、谷歌和必应。抓取的原理是什么?一个存储到展示的过程。当然,他们都会抓取robots文件,具体抓取时间和频率根据网站的更新频率+站点地图更新确定。

详解sitemap蜘蛛爬行的原理

百度蜘蛛抓取原理

爬取:百度蜘蛛会先分析网站的robots文件,然后读取网站的哪些目录可以爬取,哪些信息不加权重。百度蜘蛛抓取的信息属于广义模式,会抓取一个链接目录下的所有子链接,或者抓取一个页面上的所有链接进行存储。

百度蜘蛛也会根据爬取频率和时间来判断一个网站的性能。网站服务器在一定单位时间内(天级别)的总爬取次数,如果搜索引擎爬取该站点的频率太高,很可能导致服务器不稳定。当网站出现延迟时,将暂停当天内网站内容的获取。

还要注意网站各个页面之间的权重转换以及面包屑的合理布局。

具体的爬取频率和爬取时间需要根据网站服务器的性能来判断,对网站的内容重复进行过滤。

百度蜘蛛通常最热衷于静态目录形式的链接:

如同:

所有的域名都会有pr的权重参数,所以在网站的布局中,所有的列都需要根据蜘蛛爬取的信息进行排序,即“信息在先,功能在后”的布局被俘。

过滤:百度蜘蛛不会抓取JS脚本、iframe框架、网页需要登录的信息、flash视频。(这些都是禁忌!)

正常情况下,百度蜘蛛会从每天提交的新内容中识别并抓取内容网站;然后过滤内容,过滤掉发现不舒服的内容;

惩罚:如果在网站上发现大量类似内容,直接过滤掉。如果采集的内容严重的话,网站可能会被黑1-2个月收录内没有给出,结果是网站进入沙盒期并且它的排名下降了。

存储:百度蜘蛛会过滤数据,保留符合条件的内容,存储在临时索引库中,进行分类存储。

显示:库中存储的内容,我们将通过站点命令查看索引。当用户搜索内容时,百度蜘蛛会选择符合用户习惯并需要展示的内容。

对抗采集站的算法:此外,百度会定期发布相应算法对抗采集网站,保护原创。采集不同文章的多篇文章拼接在一起,整体内容没有形成完整的逻辑,存在阅读不一致、文章不连贯等问题,并且当内容不能满足用户需求,百度也将严打,收录网站的内容在一段时间内将无法使用。

搜狗搜索引擎抓取原理

搜狗的搜索引擎采用目录爬取,即注重深度索引。(批量推送时,会选择性抓取内部链接)

一个内容好、内容独特的页面,如果你的页面内容与互联网上已经存在的其他页面的相似度高,可能不是搜狗收录。

1、 链接级别浅的页面,以及链接级别太深的页面,尤其是动态网页的链接,将被丢弃而不是 收录。

2、 如果是动态网页,请控制参数个数和URL长度。搜狗更喜欢 收录 静态网页。

搜狗搜索引擎主要抓取微信内容。

360搜索引擎抓取原理

360搜索引擎主要抓取网站的ALT图片,是一款专业的图片搜索引擎工具。通常,站长也会将图片提交给360进行抓取,并有选择地存储和构建索引库。

360搜索引擎主要抓取网站图片。

谷歌搜索引擎抓取原理

谷歌搜索引擎又称通用搜索引擎,分为索引蜘蛛爬行和目录蜘蛛爬行,爬取网络上的所有链接。【做站群时需要禁止谷歌抓取】

Bing搜索引擎抓取原理

主要用在手机端的UC浏览器,差点挂了。(武汉seo优化)

网页中flash数据抓取(项目招商找A5快速获取精准代理名单如何设计让搜索引擎Spider喜欢的网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-20 16:02

项目招商找A5快速获取精准代理商名单

如何设计搜索引擎蜘蛛喜欢的网站? 网站 有利于搜索引擎蜘蛛爬取的,是网站 搜索引擎喜欢的。山西seoer珍惜有利于搜索引擎蜘蛛爬行、对用户有帮助的网站可以成为网站优化。虽然比较窄,但是一个网站可以达到这个水平。 网站还算不错,那么如何设计一个能够帮助搜索引擎Spider爬取的网站呢?下面山西seoer给大家详细介绍。以下内容仅是山西seoer家珍爱一句话,不敢相信。

首先,搜索引擎必须能够爬到网站的首页。爬到网站的首页后,搜索引擎蜘蛛会沿着网站的导航页面、栏目等页面爬到网站最深的文章页面,所以一个好的网站结构更重要,把网站的内部链接布置好。搜索引擎将遵循正常的 html 代码。爬行,网站的内页最好尽量少从首页点击。另外,现在搜索引擎在抓取JS和flash链接抓取方面还有一些困难,所以优化一下网站时尽量避免这些。

让搜索引擎找到网页,抓取网站的内页内容。找到的 URL 必须是可抓取的。数据库是动态生成的,参数过多的URL,sessionID,以及整个页面的flash、frame、可疑的翻页、大量的复制粘贴内容,不利于网站的发展壮大。如果有什么网站不想被搜索引擎抓取,可以直接把robots.txt拿去屏蔽,但robots.txt毕竟只是一个协议。是否真的能达到效果还不得而知。有兴趣的可以参考:什么是robots.txt?

网站 爬取后能否提取网站的信息,搜索引擎爬取网站后是否能提取出与网站更相关的信息,现在很多网站企业网站都做网站,以达到良好的视觉效果。 网站首页直接使用flash制作动画效果。虽然视觉上感觉很不错,但对搜索引擎Spider并不友好。这里的主要参考是能否帮助搜索引擎更好地抓取,作为判断依据。

以上是山西搜尔珍视和介绍的《如何设计搜索引擎喜欢的网站》。以上内容仅代表个人观点,欢迎大家一起交流。 查看全部

网页中flash数据抓取(项目招商找A5快速获取精准代理名单如何设计让搜索引擎Spider喜欢的网站)

项目招商找A5快速获取精准代理商名单

如何设计搜索引擎蜘蛛喜欢的网站? 网站 有利于搜索引擎蜘蛛爬取的,是网站 搜索引擎喜欢的。山西seoer珍惜有利于搜索引擎蜘蛛爬行、对用户有帮助的网站可以成为网站优化。虽然比较窄,但是一个网站可以达到这个水平。 网站还算不错,那么如何设计一个能够帮助搜索引擎Spider爬取的网站呢?下面山西seoer给大家详细介绍。以下内容仅是山西seoer家珍爱一句话,不敢相信。

首先,搜索引擎必须能够爬到网站的首页。爬到网站的首页后,搜索引擎蜘蛛会沿着网站的导航页面、栏目等页面爬到网站最深的文章页面,所以一个好的网站结构更重要,把网站的内部链接布置好。搜索引擎将遵循正常的 html 代码。爬行,网站的内页最好尽量少从首页点击。另外,现在搜索引擎在抓取JS和flash链接抓取方面还有一些困难,所以优化一下网站时尽量避免这些。

让搜索引擎找到网页,抓取网站的内页内容。找到的 URL 必须是可抓取的。数据库是动态生成的,参数过多的URL,sessionID,以及整个页面的flash、frame、可疑的翻页、大量的复制粘贴内容,不利于网站的发展壮大。如果有什么网站不想被搜索引擎抓取,可以直接把robots.txt拿去屏蔽,但robots.txt毕竟只是一个协议。是否真的能达到效果还不得而知。有兴趣的可以参考:什么是robots.txt?

网站 爬取后能否提取网站的信息,搜索引擎爬取网站后是否能提取出与网站更相关的信息,现在很多网站企业网站都做网站,以达到良好的视觉效果。 网站首页直接使用flash制作动画效果。虽然视觉上感觉很不错,但对搜索引擎Spider并不友好。这里的主要参考是能否帮助搜索引擎更好地抓取,作为判断依据。

以上是山西搜尔珍视和介绍的《如何设计搜索引擎喜欢的网站》。以上内容仅代表个人观点,欢迎大家一起交流。

网页中flash数据抓取(我分别用过三种方式写过一些简单的爬虫,解决了方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-12-19 06:02

我用三种方式写了一些简单的爬虫。下面总结一下我对爬虫的理解和使用方法(欢迎指正和补充):

使用任何语言的http库(比如python的urllib2,或者使用支持连接池的urllib3来提高效率),加上一个解析html的库(比如python的beautifulsoup)。使用urllib模拟get/post请求爬取网页,然后通过解析html库得到需要爬取的内容。如果可以获取一个页面的内容,就可以通过URL获取所有页面的内容。

优点:直接,速度快,占用资源少,可以同时运行多个进程/线程,可以在命令行上完成

缺点:这种方法的致命缺点是如果遇到的页面是通过js动态渲染或者通过ajax动态加载的,获取页面内容比较困难。这种情况下,还需要一个js解释器(也可以说是浏览器)来进一步分析,得到想要的内容。

PS:遇到ip限制可以设置代理。

使用firefox/chrome浏览器插件方式(即javascript+浏览器方式做爬虫)。使用firefox插件,不存在跨域访问提交问题。下面是我去年写的一个简单的firefox插件爬取论文网站的作者/邮箱的firefox插件比较粗糙,但基本流程通用。基本原理是在浏览器加载页面后,使用javascript/jquery模拟点击等事件,获取相应的内容,然后Post到远程服务器的url进行处理保存。或者写入浏览器的本地存储(如sqlite)

优点:直观,纯js实现,jquery简单易用,调试方便,解决了方法1的动态内容渲染问题,可以与浏览器交互,轻松解决验证码输入限制

缺点:必须依赖本地浏览器,速度慢,比方法1消耗资源,进程/线程多,或多或少需要考虑干预(因为我的代码写得不好...)

第三种方法使用了一个叫selenium-automated browser的神器,它是一个支持多语言界面的库,通过它你可以使用java/python/ruby等语言来操作浏览器(firefox/chrome等)完成任务,通常用于测试前端代码。这样写的爬虫,或者用python/java等语言写主要结构(分析和修改数据,存入数据库等),通过selenium js/jquery接口完成渲染和触发的网页内容。

优点:结合了方法一和方法二的大部分优点。 查看全部

网页中flash数据抓取(我分别用过三种方式写过一些简单的爬虫,解决了方法)

我用三种方式写了一些简单的爬虫。下面总结一下我对爬虫的理解和使用方法(欢迎指正和补充):

使用任何语言的http库(比如python的urllib2,或者使用支持连接池的urllib3来提高效率),加上一个解析html的库(比如python的beautifulsoup)。使用urllib模拟get/post请求爬取网页,然后通过解析html库得到需要爬取的内容。如果可以获取一个页面的内容,就可以通过URL获取所有页面的内容。

优点:直接,速度快,占用资源少,可以同时运行多个进程/线程,可以在命令行上完成

缺点:这种方法的致命缺点是如果遇到的页面是通过js动态渲染或者通过ajax动态加载的,获取页面内容比较困难。这种情况下,还需要一个js解释器(也可以说是浏览器)来进一步分析,得到想要的内容。

PS:遇到ip限制可以设置代理。

使用firefox/chrome浏览器插件方式(即javascript+浏览器方式做爬虫)。使用firefox插件,不存在跨域访问提交问题。下面是我去年写的一个简单的firefox插件爬取论文网站的作者/邮箱的firefox插件比较粗糙,但基本流程通用。基本原理是在浏览器加载页面后,使用javascript/jquery模拟点击等事件,获取相应的内容,然后Post到远程服务器的url进行处理保存。或者写入浏览器的本地存储(如sqlite)

优点:直观,纯js实现,jquery简单易用,调试方便,解决了方法1的动态内容渲染问题,可以与浏览器交互,轻松解决验证码输入限制

缺点:必须依赖本地浏览器,速度慢,比方法1消耗资源,进程/线程多,或多或少需要考虑干预(因为我的代码写得不好...)

第三种方法使用了一个叫selenium-automated browser的神器,它是一个支持多语言界面的库,通过它你可以使用java/python/ruby等语言来操作浏览器(firefox/chrome等)完成任务,通常用于测试前端代码。这样写的爬虫,或者用python/java等语言写主要结构(分析和修改数据,存入数据库等),通过selenium js/jquery接口完成渲染和触发的网页内容。

优点:结合了方法一和方法二的大部分优点。

网页中flash数据抓取(网站ASP程序开发学习目标:学习PHP环境配置,PHP语言编程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-12-19 05:01

课程详情 2021-12-09

网站后台开发培训班

课程名称

示例图片

课程内容

第一部分:网站ASP程序开发

学习目标:掌握基本的Web构建技术,了解动态网页的设计规范,掌握VBScript和ASP的编程方法,以及ASP与Web数据库结合的集成技术。使学生具备搭建中小型网站的基本技能。

ASP

地基与环境搭建

ASP基础知识,掌握数据库的基本概念和Web数据库的特点。熟练掌握WindowsXP下虚拟Web的安装和服务器配置。数据库的基本概念;熟悉过程控制结构;条件语句;select语句计数循环语句;数组循环语句;条件循环语句、子程序设计、函数使用;错误处理;识别 ASP 内置对象的集合、属性和方法。

使用 VBScript 和 ASP 语言进行客户端和服务器端脚本设计

从浏览器获取数据的方法;表单的后端处理;文件的上传和下载;Request 对象的集合、属性和方法;服务器对象和服务器端文件访问;服务器对象的属性和方法;访问服务器端文件的打开、读写、更新和删除操作;数据库查询;使用 SQL 查询;掌握SQL语句的语法。

掌握ASP中对象和组件项目的实战

访客留言簿和讨论区设计示例;访客留言簿;讨论区权限设置、分页码编写、搜索引擎设置、搜索引擎管理和使用;索引服务内置对象;学习规划编制网页程序的流程设计清单。

第二部分:网站PHP程序开发

学习目标:学习PHP环境配置、PHP语言编程、PHP进阶技术、PHP进阶应用;系统学习MySql数据库,PHP操作MySQL数据库等示例开发网站通用系统,完成了一个中小型网站的开发。

PHP基础和环境配置

PHP环境配置、表单应用、PHP输入输出协调应用、PHP语法数据流控制设计;MYSQL设计信息表;。使用phpMyAdmin操作MySql数据库,完成信息管理系统的设计。

php 语法

php语法规则、If语句、if-else语句、elseif语句、switch语句、while循环、for循环、数组、数字数组、关联数组等,使用while和if绘制10×10的表格等。 示例:九九乘法表,多维数组存储数据的应用。

MySQL在php中的使用

学习SQL语句:字段列表、条件语句、分组字段、排序字段列表、截取数据等、多表操作、流程应用等,完成信息管理系统的设计。PHP连接mysql函数的应用,自定义函数的应用。使用自定义函数,进行表间操作,使用JS完成表单校验,同时进行数据过滤应用,制作PHP分页模块。阶段项目实战:PHP留言板示例。

php后台管理系统开发

php技术规范,SQL语句优化练习,用户设置。.MySQL数据库、SQL查询语言应用技巧、SQL语句优化、mysql用户分配与安全等,以及数据备份练习。可以灵活使用常用的字符串函数。使用GD库创建图形和图像,设计验证码程序;使用session、cookie、MD5等应用,结合实例设计用户管理系统,结合实例开发登录注册系统。

高级PHP后台系统开发

主流编辑使用学习;.Smarty模板技术;AJAX应用、用户验证、多功能菜单连接、分页应用等;CACHE缓存技术,实用的动态页面生成静态技术;常规应用,实现网页抓取技术。掌握Flash JS PHP的组合操作能力,滚动广告系统的设计。实际项目:cms内容管理系统、新闻系统、产品系统、图片上传系统、应用文件上传和缩略图功能开发、相册管理系统开发、会员系统、投票系统开发、电子商务平台开发系统。

网站后台开发班

上课时间

两个月

培训目标

本课程重点培养掌握网页设计和php、asp程序开发技术的高级网页程序员。本课程通过多个真实项目的训练,使学员能够掌握网站cms系统、PHP/ASP编程等高级技术。让学生真正拥有一年左右的后台开发经验网站。

适用于

具有高中或同等学历及以上学历,有兴趣从事网页设计行业的相关学生

就业

高级web程序工程师(起薪3500-5000元,随着市场对PHP人才的不断需求,一年后薪水6000多元,工作几年后升为网站首席程序技术总监,年薪超15万。)

更多关注:广州网页设计培训班、广州网页设计培训学校、广州网页设计培训

更多培训课程、学习信息、课程折扣、开课时间、学校地址等学校信息,请输入

了解更多关于广州设计培训学院 查看全部

网页中flash数据抓取(网站ASP程序开发学习目标:学习PHP环境配置,PHP语言编程)

课程详情 2021-12-09

网站后台开发培训班

课程名称

示例图片

课程内容

第一部分:网站ASP程序开发

学习目标:掌握基本的Web构建技术,了解动态网页的设计规范,掌握VBScript和ASP的编程方法,以及ASP与Web数据库结合的集成技术。使学生具备搭建中小型网站的基本技能。

ASP

地基与环境搭建

ASP基础知识,掌握数据库的基本概念和Web数据库的特点。熟练掌握WindowsXP下虚拟Web的安装和服务器配置。数据库的基本概念;熟悉过程控制结构;条件语句;select语句计数循环语句;数组循环语句;条件循环语句、子程序设计、函数使用;错误处理;识别 ASP 内置对象的集合、属性和方法。

使用 VBScript 和 ASP 语言进行客户端和服务器端脚本设计

从浏览器获取数据的方法;表单的后端处理;文件的上传和下载;Request 对象的集合、属性和方法;服务器对象和服务器端文件访问;服务器对象的属性和方法;访问服务器端文件的打开、读写、更新和删除操作;数据库查询;使用 SQL 查询;掌握SQL语句的语法。

掌握ASP中对象和组件项目的实战

访客留言簿和讨论区设计示例;访客留言簿;讨论区权限设置、分页码编写、搜索引擎设置、搜索引擎管理和使用;索引服务内置对象;学习规划编制网页程序的流程设计清单。

第二部分:网站PHP程序开发

学习目标:学习PHP环境配置、PHP语言编程、PHP进阶技术、PHP进阶应用;系统学习MySql数据库,PHP操作MySQL数据库等示例开发网站通用系统,完成了一个中小型网站的开发。

PHP基础和环境配置

PHP环境配置、表单应用、PHP输入输出协调应用、PHP语法数据流控制设计;MYSQL设计信息表;。使用phpMyAdmin操作MySql数据库,完成信息管理系统的设计。

php 语法

php语法规则、If语句、if-else语句、elseif语句、switch语句、while循环、for循环、数组、数字数组、关联数组等,使用while和if绘制10×10的表格等。 示例:九九乘法表,多维数组存储数据的应用。

MySQL在php中的使用

学习SQL语句:字段列表、条件语句、分组字段、排序字段列表、截取数据等、多表操作、流程应用等,完成信息管理系统的设计。PHP连接mysql函数的应用,自定义函数的应用。使用自定义函数,进行表间操作,使用JS完成表单校验,同时进行数据过滤应用,制作PHP分页模块。阶段项目实战:PHP留言板示例。

php后台管理系统开发

php技术规范,SQL语句优化练习,用户设置。.MySQL数据库、SQL查询语言应用技巧、SQL语句优化、mysql用户分配与安全等,以及数据备份练习。可以灵活使用常用的字符串函数。使用GD库创建图形和图像,设计验证码程序;使用session、cookie、MD5等应用,结合实例设计用户管理系统,结合实例开发登录注册系统。

高级PHP后台系统开发

主流编辑使用学习;.Smarty模板技术;AJAX应用、用户验证、多功能菜单连接、分页应用等;CACHE缓存技术,实用的动态页面生成静态技术;常规应用,实现网页抓取技术。掌握Flash JS PHP的组合操作能力,滚动广告系统的设计。实际项目:cms内容管理系统、新闻系统、产品系统、图片上传系统、应用文件上传和缩略图功能开发、相册管理系统开发、会员系统、投票系统开发、电子商务平台开发系统。

网站后台开发班

上课时间

两个月

培训目标

本课程重点培养掌握网页设计和php、asp程序开发技术的高级网页程序员。本课程通过多个真实项目的训练,使学员能够掌握网站cms系统、PHP/ASP编程等高级技术。让学生真正拥有一年左右的后台开发经验网站。

适用于

具有高中或同等学历及以上学历,有兴趣从事网页设计行业的相关学生

就业

高级web程序工程师(起薪3500-5000元,随着市场对PHP人才的不断需求,一年后薪水6000多元,工作几年后升为网站首席程序技术总监,年薪超15万。)

更多关注:广州网页设计培训班、广州网页设计培训学校、广州网页设计培训

更多培训课程、学习信息、课程折扣、开课时间、学校地址等学校信息,请输入

了解更多关于广州设计培训学院

网页中flash数据抓取(分为静态网站和动态网站静态网页的网址形式通常是什么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2021-12-19 04:20

分为静态网站和动态网站

静态网站

静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀。在HTML格式的网页上,还可以出现各种动态效果,如.GIF格式动画、FLASH、滚动字母等等,这些“动态效果”只是视觉上的,而“静态”的致命弱点网站不容易维护。为了不断更新网页的内容,你必须不断地复制 HTML 文档。随着网站的内容和信息量与日俱增,你会觉得工作量超乎想象。

动态 网站

动态的网站不是指功能性的网站,而是指通过数据库结构化的网站。动态网站除了设计网页之外,还需要借助数据库和编程,让网站具备更多的自动化和高级功能。比如网站里面有很多产品资料和图片,种类也很多。为了方便客户查找,需要通过数据库编程实现网络自动搜索;系统、在线采购系统、商务交流系统等均采用数据库

(1)动态网页基于数据库技术,可以大大减少网站维护的工作量;

(2)网站采用动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎检索有一定的问题,一般搜索引擎无法访问网站的数据库中的所有网页,或者出于技术考虑,搜索蜘蛛可以不抓取网址中“?”后的内容,因此使用动态网页的网站在进行搜索引擎推广时需要做一定的技术处理以满足搜索引擎的要求。

浏览了解2016年大连网站生产价格、联合企业状态网站生产优势、客户评价、服务承诺、服务区域、大连网站生产语言版本及收费。

感谢大连网站建设、大连网站制作、大连响应式设计第一品牌的关注。联合企业致力于为企业用户提供高效、快捷、优质的互联网技术服务。业务范围包括响应式网站制作、微网站、电商平台、微媒体、android/ios开发、域名注册、云托管和互联网技术服务。 查看全部

网页中flash数据抓取(分为静态网站和动态网站静态网页的网址形式通常是什么)

分为静态网站和动态网站

静态网站

静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀。在HTML格式的网页上,还可以出现各种动态效果,如.GIF格式动画、FLASH、滚动字母等等,这些“动态效果”只是视觉上的,而“静态”的致命弱点网站不容易维护。为了不断更新网页的内容,你必须不断地复制 HTML 文档。随着网站的内容和信息量与日俱增,你会觉得工作量超乎想象。

动态 网站

动态的网站不是指功能性的网站,而是指通过数据库结构化的网站。动态网站除了设计网页之外,还需要借助数据库和编程,让网站具备更多的自动化和高级功能。比如网站里面有很多产品资料和图片,种类也很多。为了方便客户查找,需要通过数据库编程实现网络自动搜索;系统、在线采购系统、商务交流系统等均采用数据库

(1)动态网页基于数据库技术,可以大大减少网站维护的工作量;

(2)网站采用动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎检索有一定的问题,一般搜索引擎无法访问网站的数据库中的所有网页,或者出于技术考虑,搜索蜘蛛可以不抓取网址中“?”后的内容,因此使用动态网页的网站在进行搜索引擎推广时需要做一定的技术处理以满足搜索引擎的要求。

浏览了解2016年大连网站生产价格、联合企业状态网站生产优势、客户评价、服务承诺、服务区域、大连网站生产语言版本及收费。

感谢大连网站建设、大连网站制作、大连响应式设计第一品牌的关注。联合企业致力于为企业用户提供高效、快捷、优质的互联网技术服务。业务范围包括响应式网站制作、微网站、电商平台、微媒体、android/ios开发、域名注册、云托管和互联网技术服务。

网页中flash数据抓取(网页中的Flash怎么解决问题的解决方法(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-12-18 16:00

解决方案:

因为网页中的Flash是控件的形式,它的优先级更高,所以直接给它添加链接是无效的,但是可以通过按钮控件BUTTON来实现。

具体步骤

1.直接在按钮上添加onClick事件,打开指定页面:

onClick="window.open('','_blank')"隐藏焦点>

2、方法一中的代码运行后点击按钮时,按钮中的Flash有下沉动作。如果要取消这个动作,可以禁用按钮的交互性,然后使用标准的A标签作为链接。代码如下:

注意:Flash 对象的 wmode 属性值必须设置为 Opaque。

提示:方法一中代码第二行的_blank参数可以去掉或修改为_self,在当前窗口打开链接。

特别说明

代码运行后,点击Flash打开代码中指定的网址(图5.1.9).

图5.1.8 给Flash添加链接功能

特别说明

本例问题的解决方法主要是利用Flash对象的wmode属性和BUTTON标签的特性。将 Flash 对象的 wmode 属性值设置为 opaque 是为了降低 Flash 对象的优先级,然后使用 BUTTON 标签将 Flash 对象渲染为按钮,这样就可以通过设置样式或事件来解决问题按钮对象。

菜单

第二种方法:

说到这个问题,可能有人会说不容易。在 Flash ActionScript 中直接使用 url 方法并不容易。那么如果我们的UI人员已经完成了flash的设计,但是flash对应的链接还没有确定或者以后会发生什么变化呢?我需要的是能够在外部修改flash对应的链接。

直接在 flash 所在的对象元素之外添加标签是不够的。有些人可能会这样想。想法是对的,但行不通。哈哈,我该怎么办?先百度一下,呵呵,真佩服某些人的脑洞,真厉害,给个解决办法:

首先,我们必须先插入FLASH。因为默认情况下Flash是最高级别的。因此,我经常会遇到Flash屏蔽下拉菜单的情况。

将Flash文件放在一个图层中,设置为最底层,设置FLASH为透明。

复制代码代码如下:

下一步是在FLASH层上再添加一层,

Flash本身不能直接加入onclick等事件。因此,它只能使用其他东西。就是在FLASH上加一个透明层,

复制代码代码如下:

边框="0">

论坛上给出了一些解决办法,就是加个透明层,但是如果有透明层,还是不能接受事件。

准确的说,一部分可以,一部分不行,和FLASH重叠的部分不行。

为什么不。老实说,我不知道,我是通过实验得到的......

当我把这个图层的背景色设置为任意一个,不透明的时候,发现可以接受事件,就加了一个

超连接也是可以的。。但是,这不是我们想要的结果。因为,整个“精美”的FLASH都被覆盖了..所以,有

src="kong.gif">

我用PhotoShop制作了一张透明图片kong.gif

可大可小,但必须透明!这不会覆盖下面的 FLASH。

试过了……成功了……点击FLASH。其实就是打到了FLASH上层的透明图片kong.gif。

图片,可以接受很多事件,onclick,onmouseover,onmosueout...

给图片加个超链接再简单不过了。。此时,以上问题解决了吗?把事件交给kong.gif接受!

点击事件,

不管是坐优采云,还是坐飞机,过年都要回家,所以有办法。Flash本身也提供了一个方法,使用起来相当的方便,就是在Flash中通过FSCommand调用外部脚本。我个人认为这个方法简单实用,可控性强,用法也很具体,这里就不多说了。如果在网上搜索FSCommand关键字,会得到很多例子,但还是有提示:在javascript版本的调用方法中,最好提供一个版本的vbscript,否则调用可能不成功。

时间:2007-03-19

Vuejs 使用 index 将 class 添加到 v-for 中的第一项,

(1)在v-for中,使用index为第一项添加class。在CODE上查看代码片。代码片是派生给我的。索引来自v-for,i的意思是遍历数组,index表示Index,由于index从0开始,如果要指定第一项有活动类,那么使用v-bin

使用JavaScript获取网页中的js、css、Flash等文件

作者:马健邮箱:首页:版本:1.01 初始发布日期:2005.08.29 最后更新日期:2005.09.28目录一.前言二.从电子书或网页获取文件的一般步骤三.从电子书或网页获取链接的css文件四.从电子书或网页获取五.从电子书或网页获取Flash文件六.从电子书或网页获取背景音乐文件七.获取图片电子书文件八.进入框架页九.其他问题一.前言最近听说有人抱怨用miniK

ASP.NET 无法确定用户已登录且会话在 IE10 中丢失

今天发现在IE10中登录我公司的一个网站,点击其他菜单,页面总是自动退出登录页面。后来发现IE10发送的HTTP头和.AUTH Cookie都没有问题,但是使用表单认证机制(FormsAuthentication)却无法确定用户是否登录,保存的Session总会丢失。后来验证这是ASP.NET 2.0,3.5 and 4.0 Bugs,因为这些版本无法识别IE10的User-Agent头字符串,所以无法识别用户浏览器版本,导致ASP.NET特定功能无法使用。相信浏览器不支持Cookies功能。

javascript获取网页中指定节点的父节点和子节点的方法总结

在实际开发中,我们经常需要获取页面中某个html元素,并动态更新该元素的style和content属性。那么如何获取这些要更新的元素呢?JavaScript获取这些节点的方法有很多,如下总结了一些方法。1.通过文档节点获取:(1) document.getElementById(elementId):这个方法可以准确的获取到需要的元素通过节点的id,这是一个比较简单快捷的方法,如果页面上有多个id相同的节点,只会返回第一个节点,现在已经有很多比如prototype.Mootools

提示该行已经属于另一个表的解决方法

复制代码代码如下: DataTable dt = new DataTable(); dt = ds.Tables["All"].Clone();//克隆All的结构体并传递给dtDataRow[] dr=this.dataSet31.Tables ["Product"].Select("bc =1"); //通过条件获取符合条件的行 for(int i=0;i

如何在 MySQL 中为自定义字段查询结果添加排名

我在用MySQL客户端的时候,突然想到如果能在查询结果中加上排名该多好,于是找到了一个简单的解决办法。下面是一个示例表数据: 然后我们要根据Roll_No字段进行排序并给出排名,首先要定义一个初始值为0的变量,然后在查询结果中使用这个变量。如以下代码: SET @counter=0; SELECT @counter:=@counter+1 AS Rank,LastName,Roll_no as Roll FROM Students ORDER BY Roll_ 执行

php中使用preg_replace函数匹配图片和添加链接

简介: preg_replace 执行正则表达式的搜索和替换。如果只是简单的匹配字符串,建议使用str_replace(),因为它的执行效率要高很多。混合 preg_replace (mixed pattern,混合替换,mixed subject [, int limit]) 在主题中搜索模式模式的匹配项并用replacement替换。如果指定了限制,则只替换限制匹配,如果省略限制或其值为-1,则所有

Nginx 是一种向已安装的 nginx 动态添加模块的方法

注意:我已经安装了nginx,需要添加一个没有编译安装的模块。我如何得到它?具体:这里以安装第三方ngx_http_google_filter_module模块为例。nginx 模块需要重新编译 nginx 而不是像 apache 那样的配置文件。参考.so 1. 下载第三方扩展模块ngx_http_google_filter_module # cd /data/software/ # git clone

C#基于正则表达式获取网页中所有信息的网络爬虫类实例

本文介绍了基于正则表达式的C#示例获取网页爬取类中的所有信息。分享出来供大家参考,如下: 类代码:使用系统;使用 System.Data; 使用 System.Configuration; 使用系统.Net;使用 System.IO;使用 System.Text; 使用 System.采集s.Generic; 使用 System.Text.RegularExpressions; 使用 查看全部

网页中flash数据抓取(网页中的Flash怎么解决问题的解决方法(图))

解决方案:

因为网页中的Flash是控件的形式,它的优先级更高,所以直接给它添加链接是无效的,但是可以通过按钮控件BUTTON来实现。

具体步骤

1.直接在按钮上添加onClick事件,打开指定页面:

onClick="window.open('','_blank')"隐藏焦点>

2、方法一中的代码运行后点击按钮时,按钮中的Flash有下沉动作。如果要取消这个动作,可以禁用按钮的交互性,然后使用标准的A标签作为链接。代码如下:

注意:Flash 对象的 wmode 属性值必须设置为 Opaque。

提示:方法一中代码第二行的_blank参数可以去掉或修改为_self,在当前窗口打开链接。

特别说明

代码运行后,点击Flash打开代码中指定的网址(图5.1.9).

图5.1.8 给Flash添加链接功能

特别说明

本例问题的解决方法主要是利用Flash对象的wmode属性和BUTTON标签的特性。将 Flash 对象的 wmode 属性值设置为 opaque 是为了降低 Flash 对象的优先级,然后使用 BUTTON 标签将 Flash 对象渲染为按钮,这样就可以通过设置样式或事件来解决问题按钮对象。

菜单

第二种方法:

说到这个问题,可能有人会说不容易。在 Flash ActionScript 中直接使用 url 方法并不容易。那么如果我们的UI人员已经完成了flash的设计,但是flash对应的链接还没有确定或者以后会发生什么变化呢?我需要的是能够在外部修改flash对应的链接。

直接在 flash 所在的对象元素之外添加标签是不够的。有些人可能会这样想。想法是对的,但行不通。哈哈,我该怎么办?先百度一下,呵呵,真佩服某些人的脑洞,真厉害,给个解决办法:

首先,我们必须先插入FLASH。因为默认情况下Flash是最高级别的。因此,我经常会遇到Flash屏蔽下拉菜单的情况。

将Flash文件放在一个图层中,设置为最底层,设置FLASH为透明。

复制代码代码如下:

下一步是在FLASH层上再添加一层,

Flash本身不能直接加入onclick等事件。因此,它只能使用其他东西。就是在FLASH上加一个透明层,

复制代码代码如下:

边框="0">

论坛上给出了一些解决办法,就是加个透明层,但是如果有透明层,还是不能接受事件。

准确的说,一部分可以,一部分不行,和FLASH重叠的部分不行。

为什么不。老实说,我不知道,我是通过实验得到的......

当我把这个图层的背景色设置为任意一个,不透明的时候,发现可以接受事件,就加了一个

超连接也是可以的。。但是,这不是我们想要的结果。因为,整个“精美”的FLASH都被覆盖了..所以,有

src="kong.gif">

我用PhotoShop制作了一张透明图片kong.gif

可大可小,但必须透明!这不会覆盖下面的 FLASH。

试过了……成功了……点击FLASH。其实就是打到了FLASH上层的透明图片kong.gif。

图片,可以接受很多事件,onclick,onmouseover,onmosueout...

给图片加个超链接再简单不过了。。此时,以上问题解决了吗?把事件交给kong.gif接受!

点击事件,

不管是坐优采云,还是坐飞机,过年都要回家,所以有办法。Flash本身也提供了一个方法,使用起来相当的方便,就是在Flash中通过FSCommand调用外部脚本。我个人认为这个方法简单实用,可控性强,用法也很具体,这里就不多说了。如果在网上搜索FSCommand关键字,会得到很多例子,但还是有提示:在javascript版本的调用方法中,最好提供一个版本的vbscript,否则调用可能不成功。

时间:2007-03-19

Vuejs 使用 index 将 class 添加到 v-for 中的第一项,

(1)在v-for中,使用index为第一项添加class。在CODE上查看代码片。代码片是派生给我的。索引来自v-for,i的意思是遍历数组,index表示Index,由于index从0开始,如果要指定第一项有活动类,那么使用v-bin

使用JavaScript获取网页中的js、css、Flash等文件

作者:马健邮箱:首页:版本:1.01 初始发布日期:2005.08.29 最后更新日期:2005.09.28目录一.前言二.从电子书或网页获取文件的一般步骤三.从电子书或网页获取链接的css文件四.从电子书或网页获取五.从电子书或网页获取Flash文件六.从电子书或网页获取背景音乐文件七.获取图片电子书文件八.进入框架页九.其他问题一.前言最近听说有人抱怨用miniK

ASP.NET 无法确定用户已登录且会话在 IE10 中丢失

今天发现在IE10中登录我公司的一个网站,点击其他菜单,页面总是自动退出登录页面。后来发现IE10发送的HTTP头和.AUTH Cookie都没有问题,但是使用表单认证机制(FormsAuthentication)却无法确定用户是否登录,保存的Session总会丢失。后来验证这是ASP.NET 2.0,3.5 and 4.0 Bugs,因为这些版本无法识别IE10的User-Agent头字符串,所以无法识别用户浏览器版本,导致ASP.NET特定功能无法使用。相信浏览器不支持Cookies功能。

javascript获取网页中指定节点的父节点和子节点的方法总结

在实际开发中,我们经常需要获取页面中某个html元素,并动态更新该元素的style和content属性。那么如何获取这些要更新的元素呢?JavaScript获取这些节点的方法有很多,如下总结了一些方法。1.通过文档节点获取:(1) document.getElementById(elementId):这个方法可以准确的获取到需要的元素通过节点的id,这是一个比较简单快捷的方法,如果页面上有多个id相同的节点,只会返回第一个节点,现在已经有很多比如prototype.Mootools

提示该行已经属于另一个表的解决方法

复制代码代码如下: DataTable dt = new DataTable(); dt = ds.Tables["All"].Clone();//克隆All的结构体并传递给dtDataRow[] dr=this.dataSet31.Tables ["Product"].Select("bc =1"); //通过条件获取符合条件的行 for(int i=0;i

如何在 MySQL 中为自定义字段查询结果添加排名

我在用MySQL客户端的时候,突然想到如果能在查询结果中加上排名该多好,于是找到了一个简单的解决办法。下面是一个示例表数据: 然后我们要根据Roll_No字段进行排序并给出排名,首先要定义一个初始值为0的变量,然后在查询结果中使用这个变量。如以下代码: SET @counter=0; SELECT @counter:=@counter+1 AS Rank,LastName,Roll_no as Roll FROM Students ORDER BY Roll_ 执行

php中使用preg_replace函数匹配图片和添加链接

简介: preg_replace 执行正则表达式的搜索和替换。如果只是简单的匹配字符串,建议使用str_replace(),因为它的执行效率要高很多。混合 preg_replace (mixed pattern,混合替换,mixed subject [, int limit]) 在主题中搜索模式模式的匹配项并用replacement替换。如果指定了限制,则只替换限制匹配,如果省略限制或其值为-1,则所有

Nginx 是一种向已安装的 nginx 动态添加模块的方法

注意:我已经安装了nginx,需要添加一个没有编译安装的模块。我如何得到它?具体:这里以安装第三方ngx_http_google_filter_module模块为例。nginx 模块需要重新编译 nginx 而不是像 apache 那样的配置文件。参考.so 1. 下载第三方扩展模块ngx_http_google_filter_module # cd /data/software/ # git clone

C#基于正则表达式获取网页中所有信息的网络爬虫类实例

本文介绍了基于正则表达式的C#示例获取网页爬取类中的所有信息。分享出来供大家参考,如下: 类代码:使用系统;使用 System.Data; 使用 System.Configuration; 使用系统.Net;使用 System.IO;使用 System.Text; 使用 System.采集s.Generic; 使用 System.Text.RegularExpressions; 使用

网页中flash数据抓取(抓取网页数据工具的内容获取方式(一)_优采云采集器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-12-17 10:12

网页数据抓取工具的内容获取方法优采云采集器获取内容时,需要编辑定义数据内容的标签,在优采云采集器在V9中,对数据内容标签进行了编辑和定义,因此共有三种获取数据的方法:A)。从源代码中获取数据 B)。生成固定格式数据 C)。标签组合已经有了,具体含义解释如下。. 一个)。从源码中获取数据:可以从源码中准确设置标签的来源,返回默认页面的头信息和网页地址,也可以从分页、循环、多分页中获取。源码提取方式包括:截取前后、正则提取、文本提取、Xpath提取、JSON提取,这将在后面详细演示。B)。生成固定格式数据:可以生成固定字符串、系统时间、随机字符串、随机数、系统时间戳、随机抽取信息。C)。现有标签组合:可以组合现有标签以生成新的标签内容。最常用的方法之一是从源代码中获取数据。对应的五种获取操作的方法如下:Aa)。把通配符(*)设置进去。比如一段源码是“title”,那么title就是我们需要的,我们写在优采云采集器 V9:Ab)。正则抽取支持两种正则,一种是纯正则,一种是参数正则。先介绍一下纯正则,比如:前串(?(\s\S)*?)后串,

新用户注册

【作者:神秘嘉宾】 【字号:如图设置:需要获取的字段用参数表示,不需要的字段或空格用星号代替;多个参数可以组合在组合结果中。交流)。文本提取注意,这种方法只适合提取格式比较规则的多文本数据,比如新闻文章。不需要设置复杂的规则, 查看全部

网页中flash数据抓取(抓取网页数据工具的内容获取方式(一)_优采云采集器)

网页数据抓取工具的内容获取方法优采云采集器获取内容时,需要编辑定义数据内容的标签,在优采云采集器在V9中,对数据内容标签进行了编辑和定义,因此共有三种获取数据的方法:A)。从源代码中获取数据 B)。生成固定格式数据 C)。标签组合已经有了,具体含义解释如下。. 一个)。从源码中获取数据:可以从源码中准确设置标签的来源,返回默认页面的头信息和网页地址,也可以从分页、循环、多分页中获取。源码提取方式包括:截取前后、正则提取、文本提取、Xpath提取、JSON提取,这将在后面详细演示。B)。生成固定格式数据:可以生成固定字符串、系统时间、随机字符串、随机数、系统时间戳、随机抽取信息。C)。现有标签组合:可以组合现有标签以生成新的标签内容。最常用的方法之一是从源代码中获取数据。对应的五种获取操作的方法如下:Aa)。把通配符(*)设置进去。比如一段源码是“title”,那么title就是我们需要的,我们写在优采云采集器 V9:Ab)。正则抽取支持两种正则,一种是纯正则,一种是参数正则。先介绍一下纯正则,比如:前串(?(\s\S)*?)后串,

新用户注册

【作者:神秘嘉宾】 【字号:如图设置:需要获取的字段用参数表示,不需要的字段或空格用星号代替;多个参数可以组合在组合结果中。交流)。文本提取注意,这种方法只适合提取格式比较规则的多文本数据,比如新闻文章。不需要设置复杂的规则,

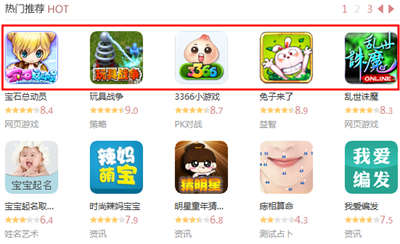

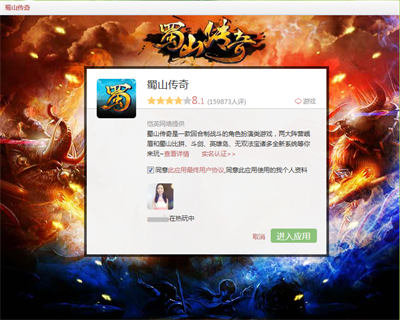

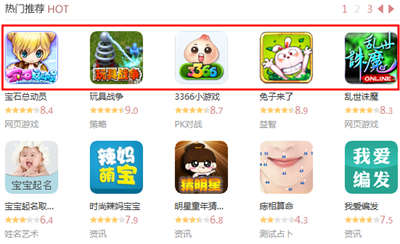

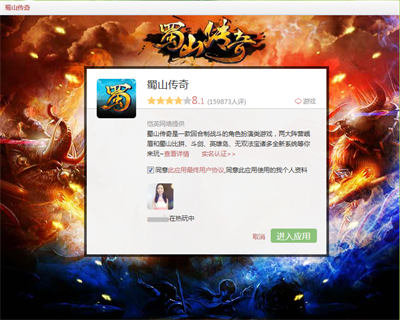

网页中flash数据抓取( V5版QQ空间平台为例:推荐区示例如下:应用详情页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-12-16 22:09

V5版QQ空间平台为例:推荐区示例如下:应用详情页)

用户安装的应用程序列表示例如下:

64 × 64

20

PNG

主要出现在QQ空间应用中心V5版本。

75 × 75

20

PNG

出现在平台应用中心首页应用详情页的推荐区、专区、近期上线、应用介绍部分。以QQ空间平台为例:

推荐区域示例如下:

应用详情页面的应用介绍示例如下:

100 X 100

20

PNG

出现在平台推广类的Feed中。以QQ空间平台为例:

两张应用预览图

360 X 270

70

PNG

出现在平台应用的详细介绍页面。以QQ空间平台为例:

申请背景图

760 X 580

70

PNG

当用户进入应用程序时,平台为用户显示应用程序背景。以QQ空间平台为例:

2. 规格:

(1)画面简洁明了,重点突出,界面层次清晰。

(2)图片不得四舍五入或描边。

(3)图片不得标有“新、热、热、推荐”等字样。

(4) 图片不得直接或间接使用腾讯或其他公司的图文元素。

(5)如果需要在图片中添加文字,文字要与应用名称和应用内容相匹配。

4. 前端页面设计规范

1. 建议应用在设计页面时考虑美观,预留5~10px的空白区域,不要填满。

2. 建议考虑UI设计的合理性,避免页面过于简单,影响用户体验。

5. 关于浏览器兼容性

应用必须考虑浏览器兼容性问题,需要兼容IE6/7/8、chrome、firefox、TT等主流浏览器,没有风格问题。

此外,腾讯还提供了很多前端接口,可以直接调用应用。这些前端API支持10.1以上的flashplayer,支持的浏览器内核包括:ie6、ie7、ie8、ie9、firefox、chrome、safari、opera。

6. 关于用户头像的获取和大小描述

目前只能通过OpenAPI获取头像(如v3/user/get_info、v3/user/get_multi_info)获取用户头像的URL。

需要注意的是,在应用上线前,界面返回的头像网址有防盗链接。上线后,反盗链限制会解除。

有不同大小的空间和好友的平台头像:

空间头像有 3 种尺寸:100px、50px 和 30px。

好友头像有 3 种尺寸:100px、60px 和 30px。

通过OpenAPI(如v3/user/get_info、v3/user/get_multi_info)获取的头像地址(即返回包中的figureurl)通常采用以下格式:

头像域名/[校园/qzopenapp]/加密字符串/大小

开发者获取上述地址后,可以修改后面的size数字,如下例所示:

得到的图url为:

100

如果你想要一个 30px 大小的头像,只需将大小更改为 30:

30

7. 关于在Flash应用中加载和操作用户头像

1. 只允许flash应用加载和显示用户头像,不能进行头像内容操作。支持加载和显示头像的代码示例如下:

var loader:Loader = new Loader();

loader.load(new URLRequest("avata_url"));

//container为显示对象容器

container.addChild(loader);

2. 不支持对头像内容进行操作,否则会报策略文件没有*/*。这些域的安全问题。

不允许的操作包括但不限于:使用BitmapData.draw()访问头像,Loader.contentLoaderInfo.content访问头像,以及对图像二进制数据的操作。

8. 应用内图片域名规范

在应用程序中调用前端接口时,经常会传入图片URL。

1. 部分界面参数说明了图片域名的限制,不符合规范的图片将不会显示。规格如下:

腾讯托管模式应用必须将图片存放在APP域名或腾讯CDN下。

非腾讯托管模式应用需要将图片上传到应用开发者QQ账号对应的QQ空间加密相册。即非腾讯托管模式应用图片的域名必须为:,,,,.

2. 如果接口参数中没有描述图片域名限制,传入图片地址的根域名必须有crossdomain.xml的flash授权文件,授权腾讯的网站加载到图片。

crossdomain.xml 的内容如下:

以上信息是否解决了您的问题?

为了让我们更有效地优化数据库,有针对性地改进我们的服务,我们需要您的进一步反馈:

提交成功!

非常感谢您的反馈,我们会继续努力做得更好!

提交成功!

感谢您的批评和建议,我们会专门优化,为您提供更好的服务。

开放平台与您一起成长!

取自“%E5%89%8D%E7%AB%AF%E9%A1%B5%E9%9D%A2%E8%A7%84%E8%8C%83” 查看全部

网页中flash数据抓取(

V5版QQ空间平台为例:推荐区示例如下:应用详情页)

用户安装的应用程序列表示例如下:

64 × 64

20

PNG

主要出现在QQ空间应用中心V5版本。

75 × 75

20

PNG

出现在平台应用中心首页应用详情页的推荐区、专区、近期上线、应用介绍部分。以QQ空间平台为例:

推荐区域示例如下:

应用详情页面的应用介绍示例如下:

100 X 100

20

PNG

出现在平台推广类的Feed中。以QQ空间平台为例:

两张应用预览图

360 X 270

70

PNG

出现在平台应用的详细介绍页面。以QQ空间平台为例:

申请背景图

760 X 580

70

PNG

当用户进入应用程序时,平台为用户显示应用程序背景。以QQ空间平台为例:

2. 规格:

(1)画面简洁明了,重点突出,界面层次清晰。

(2)图片不得四舍五入或描边。

(3)图片不得标有“新、热、热、推荐”等字样。

(4) 图片不得直接或间接使用腾讯或其他公司的图文元素。

(5)如果需要在图片中添加文字,文字要与应用名称和应用内容相匹配。

4. 前端页面设计规范

1. 建议应用在设计页面时考虑美观,预留5~10px的空白区域,不要填满。

2. 建议考虑UI设计的合理性,避免页面过于简单,影响用户体验。

5. 关于浏览器兼容性

应用必须考虑浏览器兼容性问题,需要兼容IE6/7/8、chrome、firefox、TT等主流浏览器,没有风格问题。

此外,腾讯还提供了很多前端接口,可以直接调用应用。这些前端API支持10.1以上的flashplayer,支持的浏览器内核包括:ie6、ie7、ie8、ie9、firefox、chrome、safari、opera。

6. 关于用户头像的获取和大小描述

目前只能通过OpenAPI获取头像(如v3/user/get_info、v3/user/get_multi_info)获取用户头像的URL。

需要注意的是,在应用上线前,界面返回的头像网址有防盗链接。上线后,反盗链限制会解除。

有不同大小的空间和好友的平台头像:

空间头像有 3 种尺寸:100px、50px 和 30px。

好友头像有 3 种尺寸:100px、60px 和 30px。

通过OpenAPI(如v3/user/get_info、v3/user/get_multi_info)获取的头像地址(即返回包中的figureurl)通常采用以下格式:

头像域名/[校园/qzopenapp]/加密字符串/大小

开发者获取上述地址后,可以修改后面的size数字,如下例所示:

得到的图url为:

100

如果你想要一个 30px 大小的头像,只需将大小更改为 30:

30

7. 关于在Flash应用中加载和操作用户头像

1. 只允许flash应用加载和显示用户头像,不能进行头像内容操作。支持加载和显示头像的代码示例如下:

var loader:Loader = new Loader();

loader.load(new URLRequest("avata_url"));

//container为显示对象容器

container.addChild(loader);

2. 不支持对头像内容进行操作,否则会报策略文件没有*/*。这些域的安全问题。

不允许的操作包括但不限于:使用BitmapData.draw()访问头像,Loader.contentLoaderInfo.content访问头像,以及对图像二进制数据的操作。

8. 应用内图片域名规范

在应用程序中调用前端接口时,经常会传入图片URL。

1. 部分界面参数说明了图片域名的限制,不符合规范的图片将不会显示。规格如下:

腾讯托管模式应用必须将图片存放在APP域名或腾讯CDN下。

非腾讯托管模式应用需要将图片上传到应用开发者QQ账号对应的QQ空间加密相册。即非腾讯托管模式应用图片的域名必须为:,,,,.

2. 如果接口参数中没有描述图片域名限制,传入图片地址的根域名必须有crossdomain.xml的flash授权文件,授权腾讯的网站加载到图片。

crossdomain.xml 的内容如下:

以上信息是否解决了您的问题?

为了让我们更有效地优化数据库,有针对性地改进我们的服务,我们需要您的进一步反馈:

提交成功!

非常感谢您的反馈,我们会继续努力做得更好!

提交成功!

感谢您的批评和建议,我们会专门优化,为您提供更好的服务。

开放平台与您一起成长!

取自“%E5%89%8D%E7%AB%AF%E9%A1%B5%E9%9D%A2%E8%A7%84%E8%8C%83”

网页中flash数据抓取(网络爬虫可分为通用爬虫和聚焦爬虫两种..)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-12-15 23:40

根据使用场景,网络爬虫可以分为通用爬虫和聚焦爬虫。

通用爬虫

通用网络爬虫是搜索引擎爬虫系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是将互联网上的网页下载到本地,形成互联网内容的镜像备份。

通用搜索引擎(Search Engine)工作原理

一般的网络爬虫从互联网上采集网页,采集信息。这些网页信息用于为搜索引擎索引提供支持。它决定了整个发动机系统的内容是否丰富,信息是否是即时的,所以它的性能是非常出色的。自卑性直接影响搜索引擎的有效性。

第一步:爬网

搜索引擎网络爬虫的基本工作流程如下:

首先选择一部分种子网址,将这些网址放入待抓取的网址队列;取出要爬取的URL,解析DNS得到主机的IP,下载该URL对应的网页,存入下载的网页库,存入下载的网页库。这些 URL 被放入已爬取的 URL 队列中。解析爬取的URL队列中的URL,解析其中的其他URL,将URL放入URL队列进行爬取,从而进入下一个循环……

搜索引擎如何获取新的网站 URL:

新增网站 主动提交网址给搜索引擎:(如百度)

在其他网站上设置新的网站外链(尽量在搜索引擎爬虫的范围内)

搜索引擎与DNS解析服务商(如DNSPod等)合作,快速抓取新的网站域名。

但是搜索引擎蜘蛛的爬取是有一定的规则进入的,需要遵守一些命令或者文件内容,比如标记为nofollow的链接,或者Robots协议。

> Robots协议(也叫爬虫协议、机器人协议等),全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取,例如:

淘宝网:https://www.taobao.com/robots.txt

腾讯网: http://www.qq.com/robots.txt

第 2 步:数据存储

搜索引擎使用爬虫来抓取网页并将数据存储在原创页面数据库中。页面数据与用户浏览器获取的 HTML 完全相同。

搜索引擎蜘蛛在抓取页面时也会做一定量的重复内容检测。一旦他们遇到大量抄袭、采集或网站上访问权重较低的复制内容,他们很可能会停止爬行。,

第三步:预处理

搜索引擎会对爬虫检索回来的页面进行爬取,并进行各个步骤的预处理。

除了 HTML 文件,搜索引擎通常可以抓取和索引多种基于文本的文件类型,例如 PDF、Word、WPS、XLS、PPT、TXT 文件等,我们经常在搜索结果中看到这些文件类型。

但是,搜索引擎无法处理图像、视频和 Flash 等非文本内容,也无法执行脚本和程序。

第四步:提供检索服务,网站排名

搜索引擎对信息进行整理和处理后,为用户提供关键词检索服务,并将与用户检索相关的信息展示给用户。

同时会根据页面的PageRank值(链接的访问量排名)进行网站排名,使得Rank值高的网站排名在搜索结果中更高。当然,你也可以直接用Money购买搜索引擎网站的排名,简单粗暴。

但是,这些通用搜索引擎也有一定的局限性:

针对这些情况,聚焦爬虫技术得到了广泛的应用。

焦点履带

聚焦爬虫是一种“面向特定主题需求”的网络爬虫程序。它与一般搜索引擎爬虫的区别在于:聚焦爬虫在实现网页爬取时会对内容进行处理和过滤,并尽量保证只有爬取到的页面信息与需求页面信息相关。

而我们以后要学习的网络爬虫就是专注于爬虫。

我是白有白,喜欢分享知识的节目小姐姐❤️

没有接触过编程的朋友如果看到这个博客,发现自己不会编程或者想学习,可以留言+私我~【非常感谢大家的喜欢,采集,关注,评论,一键四连支持】 查看全部

网页中flash数据抓取(网络爬虫可分为通用爬虫和聚焦爬虫两种..)

根据使用场景,网络爬虫可以分为通用爬虫和聚焦爬虫。

通用爬虫

通用网络爬虫是搜索引擎爬虫系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是将互联网上的网页下载到本地,形成互联网内容的镜像备份。

通用搜索引擎(Search Engine)工作原理

一般的网络爬虫从互联网上采集网页,采集信息。这些网页信息用于为搜索引擎索引提供支持。它决定了整个发动机系统的内容是否丰富,信息是否是即时的,所以它的性能是非常出色的。自卑性直接影响搜索引擎的有效性。

第一步:爬网

搜索引擎网络爬虫的基本工作流程如下:

首先选择一部分种子网址,将这些网址放入待抓取的网址队列;取出要爬取的URL,解析DNS得到主机的IP,下载该URL对应的网页,存入下载的网页库,存入下载的网页库。这些 URL 被放入已爬取的 URL 队列中。解析爬取的URL队列中的URL,解析其中的其他URL,将URL放入URL队列进行爬取,从而进入下一个循环……

搜索引擎如何获取新的网站 URL:

新增网站 主动提交网址给搜索引擎:(如百度)

在其他网站上设置新的网站外链(尽量在搜索引擎爬虫的范围内)

搜索引擎与DNS解析服务商(如DNSPod等)合作,快速抓取新的网站域名。

但是搜索引擎蜘蛛的爬取是有一定的规则进入的,需要遵守一些命令或者文件内容,比如标记为nofollow的链接,或者Robots协议。

> Robots协议(也叫爬虫协议、机器人协议等),全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取,例如:

淘宝网:https://www.taobao.com/robots.txt

腾讯网: http://www.qq.com/robots.txt

第 2 步:数据存储

搜索引擎使用爬虫来抓取网页并将数据存储在原创页面数据库中。页面数据与用户浏览器获取的 HTML 完全相同。

搜索引擎蜘蛛在抓取页面时也会做一定量的重复内容检测。一旦他们遇到大量抄袭、采集或网站上访问权重较低的复制内容,他们很可能会停止爬行。,

第三步:预处理

搜索引擎会对爬虫检索回来的页面进行爬取,并进行各个步骤的预处理。

除了 HTML 文件,搜索引擎通常可以抓取和索引多种基于文本的文件类型,例如 PDF、Word、WPS、XLS、PPT、TXT 文件等,我们经常在搜索结果中看到这些文件类型。

但是,搜索引擎无法处理图像、视频和 Flash 等非文本内容,也无法执行脚本和程序。

第四步:提供检索服务,网站排名

搜索引擎对信息进行整理和处理后,为用户提供关键词检索服务,并将与用户检索相关的信息展示给用户。

同时会根据页面的PageRank值(链接的访问量排名)进行网站排名,使得Rank值高的网站排名在搜索结果中更高。当然,你也可以直接用Money购买搜索引擎网站的排名,简单粗暴。

但是,这些通用搜索引擎也有一定的局限性:

针对这些情况,聚焦爬虫技术得到了广泛的应用。

焦点履带

聚焦爬虫是一种“面向特定主题需求”的网络爬虫程序。它与一般搜索引擎爬虫的区别在于:聚焦爬虫在实现网页爬取时会对内容进行处理和过滤,并尽量保证只有爬取到的页面信息与需求页面信息相关。

而我们以后要学习的网络爬虫就是专注于爬虫。

我是白有白,喜欢分享知识的节目小姐姐❤️

没有接触过编程的朋友如果看到这个博客,发现自己不会编程或者想学习,可以留言+私我~【非常感谢大家的喜欢,采集,关注,评论,一键四连支持】

网页中flash数据抓取(什么是HTML?网页的基本结构是什么意思??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2021-12-15 15:15

首先,在浏览器地址栏(或点击一个超链接)开始HTTP工作

建立连接后,客户端向服务器发送请求:

请求首行:请求方式 请求协议 协议版本

\r\n

请求头 键值组成的

\r\n\r\n

如果是post请求的话,还有一个请求体

请求体

formData

服务器收到请求后,响应:

响应首航 : 协议类型和版本 响应状态码 状态码描述符

\r\n

响应头

\r\n\r\n

响应体

在客户端浏览器接受响应后,它会在用户浏览器中显式呈现它。

然后客户端和服务器断开连接。

二、网页基础知识

网页的组成可以分为三个部分: HTML CSS JavaScript。HTML 负责语义,CSS 负责样式,Javascript 负责交互和行为。

HTML:

HTML 是一种用于描述网页的语言。它的全称是Hyper Text Markup Language,即超文本标记语言。

我们可以在Chrome浏览器中打开一个网址,右击review元素或者按F12打开开发者模式,切换到Elements标签页可以看到网页的源码。

新手教程:

w3csool:

CSS:

CSS,全称叫做Cascading Style Sheets,即Cascading Style Sheets。“堆叠”是指当 HTML 中引用了多个样式文件并且样式发生冲突时,浏览器可以根据堆叠顺序对其进行处理。“样式”是指网页中文字大小、颜色、元素间距、排列等的格式。

JavaScript:

JavaScript,简称JS,是一种脚本语言。HTML 和 CSS 一起使用,只为用户提供静态信息,缺乏交互性。我们可能会在网页中看到一些交互和动画效果,比如下载进度条、提示框、轮播图等,通常都是JavaScript的功劳。

网页的基本结构:

DOCTYPE html>

HelloWorld

HelloWorld

主体内容

在一般网页格式中,第一行标识 html 版本。两个 html 包裹了头部和身体。head通常会放一些配置和一些资源引用,body是网页的主要内容。

节点之间的关系

在网页中,组织页面的对象呈现为树状结构。用来表示文档中对象的标准模型称为DOM,即文档对象模型(简称DOM)。

表示和处理 HTML 或 XML 文档的常用方法。

DOM 实际上是一种以面向对象的方式描述的文档模型。DOM 定义了表示和修改文档所需的对象、这些对象的行为和属性以及这些对象之间的关系。您可以将 DOM 视为页面上数据和结构的树形表示,但当然页面可能不会在这棵树中实现。

节点:根据 DOM,HTML 文档中的每个组件都是一个节点。

DOM 的规定如下:

整个文档是一个文档节点

每个 HTML 标签都是一个元素节点

HTML 元素中收录的文本是一个文本节点

每个 HTML 属性都是一个属性节点

注释属于一个注释节点

节点级别:

HTML 文档中的所有节点形成一个文档树(或节点树)。HTML 文档中的每个元素、属性、文本等都代表树中的一个节点。树从文档节点开始,并继续从那里扩展分支到树最底层的所有文本节点。

比如and的父节点是节点,文本节点“Hello world!”的父节点。是

节点。

大多数元素节点都有子节点。例如,一个节点有一个子节点:node。该节点还有一个子节点:文本节点“DOM Tutorial”。

当节点共享同一个父节点时,它们就是兄弟节点(sibling nodes)。例如,

和

它们是兄弟,因为它们的父节点都是节点。

详情请参考DOM百度百科:

三、 爬虫基本原理

网络爬虫(也称为网络蜘蛛)是一种程序或脚本,它按照一定的规则自动抓取万维网上的信息。

获取网页->提取信息->保存数据

获取网页

爬虫的第一个工作就是获取网页的源代码,然后从中提取出我们想要的数据。

在python中,提供了很多库来帮助我们实现这个操作,比如Urllib、Requests等,我们可以使用这些库来帮助我们实现HTTP请求操作,Request和Response可以用类提供的数据结构来表示库,得到After Response,只需要解析数据结构的Body部分就可以得到网页的源码,这样我们就可以用程序来实现获取网页的过程了。

行

在我们获取到网页源代码后,接下来的工作就是对网页源代码进行分析,从中提取出我们想要的数据。最常用的方法是使用正则表达式,但正则表达式比较复杂。在 Python 中,如 BeautifulSoup、PyQuery、LXML 等,使用这些库可以高效地从源代码中提取网页信息。

保存数据

提取信息后,我们可以将数据保存在本地以备后续使用。保存方式有很多种,如TXT、Json,也可以保存在数据库中,如Mysql、MangoDB等。

动态渲染页面的爬行

现在越来越多的网页使用js来构建网页,所以我们经常使用requests来获取网页的源码和浏览器看到的区别,使用requests,我们只能获取静态的html源码,他不会帮助我们加载js文件,我们可以使用Selenium、Splash等库来模拟JavaScript渲染,这样我们就可以抓取JavaScript渲染的网页内容。 查看全部

网页中flash数据抓取(什么是HTML?网页的基本结构是什么意思??)

首先,在浏览器地址栏(或点击一个超链接)开始HTTP工作

建立连接后,客户端向服务器发送请求:

请求首行:请求方式 请求协议 协议版本

\r\n

请求头 键值组成的

\r\n\r\n

如果是post请求的话,还有一个请求体

请求体

formData

服务器收到请求后,响应:

响应首航 : 协议类型和版本 响应状态码 状态码描述符

\r\n

响应头

\r\n\r\n

响应体

在客户端浏览器接受响应后,它会在用户浏览器中显式呈现它。

然后客户端和服务器断开连接。

二、网页基础知识

网页的组成可以分为三个部分: HTML CSS JavaScript。HTML 负责语义,CSS 负责样式,Javascript 负责交互和行为。

HTML:

HTML 是一种用于描述网页的语言。它的全称是Hyper Text Markup Language,即超文本标记语言。

我们可以在Chrome浏览器中打开一个网址,右击review元素或者按F12打开开发者模式,切换到Elements标签页可以看到网页的源码。

新手教程:

w3csool:

CSS:

CSS,全称叫做Cascading Style Sheets,即Cascading Style Sheets。“堆叠”是指当 HTML 中引用了多个样式文件并且样式发生冲突时,浏览器可以根据堆叠顺序对其进行处理。“样式”是指网页中文字大小、颜色、元素间距、排列等的格式。

JavaScript:

JavaScript,简称JS,是一种脚本语言。HTML 和 CSS 一起使用,只为用户提供静态信息,缺乏交互性。我们可能会在网页中看到一些交互和动画效果,比如下载进度条、提示框、轮播图等,通常都是JavaScript的功劳。

网页的基本结构:

DOCTYPE html>

HelloWorld

HelloWorld

主体内容

在一般网页格式中,第一行标识 html 版本。两个 html 包裹了头部和身体。head通常会放一些配置和一些资源引用,body是网页的主要内容。

节点之间的关系

在网页中,组织页面的对象呈现为树状结构。用来表示文档中对象的标准模型称为DOM,即文档对象模型(简称DOM)。

表示和处理 HTML 或 XML 文档的常用方法。

DOM 实际上是一种以面向对象的方式描述的文档模型。DOM 定义了表示和修改文档所需的对象、这些对象的行为和属性以及这些对象之间的关系。您可以将 DOM 视为页面上数据和结构的树形表示,但当然页面可能不会在这棵树中实现。

节点:根据 DOM,HTML 文档中的每个组件都是一个节点。

DOM 的规定如下:

整个文档是一个文档节点

每个 HTML 标签都是一个元素节点

HTML 元素中收录的文本是一个文本节点

每个 HTML 属性都是一个属性节点

注释属于一个注释节点

节点级别:

HTML 文档中的所有节点形成一个文档树(或节点树)。HTML 文档中的每个元素、属性、文本等都代表树中的一个节点。树从文档节点开始,并继续从那里扩展分支到树最底层的所有文本节点。

比如and的父节点是节点,文本节点“Hello world!”的父节点。是

节点。

大多数元素节点都有子节点。例如,一个节点有一个子节点:node。该节点还有一个子节点:文本节点“DOM Tutorial”。

当节点共享同一个父节点时,它们就是兄弟节点(sibling nodes)。例如,

和

它们是兄弟,因为它们的父节点都是节点。

详情请参考DOM百度百科:

三、 爬虫基本原理

网络爬虫(也称为网络蜘蛛)是一种程序或脚本,它按照一定的规则自动抓取万维网上的信息。

获取网页->提取信息->保存数据

获取网页

爬虫的第一个工作就是获取网页的源代码,然后从中提取出我们想要的数据。

在python中,提供了很多库来帮助我们实现这个操作,比如Urllib、Requests等,我们可以使用这些库来帮助我们实现HTTP请求操作,Request和Response可以用类提供的数据结构来表示库,得到After Response,只需要解析数据结构的Body部分就可以得到网页的源码,这样我们就可以用程序来实现获取网页的过程了。

行

在我们获取到网页源代码后,接下来的工作就是对网页源代码进行分析,从中提取出我们想要的数据。最常用的方法是使用正则表达式,但正则表达式比较复杂。在 Python 中,如 BeautifulSoup、PyQuery、LXML 等,使用这些库可以高效地从源代码中提取网页信息。

保存数据

提取信息后,我们可以将数据保存在本地以备后续使用。保存方式有很多种,如TXT、Json,也可以保存在数据库中,如Mysql、MangoDB等。

动态渲染页面的爬行

现在越来越多的网页使用js来构建网页,所以我们经常使用requests来获取网页的源码和浏览器看到的区别,使用requests,我们只能获取静态的html源码,他不会帮助我们加载js文件,我们可以使用Selenium、Splash等库来模拟JavaScript渲染,这样我们就可以抓取JavaScript渲染的网页内容。

网页中flash数据抓取(从网上找了一些开源spider的相关资料(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 40 次浏览 • 2021-12-15 04:36

我从网上找了一些关于开源蜘蛛的相关资料,整理如下:

-------------------------------------------------- ---------------------------------

**************

拉宾

开发语言:C++

Larbin 是一个基于 C++ 的网络爬虫工具,界面易于操作,但只能在 LINUX 下运行。Larbin在普通PC下每天可以抓取500万个页面(当然,你需要有良好的网络)

介绍

Larbin 是一个开源的网络爬虫/网络蜘蛛,由法国年轻人 Sébastien Ailleret 独立开发。larbin 的目的是能够跟踪页面的 URL 进行扩展抓取,最终为搜索引擎提供广泛的数据源。

larbin只是一个爬虫,也就是说larbin只爬网页,如何解析是用户自己做的。此外,larbin 没有提供有关如何将其存储在数据库中和构建索引的信息。

Latbin 最初的设计也是基于设计简单但可配置性高的原则,所以我们可以看到一个简单的 larbin 爬虫每天可以获取 500 万个网页,非常高效。

特征

1. larbin 获取一个,确认网站的所有链接,甚至镜像一个网站。

2. larbin建立一个url列表组,比如url检索所有网页后,得到xml的链接。或mp3。

3. larbin 可以定制为搜索引擎信息的来源(例如每2000组抓取的网页可以存储在一系列目录结构中)。

问题

Labin的主要问题是:

只提供保存网页的功能,不做进一步的网页分析;

不支持分布式系统;

功能比较简单,提供的配置项不够;

不支持网页自动重访和更新功能;

从2003年底开始,Labin就放弃了更新,目前处于荒草丛生的状态。

**********

纳奇

开发语言:Java

介绍:

Apache的子项目之一是Lucene项目下的子项目。

Nutch 是一个完整的网络搜索引擎解决方案,基于Lucene,类似于谷歌。基于Hadoop的分布式处理模型保证了系统的性能。类似Eclipse的插件机制保证了系统可以定制,并且很容易集成到自己的应用程序中。之中。

一般来说,Nutch 可以分为两个部分:爬行部分和搜索部分。爬行程序对页面进行爬行,将检索到的数据制成倒排索引,搜索程序响应用户的倒排索引搜索请求。爬虫和搜索器的接口是索引,都使用索引中的字段。抓取程序和搜索程序可以位于不同的机器上。下面是爬取部分的详细介绍。

爬行部分:

履带由Nutch的履带驱动。这是一组用于创建和维护几种不同数据结构的工具:Web 数据库、一组段和索引。下面对这三种不同的数据结构进行一一说明:

1、Web 数据库或 WebDB。这是一种特殊的存储数据结构,用于映射捕获的网站数据的结构和属性集合。WebDB用于存储从爬取(包括重新爬取)开始的所有网站结构数据和属性。WebDB 仅供爬虫程序使用,搜索程序不使用。WebDB 存储两种实体:页面和链接。该页面代表 Internet 上的网页。将该网页的URL作为标记编入索引,同时创建该网页内容的MD5哈希签名。与网页相关的其他内容也被存储,包括:页面中的链接数(外部链接)、页面爬取信息(在页面被重复爬取的情况下)、以及表示页面级别的分数。链接代表从一个网页到其他网页的链接。因此,WebDB 可以说是一个网络图,以节点为页面,以链接为边。

2、段。这是网页的集合,并已编入索引。Segment 的 Fetchlist 是爬虫使用的 URL 列表,由 WebDB 生成。Fetcher 的输出数据是从 fetchlist 中取出的网页。Fetcher的输出数据先进行反向索引,然后将索引结果存入segment中。一个segment的生命周期是有限的,下一轮爬行开始的时候就没用了。默认重新爬网间隔为 30 天。因此,可以删除超过此时间限制的段。并且可以节省大量磁盘空间。Segment 以日期和时间命名,因此可以非常直观地查看其生命周期。

3、索引。索引库是系统中所有爬取到的页面的反向索引。它不是直接从页面反向索引生成的,而是由许多小段索引合并生成的。Nutch 使用Lucene 来构建索引,所以所有与Lucene 相关的工具API 都用于构建索引库。需要说明的是,Lucene的segment概念与Nutch的segment概念完全不同,不要混淆。简单的说,Lucene的segment是Lucene索引库的一部分,而Nutch的segment是被爬取索引的WebDB的一部分。

爬取过程的详细说明:

获取是一个循环过程:获取工具从 WebDB 生成一个 fetchlist 集合;提取工具根据fetchlist从互联网上下载网页内容;工具程序根据提取工具找到的新链接更新WebDB;然后生成一个新的fetchlist;反复。这个 fetch 循环在 nutch 中通常被称为:生成/获取/更新循环。

一般来说,同一个域名下的url链接会被合成到同一个fetchlist中。这样做的考虑是当同时使用多个工具进行抓取时,不会出现重复抓取。Nutch 遵循Robots Exclusion Protocol,可以使用robots.txt 来定义和保护私人网页数据不被捕获。

以上抓取工具的组合是Nutch的最外层。也可以直接使用底层工具,结合这些底层工具的执行顺序,也可以达到同样的效果。这就是纳奇的魅力所在。下面详细描述上述过程。基础工具的名称在括号中:

1、创建一个新的 WebDB (admin db -create)。

2、将开始爬取和Url放入WebDb(注入)。

3、 从WebDb的新段生成fetchlist(生成)。

4、 根据fetchlist列表(fetch)获取网页的内容。

5、根据检索到的网页链接url更新WebDB(updatedb)。

6、重复以上3-5步,直到达到指定的爬行层数。

7、 使用计算出的 web url 权重分数更新段 (updatesegs)。

8、 将抓取的网页编入索引。

9、 消除索引中的重复内容和重复网址(dedup)。

10、将多个索引合并为一个大索引,并提供索引库(merge)进行搜索。

*****************

赫里特克斯

开发语言:Java

Heritrix 是一个开源、可扩展的网络爬虫项目。Heritrix 的设计严格遵循 robots.txt 文件和 META 机器人标签的排除说明。

介绍

Heritrix 和 Nutch 的比较

还有纳奇。两者都是 Java 开源框架。Heritrix 是 SourceForge 上的开源产品。Nutch 是 Apache 的一个子项目。它们都被称为网络爬虫。它们的实现原理基本一致:深度遍历网站在本地捕获这些资源,使用的方法是分析每个有效的URI网站并提交一个Http请求得到相应的结果,生成本地文件和相应的日志信息等。

Heritrix 是一个“档案爬虫”——用于获取完整、准确、深层的网站内容副本。包括获取图片等非文字内容。抓取和存储相关内容。不拒绝内容,不修改页面内容。重新抓取不会替换同一 URL 的前一次抓取。通过Web用户界面启动、监控和调整爬虫,可以灵活定义获取URL。

Nutch和Heritrix的区别:

Nutch 只获取和保存可索引的内容。Heritrix 接受这一切。力求保留页面原貌

Nutch 可以修剪内容,或转换内容格式。

Nutch 以数据库优化格式保存内容,以备将来索引;刷新并替换旧内容。而 Heritrix 正在添加(追加)新的内容。

Nutch 是从命令行运行和控制的。Heritrix 有一个网页控制管理界面。

Nutch 的定制能力还不够强大,但现在已经改进了。Heritrix 可以控制更多的参数。

Heritrix 提供的功能没有 nutch 多,有点像从整个站点下载。既没有索引也没有解析,即使是重复的URL爬取也不是很好。

Heritrix 功能强大,但配置起来有点麻烦。

************************

三者的比较

一、 在功能上,Heritrix 和 Larbin 有着相似的功能。两者都是纯网络爬虫,提供网站的镜像下载。虽然 Nutch 是一个网络搜索引擎框架,但抓取网页只是其功能的一部分。

二、 从分布式处理的角度来看,Nutch 支持分布式处理,而另外两个好像还没有被支持。

三、 从抓取的网页存储方式来看,Heritrix和Larbin都将抓取的内容保存为原创内容类型。并且 Nutch 将内容保存到其特定的格式段。

第四,对于爬取内容的处理,Heritrix和Larbin都将爬取的内容直接保存为原创内容,不做任何处理。Nutch 处理文本包括链接分析、文本提取和索引(Lucene 索引)。

第五,在爬取效率方面,Larbin的效率更高,因为它是用C++实现的,功能单一。

爬虫

发展

语

特征

单身的

支持分布式

爬行

高效的

镜像

保存

纳奇

爪哇

X

√

低的

X

拉宾

C++

√

X

高的

√

赫里特克斯

爪哇

√

X

中间

√

-------------------------------------------------- ---------

其他一些开源爬虫的总结:

网络SPHINX

WebSPHINX 是 Java 类包和网络爬虫的交互式开发环境。网络爬虫(也称为机器人或蜘蛛)是可以自动浏览和处理网页的程序。WebSPHINX由两部分组成:爬虫工作平台和WebSPHINX包。

~rcm/websphinx/

网络学习

WebLech 是一个强大的网站下载和镜像工具。支持根据功能需求下载网站,并尽可能模仿标准网页浏览器的行为。WebLech 有功能控制台,使用多线程操作。

阿拉蕾

Arale 主要是为个人使用而设计的,不像其他爬虫那样专注于页面索引。Arale 可以下载整个网站或网站上的部分资源。Arale 还可以将动态页面映射到静态页面。

J-蜘蛛

J-Spider:是一个完全可配置和可定制的 Web Spider 引擎。可以用它来检查网站错误(内部服务器错误等),网站内外部链接检查,分析网站的结构(可以创建一个网站@ > map),下载整个网站,也可以写一个JSpider插件扩展你需要的功能。

主轴

Spindle 是一种建立在 Lucene 工具包上的 Web 索引/搜索工具。它包括一个用于创建索引的 HTTP 蜘蛛和一个用于搜索这些索引的搜索类。Spindle 项目提供了一套JSP 标签库,让那些基于JSP 的站点无需开发任何Java 类就可以添加搜索功能。

蛛形纲动物

Arachnid:是一个基于 Java 的网络蜘蛛框架。它收录一个简单的 HTML 解析器,可以分析收录 HTML 内容的输入流。通过实现Arachnid子类,就可以开发出一个简单的网络蜘蛛,可以在每一个网站中使用 解析一个页面后,添加几行代码调用。Arachnid 下载包中收录两个蜘蛛应用程序示例,用于演示如何使用该框架。

警报器

LARM 可为 Jakarta Lucene 搜索引擎框架的用户提供纯 Java 搜索解决方案。它收录索引文件、数据库表和用于索引网站的爬虫的方法。

乔博

JoBo 是一个用于下载整个网站的简单工具。它本质上是一个网络蜘蛛。与其他下载工具相比,它的主要优点是能够自动填写表单(如自动登录)和使用cookies来处理会话。JoBo 还具有灵活的下载规则(如:URL、大小、MIME 类型等)来限制下载。

snoics-爬行动物

snoics -reptile 是用纯 Java 开发的。它是用于捕获网站 图像的工具。您可以使用配置文件中提供的 URL 条目。这种方式获取的所有资源都是本地抓取的,包括网页和各类文件,如图片、flash、mp3、zip、rar、exe等文件。整个网站可以完全转移到硬盘上,保持原有的网站结构准确不变。只需将捕获到的网站放入Web服务器(如Apache)即可实现完整的网站镜像。

网络收获

Web-Harvest 是一个 Java 开源 Web 数据提取工具。它可以采集指定的网页并从这些网页中提取有用的数据。Web-Harvest主要使用XSLT、XQuery、正则表达式等技术来实现text/xml的操作。

蜘蛛

Spiderpy 是一个基于 Python 编码的开源网络爬虫工具,允许用户采集文件和搜索网站,并具有可配置的界面。

蜘蛛网网络 Xoops Mod 团队

pider Web Network Xoops Mod 是 Xoops 下的一个模块,完全由 PHP 语言实现。 查看全部

网页中flash数据抓取(从网上找了一些开源spider的相关资料(图))

我从网上找了一些关于开源蜘蛛的相关资料,整理如下:

-------------------------------------------------- ---------------------------------

**************

拉宾

开发语言:C++

Larbin 是一个基于 C++ 的网络爬虫工具,界面易于操作,但只能在 LINUX 下运行。Larbin在普通PC下每天可以抓取500万个页面(当然,你需要有良好的网络)

介绍

Larbin 是一个开源的网络爬虫/网络蜘蛛,由法国年轻人 Sébastien Ailleret 独立开发。larbin 的目的是能够跟踪页面的 URL 进行扩展抓取,最终为搜索引擎提供广泛的数据源。

larbin只是一个爬虫,也就是说larbin只爬网页,如何解析是用户自己做的。此外,larbin 没有提供有关如何将其存储在数据库中和构建索引的信息。

Latbin 最初的设计也是基于设计简单但可配置性高的原则,所以我们可以看到一个简单的 larbin 爬虫每天可以获取 500 万个网页,非常高效。

特征

1. larbin 获取一个,确认网站的所有链接,甚至镜像一个网站。

2. larbin建立一个url列表组,比如url检索所有网页后,得到xml的链接。或mp3。

3. larbin 可以定制为搜索引擎信息的来源(例如每2000组抓取的网页可以存储在一系列目录结构中)。

问题

Labin的主要问题是:

只提供保存网页的功能,不做进一步的网页分析;

不支持分布式系统;

功能比较简单,提供的配置项不够;

不支持网页自动重访和更新功能;

从2003年底开始,Labin就放弃了更新,目前处于荒草丛生的状态。

**********

纳奇

开发语言:Java

介绍:

Apache的子项目之一是Lucene项目下的子项目。

Nutch 是一个完整的网络搜索引擎解决方案,基于Lucene,类似于谷歌。基于Hadoop的分布式处理模型保证了系统的性能。类似Eclipse的插件机制保证了系统可以定制,并且很容易集成到自己的应用程序中。之中。

一般来说,Nutch 可以分为两个部分:爬行部分和搜索部分。爬行程序对页面进行爬行,将检索到的数据制成倒排索引,搜索程序响应用户的倒排索引搜索请求。爬虫和搜索器的接口是索引,都使用索引中的字段。抓取程序和搜索程序可以位于不同的机器上。下面是爬取部分的详细介绍。

爬行部分:

履带由Nutch的履带驱动。这是一组用于创建和维护几种不同数据结构的工具:Web 数据库、一组段和索引。下面对这三种不同的数据结构进行一一说明:

1、Web 数据库或 WebDB。这是一种特殊的存储数据结构,用于映射捕获的网站数据的结构和属性集合。WebDB用于存储从爬取(包括重新爬取)开始的所有网站结构数据和属性。WebDB 仅供爬虫程序使用,搜索程序不使用。WebDB 存储两种实体:页面和链接。该页面代表 Internet 上的网页。将该网页的URL作为标记编入索引,同时创建该网页内容的MD5哈希签名。与网页相关的其他内容也被存储,包括:页面中的链接数(外部链接)、页面爬取信息(在页面被重复爬取的情况下)、以及表示页面级别的分数。链接代表从一个网页到其他网页的链接。因此,WebDB 可以说是一个网络图,以节点为页面,以链接为边。

2、段。这是网页的集合,并已编入索引。Segment 的 Fetchlist 是爬虫使用的 URL 列表,由 WebDB 生成。Fetcher 的输出数据是从 fetchlist 中取出的网页。Fetcher的输出数据先进行反向索引,然后将索引结果存入segment中。一个segment的生命周期是有限的,下一轮爬行开始的时候就没用了。默认重新爬网间隔为 30 天。因此,可以删除超过此时间限制的段。并且可以节省大量磁盘空间。Segment 以日期和时间命名,因此可以非常直观地查看其生命周期。

3、索引。索引库是系统中所有爬取到的页面的反向索引。它不是直接从页面反向索引生成的,而是由许多小段索引合并生成的。Nutch 使用Lucene 来构建索引,所以所有与Lucene 相关的工具API 都用于构建索引库。需要说明的是,Lucene的segment概念与Nutch的segment概念完全不同,不要混淆。简单的说,Lucene的segment是Lucene索引库的一部分,而Nutch的segment是被爬取索引的WebDB的一部分。

爬取过程的详细说明:

获取是一个循环过程:获取工具从 WebDB 生成一个 fetchlist 集合;提取工具根据fetchlist从互联网上下载网页内容;工具程序根据提取工具找到的新链接更新WebDB;然后生成一个新的fetchlist;反复。这个 fetch 循环在 nutch 中通常被称为:生成/获取/更新循环。

一般来说,同一个域名下的url链接会被合成到同一个fetchlist中。这样做的考虑是当同时使用多个工具进行抓取时,不会出现重复抓取。Nutch 遵循Robots Exclusion Protocol,可以使用robots.txt 来定义和保护私人网页数据不被捕获。

以上抓取工具的组合是Nutch的最外层。也可以直接使用底层工具,结合这些底层工具的执行顺序,也可以达到同样的效果。这就是纳奇的魅力所在。下面详细描述上述过程。基础工具的名称在括号中:

1、创建一个新的 WebDB (admin db -create)。

2、将开始爬取和Url放入WebDb(注入)。

3、 从WebDb的新段生成fetchlist(生成)。

4、 根据fetchlist列表(fetch)获取网页的内容。

5、根据检索到的网页链接url更新WebDB(updatedb)。

6、重复以上3-5步,直到达到指定的爬行层数。

7、 使用计算出的 web url 权重分数更新段 (updatesegs)。

8、 将抓取的网页编入索引。

9、 消除索引中的重复内容和重复网址(dedup)。

10、将多个索引合并为一个大索引,并提供索引库(merge)进行搜索。

*****************

赫里特克斯

开发语言:Java

Heritrix 是一个开源、可扩展的网络爬虫项目。Heritrix 的设计严格遵循 robots.txt 文件和 META 机器人标签的排除说明。

介绍

Heritrix 和 Nutch 的比较

还有纳奇。两者都是 Java 开源框架。Heritrix 是 SourceForge 上的开源产品。Nutch 是 Apache 的一个子项目。它们都被称为网络爬虫。它们的实现原理基本一致:深度遍历网站在本地捕获这些资源,使用的方法是分析每个有效的URI网站并提交一个Http请求得到相应的结果,生成本地文件和相应的日志信息等。

Heritrix 是一个“档案爬虫”——用于获取完整、准确、深层的网站内容副本。包括获取图片等非文字内容。抓取和存储相关内容。不拒绝内容,不修改页面内容。重新抓取不会替换同一 URL 的前一次抓取。通过Web用户界面启动、监控和调整爬虫,可以灵活定义获取URL。

Nutch和Heritrix的区别:

Nutch 只获取和保存可索引的内容。Heritrix 接受这一切。力求保留页面原貌

Nutch 可以修剪内容,或转换内容格式。

Nutch 以数据库优化格式保存内容,以备将来索引;刷新并替换旧内容。而 Heritrix 正在添加(追加)新的内容。

Nutch 是从命令行运行和控制的。Heritrix 有一个网页控制管理界面。

Nutch 的定制能力还不够强大,但现在已经改进了。Heritrix 可以控制更多的参数。

Heritrix 提供的功能没有 nutch 多,有点像从整个站点下载。既没有索引也没有解析,即使是重复的URL爬取也不是很好。

Heritrix 功能强大,但配置起来有点麻烦。

************************

三者的比较

一、 在功能上,Heritrix 和 Larbin 有着相似的功能。两者都是纯网络爬虫,提供网站的镜像下载。虽然 Nutch 是一个网络搜索引擎框架,但抓取网页只是其功能的一部分。

二、 从分布式处理的角度来看,Nutch 支持分布式处理,而另外两个好像还没有被支持。

三、 从抓取的网页存储方式来看,Heritrix和Larbin都将抓取的内容保存为原创内容类型。并且 Nutch 将内容保存到其特定的格式段。

第四,对于爬取内容的处理,Heritrix和Larbin都将爬取的内容直接保存为原创内容,不做任何处理。Nutch 处理文本包括链接分析、文本提取和索引(Lucene 索引)。

第五,在爬取效率方面,Larbin的效率更高,因为它是用C++实现的,功能单一。

爬虫

发展

语

特征

单身的

支持分布式

爬行

高效的

镜像

保存

纳奇

爪哇

X

√

低的

X

拉宾

C++

√

X

高的

√

赫里特克斯

爪哇

√

X

中间

√

-------------------------------------------------- ---------

其他一些开源爬虫的总结:

网络SPHINX

WebSPHINX 是 Java 类包和网络爬虫的交互式开发环境。网络爬虫(也称为机器人或蜘蛛)是可以自动浏览和处理网页的程序。WebSPHINX由两部分组成:爬虫工作平台和WebSPHINX包。

~rcm/websphinx/

网络学习

WebLech 是一个强大的网站下载和镜像工具。支持根据功能需求下载网站,并尽可能模仿标准网页浏览器的行为。WebLech 有功能控制台,使用多线程操作。

阿拉蕾

Arale 主要是为个人使用而设计的,不像其他爬虫那样专注于页面索引。Arale 可以下载整个网站或网站上的部分资源。Arale 还可以将动态页面映射到静态页面。

J-蜘蛛

J-Spider:是一个完全可配置和可定制的 Web Spider 引擎。可以用它来检查网站错误(内部服务器错误等),网站内外部链接检查,分析网站的结构(可以创建一个网站@ > map),下载整个网站,也可以写一个JSpider插件扩展你需要的功能。

主轴

Spindle 是一种建立在 Lucene 工具包上的 Web 索引/搜索工具。它包括一个用于创建索引的 HTTP 蜘蛛和一个用于搜索这些索引的搜索类。Spindle 项目提供了一套JSP 标签库,让那些基于JSP 的站点无需开发任何Java 类就可以添加搜索功能。

蛛形纲动物

Arachnid:是一个基于 Java 的网络蜘蛛框架。它收录一个简单的 HTML 解析器,可以分析收录 HTML 内容的输入流。通过实现Arachnid子类,就可以开发出一个简单的网络蜘蛛,可以在每一个网站中使用 解析一个页面后,添加几行代码调用。Arachnid 下载包中收录两个蜘蛛应用程序示例,用于演示如何使用该框架。

警报器

LARM 可为 Jakarta Lucene 搜索引擎框架的用户提供纯 Java 搜索解决方案。它收录索引文件、数据库表和用于索引网站的爬虫的方法。

乔博

JoBo 是一个用于下载整个网站的简单工具。它本质上是一个网络蜘蛛。与其他下载工具相比,它的主要优点是能够自动填写表单(如自动登录)和使用cookies来处理会话。JoBo 还具有灵活的下载规则(如:URL、大小、MIME 类型等)来限制下载。

snoics-爬行动物

snoics -reptile 是用纯 Java 开发的。它是用于捕获网站 图像的工具。您可以使用配置文件中提供的 URL 条目。这种方式获取的所有资源都是本地抓取的,包括网页和各类文件,如图片、flash、mp3、zip、rar、exe等文件。整个网站可以完全转移到硬盘上,保持原有的网站结构准确不变。只需将捕获到的网站放入Web服务器(如Apache)即可实现完整的网站镜像。

网络收获

Web-Harvest 是一个 Java 开源 Web 数据提取工具。它可以采集指定的网页并从这些网页中提取有用的数据。Web-Harvest主要使用XSLT、XQuery、正则表达式等技术来实现text/xml的操作。

蜘蛛

Spiderpy 是一个基于 Python 编码的开源网络爬虫工具,允许用户采集文件和搜索网站,并具有可配置的界面。

蜘蛛网网络 Xoops Mod 团队

pider Web Network Xoops Mod 是 Xoops 下的一个模块,完全由 PHP 语言实现。

网页中flash数据抓取(为什么我的网站不显示关键词和页面描述的是乱码?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-12-15 01:18

·显示:本站所有网址的显示顺序是动态的。在首页,最近点击的网址会排在第一位;你被点击的机会就越大。请注意,来自同一 IP 的连续点击无效。

·更新:当前系统设置每7天自动更新您的网站标题和关键词。如需提前更新,请联系本站管理员。

为什么我的连接标题显示乱码?

原因:可能是你的网页文件使用了utf-8编码,文件中没有添加正确的编码描述码。

解决方法:在页面中添加如下代码:

为什么标题只显示网址?

原因:您的网站没有默认主页,或者您的主页是重定向地址而不是域名地址作为默认主页,所以无法提取标题文本。

解决方法:把你的网站放在域名的默认根目录下,首页文件名设置为默认文件名。也就是说,直接输入域名就可以访问了,不用重定向。

为什么我的网站不显示关键词和页面描述?

原因:您的网页中没有关键字标签和描述标签。

解决方案:在网页的标签之间添加关键字标签和描述标签。

关键词 标签代码:

页面描述标签代码:

为什么网址被屏蔽了?

当您的网站有以下情况时,您的网址将被屏蔽:

1、网站 内容收录色情成人和政治表达。(边球也包括在内)

2、 广告很多,有带广告的弹窗,没有实质内容。

3、 有恶意代码、病毒和木马。

4、 假网址:无内容,页面跳转。

解决方案:

认真做好网站,丰富网站的内容,给用户良好的浏览体验。以上现有内容更改后,我们会人工审核,重新收录你的网站。

维护良好的互联网氛围是我们每个人的责任。

百度给站长的建站建议 查看全部

网页中flash数据抓取(为什么我的网站不显示关键词和页面描述的是乱码?)

·显示:本站所有网址的显示顺序是动态的。在首页,最近点击的网址会排在第一位;你被点击的机会就越大。请注意,来自同一 IP 的连续点击无效。

·更新:当前系统设置每7天自动更新您的网站标题和关键词。如需提前更新,请联系本站管理员。

为什么我的连接标题显示乱码?

原因:可能是你的网页文件使用了utf-8编码,文件中没有添加正确的编码描述码。

解决方法:在页面中添加如下代码:

为什么标题只显示网址?

原因:您的网站没有默认主页,或者您的主页是重定向地址而不是域名地址作为默认主页,所以无法提取标题文本。

解决方法:把你的网站放在域名的默认根目录下,首页文件名设置为默认文件名。也就是说,直接输入域名就可以访问了,不用重定向。

为什么我的网站不显示关键词和页面描述?

原因:您的网页中没有关键字标签和描述标签。

解决方案:在网页的标签之间添加关键字标签和描述标签。

关键词 标签代码:

页面描述标签代码:

为什么网址被屏蔽了?

当您的网站有以下情况时,您的网址将被屏蔽:

1、网站 内容收录色情成人和政治表达。(边球也包括在内)

2、 广告很多,有带广告的弹窗,没有实质内容。

3、 有恶意代码、病毒和木马。

4、 假网址:无内容,页面跳转。

解决方案:

认真做好网站,丰富网站的内容,给用户良好的浏览体验。以上现有内容更改后,我们会人工审核,重新收录你的网站。

维护良好的互联网氛围是我们每个人的责任。

百度给站长的建站建议

网页中flash数据抓取(一下实现简单爬虫功能的示例python爬虫实战之最简单的网页爬虫教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-15 01:13

既然这篇文章文章讲的是Python搭建网络爬虫的原理分析,那我先给大家介绍一下Python中爬虫的选择文章:

Python实现简单爬虫功能示例

python爬虫实战最简单的网络爬虫教程

网络爬虫是当今最常用的系统之一。最流行的例子是 Google 使用爬虫从所有 网站 采集信息。除了搜索引擎,新闻网站还需要爬虫来聚合数据源。看来只要想聚合很多信息,就可以考虑使用爬虫了。

构建网络爬虫有很多因素,尤其是当您要扩展系统时。这就是为什么这已经成为最流行的系统设计面试问题之一。在这个文章中,我们将讨论从基础爬虫到大型爬虫的话题,讨论面试中可能遇到的各种问题。

1-基本解决方案

如何构建一个基本的网络爬虫?

在系统设计面试之前,我们已经讲过“系统设计面试前你需要知道的八件事”,就是从简单的事情开始。让我们专注于构建一个在单线程上运行的基本网络爬虫。通过这个简单的解决方案,我们可以继续优化。

爬取单个网页,我们只需要向对应的URL发出HTTP GET请求,解析响应数据,这是爬虫的核心。考虑到这一点,一个基本的网络爬虫可以这样工作:

从收录我们要爬取的所有 网站 的 URL 池开始。

对于每个 URL,都会发出 HTTP GET 请求以获取网页的内容。

解析内容(通常是 HTML)并提取我们想要抓取的潜在 URL。

向池中添加新 URL 并继续爬行。

根据具体问题,有时我们可能有一个单独的系统来生成抓取网址。例如,一个程序可以持续监控RSS订阅,对于每一个新的文章,都可以将URL添加到爬取池中。

2 尺度问题

众所周知,任何系统在扩展后都会面临一系列的问题。在网络爬虫中,当系统扩展到多台机器时,很多事情都可能出错。

在跳到下一节之前,请花几分钟思考一下分布式网络爬虫的瓶颈以及如何解决这个问题。在本文章的其余部分,我们将讨论解决方案的主要问题。

3-爬行频率

你多久爬一次 网站?

这听起来可能没什么大不了的,除非系统达到一定规模并且您需要非常新鲜的内容。例如,如果你想获取最近一小时的最新消息,爬虫可能需要保持每小时爬一次新闻网站。但是有什么问题呢?

对于一些小的网站,他们的服务器可能无法处理如此频繁的请求。一种方法是跟踪每个站点的robot.txt。对于不知道robot.txt是什么的人来说,这基本上是网站与网络爬虫通信的标准。它可以指定哪些文件不应该被抓取,大多数网络爬虫都遵循这个配置。另外,你可以为不同的网站设置不同的爬取频率。通常,每天只需要爬取几次网站。

4-重复数据删除

在一台机器上,您可以将 URL 池保留在内存中并删除重复条目。然而,分布式系统中的事情变得更加复杂。基本上,多个爬虫可以从不同的网页中提取同一个网址,并且都想把这个网址加入到网址池中。当然,多次爬取同一个页面是没有意义的。那么我们如何重复这些网址呢?

一种常用的方法是使用布隆过滤器。简而言之,Bloom Filter 是一个节省空间的系统,它允许您测试元素是否在集合中。但是,它可能有误报。换句话说,如果布隆过滤器可以告诉你一个 URL 肯定不在池中,或者可能在池中。

为了简要说明布隆过滤器的工作原理,空布隆过滤器是 m 位(所有 0) 位数组。还有 k 个哈希函数将每个元素映射到 m 位 A。所以当我们添加一个新元素时(URL)在Bloom filter中,我们会从hash函数中得到k位,并将它们都设置为 1. 所以当我们检查一个元素时,我们首先得到k位,如果其中任何一个不是1 ,我们立即知道该元素不存在。然而,如果所有k位都是1,这可能来自其他几个元素的组合。

布隆过滤器是一种非常常用的技术,它是网络爬虫中去除重复网址的完美解决方案。

5-解析

从网站得到响应数据后,下一步就是解析数据(通常是HTML),提取出我们关心的信息。这听起来很简单,但要让它健壮可能很难。

我们面临的挑战是你总会在 HTML 代码中发现奇怪的标签、URL 等,并且很难覆盖所有的边界条件。例如,当 HTML 收录非 Unicode 字符时,您可能需要处理编码和解码问题。此外,当网页中收录图片、视频甚至PDF文件时,也会引起奇怪的行为。

另外,有些网页像AngularJS一样是用Javascript渲染的,你的爬虫可能无法获取到任何内容。

我想说,没有灵丹妙药,就不可能为所有网页制作完美而强大的爬虫。您需要进行大量的稳健性测试以确保它按预期工作。

总结

有很多有趣的话题我还没有触及,但我想提一下其中的一些,以便您可以思考它们。一件事是检测循环。很多网站都收录链接,比如A->B->C->A,你的爬虫可能会一直跑下去。想想如何解决这个问题?

另一个问题是 DNS 查找。当系统扩展到一定程度时,DNS 查找可能会成为瓶颈,您可能需要构建自己的 DNS 服务器。

与许多其他系统类似,扩展的网络爬虫可能比构建单机版本困难得多,并且可以在系统设计面试中讨论很多事情。尝试从一些简单的解决方案开始并继续优化它,这会使事情变得比看起来更容易。

以上是我们对网络爬虫相关文章内容的总结。如果你还有什么想知道的,可以在下方评论区讨论。感谢您对脸圈教程的支持。 查看全部

网页中flash数据抓取(一下实现简单爬虫功能的示例python爬虫实战之最简单的网页爬虫教程)

既然这篇文章文章讲的是Python搭建网络爬虫的原理分析,那我先给大家介绍一下Python中爬虫的选择文章:

Python实现简单爬虫功能示例

python爬虫实战最简单的网络爬虫教程

网络爬虫是当今最常用的系统之一。最流行的例子是 Google 使用爬虫从所有 网站 采集信息。除了搜索引擎,新闻网站还需要爬虫来聚合数据源。看来只要想聚合很多信息,就可以考虑使用爬虫了。

构建网络爬虫有很多因素,尤其是当您要扩展系统时。这就是为什么这已经成为最流行的系统设计面试问题之一。在这个文章中,我们将讨论从基础爬虫到大型爬虫的话题,讨论面试中可能遇到的各种问题。

1-基本解决方案

如何构建一个基本的网络爬虫?

在系统设计面试之前,我们已经讲过“系统设计面试前你需要知道的八件事”,就是从简单的事情开始。让我们专注于构建一个在单线程上运行的基本网络爬虫。通过这个简单的解决方案,我们可以继续优化。

爬取单个网页,我们只需要向对应的URL发出HTTP GET请求,解析响应数据,这是爬虫的核心。考虑到这一点,一个基本的网络爬虫可以这样工作:

从收录我们要爬取的所有 网站 的 URL 池开始。

对于每个 URL,都会发出 HTTP GET 请求以获取网页的内容。

解析内容(通常是 HTML)并提取我们想要抓取的潜在 URL。

向池中添加新 URL 并继续爬行。

根据具体问题,有时我们可能有一个单独的系统来生成抓取网址。例如,一个程序可以持续监控RSS订阅,对于每一个新的文章,都可以将URL添加到爬取池中。

2 尺度问题

众所周知,任何系统在扩展后都会面临一系列的问题。在网络爬虫中,当系统扩展到多台机器时,很多事情都可能出错。

在跳到下一节之前,请花几分钟思考一下分布式网络爬虫的瓶颈以及如何解决这个问题。在本文章的其余部分,我们将讨论解决方案的主要问题。

3-爬行频率

你多久爬一次 网站?

这听起来可能没什么大不了的,除非系统达到一定规模并且您需要非常新鲜的内容。例如,如果你想获取最近一小时的最新消息,爬虫可能需要保持每小时爬一次新闻网站。但是有什么问题呢?

对于一些小的网站,他们的服务器可能无法处理如此频繁的请求。一种方法是跟踪每个站点的robot.txt。对于不知道robot.txt是什么的人来说,这基本上是网站与网络爬虫通信的标准。它可以指定哪些文件不应该被抓取,大多数网络爬虫都遵循这个配置。另外,你可以为不同的网站设置不同的爬取频率。通常,每天只需要爬取几次网站。

4-重复数据删除

在一台机器上,您可以将 URL 池保留在内存中并删除重复条目。然而,分布式系统中的事情变得更加复杂。基本上,多个爬虫可以从不同的网页中提取同一个网址,并且都想把这个网址加入到网址池中。当然,多次爬取同一个页面是没有意义的。那么我们如何重复这些网址呢?

一种常用的方法是使用布隆过滤器。简而言之,Bloom Filter 是一个节省空间的系统,它允许您测试元素是否在集合中。但是,它可能有误报。换句话说,如果布隆过滤器可以告诉你一个 URL 肯定不在池中,或者可能在池中。

为了简要说明布隆过滤器的工作原理,空布隆过滤器是 m 位(所有 0) 位数组。还有 k 个哈希函数将每个元素映射到 m 位 A。所以当我们添加一个新元素时(URL)在Bloom filter中,我们会从hash函数中得到k位,并将它们都设置为 1. 所以当我们检查一个元素时,我们首先得到k位,如果其中任何一个不是1 ,我们立即知道该元素不存在。然而,如果所有k位都是1,这可能来自其他几个元素的组合。

布隆过滤器是一种非常常用的技术,它是网络爬虫中去除重复网址的完美解决方案。

5-解析

从网站得到响应数据后,下一步就是解析数据(通常是HTML),提取出我们关心的信息。这听起来很简单,但要让它健壮可能很难。

我们面临的挑战是你总会在 HTML 代码中发现奇怪的标签、URL 等,并且很难覆盖所有的边界条件。例如,当 HTML 收录非 Unicode 字符时,您可能需要处理编码和解码问题。此外,当网页中收录图片、视频甚至PDF文件时,也会引起奇怪的行为。

另外,有些网页像AngularJS一样是用Javascript渲染的,你的爬虫可能无法获取到任何内容。

我想说,没有灵丹妙药,就不可能为所有网页制作完美而强大的爬虫。您需要进行大量的稳健性测试以确保它按预期工作。

总结

有很多有趣的话题我还没有触及,但我想提一下其中的一些,以便您可以思考它们。一件事是检测循环。很多网站都收录链接,比如A->B->C->A,你的爬虫可能会一直跑下去。想想如何解决这个问题?

另一个问题是 DNS 查找。当系统扩展到一定程度时,DNS 查找可能会成为瓶颈,您可能需要构建自己的 DNS 服务器。

与许多其他系统类似,扩展的网络爬虫可能比构建单机版本困难得多,并且可以在系统设计面试中讨论很多事情。尝试从一些简单的解决方案开始并继续优化它,这会使事情变得比看起来更容易。

以上是我们对网络爬虫相关文章内容的总结。如果你还有什么想知道的,可以在下方评论区讨论。感谢您对脸圈教程的支持。

网页中flash数据抓取(python爬虫简单的版本,那个时候还不懂原理,现在算是收尾吧 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-14 07:25

)

今天又浪费了一天。Python爬虫,之前写过一个简单的版本,当时没看懂原理。现在是结束了。

以前对网络爬虫一无所知,感觉很神奇,但揭开这面纱,似乎里面的原理不难掌握。首先了解一个概念,HTTP协议,为什么叫超文本协议。超文本的概念是几乎所有的数据都是以文本方式传输的,包括文本、图片等,然后在一个网页中,需要做的就是解析这些字符数据,还原成原创文件。

爬虫的概念是以一个网页为起点,从中找到更多的链接和数据信息,然后展开成树状,可以想象成一棵树。对于每个网页,都需要根据需求对数据进行过滤(查找图片,或搜索关键字,或搜索音频等),最后根据过滤后的URL下载数据。一般步骤是:

网页==》网页树==》过滤信息==》下载

笔者这里以网页图片为例:

例如,一个网页中可能有很多图片。最基本的就是能够识别这个网页中的所有图片链接。这里的一般方法是根据正则表达式匹配网页的文本,从而采集内容。图片的链接。eg: reg = r"""src\s*="?(\S+)\.jpg"""。其次,把这些链接归档。看起来很抽象的东西可以通过这两步来实现。然后,网络树有点难,需要从网页中找到有用的网页链接,然后再过滤这些链接,有点像递归。这里有很多难点,比如当网页链接很多的时候,如何有效地过滤有效链接,如何控制搜索深度,如何分配进程等等。

另外,由于很多国外的网站无法上传,部分网页数据下载需要通过代理;另外,考虑到部分机器性能更好,也实现了多线程机制。笔者进行了一天的研究,终于通过了调试。这是代码:

<p>import re

import os

import sys

import time

import threading

import socket

import urllib

import urllib2

server = \'127.0.0.1\'

port = \'8087\'

timeout = 720

socket.setdefaulttimeout(timeout)

class timer(threading.Thread): #The timer class is derived from the class threading.Thread

def __init__(self, num, interval,dir,url):

threading.Thread.__init__(self)

self.thread_num = num

self.interval = interval

self.url = url

self.dir = dir

self.thread_stop = False

def run(self): #Overwrite run() method, put what you want the thread do here

#while not self.thread_stop:

DownloadImgs(self.interval,self.url,self.dir)

#print \'Thread Object(%d), Time:%s\' %(self.thread_num, time.ctime())

#time.sleep(self.interval)

def stop(self):

self.thread_stop = True

def getContent(url,type):

print(">>start connecting:%s" % url)

from urllib2 import Request, urlopen, URLError, HTTPError

proxy = urllib2.ProxyHandler({\'http\':\'http://127.0.0.1:8087\'})

opener = urllib2.build_opener(proxy,urllib2.HTTPHandler)

urllib2.install_opener(opener)

try:

urlHandler = urllib2.urlopen(url)

headers = urlHandler.info().headers

length = 0

for header in headers:

if header.find(\'Length\') != -1:

length = header.split(\':\')[-1].strip()

length = int(length)

if(type=="img" and length 查看全部

网页中flash数据抓取(python爬虫简单的版本,那个时候还不懂原理,现在算是收尾吧

)

今天又浪费了一天。Python爬虫,之前写过一个简单的版本,当时没看懂原理。现在是结束了。

以前对网络爬虫一无所知,感觉很神奇,但揭开这面纱,似乎里面的原理不难掌握。首先了解一个概念,HTTP协议,为什么叫超文本协议。超文本的概念是几乎所有的数据都是以文本方式传输的,包括文本、图片等,然后在一个网页中,需要做的就是解析这些字符数据,还原成原创文件。

爬虫的概念是以一个网页为起点,从中找到更多的链接和数据信息,然后展开成树状,可以想象成一棵树。对于每个网页,都需要根据需求对数据进行过滤(查找图片,或搜索关键字,或搜索音频等),最后根据过滤后的URL下载数据。一般步骤是:

网页==》网页树==》过滤信息==》下载

笔者这里以网页图片为例:

例如,一个网页中可能有很多图片。最基本的就是能够识别这个网页中的所有图片链接。这里的一般方法是根据正则表达式匹配网页的文本,从而采集内容。图片的链接。eg: reg = r"""src\s*="?(\S+)\.jpg"""。其次,把这些链接归档。看起来很抽象的东西可以通过这两步来实现。然后,网络树有点难,需要从网页中找到有用的网页链接,然后再过滤这些链接,有点像递归。这里有很多难点,比如当网页链接很多的时候,如何有效地过滤有效链接,如何控制搜索深度,如何分配进程等等。

另外,由于很多国外的网站无法上传,部分网页数据下载需要通过代理;另外,考虑到部分机器性能更好,也实现了多线程机制。笔者进行了一天的研究,终于通过了调试。这是代码:

<p>import re

import os

import sys

import time

import threading

import socket

import urllib

import urllib2

server = \'127.0.0.1\'

port = \'8087\'

timeout = 720

socket.setdefaulttimeout(timeout)

class timer(threading.Thread): #The timer class is derived from the class threading.Thread

def __init__(self, num, interval,dir,url):

threading.Thread.__init__(self)

self.thread_num = num

self.interval = interval

self.url = url

self.dir = dir

self.thread_stop = False

def run(self): #Overwrite run() method, put what you want the thread do here

#while not self.thread_stop:

DownloadImgs(self.interval,self.url,self.dir)

#print \'Thread Object(%d), Time:%s\' %(self.thread_num, time.ctime())

#time.sleep(self.interval)

def stop(self):

self.thread_stop = True

def getContent(url,type):

print(">>start connecting:%s" % url)

from urllib2 import Request, urlopen, URLError, HTTPError

proxy = urllib2.ProxyHandler({\'http\':\'http://127.0.0.1:8087\'})

opener = urllib2.build_opener(proxy,urllib2.HTTPHandler)

urllib2.install_opener(opener)

try:

urlHandler = urllib2.urlopen(url)

headers = urlHandler.info().headers

length = 0

for header in headers:

if header.find(\'Length\') != -1:

length = header.split(\':\')[-1].strip()

length = int(length)

if(type=="img" and length

网页中flash数据抓取(大数据抓取网页访客/程序/软件/系统方法/步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 42 次浏览 • 2021-12-13 21:16

大数据抓取网页访问者/程序/软件/系统方法/步骤

1、大数据的定义。大数据又称海量数据,手机号是指涉及的数据量大到人脑甚至主流软件都无法捕捉到。它可以在合理的时间内被捕获、管理、处理和组织。在业务决策中用于更积极目的的信息。

2、大数据的特征。数据量大,数据类型多样,对实时性要求高,数据中收录的价值很大。手机号码在各行各业都有大数据,但大量的信息和咨询比较复杂,需要我们去搜索、处理、分析、归纳、总结其深层次规律。

3、采集 大数据。科技和互联网的发展推动了大数据时代的到来。各行各业每天都在产生大量的数据抓取碎片。数据计量单位已经从Byte、KB、MB、GB、TB演变为PB、EB。, ZB, YB 甚至 BB, NB, DB。大数据时代,数据的采集不再是技术问题,但面对如此多的数据,如何才能找到它的内在规律。

4、 大数据挖掘与处理。大数据必然无法用人脑来计算、估计,也不能用单一的计算机来捕捉和处理。它必须采用分布式计算架构,并依赖于云计算的分布式处理、分布式数据库、云存储和虚拟化技术。因此,大数据的挖掘和处理必须使用云技术。

5、大数据的应用。大数据可以应用于各行各业,对人们采集和捕获的海量数据进行分析和整理,实现信息的有效利用。举这个专业的例子,比如在奶牛的基因层面寻找与产奶相关的主要基因,我们可以先用手机号扫描奶牛的全基因组。虽然我们已经获得了所有的表型和遗传信息,但由于数据量巨大,这就需要利用大数据技术,分析比较,挖掘主要基因。还有很多例子。

6、大数据的意义和前景。总的来说,抢大数据手机号就是利用新系统、新工具、新模型,挖掘大量动态、可持续的数据,获得洞察力和新价值。过去,面对海量的数据,我们可能会被蒙蔽、被看见,从而无法了解事物的真实本质,从而在科学工作中做出错误的推论。随着大数据时代的到来,所有的真相都将向我们揭晓。. 问:65203436 查看全部

网页中flash数据抓取(大数据抓取网页访客/程序/软件/系统方法/步骤)

大数据抓取网页访问者/程序/软件/系统方法/步骤

1、大数据的定义。大数据又称海量数据,手机号是指涉及的数据量大到人脑甚至主流软件都无法捕捉到。它可以在合理的时间内被捕获、管理、处理和组织。在业务决策中用于更积极目的的信息。

2、大数据的特征。数据量大,数据类型多样,对实时性要求高,数据中收录的价值很大。手机号码在各行各业都有大数据,但大量的信息和咨询比较复杂,需要我们去搜索、处理、分析、归纳、总结其深层次规律。

3、采集 大数据。科技和互联网的发展推动了大数据时代的到来。各行各业每天都在产生大量的数据抓取碎片。数据计量单位已经从Byte、KB、MB、GB、TB演变为PB、EB。, ZB, YB 甚至 BB, NB, DB。大数据时代,数据的采集不再是技术问题,但面对如此多的数据,如何才能找到它的内在规律。

4、 大数据挖掘与处理。大数据必然无法用人脑来计算、估计,也不能用单一的计算机来捕捉和处理。它必须采用分布式计算架构,并依赖于云计算的分布式处理、分布式数据库、云存储和虚拟化技术。因此,大数据的挖掘和处理必须使用云技术。

5、大数据的应用。大数据可以应用于各行各业,对人们采集和捕获的海量数据进行分析和整理,实现信息的有效利用。举这个专业的例子,比如在奶牛的基因层面寻找与产奶相关的主要基因,我们可以先用手机号扫描奶牛的全基因组。虽然我们已经获得了所有的表型和遗传信息,但由于数据量巨大,这就需要利用大数据技术,分析比较,挖掘主要基因。还有很多例子。

6、大数据的意义和前景。总的来说,抢大数据手机号就是利用新系统、新工具、新模型,挖掘大量动态、可持续的数据,获得洞察力和新价值。过去,面对海量的数据,我们可能会被蒙蔽、被看见,从而无法了解事物的真实本质,从而在科学工作中做出错误的推论。随着大数据时代的到来,所有的真相都将向我们揭晓。. 问:65203436

网页中flash数据抓取(VisualWebRipper如何等待网页完成后再继续其他解决方案?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2021-12-13 10:02

问题

我正在用 C# 开发 Microsoft .NET 应用程序,用于网络采集、网络抓取、网络数据提取、屏幕抓取等。不管你想怎么称呼它。为了解析HTML,我尝试合并HTML Agility Pack,但并没有我想象的那么容易。我已经收录了迄今为止我拥有的一些规格和图像,希望能得到您对我的处理方式的意见。基本上,我想做一些类似于 Visual Web Ripper Layout 中使用的事情,但我不知道他们是如何做到的......有什么想法吗?

规格:

我的目标是制作一个非常用户友好的点击式应用程序,用于从网络下载数据和图像。我想使用网络浏览器加载 HTML 页面并将解析后的数据和图像链接输出到文本框中。用户可以指定他们想要的 HTML 标签,然后将数据下载到网格中。最后,将数据导出为他们需要的任何格式。

我正在尝试使用 HTML Agility Pack 在网页上加载 HTML 并将其显示在文本框中。

// Load Web Browser

private void Form6_Load(object sender, EventArgs e)

{

// Navigate to webpage

webBrowser.Navigate("http://www.webopedia.com/TERM/H/HTML.html");

// Save URL to memory

SiteMemoryArray[count] = urlTextBox.Text;

// Load HTML from webBrowser

HtmlWindow window = webBrowser.Document.Window;

string str = window.Document.Body.OuterHtml;

// Extract tags using HtmlAgilityPack and display in textbox

HtmlAgilityPack.HtmlDocument HtmlDoc = new HtmlAgilityPack.HtmlDocument();

HtmlDoc.LoadHtml(str);

HtmlAgilityPack.HtmlNodeCollection Nodes =

HtmlDoc.DocumentNode.SelectNodes("//a");

foreach (HtmlAgilityPack.HtmlNode Node in Nodes)

{

textBox2.Text += Node.OuterHtml + "\r\n";

}

}

利用:

HtmlWindow window = webBrowser.Document.Window;

我收到错误:未将对象引用设置为对象的实例。

解决方案

当您参考浏览器窗口时,您可能无法完成页面加载。您可以让浏览器控件在完成后触发导航完成事件。请参阅此 SO 答案以获取示例:C# 如何在继续之前等待页面加载

其他解决方案

我不熟悉 HTMLAgilityPack,但我过去使用过的一个组件是 SGMLReader:它的功能类似于 XMLReader 的替代品,甚至可以根据需要将文档转换为 XML。您可以将其加载到 XMLDocument(甚至 XDocument)中,然后您决定如何使用它。 查看全部

网页中flash数据抓取(VisualWebRipper如何等待网页完成后再继续其他解决方案?)

问题

我正在用 C# 开发 Microsoft .NET 应用程序,用于网络采集、网络抓取、网络数据提取、屏幕抓取等。不管你想怎么称呼它。为了解析HTML,我尝试合并HTML Agility Pack,但并没有我想象的那么容易。我已经收录了迄今为止我拥有的一些规格和图像,希望能得到您对我的处理方式的意见。基本上,我想做一些类似于 Visual Web Ripper Layout 中使用的事情,但我不知道他们是如何做到的......有什么想法吗?

规格:

我的目标是制作一个非常用户友好的点击式应用程序,用于从网络下载数据和图像。我想使用网络浏览器加载 HTML 页面并将解析后的数据和图像链接输出到文本框中。用户可以指定他们想要的 HTML 标签,然后将数据下载到网格中。最后,将数据导出为他们需要的任何格式。

我正在尝试使用 HTML Agility Pack 在网页上加载 HTML 并将其显示在文本框中。

// Load Web Browser

private void Form6_Load(object sender, EventArgs e)

{

// Navigate to webpage

webBrowser.Navigate("http://www.webopedia.com/TERM/H/HTML.html";);

// Save URL to memory

SiteMemoryArray[count] = urlTextBox.Text;

// Load HTML from webBrowser

HtmlWindow window = webBrowser.Document.Window;

string str = window.Document.Body.OuterHtml;

// Extract tags using HtmlAgilityPack and display in textbox

HtmlAgilityPack.HtmlDocument HtmlDoc = new HtmlAgilityPack.HtmlDocument();

HtmlDoc.LoadHtml(str);

HtmlAgilityPack.HtmlNodeCollection Nodes =

HtmlDoc.DocumentNode.SelectNodes("//a");

foreach (HtmlAgilityPack.HtmlNode Node in Nodes)

{

textBox2.Text += Node.OuterHtml + "\r\n";

}

}

利用:

HtmlWindow window = webBrowser.Document.Window;

我收到错误:未将对象引用设置为对象的实例。

解决方案

当您参考浏览器窗口时,您可能无法完成页面加载。您可以让浏览器控件在完成后触发导航完成事件。请参阅此 SO 答案以获取示例:C# 如何在继续之前等待页面加载

其他解决方案

我不熟悉 HTMLAgilityPack,但我过去使用过的一个组件是 SGMLReader:它的功能类似于 XMLReader 的替代品,甚至可以根据需要将文档转换为 XML。您可以将其加载到 XMLDocument(甚至 XDocument)中,然后您决定如何使用它。

网页中flash数据抓取( 如何实现将网页缓存到本地,再从缓存中读取出来)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-12-13 09:30

如何实现将网页缓存到本地,再从缓存中读取出来)

Swift-cache web页面本地(抓取html页面,实现离线浏览)

添加一名作者 2016-05-05 08:35

(本文代码已升级为Swift3)

市场上有很多新闻客户端提供离线阅读功能。用户可以在本地下载新闻页面,然后在没有网络的情况下离线浏览。或者在使用wifi的时候缓存一些页面,这样在使用手机网络的时候就不需要网络请求了,直接读取read缓存,既提高了响应速度,又节省了流量。

本文介绍如何在本地缓存网页,然后从缓存中读取。

一、实现原理

整个应用使用的核心技术是:URLProtocol 拦截。通过 URLProtocol 拦截,我们可以捕获并处理所有网络请求。

例如,当我们通过WebView访问一个网页时,我们首先将抓取到的url地址与本地缓存中的数据进行匹配。如果有这个url对应的缓存数据,则直接使用缓存数据。

如果未找到,则发出网络请求并将接收到的数据缓存以备下次使用。

前面说过,所有的请求都可以通过URLProtocol拦截,也就是说无论是html页面,还是里面用到的css、js、image等文件都可以被拦截缓存。

2. 使用 Core Data 进行数据持久化存储。本示例使用 Core Data 来缓存网页数据。如果你对Core Data不熟悉,可以参考我的原创文章文章:Swift-Use Core Data for Data Persistent storage

(1) 创建项目时,勾选“Use Core Data”

(2)打开项目中的xcdatamodeld文件,添加实体“CachedURLResponse”,在Attribute栏中添加如下属性:

数据:内容数据

encoding: 响应编码

mimeType:响应数据类型

timestamp:时间戳(记录缓存时间)

url: 请求地址

3.创建拦截类(1)通过继承URLProtocol,我们创建拦截类:MyURLProtocol.swift

import UIKit

import CoreData

//记录请求数量

var requestCount = 0

class MyURLProtocol: URLProtocol , URLSessionDataDelegate, URLSessionTaskDelegate{

//URLSession数据请求任务

var dataTask:URLSessionDataTask?

//url请求响应

var urlResponse: URLResponse?

//url请求获取到的数据

var receivedData: NSMutableData?

//判断这个 protocol 是否可以处理传入的 request

override class func canInit(with request: URLRequest) -> Bool {

//对于已处理过的请求则跳过,避免无限循环标签问题

if URLProtocol.property(forKey: "MyURLProtocolHandledKey", in: request) != nil {

return false

}

return true

}

//回规范化的请求(通常只要返回原来的请求就可以)

override class func canonicalRequest(for request: URLRequest) -> URLRequest {

return request

}

//判断两个请求是否为同一个请求,如果为同一个请求那么就会使用缓存数据。

//通常都是调用父类的该方法。我们也不许要特殊处理。

override class func requestIsCacheEquivalent(_ aRequest: URLRequest,

to bRequest: URLRequest) -> Bool {

return super.requestIsCacheEquivalent(aRequest, to:bRequest)

}

//开始处理这个请求

override func startLoading() {

requestCount+=1

print("Request请求\(requestCount): \(request.url!.absoluteString)")

//判断是否有本地缓存

let possibleCachedResponse = self.cachedResponseForCurrentRequest()

if let cachedResponse = possibleCachedResponse {

print("----- 从缓存中获取响应内容 -----")

//从本地缓中读取数据

let data = cachedResponse.value(forKey: "data") as! Data!

let mimeType = cachedResponse.value(forKey: "mimeType") as! String!

let encoding = cachedResponse.value(forKey: "encoding") as! String!

//创建一个NSURLResponse 对象用来存储数据。

let response = URLResponse(url: self.request.url!, mimeType: mimeType,

expectedContentLength: data!.count,

textEncodingName: encoding)

//将数据返回到客户端。然后调用URLProtocolDidFinishLoading方法来结束加载。

//(设置客户端的缓存存储策略.NotAllowed ,即让客户端做任何缓存的相关工作)

self.client!.urlProtocol(self, didReceive: response,

cacheStoragePolicy: .notAllowed)

self.client!.urlProtocol(self, didLoad: data!)

self.client!.urlProtocolDidFinishLoading(self)

} else {

//请求网络数据

print("===== 从网络获取响应内容 =====")

let newRequest = (self.request as NSURLRequest).mutableCopy() as! NSMutableURLRequest

//NSURLProtocol接口的setProperty()方法可以给URL请求添加自定义属性。

//(这样把处理过的请求做个标记,下一次就不再处理了,避免无限循环请求)

URLProtocol.setProperty(true, forKey: "MyURLProtocolHandledKey",

in: newRequest)

//使用URLSession从网络获取数据

let defaultConfigObj = URLSessionConfiguration.default

let defaultSession = Foundation.URLSession(configuration: defaultConfigObj,

delegate: self, delegateQueue: nil)

self.dataTask = defaultSession.dataTask(with: self.request)

self.dataTask!.resume()

}

}

//结束处理这个请求

override func stopLoading() {

self.dataTask?.cancel()

self.dataTask = nil

self.receivedData = nil

self.urlResponse = nil

}

//URLSessionDataDelegate相关的代理方法

func urlSession(_ session: URLSession, dataTask: URLSessionDataTask,

didReceive response: URLResponse,

completionHandler: @escaping (URLSession.ResponseDisposition) -> Void) {

self.client?.urlProtocol(self, didReceive: response,

cacheStoragePolicy: .notAllowed)

self.urlResponse = response

self.receivedData = NSMutableData()

completionHandler(.allow)

}

func urlSession(_ session: URLSession, dataTask: URLSessionDataTask,

didReceive data: Data) {

self.client?.urlProtocol(self, didLoad: data)

self.receivedData?.append(data)

}

//URLSessionTaskDelegate相关的代理方法

func urlSession(_ session: URLSession, task: URLSessionTask

, didCompleteWithError error: Error?) {

if error != nil {

self.client?.urlProtocol(self, didFailWithError: error!)

} else {

//保存获取到的请求响应数据

saveCachedResponse()

self.client?.urlProtocolDidFinishLoading(self)

}

}

//保存获取到的请求响应数据

func saveCachedResponse () {

print("+++++ 将获取到的数据缓存起来 +++++")

//获取管理的数据上下文 对象

let app = UIApplication.shared.delegate as! AppDelegate

let context = app.persistentContainer.viewContext

//创建NSManagedObject的实例,来匹配在.xcdatamodeld 文件中所对应的数据模型。

let cachedResponse = NSEntityDescription

.insertNewObject(forEntityName: "CachedURLResponse",

into: context) as NSManagedObject

cachedResponse.setValue(self.receivedData, forKey: "data")

cachedResponse.setValue(self.request.url!.absoluteString, forKey: "url")

cachedResponse.setValue(Date(), forKey: "timestamp")

cachedResponse.setValue(self.urlResponse?.mimeType, forKey: "mimeType")

cachedResponse.setValue(self.urlResponse?.textEncodingName, forKey: "encoding")

//保存(Core Data数据要放在主线程中保存,要不并发是容易崩溃)

DispatchQueue.main.async(execute: {

do {

try context.save()

} catch {

print("不能保存:\(error)")

}

})

}

//检索缓存请求

func cachedResponseForCurrentRequest() -> NSManagedObject? {

//获取管理的数据上下文 对象

let app = UIApplication.shared.delegate as! AppDelegate

let context = app.persistentContainer.viewContext

//创建一个NSFetchRequest,通过它得到对象模型实体:CachedURLResponse

let fetchRequest = NSFetchRequest()

let entity = NSEntityDescription.entity(forEntityName: "CachedURLResponse",

in: context)

fetchRequest.entity = entity

//设置查询条件

let predicate = NSPredicate(format:"url == %@", self.request.url!.absoluteString)

fetchRequest.predicate = predicate

//执行获取到的请求

do {

let possibleResult = try context.fetch(fetchRequest)

as? Array

if let result = possibleResult {

if !result.isEmpty {

return result[0]

}

}

}

catch {

print("获取缓存数据失败:\(error)")

}

return nil

}

}

(2) 在 AppDelegate.swift 的 didFinishLaunchingWithOptions 方法中注册它。

这样,程序运行后,MyURLProtocol 会处理每一个请求,并传递给 URL Loading System。包括直接调用加载系统的代码,很多系统组件依赖加载框架的URL,比如UIWebView。

import UIKit

import CoreData

@UIApplicationMain

class AppDelegate: UIResponder, UIApplicationDelegate {

var window: UIWindow?

func application(application: UIApplication,

didFinishLaunchingWithOptions launchOptions: [NSObject: AnyObject]?) -> Bool {

// Override point for customization after application launch.

//注册URL Loading System协议,让每一个请求都会经过MyURLProtocol处理

URLProtocol.registerClass(MyURLProtocol.self)

return true

}

//................

4、测试页面(1)我们在textField中输入url,点击“确定”,然后使用下面的webView加载相应的页面。

(2)页面对应的代码如下,这个和之前使用webView没有区别。(其实程序已经在后台默默的拦截并缓存了请求)

import UIKit

class ViewController: UIViewController , UITextFieldDelegate {

//网址输入框

@IBOutlet var textField: UITextField!

@IBOutlet var webView: UIWebView!

override func viewDidLoad() {

super.viewDidLoad()

}

//确定按钮点击

@IBAction func buttonGoClicked(_ sender: UIButton) {

if self.textField.isFirstResponder {

self.textField.resignFirstResponder()

}

self.sendRequest()

}

//键盘确定按钮点击

func textFieldShouldReturn(_ textField: UITextField) -> Bool {

textField.resignFirstResponder()

self.sendRequest()

return true

}

//请求页面

func sendRequest() {

if let text = self.textField.text {

let url = URL(string:text)

let request = URLRequest(url:url!)

self.webView.loadRequest(request)

}

}

override func didReceiveMemoryWarning() {

super.didReceiveMemoryWarning()

}

}

5.开始测试(1)访问

(2)可以看到控制台会打印出所有的请求请求,因为是第一次访问,本地没有发现缓存数据,程序通过网络请求数据,缓存起来。

(3) 然后再访问几个页面(无论是点击页面跳转还是重新输入url请求)

(4) 然后关闭网络,访问之前访问过的页面,可以看到页面在没有网络的情况下依然可以加载。

(5)查看控制台,发现这些请求请求都是从本地缓存中获取数据的(如果网络不变,也会从缓存中获取数据)

源码下载:

hangge_1118.zip 查看全部

网页中flash数据抓取(

如何实现将网页缓存到本地,再从缓存中读取出来)

Swift-cache web页面本地(抓取html页面,实现离线浏览)

添加一名作者 2016-05-05 08:35

(本文代码已升级为Swift3)

市场上有很多新闻客户端提供离线阅读功能。用户可以在本地下载新闻页面,然后在没有网络的情况下离线浏览。或者在使用wifi的时候缓存一些页面,这样在使用手机网络的时候就不需要网络请求了,直接读取read缓存,既提高了响应速度,又节省了流量。

本文介绍如何在本地缓存网页,然后从缓存中读取。

一、实现原理

整个应用使用的核心技术是:URLProtocol 拦截。通过 URLProtocol 拦截,我们可以捕获并处理所有网络请求。

例如,当我们通过WebView访问一个网页时,我们首先将抓取到的url地址与本地缓存中的数据进行匹配。如果有这个url对应的缓存数据,则直接使用缓存数据。

如果未找到,则发出网络请求并将接收到的数据缓存以备下次使用。

前面说过,所有的请求都可以通过URLProtocol拦截,也就是说无论是html页面,还是里面用到的css、js、image等文件都可以被拦截缓存。

2. 使用 Core Data 进行数据持久化存储。本示例使用 Core Data 来缓存网页数据。如果你对Core Data不熟悉,可以参考我的原创文章文章:Swift-Use Core Data for Data Persistent storage

(1) 创建项目时,勾选“Use Core Data”

(2)打开项目中的xcdatamodeld文件,添加实体“CachedURLResponse”,在Attribute栏中添加如下属性:

数据:内容数据

encoding: 响应编码

mimeType:响应数据类型

timestamp:时间戳(记录缓存时间)

url: 请求地址

3.创建拦截类(1)通过继承URLProtocol,我们创建拦截类:MyURLProtocol.swift

import UIKit

import CoreData

//记录请求数量

var requestCount = 0

class MyURLProtocol: URLProtocol , URLSessionDataDelegate, URLSessionTaskDelegate{

//URLSession数据请求任务

var dataTask:URLSessionDataTask?

//url请求响应

var urlResponse: URLResponse?

//url请求获取到的数据

var receivedData: NSMutableData?

//判断这个 protocol 是否可以处理传入的 request

override class func canInit(with request: URLRequest) -> Bool {

//对于已处理过的请求则跳过,避免无限循环标签问题

if URLProtocol.property(forKey: "MyURLProtocolHandledKey", in: request) != nil {

return false

}

return true

}

//回规范化的请求(通常只要返回原来的请求就可以)

override class func canonicalRequest(for request: URLRequest) -> URLRequest {

return request

}

//判断两个请求是否为同一个请求,如果为同一个请求那么就会使用缓存数据。

//通常都是调用父类的该方法。我们也不许要特殊处理。

override class func requestIsCacheEquivalent(_ aRequest: URLRequest,

to bRequest: URLRequest) -> Bool {

return super.requestIsCacheEquivalent(aRequest, to:bRequest)

}

//开始处理这个请求

override func startLoading() {

requestCount+=1

print("Request请求\(requestCount): \(request.url!.absoluteString)")

//判断是否有本地缓存

let possibleCachedResponse = self.cachedResponseForCurrentRequest()

if let cachedResponse = possibleCachedResponse {

print("----- 从缓存中获取响应内容 -----")

//从本地缓中读取数据

let data = cachedResponse.value(forKey: "data") as! Data!

let mimeType = cachedResponse.value(forKey: "mimeType") as! String!

let encoding = cachedResponse.value(forKey: "encoding") as! String!

//创建一个NSURLResponse 对象用来存储数据。

let response = URLResponse(url: self.request.url!, mimeType: mimeType,

expectedContentLength: data!.count,

textEncodingName: encoding)

//将数据返回到客户端。然后调用URLProtocolDidFinishLoading方法来结束加载。

//(设置客户端的缓存存储策略.NotAllowed ,即让客户端做任何缓存的相关工作)

self.client!.urlProtocol(self, didReceive: response,

cacheStoragePolicy: .notAllowed)

self.client!.urlProtocol(self, didLoad: data!)

self.client!.urlProtocolDidFinishLoading(self)

} else {

//请求网络数据

print("===== 从网络获取响应内容 =====")

let newRequest = (self.request as NSURLRequest).mutableCopy() as! NSMutableURLRequest

//NSURLProtocol接口的setProperty()方法可以给URL请求添加自定义属性。

//(这样把处理过的请求做个标记,下一次就不再处理了,避免无限循环请求)

URLProtocol.setProperty(true, forKey: "MyURLProtocolHandledKey",

in: newRequest)

//使用URLSession从网络获取数据

let defaultConfigObj = URLSessionConfiguration.default

let defaultSession = Foundation.URLSession(configuration: defaultConfigObj,

delegate: self, delegateQueue: nil)

self.dataTask = defaultSession.dataTask(with: self.request)

self.dataTask!.resume()

}

}

//结束处理这个请求

override func stopLoading() {

self.dataTask?.cancel()