网页中flash数据抓取

网页中flash数据抓取( 网站结构建设对网站后期页面收录的怎样的影响?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-01-06 02:10

网站结构建设对网站后期页面收录的怎样的影响?)

网站结构对网站收录有什么影响?

网站结构构建是网站优化的第一步。对网站后面的页面收录会有什么影响?网站结构优化是网站在构建之初就必须考虑的。文章 针对网站结构构建对网站的影响,做了一些一般性的分析。

1.flash 链接不利于蜘蛛抓取页面

说起搜索引擎喜欢的网站结构,还是偏爱静态页面。尤其是flash链接不利于蜘蛛抓取页面。百度给站长的明确建议提到,百度暂时无法识别Flash和Javascript中的内容。这部分内容在百度搜索中可能找不到;仅收录 Flash 和 Javascript 中的链接。百度可能无法在指向的网页上收录。因此,网站 中每个需要 收录 的页面都应该有一个指向它的 HTML 链接。

2. 动态网址参数过多不利于搜索引擎抓取页面

如果网站采用动态网页,减少参数数量和控制参数长度对收录都有好处。一般来说,超过三个参数的网址对于百度的智商来说是难以理解的。太多的参数会阻止蜘蛛爬取或爬取一些指向同一页面的肉到数据库中。

3.网站结构深度

网站应该有清晰的导航和层次结构,网站上的重要网页应该在网站的相对较浅的位置找到。百度对低权重网站的爬取深度有限制。一般一个小的网站百度爬取深度不超过3层。这就是为什么首页上的链接更有可能是收录。大家一定发现,SEO互动论坛的收录一直在上升,尤其是首页本周热门栏目的帖子无一例外的收录。甚至这些帖子收录 的回复也达到了十几页。

4.完整站点链接

全站链接是指网站中所有页面指向的链接。全站链接通常是权重最高的网站链接。全站链接积累了太多的权重,降低了其他内页的权重,从而影响了内容页的收录。为了避免这种情况,一般不要做不必要的全站链接。取消分类导航,保留面包屑导航。

5.内部链权重转移

内部链是网站结构中最复杂的部分。做好内链,有利于网站的权重传递。更多的页面可以达到搜索引擎抓取的页面权重下限。鼓励搜索引擎为更多页面完成收录。在内部链构建过程中,需要对网站结构进行基本布局,使网站达到最佳效果。

【网站结构对网站收录有什么影响?】相关文章:

1.如何改进网站收录

2.网站快速收录提示

3.可以改进网站收录的html标签

4.网站SEO秒优化收录方法

5.网站如何更好的运营收录?

6.网站结构优化对网站有什么好处

7.网站结构优化方法

8.手脚无助网站收录下降对网站有帮助吗? 查看全部

网页中flash数据抓取(

网站结构建设对网站后期页面收录的怎样的影响?)

网站结构对网站收录有什么影响?

网站结构构建是网站优化的第一步。对网站后面的页面收录会有什么影响?网站结构优化是网站在构建之初就必须考虑的。文章 针对网站结构构建对网站的影响,做了一些一般性的分析。

1.flash 链接不利于蜘蛛抓取页面

说起搜索引擎喜欢的网站结构,还是偏爱静态页面。尤其是flash链接不利于蜘蛛抓取页面。百度给站长的明确建议提到,百度暂时无法识别Flash和Javascript中的内容。这部分内容在百度搜索中可能找不到;仅收录 Flash 和 Javascript 中的链接。百度可能无法在指向的网页上收录。因此,网站 中每个需要 收录 的页面都应该有一个指向它的 HTML 链接。

2. 动态网址参数过多不利于搜索引擎抓取页面

如果网站采用动态网页,减少参数数量和控制参数长度对收录都有好处。一般来说,超过三个参数的网址对于百度的智商来说是难以理解的。太多的参数会阻止蜘蛛爬取或爬取一些指向同一页面的肉到数据库中。

3.网站结构深度

网站应该有清晰的导航和层次结构,网站上的重要网页应该在网站的相对较浅的位置找到。百度对低权重网站的爬取深度有限制。一般一个小的网站百度爬取深度不超过3层。这就是为什么首页上的链接更有可能是收录。大家一定发现,SEO互动论坛的收录一直在上升,尤其是首页本周热门栏目的帖子无一例外的收录。甚至这些帖子收录 的回复也达到了十几页。

4.完整站点链接

全站链接是指网站中所有页面指向的链接。全站链接通常是权重最高的网站链接。全站链接积累了太多的权重,降低了其他内页的权重,从而影响了内容页的收录。为了避免这种情况,一般不要做不必要的全站链接。取消分类导航,保留面包屑导航。

5.内部链权重转移

内部链是网站结构中最复杂的部分。做好内链,有利于网站的权重传递。更多的页面可以达到搜索引擎抓取的页面权重下限。鼓励搜索引擎为更多页面完成收录。在内部链构建过程中,需要对网站结构进行基本布局,使网站达到最佳效果。

【网站结构对网站收录有什么影响?】相关文章:

1.如何改进网站收录

2.网站快速收录提示

3.可以改进网站收录的html标签

4.网站SEO秒优化收录方法

5.网站如何更好的运营收录?

6.网站结构优化对网站有什么好处

7.网站结构优化方法

8.手脚无助网站收录下降对网站有帮助吗?

网页中flash数据抓取( 网站优化到百度首页但又不知该怎么做??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-06 02:07

网站优化到百度首页但又不知该怎么做??)

对于刚接触SEO的小白来说,会遇到这样的困惑。想把网站优化到百度首页不知道怎么做?其实很简单,知己知彼才能百战百胜。既然要把网站优化到首页,首先要了解搜索引擎的习惯,是这样的。

抓

搜索引擎后台会派百度蜘蛛24小时从海量数据中识别抓取内容;然后过滤内容以去除低质量的内容;将过滤后的合格内容存放在临时索引库中进行分类存储。

网上这么多信息,百度蜘蛛是怎么注意到你的网站的?

这时候就需要吸引它——优质的外链或者好友链接,百度可以通过这些链接来到你的网站!

不过要小心!百度蜘蛛也有自己不喜欢的东西——比如:js、没有ALT属性的图片、iframe框架、网页需要登录的信息、flash。

这些都是百度不太喜欢的东西,一定要注意!

百度蜘蛛的爬取方式分为:深爬和宽爬。

深度爬取:百度蜘蛛会一一跟踪网页中的链接,有点跟不上。

广泛抓取:百度蜘蛛会抓取一个页面的所有链接。

一旦用户在前台触发搜索,搜索引擎会根据用户的关键词选择搜索库中的内容,猜测用户的搜索需求,并显示与搜索结果相关的、能够满足用户需求的内容按顺序搜索目标。在用户面前。

筛选

物品质量有好有坏,我们都喜欢质量好的。百度蜘蛛也是一样。要知道,搜索引擎的最终目的是满足用户的搜索需求。为了保证搜索结果的相关性和丰富性,那些低质量的内容会被过滤掉并丢弃。哪些内容属于这个范围?

低质量:句子不清楚,下一句与上句没有联系,意思不流畅。这会让蜘蛛头晕目眩,自然会被丢弃。

其次,存在重复性强、与主题无关、全屏广告、死链接全、时效性差等问题。

贮存

过滤差不多完成了,百度留下了所有的“喜欢”。将这些数据组织起来,建立索引库并进行排序。

过滤出的优质内容被提取理解,分类存储,建立目录,最后汇总成索引库,机器可以快速调用,易于理解,为数据的检索做准备。

展示

百度将所有精品店存储在索引库中。用户在前台触发搜索后,会触发索引库查询。例如,当网友输入关键词(如SEO)时,百度蜘蛛会在索引库中找到相关展示。在网友面前。

搜索引擎根据用户搜索意图、内容相关性等指标依次显示搜索结果。

相关性强的优质内容将排在第一位。如果没有达到搜索目标,用户可以根据显示结果搜索2-3次,搜索引擎会根据关键词进一步精准优化显示结果。 查看全部

网页中flash数据抓取(

网站优化到百度首页但又不知该怎么做??)

对于刚接触SEO的小白来说,会遇到这样的困惑。想把网站优化到百度首页不知道怎么做?其实很简单,知己知彼才能百战百胜。既然要把网站优化到首页,首先要了解搜索引擎的习惯,是这样的。

抓

搜索引擎后台会派百度蜘蛛24小时从海量数据中识别抓取内容;然后过滤内容以去除低质量的内容;将过滤后的合格内容存放在临时索引库中进行分类存储。

网上这么多信息,百度蜘蛛是怎么注意到你的网站的?

这时候就需要吸引它——优质的外链或者好友链接,百度可以通过这些链接来到你的网站!

不过要小心!百度蜘蛛也有自己不喜欢的东西——比如:js、没有ALT属性的图片、iframe框架、网页需要登录的信息、flash。

这些都是百度不太喜欢的东西,一定要注意!

百度蜘蛛的爬取方式分为:深爬和宽爬。

深度爬取:百度蜘蛛会一一跟踪网页中的链接,有点跟不上。

广泛抓取:百度蜘蛛会抓取一个页面的所有链接。

一旦用户在前台触发搜索,搜索引擎会根据用户的关键词选择搜索库中的内容,猜测用户的搜索需求,并显示与搜索结果相关的、能够满足用户需求的内容按顺序搜索目标。在用户面前。

筛选

物品质量有好有坏,我们都喜欢质量好的。百度蜘蛛也是一样。要知道,搜索引擎的最终目的是满足用户的搜索需求。为了保证搜索结果的相关性和丰富性,那些低质量的内容会被过滤掉并丢弃。哪些内容属于这个范围?

低质量:句子不清楚,下一句与上句没有联系,意思不流畅。这会让蜘蛛头晕目眩,自然会被丢弃。

其次,存在重复性强、与主题无关、全屏广告、死链接全、时效性差等问题。

贮存

过滤差不多完成了,百度留下了所有的“喜欢”。将这些数据组织起来,建立索引库并进行排序。

过滤出的优质内容被提取理解,分类存储,建立目录,最后汇总成索引库,机器可以快速调用,易于理解,为数据的检索做准备。

展示

百度将所有精品店存储在索引库中。用户在前台触发搜索后,会触发索引库查询。例如,当网友输入关键词(如SEO)时,百度蜘蛛会在索引库中找到相关展示。在网友面前。

搜索引擎根据用户搜索意图、内容相关性等指标依次显示搜索结果。

相关性强的优质内容将排在第一位。如果没有达到搜索目标,用户可以根据显示结果搜索2-3次,搜索引擎会根据关键词进一步精准优化显示结果。

网页中flash数据抓取( Python中解析网页的一个重要的应用,使用Python爬虫 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2022-01-05 17:13

Python中解析网页的一个重要的应用,使用Python爬虫

)

爬虫是Python的一个重要应用。使用Python爬虫,我们可以很方便的从网上抓取我们想要的数据。本文将以抓取B站的视频热搜榜数据并存储为例。详细介绍了四个步骤。Python爬虫的基本流程。

步骤1

请求尝试进入b站首页,点击排行榜,复制链接。

1https://www.bilibili.com/ranki ... 162.3

2

3

1 启动 Jupyter notebook ,并运行以下代码:

2

1import requests

2url = 'https://www.bilibili.com/ranki ... 27%3B

3res = requests.get('url')

4print(res.status_code)

5#200

6

7

1 在上面的代码中,完成下面三件事:

2

可以看到返回值为200,说明服务器响应正常,可以继续。

第2步

页面解析通过上一步的请求向网站请求数据后,我们成功获取到一个收录服务器资源的Response对象。现在我们可以使用 .text 来查看其内容。

可以看到返回的是一个字符串,里面收录了我们需要的热门视频数据,但是直接从字符串中提取内容比较复杂,效率低下,所以我们需要对其进行解析,将字符串转换成结构化的web页面数据,以便您可以轻松找到 HTML 标签及其属性和内容。Python中解析网页的方法有很多种,可以使用正则表达式,也可以使用BeautifulSoup、pyquery或lxml。本文将基于 BeautifulSoup 进行讲解。Beautiful Soup 是一个第三方库,可以从 HTML 或 XML 文件中提取数据。安装也非常简单。使用 pip install bs4 进行安装。让我们用一个简单的例子来说明它是如何工作的。

1from bs4 import BeautifulSoup

2page = requests.get(url)

3soup = BeautifulSoup(page.content, 'html.parser')

4title = soup.title.text

5print(title)

6# 热门视频排行榜 - 哔哩哔哩 (゜-゜)つロ 干杯~-bilibili

7

8

1 在上面的代码中,我们通过bs4中的BeautifulSoup类将上一步得到的html格式字符串转换为一个BeautifulSoup对象,注意在使用时需要制定一个解析器,这里使用的是html.parser。 接着就可以获取其中的某个结构化元素及其属性,比如使用soup.title.text获取页面标题,同样可以使用soup.body、soup.p等获取任意需要的元素。

2

第 3 步

提取内容在上面两步中,我们使用requests向网页请求数据,使用bs4解析页面。现在我们到了最关键的一步:如何从解析后的页面中提取需要的内容。在 Beautiful Soup 中,我们可以使用 find/find_all 来定位元素,但我更习惯使用 CSS 选择器 .select,因为我们可以像使用 CSS 选择元素一样向下访问 DOM 树。下面我们用代码来说明如何从解析后的页面中提取B站的热点列表数据。首先我们需要找到存储数据的标签,在列表页面按F12,按照下图的说明找到。

可以看到每条视频信息都包裹在li标签下,那么代码可以这样写吗?

1all_products = []

2products = soup.select('li.rank-item')

3for product in products:

4 rank = product.select('div.num')[0].text

5 name = product.select('div.info > a')[0].text.strip()

6 play = product.select('span.data-box')[0].text

7 comment = product.select('span.data-box')[1].text

8 up = product.select('span.data-box')[2].text

9 url = product.select('div.info > a')[0].attrs['href']

10 all_products.append({

11 "视频排名":rank,

12 "视频名": name,

13 "播放量": play,

14 "弹幕量": comment,

15 "up主": up,

16 "视频链接": url

17 })

18

19

1 在上面的代码中,我们先使用soup.select('li.rank-item'),此时返回一个list包含每一个视频信息,接着遍历每一个视频信息,依旧使用CSS选择器来提取我们要的字段信息,并以字典的形式存储在开头定义好的空列表中。 可以注意到我用了多种选择方法提取去元素,**这也是select方法的灵活之处**,感兴趣的读者可以进一步自行研究。

2

步骤4

存储数据 经过前面三步,我们成功地使用requests+bs4从网站中提取出需要的数据,最后只需要将数据写入Excel保存即可。如果你对pandas不熟悉,可以使用csv模块来编写。需要注意的是设置了encoding='utf-8-sig',否则会出现中文乱码的问题。

1import csv

2keys = all_products[0].keys()

3with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

4 dict_writer = csv.DictWriter(output_file, keys)

5 dict_writer.writeheader()

6 dict_writer.writerows(all_products)

7

8

1 如果你熟悉pandas的话,更是可以轻松将字典转换为DataFrame,一行代码即可完成。

2

1import pandas as pd

2keys = all_products[0].keys()

3pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

4

结论 至此,我们已经成功地使用Python在本地存储了b站的热门视频列表数据。大多数基于请求的爬虫基本上都是按照以上四个步骤进行的。然而,虽然看起来简单,但在真实场景中的每一步都不是那么容易。从请求数据开始,目标网站有多种形式的反爬和加密,后期解析、提取甚至存储数据的方式也很多。需要进一步探索和学习。

本文选择B站视频热榜是因为足够简单,希望通过这个案例,让大家了解Python爬虫工作的基本流程,最后附上完整的代码?

1import requests

2from bs4 import BeautifulSoup

3import csv

4import pandas as pd

5url = 'https://www.bilibili.com/ranki ... 27%3B

6page = requests.get(url)

7soup = BeautifulSoup(page.content, 'html.parser')

8all_products = []

9products = soup.select('li.rank-item')

10for product in products:

11 rank = product.select('div.num')[0].text

12 name = product.select('div.info > a')[0].text.strip()

13 play = product.select('span.data-box')[0].text

14 comment = product.select('span.data-box')[1].text

15 up = product.select('span.data-box')[2].text

16 url = product.select('div.info > a')[0].attrs['href']

17 all_products.append({

18 "视频排名":rank,

19 "视频名": name,

20 "播放量": play,

21 "弹幕量": comment,

22 "up主": up,

23 "视频链接": url

24 })

25keys = all_products[0].keys()

26with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

27 dict_writer = csv.DictWriter(output_file, keys)

28 dict_writer.writeheader()

29 dict_writer.writerows(all_products)

30### 使用pandas写入数据

31pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

32

33 查看全部

网页中flash数据抓取(

Python中解析网页的一个重要的应用,使用Python爬虫

)

爬虫是Python的一个重要应用。使用Python爬虫,我们可以很方便的从网上抓取我们想要的数据。本文将以抓取B站的视频热搜榜数据并存储为例。详细介绍了四个步骤。Python爬虫的基本流程。

步骤1

请求尝试进入b站首页,点击排行榜,复制链接。

1https://www.bilibili.com/ranki ... 162.3

2

3

1 启动 Jupyter notebook ,并运行以下代码:

2

1import requests

2url = 'https://www.bilibili.com/ranki ... 27%3B

3res = requests.get('url')

4print(res.status_code)

5#200

6

7

1 在上面的代码中,完成下面三件事:

2

可以看到返回值为200,说明服务器响应正常,可以继续。

第2步

页面解析通过上一步的请求向网站请求数据后,我们成功获取到一个收录服务器资源的Response对象。现在我们可以使用 .text 来查看其内容。

可以看到返回的是一个字符串,里面收录了我们需要的热门视频数据,但是直接从字符串中提取内容比较复杂,效率低下,所以我们需要对其进行解析,将字符串转换成结构化的web页面数据,以便您可以轻松找到 HTML 标签及其属性和内容。Python中解析网页的方法有很多种,可以使用正则表达式,也可以使用BeautifulSoup、pyquery或lxml。本文将基于 BeautifulSoup 进行讲解。Beautiful Soup 是一个第三方库,可以从 HTML 或 XML 文件中提取数据。安装也非常简单。使用 pip install bs4 进行安装。让我们用一个简单的例子来说明它是如何工作的。

1from bs4 import BeautifulSoup

2page = requests.get(url)

3soup = BeautifulSoup(page.content, 'html.parser')

4title = soup.title.text

5print(title)

6# 热门视频排行榜 - 哔哩哔哩 (゜-゜)つロ 干杯~-bilibili

7

8

1 在上面的代码中,我们通过bs4中的BeautifulSoup类将上一步得到的html格式字符串转换为一个BeautifulSoup对象,注意在使用时需要制定一个解析器,这里使用的是html.parser。 接着就可以获取其中的某个结构化元素及其属性,比如使用soup.title.text获取页面标题,同样可以使用soup.body、soup.p等获取任意需要的元素。

2

第 3 步

提取内容在上面两步中,我们使用requests向网页请求数据,使用bs4解析页面。现在我们到了最关键的一步:如何从解析后的页面中提取需要的内容。在 Beautiful Soup 中,我们可以使用 find/find_all 来定位元素,但我更习惯使用 CSS 选择器 .select,因为我们可以像使用 CSS 选择元素一样向下访问 DOM 树。下面我们用代码来说明如何从解析后的页面中提取B站的热点列表数据。首先我们需要找到存储数据的标签,在列表页面按F12,按照下图的说明找到。

可以看到每条视频信息都包裹在li标签下,那么代码可以这样写吗?

1all_products = []

2products = soup.select('li.rank-item')

3for product in products:

4 rank = product.select('div.num')[0].text

5 name = product.select('div.info > a')[0].text.strip()

6 play = product.select('span.data-box')[0].text

7 comment = product.select('span.data-box')[1].text

8 up = product.select('span.data-box')[2].text

9 url = product.select('div.info > a')[0].attrs['href']

10 all_products.append({

11 "视频排名":rank,

12 "视频名": name,

13 "播放量": play,

14 "弹幕量": comment,

15 "up主": up,

16 "视频链接": url

17 })

18

19

1 在上面的代码中,我们先使用soup.select('li.rank-item'),此时返回一个list包含每一个视频信息,接着遍历每一个视频信息,依旧使用CSS选择器来提取我们要的字段信息,并以字典的形式存储在开头定义好的空列表中。 可以注意到我用了多种选择方法提取去元素,**这也是select方法的灵活之处**,感兴趣的读者可以进一步自行研究。

2

步骤4

存储数据 经过前面三步,我们成功地使用requests+bs4从网站中提取出需要的数据,最后只需要将数据写入Excel保存即可。如果你对pandas不熟悉,可以使用csv模块来编写。需要注意的是设置了encoding='utf-8-sig',否则会出现中文乱码的问题。

1import csv

2keys = all_products[0].keys()

3with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

4 dict_writer = csv.DictWriter(output_file, keys)

5 dict_writer.writeheader()

6 dict_writer.writerows(all_products)

7

8

1 如果你熟悉pandas的话,更是可以轻松将字典转换为DataFrame,一行代码即可完成。

2

1import pandas as pd

2keys = all_products[0].keys()

3pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

4

结论 至此,我们已经成功地使用Python在本地存储了b站的热门视频列表数据。大多数基于请求的爬虫基本上都是按照以上四个步骤进行的。然而,虽然看起来简单,但在真实场景中的每一步都不是那么容易。从请求数据开始,目标网站有多种形式的反爬和加密,后期解析、提取甚至存储数据的方式也很多。需要进一步探索和学习。

本文选择B站视频热榜是因为足够简单,希望通过这个案例,让大家了解Python爬虫工作的基本流程,最后附上完整的代码?

1import requests

2from bs4 import BeautifulSoup

3import csv

4import pandas as pd

5url = 'https://www.bilibili.com/ranki ... 27%3B

6page = requests.get(url)

7soup = BeautifulSoup(page.content, 'html.parser')

8all_products = []

9products = soup.select('li.rank-item')

10for product in products:

11 rank = product.select('div.num')[0].text

12 name = product.select('div.info > a')[0].text.strip()

13 play = product.select('span.data-box')[0].text

14 comment = product.select('span.data-box')[1].text

15 up = product.select('span.data-box')[2].text

16 url = product.select('div.info > a')[0].attrs['href']

17 all_products.append({

18 "视频排名":rank,

19 "视频名": name,

20 "播放量": play,

21 "弹幕量": comment,

22 "up主": up,

23 "视频链接": url

24 })

25keys = all_products[0].keys()

26with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

27 dict_writer = csv.DictWriter(output_file, keys)

28 dict_writer.writeheader()

29 dict_writer.writerows(all_products)

30### 使用pandas写入数据

31pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

32

33

网页中flash数据抓取(千人基因组数据库中爬取CHB人群的等位基因频率信息解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-05 17:09

该计划的目的:

根据特定的SNP列表,从千基因组数据库中爬取CHB群体的等位基因频率信息,例如。

因为网页是动态数据,内嵌了JavaScript代码,所以使用selenium来爬取信息。

Beautiful Soup 是一个 Python 库,其主要功能是从网页中抓取数据。Beautiful Soup 提供了一些简单的、python 风格的函数来处理导航、搜索、修改分析树和其他功能。它是一个工具箱,为用户提供需要通过解析文档捕获的数据,避免复杂的正则表达式。

准备:源代码

# -*- coding:utf-8 -*-

from bs4 import BeautifulSoup

import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

def get_allele_feq(browser, snp):

browser.get(

'https://www.ncbi.nlm.nih.gov/variation/tools/1000genomes/?q=%s' %snp) #Load page

# browser.implicitly_wait(60) #智能等待xx秒

time.sleep(30) #加载时间较长,等待加载完毕

# browser.find_element_by_css_selector("div[title=\"Han Chinese in Bejing, China\"]") #use selenium function to find elements

# 把selenium的webdriver调用page_source函数在传入BeautifulSoup中,就可以用BeautifulSoup解析网页了

bs = BeautifulSoup(browser.page_source, "lxml")

# bs.find_all("div", title="Han Chinese in Bejing, China")

try:

race = bs.find(string="CHB")

race_data = race.find_parent("div").find_parent(

"div").find_next_sibling("div")

# print race_data

race_feq = race_data.find("span", class_="gt-selected").find_all("li") # class_ 防止Python中类关键字重复,产生语法错误

base1_feq = race_feq[0].text #获取标签的内容

base2_feq = race_feq[1].text

return snp, base1_feq, base2_feq # T=0.1408 C=0.8592

except NoSuchElementException:

return "%s:can't find element" %snp

def main():

browser = webdriver.Chrome() # Get local session of chrome

fh = open("./4diseases_snps_1kCHB_allele_feq.list2", 'w')

snps = open("./4diseases_snps.list.uniq2",'r')

for line in snps:

snp = line.strip()

response = get_allele_feq(browser, snp)

time.sleep(1)

fh.write("\t".join(response)) #unicode 编码的对象写到文件中后相当于print效果

fh.write("\n")

print "\t".join(response)

time.sleep(1) # sleep a few seconds

fh.close()

browser.quit() # 退出并关闭窗口的每一个相关的驱动程序

if __name__ == '__main__':

main()

参考资料:

1]:#Beautiful Soup 4.4.0 文档

2]:

3]:

4]:

5]:

6]:

7]: 查看全部

网页中flash数据抓取(千人基因组数据库中爬取CHB人群的等位基因频率信息解析)

该计划的目的:

根据特定的SNP列表,从千基因组数据库中爬取CHB群体的等位基因频率信息,例如。

因为网页是动态数据,内嵌了JavaScript代码,所以使用selenium来爬取信息。

Beautiful Soup 是一个 Python 库,其主要功能是从网页中抓取数据。Beautiful Soup 提供了一些简单的、python 风格的函数来处理导航、搜索、修改分析树和其他功能。它是一个工具箱,为用户提供需要通过解析文档捕获的数据,避免复杂的正则表达式。

准备:源代码

# -*- coding:utf-8 -*-

from bs4 import BeautifulSoup

import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

def get_allele_feq(browser, snp):

browser.get(

'https://www.ncbi.nlm.nih.gov/variation/tools/1000genomes/?q=%s' %snp) #Load page

# browser.implicitly_wait(60) #智能等待xx秒

time.sleep(30) #加载时间较长,等待加载完毕

# browser.find_element_by_css_selector("div[title=\"Han Chinese in Bejing, China\"]") #use selenium function to find elements

# 把selenium的webdriver调用page_source函数在传入BeautifulSoup中,就可以用BeautifulSoup解析网页了

bs = BeautifulSoup(browser.page_source, "lxml")

# bs.find_all("div", title="Han Chinese in Bejing, China")

try:

race = bs.find(string="CHB")

race_data = race.find_parent("div").find_parent(

"div").find_next_sibling("div")

# print race_data

race_feq = race_data.find("span", class_="gt-selected").find_all("li") # class_ 防止Python中类关键字重复,产生语法错误

base1_feq = race_feq[0].text #获取标签的内容

base2_feq = race_feq[1].text

return snp, base1_feq, base2_feq # T=0.1408 C=0.8592

except NoSuchElementException:

return "%s:can't find element" %snp

def main():

browser = webdriver.Chrome() # Get local session of chrome

fh = open("./4diseases_snps_1kCHB_allele_feq.list2", 'w')

snps = open("./4diseases_snps.list.uniq2",'r')

for line in snps:

snp = line.strip()

response = get_allele_feq(browser, snp)

time.sleep(1)

fh.write("\t".join(response)) #unicode 编码的对象写到文件中后相当于print效果

fh.write("\n")

print "\t".join(response)

time.sleep(1) # sleep a few seconds

fh.close()

browser.quit() # 退出并关闭窗口的每一个相关的驱动程序

if __name__ == '__main__':

main()

参考资料:

1]:#Beautiful Soup 4.4.0 文档

2]:

3]:

4]:

5]:

6]:

7]:

网页中flash数据抓取(您有两种解决方案:I.如果这是您的站点功能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-01-05 16:12

所以,你需要从网页中获取的图片,输入数据是页面的THH地址。所以,你有两个解决方案:

I. 如果这是您网站的一个功能,其他人会使用它,那么纯JavaScript 是不够的,因为浏览器的隐私政策会阻止从其他页面获取此类数据。在这种情况下,您需要将 URL 发送到服务器上的脚本,该脚本将下载页面、解析 s 并返回图像 srcs 列表。

如何做到这一点是一个非常复杂的问题,因为它在服务器端取决于你的网站 编程语言。在任何情况下,此类功能都将包括使用 AJAX 技术和服务器站点脚本(例如 php)的客户端 JavaScript。客户端脚本非常简单。

客户端的JS有:

1. Get desired URLs

2. Send them to server

3. Wait for server's response (which contains srcs of images on desired page)

4. Create img tags with srcs which you got from server script

关键词 对于 Google 来说,例如 AJAX XmlHttpRequest 和 JSONP(抱歉,如果你已经知道了:)

在服务器端,你的 (php | ruby | python | perl | Brainfuck) 必须:

1. Get page URL from javascript code at step 2

2. Download a page by that url

3. Parse it looking for img tags and their srcs

4. Send list of srcs (in XML, JSONP or any other form) back to client

二、如果您需要从其他页面获取图像仅供个人使用,您可以为您的浏览器编写扩展程序。此方法不需要任何服务器端脚本。 查看全部

网页中flash数据抓取(您有两种解决方案:I.如果这是您的站点功能)

所以,你需要从网页中获取的图片,输入数据是页面的THH地址。所以,你有两个解决方案:

I. 如果这是您网站的一个功能,其他人会使用它,那么纯JavaScript 是不够的,因为浏览器的隐私政策会阻止从其他页面获取此类数据。在这种情况下,您需要将 URL 发送到服务器上的脚本,该脚本将下载页面、解析 s 并返回图像 srcs 列表。

如何做到这一点是一个非常复杂的问题,因为它在服务器端取决于你的网站 编程语言。在任何情况下,此类功能都将包括使用 AJAX 技术和服务器站点脚本(例如 php)的客户端 JavaScript。客户端脚本非常简单。

客户端的JS有:

1. Get desired URLs

2. Send them to server

3. Wait for server's response (which contains srcs of images on desired page)

4. Create img tags with srcs which you got from server script

关键词 对于 Google 来说,例如 AJAX XmlHttpRequest 和 JSONP(抱歉,如果你已经知道了:)

在服务器端,你的 (php | ruby | python | perl | Brainfuck) 必须:

1. Get page URL from javascript code at step 2

2. Download a page by that url

3. Parse it looking for img tags and their srcs

4. Send list of srcs (in XML, JSONP or any other form) back to client

二、如果您需要从其他页面获取图像仅供个人使用,您可以为您的浏览器编写扩展程序。此方法不需要任何服务器端脚本。

网页中flash数据抓取( 暗网要比表面网络大好几个数量级)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-01-01 00:27

暗网要比表面网络大好几个数量级)

如何进入暗网,看百度暗网爬取技术分析

暗网,根据互联网的说法,是那些隐藏在表层网络深处的隐藏网络。一般来说,暗网的数据量比地表的数据量大几个数量级。链接是直接访问的,但是需要动态网页技术来采集资源访问,即不是可以被搜索引擎索引的地表网络。比如大型商场、携程网、12306等网站账单数据的搜索内容,这些数据很难直接链接到数据库,都是以查询界面的形式供用户查询,只有当用户需要时,只有通过查询才能看到并得到相关数据。换句话说,暗网,也就是常规爬虫,无法索引这些数据内容,就好像隐藏在背后一样。这也是暗网名字的由来。

任何不能通过 GET 或 POST 请求直接下载的页面都可以被认为是在“暗网”上。

暗网原因的一个简单例子:

1. 由于网络原因无法下载;

2. 内部 网站;

3. 动态页面需要用户认证,登录后才能访问;

4. 相关结果的索引列表只有在搜索词条时才能得到。

简单来说,没有入口(链接)或者搜索引擎难以抓取的网页,都属于暗网的范畴。互联网上搜索引擎能够检索到的内容仅占全部内容的千分之二左右。暗网抓取可以为用户提供更丰富的搜索结果,大大提高了搜索引擎的友好度。

为了能够对暗网数据进行索引,需要开发一种不同于常规爬虫机制的系统。这种类型的爬虫被称为暗网爬虫。暗网爬虫的目的是从数据库中挖掘出暗网数据并加入到搜索引擎的索引中,让用户在搜索时可以使用这些数据,增加信息覆盖度。

目前,大型搜索引擎服务商都将暗网挖掘作为一个重要的研究方向,因为它直接关系到索引的大小。这个领域的技术差异会直接体现在搜索结果的综合性上,这自然是竞争者的战场。谷歌目前将其作为重点研发方向,百度的“阿拉丁计划”也正是针对于此。

垂直网站提供的搜索界面,往往需要手动选择或填写内容。例如,航班搜索需要选择出发地、到达地点和日期,书籍搜索需要书名或作者。为了能够挖掘数据库的记录,暗网爬虫必须模拟人类行为。如果遍历是一一组合,对被访问的网站造成太大的压力,所以如何仔细组合查询选项是一个难点;第二点 重点是:一些查询的文本框,比如书籍搜索,需要输入书名,爬虫如何填写合适的内容?这也很有挑战性。

在暗网上执行 SEO 时需要注意的事项:

1. 避免将有用的页面存储在暗网上,并尽可能暴露这些页面。

2.可能会产生大量类似的暗网页面,需要做好搜索引擎的去重工作。

3. 将可集成的暗网页面整合到通道中,增加它们之间的相关性,更有利于排名。

本文摘要:

以上只是对暗网信息采集的简单介绍,目的只是让普通读者对暗网信息采集有一个基本的了解。如果您想了解更多关于暗网信息的爬取,可以在网上搜索相关信息!

内容 查看全部

网页中flash数据抓取(

暗网要比表面网络大好几个数量级)

如何进入暗网,看百度暗网爬取技术分析

暗网,根据互联网的说法,是那些隐藏在表层网络深处的隐藏网络。一般来说,暗网的数据量比地表的数据量大几个数量级。链接是直接访问的,但是需要动态网页技术来采集资源访问,即不是可以被搜索引擎索引的地表网络。比如大型商场、携程网、12306等网站账单数据的搜索内容,这些数据很难直接链接到数据库,都是以查询界面的形式供用户查询,只有当用户需要时,只有通过查询才能看到并得到相关数据。换句话说,暗网,也就是常规爬虫,无法索引这些数据内容,就好像隐藏在背后一样。这也是暗网名字的由来。

任何不能通过 GET 或 POST 请求直接下载的页面都可以被认为是在“暗网”上。

暗网原因的一个简单例子:

1. 由于网络原因无法下载;

2. 内部 网站;

3. 动态页面需要用户认证,登录后才能访问;

4. 相关结果的索引列表只有在搜索词条时才能得到。

简单来说,没有入口(链接)或者搜索引擎难以抓取的网页,都属于暗网的范畴。互联网上搜索引擎能够检索到的内容仅占全部内容的千分之二左右。暗网抓取可以为用户提供更丰富的搜索结果,大大提高了搜索引擎的友好度。

为了能够对暗网数据进行索引,需要开发一种不同于常规爬虫机制的系统。这种类型的爬虫被称为暗网爬虫。暗网爬虫的目的是从数据库中挖掘出暗网数据并加入到搜索引擎的索引中,让用户在搜索时可以使用这些数据,增加信息覆盖度。

目前,大型搜索引擎服务商都将暗网挖掘作为一个重要的研究方向,因为它直接关系到索引的大小。这个领域的技术差异会直接体现在搜索结果的综合性上,这自然是竞争者的战场。谷歌目前将其作为重点研发方向,百度的“阿拉丁计划”也正是针对于此。

垂直网站提供的搜索界面,往往需要手动选择或填写内容。例如,航班搜索需要选择出发地、到达地点和日期,书籍搜索需要书名或作者。为了能够挖掘数据库的记录,暗网爬虫必须模拟人类行为。如果遍历是一一组合,对被访问的网站造成太大的压力,所以如何仔细组合查询选项是一个难点;第二点 重点是:一些查询的文本框,比如书籍搜索,需要输入书名,爬虫如何填写合适的内容?这也很有挑战性。

在暗网上执行 SEO 时需要注意的事项:

1. 避免将有用的页面存储在暗网上,并尽可能暴露这些页面。

2.可能会产生大量类似的暗网页面,需要做好搜索引擎的去重工作。

3. 将可集成的暗网页面整合到通道中,增加它们之间的相关性,更有利于排名。

本文摘要:

以上只是对暗网信息采集的简单介绍,目的只是让普通读者对暗网信息采集有一个基本的了解。如果您想了解更多关于暗网信息的爬取,可以在网上搜索相关信息!

内容

网页中flash数据抓取(降低网站用户体验感的功能是哪几一些?快来看看)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-30 19:01

随着互联网的不断发展,搜索引擎现在越来越注重用户体验。用户体验是指用户在使用产品或工具时建立的主观心理感受。个人有不同的地方,感觉每个人的用户体验都不一样,但是很多较差的用户体验却有着相同的特点。那么降低网站用户体验的功能有哪些呢?快来和八达通看看吧。

一、弹窗广告

弹窗广告就不用说了,相信大家都很烦,不管是哪种弹窗广告,都是极其烦人的。搜索引擎不喜欢这个功能,因此他们会因此降低网站的权重。一些弹出式广告在您关闭后每隔几秒钟就会再次弹出。这大大降低了用户体验。虽然初衷是让用户看到产品广告,但实际上降低了用户体验。

二、导航

导航是网站的一项非常重要的功能,可以直接让用户找到自己想要的信息,是一种类似向导的功能。如果在导航中也找不到想要的东西,用户如何访问呢?所以,导航不仅包括整个网站,还包括一些小导航,引导用户进一步访问。

三、错误链接

网站中的死链接将阻止用户在需要时发布和查看他们想看到的内容。而这里提到的错误链接只是链接的网页是不相关的内容。这些都是导致用户快速跳出网站的原因,因为找不到自己想看的内容,也降低了对网站的信任度。

六大功能降低网站用户体验

四、 图片和闪光灯太多

网页可以使用一些图片和flash文件来丰富自己,让页面更有冲击力,但是如果用的太多,就会让用户觉得太夸张了,而且还占用cpu,而且图片和flash文件都是也不利于搜索引擎抓取。

五、过期内容

一些网站的内容是很久以前的。如果用户点入看到的内容已经过时或者陈旧,用户很容易对您的网站产生不信任。如果网站的原创内容很多,而且日期和内容新鲜,就会让用户想继续访问网站的热情。

六、页面老土

如果一个网页没有层次感,看起来很旧,有年代感,很容易让用户觉得你的网站不是很靠谱,也很难出现一些咨询和订单。

好了,以上就是一些降低网站用户体验的功能。其实网站建设的目的就是为了让用户方便,喜欢在网站上浏览。从用户的角度来看,网站运营应该把用户体验放在第一位。少量。希望八扎网今天的分享可以帮到大家。

原文来自八角网,更多网络知识等你来。 查看全部

网页中flash数据抓取(降低网站用户体验感的功能是哪几一些?快来看看)

随着互联网的不断发展,搜索引擎现在越来越注重用户体验。用户体验是指用户在使用产品或工具时建立的主观心理感受。个人有不同的地方,感觉每个人的用户体验都不一样,但是很多较差的用户体验却有着相同的特点。那么降低网站用户体验的功能有哪些呢?快来和八达通看看吧。

一、弹窗广告

弹窗广告就不用说了,相信大家都很烦,不管是哪种弹窗广告,都是极其烦人的。搜索引擎不喜欢这个功能,因此他们会因此降低网站的权重。一些弹出式广告在您关闭后每隔几秒钟就会再次弹出。这大大降低了用户体验。虽然初衷是让用户看到产品广告,但实际上降低了用户体验。

二、导航

导航是网站的一项非常重要的功能,可以直接让用户找到自己想要的信息,是一种类似向导的功能。如果在导航中也找不到想要的东西,用户如何访问呢?所以,导航不仅包括整个网站,还包括一些小导航,引导用户进一步访问。

三、错误链接

网站中的死链接将阻止用户在需要时发布和查看他们想看到的内容。而这里提到的错误链接只是链接的网页是不相关的内容。这些都是导致用户快速跳出网站的原因,因为找不到自己想看的内容,也降低了对网站的信任度。

六大功能降低网站用户体验

四、 图片和闪光灯太多

网页可以使用一些图片和flash文件来丰富自己,让页面更有冲击力,但是如果用的太多,就会让用户觉得太夸张了,而且还占用cpu,而且图片和flash文件都是也不利于搜索引擎抓取。

五、过期内容

一些网站的内容是很久以前的。如果用户点入看到的内容已经过时或者陈旧,用户很容易对您的网站产生不信任。如果网站的原创内容很多,而且日期和内容新鲜,就会让用户想继续访问网站的热情。

六、页面老土

如果一个网页没有层次感,看起来很旧,有年代感,很容易让用户觉得你的网站不是很靠谱,也很难出现一些咨询和订单。

好了,以上就是一些降低网站用户体验的功能。其实网站建设的目的就是为了让用户方便,喜欢在网站上浏览。从用户的角度来看,网站运营应该把用户体验放在第一位。少量。希望八扎网今天的分享可以帮到大家。

原文来自八角网,更多网络知识等你来。

网页中flash数据抓取(商夏传媒小编来介绍(页)策划的主要内容页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-12-30 12:11

如何处理网站优化和推广及其工作?上下传媒小编将介绍重要参数设置如:一、网页标题、关键词密度描述、图片属性超链接等重要参数设置。网页标签设计合理,吸引用户点击;网站的内部链接结构、网页之间的关联性、内容页面的合理导航以及如何方便用户操作。网页中最有价值的信息内容的布局,突出的广告信息和突出的信息内容,影响用户对网页价值的怀疑等。网页中的图片(flash)处理得很好。URL 设计问题。本网站所有功能在编程上均符合搜索引擎的抓取规则。导出链接设置。如何把资源放到位,充分发挥主站等渠道的资源优势。静态,方便搜索引擎抓取网页,增加收录网页数。

二、采用最先进的企业招投标广告投放军师同时监测7大搜索引擎,采用第三方独立监测工具,最先进的关键词推荐方式,第一时间让您找到最适合您购买的关键词 全程序控制,无需人工干预,极高科技监测结果随时更新,即使前一天的排名也能掌握竞争对手的互联网投资,轻松掌握监测网站优化效果,在一个“web”服务中进行所有投标,为企业节省至少30%的成本。

三、专题网站(页面)策划与撰写。强大的网站建设团队和营销策划团队相结合,打造特色营销理念,包括页面、美术、关键词布局等重点项目。

尚夏网站分析师最后要做的工作

1. 整理分析网站流量统计、检索分析、客户分析、客户行为分析、流量导入分析、广告分析等。

2. 负责网站营销项目相关数据的统计分析。

3. 负责采集

、分析和跟踪竞争对手网站的相关数据。

4.设计各种网站数据报表,进行系统的数据分析。

5.负责网站广告和活动的效果评估。

6. 负责跟踪互联网最新动态,对新产品进行需求分析。

7. 支持和配合各部门的工作,及时提供各种需求报告。

8.分析网站产品和用户行为,提出网站产品方案。 查看全部

网页中flash数据抓取(商夏传媒小编来介绍(页)策划的主要内容页)

如何处理网站优化和推广及其工作?上下传媒小编将介绍重要参数设置如:一、网页标题、关键词密度描述、图片属性超链接等重要参数设置。网页标签设计合理,吸引用户点击;网站的内部链接结构、网页之间的关联性、内容页面的合理导航以及如何方便用户操作。网页中最有价值的信息内容的布局,突出的广告信息和突出的信息内容,影响用户对网页价值的怀疑等。网页中的图片(flash)处理得很好。URL 设计问题。本网站所有功能在编程上均符合搜索引擎的抓取规则。导出链接设置。如何把资源放到位,充分发挥主站等渠道的资源优势。静态,方便搜索引擎抓取网页,增加收录网页数。

二、采用最先进的企业招投标广告投放军师同时监测7大搜索引擎,采用第三方独立监测工具,最先进的关键词推荐方式,第一时间让您找到最适合您购买的关键词 全程序控制,无需人工干预,极高科技监测结果随时更新,即使前一天的排名也能掌握竞争对手的互联网投资,轻松掌握监测网站优化效果,在一个“web”服务中进行所有投标,为企业节省至少30%的成本。

三、专题网站(页面)策划与撰写。强大的网站建设团队和营销策划团队相结合,打造特色营销理念,包括页面、美术、关键词布局等重点项目。

尚夏网站分析师最后要做的工作

1. 整理分析网站流量统计、检索分析、客户分析、客户行为分析、流量导入分析、广告分析等。

2. 负责网站营销项目相关数据的统计分析。

3. 负责采集

、分析和跟踪竞争对手网站的相关数据。

4.设计各种网站数据报表,进行系统的数据分析。

5.负责网站广告和活动的效果评估。

6. 负责跟踪互联网最新动态,对新产品进行需求分析。

7. 支持和配合各部门的工作,及时提供各种需求报告。

8.分析网站产品和用户行为,提出网站产品方案。

网页中flash数据抓取(网站的收录是SEO优化的基础之一如何做网站优化)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-30 12:11

现在很多人都在为网站和网页之间被百度收录的问题而苦恼。网站收录是SEO优化的基础之一。如何对网站进行有效的战略规划和优化,需要从以下几点入手。对于网站优化,首先要考虑服务器的稳定性。如果服务器的稳定性不够好,再好的网站和网页也得不到相应的索引。服务器稳定后,问题就解决了。所以在优化的过程中,首先需要考虑的就是服务器的稳定性,服务器的稳定性和服务器的空间,这两点很重要。

优化联盟专家对网站搜索引擎的问题有着深刻的研究。网站seo也可以从网站的设计中找出网站没有收录的部分原因,比如网站的设计页面是否有缺陷,是的,错误的页面缺陷太多,无法正常抓取。这里提到的设计缺陷是指搜索引擎,例如flash动画和帧结构必须清楚地标明。因此,对于新站点,需要区分web标签,尽量使用Label。

优化师联盟专家在网站优化方面拥有多年的优化经验。他们可以利用经验找到不符合流行搜索习惯的页面。由于这种糟糕的体验,百度也将不愿意收录

自己的网站。针对这个问题,我们应该在网站建设过程中足够重视用户体验,这对于网站来说是非常重要的。

另一个是该网站尚未被搜索引擎索引。在这种情况下,百度通常不会意识到新网站的出现。怎样才能有结果呢?网站上线后,确认后台是否已经开始写网站启动页,分析相关设置是否正确。值得一提的是,网站建设需要一个漫长的过程。所以我们在做网站优化的时候需要更多的耐心和奉献。 查看全部

网页中flash数据抓取(网站的收录是SEO优化的基础之一如何做网站优化)

现在很多人都在为网站和网页之间被百度收录的问题而苦恼。网站收录是SEO优化的基础之一。如何对网站进行有效的战略规划和优化,需要从以下几点入手。对于网站优化,首先要考虑服务器的稳定性。如果服务器的稳定性不够好,再好的网站和网页也得不到相应的索引。服务器稳定后,问题就解决了。所以在优化的过程中,首先需要考虑的就是服务器的稳定性,服务器的稳定性和服务器的空间,这两点很重要。

优化联盟专家对网站搜索引擎的问题有着深刻的研究。网站seo也可以从网站的设计中找出网站没有收录的部分原因,比如网站的设计页面是否有缺陷,是的,错误的页面缺陷太多,无法正常抓取。这里提到的设计缺陷是指搜索引擎,例如flash动画和帧结构必须清楚地标明。因此,对于新站点,需要区分web标签,尽量使用Label。

优化师联盟专家在网站优化方面拥有多年的优化经验。他们可以利用经验找到不符合流行搜索习惯的页面。由于这种糟糕的体验,百度也将不愿意收录

自己的网站。针对这个问题,我们应该在网站建设过程中足够重视用户体验,这对于网站来说是非常重要的。

另一个是该网站尚未被搜索引擎索引。在这种情况下,百度通常不会意识到新网站的出现。怎样才能有结果呢?网站上线后,确认后台是否已经开始写网站启动页,分析相关设置是否正确。值得一提的是,网站建设需要一个漫长的过程。所以我们在做网站优化的时候需要更多的耐心和奉献。

网页中flash数据抓取(网页中flash数据抓取要实现的功能就是获取请求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-12-29 17:09

网页中flash数据抓取要实现的功能就是获取请求的headers,如果没有flash的话,无法抓取对应的headers对应数据。//javascript提取headers数据importrequestsfromrequests.exceptionsimporthttp_http_serverresponse=requests.get('')response.text由于网页内部的动态加载url,这个网址提取headers中的data方法,有的可能反应不出来,要是能成功反应出来就能抓取对应的headers值。

内容比较多的网站,建议对headers和cookies做过滤后再提取,

我写了一篇使用requests抓取豆瓣电影top250的文章,里面的步骤都有,

post参数设置问题,比如获取时需要同时提交微信账号和movieid,可以考虑提交movieid,或者是先返回movieid,有了movieid之后再用get重新抓取。

作为研究人员也去做了个小项目,大概有以下步骤:1,登录豆瓣,找到个人页面的id,或者你自己的visa代码,会返回给你。2,上传文件,包括id的图片,然后解析图片数据,获取图片名称、标签、url地址等信息。3,如果是带着movieid的图片返回给你,那么图片名称是不会返回给你的,可以用id枚举法查找。4,如果有tag,那么查找所有tag的id,会返回给你。 查看全部

网页中flash数据抓取(网页中flash数据抓取要实现的功能就是获取请求)

网页中flash数据抓取要实现的功能就是获取请求的headers,如果没有flash的话,无法抓取对应的headers对应数据。//javascript提取headers数据importrequestsfromrequests.exceptionsimporthttp_http_serverresponse=requests.get('')response.text由于网页内部的动态加载url,这个网址提取headers中的data方法,有的可能反应不出来,要是能成功反应出来就能抓取对应的headers值。

内容比较多的网站,建议对headers和cookies做过滤后再提取,

我写了一篇使用requests抓取豆瓣电影top250的文章,里面的步骤都有,

post参数设置问题,比如获取时需要同时提交微信账号和movieid,可以考虑提交movieid,或者是先返回movieid,有了movieid之后再用get重新抓取。

作为研究人员也去做了个小项目,大概有以下步骤:1,登录豆瓣,找到个人页面的id,或者你自己的visa代码,会返回给你。2,上传文件,包括id的图片,然后解析图片数据,获取图片名称、标签、url地址等信息。3,如果是带着movieid的图片返回给你,那么图片名称是不会返回给你的,可以用id枚举法查找。4,如果有tag,那么查找所有tag的id,会返回给你。

网页中flash数据抓取(本文讨论如何使用BeautifulSoup库从HTML页面中提取内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-28 16:15

本文讨论如何使用 Beautiful Soup 库从 HTML 页面中提取内容。提取后,我们将使用 Beautiful Soup 将其转换为 Python 列表或字典。

为了让网络抓取在 Python 中工作,我们将执行三个基本步骤:

使用请求库来提取 HTML 内容。

分析 HTML 结构并识别收录

内容的标签。

使用 Beautiful Soup 提取标签并将数据放入 Python 列表中。

安装库

首先安装我们需要的库。requests 库可以从网站获取 HTML 内容。Beautiful Soup 解析 HTML 并将其转换为 Python 对象。Python 3 中需要安装以下两个库:

[root@localhost ~]# pip3 install requests beautifulsoup4

提取html

本文抓取网站的技术页面。如果您转到此页面,您将看到带有标题、摘录和出版日期的文章列表。我们的目标是创建一个收录

此信息的文章列表。

技术页面的完整 URL 是:

https://notes.ayushsharma.in/technology

我们可以使用请求从这个页面获取 HTML 内容:

#!/usr/bin/python3

import requests

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

print(data.text)

变量 data 将收录

页面的 HTML 源代码。

从 HTML 中提取内容

为了从数据中提取我们的数据,我们需要确定哪些标签具有我们需要的内容。

如果您浏览 HTML,您会在顶部附近找到此部分:

Using variables in Jekyll to define custom content

I recently discovered that Jekyll's config.yml can be used to define custom

variables for reusing content. I feel like I've been living under a rock all this time. But to err over and

over again is human.

Aug 2021

这是在每篇文章的整个页面中重复的部分。我们可以看到.card-title有文章标题,.card-text有摘录,.card-footer类下的小标签有发布日期。

让我们使用 Beautiful Soup 提取这些内容。

#!/usr/bin/python3

import requests

from bs4 import BeautifulSoup

from pprint import pprint

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

my_data = []

html = BeautifulSoup(data.text, 'html.parser')

articles = html.select('a.post-card')

for article in articles:

title = article.select('.card-title')[0].get_text()

excerpt = article.select('.card-text')[0].get_text()

pub_date = article.select('.card-footer small')[0].get_text()

my_data.append({"title": title, "excerpt": excerpt, "pub_date": pub_date})

pprint(my_data)

上面的代码提取文章并将它们放入 my_data 变量中。我正在使用 pprint 打印输出。

总结

我们可以将其作为 JSON 返回给另一个应用程序,或者使用自定义样式将其转换为 HTML。

本文地址:Python 中使用 Beautiful Soup 抓取网页 | “Linux 应该这样学” 查看全部

网页中flash数据抓取(本文讨论如何使用BeautifulSoup库从HTML页面中提取内容)

本文讨论如何使用 Beautiful Soup 库从 HTML 页面中提取内容。提取后,我们将使用 Beautiful Soup 将其转换为 Python 列表或字典。

为了让网络抓取在 Python 中工作,我们将执行三个基本步骤:

使用请求库来提取 HTML 内容。

分析 HTML 结构并识别收录

内容的标签。

使用 Beautiful Soup 提取标签并将数据放入 Python 列表中。

安装库

首先安装我们需要的库。requests 库可以从网站获取 HTML 内容。Beautiful Soup 解析 HTML 并将其转换为 Python 对象。Python 3 中需要安装以下两个库:

[root@localhost ~]# pip3 install requests beautifulsoup4

提取html

本文抓取网站的技术页面。如果您转到此页面,您将看到带有标题、摘录和出版日期的文章列表。我们的目标是创建一个收录

此信息的文章列表。

技术页面的完整 URL 是:

https://notes.ayushsharma.in/technology

我们可以使用请求从这个页面获取 HTML 内容:

#!/usr/bin/python3

import requests

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

print(data.text)

变量 data 将收录

页面的 HTML 源代码。

从 HTML 中提取内容

为了从数据中提取我们的数据,我们需要确定哪些标签具有我们需要的内容。

如果您浏览 HTML,您会在顶部附近找到此部分:

Using variables in Jekyll to define custom content

I recently discovered that Jekyll's config.yml can be used to define custom

variables for reusing content. I feel like I've been living under a rock all this time. But to err over and

over again is human.

Aug 2021

这是在每篇文章的整个页面中重复的部分。我们可以看到.card-title有文章标题,.card-text有摘录,.card-footer类下的小标签有发布日期。

让我们使用 Beautiful Soup 提取这些内容。

#!/usr/bin/python3

import requests

from bs4 import BeautifulSoup

from pprint import pprint

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

my_data = []

html = BeautifulSoup(data.text, 'html.parser')

articles = html.select('a.post-card')

for article in articles:

title = article.select('.card-title')[0].get_text()

excerpt = article.select('.card-text')[0].get_text()

pub_date = article.select('.card-footer small')[0].get_text()

my_data.append({"title": title, "excerpt": excerpt, "pub_date": pub_date})

pprint(my_data)

上面的代码提取文章并将它们放入 my_data 变量中。我正在使用 pprint 打印输出。

总结

我们可以将其作为 JSON 返回给另一个应用程序,或者使用自定义样式将其转换为 HTML。

本文地址:Python 中使用 Beautiful Soup 抓取网页 | “Linux 应该这样学”

网页中flash数据抓取( 什么是静态网页静态有时也被称为平面页的重要方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-28 04:00

什么是静态网页静态有时也被称为平面页的重要方式)

网页设计是网站设计的基础,是传达信息的重要方式之一。对于很多网站来说,网页设计的要求和种类很多,其中最特别的就是静态网页。有些人认为静态网页是 HTML 文件,其实不然。静态网页可以有一些动态效果。今天就让faceui给大家介绍一下什么是静态网页以及静态网页设计步骤。

什么是静态网页

静态网页有时也称为平面页面。在网站设计中,纯HTML(标准通用标记语言下的应用程序)格式的网页通常被称为“静态网页”。静态网页是标准的 HTML 文件,其文件扩展名为 .htm 和 .html。包括文字、图片、声音、FLASH动画、客户端脚本、ActiveX控件和JAVA小程序等。静态网页是网站建设的基础。早期的网站通常由静态网页组成。与动态网页相比,静态网页是指没有后端数据库、没有程序、没有交互的网页。静态网页更新比较麻烦,适用于一般更新较少的展示类网站。很容易误解静态页面都是htm页面。实际上,静态页面并不是完全静态的。它们还可以具有各种动态效果,例如GIF格式的动画、FLASH、滚动字幕等。

静态网页设计(图片来自网络)

特征:

1、静态网页每个网页都有一个固定的网址,网页网址采用.htm、.html、.shtml等常见形式后缀,不收录

“?”;(动态网页中的“?”搜索引擎检索存在一定的问题。搜索引擎一般不可能访问一个网站的数据库中的所有网页,或者由于技术考虑,搜索蜘蛛不会抓取“?”之后的内容。 "在 URL 中。)

2、 一旦网页内容发布到web服务器上,无论用户是否访问,每个静态网页的内容都存储在web服务器上,也就是说,静态网页实际上存储在server 文件,每个网页都是一个独立的文件。

3、静态网页的内容比较稳定,容易被搜索引擎检索到。

4、静态网页没有数据库支持,网站制作维护工作量大。因此,在网站信息量较大的情况下,难以单纯依靠静态网页制作方式。

5、 静态网页交互性较差,在功能上有较大限制。

6、页面浏览速度快,过程中无需连接数据库,页面打开速度比动态页面快。

7、减轻服务器负担,减少工作量,降低数据库成本。

静态网页设计(图片来自网络)

静态网页设计步骤

1、 设计一个什么样的静态网页画面来写,然后在网上搜集图片资料或者其他资源。小编自己去网上找了个参考,然后自己用ps编辑了一张图片,同时还有很多需要用到的按钮等背景图片。

2、 创建一个新的项目文件夹。这是一个好习惯。将网页放在文件夹中,方便您以后查找。这里的编辑器是moban1,然后在moban1文件夹中再创建两个文件夹style和images和一个html文件,style文件test.css存放在style中,图片存放在需要用到的图片中。

3、编写 test.html 文件。编辑的习惯是在写完html文件的一个div后同时调整css样式文件。下面是完整的 html 文件和 css 文件代码。

4、在浏览器中打开,因为是html文件,可以直接右键打开,右键--打开方式--(选择要在哪个浏览器打开)或者直接点击打开选项,它将使用默认浏览器打开。

以上就是faceui介绍的静态网页设计相关的内容。静态网页设计与其他网页设计不同,但它是保存网站数据和信息的好方法。

上一篇:如何让湖南网页设计更精致,这几点很重要

下一篇:昆明网页设计:网站导航的设计方法是什么?如何更好地设计

相关文章

最新的文章 查看全部

网页中flash数据抓取(

什么是静态网页静态有时也被称为平面页的重要方式)

网页设计是网站设计的基础,是传达信息的重要方式之一。对于很多网站来说,网页设计的要求和种类很多,其中最特别的就是静态网页。有些人认为静态网页是 HTML 文件,其实不然。静态网页可以有一些动态效果。今天就让faceui给大家介绍一下什么是静态网页以及静态网页设计步骤。

什么是静态网页

静态网页有时也称为平面页面。在网站设计中,纯HTML(标准通用标记语言下的应用程序)格式的网页通常被称为“静态网页”。静态网页是标准的 HTML 文件,其文件扩展名为 .htm 和 .html。包括文字、图片、声音、FLASH动画、客户端脚本、ActiveX控件和JAVA小程序等。静态网页是网站建设的基础。早期的网站通常由静态网页组成。与动态网页相比,静态网页是指没有后端数据库、没有程序、没有交互的网页。静态网页更新比较麻烦,适用于一般更新较少的展示类网站。很容易误解静态页面都是htm页面。实际上,静态页面并不是完全静态的。它们还可以具有各种动态效果,例如GIF格式的动画、FLASH、滚动字幕等。

静态网页设计(图片来自网络)

特征:

1、静态网页每个网页都有一个固定的网址,网页网址采用.htm、.html、.shtml等常见形式后缀,不收录

“?”;(动态网页中的“?”搜索引擎检索存在一定的问题。搜索引擎一般不可能访问一个网站的数据库中的所有网页,或者由于技术考虑,搜索蜘蛛不会抓取“?”之后的内容。 "在 URL 中。)

2、 一旦网页内容发布到web服务器上,无论用户是否访问,每个静态网页的内容都存储在web服务器上,也就是说,静态网页实际上存储在server 文件,每个网页都是一个独立的文件。

3、静态网页的内容比较稳定,容易被搜索引擎检索到。

4、静态网页没有数据库支持,网站制作维护工作量大。因此,在网站信息量较大的情况下,难以单纯依靠静态网页制作方式。

5、 静态网页交互性较差,在功能上有较大限制。

6、页面浏览速度快,过程中无需连接数据库,页面打开速度比动态页面快。

7、减轻服务器负担,减少工作量,降低数据库成本。

静态网页设计(图片来自网络)

静态网页设计步骤

1、 设计一个什么样的静态网页画面来写,然后在网上搜集图片资料或者其他资源。小编自己去网上找了个参考,然后自己用ps编辑了一张图片,同时还有很多需要用到的按钮等背景图片。

2、 创建一个新的项目文件夹。这是一个好习惯。将网页放在文件夹中,方便您以后查找。这里的编辑器是moban1,然后在moban1文件夹中再创建两个文件夹style和images和一个html文件,style文件test.css存放在style中,图片存放在需要用到的图片中。

3、编写 test.html 文件。编辑的习惯是在写完html文件的一个div后同时调整css样式文件。下面是完整的 html 文件和 css 文件代码。

4、在浏览器中打开,因为是html文件,可以直接右键打开,右键--打开方式--(选择要在哪个浏览器打开)或者直接点击打开选项,它将使用默认浏览器打开。

以上就是faceui介绍的静态网页设计相关的内容。静态网页设计与其他网页设计不同,但它是保存网站数据和信息的好方法。

上一篇:如何让湖南网页设计更精致,这几点很重要

下一篇:昆明网页设计:网站导航的设计方法是什么?如何更好地设计

相关文章

最新的文章

网页中flash数据抓取(2016年搜索引擎推广需要做哪些调整呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-12-28 03:20

2016年是中国搜索引擎市场的过渡期。搜索的边界进一步模糊,搜索和社交数据越来越多地用于指导内容创作,搜索引擎将为用户提供更好的服务。基于这种情况,搜索引擎推广需要做哪些调整?

搜索引擎推广:注意优化网站布局

在激烈的内容战之后,2016年参与度将占据主导地位,搜索引擎推广采取了增加用户参与度的方法,以保持用户对网站的兴趣。网站版面可以直观地向用户展示网站功能,帮助用户查找网站信息。网站在推广搜索引擎时首先要做的就是为访问者优化网站布局和转化方式,让访问者轻松掌控网站。二是保证用户可以轻松理解和使用网站的栏目页面。此外,下拉菜单可以帮助访问者最大限度地减少点击次数,方便用户使用。建议设置内部搜索栏,让用户更方便的搜索到自己想要的东西。

搜索引擎推广:内链和外链还是必不可少的

在搜索引擎的推广中,网站内外部链接还是很重要的。在执行推广计划时,重点是获取反向链接。那些信誉良好的网站的链接可以对其反向链接网站产生积极的影响,因此公司需要获得这些网站的链接。靠谱的网站推广知道,在一个网页中创建到其他网站的链接就意味着他们信任这个网站,所以创建一个高质量的反链接文件意味着要注意。

建议:积极为访问者提供高价值的内容,创建高质量的反向链接文件,在文章关键词中使用一些用户支持的常用词汇和数据,并应包括一些高质量的图片和引人入胜的文案。

搜索引擎推广:更多自然流量来源于网站内容和图片

随着移动应用程序的应用范围和重要性的增加,网站需要与其他在线平台,尤其是社交媒体进行整合,同时优化网站在社交媒体上的形象。因为用户会更频繁地使用这些应用程序,这意味着发布在社交媒体上的内容也需要可以在这些应用程序上搜索到。优化过程需要密切关注已发表的文章和自身形象的构建。

建议:在网站的“关于我们”模块中尽可能完整地展示自己的特点。

在明确了上述搜索引擎推广的调整方向后,还需要了解搜索引擎的工作原理,这将有助于搜索引擎推广者在遇到问题时及时做出正确响应。

随附的:

上面我们已经提到了搜索引擎的工作原理,即爬取->过滤->存储索引库->显示排序。接下来,我给大家做一个深入的解读。

搜索引擎的工作原理

爬行,即搜索引擎爬行。

搜索引擎抓取的网站内容是通过蜘蛛爬行获取的,分为深爬和宽爬。深度爬取是指先爬取一列的内容页,然后换到另一列以同样的方式爬取;而宽爬则是横向爬取,蜘蛛先爬取每一列,然后再爬取每一列页面下方的内容页面。

注:reduce蜘蛛也有难以识别的内容

蜘蛛虽然很厉害,但是由于技术限制,并不是所有的信息都可以识别,比如图片、flash(视频前后有文字辅助搜索引擎识别)等,这时候搜索引擎推广需要付费关注你。它有助于促进其他内容的实施。

过滤:去除粗细

并非所有蜘蛛抓取的内容都是有用的,也并非所有信息都需要存储在数据库中,因此搜索引擎需要对这些蜘蛛抓取的内容进行过滤。过滤掉那些没有价值和质量的内容,让用户看到的是具有一定价值的内容。

创建索引缓存数据库

蜘蛛刚刚抓取的页面内容不会存储在自己的数据库中。而是先建立一个临时索引数据库,通过一定的规则来判断内容的有用性。

搜索引擎显示:排名顺序

搜索引擎赋予用户决定索引数据库中信息的权力,允许用户判断信息的质量,然后显示索引数据库中的内容,同时将信息转换并存储在它的数据库中。自己的真实数据库。. 所以我们在搜索引擎中看到的结果是:搜索按照各种算法排序,质量最好的十个结果放在第一页。 查看全部

网页中flash数据抓取(2016年搜索引擎推广需要做哪些调整呢?(组图))

2016年是中国搜索引擎市场的过渡期。搜索的边界进一步模糊,搜索和社交数据越来越多地用于指导内容创作,搜索引擎将为用户提供更好的服务。基于这种情况,搜索引擎推广需要做哪些调整?

搜索引擎推广:注意优化网站布局

在激烈的内容战之后,2016年参与度将占据主导地位,搜索引擎推广采取了增加用户参与度的方法,以保持用户对网站的兴趣。网站版面可以直观地向用户展示网站功能,帮助用户查找网站信息。网站在推广搜索引擎时首先要做的就是为访问者优化网站布局和转化方式,让访问者轻松掌控网站。二是保证用户可以轻松理解和使用网站的栏目页面。此外,下拉菜单可以帮助访问者最大限度地减少点击次数,方便用户使用。建议设置内部搜索栏,让用户更方便的搜索到自己想要的东西。

搜索引擎推广:内链和外链还是必不可少的

在搜索引擎的推广中,网站内外部链接还是很重要的。在执行推广计划时,重点是获取反向链接。那些信誉良好的网站的链接可以对其反向链接网站产生积极的影响,因此公司需要获得这些网站的链接。靠谱的网站推广知道,在一个网页中创建到其他网站的链接就意味着他们信任这个网站,所以创建一个高质量的反链接文件意味着要注意。

建议:积极为访问者提供高价值的内容,创建高质量的反向链接文件,在文章关键词中使用一些用户支持的常用词汇和数据,并应包括一些高质量的图片和引人入胜的文案。

搜索引擎推广:更多自然流量来源于网站内容和图片

随着移动应用程序的应用范围和重要性的增加,网站需要与其他在线平台,尤其是社交媒体进行整合,同时优化网站在社交媒体上的形象。因为用户会更频繁地使用这些应用程序,这意味着发布在社交媒体上的内容也需要可以在这些应用程序上搜索到。优化过程需要密切关注已发表的文章和自身形象的构建。

建议:在网站的“关于我们”模块中尽可能完整地展示自己的特点。

在明确了上述搜索引擎推广的调整方向后,还需要了解搜索引擎的工作原理,这将有助于搜索引擎推广者在遇到问题时及时做出正确响应。

随附的:

上面我们已经提到了搜索引擎的工作原理,即爬取->过滤->存储索引库->显示排序。接下来,我给大家做一个深入的解读。

搜索引擎的工作原理

爬行,即搜索引擎爬行。

搜索引擎抓取的网站内容是通过蜘蛛爬行获取的,分为深爬和宽爬。深度爬取是指先爬取一列的内容页,然后换到另一列以同样的方式爬取;而宽爬则是横向爬取,蜘蛛先爬取每一列,然后再爬取每一列页面下方的内容页面。

注:reduce蜘蛛也有难以识别的内容

蜘蛛虽然很厉害,但是由于技术限制,并不是所有的信息都可以识别,比如图片、flash(视频前后有文字辅助搜索引擎识别)等,这时候搜索引擎推广需要付费关注你。它有助于促进其他内容的实施。

过滤:去除粗细

并非所有蜘蛛抓取的内容都是有用的,也并非所有信息都需要存储在数据库中,因此搜索引擎需要对这些蜘蛛抓取的内容进行过滤。过滤掉那些没有价值和质量的内容,让用户看到的是具有一定价值的内容。

创建索引缓存数据库

蜘蛛刚刚抓取的页面内容不会存储在自己的数据库中。而是先建立一个临时索引数据库,通过一定的规则来判断内容的有用性。

搜索引擎显示:排名顺序

搜索引擎赋予用户决定索引数据库中信息的权力,允许用户判断信息的质量,然后显示索引数据库中的内容,同时将信息转换并存储在它的数据库中。自己的真实数据库。. 所以我们在搜索引擎中看到的结果是:搜索按照各种算法排序,质量最好的十个结果放在第一页。

网页中flash数据抓取(《热血三国》评测:使用AMF做架构,使用Flex协议做数据通讯)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-12-26 09:00

《三国志》好像比较火,玩的人也不少。一年前,一个朋友要我为这个游戏写一个插件。也是因为无聊,所以就去玩了。谁知道我玩了之后有点喜欢。当然,这场比赛是要玩的,事情还有待完成。当然不能算是插件,最多可以算是辅助工具。

Three Kingdoms 是一款完全由 Flash 制作的网页游戏,使用 Flex 作为框架,使用 AMF 协议进行数据通信。

首先,对于一个Flash网页游戏,大家需要了解它的AMF协议调用方式。就三国而言,服务器返回的消息都是AMF0格式的,客户端提交给服务器的则是AMF3格式。

刚开始分析这个游戏的时候,想过自己搭建一个AMF协议解析器,但是由于时间有限,所以从网上找到了FluorineFx开源组件,想做一个功能强大的web游戏。我觉得这个工具应该是离线的。如果可以在工具中独立调用各种功能,做任何事情就相当于游戏的客户端。

但是做这个之前最头疼的问题是分析协议调用参数和返回参数结构。在做这个工具之前,我对 Flash Flex 一无所知。AS的写法只有Flash 5的水平,快十个了。多年未使用。. .

为了方便以下工具的使用

SWF Decompiler的SWF文件反编译工具

Notepad++文本编辑工具,主要用于在整个目录中查找指定文本(使用WINDOWS搜索功能太让人失望了)

Kolai网络分析系统,用于获取网络通讯数据

SocketSniff,比KELA系统更轻量级的网络监控工具,更方便了解基本通信流程

以上几个都是可以通过网络找到的实用工具,外加我自己制作的一个AMF协议半自动分析仪。主要功能是分析HEX DATA的AMF协议,跟踪游戏AMF协议通信过程,简单分析反映。为进一步分析调用过程提供参考。

一个AMF通信过程分析:

1.需要获取命令功能前打开网页游戏停止运行

2.打开网络嗅探器并进行嗅探。在这个过程中,最好按IP和端口过滤

3.执行需要的命令,等待命令执行返回

4.停止网络嗅探

5. 去除无关的网络通信数据,必须有AMF协议下业务处理的网关,比如三国地址:/server/amfPHP/gateway.php,以及HTTP头的内容格式是application/x-amf,所以只需要过滤网关相关的通信会话即可。 查看全部

网页中flash数据抓取(《热血三国》评测:使用AMF做架构,使用Flex协议做数据通讯)

《三国志》好像比较火,玩的人也不少。一年前,一个朋友要我为这个游戏写一个插件。也是因为无聊,所以就去玩了。谁知道我玩了之后有点喜欢。当然,这场比赛是要玩的,事情还有待完成。当然不能算是插件,最多可以算是辅助工具。

Three Kingdoms 是一款完全由 Flash 制作的网页游戏,使用 Flex 作为框架,使用 AMF 协议进行数据通信。

首先,对于一个Flash网页游戏,大家需要了解它的AMF协议调用方式。就三国而言,服务器返回的消息都是AMF0格式的,客户端提交给服务器的则是AMF3格式。

刚开始分析这个游戏的时候,想过自己搭建一个AMF协议解析器,但是由于时间有限,所以从网上找到了FluorineFx开源组件,想做一个功能强大的web游戏。我觉得这个工具应该是离线的。如果可以在工具中独立调用各种功能,做任何事情就相当于游戏的客户端。

但是做这个之前最头疼的问题是分析协议调用参数和返回参数结构。在做这个工具之前,我对 Flash Flex 一无所知。AS的写法只有Flash 5的水平,快十个了。多年未使用。. .

为了方便以下工具的使用

SWF Decompiler的SWF文件反编译工具

Notepad++文本编辑工具,主要用于在整个目录中查找指定文本(使用WINDOWS搜索功能太让人失望了)

Kolai网络分析系统,用于获取网络通讯数据

SocketSniff,比KELA系统更轻量级的网络监控工具,更方便了解基本通信流程

以上几个都是可以通过网络找到的实用工具,外加我自己制作的一个AMF协议半自动分析仪。主要功能是分析HEX DATA的AMF协议,跟踪游戏AMF协议通信过程,简单分析反映。为进一步分析调用过程提供参考。

一个AMF通信过程分析:

1.需要获取命令功能前打开网页游戏停止运行

2.打开网络嗅探器并进行嗅探。在这个过程中,最好按IP和端口过滤

3.执行需要的命令,等待命令执行返回

4.停止网络嗅探

5. 去除无关的网络通信数据,必须有AMF协议下业务处理的网关,比如三国地址:/server/amfPHP/gateway.php,以及HTTP头的内容格式是application/x-amf,所以只需要过滤网关相关的通信会话即可。

网页中flash数据抓取(使用Python和CSS选择器来提取网页内容_html库(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2021-12-26 05:00

)

使用pip安装requests_html库

pip install requests_html

根据您的网络情况,通常需要几分钟的时间。

在您计算机上的任何位置创建一个新的 crawler.py 文件。输入并执行以下4行代码:

from requests_html import HTMLSession

session = HTMLSession()

r = session.get(\'https://movie.douban.com/subject/1292052/\')

print(r.text)

运行

您将看到以下输出:

DOCTYPE html>

肖申克的救赎 (豆瓣)

... 以下省略 3000 行

从网页中提取所需内容

您将使用强大的 CSS 选择器从网页中提取有价值的信息。

CSS 选择器可以从结构化网页中选择特定元素。

大多数浏览器都提供获取页面上特定元素的 CSS 选择器的能力。

首先检查一段内容的代码,在代码上右击,选择Copy->Copy Selector(或Copy CSS Selector,复制CSS选择器),那么这段内容对应的CSS选择器就可以了复制到剪贴板。

现在您需要访问此页面。根据上面的介绍,复制电影名称对应的选择器

回到之前创建的 crawler.py 文件,使用 Python 和 CSS 选择器提取网页内容。

from requests_html import HTMLSession

session = HTMLSession()

r = session.get(\'https://movie.douban.com/subject/1292052/\')

title = r.html.find(\'用你的选择器替换这里的内容\', first=True)

# r.html.find() 接受一个 CSS 选择器(字符串形式)作为参数

# 返回在网页中使用该选择器选中的内容。

print(title.text)

运行看看,你有没有从网页中提取电影名称?如果成功,请尝试提取您感兴趣的其他内容!

查看全部

网页中flash数据抓取(使用Python和CSS选择器来提取网页内容_html库(图)

)

使用pip安装requests_html库

pip install requests_html

根据您的网络情况,通常需要几分钟的时间。

在您计算机上的任何位置创建一个新的 crawler.py 文件。输入并执行以下4行代码:

from requests_html import HTMLSession

session = HTMLSession()

r = session.get(\'https://movie.douban.com/subject/1292052/\')

print(r.text)

运行

您将看到以下输出:

DOCTYPE html>

肖申克的救赎 (豆瓣)

... 以下省略 3000 行

从网页中提取所需内容

您将使用强大的 CSS 选择器从网页中提取有价值的信息。

CSS 选择器可以从结构化网页中选择特定元素。

大多数浏览器都提供获取页面上特定元素的 CSS 选择器的能力。

首先检查一段内容的代码,在代码上右击,选择Copy->Copy Selector(或Copy CSS Selector,复制CSS选择器),那么这段内容对应的CSS选择器就可以了复制到剪贴板。

现在您需要访问此页面。根据上面的介绍,复制电影名称对应的选择器

回到之前创建的 crawler.py 文件,使用 Python 和 CSS 选择器提取网页内容。

from requests_html import HTMLSession

session = HTMLSession()

r = session.get(\'https://movie.douban.com/subject/1292052/\')

title = r.html.find(\'用你的选择器替换这里的内容\', first=True)

# r.html.find() 接受一个 CSS 选择器(字符串形式)作为参数

# 返回在网页中使用该选择器选中的内容。

print(title.text)

运行看看,你有没有从网页中提取电影名称?如果成功,请尝试提取您感兴趣的其他内容!

网页中flash数据抓取(什么是静态网页,什么样是动态网页?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-25 18:11

什么是静态网页,什么是动态网页?静态页面

在网站设计中,纯HTML(标准通用标记语言下的应用程序)格式的网页通常被称为“静态网页”。静态网页是标准的 HTML 文件,其文件扩展名为 .htm 和 .html。包括文字、图片、声音、FLASH动画、客户端脚本、ActiveX控件和JAVA小程序等。静态网页是网站建设的基础。早期的网站通常由静态网页组成。与动态网页相比,静态网页是指没有后端数据库、没有程序、没有交互的网页。静态网页更新比较麻烦,适用于一般更新较少的展示类网站。很容易误解静态页面都是htm页面。事实上,静态页面并不是完全静态的。

动态网页

所谓动态网页,是指一种与静态网页相对的网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会发生变化——除非你修改页面代码。这不是动态网页的情况。虽然页面代码没有改变,但显示的内容会随着时间、环境或数据库操作的结果而改变。动态网页与网页上的各种动画、滚动字幕等视觉动态效果没有直接关系。动态网页也可以是纯文本内容或收录

各种动画内容。这些只是网页具体内容的表现。形式,无论网页是否有动态效果,

它们的特点 静态网页的特点

(1)静态网页每个网页都有一个固定的网址,网页网址后缀为.htm、.html、.shtml等常见形式,不带“?”;(动态网页中的“?” “搜索引擎检索存在一定的问题。搜索引擎一般无法访问网站数据库中的所有网页,或者出于技术考虑,搜索蜘蛛不会抓取网址中“?”后的内容。)

(2)一旦网页内容发布到web服务器上,无论是否有用户访问,每个静态网页的内容都存储在web服务器上,也就是说静态网页是实际存储在服务器上的每个页面都是一个独立的文件;

(3)静态网页内容比较稳定,容易被搜索引擎检索到;

(4)静态网页没有数据库支持,网站制作和维护工作量大,因此在网站信息量大的情况下,难以单纯依靠静态网页制作方式;

(5)静态网页交互性较差,在功能上有较大限制。

(6)页面浏览速度快,过程中无需连接数据库,页面打开速度比动态页面快。

(7)减轻服务器负担,减少工作量,降低数据库成本。

动态网页的特点

(1)动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

(2)使用动态网页技术的网站可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎检索有一定的问题,搜索引擎一般不可能访问一个网站的数据库中的所有网页,或者由于技术原因,不会被搜索到爬取URL中“?”后的内容,因此使用动态网页的网站在进行搜索引擎推广时需要做一定的技术处理,以满足搜索引擎的要求。

静态网页和动态网页的区别

两者之间最简单、最明显的区别是:

静态页面不能随时更改。静态页面写一次,放到服务器上浏览。如果要改,必须在页面上修改,然后上传服务器覆盖原来的页面,这样才能更新信息,比较麻烦。该人不能随时修改它。

动态页面的内容可以随时更改。有前端和后端点。管理员可以在后台随时更新网站内容,前端页面的内容也会相应更新,比较简单易学。 查看全部

网页中flash数据抓取(什么是静态网页,什么样是动态网页?(图))

什么是静态网页,什么是动态网页?静态页面

在网站设计中,纯HTML(标准通用标记语言下的应用程序)格式的网页通常被称为“静态网页”。静态网页是标准的 HTML 文件,其文件扩展名为 .htm 和 .html。包括文字、图片、声音、FLASH动画、客户端脚本、ActiveX控件和JAVA小程序等。静态网页是网站建设的基础。早期的网站通常由静态网页组成。与动态网页相比,静态网页是指没有后端数据库、没有程序、没有交互的网页。静态网页更新比较麻烦,适用于一般更新较少的展示类网站。很容易误解静态页面都是htm页面。事实上,静态页面并不是完全静态的。

动态网页

所谓动态网页,是指一种与静态网页相对的网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会发生变化——除非你修改页面代码。这不是动态网页的情况。虽然页面代码没有改变,但显示的内容会随着时间、环境或数据库操作的结果而改变。动态网页与网页上的各种动画、滚动字幕等视觉动态效果没有直接关系。动态网页也可以是纯文本内容或收录

各种动画内容。这些只是网页具体内容的表现。形式,无论网页是否有动态效果,

它们的特点 静态网页的特点

(1)静态网页每个网页都有一个固定的网址,网页网址后缀为.htm、.html、.shtml等常见形式,不带“?”;(动态网页中的“?” “搜索引擎检索存在一定的问题。搜索引擎一般无法访问网站数据库中的所有网页,或者出于技术考虑,搜索蜘蛛不会抓取网址中“?”后的内容。)

(2)一旦网页内容发布到web服务器上,无论是否有用户访问,每个静态网页的内容都存储在web服务器上,也就是说静态网页是实际存储在服务器上的每个页面都是一个独立的文件;

(3)静态网页内容比较稳定,容易被搜索引擎检索到;

(4)静态网页没有数据库支持,网站制作和维护工作量大,因此在网站信息量大的情况下,难以单纯依靠静态网页制作方式;

(5)静态网页交互性较差,在功能上有较大限制。

(6)页面浏览速度快,过程中无需连接数据库,页面打开速度比动态页面快。

(7)减轻服务器负担,减少工作量,降低数据库成本。

动态网页的特点

(1)动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

(2)使用动态网页技术的网站可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎检索有一定的问题,搜索引擎一般不可能访问一个网站的数据库中的所有网页,或者由于技术原因,不会被搜索到爬取URL中“?”后的内容,因此使用动态网页的网站在进行搜索引擎推广时需要做一定的技术处理,以满足搜索引擎的要求。

静态网页和动态网页的区别

两者之间最简单、最明显的区别是:

静态页面不能随时更改。静态页面写一次,放到服务器上浏览。如果要改,必须在页面上修改,然后上传服务器覆盖原来的页面,这样才能更新信息,比较麻烦。该人不能随时修改它。

动态页面的内容可以随时更改。有前端和后端点。管理员可以在后台随时更新网站内容,前端页面的内容也会相应更新,比较简单易学。

网页中flash数据抓取(合肥网站优化:关键词分析分析分析(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-25 17:20

一、合肥网站优化:关键词分析

关键词分析是所有网站排名优化必须掌握的功课。大型网站虽然有海量数据,但每个页面都需要关键词分析。除了网站优化,策划和编辑也需要具备一定的关键词分析能力。

先来看看关键词分析的基本原理:

1、 调查用户的搜索习惯:这是一个重要的方面。只有了解用户的搜索习惯,才能了解我用户的搜索需求。用户喜欢搜索什么?他们使用什么搜索引擎?等等。

2、 关键词 不要太宽泛:关键词 太宽泛会导致竞争激烈,耗费大量时间但不一定能达到预期效果,并且可能会降低关键词的相关性@关键词 。

3、 关键词 不能太冷:想一想,关键词 没有用户搜索,值得优化吗?

4、 关键词 保持与页面内容的高度相关性:这样有利于优化,也有利于用户。

我们来看看关键词的选择步骤:

1、确定核心关键词:我们应该考虑哪个词或两个词最准确地描述网页的内容?用户搜索最多的词是哪个?

2、核心关键词定义扩展:例如核心关键词的别名,核心关键词后的组合,核心关键词的辅助等。

3、模拟用户思维设计关键词:把自己想成一个用户,那我要搜索什么关键词?

4、 竞争对手研究关键词:分析排名靠前的竞争对手的网页。他们用什么关键词?

二、合肥网站优化:页面反向优化

为什么要做逆向优化?因为在大型网站中,网页优化的价值一般与中小型网站不同。综合考虑各种综合因素(如品牌、页面内容、用户体验等),大型网站的页面优化值大多呈倒序排列,即:最终页>主题页>栏目页>频道页> 主页。

如何将 关键词 分配给每个页面?通常的情况是这样的:

1、 最后一页:为长尾关键词

2、 专题页面:针对热门关键词,例如“周杰伦”

3、栏目页:用于固定关键词,如“音乐试听”

4、频道页面:对于核心关键词,比如“音乐”

5、 主页:不分配关键词,而是专注于品牌。

分配完关键词后,我们可以添加匹配的内链作为最终页面的辅助,这就是大型网站内链的优势。

三、前端搜索引擎友好,包括搜索友好的UI设计和搜索友好的前端代码

1、 首先来看看UI设计对搜索引擎的友好度:主要是导航清晰,以及flash和图片的使用。一般来说,导航和带有关键词的部分不适合flash和图片,因为大多数搜索引擎无法抓取flash和图片中的文字。

2、那么前端代码的搜索引擎友好度:包括以下几点

一个。代码简洁:搜索引擎喜欢简洁的html代码,更有利于分析。

湾 重要信息优先:参考带有关键词的信息和经常更新的信息,尽量出现在html最前面的位置。

C。过滤干扰信息:大型网站的页面一般都比较复杂。有多种广告、合作、交流内容等无关信息。我们应该选择使用js、iframe等搜索引擎无法识别的代码过滤掉这部分信息。

d. 代码的基本SEO:这是避免html错误和语义标签的基本SEO工作。

四、合肥网站优化:内链策略

为什么强调内链策略?因为内链有以下优点:

1、 大型网站的海量数据使得内链的优势远远大于外链。外部链接的数量可能是数万和数十万,但大型网站有数百万、数千万甚至数亿的网页内容。如果用这些海量的网页来建立内链,优势就很明显了。

2、 导出网站内网页之间的链接是一项非常简单的任务。

3、 提高网站的搜索引擎抓取索引效率,增强采集

,也有助于PR的传递。

4、 聚焦话题,让该话题的关键词在搜索引擎中具有排名优势。

在构建内链时,我们应该遵循以下原则:

1、 控制文章中的链接数:文章中穿插的链接可以根据内容控制在3-8个左右。

2、 链接对象的相关性应该很高。

3、 对重要网页给予更多关注:让关键词值越大的重要网页获得更好的排名。

4、 使用绝对路径。

五、合肥网站优化:外链策略

我们强调大型网站的内链建设,但同时也不能过分忽视外链的建设。外链的建设虽然不如中小型网站重要,但也具有很高的价值。我们通常可以通过交换链接、制作链接诱饵、发布带链接的软文等方式来搭建外链。

1、 来看看交换链接应该遵循哪些原则:

一个。链接文本收录

关键词

湾 尝试与高度相关的网站和渠道交换链接

C。对方网站导出的链接数量不能太多,太多的话就没多大价值了

d. 避免与未被搜索引擎收录或惩罚的网站交换链接

2、 制作链接诱饵:制作链接诱饵是一项省力的工作,它使其他网站主动为我们添加链接。制作链接诱饵的技巧有很多,但可以概括为两个词:创造力。

3、 用链接做广告。指以商业推广或获取外部链接为目的,放置带有链接的软文。

六、合肥网站优化:网站地图策略

有很多大型网站不注重站点地图的建设,很多大型网站的站点地图只是一种敷衍的展示。事实上,网站对于大型网站来说是非常重要的。大型网站的海量数据、复杂的网站导航结构、极快的更新频率,使得搜索引擎无法完全抓取所有网页。这也是一些大型网站拥有数百万、数千万甚至数亿的数据,但只有一半、三分之一甚至更少的网站数据被搜索引擎收录的重要原因。我什至不能保证收录

,我如何排名?

Html 地图:

1、 为搜索引擎建立良好的导航结构。

2、 Html 地图可以分为水平导航和垂直导航。横向导航主要是频道、栏目、话题等链接,纵向导航主要针对关键词。

3、 每个页面都有一个指向站点地图的链接。

主要针对谷歌、雅虎、直播等搜索引擎。由于大型网站的数据量太大,单个站点地图会导致sitemap.xml文件过大,超出搜索引擎的承受能力。所以我们需要将sitemap.xml拆分成几个,每个拆分的sitemap.xml都保持在搜索引擎推荐的范围内。

七、日志分析和数据挖掘:

日志分析和数据挖掘经常被我们忽视。其实无论是大型网站还是中小型网站,都是非常有意义的作品。只是大型网站的日志分析和数据挖掘比较困难,因为数据量太大,所以做这个工作要有足够的耐心,而且要有针对性。

1、 网站日志分析:网站日志分析的种类很多,比如访问源、浏览器、客户端屏幕大小、入口、跳出率、PV等,主要有以下三种搜索引擎优化工作:

一个。搜索引擎流量导入

湾 搜索引擎关键词分析

C。用户搜索行为统计分析

2、 热点数据挖掘:我们可以通过自己的网站日志分析、一些外部工具以及SEO自身对热点的把握能力进行热点数据挖掘。

一个。把握行业热点,由编辑和SEO共同完成

湾 预测潜在热点,对信息敏感度要求高,能够预测潜在热点信息。

C。自己制造热点,比如炒作等。

d. 为热点做专题

八、为 关键词 创建主题:

除了最后一页,为热门关键词创建的各种主题应该是该网站搜索引擎流量的第二大来源。挖掘出热点数据后,我们可以为这些热点关键词做专题。制作的专题页面的内容从何而来?我们一般使用程序对相应的关键词相关信息进行过滤聚合,使内容与关键词高度匹配,提供给用户和搜索引擎您所需要的。 查看全部

网页中flash数据抓取(合肥网站优化:关键词分析分析分析(组图))

一、合肥网站优化:关键词分析

关键词分析是所有网站排名优化必须掌握的功课。大型网站虽然有海量数据,但每个页面都需要关键词分析。除了网站优化,策划和编辑也需要具备一定的关键词分析能力。

先来看看关键词分析的基本原理:

1、 调查用户的搜索习惯:这是一个重要的方面。只有了解用户的搜索习惯,才能了解我用户的搜索需求。用户喜欢搜索什么?他们使用什么搜索引擎?等等。

2、 关键词 不要太宽泛:关键词 太宽泛会导致竞争激烈,耗费大量时间但不一定能达到预期效果,并且可能会降低关键词的相关性@关键词 。

3、 关键词 不能太冷:想一想,关键词 没有用户搜索,值得优化吗?

4、 关键词 保持与页面内容的高度相关性:这样有利于优化,也有利于用户。

我们来看看关键词的选择步骤:

1、确定核心关键词:我们应该考虑哪个词或两个词最准确地描述网页的内容?用户搜索最多的词是哪个?

2、核心关键词定义扩展:例如核心关键词的别名,核心关键词后的组合,核心关键词的辅助等。

3、模拟用户思维设计关键词:把自己想成一个用户,那我要搜索什么关键词?

4、 竞争对手研究关键词:分析排名靠前的竞争对手的网页。他们用什么关键词?

二、合肥网站优化:页面反向优化

为什么要做逆向优化?因为在大型网站中,网页优化的价值一般与中小型网站不同。综合考虑各种综合因素(如品牌、页面内容、用户体验等),大型网站的页面优化值大多呈倒序排列,即:最终页>主题页>栏目页>频道页> 主页。

如何将 关键词 分配给每个页面?通常的情况是这样的:

1、 最后一页:为长尾关键词

2、 专题页面:针对热门关键词,例如“周杰伦”

3、栏目页:用于固定关键词,如“音乐试听”

4、频道页面:对于核心关键词,比如“音乐”

5、 主页:不分配关键词,而是专注于品牌。

分配完关键词后,我们可以添加匹配的内链作为最终页面的辅助,这就是大型网站内链的优势。

三、前端搜索引擎友好,包括搜索友好的UI设计和搜索友好的前端代码

1、 首先来看看UI设计对搜索引擎的友好度:主要是导航清晰,以及flash和图片的使用。一般来说,导航和带有关键词的部分不适合flash和图片,因为大多数搜索引擎无法抓取flash和图片中的文字。

2、那么前端代码的搜索引擎友好度:包括以下几点

一个。代码简洁:搜索引擎喜欢简洁的html代码,更有利于分析。

湾 重要信息优先:参考带有关键词的信息和经常更新的信息,尽量出现在html最前面的位置。

C。过滤干扰信息:大型网站的页面一般都比较复杂。有多种广告、合作、交流内容等无关信息。我们应该选择使用js、iframe等搜索引擎无法识别的代码过滤掉这部分信息。

d. 代码的基本SEO:这是避免html错误和语义标签的基本SEO工作。

四、合肥网站优化:内链策略

为什么强调内链策略?因为内链有以下优点:

1、 大型网站的海量数据使得内链的优势远远大于外链。外部链接的数量可能是数万和数十万,但大型网站有数百万、数千万甚至数亿的网页内容。如果用这些海量的网页来建立内链,优势就很明显了。

2、 导出网站内网页之间的链接是一项非常简单的任务。

3、 提高网站的搜索引擎抓取索引效率,增强采集

,也有助于PR的传递。

4、 聚焦话题,让该话题的关键词在搜索引擎中具有排名优势。

在构建内链时,我们应该遵循以下原则:

1、 控制文章中的链接数:文章中穿插的链接可以根据内容控制在3-8个左右。

2、 链接对象的相关性应该很高。

3、 对重要网页给予更多关注:让关键词值越大的重要网页获得更好的排名。

4、 使用绝对路径。

五、合肥网站优化:外链策略

我们强调大型网站的内链建设,但同时也不能过分忽视外链的建设。外链的建设虽然不如中小型网站重要,但也具有很高的价值。我们通常可以通过交换链接、制作链接诱饵、发布带链接的软文等方式来搭建外链。

1、 来看看交换链接应该遵循哪些原则:

一个。链接文本收录

关键词

湾 尝试与高度相关的网站和渠道交换链接

C。对方网站导出的链接数量不能太多,太多的话就没多大价值了

d. 避免与未被搜索引擎收录或惩罚的网站交换链接

2、 制作链接诱饵:制作链接诱饵是一项省力的工作,它使其他网站主动为我们添加链接。制作链接诱饵的技巧有很多,但可以概括为两个词:创造力。

3、 用链接做广告。指以商业推广或获取外部链接为目的,放置带有链接的软文。

六、合肥网站优化:网站地图策略

有很多大型网站不注重站点地图的建设,很多大型网站的站点地图只是一种敷衍的展示。事实上,网站对于大型网站来说是非常重要的。大型网站的海量数据、复杂的网站导航结构、极快的更新频率,使得搜索引擎无法完全抓取所有网页。这也是一些大型网站拥有数百万、数千万甚至数亿的数据,但只有一半、三分之一甚至更少的网站数据被搜索引擎收录的重要原因。我什至不能保证收录

,我如何排名?

Html 地图:

1、 为搜索引擎建立良好的导航结构。

2、 Html 地图可以分为水平导航和垂直导航。横向导航主要是频道、栏目、话题等链接,纵向导航主要针对关键词。

3、 每个页面都有一个指向站点地图的链接。

主要针对谷歌、雅虎、直播等搜索引擎。由于大型网站的数据量太大,单个站点地图会导致sitemap.xml文件过大,超出搜索引擎的承受能力。所以我们需要将sitemap.xml拆分成几个,每个拆分的sitemap.xml都保持在搜索引擎推荐的范围内。

七、日志分析和数据挖掘:

日志分析和数据挖掘经常被我们忽视。其实无论是大型网站还是中小型网站,都是非常有意义的作品。只是大型网站的日志分析和数据挖掘比较困难,因为数据量太大,所以做这个工作要有足够的耐心,而且要有针对性。

1、 网站日志分析:网站日志分析的种类很多,比如访问源、浏览器、客户端屏幕大小、入口、跳出率、PV等,主要有以下三种搜索引擎优化工作:

一个。搜索引擎流量导入

湾 搜索引擎关键词分析

C。用户搜索行为统计分析

2、 热点数据挖掘:我们可以通过自己的网站日志分析、一些外部工具以及SEO自身对热点的把握能力进行热点数据挖掘。

一个。把握行业热点,由编辑和SEO共同完成

湾 预测潜在热点,对信息敏感度要求高,能够预测潜在热点信息。

C。自己制造热点,比如炒作等。

d. 为热点做专题

八、为 关键词 创建主题:

除了最后一页,为热门关键词创建的各种主题应该是该网站搜索引擎流量的第二大来源。挖掘出热点数据后,我们可以为这些热点关键词做专题。制作的专题页面的内容从何而来?我们一般使用程序对相应的关键词相关信息进行过滤聚合,使内容与关键词高度匹配,提供给用户和搜索引擎您所需要的。

网页中flash数据抓取(常见的应该全力避免的网站数据技术被称为蜘蛛陷阱)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-25 17:18

由于缺乏网站优化知识,一些网站数据技术往往设计出对搜索引擎不友好、不利于搜索引擎蜘蛛抓取的页面。这些技术被称为蜘蛛陷阱。应避免的常见蜘蛛陷阱包括以下形式:

1、闪存

使用FLASH在网页的一小部分增强视觉效果是正常的,比如FLASH制作的广告和图标。这种小FLASH和图片一样。它只是 HTML 代码的一小部分。页面上还有其他基于文本的内容,因此对搜索引擎的抓取和收录没有影响。

但有的网站只是一个大的FLASH文件,构成了蜘蛛陷阱。搜索引擎抓取的HTML代码中只有一个指向FLASH文件的链接,没有其他文字或链接。搜索引擎无法读取 Flash 文件中的文本内容和链接。这种网站整体上是一个FLASH网站,视觉效果可能很精彩,可惜搜索引擎看不到,也不能索引任何文字信息,所以无法判断相关性。

2、会话ID

一些网站使用会话 ID 来跟踪用户访问。当每个用户访问网站时,都会生成一个唯一且唯一的会话 ID,并将其添加到 URL 中。搜索引擎蜘蛛的每次访问都会被当作一个新用户,在URL中添加不同的会话ID,这样搜索引擎蜘蛛每次访问得到的同一个页面的URL就会不同,遵循使用不同的会话 ID。

3、各种跳跃

除了我们最常见的 301 重定向,搜索引擎对其他形式的跳转也比较敏感,比如 302 跳转、Javascript 跳转、Flash 跳转和 Meta Refresh 跳转。

部分网站用户访问时会自动跳转到某个目录下的页面。如果是根据用户的地理位置切换到最合适的目录,那倒是情有可原。但是这种转向大多看不到任何理由或目的,如果避免,这种转向是可以避免的。

如果必须重定向,搜索引擎推荐使用 301 重定向,用于 URL 更改重定向。页面权重可以从原创

URL 转移到新 URL。其他的转向方式是爬不上蜘蛛的,因为都是作弊方式。

4、帧结构

如果你是一个网站的站长,不知道什么是框架,那么恭喜你,你避开了这个蜘蛛陷阱。无需知道框架是什么。如果你还在URL设计中使用框架结构,建议取消。框架结构不利于搜索引擎抓取。搜索赢钱,访问志愿者使用框架的URL抓取的html只收录

调用其他html文件的代码,没有文本信息。搜索引擎无法确定网页。内容是什么。

5、动态网址

动态网址是指数据库驱动的网站生成的带有问号、等号和参数的网址。一般来说,动态网址不利于搜索引擎蜘蛛的抓取,应尽量避免。

6、JavaScript 链接

因为 JavaScript 可以创造出很多吸引人的视觉效果,所以一些网站喜欢使用 JavaScript 脚本来生成导航系统,这是一个严重的蜘蛛陷阱。虽然搜索引擎在尝试解析 JS 脚本,但我们不能指望搜索引擎能够自己克服困难。相反,搜索引擎应该尽可能简单和容易地跟踪爬行链接。

7、 强制使用 Cookie

为了实现某些功能,例如记住用户登录信息和跟踪用户访问路径,一些网站会强制用户使用cookies。如果用户浏览器未启用cookies,页面显示异常。搜索引擎蜘蛛相当于禁用 cookie 的浏览器。强制使用cookies只会导致搜索引擎蜘蛛无法正常访问。

在此提醒广大站长,优化自己的网站是一个长期的过程。不想使用快速排名的方法。网站的蜘蛛陷阱是站长经常遇到的,最好避开。本文来自:跑官 查看全部

网页中flash数据抓取(常见的应该全力避免的网站数据技术被称为蜘蛛陷阱)

由于缺乏网站优化知识,一些网站数据技术往往设计出对搜索引擎不友好、不利于搜索引擎蜘蛛抓取的页面。这些技术被称为蜘蛛陷阱。应避免的常见蜘蛛陷阱包括以下形式:

1、闪存

使用FLASH在网页的一小部分增强视觉效果是正常的,比如FLASH制作的广告和图标。这种小FLASH和图片一样。它只是 HTML 代码的一小部分。页面上还有其他基于文本的内容,因此对搜索引擎的抓取和收录没有影响。

但有的网站只是一个大的FLASH文件,构成了蜘蛛陷阱。搜索引擎抓取的HTML代码中只有一个指向FLASH文件的链接,没有其他文字或链接。搜索引擎无法读取 Flash 文件中的文本内容和链接。这种网站整体上是一个FLASH网站,视觉效果可能很精彩,可惜搜索引擎看不到,也不能索引任何文字信息,所以无法判断相关性。

2、会话ID

一些网站使用会话 ID 来跟踪用户访问。当每个用户访问网站时,都会生成一个唯一且唯一的会话 ID,并将其添加到 URL 中。搜索引擎蜘蛛的每次访问都会被当作一个新用户,在URL中添加不同的会话ID,这样搜索引擎蜘蛛每次访问得到的同一个页面的URL就会不同,遵循使用不同的会话 ID。

3、各种跳跃

除了我们最常见的 301 重定向,搜索引擎对其他形式的跳转也比较敏感,比如 302 跳转、Javascript 跳转、Flash 跳转和 Meta Refresh 跳转。

部分网站用户访问时会自动跳转到某个目录下的页面。如果是根据用户的地理位置切换到最合适的目录,那倒是情有可原。但是这种转向大多看不到任何理由或目的,如果避免,这种转向是可以避免的。

如果必须重定向,搜索引擎推荐使用 301 重定向,用于 URL 更改重定向。页面权重可以从原创

URL 转移到新 URL。其他的转向方式是爬不上蜘蛛的,因为都是作弊方式。

4、帧结构

如果你是一个网站的站长,不知道什么是框架,那么恭喜你,你避开了这个蜘蛛陷阱。无需知道框架是什么。如果你还在URL设计中使用框架结构,建议取消。框架结构不利于搜索引擎抓取。搜索赢钱,访问志愿者使用框架的URL抓取的html只收录

调用其他html文件的代码,没有文本信息。搜索引擎无法确定网页。内容是什么。

5、动态网址

动态网址是指数据库驱动的网站生成的带有问号、等号和参数的网址。一般来说,动态网址不利于搜索引擎蜘蛛的抓取,应尽量避免。

6、JavaScript 链接

因为 JavaScript 可以创造出很多吸引人的视觉效果,所以一些网站喜欢使用 JavaScript 脚本来生成导航系统,这是一个严重的蜘蛛陷阱。虽然搜索引擎在尝试解析 JS 脚本,但我们不能指望搜索引擎能够自己克服困难。相反,搜索引擎应该尽可能简单和容易地跟踪爬行链接。

7、 强制使用 Cookie

为了实现某些功能,例如记住用户登录信息和跟踪用户访问路径,一些网站会强制用户使用cookies。如果用户浏览器未启用cookies,页面显示异常。搜索引擎蜘蛛相当于禁用 cookie 的浏览器。强制使用cookies只会导致搜索引擎蜘蛛无法正常访问。

在此提醒广大站长,优化自己的网站是一个长期的过程。不想使用快速排名的方法。网站的蜘蛛陷阱是站长经常遇到的,最好避开。本文来自:跑官

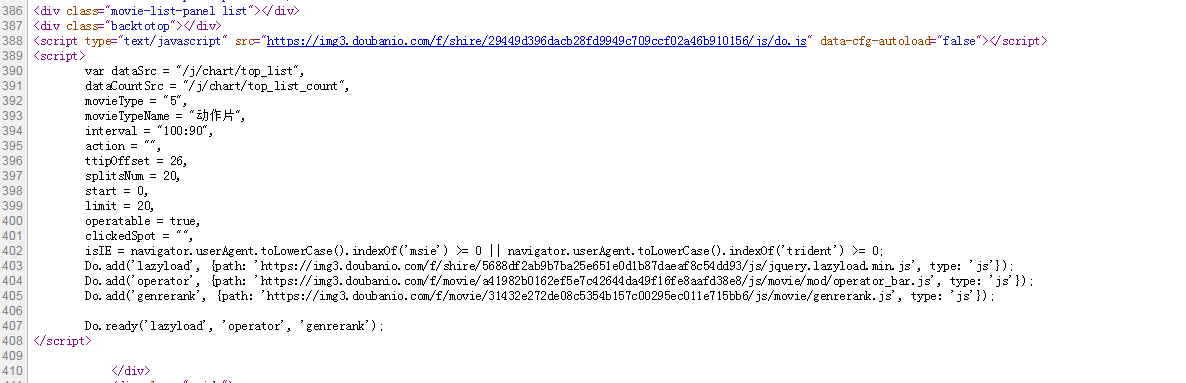

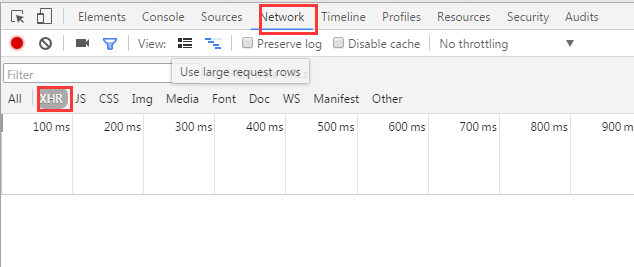

网页中flash数据抓取(如何用python来抓取页面中的JS动态加载的数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-25 17:03

)

我们经常发现网页中的很多数据并不是硬编码在HTML中,而是通过js动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中通过Javascript动态生成的页面内容,是页面加载到浏览器后动态生成的,以前没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果你还是直接从网页上爬取,你将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以将更多的电影信息加载到页面中,以便我们抓取相应的消息。

我们可以看到它使用了AJAX异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某一部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录

了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,可以发现action参数后面有“start”和“limit”两个参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这似乎很不自动化,而且很多其他网站的RequestURL都不是那么直接,所以我们将使用python进行进一步的操作,以获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text 查看全部

网页中flash数据抓取(如何用python来抓取页面中的JS动态加载的数据

)

我们经常发现网页中的很多数据并不是硬编码在HTML中,而是通过js动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中通过Javascript动态生成的页面内容,是页面加载到浏览器后动态生成的,以前没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果你还是直接从网页上爬取,你将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以将更多的电影信息加载到页面中,以便我们抓取相应的消息。

我们可以看到它使用了AJAX异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某一部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录

了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,可以发现action参数后面有“start”和“limit”两个参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这似乎很不自动化,而且很多其他网站的RequestURL都不是那么直接,所以我们将使用python进行进一步的操作,以获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text

网页中flash数据抓取(vba网页元素代码抓取小工具【支持win10+】用IE提取网页资料)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-12-20 22:17

vba网页元素代码抓取小工具【支持win10+】

使用IE提取网页信息的优点是:所见即所得,一般可以得到网页上能看到的信息。这个工具功能不多,主要是方便提取网页显示信息所在元素的代码。我希望我能帮到你一点点。网页爬虫gadget.rar (22.91 KB, 下载次数: 3601) 如何使用这个工具:1、在B1中输入网址,可以是打开的网页,也可以是2、A2和B2未打开的内容,不要改,第二行其他单元格可以自己输入元素的属性名称,其中,innertext单元格有一个下拉选项< @3、 并点击“开始”“分析”分析网页元素。< @4、A 列是每个元素的对象代码。5、 在innertext列中找到要提取的内容后,选中该行,点击“生成excel”。表格可以提取标签形式或下载 IMG 标签图像。6、 在新生成的excel中,点击“执行代码”按钮,看看是否可以生成需要的数据。如果生成的数据与开始分析的数据不匹配,原因可能是:1、网页未完全加载,对应标签的数据尚未加载,代码自动提取后续标签数据。可能的解决方法:添加do...loop time delay。2、 网页为动态网页,标签号不确定。可能的解决方案:如果元素有一个 id 名称,则使用 getelementbyid("

现在下载 查看全部

网页中flash数据抓取(vba网页元素代码抓取小工具【支持win10+】用IE提取网页资料)

vba网页元素代码抓取小工具【支持win10+】

使用IE提取网页信息的优点是:所见即所得,一般可以得到网页上能看到的信息。这个工具功能不多,主要是方便提取网页显示信息所在元素的代码。我希望我能帮到你一点点。网页爬虫gadget.rar (22.91 KB, 下载次数: 3601) 如何使用这个工具:1、在B1中输入网址,可以是打开的网页,也可以是2、A2和B2未打开的内容,不要改,第二行其他单元格可以自己输入元素的属性名称,其中,innertext单元格有一个下拉选项< @3、 并点击“开始”“分析”分析网页元素。< @4、A 列是每个元素的对象代码。5、 在innertext列中找到要提取的内容后,选中该行,点击“生成excel”。表格可以提取标签形式或下载 IMG 标签图像。6、 在新生成的excel中,点击“执行代码”按钮,看看是否可以生成需要的数据。如果生成的数据与开始分析的数据不匹配,原因可能是:1、网页未完全加载,对应标签的数据尚未加载,代码自动提取后续标签数据。可能的解决方法:添加do...loop time delay。2、 网页为动态网页,标签号不确定。可能的解决方案:如果元素有一个 id 名称,则使用 getelementbyid("

现在下载

网页中flash数据抓取( 网站结构建设对网站后期页面收录的怎样的影响?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-01-06 02:10

网站结构建设对网站后期页面收录的怎样的影响?)

网站结构对网站收录有什么影响?

网站结构构建是网站优化的第一步。对网站后面的页面收录会有什么影响?网站结构优化是网站在构建之初就必须考虑的。文章 针对网站结构构建对网站的影响,做了一些一般性的分析。

1.flash 链接不利于蜘蛛抓取页面

说起搜索引擎喜欢的网站结构,还是偏爱静态页面。尤其是flash链接不利于蜘蛛抓取页面。百度给站长的明确建议提到,百度暂时无法识别Flash和Javascript中的内容。这部分内容在百度搜索中可能找不到;仅收录 Flash 和 Javascript 中的链接。百度可能无法在指向的网页上收录。因此,网站 中每个需要 收录 的页面都应该有一个指向它的 HTML 链接。

2. 动态网址参数过多不利于搜索引擎抓取页面

如果网站采用动态网页,减少参数数量和控制参数长度对收录都有好处。一般来说,超过三个参数的网址对于百度的智商来说是难以理解的。太多的参数会阻止蜘蛛爬取或爬取一些指向同一页面的肉到数据库中。

3.网站结构深度

网站应该有清晰的导航和层次结构,网站上的重要网页应该在网站的相对较浅的位置找到。百度对低权重网站的爬取深度有限制。一般一个小的网站百度爬取深度不超过3层。这就是为什么首页上的链接更有可能是收录。大家一定发现,SEO互动论坛的收录一直在上升,尤其是首页本周热门栏目的帖子无一例外的收录。甚至这些帖子收录 的回复也达到了十几页。

4.完整站点链接

全站链接是指网站中所有页面指向的链接。全站链接通常是权重最高的网站链接。全站链接积累了太多的权重,降低了其他内页的权重,从而影响了内容页的收录。为了避免这种情况,一般不要做不必要的全站链接。取消分类导航,保留面包屑导航。

5.内部链权重转移

内部链是网站结构中最复杂的部分。做好内链,有利于网站的权重传递。更多的页面可以达到搜索引擎抓取的页面权重下限。鼓励搜索引擎为更多页面完成收录。在内部链构建过程中,需要对网站结构进行基本布局,使网站达到最佳效果。

【网站结构对网站收录有什么影响?】相关文章:

1.如何改进网站收录

2.网站快速收录提示

3.可以改进网站收录的html标签

4.网站SEO秒优化收录方法

5.网站如何更好的运营收录?

6.网站结构优化对网站有什么好处

7.网站结构优化方法

8.手脚无助网站收录下降对网站有帮助吗? 查看全部

网页中flash数据抓取(

网站结构建设对网站后期页面收录的怎样的影响?)

网站结构对网站收录有什么影响?

网站结构构建是网站优化的第一步。对网站后面的页面收录会有什么影响?网站结构优化是网站在构建之初就必须考虑的。文章 针对网站结构构建对网站的影响,做了一些一般性的分析。

1.flash 链接不利于蜘蛛抓取页面

说起搜索引擎喜欢的网站结构,还是偏爱静态页面。尤其是flash链接不利于蜘蛛抓取页面。百度给站长的明确建议提到,百度暂时无法识别Flash和Javascript中的内容。这部分内容在百度搜索中可能找不到;仅收录 Flash 和 Javascript 中的链接。百度可能无法在指向的网页上收录。因此,网站 中每个需要 收录 的页面都应该有一个指向它的 HTML 链接。

2. 动态网址参数过多不利于搜索引擎抓取页面

如果网站采用动态网页,减少参数数量和控制参数长度对收录都有好处。一般来说,超过三个参数的网址对于百度的智商来说是难以理解的。太多的参数会阻止蜘蛛爬取或爬取一些指向同一页面的肉到数据库中。

3.网站结构深度

网站应该有清晰的导航和层次结构,网站上的重要网页应该在网站的相对较浅的位置找到。百度对低权重网站的爬取深度有限制。一般一个小的网站百度爬取深度不超过3层。这就是为什么首页上的链接更有可能是收录。大家一定发现,SEO互动论坛的收录一直在上升,尤其是首页本周热门栏目的帖子无一例外的收录。甚至这些帖子收录 的回复也达到了十几页。

4.完整站点链接

全站链接是指网站中所有页面指向的链接。全站链接通常是权重最高的网站链接。全站链接积累了太多的权重,降低了其他内页的权重,从而影响了内容页的收录。为了避免这种情况,一般不要做不必要的全站链接。取消分类导航,保留面包屑导航。

5.内部链权重转移

内部链是网站结构中最复杂的部分。做好内链,有利于网站的权重传递。更多的页面可以达到搜索引擎抓取的页面权重下限。鼓励搜索引擎为更多页面完成收录。在内部链构建过程中,需要对网站结构进行基本布局,使网站达到最佳效果。

【网站结构对网站收录有什么影响?】相关文章:

1.如何改进网站收录

2.网站快速收录提示

3.可以改进网站收录的html标签

4.网站SEO秒优化收录方法

5.网站如何更好的运营收录?

6.网站结构优化对网站有什么好处

7.网站结构优化方法

8.手脚无助网站收录下降对网站有帮助吗?

网页中flash数据抓取( 网站优化到百度首页但又不知该怎么做??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-06 02:07

网站优化到百度首页但又不知该怎么做??)

对于刚接触SEO的小白来说,会遇到这样的困惑。想把网站优化到百度首页不知道怎么做?其实很简单,知己知彼才能百战百胜。既然要把网站优化到首页,首先要了解搜索引擎的习惯,是这样的。

抓

搜索引擎后台会派百度蜘蛛24小时从海量数据中识别抓取内容;然后过滤内容以去除低质量的内容;将过滤后的合格内容存放在临时索引库中进行分类存储。

网上这么多信息,百度蜘蛛是怎么注意到你的网站的?

这时候就需要吸引它——优质的外链或者好友链接,百度可以通过这些链接来到你的网站!

不过要小心!百度蜘蛛也有自己不喜欢的东西——比如:js、没有ALT属性的图片、iframe框架、网页需要登录的信息、flash。

这些都是百度不太喜欢的东西,一定要注意!

百度蜘蛛的爬取方式分为:深爬和宽爬。

深度爬取:百度蜘蛛会一一跟踪网页中的链接,有点跟不上。

广泛抓取:百度蜘蛛会抓取一个页面的所有链接。

一旦用户在前台触发搜索,搜索引擎会根据用户的关键词选择搜索库中的内容,猜测用户的搜索需求,并显示与搜索结果相关的、能够满足用户需求的内容按顺序搜索目标。在用户面前。

筛选

物品质量有好有坏,我们都喜欢质量好的。百度蜘蛛也是一样。要知道,搜索引擎的最终目的是满足用户的搜索需求。为了保证搜索结果的相关性和丰富性,那些低质量的内容会被过滤掉并丢弃。哪些内容属于这个范围?

低质量:句子不清楚,下一句与上句没有联系,意思不流畅。这会让蜘蛛头晕目眩,自然会被丢弃。

其次,存在重复性强、与主题无关、全屏广告、死链接全、时效性差等问题。

贮存

过滤差不多完成了,百度留下了所有的“喜欢”。将这些数据组织起来,建立索引库并进行排序。

过滤出的优质内容被提取理解,分类存储,建立目录,最后汇总成索引库,机器可以快速调用,易于理解,为数据的检索做准备。

展示

百度将所有精品店存储在索引库中。用户在前台触发搜索后,会触发索引库查询。例如,当网友输入关键词(如SEO)时,百度蜘蛛会在索引库中找到相关展示。在网友面前。

搜索引擎根据用户搜索意图、内容相关性等指标依次显示搜索结果。

相关性强的优质内容将排在第一位。如果没有达到搜索目标,用户可以根据显示结果搜索2-3次,搜索引擎会根据关键词进一步精准优化显示结果。 查看全部

网页中flash数据抓取(

网站优化到百度首页但又不知该怎么做??)

对于刚接触SEO的小白来说,会遇到这样的困惑。想把网站优化到百度首页不知道怎么做?其实很简单,知己知彼才能百战百胜。既然要把网站优化到首页,首先要了解搜索引擎的习惯,是这样的。

抓

搜索引擎后台会派百度蜘蛛24小时从海量数据中识别抓取内容;然后过滤内容以去除低质量的内容;将过滤后的合格内容存放在临时索引库中进行分类存储。

网上这么多信息,百度蜘蛛是怎么注意到你的网站的?

这时候就需要吸引它——优质的外链或者好友链接,百度可以通过这些链接来到你的网站!

不过要小心!百度蜘蛛也有自己不喜欢的东西——比如:js、没有ALT属性的图片、iframe框架、网页需要登录的信息、flash。

这些都是百度不太喜欢的东西,一定要注意!

百度蜘蛛的爬取方式分为:深爬和宽爬。

深度爬取:百度蜘蛛会一一跟踪网页中的链接,有点跟不上。

广泛抓取:百度蜘蛛会抓取一个页面的所有链接。

一旦用户在前台触发搜索,搜索引擎会根据用户的关键词选择搜索库中的内容,猜测用户的搜索需求,并显示与搜索结果相关的、能够满足用户需求的内容按顺序搜索目标。在用户面前。

筛选

物品质量有好有坏,我们都喜欢质量好的。百度蜘蛛也是一样。要知道,搜索引擎的最终目的是满足用户的搜索需求。为了保证搜索结果的相关性和丰富性,那些低质量的内容会被过滤掉并丢弃。哪些内容属于这个范围?

低质量:句子不清楚,下一句与上句没有联系,意思不流畅。这会让蜘蛛头晕目眩,自然会被丢弃。

其次,存在重复性强、与主题无关、全屏广告、死链接全、时效性差等问题。

贮存

过滤差不多完成了,百度留下了所有的“喜欢”。将这些数据组织起来,建立索引库并进行排序。

过滤出的优质内容被提取理解,分类存储,建立目录,最后汇总成索引库,机器可以快速调用,易于理解,为数据的检索做准备。

展示

百度将所有精品店存储在索引库中。用户在前台触发搜索后,会触发索引库查询。例如,当网友输入关键词(如SEO)时,百度蜘蛛会在索引库中找到相关展示。在网友面前。

搜索引擎根据用户搜索意图、内容相关性等指标依次显示搜索结果。

相关性强的优质内容将排在第一位。如果没有达到搜索目标,用户可以根据显示结果搜索2-3次,搜索引擎会根据关键词进一步精准优化显示结果。

网页中flash数据抓取( Python中解析网页的一个重要的应用,使用Python爬虫 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2022-01-05 17:13

Python中解析网页的一个重要的应用,使用Python爬虫

)

爬虫是Python的一个重要应用。使用Python爬虫,我们可以很方便的从网上抓取我们想要的数据。本文将以抓取B站的视频热搜榜数据并存储为例。详细介绍了四个步骤。Python爬虫的基本流程。

步骤1

请求尝试进入b站首页,点击排行榜,复制链接。

1https://www.bilibili.com/ranki ... 162.3

2

3

1 启动 Jupyter notebook ,并运行以下代码:

2

1import requests

2url = 'https://www.bilibili.com/ranki ... 27%3B

3res = requests.get('url')

4print(res.status_code)

5#200

6

7

1 在上面的代码中,完成下面三件事:

2

可以看到返回值为200,说明服务器响应正常,可以继续。

第2步

页面解析通过上一步的请求向网站请求数据后,我们成功获取到一个收录服务器资源的Response对象。现在我们可以使用 .text 来查看其内容。

可以看到返回的是一个字符串,里面收录了我们需要的热门视频数据,但是直接从字符串中提取内容比较复杂,效率低下,所以我们需要对其进行解析,将字符串转换成结构化的web页面数据,以便您可以轻松找到 HTML 标签及其属性和内容。Python中解析网页的方法有很多种,可以使用正则表达式,也可以使用BeautifulSoup、pyquery或lxml。本文将基于 BeautifulSoup 进行讲解。Beautiful Soup 是一个第三方库,可以从 HTML 或 XML 文件中提取数据。安装也非常简单。使用 pip install bs4 进行安装。让我们用一个简单的例子来说明它是如何工作的。

1from bs4 import BeautifulSoup

2page = requests.get(url)

3soup = BeautifulSoup(page.content, 'html.parser')

4title = soup.title.text

5print(title)

6# 热门视频排行榜 - 哔哩哔哩 (゜-゜)つロ 干杯~-bilibili

7

8

1 在上面的代码中,我们通过bs4中的BeautifulSoup类将上一步得到的html格式字符串转换为一个BeautifulSoup对象,注意在使用时需要制定一个解析器,这里使用的是html.parser。 接着就可以获取其中的某个结构化元素及其属性,比如使用soup.title.text获取页面标题,同样可以使用soup.body、soup.p等获取任意需要的元素。

2

第 3 步

提取内容在上面两步中,我们使用requests向网页请求数据,使用bs4解析页面。现在我们到了最关键的一步:如何从解析后的页面中提取需要的内容。在 Beautiful Soup 中,我们可以使用 find/find_all 来定位元素,但我更习惯使用 CSS 选择器 .select,因为我们可以像使用 CSS 选择元素一样向下访问 DOM 树。下面我们用代码来说明如何从解析后的页面中提取B站的热点列表数据。首先我们需要找到存储数据的标签,在列表页面按F12,按照下图的说明找到。

可以看到每条视频信息都包裹在li标签下,那么代码可以这样写吗?

1all_products = []

2products = soup.select('li.rank-item')

3for product in products:

4 rank = product.select('div.num')[0].text

5 name = product.select('div.info > a')[0].text.strip()

6 play = product.select('span.data-box')[0].text

7 comment = product.select('span.data-box')[1].text

8 up = product.select('span.data-box')[2].text

9 url = product.select('div.info > a')[0].attrs['href']

10 all_products.append({

11 "视频排名":rank,

12 "视频名": name,

13 "播放量": play,

14 "弹幕量": comment,

15 "up主": up,

16 "视频链接": url

17 })

18

19

1 在上面的代码中,我们先使用soup.select('li.rank-item'),此时返回一个list包含每一个视频信息,接着遍历每一个视频信息,依旧使用CSS选择器来提取我们要的字段信息,并以字典的形式存储在开头定义好的空列表中。 可以注意到我用了多种选择方法提取去元素,**这也是select方法的灵活之处**,感兴趣的读者可以进一步自行研究。

2

步骤4

存储数据 经过前面三步,我们成功地使用requests+bs4从网站中提取出需要的数据,最后只需要将数据写入Excel保存即可。如果你对pandas不熟悉,可以使用csv模块来编写。需要注意的是设置了encoding='utf-8-sig',否则会出现中文乱码的问题。

1import csv

2keys = all_products[0].keys()

3with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

4 dict_writer = csv.DictWriter(output_file, keys)

5 dict_writer.writeheader()

6 dict_writer.writerows(all_products)

7

8

1 如果你熟悉pandas的话,更是可以轻松将字典转换为DataFrame,一行代码即可完成。

2

1import pandas as pd

2keys = all_products[0].keys()

3pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

4

结论 至此,我们已经成功地使用Python在本地存储了b站的热门视频列表数据。大多数基于请求的爬虫基本上都是按照以上四个步骤进行的。然而,虽然看起来简单,但在真实场景中的每一步都不是那么容易。从请求数据开始,目标网站有多种形式的反爬和加密,后期解析、提取甚至存储数据的方式也很多。需要进一步探索和学习。

本文选择B站视频热榜是因为足够简单,希望通过这个案例,让大家了解Python爬虫工作的基本流程,最后附上完整的代码?

1import requests

2from bs4 import BeautifulSoup

3import csv

4import pandas as pd

5url = 'https://www.bilibili.com/ranki ... 27%3B

6page = requests.get(url)

7soup = BeautifulSoup(page.content, 'html.parser')

8all_products = []

9products = soup.select('li.rank-item')

10for product in products:

11 rank = product.select('div.num')[0].text

12 name = product.select('div.info > a')[0].text.strip()

13 play = product.select('span.data-box')[0].text

14 comment = product.select('span.data-box')[1].text

15 up = product.select('span.data-box')[2].text

16 url = product.select('div.info > a')[0].attrs['href']

17 all_products.append({

18 "视频排名":rank,

19 "视频名": name,

20 "播放量": play,

21 "弹幕量": comment,

22 "up主": up,

23 "视频链接": url

24 })

25keys = all_products[0].keys()

26with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

27 dict_writer = csv.DictWriter(output_file, keys)

28 dict_writer.writeheader()

29 dict_writer.writerows(all_products)

30### 使用pandas写入数据

31pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

32

33 查看全部

网页中flash数据抓取(

Python中解析网页的一个重要的应用,使用Python爬虫

)

爬虫是Python的一个重要应用。使用Python爬虫,我们可以很方便的从网上抓取我们想要的数据。本文将以抓取B站的视频热搜榜数据并存储为例。详细介绍了四个步骤。Python爬虫的基本流程。

步骤1

请求尝试进入b站首页,点击排行榜,复制链接。

1https://www.bilibili.com/ranki ... 162.3

2

3

1 启动 Jupyter notebook ,并运行以下代码:

2

1import requests

2url = 'https://www.bilibili.com/ranki ... 27%3B

3res = requests.get('url')

4print(res.status_code)

5#200

6

7

1 在上面的代码中,完成下面三件事:

2

可以看到返回值为200,说明服务器响应正常,可以继续。

第2步

页面解析通过上一步的请求向网站请求数据后,我们成功获取到一个收录服务器资源的Response对象。现在我们可以使用 .text 来查看其内容。

可以看到返回的是一个字符串,里面收录了我们需要的热门视频数据,但是直接从字符串中提取内容比较复杂,效率低下,所以我们需要对其进行解析,将字符串转换成结构化的web页面数据,以便您可以轻松找到 HTML 标签及其属性和内容。Python中解析网页的方法有很多种,可以使用正则表达式,也可以使用BeautifulSoup、pyquery或lxml。本文将基于 BeautifulSoup 进行讲解。Beautiful Soup 是一个第三方库,可以从 HTML 或 XML 文件中提取数据。安装也非常简单。使用 pip install bs4 进行安装。让我们用一个简单的例子来说明它是如何工作的。

1from bs4 import BeautifulSoup

2page = requests.get(url)

3soup = BeautifulSoup(page.content, 'html.parser')

4title = soup.title.text

5print(title)

6# 热门视频排行榜 - 哔哩哔哩 (゜-゜)つロ 干杯~-bilibili

7

8

1 在上面的代码中,我们通过bs4中的BeautifulSoup类将上一步得到的html格式字符串转换为一个BeautifulSoup对象,注意在使用时需要制定一个解析器,这里使用的是html.parser。 接着就可以获取其中的某个结构化元素及其属性,比如使用soup.title.text获取页面标题,同样可以使用soup.body、soup.p等获取任意需要的元素。

2

第 3 步

提取内容在上面两步中,我们使用requests向网页请求数据,使用bs4解析页面。现在我们到了最关键的一步:如何从解析后的页面中提取需要的内容。在 Beautiful Soup 中,我们可以使用 find/find_all 来定位元素,但我更习惯使用 CSS 选择器 .select,因为我们可以像使用 CSS 选择元素一样向下访问 DOM 树。下面我们用代码来说明如何从解析后的页面中提取B站的热点列表数据。首先我们需要找到存储数据的标签,在列表页面按F12,按照下图的说明找到。

可以看到每条视频信息都包裹在li标签下,那么代码可以这样写吗?

1all_products = []

2products = soup.select('li.rank-item')

3for product in products:

4 rank = product.select('div.num')[0].text

5 name = product.select('div.info > a')[0].text.strip()

6 play = product.select('span.data-box')[0].text

7 comment = product.select('span.data-box')[1].text

8 up = product.select('span.data-box')[2].text

9 url = product.select('div.info > a')[0].attrs['href']

10 all_products.append({

11 "视频排名":rank,

12 "视频名": name,

13 "播放量": play,

14 "弹幕量": comment,

15 "up主": up,

16 "视频链接": url

17 })

18

19

1 在上面的代码中,我们先使用soup.select('li.rank-item'),此时返回一个list包含每一个视频信息,接着遍历每一个视频信息,依旧使用CSS选择器来提取我们要的字段信息,并以字典的形式存储在开头定义好的空列表中。 可以注意到我用了多种选择方法提取去元素,**这也是select方法的灵活之处**,感兴趣的读者可以进一步自行研究。

2

步骤4

存储数据 经过前面三步,我们成功地使用requests+bs4从网站中提取出需要的数据,最后只需要将数据写入Excel保存即可。如果你对pandas不熟悉,可以使用csv模块来编写。需要注意的是设置了encoding='utf-8-sig',否则会出现中文乱码的问题。

1import csv

2keys = all_products[0].keys()

3with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

4 dict_writer = csv.DictWriter(output_file, keys)

5 dict_writer.writeheader()

6 dict_writer.writerows(all_products)

7

8

1 如果你熟悉pandas的话,更是可以轻松将字典转换为DataFrame,一行代码即可完成。

2

1import pandas as pd

2keys = all_products[0].keys()

3pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

4

结论 至此,我们已经成功地使用Python在本地存储了b站的热门视频列表数据。大多数基于请求的爬虫基本上都是按照以上四个步骤进行的。然而,虽然看起来简单,但在真实场景中的每一步都不是那么容易。从请求数据开始,目标网站有多种形式的反爬和加密,后期解析、提取甚至存储数据的方式也很多。需要进一步探索和学习。

本文选择B站视频热榜是因为足够简单,希望通过这个案例,让大家了解Python爬虫工作的基本流程,最后附上完整的代码?

1import requests

2from bs4 import BeautifulSoup

3import csv

4import pandas as pd

5url = 'https://www.bilibili.com/ranki ... 27%3B

6page = requests.get(url)

7soup = BeautifulSoup(page.content, 'html.parser')

8all_products = []

9products = soup.select('li.rank-item')

10for product in products:

11 rank = product.select('div.num')[0].text

12 name = product.select('div.info > a')[0].text.strip()

13 play = product.select('span.data-box')[0].text

14 comment = product.select('span.data-box')[1].text

15 up = product.select('span.data-box')[2].text

16 url = product.select('div.info > a')[0].attrs['href']

17 all_products.append({

18 "视频排名":rank,

19 "视频名": name,

20 "播放量": play,

21 "弹幕量": comment,

22 "up主": up,

23 "视频链接": url

24 })

25keys = all_products[0].keys()

26with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

27 dict_writer = csv.DictWriter(output_file, keys)

28 dict_writer.writeheader()

29 dict_writer.writerows(all_products)

30### 使用pandas写入数据

31pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

32

33

网页中flash数据抓取(千人基因组数据库中爬取CHB人群的等位基因频率信息解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-05 17:09

该计划的目的:

根据特定的SNP列表,从千基因组数据库中爬取CHB群体的等位基因频率信息,例如。

因为网页是动态数据,内嵌了JavaScript代码,所以使用selenium来爬取信息。

Beautiful Soup 是一个 Python 库,其主要功能是从网页中抓取数据。Beautiful Soup 提供了一些简单的、python 风格的函数来处理导航、搜索、修改分析树和其他功能。它是一个工具箱,为用户提供需要通过解析文档捕获的数据,避免复杂的正则表达式。

准备:源代码

# -*- coding:utf-8 -*-

from bs4 import BeautifulSoup

import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

def get_allele_feq(browser, snp):

browser.get(

'https://www.ncbi.nlm.nih.gov/variation/tools/1000genomes/?q=%s' %snp) #Load page

# browser.implicitly_wait(60) #智能等待xx秒

time.sleep(30) #加载时间较长,等待加载完毕

# browser.find_element_by_css_selector("div[title=\"Han Chinese in Bejing, China\"]") #use selenium function to find elements

# 把selenium的webdriver调用page_source函数在传入BeautifulSoup中,就可以用BeautifulSoup解析网页了

bs = BeautifulSoup(browser.page_source, "lxml")

# bs.find_all("div", title="Han Chinese in Bejing, China")

try:

race = bs.find(string="CHB")

race_data = race.find_parent("div").find_parent(

"div").find_next_sibling("div")

# print race_data

race_feq = race_data.find("span", class_="gt-selected").find_all("li") # class_ 防止Python中类关键字重复,产生语法错误

base1_feq = race_feq[0].text #获取标签的内容

base2_feq = race_feq[1].text

return snp, base1_feq, base2_feq # T=0.1408 C=0.8592

except NoSuchElementException:

return "%s:can't find element" %snp

def main():

browser = webdriver.Chrome() # Get local session of chrome

fh = open("./4diseases_snps_1kCHB_allele_feq.list2", 'w')

snps = open("./4diseases_snps.list.uniq2",'r')

for line in snps:

snp = line.strip()

response = get_allele_feq(browser, snp)

time.sleep(1)

fh.write("\t".join(response)) #unicode 编码的对象写到文件中后相当于print效果

fh.write("\n")

print "\t".join(response)

time.sleep(1) # sleep a few seconds

fh.close()

browser.quit() # 退出并关闭窗口的每一个相关的驱动程序

if __name__ == '__main__':

main()

参考资料:

1]:#Beautiful Soup 4.4.0 文档

2]:

3]:

4]:

5]:

6]:

7]: 查看全部

网页中flash数据抓取(千人基因组数据库中爬取CHB人群的等位基因频率信息解析)

该计划的目的:

根据特定的SNP列表,从千基因组数据库中爬取CHB群体的等位基因频率信息,例如。

因为网页是动态数据,内嵌了JavaScript代码,所以使用selenium来爬取信息。

Beautiful Soup 是一个 Python 库,其主要功能是从网页中抓取数据。Beautiful Soup 提供了一些简单的、python 风格的函数来处理导航、搜索、修改分析树和其他功能。它是一个工具箱,为用户提供需要通过解析文档捕获的数据,避免复杂的正则表达式。

准备:源代码

# -*- coding:utf-8 -*-

from bs4 import BeautifulSoup

import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

def get_allele_feq(browser, snp):

browser.get(

'https://www.ncbi.nlm.nih.gov/variation/tools/1000genomes/?q=%s' %snp) #Load page

# browser.implicitly_wait(60) #智能等待xx秒

time.sleep(30) #加载时间较长,等待加载完毕

# browser.find_element_by_css_selector("div[title=\"Han Chinese in Bejing, China\"]") #use selenium function to find elements

# 把selenium的webdriver调用page_source函数在传入BeautifulSoup中,就可以用BeautifulSoup解析网页了

bs = BeautifulSoup(browser.page_source, "lxml")

# bs.find_all("div", title="Han Chinese in Bejing, China")

try:

race = bs.find(string="CHB")

race_data = race.find_parent("div").find_parent(

"div").find_next_sibling("div")

# print race_data

race_feq = race_data.find("span", class_="gt-selected").find_all("li") # class_ 防止Python中类关键字重复,产生语法错误

base1_feq = race_feq[0].text #获取标签的内容