浏览器抓取网页

浏览器抓取网页(手机浏览器cookie怎么查看?手机cookie获取方法汇总!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 606 次浏览 • 2022-02-09 03:17

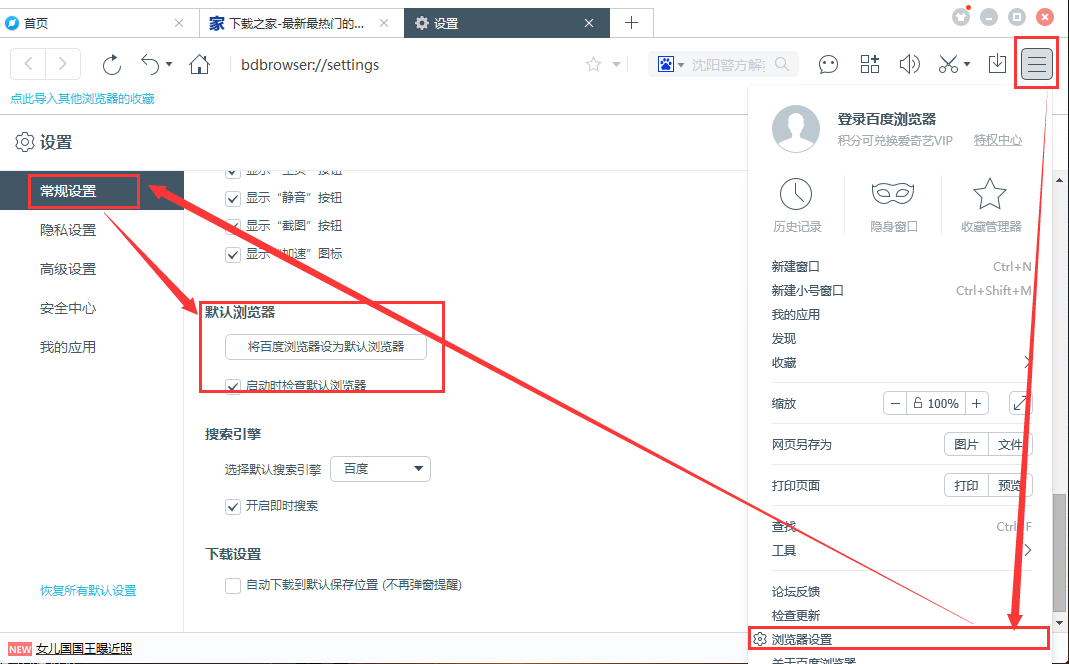

一、在IE浏览器查看cookie的方法一:在浏览器地址栏输入:javascript:alert(document.cookie)(差别不大。

手机如何查看cookies?操作步骤如下: 1、首先点击IE页面右上角的“工具”按钮,如何查看手机浏览器cookies?.

如何查看手机浏览器cookies?手机浏览器的cookie设置用于确定使用哪个浏览器。如果是 cookie 浏览器,解决方案。

csdn为您找到了可以查看cookies的手机浏览器的相关内容,包括可以查看cookies的手机浏览器的相关文档代码介绍。

手机如何获取浏览器的cookie?下面我们来看看如何获取手机cookie。一、华为手机1、先找到华为手机。

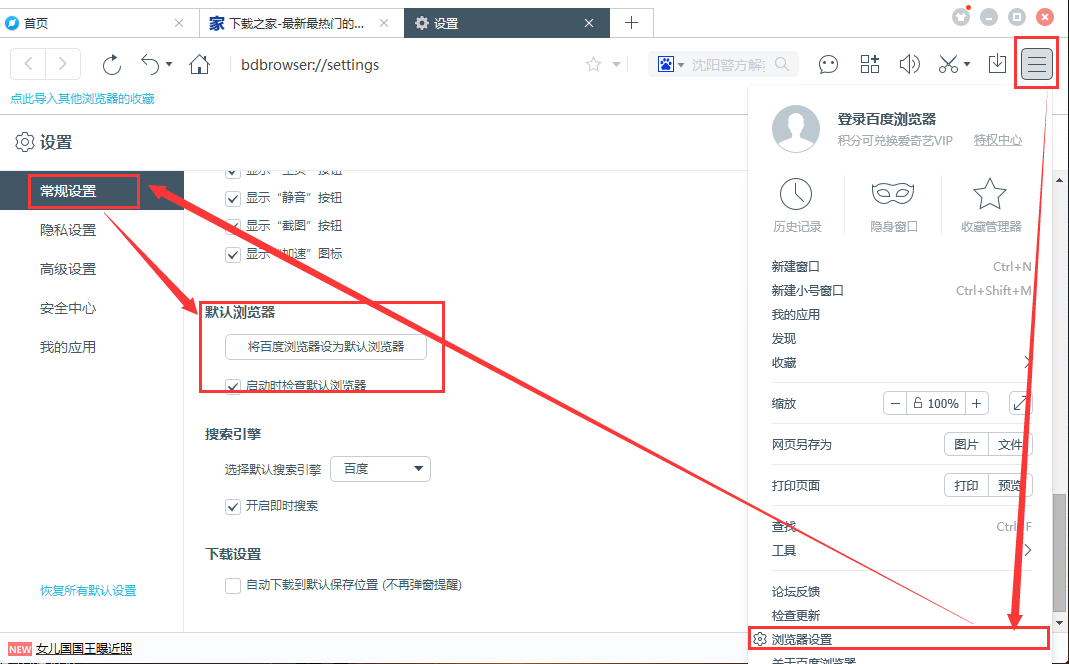

确保打开手机浏览器的cookie设置2.进入手机浏览器的设置页面后,点击当前页面的无痕浏览加快速度。

您可以直接在网页上搜索。自带的浏览器一般都不是很完善。建议您使用手机QQ浏览器的功能性、安全性和便捷性。

微信保存百度云链接的时候,虽然无法打开任何cookies,但还是有办法保存的。点击右上角三个点,用QQ浏览器打开。

我的浏览器选项里没有“cookie”选项,但是设置里有“清除缓存”,如何判断?您可以通过浏览器的菜单-系统设置-。 查看全部

浏览器抓取网页(手机浏览器cookie怎么查看?手机cookie获取方法汇总!!)

一、在IE浏览器查看cookie的方法一:在浏览器地址栏输入:javascript:alert(document.cookie)(差别不大。

手机如何查看cookies?操作步骤如下: 1、首先点击IE页面右上角的“工具”按钮,如何查看手机浏览器cookies?.

如何查看手机浏览器cookies?手机浏览器的cookie设置用于确定使用哪个浏览器。如果是 cookie 浏览器,解决方案。

csdn为您找到了可以查看cookies的手机浏览器的相关内容,包括可以查看cookies的手机浏览器的相关文档代码介绍。

手机如何获取浏览器的cookie?下面我们来看看如何获取手机cookie。一、华为手机1、先找到华为手机。

确保打开手机浏览器的cookie设置2.进入手机浏览器的设置页面后,点击当前页面的无痕浏览加快速度。

您可以直接在网页上搜索。自带的浏览器一般都不是很完善。建议您使用手机QQ浏览器的功能性、安全性和便捷性。

微信保存百度云链接的时候,虽然无法打开任何cookies,但还是有办法保存的。点击右上角三个点,用QQ浏览器打开。

我的浏览器选项里没有“cookie”选项,但是设置里有“清除缓存”,如何判断?您可以通过浏览器的菜单-系统设置-。

浏览器抓取网页(Python中爬虫基础快速入门的学习方法,值得收藏!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-02-08 04:24

对于小白来说,爬虫可能是一件非常复杂、技术含量很高的事情。比如很多人认为学习爬虫一定要掌握Python,然后系统地学习Python的每一个知识点,但是时间长了发现还是爬不出来数据;有的人认为需要先了解网页的知识,于是入手HTML\CSS,结果就是前端的坑,皱巴巴的……

但是如果知道正确的方法,短期内可以爬取主流的网站数据。我认为实现起来并不难,但建议你从一开始就设定明确的目标。

在目标的驱动下,你的学习会更有效率。你觉得必要的专业知识,可以在完成目标的过程中学习。这里为大家提供一个零基础的快速入门学习方法。

01学习Python包并执行基本爬取步骤

大多数爬虫都是按照“发送请求-获取页面-解析页面-提取并存储内容”的过程来实现的,它模拟了使用浏览器爬取网页信息的过程。

Python中有很多爬虫相关的包:urllib、requests、bs4、scrapy、pyspider等,建议从requests+Xpath入手。Requests 负责连接到 网站 并返回网页。Xpath 用于解析网页以便于提取。数据。

如果你用过BeautifulSoup,你会发现Xpath省了很多麻烦,层层检查元素代码的工作都省去了。这样,基本套路就差不多了。一般的静态网站完全没有问题,豆瓣、尴尬百科、腾讯新闻等基本都能上手。

当然,如果你需要爬取异步加载的网站,你可以学习浏览器抓取来分析真实的请求或者学习Selenium来自动化。这样动态知乎、、TripAdvisor网站也可以解决。

02 了解非结构化数据的存储

爬取的数据可以以文档的形式存储在本地,也可以存储在数据库中。

刚开始数据量不大的时候,可以直接通过Python语法或者pandas方法将数据保存为csv等文件。

当然,你可能会发现爬取的数据不干净,可能有缺失、错误等,你也需要对数据进行清洗,可以学习pandas包的基本用法来做数据预处理,得到更干净的数据。

03 掌握各种技巧应对特殊网站防爬措施

当然在爬取的过程中也会有一些绝望,比如被网站IP屏蔽,比如各种奇怪的验证码,userAgent访问限制,各种动态加载等等。

遇到这些反爬的方法,当然需要一些高级技巧来应对,比如访问频率控制、代理IP池的使用、抓包、验证码的OCR处理等等。

往往网站会在高效开发和反爬虫之间偏爱前者,这也为爬虫提供了空间。掌握了这些反爬技能,大部分网站对你来说都不再难了。

所以有些东西看起来很吓人,但当它们崩溃时,也仅此而已。当你能写出分布式爬虫的时候,就可以尝试搭建一些基本的爬虫架构,实现一些更自动化的数据获取。

同时可以使用掘金的ip代理和相关的防屏蔽来辅助。(百度搜索:掘金.com) 查看全部

浏览器抓取网页(Python中爬虫基础快速入门的学习方法,值得收藏!)

对于小白来说,爬虫可能是一件非常复杂、技术含量很高的事情。比如很多人认为学习爬虫一定要掌握Python,然后系统地学习Python的每一个知识点,但是时间长了发现还是爬不出来数据;有的人认为需要先了解网页的知识,于是入手HTML\CSS,结果就是前端的坑,皱巴巴的……

但是如果知道正确的方法,短期内可以爬取主流的网站数据。我认为实现起来并不难,但建议你从一开始就设定明确的目标。

在目标的驱动下,你的学习会更有效率。你觉得必要的专业知识,可以在完成目标的过程中学习。这里为大家提供一个零基础的快速入门学习方法。

01学习Python包并执行基本爬取步骤

大多数爬虫都是按照“发送请求-获取页面-解析页面-提取并存储内容”的过程来实现的,它模拟了使用浏览器爬取网页信息的过程。

Python中有很多爬虫相关的包:urllib、requests、bs4、scrapy、pyspider等,建议从requests+Xpath入手。Requests 负责连接到 网站 并返回网页。Xpath 用于解析网页以便于提取。数据。

如果你用过BeautifulSoup,你会发现Xpath省了很多麻烦,层层检查元素代码的工作都省去了。这样,基本套路就差不多了。一般的静态网站完全没有问题,豆瓣、尴尬百科、腾讯新闻等基本都能上手。

当然,如果你需要爬取异步加载的网站,你可以学习浏览器抓取来分析真实的请求或者学习Selenium来自动化。这样动态知乎、、TripAdvisor网站也可以解决。

02 了解非结构化数据的存储

爬取的数据可以以文档的形式存储在本地,也可以存储在数据库中。

刚开始数据量不大的时候,可以直接通过Python语法或者pandas方法将数据保存为csv等文件。

当然,你可能会发现爬取的数据不干净,可能有缺失、错误等,你也需要对数据进行清洗,可以学习pandas包的基本用法来做数据预处理,得到更干净的数据。

03 掌握各种技巧应对特殊网站防爬措施

当然在爬取的过程中也会有一些绝望,比如被网站IP屏蔽,比如各种奇怪的验证码,userAgent访问限制,各种动态加载等等。

遇到这些反爬的方法,当然需要一些高级技巧来应对,比如访问频率控制、代理IP池的使用、抓包、验证码的OCR处理等等。

往往网站会在高效开发和反爬虫之间偏爱前者,这也为爬虫提供了空间。掌握了这些反爬技能,大部分网站对你来说都不再难了。

所以有些东西看起来很吓人,但当它们崩溃时,也仅此而已。当你能写出分布式爬虫的时候,就可以尝试搭建一些基本的爬虫架构,实现一些更自动化的数据获取。

同时可以使用掘金的ip代理和相关的防屏蔽来辅助。(百度搜索:掘金.com)

浏览器抓取网页(环境核心类库puppeteer文档安装第一步获取获取文章详情 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-02-08 02:20

)

环境核心类库

傀儡师

文档

安装

npm i puppeteer -S

第一步是获取网页的内容

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend");

console.log(await page.content())

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

以上代码可以获取整个页面。测试发现问题已经解决。其实puppeteer有一个特殊的方法可以解决这个问题,page.waitForSelector,等待匹配指定选择器的元素出现在页面上。

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend");

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

console.log(await page.content())

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

第二步,获取列表中的标题和链接

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend");

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

// 获取列表中标题和链接

const list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

console.log(list.length)

console.log(list)

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

第三步,获取文章详情

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend");

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

// 获取列表中标题和链接

let list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

list = list.slice(0, 10)

// 获取文章详情

for (let i = 0; i e.innerHTML)

}

console.log(list[0])

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

第四步,保存数据

这里不介绍保存到数据库,简单写个json文件。

const puppeteer = require('puppeteer');

const fs = require('fs')

const path = require('path')

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend");

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

// 获取列表中标题和链接

let list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

list = list.slice(0, 10)

// 获取文章详情

for (let i = 0; i e.innerHTML)

}

// 保存数据

fs.writeFileSync(path.resolve(__dirname, '../out/articles.json'), JSON.stringify(list, null, 2))

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

最后进行方法提取等处理

方法文件

const fs = require('fs')

exports.init = async function (browser) {

let page = await browser.newPage();

await page.setJavaScriptEnabled(true);

await page.goto("https://juejin.cn/frontend");

await page.waitForSelector('.entry-list-wrap .entry-list .item');

return page;

}

exports.getList = async function (page) {

let list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

return list.slice(0, 10)

}

exports.getListDetail = async function (list, page) {

for (let i = 0; i e.innerHTML)

}

return list

}

exports.writeFile = async function (name, content) {

fs.writeFileSync(name, content)

}

主文件

const puppeteer = require('puppeteer');

const path = require('path')

const methods = require('./methods')

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

try {

// 初始化

let page = await methods.init(browser);

// 获取列表中标题和链接

let list = await methods.getList(page)

// 获取文章详情

list = await methods.getListDetail(list, page)

// 保存数据

methods.writeFile(path.resolve(__dirname, '../out/articles.json'), JSON.stringify(list, null, 2))

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

} catch (error) {

console.error(error)

// 关闭浏览器

await browser.close();

}

})

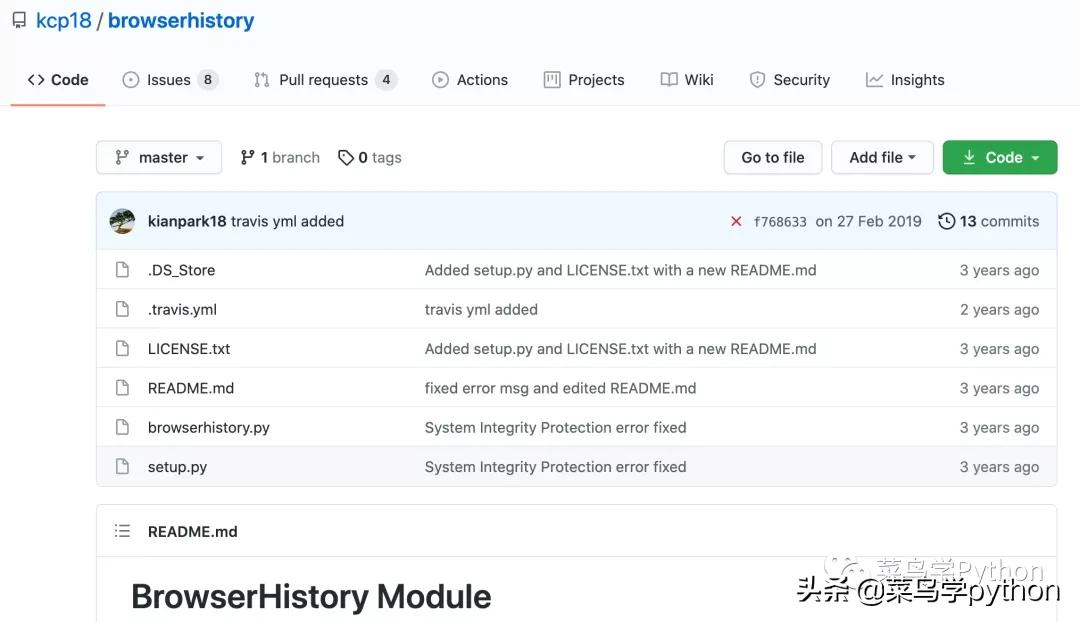

项目地址

查看全部

浏览器抓取网页(环境核心类库puppeteer文档安装第一步获取获取文章详情

)

环境核心类库

傀儡师

文档

安装

npm i puppeteer -S

第一步是获取网页的内容

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend";);

console.log(await page.content())

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

以上代码可以获取整个页面。测试发现问题已经解决。其实puppeteer有一个特殊的方法可以解决这个问题,page.waitForSelector,等待匹配指定选择器的元素出现在页面上。

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend";);

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

console.log(await page.content())

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

第二步,获取列表中的标题和链接

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend";);

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

// 获取列表中标题和链接

const list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

console.log(list.length)

console.log(list)

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

第三步,获取文章详情

const puppeteer = require('puppeteer');

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend";);

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

// 获取列表中标题和链接

let list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

list = list.slice(0, 10)

// 获取文章详情

for (let i = 0; i e.innerHTML)

}

console.log(list[0])

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

第四步,保存数据

这里不介绍保存到数据库,简单写个json文件。

const puppeteer = require('puppeteer');

const fs = require('fs')

const path = require('path')

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

// 一个新的 Page 对象

let page = await browser.newPage();

// 启用js

await page.setJavaScriptEnabled(true);

// 打开URL

await page.goto("https://juejin.cn/frontend";);

// 等待列表出现

await page.waitForSelector('.entry-list-wrap .entry-list .item');

// 获取列表中标题和链接

let list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

list = list.slice(0, 10)

// 获取文章详情

for (let i = 0; i e.innerHTML)

}

// 保存数据

fs.writeFileSync(path.resolve(__dirname, '../out/articles.json'), JSON.stringify(list, null, 2))

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

})

最后进行方法提取等处理

方法文件

const fs = require('fs')

exports.init = async function (browser) {

let page = await browser.newPage();

await page.setJavaScriptEnabled(true);

await page.goto("https://juejin.cn/frontend";);

await page.waitForSelector('.entry-list-wrap .entry-list .item');

return page;

}

exports.getList = async function (page) {

let list = await page.$$eval('.entry-list-wrap .entry-list .title-row a', list => {

return list.map(item => {

return {

title: item.innerText,

href: item.href,

}

});

});

return list.slice(0, 10)

}

exports.getListDetail = async function (list, page) {

for (let i = 0; i e.innerHTML)

}

return list

}

exports.writeFile = async function (name, content) {

fs.writeFileSync(name, content)

}

主文件

const puppeteer = require('puppeteer');

const path = require('path')

const methods = require('./methods')

puppeteer.launch({

// 在导航期间忽略 HTTPS 错误

ignoreHTTPSErrors: true,

// 不在 无头模式 下运行浏览器

headless: false,

// 将 Puppeteer 操作减少指定的毫秒数

slowMo: 250,

// 等待浏览器实例启动的最长时间,0禁用超时

timeout: 0

}).then(async browser => {

try {

// 初始化

let page = await methods.init(browser);

// 获取列表中标题和链接

let list = await methods.getList(page)

// 获取文章详情

list = await methods.getListDetail(list, page)

// 保存数据

methods.writeFile(path.resolve(__dirname, '../out/articles.json'), JSON.stringify(list, null, 2))

// 关闭页面

await page.close();

// 关闭浏览器

await browser.close();

} catch (error) {

console.error(error)

// 关闭浏览器

await browser.close();

}

})

项目地址

浏览器抓取网页(1.selenium安装selenium库的介绍及安装和常见的使用方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-02-07 16:18

本文是爬虫工具selenium的介绍,包括安装和常用的使用方法,后面会整理出来以备不时之需。

1. 硒安装

Selenium 是一种常用的爬虫工具。相比普通爬虫库,它直接模拟调用浏览器直接运行,可以避免很多反爬机制。在某种程度上,它类似于按钮向导。但它更强大。,更可定制。

首先我们需要在 python 环境中安装 selenium 库。

1

2

3

pip install selenium

# 或

conda install selenium

除了基本的python依赖库外,我们还需要安装浏览器驱动。由于我经常使用chrome,所以这里选择chomedriver,其他浏览器需要找到对应的驱动。

首先打开chrome浏览器,在地址栏输入Chrome://version,查看浏览器对应的版本号,比如我当前的版本是:98.0.4758.82(正式版)(64位)。然后在chromedriver官网找到对应的版本下载并解压。(这是官网,有墙)最后把chromedriver.exe放到python环境的Scripts文件夹下,或者项目文件夹下,或者放到自己喜欢的文件夹下(不是)。

好,那我们就开始我们的学习之旅吧!

2. 基本用法

导入库

1

from selenium import webdriver

如果初始浏览器已经放在 Scripts 文件夹中,会直接调用。

1

2

# 初始化选择chrome浏览器

browser = webdriver.Chrome()

否则需要手动选择浏览器的路径,可以是相对路径,也可以是绝对路径。

1

2

# 初始化选择chrome浏览器

browser = webdriver.Chrome(path)

这时候你会发现自动弹出一个chrome浏览器。如果我们想让程序安静地运行,我们可以设置一个无界面,也称为无头浏览器。

1

2

3

4

5

# 参数设置

option = webdriver.ChromeOptions()

option.add_argument("headless")

browser = webdriver.Chrome(options=option)

访问网址

1

2

# 访问百度

browser.get(r'https://www.baidu.com/')

关闭浏览器

1

2

# 关闭浏览器

browser.close()

3. 浏览器设置

浏览器大小

1

2

3

4

5

# 全屏

browser.maximize_window()

# 分辨率 600*800

browser.set_window_size(600,800)

浏览器刷新和刷新键一样,最好写个异常检测

1

2

3

4

5

6

try:

# 刷新页面

browser.refresh()

print('刷新页面')

except Exception as e:

print('刷新失败')

向前向后

1

2

3

4

# 后退

browser.back()

# 前进

browser.forward()

4. 网页基本信息

当前网页的标题等信息。

1

2

3

4

5

6

# 网页标题

print(browser.title)

# 当前网址

print(browser.current_url)

# 浏览器名称

print(browser.name)

也可以直接获取网页源代码,可以直接使用正则表达式、Bs4、xpath等工具解析。

1

print(browser.page_source)

5. 定位页面元素

定位页面元素,即直接在浏览器中查找渲染的元素,而不是源码。以下面的搜索框标签为例

1

2

按 id/name/class 定位

1

2

3

4

# 在百度搜索框中输入python

browser.find_element_by_id('kw').send_keys('python')

browser.find_element_by_name('wd').send_keys('python')

browser.find_element_by_class_name('s_ipt').send_keys('python')

根据标签定位,但实际上,一个页面上可能有很多相同的标签,这会使标签点模糊,从而导致错误。

1

2

# 在百度搜索框中输入python

browser.find_element_by_tag_name('input').send_keys('python')

link定位,定位连接名,例如定位在百度左上角链接的例子中。

1

2

3

4

5

6

新闻

hao123

地图

...

直接通过链接名称定位。

1

2

# 点击新闻链接

browser.find_element_by_link_text('新闻').click()

但是有时候链接名很长,可以使用模糊定位偏,当然链接指向的只是一.

1

2

# 点击含有闻的链接

browser.find_element_by_partial_link_text('闻').click()

上述xpath定位的方法必须保证元素是唯一的。当元素不唯一时,需要使用xpath进行唯一定位,比如使用xpath查找搜索框的位置。

1

2

# 在百度搜索框中输入python

browser.find_element_by_xpath("//*[@id='kw']").send_keys('python')

CSS定位这个方法比xpath更简洁更快

1

2

# 在百度搜索框中输入python

browser.find_element_by_css_selector('#kw').send_keys('python')

定位多个元素当然,有时候我们只需要多个元素,所以只需要使用复数即可。

1

2

3

4

# element s

browser.find_elements_by_class_name(name)

browser.find_elements_by_id(id_)

browser.find_elements_by_name(name)

6. 获取元素信息

通常在上一步定位元素后,对元素进行一些操作。

获取元素属性比如要获取百度logo的信息,先定位图片元素,再获取信息

1

2

3

4

5

# 先使用上述方法获取百度logo元素

logo = browser.find_element_by_class_name('index-logo-src')

# 然后使用get_attribute来获取想要的属性信息

logo = browser.find_element_by_class_name('index-logo-src')

logo_url = logo.get_attribute('src')

获取元素文本,首先使用类直接查找热列表元素,但是有多个元素,所以使用复数形式获取,使用for循环打印。获取文本时,使用文本获取

1

2

3

4

# 获取热榜

hots = browser.find_elements_by_class_name('title-content-title')

for h in hots:

print(h.text)

获取其他属性以获取例如 id 或 tag

1

2

3

4

5

logo = browser.find_element_by_class_name('index-logo-src')

print(logo.id)

print(logo.location)

print(logo.tag_name)

print(logo.size)

7. 页面交互

除了直接获取页面的元素外,有时还需要对页面进行一些操作。

在百度搜索框输入/清除“冬奥会”等文字,然后清除

1

2

3

4

5

6

# 首先获取搜索框元素, 然后使用send_keys输入内容

search_bar = browser.find_element_by_id('kw')

search_bar.send_keys('冬奥会')

# 稍微等两秒, 不然就看不见了

time.sleep(2)

search_bar.clear()

提交(Enter) 输入以上内容后,需要点击回车提交,即可得到想要的搜索信息。

2022年2月5日写这篇博文的时候,百度已经发现了selenium,所以需要添加一些伪装的方法。在本文的最后。:point_right:。

1

2

search_bar.send_keys('冬奥会')

search_bar.submit()

单击 当我们需要单击时,使用单击。比如之前的提交,你也可以找到百度,点击这个按钮,然后点击!

1

2

3

# 点击热榜第一条

hots = browser.find_elements_by_class_name('title-content-title')

hots[0].click()

单选和多选也是一样,定位到对应的元素,然后点击。

并且偶尔会用到右键,这需要一个新的依赖库。

1

2

3

4

5

6

7

from selenium.webdriver.common.action_chains import ActionChains

hots = browser.find_elements_by_class_name('title-content-title')

# 鼠标右击

ActionChains(browser).context_click(hots[0]).perform()

# 双击

# ActionChains(browser).double_click(hots[0]).perform()

双击是double_click。如果找不到合适的例子,我就不提了。这里是 ActionChains,可以深入挖掘,定义一系列操作一起执行。当然,一些常用的操作其实就足够了。

悬停,我无法将其放入。

1

ActionChains(browser).move_to_element(move).perform()

从下拉框中选择需要导入的相关库,访问MySQL官网选择下载对应的操作系统为例。

1

2

3

4

5

6

7

8

9

10

11

12

13

from selenium.webdriver.support.select import Select

# 访问mysql下载官网

browser.get(r'https://dev.mysql.com/downloads/mysql/')

select_os = browser.find_element_by_id('os-ga')

# 使用索引选择第三个

Select(select_os).select_by_index(3)

time.sleep(2)

# 使用value选择value="3"的

Select(select_os).select_by_value("3")

time.sleep(2)

# 使用文本值选择macOS

Select(select_os).select_by_visible_text("macOS")

拖拽多用于验证码之类的,参考菜鸟示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

from selenium.webdriver.common.action_chains import ActionChains

from selenium import webdriver

import time

browser = webdriver.Chrome()

url = 'https://www.runoob.com/try/try ... 27%3B

browser.get(url)

time.sleep(2)

browser.switch_to.frame('iframeResult')

# 开始位置

source = browser.find_element_by_css_selector("#draggable")

# 结束位置

target = browser.find_element_by_css_selector("#droppable")

# 执行元素的拖放操作

actions = ActionChains(browser)

actions.drag_and_drop(source, target)

actions.perform()

# 拖拽

time.sleep(15)

# 关闭浏览器

browser.close()

8. 键盘操作

键盘的大部分操作都有对应的命令,需要导入Keys类

1

2

3

4

5

6

7

8

9

10

11

12

13

14

from selenium.webdriver.common.keys import Keys

# 常见键盘操作

send_keys(Keys.BACK_SPACE) # 删除键

send_keys(Keys.SPACE) # 空格键

send_keys(Keys.TAB) # 制表键

send_keys(Keys.ESCAPE) # 回退键

send_keys(Keys.ENTER) # 回车键

send_keys(Keys.CONTRL,'a') # 全选(Ctrl+A)

send_keys(Keys.CONTRL,'c') # 复制(Ctrl+C)

send_keys(Keys.CONTRL,'x') # 剪切(Ctrl+X)

send_keys(Keys.CONTRL,'v') # 粘贴(Ctrl+V)

send_keys(Keys.F1) # 键盘F1

send_keys(Keys.F12) # 键盘F12

9. 其他

延迟等待可以发现,在上面的程序中,有些效果需要延迟等待才能出现。在实践中,它也需要一定的延迟。一方面为了不访问太频繁被认为是爬虫,另一方面也是爬虫。由于网络资源的加载,需要一定的时间等待。

1

2

3

# 简单的就可以直接使用

time.sleep(2) # 睡眠2秒

# 还有一些 隐式等待 implicitly_wait 和显示等待 WebDriverWait等操作, 另寻

截图可以保存为base64/png/file

1

browser.get_screenshot_as_file('截图.png')

窗口切换 我们的程序是针对当前窗口工作的,但是有时候程序需要切换窗口,所以需要切换当前工作窗口。

1

2

3

4

5

6

7

8

9

# 访问网址:百度

browser.get(r'https://www.baidu.com/')

hots = browser.find_elements_by_class_name('title-content-title')

hots[0].click() # 点击第一个热榜

time.sleep(2)

# 回到第 i 个窗口(按顺序)

browser.switch_to_window(browser.window_handles[0])

time.sleep(2)

hots[1].click() # 点击第一个热榜

当然,如果页面中有iframe元素,需要切换到iframe元素,可以根据它的id进行切换,类似如下

1

2

# 切换到子框架

browser.switch_to.frame('iframeResult')

下拉进度条 有些网页的内容是随着进度条的滑动出现的,所以需要下拉进度条的操作。这个操作是使用js代码实现的,所以我们需要让浏览器执行js代码,其他js代码类似。

1

browser.execute_script('window.scrollTo(0, document.body.scrollHeight)')

10. 防爬

比如上面百度找到,我们需要更好的伪装我们的浏览器浏览器。

1

2

3

4

5

6

7

8

9

10

browser = webdriver.Chrome()

browser.execute_cdp_cmd(

"Page.addScriptToEvaluateOnNewDocument",

{"source": """Object.defineProperty(

navigator,

'webdriver',

{get: () => undefined})"""

}

)

网站检测硒的原理是:

Selenium在打开后给浏览器添加了一些变量值,如:window.navigator.webdriver等。和window.navigator.webdriver一样,在普通谷歌浏览器中是undefined,在selenium打开的谷歌浏览器中为true。网站只需发送js代码,检查这个变量的值给网站,网站判断这个值,如果为真则爬虫程序被拦截或者需要验证码。

当然还有其他的手段,后面会补充。

参考2万字带你了解Selenium全攻略!selenium webdriver打开网页失败,发现是爬虫。解决方案是个人利益

这一次,我回顾了硒的使用。如果仔细观察,操作非常详细。模仿真实的浏览器操作是没有问题的。登录和访问非常简单,也可以作为浏览器上的按钮向导:joy:。

和直接获取资源的爬虫相比,肯定是慢了一些,但是比强大的要好,而且还是可以提高钓鱼效率:+1:。 查看全部

浏览器抓取网页(1.selenium安装selenium库的介绍及安装和常见的使用方法)

本文是爬虫工具selenium的介绍,包括安装和常用的使用方法,后面会整理出来以备不时之需。

1. 硒安装

Selenium 是一种常用的爬虫工具。相比普通爬虫库,它直接模拟调用浏览器直接运行,可以避免很多反爬机制。在某种程度上,它类似于按钮向导。但它更强大。,更可定制。

首先我们需要在 python 环境中安装 selenium 库。

1

2

3

pip install selenium

# 或

conda install selenium

除了基本的python依赖库外,我们还需要安装浏览器驱动。由于我经常使用chrome,所以这里选择chomedriver,其他浏览器需要找到对应的驱动。

首先打开chrome浏览器,在地址栏输入Chrome://version,查看浏览器对应的版本号,比如我当前的版本是:98.0.4758.82(正式版)(64位)。然后在chromedriver官网找到对应的版本下载并解压。(这是官网,有墙)最后把chromedriver.exe放到python环境的Scripts文件夹下,或者项目文件夹下,或者放到自己喜欢的文件夹下(不是)。

好,那我们就开始我们的学习之旅吧!

2. 基本用法

导入库

1

from selenium import webdriver

如果初始浏览器已经放在 Scripts 文件夹中,会直接调用。

1

2

# 初始化选择chrome浏览器

browser = webdriver.Chrome()

否则需要手动选择浏览器的路径,可以是相对路径,也可以是绝对路径。

1

2

# 初始化选择chrome浏览器

browser = webdriver.Chrome(path)

这时候你会发现自动弹出一个chrome浏览器。如果我们想让程序安静地运行,我们可以设置一个无界面,也称为无头浏览器。

1

2

3

4

5

# 参数设置

option = webdriver.ChromeOptions()

option.add_argument("headless")

browser = webdriver.Chrome(options=option)

访问网址

1

2

# 访问百度

browser.get(r'https://www.baidu.com/')

关闭浏览器

1

2

# 关闭浏览器

browser.close()

3. 浏览器设置

浏览器大小

1

2

3

4

5

# 全屏

browser.maximize_window()

# 分辨率 600*800

browser.set_window_size(600,800)

浏览器刷新和刷新键一样,最好写个异常检测

1

2

3

4

5

6

try:

# 刷新页面

browser.refresh()

print('刷新页面')

except Exception as e:

print('刷新失败')

向前向后

1

2

3

4

# 后退

browser.back()

# 前进

browser.forward()

4. 网页基本信息

当前网页的标题等信息。

1

2

3

4

5

6

# 网页标题

print(browser.title)

# 当前网址

print(browser.current_url)

# 浏览器名称

print(browser.name)

也可以直接获取网页源代码,可以直接使用正则表达式、Bs4、xpath等工具解析。

1

print(browser.page_source)

5. 定位页面元素

定位页面元素,即直接在浏览器中查找渲染的元素,而不是源码。以下面的搜索框标签为例

1

2

按 id/name/class 定位

1

2

3

4

# 在百度搜索框中输入python

browser.find_element_by_id('kw').send_keys('python')

browser.find_element_by_name('wd').send_keys('python')

browser.find_element_by_class_name('s_ipt').send_keys('python')

根据标签定位,但实际上,一个页面上可能有很多相同的标签,这会使标签点模糊,从而导致错误。

1

2

# 在百度搜索框中输入python

browser.find_element_by_tag_name('input').send_keys('python')

link定位,定位连接名,例如定位在百度左上角链接的例子中。

1

2

3

4

5

6

新闻

hao123

地图

...

直接通过链接名称定位。

1

2

# 点击新闻链接

browser.find_element_by_link_text('新闻').click()

但是有时候链接名很长,可以使用模糊定位偏,当然链接指向的只是一.

1

2

# 点击含有闻的链接

browser.find_element_by_partial_link_text('闻').click()

上述xpath定位的方法必须保证元素是唯一的。当元素不唯一时,需要使用xpath进行唯一定位,比如使用xpath查找搜索框的位置。

1

2

# 在百度搜索框中输入python

browser.find_element_by_xpath("//*[@id='kw']").send_keys('python')

CSS定位这个方法比xpath更简洁更快

1

2

# 在百度搜索框中输入python

browser.find_element_by_css_selector('#kw').send_keys('python')

定位多个元素当然,有时候我们只需要多个元素,所以只需要使用复数即可。

1

2

3

4

# element s

browser.find_elements_by_class_name(name)

browser.find_elements_by_id(id_)

browser.find_elements_by_name(name)

6. 获取元素信息

通常在上一步定位元素后,对元素进行一些操作。

获取元素属性比如要获取百度logo的信息,先定位图片元素,再获取信息

1

2

3

4

5

# 先使用上述方法获取百度logo元素

logo = browser.find_element_by_class_name('index-logo-src')

# 然后使用get_attribute来获取想要的属性信息

logo = browser.find_element_by_class_name('index-logo-src')

logo_url = logo.get_attribute('src')

获取元素文本,首先使用类直接查找热列表元素,但是有多个元素,所以使用复数形式获取,使用for循环打印。获取文本时,使用文本获取

1

2

3

4

# 获取热榜

hots = browser.find_elements_by_class_name('title-content-title')

for h in hots:

print(h.text)

获取其他属性以获取例如 id 或 tag

1

2

3

4

5

logo = browser.find_element_by_class_name('index-logo-src')

print(logo.id)

print(logo.location)

print(logo.tag_name)

print(logo.size)

7. 页面交互

除了直接获取页面的元素外,有时还需要对页面进行一些操作。

在百度搜索框输入/清除“冬奥会”等文字,然后清除

1

2

3

4

5

6

# 首先获取搜索框元素, 然后使用send_keys输入内容

search_bar = browser.find_element_by_id('kw')

search_bar.send_keys('冬奥会')

# 稍微等两秒, 不然就看不见了

time.sleep(2)

search_bar.clear()

提交(Enter) 输入以上内容后,需要点击回车提交,即可得到想要的搜索信息。

2022年2月5日写这篇博文的时候,百度已经发现了selenium,所以需要添加一些伪装的方法。在本文的最后。:point_right:。

1

2

search_bar.send_keys('冬奥会')

search_bar.submit()

单击 当我们需要单击时,使用单击。比如之前的提交,你也可以找到百度,点击这个按钮,然后点击!

1

2

3

# 点击热榜第一条

hots = browser.find_elements_by_class_name('title-content-title')

hots[0].click()

单选和多选也是一样,定位到对应的元素,然后点击。

并且偶尔会用到右键,这需要一个新的依赖库。

1

2

3

4

5

6

7

from selenium.webdriver.common.action_chains import ActionChains

hots = browser.find_elements_by_class_name('title-content-title')

# 鼠标右击

ActionChains(browser).context_click(hots[0]).perform()

# 双击

# ActionChains(browser).double_click(hots[0]).perform()

双击是double_click。如果找不到合适的例子,我就不提了。这里是 ActionChains,可以深入挖掘,定义一系列操作一起执行。当然,一些常用的操作其实就足够了。

悬停,我无法将其放入。

1

ActionChains(browser).move_to_element(move).perform()

从下拉框中选择需要导入的相关库,访问MySQL官网选择下载对应的操作系统为例。

1

2

3

4

5

6

7

8

9

10

11

12

13

from selenium.webdriver.support.select import Select

# 访问mysql下载官网

browser.get(r'https://dev.mysql.com/downloads/mysql/')

select_os = browser.find_element_by_id('os-ga')

# 使用索引选择第三个

Select(select_os).select_by_index(3)

time.sleep(2)

# 使用value选择value="3"的

Select(select_os).select_by_value("3")

time.sleep(2)

# 使用文本值选择macOS

Select(select_os).select_by_visible_text("macOS")

拖拽多用于验证码之类的,参考菜鸟示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

from selenium.webdriver.common.action_chains import ActionChains

from selenium import webdriver

import time

browser = webdriver.Chrome()

url = 'https://www.runoob.com/try/try ... 27%3B

browser.get(url)

time.sleep(2)

browser.switch_to.frame('iframeResult')

# 开始位置

source = browser.find_element_by_css_selector("#draggable")

# 结束位置

target = browser.find_element_by_css_selector("#droppable")

# 执行元素的拖放操作

actions = ActionChains(browser)

actions.drag_and_drop(source, target)

actions.perform()

# 拖拽

time.sleep(15)

# 关闭浏览器

browser.close()

8. 键盘操作

键盘的大部分操作都有对应的命令,需要导入Keys类

1

2

3

4

5

6

7

8

9

10

11

12

13

14

from selenium.webdriver.common.keys import Keys

# 常见键盘操作

send_keys(Keys.BACK_SPACE) # 删除键

send_keys(Keys.SPACE) # 空格键

send_keys(Keys.TAB) # 制表键

send_keys(Keys.ESCAPE) # 回退键

send_keys(Keys.ENTER) # 回车键

send_keys(Keys.CONTRL,'a') # 全选(Ctrl+A)

send_keys(Keys.CONTRL,'c') # 复制(Ctrl+C)

send_keys(Keys.CONTRL,'x') # 剪切(Ctrl+X)

send_keys(Keys.CONTRL,'v') # 粘贴(Ctrl+V)

send_keys(Keys.F1) # 键盘F1

send_keys(Keys.F12) # 键盘F12

9. 其他

延迟等待可以发现,在上面的程序中,有些效果需要延迟等待才能出现。在实践中,它也需要一定的延迟。一方面为了不访问太频繁被认为是爬虫,另一方面也是爬虫。由于网络资源的加载,需要一定的时间等待。

1

2

3

# 简单的就可以直接使用

time.sleep(2) # 睡眠2秒

# 还有一些 隐式等待 implicitly_wait 和显示等待 WebDriverWait等操作, 另寻

截图可以保存为base64/png/file

1

browser.get_screenshot_as_file('截图.png')

窗口切换 我们的程序是针对当前窗口工作的,但是有时候程序需要切换窗口,所以需要切换当前工作窗口。

1

2

3

4

5

6

7

8

9

# 访问网址:百度

browser.get(r'https://www.baidu.com/')

hots = browser.find_elements_by_class_name('title-content-title')

hots[0].click() # 点击第一个热榜

time.sleep(2)

# 回到第 i 个窗口(按顺序)

browser.switch_to_window(browser.window_handles[0])

time.sleep(2)

hots[1].click() # 点击第一个热榜

当然,如果页面中有iframe元素,需要切换到iframe元素,可以根据它的id进行切换,类似如下

1

2

# 切换到子框架

browser.switch_to.frame('iframeResult')

下拉进度条 有些网页的内容是随着进度条的滑动出现的,所以需要下拉进度条的操作。这个操作是使用js代码实现的,所以我们需要让浏览器执行js代码,其他js代码类似。

1

browser.execute_script('window.scrollTo(0, document.body.scrollHeight)')

10. 防爬

比如上面百度找到,我们需要更好的伪装我们的浏览器浏览器。

1

2

3

4

5

6

7

8

9

10

browser = webdriver.Chrome()

browser.execute_cdp_cmd(

"Page.addScriptToEvaluateOnNewDocument",

{"source": """Object.defineProperty(

navigator,

'webdriver',

{get: () => undefined})"""

}

)

网站检测硒的原理是:

Selenium在打开后给浏览器添加了一些变量值,如:window.navigator.webdriver等。和window.navigator.webdriver一样,在普通谷歌浏览器中是undefined,在selenium打开的谷歌浏览器中为true。网站只需发送js代码,检查这个变量的值给网站,网站判断这个值,如果为真则爬虫程序被拦截或者需要验证码。

当然还有其他的手段,后面会补充。

参考2万字带你了解Selenium全攻略!selenium webdriver打开网页失败,发现是爬虫。解决方案是个人利益

这一次,我回顾了硒的使用。如果仔细观察,操作非常详细。模仿真实的浏览器操作是没有问题的。登录和访问非常简单,也可以作为浏览器上的按钮向导:joy:。

和直接获取资源的爬虫相比,肯定是慢了一些,但是比强大的要好,而且还是可以提高钓鱼效率:+1:。

浏览器抓取网页(谷歌浏览器插件开发文档,插件总结经验 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2022-02-06 16:09

)

前言

由于业务需要,笔者想为公司开发几个实用的浏览器插件,所以一般花了一天时间看完了谷歌浏览器插件开发文档,这里特意总结一下经验,对插件进行复习——通过一个实际案例。开发过程及注意事项.javascript

你会得到文字

正文开始之前,先看一下作者总结的概述:css

如果你熟悉浏览器插件开发,可以直接观看最后一节插件开发实践。1.开始

首先我们看一下浏览器插件的定义:html

浏览器插件是基于 HTML、JavaScript 和 CSS 等 Web 技术构建的小型软件程序,可自定义浏览体验。它们使用户能够根据我的需要或偏好自定义 Chrome 的功能和行为。前端

要开发一个浏览器插件,我们只需要一个 manifest.json 文件。为了快速上手浏览器插件开发,我们需要打开浏览器开发者工具。具体步骤如下:vue

在谷歌浏览器中输入 chrome://extensions/ 开启开发者模式

导入自己的浏览器插件包

经过以上三步,我们就可以开始浏览器插件的开发之旅了。浏览器插件一般放在浏览器地址栏的右侧,我们可以在manifest.json文件中配置插件的图标,并配置一定的规则,就可以看到我们的浏览器插件图标,下图:java

下面详细讲解一下浏览器插件开发的核心概念。2.核心知识点

浏览器插件通常涉及以下核心文件:node

作者画了一张图来粗略表示它们之间的关系:jquery

接下来,让我们仔细看看几个核心知识点。网页包

2.1 manifest.json

谷歌官网为我们提供了一个简单的配置,如下:css3

{

"name": "My Extension",

"version": "2.1",

"description": "Gets information from Google.",

"icons": {

"128": "icon_16.png",

"128": "icon_32.png",

"128": "icon_48.png",

"128": "icon_128.png"

},

"background": {

"persistent": false,

"scripts": ["background_script.js"]

},

"permissions": ["https://*.google.com/", "activeTab"],

"browser_action": {

"default_icon": "icon_16.png",

"default_popup": "popup.html"

}

}

复制代码

每个字段的含义描述如下:

完整的配置文件地址会在文末给出,供大家参考。

2.2 背景.js

后台页面主要用于提供一些全局配置、事件监控、业务转发等,下面是几个常见的用例:

定义右键菜单

// background.js

const systems = {

a: '趣谈前端',

b: '掘金',

c: '微信'

}

chrome.runtime.onInstalled.addListener(function() {

// 上下文菜单

for (let key of Object.keys(systems)) {

chrome.contextMenus.create({

id: key,

title: systems[key],

type: 'normal',

contexts: ['selection'],

});

}

});

// manifest.json

{

"permissions": ["contextMenus"]

}

复制代码

效果如下:

仅设置带有 .com 后缀的页面以激活插件

chrome.runtime.onInstalled.addListener(function() {

// 相似于何时激活浏览器插件图标这种感受

chrome.declarativeContent.onPageChanged.removeRules(undefined, function() {

chrome.declarativeContent.onPageChanged.addRules([{

conditions: [new chrome.declarativeContent.PageStateMatcher({

pageUrl: {hostSuffix: '.com'},

})

],

actions: [new chrome.declarativeContent.ShowPageAction()]

}]);

});

});

复制代码

如下图所示,当页面地址后缀不等于.com时,插件图标不会被激活:

3. 与 content_script 或弹出页面通信

chrome.runtime.onMessage.addListener(

function(request, sender, sendResponse) {

console.log(sender.tab ?

"from a content script:" + sender.tab.url :

"from the extension");

if (request.greeting == "hello")

sendResponse({farewell: "goodbye"});

});

复制代码

2.3 个内容脚本

内容脚本通常被植入到页面中,并且可以控制页面中的dom。我们可以用它来屏蔽网页广告,自定义页面皮肤等。manifest.json中的基本配置如下:

{

"content_scripts": [{

"matches": [

"http://*/*",

"https://*/*"

],

"js": [

"lib/jquery3.4.min.js",

"content_script.js"

],

"css": ["base.css"]

}],

}

复制代码

在上面的代码中,我们定义了 content_scripts 允许注入的页面范围,插入页面的 js 和 css,这样我们就可以很方便的改变页面的样式。例如,我们可以在页面中注入一个按钮:

在下面的浏览器插件案例中,笔者将详细介绍content_scripts的用法。2.4 弹出窗口

弹出窗口是用户单击插件图标时打开的小窗口。当失去焦点时,窗口立即关闭。我们通常用它来处理一些简单的用户交互和插件描述。

因为弹窗也是网页,所以我们通常会创建一个popup.html和popup.js来控制弹窗的页面显示和交互。我们在 manifest.json 中配置如下:

{

"page_action": {

"default_title": "小夕图片提取插件",

"default_popup": "popup.html"

},

}

复制代码

这里需要注意的一点是,我们不能直接在popup.html中使用脚本脚本,我们需要导入脚本文件。下列:

在线图片提取工具

复制代码

下面是作者写的一个插件的弹窗页面:

3.通讯机制

对于一个比较复杂的浏览器插件,我们不仅需要操作 DOM 或者提供基本的功能,还需要从第三方或者我们自己的服务器上获取有用的页面数据。这时候,我们就需要使用插件式的通信机制了。

由于content_script脚本存在于当前页面且受同源策略影响,我们无法将抓取到的数据传输到第三方平台或自己的服务器,因此需要一个基于浏览器的通信API。下面是谷歌浏览器插件通信流程:

3.1 弹出和后台相互通信

从官方文档我们知道popup可以直接访问后台页面,所以popup可以直接与之通信:

// background.js

var getData = (data) => { console.log('拿到数据:' + data) }

// popup.js

let bgObj = chrome.extension.getBackgroundPage();

bgObj.getData(); // 访问bg的函数

复制代码

3.2 弹出或后台页面与content_script通信

这里我们使用chrome的tabs API,如下:

// popup.js

// 发送消息给content_script

chrome.tabs.query({active: true, currentWindow: true}, function(tabs) {

chrome.tabs.sendMessage(tabs[0].id, "activeBtn", function(response) {

console.log(response);

});

});

// 接收消息

chrome.runtime.onMessage.addListener(

function(request, sender, sendResponse) {

console.log(sender.tab ?

"from a content script:" + sender.tab.url :

"from the extension");

if (request.greeting == "hello")

sendResponse({farewell: "goodbye"});

});

复制代码

content_script 接收和发送消息:

// 接收消息

chrome.runtime.onMessage.addListener(

function(message, sender, sendResponse) {

if (message == "activeBtn"){

// ...

sendResponse({farewell: "激活成功"});

}

});

// 主动发送消息

chrome.runtime.sendMessage({greeting: "hello"}, function(response) {

console.log(response, document.body);

// document.body.style.backgroundColor="orange"

});

复制代码

这条新闻的长链接在谷歌官网上也写得很清楚:

我们可以通过以下方式制作长链接:

// content_script.js

var port = chrome.runtime.connect({name: "徐小夕"});

port.postMessage({Ling: "你好"});

port.onMessage.addListener(function(msg) {

if (msg.question == "你是作什么滴?")

port.postMessage({answer: "搬砖"});

else if (msg.question == "搬砖有钱吗?")

port.postMessage({answer: "木有"});

});

// popup.js

chrome.runtime.onConnect.addListener(function(port) {

port.onMessage.addListener(function(msg) {

if (msg.Ling == "你好")

port.postMessage({question: "你是作什么滴?"});

else if (msg.answer == "搬砖")

port.postMessage({question: "搬砖有钱吗?"});

else if (msg.answer == "木有")

port.postMessage({question: "太难了."});

});

});

复制代码

4.数据存储

chrome.storage 用于为插件全局存储数据。我们将数据存储在任何页面(弹出窗口或 content_script 或背景)下。我们可以在上面三个页面上得到它。具体用法如下:

获取数据

chrome.storage.sync.get('imgArr', function(data) {

console.log(data)

});

// 保存数据

chrome.storage.sync.set({'imgArr': imgArr}, function() {

console.log('保存成功');

});

// 另外一种方式

chrome.storage.local.set({key: value}, function() {

console.log('Value is set to ' + value);

});

复制代码

5.应用场景

谷歌浏览器插件的应用场景很多,在文章开头的思维导图中写过。以下是作者总结的一些应用场景,有兴趣可以尝试实现:

有很多实用的工具可以开发,你可以玩得开心。接下来我们通过实现一个网页图片提取插件来总结以下浏览器插件的开发流程。

6.开发一个抓取网站图片资源的浏览器插件

首先,按照作者的风格,在开发任何一种工具之前,都必须明确需求,那么我们来看看插件的功能点:

基本上,这些是功能。接下来,我将展示核心代码。在介绍代码之前,我们先来预览一下插件的实现效果:

插件目录结构如下:

由于插件的开发比较简单,所以我直接使用jquery来开发。这里我们主要关注popup.js和content_script.js。popup.js主要用于获取content_script页面传过来的图片数据,并在popup.html中显示。还有一点需要注意的是,当页面没有注入生成的按钮时,popupu需要向内容页面发送信息,并自动让它生成一个按钮,代码如下:

chrome.storage.sync.get('imgArr', function(data) {

data.imgArr && data.imgArr.forEach(item => {

var imgWrap = $("")

var img = $(""/span + item + span class="hljs-string""")

imgWrap.append(img);

$('#content').append(imgWrap);

$('.empty').hide();

})

});

$('#activeBtn').click(function(element) {

chrome.tabs.query({active: true, currentWindow: true}, function(tabs) {

chrome.tabs.sendMessage(tabs[0].id, "activeBtn", function(response) {

console.log(response);

});

});

});

复制代码

对于内容页面,我们需要实现的是动态生成一个按钮,并在页面中植入一个弹窗来显示获取到的图片。另一方面,我们需要将图像数据传递到存储中,以便弹出页面可以获取图像数据。

因为页面比较简单,所以作者不需要太多的第三方库。作者简单的先写了一个modal组件。代码如下:

// 弹窗

~function Modal() {

var modal;

if(this instanceof Modal) {

this.init = function(opt) {

modal = $("");

var title = $("" + opt.title + "");

var close_btn = $("X");

var content = $("");

var mask = $("");

close_btn.click(function(){

modal.hide()

})

title.append(close_btn);

content.append(title);

content.append(opt.content);

modal.append(content);

modal.append(mask);

$('body').append(modal);

}

this.show = function(opt) {

if(modal) {

modal.show();

}else {

var options = {

title: opt.title || '标题',

content: opt.content || ''

}

this.init(options)

modal.show();

}

}

this.hide = function() {

modal.hide();

}

}else {

window.Modal = new Modal()

}

}()

复制代码

第一步,批量获取页面图片数据:

var imgArr = []

$('img').each(function(i) {

var src = $(this).attr('src');

var realSrc = /^(http|https)/.test(src) ? src : location.protocol+ '//' + location.host + src;

imgArr.push(realSrc)

})

复制代码

由于图片的src路径多为相对地址,笔者利用正则简单处理如下,虽然我们可以进行更细粒度的控制。

第二步,将图像数据存入storage:

chrome.storage.sync.set({'imgArr': imgArr}, function() {

console.log('保存成功');

});

复制代码

第三步是生成一个用于预览图像的弹出窗口。这里使用了上面作者实现的modal组件:

Modal.show({

title: '提取结果',

content: imgBox

})

复制代码

第四步,当弹窗发送通知激活按钮时,我们需要在网页中动态插入生成的按钮:

chrome.runtime.onMessage.addListener(

function(message, sender, sendResponse) {

if (message == "activeBtn"){

if(!$('.crawl-btn')) {

$('body').append("提取")

}else {

$('.crawl-btn').css("background-color","orange");

setTimeout(() => {

$('.crawl-btn').css("background-color","#06c");

}, 3000);

}

sendResponse({farewell: "激活成功"});

}

});

复制代码

setTimeout 部分纯粹是为了吸引用户的注意力,虽然我们可以用更优雅的方式来处理它。插件的核心代码主要是这些。当然,还有很多细节需要考虑。我把配置文件和一些细节放在github上。有兴趣的朋友可以安装感受一下。

github地址:一个提取网页图片数据的浏览器插件

最后

如果想学习更多H5游戏、webpack、node、gulp、css3、javascript、nodeJS、canvas数据可视化等前端知识和实战,欢迎在公众号“趣前沿”加入我们的技术群-end”一起学习、讨论和探索前端边界。

查看全部

浏览器抓取网页(谷歌浏览器插件开发文档,插件总结经验

)

前言

由于业务需要,笔者想为公司开发几个实用的浏览器插件,所以一般花了一天时间看完了谷歌浏览器插件开发文档,这里特意总结一下经验,对插件进行复习——通过一个实际案例。开发过程及注意事项.javascript

你会得到文字

正文开始之前,先看一下作者总结的概述:css

如果你熟悉浏览器插件开发,可以直接观看最后一节插件开发实践。1.开始

首先我们看一下浏览器插件的定义:html

浏览器插件是基于 HTML、JavaScript 和 CSS 等 Web 技术构建的小型软件程序,可自定义浏览体验。它们使用户能够根据我的需要或偏好自定义 Chrome 的功能和行为。前端

要开发一个浏览器插件,我们只需要一个 manifest.json 文件。为了快速上手浏览器插件开发,我们需要打开浏览器开发者工具。具体步骤如下:vue

在谷歌浏览器中输入 chrome://extensions/ 开启开发者模式

导入自己的浏览器插件包

经过以上三步,我们就可以开始浏览器插件的开发之旅了。浏览器插件一般放在浏览器地址栏的右侧,我们可以在manifest.json文件中配置插件的图标,并配置一定的规则,就可以看到我们的浏览器插件图标,下图:java

下面详细讲解一下浏览器插件开发的核心概念。2.核心知识点

浏览器插件通常涉及以下核心文件:node

作者画了一张图来粗略表示它们之间的关系:jquery

接下来,让我们仔细看看几个核心知识点。网页包

2.1 manifest.json

谷歌官网为我们提供了一个简单的配置,如下:css3

{

"name": "My Extension",

"version": "2.1",

"description": "Gets information from Google.",

"icons": {

"128": "icon_16.png",

"128": "icon_32.png",

"128": "icon_48.png",

"128": "icon_128.png"

},

"background": {

"persistent": false,

"scripts": ["background_script.js"]

},

"permissions": ["https://*.google.com/", "activeTab"],

"browser_action": {

"default_icon": "icon_16.png",

"default_popup": "popup.html"

}

}

复制代码

每个字段的含义描述如下:

完整的配置文件地址会在文末给出,供大家参考。

2.2 背景.js

后台页面主要用于提供一些全局配置、事件监控、业务转发等,下面是几个常见的用例:

定义右键菜单

// background.js

const systems = {

a: '趣谈前端',

b: '掘金',

c: '微信'

}

chrome.runtime.onInstalled.addListener(function() {

// 上下文菜单

for (let key of Object.keys(systems)) {

chrome.contextMenus.create({

id: key,

title: systems[key],

type: 'normal',

contexts: ['selection'],

});

}

});

// manifest.json

{

"permissions": ["contextMenus"]

}

复制代码

效果如下:

仅设置带有 .com 后缀的页面以激活插件

chrome.runtime.onInstalled.addListener(function() {

// 相似于何时激活浏览器插件图标这种感受

chrome.declarativeContent.onPageChanged.removeRules(undefined, function() {

chrome.declarativeContent.onPageChanged.addRules([{

conditions: [new chrome.declarativeContent.PageStateMatcher({

pageUrl: {hostSuffix: '.com'},

})

],

actions: [new chrome.declarativeContent.ShowPageAction()]

}]);

});

});

复制代码

如下图所示,当页面地址后缀不等于.com时,插件图标不会被激活:

3. 与 content_script 或弹出页面通信

chrome.runtime.onMessage.addListener(

function(request, sender, sendResponse) {

console.log(sender.tab ?

"from a content script:" + sender.tab.url :

"from the extension");

if (request.greeting == "hello")

sendResponse({farewell: "goodbye"});

});

复制代码

2.3 个内容脚本

内容脚本通常被植入到页面中,并且可以控制页面中的dom。我们可以用它来屏蔽网页广告,自定义页面皮肤等。manifest.json中的基本配置如下:

{

"content_scripts": [{

"matches": [

"http://*/*",

"https://*/*"

],

"js": [

"lib/jquery3.4.min.js",

"content_script.js"

],

"css": ["base.css"]

}],

}

复制代码

在上面的代码中,我们定义了 content_scripts 允许注入的页面范围,插入页面的 js 和 css,这样我们就可以很方便的改变页面的样式。例如,我们可以在页面中注入一个按钮:

在下面的浏览器插件案例中,笔者将详细介绍content_scripts的用法。2.4 弹出窗口

弹出窗口是用户单击插件图标时打开的小窗口。当失去焦点时,窗口立即关闭。我们通常用它来处理一些简单的用户交互和插件描述。

因为弹窗也是网页,所以我们通常会创建一个popup.html和popup.js来控制弹窗的页面显示和交互。我们在 manifest.json 中配置如下:

{

"page_action": {

"default_title": "小夕图片提取插件",

"default_popup": "popup.html"

},

}

复制代码

这里需要注意的一点是,我们不能直接在popup.html中使用脚本脚本,我们需要导入脚本文件。下列:

在线图片提取工具

复制代码

下面是作者写的一个插件的弹窗页面:

3.通讯机制

对于一个比较复杂的浏览器插件,我们不仅需要操作 DOM 或者提供基本的功能,还需要从第三方或者我们自己的服务器上获取有用的页面数据。这时候,我们就需要使用插件式的通信机制了。

由于content_script脚本存在于当前页面且受同源策略影响,我们无法将抓取到的数据传输到第三方平台或自己的服务器,因此需要一个基于浏览器的通信API。下面是谷歌浏览器插件通信流程:

3.1 弹出和后台相互通信

从官方文档我们知道popup可以直接访问后台页面,所以popup可以直接与之通信:

// background.js

var getData = (data) => { console.log('拿到数据:' + data) }

// popup.js

let bgObj = chrome.extension.getBackgroundPage();

bgObj.getData(); // 访问bg的函数

复制代码

3.2 弹出或后台页面与content_script通信

这里我们使用chrome的tabs API,如下:

// popup.js

// 发送消息给content_script

chrome.tabs.query({active: true, currentWindow: true}, function(tabs) {

chrome.tabs.sendMessage(tabs[0].id, "activeBtn", function(response) {

console.log(response);

});

});

// 接收消息

chrome.runtime.onMessage.addListener(

function(request, sender, sendResponse) {

console.log(sender.tab ?

"from a content script:" + sender.tab.url :

"from the extension");

if (request.greeting == "hello")

sendResponse({farewell: "goodbye"});

});

复制代码

content_script 接收和发送消息:

// 接收消息

chrome.runtime.onMessage.addListener(

function(message, sender, sendResponse) {

if (message == "activeBtn"){

// ...

sendResponse({farewell: "激活成功"});

}

});

// 主动发送消息

chrome.runtime.sendMessage({greeting: "hello"}, function(response) {

console.log(response, document.body);

// document.body.style.backgroundColor="orange"

});

复制代码

这条新闻的长链接在谷歌官网上也写得很清楚:

我们可以通过以下方式制作长链接:

// content_script.js

var port = chrome.runtime.connect({name: "徐小夕"});

port.postMessage({Ling: "你好"});

port.onMessage.addListener(function(msg) {

if (msg.question == "你是作什么滴?")

port.postMessage({answer: "搬砖"});

else if (msg.question == "搬砖有钱吗?")

port.postMessage({answer: "木有"});

});

// popup.js

chrome.runtime.onConnect.addListener(function(port) {

port.onMessage.addListener(function(msg) {

if (msg.Ling == "你好")

port.postMessage({question: "你是作什么滴?"});

else if (msg.answer == "搬砖")

port.postMessage({question: "搬砖有钱吗?"});

else if (msg.answer == "木有")

port.postMessage({question: "太难了."});

});

});

复制代码

4.数据存储

chrome.storage 用于为插件全局存储数据。我们将数据存储在任何页面(弹出窗口或 content_script 或背景)下。我们可以在上面三个页面上得到它。具体用法如下:

获取数据

chrome.storage.sync.get('imgArr', function(data) {

console.log(data)

});

// 保存数据

chrome.storage.sync.set({'imgArr': imgArr}, function() {

console.log('保存成功');

});

// 另外一种方式

chrome.storage.local.set({key: value}, function() {

console.log('Value is set to ' + value);

});

复制代码

5.应用场景

谷歌浏览器插件的应用场景很多,在文章开头的思维导图中写过。以下是作者总结的一些应用场景,有兴趣可以尝试实现:

有很多实用的工具可以开发,你可以玩得开心。接下来我们通过实现一个网页图片提取插件来总结以下浏览器插件的开发流程。

6.开发一个抓取网站图片资源的浏览器插件

首先,按照作者的风格,在开发任何一种工具之前,都必须明确需求,那么我们来看看插件的功能点:

基本上,这些是功能。接下来,我将展示核心代码。在介绍代码之前,我们先来预览一下插件的实现效果:

插件目录结构如下:

由于插件的开发比较简单,所以我直接使用jquery来开发。这里我们主要关注popup.js和content_script.js。popup.js主要用于获取content_script页面传过来的图片数据,并在popup.html中显示。还有一点需要注意的是,当页面没有注入生成的按钮时,popupu需要向内容页面发送信息,并自动让它生成一个按钮,代码如下:

chrome.storage.sync.get('imgArr', function(data) {

data.imgArr && data.imgArr.forEach(item => {

var imgWrap = $("")

var img = $(""/span + item + span class="hljs-string""")

imgWrap.append(img);

$('#content').append(imgWrap);

$('.empty').hide();

})

});

$('#activeBtn').click(function(element) {

chrome.tabs.query({active: true, currentWindow: true}, function(tabs) {

chrome.tabs.sendMessage(tabs[0].id, "activeBtn", function(response) {

console.log(response);

});

});

});

复制代码

对于内容页面,我们需要实现的是动态生成一个按钮,并在页面中植入一个弹窗来显示获取到的图片。另一方面,我们需要将图像数据传递到存储中,以便弹出页面可以获取图像数据。

因为页面比较简单,所以作者不需要太多的第三方库。作者简单的先写了一个modal组件。代码如下:

// 弹窗

~function Modal() {

var modal;

if(this instanceof Modal) {

this.init = function(opt) {

modal = $("");

var title = $("" + opt.title + "");

var close_btn = $("X");

var content = $("");

var mask = $("");

close_btn.click(function(){

modal.hide()

})

title.append(close_btn);

content.append(title);

content.append(opt.content);

modal.append(content);

modal.append(mask);

$('body').append(modal);

}

this.show = function(opt) {

if(modal) {

modal.show();

}else {

var options = {

title: opt.title || '标题',

content: opt.content || ''

}

this.init(options)

modal.show();

}

}

this.hide = function() {

modal.hide();

}

}else {

window.Modal = new Modal()

}

}()

复制代码

第一步,批量获取页面图片数据:

var imgArr = []

$('img').each(function(i) {

var src = $(this).attr('src');

var realSrc = /^(http|https)/.test(src) ? src : location.protocol+ '//' + location.host + src;

imgArr.push(realSrc)

})

复制代码

由于图片的src路径多为相对地址,笔者利用正则简单处理如下,虽然我们可以进行更细粒度的控制。

第二步,将图像数据存入storage:

chrome.storage.sync.set({'imgArr': imgArr}, function() {

console.log('保存成功');

});

复制代码

第三步是生成一个用于预览图像的弹出窗口。这里使用了上面作者实现的modal组件:

Modal.show({

title: '提取结果',

content: imgBox

})

复制代码

第四步,当弹窗发送通知激活按钮时,我们需要在网页中动态插入生成的按钮:

chrome.runtime.onMessage.addListener(

function(message, sender, sendResponse) {

if (message == "activeBtn"){

if(!$('.crawl-btn')) {

$('body').append("提取")

}else {

$('.crawl-btn').css("background-color","orange");

setTimeout(() => {

$('.crawl-btn').css("background-color","#06c");

}, 3000);

}

sendResponse({farewell: "激活成功"});

}

});

复制代码

setTimeout 部分纯粹是为了吸引用户的注意力,虽然我们可以用更优雅的方式来处理它。插件的核心代码主要是这些。当然,还有很多细节需要考虑。我把配置文件和一些细节放在github上。有兴趣的朋友可以安装感受一下。

github地址:一个提取网页图片数据的浏览器插件

最后

如果想学习更多H5游戏、webpack、node、gulp、css3、javascript、nodeJS、canvas数据可视化等前端知识和实战,欢迎在公众号“趣前沿”加入我们的技术群-end”一起学习、讨论和探索前端边界。

浏览器抓取网页(网页抓取网页必须要会操作浏览器相对于(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-02-05 22:04

浏览器抓取网页必须要会操作浏览器,相对于浏览器程序员来说,那么页面抓取基本功还是有必要掌握的,javascript是一门强大的编程语言。页面抓取作为网页抓取入门都很重要,比如说登录时不同的人有不同的账号,如何去统计谁最先注册,如何搜索重要网页页面等等。当然,开发过程中碰到问题还是需要联系网站解决的。网页抓取相对java抓取就简单很多,因为网页的结构不会变化,变化的只是网页元素的排列顺序,统计相对容易。

javascript的使用,网页的重定向、iframe框架的制作,网页怎么展示大家可以用最简单的办法就能达到一定的效果,今天我们讲解一下web容器中通过html解析出来script标签,然后才能使用dom查看器解析,编写方法大家可以采用javascript引擎来进行编写和调试。我们先来看一下script标签的基本格式html/script.jsmydom.prefix为前导标签,importjs,functionxxx(){returneval(xxx);}object标签的内容是声明属性并且赋值到dom中,属性值必须是一个已有的属性属性值,如果是指向第三方库,xxx()必须带有prototype属性标签必须包含“返回类型”,一般都为"prototype"或者"void",包含类型不能在js里用,如果不加就会进入对象的null对象,或者是对象prototype属性,导致调用计算机解析的时候报错异常,例如javascript://importjsfrom"@//".src这个是importxxx()到dom上,假如name属性值为1,浏览器会解析为'{1:"1"}',但是javascript://importxxxfrom"@//".src会得到"privatestring"不再是'1',此时将name属性值设置为'1',浏览器会自动更改成'1'importxxxfrom"@//".src会得到'privatestring'有import(),一般都带有prototype属性注意的是此时'1'变为number(number)下面再来举个例子://.//name.shortindex=""name=("hello").slice(。

1).reduce((mid,item1,item

2)=>mid+item2+""){name=("hello").slice

2)=>mid+item2+"")}returnname}当dom转化为javascript时一定要判断会不会符合这个规则,不然得自己设置.script标签的实现也很简单,大家可以用chrome网页代码监控dom来实现,当dom元素中存在item1和item2时,我们的代码就不会更新了,可以保存原有 查看全部

浏览器抓取网页(网页抓取网页必须要会操作浏览器相对于(组图))

浏览器抓取网页必须要会操作浏览器,相对于浏览器程序员来说,那么页面抓取基本功还是有必要掌握的,javascript是一门强大的编程语言。页面抓取作为网页抓取入门都很重要,比如说登录时不同的人有不同的账号,如何去统计谁最先注册,如何搜索重要网页页面等等。当然,开发过程中碰到问题还是需要联系网站解决的。网页抓取相对java抓取就简单很多,因为网页的结构不会变化,变化的只是网页元素的排列顺序,统计相对容易。

javascript的使用,网页的重定向、iframe框架的制作,网页怎么展示大家可以用最简单的办法就能达到一定的效果,今天我们讲解一下web容器中通过html解析出来script标签,然后才能使用dom查看器解析,编写方法大家可以采用javascript引擎来进行编写和调试。我们先来看一下script标签的基本格式html/script.jsmydom.prefix为前导标签,importjs,functionxxx(){returneval(xxx);}object标签的内容是声明属性并且赋值到dom中,属性值必须是一个已有的属性属性值,如果是指向第三方库,xxx()必须带有prototype属性标签必须包含“返回类型”,一般都为"prototype"或者"void",包含类型不能在js里用,如果不加就会进入对象的null对象,或者是对象prototype属性,导致调用计算机解析的时候报错异常,例如javascript://importjsfrom"@//".src这个是importxxx()到dom上,假如name属性值为1,浏览器会解析为'{1:"1"}',但是javascript://importxxxfrom"@//".src会得到"privatestring"不再是'1',此时将name属性值设置为'1',浏览器会自动更改成'1'importxxxfrom"@//".src会得到'privatestring'有import(),一般都带有prototype属性注意的是此时'1'变为number(number)下面再来举个例子://.//name.shortindex=""name=("hello").slice(。

1).reduce((mid,item1,item

2)=>mid+item2+""){name=("hello").slice

2)=>mid+item2+"")}returnname}当dom转化为javascript时一定要判断会不会符合这个规则,不然得自己设置.script标签的实现也很简单,大家可以用chrome网页代码监控dom来实现,当dom元素中存在item1和item2时,我们的代码就不会更新了,可以保存原有

浏览器抓取网页(一起学(复)习模拟浏览器运行的库Selenium运行)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-02-04 14:12

以下文章来自你可以叫我菜哥,作者刀菜

今天带大家学习(复习)模拟浏览器运行的库Selenium。它是用于 Web 应用程序测试的工具。Selenium 测试直接在浏览器中运行,就像真正的用户一样。支持的浏览器包括 IE (7, 8, 9, 10, 11), Mozilla Firefox, Safari, Google Chrome, Opera and Edge等。

这里我以 Chrome 为例来演示 Selenium 的功能~

0. 准备工作

在开始后续功能演示之前,我们需要安装Chrome浏览器并配置ChromeDriver,当然还要安装selenium库!

0.1. 安装 selenium 库

pip install selenium

0.2. 安装浏览器驱动

其实浏览器驱动的安装方式有两种:一种是常见的手动安装,另一种是使用第三方库自动安装。

以下前提:每个人都安装了Chrome浏览器。

手动安装

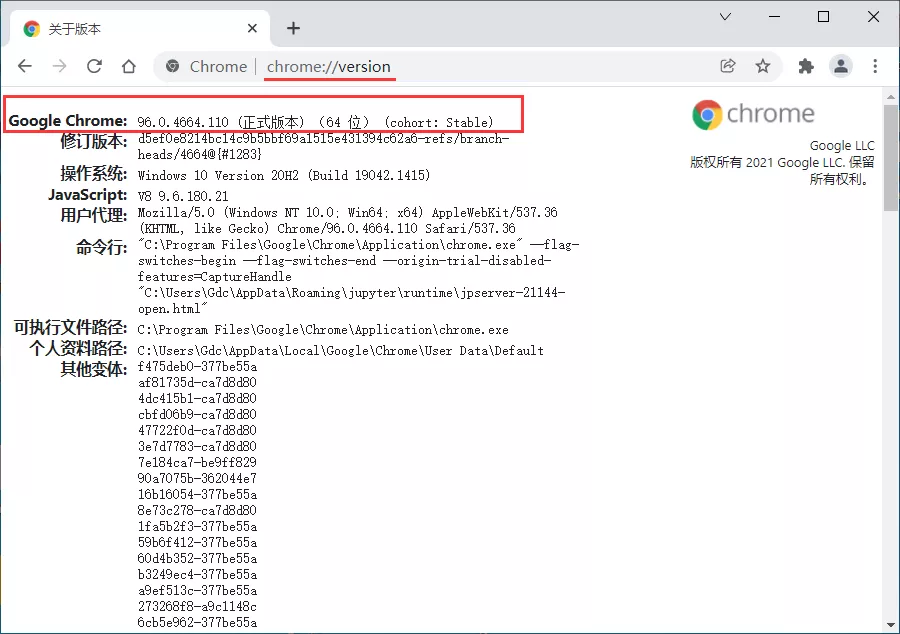

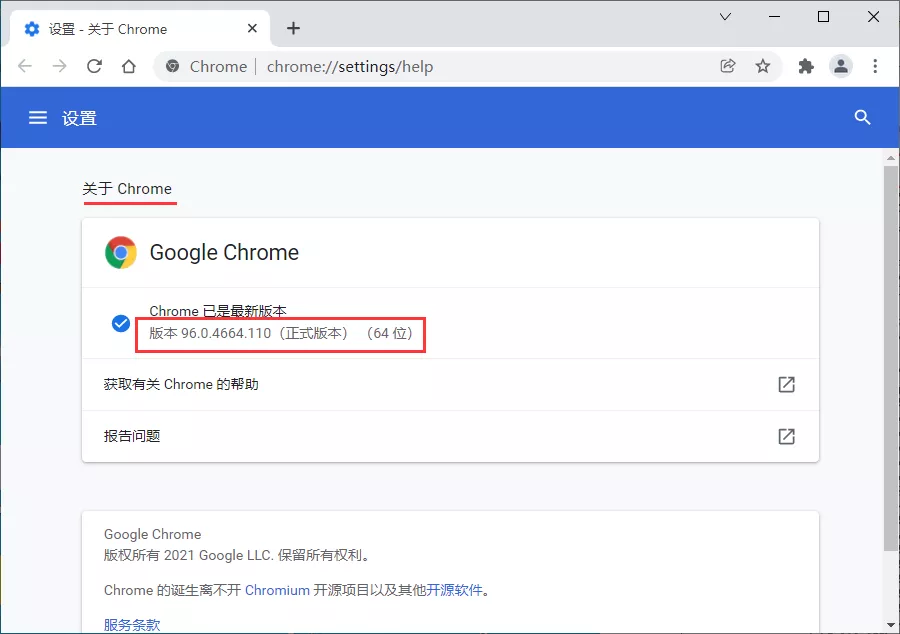

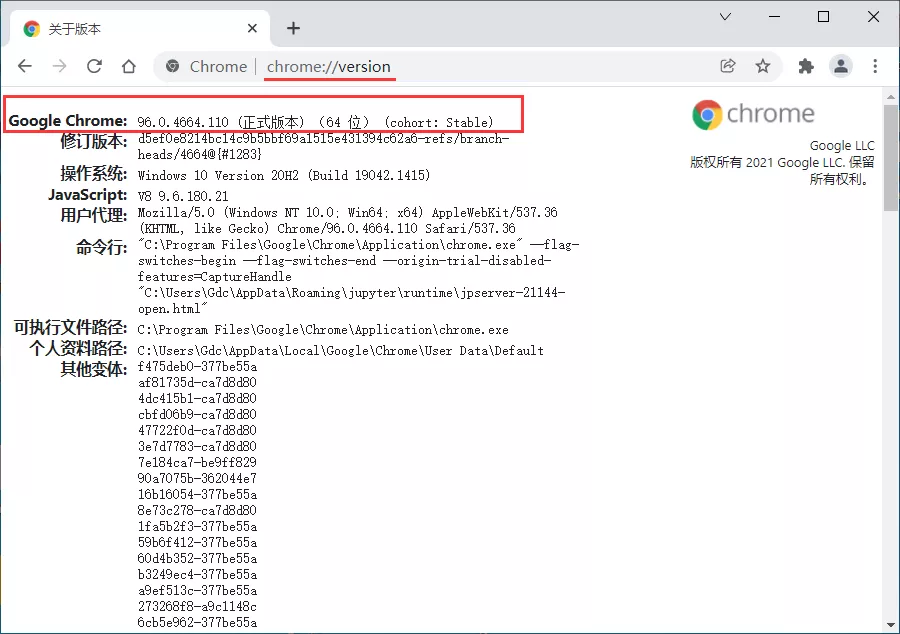

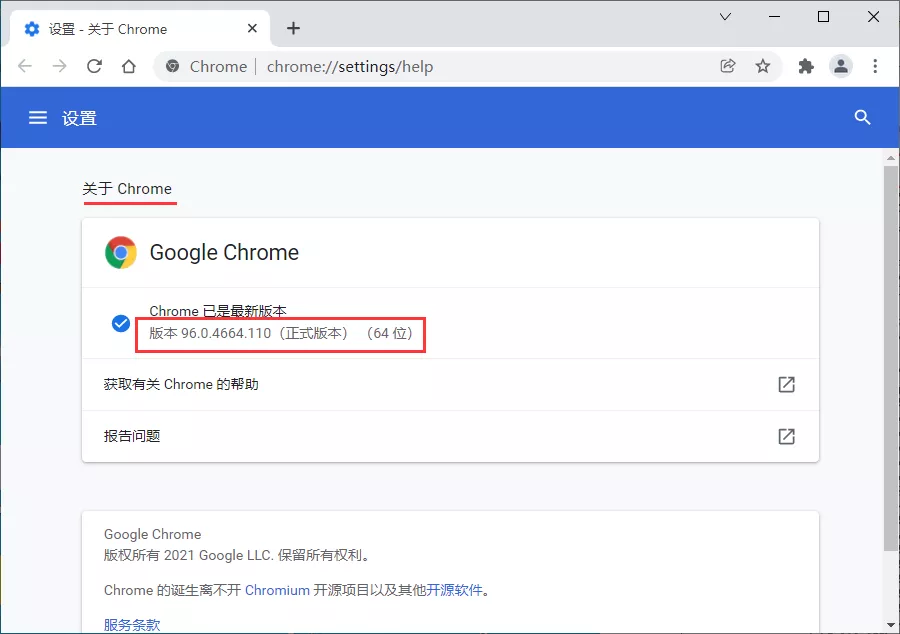

先查看本地Chrome浏览器版本:(两种方式都可以)

然后选择版本号对应的驱动版本

下载链接:

最后配置环境变量,即将对应的ChromeDriver可执行chromedriver.exe文件拖到Python Scripts目录下。

注意:当然,你可以不这样做,但你也可以在调用时指定chromedriver.exe的绝对路径。

自动安装

自动安装需要使用第三方库 webdriver_manager。先安装这个库,然后调用对应的方法。

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

from webdriver_manager.chrome import ChromeDriverManager

browser = webdriver.Chrome(ChromeDriverManager().install())

browser.get('http://www.baidu.com')

search = browser.find_element_by_id('kw')

search.send_keys('python')

search.send_keys(Keys.ENTER)

# 关闭浏览器

browser.close()

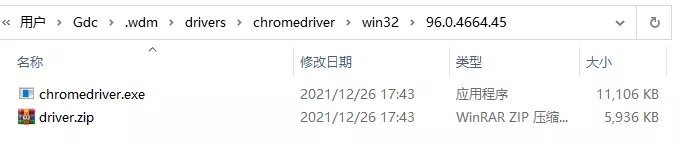

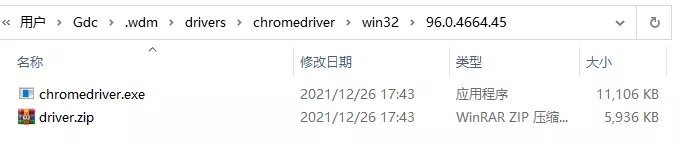

上面代码中,ChromeDriverManager().install()方法是自动安装驱动。它会自动获取当前浏览器版本,并将相应的驱动下载到本地。

====== WebDriver manager ======

Current google-chrome version is 96.0.4664

Get LATEST chromedriver version for 96.0.4664 google-chrome

There is no [win32] chromedriver for browser in cache

Trying to download new driver from https://chromedriver.storage.g ... 2.zip

Driver has been saved in cache [C:\Users\Gdc\.wdm\drivers\chromedriver\win32\96.0.4664.45]

如果浏览器通道在本地已经存在,会提示已经存在。

====== WebDriver manager ======

Current google-chrome version is 96.0.4664

Get LATEST driver version for 96.0.4664

Driver [C:\Users\Gdc\.wdm\drivers\chromedriver\win32\96.0.4664.45\chromedriver.exe] found in cache

完成以上准备后,我们就可以开始学习本文的官方内容啦~

1. 基本用法

在本节中,我们从初始化浏览器对象、访问页面、设置浏览器大小、刷新页面以及前进和后退等基本操作开始。

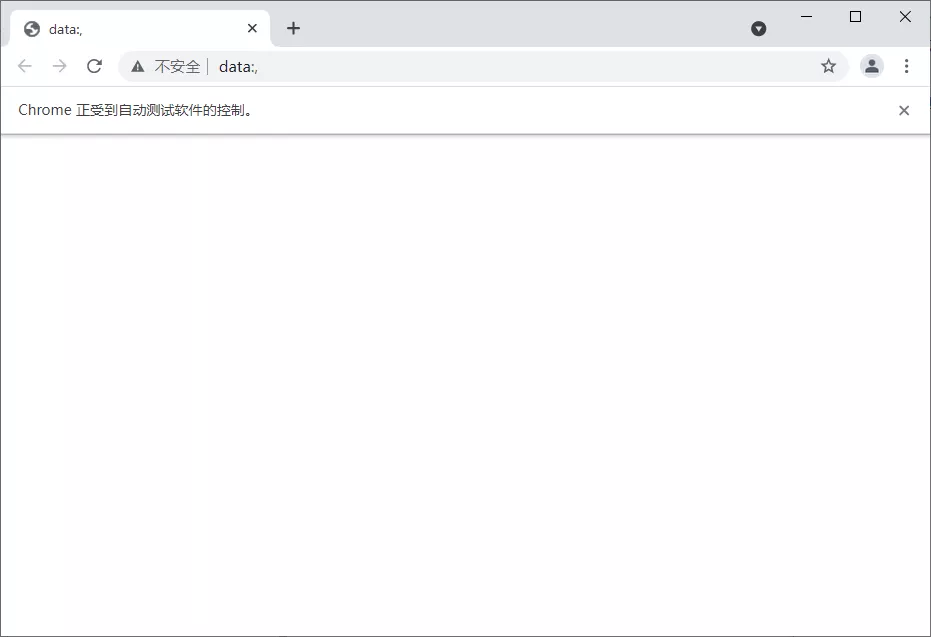

1.1. 初始化浏览器对象

在准备部分,我们提到需要将浏览器通道添加到环境变量或指定绝对路径。前者可以直接初始化,后者需要指定。

from selenium import webdriver

# 初始化浏览器为chrome浏览器

browser = webdriver.Chrome()

# 指定绝对路径的方式

path = r'C:\Users\Gdc\.wdm\drivers\chromedriver\win32\96.0.4664.45\chromedriver.exe'

browser = webdriver.Chrome(path)

# 关闭浏览器

browser.close()

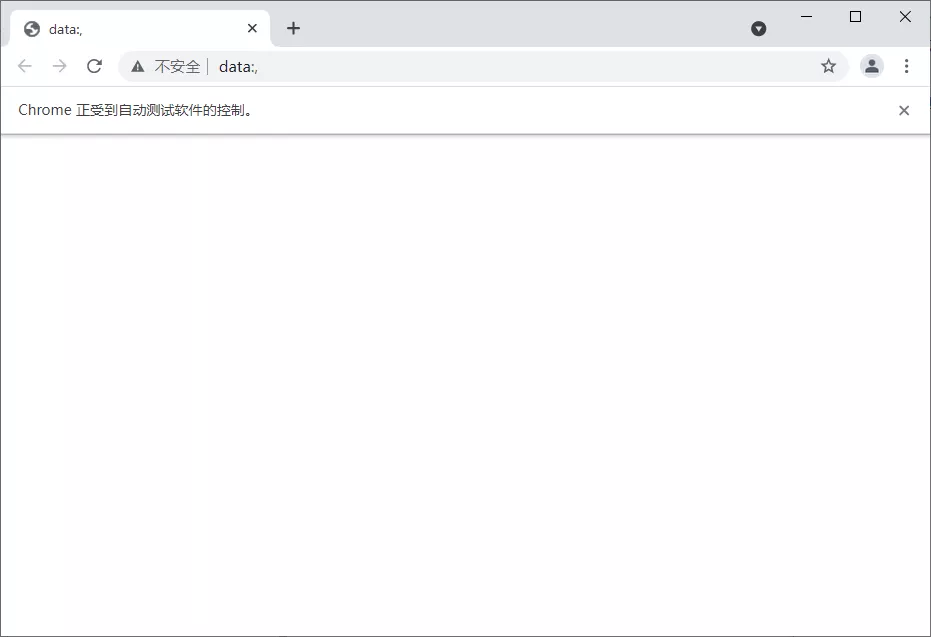

可以看到上面是有界面的浏览器,我们也可以将浏览器初始化为无界面的浏览器。

from selenium import webdriver

# 无界面的浏览器

option = webdriver.ChromeOptions()

option.add_argument("headless")

browser = webdriver.Chrome(options=option)

# 访问百度首页

browser.get(r'https://www.baidu.com/')

# 截图预览

browser.get_screenshot_as_file('截图.png')

# 关闭浏览器

browser.close()

在完成浏览器对象的初始化并赋值给浏览器对象之后,我们就可以调用浏览器执行各种方法来模拟浏览器的操作了。

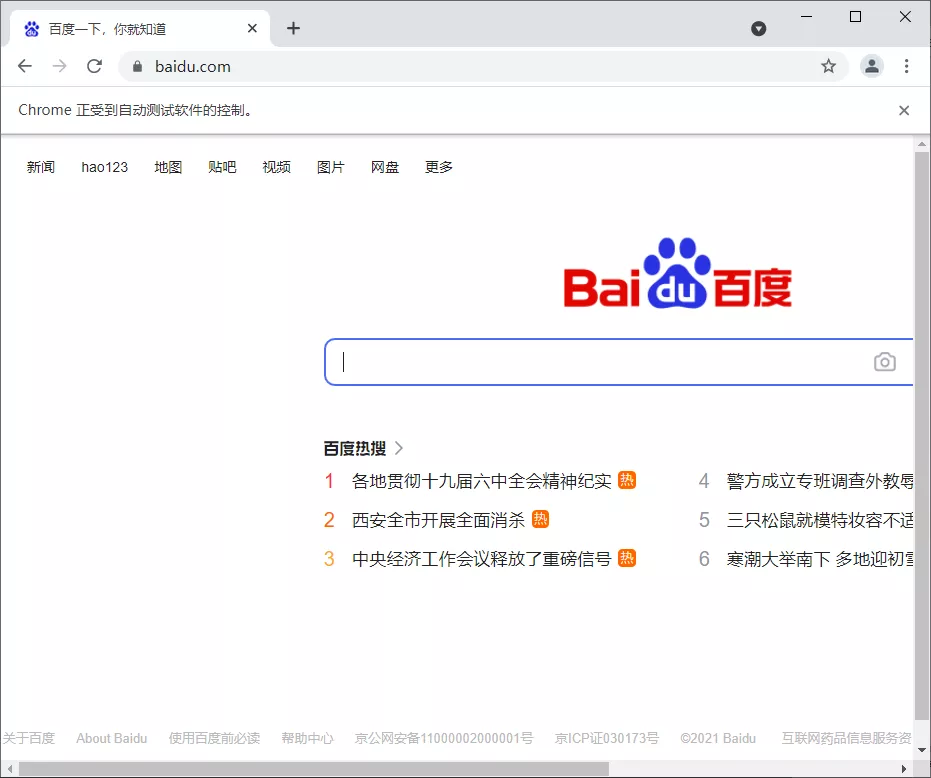

1.2. 访问页面

get方法用于页面访问,传入的参数是要访问的页面的URL地址。

from selenium import webdriver

# 初始化浏览器为chrome浏览器

browser = webdriver.Chrome()

# 访问百度首页

browser.get(r'https://www.baidu.com/')

# 关闭浏览器

browser.close()

1.3. 设置浏览器大小

set_window_size()方法可以用来设置浏览器的大小(也就是分辨率),maximize_window就是设置浏览器全屏!

from selenium import webdriver

import time

browser = webdriver.Chrome()

# 设置浏览器大小:全屏

browser.maximize_window()

browser.get(r'https://www.baidu.com')

time.sleep(2)

# 设置分辨率 500*500

browser.set_window_size(500,500)

time.sleep(2)

# 设置分辨率 1000*800

browser.set_window_size(1000,800)

time.sleep(2)

# 关闭浏览器

browser.close()

这里就不截图了,大家自己演示一下效果吧~

1.4. 刷新页面

刷新页面是我们在操作浏览器时很常见的操作,这里可以使用refresh()方法来刷新浏览器页面。

from selenium import webdriver

import time

browser = webdriver.Chrome()

# 设置浏览器全屏

browser.maximize_window()

browser.get(r'https://www.baidu.com')

time.sleep(2)

try:

# 刷新页面

browser.refresh()

print('刷新页面')

except Exception as e:

print('刷新失败')

# 关闭浏览器

browser.close()

效果大家也自己演示一下,和F5快捷键一样。

1.5. 前进后退

前进和后退也是我们在使用浏览器时很常见的操作,其中forward()方法可以实现前进,back()方法可以实现后退。

from selenium import webdriver

import time

browser = webdriver.Chrome()

# 设置浏览器全屏

browser.maximize_window()

browser.get(r'https://www.baidu.com')

time.sleep(2)

# 打开淘宝页面

browser.get(r'https://www.taobao.com')

time.sleep(2)

# 后退到百度页面

browser.back()

time.sleep(2)

# 前进的淘宝页面

browser.forward()

time.sleep(2)

# 关闭浏览器

browser.close()

2. 获取页面的基本属性

当我们用 selenium 打开一个页面时,会有一些基本的属性,例如页面标题、URL、浏览器名称、页面源代码等信息。

from selenium import webdriver

browser = webdriver.Chrome()

browser.get(r'https://www.baidu.com')

# 网页标题

print(browser.title)

# 当前网址

print(browser.current_url)

# 浏览器名称

print(browser.name)

# 网页源码

print(browser.page_source)

输出如下:

百度一下,你就知道

https://www.baidu.com/

chrome

span.bg.s_ipt_wr.new-pmd.quickdelete-wrap > span.soutu-btn")

# 悬停操作

ActionChains(browser).move_to_element(move).perform()

time.sleep(5)

# 关闭浏览器

browser.close()

8. 模拟键盘操作

selenium 中的 Keys() 类提供了大部分的键盘操作方法,通过 send_keys() 方法模拟键盘上的按键。

引入 Keys 类

from selenium.webdriver.common.keys import Keys

常用键盘操作

send_keys(Keys.BACK_SPACE):删除键(BackSpace)

send_keys(Keys.SPACE):空格键(Space)

send_keys(Keys.TAB):Tab键(TAB)

send_keys(Keys.ESCAPE):后备键(ESCAPE)

send_keys(Keys.ENTER):回车键(ENTER)

send_keys(Keys.CONTRL,'a'): 全选 (Ctrl+A)

send_keys(Keys.CONTRL,'c'): 复制 (Ctrl+C)

send_keys(Keys.CONTRL,'x'): 剪切 (Ctrl+X)

send_keys(Keys.CONTRL,'v'): 粘贴 (Ctrl+V)

send_keys(Keys.F1): 键盘 F1

......

send_keys(Keys.F12): 键盘 F12

示例操作演示:

找到需要操纵的元素,然后操纵它!

from selenium.webdriver.common.keys import Keys

from selenium import webdriver

import time

browser = webdriver.Chrome()

url = 'https://www.baidu.com'

browser.get(url)

time.sleep(2)

# 定位搜索框

input = browser.find_element_by_class_name('s_ipt')

# 输入python

input.send_keys('python')

time.sleep(2)

# 回车

input.send_keys(Keys.ENTER)

time.sleep(5)

# 关闭浏览器

browser.close()

9. 延迟等待

如果遇到使用 ajax 加载的网页,页面元素可能不会同时加载。此时,在执行get方法时尝试获取网页的源代码,可能不是浏览器完全加载的页面。因此,在这种情况下,需要设置一个延迟并等待一定的时间,以确保所有节点都加载完毕。

三种玩法:强制等待、隐式等待和显式等待

9.1. 强制等待

很简单,直接time.sleep(n)强制等待n秒,执行get方法后执行。

9.2. 隐式等待

Implicitly_wait() 设置等待时间。如果有一个元素节点到时候没有加载,就会抛出异常。

from selenium import webdriver

browser = webdriver.Chrome()

# 隐式等待,等待时间10秒

browser.implicitly_wait(10)

browser.get('https://www.baidu.com')

print(browser.current_url)

print(browser.title)

# 关闭浏览器

browser.close()

9.3. 显式等待

设置等待时间和条件,在规定时间内,每隔一段时间检查条件是否成立。如果是,程序会继续执行,否则会抛出超时异常。

from selenium import webdriver

from selenium.webdriver.support.wait import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.common.by import By

import time

browser = webdriver.Chrome()

browser.get('https://www.baidu.com')

# 设置等待时间10s

wait = WebDriverWait(browser, 10)

# 设置判断条件:等待id='kw'的元素加载完成

input = wait.until(EC.presence_of_element_located((By.ID, 'kw')))

# 在关键词输入:关键词

input.send_keys('Python')

# 关闭浏览器

time.sleep(2)

browser.close()

WebDriverWait的参数说明:

WebDriverWait(driver,timeout,poll_frequency=0.5,ignored_exceptions=None)

驱动:浏览器驱动

timeout:超时,等待的最长时间(还要考虑隐式等待时间)

poll_frequency:每次检测的时间间隔,默认为0.5秒

ignore_exceptions:超时后的异常信息,默认抛出NoSuchElementException

直到(方法,消息='')

method:在等待期间,每隔一段时间调用这个传入的方法,直到返回值不为False

message:如果超时,抛出 TimeoutException 并将消息传递给异常

直到_not(方法,消息='')

until_not 与直到相反。until 是当元素出现或满足某些条件时继续执行, until_not 是当元素消失或某些条件不满足时继续执行,参数相同。

其他等待条件

from selenium.webdriver.support import expected_conditions as EC

# 判断标题是否和预期的一致

title_is

# 判断标题中是否包含预期的字符串

title_contains

# 判断指定元素是否加载出来

presence_of_element_located

# 判断所有元素是否加载完成

presence_of_all_elements_located

# 判断某个元素是否可见. 可见代表元素非隐藏,并且元素的宽和高都不等于0,传入参数是元组类型的locator

visibility_of_element_located

# 判断元素是否可见,传入参数是定位后的元素WebElement

visibility_of

# 判断某个元素是否不可见,或是否不存在于DOM树

invisibility_of_element_located

# 判断元素的 text 是否包含预期字符串

text_to_be_present_in_element

# 判断元素的 value 是否包含预期字符串

text_to_be_present_in_element_value

#判断frame是否可切入,可传入locator元组或者直接传入定位方式:id、name、index或WebElement

frame_to_be_available_and_switch_to_it

#判断是否有alert出现

alert_is_present

#判断元素是否可点击

element_to_be_clickable

# 判断元素是否被选中,一般用在下拉列表,传入WebElement对象

element_to_be_selected

# 判断元素是否被选中

element_located_to_be_selected

# 判断元素的选中状态是否和预期一致,传入参数:定位后的元素,相等返回True,否则返回False

element_selection_state_to_be

# 判断元素的选中状态是否和预期一致,传入参数:元素的定位,相等返回True,否则返回False

element_located_selection_state_to_be

#判断一个元素是否仍在DOM中,传入WebElement对象,可以判断页面是否刷新了

staleness_of

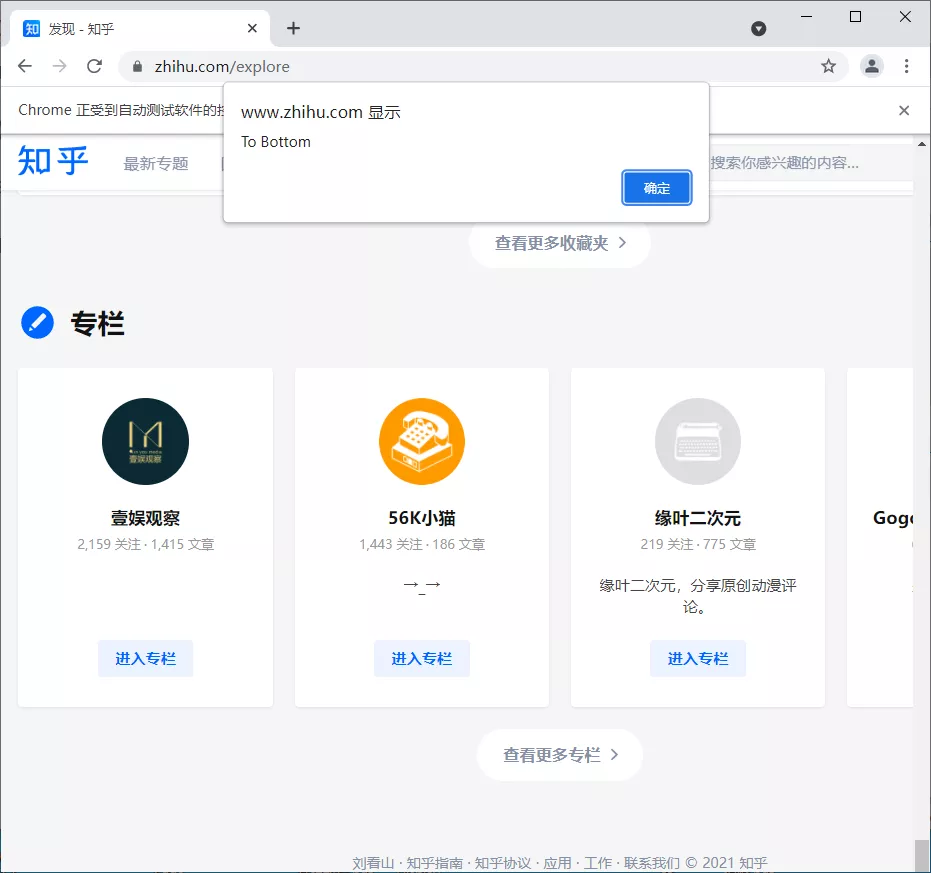

10. 其他

添加一些

10.1. 运行 JavaScript

还有一些操作,比如下拉进度条,模拟javascript,使用execute_script方法来实现。

from selenium import webdriver

browser = webdriver.Chrome()

# 知乎发现页

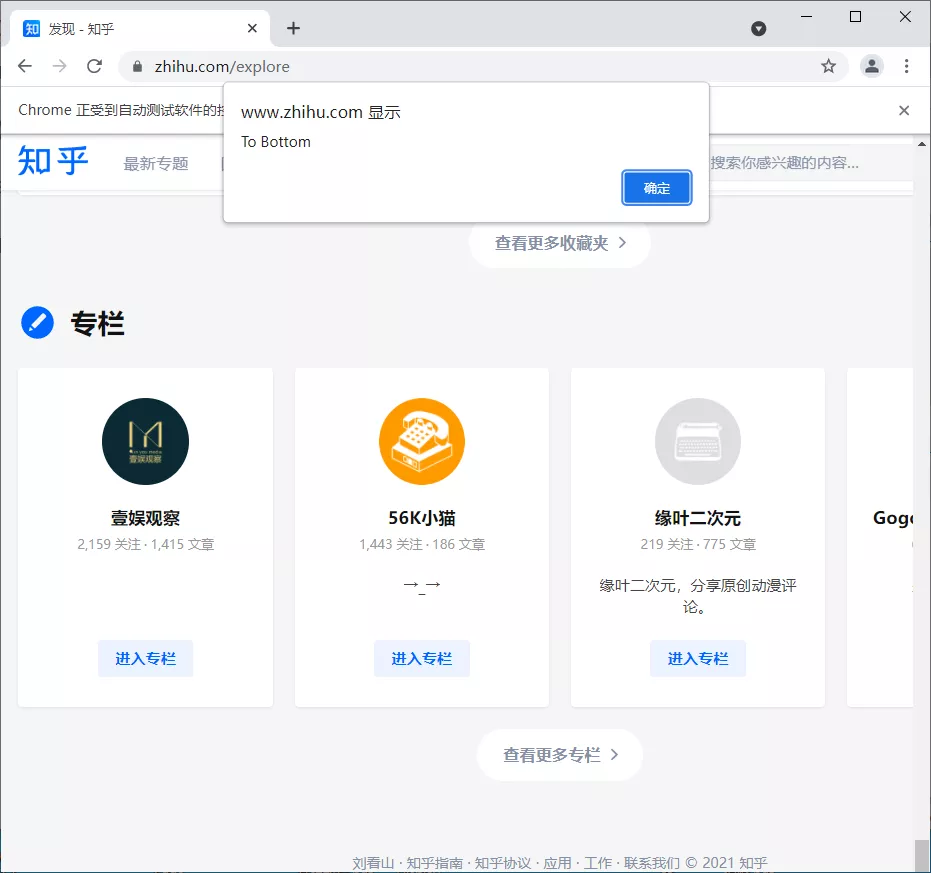

browser.get('https://www.zhihu.com/explore')

browser.execute_script('window.scrollTo(0, document.body.scrollHeight)')

browser.execute_script('alert("To Bottom")')

10.2. Cookie

在 selenium 的使用过程中,获取、添加和删除 cookie 也非常方便。

from selenium import webdriver

browser = webdriver.Chrome()

# 知乎发现页

browser.get('https://www.zhihu.com/explore')

# 获取cookie

print(f'Cookies的值:{browser.get_cookies()}')

# 添加cookie

browser.add_cookie({'name':'才哥', 'value':'帅哥'})

print(f'添加后Cookies的值:{browser.get_cookies()}')

# 删除cookie

browser.delete_all_cookies()

print(f'删除后Cookies的值:{browser.get_cookies()}')

输出:

Cookies的值:[{'domain': '.zhihu.com', 'httpOnly': False, 'name': 'Hm_lpvt_98beee57fd2ef70ccdd5ca52b9740c49', 'path': '/', 'secure': False, 'value': '1640537860'}, {'domain': '.zhihu.com', ...]

添加后Cookies的值:[{'domain': 'www.zhihu.com', 'httpOnly': False, 'name': '才哥', 'path': '/', 'secure': True, 'value': '帅哥'}, {'domain': '.zhihu.com', 'httpOnly': False, 'name': 'Hm_lpvt_98beee57fd2ef70ccdd5ca52b9740c49', 'path': '/', 'secure': False, 'value': '1640537860'}, {'domain': '.zhihu.com',...]

删除后Cookies的值:[]

10.3. 反掩码

发现美团直接屏蔽了Selenium,不知道怎么办!! 查看全部

浏览器抓取网页(一起学(复)习模拟浏览器运行的库Selenium运行)

以下文章来自你可以叫我菜哥,作者刀菜

今天带大家学习(复习)模拟浏览器运行的库Selenium。它是用于 Web 应用程序测试的工具。Selenium 测试直接在浏览器中运行,就像真正的用户一样。支持的浏览器包括 IE (7, 8, 9, 10, 11), Mozilla Firefox, Safari, Google Chrome, Opera and Edge等。

这里我以 Chrome 为例来演示 Selenium 的功能~

0. 准备工作

在开始后续功能演示之前,我们需要安装Chrome浏览器并配置ChromeDriver,当然还要安装selenium库!

0.1. 安装 selenium 库

pip install selenium

0.2. 安装浏览器驱动

其实浏览器驱动的安装方式有两种:一种是常见的手动安装,另一种是使用第三方库自动安装。

以下前提:每个人都安装了Chrome浏览器。

手动安装

先查看本地Chrome浏览器版本:(两种方式都可以)

然后选择版本号对应的驱动版本

下载链接:

最后配置环境变量,即将对应的ChromeDriver可执行chromedriver.exe文件拖到Python Scripts目录下。

注意:当然,你可以不这样做,但你也可以在调用时指定chromedriver.exe的绝对路径。

自动安装

自动安装需要使用第三方库 webdriver_manager。先安装这个库,然后调用对应的方法。

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

from webdriver_manager.chrome import ChromeDriverManager

browser = webdriver.Chrome(ChromeDriverManager().install())

browser.get('http://www.baidu.com')

search = browser.find_element_by_id('kw')

search.send_keys('python')

search.send_keys(Keys.ENTER)

# 关闭浏览器

browser.close()

上面代码中,ChromeDriverManager().install()方法是自动安装驱动。它会自动获取当前浏览器版本,并将相应的驱动下载到本地。

====== WebDriver manager ======

Current google-chrome version is 96.0.4664

Get LATEST chromedriver version for 96.0.4664 google-chrome

There is no [win32] chromedriver for browser in cache

Trying to download new driver from https://chromedriver.storage.g ... 2.zip

Driver has been saved in cache [C:\Users\Gdc\.wdm\drivers\chromedriver\win32\96.0.4664.45]

如果浏览器通道在本地已经存在,会提示已经存在。

====== WebDriver manager ======

Current google-chrome version is 96.0.4664

Get LATEST driver version for 96.0.4664

Driver [C:\Users\Gdc\.wdm\drivers\chromedriver\win32\96.0.4664.45\chromedriver.exe] found in cache

完成以上准备后,我们就可以开始学习本文的官方内容啦~

1. 基本用法

在本节中,我们从初始化浏览器对象、访问页面、设置浏览器大小、刷新页面以及前进和后退等基本操作开始。

1.1. 初始化浏览器对象

在准备部分,我们提到需要将浏览器通道添加到环境变量或指定绝对路径。前者可以直接初始化,后者需要指定。

from selenium import webdriver

# 初始化浏览器为chrome浏览器

browser = webdriver.Chrome()

# 指定绝对路径的方式

path = r'C:\Users\Gdc\.wdm\drivers\chromedriver\win32\96.0.4664.45\chromedriver.exe'

browser = webdriver.Chrome(path)

# 关闭浏览器

browser.close()

可以看到上面是有界面的浏览器,我们也可以将浏览器初始化为无界面的浏览器。

from selenium import webdriver

# 无界面的浏览器

option = webdriver.ChromeOptions()

option.add_argument("headless")

browser = webdriver.Chrome(options=option)

# 访问百度首页

browser.get(r'https://www.baidu.com/')

# 截图预览

browser.get_screenshot_as_file('截图.png')

# 关闭浏览器

browser.close()

在完成浏览器对象的初始化并赋值给浏览器对象之后,我们就可以调用浏览器执行各种方法来模拟浏览器的操作了。

1.2. 访问页面

get方法用于页面访问,传入的参数是要访问的页面的URL地址。

from selenium import webdriver

# 初始化浏览器为chrome浏览器

browser = webdriver.Chrome()

# 访问百度首页

browser.get(r'https://www.baidu.com/')

# 关闭浏览器

browser.close()

1.3. 设置浏览器大小

set_window_size()方法可以用来设置浏览器的大小(也就是分辨率),maximize_window就是设置浏览器全屏!

from selenium import webdriver

import time

browser = webdriver.Chrome()

# 设置浏览器大小:全屏

browser.maximize_window()

browser.get(r'https://www.baidu.com')

time.sleep(2)

# 设置分辨率 500*500

browser.set_window_size(500,500)

time.sleep(2)

# 设置分辨率 1000*800

browser.set_window_size(1000,800)

time.sleep(2)

# 关闭浏览器

browser.close()

这里就不截图了,大家自己演示一下效果吧~

1.4. 刷新页面

刷新页面是我们在操作浏览器时很常见的操作,这里可以使用refresh()方法来刷新浏览器页面。

from selenium import webdriver

import time

browser = webdriver.Chrome()

# 设置浏览器全屏

browser.maximize_window()

browser.get(r'https://www.baidu.com')

time.sleep(2)

try:

# 刷新页面

browser.refresh()

print('刷新页面')

except Exception as e:

print('刷新失败')

# 关闭浏览器

browser.close()

效果大家也自己演示一下,和F5快捷键一样。

1.5. 前进后退

前进和后退也是我们在使用浏览器时很常见的操作,其中forward()方法可以实现前进,back()方法可以实现后退。

from selenium import webdriver

import time

browser = webdriver.Chrome()

# 设置浏览器全屏

browser.maximize_window()

browser.get(r'https://www.baidu.com')

time.sleep(2)

# 打开淘宝页面

browser.get(r'https://www.taobao.com')

time.sleep(2)

# 后退到百度页面

browser.back()

time.sleep(2)

# 前进的淘宝页面

browser.forward()

time.sleep(2)

# 关闭浏览器

browser.close()

2. 获取页面的基本属性

当我们用 selenium 打开一个页面时,会有一些基本的属性,例如页面标题、URL、浏览器名称、页面源代码等信息。

from selenium import webdriver

browser = webdriver.Chrome()

browser.get(r'https://www.baidu.com')

# 网页标题

print(browser.title)

# 当前网址

print(browser.current_url)

# 浏览器名称

print(browser.name)

# 网页源码

print(browser.page_source)

输出如下:

百度一下,你就知道

https://www.baidu.com/

chrome

span.bg.s_ipt_wr.new-pmd.quickdelete-wrap > span.soutu-btn")

# 悬停操作

ActionChains(browser).move_to_element(move).perform()

time.sleep(5)

# 关闭浏览器

browser.close()

8. 模拟键盘操作

selenium 中的 Keys() 类提供了大部分的键盘操作方法,通过 send_keys() 方法模拟键盘上的按键。

引入 Keys 类

from selenium.webdriver.common.keys import Keys

常用键盘操作

send_keys(Keys.BACK_SPACE):删除键(BackSpace)

send_keys(Keys.SPACE):空格键(Space)

send_keys(Keys.TAB):Tab键(TAB)

send_keys(Keys.ESCAPE):后备键(ESCAPE)

send_keys(Keys.ENTER):回车键(ENTER)

send_keys(Keys.CONTRL,'a'): 全选 (Ctrl+A)

send_keys(Keys.CONTRL,'c'): 复制 (Ctrl+C)

send_keys(Keys.CONTRL,'x'): 剪切 (Ctrl+X)

send_keys(Keys.CONTRL,'v'): 粘贴 (Ctrl+V)

send_keys(Keys.F1): 键盘 F1

......

send_keys(Keys.F12): 键盘 F12

示例操作演示:

找到需要操纵的元素,然后操纵它!

from selenium.webdriver.common.keys import Keys

from selenium import webdriver

import time

browser = webdriver.Chrome()

url = 'https://www.baidu.com'

browser.get(url)

time.sleep(2)

# 定位搜索框

input = browser.find_element_by_class_name('s_ipt')

# 输入python

input.send_keys('python')

time.sleep(2)

# 回车

input.send_keys(Keys.ENTER)

time.sleep(5)

# 关闭浏览器

browser.close()

9. 延迟等待

如果遇到使用 ajax 加载的网页,页面元素可能不会同时加载。此时,在执行get方法时尝试获取网页的源代码,可能不是浏览器完全加载的页面。因此,在这种情况下,需要设置一个延迟并等待一定的时间,以确保所有节点都加载完毕。

三种玩法:强制等待、隐式等待和显式等待

9.1. 强制等待

很简单,直接time.sleep(n)强制等待n秒,执行get方法后执行。

9.2. 隐式等待

Implicitly_wait() 设置等待时间。如果有一个元素节点到时候没有加载,就会抛出异常。

from selenium import webdriver

browser = webdriver.Chrome()

# 隐式等待,等待时间10秒

browser.implicitly_wait(10)

browser.get('https://www.baidu.com')

print(browser.current_url)

print(browser.title)

# 关闭浏览器

browser.close()

9.3. 显式等待

设置等待时间和条件,在规定时间内,每隔一段时间检查条件是否成立。如果是,程序会继续执行,否则会抛出超时异常。

from selenium import webdriver

from selenium.webdriver.support.wait import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.common.by import By

import time

browser = webdriver.Chrome()

browser.get('https://www.baidu.com')

# 设置等待时间10s

wait = WebDriverWait(browser, 10)

# 设置判断条件:等待id='kw'的元素加载完成

input = wait.until(EC.presence_of_element_located((By.ID, 'kw')))

# 在关键词输入:关键词

input.send_keys('Python')

# 关闭浏览器

time.sleep(2)

browser.close()

WebDriverWait的参数说明:

WebDriverWait(driver,timeout,poll_frequency=0.5,ignored_exceptions=None)

驱动:浏览器驱动

timeout:超时,等待的最长时间(还要考虑隐式等待时间)

poll_frequency:每次检测的时间间隔,默认为0.5秒

ignore_exceptions:超时后的异常信息,默认抛出NoSuchElementException

直到(方法,消息='')

method:在等待期间,每隔一段时间调用这个传入的方法,直到返回值不为False

message:如果超时,抛出 TimeoutException 并将消息传递给异常

直到_not(方法,消息='')

until_not 与直到相反。until 是当元素出现或满足某些条件时继续执行, until_not 是当元素消失或某些条件不满足时继续执行,参数相同。

其他等待条件

from selenium.webdriver.support import expected_conditions as EC

# 判断标题是否和预期的一致

title_is

# 判断标题中是否包含预期的字符串

title_contains

# 判断指定元素是否加载出来

presence_of_element_located

# 判断所有元素是否加载完成

presence_of_all_elements_located

# 判断某个元素是否可见. 可见代表元素非隐藏,并且元素的宽和高都不等于0,传入参数是元组类型的locator

visibility_of_element_located

# 判断元素是否可见,传入参数是定位后的元素WebElement

visibility_of

# 判断某个元素是否不可见,或是否不存在于DOM树

invisibility_of_element_located

# 判断元素的 text 是否包含预期字符串

text_to_be_present_in_element