浏览器抓取网页(Python中爬虫基础快速入门的学习方法,值得收藏!)

优采云 发布时间: 2022-02-08 04:24浏览器抓取网页(Python中爬虫基础快速入门的学习方法,值得收藏!)

对于小白来说,爬虫可能是一件非常复杂、技术含量很高的事情。比如很多人认为学习爬虫一定要掌握Python,然后系统地学习Python的每一个知识点,但是时间长了发现还是爬不出来数据;有的人认为需要先了解网页的知识,于是入手HTML\CSS,结果就是前端的坑,皱巴巴的……

但是如果知道正确的方法,短期内可以爬取主流的网站数据。我认为实现起来并不难,但建议你从一开始就设定明确的目标。

在目标的驱动下,你的学习会更有效率。你觉得必要的专业知识,可以在完成目标的过程中学习。这里为大家提供一个零基础的快速入门学习方法。

01学习Python包并执行基本爬取步骤

大多数爬虫都是按照“发送请求-获取页面-解析页面-提取并存储内容”的过程来实现的,它模拟了使用浏览器爬取网页信息的过程。

Python中有很多爬虫相关的包:urllib、requests、bs4、scrapy、pyspider等,建议从requests+Xpath入手。Requests 负责连接到 网站 并返回网页。Xpath 用于解析网页以便于提取。数据。

如果你用过BeautifulSoup,你会发现Xpath省了很多麻烦,层层检查元素代码的工作都省去了。这样,基本套路就差不多了。一般的静态网站完全没有问题,豆瓣、尴尬百科、腾讯新闻等基本都能上手。

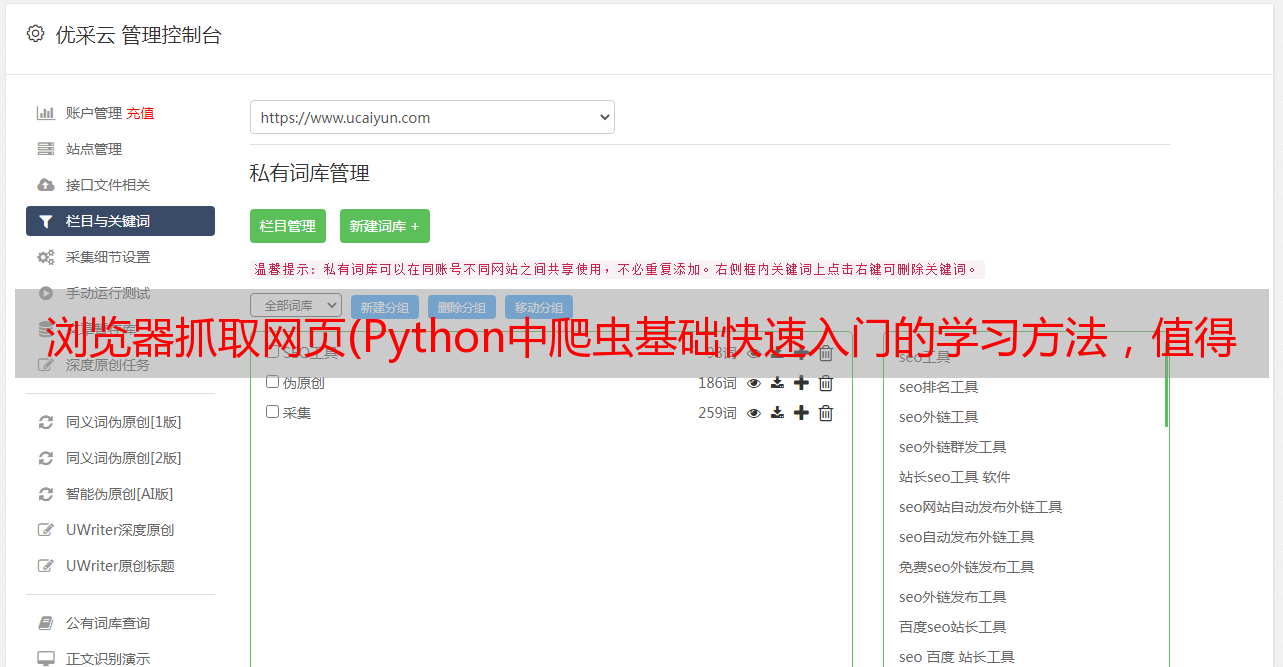

当然,如果你需要爬取异步加载的网站,你可以学习浏览器抓取来分析真实的请求或者学习Selenium来自动化。这样动态知乎、、TripAdvisor网站也可以解决。

02 了解非结构化数据的存储

爬取的数据可以以文档的形式存储在本地,也可以存储在数据库中。

刚开始数据量不大的时候,可以直接通过Python语法或者pandas方法将数据保存为csv等文件。

当然,你可能会发现爬取的数据不干净,可能有缺失、错误等,你也需要对数据进行清洗,可以学习pandas包的基本用法来做数据预处理,得到更干净的数据。

03 掌握各种技巧应对特殊网站防爬措施

当然在爬取的过程中也会有一些绝望,比如被网站IP屏蔽,比如各种奇怪的验证码,userAgent访问限制,各种动态加载等等。

遇到这些反爬的方法,当然需要一些高级技巧来应对,比如访问频率控制、代理IP池的使用、抓包、验证码的OCR处理等等。

往往网站会在高效开发和反爬虫之间偏爱前者,这也为爬虫提供了空间。掌握了这些反爬技能,大部分网站对你来说都不再难了。

所以有些东西看起来很吓人,但当它们崩溃时,也仅此而已。当你能写出分布式爬虫的时候,就可以尝试搭建一些基本的爬虫架构,实现一些更自动化的数据获取。

同时可以使用掘金的ip代理和相关的防屏蔽来辅助。(百度搜索:掘金.com)