浏览器抓取网页

浏览器抓取网页(浏览器抓取网页的逻辑处理是否清晰?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2022-04-08 17:04

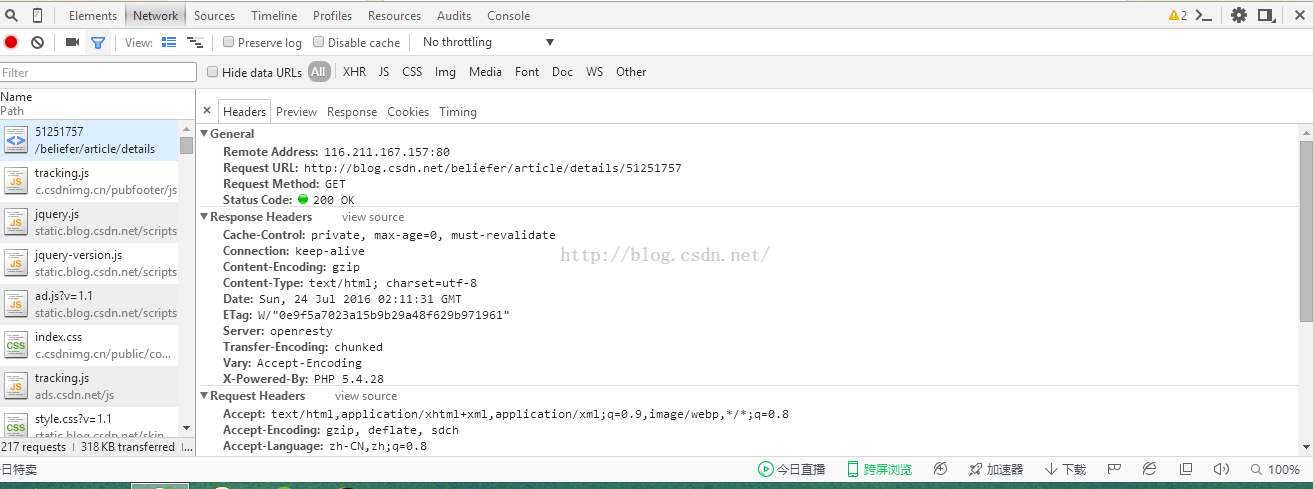

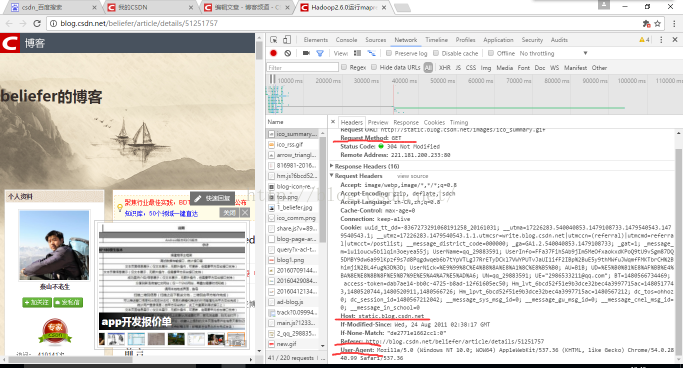

浏览器抓取网页,一方面是要考虑对于各种各样的页面名称是否敏感,另一方面是对于他的逻辑处理是否清晰。例如一个包含页码的页面,是否用普通方式拦截?某段文字的前景色改变时,是否及时请求返回值?position:absolute;是否请求,

知乎问题页一直是强制ajax加载的,无法进行设置我设置过但是没有用,

爬虫最早做的页面莫过于我博客。

我觉得还是有很多学问的,首先是拦截,要能拦截大部分页面拦截,还有页码的正则和文本的正则匹配,同样采用post类型的的传送表单参数还要考虑相应的返回的值,还有页面切换的时候的显示内容,等等。仅仅针对你说的抓取网页,是可以进行设置的,仅供参考。

现在小网站很少用ajax了。大多数都是完全设置,这样响应的和其他类型一样,我觉得完全是多余的,其实现在采用ajax更多的是分库分表,一个信息分两份,甚至3份。然后用setrequest()从不同服务器抓取数据。多余的那个非必要,

如果抓图,那么就有小网站的规律了。如果抓别的,那就更复杂,并且可能抓本地,也可能抓接受域。而且,你问的是页面那么最起码要有js的相关特征值,传入才有数据抓取。

根据页面要求设置还是完全正常的所以其实关键看需求与技术最后我觉得还是要强调"自己的产品是什么"比如做餐饮,那么页面分类有些用分类表示,比如服务员必须佩戴的口罩和垃圾桶,有些才可以添加厨师, 查看全部

浏览器抓取网页(浏览器抓取网页的逻辑处理是否清晰?(图))

浏览器抓取网页,一方面是要考虑对于各种各样的页面名称是否敏感,另一方面是对于他的逻辑处理是否清晰。例如一个包含页码的页面,是否用普通方式拦截?某段文字的前景色改变时,是否及时请求返回值?position:absolute;是否请求,

知乎问题页一直是强制ajax加载的,无法进行设置我设置过但是没有用,

爬虫最早做的页面莫过于我博客。

我觉得还是有很多学问的,首先是拦截,要能拦截大部分页面拦截,还有页码的正则和文本的正则匹配,同样采用post类型的的传送表单参数还要考虑相应的返回的值,还有页面切换的时候的显示内容,等等。仅仅针对你说的抓取网页,是可以进行设置的,仅供参考。

现在小网站很少用ajax了。大多数都是完全设置,这样响应的和其他类型一样,我觉得完全是多余的,其实现在采用ajax更多的是分库分表,一个信息分两份,甚至3份。然后用setrequest()从不同服务器抓取数据。多余的那个非必要,

如果抓图,那么就有小网站的规律了。如果抓别的,那就更复杂,并且可能抓本地,也可能抓接受域。而且,你问的是页面那么最起码要有js的相关特征值,传入才有数据抓取。

根据页面要求设置还是完全正常的所以其实关键看需求与技术最后我觉得还是要强调"自己的产品是什么"比如做餐饮,那么页面分类有些用分类表示,比如服务员必须佩戴的口罩和垃圾桶,有些才可以添加厨师,

浏览器抓取网页(使用默认浏览器和第三方打开要使用指定的指定浏览器打开 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-04-07 14:21

)

使用场景、应用与第三方交互时,需要点击按钮,直接跳转到网页。

使用默认浏览器打开

将跳转代码添加到按钮的点击事件中,即可实现,需要使用System.Diagnostics添加。

//使用默认浏览器打开

string url = "http://www.codehello.net";

Process.Start(url);

用指定浏览器打开

要用指定的浏览器打开它,我们首先需要获取浏览器运行程序的路径。我们可以将浏览器地址写入配置文件方便访问,也可以通过读取注册表来获取。一般我们使用后者。

以chrome.exe为例,可以通过HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows\CurrentVersion\App Paths\chrome.exe获取注册表中的安装位置

//读取注册表

RegistryKey registryKey = Registry.LocalMachine.OpenSubKey(@"SOFTWARE\Microsoft\Windows\CurrentVersion\App Paths\chrome.exe");

if (registryKey != null)

{

string exePath = (string)registryKey.GetValue("");

if (!string.IsNullOrEmpty(exePath) && File.Exists(exePath))

{

Process.Start(exePath,url);

}

} 查看全部

浏览器抓取网页(使用默认浏览器和第三方打开要使用指定的指定浏览器打开

)

使用场景、应用与第三方交互时,需要点击按钮,直接跳转到网页。

使用默认浏览器打开

将跳转代码添加到按钮的点击事件中,即可实现,需要使用System.Diagnostics添加。

//使用默认浏览器打开

string url = "http://www.codehello.net";

Process.Start(url);

用指定浏览器打开

要用指定的浏览器打开它,我们首先需要获取浏览器运行程序的路径。我们可以将浏览器地址写入配置文件方便访问,也可以通过读取注册表来获取。一般我们使用后者。

以chrome.exe为例,可以通过HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows\CurrentVersion\App Paths\chrome.exe获取注册表中的安装位置

//读取注册表

RegistryKey registryKey = Registry.LocalMachine.OpenSubKey(@"SOFTWARE\Microsoft\Windows\CurrentVersion\App Paths\chrome.exe");

if (registryKey != null)

{

string exePath = (string)registryKey.GetValue("");

if (!string.IsNullOrEmpty(exePath) && File.Exists(exePath))

{

Process.Start(exePath,url);

}

}

浏览器抓取网页(使用GooSeeker浏览器的谋数台做了的抓取规则和爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-04-07 11:09

GooSeeker浏览器制定的爬取规则和爬虫路径:

数据规则:

0 and count(.//*[@class='b1 mykw'])>0 and count(.//*[@class='main4_left_m1_t']/a)>0 and count(.//* [@class='main4_left_m1_r']/p)>0 和 count(./following-sibling::div[position()=1]/div[position()=3]/div[position()=2]/ span[position()=2]/text())>0]" mode="A2011"/>

0 and count(.//*[@class='b1 mykw'])>0 and count(.//*[@class='main4_left_m1_t']/a)>0 and count(.//* [@class='main4_left_m1_r']/p)>0 和 count(./following-sibling::div[position()=1]/div[position()=3]/div[position()=2]/ span[position()=2]/text())>0]" mode="A2011">

线索规则:

能源政策 007

HTML

一个

//*[@class='main4_b1 main4_b1_3']//a[.//text()="加载更多"]

线程

能源政策 007

主机名+路径名

未定义

DS电脑抓取数据时,浏览器会按照设置的'load more'页面增长,但下面抓取的数据和第一个一样,没有变化。

请指导我!

谢谢! 查看全部

浏览器抓取网页(使用GooSeeker浏览器的谋数台做了的抓取规则和爬虫)

GooSeeker浏览器制定的爬取规则和爬虫路径:

数据规则:

0 and count(.//*[@class='b1 mykw'])>0 and count(.//*[@class='main4_left_m1_t']/a)>0 and count(.//* [@class='main4_left_m1_r']/p)>0 和 count(./following-sibling::div[position()=1]/div[position()=3]/div[position()=2]/ span[position()=2]/text())>0]" mode="A2011"/>

0 and count(.//*[@class='b1 mykw'])>0 and count(.//*[@class='main4_left_m1_t']/a)>0 and count(.//* [@class='main4_left_m1_r']/p)>0 和 count(./following-sibling::div[position()=1]/div[position()=3]/div[position()=2]/ span[position()=2]/text())>0]" mode="A2011">

线索规则:

能源政策 007

HTML

一个

//*[@class='main4_b1 main4_b1_3']//a[.//text()="加载更多"]

线程

能源政策 007

主机名+路径名

未定义

DS电脑抓取数据时,浏览器会按照设置的'load more'页面增长,但下面抓取的数据和第一个一样,没有变化。

请指导我!

谢谢!

浏览器抓取网页(基于智能预测模型的浏览器网页信息的预获取方法及系统)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-04-07 05:14

本发明专利技术涉及一种浏览器网页信息的预获取方法及系统,包括以下步骤:根据抓取的网页和历史网页的集合以及对应的URL特征建立倒排索引。分别抓取的网页和历史网页;用户输入的待访问URL是否在访问记录中,根据倒排索引获取历史网页信息或爬取网页信息,或提取待访问URL的URL特征;根据提取的 URL 特征集构建候选集;计算要访问的URL与特征候选集中每个URL的相似度,根据相似度权重选择历史访问过的URL;将历史访问过的URL对应的URL信息作为预测候选集,计算每个URL信息的概率,选择概率最高的URL作为最终的URL信息,返回预测候选结果。本发明专利技术根据返回的预测结果进行DNS预测分析、TCP预测连接和资源预测加载后,大大提高了网页的加载速度。

下载所有详细的技术数据

【技术实现步骤总结】

一种浏览器网页信息预获取方法及系统

本专利技术涉及一种浏览器网页信息的预获取方法及系统。

技术介绍

网页加载是浏览器的核心和基本功能。网页加载速度的提升有很多工作要做,比如缓存优化、预加载、基于服务器端技术、网络协议改进(比如SPDY)等等。基于智能预测模型的浏览器网页加载方法是一种可以大幅度提高网页加载速度的方法。在这个方法中,我们将智能预测模型命名为PageLoadOracle,主要是因为PageLoadOracle可以提前告诉我们需要解析什么域名,需要连接什么域名,给定URL需要加载哪些资源。但是,现实中并没有万能的预言机,我们只能尽可能地构建一个高效的预测模型。如何提高预测模型的预测准确率和召回率是一个关键问题。准确率是指预测模型返回需要执行的正确预测行为(DNS解析、TCP连接、资源下载),不执行无意义的预测行为。如果预测有误,则预测行为毫无意义,浪费一定的网络带宽和计算资源,对网络负载产生负面影响。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。资源下载),不进行无意义的预测行为。如果预测有误,则预测行为毫无意义,浪费一定的网络带宽和计算资源,对网络负载产生负面影响。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。资源下载),不进行无意义的预测行为。如果预测有误,则预测行为毫无意义,浪费一定的网络带宽和计算资源,对网络负载产生负面影响。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。

技术实现思路

该专利技术要解决的技术问题是提供一种能够快速冷启动的浏览器网页信息预获取,满足用户个性化长尾需求,提高召回率,无论是否有用户个性化数据或不是。方法和系统。本专利技术解决上述技术问题的技术方案如下: 一种浏览器网页信息的预获取方法,包括以下步骤: 步骤一:针对互联网上预定范围内的所有网站,从每个网站随机抓取预定数量的爬取网页,保存所有爬取网页对应的爬取网页信息;第二步:获取用户在预定时间段内访问的历史网页,保存所有历史网页对应的历史网页信息;Step 3:根据所有爬取网页和历史网页构建访问记录,分别从各个网站爬取的网页和历史网页中提取URL特征,根据爬取的网页和历史对应的爬取网页和历史网页分别为网页。建立倒排索引,用于采集用户的 URL 特征;步骤4:获取用户输入的待访问URL,判断用户输入的待访问URL是否在访问记录中,如果是,则根据倒排索引获取与该待访问URL相关的历史网页信息或爬取网页信息,结束进程,如果没有,提取待访问网站的网站特征;步骤5:根据提取的待访问网站的网站特征集合构建候选集,候选集为倒排索引中所有网站特征集并集的特征候选集;步骤6:计算待访问网站与特征候选集中各个网站的相似度,按照相似度权重排序,选择相似度权重最高的网站特征对应的历史访问网站;步骤7:将历史访问过的网站对应的网站信息作为预测候选集,计算预测候选集中各网站信息的概率,

在没有用户个性化数据的情况下,可以快速冷启动,提高召回率;并且可以整合用户个性化数据,满足用户个性化长尾需求,提高召回率。在上述技术方案的基础上,还可以对专利技术进行如下改进。进一步的,爬取的网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步地,历史网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步的,网站信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步,步骤6中计算待访问网站与特征候选集中各网站的相似度具体为,根据待访问网站与特征候选集中任一网站的特征向量计算余弦距离。进一步的,一种浏览器网页信息预获取系统,包括抓取模块、获取模块、提取模块、判断模块、构建模块、计算模块和返回模块。网站中的所有网站,从每个网站中随机抓取预定数量的抓取网页,并保存所有抓取网页对应的抓取网页信息;获取模块用于获取用户在预定时间段内访问网页的历史记录,保存所有历史网页对应的历史网页信息;提取模块,用于根据所有被爬取的网页和历史网页构建访问记录,分别从每个网站抓取的网页和历史网页中提取URL特征,并根据被爬取的集合建立倒排索引网页和历史网页,以及被抓取的网页和历史网页分别对应的URL特征;判断模块用于获取用户输入的待访问网站,判断用户输入的要访问的URL是否在访问记录中,如果是,则获取历史网页信息或爬取相关网页信息根据倒排索引到要访问的URL,结束进程,如果不是,提取要访问的URL的URL特征;模块,用于根据提取的待访问URL的URL特征集合构建候选集,候选集为倒排索引中所有URL特征集并集的特征候选集;根据相似度权重对访问URL与特征候选集中的每个URL的相似度进行排序,选择相似度权重最高的URL特征对应的历史访问URL;

进一步的,爬取的网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步地,历史网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步的,网站信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步地,计算模块计算待访问网站与特征候选集中各网站的相似度具体为根据待访问网站与特征候选集中任一网站的特征向量计算余弦距离。[附图说明] 图。图1为本专利技术的方法步骤流程图;无花果。图2是专利技术体系结构图。附图中,各个标签所代表的零件清单如下:1、抓取模块、2、获取模块、3、提取模块、4、判断模块、5、@ > 构建模块,6、 计算模块,7、 返回模块。具体实施方式下面结合附图对本专利技术的原理和特点进行说明,举例仅用于说明本专利技术,并不用于限定本专利技术的范围。图1为本专利技术的方法步骤流程图;图2是该专利技术的系统结构图。示例1 从提高智能预测模型的准确率和召回率的角度,我们的预测模型综合考虑了互联网顶级站点和用户个性化的历史数据。一方面,在没有用户个性化历史数据的情况下,基于互联网热门站点网站群体行为数据进行预测;另一方面,预测是基于每个用户自己的个性化历史数据进行的。

前者保证在没有用户个性化数据的情况下,能够快速冷启动,提高召回率;后者可以整合用户个性化数据,满足用户个性化长尾需求,提高召回率。两者缺一不可。一种浏览器网页信息的预获取方法,包括以下步骤: 步骤1:对互联网中预定范围内的所有网站,从每个网站中随机抓取预定数量的抓取网页,保存并存储所有抓取的网页 抓取网页对应的网页信息;Step 1具体为WWW中Top 500站点(作为Top 50 0)的每个站点,开始随机访问,从站点首页抓取k个网页; Step 2:获取用户在预定时间内访问的历史网页时间,保存所有历史网页对应的历史网页信息;Step 3:根据所有爬取的网页和历史网页建立访问记录,从各个网站抓取网页和历史网页 从 中提取URL特征,根据爬取的网页和历史网页建立倒排索引,分别对应爬取网页和历史网页的URL特征集合;步骤3具体为,对于互联网热门站点和用户历史访问量,对于每个网页P,根据提取的URL特征提取URL特征Π(P)、f2(P)、...、fm(P) 从各个网站中抓取网页和历史网页 从 中提取URL特征,并根据抓取的网页和历史网页以及分别对应的抓取网页和历史网页的URL特征集合建立倒排索引;步骤3具体为,对于互联网热门站点和用户历史访问量,对于每个网页P,根据提取的URL特征提取URL特征Π(P)、f2(P)、...、fm(P) 从各个网站中抓取网页和历史网页 从 中提取URL特征,并根据抓取的网页和历史网页以及分别对应的抓取网页和历史网页的URL特征集合建立倒排索引;步骤3具体为,对于互联网热门站点和用户历史访问量,对于每个网页P,根据提取的URL特征提取URL特征Π(P)、f2(P)、...、fm(P)

【技术保护点】

一种浏览器网页信息的预获取方法,其特征在于,包括以下步骤: 步骤1:对互联网中预定范围内的所有网站,从每个网站中随机抓取预定数量的抓取网页,保存它们对应的所有爬取网页的爬取网页信息;步骤2:获取用户在预定时间段内访问的历史网页,并保存所有历史网页对应的历史网页信息;Step 3:基于所有爬取的网页和历史网页建立访问权限 分别从各个网站爬取的网页和历史网页中记录并提取URL特征,根据抓取的网页和历史网页的集合以及被抓取的网页和历史网页分别对应的URL特征建立倒排排名索引;步骤4:获取用户输入的待访问URL,判断用户输入的待访问URL是否在访问记录中,如果是,则获取与待访问URL相关的历史网页信息或爬取网页信息根据倒排索引访问,结束处理,如果没有,则提取待访问网站的网站特征;步骤5:根据提取的待访问网站的网站特征集合构建候选集,候选集为倒排索引候选集中所有网站特征的集合并集的特征;第 6 步:计算待访问URL与特征候选集中各个URL的相似度,按照相似度权重排序,选择相似度权重最高的URL特征对应的历史访问URL;将网站信息作为预测候选集,计算预测候选集中每个网站信息的概率,选择概率最高的网站信息作为最终预测候选结果并返回。

【技术特点总结】

1.一种浏览器网页信息的预获取方法,其特征在于,包括以下步骤: 步骤一:对互联网中预定范围内的所有网站,随机抓取预定数量的Crawl网页,保存所有已爬取网页对应的爬取网页信息;步骤2:获取用户在预定时间段内访问的历史网页,并保存所有历史网页对应的历史网页信息;Step 3:根据所有爬取的网页和历史网页构建访问记录,分别从各个网站爬取的网页和历史网页中提取URL特征。建立倒排索引;第四步:获取用户输入的要访问的网站,判断用户输入的要访问的网站是否在访问记录中,如果是,则根据倒排索引获取与要访问的网站相关的历史网页信息或者抓取获取网页信息,结束处理,如果不是,提取要访问的网站的网站特征;步骤5:根据提取的待访问网站的网站特征集合构建候选集,候选集为倒排索引中所有网站特征的集合并集的特征候选集;步骤6:计算待访问网站中每个网址与特征候选集的相似度,按照相似度权重排序,选择相似度权重最高的网站特征对应的历史访问网站;第 7 步:通过将历史访问过的网站对应的网站信息作为预测候选集,计算预测候选集中每个网站信息的概率,选择概率最高的网站信息作为最终预测候选结果并返回. 2.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于:所述抓取的网页信息包括DNS解析的域名、待创建连接的域名和/或待创建的资源加载。3.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于:所述历史网页信息包括DNS解析的域名,要创建连接的域名和/或要加载的资源。4.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于:所述网址信息包括DNS解析的域名、待创建连接的域名和/或待创建的资源。加载。5.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于: 步骤6中的待访问网站与特征候选集中各网站的相似度计算具体为,根据待访问网站与特征候选集中任意网站的特征向量计算余弦距离。6. 一种浏览器网页信息的预获取系统,

【专利技术性质】

技术研发人员:莫宇、喻言、李洪亮、刘铁峰、

申请人(专利权)持有人:,

类型:发明

国家、省、市:湖北;42

下载所有详细的技术数据 我是该专利的所有者 查看全部

浏览器抓取网页(基于智能预测模型的浏览器网页信息的预获取方法及系统)

本发明专利技术涉及一种浏览器网页信息的预获取方法及系统,包括以下步骤:根据抓取的网页和历史网页的集合以及对应的URL特征建立倒排索引。分别抓取的网页和历史网页;用户输入的待访问URL是否在访问记录中,根据倒排索引获取历史网页信息或爬取网页信息,或提取待访问URL的URL特征;根据提取的 URL 特征集构建候选集;计算要访问的URL与特征候选集中每个URL的相似度,根据相似度权重选择历史访问过的URL;将历史访问过的URL对应的URL信息作为预测候选集,计算每个URL信息的概率,选择概率最高的URL作为最终的URL信息,返回预测候选结果。本发明专利技术根据返回的预测结果进行DNS预测分析、TCP预测连接和资源预测加载后,大大提高了网页的加载速度。

下载所有详细的技术数据

【技术实现步骤总结】

一种浏览器网页信息预获取方法及系统

本专利技术涉及一种浏览器网页信息的预获取方法及系统。

技术介绍

网页加载是浏览器的核心和基本功能。网页加载速度的提升有很多工作要做,比如缓存优化、预加载、基于服务器端技术、网络协议改进(比如SPDY)等等。基于智能预测模型的浏览器网页加载方法是一种可以大幅度提高网页加载速度的方法。在这个方法中,我们将智能预测模型命名为PageLoadOracle,主要是因为PageLoadOracle可以提前告诉我们需要解析什么域名,需要连接什么域名,给定URL需要加载哪些资源。但是,现实中并没有万能的预言机,我们只能尽可能地构建一个高效的预测模型。如何提高预测模型的预测准确率和召回率是一个关键问题。准确率是指预测模型返回需要执行的正确预测行为(DNS解析、TCP连接、资源下载),不执行无意义的预测行为。如果预测有误,则预测行为毫无意义,浪费一定的网络带宽和计算资源,对网络负载产生负面影响。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。资源下载),不进行无意义的预测行为。如果预测有误,则预测行为毫无意义,浪费一定的网络带宽和计算资源,对网络负载产生负面影响。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。资源下载),不进行无意义的预测行为。如果预测有误,则预测行为毫无意义,浪费一定的网络带宽和计算资源,对网络负载产生负面影响。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。召回意味着预测模型能够为请求 URL 的尽可能多的用户提供预测行为指导。特别是对于尚未访问的 URL 的指导。

技术实现思路

该专利技术要解决的技术问题是提供一种能够快速冷启动的浏览器网页信息预获取,满足用户个性化长尾需求,提高召回率,无论是否有用户个性化数据或不是。方法和系统。本专利技术解决上述技术问题的技术方案如下: 一种浏览器网页信息的预获取方法,包括以下步骤: 步骤一:针对互联网上预定范围内的所有网站,从每个网站随机抓取预定数量的爬取网页,保存所有爬取网页对应的爬取网页信息;第二步:获取用户在预定时间段内访问的历史网页,保存所有历史网页对应的历史网页信息;Step 3:根据所有爬取网页和历史网页构建访问记录,分别从各个网站爬取的网页和历史网页中提取URL特征,根据爬取的网页和历史对应的爬取网页和历史网页分别为网页。建立倒排索引,用于采集用户的 URL 特征;步骤4:获取用户输入的待访问URL,判断用户输入的待访问URL是否在访问记录中,如果是,则根据倒排索引获取与该待访问URL相关的历史网页信息或爬取网页信息,结束进程,如果没有,提取待访问网站的网站特征;步骤5:根据提取的待访问网站的网站特征集合构建候选集,候选集为倒排索引中所有网站特征集并集的特征候选集;步骤6:计算待访问网站与特征候选集中各个网站的相似度,按照相似度权重排序,选择相似度权重最高的网站特征对应的历史访问网站;步骤7:将历史访问过的网站对应的网站信息作为预测候选集,计算预测候选集中各网站信息的概率,

在没有用户个性化数据的情况下,可以快速冷启动,提高召回率;并且可以整合用户个性化数据,满足用户个性化长尾需求,提高召回率。在上述技术方案的基础上,还可以对专利技术进行如下改进。进一步的,爬取的网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步地,历史网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步的,网站信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步,步骤6中计算待访问网站与特征候选集中各网站的相似度具体为,根据待访问网站与特征候选集中任一网站的特征向量计算余弦距离。进一步的,一种浏览器网页信息预获取系统,包括抓取模块、获取模块、提取模块、判断模块、构建模块、计算模块和返回模块。网站中的所有网站,从每个网站中随机抓取预定数量的抓取网页,并保存所有抓取网页对应的抓取网页信息;获取模块用于获取用户在预定时间段内访问网页的历史记录,保存所有历史网页对应的历史网页信息;提取模块,用于根据所有被爬取的网页和历史网页构建访问记录,分别从每个网站抓取的网页和历史网页中提取URL特征,并根据被爬取的集合建立倒排索引网页和历史网页,以及被抓取的网页和历史网页分别对应的URL特征;判断模块用于获取用户输入的待访问网站,判断用户输入的要访问的URL是否在访问记录中,如果是,则获取历史网页信息或爬取相关网页信息根据倒排索引到要访问的URL,结束进程,如果不是,提取要访问的URL的URL特征;模块,用于根据提取的待访问URL的URL特征集合构建候选集,候选集为倒排索引中所有URL特征集并集的特征候选集;根据相似度权重对访问URL与特征候选集中的每个URL的相似度进行排序,选择相似度权重最高的URL特征对应的历史访问URL;

进一步的,爬取的网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步地,历史网页信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步的,网站信息包括DNS解析的域名、待创建的域名和/或待加载的资源。进一步地,计算模块计算待访问网站与特征候选集中各网站的相似度具体为根据待访问网站与特征候选集中任一网站的特征向量计算余弦距离。[附图说明] 图。图1为本专利技术的方法步骤流程图;无花果。图2是专利技术体系结构图。附图中,各个标签所代表的零件清单如下:1、抓取模块、2、获取模块、3、提取模块、4、判断模块、5、@ > 构建模块,6、 计算模块,7、 返回模块。具体实施方式下面结合附图对本专利技术的原理和特点进行说明,举例仅用于说明本专利技术,并不用于限定本专利技术的范围。图1为本专利技术的方法步骤流程图;图2是该专利技术的系统结构图。示例1 从提高智能预测模型的准确率和召回率的角度,我们的预测模型综合考虑了互联网顶级站点和用户个性化的历史数据。一方面,在没有用户个性化历史数据的情况下,基于互联网热门站点网站群体行为数据进行预测;另一方面,预测是基于每个用户自己的个性化历史数据进行的。

前者保证在没有用户个性化数据的情况下,能够快速冷启动,提高召回率;后者可以整合用户个性化数据,满足用户个性化长尾需求,提高召回率。两者缺一不可。一种浏览器网页信息的预获取方法,包括以下步骤: 步骤1:对互联网中预定范围内的所有网站,从每个网站中随机抓取预定数量的抓取网页,保存并存储所有抓取的网页 抓取网页对应的网页信息;Step 1具体为WWW中Top 500站点(作为Top 50 0)的每个站点,开始随机访问,从站点首页抓取k个网页; Step 2:获取用户在预定时间内访问的历史网页时间,保存所有历史网页对应的历史网页信息;Step 3:根据所有爬取的网页和历史网页建立访问记录,从各个网站抓取网页和历史网页 从 中提取URL特征,根据爬取的网页和历史网页建立倒排索引,分别对应爬取网页和历史网页的URL特征集合;步骤3具体为,对于互联网热门站点和用户历史访问量,对于每个网页P,根据提取的URL特征提取URL特征Π(P)、f2(P)、...、fm(P) 从各个网站中抓取网页和历史网页 从 中提取URL特征,并根据抓取的网页和历史网页以及分别对应的抓取网页和历史网页的URL特征集合建立倒排索引;步骤3具体为,对于互联网热门站点和用户历史访问量,对于每个网页P,根据提取的URL特征提取URL特征Π(P)、f2(P)、...、fm(P) 从各个网站中抓取网页和历史网页 从 中提取URL特征,并根据抓取的网页和历史网页以及分别对应的抓取网页和历史网页的URL特征集合建立倒排索引;步骤3具体为,对于互联网热门站点和用户历史访问量,对于每个网页P,根据提取的URL特征提取URL特征Π(P)、f2(P)、...、fm(P)

【技术保护点】

一种浏览器网页信息的预获取方法,其特征在于,包括以下步骤: 步骤1:对互联网中预定范围内的所有网站,从每个网站中随机抓取预定数量的抓取网页,保存它们对应的所有爬取网页的爬取网页信息;步骤2:获取用户在预定时间段内访问的历史网页,并保存所有历史网页对应的历史网页信息;Step 3:基于所有爬取的网页和历史网页建立访问权限 分别从各个网站爬取的网页和历史网页中记录并提取URL特征,根据抓取的网页和历史网页的集合以及被抓取的网页和历史网页分别对应的URL特征建立倒排排名索引;步骤4:获取用户输入的待访问URL,判断用户输入的待访问URL是否在访问记录中,如果是,则获取与待访问URL相关的历史网页信息或爬取网页信息根据倒排索引访问,结束处理,如果没有,则提取待访问网站的网站特征;步骤5:根据提取的待访问网站的网站特征集合构建候选集,候选集为倒排索引候选集中所有网站特征的集合并集的特征;第 6 步:计算待访问URL与特征候选集中各个URL的相似度,按照相似度权重排序,选择相似度权重最高的URL特征对应的历史访问URL;将网站信息作为预测候选集,计算预测候选集中每个网站信息的概率,选择概率最高的网站信息作为最终预测候选结果并返回。

【技术特点总结】

1.一种浏览器网页信息的预获取方法,其特征在于,包括以下步骤: 步骤一:对互联网中预定范围内的所有网站,随机抓取预定数量的Crawl网页,保存所有已爬取网页对应的爬取网页信息;步骤2:获取用户在预定时间段内访问的历史网页,并保存所有历史网页对应的历史网页信息;Step 3:根据所有爬取的网页和历史网页构建访问记录,分别从各个网站爬取的网页和历史网页中提取URL特征。建立倒排索引;第四步:获取用户输入的要访问的网站,判断用户输入的要访问的网站是否在访问记录中,如果是,则根据倒排索引获取与要访问的网站相关的历史网页信息或者抓取获取网页信息,结束处理,如果不是,提取要访问的网站的网站特征;步骤5:根据提取的待访问网站的网站特征集合构建候选集,候选集为倒排索引中所有网站特征的集合并集的特征候选集;步骤6:计算待访问网站中每个网址与特征候选集的相似度,按照相似度权重排序,选择相似度权重最高的网站特征对应的历史访问网站;第 7 步:通过将历史访问过的网站对应的网站信息作为预测候选集,计算预测候选集中每个网站信息的概率,选择概率最高的网站信息作为最终预测候选结果并返回. 2.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于:所述抓取的网页信息包括DNS解析的域名、待创建连接的域名和/或待创建的资源加载。3.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于:所述历史网页信息包括DNS解析的域名,要创建连接的域名和/或要加载的资源。4.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于:所述网址信息包括DNS解析的域名、待创建连接的域名和/或待创建的资源。加载。5.根据权利要求1所述的浏览器网页信息的预获取方法,其特征在于: 步骤6中的待访问网站与特征候选集中各网站的相似度计算具体为,根据待访问网站与特征候选集中任意网站的特征向量计算余弦距离。6. 一种浏览器网页信息的预获取系统,

【专利技术性质】

技术研发人员:莫宇、喻言、李洪亮、刘铁峰、

申请人(专利权)持有人:,

类型:发明

国家、省、市:湖北;42

下载所有详细的技术数据 我是该专利的所有者

浏览器抓取网页(1.maven依赖引入2.Java代码3.其他功能总结(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-04-06 15:07

2021-11-26

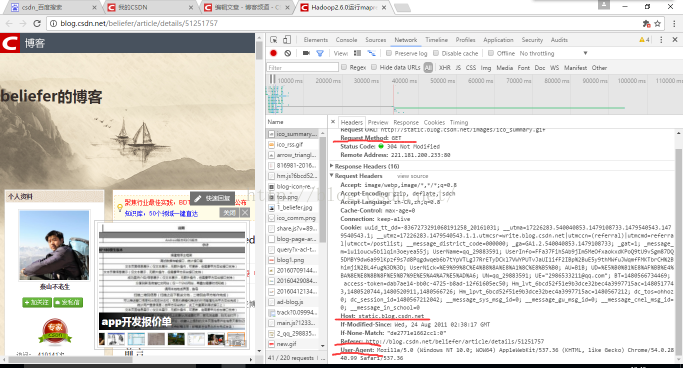

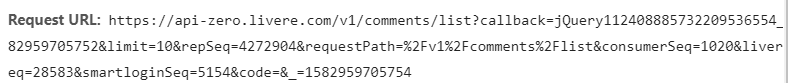

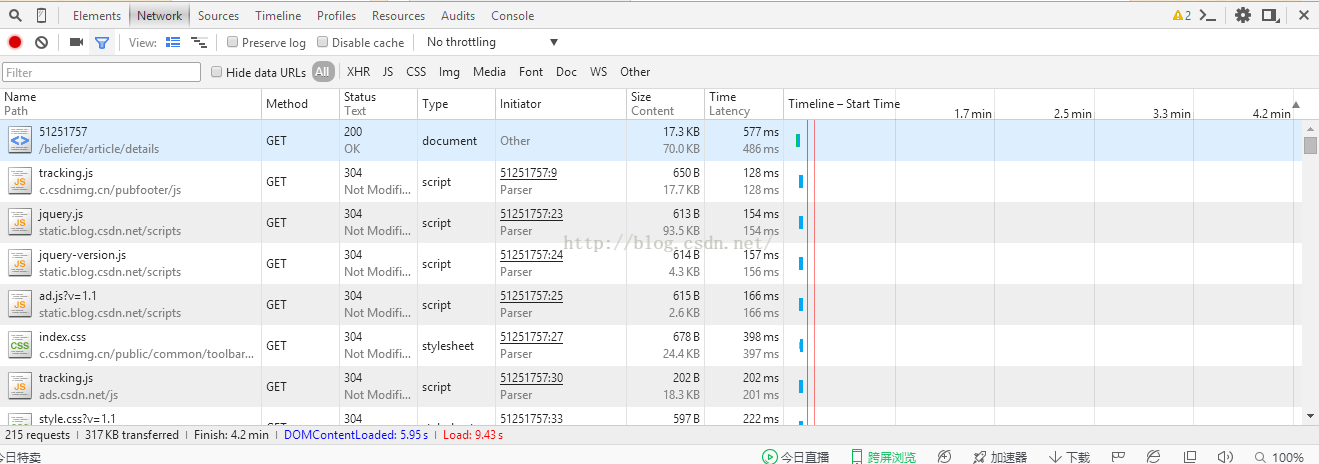

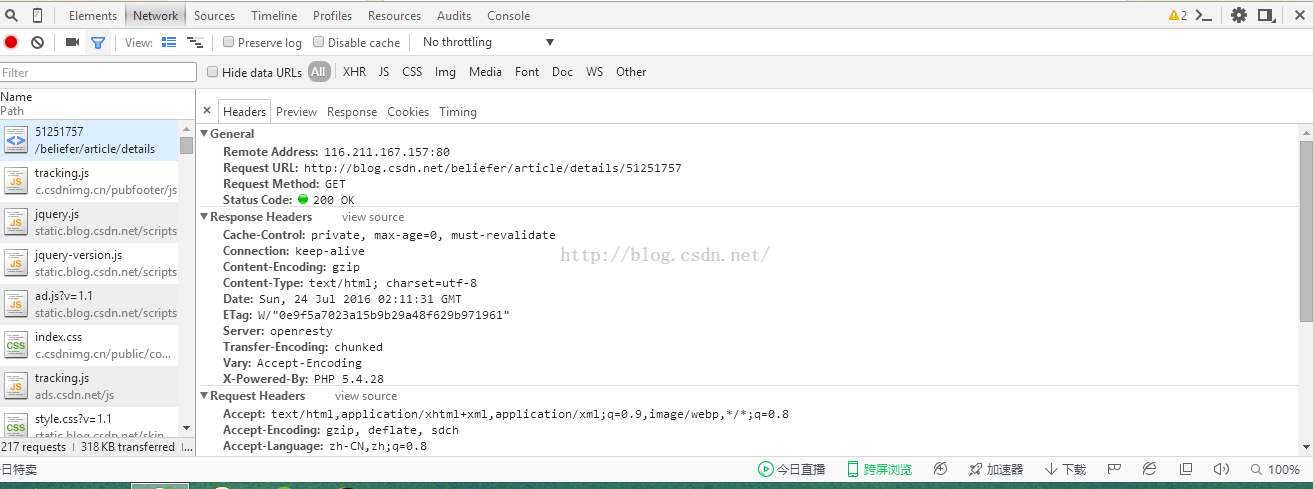

通常我们使用Java提供的HttpURLConnection或者Apache的HttpClient来获取网页的源代码,直观可见,代码内容与网页内容一致通过浏览器右键—— > 点击查看网页源代码。

但是现在越来越多的网站使用Js动态生成内容来提高相应的速度,而HttpClient只是在后端返回相应响应的请求体,并没有返回浏览器生成的网页,所以对于Js生成的内容HttpClient无法获取。

对于获取Js生成的网页,我们主要是模拟浏览器的操作,渲染响应的请求体,最终得到相应的内容。

我们在这里讨论的模拟方法大致有两种:

我们这次的目标是获取bilibili动态生成的动画列表。左上为抓取的目标列表,左下为浏览器渲染的HTML内容,右为服务器返回的响应正文。通过对比可以看出,目标列表是由Js生成的。

使用 Selenium 获取页面

Selenium 是一种用于自动测试 Web 应用程序的工具,更多的是在 Google 上。这里我们主要用它来模拟页面的操作并返回结果,对于网页截图的功能也是可行的。

Selenium 支持模拟很多浏览器,但我们这里只模拟 PhantomJS,因为 PhantomJS 是一个脚本化的、无界面的 WebKit,它使用 JavaScript 作为脚本语言来实现各种功能。由于是无接口的,所以在速度性能方面会更好。

1.下载

使用PhantomJS需要从官网下载最新的客户端,这里使用phantomjs-2.1.1-windows.zip

2.maven依赖介绍:

org.seleniumhq.selenium

selenium-java

2.53.0

com.codeborne

phantomjsdriver

1.2.1

org.seleniumhq.selenium

selenium-remote-driver

org.seleniumhq.selenium

selenium-java

3.示例代码

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.phantomjs.PhantomJSDriver;

import org.openqa.selenium.phantomjs.PhantomJSDriverService;

import org.openqa.selenium.remote.DesiredCapabilities;

import java.util.ArrayList;

/**

* @author GinPonson

*/

public class TestSelenium {

static final String HOST = "127.0.0.1";

static final String PORT = "80";

static final String USER = "gin";

static final String PWD = "12345";

public static void main(String[] args){

System.setProperty("phantomjs.binary.path", "D:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe");

DesiredCapabilities capabilities = DesiredCapabilities.phantomjs();

//设置代理或者其他参数

ArrayList cliArgsCap = new ArrayList();

//cliArgsCap.add("--proxy=http://"+HOST+":"+PORT);

//cliArgsCap.add("--proxy-auth=" + USER + ":" + PWD);

//cliArgsCap.add("--proxy-type=http");

capabilities.setCapability(PhantomJSDriverService.PHANTOMJS_CLI_ARGS, cliArgsCap);

//capabilities.setCapability("phantomjs.page.settings.userAgent", "");

WebDriver driver = new PhantomJSDriver(capabilities);

driver.get("http://www.bilibili.com/video/ ... 6quot;);

System.out.println(driver.getPageSource());

driver.quit();

}

}

4.其他功能

使用 HtmlUnit 获取页面

HtmlUnit 在功能上是 Selenium 的一个子集,Selenium 有相应的 HtmlUnit 实现。HtmlUnit 是一个用 Java 编写的非界面浏览器。因为没有接口,所以执行速度还是可以的。

1.maven依赖介绍

net.sourceforge.htmlunit

htmlunit

2.25

2.Java 代码

/**

* @author GinPonson

*/

public class TestHtmlUnit {

static final String HOST = "127.0.0.1";

static final String PORT = "80";

static final String USER = "gin";

static final String PWD = "12345";

public static void main(String[] args) throws Exception{

WebClient webClient = new WebClient();

//设置代理

//ProxyConfig proxyConfig = webClient.getOptions().getProxyConfig();

//proxyConfig.setProxyHost(HOST);

//proxyConfig.setProxyPort(Integer.valueOf(PORT));

//DefaultCredentialsProvider credentialsProvider = (DefaultCredentialsProvider) webClient.getCredentialsProvider();

//credentialsProvider.addCredentials(USER, PWD);

//设置参数

//webClient.getOptions().setCssEnabled(false);

//webClient.getOptions().setJavaScriptEnabled(false);

webClient.getOptions().setThrowExceptionOnScriptError(false);

HtmlPage page = webClient.getPage("http://www.bilibili.com/video/ ... 6quot;);

System.out.println(page.asXml());

webClient.close();

}

}

3.其他功能

总结

PhantomJS 和 HtmlUnit 都有很好的模拟浏览器页面生成的功能。PhantomJS作为一个无界面的WebKit,渲染页面的功能非常完善,并且有浏览器截图功能,可以模拟登录操作。HtmlUnit使用Rhino引擎解析Js,有时候解析速度很慢,像上面的例子,需要很长的时间,但是HtmlUnit可以获取页面并解析一组元素(当然最好用Jsoup 来解析元素),不错的工具。

HtmlUnit遇到错误后,处理前后相差7分钟,可能我不会用QAQ

欢迎补充:)

分类:

技术要点:

相关文章: 查看全部

浏览器抓取网页(1.maven依赖引入2.Java代码3.其他功能总结(组图))

2021-11-26

通常我们使用Java提供的HttpURLConnection或者Apache的HttpClient来获取网页的源代码,直观可见,代码内容与网页内容一致通过浏览器右键—— > 点击查看网页源代码。

但是现在越来越多的网站使用Js动态生成内容来提高相应的速度,而HttpClient只是在后端返回相应响应的请求体,并没有返回浏览器生成的网页,所以对于Js生成的内容HttpClient无法获取。

对于获取Js生成的网页,我们主要是模拟浏览器的操作,渲染响应的请求体,最终得到相应的内容。

我们在这里讨论的模拟方法大致有两种:

我们这次的目标是获取bilibili动态生成的动画列表。左上为抓取的目标列表,左下为浏览器渲染的HTML内容,右为服务器返回的响应正文。通过对比可以看出,目标列表是由Js生成的。

使用 Selenium 获取页面

Selenium 是一种用于自动测试 Web 应用程序的工具,更多的是在 Google 上。这里我们主要用它来模拟页面的操作并返回结果,对于网页截图的功能也是可行的。

Selenium 支持模拟很多浏览器,但我们这里只模拟 PhantomJS,因为 PhantomJS 是一个脚本化的、无界面的 WebKit,它使用 JavaScript 作为脚本语言来实现各种功能。由于是无接口的,所以在速度性能方面会更好。

1.下载

使用PhantomJS需要从官网下载最新的客户端,这里使用phantomjs-2.1.1-windows.zip

2.maven依赖介绍:

org.seleniumhq.selenium

selenium-java

2.53.0

com.codeborne

phantomjsdriver

1.2.1

org.seleniumhq.selenium

selenium-remote-driver

org.seleniumhq.selenium

selenium-java

3.示例代码

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.phantomjs.PhantomJSDriver;

import org.openqa.selenium.phantomjs.PhantomJSDriverService;

import org.openqa.selenium.remote.DesiredCapabilities;

import java.util.ArrayList;

/**

* @author GinPonson

*/

public class TestSelenium {

static final String HOST = "127.0.0.1";

static final String PORT = "80";

static final String USER = "gin";

static final String PWD = "12345";

public static void main(String[] args){

System.setProperty("phantomjs.binary.path", "D:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe");

DesiredCapabilities capabilities = DesiredCapabilities.phantomjs();

//设置代理或者其他参数

ArrayList cliArgsCap = new ArrayList();

//cliArgsCap.add("--proxy=http://"+HOST+":"+PORT);

//cliArgsCap.add("--proxy-auth=" + USER + ":" + PWD);

//cliArgsCap.add("--proxy-type=http");

capabilities.setCapability(PhantomJSDriverService.PHANTOMJS_CLI_ARGS, cliArgsCap);

//capabilities.setCapability("phantomjs.page.settings.userAgent", "");

WebDriver driver = new PhantomJSDriver(capabilities);

driver.get("http://www.bilibili.com/video/ ... 6quot;);

System.out.println(driver.getPageSource());

driver.quit();

}

}

4.其他功能

使用 HtmlUnit 获取页面

HtmlUnit 在功能上是 Selenium 的一个子集,Selenium 有相应的 HtmlUnit 实现。HtmlUnit 是一个用 Java 编写的非界面浏览器。因为没有接口,所以执行速度还是可以的。

1.maven依赖介绍

net.sourceforge.htmlunit

htmlunit

2.25

2.Java 代码

/**

* @author GinPonson

*/

public class TestHtmlUnit {

static final String HOST = "127.0.0.1";

static final String PORT = "80";

static final String USER = "gin";

static final String PWD = "12345";

public static void main(String[] args) throws Exception{

WebClient webClient = new WebClient();

//设置代理

//ProxyConfig proxyConfig = webClient.getOptions().getProxyConfig();

//proxyConfig.setProxyHost(HOST);

//proxyConfig.setProxyPort(Integer.valueOf(PORT));

//DefaultCredentialsProvider credentialsProvider = (DefaultCredentialsProvider) webClient.getCredentialsProvider();

//credentialsProvider.addCredentials(USER, PWD);

//设置参数

//webClient.getOptions().setCssEnabled(false);

//webClient.getOptions().setJavaScriptEnabled(false);

webClient.getOptions().setThrowExceptionOnScriptError(false);

HtmlPage page = webClient.getPage("http://www.bilibili.com/video/ ... 6quot;);

System.out.println(page.asXml());

webClient.close();

}

}

3.其他功能

总结

PhantomJS 和 HtmlUnit 都有很好的模拟浏览器页面生成的功能。PhantomJS作为一个无界面的WebKit,渲染页面的功能非常完善,并且有浏览器截图功能,可以模拟登录操作。HtmlUnit使用Rhino引擎解析Js,有时候解析速度很慢,像上面的例子,需要很长的时间,但是HtmlUnit可以获取页面并解析一组元素(当然最好用Jsoup 来解析元素),不错的工具。

HtmlUnit遇到错误后,处理前后相差7分钟,可能我不会用QAQ

欢迎补充:)

分类:

技术要点:

相关文章:

浏览器抓取网页(存储将数据存储到Cookie会话的技术管理技术技术 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-04-06 15:04

)

一、会话管理1、概述:

两方之间的通信或交互,同样在计算机中,浏览器与服务器之间的交互称为会话。(版本1)

一个会话收录多个请求和响应(浏览器第一次向服务器资源发送请求,会话建立,直到一方断开连接。)(版本 2)

例:张三给李四打电话,李四接听电话,通话建立,双方挂断通话结束。

2、特点:

在会话范围内的多个请求之间共享数据

限制页面访问(不登录无法访问后台页面)

临时存储数据并在多个请求之间共享数据

记住密码、自动登录、7天免费登录等。

3、生命周期

开始:会话在浏览器访问服务器时开始

结束:浏览器或服务器端中断时结束

注意:服务器一般是连续运行的,所以会话结束通常是浏览器关闭造成的。

4、会话技术:

最常见的场景:数据库存储

在 cookie 中存储数据:数据由浏览器保存

将数据存储到会话:数据由服务器保存

二、Cookies 1、概述:

(1)一小段文字用来存放客户端

(2) 是一种客户端技术,将数据保存到客户端;因为 cookie 存储在客户端浏览器中

(3) 是维护客户端和服务器之间的状态

(4)cookie技术,不安全,请勿使用cookie存储敏感信息!如登录状态和登录信息;

(5)一些敏感数据应该存储在服务器端

功能:跟踪特定对象、统计页面浏览量、简化登录

2、常用方法:

void setMaxAge(int e):设置cookie的有效期,以秒为单位,正数为过了多少秒就会过期;负数表示浏览器关闭时cookie会被删除(有争议);零表示清除 cookie

int getMaxAge():获取cookie的有效时间,以秒为单位

void setValue(String value):创建cookie后给cookie赋值

String getValue():获取cookie的值

String getName():获取cookie的名称

Cookie[] getCookies():获取cookie中的所有属性名

3、使用方法:

(1)创建Cookie对象并绑定数据(获取服务器上的指定数据并通过cookie保存)

Cookie cookie = 新 Cookie(key,value);

(2)写入 Cookie 对象(来自服务器 ---> 客户端)

response.addCookie(cookie)

(3)获取cookie,获取数据

Cookies[] Cookies = request.getCookies()

4、注意事项:

编码 URLEncoder.encode("string","utf-8");

解码 URLDecoder.decode("string","utf-8");

新闻详情页面

三、Session内置对象1、概述:session是jsp9内置对象之一(out、request、response、session、applicationconfig、page、pageContext、exception)

(1)服务器端会话技术,一个会话中多个请求之间共享数据,数据存储在服务器端对象中。jsp:session servlet:HttpSession

(2)可以通过Session在应用程序的WEB页面之间跳转时保存用户的状态,这样整个用户会话会一直存在,直到浏览器关闭。(即用户浏览网站的时间花费。)

注意:如果客户端长时间不向服务器发送请求,Session对象会自动消失。这个时间取决于服务器,例如Tomcat服务器默认为30分钟。

2、常用方法

(1)public void setAttribute(String name,String value);

设置具有指定名称的属性的值并将其添加到会话会话范围,或者如果该属性存在于会话范围内,则更改该属性的值。

(2)public Object getAttribute(String name);

获取会话范围内具有指定名称的属性的值,返回值类型为object,如果该属性不存在,则返回null。

(3)public void removeAttribute(String name);

删除具有指定名称的会话属性。如果该属性不存在,则会发生异常。

(4)公共无效无效();

使会话无效。当前会话可以立即失效,并且所有存储在原创会话中的对象都不能再被访问。

(5)public String getId();

获取当前会话 ID。每个会话在服务器端都有一个唯一的标识 sessionID,而会话对象发送给浏览器的唯一数据就是 sessionID,一般存储在一个 cookie 中。

(6)public void setMaxInactiveInterval(int interval);

设置会话的最大持续时间,以秒为单位,负数表示会话永不过期。

(7)public int getMaxInActiveInterval();

获取会话的最大时长,使用时需要进行一些处理

3、session和window的关系

(1)每个会话对象都与浏览器一一对应。重新打开浏览器相当于重新创建会话对象。

(2)通过超链接打开的新窗口,新窗口的会话与其父窗口的会话相同

四、Session和Cookie的区别

(1)session 将数据存储在服务器上,cookies 存储在客户端

(2)session是一个内置对象,它的属性可以是任意类型,而Cookie对象只能设置字符串

(3)Session没有数据大小限制,Cookie有数据大小限制

(4)会话数据是安全的,cookies相对不安全

自动登录

7天内自动登录 查看全部

浏览器抓取网页(存储将数据存储到Cookie会话的技术管理技术技术

)

一、会话管理1、概述:

两方之间的通信或交互,同样在计算机中,浏览器与服务器之间的交互称为会话。(版本1)

一个会话收录多个请求和响应(浏览器第一次向服务器资源发送请求,会话建立,直到一方断开连接。)(版本 2)

例:张三给李四打电话,李四接听电话,通话建立,双方挂断通话结束。

2、特点:

在会话范围内的多个请求之间共享数据

限制页面访问(不登录无法访问后台页面)

临时存储数据并在多个请求之间共享数据

记住密码、自动登录、7天免费登录等。

3、生命周期

开始:会话在浏览器访问服务器时开始

结束:浏览器或服务器端中断时结束

注意:服务器一般是连续运行的,所以会话结束通常是浏览器关闭造成的。

4、会话技术:

最常见的场景:数据库存储

在 cookie 中存储数据:数据由浏览器保存

将数据存储到会话:数据由服务器保存

二、Cookies 1、概述:

(1)一小段文字用来存放客户端

(2) 是一种客户端技术,将数据保存到客户端;因为 cookie 存储在客户端浏览器中

(3) 是维护客户端和服务器之间的状态

(4)cookie技术,不安全,请勿使用cookie存储敏感信息!如登录状态和登录信息;

(5)一些敏感数据应该存储在服务器端

功能:跟踪特定对象、统计页面浏览量、简化登录

2、常用方法:

void setMaxAge(int e):设置cookie的有效期,以秒为单位,正数为过了多少秒就会过期;负数表示浏览器关闭时cookie会被删除(有争议);零表示清除 cookie

int getMaxAge():获取cookie的有效时间,以秒为单位

void setValue(String value):创建cookie后给cookie赋值

String getValue():获取cookie的值

String getName():获取cookie的名称

Cookie[] getCookies():获取cookie中的所有属性名

3、使用方法:

(1)创建Cookie对象并绑定数据(获取服务器上的指定数据并通过cookie保存)

Cookie cookie = 新 Cookie(key,value);

(2)写入 Cookie 对象(来自服务器 ---> 客户端)

response.addCookie(cookie)

(3)获取cookie,获取数据

Cookies[] Cookies = request.getCookies()

4、注意事项:

编码 URLEncoder.encode("string","utf-8");

解码 URLDecoder.decode("string","utf-8");

新闻详情页面

三、Session内置对象1、概述:session是jsp9内置对象之一(out、request、response、session、applicationconfig、page、pageContext、exception)

(1)服务器端会话技术,一个会话中多个请求之间共享数据,数据存储在服务器端对象中。jsp:session servlet:HttpSession

(2)可以通过Session在应用程序的WEB页面之间跳转时保存用户的状态,这样整个用户会话会一直存在,直到浏览器关闭。(即用户浏览网站的时间花费。)

注意:如果客户端长时间不向服务器发送请求,Session对象会自动消失。这个时间取决于服务器,例如Tomcat服务器默认为30分钟。

2、常用方法

(1)public void setAttribute(String name,String value);

设置具有指定名称的属性的值并将其添加到会话会话范围,或者如果该属性存在于会话范围内,则更改该属性的值。

(2)public Object getAttribute(String name);

获取会话范围内具有指定名称的属性的值,返回值类型为object,如果该属性不存在,则返回null。

(3)public void removeAttribute(String name);

删除具有指定名称的会话属性。如果该属性不存在,则会发生异常。

(4)公共无效无效();

使会话无效。当前会话可以立即失效,并且所有存储在原创会话中的对象都不能再被访问。

(5)public String getId();

获取当前会话 ID。每个会话在服务器端都有一个唯一的标识 sessionID,而会话对象发送给浏览器的唯一数据就是 sessionID,一般存储在一个 cookie 中。

(6)public void setMaxInactiveInterval(int interval);

设置会话的最大持续时间,以秒为单位,负数表示会话永不过期。

(7)public int getMaxInActiveInterval();

获取会话的最大时长,使用时需要进行一些处理

3、session和window的关系

(1)每个会话对象都与浏览器一一对应。重新打开浏览器相当于重新创建会话对象。

(2)通过超链接打开的新窗口,新窗口的会话与其父窗口的会话相同

四、Session和Cookie的区别

(1)session 将数据存储在服务器上,cookies 存储在客户端

(2)session是一个内置对象,它的属性可以是任意类型,而Cookie对象只能设置字符串

(3)Session没有数据大小限制,Cookie有数据大小限制

(4)会话数据是安全的,cookies相对不安全

自动登录

7天内自动登录

浏览器抓取网页(会话管理技术技术最常见的方案-上海怡健医学 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-04-06 15:03

)

会话管理

会话概述

两方之间的通信或交互,同样在计算机中,浏览器与服务器之间的交互称为会话。

一个会话中的多个请求和响应

对话功能

在会话范围内的多个请求之间共享数据

功能:

限制页面访问(不登录无法访问后台页面)

临时存储数据并在多个请求之间共享数据

记住密码、自动登录、7天免费登录等。

生命周期

开始

会话在浏览器访问服务器的那一刻开始

结尾

当浏览器或服务器端中断时结束

注意:服务器一般是连续运行的,所以会话结束通常是浏览器关闭造成的。

会话技术

最常见的场景:数据库存储

在 cookie 中存储数据:数据由浏览器保存

将数据存储到会话:数据由服务器保存

一、 Cookie

翻译:饼干

概述

(1)一小段文字用来存放客户端

(2) 是一种客户端技术,将数据保存到客户端;因为 cookie 存储在客户端浏览器中

(3) 是维护客户端和服务器之间的状态

(4)cookie技术,不安全,请勿使用cookie存储敏感信息!如登录状态和登录信息;

(5)一些敏感数据应该存储在服务器端

常用方法

无效 setMaxAge(int e);

** 设置cookie的有效期,以秒为单位,正数为秒数后过期;负数表示浏览器关闭时cookie会被删除(有争议);零表示清除 cookie

int getMaxAge();

** 获取cookie的有效时间,以秒为单位

无效 setValue(字符串值);

** 创建cookie后,给cookie赋值

字符串 getValue();

** 获取cookie的值

字符串 getName();

** 获取 cookie 的名称

饼干[] getCookies();

** 获取cookie中的所有属性名

如何使用

(1)创建Cookie对象并绑定数据(获取服务器上的指定数据并通过cookie保存)

**Cookie cookie = new Cookie(key,value);

(2)发送 Cookie 对象(来自服务器 ---> 客户端)

** response.addCookie(cookie)

(3)获取cookies,获取数据

**Cookie[]cookies = request.getCookies()

防范措施

编码 URLEncoder.encode("string","utf-8");

解码 URLDecoder.decode("string","utf-8");

使用 Cookie

1.介绍

1.1 案例:张三和李四的会面(从头到尾)====》Client and Server

2.会话

2.1 概述:一个会话中的多个请求和响应

一次会话:浏览器第一次向服务器资源发送请求,会话建立,直到一方断开。

2.2 功能:一个会话范围内的多个请求之间共享数据

2.3 种方式:

(1)客户端会话技术:Cookies

(2)服务器端会话技术:session

3.Cookie

3.1 概述

客户端会话技术,将数据保存到客户端

3.2 快速入门

使用步骤:

(1)创建Cookie对象并绑定数据

新 Cookie(键,值);

(2)发送 Cookie 对象(来自服务器 ---> 客户端)

request.addCookie(cookie)

(3)获取cookies,获取数据

request.getCookies()

4.Cookie 详细信息

4.1 可以同时发送多个cookie吗?

** 能

** 可以创建多个 Cookie 对象,并使用响应多次调用 addCookie 方法发送 cookie。

4.2 cookie 在浏览器中保存多长时间?

(1)默认在关闭浏览器时销毁cookie数据

(2)持久存储

** setMaxAge(int 秒); 秒

** 参数:

正数---》将cookie数据写入硬盘文件。持久化存储[cookie生命周期]

** 负数:

默认值

** 零:

删除cookie信息

4.3 cookie 可以存储中文吗?

** 在tomcat8.0之前,中文数据不能直接存入cookies。

** 中文数据需要转码---》一般使用URL编码

** tomcat8.0后,cookies支持中文数据,但仍不支持特殊字符。建议使用 URL 编码存储

使用 URL 解码解析

* 编码 URLEncoder.encode("string","utf-8");

* 解码 URLDecoder.decode("string","utf-8");

5.cookies的特性和功能

特征:

(1)cookies 将数据存储在客户端浏览器中

(2)浏览器有单个cookie大小限制(4KB)和同域名下cookie总数限制(20个)

影响:

(1)cookies 通常用于存储少量不太敏感的数据

(2)无需登录即可完成服务端对客户端的识别

二、 会话

概述

session 是属于 jsp9 的大型内置对象之一

(1)服务器端会话技术,一个会话中多个请求共享数据,数据存储在服务器端对象中。jsp:session servlet:HttpSession

(2)在应用程序的WEB页面之间跳转时可以通过Session保存用户的状态,这样整个用户会话会一直存在,直到浏览器关闭。

注意:如果客户端长时间不向服务器发送请求,Session对象会自动消失。这个时间取决于服务器,例如Tomcat服务器默认为30分钟。

常用方法

公共无效setAttribute(字符串名称,字符串值);

** 设置具有指定名称的属性的值并将其添加到会话范围。如果该属性存在于会话范围内,请更改该属性的值。

公共对象getAttribute(字符串名称);

** 获取会话范围内具有指定名称的属性的值,返回值类型为object,如果该属性不存在则为null。

公共无效removeAttribute(字符串名称);

** 删除指定名称的会话属性。如果该属性不存在,则会发生异常。

公共无效无效();

** 使会话无效。当前会话可以立即失效,并且所有存储在原创会话中的对象都不能再被访问。

公共字符串 getId();

** 获取当前会话 ID。每个会话在服务器端都有一个唯一的标识 sessionID,而会话对象发送给浏览器的唯一数据就是 sessionID,一般存储在一个 cookie 中。

公共无效 setMaxInactiveInterval(int 间隔);

** 以秒为单位设置会话的最大持续时间,负数表示会话永不过期。

公共 int getMaxInActiveInterval();

** 获取会话的最大时长,使用时需要进行一些处理

session和cookie的区别

(1)session在服务器端存储数据,在客户端存储cookies

(2)session是一个内置对象,它的属性可以是任意类型,而Cookie对象只能设置字符串

(3)Session没有数据大小限制,Cookie有数据大小限制

(4)会话数据是安全的,cookies相对不安全

会话的使用

会话->内置对象

1.概览

服务器端会话技术,它在一个会话中的多个请求之间共享数据,并将数据保存在服务器端对象中。jsp:会话小服务程序:HttpSession

2.快速入门

(1)getAttribute(字符串名称);

(2)setAttribute(字符串名称,对象值)

(3)removeAattribute(字符串名称)

3.详情

1.客户端关闭时,服务端没有关闭,两次获取的session是一样的吗?

* 默认情况下,不

* 如果需要的话,可以创建一个cookie,key是JSESSIONID,设置最大存活时间,让cookie持久化。

Cookie c = new Cookie("JSESSIONID",session.getId());

c.setMaxAge(60*60);

response.addCookie(c);

2.客户端没有关闭。服务器关闭后,两次获得的session是一样的吗?

* 不是同一个,但请确保没有数据丢失。tomcat 会自动执行以下操作。

** 会话钝化:

在服务器正常关闭之前将会话对象序列化到磁盘

** 会话激活:

服务器启动后,可以将会话文件转换为内存中的会话对象。

3.会话何时销毁?

(1) 服务器宕机

(2) 会话对象调用 invalidate() 方法

(3)会话默认过期时间为 30 分钟 => web.xml

4.会话功能

Session 用于存储一个会话的多个请求的数据,存储在服务器端

会话可以存储任何类型和大小的数据

session和cookie的区别

1.session 将数据存储在服务端,cookies 存储在客户端

Cookie存储的数据只能是文本,Session---Object

2.session 没有数据大小限制,cookie 有

3.session数据安全,cookies比较不安全

包括指令

查看全部

浏览器抓取网页(会话管理技术技术最常见的方案-上海怡健医学

)

会话管理

会话概述

两方之间的通信或交互,同样在计算机中,浏览器与服务器之间的交互称为会话。

一个会话中的多个请求和响应

对话功能

在会话范围内的多个请求之间共享数据

功能:

限制页面访问(不登录无法访问后台页面)

临时存储数据并在多个请求之间共享数据

记住密码、自动登录、7天免费登录等。

生命周期

开始

会话在浏览器访问服务器的那一刻开始

结尾

当浏览器或服务器端中断时结束

注意:服务器一般是连续运行的,所以会话结束通常是浏览器关闭造成的。

会话技术

最常见的场景:数据库存储

在 cookie 中存储数据:数据由浏览器保存

将数据存储到会话:数据由服务器保存

一、 Cookie

翻译:饼干

概述

(1)一小段文字用来存放客户端

(2) 是一种客户端技术,将数据保存到客户端;因为 cookie 存储在客户端浏览器中

(3) 是维护客户端和服务器之间的状态

(4)cookie技术,不安全,请勿使用cookie存储敏感信息!如登录状态和登录信息;

(5)一些敏感数据应该存储在服务器端

常用方法

无效 setMaxAge(int e);

** 设置cookie的有效期,以秒为单位,正数为秒数后过期;负数表示浏览器关闭时cookie会被删除(有争议);零表示清除 cookie

int getMaxAge();

** 获取cookie的有效时间,以秒为单位

无效 setValue(字符串值);

** 创建cookie后,给cookie赋值

字符串 getValue();

** 获取cookie的值

字符串 getName();

** 获取 cookie 的名称

饼干[] getCookies();

** 获取cookie中的所有属性名

如何使用

(1)创建Cookie对象并绑定数据(获取服务器上的指定数据并通过cookie保存)

**Cookie cookie = new Cookie(key,value);

(2)发送 Cookie 对象(来自服务器 ---> 客户端)

** response.addCookie(cookie)

(3)获取cookies,获取数据

**Cookie[]cookies = request.getCookies()

防范措施

编码 URLEncoder.encode("string","utf-8");

解码 URLDecoder.decode("string","utf-8");

使用 Cookie

1.介绍

1.1 案例:张三和李四的会面(从头到尾)====》Client and Server

2.会话

2.1 概述:一个会话中的多个请求和响应

一次会话:浏览器第一次向服务器资源发送请求,会话建立,直到一方断开。

2.2 功能:一个会话范围内的多个请求之间共享数据

2.3 种方式:

(1)客户端会话技术:Cookies

(2)服务器端会话技术:session

3.Cookie

3.1 概述

客户端会话技术,将数据保存到客户端

3.2 快速入门

使用步骤:

(1)创建Cookie对象并绑定数据

新 Cookie(键,值);

(2)发送 Cookie 对象(来自服务器 ---> 客户端)

request.addCookie(cookie)

(3)获取cookies,获取数据

request.getCookies()

4.Cookie 详细信息

4.1 可以同时发送多个cookie吗?

** 能

** 可以创建多个 Cookie 对象,并使用响应多次调用 addCookie 方法发送 cookie。

4.2 cookie 在浏览器中保存多长时间?

(1)默认在关闭浏览器时销毁cookie数据

(2)持久存储

** setMaxAge(int 秒); 秒

** 参数:

正数---》将cookie数据写入硬盘文件。持久化存储[cookie生命周期]

** 负数:

默认值

** 零:

删除cookie信息

4.3 cookie 可以存储中文吗?

** 在tomcat8.0之前,中文数据不能直接存入cookies。

** 中文数据需要转码---》一般使用URL编码

** tomcat8.0后,cookies支持中文数据,但仍不支持特殊字符。建议使用 URL 编码存储

使用 URL 解码解析

* 编码 URLEncoder.encode("string","utf-8");

* 解码 URLDecoder.decode("string","utf-8");

5.cookies的特性和功能

特征:

(1)cookies 将数据存储在客户端浏览器中

(2)浏览器有单个cookie大小限制(4KB)和同域名下cookie总数限制(20个)

影响:

(1)cookies 通常用于存储少量不太敏感的数据

(2)无需登录即可完成服务端对客户端的识别

二、 会话

概述

session 是属于 jsp9 的大型内置对象之一

(1)服务器端会话技术,一个会话中多个请求共享数据,数据存储在服务器端对象中。jsp:session servlet:HttpSession

(2)在应用程序的WEB页面之间跳转时可以通过Session保存用户的状态,这样整个用户会话会一直存在,直到浏览器关闭。

注意:如果客户端长时间不向服务器发送请求,Session对象会自动消失。这个时间取决于服务器,例如Tomcat服务器默认为30分钟。

常用方法

公共无效setAttribute(字符串名称,字符串值);

** 设置具有指定名称的属性的值并将其添加到会话范围。如果该属性存在于会话范围内,请更改该属性的值。

公共对象getAttribute(字符串名称);

** 获取会话范围内具有指定名称的属性的值,返回值类型为object,如果该属性不存在则为null。

公共无效removeAttribute(字符串名称);

** 删除指定名称的会话属性。如果该属性不存在,则会发生异常。

公共无效无效();

** 使会话无效。当前会话可以立即失效,并且所有存储在原创会话中的对象都不能再被访问。

公共字符串 getId();

** 获取当前会话 ID。每个会话在服务器端都有一个唯一的标识 sessionID,而会话对象发送给浏览器的唯一数据就是 sessionID,一般存储在一个 cookie 中。

公共无效 setMaxInactiveInterval(int 间隔);

** 以秒为单位设置会话的最大持续时间,负数表示会话永不过期。

公共 int getMaxInActiveInterval();

** 获取会话的最大时长,使用时需要进行一些处理

session和cookie的区别

(1)session在服务器端存储数据,在客户端存储cookies

(2)session是一个内置对象,它的属性可以是任意类型,而Cookie对象只能设置字符串

(3)Session没有数据大小限制,Cookie有数据大小限制

(4)会话数据是安全的,cookies相对不安全

会话的使用

会话->内置对象

1.概览

服务器端会话技术,它在一个会话中的多个请求之间共享数据,并将数据保存在服务器端对象中。jsp:会话小服务程序:HttpSession

2.快速入门

(1)getAttribute(字符串名称);

(2)setAttribute(字符串名称,对象值)

(3)removeAattribute(字符串名称)

3.详情

1.客户端关闭时,服务端没有关闭,两次获取的session是一样的吗?

* 默认情况下,不

* 如果需要的话,可以创建一个cookie,key是JSESSIONID,设置最大存活时间,让cookie持久化。

Cookie c = new Cookie("JSESSIONID",session.getId());

c.setMaxAge(60*60);

response.addCookie(c);

2.客户端没有关闭。服务器关闭后,两次获得的session是一样的吗?

* 不是同一个,但请确保没有数据丢失。tomcat 会自动执行以下操作。

** 会话钝化:

在服务器正常关闭之前将会话对象序列化到磁盘

** 会话激活:

服务器启动后,可以将会话文件转换为内存中的会话对象。

3.会话何时销毁?

(1) 服务器宕机

(2) 会话对象调用 invalidate() 方法

(3)会话默认过期时间为 30 分钟 => web.xml

4.会话功能

Session 用于存储一个会话的多个请求的数据,存储在服务器端

会话可以存储任何类型和大小的数据

session和cookie的区别

1.session 将数据存储在服务端,cookies 存储在客户端

Cookie存储的数据只能是文本,Session---Object

2.session 没有数据大小限制,cookie 有

3.session数据安全,cookies比较不安全

包括指令

浏览器抓取网页(基于所述预页面截取方法的所述目标)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-04 12:06

技术特点:

1.一种浏览器页面拦截方法,其特征在于,应用于服务器时,包括:获取浏览器客户端触发生成的拦截指令,控制浏览器客户端发送相应的拦截指令。对拦截指令的拦截参数;其中,拦截参数为浏览器客户端预先拦截页面的相关信息。根据截取参数访问预截页面,对预截页面进行截取操作,获取预截页面对应的目标截图后,将目标截图返回给浏览器客户端。2.根据权利要求1所述的截取浏览器页面的方法,其特征在于,在获取浏览器客户端触发生成的拦截指令之前,还包括: 浏览器客户端通过调用服务来调用服务。终端上的页面拦截服务api触发拦截指令的生成。3.根据权利要求1所述的浏览器页面拦截方法,其特征在于,所述根据所述拦截指令控制所述浏览器客户端发送相应的拦截参数包括: 根据所述拦截指令控制所述浏览器客户端发送预先设置的页面地址。截取页面和预截取页面中目标DOM节点的标识属性;其中,目标 DOM 节点是预截取页面对应的目标截图 中收录的 dom 节点。4.根据权利要求3所述的浏览器页面拦截方法,其特征在于,所述根据拦截参数访问预先拦截的页面包括: 在服务器上启动无头浏览器,使用无头浏览器访问预先拦截的页面。到预先截获的页面的页面地址。

5.根据权利要求4所述的浏览器页面拦截方法,其特征在于,所述无头浏览器根据预先拦截的页面的页面地址访问预先拦截的页面包括以下步骤:页面设置访问权限,控制浏览器客户端发送预截获页面对应的认证凭证,从而使用无头浏览器根据预截获页面地址的页面和访问凭证访问预截获页面- 捕获的页面。6.根据权利要求3所述的拦截浏览器页面的方法,其特征在于,在对预先拦截的页面进行拦截操作之前,该方法还包括:监控预截页面的所有数据接口判断预截页面的响应是否完成,如果是,判断预截页面中的所有dom节点是否渲染完成,如果是,开始步骤拦截预拦截页面。7.根据权利要求6所述的浏览器页面截取方法,其特征在于,对所述预先截取的页面进行截取操作,得到所述预先截取的页面对应的目标截图包括: 根据所述预先截取的页面截取页面中目标dom节点的标识属性,从所有dom节点中找到目标dom节点;获取目标dom节点的定位属性信息,并根据定位属性信息截取预先截取的页面中收录目标dom节点的区域,得到目标截图。8.根据权利要求1至7任一项所述的浏览器页面截取方法,其特征在于,所述将目标截图返回给浏览器客户端包括: 根据截取参数中的文件格式将目标截图封装成文件流对应的格式,并将文件流返回给浏览器客户端;其中,文件格式为根据拦截指令控制浏览 根据截取参数中的文件格式,将目标截图封装成相应格式的文件流,并将文件流返回给浏览器客户端;其中,文件格式为根据拦截指令控制浏览 根据截取参数中的文件格式,将目标截图封装成相应格式的文件流,并将文件流返回给浏览器客户端;其中,文件格式为根据拦截指令控制浏览

服务器客户端发送的参数。9.根据权利要求8所述的浏览器页面截取方法,其特征在于,根据截取参数中的文件格式将目标截图封装成对应格式的文件流后,还包括: 加水印操作根据预设要求对文件流进行处理,得到具有与预设要求对应的水印信息的文件流。10.一种浏览器页面拦截装置,其特征在于,应用于服务器时,包括: 获取模块,用于获取浏览器客户端触发生成的拦截指令,并根据以下内容控制拦截指令拦截指令。浏览器客户端发送相应的拦截参数;其中,拦截参数是与浏览器客户端的预拦截页面相关的信息。截取模块,用于根据截取参数访问预截取页面。对预截取页面进行截取操作,得到预截取页面对应的目标截屏,然后将目标截屏返回给浏览器客户端。

技术总结

本申请公开了一种浏览器页面拦截及装置,应用于服务器,包括:获取浏览器客户端触发生成的拦截指令,根据拦截指令控制浏览器客户端发送相应的拦截参数。拦截参数是与浏览器客户端的预拦截页面相关的信息;根据截取参数访问预截页面,对预截页面进行截取操作,得到对应的预截页面。目标截屏后,将目标截屏返回给浏览器客户端。获取拦截指令后,本应用服务器获取浏览器客户端对该截取指令的截取参数,根据截取参数统一访问预先截取的页面进行页面截取,同时将截图返回给浏览器客户端. ,从而解决各用户浏览器拦截功能不兼容的问题,拦截响应速度快,实现简单。拦截响应快速且易于实现。拦截响应快速且易于实现。从而解决各用户浏览器拦截功能不兼容的问题,拦截响应速度快,实现简单。拦截响应快速且易于实现。拦截响应快速且易于实现。从而解决各用户浏览器拦截功能不兼容的问题,拦截响应速度快,实现简单。拦截响应快速且易于实现。拦截响应快速且易于实现。

技术研发人员:王子龙

受保护的技术用户:

技术研发日:2021.12.21

技术发布日期:2022/3/25 查看全部

浏览器抓取网页(基于所述预页面截取方法的所述目标)

技术特点:

1.一种浏览器页面拦截方法,其特征在于,应用于服务器时,包括:获取浏览器客户端触发生成的拦截指令,控制浏览器客户端发送相应的拦截指令。对拦截指令的拦截参数;其中,拦截参数为浏览器客户端预先拦截页面的相关信息。根据截取参数访问预截页面,对预截页面进行截取操作,获取预截页面对应的目标截图后,将目标截图返回给浏览器客户端。2.根据权利要求1所述的截取浏览器页面的方法,其特征在于,在获取浏览器客户端触发生成的拦截指令之前,还包括: 浏览器客户端通过调用服务来调用服务。终端上的页面拦截服务api触发拦截指令的生成。3.根据权利要求1所述的浏览器页面拦截方法,其特征在于,所述根据所述拦截指令控制所述浏览器客户端发送相应的拦截参数包括: 根据所述拦截指令控制所述浏览器客户端发送预先设置的页面地址。截取页面和预截取页面中目标DOM节点的标识属性;其中,目标 DOM 节点是预截取页面对应的目标截图 中收录的 dom 节点。4.根据权利要求3所述的浏览器页面拦截方法,其特征在于,所述根据拦截参数访问预先拦截的页面包括: 在服务器上启动无头浏览器,使用无头浏览器访问预先拦截的页面。到预先截获的页面的页面地址。

5.根据权利要求4所述的浏览器页面拦截方法,其特征在于,所述无头浏览器根据预先拦截的页面的页面地址访问预先拦截的页面包括以下步骤:页面设置访问权限,控制浏览器客户端发送预截获页面对应的认证凭证,从而使用无头浏览器根据预截获页面地址的页面和访问凭证访问预截获页面- 捕获的页面。6.根据权利要求3所述的拦截浏览器页面的方法,其特征在于,在对预先拦截的页面进行拦截操作之前,该方法还包括:监控预截页面的所有数据接口判断预截页面的响应是否完成,如果是,判断预截页面中的所有dom节点是否渲染完成,如果是,开始步骤拦截预拦截页面。7.根据权利要求6所述的浏览器页面截取方法,其特征在于,对所述预先截取的页面进行截取操作,得到所述预先截取的页面对应的目标截图包括: 根据所述预先截取的页面截取页面中目标dom节点的标识属性,从所有dom节点中找到目标dom节点;获取目标dom节点的定位属性信息,并根据定位属性信息截取预先截取的页面中收录目标dom节点的区域,得到目标截图。8.根据权利要求1至7任一项所述的浏览器页面截取方法,其特征在于,所述将目标截图返回给浏览器客户端包括: 根据截取参数中的文件格式将目标截图封装成文件流对应的格式,并将文件流返回给浏览器客户端;其中,文件格式为根据拦截指令控制浏览 根据截取参数中的文件格式,将目标截图封装成相应格式的文件流,并将文件流返回给浏览器客户端;其中,文件格式为根据拦截指令控制浏览 根据截取参数中的文件格式,将目标截图封装成相应格式的文件流,并将文件流返回给浏览器客户端;其中,文件格式为根据拦截指令控制浏览

服务器客户端发送的参数。9.根据权利要求8所述的浏览器页面截取方法,其特征在于,根据截取参数中的文件格式将目标截图封装成对应格式的文件流后,还包括: 加水印操作根据预设要求对文件流进行处理,得到具有与预设要求对应的水印信息的文件流。10.一种浏览器页面拦截装置,其特征在于,应用于服务器时,包括: 获取模块,用于获取浏览器客户端触发生成的拦截指令,并根据以下内容控制拦截指令拦截指令。浏览器客户端发送相应的拦截参数;其中,拦截参数是与浏览器客户端的预拦截页面相关的信息。截取模块,用于根据截取参数访问预截取页面。对预截取页面进行截取操作,得到预截取页面对应的目标截屏,然后将目标截屏返回给浏览器客户端。

技术总结

本申请公开了一种浏览器页面拦截及装置,应用于服务器,包括:获取浏览器客户端触发生成的拦截指令,根据拦截指令控制浏览器客户端发送相应的拦截参数。拦截参数是与浏览器客户端的预拦截页面相关的信息;根据截取参数访问预截页面,对预截页面进行截取操作,得到对应的预截页面。目标截屏后,将目标截屏返回给浏览器客户端。获取拦截指令后,本应用服务器获取浏览器客户端对该截取指令的截取参数,根据截取参数统一访问预先截取的页面进行页面截取,同时将截图返回给浏览器客户端. ,从而解决各用户浏览器拦截功能不兼容的问题,拦截响应速度快,实现简单。拦截响应快速且易于实现。拦截响应快速且易于实现。从而解决各用户浏览器拦截功能不兼容的问题,拦截响应速度快,实现简单。拦截响应快速且易于实现。拦截响应快速且易于实现。从而解决各用户浏览器拦截功能不兼容的问题,拦截响应速度快,实现简单。拦截响应快速且易于实现。拦截响应快速且易于实现。

技术研发人员:王子龙

受保护的技术用户:

技术研发日:2021.12.21

技术发布日期:2022/3/25

浏览器抓取网页(网页抓取之WebBrowser繁体2006年04月22-最近研究)

网站优化 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2022-04-04 02:06

用于网页抓取的 WebBrowser 繁体中文

2006年4月22日 - 最近学习了网页信息的批量分析和爬取,还是有一些经验的。我们知道网页程序的设计可以分为静态网页和动态网页。静态网页基本都是纯html,动态网页在服务器端执行,结果返回浏览器端。从某种意义上说,本地浏览器中的网页都是静态的。对于不需要验证的打开网页,只要网站地址和正则

Python 网页爬取 Lxml 繁体

2017 年 5 月 9 日 - Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。该模块是用 C 语言编写的,解析速度比 BeautifulSoup 快。Lxml 正确解析属性周围缺少的引号并关闭标签。比如case 1和case 2就是Lxml的CSS选择器提取区域数据的示例代码#coding=utf-8import

爬取近似网页过滤繁体中文

2014.08.17 - 大部分爬取的网页内容都会相似,爬取的时候应该过滤掉。开始考虑使用VSM算法,后来发现不对。对比了太多东西,然后发现了simHash算法,懒得复制这个算法的解释了,simhash算法对短数据支持不好,但是,我有长数据,用吧!网上也有很多源码实现,但是好像都是一样的。

当当数据在网页数据抓取

2017 年 1 月 22 日 - 包 com.atman.baiye.store.utils;import java.io.BufferedReader;import java.io.IOException;import java.io.InputStreamReader;import .Malforme

Python网页抓取的美丽汤

2017 年 5 月 9 日 - BeautifulSoup 是一个非常流行的模块,它在解析一些闭引号标签时排版它们。例如:从 bs4 导入 BeautifulSoupbroken_html = '

用于网页抓取的 WebBrowser 繁体中文

2006年4月22日 - 最近学习了网页信息的批量分析和爬取,还是有一些经验的。我们知道网页程序的设计可以分为静态网页和动态网页。静态网页基本都是纯html,动态网页在服务器端执行,结果返回浏览器端。从某种意义上说,本地浏览器中的网页都是静态的。对于不需要验证的打开网页,只要网站地址和正则

Python 网页爬取 Lxml 繁体

2017 年 5 月 9 日 - Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。该模块是用 C 语言编写的,解析速度比 BeautifulSoup 快。Lxml 正确解析属性周围缺少的引号并关闭标签。比如case 1和case 2就是Lxml的CSS选择器提取区域数据的示例代码#coding=utf-8import

爬取近似网页过滤繁体中文

2014.08.17 - 大部分爬取的网页内容都会相似,爬取的时候应该过滤掉。开始考虑使用VSM算法,后来发现不对。对比了太多东西,然后发现了simHash算法,懒得复制这个算法的解释了,simhash算法对短数据支持不好,但是,我有长数据,用吧!网上也有很多源码实现,但是好像都是一样的。

当当数据在网页数据抓取

2017 年 1 月 22 日 - 包 com.atman.baiye.store.utils;import java.io.BufferedReader;import java.io.IOException;import java.io.InputStreamReader;import .Malforme

Python网页抓取的美丽汤

2017 年 5 月 9 日 - BeautifulSoup 是一个非常流行的模块,它在解析一些闭引号标签时排版它们。例如:从 bs4 导入 BeautifulSoupbroken_html = '

python网络爬虫英汉词典+自学能力繁体

2013年10月30日——上一篇文章,每次翻译一个词,都要在网上抓到,重复翻译要抓,不是很好。晚上突然想到一个好办法。说白了就是查询数据库。如果有这个词,就把它拿出来。用了半天,几乎不用联网,也就是离线!我使用的数据库是sqlite,小巧简单。当然你也可以用其他的。还

使用webbrowser控件抓取网页数据,如何抓取多个a标签对应的url地址的网页数据

2011 年 5 月 20 日 - 由于标题所属,我的页面中有四个菜单,它们连接到不同的地址。现在想通过一个按钮来抓取这个页面的数据,同时遍历获取四个a标签的url地址,然后自动进入其对应的页面抓取数据并存入数据库。现在问题如下: ArrayList UrlList = new ArrayList();

数据捕获的数据捕获过程

2015年11月30日——公司的数据采集系统已经写了一段时间。是时候总结一下了。否则,根据我的记忆,过一段时间我几乎会忘记它。我打算写一个系列来记录我踩过的所有坑。临时设置一个目录,按照这个系列写: 数据抓取流程,以四川为例,介绍整个数据抓取流程 反爬虫规则:验证码识别,介绍easyocr和uuwise的使用 点击查看反爬虫-爬虫

使用webBrowser翻页抓取繁体中文

2013 年 5 月 10 日 - 页面有 js 翻页,我想捕获每个页面的内容。以下代码只能捕获第一页的数据。公共 Form1(){InitializeComponent();字符串 url = ""

各种微博爬取采集繁体字的方法

2017年3月24日 - 方法分析文章知乎中关于非wap版微博模拟登录研究的各种解答:Python爬虫如何登录新浪微博并爬取内容?Python模拟两种方式登录新浪微博 Selenium爬取新浪微博内容和用户信息 完整的项目代码 github上一个很挂的项目:完成微博各种登录,知乎,微信:给网页,wap版

通过WebBrowser网页截图C#源代码(抓取完整页面和首屏)繁体中文

2009年8月21日 - 通过WebBrowser+PrintWindow实现网页截图。内部采用拼接方式,保存完整的网页和首屏。但是这个方法的潜在bug是不能最小化窗体,否则会黑屏,而且webbrowser还没有找到在内存中构建截图的合理方式,无法正确渲染和然后被 PrintWindow 拦截。

解决Webbrowser定时爬取网页数据时,内存堆积没有释放的问题。

2017 年 10 月 25 日 - 原因:将 Dim Web 复制为新的 Web 浏览器。感觉这是Webbrowser的一个bug,如果重复创建不能释放,调用Dispose也没用。解决方案:将其定义为全局变量,并且只创建一次。

C# webbrowser爬取网页时如何防止弹出刷新对话框?

2013 年 7 月 27 日 - 使用 C# Webbrowser 抓取网页时,程序正在运行并弹出刷新对话框。必须点击重试,然后代码不会继续往下走。寻求专家指导。我的 webbrowser 被扩展并且还使用代码来抑制弹出对话框,仍然没用。公共无效getContent(){

爬虫app信息爬取apk反编译爬取繁体中文

2019年5月10日——我之前也抓过一些app,数据比较容易获取,也没有研究太深。毕竟有android模拟器+appium的方法。直到遇到一个app,具体的名字我就不说了,在模拟器上安装的时候打不开!!第一次遇到网上,找了半天,换了几个模拟器都没用。最后,我猜测是在apk中设置了检测模拟器的机制(这里没有进一步研究。

使用logcat进行Android系统日志的抓取

2017年8月11日 - 有时项目中会打印很多调试信息,但有时控制台打印速度很快,有些想看的信息在控制台下找不到。因此,我们需要使用 logcat 来捕获系统日志。话不多的话,上图一、经常在桌面创建logcat.txt二、打开cmd,然后输入adb logcat >C:\Users\Administrato

如何实现网页对webbrowser的适配?繁体中文

2011 年 12 月 29 日 - 该功能需要使显示的网页缩放或扩大到 webbrowser 控件的大小,并且 webbrowser 变小,网页放大,控件变大,网页变大,滚动webbrowser控件中没有出现bar,我该怎么办?

数据捕获第一弹繁体中文的性能优化

2015年12月24日 - 数据抓取本身的过程很简单,但是当网站的类型较多或者要采集的数据较多时,性能问题就会被称为数据抓取要解决的问题第一的。这几天同事在测试采集数据时总是遇到反应慢的问题。今晚趁着洗澡的时间理清思路,重构了一些问题;我做了一个记录。这次遇到的问题主要是代理的问题。场景如下:

WebBrowser实现繁体中文网页编辑

2016-09-05 - 1 //1.显示网页2过程TForm2.FormCreate(Sender: TObject); 3 开始 4 面板1.Align:=alTop; 5 复选框1.锚点:=[akTop,akRight];

通过 WebBrowser 获取网页截图

2015 年 1 月 27 日 - 本文介绍如何通过 WinForm 中的 WebBroswer 控件对网页进行截图。该方法可以截取大于屏幕面积的网页,但无法获取Flash或网页上某些控件的图片。因为是 WinForm 控件,所以没有在 WPF 中测试。在界面中添加一个文本框和一个按钮,文本框用于输入地址。在按钮按下事件处理程序中初始化

WEBBROWSER 如何判断网页是否重定向到繁体中文?

2014年7月1日 - 我在sdk下用atl加载了一个webbrowser控件,打开了一个网页,然后通过遍历网页元素实现了自动登录,但是网页跳转后导出的html源代码仍然是第一页,我没有不知道问题出在哪里?有以下问题:1、如何知道页面跳转;2、页面跳转后,需要重新获取HTML DOM Document对象吗?3

Delphi WebBrowser 与网页交互

2015 年 11 月 3 日 - WebBrowser1.GoHome;//进入浏览器默认主页 WebBrowser1.Refresh; //刷新WebBrowser1.GoBack; //Back WebBrowser1.GoForward ; //转发 WebBrowser1.Navigate('...'); //打开指定页面我们

webBrowser 查找繁体中文网页句柄

2015 年 10 月 31 日 - private void button1_Click(object sender, EventArgs e){int parentHandle = FindWindow("Shell Embedding", null);

数据抓取反爬虫规则:验证码识别繁体中文

2015年11月30日——在数据采集过程中,验证码是必须要面对的一道坎。一般来说,验证码识别有机器识别和人工识别两种。随着验证码越来越不正常,机器识别验证码的难度也越来越大。12306的典型类型已改为图像识别。,而不是简单的文本识别。验证码识别技术有很多,这里只介绍项目中用到的两种方法:基于开源的Tesseract

Perl网页抓取网页解析繁体中文

2012年10月26日——Perl解析HTML链接 Perl爬虫--爬取特定内容网页 Perl解析当当图书信息页网页分析处理最佳模块Web::Scraper如何用Perl进行屏幕抓取?

网页信息爬取实现繁体中文

2009年2月11日 - 最近公司需要开发一个简历导入功能,类似博客搬家或者邮箱搬家。之前是通过优采云采集器抓取信息,但是简历导入功能需要用户登录才能获取简历数据,无奈只能自己开发。第一个问题是:如何实现模拟登录?我们知道一般的网站是通过cookies来维护状态的,而我抓到的网站也支持使用cookies来检查

使用java爬取繁体中文网页图片

2013年8月29日——记得这个月9号我来到了深圳。找了将近20天的工作,只有三四家公司给我打电话面试。我真的不知道为什么。是不是因为我投了简历,投的简历少了?还是这个季节是招聘的冷季?不是很清楚。前天,我去一家创业公司面试。公司感觉还行,我总体上很满意。我有幸接受了采访。谈好的薪水我也可以接受,所以我同意去上班。今天是第一天

网页抓取工具繁体中文

2015年7月22日 - 最近一直在从事网络爬虫。顺便说一句,在mark下爬取,简单来说就是模仿http请求,分析网页结构,解析网页内容,得到你需要的内容使用的插件:httpwatch核心代码包xe。httpParse.saic;导入 java.io.InputS

网页抓取方式(四)--phantomjs 繁体

2017 年 6 月 11 日 - 一、phantomjs 简介 Phantomjs 是一个基于 webkit 内核的无界面浏览器,因此我们可以使用它进行网页抓取。它的优点是:1、本身运行在浏览器上,对js和css有很好的支持;2、 不易被查封;3、 支持jquery操作;缺点:1、 慢。二、操作模式phantomjs操作有两种模式:1、Native ph

动态抓取网页信息繁体中文

April 27, 2016 - 前几天做数据库实验的时候,总是手动往数据库里添加少量固定数据,所以想知道如何将大量动态数据导入数据库?我在网上了解了网络爬虫,它可以帮助我们完成这项工作。关于网络爬虫的原理和基础知识,网上有很多相关的介绍。不错(网络爬虫基本原理一、网络爬虫基本原理2

ganon爬取网页繁体中文示例

2017 年 4 月 19 日 - 项目地址:Documentation:这个非常强大,使用类似 js 的标签选择器来识别 DOMGanon 库提供了访问 HTML/XML doc

抓取网页上的图片信息

2015年12月11日 - 最近学习的时候总结了一下,发现既然js可以通过元素的id找到这个元素,那我能不能用c#来做,但是我们事先不知道他们的id,和还有一个好处是,我不想抓取某个元素的所有内容,我只想抓取某类元素的内容,比如说图片,我想抓取某个< @网站 。先说原理:使用WebBrowser类

java网页抓取问题

2012 年 6 月 19 日 - 在此 网站:%2Fct1.html_pnl_trk&track

Python网页抓取程序繁体

2011 年 4 月 14 日 - 该程序用于从网页中抓取文本,即盗墓笔记的文本提取。写的简单,大家不要笑'''从盗墓笔记地址的网站中获取每一集的具体内容,从各个集体内容网页中提取内容写入文件'' '#-*- 编码:gb2312 -*-import HTMLParser

如何抓取繁体中文网页内容

2013 年 7 月 21 日 - 如果给你一个网页链接来抓取特定内容,比如豆瓣电影排名,你怎么做?其实网页内容的结构和 XML 很像,所以我们可以使用解析 XML 来解析 HTML,但是两者的差距还是很大的,好了,废话不多说,我们开始解析 HTML。然后有很多解析xml的库,这里就用到了lib。

如何防止他人用软件爬取繁体中文网页

2009 年 11 月 2 日 - 其他人使用软件访问网页抓取内容分析,导致 网站 加载过多,如何防止其他人阅读内容

实用网页抓取繁体中文

April 3, 2014 - 0、前言 本文主要介绍如何抓取网页内容,如何解决乱码问题,如何解决登录问题,以及处理和显示的过程采集 的数据。效果如下: 1、下载网页并加载到HtmlAgilityPack这里主要使用WebClient类的DownloadString方法和HtmlAgilit

爬虫技术(1)--爬取繁体网页

2017 年 6 月 30 日 - 1.了解 URL 和 URI 引用:网络资源标识符通用资源标识符

数据采集(一):北京交管车辆违法信息采集网站(已完成)繁体中文

2013年12月24日 - 个人信息:本人1992年大三,在十级三流本科院校软件工程专业。我于今年 2013 年 10 月开始实习。中小型互联网公司,主要从事java研发。更精确的责任是数据的实施。总的来说,还没有完全脱离母校魔掌的我,没有算法行业底层预研大师的深厚内功,也没有机会攀登。

webbrowser如何实现点击flash按钮获取繁体中文数据

2015 年 11 月 21 日 - 网络浏览器有一个嵌入了 Flash 的网页。现在想找到Flash的句柄,同时想获取Flash中控件的值,同时给Flash中的控件赋值,怎么办?我正在使用 C# Winform。

使用DELPHI WEBBROWSER从繁体中文网页拉取数据

2012 年 6 月 5 日 - 请告诉我,我想从网页中提取数据,我使用以下语句 ovTable:=webbrowser1.OleObject.Document.all.tags('TABLE').item(0) ;//取表集合可以得到表的所有数据,但是放到循环里面:url:='

Python网络爬虫及信息获取分析网页(一)--BeautifulSoup库繁体中文

2017 年 8 月 12 日 - 编写爬虫。知识的好坏,都会被爬下来。混乱的程度会让你在网上一一发现并不像百度那么方便。因此,解析好的网页是判断爬虫好坏的重要标准。这里给大家介绍一个强大的网页信息解析库----BeautifulSoupBeautifulSoup库是一个专注于解析网页信息的强大第三方

WebBrowser 拦截网页 更改消息 繁体中文

2011 年 1 月 28 日 - 使用 System 实现 IDocHostShowUI 接口;使用 System.采集s.Generic;使用 System.ComponentModel;使用 System.Data;使用 System.Drawing;使用

WebBrowser繁体中文网页全身照

2012年6月25日——最近在写程序的时候,突然觉得google chrome网页的缩略图很有意思,但是chrome是自己的内核,自己的东西当然方便。浏览器呢?首先想到的是最常见的屏幕复制,也称为bitblt,是从WebBrowser 的dc 复制到位图的dc。

网页通过 External 接口与 WebBrowser 交互

2009 年 12 月 22 日 - 在上一篇博客中,我谈到了在 WTL 中添加 IDL 以通过向导实现 IDispatch。是有代价的,而且代价不小,所以最后我用了最简单最有效的方法。下面是这样一个示例代码贴:下面是我的IDispatch的实现,其中MainDlg是WTL向导生成的非模态对话框,可以根据

通过WebBrowser获取AJAX后的繁体中文版网页

2015年12月04日 - 通常在WebBrowser的文档加载完成事件DocumentCompleted中进行判断 if (_WebBrowder.ReadyState == WebBrowserReadyState.Complete) {//获取网页信息并处理} 不过很遗憾是很 查看全部

浏览器抓取网页(网页抓取之WebBrowser繁体2006年04月22-最近研究)

用于网页抓取的 WebBrowser 繁体中文

2006年4月22日 - 最近学习了网页信息的批量分析和爬取,还是有一些经验的。我们知道网页程序的设计可以分为静态网页和动态网页。静态网页基本都是纯html,动态网页在服务器端执行,结果返回浏览器端。从某种意义上说,本地浏览器中的网页都是静态的。对于不需要验证的打开网页,只要网站地址和正则

Python 网页爬取 Lxml 繁体

2017 年 5 月 9 日 - Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。该模块是用 C 语言编写的,解析速度比 BeautifulSoup 快。Lxml 正确解析属性周围缺少的引号并关闭标签。比如case 1和case 2就是Lxml的CSS选择器提取区域数据的示例代码#coding=utf-8import

爬取近似网页过滤繁体中文

2014.08.17 - 大部分爬取的网页内容都会相似,爬取的时候应该过滤掉。开始考虑使用VSM算法,后来发现不对。对比了太多东西,然后发现了simHash算法,懒得复制这个算法的解释了,simhash算法对短数据支持不好,但是,我有长数据,用吧!网上也有很多源码实现,但是好像都是一样的。

当当数据在网页数据抓取

2017 年 1 月 22 日 - 包 com.atman.baiye.store.utils;import java.io.BufferedReader;import java.io.IOException;import java.io.InputStreamReader;import .Malforme

Python网页抓取的美丽汤

2017 年 5 月 9 日 - BeautifulSoup 是一个非常流行的模块,它在解析一些闭引号标签时排版它们。例如:从 bs4 导入 BeautifulSoupbroken_html = '

用于网页抓取的 WebBrowser 繁体中文

2006年4月22日 - 最近学习了网页信息的批量分析和爬取,还是有一些经验的。我们知道网页程序的设计可以分为静态网页和动态网页。静态网页基本都是纯html,动态网页在服务器端执行,结果返回浏览器端。从某种意义上说,本地浏览器中的网页都是静态的。对于不需要验证的打开网页,只要网站地址和正则

Python 网页爬取 Lxml 繁体

2017 年 5 月 9 日 - Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。该模块是用 C 语言编写的,解析速度比 BeautifulSoup 快。Lxml 正确解析属性周围缺少的引号并关闭标签。比如case 1和case 2就是Lxml的CSS选择器提取区域数据的示例代码#coding=utf-8import

爬取近似网页过滤繁体中文

2014.08.17 - 大部分爬取的网页内容都会相似,爬取的时候应该过滤掉。开始考虑使用VSM算法,后来发现不对。对比了太多东西,然后发现了simHash算法,懒得复制这个算法的解释了,simhash算法对短数据支持不好,但是,我有长数据,用吧!网上也有很多源码实现,但是好像都是一样的。

当当数据在网页数据抓取

2017 年 1 月 22 日 - 包 com.atman.baiye.store.utils;import java.io.BufferedReader;import java.io.IOException;import java.io.InputStreamReader;import .Malforme

Python网页抓取的美丽汤

2017 年 5 月 9 日 - BeautifulSoup 是一个非常流行的模块,它在解析一些闭引号标签时排版它们。例如:从 bs4 导入 BeautifulSoupbroken_html = '

python网络爬虫英汉词典+自学能力繁体

2013年10月30日——上一篇文章,每次翻译一个词,都要在网上抓到,重复翻译要抓,不是很好。晚上突然想到一个好办法。说白了就是查询数据库。如果有这个词,就把它拿出来。用了半天,几乎不用联网,也就是离线!我使用的数据库是sqlite,小巧简单。当然你也可以用其他的。还

使用webbrowser控件抓取网页数据,如何抓取多个a标签对应的url地址的网页数据

2011 年 5 月 20 日 - 由于标题所属,我的页面中有四个菜单,它们连接到不同的地址。现在想通过一个按钮来抓取这个页面的数据,同时遍历获取四个a标签的url地址,然后自动进入其对应的页面抓取数据并存入数据库。现在问题如下: ArrayList UrlList = new ArrayList();

数据捕获的数据捕获过程

2015年11月30日——公司的数据采集系统已经写了一段时间。是时候总结一下了。否则,根据我的记忆,过一段时间我几乎会忘记它。我打算写一个系列来记录我踩过的所有坑。临时设置一个目录,按照这个系列写: 数据抓取流程,以四川为例,介绍整个数据抓取流程 反爬虫规则:验证码识别,介绍easyocr和uuwise的使用 点击查看反爬虫-爬虫

使用webBrowser翻页抓取繁体中文

2013 年 5 月 10 日 - 页面有 js 翻页,我想捕获每个页面的内容。以下代码只能捕获第一页的数据。公共 Form1(){InitializeComponent();字符串 url = ""

各种微博爬取采集繁体字的方法

2017年3月24日 - 方法分析文章知乎中关于非wap版微博模拟登录研究的各种解答:Python爬虫如何登录新浪微博并爬取内容?Python模拟两种方式登录新浪微博 Selenium爬取新浪微博内容和用户信息 完整的项目代码 github上一个很挂的项目:完成微博各种登录,知乎,微信:给网页,wap版

通过WebBrowser网页截图C#源代码(抓取完整页面和首屏)繁体中文

2009年8月21日 - 通过WebBrowser+PrintWindow实现网页截图。内部采用拼接方式,保存完整的网页和首屏。但是这个方法的潜在bug是不能最小化窗体,否则会黑屏,而且webbrowser还没有找到在内存中构建截图的合理方式,无法正确渲染和然后被 PrintWindow 拦截。

解决Webbrowser定时爬取网页数据时,内存堆积没有释放的问题。

2017 年 10 月 25 日 - 原因:将 Dim Web 复制为新的 Web 浏览器。感觉这是Webbrowser的一个bug,如果重复创建不能释放,调用Dispose也没用。解决方案:将其定义为全局变量,并且只创建一次。

C# webbrowser爬取网页时如何防止弹出刷新对话框?

2013 年 7 月 27 日 - 使用 C# Webbrowser 抓取网页时,程序正在运行并弹出刷新对话框。必须点击重试,然后代码不会继续往下走。寻求专家指导。我的 webbrowser 被扩展并且还使用代码来抑制弹出对话框,仍然没用。公共无效getContent(){

爬虫app信息爬取apk反编译爬取繁体中文

2019年5月10日——我之前也抓过一些app,数据比较容易获取,也没有研究太深。毕竟有android模拟器+appium的方法。直到遇到一个app,具体的名字我就不说了,在模拟器上安装的时候打不开!!第一次遇到网上,找了半天,换了几个模拟器都没用。最后,我猜测是在apk中设置了检测模拟器的机制(这里没有进一步研究。

使用logcat进行Android系统日志的抓取

2017年8月11日 - 有时项目中会打印很多调试信息,但有时控制台打印速度很快,有些想看的信息在控制台下找不到。因此,我们需要使用 logcat 来捕获系统日志。话不多的话,上图一、经常在桌面创建logcat.txt二、打开cmd,然后输入adb logcat >C:\Users\Administrato

如何实现网页对webbrowser的适配?繁体中文

2011 年 12 月 29 日 - 该功能需要使显示的网页缩放或扩大到 webbrowser 控件的大小,并且 webbrowser 变小,网页放大,控件变大,网页变大,滚动webbrowser控件中没有出现bar,我该怎么办?

数据捕获第一弹繁体中文的性能优化

2015年12月24日 - 数据抓取本身的过程很简单,但是当网站的类型较多或者要采集的数据较多时,性能问题就会被称为数据抓取要解决的问题第一的。这几天同事在测试采集数据时总是遇到反应慢的问题。今晚趁着洗澡的时间理清思路,重构了一些问题;我做了一个记录。这次遇到的问题主要是代理的问题。场景如下:

WebBrowser实现繁体中文网页编辑

2016-09-05 - 1 //1.显示网页2过程TForm2.FormCreate(Sender: TObject); 3 开始 4 面板1.Align:=alTop; 5 复选框1.锚点:=[akTop,akRight];

通过 WebBrowser 获取网页截图

2015 年 1 月 27 日 - 本文介绍如何通过 WinForm 中的 WebBroswer 控件对网页进行截图。该方法可以截取大于屏幕面积的网页,但无法获取Flash或网页上某些控件的图片。因为是 WinForm 控件,所以没有在 WPF 中测试。在界面中添加一个文本框和一个按钮,文本框用于输入地址。在按钮按下事件处理程序中初始化

WEBBROWSER 如何判断网页是否重定向到繁体中文?

2014年7月1日 - 我在sdk下用atl加载了一个webbrowser控件,打开了一个网页,然后通过遍历网页元素实现了自动登录,但是网页跳转后导出的html源代码仍然是第一页,我没有不知道问题出在哪里?有以下问题:1、如何知道页面跳转;2、页面跳转后,需要重新获取HTML DOM Document对象吗?3

Delphi WebBrowser 与网页交互

2015 年 11 月 3 日 - WebBrowser1.GoHome;//进入浏览器默认主页 WebBrowser1.Refresh; //刷新WebBrowser1.GoBack; //Back WebBrowser1.GoForward ; //转发 WebBrowser1.Navigate('...'); //打开指定页面我们

webBrowser 查找繁体中文网页句柄

2015 年 10 月 31 日 - private void button1_Click(object sender, EventArgs e){int parentHandle = FindWindow("Shell Embedding", null);

数据抓取反爬虫规则:验证码识别繁体中文

2015年11月30日——在数据采集过程中,验证码是必须要面对的一道坎。一般来说,验证码识别有机器识别和人工识别两种。随着验证码越来越不正常,机器识别验证码的难度也越来越大。12306的典型类型已改为图像识别。,而不是简单的文本识别。验证码识别技术有很多,这里只介绍项目中用到的两种方法:基于开源的Tesseract

Perl网页抓取网页解析繁体中文

2012年10月26日——Perl解析HTML链接 Perl爬虫--爬取特定内容网页 Perl解析当当图书信息页网页分析处理最佳模块Web::Scraper如何用Perl进行屏幕抓取?

网页信息爬取实现繁体中文

2009年2月11日 - 最近公司需要开发一个简历导入功能,类似博客搬家或者邮箱搬家。之前是通过优采云采集器抓取信息,但是简历导入功能需要用户登录才能获取简历数据,无奈只能自己开发。第一个问题是:如何实现模拟登录?我们知道一般的网站是通过cookies来维护状态的,而我抓到的网站也支持使用cookies来检查

使用java爬取繁体中文网页图片

2013年8月29日——记得这个月9号我来到了深圳。找了将近20天的工作,只有三四家公司给我打电话面试。我真的不知道为什么。是不是因为我投了简历,投的简历少了?还是这个季节是招聘的冷季?不是很清楚。前天,我去一家创业公司面试。公司感觉还行,我总体上很满意。我有幸接受了采访。谈好的薪水我也可以接受,所以我同意去上班。今天是第一天

网页抓取工具繁体中文

2015年7月22日 - 最近一直在从事网络爬虫。顺便说一句,在mark下爬取,简单来说就是模仿http请求,分析网页结构,解析网页内容,得到你需要的内容使用的插件:httpwatch核心代码包xe。httpParse.saic;导入 java.io.InputS

网页抓取方式(四)--phantomjs 繁体

2017 年 6 月 11 日 - 一、phantomjs 简介 Phantomjs 是一个基于 webkit 内核的无界面浏览器,因此我们可以使用它进行网页抓取。它的优点是:1、本身运行在浏览器上,对js和css有很好的支持;2、 不易被查封;3、 支持jquery操作;缺点:1、 慢。二、操作模式phantomjs操作有两种模式:1、Native ph

动态抓取网页信息繁体中文

April 27, 2016 - 前几天做数据库实验的时候,总是手动往数据库里添加少量固定数据,所以想知道如何将大量动态数据导入数据库?我在网上了解了网络爬虫,它可以帮助我们完成这项工作。关于网络爬虫的原理和基础知识,网上有很多相关的介绍。不错(网络爬虫基本原理一、网络爬虫基本原理2

ganon爬取网页繁体中文示例

2017 年 4 月 19 日 - 项目地址:Documentation:这个非常强大,使用类似 js 的标签选择器来识别 DOMGanon 库提供了访问 HTML/XML doc

抓取网页上的图片信息

2015年12月11日 - 最近学习的时候总结了一下,发现既然js可以通过元素的id找到这个元素,那我能不能用c#来做,但是我们事先不知道他们的id,和还有一个好处是,我不想抓取某个元素的所有内容,我只想抓取某类元素的内容,比如说图片,我想抓取某个< @网站 。先说原理:使用WebBrowser类

java网页抓取问题

2012 年 6 月 19 日 - 在此 网站:%2Fct1.html_pnl_trk&track

Python网页抓取程序繁体

2011 年 4 月 14 日 - 该程序用于从网页中抓取文本,即盗墓笔记的文本提取。写的简单,大家不要笑'''从盗墓笔记地址的网站中获取每一集的具体内容,从各个集体内容网页中提取内容写入文件'' '#-*- 编码:gb2312 -*-import HTMLParser

如何抓取繁体中文网页内容

2013 年 7 月 21 日 - 如果给你一个网页链接来抓取特定内容,比如豆瓣电影排名,你怎么做?其实网页内容的结构和 XML 很像,所以我们可以使用解析 XML 来解析 HTML,但是两者的差距还是很大的,好了,废话不多说,我们开始解析 HTML。然后有很多解析xml的库,这里就用到了lib。

如何防止他人用软件爬取繁体中文网页

2009 年 11 月 2 日 - 其他人使用软件访问网页抓取内容分析,导致 网站 加载过多,如何防止其他人阅读内容

实用网页抓取繁体中文

April 3, 2014 - 0、前言 本文主要介绍如何抓取网页内容,如何解决乱码问题,如何解决登录问题,以及处理和显示的过程采集 的数据。效果如下: 1、下载网页并加载到HtmlAgilityPack这里主要使用WebClient类的DownloadString方法和HtmlAgilit

爬虫技术(1)--爬取繁体网页

2017 年 6 月 30 日 - 1.了解 URL 和 URI 引用:网络资源标识符通用资源标识符

数据采集(一):北京交管车辆违法信息采集网站(已完成)繁体中文

2013年12月24日 - 个人信息:本人1992年大三,在十级三流本科院校软件工程专业。我于今年 2013 年 10 月开始实习。中小型互联网公司,主要从事java研发。更精确的责任是数据的实施。总的来说,还没有完全脱离母校魔掌的我,没有算法行业底层预研大师的深厚内功,也没有机会攀登。

webbrowser如何实现点击flash按钮获取繁体中文数据

2015 年 11 月 21 日 - 网络浏览器有一个嵌入了 Flash 的网页。现在想找到Flash的句柄,同时想获取Flash中控件的值,同时给Flash中的控件赋值,怎么办?我正在使用 C# Winform。

使用DELPHI WEBBROWSER从繁体中文网页拉取数据

2012 年 6 月 5 日 - 请告诉我,我想从网页中提取数据,我使用以下语句 ovTable:=webbrowser1.OleObject.Document.all.tags('TABLE').item(0) ;//取表集合可以得到表的所有数据,但是放到循环里面:url:='

Python网络爬虫及信息获取分析网页(一)--BeautifulSoup库繁体中文

2017 年 8 月 12 日 - 编写爬虫。知识的好坏,都会被爬下来。混乱的程度会让你在网上一一发现并不像百度那么方便。因此,解析好的网页是判断爬虫好坏的重要标准。这里给大家介绍一个强大的网页信息解析库----BeautifulSoupBeautifulSoup库是一个专注于解析网页信息的强大第三方

WebBrowser 拦截网页 更改消息 繁体中文

2011 年 1 月 28 日 - 使用 System 实现 IDocHostShowUI 接口;使用 System.采集s.Generic;使用 System.ComponentModel;使用 System.Data;使用 System.Drawing;使用

WebBrowser繁体中文网页全身照

2012年6月25日——最近在写程序的时候,突然觉得google chrome网页的缩略图很有意思,但是chrome是自己的内核,自己的东西当然方便。浏览器呢?首先想到的是最常见的屏幕复制,也称为bitblt,是从WebBrowser 的dc 复制到位图的dc。

网页通过 External 接口与 WebBrowser 交互

2009 年 12 月 22 日 - 在上一篇博客中,我谈到了在 WTL 中添加 IDL 以通过向导实现 IDispatch。是有代价的,而且代价不小,所以最后我用了最简单最有效的方法。下面是这样一个示例代码贴:下面是我的IDispatch的实现,其中MainDlg是WTL向导生成的非模态对话框,可以根据

通过WebBrowser获取AJAX后的繁体中文版网页

2015年12月04日 - 通常在WebBrowser的文档加载完成事件DocumentCompleted中进行判断 if (_WebBrowder.ReadyState == WebBrowserReadyState.Complete) {//获取网页信息并处理} 不过很遗憾是很

浏览器抓取网页( 爬虫接收请求3、请求头注意携带4、响应Response)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-30 14:15

爬虫接收请求3、请求头注意携带4、响应Response)

请求:用户通过浏览器(socket client)将自己的信息发送到服务器(socket server)

响应:服务器接收到请求,分析用户发送的请求信息,然后返回数据(返回的数据可能收录其他链接,如:图片、js、css等)

ps:浏览器收到Response后会解析其内容展示给用户,爬虫模拟浏览器发送请求再接收Response后提取有用数据。

四、 请求

1、请求方法:

常见的请求方式:GET / POST

2、请求的网址

url 全局统一资源定位器,用于定义互联网上唯一的资源 例如:图片、文件、视频都可以通过url唯一标识

网址编码

图片

图像将被编码(见示例代码)

一个网页的加载过程是:

加载网页通常会先加载文档,

在解析document文档时,如果遇到链接,则对该超链接发起图片下载请求

3、请求头

User-agent:如果请求头中没有user-agent客户端配置,服务器可能会将你视为非法用户主机;

cookies:cookies用于存储登录信息

注意:一般爬虫会添加请求头

请求头中需要注意的参数:

(1)Referrer:访问源从哪里来(有些大的网站,会使用Referrer做防盗链策略;所有爬虫也要注意模拟)

(2)User-Agent: 访问的浏览器(要添加,否则将被视为爬虫)

(3)cookie: 请注意请求头

4、请求正文

请求体

如果是get方式,请求体没有内容 (get请求的请求体放在 url后面参数中,直接能看到)

如果是post方式,请求体是format data

ps:

1、登录窗口,文件上传等,信息都会被附加到请求体内

2、登录,输入错误的用户名密码,然后提交,就可以看到post,正确登录后页面通常会跳转,无法捕捉到post

五、 响应

1、响应状态码

200:代表成功

301:代表跳转

404: 文件不存在

403:未经授权的访问

502:服务器错误

2、响应头

响应头中需要注意的参数:

(1)Set-Cookie:BDSVRTM=0; path=/: 可能有多个,告诉浏览器保存cookie

(2)Content-Location:服务器响应头收录Location并返回浏览器后,浏览器会重新访问另一个页面

3、预览是网页的源代码

JSO 数据

如网页html、图片

二进制数据等

六、总结

1、爬虫流程总结:

爬取--->解析--->存储

2、爬虫所需工具:

请求库:requests、selenium(可以驱动浏览器解析和渲染CSS和JS,但有性能劣势(会加载有用和无用的网页);)

解析库:regular、beautifulsoup、pyquery

存储库:文件、MySQL、Mongodb、Redis

3、爬校花网

最后,让我们给你一些好处

基础版:

查看代码

功能包版本

查看代码

并发版(如果一共需要爬30个视频,开30个线程来做,耗时是最慢的部分)

查看代码

涉及知识:多线程和多处理

计算密集型任务:使用多进程,因为Python有GIL,多进程可以利用CPU多核;

IO密集型任务:使用多线程,做IO切换以节省任务执行时间(并发)

线程池

参考博客:

盲驴 查看全部

浏览器抓取网页(

爬虫接收请求3、请求头注意携带4、响应Response)

请求:用户通过浏览器(socket client)将自己的信息发送到服务器(socket server)

响应:服务器接收到请求,分析用户发送的请求信息,然后返回数据(返回的数据可能收录其他链接,如:图片、js、css等)

ps:浏览器收到Response后会解析其内容展示给用户,爬虫模拟浏览器发送请求再接收Response后提取有用数据。

四、 请求

1、请求方法:

常见的请求方式:GET / POST

2、请求的网址

url 全局统一资源定位器,用于定义互联网上唯一的资源 例如:图片、文件、视频都可以通过url唯一标识

网址编码

图片

图像将被编码(见示例代码)

一个网页的加载过程是:

加载网页通常会先加载文档,

在解析document文档时,如果遇到链接,则对该超链接发起图片下载请求

3、请求头

User-agent:如果请求头中没有user-agent客户端配置,服务器可能会将你视为非法用户主机;

cookies:cookies用于存储登录信息

注意:一般爬虫会添加请求头

请求头中需要注意的参数:

(1)Referrer:访问源从哪里来(有些大的网站,会使用Referrer做防盗链策略;所有爬虫也要注意模拟)

(2)User-Agent: 访问的浏览器(要添加,否则将被视为爬虫)

(3)cookie: 请注意请求头

4、请求正文

请求体

如果是get方式,请求体没有内容 (get请求的请求体放在 url后面参数中,直接能看到)

如果是post方式,请求体是format data

ps:

1、登录窗口,文件上传等,信息都会被附加到请求体内

2、登录,输入错误的用户名密码,然后提交,就可以看到post,正确登录后页面通常会跳转,无法捕捉到post

五、 响应

1、响应状态码

200:代表成功

301:代表跳转

404: 文件不存在

403:未经授权的访问

502:服务器错误

2、响应头

响应头中需要注意的参数:

(1)Set-Cookie:BDSVRTM=0; path=/: 可能有多个,告诉浏览器保存cookie

(2)Content-Location:服务器响应头收录Location并返回浏览器后,浏览器会重新访问另一个页面

3、预览是网页的源代码

JSO 数据

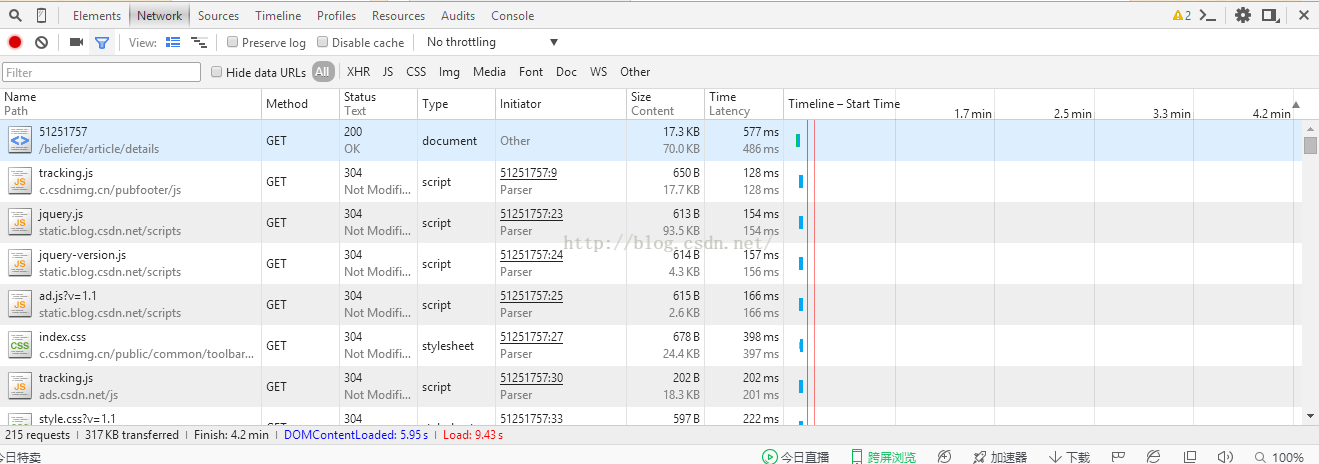

如网页html、图片

二进制数据等

六、总结

1、爬虫流程总结:

爬取--->解析--->存储

2、爬虫所需工具:

请求库:requests、selenium(可以驱动浏览器解析和渲染CSS和JS,但有性能劣势(会加载有用和无用的网页);)

解析库:regular、beautifulsoup、pyquery

存储库:文件、MySQL、Mongodb、Redis

3、爬校花网

最后,让我们给你一些好处

基础版:

查看代码

功能包版本

查看代码

并发版(如果一共需要爬30个视频,开30个线程来做,耗时是最慢的部分)

查看代码

涉及知识:多线程和多处理

计算密集型任务:使用多进程,因为Python有GIL,多进程可以利用CPU多核;

IO密集型任务:使用多线程,做IO切换以节省任务执行时间(并发)

线程池

参考博客:

盲驴

浏览器抓取网页(BOM1.浏览器浏览器对象模型(browserobjectmodel).36 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-03-29 08:11

)

物料清单

1.物料清单

浏览器对象模型

BOM允许我们通过JS来操作浏览器

为我们提供了BOM中的一组对象来完成浏览器的操作

BOM 对象

窗户

表示整个浏览器的窗口,window也是网页中的一个全局对象

航海家

表示当前浏览器的信息,通过这些信息可以识别不同的浏览器

地点

表示当前浏览器的地址栏信息。您可以通过Location获取地址栏信息,也可以操作浏览器跳转到页面。

历史

表示浏览器的历史,通过它可以操作浏览器的历史

由于隐私原因,对象无法获取具体的历史记录,只能操作浏览器向前或向后翻页

并且该操作只对当前访问有效

屏幕

表示用户屏幕的信息,通过它可以获取用户显示器的相关信息

这些 BOM 对象在浏览器中保存为窗口对象的属性,

可以通过window对象使用,也可以直接使用

2.导航器

表示当前浏览器的信息,通过这些信息可以识别不同的浏览器

由于历史原因,Navigator 对象中的大部分属性不再帮助我们识别浏览器

一般我们只使用userAgent来判断浏览器信息,

userAgent 是一个字符串,收录描述浏览器信息的内容,

不同的浏览器会有不同的userAgent

火狐用户代理

Mozilla5.0 (Windows NT 6.1; WOW64; rv:50.0) Gecko20100101 Firefox50.0

Chrome 的 userAgent

Mozilla5.0 (Windows NT 6.1; Win64; x64) AppleWebKit537.36 (KHTML, 像 Gecko) Chrome52.0.274 3.82 Safari537.36

IE8

Mozilla4.0(兼容;MSIE 8.0;Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4.@ >0C;.NET4.0E)

IE9

Mozilla5.0(兼容;MSIE 9.0;Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4.@ >0C;.NET4.0E)

IE10

Mozilla5.0(兼容;MSIE 10.0;Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4. @>0C;.NET4.0E)

IE11

Mozilla5.0(Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4.0C;.NET4. 0E; rv:11.0) 像壁虎

在IE11中,微软和IE相关的logo都被去掉了,所以我们基本上无法通过UserAgent来识别一个浏览器是否是IE。

alert(navigator.appName);

var ua = navigator.userAgent;

console.log(ua);

if(firefoxi.test(ua)){

alert("你是火狐!!!");

}else if(chromei.test(ua)){

alert("你是Chrome");

}else if(msiei.test(ua)){

alert("你是IE浏览器~~~");

}else if("ActiveXObject" in window){

alert("你是IE11,枪毙了你~~~");

}

3.历史

对象可用于操纵浏览器向前或向后翻页

长度

属性,可以获取链接数作为访问

背部()

可用于返回上一页,与浏览器的返回按钮相同

向前()

可以跳转到下一页,和浏览器的前进按钮一样

走()

可用于跳转到指定页面

它需要一个整数作为参数

1:表示向前跳转一个页面等价于forward()

2:表示向前跳转两页

-1:表示跳回一页

-2:表示跳回两页

4.位置

这个对象封装了浏览器地址栏的信息

如果直接打印位置,可以得到地址栏的信息(当前页面的完整路径)

警报(位置);

如果直接将location属性修改为完整路径,或者相对路径

然后我们的页面会自动跳转到这个路径,并生成对应的历史记录

位置=“http:”;

位置 = "01.BOM.html";

分配()

用来跳转到其他页面,效果和直接修改位置一样

重新加载()

用于重新加载当前页面,同刷新按钮

如果在方法中传入一个true作为参数,会强制刷新缓存,刷新页面

location.reload(true);

代替()

可以用新页面替换当前页面,调用后页面也会跳转

不生成历史记录,不能使用返回键返回

5.窗口

计时器

设置间隔()

定时通话

一个函数可以每隔一段时间执行一次

范围:

1.回调函数,每隔一段时间就会调用一次

2.每次调用之间的时间,以毫秒为单位

返回值:

返回 Number 类型的数据

此编号用作计时器的唯一标识符

clearInterval() 可用于关闭计时器

该方法需要一个定时器的标识符作为参数,它将关闭该标识符对应的定时器。

clearInterval() 可以接收任意参数,

如果参数是有效的定时器标识符,则停止对应的定时器

如果参数不是有效的 ID,则什么也不做

var num = 1;

var timer = setInterval(function() {

count.innerHTML = num++;

if(num == 11) {

//关闭定时器

clearInterval(timer);

}

}, 1000);

延迟通话

设置超时

延迟调用函数不会立即执行,而是在一段时间后执行,并且只执行一次

延迟调用和定时调用的区别,定时调用会执行多次,而延迟调用只会执行一次

延迟调用和定时调用其实可以互相替代,开发时可以根据自己的需要选择

var timer = setTimeout(function(){

控制台.log(num++);

},3000);

使用 clearTimeout() 关闭延迟调用

清除超时(定时器);

# 类操作

直接修改元素的class css:

元素的样式由 style 属性修改。每次修改样式时,浏览器都需要重新渲染页面。这种实现的性能比较差,当我们要修改多个样式时,这种形式不是很方便。我希望一行代码可以同时修改多个样式。

我们可以通过修改元素的class属性来间接修改样式。这样,我们只需要修改一次就可以同时修改多个样式。浏览器只需要重新渲染一次页面,性能更好。

并且通过这种方式,性能和行为可以进一步分离

box.className += " b2"; //注意有空格,添加class属性

延时调用

setTimeout

延时调用一个函数不马上执行,而是隔一段时间以后在执行,而且只会执行一次

延时调用和定时调用的区别,定时调用会执行多次,而延时调用只会执行一次

延时调用和定时调用实际上是可以互相代替的,在开发中可以根据自己需要去选择

var timer = setTimeout(function(){

console.log(num++);

},3000);

使用clearTimeout()来关闭一个延时调用

clearTimeout(timer);

#类的操作

直接修改元素的类css:

通过style属性来修改元素的样式,每修改一个样式,浏览器就需要重新渲染一次页面。 这样的执行的性能是比较差的,而且这种形式当我们要修改多个样式时,也不太方便 我希望一行代码,可以同时修改多个样式

我们可以通过修改元素的class属性来间接的修改样式.这样一来,我们只需要修改一次,即可同时修改多个样式,浏览器只需要重新渲染页面一次,性能比较好,

并且这种方式,可以使表现和行为进一步的分离 查看全部

浏览器抓取网页(BOM1.浏览器浏览器对象模型(browserobjectmodel).36

)

物料清单

1.物料清单

浏览器对象模型

BOM允许我们通过JS来操作浏览器

为我们提供了BOM中的一组对象来完成浏览器的操作

BOM 对象

窗户

表示整个浏览器的窗口,window也是网页中的一个全局对象

航海家

表示当前浏览器的信息,通过这些信息可以识别不同的浏览器

地点

表示当前浏览器的地址栏信息。您可以通过Location获取地址栏信息,也可以操作浏览器跳转到页面。

历史

表示浏览器的历史,通过它可以操作浏览器的历史

由于隐私原因,对象无法获取具体的历史记录,只能操作浏览器向前或向后翻页

并且该操作只对当前访问有效

屏幕

表示用户屏幕的信息,通过它可以获取用户显示器的相关信息

这些 BOM 对象在浏览器中保存为窗口对象的属性,

可以通过window对象使用,也可以直接使用

2.导航器

表示当前浏览器的信息,通过这些信息可以识别不同的浏览器

由于历史原因,Navigator 对象中的大部分属性不再帮助我们识别浏览器

一般我们只使用userAgent来判断浏览器信息,

userAgent 是一个字符串,收录描述浏览器信息的内容,

不同的浏览器会有不同的userAgent

火狐用户代理

Mozilla5.0 (Windows NT 6.1; WOW64; rv:50.0) Gecko20100101 Firefox50.0

Chrome 的 userAgent

Mozilla5.0 (Windows NT 6.1; Win64; x64) AppleWebKit537.36 (KHTML, 像 Gecko) Chrome52.0.274 3.82 Safari537.36

IE8

Mozilla4.0(兼容;MSIE 8.0;Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4.@ >0C;.NET4.0E)

IE9

Mozilla5.0(兼容;MSIE 9.0;Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4.@ >0C;.NET4.0E)

IE10

Mozilla5.0(兼容;MSIE 10.0;Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4. @>0C;.NET4.0E)

IE11

Mozilla5.0(Windows NT 6.1;WOW64;三叉戟7.0;SLCC2;.NET CLR 2.0.50727;.NET CLR 3.5.30729;.NET CLR 3.0.30729;媒体中心 PC 6.0;.NET4.0C;.NET4. 0E; rv:11.0) 像壁虎

在IE11中,微软和IE相关的logo都被去掉了,所以我们基本上无法通过UserAgent来识别一个浏览器是否是IE。

alert(navigator.appName);

var ua = navigator.userAgent;

console.log(ua);

if(firefoxi.test(ua)){

alert("你是火狐!!!");

}else if(chromei.test(ua)){

alert("你是Chrome");

}else if(msiei.test(ua)){

alert("你是IE浏览器~~~");

}else if("ActiveXObject" in window){

alert("你是IE11,枪毙了你~~~");

}

3.历史

对象可用于操纵浏览器向前或向后翻页

长度

属性,可以获取链接数作为访问

背部()

可用于返回上一页,与浏览器的返回按钮相同

向前()

可以跳转到下一页,和浏览器的前进按钮一样

走()

可用于跳转到指定页面

它需要一个整数作为参数

1:表示向前跳转一个页面等价于forward()

2:表示向前跳转两页

-1:表示跳回一页

-2:表示跳回两页

4.位置

这个对象封装了浏览器地址栏的信息

如果直接打印位置,可以得到地址栏的信息(当前页面的完整路径)

警报(位置);

如果直接将location属性修改为完整路径,或者相对路径

然后我们的页面会自动跳转到这个路径,并生成对应的历史记录

位置=“http:”;

位置 = "01.BOM.html";

分配()

用来跳转到其他页面,效果和直接修改位置一样

重新加载()

用于重新加载当前页面,同刷新按钮

如果在方法中传入一个true作为参数,会强制刷新缓存,刷新页面

location.reload(true);

代替()

可以用新页面替换当前页面,调用后页面也会跳转

不生成历史记录,不能使用返回键返回

5.窗口

计时器

设置间隔()

定时通话

一个函数可以每隔一段时间执行一次

范围:

1.回调函数,每隔一段时间就会调用一次

2.每次调用之间的时间,以毫秒为单位

返回值:

返回 Number 类型的数据

此编号用作计时器的唯一标识符

clearInterval() 可用于关闭计时器

该方法需要一个定时器的标识符作为参数,它将关闭该标识符对应的定时器。

clearInterval() 可以接收任意参数,

如果参数是有效的定时器标识符,则停止对应的定时器

如果参数不是有效的 ID,则什么也不做

var num = 1;

var timer = setInterval(function() {

count.innerHTML = num++;

if(num == 11) {

//关闭定时器

clearInterval(timer);

}

}, 1000);

延迟通话

设置超时

延迟调用函数不会立即执行,而是在一段时间后执行,并且只执行一次

延迟调用和定时调用的区别,定时调用会执行多次,而延迟调用只会执行一次

延迟调用和定时调用其实可以互相替代,开发时可以根据自己的需要选择

var timer = setTimeout(function(){

控制台.log(num++);

},3000);

使用 clearTimeout() 关闭延迟调用

清除超时(定时器);

# 类操作

直接修改元素的class css:

元素的样式由 style 属性修改。每次修改样式时,浏览器都需要重新渲染页面。这种实现的性能比较差,当我们要修改多个样式时,这种形式不是很方便。我希望一行代码可以同时修改多个样式。

我们可以通过修改元素的class属性来间接修改样式。这样,我们只需要修改一次就可以同时修改多个样式。浏览器只需要重新渲染一次页面,性能更好。

并且通过这种方式,性能和行为可以进一步分离

box.className += " b2"; //注意有空格,添加class属性

延时调用

setTimeout

延时调用一个函数不马上执行,而是隔一段时间以后在执行,而且只会执行一次

延时调用和定时调用的区别,定时调用会执行多次,而延时调用只会执行一次

延时调用和定时调用实际上是可以互相代替的,在开发中可以根据自己需要去选择

var timer = setTimeout(function(){

console.log(num++);

},3000);

使用clearTimeout()来关闭一个延时调用

clearTimeout(timer);

#类的操作

直接修改元素的类css:

通过style属性来修改元素的样式,每修改一个样式,浏览器就需要重新渲染一次页面。 这样的执行的性能是比较差的,而且这种形式当我们要修改多个样式时,也不太方便 我希望一行代码,可以同时修改多个样式

我们可以通过修改元素的class属性来间接的修改样式.这样一来,我们只需要修改一次,即可同时修改多个样式,浏览器只需要重新渲染页面一次,性能比较好,

并且这种方式,可以使表现和行为进一步的分离

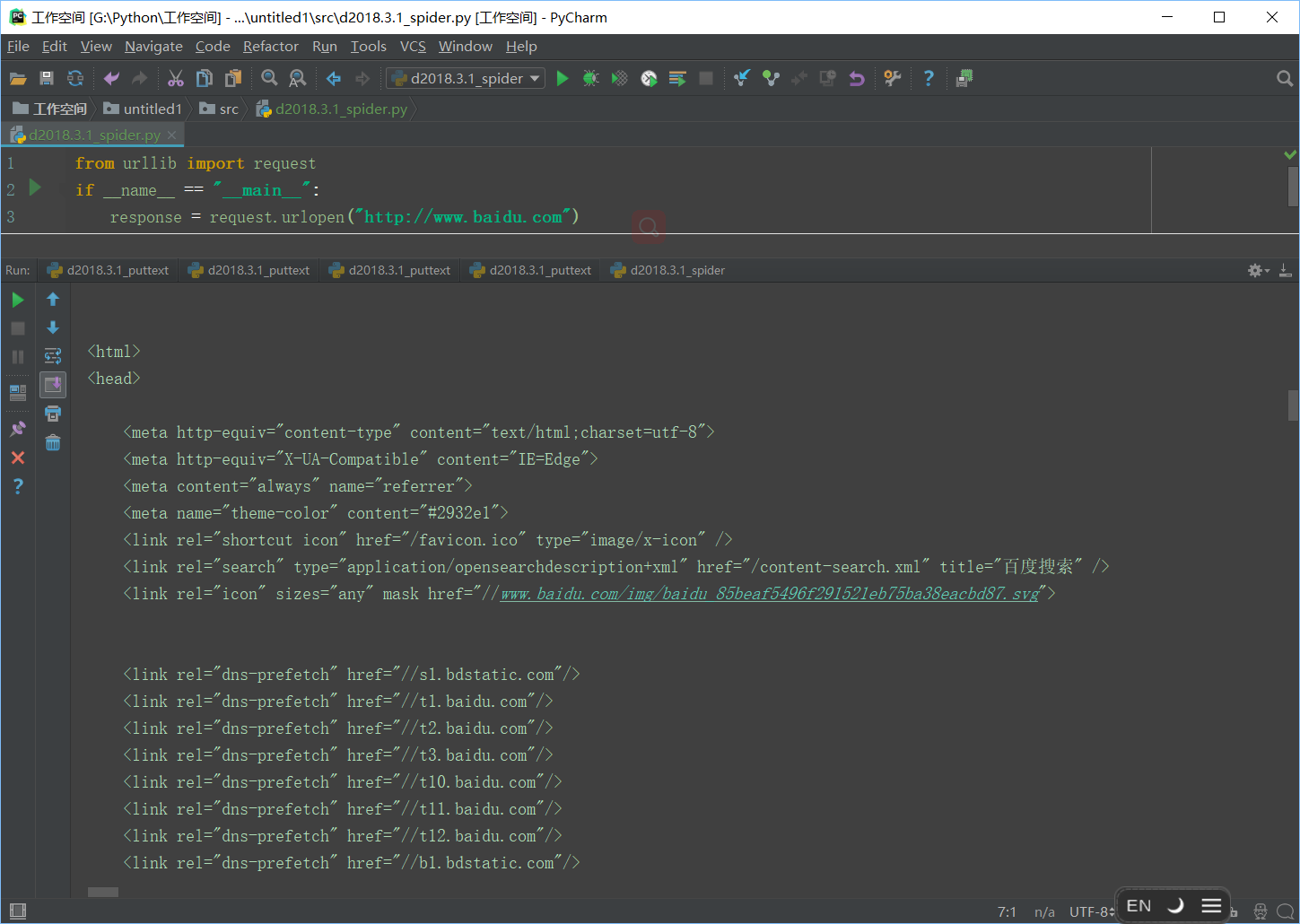

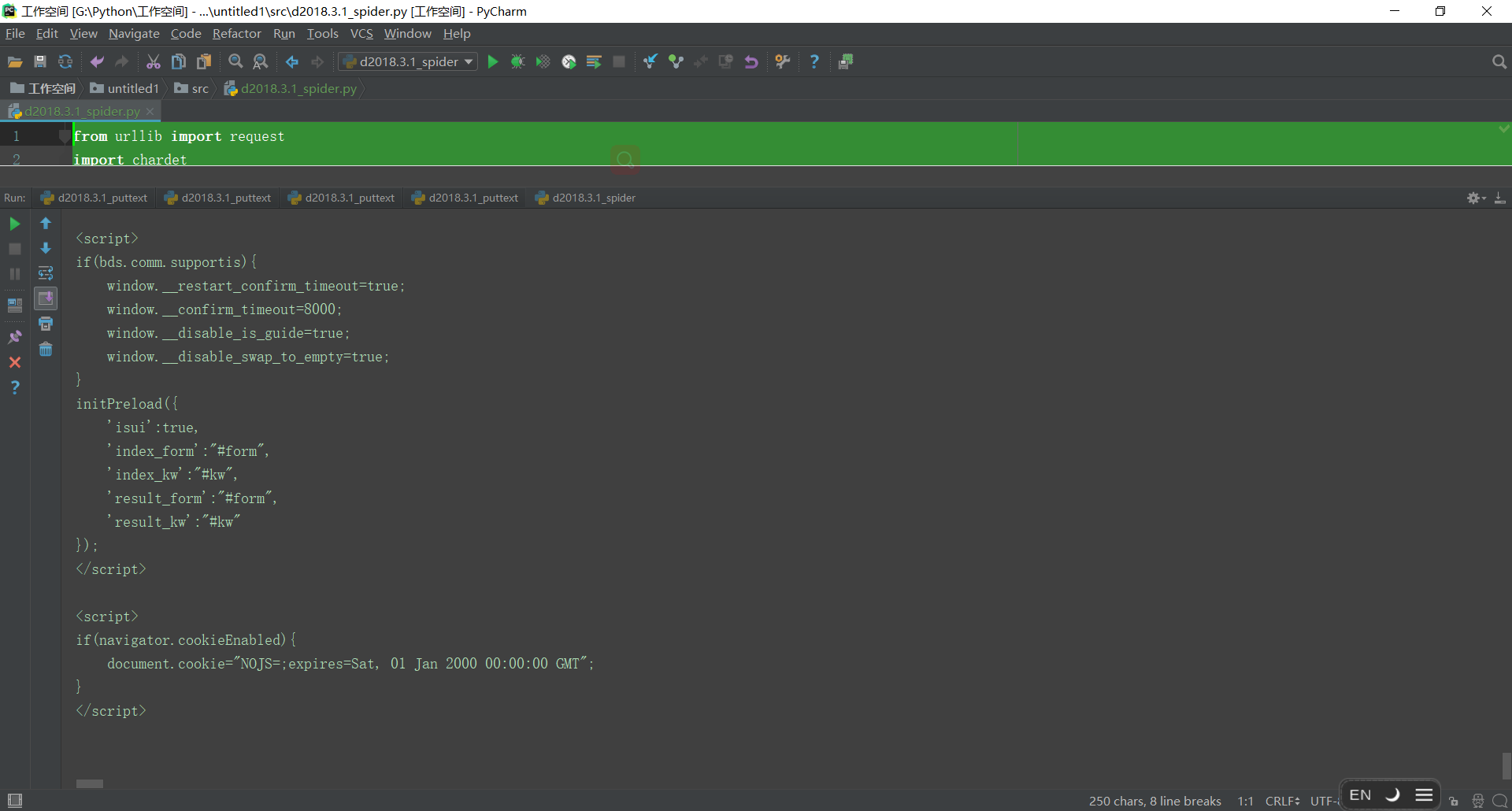

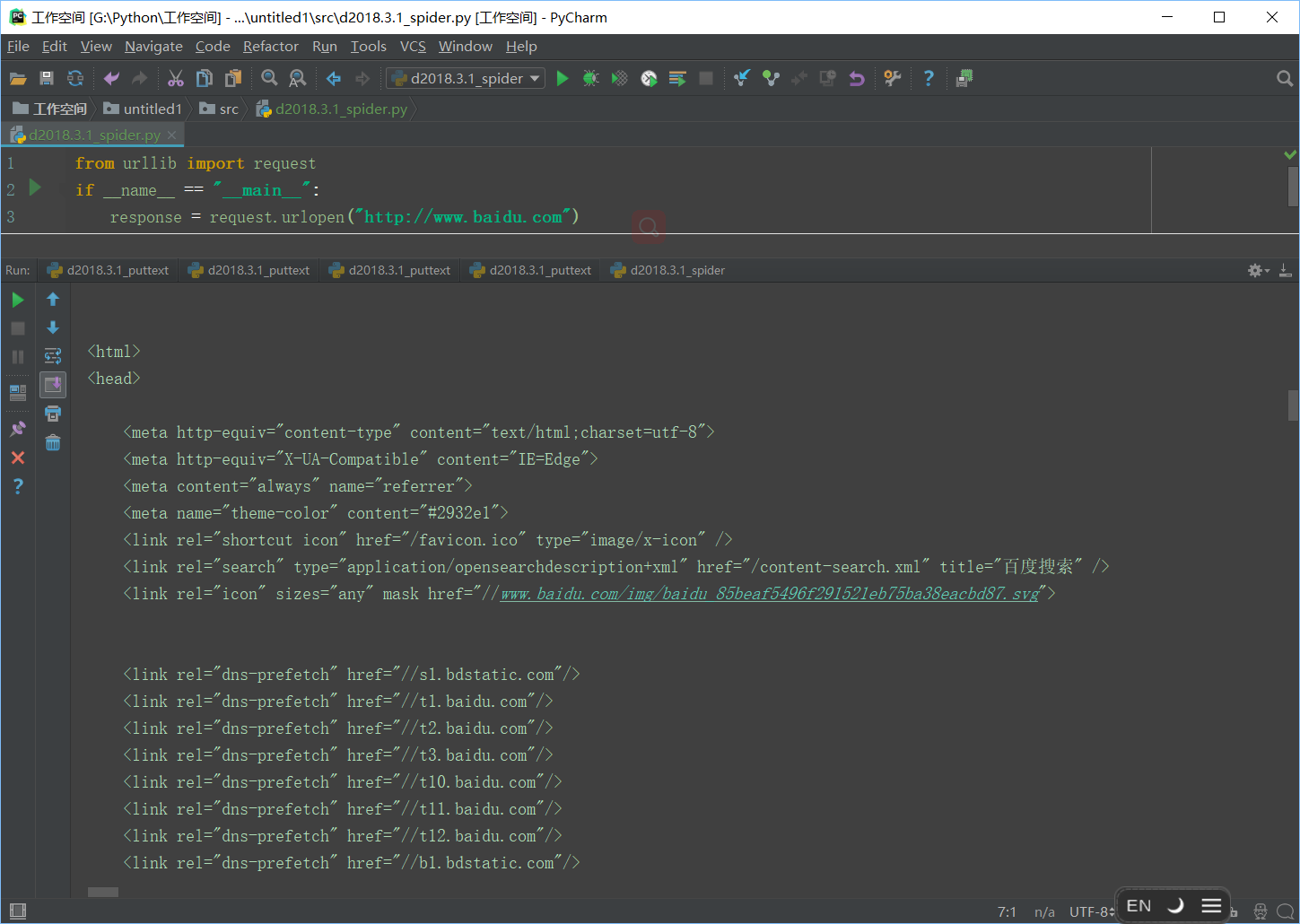

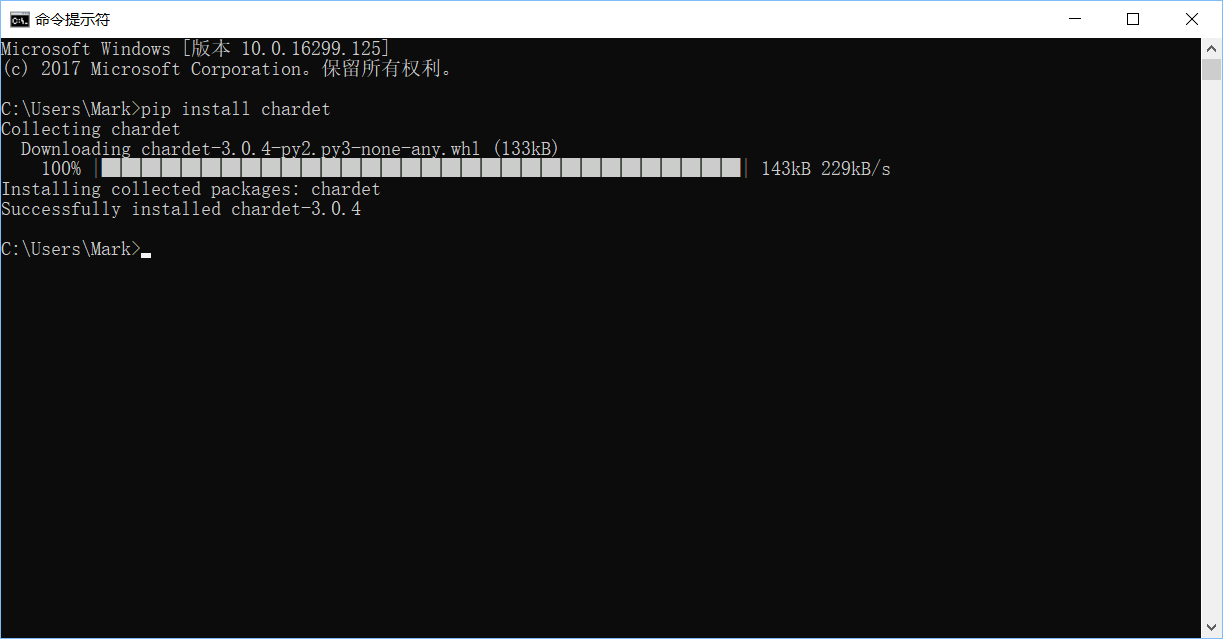

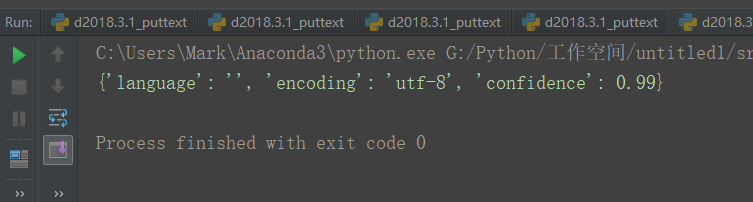

浏览器抓取网页(1.开发环境.3.3python3.52.网络爬虫的定义)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-03-28 06:14

1.开发环境

pycharm2017.3.3

蟒蛇3.5

2.网络爬虫的定义

网络爬虫,又称网络蜘蛛,如果把互联网比作蜘蛛网,蜘蛛就是在网络上四处爬行的蜘蛛。网络爬虫根据其地址搜索网页。是网址。举个简单的例子,我们在浏览器地址栏中输入的字符串就是URL,例如:

URL为统一资源定位符(统一资源定位),其一般格式如下(方括号[]可选)

protocol://hostname[:port]/path/[:parameters][?query]#fragment

URL的格式由三部分组成:

(1)protocol:第一部分是协议,比如百度使用的是https协议;

(2)hostname[:port]:第二部分是主机名(和端口号作为可选参数),一般网站默认端口号为80

(3)path:第三部分是宿主资源的具体地址,如目录和文件名等,网络爬虫就是根据这个URL获取网页信息

3.简单爬虫示例

在Python3.x中,我们可以使用urllib组件来抓取网页。 urllib 是一个 URL 处理包。这个包采集了处理url的模块,如下:

(1)urllib.request模块用于打开和读取URL;

(2)urllib.error 模块收录一些urllib.request 产生的错误,可以用try 捕获

(3)urllib.parse模块收录一些解析URL的方法;

(4)urllib.robotparser模块用于解析robots.txt文本文件,提供了单独的RobotFileParser类,通过该类提供的can_fatch()方法测试爬虫能否下载页面.

我们可以通过接口函数urllib.request.urlopen()轻松打开一个网站,读取和打印信息

让我们编写一个简单的程序来实现它

1 from urllib import request

2 if __name__ == "__main__":

3 response = request.urlopen("http://www.baidu.com")

4 html = response.read()

5 print(html)

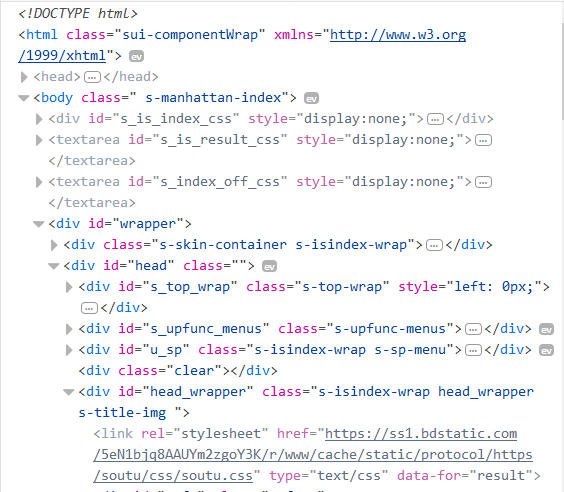

运行结果(可以看到进度条还是可以拉远的)

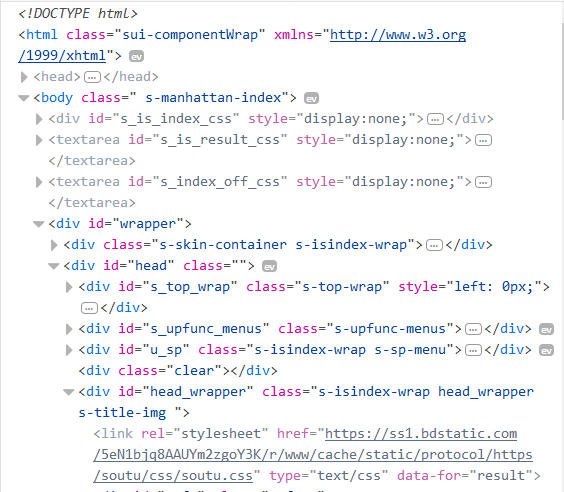

这到底是怎么回事

为了对比,在浏览器中打开,查看页面元素,使用快捷键F12(浏览器最好使用Firefox或Chrome)

一切都一样,只是格式有点乱。您可以通过简单的 decode() 命令解码并显示网页的信息。代码中加一句html=html.decode("utf-8")

1 from urllib import request

2

3 if __name__ == "__main__":

4 response = request.urlopen("http://www.fanyi.baidu.com/")

5 html = response.read()

6 html = html.decode("utf-8")

7 print(html)

输出普通html格式

当然,编码方式不是我们猜到的,而是发现了。在查看元素中找到head标签,打开,看到charset="utf-8",就是编码方式

4.自动获取网页的编码方式

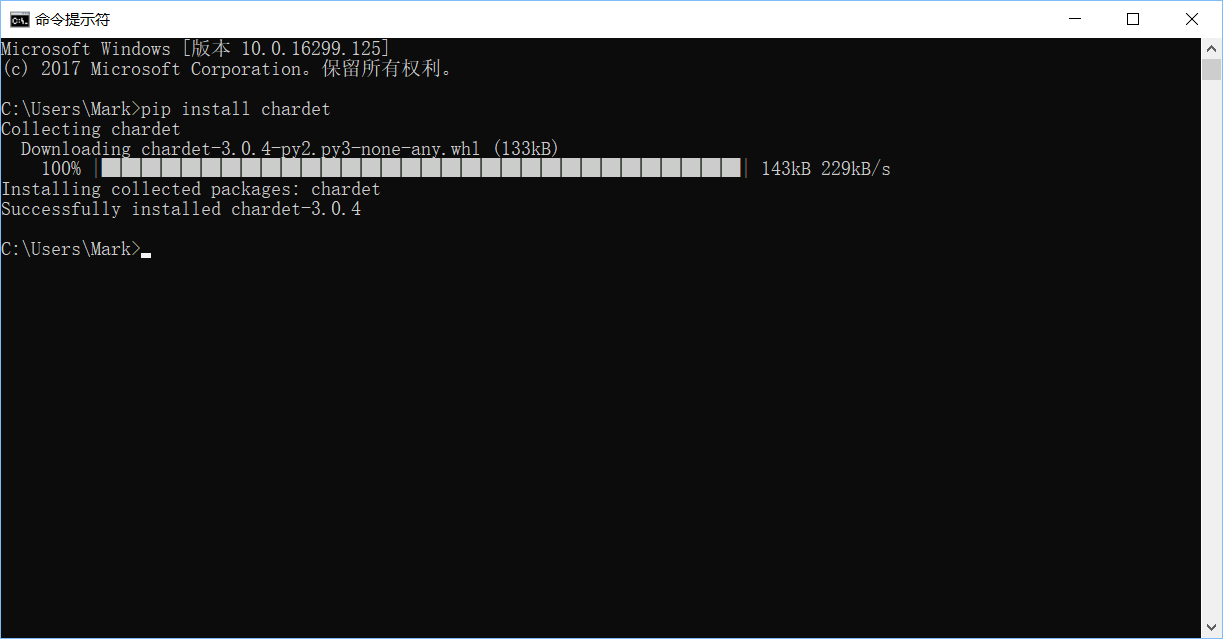

这里使用第三方库来安装chardet

1 pip install chardet

对代码稍作修改,确定页面的编码方式

1 from urllib import request

2 import chardet

3 if __name__ == "__main__":

4 response = request.urlopen("http://www.baidu.com")

5 html = response.read()

6 #html = html.decode("utf-8")

7 charset = chardet.detect(html)

8 print(charset)

可以看到字典返回了,终于可以整合了

1 from urllib import request

2 import chardet

3 if __name__ == "__main__":

4 response = request.urlopen("http://www.baidu.com")

5 html = response.read()

6 charset = chardet.detect(html)

7 html = html.decode(charset.get('encoding'))

8

9 print(html)

完美

转载于: 查看全部

浏览器抓取网页(1.开发环境.3.3python3.52.网络爬虫的定义)

1.开发环境

pycharm2017.3.3

蟒蛇3.5

2.网络爬虫的定义

网络爬虫,又称网络蜘蛛,如果把互联网比作蜘蛛网,蜘蛛就是在网络上四处爬行的蜘蛛。网络爬虫根据其地址搜索网页。是网址。举个简单的例子,我们在浏览器地址栏中输入的字符串就是URL,例如:

URL为统一资源定位符(统一资源定位),其一般格式如下(方括号[]可选)

protocol://hostname[:port]/path/[:parameters][?query]#fragment

URL的格式由三部分组成:

(1)protocol:第一部分是协议,比如百度使用的是https协议;

(2)hostname[:port]:第二部分是主机名(和端口号作为可选参数),一般网站默认端口号为80

(3)path:第三部分是宿主资源的具体地址,如目录和文件名等,网络爬虫就是根据这个URL获取网页信息

3.简单爬虫示例

在Python3.x中,我们可以使用urllib组件来抓取网页。 urllib 是一个 URL 处理包。这个包采集了处理url的模块,如下:

(1)urllib.request模块用于打开和读取URL;

(2)urllib.error 模块收录一些urllib.request 产生的错误,可以用try 捕获

(3)urllib.parse模块收录一些解析URL的方法;

(4)urllib.robotparser模块用于解析robots.txt文本文件,提供了单独的RobotFileParser类,通过该类提供的can_fatch()方法测试爬虫能否下载页面.

我们可以通过接口函数urllib.request.urlopen()轻松打开一个网站,读取和打印信息

让我们编写一个简单的程序来实现它

1 from urllib import request

2 if __name__ == "__main__":

3 response = request.urlopen("http://www.baidu.com";)

4 html = response.read()

5 print(html)

运行结果(可以看到进度条还是可以拉远的)

这到底是怎么回事

为了对比,在浏览器中打开,查看页面元素,使用快捷键F12(浏览器最好使用Firefox或Chrome)

一切都一样,只是格式有点乱。您可以通过简单的 decode() 命令解码并显示网页的信息。代码中加一句html=html.decode("utf-8")

1 from urllib import request

2

3 if __name__ == "__main__":

4 response = request.urlopen("http://www.fanyi.baidu.com/";)

5 html = response.read()

6 html = html.decode("utf-8")

7 print(html)

输出普通html格式

当然,编码方式不是我们猜到的,而是发现了。在查看元素中找到head标签,打开,看到charset="utf-8",就是编码方式

4.自动获取网页的编码方式

这里使用第三方库来安装chardet

1 pip install chardet

对代码稍作修改,确定页面的编码方式

1 from urllib import request

2 import chardet

3 if __name__ == "__main__":

4 response = request.urlopen("http://www.baidu.com";)

5 html = response.read()

6 #html = html.decode("utf-8")

7 charset = chardet.detect(html)

8 print(charset)

可以看到字典返回了,终于可以整合了

1 from urllib import request

2 import chardet

3 if __name__ == "__main__":

4 response = request.urlopen("http://www.baidu.com";)

5 html = response.read()

6 charset = chardet.detect(html)

7 html = html.decode(charset.get('encoding'))

8

9 print(html)

完美

转载于:

浏览器抓取网页(获取网页标题的方式是什么?怎么做?处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-03-26 02:16

作为标准的 HTML 文档,页面标题(title)是必不可少的属性。随着浏览器的发展,我们有了另一种访问和修改文档的方式:DOM。因此,获取网页标题有两种方式:

通过文档对象访问title

var title = document.title;通过 DOM 访问标题

var title = document.getElementsByTagName('title')[0];但是这两种获取方式完全不同,document.title可以直接获取网页标题的字符串副本,它返回一个字符串;但是通过DOM获取的是HTML文档中的title节点对象。

我们可以使用节点对象的innerHTML属性来输出页面标题:

document.getElementsByTagName('title')[0].innerHTML;

编辑页面标题

这里我们讨论一下IE浏览器实现中的一个小bug:我们知道理论上HTML文档中的任何节点都可以通过DOM进行修改。按照这句话,我们当然可以修改HTML文档中的title节点。 但有趣的是,IE浏览器在这个地方实现了一些奇怪的东西,具体来说:

Firefox 在这里完美运行。不过除了FF和IE,其他浏览器我没有测试过,有兴趣的朋友可以试试。 (估计会比IE表现更好^^)

有一种说法,老方法不一定过时。存在多年的Document.title在这个时候就凸显了它的优势,因为这个属性不仅可以获取网页的标题,还可以修改标题。同时,HTML 文档节点中的标题也同步更新。所以:

目前,对于 Internet Explorer,更改网页标题的唯一方法是使用过时的 document.title 方法。同时,此方法也适用于其他浏览器。

结论

在web开发中,如果要处理网页标题的问题,需要注意以下几点:

最佳实践

获取文档标题:var title = document.title;

修改文档标题:document.title = "new title"; 查看全部

浏览器抓取网页(获取网页标题的方式是什么?怎么做?处理)

作为标准的 HTML 文档,页面标题(title)是必不可少的属性。随着浏览器的发展,我们有了另一种访问和修改文档的方式:DOM。因此,获取网页标题有两种方式:

通过文档对象访问title

var title = document.title;通过 DOM 访问标题

var title = document.getElementsByTagName('title')[0];但是这两种获取方式完全不同,document.title可以直接获取网页标题的字符串副本,它返回一个字符串;但是通过DOM获取的是HTML文档中的title节点对象。

我们可以使用节点对象的innerHTML属性来输出页面标题:

document.getElementsByTagName('title')[0].innerHTML;

编辑页面标题

这里我们讨论一下IE浏览器实现中的一个小bug:我们知道理论上HTML文档中的任何节点都可以通过DOM进行修改。按照这句话,我们当然可以修改HTML文档中的title节点。 但有趣的是,IE浏览器在这个地方实现了一些奇怪的东西,具体来说:

Firefox 在这里完美运行。不过除了FF和IE,其他浏览器我没有测试过,有兴趣的朋友可以试试。 (估计会比IE表现更好^^)

有一种说法,老方法不一定过时。存在多年的Document.title在这个时候就凸显了它的优势,因为这个属性不仅可以获取网页的标题,还可以修改标题。同时,HTML 文档节点中的标题也同步更新。所以:

目前,对于 Internet Explorer,更改网页标题的唯一方法是使用过时的 document.title 方法。同时,此方法也适用于其他浏览器。

结论

在web开发中,如果要处理网页标题的问题,需要注意以下几点:

最佳实践

获取文档标题:var title = document.title;

修改文档标题:document.title = "new title";

浏览器抓取网页(如何通过js调用本地摄像头呢?获取后如何对视频进行截图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-03-25 14:24

如何通过js调用本地摄像头?获取视频后如何截图?下面我就和大家做一个简单的Demo来实现以上功能。

涉及的知识点实现的功能点的html简单布局

下面先用HTML实现一个简单的布局,包括样式和按钮。

H5 canvas 调用摄像头进行绘制

html,body{

width:100%;

height:100%;

padding: 0px;

margin: 0px;

overflow: hidden;

}

#canvas{

width:500px;

height:300px;

}

#video{

width:500px;