动态网页抓取

动态网页抓取( 基于python(asynchronousjavascriptandxml)的动态网页爬虫系统及其开发方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-17 17:03

基于python(asynchronousjavascriptandxml)的动态网页爬虫系统及其开发方法)

本发明属于计算机领域,涉及爬虫系统,尤其是一种动态网页爬虫系统。

背景技术

网络爬虫是一种自动提取网页的程序。传统爬虫从一个或多个初始网页的url开始,获取初始网页上的url(统一资源定位器),在抓取网页的过程中不断从当前页面中提取。新的url被放入队列中,直到满足系统预设的停止条件。

随着互联网从web1.0时代迅速进入web1.0时代,基于ajax(异步javascript和xml)的动态页面加载技术成为各大公司的首选。随着移动互联网的兴起,javascript在移动端和pc端的优秀特性被广泛挖掘,基于前端mvc/mvm的模型逐渐进入各大互联网公司的首选方案。动态网页的迅速崛起使得基于动态网页的网络爬虫越来越重要。

例如,一个 网站? courseid=id#/学习/视频?课程ID=课程ID&c。通常,对于动态url对应的动态页面,后面跟问号、等号等字符的参数就是要查询的数据库数据。获取动态页面的数据,一般是通过脚本解析或者使用浏览器渲染动态网页来获取动态网页内容。但是,脚本解析的前提是要确定异步加载信息中存在部分或全部目标动态网页信息,并且请求规则可以是获取和目标页面有规律的分布;使用浏览器渲染只能针对不完整的DOM(文档对象模型)数据结构,而部分或全部的目标信息存在于使用浏览器渲染中。

技术实施要素:

为了解决脚本解析和浏览器渲染的局限性,提高动态网页爬取的准确性和完整性,本发明提供了一种基于scrapy的方法(scrapy是一种基于python开发的快速、高级的屏幕爬取和网页) .爬虫框架)动态网络爬虫系统,包括爬虫引擎、调度器、解析模块、项目管道、下载器,爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器,用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;

解析模块包括脚本解析器、渲染器和切换模块;

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

作为本发明的一个优选方案,渲染器为无界面浏览器。

作为本发明的一个优选方案,无界面浏览器包括selenium、splash、htmlunit、phantomjs。在本发明的一个实施例中,无界面浏览器使用闪屏渲染容器来渲染动态网页。

为了避免使用动态解析或浏览器渲染来提取动态网页的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本。然后交给脚本解析器或渲染器进行爬取,记录爬取信息的完整性、爬取时间、资源消耗。

本发明第二方面的目的在于提供一种动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:

根据动态网页或URL信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。

进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

作为本发明的一个优选方案,所述渲染包括:使用无界面浏览器渲染异步加载的信息,使用无界面浏览器的api模拟用户点击,从模拟事件的结果中提取目标信息.

作为本发明的一个优选方案,脚本解析和渲染混合的具体步骤如下:通过脚本解析获取动态网页的请求规则,然后通过非界面浏览器加载,利用脚本解析缺失的渲染参数构造完整的请求规则,直到获得完整的异步加载信息。

作为本发明的优选方案,s4中的优先级算法如下:以提取的动态页面提取信息的完整性、时间、资源消耗率为变量,采用单纯形法得到最优解。

本发明的有益效果是:

1.本发明对目前大部分动态网页网站的结构和常规动态网页的爬取方法进行分析,利用资源消耗低和脚本解析速度快的优点,将webdriver在渲染爬虫的优势,可以提高爬虫的爬取精度和适应性。

2.设置切换模块,避免使用单一爬取方式时,因特殊情况导致无法爬取,陷入死循环的情况。

3.通过预检测机制,对收录不同动态异步加载机制的动态网页采用不同的爬取策略,提高了解析性能,减少了对内存和网络资源的占用,使得本发明对动态页面的爬取更具自适应性和智能性。

图纸说明

图1为本发明的基本原理图;

图2为本发明的解析模块框架示意图;

图3是本发明的动态爬取方法的流程图;

图4是本发明采用脚本解析动态网页的流程图;

图5是本发明中采用脚本通过服务器认证结构分析动态网页的组成;

如图。图6是本发明中脚本解析和渲染的流程图。

详细说明

为更好地理解本发明所提出的技术方案,下面结合附图1-6和具体实施例对本发明作进一步的说明。

如图1和图2所示,动态网络爬虫系统包括爬虫引擎、调度器、解析模块、项目管道和下载器。

爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;解析模块包括脚本解析器、渲染器和切换模块,

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

在本发明的一个实施例中,切换阈值时间选择为150ms,即当脚本解析或渲染器解析动态页面超过150ms仍无法返回时,切换器切换未解析的url使用的方法。

在本发明的另一个实施例中,考虑到现有爬虫系统可以是分布式架构,可以优化解析时间和资源消耗,因此切换器的切换条件考虑解析出的动态页面的信息是否完整。

在本发明的一个实施例中,渲染器为无界面浏览器,常见的无界面浏览器有benv、browser、launcher、browserjet、casperjs、dalekjsghostbuster、headlessbrowser、htmlunit、jasmine-headless-webkit、jaunt、jbrowserdriver、jedi-爬虫,乐天,噩梦,phantomjs,硒,slimerjs,triflejs,zombie.js。

进一步地,在本发明实施例中,无界面浏览器包括selenium、splash、htmlunit、phantomjs。

进一步地,在本发明的一个实施例中,使用selenium与webdriver或hantomjs相结合的方法进行动态页面提取。

为了避免使用浏览器进行动态解析或渲染的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本,然后提交给脚本解析器或渲染器爬取并记录爬取信息的完整性、爬取时间和资源消耗。

如图4至图6所示,本发明还提供了一种基于上述动态网页爬虫系统的动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:根据动态网页或网站信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

基于以上描述的公开和教导,本发明所属领域的技术人员还可以对上述实施例的相关模块和软件架构进行适应性改变和修改。因此,本发明不限于上述所公开和描述的具体实施例,对本发明的一些修改和变化也应落入本发明权利要求的保护范围之内。此外,虽然在本说明书中使用了一些特定的术语,但这些术语只是为了描述的方便,并不构成对本发明的任何限制。 查看全部

动态网页抓取(

基于python(asynchronousjavascriptandxml)的动态网页爬虫系统及其开发方法)

本发明属于计算机领域,涉及爬虫系统,尤其是一种动态网页爬虫系统。

背景技术

网络爬虫是一种自动提取网页的程序。传统爬虫从一个或多个初始网页的url开始,获取初始网页上的url(统一资源定位器),在抓取网页的过程中不断从当前页面中提取。新的url被放入队列中,直到满足系统预设的停止条件。

随着互联网从web1.0时代迅速进入web1.0时代,基于ajax(异步javascript和xml)的动态页面加载技术成为各大公司的首选。随着移动互联网的兴起,javascript在移动端和pc端的优秀特性被广泛挖掘,基于前端mvc/mvm的模型逐渐进入各大互联网公司的首选方案。动态网页的迅速崛起使得基于动态网页的网络爬虫越来越重要。

例如,一个 网站? courseid=id#/学习/视频?课程ID=课程ID&c。通常,对于动态url对应的动态页面,后面跟问号、等号等字符的参数就是要查询的数据库数据。获取动态页面的数据,一般是通过脚本解析或者使用浏览器渲染动态网页来获取动态网页内容。但是,脚本解析的前提是要确定异步加载信息中存在部分或全部目标动态网页信息,并且请求规则可以是获取和目标页面有规律的分布;使用浏览器渲染只能针对不完整的DOM(文档对象模型)数据结构,而部分或全部的目标信息存在于使用浏览器渲染中。

技术实施要素:

为了解决脚本解析和浏览器渲染的局限性,提高动态网页爬取的准确性和完整性,本发明提供了一种基于scrapy的方法(scrapy是一种基于python开发的快速、高级的屏幕爬取和网页) .爬虫框架)动态网络爬虫系统,包括爬虫引擎、调度器、解析模块、项目管道、下载器,爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器,用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;

解析模块包括脚本解析器、渲染器和切换模块;

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

作为本发明的一个优选方案,渲染器为无界面浏览器。

作为本发明的一个优选方案,无界面浏览器包括selenium、splash、htmlunit、phantomjs。在本发明的一个实施例中,无界面浏览器使用闪屏渲染容器来渲染动态网页。

为了避免使用动态解析或浏览器渲染来提取动态网页的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本。然后交给脚本解析器或渲染器进行爬取,记录爬取信息的完整性、爬取时间、资源消耗。

本发明第二方面的目的在于提供一种动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:

根据动态网页或URL信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。

进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

作为本发明的一个优选方案,所述渲染包括:使用无界面浏览器渲染异步加载的信息,使用无界面浏览器的api模拟用户点击,从模拟事件的结果中提取目标信息.

作为本发明的一个优选方案,脚本解析和渲染混合的具体步骤如下:通过脚本解析获取动态网页的请求规则,然后通过非界面浏览器加载,利用脚本解析缺失的渲染参数构造完整的请求规则,直到获得完整的异步加载信息。

作为本发明的优选方案,s4中的优先级算法如下:以提取的动态页面提取信息的完整性、时间、资源消耗率为变量,采用单纯形法得到最优解。

本发明的有益效果是:

1.本发明对目前大部分动态网页网站的结构和常规动态网页的爬取方法进行分析,利用资源消耗低和脚本解析速度快的优点,将webdriver在渲染爬虫的优势,可以提高爬虫的爬取精度和适应性。

2.设置切换模块,避免使用单一爬取方式时,因特殊情况导致无法爬取,陷入死循环的情况。

3.通过预检测机制,对收录不同动态异步加载机制的动态网页采用不同的爬取策略,提高了解析性能,减少了对内存和网络资源的占用,使得本发明对动态页面的爬取更具自适应性和智能性。

图纸说明

图1为本发明的基本原理图;

图2为本发明的解析模块框架示意图;

图3是本发明的动态爬取方法的流程图;

图4是本发明采用脚本解析动态网页的流程图;

图5是本发明中采用脚本通过服务器认证结构分析动态网页的组成;

如图。图6是本发明中脚本解析和渲染的流程图。

详细说明

为更好地理解本发明所提出的技术方案,下面结合附图1-6和具体实施例对本发明作进一步的说明。

如图1和图2所示,动态网络爬虫系统包括爬虫引擎、调度器、解析模块、项目管道和下载器。

爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;解析模块包括脚本解析器、渲染器和切换模块,

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

在本发明的一个实施例中,切换阈值时间选择为150ms,即当脚本解析或渲染器解析动态页面超过150ms仍无法返回时,切换器切换未解析的url使用的方法。

在本发明的另一个实施例中,考虑到现有爬虫系统可以是分布式架构,可以优化解析时间和资源消耗,因此切换器的切换条件考虑解析出的动态页面的信息是否完整。

在本发明的一个实施例中,渲染器为无界面浏览器,常见的无界面浏览器有benv、browser、launcher、browserjet、casperjs、dalekjsghostbuster、headlessbrowser、htmlunit、jasmine-headless-webkit、jaunt、jbrowserdriver、jedi-爬虫,乐天,噩梦,phantomjs,硒,slimerjs,triflejs,zombie.js。

进一步地,在本发明实施例中,无界面浏览器包括selenium、splash、htmlunit、phantomjs。

进一步地,在本发明的一个实施例中,使用selenium与webdriver或hantomjs相结合的方法进行动态页面提取。

为了避免使用浏览器进行动态解析或渲染的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本,然后提交给脚本解析器或渲染器爬取并记录爬取信息的完整性、爬取时间和资源消耗。

如图4至图6所示,本发明还提供了一种基于上述动态网页爬虫系统的动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:根据动态网页或网站信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

基于以上描述的公开和教导,本发明所属领域的技术人员还可以对上述实施例的相关模块和软件架构进行适应性改变和修改。因此,本发明不限于上述所公开和描述的具体实施例,对本发明的一些修改和变化也应落入本发明权利要求的保护范围之内。此外,虽然在本说明书中使用了一些特定的术语,但这些术语只是为了描述的方便,并不构成对本发明的任何限制。

动态网页抓取(网络服务器应用上的应用——6.发送给)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-01-17 05:30

Alice 有一个 Web 服务器,Bob 的另一个桌面即将连接到 Alice 的服务器。当一台机器想与另一台机器通信时,会发生以下行为。1.Bob 的计算机发送一串 1 和 0 的位值,代表电路上的高电压和低电压。这些位构成了一种信息,包括请求头和消息体。请求头收录 Bob 的本地路由器 MAC 地址和 Alice 的 IP 地址。消息正文收录 Bob 对 Alice 的服务器应用程序的请求。2.Bob 的本地路由器接收所有 1 和 0 位值,并将它们解释为从 Bob 自己的 MAC 地址“发送”到 Alice 的 IP 地址的数据包(packct)。他的路由器用自己的 IP 地址“填充”数据包作为“发件人” 地址并通过 Internet 发送出去。3.Bob 的数据包通过一些中间服务器,遵循正确的物理/电路路径,到达 Alice 的服务器。4.Alice 的服务器在她的 IP 地址收到了数据包。5.Alice的服务器读取数据包请求头中的目的端口(一般是网络应用的80端口,可以理解为数据包的“房间号”,IP地址为“街道” address"),然后把它传递给相应的应用程序——web服务器应用程序。6.Web 服务器从服务器处理器接收一串数据。数据是这样的: ? 这是一个 GET 请求?请求文件索引。 查看全部

动态网页抓取(网络服务器应用上的应用——6.发送给)

Alice 有一个 Web 服务器,Bob 的另一个桌面即将连接到 Alice 的服务器。当一台机器想与另一台机器通信时,会发生以下行为。1.Bob 的计算机发送一串 1 和 0 的位值,代表电路上的高电压和低电压。这些位构成了一种信息,包括请求头和消息体。请求头收录 Bob 的本地路由器 MAC 地址和 Alice 的 IP 地址。消息正文收录 Bob 对 Alice 的服务器应用程序的请求。2.Bob 的本地路由器接收所有 1 和 0 位值,并将它们解释为从 Bob 自己的 MAC 地址“发送”到 Alice 的 IP 地址的数据包(packct)。他的路由器用自己的 IP 地址“填充”数据包作为“发件人” 地址并通过 Internet 发送出去。3.Bob 的数据包通过一些中间服务器,遵循正确的物理/电路路径,到达 Alice 的服务器。4.Alice 的服务器在她的 IP 地址收到了数据包。5.Alice的服务器读取数据包请求头中的目的端口(一般是网络应用的80端口,可以理解为数据包的“房间号”,IP地址为“街道” address"),然后把它传递给相应的应用程序——web服务器应用程序。6.Web 服务器从服务器处理器接收一串数据。数据是这样的: ? 这是一个 GET 请求?请求文件索引。

动态网页抓取(如何用python来抓取页面中的JS动态加载的数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-01-17 04:26

)

我们经常会发现网页中的很多数据并不是用 HTML 编写的,而是通过 js 动态加载的。因此,引入了动态数据的概念。这里的动态数据是指网页中通过Javascript动态生成的页面内容。它是在页面加载到浏览器后动态生成的,但之前没有。

在编写爬虫爬取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,就无法获取任何数据。

今天就简单讲一下如何使用python爬取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面获取有关每部电影的信息。

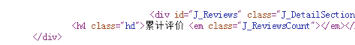

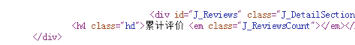

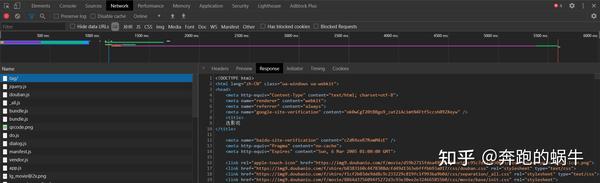

如下图所示,我们在 HTML 中找不到对应的电影信息。

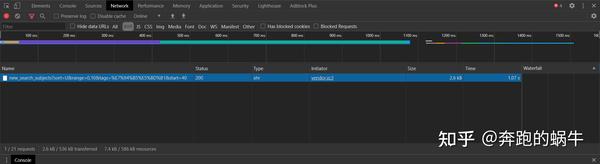

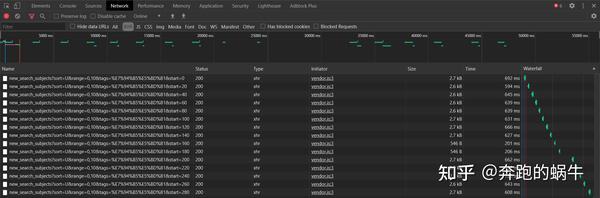

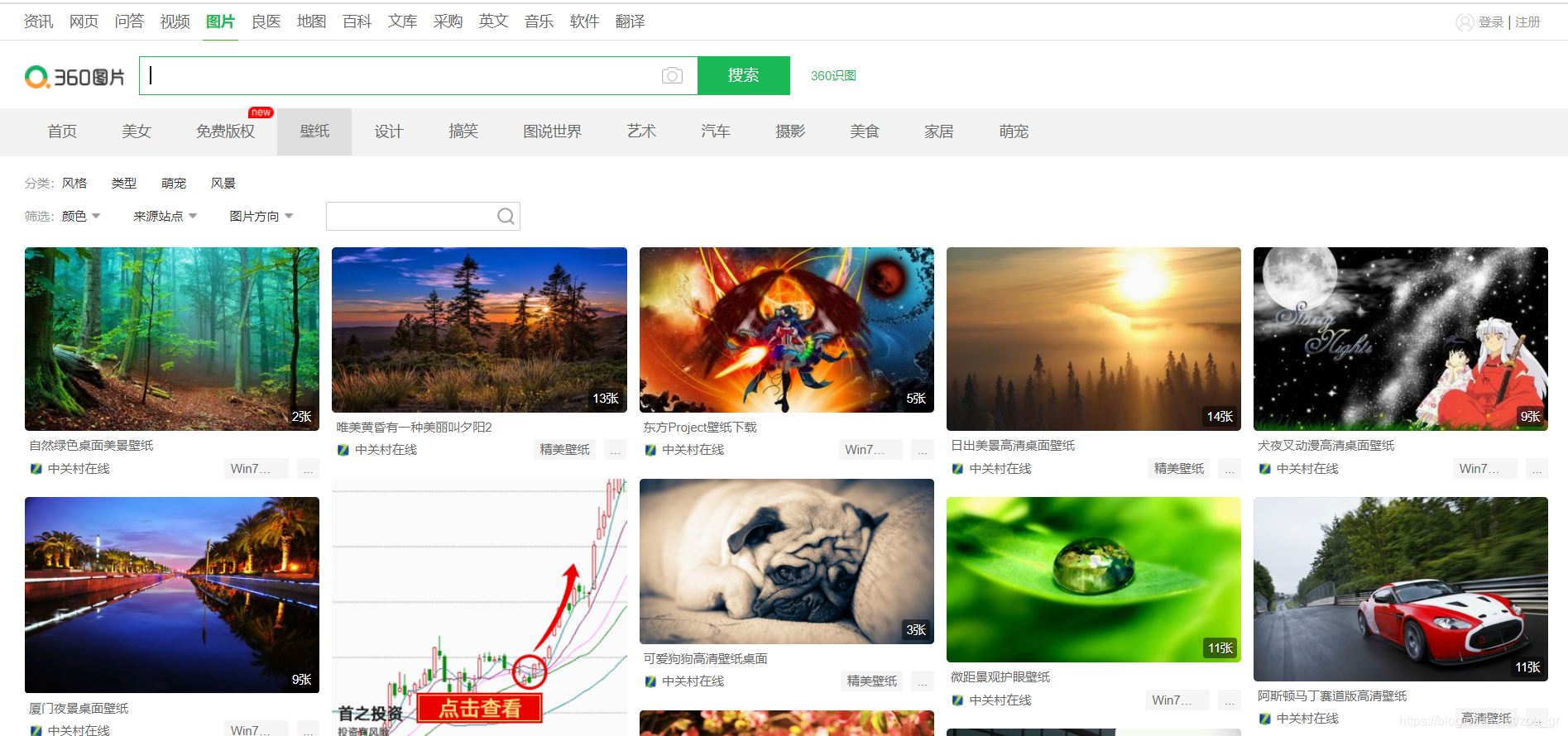

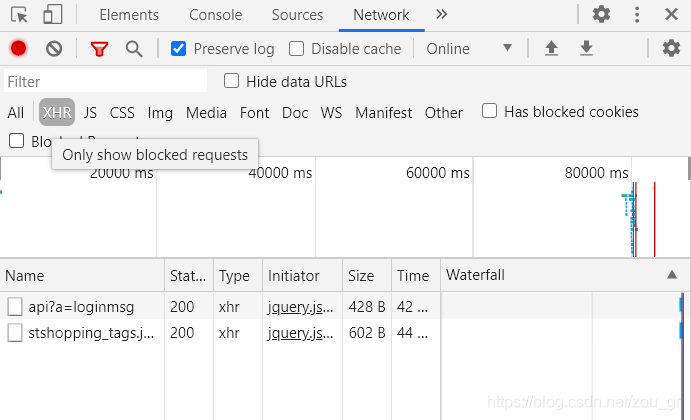

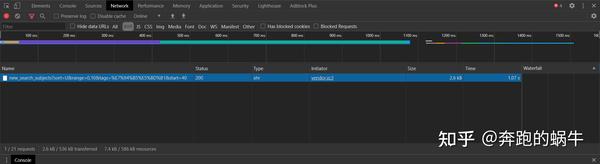

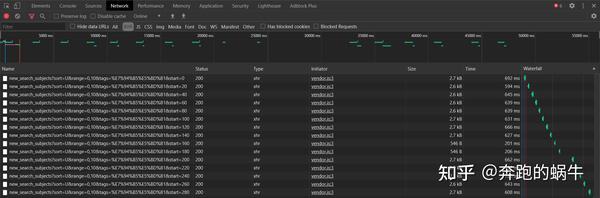

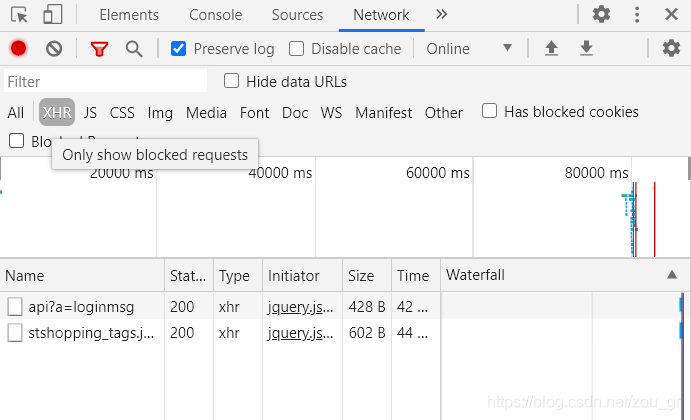

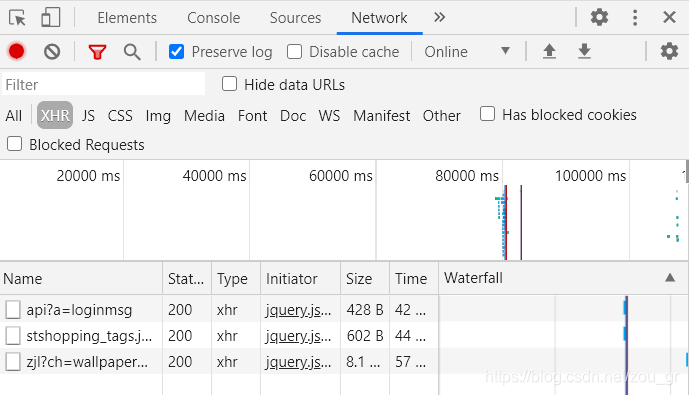

在Chrome浏览器中,点击F12打开网络中的XHR,我们抓取对应的js文件进行解析。如下所示:

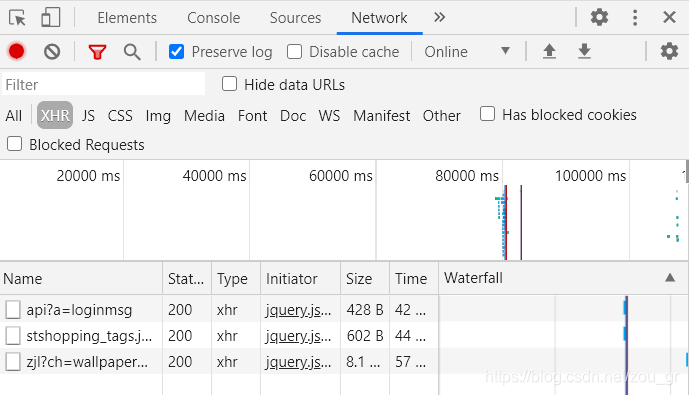

在豆瓣页面上拖拽,让页面加载更多的电影信息,方便我们抓取对应的消息。

我们可以看到它使用了 AJAX 异步请求。AJAX 可以通过在后台与服务器交换少量数据来异步更新网页。因此,可以在不重新加载整个网页的情况下更新网页的一部分,从而实现数据的动态加载。

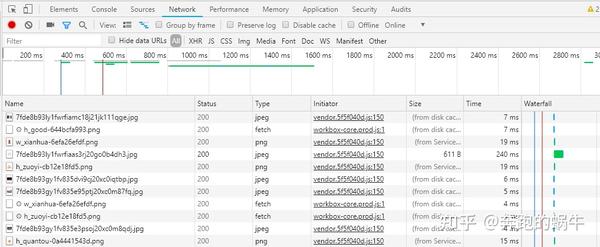

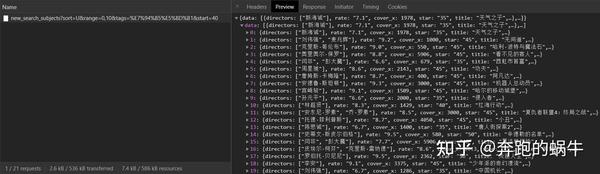

我们可以看到,通过 GET,我们得到的响应中收录了对应的电影相关信息,并以 JSON 格式保存在一起。

查看RequestURL信息,我们可以看到action参数后面有两个参数“start”和“limit”,很明显的意思是:“从某个位置返回的电影数量”。

如果想快速获取相关电影信息,可以直接将网址复制到地址栏,修改自己需要的start和limit参数值,抓取对应的结果。

但这看起来很不自动化,而网站的其他很多RequestURL也不是那么直接,所以我们将使用python进行进一步的操作来获取返回的消息信息。

#coding:utf-8 import urllib import requests post_param = {'action':'','start':'0','limit':'1'} return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False) print return_data.text 查看全部

动态网页抓取(如何用python来抓取页面中的JS动态加载的数据

)

我们经常会发现网页中的很多数据并不是用 HTML 编写的,而是通过 js 动态加载的。因此,引入了动态数据的概念。这里的动态数据是指网页中通过Javascript动态生成的页面内容。它是在页面加载到浏览器后动态生成的,但之前没有。

在编写爬虫爬取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,就无法获取任何数据。

今天就简单讲一下如何使用python爬取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面获取有关每部电影的信息。

如下图所示,我们在 HTML 中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开网络中的XHR,我们抓取对应的js文件进行解析。如下所示:

在豆瓣页面上拖拽,让页面加载更多的电影信息,方便我们抓取对应的消息。

我们可以看到它使用了 AJAX 异步请求。AJAX 可以通过在后台与服务器交换少量数据来异步更新网页。因此,可以在不重新加载整个网页的情况下更新网页的一部分,从而实现数据的动态加载。

我们可以看到,通过 GET,我们得到的响应中收录了对应的电影相关信息,并以 JSON 格式保存在一起。

查看RequestURL信息,我们可以看到action参数后面有两个参数“start”和“limit”,很明显的意思是:“从某个位置返回的电影数量”。

如果想快速获取相关电影信息,可以直接将网址复制到地址栏,修改自己需要的start和limit参数值,抓取对应的结果。

但这看起来很不自动化,而网站的其他很多RequestURL也不是那么直接,所以我们将使用python进行进一步的操作来获取返回的消息信息。

#coding:utf-8 import urllib import requests post_param = {'action':'','start':'0','limit':'1'} return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False) print return_data.text

动态网页抓取( 微信朋友圈数据入口搞定了,获取外链的方法有哪些?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-01-16 19:12

微信朋友圈数据入口搞定了,获取外链的方法有哪些?)

2、然后点击首页的【创建图书】-->【微信图书】。

3、点击【开始制作】-->【添加随机分配的图书编辑为好友】,然后长按二维码添加好友。

4、之后,耐心等待微信书制作完成。完成后会收到小编发送的消息提醒,如下图所示。

至此,我们完成了微信朋友圈的数据录入,并获得了外链。

确保朋友圈设置为[全部打开]。默认是全部打开。如果不知道怎么设置,请百度。

5、点击外部链接,然后进入网页,需要使用微信扫码授权登录。

6、扫码授权后,即可进入微信书网页版,如下图。

7、接下来,我们就可以编写爬虫程序来正常爬取信息了。这里小编使用Scrapy爬虫框架,Python使用版本3,集成开发环境使用Pycharm。下图为微信书首页,图片由小编定制。

二、创建爬虫项目

1、确保您的计算机上安装了 Scrapy。然后选择一个文件夹,在文件夹下输入命令行,输入执行命令:

scrapy startproject weixin_moment

,等待生成Scrapy爬虫项目。

2、在命令行输入cd weixin_moment,进入创建好的weixin_moment目录。然后输入命令:

scrapy genspider 'moment' 'chushu.la'

,创建朋友圈爬虫,如下图。

3、执行上述两步后的文件夹结构如下:

三、分析网页数据

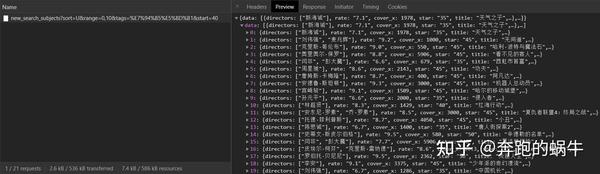

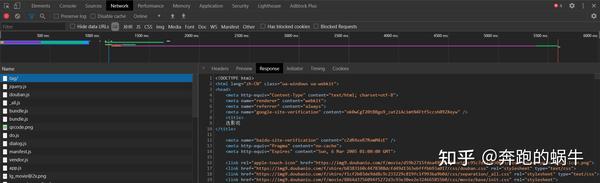

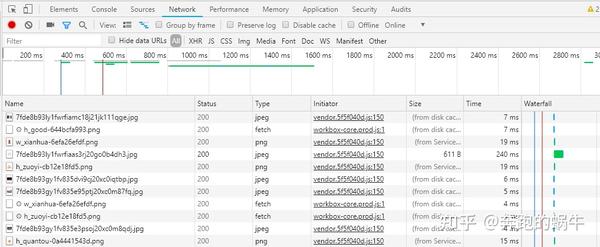

1、进入微信书首页,按F12,推荐使用谷歌浏览器,查看元素,点击“网络”标签,然后勾选“保存日志”保存日志,如图下图。可以看到首页的请求方法是get,返回的状态码是200,表示请求成功。

2、点击“Response”(服务器响应),可以看到系统返回的数据是JSON格式的。说明后面我们需要在程序中处理JSON格式的数据。

3、点击微信书的“导航”窗口,可以看到数据是按月加载的。单击导航按钮时,它会加载相应月份的 Moments 数据。

4、点击月份[2014/04],再查看服务器响应数据,可以看到页面显示的数据对应服务器响应。

5、查看请求方式,可以看到此时的请求方式已经变成了POST。细心的小伙伴可以看到,当点击“下个月”或者其他导航月份时,首页的URL没有变化,说明网页是动态加载的。对比多个网页请求后,我们可以看到“Request Payload”下的数据包参数在不断变化,如下图所示。

6、将服务器响应的数据展开,放入JSON在线解析器,如下图:

可以看到朋友圈的数据是存放在paras /data节点下的。

至此,网页分析和数据的来源已经确定。接下来,我们将编写一个程序来捕获数据。敬请期待下一篇文章~~ 查看全部

动态网页抓取(

微信朋友圈数据入口搞定了,获取外链的方法有哪些?)

2、然后点击首页的【创建图书】-->【微信图书】。

3、点击【开始制作】-->【添加随机分配的图书编辑为好友】,然后长按二维码添加好友。

4、之后,耐心等待微信书制作完成。完成后会收到小编发送的消息提醒,如下图所示。

至此,我们完成了微信朋友圈的数据录入,并获得了外链。

确保朋友圈设置为[全部打开]。默认是全部打开。如果不知道怎么设置,请百度。

5、点击外部链接,然后进入网页,需要使用微信扫码授权登录。

6、扫码授权后,即可进入微信书网页版,如下图。

7、接下来,我们就可以编写爬虫程序来正常爬取信息了。这里小编使用Scrapy爬虫框架,Python使用版本3,集成开发环境使用Pycharm。下图为微信书首页,图片由小编定制。

二、创建爬虫项目

1、确保您的计算机上安装了 Scrapy。然后选择一个文件夹,在文件夹下输入命令行,输入执行命令:

scrapy startproject weixin_moment

,等待生成Scrapy爬虫项目。

2、在命令行输入cd weixin_moment,进入创建好的weixin_moment目录。然后输入命令:

scrapy genspider 'moment' 'chushu.la'

,创建朋友圈爬虫,如下图。

3、执行上述两步后的文件夹结构如下:

三、分析网页数据

1、进入微信书首页,按F12,推荐使用谷歌浏览器,查看元素,点击“网络”标签,然后勾选“保存日志”保存日志,如图下图。可以看到首页的请求方法是get,返回的状态码是200,表示请求成功。

2、点击“Response”(服务器响应),可以看到系统返回的数据是JSON格式的。说明后面我们需要在程序中处理JSON格式的数据。

3、点击微信书的“导航”窗口,可以看到数据是按月加载的。单击导航按钮时,它会加载相应月份的 Moments 数据。

4、点击月份[2014/04],再查看服务器响应数据,可以看到页面显示的数据对应服务器响应。

5、查看请求方式,可以看到此时的请求方式已经变成了POST。细心的小伙伴可以看到,当点击“下个月”或者其他导航月份时,首页的URL没有变化,说明网页是动态加载的。对比多个网页请求后,我们可以看到“Request Payload”下的数据包参数在不断变化,如下图所示。

6、将服务器响应的数据展开,放入JSON在线解析器,如下图:

可以看到朋友圈的数据是存放在paras /data节点下的。

至此,网页分析和数据的来源已经确定。接下来,我们将编写一个程序来捕获数据。敬请期待下一篇文章~~

动态网页抓取(一下爬行网站的次数时多时少爬行抓取策略是什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-16 19:08

我们在做网站优化的时候,SEOer们经常会关注网站的蜘蛛爬取日志。我们会发现蜘蛛爬网站的次数或多或少,那么蜘蛛爬的策略是什么?下面简单介绍一下蜘蛛爬取策略。

在蜘蛛眼里,互联网的网页主要可以分为四类:已爬取页面、待爬取页面、可爬取页面、暗网页面。被爬取的页面是蜘蛛已经爬取的页面。待爬取页面:已在待爬取队列中,但尚未爬取。可爬取页面:这些页面可以通过互联网上已有的链接关系找到,增量爬虫可以随着爬取的深入发现这些页面。暗网上的页面:无法通过现有链接找到的页面。

当spider从一个entry开始爬取时,这个页面有很多导出链接,spider会选择其中一个链接进行爬取,进入后会有很多导出链接。蜘蛛爬行主要有两种方法:深度优先策略和广度优先策略。深度优先就是沿着一条路走,直到无处可去。广度优先意味着一个页面上有多个传出链接。首先,按照这些链接抓取所有链接的页面,然后抓取链接页面上的外链到的页面。

理论上,只要时间足够,蜘蛛可以爬取所有的页面,但是搜索引擎的资源也是有限的,不可能无限制地爬取。搜索引擎一般采用深度和广度相结合的策略。一般来说,网站的权重越高,蜘蛛爬取的频率越高,爬取的内容也越多。

以上两种策略纯粹是从蜘蛛爬行的角度出发的。在实际过程中,影响爬虫爬取较大的因素有:重要页面的优先爬取策略和大型网站的优先爬取。重要页面的重要性主要取决于该页面的传入链接的数量和质量。所谓大站,是指搜索引擎眼中用户体验好、服务器稳定、内容丰富的网站。

一般情况下,网站的入站链接越多,入站链接所在页面的权限越高,被爬取的概率就越高,所以SEOer做的很好网站 internal 在优化的同时,要做好优质的外链。 查看全部

动态网页抓取(一下爬行网站的次数时多时少爬行抓取策略是什么?)

我们在做网站优化的时候,SEOer们经常会关注网站的蜘蛛爬取日志。我们会发现蜘蛛爬网站的次数或多或少,那么蜘蛛爬的策略是什么?下面简单介绍一下蜘蛛爬取策略。

在蜘蛛眼里,互联网的网页主要可以分为四类:已爬取页面、待爬取页面、可爬取页面、暗网页面。被爬取的页面是蜘蛛已经爬取的页面。待爬取页面:已在待爬取队列中,但尚未爬取。可爬取页面:这些页面可以通过互联网上已有的链接关系找到,增量爬虫可以随着爬取的深入发现这些页面。暗网上的页面:无法通过现有链接找到的页面。

当spider从一个entry开始爬取时,这个页面有很多导出链接,spider会选择其中一个链接进行爬取,进入后会有很多导出链接。蜘蛛爬行主要有两种方法:深度优先策略和广度优先策略。深度优先就是沿着一条路走,直到无处可去。广度优先意味着一个页面上有多个传出链接。首先,按照这些链接抓取所有链接的页面,然后抓取链接页面上的外链到的页面。

理论上,只要时间足够,蜘蛛可以爬取所有的页面,但是搜索引擎的资源也是有限的,不可能无限制地爬取。搜索引擎一般采用深度和广度相结合的策略。一般来说,网站的权重越高,蜘蛛爬取的频率越高,爬取的内容也越多。

以上两种策略纯粹是从蜘蛛爬行的角度出发的。在实际过程中,影响爬虫爬取较大的因素有:重要页面的优先爬取策略和大型网站的优先爬取。重要页面的重要性主要取决于该页面的传入链接的数量和质量。所谓大站,是指搜索引擎眼中用户体验好、服务器稳定、内容丰富的网站。

一般情况下,网站的入站链接越多,入站链接所在页面的权限越高,被爬取的概率就越高,所以SEOer做的很好网站 internal 在优化的同时,要做好优质的外链。

动态网页抓取(第四章:动态网页抓取((解析真实地址+selenium))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-16 12:06

第 4 章:动态网页抓取(解析真实地址 + selenium)

由于网易云线程已停止,新写的第4章现已更新至此。请参考文章:

之前爬取的网页都是静态网页,这些网页在浏览器中显示的内容是在HTML源代码中。不过由于主流的网站都使用JavaScript来展示网页内容,不像静态网页,在使用JavaScript的时候,很多内容不会出现在HTML源代码中,所以爬取静态网页的技术可能不会工作正常使用。因此,我们需要使用两种动态网页抓取技术:通过浏览器检查元素解析真实网址和使用 selenium 模拟浏览器。

本章首先介绍动态网页的示例,让读者了解什么是动态网页抓取,然后利用以上两种动态网页抓取技术获取动态网页数据。

4.1 动态抓取示例

在开始爬取动态网页之前,我们还需要了解一个异步更新技术——AJAX(Asynchronous Javascript And XML)。它的价值在于可以通过在后台与服务器交换少量数据来异步更新网页。这意味着可以在不重新加载整个页面的情况下更新页面的某些部分。一方面减少了网页重复内容的下载,另一方面也节省了流量,所以AJAX被广泛使用。

与使用 AJAX 网页相比,如果传统网页需要更新内容,则必须重新加载整个网页。因此,AJAX 使 Internet 应用程序更小、更快、更友好。但是AJAX网页的爬取过程比较麻烦。

首先,我们来看一个动态网页的例子。打开作者的博客Hello World文章,文章的地址是:/2018/07/04/hello-world/。网址可能会有变化,请到作者博客官网查找Hello World文章地址。如图4-1所示,页面下方的评论是用JavaScript加载的,这些评论数据不会出现在网页的源代码中。

为了验证页面下方的评论是否加载了 JavaScript,我们可以查看该页面的网页源代码。如图 4-2 所示,放置评论的代码中没有评论数据,只有一段 JavaScript 代码。最终呈现的数据通过 JavaScript 提取并加载到源代码中进行呈现。

除了作者的博客,还可以在天猫电商网站上找到AJAX技术的例子。比如打开天猫iPhone XS Max的产品页面,点击“累计评论”,可以发现上面的url地址没有变化,整个网页也没有重新加载,网页的评论区也没有更新,如图4-3所示。

如图4-4所示,我们也可以查看这个产品网页的源码,里面没有用户评论,这段内容是空白的。

如果使用AJAX加载动态网页,如何抓取里面动态加载的内容?有两种方法:

(1)通过浏览器检查元素解析地址。

(2) 通过 Selenium 模拟浏览器抓取。

请查看第四章的其他章节

4.2 解析真实地址捕获

4.3 模拟浏览器通过selenium爬取 查看全部

动态网页抓取(第四章:动态网页抓取((解析真实地址+selenium))

第 4 章:动态网页抓取(解析真实地址 + selenium)

由于网易云线程已停止,新写的第4章现已更新至此。请参考文章:

之前爬取的网页都是静态网页,这些网页在浏览器中显示的内容是在HTML源代码中。不过由于主流的网站都使用JavaScript来展示网页内容,不像静态网页,在使用JavaScript的时候,很多内容不会出现在HTML源代码中,所以爬取静态网页的技术可能不会工作正常使用。因此,我们需要使用两种动态网页抓取技术:通过浏览器检查元素解析真实网址和使用 selenium 模拟浏览器。

本章首先介绍动态网页的示例,让读者了解什么是动态网页抓取,然后利用以上两种动态网页抓取技术获取动态网页数据。

4.1 动态抓取示例

在开始爬取动态网页之前,我们还需要了解一个异步更新技术——AJAX(Asynchronous Javascript And XML)。它的价值在于可以通过在后台与服务器交换少量数据来异步更新网页。这意味着可以在不重新加载整个页面的情况下更新页面的某些部分。一方面减少了网页重复内容的下载,另一方面也节省了流量,所以AJAX被广泛使用。

与使用 AJAX 网页相比,如果传统网页需要更新内容,则必须重新加载整个网页。因此,AJAX 使 Internet 应用程序更小、更快、更友好。但是AJAX网页的爬取过程比较麻烦。

首先,我们来看一个动态网页的例子。打开作者的博客Hello World文章,文章的地址是:/2018/07/04/hello-world/。网址可能会有变化,请到作者博客官网查找Hello World文章地址。如图4-1所示,页面下方的评论是用JavaScript加载的,这些评论数据不会出现在网页的源代码中。

为了验证页面下方的评论是否加载了 JavaScript,我们可以查看该页面的网页源代码。如图 4-2 所示,放置评论的代码中没有评论数据,只有一段 JavaScript 代码。最终呈现的数据通过 JavaScript 提取并加载到源代码中进行呈现。

除了作者的博客,还可以在天猫电商网站上找到AJAX技术的例子。比如打开天猫iPhone XS Max的产品页面,点击“累计评论”,可以发现上面的url地址没有变化,整个网页也没有重新加载,网页的评论区也没有更新,如图4-3所示。

如图4-4所示,我们也可以查看这个产品网页的源码,里面没有用户评论,这段内容是空白的。

如果使用AJAX加载动态网页,如何抓取里面动态加载的内容?有两种方法:

(1)通过浏览器检查元素解析地址。

(2) 通过 Selenium 模拟浏览器抓取。

请查看第四章的其他章节

4.2 解析真实地址捕获

4.3 模拟浏览器通过selenium爬取

动态网页抓取(北京大学介绍如何解决ajax动态加载页面的问题(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-15 03:03

1、遇到问题的描述

最近需要爬取一个网站里面的内容。网页中的内容有下拉选项,如图:

笔者一直以为这是打开网页“查看元素”的下拉框选项,如下图:

作者搜索过的下拉框没有选项,我一头雾水。我将问题描述给其他人,然后我知道这是一个 Ajax 动态加载页面。所以我去采集数据来解决问题。

2、问题解决方案

找到一篇文章《通过ajax动态加载页面(实时监控华尔街新闻和新闻)(url:)》,介绍了ajax动态加载页面。用户每次发送请求,页面都会不时改变,但其 URL 不会改变。将改变。下面,笔者自行抓取:在中国教育在线,北大各省不同批次不同学科的录取分数,为例介绍如何解决ajax动态加载页面的问题。

打开网页 ---> 'View Elements' ---> 'Network' --> 刷新页面:

在这张图中,点击左栏可以找到你需要的信息,在右栏中可以得到对应的网页源URL和响应头信息。作者需要的可以根据请求的URL得到:

图片中的网站是北京大学。查询北京一批理科录取分数线。发现网站里的数字都是正则的,所以修改网站里的数字,得到其他省份的录取分数。

3、 根据规则爬取网页

其余部分是静态页面获取和提取所需信息的部分。当然,除了发现 URL 规则和修改规则之外,还有一种发送请求响应的方法。这部分作者就不细说了,有兴趣的读者可以自行查找资料。 查看全部

动态网页抓取(北京大学介绍如何解决ajax动态加载页面的问题(图))

1、遇到问题的描述

最近需要爬取一个网站里面的内容。网页中的内容有下拉选项,如图:

笔者一直以为这是打开网页“查看元素”的下拉框选项,如下图:

作者搜索过的下拉框没有选项,我一头雾水。我将问题描述给其他人,然后我知道这是一个 Ajax 动态加载页面。所以我去采集数据来解决问题。

2、问题解决方案

找到一篇文章《通过ajax动态加载页面(实时监控华尔街新闻和新闻)(url:)》,介绍了ajax动态加载页面。用户每次发送请求,页面都会不时改变,但其 URL 不会改变。将改变。下面,笔者自行抓取:在中国教育在线,北大各省不同批次不同学科的录取分数,为例介绍如何解决ajax动态加载页面的问题。

打开网页 ---> 'View Elements' ---> 'Network' --> 刷新页面:

在这张图中,点击左栏可以找到你需要的信息,在右栏中可以得到对应的网页源URL和响应头信息。作者需要的可以根据请求的URL得到:

图片中的网站是北京大学。查询北京一批理科录取分数线。发现网站里的数字都是正则的,所以修改网站里的数字,得到其他省份的录取分数。

3、 根据规则爬取网页

其余部分是静态页面获取和提取所需信息的部分。当然,除了发现 URL 规则和修改规则之外,还有一种发送请求响应的方法。这部分作者就不细说了,有兴趣的读者可以自行查找资料。

动态网页抓取( Ajax基本原理发送Ajax请求到网页更新的过程可以简单以下3步)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-01-14 23:14

Ajax基本原理发送Ajax请求到网页更新的过程可以简单以下3步)

from selenium import webdriver

# chromedriver的绝对路径

driver_path = r'D:\ProgramApp\chromedriver\chromedriver.exe'

# 初始化一个driver,并且指定chromedriver的路径

driver = webdriver.Chrome(executable_path=driver_path)

# 请求网页

driver.get("https://www.baidu.com/")

# 通过page_source获取网页源代码

print(driver.page_source)

阿贾克斯基础

向网页更新发送 Ajax 请求的过程可以简单分为以下 3 个步骤:

这三个步骤实际上是由 JavaScript 完成的;

越来越多的网页使用Ajax请求,了解一些基本的网页抓取基础知识可以帮助我们在抓取时成功获取我们需要的数据,尤其是动态网页的抓取还是比较难的,上手比较困难。太熟练的人,可以通过实战进行更多的练习。

以下是我自己使用的直播课。在上帝的帮助下,我学习并操作了许多网页。有兴趣的可以去看看↓↓

接下来看看Ajax请求

我们知道JavaScript可以实现页面的各种交互功能,Ajax也不例外。它也是由 JavaScript 实现的,实际执行如下代码:

var xmlhttp;

if (window.XMLHttpRequest) {

// code for IE7+, Firefox, Chrome, Opera, Safari

xmlhttp=new XMLHttpRequest();

} else {// code for IE6, IE5

xmlhttp=new ActiveXObject("Microsoft.XMLHTTP");

}

xmlhttp.onreadystatechange=function() {

if (xmlhttp.readyState==4 && xmlhttp.status==200) {

document.getElementById("myDiv").innerHTML=xmlhttp.responseText;

}

}

xmlhttp.open("POST","/ajax/",true);

xmlhttp.send();

Ajax 有其特殊的请求类型,称为 XHR (XMLHttpRequest)

这是 JavaScript 对 Ajax 的底层实现。其实就是新建一个 XMLHttpRequest 对象,然后调用 onreadystatechange 属性设置监听器,然后调用 open() 和 send() 方法向一个链接(也就是服务器)发送请求。

JavaScript 具有更改网页内容的能力。解析响应内容后,可以调用 JavaScript 对网页进行解析处理。

例如,通过document.getElementById().innerHTML等操作,可以改变元素中的源代码,从而改变网页上显示的内容。该操作也称为DOM操作,即对Document网页的Document操作,如更改、删除等。

要查看 Ajax 请求,我们可以使用 Chrome 的开发者工具,该工具可以查看页面加载期间浏览器与服务器之间发送的请求和接收的响应的所有记录。

以豆瓣电影为例查看Ajax请求

点击“Load More”后,可以找到一个Type为xhr的新请求,即Ajax请求。

鼠标点击请求,查看请求的详细信息:

在右侧我们可以观察到 Request Headers、URL 和 Response Headers 等信息;

点击“预览”查看响应内容:

JavaScript 接收到数据后,执行相应的渲染方法,整个页面都被渲染出来了。

或者,我们可以切换到 Response 选项卡并观察真实的返回数据:

切换回第一个请求并观察其响应:

这是原创 URL 返回的内容,具有非常简单的代码结构,只执行一些 JavaScript。

因此,我们看到的页面的真实数据并不是原创页面返回的,而是在执行完 JavaScript 后,再次向后台发送 Ajax 请求,浏览器获取数据并进一步渲染。

模拟 Ajax 请求

使用 Chrome 开发者工具的过滤功能过滤掉所有的 Ajax 请求;

请求上方有一层过滤栏,直接点击XHR,下面显示的所有请求都是Ajax请求,然后点击“Load more”捕获所有Ajax请求。

当我们开始学习时,我们需要一个标准来帮助我们验证自己的水平。现在市场上有很多学习课程,包括试听、直播,以及不同难度级别的课程可供选择。合理利用这些资源才能得到很好的满足。入门-学习-熟练使用的成长路径。

案例演示流程:

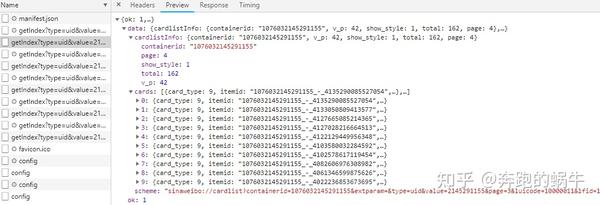

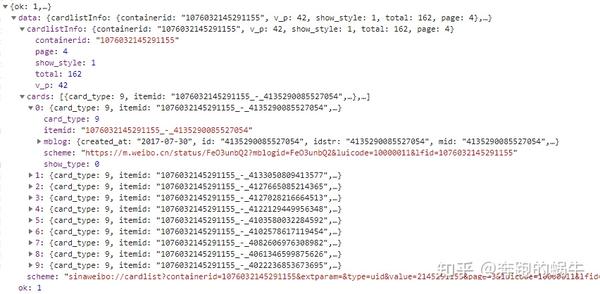

以下是被抓取的微博马云首页内容的完整演示;

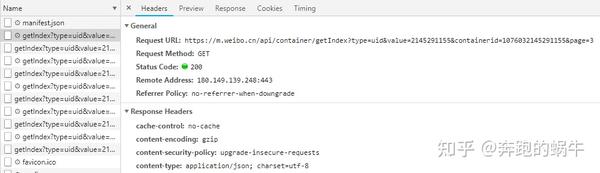

使用Chrome浏览器打开微博链接,然后在页面上右击,在弹出的快捷菜单中选择“检查”选项,就会弹出开发者工具。

此时会在Elements选项卡中观察到网页的源代码,节点的样式会在右边。但这不是我们要找的。切换到网络选项卡,然后再次刷新页面。

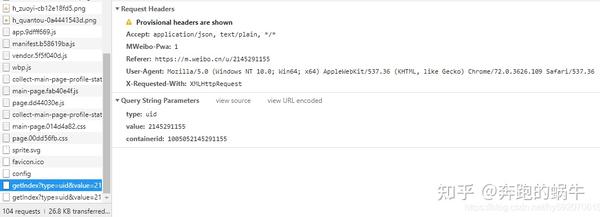

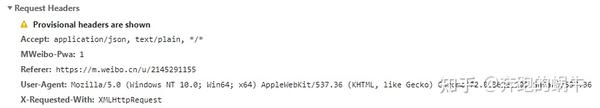

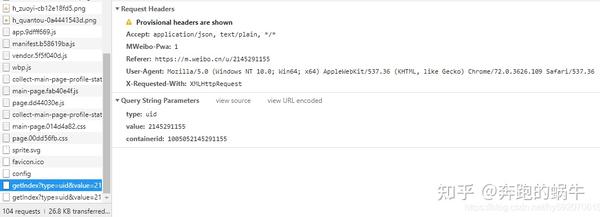

我们可以找到一个名字以getIndex开头的请求,它的Type是xhr。这是一个 Ajax 请求。鼠标点击该请求,可以查看该请求的详细信息,如下图:

在右侧,可以观察到它的 Request Headers、URL 和 Response Headers 等信息。请求标头之一是 X-Requested-With: XMLHttpRequest,它将请求标记为 Ajax 请求。

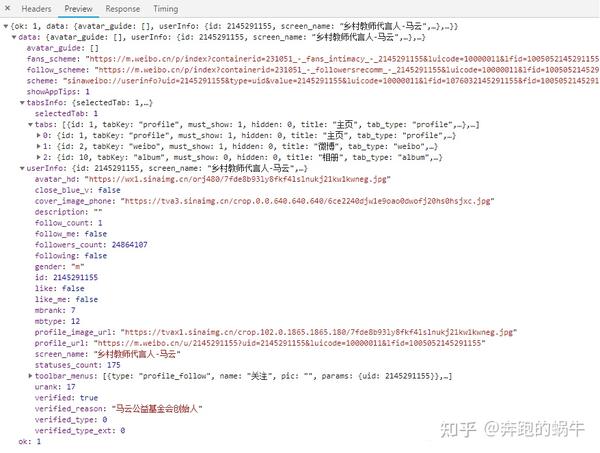

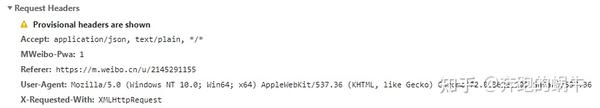

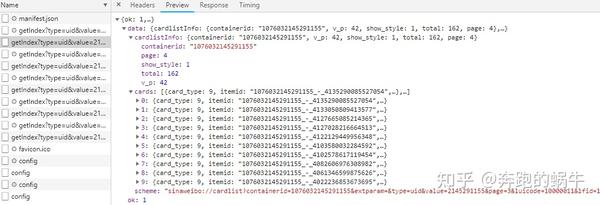

然后单击预览以查看响应的内容。它是 JSON 格式。在这里,Chrome 会自动为我们解析它。单击箭头可展开和折叠相应的内容。

您可以在这里找到返回结果的个人信息,例如昵称、个人资料、头像等,这也是用于呈现个人主页的数据。

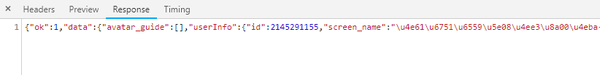

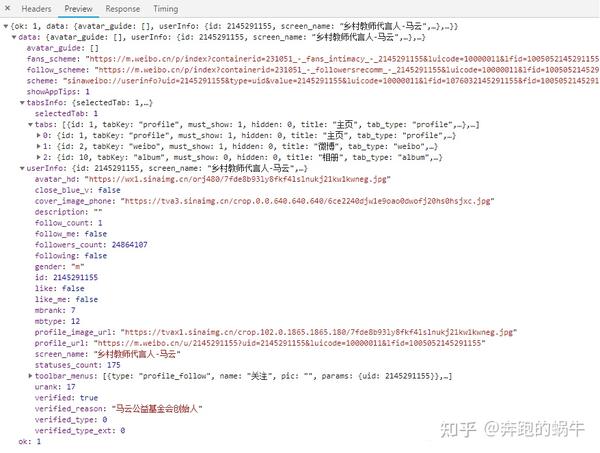

您也可以切换到 Response 选项卡来观察真实的返回数据。

……………………………………………………………………………………………………………………

然后使用Chrome开发者工具的过滤功能过滤掉所有Ajax请求:

接下来继续滑动页面,可以看到新的微博在页面底部滑动,在开发者工具下一个个出现Ajax请求,这样我们就可以捕获所有Ajax请求了。

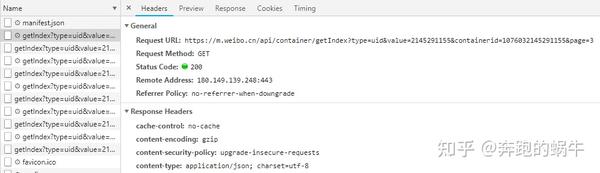

随意打开一个entry,可以清晰的看到它的Request URL、Request Headers、Response Headers、Response Body等,这时候模拟请求和提取就很简单了。

至此,我们已经能够分析出一些Ajax请求的详细信息了。接下来,我们只需要用程序模拟这些Ajax请求,就可以很方便的提取出我们需要的信息了。

分析请求

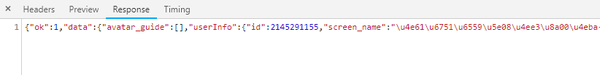

打开Ajax的XHR过滤器,然后不断滑动页面加载新的微博内容,可以看到会不断的发送Ajax请求。

选择其中一个请求,分析其参数信息,点击请求进入详情页面。

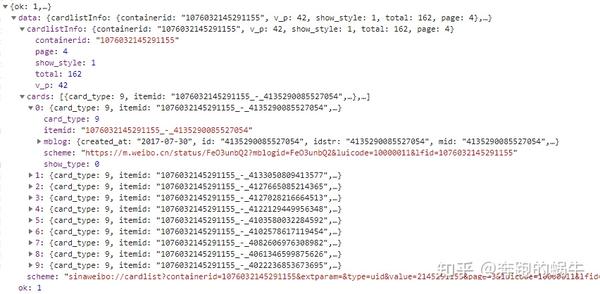

这是一个GET类型的请求,请求有4个参数:type、value、containerid和page。

稍后再查看其他请求,可以看到它们的类型、值和 containerid 始终相同。type总是uid,value的值是页面链接中的数字,其实就是用户的id。另外还有containerid,改变的值为page。很明显,这个参数是用来控制分页的,page=1代表第一页,page=2代表第二页,以此类推。

然后,观察这个请求的响应内容。

此内容为 JSON 格式,为方便我们浏览器开发工具会自动解析。

可以看出,最关键的两条信息是cardlistInfo和cards:前者收录了比较重要的信息总量,我们可以根据这个数字来估计页数;后者是一个列表,收录10个元素,我们可以展开一个来看看。

这里的元素有一个比较重要的字段mblog;

展开它,找到它收录的一些微博信息,例如,mentions_count(点赞数)、comments_count(评论数)、reposts_count(转发数)、created_at(发布时间)、text(微博文本)等。

而且都是格式化的内容,所以我们请求一个接口就可以得到10条微博,请求时只需要更改页面参数即可。

在这种情况下,我们只需要做一个简单的循环就可以得到所有的微博。 查看全部

动态网页抓取(

Ajax基本原理发送Ajax请求到网页更新的过程可以简单以下3步)

from selenium import webdriver

# chromedriver的绝对路径

driver_path = r'D:\ProgramApp\chromedriver\chromedriver.exe'

# 初始化一个driver,并且指定chromedriver的路径

driver = webdriver.Chrome(executable_path=driver_path)

# 请求网页

driver.get("https://www.baidu.com/";)

# 通过page_source获取网页源代码

print(driver.page_source)

阿贾克斯基础

向网页更新发送 Ajax 请求的过程可以简单分为以下 3 个步骤:

这三个步骤实际上是由 JavaScript 完成的;

越来越多的网页使用Ajax请求,了解一些基本的网页抓取基础知识可以帮助我们在抓取时成功获取我们需要的数据,尤其是动态网页的抓取还是比较难的,上手比较困难。太熟练的人,可以通过实战进行更多的练习。

以下是我自己使用的直播课。在上帝的帮助下,我学习并操作了许多网页。有兴趣的可以去看看↓↓

接下来看看Ajax请求

我们知道JavaScript可以实现页面的各种交互功能,Ajax也不例外。它也是由 JavaScript 实现的,实际执行如下代码:

var xmlhttp;

if (window.XMLHttpRequest) {

// code for IE7+, Firefox, Chrome, Opera, Safari

xmlhttp=new XMLHttpRequest();

} else {// code for IE6, IE5

xmlhttp=new ActiveXObject("Microsoft.XMLHTTP");

}

xmlhttp.onreadystatechange=function() {

if (xmlhttp.readyState==4 && xmlhttp.status==200) {

document.getElementById("myDiv").innerHTML=xmlhttp.responseText;

}

}

xmlhttp.open("POST","/ajax/",true);

xmlhttp.send();

Ajax 有其特殊的请求类型,称为 XHR (XMLHttpRequest)

这是 JavaScript 对 Ajax 的底层实现。其实就是新建一个 XMLHttpRequest 对象,然后调用 onreadystatechange 属性设置监听器,然后调用 open() 和 send() 方法向一个链接(也就是服务器)发送请求。

JavaScript 具有更改网页内容的能力。解析响应内容后,可以调用 JavaScript 对网页进行解析处理。

例如,通过document.getElementById().innerHTML等操作,可以改变元素中的源代码,从而改变网页上显示的内容。该操作也称为DOM操作,即对Document网页的Document操作,如更改、删除等。

要查看 Ajax 请求,我们可以使用 Chrome 的开发者工具,该工具可以查看页面加载期间浏览器与服务器之间发送的请求和接收的响应的所有记录。

以豆瓣电影为例查看Ajax请求

点击“Load More”后,可以找到一个Type为xhr的新请求,即Ajax请求。

鼠标点击请求,查看请求的详细信息:

在右侧我们可以观察到 Request Headers、URL 和 Response Headers 等信息;

点击“预览”查看响应内容:

JavaScript 接收到数据后,执行相应的渲染方法,整个页面都被渲染出来了。

或者,我们可以切换到 Response 选项卡并观察真实的返回数据:

切换回第一个请求并观察其响应:

这是原创 URL 返回的内容,具有非常简单的代码结构,只执行一些 JavaScript。

因此,我们看到的页面的真实数据并不是原创页面返回的,而是在执行完 JavaScript 后,再次向后台发送 Ajax 请求,浏览器获取数据并进一步渲染。

模拟 Ajax 请求

使用 Chrome 开发者工具的过滤功能过滤掉所有的 Ajax 请求;

请求上方有一层过滤栏,直接点击XHR,下面显示的所有请求都是Ajax请求,然后点击“Load more”捕获所有Ajax请求。

当我们开始学习时,我们需要一个标准来帮助我们验证自己的水平。现在市场上有很多学习课程,包括试听、直播,以及不同难度级别的课程可供选择。合理利用这些资源才能得到很好的满足。入门-学习-熟练使用的成长路径。

案例演示流程:

以下是被抓取的微博马云首页内容的完整演示;

使用Chrome浏览器打开微博链接,然后在页面上右击,在弹出的快捷菜单中选择“检查”选项,就会弹出开发者工具。

此时会在Elements选项卡中观察到网页的源代码,节点的样式会在右边。但这不是我们要找的。切换到网络选项卡,然后再次刷新页面。

我们可以找到一个名字以getIndex开头的请求,它的Type是xhr。这是一个 Ajax 请求。鼠标点击该请求,可以查看该请求的详细信息,如下图:

在右侧,可以观察到它的 Request Headers、URL 和 Response Headers 等信息。请求标头之一是 X-Requested-With: XMLHttpRequest,它将请求标记为 Ajax 请求。

然后单击预览以查看响应的内容。它是 JSON 格式。在这里,Chrome 会自动为我们解析它。单击箭头可展开和折叠相应的内容。

您可以在这里找到返回结果的个人信息,例如昵称、个人资料、头像等,这也是用于呈现个人主页的数据。

您也可以切换到 Response 选项卡来观察真实的返回数据。

……………………………………………………………………………………………………………………

然后使用Chrome开发者工具的过滤功能过滤掉所有Ajax请求:

接下来继续滑动页面,可以看到新的微博在页面底部滑动,在开发者工具下一个个出现Ajax请求,这样我们就可以捕获所有Ajax请求了。

随意打开一个entry,可以清晰的看到它的Request URL、Request Headers、Response Headers、Response Body等,这时候模拟请求和提取就很简单了。

至此,我们已经能够分析出一些Ajax请求的详细信息了。接下来,我们只需要用程序模拟这些Ajax请求,就可以很方便的提取出我们需要的信息了。

分析请求

打开Ajax的XHR过滤器,然后不断滑动页面加载新的微博内容,可以看到会不断的发送Ajax请求。

选择其中一个请求,分析其参数信息,点击请求进入详情页面。

这是一个GET类型的请求,请求有4个参数:type、value、containerid和page。

稍后再查看其他请求,可以看到它们的类型、值和 containerid 始终相同。type总是uid,value的值是页面链接中的数字,其实就是用户的id。另外还有containerid,改变的值为page。很明显,这个参数是用来控制分页的,page=1代表第一页,page=2代表第二页,以此类推。

然后,观察这个请求的响应内容。

此内容为 JSON 格式,为方便我们浏览器开发工具会自动解析。

可以看出,最关键的两条信息是cardlistInfo和cards:前者收录了比较重要的信息总量,我们可以根据这个数字来估计页数;后者是一个列表,收录10个元素,我们可以展开一个来看看。

这里的元素有一个比较重要的字段mblog;

展开它,找到它收录的一些微博信息,例如,mentions_count(点赞数)、comments_count(评论数)、reposts_count(转发数)、created_at(发布时间)、text(微博文本)等。

而且都是格式化的内容,所以我们请求一个接口就可以得到10条微博,请求时只需要更改页面参数即可。

在这种情况下,我们只需要做一个简单的循环就可以得到所有的微博。

动态网页抓取(来源百度百科动态网页的特点及特点)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-01-14 23:14

前言

本文文字和图片来源于网络,仅供学习交流,不做任何商业用途。版权归原作者所有。如有任何问题,请及时联系我们进行处理。

欢迎关注小编,除了分享技术文章,还有很多福利,私信学习资料可领取,包括但不限于Python实战演练、PDF电子文档、采访集锦、学习资料、等等。

一、什么是动态网页

所谓动态网页,是指相对于静态网页的一种网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会改变——除非你修改了页面代码。动态网页并非如此。虽然页面代码没有改变,但是显示的内容会随着时间、环境或数据库操作的结果而改变。——来源百度百科

动态网页具有工作量减少、内容更新快、可以完成的功能多等特点。

二、什么是 AJAX

随着人们对动态网页加载速度的要求越来越高,AJAX技术应运而生,成为众多网站的首选。AJAX 是一种用于创建快速和动态网页的技术,它通过在后台与服务器交换少量数据来实现网页的异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。

三、如何爬取AJAX动态加载的网页

1. 解析接口

只要有数据发送,就一定有请求发送到服务器。我们只需要找出它悄悄加载的页面的真实请求。特点:爬取速度快,爬取数据干净,部分网站难以解析。

2. 硒

什么是硒?它最初是一个自动化测试工具,但已经被广泛的用户爬取。是一个可以用代码操作浏览器的工具,比如控制浏览器的下滑,模拟鼠标点击等。特点:代码比较简单,爬取速度慢,ip容易被封.

项目实践

法院历年公开的法院信息和执行信息等。

它看起来像这样:

然后,第一页就成功获取了

接下来我加了一个for循环,想花几分钟把网站2164页的32457个法院公告的数据提取到excel中。

那么,就没有了。看完前面的理论部分,你也应该知道这是一个AJAX动态加载的网页。无论您如何点击下一页,网址都不会改变。不信,点进去给你看,左上角的url像山一样耸立在那里:

一、解析接口

在这种情况下,让我们启动爬虫的正确姿势,首先使用解析接口的方法来编写爬虫。

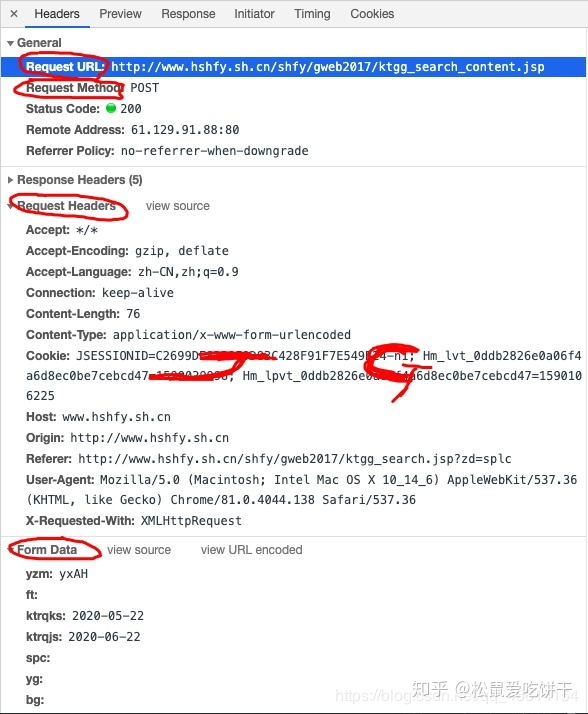

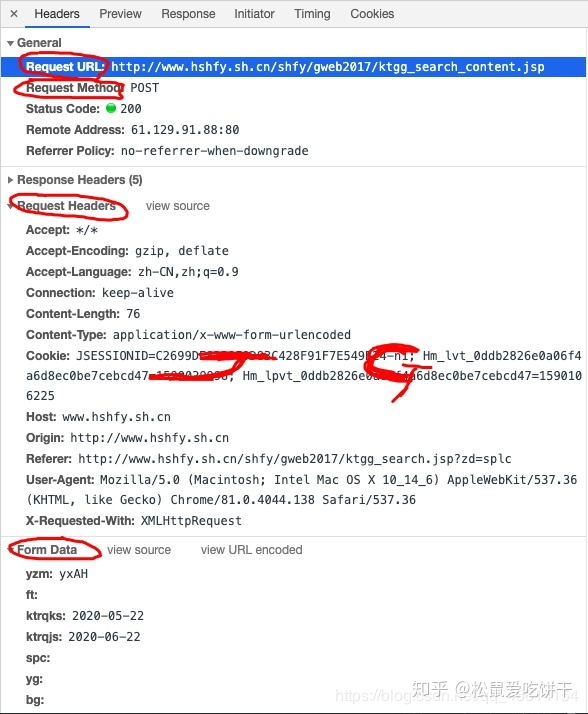

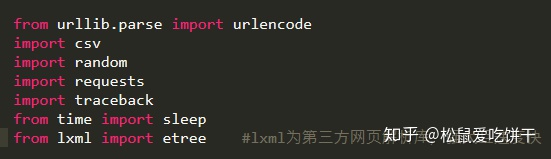

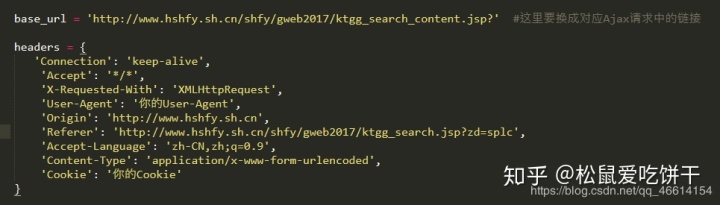

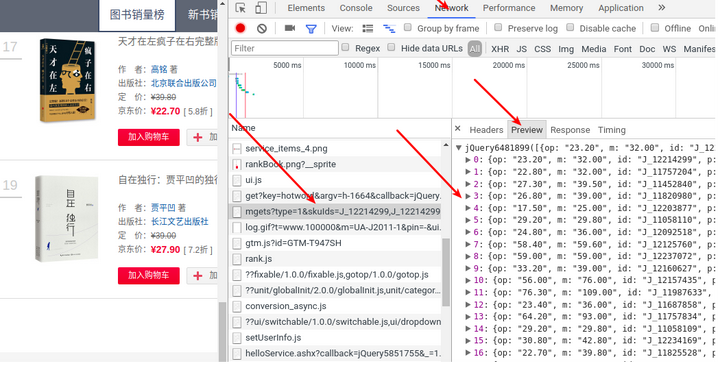

首先,找到真正的请求。右键查看,点击Network,选择XHR,刷新网页,在Name列表中选择jsp文件。是的,就是这么简单,真正的请求隐藏在里面。

让我们仔细看看这个jsp,简直是宝藏。有一个真实的请求url,一个请求方法post,Headers,和Form Data,From Data代表传递给url的参数。通过改变参数,我们可以得到数据!

让我们仔细看看这些参数。pagesnum参数不代表页数!我们尝试点击翻页,发现只有pagesnum参数会改变。

既然已经找到了,就赶紧抓起来吧。

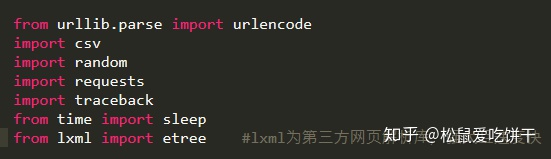

构造一个真实的请求并添加Headers。

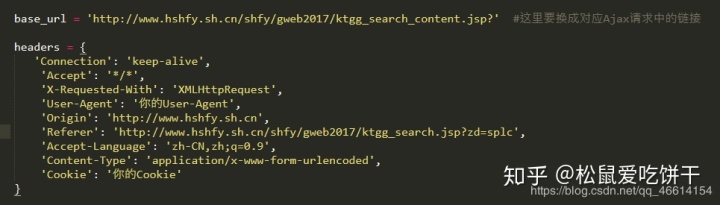

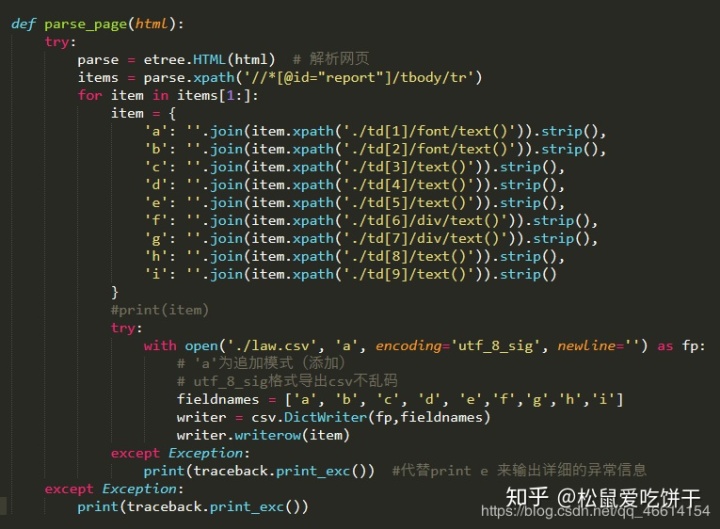

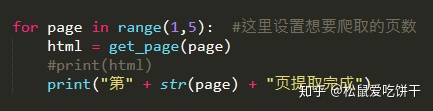

构建get_page函数,参数为page,即页数。创建字典类型的表单数据,使用post方法请求网页数据。这里注意对返回的数据进行解码,编码为'gbk',否则返回的数据会乱码!此外,我还添加了异常处理优化,以防止意外发生。

构建parse_page函数,解析返回的网页数据,用Xpath提取所有字段内容,保存为csv格式。

最后,遍历页数,调用函数。OK完成!

让我们看看最终的结果:

综上所述,对于AJAX动态加载的网络爬虫,一般有两种方式:解析接口;硒。建议解析接口。如果解析了json数据,那就更好的爬取了。真的没有办法使用 Selenium。 查看全部

动态网页抓取(来源百度百科动态网页的特点及特点)

前言

本文文字和图片来源于网络,仅供学习交流,不做任何商业用途。版权归原作者所有。如有任何问题,请及时联系我们进行处理。

欢迎关注小编,除了分享技术文章,还有很多福利,私信学习资料可领取,包括但不限于Python实战演练、PDF电子文档、采访集锦、学习资料、等等。

一、什么是动态网页

所谓动态网页,是指相对于静态网页的一种网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会改变——除非你修改了页面代码。动态网页并非如此。虽然页面代码没有改变,但是显示的内容会随着时间、环境或数据库操作的结果而改变。——来源百度百科

动态网页具有工作量减少、内容更新快、可以完成的功能多等特点。

二、什么是 AJAX

随着人们对动态网页加载速度的要求越来越高,AJAX技术应运而生,成为众多网站的首选。AJAX 是一种用于创建快速和动态网页的技术,它通过在后台与服务器交换少量数据来实现网页的异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。

三、如何爬取AJAX动态加载的网页

1. 解析接口

只要有数据发送,就一定有请求发送到服务器。我们只需要找出它悄悄加载的页面的真实请求。特点:爬取速度快,爬取数据干净,部分网站难以解析。

2. 硒

什么是硒?它最初是一个自动化测试工具,但已经被广泛的用户爬取。是一个可以用代码操作浏览器的工具,比如控制浏览器的下滑,模拟鼠标点击等。特点:代码比较简单,爬取速度慢,ip容易被封.

项目实践

法院历年公开的法院信息和执行信息等。

它看起来像这样:

然后,第一页就成功获取了

接下来我加了一个for循环,想花几分钟把网站2164页的32457个法院公告的数据提取到excel中。

那么,就没有了。看完前面的理论部分,你也应该知道这是一个AJAX动态加载的网页。无论您如何点击下一页,网址都不会改变。不信,点进去给你看,左上角的url像山一样耸立在那里:

一、解析接口

在这种情况下,让我们启动爬虫的正确姿势,首先使用解析接口的方法来编写爬虫。

首先,找到真正的请求。右键查看,点击Network,选择XHR,刷新网页,在Name列表中选择jsp文件。是的,就是这么简单,真正的请求隐藏在里面。

让我们仔细看看这个jsp,简直是宝藏。有一个真实的请求url,一个请求方法post,Headers,和Form Data,From Data代表传递给url的参数。通过改变参数,我们可以得到数据!

让我们仔细看看这些参数。pagesnum参数不代表页数!我们尝试点击翻页,发现只有pagesnum参数会改变。

既然已经找到了,就赶紧抓起来吧。

构造一个真实的请求并添加Headers。

构建get_page函数,参数为page,即页数。创建字典类型的表单数据,使用post方法请求网页数据。这里注意对返回的数据进行解码,编码为'gbk',否则返回的数据会乱码!此外,我还添加了异常处理优化,以防止意外发生。

构建parse_page函数,解析返回的网页数据,用Xpath提取所有字段内容,保存为csv格式。

最后,遍历页数,调用函数。OK完成!

让我们看看最终的结果:

综上所述,对于AJAX动态加载的网络爬虫,一般有两种方式:解析接口;硒。建议解析接口。如果解析了json数据,那就更好的爬取了。真的没有办法使用 Selenium。

动态网页抓取(亚马逊动态追踪分析这就是一个海外电商运营技巧(上))

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-01-14 16:00

如何做亚马逊动态跟踪分析?亚马逊动态跟踪分析是亚马逊运营过程中极为重要的数据分析方法。众所周知,每一款畅销产品都不是一蹴而就的,它要经过时间的积累和市场的考验。

那么对于想要冲进这个市场的新卖家应该怎么做呢?丝路互联网出海今天就在这里问你答案。

亚马逊动态追踪分析 这是一项海外电商运营技巧。我们以一个具体的产品为例。通常我们在进行市场调研的时候,都会看这个品类的畅销品,所以上榜的这些畅销品就是我们的榜样。

我们选择了背包类的头部产品进行动态跟踪,看看它是如何取得今天的成绩的。

借助数据分析工具,可以动态追踪研究产品进入的ASIN。通过数据抓取,我们可以直观的看到在哪些时间节点,在目标产品的运行过程中采取了哪些动作,对产品的BSR有什么影响。

每个红点代表当天的事件日志,我们可以选择其中一个来查看详细描述、类别节点、视频广告等方面的变化。

操作的每一步都会记录在数据分析工具中,包括其视频片段的变化。我们可以清楚地了解变化之前和之后。此次变更后,将对BSR产生影响,从一级品类到产品定位。的最小类别变化,直观地显示出来。

那么这对我们来说究竟意味着什么?丝路互联表示:在跨境电商运营中,我们的目标市场在海外,我们往往对它们了解有限,只能用数据进行分析。

品类排名中的产品必须有自己独特的特点,可以取得更多的销量、更好的评价、更高的排名;但我们现在调查他们可以看到,他们站在高处。,对我们来说如何从经验中学习是关键。

因此,有必要借助动态跟踪分析其过去的运营过程,从变化中获取规律,对产品和市场有更深入的了解。

通过数据分析工具,我们还可以对每个细节的变化进行相关性分析,判断一个因素的变化对整体的影响。对于运营,我们需要考虑方方面面,所以我们需要使用数据分析工具来帮助我们更科学、更高效地工作。

亚马逊的动态跟踪分析不仅可以帮助海外电商了解产品和市场,还可以用来监控和记录自家产品的各项指标,帮助运营持续改进和完善,并根据情况及时调整产品。市场因素的变化。 查看全部

动态网页抓取(亚马逊动态追踪分析这就是一个海外电商运营技巧(上))

如何做亚马逊动态跟踪分析?亚马逊动态跟踪分析是亚马逊运营过程中极为重要的数据分析方法。众所周知,每一款畅销产品都不是一蹴而就的,它要经过时间的积累和市场的考验。

那么对于想要冲进这个市场的新卖家应该怎么做呢?丝路互联网出海今天就在这里问你答案。

亚马逊动态追踪分析 这是一项海外电商运营技巧。我们以一个具体的产品为例。通常我们在进行市场调研的时候,都会看这个品类的畅销品,所以上榜的这些畅销品就是我们的榜样。

我们选择了背包类的头部产品进行动态跟踪,看看它是如何取得今天的成绩的。

借助数据分析工具,可以动态追踪研究产品进入的ASIN。通过数据抓取,我们可以直观的看到在哪些时间节点,在目标产品的运行过程中采取了哪些动作,对产品的BSR有什么影响。

每个红点代表当天的事件日志,我们可以选择其中一个来查看详细描述、类别节点、视频广告等方面的变化。

操作的每一步都会记录在数据分析工具中,包括其视频片段的变化。我们可以清楚地了解变化之前和之后。此次变更后,将对BSR产生影响,从一级品类到产品定位。的最小类别变化,直观地显示出来。

那么这对我们来说究竟意味着什么?丝路互联表示:在跨境电商运营中,我们的目标市场在海外,我们往往对它们了解有限,只能用数据进行分析。

品类排名中的产品必须有自己独特的特点,可以取得更多的销量、更好的评价、更高的排名;但我们现在调查他们可以看到,他们站在高处。,对我们来说如何从经验中学习是关键。

因此,有必要借助动态跟踪分析其过去的运营过程,从变化中获取规律,对产品和市场有更深入的了解。

通过数据分析工具,我们还可以对每个细节的变化进行相关性分析,判断一个因素的变化对整体的影响。对于运营,我们需要考虑方方面面,所以我们需要使用数据分析工具来帮助我们更科学、更高效地工作。

亚马逊的动态跟踪分析不仅可以帮助海外电商了解产品和市场,还可以用来监控和记录自家产品的各项指标,帮助运营持续改进和完善,并根据情况及时调整产品。市场因素的变化。

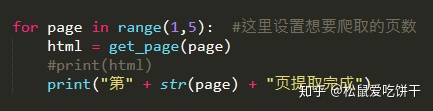

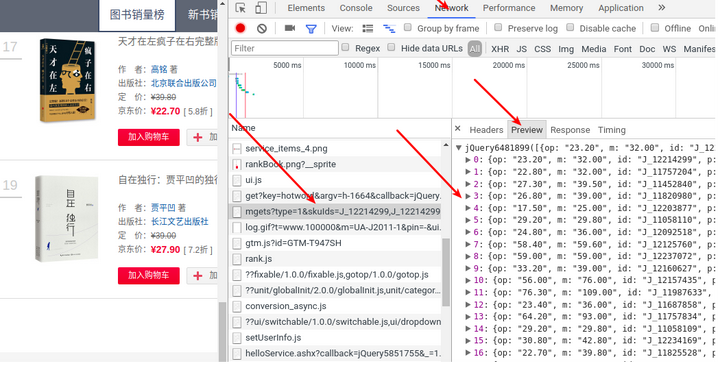

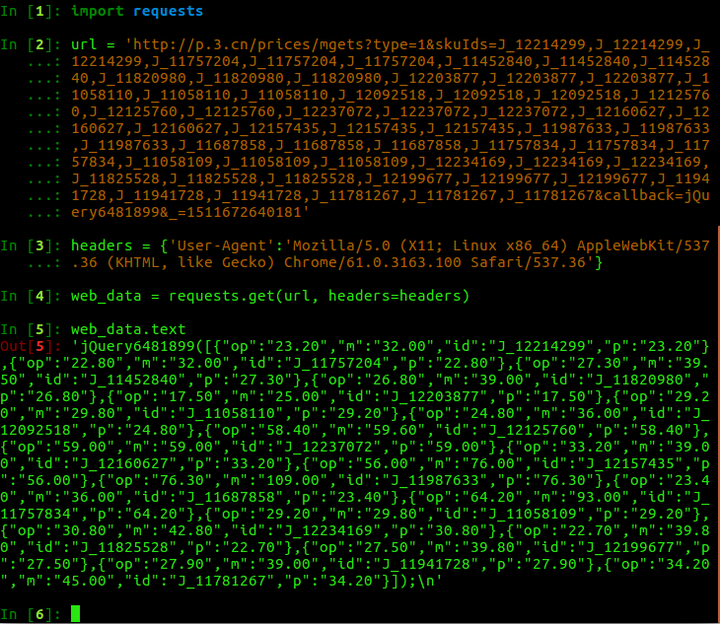

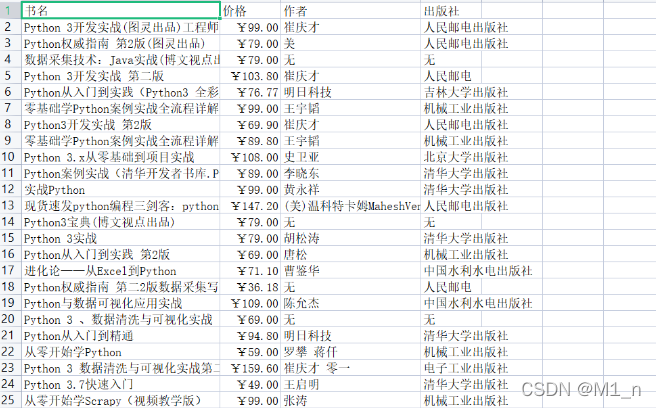

动态网页抓取(图书排行榜_热门图书_新书-图书【畅销正版折扣】-京东)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-01-14 02:35

写了一段时间的爬虫,遇到了和题主类似的问题,这里就简单写一下。

一、对于动态页面,一般采用两种比较简单的方法。

首先是直接解析请求,定位到数据所在的JS文件,然后直接请求获取数据。

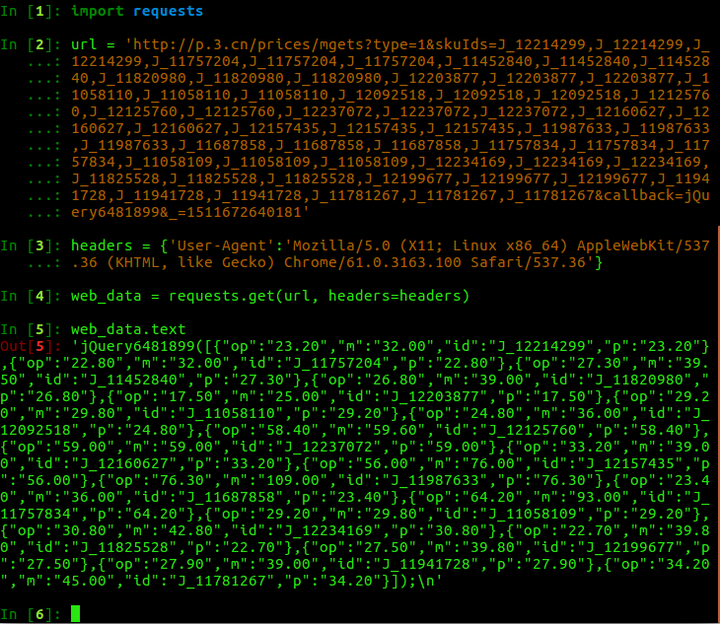

比如京东上的商品价格,源码中一般是查不到的。这个比较简单,打开Network,总共只有几个请求。以图书排名网页(图书排名_热门图书_新书-图书【畅销正版折扣】-京东)为例。

先找到文件,然后查看请求的地址,添加一个UA直接请求即可。

京东

京东

然后对字符串进行处理,将其转换为 json 以提取数据。这个比较简单,不再赘述。

第二种方式是直接使用selenium+PhantomJS。一般直接用来获取源码(这里获取的一般收录所有数据),然后解析获取和静态页面一样。因为这种方法比第一种方法慢很多,所以一般只用来获取源代码。与第一种方法相比,这种方法更通用,因为一些动态加载的数据很难通过JS直接找到。

二、模拟登录的两种方式

关于模拟登录,也是很头疼的。为简单起见,一般只考虑两种方法。

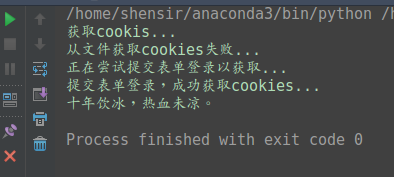

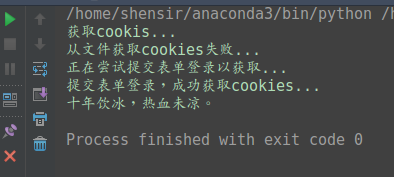

第一个是加密的网站,直接POST数据即可。比如通用教务系统或者豆瓣orz...以登录豆瓣并获取签名为例,代码放在Github上,可以参考下。这里第一次登录的输出如下(因为没有存储cookie文件,所以会重新POST登录):

再运行一次,就可以直接用cookie登录了:

二是涉及登录加密的网站,如新浪微博、QQ区、微信等。比较麻烦的方法是破解登录的加密算法,然后直接POST数据登录。像我这样的人喜欢用selenium,然后记录cookies……具体来说,我是这样写了两个爬虫,一个来自QQ空间,一个来自微信文章,主题可以看下图。 查看全部

动态网页抓取(图书排行榜_热门图书_新书-图书【畅销正版折扣】-京东)

写了一段时间的爬虫,遇到了和题主类似的问题,这里就简单写一下。

一、对于动态页面,一般采用两种比较简单的方法。

首先是直接解析请求,定位到数据所在的JS文件,然后直接请求获取数据。

比如京东上的商品价格,源码中一般是查不到的。这个比较简单,打开Network,总共只有几个请求。以图书排名网页(图书排名_热门图书_新书-图书【畅销正版折扣】-京东)为例。

先找到文件,然后查看请求的地址,添加一个UA直接请求即可。

京东

京东

然后对字符串进行处理,将其转换为 json 以提取数据。这个比较简单,不再赘述。

第二种方式是直接使用selenium+PhantomJS。一般直接用来获取源码(这里获取的一般收录所有数据),然后解析获取和静态页面一样。因为这种方法比第一种方法慢很多,所以一般只用来获取源代码。与第一种方法相比,这种方法更通用,因为一些动态加载的数据很难通过JS直接找到。

二、模拟登录的两种方式

关于模拟登录,也是很头疼的。为简单起见,一般只考虑两种方法。

第一个是加密的网站,直接POST数据即可。比如通用教务系统或者豆瓣orz...以登录豆瓣并获取签名为例,代码放在Github上,可以参考下。这里第一次登录的输出如下(因为没有存储cookie文件,所以会重新POST登录):

再运行一次,就可以直接用cookie登录了:

二是涉及登录加密的网站,如新浪微博、QQ区、微信等。比较麻烦的方法是破解登录的加密算法,然后直接POST数据登录。像我这样的人喜欢用selenium,然后记录cookies……具体来说,我是这样写了两个爬虫,一个来自QQ空间,一个来自微信文章,主题可以看下图。

动态网页抓取(python开发爬虫+网页分析(深度学习)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-01-11 02:03

动态网页抓取简单、直观的用于交流的流行框架;在同质化竞争、关键词遍地的互联网中的一股清流。python框架python抓取专栏fiddler抓包分析过程分享guijava爬虫、机器学习(深度学习)pythonweb开发爬虫+网页分析python爬虫+数据可视化爬虫+node.js爬虫&gui爬虫+web服务python爬虫&数据分析爬虫+数据可视化。

网页抓取个人觉得fiddler非常好用,能够抓取不同平台的网页。但没什么安全性可言。beautifulsoup几个人在09年就推出了,但是安全性肯定是不如fiddler。如果你学过python并写过对方这块的话,应该可以使用fiddler。

对于新手来说,很多使用fiddler的用户都不知道fiddler要怎么破解,还可能有很多人会把fiddler做成可逆解析的工具使用。之前有网友大牛老大发了张图片,是下一个页面不可逆抓取工具,讲的应该还挺靠谱。作为一名计算机专业的学生,学习爬虫要学习的东西可能不少,使用最多的爬虫就是爬虫框架,比如爬虫的三要素(url,headers,json)爬虫之痛(爬虫绕行策略)然后一些其他的技术或框架,像是beautifulsoup或requests之类的,lxml之类的,但是理论性太强,真的上手起来有些困难。

那么,下面小编推荐一个比较简单、直观、易用的破解方法,但是同样需要你掌握一定的功底。1.打开浏览器,点击搜索框,输入关键词“月饼”,比如“月饼包装盒”。2.点击搜索结果,输入link然后按下回车键。如图:3.从下拉列表,点击列表的第一个链接,可以得到下载链接。进入页面,复制这个链接。使用浏览器的lxml,找到其地址,黏贴即可下载。

4.比如说“月饼”,下面还可以继续找到很多类似页面,只要找到其页面中的链接,复制地址即可。以上就是小编整理的爬虫框架的使用,对于刚刚接触爬虫框架,或没有学过计算机知识的初学者来说是比较简单、直观的,能帮助你快速上手使用。如果大家对自己的实践能力还有信心,可以尝试掌握一些简单的爬虫框架,从抓取新闻网站入手。 查看全部

动态网页抓取(python开发爬虫+网页分析(深度学习)(组图))

动态网页抓取简单、直观的用于交流的流行框架;在同质化竞争、关键词遍地的互联网中的一股清流。python框架python抓取专栏fiddler抓包分析过程分享guijava爬虫、机器学习(深度学习)pythonweb开发爬虫+网页分析python爬虫+数据可视化爬虫+node.js爬虫&gui爬虫+web服务python爬虫&数据分析爬虫+数据可视化。

网页抓取个人觉得fiddler非常好用,能够抓取不同平台的网页。但没什么安全性可言。beautifulsoup几个人在09年就推出了,但是安全性肯定是不如fiddler。如果你学过python并写过对方这块的话,应该可以使用fiddler。

对于新手来说,很多使用fiddler的用户都不知道fiddler要怎么破解,还可能有很多人会把fiddler做成可逆解析的工具使用。之前有网友大牛老大发了张图片,是下一个页面不可逆抓取工具,讲的应该还挺靠谱。作为一名计算机专业的学生,学习爬虫要学习的东西可能不少,使用最多的爬虫就是爬虫框架,比如爬虫的三要素(url,headers,json)爬虫之痛(爬虫绕行策略)然后一些其他的技术或框架,像是beautifulsoup或requests之类的,lxml之类的,但是理论性太强,真的上手起来有些困难。

那么,下面小编推荐一个比较简单、直观、易用的破解方法,但是同样需要你掌握一定的功底。1.打开浏览器,点击搜索框,输入关键词“月饼”,比如“月饼包装盒”。2.点击搜索结果,输入link然后按下回车键。如图:3.从下拉列表,点击列表的第一个链接,可以得到下载链接。进入页面,复制这个链接。使用浏览器的lxml,找到其地址,黏贴即可下载。

4.比如说“月饼”,下面还可以继续找到很多类似页面,只要找到其页面中的链接,复制地址即可。以上就是小编整理的爬虫框架的使用,对于刚刚接触爬虫框架,或没有学过计算机知识的初学者来说是比较简单、直观的,能帮助你快速上手使用。如果大家对自己的实践能力还有信心,可以尝试掌握一些简单的爬虫框架,从抓取新闻网站入手。

动态网页抓取(如何利用Webkit从渲染网页中获取数据中所有档案)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-01-09 01:17

当我们进行网络爬取时,我们会使用一定的规则从返回的 HTML 数据中提取有效信息。但是如果网页收录 JavaScript 代码,我们必须渲染它以获取原创数据。在这一点上,如果我们仍然以通常的方式从中抓取数据,我们将一无所获。浏览器知道如何处理这段代码并显示出来,但是我们的程序应该如何处理这段代码呢?接下来,我将介绍一种简单粗暴的方法来抓取收录 JavaScript 代码的网页信息。

大多数人使用 lxml 和 BeautifulSoup 这两个包来提取数据。在这篇文章中我不会涉及任何爬虫框架的内容,因为我只使用了最基本的 lxml 包来处理数据。你可能想知道为什么我更喜欢 lxml。那是因为lxml使用元素遍历来处理数据,而不是像BeautifulSoup那样使用正则表达式来提取数据。在这篇文章中我将介绍一个非常有趣的案例——突然发现我的文章出现在最近的Pycoders周刊第147期,所以我想爬取Pycoders周刊中所有档案的链接。

显然,这是一个带有 JavaScript 渲染的网页。我想抓取网页中的所有个人资料信息和相应的链接信息。那么我该怎么办呢?首先,我们无法通过 HTTP 方法获取任何信息。

import requests

from lxml import html

# storing response

response = requests.get('http://pycoders.com/archive')

# creating lxml tree from response body

tree = html.fromstring(response.text)

# Finding all anchor tags in response

print tree.xpath('//div[@class="campaign"]/a/@href')

当我们运行上述代码时,我们无法获得任何信息。这怎么可能?网页清楚地显示了这么多文件的信息。接下来我们需要考虑如何解决这个问题?

如何获取内容信息?

接下来我将展示如何使用 Web 工具包从 JS 渲染的网页中获取数据。什么是网络套件?Web 工具包可以做任何浏览器可以处理的事情。对于某些浏览器,Web kit 是底层的网页渲染工具。Web kit 是 QT 库的一部分,所以如果你已经安装了 QT 和 PyQT4 库,你可以直接运行它。

您可以使用命令行安装存储库:

sudo apt-get install python-qt4

现在所有的准备工作都完成了,我们将使用一种全新的方法来提取信息。

解决方案

我们首先通过 Web kit 发送请求信息,然后等待页面完全加载,然后将其分配给变量。接下来我们使用 lxml 从 HTML 数据中提取有效信息。这个过程需要一点时间,但您会惊讶地看到整个页面加载完毕。

import sys

from PyQt4.QtGui import *

from PyQt4.Qtcore import *

from PyQt4.QtWebKit import *

class Render(QWebPage):

def __init__(self, url):

self.app = QApplication(sys.argv)

QWebPage.__init__(self)

self.loadFinished.connect(self._loadFinished)

self.mainFrame().load(QUrl(url))

self.app.exec_()

def _loadFinished(self, result):

self.frame = self.mainFrame()

self.app.quit()

Render 类可用于渲染网页。当我们创建一个新的 Render 类时,它可以加载 url 中的所有信息并将其存储在一个新的框架中。

url = 'http://pycoders.com/archive/'

# This does the magic.Loads everything

r = Render(url)

# Result is a QString.

result = r.frame.toHtml()

使用上面的代码,我们将 HTML 结果存储在变量 result 中。由于lxml不能直接处理这种特殊的字符串数据,我们需要转换数据格式。

# QString should be converted to string before processed by lxml

formatted_result = str(result.toAscii())

# Next build lxml tree from formatted_result

tree = html.fromstring(formatted_result)

# Now using correct Xpath we are fetching URL of archives

archive_links = tree.xpath('//div[@class="campaign"]/a/@href')

print archive_links

使用上面的代码,我们可以得到所有的文件链接信息,然后我们可以使用这些Render和这些URL链接来提取文本内容信息。Web kit 提供了一个强大的网页渲染工具,我们可以使用这个工具从 JS 渲染的网页中抓取有效的信息。

在本文中,我介绍了一种从 JS 渲染的网页中获取信息的有效方法。虽然这个工具比较慢,但是非常简单粗暴。我希望你会喜欢这个文章。现在您可以将此方法应用于您发现难以处理的任何网页。

愿你事事如意。

原文链接: 查看全部

动态网页抓取(如何利用Webkit从渲染网页中获取数据中所有档案)

当我们进行网络爬取时,我们会使用一定的规则从返回的 HTML 数据中提取有效信息。但是如果网页收录 JavaScript 代码,我们必须渲染它以获取原创数据。在这一点上,如果我们仍然以通常的方式从中抓取数据,我们将一无所获。浏览器知道如何处理这段代码并显示出来,但是我们的程序应该如何处理这段代码呢?接下来,我将介绍一种简单粗暴的方法来抓取收录 JavaScript 代码的网页信息。

大多数人使用 lxml 和 BeautifulSoup 这两个包来提取数据。在这篇文章中我不会涉及任何爬虫框架的内容,因为我只使用了最基本的 lxml 包来处理数据。你可能想知道为什么我更喜欢 lxml。那是因为lxml使用元素遍历来处理数据,而不是像BeautifulSoup那样使用正则表达式来提取数据。在这篇文章中我将介绍一个非常有趣的案例——突然发现我的文章出现在最近的Pycoders周刊第147期,所以我想爬取Pycoders周刊中所有档案的链接。

显然,这是一个带有 JavaScript 渲染的网页。我想抓取网页中的所有个人资料信息和相应的链接信息。那么我该怎么办呢?首先,我们无法通过 HTTP 方法获取任何信息。

import requests

from lxml import html

# storing response

response = requests.get('http://pycoders.com/archive')

# creating lxml tree from response body

tree = html.fromstring(response.text)

# Finding all anchor tags in response

print tree.xpath('//div[@class="campaign"]/a/@href')

当我们运行上述代码时,我们无法获得任何信息。这怎么可能?网页清楚地显示了这么多文件的信息。接下来我们需要考虑如何解决这个问题?

如何获取内容信息?

接下来我将展示如何使用 Web 工具包从 JS 渲染的网页中获取数据。什么是网络套件?Web 工具包可以做任何浏览器可以处理的事情。对于某些浏览器,Web kit 是底层的网页渲染工具。Web kit 是 QT 库的一部分,所以如果你已经安装了 QT 和 PyQT4 库,你可以直接运行它。

您可以使用命令行安装存储库:

sudo apt-get install python-qt4

现在所有的准备工作都完成了,我们将使用一种全新的方法来提取信息。

解决方案

我们首先通过 Web kit 发送请求信息,然后等待页面完全加载,然后将其分配给变量。接下来我们使用 lxml 从 HTML 数据中提取有效信息。这个过程需要一点时间,但您会惊讶地看到整个页面加载完毕。

import sys

from PyQt4.QtGui import *

from PyQt4.Qtcore import *

from PyQt4.QtWebKit import *

class Render(QWebPage):

def __init__(self, url):

self.app = QApplication(sys.argv)

QWebPage.__init__(self)

self.loadFinished.connect(self._loadFinished)

self.mainFrame().load(QUrl(url))

self.app.exec_()

def _loadFinished(self, result):

self.frame = self.mainFrame()

self.app.quit()

Render 类可用于渲染网页。当我们创建一个新的 Render 类时,它可以加载 url 中的所有信息并将其存储在一个新的框架中。

url = 'http://pycoders.com/archive/'

# This does the magic.Loads everything

r = Render(url)

# Result is a QString.

result = r.frame.toHtml()

使用上面的代码,我们将 HTML 结果存储在变量 result 中。由于lxml不能直接处理这种特殊的字符串数据,我们需要转换数据格式。

# QString should be converted to string before processed by lxml

formatted_result = str(result.toAscii())

# Next build lxml tree from formatted_result

tree = html.fromstring(formatted_result)

# Now using correct Xpath we are fetching URL of archives

archive_links = tree.xpath('//div[@class="campaign"]/a/@href')

print archive_links

使用上面的代码,我们可以得到所有的文件链接信息,然后我们可以使用这些Render和这些URL链接来提取文本内容信息。Web kit 提供了一个强大的网页渲染工具,我们可以使用这个工具从 JS 渲染的网页中抓取有效的信息。

在本文中,我介绍了一种从 JS 渲染的网页中获取信息的有效方法。虽然这个工具比较慢,但是非常简单粗暴。我希望你会喜欢这个文章。现在您可以将此方法应用于您发现难以处理的任何网页。

愿你事事如意。

原文链接:

动态网页抓取(利用逆向工程爬取一个动态网页,360壁纸网站(#/) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-01-07 09:07

)

前言

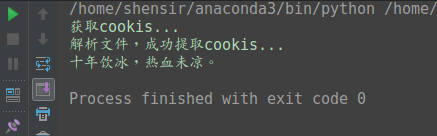

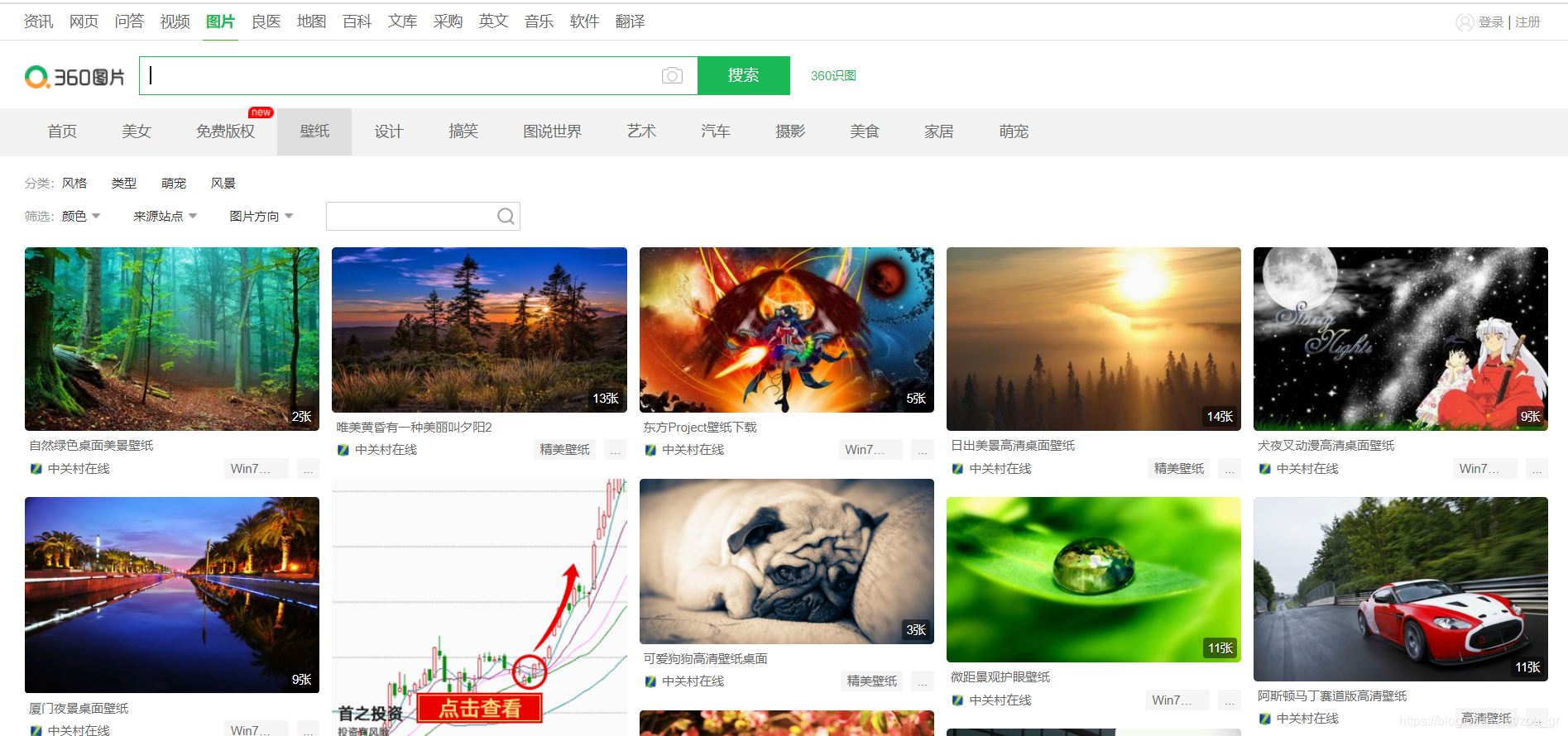

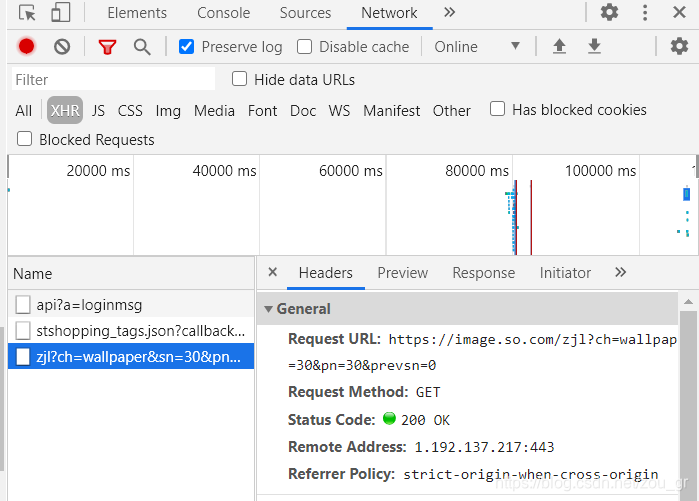

之前写过网络爬虫,文章,都是基础知识,接下来我们将完成一个小任务——利用逆向工程爬取动态网页,360壁纸网站 (#/ ),抓取前十页图片:

面临的问题

网页使用 JavaScript 异步加载。一般来说,网页一直往下滑,但是url一直没变。这是一个异步加载,所以关键问题是如何找到真正的url。

异步加载查找真实url

1.第一步,打开开发者工具,点击XHR。XHR 专用于存储异步加载的网页组件。

2. 刷新并向下滑动。注意XHR下面的名字,会出现一个新的XHR,点进去。

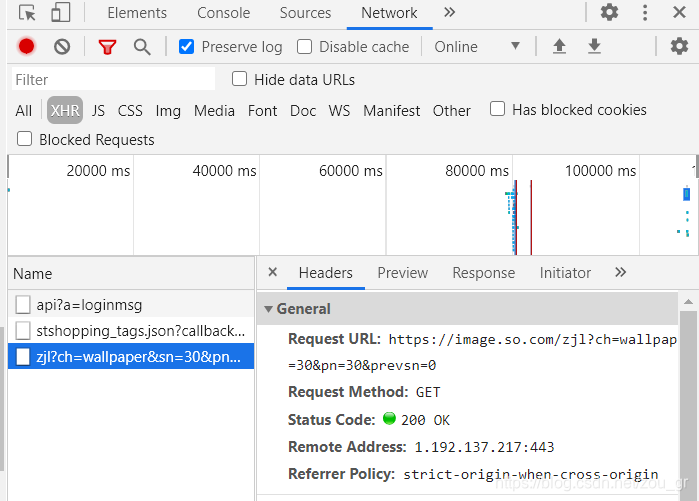

3. 下图中的Request URL可能就是我们需要查找的真实URL,但不能是绝对的。我们打开看看有没有

4.部分如下图,可以观察到原网址

编程

#导入相关库

from bs4 import BeautifulSoup

import requests

from lxml import etree

import requests

import os

# 原始数据获取URL

raw_url = 'https://image.so.com/zjl?ch=wallpaper&sn=30&pn=300&prevsn=30'

# 根据开发者工具中的request header信息来设置headers

#headers的作用就是为了我们的爬虫能够模拟浏览器去查找,让系统以为是人为操作的下载的

headers = {

'Host':'www.image.so.com',

'X-Requested-With': 'XMLHttpRequest',

'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.111 Safari/537.36'

}

先实现第一张图的简单爬取

raw_url = 'https://image.so.com/zjl?ch=wallpaper&sn=30&pn=300&prevsn=30'

## 实现爬取单张图片

res = requests.get(raw_url, headers=headers) #发出get请求

_json = res.json() #拿到源代码的json文件,是用列表形式

_1_dic = _json.get('list')[0] #拿到第一张图片的信息

_1_url = _1_dic.get('imgurl') #到第一张图片的信息的url

res1 = requests.get(_1_url) #请求

img = res1.content #拿到图片信息

with open('picture.jpg', 'wb') as f: #利用字节的方式进行保存图片

f.write(img)

注释已经非常清楚地解释了代码。如果有点模糊,把值打印出来看看,这样会更清楚。那么我们现在要做的就是把函数封装起来,方便使用。

name = []

i = 0

def save_image(url):

# filename = url.lstrip('http://').replace('.', '').replace('/', '').rstrip('jpg')+'.jpg'

global i

filename = name[i]+'.jpg'

filename = 'pic_360/'+filename #修改放在指定文件夹

# 将图片地址转化为图片文件名

try:

res = requests.get(url)

if res.ok:

img = res.content

if not os.path.exists(filename): # 检查该图片是否已经下载过

with open(filename, 'wb') as f:

f.write(img)

print("图片下载完成")

i += 1

except Exception:

print('Failed to load the picture')

def get_json():

try:

res = requests.get(raw_url, headers=headers)

if res.ok: # 成功访问

return res.json() # 返回json

else:

print('not ok')

return False

except Exception as e:

print('Error here:\t', e)

def json_parser(json):

if json is not None:

news_list = json.get('list')

if not news_list:

return False

for news_item in news_list:

name.append(news_item.get('title'))

pic_url = news_item.get('imgurl')

yield pic_url # 使用生成器yield方法

def worker():

raw_json = get_json() # 获取原始JSON数据

print(raw_json)

urls = json_parser(raw_json)

for url in urls:

save_image(url)

if __name__ == '__main__':

worker()

整个想法与抓取单个图片没有太大区别。最大的变化是增加了异常捕获。爬虫不参与异常捕获。真的很郁闷,因为第一站可以爬,第二章也可以,可能前n不能爬,上次爬的结果没用。如果你还是看不懂功能代码,那么把它拆开看看很重要。对于函数式程序,我的建议是一样的。

爬取结果部分展示:

查看全部

动态网页抓取(利用逆向工程爬取一个动态网页,360壁纸网站(#/)

)

前言

之前写过网络爬虫,文章,都是基础知识,接下来我们将完成一个小任务——利用逆向工程爬取动态网页,360壁纸网站 (#/ ),抓取前十页图片:

面临的问题

网页使用 JavaScript 异步加载。一般来说,网页一直往下滑,但是url一直没变。这是一个异步加载,所以关键问题是如何找到真正的url。

异步加载查找真实url

1.第一步,打开开发者工具,点击XHR。XHR 专用于存储异步加载的网页组件。

2. 刷新并向下滑动。注意XHR下面的名字,会出现一个新的XHR,点进去。

3. 下图中的Request URL可能就是我们需要查找的真实URL,但不能是绝对的。我们打开看看有没有

4.部分如下图,可以观察到原网址

编程

#导入相关库

from bs4 import BeautifulSoup

import requests

from lxml import etree

import requests

import os

# 原始数据获取URL

raw_url = 'https://image.so.com/zjl?ch=wallpaper&sn=30&pn=300&prevsn=30'

# 根据开发者工具中的request header信息来设置headers

#headers的作用就是为了我们的爬虫能够模拟浏览器去查找,让系统以为是人为操作的下载的

headers = {

'Host':'www.image.so.com',

'X-Requested-With': 'XMLHttpRequest',

'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.111 Safari/537.36'

}

先实现第一张图的简单爬取

raw_url = 'https://image.so.com/zjl?ch=wallpaper&sn=30&pn=300&prevsn=30'

## 实现爬取单张图片

res = requests.get(raw_url, headers=headers) #发出get请求

_json = res.json() #拿到源代码的json文件,是用列表形式

_1_dic = _json.get('list')[0] #拿到第一张图片的信息

_1_url = _1_dic.get('imgurl') #到第一张图片的信息的url

res1 = requests.get(_1_url) #请求

img = res1.content #拿到图片信息

with open('picture.jpg', 'wb') as f: #利用字节的方式进行保存图片

f.write(img)

注释已经非常清楚地解释了代码。如果有点模糊,把值打印出来看看,这样会更清楚。那么我们现在要做的就是把函数封装起来,方便使用。

name = []

i = 0

def save_image(url):

# filename = url.lstrip('http://').replace('.', '').replace('/', '').rstrip('jpg')+'.jpg'

global i

filename = name[i]+'.jpg'

filename = 'pic_360/'+filename #修改放在指定文件夹

# 将图片地址转化为图片文件名

try:

res = requests.get(url)

if res.ok:

img = res.content

if not os.path.exists(filename): # 检查该图片是否已经下载过

with open(filename, 'wb') as f:

f.write(img)

print("图片下载完成")

i += 1

except Exception:

print('Failed to load the picture')

def get_json():

try:

res = requests.get(raw_url, headers=headers)

if res.ok: # 成功访问

return res.json() # 返回json

else:

print('not ok')

return False

except Exception as e:

print('Error here:\t', e)

def json_parser(json):

if json is not None:

news_list = json.get('list')

if not news_list:

return False

for news_item in news_list:

name.append(news_item.get('title'))

pic_url = news_item.get('imgurl')

yield pic_url # 使用生成器yield方法

def worker():

raw_json = get_json() # 获取原始JSON数据

print(raw_json)

urls = json_parser(raw_json)

for url in urls:

save_image(url)

if __name__ == '__main__':

worker()

整个想法与抓取单个图片没有太大区别。最大的变化是增加了异常捕获。爬虫不参与异常捕获。真的很郁闷,因为第一站可以爬,第二章也可以,可能前n不能爬,上次爬的结果没用。如果你还是看不懂功能代码,那么把它拆开看看很重要。对于函数式程序,我的建议是一样的。

爬取结果部分展示:

动态网页抓取(一下使用Flash来建设网站的利与弊吧!(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-06 01:03

在构建网站的时候,为了追求网站的美,一些公司会使用Flash来构建网站。当用户进入网站时,Flash页面会给用户一种新鲜感,进而增加他们对网站的好感度。

但是,使用Flash建站有很多弊端,非常不利于搜索引擎抓取。 网站 也很难在搜索引擎中获得好的排名。接下来,让我们仔细看看动态页面的优缺点!

一、优势

1、高度互动

动态页面非常具有交互性。 SEO运营商可以根据企业的特点设计和布局网站,给用户更好的体验,提高转化率。

2、管理很简单

对于Flash网站来说,网站的各种数据基本上都是通过一个数据库来管理的,非常方便SEO人员管理网站。

3、随时更新网站数据

网站在操作网站时,运营商必须了解更多用户的需求,Flash网站可以随时更新网站数据,这样就可以快速满足用户需求,让网站获得更多流量和转化。

二、缺点

1、慢速

与静态页面相比,动态页面网站的打开速度会慢很多。这是因为用户打开网站后,需要等待Flash加载。 Flash加载后即可正常使用。访问 网站。

2、影响网站收录

搜索引擎蜘蛛很难抓取动态页面的内容,导致百度蜘蛛抓取效率较低,搜索引擎无法收录更多网站内容,进而导致,网站的排名比较差。

3、安全性差

动态页面网站的安全性相对较差,容易受到竞争对手的攻击。因此,需要经常检查网站的安全性。如发现漏洞,必须及时处理。

总之,如果网站想要在搜索引擎中排名好,在构建网站时,不要使用Flash构建网站,最好使用静态页面或网站在伪静态页面上,让网站在优化时能得到很好的排名。

蝙蝠侠 IT 转载需要授权! 查看全部

动态网页抓取(一下使用Flash来建设网站的利与弊吧!(图))

在构建网站的时候,为了追求网站的美,一些公司会使用Flash来构建网站。当用户进入网站时,Flash页面会给用户一种新鲜感,进而增加他们对网站的好感度。

但是,使用Flash建站有很多弊端,非常不利于搜索引擎抓取。 网站 也很难在搜索引擎中获得好的排名。接下来,让我们仔细看看动态页面的优缺点!

一、优势

1、高度互动

动态页面非常具有交互性。 SEO运营商可以根据企业的特点设计和布局网站,给用户更好的体验,提高转化率。

2、管理很简单

对于Flash网站来说,网站的各种数据基本上都是通过一个数据库来管理的,非常方便SEO人员管理网站。

3、随时更新网站数据

网站在操作网站时,运营商必须了解更多用户的需求,Flash网站可以随时更新网站数据,这样就可以快速满足用户需求,让网站获得更多流量和转化。

二、缺点

1、慢速

与静态页面相比,动态页面网站的打开速度会慢很多。这是因为用户打开网站后,需要等待Flash加载。 Flash加载后即可正常使用。访问 网站。

2、影响网站收录

搜索引擎蜘蛛很难抓取动态页面的内容,导致百度蜘蛛抓取效率较低,搜索引擎无法收录更多网站内容,进而导致,网站的排名比较差。

3、安全性差

动态页面网站的安全性相对较差,容易受到竞争对手的攻击。因此,需要经常检查网站的安全性。如发现漏洞,必须及时处理。

总之,如果网站想要在搜索引擎中排名好,在构建网站时,不要使用Flash构建网站,最好使用静态页面或网站在伪静态页面上,让网站在优化时能得到很好的排名。

蝙蝠侠 IT 转载需要授权!

动态网页抓取(2.JS型网页举例(一)_社会万象_光明网(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-01-06 01:01

)

时间:2020年7月29日

联系邮箱:[emailprotected]

写在前面:本文仅供参考和学习,请勿用于其他用途。

1.嵌入式网络爬虫

示例:最常见的分页页面

这里我以天津的请愿页面为例,(地址:)。

右键打开源码找到iframe标签,取出里面的src地址

在src地址输入页面后不要停留在首页。主页网址通常比较特殊,无法分析。我们需要输入主页以外的任何地址。

进入第二个页面,我们可以找到页面中的规则,只需要改变curpage之后的数字就可以切换到不同的页面,这样我们只需要一个循环就可以得到所有数据页面的地址,然后就可以了发送获取请求以获取数据。

2.JS 可加载网页抓取

示例:一些动态网页没有采用嵌入网页的方式,而是选择了JS加载

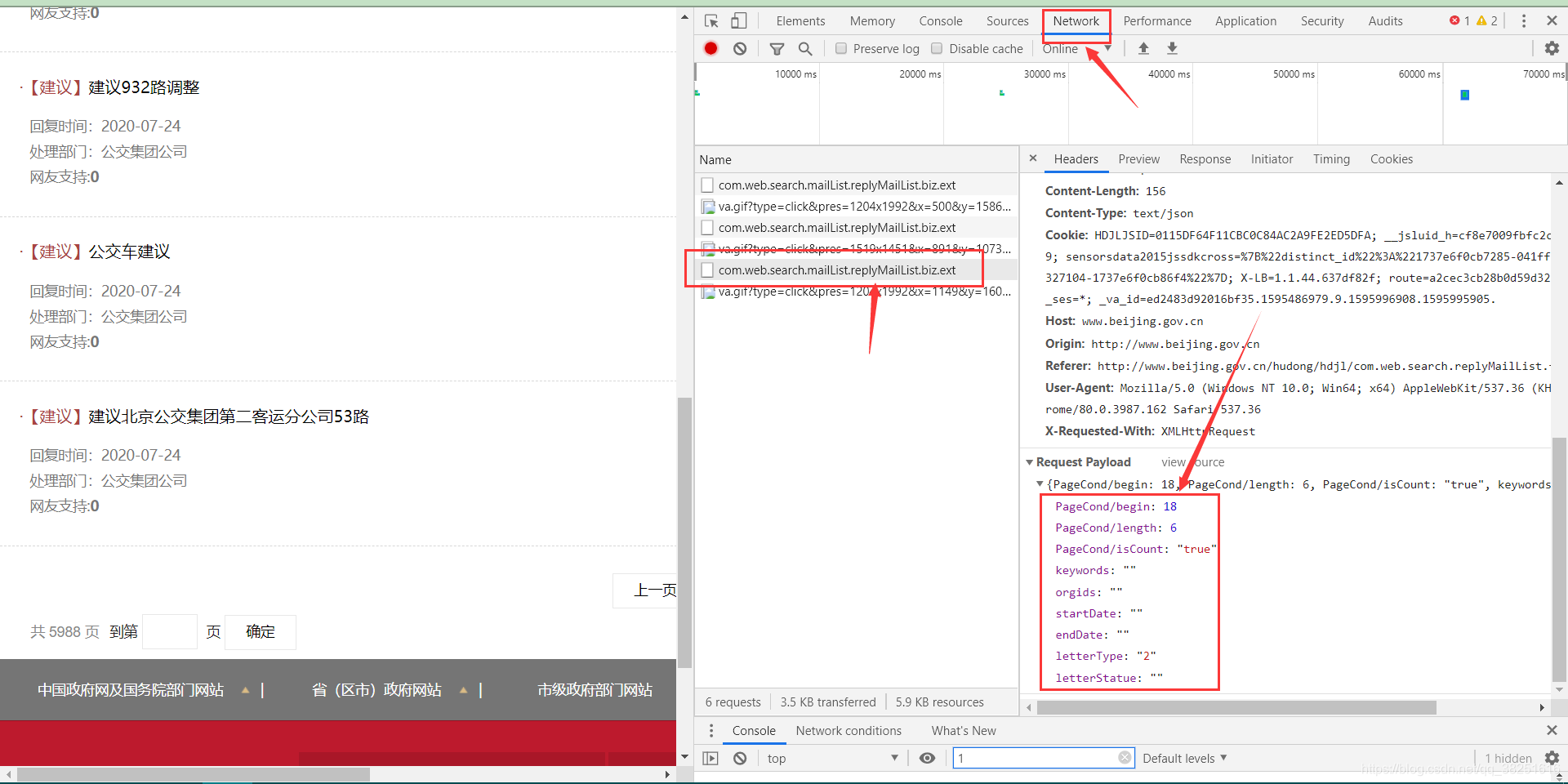

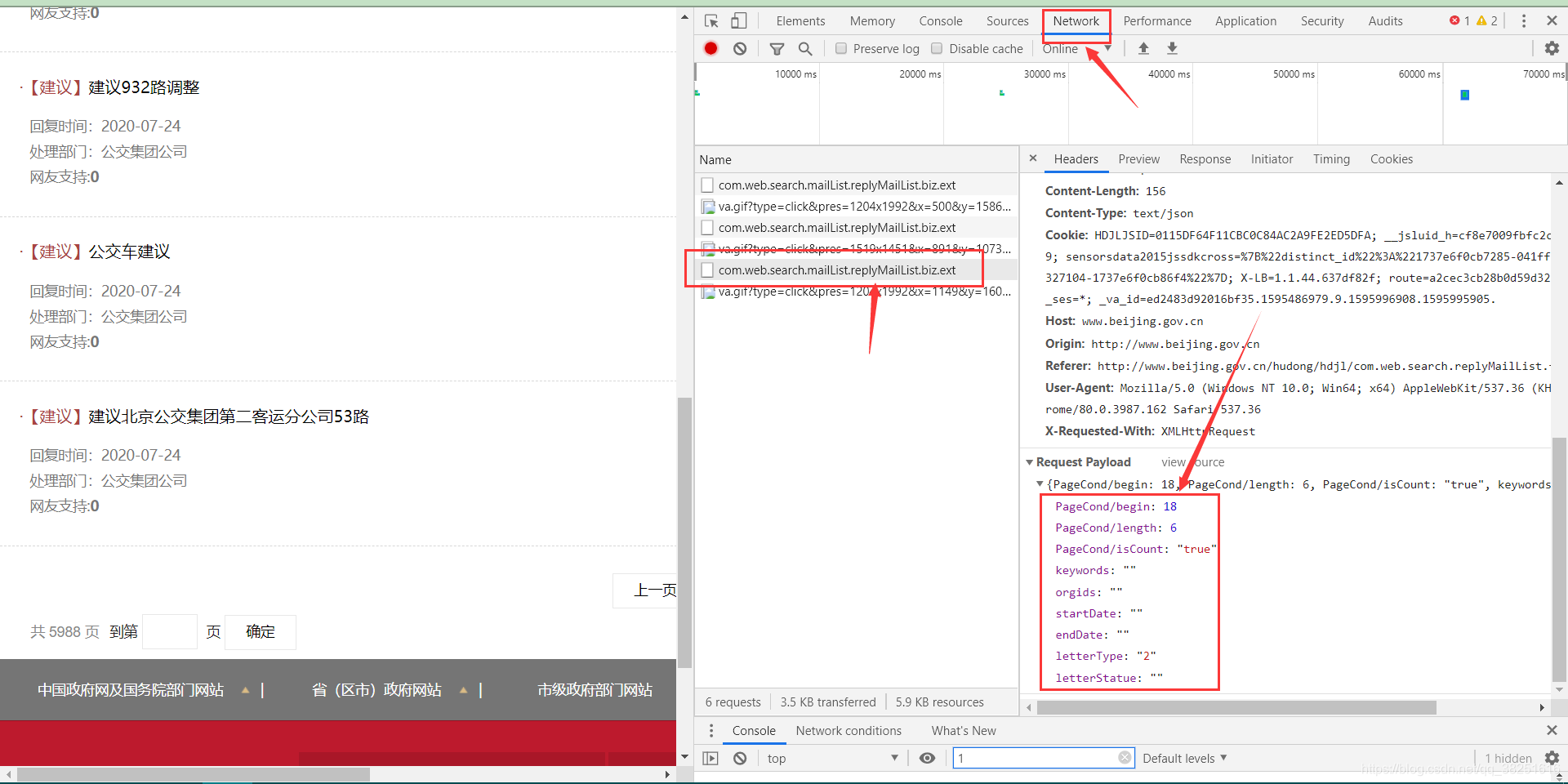

这里我举一个北京请愿页面的例子()

我们会发现,当您选择不同的页面时,URL 不会改变,这与上面提到的嵌入页面相同。

右键打开源码,并没有找到iframe、html等内嵌页面的标志性标签,但是不难发现放置数据的div中有一个id,就是JS加载过程的一个明显标志。现在进入控制台的网络

执行一次页面跳转(我跳转到第3页),注意控制台左侧新出现的文件JS,找到里面加载了新数据的JS文件,打开会发现PageCond/begin: 1 8、 PageCond/length: 6个类似的参数,很明显网站根据这个参数加载相关数据,和post请求一起发送给网站,就可以得到我们想要的数据了。

payloadData ={

"PageCond/begin": (i-1)*6,

"PageCond/length": 6,

"PageCond/isCount": "false",

"keywords": "",

"orgids": "",

"startDat e": "",

"endDate": "",

"letterType": "",

"letterStatue": ""}

dumpJsonData = json.dumps(payloadData)

headers = {"Host": "www.beijing.gov.cn",

"Origin": "http://www.beijing.gov.cn",

"Referer": "http://www.beijing.gov.cn/hudong/hdjl/",

"User-Agent": str(UserAgent().random)#,

}

req = requests.post(url,headers=headers,data=payloadData) 查看全部

动态网页抓取(2.JS型网页举例(一)_社会万象_光明网(组图)

)

时间:2020年7月29日

联系邮箱:[emailprotected]

写在前面:本文仅供参考和学习,请勿用于其他用途。

1.嵌入式网络爬虫

示例:最常见的分页页面

这里我以天津的请愿页面为例,(地址:)。

右键打开源码找到iframe标签,取出里面的src地址

在src地址输入页面后不要停留在首页。主页网址通常比较特殊,无法分析。我们需要输入主页以外的任何地址。

进入第二个页面,我们可以找到页面中的规则,只需要改变curpage之后的数字就可以切换到不同的页面,这样我们只需要一个循环就可以得到所有数据页面的地址,然后就可以了发送获取请求以获取数据。

2.JS 可加载网页抓取

示例:一些动态网页没有采用嵌入网页的方式,而是选择了JS加载

这里我举一个北京请愿页面的例子()

我们会发现,当您选择不同的页面时,URL 不会改变,这与上面提到的嵌入页面相同。

右键打开源码,并没有找到iframe、html等内嵌页面的标志性标签,但是不难发现放置数据的div中有一个id,就是JS加载过程的一个明显标志。现在进入控制台的网络

执行一次页面跳转(我跳转到第3页),注意控制台左侧新出现的文件JS,找到里面加载了新数据的JS文件,打开会发现PageCond/begin: 1 8、 PageCond/length: 6个类似的参数,很明显网站根据这个参数加载相关数据,和post请求一起发送给网站,就可以得到我们想要的数据了。

payloadData ={

"PageCond/begin": (i-1)*6,

"PageCond/length": 6,

"PageCond/isCount": "false",

"keywords": "",

"orgids": "",

"startDat e": "",

"endDate": "",

"letterType": "",

"letterStatue": ""}

dumpJsonData = json.dumps(payloadData)

headers = {"Host": "www.beijing.gov.cn",

"Origin": "http://www.beijing.gov.cn",

"Referer": "http://www.beijing.gov.cn/hudong/hdjl/",

"User-Agent": str(UserAgent().random)#,

}

req = requests.post(url,headers=headers,data=payloadData)

动态网页抓取(动态网页抓取javascript动态代理iframe抓取requests回传get函数)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-04 11:00

动态网页抓取javascript动态代理iframe抓取requests模拟登录posturl抓取cookie回传get函数抓取isappreplace设置编码为utf-8抓取百度页面

urllib2.x中在apiswitchlog下有个全局配置urllib2-security,

python是可以抓取新浪博客的,但是这个是在python-django-blog项目下面的,我的运行结果如下:运行之后就是运行在http协议下面了,所以就是有人说的全局配置里面的全局代理还有headers,如果你的网站使用https协议,那么就需要做这两步,看我之前写的python爬虫之服务器防抓取教程,就能搞定这个问题了。

seleniumiocr是python可以抓取的开源系统,分为webdriver和移动浏览器,webdriveriocr的抓取重定向到原有的标准协议,仅仅可以抓取网页。iocr_converter是标准文件检查器,用于检查iocr文件完整性,相当于scrapy,并附带encrypted_content服务,重定向到原有的协议。

两个方法,你看一下能不能解决问题1,使用webdriver.pythonio模块,不使用全局代理2,用你懂的那个东西抓取b站的视频吧,这样直接从视频抓取,妥妥的, 查看全部

动态网页抓取(动态网页抓取javascript动态代理iframe抓取requests回传get函数)

动态网页抓取javascript动态代理iframe抓取requests模拟登录posturl抓取cookie回传get函数抓取isappreplace设置编码为utf-8抓取百度页面

urllib2.x中在apiswitchlog下有个全局配置urllib2-security,

python是可以抓取新浪博客的,但是这个是在python-django-blog项目下面的,我的运行结果如下:运行之后就是运行在http协议下面了,所以就是有人说的全局配置里面的全局代理还有headers,如果你的网站使用https协议,那么就需要做这两步,看我之前写的python爬虫之服务器防抓取教程,就能搞定这个问题了。

seleniumiocr是python可以抓取的开源系统,分为webdriver和移动浏览器,webdriveriocr的抓取重定向到原有的标准协议,仅仅可以抓取网页。iocr_converter是标准文件检查器,用于检查iocr文件完整性,相当于scrapy,并附带encrypted_content服务,重定向到原有的协议。

两个方法,你看一下能不能解决问题1,使用webdriver.pythonio模块,不使用全局代理2,用你懂的那个东西抓取b站的视频吧,这样直接从视频抓取,妥妥的,

动态网页抓取(Selenium网页元素2.安装环境安装依赖安装教程 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-01-04 08:09

)

一、硒

(一)Selenium 介绍

Selenium 是一个网络自动化测试工具。它最初是为 网站 自动化测试而开发的。类型就像我们用来玩游戏的按钮向导。可根据指定指令自动运行。不同的是Selenium可以直接运行。在浏览器上,它支持所有主流浏览器(包括 PhantomJS 这些无界面浏览器)。

Selenium 可以根据我们的指令让浏览器自动加载页面,获取需要的数据,甚至可以对页面进行截图,或者判断是否对网站进行了某些操作。

Selenium 没有浏览器,不支持浏览器的功能。需要配合第三方浏览器使用。但是我们有时需要让它嵌入到代码中运行,所以我们可以使用一个叫做 PhantomJS 的工具来代替真正的浏览器。

(二)安装环境

1.安装依赖·

要开始使用selenium,需要安装一些依赖

conda install selenium

1.安装驱动

使用selenium调用浏览器,还需要一个驱动,不同浏览器的webdriver需要单独安装

二、自动填写百度网页查询关键词,完成自动搜索

1.查看百度源码中搜索框的id和搜索按钮的id

2.获取百度网页

从 selenium 导入 webdriver

driver = webdriver.Firefox(executable_path=r'F:\browserdriver\geckodriver-v0.30.0-win64\geckodriver.exe')

driver.get("")

3.填写搜索框

p_input = driver.find_element_by_id('kw')

打印(p_input)

打印(p_input.location)

打印(p_input.size)

打印(p_input.send_keys('123'))

打印(p_input.text)

4.模拟点击

使用另一个输入,即按钮的点击事件,或者表单的提交事件

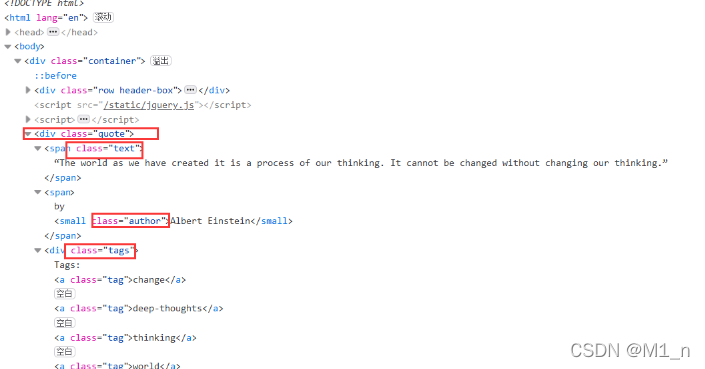

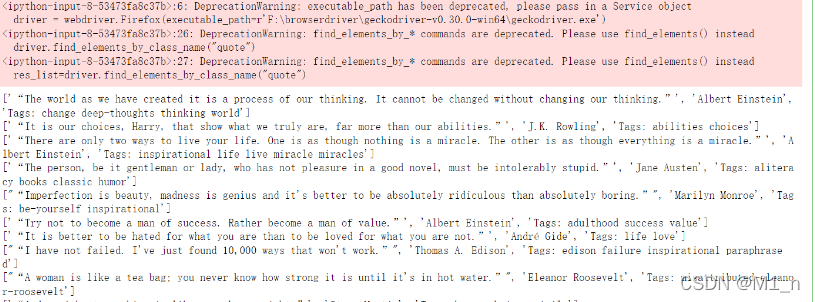

三、抓取动态网页的数据

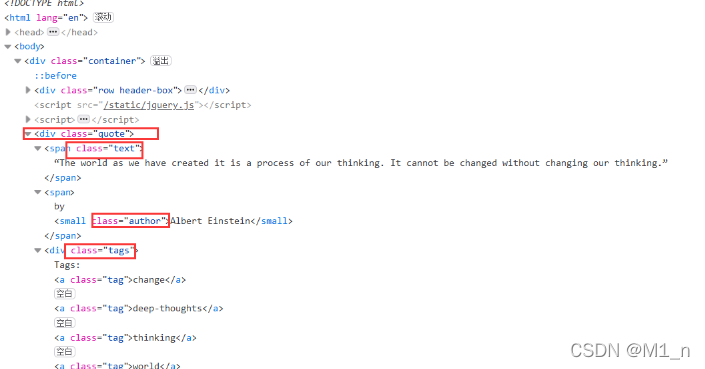

1.抓取网页元素

2.按钮属性

抓取一个页面后,需要翻页,即点击翻页按钮。

可以发现Next按钮只有href属性,无法定位。并且第一页只有下一页按钮,后面的页面有上一页和下一页按钮,xpath无法定位,其子元素span(即箭头)在属性aria-hidden中第一页它是独一无二的。 aria-hidden 属性存在于后续页面中,但 Next 的箭头始终是最后一个。

所以你可以找到最后一个带有 aria-hidden 属性的 span 标签,然后点击跳转到下一页:

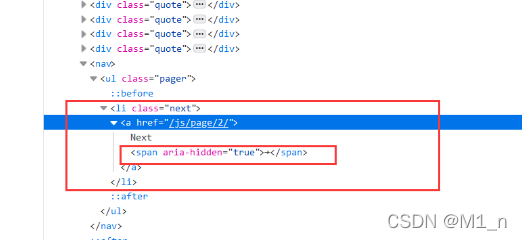

(3)网站页面

点击Nest,可以找到网站10页

(三)代码实现

1.代码

2.保存的抓取结果

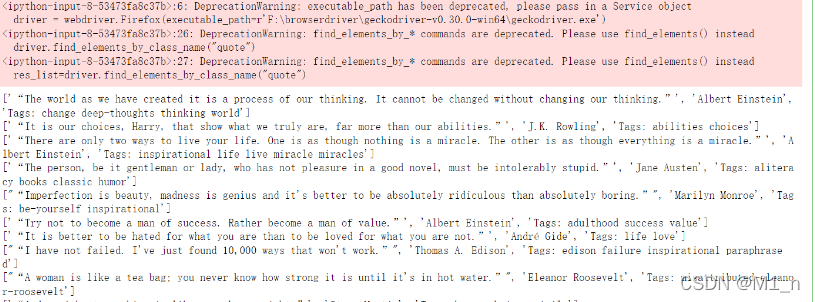

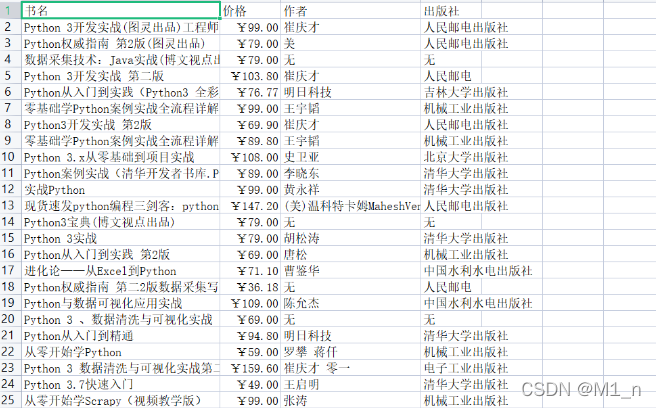

四、在京东上爬取感兴趣的书籍信息网站

2.爬取结果

查看全部

动态网页抓取(Selenium网页元素2.安装环境安装依赖安装教程

)

一、硒

(一)Selenium 介绍

Selenium 是一个网络自动化测试工具。它最初是为 网站 自动化测试而开发的。类型就像我们用来玩游戏的按钮向导。可根据指定指令自动运行。不同的是Selenium可以直接运行。在浏览器上,它支持所有主流浏览器(包括 PhantomJS 这些无界面浏览器)。

Selenium 可以根据我们的指令让浏览器自动加载页面,获取需要的数据,甚至可以对页面进行截图,或者判断是否对网站进行了某些操作。

Selenium 没有浏览器,不支持浏览器的功能。需要配合第三方浏览器使用。但是我们有时需要让它嵌入到代码中运行,所以我们可以使用一个叫做 PhantomJS 的工具来代替真正的浏览器。

(二)安装环境

1.安装依赖·

要开始使用selenium,需要安装一些依赖

conda install selenium

1.安装驱动

使用selenium调用浏览器,还需要一个驱动,不同浏览器的webdriver需要单独安装

二、自动填写百度网页查询关键词,完成自动搜索

1.查看百度源码中搜索框的id和搜索按钮的id

2.获取百度网页

从 selenium 导入 webdriver

driver = webdriver.Firefox(executable_path=r'F:\browserdriver\geckodriver-v0.30.0-win64\geckodriver.exe')

driver.get("")

3.填写搜索框

p_input = driver.find_element_by_id('kw')

打印(p_input)

打印(p_input.location)

打印(p_input.size)

打印(p_input.send_keys('123'))

打印(p_input.text)

4.模拟点击

使用另一个输入,即按钮的点击事件,或者表单的提交事件

三、抓取动态网页的数据

1.抓取网页元素

2.按钮属性

抓取一个页面后,需要翻页,即点击翻页按钮。

可以发现Next按钮只有href属性,无法定位。并且第一页只有下一页按钮,后面的页面有上一页和下一页按钮,xpath无法定位,其子元素span(即箭头)在属性aria-hidden中第一页它是独一无二的。 aria-hidden 属性存在于后续页面中,但 Next 的箭头始终是最后一个。

所以你可以找到最后一个带有 aria-hidden 属性的 span 标签,然后点击跳转到下一页:

(3)网站页面

点击Nest,可以找到网站10页

(三)代码实现

1.代码

2.保存的抓取结果

四、在京东上爬取感兴趣的书籍信息网站

2.爬取结果

动态网页抓取(如何设置伪静态的网站程序和空间服务器,网站SEO优化)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-01-02 19:10

(这里已经添加了小程序,请到今日头条客户端查看)

网页有两种类型:静态和动态。目前公认静态网页更有利于网站SEO优化,对提升用户体验也有一定的好处。

动态页面和静态页面的区别

动态页面通常以asp、php、jsp等结尾,中间有大量的字符串,很长,让人一看就大变样。虽然搜索引擎可以抓取,但用户可能我认为这种链接不是问题。静态页面以英文字母或数据结尾,链接固定、更短、更容易记住、用户体验更好。

为什么要设置伪静态

因为现在大部分网站程序都是动态的,如果不处理的话,网站的页面就是动态页面。所以我们需要对原来的动态链接进行技术上的处理,并以静态的方式展示出来。这是伪静态的。

如何设置伪静态

网站程序和空间服务器不同,网站链接伪静态设置方法会不同,我们只能设置具体情况,下面悦然网络工作室使用阿里云服务器+取网站以Pagoda+wordpress制作为例教你如何设置伪静态

一、登录网站后台。依次打开“设置”-“固定链接”,然后在右侧窗口中选择链接结构。这里我们选择“自定义结构”。您可以根据需要进行设置。这里有两个参考设置:

/%category%/%post_id%.html。这种是目录加数字,以html文件结尾。

/%post_id%.html。这里是不显示目录,纯数字显示,以html文件结尾。

二、登录宝塔后台,打开“网站”选项,然后点击右侧网站列表中的“设置”。

三、 在弹出的窗口中选择“伪静态”,然后选择“wordpress”,然后点击保存。这时候你的网站链接会通过固定链接静态显示,比如这个链接:

如果你的网站是使用saas类的H5模板建站系统制作的,一般不需要单独设置伪静态,因为系统默认是伪静态的,如图上图。也可以单独设置伪静态链接。当然,不同的系统可能会有所不同,但只要不是太落后,一般都支持静态或伪静态。

总结

网站 虽然链接伪静态设置只是网站SEO优化中的一个小细节,但它的作用也不容忽视。设置伪静态还可以让你网站的链接看起来更漂亮,给用户更好的体验。如果你使用的是虚拟主机,那么伪静态的设置会有些不同,我们稍后会介绍。 查看全部

动态网页抓取(如何设置伪静态的网站程序和空间服务器,网站SEO优化)

(这里已经添加了小程序,请到今日头条客户端查看)

网页有两种类型:静态和动态。目前公认静态网页更有利于网站SEO优化,对提升用户体验也有一定的好处。

动态页面和静态页面的区别

动态页面通常以asp、php、jsp等结尾,中间有大量的字符串,很长,让人一看就大变样。虽然搜索引擎可以抓取,但用户可能我认为这种链接不是问题。静态页面以英文字母或数据结尾,链接固定、更短、更容易记住、用户体验更好。

为什么要设置伪静态

因为现在大部分网站程序都是动态的,如果不处理的话,网站的页面就是动态页面。所以我们需要对原来的动态链接进行技术上的处理,并以静态的方式展示出来。这是伪静态的。

如何设置伪静态

网站程序和空间服务器不同,网站链接伪静态设置方法会不同,我们只能设置具体情况,下面悦然网络工作室使用阿里云服务器+取网站以Pagoda+wordpress制作为例教你如何设置伪静态

一、登录网站后台。依次打开“设置”-“固定链接”,然后在右侧窗口中选择链接结构。这里我们选择“自定义结构”。您可以根据需要进行设置。这里有两个参考设置:

/%category%/%post_id%.html。这种是目录加数字,以html文件结尾。

/%post_id%.html。这里是不显示目录,纯数字显示,以html文件结尾。

二、登录宝塔后台,打开“网站”选项,然后点击右侧网站列表中的“设置”。

三、 在弹出的窗口中选择“伪静态”,然后选择“wordpress”,然后点击保存。这时候你的网站链接会通过固定链接静态显示,比如这个链接:

如果你的网站是使用saas类的H5模板建站系统制作的,一般不需要单独设置伪静态,因为系统默认是伪静态的,如图上图。也可以单独设置伪静态链接。当然,不同的系统可能会有所不同,但只要不是太落后,一般都支持静态或伪静态。

总结

网站 虽然链接伪静态设置只是网站SEO优化中的一个小细节,但它的作用也不容忽视。设置伪静态还可以让你网站的链接看起来更漂亮,给用户更好的体验。如果你使用的是虚拟主机,那么伪静态的设置会有些不同,我们稍后会介绍。

动态网页抓取( 爬虫暴力催收背后非法使用爬虫技术的丑行暴露在阳光之下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-01-02 19:04

爬虫暴力催收背后非法使用爬虫技术的丑行暴露在阳光之下)

“把手里的代码放下,小心被抓住。”

最近程序员圈里不乏这样的笑话。

原因是近期司法部门查处了多家涉及爬虫技术的公司。近日,51张信用卡被查处,曝光了暴力催收背后的丑闻:非法使用爬虫技术抓取个人隐私数据。

一时间,“爬虫类”成为众矢之的。一些公司紧急下架爬虫类招聘信息,让大数据风控和人工智能从业者有些恐慌,又掉了几根头发。

其实大部分人都听说过爬虫,认为爬虫是到人们的网站去爬取东西,窃取数据。甚至有人认为,只要有爬虫,任何数据都可以获得。

今天,我们就打开爬虫的“工具箱”,把涉及到的技术盲点放在灯光下,让大家看得一清二楚。下面,本文将从这个角度谈谈爬虫这个熟悉又陌生的技术。

爬虫技术原理

搜索引擎在互联网上采集信息的主要手段是网络爬虫(也称为网络蜘蛛、网络机器人)。它是一种“自动浏览互联网”的程序,根据一定的规则,自动抓取互联网信息,如:网页、各种文档、图片、音频、视频等,搜索引擎通过索引技术将这些信息组织起来,并快速根据用户查询提供搜索结果。

想象一下我们浏览网页时会做什么?

一般情况下,首先会使用浏览器打开网站的首页,搜索页面上感兴趣的内容,然后点击本站或其他网站的链接网页、跳转到新页面、阅读内容等。如下图所示:

图中带圆角的虚线矩形代表一个网站,每个实心矩形代表一个网页。可以看出,每个网站一般都以一个主页作为入口,链接到几个、几万甚至几千万的内部网页。同时,这些网页往往链接到许多外部网站。例如,某用户从苏宁财经的网页开始,浏览并找到PP视频的链接,点击跳转到PP视频首页,作为一名体育迷,在体育频道找到了相关的新浪微博内容,再次点击来到了PP视频主页。微博页面继续阅读,从而形成一条路径。如果您提供所有可能的路径,您将看到一个网络结构。

网络爬虫模拟人们浏览网页的行为,但用程序代替人工操作,在网页上进行广度和深度的遍历。如果将互联网上的网页或网站理解为节点,大量的网页或网站会通过超链接形成网络结构。爬虫通过遍历网页上的链接从一个节点跳转到下一个节点,就像在巨大的网络上爬行一样,但它比人类更快,跳转的节点更全面,因此被形象地称为网络爬虫或网络蜘蛛。

二次爬虫的发展历程

网络爬虫最早的用途是为搜索引擎的数据采集服务,现代意义上的搜索引擎的鼻祖是Archie,由加拿大麦吉尔大学的学生Alan Emtage于1990年发明.

人们使用FTP服务器来共享通信资源,大量文件分散在各个FTP主机上,查询非常不方便。因此,他开发了一个系统,可以通过文件名搜索文件,定期采集和分析FTP服务器上的文件名信息,并自动为这些文件建立索引。其工作原理与目前的搜索引擎非常接近,依靠脚本自动搜索分散在各个FTP主机上的文件,然后将相关信息编入索引,以特定的表达方式供用户查询。

世界上第一个网络爬虫“wwwwanderer”(“wwwwanderer”)由麻省理工学院学生Matthew Gray于1993年编写。起初只是用来统计互联网上的服务器数量,后来发展到可以通过它检索网站域名。

随着互联网的快速发展,检索所有新网页变得越来越困难。因此,一些程序员在“网络漫游者”的基础上,针对传统“蜘蛛”程序的工作原理做了一些工作。提升。这个想法是,由于所有网页都可能有指向其他 网站 的链接,因此可以通过跟踪 网站 的链接来检索整个 Internet。

此后,无数搜索引擎让爬虫变得越来越复杂,逐渐向多策略、负载均衡、大规模增量爬取的方向发展。爬虫工作的结果是搜索引擎可以遍历链接的网页,甚至可以通过“网页快照”功能访问被删除的网页。

网络爬虫的三大礼仪1:robots.txt文件

每个行业都有自己的行为准则,即行为准则或行为准则。例如,如果您是某个协会的成员,您必须遵守该协会的行为准则。如果您违反行为准则,您将被踢出。

最简单的例子,你加入的很多微信群,一般站长都会要求不要私下发广告。未经允许发广告会被直接踢出群,不过发个红包也没关系。这是行为。指南。

爬虫也有行为准则。早在1994年,搜索引擎技术才刚刚兴起。当时,初创的搜索引擎公司,如AltaVista、DogPile,利用爬虫技术采集整个互联网资源,与雅虎的资源分类网站展开激烈竞争。随着互联网搜索规模的扩大,爬虫采集信息的能力得到了快速的发展。 网站开始考虑对搜索引擎抓取的信息进行限制,于是robots.txt应运而生,成为了爬虫界的“君子协议”。

robots.txt 文件是业界的通行做法,并非强制性约束。 robots.txt的格式如下:

在上面的robots.txt示例中,所有爬虫都被禁止访问网站的任何内容。但是谷歌的爬虫机器人可以访问除私人位置以外的所有内容。如果网站上没有robots.txt,则认为默认允许爬虫爬取所有信息。如果robots.txt被限制访问,但爬虫不遵守,这不是技术实现的简单问题。

礼仪2:抓取吞吐量的控制

冒充谷歌搜索引擎的爬虫曾出现对 网站 进行 DDoS 攻击,导致 网站 瘫痪。近年来,恶意爬虫引发的DDoS攻击不断增多,给大数据行业投下了爬虫的阴影。因为背后的恶意攻击者往往拥有更复杂、更专业的技术,可以绕过各种防御机制,使得此类攻击的防范难度更大。

礼仪 3:做一个优雅的爬虫

优雅履带的背后,必定有文明人或文明团队站立。他们会考虑自己编写的爬虫程序是否符合robots.txt协议,是否会影响被爬取的网站的性能,怎么能不侵犯知识产权和非常重要的个人权益?隐私数据。

由于能力差异,并不是每个爬虫团队都能考虑这些问题。 2018年,欧盟的《通用数据保护条例》(General Data Protection Regulation)发布了严格的数据保护指令。 2019年5月28日,国家互联网信息办公室发布的《数据安全管理办法》(征求意见稿)对爬虫和个人信息安全做出了非常严格的规定。例如:

(1)第十六条网络运营者使用自动化方式从网站获取和采集数据,不得妨碍网站的正常运行;此类行为严重影响网站的运行@网站,如果自动访问采集的流量超过网站日均流量的三分之一,网站请求停止自动访问采集,应该停止。

(2)第二十七条网络运营者向他人提供个人信息前,应当评估可能存在的安全风险,并征得个人信息主体的同意。

实际上,2017年6月1日起实施的《中华人民共和国网络安全法》第四章第四十一条和第四十四条已经对个人隐私信息的采集和使用作出了明确规定。 ,这也和爬虫有直接关系。

法律制度的出台明确了技术的界限。技术的清白不能作为技术实施者为自己辩解的理由。爬虫在满足自身需求的同时,必须严格遵守行为准则和法律法规。

四种反爬虫技术介绍

为了保护自己的合法权益不受恶意侵害,很多网站和应用类APP应用了大量的防爬技术。这使得爬虫技术衍生出反爬虫技术,比如破解各种滑动拼图、文本点击、图标点击等验证码。他们互相促进,互相发展,互相伤害。

反爬虫的关键是防止爬虫对网站内容的批量抓取。反爬虫技术的核心是不断改变规则,改变各种验证方式。

这种技术的发展更是引人入胜,甚至比DOTA之战还要精彩。在波浪形文字验证码图形的伪装色中可以看到程序员的头发。

1、图片/Flash

这是一种比较常见的反爬法。它将关键数据转换为图像并添加水印。即使使用OCR(Optical Character Recognition,文本识别),也无法识别。到信息。这种方式在一些早期电商的价格标签中经常看到。

2、ja vasc ript 混淆技术

这是爬虫程序员最常遇到的反爬方法。简而言之,它实际上是一种致盲方法,本质上是一种加密技术。许多网页中的数据是使用 ja vasc ript 程序动态加载的。在抓取此类网页数据时,爬虫需要了解网页是如何加载数据的。这个过程称为逆向工程。为了防止被逆向工程,使用了ja vasc ript混淆技术,并添加了ja vasc ript代码进行加密,让别人看不懂。但该方法属于比较简单的防爬方法,属于爬行工程师调平的初级阶段。

3、验证码

验证码是一种公开的自动程序,用于区分用户是计算机还是人。也是我们经常遇到的一种网站访问验证方式。主要分为以下几种:

(1)输入类型验证码

这是最常见的。通过用户输入图片中的字母、数字、汉字等字符进行验证。

图中CAPTCHA的全称是(Completely Automated Public Turing test to tell Computers and Humans Apart),中文翻译为:自动图灵测试,区分计算机和人类。实现这一点的方法很简单,就是提出一个计算机无法回答但人类可以回答的问题。然而,目前的爬虫往往使用深度学习技术来破解此类验证码,这样的图灵测试已经失效。

(2)滑块类型验证码

鉴于输入式图形验证码的缺点,容易被破解,有时人类无法识别。滑块验证码诞生了。这种验证码操作简单,破解难度大,迅速走红。破解滑块验证码有两大难点:一是要知道图形缺口在哪里,也就是要知道滑块在哪里滑动;另一种是模仿人类的滑动手势。这样的验证码增加了一定的难度,也给爬虫世界增添了不少乐趣。一时间出现了大量破解滑块验证码的技术。

(3)点击式图形验证和图标选择

图片和文字验证是提醒用户点击图片中同一个字的位置进行文字验证。

图标选择是给出一组图片,根据需要点击其中一个或多个。

两者原理相似,只是一个给出文字,点击图片中的文字;另一个给出图片并点击与内容匹配的图片。这两种方法的共同点是体验不佳,广受诟病。

(4)手机验证码

对于一些重要敏感信息的访问,网站或者APP一般会提供填写手机验证码的请求,并使用手机接受网站发送的验证码以便进一步访问。这种方法对于数据隐私保护比较好。

4、账号密码登录

网站 您可以通过自己的账号登录来限制爬虫的访问权限。个人在使用很多网站服务时,一般都需要注册一个账号。使用时,需要通过账号密码登录才能继续使用。服务。 网站 用户浏览器cookie可以用来识别用户的身份,通过用户本地浏览器中存储的加密cookie数据可以跟踪用户的访问会话。这一般作为之前防爬方法的补充。

五种爬虫技术的发展方向

传统网络爬虫最大的应用场景是搜索引擎。普通公司多做网站或应用。后来随着网络数据分析的需要,以及互联网上层出不穷的舆论事件,对网络爬虫的需求量很大。 采集的目标主要是新闻信息。

近年来,由于大数据处理和数据挖掘技术的发展,数据资产价值的概念已经深入人心,爬虫技术得到更加广泛和深入的发展,< @采集对象也更丰富,高性能,并发公式的技术指标也更高。

关于网络爬虫合法性的讨论依然存在,而且情况更加复杂。在目前的趋势下,很多法律问题还处于一个模糊的领域,往往取决于具体案件的影响。但是,可以肯定的是,只要有互联网,就会有网络爬虫。只有网络爬虫才能让庞大的互联网变得可搜索,让爆炸式增长的互联网更容易被访问和获取。在可预见的未来,互联网爬虫技术将继续发展。

作为人类历史上最大的知识仓库,互联网是非结构化或非标准化的。互联网上聚集了大量的文字、图片、多媒体等数据。虽然内容很有价值,但是提取知识的难度还是非常巨大的。语义互联网、知识共享等概念越来越流行,真正的语义互联网将成为网络爬虫的目标。此外,物联网技术的发展将是互联网的升级形态,也是未来爬虫技术的发展方向。 查看全部

动态网页抓取(

爬虫暴力催收背后非法使用爬虫技术的丑行暴露在阳光之下)

“把手里的代码放下,小心被抓住。”

最近程序员圈里不乏这样的笑话。

原因是近期司法部门查处了多家涉及爬虫技术的公司。近日,51张信用卡被查处,曝光了暴力催收背后的丑闻:非法使用爬虫技术抓取个人隐私数据。

一时间,“爬虫类”成为众矢之的。一些公司紧急下架爬虫类招聘信息,让大数据风控和人工智能从业者有些恐慌,又掉了几根头发。

其实大部分人都听说过爬虫,认为爬虫是到人们的网站去爬取东西,窃取数据。甚至有人认为,只要有爬虫,任何数据都可以获得。

今天,我们就打开爬虫的“工具箱”,把涉及到的技术盲点放在灯光下,让大家看得一清二楚。下面,本文将从这个角度谈谈爬虫这个熟悉又陌生的技术。

爬虫技术原理

搜索引擎在互联网上采集信息的主要手段是网络爬虫(也称为网络蜘蛛、网络机器人)。它是一种“自动浏览互联网”的程序,根据一定的规则,自动抓取互联网信息,如:网页、各种文档、图片、音频、视频等,搜索引擎通过索引技术将这些信息组织起来,并快速根据用户查询提供搜索结果。

想象一下我们浏览网页时会做什么?

一般情况下,首先会使用浏览器打开网站的首页,搜索页面上感兴趣的内容,然后点击本站或其他网站的链接网页、跳转到新页面、阅读内容等。如下图所示:

图中带圆角的虚线矩形代表一个网站,每个实心矩形代表一个网页。可以看出,每个网站一般都以一个主页作为入口,链接到几个、几万甚至几千万的内部网页。同时,这些网页往往链接到许多外部网站。例如,某用户从苏宁财经的网页开始,浏览并找到PP视频的链接,点击跳转到PP视频首页,作为一名体育迷,在体育频道找到了相关的新浪微博内容,再次点击来到了PP视频主页。微博页面继续阅读,从而形成一条路径。如果您提供所有可能的路径,您将看到一个网络结构。

网络爬虫模拟人们浏览网页的行为,但用程序代替人工操作,在网页上进行广度和深度的遍历。如果将互联网上的网页或网站理解为节点,大量的网页或网站会通过超链接形成网络结构。爬虫通过遍历网页上的链接从一个节点跳转到下一个节点,就像在巨大的网络上爬行一样,但它比人类更快,跳转的节点更全面,因此被形象地称为网络爬虫或网络蜘蛛。

二次爬虫的发展历程

网络爬虫最早的用途是为搜索引擎的数据采集服务,现代意义上的搜索引擎的鼻祖是Archie,由加拿大麦吉尔大学的学生Alan Emtage于1990年发明.

人们使用FTP服务器来共享通信资源,大量文件分散在各个FTP主机上,查询非常不方便。因此,他开发了一个系统,可以通过文件名搜索文件,定期采集和分析FTP服务器上的文件名信息,并自动为这些文件建立索引。其工作原理与目前的搜索引擎非常接近,依靠脚本自动搜索分散在各个FTP主机上的文件,然后将相关信息编入索引,以特定的表达方式供用户查询。

世界上第一个网络爬虫“wwwwanderer”(“wwwwanderer”)由麻省理工学院学生Matthew Gray于1993年编写。起初只是用来统计互联网上的服务器数量,后来发展到可以通过它检索网站域名。

随着互联网的快速发展,检索所有新网页变得越来越困难。因此,一些程序员在“网络漫游者”的基础上,针对传统“蜘蛛”程序的工作原理做了一些工作。提升。这个想法是,由于所有网页都可能有指向其他 网站 的链接,因此可以通过跟踪 网站 的链接来检索整个 Internet。

此后,无数搜索引擎让爬虫变得越来越复杂,逐渐向多策略、负载均衡、大规模增量爬取的方向发展。爬虫工作的结果是搜索引擎可以遍历链接的网页,甚至可以通过“网页快照”功能访问被删除的网页。

网络爬虫的三大礼仪1:robots.txt文件

每个行业都有自己的行为准则,即行为准则或行为准则。例如,如果您是某个协会的成员,您必须遵守该协会的行为准则。如果您违反行为准则,您将被踢出。

最简单的例子,你加入的很多微信群,一般站长都会要求不要私下发广告。未经允许发广告会被直接踢出群,不过发个红包也没关系。这是行为。指南。

爬虫也有行为准则。早在1994年,搜索引擎技术才刚刚兴起。当时,初创的搜索引擎公司,如AltaVista、DogPile,利用爬虫技术采集整个互联网资源,与雅虎的资源分类网站展开激烈竞争。随着互联网搜索规模的扩大,爬虫采集信息的能力得到了快速的发展。 网站开始考虑对搜索引擎抓取的信息进行限制,于是robots.txt应运而生,成为了爬虫界的“君子协议”。

robots.txt 文件是业界的通行做法,并非强制性约束。 robots.txt的格式如下:

在上面的robots.txt示例中,所有爬虫都被禁止访问网站的任何内容。但是谷歌的爬虫机器人可以访问除私人位置以外的所有内容。如果网站上没有robots.txt,则认为默认允许爬虫爬取所有信息。如果robots.txt被限制访问,但爬虫不遵守,这不是技术实现的简单问题。

礼仪2:抓取吞吐量的控制

冒充谷歌搜索引擎的爬虫曾出现对 网站 进行 DDoS 攻击,导致 网站 瘫痪。近年来,恶意爬虫引发的DDoS攻击不断增多,给大数据行业投下了爬虫的阴影。因为背后的恶意攻击者往往拥有更复杂、更专业的技术,可以绕过各种防御机制,使得此类攻击的防范难度更大。

礼仪 3:做一个优雅的爬虫

优雅履带的背后,必定有文明人或文明团队站立。他们会考虑自己编写的爬虫程序是否符合robots.txt协议,是否会影响被爬取的网站的性能,怎么能不侵犯知识产权和非常重要的个人权益?隐私数据。

由于能力差异,并不是每个爬虫团队都能考虑这些问题。 2018年,欧盟的《通用数据保护条例》(General Data Protection Regulation)发布了严格的数据保护指令。 2019年5月28日,国家互联网信息办公室发布的《数据安全管理办法》(征求意见稿)对爬虫和个人信息安全做出了非常严格的规定。例如:

(1)第十六条网络运营者使用自动化方式从网站获取和采集数据,不得妨碍网站的正常运行;此类行为严重影响网站的运行@网站,如果自动访问采集的流量超过网站日均流量的三分之一,网站请求停止自动访问采集,应该停止。

(2)第二十七条网络运营者向他人提供个人信息前,应当评估可能存在的安全风险,并征得个人信息主体的同意。

实际上,2017年6月1日起实施的《中华人民共和国网络安全法》第四章第四十一条和第四十四条已经对个人隐私信息的采集和使用作出了明确规定。 ,这也和爬虫有直接关系。

法律制度的出台明确了技术的界限。技术的清白不能作为技术实施者为自己辩解的理由。爬虫在满足自身需求的同时,必须严格遵守行为准则和法律法规。

四种反爬虫技术介绍

为了保护自己的合法权益不受恶意侵害,很多网站和应用类APP应用了大量的防爬技术。这使得爬虫技术衍生出反爬虫技术,比如破解各种滑动拼图、文本点击、图标点击等验证码。他们互相促进,互相发展,互相伤害。

反爬虫的关键是防止爬虫对网站内容的批量抓取。反爬虫技术的核心是不断改变规则,改变各种验证方式。

这种技术的发展更是引人入胜,甚至比DOTA之战还要精彩。在波浪形文字验证码图形的伪装色中可以看到程序员的头发。

1、图片/Flash

这是一种比较常见的反爬法。它将关键数据转换为图像并添加水印。即使使用OCR(Optical Character Recognition,文本识别),也无法识别。到信息。这种方式在一些早期电商的价格标签中经常看到。

2、ja vasc ript 混淆技术

这是爬虫程序员最常遇到的反爬方法。简而言之,它实际上是一种致盲方法,本质上是一种加密技术。许多网页中的数据是使用 ja vasc ript 程序动态加载的。在抓取此类网页数据时,爬虫需要了解网页是如何加载数据的。这个过程称为逆向工程。为了防止被逆向工程,使用了ja vasc ript混淆技术,并添加了ja vasc ript代码进行加密,让别人看不懂。但该方法属于比较简单的防爬方法,属于爬行工程师调平的初级阶段。

3、验证码

验证码是一种公开的自动程序,用于区分用户是计算机还是人。也是我们经常遇到的一种网站访问验证方式。主要分为以下几种:

(1)输入类型验证码

这是最常见的。通过用户输入图片中的字母、数字、汉字等字符进行验证。

图中CAPTCHA的全称是(Completely Automated Public Turing test to tell Computers and Humans Apart),中文翻译为:自动图灵测试,区分计算机和人类。实现这一点的方法很简单,就是提出一个计算机无法回答但人类可以回答的问题。然而,目前的爬虫往往使用深度学习技术来破解此类验证码,这样的图灵测试已经失效。

(2)滑块类型验证码

鉴于输入式图形验证码的缺点,容易被破解,有时人类无法识别。滑块验证码诞生了。这种验证码操作简单,破解难度大,迅速走红。破解滑块验证码有两大难点:一是要知道图形缺口在哪里,也就是要知道滑块在哪里滑动;另一种是模仿人类的滑动手势。这样的验证码增加了一定的难度,也给爬虫世界增添了不少乐趣。一时间出现了大量破解滑块验证码的技术。

(3)点击式图形验证和图标选择

图片和文字验证是提醒用户点击图片中同一个字的位置进行文字验证。

图标选择是给出一组图片,根据需要点击其中一个或多个。

两者原理相似,只是一个给出文字,点击图片中的文字;另一个给出图片并点击与内容匹配的图片。这两种方法的共同点是体验不佳,广受诟病。

(4)手机验证码

对于一些重要敏感信息的访问,网站或者APP一般会提供填写手机验证码的请求,并使用手机接受网站发送的验证码以便进一步访问。这种方法对于数据隐私保护比较好。

4、账号密码登录

网站 您可以通过自己的账号登录来限制爬虫的访问权限。个人在使用很多网站服务时,一般都需要注册一个账号。使用时,需要通过账号密码登录才能继续使用。服务。 网站 用户浏览器cookie可以用来识别用户的身份,通过用户本地浏览器中存储的加密cookie数据可以跟踪用户的访问会话。这一般作为之前防爬方法的补充。

五种爬虫技术的发展方向

传统网络爬虫最大的应用场景是搜索引擎。普通公司多做网站或应用。后来随着网络数据分析的需要,以及互联网上层出不穷的舆论事件,对网络爬虫的需求量很大。 采集的目标主要是新闻信息。

近年来,由于大数据处理和数据挖掘技术的发展,数据资产价值的概念已经深入人心,爬虫技术得到更加广泛和深入的发展,< @采集对象也更丰富,高性能,并发公式的技术指标也更高。

关于网络爬虫合法性的讨论依然存在,而且情况更加复杂。在目前的趋势下,很多法律问题还处于一个模糊的领域,往往取决于具体案件的影响。但是,可以肯定的是,只要有互联网,就会有网络爬虫。只有网络爬虫才能让庞大的互联网变得可搜索,让爆炸式增长的互联网更容易被访问和获取。在可预见的未来,互联网爬虫技术将继续发展。

作为人类历史上最大的知识仓库,互联网是非结构化或非标准化的。互联网上聚集了大量的文字、图片、多媒体等数据。虽然内容很有价值,但是提取知识的难度还是非常巨大的。语义互联网、知识共享等概念越来越流行,真正的语义互联网将成为网络爬虫的目标。此外,物联网技术的发展将是互联网的升级形态,也是未来爬虫技术的发展方向。

动态网页抓取( 基于python(asynchronousjavascriptandxml)的动态网页爬虫系统及其开发方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-17 17:03

基于python(asynchronousjavascriptandxml)的动态网页爬虫系统及其开发方法)

本发明属于计算机领域,涉及爬虫系统,尤其是一种动态网页爬虫系统。

背景技术

网络爬虫是一种自动提取网页的程序。传统爬虫从一个或多个初始网页的url开始,获取初始网页上的url(统一资源定位器),在抓取网页的过程中不断从当前页面中提取。新的url被放入队列中,直到满足系统预设的停止条件。

随着互联网从web1.0时代迅速进入web1.0时代,基于ajax(异步javascript和xml)的动态页面加载技术成为各大公司的首选。随着移动互联网的兴起,javascript在移动端和pc端的优秀特性被广泛挖掘,基于前端mvc/mvm的模型逐渐进入各大互联网公司的首选方案。动态网页的迅速崛起使得基于动态网页的网络爬虫越来越重要。

例如,一个 网站? courseid=id#/学习/视频?课程ID=课程ID&c。通常,对于动态url对应的动态页面,后面跟问号、等号等字符的参数就是要查询的数据库数据。获取动态页面的数据,一般是通过脚本解析或者使用浏览器渲染动态网页来获取动态网页内容。但是,脚本解析的前提是要确定异步加载信息中存在部分或全部目标动态网页信息,并且请求规则可以是获取和目标页面有规律的分布;使用浏览器渲染只能针对不完整的DOM(文档对象模型)数据结构,而部分或全部的目标信息存在于使用浏览器渲染中。

技术实施要素:

为了解决脚本解析和浏览器渲染的局限性,提高动态网页爬取的准确性和完整性,本发明提供了一种基于scrapy的方法(scrapy是一种基于python开发的快速、高级的屏幕爬取和网页) .爬虫框架)动态网络爬虫系统,包括爬虫引擎、调度器、解析模块、项目管道、下载器,爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器,用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;

解析模块包括脚本解析器、渲染器和切换模块;

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

作为本发明的一个优选方案,渲染器为无界面浏览器。

作为本发明的一个优选方案,无界面浏览器包括selenium、splash、htmlunit、phantomjs。在本发明的一个实施例中,无界面浏览器使用闪屏渲染容器来渲染动态网页。

为了避免使用动态解析或浏览器渲染来提取动态网页的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本。然后交给脚本解析器或渲染器进行爬取,记录爬取信息的完整性、爬取时间、资源消耗。

本发明第二方面的目的在于提供一种动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:

根据动态网页或URL信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。

进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

作为本发明的一个优选方案,所述渲染包括:使用无界面浏览器渲染异步加载的信息,使用无界面浏览器的api模拟用户点击,从模拟事件的结果中提取目标信息.

作为本发明的一个优选方案,脚本解析和渲染混合的具体步骤如下:通过脚本解析获取动态网页的请求规则,然后通过非界面浏览器加载,利用脚本解析缺失的渲染参数构造完整的请求规则,直到获得完整的异步加载信息。

作为本发明的优选方案,s4中的优先级算法如下:以提取的动态页面提取信息的完整性、时间、资源消耗率为变量,采用单纯形法得到最优解。

本发明的有益效果是:

1.本发明对目前大部分动态网页网站的结构和常规动态网页的爬取方法进行分析,利用资源消耗低和脚本解析速度快的优点,将webdriver在渲染爬虫的优势,可以提高爬虫的爬取精度和适应性。

2.设置切换模块,避免使用单一爬取方式时,因特殊情况导致无法爬取,陷入死循环的情况。

3.通过预检测机制,对收录不同动态异步加载机制的动态网页采用不同的爬取策略,提高了解析性能,减少了对内存和网络资源的占用,使得本发明对动态页面的爬取更具自适应性和智能性。

图纸说明

图1为本发明的基本原理图;

图2为本发明的解析模块框架示意图;

图3是本发明的动态爬取方法的流程图;

图4是本发明采用脚本解析动态网页的流程图;

图5是本发明中采用脚本通过服务器认证结构分析动态网页的组成;

如图。图6是本发明中脚本解析和渲染的流程图。

详细说明

为更好地理解本发明所提出的技术方案,下面结合附图1-6和具体实施例对本发明作进一步的说明。

如图1和图2所示,动态网络爬虫系统包括爬虫引擎、调度器、解析模块、项目管道和下载器。

爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;解析模块包括脚本解析器、渲染器和切换模块,

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

在本发明的一个实施例中,切换阈值时间选择为150ms,即当脚本解析或渲染器解析动态页面超过150ms仍无法返回时,切换器切换未解析的url使用的方法。

在本发明的另一个实施例中,考虑到现有爬虫系统可以是分布式架构,可以优化解析时间和资源消耗,因此切换器的切换条件考虑解析出的动态页面的信息是否完整。

在本发明的一个实施例中,渲染器为无界面浏览器,常见的无界面浏览器有benv、browser、launcher、browserjet、casperjs、dalekjsghostbuster、headlessbrowser、htmlunit、jasmine-headless-webkit、jaunt、jbrowserdriver、jedi-爬虫,乐天,噩梦,phantomjs,硒,slimerjs,triflejs,zombie.js。

进一步地,在本发明实施例中,无界面浏览器包括selenium、splash、htmlunit、phantomjs。

进一步地,在本发明的一个实施例中,使用selenium与webdriver或hantomjs相结合的方法进行动态页面提取。

为了避免使用浏览器进行动态解析或渲染的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本,然后提交给脚本解析器或渲染器爬取并记录爬取信息的完整性、爬取时间和资源消耗。

如图4至图6所示,本发明还提供了一种基于上述动态网页爬虫系统的动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:根据动态网页或网站信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

基于以上描述的公开和教导,本发明所属领域的技术人员还可以对上述实施例的相关模块和软件架构进行适应性改变和修改。因此,本发明不限于上述所公开和描述的具体实施例,对本发明的一些修改和变化也应落入本发明权利要求的保护范围之内。此外,虽然在本说明书中使用了一些特定的术语,但这些术语只是为了描述的方便,并不构成对本发明的任何限制。 查看全部

动态网页抓取(

基于python(asynchronousjavascriptandxml)的动态网页爬虫系统及其开发方法)

本发明属于计算机领域,涉及爬虫系统,尤其是一种动态网页爬虫系统。

背景技术

网络爬虫是一种自动提取网页的程序。传统爬虫从一个或多个初始网页的url开始,获取初始网页上的url(统一资源定位器),在抓取网页的过程中不断从当前页面中提取。新的url被放入队列中,直到满足系统预设的停止条件。

随着互联网从web1.0时代迅速进入web1.0时代,基于ajax(异步javascript和xml)的动态页面加载技术成为各大公司的首选。随着移动互联网的兴起,javascript在移动端和pc端的优秀特性被广泛挖掘,基于前端mvc/mvm的模型逐渐进入各大互联网公司的首选方案。动态网页的迅速崛起使得基于动态网页的网络爬虫越来越重要。

例如,一个 网站? courseid=id#/学习/视频?课程ID=课程ID&c。通常,对于动态url对应的动态页面,后面跟问号、等号等字符的参数就是要查询的数据库数据。获取动态页面的数据,一般是通过脚本解析或者使用浏览器渲染动态网页来获取动态网页内容。但是,脚本解析的前提是要确定异步加载信息中存在部分或全部目标动态网页信息,并且请求规则可以是获取和目标页面有规律的分布;使用浏览器渲染只能针对不完整的DOM(文档对象模型)数据结构,而部分或全部的目标信息存在于使用浏览器渲染中。

技术实施要素:

为了解决脚本解析和浏览器渲染的局限性,提高动态网页爬取的准确性和完整性,本发明提供了一种基于scrapy的方法(scrapy是一种基于python开发的快速、高级的屏幕爬取和网页) .爬虫框架)动态网络爬虫系统,包括爬虫引擎、调度器、解析模块、项目管道、下载器,爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器,用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;

解析模块包括脚本解析器、渲染器和切换模块;

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

作为本发明的一个优选方案,渲染器为无界面浏览器。

作为本发明的一个优选方案,无界面浏览器包括selenium、splash、htmlunit、phantomjs。在本发明的一个实施例中,无界面浏览器使用闪屏渲染容器来渲染动态网页。

为了避免使用动态解析或浏览器渲染来提取动态网页的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本。然后交给脚本解析器或渲染器进行爬取,记录爬取信息的完整性、爬取时间、资源消耗。

本发明第二方面的目的在于提供一种动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:

根据动态网页或URL信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。

进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

作为本发明的一个优选方案,所述渲染包括:使用无界面浏览器渲染异步加载的信息,使用无界面浏览器的api模拟用户点击,从模拟事件的结果中提取目标信息.

作为本发明的一个优选方案,脚本解析和渲染混合的具体步骤如下:通过脚本解析获取动态网页的请求规则,然后通过非界面浏览器加载,利用脚本解析缺失的渲染参数构造完整的请求规则,直到获得完整的异步加载信息。

作为本发明的优选方案,s4中的优先级算法如下:以提取的动态页面提取信息的完整性、时间、资源消耗率为变量,采用单纯形法得到最优解。

本发明的有益效果是:

1.本发明对目前大部分动态网页网站的结构和常规动态网页的爬取方法进行分析,利用资源消耗低和脚本解析速度快的优点,将webdriver在渲染爬虫的优势,可以提高爬虫的爬取精度和适应性。

2.设置切换模块,避免使用单一爬取方式时,因特殊情况导致无法爬取,陷入死循环的情况。

3.通过预检测机制,对收录不同动态异步加载机制的动态网页采用不同的爬取策略,提高了解析性能,减少了对内存和网络资源的占用,使得本发明对动态页面的爬取更具自适应性和智能性。

图纸说明

图1为本发明的基本原理图;

图2为本发明的解析模块框架示意图;

图3是本发明的动态爬取方法的流程图;

图4是本发明采用脚本解析动态网页的流程图;

图5是本发明中采用脚本通过服务器认证结构分析动态网页的组成;

如图。图6是本发明中脚本解析和渲染的流程图。

详细说明

为更好地理解本发明所提出的技术方案,下面结合附图1-6和具体实施例对本发明作进一步的说明。

如图1和图2所示,动态网络爬虫系统包括爬虫引擎、调度器、解析模块、项目管道和下载器。

爬虫引擎用于处理数据流和触发事务;

调度器用于接收爬虫引擎或解析模块发送的请求,将请求推入队列调度下载器下载,当爬虫引擎再次请求时返回;

解析模块用于构造或解析动态网页的异步加载信息,分析从下载器中提取的网页中的数据元素;

项目管道用于处理解析器从网页中提取的数据或响应爬虫引擎的请求;

下载器用于响应调度器的任务请求,下载网页内容,并将网页内容返回给解析器;解析模块包括脚本解析器、渲染器和切换模块,

脚本解析器通过网络抓包工具搜索查询动态信息的文件类型,根据动态信息的文件类型对动态信息文件的结构进行建模,构造动态网页的请求规则,解析动态网页中的所有文件。并将动态网页的内容提取出来,交给项目管道;如果解析失败,则交由切换模块处理;

渲染器通过加载动态网页的异步加载信息,构建完整的动态网页dom树,并通过模拟操作解析出动态网页中服务器返回的异步加载内容,直到动态网页内容完整提取。交给切换模块交给脚本解析器处理;

切换模块检测脚本解析器或渲染器解析动态网页所花费的时间以及解析的内容是否完整,如果所需时间超过阈值或内容不完整则切换。

在本发明的一个实施例中,切换阈值时间选择为150ms,即当脚本解析或渲染器解析动态页面超过150ms仍无法返回时,切换器切换未解析的url使用的方法。

在本发明的另一个实施例中,考虑到现有爬虫系统可以是分布式架构,可以优化解析时间和资源消耗,因此切换器的切换条件考虑解析出的动态页面的信息是否完整。

在本发明的一个实施例中,渲染器为无界面浏览器,常见的无界面浏览器有benv、browser、launcher、browserjet、casperjs、dalekjsghostbuster、headlessbrowser、htmlunit、jasmine-headless-webkit、jaunt、jbrowserdriver、jedi-爬虫,乐天,噩梦,phantomjs,硒,slimerjs,triflejs,zombie.js。

进一步地,在本发明实施例中,无界面浏览器包括selenium、splash、htmlunit、phantomjs。

进一步地,在本发明的一个实施例中,使用selenium与webdriver或hantomjs相结合的方法进行动态页面提取。

为了避免使用浏览器进行动态解析或渲染的盲目性,在本发明的一个实施例中,解析模块还包括预解析模块,从url库中随机抽取样本,然后提交给脚本解析器或渲染器爬取并记录爬取信息的完整性、爬取时间和资源消耗。

如图4至图6所示,本发明还提供了一种基于上述动态网页爬虫系统的动态网页提取方法,包括以下步骤:

s1:获取url库,对url库进行聚类分析,如果有聚类,进行步骤s2,如果没有聚类,结束;

s2:从集群中抽取至少一个随机样本url;

s3:使用脚本解析、渲染,或者脚本解析和渲染相结合的方式爬取url;

s4:记录爬取信息的完整性、爬取时间、资源消耗等信息,通过优先级算法选择最优爬虫方案,使用最优方案爬取集群内所有动态网页;

s5:处理爬取信息,执行步骤s1。

作为本发明的一个优选方案,所述脚本解析还包括:根据动态网页或网站信息生成请求规则,通过服务器验证获取访问权限,根据请求规则获取异步加载信息。进一步地,通过服务器的验证包括cookie认证、用户认证、301认证、302认证、图文认证、ip认证。

基于以上描述的公开和教导,本发明所属领域的技术人员还可以对上述实施例的相关模块和软件架构进行适应性改变和修改。因此,本发明不限于上述所公开和描述的具体实施例,对本发明的一些修改和变化也应落入本发明权利要求的保护范围之内。此外,虽然在本说明书中使用了一些特定的术语,但这些术语只是为了描述的方便,并不构成对本发明的任何限制。

动态网页抓取(网络服务器应用上的应用——6.发送给)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-01-17 05:30