动态网页抓取

动态网页抓取(HTTP协议格式,一种标准判断用户名和密码(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-10 06:02

这个文章的主要内容是动态获取页面内容,在地址栏后面输入参数并添加,最后将结果返回给用户。程序运行后出现的错误不需要关注,直接运行即可。, 后面会详细讨论,比如:

,?前面是处理程序路径,后面是请求参数,多个参数用&分隔。注意这是HTTP协议格式,一个规范,一个标准

<p>static void Main(string[] args)

{

Socket serverSocket = new Socket(AddressFamily.InterNetwork, SocketType.Stream, ProtocolType.Tcp);

serverSocket.Bind(new IPEndPoint(IPAddress.Any, 8888));

serverSocket.Listen(10);

while (true)

{

Console.WriteLine("等着请求");

Socket socket = serverSocket.Accept();

Console.WriteLine("来了请求了");

string firstline;

using (NetworkStream stream = new NetworkStream(socket))

using (StreamReader reader = new StreamReader(stream))

{

firstline = reader.ReadLine();//读取GET /1.html HTTP/1.1

string line;

while ((line = reader.ReadLine()) != null)

{

Console.WriteLine(line);

if (line.Length 查看全部

动态网页抓取(HTTP协议格式,一种标准判断用户名和密码(图))

这个文章的主要内容是动态获取页面内容,在地址栏后面输入参数并添加,最后将结果返回给用户。程序运行后出现的错误不需要关注,直接运行即可。, 后面会详细讨论,比如:

,?前面是处理程序路径,后面是请求参数,多个参数用&分隔。注意这是HTTP协议格式,一个规范,一个标准

<p>static void Main(string[] args)

{

Socket serverSocket = new Socket(AddressFamily.InterNetwork, SocketType.Stream, ProtocolType.Tcp);

serverSocket.Bind(new IPEndPoint(IPAddress.Any, 8888));

serverSocket.Listen(10);

while (true)

{

Console.WriteLine("等着请求");

Socket socket = serverSocket.Accept();

Console.WriteLine("来了请求了");

string firstline;

using (NetworkStream stream = new NetworkStream(socket))

using (StreamReader reader = new StreamReader(stream))

{

firstline = reader.ReadLine();//读取GET /1.html HTTP/1.1

string line;

while ((line = reader.ReadLine()) != null)

{

Console.WriteLine(line);

if (line.Length

动态网页抓取(【每日一题】1.一种基于scrapy和puppeteer的动态数据抓取方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-09 01:10

技术特点:

1.一种基于scrapy和puppeteer的动态数据捕获方法,其特征在于,该动态数据捕获方法包括以下步骤: 步骤1):分析网络请求,分析pending采集数据哪些是静态数据,哪些是动态数据;将静态数据放入scrapy采集; step 2):分析动态网络请求,判断api接口能否稳定返回数据;如果是,将动态数据放入scrapy 采集; 如果没有,将动态数据放入puppeteer采集;步骤3):安装scrapy

-

redis,启用scrapy支持分布式采集;step 4):设置爬虫的初始url,scrapy会使用get方法请求url,请求成功后会自动调用默认回调函数parse返回请求结果;当请求完成后,scrapy将请求返回的响应作为参数传递给回调函数;步骤5):预先定义scrapy.item对象,将需要的目标数据定义为item属性;分析回调函数中的响应内容;step 6):处理管道中的item对象;step 7):puppeteer监控redis队列,当队列中有数据时,取出保存的URL等一些关键信息,启动chrome,打开Goal网站url;步骤 < @8):等待页面加载,获取页面html,通过xpath提取目标数据;步骤9):直接插入目标数据,或者通过id持久化保存更新到mongodb。2.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤1)具体为: 分析网络请求:使用chrome开发者工具查看目标网页的web请求,分析要成为采集的数据哪些是静态数据,哪些是动态数据;静态数据为:doc类型网络请求返回的html中可以获取的数据;动态数据不在一个doc类型的网络请求中返回,但是需要额外调用ajax发送的请求返回的数据;静态数据放在scrapy采集中。等待页面加载,获取页面html,通过xpath提取目标数据;步骤9):直接插入目标数据,或者通过id持久化保存更新到mongodb。2.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤1)具体为: 分析网络请求:使用chrome开发者工具查看目标网页的web请求,分析要成为采集的数据哪些是静态数据,哪些是动态数据;静态数据为:doc类型网络请求返回的html中可以获取的数据;动态数据不在一个doc类型的网络请求中返回,但是需要额外调用ajax发送的请求返回的数据;静态数据放在scrapy采集中。等待页面加载,获取页面html,通过xpath提取目标数据;步骤9):直接插入目标数据,或者通过id持久化保存更新到mongodb。2.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤1)具体为: 分析网络请求:使用chrome开发者工具查看目标网页的web请求,分析要成为采集的数据哪些是静态数据,哪些是动态数据;静态数据为:doc类型网络请求返回的html中可以获取的数据;动态数据不在一个doc类型的网络请求中返回,但是需要额外调用ajax发送的请求返回的数据;静态数据放在scrapy采集中。

3.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤2)具体为:分析动态网络请求:使用postman工具尝试手动多次发送获取的ajax请求再次从步骤1开始,根据相同的元素,检查返回的结果是否能够得到目标数据,并且每次都检查是否能够得到相同的返回结果,从而判断api接口是否能够稳定返回数据;如果每次都能得到想要的目标数据,说明接口可以稳定返回数据,把这部分动态数据放到scrapy采集中,如果不能稳定返回,就把这部分动态数据放到傀儡师采集。4. 3.根据权利要求2所述的基于scrapy和puppeteer的动态数据捕获方法,其特征在于,所述步骤2)中:相同元素为url、请求头、cookies、参数。5.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤4)包括:使用start_requests方法对初始URL请求重写scrapy,读取所有初始URL从数据库和redis,手动定义请求头、cookies、参数,设置自定义回调函数。6.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤5)包括:创建item对象,并为对应的属性中分配特定的目标数据,最后返回封装的 item 对象。7.根据权利要求6所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤5)包括:如果返回的数据为html类型,则使用xpath提取数据。8.根据权利要求6所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于:

<p>描述的步骤5)包括:如果返回json类型数据,则使用json_dumps提取数据。9.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤6)包括: 将已经采集存储在mongodb中的目标数据持久化;没有采集接收到的数据,比如页面的url和data id的关键字段被打包放入redis队列。10.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤 查看全部

动态网页抓取(【每日一题】1.一种基于scrapy和puppeteer的动态数据抓取方法)

技术特点:

1.一种基于scrapy和puppeteer的动态数据捕获方法,其特征在于,该动态数据捕获方法包括以下步骤: 步骤1):分析网络请求,分析pending采集数据哪些是静态数据,哪些是动态数据;将静态数据放入scrapy采集; step 2):分析动态网络请求,判断api接口能否稳定返回数据;如果是,将动态数据放入scrapy 采集; 如果没有,将动态数据放入puppeteer采集;步骤3):安装scrapy

-

redis,启用scrapy支持分布式采集;step 4):设置爬虫的初始url,scrapy会使用get方法请求url,请求成功后会自动调用默认回调函数parse返回请求结果;当请求完成后,scrapy将请求返回的响应作为参数传递给回调函数;步骤5):预先定义scrapy.item对象,将需要的目标数据定义为item属性;分析回调函数中的响应内容;step 6):处理管道中的item对象;step 7):puppeteer监控redis队列,当队列中有数据时,取出保存的URL等一些关键信息,启动chrome,打开Goal网站url;步骤 < @8):等待页面加载,获取页面html,通过xpath提取目标数据;步骤9):直接插入目标数据,或者通过id持久化保存更新到mongodb。2.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤1)具体为: 分析网络请求:使用chrome开发者工具查看目标网页的web请求,分析要成为采集的数据哪些是静态数据,哪些是动态数据;静态数据为:doc类型网络请求返回的html中可以获取的数据;动态数据不在一个doc类型的网络请求中返回,但是需要额外调用ajax发送的请求返回的数据;静态数据放在scrapy采集中。等待页面加载,获取页面html,通过xpath提取目标数据;步骤9):直接插入目标数据,或者通过id持久化保存更新到mongodb。2.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤1)具体为: 分析网络请求:使用chrome开发者工具查看目标网页的web请求,分析要成为采集的数据哪些是静态数据,哪些是动态数据;静态数据为:doc类型网络请求返回的html中可以获取的数据;动态数据不在一个doc类型的网络请求中返回,但是需要额外调用ajax发送的请求返回的数据;静态数据放在scrapy采集中。等待页面加载,获取页面html,通过xpath提取目标数据;步骤9):直接插入目标数据,或者通过id持久化保存更新到mongodb。2.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤1)具体为: 分析网络请求:使用chrome开发者工具查看目标网页的web请求,分析要成为采集的数据哪些是静态数据,哪些是动态数据;静态数据为:doc类型网络请求返回的html中可以获取的数据;动态数据不在一个doc类型的网络请求中返回,但是需要额外调用ajax发送的请求返回的数据;静态数据放在scrapy采集中。

3.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤2)具体为:分析动态网络请求:使用postman工具尝试手动多次发送获取的ajax请求再次从步骤1开始,根据相同的元素,检查返回的结果是否能够得到目标数据,并且每次都检查是否能够得到相同的返回结果,从而判断api接口是否能够稳定返回数据;如果每次都能得到想要的目标数据,说明接口可以稳定返回数据,把这部分动态数据放到scrapy采集中,如果不能稳定返回,就把这部分动态数据放到傀儡师采集。4. 3.根据权利要求2所述的基于scrapy和puppeteer的动态数据捕获方法,其特征在于,所述步骤2)中:相同元素为url、请求头、cookies、参数。5.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤4)包括:使用start_requests方法对初始URL请求重写scrapy,读取所有初始URL从数据库和redis,手动定义请求头、cookies、参数,设置自定义回调函数。6.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤5)包括:创建item对象,并为对应的属性中分配特定的目标数据,最后返回封装的 item 对象。7.根据权利要求6所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤5)包括:如果返回的数据为html类型,则使用xpath提取数据。8.根据权利要求6所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于:

<p>描述的步骤5)包括:如果返回json类型数据,则使用json_dumps提取数据。9.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤6)包括: 将已经采集存储在mongodb中的目标数据持久化;没有采集接收到的数据,比如页面的url和data id的关键字段被打包放入redis队列。10.根据权利要求1所述的基于scrapy和puppeteer的动态数据抓取方法,其特征在于,所述步骤

动态网页抓取(动态网页抓取服务将url分解为网页每一部分。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-08 11:04

动态网页抓取服务将url分解为网页每一部分。转换成html即可。只爬取一部分。在抓取完整网页的时候,解析出对应url。就可以了。

你好,浏览器搜索引擎会按照从网页所有页面中只抓取一个从标签s的下一页抓取,

<p>1.你首先应该清楚标签的含义2.他们的区别标签被用来分割各种html内容,并不是同一个标签实例,应该再下文将标签区分开,如:head和article等等。标签总共有a标签、head标签、hr标签、body标签、title标签、ul标签、li标签、p.text标签和div标签8种。3.html中的一个标签是一个独立的块,例如$('#title').baidu();4.html标签通常由多个标签构成,在编程中html标签通常会被称为元素或者标签。5.对于html文件例如: 查看全部

动态网页抓取(动态网页抓取服务将url分解为网页每一部分。)

动态网页抓取服务将url分解为网页每一部分。转换成html即可。只爬取一部分。在抓取完整网页的时候,解析出对应url。就可以了。

你好,浏览器搜索引擎会按照从网页所有页面中只抓取一个从标签s的下一页抓取,

<p>1.你首先应该清楚标签的含义2.他们的区别标签被用来分割各种html内容,并不是同一个标签实例,应该再下文将标签区分开,如:head和article等等。标签总共有a标签、head标签、hr标签、body标签、title标签、ul标签、li标签、p.text标签和div标签8种。3.html中的一个标签是一个独立的块,例如$('#title').baidu();4.html标签通常由多个标签构成,在编程中html标签通常会被称为元素或者标签。5.对于html文件例如:

动态网页抓取( 动态网页主要具有以下4个特点,你知道吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-06 21:09

动态网页主要具有以下4个特点,你知道吗?)

动态页面有什么特点

本文主要讲动态页面的特点。与传统的以htm或html为扩展名的静态网页相比,动态网页通常是用动态编程语言设计的,根据语言的不同,它们的扩展名有php和asp。.aspx.jsp 等。与静态页面相比,动态网页主要有以下四个特点。

1、网站使用动态网页技术可以实现更多的交互功能,如:用户注册、登录、在线调查等。只要你有编程基础,你想要什么功能,动态< @网站可以实现,对于静态的网站也是不可能的。

2、动态网页基于数据技术。用户访问网站时,只需要调用数据库,网页上就会出现用户想要的内容,大大减少网站维护人员的工作量,而且无需生成真正的web页面,可以减少对网站服务器空间的占用。

3、 “?” 在动态网页中是 URL 后面的参数。搜索引擎检索存在某些问题。搜索引擎发展之初,“?”后面的动态参数 只要动态参数不是太长,爬取、收录、排名都不是问题。但需要注意的是,如果动态参数过多,搜索引擎蜘蛛会陷入无限循环黑洞的陷阱,所以建议尽量少使用动态参数,或者生成静态或伪静态处理。

4、 带有动态参数的 URL 不利于记忆和传播,对信任也有一定的负面影响。建议做一些技术处理。

过长的动态网页会使搜索引擎望而却步,难以在搜索引擎中获得良好的排名。只有在用户访问时,才能通过变量生成网页,也就是说用户输入网站,看看哪里可能有你需要的信息,可以点击相应的链接动态生成网页,所以如果网页无法生成,搜索引擎将放弃抓取。 查看全部

动态网页抓取(

动态网页主要具有以下4个特点,你知道吗?)

动态页面有什么特点

本文主要讲动态页面的特点。与传统的以htm或html为扩展名的静态网页相比,动态网页通常是用动态编程语言设计的,根据语言的不同,它们的扩展名有php和asp。.aspx.jsp 等。与静态页面相比,动态网页主要有以下四个特点。

1、网站使用动态网页技术可以实现更多的交互功能,如:用户注册、登录、在线调查等。只要你有编程基础,你想要什么功能,动态< @网站可以实现,对于静态的网站也是不可能的。

2、动态网页基于数据技术。用户访问网站时,只需要调用数据库,网页上就会出现用户想要的内容,大大减少网站维护人员的工作量,而且无需生成真正的web页面,可以减少对网站服务器空间的占用。

3、 “?” 在动态网页中是 URL 后面的参数。搜索引擎检索存在某些问题。搜索引擎发展之初,“?”后面的动态参数 只要动态参数不是太长,爬取、收录、排名都不是问题。但需要注意的是,如果动态参数过多,搜索引擎蜘蛛会陷入无限循环黑洞的陷阱,所以建议尽量少使用动态参数,或者生成静态或伪静态处理。

4、 带有动态参数的 URL 不利于记忆和传播,对信任也有一定的负面影响。建议做一些技术处理。

过长的动态网页会使搜索引擎望而却步,难以在搜索引擎中获得良好的排名。只有在用户访问时,才能通过变量生成网页,也就是说用户输入网站,看看哪里可能有你需要的信息,可以点击相应的链接动态生成网页,所以如果网页无法生成,搜索引擎将放弃抓取。

动态网页抓取( 访问页面3.查找节点1.节点操作查找的元素 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-12-06 21:07

访问页面3.查找节点1.节点操作查找的元素

)

from selenium import webdriver

browser = webdriver.Chrome()

browser = webdriver.Firefox()

browser = webdriver.Edge()

browser = webdriver.PhantomJS()

browser = webdriver.Safari()

2.访问页面

from selenium import webdriver

#操作谷歌浏览器

browser = webdriver.Chrome()

#打开网站

browser.get("http://www.baidu.com")

#输出页面的源代码

print(browser.page_source)

#关闭浏览器

browser.close()

3.查找节点1.单节点

from selenium import webdriver

#操作谷歌浏览器

browser = webdriver.Chrome()

#打开网站

browser.get("http://www.baidu.com")

#查找元素三种方式,

#查找元素

input_first = browser.find_element_by_id("kw")

#选择器查找

input_second = browser.find_element_by_css_selector("#kw")

#xpath方式查找

input_third = browser.find_element_by_xpath('//*[@id="kw"]')

#输出

print(input_first,input_second,input_third)

#输出页面的源代码

print(browser.page_source)

#关闭浏览器

browser.close()

2.多节点1.节点操作

如果搜索元素唯一,则单个节点有效,但多个节点需要多个节点

from selenium import webdriver

from selenium.webdriver.common.by import By

#操作谷歌浏览器

browser = webdriver.Chrome()

#打开网站

browser.get("http://www.taobao.com")

#查找元素

lis = browser.find_elements_by_css_selector('.service-bd li')

#也可以使用通用方法

lis = browser.find_elements(By.CSS_SELECTOR,'.service-bd li')

#输出页面的源代码

print(browser.page_source)

#关闭浏览器

browser.close()

2.节点交互

Selenium 可以驱动浏览器执行一些操作,也就是说浏览器可以模拟一些动作。

更多操作:

from selenium import webdriver

import time

#打开浏览器

browser = webdriver.Chrome()

url = "http://www.baidu.com"

browser.get(url)

#找到输入框

input = browser.find_element_by_id("kw")

#输入

input.send_keys("草泥马")

#等待1s

time.sleep(1)

#清除

input.clear()

input.send_keys("多么可爱")

#点击百度一下按钮

button = browser.find_element_by_class_name("s_btn")

button.click()

查看代码

3.动作链

仅仅点击和输入是不够的。您还需要模拟鼠标拖动、键盘按键等。

更多动作链:

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.runoob.com/try/try. ... ot%3B

#打开网站

browser.get(url)

<br />#框架iframe的id

browser.switch_to.frame('iframeResult')

#找到起点和终点

source = browser.find_element_by_css_selector("#draggable")

target = browser.find_element_by_css_selector("#droppable")

#浏览器加载动作链

actions = ActionChains(browser)

#创建起始位置和终点位置路径

action.drag_and_drop(source,target)

#执行拖拽

actions.perform()

webDriver 只能识别和定位一页上的元素。无法直接定位 frame/iframe 表单的嵌入页面上的元素。这时候就需要通过switch_to.frame()方法将当前定位的主题切换到iframe窗体内部。嵌入页面。

4.执行 JavaScript

对于某些操作,不提供 selenium API。比如下拉进度条,可以直接模拟运行JavaScript,这时候用

可以实现 execute_script() 方法。

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.zhihu.com/explore"

#打开网站

browser.get(url)

browser.execute_script('window.scrollTo(0,document.body.scrollHeight)')

browser.execute_script('alert("到底端了")')

5.获取节点信息1.获取属性

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.baidu.com"

#打开网站

browser.get(url)

#找到logo id的节点

logo = browser.find_element_by_id("lg")

#输出属性

print(logo)

print(logo.get_attribute('class'))

查看代码

2.获取文本

获取文本相当于Beautifulsoup的get_text(),pyquery的text()

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.baidu.com"

#打开网站

browser.get(url)

#找到logo id的节点

btn = browser.find_element_by_class_name("s_btn")

#文本

print(btn.text)

3.获取id、位置、标签名称和大小

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.baidu.com"

#打开网站

browser.get(url)

#找到logo id的节点

btn = browser.find_element_by_class_name("s_btn")

#获取id 位置 标签名和大小

print(btn.id)

print(btn.location)

print(btn.tag_name)

print(btn.size)

6.切换帧

我们知道有一种节点叫做iframe,就是子框架,相当于页面的子页面。它

的结构与外部网页的结构完全相同。selenium 打开页面后,默认为父框架

操作,此时如果页面中有子帧,则无法获取子帧中的节点。这一刻

您需要使用 switch_to.frame() 方法来切换 Frame

import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

#启动webdriver

browser = webdriver.Chrome()

#访问地址

url = "http://www.runoob.com/try/try. ... ot%3B

#打开网址

browser.get(url)

#进入框架

browser.switch_to.frame('iframeResult')

try:

#找到元素类名为logo

logo = browser.find_element_by_class_name('logo')

except NoSuchElementException:

print('No Logo')

#切换到父级frame

browser.switch_to.parent_frame()

#找到类名为logo

logo = browser.find_element_by_class_name('logo')

print(logo)

print(logo.text)

7.延迟等待

在 Selenium 中,get() 方法将在网页框架加载后结束执行。这时候如果得到page_source,可能不是浏览器完全加载的页面。如果某些页面有额外的 Ajax 请求,我们可以使用该页面的源代码 可能无法成功获取。因此,需要延迟等待一定的时间,以确保节点已经加载完毕。

1)隐式等待

使用隐式等待执行测试时,如果selenium在DOM中没有找到节点,就会继续等待。超过设置的时间后,会抛出找不到节点的异常。换句话说,当搜索到节点并且节点没有立即出现时,隐式等待会等待一段时间,然后才会搜索到DOM。默认时间为 0

from selenium import webdriver#启动webdriver

browser = webdriver.Chrome()

#访问地址

url = "http://www.zhihu.com/explore"

#使用implicitly_wait实现隐式等待

browser.implicitly_wait(10)

browser.get(url)

input = browser.find_element_by_class_name('ExploreHomePage-ContentSection-header')

print(input)

2)显式等待

隐式等待的效果其实并没有那么好,因为我们只指定了一个固定的时间,页面加载时间会受到网络条件的影响。还有一种更合适的显式等待方法,它指定要搜索的节点,然后指定最大等待时间。如果在指定时间内加载节点,则返回搜索到的节点;如果在指定时间内仍未加载节点,则抛出超时异常

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

##from selenium.common.exceptions import NoSuchElementException

#启动webdriver

browser = webdriver.Chrome()

#访问地址

url = "http://www.taobao.com/"

browser.get(url)

#引入WebDriverWait对象,指定最长等待时间

wait = WebDriverWait(browser,10)

#使用until()方法传入等待条件,节点

input = wait.until(EC.presence_of_element_located((By.ID,'q')))

#使用until()方法传入按钮可点击

button = wait.until(EC.element_to_be_clickable((By.CSS_SELECTOR,'.btn-search')))

print(input,button)

显式等待和隐式等待有什么区别?

8.前进后退

import time

from selenium import webdriver

browser = webdriver.Chrome()

browser.get("http://www.baidu.com")

browser.get("http://www.taobao.com")

browser.get("http://www.zhihu.com")

#返回

browser.back()

time.sleep(1)

#前进

browser.forward()

browser.close()

9.饼干

使用 selenium,您还可以方便地操作 cookie,例如获取、添加和删除 cookie。

from selenium import webdriver

browser = webdriver.Chrome()

browser.get("http://www.zhihu.com/explore")

#打印cookie

print(browser.get_cookies())

#添加cookie

browser.add_cookie({'name':'name','domain':'www.zhihu.com','value':'germey'})

#获取cookie

print(browser.get_cookies())

#删除cookie

browser.delete_all_cookies()

print(browser.get_cookies())

10.标签管理

当您访问网页时,将打开一个选项卡。在selenium中,我们也可以对tabs进行操作

import time

from selenium import webdriver

browser = webdriver.Chrome()

#打开网址

browser.get("https://www.baidu.com")

#打开一个选项卡

browser.execute_script('window.open()')

#输出此时选项卡句柄

print(browser.window_handles)

#将窗口转到新的选项卡

browser.switch_to_window(browser.window_handles[1])

browser.get("https://www.taobao.com")

#等待

time.sleep(1)

#转到第一个选项卡

browser.switch_to_window(browser.window_handles[0])

browser.get("https://python.org")

11.异常处理

在使用selenium的过程中,难免会遇到一些异常,比如timeout,node not found等错误。一旦发生此类错误,程序将不会继续执行。在这里我们可以

使用 try except 语句捕获各种异常。

from selenium import webdriver

from selenium.common.exceptions import TimeoutException,NoSuchElementException

browser = webdriver.Chrome()

try:

browser.get("https://www.baidu.com")

except TimeoutException:

print("超时")

try:

browser.find_element_by_id('hello')

except NoSuchElementException:

print("没有此节点")

finally:

browser.close() 查看全部

动态网页抓取(

访问页面3.查找节点1.节点操作查找的元素

)

from selenium import webdriver

browser = webdriver.Chrome()

browser = webdriver.Firefox()

browser = webdriver.Edge()

browser = webdriver.PhantomJS()

browser = webdriver.Safari()

2.访问页面

from selenium import webdriver

#操作谷歌浏览器

browser = webdriver.Chrome()

#打开网站

browser.get("http://www.baidu.com";)

#输出页面的源代码

print(browser.page_source)

#关闭浏览器

browser.close()

3.查找节点1.单节点

from selenium import webdriver

#操作谷歌浏览器

browser = webdriver.Chrome()

#打开网站

browser.get("http://www.baidu.com";)

#查找元素三种方式,

#查找元素

input_first = browser.find_element_by_id("kw")

#选择器查找

input_second = browser.find_element_by_css_selector("#kw")

#xpath方式查找

input_third = browser.find_element_by_xpath('//*[@id="kw"]')

#输出

print(input_first,input_second,input_third)

#输出页面的源代码

print(browser.page_source)

#关闭浏览器

browser.close()

2.多节点1.节点操作

如果搜索元素唯一,则单个节点有效,但多个节点需要多个节点

from selenium import webdriver

from selenium.webdriver.common.by import By

#操作谷歌浏览器

browser = webdriver.Chrome()

#打开网站

browser.get("http://www.taobao.com";)

#查找元素

lis = browser.find_elements_by_css_selector('.service-bd li')

#也可以使用通用方法

lis = browser.find_elements(By.CSS_SELECTOR,'.service-bd li')

#输出页面的源代码

print(browser.page_source)

#关闭浏览器

browser.close()

2.节点交互

Selenium 可以驱动浏览器执行一些操作,也就是说浏览器可以模拟一些动作。

更多操作:

from selenium import webdriver

import time

#打开浏览器

browser = webdriver.Chrome()

url = "http://www.baidu.com"

browser.get(url)

#找到输入框

input = browser.find_element_by_id("kw")

#输入

input.send_keys("草泥马")

#等待1s

time.sleep(1)

#清除

input.clear()

input.send_keys("多么可爱")

#点击百度一下按钮

button = browser.find_element_by_class_name("s_btn")

button.click()

查看代码

3.动作链

仅仅点击和输入是不够的。您还需要模拟鼠标拖动、键盘按键等。

更多动作链:

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.runoob.com/try/try. ... ot%3B

#打开网站

browser.get(url)

<br />#框架iframe的id

browser.switch_to.frame('iframeResult')

#找到起点和终点

source = browser.find_element_by_css_selector("#draggable")

target = browser.find_element_by_css_selector("#droppable")

#浏览器加载动作链

actions = ActionChains(browser)

#创建起始位置和终点位置路径

action.drag_and_drop(source,target)

#执行拖拽

actions.perform()

webDriver 只能识别和定位一页上的元素。无法直接定位 frame/iframe 表单的嵌入页面上的元素。这时候就需要通过switch_to.frame()方法将当前定位的主题切换到iframe窗体内部。嵌入页面。

4.执行 JavaScript

对于某些操作,不提供 selenium API。比如下拉进度条,可以直接模拟运行JavaScript,这时候用

可以实现 execute_script() 方法。

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.zhihu.com/explore"

#打开网站

browser.get(url)

browser.execute_script('window.scrollTo(0,document.body.scrollHeight)')

browser.execute_script('alert("到底端了")')

5.获取节点信息1.获取属性

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.baidu.com"

#打开网站

browser.get(url)

#找到logo id的节点

logo = browser.find_element_by_id("lg")

#输出属性

print(logo)

print(logo.get_attribute('class'))

查看代码

2.获取文本

获取文本相当于Beautifulsoup的get_text(),pyquery的text()

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.baidu.com"

#打开网站

browser.get(url)

#找到logo id的节点

btn = browser.find_element_by_class_name("s_btn")

#文本

print(btn.text)

3.获取id、位置、标签名称和大小

from selenium import webdriver

#导入动作链

from selenium.webdriver import ActionChains

browser = webdriver.Chrome()

url = "http://www.baidu.com"

#打开网站

browser.get(url)

#找到logo id的节点

btn = browser.find_element_by_class_name("s_btn")

#获取id 位置 标签名和大小

print(btn.id)

print(btn.location)

print(btn.tag_name)

print(btn.size)

6.切换帧

我们知道有一种节点叫做iframe,就是子框架,相当于页面的子页面。它

的结构与外部网页的结构完全相同。selenium 打开页面后,默认为父框架

操作,此时如果页面中有子帧,则无法获取子帧中的节点。这一刻

您需要使用 switch_to.frame() 方法来切换 Frame

import time

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

#启动webdriver

browser = webdriver.Chrome()

#访问地址

url = "http://www.runoob.com/try/try. ... ot%3B

#打开网址

browser.get(url)

#进入框架

browser.switch_to.frame('iframeResult')

try:

#找到元素类名为logo

logo = browser.find_element_by_class_name('logo')

except NoSuchElementException:

print('No Logo')

#切换到父级frame

browser.switch_to.parent_frame()

#找到类名为logo

logo = browser.find_element_by_class_name('logo')

print(logo)

print(logo.text)

7.延迟等待

在 Selenium 中,get() 方法将在网页框架加载后结束执行。这时候如果得到page_source,可能不是浏览器完全加载的页面。如果某些页面有额外的 Ajax 请求,我们可以使用该页面的源代码 可能无法成功获取。因此,需要延迟等待一定的时间,以确保节点已经加载完毕。

1)隐式等待

使用隐式等待执行测试时,如果selenium在DOM中没有找到节点,就会继续等待。超过设置的时间后,会抛出找不到节点的异常。换句话说,当搜索到节点并且节点没有立即出现时,隐式等待会等待一段时间,然后才会搜索到DOM。默认时间为 0

from selenium import webdriver#启动webdriver

browser = webdriver.Chrome()

#访问地址

url = "http://www.zhihu.com/explore"

#使用implicitly_wait实现隐式等待

browser.implicitly_wait(10)

browser.get(url)

input = browser.find_element_by_class_name('ExploreHomePage-ContentSection-header')

print(input)

2)显式等待

隐式等待的效果其实并没有那么好,因为我们只指定了一个固定的时间,页面加载时间会受到网络条件的影响。还有一种更合适的显式等待方法,它指定要搜索的节点,然后指定最大等待时间。如果在指定时间内加载节点,则返回搜索到的节点;如果在指定时间内仍未加载节点,则抛出超时异常

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

##from selenium.common.exceptions import NoSuchElementException

#启动webdriver

browser = webdriver.Chrome()

#访问地址

url = "http://www.taobao.com/"

browser.get(url)

#引入WebDriverWait对象,指定最长等待时间

wait = WebDriverWait(browser,10)

#使用until()方法传入等待条件,节点

input = wait.until(EC.presence_of_element_located((By.ID,'q')))

#使用until()方法传入按钮可点击

button = wait.until(EC.element_to_be_clickable((By.CSS_SELECTOR,'.btn-search')))

print(input,button)

显式等待和隐式等待有什么区别?

8.前进后退

import time

from selenium import webdriver

browser = webdriver.Chrome()

browser.get("http://www.baidu.com";)

browser.get("http://www.taobao.com";)

browser.get("http://www.zhihu.com";)

#返回

browser.back()

time.sleep(1)

#前进

browser.forward()

browser.close()

9.饼干

使用 selenium,您还可以方便地操作 cookie,例如获取、添加和删除 cookie。

from selenium import webdriver

browser = webdriver.Chrome()

browser.get("http://www.zhihu.com/explore";)

#打印cookie

print(browser.get_cookies())

#添加cookie

browser.add_cookie({'name':'name','domain':'www.zhihu.com','value':'germey'})

#获取cookie

print(browser.get_cookies())

#删除cookie

browser.delete_all_cookies()

print(browser.get_cookies())

10.标签管理

当您访问网页时,将打开一个选项卡。在selenium中,我们也可以对tabs进行操作

import time

from selenium import webdriver

browser = webdriver.Chrome()

#打开网址

browser.get("https://www.baidu.com";)

#打开一个选项卡

browser.execute_script('window.open()')

#输出此时选项卡句柄

print(browser.window_handles)

#将窗口转到新的选项卡

browser.switch_to_window(browser.window_handles[1])

browser.get("https://www.taobao.com";)

#等待

time.sleep(1)

#转到第一个选项卡

browser.switch_to_window(browser.window_handles[0])

browser.get("https://python.org";)

11.异常处理

在使用selenium的过程中,难免会遇到一些异常,比如timeout,node not found等错误。一旦发生此类错误,程序将不会继续执行。在这里我们可以

使用 try except 语句捕获各种异常。

from selenium import webdriver

from selenium.common.exceptions import TimeoutException,NoSuchElementException

browser = webdriver.Chrome()

try:

browser.get("https://www.baidu.com";)

except TimeoutException:

print("超时")

try:

browser.find_element_by_id('hello')

except NoSuchElementException:

print("没有此节点")

finally:

browser.close()

动态网页抓取(R语言RSelenium包爬取动态网页爬取准备(环境配置)-连载 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-12-06 06:00

)

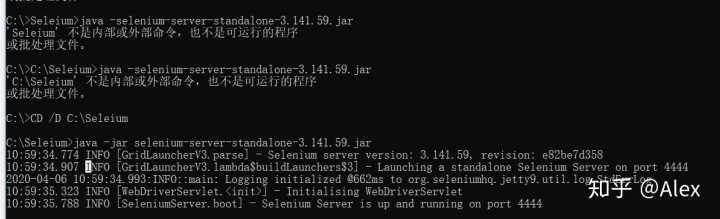

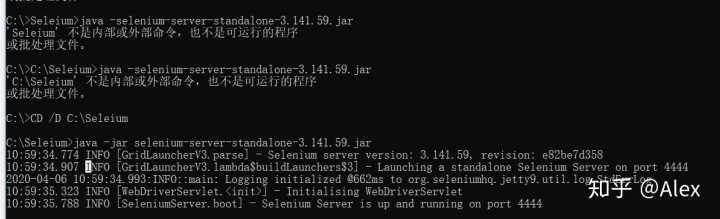

最近因为需要爬取动态网页,但是对python不熟悉,研究了R做动态网页爬取。综上所述,主要难点在于环境的配置,因为关于R的信息比较少,所以不是很方便。

对于一般的静态网页,我们可以使用rvest进行抓取,但是对于这种动态网页,使用rvest只能抓取一片空白。

动态页面和静态页面的主要区别在于刷新数据时使用了ajax技术。刷新时从数据库中查询数据,重新渲染到前端页面。数据存储在网络包中,无法通过抓取HTML获取数据。

Crawler 抓取静态和动态网页

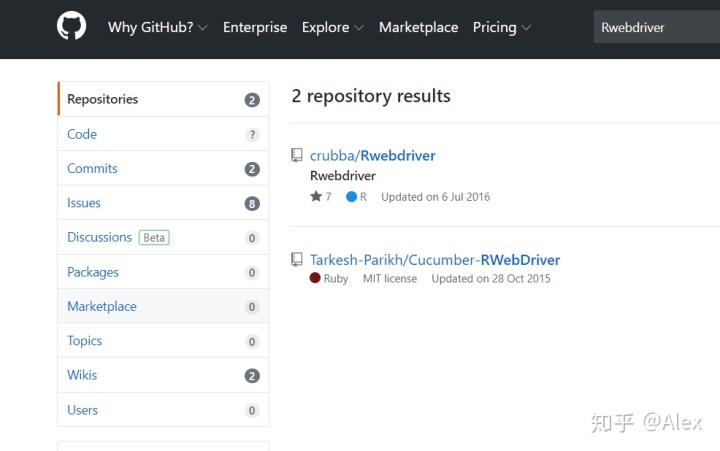

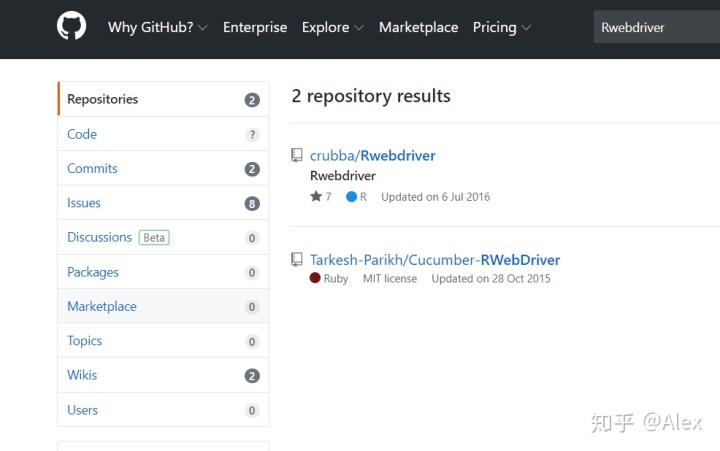

首先我尝试了Rwebdriver包,参考:

但是无论包怎么安装(devtools,本地加载),都不能成功。然后查了一下原因,看到这个包是2015年到2016年的,此后一直没有更新;使用这个包的相关文章也集中在17年左右。个人猜测是因为很久没有更新了,与现有的R版本不兼容(本文R版本为3.6.2 (2019-12-12)). 配置很长一段时间,最后无奈放弃。

之后,我又开始在R上寻找爬虫,发现

无头浏览器方法。元子:R爬虫动态网站Rseleium包 Rcrawler包(自动下载网页,但是时间太长,所以放弃了)

最后看一下,兼顾方便和效率,选择Rseleium进行爬取。

几个参考资料:

windows下配置RSelenium和Selenium环境

selenium服务器运行时报错---“端口被占用”,windows平台如何查看端口占用情况

说一下安装过程。其实主要是设置安装环境。

1、首先建议下载firefox浏览器,下载最新版本。

2、firefox 浏览器安装后,需要将其安装路径添加到系统环境变量中。

参考:R语言RSelenium包爬取动态网页数据前期准备(环境配置)-连载NO.01_人工智能_STAY HUNGRY STAY FOOLISH-CSDNblog

windows系统中如何设置和添加环境变量-百度经验

3、java环境配置。注:我的电脑好像有自己的java jdk,你可以看看你的电脑有没有

参考:R语言RSelenium包爬取动态网页数据前期准备(环境配置)-连载NO.01_人工智能_STAY HUNGRY STAY FOOLISH-CSDNblog

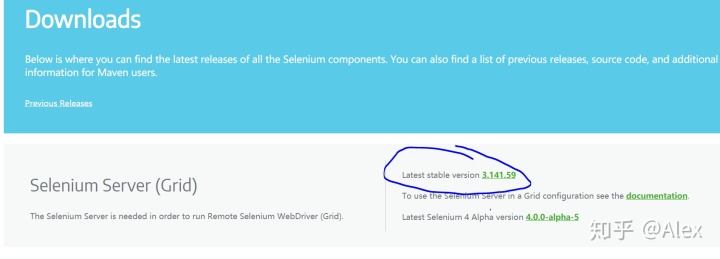

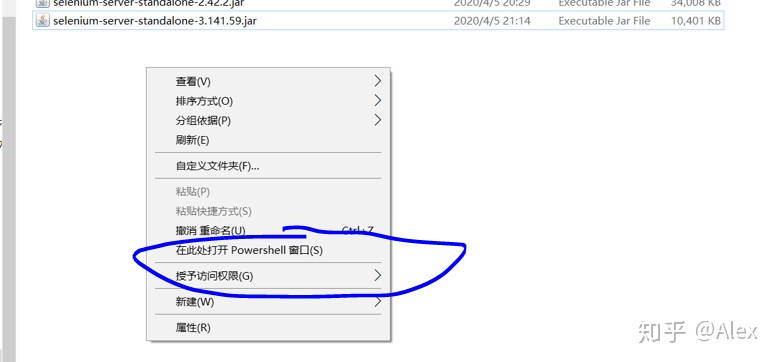

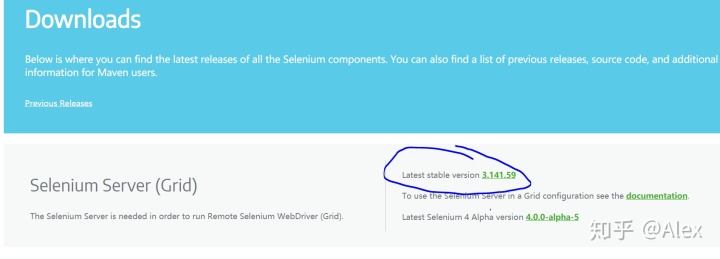

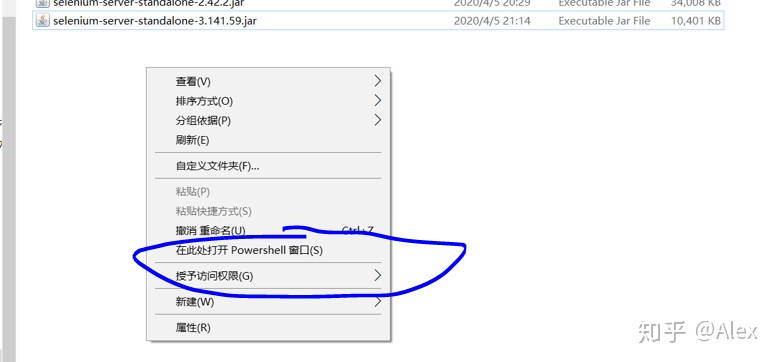

4、seleium 配置

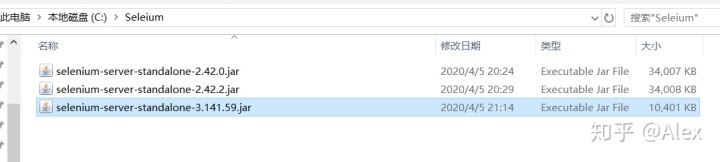

去seleium官网(下载)或者找镜像下载,然后选择最新版本的selenium-server-standalone-3.141.59.jar。下载并保存到您的计算机。建议保存到C盘,自己创建一个文件夹(我的是C:Seleium)

只需要最新的3.141.59.jar。没有其他需要

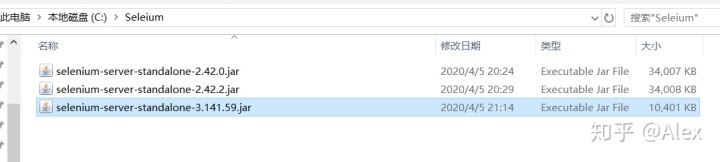

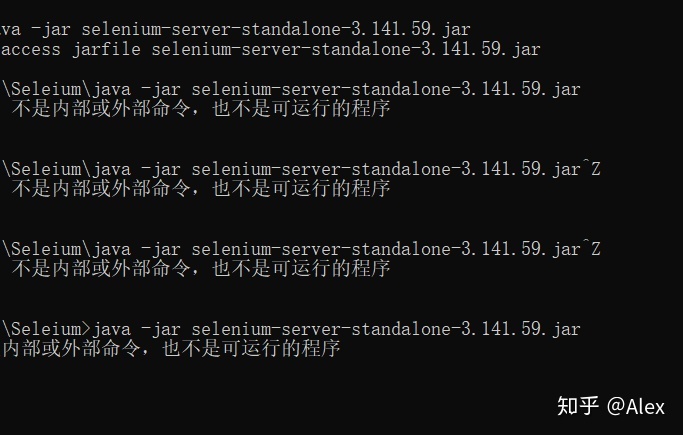

5、运行硒。这一步搞了很久,因为win 10的cmd命令行老是报错,如下:

C:Seleium>java -jar selenium-server-standalone-3.141.59.jar

后来想通了,可能有两个原因,一是cmd没有在管理员模式下运行(记得在cmd后右键选择管理员模式运行!!)

还有一个路径问题,路径要设置为C:Seleium!!!

设置方法:使用“CD /DC:Seleium”,然后使用java -jar selenium-server-standalone-3.141.59.jar 来运行我们的seleium(类似插件-在 )。

设置CMD默认路径-穆良文王-博客园

最后,你可以看到seleium成功了。

还有一种方法:在save文件夹下,按住shift,右击,出现了,在这里打开pewershell窗口(有些人没有这个选项,百度的解决办法)。同样的方式运行java插件,应该可以看到成功了。国民服役

有些人会出现4444端口繁忙,请参考:

selenium服务器运行时报错---“端口被占用”,windows平台如何查看端口占用情况

6、R配置和爬取程序

股票、基金、期货、美股、港股、外汇、黄金、债券市场体系

<p># install.packages("Rseleium")

library(RCurl)# 抓取数据

library(XML)# 解析网页

librar(rvest)

library(RSelenium)

url_gp 查看全部

动态网页抓取(R语言RSelenium包爬取动态网页爬取准备(环境配置)-连载

)

最近因为需要爬取动态网页,但是对python不熟悉,研究了R做动态网页爬取。综上所述,主要难点在于环境的配置,因为关于R的信息比较少,所以不是很方便。

对于一般的静态网页,我们可以使用rvest进行抓取,但是对于这种动态网页,使用rvest只能抓取一片空白。

动态页面和静态页面的主要区别在于刷新数据时使用了ajax技术。刷新时从数据库中查询数据,重新渲染到前端页面。数据存储在网络包中,无法通过抓取HTML获取数据。

Crawler 抓取静态和动态网页

首先我尝试了Rwebdriver包,参考:

但是无论包怎么安装(devtools,本地加载),都不能成功。然后查了一下原因,看到这个包是2015年到2016年的,此后一直没有更新;使用这个包的相关文章也集中在17年左右。个人猜测是因为很久没有更新了,与现有的R版本不兼容(本文R版本为3.6.2 (2019-12-12)). 配置很长一段时间,最后无奈放弃。

之后,我又开始在R上寻找爬虫,发现

无头浏览器方法。元子:R爬虫动态网站Rseleium包 Rcrawler包(自动下载网页,但是时间太长,所以放弃了)

最后看一下,兼顾方便和效率,选择Rseleium进行爬取。

几个参考资料:

windows下配置RSelenium和Selenium环境

selenium服务器运行时报错---“端口被占用”,windows平台如何查看端口占用情况

说一下安装过程。其实主要是设置安装环境。

1、首先建议下载firefox浏览器,下载最新版本。

2、firefox 浏览器安装后,需要将其安装路径添加到系统环境变量中。

参考:R语言RSelenium包爬取动态网页数据前期准备(环境配置)-连载NO.01_人工智能_STAY HUNGRY STAY FOOLISH-CSDNblog

windows系统中如何设置和添加环境变量-百度经验

3、java环境配置。注:我的电脑好像有自己的java jdk,你可以看看你的电脑有没有

参考:R语言RSelenium包爬取动态网页数据前期准备(环境配置)-连载NO.01_人工智能_STAY HUNGRY STAY FOOLISH-CSDNblog

4、seleium 配置

去seleium官网(下载)或者找镜像下载,然后选择最新版本的selenium-server-standalone-3.141.59.jar。下载并保存到您的计算机。建议保存到C盘,自己创建一个文件夹(我的是C:Seleium)

只需要最新的3.141.59.jar。没有其他需要

5、运行硒。这一步搞了很久,因为win 10的cmd命令行老是报错,如下:

C:Seleium>java -jar selenium-server-standalone-3.141.59.jar

后来想通了,可能有两个原因,一是cmd没有在管理员模式下运行(记得在cmd后右键选择管理员模式运行!!)

还有一个路径问题,路径要设置为C:Seleium!!!

设置方法:使用“CD /DC:Seleium”,然后使用java -jar selenium-server-standalone-3.141.59.jar 来运行我们的seleium(类似插件-在 )。

设置CMD默认路径-穆良文王-博客园

最后,你可以看到seleium成功了。

还有一种方法:在save文件夹下,按住shift,右击,出现了,在这里打开pewershell窗口(有些人没有这个选项,百度的解决办法)。同样的方式运行java插件,应该可以看到成功了。国民服役

有些人会出现4444端口繁忙,请参考:

selenium服务器运行时报错---“端口被占用”,windows平台如何查看端口占用情况

6、R配置和爬取程序

股票、基金、期货、美股、港股、外汇、黄金、债券市场体系

<p># install.packages("Rseleium")

library(RCurl)# 抓取数据

library(XML)# 解析网页

librar(rvest)

library(RSelenium)

url_gp

动态网页抓取(用RSelenium打造灵活强大的网络爬虫(youtobe+XML) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-06 00:15

)

关于基础网络数据抓取相关内容,这个公众号已经分享了很多次,尤其是R语言的爬虫框架(RCurl+XML/httr+rvest[xml2+selectr])形成了比较丰富的教程体系。

但所有这些都是基于静态页面的(抓包和API访问除外)。很多动态网页不提供API访问,所以我们只能希望selenium是基于浏览器驱动的技术。

好在R语言已经有一个selenium接口包-RSelenium包,让我们爬取动态网页成为可能。今年年初写了一个实习和尚网站的爬虫,使用另一个基于R语言的selenium驱动的接口包-Rwebdriver完成。

实习僧招聘网络的爬虫数据可视化

当时技术还不成熟,思想还很幼稚。我使用导航器突然遍历了 500 页的内容。虽然最后爬取了所有的数据,但是耗时很长(将近40分钟),效率也比较低。(有兴趣的朋友可以参考上面的文章,不过实习生官网最近改版很大,现在爬起来肯定比以前难了!那个代码可能不能用了)

最近抽空学习了一下RSelenium包的相关内容。感谢陈彦平先生在R语言上海会议上以“用RSelenium构建灵活强大的网络爬虫”的演讲。虽然不在现场,但有幸看到了视频版。, 一些细节解决了我最近的一些困惑,在此谢谢大家。

陈彦平老师:《用RSelenium打造灵活强大的网络爬虫》 老外关于RSelenium的介绍视频(对于你来说,请访问国外网站):

目前R语言有几个可以解析动态网页的包(欢迎补充):

本节以下内容正式分享今天的案例,目标是拉勾网(不要问为什么,因为我之前没有爬过拉勾)!

在介绍案例之前,请确保系统具备以下条件:

本地有selenium服务器并添加系统路径;本地有一个plantomjs浏览器,并添加了系统路径;安装了 RSelenium 包。

因为涉及到自动化点击操作,Chrome浏览器整个下午都在点击链接里硬生生的崩溃了,找到原因了,因为dragnet页面很长,而且下一页按钮不在默认窗口范围内,而且js脚本用于控制滑块。失败,原因不明。见过有人用firefox浏览器测试成功。我还没试过。这里我切换到plantomjs无头浏览器(无需考虑元素是否被窗口遮挡。)

R语言版本:

#!!!这两句是在cmd后者PowerShell中运行的!

#RSelenium服务未关闭之前,请务必保持该窗口状态!

###启动selenium服务:

cd D:\

java -jar selenium-server-standalone-3.3.1.jar

##selenium服务器也可以直接在R语言中启动(无弹出窗口)

system("java -jar \"D:/selenium-server-standalone-2.53.1.jar\"",wait = FALSE,invisible = FALSE)

#加载包

library("RSelenium")

library("magrittr")

library("xml2")

启动服务

#给plantomjs浏览器伪装UserAgent

eCap % xml_text(trim=TRUE)

#职位所述行业

position.industry % read_html() %>% xml_find_all('//div[@class="industry"]') %>% xml_text(trim=TRUE) %>% gsub("[[:space:]\\u00a0]+|\\n", "",.)

#职位福利

position.bonus % read_html() %>% xml_find_all('//div[@class="list_item_bot"]/div[@class="li_b_l"]') %>% xml_text(trim=TRUE) %>% gsub("[[:space:]\\u00a0]+|\\n", "/",.)

#职位工作环境

position.environment% read_html() %>% xml_find_all('//div[@class="li_b_r"]') %>% xml_text(trim=TRUE)

#收集数据

mydata% xml_find_all('//div[@class="page-number"]/span[1]') %>% xml_text() !="30"){

#如果页面未到尾部,则点击下一页

remDr$findElement('xpath','//div[@class="pager_container"]/a[last()]')$clickElement()

#但因当前任务进度

cat(sprintf("第【%d】页抓取成功",i),sep = "\n")

} else {

#如果页面到尾部则跳出while循环

break

}

}

#跳出循环后关闭remDr服务窗口

remDr$close()

#但因全局任务状态(也即任务结束)

cat("all work is done!!!",sep = "\n")

#返回最终数据

return(myresult)

}

运行抓取功能

<p>url 查看全部

动态网页抓取(用RSelenium打造灵活强大的网络爬虫(youtobe+XML)

)

关于基础网络数据抓取相关内容,这个公众号已经分享了很多次,尤其是R语言的爬虫框架(RCurl+XML/httr+rvest[xml2+selectr])形成了比较丰富的教程体系。

但所有这些都是基于静态页面的(抓包和API访问除外)。很多动态网页不提供API访问,所以我们只能希望selenium是基于浏览器驱动的技术。

好在R语言已经有一个selenium接口包-RSelenium包,让我们爬取动态网页成为可能。今年年初写了一个实习和尚网站的爬虫,使用另一个基于R语言的selenium驱动的接口包-Rwebdriver完成。

实习僧招聘网络的爬虫数据可视化

当时技术还不成熟,思想还很幼稚。我使用导航器突然遍历了 500 页的内容。虽然最后爬取了所有的数据,但是耗时很长(将近40分钟),效率也比较低。(有兴趣的朋友可以参考上面的文章,不过实习生官网最近改版很大,现在爬起来肯定比以前难了!那个代码可能不能用了)

最近抽空学习了一下RSelenium包的相关内容。感谢陈彦平先生在R语言上海会议上以“用RSelenium构建灵活强大的网络爬虫”的演讲。虽然不在现场,但有幸看到了视频版。, 一些细节解决了我最近的一些困惑,在此谢谢大家。

陈彦平老师:《用RSelenium打造灵活强大的网络爬虫》 老外关于RSelenium的介绍视频(对于你来说,请访问国外网站):

目前R语言有几个可以解析动态网页的包(欢迎补充):

本节以下内容正式分享今天的案例,目标是拉勾网(不要问为什么,因为我之前没有爬过拉勾)!

在介绍案例之前,请确保系统具备以下条件:

本地有selenium服务器并添加系统路径;本地有一个plantomjs浏览器,并添加了系统路径;安装了 RSelenium 包。

因为涉及到自动化点击操作,Chrome浏览器整个下午都在点击链接里硬生生的崩溃了,找到原因了,因为dragnet页面很长,而且下一页按钮不在默认窗口范围内,而且js脚本用于控制滑块。失败,原因不明。见过有人用firefox浏览器测试成功。我还没试过。这里我切换到plantomjs无头浏览器(无需考虑元素是否被窗口遮挡。)

R语言版本:

#!!!这两句是在cmd后者PowerShell中运行的!

#RSelenium服务未关闭之前,请务必保持该窗口状态!

###启动selenium服务:

cd D:\

java -jar selenium-server-standalone-3.3.1.jar

##selenium服务器也可以直接在R语言中启动(无弹出窗口)

system("java -jar \"D:/selenium-server-standalone-2.53.1.jar\"",wait = FALSE,invisible = FALSE)

#加载包

library("RSelenium")

library("magrittr")

library("xml2")

启动服务

#给plantomjs浏览器伪装UserAgent

eCap % xml_text(trim=TRUE)

#职位所述行业

position.industry % read_html() %>% xml_find_all('//div[@class="industry"]') %>% xml_text(trim=TRUE) %>% gsub("[[:space:]\\u00a0]+|\\n", "",.)

#职位福利

position.bonus % read_html() %>% xml_find_all('//div[@class="list_item_bot"]/div[@class="li_b_l"]') %>% xml_text(trim=TRUE) %>% gsub("[[:space:]\\u00a0]+|\\n", "/",.)

#职位工作环境

position.environment% read_html() %>% xml_find_all('//div[@class="li_b_r"]') %>% xml_text(trim=TRUE)

#收集数据

mydata% xml_find_all('//div[@class="page-number"]/span[1]') %>% xml_text() !="30"){

#如果页面未到尾部,则点击下一页

remDr$findElement('xpath','//div[@class="pager_container"]/a[last()]')$clickElement()

#但因当前任务进度

cat(sprintf("第【%d】页抓取成功",i),sep = "\n")

} else {

#如果页面到尾部则跳出while循环

break

}

}

#跳出循环后关闭remDr服务窗口

remDr$close()

#但因全局任务状态(也即任务结束)

cat("all work is done!!!",sep = "\n")

#返回最终数据

return(myresult)

}

运行抓取功能

<p>url

动态网页抓取(爬取一个图片网站花瓣网,写一个比较简单的爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-12-05 14:12

今天我们要爬取一张图片网站花瓣网,写一个比较简单的图片下载爬虫;

迪列巴

图片太多了,我只剪了这些,大概几千张;

对,没错,就是你喜欢的胖迪,

1、 先分析一下花瓣网图片的加载方式

打开花瓣网首页,搜索“迪丽热巴”,

第一页加载20张图片

弹出登录框时下拉加载第二页图片,只有登录账号才能继续加载后续所有图片;

第二页加载了20张图片

可以看出的图片加载是异步的。这时候我们可以选择selenium来模拟登录网页,模仿浏览器的操作不断下拉加载所有图片;

2、主要思想:

首先,登录您的帐户并输入您要搜索的图片。每次下拉加载当前页面的图片后,提取图片的url并保存在列表中。由于每页有20张图片,我也在这里下载图片。每保存20个url就下载对应的20张图片;

3、准备:

安装selenium库,pip或者下载到本地安装都可以;

下面是安装Phantomjs或者Chrome

chromedriver的安装路径

phantomjs安装路径

可以自己百度下载,也可以参考下面的博客,谢谢这位博主

Windows下安装PIP+Phantomjs+Selenium

4、 直接上传下面的代码

<p>from selenium import webdriver

import time

import os

import requests

class Huaban():

#获取图片url并存到列表urls_list

def get_picture_url(self, content):

global path

path = "E:\spider\pictures\huaban" + '\\' + content

# 保存图片到磁盘文件夹 file_path中,默认为当前脚本运行目录下的文件夹

if not os.path.exists(path):

os.makedirs(path)

url = "http://huaban.com"

# 使用Chrome浏览器模拟打开网页,但是要把下载的chromedriver.exe放在python的文件路径下,

# 调试好之后换成PhantomJs,速度应该会快一点

# driver = webdriver.PhantomJs()

# 下拉滑动浏览器屏幕,具体下拉多少根据自己实际情况决定

driver = webdriver.PhantomJS()

#driver = webdriver.Chrome()

# 设置全屏

driver.maximize_window()

driver.get(url)

time.sleep(8)

# 点击登录、呼起登录窗口

driver.find_elements_by_xpath('//a[@class="login btn wbtn"]')[0].click()

# sign in the username

try:

driver.find_elements_by_xpath('//input[@name="email"]')[0].send_keys('花瓣账号')

print('user success!')

except:

print('user error!')

time.sleep(3)

# sign in the pasword

try:

driver.find_elements_by_xpath('//input[@name="password"]')[0].send_keys('账号密码')

print('pw success!')

except:

print('pw error!')

time.sleep(3)

# click to login

try:

driver.find_elements_by_xpath('//a[@class="btn btn18 rbtn"]')[0].click()

print('click success!')

except:

print('click error!')

time.sleep(3)

#搜索图片

driver.find_elements_by_xpath('//input[@placeholder="搜索你喜欢的"]')[0].send_keys(content)

driver.find_elements_by_xpath('//form[@id="search_form"]/a')[0].click()

time.sleep(5)

i = 0

page = 1

global name

global store_path

global urls_list

urls_list = []

#获取图片的总数

pictures_count = driver.find_elements_by_xpath('//a[@class="selected"]/i')[0].text

print(pictures_count)

pages = int(int(pictures_count) / 20)

print(pages)

#匹配到图片url所在的元素

url_elements = driver.find_elements_by_xpath('//span[@class="stop"]/../img')

#遍历图片元素的列表获取图片的url

for url_element in url_elements:

picture_url = url_element.get_attribute("src")[:-3] + "658"

#防止获取重复的图片url

if picture_url not in urls_list:

urls_list.append(picture_url)

while page 查看全部

动态网页抓取(爬取一个图片网站花瓣网,写一个比较简单的爬虫)

今天我们要爬取一张图片网站花瓣网,写一个比较简单的图片下载爬虫;

迪列巴

图片太多了,我只剪了这些,大概几千张;

对,没错,就是你喜欢的胖迪,

1、 先分析一下花瓣网图片的加载方式

打开花瓣网首页,搜索“迪丽热巴”,

第一页加载20张图片

弹出登录框时下拉加载第二页图片,只有登录账号才能继续加载后续所有图片;

第二页加载了20张图片

可以看出的图片加载是异步的。这时候我们可以选择selenium来模拟登录网页,模仿浏览器的操作不断下拉加载所有图片;

2、主要思想:

首先,登录您的帐户并输入您要搜索的图片。每次下拉加载当前页面的图片后,提取图片的url并保存在列表中。由于每页有20张图片,我也在这里下载图片。每保存20个url就下载对应的20张图片;

3、准备:

安装selenium库,pip或者下载到本地安装都可以;

下面是安装Phantomjs或者Chrome

chromedriver的安装路径

phantomjs安装路径

可以自己百度下载,也可以参考下面的博客,谢谢这位博主

Windows下安装PIP+Phantomjs+Selenium

4、 直接上传下面的代码

<p>from selenium import webdriver

import time

import os

import requests

class Huaban():

#获取图片url并存到列表urls_list

def get_picture_url(self, content):

global path

path = "E:\spider\pictures\huaban" + '\\' + content

# 保存图片到磁盘文件夹 file_path中,默认为当前脚本运行目录下的文件夹

if not os.path.exists(path):

os.makedirs(path)

url = "http://huaban.com"

# 使用Chrome浏览器模拟打开网页,但是要把下载的chromedriver.exe放在python的文件路径下,

# 调试好之后换成PhantomJs,速度应该会快一点

# driver = webdriver.PhantomJs()

# 下拉滑动浏览器屏幕,具体下拉多少根据自己实际情况决定

driver = webdriver.PhantomJS()

#driver = webdriver.Chrome()

# 设置全屏

driver.maximize_window()

driver.get(url)

time.sleep(8)

# 点击登录、呼起登录窗口

driver.find_elements_by_xpath('//a[@class="login btn wbtn"]')[0].click()

# sign in the username

try:

driver.find_elements_by_xpath('//input[@name="email"]')[0].send_keys('花瓣账号')

print('user success!')

except:

print('user error!')

time.sleep(3)

# sign in the pasword

try:

driver.find_elements_by_xpath('//input[@name="password"]')[0].send_keys('账号密码')

print('pw success!')

except:

print('pw error!')

time.sleep(3)

# click to login

try:

driver.find_elements_by_xpath('//a[@class="btn btn18 rbtn"]')[0].click()

print('click success!')

except:

print('click error!')

time.sleep(3)

#搜索图片

driver.find_elements_by_xpath('//input[@placeholder="搜索你喜欢的"]')[0].send_keys(content)

driver.find_elements_by_xpath('//form[@id="search_form"]/a')[0].click()

time.sleep(5)

i = 0

page = 1

global name

global store_path

global urls_list

urls_list = []

#获取图片的总数

pictures_count = driver.find_elements_by_xpath('//a[@class="selected"]/i')[0].text

print(pictures_count)

pages = int(int(pictures_count) / 20)

print(pages)

#匹配到图片url所在的元素

url_elements = driver.find_elements_by_xpath('//span[@class="stop"]/../img')

#遍历图片元素的列表获取图片的url

for url_element in url_elements:

picture_url = url_element.get_attribute("src")[:-3] + "658"

#防止获取重复的图片url

if picture_url not in urls_list:

urls_list.append(picture_url)

while page

动态网页抓取(整站优化怎样才能做得更好这是做地时候一直都要关心排名)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-04 08:09

如何更好的优化整个网站?这是很多朋友比较关心的问题。在优化选址时,必须考虑很多因素,比如收入和外链选址。在优化工作中,一定要经常查看之前的收益情况,不断更新网站的内容,让更多的链接可能是收录。还要经常查看收入的增长情况,查看网页权重的增减情况。如果您发现最近一段时间的收入数量有所减少,或者发现权重有所下降,那么您需要分析具体原因才能找到。该方法应该在地面上。下面,内蒙古手机网站的工作人员将简单介绍一下操作方法。

<p>在优化整个网站时,我们总是关心排名。最近所谓的排名就是关键词在搜索引擎中的排名。内蒙古手机网站的工作人员可能会选择关键词和网站的关系不是特别大,所以这个时候可能需要重新选择关键点关键词,并把这些关键点关键词做长尾关键词,争取这些长尾关键词更容易被搜索引擎抓到,争取拥有更多出现在搜索引擎排名中的网页标题。优化的时候要解决动态网页的问题,因为现在很多网页内容都是通过数据库查询来展示的,但是这样不利于搜索引擎抓取,所以有必要把这个动态展示改为静态网页模式,内蒙古手机网站的工作人员提醒,这样会使网站中的内容更容易被搜索引擎抓取。这涉及将动态网页转换为静态网页。当然,这些技术都是网上很容易得到的。网站中可能有各种楼层块。这些块中的每一个都可以单独优化,每个块都可以设置一个主关键词,使这些单独的楼层块逐渐增加搜索引擎的权重,可以逐渐增加整个 查看全部

动态网页抓取(整站优化怎样才能做得更好这是做地时候一直都要关心排名)

如何更好的优化整个网站?这是很多朋友比较关心的问题。在优化选址时,必须考虑很多因素,比如收入和外链选址。在优化工作中,一定要经常查看之前的收益情况,不断更新网站的内容,让更多的链接可能是收录。还要经常查看收入的增长情况,查看网页权重的增减情况。如果您发现最近一段时间的收入数量有所减少,或者发现权重有所下降,那么您需要分析具体原因才能找到。该方法应该在地面上。下面,内蒙古手机网站的工作人员将简单介绍一下操作方法。

<p>在优化整个网站时,我们总是关心排名。最近所谓的排名就是关键词在搜索引擎中的排名。内蒙古手机网站的工作人员可能会选择关键词和网站的关系不是特别大,所以这个时候可能需要重新选择关键点关键词,并把这些关键点关键词做长尾关键词,争取这些长尾关键词更容易被搜索引擎抓到,争取拥有更多出现在搜索引擎排名中的网页标题。优化的时候要解决动态网页的问题,因为现在很多网页内容都是通过数据库查询来展示的,但是这样不利于搜索引擎抓取,所以有必要把这个动态展示改为静态网页模式,内蒙古手机网站的工作人员提醒,这样会使网站中的内容更容易被搜索引擎抓取。这涉及将动态网页转换为静态网页。当然,这些技术都是网上很容易得到的。网站中可能有各种楼层块。这些块中的每一个都可以单独优化,每个块都可以设置一个主关键词,使这些单独的楼层块逐渐增加搜索引擎的权重,可以逐渐增加整个

动态网页抓取(动态站转化静态网站需要注意的问题相比较而言的优势 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-12-04 08:07

)

一、静态分析优缺点网站

静态网站的优势非常明显。用户浏览器打开静态网站的速度比动态网站快,因为动态网站的网页需要结合用户的参数才能形成相应的页面。,服务器的速度和网络的速度会严重影响动态网站的访问速度,而网站的静态网页已经在服务器上可用,用户只需提交申请,并且静态网页会下载到浏览器中,而且你也可以使用浏览器的缓存,这样当你第二次打开的时候,基本上不用再去虚拟主机下载了。可以看出,这个访问速度比动态站点要快。

静态网站的另一个优点是非常有利于搜索引擎收录和爬取。只要能在服务器上的各个静态网页之间形成内链网络,搜索引擎蜘蛛就可以通过收录@网站的主页,遍历网站中的整个静态网页,从而实现网站的完整收录。当然,为了提高蜘蛛爬取网站的速度,很多站长可能会设置ROBOTS.TXT文件来屏蔽一些不必要的收录页面,比如联系我们页面和支付方式页面许多公司网站。通过设置内链和ROBOTS.TXT文件,可以提高网站的爬取速度。

当然,静态网站的缺点也很明显。如果是大的网站,尤其是信息网站,如果每个页面都变成静态页面,工作量肯定很大,而且对网站的维护也是非常不利的,因为静态网站没有数据库,每个页面都需要手动检查。如果网站的链接有错误,想要更正往往需要很长时间一一排查!

二、动态站台转换静态网站需要注意的问题

相比之下,静态网站的优势比较明显,尤其是搜索引擎的优势。如今,没有搜索引擎的支持,网站越来越难成功,所以现在很多原本经营动态站的站长,都把自己的网站变成了静态的网站。这样我们就可以同时获得动态站和静态网站的优势。

然而,在转换的过程中,很多站长都渴望成功。通过一些号称转为静态网站的程序,瞬间实现了动态站的伪静态。这样做的结果就是本文前面描述的结果。这样一来,网站就完全是K了。正确的做法是把网站的动静结合起来,也就是网站上的众多丰富的关键词页面,用户信息页,网站地图页,应该使用静态网页,而对于网站的大量更新版块,应该通过动态转换程序来完成!

查看全部

动态网页抓取(动态站转化静态网站需要注意的问题相比较而言的优势

)

一、静态分析优缺点网站

静态网站的优势非常明显。用户浏览器打开静态网站的速度比动态网站快,因为动态网站的网页需要结合用户的参数才能形成相应的页面。,服务器的速度和网络的速度会严重影响动态网站的访问速度,而网站的静态网页已经在服务器上可用,用户只需提交申请,并且静态网页会下载到浏览器中,而且你也可以使用浏览器的缓存,这样当你第二次打开的时候,基本上不用再去虚拟主机下载了。可以看出,这个访问速度比动态站点要快。

静态网站的另一个优点是非常有利于搜索引擎收录和爬取。只要能在服务器上的各个静态网页之间形成内链网络,搜索引擎蜘蛛就可以通过收录@网站的主页,遍历网站中的整个静态网页,从而实现网站的完整收录。当然,为了提高蜘蛛爬取网站的速度,很多站长可能会设置ROBOTS.TXT文件来屏蔽一些不必要的收录页面,比如联系我们页面和支付方式页面许多公司网站。通过设置内链和ROBOTS.TXT文件,可以提高网站的爬取速度。

当然,静态网站的缺点也很明显。如果是大的网站,尤其是信息网站,如果每个页面都变成静态页面,工作量肯定很大,而且对网站的维护也是非常不利的,因为静态网站没有数据库,每个页面都需要手动检查。如果网站的链接有错误,想要更正往往需要很长时间一一排查!

二、动态站台转换静态网站需要注意的问题

相比之下,静态网站的优势比较明显,尤其是搜索引擎的优势。如今,没有搜索引擎的支持,网站越来越难成功,所以现在很多原本经营动态站的站长,都把自己的网站变成了静态的网站。这样我们就可以同时获得动态站和静态网站的优势。

然而,在转换的过程中,很多站长都渴望成功。通过一些号称转为静态网站的程序,瞬间实现了动态站的伪静态。这样做的结果就是本文前面描述的结果。这样一来,网站就完全是K了。正确的做法是把网站的动静结合起来,也就是网站上的众多丰富的关键词页面,用户信息页,网站地图页,应该使用静态网页,而对于网站的大量更新版块,应该通过动态转换程序来完成!

动态网页抓取( 动态页面及伪静态页面分别是什么及区别在哪?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-12-04 08:03

动态页面及伪静态页面分别是什么及区别在哪?)

什么是动态页面、静态页面和伪静态页面,它们的区别是什么?学习建网站从知道网页地址开始。老魏会详细讲解常见的网页格式,让新手和小白对网页地址格式有更深入的了解和认识,有助于网站的知识积累。

一、动态页面

我们经常看到浏览器地址栏中的一些网址很长,而且链接中还收录“?” 一般是动态链接,对应的页面是动态页面;

动态页面是用ASP、PHP、JSP、Perl或CGI等编程语言制作的。它们不存在于服务器中。服务器只有在用户访问请求时才返回一个完整的网页;

动态页面的内容存在于数据库中,根据不同的用户访问请求提供不同的网页内容。同时大大减少了网站维护的工作量;

网站,提供动态网页技术,实现用户注册、登录、用户管理、购买、在线调查、投票等多种交互功能。相反,静态网页无法提供这些功能。

动态页面通常以.php、asp 和jsp 等不同形式结束。

动态页面:简单的说就是将改变的内容放入数据库,相对不变的内容放入动态页面。当访问者请求访问时,读取并返回数据库中的内容,这样一个独立的动态页面就可以支持网站无限数量的文章内容发布,大大节省了网站的空间方便 网站 内容管理。

二、静态页面

存储在服务器云盘中的html文件在用户访问时从硬盘中读取并返回给用户。它通常以.htm.html 结尾,每个文件代表一个页面。

三、伪静态页面

它是由 wordpress 等程序生成的“静态页面”。它的表现形式是静态页面,但本质上是动态页面。

四、动态页面、静态页面和伪静态页面的区别

1、 动态页面的优缺点:易于维护和更新。比如调整一个产品的价格,站长只需要修改数据库,不需要修改每个单独的静态页面,节省了大量的人力和时间。

访问者很容易看到动态页面。但搜索引擎蜘蛛爬取并不容易,因为真正的网络内容存储在数据库中。这也使得动态网页难以被搜索引擎蜘蛛检索和抓取。蜘蛛程序会停在动态页面上,停止爬行。在相同的字段和内容下,静态页面的网站可以很容易地被索引和抓取。

搜索引擎不读取符号“?”后内容的原因:

动态页面的 URL 收录一个问号 (?) 和一个百分号 (%)。还有诸如 &、%、+ 和 $ 等符号。这样的网址被称为“环境变量”,这些环境变量很容易让蜘蛛程序陷入死循环。是蜘蛛程序无法理解符号“?”后的字符,URL 仍然不存在。为了避开那些蜘蛛陷阱,蜘蛛会不会不读?以下内容导致页面无法被索引和抓取。

2、 静态页面的优缺点:URL格式简单易懂。它是存在于云服务器硬盘中的文件,很容易被搜索引擎索引和抓取。

更新和维护并不容易。更改时必须手动更改每个文件。如果有数千个静态页面,工作量是难以想象的。

3、 伪静态页面的优缺点:URL格式和静态页面完全一样。访问者和蜘蛛程序看到的都是html地址,方便识别和爬取。它实际存在于服务器上,被搜索引擎收录搜索到后网址不会改变,用户访问时不会出现问题。而且,网站管理后台是动态程序,更容易改变。缺点:本质还是动态页面。用户每次访问,都要读取数据库内容返回给访问者,消耗服务器资源。

4、静态和伪静态比较

速度。在速度方面,静态页面比伪静态要好很多。静态页面是放置在服务器上的页面。当用户向服务器发出请求时,可以直接调用并返回给用户。动态页面,伪静态,其实就是动态页面,用技术手段读取数据库内容,动态页面?必须根据后面的参数读取数据库的次数。如果同时访问请求过多,会大大增加服务器负载,进而影响服务器采购成本,违背高性价比的目的。

容量。静态页面存在于服务器中,占用一定的空间。有多少内容就有多少独立的页面,相应地占用的空间也更多。这可以通过使用伪静态来避免。伪静态是动态 URL 到静态的转换,在服务器上实际上并不存在。

伪静态兼顾了静态页面和动态页面的优点,方便收录和搜索排名,后期可以自由修改内容。Wordpress 是最常见的伪静态程序。

现在很多程序本身就是动态页面。通过技术手段,可以生成真正的html静态页面,并存储在硬盘上供访问者阅读。以后修改也无所谓,重新生成所有静态页面即可。缺点也很明显:如果有几千个独立的静态页面,一代会占用大量的服务器资源,严重的会导致死机、假死、服务器崩溃等不良后果。 查看全部

动态网页抓取(

动态页面及伪静态页面分别是什么及区别在哪?)

什么是动态页面、静态页面和伪静态页面,它们的区别是什么?学习建网站从知道网页地址开始。老魏会详细讲解常见的网页格式,让新手和小白对网页地址格式有更深入的了解和认识,有助于网站的知识积累。

一、动态页面

我们经常看到浏览器地址栏中的一些网址很长,而且链接中还收录“?” 一般是动态链接,对应的页面是动态页面;

动态页面是用ASP、PHP、JSP、Perl或CGI等编程语言制作的。它们不存在于服务器中。服务器只有在用户访问请求时才返回一个完整的网页;

动态页面的内容存在于数据库中,根据不同的用户访问请求提供不同的网页内容。同时大大减少了网站维护的工作量;

网站,提供动态网页技术,实现用户注册、登录、用户管理、购买、在线调查、投票等多种交互功能。相反,静态网页无法提供这些功能。

动态页面通常以.php、asp 和jsp 等不同形式结束。

动态页面:简单的说就是将改变的内容放入数据库,相对不变的内容放入动态页面。当访问者请求访问时,读取并返回数据库中的内容,这样一个独立的动态页面就可以支持网站无限数量的文章内容发布,大大节省了网站的空间方便 网站 内容管理。

二、静态页面

存储在服务器云盘中的html文件在用户访问时从硬盘中读取并返回给用户。它通常以.htm.html 结尾,每个文件代表一个页面。

三、伪静态页面

它是由 wordpress 等程序生成的“静态页面”。它的表现形式是静态页面,但本质上是动态页面。

四、动态页面、静态页面和伪静态页面的区别

1、 动态页面的优缺点:易于维护和更新。比如调整一个产品的价格,站长只需要修改数据库,不需要修改每个单独的静态页面,节省了大量的人力和时间。

访问者很容易看到动态页面。但搜索引擎蜘蛛爬取并不容易,因为真正的网络内容存储在数据库中。这也使得动态网页难以被搜索引擎蜘蛛检索和抓取。蜘蛛程序会停在动态页面上,停止爬行。在相同的字段和内容下,静态页面的网站可以很容易地被索引和抓取。

搜索引擎不读取符号“?”后内容的原因:

动态页面的 URL 收录一个问号 (?) 和一个百分号 (%)。还有诸如 &、%、+ 和 $ 等符号。这样的网址被称为“环境变量”,这些环境变量很容易让蜘蛛程序陷入死循环。是蜘蛛程序无法理解符号“?”后的字符,URL 仍然不存在。为了避开那些蜘蛛陷阱,蜘蛛会不会不读?以下内容导致页面无法被索引和抓取。

2、 静态页面的优缺点:URL格式简单易懂。它是存在于云服务器硬盘中的文件,很容易被搜索引擎索引和抓取。

更新和维护并不容易。更改时必须手动更改每个文件。如果有数千个静态页面,工作量是难以想象的。

3、 伪静态页面的优缺点:URL格式和静态页面完全一样。访问者和蜘蛛程序看到的都是html地址,方便识别和爬取。它实际存在于服务器上,被搜索引擎收录搜索到后网址不会改变,用户访问时不会出现问题。而且,网站管理后台是动态程序,更容易改变。缺点:本质还是动态页面。用户每次访问,都要读取数据库内容返回给访问者,消耗服务器资源。

4、静态和伪静态比较

速度。在速度方面,静态页面比伪静态要好很多。静态页面是放置在服务器上的页面。当用户向服务器发出请求时,可以直接调用并返回给用户。动态页面,伪静态,其实就是动态页面,用技术手段读取数据库内容,动态页面?必须根据后面的参数读取数据库的次数。如果同时访问请求过多,会大大增加服务器负载,进而影响服务器采购成本,违背高性价比的目的。

容量。静态页面存在于服务器中,占用一定的空间。有多少内容就有多少独立的页面,相应地占用的空间也更多。这可以通过使用伪静态来避免。伪静态是动态 URL 到静态的转换,在服务器上实际上并不存在。

伪静态兼顾了静态页面和动态页面的优点,方便收录和搜索排名,后期可以自由修改内容。Wordpress 是最常见的伪静态程序。

现在很多程序本身就是动态页面。通过技术手段,可以生成真正的html静态页面,并存储在硬盘上供访问者阅读。以后修改也无所谓,重新生成所有静态页面即可。缺点也很明显:如果有几千个独立的静态页面,一代会占用大量的服务器资源,严重的会导致死机、假死、服务器崩溃等不良后果。

动态网页抓取( 企业百科推广整型医院网站规整漂亮企业网站建设服务)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-04 08:02

企业百科推广整型医院网站规整漂亮企业网站建设服务)

动态网页的缺点是什么?

1、第一动态网页在访问速度上没有优势

动态网页首先获取用户的指令,然后网页将该指令带到数据库中,找到该指令对应的数据,然后传递给服务器。通过服务器的编译,动态页面被编译成标准的HTML代码传递给用户的浏览器。用户看到网页。问题出现了。每次访问一个网页,都要经过这样一个过程。这个过程至少需要几秒钟。随着访问量的增加,页面加载速度会变慢,这也是服务器的负担。; 从用户的角度来看,网页加载缓慢,没有响应。谁会在下次访问您的网站。

静态网页很简单。静态网页实际上是存在的,它直接加载到客户端浏览器上显示,无需服务器编译。

这说明动态网页在访问速度上没有优势。

2、在搜索引擎中不占优势收录

上面从服务器和用户体验的角度讲,下面从搜索引擎收录的角度讲,动态网页是用户输入指令后形成的页面。这个页面不存在,搜索引擎只抓取现成的,不自己输入,所以网站在搜索引擎收录中没有优势。搜索引擎仍然喜欢静态页面。但是,搜索引擎也在不断改进和发展。到目前为止,大多数搜索引擎都支持动态页面的抓取。文章由,网站构建服务,组织发布。

华旗商城更多产品介绍:企业百科推动整形医院网站正规美企网站建设 查看全部

动态网页抓取(

企业百科推广整型医院网站规整漂亮企业网站建设服务)

动态网页的缺点是什么?

1、第一动态网页在访问速度上没有优势

动态网页首先获取用户的指令,然后网页将该指令带到数据库中,找到该指令对应的数据,然后传递给服务器。通过服务器的编译,动态页面被编译成标准的HTML代码传递给用户的浏览器。用户看到网页。问题出现了。每次访问一个网页,都要经过这样一个过程。这个过程至少需要几秒钟。随着访问量的增加,页面加载速度会变慢,这也是服务器的负担。; 从用户的角度来看,网页加载缓慢,没有响应。谁会在下次访问您的网站。

静态网页很简单。静态网页实际上是存在的,它直接加载到客户端浏览器上显示,无需服务器编译。

这说明动态网页在访问速度上没有优势。

2、在搜索引擎中不占优势收录

上面从服务器和用户体验的角度讲,下面从搜索引擎收录的角度讲,动态网页是用户输入指令后形成的页面。这个页面不存在,搜索引擎只抓取现成的,不自己输入,所以网站在搜索引擎收录中没有优势。搜索引擎仍然喜欢静态页面。但是,搜索引擎也在不断改进和发展。到目前为止,大多数搜索引擎都支持动态页面的抓取。文章由,网站构建服务,组织发布。

华旗商城更多产品介绍:企业百科推动整形医院网站正规美企网站建设

动态网页抓取(宜春网站建设教你如何给新网站制作静态页面呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-04 08:00

网站做SEO优化,静态页面是必不可少的,那么新的网站怎么做静态页面呢?接下来,宜春网站建设教你如何给新的网站制作静态页面。

第一步:确保网站有明确的关键字。

蜘蛛进来网站,主要是剧情关键字网站进来了。站长往往不让蜘蛛清楚网站的主要关键字是哪个,蜘蛛无法区分的就不会给 网站 赋予长期的权重,关键词的排名也不会好。所以,要想吸引蜘蛛爬取网站,最终的目的就是为网站确认好关键词。网站的标题和描述一定要写清楚清楚,并且网站@在>的内链开启的同一篇文章文章中,不要使用不同的关键字指向同一个页面. 这种内链开路是一种缺陷。另外,不要将首页的标题和内页的标题设置为相同的标题。设置首页主关键字,设置内页标题与文章的标题相关。蜘蛛更容易区分内页,同时也会给内页赋予权重。

第二步:新网站上线时,往往缺乏实质性内容,优质的软文非常少见。

这时候很多站长觉得新站上线了,网站的建设离不开内容,于是在网站上加了几十个甚至上百个文章一天下来,无路可走采集,是不是有太多的投入寻找德清,结果往往是悲剧。新网站是否上线搜索德清还是一回事。加这么多内容原创也是嘛,要不是原创搜音德清会认为网站就是采集的网站没有新意,而方晋,你可以一天加这么多内容,蜘蛛都变成你了网站每天加这么多内容。一天不加,蜘蛛就会来找你网站 吃不下东西,并且您将能够在不更新的情况下刷新快照。查看网站的日记,看看蜘蛛什么时候来网站。只有网站具有良好的更新频率,这样的网站才能更好地吸引蜘蛛。

第三步:为网站制作一个静态页面。

与 WP 的 网站 一样,默认链接是动态的。真静态和伪静态链接对网站各有利弊,但伪静态页面更容易引起蜘蛛爬行。对于刚上线的网站,搜索引擎总是不来网站抓取页面,或者来的时候没有输入文章,那么你可以搜索网站能如果不没有,可以在网站中添加伪静态页面。有的网站顺序支持网站的伪静态,你可以用插件来处理。如果不支持,就写伪静态。因为动态内容蜘蛛不会爬行。如果你想让网站吸引蜘蛛,伪静态的网站是蜘蛛的最爱,而动态的网站有时不会被蜘蛛输入。

编辑:市场营销网站 建筑专家 查看全部

动态网页抓取(宜春网站建设教你如何给新网站制作静态页面呢?)

网站做SEO优化,静态页面是必不可少的,那么新的网站怎么做静态页面呢?接下来,宜春网站建设教你如何给新的网站制作静态页面。

第一步:确保网站有明确的关键字。

蜘蛛进来网站,主要是剧情关键字网站进来了。站长往往不让蜘蛛清楚网站的主要关键字是哪个,蜘蛛无法区分的就不会给 网站 赋予长期的权重,关键词的排名也不会好。所以,要想吸引蜘蛛爬取网站,最终的目的就是为网站确认好关键词。网站的标题和描述一定要写清楚清楚,并且网站@在>的内链开启的同一篇文章文章中,不要使用不同的关键字指向同一个页面. 这种内链开路是一种缺陷。另外,不要将首页的标题和内页的标题设置为相同的标题。设置首页主关键字,设置内页标题与文章的标题相关。蜘蛛更容易区分内页,同时也会给内页赋予权重。

第二步:新网站上线时,往往缺乏实质性内容,优质的软文非常少见。

这时候很多站长觉得新站上线了,网站的建设离不开内容,于是在网站上加了几十个甚至上百个文章一天下来,无路可走采集,是不是有太多的投入寻找德清,结果往往是悲剧。新网站是否上线搜索德清还是一回事。加这么多内容原创也是嘛,要不是原创搜音德清会认为网站就是采集的网站没有新意,而方晋,你可以一天加这么多内容,蜘蛛都变成你了网站每天加这么多内容。一天不加,蜘蛛就会来找你网站 吃不下东西,并且您将能够在不更新的情况下刷新快照。查看网站的日记,看看蜘蛛什么时候来网站。只有网站具有良好的更新频率,这样的网站才能更好地吸引蜘蛛。

第三步:为网站制作一个静态页面。

与 WP 的 网站 一样,默认链接是动态的。真静态和伪静态链接对网站各有利弊,但伪静态页面更容易引起蜘蛛爬行。对于刚上线的网站,搜索引擎总是不来网站抓取页面,或者来的时候没有输入文章,那么你可以搜索网站能如果不没有,可以在网站中添加伪静态页面。有的网站顺序支持网站的伪静态,你可以用插件来处理。如果不支持,就写伪静态。因为动态内容蜘蛛不会爬行。如果你想让网站吸引蜘蛛,伪静态的网站是蜘蛛的最爱,而动态的网站有时不会被蜘蛛输入。

编辑:市场营销网站 建筑专家

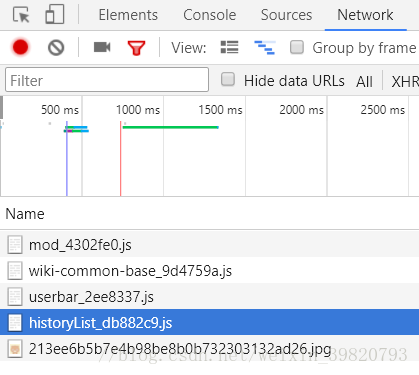

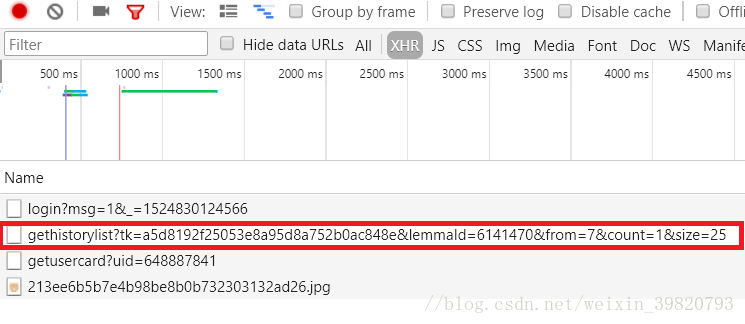

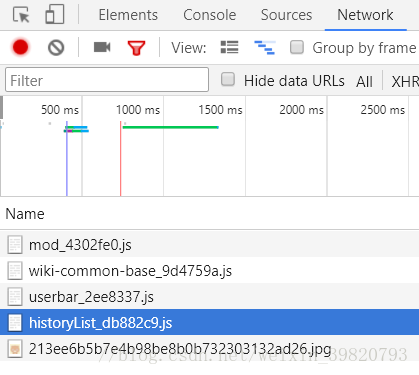

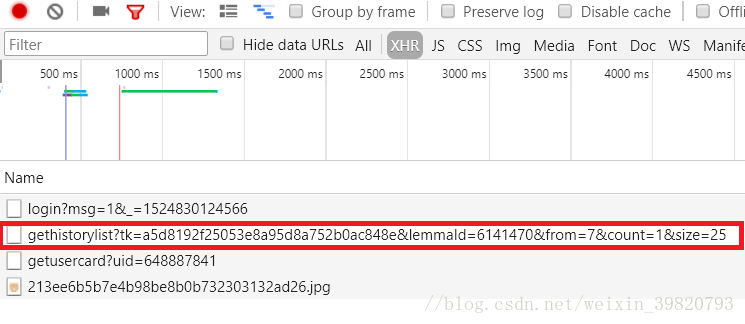

动态网页抓取(HTML网页时会模拟浏览器行为分析方法分析及注意事项)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-12-03 12:07

介绍

有时,当我们天真地使用urllib库或Scrapy下载HTML网页时,我们发现我们要提取的网页元素不在我们下载的HTML中,即使它们在浏览器中看起来很容易获得。

这说明我们想要的元素是在我们的一些操作下通过js事件动态生成的。例如,当我们滑动Qzone或微博评论时,我们一直向下滑动。网页越来越长,内容也越来越多。这就是让人又爱又恨的动态加载。

目前有两种爬取动态页面的方式

分析页面请求

Selenium 模拟浏览器行为

1.分析页面请求

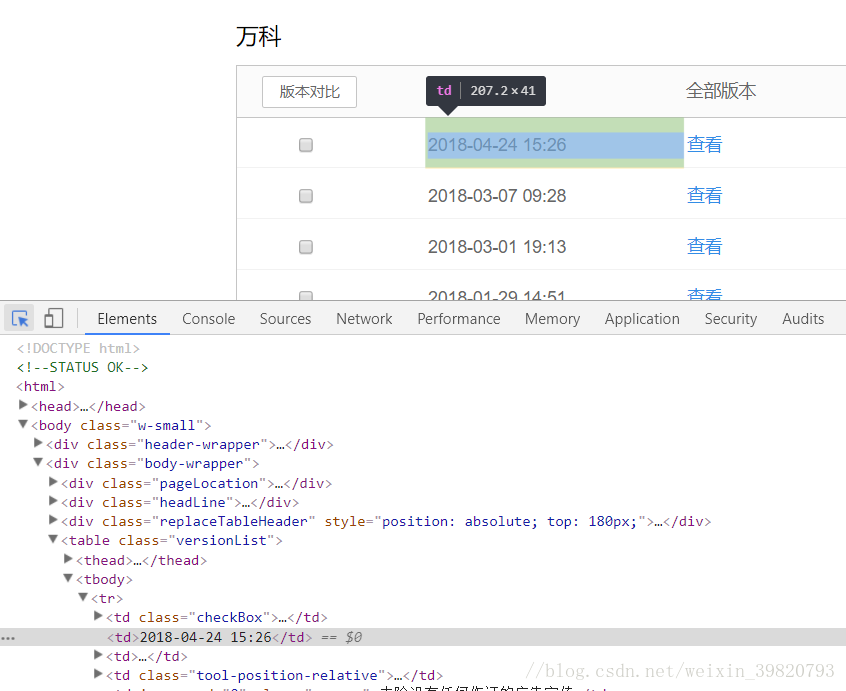

键盘F12打开开发者工具,选择Network选项卡,选择JS(除了JS选项卡和XHR选项卡,当然也可以使用其他抓包工具),如下图

然后,让我们拖动右侧的滚动条,然后我们会发现开发者工具中有新的js请求(很多),但是经过快速翻译,很容易看到哪个是评论,如下所示

OK,复制js请求的目标url

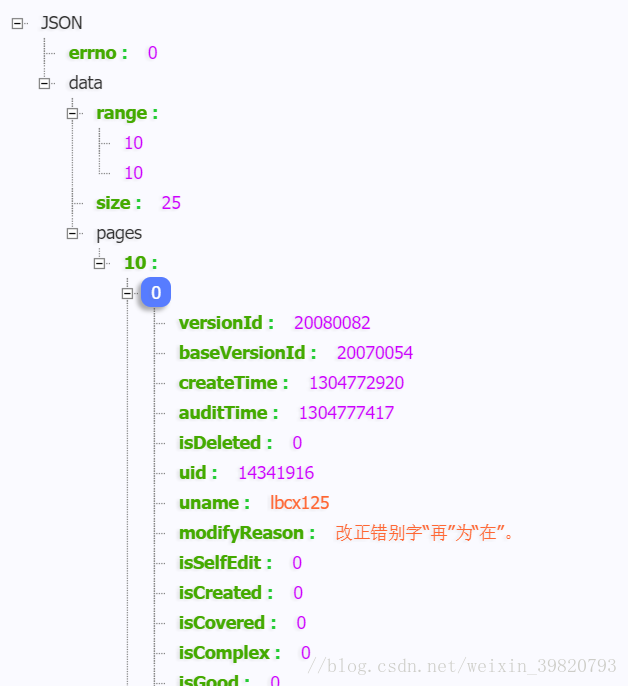

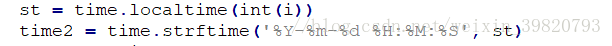

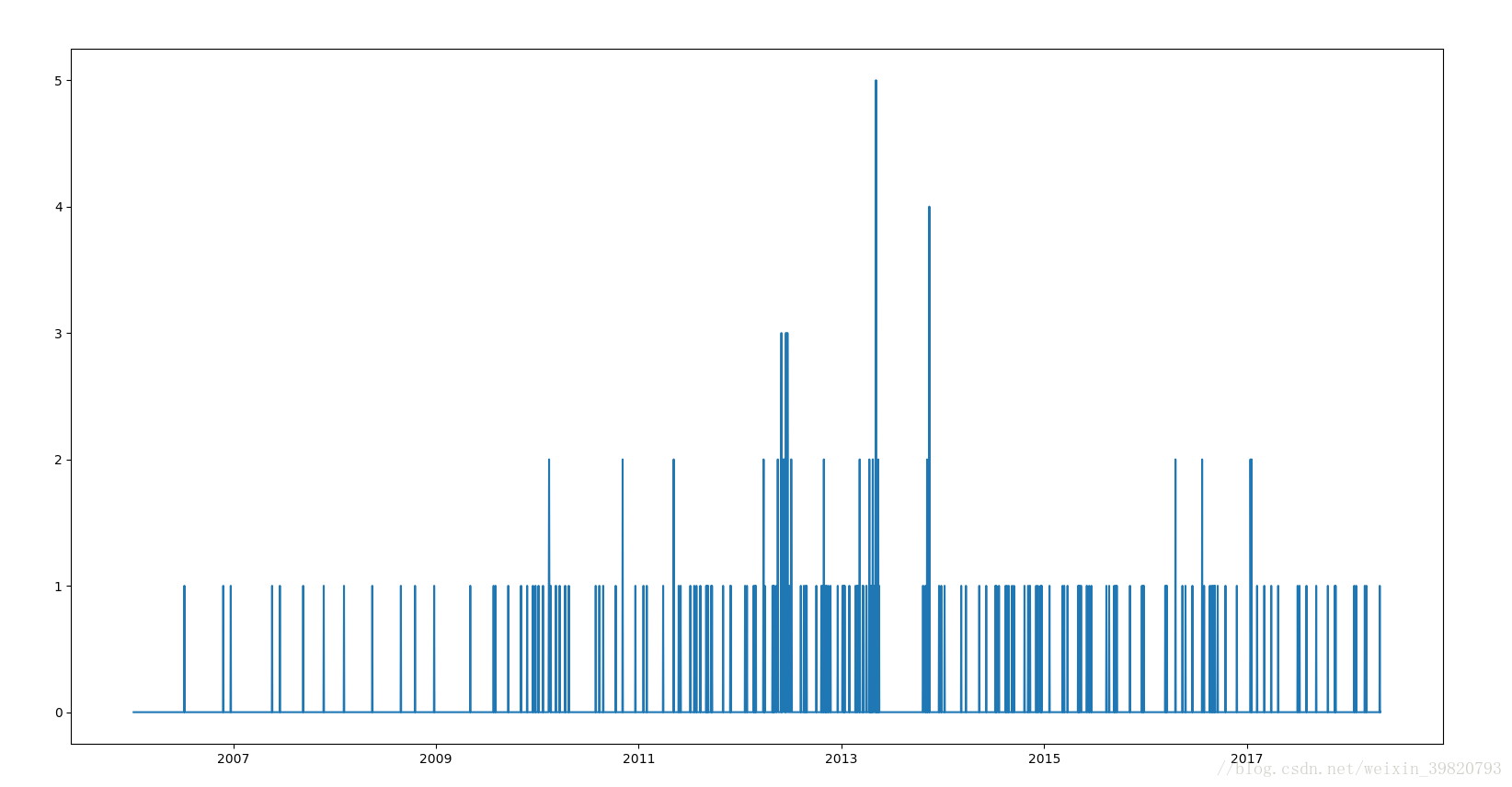

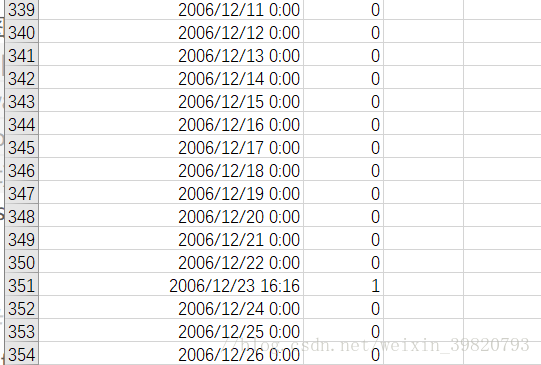

在浏览器中打开,发现我们想要的数据就在这里,如下图

整个页面都是json格式的数据。对于京东来说,当用户下拉页面时,会触发一个js事件,将上面的请求发送到服务器端去取数据,取到的json数据通过一定的js逻辑填充到服务器端的HTML页面中。对于我们的Spider,我们要做的就是对这些json数据进行排序提取。

在实际应用中,当然我们不可能在每个页面中都找出这个js发起的请求的目标地址,所以我们需要分析一下这个请求地址的规律。一般来说,法律更容易找到,因为法律太复杂了。维护也很困难。

2.selenium 模拟浏览器行为

对于动态加载,可以看到Selenium+Phantomjs的强大。打开网页查看网页的源码(注意不是check元素),会发现要爬取的信息不在源码中。也就是说,无法从网页的源代码中解析得到数据。Selenium+Phantomjs 的强大之处在于能够捕获完整的源代码

示例:在豆瓣电影上根据给定的名称搜索相应信息

#-*- 编码:utf-8 -*-

importsysfrom selenium importwebdriverfrom mon.keys importKeysfrom bs4 importBeautifulSoup

重新加载(系统)

sys.setdefaultencoding('utf-8')

网址 ='#39;

#这个路径就是你添加到PATH的路径

driver = webdriver.PhantomJS(executable_path='C:/Python27/Scripts/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get(url)#在搜索框模拟输入信息,点击

elem = driver.find_element_by_name("search_text")

elem.send_keys("疯狂")

elem.send_keys(Keys.RETURN)#获取动态加载的网页

数据 =driver.page_source

汤 = BeautifulSoup(data, "lxml")#match

对于我在soup.select("div[class='item-root']"):

name= i.find("a", class_="title-text").text

pic = i.find("img").get('src')

url= i.find("a").get('href')

rate=""num=""

如果 i.find("span", class_="rating_nums") isNone:print name.encode("gbk", "ignore"), pic, urlelse:

rate= i.find("span", class_="rating_nums").text

num= i.find("span", class_="pl").textprint name.encode("gbk", "ignore"),pic,url,rate.encode("gbk", "ignore"),num. 编码(“gbk”,“忽略”) 查看全部

动态网页抓取(HTML网页时会模拟浏览器行为分析方法分析及注意事项)

介绍

有时,当我们天真地使用urllib库或Scrapy下载HTML网页时,我们发现我们要提取的网页元素不在我们下载的HTML中,即使它们在浏览器中看起来很容易获得。

这说明我们想要的元素是在我们的一些操作下通过js事件动态生成的。例如,当我们滑动Qzone或微博评论时,我们一直向下滑动。网页越来越长,内容也越来越多。这就是让人又爱又恨的动态加载。

目前有两种爬取动态页面的方式

分析页面请求

Selenium 模拟浏览器行为

1.分析页面请求

键盘F12打开开发者工具,选择Network选项卡,选择JS(除了JS选项卡和XHR选项卡,当然也可以使用其他抓包工具),如下图

然后,让我们拖动右侧的滚动条,然后我们会发现开发者工具中有新的js请求(很多),但是经过快速翻译,很容易看到哪个是评论,如下所示

OK,复制js请求的目标url

在浏览器中打开,发现我们想要的数据就在这里,如下图

整个页面都是json格式的数据。对于京东来说,当用户下拉页面时,会触发一个js事件,将上面的请求发送到服务器端去取数据,取到的json数据通过一定的js逻辑填充到服务器端的HTML页面中。对于我们的Spider,我们要做的就是对这些json数据进行排序提取。

在实际应用中,当然我们不可能在每个页面中都找出这个js发起的请求的目标地址,所以我们需要分析一下这个请求地址的规律。一般来说,法律更容易找到,因为法律太复杂了。维护也很困难。

2.selenium 模拟浏览器行为

对于动态加载,可以看到Selenium+Phantomjs的强大。打开网页查看网页的源码(注意不是check元素),会发现要爬取的信息不在源码中。也就是说,无法从网页的源代码中解析得到数据。Selenium+Phantomjs 的强大之处在于能够捕获完整的源代码

示例:在豆瓣电影上根据给定的名称搜索相应信息

#-*- 编码:utf-8 -*-

importsysfrom selenium importwebdriverfrom mon.keys importKeysfrom bs4 importBeautifulSoup

重新加载(系统)

sys.setdefaultencoding('utf-8')

网址 ='#39;

#这个路径就是你添加到PATH的路径

driver = webdriver.PhantomJS(executable_path='C:/Python27/Scripts/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get(url)#在搜索框模拟输入信息,点击

elem = driver.find_element_by_name("search_text")

elem.send_keys("疯狂")

elem.send_keys(Keys.RETURN)#获取动态加载的网页

数据 =driver.page_source

汤 = BeautifulSoup(data, "lxml")#match

对于我在soup.select("div[class='item-root']"):

name= i.find("a", class_="title-text").text

pic = i.find("img").get('src')

url= i.find("a").get('href')

rate=""num=""

如果 i.find("span", class_="rating_nums") isNone:print name.encode("gbk", "ignore"), pic, urlelse:

rate= i.find("span", class_="rating_nums").text

num= i.find("span", class_="pl").textprint name.encode("gbk", "ignore"),pic,url,rate.encode("gbk", "ignore"),num. 编码(“gbk”,“忽略”)

动态网页抓取(静态网页资源在网页设计中的纯HTMl格式的网页 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-12-03 07:22

)

静态网页资源

在网页设计中,纯HTML格式(包括图片、视频、JS、CSS等样式)的网页通常被称为“静态网页”。

静态网页是相对于动态网页而言的,是指没有后台数据库、不收录任何程序、不具有交互性的网页。

静态网页的特点

开发人员写了什么,显示就是什么,一旦编写完成,就不会有任何改变。静态网页一般适用于更新较少的展示型网页,例如(酒水,家具,水果等宣传页),是很多中小网站的展示方式。

静态 Web 资源的文件扩展名是

静态网页的重要特性

例子(吃火锅、现成的蔬菜)

关于高并发架构思路

在高并发,高访问量的场景下做架构优化时,比较关键的就是把动态网页转化成静态网页,而不是直接请求数据库和动态服务器,并且可以吧静态内容推到缓存中,这样就提升用户体验,节约服务器压力成本。

动态网络资源

动态网页是和静态网页相对而言的,动态网页的url后缀一般是.asp .aspx .php .js .cgi

并且动态网页都有标志性的符号"? &",后端都有数据库的支持。

动态网址

添加新随笔

https://i.cnblogs.com/EditPosts.aspx?opt=1

动态网络资源特性

网页采用数据库技术支持,大大减少了网站的维护工作量。动态网页技术网站可以实现更多功能,如用户注册、用户登录、投票、用户管理、博客管理等。网页不是独立存在于服务器上的网页文件。当用户请求动态节目时,服务器会解析节目并读取数据库,返回完整的网页内容。搜索引擎(爬虫)一般不会抓取“?”后面的内容。在网址中。因此,公司会制作伪静态技术页面

示例(在餐厅炒,准备做饭)

网络服务软件

互联网主流网络服务软件

ApacheIISNginxTengineTomcatLighthttpd

主流网络服务软件说明

提供动态服务的软件

网站交通条件

网站 统计一般以IP和PV值越大越好

知识产权

IP即Internet Protocol,这里是指独立ip数,不同的ip地址的计算机访问网站时被计算的总次数。独立ip数是网站流量的一个重要指标。一般相同ip地址的客户端访问网站页面一天内只会被计算一次。

这里的ip指的是是固定的公网ip

光伏

pv(Page View)即是页面浏览量,不管客户端是不是相同,也不管ip是否相同,用户只要访问网站页面就会被计算PV,一次计算一个PV。

pv的度量方法就是客户端从浏览器发出一个web请求(request),服务器接收请求返回一个页面给客户端,这样就产生一个pv。

pv是衡量网站被访问的一个标准,但并不准确有多少人访问了网站。

例如

紫外线

UV即unique visitor,同一个客户端(pc或移动端)访问网站被计算为一个访客。

一天内相同的客户端访问同一个网站只计一次uv,uv是以cookie等技术为统计依据,实际统计存在误差。

一台计算机可能有多人使用,因此uv也不是最准确的。

并发

并发数指系统同时能处理的请求数量,也反应了系统的负载能力

响应时间

响应时间是指执行一个请求从开始到最后收到响应数据所花费的总体时间。

QPS

Query Per Second

每秒查询数

服务器在一秒内处理了多少个请求,显然数字越大代表服务器的负载越高,处理能力越强。

解释一下流量术语的博客地址:

话题

1.简述dns系统的解析原理

2.简述http协议的工作原理

4.请说出状态码200,301,403,404,500,504的含义

5.请简述什么是动态网页,静态网页

6.简述http报文有哪些部分 查看全部

动态网页抓取(静态网页资源在网页设计中的纯HTMl格式的网页

)

静态网页资源

在网页设计中,纯HTML格式(包括图片、视频、JS、CSS等样式)的网页通常被称为“静态网页”。

静态网页是相对于动态网页而言的,是指没有后台数据库、不收录任何程序、不具有交互性的网页。

静态网页的特点

开发人员写了什么,显示就是什么,一旦编写完成,就不会有任何改变。静态网页一般适用于更新较少的展示型网页,例如(酒水,家具,水果等宣传页),是很多中小网站的展示方式。

静态 Web 资源的文件扩展名是

静态网页的重要特性

例子(吃火锅、现成的蔬菜)

关于高并发架构思路

在高并发,高访问量的场景下做架构优化时,比较关键的就是把动态网页转化成静态网页,而不是直接请求数据库和动态服务器,并且可以吧静态内容推到缓存中,这样就提升用户体验,节约服务器压力成本。

动态网络资源

动态网页是和静态网页相对而言的,动态网页的url后缀一般是.asp .aspx .php .js .cgi

并且动态网页都有标志性的符号"? &",后端都有数据库的支持。

动态网址

添加新随笔

https://i.cnblogs.com/EditPosts.aspx?opt=1

动态网络资源特性

网页采用数据库技术支持,大大减少了网站的维护工作量。动态网页技术网站可以实现更多功能,如用户注册、用户登录、投票、用户管理、博客管理等。网页不是独立存在于服务器上的网页文件。当用户请求动态节目时,服务器会解析节目并读取数据库,返回完整的网页内容。搜索引擎(爬虫)一般不会抓取“?”后面的内容。在网址中。因此,公司会制作伪静态技术页面

示例(在餐厅炒,准备做饭)

网络服务软件

互联网主流网络服务软件

ApacheIISNginxTengineTomcatLighthttpd

主流网络服务软件说明

提供动态服务的软件

网站交通条件

网站 统计一般以IP和PV值越大越好

知识产权

IP即Internet Protocol,这里是指独立ip数,不同的ip地址的计算机访问网站时被计算的总次数。独立ip数是网站流量的一个重要指标。一般相同ip地址的客户端访问网站页面一天内只会被计算一次。

这里的ip指的是是固定的公网ip

光伏

pv(Page View)即是页面浏览量,不管客户端是不是相同,也不管ip是否相同,用户只要访问网站页面就会被计算PV,一次计算一个PV。

pv的度量方法就是客户端从浏览器发出一个web请求(request),服务器接收请求返回一个页面给客户端,这样就产生一个pv。

pv是衡量网站被访问的一个标准,但并不准确有多少人访问了网站。

例如

紫外线

UV即unique visitor,同一个客户端(pc或移动端)访问网站被计算为一个访客。

一天内相同的客户端访问同一个网站只计一次uv,uv是以cookie等技术为统计依据,实际统计存在误差。

一台计算机可能有多人使用,因此uv也不是最准确的。

并发

并发数指系统同时能处理的请求数量,也反应了系统的负载能力

响应时间

响应时间是指执行一个请求从开始到最后收到响应数据所花费的总体时间。

QPS

Query Per Second

每秒查询数

服务器在一秒内处理了多少个请求,显然数字越大代表服务器的负载越高,处理能力越强。

解释一下流量术语的博客地址:

话题

1.简述dns系统的解析原理

2.简述http协议的工作原理

4.请说出状态码200,301,403,404,500,504的含义

5.请简述什么是动态网页,静态网页

6.简述http报文有哪些部分

动态网页抓取(selenium动态网页有两种方法:1.分析网页找到真实网页地址)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-12-02 05:14

selenium的安装和使用

一.评论

我们之前抓取的网页被列为百度贴吧。起点中文网站都是静态网页。此类网页在浏览器中显示的内容都在HTML源代码中。但是现在很多网站都使用JavaScript来展示网页内容,这时候静态网页爬取技术就不行了。爬取动态网页有两种方式:

1.分析网页,找到真实的网页地址(比如爬取中财网的双色球信息实例),

2.使用selenium模拟浏览器。

二.Selenium 介绍和安装

1.什么是硒?

Selenium 也是一种用于 Web 应用程序测试的工具。Selenium 测试直接在浏览器中运行,就像真实用户在操作一样。支持的浏览器包括 IE、Mozilla Firefox、Mozilla Suite 等。

2.安装

只需使用 pip 命令安装它!

pip install selenium

安装可能会失败。请多试几次。如果下载太慢,我们可以用pip换源,重新下载。

部分国内资源:

阿里云

中国科学技术大学

豆瓣

清华大学

中国科学技术大学

具体步骤:

如图,进入用户目录下APPData下Local下的pip文件夹,不创建就创建了。创建 pip.ini 文件并复制以下代码并保存。

[global]

timeout=6000

index-url=https://pypi.tuna.tsinghua.edu.cn/simple

三.浏览器选择与安装

1.查看selenium webdriver支持的浏览器类型

from selenium import webdriver

help(webdriver)

常用的浏览器有phantomjs、Google Firefox

2.安装phantomjs

官网下载:""

安装:将phantomjs压缩包中的可执行文件添加到python目录下。如果使用anaconda,添加到anaconda目录下(与python.exe同级)

如图:

3.测试

输入python,输入以下命令没有错误!

from selenium import webdriver

driver=webdriver.PathtomJS()

四.申请

我们使用百度来测试selenium+phantomjs的功能。测试模拟输入关键字进行搜索。这里我们使用了一种新的元素定位方法xpath

有兴趣的可以阅读菜鸟教程《》学习他的语法

#! -*- encoding:utf-8 -*-

from selenium import webdriver

browser=webdriver.PhantomJS()

browser.get('http://www.baidu.com')

browser.implicitly_wait(10) #他是一个智能等待函数 因为利用JS引擎运行需要时间

#找到页面表单的文本框

textElement=browser.find_element_by_id('kw')

textElement.send_keys('python selenium') #模拟按键输入

#找到提交按钮

submitElement=browser.find_element_by_id('su')

submitElement.click() #点击元素

print (browser.title)

#xpath解析

"""

定位网页中的元素(locate elements)

find_element_by_id

find_element_by_name

find_element_by_xpath

find_element_by_link_text

find_element_by_partial_link_text

find_element_by_tag_name

find_element_by_class_name

find_element_by_css_selector

操作元素方法:

clear 清除元素的内容

send_keys 模拟按键输入

click 点击元素

submit 提交表单

"""

有很多浏览器选择。这里选择的是.PhantomJS(),它没有接口。

除了选择:browser=webdriver.PhantomJS(),还可以选择谷歌火狐等有界面的浏览器(前提是电脑有这样的浏览器)。例如,我们可以选择:

browser=webdriver.Chrome()

browser=webdriver.Firefox()

但是如果直接使用,就会报错

根据提示,我们知道我们缺少“geckodriver”,我们可以在线下载

“”

记得下载与你的浏览器版本一致或兼容的geckodriver,然后放到你的火狐浏览器目录下

这同样适用于 Google Chrome 的安装。如果Chromedriver版本与浏览器不兼容,可能会出现以下问题:

版本参考:

Chrome 驱动程序:"

司机:””

最好在路径中添加环境变量

小路:

这里的坑已经快填满了。遇到问题一定要记得百度。环境搭建好后,爬虫就会轻松愉快!

参考文章:

“”

“”

“” 查看全部

动态网页抓取(selenium动态网页有两种方法:1.分析网页找到真实网页地址)

selenium的安装和使用

一.评论

我们之前抓取的网页被列为百度贴吧。起点中文网站都是静态网页。此类网页在浏览器中显示的内容都在HTML源代码中。但是现在很多网站都使用JavaScript来展示网页内容,这时候静态网页爬取技术就不行了。爬取动态网页有两种方式:

1.分析网页,找到真实的网页地址(比如爬取中财网的双色球信息实例),

2.使用selenium模拟浏览器。

二.Selenium 介绍和安装

1.什么是硒?

Selenium 也是一种用于 Web 应用程序测试的工具。Selenium 测试直接在浏览器中运行,就像真实用户在操作一样。支持的浏览器包括 IE、Mozilla Firefox、Mozilla Suite 等。

2.安装

只需使用 pip 命令安装它!

pip install selenium

安装可能会失败。请多试几次。如果下载太慢,我们可以用pip换源,重新下载。

部分国内资源:

阿里云

中国科学技术大学

豆瓣

清华大学

中国科学技术大学

具体步骤:

如图,进入用户目录下APPData下Local下的pip文件夹,不创建就创建了。创建 pip.ini 文件并复制以下代码并保存。

[global]

timeout=6000

index-url=https://pypi.tuna.tsinghua.edu.cn/simple

三.浏览器选择与安装

1.查看selenium webdriver支持的浏览器类型

from selenium import webdriver

help(webdriver)

常用的浏览器有phantomjs、Google Firefox

2.安装phantomjs

官网下载:""

安装:将phantomjs压缩包中的可执行文件添加到python目录下。如果使用anaconda,添加到anaconda目录下(与python.exe同级)

如图:

3.测试

输入python,输入以下命令没有错误!

from selenium import webdriver

driver=webdriver.PathtomJS()

四.申请

我们使用百度来测试selenium+phantomjs的功能。测试模拟输入关键字进行搜索。这里我们使用了一种新的元素定位方法xpath

有兴趣的可以阅读菜鸟教程《》学习他的语法

#! -*- encoding:utf-8 -*-

from selenium import webdriver

browser=webdriver.PhantomJS()

browser.get('http://www.baidu.com')

browser.implicitly_wait(10) #他是一个智能等待函数 因为利用JS引擎运行需要时间

#找到页面表单的文本框

textElement=browser.find_element_by_id('kw')

textElement.send_keys('python selenium') #模拟按键输入

#找到提交按钮

submitElement=browser.find_element_by_id('su')

submitElement.click() #点击元素

print (browser.title)

#xpath解析

"""

定位网页中的元素(locate elements)

find_element_by_id

find_element_by_name

find_element_by_xpath

find_element_by_link_text

find_element_by_partial_link_text

find_element_by_tag_name

find_element_by_class_name

find_element_by_css_selector

操作元素方法:

clear 清除元素的内容

send_keys 模拟按键输入

click 点击元素

submit 提交表单

"""

有很多浏览器选择。这里选择的是.PhantomJS(),它没有接口。

除了选择:browser=webdriver.PhantomJS(),还可以选择谷歌火狐等有界面的浏览器(前提是电脑有这样的浏览器)。例如,我们可以选择:

browser=webdriver.Chrome()

browser=webdriver.Firefox()

但是如果直接使用,就会报错

根据提示,我们知道我们缺少“geckodriver”,我们可以在线下载

“”

记得下载与你的浏览器版本一致或兼容的geckodriver,然后放到你的火狐浏览器目录下

这同样适用于 Google Chrome 的安装。如果Chromedriver版本与浏览器不兼容,可能会出现以下问题:

版本参考:

Chrome 驱动程序:"

司机:””

最好在路径中添加环境变量

小路:

这里的坑已经快填满了。遇到问题一定要记得百度。环境搭建好后,爬虫就会轻松愉快!

参考文章:

“”

“”

“”

动态网页抓取( 5.ROBOT协议的基本语法:爬虫的网页抓取1.)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-11-30 10:21

5.ROBOT协议的基本语法:爬虫的网页抓取1.)

import urllib.request

# 私密代理授权的账户

user = "user_name"

# 私密代理授权的密码

passwd = "uesr_password"

# 代理IP地址 比如可以使用百度西刺代理随便选择即可

proxyserver = "177.87.168.97:53281"

# 1. 构建一个密码管理对象,用来保存需要处理的用户名和密码

passwdmgr = urllib.request.HTTPPasswordMgrWithDefaultRealm()

# 2. 添加账户信息,第一个参数realm是与远程服务器相关的域信息,一般没人管它都是写None,后面三个参数分别是 代理服务器、用户名、密码

passwdmgr.add_password(None, proxyserver, user, passwd)

# 3. 构建一个代理基础用户名/密码验证的ProxyBasicAuthHandler处理器对象,参数是创建的密码管理对象

# 注意,这里不再使用普通ProxyHandler类了

proxyauth_handler = urllib.request.ProxyBasicAuthHandler(passwdmgr)

# 4. 通过 build_opener()方法使用这些代理Handler对象,创建自定义opener对象,参数包括构建的 proxy_handler 和 proxyauth_handler

opener = urllib.request.build_opener(proxyauth_handler)

# 5. 构造Request 请求

request = urllib.request.Request("http://bbs.pinggu.org/")

# 6. 使用自定义opener发送请求

response = opener.open(request)

# 7. 打印响应内容

print (response.read())

5.ROBOT协议

在目标 URL 后添加 /robots.txt,例如:

第一个意思是,对于所有爬虫来说,它们不能在 /? 开头的路径无法访问匹配/pop/*.html的路径。

最后四个用户代理的爬虫不允许访问任何资源。

所以Robots协议的基本语法如下:

二、 爬虫的网络爬行

1.爬虫的目的

实现浏览器的功能,通过指定的URL直接返回用户需要的数据。

一般步骤:

2.网络分析

获取到相应的内容进行分析后,其实需要对一段文本进行处理,从网页中的代码中提取出你需要的内容。BeautifulSoup 可以实现通常的文档导航、搜索和修改文档功能。如果lib文件夹中没有BeautifulSoup,请使用命令行安装。

pip install BeautifulSoup

3.数据提取

# 想要抓取我们需要的东西需要进行定位,寻找到标志

from bs4 import BeautifulSoup

soup = BeautifulSoup("","html.parser")

tag=soup.meta

# tag的类别

type(tag)

>>> bs4.element.Tag

# tag的name属性

tag.name

>>> "meta"

# attributes属性

tag.attrs

>>> {"content": "all", "name": "robots"}

# BeautifulSoup属性

type(soup)

>>> bs4.BeautifulSoup

soup.name

>>> "[document]"

# 字符串的提取

markup="房产"

soup=BeautifulSoup(markup,"lxml")

text=soup.b.string

text

>>> "房产"

type(text)

>>> bs4.element.NavigableString

4.BeautifulSoup 应用实例

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=2"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

#通过页面解析得到结构数据进行处理

from bs4 import BeautifulSoup

soup=BeautifulSoup(html.text,"lxml")

#定位

lptable = soup.find("table",width="780")

# 解析

for i in lptable.find_all("td",width="680"): href = "http://www.cwestc.com"+i.find("a")["href"]

# href = i.find("a")["href"]

date = href.split("/")[4]

print (title,href,date)

4.Xpath 应用实例

XPath 是一种用于在 XML 文档中查找信息的语言。XPath 可用于遍历 XML 文档中的元素和属性。XPath 是 W3C XSLT 标准的主要元素,XQuery 和 XPointer 都建立在 XPath 表达式之上。

四个标签的使用方法

<p>

from lxml import etree

html="""

test

NO.1

NO.2

NO.3

one

two 查看全部

动态网页抓取(

5.ROBOT协议的基本语法:爬虫的网页抓取1.)

import urllib.request

# 私密代理授权的账户

user = "user_name"

# 私密代理授权的密码

passwd = "uesr_password"

# 代理IP地址 比如可以使用百度西刺代理随便选择即可

proxyserver = "177.87.168.97:53281"

# 1. 构建一个密码管理对象,用来保存需要处理的用户名和密码

passwdmgr = urllib.request.HTTPPasswordMgrWithDefaultRealm()

# 2. 添加账户信息,第一个参数realm是与远程服务器相关的域信息,一般没人管它都是写None,后面三个参数分别是 代理服务器、用户名、密码

passwdmgr.add_password(None, proxyserver, user, passwd)

# 3. 构建一个代理基础用户名/密码验证的ProxyBasicAuthHandler处理器对象,参数是创建的密码管理对象

# 注意,这里不再使用普通ProxyHandler类了

proxyauth_handler = urllib.request.ProxyBasicAuthHandler(passwdmgr)

# 4. 通过 build_opener()方法使用这些代理Handler对象,创建自定义opener对象,参数包括构建的 proxy_handler 和 proxyauth_handler

opener = urllib.request.build_opener(proxyauth_handler)

# 5. 构造Request 请求

request = urllib.request.Request("http://bbs.pinggu.org/";)

# 6. 使用自定义opener发送请求

response = opener.open(request)

# 7. 打印响应内容

print (response.read())

5.ROBOT协议

在目标 URL 后添加 /robots.txt,例如:

第一个意思是,对于所有爬虫来说,它们不能在 /? 开头的路径无法访问匹配/pop/*.html的路径。

最后四个用户代理的爬虫不允许访问任何资源。

所以Robots协议的基本语法如下:

二、 爬虫的网络爬行

1.爬虫的目的

实现浏览器的功能,通过指定的URL直接返回用户需要的数据。

一般步骤:

2.网络分析

获取到相应的内容进行分析后,其实需要对一段文本进行处理,从网页中的代码中提取出你需要的内容。BeautifulSoup 可以实现通常的文档导航、搜索和修改文档功能。如果lib文件夹中没有BeautifulSoup,请使用命令行安装。

pip install BeautifulSoup

3.数据提取

# 想要抓取我们需要的东西需要进行定位,寻找到标志

from bs4 import BeautifulSoup

soup = BeautifulSoup("","html.parser")

tag=soup.meta

# tag的类别

type(tag)

>>> bs4.element.Tag

# tag的name属性

tag.name

>>> "meta"

# attributes属性

tag.attrs

>>> {"content": "all", "name": "robots"}

# BeautifulSoup属性

type(soup)

>>> bs4.BeautifulSoup

soup.name

>>> "[document]"

# 字符串的提取

markup="房产"

soup=BeautifulSoup(markup,"lxml")

text=soup.b.string

text

>>> "房产"

type(text)

>>> bs4.element.NavigableString

4.BeautifulSoup 应用实例

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=2"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

#通过页面解析得到结构数据进行处理

from bs4 import BeautifulSoup

soup=BeautifulSoup(html.text,"lxml")

#定位

lptable = soup.find("table",width="780")

# 解析

for i in lptable.find_all("td",width="680"): href = "http://www.cwestc.com"+i.find("a")["href"]

# href = i.find("a")["href"]

date = href.split("/")[4]

print (title,href,date)

4.Xpath 应用实例

XPath 是一种用于在 XML 文档中查找信息的语言。XPath 可用于遍历 XML 文档中的元素和属性。XPath 是 W3C XSLT 标准的主要元素,XQuery 和 XPointer 都建立在 XPath 表达式之上。

四个标签的使用方法

<p>

from lxml import etree

html="""

test

NO.1

NO.2

NO.3

one

two

动态网页抓取(python如何检测网页中是否存在动态加载的数据?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-11-29 23:11

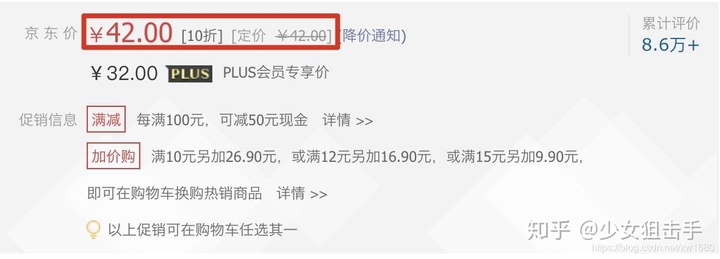

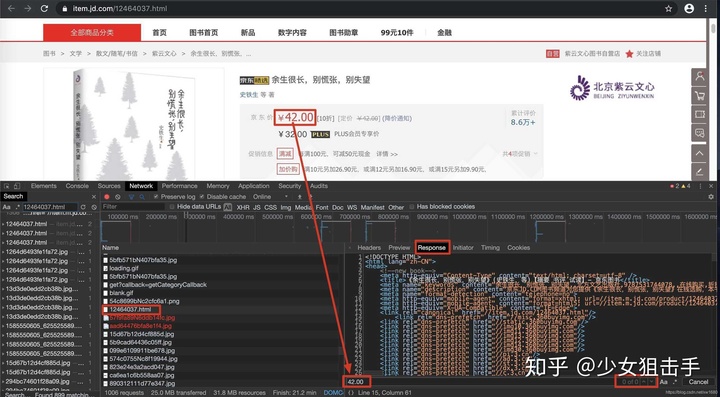

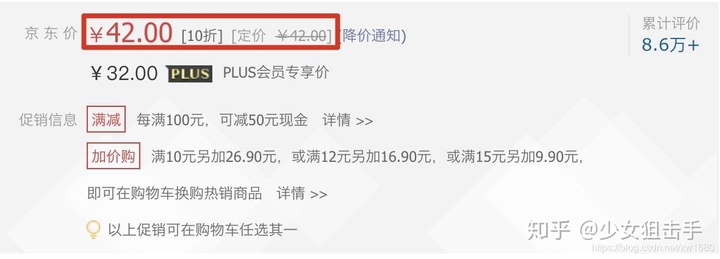

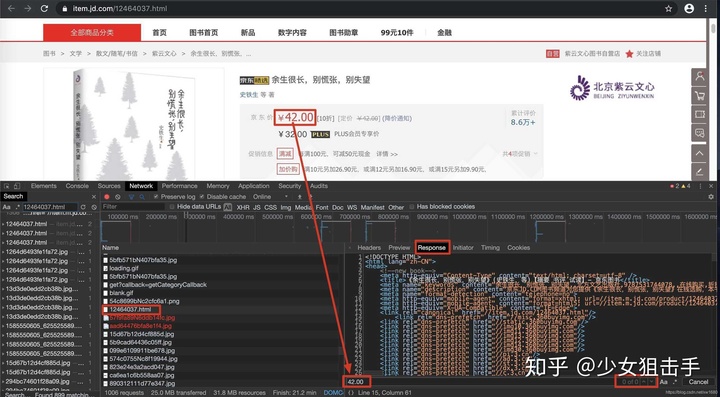

在使用python爬虫技术采集数据信息时,我们经常会遇到在返回的网页信息中,无法抓取到动态加载的可用数据。例如,当获取某个网页中的产品价格时,就会出现这种现象。如下所示。本文将实现对网页中类似动态加载数据的抓取。

1. 那么什么是动态加载的数据呢?

我们可以通过requests模块抓取数据,不能每次都可见。部分数据是通过非浏览器地址栏中的url请求获取的。但是通过其他请求请求的数据,那么通过其他请求请求的这些数据就是动态加载的数据。(猜测是我们访问这个页面的时候js代码会发送get请求,从其他url获取数据)

2. 如何检测网页中是否有动态加载的数据?

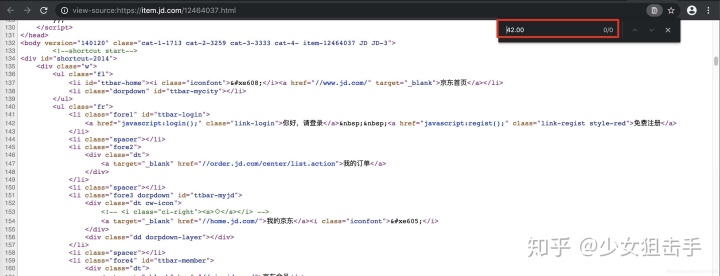

在当前页面打开抓包工具,抓包地址栏中url对应的数据包,在数据包的响应选项卡中搜索我们要抓取的数据,如果找到搜索结果,则表示数据不是动态加载的。否则,数据是动态加载的。如图所示:

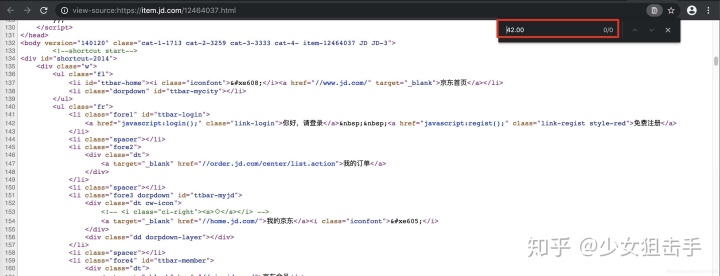

或者在要爬取的页面上右键,显示该网页的源代码。搜索我们要抓取的数据。如果找到搜索结果,则说明该数据不是动态加载的,否则说明该数据是动态加载的。如图所示:

3. 如果数据是动态加载的,我们如何捕获动态加载的数据?

在抓取动态加载的数据信息时,首先需要根据动态加载技术在浏览器的网络监控中选择网络请求的类型,然后通过一一过滤的方式查询预览信息中的关键数据,得到相应的Request地址,最后分析信息。具体步骤如下:

在浏览器中,快捷键F12打开开发者工具,然后在网络类型中选择Network(网络监视器)并选择JS,然后按快捷键F5刷新,如下图所示。

在请求信息列表中依次点击各个请求信息,然后在对应的Preview(请求结果预览)中查看是否是需要获取的动态加载数据,如下图所示。

查看动态加载的数据信息后,点击Headers,获取当前网络请求地址和所需参数,如下图所示。

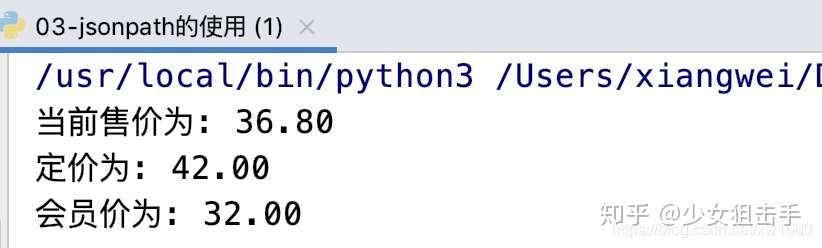

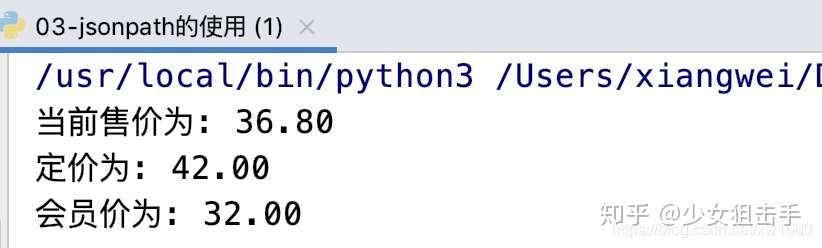

根据上述步骤获取的请求地址,发送网络请求,从返回的信息中提取商品价格信息。作者在代码中使用了反序列化。可以点击这里了解json序列化和反序列化。代码如下:

import requests

import json

# 获取商品价格的请求地址

url = "https://c0.3.cn/stock?skuId=12464037&cat=1713,3259,3333&venderId=1000077923&area"

"=4_113_9786_0&buyNum=1&choseSuitSkuIds=&extraParam={%22originid%22:%221%22}&ch=1&fqsp=0&"

"pduid=1573698619147398205303&pdpin=jd_635f3b795bb1c&coord=&detailedAdd=&callback=jQuery6495921"

jQuery_id = url.split("=")[-1] + "("

# 头部信息

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) "

"AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.129 Safari/537.36"

}

# 发送网络请求

response = requests.get(url, headers=headers)

if response.status_code == 200:

goods_dict = json.loads(response.text.replace(jQuery_id, "")[:-1]) # 反序列化

print(f"当前售价为: {goods_dict['stock']['jdPrice']['op']}")

print(f"定价为: {goods_dict['stock']['jdPrice']['m']}")

print(f"会员价为: {goods_dict['stock']['jdPrice']['tpp']}")

else:

print("请求失败!")

作者写博文的时候,价格发生了变化,运行结果如下图所示:

注意:抓取动态加载数据信息时,需要根据不同的网页采用不同的方法进行数据提取。如果在运行源代码时出现错误,请按照步骤获取新的请求地址。

至此,这篇关于Python爬取网页中动态加载数据的实现的文章就介绍到这里了。更多Python爬取网页动态数据相关内容,请搜索之前的文章或继续浏览下方相关文章希望大家以后多多支持! 查看全部

动态网页抓取(python如何检测网页中是否存在动态加载的数据?(图))

在使用python爬虫技术采集数据信息时,我们经常会遇到在返回的网页信息中,无法抓取到动态加载的可用数据。例如,当获取某个网页中的产品价格时,就会出现这种现象。如下所示。本文将实现对网页中类似动态加载数据的抓取。

1. 那么什么是动态加载的数据呢?

我们可以通过requests模块抓取数据,不能每次都可见。部分数据是通过非浏览器地址栏中的url请求获取的。但是通过其他请求请求的数据,那么通过其他请求请求的这些数据就是动态加载的数据。(猜测是我们访问这个页面的时候js代码会发送get请求,从其他url获取数据)

2. 如何检测网页中是否有动态加载的数据?

在当前页面打开抓包工具,抓包地址栏中url对应的数据包,在数据包的响应选项卡中搜索我们要抓取的数据,如果找到搜索结果,则表示数据不是动态加载的。否则,数据是动态加载的。如图所示:

或者在要爬取的页面上右键,显示该网页的源代码。搜索我们要抓取的数据。如果找到搜索结果,则说明该数据不是动态加载的,否则说明该数据是动态加载的。如图所示:

3. 如果数据是动态加载的,我们如何捕获动态加载的数据?

在抓取动态加载的数据信息时,首先需要根据动态加载技术在浏览器的网络监控中选择网络请求的类型,然后通过一一过滤的方式查询预览信息中的关键数据,得到相应的Request地址,最后分析信息。具体步骤如下:

在浏览器中,快捷键F12打开开发者工具,然后在网络类型中选择Network(网络监视器)并选择JS,然后按快捷键F5刷新,如下图所示。

在请求信息列表中依次点击各个请求信息,然后在对应的Preview(请求结果预览)中查看是否是需要获取的动态加载数据,如下图所示。

查看动态加载的数据信息后,点击Headers,获取当前网络请求地址和所需参数,如下图所示。

根据上述步骤获取的请求地址,发送网络请求,从返回的信息中提取商品价格信息。作者在代码中使用了反序列化。可以点击这里了解json序列化和反序列化。代码如下:

import requests

import json

# 获取商品价格的请求地址

url = "https://c0.3.cn/stock?skuId=12464037&cat=1713,3259,3333&venderId=1000077923&area"

"=4_113_9786_0&buyNum=1&choseSuitSkuIds=&extraParam={%22originid%22:%221%22}&ch=1&fqsp=0&"

"pduid=1573698619147398205303&pdpin=jd_635f3b795bb1c&coord=&detailedAdd=&callback=jQuery6495921"

jQuery_id = url.split("=")[-1] + "("

# 头部信息

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) "

"AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.129 Safari/537.36"

}

# 发送网络请求

response = requests.get(url, headers=headers)

if response.status_code == 200:

goods_dict = json.loads(response.text.replace(jQuery_id, "")[:-1]) # 反序列化

print(f"当前售价为: {goods_dict['stock']['jdPrice']['op']}")

print(f"定价为: {goods_dict['stock']['jdPrice']['m']}")

print(f"会员价为: {goods_dict['stock']['jdPrice']['tpp']}")

else:

print("请求失败!")

作者写博文的时候,价格发生了变化,运行结果如下图所示:

注意:抓取动态加载数据信息时,需要根据不同的网页采用不同的方法进行数据提取。如果在运行源代码时出现错误,请按照步骤获取新的请求地址。

至此,这篇关于Python爬取网页中动态加载数据的实现的文章就介绍到这里了。更多Python爬取网页动态数据相关内容,请搜索之前的文章或继续浏览下方相关文章希望大家以后多多支持!

动态网页抓取( 2.访问页面使用get_attribute查找节点用get方法(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-11-29 14:19

2.访问页面使用get_attribute查找节点用get方法(组图)

)

from selenium import webdriver

chrome = webdriver.Chrome()

这样初始化后,当使用它进行浏览器操作时,会弹出浏览器界面,直到关闭。显然我们希望它在后台静默工作而不弹出任何界面,所以我们还需要设置chrome的无界面模式(旧版本可能不支持):

from selenium.webdriver.chrome.options import Options

chrome_options = Options()

chrome_options.add_argument('--headless')

chrome_options.add_argument('--disable-gpu')

chrome = webdriver.Chrome(chrome_options=chrome_options)

2. 访问页面

访问页面,使用get函数传入url:

chrome.get('https://www.baidu.com')

print(chrome.page_source) # 输出当前页面源码

3. 查找节点

使用get方法打开一个页面后,可以使用page_source方法获取其源码,然后使用BeautifulSoup等库进行解析,但是selenium已经提供了一系列操作节点的方法,所以不需要额外使用解析库。

可以通过find_element_by_id等方法获取id、class等通用属性的节点。获取单个节点的方法有:

find_element_by_tag_name()

find_element_by_id()

find_element_by_name()

find_element_by_class_name()

另外,还有一个通用的查找节点的方法find_element(attribute name, value),可以灵活的查找自定义属性的节点。以上方法都是获取单个节点的方法。如果页面中有多个符合条件的节点,则只能返回第一个结果。如果要查找所有符合条件的节点,只需将方法中的元素改为元素即可。, 这将返回一个节点列表。

4. 获取节点信息

定位到一个节点后,可以使用get_attribute('attribute name')方法获取其属性信息,获取节点的内容可以使用.txt方法:

node = chrome.find_element_by_id('kw')

print(node.get_attribute('class'))

print(node.text)

5. 节点交互

Selenium 为节点提供了一系列的操作方法,比如在输入框中填写:

input = chrome.find_element_by_id('kw')

input.send_keys('python') # 填入内容

input.clear() # 清空输入

input.send_keys('zzu')

点击指定按钮:

button = chrome.find_element_by_id('su')

button.click()

6. 延迟等待

在打开一个页面时,可能是网络问题导致的或者页面需要加载大量动态信息,在立即操作页面时可能会出现错误。因此,最好在打开页面后稍等片刻再继续。最简单的等待方法是使用时间库。:

显然这种方法很不灵活,大多数页面都可以快速加载,这样固定的延迟会浪费很多时间。更好的方法是使用WebDriverWait类,用浏览器对象和最大等待时间初始化,然后调用until方法,传入等待条件。如果达到最大等待时间,则等待立即结束,否则会抛出异常,例如:

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

# 5秒内id为content_left的节点出现则结束等待,否则抛出异常

WebDriverWait(chrome, 5).until(EC.presence_of_element_located(('id', 'content_left')))

完整的等待条件可以查看官方文档

7. 执行 JavaScript 代码

Selenium 提供了一种直接运行 JavaScript 代码的方法,excute_script。Selenium 没有提供的动作可以通过执行 JavaScript 代码来实现,比如下拉进度条加载更多内容:

# 下拉进度条到最底部

chrome.execute_script('window.scrollTo(0, document.body.scrollHeight)')

chrome.execute_script('alert("to bottom")') 查看全部

动态网页抓取(

2.访问页面使用get_attribute查找节点用get方法(组图)

)

from selenium import webdriver

chrome = webdriver.Chrome()

这样初始化后,当使用它进行浏览器操作时,会弹出浏览器界面,直到关闭。显然我们希望它在后台静默工作而不弹出任何界面,所以我们还需要设置chrome的无界面模式(旧版本可能不支持):

from selenium.webdriver.chrome.options import Options

chrome_options = Options()

chrome_options.add_argument('--headless')

chrome_options.add_argument('--disable-gpu')

chrome = webdriver.Chrome(chrome_options=chrome_options)

2. 访问页面

访问页面,使用get函数传入url:

chrome.get('https://www.baidu.com')

print(chrome.page_source) # 输出当前页面源码

3. 查找节点

使用get方法打开一个页面后,可以使用page_source方法获取其源码,然后使用BeautifulSoup等库进行解析,但是selenium已经提供了一系列操作节点的方法,所以不需要额外使用解析库。

可以通过find_element_by_id等方法获取id、class等通用属性的节点。获取单个节点的方法有:

find_element_by_tag_name()

find_element_by_id()

find_element_by_name()

find_element_by_class_name()

另外,还有一个通用的查找节点的方法find_element(attribute name, value),可以灵活的查找自定义属性的节点。以上方法都是获取单个节点的方法。如果页面中有多个符合条件的节点,则只能返回第一个结果。如果要查找所有符合条件的节点,只需将方法中的元素改为元素即可。, 这将返回一个节点列表。

4. 获取节点信息

定位到一个节点后,可以使用get_attribute('attribute name')方法获取其属性信息,获取节点的内容可以使用.txt方法:

node = chrome.find_element_by_id('kw')