js抓取网页内容

js抓取网页内容(JavaScript()方法强迫浏览器刷新当前页面重新获取页面资源)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-12-20 13:02

在电脑网页中,如果我们想获取当前页面的最新内容,可以刷新当前页面再次获取数据。在 JavaScript 开发中也是如此。对于已编写的代码测试,我们也可以通过刷新来检索测试成功的代码。本文介绍了通过js刷新当前页面获取数据的reload()方法。

一、reload() 方法

强制浏览器刷新当前页面并重新加载当前文档以获取数据。

二、语法

Location.reload(forcedReload)

三、参数

forcedReload:需要布尔类型,

1、当值为true时,浏览器会强制从服务器获取当前页面资源,而不是从浏览器缓存中读取,

2、当值为false或不传入参数时,浏览器可能会从缓存中读取当前页面。

四、使用reload()方法刷新当前页面重新获取数据

function myrefresh(){

window.location.reload();

}

setTimeout('myrefresh()',1000); //指定1秒刷新一次

以上就是js刷新当前页面获取数据的reload()方法的介绍,希望对大家有帮助~ 查看全部

js抓取网页内容(JavaScript()方法强迫浏览器刷新当前页面重新获取页面资源)

在电脑网页中,如果我们想获取当前页面的最新内容,可以刷新当前页面再次获取数据。在 JavaScript 开发中也是如此。对于已编写的代码测试,我们也可以通过刷新来检索测试成功的代码。本文介绍了通过js刷新当前页面获取数据的reload()方法。

一、reload() 方法

强制浏览器刷新当前页面并重新加载当前文档以获取数据。

二、语法

Location.reload(forcedReload)

三、参数

forcedReload:需要布尔类型,

1、当值为true时,浏览器会强制从服务器获取当前页面资源,而不是从浏览器缓存中读取,

2、当值为false或不传入参数时,浏览器可能会从缓存中读取当前页面。

四、使用reload()方法刷新当前页面重新获取数据

function myrefresh(){

window.location.reload();

}

setTimeout('myrefresh()',1000); //指定1秒刷新一次

以上就是js刷新当前页面获取数据的reload()方法的介绍,希望对大家有帮助~

js抓取网页内容(js抓取网页内容的方法本质上就是一个轻量级的后端egg-restful)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-19 20:09

js抓取网页内容的方法本质上就是一个循环+判断+拿着元素的js源码执行+加载内容js脚本我推荐一个轻量级的后端egg-restful来帮助你。一个新型javascript轻量级服务器或者是前端后端一体的restful服务器-xgg,前后端通吃,适合中后台前端开发,单页面web和nodejs都可以快速进行调用,部署,后台选择restful更佳,可以提供稳定的支持。

<p>这款的代码是发布在github上的。不用编写babel代码。js拿着内容我这边按照字典把js拿过来,比如一个函数名,我们可以拿for(vari=0;i 查看全部

js抓取网页内容(js抓取网页内容的方法本质上就是一个轻量级的后端egg-restful)

js抓取网页内容的方法本质上就是一个循环+判断+拿着元素的js源码执行+加载内容js脚本我推荐一个轻量级的后端egg-restful来帮助你。一个新型javascript轻量级服务器或者是前端后端一体的restful服务器-xgg,前后端通吃,适合中后台前端开发,单页面web和nodejs都可以快速进行调用,部署,后台选择restful更佳,可以提供稳定的支持。

<p>这款的代码是发布在github上的。不用编写babel代码。js拿着内容我这边按照字典把js拿过来,比如一个函数名,我们可以拿for(vari=0;i

js抓取网页内容(代理支持·支持TLS/SSL协议)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-18 10:39

· 代理支持

· 支持TLS/SSL协议

2. Cheerio(也称为解析器):

· Cheerio 提供了一个快速、灵活和精益的核心jQuery 实现,专为服务器设计。

· Cheerio 解析标记并提供 API 用于遍历/操作结果数据结构。

特征:

· 熟悉的语法:Cheerio 实现了核心 jQuery 的一个子集。它去除了jQuery库中所有的DOM不一致和浏览痕迹,充分展示了API的魅力。

· 快速:Cheerio 使用非常简单且一致的 DOM 模型。因此,分析、操作和呈现非常高效。初步的端到端基准测试表明,cheerio 比 JSDOM 快 8 倍左右。

· 惊人的灵活性:Cheerio 几乎可以解析任何 HTML 或 XML 文档。

3.渗透(又名解析器)

· Osmosis 包括 HTML/XML 解析器和 webscraper。

· 它是用 node.js 编写的,包括 css3/xpath 选择器和轻量级 http 包装器。

· 没有像 Cheerio 这样的大依赖。

特征:

· 支持 CSS 3.0 和 XPath1.0 选择器的混合

· 加载和搜索 AJAX 内容

· 记录 URL、重定向和错误

· Cookie jar 和自定义 cookie/header/user agent

· 登录/表单提交、会话 cookie 和基本身份验证

· 单代理或多代理处理代理故障

· 重试和重定向限制

4. Puppeteer(也称为无头 Chrome 自动化浏览器):

Puppeteer 是一个 Node.js 库,它提供了一个简单但高效的 API,使您能够控制 Google 的 Chrome 或 Chromium 浏览器。

它还可以在无头模式下运行 Chromium(对于在服务器上运行浏览器非常有用),并且可以在没有用户界面的情况下发送和接收请求。

最好的部分是它可以在后台操作,遵循 API 的说明。

特征:

· 单击按钮、链接和图像等元素

· 自动表单提交

· 导航页面

· 使用时间线追踪找出问题所在

· 直接在浏览器中自动测试用户界面和各种前端应用程序

· 截屏

· 将网页转换为pdf文件

5. Apify SDK(也称为完整的网页抓取框架):

· Apify SDK 是一个开源的Node.js 库,用于爬虫和网络爬虫。

· Apify SDK 是一个独特的工具,可以简化网络爬虫、爬虫、数据提取和网络自动化任务的开发。

· 提供管理和自动扩容headless Chrome/Puppeteer实例池、维护要爬取的URL队列、将爬取结果存储到本地文件系统或云端、轮换代理等工具。

· 可以在自己的应用中独立使用,也可以在Apify云上运行的参与者之间使用。

特征:

· 使用 URL 的持久队列来深度获取整个 网站。

· 运行CSV文件中收录100k URL的爬取代码,代码崩溃时不会丢失任何数据。

· 通过旋转代理隐藏您的浏览器源。

· 安排代码定期运行并发送错误通知。

· 禁用网站 使用的浏览器指纹保护。

JS 代码经过混淆和加密,只需使用 JShaman()。 查看全部

js抓取网页内容(代理支持·支持TLS/SSL协议)

· 代理支持

· 支持TLS/SSL协议

2. Cheerio(也称为解析器):

· Cheerio 提供了一个快速、灵活和精益的核心jQuery 实现,专为服务器设计。

· Cheerio 解析标记并提供 API 用于遍历/操作结果数据结构。

特征:

· 熟悉的语法:Cheerio 实现了核心 jQuery 的一个子集。它去除了jQuery库中所有的DOM不一致和浏览痕迹,充分展示了API的魅力。

· 快速:Cheerio 使用非常简单且一致的 DOM 模型。因此,分析、操作和呈现非常高效。初步的端到端基准测试表明,cheerio 比 JSDOM 快 8 倍左右。

· 惊人的灵活性:Cheerio 几乎可以解析任何 HTML 或 XML 文档。

3.渗透(又名解析器)

· Osmosis 包括 HTML/XML 解析器和 webscraper。

· 它是用 node.js 编写的,包括 css3/xpath 选择器和轻量级 http 包装器。

· 没有像 Cheerio 这样的大依赖。

特征:

· 支持 CSS 3.0 和 XPath1.0 选择器的混合

· 加载和搜索 AJAX 内容

· 记录 URL、重定向和错误

· Cookie jar 和自定义 cookie/header/user agent

· 登录/表单提交、会话 cookie 和基本身份验证

· 单代理或多代理处理代理故障

· 重试和重定向限制

4. Puppeteer(也称为无头 Chrome 自动化浏览器):

Puppeteer 是一个 Node.js 库,它提供了一个简单但高效的 API,使您能够控制 Google 的 Chrome 或 Chromium 浏览器。

它还可以在无头模式下运行 Chromium(对于在服务器上运行浏览器非常有用),并且可以在没有用户界面的情况下发送和接收请求。

最好的部分是它可以在后台操作,遵循 API 的说明。

特征:

· 单击按钮、链接和图像等元素

· 自动表单提交

· 导航页面

· 使用时间线追踪找出问题所在

· 直接在浏览器中自动测试用户界面和各种前端应用程序

· 截屏

· 将网页转换为pdf文件

5. Apify SDK(也称为完整的网页抓取框架):

· Apify SDK 是一个开源的Node.js 库,用于爬虫和网络爬虫。

· Apify SDK 是一个独特的工具,可以简化网络爬虫、爬虫、数据提取和网络自动化任务的开发。

· 提供管理和自动扩容headless Chrome/Puppeteer实例池、维护要爬取的URL队列、将爬取结果存储到本地文件系统或云端、轮换代理等工具。

· 可以在自己的应用中独立使用,也可以在Apify云上运行的参与者之间使用。

特征:

· 使用 URL 的持久队列来深度获取整个 网站。

· 运行CSV文件中收录100k URL的爬取代码,代码崩溃时不会丢失任何数据。

· 通过旋转代理隐藏您的浏览器源。

· 安排代码定期运行并发送错误通知。

· 禁用网站 使用的浏览器指纹保护。

JS 代码经过混淆和加密,只需使用 JShaman()。

js抓取网页内容(问一个问题,js可以抓取其它网页里面的内容吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-12-17 00:07

请教一个问题,js可以抓取其他网页的内容吗?? ?

请教一个问题,js可以抓取其他网页的内容吗?? ?

比如网站打开的内容是一个列表,我需要的是该列表中的内容(编号)和名称

有没有办法实现它

HTML代码

股市名称

最新

涨跌幅%

道琼斯13005.12+0.18%纳斯达克2986.76+0.69%标普5001372.18+0.34%法国CAC403453.99+0.36%日经2259800.22+0.80%英国富时5927.91+0.21%澳洲全股4388.10+0.85%

和讯行情中心>>

- - - 解决方案 - - - - - - - - - -

如果把这个表嵌套到当前网页中,应该可以根据ID获取到。去试试吧。不部署项目不方便我试试--

- - - 解决方案 - - - - - - - - - -

这个好像是后台程序实现的,写.NET之前也写过类似的功能

- - - 解决方案 - - - - - - - - - -

不,跨域

- - - 解决方案 - - - - - - - - - -

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

本来可以,但受浏览器限制。

- - - 解决方案 - - - - - - - - - -

讨论

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

JS跨域操作不安全。

- - - 解决方案 - - - - - - - - - -

只有当服务器对另一个域中的页面使用写请求时,才会读取数据,然后将其发回。

- - - 解决方案 - - - - - - - - - -

使用 HTMLParser 抓取指定规则的内容 查看全部

js抓取网页内容(问一个问题,js可以抓取其它网页里面的内容吗?)

请教一个问题,js可以抓取其他网页的内容吗?? ?

请教一个问题,js可以抓取其他网页的内容吗?? ?

比如网站打开的内容是一个列表,我需要的是该列表中的内容(编号)和名称

有没有办法实现它

HTML代码

股市名称

最新

涨跌幅%

道琼斯13005.12+0.18%纳斯达克2986.76+0.69%标普5001372.18+0.34%法国CAC403453.99+0.36%日经2259800.22+0.80%英国富时5927.91+0.21%澳洲全股4388.10+0.85%

和讯行情中心>>

- - - 解决方案 - - - - - - - - - -

如果把这个表嵌套到当前网页中,应该可以根据ID获取到。去试试吧。不部署项目不方便我试试--

- - - 解决方案 - - - - - - - - - -

这个好像是后台程序实现的,写.NET之前也写过类似的功能

- - - 解决方案 - - - - - - - - - -

不,跨域

- - - 解决方案 - - - - - - - - - -

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

本来可以,但受浏览器限制。

- - - 解决方案 - - - - - - - - - -

讨论

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

JS跨域操作不安全。

- - - 解决方案 - - - - - - - - - -

只有当服务器对另一个域中的页面使用写请求时,才会读取数据,然后将其发回。

- - - 解决方案 - - - - - - - - - -

使用 HTMLParser 抓取指定规则的内容

js抓取网页内容(国内开始流行另一种流氓行为流氓行为:使用框架(Frame))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-13 17:27

最近,另一种流氓行为在中国流行起来:使用框架将您的网页嵌入到其网页中。

比如有一个网站号称是“口碑聚合门户”,提供全国各种在线论坛的最佳内容。但是,实际上,它使用框架来抓取其他人的网页,然后在其上添加您自己的广告和站点徽标。这和盗版书商有什么区别?!

预防方法,在

在添加此代码之前:

if ( top.location !== self.location )

{

top.location = self.location;

}

此代码有效。但是,有一个问题:使用后,没有人可以再将您的网页嵌入到框架中,包括您自己。

有没有办法让我的网页只嵌入我自己的框架而不是别人的框架?

try{

top.location.hostname;

if (top.location.hostname != window.location.hostname) {

top.location.href =window.location.href;

}

}

catch(e){

top.location.href = window.location.href;

}

好了,升级版的代码就完成了。除了本地域名,没有其他域名可以将您的网页嵌入到框架中。我的博客现在使用此代码。 查看全部

js抓取网页内容(国内开始流行另一种流氓行为流氓行为:使用框架(Frame))

最近,另一种流氓行为在中国流行起来:使用框架将您的网页嵌入到其网页中。

比如有一个网站号称是“口碑聚合门户”,提供全国各种在线论坛的最佳内容。但是,实际上,它使用框架来抓取其他人的网页,然后在其上添加您自己的广告和站点徽标。这和盗版书商有什么区别?!

预防方法,在

在添加此代码之前:

if ( top.location !== self.location )

{

top.location = self.location;

}

此代码有效。但是,有一个问题:使用后,没有人可以再将您的网页嵌入到框架中,包括您自己。

有没有办法让我的网页只嵌入我自己的框架而不是别人的框架?

try{

top.location.hostname;

if (top.location.hostname != window.location.hostname) {

top.location.href =window.location.href;

}

}

catch(e){

top.location.href = window.location.href;

}

好了,升级版的代码就完成了。除了本地域名,没有其他域名可以将您的网页嵌入到框架中。我的博客现在使用此代码。

js抓取网页内容(【知识点】HTML文档的域有关(一)示例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 363 次浏览 • 2021-12-13 11:27

同源政策

页面中的Javascript只能读取和访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但JQuery的域只和它所在的HTML文档的域相关。从而可以访问到HTML文档的属性,所以上面的代码就可以正常运行了。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么就无法实现你所期望的功能;如果远程点是指您可以控制的发问者网站,请参阅下面的放宽同源策略;

放宽同源 policyDocument.domain:用于子域的情况。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

参考

同源策略

谷歌托管图书馆

跨域资源共享

幻象 查看全部

js抓取网页内容(【知识点】HTML文档的域有关(一)示例)

同源政策

页面中的Javascript只能读取和访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但JQuery的域只和它所在的HTML文档的域相关。从而可以访问到HTML文档的属性,所以上面的代码就可以正常运行了。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么就无法实现你所期望的功能;如果远程点是指您可以控制的发问者网站,请参阅下面的放宽同源策略;

放宽同源 policyDocument.domain:用于子域的情况。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

参考

同源策略

谷歌托管图书馆

跨域资源共享

幻象

js抓取网页内容(#家居设计工作室网站模板介绍#SEO网站抓取频率的意义)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-12-10 17:34

#家居设计工作室网站模板介绍

每天都有数以千计的 URL 被搜索引擎抓取和抓取。它相互链接,形成我们现有的互联网关系。对于SEO人员,我们常说的名词是:网站爬取频率。它在SEO日常工作中扮演着重要的角色,为网站优化提供有价值的建议。那么,SEO网站爬取频率有什么意义呢?根据以往的工作经验,我们知道网页收录的基本流程主要是:抓取网址->内容质量评估->索引库筛选->网页入口(显示在搜索结果中)其中,如果你的内容质量比较低,会直接进入低质量的索引库,那么很难被百度收录。从这个过程中,不难看出,网站的爬取频率会直接影响到网站。收录率和内容质量评估。影响网站爬取频率的因素: 1 入站链接:理论上,只要是外部链接,无论其质量和形态如何,都会起到引导蜘蛛爬行和爬行的作用。2网站结构:网站最好是短域名,这样可以简化目录层次结构,避免URL过长,动态参数过多。3页面速度:移动优先指标,百度不止一次提到,最重要的指标是页面的首次加载,控制在3秒以内。4 有效提交:站点地图、官方API提交、JS访问提交等。 5 内容更新:优质内容更新的频率是网站大规模排名的核心因素。6BaiduBearPalm:如果你的网站配备了熊掌号,如果内容够高,抓取率几乎是100%。

如何查看网站爬取的频率:1个cms系统自带的“百度蜘蛛”分析插件。2 定期进行“博客日志分析”更方便。页面抓取对你的网站的影响:1.网站Revision 如果你的网站已经升级改版,部分网址已经修复,可能需要搜索引擎紧急抓取重新评估页面内容。这时候其实有一个好用的小技巧:主动把网址添加到站点地图中,并在百度上下文中更新,并尽快通知搜索引擎变化。2.网站排名最多的网站管理员认为,百度雄章上线以来,解决了包容性问题。实际上,目标网址只能连续爬取,可以不断重新评估权重,提高排名。因此,当您有一个页面需要进行排名时,您需要将其放置在更高的爬网列中。3. 压控页面爬取频率不高不一定好。它来自恶意爬虫。往往会导致服务器资源严重浪费甚至宕机,尤其是一些外链分析爬虫。如有必要,您可能需要使用 Robots.txt 进行有效阻止。4. 异常诊断 如果你早就发现某个页面没有收录,那么你需要知道:百度蜘蛛可访问性,可以使用百度官方后台抓取诊断来检查具体原因。介绍:页面抓取的频率对索引、索引、排名和二级排名起着至关重要的作用。作为 SEO 人员,您可能需要给予应有的关注。以上内容仅供参考。在这里,我推荐seomaster的三个插件。

有了这三个 SEO 插件,您可以立即成为 SEO 高手。俗话说,工欲善其事,必先利其器。对于SEOer来说,好的浏览器插件和电脑软件可以大大提高SEOer的效率。接下来,优光启社就为大家推荐三款好用的SEO插件,让你换个SEO高手!1.SEOMETA in SEOCLA 对于SEOer来说,每天必不可少的工作就是分析竞争对手网站。一般来说,我们会通过观察其他网站的标题、描述、关键词、图片、链接等来了解对方的SEO优化方法,以便更好的规划和竞争。过去,我们使用浏览器附带的“查看页面源代码”功能来查看对方的信息。然而,这个操作比较复杂。毕竟源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。

可以说这些功能非常符合SEOer的办公需求,有需要的可以自行下载。下载链接见文章文末。二、打开SEO统计理光推荐的第二个插件是SEO界的知名插件。它的名字是 OpenSEOStats。这个插件的用途很广,包括搜索引擎优化分析、流量统计、网站信息、网页信息、链接分析、网页速度、实用程序等等,可以说OpenSEOStats在手,我在世界各地都有。打开SEO统计1.SEO分析使用本软件,您可以对自己或他人的网站进行简单的SEO分析。稍加努力,就可以查看目标网站的外部链接,网站等的IP地址信息,与网站管理员工具和爱站工具中的信息相比,这不是一星半点。2.流量统计 另外,通过OpenSEOStats的流量统计功能,可以查看目标网站在Alexa网站上的世界排名信息。当然,如果你的网站没有被列入Alexa世界排名,那么这个工具可以说是遥不可及。3.网站Information 通过自己的站点信息功能,还可以查看他的站点是否有robots.txt协议和站点地图文件,了解竞争对手的SEO情况。此外,还可以了解目标网站的DNS信息和IP地理信息。4.

不过和1 CCK中的SEOMETA相比,这个插件里面的信息并不是特别详细,只有部分内容,但是功能齐全。该插件可以一键与 SEOMETA 结合使用。5.链接分析通过链接分析功能,OpenSEOStats可以快速找到网站中的出站链接数和链接数。这将使您更容易找到您的问题网站。另外,链接其他网站添加nofollow标签,也可以看到。这样就可以避免在交换友情链接时上当受骗。6、页面速度网站加速速度是网站体验中比较重要的部分。网站加载速度越快,留存用户越多。现在,借助OpenSEOStats网页速度功能,您可以帮助检测网站的速度 基于世界上所有的信息。比如网站速度8.26秒,还是很慢的。7.实用工具 此外,OpenSEOStats还配置了一些主要搜索引擎网站管理员平台的门户,包括谷歌、必应、百度等,缺少360和搜狗。下载链接见文章文末。三、5118网站Administrator Toolbox Streaming Media推荐的第三个插件是-5118网站Administrator Toolbox。这个插件可以说是比较符合中国本土环境的SEO插件。可以查询网站的SEO大数据,了解网站操作的各种属性,帮助SEOer科学优化网站。5118网站管理员工具箱另外,

只需在输入框中输入您的关键字,即可快速获取关键字排名信息。当然还有50多个关键词,默认是不显示的。此外,您可以使用此插件检查 nofollow 标签和 网站 死链接。当网站关键词突然下降,没有关键词排名时,可以使用5118网站管理员工具箱查看网站中是否有死链接,通过快速查找死链接关键字 死链接。5118网站管理员工具箱。位置。这样可以快速减少死链接造成的负面情况。原文来自微信公众号(6亿人关注我):百度SEO:为什么要关注“网页抓取频率”?家居设计工作室 网站 模板

请允许我先写下理论,然后再解决问题。作为一个在网络上呆了近十年的老油条,我还是需要用白话文。我先梳理一下这个理论和原理。这个问题有几个关键词:产品、促销和方法。事实上,这是一个普遍的问题。是不是有点像赚人生第一个百万是个逻辑?如果是我,我会如何判断?首先,我会先研究一下这个产品是什么,这个产品的对象。这个产品在运营中叫什么用户?它的特点是什么?有什么优势,有什么亮点,有什么功能,有什么竞争对手,什么是关键词,提炼出来,推广后会用到这些词。本产品的用户为个人用户(专业为TOC)或本产品的用户为商家(专业为TOB)。在不知道如何下手之前,只知道产品的用户属性。如何判断是TOTO还是TOB?事实上,很容易看出谁为这个产品买单。比如天猫就是B2C,1688就是B2B。比如你是一家鞋店网站,那么你就是2C。如果您为企业提供服务,则为 2B。其次,使用工具或研究找出用户的位置。既然我们知道用户是谁,那么我们将研究用户和用户的位置。我们在做流量的时候,经常会说:你的用户在哪里,你去哪里推广(免费还是付费,看你打算怎么做)理论就在这里。我们常说的三大流量体系,BAT+职称+其他。如果你是2B业务,比如什么软件系统,一般2B(TOB也可以写2B)客户决策时间长,喜欢比较,所以一般搜索会比较习惯,所以B表示百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。所以一般来说,搜索会比较习惯,所以B就代表百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。所以一般来说,搜索会比较习惯,所以B就代表百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。这些统称为[频道]。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。这些统称为[频道]。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。 查看全部

js抓取网页内容(#家居设计工作室网站模板介绍#SEO网站抓取频率的意义)

#家居设计工作室网站模板介绍

每天都有数以千计的 URL 被搜索引擎抓取和抓取。它相互链接,形成我们现有的互联网关系。对于SEO人员,我们常说的名词是:网站爬取频率。它在SEO日常工作中扮演着重要的角色,为网站优化提供有价值的建议。那么,SEO网站爬取频率有什么意义呢?根据以往的工作经验,我们知道网页收录的基本流程主要是:抓取网址->内容质量评估->索引库筛选->网页入口(显示在搜索结果中)其中,如果你的内容质量比较低,会直接进入低质量的索引库,那么很难被百度收录。从这个过程中,不难看出,网站的爬取频率会直接影响到网站。收录率和内容质量评估。影响网站爬取频率的因素: 1 入站链接:理论上,只要是外部链接,无论其质量和形态如何,都会起到引导蜘蛛爬行和爬行的作用。2网站结构:网站最好是短域名,这样可以简化目录层次结构,避免URL过长,动态参数过多。3页面速度:移动优先指标,百度不止一次提到,最重要的指标是页面的首次加载,控制在3秒以内。4 有效提交:站点地图、官方API提交、JS访问提交等。 5 内容更新:优质内容更新的频率是网站大规模排名的核心因素。6BaiduBearPalm:如果你的网站配备了熊掌号,如果内容够高,抓取率几乎是100%。

如何查看网站爬取的频率:1个cms系统自带的“百度蜘蛛”分析插件。2 定期进行“博客日志分析”更方便。页面抓取对你的网站的影响:1.网站Revision 如果你的网站已经升级改版,部分网址已经修复,可能需要搜索引擎紧急抓取重新评估页面内容。这时候其实有一个好用的小技巧:主动把网址添加到站点地图中,并在百度上下文中更新,并尽快通知搜索引擎变化。2.网站排名最多的网站管理员认为,百度雄章上线以来,解决了包容性问题。实际上,目标网址只能连续爬取,可以不断重新评估权重,提高排名。因此,当您有一个页面需要进行排名时,您需要将其放置在更高的爬网列中。3. 压控页面爬取频率不高不一定好。它来自恶意爬虫。往往会导致服务器资源严重浪费甚至宕机,尤其是一些外链分析爬虫。如有必要,您可能需要使用 Robots.txt 进行有效阻止。4. 异常诊断 如果你早就发现某个页面没有收录,那么你需要知道:百度蜘蛛可访问性,可以使用百度官方后台抓取诊断来检查具体原因。介绍:页面抓取的频率对索引、索引、排名和二级排名起着至关重要的作用。作为 SEO 人员,您可能需要给予应有的关注。以上内容仅供参考。在这里,我推荐seomaster的三个插件。

有了这三个 SEO 插件,您可以立即成为 SEO 高手。俗话说,工欲善其事,必先利其器。对于SEOer来说,好的浏览器插件和电脑软件可以大大提高SEOer的效率。接下来,优光启社就为大家推荐三款好用的SEO插件,让你换个SEO高手!1.SEOMETA in SEOCLA 对于SEOer来说,每天必不可少的工作就是分析竞争对手网站。一般来说,我们会通过观察其他网站的标题、描述、关键词、图片、链接等来了解对方的SEO优化方法,以便更好的规划和竞争。过去,我们使用浏览器附带的“查看页面源代码”功能来查看对方的信息。然而,这个操作比较复杂。毕竟源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。

可以说这些功能非常符合SEOer的办公需求,有需要的可以自行下载。下载链接见文章文末。二、打开SEO统计理光推荐的第二个插件是SEO界的知名插件。它的名字是 OpenSEOStats。这个插件的用途很广,包括搜索引擎优化分析、流量统计、网站信息、网页信息、链接分析、网页速度、实用程序等等,可以说OpenSEOStats在手,我在世界各地都有。打开SEO统计1.SEO分析使用本软件,您可以对自己或他人的网站进行简单的SEO分析。稍加努力,就可以查看目标网站的外部链接,网站等的IP地址信息,与网站管理员工具和爱站工具中的信息相比,这不是一星半点。2.流量统计 另外,通过OpenSEOStats的流量统计功能,可以查看目标网站在Alexa网站上的世界排名信息。当然,如果你的网站没有被列入Alexa世界排名,那么这个工具可以说是遥不可及。3.网站Information 通过自己的站点信息功能,还可以查看他的站点是否有robots.txt协议和站点地图文件,了解竞争对手的SEO情况。此外,还可以了解目标网站的DNS信息和IP地理信息。4.

不过和1 CCK中的SEOMETA相比,这个插件里面的信息并不是特别详细,只有部分内容,但是功能齐全。该插件可以一键与 SEOMETA 结合使用。5.链接分析通过链接分析功能,OpenSEOStats可以快速找到网站中的出站链接数和链接数。这将使您更容易找到您的问题网站。另外,链接其他网站添加nofollow标签,也可以看到。这样就可以避免在交换友情链接时上当受骗。6、页面速度网站加速速度是网站体验中比较重要的部分。网站加载速度越快,留存用户越多。现在,借助OpenSEOStats网页速度功能,您可以帮助检测网站的速度 基于世界上所有的信息。比如网站速度8.26秒,还是很慢的。7.实用工具 此外,OpenSEOStats还配置了一些主要搜索引擎网站管理员平台的门户,包括谷歌、必应、百度等,缺少360和搜狗。下载链接见文章文末。三、5118网站Administrator Toolbox Streaming Media推荐的第三个插件是-5118网站Administrator Toolbox。这个插件可以说是比较符合中国本土环境的SEO插件。可以查询网站的SEO大数据,了解网站操作的各种属性,帮助SEOer科学优化网站。5118网站管理员工具箱另外,

只需在输入框中输入您的关键字,即可快速获取关键字排名信息。当然还有50多个关键词,默认是不显示的。此外,您可以使用此插件检查 nofollow 标签和 网站 死链接。当网站关键词突然下降,没有关键词排名时,可以使用5118网站管理员工具箱查看网站中是否有死链接,通过快速查找死链接关键字 死链接。5118网站管理员工具箱。位置。这样可以快速减少死链接造成的负面情况。原文来自微信公众号(6亿人关注我):百度SEO:为什么要关注“网页抓取频率”?家居设计工作室 网站 模板

请允许我先写下理论,然后再解决问题。作为一个在网络上呆了近十年的老油条,我还是需要用白话文。我先梳理一下这个理论和原理。这个问题有几个关键词:产品、促销和方法。事实上,这是一个普遍的问题。是不是有点像赚人生第一个百万是个逻辑?如果是我,我会如何判断?首先,我会先研究一下这个产品是什么,这个产品的对象。这个产品在运营中叫什么用户?它的特点是什么?有什么优势,有什么亮点,有什么功能,有什么竞争对手,什么是关键词,提炼出来,推广后会用到这些词。本产品的用户为个人用户(专业为TOC)或本产品的用户为商家(专业为TOB)。在不知道如何下手之前,只知道产品的用户属性。如何判断是TOTO还是TOB?事实上,很容易看出谁为这个产品买单。比如天猫就是B2C,1688就是B2B。比如你是一家鞋店网站,那么你就是2C。如果您为企业提供服务,则为 2B。其次,使用工具或研究找出用户的位置。既然我们知道用户是谁,那么我们将研究用户和用户的位置。我们在做流量的时候,经常会说:你的用户在哪里,你去哪里推广(免费还是付费,看你打算怎么做)理论就在这里。我们常说的三大流量体系,BAT+职称+其他。如果你是2B业务,比如什么软件系统,一般2B(TOB也可以写2B)客户决策时间长,喜欢比较,所以一般搜索会比较习惯,所以B表示百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。所以一般来说,搜索会比较习惯,所以B就代表百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。所以一般来说,搜索会比较习惯,所以B就代表百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。这些统称为[频道]。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。这些统称为[频道]。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。

js抓取网页内容(华为云StackIass首席架构师聊设计架构(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-09 14:21

)

华为Cloud Stack Iass首席架构师谈设计架构>>>

我们在抓取数据的时候,如果目标网站是在Js中动态生成数据,通过滚动来分页,那我们怎么抓取呢?

类似于今日头条网站:

我们可以使用 Selenium 来做到这一点。尽管 Selenium 是为 Web 应用程序的自动化测试而设计的,但它非常适合用于数据捕获。可以轻松绕过网站的反爬虫限制,因为Selenium直接运行在浏览器中,就像真实用户在操作一样。

使用Selenium,我们不仅可以抓取Js动态生成的网页,还可以抓取滚动页面分页的网页。

首先我们使用maven来引入Selenium依赖:

org.seleniumhq.selenium

selenium-java

2.47.1

接下来就可以编写代码进行捕获了:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000;

int waitLoadRandomTime = 3000;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get("http://toutiao.com/");

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages=5;

for(int i=0; i 查看全部

js抓取网页内容(华为云StackIass首席架构师聊设计架构(图)

)

华为Cloud Stack Iass首席架构师谈设计架构>>>

我们在抓取数据的时候,如果目标网站是在Js中动态生成数据,通过滚动来分页,那我们怎么抓取呢?

类似于今日头条网站:

我们可以使用 Selenium 来做到这一点。尽管 Selenium 是为 Web 应用程序的自动化测试而设计的,但它非常适合用于数据捕获。可以轻松绕过网站的反爬虫限制,因为Selenium直接运行在浏览器中,就像真实用户在操作一样。

使用Selenium,我们不仅可以抓取Js动态生成的网页,还可以抓取滚动页面分页的网页。

首先我们使用maven来引入Selenium依赖:

org.seleniumhq.selenium

selenium-java

2.47.1

接下来就可以编写代码进行捕获了:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000;

int waitLoadRandomTime = 3000;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get("http://toutiao.com/";);

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages=5;

for(int i=0; i

js抓取网页内容(华为云StackIass首席架构师聊设计架构(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-12-09 14:18

)

华为Cloud Stack Iass首席架构师谈设计架构>>>

我们在抓取数据的时候,如果目标网站是在Js中动态生成数据,通过滚动来分页,那我们怎么抓取呢?

类似于今日头条网站:

我们可以使用 Selenium 来做到这一点。尽管 Selenium 是为 Web 应用程序的自动化测试而设计的,但它非常适合用于数据捕获。可以轻松绕过网站的反爬虫限制,因为Selenium直接运行在浏览器中,就像真实用户在操作一样。

使用Selenium,我们不仅可以抓取Js动态生成的网页,还可以抓取滚动页面分页的网页。

首先我们使用maven来引入Selenium依赖:

org.seleniumhq.selenium

selenium-java

2.47.1

接下来就可以编写代码进行捕获了:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000;

int waitLoadRandomTime = 3000;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get("http://toutiao.com/");

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages=5;

for(int i=0; i 查看全部

js抓取网页内容(华为云StackIass首席架构师聊设计架构(图)

)

华为Cloud Stack Iass首席架构师谈设计架构>>>

我们在抓取数据的时候,如果目标网站是在Js中动态生成数据,通过滚动来分页,那我们怎么抓取呢?

类似于今日头条网站:

我们可以使用 Selenium 来做到这一点。尽管 Selenium 是为 Web 应用程序的自动化测试而设计的,但它非常适合用于数据捕获。可以轻松绕过网站的反爬虫限制,因为Selenium直接运行在浏览器中,就像真实用户在操作一样。

使用Selenium,我们不仅可以抓取Js动态生成的网页,还可以抓取滚动页面分页的网页。

首先我们使用maven来引入Selenium依赖:

org.seleniumhq.selenium

selenium-java

2.47.1

接下来就可以编写代码进行捕获了:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000;

int waitLoadRandomTime = 3000;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get("http://toutiao.com/";);

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages=5;

for(int i=0; i

js抓取网页内容(运行chrome的docker容器有什么作用?参数指定远程地址)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-12-09 11:05

使用scrapy抓取网页时,由于很多网站使用js渲染,无法直接通过获取源码获取需要的网页内容。这时候经常使用selenium驱动的浏览器来获取网页。内容很贴切。但是有一个问题,这种情况下需要在本地安装浏览器,而且不是非root运行,所以chrome服务通过docker方式提供,使用selenium驱动获取呈现的网页内容。

运行 chrome 的 docker 容器

通过搜索,我知道docker hub上的容器是selenium/standalone-chrome。如果本地安装了docker,直接在14444端口运行服务。为了安全起见,只允许本地访问。

docker run -itd --name=chrome -p 127.0.0.1:14444:4444 --shm-size="2g" selenium/standalone-chrome

参数很简单,只配置了后端操作,端口映射,shm大小

Selenium 调用远程服务抓取网页

Selenium 的 webdrive 有一个 Remote 参数来指定远程地址

from selenium import webdriver

from scrapy.selector import Selector

options = webdriver.ChromeOptions()

options.add_argument('--headless') # example

driver = webdriver.Remote("http://127.0.0.1:14444/wd/hub", options=options)

driver.get("https://www.bobobk.com")

hrefs = Selector(text=driver.page_source).xpath("//article/header/h1/a/@href").extract()

for url in hrefs:

print(url)

#https://www.bobobk.com/833.html

#https://www.bobobk.com/621.html

#https://www.bobobk.com/852.html

#https://www.bobobk.com/731.html

#https://www.bobobk.com/682.html

#https://www.bobobk.com/671.html

#https://www.bobobk.com/523.html

#https://www.bobobk.com/521.html

#https://www.bobobk.com/823.html

#https://www.bobobk.com/512.html

示例中以这个网站为目标,实际验证中javascript渲染的网站可以完美捕获

总结

使用docker提供浏览器服务,可以很好的解决网页被js实时渲染,导致无法获取需要的网页内容的问题。 查看全部

js抓取网页内容(运行chrome的docker容器有什么作用?参数指定远程地址)

使用scrapy抓取网页时,由于很多网站使用js渲染,无法直接通过获取源码获取需要的网页内容。这时候经常使用selenium驱动的浏览器来获取网页。内容很贴切。但是有一个问题,这种情况下需要在本地安装浏览器,而且不是非root运行,所以chrome服务通过docker方式提供,使用selenium驱动获取呈现的网页内容。

运行 chrome 的 docker 容器

通过搜索,我知道docker hub上的容器是selenium/standalone-chrome。如果本地安装了docker,直接在14444端口运行服务。为了安全起见,只允许本地访问。

docker run -itd --name=chrome -p 127.0.0.1:14444:4444 --shm-size="2g" selenium/standalone-chrome

参数很简单,只配置了后端操作,端口映射,shm大小

Selenium 调用远程服务抓取网页

Selenium 的 webdrive 有一个 Remote 参数来指定远程地址

from selenium import webdriver

from scrapy.selector import Selector

options = webdriver.ChromeOptions()

options.add_argument('--headless') # example

driver = webdriver.Remote("http://127.0.0.1:14444/wd/hub", options=options)

driver.get("https://www.bobobk.com";)

hrefs = Selector(text=driver.page_source).xpath("//article/header/h1/a/@href").extract()

for url in hrefs:

print(url)

#https://www.bobobk.com/833.html

#https://www.bobobk.com/621.html

#https://www.bobobk.com/852.html

#https://www.bobobk.com/731.html

#https://www.bobobk.com/682.html

#https://www.bobobk.com/671.html

#https://www.bobobk.com/523.html

#https://www.bobobk.com/521.html

#https://www.bobobk.com/823.html

#https://www.bobobk.com/512.html

示例中以这个网站为目标,实际验证中javascript渲染的网站可以完美捕获

总结

使用docker提供浏览器服务,可以很好的解决网页被js实时渲染,导致无法获取需要的网页内容的问题。

js抓取网页内容(什么是jQuery的HTTP模块?以及如何使用? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-12-08 04:04

)

一、基本思路

首先找一个网址:因为这是http协议,所以需要用到node.js的http模块,我们使用http模块中的get()方法来抓取。其中,如果我们不需要捕获所有的数据,而只需要部分数据,比如某个类下的a标签中的文本,那么如果我们在前端,就可以使用DOM操作找到这个节点,但是node.js中没有DOM操作,所以这里需要用到cheerio库。既然抓到了网站上的数据,就涉及到文件的写入,此时需要用到node.js中的fs模块。

二、学习网址

cheerio 官方学习文档cheerio npm 网站 node.js 官方文档 node.js 中文文档

二、cheerio 是什么以及如何使用

Cheerio 是为服务器设计的核心 jQuery 的快速、灵活和精益实现。他可以像jquery一样操作字符串。

安装cheerio

npm install cheerio

具体用途

const cheerio = require('cheerio')

const $ = cheerio.load('Hello world')

$('h2.title').text('Hello there!')

$('h2').addClass('welcome')

$.html()

//=> Hello there!

三、具体代码

const http = require("http");

const fs = require("fs");

const cheerio = require("cheerio");

http.get("http://tech.ifeng.com/", function(res) {

// 设置编码

res.setEncoding("utf8");

// 当接收到数据时,会触发 "data" 事件的执行

let html = "";

res.on("data", function(data){

html += data;

});

// 数据接收完毕,会触发 "end" 事件的执行

res.on("end", function(){

// 待保存到文件中的字符串

let fileData = "";

// 调用 cheerio.load() 方法,生成一个类似于 jQuery 的对象

const $ = cheerio.load(html);

// 接下来像使用 jQuery 一样来使用 cheerio

$(".pictxt02").each(function(index, element) {

const el = $(element);

let link = el.find("h3 a").attr("href"),

title = el.find("h3 a").text(),

desc = el.children("p").text();

fileData += `${link}\r\n${title}\r\n\t${desc}\r\n\r\n`;

});

// console.log("读取结束,内容:");

// console.log(html);

fs.writeFile("./dist/source.txt", fileData, function(err) {

if (err)

return;

console.log("成功")

});

})

}); 查看全部

js抓取网页内容(什么是jQuery的HTTP模块?以及如何使用?

)

一、基本思路

首先找一个网址:因为这是http协议,所以需要用到node.js的http模块,我们使用http模块中的get()方法来抓取。其中,如果我们不需要捕获所有的数据,而只需要部分数据,比如某个类下的a标签中的文本,那么如果我们在前端,就可以使用DOM操作找到这个节点,但是node.js中没有DOM操作,所以这里需要用到cheerio库。既然抓到了网站上的数据,就涉及到文件的写入,此时需要用到node.js中的fs模块。

二、学习网址

cheerio 官方学习文档cheerio npm 网站 node.js 官方文档 node.js 中文文档

二、cheerio 是什么以及如何使用

Cheerio 是为服务器设计的核心 jQuery 的快速、灵活和精益实现。他可以像jquery一样操作字符串。

安装cheerio

npm install cheerio

具体用途

const cheerio = require('cheerio')

const $ = cheerio.load('Hello world')

$('h2.title').text('Hello there!')

$('h2').addClass('welcome')

$.html()

//=> Hello there!

三、具体代码

const http = require("http");

const fs = require("fs");

const cheerio = require("cheerio");

http.get("http://tech.ifeng.com/", function(res) {

// 设置编码

res.setEncoding("utf8");

// 当接收到数据时,会触发 "data" 事件的执行

let html = "";

res.on("data", function(data){

html += data;

});

// 数据接收完毕,会触发 "end" 事件的执行

res.on("end", function(){

// 待保存到文件中的字符串

let fileData = "";

// 调用 cheerio.load() 方法,生成一个类似于 jQuery 的对象

const $ = cheerio.load(html);

// 接下来像使用 jQuery 一样来使用 cheerio

$(".pictxt02").each(function(index, element) {

const el = $(element);

let link = el.find("h3 a").attr("href"),

title = el.find("h3 a").text(),

desc = el.children("p").text();

fileData += `${link}\r\n${title}\r\n\t${desc}\r\n\r\n`;

});

// console.log("读取结束,内容:");

// console.log(html);

fs.writeFile("./dist/source.txt", fileData, function(err) {

if (err)

return;

console.log("成功")

});

})

});

js抓取网页内容(新浪新闻国内新闻页静态网页数据在函数中的应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-06 07:11

昨天,一个朋友来找我。新浪新闻国内新闻页面的其他部分是静态网页,但左下方的最新新闻部分不是静态网页,也没有json数据。让我帮你抓住它。大概看了一下,是js加载的,数据在js函数里面,很有意思,所以分享给大家看看!

抓取目标

我们今天的目标是上图的红框部分。首先,我们确定这部分内容不在网页的源代码中,而是属于js加载的部分。点击翻页后没有json数据传输!

但是我发现有一个js请求,点击请求,是一行js函数代码,我们复制到json的view viewer,然后格式化看看结果

发现可能有我们需要的内容,比如url、title、intro这3个参数,猜测是对应的新闻网址、标题、介绍

只是它的内容,需要处理,我们写在代码里看看

开始写代码

先导入库,因为需要截取字符串的最后一部分,所以使用requests库来获取请求,重新匹配内容即可。然后我们先匹配上面的3个item

可以看到,url中有\\,标题和介绍都是\u4e09的形式。这些是我们需要处理的后续步骤!

先用replace函数去掉url中的\\,就可以得到url了,下面的\u4e09是unicode编码,可以直接解码内容,直接写代码

eval函数用于解码,解码内容可以是u"+unicode编码内容+"!

这样就把这个页面上所有的新闻和URL相关的内容都取出来了,在外层加了一个循环来爬取所有的新闻页面,任务就完成了!

后记

新浪新闻的页面js功能比较简单,可以直接抓取数据。如果是比较复杂的功能,就需要了解前端知识。这就是学习爬虫需要学习前端知识的原因!

ps:上面使用的json查看器是第三方的网站,你可以直接百度找很多,当然你也可以直接修改上面抓包的内容,然后用json读取数据!

基本代码不多。有看不清楚的小伙伴可以私信我索取代码或者一起研究爬虫! 查看全部

js抓取网页内容(新浪新闻国内新闻页静态网页数据在函数中的应用)

昨天,一个朋友来找我。新浪新闻国内新闻页面的其他部分是静态网页,但左下方的最新新闻部分不是静态网页,也没有json数据。让我帮你抓住它。大概看了一下,是js加载的,数据在js函数里面,很有意思,所以分享给大家看看!

抓取目标

我们今天的目标是上图的红框部分。首先,我们确定这部分内容不在网页的源代码中,而是属于js加载的部分。点击翻页后没有json数据传输!

但是我发现有一个js请求,点击请求,是一行js函数代码,我们复制到json的view viewer,然后格式化看看结果

发现可能有我们需要的内容,比如url、title、intro这3个参数,猜测是对应的新闻网址、标题、介绍

只是它的内容,需要处理,我们写在代码里看看

开始写代码

先导入库,因为需要截取字符串的最后一部分,所以使用requests库来获取请求,重新匹配内容即可。然后我们先匹配上面的3个item

可以看到,url中有\\,标题和介绍都是\u4e09的形式。这些是我们需要处理的后续步骤!

先用replace函数去掉url中的\\,就可以得到url了,下面的\u4e09是unicode编码,可以直接解码内容,直接写代码

eval函数用于解码,解码内容可以是u"+unicode编码内容+"!

这样就把这个页面上所有的新闻和URL相关的内容都取出来了,在外层加了一个循环来爬取所有的新闻页面,任务就完成了!

后记

新浪新闻的页面js功能比较简单,可以直接抓取数据。如果是比较复杂的功能,就需要了解前端知识。这就是学习爬虫需要学习前端知识的原因!

ps:上面使用的json查看器是第三方的网站,你可以直接百度找很多,当然你也可以直接修改上面抓包的内容,然后用json读取数据!

基本代码不多。有看不清楚的小伙伴可以私信我索取代码或者一起研究爬虫!

js抓取网页内容(什么是HTML源码中的JS动态生成?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-06 07:08

我们之前抓取的网页大多是 HTML 静态生成的内容。您可以直接从 HTML 源代码中找到您看到的数据和内容。然而,并不是所有的网页都是这样。

网站的部分内容是前端JS动态生成的。由于网页呈现的内容是由JS生成的,我们可以在浏览器上看到,但是在HTML源代码中是找不到的。比如今天的头条新闻:

浏览器渲染出来的网页如下图所示:

查看源码,却是如下图:

网页上的新闻在HTML源代码中是找不到的,都是JS动态生成和加载的。

在这种情况下,我们应该如何抓取网页呢?有两种方式:

从网页响应中查找JS脚本返回的JSON数据;

使用 Selenium 模拟对网页的访问

这里只介绍第一种方法。关于Selenium的使用有专门的文章。

一、从网页响应中查找JS脚本返回的JSON数据

即使网页内容是由JS动态生成和加载的,JS也需要调用一个接口,然后根据接口返回的JSON数据进行加载和渲染。

这样我们就可以找到JS调用的数据接口,从数据接口中找到网页最后呈现的数据。

以今日头条为例来说明:

1、找到JS请求的数据接口

F12打开网页调试工具

网页调试工具

选择“网络”选项卡后,我们发现有很多响应。让我们过滤它们,只查看 XHR 响应。(XHR 是 Ajax 中的一个概念,意思是 XMLHTTPrequest)

然后我们发现很多链接都没有了,随便点一个看看:

我们选择city,预览中有一串json数据:

我们再次点击打开:

原来它们都是城市列表,应该用来加载地区新闻。

现在你应该明白如何找到JS请求的接口了吧?但是刚才没有找到我们想要的消息,所以我们再找一遍:

有一个焦点,我们打开看看:

图片新闻在首页呈现的数据是一样的,所以数据应该是有的。

查看其他链接:

这个应该是热搜关键词

返回一串乱码,但是从响应中查看的是正常的编码数据:

有了对应的数据接口,我们就可以模仿前面的方法去请求数据接口,得到响应了

2、请求和解析数据接口数据

先上传完整代码:

# 编码:utf-8

进口请求

导入json

网址 ='#39;

wbdata = requests.get(url).text

数据 = json.loads(wbdata)

新闻 = 数据['数据']['pc_feed_focus']

对于新闻中的 n:

标题 = n['标题']

img_url = n['image_url']

url = n['media_url']

打印(网址,标题,img_url)

返回结果如下:

像往常一样,稍微解释一下代码:

代码分为四部分,

第一部分:相关库介绍

# 编码:utf-8

进口请求

导入json

第二部分:向数据接口发出http请求

网址 ='#39;

wbdata = requests.get(url).text 查看全部

js抓取网页内容(什么是HTML源码中的JS动态生成?(一))

我们之前抓取的网页大多是 HTML 静态生成的内容。您可以直接从 HTML 源代码中找到您看到的数据和内容。然而,并不是所有的网页都是这样。

网站的部分内容是前端JS动态生成的。由于网页呈现的内容是由JS生成的,我们可以在浏览器上看到,但是在HTML源代码中是找不到的。比如今天的头条新闻:

浏览器渲染出来的网页如下图所示:

查看源码,却是如下图:

网页上的新闻在HTML源代码中是找不到的,都是JS动态生成和加载的。

在这种情况下,我们应该如何抓取网页呢?有两种方式:

从网页响应中查找JS脚本返回的JSON数据;

使用 Selenium 模拟对网页的访问

这里只介绍第一种方法。关于Selenium的使用有专门的文章。

一、从网页响应中查找JS脚本返回的JSON数据

即使网页内容是由JS动态生成和加载的,JS也需要调用一个接口,然后根据接口返回的JSON数据进行加载和渲染。

这样我们就可以找到JS调用的数据接口,从数据接口中找到网页最后呈现的数据。

以今日头条为例来说明:

1、找到JS请求的数据接口

F12打开网页调试工具

网页调试工具

选择“网络”选项卡后,我们发现有很多响应。让我们过滤它们,只查看 XHR 响应。(XHR 是 Ajax 中的一个概念,意思是 XMLHTTPrequest)

然后我们发现很多链接都没有了,随便点一个看看:

我们选择city,预览中有一串json数据:

我们再次点击打开:

原来它们都是城市列表,应该用来加载地区新闻。

现在你应该明白如何找到JS请求的接口了吧?但是刚才没有找到我们想要的消息,所以我们再找一遍:

有一个焦点,我们打开看看:

图片新闻在首页呈现的数据是一样的,所以数据应该是有的。

查看其他链接:

这个应该是热搜关键词

返回一串乱码,但是从响应中查看的是正常的编码数据:

有了对应的数据接口,我们就可以模仿前面的方法去请求数据接口,得到响应了

2、请求和解析数据接口数据

先上传完整代码:

# 编码:utf-8

进口请求

导入json

网址 ='#39;

wbdata = requests.get(url).text

数据 = json.loads(wbdata)

新闻 = 数据['数据']['pc_feed_focus']

对于新闻中的 n:

标题 = n['标题']

img_url = n['image_url']

url = n['media_url']

打印(网址,标题,img_url)

返回结果如下:

像往常一样,稍微解释一下代码:

代码分为四部分,

第一部分:相关库介绍

# 编码:utf-8

进口请求

导入json

第二部分:向数据接口发出http请求

网址 ='#39;

wbdata = requests.get(url).text

js抓取网页内容(【知识点】各种常见的HTML文档的域有关详解)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-05 01:16

1、有问题

同源政策

页面中的Javascript只能读取和访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

DOCTYPE HTML>

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但JQuery的域只和它所在的HTML文档的域相关。从而可以访问到HTML文档的属性,所以上面的代码就可以正常运行了。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么就无法实现你所期望的功能;如果远程点是指您可以控制的发问者网站,请参阅下面的放宽同源策略;

放宽同源策略 Document.domain:用于子域的情况。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

综上所述:

(1)服务器开启网页的跨域限制;

(2)使用服务器请求页面

转载于: 查看全部

js抓取网页内容(【知识点】各种常见的HTML文档的域有关详解)

1、有问题

同源政策

页面中的Javascript只能读取和访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

DOCTYPE HTML>

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但JQuery的域只和它所在的HTML文档的域相关。从而可以访问到HTML文档的属性,所以上面的代码就可以正常运行了。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么就无法实现你所期望的功能;如果远程点是指您可以控制的发问者网站,请参阅下面的放宽同源策略;

放宽同源策略 Document.domain:用于子域的情况。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

综上所述:

(1)服务器开启网页的跨域限制;

(2)使用服务器请求页面

转载于:

js抓取网页内容(java项目有时候我们需要别人网页上的数据(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-02 18:20

有时候我们在java项目中需要从别人的网页中获取数据,我们该怎么办?我们可以使用第三方框架包jsou来实现,jsoup的中文文档,具体怎么实现?然后跟着我一步一步

首先要做的就是准备第三方机架包,下载地址,拿到jar后需要做什么?别着急,让我们慢慢来

将jsoup.jar复制到项目的WebRoot—>WEB-INF—>lib文件夹

那我们就来介绍一下这款架子包吧!

项目右键选择构建路径—>配置构建路径—>库—>添加jars—>在刚才放入的目录中找到jsoup

准备工作已经完成,接下来就是我们的编码部分,加油!

既然是爬取网页的内容,那么首先肯定是抓到的网站的地址,这里是我的一篇博客。

这是我的文章的截图。比如我想抓取Android片段和知识点,我会不断更新本文。

//获取整个网站的根节点,即html的开头和结尾,这里get方法和post方法是一样的

文档文档 = Jsoup.connect(url).get();

//输出后,我们会看到整个字符串如下

System.out.println(文件);

这里只是截图的一部分

我们会看到我们需要抓取的那段文字被包裹在了a标签中,另外一个重要的就是id=cb_post_title_url。看过文档的应该知道,jsoup中有一个getElementById方法,其实和js中获取元素是一样的。是的,这里我们可以使用

GetElementById方法来获取这个标签,获取之后就可以获取里面的内容了吧?而且正好jsou也给我们提供了这样一个方法text()方法,就是获取label的文本内容,记住是text的形式,而不是html

如下,我们使用getElementById方法获取我们想要的a标签

元素 a = document.getElementById("cb_post_title_url");

这时候我们输出的内容如下

System.out.println(a.text());

你得到了我们想要的吗?当然,这只是jsoup最简单的爬取。如果需要获取列表形式,jsoup也是可以的。我们都知道 id 是唯一的,不能重复,所以我们通过 id 得到的 只能是一行标签

但是对于ul-li这样的一般列表,我们可以使用getElementsByTag这个方法通过标签名来获取,然后通过for循环一一抓取。然后我们将附上代码。

package com.luhan.text;

import java.io.IOException;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

public class Text {

private static final String url = "http://www.cnblogs.com/luhan/p/5953387.html";

public static void main(String[] args) {

try {

//获取整个网站的根节点,也就是html开头部分一直到结束

Document document = Jsoup.connect(url).post();

Element a = document.getElementById("cb_post_title_url");

System.out.println(a.text());

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

jsoup中的方法我就不一一介绍了。不明白的可以去jsoup的中文文档。再说说比较重要的方法。

Jsoup.connect(url).post(); 获取网页的follow目录

getElementById 通过 id 获取

getElementsByClass 通过类获取

getElementsByTag 按标签名称获取

text() 获取标签的文字,再次强调是文字

html() 获取标签中的所有字符串,包括html标签

attr(attributeKey) 获取属性内部的值,参数为属性名

注意

jsoup获取的网页根目录可能与源码不同,需要注意

至此,jsoup对网页数据的抓取就结束了。这不是很好。欢迎大家指点。我使用java控制台。javaweb和Android的用法是一样的。首先导入框架,然后调用方法。 查看全部

js抓取网页内容(java项目有时候我们需要别人网页上的数据(组图))

有时候我们在java项目中需要从别人的网页中获取数据,我们该怎么办?我们可以使用第三方框架包jsou来实现,jsoup的中文文档,具体怎么实现?然后跟着我一步一步

首先要做的就是准备第三方机架包,下载地址,拿到jar后需要做什么?别着急,让我们慢慢来

将jsoup.jar复制到项目的WebRoot—>WEB-INF—>lib文件夹

那我们就来介绍一下这款架子包吧!

项目右键选择构建路径—>配置构建路径—>库—>添加jars—>在刚才放入的目录中找到jsoup

准备工作已经完成,接下来就是我们的编码部分,加油!

既然是爬取网页的内容,那么首先肯定是抓到的网站的地址,这里是我的一篇博客。

这是我的文章的截图。比如我想抓取Android片段和知识点,我会不断更新本文。

//获取整个网站的根节点,即html的开头和结尾,这里get方法和post方法是一样的

文档文档 = Jsoup.connect(url).get();

//输出后,我们会看到整个字符串如下

System.out.println(文件);

这里只是截图的一部分

我们会看到我们需要抓取的那段文字被包裹在了a标签中,另外一个重要的就是id=cb_post_title_url。看过文档的应该知道,jsoup中有一个getElementById方法,其实和js中获取元素是一样的。是的,这里我们可以使用

GetElementById方法来获取这个标签,获取之后就可以获取里面的内容了吧?而且正好jsou也给我们提供了这样一个方法text()方法,就是获取label的文本内容,记住是text的形式,而不是html

如下,我们使用getElementById方法获取我们想要的a标签

元素 a = document.getElementById("cb_post_title_url");

这时候我们输出的内容如下

System.out.println(a.text());

你得到了我们想要的吗?当然,这只是jsoup最简单的爬取。如果需要获取列表形式,jsoup也是可以的。我们都知道 id 是唯一的,不能重复,所以我们通过 id 得到的 只能是一行标签

但是对于ul-li这样的一般列表,我们可以使用getElementsByTag这个方法通过标签名来获取,然后通过for循环一一抓取。然后我们将附上代码。

package com.luhan.text;

import java.io.IOException;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

public class Text {

private static final String url = "http://www.cnblogs.com/luhan/p/5953387.html";

public static void main(String[] args) {

try {

//获取整个网站的根节点,也就是html开头部分一直到结束

Document document = Jsoup.connect(url).post();

Element a = document.getElementById("cb_post_title_url");

System.out.println(a.text());

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

jsoup中的方法我就不一一介绍了。不明白的可以去jsoup的中文文档。再说说比较重要的方法。

Jsoup.connect(url).post(); 获取网页的follow目录

getElementById 通过 id 获取

getElementsByClass 通过类获取

getElementsByTag 按标签名称获取

text() 获取标签的文字,再次强调是文字

html() 获取标签中的所有字符串,包括html标签

attr(attributeKey) 获取属性内部的值,参数为属性名

注意

jsoup获取的网页根目录可能与源码不同,需要注意

至此,jsoup对网页数据的抓取就结束了。这不是很好。欢迎大家指点。我使用java控制台。javaweb和Android的用法是一样的。首先导入框架,然后调用方法。

js抓取网页内容(网站所有者会为网站设置各种反抓取技术来阻止抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-12-02 18:19

网页抓取是一种经常用于自动化人类浏览行为的技术,其目的是从网页中有效地检索大量数据。各种网页抓取工具越来越流行,也让各行各业的人们受益匪浅。由于过度的网络爬虫使网络服务器过载,导致服务器出现故障,网站的所有者会为网站设置各种反爬虫技术来防止爬虫工具,这使得网络爬虫更加困难。本文将重点介绍如何在不被拦截的情况下持续抓取网页。

1、放慢抓取速度

大多数网络抓取活动旨在尽快获取数据。当人们访问一个网站时,浏览速度会比网络爬行慢很多。因此,网站 可以通过跟踪您的访问速度轻松捕获您为爬虫。因此,您可以在请求之间放置一些随机的时间延迟,并将并发页面访问一次减少到 1-2 个页面。

2、,使用代理服务器

当站点检测到来自单个 IP 地址的多个请求时,它可以轻松阻止该 IP 地址。为避免通过同一个IP地址发送所有请求,您可以使用代理服务器,您可以随意使用它们,并使用不同的IP地址来路由您的请求。

3、应用不同的爬取模式

人们通常会随意点击或查看时间来浏览网站,网络爬行总是遵循与编程机器人遵循特定逻辑相同的爬行模式。反爬虫机制可以识别对网站爬行行为的重复执行,轻松检测爬虫。因此,您需要不时改变抓取方式,结合随机点击、鼠标移动或等待时间,使网页抓取更加人性化。

4、蜜罐陷阱

蜜罐是一个普通访问者看不到的链接,但存在于HTML代码中,可以被网络爬虫发现。它们就像陷阱,通过将刮板引导到空白页面来检测刮板。一旦特定访问者浏览了蜜罐页面,网站 就可以相对确定它不是人类访问者,并开始限制或阻止来自客户端的所有请求。在为特定站点构建爬虫时,您需要仔细检查是否存在任何使用标准浏览器对用户隐藏的链接。 查看全部

js抓取网页内容(网站所有者会为网站设置各种反抓取技术来阻止抓取工具)

网页抓取是一种经常用于自动化人类浏览行为的技术,其目的是从网页中有效地检索大量数据。各种网页抓取工具越来越流行,也让各行各业的人们受益匪浅。由于过度的网络爬虫使网络服务器过载,导致服务器出现故障,网站的所有者会为网站设置各种反爬虫技术来防止爬虫工具,这使得网络爬虫更加困难。本文将重点介绍如何在不被拦截的情况下持续抓取网页。

1、放慢抓取速度

大多数网络抓取活动旨在尽快获取数据。当人们访问一个网站时,浏览速度会比网络爬行慢很多。因此,网站 可以通过跟踪您的访问速度轻松捕获您为爬虫。因此,您可以在请求之间放置一些随机的时间延迟,并将并发页面访问一次减少到 1-2 个页面。

2、,使用代理服务器

当站点检测到来自单个 IP 地址的多个请求时,它可以轻松阻止该 IP 地址。为避免通过同一个IP地址发送所有请求,您可以使用代理服务器,您可以随意使用它们,并使用不同的IP地址来路由您的请求。

3、应用不同的爬取模式

人们通常会随意点击或查看时间来浏览网站,网络爬行总是遵循与编程机器人遵循特定逻辑相同的爬行模式。反爬虫机制可以识别对网站爬行行为的重复执行,轻松检测爬虫。因此,您需要不时改变抓取方式,结合随机点击、鼠标移动或等待时间,使网页抓取更加人性化。

4、蜜罐陷阱

蜜罐是一个普通访问者看不到的链接,但存在于HTML代码中,可以被网络爬虫发现。它们就像陷阱,通过将刮板引导到空白页面来检测刮板。一旦特定访问者浏览了蜜罐页面,网站 就可以相对确定它不是人类访问者,并开始限制或阻止来自客户端的所有请求。在为特定站点构建爬虫时,您需要仔细检查是否存在任何使用标准浏览器对用户隐藏的链接。

js抓取网页内容(网站所有者会为网站设置各种反抓取技术来阻止抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2021-12-02 18:18

网页抓取是一种经常用于自动化人类浏览行为的技术,其目的是从网页中有效地检索大量数据。各种网页抓取工具越来越流行,也让各行各业的人们受益匪浅。由于过度的网络爬虫使网络服务器过载,导致服务器出现故障,网站的所有者会为网站设置各种反爬虫技术来防止爬虫工具,这使得网络爬虫更加困难。本文将重点介绍如何在不被拦截的情况下持续抓取网页。

1、放慢抓取速度

大多数网络抓取活动旨在尽快获取数据。当人们访问一个网站时,浏览速度会比网络爬行慢很多。因此,网站 可以通过跟踪您的访问速度轻松捕获您为爬虫。因此,您可以在请求之间放置一些随机的时间延迟,并将并发页面访问一次减少到 1-2 个页面。

2、,使用代理服务器

当站点检测到来自单个 IP 地址的多个请求时,它可以轻松阻止该 IP 地址。为避免通过同一个IP地址发送所有请求,您可以使用代理服务器,您可以随意使用它们,并使用不同的IP地址来路由您的请求。

3、应用不同的爬取模式

人们通常会随意点击或查看时间来浏览网站,网络爬行总是遵循与编程机器人遵循特定逻辑相同的爬行模式。反爬虫机制可以识别对网站爬行行为的重复执行,轻松检测爬虫。因此,您需要不时改变抓取方式,结合随机点击、鼠标移动或等待时间,使网页抓取更加人性化。

4、蜜罐陷阱

蜜罐是一个普通访问者看不到的链接,但存在于HTML代码中,可以被网络爬虫发现。它们就像陷阱,通过将刮板引导到空白页面来检测刮板。一旦特定访问者浏览了蜜罐页面,网站 就可以相对确定它不是人类访问者,并开始限制或阻止来自客户端的所有请求。在为特定站点构建爬虫时,您需要仔细检查是否存在任何使用标准浏览器对用户隐藏的链接。 查看全部

js抓取网页内容(网站所有者会为网站设置各种反抓取技术来阻止抓取工具)

网页抓取是一种经常用于自动化人类浏览行为的技术,其目的是从网页中有效地检索大量数据。各种网页抓取工具越来越流行,也让各行各业的人们受益匪浅。由于过度的网络爬虫使网络服务器过载,导致服务器出现故障,网站的所有者会为网站设置各种反爬虫技术来防止爬虫工具,这使得网络爬虫更加困难。本文将重点介绍如何在不被拦截的情况下持续抓取网页。

1、放慢抓取速度

大多数网络抓取活动旨在尽快获取数据。当人们访问一个网站时,浏览速度会比网络爬行慢很多。因此,网站 可以通过跟踪您的访问速度轻松捕获您为爬虫。因此,您可以在请求之间放置一些随机的时间延迟,并将并发页面访问一次减少到 1-2 个页面。

2、,使用代理服务器

当站点检测到来自单个 IP 地址的多个请求时,它可以轻松阻止该 IP 地址。为避免通过同一个IP地址发送所有请求,您可以使用代理服务器,您可以随意使用它们,并使用不同的IP地址来路由您的请求。

3、应用不同的爬取模式

人们通常会随意点击或查看时间来浏览网站,网络爬行总是遵循与编程机器人遵循特定逻辑相同的爬行模式。反爬虫机制可以识别对网站爬行行为的重复执行,轻松检测爬虫。因此,您需要不时改变抓取方式,结合随机点击、鼠标移动或等待时间,使网页抓取更加人性化。

4、蜜罐陷阱

蜜罐是一个普通访问者看不到的链接,但存在于HTML代码中,可以被网络爬虫发现。它们就像陷阱,通过将刮板引导到空白页面来检测刮板。一旦特定访问者浏览了蜜罐页面,网站 就可以相对确定它不是人类访问者,并开始限制或阻止来自客户端的所有请求。在为特定站点构建爬虫时,您需要仔细检查是否存在任何使用标准浏览器对用户隐藏的链接。

js抓取网页内容(这里有新鲜出炉的Javascript教程,程序狗速度看过来!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-11-30 13:01

这里有一个新发布的Javascript教程,来看看程序狗的速度吧!

JavaScript 客户端脚本语言 JavaScript 是一种基于对象的动态类型区分大小写的客户端脚本语言,由 Netscape 的 LiveScript 发展而来,由 Netscape 的 LiveScript 发展而来。主要目的是解决服务端语言,如Perl,遗留的Speed问题,为客户提供更流畅的浏览效果。

本文文章主要介绍JavaScript的history API,使搜索引擎能够抓取AJAX内容相关信息。有需要的朋友可以参考

大家在浏览Facebook相册的时候有没有注意到,页面部分刷新时地址栏中的地址也发生了变化,并不是hash方法。它使用了 HTML5 历史上的几个新 API。作为窗口的全局变量,历史在 HTML4 时代并不是什么新鲜事。我们经常使用 history.back() 和 history.go()。

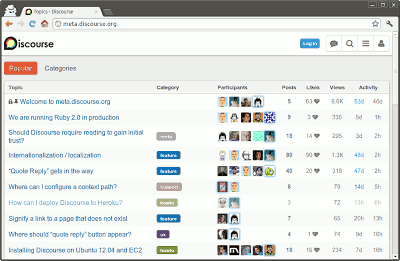

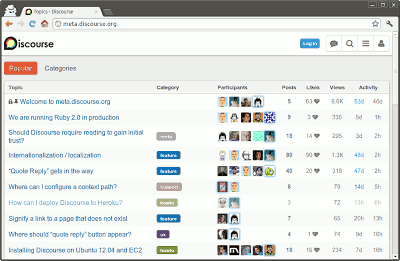

一直觉得没办法,直到两天前看到Discourse创始人之一Robin Ward的解决方案,忍不住尖叫起来。

Discourse 是一个严重依赖 Ajax 的论坛程序,但它必须让 Google收录 内容。它的解决方案是放弃hash结构,使用History API。

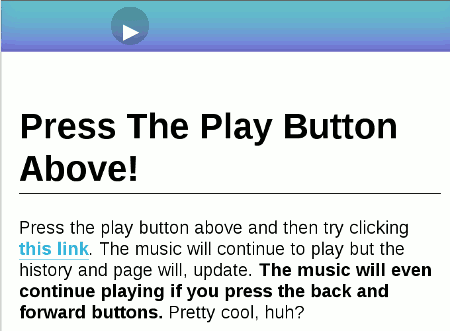

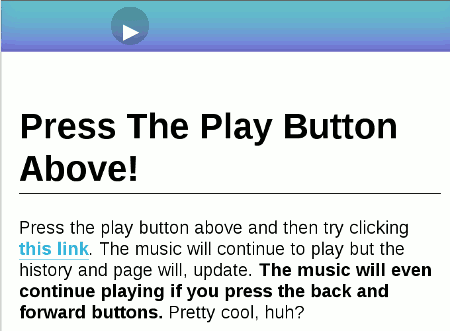

所谓History API,就是在不刷新页面的情况下,改变浏览器地址栏中显示的URL(准确的说是改变网页的当前状态)。这是一个示例,您单击上面的按钮开始播放音乐。然后,点击下面的链接看看发生了什么?

地址栏中的网址已更改,但音乐播放并未中断!

History API 的详细介绍超出了本文章的范围。简单的说到这里,它的作用就是给浏览器的History对象添加一条记录。

window.history.pushState(state object, title, url);

上面这行命令可以让地址栏中出现一个新的 URL。History对象的pushState方法接受三个参数,新的URL为第三个参数,前两个参数可以为null。

window.history.pushState(null, null, newURL);

目前主流浏览器都支持这种方式:Chrome(26.0+)、Firefox(20.0+)、IE(10.0+)、Safari(5.1+)、歌剧 (12.1+)。

这是罗宾沃德的方法。

首先,用History API替换hash结构,让每一个hash符号变成一个正常路径的URL,这样搜索引擎就会抓取每一个网页。

/1

/2

/3

然后,定义一个 JavaScript 函数来处理 Ajax 部分并根据 URL 抓取内容(假设使用 jQuery)。

function anchorClick(link) {

var linkSplit = link.split('/').pop();

$.get('api/' + linkSplit, function(data) {

$('#content').html(data);

});

}

然后定义鼠标的点击事件。

$('#container').on('click', 'a', function(e) {

window.history.pushState(null, null, $(this).attr('href'));

anchorClick($(this).attr('href'));

e.preventDefault();

});

还要考虑用户单击浏览器的“前进/后退”按钮。这时候会触发History对象的popstate事件。

window.addEventListener('popstate', function(e) {

anchorClick(location.pathname);

});

定义以上三段代码后,无需刷新页面即可显示正常路径URL和AJAX内容。

最后,设置服务器端。

因为没有使用 hashtag 结构,所以每个 URL 都是不同的请求。因此,服务器需要向所有这些请求返回具有以下结构的网页,以防止 404 错误。

... ...

仔细看上面的代码,你会发现一个noscript标签,这就是秘密。

我们将所有我们想要搜索引擎的内容放在了 noscript 标签中。在这种情况下,用户仍然可以在不刷新页面的情况下进行AJAX操作,但是搜索引擎会收录每个页面的主要内容! 查看全部

js抓取网页内容(这里有新鲜出炉的Javascript教程,程序狗速度看过来!)

这里有一个新发布的Javascript教程,来看看程序狗的速度吧!

JavaScript 客户端脚本语言 JavaScript 是一种基于对象的动态类型区分大小写的客户端脚本语言,由 Netscape 的 LiveScript 发展而来,由 Netscape 的 LiveScript 发展而来。主要目的是解决服务端语言,如Perl,遗留的Speed问题,为客户提供更流畅的浏览效果。

本文文章主要介绍JavaScript的history API,使搜索引擎能够抓取AJAX内容相关信息。有需要的朋友可以参考

大家在浏览Facebook相册的时候有没有注意到,页面部分刷新时地址栏中的地址也发生了变化,并不是hash方法。它使用了 HTML5 历史上的几个新 API。作为窗口的全局变量,历史在 HTML4 时代并不是什么新鲜事。我们经常使用 history.back() 和 history.go()。

一直觉得没办法,直到两天前看到Discourse创始人之一Robin Ward的解决方案,忍不住尖叫起来。

Discourse 是一个严重依赖 Ajax 的论坛程序,但它必须让 Google收录 内容。它的解决方案是放弃hash结构,使用History API。

所谓History API,就是在不刷新页面的情况下,改变浏览器地址栏中显示的URL(准确的说是改变网页的当前状态)。这是一个示例,您单击上面的按钮开始播放音乐。然后,点击下面的链接看看发生了什么?

地址栏中的网址已更改,但音乐播放并未中断!

History API 的详细介绍超出了本文章的范围。简单的说到这里,它的作用就是给浏览器的History对象添加一条记录。

window.history.pushState(state object, title, url);

上面这行命令可以让地址栏中出现一个新的 URL。History对象的pushState方法接受三个参数,新的URL为第三个参数,前两个参数可以为null。

window.history.pushState(null, null, newURL);

目前主流浏览器都支持这种方式:Chrome(26.0+)、Firefox(20.0+)、IE(10.0+)、Safari(5.1+)、歌剧 (12.1+)。

这是罗宾沃德的方法。

首先,用History API替换hash结构,让每一个hash符号变成一个正常路径的URL,这样搜索引擎就会抓取每一个网页。

/1

/2

/3

然后,定义一个 JavaScript 函数来处理 Ajax 部分并根据 URL 抓取内容(假设使用 jQuery)。

function anchorClick(link) {

var linkSplit = link.split('/').pop();

$.get('api/' + linkSplit, function(data) {

$('#content').html(data);

});

}

然后定义鼠标的点击事件。

$('#container').on('click', 'a', function(e) {

window.history.pushState(null, null, $(this).attr('href'));

anchorClick($(this).attr('href'));

e.preventDefault();

});

还要考虑用户单击浏览器的“前进/后退”按钮。这时候会触发History对象的popstate事件。

window.addEventListener('popstate', function(e) {

anchorClick(location.pathname);

});

定义以上三段代码后,无需刷新页面即可显示正常路径URL和AJAX内容。

最后,设置服务器端。

因为没有使用 hashtag 结构,所以每个 URL 都是不同的请求。因此,服务器需要向所有这些请求返回具有以下结构的网页,以防止 404 错误。

... ...

仔细看上面的代码,你会发现一个noscript标签,这就是秘密。

我们将所有我们想要搜索引擎的内容放在了 noscript 标签中。在这种情况下,用户仍然可以在不刷新页面的情况下进行AJAX操作,但是搜索引擎会收录每个页面的主要内容!

js抓取网页内容(网站首页(home或index页等)应该采用文本的形式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-11-30 13:00

网站的首页(首页或索引页等)应为文本形式,不能为flash等,此文本应收录您的目标关键词或目标词组,如瑞美热水器、时代海创等。请记住用半角逗号分隔 关键词。

3个标签

</title>这是标题标签,应该收录你最重要的目标关键词。一般网站的标题就是这个标签中间的内容。每个人都忽略了一点。网页的标题实际上是 关键词 显示中最好的部分之一。

4元标签

'description tag'(描述标签)和'keyword tag'(关键词 标签)应该收录你的目标关键词或目标词组,但不要重复。这部分主要显示在你网页的代码中。

替代标签

5 网站上的重要图片,如标志、照片、导航图片等,应简要描述。人们往往不会这样做,因为这部分主要是体力劳动,比较繁琐,但这部分也恰好是优化的关键之一。

6关键词 文字

在您的网站中,应该有关键字密度高的页面。但这种方法不宜过多使用,否则会被搜索引擎视为作弊,适得其反。

关键词请记住这一段文字,如果你不是很了解SEO,不要盲目使用,否则会出现大家都知道的效果!

7 提交给搜索引擎

请不要使用软件或自动提交服务。事实上,无需将您的 URL 提交给数百个搜索引擎。5大搜索引擎和目录占搜索流量的90%。手动向那些熟悉的搜索引擎提交您的 URL 就足够了,不会花费您几分钟的时间。

8友情链接

与同行链接网站。内容相关、PR值高的网站是最好的。不要加入链接表单,它会阻止您访问搜索引擎。

9 关键词的密度

很多SEO前辈都回答过这个问题。答案是:2-8%、3-7%、不到10%、5%左右,可以任选其一。关键词 密度是一个模糊的概念,不是绝对的。

关键词 密度不是越高越好。在下面的解释中,你可能明白关键词密度是什么意思?

搜索引擎的工作流程如下所示:

(1)索引网页。这是Robot的工作。搜索机器人非常勤奋,所以成为收录是最容易的事情。(但很多人总是抱怨:我的为什么不停止成为收录?)

(2)按关键词对网页进行分类归档。

(3) 对关键词 存档中的所有网页进行排序。这涉及到域名 PR 值、链接锚文本等。

(4)对于流行的关键词,结果的第一页会生成一个静态页面。(如果你不明白这个,跳过它)

第二点是搜索引擎将网页内容中符合关键词密度标准的词确定为网页的关键词。那么,关键词 密度是什么意思?如果关键词的密度没有确定,就不可能有第三点排名。

其次,网站现在大部分都是用PHP写的或者开源的cms(只是简单的理解)

去专门的论坛再次学习。 查看全部

js抓取网页内容(网站首页(home或index页等)应该采用文本的形式)

网站的首页(首页或索引页等)应为文本形式,不能为flash等,此文本应收录您的目标关键词或目标词组,如瑞美热水器、时代海创等。请记住用半角逗号分隔 关键词。

3个标签

</title>这是标题标签,应该收录你最重要的目标关键词。一般网站的标题就是这个标签中间的内容。每个人都忽略了一点。网页的标题实际上是 关键词 显示中最好的部分之一。

4元标签

'description tag'(描述标签)和'keyword tag'(关键词 标签)应该收录你的目标关键词或目标词组,但不要重复。这部分主要显示在你网页的代码中。

替代标签

5 网站上的重要图片,如标志、照片、导航图片等,应简要描述。人们往往不会这样做,因为这部分主要是体力劳动,比较繁琐,但这部分也恰好是优化的关键之一。

6关键词 文字

在您的网站中,应该有关键字密度高的页面。但这种方法不宜过多使用,否则会被搜索引擎视为作弊,适得其反。

关键词请记住这一段文字,如果你不是很了解SEO,不要盲目使用,否则会出现大家都知道的效果!

7 提交给搜索引擎

请不要使用软件或自动提交服务。事实上,无需将您的 URL 提交给数百个搜索引擎。5大搜索引擎和目录占搜索流量的90%。手动向那些熟悉的搜索引擎提交您的 URL 就足够了,不会花费您几分钟的时间。

8友情链接

与同行链接网站。内容相关、PR值高的网站是最好的。不要加入链接表单,它会阻止您访问搜索引擎。

9 关键词的密度

很多SEO前辈都回答过这个问题。答案是:2-8%、3-7%、不到10%、5%左右,可以任选其一。关键词 密度是一个模糊的概念,不是绝对的。

关键词 密度不是越高越好。在下面的解释中,你可能明白关键词密度是什么意思?

搜索引擎的工作流程如下所示:

(1)索引网页。这是Robot的工作。搜索机器人非常勤奋,所以成为收录是最容易的事情。(但很多人总是抱怨:我的为什么不停止成为收录?)

(2)按关键词对网页进行分类归档。

(3) 对关键词 存档中的所有网页进行排序。这涉及到域名 PR 值、链接锚文本等。

(4)对于流行的关键词,结果的第一页会生成一个静态页面。(如果你不明白这个,跳过它)

第二点是搜索引擎将网页内容中符合关键词密度标准的词确定为网页的关键词。那么,关键词 密度是什么意思?如果关键词的密度没有确定,就不可能有第三点排名。

其次,网站现在大部分都是用PHP写的或者开源的cms(只是简单的理解)

去专门的论坛再次学习。

js抓取网页内容(Python爬虫爬取模块前的基本结构和编写程序的必备知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-29 14:31

爬虫程序之所以能够抓取数据,是因为爬虫可以对网页进行分析,从网页中提取出想要的数据。在学习Python爬虫模块之前,我们有必要熟悉网页的基本结构,这是编写爬虫程序的必备知识。

Python爬虫爬取的网页信息中,HTML是网站的主要结构,CSS是网页的外观细节,JavaScript是页面处理动作,通过分析提取信息的 HTML 文本。

了解网络

以Circlenet()主页为例,抓取Circlenet主页上的信息(标题和链接),数据在源代码中以纯文本形式呈现。在Circlenet首页,按快捷键【Ctrl+U】打开源代码页,如图:

网页一般由HTML(超文本标记语言)、CSS(层叠样式表)和JavaScript(简称“JS”动态脚本语言)三部分组成,每部分在网页中承担不同的任务。

HTML

HTML是网页的基本结构,相当于人体的骨骼结构。所有同时带有“<”和“>”符号的网页都属于HTML标签。常见的 HTML 标签如下:

声明为 HTML5 文档

.. 是网页的根元素

.. 元素包含了文档的元(meta)数据,如 定义网页编码格式为 utf-8。

.. 元素描述了文档的标题

.. 表示用户可见的内容

.. 表示框架

<p>.. 表示段落

.. 定义无序列表

..定义有序列表

..表示列表项

表示图片

..表示标题

..</a>表示超链接</p>

编写以下代码:

一点Python网

点击访问</a>

一点Python网www.1dit.cn

Python爬虫

<p>认识网页结构

HTML

CSS

</p>

CSS

CSS 代表级联样式表。有三种写法:内联样式、内联样式和大纲样式。CSS代码演示如下:

body{

background-color:yellow;

}

p{

font-size: 30px;

color: springgreen;

}

一点Python网

一点Python网www.1dit.cn

点击访问</a>

Python爬虫

<p>认识网页结构

HTML

CSS

</p>

如图2所示,内联样式通过style标签写入样式表:

内嵌样式使用 HTML 元素的 style 属性来编写 CSS 代码。请注意,每个 HTML 元素都有 style、class、id、name 和 title 属性。

外部样式表是指将 CSS 代码单独保存为一个以 .css 结尾的文件,并使用它来将其导入所需的页面:

当样式需要应用于多个页面时,使用外部样式表是最好的选择。

JavaScript

JavaScript 负责描述网页的行为。例如,可以使用 JavaScript 实现交互式内容和各种特殊效果。当然也可以通过其他方式实现,比如jQuery,以及一些前端框架(vue、React等),但都是在“JS”的基础上实现的。

简单的例子:

body{

background-color: rgb(220, 226, 226);

}

一点Python网

一点Python网www.1dit.cn

Python爬虫

<p>点击下方按钮获取当前时间

点击这里

</p>

function DisplayDate(){

document.getElementById("time").innerHTML=Date()

}

</p>

如果用人体作为比喻,HTML 就是人体骨架,它定义了人的嘴巴、眼睛、耳朵等应该长在哪里。CSS是一个人的外貌细节,比如嘴巴长什么样,眼睛是双眼皮还是单眼皮,眼睛是大是小,皮肤是黑还是白。JScript 代表人类技能,例如跳舞、唱歌或演奏乐器。 查看全部

js抓取网页内容(Python爬虫爬取模块前的基本结构和编写程序的必备知识)

爬虫程序之所以能够抓取数据,是因为爬虫可以对网页进行分析,从网页中提取出想要的数据。在学习Python爬虫模块之前,我们有必要熟悉网页的基本结构,这是编写爬虫程序的必备知识。

Python爬虫爬取的网页信息中,HTML是网站的主要结构,CSS是网页的外观细节,JavaScript是页面处理动作,通过分析提取信息的 HTML 文本。

了解网络

以Circlenet()主页为例,抓取Circlenet主页上的信息(标题和链接),数据在源代码中以纯文本形式呈现。在Circlenet首页,按快捷键【Ctrl+U】打开源代码页,如图:

网页一般由HTML(超文本标记语言)、CSS(层叠样式表)和JavaScript(简称“JS”动态脚本语言)三部分组成,每部分在网页中承担不同的任务。

HTML

HTML是网页的基本结构,相当于人体的骨骼结构。所有同时带有“<”和“>”符号的网页都属于HTML标签。常见的 HTML 标签如下:

声明为 HTML5 文档

.. 是网页的根元素

.. 元素包含了文档的元(meta)数据,如 定义网页编码格式为 utf-8。

.. 元素描述了文档的标题

.. 表示用户可见的内容

.. 表示框架

<p>.. 表示段落

.. 定义无序列表

..定义有序列表

..表示列表项

表示图片

..表示标题

..</a>表示超链接</p>

编写以下代码:

一点Python网

点击访问</a>

一点Python网www.1dit.cn

Python爬虫

<p>认识网页结构

HTML

CSS

</p>

CSS

CSS 代表级联样式表。有三种写法:内联样式、内联样式和大纲样式。CSS代码演示如下:

body{

background-color:yellow;

}

p{

font-size: 30px;

color: springgreen;

}

一点Python网

一点Python网www.1dit.cn

点击访问</a>

Python爬虫

<p>认识网页结构

HTML

CSS

</p>

如图2所示,内联样式通过style标签写入样式表:

内嵌样式使用 HTML 元素的 style 属性来编写 CSS 代码。请注意,每个 HTML 元素都有 style、class、id、name 和 title 属性。

外部样式表是指将 CSS 代码单独保存为一个以 .css 结尾的文件,并使用它来将其导入所需的页面:

当样式需要应用于多个页面时,使用外部样式表是最好的选择。

JavaScript

JavaScript 负责描述网页的行为。例如,可以使用 JavaScript 实现交互式内容和各种特殊效果。当然也可以通过其他方式实现,比如jQuery,以及一些前端框架(vue、React等),但都是在“JS”的基础上实现的。

简单的例子:

body{

background-color: rgb(220, 226, 226);

}

一点Python网

一点Python网www.1dit.cn

Python爬虫

<p>点击下方按钮获取当前时间

点击这里

</p>

function DisplayDate(){

document.getElementById("time").innerHTML=Date()

}

</p>

如果用人体作为比喻,HTML 就是人体骨架,它定义了人的嘴巴、眼睛、耳朵等应该长在哪里。CSS是一个人的外貌细节,比如嘴巴长什么样,眼睛是双眼皮还是单眼皮,眼睛是大是小,皮肤是黑还是白。JScript 代表人类技能,例如跳舞、唱歌或演奏乐器。

js抓取网页内容(JavaScript()方法强迫浏览器刷新当前页面重新获取页面资源)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-12-20 13:02

在电脑网页中,如果我们想获取当前页面的最新内容,可以刷新当前页面再次获取数据。在 JavaScript 开发中也是如此。对于已编写的代码测试,我们也可以通过刷新来检索测试成功的代码。本文介绍了通过js刷新当前页面获取数据的reload()方法。

一、reload() 方法

强制浏览器刷新当前页面并重新加载当前文档以获取数据。

二、语法

Location.reload(forcedReload)

三、参数

forcedReload:需要布尔类型,

1、当值为true时,浏览器会强制从服务器获取当前页面资源,而不是从浏览器缓存中读取,

2、当值为false或不传入参数时,浏览器可能会从缓存中读取当前页面。

四、使用reload()方法刷新当前页面重新获取数据

function myrefresh(){

window.location.reload();

}

setTimeout('myrefresh()',1000); //指定1秒刷新一次

以上就是js刷新当前页面获取数据的reload()方法的介绍,希望对大家有帮助~ 查看全部

js抓取网页内容(JavaScript()方法强迫浏览器刷新当前页面重新获取页面资源)

在电脑网页中,如果我们想获取当前页面的最新内容,可以刷新当前页面再次获取数据。在 JavaScript 开发中也是如此。对于已编写的代码测试,我们也可以通过刷新来检索测试成功的代码。本文介绍了通过js刷新当前页面获取数据的reload()方法。

一、reload() 方法

强制浏览器刷新当前页面并重新加载当前文档以获取数据。

二、语法

Location.reload(forcedReload)

三、参数

forcedReload:需要布尔类型,

1、当值为true时,浏览器会强制从服务器获取当前页面资源,而不是从浏览器缓存中读取,

2、当值为false或不传入参数时,浏览器可能会从缓存中读取当前页面。

四、使用reload()方法刷新当前页面重新获取数据

function myrefresh(){

window.location.reload();

}

setTimeout('myrefresh()',1000); //指定1秒刷新一次

以上就是js刷新当前页面获取数据的reload()方法的介绍,希望对大家有帮助~

js抓取网页内容(js抓取网页内容的方法本质上就是一个轻量级的后端egg-restful)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-19 20:09

js抓取网页内容的方法本质上就是一个循环+判断+拿着元素的js源码执行+加载内容js脚本我推荐一个轻量级的后端egg-restful来帮助你。一个新型javascript轻量级服务器或者是前端后端一体的restful服务器-xgg,前后端通吃,适合中后台前端开发,单页面web和nodejs都可以快速进行调用,部署,后台选择restful更佳,可以提供稳定的支持。

<p>这款的代码是发布在github上的。不用编写babel代码。js拿着内容我这边按照字典把js拿过来,比如一个函数名,我们可以拿for(vari=0;i 查看全部

js抓取网页内容(js抓取网页内容的方法本质上就是一个轻量级的后端egg-restful)

js抓取网页内容的方法本质上就是一个循环+判断+拿着元素的js源码执行+加载内容js脚本我推荐一个轻量级的后端egg-restful来帮助你。一个新型javascript轻量级服务器或者是前端后端一体的restful服务器-xgg,前后端通吃,适合中后台前端开发,单页面web和nodejs都可以快速进行调用,部署,后台选择restful更佳,可以提供稳定的支持。

<p>这款的代码是发布在github上的。不用编写babel代码。js拿着内容我这边按照字典把js拿过来,比如一个函数名,我们可以拿for(vari=0;i

js抓取网页内容(代理支持·支持TLS/SSL协议)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-18 10:39

· 代理支持

· 支持TLS/SSL协议

2. Cheerio(也称为解析器):

· Cheerio 提供了一个快速、灵活和精益的核心jQuery 实现,专为服务器设计。

· Cheerio 解析标记并提供 API 用于遍历/操作结果数据结构。

特征:

· 熟悉的语法:Cheerio 实现了核心 jQuery 的一个子集。它去除了jQuery库中所有的DOM不一致和浏览痕迹,充分展示了API的魅力。

· 快速:Cheerio 使用非常简单且一致的 DOM 模型。因此,分析、操作和呈现非常高效。初步的端到端基准测试表明,cheerio 比 JSDOM 快 8 倍左右。

· 惊人的灵活性:Cheerio 几乎可以解析任何 HTML 或 XML 文档。

3.渗透(又名解析器)

· Osmosis 包括 HTML/XML 解析器和 webscraper。

· 它是用 node.js 编写的,包括 css3/xpath 选择器和轻量级 http 包装器。

· 没有像 Cheerio 这样的大依赖。

特征:

· 支持 CSS 3.0 和 XPath1.0 选择器的混合

· 加载和搜索 AJAX 内容

· 记录 URL、重定向和错误

· Cookie jar 和自定义 cookie/header/user agent

· 登录/表单提交、会话 cookie 和基本身份验证

· 单代理或多代理处理代理故障

· 重试和重定向限制

4. Puppeteer(也称为无头 Chrome 自动化浏览器):

Puppeteer 是一个 Node.js 库,它提供了一个简单但高效的 API,使您能够控制 Google 的 Chrome 或 Chromium 浏览器。

它还可以在无头模式下运行 Chromium(对于在服务器上运行浏览器非常有用),并且可以在没有用户界面的情况下发送和接收请求。

最好的部分是它可以在后台操作,遵循 API 的说明。

特征:

· 单击按钮、链接和图像等元素

· 自动表单提交

· 导航页面

· 使用时间线追踪找出问题所在

· 直接在浏览器中自动测试用户界面和各种前端应用程序

· 截屏

· 将网页转换为pdf文件

5. Apify SDK(也称为完整的网页抓取框架):

· Apify SDK 是一个开源的Node.js 库,用于爬虫和网络爬虫。

· Apify SDK 是一个独特的工具,可以简化网络爬虫、爬虫、数据提取和网络自动化任务的开发。

· 提供管理和自动扩容headless Chrome/Puppeteer实例池、维护要爬取的URL队列、将爬取结果存储到本地文件系统或云端、轮换代理等工具。

· 可以在自己的应用中独立使用,也可以在Apify云上运行的参与者之间使用。

特征:

· 使用 URL 的持久队列来深度获取整个 网站。

· 运行CSV文件中收录100k URL的爬取代码,代码崩溃时不会丢失任何数据。

· 通过旋转代理隐藏您的浏览器源。

· 安排代码定期运行并发送错误通知。

· 禁用网站 使用的浏览器指纹保护。

JS 代码经过混淆和加密,只需使用 JShaman()。 查看全部

js抓取网页内容(代理支持·支持TLS/SSL协议)

· 代理支持

· 支持TLS/SSL协议

2. Cheerio(也称为解析器):

· Cheerio 提供了一个快速、灵活和精益的核心jQuery 实现,专为服务器设计。

· Cheerio 解析标记并提供 API 用于遍历/操作结果数据结构。

特征:

· 熟悉的语法:Cheerio 实现了核心 jQuery 的一个子集。它去除了jQuery库中所有的DOM不一致和浏览痕迹,充分展示了API的魅力。

· 快速:Cheerio 使用非常简单且一致的 DOM 模型。因此,分析、操作和呈现非常高效。初步的端到端基准测试表明,cheerio 比 JSDOM 快 8 倍左右。

· 惊人的灵活性:Cheerio 几乎可以解析任何 HTML 或 XML 文档。

3.渗透(又名解析器)

· Osmosis 包括 HTML/XML 解析器和 webscraper。

· 它是用 node.js 编写的,包括 css3/xpath 选择器和轻量级 http 包装器。

· 没有像 Cheerio 这样的大依赖。

特征:

· 支持 CSS 3.0 和 XPath1.0 选择器的混合

· 加载和搜索 AJAX 内容

· 记录 URL、重定向和错误

· Cookie jar 和自定义 cookie/header/user agent

· 登录/表单提交、会话 cookie 和基本身份验证

· 单代理或多代理处理代理故障

· 重试和重定向限制

4. Puppeteer(也称为无头 Chrome 自动化浏览器):

Puppeteer 是一个 Node.js 库,它提供了一个简单但高效的 API,使您能够控制 Google 的 Chrome 或 Chromium 浏览器。

它还可以在无头模式下运行 Chromium(对于在服务器上运行浏览器非常有用),并且可以在没有用户界面的情况下发送和接收请求。

最好的部分是它可以在后台操作,遵循 API 的说明。

特征:

· 单击按钮、链接和图像等元素

· 自动表单提交

· 导航页面

· 使用时间线追踪找出问题所在

· 直接在浏览器中自动测试用户界面和各种前端应用程序

· 截屏

· 将网页转换为pdf文件

5. Apify SDK(也称为完整的网页抓取框架):

· Apify SDK 是一个开源的Node.js 库,用于爬虫和网络爬虫。

· Apify SDK 是一个独特的工具,可以简化网络爬虫、爬虫、数据提取和网络自动化任务的开发。

· 提供管理和自动扩容headless Chrome/Puppeteer实例池、维护要爬取的URL队列、将爬取结果存储到本地文件系统或云端、轮换代理等工具。

· 可以在自己的应用中独立使用,也可以在Apify云上运行的参与者之间使用。

特征:

· 使用 URL 的持久队列来深度获取整个 网站。

· 运行CSV文件中收录100k URL的爬取代码,代码崩溃时不会丢失任何数据。

· 通过旋转代理隐藏您的浏览器源。

· 安排代码定期运行并发送错误通知。

· 禁用网站 使用的浏览器指纹保护。

JS 代码经过混淆和加密,只需使用 JShaman()。

js抓取网页内容(问一个问题,js可以抓取其它网页里面的内容吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-12-17 00:07

请教一个问题,js可以抓取其他网页的内容吗?? ?

请教一个问题,js可以抓取其他网页的内容吗?? ?

比如网站打开的内容是一个列表,我需要的是该列表中的内容(编号)和名称

有没有办法实现它

HTML代码

股市名称

最新

涨跌幅%

道琼斯13005.12+0.18%纳斯达克2986.76+0.69%标普5001372.18+0.34%法国CAC403453.99+0.36%日经2259800.22+0.80%英国富时5927.91+0.21%澳洲全股4388.10+0.85%

和讯行情中心>>

- - - 解决方案 - - - - - - - - - -

如果把这个表嵌套到当前网页中,应该可以根据ID获取到。去试试吧。不部署项目不方便我试试--

- - - 解决方案 - - - - - - - - - -

这个好像是后台程序实现的,写.NET之前也写过类似的功能

- - - 解决方案 - - - - - - - - - -

不,跨域

- - - 解决方案 - - - - - - - - - -

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

本来可以,但受浏览器限制。

- - - 解决方案 - - - - - - - - - -

讨论

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

JS跨域操作不安全。

- - - 解决方案 - - - - - - - - - -

只有当服务器对另一个域中的页面使用写请求时,才会读取数据,然后将其发回。

- - - 解决方案 - - - - - - - - - -

使用 HTMLParser 抓取指定规则的内容 查看全部

js抓取网页内容(问一个问题,js可以抓取其它网页里面的内容吗?)

请教一个问题,js可以抓取其他网页的内容吗?? ?

请教一个问题,js可以抓取其他网页的内容吗?? ?

比如网站打开的内容是一个列表,我需要的是该列表中的内容(编号)和名称

有没有办法实现它

HTML代码

股市名称

最新

涨跌幅%

道琼斯13005.12+0.18%纳斯达克2986.76+0.69%标普5001372.18+0.34%法国CAC403453.99+0.36%日经2259800.22+0.80%英国富时5927.91+0.21%澳洲全股4388.10+0.85%

和讯行情中心>>

- - - 解决方案 - - - - - - - - - -

如果把这个表嵌套到当前网页中,应该可以根据ID获取到。去试试吧。不部署项目不方便我试试--

- - - 解决方案 - - - - - - - - - -

这个好像是后台程序实现的,写.NET之前也写过类似的功能

- - - 解决方案 - - - - - - - - - -

不,跨域

- - - 解决方案 - - - - - - - - - -

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

本来可以,但受浏览器限制。

- - - 解决方案 - - - - - - - - - -

讨论

通过 URL 下载 HTML 源代码,然后定期解析。

- - - 解决方案 - - - - - - - - - -

JS跨域操作不安全。

- - - 解决方案 - - - - - - - - - -

只有当服务器对另一个域中的页面使用写请求时,才会读取数据,然后将其发回。

- - - 解决方案 - - - - - - - - - -

使用 HTMLParser 抓取指定规则的内容

js抓取网页内容(国内开始流行另一种流氓行为流氓行为:使用框架(Frame))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-13 17:27

最近,另一种流氓行为在中国流行起来:使用框架将您的网页嵌入到其网页中。

比如有一个网站号称是“口碑聚合门户”,提供全国各种在线论坛的最佳内容。但是,实际上,它使用框架来抓取其他人的网页,然后在其上添加您自己的广告和站点徽标。这和盗版书商有什么区别?!

预防方法,在

在添加此代码之前:

if ( top.location !== self.location )

{

top.location = self.location;

}

此代码有效。但是,有一个问题:使用后,没有人可以再将您的网页嵌入到框架中,包括您自己。

有没有办法让我的网页只嵌入我自己的框架而不是别人的框架?

try{

top.location.hostname;

if (top.location.hostname != window.location.hostname) {

top.location.href =window.location.href;

}

}

catch(e){

top.location.href = window.location.href;

}

好了,升级版的代码就完成了。除了本地域名,没有其他域名可以将您的网页嵌入到框架中。我的博客现在使用此代码。 查看全部

js抓取网页内容(国内开始流行另一种流氓行为流氓行为:使用框架(Frame))

最近,另一种流氓行为在中国流行起来:使用框架将您的网页嵌入到其网页中。

比如有一个网站号称是“口碑聚合门户”,提供全国各种在线论坛的最佳内容。但是,实际上,它使用框架来抓取其他人的网页,然后在其上添加您自己的广告和站点徽标。这和盗版书商有什么区别?!

预防方法,在

在添加此代码之前:

if ( top.location !== self.location )

{

top.location = self.location;

}

此代码有效。但是,有一个问题:使用后,没有人可以再将您的网页嵌入到框架中,包括您自己。

有没有办法让我的网页只嵌入我自己的框架而不是别人的框架?

try{

top.location.hostname;

if (top.location.hostname != window.location.hostname) {

top.location.href =window.location.href;

}

}

catch(e){

top.location.href = window.location.href;

}

好了,升级版的代码就完成了。除了本地域名,没有其他域名可以将您的网页嵌入到框架中。我的博客现在使用此代码。

js抓取网页内容(【知识点】HTML文档的域有关(一)示例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 363 次浏览 • 2021-12-13 11:27

同源政策

页面中的Javascript只能读取和访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但JQuery的域只和它所在的HTML文档的域相关。从而可以访问到HTML文档的属性,所以上面的代码就可以正常运行了。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么就无法实现你所期望的功能;如果远程点是指您可以控制的发问者网站,请参阅下面的放宽同源策略;

放宽同源 policyDocument.domain:用于子域的情况。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

参考

同源策略

谷歌托管图书馆

跨域资源共享

幻象 查看全部

js抓取网页内容(【知识点】HTML文档的域有关(一)示例)

同源政策

页面中的Javascript只能读取和访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但JQuery的域只和它所在的HTML文档的域相关。从而可以访问到HTML文档的属性,所以上面的代码就可以正常运行了。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么就无法实现你所期望的功能;如果远程点是指您可以控制的发问者网站,请参阅下面的放宽同源策略;

放宽同源 policyDocument.domain:用于子域的情况。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

参考

同源策略

谷歌托管图书馆

跨域资源共享

幻象

js抓取网页内容(#家居设计工作室网站模板介绍#SEO网站抓取频率的意义)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-12-10 17:34

#家居设计工作室网站模板介绍

每天都有数以千计的 URL 被搜索引擎抓取和抓取。它相互链接,形成我们现有的互联网关系。对于SEO人员,我们常说的名词是:网站爬取频率。它在SEO日常工作中扮演着重要的角色,为网站优化提供有价值的建议。那么,SEO网站爬取频率有什么意义呢?根据以往的工作经验,我们知道网页收录的基本流程主要是:抓取网址->内容质量评估->索引库筛选->网页入口(显示在搜索结果中)其中,如果你的内容质量比较低,会直接进入低质量的索引库,那么很难被百度收录。从这个过程中,不难看出,网站的爬取频率会直接影响到网站。收录率和内容质量评估。影响网站爬取频率的因素: 1 入站链接:理论上,只要是外部链接,无论其质量和形态如何,都会起到引导蜘蛛爬行和爬行的作用。2网站结构:网站最好是短域名,这样可以简化目录层次结构,避免URL过长,动态参数过多。3页面速度:移动优先指标,百度不止一次提到,最重要的指标是页面的首次加载,控制在3秒以内。4 有效提交:站点地图、官方API提交、JS访问提交等。 5 内容更新:优质内容更新的频率是网站大规模排名的核心因素。6BaiduBearPalm:如果你的网站配备了熊掌号,如果内容够高,抓取率几乎是100%。

如何查看网站爬取的频率:1个cms系统自带的“百度蜘蛛”分析插件。2 定期进行“博客日志分析”更方便。页面抓取对你的网站的影响:1.网站Revision 如果你的网站已经升级改版,部分网址已经修复,可能需要搜索引擎紧急抓取重新评估页面内容。这时候其实有一个好用的小技巧:主动把网址添加到站点地图中,并在百度上下文中更新,并尽快通知搜索引擎变化。2.网站排名最多的网站管理员认为,百度雄章上线以来,解决了包容性问题。实际上,目标网址只能连续爬取,可以不断重新评估权重,提高排名。因此,当您有一个页面需要进行排名时,您需要将其放置在更高的爬网列中。3. 压控页面爬取频率不高不一定好。它来自恶意爬虫。往往会导致服务器资源严重浪费甚至宕机,尤其是一些外链分析爬虫。如有必要,您可能需要使用 Robots.txt 进行有效阻止。4. 异常诊断 如果你早就发现某个页面没有收录,那么你需要知道:百度蜘蛛可访问性,可以使用百度官方后台抓取诊断来检查具体原因。介绍:页面抓取的频率对索引、索引、排名和二级排名起着至关重要的作用。作为 SEO 人员,您可能需要给予应有的关注。以上内容仅供参考。在这里,我推荐seomaster的三个插件。

有了这三个 SEO 插件,您可以立即成为 SEO 高手。俗话说,工欲善其事,必先利其器。对于SEOer来说,好的浏览器插件和电脑软件可以大大提高SEOer的效率。接下来,优光启社就为大家推荐三款好用的SEO插件,让你换个SEO高手!1.SEOMETA in SEOCLA 对于SEOer来说,每天必不可少的工作就是分析竞争对手网站。一般来说,我们会通过观察其他网站的标题、描述、关键词、图片、链接等来了解对方的SEO优化方法,以便更好的规划和竞争。过去,我们使用浏览器附带的“查看页面源代码”功能来查看对方的信息。然而,这个操作比较复杂。毕竟源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。

可以说这些功能非常符合SEOer的办公需求,有需要的可以自行下载。下载链接见文章文末。二、打开SEO统计理光推荐的第二个插件是SEO界的知名插件。它的名字是 OpenSEOStats。这个插件的用途很广,包括搜索引擎优化分析、流量统计、网站信息、网页信息、链接分析、网页速度、实用程序等等,可以说OpenSEOStats在手,我在世界各地都有。打开SEO统计1.SEO分析使用本软件,您可以对自己或他人的网站进行简单的SEO分析。稍加努力,就可以查看目标网站的外部链接,网站等的IP地址信息,与网站管理员工具和爱站工具中的信息相比,这不是一星半点。2.流量统计 另外,通过OpenSEOStats的流量统计功能,可以查看目标网站在Alexa网站上的世界排名信息。当然,如果你的网站没有被列入Alexa世界排名,那么这个工具可以说是遥不可及。3.网站Information 通过自己的站点信息功能,还可以查看他的站点是否有robots.txt协议和站点地图文件,了解竞争对手的SEO情况。此外,还可以了解目标网站的DNS信息和IP地理信息。4.

不过和1 CCK中的SEOMETA相比,这个插件里面的信息并不是特别详细,只有部分内容,但是功能齐全。该插件可以一键与 SEOMETA 结合使用。5.链接分析通过链接分析功能,OpenSEOStats可以快速找到网站中的出站链接数和链接数。这将使您更容易找到您的问题网站。另外,链接其他网站添加nofollow标签,也可以看到。这样就可以避免在交换友情链接时上当受骗。6、页面速度网站加速速度是网站体验中比较重要的部分。网站加载速度越快,留存用户越多。现在,借助OpenSEOStats网页速度功能,您可以帮助检测网站的速度 基于世界上所有的信息。比如网站速度8.26秒,还是很慢的。7.实用工具 此外,OpenSEOStats还配置了一些主要搜索引擎网站管理员平台的门户,包括谷歌、必应、百度等,缺少360和搜狗。下载链接见文章文末。三、5118网站Administrator Toolbox Streaming Media推荐的第三个插件是-5118网站Administrator Toolbox。这个插件可以说是比较符合中国本土环境的SEO插件。可以查询网站的SEO大数据,了解网站操作的各种属性,帮助SEOer科学优化网站。5118网站管理员工具箱另外,

只需在输入框中输入您的关键字,即可快速获取关键字排名信息。当然还有50多个关键词,默认是不显示的。此外,您可以使用此插件检查 nofollow 标签和 网站 死链接。当网站关键词突然下降,没有关键词排名时,可以使用5118网站管理员工具箱查看网站中是否有死链接,通过快速查找死链接关键字 死链接。5118网站管理员工具箱。位置。这样可以快速减少死链接造成的负面情况。原文来自微信公众号(6亿人关注我):百度SEO:为什么要关注“网页抓取频率”?家居设计工作室 网站 模板

请允许我先写下理论,然后再解决问题。作为一个在网络上呆了近十年的老油条,我还是需要用白话文。我先梳理一下这个理论和原理。这个问题有几个关键词:产品、促销和方法。事实上,这是一个普遍的问题。是不是有点像赚人生第一个百万是个逻辑?如果是我,我会如何判断?首先,我会先研究一下这个产品是什么,这个产品的对象。这个产品在运营中叫什么用户?它的特点是什么?有什么优势,有什么亮点,有什么功能,有什么竞争对手,什么是关键词,提炼出来,推广后会用到这些词。本产品的用户为个人用户(专业为TOC)或本产品的用户为商家(专业为TOB)。在不知道如何下手之前,只知道产品的用户属性。如何判断是TOTO还是TOB?事实上,很容易看出谁为这个产品买单。比如天猫就是B2C,1688就是B2B。比如你是一家鞋店网站,那么你就是2C。如果您为企业提供服务,则为 2B。其次,使用工具或研究找出用户的位置。既然我们知道用户是谁,那么我们将研究用户和用户的位置。我们在做流量的时候,经常会说:你的用户在哪里,你去哪里推广(免费还是付费,看你打算怎么做)理论就在这里。我们常说的三大流量体系,BAT+职称+其他。如果你是2B业务,比如什么软件系统,一般2B(TOB也可以写2B)客户决策时间长,喜欢比较,所以一般搜索会比较习惯,所以B表示百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。所以一般来说,搜索会比较习惯,所以B就代表百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。所以一般来说,搜索会比较习惯,所以B就代表百度有很多流量。本来想讲搜索,但是在大多数人眼里,搜索就是百度。如果你是做电商流量的,请去A.社交流量,当然还有微信。至于什么抖音等等,这些统称为【频道】。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。这些统称为[频道]。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。这些统称为[频道]。从运营的角度来说,无非是:产品/服务-渠道/平台-用户/客户,用户/客户可以通过哪个渠道了解产品或服务。 查看全部

js抓取网页内容(#家居设计工作室网站模板介绍#SEO网站抓取频率的意义)

#家居设计工作室网站模板介绍

每天都有数以千计的 URL 被搜索引擎抓取和抓取。它相互链接,形成我们现有的互联网关系。对于SEO人员,我们常说的名词是:网站爬取频率。它在SEO日常工作中扮演着重要的角色,为网站优化提供有价值的建议。那么,SEO网站爬取频率有什么意义呢?根据以往的工作经验,我们知道网页收录的基本流程主要是:抓取网址->内容质量评估->索引库筛选->网页入口(显示在搜索结果中)其中,如果你的内容质量比较低,会直接进入低质量的索引库,那么很难被百度收录。从这个过程中,不难看出,网站的爬取频率会直接影响到网站。收录率和内容质量评估。影响网站爬取频率的因素: 1 入站链接:理论上,只要是外部链接,无论其质量和形态如何,都会起到引导蜘蛛爬行和爬行的作用。2网站结构:网站最好是短域名,这样可以简化目录层次结构,避免URL过长,动态参数过多。3页面速度:移动优先指标,百度不止一次提到,最重要的指标是页面的首次加载,控制在3秒以内。4 有效提交:站点地图、官方API提交、JS访问提交等。 5 内容更新:优质内容更新的频率是网站大规模排名的核心因素。6BaiduBearPalm:如果你的网站配备了熊掌号,如果内容够高,抓取率几乎是100%。

如何查看网站爬取的频率:1个cms系统自带的“百度蜘蛛”分析插件。2 定期进行“博客日志分析”更方便。页面抓取对你的网站的影响:1.网站Revision 如果你的网站已经升级改版,部分网址已经修复,可能需要搜索引擎紧急抓取重新评估页面内容。这时候其实有一个好用的小技巧:主动把网址添加到站点地图中,并在百度上下文中更新,并尽快通知搜索引擎变化。2.网站排名最多的网站管理员认为,百度雄章上线以来,解决了包容性问题。实际上,目标网址只能连续爬取,可以不断重新评估权重,提高排名。因此,当您有一个页面需要进行排名时,您需要将其放置在更高的爬网列中。3. 压控页面爬取频率不高不一定好。它来自恶意爬虫。往往会导致服务器资源严重浪费甚至宕机,尤其是一些外链分析爬虫。如有必要,您可能需要使用 Robots.txt 进行有效阻止。4. 异常诊断 如果你早就发现某个页面没有收录,那么你需要知道:百度蜘蛛可访问性,可以使用百度官方后台抓取诊断来检查具体原因。介绍:页面抓取的频率对索引、索引、排名和二级排名起着至关重要的作用。作为 SEO 人员,您可能需要给予应有的关注。以上内容仅供参考。在这里,我推荐seomaster的三个插件。

有了这三个 SEO 插件,您可以立即成为 SEO 高手。俗话说,工欲善其事,必先利其器。对于SEOer来说,好的浏览器插件和电脑软件可以大大提高SEOer的效率。接下来,优光启社就为大家推荐三款好用的SEO插件,让你换个SEO高手!1.SEOMETA in SEOCLA 对于SEOer来说,每天必不可少的工作就是分析竞争对手网站。一般来说,我们会通过观察其他网站的标题、描述、关键词、图片、链接等来了解对方的SEO优化方法,以便更好的规划和竞争。过去,我们使用浏览器附带的“查看页面源代码”功能来查看对方的信息。然而,这个操作比较复杂。毕竟源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。源代码非常复杂,查看内容需要很多时间。现在,我为您推荐一个优秀的 SEO 插件。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。有了它,您可以快速完成以上操作。它在 1CCK 中称为 SEOMETA。SEOMETAin1CCK安装这个插件后,你只需要在插件上点一下,马上就会弹出一个收录“标题、描述、关键词、图片、链接”等信息的窗口,可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。并且您会立即弹出一个收录“标题、描述、关键字、图片、链接”等信息的窗口,您可以查看插件的所有信息。其他网站一目了然。当然,这个插件的功能远不止这些。甚至可以在对方的网站上查看标题的数量,如H1、H2等,图片是否有Alt标签等。

可以说这些功能非常符合SEOer的办公需求,有需要的可以自行下载。下载链接见文章文末。二、打开SEO统计理光推荐的第二个插件是SEO界的知名插件。它的名字是 OpenSEOStats。这个插件的用途很广,包括搜索引擎优化分析、流量统计、网站信息、网页信息、链接分析、网页速度、实用程序等等,可以说OpenSEOStats在手,我在世界各地都有。打开SEO统计1.SEO分析使用本软件,您可以对自己或他人的网站进行简单的SEO分析。稍加努力,就可以查看目标网站的外部链接,网站等的IP地址信息,与网站管理员工具和爱站工具中的信息相比,这不是一星半点。2.流量统计 另外,通过OpenSEOStats的流量统计功能,可以查看目标网站在Alexa网站上的世界排名信息。当然,如果你的网站没有被列入Alexa世界排名,那么这个工具可以说是遥不可及。3.网站Information 通过自己的站点信息功能,还可以查看他的站点是否有robots.txt协议和站点地图文件,了解竞争对手的SEO情况。此外,还可以了解目标网站的DNS信息和IP地理信息。4.

不过和1 CCK中的SEOMETA相比,这个插件里面的信息并不是特别详细,只有部分内容,但是功能齐全。该插件可以一键与 SEOMETA 结合使用。5.链接分析通过链接分析功能,OpenSEOStats可以快速找到网站中的出站链接数和链接数。这将使您更容易找到您的问题网站。另外,链接其他网站添加nofollow标签,也可以看到。这样就可以避免在交换友情链接时上当受骗。6、页面速度网站加速速度是网站体验中比较重要的部分。网站加载速度越快,留存用户越多。现在,借助OpenSEOStats网页速度功能,您可以帮助检测网站的速度 基于世界上所有的信息。比如网站速度8.26秒,还是很慢的。7.实用工具 此外,OpenSEOStats还配置了一些主要搜索引擎网站管理员平台的门户,包括谷歌、必应、百度等,缺少360和搜狗。下载链接见文章文末。三、5118网站Administrator Toolbox Streaming Media推荐的第三个插件是-5118网站Administrator Toolbox。这个插件可以说是比较符合中国本土环境的SEO插件。可以查询网站的SEO大数据,了解网站操作的各种属性,帮助SEOer科学优化网站。5118网站管理员工具箱另外,

只需在输入框中输入您的关键字,即可快速获取关键字排名信息。当然还有50多个关键词,默认是不显示的。此外,您可以使用此插件检查 nofollow 标签和 网站 死链接。当网站关键词突然下降,没有关键词排名时,可以使用5118网站管理员工具箱查看网站中是否有死链接,通过快速查找死链接关键字 死链接。5118网站管理员工具箱。位置。这样可以快速减少死链接造成的负面情况。原文来自微信公众号(6亿人关注我):百度SEO:为什么要关注“网页抓取频率”?家居设计工作室 网站 模板