java爬虫抓取网页数据(一下关于网络爬虫的入门知识入门教程)

优采云 发布时间: 2022-03-18 05:11java爬虫抓取网页数据(一下关于网络爬虫的入门知识入门教程)

经常听到“爬行动物”这个词,但它是什么意思呢?它是干什么用的?下面是万和专业老师为大家分享网络爬虫的入门知识。

0 1

网络爬虫

1.1. 名称

网络爬虫(也称为网络蜘蛛或网络机器人)是一种程序或脚本,它根据一定的规则自动爬取万维网上的信息。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。

1.2. 简要说明

网络爬虫通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,读取网页的内容,寻找网页中的其他链接地址,然后通过这些链接地址寻找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取。

如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。

因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发回的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

0 2

过程

网络爬虫有什么作用?他的主要工作是根据指定的url地址发送请求,得到响应,然后解析响应。新的URL路径,然后继续访问,继续解析;继续寻找需要的数据,继续解析出新的URL路径。

这是网络爬虫的主要工作。以下是流程图:

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

一个简单爬虫的必要功能包括:

发送请求和获取响应的函数;

解析响应的函数;

存储过滤数据的功能;

处理解析后的URL路径的函数;

2.1. 专注

爬虫需要注意的三点:

抓取目标的描述或定义;

网页或数据的分析和过滤;

URL 的搜索策略。

0 3

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:

通用网络爬虫

专注的网络爬虫

增量网络爬虫

深网爬虫。

实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

0 4

思想分析

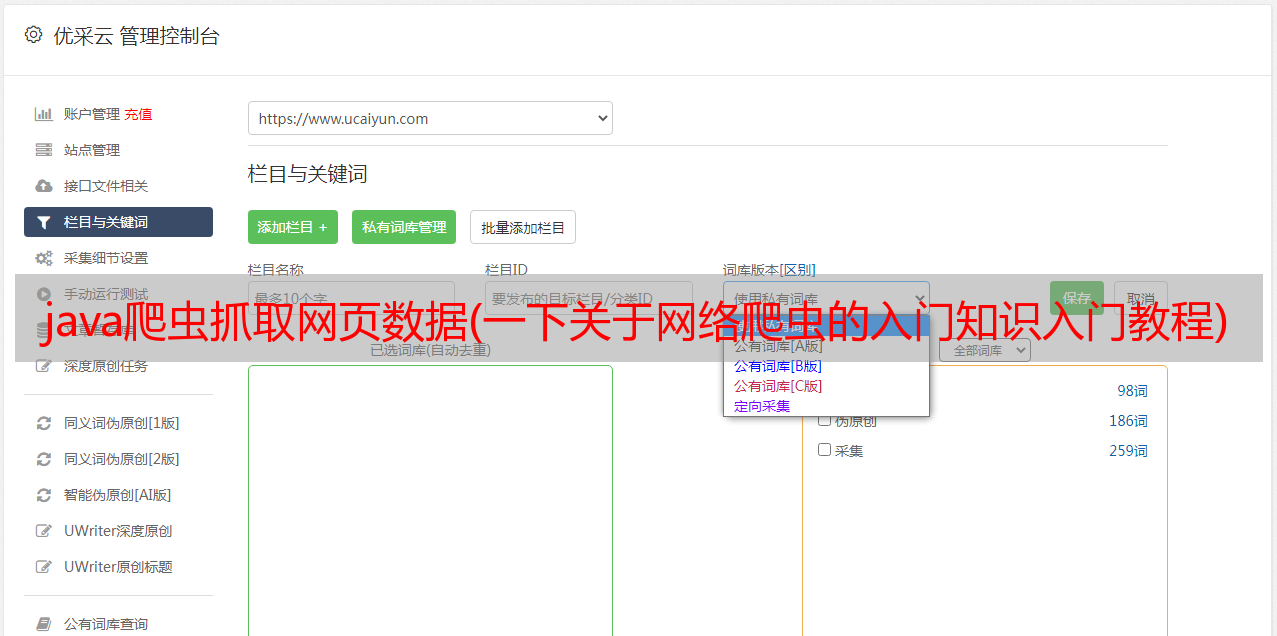

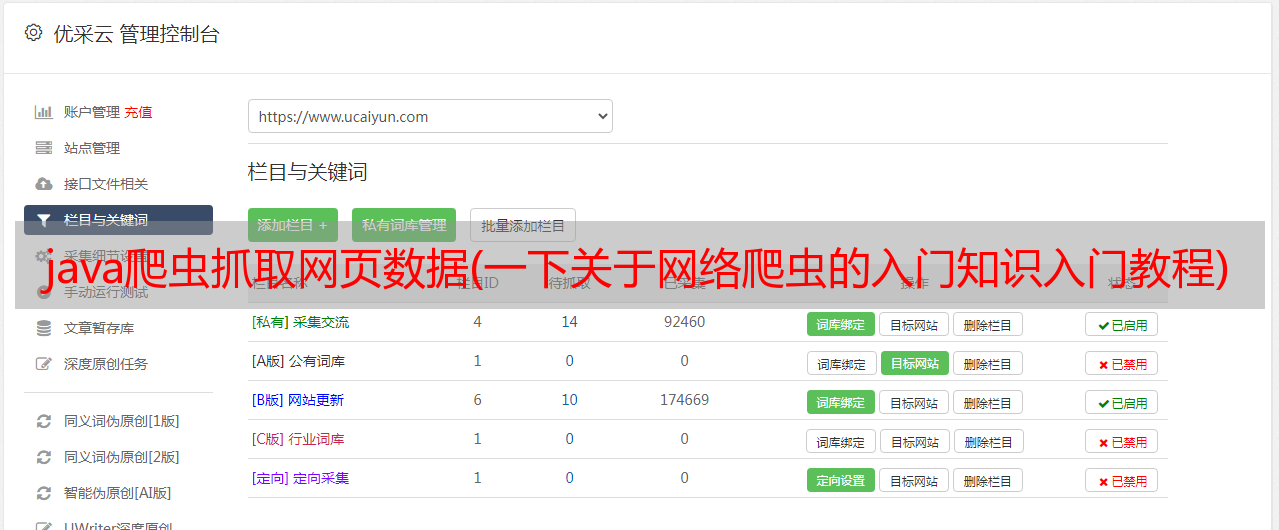

接下来,我将通过我们的官网来和大家一起分析一下如何实现这样的爬虫:

首先观察我们爬虫的起始页是:

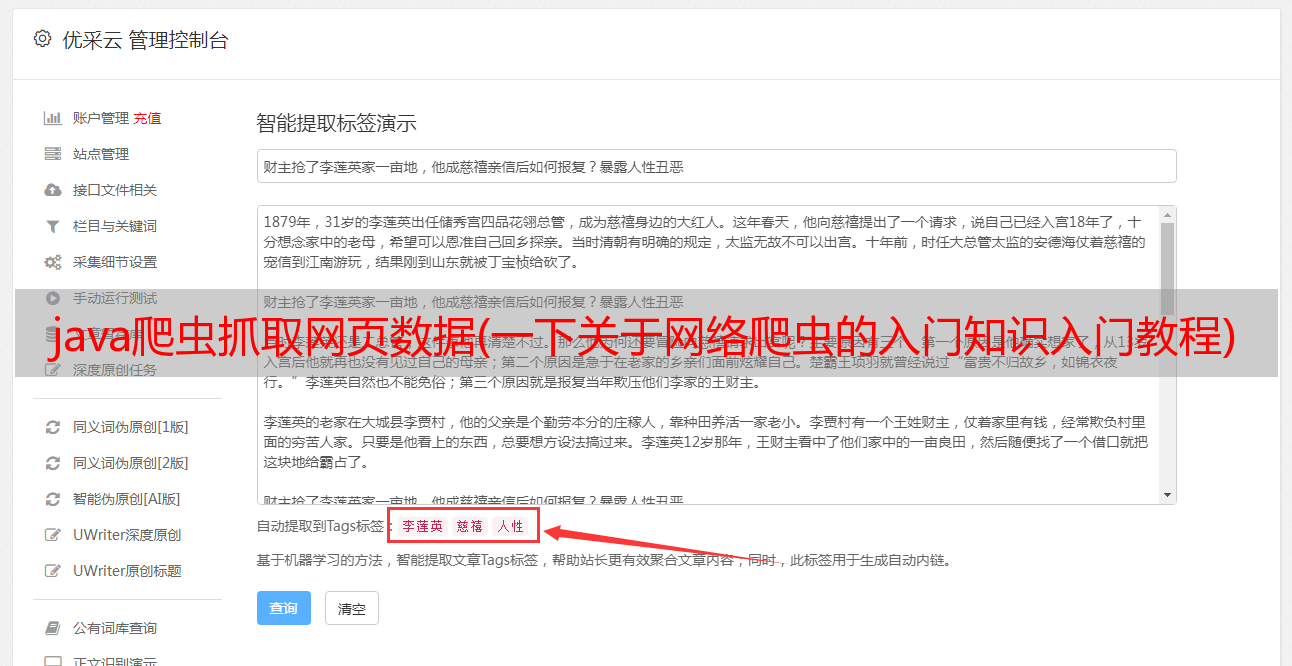

分析页面:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据:

标题:由 XPath 表达式表示 //div[@class='content']/h4/a/text()

说明:使用XPath表达式表示 //div[@class='content']/p/text()

图片://a/img/@src 作为 XPath 表达式

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式编写代码来实现了。

0 5

代码

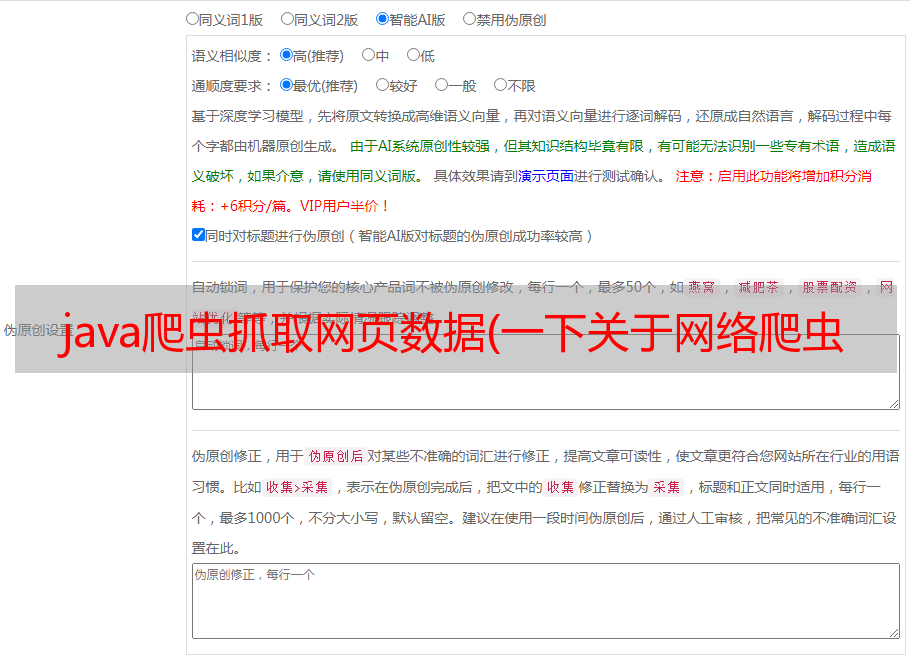

代码实现部分使用了webmagic框架,因为它比使用基本的Java网络编程要简单得多。

5.1. 代码结构

5.2. 程序入口

演示.java

5.3. 爬取过程

WanhoPageProcessor.java

5.4. 结果保存

WanhoPipeline.java

5.5. 模型对象

ArticleVo.java

如果你想了解更多关于网络爬虫的知识,可以去万和官网,注册后可以免费学习Java爬虫项目。

面对面专业指导

白手起家

进入IT高薪圈

从这里开始