网页爬虫抓取百度图片

网页爬虫抓取百度图片(爬取某个前端知识分析之不会网站页面的定位与布局 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-11-08 17:06

)

介绍

本案例只是为了巩固Xpath语法的使用,不会涉及到爬虫知识太深

分析:

一般我们在爬取某个网站页面时,有以下几个步骤:

1、获取爬取目标地址

2、明确需求,即要知道网页中获取哪些数据

3、 明确目标后,通过相应的解析语法(Xpath)分析网页的结构,得到想要的数据

4、写代码实现

1、获取爬取目标地址

以百度贴吧为例:

程序员吧-百度贴吧--程序员之家,全球最大的程序员中文交流区。--Programmer(英文程序员)是从事程序开发和维护的专业人士。一般来说,程序员分为程序员和程序员,但两者的界限不是很清楚。

2、明确需求

获取贴吧的每个帖子的标题,如下图:

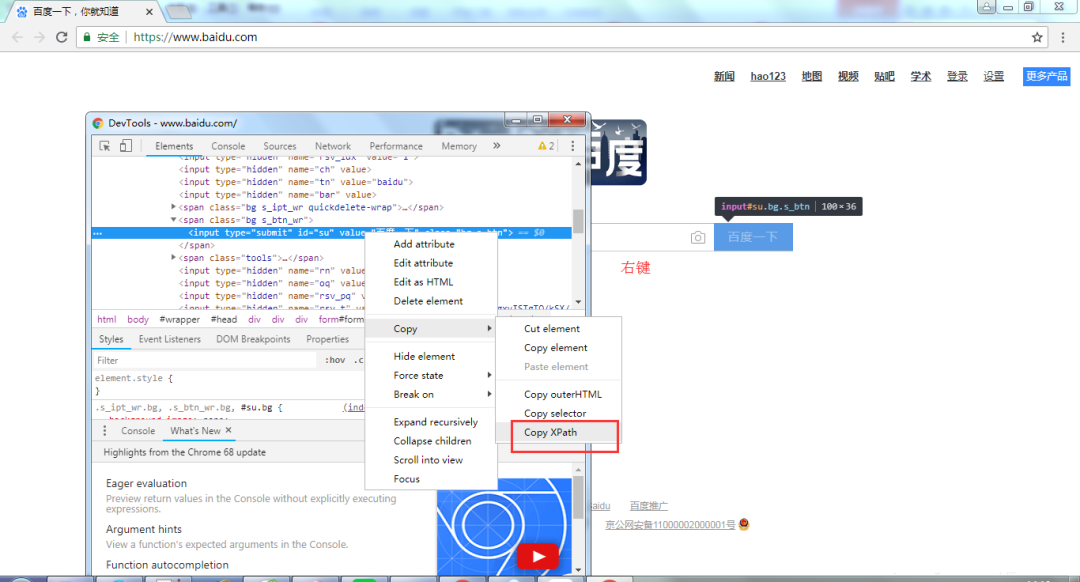

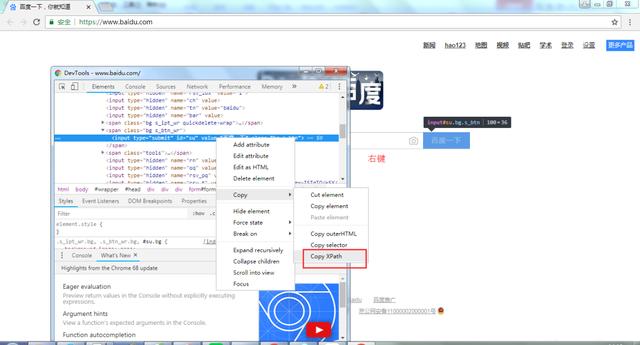

3、使用Xpath解析网页结构获取想要的数据1、通过浏览器工具快速定位到网页中需要获取的数据的标签位置

1、在网页上右键,点击检查

2、 然后弹出

3、点击左上角的箭头标志

4、 鼠标悬停在网页的数据上,左边的显示会自动跳转到对应的标签,既然是获取文章的标题,那么我们将鼠标悬停在一个的标题上邮政

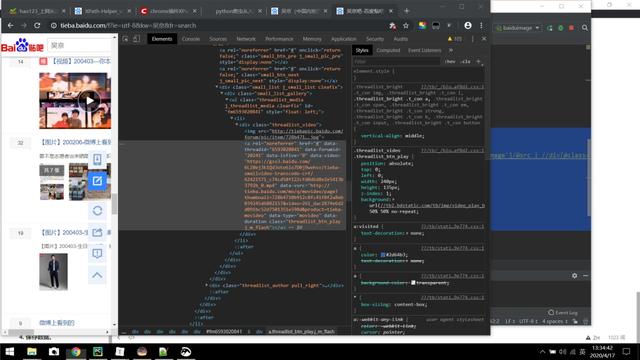

定位已定位,但这就是我们想要的吗?显然不是,因为这只是定位一个帖子,显然不符合我们的需求。我们想要得到整个网页(注意这是一个网页,不是网站)所有帖子的标题。

其实一个的定位已经是一半了,因为其他帖子的tag结构和属性都是一样的,不会有什么区别,做过前端的兄弟都知道。那么问题来了,既然是一样的,为什么不直接使用呢?这又是一个前端知识。其实网站的大部分布局就像很多拼图,所以这部分帖子是一体的。在拼图中,我们现在要找到这块拼图。从Xpath语法的角度,我们通过路径搜索和属性值定位来定位标签。如果直接用label属性值来定位,就可以了,因为一下子就定位到了。显然不可保,可能会有更多不需要的数据。

想法:

1、 先搜索路径,找到存放所有帖子的父标签

2、由于帖子的标签结构和属性值都是一样的,随便找一篇帖子分析一下就行了。后面写个例子看看效果

2.使用Xpath-helper插件验证Xapth语法是否正确获取数据

知道了数据的位置,我们就开始写Xpath语法来定位数据,那我们怎么知道我们写的语法是否正确,这个就用我们的Xpath-helper插件来验证。

1、 首先,我们观察一下贴吧中一个网页上有多少帖子

不收录广告,一共50条,所以只要我们写好语法就可以得到50条帖子的数据是正确的

2、使用插件,点击右上角拼图

3、点击Xpath-helper插件

4、 弹出两个框

5、 左边的框是输入我们的Xapth语法,右边是根据语法自动获取的数据

编写 Xpath 语法

1、只使用属性值定位(不推荐)

使用鼠标定位其中一个帖子

提供日千万预算,长期高价收wap量,正规无感广告,寻站长合作共

语法:

//a[@class="j_th_tit"]

影响:

可以得到五十条数据,语法正确,为什么不推荐呢,比如我们不使用class属性而是使用rel属性

//a[@rel="noreferrer"]

影响:

230条数据,明显错误。

2、结合路径搜索和属性搜索(推荐)

首先,您需要知道帖子拼图的标签。您只需要收录帖子这部分内容的标签即可。

从图中我们可以知道帖子的信息在li标签中,我们想要的数据肯定在li标签中,解析li标签

我们可以根据a标签逐层查找。有一个问题,就是会出现同一个标签,而且两个级别相同,那么如何区分,如下图:

可以看出我们想要的内容在第二个div标签下。两者如何区分,通过属性值很容易区分。

语法:

//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a

影响:

语法的写法是自己决定的,只要得到正确的数据即可

3、获取数据

我们上面所做的只是定位数据所在的标签,并没有真正获取到值,根据标签中数据的形式获取

提供日千万预算,长期高价收wap量,正规无感广告,寻站长合作共

可以看到a标签的title属性的值就是我们想要的数据,中间也有我们想要的值,所以有两种写法,根据自己的喜好

语法:

写一:

//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a/text()

影响:

写作二:

//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a/@title

影响:

4、写代码实现

代码:

import requests

import time

from lxml import etree

def getHTMLContent(url):

# 伪装用户代理,防反爬

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.77 Safari/537.36'

}

# 向url发送get请求

respone = requests.get(url,headers = header)

# 将返回的二进制流文件转化成文本文件

content = respone.text

# 减少一些无用的标签的干扰,这个标签在html语言是属于注释标签

content = content.replace('', '')

# 将返回的html文本文件转化成xpath能解析的对象

tree = etree.HTML(content)

# 根据xpath语法获取内容

titles = tree.xpath('//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a/text()')

# 循环打印结果

for title in titles:

print(title)

if __name__ =="__main__":

url = "https://tieba.baidu.com/f%3Fkw ... ot%3B

getHTMLContent(url)

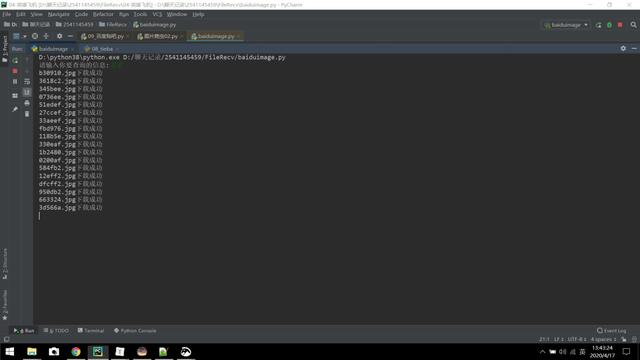

结果:

查看全部

网页爬虫抓取百度图片(爬取某个前端知识分析之不会网站页面的定位与布局

)

介绍

本案例只是为了巩固Xpath语法的使用,不会涉及到爬虫知识太深

分析:

一般我们在爬取某个网站页面时,有以下几个步骤:

1、获取爬取目标地址

2、明确需求,即要知道网页中获取哪些数据

3、 明确目标后,通过相应的解析语法(Xpath)分析网页的结构,得到想要的数据

4、写代码实现

1、获取爬取目标地址

以百度贴吧为例:

程序员吧-百度贴吧--程序员之家,全球最大的程序员中文交流区。--Programmer(英文程序员)是从事程序开发和维护的专业人士。一般来说,程序员分为程序员和程序员,但两者的界限不是很清楚。

2、明确需求

获取贴吧的每个帖子的标题,如下图:

3、使用Xpath解析网页结构获取想要的数据1、通过浏览器工具快速定位到网页中需要获取的数据的标签位置

1、在网页上右键,点击检查

2、 然后弹出

3、点击左上角的箭头标志

4、 鼠标悬停在网页的数据上,左边的显示会自动跳转到对应的标签,既然是获取文章的标题,那么我们将鼠标悬停在一个的标题上邮政

定位已定位,但这就是我们想要的吗?显然不是,因为这只是定位一个帖子,显然不符合我们的需求。我们想要得到整个网页(注意这是一个网页,不是网站)所有帖子的标题。

其实一个的定位已经是一半了,因为其他帖子的tag结构和属性都是一样的,不会有什么区别,做过前端的兄弟都知道。那么问题来了,既然是一样的,为什么不直接使用呢?这又是一个前端知识。其实网站的大部分布局就像很多拼图,所以这部分帖子是一体的。在拼图中,我们现在要找到这块拼图。从Xpath语法的角度,我们通过路径搜索和属性值定位来定位标签。如果直接用label属性值来定位,就可以了,因为一下子就定位到了。显然不可保,可能会有更多不需要的数据。

想法:

1、 先搜索路径,找到存放所有帖子的父标签

2、由于帖子的标签结构和属性值都是一样的,随便找一篇帖子分析一下就行了。后面写个例子看看效果

2.使用Xpath-helper插件验证Xapth语法是否正确获取数据

知道了数据的位置,我们就开始写Xpath语法来定位数据,那我们怎么知道我们写的语法是否正确,这个就用我们的Xpath-helper插件来验证。

1、 首先,我们观察一下贴吧中一个网页上有多少帖子

不收录广告,一共50条,所以只要我们写好语法就可以得到50条帖子的数据是正确的

2、使用插件,点击右上角拼图

3、点击Xpath-helper插件

4、 弹出两个框

5、 左边的框是输入我们的Xapth语法,右边是根据语法自动获取的数据

编写 Xpath 语法

1、只使用属性值定位(不推荐)

使用鼠标定位其中一个帖子

提供日千万预算,长期高价收wap量,正规无感广告,寻站长合作共

语法:

//a[@class="j_th_tit"]

影响:

可以得到五十条数据,语法正确,为什么不推荐呢,比如我们不使用class属性而是使用rel属性

//a[@rel="noreferrer"]

影响:

230条数据,明显错误。

2、结合路径搜索和属性搜索(推荐)

首先,您需要知道帖子拼图的标签。您只需要收录帖子这部分内容的标签即可。

从图中我们可以知道帖子的信息在li标签中,我们想要的数据肯定在li标签中,解析li标签

我们可以根据a标签逐层查找。有一个问题,就是会出现同一个标签,而且两个级别相同,那么如何区分,如下图:

可以看出我们想要的内容在第二个div标签下。两者如何区分,通过属性值很容易区分。

语法:

//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a

影响:

语法的写法是自己决定的,只要得到正确的数据即可

3、获取数据

我们上面所做的只是定位数据所在的标签,并没有真正获取到值,根据标签中数据的形式获取

提供日千万预算,长期高价收wap量,正规无感广告,寻站长合作共

可以看到a标签的title属性的值就是我们想要的数据,中间也有我们想要的值,所以有两种写法,根据自己的喜好

语法:

写一:

//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a/text()

影响:

写作二:

//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a/@title

影响:

4、写代码实现

代码:

import requests

import time

from lxml import etree

def getHTMLContent(url):

# 伪装用户代理,防反爬

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.77 Safari/537.36'

}

# 向url发送get请求

respone = requests.get(url,headers = header)

# 将返回的二进制流文件转化成文本文件

content = respone.text

# 减少一些无用的标签的干扰,这个标签在html语言是属于注释标签

content = content.replace('', '')

# 将返回的html文本文件转化成xpath能解析的对象

tree = etree.HTML(content)

# 根据xpath语法获取内容

titles = tree.xpath('//ul[@id="thread_list"]/li/div/div[@class="col2_right j_threadlist_li_right "]/div/div/a/text()')

# 循环打印结果

for title in titles:

print(title)

if __name__ =="__main__":

url = "https://tieba.baidu.com/f%3Fkw ... ot%3B

getHTMLContent(url)

结果:

网页爬虫抓取百度图片( 网络上爬行的一直蜘蛛,互联网什么是爬虫爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-11-08 04:07

网络上爬行的一直蜘蛛,互联网什么是爬虫爬虫)

1.什么是爬虫

爬虫,或网络爬虫,可以理解为无时无刻不在网络上爬行的蜘蛛。互联网就像一个大网,爬虫就是在这个网上爬来爬去的蜘蛛。如果它遇到资源,那么它会被爬下来。你想爬什么?这取决于你来控制它。比如它在爬一个网页,他在这个网上找到了一条路,其实就是一个网页的超链接,然后就可以爬到另一个网页上获取数据了。这样一来,整个相连的网都在这只蜘蛛的触手可及的范围内,分分钟爬下来也不成问题。

2.浏览网页的过程

当用户浏览网页时,我们可能会看到很多漂亮的图片,比如我们会看到几张图片和百度搜索框。这个过程其实就是用户输入URL,通过DNS服务器找到服务器主机之后。向服务器发送请求。服务器解析后,将浏览器的HTML、JS、CSS等文件发送给用户。浏览器解析出来,用户可以看到各种图片。因此,用户看到的网页本质上是由HTML代码组成的,爬虫爬取这个内容。通过对这些HTML代码进行分析和过滤,可以获得图片、文字等资源。

3.URL的含义

URL,即统一资源定位符,也就是我们所说的网址。统一资源定位符是互联网上可用资源的位置和访问方式的简明表示,是互联网上标准资源的地址。Internet 上的每个文件都有一个唯一的 URL,其中收录指示文件位置以及浏览器应如何处理它的信息。

URL 的格式由三部分组成: ① 第一部分是协议(或称服务模式)。②第二部分是收录资源的主机的IP地址(有时包括端口号)。③第三部分是宿主机资源的具体地址,如目录、文件名等。

爬虫在爬取数据时,必须要有目标网址才能获取数据。因此,它是爬虫获取数据的基本依据。准确理解其含义对爬虫学习有很大帮助。

4. 环境配置

学习Python,环境配置是必不可少的。一开始我用的是Notepad++,但是发现它的提示功能太弱了,所以我在Windows下使用了PyCharm,Linux下使用了Eclipse for Python。有几个优秀的IDE,可以参考这个文章学习Python推荐的IDE。好的开发工具是一种动力。我希望你能找到适合你的 IDE。下一节,我们将正式进入Python爬虫学习的殿堂。你准备好了吗? 查看全部

网页爬虫抓取百度图片(

网络上爬行的一直蜘蛛,互联网什么是爬虫爬虫)

1.什么是爬虫

爬虫,或网络爬虫,可以理解为无时无刻不在网络上爬行的蜘蛛。互联网就像一个大网,爬虫就是在这个网上爬来爬去的蜘蛛。如果它遇到资源,那么它会被爬下来。你想爬什么?这取决于你来控制它。比如它在爬一个网页,他在这个网上找到了一条路,其实就是一个网页的超链接,然后就可以爬到另一个网页上获取数据了。这样一来,整个相连的网都在这只蜘蛛的触手可及的范围内,分分钟爬下来也不成问题。

2.浏览网页的过程

当用户浏览网页时,我们可能会看到很多漂亮的图片,比如我们会看到几张图片和百度搜索框。这个过程其实就是用户输入URL,通过DNS服务器找到服务器主机之后。向服务器发送请求。服务器解析后,将浏览器的HTML、JS、CSS等文件发送给用户。浏览器解析出来,用户可以看到各种图片。因此,用户看到的网页本质上是由HTML代码组成的,爬虫爬取这个内容。通过对这些HTML代码进行分析和过滤,可以获得图片、文字等资源。

3.URL的含义

URL,即统一资源定位符,也就是我们所说的网址。统一资源定位符是互联网上可用资源的位置和访问方式的简明表示,是互联网上标准资源的地址。Internet 上的每个文件都有一个唯一的 URL,其中收录指示文件位置以及浏览器应如何处理它的信息。

URL 的格式由三部分组成: ① 第一部分是协议(或称服务模式)。②第二部分是收录资源的主机的IP地址(有时包括端口号)。③第三部分是宿主机资源的具体地址,如目录、文件名等。

爬虫在爬取数据时,必须要有目标网址才能获取数据。因此,它是爬虫获取数据的基本依据。准确理解其含义对爬虫学习有很大帮助。

4. 环境配置

学习Python,环境配置是必不可少的。一开始我用的是Notepad++,但是发现它的提示功能太弱了,所以我在Windows下使用了PyCharm,Linux下使用了Eclipse for Python。有几个优秀的IDE,可以参考这个文章学习Python推荐的IDE。好的开发工具是一种动力。我希望你能找到适合你的 IDE。下一节,我们将正式进入Python爬虫学习的殿堂。你准备好了吗?

网页爬虫抓取百度图片(浅谈一下爬虫什么是爬虫?(二):请求网站并提取数据的自动化程序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-11-07 19:27

前言

爬虫是一项非常有趣的技术。您可以使用爬虫技术来获取其他人无法获得或需要付费的东西。您还可以自动抓取并保存大量数据,减少手动完成一些繁琐任务的时间和精力。

可以说学编程的人很多,不玩爬虫的意义就少了很多。无论是业余爱好者、私人工作还是专业爬行动物,爬行动物世界都非常令人兴奋。

今天给大家讲一下爬虫,目的是让准备学习爬虫或者刚入门的人对爬虫有更深入、更全面的了解。

一、认识爬虫

1.什么是爬虫?

一句话介绍著名的爬虫:一个请求网站并提取数据的自动化程序。

下面我们来拆解了解一下爬虫:

网站的请求就是向网站发送请求。比如去百度搜索关键词“Python”。这时,我们的浏览器会向网站发送请求;

提取数据。数据包括图片、文字、视频等,统称为数据。我们发送请求后,网站 会将搜索结果呈现给我们。这实际上是返回数据。这时候我们可以查看数据来提取

自动化的程序,也就是我们写的代码,实现了过程数据的自动提取,比如批量下载和保存返回的图片,而不是手动一一操作。

2. 爬虫分类

根据使用场景,爬虫可以分为三类:

①万向履带(大而全)

它具有强大的功能和广泛的采集。它通常用于搜索引擎。比如百度浏览器就是一个大爬虫程序。

②关注爬虫(小而精)

功能比较单一,只抓取特定网站的特定内容。比如去一个网站批量获取一些数据。这也是我们最常用的爬虫。

③增量爬虫(仅采集更新内容)

这实际上是 Focused Crawler 的一个迭代爬虫。它只采集 更新数据。对于旧数据,它不是采集,相当于一直存在和运行。只要有符合要求的更新数据,就会自动抓取新数据。

3.机器人协议

爬虫中有一个叫做Robots的协议需要注意,也称为“网络爬虫排除标准”。它的作用是网站告诉你什么可以爬,什么不能爬。

在哪里看这个机器人协议?

一般情况下,可以直接在网站的首页URL后添加/robots.txt进行查看。例如,百度的机器人协议就在那里。可以看到有很多URL是规定不能爬取的,比如Disallow:/shifen/ 说明目前Disallow:/shifen和Disallow:/shifen下的子目录是不能爬取的。

实际上,这份Robots协议属于君子协议。对于爬虫来说,基本上是口头约定。如果你违反了它,你可能会被追究责任。但是,如果你不违反它,爬虫将无法抓取任何数据,所以通常双方都视而不见,只是不要太嚣张。

二、爬取的基本过程

1.爬行4步

爬行动物是如何工作的?

爬虫程序大致可以分为四个步骤:

①发起请求

通过HTTP库向目标站点发起请求,即发送一个Request,可以收录额外的headers等信息,等待服务器响应。

②获取回复内容

如果服务器可以正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可能包括 HTML、Json 字符串和二进制数据(如图片和视频)。

③内容分析

获取的内容可能是HTML,可以使用正则表达式和网页解析库进行解析。可能是Json,可以直接转成Json对象解析,也可能是二进制数据,可以保存或者进一步处理。

④保存数据

保存的数据有多种类型,可以保存为文本、保存到数据库或保存为特定格式的文件。

基本上,这是爬虫必须遵循的四个步骤。

2.请求和响应

请求和响应是爬虫最重要的部分。请求和响应之间是什么关系?

两者的关系如下:

简单理解一下,当我们在电脑浏览器上搜索东西的时候,比如前面提到的在百度搜索“Python”,你点击百度,已经向百度的服务器发送了一个Request请求,Request中收录很多信息,比如如身份信息、请求信息等,服务器收到请求后做出判断,然后返回一个Response给我们的电脑,里面也收录了很多信息,比如请求成功,比如我们请求的信息结果(文本、图片、视频等)。

应该很容易理解吧?

接下来,让我们仔细看看请求和响应。

三、了解RequestRequest中收录什么?

它主要收录以下内容:

1.请求方法

请求方法可以理解为你向网站问好的方式。如果你从网站那里得到数据,你要以正确的方式迎接它,这样它才能回应你,就像你从别人家借东西一样,你要先敲门再说你好。可以直接爬上窗户进去,看到的人必须出去。

主要的请求方法是GET和POST,还有其他方法如HEAD/PUT/DELETE/OPTIONS,最常用的方法是GET。

2.请求网址

什么是网址?

URL的全称是Uniform Resource Locator。例如,一个网页文档、图片、视频等都有一个唯一的网址,可以理解为爬虫中的网址或链接。

3.请求头

请求头是什么?

英文名称Request Headers通常是指请求中收录的头信息,如User-Agent、Host、Cookies等。

当你向网站发送请求时,这些东西就相当于你的身份信息。经常需要伪装自己,伪装成普通用户来躲避你的目标。网站 识别你是爬虫,避免一些反扒问题,顺利获取数据。

4.请求正文

官方说法是请求中携带的附加数据,例如提交表单时的表单数据。

在爬虫中如何理解?

例如,在某些页面上,您必须先登录,或者您必须告诉我您的请求。比如你在百度页面搜索“Python”,那么关键词“Python”就是你要携带的请求体,看到你的请求体,看到百度就知道你要做什么了。

当然,请求体通常用在 POST 请求方法中。GET 请求时,我们通常将其拼接在 URL 中。先了解一下就够了,后续具体爬虫可以去加深了解。

5.实用视图请求

既然我们已经讲了Request的理论,那我们就可以进入实际操作,看看Request在哪里,收录什么。

以谷歌浏览器为例,我输入关键词“Python”就可以搜索到一堆结果。我们使用网页自带的控制台窗口来分析我们发送的Request请求。

按住F12或者在网页空白处右击选择“检查”,然后就可以看到控制台里有很多选项了。例如,上列有一个菜单栏。初级爬虫一般使用元素(Elements)。还有Network(网络),其他的东西暂时不需要,等你学习更高级一点的爬虫时会用到,比如JS逆向工程可能会用到Application窗口,以后再学习。

Elements 收录了所有请求结果的每一个元素,比如每张图片的源代码,尤其是点击左上角的小箭头,你移动到的每一个地方都会在 Elements 窗口下显示为源代码。

网络是爬虫常用的网络信息。其中包括我们的请求。让我们来看看。在“网络”窗口下,选中“禁用缓存”并单击“全部”。

刷新网页看看效果。您可以看到我们发送了 132 个请求请求。不要对这个好奇。虽然我们只向百度发送了类似“Python”这样的请求,但其中一些是附加到网页的请求。

虽然图片格式有很多种,比如png、jpeg等,但是可以滑动到顶部。在Type栏中,有文档类型,即web文档的含义。点击进入,我们将是我们的。索取资料。

点击文档进入后,有一个新的菜单栏。在Headers列下,我们可以看到Request URL,也就是我们之前提到的请求URL。这个URL就是我们实际从网页请求的URL,然后返回 有一个请求方法,可以看出是一个GET请求。

如果再次向下滑动,还可以看到我们之前提到的 Request Headers。信息很多,但是我们前面提到的User-Agent、Host、Cookies都是我们提供给服务器的信息。

虽然Request Headers里面的内容很多,我们在写爬虫程序的时候也要做这方面的伪装工作,但是不是所有的信息都要写,有选择的写一些重要的信息就足够了,比如User-Agent必需的。Referer 和 Host 是可选区域。登录时会携带cookies,常见的有4种需要伪装。

至于请求体,我暂时不去查了,因为我们这里的请求方法是GET请求。请求正文只能在 POST 请求中查看。没关系,爬虫什么时候用你自然就明白了。

四、了解响应

Response 主要包括 3 条内容,我们来一一看看。

1.响应状态

我们发送请求后,网站会返回给我们一个Response,其中收录响应状态码的响应状态,大致可以分为以下几种:

①例如在200以内,响应状态码200表示成功。

②三百的范围,比如301就是跳跃。

③四百范围内,如404找不到页面。

④五百范围内,如502找不到页面。

对于爬虫来说,两三百是我们最想看到的响应状态,有可能获取到数据,而四五百基本是冷的,获取不到数据。

比如我们刚刚发送了之前的Request请求时,在文档文件中,在Headers窗口下的General中,可以看到响应状态码为200,表示网页成功响应了我们的请求。

2. 响应头

服务器给我们的信息也会收录响应头,其中包括内容类型、内容长度、服务器信息、设置cookies等。

其实响应头对我们来说并没有那么重要,在这里了解一下就行了。

3.响应体

这一点很重要,除了上面第一点的响应状态,就是它,因为它收录了请求资源的内容,比如网页HTML和图像二进制数。

响应体在哪里?它也在文档文件的响应列中。可以向下滑动,看到有很多响应数据。这是我们得到的数据。有些可以直接下载,有些需要技术分析。知道了。

五、爬虫能得到什么样的数据?

爬虫能得到什么样的数据?基本上可以分为以下几类:

① Web 文档,如 HTML 文档、Json 格式的文本等。

②图片以二进制文件形式获取,可以保存为图片格式。

③视频,也是二进制文件,可以保存为视频格式。

④其他,反正其他能看到的东西理论上爬虫都能得到,看难易程度。

六、如何解析数据?

从前面我们可以成功发送请求,网页会返回给我们很多数据,有几千甚至几万个代码,那么如何在这么多代码中找到我们想要的数据呢?常用的方法如下:

①直接治疗。当网页返回的数据是一些文本时,就是我们想要的内容,不需要过滤处理,直接处理即可。

②Json分析。如果返回的网页不是HTML数据而是Json数据,则需要Json解析技术。

③正则表达式。如果返回的数据是符合正则表达式的数据,可以使用正则表达式进行分析。

④其他分析方法。常用的有XPath、BeautifulSoup、PyQuery,都是爬虫常用的解析库。

七、如何保存数据?

获取数据后,常用的保存数据的方法如下:

①文字。可以直接保存为纯文本、EXCEL、Json、Xml等类型的文本。

②关系数据库。数据可以保存到关系型数据库,如MySQL和Oracle数据库。

③非关系型数据库。比如MongoDB、Readis和Key-Value存储。

④ 二进制文件。比如图片、视频、音频等可以直接保存为特定格式。

练习视频: 查看全部

网页爬虫抓取百度图片(浅谈一下爬虫什么是爬虫?(二):请求网站并提取数据的自动化程序)

前言

爬虫是一项非常有趣的技术。您可以使用爬虫技术来获取其他人无法获得或需要付费的东西。您还可以自动抓取并保存大量数据,减少手动完成一些繁琐任务的时间和精力。

可以说学编程的人很多,不玩爬虫的意义就少了很多。无论是业余爱好者、私人工作还是专业爬行动物,爬行动物世界都非常令人兴奋。

今天给大家讲一下爬虫,目的是让准备学习爬虫或者刚入门的人对爬虫有更深入、更全面的了解。

一、认识爬虫

1.什么是爬虫?

一句话介绍著名的爬虫:一个请求网站并提取数据的自动化程序。

下面我们来拆解了解一下爬虫:

网站的请求就是向网站发送请求。比如去百度搜索关键词“Python”。这时,我们的浏览器会向网站发送请求;

提取数据。数据包括图片、文字、视频等,统称为数据。我们发送请求后,网站 会将搜索结果呈现给我们。这实际上是返回数据。这时候我们可以查看数据来提取

自动化的程序,也就是我们写的代码,实现了过程数据的自动提取,比如批量下载和保存返回的图片,而不是手动一一操作。

2. 爬虫分类

根据使用场景,爬虫可以分为三类:

①万向履带(大而全)

它具有强大的功能和广泛的采集。它通常用于搜索引擎。比如百度浏览器就是一个大爬虫程序。

②关注爬虫(小而精)

功能比较单一,只抓取特定网站的特定内容。比如去一个网站批量获取一些数据。这也是我们最常用的爬虫。

③增量爬虫(仅采集更新内容)

这实际上是 Focused Crawler 的一个迭代爬虫。它只采集 更新数据。对于旧数据,它不是采集,相当于一直存在和运行。只要有符合要求的更新数据,就会自动抓取新数据。

3.机器人协议

爬虫中有一个叫做Robots的协议需要注意,也称为“网络爬虫排除标准”。它的作用是网站告诉你什么可以爬,什么不能爬。

在哪里看这个机器人协议?

一般情况下,可以直接在网站的首页URL后添加/robots.txt进行查看。例如,百度的机器人协议就在那里。可以看到有很多URL是规定不能爬取的,比如Disallow:/shifen/ 说明目前Disallow:/shifen和Disallow:/shifen下的子目录是不能爬取的。

实际上,这份Robots协议属于君子协议。对于爬虫来说,基本上是口头约定。如果你违反了它,你可能会被追究责任。但是,如果你不违反它,爬虫将无法抓取任何数据,所以通常双方都视而不见,只是不要太嚣张。

二、爬取的基本过程

1.爬行4步

爬行动物是如何工作的?

爬虫程序大致可以分为四个步骤:

①发起请求

通过HTTP库向目标站点发起请求,即发送一个Request,可以收录额外的headers等信息,等待服务器响应。

②获取回复内容

如果服务器可以正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可能包括 HTML、Json 字符串和二进制数据(如图片和视频)。

③内容分析

获取的内容可能是HTML,可以使用正则表达式和网页解析库进行解析。可能是Json,可以直接转成Json对象解析,也可能是二进制数据,可以保存或者进一步处理。

④保存数据

保存的数据有多种类型,可以保存为文本、保存到数据库或保存为特定格式的文件。

基本上,这是爬虫必须遵循的四个步骤。

2.请求和响应

请求和响应是爬虫最重要的部分。请求和响应之间是什么关系?

两者的关系如下:

简单理解一下,当我们在电脑浏览器上搜索东西的时候,比如前面提到的在百度搜索“Python”,你点击百度,已经向百度的服务器发送了一个Request请求,Request中收录很多信息,比如如身份信息、请求信息等,服务器收到请求后做出判断,然后返回一个Response给我们的电脑,里面也收录了很多信息,比如请求成功,比如我们请求的信息结果(文本、图片、视频等)。

应该很容易理解吧?

接下来,让我们仔细看看请求和响应。

三、了解RequestRequest中收录什么?

它主要收录以下内容:

1.请求方法

请求方法可以理解为你向网站问好的方式。如果你从网站那里得到数据,你要以正确的方式迎接它,这样它才能回应你,就像你从别人家借东西一样,你要先敲门再说你好。可以直接爬上窗户进去,看到的人必须出去。

主要的请求方法是GET和POST,还有其他方法如HEAD/PUT/DELETE/OPTIONS,最常用的方法是GET。

2.请求网址

什么是网址?

URL的全称是Uniform Resource Locator。例如,一个网页文档、图片、视频等都有一个唯一的网址,可以理解为爬虫中的网址或链接。

3.请求头

请求头是什么?

英文名称Request Headers通常是指请求中收录的头信息,如User-Agent、Host、Cookies等。

当你向网站发送请求时,这些东西就相当于你的身份信息。经常需要伪装自己,伪装成普通用户来躲避你的目标。网站 识别你是爬虫,避免一些反扒问题,顺利获取数据。

4.请求正文

官方说法是请求中携带的附加数据,例如提交表单时的表单数据。

在爬虫中如何理解?

例如,在某些页面上,您必须先登录,或者您必须告诉我您的请求。比如你在百度页面搜索“Python”,那么关键词“Python”就是你要携带的请求体,看到你的请求体,看到百度就知道你要做什么了。

当然,请求体通常用在 POST 请求方法中。GET 请求时,我们通常将其拼接在 URL 中。先了解一下就够了,后续具体爬虫可以去加深了解。

5.实用视图请求

既然我们已经讲了Request的理论,那我们就可以进入实际操作,看看Request在哪里,收录什么。

以谷歌浏览器为例,我输入关键词“Python”就可以搜索到一堆结果。我们使用网页自带的控制台窗口来分析我们发送的Request请求。

按住F12或者在网页空白处右击选择“检查”,然后就可以看到控制台里有很多选项了。例如,上列有一个菜单栏。初级爬虫一般使用元素(Elements)。还有Network(网络),其他的东西暂时不需要,等你学习更高级一点的爬虫时会用到,比如JS逆向工程可能会用到Application窗口,以后再学习。

Elements 收录了所有请求结果的每一个元素,比如每张图片的源代码,尤其是点击左上角的小箭头,你移动到的每一个地方都会在 Elements 窗口下显示为源代码。

网络是爬虫常用的网络信息。其中包括我们的请求。让我们来看看。在“网络”窗口下,选中“禁用缓存”并单击“全部”。

刷新网页看看效果。您可以看到我们发送了 132 个请求请求。不要对这个好奇。虽然我们只向百度发送了类似“Python”这样的请求,但其中一些是附加到网页的请求。

虽然图片格式有很多种,比如png、jpeg等,但是可以滑动到顶部。在Type栏中,有文档类型,即web文档的含义。点击进入,我们将是我们的。索取资料。

点击文档进入后,有一个新的菜单栏。在Headers列下,我们可以看到Request URL,也就是我们之前提到的请求URL。这个URL就是我们实际从网页请求的URL,然后返回 有一个请求方法,可以看出是一个GET请求。

如果再次向下滑动,还可以看到我们之前提到的 Request Headers。信息很多,但是我们前面提到的User-Agent、Host、Cookies都是我们提供给服务器的信息。

虽然Request Headers里面的内容很多,我们在写爬虫程序的时候也要做这方面的伪装工作,但是不是所有的信息都要写,有选择的写一些重要的信息就足够了,比如User-Agent必需的。Referer 和 Host 是可选区域。登录时会携带cookies,常见的有4种需要伪装。

至于请求体,我暂时不去查了,因为我们这里的请求方法是GET请求。请求正文只能在 POST 请求中查看。没关系,爬虫什么时候用你自然就明白了。

四、了解响应

Response 主要包括 3 条内容,我们来一一看看。

1.响应状态

我们发送请求后,网站会返回给我们一个Response,其中收录响应状态码的响应状态,大致可以分为以下几种:

①例如在200以内,响应状态码200表示成功。

②三百的范围,比如301就是跳跃。

③四百范围内,如404找不到页面。

④五百范围内,如502找不到页面。

对于爬虫来说,两三百是我们最想看到的响应状态,有可能获取到数据,而四五百基本是冷的,获取不到数据。

比如我们刚刚发送了之前的Request请求时,在文档文件中,在Headers窗口下的General中,可以看到响应状态码为200,表示网页成功响应了我们的请求。

2. 响应头

服务器给我们的信息也会收录响应头,其中包括内容类型、内容长度、服务器信息、设置cookies等。

其实响应头对我们来说并没有那么重要,在这里了解一下就行了。

3.响应体

这一点很重要,除了上面第一点的响应状态,就是它,因为它收录了请求资源的内容,比如网页HTML和图像二进制数。

响应体在哪里?它也在文档文件的响应列中。可以向下滑动,看到有很多响应数据。这是我们得到的数据。有些可以直接下载,有些需要技术分析。知道了。

五、爬虫能得到什么样的数据?

爬虫能得到什么样的数据?基本上可以分为以下几类:

① Web 文档,如 HTML 文档、Json 格式的文本等。

②图片以二进制文件形式获取,可以保存为图片格式。

③视频,也是二进制文件,可以保存为视频格式。

④其他,反正其他能看到的东西理论上爬虫都能得到,看难易程度。

六、如何解析数据?

从前面我们可以成功发送请求,网页会返回给我们很多数据,有几千甚至几万个代码,那么如何在这么多代码中找到我们想要的数据呢?常用的方法如下:

①直接治疗。当网页返回的数据是一些文本时,就是我们想要的内容,不需要过滤处理,直接处理即可。

②Json分析。如果返回的网页不是HTML数据而是Json数据,则需要Json解析技术。

③正则表达式。如果返回的数据是符合正则表达式的数据,可以使用正则表达式进行分析。

④其他分析方法。常用的有XPath、BeautifulSoup、PyQuery,都是爬虫常用的解析库。

七、如何保存数据?

获取数据后,常用的保存数据的方法如下:

①文字。可以直接保存为纯文本、EXCEL、Json、Xml等类型的文本。

②关系数据库。数据可以保存到关系型数据库,如MySQL和Oracle数据库。

③非关系型数据库。比如MongoDB、Readis和Key-Value存储。

④ 二进制文件。比如图片、视频、音频等可以直接保存为特定格式。

练习视频:

网页爬虫抓取百度图片(什么是网络爬虫?向日葵智能实战小项目)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-11-07 08:00

原帖:向日葵智能

现在基于python的爬虫实战项目,网上资料还是很多的,但是本节介绍的爬虫略有不同:同样是下载某个网页的漂亮图片,不同的是我们使用人工智能过滤掉漂亮的。. 慢慢说爬虫吧。过滤的原理很简单。参考python实战项目,人脸检测,让电脑给你的外表打分。

什么是网络爬虫?

网络爬虫也称为网络蜘蛛。它的官方定义可以在百科全书中找到。这里我们只说什么是网络爬虫,可能不准确,但相对来说比较好理解,举个例子吧。

有时,您可能会从某个网页上看到一条信息,并觉得它符合您的口味,因此您将其保存。这种读取和存储数据的过程类似于网络爬虫。百度、谷歌等搜索引擎,相信大家都用过,他们是怎么实现搜索功能的?

事实上,这一切都取决于爬虫。他们的网络爬虫不断地爬取互联网上的信息,并保存他们认为有用的信息。当用户输入关键词进行搜索时,百度谷歌将关键词与自己的数据库进行匹配,匹配最相关的网页展示给用户,从而完成一次搜索。

再设想一个场景:有一天,你可能会看到某个网站的很多信息非常好,一个个打开和存储网页真的很麻烦。那么这时候就可以使用网络爬虫爬下整个网站的信息了。这也是爬虫的一个目的。

Python实战项目

经过上面的解释,我们可以知道网络爬虫的行为和我们浏览器的行为非常相似。所以,这里介绍的python网络爬虫其实就是模拟一个浏览器。

上图是一组图片。如果我们要保存这些图片,要一一保存就太麻烦了。貌似迅雷可以下载所有的链接,但它也会下载不该下载的,比如红框里的怪人。

右键查看网页源码:

我们得到的字符很多,我们只关心图片链接,打开上图红框中的链接,得到的图片如下:

明明图片的链接在网页的源码里,那么这个python实战项目,网络爬虫怎么写呢?

Python实战项目,网络爬虫1. 先获取网页源码

其实就是模拟浏览器请求图片页面的URL。话不多说,看源码,很简单

#coding:utf-8

import requests

# url 即为图片网页的网址

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

print data.content

Python

复制

运行后会发现我们刚才在浏览器中查看的源代码已经打印出来了。

2. Python项目实战,提取图片链接

如何从大量字符中提取关键美女图片链接?答案是使用正则表达式。关于正则表达式,可以参考:

Python基础,什么是正则表达式,正则表达式的使用

使用正则表达式的第一步是找出链接的模式及其出现的位置。这是一个粗略的尝试:

注意"objURL":和逗号(,)之间存在链接,那么我们的实战项目,python网络爬虫的正则表达式代码可以这样写:

#coding:utf-8

import requests

# url 即为图片网页的网址

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

#print data.content

# 正则表达式的使用,可参照上一节

pattern = re.compile(r'.*?"objURL":"(.*?)",', re.S)

result = pattern.findall(data.content)

for item in result:

print item

Python

复制

运行实战项目的python网络爬虫脚本,发现成功了,得到了一系列图片地址:

3. Python实战项目,下载图片

获取到图片的链接后,我们如何保存它们?答案是模拟浏览器访问一次图片链接,然后将获取到的数据写入文件。我们直接上传代码:

#coding:utf-8

import requests

# url 即为图片网页的网址

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

#print data.content

# 正则表达式的使用,可参照上一节

pattern = re.compile(r'.*?"objURL":"(.*?)",', re.S)

result = pattern.findall(data.content)

for item in result:

try:

pic = requests.get(item, timeout=2)

fp = open("pic/%d.jpg"%i, "w+")

fp.write(pic.content)

fp.close()

i = i + 1

except Exception, e:

pass

Python

复制

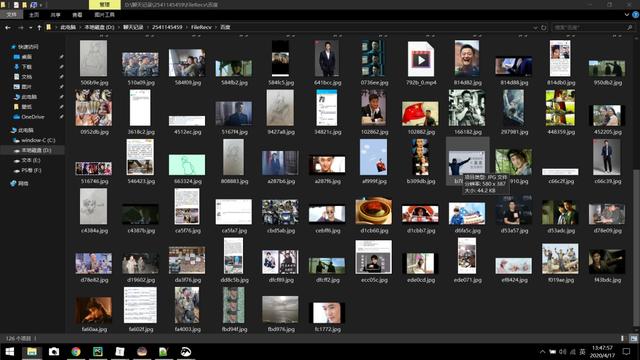

执行代码前,创建一个文件夹pic存放图片,然后执行实战项目python脚本得到

这是一个成功!

4. Python实战项目,过滤图片

可以看到,虽然图片被爬下来了,但并不完美,因为怪人也被下载了。如何过滤?其实可以参考我们之前的博客:

Python实战小项目,人脸检测,让电脑给你的颜值打分。我们只下载女(女),颜值大于55分,代码如下:

#coding:utf-8

import requests

import urllib2

import random

import time, re

import base64

import urllib, json

from token import GetToken

faceDetectUrl = "https://aip.baidubce.com/rest/ ... ot%3B

# 根据人脸检测的颜值打分,判断是否下载

def IfDownLoad(pic, token):

img = base64.b64encode(pic)

params = {

"face_fields":"age,beauty,expression,faceshape,gender,glasses,landmark,race,qualities","image":img,"max_face_num":5}

params = urllib.urlencode(params)

request_url = faceDetectUrl + "?access_token=" + token

request = urllib2.Request(url=request_url, data=params)

request.add_header('Content-Type', 'application/x-www-form-urlencoded')

response = urllib2.urlopen(request)

content = response.read()

if content:

js = json.loads(content)

for item in js['result']:

print "age: %d, beauty: %d" % (item['age'], item['beauty'])

if 0 == cmp('female', item['gender']):

if (item['age']55): # 只下载女孩,年龄小于 29,颜值大于 55分

return True

return False

def DownLoad(url, i):

fp = open("pic/%d.jpg"%i, "w+")

fp.write(pic.content)

fp.close()

if __name__ == "__main__":

# 获取网页源代码

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

# print data.content

# 获取链接并判断是否下载

pattern = re.compile(r'.*?"objURL":"(.*?)",', re.S)

result = pattern.findall(data.content)

i = 0

token = GetToken()

for item in result:

print item

try:

pic = requests.get(item, timeout=2)

if(True == IfDownLoad(pic.content, token)):

DownLoad(pic.content, i)

i = i + 1

except Exception, e:

pass

Python

复制

运行实战项目python脚本,结果如下:

可以看到,怪人都被淘汰了,下载的图片基本都是颜值高的美图。这样我们就完成了实战项目,python人工智能爬虫-图片的选择性爬取。 查看全部

网页爬虫抓取百度图片(什么是网络爬虫?向日葵智能实战小项目)

原帖:向日葵智能

现在基于python的爬虫实战项目,网上资料还是很多的,但是本节介绍的爬虫略有不同:同样是下载某个网页的漂亮图片,不同的是我们使用人工智能过滤掉漂亮的。. 慢慢说爬虫吧。过滤的原理很简单。参考python实战项目,人脸检测,让电脑给你的外表打分。

什么是网络爬虫?

网络爬虫也称为网络蜘蛛。它的官方定义可以在百科全书中找到。这里我们只说什么是网络爬虫,可能不准确,但相对来说比较好理解,举个例子吧。

有时,您可能会从某个网页上看到一条信息,并觉得它符合您的口味,因此您将其保存。这种读取和存储数据的过程类似于网络爬虫。百度、谷歌等搜索引擎,相信大家都用过,他们是怎么实现搜索功能的?

事实上,这一切都取决于爬虫。他们的网络爬虫不断地爬取互联网上的信息,并保存他们认为有用的信息。当用户输入关键词进行搜索时,百度谷歌将关键词与自己的数据库进行匹配,匹配最相关的网页展示给用户,从而完成一次搜索。

再设想一个场景:有一天,你可能会看到某个网站的很多信息非常好,一个个打开和存储网页真的很麻烦。那么这时候就可以使用网络爬虫爬下整个网站的信息了。这也是爬虫的一个目的。

Python实战项目

经过上面的解释,我们可以知道网络爬虫的行为和我们浏览器的行为非常相似。所以,这里介绍的python网络爬虫其实就是模拟一个浏览器。

上图是一组图片。如果我们要保存这些图片,要一一保存就太麻烦了。貌似迅雷可以下载所有的链接,但它也会下载不该下载的,比如红框里的怪人。

右键查看网页源码:

我们得到的字符很多,我们只关心图片链接,打开上图红框中的链接,得到的图片如下:

明明图片的链接在网页的源码里,那么这个python实战项目,网络爬虫怎么写呢?

Python实战项目,网络爬虫1. 先获取网页源码

其实就是模拟浏览器请求图片页面的URL。话不多说,看源码,很简单

#coding:utf-8

import requests

# url 即为图片网页的网址

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

print data.content

Python

复制

运行后会发现我们刚才在浏览器中查看的源代码已经打印出来了。

2. Python项目实战,提取图片链接

如何从大量字符中提取关键美女图片链接?答案是使用正则表达式。关于正则表达式,可以参考:

Python基础,什么是正则表达式,正则表达式的使用

使用正则表达式的第一步是找出链接的模式及其出现的位置。这是一个粗略的尝试:

注意"objURL":和逗号(,)之间存在链接,那么我们的实战项目,python网络爬虫的正则表达式代码可以这样写:

#coding:utf-8

import requests

# url 即为图片网页的网址

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

#print data.content

# 正则表达式的使用,可参照上一节

pattern = re.compile(r'.*?"objURL":"(.*?)",', re.S)

result = pattern.findall(data.content)

for item in result:

print item

Python

复制

运行实战项目的python网络爬虫脚本,发现成功了,得到了一系列图片地址:

3. Python实战项目,下载图片

获取到图片的链接后,我们如何保存它们?答案是模拟浏览器访问一次图片链接,然后将获取到的数据写入文件。我们直接上传代码:

#coding:utf-8

import requests

# url 即为图片网页的网址

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

#print data.content

# 正则表达式的使用,可参照上一节

pattern = re.compile(r'.*?"objURL":"(.*?)",', re.S)

result = pattern.findall(data.content)

for item in result:

try:

pic = requests.get(item, timeout=2)

fp = open("pic/%d.jpg"%i, "w+")

fp.write(pic.content)

fp.close()

i = i + 1

except Exception, e:

pass

Python

复制

执行代码前,创建一个文件夹pic存放图片,然后执行实战项目python脚本得到

这是一个成功!

4. Python实战项目,过滤图片

可以看到,虽然图片被爬下来了,但并不完美,因为怪人也被下载了。如何过滤?其实可以参考我们之前的博客:

Python实战小项目,人脸检测,让电脑给你的颜值打分。我们只下载女(女),颜值大于55分,代码如下:

#coding:utf-8

import requests

import urllib2

import random

import time, re

import base64

import urllib, json

from token import GetToken

faceDetectUrl = "https://aip.baidubce.com/rest/ ... ot%3B

# 根据人脸检测的颜值打分,判断是否下载

def IfDownLoad(pic, token):

img = base64.b64encode(pic)

params = {

"face_fields":"age,beauty,expression,faceshape,gender,glasses,landmark,race,qualities","image":img,"max_face_num":5}

params = urllib.urlencode(params)

request_url = faceDetectUrl + "?access_token=" + token

request = urllib2.Request(url=request_url, data=params)

request.add_header('Content-Type', 'application/x-www-form-urlencoded')

response = urllib2.urlopen(request)

content = response.read()

if content:

js = json.loads(content)

for item in js['result']:

print "age: %d, beauty: %d" % (item['age'], item['beauty'])

if 0 == cmp('female', item['gender']):

if (item['age']55): # 只下载女孩,年龄小于 29,颜值大于 55分

return True

return False

def DownLoad(url, i):

fp = open("pic/%d.jpg"%i, "w+")

fp.write(pic.content)

fp.close()

if __name__ == "__main__":

# 获取网页源代码

url = "https://image.baidu.com/search ... mp%3B【...】"

data = requests.get(url)

# print data.content

# 获取链接并判断是否下载

pattern = re.compile(r'.*?"objURL":"(.*?)",', re.S)

result = pattern.findall(data.content)

i = 0

token = GetToken()

for item in result:

print item

try:

pic = requests.get(item, timeout=2)

if(True == IfDownLoad(pic.content, token)):

DownLoad(pic.content, i)

i = i + 1

except Exception, e:

pass

Python

复制

运行实战项目python脚本,结果如下:

可以看到,怪人都被淘汰了,下载的图片基本都是颜值高的美图。这样我们就完成了实战项目,python人工智能爬虫-图片的选择性爬取。

网页爬虫抓取百度图片(来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生夏敏捷主编) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-11-04 19:10

)

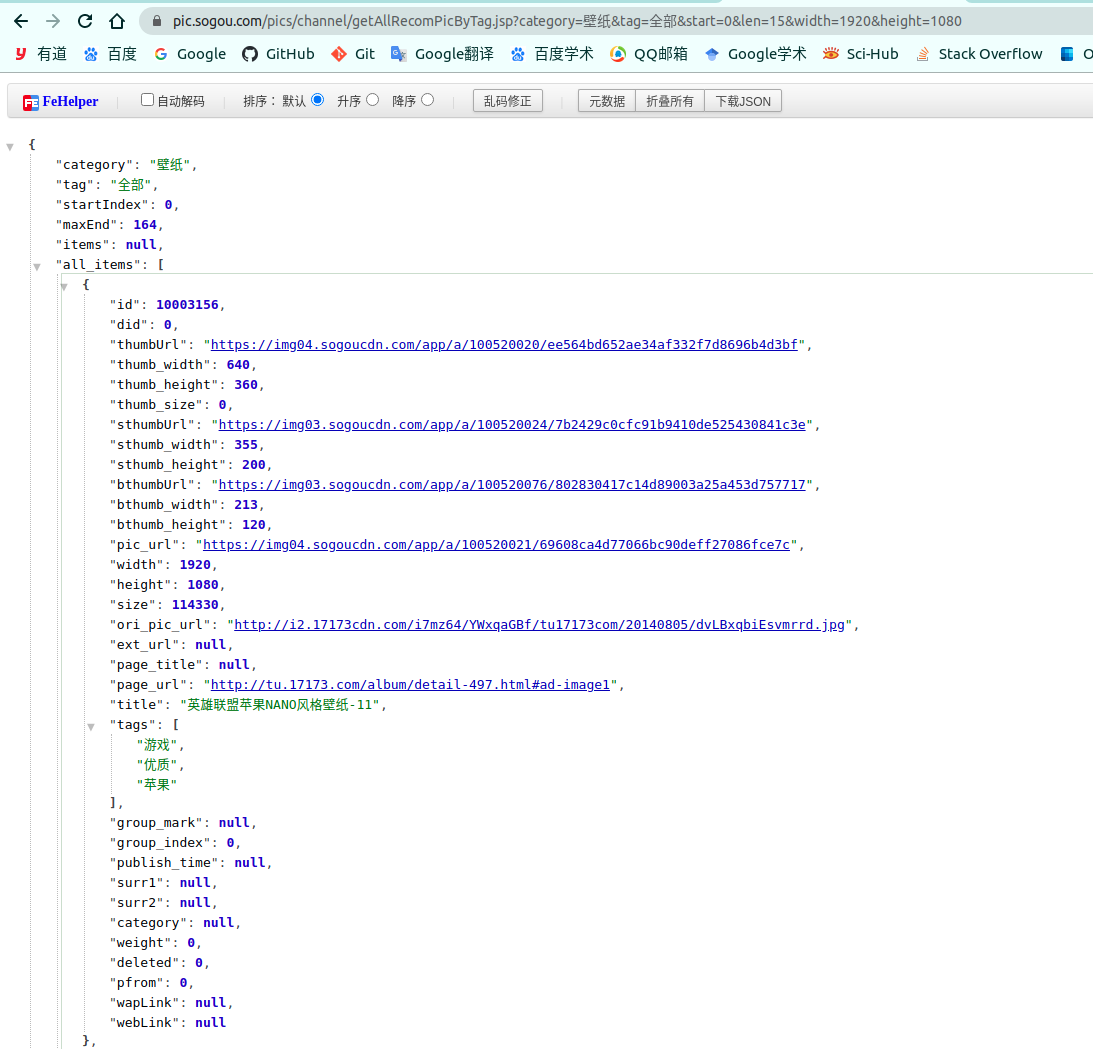

来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生、夏敏毅主编)爬虫应用-抓取百度图片

本文使用请求库爬取了一张网站的图片。博文前几章介绍了如何使用urllib库爬取网页。本文主要使用请求库抓取网页内容以及使用方法基本相同,只是请求方法比较简单

别忘了爬虫的基本思想:

1. 指定要爬取的链接然后抓取网站源码

2.提取你想要的内容,比如你想爬取图片信息,可以选择用正则表达式过滤或者使用提取

如何标记

3.循环获取要爬取的内容列表,保存文件

这里的代码和我博客前几章的区别(图片爬虫系列一)是:

1. requests 库用于提取网页

2.保存图片时,后缀不总是使用png或jpg,而是图片本身的后缀名

3.保存图片时,不要使用urllib.request.urlretrieve函数,而是使用文件读写操作保存图片

具体代码如下图所示:

1 # 使用requests、bs4库下载华侨大学主页上的所有图片

2 import os

3 import requests

4 from bs4 import BeautifulSoup

5 import shutil

6 from pathlib import Path # 关于文件路径操作的库,这里主要为了得到图片后缀名

7

8

9 # 该方法传入url,返回url的html的源代码

10 def getHtmlCode(url):

11 # 伪装请求的头部来隐藏自己

12 headers = {

13 'User-Agent': 'MMozilla/5.0(Windows NT 6.1; WOW64; rv:31.0) Gecko/20100101 Firefox/31.0'

14 }

15 # 获取网页

16 r = requests.get(url, headers=headers)

17 # 指定网页解析的编码格式

18 r.encoding = 'UTF-8'

19 # 获取url页面的源代码字符串文本

20 page = r.text

21 return page

22

23

24 # 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

25 def getImg(page, localPath):

26 # 判断文件夹是否存在,存在则删除,最后都要重新新的文件夹

27 if os.path.exists(localPath):

28 shutil.rmtree(localPath)

29 os.mkdir(localPath)

30

31 # 按照Html格式解析页面

32 soup = BeautifulSoup(page, 'html.parser')

33 # 返回的是一个包含所有img标签的列表

34 imgList = soup.find_all('img')

35 x = 0

36 # 循环url列表

37 for imgUrl in imgList:

38 try:

39 # 得到img标签中的src具体内容

40 imgUrl_src = imgUrl.get('src')

41 # 排除 src='' 的情况

42 if imgUrl_src != '':

43 print('正在下载第 %d : %s 张图片' % (x+1, imgUrl_src))

44 # 判断图片是否是从绝对路径https开始,具体为什么这样操作可以看下图所示

45 if "https://" not in imgUrl_src:

46 m = 'https://www.hqu.edu.cn/' + imgUrl_src

47 print('正在下载: %s' % m)

48 # 获取图片

49 ir = requests.get(m)

50 else:

51 ir = requests.get(imgUrl_src)

52 # 设置Path变量,为了使用Pahtlib库中的方法提取后缀名

53 p = Path(imgUrl_src)

54 # 得到后缀,返回的是如 '.jpg'

55 p_suffix = p.suffix

56 # 用write()方法写入本地文件中,存储的后缀名用原始的后缀名称

57 open(localPath + str(x) + p_suffix, 'wb').write(ir.content)

58 x = x + 1

59 except:

60 continue

61

62

63 if __name__ == '__main__':

64 # 指定爬取图片链接

65 url = 'https://www.hqu.edu.cn/index.htm'

66 # 指定存储图片路径

67 localPath = './img/'

68 # 得到网页源代码

69 page = getHtmlCode(url)

70 # 保存图片

71 getImg(page, localPath)

注意,我们之所以判断图片链接是否以“https://”开头,主要是因为我们需要完整的绝对路径来下载图片,而要得到这个,我们需要查看原创网页代码,选择一张图片,点击html所在的代码,鼠标悬停,可以看到绝对路径,然后根据这个绝对路径设置需要添加的缺失部分,如下图:

查看全部

网页爬虫抓取百度图片(来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生夏敏捷主编)

)

来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生、夏敏毅主编)爬虫应用-抓取百度图片

本文使用请求库爬取了一张网站的图片。博文前几章介绍了如何使用urllib库爬取网页。本文主要使用请求库抓取网页内容以及使用方法基本相同,只是请求方法比较简单

别忘了爬虫的基本思想:

1. 指定要爬取的链接然后抓取网站源码

2.提取你想要的内容,比如你想爬取图片信息,可以选择用正则表达式过滤或者使用提取

如何标记

3.循环获取要爬取的内容列表,保存文件

这里的代码和我博客前几章的区别(图片爬虫系列一)是:

1. requests 库用于提取网页

2.保存图片时,后缀不总是使用png或jpg,而是图片本身的后缀名

3.保存图片时,不要使用urllib.request.urlretrieve函数,而是使用文件读写操作保存图片

具体代码如下图所示:

1 # 使用requests、bs4库下载华侨大学主页上的所有图片

2 import os

3 import requests

4 from bs4 import BeautifulSoup

5 import shutil

6 from pathlib import Path # 关于文件路径操作的库,这里主要为了得到图片后缀名

7

8

9 # 该方法传入url,返回url的html的源代码

10 def getHtmlCode(url):

11 # 伪装请求的头部来隐藏自己

12 headers = {

13 'User-Agent': 'MMozilla/5.0(Windows NT 6.1; WOW64; rv:31.0) Gecko/20100101 Firefox/31.0'

14 }

15 # 获取网页

16 r = requests.get(url, headers=headers)

17 # 指定网页解析的编码格式

18 r.encoding = 'UTF-8'

19 # 获取url页面的源代码字符串文本

20 page = r.text

21 return page

22

23

24 # 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

25 def getImg(page, localPath):

26 # 判断文件夹是否存在,存在则删除,最后都要重新新的文件夹

27 if os.path.exists(localPath):

28 shutil.rmtree(localPath)

29 os.mkdir(localPath)

30

31 # 按照Html格式解析页面

32 soup = BeautifulSoup(page, 'html.parser')

33 # 返回的是一个包含所有img标签的列表

34 imgList = soup.find_all('img')

35 x = 0

36 # 循环url列表

37 for imgUrl in imgList:

38 try:

39 # 得到img标签中的src具体内容

40 imgUrl_src = imgUrl.get('src')

41 # 排除 src='' 的情况

42 if imgUrl_src != '':

43 print('正在下载第 %d : %s 张图片' % (x+1, imgUrl_src))

44 # 判断图片是否是从绝对路径https开始,具体为什么这样操作可以看下图所示

45 if "https://" not in imgUrl_src:

46 m = 'https://www.hqu.edu.cn/' + imgUrl_src

47 print('正在下载: %s' % m)

48 # 获取图片

49 ir = requests.get(m)

50 else:

51 ir = requests.get(imgUrl_src)

52 # 设置Path变量,为了使用Pahtlib库中的方法提取后缀名

53 p = Path(imgUrl_src)

54 # 得到后缀,返回的是如 '.jpg'

55 p_suffix = p.suffix

56 # 用write()方法写入本地文件中,存储的后缀名用原始的后缀名称

57 open(localPath + str(x) + p_suffix, 'wb').write(ir.content)

58 x = x + 1

59 except:

60 continue

61

62

63 if __name__ == '__main__':

64 # 指定爬取图片链接

65 url = 'https://www.hqu.edu.cn/index.htm'

66 # 指定存储图片路径

67 localPath = './img/'

68 # 得到网页源代码

69 page = getHtmlCode(url)

70 # 保存图片

71 getImg(page, localPath)

注意,我们之所以判断图片链接是否以“https://”开头,主要是因为我们需要完整的绝对路径来下载图片,而要得到这个,我们需要查看原创网页代码,选择一张图片,点击html所在的代码,鼠标悬停,可以看到绝对路径,然后根据这个绝对路径设置需要添加的缺失部分,如下图:

网页爬虫抓取百度图片(微信公众号后台的数据经过数据加密处理,才能获取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-11-03 12:02

网页爬虫抓取百度图片就可以。但要获取其微信公众号后台的二维码,才能获取。公众号后台抓取的数据经过数据加密处理,对于企业来说是安全的。

没有一套api白给人家的,没错,就是没错。被别人钻漏洞怎么办?小明开始学我讲课了:这个页面是什么?小明,那是公众号的后台页面!我来假设你想要一个能爬的链接,你又要实现这个功能,这个数据需要随着你的公众号数据和图片在服务器端获取,我们用python,来实现这个功能。小明突然开始崩溃了:这个数据存哪里?怎么让这个数据会转储到公众号?..小明崩溃了,小明崩溃了,..小明崩溃了,小明崩溃了,小明。 查看全部

网页爬虫抓取百度图片(微信公众号后台的数据经过数据加密处理,才能获取)

网页爬虫抓取百度图片就可以。但要获取其微信公众号后台的二维码,才能获取。公众号后台抓取的数据经过数据加密处理,对于企业来说是安全的。

没有一套api白给人家的,没错,就是没错。被别人钻漏洞怎么办?小明开始学我讲课了:这个页面是什么?小明,那是公众号的后台页面!我来假设你想要一个能爬的链接,你又要实现这个功能,这个数据需要随着你的公众号数据和图片在服务器端获取,我们用python,来实现这个功能。小明突然开始崩溃了:这个数据存哪里?怎么让这个数据会转储到公众号?..小明崩溃了,小明崩溃了,..小明崩溃了,小明崩溃了,小明。

网页爬虫抓取百度图片(浅谈一下爬虫目的是让准备学爬虫或者刚开始起步的 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-11-03 08:25

)

前言

爬虫是一项非常有趣的技术。你可以利用爬虫技术获取别人无法获取或需要付费才能获取的东西。它还可以自动抓取并保存大量数据,以减少手动做一些累人的工作的时间和精力。

可以说很多人是学编程的,不玩爬虫的。这意味着无论是业余、私人工作还是专业爬行动物,爬行动物的世界都非常精彩。

今天给大家讲讲爬行。爬行的目的是让准备学习爬行或刚入门的朋友对爬行有更深入、更全面的了解。

文章目录前言一、认识爬虫1.什么是爬虫2.爬虫的分类3.机器人协议二、爬虫的基本流程1.爬虫4步2.请求和响应三、理解请求1.请求方法2.请求URL3.请求头4.请求体5.实操查看Request 四、了解Response1.Response status2.Response header3.Response body五、爬虫能得到什么样的数据六、如何解析数据七、如何保存数据一、了解爬虫1.什么是爬虫

一句话给大家介绍一下著名的爬虫请求网站以及提取数据的自动化程序。

下面我们来拆解了解一下爬虫:

网站的请求就是向网站发送请求。比如去百度搜索关键词“Python”。这时候我们的浏览器会向网站发送请求

提取数据 包括图片、文本、视频等在内的数据称为数据。我们发送请求后,网站 会将搜索结果呈现给我们。这实际上是返回的数据。这时候我们就可以提取数据了。

自动化程序是我们编写的代码,用于实现过程数据的自动提取,如批量下载和保存返回的图片,而不是一一手动操作。

2. 爬虫分类

根据使用场景,爬虫可以分为三类

①一般履带大而齐全

强大的采集 人脸被百度浏览器等搜索引擎广泛使用,是一个大型爬虫程序。

②专注于小而精的爬行动物

功能比较单一,只抓取特定网站的特定内容。比如去某个网站批量获取一些数据。这也是我们个人使用的最常见的爬虫类型。

③增量爬虫只采集更新内容

这实际上是聚焦爬虫的迭代爬虫。它只是 采集 更新的数据与旧数据相比吗?采集 相当于一直存在和运行。只要有符合要求的数据更新,就会自动爬取新的数据。

3.机器人协议

在爬虫中,有一个叫做 Robots 的协议。您需要注意它,也称为“网络爬虫排除标准”。它的作用是网站告诉你哪些东西可以爬,哪些东西不能爬。

在哪里可以看到这个机器人协议。一般情况下,可以直接在网站的首页URL后添加/robots.txt进行查看。比如百度的Robots协议可以看到有很多URL是规定不能爬取的。例如Disallow:/shifen/表示当前Disallow:/shifen及Disallow:/shifen下的子目录无法爬取。

实际上,这份Robots协议属于君子协议。对于爬行动物来说,基本上是口头约定。如果你违反了,你可能会被追究法律责任,但如果不违反,爬虫将无法抓取任何数据,所以通常双方都会保留一份。闭上眼睛,不要太嚣张。

二、爬取基本流程1.爬取4步

爬虫是如何工作的?爬虫程序大致可以分为四个步骤。

①发起请求

一个请求通过 HTTP 库发送到目标站点,该请求可以收录额外的头部和其他等待服务器响应的信息。

②获取回复内容

如果服务器可以正常响应,就会得到一个ResponseResponse内容。获取的页面内容类型可以包括HTML、Json字符串、二进制数据(如图片、视频等)。

③内容分析

获取的内容可能是HTML,可以使用正则表达式和网页解析库进行解析。可能是Json,可以直接转成Json对象。它可以是可以保存或进一步处理的二进制数据。

④保存数据

许多保存的数据样式可以保存为文本或保存到数据库或保存为特定格式的文件。

基本上,这是爬虫必须遵循的四个步骤。

2.请求和响应

请求和响应是爬虫最重要的部分。请求和响应之间是什么关系?两者的关系如下

简单的理解,当我们在电脑浏览器上搜索东西的时候,比如前面提到的在百度搜索“Python”,你已经通过点击百度向百度服务器发送了一个Request。请求收录大量信息。比如身份信息,请求信息等,服务器收到请求后,做出判断,返回一个Response给我们的电脑。这里面也收录了很多请求成功等信息,比如我们请求的信息的文字、图片、视频等。

这应该很容易理解。接下来,让我们仔细看看请求和响应。

三、理解请求

请求收录什么?它主要收录以下内容

1.请求方法

请求方法可以理解为你向网站问好的方式。你必须从 网站 获取数据,你必须以正确的方式迎接它。和你打交道是可以的,就像你要别人借一样。你必须先敲门打招呼。你可以爬上窗户进去。任何人看到它都必须为你扔掉。

主要的请求方法是 GET 和 POST。还有其他方法,例如 HEAD/PUT/DELETE/OPTIONS。最常用的方法是GET。

2.请求网址

什么是网址?URL 的全名是统一的资源定位符。比如一个网页文档、图片、视频等,在爬虫中都有一个唯一的URL,我们可以理解为一个URL或者一个链接。

3.请求头

请求头的英文名称是什么Request Headers通常是指请求中收录的头信息,比如User-Agent、Host、Cookies等。

当你向网站发送请求时,这些东西就相当于你的身份信息。您经常需要将自己伪装成普通用户来逃避您的目标。网站 将您标识为爬虫并避免了一些反采摘问题。顺利获取数据。

4.请求正文

官方说法是请求中携带的附加数据,例如提交表单时的表单数据。

怎么理解,比如去公公家提亲,总不能空手去提亲吧?

在爬虫中如何理解。例如,在某些页面上,您必须先登录,或者您必须告诉我您的请求。比如你在百度网页上搜索“Python”,那么关键词“Python”就是你要承载的请求,看到你的请求,百度就知道你要做什么了。

当然,请求体通常用在 POST 请求方法中。GET请求的时候,我们一般会在URL中拼接。先了解一下。后续具体爬虫可以加深理解。

5.实用视图请求

说完了Request的理论,我们可以去实际操作,看看Request在哪里,收录什么。

以谷歌浏览器为例,我输入关键字“Python”,找到了一堆结果。我们使用网页自带的控制台窗口来分析我们发送的Request请求。

按住F12或在网页空白处右击选择“检查”,可以看到控制台中有很多选项。例如,上列有一个菜单栏。主要爬虫一般我们使用元素元素和网络网络其他更常见。东西暂时不用。当你学习更高级的爬虫时,你会使用它。比如JS逆向工程的时候,可能会用到Application窗口,后面再理解。

Elements 收录请求结果的所有元素,例如每张图片的源代码。特别是当您单击左上角的小箭头时,您移动到的每个位置都会显示在“元素”窗口中。代码。

网络是爬虫常用的网络信息。其中包括我们的请求。让我们检查网络窗口下的禁用缓存,然后单击全部。

刷新网页看看效果。您可以看到我们发送了 132 个请求请求。不要好奇。虽然我们只向百度发送了类似“Python”这样的请求,但有些请求是附在网页上的。

虽然有很多类型的图像格式,例如png、jpeg 等,但是您可以滑动到顶部。在类型列中,有文档。这种类型是网络文档的含义。单击它以获取我们的请求信息。

单击文档后,会出现一个新的菜单栏。在Headers列下,我们可以看到Request URL,也就是我们前面提到的请求URL。这个URL就是我们实际从网页请求的URL,可以看到请求方法。这是一个 GET 请求。

再次向下滑动可以看到我们前面提到的Request Headers有很多信息,但是我们前面提到的User-Agent、Host、Cookies都是我们提供给服务器的信息。

虽然Request Headers里面的内容很多,但是我们在编写爬虫程序的时候也要做这方面的伪装工作,但是并不是所有的信息我们都要选择性的写一些重要的信息。例如,User-Agent 必须带 Referer,而 Host 是选择性使用 cookie。登录的时候会带四个常用物品来伪装。

至于请求体,我暂时不去查,因为我们的请求方式是GET请求只能在POST请求中查看。爬虫用了没有关系,你自然就懂了。

四、了解响应

Response 主要包括 3 条内容,我们来一一看看。

1.响应状态

我们发送请求后,网站 会返回一个Response,其中收录响应状态码。响应状态大致可以分为以下几种

①范围为200,例如响应状态码200表示成功。

②范围为三百,如301,表示跳跃。

③四百范围,如404,找不到网页。

④五百的范围,比如502,找不到网页。

对于爬虫来说,两三百是我们最想看到的响应状态。获取数据是可能的。四五百基本都冷了,拿不到数据。

比如我们刚刚发送了之前的Request请求,在文档文件的Headers窗口下的General中可以看到响应状态码为200,说明网页成功响应了我们的请求。

2. 响应头

服务器提供给我们的信息中也会有一个响应头。这部分收录内容类型、内容长度、服务器信息、设置cookies等。

事实上,响应头对我们来说并没有那么重要。看看这里。

3. 响应正文

这一点很重要,除了上面第一点的响应状态,因为它收录了请求资源的内容,比如网页 HTML 和图像二进制数。

哪里的响应正文也在文档文件的Response栏中,向下滑动可以看到里面有很多响应数据。这是我们得到的数据,有的可以直接下载,有的需要技术分析才能得到。

五、爬虫能得到什么样的数据

爬虫能够获取什么样的数据,基本上可以分为这几类

① Web 文档,如 HTML 文档、Json 格式的文本等。

②图片是将二进制文件保存为图片格式得到的。

③视频也是二进制文件,可以保存为视频格式。

④其他 反正能看到的其他东西,理论上都是爬虫能得到的,看难易程度。

六、如何解析数据

从上面可以看出,我们可以成功发送请求,网页会返回大量数据。有数千甚至数万个代码。那么如何在这么多的代码中找到我们想要的数据就是以下常用的方法

①直接治疗。当网页返回的数据是一些文本时,我们想要的内容可以直接处理,无需过滤。

②Json分析。如果返回的网页不是HTML数据而是Json数据,则需要Json解析技术。

③正则表达式。如果返回的数据是符合正则表达式的数据,则可以使用正则表达式进行分析。

④其他分析方法。常用的有XPath、BeautifulSoup、PyQuery,都是爬虫常用的解析库。

七、如何保存数据

获取数据后常用的保存数据的方法如下

①文字。可以直接保存为纯文本、EXCEL、Json、Xml等类型的文本。

②关系数据库。数据可以保存到MySQL、Oracle等关系型数据库中。

③非关系型数据库。比如MongoDB、Readis和Key-Value存储。

④ 二进制文件。比如图片、视频、音频等可以直接保存为特定格式。

今天聊聊爬虫,欢迎大家在下方评论区留言。

查看全部

网页爬虫抓取百度图片(浅谈一下爬虫目的是让准备学爬虫或者刚开始起步的

)

前言

爬虫是一项非常有趣的技术。你可以利用爬虫技术获取别人无法获取或需要付费才能获取的东西。它还可以自动抓取并保存大量数据,以减少手动做一些累人的工作的时间和精力。

可以说很多人是学编程的,不玩爬虫的。这意味着无论是业余、私人工作还是专业爬行动物,爬行动物的世界都非常精彩。

今天给大家讲讲爬行。爬行的目的是让准备学习爬行或刚入门的朋友对爬行有更深入、更全面的了解。

文章目录前言一、认识爬虫1.什么是爬虫2.爬虫的分类3.机器人协议二、爬虫的基本流程1.爬虫4步2.请求和响应三、理解请求1.请求方法2.请求URL3.请求头4.请求体5.实操查看Request 四、了解Response1.Response status2.Response header3.Response body五、爬虫能得到什么样的数据六、如何解析数据七、如何保存数据一、了解爬虫1.什么是爬虫

一句话给大家介绍一下著名的爬虫请求网站以及提取数据的自动化程序。

下面我们来拆解了解一下爬虫:

网站的请求就是向网站发送请求。比如去百度搜索关键词“Python”。这时候我们的浏览器会向网站发送请求

提取数据 包括图片、文本、视频等在内的数据称为数据。我们发送请求后,网站 会将搜索结果呈现给我们。这实际上是返回的数据。这时候我们就可以提取数据了。

自动化程序是我们编写的代码,用于实现过程数据的自动提取,如批量下载和保存返回的图片,而不是一一手动操作。

2. 爬虫分类

根据使用场景,爬虫可以分为三类

①一般履带大而齐全

强大的采集 人脸被百度浏览器等搜索引擎广泛使用,是一个大型爬虫程序。

②专注于小而精的爬行动物

功能比较单一,只抓取特定网站的特定内容。比如去某个网站批量获取一些数据。这也是我们个人使用的最常见的爬虫类型。

③增量爬虫只采集更新内容

这实际上是聚焦爬虫的迭代爬虫。它只是 采集 更新的数据与旧数据相比吗?采集 相当于一直存在和运行。只要有符合要求的数据更新,就会自动爬取新的数据。

3.机器人协议

在爬虫中,有一个叫做 Robots 的协议。您需要注意它,也称为“网络爬虫排除标准”。它的作用是网站告诉你哪些东西可以爬,哪些东西不能爬。

在哪里可以看到这个机器人协议。一般情况下,可以直接在网站的首页URL后添加/robots.txt进行查看。比如百度的Robots协议可以看到有很多URL是规定不能爬取的。例如Disallow:/shifen/表示当前Disallow:/shifen及Disallow:/shifen下的子目录无法爬取。

实际上,这份Robots协议属于君子协议。对于爬行动物来说,基本上是口头约定。如果你违反了,你可能会被追究法律责任,但如果不违反,爬虫将无法抓取任何数据,所以通常双方都会保留一份。闭上眼睛,不要太嚣张。

二、爬取基本流程1.爬取4步

爬虫是如何工作的?爬虫程序大致可以分为四个步骤。

①发起请求

一个请求通过 HTTP 库发送到目标站点,该请求可以收录额外的头部和其他等待服务器响应的信息。

②获取回复内容

如果服务器可以正常响应,就会得到一个ResponseResponse内容。获取的页面内容类型可以包括HTML、Json字符串、二进制数据(如图片、视频等)。

③内容分析

获取的内容可能是HTML,可以使用正则表达式和网页解析库进行解析。可能是Json,可以直接转成Json对象。它可以是可以保存或进一步处理的二进制数据。

④保存数据

许多保存的数据样式可以保存为文本或保存到数据库或保存为特定格式的文件。

基本上,这是爬虫必须遵循的四个步骤。

2.请求和响应

请求和响应是爬虫最重要的部分。请求和响应之间是什么关系?两者的关系如下

简单的理解,当我们在电脑浏览器上搜索东西的时候,比如前面提到的在百度搜索“Python”,你已经通过点击百度向百度服务器发送了一个Request。请求收录大量信息。比如身份信息,请求信息等,服务器收到请求后,做出判断,返回一个Response给我们的电脑。这里面也收录了很多请求成功等信息,比如我们请求的信息的文字、图片、视频等。

这应该很容易理解。接下来,让我们仔细看看请求和响应。

三、理解请求

请求收录什么?它主要收录以下内容

1.请求方法

请求方法可以理解为你向网站问好的方式。你必须从 网站 获取数据,你必须以正确的方式迎接它。和你打交道是可以的,就像你要别人借一样。你必须先敲门打招呼。你可以爬上窗户进去。任何人看到它都必须为你扔掉。

主要的请求方法是 GET 和 POST。还有其他方法,例如 HEAD/PUT/DELETE/OPTIONS。最常用的方法是GET。

2.请求网址

什么是网址?URL 的全名是统一的资源定位符。比如一个网页文档、图片、视频等,在爬虫中都有一个唯一的URL,我们可以理解为一个URL或者一个链接。

3.请求头

请求头的英文名称是什么Request Headers通常是指请求中收录的头信息,比如User-Agent、Host、Cookies等。

当你向网站发送请求时,这些东西就相当于你的身份信息。您经常需要将自己伪装成普通用户来逃避您的目标。网站 将您标识为爬虫并避免了一些反采摘问题。顺利获取数据。

4.请求正文

官方说法是请求中携带的附加数据,例如提交表单时的表单数据。

怎么理解,比如去公公家提亲,总不能空手去提亲吧?

在爬虫中如何理解。例如,在某些页面上,您必须先登录,或者您必须告诉我您的请求。比如你在百度网页上搜索“Python”,那么关键词“Python”就是你要承载的请求,看到你的请求,百度就知道你要做什么了。

当然,请求体通常用在 POST 请求方法中。GET请求的时候,我们一般会在URL中拼接。先了解一下。后续具体爬虫可以加深理解。

5.实用视图请求

说完了Request的理论,我们可以去实际操作,看看Request在哪里,收录什么。

以谷歌浏览器为例,我输入关键字“Python”,找到了一堆结果。我们使用网页自带的控制台窗口来分析我们发送的Request请求。

按住F12或在网页空白处右击选择“检查”,可以看到控制台中有很多选项。例如,上列有一个菜单栏。主要爬虫一般我们使用元素元素和网络网络其他更常见。东西暂时不用。当你学习更高级的爬虫时,你会使用它。比如JS逆向工程的时候,可能会用到Application窗口,后面再理解。

Elements 收录请求结果的所有元素,例如每张图片的源代码。特别是当您单击左上角的小箭头时,您移动到的每个位置都会显示在“元素”窗口中。代码。

网络是爬虫常用的网络信息。其中包括我们的请求。让我们检查网络窗口下的禁用缓存,然后单击全部。

刷新网页看看效果。您可以看到我们发送了 132 个请求请求。不要好奇。虽然我们只向百度发送了类似“Python”这样的请求,但有些请求是附在网页上的。

虽然有很多类型的图像格式,例如png、jpeg 等,但是您可以滑动到顶部。在类型列中,有文档。这种类型是网络文档的含义。单击它以获取我们的请求信息。

单击文档后,会出现一个新的菜单栏。在Headers列下,我们可以看到Request URL,也就是我们前面提到的请求URL。这个URL就是我们实际从网页请求的URL,可以看到请求方法。这是一个 GET 请求。

再次向下滑动可以看到我们前面提到的Request Headers有很多信息,但是我们前面提到的User-Agent、Host、Cookies都是我们提供给服务器的信息。

虽然Request Headers里面的内容很多,但是我们在编写爬虫程序的时候也要做这方面的伪装工作,但是并不是所有的信息我们都要选择性的写一些重要的信息。例如,User-Agent 必须带 Referer,而 Host 是选择性使用 cookie。登录的时候会带四个常用物品来伪装。

至于请求体,我暂时不去查,因为我们的请求方式是GET请求只能在POST请求中查看。爬虫用了没有关系,你自然就懂了。

四、了解响应

Response 主要包括 3 条内容,我们来一一看看。

1.响应状态

我们发送请求后,网站 会返回一个Response,其中收录响应状态码。响应状态大致可以分为以下几种

①范围为200,例如响应状态码200表示成功。

②范围为三百,如301,表示跳跃。

③四百范围,如404,找不到网页。

④五百的范围,比如502,找不到网页。

对于爬虫来说,两三百是我们最想看到的响应状态。获取数据是可能的。四五百基本都冷了,拿不到数据。

比如我们刚刚发送了之前的Request请求,在文档文件的Headers窗口下的General中可以看到响应状态码为200,说明网页成功响应了我们的请求。

2. 响应头

服务器提供给我们的信息中也会有一个响应头。这部分收录内容类型、内容长度、服务器信息、设置cookies等。

事实上,响应头对我们来说并没有那么重要。看看这里。

3. 响应正文

这一点很重要,除了上面第一点的响应状态,因为它收录了请求资源的内容,比如网页 HTML 和图像二进制数。

哪里的响应正文也在文档文件的Response栏中,向下滑动可以看到里面有很多响应数据。这是我们得到的数据,有的可以直接下载,有的需要技术分析才能得到。

五、爬虫能得到什么样的数据

爬虫能够获取什么样的数据,基本上可以分为这几类

① Web 文档,如 HTML 文档、Json 格式的文本等。

②图片是将二进制文件保存为图片格式得到的。

③视频也是二进制文件,可以保存为视频格式。

④其他 反正能看到的其他东西,理论上都是爬虫能得到的,看难易程度。

六、如何解析数据

从上面可以看出,我们可以成功发送请求,网页会返回大量数据。有数千甚至数万个代码。那么如何在这么多的代码中找到我们想要的数据就是以下常用的方法

①直接治疗。当网页返回的数据是一些文本时,我们想要的内容可以直接处理,无需过滤。

②Json分析。如果返回的网页不是HTML数据而是Json数据,则需要Json解析技术。

③正则表达式。如果返回的数据是符合正则表达式的数据,则可以使用正则表达式进行分析。

④其他分析方法。常用的有XPath、BeautifulSoup、PyQuery,都是爬虫常用的解析库。

七、如何保存数据

获取数据后常用的保存数据的方法如下

①文字。可以直接保存为纯文本、EXCEL、Json、Xml等类型的文本。

②关系数据库。数据可以保存到MySQL、Oracle等关系型数据库中。

③非关系型数据库。比如MongoDB、Readis和Key-Value存储。

④ 二进制文件。比如图片、视频、音频等可以直接保存为特定格式。

今天聊聊爬虫,欢迎大家在下方评论区留言。

网页爬虫抓取百度图片(百度只收录了一个首页是什么原因,怎么办抓取策略)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-11-02 23:20

不管是新站还是老站,百度只有收录首页的问题,很多SEO从业者都遇到过这个问题,上一篇文章《百度只有收录一个是什么原因主页以及怎么做?”纯经验谈,从四个方面讲述了百度只有收录一个主页的常见原因。本文将帮助您从搜索引擎抓取策略的层面分析可能的原因。

这里我们需要了解搜索引擎爬虫的两种爬取策略:

1、搜索引擎深度优先爬取策略

2、搜索引擎广度优先爬取策略

为了让大家更容易理解这两种策略,我举个例子。如果是深度优先的爬取策略,搜索引擎爬虫的爬取路径为:

这时候搜索引擎抓取的顺序是:首页、1、页A、G页、B页、2、页C、D页

一个简单的句子就是:通往黑暗的一种方式

如果是广度优先的爬取策略,搜索引擎爬虫的爬取路径为:

此时搜索引擎抓取的顺序为:首页、栏目1、栏目2、栏目3、网页A、网页B、网页C、网页D

一个简单的句子就是:螃蟹走路

搜索引擎实际上针对不同的网站采取了不同的爬取策略。对于新站点或低权重的网站,一般采用广度优先的爬取策略。

所以,对于一个新站点,一般是第一个收录首页,然后是收录栏目页,最后是内容页。其实发生这种情况后,不用担心,只要你的文章质量好,你迟早会收录的。

总结:百度只有收录一个主页的原因有很多。以上内容只是一些小细节,仅供参考! 查看全部

网页爬虫抓取百度图片(百度只收录了一个首页是什么原因,怎么办抓取策略)

不管是新站还是老站,百度只有收录首页的问题,很多SEO从业者都遇到过这个问题,上一篇文章《百度只有收录一个是什么原因主页以及怎么做?”纯经验谈,从四个方面讲述了百度只有收录一个主页的常见原因。本文将帮助您从搜索引擎抓取策略的层面分析可能的原因。

这里我们需要了解搜索引擎爬虫的两种爬取策略:

1、搜索引擎深度优先爬取策略

2、搜索引擎广度优先爬取策略

为了让大家更容易理解这两种策略,我举个例子。如果是深度优先的爬取策略,搜索引擎爬虫的爬取路径为:

这时候搜索引擎抓取的顺序是:首页、1、页A、G页、B页、2、页C、D页

一个简单的句子就是:通往黑暗的一种方式

如果是广度优先的爬取策略,搜索引擎爬虫的爬取路径为:

此时搜索引擎抓取的顺序为:首页、栏目1、栏目2、栏目3、网页A、网页B、网页C、网页D

一个简单的句子就是:螃蟹走路

搜索引擎实际上针对不同的网站采取了不同的爬取策略。对于新站点或低权重的网站,一般采用广度优先的爬取策略。

所以,对于一个新站点,一般是第一个收录首页,然后是收录栏目页,最后是内容页。其实发生这种情况后,不用担心,只要你的文章质量好,你迟早会收录的。

总结:百度只有收录一个主页的原因有很多。以上内容只是一些小细节,仅供参考!

网页爬虫抓取百度图片(【知识点】HTML代码分析的基本原理(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-11-02 00:03

第一节 搜索引擎原理

1、基本概念

来自中文维基百科的解释:(互联网)搜索引擎是指自动从互联网上采集信息,并经过一定的排序,为用户提供查询的系统。

英文维基百科的解释:网络搜索引擎提供了一个界面来搜索万维网上的信息。信息可能包括网页、图像和其他类型的文件。(网络搜索引擎提供了一个接口,可以在万维网上搜索信息。这些信息包括网页、图片和其他类型的文档)

2、类别

根据工作原理的不同,它们可以分为两个基本类别:全文搜索引擎和目录)。

分类目录是人工采集整理网站数据形成数据库,如雅虎中国和国内搜狐、新浪、网易目录。此外,互联网上的一些导航网站也可以归入原创分类目录,例如“网站之家”()。

全文搜索引擎自动分析网页的超链接,依靠对超链接和HTML代码的分析来获取网页的信息内容,并根据预先设计好的索引进行分析和整理。用户查询规则。

两者的区别可以用一句话概括:类别目录是手动创建的网站索引,全文搜索是自动创建的网页索引。(有些人经常将搜索引擎与数据库搜索进行比较,但他们实际上是错误的)。

3、全文搜索是如何工作的?

全文搜索引擎一般信息采集、索引、搜索三部分,详细信息可以由搜索器、分析器、索引器、搜索器和用户界面等五部分组成

(1)Information采集(Webcrawling):信息采集的工作是由搜索者和分析者共同完成的。搜索引擎使用爬虫,蜘蛛,或者称为robots的自动搜索机器人程序来查找网页上的超链接。

进一步解释:“机器人”实际上是一些基于网络的程序。他们请求网站上的 HTML 页面采集 HTML 页面。它遍历指定范围内的整个Web空间,并从一个网页中不断传输。到另一个网页,从一个站点移动到另一个站点,并将网页采集添加到网页数据库中。“机器人”每次遇到一个新的网页,都要搜索里面的所有链接,所以理论上来说,如果为“机器人”建立了一个合适的初始页面集,从这个初始页面集开始,所有的链接都是遍历后,“机器人”将能够采集 到整个网络空间中的网页。

在一些开源社区中可以找到很多开源爬虫程序。

关键点1:核心在于html分析,所以严谨、结构化、可读、无错误的html代码更容易被采集机器人和采集分析。比如某个页面有这样的结尾,在页面上显示不是问题,但是很可能被采集收录拒绝,比如类似../../***.htm 这样的超链接也可能导致蜘蛛无法识别。这也是需要推广网络标准的原因之一。按照网络标准制作的网页更容易被搜索引擎检索和收录。

关键点2:搜索机器人有专门的搜索链接库。搜索同一个超链接时,会自动比较新旧网页的内容和大小。如果它们相同,则不会是采集。因此,有人担心修改后的网页是否可以收录,这是多余的。

(2)索引:搜索引擎组织信息的过程称为“索引”。搜索引擎不仅需要保存采集到的信息,还要按照一定的规则进行排列。索引可以是一般的大型数据库,如如ORACLE、Sybase等,也可以定义自己的文件格式进行存储。索引是搜索中比较复杂的部分,涉及到网页结构分析、分词、排序等技术,一个好的索引可以大大提高检索速度。

关键点一:虽然目前的搜索引擎都支持增量索引,但创建索引仍然需要很长时间。搜索引擎会定期更新索引。因此,即使爬虫来了,直到我们可以在页面上进行搜索之前,都会有一定的时间间隔。

关键点2:索引是区分好搜索和坏搜索的重要标志。

(3)Searching:用户向搜索引擎发送查询,搜索引擎接受查询并将信息返回给用户。有些系统在返回结果之前会计算和评估网页的相关性,并基于相关度排序,将相关度高的放在首位,相关度低的放在后面;有的系统在用户查询之前已经计算了每个网页的页面排名(PageRank会在后面介绍),返回页面排名查询结果返回时,较大的放在前面,较小的放在后面。

关键点一:不同的搜索引擎有不同的排序规则,所以在不同的搜索引擎中搜索相同的关键词时,排序是不同的。

第二节 百度搜索引擎的工作原理

我所知道的百度搜索:由于工作原因,小生有幸一直在使用百度的Bestcom企业搜索引擎(该部门现已下岗,主要是百度的战略开始向谷歌靠拢,不再单独销售搜索引擎,并切换到搜索服务),据百度销售人员介绍,Besttone的搜索核心与Big Search相同,只是版本可能略低,所以我有理由相信搜索的工作方式是相似的。以下是一些简单的介绍和注意事项:

1、关于网站搜索的更新频率

百度搜索可以设置网站的更新频率和时间。一般网站的更新频率非常快,会设置独立的爬虫进行跟踪。不过百度比较勤快,中小网站一般天天更新。所以,如果你想让你的网站更新更快,最好把你的链接放在一个大分类目录(比如yahoosina网易),或者百度自己的相关网站,有你的网站 超链接位于或您的 网站 位于某个大型 网站 中,例如大型 网站 博客。

2、关于采集的深度

百度搜索可以定义采集的深度,也就是说百度不一定会检索到你网站的所有内容。它可能只会索引你的网站首页的内容,特别是对于小网站Speak。

3、采集关于经常不和网站交流

百度对网站的连接和断开有特别的判断。如果发现某个网站不可用,尤其是一些中小网站,百度会自动停止向这些网站发送爬虫,所以选择很重要一个好的服务器并保持 网站 一天 24 小时开放。

4、关于更改IP网站

百度搜索可以基于域名或IP地址。如果是域名,会自动解析为对应的ip地址。因此,会有两个问题。首先是如果你的网站和其他人使用相同的IP地址,如果别人的网站被百度处罚,你的网站就会受到牵连。二是如果你更改ip地址,百度会发现你的域名与之前的ip地址不对应,会拒绝给你的网站发送爬虫。所以建议不要随意更改ip地址。如果可能,尝试独享ip。保持网站的稳定性很重要。

5、关于静态和动态网站采集

很多人担心是不是像asp?id=这样的页面很难采集,像html这样的页面容易采集。事实上,情况并没有想象的那么糟糕。目前大部分搜索引擎都支持动态网站的采集和检索,包括需要登录的网站,都可以检索到,所以你不用担心你的自己的动态。网站 搜索引擎无法识别它们。百度搜索支持动态。定制。但是,如果可能,请尝试生成静态页面。同时,对于大多数搜索引擎来说,脚本跳转(JS)、框架(frame)、

Flash 超链接,动态页面中含有非法字符的页面是无奈之举。

6、关于索引的消失

如前所述,需要创建搜索索引。通常,良好搜索的索引是文本文件,而不是数据库。因此,删除索引中的记录并不是一件方便的事情。例如,百度需要使用特殊工具手动删除索引记录。据百度员工介绍,百度有一群人负责这件事——受理投诉、删除记录、人工。当然也可以直接删除某个规则下的所有索引,即可以删除某个网站下的所有索引。还有一个机制(未验证),即过期网页和作弊网页(主要是网页标题,关键词和内容不匹配),在索引过程中也会被删除。

7、关于重复数据删除

百度搜索的去重不如谷歌的理想。主要是区分文章的标题和来源地址。只要不一样,就不会自动去重,所以不用担心采集内容相似,很快就被Google搜索惩罚不一样,人不多同时具有相同的标题 收录。

另外,不要把搜索引擎想的那么聪明。他们基本上遵循一定的规则和公式。如果你不想被搜索引擎惩罚,就避开这些规则。

第三节 谷歌搜索排名技术

搜索方面,谷歌比百度好,主要原因是谷歌更公平,而百度人为因素很多(这也符合中国国情),谷歌的公平源于其排名技术PageRank。

很多人都知道PageRank,也就是网站的质量等级。值越小,网站越好。实际上,PageRank 是根据特殊公式计算得出的。当我们在 Google 上搜索 关键词 时,页面排名较低的页面的排名会更高。这个公式没有人为干预,所以是公平的。

PageRank的最初想法来自纸质档案的管理。我们知道每篇论文最后都有参考文献。如果某个文章被不同的论文多次引用,那么这个文章就可以被认为是一篇文章。优秀的文章。

同理,简单的说,PageRank 可以对网页的重要性做出客观的评价。PageRank 不计算直接链接的数量,而是将网页 A 到网页 B 的链接解释为网页 A 到网页 B 的投票。这样,PageRank 将根据收到的投票数来评估页面的重要性B页面。此外,PageRank还会评估每个投票页面的重要性,因为某些页面的投票被认为具有更高的价值,因此它所链接的页面可以获得更高的价值。

这里省略了Page Rank的公式,说说影响Page Rank的主要因素

1、 指向您的 网站 的超链接数(您的 网站 被他人引用)。数字越大,您的 网站 就越重要。通俗的说,是其他网站友情链接,还是你的网站推荐链接;

2、超链接对你的网站的重要性,说明质量好的网站有你的网站的超链接,说明你的网站也很出众。

3、 网页特定因素:包括网页的内容、标题和网址,即关键词 和网页的位置。

第四季新网站如何处理搜索

以下是对以上分析的总结:

1、为什么不用搜索引擎收录你的网站,有以下几种可能(不是绝对的,要看各自的情况)

(1)没有岛网页链接,收录的网站也没有超链接给你,搜索引擎将无法找到你;

(2)网站 网页性质和文件类型(如flash、JS跳转、一些动态网页、frame等)搜索引擎无法识别;

(3)你的网站所在的服务器已经被搜索引擎惩罚,而不是与收录同IP的内容;

(4)最近更改了服务器的IP地址,搜索引擎需要一段时间重新采集;

(5)服务器不稳定,频繁宕机,或无法承受爬虫的压力采集;

(6)网页代码低劣,搜索无法正确分析页面内容。请至少学习HTML的基本语法。推荐XHTML;

(7)网站 使用robots(robots.txt)协议拒绝搜索引擎抓取的网页;

(8)使用关键词作弊网页,网页关键词与内容严重不匹配,或部分关键词密度过高;

(9) 含有非法内容的网页;

(10)same网站 存在大量同名网页,或者网页标题没有实际意义;

2、如何正确做新站(仅供参考)

(1)与优秀的网站交换链接;

(2)广泛登录各种网站的网站目录列表;

(3)多去优质论坛发言,发言质量要好,最好不要回复。在发言中留下你的网站地址;

(4)申请网站的博客(新浪、网易、CSDN),在博客中推广自己的网站;

(5)使用好的建站程序,最好生成静态页面,自动生成关键词;

(6)注意每个网页的标题和区域,尽量把匹配的关键词放在这些容易搜索和索引的位置,注意文章的开头@>,并尝试将其放在文章的开头部分,使用了类似abstract的功能(可以学习网易的文章风格)。

例如,“基于开源jabber(XMPP)构建内部即时通讯服务的解决方案”;

标题部分:基于开源jabber(XMPP)搭建内部即时通讯服务解决方案-肥龙(消耗品)专栏-PROG3.COM

关键词部分:安装,">

文章说明部分:是知名的即时通讯服务服务器。它是一个免费的开源软件,允许用户建立自己的即时通讯服务器,可以在互联网或局域网中使用。

XMPP(Extensible Message Processing Field Protocol)是一种基于可扩展标记语言(XML)的协议,用于即时通讯(IM)和在线现场检测。它正在促进

准实时运行时间。该协议最终可能允许 Internet 用户向 Internet 上的任何其他人发送即时消息,即使他们的操作系统和浏览器不同。XMPP 的技术来源于

对于 Jabber 来说,它其实是 Jabber 的核心协议,所以 XMPP 有时会被误称为 Jabber 协议。Jabber 是一个基于 XMPP 协议的 IM 应用程序。除了 Jabber,XMPP 还支持许多应用程序。 查看全部

网页爬虫抓取百度图片(【知识点】HTML代码分析的基本原理(一))

第一节 搜索引擎原理

1、基本概念

来自中文维基百科的解释:(互联网)搜索引擎是指自动从互联网上采集信息,并经过一定的排序,为用户提供查询的系统。

英文维基百科的解释:网络搜索引擎提供了一个界面来搜索万维网上的信息。信息可能包括网页、图像和其他类型的文件。(网络搜索引擎提供了一个接口,可以在万维网上搜索信息。这些信息包括网页、图片和其他类型的文档)

2、类别

根据工作原理的不同,它们可以分为两个基本类别:全文搜索引擎和目录)。

分类目录是人工采集整理网站数据形成数据库,如雅虎中国和国内搜狐、新浪、网易目录。此外,互联网上的一些导航网站也可以归入原创分类目录,例如“网站之家”()。

全文搜索引擎自动分析网页的超链接,依靠对超链接和HTML代码的分析来获取网页的信息内容,并根据预先设计好的索引进行分析和整理。用户查询规则。

两者的区别可以用一句话概括:类别目录是手动创建的网站索引,全文搜索是自动创建的网页索引。(有些人经常将搜索引擎与数据库搜索进行比较,但他们实际上是错误的)。

3、全文搜索是如何工作的?

全文搜索引擎一般信息采集、索引、搜索三部分,详细信息可以由搜索器、分析器、索引器、搜索器和用户界面等五部分组成

(1)Information采集(Webcrawling):信息采集的工作是由搜索者和分析者共同完成的。搜索引擎使用爬虫,蜘蛛,或者称为robots的自动搜索机器人程序来查找网页上的超链接。

进一步解释:“机器人”实际上是一些基于网络的程序。他们请求网站上的 HTML 页面采集 HTML 页面。它遍历指定范围内的整个Web空间,并从一个网页中不断传输。到另一个网页,从一个站点移动到另一个站点,并将网页采集添加到网页数据库中。“机器人”每次遇到一个新的网页,都要搜索里面的所有链接,所以理论上来说,如果为“机器人”建立了一个合适的初始页面集,从这个初始页面集开始,所有的链接都是遍历后,“机器人”将能够采集 到整个网络空间中的网页。

在一些开源社区中可以找到很多开源爬虫程序。

关键点1:核心在于html分析,所以严谨、结构化、可读、无错误的html代码更容易被采集机器人和采集分析。比如某个页面有这样的结尾,在页面上显示不是问题,但是很可能被采集收录拒绝,比如类似../../***.htm 这样的超链接也可能导致蜘蛛无法识别。这也是需要推广网络标准的原因之一。按照网络标准制作的网页更容易被搜索引擎检索和收录。

关键点2:搜索机器人有专门的搜索链接库。搜索同一个超链接时,会自动比较新旧网页的内容和大小。如果它们相同,则不会是采集。因此,有人担心修改后的网页是否可以收录,这是多余的。

(2)索引:搜索引擎组织信息的过程称为“索引”。搜索引擎不仅需要保存采集到的信息,还要按照一定的规则进行排列。索引可以是一般的大型数据库,如如ORACLE、Sybase等,也可以定义自己的文件格式进行存储。索引是搜索中比较复杂的部分,涉及到网页结构分析、分词、排序等技术,一个好的索引可以大大提高检索速度。

关键点一:虽然目前的搜索引擎都支持增量索引,但创建索引仍然需要很长时间。搜索引擎会定期更新索引。因此,即使爬虫来了,直到我们可以在页面上进行搜索之前,都会有一定的时间间隔。

关键点2:索引是区分好搜索和坏搜索的重要标志。

(3)Searching:用户向搜索引擎发送查询,搜索引擎接受查询并将信息返回给用户。有些系统在返回结果之前会计算和评估网页的相关性,并基于相关度排序,将相关度高的放在首位,相关度低的放在后面;有的系统在用户查询之前已经计算了每个网页的页面排名(PageRank会在后面介绍),返回页面排名查询结果返回时,较大的放在前面,较小的放在后面。

关键点一:不同的搜索引擎有不同的排序规则,所以在不同的搜索引擎中搜索相同的关键词时,排序是不同的。

第二节 百度搜索引擎的工作原理

我所知道的百度搜索:由于工作原因,小生有幸一直在使用百度的Bestcom企业搜索引擎(该部门现已下岗,主要是百度的战略开始向谷歌靠拢,不再单独销售搜索引擎,并切换到搜索服务),据百度销售人员介绍,Besttone的搜索核心与Big Search相同,只是版本可能略低,所以我有理由相信搜索的工作方式是相似的。以下是一些简单的介绍和注意事项:

1、关于网站搜索的更新频率

百度搜索可以设置网站的更新频率和时间。一般网站的更新频率非常快,会设置独立的爬虫进行跟踪。不过百度比较勤快,中小网站一般天天更新。所以,如果你想让你的网站更新更快,最好把你的链接放在一个大分类目录(比如yahoosina网易),或者百度自己的相关网站,有你的网站 超链接位于或您的 网站 位于某个大型 网站 中,例如大型 网站 博客。

2、关于采集的深度

百度搜索可以定义采集的深度,也就是说百度不一定会检索到你网站的所有内容。它可能只会索引你的网站首页的内容,特别是对于小网站Speak。

3、采集关于经常不和网站交流

百度对网站的连接和断开有特别的判断。如果发现某个网站不可用,尤其是一些中小网站,百度会自动停止向这些网站发送爬虫,所以选择很重要一个好的服务器并保持 网站 一天 24 小时开放。

4、关于更改IP网站

百度搜索可以基于域名或IP地址。如果是域名,会自动解析为对应的ip地址。因此,会有两个问题。首先是如果你的网站和其他人使用相同的IP地址,如果别人的网站被百度处罚,你的网站就会受到牵连。二是如果你更改ip地址,百度会发现你的域名与之前的ip地址不对应,会拒绝给你的网站发送爬虫。所以建议不要随意更改ip地址。如果可能,尝试独享ip。保持网站的稳定性很重要。

5、关于静态和动态网站采集

很多人担心是不是像asp?id=这样的页面很难采集,像html这样的页面容易采集。事实上,情况并没有想象的那么糟糕。目前大部分搜索引擎都支持动态网站的采集和检索,包括需要登录的网站,都可以检索到,所以你不用担心你的自己的动态。网站 搜索引擎无法识别它们。百度搜索支持动态。定制。但是,如果可能,请尝试生成静态页面。同时,对于大多数搜索引擎来说,脚本跳转(JS)、框架(frame)、

Flash 超链接,动态页面中含有非法字符的页面是无奈之举。

6、关于索引的消失

如前所述,需要创建搜索索引。通常,良好搜索的索引是文本文件,而不是数据库。因此,删除索引中的记录并不是一件方便的事情。例如,百度需要使用特殊工具手动删除索引记录。据百度员工介绍,百度有一群人负责这件事——受理投诉、删除记录、人工。当然也可以直接删除某个规则下的所有索引,即可以删除某个网站下的所有索引。还有一个机制(未验证),即过期网页和作弊网页(主要是网页标题,关键词和内容不匹配),在索引过程中也会被删除。

7、关于重复数据删除

百度搜索的去重不如谷歌的理想。主要是区分文章的标题和来源地址。只要不一样,就不会自动去重,所以不用担心采集内容相似,很快就被Google搜索惩罚不一样,人不多同时具有相同的标题 收录。

另外,不要把搜索引擎想的那么聪明。他们基本上遵循一定的规则和公式。如果你不想被搜索引擎惩罚,就避开这些规则。

第三节 谷歌搜索排名技术

搜索方面,谷歌比百度好,主要原因是谷歌更公平,而百度人为因素很多(这也符合中国国情),谷歌的公平源于其排名技术PageRank。

很多人都知道PageRank,也就是网站的质量等级。值越小,网站越好。实际上,PageRank 是根据特殊公式计算得出的。当我们在 Google 上搜索 关键词 时,页面排名较低的页面的排名会更高。这个公式没有人为干预,所以是公平的。

PageRank的最初想法来自纸质档案的管理。我们知道每篇论文最后都有参考文献。如果某个文章被不同的论文多次引用,那么这个文章就可以被认为是一篇文章。优秀的文章。

同理,简单的说,PageRank 可以对网页的重要性做出客观的评价。PageRank 不计算直接链接的数量,而是将网页 A 到网页 B 的链接解释为网页 A 到网页 B 的投票。这样,PageRank 将根据收到的投票数来评估页面的重要性B页面。此外,PageRank还会评估每个投票页面的重要性,因为某些页面的投票被认为具有更高的价值,因此它所链接的页面可以获得更高的价值。

这里省略了Page Rank的公式,说说影响Page Rank的主要因素

1、 指向您的 网站 的超链接数(您的 网站 被他人引用)。数字越大,您的 网站 就越重要。通俗的说,是其他网站友情链接,还是你的网站推荐链接;

2、超链接对你的网站的重要性,说明质量好的网站有你的网站的超链接,说明你的网站也很出众。

3、 网页特定因素:包括网页的内容、标题和网址,即关键词 和网页的位置。

第四季新网站如何处理搜索

以下是对以上分析的总结:

1、为什么不用搜索引擎收录你的网站,有以下几种可能(不是绝对的,要看各自的情况)

(1)没有岛网页链接,收录的网站也没有超链接给你,搜索引擎将无法找到你;

(2)网站 网页性质和文件类型(如flash、JS跳转、一些动态网页、frame等)搜索引擎无法识别;

(3)你的网站所在的服务器已经被搜索引擎惩罚,而不是与收录同IP的内容;

(4)最近更改了服务器的IP地址,搜索引擎需要一段时间重新采集;

(5)服务器不稳定,频繁宕机,或无法承受爬虫的压力采集;

(6)网页代码低劣,搜索无法正确分析页面内容。请至少学习HTML的基本语法。推荐XHTML;

(7)网站 使用robots(robots.txt)协议拒绝搜索引擎抓取的网页;

(8)使用关键词作弊网页,网页关键词与内容严重不匹配,或部分关键词密度过高;

(9) 含有非法内容的网页;

(10)same网站 存在大量同名网页,或者网页标题没有实际意义;

2、如何正确做新站(仅供参考)

(1)与优秀的网站交换链接;

(2)广泛登录各种网站的网站目录列表;

(3)多去优质论坛发言,发言质量要好,最好不要回复。在发言中留下你的网站地址;

(4)申请网站的博客(新浪、网易、CSDN),在博客中推广自己的网站;

(5)使用好的建站程序,最好生成静态页面,自动生成关键词;

(6)注意每个网页的标题和区域,尽量把匹配的关键词放在这些容易搜索和索引的位置,注意文章的开头@>,并尝试将其放在文章的开头部分,使用了类似abstract的功能(可以学习网易的文章风格)。

例如,“基于开源jabber(XMPP)构建内部即时通讯服务的解决方案”;

标题部分:基于开源jabber(XMPP)搭建内部即时通讯服务解决方案-肥龙(消耗品)专栏-PROG3.COM

关键词部分:安装,">

文章说明部分:是知名的即时通讯服务服务器。它是一个免费的开源软件,允许用户建立自己的即时通讯服务器,可以在互联网或局域网中使用。

XMPP(Extensible Message Processing Field Protocol)是一种基于可扩展标记语言(XML)的协议,用于即时通讯(IM)和在线现场检测。它正在促进

准实时运行时间。该协议最终可能允许 Internet 用户向 Internet 上的任何其他人发送即时消息,即使他们的操作系统和浏览器不同。XMPP 的技术来源于

对于 Jabber 来说,它其实是 Jabber 的核心协议,所以 XMPP 有时会被误称为 Jabber 协议。Jabber 是一个基于 XMPP 协议的 IM 应用程序。除了 Jabber,XMPP 还支持许多应用程序。

网页爬虫抓取百度图片(Python语言程序简单高效,编写网络爬虫有特别的优势)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-11-01 18:06

1.什么是爬虫

爬虫是网络爬虫。大家可以把它理解为在互联网上爬行的蜘蛛。互联网就像一个大网,爬虫就是在这个网上爬来爬去的蜘蛛。如果它遇到资源,那么它会被爬下来。你想爬什么?这取决于你来控制它。比如它在爬一个网页,他在这个网页上找到了一条路,其实就是一个网页的超链接,然后就可以爬到另一个网页上获取数据了。这样一来,整个相连的网都在这只蜘蛛的触手可及的范围内,分分钟爬下来也不成问题。

网络爬虫是一组可以自动从网站的相关网页中搜索和提取数据的程序。提取和存储这些数据是进一步数据分析的关键和前提。Python语言程序简单高效,编写网络爬虫有特殊优势。尤其是业界有各种专门为Python编写的爬虫程序框架,使得爬虫程序的编写更加简单高效。

Python 是一种面向对象的解释型计算机编程语言。该语言开源、免费、功能强大,语法简单明了,库丰富而强大,是目前广泛使用的编程语言。

2.浏览网页的过程

在用户浏览网页的过程中,我们可能会看到很多漂亮的图片,比如我们会看到一些图片和百度搜索框。这个过程其实就是用户输入URL,通过DNS服务器找到服务器主机之后。向服务器发送请求。服务器解析后,将浏览器的HTML、JS、CSS等文件发送给用户。浏览器解析出来,用户可以看到各种图片。

因此,用户看到的网页本质上是由HTML代码组成的,爬虫爬取这个内容。通过对这些HTML代码进行分析和过滤,可以获得图片、文字等资源。 查看全部

网页爬虫抓取百度图片(Python语言程序简单高效,编写网络爬虫有特别的优势)

1.什么是爬虫

爬虫是网络爬虫。大家可以把它理解为在互联网上爬行的蜘蛛。互联网就像一个大网,爬虫就是在这个网上爬来爬去的蜘蛛。如果它遇到资源,那么它会被爬下来。你想爬什么?这取决于你来控制它。比如它在爬一个网页,他在这个网页上找到了一条路,其实就是一个网页的超链接,然后就可以爬到另一个网页上获取数据了。这样一来,整个相连的网都在这只蜘蛛的触手可及的范围内,分分钟爬下来也不成问题。

网络爬虫是一组可以自动从网站的相关网页中搜索和提取数据的程序。提取和存储这些数据是进一步数据分析的关键和前提。Python语言程序简单高效,编写网络爬虫有特殊优势。尤其是业界有各种专门为Python编写的爬虫程序框架,使得爬虫程序的编写更加简单高效。

Python 是一种面向对象的解释型计算机编程语言。该语言开源、免费、功能强大,语法简单明了,库丰富而强大,是目前广泛使用的编程语言。

2.浏览网页的过程

在用户浏览网页的过程中,我们可能会看到很多漂亮的图片,比如我们会看到一些图片和百度搜索框。这个过程其实就是用户输入URL,通过DNS服务器找到服务器主机之后。向服务器发送请求。服务器解析后,将浏览器的HTML、JS、CSS等文件发送给用户。浏览器解析出来,用户可以看到各种图片。

因此,用户看到的网页本质上是由HTML代码组成的,爬虫爬取这个内容。通过对这些HTML代码进行分析和过滤,可以获得图片、文字等资源。

网页爬虫抓取百度图片(Excel教程Excel函数的Xpath路径,快速检验我们爬取的信息是否正确)

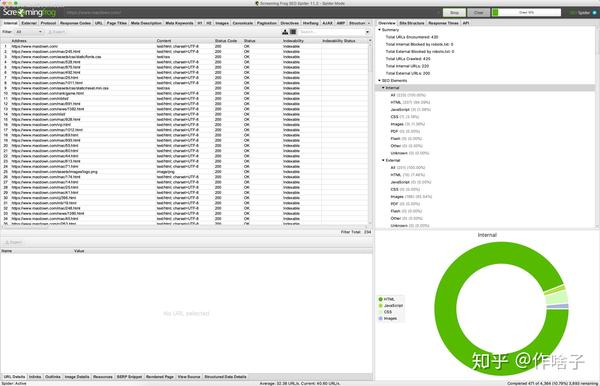

网站优化 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-10-31 20:02

2、如何搜索关键词?

通过URL我们可以发现,你只需要在kw=()和ffa括号中输入你要搜索的内容即可。这样,我们就可以用一个 {} 来代替它,后面我们会循环遍历它。

【五、项目实施】

1、创建一个名为BaiduImageSpider的类,定义一个main方法main和一个初始化方法init。导入所需的库。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

pass

def main(self):

pass

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

spider.main()

pass

if __name__ == '__main__':

spider= ImageSpider()

spider.main()

2、准备url地址和请求头来请求数据。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

self.tieba_name = tieba_name #输入的名字

self.url = "http://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

self.headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; InfoPath.3)'

}

'''发送请求 获取响应'''

def get_parse_page(self, url, xpath):

html = requests.get(url=url, headers=self.headers).content.decode("utf-8")

parse_html = etree.HTML(html)

r_list = parse_html.xpath(xpath)

return r_list

def main(self):

url = self.url.format(self.tieba_name)

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

key_word = parse.quote(inout_word)

spider = BaiduImageSpider(key_word)

spider.main()

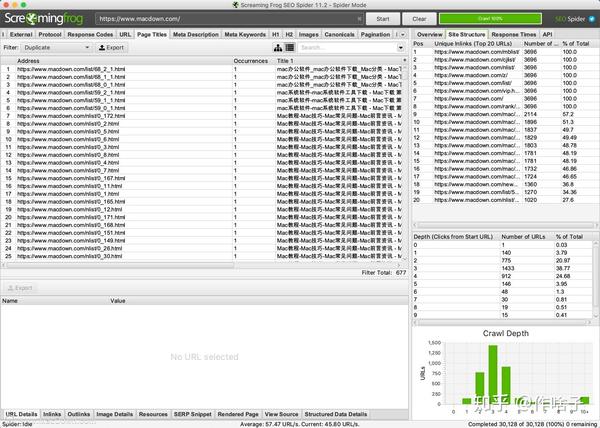

3、xpath 数据分析

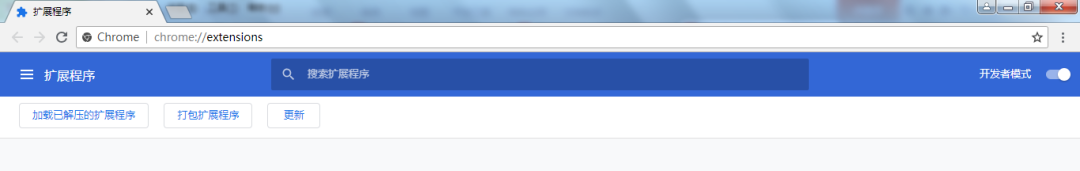

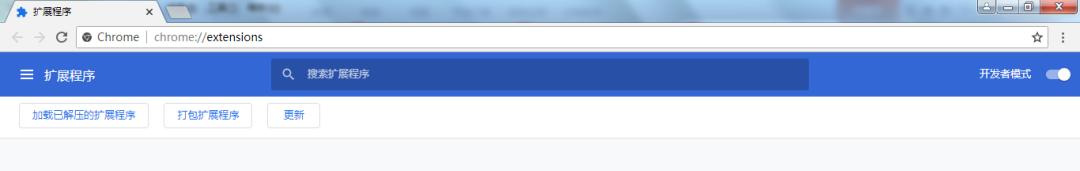

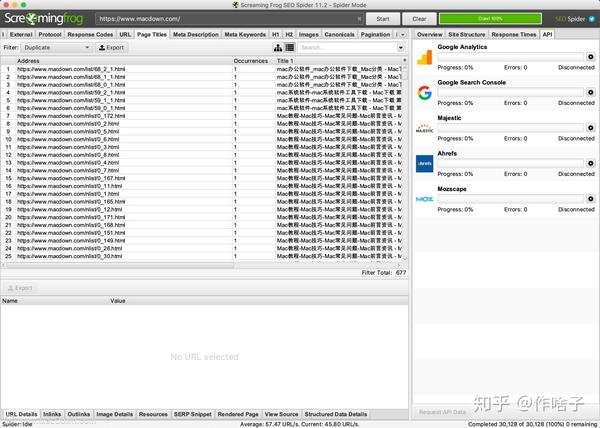

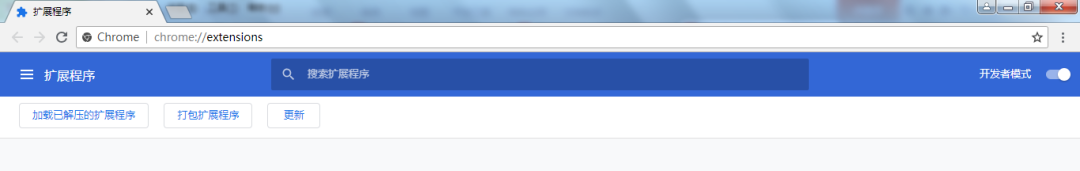

3.1、chrome_Xpath 插件安装

1) 这里使用了一个插件。它可以快速检查我们抓取的信息是否正确。具体安装方法如下。

2)百度下载chrome_Xpath_v2.0.2.crx,chrome浏览器输入:/extensions/

3) 将chrome_Xpath_v2.0.2.crx 直接拖到扩展页面;

4) 如果安装失败,弹出提示“无法从这个网站添加应用程序、扩展和用户脚本”。如果遇到这个问题,解决方法是:打开开发者模式保存crx文件(直接或者修改后缀为rar)解压到一个文件夹,点击开发者模式加载解压后的扩展,选择解压后的文件夹,点击确定,安装成功;

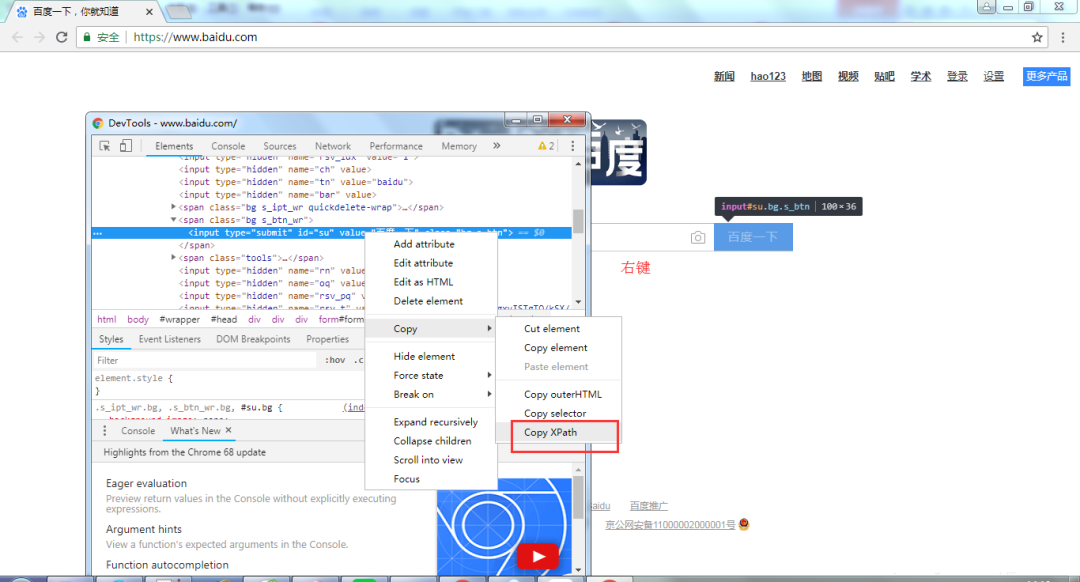

3.2、chrome_Xpath 插件使用

上面的chrome_Xpath插件我们已经安装好了,接下来就要用到了。

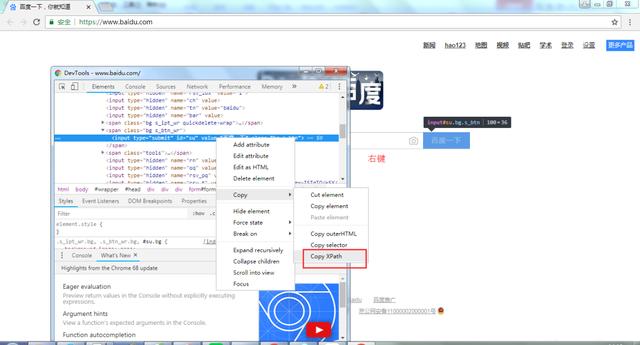

打开浏览器,按快捷键F12。

选择下图所示的元素。

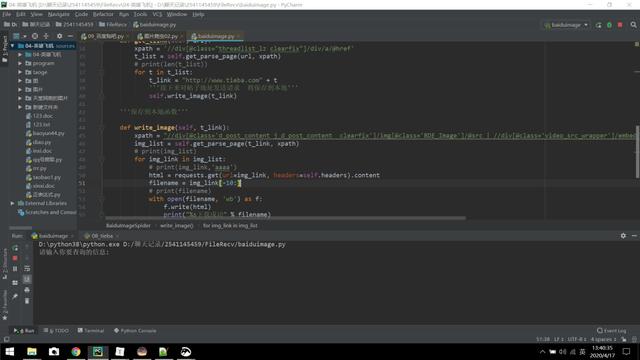

3) 右击,然后选择“Copy XPath”,如下图。

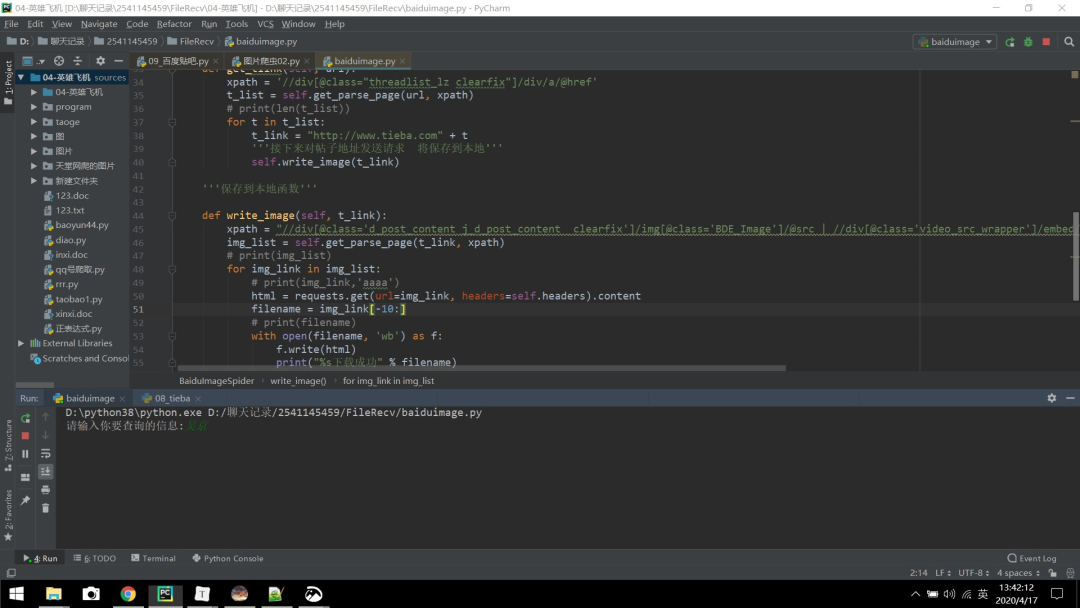

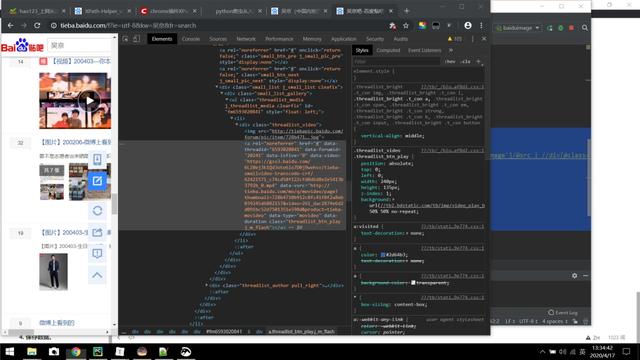

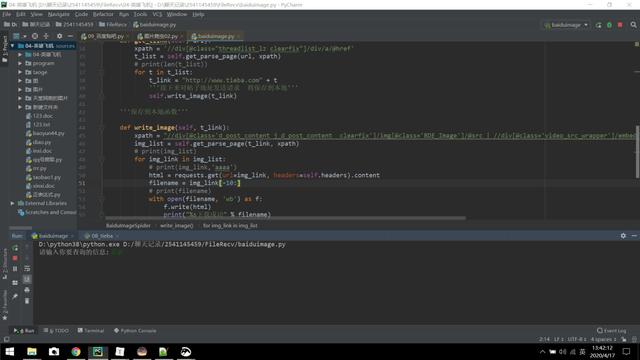

3.3、写代码,获取链接函数。

我们已经获得了上面链接函数的Xpath路径,然后定义了一个链接函数get_tlink并继承self来实现多页面抓取。

'''获取链接函数'''

def get_tlink(self, url):

xpath = '//div[@class="threadlist_lz clearfix"]/div/a/@href'

t_list = self.get_parse_page(url, xpath)

# print(len(t_list))

for t in t_list:

t_link = "http://www.tieba.com" + t

'''接下来对帖子地址发送请求 将保存到本地'''

self.write_image(t_link)

4、保存数据

这里定义了一个write_image方法来保存数据,如下图。

'''保存到本地函数'''

d

1000

ef write_image(self, t_link):

xpath = "//div[@class='d_post_content j_d_post_content clearfix']/img[@class='BDE_Image']/@src | //div[@class='video_src_wrapper']/embed/@data-video"

img_list = self.get_parse_page(t_link, xpath)

for img_link in img_list:

html = requests.get(url=img_link, headers=self.headers).content

filename = "百度/"+img_link[-10:]

with open(filename, 'wb') as f:

f.write(html)

print("%s下载成功" % filename)

注:@data-video 为 URL 中的视频,如下图所示。

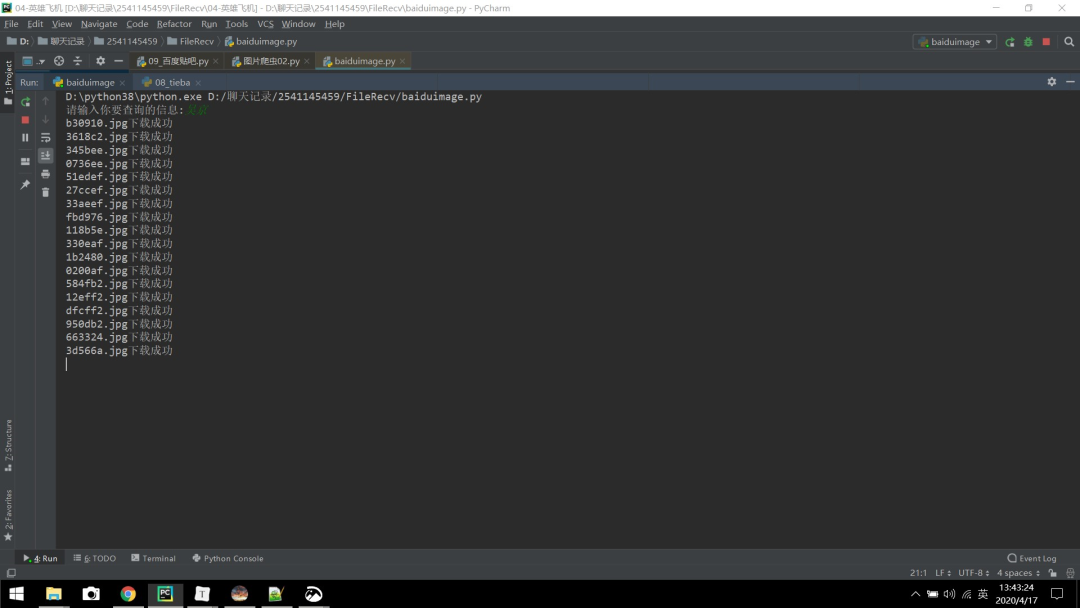

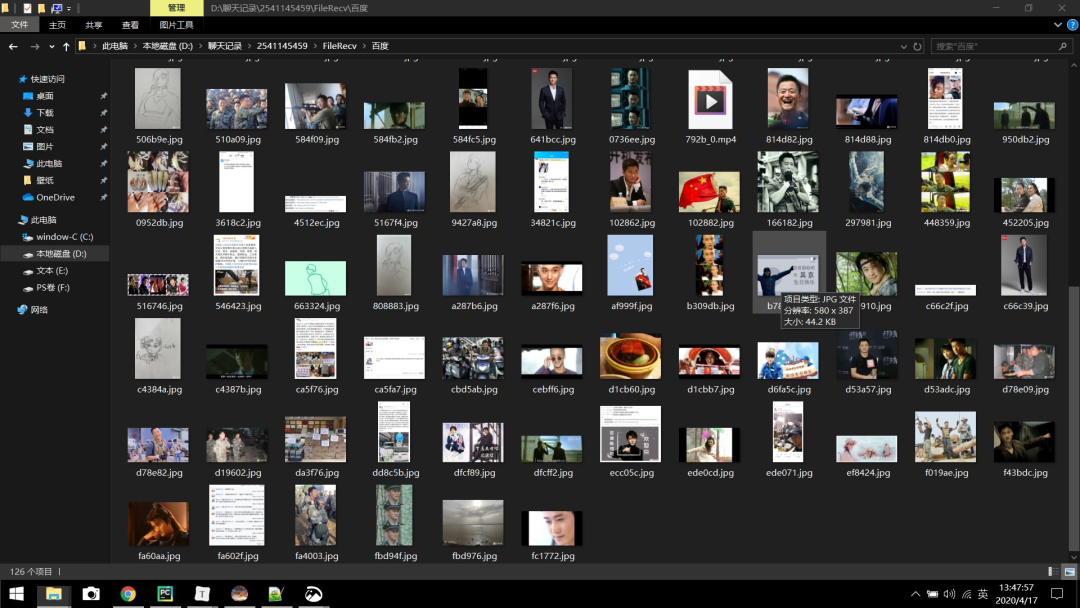

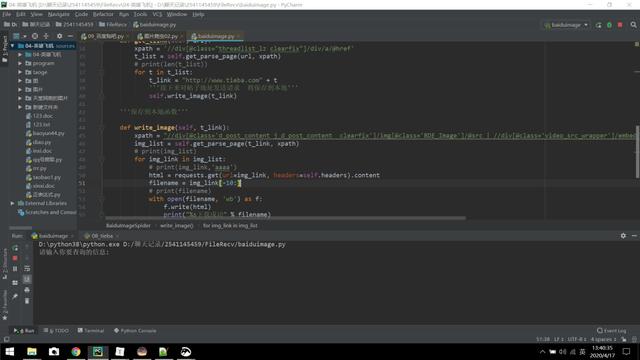

【六、效果展示】

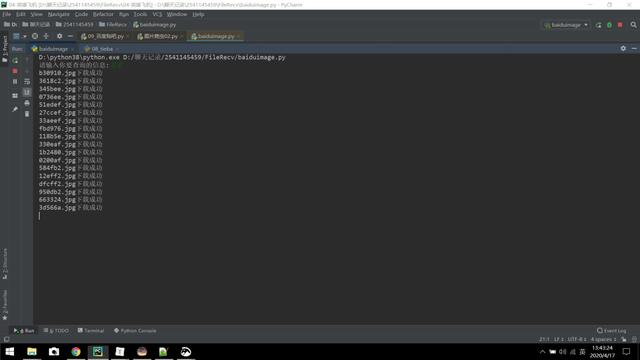

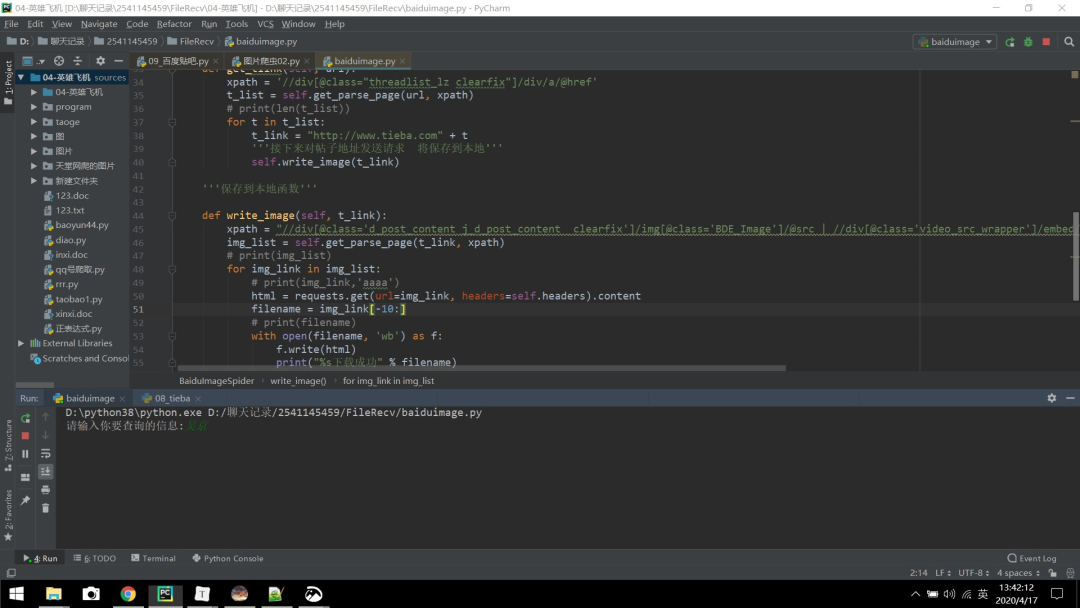

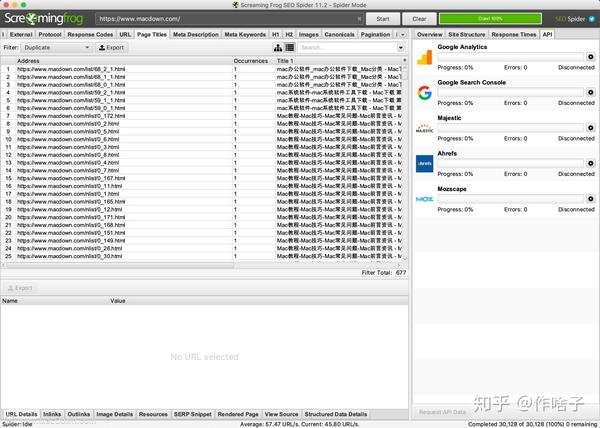

1、点击运行,如下图(请输入您要查询的信息):

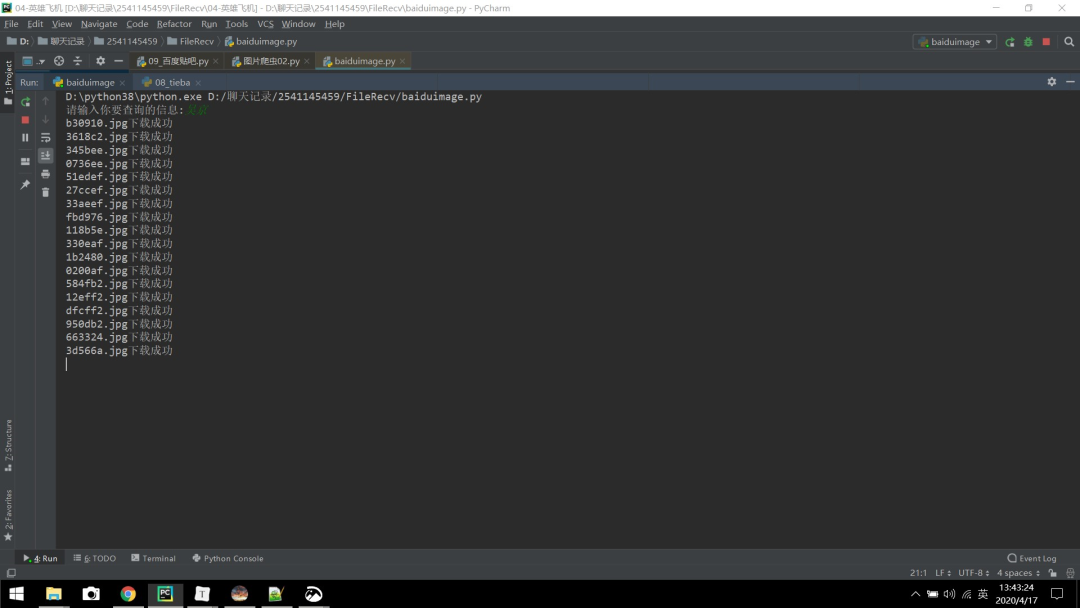

2、以吴京为例输入后回车:

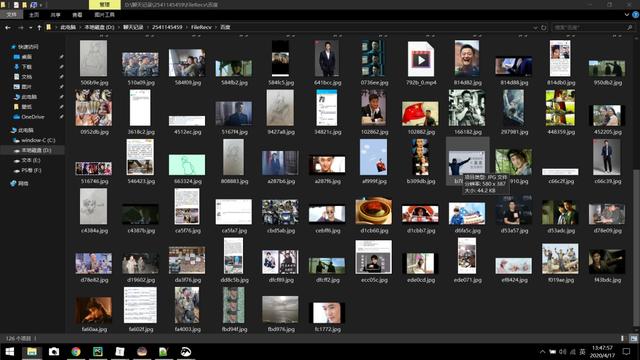

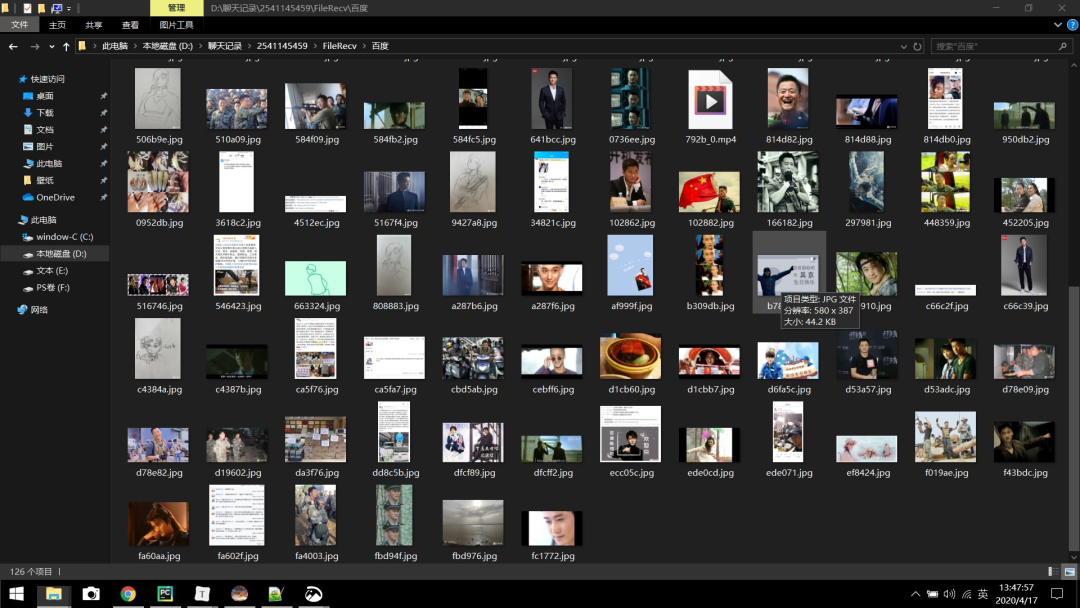

3、将下载的图片保存在名为“百度”的文件夹中,该文件夹需要提前在本地创建。一定要记得提前在当前代码的同级目录下新建一个名为“百度”的文件夹,否则系统会找不到文件夹,会报错找不到文件夹“百度”。

4、下图中的MP4为评论区视频。

[七、总结]

1、 不建议抓取太多数据,可能造成服务器负载,简单试一下。

2、本文基于Python网络爬虫,利用爬虫库实现百度贴吧评论区爬取。对Python爬取百度贴吧的一些难点进行详细讲解并提供有效的解决方案。

3、欢迎积极尝试。有时你看到别人实施起来很容易,但自己动手时,总会出现各种问题。不要自卑,勤于理解。深刻的。学习requests库的使用和爬虫程序的编写。

4、 通过这个项目,你可以更快的得到你想要的信息。

5、如需本文源码,请后台回复“百度贴吧”获取。

看完这篇文章你学会了吗?请转发并分享给更多人

IT共享之家 查看全部

网页爬虫抓取百度图片(Excel教程Excel函数的Xpath路径,快速检验我们爬取的信息是否正确)

2、如何搜索关键词?

通过URL我们可以发现,你只需要在kw=()和ffa括号中输入你要搜索的内容即可。这样,我们就可以用一个 {} 来代替它,后面我们会循环遍历它。

【五、项目实施】

1、创建一个名为BaiduImageSpider的类,定义一个main方法main和一个初始化方法init。导入所需的库。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

pass

def main(self):

pass

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

spider.main()

pass

if __name__ == '__main__':

spider= ImageSpider()

spider.main()

2、准备url地址和请求头来请求数据。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

self.tieba_name = tieba_name #输入的名字

self.url = "http://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

self.headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; InfoPath.3)'

}

'''发送请求 获取响应'''

def get_parse_page(self, url, xpath):

html = requests.get(url=url, headers=self.headers).content.decode("utf-8")

parse_html = etree.HTML(html)

r_list = parse_html.xpath(xpath)

return r_list

def main(self):

url = self.url.format(self.tieba_name)

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

key_word = parse.quote(inout_word)

spider = BaiduImageSpider(key_word)

spider.main()

3、xpath 数据分析

3.1、chrome_Xpath 插件安装

1) 这里使用了一个插件。它可以快速检查我们抓取的信息是否正确。具体安装方法如下。

2)百度下载chrome_Xpath_v2.0.2.crx,chrome浏览器输入:/extensions/

3) 将chrome_Xpath_v2.0.2.crx 直接拖到扩展页面;

4) 如果安装失败,弹出提示“无法从这个网站添加应用程序、扩展和用户脚本”。如果遇到这个问题,解决方法是:打开开发者模式保存crx文件(直接或者修改后缀为rar)解压到一个文件夹,点击开发者模式加载解压后的扩展,选择解压后的文件夹,点击确定,安装成功;

3.2、chrome_Xpath 插件使用

上面的chrome_Xpath插件我们已经安装好了,接下来就要用到了。

打开浏览器,按快捷键F12。

选择下图所示的元素。

3) 右击,然后选择“Copy XPath”,如下图。

3.3、写代码,获取链接函数。

我们已经获得了上面链接函数的Xpath路径,然后定义了一个链接函数get_tlink并继承self来实现多页面抓取。

'''获取链接函数'''

def get_tlink(self, url):

xpath = '//div[@class="threadlist_lz clearfix"]/div/a/@href'

t_list = self.get_parse_page(url, xpath)

# print(len(t_list))

for t in t_list:

t_link = "http://www.tieba.com" + t

'''接下来对帖子地址发送请求 将保存到本地'''

self.write_image(t_link)

4、保存数据

这里定义了一个write_image方法来保存数据,如下图。

'''保存到本地函数'''

d

1000

ef write_image(self, t_link):

xpath = "//div[@class='d_post_content j_d_post_content clearfix']/img[@class='BDE_Image']/@src | //div[@class='video_src_wrapper']/embed/@data-video"

img_list = self.get_parse_page(t_link, xpath)

for img_link in img_list:

html = requests.get(url=img_link, headers=self.headers).content

filename = "百度/"+img_link[-10:]

with open(filename, 'wb') as f:

f.write(html)

print("%s下载成功" % filename)

注:@data-video 为 URL 中的视频,如下图所示。

【六、效果展示】

1、点击运行,如下图(请输入您要查询的信息):

2、以吴京为例输入后回车:

3、将下载的图片保存在名为“百度”的文件夹中,该文件夹需要提前在本地创建。一定要记得提前在当前代码的同级目录下新建一个名为“百度”的文件夹,否则系统会找不到文件夹,会报错找不到文件夹“百度”。

4、下图中的MP4为评论区视频。

[七、总结]

1、 不建议抓取太多数据,可能造成服务器负载,简单试一下。

2、本文基于Python网络爬虫,利用爬虫库实现百度贴吧评论区爬取。对Python爬取百度贴吧的一些难点进行详细讲解并提供有效的解决方案。

3、欢迎积极尝试。有时你看到别人实施起来很容易,但自己动手时,总会出现各种问题。不要自卑,勤于理解。深刻的。学习requests库的使用和爬虫程序的编写。

4、 通过这个项目,你可以更快的得到你想要的信息。

5、如需本文源码,请后台回复“百度贴吧”获取。

看完这篇文章你学会了吗?请转发并分享给更多人

IT共享之家

网页爬虫抓取百度图片(如何实现搜索关键字?(一)_e操盘_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-10-30 10:05

2、如何搜索关键词?

通过URL,我们可以发现我们只需要在kw=()和括号中输入你要搜索的内容即可。这样,我们就可以用一个 {} 来代替它,后面我们会循环遍历它。

【五、项目实施】

1、创建一个名为BaiduImageSpider的类,定义一个main方法main和一个初始化方法init。导入所需的库。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

pass

def main(self):

pass

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

spider.main()

pass

if __name__ == '__main__':

spider= ImageSpider()

spider.main()

2、准备url地址和请求头来请求数据。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

self.tieba_name = tieba_name #输入的名字

self.url = "http://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

self.headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; InfoPath.3)'

}

'''发送请求 获取响应'''

def get_parse_page(self, url, xpath):

html = requests.get(url=url, headers=self.headers).content.decode("utf-8")

parse_html = etree.HTML(html)

r_list = parse_html.xpath(xpath)

return r_list

def main(self):

url = self.url.format(self.tieba_name)

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

key_word = parse.quote(inout_word)

spider = BaiduImageSpider(key_word)

spider.main()

3、xpath 数据分析

3.1、chrome_Xpath 插件安装

1) 这里使用了一个插件。它可以快速检查我们抓取的信息是否正确。具体安装方法如下。

2)百度下载chrome_Xpath_v2.0.2.crx,chrome浏览器输入:chrome://extensions/

3) 将chrome_Xpath_v2.0.2.crx 直接拖到扩展页面;

4) 如果安装失败,弹出提示“无法从这个网站添加应用程序、扩展和用户脚本”。如果遇到这个问题,解决方法是:打开开发者模式保存crx文件(直接或者修改后缀为rar)解压到一个文件夹,点击开发者模式加载解压后的扩展,选择解压后的文件夹,点击确定,安装成功;

3.2、chrome_Xpath 插件使用

上面的chrome_Xpath插件我们已经安装好了,接下来就要用到了。

1) 打开浏览器,按快捷键F12。

2) 选择下图所示的元素。

3) 右击,然后选择“Copy XPath”,如下图。

3.3、写代码,获取链接函数。

我们已经获得了上面链接函数的Xpath路径,然后定义了一个链接函数get_tlink并继承self来实现多页面抓取。

'''获取链接函数'''

def get_tlink(self, url):

xpath = '//div[@class="threadlist_lz clearfix"]/div/a/@href'

t_list = self.get_parse_page(url, xpath)

# print(len(t_list))

for t in t_list:

t_link = "http://www.tieba.com" + t

'''接下来对帖子地址发送请求 将保存到本地'''

self.write_image(t_link)

4、保存数据

这里定义了一个write_image方法来保存数据,如下图。

'''保存到本地函数'''

def write_image(self, t_link):

xpath = "//div[@class='d_post_content j_d_post_content clearfix']/img[@class='BDE_Image']/@src | //div[@class='video_src_wrapper']/embed/@data-video"

img_list = self.get_parse_page(t_link, xpath)

for img_link in img_list:

html = requests.get(url=img_link, headers=self.headers).content

filename = "百度/"+img_link[-10:]

with open(filename, 'wb') as f:

f.write(html)

print("%s下载成功" % filename)

注:@data-video 为 URL 中的视频,如下图所示。

【六、效果展示】

1、点击运行,如下图(请输入您要查询的信息):

2、以吴京为例输入后回车:

3、将下载的图片保存在名为“百度”的文件夹中,该文件夹需要提前在本地创建。记得提前在当前代码的同级目录下新建一个名为“百度”的文件夹,否则系统找不到文件夹,会报错找不到文件夹“百度”。

4、 下图中的MP4为评论区视频。

[七、总结]

1、 不建议抓取太多数据,可能造成服务器负载,简单试一下。

2、本文基于Python网络爬虫,利用爬虫库实现百度贴吧评论区爬取。对Python爬取百度贴吧的一些难点进行详细讲解并提供有效的解决方案。

3、欢迎积极尝试。有时你看到别人实施起来很容易,但自己动手时,总会出现各种问题。不看高手,努力理解更好。深刻的。学习requests库的使用和爬虫程序的编写。

4、 通过这个项目,你可以更快的得到你想要的信息。

5、如需本文源码,请后台回复“百度贴吧”获取。

看完这篇文章你学会了吗?请转发并分享给更多人

IT共享之家 查看全部

网页爬虫抓取百度图片(如何实现搜索关键字?(一)_e操盘_)

2、如何搜索关键词?

通过URL,我们可以发现我们只需要在kw=()和括号中输入你要搜索的内容即可。这样,我们就可以用一个 {} 来代替它,后面我们会循环遍历它。

【五、项目实施】

1、创建一个名为BaiduImageSpider的类,定义一个main方法main和一个初始化方法init。导入所需的库。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

pass

def main(self):

pass

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

spider.main()

pass

if __name__ == '__main__':

spider= ImageSpider()

spider.main()

2、准备url地址和请求头来请求数据。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

self.tieba_name = tieba_name #输入的名字

self.url = "http://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

self.headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; InfoPath.3)'

}

'''发送请求 获取响应'''

def get_parse_page(self, url, xpath):

html = requests.get(url=url, headers=self.headers).content.decode("utf-8")

parse_html = etree.HTML(html)

r_list = parse_html.xpath(xpath)

return r_list

def main(self):

url = self.url.format(self.tieba_name)

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

key_word = parse.quote(inout_word)

spider = BaiduImageSpider(key_word)

spider.main()

3、xpath 数据分析

3.1、chrome_Xpath 插件安装

1) 这里使用了一个插件。它可以快速检查我们抓取的信息是否正确。具体安装方法如下。

2)百度下载chrome_Xpath_v2.0.2.crx,chrome浏览器输入:chrome://extensions/

3) 将chrome_Xpath_v2.0.2.crx 直接拖到扩展页面;

4) 如果安装失败,弹出提示“无法从这个网站添加应用程序、扩展和用户脚本”。如果遇到这个问题,解决方法是:打开开发者模式保存crx文件(直接或者修改后缀为rar)解压到一个文件夹,点击开发者模式加载解压后的扩展,选择解压后的文件夹,点击确定,安装成功;

3.2、chrome_Xpath 插件使用

上面的chrome_Xpath插件我们已经安装好了,接下来就要用到了。

1) 打开浏览器,按快捷键F12。

2) 选择下图所示的元素。

3) 右击,然后选择“Copy XPath”,如下图。

3.3、写代码,获取链接函数。

我们已经获得了上面链接函数的Xpath路径,然后定义了一个链接函数get_tlink并继承self来实现多页面抓取。

'''获取链接函数'''

def get_tlink(self, url):

xpath = '//div[@class="threadlist_lz clearfix"]/div/a/@href'

t_list = self.get_parse_page(url, xpath)

# print(len(t_list))

for t in t_list:

t_link = "http://www.tieba.com" + t

'''接下来对帖子地址发送请求 将保存到本地'''

self.write_image(t_link)

4、保存数据

这里定义了一个write_image方法来保存数据,如下图。

'''保存到本地函数'''

def write_image(self, t_link):

xpath = "//div[@class='d_post_content j_d_post_content clearfix']/img[@class='BDE_Image']/@src | //div[@class='video_src_wrapper']/embed/@data-video"

img_list = self.get_parse_page(t_link, xpath)

for img_link in img_list:

html = requests.get(url=img_link, headers=self.headers).content

filename = "百度/"+img_link[-10:]

with open(filename, 'wb') as f:

f.write(html)

print("%s下载成功" % filename)

注:@data-video 为 URL 中的视频,如下图所示。

【六、效果展示】

1、点击运行,如下图(请输入您要查询的信息):

2、以吴京为例输入后回车:

3、将下载的图片保存在名为“百度”的文件夹中,该文件夹需要提前在本地创建。记得提前在当前代码的同级目录下新建一个名为“百度”的文件夹,否则系统找不到文件夹,会报错找不到文件夹“百度”。

4、 下图中的MP4为评论区视频。

[七、总结]

1、 不建议抓取太多数据,可能造成服务器负载,简单试一下。

2、本文基于Python网络爬虫,利用爬虫库实现百度贴吧评论区爬取。对Python爬取百度贴吧的一些难点进行详细讲解并提供有效的解决方案。

3、欢迎积极尝试。有时你看到别人实施起来很容易,但自己动手时,总会出现各种问题。不看高手,努力理解更好。深刻的。学习requests库的使用和爬虫程序的编写。

4、 通过这个项目,你可以更快的得到你想要的信息。

5、如需本文源码,请后台回复“百度贴吧”获取。

看完这篇文章你学会了吗?请转发并分享给更多人

IT共享之家

网页爬虫抓取百度图片(如何实现搜索关键字?(一)_e操盘_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-10-29 15:21

2、如何搜索关键词?

通过URL,我们可以发现我们只需要在kw=()和括号中输入你要搜索的内容即可。这样,我们就可以用一个 {} 来代替它,后面我们会循环遍历它。

【五、项目实施】

1、创建一个名为BaiduImageSpider的类,定义一个main方法main和一个初始化方法init。导入所需的库。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

pass

def main(self):

pass

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

spider.main()

pass

if __name__ == '__main__':

spider= ImageSpider()

spider.main()

2、准备url地址和请求头来请求数据。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

self.tieba_name = tieba_name #输入的名字

self.url = "http://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

self.headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; InfoPath.3)'

}

'''发送请求 获取响应'''

def get_parse_page(self, url, xpath):

html = requests.get(url=url, headers=self.headers).content.decode("utf-8")

parse_html = etree.HTML(html)

r_list = parse_html.xpath(xpath)

return r_list

def main(self):

url = self.url.format(self.tieba_name)

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

key_word = parse.quote(inout_word)

spider = BaiduImageSpider(key_word)

spider.main()

3、xpath 数据分析

3.1、chrome_Xpath 插件安装

1) 这里使用了一个插件。它可以快速检查我们抓取的信息是否正确。具体安装方法如下。

2)百度下载chrome_Xpath_v2.0.2.crx,chrome浏览器输入:chrome://extensions/

3) 将chrome_Xpath_v2.0.2.crx 直接拖到扩展页面;

4) 如果安装失败,弹窗提示“无法从这个网站添加应用程序、扩展和用户脚本”。如果遇到这个问题,解决方法是:打开开发者模式保存crx文件(直接或者修改后缀为rar)解压到一个文件夹,点击开发者模式加载解压后的扩展,选择解压后的文件夹,点击确定,安装成功;

3.2、chrome_Xpath 插件使用

上面的chrome_Xpath插件我们已经安装好了,接下来就要用到了。1) 打开浏览器,按快捷键F12。2) 选择下图所示的元素。

3) 右击,然后选择“复制XPath”,如下图。

3.3、写代码,获取链接函数。

我们已经获得了上面链接函数的Xpath路径,然后定义了一个链接函数get_tlink并继承self来实现多页面抓取。

'''获取链接函数'''

def get_tlink(self, url):

xpath = '//div[@class="threadlist_lz clearfix"]/div/a/@href'

t_list = self.get_parse_page(url, xpath)

# print(len(t_list))

for t in t_list:

t_link = "http://www.tieba.com" + t

'''接下来对帖子地址发送请求 将保存到本地'''

self.write_image(t_link)

4、保存数据

这里定义了一个write_image方法来保存数据,如下图。

'''保存到本地函数'''

def write_image(self, t_link):

xpath = "//div[@class='d_post_content j_d_post_content clearfix']/img[@class='BDE_Image']/@src | //div[@class='video_src_wrapper']/embed/@data-video"

img_list = self.get_parse_page(t_link, xpath)

for img_link in img_list:

html = requests.get(url=img_link, headers=self.headers).content

filename = "百度/"+img_link[-10:]

with open(filename, 'wb') as f:

f.write(html)

print("%s下载成功" % filename)

注:@data-video 为 URL 中的视频,如下图所示。

【六、效果展示】

1、点击运行,如下图(请输入您要查询的信息):

2、以吴京为例输入后回车:

3、将下载的图片保存在名为“百度”的文件夹中,该文件夹需要提前在本地创建。记得提前在当前代码的同级目录下新建一个名为“百度”的文件夹,否则系统找不到文件夹,会报错找不到文件夹“百度”。

4、下图中的MP4为评论区视频。

[七、总结]

1、 不建议抓取太多数据,可能造成服务器负载,简单试一下。

2、本文基于Python网络爬虫,利用爬虫库实现百度贴吧评论区爬取。对Python爬取百度贴吧的一些难点进行详细讲解并提供有效的解决方案。3、欢迎积极尝试。有时你看到别人实施起来很容易,但自己动手时,总会出现各种问题。不要自卑,勤于理解。深刻的。学习requests库的使用和爬虫程序的编写。4、 通过这个项目,你可以更快的得到你想要的信息。 查看全部

网页爬虫抓取百度图片(如何实现搜索关键字?(一)_e操盘_)

2、如何搜索关键词?

通过URL,我们可以发现我们只需要在kw=()和括号中输入你要搜索的内容即可。这样,我们就可以用一个 {} 来代替它,后面我们会循环遍历它。

【五、项目实施】

1、创建一个名为BaiduImageSpider的类,定义一个main方法main和一个初始化方法init。导入所需的库。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

pass

def main(self):

pass

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

spider.main()

pass

if __name__ == '__main__':

spider= ImageSpider()

spider.main()

2、准备url地址和请求头来请求数据。

import requests

from lxml import etree

from urllib import parse

class BaiduImageSpider(object):

def __init__(self, tieba_name):

self.tieba_name = tieba_name #输入的名字

self.url = "http://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

self.headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; InfoPath.3)'

}

'''发送请求 获取响应'''

def get_parse_page(self, url, xpath):

html = requests.get(url=url, headers=self.headers).content.decode("utf-8")

parse_html = etree.HTML(html)

r_list = parse_html.xpath(xpath)

return r_list

def main(self):

url = self.url.format(self.tieba_name)

if __name__ == '__main__':

inout_word = input("请输入你要查询的信息:")

key_word = parse.quote(inout_word)

spider = BaiduImageSpider(key_word)

spider.main()

3、xpath 数据分析

3.1、chrome_Xpath 插件安装

1) 这里使用了一个插件。它可以快速检查我们抓取的信息是否正确。具体安装方法如下。

2)百度下载chrome_Xpath_v2.0.2.crx,chrome浏览器输入:chrome://extensions/

3) 将chrome_Xpath_v2.0.2.crx 直接拖到扩展页面;

4) 如果安装失败,弹窗提示“无法从这个网站添加应用程序、扩展和用户脚本”。如果遇到这个问题,解决方法是:打开开发者模式保存crx文件(直接或者修改后缀为rar)解压到一个文件夹,点击开发者模式加载解压后的扩展,选择解压后的文件夹,点击确定,安装成功;

3.2、chrome_Xpath 插件使用

上面的chrome_Xpath插件我们已经安装好了,接下来就要用到了。1) 打开浏览器,按快捷键F12。2) 选择下图所示的元素。

3) 右击,然后选择“复制XPath”,如下图。

3.3、写代码,获取链接函数。

我们已经获得了上面链接函数的Xpath路径,然后定义了一个链接函数get_tlink并继承self来实现多页面抓取。

'''获取链接函数'''

def get_tlink(self, url):

xpath = '//div[@class="threadlist_lz clearfix"]/div/a/@href'

t_list = self.get_parse_page(url, xpath)

# print(len(t_list))

for t in t_list:

t_link = "http://www.tieba.com" + t

'''接下来对帖子地址发送请求 将保存到本地'''

self.write_image(t_link)

4、保存数据

这里定义了一个write_image方法来保存数据,如下图。

'''保存到本地函数'''

def write_image(self, t_link):

xpath = "//div[@class='d_post_content j_d_post_content clearfix']/img[@class='BDE_Image']/@src | //div[@class='video_src_wrapper']/embed/@data-video"

img_list = self.get_parse_page(t_link, xpath)

for img_link in img_list:

html = requests.get(url=img_link, headers=self.headers).content

filename = "百度/"+img_link[-10:]

with open(filename, 'wb') as f:

f.write(html)

print("%s下载成功" % filename)

注:@data-video 为 URL 中的视频,如下图所示。

【六、效果展示】

1、点击运行,如下图(请输入您要查询的信息):

2、以吴京为例输入后回车:

3、将下载的图片保存在名为“百度”的文件夹中,该文件夹需要提前在本地创建。记得提前在当前代码的同级目录下新建一个名为“百度”的文件夹,否则系统找不到文件夹,会报错找不到文件夹“百度”。

4、下图中的MP4为评论区视频。

[七、总结]

1、 不建议抓取太多数据,可能造成服务器负载,简单试一下。