从网页抓取数据

从网页抓取数据(web旧方案日志:,改了机制,模拟登录机制)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-18 11:05

前言网

旧计划日志

2015年,微信网页版的限制还没有那么严格。当时的主要思路是用微信网页版,然后用requests来模拟登录,代码

然后继续访问类似如下的界面爬取信息:

('')

当时为了让爬虫的多实例运行,我用的是Celery框架(现在觉得是智障,跑多实例后启动程序N次就好了。。。跌倒了),因为这是一个模拟登录,所以我写了另一个。设置复杂的东西生成二维码,然后获取登录URL。具体模拟登录原理请参考这条微信-删除-好友。另外,相关的Celery Task中写的逻辑过于复杂,一个请求在一个任务中被打断。线路重连机制,模拟登录机制,解析列表,解析文章等。另外,由于网页版微信有非常复杂的同步机制,有时候如果连不上手动重新登录很麻烦直接掉了。

未来网页版微信将不再能够获取密钥(2016年开始),此方案将被废弃。.

新计划

经领导提醒,改了结构。项目总体结构如下:

微信爬虫架构图

更新

生成key的方法是编写按钮向导的脚本不断生成文章列表URL然后不断点击,使用squid作为代理获取带key的url(squid需要配置ssl-bump 透明代理)

超过 查看全部

从网页抓取数据(web旧方案日志:,改了机制,模拟登录机制)

前言网

旧计划日志

2015年,微信网页版的限制还没有那么严格。当时的主要思路是用微信网页版,然后用requests来模拟登录,代码

然后继续访问类似如下的界面爬取信息:

('')

当时为了让爬虫的多实例运行,我用的是Celery框架(现在觉得是智障,跑多实例后启动程序N次就好了。。。跌倒了),因为这是一个模拟登录,所以我写了另一个。设置复杂的东西生成二维码,然后获取登录URL。具体模拟登录原理请参考这条微信-删除-好友。另外,相关的Celery Task中写的逻辑过于复杂,一个请求在一个任务中被打断。线路重连机制,模拟登录机制,解析列表,解析文章等。另外,由于网页版微信有非常复杂的同步机制,有时候如果连不上手动重新登录很麻烦直接掉了。

未来网页版微信将不再能够获取密钥(2016年开始),此方案将被废弃。.

新计划

经领导提醒,改了结构。项目总体结构如下:

微信爬虫架构图

更新

生成key的方法是编写按钮向导的脚本不断生成文章列表URL然后不断点击,使用squid作为代理获取带key的url(squid需要配置ssl-bump 透明代理)

超过

从网页抓取数据(三种抓取网页数据的方法-2.Beautiful)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-01-15 04:15

下面我们将介绍三种抓取网页数据的方法,首先是正则表达式,然后是流行的 BeautifulSoup 模块,最后是强大的 lxml 模块。

1. 正则表达式

如果您是正则表达式的新手,或者需要一些提示,请查看正则表达式 HOWTO 以获得完整的介绍。

当我们使用正则表达式抓取国家/地区数据时,我们首先尝试匹配元素的内容,如下所示:

>>> import re

>>> import urllib2

>>> url = 'http://example.webscraping.com/view/United-Kingdom-239' >>> html = urllib2.urlopen(url).read() >>> re.findall('(.*?)', html) ['/places/static/images/flags/gb.png', '244,820 square kilometres', '62,348,447', 'GB', 'United Kingdom', 'London', 'EU', '.uk', 'GBP', 'Pound', '44', '@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA', '^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$', 'en-GB,cy-GB,gd', 'IE '] >>>

从以上结果可以看出,标签用于多个国家属性。要隔离 area 属性,我们只需选择其中的第二个元素,如下所示:

>>> re.findall('(.*?)', html)[1]

'244,820 square kilometres'

虽然这个方案现在可用,但如果页面发生变化,它很可能会失败。例如,该表已更改为删除第二行中的土地面积数据。如果我们现在只抓取数据,我们可以忽略这种未来可能发生的变化。但是,如果我们以后想再次获取这些数据,我们需要一个更健壮的解决方案,尽可能避免这种布局更改的影响。为了使正则表达式更加健壮,我们也可以添加它的父元素。由于元素具有 ID 属性,因此它应该是唯一的。

>>> re.findall('Area: (.*?)', html) ['244,820 square kilometres']

这个迭代版本看起来好一点,但是网页更新还有很多其他的方式也会让这个正则表达式不令人满意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或者更改 area_label 等。下面是一个尝试支持这些可能性的改进版本。

>>> re.findall('.*?>> from bs4 import BeautifulSoup

>>> broken_html = 'AreaPopulation' >>> # parse the HTML >>> soup = BeautifulSoup(broken_html, 'html.parser') >>> fixed_html = soup.prettify() >>> print fixed_html Area Population

从上面的执行结果可以看出,Beautiful Soup 能够正确解析缺失的引号并关闭标签。现在我们可以使用 find() 和 find_all() 方法来定位我们需要的元素。

>>> ul = soup.find('ul', attrs={'class':'country'})

>>> ul.find('li') # return just the first match

AreaPopulation >>> ul.find_all('li') # return all matches [AreaPopulation, Population]

注意:由于不同版本的Python内置库的容错能力存在差异,处理结果可能与上述不同。详情请参阅: 。想知道所有的方法和参数,可以参考 Beautiful Soup 的官方文档

以下是使用此方法提取样本国家地区数据的完整代码。

>>> from bs4 import BeautifulSoup

>>> import urllib2 >>> url = 'http://example.webscraping.com/view/United-Kingdom-239' >>> html = urllib2.urlopen(url).read() >>> # locate the area row >>> tr = soup.find(attrs={'id':'places_area__row'}) >>> # locate the area tag >>> td = tr.find(attrs={'class':'w2p_fw'}) >>> area = td.text # extract the text from this tag >>> print area 244,820 square kilometres

此代码虽然比正则表达式代码更复杂,但更易于构建和理解。此外,布局中的一些小变化,例如额外的空白和制表符属性,我们不再需要担心它了。

3. Lxml

Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。最新安装说明可以参考。**

与 Beautiful Soup 一样,使用 lxml 模块的第一步是将可能无效的 HTML 解析为统一格式。以下是使用此模块解析不完整 HTML 的示例:

>>> import lxml.html

>>> broken_html = 'AreaPopulation' >>> # parse the HTML >>> tree = lxml.html.fromstring(broken_html) >>> fixed_html = lxml.html.tostring(tree, pretty_print=True) >>> print fixed_html Area Population

同样,lxml 正确解析属性周围缺少的引号并关闭标签,但模块不会添加和标签。

解析输入后,进入选择元素的步骤。此时,lxml 有几种不同的方法,例如类似于 Beautiful Soup 的 XPath 选择器和 find() 方法。但是,将来我们会使用 CSS 选择器,因为它们更简洁,可以在解析动态内容时重复使用。此外,一些有 jQuery 选择器经验的读者会更熟悉它。

以下是使用 lxml 的 CSS 选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = 'http://example.webscraping.com/view/United-Kingdom-239' >>> html = urllib2.urlopen(url).read() >>> tree = lxml.html.fromstring(html) >>> td = tree.cssselect('tr#places_area__row > td.w2p_fw')[0] # *行代码 >>> area = td.text_content() >>> print area 244,820 square kilometres

*行代码会先找到ID为places_area__row的表格行元素,然后选择类为w2p_fw的表格数据子标签。

CSS 选择器表示用于选择元素的模式。以下是一些常用选择器的示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link 选择 id="home" 的 标签: a#home 选择父元素为 标签的所有 子标签: a > span 选择 标签内部的所有 标签: a span 选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C 在

Lxml 已经实现了大部分 CSS3 属性,其不支持的功能可以在:.

注意:lxml 的内部实现实际上将 CSS 选择器转换为等效的 XPath 选择器。

4. 性能比较

在下面的代码中,每个爬虫会执行1000次,每次执行都会检查爬取结果是否正确,然后打印总时间。

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re import timeit from bs4 import BeautifulSoup import lxml.html FIELDS = ('area', 'population', 'iso', 'country', 'capital', 'continent', 'tld', 'currency_code', 'currency_name', 'phone', 'postal_code_format', 'postal_code_regex', 'languages', 'neighbours') def regex_scraper(html): results = {} for field in FIELDS: results[field] = re.search('.*?(.*?)'.format(field), html).groups()[0] return results def beautiful_soup_scraper(html): soup = BeautifulSoup(html, 'html.parser') results = {} for field in FIELDS: results[field] = soup.find('table').find('tr', id='places_{}__row'.format(field)).find('td', class_='w2p_fw').text return results def lxml_scraper(html): tree = lxml.html.fromstring(html) results = {} for field in FIELDS: results[field] = tree.cssselect('table > tr#places_{}__row > td.w2p_fw'.format(field))[0].text_content() return results def main(): times = {} html = urllib2.urlopen('http://example.webscraping.com/view/United-Kingdom-239').read() NUM_ITERATIONS = 1000 # number of times to test each scraper for name, scraper in ('Regular expressions', regex_scraper), ('Beautiful Soup', beautiful_soup_scraper), ('Lxml', lxml_scraper): times[name] = [] # record start time of scrape start = time.time() for i in range(NUM_ITERATIONS): if scraper == regex_scraper: # the regular expression module will cache results # so need to purge this cache for meaningful timings re.purge() # *行代码 result = scraper(html) # check scraped result is as expected assert(result['area'] == '244,820 square kilometres') times[name].append(time.time() - start) # record end time of scrape and output the total end = time.time() print '{}: {:.2f} seconds'.format(name, end - start) writer = csv.writer(open('times.csv', 'w')) header = sorted(times.keys()) writer.writerow(header) for row in zip(*[times[scraper] for scraper in header]): writer.writerow(row) if __name__ == '__main__': main()

请注意,我们在 * 行代码中调用了 re.purge() 方法。默认情况下,正则表达式会缓存搜索结果,公平起见,我们需要使用这种方法来清除缓存。

这是在我的计算机上运行脚本的结果:

由于硬件条件的不同,不同计算机的执行结果也会有一定的差异。但是,每种方法之间的相对差异应该具有可比性。从结果可以看出,Beautiful Soup 在爬取我们的示例网页时比其他两种方法慢 7 倍以上。事实上,这个结果是意料之中的,因为 lxml 和 regex 模块是用 C 编写的,而 Beautiful Soup 是用纯 Python 编写的。一个有趣的事实是 lxml 的性能与正则表达式差不多。由于 lxml 必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一个网页的多个特征时,这种初始解析的开销会降低,lxml 会更有竞争力。所以,

5. 总结

三种网页抓取方式的优缺点:

抓取方式 性能 使用难度 安装难度

正则表达式

快的

困难

简单(内置模块)

美丽的汤

慢的

简单的

简单(纯 Python)

lxml

快的

简单的

比较困难

如果您的爬虫的瓶颈是下载页面,而不是提取数据,那么使用较慢的方法(如 Beautiful Soup)不是问题。正则表达式在一次性提取中非常有用,除了可以避免解析整个网页的开销,如果只需要抓取少量数据并想避免额外的依赖,那么正则表达式可能更适合. 但是,一般来说,lxml 是抓取数据的最佳选择,因为它不仅速度更快,而且功能更多,而正则表达式和 Beautiful Soup 仅在某些特定场景下才有用。 查看全部

从网页抓取数据(三种抓取网页数据的方法-2.Beautiful)

下面我们将介绍三种抓取网页数据的方法,首先是正则表达式,然后是流行的 BeautifulSoup 模块,最后是强大的 lxml 模块。

1. 正则表达式

如果您是正则表达式的新手,或者需要一些提示,请查看正则表达式 HOWTO 以获得完整的介绍。

当我们使用正则表达式抓取国家/地区数据时,我们首先尝试匹配元素的内容,如下所示:

>>> import re

>>> import urllib2

>>> url = 'http://example.webscraping.com/view/United-Kingdom-239' >>> html = urllib2.urlopen(url).read() >>> re.findall('(.*?)', html) ['/places/static/images/flags/gb.png', '244,820 square kilometres', '62,348,447', 'GB', 'United Kingdom', 'London', 'EU', '.uk', 'GBP', 'Pound', '44', '@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA', '^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$', 'en-GB,cy-GB,gd', 'IE '] >>>

从以上结果可以看出,标签用于多个国家属性。要隔离 area 属性,我们只需选择其中的第二个元素,如下所示:

>>> re.findall('(.*?)', html)[1]

'244,820 square kilometres'

虽然这个方案现在可用,但如果页面发生变化,它很可能会失败。例如,该表已更改为删除第二行中的土地面积数据。如果我们现在只抓取数据,我们可以忽略这种未来可能发生的变化。但是,如果我们以后想再次获取这些数据,我们需要一个更健壮的解决方案,尽可能避免这种布局更改的影响。为了使正则表达式更加健壮,我们也可以添加它的父元素。由于元素具有 ID 属性,因此它应该是唯一的。

>>> re.findall('Area: (.*?)', html) ['244,820 square kilometres']

这个迭代版本看起来好一点,但是网页更新还有很多其他的方式也会让这个正则表达式不令人满意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或者更改 area_label 等。下面是一个尝试支持这些可能性的改进版本。

>>> re.findall('.*?>> from bs4 import BeautifulSoup

>>> broken_html = 'AreaPopulation' >>> # parse the HTML >>> soup = BeautifulSoup(broken_html, 'html.parser') >>> fixed_html = soup.prettify() >>> print fixed_html Area Population

从上面的执行结果可以看出,Beautiful Soup 能够正确解析缺失的引号并关闭标签。现在我们可以使用 find() 和 find_all() 方法来定位我们需要的元素。

>>> ul = soup.find('ul', attrs={'class':'country'})

>>> ul.find('li') # return just the first match

AreaPopulation >>> ul.find_all('li') # return all matches [AreaPopulation, Population]

注意:由于不同版本的Python内置库的容错能力存在差异,处理结果可能与上述不同。详情请参阅: 。想知道所有的方法和参数,可以参考 Beautiful Soup 的官方文档

以下是使用此方法提取样本国家地区数据的完整代码。

>>> from bs4 import BeautifulSoup

>>> import urllib2 >>> url = 'http://example.webscraping.com/view/United-Kingdom-239' >>> html = urllib2.urlopen(url).read() >>> # locate the area row >>> tr = soup.find(attrs={'id':'places_area__row'}) >>> # locate the area tag >>> td = tr.find(attrs={'class':'w2p_fw'}) >>> area = td.text # extract the text from this tag >>> print area 244,820 square kilometres

此代码虽然比正则表达式代码更复杂,但更易于构建和理解。此外,布局中的一些小变化,例如额外的空白和制表符属性,我们不再需要担心它了。

3. Lxml

Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。最新安装说明可以参考。**

与 Beautiful Soup 一样,使用 lxml 模块的第一步是将可能无效的 HTML 解析为统一格式。以下是使用此模块解析不完整 HTML 的示例:

>>> import lxml.html

>>> broken_html = 'AreaPopulation' >>> # parse the HTML >>> tree = lxml.html.fromstring(broken_html) >>> fixed_html = lxml.html.tostring(tree, pretty_print=True) >>> print fixed_html Area Population

同样,lxml 正确解析属性周围缺少的引号并关闭标签,但模块不会添加和标签。

解析输入后,进入选择元素的步骤。此时,lxml 有几种不同的方法,例如类似于 Beautiful Soup 的 XPath 选择器和 find() 方法。但是,将来我们会使用 CSS 选择器,因为它们更简洁,可以在解析动态内容时重复使用。此外,一些有 jQuery 选择器经验的读者会更熟悉它。

以下是使用 lxml 的 CSS 选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = 'http://example.webscraping.com/view/United-Kingdom-239' >>> html = urllib2.urlopen(url).read() >>> tree = lxml.html.fromstring(html) >>> td = tree.cssselect('tr#places_area__row > td.w2p_fw')[0] # *行代码 >>> area = td.text_content() >>> print area 244,820 square kilometres

*行代码会先找到ID为places_area__row的表格行元素,然后选择类为w2p_fw的表格数据子标签。

CSS 选择器表示用于选择元素的模式。以下是一些常用选择器的示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link 选择 id="home" 的 标签: a#home 选择父元素为 标签的所有 子标签: a > span 选择 标签内部的所有 标签: a span 选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C 在

Lxml 已经实现了大部分 CSS3 属性,其不支持的功能可以在:.

注意:lxml 的内部实现实际上将 CSS 选择器转换为等效的 XPath 选择器。

4. 性能比较

在下面的代码中,每个爬虫会执行1000次,每次执行都会检查爬取结果是否正确,然后打印总时间。

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re import timeit from bs4 import BeautifulSoup import lxml.html FIELDS = ('area', 'population', 'iso', 'country', 'capital', 'continent', 'tld', 'currency_code', 'currency_name', 'phone', 'postal_code_format', 'postal_code_regex', 'languages', 'neighbours') def regex_scraper(html): results = {} for field in FIELDS: results[field] = re.search('.*?(.*?)'.format(field), html).groups()[0] return results def beautiful_soup_scraper(html): soup = BeautifulSoup(html, 'html.parser') results = {} for field in FIELDS: results[field] = soup.find('table').find('tr', id='places_{}__row'.format(field)).find('td', class_='w2p_fw').text return results def lxml_scraper(html): tree = lxml.html.fromstring(html) results = {} for field in FIELDS: results[field] = tree.cssselect('table > tr#places_{}__row > td.w2p_fw'.format(field))[0].text_content() return results def main(): times = {} html = urllib2.urlopen('http://example.webscraping.com/view/United-Kingdom-239').read() NUM_ITERATIONS = 1000 # number of times to test each scraper for name, scraper in ('Regular expressions', regex_scraper), ('Beautiful Soup', beautiful_soup_scraper), ('Lxml', lxml_scraper): times[name] = [] # record start time of scrape start = time.time() for i in range(NUM_ITERATIONS): if scraper == regex_scraper: # the regular expression module will cache results # so need to purge this cache for meaningful timings re.purge() # *行代码 result = scraper(html) # check scraped result is as expected assert(result['area'] == '244,820 square kilometres') times[name].append(time.time() - start) # record end time of scrape and output the total end = time.time() print '{}: {:.2f} seconds'.format(name, end - start) writer = csv.writer(open('times.csv', 'w')) header = sorted(times.keys()) writer.writerow(header) for row in zip(*[times[scraper] for scraper in header]): writer.writerow(row) if __name__ == '__main__': main()

请注意,我们在 * 行代码中调用了 re.purge() 方法。默认情况下,正则表达式会缓存搜索结果,公平起见,我们需要使用这种方法来清除缓存。

这是在我的计算机上运行脚本的结果:

由于硬件条件的不同,不同计算机的执行结果也会有一定的差异。但是,每种方法之间的相对差异应该具有可比性。从结果可以看出,Beautiful Soup 在爬取我们的示例网页时比其他两种方法慢 7 倍以上。事实上,这个结果是意料之中的,因为 lxml 和 regex 模块是用 C 编写的,而 Beautiful Soup 是用纯 Python 编写的。一个有趣的事实是 lxml 的性能与正则表达式差不多。由于 lxml 必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一个网页的多个特征时,这种初始解析的开销会降低,lxml 会更有竞争力。所以,

5. 总结

三种网页抓取方式的优缺点:

抓取方式 性能 使用难度 安装难度

正则表达式

快的

困难

简单(内置模块)

美丽的汤

慢的

简单的

简单(纯 Python)

lxml

快的

简单的

比较困难

如果您的爬虫的瓶颈是下载页面,而不是提取数据,那么使用较慢的方法(如 Beautiful Soup)不是问题。正则表达式在一次性提取中非常有用,除了可以避免解析整个网页的开销,如果只需要抓取少量数据并想避免额外的依赖,那么正则表达式可能更适合. 但是,一般来说,lxml 是抓取数据的最佳选择,因为它不仅速度更快,而且功能更多,而正则表达式和 Beautiful Soup 仅在某些特定场景下才有用。

从网页抓取数据(什么是网络抓取,它有什么帮助呢?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-01-14 14:05

一些网站可能收录大量有价值的数据,比如股票价格、产品详情、体育统计、公司联系方式等等。

如果要访问此信息,您必须使用站点使用的任何格式,或者手动将信息复制并粘贴到新文档中。这个过程称为网页抓取或数据抓取。那么什么是网络抓取,它有什么帮助呢?

通过下面的 文章 一路寻找答案!

什么是网页抓取?

网页抓取是从 网站 中提取数据。采集此信息并将其导出为对用户更有用的格式(电子表格或 API)。

网页抓取是从 网站 中提取数据

虽然网页抓取可以手动完成,但在大多数情况下,提取网页数据时首选自动化工具,因为它们成本更低且运行速度更快。

但在大多数情况下,网页抓取并不是一项简单的任务。网站形式多,形式多,所以网络爬虫的功能和特点各不相同。

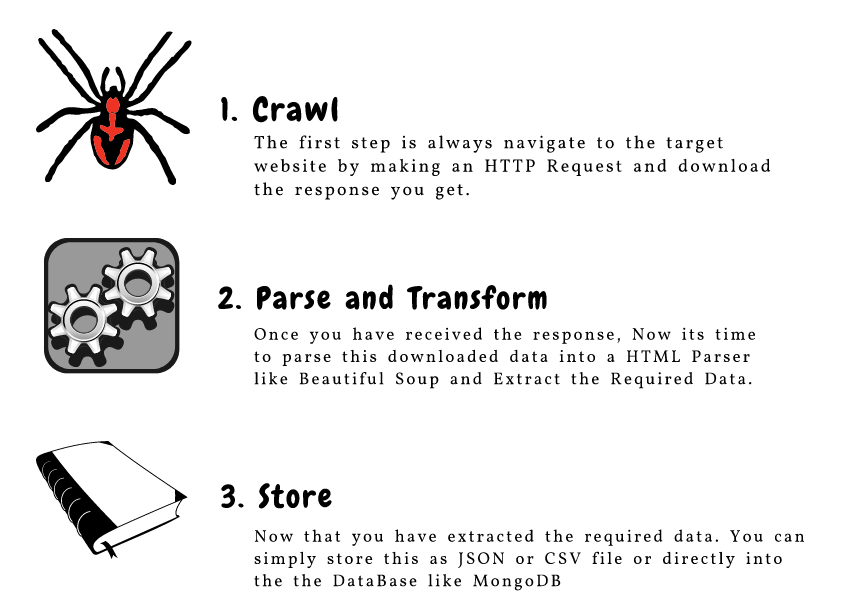

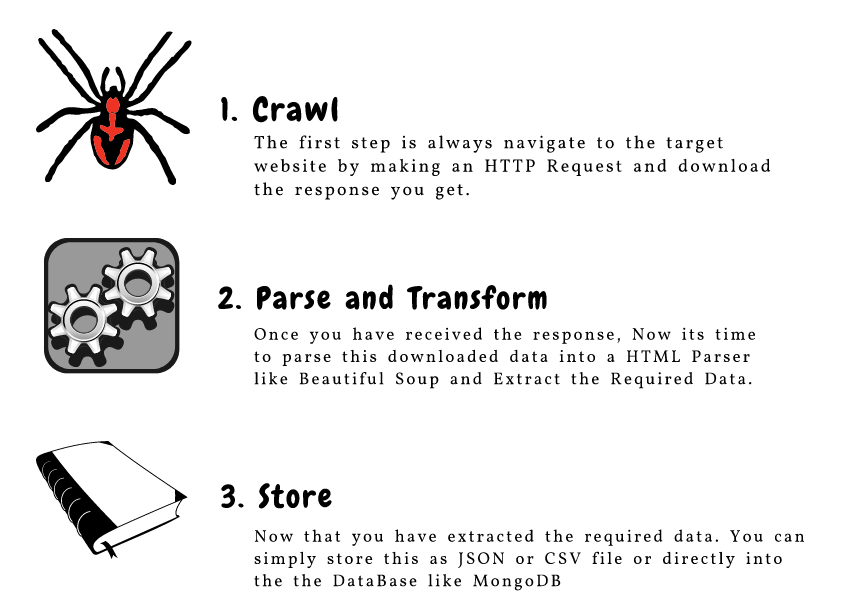

网络爬虫如何工作?

自动网络爬虫的工作方式相当简单但非常复杂。毕竟,网站 是为人而非机器而构建的。

首先,网络爬虫将在提取数据之前提供一个或多个要加载的 URL。然后爬虫将加载相关页面的整个 HTML 代码。更高级的爬虫会渲染整个 网站,包括 CSS 和 Javascript 元素。

然后爬虫将在运行项目之前提取页面上的所有数据或用户选择的特定数据。

理想情况下,用户将经历从页面中选择他们想要的特定数据的过程。例如,您可能想提取亚马逊产品页面进行定价和设计,但您不一定关心产品评论。

最后,网络爬虫会将所有采集到的数据输出为对用户更有用的格式。

大多数网络爬虫会将数据导出为 CSV 或 Excel 电子表格,而更高级的爬虫将支持其他格式,例如 JSON,可以在 API 中使用。

网络爬虫是做什么用的?

你可以用网络抓取做的事情清单几乎是无穷无尽的

此时,或许你可以想出一些不同的方式来使用网络爬虫。以下是一些最常见的用途:

将股票价格提取到应用程序 API 从黄页中提取数据以生成潜在客户 从商店定位器工具中提取数据以创建营业地点列表 从亚马逊或 eBay 等中提取产品数据 网站 用于竞争对手分析 网站之前提取< @网站数据 购物时提取产品详细信息进行比较 提取财务数据进行市场研究

你可以用网络抓取做的事情几乎是无穷无尽的。归根结底,您可以如何处理采集到的数据并确定其价值取决于您自己。 查看全部

从网页抓取数据(什么是网络抓取,它有什么帮助呢?(一))

一些网站可能收录大量有价值的数据,比如股票价格、产品详情、体育统计、公司联系方式等等。

如果要访问此信息,您必须使用站点使用的任何格式,或者手动将信息复制并粘贴到新文档中。这个过程称为网页抓取或数据抓取。那么什么是网络抓取,它有什么帮助呢?

通过下面的 文章 一路寻找答案!

什么是网页抓取?

网页抓取是从 网站 中提取数据。采集此信息并将其导出为对用户更有用的格式(电子表格或 API)。

.png)

网页抓取是从 网站 中提取数据

虽然网页抓取可以手动完成,但在大多数情况下,提取网页数据时首选自动化工具,因为它们成本更低且运行速度更快。

但在大多数情况下,网页抓取并不是一项简单的任务。网站形式多,形式多,所以网络爬虫的功能和特点各不相同。

网络爬虫如何工作?

自动网络爬虫的工作方式相当简单但非常复杂。毕竟,网站 是为人而非机器而构建的。

首先,网络爬虫将在提取数据之前提供一个或多个要加载的 URL。然后爬虫将加载相关页面的整个 HTML 代码。更高级的爬虫会渲染整个 网站,包括 CSS 和 Javascript 元素。

然后爬虫将在运行项目之前提取页面上的所有数据或用户选择的特定数据。

理想情况下,用户将经历从页面中选择他们想要的特定数据的过程。例如,您可能想提取亚马逊产品页面进行定价和设计,但您不一定关心产品评论。

最后,网络爬虫会将所有采集到的数据输出为对用户更有用的格式。

大多数网络爬虫会将数据导出为 CSV 或 Excel 电子表格,而更高级的爬虫将支持其他格式,例如 JSON,可以在 API 中使用。

网络爬虫是做什么用的?

.png)

你可以用网络抓取做的事情清单几乎是无穷无尽的

此时,或许你可以想出一些不同的方式来使用网络爬虫。以下是一些最常见的用途:

将股票价格提取到应用程序 API 从黄页中提取数据以生成潜在客户 从商店定位器工具中提取数据以创建营业地点列表 从亚马逊或 eBay 等中提取产品数据 网站 用于竞争对手分析 网站之前提取< @网站数据 购物时提取产品详细信息进行比较 提取财务数据进行市场研究

你可以用网络抓取做的事情几乎是无穷无尽的。归根结底,您可以如何处理采集到的数据并确定其价值取决于您自己。

从网页抓取数据(本文讨论如何使用BeautifulSoup库从HTML页面中提取内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-14 14:04

简介

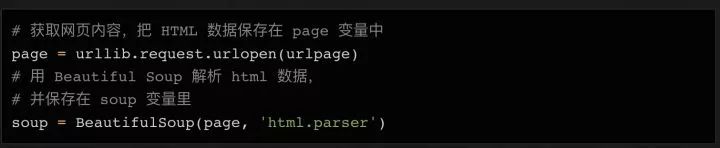

本文讨论了如何使用 Beautiful Soup 库从 HTML 页面中提取内容。提取后,我们将使用 Beautiful Soup 将其转换为 Python 列表或字典。

为了使网络抓取在 Python 中工作,我们将执行三个基本步骤:

使用 requests 库提取 HTML 内容。

分析 HTML 结构并识别收录内容的标签。

使用 Beautiful Soup 提取标签并将数据放入 Python 列表中。

安装库

首先安装我们需要的库。 requests 库可以从 网站 获取 HTML 内容。 Beautiful Soup 解析 HTML 并将其转换为 Python 对象。 Python 3 需要安装以下两个库:

[root@localhost ~]# pip3 install requests beautifulsoup4

提取html

本文爬取了本网站的技术页面。如果您转到该页面,您将看到一个 文章 列表,其中收录标题、摘录和发布日期。我们的目标是创建一个收录该信息的文章列表。

技术页面的完整网址是:

https://notes.ayushsharma.in/technology

我们可以使用请求从这个页面获取 HTML 内容:

#!/usr/bin/python3

import requests

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

print(data.text)

可变数据将收录页面的 HTML 源代码。

从 HTML 中提取内容

为了从数据中提取我们的数据,我们需要确定哪些标签有我们需要的内容。

如果您浏览 HTML,您会在顶部附近找到此部分:

Using variables in Jekyll to define custom content

I recently discovered that Jekyll's config.yml can be used to define custom

variables for reusing content. I feel like I've been living under a rock all this time. But to err over and

over again is human.

Aug 2021

每篇文章 文章都会在整个页面中重复此操作。我们可以看到.card-title有文章标题,.card-text有摘录,.card-footer类下的小标签有发布日期。

让我们用 Beautiful Soup 提取这些。

#!/usr/bin/python3

import requests

from bs4 import BeautifulSoup

from pprint import pprint

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

my_data = []

html = BeautifulSoup(data.text, 'html.parser')

articles = html.select('a.post-card')

for article in articles:

title = article.select('.card-title')[0].get_text()

excerpt = article.select('.card-text')[0].get_text()

pub_date = article.select('.card-footer small')[0].get_text()

my_data.append({"title": title, "excerpt": excerpt, "pub_date": pub_date})

pprint(my_data)

上面的代码提取出文章 并将它们放入my_data 变量中。我正在使用 pprint 打印输出。

总结

我们可以将其作为 JSON 返回到另一个应用程序,或者将其转换为具有自定义样式的 HTML。这就是Linux应该学习的方式 查看全部

从网页抓取数据(本文讨论如何使用BeautifulSoup库从HTML页面中提取内容)

简介

本文讨论了如何使用 Beautiful Soup 库从 HTML 页面中提取内容。提取后,我们将使用 Beautiful Soup 将其转换为 Python 列表或字典。

为了使网络抓取在 Python 中工作,我们将执行三个基本步骤:

使用 requests 库提取 HTML 内容。

分析 HTML 结构并识别收录内容的标签。

使用 Beautiful Soup 提取标签并将数据放入 Python 列表中。

安装库

首先安装我们需要的库。 requests 库可以从 网站 获取 HTML 内容。 Beautiful Soup 解析 HTML 并将其转换为 Python 对象。 Python 3 需要安装以下两个库:

[root@localhost ~]# pip3 install requests beautifulsoup4

提取html

本文爬取了本网站的技术页面。如果您转到该页面,您将看到一个 文章 列表,其中收录标题、摘录和发布日期。我们的目标是创建一个收录该信息的文章列表。

技术页面的完整网址是:

https://notes.ayushsharma.in/technology

我们可以使用请求从这个页面获取 HTML 内容:

#!/usr/bin/python3

import requests

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

print(data.text)

可变数据将收录页面的 HTML 源代码。

从 HTML 中提取内容

为了从数据中提取我们的数据,我们需要确定哪些标签有我们需要的内容。

如果您浏览 HTML,您会在顶部附近找到此部分:

Using variables in Jekyll to define custom content

I recently discovered that Jekyll's config.yml can be used to define custom

variables for reusing content. I feel like I've been living under a rock all this time. But to err over and

over again is human.

Aug 2021

每篇文章 文章都会在整个页面中重复此操作。我们可以看到.card-title有文章标题,.card-text有摘录,.card-footer类下的小标签有发布日期。

让我们用 Beautiful Soup 提取这些。

#!/usr/bin/python3

import requests

from bs4 import BeautifulSoup

from pprint import pprint

url = 'https://notes.ayushsharma.in/technology'

data = requests.get(url)

my_data = []

html = BeautifulSoup(data.text, 'html.parser')

articles = html.select('a.post-card')

for article in articles:

title = article.select('.card-title')[0].get_text()

excerpt = article.select('.card-text')[0].get_text()

pub_date = article.select('.card-footer small')[0].get_text()

my_data.append({"title": title, "excerpt": excerpt, "pub_date": pub_date})

pprint(my_data)

上面的代码提取出文章 并将它们放入my_data 变量中。我正在使用 pprint 打印输出。

总结

我们可以将其作为 JSON 返回到另一个应用程序,或者将其转换为具有自定义样式的 HTML。这就是Linux应该学习的方式

从网页抓取数据(想了解页面生命周期详解的相关知识和一些实例欢迎阅读)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-01-12 20:08

想了解页面生命周期详解吗?在本文中,我将讲解页面生命周期的相关知识和一些代码示例。欢迎阅读和指正。我们先把重点放在:生命周期下面一起学习。

是 Microsoft .Net 战略的一个组成部分。与之前的Asp相比,有了很大的发展,引入了很多新的机制。本文将对页面的生命周期进行初步介绍,以指导您更好更灵活的操作。当获取网页的请求(由用户提交或通过超链接提交)被发送到 Web 服务器时,该页面会运行从创建到完成的一系列事件。当我们尝试构建页面时,这个执行周期是没有必要考虑的,只会自找麻烦。但是,如果操作得当,页面的执行周期可以成为一种有效且强大的工具。许多编写页面和用户控件的开发人员发现了解正在发生的事情和时间很有帮助。下面我给大家介绍一下从页面创建到处理完成的十个事件。它还向您展示了如何将自己的代码添加到这些事件中以达到预期的效果。

一。初始化对象

页面的控件(以及页面本身)最初应该被正确初始化。通过在 C# 文件的构造函数中声明所有对象(如 1) 页面所示),了解要创建的对象数量及其类型。一旦你在构造函数中声明了所有对象,你就可以通过继承类、方法、事件或属性来传递访问它们。但是,如果您的某些对象是在 Aspx 文件中指定的某些控件,则这些控件根本没有属性。同时通过代码访问它们会产生一些意想不到的错误,因为这些 Control 实例不是按一定的顺序创建的(如果它们是一起创建的)。您也可以通过 OnInit 覆盖初始化事件。

二。导入 Viewstate 数据

在初始化事件之后,所有控件只能通过它们的 ID 引用来访问(因为还没有相应的 DOM 可以使用)。在 LoadViewState 事件中,所有控件都将获得它们的第一个属性:Viewstate 属性。这个属性最终会返回给服务器来判断页面是已经被用户访问过还是正在被用户访问。Viewstate 属性存储为名称/值对字符串,并收录控件的文本和值等信息。此属性存储在请求页面时传递的隐藏控件的 value 属性中。与Asp3.0 的维护和判断页面状态的方式相比,这种方法有了很大的进步。也可以重载LoadViewState事件函数来设置相应控件的值。

三。使用 LoadPostData 处理回发数据

在页面创建的这个阶段,服务器处理页面上的控件提交的表单数据(称为回发数据)。当页面提交表单时,框架会对每个提交数据的控件执行一个 IPostBackDataHandler 接口操作。页面然后执行 LoadPostData 事件来解析页面以找到每个已执行 IpostBackDataHandler 接口操作的控件,并使用适当的回发数据更新这些控件的状态。它通过将 NameValue 集中的“名称/值”对与每个控件的唯一 ID 匹配来实现这一点。因此,每个控件在页面上必须具有唯一的 ID。不可能有多个控件共享一个 ID。甚至一些用户定义的控制框架也会给他们自己的唯一ID。

四。导入对象

对象在 Load 事件中实例化。首次将所有对象布局在 DOM 页面中(中文称为控制树),可以通过代码或相对位置进行引用。这样,对象就可以很方便的从客户端获取Html中的宽度、高度、值、可见性等属性。当然,设置控件属性等操作发生在Load事件中。这个过程是整个生命周期中最重要的,也是最重要的。您可以通过调用 OnLoad 来重载 Load 事件

五。引发PostBackChanged 事件

如上所述,此事件发生在所有控件都执行了 IPostBackDataHandler 接口操作并使用正确的回发数据更新之后。在这个过程中,每个控件都被分配一个布尔值来标记该控件是否已经被更新。然后只需在整个页面上查找任何已更新的控件并执行 RaisePostDataChanged 事件操作。但是这个事件只有在所有控件都被更新并且Load事件完成之后才会发生。这可确保在回发数据更新另一个控件之前,不会在 RaisePostDataChanged 事件中手动更改一个控件。

六。处理客户端 PostBack 事件

当服务器端回发数据引发的事件完成后,产生回发数据的对象执行RaisePostBackEvent事件操作。但是,在某些情况下,控件状态的更改会导致其将表单返回到服务器,或者用户单击提交按钮会导致表单返回到服务器。在这种情况下,应该有相应的处理代码来体现面向对象(OOP)编程的事件驱动原则。由于呈现给浏览器的数据的准确性要求,RaisePostBackEvent 事件在一系列回发事件中最后发生。

在调用执行函数后不应更新回发期间更改的控件。也就是说,由于预期事件而更改的任何数据都应反映在最终页面上。您可以修改 RaisePostBackEvent 函数以满足您的要求

七。预渲染对象

可以更改对象并保存更改的最后时刻是此步骤 - 预渲染对象。这允许您在此步骤中对控件的属性、控件树结构等进行最终更改。甚至不要考虑对其进行任何更改,因为它不影响数据库调用和视图状态更新。在这一步之后对对象的所有修改最终都会被确定为不保存到页面的视图状态中。您可以使用 OnPreRender 覆盖此步骤。

八。保存视图状态

在对页面控件进行所有修改后保存视图状态。对象的状态数据仍然保存在隐藏控件中,呈现给Html的对象状态数据也是从这里获取的。在 SaveViewState 事件中,它的值可以保存到 viewstate 对象中,但是此时不能修改页面上的控件。您可以使用 SaveViewState 覆盖此步骤

九。渲染为 Html

Render 事件在使用 HTML 创建输出到浏览器的页面时发生。在 Render 事件期间,页面调用其中的对象以将它们呈现为 Html。然后,用户的浏览器可以以 Html 的形式访问该页面。当Render事件重载时,开发者可以编写自定义的Html代码,使原来生成的Html失效,按照新的Html组织页面。Render 方法将 HtmlTextWriter 对象作为参数,并使用它在浏览器上将 Html 显示为网页。此时仍然可以进行一些修改,但它们只是客户端的一些更改。您可以覆盖 Render 事件

十。销毁对象

渲染到 Html 完成后,应销毁所有对象。在 Dispose 事件中,您应该销毁创建页面时创建的所有对象。此时所有处理都已完成,因此销毁任何剩余的对象都不会产生错误,包括页面对象。您可以覆盖 Dispose 事件

全文摘要

这些是页面生命周期中的十个事件。每次我们请求一个页面时,我们都会经历相同的过程:从初始化对象到销毁对象。通过了解页面内部的运行机制,相信大家在编写和调试代码的时候会更加自如。

相关文章 查看全部

从网页抓取数据(想了解页面生命周期详解的相关知识和一些实例欢迎阅读)

想了解页面生命周期详解吗?在本文中,我将讲解页面生命周期的相关知识和一些代码示例。欢迎阅读和指正。我们先把重点放在:生命周期下面一起学习。

是 Microsoft .Net 战略的一个组成部分。与之前的Asp相比,有了很大的发展,引入了很多新的机制。本文将对页面的生命周期进行初步介绍,以指导您更好更灵活的操作。当获取网页的请求(由用户提交或通过超链接提交)被发送到 Web 服务器时,该页面会运行从创建到完成的一系列事件。当我们尝试构建页面时,这个执行周期是没有必要考虑的,只会自找麻烦。但是,如果操作得当,页面的执行周期可以成为一种有效且强大的工具。许多编写页面和用户控件的开发人员发现了解正在发生的事情和时间很有帮助。下面我给大家介绍一下从页面创建到处理完成的十个事件。它还向您展示了如何将自己的代码添加到这些事件中以达到预期的效果。

一。初始化对象

页面的控件(以及页面本身)最初应该被正确初始化。通过在 C# 文件的构造函数中声明所有对象(如 1) 页面所示),了解要创建的对象数量及其类型。一旦你在构造函数中声明了所有对象,你就可以通过继承类、方法、事件或属性来传递访问它们。但是,如果您的某些对象是在 Aspx 文件中指定的某些控件,则这些控件根本没有属性。同时通过代码访问它们会产生一些意想不到的错误,因为这些 Control 实例不是按一定的顺序创建的(如果它们是一起创建的)。您也可以通过 OnInit 覆盖初始化事件。

二。导入 Viewstate 数据

在初始化事件之后,所有控件只能通过它们的 ID 引用来访问(因为还没有相应的 DOM 可以使用)。在 LoadViewState 事件中,所有控件都将获得它们的第一个属性:Viewstate 属性。这个属性最终会返回给服务器来判断页面是已经被用户访问过还是正在被用户访问。Viewstate 属性存储为名称/值对字符串,并收录控件的文本和值等信息。此属性存储在请求页面时传递的隐藏控件的 value 属性中。与Asp3.0 的维护和判断页面状态的方式相比,这种方法有了很大的进步。也可以重载LoadViewState事件函数来设置相应控件的值。

三。使用 LoadPostData 处理回发数据

在页面创建的这个阶段,服务器处理页面上的控件提交的表单数据(称为回发数据)。当页面提交表单时,框架会对每个提交数据的控件执行一个 IPostBackDataHandler 接口操作。页面然后执行 LoadPostData 事件来解析页面以找到每个已执行 IpostBackDataHandler 接口操作的控件,并使用适当的回发数据更新这些控件的状态。它通过将 NameValue 集中的“名称/值”对与每个控件的唯一 ID 匹配来实现这一点。因此,每个控件在页面上必须具有唯一的 ID。不可能有多个控件共享一个 ID。甚至一些用户定义的控制框架也会给他们自己的唯一ID。

四。导入对象

对象在 Load 事件中实例化。首次将所有对象布局在 DOM 页面中(中文称为控制树),可以通过代码或相对位置进行引用。这样,对象就可以很方便的从客户端获取Html中的宽度、高度、值、可见性等属性。当然,设置控件属性等操作发生在Load事件中。这个过程是整个生命周期中最重要的,也是最重要的。您可以通过调用 OnLoad 来重载 Load 事件

五。引发PostBackChanged 事件

如上所述,此事件发生在所有控件都执行了 IPostBackDataHandler 接口操作并使用正确的回发数据更新之后。在这个过程中,每个控件都被分配一个布尔值来标记该控件是否已经被更新。然后只需在整个页面上查找任何已更新的控件并执行 RaisePostDataChanged 事件操作。但是这个事件只有在所有控件都被更新并且Load事件完成之后才会发生。这可确保在回发数据更新另一个控件之前,不会在 RaisePostDataChanged 事件中手动更改一个控件。

六。处理客户端 PostBack 事件

当服务器端回发数据引发的事件完成后,产生回发数据的对象执行RaisePostBackEvent事件操作。但是,在某些情况下,控件状态的更改会导致其将表单返回到服务器,或者用户单击提交按钮会导致表单返回到服务器。在这种情况下,应该有相应的处理代码来体现面向对象(OOP)编程的事件驱动原则。由于呈现给浏览器的数据的准确性要求,RaisePostBackEvent 事件在一系列回发事件中最后发生。

在调用执行函数后不应更新回发期间更改的控件。也就是说,由于预期事件而更改的任何数据都应反映在最终页面上。您可以修改 RaisePostBackEvent 函数以满足您的要求

七。预渲染对象

可以更改对象并保存更改的最后时刻是此步骤 - 预渲染对象。这允许您在此步骤中对控件的属性、控件树结构等进行最终更改。甚至不要考虑对其进行任何更改,因为它不影响数据库调用和视图状态更新。在这一步之后对对象的所有修改最终都会被确定为不保存到页面的视图状态中。您可以使用 OnPreRender 覆盖此步骤。

八。保存视图状态

在对页面控件进行所有修改后保存视图状态。对象的状态数据仍然保存在隐藏控件中,呈现给Html的对象状态数据也是从这里获取的。在 SaveViewState 事件中,它的值可以保存到 viewstate 对象中,但是此时不能修改页面上的控件。您可以使用 SaveViewState 覆盖此步骤

九。渲染为 Html

Render 事件在使用 HTML 创建输出到浏览器的页面时发生。在 Render 事件期间,页面调用其中的对象以将它们呈现为 Html。然后,用户的浏览器可以以 Html 的形式访问该页面。当Render事件重载时,开发者可以编写自定义的Html代码,使原来生成的Html失效,按照新的Html组织页面。Render 方法将 HtmlTextWriter 对象作为参数,并使用它在浏览器上将 Html 显示为网页。此时仍然可以进行一些修改,但它们只是客户端的一些更改。您可以覆盖 Render 事件

十。销毁对象

渲染到 Html 完成后,应销毁所有对象。在 Dispose 事件中,您应该销毁创建页面时创建的所有对象。此时所有处理都已完成,因此销毁任何剩余的对象都不会产生错误,包括页面对象。您可以覆盖 Dispose 事件

全文摘要

这些是页面生命周期中的十个事件。每次我们请求一个页面时,我们都会经历相同的过程:从初始化对象到销毁对象。通过了解页面内部的运行机制,相信大家在编写和调试代码的时候会更加自如。

相关文章

从网页抓取数据(具体数据请求的方法:Dwzb分为如下部分两种查看网页源代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-01-08 12:16

有关如何请求数据的详细信息,请参阅:

ajax动态加载网页抓取

dwzb

统计学学生

25 人点赞文章

AJAX 是一种无需重新加载整个网页即可更新部分网页的技术。

比如打开这个页面,先不要移动,观察右边滚动条的长度,然后当你把滚动条拉到底的时候,滚动条变短了,也就是页面变长了,也就是说,有些数据是这个时候加载的。这个过程是动态加载的,基于ajax技术。我们可以看到,当拉动滚动条时,页面上的数据增加了,但是 URL 并没有改变。它不会像翻页那样将数据存储到另一个网页。现在让我们解释如何爬取这种网页。

本文分为以下几个部分

查看网页源代码的两种方式

首先需要声明的是,在使用浏览器时,两种查看网页源代码的方式是不同的。这里我们使用chrome浏览器来说明。

首先是右键检查,在 element 中查看网页的源代码,这种模式具有折叠和选择的功能,对于我们找到位置抓取信息非常有帮助。这里的源码就是我们面前当前显示的页面对应的源码。

二是右键-查看网页源代码,是网页真正的源代码,请求网页得到的源代码(r.text)与此如出一辙。

大多数情况下,这两个位置显示的源代码完全相同,但有时也存在差异。例如,在当前的动态加载示例中,当我拉下滚轮时,会重新加载新数据。这部分数据会出现在“检查”的源代码中,但不会出现在“查看页面源代码”中。. 后者是这个URL的原创源代码,不会被后面执行的JS程序改变,而“check”中的源代码和当前页面是一样的,是执行了一些JS代码后重新生成的源代码. 代码。

有时会发生两个位置的源代码几乎相同,但在一些小标签属性或某个值上存在差异。在解析网页时,我们经常会根据“check”中的源代码来进行解析。当我们觉得解析代码没有问题,但又找不到什么(或有什么不对)时,可以考虑去“查看网页源代码”。那个页面,是不是有一个小地方的区别。

比如拿一个链家二手房的页面,看这里的“税费”,你先刷新页面观察这个位置,你会发现它会先加载13.8,然后变成 45.@ >

两种方式查看源码都会发现勾选是45,查看页面源码是13.8不变。所以,如果你想爬这个网站,不做任何处理,你会得到13.8,这是链家故意给你的假数据。

言归正传,如果我们要捕获这个网页的数据,如果我们像以前一样只提取r.text来解析网页,我们只能得到一开始加载的数据,如何才能将所有数据捕获到稍后加载这就是我们要在这里讨论的内容。

分析网页请求

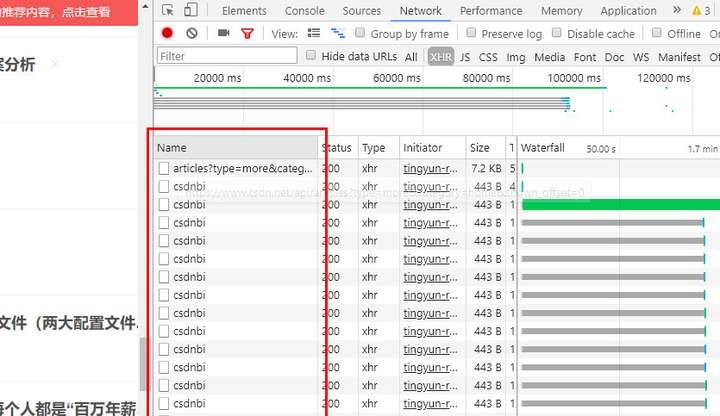

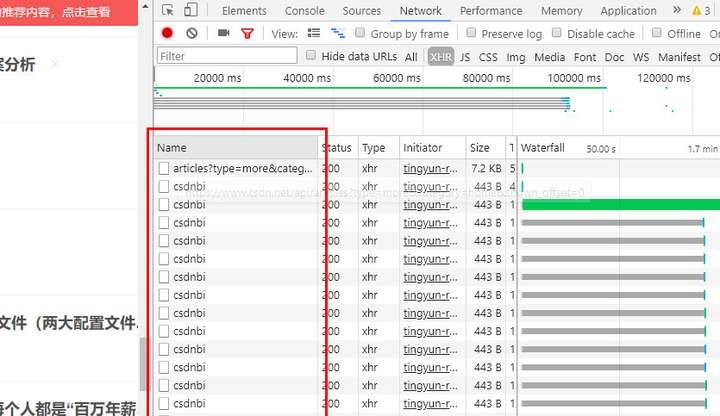

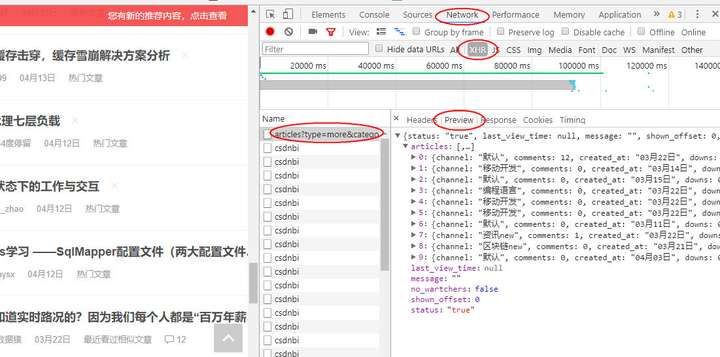

我们在页面中右键--勾选,选择network,选择XHR,将左侧网页的滚动条拖到底部加载新数据,可以看到network中出现了一个新文件

这些是你拖动时浏览器对网页的新请求,加载的数据就是从这个请求中获取的。也就是说,我们可以在这些新加载的文件中找到我们想要的数据。根据经验数据,它存在于第一个URL中。点击这个网址,可以看到如下图(读者可以点击其他网址,会发现其他文件对我们抓取数据没有帮助)

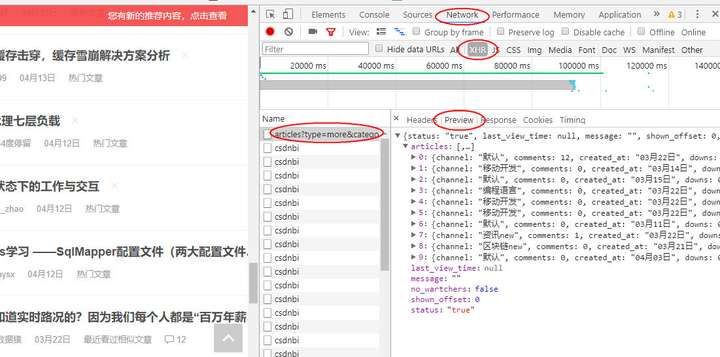

preview 指示此 URL 的内容是什么。从上图可以看出,这是json格式的数据。我们可以展开每一项来看看里面有什么信息。

可以看到我们想要的关于文章的所有信息都在这里了,有些字段没有显示在网页上。对于这部分信息,我们只能根据里面的键值对名称来猜测这个字段是什么。意思是。

接下来我们可以请求这个URL获取数据,在headers中可以查看到URL

从json中提取信息会比解析网页容易很多,所以以后如果遇到爬虫任务,首先检查网页请求中是否有类似的文件。.

一般这种json文件在XHR中很容易找到,但不排除有时需要全部找到这样的文件。

请求的文件通常非常大。没有方向的时候,只能一个一个的点击,但也不麻烦。每个网址都关注预览。json格式的数据就像刚才一样,其实很明显。

接下来,让我们编写代码来抓取数据。

抓取一页数据

现在假设我们只想要文章这个标题,我们只需要在XHR中请求那个URL,然后像字典一样处理得到的内容,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/articles?type=more&category=home&shown_offset=0',

headers = headers)

d = r.json()

articles = d['articles']

for article in articles:

yield article['title']

for i in get_page():

print(i)

其中r.json是将json格式的字符串转换成python对象,这里是转换成字典。(读者可以尝试调用r.text,发现是json字符串,可以用json模块中的json.loads转换成字典对象,但是requests中提供的.json()使用起来更方便)

注意:如果您不使用cookies,您将无法获得主页上显示的数据。因此,即使您没有登录,也可以复制 cookie。

接下来让我们获取所有数据。

页面更新策略

当我们再次拉下页面时,我们会发现加载了一个新的 URL。

看它的headers,惊讶的发现和上一个一模一样,再看它的request header,也差不多,所以我们可以尝试连续两次请求这个页面,看看有没有我们得到不同的数据——真正不同的数据。

所以我们可以设置一个爬取策略:一直访问这个URL,直到获取不到数据为止。

我们连续请求20次,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/articles?type=more&category=home&shown_offset=0',

headers = headers)

d = r.json()

articles = d['articles']

print(len(articles)) # 每次看抓取到了多少信息

for article in articles:

yield article['title']

def get_pages():

for i in range(20):

yield from get_page()

l = list(get_pages())

len(l) # 看总共抓了多少条

这段代码的结果是,在20个请求中,前15次获取到10条数据,后5次没有获取到数据,说明我们只能获取到150条信息。

这时候我们再看浏览器,会发现滚动条不会加载新的数据,刷新网页就会得到这个界面。

这意味着你的爬虫已经用尽了这个cookie,浏览器无法使用这个cookie获取数据,需要一段时间才能发出请求。

其他例子

ajax加载的页面的爬取是类似的,可能只是不同网站每个加载URL的设计不同。让我们再举一些例子

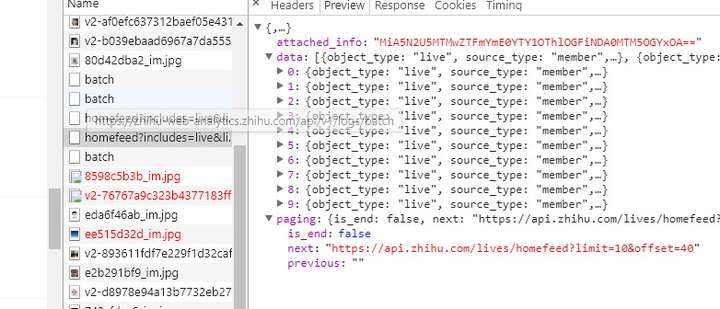

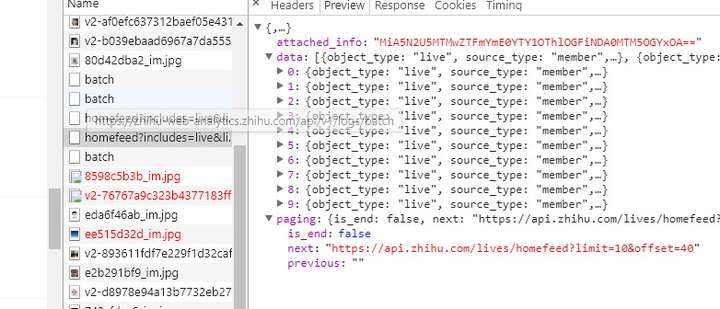

知乎live,它也是用鼠标下拉页面加载新数据,我们会怀疑是ajax加载的。同理可以找到如下文件

可以看到比CSDN多了一个字段分页,显示本页是否为最后一页,下一页的链接是什么。这样我们只需要像上图那样下拉一次就可以得到页面,然后请求页面,获取数据和下一页的url,然后请求下一页,获取数据并获取下一页,并通过判断is_end结束循环。

换句话说,我们可以查看当前 URL 和下一个 URL 之间是否存在模式,并通过构造 URL 进行循环。

如果读者没有尝试过,他可能会怀疑这里的下一页是否真的是下一页的数据。然后可以多次下拉网页,看后面的网址是不是前面的下一个。

知乎live 这种形式的 ajax 加载内容和 URL 设计应该是最常见的。我们可以看到它的URL其实就是知乎的API(看那个URL的域名),也就是我们浏览网页的时候,页面就是请求API得到的数据。API可以理解为一个数据接口,通过请求这个URL就可以得到对应的数据,那么这个URL就是一个接口。本专栏后面会写一篇文章文章来介绍API。

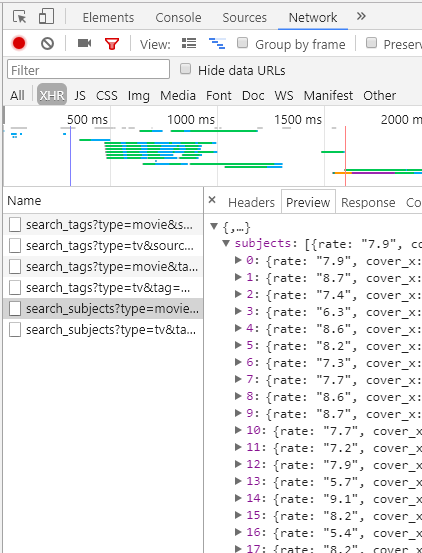

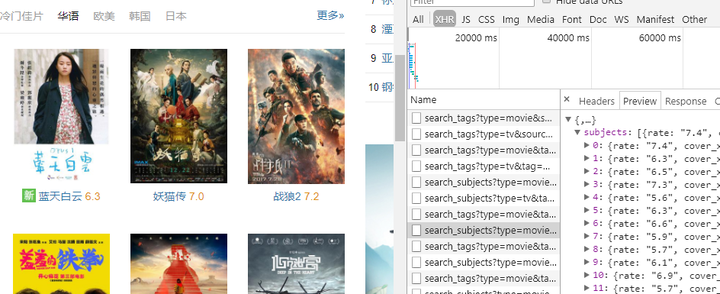

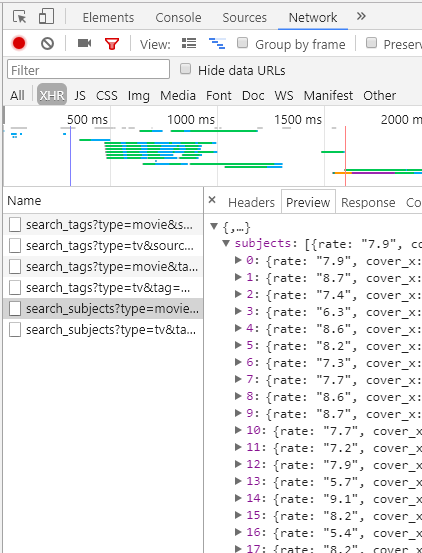

2.豆瓣电影

点击上面的标签:电影、热门、最新、豆瓣高分等。每次点击都会发现浏览器中显示的网址没有变化,包括点击下面的点翻页,网址有没变,也就是说这里的数据可能是用ajax加载的,看下检查网络的XHR

发现数据确实是用ajax加载的,我们只需要请求这个URL就可以获取数据。

这时候我们选择最新和豆瓣高分标签,可以看到XHR中加载了一个新文件,如下图

只要我们分析这些文件的URL的规律性,我们就可以在这个窗口中抓取所有标签的电影数据。 查看全部

从网页抓取数据(具体数据请求的方法:Dwzb分为如下部分两种查看网页源代码)

有关如何请求数据的详细信息,请参阅:

ajax动态加载网页抓取

dwzb

统计学学生

25 人点赞文章

AJAX 是一种无需重新加载整个网页即可更新部分网页的技术。

比如打开这个页面,先不要移动,观察右边滚动条的长度,然后当你把滚动条拉到底的时候,滚动条变短了,也就是页面变长了,也就是说,有些数据是这个时候加载的。这个过程是动态加载的,基于ajax技术。我们可以看到,当拉动滚动条时,页面上的数据增加了,但是 URL 并没有改变。它不会像翻页那样将数据存储到另一个网页。现在让我们解释如何爬取这种网页。

本文分为以下几个部分

查看网页源代码的两种方式

首先需要声明的是,在使用浏览器时,两种查看网页源代码的方式是不同的。这里我们使用chrome浏览器来说明。

首先是右键检查,在 element 中查看网页的源代码,这种模式具有折叠和选择的功能,对于我们找到位置抓取信息非常有帮助。这里的源码就是我们面前当前显示的页面对应的源码。

二是右键-查看网页源代码,是网页真正的源代码,请求网页得到的源代码(r.text)与此如出一辙。

大多数情况下,这两个位置显示的源代码完全相同,但有时也存在差异。例如,在当前的动态加载示例中,当我拉下滚轮时,会重新加载新数据。这部分数据会出现在“检查”的源代码中,但不会出现在“查看页面源代码”中。. 后者是这个URL的原创源代码,不会被后面执行的JS程序改变,而“check”中的源代码和当前页面是一样的,是执行了一些JS代码后重新生成的源代码. 代码。

有时会发生两个位置的源代码几乎相同,但在一些小标签属性或某个值上存在差异。在解析网页时,我们经常会根据“check”中的源代码来进行解析。当我们觉得解析代码没有问题,但又找不到什么(或有什么不对)时,可以考虑去“查看网页源代码”。那个页面,是不是有一个小地方的区别。

比如拿一个链家二手房的页面,看这里的“税费”,你先刷新页面观察这个位置,你会发现它会先加载13.8,然后变成 45.@ >

两种方式查看源码都会发现勾选是45,查看页面源码是13.8不变。所以,如果你想爬这个网站,不做任何处理,你会得到13.8,这是链家故意给你的假数据。

言归正传,如果我们要捕获这个网页的数据,如果我们像以前一样只提取r.text来解析网页,我们只能得到一开始加载的数据,如何才能将所有数据捕获到稍后加载这就是我们要在这里讨论的内容。

分析网页请求

我们在页面中右键--勾选,选择network,选择XHR,将左侧网页的滚动条拖到底部加载新数据,可以看到network中出现了一个新文件

这些是你拖动时浏览器对网页的新请求,加载的数据就是从这个请求中获取的。也就是说,我们可以在这些新加载的文件中找到我们想要的数据。根据经验数据,它存在于第一个URL中。点击这个网址,可以看到如下图(读者可以点击其他网址,会发现其他文件对我们抓取数据没有帮助)

preview 指示此 URL 的内容是什么。从上图可以看出,这是json格式的数据。我们可以展开每一项来看看里面有什么信息。

可以看到我们想要的关于文章的所有信息都在这里了,有些字段没有显示在网页上。对于这部分信息,我们只能根据里面的键值对名称来猜测这个字段是什么。意思是。

接下来我们可以请求这个URL获取数据,在headers中可以查看到URL

从json中提取信息会比解析网页容易很多,所以以后如果遇到爬虫任务,首先检查网页请求中是否有类似的文件。.

一般这种json文件在XHR中很容易找到,但不排除有时需要全部找到这样的文件。

请求的文件通常非常大。没有方向的时候,只能一个一个的点击,但也不麻烦。每个网址都关注预览。json格式的数据就像刚才一样,其实很明显。

接下来,让我们编写代码来抓取数据。

抓取一页数据

现在假设我们只想要文章这个标题,我们只需要在XHR中请求那个URL,然后像字典一样处理得到的内容,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/articles?type=more&category=home&shown_offset=0',

headers = headers)

d = r.json()

articles = d['articles']

for article in articles:

yield article['title']

for i in get_page():

print(i)

其中r.json是将json格式的字符串转换成python对象,这里是转换成字典。(读者可以尝试调用r.text,发现是json字符串,可以用json模块中的json.loads转换成字典对象,但是requests中提供的.json()使用起来更方便)

注意:如果您不使用cookies,您将无法获得主页上显示的数据。因此,即使您没有登录,也可以复制 cookie。

接下来让我们获取所有数据。

页面更新策略

当我们再次拉下页面时,我们会发现加载了一个新的 URL。

看它的headers,惊讶的发现和上一个一模一样,再看它的request header,也差不多,所以我们可以尝试连续两次请求这个页面,看看有没有我们得到不同的数据——真正不同的数据。

所以我们可以设置一个爬取策略:一直访问这个URL,直到获取不到数据为止。

我们连续请求20次,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/articles?type=more&category=home&shown_offset=0',

headers = headers)

d = r.json()

articles = d['articles']

print(len(articles)) # 每次看抓取到了多少信息

for article in articles:

yield article['title']

def get_pages():

for i in range(20):

yield from get_page()

l = list(get_pages())

len(l) # 看总共抓了多少条

这段代码的结果是,在20个请求中,前15次获取到10条数据,后5次没有获取到数据,说明我们只能获取到150条信息。

这时候我们再看浏览器,会发现滚动条不会加载新的数据,刷新网页就会得到这个界面。

这意味着你的爬虫已经用尽了这个cookie,浏览器无法使用这个cookie获取数据,需要一段时间才能发出请求。

其他例子

ajax加载的页面的爬取是类似的,可能只是不同网站每个加载URL的设计不同。让我们再举一些例子

知乎live,它也是用鼠标下拉页面加载新数据,我们会怀疑是ajax加载的。同理可以找到如下文件

可以看到比CSDN多了一个字段分页,显示本页是否为最后一页,下一页的链接是什么。这样我们只需要像上图那样下拉一次就可以得到页面,然后请求页面,获取数据和下一页的url,然后请求下一页,获取数据并获取下一页,并通过判断is_end结束循环。

换句话说,我们可以查看当前 URL 和下一个 URL 之间是否存在模式,并通过构造 URL 进行循环。

如果读者没有尝试过,他可能会怀疑这里的下一页是否真的是下一页的数据。然后可以多次下拉网页,看后面的网址是不是前面的下一个。

知乎live 这种形式的 ajax 加载内容和 URL 设计应该是最常见的。我们可以看到它的URL其实就是知乎的API(看那个URL的域名),也就是我们浏览网页的时候,页面就是请求API得到的数据。API可以理解为一个数据接口,通过请求这个URL就可以得到对应的数据,那么这个URL就是一个接口。本专栏后面会写一篇文章文章来介绍API。

2.豆瓣电影

点击上面的标签:电影、热门、最新、豆瓣高分等。每次点击都会发现浏览器中显示的网址没有变化,包括点击下面的点翻页,网址有没变,也就是说这里的数据可能是用ajax加载的,看下检查网络的XHR

发现数据确实是用ajax加载的,我们只需要请求这个URL就可以获取数据。

这时候我们选择最新和豆瓣高分标签,可以看到XHR中加载了一个新文件,如下图

只要我们分析这些文件的URL的规律性,我们就可以在这个窗口中抓取所有标签的电影数据。

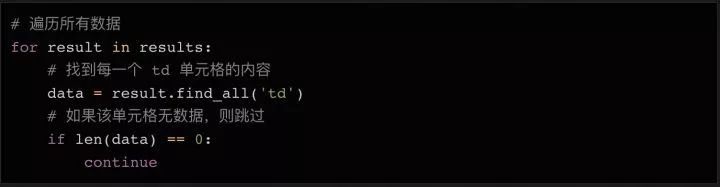

从网页抓取数据( soup:如何用一些有用的数据抓取一个网页数据?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-01-08 12:09

soup:如何用一些有用的数据抓取一个网页数据?)

作者 | 托比·奥拉博德

翻译 | 三菩提

规划 | 凌敏

不久前,我在LearnML 子论坛上看到了一个帖子。楼主在这篇文章中提到,他的机器学习项目需要抓取网络数据。很多人在回复中给出了自己的方法,主要是学习BeautifulSoup和Selenium的使用方法。

我在一些数据科学项目中使用了 BeautifulSoup 和 Selenium。在本文中,我将向您展示如何使用一些有用的数据抓取网页并将其转换为 pandas 数据结构(DataFrame)。

为什么要将其转换为数据结构?这是因为大多数机器学习库都可以处理 pandas 数据结构并以最少的修改来编辑您的模型。

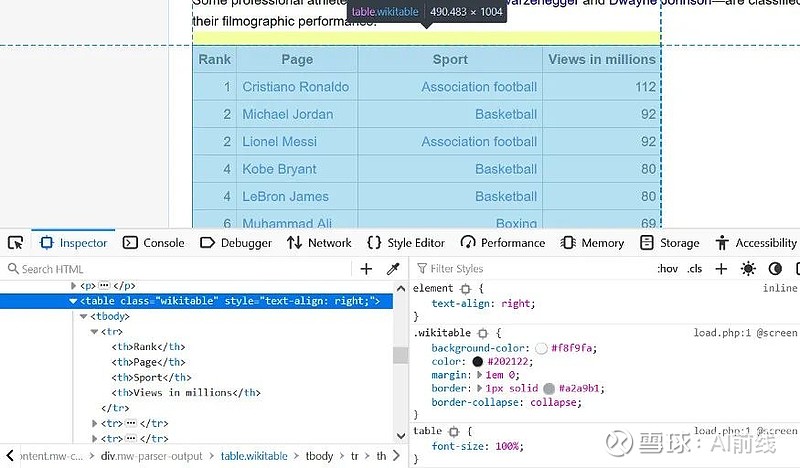

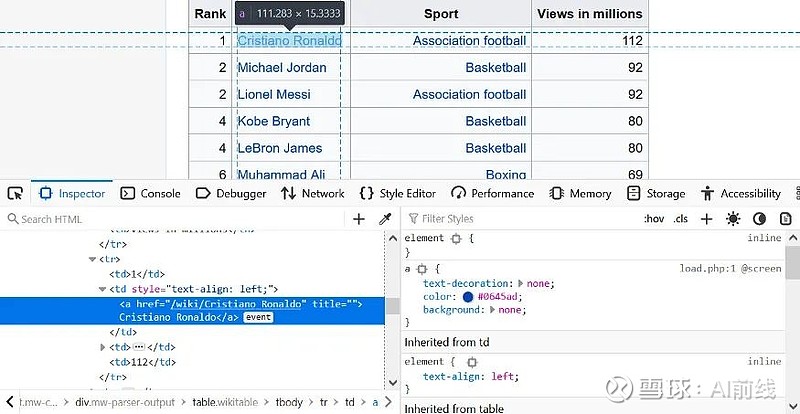

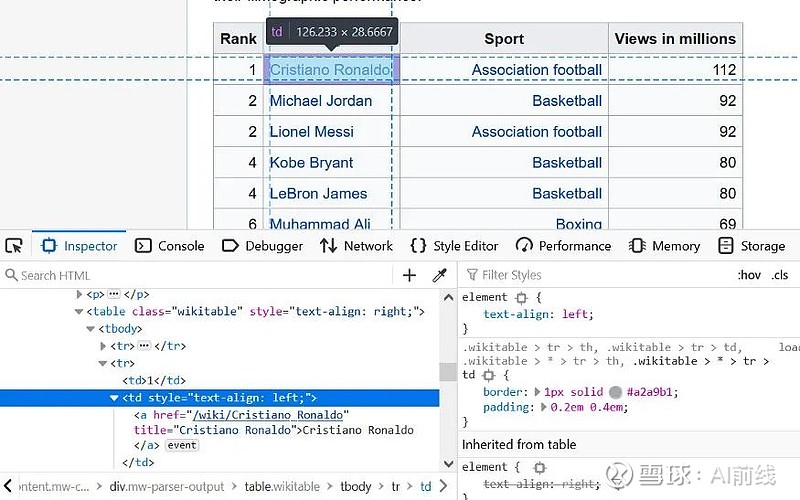

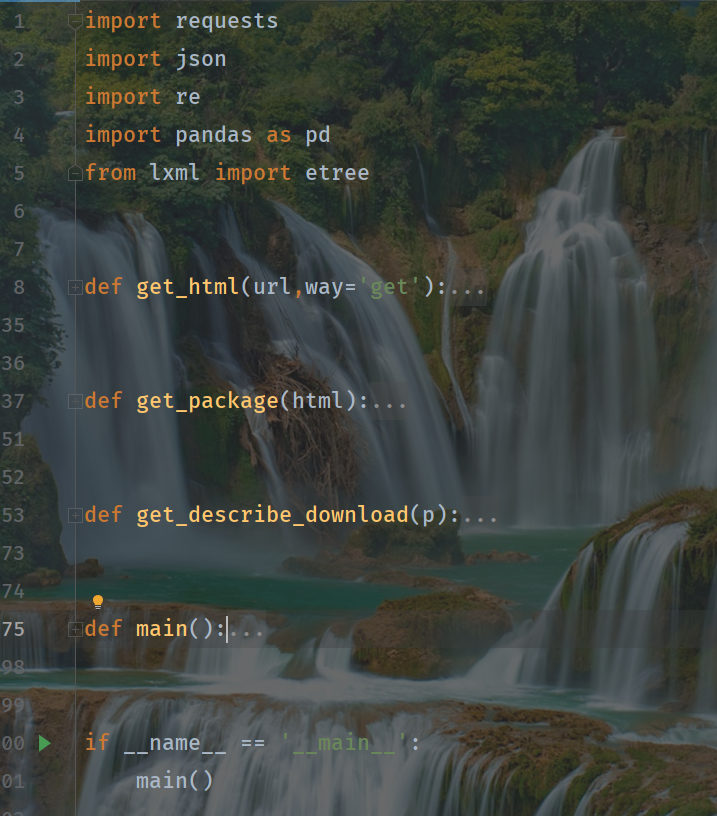

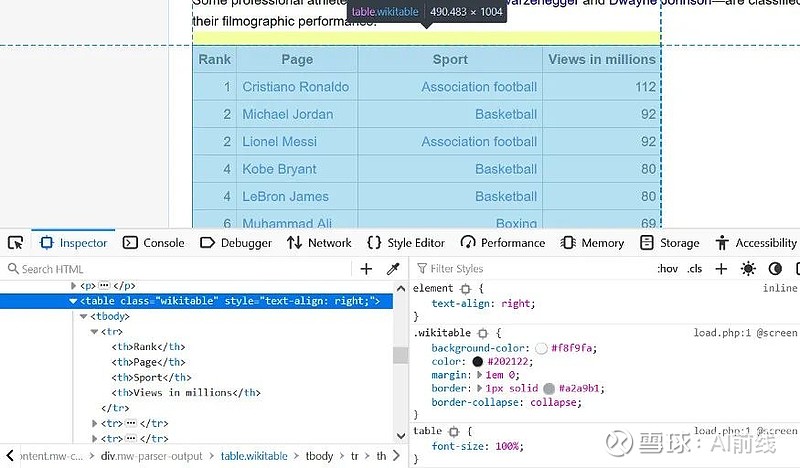

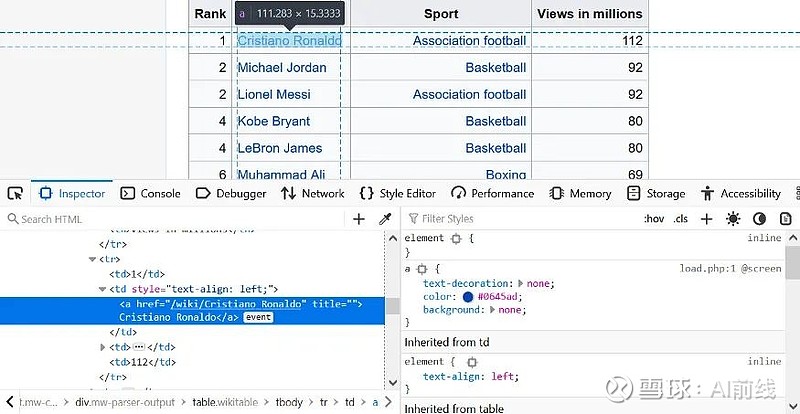

首先,我们将在 Wikipedia 上找到一个表以转换为数据结构。我抓取的这张表显示了维基百科上浏览次数最多的运动员数据。

很多工作都是通过 HTML 树来获取我们需要的表格。

通过 request 和 regex 库,我们开始使用 BeautifulSoup。

从 bs4 导入 BeautifulSoup

导入请求

进口重新

将熊猫导入为 pd

接下来,我们将从网页中提取 HTML 代码:

website_url = requests.get(').text

汤 = BeautifulSoup(website_url, 'lxml')

打印(汤。美化())

免责声明

联系维基百科

从语料库中采集所有表格,我们有一个小的表面积要搜索。

wiki_tables = soup.find_all('table', class_='wikitable')

wiki_tables

因为有很多表,所以需要一种过滤它们的方法。

据我们所知,克里斯蒂亚诺·罗纳尔多(又名葡萄牙足球运动员克里斯蒂亚诺·罗纳尔多)有一个锚标签,这在几张桌子中可能是独一无二的。

使用 Cristiano Ronaldo 文本,我们可以过滤那些由锚点标记的表格。此外,我们还发现了一些收录此锚标记的父元素。

链接= []

对于 wiki_tables 中的表:

_table = table.find('a', string=pile('Cristiano Ronaldo'))

如果不是_table:

继续

打印(_table)

_parent = _table.parent

打印(_父)

links.append(_parent)

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

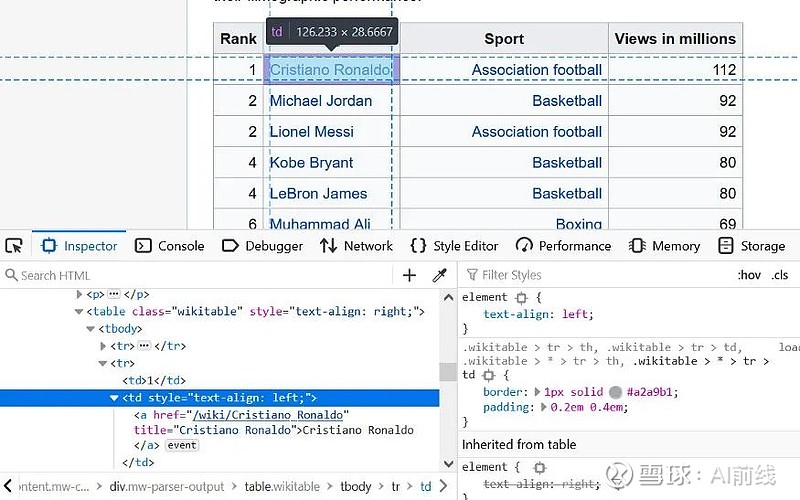

父元素仅显示单元格。

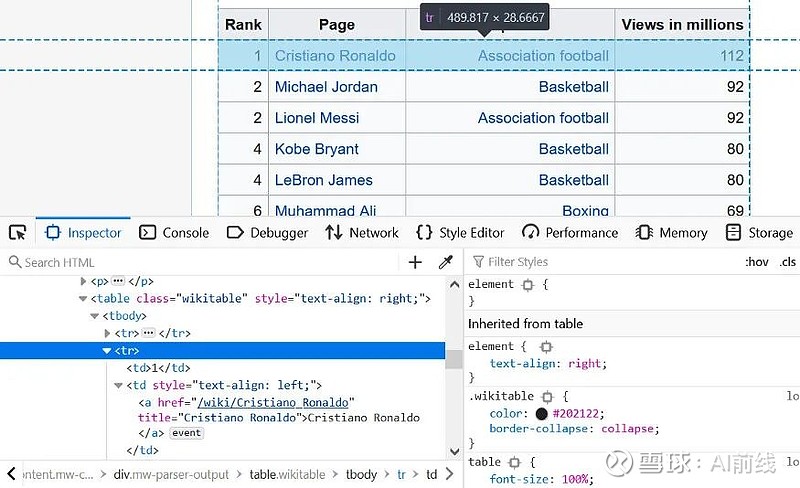

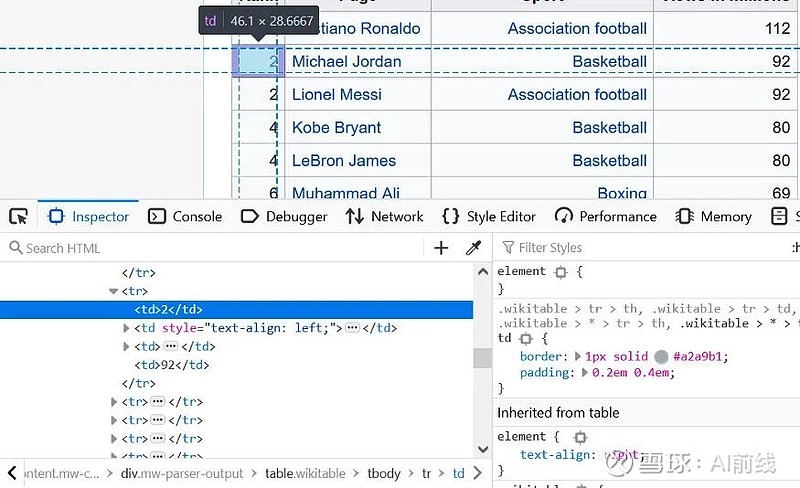

这是一个带有浏览器 Web 开发工具的单元。

parent_lst = []

对于链接中的锚点:

_ = anchor.find_parents('tbody')

打印(_)

parent_lst.append(_)

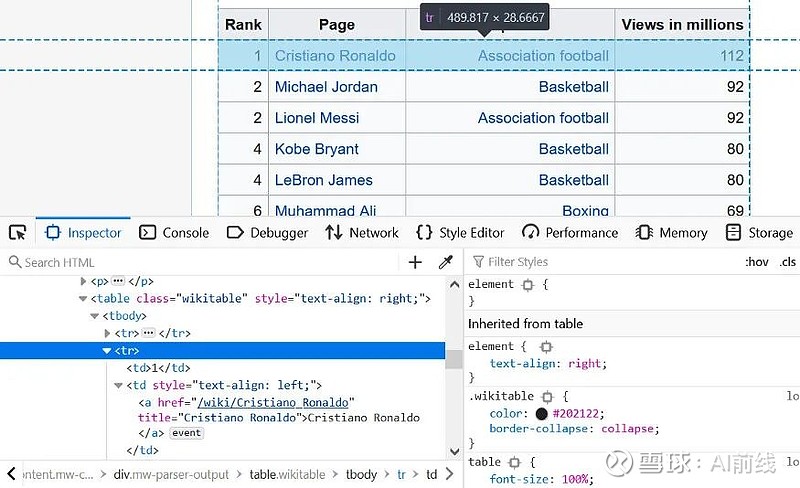

使用 tbody,我们可以返回收录先前锚标记的其他表。

为了进一步过滤,我们可以在下表中的不同标题下进行搜索:

对于 parent_lst 中的 i:

打印(i[0].find('tr'))

tr>

秩*

页

百万浏览量

秩

页

百万浏览量

秩

页

运动

百万浏览量

第三个看起来很像我们需要的表格。

接下来,我们开始创建必要的逻辑来提取和清理我们需要的细节。

sports_table = parent_lst[2]

完成行 = []

对于我在 sports_table 中:

行 = i.find_all('tr')

print('\n--------行--------\n')

打印(行)

对于行中的行:

细胞 = row.find_all('td')

print('\n--------细胞--------\n')

打印(单元格)

如果不是细胞:

继续

rank = cells[0].text.strip('\n')

page_name = 单元格[1].find('a').text

运动 = 细胞[2].find('a').text

视图 = 单元格[3].text.strip('\n')

print('\n--------干净--------\n')

打印(排名)

打印(页面名称)

打印(运动)

打印(视图)

complete_row.append([排名,页面名称,运动,视图])

对于我在 complete_row:

打印(一)

分解它:

sports_table = parent_lst[2]

完成行 = []

接下来,我们从上面的列表中选择第三个元素。这是我们需要的表。

接下来创建一个空列表来存储每一行的详细信息。遍历表时,设置一个循环来遍历表中的每一行并将其保存到 rows 变量。

对于我在 sports_table 中:

行 = i.find_all('tr')

print('\n--------行--------\n')

打印(行)

对于行中的行:

细胞 = row.find_all('td')

print('\n--------细胞--------\n')

打印(单元格)

创建嵌套循环。遍历前一个循环中保存的每一行。在遍历这些单元格时,我们将每个单元格保存在一个新变量中。

如果不是细胞:

继续

这段简短的代码让我们在从单元格中提取文本时避免出现空单元格并防止错误。

rank = cells[0].text.strip('\n')

page_name = 单元格[1].find('a').text

运动 = 细胞[2].find('a').text

视图 = 单元格[3].text.strip('\n')

在这里,我们将各种单元格清理为纯文本。清除的值保存在其列名下的变量中。

print('\n--------干净--------\n')

打印(排名)

打印(页面名称)

打印(运动)

打印(视图)

complete_row.append([排名,页面名称,运动,视图])

在这里,我们将这些值添加到行列表中。然后输出清理后的值。

- - - -细胞 - - - -

[13

, 康纳·麦格雷戈

, 混合武术

, 43

]

- - - -干净的 - - - -

13

康纳麦格雷戈

混合武术

43

以下将其转换为数据结构:

headers = ['Rank', 'Name', 'Sport', 'Views Mil']

df = pd.DataFrame(complete_row, columns=headers)

df

现在,您拥有可以在机器学习项目中使用的 pandas 数据结构。您可以使用自己喜欢的库来拟合模型数据。

关于作者:

Tobi Olabode 对技术感兴趣,目前专注于机器学习。

原文链接:

网页链接

你也在“看”吗? 查看全部

从网页抓取数据(

soup:如何用一些有用的数据抓取一个网页数据?)

作者 | 托比·奥拉博德

翻译 | 三菩提

规划 | 凌敏

不久前,我在LearnML 子论坛上看到了一个帖子。楼主在这篇文章中提到,他的机器学习项目需要抓取网络数据。很多人在回复中给出了自己的方法,主要是学习BeautifulSoup和Selenium的使用方法。

我在一些数据科学项目中使用了 BeautifulSoup 和 Selenium。在本文中,我将向您展示如何使用一些有用的数据抓取网页并将其转换为 pandas 数据结构(DataFrame)。

为什么要将其转换为数据结构?这是因为大多数机器学习库都可以处理 pandas 数据结构并以最少的修改来编辑您的模型。

首先,我们将在 Wikipedia 上找到一个表以转换为数据结构。我抓取的这张表显示了维基百科上浏览次数最多的运动员数据。

很多工作都是通过 HTML 树来获取我们需要的表格。

通过 request 和 regex 库,我们开始使用 BeautifulSoup。

从 bs4 导入 BeautifulSoup

导入请求

进口重新

将熊猫导入为 pd

接下来,我们将从网页中提取 HTML 代码:

website_url = requests.get(').text

汤 = BeautifulSoup(website_url, 'lxml')

打印(汤。美化())

免责声明

联系维基百科

从语料库中采集所有表格,我们有一个小的表面积要搜索。

wiki_tables = soup.find_all('table', class_='wikitable')

wiki_tables

因为有很多表,所以需要一种过滤它们的方法。

据我们所知,克里斯蒂亚诺·罗纳尔多(又名葡萄牙足球运动员克里斯蒂亚诺·罗纳尔多)有一个锚标签,这在几张桌子中可能是独一无二的。

使用 Cristiano Ronaldo 文本,我们可以过滤那些由锚点标记的表格。此外,我们还发现了一些收录此锚标记的父元素。

链接= []

对于 wiki_tables 中的表:

_table = table.find('a', string=pile('Cristiano Ronaldo'))

如果不是_table:

继续

打印(_table)

_parent = _table.parent

打印(_父)

links.append(_parent)

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

克里斯蒂亚诺·罗纳尔多

父元素仅显示单元格。

这是一个带有浏览器 Web 开发工具的单元。

parent_lst = []

对于链接中的锚点:

_ = anchor.find_parents('tbody')

打印(_)

parent_lst.append(_)

使用 tbody,我们可以返回收录先前锚标记的其他表。

为了进一步过滤,我们可以在下表中的不同标题下进行搜索:

对于 parent_lst 中的 i:

打印(i[0].find('tr'))

tr>

秩*

页

百万浏览量

秩

页

百万浏览量

秩

页

运动

百万浏览量

第三个看起来很像我们需要的表格。

接下来,我们开始创建必要的逻辑来提取和清理我们需要的细节。

sports_table = parent_lst[2]

完成行 = []

对于我在 sports_table 中:

行 = i.find_all('tr')

print('\n--------行--------\n')

打印(行)

对于行中的行:

细胞 = row.find_all('td')

print('\n--------细胞--------\n')

打印(单元格)

如果不是细胞:

继续

rank = cells[0].text.strip('\n')

page_name = 单元格[1].find('a').text

运动 = 细胞[2].find('a').text

视图 = 单元格[3].text.strip('\n')

print('\n--------干净--------\n')

打印(排名)

打印(页面名称)

打印(运动)

打印(视图)

complete_row.append([排名,页面名称,运动,视图])

对于我在 complete_row:

打印(一)

分解它:

sports_table = parent_lst[2]

完成行 = []

接下来,我们从上面的列表中选择第三个元素。这是我们需要的表。

接下来创建一个空列表来存储每一行的详细信息。遍历表时,设置一个循环来遍历表中的每一行并将其保存到 rows 变量。

对于我在 sports_table 中:

行 = i.find_all('tr')

print('\n--------行--------\n')

打印(行)

对于行中的行:

细胞 = row.find_all('td')

print('\n--------细胞--------\n')

打印(单元格)

创建嵌套循环。遍历前一个循环中保存的每一行。在遍历这些单元格时,我们将每个单元格保存在一个新变量中。

如果不是细胞:

继续

这段简短的代码让我们在从单元格中提取文本时避免出现空单元格并防止错误。

rank = cells[0].text.strip('\n')

page_name = 单元格[1].find('a').text

运动 = 细胞[2].find('a').text

视图 = 单元格[3].text.strip('\n')

在这里,我们将各种单元格清理为纯文本。清除的值保存在其列名下的变量中。

print('\n--------干净--------\n')

打印(排名)

打印(页面名称)

打印(运动)

打印(视图)

complete_row.append([排名,页面名称,运动,视图])

在这里,我们将这些值添加到行列表中。然后输出清理后的值。

- - - -细胞 - - - -

[13

, 康纳·麦格雷戈

, 混合武术

, 43

]

- - - -干净的 - - - -

13

康纳麦格雷戈

混合武术

43

以下将其转换为数据结构:

headers = ['Rank', 'Name', 'Sport', 'Views Mil']

df = pd.DataFrame(complete_row, columns=headers)

df

现在,您拥有可以在机器学习项目中使用的 pandas 数据结构。您可以使用自己喜欢的库来拟合模型数据。

关于作者:

Tobi Olabode 对技术感兴趣,目前专注于机器学习。

原文链接:

网页链接

你也在“看”吗?

从网页抓取数据( 捕获异常时应的异常写法:捕获父类的父类异常)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-01-08 07:08

捕获异常时应的异常写法:捕获父类的父类异常)

from urllib import request,error

try:

#此处访问了一个不存在的网页

response = request.urlopen('https://cuiqingcai.com/indea.html')

except error.HTTPError as e:

print(e.reason)

print(e.code)

print(e.headers)

2)因为URLError类是HTTPError的父类,所以在捕获异常的时候,应该选择先捕获子类的异常,再捕获父类的异常。它是这样写的:

from urllib import request,error

try:

response = request.urlopen('https://cuiqingcai.com/indea.html')

#先捕获子类异常

except error.HTTPError as e:

print(e.reason)

print(e.code)

print(e.headers)

#后捕获父类异常

except error.URLError as e:

print(e.reason)

#用else来处理正常的逻辑

else:

print("Request Successfully")

上面的案例是一个很好的异常处理格式。

3)有时,reason 属性返回的不一定是字符串,而是对象。

import socket

import urllib.request

import urllib.error

try:

response = urllib.request.urlopen('https://www.baidu.com',timeout=0.01)

except urllib.error.URLError as e:

print(type(e.reason))

if isinstance(e.reason,socket.timeout):

print('Time Out')

设置超时时间0.01秒,强制抛出超时异常。从运行结果可以看出,reason属性的类型是socket.timeout类,所以可以使用isinstance()方法判断其类型,进行更细致的针对性处理。

解析模块

urllib 库中的 parse 模块定义了处理 URL 的标准接口,例如提取、合并和链接 URL 的各个部分。支持以下协议的URL处理:file、ftp、gopher、hdl、http、https、imap、mailto、mms、news、prospero、rsync、rtsp、rtspu、sftp、sip、sips、snews、svn、svn+shh ,远程登录,wais。

1. urlparse()

urlparse() 方法可以实现 URL 的识别和分割。API使用如下:

urllib.parse.urlparse(urlstring,scheme='',allow_fragments=True)

其中,urlstring参数为必填项,其余可选。

urlparse()方法的返回结果是一个ParseResult类型的对象,它收录6部分,分别是scheme(协议)、netloc(域名)、path(访问路径)、params(参数)、query(查询条件,一般使用 GET 类型的 URL),片段(锚点)。通用 URL 将由这 6 个部分组成。

1)urlparse() 方法的基本用法,用于解析 URL。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... %2339;)

print(type(result))

print(result)

2)如果指定了scheme参数并且URL中不收录scheme参数,解析时会使用scheme参数指定的协议。

from urllib.parse import urlparse

result = urlparse('www.baidu.com/index.html;user?id=5#comment',scheme='http')

print(result)

由于URL中不收录scheme,而协议是通过scheme参数指定的,从运行结果可以看出解析时使用的是scheme指定的协议,但是由于URL中没有指定scheme,解析的 netloc 为空。

3) 如果URL中收录scheme,同时指定了scheme参数,解析时默认使用URL中的scheme。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... 39%3B,scheme='https')

print(result)

从运行结果可以看出,URL中的scheme是用来解析的。

4)如果 allow_fragments 为 False,则 URL 中收录的片段将被解析为路径、参数或查询的一部分。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... 39%3B,allow_fragments=False)

print(result)

可以看出,fragment被解析为query的一部分,fragment为空。如果 URL 不收录参数和查询:

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... 39%3B,allow_fragments=False)

print(result)

可以看出,当URL不收录params和query时,fragment被解析为路径的一部分,fragment为空。

5)urlparse()的返回结果ParseResult实际上是一个元组,可以通过索引顺序或者属性名来获取。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.html#comment',allow_fragments=False)

#打印:http http www.baidu.com www.baidu.com

print(result.scheme,result[0],result.netloc,result[1])

2. urlunparse()

urlparse() 的相反方法是 urlunparse(),用于构造 URL。接收到的参数是一个可迭代的对象(如列表、元组等),长度必须为6,否则会抛出参数数量不足或过多的问题。

from urllib.parse import urlunparse

data = ['http','www.baidu.com','index.html','user','a=6','comment']

#打印:http://www.baidu.com/index.html;user?a=6#comment

print(urlunparse(data));

3. urlsplit( )

urlsplit()方法和urlparse()方法类似,只是urlsplit()方法不单独解析params部分,而是解析成path部分。

from urllib.parse import urlsplit

result = urlsplit('http://www.baidu.com/index.htm ... %2339;)

#打印:SplitResult(scheme='http', netloc='www.baidu.com', path='/index.html;user', query='id=5', fragment='comment')

print(result)

它返回一个SplitResult类型的对象,它实际上是一个元组类型,所以你可以使用属性来获取值,也可以使用索引来获取它。

from urllib.parse import urlsplit

result = urlsplit('http://www.baidu.com/index.htm ... %2339;)

#打印:http

print(result.scheme)

#打印:http

print(result[0])

4. urlunsplit()

urlsplit() 的相反方法是 urlunsplit(),它用于构造 URL。接收到的参数是一个可迭代对象(如列表、元组等),长度必须为5,否则会抛出参数数量不足或过多的问题。

from urllib.parse import urlunsplit

data = ['http','www.baidu.com','index.html','a=6','comment']

#打印:http://www.baidu.com/index.html?a=6#comment

print(urlunsplit(data))

5. urljoin( )

除了使用 urlunparse( ) 和 urlunsplit( ) 方法构造 URL 之外,您还可以使用 urljoin( ) 方法构造 URL。使用urljoin()方法时,提供一个base_url(base URL)作为第一个参数,新的URL作为第二个参数,该方法会分析base_url中的scheme、netloc和path这三个内容URL的缺失部分补充,最后补充后的网址。

from urllib.parse import urljoin

print(urljoin('http://www.baidu.com','FAQ.html'))

print(urljoin('http://www.baidu.com','https://cuiqingcai.com/FAQ.html'))

print(urljoin('http://www.baidu.com/about.html','https://cuiqingcai.com/FAQ.html'))

print(urljoin('http://www.baidu.com/about.html','https://cuiqingcai.com/FAQ.html?question=2'))

print(urljoin('http://www.baidu.com/about.html','https://cuiqingcai.com/index.php'))

print(urljoin('http://www.baidu.com','?category=2#comment'))

print(urljoin('www.baidu.com','?category=2#comment'))

print(urljoin('www.baidu.com#comment','?category=2'))

可以发现base_url提供了三种内容scheme,netloc和path。如果新网址中不存在这三项,则进行补充;如果它们已经存在于新 URL 中,它们将不会被替换。base_url 中的参数、查询和片段不起作用。

6. urlcode( )

urlencode() 方法在构造请求参数时使用。

1)在GET请求方法中构造请求参数。

from urllib.parse import urlencode

params = {

'name':'germey',

'age':22

}

base_url = 'http://www.baidu.com?'

url = base_url+urlencode(params)

#打印:http://www.baidu.com?name=germey&age=22

print(url)

2)在POST请求方法中构造请求参数。

import urllib.request

from urllib.parse import urlencode

params = {

'name':'germey',

'age':22

}

data = bytes(urlencode(params),encoding='utf-8')

response = urllib.request.urlopen('http://httpbin.org/post',data=data)

print(response.read())

7. parse_qs( )

parse_qs() 方法可以将表示参数的字符串转换回字典。

from urllib.parse import parse_qs

query = 'name=germey&age=22'

#打印:{'name': ['germey'], 'age': ['22']}

print(parse_qs(query))

8. parse_qsl( )

类似于 parse_qs() 方法,它将表示参数的字符串转换为元组列表。

from urllib.parse import parse_qsl

query = 'name=germey&age=22'

#打印:[('name', 'germey'), ('age', '22')]

print(parse_qsl(query))

返回的结果是一个列表,列表中的每个元素都是一个元组,元组的第一个内容是参数名,第二个内容是参数值。

9. 引用()

quote() 方法可以将内容转换为 URL 编码格式。URL中有中文参数时,会造成乱码。在这种情况下,您可以使用 quote() 方法将其转换为 URL 编码。

from urllib.parse import quote

keyword = '你好'

url = 'https://www.baidu.com/s?wd='+quote(keyword)

#打印:https://www.baidu.com/s?wd=%E4%BD%A0%E5%A5%BD

print(url)

10. 取消引用()

unquote() 对应于 quote() 方法,可以解码 URL 编码的字符串。

from urllib.parse import unquote

url = 'https://www.baidu.com/s%3Fwd%3 ... 39%3B

#打印:https://www.baidu.com/s?wd=你好

print(unquote(url))

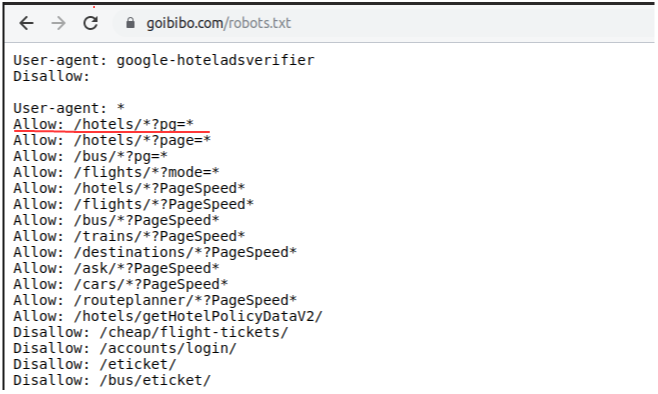

机器人解析器模块

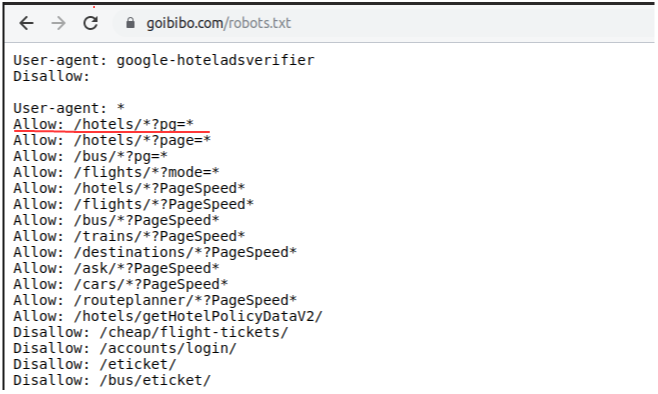

使用urllib库中的robotparser模块,可以实现对网站Robots协议的解析。

1. 机器人协议

Robots 协议也称为爬虫协议和机器人协议。它的全称是Robots Exclusion Protocol,用来告诉爬虫和搜索引擎哪些页面可以爬取,哪些页面不能爬取。它通常是一个名为 robots.txt 的文本文件,通常放在 网站 的根目录下。搜索爬虫访问站点时,首先会检查站点根目录下是否存在robots.txt文件。如果存在,则搜索爬虫将根据其中定义的爬取范围进行爬取;如果没有找到该文件,搜索爬虫将访问所有可直接访问的页面。

1)robots.txt 文件示例 1、所有爬虫都不能爬取任何页面,但是公共目录可以爬取。

User-agent:*

Disallow:/

Allow:/public/

2)robots.txt 文件示例 2. 禁止爬虫爬取任何目录。

User-agent:*

Disallow:/

3)robots.txt 文件示例 3. 允许爬虫爬取任何页面。

User-agent:*

Disallow:

4)robots.txt 文件示例。只允许名为 WebCrawler 的爬虫爬取任何页面,不允许其他爬虫爬取任何页面。

User-agent:WebCrawler

Disallow:

User-agent:*

Disallow:/

2. 爬虫名称

爬虫有名字,常用的搜索爬虫名字和对应的网站。

爬虫名称属于网站

百度蜘蛛

百度

谷歌机器人

谷歌

360蜘蛛

360搜索

游道机器人

有道

ia_archiver

亚历克萨

小型摩托车

阿尔塔维斯塔

3. 使用机器人解析模块

robotsparse模块提供了一个RobotFileParser类,可以根据网站的robots.txt文件判断爬虫是否有权限爬取这个网页。这个类使用简单,在构造函数中传入robots.txt的链接即可。

urllib.robotparser.RobotFileParser(url='')

url 参数是可选的。如果构造时没有传入url,也可以通过set_url()方法设置。RobotFileParser类的常用方法如下:

1)判断简书的某些网页是否可以爬取。

from urllib.robotparser import RobotFileParser

rp = RobotFileParser()

#设置robots.txt文件的路径

rp.set_url('https://www.jianshu.com/')

#执行读取分析操作

rp.read()

#判断是否可爬

print(rp.can_fetch('*','https://www.jianshu.com/p/b67554025d7d'))

print(rp.can_fetch('*','https://www.jianshu.com/search ... %2339;))

2)使用 parse() 方法执行读取和解析操作。

from urllib.robotparser import RobotFileParser

from urllib.request import urlopen

rp = RobotFileParser()

#通过urlopen()直接打开百度的robots.txt文件并交给RobotFileParser进行分析

rp.parse(urlopen('https://www.baidu.com/robots.txt').read().decode('utf-8').split('\n'))

#判断是否可爬

print(rp.can_fetch('*','https://www.baidu.com/p/b67554025d7d'))

print(rp.can_fetch('*','https://www.baidu/search%3Fq%3 ... %2339;))

有时,判断是否可以爬取时返回False,或者爬虫运行时出现403拒绝服务。发送请求时,在请求头中设置 User-Agent 和 Host 可能会返回 True。 查看全部

从网页抓取数据(

捕获异常时应的异常写法:捕获父类的父类异常)

from urllib import request,error

try:

#此处访问了一个不存在的网页

response = request.urlopen('https://cuiqingcai.com/indea.html')

except error.HTTPError as e:

print(e.reason)

print(e.code)

print(e.headers)

2)因为URLError类是HTTPError的父类,所以在捕获异常的时候,应该选择先捕获子类的异常,再捕获父类的异常。它是这样写的:

from urllib import request,error

try:

response = request.urlopen('https://cuiqingcai.com/indea.html')

#先捕获子类异常

except error.HTTPError as e:

print(e.reason)

print(e.code)

print(e.headers)

#后捕获父类异常

except error.URLError as e:

print(e.reason)

#用else来处理正常的逻辑

else:

print("Request Successfully")

上面的案例是一个很好的异常处理格式。

3)有时,reason 属性返回的不一定是字符串,而是对象。

import socket

import urllib.request

import urllib.error

try:

response = urllib.request.urlopen('https://www.baidu.com',timeout=0.01)

except urllib.error.URLError as e:

print(type(e.reason))

if isinstance(e.reason,socket.timeout):

print('Time Out')

设置超时时间0.01秒,强制抛出超时异常。从运行结果可以看出,reason属性的类型是socket.timeout类,所以可以使用isinstance()方法判断其类型,进行更细致的针对性处理。

解析模块

urllib 库中的 parse 模块定义了处理 URL 的标准接口,例如提取、合并和链接 URL 的各个部分。支持以下协议的URL处理:file、ftp、gopher、hdl、http、https、imap、mailto、mms、news、prospero、rsync、rtsp、rtspu、sftp、sip、sips、snews、svn、svn+shh ,远程登录,wais。

1. urlparse()

urlparse() 方法可以实现 URL 的识别和分割。API使用如下:

urllib.parse.urlparse(urlstring,scheme='',allow_fragments=True)

其中,urlstring参数为必填项,其余可选。

urlparse()方法的返回结果是一个ParseResult类型的对象,它收录6部分,分别是scheme(协议)、netloc(域名)、path(访问路径)、params(参数)、query(查询条件,一般使用 GET 类型的 URL),片段(锚点)。通用 URL 将由这 6 个部分组成。

1)urlparse() 方法的基本用法,用于解析 URL。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... %2339;)

print(type(result))

print(result)

2)如果指定了scheme参数并且URL中不收录scheme参数,解析时会使用scheme参数指定的协议。

from urllib.parse import urlparse

result = urlparse('www.baidu.com/index.html;user?id=5#comment',scheme='http')

print(result)

由于URL中不收录scheme,而协议是通过scheme参数指定的,从运行结果可以看出解析时使用的是scheme指定的协议,但是由于URL中没有指定scheme,解析的 netloc 为空。

3) 如果URL中收录scheme,同时指定了scheme参数,解析时默认使用URL中的scheme。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... 39%3B,scheme='https')

print(result)

从运行结果可以看出,URL中的scheme是用来解析的。

4)如果 allow_fragments 为 False,则 URL 中收录的片段将被解析为路径、参数或查询的一部分。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... 39%3B,allow_fragments=False)

print(result)

可以看出,fragment被解析为query的一部分,fragment为空。如果 URL 不收录参数和查询:

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.htm ... 39%3B,allow_fragments=False)

print(result)

可以看出,当URL不收录params和query时,fragment被解析为路径的一部分,fragment为空。

5)urlparse()的返回结果ParseResult实际上是一个元组,可以通过索引顺序或者属性名来获取。

from urllib.parse import urlparse

result = urlparse('http://www.baidu.com/index.html#comment',allow_fragments=False)

#打印:http http www.baidu.com www.baidu.com

print(result.scheme,result[0],result.netloc,result[1])

2. urlunparse()

urlparse() 的相反方法是 urlunparse(),用于构造 URL。接收到的参数是一个可迭代的对象(如列表、元组等),长度必须为6,否则会抛出参数数量不足或过多的问题。

from urllib.parse import urlunparse

data = ['http','www.baidu.com','index.html','user','a=6','comment']

#打印:http://www.baidu.com/index.html;user?a=6#comment

print(urlunparse(data));

3. urlsplit( )

urlsplit()方法和urlparse()方法类似,只是urlsplit()方法不单独解析params部分,而是解析成path部分。

from urllib.parse import urlsplit

result = urlsplit('http://www.baidu.com/index.htm ... %2339;)

#打印:SplitResult(scheme='http', netloc='www.baidu.com', path='/index.html;user', query='id=5', fragment='comment')

print(result)

它返回一个SplitResult类型的对象,它实际上是一个元组类型,所以你可以使用属性来获取值,也可以使用索引来获取它。

from urllib.parse import urlsplit

result = urlsplit('http://www.baidu.com/index.htm ... %2339;)

#打印:http

print(result.scheme)

#打印:http

print(result[0])

4. urlunsplit()

urlsplit() 的相反方法是 urlunsplit(),它用于构造 URL。接收到的参数是一个可迭代对象(如列表、元组等),长度必须为5,否则会抛出参数数量不足或过多的问题。

from urllib.parse import urlunsplit

data = ['http','www.baidu.com','index.html','a=6','comment']

#打印:http://www.baidu.com/index.html?a=6#comment

print(urlunsplit(data))

5. urljoin( )

除了使用 urlunparse( ) 和 urlunsplit( ) 方法构造 URL 之外,您还可以使用 urljoin( ) 方法构造 URL。使用urljoin()方法时,提供一个base_url(base URL)作为第一个参数,新的URL作为第二个参数,该方法会分析base_url中的scheme、netloc和path这三个内容URL的缺失部分补充,最后补充后的网址。

from urllib.parse import urljoin

print(urljoin('http://www.baidu.com','FAQ.html'))

print(urljoin('http://www.baidu.com','https://cuiqingcai.com/FAQ.html'))

print(urljoin('http://www.baidu.com/about.html','https://cuiqingcai.com/FAQ.html'))

print(urljoin('http://www.baidu.com/about.html','https://cuiqingcai.com/FAQ.html?question=2'))

print(urljoin('http://www.baidu.com/about.html','https://cuiqingcai.com/index.php'))

print(urljoin('http://www.baidu.com','?category=2#comment'))

print(urljoin('www.baidu.com','?category=2#comment'))

print(urljoin('www.baidu.com#comment','?category=2'))

可以发现base_url提供了三种内容scheme,netloc和path。如果新网址中不存在这三项,则进行补充;如果它们已经存在于新 URL 中,它们将不会被替换。base_url 中的参数、查询和片段不起作用。

6. urlcode( )

urlencode() 方法在构造请求参数时使用。

1)在GET请求方法中构造请求参数。

from urllib.parse import urlencode

params = {

'name':'germey',

'age':22

}

base_url = 'http://www.baidu.com?'

url = base_url+urlencode(params)

#打印:http://www.baidu.com?name=germey&age=22

print(url)

2)在POST请求方法中构造请求参数。

import urllib.request

from urllib.parse import urlencode

params = {

'name':'germey',

'age':22

}

data = bytes(urlencode(params),encoding='utf-8')

response = urllib.request.urlopen('http://httpbin.org/post',data=data)

print(response.read())

7. parse_qs( )

parse_qs() 方法可以将表示参数的字符串转换回字典。

from urllib.parse import parse_qs

query = 'name=germey&age=22'

#打印:{'name': ['germey'], 'age': ['22']}

print(parse_qs(query))

8. parse_qsl( )

类似于 parse_qs() 方法,它将表示参数的字符串转换为元组列表。

from urllib.parse import parse_qsl

query = 'name=germey&age=22'

#打印:[('name', 'germey'), ('age', '22')]

print(parse_qsl(query))

返回的结果是一个列表,列表中的每个元素都是一个元组,元组的第一个内容是参数名,第二个内容是参数值。

9. 引用()

quote() 方法可以将内容转换为 URL 编码格式。URL中有中文参数时,会造成乱码。在这种情况下,您可以使用 quote() 方法将其转换为 URL 编码。

from urllib.parse import quote

keyword = '你好'

url = 'https://www.baidu.com/s?wd='+quote(keyword)

#打印:https://www.baidu.com/s?wd=%E4%BD%A0%E5%A5%BD

print(url)

10. 取消引用()

unquote() 对应于 quote() 方法,可以解码 URL 编码的字符串。

from urllib.parse import unquote

url = 'https://www.baidu.com/s%3Fwd%3 ... 39%3B

#打印:https://www.baidu.com/s?wd=你好

print(unquote(url))

机器人解析器模块

使用urllib库中的robotparser模块,可以实现对网站Robots协议的解析。

1. 机器人协议

Robots 协议也称为爬虫协议和机器人协议。它的全称是Robots Exclusion Protocol,用来告诉爬虫和搜索引擎哪些页面可以爬取,哪些页面不能爬取。它通常是一个名为 robots.txt 的文本文件,通常放在 网站 的根目录下。搜索爬虫访问站点时,首先会检查站点根目录下是否存在robots.txt文件。如果存在,则搜索爬虫将根据其中定义的爬取范围进行爬取;如果没有找到该文件,搜索爬虫将访问所有可直接访问的页面。

1)robots.txt 文件示例 1、所有爬虫都不能爬取任何页面,但是公共目录可以爬取。

User-agent:*

Disallow:/

Allow:/public/

2)robots.txt 文件示例 2. 禁止爬虫爬取任何目录。

User-agent:*

Disallow:/

3)robots.txt 文件示例 3. 允许爬虫爬取任何页面。

User-agent:*

Disallow:

4)robots.txt 文件示例。只允许名为 WebCrawler 的爬虫爬取任何页面,不允许其他爬虫爬取任何页面。

User-agent:WebCrawler

Disallow:

User-agent:*

Disallow:/

2. 爬虫名称

爬虫有名字,常用的搜索爬虫名字和对应的网站。

爬虫名称属于网站

百度蜘蛛

百度

谷歌机器人

谷歌

360蜘蛛

360搜索

游道机器人

有道

ia_archiver

亚历克萨

小型摩托车

阿尔塔维斯塔

3. 使用机器人解析模块

robotsparse模块提供了一个RobotFileParser类,可以根据网站的robots.txt文件判断爬虫是否有权限爬取这个网页。这个类使用简单,在构造函数中传入robots.txt的链接即可。

urllib.robotparser.RobotFileParser(url='')

url 参数是可选的。如果构造时没有传入url,也可以通过set_url()方法设置。RobotFileParser类的常用方法如下:

1)判断简书的某些网页是否可以爬取。

from urllib.robotparser import RobotFileParser

rp = RobotFileParser()

#设置robots.txt文件的路径

rp.set_url('https://www.jianshu.com/')

#执行读取分析操作

rp.read()

#判断是否可爬

print(rp.can_fetch('*','https://www.jianshu.com/p/b67554025d7d'))

print(rp.can_fetch('*','https://www.jianshu.com/search ... %2339;))

2)使用 parse() 方法执行读取和解析操作。

from urllib.robotparser import RobotFileParser

from urllib.request import urlopen

rp = RobotFileParser()

#通过urlopen()直接打开百度的robots.txt文件并交给RobotFileParser进行分析

rp.parse(urlopen('https://www.baidu.com/robots.txt').read().decode('utf-8').split('\n'))

#判断是否可爬

print(rp.can_fetch('*','https://www.baidu.com/p/b67554025d7d'))

print(rp.can_fetch('*','https://www.baidu/search%3Fq%3 ... %2339;))

有时,判断是否可以爬取时返回False,或者爬虫运行时出现403拒绝服务。发送请求时,在请求头中设置 User-Agent 和 Host 可能会返回 True。

从网页抓取数据( 近30天Python第三方库下载量居然高达2亿!小编查了查)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-01-08 07:06

近30天Python第三方库下载量居然高达2亿!小编查了查)

前言

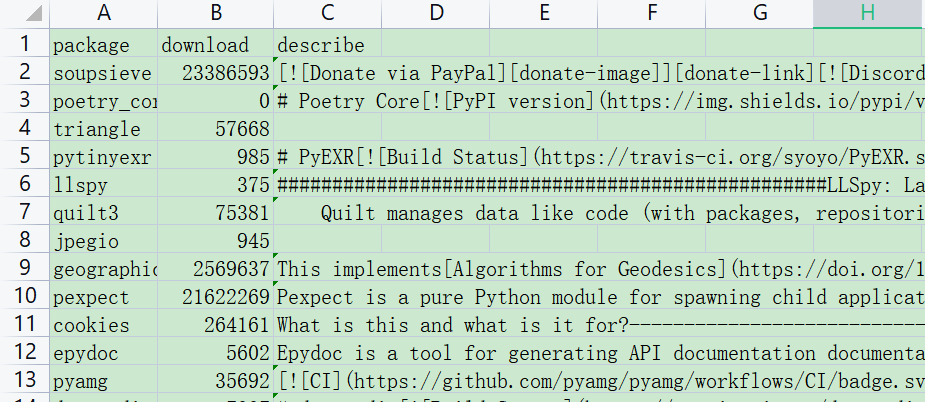

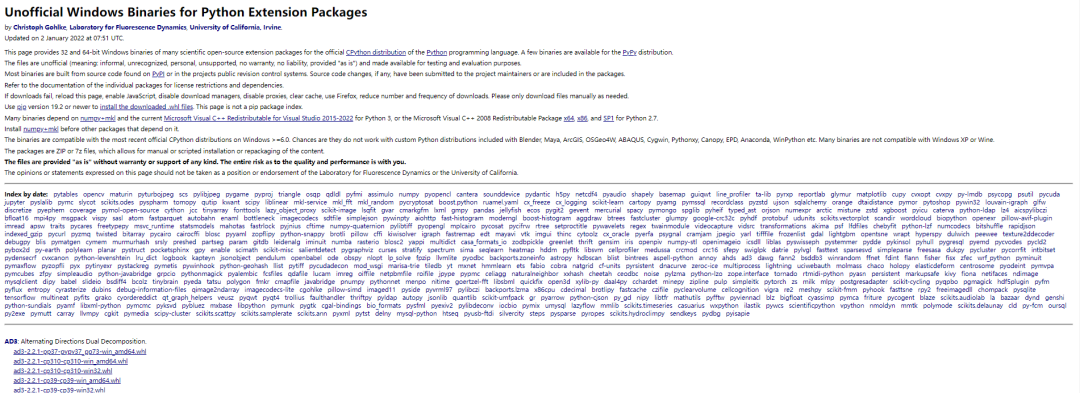

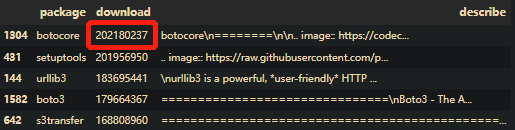

最近有读者分享了一个网站,可以用来查看Python第三方库的信息,包括库的介绍版本、近30天的总下载量、pip下载量过去 30 天:

我搜索了资料。Python语言的第三方库超过12万个,几乎涵盖了信息技术的所有领域。

小编自己安装第三方库的时候,用pip基本可以解决,但是有时候有些库不能用pip安装,所以我下载whl文件安装。

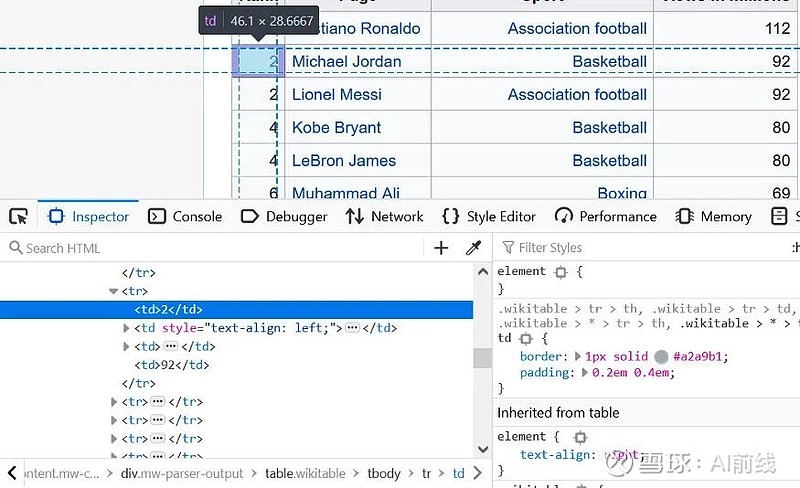

小编下载的whl文件都是从下面的网站下载的,比较全,包括很多库,基本都能找到需要的库:

~gohlke/pythonlibs/

从这个网站爬取所有库名,爬取该库过去30天的下载量,并描述简要信息。

虽然很多库不知道自己是做什么的,也没有使用过,但是可以根据数据分析出哪些流行的第三方库,描述一下介绍涉及到哪个方向。

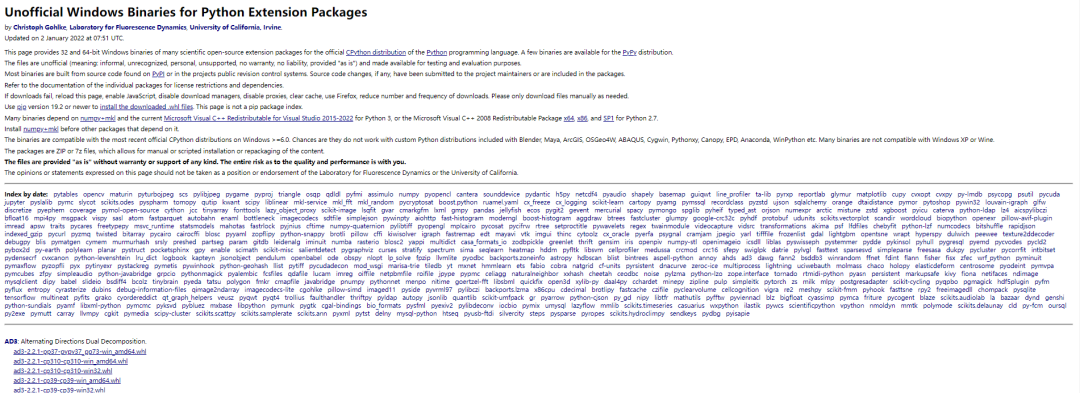

数据采集

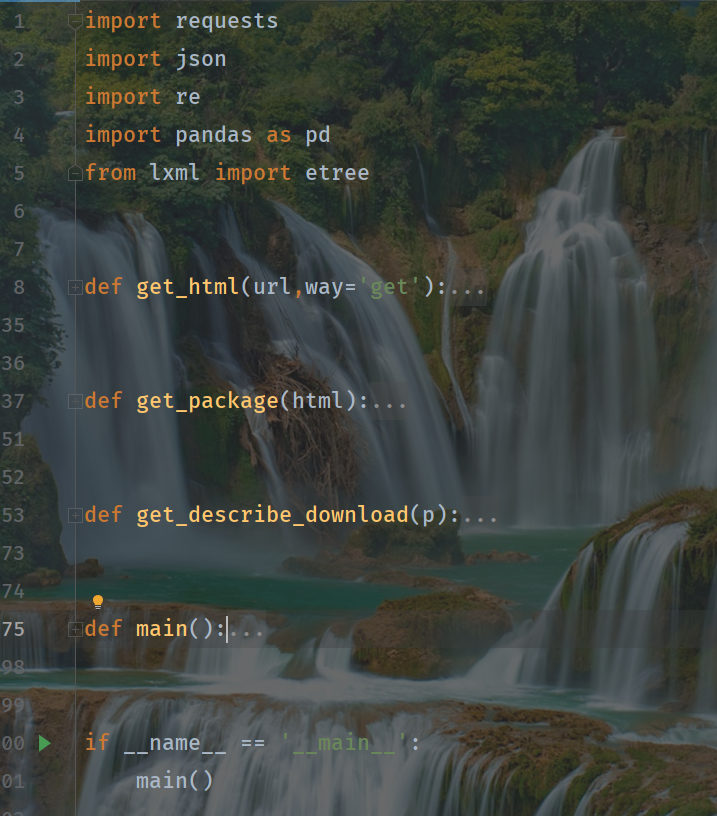

先从第三方库网站爬取所有库名,然后爬取各个库近30天的下载量,描述信息,最后保存数据。整个逻辑并不难。完整的源码在文末获取:

可视化

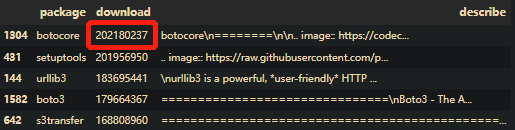

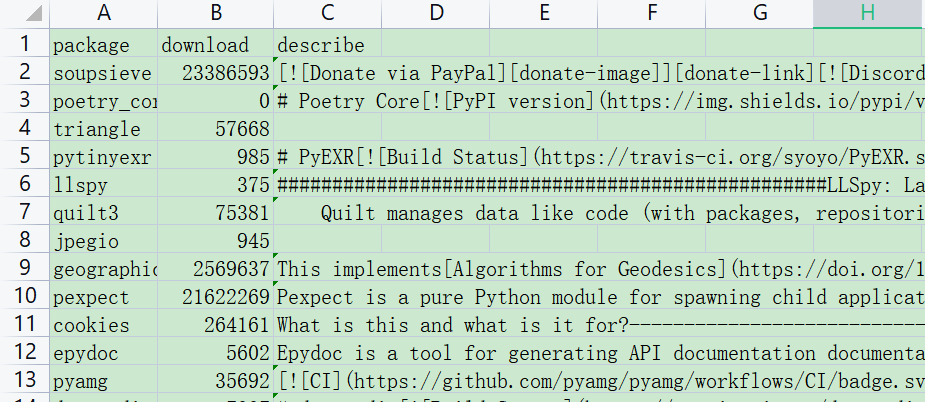

近30天下载量降序排序,第三方库下载量最高高达2亿!

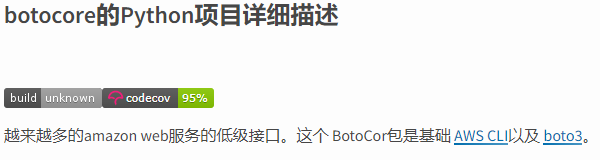

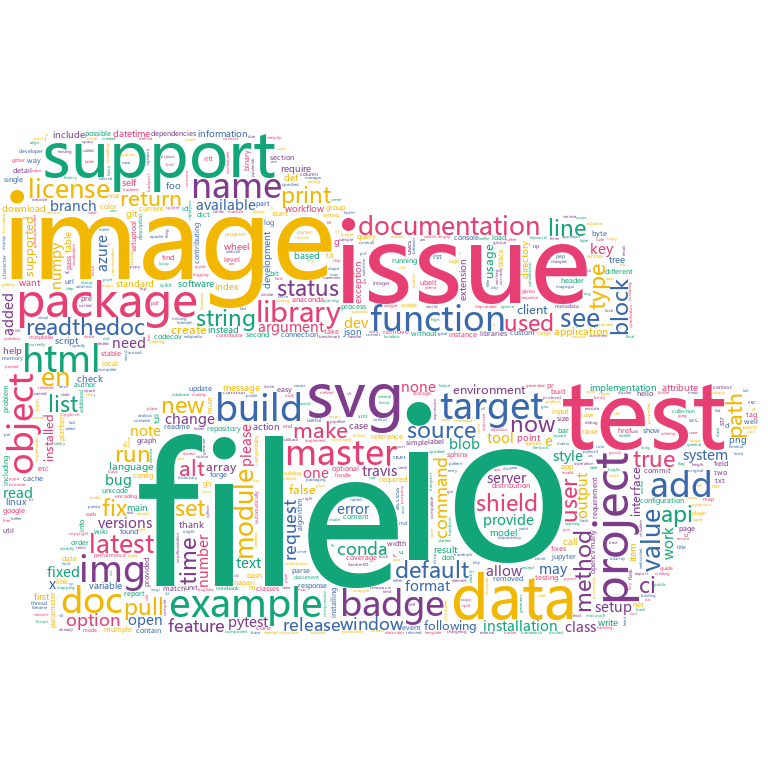

小编查了一下,这个库是web开发相关的库:

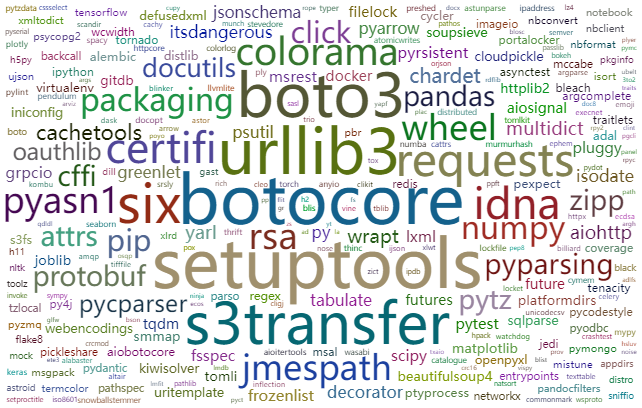

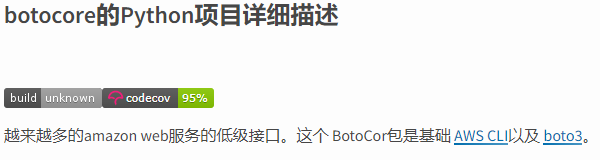

我们通过词云图直接看近30天第三方库下载量的主要分布:

上面提到的botocore是一个web相关的库,boto3也是。

setuptools 是 pip 安装的必备模块。大概率是环境有问题,无法安装包,所以我先下载这个。

然后就可以看到爬虫熟悉的urllib3和requests这两个库了。近年来,爬虫逐渐进入大众视野,引起了很多人的兴趣。

还有pandas、numpy数据处理库、机器学习、大数据最热门词汇。这两个库更常用于 Python 中的数据处理和清洗。

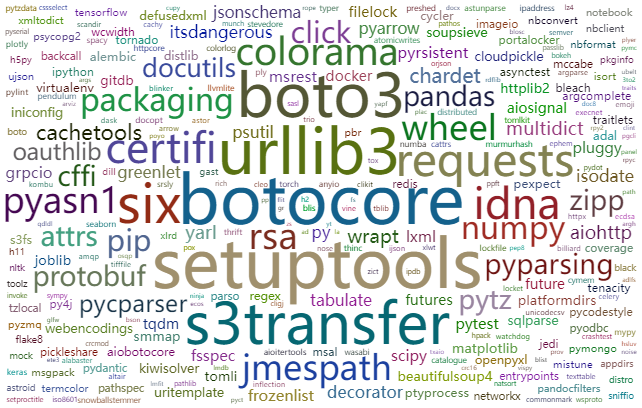

其他库我就不多说了。第三方库太多了。从那网站到采集再到1700多个库名,通过所有的描述信息,看看哪些方向涉及的最多。:

io,文件读写文件数据流,貌似会涉及很多模块。

image、img 图像图像、绘制图表、图像处理等的各种库,现在有很多,比如典型的matplotlib、PIL、seaborn、pyecharts等。可视化数据,图像数据处理也是一个比较热门的方向。

数据可以让人联想到数据时代。Python在处理采集数据方面有一定优势,所以爬虫相关的请求、urllib3、数据相关的pandas、numpy的下载量都比较高。

. . . . . .

2022年了,祝你新年快乐,找到你感兴趣的方向,一路前行~

感兴趣的读者可以继续探索探索。

源码获取

扫描下方二维码,在公众号对话框回复关键词“包”即可获取

结尾

读者交流群已成立,找我并备注“交流”,即可加入我们~

听说“看”的人更好看~

关注小编~小编给大家分享爬虫、数据分析和可视化的内容~ 查看全部

从网页抓取数据(

近30天Python第三方库下载量居然高达2亿!小编查了查)

前言

最近有读者分享了一个网站,可以用来查看Python第三方库的信息,包括库的介绍版本、近30天的总下载量、pip下载量过去 30 天:

我搜索了资料。Python语言的第三方库超过12万个,几乎涵盖了信息技术的所有领域。

小编自己安装第三方库的时候,用pip基本可以解决,但是有时候有些库不能用pip安装,所以我下载whl文件安装。

小编下载的whl文件都是从下面的网站下载的,比较全,包括很多库,基本都能找到需要的库:

~gohlke/pythonlibs/

从这个网站爬取所有库名,爬取该库过去30天的下载量,并描述简要信息。

虽然很多库不知道自己是做什么的,也没有使用过,但是可以根据数据分析出哪些流行的第三方库,描述一下介绍涉及到哪个方向。

数据采集

先从第三方库网站爬取所有库名,然后爬取各个库近30天的下载量,描述信息,最后保存数据。整个逻辑并不难。完整的源码在文末获取:

可视化

近30天下载量降序排序,第三方库下载量最高高达2亿!

小编查了一下,这个库是web开发相关的库:

我们通过词云图直接看近30天第三方库下载量的主要分布:

上面提到的botocore是一个web相关的库,boto3也是。

setuptools 是 pip 安装的必备模块。大概率是环境有问题,无法安装包,所以我先下载这个。

然后就可以看到爬虫熟悉的urllib3和requests这两个库了。近年来,爬虫逐渐进入大众视野,引起了很多人的兴趣。

还有pandas、numpy数据处理库、机器学习、大数据最热门词汇。这两个库更常用于 Python 中的数据处理和清洗。

其他库我就不多说了。第三方库太多了。从那网站到采集再到1700多个库名,通过所有的描述信息,看看哪些方向涉及的最多。:

io,文件读写文件数据流,貌似会涉及很多模块。

image、img 图像图像、绘制图表、图像处理等的各种库,现在有很多,比如典型的matplotlib、PIL、seaborn、pyecharts等。可视化数据,图像数据处理也是一个比较热门的方向。

数据可以让人联想到数据时代。Python在处理采集数据方面有一定优势,所以爬虫相关的请求、urllib3、数据相关的pandas、numpy的下载量都比较高。

. . . . . .

2022年了,祝你新年快乐,找到你感兴趣的方向,一路前行~

感兴趣的读者可以继续探索探索。

源码获取

扫描下方二维码,在公众号对话框回复关键词“包”即可获取

结尾

读者交流群已成立,找我并备注“交流”,即可加入我们~

听说“看”的人更好看~

关注小编~小编给大家分享爬虫、数据分析和可视化的内容~

从网页抓取数据(本发明公开了一种的访问策略基于IP级的网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-01-06 08:08

摘要:本发明公开了一种在网站中从多个不同IP的服务器抓取网页的方法和系统。本发明首先为客户端的网页抓取任务分配目标网站服务器IP。网页抓取任务包括要抓取的网页的网页地址;礼貌的访问条件;如果满足,则使用该IP与服务器建立连接,并从服务器抓取该网页地址的网页。本发明的访问策略基于IP级别,更容易控制采集工作线程礼貌地访问网站;通过缓存DNS,同时使用多个IP,优先分配最快的IP,极大地提高了网页抓取效率;当目标 网站

抽象的:

申请人:

申请人:UNIV PEKING FOUNDER GROUP CO; 北京大学;北京方正电子有限公司

地址:北京市海淀区成府路100871号*******(隐藏)

发明人(设计师):

发明人:李向军;于晓明;杨建武;吴新丽

主要分类号:H04L29/08(2006.01)I

分类号: 查看全部

从网页抓取数据(本发明公开了一种的访问策略基于IP级的网页)

摘要:本发明公开了一种在网站中从多个不同IP的服务器抓取网页的方法和系统。本发明首先为客户端的网页抓取任务分配目标网站服务器IP。网页抓取任务包括要抓取的网页的网页地址;礼貌的访问条件;如果满足,则使用该IP与服务器建立连接,并从服务器抓取该网页地址的网页。本发明的访问策略基于IP级别,更容易控制采集工作线程礼貌地访问网站;通过缓存DNS,同时使用多个IP,优先分配最快的IP,极大地提高了网页抓取效率;当目标 网站

抽象的:

申请人:

申请人:UNIV PEKING FOUNDER GROUP CO; 北京大学;北京方正电子有限公司

地址:北京市海淀区成府路100871号*******(隐藏)

发明人(设计师):

发明人:李向军;于晓明;杨建武;吴新丽

主要分类号:H04L29/08(2006.01)I

分类号:

从网页抓取数据(如何从数据中挖掘价值不同常见的网络数据抓取方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-05 14:12

本文链接:/BAZHUAYUdata/article/details/101072022

互联网上有大量数据。如何捕捉这些零散的数据并存储在公司数据库中?如何从数据中挖掘价值,洞察市场发展方向,助力业务持续增长?

本文将分享几种常见的网络数据采集方法,并展示多个真实的数据应用实例,希望对大家有所帮助。

1. 内容聚合

对于大多数媒体网站来说,实时访问互联网上的大量信息/新闻是非常重要的。网络数据采集可以监控各种新闻门户网站和主流社交媒体,通过关键词搜索等方式实时获取更新数据。

使用内容聚合的另一个示例是业务组。例如,招标团队。借助网络数据采集,可以自动采集每次招标网站更新的、与业务相关的招标项目信息,以便及时跟进,快速发现商机。

2. 竞争对手监控

电子商务从业者需要时刻关注竞争对手的情况,调整自己的经营策略。网络数据采集可以实时监控竞争对手官网、店铺等网页的信息,包括产品更新、促销活动、客户评价等。

电子商务领域的竞争日趋激烈,挖掘细分市场是一条出路。网络数据采集将有助于通过产品细节挖掘细分市场,提高品牌知名度和交易量。同时,可以通过分析捕获的数据来合理定价产品。

3. 情绪分析

用户生成的文本内容是情感分析的基础。此类数据主要是评论、意见或投诉,通常在以消费者为中心的产品、服务或特定事件(例如音乐、电影和书籍)中生成。通过部署多个网络爬虫工具,您可以轻松地从不同的网站 获取所有这些信息。

4. 市场研究

几乎每家公司都需要进行市场调查。互联网上可以提供不同类型的数据,包括产品信息、标签、社交媒体或其他平台上的产品评论、新闻等。使用传统数据采集方法进行市场调查既费时又费钱任务。到目前为止,如果您需要采集大量数据进行市场调查,网络数据提取是最简单的方法。

5. 机器学习

与情感分析一样,可用的网络数据是机器学习的高质量材料。标记和提取内容以及从元数据字段和值中提取实体是自然语言处理的源头。类别和标签信息可用于完成统计标签或聚类系统。Web 数据捕获可以帮助您以更高效、更准确的方式获取数据。

网络数据采集工具和方法

到目前为止,从网页中提取数据的最佳方法是将数据抓取项目外包给 DaaS 提供商。拥有必要的专业知识和基础设施来捕获数据。这样,也可以完全免除网络爬虫的责任。

还有一种更简单的方式来完成项目——使用网络爬虫!我们在之前的博客中介绍了很多工具。所有工具都有其优点和缺点,它们在某些方面更适合不同的人。优采云 是为非程序员创建的,比任何其他网络数据抓取工具都更容易使用。通过浏览一些教程,你可以零基础轻松掌握。

网络爬虫最灵活的方法是编写自己的爬虫程序。大多数网页抓取工具都是用 Python 编写的,以进一步简化采集数据的过程。但是对于大多数人来说,编写爬虫并不容易。 查看全部

从网页抓取数据(如何从数据中挖掘价值不同常见的网络数据抓取方法)

本文链接:/BAZHUAYUdata/article/details/101072022

互联网上有大量数据。如何捕捉这些零散的数据并存储在公司数据库中?如何从数据中挖掘价值,洞察市场发展方向,助力业务持续增长?

本文将分享几种常见的网络数据采集方法,并展示多个真实的数据应用实例,希望对大家有所帮助。

1. 内容聚合

对于大多数媒体网站来说,实时访问互联网上的大量信息/新闻是非常重要的。网络数据采集可以监控各种新闻门户网站和主流社交媒体,通过关键词搜索等方式实时获取更新数据。

使用内容聚合的另一个示例是业务组。例如,招标团队。借助网络数据采集,可以自动采集每次招标网站更新的、与业务相关的招标项目信息,以便及时跟进,快速发现商机。

2. 竞争对手监控

电子商务从业者需要时刻关注竞争对手的情况,调整自己的经营策略。网络数据采集可以实时监控竞争对手官网、店铺等网页的信息,包括产品更新、促销活动、客户评价等。

电子商务领域的竞争日趋激烈,挖掘细分市场是一条出路。网络数据采集将有助于通过产品细节挖掘细分市场,提高品牌知名度和交易量。同时,可以通过分析捕获的数据来合理定价产品。

3. 情绪分析

用户生成的文本内容是情感分析的基础。此类数据主要是评论、意见或投诉,通常在以消费者为中心的产品、服务或特定事件(例如音乐、电影和书籍)中生成。通过部署多个网络爬虫工具,您可以轻松地从不同的网站 获取所有这些信息。

4. 市场研究

几乎每家公司都需要进行市场调查。互联网上可以提供不同类型的数据,包括产品信息、标签、社交媒体或其他平台上的产品评论、新闻等。使用传统数据采集方法进行市场调查既费时又费钱任务。到目前为止,如果您需要采集大量数据进行市场调查,网络数据提取是最简单的方法。

5. 机器学习

与情感分析一样,可用的网络数据是机器学习的高质量材料。标记和提取内容以及从元数据字段和值中提取实体是自然语言处理的源头。类别和标签信息可用于完成统计标签或聚类系统。Web 数据捕获可以帮助您以更高效、更准确的方式获取数据。

网络数据采集工具和方法

到目前为止,从网页中提取数据的最佳方法是将数据抓取项目外包给 DaaS 提供商。拥有必要的专业知识和基础设施来捕获数据。这样,也可以完全免除网络爬虫的责任。

还有一种更简单的方式来完成项目——使用网络爬虫!我们在之前的博客中介绍了很多工具。所有工具都有其优点和缺点,它们在某些方面更适合不同的人。优采云 是为非程序员创建的,比任何其他网络数据抓取工具都更容易使用。通过浏览一些教程,你可以零基础轻松掌握。

网络爬虫最灵活的方法是编写自己的爬虫程序。大多数网页抓取工具都是用 Python 编写的,以进一步简化采集数据的过程。但是对于大多数人来说,编写爬虫并不容易。

从网页抓取数据(是不是的博客-程序员宝宝_内存分布图C语言内存分布)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-01-05 07:19

委派和工作中的事件有什么区别?_haozige888的博客程序员宝贝

一:背景讲故事 前几天,公司的一个女孩问我,活动和委托有什么区别?让我从心底叹息。小时候经常被面试官问到。现在我年纪大了,经常受到年轻一代的欢迎。好像逃不掉我的编码生涯之前是跑不掉的,但是奇怪的是,这个问题被问到的时候,发现很多人都用过:Event是一个特别委托来总结的,有意思吗?我想这句话可能来自于网上对面试问题的回答。我将尝试彻底总结它。二:活动真的是特约吗?猫捉老鼠的经典案例。想知道两者是什么关系吗?你必须先有一些基本的代码,

合并排序_zhangfuzhi123的博客-程序员分享

归并排序分为三个步骤,将两个已排序数组合并为一个已排序数组,将二维数组的元素压缩为一半,构造归并排序方法1、将两个已排序数组合并为一个已排序数组 public static int[] mergeArr(int[] arr1, int[] arr2) {int[] result=new int[arr1.length + arr2.length]; int startA...

C语言内存分布图_liuchunjie11的博客-程序员求

原C语言内存分布文章在此:一. 学习前先看一下ELF文件。ELF 分为三种:.o 可重定位文件(relocalble files)、可执行文件和共享库(shared library)。三种格式在结构上基本相同,但每种格式都不同。让我们从整体上看一下这 3 种格式...

Java多线程系列-《基础》08-join()_Laputa_Spring-程序员

小结本章我们将介绍Thread中的join()方法。涉及的内容包括:1.join()介绍2.join()源码分析(基于JDK1.7.0_40)3. join() 转载示例请注明出处:1. join() 介绍了join()在Thread.java中定义,join()的作用:让“主线程”等待“子线程”。 ..

删除二叉树(BST树)中的节点(3种情况的全解)_Zxn,天狼星荣耀之路

现在有一个二叉搜索树如下: 如果我们需要删除一个节点,并且删除后仍然满足二叉搜索树的数据排序策略。这时候的删除操作可以分为以下三种情况。以下情况1:节点没有左子树。如图:一棵没有左子树的二叉树,这种情况下如果删除节点,可以根据节点的位置分为三种处理方式。删除根节点如下:删除根节点也就是删除节点5,此时只需将根节点的指针指向其右子树节点即可。删除叶子节点如下图: 如果删除的节点是叶子节点

Android:JNI_Arthur__yan 博客程序员寻求的基本原理

在Android Framework中,上层Java和底层C/C++可以通过JNI有机结合。JNI 提供了一系列接口,允许 Java 类与其他编程语言(如 C/C++)编写的应用程序、模块和库一起使用。互动操作。通过JNI在Java代码中调用C函数的步骤如下:1.编写Java代码2.编译Java代码3.生成C语言头文件4.编写C代码< @5. 生成 C 共享库 6. 云 查看全部

从网页抓取数据(是不是的博客-程序员宝宝_内存分布图C语言内存分布)

委派和工作中的事件有什么区别?_haozige888的博客程序员宝贝

一:背景讲故事 前几天,公司的一个女孩问我,活动和委托有什么区别?让我从心底叹息。小时候经常被面试官问到。现在我年纪大了,经常受到年轻一代的欢迎。好像逃不掉我的编码生涯之前是跑不掉的,但是奇怪的是,这个问题被问到的时候,发现很多人都用过:Event是一个特别委托来总结的,有意思吗?我想这句话可能来自于网上对面试问题的回答。我将尝试彻底总结它。二:活动真的是特约吗?猫捉老鼠的经典案例。想知道两者是什么关系吗?你必须先有一些基本的代码,

合并排序_zhangfuzhi123的博客-程序员分享

归并排序分为三个步骤,将两个已排序数组合并为一个已排序数组,将二维数组的元素压缩为一半,构造归并排序方法1、将两个已排序数组合并为一个已排序数组 public static int[] mergeArr(int[] arr1, int[] arr2) {int[] result=new int[arr1.length + arr2.length]; int startA...

C语言内存分布图_liuchunjie11的博客-程序员求

原C语言内存分布文章在此:一. 学习前先看一下ELF文件。ELF 分为三种:.o 可重定位文件(relocalble files)、可执行文件和共享库(shared library)。三种格式在结构上基本相同,但每种格式都不同。让我们从整体上看一下这 3 种格式...

Java多线程系列-《基础》08-join()_Laputa_Spring-程序员

小结本章我们将介绍Thread中的join()方法。涉及的内容包括:1.join()介绍2.join()源码分析(基于JDK1.7.0_40)3. join() 转载示例请注明出处:1. join() 介绍了join()在Thread.java中定义,join()的作用:让“主线程”等待“子线程”。 ..

删除二叉树(BST树)中的节点(3种情况的全解)_Zxn,天狼星荣耀之路

现在有一个二叉搜索树如下: 如果我们需要删除一个节点,并且删除后仍然满足二叉搜索树的数据排序策略。这时候的删除操作可以分为以下三种情况。以下情况1:节点没有左子树。如图:一棵没有左子树的二叉树,这种情况下如果删除节点,可以根据节点的位置分为三种处理方式。删除根节点如下:删除根节点也就是删除节点5,此时只需将根节点的指针指向其右子树节点即可。删除叶子节点如下图: 如果删除的节点是叶子节点

Android:JNI_Arthur__yan 博客程序员寻求的基本原理

在Android Framework中,上层Java和底层C/C++可以通过JNI有机结合。JNI 提供了一系列接口,允许 Java 类与其他编程语言(如 C/C++)编写的应用程序、模块和库一起使用。互动操作。通过JNI在Java代码中调用C函数的步骤如下:1.编写Java代码2.编译Java代码3.生成C语言头文件4.编写C代码< @5. 生成 C 共享库 6. 云

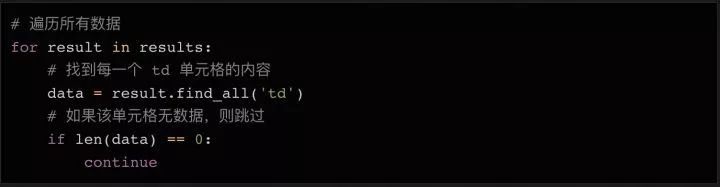

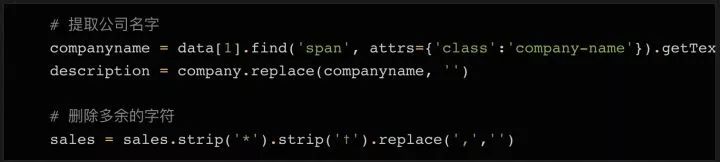

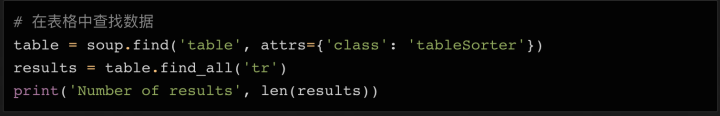

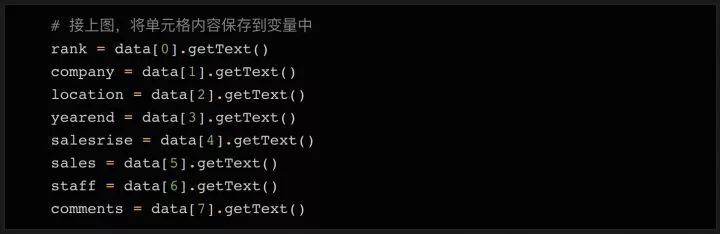

从网页抓取数据(用脚本将获取信息上获取2018年100强企业的信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-01-04 04:18

(点击上方公众号,快速关注,一起学习Python)

编译:Ou Shave

数据科学家的首要任务是进行网络爬虫。那时,我对使用代码从网站获取数据的技术一无所知。它恰好是最合乎逻辑和最简单的数据来源。经过几次尝试,网络爬行对我来说几乎是本能的。今天,它已成为我几乎每天都在使用的少数技术之一。

在今天的文章中,我会用几个简单的例子来给大家展示一下如何爬取一个网站——比如从Fast Track获取2018年排名前100的公司信息。使用脚本实现信息获取过程的自动化,不仅可以节省人工整理的时间,还可以将企业所有数据整理成结构化的文件,以便进一步分析查询。

看版本太长:如果你只是想要一个最基本的Python爬虫程序的示例代码,本文用到的所有代码都在GitHub()上,欢迎大家来取。

准备工作

每次你打算用 Python 做某事时,你问的第一个问题应该是:“我需要使用什么库”。

有几个不同的库可用于网络抓取,包括:

今天我们计划使用 Beautiful Soup 库。您只需要使用 pip(Python 包管理工具)即可轻松将其安装到您的计算机上:

安装完成后,我们就可以开始了!

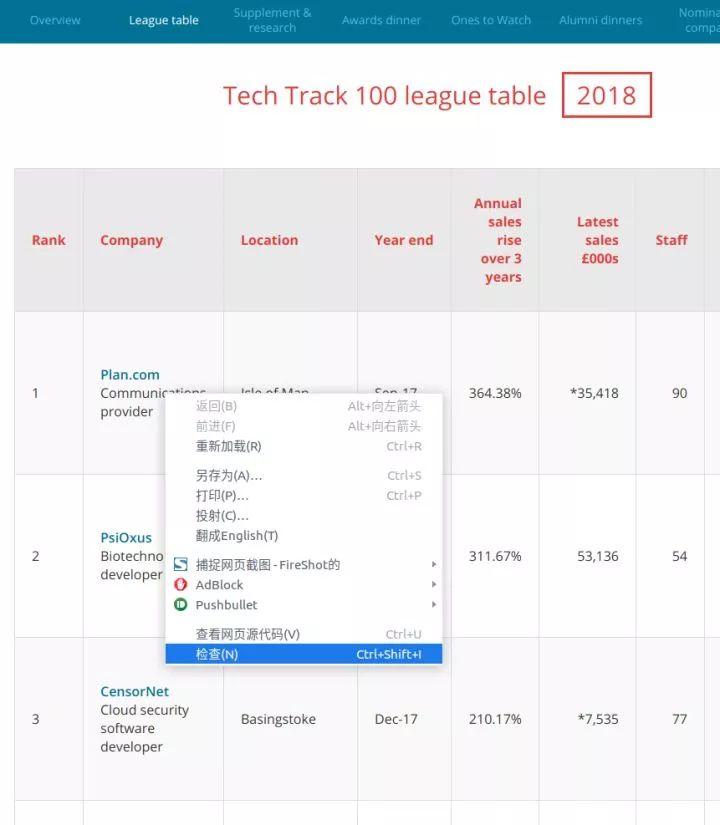

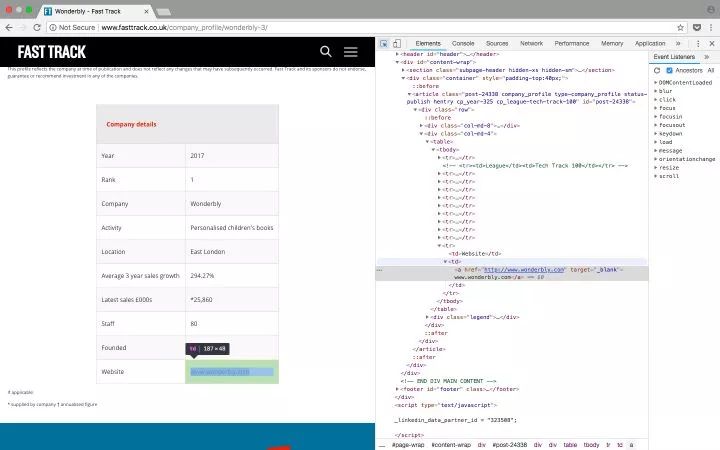

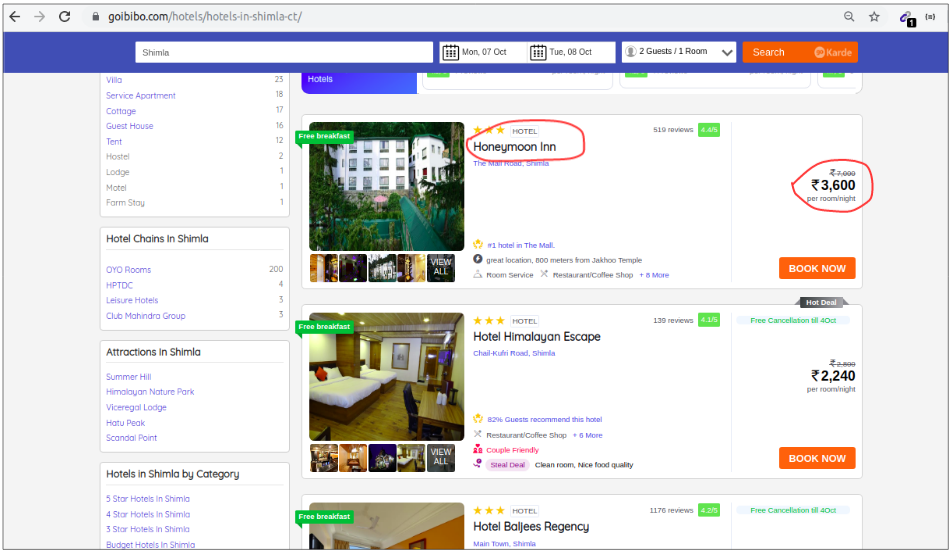

检查网页

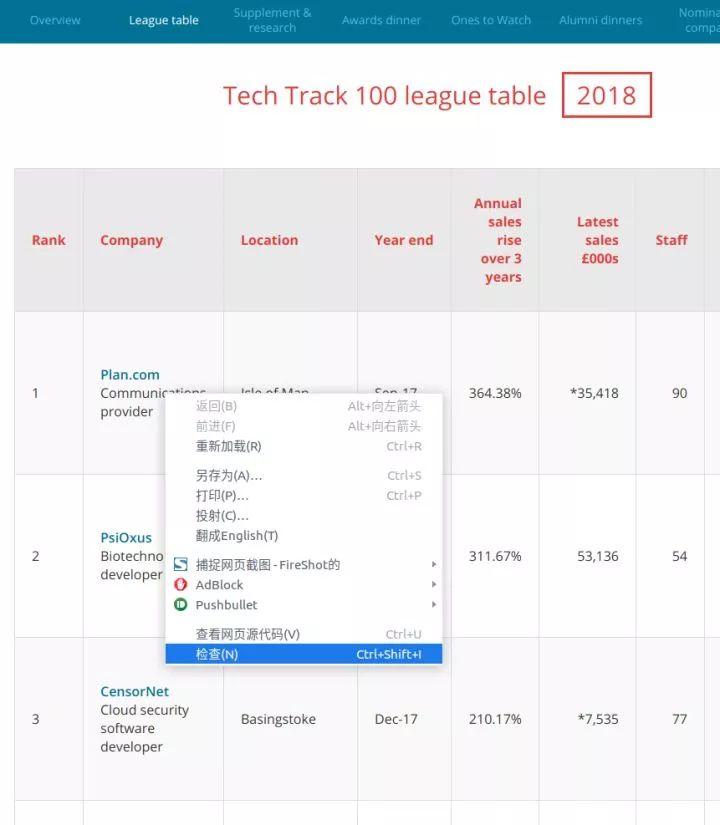

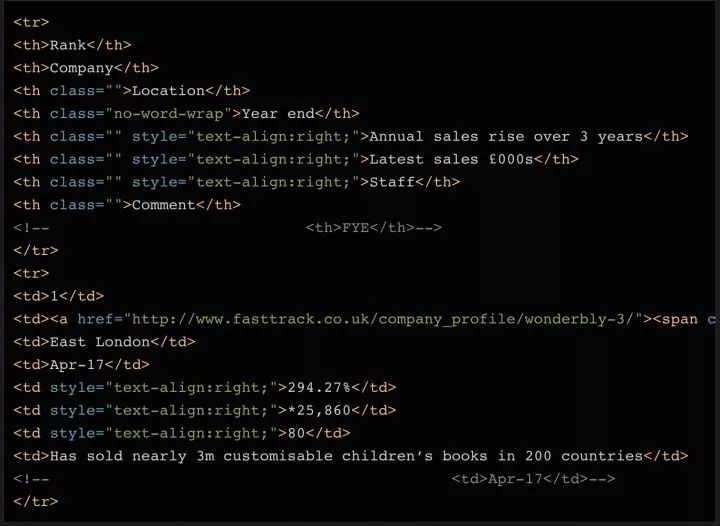

为了确定要抓取网页的哪些元素,首先需要检查网页的结构。

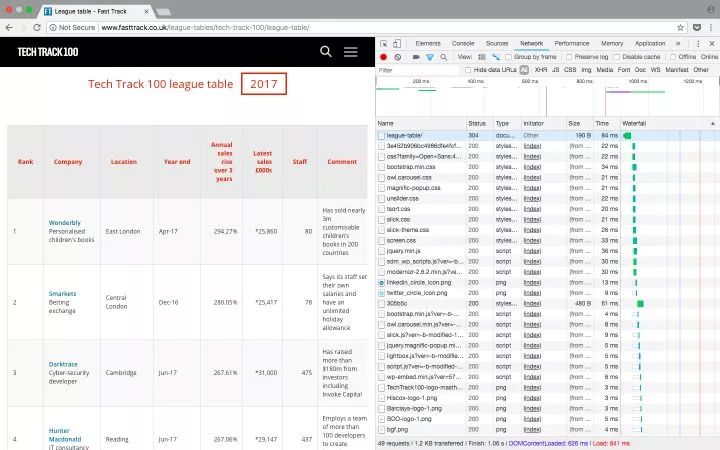

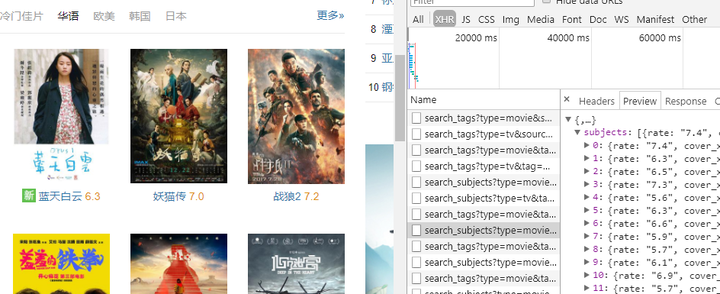

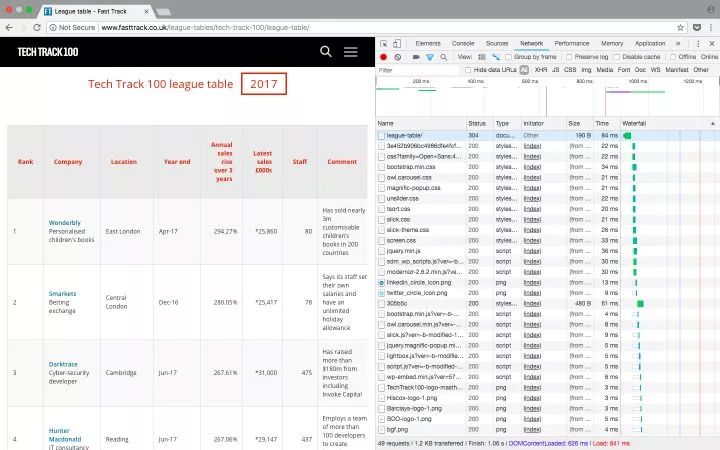

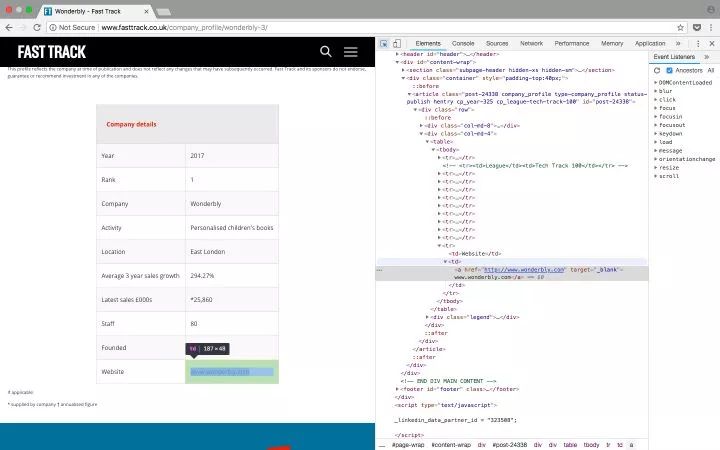

以 Tech Track 前 100 名公司 (%3A//www.fasttrack.co.uk/league-tables/tech-track-100/league-table/) 为例。您可以右键单击表格并选择“考试”。在弹出的“开发者工具”中,我们可以看到页面上的每个元素以及其中收录的内容。

在要查看的网页元素上右击,选择“check”查看具体的HTML元素内容

由于数据是存放在表中的,所以只需要几行代码就可以直接得到完整的信息。如果您想自己练习抓取网页内容,这是一个很好的例子。但请记住,实际情况往往并非如此简单。

在此示例中,所有 100 个结果都收录在同一页面上,并由标签分隔成行。但是,在实际的爬取过程中,很多数据往往分布在多个不同的页面上。您需要调整每个页面显示的结果总数或遍历所有页面以捕获完整数据。

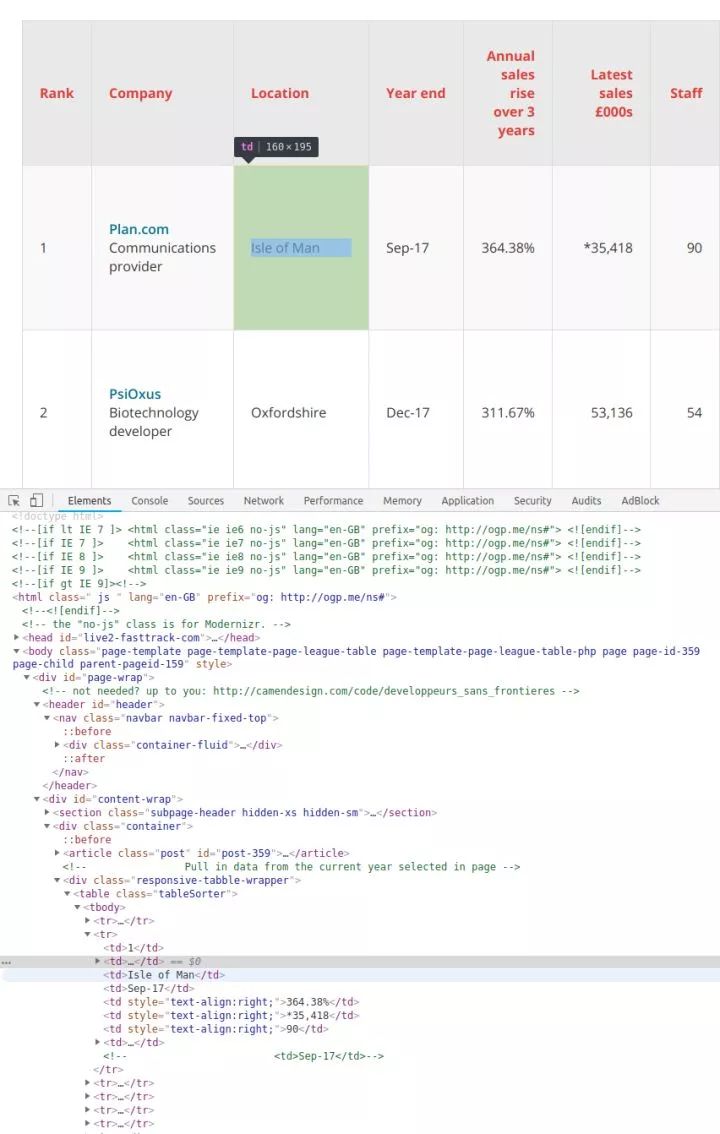

在表格页面,可以看到一个收录全部100条数据的表格,右键点击选择“检查”,可以很容易的看到HTML表格的结构。收录内容的表格的主体在这个标签中:

每一行都在一个标签中,也就是我们不需要太复杂的代码,只要一个循环,就可以读取所有的表数据并保存到文件中。

注意:您还可以通过检查当前页面是否发送了HTTP GET请求并获取该请求的返回值来获取页面显示的信息。因为 HTTP GET 请求往往可以返回结构化数据,例如 JSON 或 XML 格式的数据,以方便后续处理。您可以在开发者工具中点击Network类别(如果需要,您只能查看XHR标签的内容)。这时候可以刷新页面,这样页面上加载的所有请求和返回的内容都会在Network中列出。此外,您还可以使用某种REST客户端(例如Insomnia)发起请求并输出返回值。

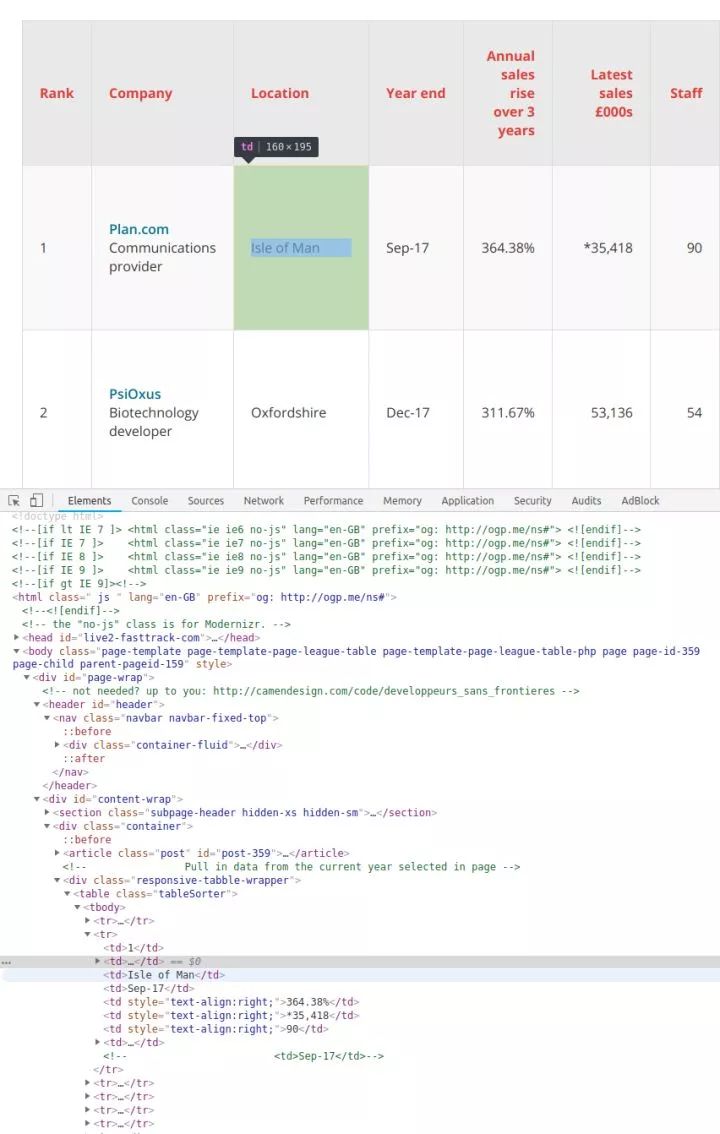

刷新页面后,更新Network标签的内容

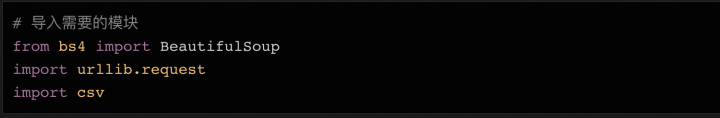

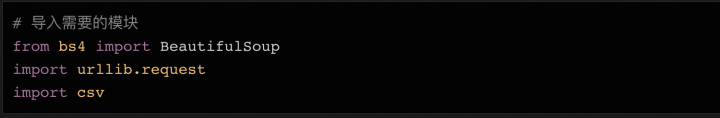

使用 Beautiful Soup 库处理网页的 HTML 内容

熟悉了网页的结构,了解了需要爬取的内容后,我们终于拿起代码开始工作了~

首先要导入代码中需要用到的各个模块。我们上面已经提到过 BeautifulSoup,这个模块可以帮助我们处理 HTML 结构。下一个要导入的模块是urllib,负责连接目标地址,获取网页内容。最后,我们需要能够将数据写入CSV文件并保存在本地硬盘上,因此我们需要导入csv库。当然,这不是唯一的选择。如果要将数据保存为json文件,则需要相应地导入json库。

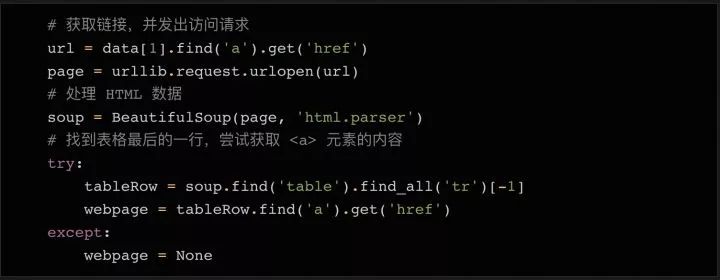

接下来,我们需要准备需要爬取的目标网址。如上所述,这个页面已经收录了我们需要的所有内容,所以我们只需要复制完整的 URL 并将其赋值给变量即可:

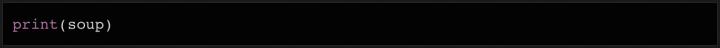

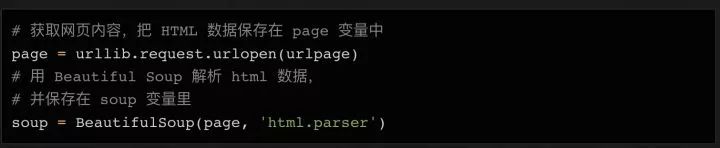

接下来我们可以使用urllib连接这个URL,将内容保存在page变量中,然后使用BeautifulSoup对页面进行处理,并将处理结果保存在soup变量中:

这时候可以尝试打印soup变量,看看处理后的html数据是什么样子的:

如果变量内容为空或者返回一些错误信息,则表示可能无法正确获取网页数据。您可能需要在 urllib.error() 模块中使用一些错误捕获代码来查找可能的问题。

查找 HTML 元素

由于所有内容都在表格中(

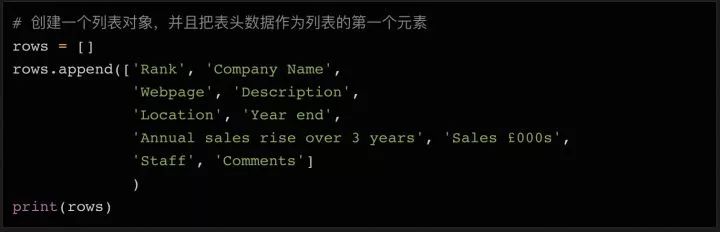

tag),我们可以在soup对象中搜索需要的表,然后使用find_all方法遍历表中的每一行数据。

如果您尝试打印出所有行,则应该有 101 行-100 行内容,加上一个标题。

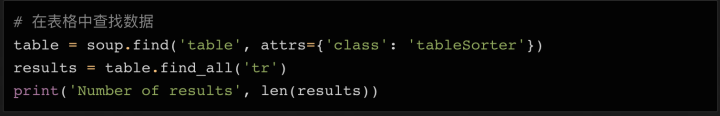

看看打印出来的内容,如果没有问题,我们可以用一个循环来获取所有的数据。

如果打印出soup对象的前2行,可以看到每一行的结构是这样的:

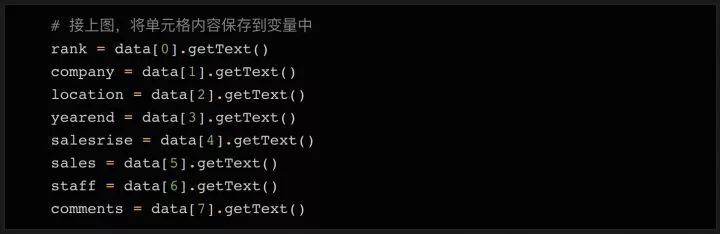

如您所见,该表共有 8 列,分别为 Rank、Company、Location、Year End、Annual Sales Rise、Latest Sales(今年的销售额)、Staff(员工人数)和 Comments(备注)。

这些是我们需要的数据。

这个结构在整个网页中是一致的(但在其他网站上可能没有这么简单!),所以我们可以再次使用find_all方法通过搜索元素逐行提取数据,就是存储在变量中,以后可以写入 csv 或 json 文件。

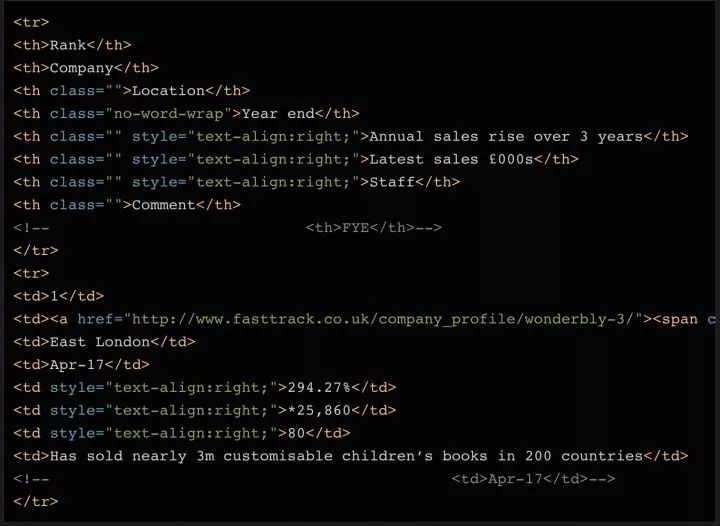

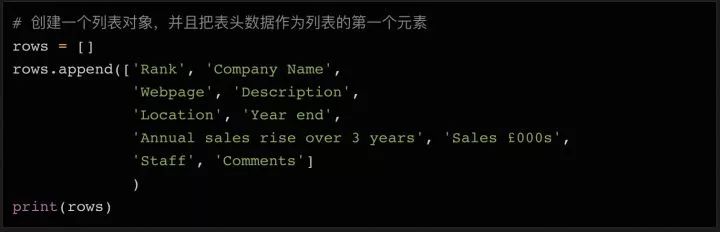

遍历所有元素并将它们存储在变量中

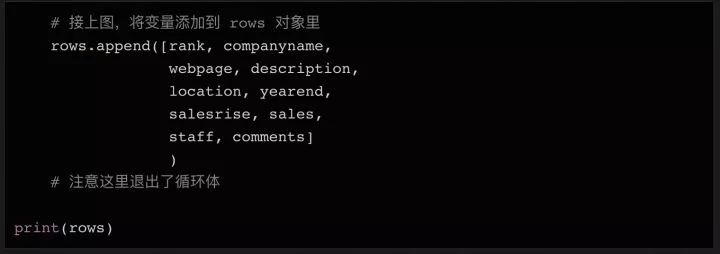

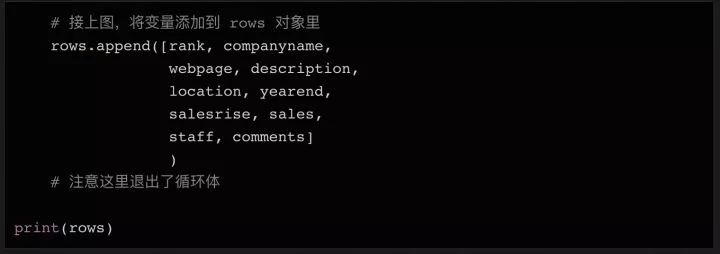

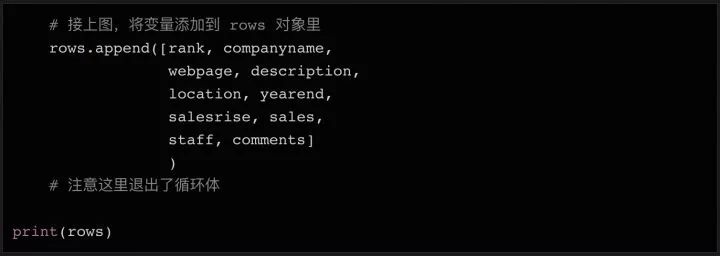

在Python中,如果需要处理大量数据,需要写入文件,list对象非常有用。我们可以先声明一个空的列表,填入初始的header(供以后在CSV文件中使用),后面的数据只需要调用list对象的append方法即可。

这将打印出我们刚刚添加到列表对象行中的第一行标题。

您可能会注意到,我输入的标题中的列名称比网页上的表格多几个,例如网页和说明。请仔细看上面打印的汤变量数据——在数据的第二行第二列,不仅有公司名称,还有公司网站和简要说明。所以我们需要这些额外的列来存储这些数据。

接下来,我们遍历所有 100 行数据,提取内容,并将其保存到列表中。

如何循环读取数据:

因为第一行数据是html表格的表头,我们可以跳过阅读。因为header使用了标签,没有使用标签,所以我们简单的查询标签中的数据,丢弃空值。

接下来,我们读取数据的内容并赋值给变量:

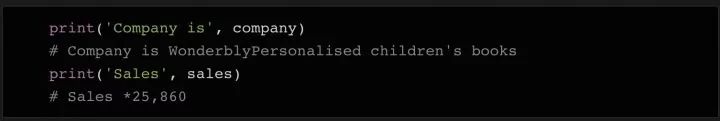

如上代码所示,我们将8列的内容依次存入8个变量中。当然,有些数据的内容需要清理,去除多余的字符,导出需要的数据。

数据清洗

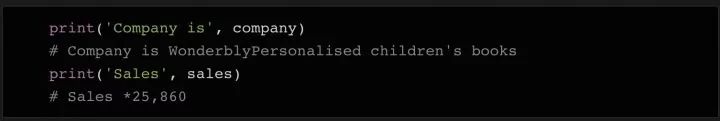

如果我们把company变量的内容打印出来,可以发现它不仅收录了公司名称,还收录了include和description。如果我们把sales变量的内容打印出来,可以发现里面还有一些备注等需要清除的字符。

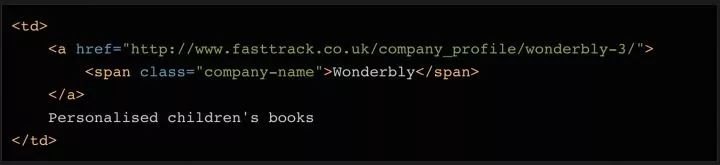

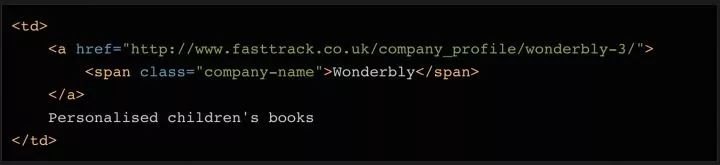

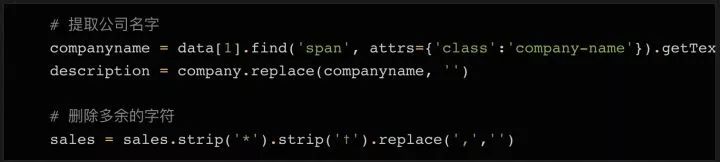

我们想把公司变量的内容分成两部分,公司名称和描述。这可以在几行代码中完成。再看一下对应的html代码,你会发现这个单元格里还有一个元素,里面只有公司名。此外,还有一个链接元素,其中收录指向公司详细信息页面的链接。以后会用到!

为了区分公司名称和描述这两个字段,我们然后使用find方法读取元素中的内容,然后删除或替换公司变量中对应的内容,这样就只有描述了留在变量中。

要删除sales变量中多余的字符,我们可以使用一次strip方法。

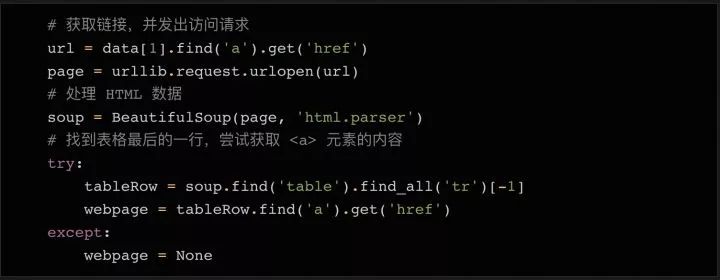

我们最不想保存的是公司的 网站 链接。如上所述,在第二列中有一个指向公司详细信息页面的链接。每个公司的详细信息页面上都有一个表格。在大多数情况下,表格中有一个到公司的链接网站。

在公司详细信息页面上查看表格中的链接

为了抓取每个表中的 URL 并将其保存在变量中,我们需要执行以下步骤:

在原来的快速通道页面,找到您需要访问的公司详细信息页面的链接。

发起指向公司详细信息页面链接的请求

使用 Beautifulsoup 处理得到的 html 数据

找到您需要的链接元素

如上图所示,看了几个公司详情页,你会发现公司的网址基本都在表格的最后一行。所以我们可以找到表格最后一行的元素。

同理,最后一行可能没有链接。所以我们添加了一个 try...except 语句,如果找不到 URL,则将该变量设置为 None。在我们将所有需要的数据都存储在变量中之后(还在循环体中),我们可以将所有变量整合到一个列表中,然后将这个列表附加到我们上面初始化的行对象的末尾。

在上面代码的最后,我们在循环体完成后打印了行的内容,以便您在将数据写入文件之前再次检查。

写入外部文件

最后,我们将上面得到的数据写入外部文件,方便后续的分析处理。在 Python 中,我们只需要简单的几行代码就可以将列表对象保存为文件。

最后,让我们运行这个python代码。如果一切顺利,您会在目录中找到一个收录 100 行数据的 csv 文件。你可以用python轻松阅读和处理它。

总结

在这个简单的 Python 教程中,我们采取了以下步骤来抓取网页内容:

连接并获取网页内容

使用 BeautifulSoup 处理获取的 html 数据

循环搜索soup对象中需要的html元素

进行简单的数据清理

将数据写入csv文件

如果有什么不明白的,请在下方留言,我会尽力解答!

附件:本文所有代码()

祝您的爬虫之旅有一个好的开始!

编译源:

(完)

看完这篇文章你学会了吗?请转发并分享给更多人

专注“Python事物”,做全栈开发工程师

点击“观看”的人看起来会更好。 查看全部

从网页抓取数据(用脚本将获取信息上获取2018年100强企业的信息)

(点击上方公众号,快速关注,一起学习Python)

编译:Ou Shave

数据科学家的首要任务是进行网络爬虫。那时,我对使用代码从网站获取数据的技术一无所知。它恰好是最合乎逻辑和最简单的数据来源。经过几次尝试,网络爬行对我来说几乎是本能的。今天,它已成为我几乎每天都在使用的少数技术之一。

在今天的文章中,我会用几个简单的例子来给大家展示一下如何爬取一个网站——比如从Fast Track获取2018年排名前100的公司信息。使用脚本实现信息获取过程的自动化,不仅可以节省人工整理的时间,还可以将企业所有数据整理成结构化的文件,以便进一步分析查询。

看版本太长:如果你只是想要一个最基本的Python爬虫程序的示例代码,本文用到的所有代码都在GitHub()上,欢迎大家来取。

准备工作

每次你打算用 Python 做某事时,你问的第一个问题应该是:“我需要使用什么库”。

有几个不同的库可用于网络抓取,包括:

今天我们计划使用 Beautiful Soup 库。您只需要使用 pip(Python 包管理工具)即可轻松将其安装到您的计算机上:

安装完成后,我们就可以开始了!

检查网页

为了确定要抓取网页的哪些元素,首先需要检查网页的结构。

以 Tech Track 前 100 名公司 (%3A//www.fasttrack.co.uk/league-tables/tech-track-100/league-table/) 为例。您可以右键单击表格并选择“考试”。在弹出的“开发者工具”中,我们可以看到页面上的每个元素以及其中收录的内容。

在要查看的网页元素上右击,选择“check”查看具体的HTML元素内容

由于数据是存放在表中的,所以只需要几行代码就可以直接得到完整的信息。如果您想自己练习抓取网页内容,这是一个很好的例子。但请记住,实际情况往往并非如此简单。

在此示例中,所有 100 个结果都收录在同一页面上,并由标签分隔成行。但是,在实际的爬取过程中,很多数据往往分布在多个不同的页面上。您需要调整每个页面显示的结果总数或遍历所有页面以捕获完整数据。

在表格页面,可以看到一个收录全部100条数据的表格,右键点击选择“检查”,可以很容易的看到HTML表格的结构。收录内容的表格的主体在这个标签中:

每一行都在一个标签中,也就是我们不需要太复杂的代码,只要一个循环,就可以读取所有的表数据并保存到文件中。

注意:您还可以通过检查当前页面是否发送了HTTP GET请求并获取该请求的返回值来获取页面显示的信息。因为 HTTP GET 请求往往可以返回结构化数据,例如 JSON 或 XML 格式的数据,以方便后续处理。您可以在开发者工具中点击Network类别(如果需要,您只能查看XHR标签的内容)。这时候可以刷新页面,这样页面上加载的所有请求和返回的内容都会在Network中列出。此外,您还可以使用某种REST客户端(例如Insomnia)发起请求并输出返回值。

刷新页面后,更新Network标签的内容

使用 Beautiful Soup 库处理网页的 HTML 内容

熟悉了网页的结构,了解了需要爬取的内容后,我们终于拿起代码开始工作了~

首先要导入代码中需要用到的各个模块。我们上面已经提到过 BeautifulSoup,这个模块可以帮助我们处理 HTML 结构。下一个要导入的模块是urllib,负责连接目标地址,获取网页内容。最后,我们需要能够将数据写入CSV文件并保存在本地硬盘上,因此我们需要导入csv库。当然,这不是唯一的选择。如果要将数据保存为json文件,则需要相应地导入json库。

接下来,我们需要准备需要爬取的目标网址。如上所述,这个页面已经收录了我们需要的所有内容,所以我们只需要复制完整的 URL 并将其赋值给变量即可:

接下来我们可以使用urllib连接这个URL,将内容保存在page变量中,然后使用BeautifulSoup对页面进行处理,并将处理结果保存在soup变量中:

这时候可以尝试打印soup变量,看看处理后的html数据是什么样子的:

如果变量内容为空或者返回一些错误信息,则表示可能无法正确获取网页数据。您可能需要在 urllib.error() 模块中使用一些错误捕获代码来查找可能的问题。

查找 HTML 元素

由于所有内容都在表格中(

tag),我们可以在soup对象中搜索需要的表,然后使用find_all方法遍历表中的每一行数据。

如果您尝试打印出所有行,则应该有 101 行-100 行内容,加上一个标题。

看看打印出来的内容,如果没有问题,我们可以用一个循环来获取所有的数据。

如果打印出soup对象的前2行,可以看到每一行的结构是这样的:

如您所见,该表共有 8 列,分别为 Rank、Company、Location、Year End、Annual Sales Rise、Latest Sales(今年的销售额)、Staff(员工人数)和 Comments(备注)。

这些是我们需要的数据。

这个结构在整个网页中是一致的(但在其他网站上可能没有这么简单!),所以我们可以再次使用find_all方法通过搜索元素逐行提取数据,就是存储在变量中,以后可以写入 csv 或 json 文件。

遍历所有元素并将它们存储在变量中

在Python中,如果需要处理大量数据,需要写入文件,list对象非常有用。我们可以先声明一个空的列表,填入初始的header(供以后在CSV文件中使用),后面的数据只需要调用list对象的append方法即可。

这将打印出我们刚刚添加到列表对象行中的第一行标题。

您可能会注意到,我输入的标题中的列名称比网页上的表格多几个,例如网页和说明。请仔细看上面打印的汤变量数据——在数据的第二行第二列,不仅有公司名称,还有公司网站和简要说明。所以我们需要这些额外的列来存储这些数据。

接下来,我们遍历所有 100 行数据,提取内容,并将其保存到列表中。

如何循环读取数据:

因为第一行数据是html表格的表头,我们可以跳过阅读。因为header使用了标签,没有使用标签,所以我们简单的查询标签中的数据,丢弃空值。

接下来,我们读取数据的内容并赋值给变量:

如上代码所示,我们将8列的内容依次存入8个变量中。当然,有些数据的内容需要清理,去除多余的字符,导出需要的数据。

数据清洗

如果我们把company变量的内容打印出来,可以发现它不仅收录了公司名称,还收录了include和description。如果我们把sales变量的内容打印出来,可以发现里面还有一些备注等需要清除的字符。

我们想把公司变量的内容分成两部分,公司名称和描述。这可以在几行代码中完成。再看一下对应的html代码,你会发现这个单元格里还有一个元素,里面只有公司名。此外,还有一个链接元素,其中收录指向公司详细信息页面的链接。以后会用到!

为了区分公司名称和描述这两个字段,我们然后使用find方法读取元素中的内容,然后删除或替换公司变量中对应的内容,这样就只有描述了留在变量中。

要删除sales变量中多余的字符,我们可以使用一次strip方法。

我们最不想保存的是公司的 网站 链接。如上所述,在第二列中有一个指向公司详细信息页面的链接。每个公司的详细信息页面上都有一个表格。在大多数情况下,表格中有一个到公司的链接网站。

在公司详细信息页面上查看表格中的链接

为了抓取每个表中的 URL 并将其保存在变量中,我们需要执行以下步骤:

在原来的快速通道页面,找到您需要访问的公司详细信息页面的链接。

发起指向公司详细信息页面链接的请求

使用 Beautifulsoup 处理得到的 html 数据

找到您需要的链接元素

如上图所示,看了几个公司详情页,你会发现公司的网址基本都在表格的最后一行。所以我们可以找到表格最后一行的元素。

同理,最后一行可能没有链接。所以我们添加了一个 try...except 语句,如果找不到 URL,则将该变量设置为 None。在我们将所有需要的数据都存储在变量中之后(还在循环体中),我们可以将所有变量整合到一个列表中,然后将这个列表附加到我们上面初始化的行对象的末尾。