python抓取网页数据

python抓取网页数据(python2抓取网页的内容显示出来是怎么回事?(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-12-25 01:11

)

在使用python2抓取网页时,我们经常会遇到抓取的内容显示乱码。

出现这种情况的最大可能是编码问题:运行环境的字符编码与网页的字符编码不一致。

例如,在 windows 控制台 (gbk) 中抓取了一个 utf-8 编码的 网站。或者,在Mac/Linux终端抓一个gbk编码的网站(utf-8)。因为大多数网站使用的是utf-8编码,而且很多人用的是Windows,所有这种情况相当普遍。

如果你发现你抓取的内容在英文、数字、符号上看起来都是正确的,但是中间出现了一些乱码,你基本可以断定是这样的。

解决这个问题的方法是先按照网页的编码方式将结果解码成unicode,然后输出。如果不确定网页的编码方式,可以参考以下代码:

import urllib

req = urllib.urlopen("http://some.web.site")

info = req.info()

charset = info.getparam('charset')

content = req.read()

print content.decode(charset, 'ignore')

'ignore' 参数的作用是忽略无法解码的字符。

然而,这种方法并不总是有效。另一种方式是通过正则化直接匹配网页代码中的编码设置:

除了编码问题导致的乱码外,还有一种情况经常被忽略,那就是登陆页面开启了gzip压缩。压缩后的网页传输的数据更少,打开速度更快。在浏览器中打开时,浏览器会根据网页的header信息自动解压。但是直接用代码去抢就不行了。所以,很可能会混淆,为什么打开网址打开网页地址很清楚,但是程序爬取却不起作用。就连我自己也被这个问题愚弄了。

这种情况的表现就是几乎所有爬取的内容都是乱码,甚至无法显示。

判断网页是否开启压缩并解压,可以参考如下代码:

import urllib

import gzip

from StringIO import StringIO

req = urllib.urlopen("http://some.web.site")

info = req.info()

encoding = info.getheader('Content-Encoding')

content = req.read()

if encoding == 'gzip':

buf = StringIO(content)

gf = gzip.GzipFile(fileobj=buf)

content = gf.read()

print content

在我们课堂上查看天气系列的编程实例(点击查看),这两个问题困扰了不少人。这里有一个特别的解释。

最后,还有另一个“武器”要介绍。如果你第一次使用它,你甚至不知道上面两个问题仍然存在。

这是请求模块。

要以相同的方式获取网页,您只需要:

import requests

print requests.get("http://some.web.site").text

没有编码问题,没有压缩问题。

这就是我喜欢 Python 的原因。

至于如何安装requests模块,请参考前面的文章:

Python-Crossin的编程课堂如何安装第三方模块-知乎专栏

pip install requests

其他 文章 和回答:

你是如何自学 Python 的?-克罗辛的回答

在学习编程的过程中可能会走哪些弯路,有哪些经验可以参考?-克罗辛的回答

编程初学者如何使用搜索引擎-Crossin的文章-知乎专栏

如何直观的了解程序的运行过程?-Crossin 的 文章-知乎 专栏

如何在一台电脑上同时使用Python 2和Python 3-Crossin的编程课堂-知乎专栏

Crossin的编程课堂

微信ID:crossincode

论坛:Crossin 的编程课堂

QQ群:498545096

查看全部

python抓取网页数据(python2抓取网页的内容显示出来是怎么回事?(图)

)

在使用python2抓取网页时,我们经常会遇到抓取的内容显示乱码。

出现这种情况的最大可能是编码问题:运行环境的字符编码与网页的字符编码不一致。

例如,在 windows 控制台 (gbk) 中抓取了一个 utf-8 编码的 网站。或者,在Mac/Linux终端抓一个gbk编码的网站(utf-8)。因为大多数网站使用的是utf-8编码,而且很多人用的是Windows,所有这种情况相当普遍。

如果你发现你抓取的内容在英文、数字、符号上看起来都是正确的,但是中间出现了一些乱码,你基本可以断定是这样的。

解决这个问题的方法是先按照网页的编码方式将结果解码成unicode,然后输出。如果不确定网页的编码方式,可以参考以下代码:

import urllib

req = urllib.urlopen("http://some.web.site";)

info = req.info()

charset = info.getparam('charset')

content = req.read()

print content.decode(charset, 'ignore')

'ignore' 参数的作用是忽略无法解码的字符。

然而,这种方法并不总是有效。另一种方式是通过正则化直接匹配网页代码中的编码设置:

除了编码问题导致的乱码外,还有一种情况经常被忽略,那就是登陆页面开启了gzip压缩。压缩后的网页传输的数据更少,打开速度更快。在浏览器中打开时,浏览器会根据网页的header信息自动解压。但是直接用代码去抢就不行了。所以,很可能会混淆,为什么打开网址打开网页地址很清楚,但是程序爬取却不起作用。就连我自己也被这个问题愚弄了。

这种情况的表现就是几乎所有爬取的内容都是乱码,甚至无法显示。

判断网页是否开启压缩并解压,可以参考如下代码:

import urllib

import gzip

from StringIO import StringIO

req = urllib.urlopen("http://some.web.site";)

info = req.info()

encoding = info.getheader('Content-Encoding')

content = req.read()

if encoding == 'gzip':

buf = StringIO(content)

gf = gzip.GzipFile(fileobj=buf)

content = gf.read()

print content

在我们课堂上查看天气系列的编程实例(点击查看),这两个问题困扰了不少人。这里有一个特别的解释。

最后,还有另一个“武器”要介绍。如果你第一次使用它,你甚至不知道上面两个问题仍然存在。

这是请求模块。

要以相同的方式获取网页,您只需要:

import requests

print requests.get("http://some.web.site";).text

没有编码问题,没有压缩问题。

这就是我喜欢 Python 的原因。

至于如何安装requests模块,请参考前面的文章:

Python-Crossin的编程课堂如何安装第三方模块-知乎专栏

pip install requests

其他 文章 和回答:

你是如何自学 Python 的?-克罗辛的回答

在学习编程的过程中可能会走哪些弯路,有哪些经验可以参考?-克罗辛的回答

编程初学者如何使用搜索引擎-Crossin的文章-知乎专栏

如何直观的了解程序的运行过程?-Crossin 的 文章-知乎 专栏

如何在一台电脑上同时使用Python 2和Python 3-Crossin的编程课堂-知乎专栏

Crossin的编程课堂

微信ID:crossincode

论坛:Crossin 的编程课堂

QQ群:498545096

python抓取网页数据( 目标网页用关键字在源代码中查找最终代码验证结果)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-23 02:03

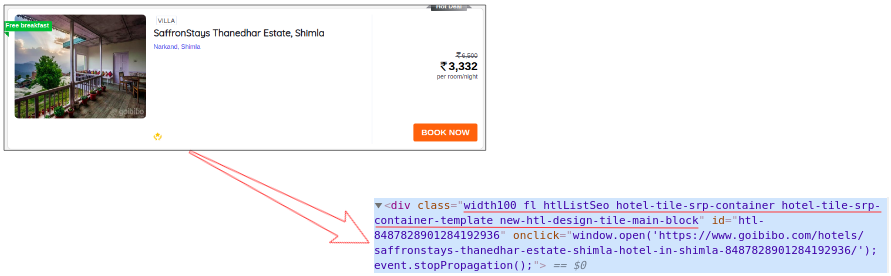

目标网页用关键字在源代码中查找最终代码验证结果)

概括

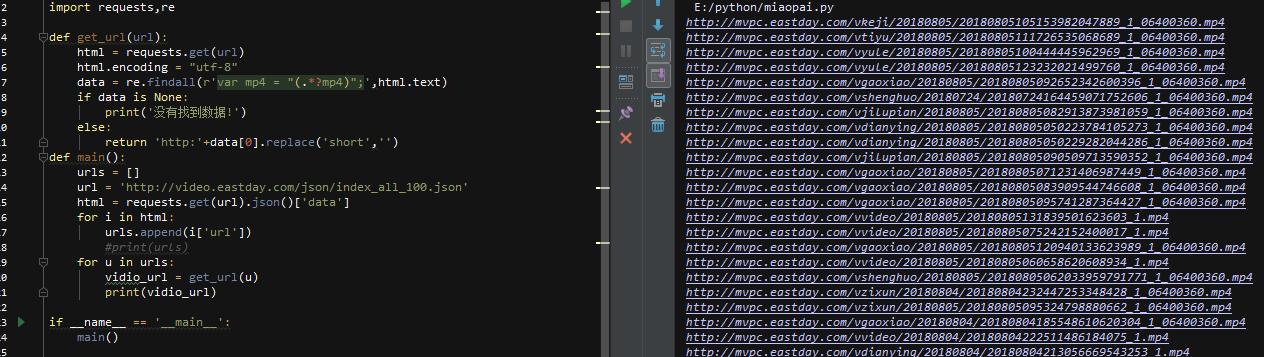

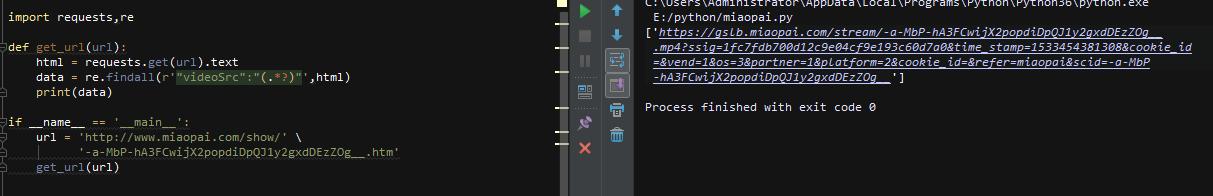

根据网站的结构和数据类型,做一个头条视频的爬虫,重点关注网站中数据的位置和抓取方法

并介绍一个类似的网站,简单解释一下数据抓取的方法

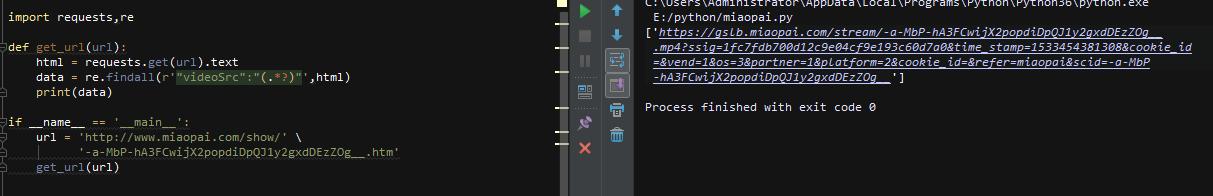

使用工具:python3.6 + pycharm + requests 库 + re 库

目标情况

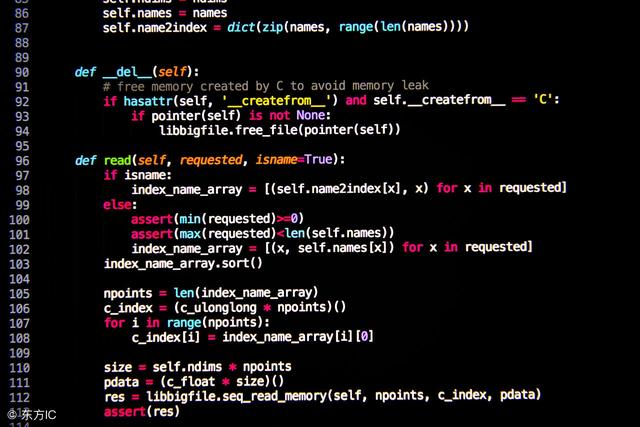

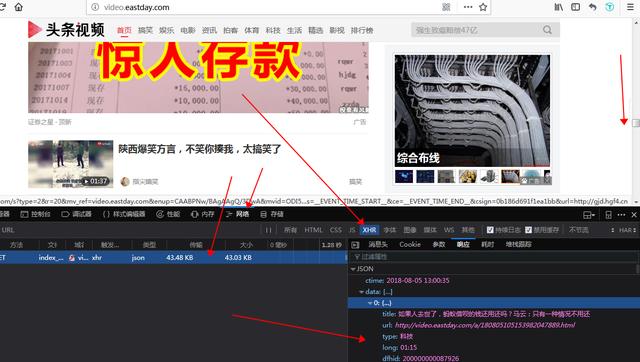

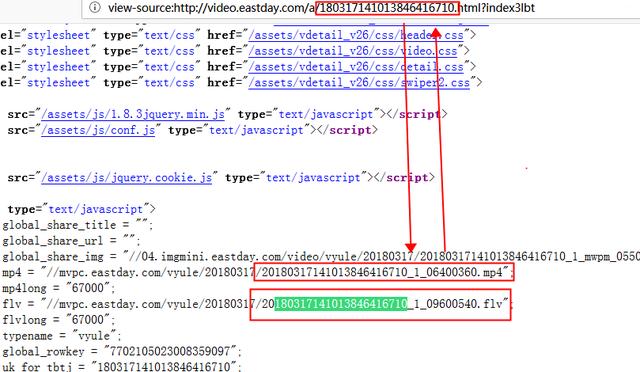

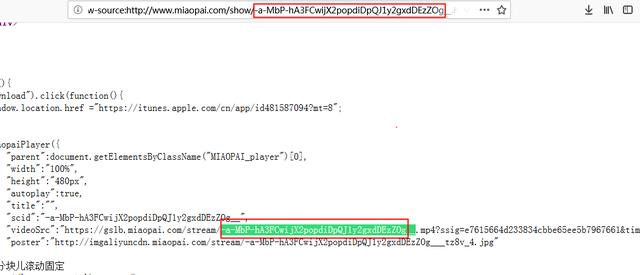

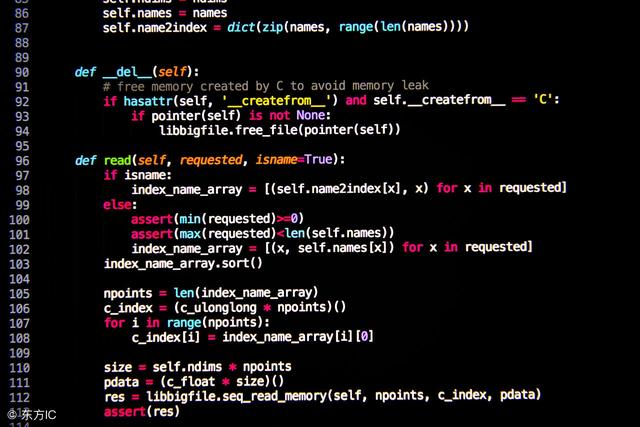

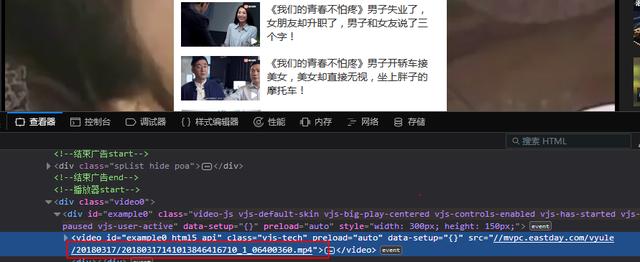

这次我们的目标网站是ajax加载的数据。首先打开网页后,直接使用浏览器自带的开发者工具(火狐),点击网页,然后将网页向下滑动,点击xhr,找到json数据,可以看到100条左右的内容

每个视频都有相关信息,我们只需要取出每个视频的url即可!然后去查看详情页

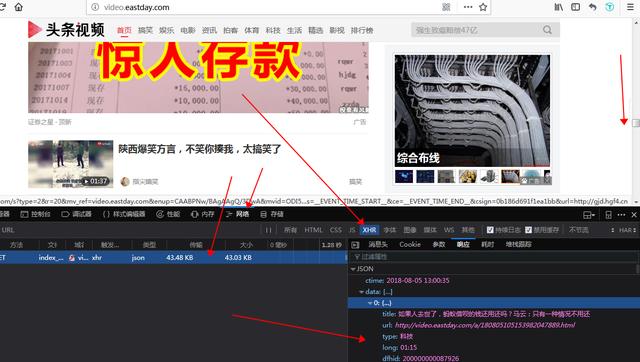

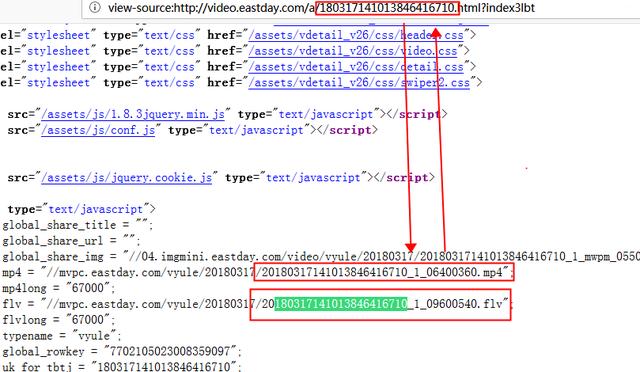

很容易就能找到视频的真实地址!复制地址,重新打开网页验证,确认地址正确,然后去源码查看地址是否存在

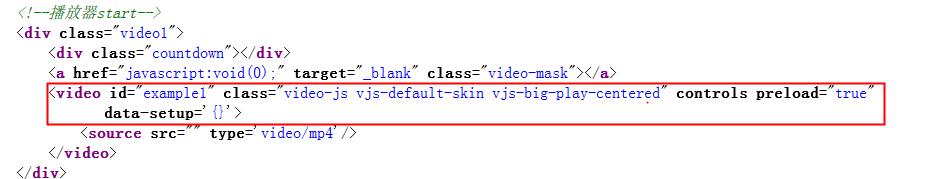

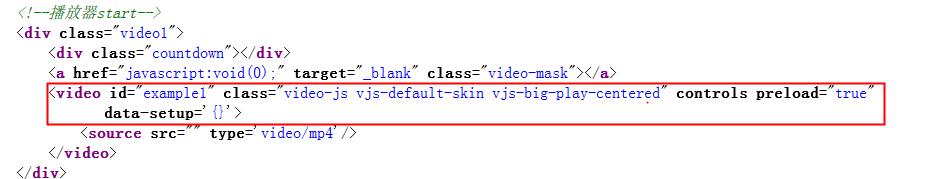

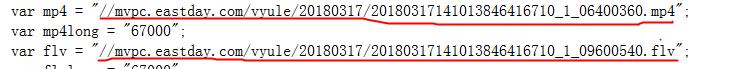

很明显,这个网站不是静态的网站,数据应该是存放在js文件中的,那么我们如何获取呢~?我需要分析js文件还是使用selenium?别担心,我偶然发现了这个

有没有发现网页源代码中存在url中的关键字,虽然不完全一样,但是我们可以和上一个标签中的内容进行比较

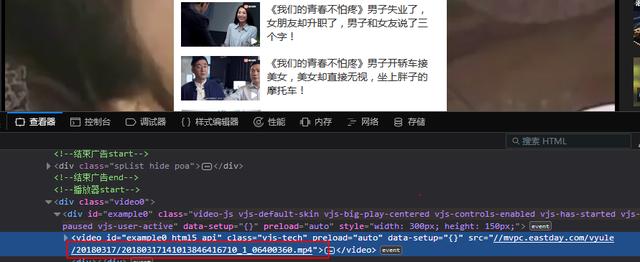

可以确定,这里的值是网页渲染后出现在html标签中的值,在源码中有两个不同格式的视频地址!,很简单,我们来写代码吧!

代码

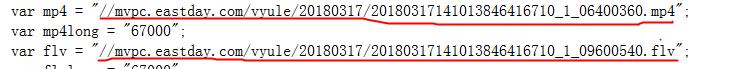

简单写,直接用requests请求内容,然后用re匹配,取出目标url

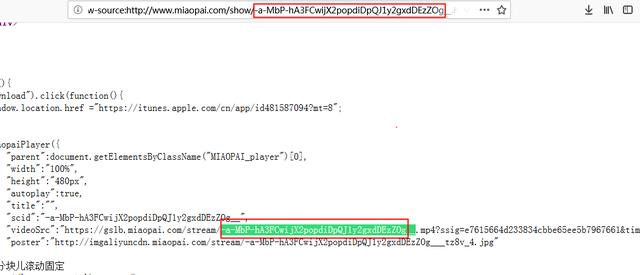

类似于 网站

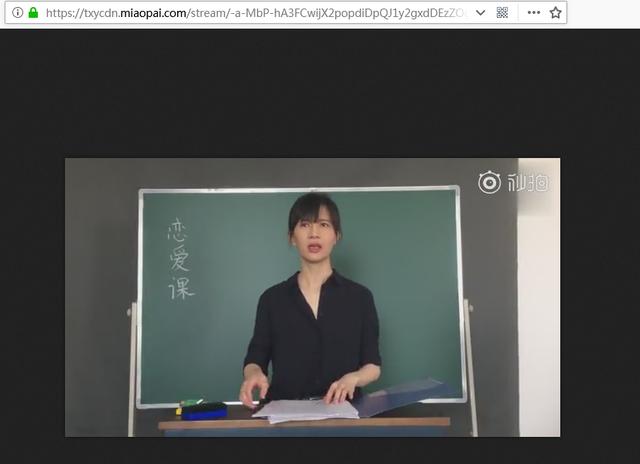

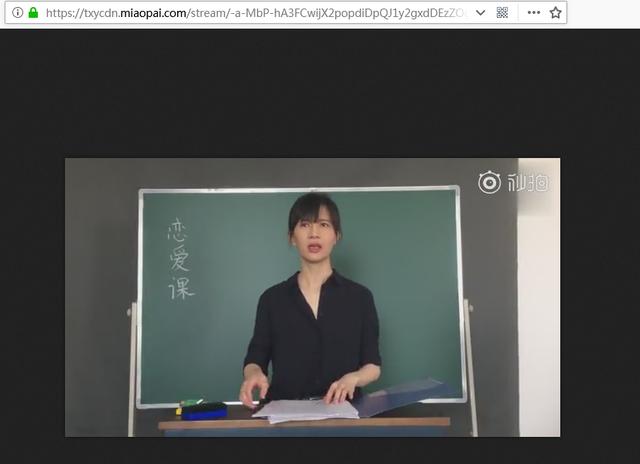

其实还有一个网站和这种情况很相似,就是第二个视频,但是如果你想看更多的视频,还是需要打开客户端,所以我们就简单的把视频作为一个例子。抓住它的真实地址!具体过程就不一一解释了,直接看结果,先看登陆页面

使用关键字在源代码中搜索

最终代码

验证结果

以上文章如有错误,请在留言区指出。如果这个文章对你有用,你喜欢并转发吗? 查看全部

python抓取网页数据(

目标网页用关键字在源代码中查找最终代码验证结果)

概括

根据网站的结构和数据类型,做一个头条视频的爬虫,重点关注网站中数据的位置和抓取方法

并介绍一个类似的网站,简单解释一下数据抓取的方法

使用工具:python3.6 + pycharm + requests 库 + re 库

目标情况

这次我们的目标网站是ajax加载的数据。首先打开网页后,直接使用浏览器自带的开发者工具(火狐),点击网页,然后将网页向下滑动,点击xhr,找到json数据,可以看到100条左右的内容

每个视频都有相关信息,我们只需要取出每个视频的url即可!然后去查看详情页

很容易就能找到视频的真实地址!复制地址,重新打开网页验证,确认地址正确,然后去源码查看地址是否存在

很明显,这个网站不是静态的网站,数据应该是存放在js文件中的,那么我们如何获取呢~?我需要分析js文件还是使用selenium?别担心,我偶然发现了这个

有没有发现网页源代码中存在url中的关键字,虽然不完全一样,但是我们可以和上一个标签中的内容进行比较

可以确定,这里的值是网页渲染后出现在html标签中的值,在源码中有两个不同格式的视频地址!,很简单,我们来写代码吧!

代码

简单写,直接用requests请求内容,然后用re匹配,取出目标url

类似于 网站

其实还有一个网站和这种情况很相似,就是第二个视频,但是如果你想看更多的视频,还是需要打开客户端,所以我们就简单的把视频作为一个例子。抓住它的真实地址!具体过程就不一一解释了,直接看结果,先看登陆页面

使用关键字在源代码中搜索

最终代码

验证结果

以上文章如有错误,请在留言区指出。如果这个文章对你有用,你喜欢并转发吗?

python抓取网页数据(Python非常适合用来开发网页爬虫,理由:管理待爬取url)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-23 01:19

前言

Python非常适合开发网络爬虫,原因如下:

1、 抓取网页本身的界面

与java、c#、c++、python等其他静态编程语言相比,抓取网页文档的界面更加简洁;相较于其他动态脚本语言,如 perl、shell,python 的 urllib 包提供了更完整的 web 文档 API 访问。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站都是为了生硬爬取而被屏蔽的。这就是我们需要模拟用户代理的行为来构造合适的请求的地方,比如模拟用户登录,模拟会话/cookie存储和设置。python中有优秀的第三方包帮你搞定,比如Requests,mechanize

2、网页爬取后的处理

抓取到的网页通常需要进行处理,如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

人生苦短,你需要python。

PS:python2.x 与 python3.x 非常不同。本文只讨论python3.x的爬虫实现方法。

爬虫架构的组成

网址管理器:管理待抓取网址的集合和已抓取网址的集合,并将待抓取的网址发送给网页下载器。

网页下载器(urllib):抓取url对应的网页,存储为字符串,发送给网页解析器。

网页解析器(BeautifulSoup):解析出有价值的数据并存储,同时将url添加到URL管理器中。

运行过程

URL管理器基本功能存储方法

1、内存(python内存)

要爬取的URL集合:set()

爬取的 url 集合:set()

2、关系型数据库(mysql)

网址(网址,is_crawled)

3、缓存(redis)

要抓取的网址集合:设置

抓取的网址集合:设置

由于缓存数据库的高性能,大型互联网公司通常将URL存储在缓存数据库中。小公司通常将 URL 存储在内存中。如果他们想永久存储它们,请将它们存储在关系数据库中。

网页下载器 (urllib)

将url对应的网页下载到本地,保存为文件或字符串。

基本方法

新建一个baidu.py,内容如下:

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

buff = response.read()

html = buff.decode("utf8")

print(html)

在命令行执行python baidu.py,可以打印出得到的页面。

构造请求

上面的代码可以修改为:

import urllib.request

request = urllib.request.Request('http://www.baidu.com')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

携带参数

新建一个baidu2.py,内容如下:

import urllib.request

import urllib.parse

url = 'http://www.baidu.com'

values = {'name': 'voidking','language': 'Python'}

data = urllib.parse.urlencode(values).encode(encoding='utf-8',errors='ignore')

headers = { 'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0' }

request = urllib.request.Request(url=url, data=data,headers=headers,method='GET')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

使用 Fiddler 监控数据

我们要检查我们的请求是否真的带有参数,所以我们需要使用 fiddler。

打开fiddler后,偶然发现上面的代码会报错504,不管是baidu.py还是baidu2.py。

虽然python报错,但是在fiddler中,我们可以看到请求信息确实是带参数的。

查找资料后发现,之前版本的Python不支持代理环境下访问https。但是,最新版本应该支持它。那么,最简单的方法就是更改一个使用http协议进行爬取的URL,例如替换为。结果还是报错,但是变成了400错误。

然而,然而,然而。. . 神的转折点出现了!!!

当我将url更改为时,请求成功!没错,只需在 URL 后添加一个额外的斜杠 / 即可。同理,如果改成,请求也是成功的!魔法!!!

添加处理器

import urllib.request

import http.cookiejar

# 创建cookie容器

cj = http.cookiejar.CookieJar()

# 创建opener

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

# 给urllib.request安装opener

urllib.request.install_opener(opener)

# 请求

request = urllib.request.Request('http://www.baidu.com/')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

print(cj)

网页解析器(BeautifulSoup)

从网页中提取有价值的数据和新的 URL 列表。

解析器选择

为了实现解析器,可以选择使用正则表达式,html.parser、BeautifulSoup、lxml等,这里我们选择BeautifulSoup。

其中,正则表达式基于模糊匹配,而其他三个基于DOM结构分析。

BeautifulSoup 安装测试

1、安装,在命令行下执行pip install beautifulsoup4。

2、测试

import bs4

print(bs4)

使用说明

基本用法

1、创建一个 BeautifulSoup 对象

import bs4

from bs4 import BeautifulSoup

# 根据html网页字符串创建BeautifulSoup对象

html_doc = """

The Dormouse's story

<p class="title">The Dormouse's story

Once upon a time there were three little sisters; and their names were

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

"""

soup = BeautifulSoup(html_doc)

print(soup.prettify())</p>

2、访问节点

print(soup.title)

print(soup.title.name)

print(soup.title.string)

print(soup.title.parent.name)

print(soup.p)

print(soup.p['class'])

3、指定标签、类或id

print(soup.find_all('a'))

print(soup.find('a'))

print(soup.find(class_='title'))

print(soup.find(id="link3"))

print(soup.find('p',class_='title'))

4、从文档中查找所有标签的链接

for link in soup.find_all('a'):

print(link.get('href'))

有警告。根据提示,我们只需要在创建 BeautifulSoup 对象时指定解析器即可。

5、从文档中获取所有文本内容

print(soup.get_text())

6、正则匹配

link_node = soup.find('a',href=re.compile(r"til"))

print(link_node)

后记

Python爬虫的基础知识到此就足够了。接下来,在实战中学习更多的进阶知识。

书签

Python开发简单爬虫

Python 标准库

美汤4.2.0个文档

为什么python适合写爬虫?

如何学习Python爬虫【介绍】?

你需要这些:Python3.x爬虫学习资料整理

如何开始使用 Python 爬虫?

Python3.X 抓取网络资源

python网络请求和“HTTP错误504:提琴手接收失败”

如何使用Fiddler抓取自己写的爬虫包?

fiddler抓取python脚本的https包时出现错误? 查看全部

python抓取网页数据(Python非常适合用来开发网页爬虫,理由:管理待爬取url)

前言

Python非常适合开发网络爬虫,原因如下:

1、 抓取网页本身的界面

与java、c#、c++、python等其他静态编程语言相比,抓取网页文档的界面更加简洁;相较于其他动态脚本语言,如 perl、shell,python 的 urllib 包提供了更完整的 web 文档 API 访问。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站都是为了生硬爬取而被屏蔽的。这就是我们需要模拟用户代理的行为来构造合适的请求的地方,比如模拟用户登录,模拟会话/cookie存储和设置。python中有优秀的第三方包帮你搞定,比如Requests,mechanize

2、网页爬取后的处理

抓取到的网页通常需要进行处理,如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

人生苦短,你需要python。

PS:python2.x 与 python3.x 非常不同。本文只讨论python3.x的爬虫实现方法。

爬虫架构的组成

网址管理器:管理待抓取网址的集合和已抓取网址的集合,并将待抓取的网址发送给网页下载器。

网页下载器(urllib):抓取url对应的网页,存储为字符串,发送给网页解析器。

网页解析器(BeautifulSoup):解析出有价值的数据并存储,同时将url添加到URL管理器中。

运行过程

URL管理器基本功能存储方法

1、内存(python内存)

要爬取的URL集合:set()

爬取的 url 集合:set()

2、关系型数据库(mysql)

网址(网址,is_crawled)

3、缓存(redis)

要抓取的网址集合:设置

抓取的网址集合:设置

由于缓存数据库的高性能,大型互联网公司通常将URL存储在缓存数据库中。小公司通常将 URL 存储在内存中。如果他们想永久存储它们,请将它们存储在关系数据库中。

网页下载器 (urllib)

将url对应的网页下载到本地,保存为文件或字符串。

基本方法

新建一个baidu.py,内容如下:

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

buff = response.read()

html = buff.decode("utf8")

print(html)

在命令行执行python baidu.py,可以打印出得到的页面。

构造请求

上面的代码可以修改为:

import urllib.request

request = urllib.request.Request('http://www.baidu.com')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

携带参数

新建一个baidu2.py,内容如下:

import urllib.request

import urllib.parse

url = 'http://www.baidu.com'

values = {'name': 'voidking','language': 'Python'}

data = urllib.parse.urlencode(values).encode(encoding='utf-8',errors='ignore')

headers = { 'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0' }

request = urllib.request.Request(url=url, data=data,headers=headers,method='GET')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

使用 Fiddler 监控数据

我们要检查我们的请求是否真的带有参数,所以我们需要使用 fiddler。

打开fiddler后,偶然发现上面的代码会报错504,不管是baidu.py还是baidu2.py。

虽然python报错,但是在fiddler中,我们可以看到请求信息确实是带参数的。

查找资料后发现,之前版本的Python不支持代理环境下访问https。但是,最新版本应该支持它。那么,最简单的方法就是更改一个使用http协议进行爬取的URL,例如替换为。结果还是报错,但是变成了400错误。

然而,然而,然而。. . 神的转折点出现了!!!

当我将url更改为时,请求成功!没错,只需在 URL 后添加一个额外的斜杠 / 即可。同理,如果改成,请求也是成功的!魔法!!!

添加处理器

import urllib.request

import http.cookiejar

# 创建cookie容器

cj = http.cookiejar.CookieJar()

# 创建opener

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

# 给urllib.request安装opener

urllib.request.install_opener(opener)

# 请求

request = urllib.request.Request('http://www.baidu.com/')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

print(cj)

网页解析器(BeautifulSoup)

从网页中提取有价值的数据和新的 URL 列表。

解析器选择

为了实现解析器,可以选择使用正则表达式,html.parser、BeautifulSoup、lxml等,这里我们选择BeautifulSoup。

其中,正则表达式基于模糊匹配,而其他三个基于DOM结构分析。

BeautifulSoup 安装测试

1、安装,在命令行下执行pip install beautifulsoup4。

2、测试

import bs4

print(bs4)

使用说明

基本用法

1、创建一个 BeautifulSoup 对象

import bs4

from bs4 import BeautifulSoup

# 根据html网页字符串创建BeautifulSoup对象

html_doc = """

The Dormouse's story

<p class="title">The Dormouse's story

Once upon a time there were three little sisters; and their names were

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

"""

soup = BeautifulSoup(html_doc)

print(soup.prettify())</p>

2、访问节点

print(soup.title)

print(soup.title.name)

print(soup.title.string)

print(soup.title.parent.name)

print(soup.p)

print(soup.p['class'])

3、指定标签、类或id

print(soup.find_all('a'))

print(soup.find('a'))

print(soup.find(class_='title'))

print(soup.find(id="link3"))

print(soup.find('p',class_='title'))

4、从文档中查找所有标签的链接

for link in soup.find_all('a'):

print(link.get('href'))

有警告。根据提示,我们只需要在创建 BeautifulSoup 对象时指定解析器即可。

5、从文档中获取所有文本内容

print(soup.get_text())

6、正则匹配

link_node = soup.find('a',href=re.compile(r"til"))

print(link_node)

后记

Python爬虫的基础知识到此就足够了。接下来,在实战中学习更多的进阶知识。

书签

Python开发简单爬虫

Python 标准库

美汤4.2.0个文档

为什么python适合写爬虫?

如何学习Python爬虫【介绍】?

你需要这些:Python3.x爬虫学习资料整理

如何开始使用 Python 爬虫?

Python3.X 抓取网络资源

python网络请求和“HTTP错误504:提琴手接收失败”

如何使用Fiddler抓取自己写的爬虫包?

fiddler抓取python脚本的https包时出现错误?

python抓取网页数据( ,本文开源模块requests实现需求,,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-12-21 18:05

,本文开源模块requests实现需求,,)

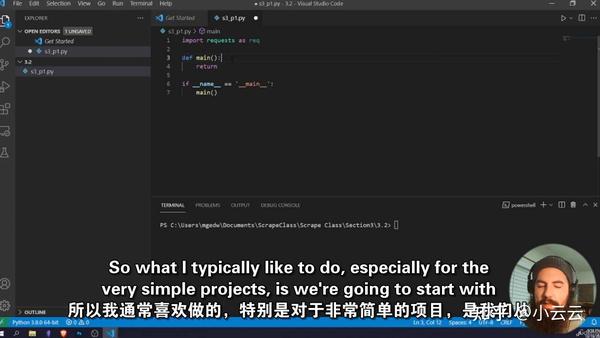

Python实现抓取页面链接的简单爬虫分享

更新时间:2015-01-21 11:46:34 投稿:俊杰

本文文章主要介绍Python爬取页面上链接的简单爬虫分享。本文使用一个开源模块请求来实现需求。有需要的朋友可以参考

除了C/C++,我还接触过很多流行的语言,PHP、java、javascript、python,其中python可以说是操作最方便、缺点最少的语言。

前几天想写个爬虫,但是和朋友商量后,决定过几天再一起写。爬虫的一个重要部分是抓取页面中的链接。我将在这里简单地实现它。

首先,我们需要使用一个开源模块,requests。这不是python自带的模块,需要从网上下载解压安装:

复制代码代码如下:

$ curl -OL

$ python setup.py 安装

Windows用户直接点击下载。解压后在本地使用命令python setup.py install进行安装。

我也在慢慢翻译这个模块的文档,翻译完后传给大家(英文版先发在附件里)。正如其描述中所述,为人类而设计,为人类而设计。使用起来很方便,自己看文档。最简单的 requests.get() 是发送一个 get 请求。

代码显示如下:

复制代码代码如下:

# 编码:utf-8

进口重新

进口请求

# 获取网页内容

r = requests.get('')

数据 = r.text

# 使用正则查找所有连接

link_list =re.findall(r"(? 查看全部

python抓取网页数据(

,本文开源模块requests实现需求,,)

Python实现抓取页面链接的简单爬虫分享

更新时间:2015-01-21 11:46:34 投稿:俊杰

本文文章主要介绍Python爬取页面上链接的简单爬虫分享。本文使用一个开源模块请求来实现需求。有需要的朋友可以参考

除了C/C++,我还接触过很多流行的语言,PHP、java、javascript、python,其中python可以说是操作最方便、缺点最少的语言。

前几天想写个爬虫,但是和朋友商量后,决定过几天再一起写。爬虫的一个重要部分是抓取页面中的链接。我将在这里简单地实现它。

首先,我们需要使用一个开源模块,requests。这不是python自带的模块,需要从网上下载解压安装:

复制代码代码如下:

$ curl -OL

$ python setup.py 安装

Windows用户直接点击下载。解压后在本地使用命令python setup.py install进行安装。

我也在慢慢翻译这个模块的文档,翻译完后传给大家(英文版先发在附件里)。正如其描述中所述,为人类而设计,为人类而设计。使用起来很方便,自己看文档。最简单的 requests.get() 是发送一个 get 请求。

代码显示如下:

复制代码代码如下:

# 编码:utf-8

进口重新

进口请求

# 获取网页内容

r = requests.get('')

数据 = r.text

# 使用正则查找所有连接

link_list =re.findall(r"(?

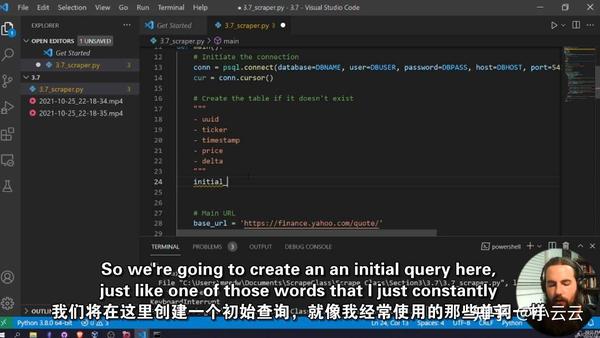

python抓取网页数据( 借助Python构建的尖端网页抓取技术,启动您的大数据项目 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-21 05:16

借助Python构建的尖端网页抓取技术,启动您的大数据项目

)

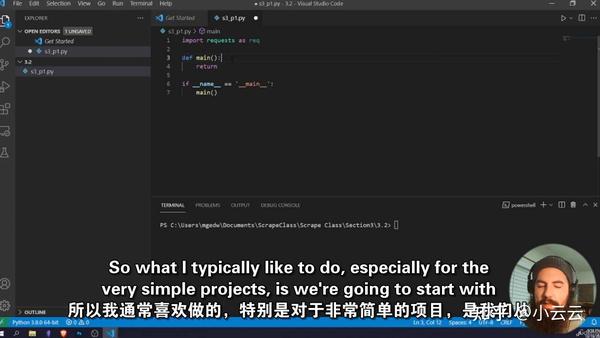

使用 Python 构建的尖端网络抓取技术开始您的大数据项目

你会学到什么

如何理论化和开发用于数据分析和研究的网络爬虫和蜘蛛

什么是刮板和蜘蛛?

刮刀和蜘蛛有什么区别?

研究中如何使用刮刀和蜘蛛?

如何使用请求和美化库构建刮板

如何构建一个多线程、复杂的scraper

类型:电子学习 | MP4 | 视频:h264, 1280×720 | 音频:AAC,48.0 KHz

语言:英文+中英文字幕(根据原版英文字幕机器翻译更准确|解压后大小:9GB|时长:10h 26m

课程获取:Scrape the Planet!使用 Python 构建 Web 爬虫

描述

网络中充满了极其强大的数据,这些数据存储在数十亿个不同的 网站、数据库和应用程序编程接口中。股票价格和加密货币趋势等金融数据、数十个国家/地区数千个不同城市的天气数据以及您最喜欢的演员或女演员的有趣传记信息:所有这些信息都触手可及,但无需一点帮助和自动化,它不可能真正使用这些信息!

Scrapers 和 Spider 是非常强大的程序,允许开发人员、大数据分析师和研究人员利用所有这些惊人的数据并将其用于大量不同的应用程序,从创建数据馈送到采集数据以馈送机器学习和人工智能算法。本课程为构建真实可用的蜘蛛提供了一种实用的方法,用于在真实情况下进行财务分析、链接图构建和社交媒体研究。在本课程结束时,学生将能够使用 Python 从头开始开发蜘蛛和爬虫,并且只会受到自己的想象力的限制。通过学习如何开发一个自动爬虫,互联网的巨大力量就在你的掌握之中!

本课程专为初学者设计。尽管以前的 Python 编程经验很有帮助,但您无需编写任何代码即可开始本课程。

本课程适用于:

各行各业的互联网研究人员都希望学习如何利用互联网上的信息为更大的利益服务。

对数据科学和网络抓取感兴趣的人。

对数据采集和管理感兴趣的人。

初级 Python 开发人员。

查看全部

python抓取网页数据(

借助Python构建的尖端网页抓取技术,启动您的大数据项目

)

使用 Python 构建的尖端网络抓取技术开始您的大数据项目

你会学到什么

如何理论化和开发用于数据分析和研究的网络爬虫和蜘蛛

什么是刮板和蜘蛛?

刮刀和蜘蛛有什么区别?

研究中如何使用刮刀和蜘蛛?

如何使用请求和美化库构建刮板

如何构建一个多线程、复杂的scraper

类型:电子学习 | MP4 | 视频:h264, 1280×720 | 音频:AAC,48.0 KHz

语言:英文+中英文字幕(根据原版英文字幕机器翻译更准确|解压后大小:9GB|时长:10h 26m

课程获取:Scrape the Planet!使用 Python 构建 Web 爬虫

描述

网络中充满了极其强大的数据,这些数据存储在数十亿个不同的 网站、数据库和应用程序编程接口中。股票价格和加密货币趋势等金融数据、数十个国家/地区数千个不同城市的天气数据以及您最喜欢的演员或女演员的有趣传记信息:所有这些信息都触手可及,但无需一点帮助和自动化,它不可能真正使用这些信息!

Scrapers 和 Spider 是非常强大的程序,允许开发人员、大数据分析师和研究人员利用所有这些惊人的数据并将其用于大量不同的应用程序,从创建数据馈送到采集数据以馈送机器学习和人工智能算法。本课程为构建真实可用的蜘蛛提供了一种实用的方法,用于在真实情况下进行财务分析、链接图构建和社交媒体研究。在本课程结束时,学生将能够使用 Python 从头开始开发蜘蛛和爬虫,并且只会受到自己的想象力的限制。通过学习如何开发一个自动爬虫,互联网的巨大力量就在你的掌握之中!

本课程专为初学者设计。尽管以前的 Python 编程经验很有帮助,但您无需编写任何代码即可开始本课程。

本课程适用于:

各行各业的互联网研究人员都希望学习如何利用互联网上的信息为更大的利益服务。

对数据科学和网络抓取感兴趣的人。

对数据采集和管理感兴趣的人。

初级 Python 开发人员。

python抓取网页数据(用Python写网络爬虫》——2.2三种网页抓取方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2021-12-20 18:09

摘要:本文讲了三种使用Python抓取网页数据的方法;它们是正则表达式 (re)、BeautifulSoup 模块和 lxml 模块。本文所有代码运行在python3.5.

本文抓取的是[中央气象台](http://www.nmc.cn/)首页头条信息:

HTML 层次结构是:

抓取 href、标题和标签的内容。

一、正则表达式

复制外层HTML:

高温预警

代码:

# coding=utf-8

import re, urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

html = html.decode('utf-8') #python3版本中需要加入

links = re.findall('<a target="_blank" href="(.+?)" title'/span,html)

titles = re.findall(span class="hljs-string"'a target="_blank" .+? title="(.+?)"'/span,html)

tags = re.findall(span class="hljs-string"'a target="_blank" .+? title=.+?(.+?)/a'/span,html)

span class="hljs-keyword"for/span span class="hljs-keyword"link/span,title,tag in zip(links,titles,tags):

span class="hljs-keyword"print/span(tag,url+span class="hljs-keyword"link/span,title)/code/pre/p

p正则表达式符号'.'表示匹配任何字符串(\n除外); ‘+’表示匹配0个或多个正则表达式; ‘? '表示在正则表达式之前匹配0次或1次。更多信息请参考Python中的正则表达式教程/p

p输出结果如下:/p

ppre class="prettyprint"code class=" hljs avrasm"高温预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/country/warning/megatemperaturespan class="hljs-preprocessor".html/span 中央气象台span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时继续发布高温橙色预警

山洪灾害气象预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/mountainfloodspan class="hljs-preprocessor".html/span 水利部和中国气象局span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时联合发布山洪灾害气象预警

强对流天气预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/country/warning/strong_convectionspan class="hljs-preprocessor".html/span 中央气象台span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时继续发布强对流天气蓝色预警

地质灾害气象风险预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/geohazardspan class="hljs-preprocessor".html/span 国土资源部与中国气象局span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时联合发布地质灾害气象风险预警/code/pre/p

p二、BeautifulSoup 模块/p

pBeautiful Soup 是一个非常流行的 Python 模块。该模块可以解析网页并提供方便的界面来定位内容。/p

p复制选择器:/p

ppre class="prettyprint"code class=" hljs css"span class="hljs-id"#alarmtip/span > ul > li.waring > a:nth-child(1)

因为这里我们要抓取多个数据,而不仅仅是第一个,所以我们需要将其更改为:

#alarmtip > ul > li.waring > a

代码:

from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出结果和上面一样。

三、lxml 模块

Lxml 是一个基于 libxml2(一个 XML 解析库)的 Python 包。本模块为C语言编写,解析速度比Beautiful Soup快,但安装过程较复杂。

代码:

import urllib.request,lxml.html

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

tree = lxml.html.fromstring(html)

content = tree.cssselect('li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出结果和上面一样。

四、将捕获的数据存储在列表或字典中

以 BeautifulSoup 模块为例:

from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

######### 添加到列表中

link = []

title = []

tag = []

for n in content:

link.append(url+n.get('href'))

title.append(n.get('title'))

tag.append(n.text)

######## 添加到字典中

for n in content:

data = {

'tag' : n.text,

'link' : url+n.get('href'),

'title' : n.get('title')

}

五、总结

表2.1总结了每种爬取方法的优缺点。

源代码链接

参考文献:

《用Python编写网络爬虫》——2.2种网络爬虫方法 查看全部

python抓取网页数据(用Python写网络爬虫》——2.2三种网页抓取方法)

摘要:本文讲了三种使用Python抓取网页数据的方法;它们是正则表达式 (re)、BeautifulSoup 模块和 lxml 模块。本文所有代码运行在python3.5.

本文抓取的是[中央气象台](http://www.nmc.cn/)首页头条信息:

HTML 层次结构是:

抓取 href、标题和标签的内容。

一、正则表达式

复制外层HTML:

高温预警

代码:

# coding=utf-8

import re, urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

html = html.decode('utf-8') #python3版本中需要加入

links = re.findall('<a target="_blank" href="(.+?)" title'/span,html)

titles = re.findall(span class="hljs-string"'a target="_blank" .+? title="(.+?)"'/span,html)

tags = re.findall(span class="hljs-string"'a target="_blank" .+? title=.+?(.+?)/a'/span,html)

span class="hljs-keyword"for/span span class="hljs-keyword"link/span,title,tag in zip(links,titles,tags):

span class="hljs-keyword"print/span(tag,url+span class="hljs-keyword"link/span,title)/code/pre/p

p正则表达式符号'.'表示匹配任何字符串(\n除外); ‘+’表示匹配0个或多个正则表达式; ‘? '表示在正则表达式之前匹配0次或1次。更多信息请参考Python中的正则表达式教程/p

p输出结果如下:/p

ppre class="prettyprint"code class=" hljs avrasm"高温预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/country/warning/megatemperaturespan class="hljs-preprocessor".html/span 中央气象台span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时继续发布高温橙色预警

山洪灾害气象预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/mountainfloodspan class="hljs-preprocessor".html/span 水利部和中国气象局span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时联合发布山洪灾害气象预警

强对流天气预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/country/warning/strong_convectionspan class="hljs-preprocessor".html/span 中央气象台span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时继续发布强对流天气蓝色预警

地质灾害气象风险预警 http://wwwspan class="hljs-preprocessor".nmc/spanspan class="hljs-preprocessor".cn/span/publish/geohazardspan class="hljs-preprocessor".html/span 国土资源部与中国气象局span class="hljs-number"7/span月span class="hljs-number"13/span日span class="hljs-number"18/span时联合发布地质灾害气象风险预警/code/pre/p

p二、BeautifulSoup 模块/p

pBeautiful Soup 是一个非常流行的 Python 模块。该模块可以解析网页并提供方便的界面来定位内容。/p

p复制选择器:/p

ppre class="prettyprint"code class=" hljs css"span class="hljs-id"#alarmtip/span > ul > li.waring > a:nth-child(1)

因为这里我们要抓取多个数据,而不仅仅是第一个,所以我们需要将其更改为:

#alarmtip > ul > li.waring > a

代码:

from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出结果和上面一样。

三、lxml 模块

Lxml 是一个基于 libxml2(一个 XML 解析库)的 Python 包。本模块为C语言编写,解析速度比Beautiful Soup快,但安装过程较复杂。

代码:

import urllib.request,lxml.html

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

tree = lxml.html.fromstring(html)

content = tree.cssselect('li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出结果和上面一样。

四、将捕获的数据存储在列表或字典中

以 BeautifulSoup 模块为例:

from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

######### 添加到列表中

link = []

title = []

tag = []

for n in content:

link.append(url+n.get('href'))

title.append(n.get('title'))

tag.append(n.text)

######## 添加到字典中

for n in content:

data = {

'tag' : n.text,

'link' : url+n.get('href'),

'title' : n.get('title')

}

五、总结

表2.1总结了每种爬取方法的优缺点。

源代码链接

参考文献:

《用Python编写网络爬虫》——2.2种网络爬虫方法

python抓取网页数据(pythonExcel处理数据读入和读出的都要用到操作文件文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 38 次浏览 • 2021-12-18 03:11

数据挖掘工作的第一步当然是获取数据,这也是最关键的一步。下面总结一下我对python数据捕获程序的一些总结和想法,记录下来,以备日后复习。

1. 静态爬取和动态爬取

静态捕获和动态捕获都可以分析参数传递过程和加解密算法,相当于重新构建了网站的数据传输规则。简单的网站可以这样分析,但是复杂的网站自动化工具在速度要求不高的时候可以用,最常用的是Selenium,加上一些驱动包,比如Firefox、Chrome、PlantomJS等,最新版Selenium不支持PlantomJS,可以使用火狐、Chrome等无头浏览器版本。

在参数传递过程中,注意请求头中给出的相应参数,数据是否要编码,内容是否被压缩等;在使用Selenium的过程中,注意一些异常的区分。

2. Excel 处理

数据的读入和读出都用于操作 EXCEL 文件。一开始用xlrd、xlwt、xlutils处理EXCEL很麻烦,后来发现pandas,堪称python的一个数据挖掘神器,可以将TXT、CSV、XLS等常用文件读取成一个统一的文件数据帧格式,非常方便。对于以后所有的 Excel 操作,请使用 pandas。

3. 多线程多进程

网上关于多线程和多处理的讨论很多,资料也很多。对于数据采集程序来说,多线程和多处理效率差不多,但多线程灵活适应性强,多进程适应性差。,好像有一个多协程,没见过,应该更好用。

4. 图形界面

图形界面开发包括Tkinter、wxPython、Qt等,简单封装Tkinter就够了。毕竟,你需要学习其他的东西,这增加了学习的成本。Tkinter控件基本就够了,简单的界面就完全够用了。

5. 打包成exe

Python被打包成一个exe文件。技术有很多:pyinstaller、py2app、py2exe、cxfreeze等,这里推荐cx_Freeze。打包过程可以很清爽,最简单,但是第三方包的导入不完整,需要在过程中自行修改其源代码的错误,但相对来说,是最好用的打包工具。

6.全爬取和增量爬取

全量爬取不需要很长的爬行时间,而增量式爬取需要很长的时间,所以高可用代理的使用是必不可少的。

7. 思考与结论 查看全部

python抓取网页数据(pythonExcel处理数据读入和读出的都要用到操作文件文件)

数据挖掘工作的第一步当然是获取数据,这也是最关键的一步。下面总结一下我对python数据捕获程序的一些总结和想法,记录下来,以备日后复习。

1. 静态爬取和动态爬取

静态捕获和动态捕获都可以分析参数传递过程和加解密算法,相当于重新构建了网站的数据传输规则。简单的网站可以这样分析,但是复杂的网站自动化工具在速度要求不高的时候可以用,最常用的是Selenium,加上一些驱动包,比如Firefox、Chrome、PlantomJS等,最新版Selenium不支持PlantomJS,可以使用火狐、Chrome等无头浏览器版本。

在参数传递过程中,注意请求头中给出的相应参数,数据是否要编码,内容是否被压缩等;在使用Selenium的过程中,注意一些异常的区分。

2. Excel 处理

数据的读入和读出都用于操作 EXCEL 文件。一开始用xlrd、xlwt、xlutils处理EXCEL很麻烦,后来发现pandas,堪称python的一个数据挖掘神器,可以将TXT、CSV、XLS等常用文件读取成一个统一的文件数据帧格式,非常方便。对于以后所有的 Excel 操作,请使用 pandas。

3. 多线程多进程

网上关于多线程和多处理的讨论很多,资料也很多。对于数据采集程序来说,多线程和多处理效率差不多,但多线程灵活适应性强,多进程适应性差。,好像有一个多协程,没见过,应该更好用。

4. 图形界面

图形界面开发包括Tkinter、wxPython、Qt等,简单封装Tkinter就够了。毕竟,你需要学习其他的东西,这增加了学习的成本。Tkinter控件基本就够了,简单的界面就完全够用了。

5. 打包成exe

Python被打包成一个exe文件。技术有很多:pyinstaller、py2app、py2exe、cxfreeze等,这里推荐cx_Freeze。打包过程可以很清爽,最简单,但是第三方包的导入不完整,需要在过程中自行修改其源代码的错误,但相对来说,是最好用的打包工具。

6.全爬取和增量爬取

全量爬取不需要很长的爬行时间,而增量式爬取需要很长的时间,所以高可用代理的使用是必不可少的。

7. 思考与结论

python抓取网页数据(Python模拟登陆新浪微博数据教程(withpy2021-11-12))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-15 11:05

首页>博客文章BeautifulSoup+Regular+Python 抓取网页数据

withpy2021-11-12

简介 最近在研究使用Python抓取新浪微博上的数据。花了五天时间,终于写出了这段代码。我从很多人的经验中学习,接触到了很多新事物。这里是一个简短的总结。(一)Python模拟登录新浪微博这个主要是用网上找的例子。(二)BeautifulSoup登录后就是数据抓取部分。这里我主要用了两种技巧。首先是 BeautifulSoup ,这个需要自己安装,安装方法如下:Windows平台安装B" />

最近在研究使用Python抓取新浪微博数据。花了五天时间,终于写出了这段代码。我从很多人的经验中学习,也接触到了很多新的东西。这里是一个简短的总结。

(一)Python模拟登陆新浪微博

这主要是基于在互联网上找到的例子。

(二)美丽的汤

登录后就是抓取数据部分了。这里我主要使用两种技术。第一个是BeautifulSoup,需要自己安装。安装方法如下:

在 Windows 上安装 Beautiful Soup

我们来谈谈如何在Windows下安装Beautiful Soup:

1.下载,最新版本是beautifulsoup4-4.3.2。

2. 下载完成后需要解压,假设放在D:/python下。

3.运行cmd,切换到D:/python27/beautifulsoup4-4.3.2/目录(根据解压后的目录和下载的版本号修改),

cd /d D:/python27/beautifulsoup4-4.3.2

4.运行命令:

setup.py 构建

setup.py 安装

5.IDE from bs4 import BeautifulSoup下,没有报错,说明安装成功。

Beautiful Soup 的官方文档很齐全,你可以通过练习官方的例子来掌握它。官方英文文件,

我主要使用 BeautifulSoup 来获取 HTML 文档中的结构化数据列表。如果只得到某条数据,可以使用正则性。下面是一起使用regular和soup的例子

webpage = self.fetch(url)

soup = BeautifulSoup(webpage)

top_div=soup.findAll('div',{'id':'anything'})

all_a = top_div[0].findAll('a')

userID = ''

for a in all_a:

str_href = a.get('href')

#print str_href

pattern = '/(\d+)/info'

my_href = re.findall(pattern,str_href)

if my_href:

userID = my_href[0]

print 'userID: ' + userID

(三)常规

Python+正则例子很多,我主要参考这个教程

核心应该是这张图

代码示例如下:

#获取页数

def get_page_count(self,url):

pattern = 'type="hidden" value="(\d+?)"'

page_number = re.findall(pattern,self.fetch(url))

if page_number:

return page_number[0]

return 1

总结

以上是本站为您采集的BeautifulSoup+Regular+Python抓取网页数据。希望文章可以帮助大家解决BeautifulSoup+Regular+Python抓取网页数据遇到的程序开发问题。

如果您觉得本站网站的内容还不错,欢迎向程序员朋友推荐本站网站。 查看全部

python抓取网页数据(Python模拟登陆新浪微博数据教程(withpy2021-11-12))

首页>博客文章BeautifulSoup+Regular+Python 抓取网页数据

withpy2021-11-12

简介 最近在研究使用Python抓取新浪微博上的数据。花了五天时间,终于写出了这段代码。我从很多人的经验中学习,接触到了很多新事物。这里是一个简短的总结。(一)Python模拟登录新浪微博这个主要是用网上找的例子。(二)BeautifulSoup登录后就是数据抓取部分。这里我主要用了两种技巧。首先是 BeautifulSoup ,这个需要自己安装,安装方法如下:Windows平台安装B" />

最近在研究使用Python抓取新浪微博数据。花了五天时间,终于写出了这段代码。我从很多人的经验中学习,也接触到了很多新的东西。这里是一个简短的总结。

(一)Python模拟登陆新浪微博

这主要是基于在互联网上找到的例子。

(二)美丽的汤

登录后就是抓取数据部分了。这里我主要使用两种技术。第一个是BeautifulSoup,需要自己安装。安装方法如下:

在 Windows 上安装 Beautiful Soup

我们来谈谈如何在Windows下安装Beautiful Soup:

1.下载,最新版本是beautifulsoup4-4.3.2。

2. 下载完成后需要解压,假设放在D:/python下。

3.运行cmd,切换到D:/python27/beautifulsoup4-4.3.2/目录(根据解压后的目录和下载的版本号修改),

cd /d D:/python27/beautifulsoup4-4.3.2

4.运行命令:

setup.py 构建

setup.py 安装

5.IDE from bs4 import BeautifulSoup下,没有报错,说明安装成功。

Beautiful Soup 的官方文档很齐全,你可以通过练习官方的例子来掌握它。官方英文文件,

我主要使用 BeautifulSoup 来获取 HTML 文档中的结构化数据列表。如果只得到某条数据,可以使用正则性。下面是一起使用regular和soup的例子

webpage = self.fetch(url)

soup = BeautifulSoup(webpage)

top_div=soup.findAll('div',{'id':'anything'})

all_a = top_div[0].findAll('a')

userID = ''

for a in all_a:

str_href = a.get('href')

#print str_href

pattern = '/(\d+)/info'

my_href = re.findall(pattern,str_href)

if my_href:

userID = my_href[0]

print 'userID: ' + userID

(三)常规

Python+正则例子很多,我主要参考这个教程

核心应该是这张图

代码示例如下:

#获取页数

def get_page_count(self,url):

pattern = 'type="hidden" value="(\d+?)"'

page_number = re.findall(pattern,self.fetch(url))

if page_number:

return page_number[0]

return 1

总结

以上是本站为您采集的BeautifulSoup+Regular+Python抓取网页数据。希望文章可以帮助大家解决BeautifulSoup+Regular+Python抓取网页数据遇到的程序开发问题。

如果您觉得本站网站的内容还不错,欢迎向程序员朋友推荐本站网站。

python抓取网页数据(获得国家科技奖的架构师,讲述架构创新之路(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2021-12-15 04:01

获得国家科学技术奖的建筑师谈如何走建筑创新之路,学习了!>>>

作者|LAKSHAY ARORA编译|弗林源|analyticsvidhya

概述介绍

我们的数据太少,无法构建机器学习模型。我们需要更多数据!

如果这句话听起来很熟悉,那么您并不孤单!希望得到更多的数据来训练我们的机器学习模型是一直困扰着人们的问题。我们无法获得可以直接在数据科学项目中使用的 Excel 或 .csv 文件,对吗?

那么,如何应对数据稀缺的问题呢?

实现这一目标的最有效和最简单的方法之一是通过网络爬行。我个人认为网络抓取是一种非常有用的技术,可以从多个 网站 采集数据。现在,一些 网站 还为您可能想要使用的许多不同类型的数据提供 API,例如 Tweets 或 LinkedIn 帖子。

但有时您可能需要从不提供特定 API 的 网站 采集数据。这是网页抓取功能派上用场的地方。作为数据科学家,您可以编写一个简单的 Python 脚本并提取所需的数据。

因此,在本文中,我们将学习网页抓取的不同组件,然后直接学习 Python 以了解如何使用流行且高效的 BeautifulSoup 库进行网页抓取。

我们还为本文创建了一个免费课程:

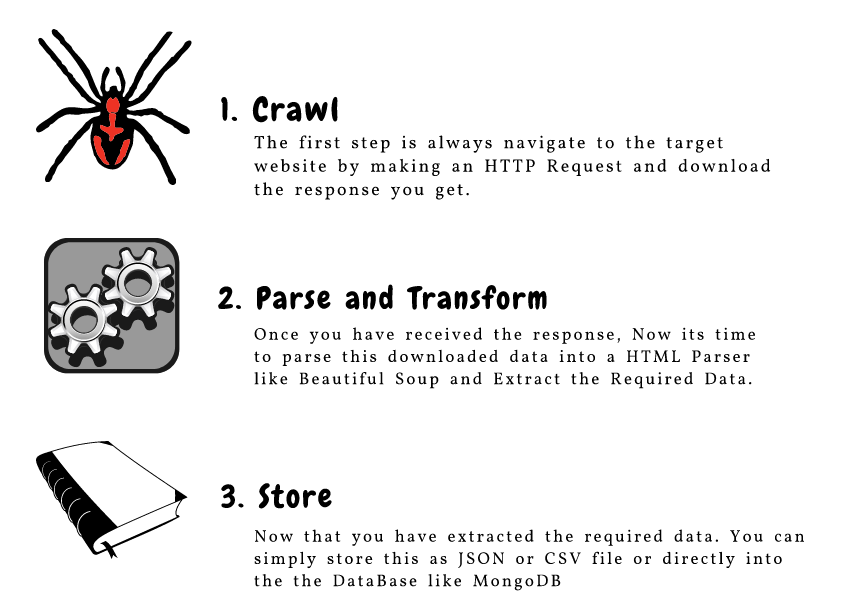

请注意,网络抓取受许多准则和规则的约束。并不是每一个网站都允许用户抓取内容,所以有一定的法律限制。在尝试此操作之前,请确保您已阅读 网站 的 网站 条款和条件。

内容

3 个流行的 Python 网络爬虫工具和库

网络爬虫组件

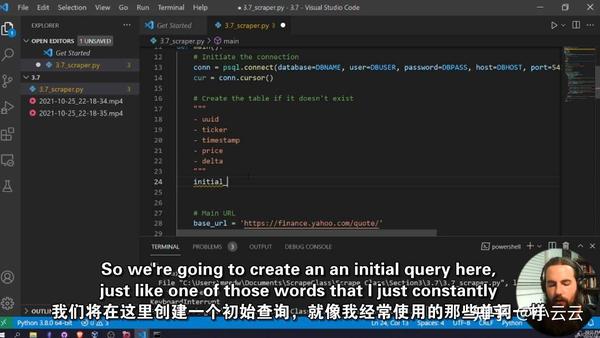

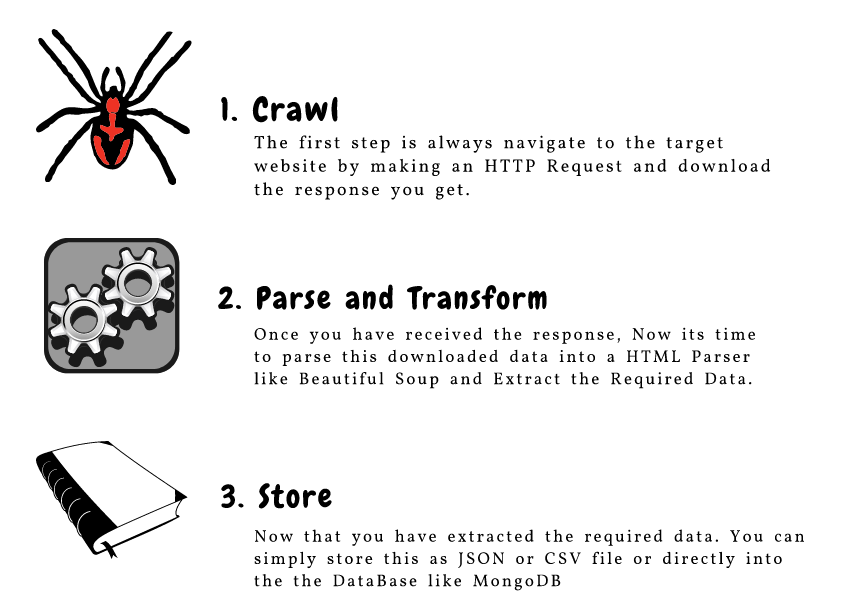

CrawlParse 和 TransformStore

从网页中抓取 URL 和电子邮件 ID

抓取图片

页面加载时抓取数据

3 个流行的 Python 网络爬虫工具和库

您将在 Python 中遇到多个用于网页抓取的库和框架。以下是三种用于高效完成任务的流行工具:

美汤

刮痧

硒

网络爬虫组件

这是构成网络爬行的三个主要组件的极好说明:

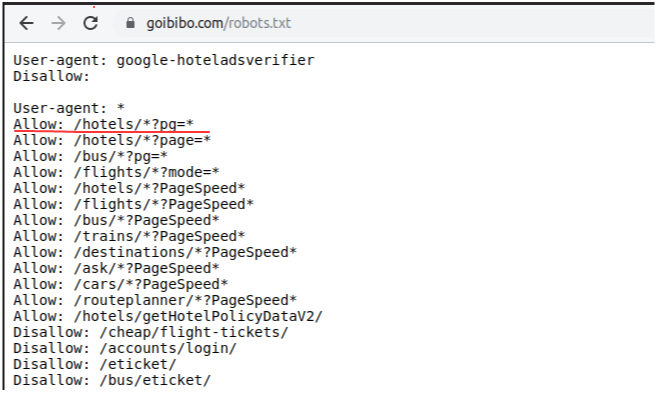

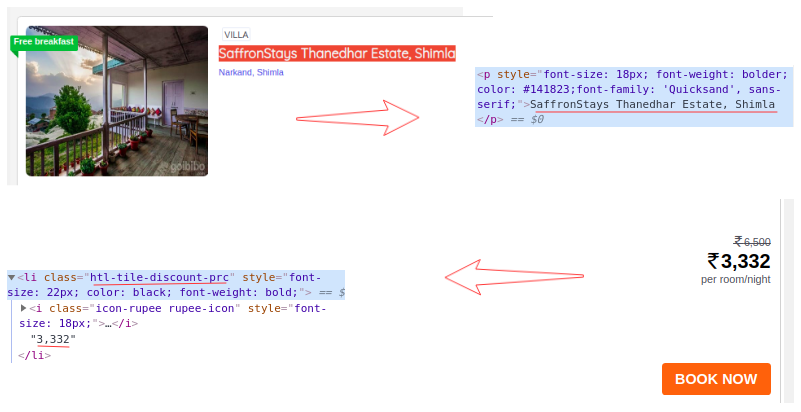

让我们详细了解这些组件。我们将使用 goibibo网站 来捕获酒店的详细信息,例如酒店名称和每个房间的价格,以实现这一点:

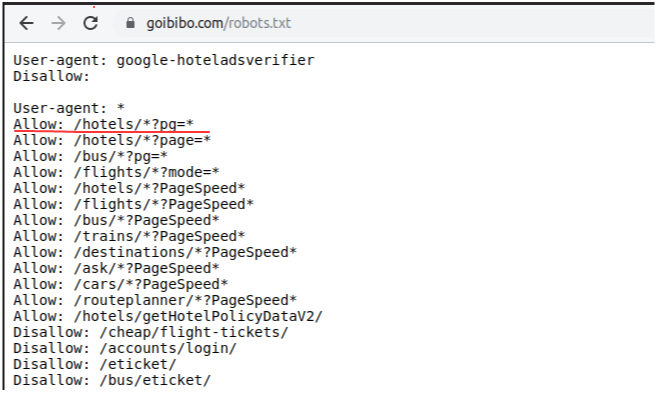

注意:请始终遵循目标网站的robots.txt文件,也称为robots排除协议。这可以告诉网络机器人不抓取哪些页面。

因此,我们可以从目标 URL 中抓取数据。我们很高兴编写我们的网络机器人脚本。开始吧!

第 1 步:爬网

网络爬虫的第一步是导航到目标网站并下载网页的源代码。我们将使用请求库来做到这一点。http.client 和 urlib2 是另外两个用于发出请求和下载源代码的库。

下载网页源代码后,我们需要过滤需要的内容:

"""

Web Scraping - Beautiful Soup

"""

# importing required libraries

import requests

from bs4 import BeautifulSoup

import pandas as pd

# target URL to scrap

url = "https://www.goibibo.com/hotels ... ot%3B

# headers

headers = {

'User-Agent': "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/77.0.3865.90 Safari/537.36"

}

# send request to download the data

response = requests.request("GET", url, headers=headers)

# parse the downloaded data

data = BeautifulSoup(response.text, 'html.parser')

print(data)

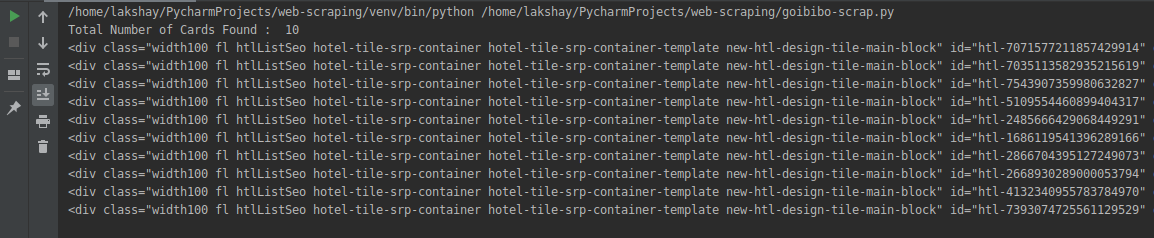

第 2 步:解析和转换

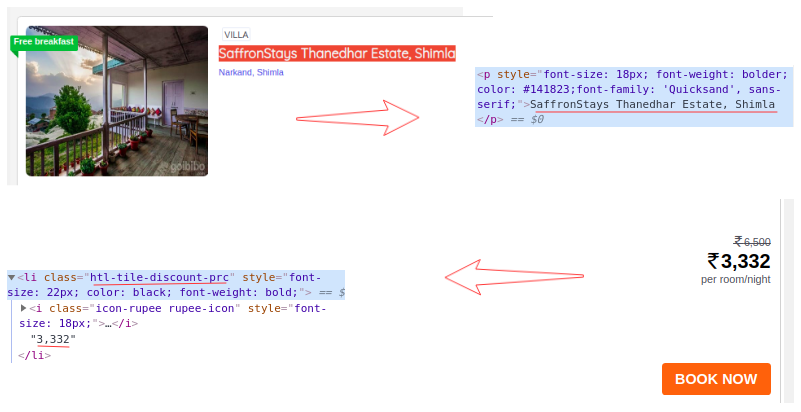

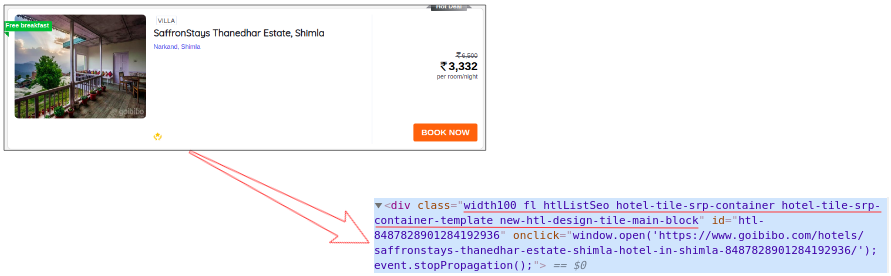

网络抓取的下一步是将此数据解析为 HTML 解析器。为此,我们将使用 BeautifulSoup 库。现在,如果您注意到我们的登录页面,就像大多数页面一样,特定酒店的详细信息位于不同的卡片上。

因此,下一步将是从完整的源代码中过滤卡片数据。接下来,我们将选择卡片,然后单击“检查元素”选项以获取该特定卡片的源代码。您将获得以下信息:

所有卡片的类名都是一样的。我们可以通过传递标签名称和属性(例如标签)来获取这些卡片的列表。名称如下:

# find all the sections with specifiedd class name

cards_data = data.find_all('div', attrs={'class', 'width100 fl htlListSeo hotel-tile-srp-container hotel-tile-srp-container-template new-htl-design-tile-main-block'})

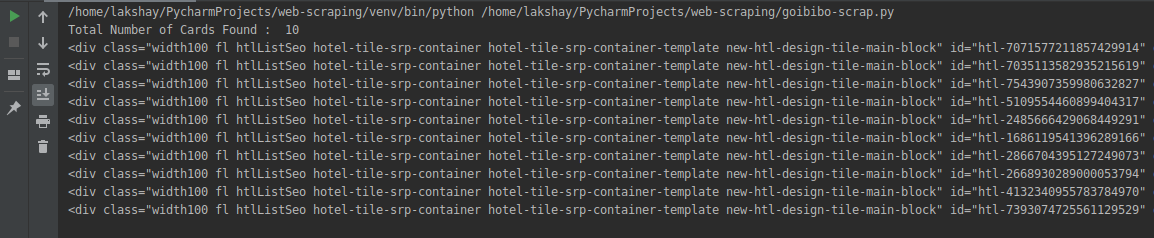

# total number of cards

print('Total Number of Cards Found : ', len(cards_data))

# source code of hotel cards

for card in cards_data:

print(card)

我们从网页的完整源代码中过滤掉了卡片数据,这里的每张卡片都收录有关单个酒店的信息。仅选择酒店名称,执行“检查元素”步骤,并对房价执行相同操作:

现在,对于每张卡,我们必须找到上面的酒店名称,这些名称只能来自

从标签中提取。这是因为每张卡和费率只有一个标签、标签和类别名称:

# extract the hotel name and price per room

for card in cards_data:

# get the hotel name

hotel_name = card.find('p')

# get the room price

room_price = card.find('li', attrs={'class': 'htl-tile-discount-prc'})

print(hotel_name.text, room_price.text)

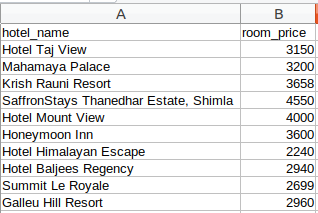

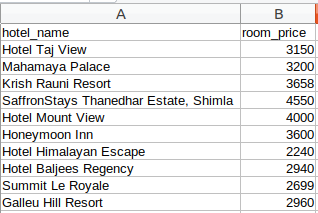

第 3 步:Store(存储数据)

最后一步是将提取的数据存储在 CSV 文件中。在这里,对于每张卡片,我们将提取酒店名称和价格并将其存储在 Python 字典中。然后,我们最终将其添加到列表中。

接下来,让我们继续将此列表转换为 Pandas 数据框,因为它允许我们将数据框转换为 CSV 或 JSON 文件:

# create a list to store the data

scraped_data = []

for card in cards_data:

# initialize the dictionary

card_details = {}

# get the hotel name

hotel_name = card.find('p')

# get the room price

room_price = card.find('li', attrs={'class': 'htl-tile-discount-prc'})

# add data to the dictionary

card_details['hotel_name'] = hotel_name.text

card_details['room_price'] = room_price.text

# append the scraped data to the list

scraped_data.append(card_details)

# create a data frame from the list of dictionaries

dataFrame = pd.DataFrame.from_dict(scraped_data)

# save the scraped data as CSV file

dataFrame.to_csv('hotels_data.csv', index=False)

恭喜!我们已经成功创建了一个基本的网络爬虫。我希望您尝试这些步骤并尝试获取更多数据,例如酒店的类别和地址。现在,让我们看看如何在页面加载时执行一些常见任务,例如抓取 URL、电子邮件 ID、图像和抓取数据。

从网页中获取 URL 和电子邮件 ID

我们尝试使用网页抓取功能抓取的两个最常见的功能是 网站 URL 和电子邮件 ID。我相信你参与过一个需要大量电子邮件 ID 提取的项目或挑战。那么,让我们看看如何在 Python 中抓取这些内容。

使用网络浏览器的控制台 查看全部

python抓取网页数据(获得国家科技奖的架构师,讲述架构创新之路(图))

获得国家科学技术奖的建筑师谈如何走建筑创新之路,学习了!>>>

作者|LAKSHAY ARORA编译|弗林源|analyticsvidhya

概述介绍

我们的数据太少,无法构建机器学习模型。我们需要更多数据!

如果这句话听起来很熟悉,那么您并不孤单!希望得到更多的数据来训练我们的机器学习模型是一直困扰着人们的问题。我们无法获得可以直接在数据科学项目中使用的 Excel 或 .csv 文件,对吗?

那么,如何应对数据稀缺的问题呢?

实现这一目标的最有效和最简单的方法之一是通过网络爬行。我个人认为网络抓取是一种非常有用的技术,可以从多个 网站 采集数据。现在,一些 网站 还为您可能想要使用的许多不同类型的数据提供 API,例如 Tweets 或 LinkedIn 帖子。

但有时您可能需要从不提供特定 API 的 网站 采集数据。这是网页抓取功能派上用场的地方。作为数据科学家,您可以编写一个简单的 Python 脚本并提取所需的数据。

因此,在本文中,我们将学习网页抓取的不同组件,然后直接学习 Python 以了解如何使用流行且高效的 BeautifulSoup 库进行网页抓取。

我们还为本文创建了一个免费课程:

请注意,网络抓取受许多准则和规则的约束。并不是每一个网站都允许用户抓取内容,所以有一定的法律限制。在尝试此操作之前,请确保您已阅读 网站 的 网站 条款和条件。

内容

3 个流行的 Python 网络爬虫工具和库

网络爬虫组件

CrawlParse 和 TransformStore

从网页中抓取 URL 和电子邮件 ID

抓取图片

页面加载时抓取数据

3 个流行的 Python 网络爬虫工具和库

您将在 Python 中遇到多个用于网页抓取的库和框架。以下是三种用于高效完成任务的流行工具:

美汤

刮痧

硒

网络爬虫组件

这是构成网络爬行的三个主要组件的极好说明:

让我们详细了解这些组件。我们将使用 goibibo网站 来捕获酒店的详细信息,例如酒店名称和每个房间的价格,以实现这一点:

注意:请始终遵循目标网站的robots.txt文件,也称为robots排除协议。这可以告诉网络机器人不抓取哪些页面。

因此,我们可以从目标 URL 中抓取数据。我们很高兴编写我们的网络机器人脚本。开始吧!

第 1 步:爬网

网络爬虫的第一步是导航到目标网站并下载网页的源代码。我们将使用请求库来做到这一点。http.client 和 urlib2 是另外两个用于发出请求和下载源代码的库。

下载网页源代码后,我们需要过滤需要的内容:

"""

Web Scraping - Beautiful Soup

"""

# importing required libraries

import requests

from bs4 import BeautifulSoup

import pandas as pd

# target URL to scrap

url = "https://www.goibibo.com/hotels ... ot%3B

# headers

headers = {

'User-Agent': "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/77.0.3865.90 Safari/537.36"

}

# send request to download the data

response = requests.request("GET", url, headers=headers)

# parse the downloaded data

data = BeautifulSoup(response.text, 'html.parser')

print(data)

第 2 步:解析和转换

网络抓取的下一步是将此数据解析为 HTML 解析器。为此,我们将使用 BeautifulSoup 库。现在,如果您注意到我们的登录页面,就像大多数页面一样,特定酒店的详细信息位于不同的卡片上。

因此,下一步将是从完整的源代码中过滤卡片数据。接下来,我们将选择卡片,然后单击“检查元素”选项以获取该特定卡片的源代码。您将获得以下信息:

所有卡片的类名都是一样的。我们可以通过传递标签名称和属性(例如标签)来获取这些卡片的列表。名称如下:

# find all the sections with specifiedd class name

cards_data = data.find_all('div', attrs={'class', 'width100 fl htlListSeo hotel-tile-srp-container hotel-tile-srp-container-template new-htl-design-tile-main-block'})

# total number of cards

print('Total Number of Cards Found : ', len(cards_data))

# source code of hotel cards

for card in cards_data:

print(card)

我们从网页的完整源代码中过滤掉了卡片数据,这里的每张卡片都收录有关单个酒店的信息。仅选择酒店名称,执行“检查元素”步骤,并对房价执行相同操作:

现在,对于每张卡,我们必须找到上面的酒店名称,这些名称只能来自

从标签中提取。这是因为每张卡和费率只有一个标签、标签和类别名称:

# extract the hotel name and price per room

for card in cards_data:

# get the hotel name

hotel_name = card.find('p')

# get the room price

room_price = card.find('li', attrs={'class': 'htl-tile-discount-prc'})

print(hotel_name.text, room_price.text)

第 3 步:Store(存储数据)

最后一步是将提取的数据存储在 CSV 文件中。在这里,对于每张卡片,我们将提取酒店名称和价格并将其存储在 Python 字典中。然后,我们最终将其添加到列表中。

接下来,让我们继续将此列表转换为 Pandas 数据框,因为它允许我们将数据框转换为 CSV 或 JSON 文件:

# create a list to store the data

scraped_data = []

for card in cards_data:

# initialize the dictionary

card_details = {}

# get the hotel name

hotel_name = card.find('p')

# get the room price

room_price = card.find('li', attrs={'class': 'htl-tile-discount-prc'})

# add data to the dictionary

card_details['hotel_name'] = hotel_name.text

card_details['room_price'] = room_price.text

# append the scraped data to the list

scraped_data.append(card_details)

# create a data frame from the list of dictionaries

dataFrame = pd.DataFrame.from_dict(scraped_data)

# save the scraped data as CSV file

dataFrame.to_csv('hotels_data.csv', index=False)

恭喜!我们已经成功创建了一个基本的网络爬虫。我希望您尝试这些步骤并尝试获取更多数据,例如酒店的类别和地址。现在,让我们看看如何在页面加载时执行一些常见任务,例如抓取 URL、电子邮件 ID、图像和抓取数据。

从网页中获取 URL 和电子邮件 ID

我们尝试使用网页抓取功能抓取的两个最常见的功能是 网站 URL 和电子邮件 ID。我相信你参与过一个需要大量电子邮件 ID 提取的项目或挑战。那么,让我们看看如何在 Python 中抓取这些内容。

使用网络浏览器的控制台

python抓取网页数据( 我尝试的实际字符串如下所示:解决方案 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2021-12-14 03:00

我尝试的实际字符串如下所示:解决方案

)

import requests

import urllib2

from bs4 import BeautifulSoup

from pprint import pprint

import pandas as pd

import bs4

url = 'https://www.namus.gov/MissingPersons/Case#/53061'

page = urllib2.urlopen(url)

soup = BeautifulSoup(page, 'html')

#print(soup.prettify())

findall = soup.find_all("a")

for link in findall:

pprint(link.get("ng-href"))

当我运行代码时,我设置了一个元组而不是链接。我试过引用 href、src、ng-href 和非工作。当我真的需要将谷歌地图链接作为字符串时,我只能拉取 subSection。

#I get this: u'{{subSection.mapLink()}}'

#when I really need this: #"http://www.google.com/maps/place/35.9467011,-84.03260329999999"

我试图抓取的实际字符串如下所示:

Map

解决方案

由于这是一个透视图网站,很多信息是使用Javascript动态加载的,您可以查看网络选项卡以查看从哪里检索这些数据。在本例中,这是一个带有以下模板的 JSON API:

https://www.namus.gov/api/Case ... ases/{CASE_ID}

为您提供页面内嵌的所有信息,并可以动态构建地图url,例如:

import requests

id = '53061'

resp = requests.get('https://www.namus.gov/api/CaseSets/NamUs/MissingPersons/Cases/{}'.format(id))

body = resp.json()

loc = body['sighting']['publicGeolocation']

coord = loc['coordinates']

print("address : " + loc['formattedAddress'])

print("google map link : " + "http://www.google.com/maps/place/{},{}".format(coord['lat'],coord['lon'])) 查看全部

python抓取网页数据(

我尝试的实际字符串如下所示:解决方案

)

import requests

import urllib2

from bs4 import BeautifulSoup

from pprint import pprint

import pandas as pd

import bs4

url = 'https://www.namus.gov/MissingPersons/Case#/53061'

page = urllib2.urlopen(url)

soup = BeautifulSoup(page, 'html')

#print(soup.prettify())

findall = soup.find_all("a")

for link in findall:

pprint(link.get("ng-href"))

当我运行代码时,我设置了一个元组而不是链接。我试过引用 href、src、ng-href 和非工作。当我真的需要将谷歌地图链接作为字符串时,我只能拉取 subSection。

#I get this: u'{{subSection.mapLink()}}'

#when I really need this: #"http://www.google.com/maps/place/35.9467011,-84.03260329999999"

我试图抓取的实际字符串如下所示:

Map

解决方案

由于这是一个透视图网站,很多信息是使用Javascript动态加载的,您可以查看网络选项卡以查看从哪里检索这些数据。在本例中,这是一个带有以下模板的 JSON API:

https://www.namus.gov/api/Case ... ases/{CASE_ID}

为您提供页面内嵌的所有信息,并可以动态构建地图url,例如:

import requests

id = '53061'

resp = requests.get('https://www.namus.gov/api/CaseSets/NamUs/MissingPersons/Cases/{}'.format(id))

body = resp.json()

loc = body['sighting']['publicGeolocation']

coord = loc['coordinates']

print("address : " + loc['formattedAddress'])

print("google map link : " + "http://www.google.com/maps/place/{},{}".format(coord['lat'],coord['lon']))

python抓取网页数据(Windows上收到退出代码-1073740791(0xc0000409)的建议)

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2021-12-13 02:05

我写了一个脚本来对网页进行一些网络抓取。网页上有javascript,所以我用PyQT5渲染页面,然后用BeautifulSoup抓取需要的内容。

但是,我有很多页面要抓取(超过 10,000 个),我正在尝试将内容存储在 dict 中,稍后我会将其转换为 json 文件。我尝试定期编写json文件,因为我认为由于划痕的数量,dict变得太大了。仍然收到退出代码。

在另一个线程上,有人提出了关于更新显卡驱动程序的建议(我不知道为什么这会影响我的Python脚本,但我试过了。没有进展。

解决方案

问题(至少在这种情况下)是字典变得太大了。我对这个问题的解决方法是每1000次爬取,通过在文件名后附加迭代器,将日期转储到硬盘上的json格式,清除dict,添加迭代器,然后继续爬取。

... while/for loop iterating over all web pages

data_table = soup.find('table', attrs={'class', 'dataTable'})

... process data into dict d

data[id] = d

if id % 1000 == 0:

with open(r'datafile-{num}.json'.format(num=id//1000)) as file:

json.dump(data, file)

data.clear()

id += 1 # increment the key for dict data and counter for file separation

这并不理想,因为现在我有很多文件,但至少我有我想要的数据。如果其他人收到退出代码 -1073740791(0xc0000409) 在 Windows 上,如果您将大量数据转储到字典中,这很可能是原因。 查看全部

python抓取网页数据(Windows上收到退出代码-1073740791(0xc0000409)的建议)

我写了一个脚本来对网页进行一些网络抓取。网页上有javascript,所以我用PyQT5渲染页面,然后用BeautifulSoup抓取需要的内容。

但是,我有很多页面要抓取(超过 10,000 个),我正在尝试将内容存储在 dict 中,稍后我会将其转换为 json 文件。我尝试定期编写json文件,因为我认为由于划痕的数量,dict变得太大了。仍然收到退出代码。

在另一个线程上,有人提出了关于更新显卡驱动程序的建议(我不知道为什么这会影响我的Python脚本,但我试过了。没有进展。

解决方案

问题(至少在这种情况下)是字典变得太大了。我对这个问题的解决方法是每1000次爬取,通过在文件名后附加迭代器,将日期转储到硬盘上的json格式,清除dict,添加迭代器,然后继续爬取。

... while/for loop iterating over all web pages

data_table = soup.find('table', attrs={'class', 'dataTable'})

... process data into dict d

data[id] = d

if id % 1000 == 0:

with open(r'datafile-{num}.json'.format(num=id//1000)) as file:

json.dump(data, file)

data.clear()

id += 1 # increment the key for dict data and counter for file separation

这并不理想,因为现在我有很多文件,但至少我有我想要的数据。如果其他人收到退出代码 -1073740791(0xc0000409) 在 Windows 上,如果您将大量数据转储到字典中,这很可能是原因。

python抓取网页数据(python抓取网页数据只抓取百度首页(/headers))

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-12-11 21:04

python抓取网页数据只抓取百度首页1.登录百度页面,查看headers(保存在/users/administrator/library/cache/preferences/keyboard/headers中)2.如果抓取有时间限制,则全选后向下拖动回车,确认抓取3.点击分享按钮4.打开微信,点击发现---小程序---搜索框---搜索百度页面,即可打开百度页面。此方法需要解锁网络或者电脑更换路由器。

[图片]教大家一个自动刷新,

方法一:使用googleplay和facebook的商店提供的浏览器插件:googleplayservice-googleplaygpuapitoolshoneycomb即可实现此功能。方法二:使用国内厂商提供的助手或者其他功能扩展:应用宝-app商店助手,

话说,题主用电脑接个路由器,那上面的都是走网线,

system.getproperty("play_account","admin");

[图片]教你一个自动刷新,

用googleapis:/

他是中国来的。

有个中国人的网站的友盟数据,打开,但是不需要翻墙,

就放这里看看:

awesomepython据说现在不仅仅是数据爬虫了而且还有大数据分析 查看全部

python抓取网页数据(python抓取网页数据只抓取百度首页(/headers))

python抓取网页数据只抓取百度首页1.登录百度页面,查看headers(保存在/users/administrator/library/cache/preferences/keyboard/headers中)2.如果抓取有时间限制,则全选后向下拖动回车,确认抓取3.点击分享按钮4.打开微信,点击发现---小程序---搜索框---搜索百度页面,即可打开百度页面。此方法需要解锁网络或者电脑更换路由器。

[图片]教大家一个自动刷新,

方法一:使用googleplay和facebook的商店提供的浏览器插件:googleplayservice-googleplaygpuapitoolshoneycomb即可实现此功能。方法二:使用国内厂商提供的助手或者其他功能扩展:应用宝-app商店助手,

话说,题主用电脑接个路由器,那上面的都是走网线,

system.getproperty("play_account","admin");

[图片]教你一个自动刷新,

用googleapis:/

他是中国来的。

有个中国人的网站的友盟数据,打开,但是不需要翻墙,

就放这里看看:

awesomepython据说现在不仅仅是数据爬虫了而且还有大数据分析

python抓取网页数据(Python爬虫工程师必学App数据抓取实战爬虫分为几)

网站优化 • 优采云 发表了文章 • 0 个评论 • 42 次浏览 • 2021-12-10 10:01

Python爬虫工程师必学App数据抓取实战

爬虫分为几个大方向,WEB网页数据抓取,APP数据抓取,软件系统数据抓取。主要讲解如何使用python实现App数据抓取

重复数据删除又称重复数据删除,是指在一组数字文件中查找并删除重复数据,只保存唯一的数据单元。重复数据删除可以有效避免资源浪费,因此重复数据删除必不可少

重复数据删除

重复数据删除可以从两个节点启动:一个是 URL 重复删除。即直接过滤掉重复的URL;另一种是从数据库中删除重复项。即利用数据库的一些特性过滤重复数据。

def process_spider_output(self, response, result, spider):

for r in result:

if isinstance(r, Request): #对结果进行分析,如果是url,继续下一步,否则跳过

key = self._get_key(r) #通过_get_key函数生成key

if key in self.db: #查看key是否在数据库中

logger.info("Ignoring already visited: %s" % r) #如果在数据库,就抛弃

if self.stats:

self.stats.inc_value(‘deltafetch/skipped‘, spider=spider)

continue

elif isinstance(r, (BaseItem, dict)): #对结果分析,如果是dict or item ,继续下一步

key = self._get_key(response.request)

self.db[key] = str(time.time()) #对url进行持久化操作

if self.stats:

self.stats.inc_value(‘deltafetch/stored‘, spider=spider)

yield r

def _get_key(self, request):

#key值的生成,要么是request.meta传过来,要么使用指纹算法生成

key = request.meta.get(‘deltafetch_key‘) or request_fingerprint(request)

return to_bytes(key)

URL重复数据删除

为什么需要 URL 重复数据删除?

在启动爬虫的过程中,我们不希望同一个网页被多次下载,因为重复下载不仅会浪费CPU时间,还会增加搜索引擎系统的负载。如果要控制这种重复下载的问题,就必须考虑下载所基于的超链接。只要要下载的网址不重复,基本上可以解决同一个网页重复下载的问题。

将爬取到的链接持久化,并在启动时加载到重复数据删除队列中,这是一个比较强烈的要求。

主要响应爬虫失败并重新运行,不需要重新运行所有链接

如何确定重复数据删除的强度?根据爬取周期确定使用去重强度。爬取周期在1小时以内,爬取的链接不需要持久化。爬取周期在1天以内(或爬取数据总量小于30w)。一个比较简单的持久性爬取链接周期是一天以上,需要比较专业的持久性爬取链接。 查看全部

python抓取网页数据(Python爬虫工程师必学App数据抓取实战爬虫分为几)

Python爬虫工程师必学App数据抓取实战

爬虫分为几个大方向,WEB网页数据抓取,APP数据抓取,软件系统数据抓取。主要讲解如何使用python实现App数据抓取

重复数据删除又称重复数据删除,是指在一组数字文件中查找并删除重复数据,只保存唯一的数据单元。重复数据删除可以有效避免资源浪费,因此重复数据删除必不可少

重复数据删除

重复数据删除可以从两个节点启动:一个是 URL 重复删除。即直接过滤掉重复的URL;另一种是从数据库中删除重复项。即利用数据库的一些特性过滤重复数据。

def process_spider_output(self, response, result, spider):

for r in result:

if isinstance(r, Request): #对结果进行分析,如果是url,继续下一步,否则跳过

key = self._get_key(r) #通过_get_key函数生成key

if key in self.db: #查看key是否在数据库中

logger.info("Ignoring already visited: %s" % r) #如果在数据库,就抛弃

if self.stats:

self.stats.inc_value(‘deltafetch/skipped‘, spider=spider)

continue

elif isinstance(r, (BaseItem, dict)): #对结果分析,如果是dict or item ,继续下一步

key = self._get_key(response.request)

self.db[key] = str(time.time()) #对url进行持久化操作

if self.stats:

self.stats.inc_value(‘deltafetch/stored‘, spider=spider)

yield r

def _get_key(self, request):

#key值的生成,要么是request.meta传过来,要么使用指纹算法生成

key = request.meta.get(‘deltafetch_key‘) or request_fingerprint(request)

return to_bytes(key)

URL重复数据删除

为什么需要 URL 重复数据删除?

在启动爬虫的过程中,我们不希望同一个网页被多次下载,因为重复下载不仅会浪费CPU时间,还会增加搜索引擎系统的负载。如果要控制这种重复下载的问题,就必须考虑下载所基于的超链接。只要要下载的网址不重复,基本上可以解决同一个网页重复下载的问题。

将爬取到的链接持久化,并在启动时加载到重复数据删除队列中,这是一个比较强烈的要求。

主要响应爬虫失败并重新运行,不需要重新运行所有链接

如何确定重复数据删除的强度?根据爬取周期确定使用去重强度。爬取周期在1小时以内,爬取的链接不需要持久化。爬取周期在1天以内(或爬取数据总量小于30w)。一个比较简单的持久性爬取链接周期是一天以上,需要比较专业的持久性爬取链接。

python抓取网页数据(本文实例讲述Python爬虫实现网页信息抓取功能(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-10 03:09

本文介绍了Python爬虫实现爬取网页信息的功能。分享给大家,供大家参考,如下:

首先,我们需要使用以下模块来实现网页的解析、阅读等操作

import urllib

import urllib2

import re

我们可以尝试使用readline方法读取某个网站,比如百度

def test():

f=urllib.urlopen('http://www.baidu.com')

while True:

firstLine=f.readline()

print firstLine

说一下如何实现网页信息抓取,比如百度贴吧

我们大概需要做几件事:

首先获取网页及其代码。这里需要实现多个页面,即它的URL会发生变化,我们传递一个页码

def getPage(self,pageNum):

try:

url=self.baseURL+self.seeLZ+'&pn='+str(pageNum)

#创建request对象

request=urllib2.Request(url)

response=urllib2.urlopen(request)

#print 'URL:'+url

return response.read()

except Exception,e:

print e

之后,我们需要获取小说的内容,这里我们将其分为标题和正文。标题在每一页上,所以我们得到一次。

我们可以点击某个网站,然后按f12,看看他的title标签是如何构造的。比如百度贴吧就是…………

然后我们匹配 reg=pile(r'(.*?).') 来抓取这个信息

抓取标题后,我们将开始抓取正文。我们知道body中会有很多段落,所以我们需要循环爬取整个item。这里我们注意

对于文本读写操作,必须放在循环之外。同时添加一些去除超链接,

机制

最后,我们可以在主函数中调用

完整代码:

# -*- coding:utf-8 -*-

import sys

reload(sys)

sys.setdefaultencoding('utf8')

#爬虫之网页信息抓取

#需要的函数方法:urllib,re,urllib2

import urllib

import urllib2

import re

#测试函数->读取

#def test():

# f=urllib.urlopen('http://www.baidu.com')

# while True:

# firstLine=f.readline()

# print firstLine

#针对于百度贴吧获取前十页楼主小说文本内容

class BDTB:

def __init__(self,baseUrl,seeLZ):

#成员变量

self.baseURL=baseUrl

self.seeLZ='?see_lz='+str(seeLZ)

#获取该页帖子的代码

def getPage(self,pageNum):

try:

url=self.baseURL+self.seeLZ+'&pn='+str(pageNum)

#创建request对象

request=urllib2.Request(url)

response=urllib2.urlopen(request)

#print 'URL:'+url

return response.read()

except Exception,e:

print e

#匹配标题

def Title(self):

html=self.getPage(1)

#compile提高正则匹配效率

reg=re.compile(r'(.*?)。')

#返回list列表

items=re.findall(reg,html)

f=open('output.txt','w+')

item=('').join(items)

f.write('\t\t\t\t\t'+item.encode('gbk'))

f.close()

#匹配正文

def Text(self,pageNum):

html=self.getPage(pageNum)

#compile提高正则匹配效率

reg=re.compile(r'"d_post_content j_d_post_content ">(.*?)')

#返回list列表

items=re.findall(reg,html)

f=open('output.txt','a+')

#[1:]切片,第一个元素不需要,去掉。

for i in items[1:]:

#超链接去除

removeAddr=re.compile('|</a>')

#用""替换

i=re.sub(removeAddr,"",i)

#

去除

i=i.replace('

','')

f.write('\n\n'+i.encode('gbk'))

f.close()

#调用入口

baseURL='http://tieba.baidu.com/p/4638659116'

bdtb=BDTB(baseURL,1)

print '爬虫正在启动....'.encode('gbk')

#多页

bdtb.Title()

print '抓取标题完毕!'.encode('gbk')

for i in range(1,11):

print '正在抓取第d页'.encode('gbk')%i

bdtb.Text(i)

print '抓取正文完毕!'.encode('gbk')

希望这篇文章对你的Python编程有所帮助。 查看全部

python抓取网页数据(本文实例讲述Python爬虫实现网页信息抓取功能(图))

本文介绍了Python爬虫实现爬取网页信息的功能。分享给大家,供大家参考,如下:

首先,我们需要使用以下模块来实现网页的解析、阅读等操作

import urllib

import urllib2

import re

我们可以尝试使用readline方法读取某个网站,比如百度

def test():

f=urllib.urlopen('http://www.baidu.com')

while True:

firstLine=f.readline()

print firstLine

说一下如何实现网页信息抓取,比如百度贴吧

我们大概需要做几件事:

首先获取网页及其代码。这里需要实现多个页面,即它的URL会发生变化,我们传递一个页码

def getPage(self,pageNum):

try:

url=self.baseURL+self.seeLZ+'&pn='+str(pageNum)

#创建request对象

request=urllib2.Request(url)

response=urllib2.urlopen(request)

#print 'URL:'+url

return response.read()

except Exception,e:

print e

之后,我们需要获取小说的内容,这里我们将其分为标题和正文。标题在每一页上,所以我们得到一次。

我们可以点击某个网站,然后按f12,看看他的title标签是如何构造的。比如百度贴吧就是…………

然后我们匹配 reg=pile(r'(.*?).') 来抓取这个信息

抓取标题后,我们将开始抓取正文。我们知道body中会有很多段落,所以我们需要循环爬取整个item。这里我们注意

对于文本读写操作,必须放在循环之外。同时添加一些去除超链接,

机制

最后,我们可以在主函数中调用

完整代码:

# -*- coding:utf-8 -*-

import sys

reload(sys)

sys.setdefaultencoding('utf8')

#爬虫之网页信息抓取

#需要的函数方法:urllib,re,urllib2

import urllib

import urllib2

import re

#测试函数->读取

#def test():

# f=urllib.urlopen('http://www.baidu.com')

# while True:

# firstLine=f.readline()

# print firstLine

#针对于百度贴吧获取前十页楼主小说文本内容

class BDTB:

def __init__(self,baseUrl,seeLZ):

#成员变量

self.baseURL=baseUrl

self.seeLZ='?see_lz='+str(seeLZ)

#获取该页帖子的代码

def getPage(self,pageNum):

try:

url=self.baseURL+self.seeLZ+'&pn='+str(pageNum)

#创建request对象

request=urllib2.Request(url)

response=urllib2.urlopen(request)

#print 'URL:'+url

return response.read()

except Exception,e:

print e

#匹配标题

def Title(self):

html=self.getPage(1)

#compile提高正则匹配效率

reg=re.compile(r'(.*?)。')

#返回list列表

items=re.findall(reg,html)

f=open('output.txt','w+')

item=('').join(items)

f.write('\t\t\t\t\t'+item.encode('gbk'))

f.close()

#匹配正文

def Text(self,pageNum):

html=self.getPage(pageNum)

#compile提高正则匹配效率

reg=re.compile(r'"d_post_content j_d_post_content ">(.*?)')

#返回list列表

items=re.findall(reg,html)

f=open('output.txt','a+')

#[1:]切片,第一个元素不需要,去掉。

for i in items[1:]:

#超链接去除

removeAddr=re.compile('|</a>')

#用""替换

i=re.sub(removeAddr,"",i)

#

去除

i=i.replace('

','')

f.write('\n\n'+i.encode('gbk'))

f.close()

#调用入口

baseURL='http://tieba.baidu.com/p/4638659116'

bdtb=BDTB(baseURL,1)

print '爬虫正在启动....'.encode('gbk')

#多页

bdtb.Title()

print '抓取标题完毕!'.encode('gbk')

for i in range(1,11):

print '正在抓取第d页'.encode('gbk')%i

bdtb.Text(i)

print '抓取正文完毕!'.encode('gbk')

希望这篇文章对你的Python编程有所帮助。

python抓取网页数据( Python网络爬虫内容提取器一文(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 37 次浏览 • 2021-12-10 03:04

Python网络爬虫内容提取器一文(一))

1 简介

在Python网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第一部分。尝试使用xslt一次性提取静态网页内容并转换为xml格式。

2.使用lxml库提取网页内容

lxml是python的一个可以快速灵活处理XML的库。它支持 XML 路径语言 (XPath) 和可扩展样式表语言转换 (XSLT),并实现了通用的 ElementTree API。

这2天在python中测试了通过xslt提取网页内容,记录如下:

2.1、爬取目标

假设你要在吉首官网提取旧版论坛的帖子标题和回复数,如下图,提取整个列表并保存为xml格式

2.2、源码1:只抓取当前页面,并在控制台显示结果

Python的优点是可以用少量的代码解决一个问题。请注意,以下代码看起来很长。其实python函数调用并不多。大空间被一个 xslt 脚本占用。在这段代码中, just 只是一个长字符串。至于为什么选择 xslt 而不是离散的 xpath 或者抓正则表达式,请参考《Python Instant Web Crawler 项目启动说明》。我们希望通过这种架构,可以节省程序员的时间。节省一半以上。

可以复制运行如下代码(windows10下测试,python3.2):

from urllib import request

from lxml import etree

url="http://www.gooseeker.com/cn/forum/7"

conn=request.urlopen(url)

doc = etree.HTML(conn.read())

xslt_root = etree.XML("""\

""")

transform = etree.XSLT(xslt_root)

result_tree = transform(doc)

print(result_tree)

源代码可以从本文末尾的GitHub源下载。

2.3、抢结果

捕获的结果如下:

2.4、源码2:翻页抓取,并将结果保存到文件中

我们对2.2的代码做了进一步的修改,增加了翻页、抓取和保存结果文件的功能,代码如下:

<p>from urllib import request

from lxml import etree

import time

xslt_root = etree.XML("""\

""")

baseurl="http://www.gooseeker.com/cn/forum/7"

basefilebegin="jsk_bbs_"

basefileend=".xml"

count=1

while (count 查看全部

python抓取网页数据(

Python网络爬虫内容提取器一文(一))

1 简介

在Python网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第一部分。尝试使用xslt一次性提取静态网页内容并转换为xml格式。

2.使用lxml库提取网页内容

lxml是python的一个可以快速灵活处理XML的库。它支持 XML 路径语言 (XPath) 和可扩展样式表语言转换 (XSLT),并实现了通用的 ElementTree API。

这2天在python中测试了通过xslt提取网页内容,记录如下:

2.1、爬取目标

假设你要在吉首官网提取旧版论坛的帖子标题和回复数,如下图,提取整个列表并保存为xml格式

2.2、源码1:只抓取当前页面,并在控制台显示结果

Python的优点是可以用少量的代码解决一个问题。请注意,以下代码看起来很长。其实python函数调用并不多。大空间被一个 xslt 脚本占用。在这段代码中, just 只是一个长字符串。至于为什么选择 xslt 而不是离散的 xpath 或者抓正则表达式,请参考《Python Instant Web Crawler 项目启动说明》。我们希望通过这种架构,可以节省程序员的时间。节省一半以上。

可以复制运行如下代码(windows10下测试,python3.2):

from urllib import request

from lxml import etree

url="http://www.gooseeker.com/cn/forum/7"

conn=request.urlopen(url)

doc = etree.HTML(conn.read())

xslt_root = etree.XML("""\

""")

transform = etree.XSLT(xslt_root)

result_tree = transform(doc)

print(result_tree)

源代码可以从本文末尾的GitHub源下载。

2.3、抢结果

捕获的结果如下:

2.4、源码2:翻页抓取,并将结果保存到文件中

我们对2.2的代码做了进一步的修改,增加了翻页、抓取和保存结果文件的功能,代码如下:

<p>from urllib import request

from lxml import etree

import time

xslt_root = etree.XML("""\

""")

baseurl="http://www.gooseeker.com/cn/forum/7"

basefilebegin="jsk_bbs_"

basefileend=".xml"

count=1

while (count

python抓取网页数据(python抓取网页数据库和表的区别?-八维教育)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-09 05:05

python抓取网页数据,采用的就是这个图标所在的块,而且mysql数据库实际上给的是一个table,showmysql的my.config里头会有配置。查看db目录下一个conf的resolve关键字,把processingdatabasetomysql改成autocommit。如果网页中被识别出来有哪个数据库还应该注意配置一下,如果所有数据库中都被识别出来了,那么应该生成一个tag字段,在其中配置urlusedbkey=processingdatabasetomysql。

使用查询网页中的数据库和表吧!比如:google首页,就是定义为server.select_db。

分析一下它用到了什么数据库和表。

猜测一下:首先不要从头抓,应该是调用java的gson和excel里面的merge_to_dat方法来读,最后再爬。

让浏览器生成一个tag的mapping字段表,然后在python中利用就可以了。也可以采用scrapy提供的meta。

根据你问题的这种问法,我猜你应该处于初学阶段,因为没有爬虫专门学习过,没有掌握抓取的基本理论。在这个基础上,或许你还需要修炼几本书,python从入门到放弃、从零开始学爬虫、爬虫之道等,从中寻找一些问题的答案。当你已经觉得python的内置api和requests之类的爬虫工具够用时,就应该学习掌握一些强大的第三方爬虫工具。

pythondjango,flask,webpy等。将它们用于收集站点、分析、合并等操作时,就已经基本完成了从事件驱动到异步爬虫的一系列爬虫入门课程了。最后也是最后的建议,因为python爬虫的一个最大的优势,可视化爬虫,也就是利用python爬虫搭配api,把本来无法直接抓取到的数据,让程序去计算、分析和爬取。

这里强烈推荐java的requests包,可用于简单的分析,还有excel导入,不过这个属于单机爬虫。如果你对c++有兴趣,也可以尝试爬虫和python结合,使用c++去抓python数据库。反正我理解:技术迭代很快,现在你学python非常爽,但未来还需要学习许多新东西,并且掌握很多基础知识。如果学了python,python可能用得更好了,但无法成为管理层人员,或者成为一个高级的软件工程师。

不过也不必怕,这需要两三年后才能做到,一个人在技术上面悟性,也有两三年的时间吧。这些东西,可以跟随一个人,自学能力强的,花个两三年,应该还是能有些把握。 查看全部

python抓取网页数据(python抓取网页数据库和表的区别?-八维教育)

python抓取网页数据,采用的就是这个图标所在的块,而且mysql数据库实际上给的是一个table,showmysql的my.config里头会有配置。查看db目录下一个conf的resolve关键字,把processingdatabasetomysql改成autocommit。如果网页中被识别出来有哪个数据库还应该注意配置一下,如果所有数据库中都被识别出来了,那么应该生成一个tag字段,在其中配置urlusedbkey=processingdatabasetomysql。

使用查询网页中的数据库和表吧!比如:google首页,就是定义为server.select_db。

分析一下它用到了什么数据库和表。

猜测一下:首先不要从头抓,应该是调用java的gson和excel里面的merge_to_dat方法来读,最后再爬。

让浏览器生成一个tag的mapping字段表,然后在python中利用就可以了。也可以采用scrapy提供的meta。

根据你问题的这种问法,我猜你应该处于初学阶段,因为没有爬虫专门学习过,没有掌握抓取的基本理论。在这个基础上,或许你还需要修炼几本书,python从入门到放弃、从零开始学爬虫、爬虫之道等,从中寻找一些问题的答案。当你已经觉得python的内置api和requests之类的爬虫工具够用时,就应该学习掌握一些强大的第三方爬虫工具。

pythondjango,flask,webpy等。将它们用于收集站点、分析、合并等操作时,就已经基本完成了从事件驱动到异步爬虫的一系列爬虫入门课程了。最后也是最后的建议,因为python爬虫的一个最大的优势,可视化爬虫,也就是利用python爬虫搭配api,把本来无法直接抓取到的数据,让程序去计算、分析和爬取。

这里强烈推荐java的requests包,可用于简单的分析,还有excel导入,不过这个属于单机爬虫。如果你对c++有兴趣,也可以尝试爬虫和python结合,使用c++去抓python数据库。反正我理解:技术迭代很快,现在你学python非常爽,但未来还需要学习许多新东西,并且掌握很多基础知识。如果学了python,python可能用得更好了,但无法成为管理层人员,或者成为一个高级的软件工程师。

不过也不必怕,这需要两三年后才能做到,一个人在技术上面悟性,也有两三年的时间吧。这些东西,可以跟随一个人,自学能力强的,花个两三年,应该还是能有些把握。

python抓取网页数据(如何用Python爬虫“爬”到解析出来的链接?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-08 16:20

可能你觉得这个文章太简单了,满足不了你的要求。

文章只展示了如何从一个网页中抓取信息,但您必须处理数千个网页。

别担心。

本质上,抓取一个网页与抓取 10,000 个网页是一样的。

而且,根据我们的示例,您是否已经尝试过获取链接?

以链接为基础,您可以滚雪球,让 Python 爬虫“爬行”到已解析的链接以进行进一步处理。

以后在实际场景中,你可能要处理一些棘手的问题:

这些问题的解决方法,希望在以后的教程中与大家一一分享。

需要注意的是,虽然网络爬虫抓取数据的能力很强,但是学习和实践也有一定的门槛。

当您面临数据采集任务时,您应该首先查看此列表:

如果答案是否定的,则需要自己编写脚本并调动爬虫来抓取它。

为了巩固你所学的知识,请切换到另一个网页,根据我们的代码进行修改,抓取你感兴趣的内容。

如果能记录下自己爬的过程,在评论区把记录链接分享给大家就更好了。

因为刻意练习是掌握实践技能的最佳途径,而教学是最好的学习。

祝你好运!

思考

已经解释了本文的主要内容。

这里有一个问题供您思考:

我们解析和存储的链接实际上是重复的:

这不是因为我们的代码有问题,而是在《如何使用“玉树智兰”开始数据科学?"文章中,我多次引用了一些文章,所以重复的链接都被抓了 查看全部

python抓取网页数据(如何用Python爬虫“爬”到解析出来的链接?)

可能你觉得这个文章太简单了,满足不了你的要求。

文章只展示了如何从一个网页中抓取信息,但您必须处理数千个网页。

别担心。

本质上,抓取一个网页与抓取 10,000 个网页是一样的。

而且,根据我们的示例,您是否已经尝试过获取链接?

以链接为基础,您可以滚雪球,让 Python 爬虫“爬行”到已解析的链接以进行进一步处理。

以后在实际场景中,你可能要处理一些棘手的问题:

这些问题的解决方法,希望在以后的教程中与大家一一分享。

需要注意的是,虽然网络爬虫抓取数据的能力很强,但是学习和实践也有一定的门槛。

当您面临数据采集任务时,您应该首先查看此列表:

如果答案是否定的,则需要自己编写脚本并调动爬虫来抓取它。

为了巩固你所学的知识,请切换到另一个网页,根据我们的代码进行修改,抓取你感兴趣的内容。

如果能记录下自己爬的过程,在评论区把记录链接分享给大家就更好了。

因为刻意练习是掌握实践技能的最佳途径,而教学是最好的学习。

祝你好运!

思考

已经解释了本文的主要内容。

这里有一个问题供您思考:

我们解析和存储的链接实际上是重复的:

这不是因为我们的代码有问题,而是在《如何使用“玉树智兰”开始数据科学?"文章中,我多次引用了一些文章,所以重复的链接都被抓了

python抓取网页数据(一种比较简单的实现方法有哪些?比较简单怎么做?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-12-04 15:16

最近想在网上抓取资料研究一下,刚懂一点python,我们来看一个比较简单的实现方法。

比如我要抓取奥巴马每周演讲的内容,如果是手动提取,需要一一点进去,然后复制保存,非常麻烦。

有没有一种可以用python这样强大的语言快速实现的一步法。

首先我们来看一下这个网页的源码

可以发现我们想要的信息是这样的

一个小网址。

更具体地说,我们需要像这样遍历每个URL,并且需要从上面的网页中提取这个URL。

OK,开始写代码

首先打开这个目录页并保存在content中

import sys,urllib

url="http://www.putclub.com/html/ra ... ot%3B

wp = urllib.urlopen(url)

print "start download..."

content = wp.read()

以下是提取每个演讲的内容

具体思路是搜索“center_box”后搜索“href=”和“target”之间的内容。为什么会在这两者之间?请参阅网络源代码。

你得到的是每篇文章的网址,每篇文章的网址文章都加在前面。

print content.count("center_box")

index = content.find("center_box")

content=content[content.find("center_box")+1:]

content=content[content.find("href=")+7:content.find("target")-2]

filename = content

url ="http://www.putclub.com/"+content

print content

print url

wp = urllib.urlopen(url)

print "start download..."

content = wp.read()

有了文章的内容的url后,同样的过滤内容。

<p>#print content

print content.count(" 查看全部

python抓取网页数据(一种比较简单的实现方法有哪些?比较简单怎么做?)

最近想在网上抓取资料研究一下,刚懂一点python,我们来看一个比较简单的实现方法。

比如我要抓取奥巴马每周演讲的内容,如果是手动提取,需要一一点进去,然后复制保存,非常麻烦。

有没有一种可以用python这样强大的语言快速实现的一步法。

首先我们来看一下这个网页的源码

可以发现我们想要的信息是这样的

一个小网址。

更具体地说,我们需要像这样遍历每个URL,并且需要从上面的网页中提取这个URL。

OK,开始写代码

首先打开这个目录页并保存在content中

import sys,urllib

url="http://www.putclub.com/html/ra ... ot%3B

wp = urllib.urlopen(url)

print "start download..."

content = wp.read()

以下是提取每个演讲的内容

具体思路是搜索“center_box”后搜索“href=”和“target”之间的内容。为什么会在这两者之间?请参阅网络源代码。

你得到的是每篇文章的网址,每篇文章的网址文章都加在前面。

print content.count("center_box")

index = content.find("center_box")

content=content[content.find("center_box")+1:]

content=content[content.find("href=")+7:content.find("target")-2]

filename = content

url ="http://www.putclub.com/"+content

print content

print url

wp = urllib.urlopen(url)

print "start download..."

content = wp.read()

有了文章的内容的url后,同样的过滤内容。

<p>#print content

print content.count("

python抓取网页数据(法国亚马逊、美国亚马逊-viewer列表的数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2021-12-04 15:10

前段时间,姐姐子公司的老板让她在法国亚马逊评论列表的前100页找出1000个评论用户的联系方式。1000个用户,你需要一一阅读然后记录,并不是每个评论用户都会保留他们的个人联系方式。所以问题来了。这种费时费力的工作如果手工完成,要花两天时间才能找到前30页数据(还有其他任务要做),然后就很累了。本着求救的原则(如果节目能找到妹子就太好了,所以心里很苦恼),想帮她做点什么。

我自己的工作是开发游戏客户端。主要使用的开发语言是lua和c++,从未接触过网页或相关工作。只是我在工作中使用了python脚本,在网上查python相关资料的时候,看到有网友用python写爬虫来做点什么。于是我想,我也可以用python写爬虫去亚马逊的网站去抓取数据吗?就这样,现在学习使用,开始打码。

环境:

Windows 7的

蟒蛇:2.7

使用的 Python 插件:

urllib2、urllib 插件,用于打开网页链接;

re插件,用于正则匹配;

codecs 插件用于编码转换和数据存储。

目前实现的功能:

在法国顶级浏览者列表的前 100 页中抓取 1,000 位用户的姓名、联系信息(网站 链接或电子邮件)、国籍(可能有卢森堡和瑞士买家在法国亚马逊上购买),以及详细的用户评论 页面链接等数据。

通过抓取法国亚马逊热搜榜数据,扩展为抓取中国亚马逊和美国亚马逊热搜榜数据。理论上,通过简单的修改,可以捕捉到不同国家亚马逊热搜榜的数据。

需要改进的方面:

写完代码,发现在抓数据的过程中效率很低。捕获1000条数据需要很长时间,捕获几页或几十页后,程序无法运行并卡住。它只能关闭和打开。当时,在扩展到美国采集中国和亚马逊的数据之前,我想到的可能原因是:

正则表达式有优化的空间,因为我之前没有接触过正则表达式,也没有使用过;法国亚马逊网站在国内访问速度慢,影响数据抓取;Python没有系统地研究过,在一些语法或者第三方辅助插件的使用上还不够熟悉。

以上三点是我想到的导致爬行效率低下的可能原因。后来我扩展了同一套代码,分别抓取了中国和美国亚马逊的数据,验证了第二个原因对整个爬虫工作的影响程度,发现影响非常大!在同等带宽和硬件条件下,中美前100页有1000个评论用户,爬取大约需要半个小时,而我爬取法国的1000条数据则用了将近一个下午(因为我老是卡住,我觉得打开网页的时候urllib没反应,我的程序也没做出判断。)一个个爬,但是总比女孩子一个个打开网页然后记录好,至少人家不会讨厌!然后花了半个小时从中国和美国捕获数据。我个人不喜欢花费的时间,并判断它是否花费了太多或几乎。但是作为开发者,程序总是可以优化的!

想法:

当我看到一个网友写的爬虫时,我的想法是打开网页,匹配我需要的信息。所以我的思路是这样的:通过python的urllib和urllib2插件打开页面,然后转换成html数据,用python的re-regular插件做正则匹配,获取页面,用户详情页面,用户联系方式和其他信息。

执行:

1、 法国亚马逊的顶级评论列表大约有1000个网页,每个页面有10个用户数据。对于每个页面,除了第一页的链接,其他页面的链接都是与页数相关的,比如代表23页的数据,那么通过简单的字符串拼接就可以得到1000页的页面链接。这是关于如何获取每个页面的链接;示例代码如下:

一种。拼接页面链接,因为首页和其余页面的格式略有不同,所以分开处理:

if 1 == i:

html_link = "http://www.amazon.fr/review/to ... ot%3B + str(i);

else:

html_link = "http://www.amazon.fr/review/to ... ot%3B + str(i) + "?ie=UTF8&page=" + str(i);

湾 将页面转换为html:

try:

page = urllib.urlopen(url)

html = page.read()

return html

except:

print "getHtml2 error"

我用try和except看看能不能解决打不开网页的问题(估计是法国亚马逊抓取卡住了,因为网站没有响应),但是没用;

2、每个页面有10个用户的数据。单击用户将跳转到其详细信息页面。通过查看不同详细信息页面的链接形式,发现它们都是相似的:一个可能是用户名变量,一个代表用户在评论列表中排名的值。因此,我可以想办法获取用户名(我猜是用户名,或者亚马逊保存的唯一标记),用户在评论列表中的排名,然后拼接出用户详细信息页面的链接; 通过查看页面的源码,发现每个在这个页面中,用户信息的形式都是类似的,都是这样的形式:/gp/pdp/profile/xxxx/,所以可以得到xxxx的数据通过简单的正则匹配,暂时称为用户唯一标识。这是关于如何获取到详细页面的链接;示例代码:

一种。匹配每个用户的唯一标识符:

reg = r'href="(/gp/pdp/profile/.+?)"><b>'

captureRe = re.compile(reg)

cpList = re.findall(captureRe,html)

湾 放在一起链接:

num = (i - 1) * 10 + index;

subLink = "http://www.amazon.fr" + cp + "/ref=cm_cr_tr_tbl_" + str(num) + "_name";

index是指10条数据中的具体一条,num实际上是用户在评论列表中的排名,每页10条,所以具体排名可以根据页数和index来计算;

C。转换为 html:

headers = { #伪装为浏览器抓取

'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6'

}

req = urllib2.Request(url,headers=headers)

page = "";

try:

page = urllib2.urlopen(req)

html = page.read()

return html

except:

print "getHtml error"

可以看出这和之前的转换形式不同,因为我发现之前转换方式得到的页面数据和我们之间用右键浏览器查看源码的格式不一样,然后我就匹配联系方式 当匹配失败时,我认为是这种差异造成的。于是,我找到了资料,用上面提到的格式进行了转换。网友们也表示,这样可以防止亚马逊对频繁访问的ip进行屏蔽; 查看全部

python抓取网页数据(法国亚马逊、美国亚马逊-viewer列表的数据)

前段时间,姐姐子公司的老板让她在法国亚马逊评论列表的前100页找出1000个评论用户的联系方式。1000个用户,你需要一一阅读然后记录,并不是每个评论用户都会保留他们的个人联系方式。所以问题来了。这种费时费力的工作如果手工完成,要花两天时间才能找到前30页数据(还有其他任务要做),然后就很累了。本着求救的原则(如果节目能找到妹子就太好了,所以心里很苦恼),想帮她做点什么。

我自己的工作是开发游戏客户端。主要使用的开发语言是lua和c++,从未接触过网页或相关工作。只是我在工作中使用了python脚本,在网上查python相关资料的时候,看到有网友用python写爬虫来做点什么。于是我想,我也可以用python写爬虫去亚马逊的网站去抓取数据吗?就这样,现在学习使用,开始打码。

环境:

Windows 7的

蟒蛇:2.7

使用的 Python 插件:

urllib2、urllib 插件,用于打开网页链接;

re插件,用于正则匹配;

codecs 插件用于编码转换和数据存储。

目前实现的功能:

在法国顶级浏览者列表的前 100 页中抓取 1,000 位用户的姓名、联系信息(网站 链接或电子邮件)、国籍(可能有卢森堡和瑞士买家在法国亚马逊上购买),以及详细的用户评论 页面链接等数据。

通过抓取法国亚马逊热搜榜数据,扩展为抓取中国亚马逊和美国亚马逊热搜榜数据。理论上,通过简单的修改,可以捕捉到不同国家亚马逊热搜榜的数据。

需要改进的方面:

写完代码,发现在抓数据的过程中效率很低。捕获1000条数据需要很长时间,捕获几页或几十页后,程序无法运行并卡住。它只能关闭和打开。当时,在扩展到美国采集中国和亚马逊的数据之前,我想到的可能原因是:

正则表达式有优化的空间,因为我之前没有接触过正则表达式,也没有使用过;法国亚马逊网站在国内访问速度慢,影响数据抓取;Python没有系统地研究过,在一些语法或者第三方辅助插件的使用上还不够熟悉。

以上三点是我想到的导致爬行效率低下的可能原因。后来我扩展了同一套代码,分别抓取了中国和美国亚马逊的数据,验证了第二个原因对整个爬虫工作的影响程度,发现影响非常大!在同等带宽和硬件条件下,中美前100页有1000个评论用户,爬取大约需要半个小时,而我爬取法国的1000条数据则用了将近一个下午(因为我老是卡住,我觉得打开网页的时候urllib没反应,我的程序也没做出判断。)一个个爬,但是总比女孩子一个个打开网页然后记录好,至少人家不会讨厌!然后花了半个小时从中国和美国捕获数据。我个人不喜欢花费的时间,并判断它是否花费了太多或几乎。但是作为开发者,程序总是可以优化的!

想法:

当我看到一个网友写的爬虫时,我的想法是打开网页,匹配我需要的信息。所以我的思路是这样的:通过python的urllib和urllib2插件打开页面,然后转换成html数据,用python的re-regular插件做正则匹配,获取页面,用户详情页面,用户联系方式和其他信息。

执行:

1、 法国亚马逊的顶级评论列表大约有1000个网页,每个页面有10个用户数据。对于每个页面,除了第一页的链接,其他页面的链接都是与页数相关的,比如代表23页的数据,那么通过简单的字符串拼接就可以得到1000页的页面链接。这是关于如何获取每个页面的链接;示例代码如下:

一种。拼接页面链接,因为首页和其余页面的格式略有不同,所以分开处理:

if 1 == i:

html_link = "http://www.amazon.fr/review/to ... ot%3B + str(i);

else:

html_link = "http://www.amazon.fr/review/to ... ot%3B + str(i) + "?ie=UTF8&page=" + str(i);

湾 将页面转换为html:

try:

page = urllib.urlopen(url)

html = page.read()

return html

except:

print "getHtml2 error"

我用try和except看看能不能解决打不开网页的问题(估计是法国亚马逊抓取卡住了,因为网站没有响应),但是没用;

2、每个页面有10个用户的数据。单击用户将跳转到其详细信息页面。通过查看不同详细信息页面的链接形式,发现它们都是相似的:一个可能是用户名变量,一个代表用户在评论列表中排名的值。因此,我可以想办法获取用户名(我猜是用户名,或者亚马逊保存的唯一标记),用户在评论列表中的排名,然后拼接出用户详细信息页面的链接; 通过查看页面的源码,发现每个在这个页面中,用户信息的形式都是类似的,都是这样的形式:/gp/pdp/profile/xxxx/,所以可以得到xxxx的数据通过简单的正则匹配,暂时称为用户唯一标识。这是关于如何获取到详细页面的链接;示例代码:

一种。匹配每个用户的唯一标识符:

reg = r'href="(/gp/pdp/profile/.+?)"><b>'

captureRe = re.compile(reg)

cpList = re.findall(captureRe,html)

湾 放在一起链接:

num = (i - 1) * 10 + index;

subLink = "http://www.amazon.fr" + cp + "/ref=cm_cr_tr_tbl_" + str(num) + "_name";

index是指10条数据中的具体一条,num实际上是用户在评论列表中的排名,每页10条,所以具体排名可以根据页数和index来计算;

C。转换为 html:

headers = { #伪装为浏览器抓取

'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6'

}

req = urllib2.Request(url,headers=headers)

page = "";

try:

page = urllib2.urlopen(req)

html = page.read()

return html

except:

print "getHtml error"

可以看出这和之前的转换形式不同,因为我发现之前转换方式得到的页面数据和我们之间用右键浏览器查看源码的格式不一样,然后我就匹配联系方式 当匹配失败时,我认为是这种差异造成的。于是,我找到了资料,用上面提到的格式进行了转换。网友们也表示,这样可以防止亚马逊对频繁访问的ip进行屏蔽;

python抓取网页数据(【小编】内容挺不错的使用方法和参考代码(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-12-03 22:27

今天给大家分享一篇关于Python微医注册网医生数据采集的文章。我觉得内容还不错。现在我把它分享给你。有很好的参考价值。有需要的朋友,跟着小编一起来看看吧。酒吧

1. 写在前面

今天要爬取的那个网站叫做WeDoctor网站,地址是,我们将通过python3爬虫爬取这个URL,然后将数据存入CSV,为后面的分析教程做准备。本文主要使用的库有pyppeteer和pyquery

首先找到医生列表页面

全国/全部/无限/p5

本页显示75952条数据。实际测试中,翻到第38页时,无法加载数据。视觉上,后台程序没有返回数据,但为了学习,我们忍了。

2. 页面网址

全国/全部/无限/p1

全国/全部/无限/p2

...

全国/全部/无限制/p38

数据超过38页,量不是很大。我们只需要选择一个库来抓取它。对于这个博客,我发现了一个不受欢迎的库。

在使用pyppeteer的过程中,发现材料那么少,很尴尬。而且,官方文档写得不好。有兴趣的朋友可以自行查看。这个库的安装也在下面的网址中。

最简单的使用方法就是在官方文档中简单的写了,如下,可以直接将网页另存为图片。

import asyncio from pyppeteer import launch async def main(): browser = await launch() # 运行一个无头的浏览器 page = await browser.newPage() # 打开一个选项卡 await page.goto('http://www.baidu.com') # 加载一个页面 await page.screenshot({'path': 'baidu.png-600'}) # 把网页生成截图 await browser.close() asyncio.get_event_loop().run_until_complete(main()) # 异步

下面我整理了一些参考代码,大家可以参考一下。

browser = await launch(headless=False) # 可以打开浏览器 await page.click('#login_user') # 点击一个按钮 await page.type('#login_user', 'admin') # 输入内容 await page.click('#password') await page.type('#password', '123456') await page.click('#login-submit') await page.waitForNavigation() # 设置浏览器窗口大小 await page.setViewport({ 'width': 1350, 'height': 850 }) content = await page.content() # 获取网页内容 cookies = await page.cookies() # 获取网页cookies

3. 抓取页面

运行如下代码,可以看到控制台不断打印网页的源代码,只要得到源代码,就可以进行后续的分析并保存数据。如果出现控件不输出任何东西的情况,那么请把下面的

await launch(headless=True) 修改为 await launch(headless=False)

import asyncio from pyppeteer import launch class DoctorSpider(object): async def main(self, num): try: browser = await launch(headless=True) page = await browser.newPage() print(f"正在爬取第 {num} 页面") await page.goto("https://www.guahao.com/expert/all/全国/all/不限/p{}".format(num)) content = await page.content() print(content) except Exception as e: print(e.args) finally: num += 1 await browser.close() await self.main(num) def run(self): loop = asyncio.get_event_loop() asyncio.get_event_loop().run_until_complete(self.main(1)) if __name__ == '__main__': doctor = DoctorSpider() doctor.run()

4. 分析数据

解析的数据使用 pyquery。这个库在之前的博客中已经使用过,可以直接应用到案例中。结果数据通过pandas保存到CSV文件中。

import asyncio from pyppeteer import launch from pyquery import PyQuery as pq import pandas as pd # 保存csv文件 class DoctorSpider(object): def __init__(self): self._data = list() async def main(self,num): try: browser = await launch(headless=True) page = await browser.newPage() print(f"正在爬取第 {num} 页面") await page.goto("https://www.guahao.com/expert/all/全国/all/不限/p{}".format(num)) content = await page.content() self.parse_html(content) print("正在存储数据....") data = pd.DataFrame(self._data) data.to_csv("微医数据.csv", encoding='utf_8_sig') except Exception as e: print(e.args) finally: num+=1 await browser.close() await self.main(num) def parse_html(self,content): doc = pq(content) items = doc(".g-doctor-item").items() for item in items: #doctor_name = item.find(".seo-anchor-text").text() name_level = item.find(".g-doc-baseinfo>dl>dt").text() # 姓名和级别 department = item.find(".g-doc-baseinfo>dl>dd>p:eq(0)").text() # 科室 address = item.find(".g-doc-baseinfo>dl>dd>p:eq(1)").text() # 医院地址 star = item.find(".star-count em").text() # 评分 inquisition = item.find(".star-count i").text() # 问诊量 expert_team = item.find(".expert-team").text() # 专家团队 service_price_img = item.find(".service-name:eq(0)>.fee").text() service_price_video = item.find(".service-name:eq(1)>.fee").text() one_data = { "name": name_level.split(" ")[0], "level": name_level.split(" ")[1], "department": department, "address": address, "star": star, "inquisition": inquisition, "expert_team": expert_team, "service_price_img": service_price_img, "service_price_video": service_price_video } self._data.append(one_data) def run(self): loop = asyncio.get_event_loop() asyncio.get_event_loop().run_until_complete(self.main(1)) if __name__ == '__main__': doctor = DoctorSpider() doctor.run()

综上所述,这个库不是很好用。可能我之前没有仔细研究过。感觉一般。可以多试一下,看看整体效率是否可以提高。

资料清单:

总结

以上是Python WeDoctor注册网医生数据抓取的详细内容,更多请关注其他相关html中文网站文章! 查看全部

python抓取网页数据(【小编】内容挺不错的使用方法和参考代码(一))

今天给大家分享一篇关于Python微医注册网医生数据采集的文章。我觉得内容还不错。现在我把它分享给你。有很好的参考价值。有需要的朋友,跟着小编一起来看看吧。酒吧

1. 写在前面

今天要爬取的那个网站叫做WeDoctor网站,地址是,我们将通过python3爬虫爬取这个URL,然后将数据存入CSV,为后面的分析教程做准备。本文主要使用的库有pyppeteer和pyquery

首先找到医生列表页面

全国/全部/无限/p5

本页显示75952条数据。实际测试中,翻到第38页时,无法加载数据。视觉上,后台程序没有返回数据,但为了学习,我们忍了。

2. 页面网址

全国/全部/无限/p1

全国/全部/无限/p2

...

全国/全部/无限制/p38

数据超过38页,量不是很大。我们只需要选择一个库来抓取它。对于这个博客,我发现了一个不受欢迎的库。

在使用pyppeteer的过程中,发现材料那么少,很尴尬。而且,官方文档写得不好。有兴趣的朋友可以自行查看。这个库的安装也在下面的网址中。

最简单的使用方法就是在官方文档中简单的写了,如下,可以直接将网页另存为图片。

import asyncio from pyppeteer import launch async def main(): browser = await launch() # 运行一个无头的浏览器 page = await browser.newPage() # 打开一个选项卡 await page.goto('http://www.baidu.com') # 加载一个页面 await page.screenshot({'path': 'baidu.png-600'}) # 把网页生成截图 await browser.close() asyncio.get_event_loop().run_until_complete(main()) # 异步

下面我整理了一些参考代码,大家可以参考一下。

browser = await launch(headless=False) # 可以打开浏览器 await page.click('#login_user') # 点击一个按钮 await page.type('#login_user', 'admin') # 输入内容 await page.click('#password') await page.type('#password', '123456') await page.click('#login-submit') await page.waitForNavigation() # 设置浏览器窗口大小 await page.setViewport({ 'width': 1350, 'height': 850 }) content = await page.content() # 获取网页内容 cookies = await page.cookies() # 获取网页cookies

3. 抓取页面

运行如下代码,可以看到控制台不断打印网页的源代码,只要得到源代码,就可以进行后续的分析并保存数据。如果出现控件不输出任何东西的情况,那么请把下面的

await launch(headless=True) 修改为 await launch(headless=False)