python抓取网页数据(Python模拟登陆新浪微博数据教程(withpy2021-11-12))

优采云 发布时间: 2021-12-15 11:05python抓取网页数据(Python模拟登陆新浪微博数据教程(withpy2021-11-12))

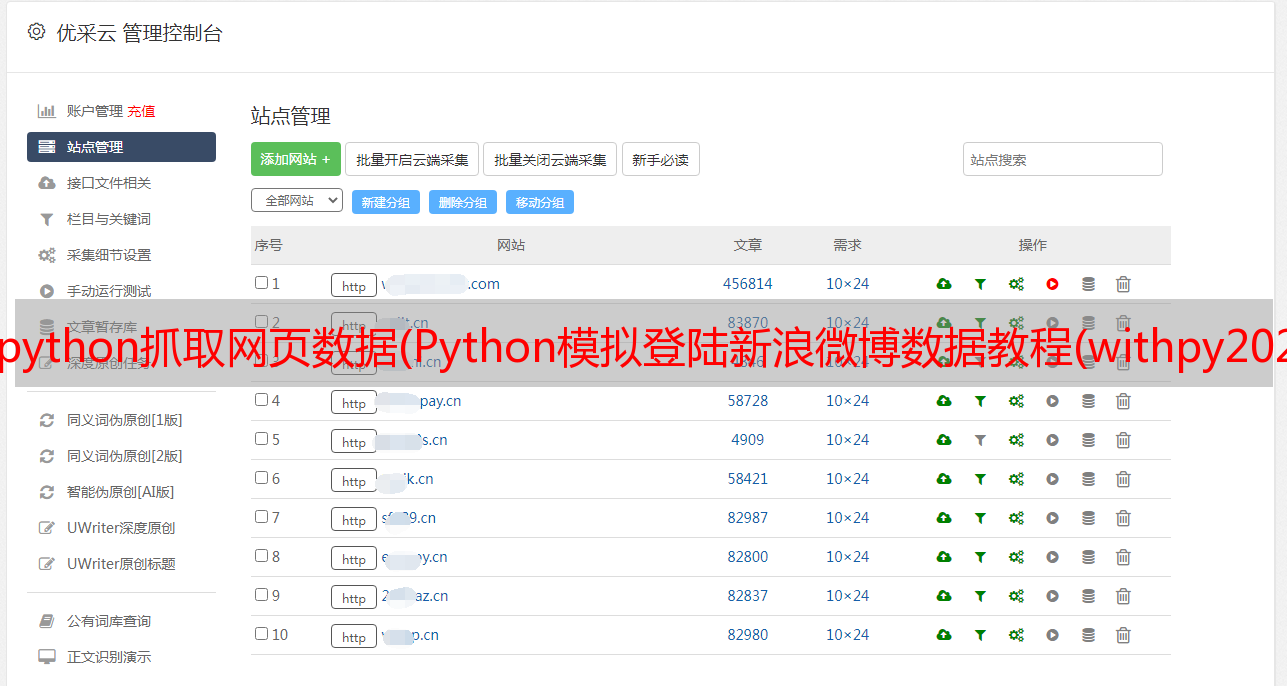

首页>博客文章BeautifulSoup+Regular+Python 抓取网页数据

withpy2021-11-12

简介 最近在研究使用Python抓取新浪微博上的数据。花了五天时间,终于写出了这段代码。我从很多人的经验中学习,接触到了很多新事物。这里是一个简短的总结。(一)Python模拟登录新浪微博这个主要是用网上找的例子。(二)BeautifulSoup登录后就是数据抓取部分。这里我主要用了两种技巧。首先是 BeautifulSoup ,这个需要自己安装,安装方法如下:Windows平台安装B" />

最近在研究使用Python抓取新浪微博数据。花了五天时间,终于写出了这段代码。我从很多人的经验中学习,也接触到了很多新的东西。这里是一个简短的总结。

(一)Python模拟登陆新浪微博

这主要是基于在互联网上找到的例子。

(二)美丽的汤

登录后就是抓取数据部分了。这里我主要使用两种技术。第一个是BeautifulSoup,需要自己安装。安装方法如下:

在 Windows 上安装 Beautiful Soup

我们来谈谈如何在Windows下安装Beautiful Soup:

1.下载,最新版本是beautifulsoup4-4.3.2。

2. 下载完成后需要解压,假设放在D:/python下。

3.运行cmd,切换到D:/python27/beautifulsoup4-4.3.2/目录(根据解压后的目录和下载的版本号修改),

cd /d D:/python27/beautifulsoup4-4.3.2

4.运行命令:

setup.py 构建

setup.py 安装

5.IDE from bs4 import BeautifulSoup下,没有报错,说明安装成功。

Beautiful Soup 的官方文档很齐全,你可以通过练习官方的例子来掌握它。官方英文文件,

我主要使用 BeautifulSoup 来获取 HTML 文档中的结构化数据列表。如果只得到某条数据,可以使用正则性。下面是一起使用regular和soup的例子

webpage = self.fetch(url)

soup = BeautifulSoup(webpage)

top_div=soup.findAll('div',{'id':'anything'})

all_a = top_div[0].findAll('a')

userID = ''

for a in all_a:

str_href = a.get('href')

#print str_href

pattern = '/(\d+)/info'

my_href = re.findall(pattern,str_href)

if my_href:

userID = my_href[0]

print 'userID: ' + userID

(三)常规

Python+正则例子很多,我主要参考这个教程

核心应该是这张图

代码示例如下:

#获取页数

def get_page_count(self,url):

pattern = 'type="hidden" value="(\d+?)"'

page_number = re.findall(pattern,self.fetch(url))

if page_number:

return page_number[0]

return 1

总结

以上是本站为您采集的BeautifulSoup+Regular+Python抓取网页数据。希望文章可以帮助大家解决BeautifulSoup+Regular+Python抓取网页数据遇到的程序开发问题。

如果您觉得本站网站的内容还不错,欢迎向程序员朋友推荐本站网站。