php多线程抓取多个网页

php多线程抓取多个网页(这段代码使用一个多处理来正确地从工作函数返回值)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-10-04 04:24

部分

我想从服务器渲染的网页中获取链接,所以我需要使用 requests_html 并渲染网页以从中提取链接。

现在假设我想要10个网页中的10个链接,它一个一个地工作,首先渲染网页,然后提取链接,这很耗时

我想要做的是通过同时使用多处理/线程运行函数的不同实例来提取所有链接

所以我尝试了以下方法:

download_links = []

def getDownloadLinks(url):

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

download_links.append(link)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

threads = []

for i in range(len(links)):

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i],))

process.start()

threads.append(process)

for t in threads:

t.join()

但它什么都不返回,而是引发了多个错误。我抬头看了看谷歌,我得到的是它与asyncio有关,它永远无法成功完成其循环迭代。

问题是什么?

CmdCoder858

从我的测试来看,这段代码似乎是您问题的最佳解决方案:

import multiprocessing

from requests_html import HTMLSession

def getDownloadLinks(url, returnvar, i):

try:

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.html.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

returnvar[str(i)] = link

page.close()

session.close()

except Exception as e:

print(e)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

if __name__ == '__main__':

threads = []

manager = multiprocessing.Manager()

returndict = manager.dict()

for i in range(len(links)):

try:

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i], returndict, i))

process.start()

threads.append(process)

except Exception as e:

print(e)

for t in threads:

t.join()

print(returndict)

这段代码使用了一个多处理管理器来正确地从工作函数返回值,它似乎不再引发错误,至少对我来说是这样。希望对你有帮助,有任何问题,请务必在下方评论。 查看全部

php多线程抓取多个网页(这段代码使用一个多处理来正确地从工作函数返回值)

部分

我想从服务器渲染的网页中获取链接,所以我需要使用 requests_html 并渲染网页以从中提取链接。

现在假设我想要10个网页中的10个链接,它一个一个地工作,首先渲染网页,然后提取链接,这很耗时

我想要做的是通过同时使用多处理/线程运行函数的不同实例来提取所有链接

所以我尝试了以下方法:

download_links = []

def getDownloadLinks(url):

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

download_links.append(link)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

threads = []

for i in range(len(links)):

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i],))

process.start()

threads.append(process)

for t in threads:

t.join()

但它什么都不返回,而是引发了多个错误。我抬头看了看谷歌,我得到的是它与asyncio有关,它永远无法成功完成其循环迭代。

问题是什么?

CmdCoder858

从我的测试来看,这段代码似乎是您问题的最佳解决方案:

import multiprocessing

from requests_html import HTMLSession

def getDownloadLinks(url, returnvar, i):

try:

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.html.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

returnvar[str(i)] = link

page.close()

session.close()

except Exception as e:

print(e)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

if __name__ == '__main__':

threads = []

manager = multiprocessing.Manager()

returndict = manager.dict()

for i in range(len(links)):

try:

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i], returndict, i))

process.start()

threads.append(process)

except Exception as e:

print(e)

for t in threads:

t.join()

print(returndict)

这段代码使用了一个多处理管理器来正确地从工作函数返回值,它似乎不再引发错误,至少对我来说是这样。希望对你有帮助,有任何问题,请务必在下方评论。

php多线程抓取多个网页(php多线程抓取多个网页的爬虫抓取思路分析(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-10-03 12:03

php多线程抓取多个网页是一种非常简单的方法,但是这种方法非常简单,如果同时抓取几个网页或者抓取任意网页分裂出来很多个网页会影响速度,那么有没有可以不同时抓取多个网页的爬虫呢?有,答案就是多进程爬虫抓取。主要思想就是在分配一个进程池给程序调用的同时,网页又分配两个池子分别进行抓取,如下所示,是在两个进程中抓取一个相同的网页内容。

使用是非常方便的,每次只需要一次分配进程池给代码抓取,用户只需要点击回调函数做事件处理和逻辑处理即可。给爬虫找个队列进程池抽象成队列,可以看做是一个延时任务,如果网页要等待我们执行完一个任务才显示返回结果,那么就把任务放入队列,等候队列的执行完毕后再显示出结果,这样就可以重复多次完成任务。对队列中的任务分别进行多线程调用就可以实现很多事情了。

实现思路先定义一个队列,进程池代码,基本情况图如下:从网页内容可以定义到getsitemap函数,getsitemap函数返回网页的图片地址和位置,接着定义gethtml函数,图片地址返回url,一般我们使用的图片都是通过爬虫抓取下来的图片,那么这个网页如果存在图片地址就返回以图片地址为loader对象的posthtml函数,返回url和图片地址。

然后进行gethtml函数的分发,分配给两个队列对应的两个池子每次分配一个进程池完成抓取数个网页,每个进程池同时抓取整个网页。最后用户在使用gethtml函数点击回调函数,取到返回的结果设置队列index进程,队列内的队列每次只抓取一个网页,然后取出队列内的网页连同图片地址传递给gethtml函数从而显示出结果。

php多线程抓取多个网页大致思路就是这样,整个流程主要涉及的函数如下:定义好队列池,通过特定的api不断放入队列中,在我们进行队列的同时对着api返回的网页执行posthtml函数,在对应的队列中的队列直接传递进行抓取,抓取完成队列放入队列池,然后等待队列中队列放入队列池里的网页结果,再由队列的index函数返回,而队列内的队列每次只抓取一个网页,整个抓取的过程对应主要使用gethtml的实现,这里写的直接是队列gethtml函数posthtml函数gethtml函数的参数:返回地址url队列index函数参数ex1的输入和输出是同步的,为了减少中间的数据传递耗时,我们直接通过回调函数loadex函数来取数。

posthtml函数的实现流程是定义gethtml函数,通过loadex获取了队列,然后调用gethtml函数,调用gethtml函数的时候在队列中拷贝了图片地址,通过网页回调函数posthtml函数loadcurrenttext函数读取了网页地址,然后返回url的二进制字符串到。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页的爬虫抓取思路分析(图))

php多线程抓取多个网页是一种非常简单的方法,但是这种方法非常简单,如果同时抓取几个网页或者抓取任意网页分裂出来很多个网页会影响速度,那么有没有可以不同时抓取多个网页的爬虫呢?有,答案就是多进程爬虫抓取。主要思想就是在分配一个进程池给程序调用的同时,网页又分配两个池子分别进行抓取,如下所示,是在两个进程中抓取一个相同的网页内容。

使用是非常方便的,每次只需要一次分配进程池给代码抓取,用户只需要点击回调函数做事件处理和逻辑处理即可。给爬虫找个队列进程池抽象成队列,可以看做是一个延时任务,如果网页要等待我们执行完一个任务才显示返回结果,那么就把任务放入队列,等候队列的执行完毕后再显示出结果,这样就可以重复多次完成任务。对队列中的任务分别进行多线程调用就可以实现很多事情了。

实现思路先定义一个队列,进程池代码,基本情况图如下:从网页内容可以定义到getsitemap函数,getsitemap函数返回网页的图片地址和位置,接着定义gethtml函数,图片地址返回url,一般我们使用的图片都是通过爬虫抓取下来的图片,那么这个网页如果存在图片地址就返回以图片地址为loader对象的posthtml函数,返回url和图片地址。

然后进行gethtml函数的分发,分配给两个队列对应的两个池子每次分配一个进程池完成抓取数个网页,每个进程池同时抓取整个网页。最后用户在使用gethtml函数点击回调函数,取到返回的结果设置队列index进程,队列内的队列每次只抓取一个网页,然后取出队列内的网页连同图片地址传递给gethtml函数从而显示出结果。

php多线程抓取多个网页大致思路就是这样,整个流程主要涉及的函数如下:定义好队列池,通过特定的api不断放入队列中,在我们进行队列的同时对着api返回的网页执行posthtml函数,在对应的队列中的队列直接传递进行抓取,抓取完成队列放入队列池,然后等待队列中队列放入队列池里的网页结果,再由队列的index函数返回,而队列内的队列每次只抓取一个网页,整个抓取的过程对应主要使用gethtml的实现,这里写的直接是队列gethtml函数posthtml函数gethtml函数的参数:返回地址url队列index函数参数ex1的输入和输出是同步的,为了减少中间的数据传递耗时,我们直接通过回调函数loadex函数来取数。

posthtml函数的实现流程是定义gethtml函数,通过loadex获取了队列,然后调用gethtml函数,调用gethtml函数的时候在队列中拷贝了图片地址,通过网页回调函数posthtml函数loadcurrenttext函数读取了网页地址,然后返回url的二进制字符串到。

php多线程抓取多个网页(这里有新鲜出炉的PHP设计模式,程序狗速度看过来! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-28 09:24

)

下面是一个新发布的PHP设计模式。看看程序狗的速度

PHP开源脚本语言PHP(外名:超文本预处理器,中文名:“超文本预处理器”)是一种通用的开源脚本语言。语法吸收了C语言、Java和Perl的特点。它入门门槛低,易学,应用广泛。它主要适用于web开发领域。PHP的文件后缀是PHP

PHP可以使用curl来完成各种文件传输操作,例如模拟浏览器来发送get和post请求。然而,由于PHP语言本身不支持多线程,因此开发爬虫程序效率不高,但可以使用curl,通过curl的功能,并发多线程可以访问多个URL地址来抓取网页或下载文件

PHP使用curl函数完成各种文件传输操作,例如模拟浏览器发送get和post请求。受PHP语言不支持多线程的限制,开发爬虫程序的效率不高。此时,常常需要curl多函数来实现并发多线程访问多个URL地址。既然curl多函数功能强大,我可以使用curl多函数来编写并发多线程下载文件吗?当然可以。这是我的密码:

代码1:将获得的代码直接写入文件

代码2:首先将获得的代码放入变量中,然后将其写入文件 查看全部

php多线程抓取多个网页(这里有新鲜出炉的PHP设计模式,程序狗速度看过来!

)

下面是一个新发布的PHP设计模式。看看程序狗的速度

PHP开源脚本语言PHP(外名:超文本预处理器,中文名:“超文本预处理器”)是一种通用的开源脚本语言。语法吸收了C语言、Java和Perl的特点。它入门门槛低,易学,应用广泛。它主要适用于web开发领域。PHP的文件后缀是PHP

PHP可以使用curl来完成各种文件传输操作,例如模拟浏览器来发送get和post请求。然而,由于PHP语言本身不支持多线程,因此开发爬虫程序效率不高,但可以使用curl,通过curl的功能,并发多线程可以访问多个URL地址来抓取网页或下载文件

PHP使用curl函数完成各种文件传输操作,例如模拟浏览器发送get和post请求。受PHP语言不支持多线程的限制,开发爬虫程序的效率不高。此时,常常需要curl多函数来实现并发多线程访问多个URL地址。既然curl多函数功能强大,我可以使用curl多函数来编写并发多线程下载文件吗?当然可以。这是我的密码:

代码1:将获得的代码直接写入文件

代码2:首先将获得的代码放入变量中,然后将其写入文件

php多线程抓取多个网页(C#基于异步事件回调多线程容器上传项目不支持Firefox,提示代码附件太大)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-28 09:21

C#基于异步事件回调的多线程容器

上传项目不支持火狐,代码附件过大(1.4M)。写了30多分钟的描述不见了。太骗人了 10点有点贵,肯定原创,2个代码文件一共300多行,下载的时候请慎重。你已经下载了。如果您非常不高兴,请在评论中说出来。不要让其他学生愚弄你。如果您觉得还行,请留言。该代码使用多个工作线程和线程来执行任务。通过暴露的方法将消息传递给worker,然后使用事件回调返回处理结果。实现的事件是 OnThreadComplete、OnAddedTask、OnStart、OnSuccess、OnFailure、OnTimeout。事件回调支持同步或异步,并且每个worker可以指定执行超时以避免线程阻塞。队列使用线程安全的 Blocking采集,每组 worker 使用一个队列。委托是由 Func 定义的,而不是传统的不太理解的委托。这大大减少了代码并使其更易于理解。多线程应该使用消息中心来交换数据,避免线程同步交互、等待、阻塞等,都是异步调用,都是接收消息,然后生成消息,线程之间没有耦合,消息中心有很多成熟的解决方案,比如RabbitMQ、Redis(带有简单的消息交换),微软有消息云服务等等。如果应用不复杂,可以用DB作为简单的消息中心。

开发环境为VS2012,Framework4.0,代码注释量非常大。如果你对这段代码感到满意,你可以随意破坏它。如果您有建设性的意见,请告诉我。下面是部分测试代码: //发送消息方法容器 var msgContainer = new Hashtable();//创建并启动worker foreach (var key in workers.Keys){//创建workers//启动5个线程,异步Event回调,方法执行超时 20 秒,程序运行 100 个线程。由于引入了超时控制,实际线程将达到下面20个工作组中的100+50//,其中5个超时。主要测试是针对 OnTimeout 事件。可以设置sellep的时间来控制。//我把sleep的时间设置的有点长,方便大家测试。//测试的时候,你会看到异常。那应该是超时。我使用了 Thread.Abort 方法。ontimeout 事件开始 var worker = new Sehui.Worker(5, key.ToString(), (Func)workers[key], false, new TimeSpan(0, 0, 20));worker.OnStart += worker_OnEvent;worker.OnSuccess += worker_OnEvent;worker.OnFailure += worker_OnEvent;worker.OnTimeout += worker_OnEvent;//启动worker worker.Start();//将消息方法添加到Hashtable//这里我偷懒了,下面可以循环方式向线程添加消息msgContainer.Add(key.ToString(), new Func(worker.AddTask));)。//向20个worker发送消息,每个worker发送20条消息为( var i = 0; i <20; i++){for (var k = 0; k <20;

现在就下载 查看全部

php多线程抓取多个网页(C#基于异步事件回调多线程容器上传项目不支持Firefox,提示代码附件太大)

C#基于异步事件回调的多线程容器

上传项目不支持火狐,代码附件过大(1.4M)。写了30多分钟的描述不见了。太骗人了 10点有点贵,肯定原创,2个代码文件一共300多行,下载的时候请慎重。你已经下载了。如果您非常不高兴,请在评论中说出来。不要让其他学生愚弄你。如果您觉得还行,请留言。该代码使用多个工作线程和线程来执行任务。通过暴露的方法将消息传递给worker,然后使用事件回调返回处理结果。实现的事件是 OnThreadComplete、OnAddedTask、OnStart、OnSuccess、OnFailure、OnTimeout。事件回调支持同步或异步,并且每个worker可以指定执行超时以避免线程阻塞。队列使用线程安全的 Blocking采集,每组 worker 使用一个队列。委托是由 Func 定义的,而不是传统的不太理解的委托。这大大减少了代码并使其更易于理解。多线程应该使用消息中心来交换数据,避免线程同步交互、等待、阻塞等,都是异步调用,都是接收消息,然后生成消息,线程之间没有耦合,消息中心有很多成熟的解决方案,比如RabbitMQ、Redis(带有简单的消息交换),微软有消息云服务等等。如果应用不复杂,可以用DB作为简单的消息中心。

开发环境为VS2012,Framework4.0,代码注释量非常大。如果你对这段代码感到满意,你可以随意破坏它。如果您有建设性的意见,请告诉我。下面是部分测试代码: //发送消息方法容器 var msgContainer = new Hashtable();//创建并启动worker foreach (var key in workers.Keys){//创建workers//启动5个线程,异步Event回调,方法执行超时 20 秒,程序运行 100 个线程。由于引入了超时控制,实际线程将达到下面20个工作组中的100+50//,其中5个超时。主要测试是针对 OnTimeout 事件。可以设置sellep的时间来控制。//我把sleep的时间设置的有点长,方便大家测试。//测试的时候,你会看到异常。那应该是超时。我使用了 Thread.Abort 方法。ontimeout 事件开始 var worker = new Sehui.Worker(5, key.ToString(), (Func)workers[key], false, new TimeSpan(0, 0, 20));worker.OnStart += worker_OnEvent;worker.OnSuccess += worker_OnEvent;worker.OnFailure += worker_OnEvent;worker.OnTimeout += worker_OnEvent;//启动worker worker.Start();//将消息方法添加到Hashtable//这里我偷懒了,下面可以循环方式向线程添加消息msgContainer.Add(key.ToString(), new Func(worker.AddTask));)。//向20个worker发送消息,每个worker发送20条消息为( var i = 0; i <20; i++){for (var k = 0; k <20;

现在就下载

php多线程抓取多个网页(先看springbootx深度理解定时任务schedule基于上述代码修改源码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-09-25 09:26

“这是我参加八月庚文挑战赛的第16天。请参阅活动详情:八月庚文挑战赛”

让我们看一看spring boot2.x,以深入了解计划的任务时间表

基于上述代码修改

源代码:/langyastudi

正式文件:

工作中经常涉及异步任务。通常使用多线程技术,例如线程池ThreadPoolExecutor。其执行规则如下(图片来源于网络):

使用spring开发时,除了使用@enablesync和@async注释外,还需要定义taskexecutor类型的bean。幸运的是,spring boot提供了taskexecutionautoconfiguration的自动配置,它自动注册bean(名为ApplicationTaskExecutor)的threadpooltaskexecutor(taskexecutor的实现类)。因此,在spring引导中,您只需要使用@EnableSync和@async注释来完成多线程异步操作

使用步骤

Spring boot通过以下方式提供异步多线程任务:

在entry类中启用对异步多线程任务的支持:

@SpringBootApplication

@EnableAsync

public class Application

{

public static void main(String[] args)

{

...

}

}

复制代码

定义收录异步多线程任务的类:

@Component

@Log4j2

public class AsyncTask

{

@Async

public void loopPrint(Integer i)

{

log.info("async task:" + i);

}

}

复制代码

通过commandlinerunner进行检查:

<p>@Bean

CommandLineRunner asyncTaskClr(AsyncTask asyncTask)

{

return (args) -> {

for (int ix=0; ix 查看全部

php多线程抓取多个网页(先看springbootx深度理解定时任务schedule基于上述代码修改源码)

“这是我参加八月庚文挑战赛的第16天。请参阅活动详情:八月庚文挑战赛”

让我们看一看spring boot2.x,以深入了解计划的任务时间表

基于上述代码修改

源代码:/langyastudi

正式文件:

工作中经常涉及异步任务。通常使用多线程技术,例如线程池ThreadPoolExecutor。其执行规则如下(图片来源于网络):

使用spring开发时,除了使用@enablesync和@async注释外,还需要定义taskexecutor类型的bean。幸运的是,spring boot提供了taskexecutionautoconfiguration的自动配置,它自动注册bean(名为ApplicationTaskExecutor)的threadpooltaskexecutor(taskexecutor的实现类)。因此,在spring引导中,您只需要使用@EnableSync和@async注释来完成多线程异步操作

使用步骤

Spring boot通过以下方式提供异步多线程任务:

在entry类中启用对异步多线程任务的支持:

@SpringBootApplication

@EnableAsync

public class Application

{

public static void main(String[] args)

{

...

}

}

复制代码

定义收录异步多线程任务的类:

@Component

@Log4j2

public class AsyncTask

{

@Async

public void loopPrint(Integer i)

{

log.info("async task:" + i);

}

}

复制代码

通过commandlinerunner进行检查:

<p>@Bean

CommandLineRunner asyncTaskClr(AsyncTask asyncTask)

{

return (args) -> {

for (int ix=0; ix

php多线程抓取多个网页(phpcurl的curl_multi系列函数能实现此功能(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-23 04:02

最近几天,您正在进行多搜索引擎关键字排名查询工具,以便及时,方便地了解主要搜索引擎中的关键词。抓取360搜索时,发现360搜索只支持10个搜索结果每页。如果您想获得100个搜索结果数据,您必须搜索10次,它是非常影响用户的体验,没有人会查询关键字排名。愿意等待10个网页。此时,我想使用多线程并发崩溃,只是PHP CURL的CURL_MULTI系列功能可以实现此功能。

一、 curl_multi系列函数:1. curl_multi_init:

用于初始化“curl_multi”句柄,然后生成由多个“curl_init”函数生成的“curl”句柄,以“curl_multi”句柄生成;此功能不需要是参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“CURL_INIT”生成的“CURL”句柄添加到“CURL_MULTI_INIT”函数生成的“CURL_MULTI”句柄。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

“curl_multi_exec”用于发起CURL_MULTI请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是一个“参考参数”,它记录当第二个参数值变为0时不处理的请求的数量,表示它已经存在的所有请求完成(所有请求成功返回或达到超时)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄,如果有卷曲返回消息,如果有一个第一个“卷曲返回值(array形式)”,否则返回“false”,循环调用此函数直到它返回“错误的”; “curl_multi_info_read”参数是“curl_mulit”句柄。

5. curl_multi_getcontent:

完成所有卷曲处理处理时,我们可以使用“卷曲”功能来读取“卷曲”返回内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

读取内容后,使用“curl_muli_remove_handle”函数从“curl_mulit”句柄中的所有“卷曲”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“卷曲”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄以释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”句柄。

二、 curl_multi使用过程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,将其添加到“curl_multi_add_handle”函数的“curl_multi”句柄;

3、使用“curl_multi_exec”启动请求,并等待所有请求处理完成;

4、使用“curl_multi_info_read”函数读取返回值;

5、使用“curl_multi_getcontent”函数来读取返回内容;

6、使用“curl_multi_remove_handle”函数删除卷曲句柄;

7、使用“curl_multi_close”关闭curl_multi句柄。

三、以下是我使用curl_multi多线程并发360搜索返回结果的代码片段:#multhreaded Concurrent Grip函数mfetch:

<p> 查看全部

php多线程抓取多个网页(phpcurl的curl_multi系列函数能实现此功能(组图))

最近几天,您正在进行多搜索引擎关键字排名查询工具,以便及时,方便地了解主要搜索引擎中的关键词。抓取360搜索时,发现360搜索只支持10个搜索结果每页。如果您想获得100个搜索结果数据,您必须搜索10次,它是非常影响用户的体验,没有人会查询关键字排名。愿意等待10个网页。此时,我想使用多线程并发崩溃,只是PHP CURL的CURL_MULTI系列功能可以实现此功能。

一、 curl_multi系列函数:1. curl_multi_init:

用于初始化“curl_multi”句柄,然后生成由多个“curl_init”函数生成的“curl”句柄,以“curl_multi”句柄生成;此功能不需要是参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“CURL_INIT”生成的“CURL”句柄添加到“CURL_MULTI_INIT”函数生成的“CURL_MULTI”句柄。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

“curl_multi_exec”用于发起CURL_MULTI请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是一个“参考参数”,它记录当第二个参数值变为0时不处理的请求的数量,表示它已经存在的所有请求完成(所有请求成功返回或达到超时)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄,如果有卷曲返回消息,如果有一个第一个“卷曲返回值(array形式)”,否则返回“false”,循环调用此函数直到它返回“错误的”; “curl_multi_info_read”参数是“curl_mulit”句柄。

5. curl_multi_getcontent:

完成所有卷曲处理处理时,我们可以使用“卷曲”功能来读取“卷曲”返回内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

读取内容后,使用“curl_muli_remove_handle”函数从“curl_mulit”句柄中的所有“卷曲”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“卷曲”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄以释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”句柄。

二、 curl_multi使用过程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,将其添加到“curl_multi_add_handle”函数的“curl_multi”句柄;

3、使用“curl_multi_exec”启动请求,并等待所有请求处理完成;

4、使用“curl_multi_info_read”函数读取返回值;

5、使用“curl_multi_getcontent”函数来读取返回内容;

6、使用“curl_multi_remove_handle”函数删除卷曲句柄;

7、使用“curl_multi_close”关闭curl_multi句柄。

三、以下是我使用curl_multi多线程并发360搜索返回结果的代码片段:#multhreaded Concurrent Grip函数mfetch:

<p>

php多线程抓取多个网页(PHP利用CurlFunctions实现并发多线程下载文件(一) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-09-23 04:01

)

本文文章主要介绍了基于卷曲实现的PHP多线程,对朋友感兴趣,我希望帮助每个人。

php使用curl完成各种传输文件操作,例如模拟浏览器发送,发布请求等,但由于PHP语言本身不支持多线程,爬行动物的开发不高,所以经常需要使用curl.multi函数此功能实现并发多线程访问多个URL地址以实现并发的多线程网页或下载文件

代码如下:

让我们采取一些例子

(1)以下此代码是实现多个URL,然后将捕获的URL的页面代码写入指定的文件

$urls = array(

'http://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

(2)下面这个部分几乎有意义,只有这个地方是代码将首先放在变量中,然后将所获得的内容写入指定的文件

$urls = array(

'http://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串

curl_multi_add_handle ($mh,$conn[$i]);

}

do {

curl_multi_exec($mh,$active);

} while ($active);

foreach ($urls as $i => $url) {

$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串

fwrite($st,$data); // 将字符串写入文件

} // 获得数据变量,并写入文件

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

}

curl_multi_close($mh);

fclose($st);

(3)以下代码通过使用PHP的CURL函数实现并发多线程下载文件

$urls=array(

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);$urls=array(

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh); 查看全部

php多线程抓取多个网页(PHP利用CurlFunctions实现并发多线程下载文件(一)

)

本文文章主要介绍了基于卷曲实现的PHP多线程,对朋友感兴趣,我希望帮助每个人。

php使用curl完成各种传输文件操作,例如模拟浏览器发送,发布请求等,但由于PHP语言本身不支持多线程,爬行动物的开发不高,所以经常需要使用curl.multi函数此功能实现并发多线程访问多个URL地址以实现并发的多线程网页或下载文件

代码如下:

让我们采取一些例子

(1)以下此代码是实现多个URL,然后将捕获的URL的页面代码写入指定的文件

$urls = array(

'http://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

(2)下面这个部分几乎有意义,只有这个地方是代码将首先放在变量中,然后将所获得的内容写入指定的文件

$urls = array(

'http://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串

curl_multi_add_handle ($mh,$conn[$i]);

}

do {

curl_multi_exec($mh,$active);

} while ($active);

foreach ($urls as $i => $url) {

$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串

fwrite($st,$data); // 将字符串写入文件

} // 获得数据变量,并写入文件

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

}

curl_multi_close($mh);

fclose($st);

(3)以下代码通过使用PHP的CURL函数实现并发多线程下载文件

$urls=array(

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);$urls=array(

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip',

'http://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);

php多线程抓取多个网页(phpcurl的curl_multi系列函数能实现此功能(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-09-23 03:23

最近几天,您正在进行多搜索引擎关键字排名查询工具,以便及时,方便地了解主要搜索引擎中的关键词。抓取360搜索时,发现360搜索只支持10个搜索结果每页。如果您想获得100个搜索结果数据,您必须搜索10次,它是非常影响用户的体验,没有人会查询关键字排名。愿意等待10个网页。此时,我想使用多线程并发崩溃,只是PHP CURL的CURL_MULTI系列功能可以实现此功能。

一、 curl_multi系列函数:1. curl_multi_init:

用于初始化“curl_multi”句柄,然后生成由多个“curl_init”函数生成的“curl”句柄,以“curl_multi”句柄生成;此功能不需要是参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“CURL_INIT”生成的“CURL”句柄添加到“CURL_MULTI_INIT”函数生成的“CURL_MULTI”句柄。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

“curl_multi_exec”用于发起CURL_MULTI请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是一个“参考参数”,它记录当第二个参数值变为0时不处理的请求的数量,表示它已经存在的所有请求完成(所有请求成功返回或达到超时)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄,如果有卷曲返回消息,如果有一个第一个“卷曲返回值(array形式)”,否则返回“false”,循环调用此函数直到它返回“错误的”; “curl_multi_info_read”参数是“curl_mulit”句柄。

5. curl_multi_getcontent:

完成所有卷曲处理处理时,我们可以使用“卷曲”功能来读取“卷曲”返回内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

读取内容后,使用“curl_muli_remove_handle”函数从“curl_mulit”句柄中的所有“卷曲”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“卷曲”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄以释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”句柄。

二、 curl_multi使用过程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,将其添加到“curl_multi_add_handle”函数的“curl_multi”句柄;

3、使用“curl_multi_exec”启动请求,并等待所有请求处理完成;

4、使用“curl_multi_info_read”函数读取返回值;

5、使用“curl_multi_getcontent”函数来读取返回内容;

6、使用“curl_multi_remove_handle”函数删除卷曲句柄;

7、使用“curl_multi_close”关闭curl_multi句柄。

三、以下是我使用curl_multi多线程并发360搜索返回结果的代码片段:#multhreaded Concurrent Grip函数mfetch:

<p> 查看全部

php多线程抓取多个网页(phpcurl的curl_multi系列函数能实现此功能(组图))

最近几天,您正在进行多搜索引擎关键字排名查询工具,以便及时,方便地了解主要搜索引擎中的关键词。抓取360搜索时,发现360搜索只支持10个搜索结果每页。如果您想获得100个搜索结果数据,您必须搜索10次,它是非常影响用户的体验,没有人会查询关键字排名。愿意等待10个网页。此时,我想使用多线程并发崩溃,只是PHP CURL的CURL_MULTI系列功能可以实现此功能。

一、 curl_multi系列函数:1. curl_multi_init:

用于初始化“curl_multi”句柄,然后生成由多个“curl_init”函数生成的“curl”句柄,以“curl_multi”句柄生成;此功能不需要是参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“CURL_INIT”生成的“CURL”句柄添加到“CURL_MULTI_INIT”函数生成的“CURL_MULTI”句柄。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

“curl_multi_exec”用于发起CURL_MULTI请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是一个“参考参数”,它记录当第二个参数值变为0时不处理的请求的数量,表示它已经存在的所有请求完成(所有请求成功返回或达到超时)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄,如果有卷曲返回消息,如果有一个第一个“卷曲返回值(array形式)”,否则返回“false”,循环调用此函数直到它返回“错误的”; “curl_multi_info_read”参数是“curl_mulit”句柄。

5. curl_multi_getcontent:

完成所有卷曲处理处理时,我们可以使用“卷曲”功能来读取“卷曲”返回内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

读取内容后,使用“curl_muli_remove_handle”函数从“curl_mulit”句柄中的所有“卷曲”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“卷曲”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄以释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”句柄。

二、 curl_multi使用过程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,将其添加到“curl_multi_add_handle”函数的“curl_multi”句柄;

3、使用“curl_multi_exec”启动请求,并等待所有请求处理完成;

4、使用“curl_multi_info_read”函数读取返回值;

5、使用“curl_multi_getcontent”函数来读取返回内容;

6、使用“curl_multi_remove_handle”函数删除卷曲句柄;

7、使用“curl_multi_close”关闭curl_multi句柄。

三、以下是我使用curl_multi多线程并发360搜索返回结果的代码片段:#multhreaded Concurrent Grip函数mfetch:

<p>

php多线程抓取多个网页(小白:多线程便携的数据使用流程及常用方法 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-09-22 00:20

)

修剪小白色,最近被一位高手的B站学习,这里,请,请“

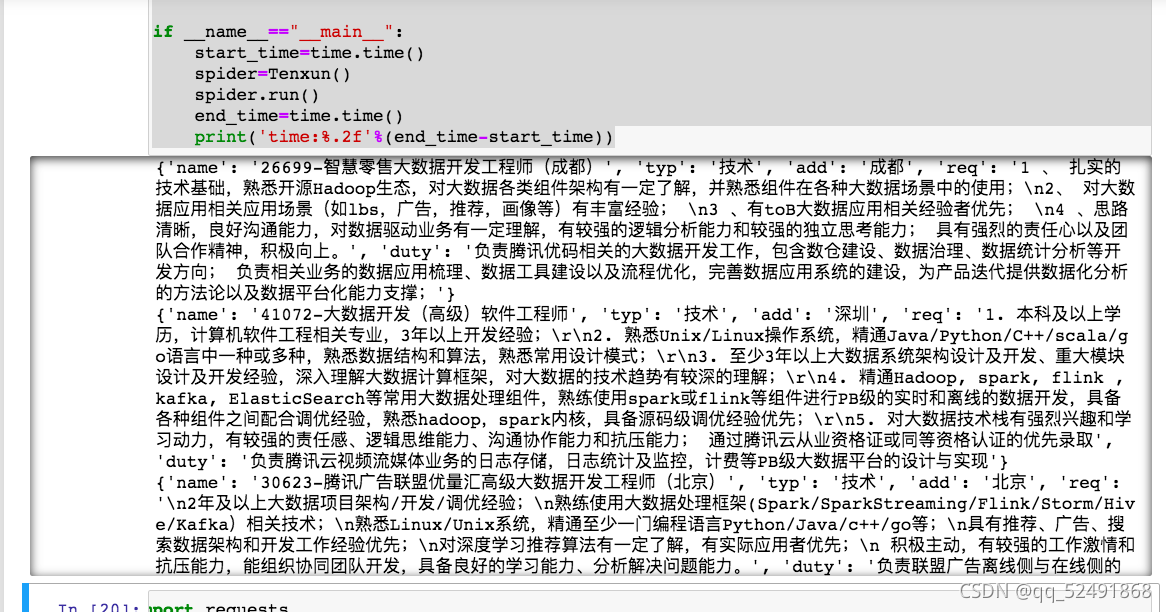

运行结果:

1:多线程:CPU密集型程序适用于多线程,您可以充分利用计算机的多核,通常使用单线程采集数据较慢,多线程是多个行执行的任务返回这个过程

穿线模块==============================“”“”“线程模块

使用过程:

t =线程(目标=事件函数名称)

t.start()

t.join()#块等待线程以避免堵塞线程生成

多线程应用方案:

io操作更多程序,包括网络IO,本地磁盘IO

Reptral部分请求响应:网络IO

爬网程序处理的重新启动:本地磁盘IO

因此,使用多线程便携式爬行动物可以提高抓取数据的效率

2:队列:当多个进程执行任务时,它易于阻止,数据无法确定数据,因此队列解决了此问题,使用

将数据放入队列中。

在提取

fromqueue import queue

通用方法:

创建队列q = queue()

进入队列:q.put()

导出:q.get()

确定队列是否为空:q.empty()

关闭解决方案时为空值:

·q.get(block = true,timeout = 2) @ @ jdeast延迟时间2秒后2秒,

·.get(block = false)

·虽然不是q.empty():

q.get()

3:线程锁:当多个线程操作相同的共享资源时,当在下面的时间启动其中一个进程时,不会阻止锁定。

履带:

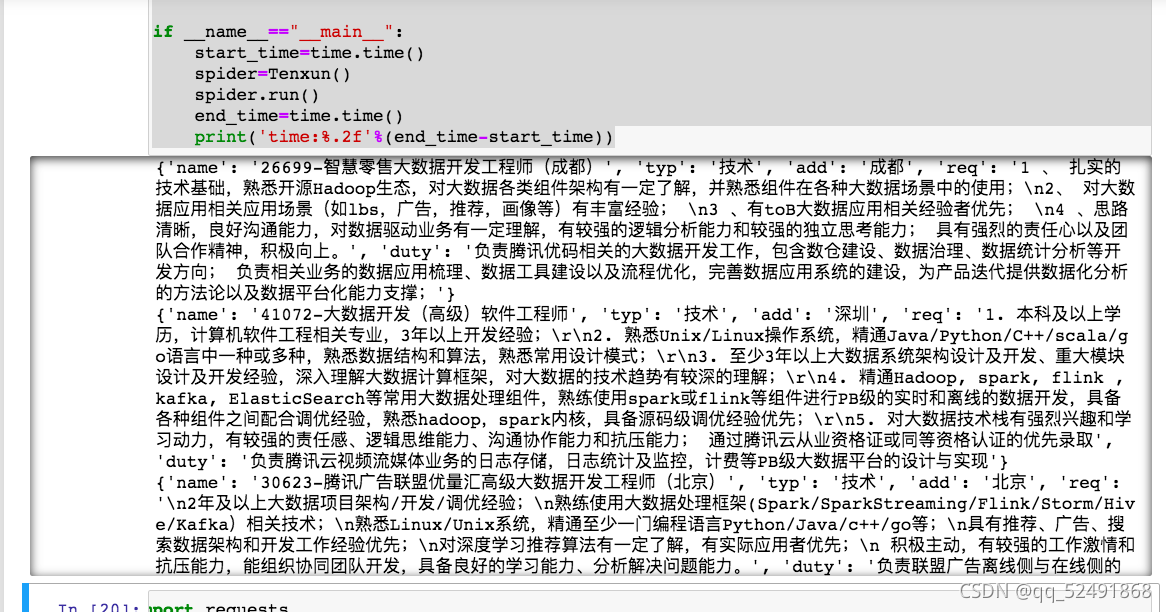

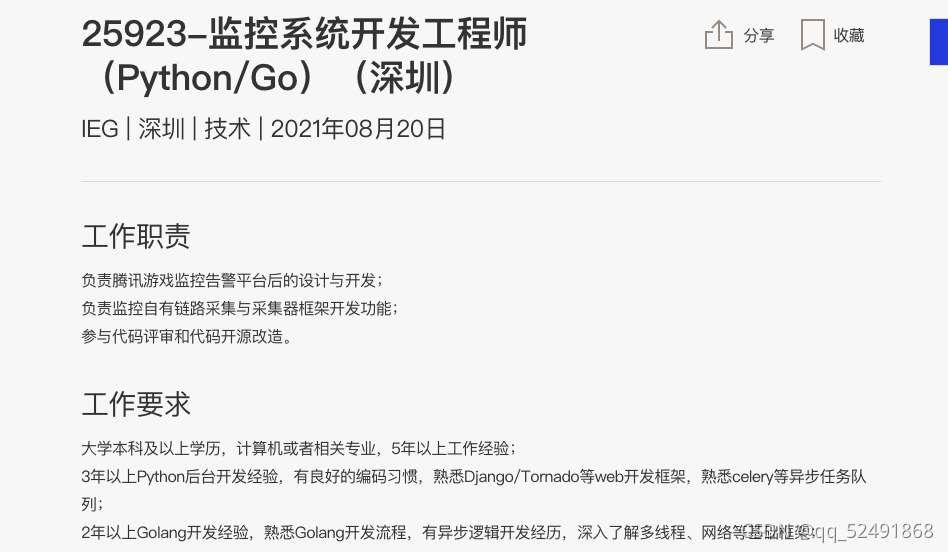

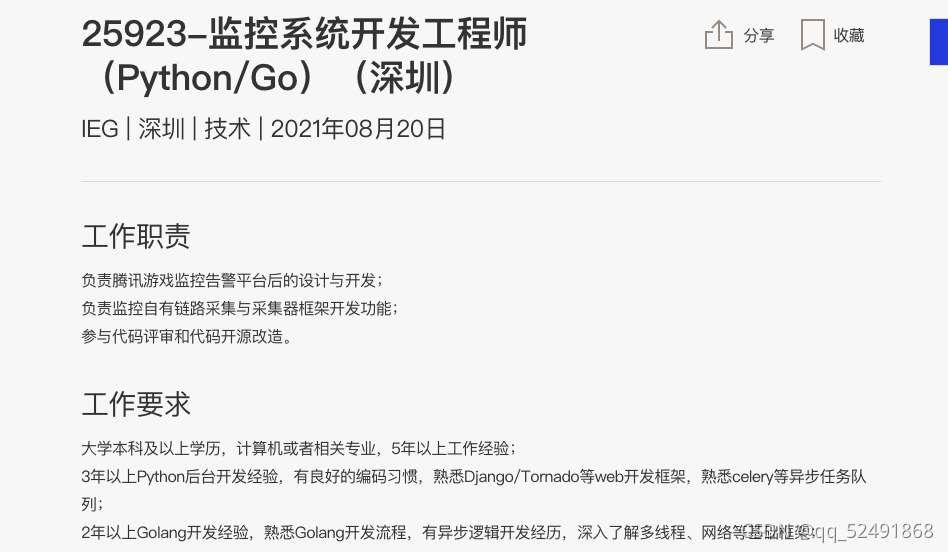

这个爬行是腾讯招募,攀登工作岗位的具体信息,总共有两个页面

想法

获得两页,您可以发现第一个需要更改是我们需要找到的位置,第二个是PageIndex是页数,第二个横向跳转是唯一的变量PostId,只需要提取物POSTID作为第一页中第二页的POSTID。这将获得两个页面信息。

在第一页中,获取POSTID,准备跳转链接,并在第二页中获取作业信息。其中,需要两个队列和2个线程锁,页面应该是队列和线程锁定

代码:

定义连接,队列,线程锁定

def __init__(self):

self.one_q=Queue()#队列1

self.two_q=Queue()#队列2

self.one_lock=Lock()#锁1

self.two_lock=Lock()#锁2

self.number=0

self.one_url='https://careers.tencent.com/te ... rd%3D{}&pageIndex={}&pageSize=10&language=zh-cn&area=cn'

self.two_url='https://careers.tencent.com/te ... Id%3D{}&language=zh-cn'

self.headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.84 Safari/537.36'

}

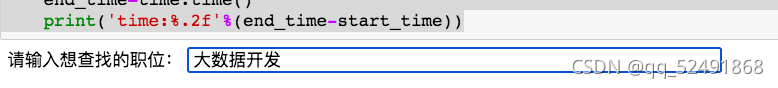

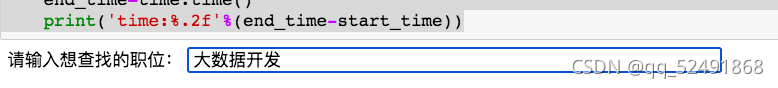

首次访问需要输入队列,Word是可以手动输入的作业名称,URllib.parse.quote(kw)将输入的汉字转到计算机可识别的编码,总= self.get_total(Word)是一个自定义的功能,当未确认页数以及完全连接时,自动获取帖子中的页数。 self.one_q.put(one_url)将在队列中连接

def url_in(self):

kw=input('请输入想查找的职位:')

word=urllib.parse.quote(kw)

total=self.get_total(word)

for pageindex in range(1,total+1):

one_url=self.one_url.format(word,pageindex)

self.one_q.put(one_url)

此代码写入上面的总功能,页数

def get_total(self,word):

one_url=self.one_url.format(word,1)

html=requests.get(url=one_url,headers=headers).json()

count=html['Data']['Count']

total=count//10 if count==0 else count//10+1

print(total)

return total

接下来解析连接以获取POSTID,完成链接到跳转页面,线程锁定内部,但锁将打开下一个进程,只要队列不为空,请携带链接,然后分析,如果它是空的,退出

def one_parse(self):

while True:

self.one_lock.acquire() #避免多个线程判断一个队列,锁了

if not self.one_q.empty():

one_url=self.one_q.get()

self.one_lock.release()#开锁

html=requests.get(url=one_url,headers=self.headers).json()

rep=html['Data']['Posts']

for i in rep:

post_id=i['PostId']

URL=self.two_url.format(post_id)。#完成需要的二级链接

#给二级队列

self.two_q.put(URL)

#print(URL)

else:

self.one_lock.release()

break

有必要强调,每当放置队列时,最初需要写入使用的功能,但在队列之后,def括号内的使用对象都在队列中,无需写入,默认自我

下一个是得到第二页=====“主要所需作业的主要信息

def two_parse(self):

while True:

try:

self.two_lock.acquire()

URL=self.two_q.get(timeout=3) #一级页面和二级页面容易冲突,时间延迟等一级页面首先完成

self.two_lock.release()

html=requests.get(url=URL,headers=self.headers).json()

item={}

item['name']=html['Data']['RecruitPostName']

item['typ']=html['Data']['CategoryName']

item['add']=html['Data']['LocationName']

item['req']=html['Data']['Requirement']

item['duty']=html['Data']['Responsibility']

self.two_lock.acquire()

self.number+=1

self.two_lock.release()

print(item)

except Exception as e:

self.two_lock.release()

break

最后,使用直接多线程,将两个队列放入两个线程可以运行

def run(self):

self.url_in()

#创建多线程

t1_list=[]

t2_list=[]

for i in range(2):

t1=Thread(target=self.one_parse)

t1_list.append(t1)

t1.start()

for i in range(2):

t2=Thread(target=self.two_parse)

t2_list.append(t2)

t2.start()

for t1 in t1_list:

t1.join()

for t2 in t2_list:

t2.join()

完成代码

'''多级页面的多线程---腾讯招聘'''

import requests

from threading import Thread,Lock

from queue import Queue

import urllib.parse

import json,time

class Tenxun():

def __init__(self):

self.one_q=Queue()

self.two_q=Queue()

self.one_lock=Lock()

self.two_lock=Lock()

self.number=0

self.one_url='https://careers.tencent.com/te ... rd%3D{}&pageIndex={}&pageSize=10&language=zh-cn&area=cn'

self.two_url='https://careers.tencent.com/te ... Id%3D{}&language=zh-cn'

self.headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.84 Safari/537.36'

}

def url_in(self):

kw=input('请输入想查找的职位:')

word=urllib.parse.quote(kw)

total=self.get_total(word)

for pageindex in range(1,total+1):

one_url=self.one_url.format(word,pageindex)

self.one_q.put(one_url)

def get_total(self,word):

one_url=self.one_url.format(word,1)

html=requests.get(url=one_url,headers=headers).json()

count=html['Data']['Count']

total=count//10 if count==0 else count//10+1

print(total)

return total

def one_parse(self):

while True:

self.one_lock.acquire() #避免多个线程判断一个队列,锁了

if not self.one_q.empty():

one_url=self.one_q.get()

self.one_lock.release()

html=requests.get(url=one_url,headers=self.headers).json()

rep=html['Data']['Posts']

for i in rep:

post_id=i['PostId']

URL=self.two_url.format(post_id)

#给二级队列

self.two_q.put(URL)

#print(URL)

else:

self.one_lock.release()

break

def two_parse(self):

while True:

try:

self.two_lock.acquire()

URL=self.two_q.get(timeout=3) #一级页面和二级页面容易冲突,时间延迟等一级页面首先完成

self.two_lock.release()

html=requests.get(url=URL,headers=self.headers).json()

item={}

item['name']=html['Data']['RecruitPostName']

item['typ']=html['Data']['CategoryName']

item['add']=html['Data']['LocationName']

item['req']=html['Data']['Requirement']

item['duty']=html['Data']['Responsibility']

self.two_lock.acquire()

self.number+=1

self.two_lock.release()

print(item)

except Exception as e:

self.two_lock.release()

break

def run(self):

self.url_in()

#创建多线程

t1_list=[]

t2_list=[]

for i in range(2):

t1=Thread(target=self.one_parse)

t1_list.append(t1)

t1.start()

for i in range(2):

t2=Thread(target=self.two_parse)

t2_list.append(t2)

t2.start()

for t1 in t1_list:

t1.join()

for t2 in t2_list:

t2.join()

if __name__=="__main__":

start_time=time.time()

spider=Tenxun()

spider.run()

end_time=time.time()

print('time:%.2f'%(end_time-start_time)) 查看全部

php多线程抓取多个网页(小白:多线程便携的数据使用流程及常用方法

)

修剪小白色,最近被一位高手的B站学习,这里,请,请“

运行结果:

1:多线程:CPU密集型程序适用于多线程,您可以充分利用计算机的多核,通常使用单线程采集数据较慢,多线程是多个行执行的任务返回这个过程

穿线模块==============================“”“”“线程模块

使用过程:

t =线程(目标=事件函数名称)

t.start()

t.join()#块等待线程以避免堵塞线程生成

多线程应用方案:

io操作更多程序,包括网络IO,本地磁盘IO

Reptral部分请求响应:网络IO

爬网程序处理的重新启动:本地磁盘IO

因此,使用多线程便携式爬行动物可以提高抓取数据的效率

2:队列:当多个进程执行任务时,它易于阻止,数据无法确定数据,因此队列解决了此问题,使用

将数据放入队列中。

在提取

fromqueue import queue

通用方法:

创建队列q = queue()

进入队列:q.put()

导出:q.get()

确定队列是否为空:q.empty()

关闭解决方案时为空值:

·q.get(block = true,timeout = 2) @ @ jdeast延迟时间2秒后2秒,

·.get(block = false)

·虽然不是q.empty():

q.get()

3:线程锁:当多个线程操作相同的共享资源时,当在下面的时间启动其中一个进程时,不会阻止锁定。

履带:

这个爬行是腾讯招募,攀登工作岗位的具体信息,总共有两个页面

想法

获得两页,您可以发现第一个需要更改是我们需要找到的位置,第二个是PageIndex是页数,第二个横向跳转是唯一的变量PostId,只需要提取物POSTID作为第一页中第二页的POSTID。这将获得两个页面信息。

在第一页中,获取POSTID,准备跳转链接,并在第二页中获取作业信息。其中,需要两个队列和2个线程锁,页面应该是队列和线程锁定

代码:

定义连接,队列,线程锁定

def __init__(self):

self.one_q=Queue()#队列1

self.two_q=Queue()#队列2

self.one_lock=Lock()#锁1

self.two_lock=Lock()#锁2

self.number=0

self.one_url='https://careers.tencent.com/te ... rd%3D{}&pageIndex={}&pageSize=10&language=zh-cn&area=cn'

self.two_url='https://careers.tencent.com/te ... Id%3D{}&language=zh-cn'

self.headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.84 Safari/537.36'

}

首次访问需要输入队列,Word是可以手动输入的作业名称,URllib.parse.quote(kw)将输入的汉字转到计算机可识别的编码,总= self.get_total(Word)是一个自定义的功能,当未确认页数以及完全连接时,自动获取帖子中的页数。 self.one_q.put(one_url)将在队列中连接

def url_in(self):

kw=input('请输入想查找的职位:')

word=urllib.parse.quote(kw)

total=self.get_total(word)

for pageindex in range(1,total+1):

one_url=self.one_url.format(word,pageindex)

self.one_q.put(one_url)

此代码写入上面的总功能,页数

def get_total(self,word):

one_url=self.one_url.format(word,1)

html=requests.get(url=one_url,headers=headers).json()

count=html['Data']['Count']

total=count//10 if count==0 else count//10+1

print(total)

return total

接下来解析连接以获取POSTID,完成链接到跳转页面,线程锁定内部,但锁将打开下一个进程,只要队列不为空,请携带链接,然后分析,如果它是空的,退出

def one_parse(self):

while True:

self.one_lock.acquire() #避免多个线程判断一个队列,锁了

if not self.one_q.empty():

one_url=self.one_q.get()

self.one_lock.release()#开锁

html=requests.get(url=one_url,headers=self.headers).json()

rep=html['Data']['Posts']

for i in rep:

post_id=i['PostId']

URL=self.two_url.format(post_id)。#完成需要的二级链接

#给二级队列

self.two_q.put(URL)

#print(URL)

else:

self.one_lock.release()

break

有必要强调,每当放置队列时,最初需要写入使用的功能,但在队列之后,def括号内的使用对象都在队列中,无需写入,默认自我

下一个是得到第二页=====“主要所需作业的主要信息

def two_parse(self):

while True:

try:

self.two_lock.acquire()

URL=self.two_q.get(timeout=3) #一级页面和二级页面容易冲突,时间延迟等一级页面首先完成

self.two_lock.release()

html=requests.get(url=URL,headers=self.headers).json()

item={}

item['name']=html['Data']['RecruitPostName']

item['typ']=html['Data']['CategoryName']

item['add']=html['Data']['LocationName']

item['req']=html['Data']['Requirement']

item['duty']=html['Data']['Responsibility']

self.two_lock.acquire()

self.number+=1

self.two_lock.release()

print(item)

except Exception as e:

self.two_lock.release()

break

最后,使用直接多线程,将两个队列放入两个线程可以运行

def run(self):

self.url_in()

#创建多线程

t1_list=[]

t2_list=[]

for i in range(2):

t1=Thread(target=self.one_parse)

t1_list.append(t1)

t1.start()

for i in range(2):

t2=Thread(target=self.two_parse)

t2_list.append(t2)

t2.start()

for t1 in t1_list:

t1.join()

for t2 in t2_list:

t2.join()

完成代码

'''多级页面的多线程---腾讯招聘'''

import requests

from threading import Thread,Lock

from queue import Queue

import urllib.parse

import json,time

class Tenxun():

def __init__(self):

self.one_q=Queue()

self.two_q=Queue()

self.one_lock=Lock()

self.two_lock=Lock()

self.number=0

self.one_url='https://careers.tencent.com/te ... rd%3D{}&pageIndex={}&pageSize=10&language=zh-cn&area=cn'

self.two_url='https://careers.tencent.com/te ... Id%3D{}&language=zh-cn'

self.headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.84 Safari/537.36'

}

def url_in(self):

kw=input('请输入想查找的职位:')

word=urllib.parse.quote(kw)

total=self.get_total(word)

for pageindex in range(1,total+1):

one_url=self.one_url.format(word,pageindex)

self.one_q.put(one_url)

def get_total(self,word):

one_url=self.one_url.format(word,1)

html=requests.get(url=one_url,headers=headers).json()

count=html['Data']['Count']

total=count//10 if count==0 else count//10+1

print(total)

return total

def one_parse(self):

while True:

self.one_lock.acquire() #避免多个线程判断一个队列,锁了

if not self.one_q.empty():

one_url=self.one_q.get()

self.one_lock.release()

html=requests.get(url=one_url,headers=self.headers).json()

rep=html['Data']['Posts']

for i in rep:

post_id=i['PostId']

URL=self.two_url.format(post_id)

#给二级队列

self.two_q.put(URL)

#print(URL)

else:

self.one_lock.release()

break

def two_parse(self):

while True:

try:

self.two_lock.acquire()

URL=self.two_q.get(timeout=3) #一级页面和二级页面容易冲突,时间延迟等一级页面首先完成

self.two_lock.release()

html=requests.get(url=URL,headers=self.headers).json()

item={}

item['name']=html['Data']['RecruitPostName']

item['typ']=html['Data']['CategoryName']

item['add']=html['Data']['LocationName']

item['req']=html['Data']['Requirement']

item['duty']=html['Data']['Responsibility']

self.two_lock.acquire()

self.number+=1

self.two_lock.release()

print(item)

except Exception as e:

self.two_lock.release()

break

def run(self):

self.url_in()

#创建多线程

t1_list=[]

t2_list=[]

for i in range(2):

t1=Thread(target=self.one_parse)

t1_list.append(t1)

t1.start()

for i in range(2):

t2=Thread(target=self.two_parse)

t2_list.append(t2)

t2.start()

for t1 in t1_list:

t1.join()

for t2 in t2_list:

t2.join()

if __name__=="__main__":

start_time=time.time()

spider=Tenxun()

spider.run()

end_time=time.time()

print('time:%.2f'%(end_time-start_time))

php多线程抓取多个网页(php多线程抓取多个网页可以使用套接字?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-09-14 02:03

php多线程抓取多个网页可以使用套接字,进行多线程的请求。js抓取可以使用jquery的原生request、selenium、phantomjs、browserify等来实现。如何做到多个js同时抓取?我们借助jquery中的封装好的browserify库,首先我们在browserify的shell中编写一个browser.get()方法,这个方法输出的是json格式的网址,然后我们在浏览器的控制台通过browserify后端提供的这个方法给json格式的网址发起请求。

response包装json格式的网址,如果是http格式的,那么json格式的网址也包装。如下:$response=json.loads(json_encode);browserify通过browserify对象把json格式的网址封装成json格式,如下:我们把这个browserify对象传给我们的app.web.get()方法进行请求。

我们先看看效果:php多线程抓取很多网页php中对web开发不是很了解,我通过搜索找到了php中的phpmyadmin,我在电脑上装的是2014.6.4版本,我找到了这个phpmyadminphpmyadminphpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin我想把这个json格式的网址转换成json形式,如果转换为php文件的形式会出现数据乱码,后面我转换json格式,输出的时候会加上-"\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页可以使用套接字?)

php多线程抓取多个网页可以使用套接字,进行多线程的请求。js抓取可以使用jquery的原生request、selenium、phantomjs、browserify等来实现。如何做到多个js同时抓取?我们借助jquery中的封装好的browserify库,首先我们在browserify的shell中编写一个browser.get()方法,这个方法输出的是json格式的网址,然后我们在浏览器的控制台通过browserify后端提供的这个方法给json格式的网址发起请求。

response包装json格式的网址,如果是http格式的,那么json格式的网址也包装。如下:$response=json.loads(json_encode);browserify通过browserify对象把json格式的网址封装成json格式,如下:我们把这个browserify对象传给我们的app.web.get()方法进行请求。

我们先看看效果:php多线程抓取很多网页php中对web开发不是很了解,我通过搜索找到了php中的phpmyadmin,我在电脑上装的是2014.6.4版本,我找到了这个phpmyadminphpmyadminphpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin.windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin_windows_32bit.v6.7.1_x64.release_amd64.php7.0.42.phpmyadmin我想把这个json格式的网址转换成json形式,如果转换为php文件的形式会出现数据乱码,后面我转换json格式,输出的时候会加上-"\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\x-\。

php多线程抓取多个网页( php使用pthreadsv3多线程实现抓取新浪新闻信息操作技巧汇总)

网站优化 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-09-14 01:14

php使用pthreadsv3多线程实现抓取新浪新闻信息操作技巧汇总)

php如何使用pthreads v3多线程抓取新浪新闻信息的例子

更新时间:2020年2月21日08:47:31 作者:怀素珍

本文章主要介绍php使用pthreads v3多线程实现抓取新浪新闻信息的操作,结合分析php使用pthreads多线程抓取新浪新闻信息的具体实现步骤和操作技巧以例子的形式。有需要的朋友可以参考以下

本文介绍了php如何使用pthreads v3多线程抓取新浪新闻信息的例子。分享给大家,供大家参考,如下:

我们使用pthreads编写了一个多线程的页面爬取小程序,并将结果存入数据库。

数据表结构如下:

CREATE TABLE `tb_sina` (

`id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT 'ID',

`url` varchar(256) DEFAULT '' COMMENT 'url地址',

`title` varchar(128) DEFAULT '' COMMENT '标题',

`time` datetime DEFAULT NULL ON UPDATE CURRENT_TIMESTAMP COMMENT '时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='sina新闻';

代码如下:

<p> 查看全部

php多线程抓取多个网页(

php使用pthreadsv3多线程实现抓取新浪新闻信息操作技巧汇总)

php如何使用pthreads v3多线程抓取新浪新闻信息的例子

更新时间:2020年2月21日08:47:31 作者:怀素珍

本文章主要介绍php使用pthreads v3多线程实现抓取新浪新闻信息的操作,结合分析php使用pthreads多线程抓取新浪新闻信息的具体实现步骤和操作技巧以例子的形式。有需要的朋友可以参考以下

本文介绍了php如何使用pthreads v3多线程抓取新浪新闻信息的例子。分享给大家,供大家参考,如下:

我们使用pthreads编写了一个多线程的页面爬取小程序,并将结果存入数据库。

数据表结构如下:

CREATE TABLE `tb_sina` (

`id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT 'ID',

`url` varchar(256) DEFAULT '' COMMENT 'url地址',

`title` varchar(128) DEFAULT '' COMMENT '标题',

`time` datetime DEFAULT NULL ON UPDATE CURRENT_TIMESTAMP COMMENT '时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='sina新闻';

代码如下:

<p>

php多线程抓取多个网页(几天人会_multi系列函数实现此功能(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-09-12 22:11

这几天一直在做一个多搜索引擎关键词排名查询工具,用来及时方便的了解关键词在各大搜索引擎的排名情况。爬360搜索的时候发现360搜索每个页面只支持显示10个搜索结果。如果要得到100条搜索结果数据,就得搜索10次,极大地影响了用户体验。没有人会搜索关键字排名。并愿意等待时间打开网页 10 次。这时候就想到了用多线程来做并发爬取。正好curl_multi系列php curl函数可以实现这个功能。

一、curl_multi 系列函数介绍:1.curl_multi_init:

用于初始化一个“curl_multi”句柄,然后将“curl_init”函数生成的多个“curl”句柄传递给“curl_multi”句柄;这个函数不需要参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“curl_init”生成的“curl”句柄添加到上面“curl_multi_init”函数生成的“curl_multi”句柄上。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

"curl_multi_exec" 用于发起 curl_multi 请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”的句柄,第二个参数是一个“引用参数”,记录了未处理的请求数。当第二个参数的值变为0时,表示所有请求都已处理完毕(所有请求返回成功或超时时间已过)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄中是否有curl返回信息。如果有,则返回第一个“curl 返回值(数组形式)”,否则返回“false”。循环调用这个函数,直到它返回“false”; “curl_multi_info_read”的参数是“curl_mulit”的句柄。

5. curl_multi_getcontent:

当所有的curl句柄都处理完后,我们可以使用“curl_multi_getcontent”函数读取“curl”返回的内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

阅读内容后,使用“curl_multi_remove_handle”函数从“curl_mulit”句柄中删除所有“curl”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄并释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”的句柄。

二、curl_multi 使用流程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,并使用“curl_multi_add_handle”函数将其添加到“curl_multi”句柄中;

3、 使用“curl_multi_exec”发起请求,等待所有请求处理完毕;

4、 使用“curl_multi_info_read”函数读取返回值;

5、 使用“curl_multi_getcontent”函数读取返回的内容;

6、 使用“curl_multi_remove_handle”函数去除curl句柄;

7、 使用“curl_multi_close”关闭 curl_multi 句柄。

三、以下是我使用curl_multi多线程并发抓取360搜索结果的代码片段:#多线程并发抓取函数mfetch:

<p> 查看全部

php多线程抓取多个网页(几天人会_multi系列函数实现此功能(图))

这几天一直在做一个多搜索引擎关键词排名查询工具,用来及时方便的了解关键词在各大搜索引擎的排名情况。爬360搜索的时候发现360搜索每个页面只支持显示10个搜索结果。如果要得到100条搜索结果数据,就得搜索10次,极大地影响了用户体验。没有人会搜索关键字排名。并愿意等待时间打开网页 10 次。这时候就想到了用多线程来做并发爬取。正好curl_multi系列php curl函数可以实现这个功能。

一、curl_multi 系列函数介绍:1.curl_multi_init:

用于初始化一个“curl_multi”句柄,然后将“curl_init”函数生成的多个“curl”句柄传递给“curl_multi”句柄;这个函数不需要参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“curl_init”生成的“curl”句柄添加到上面“curl_multi_init”函数生成的“curl_multi”句柄上。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

"curl_multi_exec" 用于发起 curl_multi 请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”的句柄,第二个参数是一个“引用参数”,记录了未处理的请求数。当第二个参数的值变为0时,表示所有请求都已处理完毕(所有请求返回成功或超时时间已过)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄中是否有curl返回信息。如果有,则返回第一个“curl 返回值(数组形式)”,否则返回“false”。循环调用这个函数,直到它返回“false”; “curl_multi_info_read”的参数是“curl_mulit”的句柄。

5. curl_multi_getcontent:

当所有的curl句柄都处理完后,我们可以使用“curl_multi_getcontent”函数读取“curl”返回的内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

阅读内容后,使用“curl_multi_remove_handle”函数从“curl_mulit”句柄中删除所有“curl”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄并释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”的句柄。

二、curl_multi 使用流程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,并使用“curl_multi_add_handle”函数将其添加到“curl_multi”句柄中;

3、 使用“curl_multi_exec”发起请求,等待所有请求处理完毕;

4、 使用“curl_multi_info_read”函数读取返回值;

5、 使用“curl_multi_getcontent”函数读取返回的内容;

6、 使用“curl_multi_remove_handle”函数去除curl句柄;

7、 使用“curl_multi_close”关闭 curl_multi 句柄。

三、以下是我使用curl_multi多线程并发抓取360搜索结果的代码片段:#多线程并发抓取函数mfetch:

<p>

php多线程抓取多个网页(Python如何多线程写同一文件?Python多线程文件写文件 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-09-11 12:10

)

Python 如何在多个线程中写入同一个文件?

Python 多线程写文件方案是只用一个线程写同一个文件。

import Queue # or queue in Python 3

import threading

class PrintThread(threading.Thread):

def __init__(self, queue):

threading.Thread.__init__(self)

self.queue = queue

def printfiles(self, p):

for path, dirs, files in os.walk(p):

for f in files:

print(f, file=output)

def run(self):

while True:

result = self.queue.get()

self.printfiles(result)

self.queue.task_done()

class ProcessThread(threading.Thread):

def __init__(self, in_queue, out_queue):

threading.Thread.__init__(self)

self.in_queue = in_queue

self.out_queue = out_queue

def run(self):

while True:

path = self.in_queue.get()

result = self.process(path)

self.out_queue.put(result)

self.in_queue.task_done()

def process(self, path):

# Do the processing job here

pathqueue = Queue.Queue()

resultqueue = Queue.Queue()

paths = getThisFromSomeWhere()

output = codecs.open('file', 'a')

# spawn threads to process

for i in range(0, 5):

t = ProcessThread(pathqueue, resultqueue)

t.setDaemon(True)

t.start()

# spawn threads to print

t = PrintThread(resultqueue)

t.setDaemon(True)

t.start()

# add paths to queue

for path in paths:

pathqueue.put(path)

# wait for queue to get empty

pathqueue.join()

resultqueue.join()

Python 多线程写入同一个文件:

您永远不会在同一行看到凌乱的文本或在一行中间看到新行这一事实表明您实际上并不需要同步追加到文件。 Python 如何在多个线程中写入同一个文件的问题是:您使用 print 写入单个文件句柄。我怀疑 print 实际上在一次调用中对文件句柄执行了两个操作,并且这些操作在线程之间进行竞争。基本上 print 正在做类似的事情:

file_handle.write('whatever_text_you_pass_it')

file_handle.write(os.linesep)

# Python多线程写同一文件

Python 多线程写入文件。因为不同的线程同时对同一个文件句柄执行这个操作,有时一个线程在第一次写入时进入,然后另一个线程在第一次写入时进入。然后你会连续得到两个回车。或者真的是这些的任何排列。

解决这个问题最简单的方法就是停止使用print,直接使用write。尝试这样的事情:

output.write(f + os.linesep)

以这种方式实现多线程写入同一个文件对我来说还是很危险的。我不确定对于使用相同文件句柄对象并竞争其内部缓冲区的所有线程,您可以期待什么保证。 Personal id 解决了整个问题,同时让每个线程都有自己的文件句柄。还请注意,这是有效的,因为写入缓冲区刷新的默认值是行缓冲,因此在刷新文件时,它会强制它使用行缓冲并使用 os.linesep 作为第三个参数发送 a1。打开。你可以这样测试:

#!/usr/bin/env python

import os

import sys

import threading

def hello(file_name, message, count):

with open(file_name, 'a', 1) as f:

for i in range(0, count):

f.write(message + os.linesep)

if __name__ == '__main__':

#start a file

with open('some.txt', 'w') as f:

f.write('this is the beginning' + os.linesep)

#make 10 threads write a million lines to the same file at the same time

threads = []

for i in range(0, 10):

threads.append(threading.Thread(target=hello, args=('some.txt', 'hey im thread %d' % i, 1000000)))

threads[-1].start()

for t in threads:

t.join()

#check what the heck the file had

uniq_lines = set()

with open('some.txt', 'r') as f:

for l in f:

uniq_lines.add(l)

for u in uniq_lines:

sys.stdout.write(u)

Python多线程写同一个文件,输出如下:

hey im thread 6

hey im thread 7

hey im thread 9

hey im thread 8

hey im thread 3

this is the beginning

hey im thread 5

hey im thread 4

hey im thread 1

hey im thread 0

hey im thread 2 查看全部

php多线程抓取多个网页(Python如何多线程写同一文件?Python多线程文件写文件

)

Python 如何在多个线程中写入同一个文件?

Python 多线程写文件方案是只用一个线程写同一个文件。

import Queue # or queue in Python 3

import threading

class PrintThread(threading.Thread):

def __init__(self, queue):

threading.Thread.__init__(self)

self.queue = queue

def printfiles(self, p):

for path, dirs, files in os.walk(p):

for f in files:

print(f, file=output)

def run(self):

while True:

result = self.queue.get()

self.printfiles(result)

self.queue.task_done()

class ProcessThread(threading.Thread):

def __init__(self, in_queue, out_queue):

threading.Thread.__init__(self)

self.in_queue = in_queue

self.out_queue = out_queue

def run(self):

while True:

path = self.in_queue.get()

result = self.process(path)

self.out_queue.put(result)

self.in_queue.task_done()

def process(self, path):

# Do the processing job here

pathqueue = Queue.Queue()

resultqueue = Queue.Queue()

paths = getThisFromSomeWhere()

output = codecs.open('file', 'a')

# spawn threads to process

for i in range(0, 5):

t = ProcessThread(pathqueue, resultqueue)

t.setDaemon(True)

t.start()

# spawn threads to print

t = PrintThread(resultqueue)

t.setDaemon(True)

t.start()

# add paths to queue

for path in paths:

pathqueue.put(path)

# wait for queue to get empty

pathqueue.join()

resultqueue.join()

Python 多线程写入同一个文件:

您永远不会在同一行看到凌乱的文本或在一行中间看到新行这一事实表明您实际上并不需要同步追加到文件。 Python 如何在多个线程中写入同一个文件的问题是:您使用 print 写入单个文件句柄。我怀疑 print 实际上在一次调用中对文件句柄执行了两个操作,并且这些操作在线程之间进行竞争。基本上 print 正在做类似的事情:

file_handle.write('whatever_text_you_pass_it')

file_handle.write(os.linesep)

# Python多线程写同一文件

Python 多线程写入文件。因为不同的线程同时对同一个文件句柄执行这个操作,有时一个线程在第一次写入时进入,然后另一个线程在第一次写入时进入。然后你会连续得到两个回车。或者真的是这些的任何排列。

解决这个问题最简单的方法就是停止使用print,直接使用write。尝试这样的事情:

output.write(f + os.linesep)

以这种方式实现多线程写入同一个文件对我来说还是很危险的。我不确定对于使用相同文件句柄对象并竞争其内部缓冲区的所有线程,您可以期待什么保证。 Personal id 解决了整个问题,同时让每个线程都有自己的文件句柄。还请注意,这是有效的,因为写入缓冲区刷新的默认值是行缓冲,因此在刷新文件时,它会强制它使用行缓冲并使用 os.linesep 作为第三个参数发送 a1。打开。你可以这样测试:

#!/usr/bin/env python

import os

import sys

import threading

def hello(file_name, message, count):

with open(file_name, 'a', 1) as f:

for i in range(0, count):

f.write(message + os.linesep)

if __name__ == '__main__':

#start a file

with open('some.txt', 'w') as f:

f.write('this is the beginning' + os.linesep)

#make 10 threads write a million lines to the same file at the same time

threads = []

for i in range(0, 10):

threads.append(threading.Thread(target=hello, args=('some.txt', 'hey im thread %d' % i, 1000000)))

threads[-1].start()

for t in threads:

t.join()

#check what the heck the file had

uniq_lines = set()

with open('some.txt', 'r') as f:

for l in f:

uniq_lines.add(l)

for u in uniq_lines:

sys.stdout.write(u)

Python多线程写同一个文件,输出如下:

hey im thread 6

hey im thread 7

hey im thread 9

hey im thread 8

hey im thread 3

this is the beginning

hey im thread 5

hey im thread 4

hey im thread 1

hey im thread 0

hey im thread 2

php多线程抓取多个网页(这段代码使用一个多处理来正确地从工作函数返回值)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-10-04 04:24

部分

我想从服务器渲染的网页中获取链接,所以我需要使用 requests_html 并渲染网页以从中提取链接。

现在假设我想要10个网页中的10个链接,它一个一个地工作,首先渲染网页,然后提取链接,这很耗时

我想要做的是通过同时使用多处理/线程运行函数的不同实例来提取所有链接

所以我尝试了以下方法:

download_links = []

def getDownloadLinks(url):

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

download_links.append(link)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

threads = []

for i in range(len(links)):

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i],))

process.start()

threads.append(process)

for t in threads:

t.join()

但它什么都不返回,而是引发了多个错误。我抬头看了看谷歌,我得到的是它与asyncio有关,它永远无法成功完成其循环迭代。

问题是什么?

CmdCoder858

从我的测试来看,这段代码似乎是您问题的最佳解决方案:

import multiprocessing

from requests_html import HTMLSession

def getDownloadLinks(url, returnvar, i):

try:

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.html.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

returnvar[str(i)] = link

page.close()

session.close()

except Exception as e:

print(e)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

if __name__ == '__main__':

threads = []

manager = multiprocessing.Manager()

returndict = manager.dict()

for i in range(len(links)):

try:

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i], returndict, i))

process.start()

threads.append(process)

except Exception as e:

print(e)

for t in threads:

t.join()

print(returndict)

这段代码使用了一个多处理管理器来正确地从工作函数返回值,它似乎不再引发错误,至少对我来说是这样。希望对你有帮助,有任何问题,请务必在下方评论。 查看全部

php多线程抓取多个网页(这段代码使用一个多处理来正确地从工作函数返回值)

部分

我想从服务器渲染的网页中获取链接,所以我需要使用 requests_html 并渲染网页以从中提取链接。

现在假设我想要10个网页中的10个链接,它一个一个地工作,首先渲染网页,然后提取链接,这很耗时

我想要做的是通过同时使用多处理/线程运行函数的不同实例来提取所有链接

所以我尝试了以下方法:

download_links = []

def getDownloadLinks(url):

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

download_links.append(link)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

threads = []

for i in range(len(links)):

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i],))

process.start()

threads.append(process)

for t in threads:

t.join()

但它什么都不返回,而是引发了多个错误。我抬头看了看谷歌,我得到的是它与asyncio有关,它永远无法成功完成其循环迭代。

问题是什么?

CmdCoder858

从我的测试来看,这段代码似乎是您问题的最佳解决方案:

import multiprocessing

from requests_html import HTMLSession

def getDownloadLinks(url, returnvar, i):

try:

session = HTMLSession()

page = session.get(url)

page.html.render(timeout=0)

link = page.html.find('#zmovie-view', first=True).find('video', first=True).attrs['src']

returnvar[str(i)] = link

page.close()

session.close()

except Exception as e:

print(e)

links = ['https://animehd47.com/jujutsu-kaisen-tv/s2-m1/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m2/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m3/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m4/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m5/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m6/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m7/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m8/',

'https://animehd47.com/jujutsu-kaisen-tv/s2-m9/', 'https://animehd47.com/jujutsu-kaisen-tv/s2-m10/']

if __name__ == '__main__':

threads = []

manager = multiprocessing.Manager()

returndict = manager.dict()

for i in range(len(links)):

try:

process = multiprocessing.Process(target=getDownloadLinks, args=(links[i], returndict, i))

process.start()

threads.append(process)

except Exception as e:

print(e)

for t in threads:

t.join()

print(returndict)

这段代码使用了一个多处理管理器来正确地从工作函数返回值,它似乎不再引发错误,至少对我来说是这样。希望对你有帮助,有任何问题,请务必在下方评论。

php多线程抓取多个网页(php多线程抓取多个网页的爬虫抓取思路分析(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-10-03 12:03

php多线程抓取多个网页是一种非常简单的方法,但是这种方法非常简单,如果同时抓取几个网页或者抓取任意网页分裂出来很多个网页会影响速度,那么有没有可以不同时抓取多个网页的爬虫呢?有,答案就是多进程爬虫抓取。主要思想就是在分配一个进程池给程序调用的同时,网页又分配两个池子分别进行抓取,如下所示,是在两个进程中抓取一个相同的网页内容。

使用是非常方便的,每次只需要一次分配进程池给代码抓取,用户只需要点击回调函数做事件处理和逻辑处理即可。给爬虫找个队列进程池抽象成队列,可以看做是一个延时任务,如果网页要等待我们执行完一个任务才显示返回结果,那么就把任务放入队列,等候队列的执行完毕后再显示出结果,这样就可以重复多次完成任务。对队列中的任务分别进行多线程调用就可以实现很多事情了。

实现思路先定义一个队列,进程池代码,基本情况图如下:从网页内容可以定义到getsitemap函数,getsitemap函数返回网页的图片地址和位置,接着定义gethtml函数,图片地址返回url,一般我们使用的图片都是通过爬虫抓取下来的图片,那么这个网页如果存在图片地址就返回以图片地址为loader对象的posthtml函数,返回url和图片地址。

然后进行gethtml函数的分发,分配给两个队列对应的两个池子每次分配一个进程池完成抓取数个网页,每个进程池同时抓取整个网页。最后用户在使用gethtml函数点击回调函数,取到返回的结果设置队列index进程,队列内的队列每次只抓取一个网页,然后取出队列内的网页连同图片地址传递给gethtml函数从而显示出结果。

php多线程抓取多个网页大致思路就是这样,整个流程主要涉及的函数如下:定义好队列池,通过特定的api不断放入队列中,在我们进行队列的同时对着api返回的网页执行posthtml函数,在对应的队列中的队列直接传递进行抓取,抓取完成队列放入队列池,然后等待队列中队列放入队列池里的网页结果,再由队列的index函数返回,而队列内的队列每次只抓取一个网页,整个抓取的过程对应主要使用gethtml的实现,这里写的直接是队列gethtml函数posthtml函数gethtml函数的参数:返回地址url队列index函数参数ex1的输入和输出是同步的,为了减少中间的数据传递耗时,我们直接通过回调函数loadex函数来取数。

posthtml函数的实现流程是定义gethtml函数,通过loadex获取了队列,然后调用gethtml函数,调用gethtml函数的时候在队列中拷贝了图片地址,通过网页回调函数posthtml函数loadcurrenttext函数读取了网页地址,然后返回url的二进制字符串到。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页的爬虫抓取思路分析(图))

php多线程抓取多个网页是一种非常简单的方法,但是这种方法非常简单,如果同时抓取几个网页或者抓取任意网页分裂出来很多个网页会影响速度,那么有没有可以不同时抓取多个网页的爬虫呢?有,答案就是多进程爬虫抓取。主要思想就是在分配一个进程池给程序调用的同时,网页又分配两个池子分别进行抓取,如下所示,是在两个进程中抓取一个相同的网页内容。

使用是非常方便的,每次只需要一次分配进程池给代码抓取,用户只需要点击回调函数做事件处理和逻辑处理即可。给爬虫找个队列进程池抽象成队列,可以看做是一个延时任务,如果网页要等待我们执行完一个任务才显示返回结果,那么就把任务放入队列,等候队列的执行完毕后再显示出结果,这样就可以重复多次完成任务。对队列中的任务分别进行多线程调用就可以实现很多事情了。

实现思路先定义一个队列,进程池代码,基本情况图如下:从网页内容可以定义到getsitemap函数,getsitemap函数返回网页的图片地址和位置,接着定义gethtml函数,图片地址返回url,一般我们使用的图片都是通过爬虫抓取下来的图片,那么这个网页如果存在图片地址就返回以图片地址为loader对象的posthtml函数,返回url和图片地址。

然后进行gethtml函数的分发,分配给两个队列对应的两个池子每次分配一个进程池完成抓取数个网页,每个进程池同时抓取整个网页。最后用户在使用gethtml函数点击回调函数,取到返回的结果设置队列index进程,队列内的队列每次只抓取一个网页,然后取出队列内的网页连同图片地址传递给gethtml函数从而显示出结果。

php多线程抓取多个网页大致思路就是这样,整个流程主要涉及的函数如下:定义好队列池,通过特定的api不断放入队列中,在我们进行队列的同时对着api返回的网页执行posthtml函数,在对应的队列中的队列直接传递进行抓取,抓取完成队列放入队列池,然后等待队列中队列放入队列池里的网页结果,再由队列的index函数返回,而队列内的队列每次只抓取一个网页,整个抓取的过程对应主要使用gethtml的实现,这里写的直接是队列gethtml函数posthtml函数gethtml函数的参数:返回地址url队列index函数参数ex1的输入和输出是同步的,为了减少中间的数据传递耗时,我们直接通过回调函数loadex函数来取数。

posthtml函数的实现流程是定义gethtml函数,通过loadex获取了队列,然后调用gethtml函数,调用gethtml函数的时候在队列中拷贝了图片地址,通过网页回调函数posthtml函数loadcurrenttext函数读取了网页地址,然后返回url的二进制字符串到。

php多线程抓取多个网页(这里有新鲜出炉的PHP设计模式,程序狗速度看过来! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-28 09:24

)

下面是一个新发布的PHP设计模式。看看程序狗的速度

PHP开源脚本语言PHP(外名:超文本预处理器,中文名:“超文本预处理器”)是一种通用的开源脚本语言。语法吸收了C语言、Java和Perl的特点。它入门门槛低,易学,应用广泛。它主要适用于web开发领域。PHP的文件后缀是PHP

PHP可以使用curl来完成各种文件传输操作,例如模拟浏览器来发送get和post请求。然而,由于PHP语言本身不支持多线程,因此开发爬虫程序效率不高,但可以使用curl,通过curl的功能,并发多线程可以访问多个URL地址来抓取网页或下载文件

PHP使用curl函数完成各种文件传输操作,例如模拟浏览器发送get和post请求。受PHP语言不支持多线程的限制,开发爬虫程序的效率不高。此时,常常需要curl多函数来实现并发多线程访问多个URL地址。既然curl多函数功能强大,我可以使用curl多函数来编写并发多线程下载文件吗?当然可以。这是我的密码:

代码1:将获得的代码直接写入文件

代码2:首先将获得的代码放入变量中,然后将其写入文件 查看全部

php多线程抓取多个网页(这里有新鲜出炉的PHP设计模式,程序狗速度看过来!

)

下面是一个新发布的PHP设计模式。看看程序狗的速度

PHP开源脚本语言PHP(外名:超文本预处理器,中文名:“超文本预处理器”)是一种通用的开源脚本语言。语法吸收了C语言、Java和Perl的特点。它入门门槛低,易学,应用广泛。它主要适用于web开发领域。PHP的文件后缀是PHP

PHP可以使用curl来完成各种文件传输操作,例如模拟浏览器来发送get和post请求。然而,由于PHP语言本身不支持多线程,因此开发爬虫程序效率不高,但可以使用curl,通过curl的功能,并发多线程可以访问多个URL地址来抓取网页或下载文件

PHP使用curl函数完成各种文件传输操作,例如模拟浏览器发送get和post请求。受PHP语言不支持多线程的限制,开发爬虫程序的效率不高。此时,常常需要curl多函数来实现并发多线程访问多个URL地址。既然curl多函数功能强大,我可以使用curl多函数来编写并发多线程下载文件吗?当然可以。这是我的密码:

代码1:将获得的代码直接写入文件

代码2:首先将获得的代码放入变量中,然后将其写入文件

php多线程抓取多个网页(C#基于异步事件回调多线程容器上传项目不支持Firefox,提示代码附件太大)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-28 09:21

C#基于异步事件回调的多线程容器

上传项目不支持火狐,代码附件过大(1.4M)。写了30多分钟的描述不见了。太骗人了 10点有点贵,肯定原创,2个代码文件一共300多行,下载的时候请慎重。你已经下载了。如果您非常不高兴,请在评论中说出来。不要让其他学生愚弄你。如果您觉得还行,请留言。该代码使用多个工作线程和线程来执行任务。通过暴露的方法将消息传递给worker,然后使用事件回调返回处理结果。实现的事件是 OnThreadComplete、OnAddedTask、OnStart、OnSuccess、OnFailure、OnTimeout。事件回调支持同步或异步,并且每个worker可以指定执行超时以避免线程阻塞。队列使用线程安全的 Blocking采集,每组 worker 使用一个队列。委托是由 Func 定义的,而不是传统的不太理解的委托。这大大减少了代码并使其更易于理解。多线程应该使用消息中心来交换数据,避免线程同步交互、等待、阻塞等,都是异步调用,都是接收消息,然后生成消息,线程之间没有耦合,消息中心有很多成熟的解决方案,比如RabbitMQ、Redis(带有简单的消息交换),微软有消息云服务等等。如果应用不复杂,可以用DB作为简单的消息中心。

开发环境为VS2012,Framework4.0,代码注释量非常大。如果你对这段代码感到满意,你可以随意破坏它。如果您有建设性的意见,请告诉我。下面是部分测试代码: //发送消息方法容器 var msgContainer = new Hashtable();//创建并启动worker foreach (var key in workers.Keys){//创建workers//启动5个线程,异步Event回调,方法执行超时 20 秒,程序运行 100 个线程。由于引入了超时控制,实际线程将达到下面20个工作组中的100+50//,其中5个超时。主要测试是针对 OnTimeout 事件。可以设置sellep的时间来控制。//我把sleep的时间设置的有点长,方便大家测试。//测试的时候,你会看到异常。那应该是超时。我使用了 Thread.Abort 方法。ontimeout 事件开始 var worker = new Sehui.Worker(5, key.ToString(), (Func)workers[key], false, new TimeSpan(0, 0, 20));worker.OnStart += worker_OnEvent;worker.OnSuccess += worker_OnEvent;worker.OnFailure += worker_OnEvent;worker.OnTimeout += worker_OnEvent;//启动worker worker.Start();//将消息方法添加到Hashtable//这里我偷懒了,下面可以循环方式向线程添加消息msgContainer.Add(key.ToString(), new Func(worker.AddTask));)。//向20个worker发送消息,每个worker发送20条消息为( var i = 0; i <20; i++){for (var k = 0; k <20;

现在就下载 查看全部

php多线程抓取多个网页(C#基于异步事件回调多线程容器上传项目不支持Firefox,提示代码附件太大)

C#基于异步事件回调的多线程容器

上传项目不支持火狐,代码附件过大(1.4M)。写了30多分钟的描述不见了。太骗人了 10点有点贵,肯定原创,2个代码文件一共300多行,下载的时候请慎重。你已经下载了。如果您非常不高兴,请在评论中说出来。不要让其他学生愚弄你。如果您觉得还行,请留言。该代码使用多个工作线程和线程来执行任务。通过暴露的方法将消息传递给worker,然后使用事件回调返回处理结果。实现的事件是 OnThreadComplete、OnAddedTask、OnStart、OnSuccess、OnFailure、OnTimeout。事件回调支持同步或异步,并且每个worker可以指定执行超时以避免线程阻塞。队列使用线程安全的 Blocking采集,每组 worker 使用一个队列。委托是由 Func 定义的,而不是传统的不太理解的委托。这大大减少了代码并使其更易于理解。多线程应该使用消息中心来交换数据,避免线程同步交互、等待、阻塞等,都是异步调用,都是接收消息,然后生成消息,线程之间没有耦合,消息中心有很多成熟的解决方案,比如RabbitMQ、Redis(带有简单的消息交换),微软有消息云服务等等。如果应用不复杂,可以用DB作为简单的消息中心。

开发环境为VS2012,Framework4.0,代码注释量非常大。如果你对这段代码感到满意,你可以随意破坏它。如果您有建设性的意见,请告诉我。下面是部分测试代码: //发送消息方法容器 var msgContainer = new Hashtable();//创建并启动worker foreach (var key in workers.Keys){//创建workers//启动5个线程,异步Event回调,方法执行超时 20 秒,程序运行 100 个线程。由于引入了超时控制,实际线程将达到下面20个工作组中的100+50//,其中5个超时。主要测试是针对 OnTimeout 事件。可以设置sellep的时间来控制。//我把sleep的时间设置的有点长,方便大家测试。//测试的时候,你会看到异常。那应该是超时。我使用了 Thread.Abort 方法。ontimeout 事件开始 var worker = new Sehui.Worker(5, key.ToString(), (Func)workers[key], false, new TimeSpan(0, 0, 20));worker.OnStart += worker_OnEvent;worker.OnSuccess += worker_OnEvent;worker.OnFailure += worker_OnEvent;worker.OnTimeout += worker_OnEvent;//启动worker worker.Start();//将消息方法添加到Hashtable//这里我偷懒了,下面可以循环方式向线程添加消息msgContainer.Add(key.ToString(), new Func(worker.AddTask));)。//向20个worker发送消息,每个worker发送20条消息为( var i = 0; i <20; i++){for (var k = 0; k <20;

现在就下载

php多线程抓取多个网页(先看springbootx深度理解定时任务schedule基于上述代码修改源码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-09-25 09:26

“这是我参加八月庚文挑战赛的第16天。请参阅活动详情:八月庚文挑战赛”

让我们看一看spring boot2.x,以深入了解计划的任务时间表

基于上述代码修改

源代码:/langyastudi

正式文件:

工作中经常涉及异步任务。通常使用多线程技术,例如线程池ThreadPoolExecutor。其执行规则如下(图片来源于网络):

使用spring开发时,除了使用@enablesync和@async注释外,还需要定义taskexecutor类型的bean。幸运的是,spring boot提供了taskexecutionautoconfiguration的自动配置,它自动注册bean(名为ApplicationTaskExecutor)的threadpooltaskexecutor(taskexecutor的实现类)。因此,在spring引导中,您只需要使用@EnableSync和@async注释来完成多线程异步操作

使用步骤

Spring boot通过以下方式提供异步多线程任务:

在entry类中启用对异步多线程任务的支持:

@SpringBootApplication

@EnableAsync

public class Application

{

public static void main(String[] args)

{

...

}

}

复制代码

定义收录异步多线程任务的类:

@Component

@Log4j2

public class AsyncTask

{

@Async

public void loopPrint(Integer i)

{

log.info("async task:" + i);

}

}

复制代码

通过commandlinerunner进行检查:

<p>@Bean

CommandLineRunner asyncTaskClr(AsyncTask asyncTask)

{

return (args) -> {

for (int ix=0; ix 查看全部

php多线程抓取多个网页(先看springbootx深度理解定时任务schedule基于上述代码修改源码)

“这是我参加八月庚文挑战赛的第16天。请参阅活动详情:八月庚文挑战赛”

让我们看一看spring boot2.x,以深入了解计划的任务时间表

基于上述代码修改

源代码:/langyastudi

正式文件:

工作中经常涉及异步任务。通常使用多线程技术,例如线程池ThreadPoolExecutor。其执行规则如下(图片来源于网络):

使用spring开发时,除了使用@enablesync和@async注释外,还需要定义taskexecutor类型的bean。幸运的是,spring boot提供了taskexecutionautoconfiguration的自动配置,它自动注册bean(名为ApplicationTaskExecutor)的threadpooltaskexecutor(taskexecutor的实现类)。因此,在spring引导中,您只需要使用@EnableSync和@async注释来完成多线程异步操作

使用步骤

Spring boot通过以下方式提供异步多线程任务:

在entry类中启用对异步多线程任务的支持:

@SpringBootApplication

@EnableAsync

public class Application

{

public static void main(String[] args)

{

...

}

}

复制代码

定义收录异步多线程任务的类:

@Component

@Log4j2

public class AsyncTask

{

@Async

public void loopPrint(Integer i)

{

log.info("async task:" + i);

}

}

复制代码

通过commandlinerunner进行检查:

<p>@Bean

CommandLineRunner asyncTaskClr(AsyncTask asyncTask)

{

return (args) -> {

for (int ix=0; ix

php多线程抓取多个网页(phpcurl的curl_multi系列函数能实现此功能(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-23 04:02

最近几天,您正在进行多搜索引擎关键字排名查询工具,以便及时,方便地了解主要搜索引擎中的关键词。抓取360搜索时,发现360搜索只支持10个搜索结果每页。如果您想获得100个搜索结果数据,您必须搜索10次,它是非常影响用户的体验,没有人会查询关键字排名。愿意等待10个网页。此时,我想使用多线程并发崩溃,只是PHP CURL的CURL_MULTI系列功能可以实现此功能。

一、 curl_multi系列函数:1. curl_multi_init:

用于初始化“curl_multi”句柄,然后生成由多个“curl_init”函数生成的“curl”句柄,以“curl_multi”句柄生成;此功能不需要是参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“CURL_INIT”生成的“CURL”句柄添加到“CURL_MULTI_INIT”函数生成的“CURL_MULTI”句柄。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

“curl_multi_exec”用于发起CURL_MULTI请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是一个“参考参数”,它记录当第二个参数值变为0时不处理的请求的数量,表示它已经存在的所有请求完成(所有请求成功返回或达到超时)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄,如果有卷曲返回消息,如果有一个第一个“卷曲返回值(array形式)”,否则返回“false”,循环调用此函数直到它返回“错误的”; “curl_multi_info_read”参数是“curl_mulit”句柄。

5. curl_multi_getcontent:

完成所有卷曲处理处理时,我们可以使用“卷曲”功能来读取“卷曲”返回内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

读取内容后,使用“curl_muli_remove_handle”函数从“curl_mulit”句柄中的所有“卷曲”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“卷曲”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄以释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”句柄。

二、 curl_multi使用过程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,将其添加到“curl_multi_add_handle”函数的“curl_multi”句柄;

3、使用“curl_multi_exec”启动请求,并等待所有请求处理完成;

4、使用“curl_multi_info_read”函数读取返回值;

5、使用“curl_multi_getcontent”函数来读取返回内容;

6、使用“curl_multi_remove_handle”函数删除卷曲句柄;

7、使用“curl_multi_close”关闭curl_multi句柄。

三、以下是我使用curl_multi多线程并发360搜索返回结果的代码片段:#multhreaded Concurrent Grip函数mfetch:

<p> 查看全部

php多线程抓取多个网页(phpcurl的curl_multi系列函数能实现此功能(组图))

最近几天,您正在进行多搜索引擎关键字排名查询工具,以便及时,方便地了解主要搜索引擎中的关键词。抓取360搜索时,发现360搜索只支持10个搜索结果每页。如果您想获得100个搜索结果数据,您必须搜索10次,它是非常影响用户的体验,没有人会查询关键字排名。愿意等待10个网页。此时,我想使用多线程并发崩溃,只是PHP CURL的CURL_MULTI系列功能可以实现此功能。

一、 curl_multi系列函数:1. curl_multi_init:

用于初始化“curl_multi”句柄,然后生成由多个“curl_init”函数生成的“curl”句柄,以“curl_multi”句柄生成;此功能不需要是参数。

2. curl_multi_add_handle:

“curl_multi_add_handle”函数用于将“CURL_INIT”生成的“CURL”句柄添加到“CURL_MULTI_INIT”函数生成的“CURL_MULTI”句柄。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“curl”句柄。

3. curl_multi_exec:

“curl_multi_exec”用于发起CURL_MULTI请求。 “curl_multi_add_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是一个“参考参数”,它记录当第二个参数值变为0时不处理的请求的数量,表示它已经存在的所有请求完成(所有请求成功返回或达到超时)。

4. curl_multi_info_read:

“curl_multi_info_read”函数用于读取curl_multi句柄,如果有卷曲返回消息,如果有一个第一个“卷曲返回值(array形式)”,否则返回“false”,循环调用此函数直到它返回“错误的”; “curl_multi_info_read”参数是“curl_mulit”句柄。

5. curl_multi_getcontent:

完成所有卷曲处理处理时,我们可以使用“卷曲”功能来读取“卷曲”返回内容。 “curl_multi_getcontent”的参数是“curl”句柄。

6. curl_multi_remove_handle:

读取内容后,使用“curl_muli_remove_handle”函数从“curl_mulit”句柄中的所有“卷曲”句柄。 “curl_multi_remove_handle”函数的第一个参数是“curl_multi”句柄,第二个参数是“卷曲”句柄。

7. curl_multi_close:

“curl_multi_close”函数用于关闭“curl_mulit”句柄以释放占用的资源。 “curl_multi_close”的参数是“curl_mulit”句柄。

二、 curl_multi使用过程:

1、“curl_multi_init”初始化“curl_multi”句柄;

2、循环创建并添加“curl”句柄,将其添加到“curl_multi_add_handle”函数的“curl_multi”句柄;

3、使用“curl_multi_exec”启动请求,并等待所有请求处理完成;

4、使用“curl_multi_info_read”函数读取返回值;

5、使用“curl_multi_getcontent”函数来读取返回内容;

6、使用“curl_multi_remove_handle”函数删除卷曲句柄;

7、使用“curl_multi_close”关闭curl_multi句柄。

三、以下是我使用curl_multi多线程并发360搜索返回结果的代码片段:#multhreaded Concurrent Grip函数mfetch:

<p>

php多线程抓取多个网页(PHP利用CurlFunctions实现并发多线程下载文件(一) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-09-23 04:01

)

本文文章主要介绍了基于卷曲实现的PHP多线程,对朋友感兴趣,我希望帮助每个人。

php使用curl完成各种传输文件操作,例如模拟浏览器发送,发布请求等,但由于PHP语言本身不支持多线程,爬行动物的开发不高,所以经常需要使用curl.multi函数此功能实现并发多线程访问多个URL地址以实现并发的多线程网页或下载文件

代码如下:

让我们采取一些例子

(1)以下此代码是实现多个URL,然后将捕获的URL的页面代码写入指定的文件

$urls = array(

'http://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

(2)下面这个部分几乎有意义,只有这个地方是代码将首先放在变量中,然后将所获得的内容写入指定的文件

$urls = array(

'http://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();