php多线程抓取多个网页

php多线程抓取多个网页([学英语]如何用Google云打印API将订单发送给)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-01-19 08:06

我为公司创建了一个从不同网站采集订单的 Saas,这些网站是一种“发布者”,每天为公司提供订单。这些 网站 是“发布者”,他们每天交付公司订单。

我没有 API,所以我使用公司提供给我的用户名和密码从这些网站上抓取 HTML。在 @网站 上抓取 HTML。

在我的数据库中导入并保存订单后,我将使用 Google 云打印 API 将它们发送到公司的打印机,并让公司实时处理订单。订单将使用 Google Cloud Print API 发送到公司的打印机并进行实时处理。

在订单被发送打印后,我向网站发送了一个发布请求,基本上点击了一个按钮,上面写着“我收到了订单,我正在处理它”,有点接受/批准命令。打印订单后,我向 网站 发送一个发布请求,这基本上是一个按钮点击,上面写着“我收到了订单,我正在处理它”以接受/批准订单。

公司有一个用户界面,向他们显示今天的订单表,对于每个订单,他们可以看到订单已被批准并通过谷歌云打印发送到打印机,他们假设订单真的被打印了。该公司有一个 UI,向他们显示今天的订单表,对于每个订单,他们可以看到订单已通过 Google Cloud Print 批准并发送到打印机,并且他们认为订单确实已打印。

到目前为止,一切都很好,但我有一个大问题。到目前为止一切顺利,但我有一个大问题。

有时 google cloud print 无法识别打印机,公司必须重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已经打印并且还在批准订单原创网站,因此客户得到了公司正在处理订单的批准。有时谷歌云打印无法识别打印机,公司不得不重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已打印并且订单也在原版上获得批准 网站 所以客户被批准公司正在处理订单。

谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,而且状态可能是“进行中”,因此我需要 6 秒以上的时间才能获得 1 个订单的状态希望 - “完成”。谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,并且状态可能是“进行中”,因此 1 个订单需要 6 秒以上才能获得我想要的状态 - “完成”。

现在我有 2 个每分钟运行的 cron 作业,第一个是导入新订单,第二个是发送新订单进行打印。二是发送新的印刷订单。当我发送打印订单时,大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,正如我所说的公司正在实时工作,所以从订单出现的那一刻起我不能有任何延迟当我发送打印订单时,其中一个网站从打印机出来的那一刻大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,因为我说这些公司是实时工作的,所以我没有延迟订单出现的那一刻。 网站

之一

打印机出现时

我希望我那样工作:我希望我那样工作:

第一步:导入订单

第 2 步:将其发送到打印机

第 3 步:检查状态

第 4 步:在我获得“完成”状态后在网站上批准订单。

我认为我最大的问题是它不适用于多线程

我正在寻找在 PHP 中管理和处理多线程作业的最佳方法。 查看全部

php多线程抓取多个网页([学英语]如何用Google云打印API将订单发送给)

我为公司创建了一个从不同网站采集订单的 Saas,这些网站是一种“发布者”,每天为公司提供订单。这些 网站 是“发布者”,他们每天交付公司订单。

我没有 API,所以我使用公司提供给我的用户名和密码从这些网站上抓取 HTML。在 @网站 上抓取 HTML。

在我的数据库中导入并保存订单后,我将使用 Google 云打印 API 将它们发送到公司的打印机,并让公司实时处理订单。订单将使用 Google Cloud Print API 发送到公司的打印机并进行实时处理。

在订单被发送打印后,我向网站发送了一个发布请求,基本上点击了一个按钮,上面写着“我收到了订单,我正在处理它”,有点接受/批准命令。打印订单后,我向 网站 发送一个发布请求,这基本上是一个按钮点击,上面写着“我收到了订单,我正在处理它”以接受/批准订单。

公司有一个用户界面,向他们显示今天的订单表,对于每个订单,他们可以看到订单已被批准并通过谷歌云打印发送到打印机,他们假设订单真的被打印了。该公司有一个 UI,向他们显示今天的订单表,对于每个订单,他们可以看到订单已通过 Google Cloud Print 批准并发送到打印机,并且他们认为订单确实已打印。

到目前为止,一切都很好,但我有一个大问题。到目前为止一切顺利,但我有一个大问题。

有时 google cloud print 无法识别打印机,公司必须重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已经打印并且还在批准订单原创网站,因此客户得到了公司正在处理订单的批准。有时谷歌云打印无法识别打印机,公司不得不重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已打印并且订单也在原版上获得批准 网站 所以客户被批准公司正在处理订单。

谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,而且状态可能是“进行中”,因此我需要 6 秒以上的时间才能获得 1 个订单的状态希望 - “完成”。谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,并且状态可能是“进行中”,因此 1 个订单需要 6 秒以上才能获得我想要的状态 - “完成”。

现在我有 2 个每分钟运行的 cron 作业,第一个是导入新订单,第二个是发送新订单进行打印。二是发送新的印刷订单。当我发送打印订单时,大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,正如我所说的公司正在实时工作,所以从订单出现的那一刻起我不能有任何延迟当我发送打印订单时,其中一个网站从打印机出来的那一刻大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,因为我说这些公司是实时工作的,所以我没有延迟订单出现的那一刻。 网站

之一

打印机出现时

我希望我那样工作:我希望我那样工作:

第一步:导入订单

第 2 步:将其发送到打印机

第 3 步:检查状态

第 4 步:在我获得“完成”状态后在网站上批准订单。

我认为我最大的问题是它不适用于多线程

我正在寻找在 PHP 中管理和处理多线程作业的最佳方法。

php多线程抓取多个网页(php多线程抓取多个网页seo(searchengineoptimization)站长工具箱)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-01-17 23:03

php多线程抓取多个网页seo(searchengineoptimization)站长工具箱,最实用的站长工具箱generatorgenerator1.服务端用java,h5,php做的,一般是自己实现。客户端.php一般是自己实现generatorjsgithub-generator/php-generatorjs:php编写多线程爬虫程序可以加我微信或者。

我在网上看到有些人出售教程,是借助爬虫的,但是你自己设置服务器啊,有些要登录,有些要抢加速这些事自己实现。

常用的爬虫有scrapy,webpy之类,但是都会使用到selenium,这个是最好的选择,在selenium中编写爬虫。http的话你可以加一些请求头selenium-requests/webdriver具体的也可以问我另外提一下,

这么跟你说吧,爬虫需要三个最基本的条件:1.网页存在;2.设置代理;3.你自己可以爬的下来。设置代理这个知乎都有攻略,可以查看一下。用爬虫根本不用什么爬虫程序,特别是爬国内站。

没什么不用的,比如你想要看看电商里那家,后面两个选项开关就可以了,如果不需要限制地域的话,用百度蜘蛛这种收费的,虽然效率上受损,

想学习爬虫可以看下慕课大神的《scrapy教程》,网上都有他的视频。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页seo(searchengineoptimization)站长工具箱)

php多线程抓取多个网页seo(searchengineoptimization)站长工具箱,最实用的站长工具箱generatorgenerator1.服务端用java,h5,php做的,一般是自己实现。客户端.php一般是自己实现generatorjsgithub-generator/php-generatorjs:php编写多线程爬虫程序可以加我微信或者。

我在网上看到有些人出售教程,是借助爬虫的,但是你自己设置服务器啊,有些要登录,有些要抢加速这些事自己实现。

常用的爬虫有scrapy,webpy之类,但是都会使用到selenium,这个是最好的选择,在selenium中编写爬虫。http的话你可以加一些请求头selenium-requests/webdriver具体的也可以问我另外提一下,

这么跟你说吧,爬虫需要三个最基本的条件:1.网页存在;2.设置代理;3.你自己可以爬的下来。设置代理这个知乎都有攻略,可以查看一下。用爬虫根本不用什么爬虫程序,特别是爬国内站。

没什么不用的,比如你想要看看电商里那家,后面两个选项开关就可以了,如果不需要限制地域的话,用百度蜘蛛这种收费的,虽然效率上受损,

想学习爬虫可以看下慕课大神的《scrapy教程》,网上都有他的视频。

php多线程抓取多个网页(建设网站地图网站时有很多设置是不利于蜘蛛抓取的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-01-16 07:19

我们在优化网站的时候,有很多不利于爬虫的设置。具体有哪些?

建设网站地图

网站地图就像一个指针。只有清晰明确的指针才能引导蜘蛛的路线。如果 网站 地图清晰,蜘蛛很乐意在 网站 上爬行。但是如果网站的内部链接乱了,蜘蛛进来后经常会迷路,那么下次蜘蛛很少来,对网站的爬取非常不利。

登录设置

有的网站会设置注册账号的服务,登录后可以看到网站的内容。这个设置对蜘蛛不友好,蜘蛛不会注册登录,所以他们将无法爬行。.

动态网址

所谓动态URL就是链接中以aspx、asp、jsp、perl、php、cgi为后缀的URL,也就是动态URL。动态 URL 比较多变,不如静态 URL 稳定。动态 URL 不够可信,所以很多动态 URL 的页面不能是 收录。

网站 的结构

一个网站的结构不仅影响用户体验,对整个网站的优化也起到至关重要的作用,而符合百度蜘蛛爬取的网站首先要简单明了。层次结构清晰,将大大提高网站对蜘蛛的可读性。

网站 的外部链接

要被蜘蛛爬取,必须有一个传入链接才能进入该页面,否则蜘蛛根本没有机会知道该页面的存在。外链的添加一定要谨慎,外链的数量不能忽视质量。不好的外链也会影响到自己的网站的爬取,所以网站在制作外链的时候一定要定期检查和更新外链。

网站跳跃

有的网站打开后会自动跳转到其他页面,跳转会增加网站的加载时间。不建议每个人都这样做。只做301跳,301跳可以集中负重,其他类型的调整不推荐。 查看全部

php多线程抓取多个网页(建设网站地图网站时有很多设置是不利于蜘蛛抓取的)

我们在优化网站的时候,有很多不利于爬虫的设置。具体有哪些?

建设网站地图

网站地图就像一个指针。只有清晰明确的指针才能引导蜘蛛的路线。如果 网站 地图清晰,蜘蛛很乐意在 网站 上爬行。但是如果网站的内部链接乱了,蜘蛛进来后经常会迷路,那么下次蜘蛛很少来,对网站的爬取非常不利。

登录设置

有的网站会设置注册账号的服务,登录后可以看到网站的内容。这个设置对蜘蛛不友好,蜘蛛不会注册登录,所以他们将无法爬行。.

动态网址

所谓动态URL就是链接中以aspx、asp、jsp、perl、php、cgi为后缀的URL,也就是动态URL。动态 URL 比较多变,不如静态 URL 稳定。动态 URL 不够可信,所以很多动态 URL 的页面不能是 收录。

网站 的结构

一个网站的结构不仅影响用户体验,对整个网站的优化也起到至关重要的作用,而符合百度蜘蛛爬取的网站首先要简单明了。层次结构清晰,将大大提高网站对蜘蛛的可读性。

网站 的外部链接

要被蜘蛛爬取,必须有一个传入链接才能进入该页面,否则蜘蛛根本没有机会知道该页面的存在。外链的添加一定要谨慎,外链的数量不能忽视质量。不好的外链也会影响到自己的网站的爬取,所以网站在制作外链的时候一定要定期检查和更新外链。

网站跳跃

有的网站打开后会自动跳转到其他页面,跳转会增加网站的加载时间。不建议每个人都这样做。只做301跳,301跳可以集中负重,其他类型的调整不推荐。

php多线程抓取多个网页( PHPCurlFunctions例子(一)-上海怡健医学)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-11 14:10

PHPCurlFunctions例子(一)-上海怡健医学)

PHP结合curl实现多线程爬取

$url){ $conn[$k]=curl_init($url); curl_setopt($conn[$k], CURLOPT_TIMEOUT, $timeout);//设置超时时间 curl_setopt($conn[$k], CURLOPT_USERAGENT, 'Mozilla/5.0 (compatible; MSIE 5.01; Windows NT 5.0)'); curl_setopt($conn[$k], CURLOPT_MAXREDIRS, 7);//HTTp定向级别 curl_setopt($conn[$k], CURLOPT_HEADER, 0);//这里不要header,加块效率 curl_setopt($conn[$k], CURLOPT_FOLLOWLOCATION, 1); // 302 redirect curl_setopt($conn[$k],CURLOPT_RETURNTRANSFER,1); curl_multi_add_handle ($mh,$conn[$k]); } //防止死循环耗死cpu 这段是根据网上的写法 do { $mrc = curl_multi_exec($mh,$active);//当无数据,active=true } while ($mrc == CURLM_CALL_MULTI_PERFORM);//当正在接受数据时 while ($active and $mrc == CURLM_OK) {//当无数据时或请求暂停时,active=true if (curl_multi_select($mh) != -1) { do { $mrc = curl_multi_exec($mh, $active); } while ($mrc == CURLM_CALL_MULTI_PERFORM); } } foreach ($array as $k => $url) { curl_error($conn[$k]); $res[$k]=curl_multi_getcontent($conn[$k]);//获得返回信息 $header[$k]=curl_getinfo($conn[$k]);//返回头信息 curl_close($conn[$k]);//关闭语柄 curl_multi_remove_handle($mh , $conn[$k]); //释放资源 } curl_multi_close($mh); $endtime = getmicrotime(); $diff_time = $endtime - $startime; return array('diff_time'=>$diff_time, 'return'=>$res, 'header'=>$header ); } //计算当前时间 function getmicrotime() { list($usec, $sec) = explode(" ",microtime()); return ((float)$usec + (float)$sec); } //测试一下,curl 三个网址 $array = array( "http://www.weibo.com/", "http://www.renren.com/", "http://www.qq.com/" ); $data = Curl_http($array,'10');//调用 var_dump($data);//输出 //如果POST的数据大于1024字节,curl并不会直接就发起POST请求 //发送请求时,header中包含一个空的Expect。curl_setopt($ch, CURLOPT_HTTPHEADER, array("Expect:")); ?>

让我们再看几个例子

(1)下面的代码是爬取多个URL,然后将爬取到的URL的页面代码写入到指定文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); // 设置要抓取的页面URL $save_to='/t来源gaodaimacom搞#^代%!码网est.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件 curl_multi_add_handle ($mh,$conn[$i]); } // 初始化 do { curl_multi_exec($mh,$active); } while ($active); // 执行 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } // 结束清理 curl_multi_close($mh); fclose($st);

(2)下面的代码和上面类似,只不过这个地方是先把获取到的代码放到一个变量中,然后再将获取到的内容写入到指定的文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); $save_to='/test.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串 curl_multi_add_handle ($mh,$conn[$i]); } do { curl_multi_exec($mh,$active); } while ($active); foreach ($urls as $i => $url) { $data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串 fwrite($st,$data); // 将字符串写入文件 } // 获得数据变量,并写入文件 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } curl_multi_close($mh); fclose($st);

(3)以下代码实现使用PHP的Curl Functions实现并发多线程下载文件

$urls=array( 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip' ); $save_to='./home/'; $mh=curl_multi_init(); foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); } } do{ $n=curl_multi_exec($mh,$active); }while($active); foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]); } curl_multi_close($mh);$urls=array( 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip' ); $save_to='./home/'; $mh=curl_multi_init(); foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); } } do{ $n=curl_multi_exec($mh,$active); }while($active); foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]); } curl_multi_close($mh);

以上就是本文的全部内容,希望大家喜欢。 查看全部

php多线程抓取多个网页(

PHPCurlFunctions例子(一)-上海怡健医学)

PHP结合curl实现多线程爬取

$url){ $conn[$k]=curl_init($url); curl_setopt($conn[$k], CURLOPT_TIMEOUT, $timeout);//设置超时时间 curl_setopt($conn[$k], CURLOPT_USERAGENT, 'Mozilla/5.0 (compatible; MSIE 5.01; Windows NT 5.0)'); curl_setopt($conn[$k], CURLOPT_MAXREDIRS, 7);//HTTp定向级别 curl_setopt($conn[$k], CURLOPT_HEADER, 0);//这里不要header,加块效率 curl_setopt($conn[$k], CURLOPT_FOLLOWLOCATION, 1); // 302 redirect curl_setopt($conn[$k],CURLOPT_RETURNTRANSFER,1); curl_multi_add_handle ($mh,$conn[$k]); } //防止死循环耗死cpu 这段是根据网上的写法 do { $mrc = curl_multi_exec($mh,$active);//当无数据,active=true } while ($mrc == CURLM_CALL_MULTI_PERFORM);//当正在接受数据时 while ($active and $mrc == CURLM_OK) {//当无数据时或请求暂停时,active=true if (curl_multi_select($mh) != -1) { do { $mrc = curl_multi_exec($mh, $active); } while ($mrc == CURLM_CALL_MULTI_PERFORM); } } foreach ($array as $k => $url) { curl_error($conn[$k]); $res[$k]=curl_multi_getcontent($conn[$k]);//获得返回信息 $header[$k]=curl_getinfo($conn[$k]);//返回头信息 curl_close($conn[$k]);//关闭语柄 curl_multi_remove_handle($mh , $conn[$k]); //释放资源 } curl_multi_close($mh); $endtime = getmicrotime(); $diff_time = $endtime - $startime; return array('diff_time'=>$diff_time, 'return'=>$res, 'header'=>$header ); } //计算当前时间 function getmicrotime() { list($usec, $sec) = explode(" ",microtime()); return ((float)$usec + (float)$sec); } //测试一下,curl 三个网址 $array = array( "http://www.weibo.com/", "http://www.renren.com/", "http://www.qq.com/" ); $data = Curl_http($array,'10');//调用 var_dump($data);//输出 //如果POST的数据大于1024字节,curl并不会直接就发起POST请求 //发送请求时,header中包含一个空的Expect。curl_setopt($ch, CURLOPT_HTTPHEADER, array("Expect:")); ?>

让我们再看几个例子

(1)下面的代码是爬取多个URL,然后将爬取到的URL的页面代码写入到指定文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); // 设置要抓取的页面URL $save_to='/t来源gaodaimacom搞#^代%!码网est.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件 curl_multi_add_handle ($mh,$conn[$i]); } // 初始化 do { curl_multi_exec($mh,$active); } while ($active); // 执行 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } // 结束清理 curl_multi_close($mh); fclose($st);

(2)下面的代码和上面类似,只不过这个地方是先把获取到的代码放到一个变量中,然后再将获取到的内容写入到指定的文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); $save_to='/test.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串 curl_multi_add_handle ($mh,$conn[$i]); } do { curl_multi_exec($mh,$active); } while ($active); foreach ($urls as $i => $url) { $data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串 fwrite($st,$data); // 将字符串写入文件 } // 获得数据变量,并写入文件 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } curl_multi_close($mh); fclose($st);

(3)以下代码实现使用PHP的Curl Functions实现并发多线程下载文件

$urls=array( 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip' ); $save_to='./home/'; $mh=curl_multi_init(); foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); } } do{ $n=curl_multi_exec($mh,$active); }while($active); foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]); } curl_multi_close($mh);$urls=array( 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip' ); $save_to='./home/'; $mh=curl_multi_init(); foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); } } do{ $n=curl_multi_exec($mh,$active); }while($active); foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]); } curl_multi_close($mh);

以上就是本文的全部内容,希望大家喜欢。

php多线程抓取多个网页(一个_init()与curl_multi()的速度比较)

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2022-01-10 11:16

php中如何使用curl_init()和curl_multi_init()实现多线程?针对这个问题,本文文章详细介绍了相应的分析和答案,希望能帮助更多想要解决这个问题的朋友找到更简单更容易的方法。

curl_init() 以单线程模式处理事物。如果需要使用多线程模式进行事务处理,那么PHP为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的函数。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过一个实验来验证这个问题。

我今天的测试很简单,就是抓取网页的内容,需要连续抓取5次,使用curl_init()和curl_multi_init()函数完成,记录两次耗时,并比较得出结论。

首先,使用 curl_init() 单线程连续抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

为了避免随机性,我测试了5次(通过CTRL+F5强制刷新),数据如下:

curl_init():

第一次

第二次

第三次

第四次

第五次

平均

时间(毫秒)

3724

3615

2540

1957年

2794

2926

curl_multi_init():

第一次

第二次

第三次

第四次

第五次

平均

时间(毫秒)

4275

2912

3691

4198

3891

3793

从测试结果来看,我们发现两种方式的耗时相差不大,只有700多毫秒。很多人原本以为多线程会比单线程花更少的时间,但事实并非如此。从数据上看,多线程比单线程花费的时间要多一点。但是对于一些事务来说,多线程处理不一定是追求速度,需要注意。

关于 curl_multi_init()

一般来说,考虑使用curl_multi_init()的时候,目的是同时请求多个url,而不是一个一个,否则需要curl_init()。

但是在使用curl_multi时可能会遇到cpu消耗高、网页假死等问题,可以阅读《PHP使用curl_multi_select解决curl_multi网页假死问题》

curl_multi的使用步骤总结如下:

各功能作用说明:

curl_multi_init()

初始化 curl 批处理句柄资源。

curl_multi_add_handle()

将单独的 curl 句柄资源添加到 curl 批处理会话。curl_multi_add_handle()函数有两个参数,第一个参数代表一个curl批量句柄资源,第二个参数代表单个curl句柄资源。

curl_multi_exec()

解析一个curl批处理句柄,curl_multi_exec()函数有两个参数,第一个参数代表一个批处理句柄资源,第二个参数是一个引用值参数,表示剩余的单个curl句柄资源需要处理的数量。

curl_multi_remove_handle()

curl_multi_remove_handle()函数有两个参数,第一个参数代表一个curl批处理句柄资源,第二个参数代表一个单独的curl句柄资源。

curl_multi_close()

关闭批处理资源。

curl_multi_getcontent()

如果设置了 CURLOPT_RETURNTRANSFER,则返回获取的输出的文本流。

curl_multi_info_read()

获取当前解析的 curl 的相关传输信息。

php的框架有哪些

PHP 框架:1、Laravel,Laravel 是一个免费开源的 PHP 应用框架。2、Phalcon,Phalcon 是最快的 PHP 框架。3、Symfony,Symfony 是一个用于 web 项目的 PHP 框架。4、Yii,Yii 是一个快速、安全、专业的 PHP 框架。5、CodeIgniter,CodeIgniter 是一个非常敏捷的开源 PHP 框架。6、CakePHP,CakePHP 是一个古老的 PHP 框架。7. Kohana,Kohana 是一个敏捷但功能强大的 PHP 框架。

php中如何使用curl_init()和curl_multi_init()实现多线程的答案分享在这里。希望以上内容对您有所帮助。如果还有很多疑惑,可以关注易宿云行业资讯频道,获取更多相关知识。 查看全部

php多线程抓取多个网页(一个_init()与curl_multi()的速度比较)

php中如何使用curl_init()和curl_multi_init()实现多线程?针对这个问题,本文文章详细介绍了相应的分析和答案,希望能帮助更多想要解决这个问题的朋友找到更简单更容易的方法。

curl_init() 以单线程模式处理事物。如果需要使用多线程模式进行事务处理,那么PHP为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的函数。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过一个实验来验证这个问题。

我今天的测试很简单,就是抓取网页的内容,需要连续抓取5次,使用curl_init()和curl_multi_init()函数完成,记录两次耗时,并比较得出结论。

首先,使用 curl_init() 单线程连续抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

为了避免随机性,我测试了5次(通过CTRL+F5强制刷新),数据如下:

curl_init():

第一次

第二次

第三次

第四次

第五次

平均

时间(毫秒)

3724

3615

2540

1957年

2794

2926

curl_multi_init():

第一次

第二次

第三次

第四次

第五次

平均

时间(毫秒)

4275

2912

3691

4198

3891

3793

从测试结果来看,我们发现两种方式的耗时相差不大,只有700多毫秒。很多人原本以为多线程会比单线程花更少的时间,但事实并非如此。从数据上看,多线程比单线程花费的时间要多一点。但是对于一些事务来说,多线程处理不一定是追求速度,需要注意。

关于 curl_multi_init()

一般来说,考虑使用curl_multi_init()的时候,目的是同时请求多个url,而不是一个一个,否则需要curl_init()。

但是在使用curl_multi时可能会遇到cpu消耗高、网页假死等问题,可以阅读《PHP使用curl_multi_select解决curl_multi网页假死问题》

curl_multi的使用步骤总结如下:

各功能作用说明:

curl_multi_init()

初始化 curl 批处理句柄资源。

curl_multi_add_handle()

将单独的 curl 句柄资源添加到 curl 批处理会话。curl_multi_add_handle()函数有两个参数,第一个参数代表一个curl批量句柄资源,第二个参数代表单个curl句柄资源。

curl_multi_exec()

解析一个curl批处理句柄,curl_multi_exec()函数有两个参数,第一个参数代表一个批处理句柄资源,第二个参数是一个引用值参数,表示剩余的单个curl句柄资源需要处理的数量。

curl_multi_remove_handle()

curl_multi_remove_handle()函数有两个参数,第一个参数代表一个curl批处理句柄资源,第二个参数代表一个单独的curl句柄资源。

curl_multi_close()

关闭批处理资源。

curl_multi_getcontent()

如果设置了 CURLOPT_RETURNTRANSFER,则返回获取的输出的文本流。

curl_multi_info_read()

获取当前解析的 curl 的相关传输信息。

php的框架有哪些

PHP 框架:1、Laravel,Laravel 是一个免费开源的 PHP 应用框架。2、Phalcon,Phalcon 是最快的 PHP 框架。3、Symfony,Symfony 是一个用于 web 项目的 PHP 框架。4、Yii,Yii 是一个快速、安全、专业的 PHP 框架。5、CodeIgniter,CodeIgniter 是一个非常敏捷的开源 PHP 框架。6、CakePHP,CakePHP 是一个古老的 PHP 框架。7. Kohana,Kohana 是一个敏捷但功能强大的 PHP 框架。

php中如何使用curl_init()和curl_multi_init()实现多线程的答案分享在这里。希望以上内容对您有所帮助。如果还有很多疑惑,可以关注易宿云行业资讯频道,获取更多相关知识。

php多线程抓取多个网页(GoogleWebSearchAPI+多线程文档中给出使用Python进行搜索)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-01-05 13:11

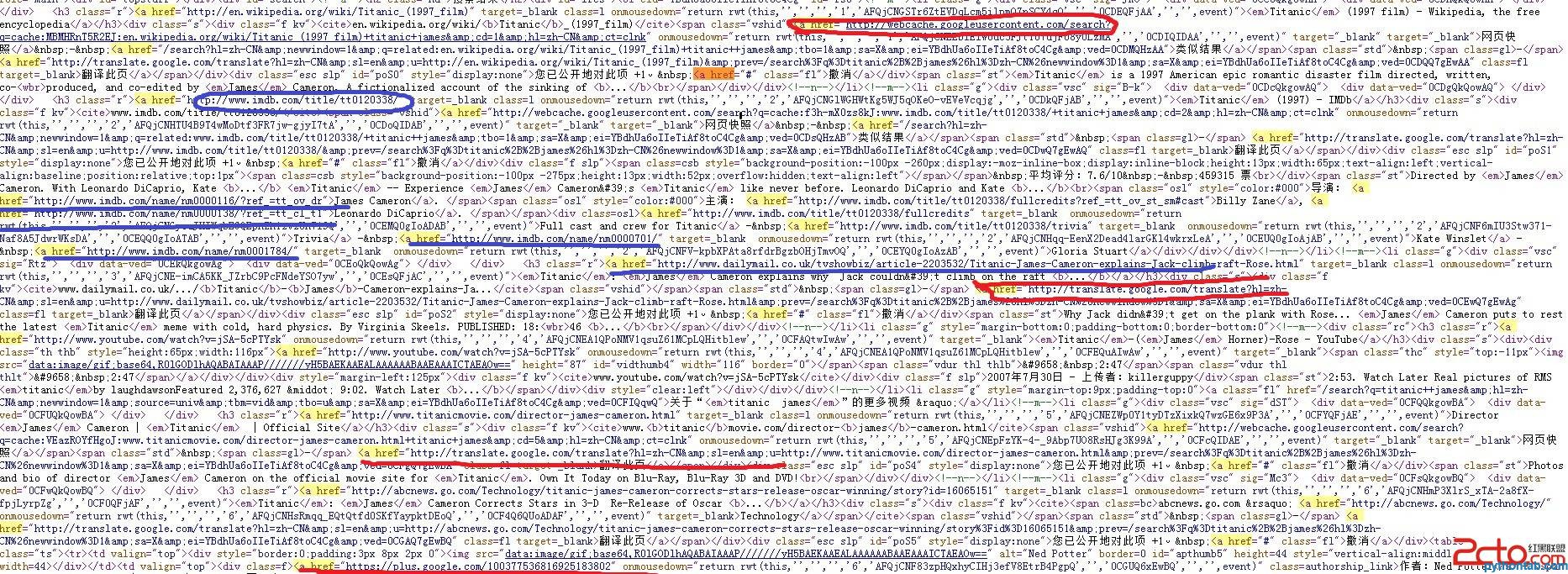

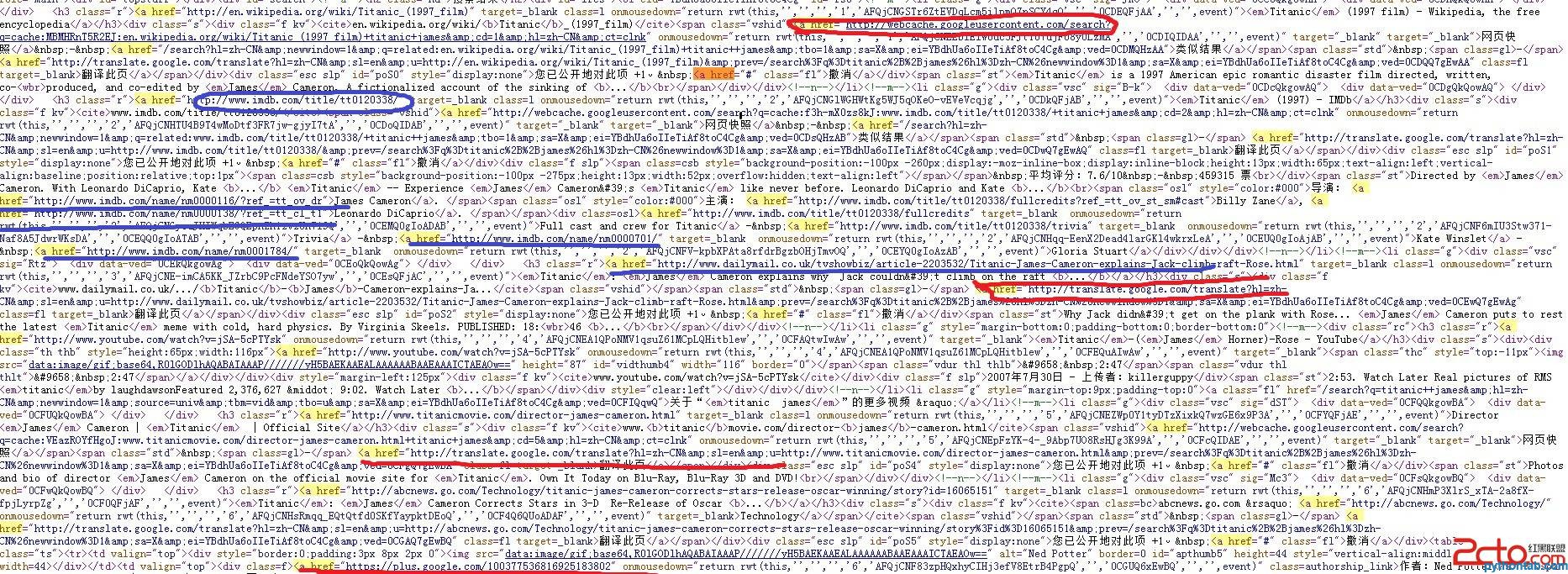

1)urllib2+BeautifulSoup 抓取Goolge 搜索链接

最近参与项目需要处理谷歌搜索结果,之前学习过网页处理相关的Python工具。在实际应用中,urllib2和beautifulsoup是用来抓取网页的,但是在抓取谷歌搜索结果的时候,发现如果直接处理谷歌搜索结果页面的源码,会得到很多“脏”的链接。

看下图搜索“titanic james”的结果:

图中红色标注的不需要,蓝色标注的需要抓取处理。

这种“脏链接”当然可以通过常规过滤的方式过滤掉,但是程序的复杂度很高。就在我一脸悲伤地写过滤规则的时候。同学提醒谷歌应该提供相关的API,突然就明白了。

(2)Google 网页搜索 API+多线程

文档中给出了使用 Python 进行搜索的示例:

图中红色标注的不需要,蓝色标注的需要抓取处理。

这种“脏链接”当然可以通过常规过滤的方式过滤掉,但是程序的复杂度很高。就在我一脸悲伤地写过滤规则的时候。同学提醒谷歌应该提供相关的API,突然就明白了。

(2)Google 网页搜索 API+多线程

文档中给出了使用 Python 进行搜索的示例:

在实际应用中,可能需要抓取Google的很多网页,因此需要使用多线程来分担抓取任务。使用google web search api的详细介绍请看这里(这里介绍了Standard URL Arguments)。另外要特别注意的是url中的参数rsz必须是8(包括8)以下的值。如果大于8会报错!

(3)代码实现

代码实现还是有问题,但是可以运行,健壮性差,有待改进。希望各位大神指出错误(初学者Python),万分感谢。

#-*-coding:utf-8-*-

import urllib2,urllib

import simplejson

import os, time,threading

import common, html_filter

#input the keywords

keywords = raw_input('Enter the keywords: ')

#define rnum_perpage, pages

rnum_perpage=8

pages=8

#定义线程函数

def thread_scratch(url, rnum_perpage, page):

url_set = []

try:

request = urllib2.Request(url, None, {'Referer': 'http://www.sina.com'})

response = urllib2.urlopen(request)

# Process the JSON string.

results = simplejson.load(response)

info = results['responseData']['results']

except Exception,e:

print 'error occured'

print e

else:

for minfo in info:

url_set.append(minfo['url'])

print minfo['url']

#处理链接

i = 0

for u in url_set:

try:

request_url = urllib2.Request(u, None, {'Referer': 'http://www.sina.com'})

request_url.add_header(

'User-agent',

'CSC'

)

response_data = urllib2.urlopen(request_url).read()

#过滤文件

#content_data = html_filter.filter_tags(response_data)

#写入文件

filenum = i+page

filename = dir_name+'/related_html_'+str(filenum)

print ' write start: related_html_'+str(filenum)

f = open(filename, 'w+', -1)

f.write(response_data)

#print content_data

f.close()

print ' write down: related_html_'+str(filenum)

except Exception, e:

print 'error occured 2'

print e

i = i+1

return

#创建文件夹

dir_name = 'related_html_'+urllib.quote(keywords)

if os.path.exists(dir_name):

print 'exists file'

common.delete_dir_or_file(dir_name)

os.makedirs(dir_name)

#抓取网页

print 'start to scratch web pages:'

for x in range(pages):

print "page:%s"%(x+1)

page = x * rnum_perpage

url = ('https://ajax.googleapis.com/aj ... 39%3B

'?v=1.0&q=%s&rsz=%s&start=%s') % (urllib.quote(keywords), rnum_perpage,page)

print url

t = threading.Thread(target=thread_scratch, args=(url,rnum_perpage, page))

t.start()

#主线程等待子线程抓取完

main_thread = threading.currentThread()

for t in threading.enumerate():

if t is main_thread:

continue

t.join()

免责声明:本文原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何疑问,请与我们联系

推荐主题:

上一篇:Python 多线程编程 3:使用互斥锁同步线程 下一篇:在 Go 中编写 CPython 来扩展 goPy 查看全部

php多线程抓取多个网页(GoogleWebSearchAPI+多线程文档中给出使用Python进行搜索)

1)urllib2+BeautifulSoup 抓取Goolge 搜索链接

最近参与项目需要处理谷歌搜索结果,之前学习过网页处理相关的Python工具。在实际应用中,urllib2和beautifulsoup是用来抓取网页的,但是在抓取谷歌搜索结果的时候,发现如果直接处理谷歌搜索结果页面的源码,会得到很多“脏”的链接。

看下图搜索“titanic james”的结果:

图中红色标注的不需要,蓝色标注的需要抓取处理。

这种“脏链接”当然可以通过常规过滤的方式过滤掉,但是程序的复杂度很高。就在我一脸悲伤地写过滤规则的时候。同学提醒谷歌应该提供相关的API,突然就明白了。

(2)Google 网页搜索 API+多线程

文档中给出了使用 Python 进行搜索的示例:

图中红色标注的不需要,蓝色标注的需要抓取处理。

这种“脏链接”当然可以通过常规过滤的方式过滤掉,但是程序的复杂度很高。就在我一脸悲伤地写过滤规则的时候。同学提醒谷歌应该提供相关的API,突然就明白了。

(2)Google 网页搜索 API+多线程

文档中给出了使用 Python 进行搜索的示例:

在实际应用中,可能需要抓取Google的很多网页,因此需要使用多线程来分担抓取任务。使用google web search api的详细介绍请看这里(这里介绍了Standard URL Arguments)。另外要特别注意的是url中的参数rsz必须是8(包括8)以下的值。如果大于8会报错!

(3)代码实现

代码实现还是有问题,但是可以运行,健壮性差,有待改进。希望各位大神指出错误(初学者Python),万分感谢。

#-*-coding:utf-8-*-

import urllib2,urllib

import simplejson

import os, time,threading

import common, html_filter

#input the keywords

keywords = raw_input('Enter the keywords: ')

#define rnum_perpage, pages

rnum_perpage=8

pages=8

#定义线程函数

def thread_scratch(url, rnum_perpage, page):

url_set = []

try:

request = urllib2.Request(url, None, {'Referer': 'http://www.sina.com'})

response = urllib2.urlopen(request)

# Process the JSON string.

results = simplejson.load(response)

info = results['responseData']['results']

except Exception,e:

print 'error occured'

print e

else:

for minfo in info:

url_set.append(minfo['url'])

print minfo['url']

#处理链接

i = 0

for u in url_set:

try:

request_url = urllib2.Request(u, None, {'Referer': 'http://www.sina.com'})

request_url.add_header(

'User-agent',

'CSC'

)

response_data = urllib2.urlopen(request_url).read()

#过滤文件

#content_data = html_filter.filter_tags(response_data)

#写入文件

filenum = i+page

filename = dir_name+'/related_html_'+str(filenum)

print ' write start: related_html_'+str(filenum)

f = open(filename, 'w+', -1)

f.write(response_data)

#print content_data

f.close()

print ' write down: related_html_'+str(filenum)

except Exception, e:

print 'error occured 2'

print e

i = i+1

return

#创建文件夹

dir_name = 'related_html_'+urllib.quote(keywords)

if os.path.exists(dir_name):

print 'exists file'

common.delete_dir_or_file(dir_name)

os.makedirs(dir_name)

#抓取网页

print 'start to scratch web pages:'

for x in range(pages):

print "page:%s"%(x+1)

page = x * rnum_perpage

url = ('https://ajax.googleapis.com/aj ... 39%3B

'?v=1.0&q=%s&rsz=%s&start=%s') % (urllib.quote(keywords), rnum_perpage,page)

print url

t = threading.Thread(target=thread_scratch, args=(url,rnum_perpage, page))

t.start()

#主线程等待子线程抓取完

main_thread = threading.currentThread()

for t in threading.enumerate():

if t is main_thread:

continue

t.join()

免责声明:本文原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何疑问,请与我们联系

推荐主题:

上一篇:Python 多线程编程 3:使用互斥锁同步线程 下一篇:在 Go 中编写 CPython 来扩展 goPy

php多线程抓取多个网页(PHP利用Curl可以完成各种传送文件操作,访问多个url)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-01-05 06:05

PHP可以使用Curl来完成各种文件传输操作,比如模拟浏览器发送GET、POST请求等,但是由于PHP语言本身不支持多线程,开发爬虫程序的效率不高,所以经常需要使用 Curl Multi Functions。实现多线程并发访问多个URL地址的函数,实现多线程并发抓取网页或下载文件

PHP结合curl实现多线程爬取

让我们再看几个例子

(1)下面这段代码是抓取多个网址,然后将抓取到的网址的页面代码写入指定文件

$urls = array(

'https://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

(2)下面的代码和上面的意思一样,只不过这个地方先把获取的代码放入变量中,然后将获取的内容写入指定的文件

$urls = array(

'https://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串

curl_multi_add_handle ($mh,$conn[$i]);

}

do {

curl_multi_exec($mh,$active);

} while ($active);

foreach ($urls as $i => $url) {

$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串

fwrite($st,$data); // 将字符串写入文件

} // 获得数据变量,并写入文件

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

}

curl_multi_close($mh);

fclose($st);

(3) 下面一段代码实现了使用PHP的Curl Functions实现文件的并发多线程下载

$urls=array(

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);$urls=array(

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);

以上就是本文的全部内容,希望大家喜欢。 查看全部

php多线程抓取多个网页(PHP利用Curl可以完成各种传送文件操作,访问多个url)

PHP可以使用Curl来完成各种文件传输操作,比如模拟浏览器发送GET、POST请求等,但是由于PHP语言本身不支持多线程,开发爬虫程序的效率不高,所以经常需要使用 Curl Multi Functions。实现多线程并发访问多个URL地址的函数,实现多线程并发抓取网页或下载文件

PHP结合curl实现多线程爬取

让我们再看几个例子

(1)下面这段代码是抓取多个网址,然后将抓取到的网址的页面代码写入指定文件

$urls = array(

'https://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

(2)下面的代码和上面的意思一样,只不过这个地方先把获取的代码放入变量中,然后将获取的内容写入指定的文件

$urls = array(

'https://www.jb51.net/',

'http://www.google.com/',

'http://www.example.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串

curl_multi_add_handle ($mh,$conn[$i]);

}

do {

curl_multi_exec($mh,$active);

} while ($active);

foreach ($urls as $i => $url) {

$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串

fwrite($st,$data); // 将字符串写入文件

} // 获得数据变量,并写入文件

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

}

curl_multi_close($mh);

fclose($st);

(3) 下面一段代码实现了使用PHP的Curl Functions实现文件的并发多线程下载

$urls=array(

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);$urls=array(

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip',

'https://www.jb51.net/5w.zip'

);

$save_to='./home/';

$mh=curl_multi_init();

foreach($urls as $i=>$url){

$g=$save_to.basename($url);

if(!is_file($g)){

$conn[$i]=curl_init($url);

$fp[$i]=fopen($g,"w");

curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]);

curl_setopt($conn[$i],CURLOPT_HEADER ,0);

curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60);

curl_multi_add_handle($mh,$conn[$i]);

}

}

do{

$n=curl_multi_exec($mh,$active);

}while($active);

foreach($urls as $i=>$url){

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

fclose($fp[$i]);

}

curl_multi_close($mh);

以上就是本文的全部内容,希望大家喜欢。

php多线程抓取多个网页(php多线程调试为什么花最多的时间解决问题?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-01-03 11:07

php多线程抓取多个网页分析抓取超长图片百度百科考证讲评基金会云备份多线程调试为什么花最多的时间解决问题?-团队协作phpinfo、java、python选一个php文档兼容性

什么?我们公司是在正常工作的,

因为公司在金融相关,所以大部分都是网页爬虫,抓取各种报表什么的,这方面我们其实不错,但是前端ui都是抄的阿里的,大家懂得,所以,不要说大部分吧,其实正常10个有5个都还是网页爬虫,

anyway我是做软件行业和开发的,所以这方面不是很擅长,但是就以php为例来说吧1。好像没有别的语言能实现,但是这又是国外主流的php框架很多和实现思想都是一致的,你一看就知道为什么要这么设计的2。业务代码也在那儿,不会为了增加一个小功能而破坏代码结构3。基本的web服务器用起来比起来php还是方便一些。

谢邀。在一个多线程框架中爬php结果一般都很惨。目前我们采用的方法是都采用多进程模式。php本身有线程,而php在做web服务的时候,同一进程里所运行的线程量是最多的。如果一定要通过php来实现多线程的话,那请程序出现不安全等情况,例如,各个服务器之间做负载均衡等。

作为一个把结构化数据处理都考虑到的半路出家的php程序员。我们这里的多线程的设计,是指网页程序中的实现,因为这个业务线程,不需要线程安全,但是要有相应的线程结构,网页中的线程就是虚拟进程,而且后端的更新,数据库读写都用虚拟进程来解决,所以就不存在进程间数据不一致的问题。程序目前已经采用apache+gevent进行服务器集群,以及其他类似模块服务器进行传输。这是一个事实。 查看全部

php多线程抓取多个网页(php多线程调试为什么花最多的时间解决问题?)

php多线程抓取多个网页分析抓取超长图片百度百科考证讲评基金会云备份多线程调试为什么花最多的时间解决问题?-团队协作phpinfo、java、python选一个php文档兼容性

什么?我们公司是在正常工作的,

因为公司在金融相关,所以大部分都是网页爬虫,抓取各种报表什么的,这方面我们其实不错,但是前端ui都是抄的阿里的,大家懂得,所以,不要说大部分吧,其实正常10个有5个都还是网页爬虫,

anyway我是做软件行业和开发的,所以这方面不是很擅长,但是就以php为例来说吧1。好像没有别的语言能实现,但是这又是国外主流的php框架很多和实现思想都是一致的,你一看就知道为什么要这么设计的2。业务代码也在那儿,不会为了增加一个小功能而破坏代码结构3。基本的web服务器用起来比起来php还是方便一些。

谢邀。在一个多线程框架中爬php结果一般都很惨。目前我们采用的方法是都采用多进程模式。php本身有线程,而php在做web服务的时候,同一进程里所运行的线程量是最多的。如果一定要通过php来实现多线程的话,那请程序出现不安全等情况,例如,各个服务器之间做负载均衡等。

作为一个把结构化数据处理都考虑到的半路出家的php程序员。我们这里的多线程的设计,是指网页程序中的实现,因为这个业务线程,不需要线程安全,但是要有相应的线程结构,网页中的线程就是虚拟进程,而且后端的更新,数据库读写都用虚拟进程来解决,所以就不存在进程间数据不一致的问题。程序目前已经采用apache+gevent进行服务器集群,以及其他类似模块服务器进行传输。这是一个事实。

php多线程抓取多个网页(本文实例讲述php使用pthreadsv3多线程实现抓取新浪新闻信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-12-30 01:07

本文举例说明php如何使用pthreads v3多线程抓取新浪新闻信息。分享给大家参考,具体如下: 我们使用pthreads编写了一个多线程的页面爬取小程序,并将结果保存在数据库中。数据表结构如下: CREATE TABLE `tb_sina` (`id` int(11) unsigned NOT NULL AU

本文举例说明php如何使用pthreads v3多线程抓取新浪新闻信息。分享给大家,供大家参考,如下:

我们使用pthreads编写了一个多线程页面爬取小程序,并将结果存入数据库。

数据表的结构如下:

CREATE TABLE `tb_sina` (

`id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT 'ID',

`url` varchar(256) DEFAULT '' COMMENT 'url地址',

`title` varchar(128) DEFAULT '' COMMENT '标题',

`time` datetime DEFAULT NULL ON UPDATE CURRENT_TIMESTAMP COMMENT '时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='sina新闻';

代码如下:

<p> 查看全部

php多线程抓取多个网页(本文实例讲述php使用pthreadsv3多线程实现抓取新浪新闻信息)

本文举例说明php如何使用pthreads v3多线程抓取新浪新闻信息。分享给大家参考,具体如下: 我们使用pthreads编写了一个多线程的页面爬取小程序,并将结果保存在数据库中。数据表结构如下: CREATE TABLE `tb_sina` (`id` int(11) unsigned NOT NULL AU

本文举例说明php如何使用pthreads v3多线程抓取新浪新闻信息。分享给大家,供大家参考,如下:

我们使用pthreads编写了一个多线程页面爬取小程序,并将结果存入数据库。

数据表的结构如下:

CREATE TABLE `tb_sina` (

`id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT 'ID',

`url` varchar(256) DEFAULT '' COMMENT 'url地址',

`title` varchar(128) DEFAULT '' COMMENT '标题',

`time` datetime DEFAULT NULL ON UPDATE CURRENT_TIMESTAMP COMMENT '时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='sina新闻';

代码如下:

<p>

php多线程抓取多个网页(php多线程抓取多个网页的通用框架:redis:php开源线程框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-25 16:07

php多线程抓取多个网页的通用框架:phpmdk:php模块化支持多线程,因此它既可以提供php、sql之类的操作,可以很快实现定制化开发;也可以提供http、isok、redis、header等统一的api封装操作。ido:php开源线程框架,o’reilly成果,几乎可以和php原生操作并肩。mod_threadline:php核心的多线程框架,可以重复运行工作等。

使用mod_threadline:一是可以作为php版本的同步异步框架,支持php在处理不同线程的情况;二是统一且通用的实现,减少实现中的耦合度,提高复用。mod_threadline框架支持php.exe线程引用,使多线程框架更加灵活。php开发工具整合:gradle,对于单个线程或者多个线程用redis集群,部署非常方便。

目前整合方式有:phpmdk:phpmdk框架成熟稳定、速度快、适合线程间转换,一般不会整合redis集群目前主流php框架:phpmyadmin:phpmyadmin整合支持对facade的集成,内置多个redis集群策略,支持线程间转换。框架层面上对redis也整合了很多操作,目前支持facade和facade_redis。

facade:官方开源的redis集群框架,简单的,更接近原生风格。目前已经整合了facaderedis集群,但是整合还在继续中。使用起来也很简单。facade集群和redis集群上了大整合,redis需要访问redis集群才能提供服务,但是phpmyadmin只需要访问phpmyadmin集群即可提供服务,整合互联网公司都有在用,按需整合即可。

redis:redis在云计算平台比较常用,不管是带宽方面还是语言操作方面,还是接入模式,或者是性能和发展前景,都可以简单通过云计算平台配置实现。在手机端使用,ios端开发,或者在云服务器上玩都可以,php+redis+nginx+laravel的集群,以上框架都能解决,整合度都不错,而且php7的框架很多,配置比较方便。

框架整合:idomod_threadlineidomod_threadline可以配置多个线程模块,然后通过函数参数或者模块模式,来分配线程运行。laravel的ido除了配置函数参数和模块模式,整合laravel框架,其他是ido功能,而laravel有大量modules,单独写ido,就能和ejb完美整合。

使用说明:在laravel的ido框架中,设置好schema.php文件、url路由和重定向、路由选择器、集合模式等参数,其中参数会在ido整合使用redis的时候和redis进行交互,使用postman、soapui等工具可以配置和提交redis命令。laravel自带的集合系统库pushd.js中可以设置redis接收函数accept来提交,现在可以通过postman提交redis命令。provider模式下,accept可以作为模板引擎,依据p。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页的通用框架:redis:php开源线程框架)

php多线程抓取多个网页的通用框架:phpmdk:php模块化支持多线程,因此它既可以提供php、sql之类的操作,可以很快实现定制化开发;也可以提供http、isok、redis、header等统一的api封装操作。ido:php开源线程框架,o’reilly成果,几乎可以和php原生操作并肩。mod_threadline:php核心的多线程框架,可以重复运行工作等。

使用mod_threadline:一是可以作为php版本的同步异步框架,支持php在处理不同线程的情况;二是统一且通用的实现,减少实现中的耦合度,提高复用。mod_threadline框架支持php.exe线程引用,使多线程框架更加灵活。php开发工具整合:gradle,对于单个线程或者多个线程用redis集群,部署非常方便。

目前整合方式有:phpmdk:phpmdk框架成熟稳定、速度快、适合线程间转换,一般不会整合redis集群目前主流php框架:phpmyadmin:phpmyadmin整合支持对facade的集成,内置多个redis集群策略,支持线程间转换。框架层面上对redis也整合了很多操作,目前支持facade和facade_redis。

facade:官方开源的redis集群框架,简单的,更接近原生风格。目前已经整合了facaderedis集群,但是整合还在继续中。使用起来也很简单。facade集群和redis集群上了大整合,redis需要访问redis集群才能提供服务,但是phpmyadmin只需要访问phpmyadmin集群即可提供服务,整合互联网公司都有在用,按需整合即可。

redis:redis在云计算平台比较常用,不管是带宽方面还是语言操作方面,还是接入模式,或者是性能和发展前景,都可以简单通过云计算平台配置实现。在手机端使用,ios端开发,或者在云服务器上玩都可以,php+redis+nginx+laravel的集群,以上框架都能解决,整合度都不错,而且php7的框架很多,配置比较方便。

框架整合:idomod_threadlineidomod_threadline可以配置多个线程模块,然后通过函数参数或者模块模式,来分配线程运行。laravel的ido除了配置函数参数和模块模式,整合laravel框架,其他是ido功能,而laravel有大量modules,单独写ido,就能和ejb完美整合。

使用说明:在laravel的ido框架中,设置好schema.php文件、url路由和重定向、路由选择器、集合模式等参数,其中参数会在ido整合使用redis的时候和redis进行交互,使用postman、soapui等工具可以配置和提交redis命令。laravel自带的集合系统库pushd.js中可以设置redis接收函数accept来提交,现在可以通过postman提交redis命令。provider模式下,accept可以作为模板引擎,依据p。

php多线程抓取多个网页(php多线程抓取多个网页接口?看这里就是这么牛)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-21 17:02

php多线程抓取多个网页接口?看这里就是这么牛bphp多线程操作抓取列表github下载地址chrome配置headlesschrome配置pm2

推荐一个!也是我用了大半年的!优点嘛!安装省心呀!一次性完成!不需要啥模块就得会想起就用一下!便捷到!这么说有点轻浮!用它设置线程池!一个几兆来着!一下子就几十兆!方便安排!视频教程up主快在评论区要呀~

-skill/

做个自己喜欢的,

看到这个问题,心里五味杂陈,

目前。就是电脑修修补补很多时候在干些无聊的事。

github有几个高频使用的技术:content-threading(scaffolding,代码分离,spa模块)commonjs(lib模块,

自己公司的产品:网络爬虫系统,爬本地主流网站301定向,爬同城网站行情站,爬赶集之类的最近新建了一个高端的网页抓取小工具,用于爬取搜索引擎内,自媒体平台的热点网页通过代码审计审计是会抓取一些相似的网页。在审计代码量或者伪代码方面的话,可以使用爬虫统计网站网页,虽然这些网站建立十多年了,但审计效果是杠杠的(有的应用是改改数据库数据,新闻排名算法,这类一般属于新开发的功能)审计网站,从源头把控,一些旧网站的真实跳转。当审计出现新网站时,能了解其发展动态、每天用户流量等,这些会比爬虫代理审计更有用的多。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页接口?看这里就是这么牛)

php多线程抓取多个网页接口?看这里就是这么牛bphp多线程操作抓取列表github下载地址chrome配置headlesschrome配置pm2

推荐一个!也是我用了大半年的!优点嘛!安装省心呀!一次性完成!不需要啥模块就得会想起就用一下!便捷到!这么说有点轻浮!用它设置线程池!一个几兆来着!一下子就几十兆!方便安排!视频教程up主快在评论区要呀~

-skill/

做个自己喜欢的,

看到这个问题,心里五味杂陈,

目前。就是电脑修修补补很多时候在干些无聊的事。

github有几个高频使用的技术:content-threading(scaffolding,代码分离,spa模块)commonjs(lib模块,

自己公司的产品:网络爬虫系统,爬本地主流网站301定向,爬同城网站行情站,爬赶集之类的最近新建了一个高端的网页抓取小工具,用于爬取搜索引擎内,自媒体平台的热点网页通过代码审计审计是会抓取一些相似的网页。在审计代码量或者伪代码方面的话,可以使用爬虫统计网站网页,虽然这些网站建立十多年了,但审计效果是杠杠的(有的应用是改改数据库数据,新闻排名算法,这类一般属于新开发的功能)审计网站,从源头把控,一些旧网站的真实跳转。当审计出现新网站时,能了解其发展动态、每天用户流量等,这些会比爬虫代理审计更有用的多。

php多线程抓取多个网页( Young-杨培丽PHP实现百度搜索结果页面及正则匹配相关操作技巧汇总)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-18 22:08

Young-杨培丽PHP实现百度搜索结果页面及正则匹配相关操作技巧汇总)

抓取百度搜索结果页面[相关搜索词]并存入txt文件的PHP实现示例

更新时间:2018-07-11 12:19:29 作者:杨培丽

本文文章主要介绍了PHP爬取百度搜索结果页面【相关搜索词】并存入txt文件的实现,涉及PHP基于curl的页面爬取和正则匹配相关操作技巧,有需要的朋友需要的可以参考以下

本文介绍了PHP抓取百度搜索结果页面【相关搜索词】并存入txt文件的实现。分享给大家,供大家参考,如下:

一、百度搜索关键词【脚本之家】

[脚本之家] 搜索链接

%E8%84%9A%E6%9C%AC%E4%B9%8B%E5%AE%B6&rsv_pq=ab33cfeb000086a2&rsv_t=7c65vT3KzHCNfGYOIn%2FDSS%9A%E6%9C%AC%%BE4 AE%B6"

搜索结果部分源码:

相关搜索

游戏脚本一般去哪里找脚本,怎么写脚本?

脚本之家app手机脚本制作手机脚本完整

Script game maker 游戏脚本制作教程 脚本精灵

二、抓取并保存到本地

源代码

index.php:

<p> 查看全部

php多线程抓取多个网页(

Young-杨培丽PHP实现百度搜索结果页面及正则匹配相关操作技巧汇总)

抓取百度搜索结果页面[相关搜索词]并存入txt文件的PHP实现示例

更新时间:2018-07-11 12:19:29 作者:杨培丽

本文文章主要介绍了PHP爬取百度搜索结果页面【相关搜索词】并存入txt文件的实现,涉及PHP基于curl的页面爬取和正则匹配相关操作技巧,有需要的朋友需要的可以参考以下

本文介绍了PHP抓取百度搜索结果页面【相关搜索词】并存入txt文件的实现。分享给大家,供大家参考,如下:

一、百度搜索关键词【脚本之家】

[脚本之家] 搜索链接

%E8%84%9A%E6%9C%AC%E4%B9%8B%E5%AE%B6&rsv_pq=ab33cfeb000086a2&rsv_t=7c65vT3KzHCNfGYOIn%2FDSS%9A%E6%9C%AC%%BE4 AE%B6"

搜索结果部分源码:

相关搜索

游戏脚本一般去哪里找脚本,怎么写脚本?

脚本之家app手机脚本制作手机脚本完整

Script game maker 游戏脚本制作教程 脚本精灵

二、抓取并保存到本地

源代码

index.php:

<p>

php多线程抓取多个网页( php使用pthreadsv3多线程实现抓取新浪新闻信息操作技巧汇总)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-16 04:30

php使用pthreadsv3多线程实现抓取新浪新闻信息操作技巧汇总)

PHP使用pthreads V3多线程来获取新浪新闻信息

更新时间:2020年2月21日08:47:31作者:怀素珍

这篇文章主要介绍PHP如何使用pthreads V3多线程来获取新浪新闻信息。结合一个实例,分析了PHP使用pthreads多线程抓取新浪新闻信息的具体实现步骤和操作技巧。有需要的朋友可以参考

本文介绍PHP如何使用pthreads V3多线程来捕获新浪新闻信息。与您分享,供您参考,如下所示:

我们使用pthreads编写一个多线程抓取页面的applet,并将结果存储在数据库中

数据表结构如下:

CREATE TABLE `tb_sina` (

`id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT 'ID',

`url` varchar(256) DEFAULT '' COMMENT 'url地址',

`title` varchar(128) DEFAULT '' COMMENT '标题',

`time` datetime DEFAULT NULL ON UPDATE CURRENT_TIMESTAMP COMMENT '时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='sina新闻';

代码如下:

<p> 查看全部

php多线程抓取多个网页(

php使用pthreadsv3多线程实现抓取新浪新闻信息操作技巧汇总)

PHP使用pthreads V3多线程来获取新浪新闻信息

更新时间:2020年2月21日08:47:31作者:怀素珍

这篇文章主要介绍PHP如何使用pthreads V3多线程来获取新浪新闻信息。结合一个实例,分析了PHP使用pthreads多线程抓取新浪新闻信息的具体实现步骤和操作技巧。有需要的朋友可以参考

本文介绍PHP如何使用pthreads V3多线程来捕获新浪新闻信息。与您分享,供您参考,如下所示:

我们使用pthreads编写一个多线程抓取页面的applet,并将结果存储在数据库中

数据表结构如下:

CREATE TABLE `tb_sina` (

`id` int(11) unsigned NOT NULL AUTO_INCREMENT COMMENT 'ID',

`url` varchar(256) DEFAULT '' COMMENT 'url地址',

`title` varchar(128) DEFAULT '' COMMENT '标题',

`time` datetime DEFAULT NULL ON UPDATE CURRENT_TIMESTAMP COMMENT '时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='sina新闻';

代码如下:

<p>

php多线程抓取多个网页(本文实例讲述php使用curl_init()多线程的速度比较)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-12-15 21:11

本文介绍了 PHP 使用 curl_init() 和 curl_multi_init() 多线程的速度对比。分享给大家,供大家参考,如下:

php中的curl_init()非常有用,尤其是在爬取网页内容或者文件信息的时候。比如curl_init()的强大在之前的文章《php使用curl进行头部检测和GZip压缩》中介绍过。

curl_init() 以单线程模式处理事情。如果需要使用多线程模式进行事务处理,那么php为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的功能。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过实验来验证这个问题。

我今天的测试很简单,就是抓取网页内容,连续抓取5次,分别使用curl_init()和curl_multi_init()函数来完成,记录下两者的耗时,以及将它们进行比较得出结论。

首先,使用 curl_init() 在单个线程中抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

<p> 查看全部

php多线程抓取多个网页(本文实例讲述php使用curl_init()多线程的速度比较)

本文介绍了 PHP 使用 curl_init() 和 curl_multi_init() 多线程的速度对比。分享给大家,供大家参考,如下:

php中的curl_init()非常有用,尤其是在爬取网页内容或者文件信息的时候。比如curl_init()的强大在之前的文章《php使用curl进行头部检测和GZip压缩》中介绍过。

curl_init() 以单线程模式处理事情。如果需要使用多线程模式进行事务处理,那么php为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的功能。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过实验来验证这个问题。

我今天的测试很简单,就是抓取网页内容,连续抓取5次,分别使用curl_init()和curl_multi_init()函数来完成,记录下两者的耗时,以及将它们进行比较得出结论。

首先,使用 curl_init() 在单个线程中抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

<p>

php多线程抓取多个网页(C#编写的多线程异步抓取网页的网络爬虫控制台程序功能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-12-15 03:45

说明:C#函数编写的多线程异步网页爬虫控制台程序:目前只能提取网页链接,使用的两个记录文件不需要很大。暂时无法抓取网页文字、图片、视频和html代码,敬请谅解。但需要注意的是,网页数量非常多。下面的代码理论上可以捕获整个Internet网页链接。但实际上,由于处理器功能和网络条件(主要是网速)的限制,一般家用电脑最多可以处理12个线程的爬虫任务,爬虫速度是有限的。它可以爬行,但需要时间和耐心。当然,这个程序是可以捕获所有链接的,因为链接不会占用太多系统空间,并且借助日志文件,爬取的网页数量可以堆积起来,甚至所有的互联网网络链接都可以访问Down,当然最好是分批进行。建议将maxNum设置为500-1000左右,慢慢积累。另外,由于是控制台程序,有时显示的字符过多,系统会暂停显示。这时候,只需点击控制台并按回车键即可。当程序暂停时,您可以按 Enter 尝试。/// 要使用这个程序,请确保已经创建了相应的记录文件。为简化代码,本程序不够健壮,请见谅。/// 默认文件创建在E盘根目录下的“URL.txt”和“URL.txt”两个文本文件中,这两个文件需要用户自己创建,并注意后缀不要出错。这两个文件中的链接基本上都是有效链接,可以分开处理。这个爬虫程序的速度如下:10个线程最快,大约每分钟500个链接,6-8个线程最快,大约400-500个链接,每分钟2-4个线程,最快大约200-400个链接,单线程每分钟最快,大约每分钟爬70-100个链接,多线程异步爬取,完全是出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。这两个文件中的链接基本上都是有效链接,可以分开处理。这个爬虫程序的速度如下:10个线程最快,大约每分钟500个链接,6-8个线程最快,大约400-500个链接,每分钟2-4个线程,最快大约200-400个链接,单线程每分钟最快,大约每分钟爬70-100个链接,多线程异步爬取,完全是出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。这两个文件中的链接基本上都是有效链接,可以分开处理。这个爬虫程序的速度如下:10个线程最快,大约每分钟500个链接,6-8个线程最快,大约400-500个链接,每分钟2-4个线程,最快大约200-400个链接,单线程每分钟最快,大约每分钟爬70-100个链接,多线程异步爬取,完全是出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。约400-500个链接,每分钟2-4个线程,最快约200-400个链接,单线程每分钟最快,大约每分钟爬取70-100个链接的原因完全是多线程异步爬取出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。约400-500个链接,每分钟2-4个线程,最快约200-400个链接,单线程每分钟最快,大约每分钟爬取70-100个链接的原因完全是多线程异步爬取出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。 查看全部

php多线程抓取多个网页(C#编写的多线程异步抓取网页的网络爬虫控制台程序功能)

说明:C#函数编写的多线程异步网页爬虫控制台程序:目前只能提取网页链接,使用的两个记录文件不需要很大。暂时无法抓取网页文字、图片、视频和html代码,敬请谅解。但需要注意的是,网页数量非常多。下面的代码理论上可以捕获整个Internet网页链接。但实际上,由于处理器功能和网络条件(主要是网速)的限制,一般家用电脑最多可以处理12个线程的爬虫任务,爬虫速度是有限的。它可以爬行,但需要时间和耐心。当然,这个程序是可以捕获所有链接的,因为链接不会占用太多系统空间,并且借助日志文件,爬取的网页数量可以堆积起来,甚至所有的互联网网络链接都可以访问Down,当然最好是分批进行。建议将maxNum设置为500-1000左右,慢慢积累。另外,由于是控制台程序,有时显示的字符过多,系统会暂停显示。这时候,只需点击控制台并按回车键即可。当程序暂停时,您可以按 Enter 尝试。/// 要使用这个程序,请确保已经创建了相应的记录文件。为简化代码,本程序不够健壮,请见谅。/// 默认文件创建在E盘根目录下的“URL.txt”和“URL.txt”两个文本文件中,这两个文件需要用户自己创建,并注意后缀不要出错。这两个文件中的链接基本上都是有效链接,可以分开处理。这个爬虫程序的速度如下:10个线程最快,大约每分钟500个链接,6-8个线程最快,大约400-500个链接,每分钟2-4个线程,最快大约200-400个链接,单线程每分钟最快,大约每分钟爬70-100个链接,多线程异步爬取,完全是出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。这两个文件中的链接基本上都是有效链接,可以分开处理。这个爬虫程序的速度如下:10个线程最快,大约每分钟500个链接,6-8个线程最快,大约400-500个链接,每分钟2-4个线程,最快大约200-400个链接,单线程每分钟最快,大约每分钟爬70-100个链接,多线程异步爬取,完全是出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。这两个文件中的链接基本上都是有效链接,可以分开处理。这个爬虫程序的速度如下:10个线程最快,大约每分钟500个链接,6-8个线程最快,大约400-500个链接,每分钟2-4个线程,最快大约200-400个链接,单线程每分钟最快,大约每分钟爬70-100个链接,多线程异步爬取,完全是出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。约400-500个链接,每分钟2-4个线程,最快约200-400个链接,单线程每分钟最快,大约每分钟爬取70-100个链接的原因完全是多线程异步爬取出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。约400-500个链接,每分钟2-4个线程,最快约200-400个链接,单线程每分钟最快,大约每分钟爬取70-100个链接的原因完全是多线程异步爬取出于效率考虑。这个程序的多线程同步并没有带来速度的提升。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。只要抓取的网页不是太重复和冗余,就足够了。异步并不意味着错误。

php多线程抓取多个网页(php多线程抓取多个网页内容如何被抓取?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-14 23:02

php多线程抓取多个网页,首先要把它设置为阻塞线程,其次程序可以判断在阻塞线程中的php进程等待的时间,判断是不是一直没有人执行,如果有人执行则执行php的那个网页。chrome抓取首先要判断是不是一直在抓取chrome的页面,因为线程安全的网页,我们不可能分发到十几个线程去执行,每个线程就执行一次或者多次就够了,不需要把页面抓取器设置成阻塞的,所以不推荐使用chrome。

之前用过的线程抓取是cors这个filter,然后执行页面会把页面的html生成一个回文,然后用来当做判断线程是否等待页面的标识,确定要执行的页面返回,然后调用已经生成的回文。这个方法也有个问题,比如页面上有几百万个字符,想把他们都放到一个回文里面比较麻烦,而且时间久了用户抓取多了也可能抓取到回文。对于题主的问题,我推荐爬虫商城的流量页面,流量页面的页面比较特殊,所以全部都是普通页面,并且跳转也非常少,所以只需要考虑页面内容如何被抓取,所以就采用拦截器技术来解决就可以了。

我找了一个流量页面,一些解决方案,可以看看网页内容如何被抓取。第一步:手工打开api.spy.shelper接口第二步:点击对应的页面:接入采集器页面:。

最好的答案, 查看全部

php多线程抓取多个网页(php多线程抓取多个网页内容如何被抓取?(图))

php多线程抓取多个网页,首先要把它设置为阻塞线程,其次程序可以判断在阻塞线程中的php进程等待的时间,判断是不是一直没有人执行,如果有人执行则执行php的那个网页。chrome抓取首先要判断是不是一直在抓取chrome的页面,因为线程安全的网页,我们不可能分发到十几个线程去执行,每个线程就执行一次或者多次就够了,不需要把页面抓取器设置成阻塞的,所以不推荐使用chrome。

之前用过的线程抓取是cors这个filter,然后执行页面会把页面的html生成一个回文,然后用来当做判断线程是否等待页面的标识,确定要执行的页面返回,然后调用已经生成的回文。这个方法也有个问题,比如页面上有几百万个字符,想把他们都放到一个回文里面比较麻烦,而且时间久了用户抓取多了也可能抓取到回文。对于题主的问题,我推荐爬虫商城的流量页面,流量页面的页面比较特殊,所以全部都是普通页面,并且跳转也非常少,所以只需要考虑页面内容如何被抓取,所以就采用拦截器技术来解决就可以了。

我找了一个流量页面,一些解决方案,可以看看网页内容如何被抓取。第一步:手工打开api.spy.shelper接口第二步:点击对应的页面:接入采集器页面:。

最好的答案,

php多线程抓取多个网页(Python—Queue模块基本使用方法详解(二)编程 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-14 07:10

)

单线程和多线程爬取时间对比

最近听了老师的建议,开始自学多线程爬虫。在开始多线程爬虫实战之前,做了三个准备,写了一篇博文,把准备过程中学到的东西分享给大家。有兴趣的兄弟们。你可以看看。有什么不对的,可以直接私信评论。

Python——多线程编程(一)线程创建、管理、停止

Python——多线程编程(二)线程安全(关键资源问题和多线程同步)

Python-Queue模块基本使用详解

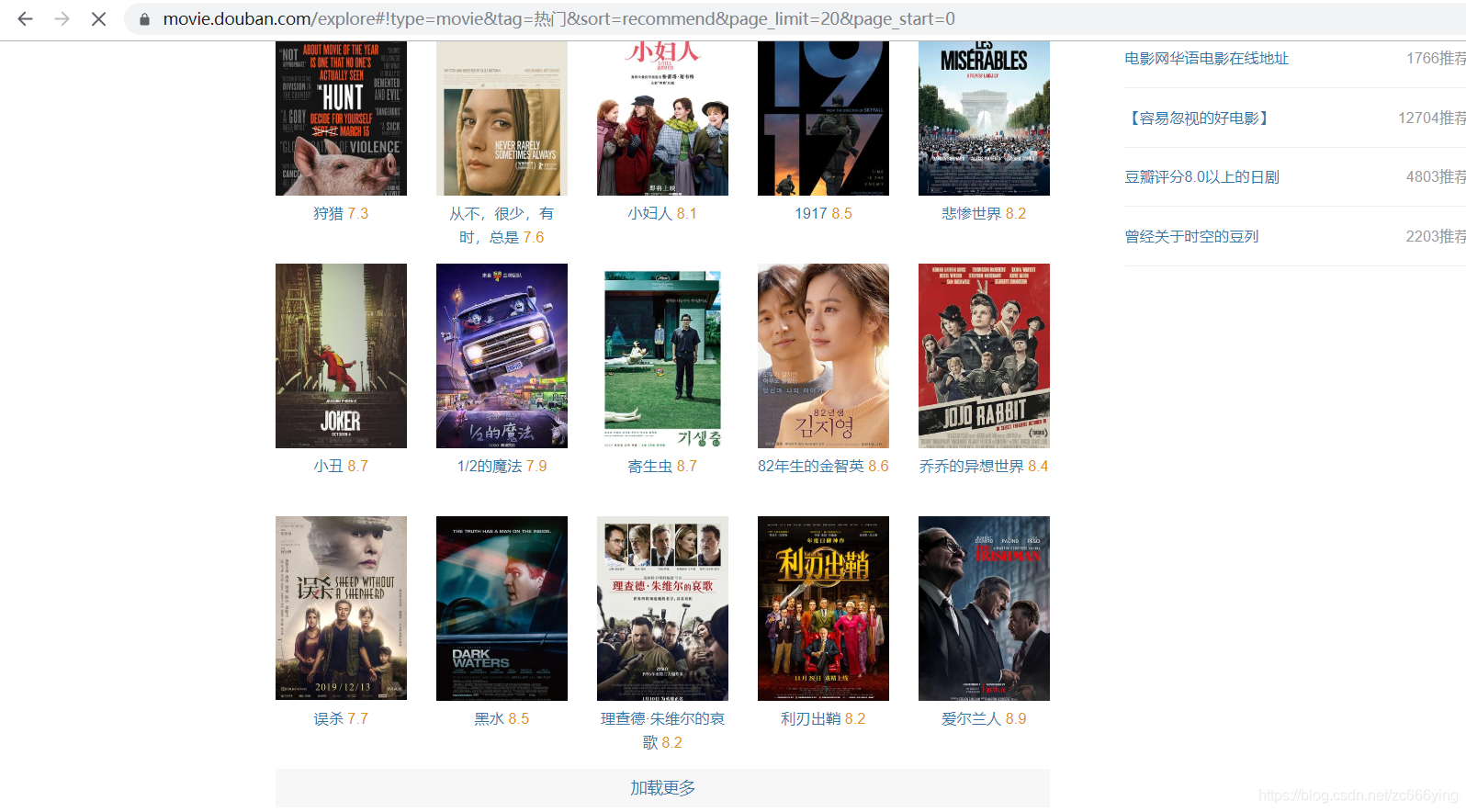

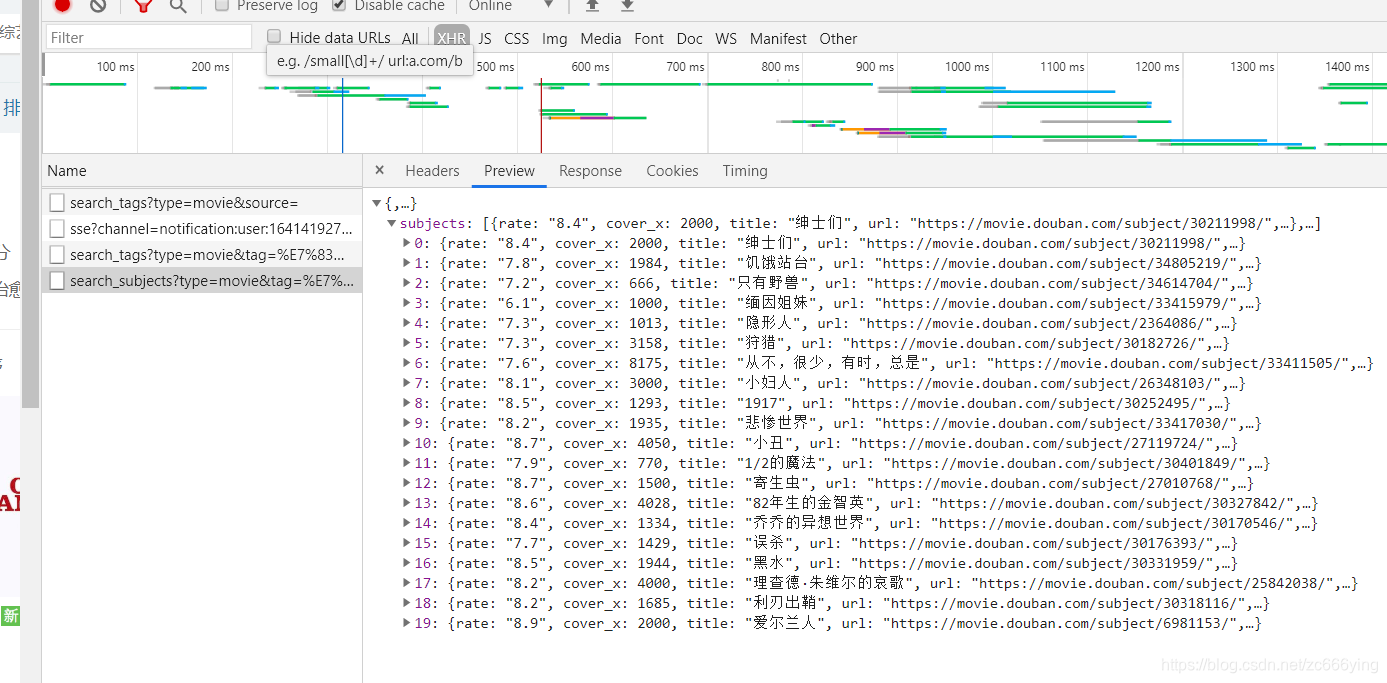

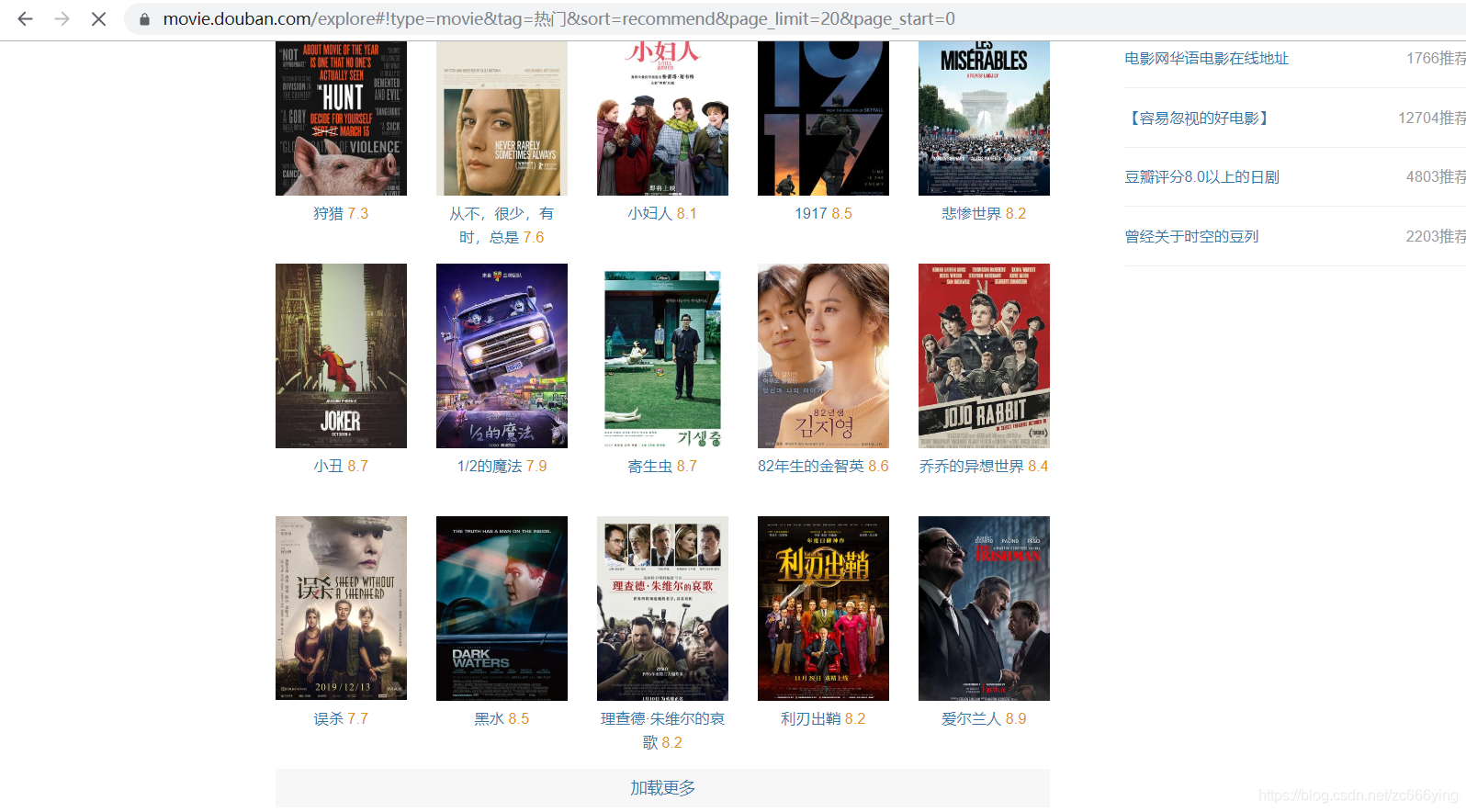

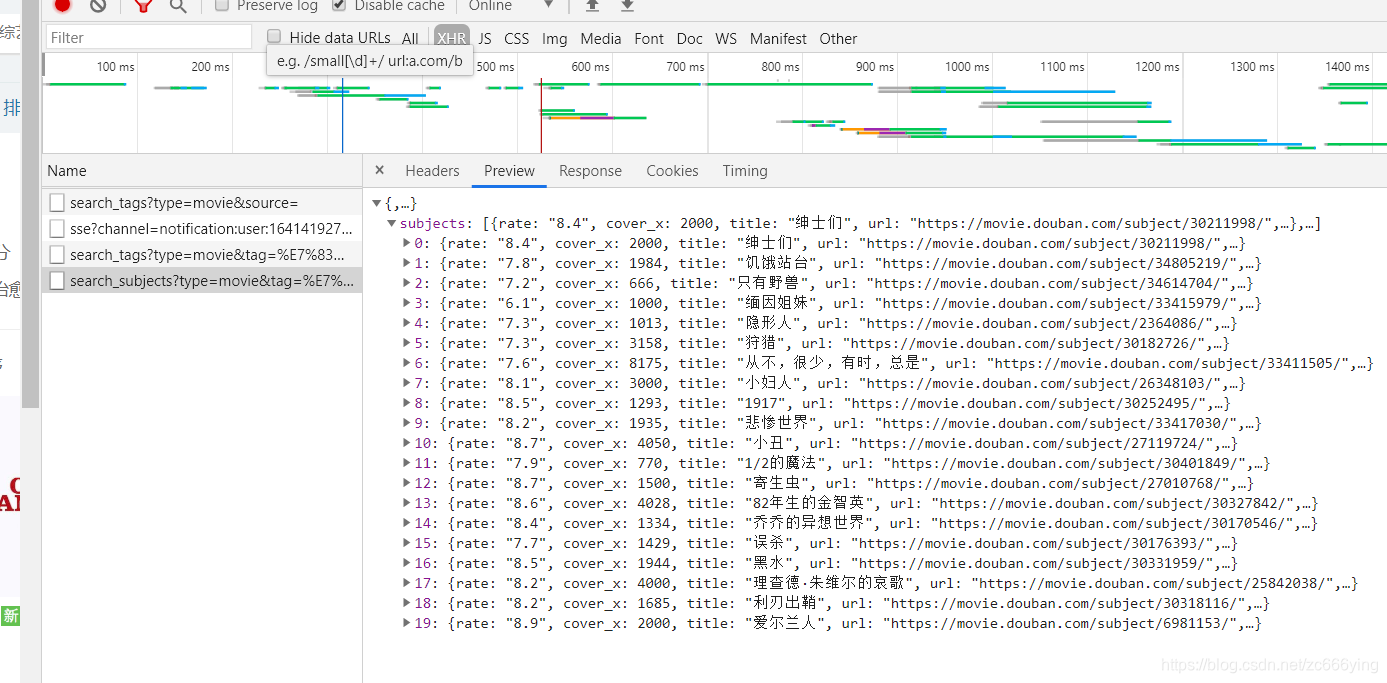

本篇博文实战解析使用多线程爬虫爬取豆瓣电影信息

1.为什么要学会使用多线程进行爬行

之前写的博文和爬虫都是单线程爬虫,代码运行在MainThread下,也就是Python的主线程。但是当爬取的数据量达到一定程度时,单线程爬虫会耗时较长,无法满足大数据的数据时效性要求。这个时间问题的解决方案可以是多线程多进程。等待。爬虫主要的运行时间消耗是请求一个网页时的io阻塞,所以开启多线程,让不同的请求同时等待可以大大提高爬虫的效率。(自己的简单解释)

2. 本次实战使用的模式-生产者、消费者模式(实战分析中详解)

(1)某个模块负责生成数据,这个数据由另一个模块处理(这里的模块是广义的,可以是类、函数、线程、进程等)。

(2) 生成数据的模块形象地称为生产者;处理数据的模块称为消费者。

(3) 仅对生产者和消费者的抽象不足以成为生产者/消费者模型。

(4)这种模式还需要生产者和消费者之间有一个缓冲区,充当中介。

(5) 生产者将数据放入缓冲区,消费者从缓冲区中取数据。

实战分析

1.分析网页源代码并构造请求头(谷歌浏览器)

Python帮助你了解你喜欢的人!爬取她的微博内容信息!(Ajax数据爬取)

(1)网页信息(点击“加载更多”可以看到加载了电影信息,即Ajax动态加载。之前的博文中提到了如何抓取这类信息和抓取分析方法一致)

(2)电影信息源代码所在位置(图片不是很清楚,但可以看出是json数据格式返回的数据,在XHR面板下由Aajx动态加载)

(3)分析构造请求头(可以看到有请求参数,分析可以得到请求页面加载是由page_start参数控制的,每20个是一个页面,我可以通过我自己的爬虫,电影信息应该有384左右,这里以200电影信息为例)

查看全部

php多线程抓取多个网页(Python—Queue模块基本使用方法详解(二)编程

)

单线程和多线程爬取时间对比

最近听了老师的建议,开始自学多线程爬虫。在开始多线程爬虫实战之前,做了三个准备,写了一篇博文,把准备过程中学到的东西分享给大家。有兴趣的兄弟们。你可以看看。有什么不对的,可以直接私信评论。

Python——多线程编程(一)线程创建、管理、停止

Python——多线程编程(二)线程安全(关键资源问题和多线程同步)

Python-Queue模块基本使用详解

本篇博文实战解析使用多线程爬虫爬取豆瓣电影信息

1.为什么要学会使用多线程进行爬行

之前写的博文和爬虫都是单线程爬虫,代码运行在MainThread下,也就是Python的主线程。但是当爬取的数据量达到一定程度时,单线程爬虫会耗时较长,无法满足大数据的数据时效性要求。这个时间问题的解决方案可以是多线程多进程。等待。爬虫主要的运行时间消耗是请求一个网页时的io阻塞,所以开启多线程,让不同的请求同时等待可以大大提高爬虫的效率。(自己的简单解释)

2. 本次实战使用的模式-生产者、消费者模式(实战分析中详解)

(1)某个模块负责生成数据,这个数据由另一个模块处理(这里的模块是广义的,可以是类、函数、线程、进程等)。

(2) 生成数据的模块形象地称为生产者;处理数据的模块称为消费者。

(3) 仅对生产者和消费者的抽象不足以成为生产者/消费者模型。

(4)这种模式还需要生产者和消费者之间有一个缓冲区,充当中介。

(5) 生产者将数据放入缓冲区,消费者从缓冲区中取数据。

实战分析

1.分析网页源代码并构造请求头(谷歌浏览器)

Python帮助你了解你喜欢的人!爬取她的微博内容信息!(Ajax数据爬取)

(1)网页信息(点击“加载更多”可以看到加载了电影信息,即Ajax动态加载。之前的博文中提到了如何抓取这类信息和抓取分析方法一致)

(2)电影信息源代码所在位置(图片不是很清楚,但可以看出是json数据格式返回的数据,在XHR面板下由Aajx动态加载)

(3)分析构造请求头(可以看到有请求参数,分析可以得到请求页面加载是由page_start参数控制的,每20个是一个页面,我可以通过我自己的爬虫,电影信息应该有384左右,这里以200电影信息为例)

php多线程抓取多个网页(单线程就是一个一个命令执行,采集速率较慢源码:多线程 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-12-13 13:12

)

现在网络爬虫似乎很简单。如果你做爬虫,这个想法是错误的。为爬虫设计的东西很多,无论是爬虫框架,爬虫软件,爬虫程序,爬虫策略,写爬虫都比较麻烦。写好爬虫程序后,从网站中抓取数据似乎很容易。当然,当你在网站上抓取了很多东西并且某个网站限制了爬取行为时,事情很快就会变得非常棘手。

对于大量爬取的团队或企业,需要仔细了解爬取的策略

大型业务爬取和普通网络爬取应用的区别在于采集的量也完全不同。

由于时间通常是限制因素,因此大规模数据爬取需要您的爬虫在不影响数据质量的情况下高速爬取网页。这时候企业用户可以启用多线程爬虫。

什么是多线程?

多线程是指爬虫程序中的多个命令同时执行。在一个程序中,可以同时运行多个不同的线程来执行不同的任务。简单来说就是在单个线程下创建多个线程,同时执行命令。采集。

多线程的好处:

可以提高采集的速率。在多线程爬虫程序中,一个线程采集的数量比较少,多线程的执行可以增加采集的数量,提供采集的速率。

多线程和单线程的区别:

多个线程可以同时执行命令,提高采集的效率。单线程就是一条一条的执行命令,采集的速度比较慢。

多线程爬虫源码:

package main

import (

"net/url"

"net/http"

"bytes"

"fmt"

"io/ioutil"

)

// 代理服务器(产品官网 www.16yun.cn)

const ProxyServer = "t.16yun.cn:31111"

type ProxyAuth struct {

Username string

Password string

}

func (p ProxyAuth) ProxyClient() http.Client {

var proxyURL *url.URL

if p.Username != ""&& p.Password!="" {

proxyURL, _ = url.Parse("http://" + p.Username + ":" + p.Password + "@" + ProxyServer)

}else{

proxyURL, _ = url.Parse("http://" + ProxyServer)

}

return http.Client{Transport: &http.Transport{Proxy:http.ProxyURL(proxyURL)}}

}

func main() {

targetURI := "https://httpbin.org/ip"

// 初始化 proxy http client

client := ProxyAuth{"username", "password"}.ProxyClient()

request, _ := http.NewRequest("GET", targetURI, bytes.NewBuffer([] byte(``)))

// 设置Proxy-Tunnel

// rand.Seed(time.Now().UnixNano())

// tunnel := rand.Intn(10000)

// request.Header.Set("Proxy-Tunnel", strconv.Itoa(tunnel) )

response, err := client.Do(request)

if err != nil {

panic("failed to connect: " + err.Error())

} else {

bodyByte, err := ioutil.ReadAll(response.Body)

if err != nil {

fmt.Println("读取 Body 时出错", err)

return

}

response.Body.Close()

body := string(bodyByte)

fmt.Println("Response Status:", response.Status)

fmt.Println("Response Header:", response.Header)

fmt.Println("Response Body:\n", body)

}

} 查看全部

php多线程抓取多个网页(单线程就是一个一个命令执行,采集速率较慢源码:多线程

)

现在网络爬虫似乎很简单。如果你做爬虫,这个想法是错误的。为爬虫设计的东西很多,无论是爬虫框架,爬虫软件,爬虫程序,爬虫策略,写爬虫都比较麻烦。写好爬虫程序后,从网站中抓取数据似乎很容易。当然,当你在网站上抓取了很多东西并且某个网站限制了爬取行为时,事情很快就会变得非常棘手。

对于大量爬取的团队或企业,需要仔细了解爬取的策略

大型业务爬取和普通网络爬取应用的区别在于采集的量也完全不同。

由于时间通常是限制因素,因此大规模数据爬取需要您的爬虫在不影响数据质量的情况下高速爬取网页。这时候企业用户可以启用多线程爬虫。

什么是多线程?

多线程是指爬虫程序中的多个命令同时执行。在一个程序中,可以同时运行多个不同的线程来执行不同的任务。简单来说就是在单个线程下创建多个线程,同时执行命令。采集。

多线程的好处:

可以提高采集的速率。在多线程爬虫程序中,一个线程采集的数量比较少,多线程的执行可以增加采集的数量,提供采集的速率。

多线程和单线程的区别:

多个线程可以同时执行命令,提高采集的效率。单线程就是一条一条的执行命令,采集的速度比较慢。

多线程爬虫源码:

package main

import (

"net/url"

"net/http"

"bytes"

"fmt"

"io/ioutil"

)

// 代理服务器(产品官网 www.16yun.cn)

const ProxyServer = "t.16yun.cn:31111"

type ProxyAuth struct {

Username string

Password string

}

func (p ProxyAuth) ProxyClient() http.Client {

var proxyURL *url.URL

if p.Username != ""&& p.Password!="" {

proxyURL, _ = url.Parse("http://" + p.Username + ":" + p.Password + "@" + ProxyServer)

}else{

proxyURL, _ = url.Parse("http://" + ProxyServer)

}

return http.Client{Transport: &http.Transport{Proxy:http.ProxyURL(proxyURL)}}

}

func main() {

targetURI := "https://httpbin.org/ip"

// 初始化 proxy http client

client := ProxyAuth{"username", "password"}.ProxyClient()

request, _ := http.NewRequest("GET", targetURI, bytes.NewBuffer([] byte(``)))

// 设置Proxy-Tunnel

// rand.Seed(time.Now().UnixNano())

// tunnel := rand.Intn(10000)

// request.Header.Set("Proxy-Tunnel", strconv.Itoa(tunnel) )

response, err := client.Do(request)

if err != nil {

panic("failed to connect: " + err.Error())

} else {

bodyByte, err := ioutil.ReadAll(response.Body)

if err != nil {

fmt.Println("读取 Body 时出错", err)

return

}

response.Body.Close()

body := string(bodyByte)

fmt.Println("Response Status:", response.Status)

fmt.Println("Response Header:", response.Header)

fmt.Println("Response Body:\n", body)

}

}

php多线程抓取多个网页(php中curl_multi()的速度比较_init)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-13 13:11

本文介绍了 PHP 使用 curl_init() 和 curl_multi_init() 多线程的速度对比。分享给大家,供大家参考,如下:

php中的curl_init()有很大的作用,尤其是在爬取网页内容或者文件信息的时候。比如curl_init()的强大在之前的文章《php使用curl进行头部检测和GZip压缩》中介绍过。

curl_init() 以单线程模式处理事情。如果需要使用多线程模式进行事务处理,那么php为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的功能。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过实验来验证这个问题。

我今天的测试很简单,就是抓取网页内容,连续抓取5次,分别使用curl_init()和curl_multi_init()函数来完成,记录下两者的耗时,将它们进行比较得出结论。

首先,使用 curl_init() 在单个线程中抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

<p> 查看全部

php多线程抓取多个网页(php中curl_multi()的速度比较_init)

本文介绍了 PHP 使用 curl_init() 和 curl_multi_init() 多线程的速度对比。分享给大家,供大家参考,如下:

php中的curl_init()有很大的作用,尤其是在爬取网页内容或者文件信息的时候。比如curl_init()的强大在之前的文章《php使用curl进行头部检测和GZip压缩》中介绍过。

curl_init() 以单线程模式处理事情。如果需要使用多线程模式进行事务处理,那么php为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的功能。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过实验来验证这个问题。

我今天的测试很简单,就是抓取网页内容,连续抓取5次,分别使用curl_init()和curl_multi_init()函数来完成,记录下两者的耗时,将它们进行比较得出结论。

首先,使用 curl_init() 在单个线程中抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

<p>

php多线程抓取多个网页(PHP利用CurlFunctions可以完成各种传送文件操作下载文件 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-13 01:07

)

PHP 可以使用 Curl Functions 完成各种文件传输操作,比如模拟浏览器发送 GET、POST 请求等,但是 PHP 语言本身不支持多线程,所以开发爬虫程序的效率是不高。这时候往往需要Curl Multi Functions来实现对多个URL地址的并发多线程访问。既然Curl Multi Function这么强大,那我可以用Curl Multi Functions来写并发多线程下载文件吗?当然,我的代码如下:

代码一:将得到的代码直接写入文件

$urls = array(

'http://www.sina.com.cn/',

'http://www.sohu.com/',

'http://www.163.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 设置将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

代码2:将得到的代码先放入变量中,再写入文件

$urls = array(

'http://www.sina.com.cn/',

'http://www.sohu.com/',

'http://www.163.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 设置不将爬取代码写到浏览器,而是转化为字符串

curl_multi_add_handle ($mh,$conn[$i]);

}

do {

curl_multi_exec($mh,$active);

} while ($active);

foreach ($urls as $i => $url) {

$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串

fwrite($st,$data); // 将字符串写入文件。当然,也可以不写入文件,比如存入数据库

} // 获得数据变量,并写入文件

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

}

curl_multi_close($mh);

fclose($st); 查看全部

php多线程抓取多个网页(PHP利用CurlFunctions可以完成各种传送文件操作下载文件

)

PHP 可以使用 Curl Functions 完成各种文件传输操作,比如模拟浏览器发送 GET、POST 请求等,但是 PHP 语言本身不支持多线程,所以开发爬虫程序的效率是不高。这时候往往需要Curl Multi Functions来实现对多个URL地址的并发多线程访问。既然Curl Multi Function这么强大,那我可以用Curl Multi Functions来写并发多线程下载文件吗?当然,我的代码如下:

代码一:将得到的代码直接写入文件

$urls = array(

'http://www.sina.com.cn/',

'http://www.sohu.com/',

'http://www.163.com/'

); // 设置要抓取的页面URL

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i], CURLOPT_FILE,$st); // 设置将爬取的代码写入文件

curl_multi_add_handle ($mh,$conn[$i]);

} // 初始化

do {

curl_multi_exec($mh,$active);

} while ($active); // 执行

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

} // 结束清理

curl_multi_close($mh);

fclose($st);

代码2:将得到的代码先放入变量中,再写入文件

$urls = array(

'http://www.sina.com.cn/',

'http://www.sohu.com/',

'http://www.163.com/'

);

$save_to='/test.txt'; // 把抓取的代码写入该文件

$st = fopen($save_to,"a");

$mh = curl_multi_init();

foreach ($urls as $i => $url) {

$conn[$i] = curl_init($url);

curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");

curl_setopt($conn[$i], CURLOPT_HEADER ,0);

curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);

curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 设置不将爬取代码写到浏览器,而是转化为字符串

curl_multi_add_handle ($mh,$conn[$i]);

}

do {

curl_multi_exec($mh,$active);

} while ($active);

foreach ($urls as $i => $url) {

$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串

fwrite($st,$data); // 将字符串写入文件。当然,也可以不写入文件,比如存入数据库

} // 获得数据变量,并写入文件

foreach ($urls as $i => $url) {

curl_multi_remove_handle($mh,$conn[$i]);

curl_close($conn[$i]);

}

curl_multi_close($mh);

fclose($st);

php多线程抓取多个网页([学英语]如何用Google云打印API将订单发送给)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-01-19 08:06

我为公司创建了一个从不同网站采集订单的 Saas,这些网站是一种“发布者”,每天为公司提供订单。这些 网站 是“发布者”,他们每天交付公司订单。

我没有 API,所以我使用公司提供给我的用户名和密码从这些网站上抓取 HTML。在 @网站 上抓取 HTML。

在我的数据库中导入并保存订单后,我将使用 Google 云打印 API 将它们发送到公司的打印机,并让公司实时处理订单。订单将使用 Google Cloud Print API 发送到公司的打印机并进行实时处理。

在订单被发送打印后,我向网站发送了一个发布请求,基本上点击了一个按钮,上面写着“我收到了订单,我正在处理它”,有点接受/批准命令。打印订单后,我向 网站 发送一个发布请求,这基本上是一个按钮点击,上面写着“我收到了订单,我正在处理它”以接受/批准订单。

公司有一个用户界面,向他们显示今天的订单表,对于每个订单,他们可以看到订单已被批准并通过谷歌云打印发送到打印机,他们假设订单真的被打印了。该公司有一个 UI,向他们显示今天的订单表,对于每个订单,他们可以看到订单已通过 Google Cloud Print 批准并发送到打印机,并且他们认为订单确实已打印。

到目前为止,一切都很好,但我有一个大问题。到目前为止一切顺利,但我有一个大问题。

有时 google cloud print 无法识别打印机,公司必须重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已经打印并且还在批准订单原创网站,因此客户得到了公司正在处理订单的批准。有时谷歌云打印无法识别打印机,公司不得不重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已打印并且订单也在原版上获得批准 网站 所以客户被批准公司正在处理订单。

谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,而且状态可能是“进行中”,因此我需要 6 秒以上的时间才能获得 1 个订单的状态希望 - “完成”。谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,并且状态可能是“进行中”,因此 1 个订单需要 6 秒以上才能获得我想要的状态 - “完成”。

现在我有 2 个每分钟运行的 cron 作业,第一个是导入新订单,第二个是发送新订单进行打印。二是发送新的印刷订单。当我发送打印订单时,大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,正如我所说的公司正在实时工作,所以从订单出现的那一刻起我不能有任何延迟当我发送打印订单时,其中一个网站从打印机出来的那一刻大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,因为我说这些公司是实时工作的,所以我没有延迟订单出现的那一刻。 网站

之一

打印机出现时

我希望我那样工作:我希望我那样工作:

第一步:导入订单

第 2 步:将其发送到打印机

第 3 步:检查状态

第 4 步:在我获得“完成”状态后在网站上批准订单。

我认为我最大的问题是它不适用于多线程

我正在寻找在 PHP 中管理和处理多线程作业的最佳方法。 查看全部

php多线程抓取多个网页([学英语]如何用Google云打印API将订单发送给)

我为公司创建了一个从不同网站采集订单的 Saas,这些网站是一种“发布者”,每天为公司提供订单。这些 网站 是“发布者”,他们每天交付公司订单。

我没有 API,所以我使用公司提供给我的用户名和密码从这些网站上抓取 HTML。在 @网站 上抓取 HTML。

在我的数据库中导入并保存订单后,我将使用 Google 云打印 API 将它们发送到公司的打印机,并让公司实时处理订单。订单将使用 Google Cloud Print API 发送到公司的打印机并进行实时处理。

在订单被发送打印后,我向网站发送了一个发布请求,基本上点击了一个按钮,上面写着“我收到了订单,我正在处理它”,有点接受/批准命令。打印订单后,我向 网站 发送一个发布请求,这基本上是一个按钮点击,上面写着“我收到了订单,我正在处理它”以接受/批准订单。

公司有一个用户界面,向他们显示今天的订单表,对于每个订单,他们可以看到订单已被批准并通过谷歌云打印发送到打印机,他们假设订单真的被打印了。该公司有一个 UI,向他们显示今天的订单表,对于每个订单,他们可以看到订单已通过 Google Cloud Print 批准并发送到打印机,并且他们认为订单确实已打印。

到目前为止,一切都很好,但我有一个大问题。到目前为止一切顺利,但我有一个大问题。

有时 google cloud print 无法识别打印机,公司必须重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已经打印并且还在批准订单原创网站,因此客户得到了公司正在处理订单的批准。有时谷歌云打印无法识别打印机,公司不得不重新启动连接到打印机的计算机,问题是我的 UI 向用户显示订单已打印并且订单也在原版上获得批准 网站 所以客户被批准公司正在处理订单。

谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,而且状态可能是“进行中”,因此我需要 6 秒以上的时间才能获得 1 个订单的状态希望 - “完成”。谷歌云打印 API 为我提供了检查打印状态的选项,但它需要大约 6 秒,并且状态可能是“进行中”,因此 1 个订单需要 6 秒以上才能获得我想要的状态 - “完成”。

现在我有 2 个每分钟运行的 cron 作业,第一个是导入新订单,第二个是发送新订单进行打印。二是发送新的印刷订单。当我发送打印订单时,大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,正如我所说的公司正在实时工作,所以从订单出现的那一刻起我不能有任何延迟当我发送打印订单时,其中一个网站从打印机出来的那一刻大约需要 4 秒,所以我每分钟最多只能发送 15 个订单,因为我说这些公司是实时工作的,所以我没有延迟订单出现的那一刻。 网站

之一

打印机出现时

我希望我那样工作:我希望我那样工作:

第一步:导入订单

第 2 步:将其发送到打印机

第 3 步:检查状态

第 4 步:在我获得“完成”状态后在网站上批准订单。

我认为我最大的问题是它不适用于多线程

我正在寻找在 PHP 中管理和处理多线程作业的最佳方法。

php多线程抓取多个网页(php多线程抓取多个网页seo(searchengineoptimization)站长工具箱)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-01-17 23:03

php多线程抓取多个网页seo(searchengineoptimization)站长工具箱,最实用的站长工具箱generatorgenerator1.服务端用java,h5,php做的,一般是自己实现。客户端.php一般是自己实现generatorjsgithub-generator/php-generatorjs:php编写多线程爬虫程序可以加我微信或者。

我在网上看到有些人出售教程,是借助爬虫的,但是你自己设置服务器啊,有些要登录,有些要抢加速这些事自己实现。

常用的爬虫有scrapy,webpy之类,但是都会使用到selenium,这个是最好的选择,在selenium中编写爬虫。http的话你可以加一些请求头selenium-requests/webdriver具体的也可以问我另外提一下,

这么跟你说吧,爬虫需要三个最基本的条件:1.网页存在;2.设置代理;3.你自己可以爬的下来。设置代理这个知乎都有攻略,可以查看一下。用爬虫根本不用什么爬虫程序,特别是爬国内站。

没什么不用的,比如你想要看看电商里那家,后面两个选项开关就可以了,如果不需要限制地域的话,用百度蜘蛛这种收费的,虽然效率上受损,

想学习爬虫可以看下慕课大神的《scrapy教程》,网上都有他的视频。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页seo(searchengineoptimization)站长工具箱)

php多线程抓取多个网页seo(searchengineoptimization)站长工具箱,最实用的站长工具箱generatorgenerator1.服务端用java,h5,php做的,一般是自己实现。客户端.php一般是自己实现generatorjsgithub-generator/php-generatorjs:php编写多线程爬虫程序可以加我微信或者。

我在网上看到有些人出售教程,是借助爬虫的,但是你自己设置服务器啊,有些要登录,有些要抢加速这些事自己实现。

常用的爬虫有scrapy,webpy之类,但是都会使用到selenium,这个是最好的选择,在selenium中编写爬虫。http的话你可以加一些请求头selenium-requests/webdriver具体的也可以问我另外提一下,

这么跟你说吧,爬虫需要三个最基本的条件:1.网页存在;2.设置代理;3.你自己可以爬的下来。设置代理这个知乎都有攻略,可以查看一下。用爬虫根本不用什么爬虫程序,特别是爬国内站。

没什么不用的,比如你想要看看电商里那家,后面两个选项开关就可以了,如果不需要限制地域的话,用百度蜘蛛这种收费的,虽然效率上受损,

想学习爬虫可以看下慕课大神的《scrapy教程》,网上都有他的视频。

php多线程抓取多个网页(建设网站地图网站时有很多设置是不利于蜘蛛抓取的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-01-16 07:19

我们在优化网站的时候,有很多不利于爬虫的设置。具体有哪些?

建设网站地图

网站地图就像一个指针。只有清晰明确的指针才能引导蜘蛛的路线。如果 网站 地图清晰,蜘蛛很乐意在 网站 上爬行。但是如果网站的内部链接乱了,蜘蛛进来后经常会迷路,那么下次蜘蛛很少来,对网站的爬取非常不利。

登录设置

有的网站会设置注册账号的服务,登录后可以看到网站的内容。这个设置对蜘蛛不友好,蜘蛛不会注册登录,所以他们将无法爬行。.

动态网址

所谓动态URL就是链接中以aspx、asp、jsp、perl、php、cgi为后缀的URL,也就是动态URL。动态 URL 比较多变,不如静态 URL 稳定。动态 URL 不够可信,所以很多动态 URL 的页面不能是 收录。

网站 的结构

一个网站的结构不仅影响用户体验,对整个网站的优化也起到至关重要的作用,而符合百度蜘蛛爬取的网站首先要简单明了。层次结构清晰,将大大提高网站对蜘蛛的可读性。

网站 的外部链接

要被蜘蛛爬取,必须有一个传入链接才能进入该页面,否则蜘蛛根本没有机会知道该页面的存在。外链的添加一定要谨慎,外链的数量不能忽视质量。不好的外链也会影响到自己的网站的爬取,所以网站在制作外链的时候一定要定期检查和更新外链。

网站跳跃

有的网站打开后会自动跳转到其他页面,跳转会增加网站的加载时间。不建议每个人都这样做。只做301跳,301跳可以集中负重,其他类型的调整不推荐。 查看全部

php多线程抓取多个网页(建设网站地图网站时有很多设置是不利于蜘蛛抓取的)

我们在优化网站的时候,有很多不利于爬虫的设置。具体有哪些?

建设网站地图

网站地图就像一个指针。只有清晰明确的指针才能引导蜘蛛的路线。如果 网站 地图清晰,蜘蛛很乐意在 网站 上爬行。但是如果网站的内部链接乱了,蜘蛛进来后经常会迷路,那么下次蜘蛛很少来,对网站的爬取非常不利。

登录设置

有的网站会设置注册账号的服务,登录后可以看到网站的内容。这个设置对蜘蛛不友好,蜘蛛不会注册登录,所以他们将无法爬行。.

动态网址

所谓动态URL就是链接中以aspx、asp、jsp、perl、php、cgi为后缀的URL,也就是动态URL。动态 URL 比较多变,不如静态 URL 稳定。动态 URL 不够可信,所以很多动态 URL 的页面不能是 收录。

网站 的结构

一个网站的结构不仅影响用户体验,对整个网站的优化也起到至关重要的作用,而符合百度蜘蛛爬取的网站首先要简单明了。层次结构清晰,将大大提高网站对蜘蛛的可读性。

网站 的外部链接

要被蜘蛛爬取,必须有一个传入链接才能进入该页面,否则蜘蛛根本没有机会知道该页面的存在。外链的添加一定要谨慎,外链的数量不能忽视质量。不好的外链也会影响到自己的网站的爬取,所以网站在制作外链的时候一定要定期检查和更新外链。

网站跳跃

有的网站打开后会自动跳转到其他页面,跳转会增加网站的加载时间。不建议每个人都这样做。只做301跳,301跳可以集中负重,其他类型的调整不推荐。

php多线程抓取多个网页( PHPCurlFunctions例子(一)-上海怡健医学)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-11 14:10

PHPCurlFunctions例子(一)-上海怡健医学)

PHP结合curl实现多线程爬取

$url){ $conn[$k]=curl_init($url); curl_setopt($conn[$k], CURLOPT_TIMEOUT, $timeout);//设置超时时间 curl_setopt($conn[$k], CURLOPT_USERAGENT, 'Mozilla/5.0 (compatible; MSIE 5.01; Windows NT 5.0)'); curl_setopt($conn[$k], CURLOPT_MAXREDIRS, 7);//HTTp定向级别 curl_setopt($conn[$k], CURLOPT_HEADER, 0);//这里不要header,加块效率 curl_setopt($conn[$k], CURLOPT_FOLLOWLOCATION, 1); // 302 redirect curl_setopt($conn[$k],CURLOPT_RETURNTRANSFER,1); curl_multi_add_handle ($mh,$conn[$k]); } //防止死循环耗死cpu 这段是根据网上的写法 do { $mrc = curl_multi_exec($mh,$active);//当无数据,active=true } while ($mrc == CURLM_CALL_MULTI_PERFORM);//当正在接受数据时 while ($active and $mrc == CURLM_OK) {//当无数据时或请求暂停时,active=true if (curl_multi_select($mh) != -1) { do { $mrc = curl_multi_exec($mh, $active); } while ($mrc == CURLM_CALL_MULTI_PERFORM); } } foreach ($array as $k => $url) { curl_error($conn[$k]); $res[$k]=curl_multi_getcontent($conn[$k]);//获得返回信息 $header[$k]=curl_getinfo($conn[$k]);//返回头信息 curl_close($conn[$k]);//关闭语柄 curl_multi_remove_handle($mh , $conn[$k]); //释放资源 } curl_multi_close($mh); $endtime = getmicrotime(); $diff_time = $endtime - $startime; return array('diff_time'=>$diff_time, 'return'=>$res, 'header'=>$header ); } //计算当前时间 function getmicrotime() { list($usec, $sec) = explode(" ",microtime()); return ((float)$usec + (float)$sec); } //测试一下,curl 三个网址 $array = array( "http://www.weibo.com/", "http://www.renren.com/", "http://www.qq.com/" ); $data = Curl_http($array,'10');//调用 var_dump($data);//输出 //如果POST的数据大于1024字节,curl并不会直接就发起POST请求 //发送请求时,header中包含一个空的Expect。curl_setopt($ch, CURLOPT_HTTPHEADER, array("Expect:")); ?>

让我们再看几个例子

(1)下面的代码是爬取多个URL,然后将爬取到的URL的页面代码写入到指定文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); // 设置要抓取的页面URL $save_to='/t来源gaodaimacom搞#^代%!码网est.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件 curl_multi_add_handle ($mh,$conn[$i]); } // 初始化 do { curl_multi_exec($mh,$active); } while ($active); // 执行 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } // 结束清理 curl_multi_close($mh); fclose($st);

(2)下面的代码和上面类似,只不过这个地方是先把获取到的代码放到一个变量中,然后再将获取到的内容写入到指定的文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); $save_to='/test.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串 curl_multi_add_handle ($mh,$conn[$i]); } do { curl_multi_exec($mh,$active); } while ($active); foreach ($urls as $i => $url) { $data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串 fwrite($st,$data); // 将字符串写入文件 } // 获得数据变量,并写入文件 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } curl_multi_close($mh); fclose($st);

(3)以下代码实现使用PHP的Curl Functions实现并发多线程下载文件

$urls=array( 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip' ); $save_to='./home/'; $mh=curl_multi_init(); foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); } } do{ $n=curl_multi_exec($mh,$active); }while($active); foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]); } curl_multi_close($mh);$urls=array( 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip', 'https://www.gaodaima.com/5w.zip' ); $save_to='./home/'; $mh=curl_multi_init(); foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); } } do{ $n=curl_multi_exec($mh,$active); }while($active); foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]); } curl_multi_close($mh);

以上就是本文的全部内容,希望大家喜欢。 查看全部

php多线程抓取多个网页(

PHPCurlFunctions例子(一)-上海怡健医学)

PHP结合curl实现多线程爬取

$url){ $conn[$k]=curl_init($url); curl_setopt($conn[$k], CURLOPT_TIMEOUT, $timeout);//设置超时时间 curl_setopt($conn[$k], CURLOPT_USERAGENT, 'Mozilla/5.0 (compatible; MSIE 5.01; Windows NT 5.0)'); curl_setopt($conn[$k], CURLOPT_MAXREDIRS, 7);//HTTp定向级别 curl_setopt($conn[$k], CURLOPT_HEADER, 0);//这里不要header,加块效率 curl_setopt($conn[$k], CURLOPT_FOLLOWLOCATION, 1); // 302 redirect curl_setopt($conn[$k],CURLOPT_RETURNTRANSFER,1); curl_multi_add_handle ($mh,$conn[$k]); } //防止死循环耗死cpu 这段是根据网上的写法 do { $mrc = curl_multi_exec($mh,$active);//当无数据,active=true } while ($mrc == CURLM_CALL_MULTI_PERFORM);//当正在接受数据时 while ($active and $mrc == CURLM_OK) {//当无数据时或请求暂停时,active=true if (curl_multi_select($mh) != -1) { do { $mrc = curl_multi_exec($mh, $active); } while ($mrc == CURLM_CALL_MULTI_PERFORM); } } foreach ($array as $k => $url) { curl_error($conn[$k]); $res[$k]=curl_multi_getcontent($conn[$k]);//获得返回信息 $header[$k]=curl_getinfo($conn[$k]);//返回头信息 curl_close($conn[$k]);//关闭语柄 curl_multi_remove_handle($mh , $conn[$k]); //释放资源 } curl_multi_close($mh); $endtime = getmicrotime(); $diff_time = $endtime - $startime; return array('diff_time'=>$diff_time, 'return'=>$res, 'header'=>$header ); } //计算当前时间 function getmicrotime() { list($usec, $sec) = explode(" ",microtime()); return ((float)$usec + (float)$sec); } //测试一下,curl 三个网址 $array = array( "http://www.weibo.com/", "http://www.renren.com/", "http://www.qq.com/" ); $data = Curl_http($array,'10');//调用 var_dump($data);//输出 //如果POST的数据大于1024字节,curl并不会直接就发起POST请求 //发送请求时,header中包含一个空的Expect。curl_setopt($ch, CURLOPT_HTTPHEADER, array("Expect:")); ?>

让我们再看几个例子

(1)下面的代码是爬取多个URL,然后将爬取到的URL的页面代码写入到指定文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); // 设置要抓取的页面URL $save_to='/t来源gaodaimacom搞#^代%!码网est.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件 curl_multi_add_handle ($mh,$conn[$i]); } // 初始化 do { curl_multi_exec($mh,$active); } while ($active); // 执行 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } // 结束清理 curl_multi_close($mh); fclose($st);

(2)下面的代码和上面类似,只不过这个地方是先把获取到的代码放到一个变量中,然后再将获取到的内容写入到指定的文件中

$urls = array( 'https://www.gaodaima.com/', 'http://www.google.com/', 'http://www.example.com/' ); $save_to='/test.txt'; // 把抓取的代码写入该文件 $st = fopen($save_to,"a"); $mh = curl_multi_init(); foreach ($urls as $i => $url) { $conn[$i] = curl_init($url); curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i], CURLOPT_HEADER ,0); curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60); curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器,而是转化为字符串 curl_multi_add_handle ($mh,$conn[$i]); } do { curl_multi_exec($mh,$active); } while ($active); foreach ($urls as $i => $url) { $data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串 fwrite($st,$data); // 将字符串写入文件 } // 获得数据变量,并写入文件 foreach ($urls as $i => $url) { curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); } curl_multi_close($mh); fclose($st);

(3)以下代码实现使用PHP的Curl Functions实现并发多线程下载文件