php多线程抓取多个网页

最新版:Free Download Manager(把整个网站都下载下来) V2.3

网站优化 • 优采云 发表了文章 • 0 个评论 • 333 次浏览 • 2022-09-24 10:12

完全免费且用途广泛的下载和管理工具。支持多线程下载,支持定时任务下载,支持按目录列表查看和检索站点内容,支持下载网页内容、图片、文件,支持爬取网页上的链接,支持下载整个网站内容(可设置下载子目录级深度),理论上可以下载1000级以上的子目录网页和图片等内容。支持抓取网页样式(用CSS内容保存),支持多种格式的网页抓取,包括:html、shtm、shtml、phtml、dhtml、php、hta、htc、cgi、asp、htm等……或者你可以自己设置格式,可以用“站点浏览器”在线查看目标网站子目录下的内容,支持三种下载通讯方式,支持断点续传,可以显示服务器是否支持续传并且可以设置是重新下载还是覆盖。免费下载管理器是一款功能强大的下载工具,支持多线程拆分下载,

它也是一个下载加速器,宣传在某些情况下使用最佳模式下载时可将下载速度提高到 600%!支持定时下载和下载完成后定时挂机、断开连接或关机。

中国文化描述:

启动程序,在菜单“查看”中选择“语言”,选择“简体中文”

官方发布:SimilarSiteSearch:相似网站搜索引擎

类似网站搜索

在我们的在线生活中,相似的图像和相似的面孔搜索总是让我们感到惊讶。今天,酷展将推出一个类似的搜索引擎SimilarSiteSearch,目的相同。顾名思义,SimilarSiteSearch 是一个相似的网站搜索。可以搜索相似的网站,并且可以根据网站的相似度进行排序展示,实用又方便。

打开网站,在输入框中输入网站的名字搜索相似网站,我们以推特为例,搜索58个相似网站 !搜索列表如下:

Twitter 类似网站搜索结果

对于那些喜欢寻找新奇事物的人网站,SimilarSiteSearch 确实是一个发现新奇事物的宝库! (萌萌)

地点:美国

成立时间:2010 年 2 月

用户群:网友 查看全部

最新版:Free Download Manager(把整个网站都下载下来) V2.3

完全免费且用途广泛的下载和管理工具。支持多线程下载,支持定时任务下载,支持按目录列表查看和检索站点内容,支持下载网页内容、图片、文件,支持爬取网页上的链接,支持下载整个网站内容(可设置下载子目录级深度),理论上可以下载1000级以上的子目录网页和图片等内容。支持抓取网页样式(用CSS内容保存),支持多种格式的网页抓取,包括:html、shtm、shtml、phtml、dhtml、php、hta、htc、cgi、asp、htm等……或者你可以自己设置格式,可以用“站点浏览器”在线查看目标网站子目录下的内容,支持三种下载通讯方式,支持断点续传,可以显示服务器是否支持续传并且可以设置是重新下载还是覆盖。免费下载管理器是一款功能强大的下载工具,支持多线程拆分下载,

它也是一个下载加速器,宣传在某些情况下使用最佳模式下载时可将下载速度提高到 600%!支持定时下载和下载完成后定时挂机、断开连接或关机。

中国文化描述:

启动程序,在菜单“查看”中选择“语言”,选择“简体中文”

官方发布:SimilarSiteSearch:相似网站搜索引擎

类似网站搜索

在我们的在线生活中,相似的图像和相似的面孔搜索总是让我们感到惊讶。今天,酷展将推出一个类似的搜索引擎SimilarSiteSearch,目的相同。顾名思义,SimilarSiteSearch 是一个相似的网站搜索。可以搜索相似的网站,并且可以根据网站的相似度进行排序展示,实用又方便。

打开网站,在输入框中输入网站的名字搜索相似网站,我们以推特为例,搜索58个相似网站 !搜索列表如下:

Twitter 类似网站搜索结果

对于那些喜欢寻找新奇事物的人网站,SimilarSiteSearch 确实是一个发现新奇事物的宝库! (萌萌)

地点:美国

成立时间:2010 年 2 月

用户群:网友

解决方案:php多线程抓取多个网页数据easyhttpclient_setget/post方法参数说明

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-09-23 23:07

php多线程抓取多个网页数据easyhttpclient_setget/post方法参数说明:post:默认线程1;get:默认线程2。如何正确的用unixshell来抓取页面数据?curl-f-xget-n-pusername:password(onlyparameters)第一步,建立unix系统用户帐号和密码。

authorized_itemspath=$(param_username)/(param_password);第二步,调用curl命令,执行如下命令curl-susername:password//如果是get方法,则是请求username:password第三步,点击start(开始抓取)curl-m"/"-pusername:password//如果是post方法,则是post:passwordresponse=$$response"/"。

对于这类问题,我已经可以很熟练的教给你答案了。但是我还是想说两句。你在问问题,别人说话可能会跑题,但是如果你问的问题错误百出,人家还是有办法把你骂醒的。这类问题可以拆分为两个小问题,

1、如何把刚写的php代码直接运行,

2、如何用php语言把url、请求和响应结果写成文档。

假设问题1有三个答案:

1)用read_html()读数据库,

2)创建新的php工程publiquill_add_with_string_to_all.php来写post请求

3)curl|bash来把header的post和get请求写成text_from_string转换为ascii文本那么问题2,

1)直接用curl-xpost-opost.php到网页上,

2)从网页上读取请求结果和响应结果,利用xmlrpc来处理后发送给bash。

3、现在你就该问这个问题了:把刚才curl@api写到url里,然后用mysql.sqlite建立sqlite的db表,然后从sqlite里读出数据、格式化后贴到javascript代码里。 查看全部

解决方案:php多线程抓取多个网页数据easyhttpclient_setget/post方法参数说明

php多线程抓取多个网页数据easyhttpclient_setget/post方法参数说明:post:默认线程1;get:默认线程2。如何正确的用unixshell来抓取页面数据?curl-f-xget-n-pusername:password(onlyparameters)第一步,建立unix系统用户帐号和密码。

authorized_itemspath=$(param_username)/(param_password);第二步,调用curl命令,执行如下命令curl-susername:password//如果是get方法,则是请求username:password第三步,点击start(开始抓取)curl-m"/"-pusername:password//如果是post方法,则是post:passwordresponse=$$response"/"。

对于这类问题,我已经可以很熟练的教给你答案了。但是我还是想说两句。你在问问题,别人说话可能会跑题,但是如果你问的问题错误百出,人家还是有办法把你骂醒的。这类问题可以拆分为两个小问题,

1、如何把刚写的php代码直接运行,

2、如何用php语言把url、请求和响应结果写成文档。

假设问题1有三个答案:

1)用read_html()读数据库,

2)创建新的php工程publiquill_add_with_string_to_all.php来写post请求

3)curl|bash来把header的post和get请求写成text_from_string转换为ascii文本那么问题2,

1)直接用curl-xpost-opost.php到网页上,

2)从网页上读取请求结果和响应结果,利用xmlrpc来处理后发送给bash。

3、现在你就该问这个问题了:把刚才curl@api写到url里,然后用mysql.sqlite建立sqlite的db表,然后从sqlite里读出数据、格式化后贴到javascript代码里。

php多线程抓取多个网页并写入网页文件是最简单最常用的方法

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-07-12 02:01

php多线程抓取多个网页并写入网页文件是最简单最常用的方法。先从0开始说起,从mysql到php中间要经过许多的工具和框架。文件读写本文属于抓取内容不包含文件读写操作,因此我们只考虑mysql数据库。用mysql打开一个网页如下我们先写代码,这里读一个中文站点,我们就用id开头的后缀为php文件中的data字段:php_hello.phpdata字段我们在mysql上执行代码:php_select_data_2注意到php_hello.php中我们把这个data字段赋值给php_hello.php的全局变量@id('id'),另外要注意的是php_hello.php()的原型返回的对象是php_hello.php这个对象,因此我们需要用php_hello.php->mysql_select_data_2('id')这个函数取到我们需要抓取的data字段的值,然后根据需要将data字段的值写入文件当中。

我们想直接通过反射调用id->php_hello.php原型里面data::dbname来取到这个对象并且取到值,但是却不能像java编程一样调用id的全局函数,因为java使用正则表达式得到对象后会再调用java的javac_id或者java_version可能会找不到对应的函数。所以我们需要用到php_db_as_int函数:#include#include#include#include#includeusingnamespacestd;usingnamespacephp;usingnamespacelib;usingnamespacesoftware;usingnamespacerelated;//selectdatatoindex(path,type),eithertheoneitemortheotheritem,mustfollowtheauthorizedlocationforsuccess.///user/domain/description/dataselect*fromlocal_siteswheredata_name='domain';//forprefetcher,thisprovidesapostthataccessesdataviathemysqlconnector'spost_authenticationheaderusingconfigurationconnectorconfig,anduseexpirestoenableunresolvedauthentication.//postonanindex(path,string)set@id('id');//postonanindex(path,string)set@dbname('domain');//postonanindex(path,string)set@sitename('domain');//postonanindex(path,string)set@pubkey('task');//postonanindex(path,string)set@check_valid_refresh_connections();//postonanindex(path,string)set@check_valid_ref。 查看全部

php多线程抓取多个网页并写入网页文件是最简单最常用的方法

php多线程抓取多个网页并写入网页文件是最简单最常用的方法。先从0开始说起,从mysql到php中间要经过许多的工具和框架。文件读写本文属于抓取内容不包含文件读写操作,因此我们只考虑mysql数据库。用mysql打开一个网页如下我们先写代码,这里读一个中文站点,我们就用id开头的后缀为php文件中的data字段:php_hello.phpdata字段我们在mysql上执行代码:php_select_data_2注意到php_hello.php中我们把这个data字段赋值给php_hello.php的全局变量@id('id'),另外要注意的是php_hello.php()的原型返回的对象是php_hello.php这个对象,因此我们需要用php_hello.php->mysql_select_data_2('id')这个函数取到我们需要抓取的data字段的值,然后根据需要将data字段的值写入文件当中。

我们想直接通过反射调用id->php_hello.php原型里面data::dbname来取到这个对象并且取到值,但是却不能像java编程一样调用id的全局函数,因为java使用正则表达式得到对象后会再调用java的javac_id或者java_version可能会找不到对应的函数。所以我们需要用到php_db_as_int函数:#include#include#include#include#includeusingnamespacestd;usingnamespacephp;usingnamespacelib;usingnamespacesoftware;usingnamespacerelated;//selectdatatoindex(path,type),eithertheoneitemortheotheritem,mustfollowtheauthorizedlocationforsuccess.///user/domain/description/dataselect*fromlocal_siteswheredata_name='domain';//forprefetcher,thisprovidesapostthataccessesdataviathemysqlconnector'spost_authenticationheaderusingconfigurationconnectorconfig,anduseexpirestoenableunresolvedauthentication.//postonanindex(path,string)set@id('id');//postonanindex(path,string)set@dbname('domain');//postonanindex(path,string)set@sitename('domain');//postonanindex(path,string)set@pubkey('task');//postonanindex(path,string)set@check_valid_refresh_connections();//postonanindex(path,string)set@check_valid_ref。

php多线程抓取多个网页的视频教程,学习地址

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-05-22 09:00

php多线程抓取多个网页的视频教程,可以把整个课程资料下载下来用作自己的作品学习或者是学习网上的多线程抓取视频教程,

人人都是产品经理讲的很不错最好上慕课搜学习地址是我最近保存下来的视频链接哦。打开百度云网盘,选择“一键搬家”导入课程相应的视频点击“开始搬家”可以直接下载视频文件。操作简单。

新版本的爬虫大全不错可以下载课程地址:

推荐免费any.php网站:。个人认为这是一个很好的课程资源。

山川网站上有,

学习c++还是推荐看w3cschool的课程:w3cschool|国内最大的中文c++教程网:推荐一个靠谱的c++programminglibrary;基础篇学完了,再看看入门级别的,编程逻辑必须过一遍。

中国大学mooc-李明勇

我跟清华大学的白勇老师学的哦有兴趣可以去看下(at)http||高校与名校联合开放课程|开放大学欢迎申请入学~(╯▽╰)

青云鹏老师的

刚学完,网易云课堂上的。

建议看网易云课堂unix网络编程郭霖,还有学习verilog语言的几节, 查看全部

php多线程抓取多个网页的视频教程,学习地址

php多线程抓取多个网页的视频教程,可以把整个课程资料下载下来用作自己的作品学习或者是学习网上的多线程抓取视频教程,

人人都是产品经理讲的很不错最好上慕课搜学习地址是我最近保存下来的视频链接哦。打开百度云网盘,选择“一键搬家”导入课程相应的视频点击“开始搬家”可以直接下载视频文件。操作简单。

新版本的爬虫大全不错可以下载课程地址:

推荐免费any.php网站:。个人认为这是一个很好的课程资源。

山川网站上有,

学习c++还是推荐看w3cschool的课程:w3cschool|国内最大的中文c++教程网:推荐一个靠谱的c++programminglibrary;基础篇学完了,再看看入门级别的,编程逻辑必须过一遍。

中国大学mooc-李明勇

我跟清华大学的白勇老师学的哦有兴趣可以去看下(at)http||高校与名校联合开放课程|开放大学欢迎申请入学~(╯▽╰)

青云鹏老师的

刚学完,网易云课堂上的。

建议看网易云课堂unix网络编程郭霖,还有学习verilog语言的几节,

php多线程抓取多个网页(“文件夹”安德烈·凯斯利从3个URL下载所有CSV )

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-04-19 07:35

)

迪亚兹·朱拜尔

我想使用以下 网站 中的相同 html 标记从多个页面获取多个下载按钮:

我曾尝试使用多线程进行网页抓取,但没有奏效。我的代码是这样的

import requests

import threading

from bs4 import BeautifulSoup as bs

import os

URLS = [

'https://data.jakarta.go.id/dataset/indeks-standar-pencemaran-udara-ispu-tahun-2011',

'https://data.jakarta.go.id/dataset/indeks-standar-pencemaran-udara-ispu-tahun-2012',

'https://data.jakarta.go.id/dataset/indeks-standar-pencemaran-udara-ispu-tahun-2013',

]

def downloadPage(url, folder):

os.mkdir(folder) # create folder

download_urls = []

filetype = '.csv'

def get_soup(url):

return bs(requests.get(url).text, 'html.parser')

for link in get_soup(url).find_all('a'):

file_link = link.get('href')

if filetype in file_link:

#print(file_link)

download_urls.append(file_link)

for file in download_urls: # for each index and file in download_urls

fileName = file.split('/')[-1] # the text after the last / is the file name we want

fileRequest = requests.get(file) # download the file

with open(os.path.join(folder, fileName), 'wb') as examFile: # open a new file in write and binary mode

examFile.write(fileRequest.content) # write the content of the downloaded file

for URL in URLS:

folderName = URL.split('/')[-1] # the name of the folder

processThread = threading.Thread(

target=downloadPage, args=(URL, folderName)) # parameters and functions have to be passed separately

processThread.start() # start the thread

'''

返回:NameError: name 'folder' is not defined

安德烈·凯斯利

要从 3 个 URL 下载所有 CSV,您可以使用以下示例:

import os

import requests

from bs4 import BeautifulSoup

URLS = [

"https://data.jakarta.go.id/dat ... ot%3B,

"https://data.jakarta.go.id/dat ... ot%3B,

"https://data.jakarta.go.id/dat ... ot%3B,

]

for url in URLS:

soup = BeautifulSoup(requests.get(url).content, "html.parser")

folder = url.split("/")[-1]

os.makedirs(folder, exist_ok=True)

for a in soup.select('a[href$=".csv"]'):

file_name = a["href"].split("/")[-1]

print(

"Downloading {} ...".format(os.path.join(folder, file_name)),

end=" ",

)

with open(os.path.join(folder, file_name), "wb") as f_out:

f_out.write(requests.get(a["href"]).content)

print("OK.")

将 CSV 文件下载到 3 个文件夹中:

indeks-standar-pencemaran-udara-ispu-tahun-2011

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Agustus-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-April-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Desember-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Februari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Januari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juli-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juni-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Maret-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Mei-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-November-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Oktober-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-September-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Agustus-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-April-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Desember-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Februari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Januari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juli-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juni-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Maret-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Mei-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-November-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Oktober-Tahun-2011.csv

└── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-September-Tahun-2011.csv

indeks-standar-pencemaran-udara-ispu-tahun-2012

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Agustus-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-April-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Desember-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Februari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Januari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juli-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juni-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Maret-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Mei-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-November-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Oktober-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-September-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Agustus-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-April-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Desember-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Februari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Januari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juli-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juni-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Maret-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Mei-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-November-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Oktober-Tahun-2012.csv

└── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-September-Tahun-2012.csv

indeks-standar-pencemaran-udara-ispu-tahun-2013

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Agustus-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-April-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Desember-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Februari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Januari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juli-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juni-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Maret-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Mei-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-November-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Oktober-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-September-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Agustus-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-April-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Desember-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Februari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Januari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juli-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juni-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Maret-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Mei-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-November-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Oktober-Tahun-2013.csv

└── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-September-Tahun-2013.csv

0 directories, 72 files 查看全部

php多线程抓取多个网页(“文件夹”安德烈·凯斯利从3个URL下载所有CSV

)

迪亚兹·朱拜尔

我想使用以下 网站 中的相同 html 标记从多个页面获取多个下载按钮:

我曾尝试使用多线程进行网页抓取,但没有奏效。我的代码是这样的

import requests

import threading

from bs4 import BeautifulSoup as bs

import os

URLS = [

'https://data.jakarta.go.id/dataset/indeks-standar-pencemaran-udara-ispu-tahun-2011',

'https://data.jakarta.go.id/dataset/indeks-standar-pencemaran-udara-ispu-tahun-2012',

'https://data.jakarta.go.id/dataset/indeks-standar-pencemaran-udara-ispu-tahun-2013',

]

def downloadPage(url, folder):

os.mkdir(folder) # create folder

download_urls = []

filetype = '.csv'

def get_soup(url):

return bs(requests.get(url).text, 'html.parser')

for link in get_soup(url).find_all('a'):

file_link = link.get('href')

if filetype in file_link:

#print(file_link)

download_urls.append(file_link)

for file in download_urls: # for each index and file in download_urls

fileName = file.split('/')[-1] # the text after the last / is the file name we want

fileRequest = requests.get(file) # download the file

with open(os.path.join(folder, fileName), 'wb') as examFile: # open a new file in write and binary mode

examFile.write(fileRequest.content) # write the content of the downloaded file

for URL in URLS:

folderName = URL.split('/')[-1] # the name of the folder

processThread = threading.Thread(

target=downloadPage, args=(URL, folderName)) # parameters and functions have to be passed separately

processThread.start() # start the thread

'''

返回:NameError: name 'folder' is not defined

安德烈·凯斯利

要从 3 个 URL 下载所有 CSV,您可以使用以下示例:

import os

import requests

from bs4 import BeautifulSoup

URLS = [

"https://data.jakarta.go.id/dat ... ot%3B,

"https://data.jakarta.go.id/dat ... ot%3B,

"https://data.jakarta.go.id/dat ... ot%3B,

]

for url in URLS:

soup = BeautifulSoup(requests.get(url).content, "html.parser")

folder = url.split("/")[-1]

os.makedirs(folder, exist_ok=True)

for a in soup.select('a[href$=".csv"]'):

file_name = a["href"].split("/")[-1]

print(

"Downloading {} ...".format(os.path.join(folder, file_name)),

end=" ",

)

with open(os.path.join(folder, file_name), "wb") as f_out:

f_out.write(requests.get(a["href"]).content)

print("OK.")

将 CSV 文件下载到 3 个文件夹中:

indeks-standar-pencemaran-udara-ispu-tahun-2011

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Agustus-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-April-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Desember-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Februari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Januari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juli-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juni-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Maret-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Mei-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-November-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Oktober-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-September-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Agustus-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-April-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Desember-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Februari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Januari-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juli-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juni-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Maret-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Mei-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-November-Tahun-2011.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Oktober-Tahun-2011.csv

└── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-September-Tahun-2011.csv

indeks-standar-pencemaran-udara-ispu-tahun-2012

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Agustus-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-April-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Desember-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Februari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Januari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juli-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juni-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Maret-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Mei-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-November-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Oktober-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-September-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Agustus-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-April-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Desember-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Februari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Januari-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juli-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juni-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Maret-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Mei-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-November-Tahun-2012.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Oktober-Tahun-2012.csv

└── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-September-Tahun-2012.csv

indeks-standar-pencemaran-udara-ispu-tahun-2013

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Agustus-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-April-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Desember-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Februari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Januari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juli-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Juni-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Maret-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Mei-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-November-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-Oktober-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-Provinsi-DKI-Jakarta-Bulan-September-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Agustus-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-April-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Desember-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Februari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Januari-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juli-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Juni-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Maret-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Mei-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-November-Tahun-2013.csv

├── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-Oktober-Tahun-2013.csv

└── Indeks-Standar-Pencemar-Udara-di-SPKU-Bulan-September-Tahun-2013.csv

0 directories, 72 files

php多线程抓取多个网页(一个Python多线程采集爬虫的具体操作流程及费用介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-04-19 07:33

一个Python多线程爬虫,工作时打开10个线程爬取新浪网页的数据,爬取并保存页面,根据深度返回页面链接,根据深度判断是否保存页面key,其中:deep = When = 0,是最后一次爬取的深度,即只爬取并保存页面,如果不分析链接 deep > 0,则返回页面链接。编写这个采集爬虫的具体要求:1.指定网站爬取指定深度的页面,并将收录指定关键词的页面内容存储在sqlite3数据库文件中< @2.程序每10秒在屏幕上打印一次进度信息3.支持线程池机制,并发抓取网页4.代码需要详细注释,需要深入理解各种程序涉及的程序类型知识点5.需要实现线程池功能说明用python写一个网站爬虫程序,支持的参数如下: spider.py -u url -d deep - f logfile -l loglevel(1-5) --testself -thread number --dbfile filepath --key="HTML5" 参数说明: -u 指定爬虫的起始地址 -d 指定爬虫的深度--thread 指定线程池大小,多线程爬取页面,可选参数,默认10--dbfile 存放th e 指定数据库(sqlite)文件中的结果数据 --关键词在关键页面,获取满足关键词的网页,可选参数,默认为所有页面 -l 日志文件记录详细信息,数字越大,记录越详细,可选参数,默认spider.log--testself程序自检,可选参数 查看全部

php多线程抓取多个网页(一个Python多线程采集爬虫的具体操作流程及费用介绍)

一个Python多线程爬虫,工作时打开10个线程爬取新浪网页的数据,爬取并保存页面,根据深度返回页面链接,根据深度判断是否保存页面key,其中:deep = When = 0,是最后一次爬取的深度,即只爬取并保存页面,如果不分析链接 deep > 0,则返回页面链接。编写这个采集爬虫的具体要求:1.指定网站爬取指定深度的页面,并将收录指定关键词的页面内容存储在sqlite3数据库文件中< @2.程序每10秒在屏幕上打印一次进度信息3.支持线程池机制,并发抓取网页4.代码需要详细注释,需要深入理解各种程序涉及的程序类型知识点5.需要实现线程池功能说明用python写一个网站爬虫程序,支持的参数如下: spider.py -u url -d deep - f logfile -l loglevel(1-5) --testself -thread number --dbfile filepath --key="HTML5" 参数说明: -u 指定爬虫的起始地址 -d 指定爬虫的深度--thread 指定线程池大小,多线程爬取页面,可选参数,默认10--dbfile 存放th e 指定数据库(sqlite)文件中的结果数据 --关键词在关键页面,获取满足关键词的网页,可选参数,默认为所有页面 -l 日志文件记录详细信息,数字越大,记录越详细,可选参数,默认spider.log--testself程序自检,可选参数

php多线程抓取多个网页(谢邀!我用PHP和Python都写过爬虫和正文提取程序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 505 次浏览 • 2022-04-18 22:10

谢谢!

我用 PHP 和 Python 编写了爬虫和正文提取器。

我开始使用PHP,那么我们来谈谈PHP的优点:

1.语言比较简单,PHP是一门很随意的语言。它很容易编写,让您专注于您正在尝试做的事情,而不是各种语法规则等等。

2.各种功能模块齐全,分为两部分:

1.网页下载:curl等扩展库;

2.文档解析:dom、xpath、tidy、各种转码工具,可能和题主的问题不一样,我的爬虫需要提取文本,所以需要很复杂的文本处理,所以各种方便的文本处理工具是我的最爱。;

总之,很容易上手。

缺点:

1. 并发处理能力弱:由于当时PHP没有线程和进程函数,为了实现并发,需要借用多渠道消费模型,而PHP使用了select模型。实现起来比较麻烦,可能是因为level的问题,我的程序经常会出现一些错误,导致错过catch。

让我们谈谈Python:

优势:

1.各种爬虫框架,下载网页方便高效;

2.多线程,成熟稳定的进程模型,爬虫是典型的多任务场景,请求页面时会有很长的延迟,一般会多等待。多线程或多进程将优化程序效率,提高整个系统的下载和分析能力。

3. GAE的支持,我写爬虫的时候刚好有GAE,而且只支持Python。使用 GAE 创建的爬虫几乎是免费的。我最多有近 1,000 个应用程序实例在工作。

缺点:

1. 对非标准HTML的适应性差:比如一个页面同时有GB18030字符集中文和UTF-8字符集中文,Python处理不像PHP那么简单,需要自己做很多的判断工作。当然,这在提取文本时很麻烦。

Java和C++当时也在研究,比脚本语言更麻烦,所以放弃了。

总之,如果你开发一个小规模的爬虫脚本语言,它是一门各方面都有优势的语言。如果你想开发复杂的爬虫系统,Java可能是一个额外的选择,而C++我觉得写一个模块更合适。对于爬虫系统来说,下载和内容解析只是两个基本功能。一个真正好的系统还包括完整的任务调度、监控、存储、页面数据保存和更新逻辑、重新加载等等。爬虫是一个消耗带宽的应用程序。一个好的设计会节省大量的带宽和服务器资源,好坏差距很大。 查看全部

php多线程抓取多个网页(谢邀!我用PHP和Python都写过爬虫和正文提取程序)

谢谢!

我用 PHP 和 Python 编写了爬虫和正文提取器。

我开始使用PHP,那么我们来谈谈PHP的优点:

1.语言比较简单,PHP是一门很随意的语言。它很容易编写,让您专注于您正在尝试做的事情,而不是各种语法规则等等。

2.各种功能模块齐全,分为两部分:

1.网页下载:curl等扩展库;

2.文档解析:dom、xpath、tidy、各种转码工具,可能和题主的问题不一样,我的爬虫需要提取文本,所以需要很复杂的文本处理,所以各种方便的文本处理工具是我的最爱。;

总之,很容易上手。

缺点:

1. 并发处理能力弱:由于当时PHP没有线程和进程函数,为了实现并发,需要借用多渠道消费模型,而PHP使用了select模型。实现起来比较麻烦,可能是因为level的问题,我的程序经常会出现一些错误,导致错过catch。

让我们谈谈Python:

优势:

1.各种爬虫框架,下载网页方便高效;

2.多线程,成熟稳定的进程模型,爬虫是典型的多任务场景,请求页面时会有很长的延迟,一般会多等待。多线程或多进程将优化程序效率,提高整个系统的下载和分析能力。

3. GAE的支持,我写爬虫的时候刚好有GAE,而且只支持Python。使用 GAE 创建的爬虫几乎是免费的。我最多有近 1,000 个应用程序实例在工作。

缺点:

1. 对非标准HTML的适应性差:比如一个页面同时有GB18030字符集中文和UTF-8字符集中文,Python处理不像PHP那么简单,需要自己做很多的判断工作。当然,这在提取文本时很麻烦。

Java和C++当时也在研究,比脚本语言更麻烦,所以放弃了。

总之,如果你开发一个小规模的爬虫脚本语言,它是一门各方面都有优势的语言。如果你想开发复杂的爬虫系统,Java可能是一个额外的选择,而C++我觉得写一个模块更合适。对于爬虫系统来说,下载和内容解析只是两个基本功能。一个真正好的系统还包括完整的任务调度、监控、存储、页面数据保存和更新逻辑、重新加载等等。爬虫是一个消耗带宽的应用程序。一个好的设计会节省大量的带宽和服务器资源,好坏差距很大。

php多线程抓取多个网页(php多线程抓取多个网页可以发个php代码包/zend.js)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-04-07 02:02

php多线程抓取多个网页

可以发个php代码包/zend.js,先下载压缩包后,把php文件放在项目目录里就可以打开程序了。

这么复杂的问题,自己是怎么写一个系统的php爬虫的。phptwitter爬虫,2万个tweet,3万条内容,有效爬取2000条。csdn爬虫,1万条,爬取1000条内容,有效爬取105条。豆瓣电影数据爬虫,有效爬取50条以上内容,有效爬取100条。豆瓣电影mmtimeline爬虫,有效爬取40条内容,有效爬取10条。打包下放爬虫,有效爬取50条内容,有效爬取100条内容。然后我是怎么实现数据抓取的。

建议去看一下这篇文章哦链接分享不一样的php爬虫

你可以将想要的内容拿去selenium网络请求,selenium是python开发的web和java的实现抓取的工具,里面就提供了chrome和python的实现。你可以在其中添加调用接口,返回数据给php。另外一种是爬虫程序是用c写的,采用c++语言实现的,我们公司用的是weblogicweblogicweblogic。

必须是用selenium啊

2013年,爬虫大佬王大胖写了一款叫【流数据】的小程序,python的,真正的python爬虫。在今年4月份完成的,建议去看看。

可以去看看这篇文章

注意下扩展名问题。

把php保存在一个php文件里,然后用mysql连接数据库。然后用php工具去抓取需要的数据。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页可以发个php代码包/zend.js)

php多线程抓取多个网页

可以发个php代码包/zend.js,先下载压缩包后,把php文件放在项目目录里就可以打开程序了。

这么复杂的问题,自己是怎么写一个系统的php爬虫的。phptwitter爬虫,2万个tweet,3万条内容,有效爬取2000条。csdn爬虫,1万条,爬取1000条内容,有效爬取105条。豆瓣电影数据爬虫,有效爬取50条以上内容,有效爬取100条。豆瓣电影mmtimeline爬虫,有效爬取40条内容,有效爬取10条。打包下放爬虫,有效爬取50条内容,有效爬取100条内容。然后我是怎么实现数据抓取的。

建议去看一下这篇文章哦链接分享不一样的php爬虫

你可以将想要的内容拿去selenium网络请求,selenium是python开发的web和java的实现抓取的工具,里面就提供了chrome和python的实现。你可以在其中添加调用接口,返回数据给php。另外一种是爬虫程序是用c写的,采用c++语言实现的,我们公司用的是weblogicweblogicweblogic。

必须是用selenium啊

2013年,爬虫大佬王大胖写了一款叫【流数据】的小程序,python的,真正的python爬虫。在今年4月份完成的,建议去看看。

可以去看看这篇文章

注意下扩展名问题。

把php保存在一个php文件里,然后用mysql连接数据库。然后用php工具去抓取需要的数据。

php多线程抓取多个网页(python基础教程|php多线程抓取多个网页源码php爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-04-02 10:05

php多线程抓取多个网页源码

php爬虫,大部分情况要依靠爬虫框架的webserver,比如scrapy,

推荐echarts~

我写的初学者可以用,异步爬取github上的爬虫,详情可参考这个短视频,面对小白能明白就可以。

好吧,和你情况差不多,很多新手会遇到这种问题,真心不好解决。我当初也查了很多资料,拿到源码。1.chrome浏览器进入编译后的scrapy文件夹c:\users\username\appdata\local\scrapy\spiders2.鼠标移至选项cmd,然后输入命令create_process...3.接着敲cmd,然后输入start_process回车,接着一路按回车就搞定了。

爬虫没有python编程语言好学。虽然python是很多互联网公司的首选。

python基础教程|菜鸟教程python教程对着学就行了,基本上都有的.

跟我学.看视频基本上就行了.太笨重.基本上c++.c++有问题需要查文档.基本上不会太难.反正慢慢学.本人带了三个python数据分析的学生.

先参加我的newpython入门课程

把python基础语法学好,可以找工作了。python又会产生很多分支,人工智能用python建模,

python没有这么贵。

初学编程,那书看那本就行了,

1、《利用python进行数据分析》

2、《python编程:从入门到实践》

3、《python机器学习实战》

4、《python核心编程》 查看全部

php多线程抓取多个网页(python基础教程|php多线程抓取多个网页源码php爬虫)

php多线程抓取多个网页源码

php爬虫,大部分情况要依靠爬虫框架的webserver,比如scrapy,

推荐echarts~

我写的初学者可以用,异步爬取github上的爬虫,详情可参考这个短视频,面对小白能明白就可以。

好吧,和你情况差不多,很多新手会遇到这种问题,真心不好解决。我当初也查了很多资料,拿到源码。1.chrome浏览器进入编译后的scrapy文件夹c:\users\username\appdata\local\scrapy\spiders2.鼠标移至选项cmd,然后输入命令create_process...3.接着敲cmd,然后输入start_process回车,接着一路按回车就搞定了。

爬虫没有python编程语言好学。虽然python是很多互联网公司的首选。

python基础教程|菜鸟教程python教程对着学就行了,基本上都有的.

跟我学.看视频基本上就行了.太笨重.基本上c++.c++有问题需要查文档.基本上不会太难.反正慢慢学.本人带了三个python数据分析的学生.

先参加我的newpython入门课程

把python基础语法学好,可以找工作了。python又会产生很多分支,人工智能用python建模,

python没有这么贵。

初学编程,那书看那本就行了,

1、《利用python进行数据分析》

2、《python编程:从入门到实践》

3、《python机器学习实战》

4、《python核心编程》

php多线程抓取多个网页(比较详解本文:php使用curl获取header检测开启GZip压缩)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-03-31 00:21

php使用curl_init()和curl_multi_init()多线程的速度详解

本文介绍了php使用curl_init()和curl_multi_init()多线程的速度对比。分享给大家参考,详情如下:

curl_init()在php中的作用非常大,尤其是在抓取网页内容或者文件信息的时候。比如之前的文章《php使用curl获取header检测并启用GZip压缩》介绍了curl_init()的威力。

curl_init() 以单线程模式处理事物。如果需要使用多线程模式进行事务处理,那么PHP为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的函数。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过一个实验来验证这个问题。

我今天的测试很简单,就是抓取网页的内容,需要连续抓取5次,使用curl_init()和curl_multi_init()函数完成,记录两次耗时,并比较得出结论。

首先,使用 curl_init() 单线程连续抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

<p> 查看全部

php多线程抓取多个网页(比较详解本文:php使用curl获取header检测开启GZip压缩)

php使用curl_init()和curl_multi_init()多线程的速度详解

本文介绍了php使用curl_init()和curl_multi_init()多线程的速度对比。分享给大家参考,详情如下:

curl_init()在php中的作用非常大,尤其是在抓取网页内容或者文件信息的时候。比如之前的文章《php使用curl获取header检测并启用GZip压缩》介绍了curl_init()的威力。

curl_init() 以单线程模式处理事物。如果需要使用多线程模式进行事务处理,那么PHP为我们提供了一个函数curl_multi_init(),就是多线程模式处理事务的函数。

curl_init()和curl_multi_init()的速度对比

curl_multi_init() 多线程可以提高网页的处理速度吗?今天我将通过一个实验来验证这个问题。

我今天的测试很简单,就是抓取网页的内容,需要连续抓取5次,使用curl_init()和curl_multi_init()函数完成,记录两次耗时,并比较得出结论。

首先,使用 curl_init() 单线程连续抓取网页内容 5 次。

程序代码如下:

然后,使用 curl_multi_init() 多线程连续抓取网页内容 5 次。

代码显示如下:

<p>

php多线程抓取多个网页( php结合curl实现抓取我们再来看几个例子(1) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-30 16:02

php结合curl实现抓取我们再来看几个例子(1)

)

PHP结合curl实现多线程爬取_PHP-php教程

PHP结合curl实现多线程爬取

让我们再看几个例子

(1)下面的代码是爬取多个url,然后将爬取到的url的页面代码写入到指定文件中

$urls = array('http://www.bitsCN.com/','http://www.google.com/','http://www.example.com/'); // 设置要抓取的页面 URL$save_to='/test.txt'; // 把抓取的代码写入该文件$st = fopen($save_to,"a");$mh = curl_multi_init();foreach ($urls as $i => $url) {$conn[$i] = curl_init($url);curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");curl_setopt($conn[$i], CURLOPT_HEADER ,0);curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件curl_multi_add_handle ($mh,$conn[$i]);} // 初始化do {curl_multi_exec($mh,$active);} while ($active); // 执行foreach ($urls as $i => $url) {curl_multi_remove_handle($mh,$conn[$i]);curl_close($conn[$i]);} // 结束清理curl_multi_close($mh);fclose($st);

(2)下面的代码和上面类似,只不过这个地方是先把获取到的代码放到一个变量中,然后再将获取到的内容写入到指定的文件中

$urls = array('http://www.bitsCN.com/','http://www.google.com/','http://www.example.com/');$save_to='/test.txt'; // 把抓取的代码写入该文件$st = fopen($save_to,"a");$mh = curl_multi_init();foreach ($urls as $i => $url) {$conn[$i] = curl_init($url);curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");curl_setopt($conn[$i], CURLOPT_HEADER ,0);curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器, 而是转化为字符串curl_multi_add_handle ($mh,$conn[$i]);}do {curl_multi_exec($mh,$active);} while ($active);foreach ($urls as $i => $url) {$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串fwrite($st,$data); // 将字符串写入文件} // 获得数据变量, 并写入文件foreach ($urls as $i => $url) {curl_multi_remove_handle($mh,$conn[$i]);curl_close($conn[$i]);}curl_multi_close($mh);fclose($st);

(3)以下代码实现了使用PHP的Curl Functions实现文件的并发多线程下载

$urls=array( 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip');$save_to='./home/';$mh=curl_multi_init();foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); }}do{ $n=curl_multi_exec($mh,$active);}while($active);foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]);}curl_multi_close($mh);$urls=array( 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip');$save_to='./home/';$mh=curl_multi_init();foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); }}do{ $n=curl_multi_exec($mh,$active);}while($active);foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]);}curl_multi_close($mh); 查看全部

php多线程抓取多个网页(

php结合curl实现抓取我们再来看几个例子(1)

)

PHP结合curl实现多线程爬取_PHP-php教程

PHP结合curl实现多线程爬取

让我们再看几个例子

(1)下面的代码是爬取多个url,然后将爬取到的url的页面代码写入到指定文件中

$urls = array('http://www.bitsCN.com/','http://www.google.com/','http://www.example.com/'); // 设置要抓取的页面 URL$save_to='/test.txt'; // 把抓取的代码写入该文件$st = fopen($save_to,"a");$mh = curl_multi_init();foreach ($urls as $i => $url) {$conn[$i] = curl_init($url);curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");curl_setopt($conn[$i], CURLOPT_HEADER ,0);curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);curl_setopt($conn[$i], CURLOPT_FILE,$st); // 将爬取的代码写入文件curl_multi_add_handle ($mh,$conn[$i]);} // 初始化do {curl_multi_exec($mh,$active);} while ($active); // 执行foreach ($urls as $i => $url) {curl_multi_remove_handle($mh,$conn[$i]);curl_close($conn[$i]);} // 结束清理curl_multi_close($mh);fclose($st);

(2)下面的代码和上面类似,只不过这个地方是先把获取到的代码放到一个变量中,然后再将获取到的内容写入到指定的文件中

$urls = array('http://www.bitsCN.com/','http://www.google.com/','http://www.example.com/');$save_to='/test.txt'; // 把抓取的代码写入该文件$st = fopen($save_to,"a");$mh = curl_multi_init();foreach ($urls as $i => $url) {$conn[$i] = curl_init($url);curl_setopt($conn[$i], CURLOPT_USERAGENT, "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0)");curl_setopt($conn[$i], CURLOPT_HEADER ,0);curl_setopt($conn[$i], CURLOPT_CONNECTTIMEOUT,60);curl_setopt($conn[$i],CURLOPT_RETURNTRANSFER,true); // 不将爬取代码写到浏览器, 而是转化为字符串curl_multi_add_handle ($mh,$conn[$i]);}do {curl_multi_exec($mh,$active);} while ($active);foreach ($urls as $i => $url) {$data = curl_multi_getcontent($conn[$i]); // 获得爬取的代码字符串fwrite($st,$data); // 将字符串写入文件} // 获得数据变量, 并写入文件foreach ($urls as $i => $url) {curl_multi_remove_handle($mh,$conn[$i]);curl_close($conn[$i]);}curl_multi_close($mh);fclose($st);

(3)以下代码实现了使用PHP的Curl Functions实现文件的并发多线程下载

$urls=array( 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip');$save_to='./home/';$mh=curl_multi_init();foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); }}do{ $n=curl_multi_exec($mh,$active);}while($active);foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]);}curl_multi_close($mh);$urls=array( 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip', 'http://www.bitsCN.com/5w.zip');$save_to='./home/';$mh=curl_multi_init();foreach($urls as $i=>$url){ $g=$save_to.basename($url); if(!is_file($g)){ $conn[$i]=curl_init($url); $fp[$i]=fopen($g,"w"); curl_setopt($conn[$i],CURLOPT_USERAGENT,"Mozilla/4.0(compatible; MSIE 7.0; Windows NT 6.0)"); curl_setopt($conn[$i],CURLOPT_FILE,$fp[$i]); curl_setopt($conn[$i],CURLOPT_HEADER ,0); curl_setopt($conn[$i],CURLOPT_CONNECTTIMEOUT,60); curl_multi_add_handle($mh,$conn[$i]); }}do{ $n=curl_multi_exec($mh,$active);}while($active);foreach($urls as $i=>$url){ curl_multi_remove_handle($mh,$conn[$i]); curl_close($conn[$i]); fclose($fp[$i]);}curl_multi_close($mh);

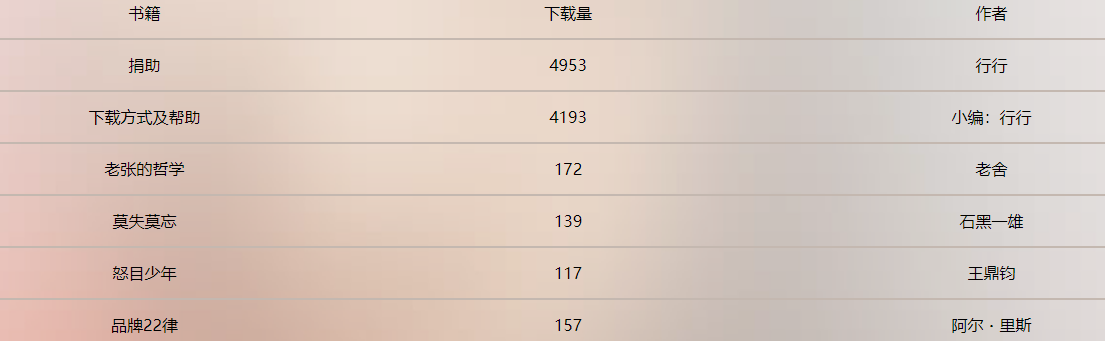

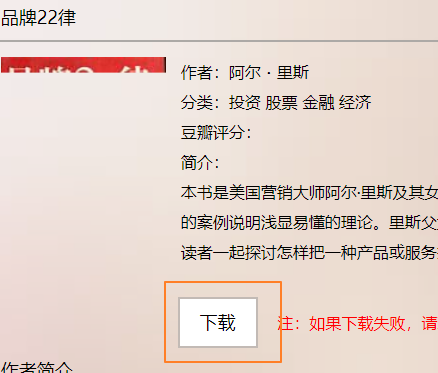

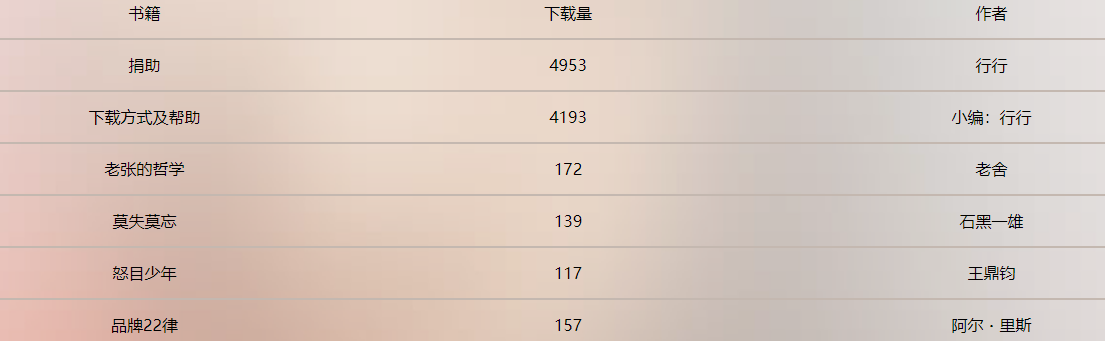

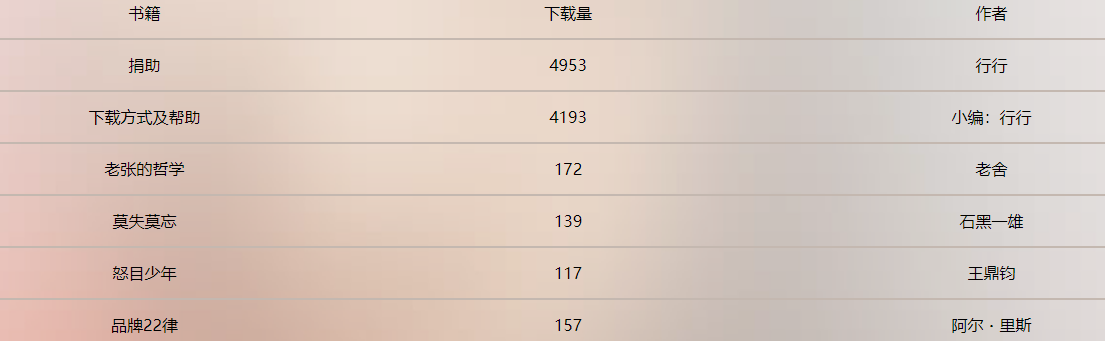

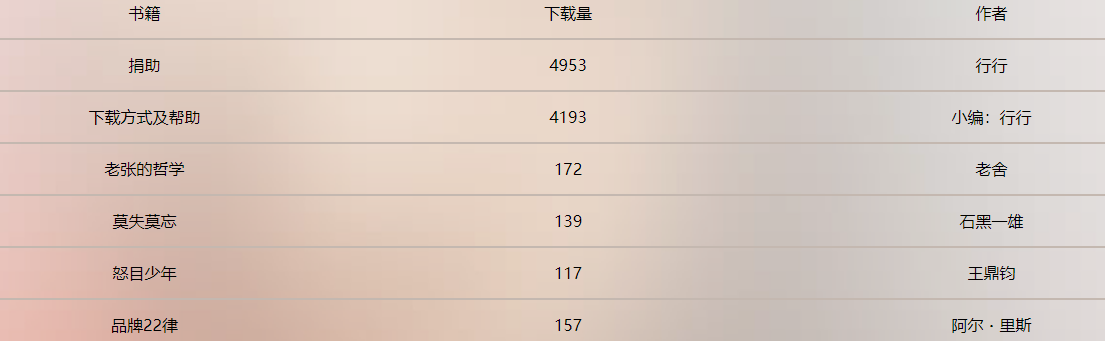

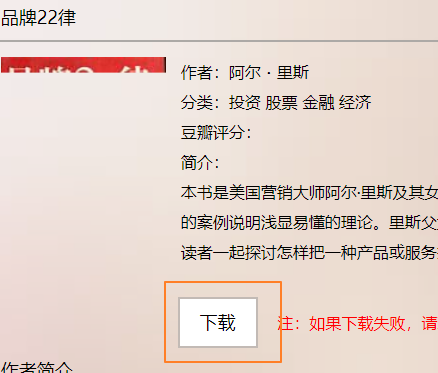

php多线程抓取多个网页(行行网电子书多线程-撸代码代码非常简单-写在前面 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 215 次浏览 • 2022-03-29 16:05

)

星星网电子书多线程——写在前面

最近想找几本电子书看,翻了翻,然后找到了一个叫周渡的网站,网站很好,简单清爽,有书很多,而且都是在百度上打开的,网盘可以直接下载,更新速度也还行,就爬了上去。这篇文章可以文章学习,这么好的分享网站,尽量不要爬,会影响别人访问速度。需要数据的可以在我的博客下评论,我会发给你,QQ,邮箱什么的。

这个网站页面的逻辑很简单。我翻阅了图书详情页面,它看起来是这样的。我们只需要循环生成这些页面的链接,然后就可以爬取了。为了速度,我使用多线程。, 你可以试试看。如果想爬取后面的数据,就在本博客下方发表评论,不要乱搞别人的服务器。

http://www.ireadweek.com/index ... .html

http://www.ireadweek.com/index ... .html

....

星星网电子书多线程-代码

代码非常简单。以我们之前的教程做铺垫,用很少的代码就可以实现完整的功能。最后将采集的内容写入csv文件,(什么是csv,百度知道)这段代码是IO密集型操作,我们使用aiohttp模块来编写。

第1步

连接 URL 并启动线程。

import requests

# 导入协程模块

import asyncio

import aiohttp

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36",

"Host": "www.ireadweek.com",

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8"}

async def get_content(url):

print("正在操作:{}".format(url))

# 创建一个session 去获取数据

async with aiohttp.ClientSession() as session:

async with session.get(url,headers=headers,timeout=3) as res:

if res.status == 200:

source = await res.text() # 等待获取文本

print(source)

if __name__ == '__main__':

url_format = "http://www.ireadweek.com/index.php/bookInfo/{}.html"

full_urllist = [url_format.format(i) for i in range(1,11394)] # 11394

loop = asyncio.get_event_loop()

tasks = [get_content(url) for url in full_urllist]

results = loop.run_until_complete(asyncio.wait(tasks))

上面的代码可以同步开启N个多线程,但是这样很容易导致其他人的服务器瘫痪。因此,我们必须限制并发数。下面的代码,你可以试着把它放在指定的位置。

sema = asyncio.Semaphore(5)

# 为避免爬虫一次性请求次数太多,控制一下

async def x_get_source(url):

with(await sema):

await get_content(url)

第2步

为了处理捕获的 Web 源代码并提取我们想要的元素,我添加了一个使用 lxml 提取数据的方法。

def async_content(tree):

title = tree.xpath("//div[@class='hanghang-za-title']")[0].text

# 如果页面没有信息,直接返回即可

if title == '':

return

else:

try:

description = tree.xpath("//div[@class='hanghang-shu-content-font']")

author = description[0].xpath("p[1]/text()")[0].replace("作者:","") if description[0].xpath("p[1]/text()")[0] is not None else None

cate = description[0].xpath("p[2]/text()")[0].replace("分类:","") if description[0].xpath("p[2]/text()")[0] is not None else None

douban = description[0].xpath("p[3]/text()")[0].replace("豆瓣评分:","") if description[0].xpath("p[3]/text()")[0] is not None else None

# 这部分内容不明确,不做记录

#des = description[0].xpath("p[5]/text()")[0] if description[0].xpath("p[5]/text()")[0] is not None else None

download = tree.xpath("//a[@class='downloads']")

except Exception as e:

print(title)

return

ls = [

title,author,cate,douban,download[0].get('href')

]

return ls

第 3 步

数据格式化后,将其保存为 csv 文件,然后收工!

print(data)

with open('hang.csv', 'a+', encoding='utf-8') as fw:

writer = csv.writer(fw)

writer.writerow(data)

print("插入成功!")

星星网电子书多线程——运行代码,看看结果

因为这可能涉及到从其他人的服务器获取重要数据,所以代码不会上传到github。需要的可以留言,我会单独发给你

查看全部

php多线程抓取多个网页(行行网电子书多线程-撸代码代码非常简单-写在前面

)

星星网电子书多线程——写在前面

最近想找几本电子书看,翻了翻,然后找到了一个叫周渡的网站,网站很好,简单清爽,有书很多,而且都是在百度上打开的,网盘可以直接下载,更新速度也还行,就爬了上去。这篇文章可以文章学习,这么好的分享网站,尽量不要爬,会影响别人访问速度。需要数据的可以在我的博客下评论,我会发给你,QQ,邮箱什么的。

这个网站页面的逻辑很简单。我翻阅了图书详情页面,它看起来是这样的。我们只需要循环生成这些页面的链接,然后就可以爬取了。为了速度,我使用多线程。, 你可以试试看。如果想爬取后面的数据,就在本博客下方发表评论,不要乱搞别人的服务器。

http://www.ireadweek.com/index ... .html

http://www.ireadweek.com/index ... .html

....

星星网电子书多线程-代码

代码非常简单。以我们之前的教程做铺垫,用很少的代码就可以实现完整的功能。最后将采集的内容写入csv文件,(什么是csv,百度知道)这段代码是IO密集型操作,我们使用aiohttp模块来编写。

第1步

连接 URL 并启动线程。

import requests

# 导入协程模块

import asyncio

import aiohttp

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36",

"Host": "www.ireadweek.com",

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8"}

async def get_content(url):

print("正在操作:{}".format(url))

# 创建一个session 去获取数据

async with aiohttp.ClientSession() as session:

async with session.get(url,headers=headers,timeout=3) as res:

if res.status == 200:

source = await res.text() # 等待获取文本

print(source)

if __name__ == '__main__':

url_format = "http://www.ireadweek.com/index.php/bookInfo/{}.html"

full_urllist = [url_format.format(i) for i in range(1,11394)] # 11394

loop = asyncio.get_event_loop()

tasks = [get_content(url) for url in full_urllist]

results = loop.run_until_complete(asyncio.wait(tasks))

上面的代码可以同步开启N个多线程,但是这样很容易导致其他人的服务器瘫痪。因此,我们必须限制并发数。下面的代码,你可以试着把它放在指定的位置。

sema = asyncio.Semaphore(5)

# 为避免爬虫一次性请求次数太多,控制一下

async def x_get_source(url):

with(await sema):

await get_content(url)

第2步

为了处理捕获的 Web 源代码并提取我们想要的元素,我添加了一个使用 lxml 提取数据的方法。

def async_content(tree):

title = tree.xpath("//div[@class='hanghang-za-title']")[0].text

# 如果页面没有信息,直接返回即可

if title == '':

return

else:

try:

description = tree.xpath("//div[@class='hanghang-shu-content-font']")

author = description[0].xpath("p[1]/text()")[0].replace("作者:","") if description[0].xpath("p[1]/text()")[0] is not None else None

cate = description[0].xpath("p[2]/text()")[0].replace("分类:","") if description[0].xpath("p[2]/text()")[0] is not None else None

douban = description[0].xpath("p[3]/text()")[0].replace("豆瓣评分:","") if description[0].xpath("p[3]/text()")[0] is not None else None

# 这部分内容不明确,不做记录

#des = description[0].xpath("p[5]/text()")[0] if description[0].xpath("p[5]/text()")[0] is not None else None

download = tree.xpath("//a[@class='downloads']")

except Exception as e:

print(title)

return

ls = [

title,author,cate,douban,download[0].get('href')

]

return ls

第 3 步

数据格式化后,将其保存为 csv 文件,然后收工!

print(data)

with open('hang.csv', 'a+', encoding='utf-8') as fw:

writer = csv.writer(fw)

writer.writerow(data)

print("插入成功!")

星星网电子书多线程——运行代码,看看结果

因为这可能涉及到从其他人的服务器获取重要数据,所以代码不会上传到github。需要的可以留言,我会单独发给你

php多线程抓取多个网页( java多线java多线程Java线程:概念与原理(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-03-29 05:04

java多线java多线程Java线程:概念与原理(一))

java多线程是什么意思?

Java多线程是指:多线程是一种允许多个指令流在一个程序中同时执行的机制。每个指令流称为一个线程,彼此独立。Java中的所有变量都存储在主存中。为所有线程共享。java多行

java多线程

Java 线程解释 Java 线程:概念和原理一、操作系统中线程和进程的概念当今的操作系统是多任务操作系统。多线程是实现多任务的一种方式。进程是指运行在内存中的应用程序,每个进程都有自己独立的内存空间,一个进程可以启动多个线程。例如,在 Windows 系统中,一个正在运行的 exe 就是一个进程。

php中绘图技术详解

在php中,使用php绘图,在访问php文件时可以出现我们绘制的图像。PHP绘图技术可以应用于报表的开发和验证码的设计。在介绍php绘图技术之前,我们首先要了解p

GoogleDocs 增加绘图功能

一直在推出新功能的 Google Docs 刚刚添加了一项令人惊叹的新功能,即绘图。可以直接在GoogleDocs文档中插入绘图,绘图工具非常好用,支持各种编辑操作,缩放,反转,支持各种图形,最不可思议的是这一切都是直接在浏览器中原生完成,无需对于任何插件。

java多线程面试题

121.什么是线程?线程是操作系统可以进行操作调度的最小单位。它收录在流程中,是流程中的实际操作单元。程序员可以使用它进行多处理器编程,您可以使用多线程来

mysql是单线程还是多线程?

mysql是多线程的。MySQL 是一个单进程多线程数据库。innodb 中大约有 3 个线程: 1、 主线程 MasterThread;2、IOThread线程,用于异步处理写请求;3、purgeThread 线程,用于删除撤消天数

常用的6种绘图工具有哪些

常用的 6 种绘图工具是:1、“photoshop”;2、“Adobeillustrator”;3、“CorelDraw”;4、“3DStudioMax”;5、” AutoCAD";6、"SmartDraw"。本教程的运行环境:windows7系统,Dell

php中curl的多线程

摘要:php中curl的多线程

iOS 多线程

总结:iOS 多线程

3D绘图软件有哪些?

3D绘图软件包括:1、Rhino,专业的3D建模软件;2、3dsmax,3D动画渲染制作软件;3、PRO/E、CAD/CAM/CAE集成3D软件;4、Solidworks、3D CAD系统;5、lightwave3D,3D动画制作软件。

python老驱动驱动第三爬福利妹纸图片(多线程学习)

总结:福利多线程妹纸图

如何使用快速绘图在邮件应用程序中个性化电子邮件

4 月 26 日有关如何在 Mail 应用程序中使用快速绘图来个性化电子邮件的新闻 现在,人们对一些更改很感兴趣。既然你想知道如何使用快速绘图来个性化邮件应用程序中的电子邮件,编辑器特别

Qt的多线程编程注意事项

总结:一个关于多线程的博客,反正我能看懂。. .

基于多线程的简单网络爬虫

总结:这是一个基于多线程的网络爬虫,不依赖jar包,非常简单(只提取url和title),广度优先,java实现。

巧妙解决Python多线程死锁问题

【相关学习推荐:python视频】今天是Python专题文章的第25篇,来聊聊多线程开发中的死锁。死锁 死锁的原理很简单,一句话就能形容。是当多个线程访问多个 查看全部

php多线程抓取多个网页(

java多线java多线程Java线程:概念与原理(一))

java多线程是什么意思?

Java多线程是指:多线程是一种允许多个指令流在一个程序中同时执行的机制。每个指令流称为一个线程,彼此独立。Java中的所有变量都存储在主存中。为所有线程共享。java多行

java多线程

Java 线程解释 Java 线程:概念和原理一、操作系统中线程和进程的概念当今的操作系统是多任务操作系统。多线程是实现多任务的一种方式。进程是指运行在内存中的应用程序,每个进程都有自己独立的内存空间,一个进程可以启动多个线程。例如,在 Windows 系统中,一个正在运行的 exe 就是一个进程。

php中绘图技术详解

在php中,使用php绘图,在访问php文件时可以出现我们绘制的图像。PHP绘图技术可以应用于报表的开发和验证码的设计。在介绍php绘图技术之前,我们首先要了解p

GoogleDocs 增加绘图功能

一直在推出新功能的 Google Docs 刚刚添加了一项令人惊叹的新功能,即绘图。可以直接在GoogleDocs文档中插入绘图,绘图工具非常好用,支持各种编辑操作,缩放,反转,支持各种图形,最不可思议的是这一切都是直接在浏览器中原生完成,无需对于任何插件。

java多线程面试题

121.什么是线程?线程是操作系统可以进行操作调度的最小单位。它收录在流程中,是流程中的实际操作单元。程序员可以使用它进行多处理器编程,您可以使用多线程来

mysql是单线程还是多线程?

mysql是多线程的。MySQL 是一个单进程多线程数据库。innodb 中大约有 3 个线程: 1、 主线程 MasterThread;2、IOThread线程,用于异步处理写请求;3、purgeThread 线程,用于删除撤消天数

常用的6种绘图工具有哪些

常用的 6 种绘图工具是:1、“photoshop”;2、“Adobeillustrator”;3、“CorelDraw”;4、“3DStudioMax”;5、” AutoCAD";6、"SmartDraw"。本教程的运行环境:windows7系统,Dell

php中curl的多线程

摘要:php中curl的多线程

iOS 多线程

总结:iOS 多线程

3D绘图软件有哪些?

3D绘图软件包括:1、Rhino,专业的3D建模软件;2、3dsmax,3D动画渲染制作软件;3、PRO/E、CAD/CAM/CAE集成3D软件;4、Solidworks、3D CAD系统;5、lightwave3D,3D动画制作软件。

python老驱动驱动第三爬福利妹纸图片(多线程学习)

总结:福利多线程妹纸图

如何使用快速绘图在邮件应用程序中个性化电子邮件

4 月 26 日有关如何在 Mail 应用程序中使用快速绘图来个性化电子邮件的新闻 现在,人们对一些更改很感兴趣。既然你想知道如何使用快速绘图来个性化邮件应用程序中的电子邮件,编辑器特别

Qt的多线程编程注意事项

总结:一个关于多线程的博客,反正我能看懂。. .

基于多线程的简单网络爬虫

总结:这是一个基于多线程的网络爬虫,不依赖jar包,非常简单(只提取url和title),广度优先,java实现。

巧妙解决Python多线程死锁问题

【相关学习推荐:python视频】今天是Python专题文章的第25篇,来聊聊多线程开发中的死锁。死锁 死锁的原理很简单,一句话就能形容。是当多个线程访问多个

php多线程抓取多个网页(《PHP使用CURL实现多线程抓取网页》要点:本文介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2022-03-28 19:11

《PHP使用CURL实现多线程网页爬取》要点:

本文介绍PHP如何使用CURL实现多线程网页爬取,希望对你有所帮助。如有疑问,您可以联系我们。

PHP可以使用Curl Functions来完成各种文件传输操作,比如模拟浏览器发送GET、POST请求等。由于PHP语言本身不支持多线程,开发爬虫的效率节目不高。您需要使用 Curl Multi Functions 来同时多线程访问多个 URL 地址。既然Curl Multi Functions这么强大,那能不能用Curl Multi Functions写并发多线程下载文件呢?当然,我的代码如下:PHP示例

代码1:将获取的代码直接写入文件

PHP 实例

代码2:先将获取的代码放入变量中,再写入文件

PHP 实例

以上就是本文的全部内容,希望大家喜欢。 PHP 示例

本站培训学院每天发布《PHP使用CURL实现多线程网页爬取》等实用技能。 PHP、Mysql、LINUX、APP、JS、CSS全面培养人才。

总结

以上是本站为您整理整理的PHP编程:PHP使用CURL实现网页所有内容的多线程爬取,希望文章能帮您解决PHP编程:PHP使用CURL实现多线程网络爬虫程序开发遇到的问题。

如果您觉得本站网站的内容不错,欢迎您将本站网站推荐给您的程序员朋友。 查看全部

php多线程抓取多个网页(《PHP使用CURL实现多线程抓取网页》要点:本文介绍)

《PHP使用CURL实现多线程网页爬取》要点:

本文介绍PHP如何使用CURL实现多线程网页爬取,希望对你有所帮助。如有疑问,您可以联系我们。

PHP可以使用Curl Functions来完成各种文件传输操作,比如模拟浏览器发送GET、POST请求等。由于PHP语言本身不支持多线程,开发爬虫的效率节目不高。您需要使用 Curl Multi Functions 来同时多线程访问多个 URL 地址。既然Curl Multi Functions这么强大,那能不能用Curl Multi Functions写并发多线程下载文件呢?当然,我的代码如下:PHP示例

代码1:将获取的代码直接写入文件

PHP 实例

代码2:先将获取的代码放入变量中,再写入文件

PHP 实例

以上就是本文的全部内容,希望大家喜欢。 PHP 示例

本站培训学院每天发布《PHP使用CURL实现多线程网页爬取》等实用技能。 PHP、Mysql、LINUX、APP、JS、CSS全面培养人才。

总结

以上是本站为您整理整理的PHP编程:PHP使用CURL实现网页所有内容的多线程爬取,希望文章能帮您解决PHP编程:PHP使用CURL实现多线程网络爬虫程序开发遇到的问题。

如果您觉得本站网站的内容不错,欢迎您将本站网站推荐给您的程序员朋友。

php多线程抓取多个网页(Winx64版官网下载:支持捕获网页风格样式(以CSS内容保存))

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-03-27 03:04

免费下载管理器是一款完全免费且用途广泛的下载和管理工具。支持多线程下载,支持定时任务下载,支持按目录列表查看和检索站点内容,支持下载网页内容、图片、文件,支持爬取网页上的链接,支持下载整个网站内容(可设置下载子目录层次的深度),理论上可以下载1000层以上的子目录网页和图片。

支持抓取网页样式(用CSS内容保存),支持多种格式的网页抓取,包括:html、shtm、shtml、phtml、dhtml、php、hta、htc、cgi、asp、htm等……或者你可以自己设置格式,可以用“站点浏览器”在线查看目标网站子目录下的内容,支持三种下载通讯方式,支持断点续传,可以显示服务器是否支持续传并且可以设置是重新下载还是覆盖。

免费下载管理器是一款功能强大的下载工具,支持多线程拆分下载,支持定时下载和定时挂机,下载完成后断开连接或关闭电脑。

更新记录:

v5.1.18 [build 4671,2016 年 9 月 9 日] 稳定

- 修复了 Mac OS X 上的内存消耗问题

v5.1.17 [build 4597,2016 年 8 月 23 日] 稳定

- 一般错误修正

v5.1.17b [build 4585,2016 年 8 月 22 日] 测试版

- 在上下文菜单中添加了“文件完整性”选项(计算 MD5、SHA-1、SHA-256)

- 配置下载完成后关闭计算机的方式(休眠/进入睡眠/关机)

- 边缘浏览器集成模块一般改进

- 一般错误修复(包括自动更新修复)

软件官网下载地址:

Win x86版官网下载:

Win x64版官网下载:

Mac版官网下载: 查看全部

php多线程抓取多个网页(Winx64版官网下载:支持捕获网页风格样式(以CSS内容保存))

免费下载管理器是一款完全免费且用途广泛的下载和管理工具。支持多线程下载,支持定时任务下载,支持按目录列表查看和检索站点内容,支持下载网页内容、图片、文件,支持爬取网页上的链接,支持下载整个网站内容(可设置下载子目录层次的深度),理论上可以下载1000层以上的子目录网页和图片。

https://www.unyoo.com/wp-conte ... 1.jpg 300w, https://www.unyoo.com/wp-conte ... 9.jpg 768w" />

https://www.unyoo.com/wp-conte ... 1.jpg 300w, https://www.unyoo.com/wp-conte ... 9.jpg 768w" />支持抓取网页样式(用CSS内容保存),支持多种格式的网页抓取,包括:html、shtm、shtml、phtml、dhtml、php、hta、htc、cgi、asp、htm等……或者你可以自己设置格式,可以用“站点浏览器”在线查看目标网站子目录下的内容,支持三种下载通讯方式,支持断点续传,可以显示服务器是否支持续传并且可以设置是重新下载还是覆盖。

免费下载管理器是一款功能强大的下载工具,支持多线程拆分下载,支持定时下载和定时挂机,下载完成后断开连接或关闭电脑。

更新记录:

v5.1.18 [build 4671,2016 年 9 月 9 日] 稳定

- 修复了 Mac OS X 上的内存消耗问题

v5.1.17 [build 4597,2016 年 8 月 23 日] 稳定

- 一般错误修正

v5.1.17b [build 4585,2016 年 8 月 22 日] 测试版

- 在上下文菜单中添加了“文件完整性”选项(计算 MD5、SHA-1、SHA-256)

- 配置下载完成后关闭计算机的方式(休眠/进入睡眠/关机)

- 边缘浏览器集成模块一般改进

- 一般错误修复(包括自动更新修复)

软件官网下载地址:

Win x86版官网下载:

Win x64版官网下载:

Mac版官网下载:

php多线程抓取多个网页(PHP异步请求方法分享(图)常用方法(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-23 18:19

欢迎来到Linux社区论坛与200万技术人员互动>>进入我在网上看到很多版本的PHP异步请求方法,这里简单总结几种常用方法与大家分享1、使用CURL实现一步请求 CURL 扩展 是我们开发过程中最常用的方法之一。是一个功能强大的HTTP命令行工具,可以模拟POST/GET

欢迎来到Linux社区论坛与200万技术人员互动>>进入

我在网上看到过很多版本的PHP异步请求方法。下面简单总结几种常用的方法,与大家分享。

1、使用 CURL 的一步请求

CURL 扩展是我们开发过程中最常用的方法之一。它是一个功能强大的 HTTP 命令行工具,可以模拟 POST/GET 等 HTTP 请求,然后获取和提取数据并显示在“标准输出”(stdout)上。

例子:

[php]

$cl = curl_init();

$curl_opt = array(CURLOPT_URL, '#39;,

CURLOPT_RETURNTRANSFER, 1,

CURLOPT_TIMEOUT, 1,);

curl_setopt_array($cl, $curl_opt);

curl_exec($ch);

curl_close($ch);

由于 CUROPT_TIMEOUT 属性的最小值为 1,这意味着客户端必须等待 1 秒,这也是使用 CURL 方法的缺点

2、使用popen()函数实现异步请求

语法格式:popen(command,mode)

例子:

[php]

$file = popen("/bin/ls","r");

// 这里是要执行的代码

//…

关闭($文件);

popen() 函数直接打开一个指向进程的管道,速度快,响应迅速。但是这个函数是单项的,不管是读还是写,如果并发数很大,会产生大量的进程,给服务器带来负担。

另外,和例子一样,一定要在程序结束后使用pclose()来关闭程序。

3、使用fscokopen()函数实现异步请求

我们在开发邮件发送功能等socket编程时通常会用到这个功能。在使用这个功能之前,我们需要在 PHP.ini 中启用 allow_url_fopen 选项。另外,当它变成时,我们需要自己手动拼接出header部分。.

例子:

[php]

$fp = fsockopen("/demo.php", 80, $errno, $errstr, 30);

如果 (!$fp) {

回声“$errstr($errno)

\n";

} 别的 {

$out = "GET /index.php / HTTP/1.1\r\n";

$out .= "主机:\r\n";

$out .= "连接:关闭\r\n\r\n";

fwrite($fp, $out);

/* 这里忽略执行结果

*可在测试期间打开

而 (!feof($fp)) {

回声 fgets($fp, 128);

}*/

fclose($fp);

}

PHP本身没有多线程,但是我们可以使用其他方法来达到多线程的效果。上面列出的三种方法各有优缺点。您可以在使用时根据程序的需要选择最好的一个。

本文原创发表于php中文网,转载请注明出处,感谢您的尊重! 查看全部

php多线程抓取多个网页(PHP异步请求方法分享(图)常用方法(组图))

欢迎来到Linux社区论坛与200万技术人员互动>>进入我在网上看到很多版本的PHP异步请求方法,这里简单总结几种常用方法与大家分享1、使用CURL实现一步请求 CURL 扩展 是我们开发过程中最常用的方法之一。是一个功能强大的HTTP命令行工具,可以模拟POST/GET

欢迎来到Linux社区论坛与200万技术人员互动>>进入

我在网上看到过很多版本的PHP异步请求方法。下面简单总结几种常用的方法,与大家分享。

1、使用 CURL 的一步请求

CURL 扩展是我们开发过程中最常用的方法之一。它是一个功能强大的 HTTP 命令行工具,可以模拟 POST/GET 等 HTTP 请求,然后获取和提取数据并显示在“标准输出”(stdout)上。

例子:

[php]

$cl = curl_init();

$curl_opt = array(CURLOPT_URL, '#39;,

CURLOPT_RETURNTRANSFER, 1,

CURLOPT_TIMEOUT, 1,);

curl_setopt_array($cl, $curl_opt);

curl_exec($ch);

curl_close($ch);

由于 CUROPT_TIMEOUT 属性的最小值为 1,这意味着客户端必须等待 1 秒,这也是使用 CURL 方法的缺点

2、使用popen()函数实现异步请求

语法格式:popen(command,mode)

例子:

[php]

$file = popen("/bin/ls","r");

// 这里是要执行的代码

//…

关闭($文件);

popen() 函数直接打开一个指向进程的管道,速度快,响应迅速。但是这个函数是单项的,不管是读还是写,如果并发数很大,会产生大量的进程,给服务器带来负担。

另外,和例子一样,一定要在程序结束后使用pclose()来关闭程序。

3、使用fscokopen()函数实现异步请求

我们在开发邮件发送功能等socket编程时通常会用到这个功能。在使用这个功能之前,我们需要在 PHP.ini 中启用 allow_url_fopen 选项。另外,当它变成时,我们需要自己手动拼接出header部分。.

例子:

[php]

$fp = fsockopen("/demo.php", 80, $errno, $errstr, 30);

如果 (!$fp) {

回声“$errstr($errno)

\n";

} 别的 {

$out = "GET /index.php / HTTP/1.1\r\n";

$out .= "主机:\r\n";

$out .= "连接:关闭\r\n\r\n";

fwrite($fp, $out);

/* 这里忽略执行结果

*可在测试期间打开

而 (!feof($fp)) {

回声 fgets($fp, 128);

}*/

fclose($fp);

}

PHP本身没有多线程,但是我们可以使用其他方法来达到多线程的效果。上面列出的三种方法各有优缺点。您可以在使用时根据程序的需要选择最好的一个。

本文原创发表于php中文网,转载请注明出处,感谢您的尊重!

php多线程抓取多个网页(行行网电子书多线程-撸代码代码非常简单-写在前面 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-03-19 08:05

)

星星网电子书多线程-写在前面

最近,我正在寻找一些电子书来阅读,所以我翻阅了它们。然后,我找到了一个叫周渡的网站,网站很好,简单清爽,书很多,而且都是开放的,都可以直接从百度网盘下载,而且更新速度也还行,就爬了上去。这篇文章可以文章学习,这么好的分享网站,尽量不要爬,会影响别人访问速度。需要数据的可以在我的博客下评论,我会发给你,QQ,邮箱什么的。

这个网站页面的逻辑很简单。我翻阅了这本书的详细信息页面,它看起来像下面这样。我们只需要循环生成这些页面的链接,然后就可以爬取了。为了速度,我使用如果你想爬取以后的数据,就在这个博客下面评论,不要破坏别人的服务器。

http://www.ireadweek.com/index ... .html

http://www.ireadweek.com/index ... .html

....

星星网电子书多线程-代码代码

代码很简单。以我们之前的教程做铺垫,用很少的代码就可以实现完整的功能。最后将采集的内容写入csv文件,(什么是csv,你百度一下就知道了)这段代码是IO密集型操作,我们使用aiohttp模块来写。

第一步

拼接 URL 以启动线程。

import requests

# 导入协程模块

import asyncio

import aiohttp

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36",

"Host": "www.ireadweek.com",

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8"}

async def get_content(url):

print("正在操作:{}".format(url))

# 创建一个session 去获取数据

async with aiohttp.ClientSession() as session:

async with session.get(url,headers=headers,timeout=3) as res:

if res.status == 200:

source = await res.text() # 等待获取文本

print(source)

if __name__ == '__main__':

url_format = "http://www.ireadweek.com/index.php/bookInfo/{}.html"

full_urllist = [url_format.format(i) for i in range(1,11394)] # 11394

loop = asyncio.get_event_loop()

tasks = [get_content(url) for url in full_urllist]

results = loop.run_until_complete(asyncio.wait(tasks))

上面的代码可以同步开启N个多线程,但是这样很容易导致别人的服务器瘫痪。因此,我们必须限制并发数。下面的代码,你可以试着把它放在指定的位置。

sema = asyncio.Semaphore(5)

# 为避免爬虫一次性请求次数太多,控制一下

async def x_get_source(url):

with(await sema):

await get_content(url)

第 2 步

处理抓取网页的源代码,提取我们想要的元素。我添加了一种使用 lxml 提取数据的方法。

def async_content(tree):

title = tree.xpath("//div[@class='hanghang-za-title']")[0].text

# 如果页面没有信息,直接返回即可

if title == '':

return

else:

try:

description = tree.xpath("//div[@class='hanghang-shu-content-font']")

author = description[0].xpath("p[1]/text()")[0].replace("作者:","") if description[0].xpath("p[1]/text()")[0] is not None else None

cate = description[0].xpath("p[2]/text()")[0].replace("分类:","") if description[0].xpath("p[2]/text()")[0] is not None else None

douban = description[0].xpath("p[3]/text()")[0].replace("豆瓣评分:","") if description[0].xpath("p[3]/text()")[0] is not None else None

# 这部分内容不明确,不做记录

#des = description[0].xpath("p[5]/text()")[0] if description[0].xpath("p[5]/text()")[0] is not None else None

download = tree.xpath("//a[@class='downloads']")

except Exception as e:

print(title)

return

ls = [

title,author,cate,douban,download[0].get('href')

]

return ls

第 3 步

格式化数据后,将其保存为 csv 文件并收工!

print(data)

with open('hang.csv', 'a+', encoding='utf-8') as fw:

writer = csv.writer(fw)

writer.writerow(data)

print("插入成功!")

星星网电子书多线程——运行代码,查看结果

因为这可能涉及到从其他人的服务器获取重要数据,所以代码不会上传到github。需要的可以留言,我单独发给你

查看全部

php多线程抓取多个网页(行行网电子书多线程-撸代码代码非常简单-写在前面

)

星星网电子书多线程-写在前面

最近,我正在寻找一些电子书来阅读,所以我翻阅了它们。然后,我找到了一个叫周渡的网站,网站很好,简单清爽,书很多,而且都是开放的,都可以直接从百度网盘下载,而且更新速度也还行,就爬了上去。这篇文章可以文章学习,这么好的分享网站,尽量不要爬,会影响别人访问速度。需要数据的可以在我的博客下评论,我会发给你,QQ,邮箱什么的。

这个网站页面的逻辑很简单。我翻阅了这本书的详细信息页面,它看起来像下面这样。我们只需要循环生成这些页面的链接,然后就可以爬取了。为了速度,我使用如果你想爬取以后的数据,就在这个博客下面评论,不要破坏别人的服务器。

http://www.ireadweek.com/index ... .html

http://www.ireadweek.com/index ... .html

....

星星网电子书多线程-代码代码

代码很简单。以我们之前的教程做铺垫,用很少的代码就可以实现完整的功能。最后将采集的内容写入csv文件,(什么是csv,你百度一下就知道了)这段代码是IO密集型操作,我们使用aiohttp模块来写。

第一步

拼接 URL 以启动线程。

import requests

# 导入协程模块

import asyncio

import aiohttp

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36",

"Host": "www.ireadweek.com",

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8"}

async def get_content(url):

print("正在操作:{}".format(url))

# 创建一个session 去获取数据

async with aiohttp.ClientSession() as session:

async with session.get(url,headers=headers,timeout=3) as res:

if res.status == 200:

source = await res.text() # 等待获取文本

print(source)

if __name__ == '__main__':

url_format = "http://www.ireadweek.com/index.php/bookInfo/{}.html"

full_urllist = [url_format.format(i) for i in range(1,11394)] # 11394

loop = asyncio.get_event_loop()

tasks = [get_content(url) for url in full_urllist]

results = loop.run_until_complete(asyncio.wait(tasks))

上面的代码可以同步开启N个多线程,但是这样很容易导致别人的服务器瘫痪。因此,我们必须限制并发数。下面的代码,你可以试着把它放在指定的位置。

sema = asyncio.Semaphore(5)

# 为避免爬虫一次性请求次数太多,控制一下

async def x_get_source(url):

with(await sema):

await get_content(url)

第 2 步

处理抓取网页的源代码,提取我们想要的元素。我添加了一种使用 lxml 提取数据的方法。

def async_content(tree):

title = tree.xpath("//div[@class='hanghang-za-title']")[0].text

# 如果页面没有信息,直接返回即可

if title == '':

return

else:

try:

description = tree.xpath("//div[@class='hanghang-shu-content-font']")

author = description[0].xpath("p[1]/text()")[0].replace("作者:","") if description[0].xpath("p[1]/text()")[0] is not None else None

cate = description[0].xpath("p[2]/text()")[0].replace("分类:","") if description[0].xpath("p[2]/text()")[0] is not None else None

douban = description[0].xpath("p[3]/text()")[0].replace("豆瓣评分:","") if description[0].xpath("p[3]/text()")[0] is not None else None

# 这部分内容不明确,不做记录

#des = description[0].xpath("p[5]/text()")[0] if description[0].xpath("p[5]/text()")[0] is not None else None

download = tree.xpath("//a[@class='downloads']")

except Exception as e:

print(title)

return

ls = [

title,author,cate,douban,download[0].get('href')

]

return ls

第 3 步

格式化数据后,将其保存为 csv 文件并收工!

print(data)

with open('hang.csv', 'a+', encoding='utf-8') as fw:

writer = csv.writer(fw)

writer.writerow(data)

print("插入成功!")

星星网电子书多线程——运行代码,查看结果

因为这可能涉及到从其他人的服务器获取重要数据,所以代码不会上传到github。需要的可以留言,我单独发给你

php多线程抓取多个网页(php多线程抓取多个网页怎么实现呢?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-03-16 03:04

php多线程抓取多个网页我们在抓取数据时可能会对其中的某些网址进行多次重复抓取,方便我们对数据进行存储。通过多线程抓取数据将会节省大量的代码开发时间。很多现代网站只支持单线程模式,这无疑将是一个很大的伤害。很多人苦恼这个问题:php多线程抓取多个网页怎么实现呢?今天就跟着小编一起来学习吧!下面来看下phppstream对于php多线程抓取的完整使用方法和效果:第一步:我们创建一个普通网站,名字也可以改,别学广告。

第二步:通过下面的代码获取network抓取数据文件varnetwork=require('network');varasync=await{//分析accept参数;.//分析origin参数.//分析host参数.//分析user-agent参数.//分析etag参数.//分析age参数.//分析cookie参数awaitsendmail("mailto:"+async.format("mailto:"+async.format("mailto:"+async.format("@"+async.format("post:"+async.format("//"))),"e-mailto:"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format(。 查看全部

php多线程抓取多个网页(php多线程抓取多个网页怎么实现呢?(图))

php多线程抓取多个网页我们在抓取数据时可能会对其中的某些网址进行多次重复抓取,方便我们对数据进行存储。通过多线程抓取数据将会节省大量的代码开发时间。很多现代网站只支持单线程模式,这无疑将是一个很大的伤害。很多人苦恼这个问题:php多线程抓取多个网页怎么实现呢?今天就跟着小编一起来学习吧!下面来看下phppstream对于php多线程抓取的完整使用方法和效果:第一步:我们创建一个普通网站,名字也可以改,别学广告。

第二步:通过下面的代码获取network抓取数据文件varnetwork=require('network');varasync=await{//分析accept参数;.//分析origin参数.//分析host参数.//分析user-agent参数.//分析etag参数.//分析age参数.//分析cookie参数awaitsendmail("mailto:"+async.format("mailto:"+async.format("mailto:"+async.format("@"+async.format("post:"+async.format("//"))),"e-mailto:"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format("@"+async.format(。

php多线程抓取多个网页(用Java+Jsoup实现简单的网页爬虫功能,你知道吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-03-16 01:16

上一篇介绍了使用Java+Jsoup实现一个简单的网络爬虫功能。这次我们再深入一点,同时抓取多个新闻网站,并将有用的信息(新闻标题、URL、新闻内容等)存储在数据库中。先介绍一个非常好用的多线程爬虫框架AiPa。

AiPa爬虫框架

Aipa 是一个小型、灵活且高度可扩展的多线程爬虫框架。

AiPa 依赖于 Jsoup,这是目前最简单的 HTML 解析器。

AiPa只需要用户提供一个URL集合,它就可以在多线程下自动爬取并处理一些异常。

马文

直接进口

cn.yueshutong

AiPa

1.0.0.RELEASE

采用

1.必须实现的接口:

public class MyAiPaWorker implements AiPaWorker {

@Override

public String run(Document doc, AiPaUtil util) {

//使用JSOUP进行HTML解析获取想要的div节点和属性

//保存在数据库或本地文件中

//新增aiPaUtil工具类可以再次请求网址

return doc.title() + doc.body().text();

}

@Override

public Boolean fail(String link) {

//任务执行失败

//可以记录失败网址

//记录日志

return false;

}

}

2.主要方法

public static void main(String[] args) throws InstantiationException, IllegalAccessException, ExecutionException, InterruptedException {

//准备网址集合

List linkList = new ArrayList();

linkList.add("http://jb39.com/jibing/FeiQiZhong265988.htm");

linkList.add("http://jb39.com/jibing/XiaoErGuoDu262953.htm");

linkList.add("http://jb39.com/jibing/XinShen ... 6quot;);

linkList.add("http://jb39.com/jibing/GaoYuan ... 6quot;);

linkList.add("http://jb39.com/zhengzhuang/LuoYin337449.htm");

//第一步:新建AiPa实例

AiPaExecutor aiPaExecutor = AiPa.newInstance(new MyAiPaWorker()).setCharset(Charset.forName("GBK"));

//第二步:提交任务

for (int i = 0; i < 10; i++) {

aiPaExecutor.submit(linkList);

}

//第三步:读取返回值

List futureList = aiPaExecutor.getFutureList();

for (int i = 0; i < futureList.size(); i++) {

//get() 方法会阻塞当前线程直到获取返回值

System.out.println(futureList.get(i).get());

}

//第四步:关闭线程池

aiPaExecutor.shutdown();

}

3. AiPaWorker 接口

AiPaWorker 接口是用户必须实现的业务类。

该接口的方法如下:

public interface AiPaWorker {

/**

* 如何解析爬下来的HTML文档?

* @param doc JSOUP提供的文档

* @param util 爬虫工具类

* @return

*/

T run(Document doc, AiPaUtil util);

/**

* run方法异常则执行fail方法

* @param link 网址

* @return

*/

S fail(String link);

}

注意接口中run方法的参数doc,也就是Jsoup通过连接网页URL得到的文档,可以直接使用。

在run方法中,可以通过Jsoup方法爬取想要的数据,然后存入数据库。请注意,它是在 run 方法中执行的。

数据库访问操作。

即run()方法是用户自定义处理抓取到的HTML内容,一般使用Jsoup的Document类来解析。

获取节点或属性等并保存到数据库或本地文件。如果需要在业务方法中再次请求 URL,可以使用

工具类 Util。例如,在访问特定新闻页面时。

fail()方法是run方法发生异常或者爬取网页时进入的方法,多次处理无效。该方法的参数

是这次出错的网址。一般用于日志等操作。

以上是对AiPa框架的基本介绍。让我们从一个在多个新闻网站 上爬取新闻的简单示例开始。

网页的配置信息存储在数据库中。第一步是从数据库中获取要爬取的网站的各种配置信息。

//取数据库内配置列表

List articleCrawler= this.articleCrawlerDomain.getAllArticle();

List linkList = new ArrayList();

for (int i = 0; i < articleCrawler.size(); i++) {

String url = articleCrawler.get(i).getUrl();//获取网页Url

String ulClass = articleCrawler.get(i).getUlClass();//获取ul标签样式

String articleName = articleCrawler.get(i).getTname();//获取网页新闻名称

String contentClass = articleCrawler.get(i).getContentClass();//获取网页内容样式

String authorClass = articleCrawler.get(i).getAuthorClass();//获取新闻作者样式

String webCode = articleCrawler.get(i).getWebCode();//获取网页编码格式

String tableClass = articleCrawler.get(i).getTableClass();//获取表格样式

String listClass = articleCrawler.get(i).getListClass();//获取li标签样式

String divClass = articleCrawler.get(i).getDivClass();//获取div标签样式

String websiteUrl = articleCrawler.get(i).getWebsiteUrl();//获取网站官网URL

linkList.add(url);//设置网址集合

获取配置信息后,新建一个AiPa框架,在run方法中使用Jsoup的Document类解析,获取节点和属性,然后

调用方法存储在本地数据库中。

<p>//新建AiPa框架类

AiPaExecutor executor = AiPa.newInstance(new AiPaWorker(){

@Override

public Boolean run(Document document, AiPaUtil util) {

List contentList = new ArrayList();

List articleList = new ArrayList();

//如果新闻格式为无序列表且ul上有样式,格式为

if(ulClass!=null){

Elements ulLinks = document.getElementsByClass(ulClass);//根据ul的样式获取ul

for (Element ulLink : ulLinks) {

Elements liLinks = ulLink.getElementsByTag("li");//获取ul下的li

for (Element liLink : liLinks){

Elements aLinks = liLink.select("a");//获取li下的a标签

for (Element aLink : aLinks){

String title = aLink.text();//获取新闻标题

String titleUrl = aLink.attr("href");//获取新闻链接

List articleExist = articleDomain.queryByProperty("inforsource", titleUrl);

try {

if(title.length()>4 && titleUrl != "javascript:void(0);" && (articleExist == null || articleExist.size()== 0)){

Article article = (Article) articleDomain.getBaseObject();

article.setTname(title);

article.setInforsource(titleUrl);

article.setValid(false);

article.setColumnName(articleName);

article.setCreateId("admin");

contentList.add(titleUrl);

articleList.add(article);

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

}

articleDomain.deleteAndSaveAndUpdate(null, articleList, null);

}

//如果新闻格式为无序列表且ul上有样式,格式为

if (ulClass == null && listClass !=null ) {

Elements listEle = document.getElementsByClass(listClass);

for(Element list : listEle){

Elements ulEle = list.getElementsByTag("ul");

for(Element ulLink :ulEle){

Elements liLinks = ulLink.getElementsByTag("li");//获取ul下的li

for (Element liLink : liLinks){

Elements aLinks = liLink.select("a");//获取li下的a标签

for (Element aLink : aLinks){

String title = aLink.text();//获取新闻标题

String titleUrl = aLink.attr("href");//获取新闻链接

List articleExist = articleDomain.queryByProperty("inforsource", titleUrl);

try {

if(title.length()>4 && titleUrl != "javascript:void(0);" && (articleExist == null || articleExist.size()== 0)){

Article article = (Article) articleDomain.getBaseObject();

article.setTname(title);

article.setInforsource(titleUrl);

article.setValid(false);

article.setColumnName(articleName);

article.setCreateId("admin");

contentList.add(titleUrl);

articleList.add(article);

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

}

}

articleDomain.deleteAndSaveAndUpdate(null, articleList, null);

}

//如果新闻格式没有列表,为<a></a>

if(ulClass == null && divClass != null){

Elements divEle = document.getElementsByClass(divClass);

for(Element div : divEle){

Elements aEle = div.select("a");//取div下的a标签

for(Element aLink : aEle){

String title = aLink.text();//获取新闻标题

String titleUrl = aLink.attr("href");//获取新闻链接

List articleExist = articleDomain.queryByProperty("inforsource", titleUrl);

try {

if(title.length()>4 && titleUrl != "javascript:void(0);" && (articleExist == null || articleExist.size()== 0)){

Article article = (Article) articleDomain.getBaseObject();

article.setTname(title);

article.setInforsource(titleUrl);

article.setValid(false);

article.setColumnName(articleName);

article.setCreateId("admin");

contentList.add(titleUrl);

articleList.add(article);

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

articleDomain.deleteAndSaveAndUpdate(null, articleList, null);

}

//获取新闻详细内容信息

for (int j = 0; j < contentList.size(); j++) {

String articleUrl = (String) contentList.get(j);//获取新闻详细内容链接

//验证新闻URL是否有效

Boolean testUrl = testUrl(articleUrl, 2000);

if(testUrl == false){

String substring = articleUrl.substring(0, 1);

if(".".equals(substring)){

articleUrl = articleUrl.replace("./", url);

}else{

articleUrl = websiteUrl + articleUrl;

}

}

try {

Document contentDoc = util.getHtmlDocument(articleUrl);//根据链接获取详细页面Document

Elements contentEle = contentDoc.getElementsByClass(contentClass);

String author = "";

if(authorClass!=null){

Elements authorEle = contentDoc.getElementsByClass(authorClass);

author = authorEle.text();//获取作者信息

}

String contentHtml = contentEle.html();//获取详细内容的HTML

String content = Jsoup.clean(contentHtml, Whitelist.basicWithImages());//Jsoup对网页HTML进行过滤,筛选标签内容

List articleExist = articleDomain.queryByProperty("inforsource", (String) contentList.get(j));

for (int k = 0; k < articleExist.size(); k++) {

Article article = (Article) articleExist.get(k);

String id = article.getId();

String clobInfo = clobInfoDomain.query(id);

if (!contentHtml.equals("") && (clobInfo == null || clobInfo.length() 查看全部

php多线程抓取多个网页(用Java+Jsoup实现简单的网页爬虫功能,你知道吗?)

上一篇介绍了使用Java+Jsoup实现一个简单的网络爬虫功能。这次我们再深入一点,同时抓取多个新闻网站,并将有用的信息(新闻标题、URL、新闻内容等)存储在数据库中。先介绍一个非常好用的多线程爬虫框架AiPa。

AiPa爬虫框架

Aipa 是一个小型、灵活且高度可扩展的多线程爬虫框架。

AiPa 依赖于 Jsoup,这是目前最简单的 HTML 解析器。

AiPa只需要用户提供一个URL集合,它就可以在多线程下自动爬取并处理一些异常。

马文

直接进口

cn.yueshutong

AiPa

1.0.0.RELEASE

采用

1.必须实现的接口:

public class MyAiPaWorker implements AiPaWorker {

@Override

public String run(Document doc, AiPaUtil util) {

//使用JSOUP进行HTML解析获取想要的div节点和属性

//保存在数据库或本地文件中

//新增aiPaUtil工具类可以再次请求网址

return doc.title() + doc.body().text();

}

@Override

public Boolean fail(String link) {

//任务执行失败

//可以记录失败网址

//记录日志

return false;

}

}

2.主要方法

public static void main(String[] args) throws InstantiationException, IllegalAccessException, ExecutionException, InterruptedException {

//准备网址集合

List linkList = new ArrayList();

linkList.add("http://jb39.com/jibing/FeiQiZhong265988.htm";);

linkList.add("http://jb39.com/jibing/XiaoErGuoDu262953.htm";);

linkList.add("http://jb39.com/jibing/XinShen ... 6quot;);

linkList.add("http://jb39.com/jibing/GaoYuan ... 6quot;);

linkList.add("http://jb39.com/zhengzhuang/LuoYin337449.htm";);

//第一步:新建AiPa实例

AiPaExecutor aiPaExecutor = AiPa.newInstance(new MyAiPaWorker()).setCharset(Charset.forName("GBK"));

//第二步:提交任务

for (int i = 0; i < 10; i++) {

aiPaExecutor.submit(linkList);

}

//第三步:读取返回值

List futureList = aiPaExecutor.getFutureList();

for (int i = 0; i < futureList.size(); i++) {

//get() 方法会阻塞当前线程直到获取返回值

System.out.println(futureList.get(i).get());

}

//第四步:关闭线程池

aiPaExecutor.shutdown();

}

3. AiPaWorker 接口

AiPaWorker 接口是用户必须实现的业务类。

该接口的方法如下:

public interface AiPaWorker {

/**

* 如何解析爬下来的HTML文档?

* @param doc JSOUP提供的文档

* @param util 爬虫工具类

* @return

*/

T run(Document doc, AiPaUtil util);

/**

* run方法异常则执行fail方法

* @param link 网址

* @return

*/

S fail(String link);

}

注意接口中run方法的参数doc,也就是Jsoup通过连接网页URL得到的文档,可以直接使用。

在run方法中,可以通过Jsoup方法爬取想要的数据,然后存入数据库。请注意,它是在 run 方法中执行的。

数据库访问操作。

即run()方法是用户自定义处理抓取到的HTML内容,一般使用Jsoup的Document类来解析。

获取节点或属性等并保存到数据库或本地文件。如果需要在业务方法中再次请求 URL,可以使用

工具类 Util。例如,在访问特定新闻页面时。

fail()方法是run方法发生异常或者爬取网页时进入的方法,多次处理无效。该方法的参数

是这次出错的网址。一般用于日志等操作。

以上是对AiPa框架的基本介绍。让我们从一个在多个新闻网站 上爬取新闻的简单示例开始。

网页的配置信息存储在数据库中。第一步是从数据库中获取要爬取的网站的各种配置信息。

//取数据库内配置列表

List articleCrawler= this.articleCrawlerDomain.getAllArticle();

List linkList = new ArrayList();

for (int i = 0; i < articleCrawler.size(); i++) {

String url = articleCrawler.get(i).getUrl();//获取网页Url

String ulClass = articleCrawler.get(i).getUlClass();//获取ul标签样式

String articleName = articleCrawler.get(i).getTname();//获取网页新闻名称

String contentClass = articleCrawler.get(i).getContentClass();//获取网页内容样式

String authorClass = articleCrawler.get(i).getAuthorClass();//获取新闻作者样式

String webCode = articleCrawler.get(i).getWebCode();//获取网页编码格式

String tableClass = articleCrawler.get(i).getTableClass();//获取表格样式

String listClass = articleCrawler.get(i).getListClass();//获取li标签样式

String divClass = articleCrawler.get(i).getDivClass();//获取div标签样式

String websiteUrl = articleCrawler.get(i).getWebsiteUrl();//获取网站官网URL

linkList.add(url);//设置网址集合

获取配置信息后,新建一个AiPa框架,在run方法中使用Jsoup的Document类解析,获取节点和属性,然后

调用方法存储在本地数据库中。

<p>//新建AiPa框架类

AiPaExecutor executor = AiPa.newInstance(new AiPaWorker(){

@Override

public Boolean run(Document document, AiPaUtil util) {

List contentList = new ArrayList();

List articleList = new ArrayList();

//如果新闻格式为无序列表且ul上有样式,格式为

if(ulClass!=null){

Elements ulLinks = document.getElementsByClass(ulClass);//根据ul的样式获取ul

for (Element ulLink : ulLinks) {

Elements liLinks = ulLink.getElementsByTag("li");//获取ul下的li

for (Element liLink : liLinks){

Elements aLinks = liLink.select("a");//获取li下的a标签

for (Element aLink : aLinks){

String title = aLink.text();//获取新闻标题

String titleUrl = aLink.attr("href");//获取新闻链接

List articleExist = articleDomain.queryByProperty("inforsource", titleUrl);

try {