c 抓取网页数据

c 抓取网页数据(/opencv.python.utilsimportimportloadmodelfromuti.exampleslsimportloadmodel2019-3-25日)

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-09-10 11:10

c 抓取网页数据(/opencv.python.utilsimportimportloadmodelfromuti.exampleslsimportloadmodel2019-3-25日)

c抓取网页数据一般是采用opencv库,这个很容易掌握,完整的程序,github有下载。caffe/opencv·github下面是获取一个视频片段的源代码,通过loadmodel.py文件中的train函数将目标数据通过shuffle方法打乱分别通过循环,每次迭代,分别在每一帧获取一组点,将这些点输入到model中进行训练。

接下来就是去fine-tune出适合自己数据集的architecture,采用pytorch的话,导入库importtorchimportnumpyasnpfromflask.frameworkimportflaskfromflask.webimportflaskfromcaffeimportconv2fromcaffe.examplesimporttorchfromcaffe.examples.python.utilsimportimportloadmodelfromutilsimportloadmodel2019-3-25日。

torchvision已经实现了自己的one-stage方法,但还是要实现源码,

目前手头上有数个三维物体的三维重建的模型,这个流程可以看下,-c3d-tf-model,每一帧可以用vgg-5最新版本进行训练:our-large-modeltrainingforandroid-images,unsupervisedlearninginspatialvisionandsimulation。vertica:-library。 查看全部

c抓取网页数据一般是采用opencv库,这个很容易掌握,完整的程序,github有下载。caffe/opencv·github下面是获取一个视频片段的源代码,通过loadmodel.py文件中的train函数将目标数据通过shuffle方法打乱分别通过循环,每次迭代,分别在每一帧获取一组点,将这些点输入到model中进行训练。

接下来就是去fine-tune出适合自己数据集的architecture,采用pytorch的话,导入库importtorchimportnumpyasnpfromflask.frameworkimportflaskfromflask.webimportflaskfromcaffeimportconv2fromcaffe.examplesimporttorchfromcaffe.examples.python.utilsimportimportloadmodelfromutilsimportloadmodel2019-3-25日。

torchvision已经实现了自己的one-stage方法,但还是要实现源码,

目前手头上有数个三维物体的三维重建的模型,这个流程可以看下,-c3d-tf-model,每一帧可以用vgg-5最新版本进行训练:our-large-modeltrainingforandroid-images,unsupervisedlearninginspatialvisionandsimulation。vertica:-library。 查看全部

c 抓取网页数据(/opencv.python.utilsimportimportloadmodelfromuti.exampleslsimportloadmodel2019-3-25日)

c抓取网页数据一般是采用opencv库,这个很容易掌握,完整的程序,github有下载。caffe/opencv·github下面是获取一个视频片段的源代码,通过loadmodel.py文件中的train函数将目标数据通过shuffle方法打乱分别通过循环,每次迭代,分别在每一帧获取一组点,将这些点输入到model中进行训练。

接下来就是去fine-tune出适合自己数据集的architecture,采用pytorch的话,导入库importtorchimportnumpyasnpfromflask.frameworkimportflaskfromflask.webimportflaskfromcaffeimportconv2fromcaffe.examplesimporttorchfromcaffe.examples.python.utilsimportimportloadmodelfromutilsimportloadmodel2019-3-25日。

torchvision已经实现了自己的one-stage方法,但还是要实现源码,

目前手头上有数个三维物体的三维重建的模型,这个流程可以看下,-c3d-tf-model,每一帧可以用vgg-5最新版本进行训练:our-large-modeltrainingforandroid-images,unsupervisedlearninginspatialvisionandsimulation。vertica:-library。

c 抓取网页数据(封装一个简单总结(一):抓取网页文档分析 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2021-09-10 00:10

c 抓取网页数据(封装一个简单总结(一):抓取网页文档分析

)

这两天学习了爬虫的基础知识,这里简单总结一下。

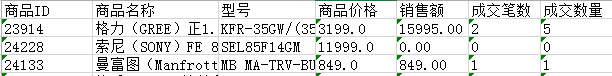

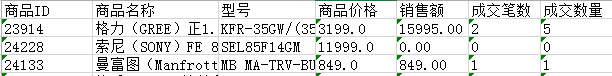

获取的网页商品数据保存在Excel表格中,效果如下:

使用Jumony Core引擎,是一个非常强大且几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并根据HTTP头自动识别。

一个抓取博客园站点导航顶部信息的例子:

var documents = new JumonyParser().LoadDocument("http://www.cnblogs.com/").Find("#site_nav_top").FirstOrDefault();

太强大了。如果你熟悉css,你就不需要手动编写很多可读性差的正则表达式来匹配和获取数据。

封装一个简单的操作库:

public class BaseAnalyzer

{

///

/// 根据Url加载html文档对象

///

///

///

protected virtual IHtmlDocument LoadDocument(string url)

{

return new JumonyParser().LoadDocument(url);

}

///

/// 查询指定url中指定选择器的元素集

///

///

///

///

protected virtual List QueryHtmlElements(string url, string selector, Func predicate = null)

{

var elementsCollection = new List();

IEnumerable elements = LoadDocument(url).Find(selector);

if (predicate != null)

{

elements = elements.Where(predicate);

}

if (elements != null)

elementsCollection.AddRange(elements);

return elementsCollection;

}

///

/// 分析Html文档,获取指定元素集第一个元素的文本内容

///

/// html文档对象

/// 选择器

/// 文本内容

protected virtual string GetFirstElementText(IHtmlContainer html, string selector)

{

var findList = html.Find(selector);

var result = findList.FirstOrDefault();

return result == null ? string.Empty : result.InnerText();

}

///

/// 分析Html文档,获取指定元素集的文本内容

///

/// html文档对象

/// 选择器

/// 自定义处理获取到的元素集,若没有,就返回第一个元素的文本内容

///

protected virtual string GetElementsText(IHtmlContainer html, string selector, Func func)

{

var findList = html.Find(selector);

if (func != null)

return func(findList);

return GetFirstElementText(html, selector);

}

}

获取产品名称的示例:

private ProductInfo AnalyzeProductInfo(string detailUrl)

{

var product = new ProductInfo();

//详情页html文档对象

var html = LoadDocument(detailUrl);

product.ProductName = GetFirstElementText(html, ".goods_particulars h1");

} 查看全部

)

这两天学习了爬虫的基础知识,这里简单总结一下。

获取的网页商品数据保存在Excel表格中,效果如下:

使用Jumony Core引擎,是一个非常强大且几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并根据HTTP头自动识别。

一个抓取博客园站点导航顶部信息的例子:

var documents = new JumonyParser().LoadDocument("http://www.cnblogs.com/").Find("#site_nav_top").FirstOrDefault();

太强大了。如果你熟悉css,你就不需要手动编写很多可读性差的正则表达式来匹配和获取数据。

封装一个简单的操作库:

public class BaseAnalyzer

{

///

/// 根据Url加载html文档对象

///

///

///

protected virtual IHtmlDocument LoadDocument(string url)

{

return new JumonyParser().LoadDocument(url);

}

///

/// 查询指定url中指定选择器的元素集

///

///

///

///

protected virtual List QueryHtmlElements(string url, string selector, Func predicate = null)

{

var elementsCollection = new List();

IEnumerable elements = LoadDocument(url).Find(selector);

if (predicate != null)

{

elements = elements.Where(predicate);

}

if (elements != null)

elementsCollection.AddRange(elements);

return elementsCollection;

}

///

/// 分析Html文档,获取指定元素集第一个元素的文本内容

///

/// html文档对象

/// 选择器

/// 文本内容

protected virtual string GetFirstElementText(IHtmlContainer html, string selector)

{

var findList = html.Find(selector);

var result = findList.FirstOrDefault();

return result == null ? string.Empty : result.InnerText();

}

///

/// 分析Html文档,获取指定元素集的文本内容

///

/// html文档对象

/// 选择器

/// 自定义处理获取到的元素集,若没有,就返回第一个元素的文本内容

///

protected virtual string GetElementsText(IHtmlContainer html, string selector, Func func)

{

var findList = html.Find(selector);

if (func != null)

return func(findList);

return GetFirstElementText(html, selector);

}

}

获取产品名称的示例:

private ProductInfo AnalyzeProductInfo(string detailUrl)

{

var product = new ProductInfo();

//详情页html文档对象

var html = LoadDocument(detailUrl);

product.ProductName = GetFirstElementText(html, ".goods_particulars h1");

} 查看全部

c 抓取网页数据(封装一个简单总结(一):抓取网页文档分析

)

这两天学习了爬虫的基础知识,这里简单总结一下。

获取的网页商品数据保存在Excel表格中,效果如下:

使用Jumony Core引擎,是一个非常强大且几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并根据HTTP头自动识别。

一个抓取博客园站点导航顶部信息的例子:

var documents = new JumonyParser().LoadDocument("http://www.cnblogs.com/";).Find("#site_nav_top").FirstOrDefault();

太强大了。如果你熟悉css,你就不需要手动编写很多可读性差的正则表达式来匹配和获取数据。

封装一个简单的操作库:

public class BaseAnalyzer

{

///

/// 根据Url加载html文档对象

///

///

///

protected virtual IHtmlDocument LoadDocument(string url)

{

return new JumonyParser().LoadDocument(url);

}

///

/// 查询指定url中指定选择器的元素集

///

///

///

///

protected virtual List QueryHtmlElements(string url, string selector, Func predicate = null)

{

var elementsCollection = new List();

IEnumerable elements = LoadDocument(url).Find(selector);

if (predicate != null)

{

elements = elements.Where(predicate);

}

if (elements != null)

elementsCollection.AddRange(elements);

return elementsCollection;

}

///

/// 分析Html文档,获取指定元素集第一个元素的文本内容

///

/// html文档对象

/// 选择器

/// 文本内容

protected virtual string GetFirstElementText(IHtmlContainer html, string selector)

{

var findList = html.Find(selector);

var result = findList.FirstOrDefault();

return result == null ? string.Empty : result.InnerText();

}

///

/// 分析Html文档,获取指定元素集的文本内容

///

/// html文档对象

/// 选择器

/// 自定义处理获取到的元素集,若没有,就返回第一个元素的文本内容

///

protected virtual string GetElementsText(IHtmlContainer html, string selector, Func func)

{

var findList = html.Find(selector);

if (func != null)

return func(findList);

return GetFirstElementText(html, selector);

}

}

获取产品名称的示例:

private ProductInfo AnalyzeProductInfo(string detailUrl)

{

var product = new ProductInfo();

//详情页html文档对象

var html = LoadDocument(detailUrl);

product.ProductName = GetFirstElementText(html, ".goods_particulars h1");

}

c 抓取网页数据(常见网页抓取语言有哪些?.js最适合练习动态编码活动)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-09-10 00:05

c 抓取网页数据(常见网页抓取语言有哪些?.js最适合练习动态编码活动)

网络爬虫是从任何网站或任何其他信息源中提取数据,并以您想要查看的格式保存在您的系统中的过程。那么,常见的网络抓取语言有哪些?

1、Python 是最常见的编码语言之一。对于任何网页抓取活动,Python 被认为是网页抓取的最佳方法。

2、Node.js 是最适合练习动态编码活动的数据爬虫活动。它还支持分布式抓取实践。 Node.js 使用 Javascript 来执行非阻塞应用程序,这有助于增强多个同时发生的事件。

3、Ruby 被认为是开源编程语言之一。它具有用户友好的语法,易于理解,易于练习和应用。 Ruby 的最大特点是它由多种语言组成,如 Perl、Smalltalk、Eiffel、Ada、Lip 和另一种新语言。

4、C 和 C++ 是一个很好的实现方案,但在进行网页抓取时可能会很昂贵。

5、 创建爬虫时,PHP 可能不是理想的选择。为了提取图形、图像、视频等视觉形式的信息,最好使用 CURL 库。 curl 库的最大优点是它可以帮助传输收录 HTTP 和 FTP 在内的协议列表的文件。拥有它可以帮助您创建可用于从在线平台下载任何类型信息的网络蜘蛛。

在使用在线平台提取数据时,上面提到的前5种网络爬虫语言是一个很好的解决方案,但没有安全保障。适用的代理服务器可以进行安全有效的网络爬虫活动。 查看全部

网络爬虫是从任何网站或任何其他信息源中提取数据,并以您想要查看的格式保存在您的系统中的过程。那么,常见的网络抓取语言有哪些?

1、Python 是最常见的编码语言之一。对于任何网页抓取活动,Python 被认为是网页抓取的最佳方法。

2、Node.js 是最适合练习动态编码活动的数据爬虫活动。它还支持分布式抓取实践。 Node.js 使用 Javascript 来执行非阻塞应用程序,这有助于增强多个同时发生的事件。

3、Ruby 被认为是开源编程语言之一。它具有用户友好的语法,易于理解,易于练习和应用。 Ruby 的最大特点是它由多种语言组成,如 Perl、Smalltalk、Eiffel、Ada、Lip 和另一种新语言。

4、C 和 C++ 是一个很好的实现方案,但在进行网页抓取时可能会很昂贵。

5、 创建爬虫时,PHP 可能不是理想的选择。为了提取图形、图像、视频等视觉形式的信息,最好使用 CURL 库。 curl 库的最大优点是它可以帮助传输收录 HTTP 和 FTP 在内的协议列表的文件。拥有它可以帮助您创建可用于从在线平台下载任何类型信息的网络蜘蛛。

在使用在线平台提取数据时,上面提到的前5种网络爬虫语言是一个很好的解决方案,但没有安全保障。适用的代理服务器可以进行安全有效的网络爬虫活动。 查看全部

c 抓取网页数据(常见网页抓取语言有哪些?.js最适合练习动态编码活动)

网络爬虫是从任何网站或任何其他信息源中提取数据,并以您想要查看的格式保存在您的系统中的过程。那么,常见的网络抓取语言有哪些?

1、Python 是最常见的编码语言之一。对于任何网页抓取活动,Python 被认为是网页抓取的最佳方法。

2、Node.js 是最适合练习动态编码活动的数据爬虫活动。它还支持分布式抓取实践。 Node.js 使用 Javascript 来执行非阻塞应用程序,这有助于增强多个同时发生的事件。

3、Ruby 被认为是开源编程语言之一。它具有用户友好的语法,易于理解,易于练习和应用。 Ruby 的最大特点是它由多种语言组成,如 Perl、Smalltalk、Eiffel、Ada、Lip 和另一种新语言。

4、C 和 C++ 是一个很好的实现方案,但在进行网页抓取时可能会很昂贵。

5、 创建爬虫时,PHP 可能不是理想的选择。为了提取图形、图像、视频等视觉形式的信息,最好使用 CURL 库。 curl 库的最大优点是它可以帮助传输收录 HTTP 和 FTP 在内的协议列表的文件。拥有它可以帮助您创建可用于从在线平台下载任何类型信息的网络蜘蛛。

在使用在线平台提取数据时,上面提到的前5种网络爬虫语言是一个很好的解决方案,但没有安全保障。适用的代理服务器可以进行安全有效的网络爬虫活动。

c 抓取网页数据(/opencv.python.utilsimportimportloadmodelfromuti.exampleslsimportloadmodel2019-3-25日)

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-09-10 11:10

c 抓取网页数据(/opencv.python.utilsimportimportloadmodelfromuti.exampleslsimportloadmodel2019-3-25日)

c抓取网页数据一般是采用opencv库,这个很容易掌握,完整的程序,github有下载。caffe/opencv·github下面是获取一个视频片段的源代码,通过loadmodel.py文件中的train函数将目标数据通过shuffle方法打乱分别通过循环,每次迭代,分别在每一帧获取一组点,将这些点输入到model中进行训练。

接下来就是去fine-tune出适合自己数据集的architecture,采用pytorch的话,导入库importtorchimportnumpyasnpfromflask.frameworkimportflaskfromflask.webimportflaskfromcaffeimportconv2fromcaffe.examplesimporttorchfromcaffe.examples.python.utilsimportimportloadmodelfromutilsimportloadmodel2019-3-25日。

torchvision已经实现了自己的one-stage方法,但还是要实现源码,

目前手头上有数个三维物体的三维重建的模型,这个流程可以看下,-c3d-tf-model,每一帧可以用vgg-5最新版本进行训练:our-large-modeltrainingforandroid-images,unsupervisedlearninginspatialvisionandsimulation。vertica:-library。 查看全部

c抓取网页数据一般是采用opencv库,这个很容易掌握,完整的程序,github有下载。caffe/opencv·github下面是获取一个视频片段的源代码,通过loadmodel.py文件中的train函数将目标数据通过shuffle方法打乱分别通过循环,每次迭代,分别在每一帧获取一组点,将这些点输入到model中进行训练。

接下来就是去fine-tune出适合自己数据集的architecture,采用pytorch的话,导入库importtorchimportnumpyasnpfromflask.frameworkimportflaskfromflask.webimportflaskfromcaffeimportconv2fromcaffe.examplesimporttorchfromcaffe.examples.python.utilsimportimportloadmodelfromutilsimportloadmodel2019-3-25日。

torchvision已经实现了自己的one-stage方法,但还是要实现源码,

目前手头上有数个三维物体的三维重建的模型,这个流程可以看下,-c3d-tf-model,每一帧可以用vgg-5最新版本进行训练:our-large-modeltrainingforandroid-images,unsupervisedlearninginspatialvisionandsimulation。vertica:-library。 查看全部

c 抓取网页数据(/opencv.python.utilsimportimportloadmodelfromuti.exampleslsimportloadmodel2019-3-25日)

c抓取网页数据一般是采用opencv库,这个很容易掌握,完整的程序,github有下载。caffe/opencv·github下面是获取一个视频片段的源代码,通过loadmodel.py文件中的train函数将目标数据通过shuffle方法打乱分别通过循环,每次迭代,分别在每一帧获取一组点,将这些点输入到model中进行训练。

接下来就是去fine-tune出适合自己数据集的architecture,采用pytorch的话,导入库importtorchimportnumpyasnpfromflask.frameworkimportflaskfromflask.webimportflaskfromcaffeimportconv2fromcaffe.examplesimporttorchfromcaffe.examples.python.utilsimportimportloadmodelfromutilsimportloadmodel2019-3-25日。

torchvision已经实现了自己的one-stage方法,但还是要实现源码,

目前手头上有数个三维物体的三维重建的模型,这个流程可以看下,-c3d-tf-model,每一帧可以用vgg-5最新版本进行训练:our-large-modeltrainingforandroid-images,unsupervisedlearninginspatialvisionandsimulation。vertica:-library。

c 抓取网页数据(封装一个简单总结(一):抓取网页文档分析 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2021-09-10 00:10

c 抓取网页数据(封装一个简单总结(一):抓取网页文档分析

)

这两天学习了爬虫的基础知识,这里简单总结一下。

获取的网页商品数据保存在Excel表格中,效果如下:

使用Jumony Core引擎,是一个非常强大且几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并根据HTTP头自动识别。

一个抓取博客园站点导航顶部信息的例子:

var documents = new JumonyParser().LoadDocument("http://www.cnblogs.com/").Find("#site_nav_top").FirstOrDefault();

太强大了。如果你熟悉css,你就不需要手动编写很多可读性差的正则表达式来匹配和获取数据。

封装一个简单的操作库:

public class BaseAnalyzer

{

///

/// 根据Url加载html文档对象

///

///

///

protected virtual IHtmlDocument LoadDocument(string url)

{

return new JumonyParser().LoadDocument(url);

}

///

/// 查询指定url中指定选择器的元素集

///

///

///

///

protected virtual List QueryHtmlElements(string url, string selector, Func predicate = null)

{

var elementsCollection = new List();

IEnumerable elements = LoadDocument(url).Find(selector);

if (predicate != null)

{

elements = elements.Where(predicate);

}

if (elements != null)

elementsCollection.AddRange(elements);

return elementsCollection;

}

///

/// 分析Html文档,获取指定元素集第一个元素的文本内容

///

/// html文档对象

/// 选择器

/// 文本内容

protected virtual string GetFirstElementText(IHtmlContainer html, string selector)

{

var findList = html.Find(selector);

var result = findList.FirstOrDefault();

return result == null ? string.Empty : result.InnerText();

}

///

/// 分析Html文档,获取指定元素集的文本内容

///

/// html文档对象

/// 选择器

/// 自定义处理获取到的元素集,若没有,就返回第一个元素的文本内容

///

protected virtual string GetElementsText(IHtmlContainer html, string selector, Func func)

{

var findList = html.Find(selector);

if (func != null)

return func(findList);

return GetFirstElementText(html, selector);

}

}

获取产品名称的示例:

private ProductInfo AnalyzeProductInfo(string detailUrl)

{

var product = new ProductInfo();

//详情页html文档对象

var html = LoadDocument(detailUrl);

product.ProductName = GetFirstElementText(html, ".goods_particulars h1");

} 查看全部

)

这两天学习了爬虫的基础知识,这里简单总结一下。

获取的网页商品数据保存在Excel表格中,效果如下:

使用Jumony Core引擎,是一个非常强大且几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并根据HTTP头自动识别。

一个抓取博客园站点导航顶部信息的例子:

var documents = new JumonyParser().LoadDocument("http://www.cnblogs.com/").Find("#site_nav_top").FirstOrDefault();

太强大了。如果你熟悉css,你就不需要手动编写很多可读性差的正则表达式来匹配和获取数据。

封装一个简单的操作库:

public class BaseAnalyzer

{

///

/// 根据Url加载html文档对象

///

///

///

protected virtual IHtmlDocument LoadDocument(string url)

{

return new JumonyParser().LoadDocument(url);

}

///

/// 查询指定url中指定选择器的元素集

///

///

///

///

protected virtual List QueryHtmlElements(string url, string selector, Func predicate = null)

{

var elementsCollection = new List();

IEnumerable elements = LoadDocument(url).Find(selector);

if (predicate != null)

{

elements = elements.Where(predicate);

}

if (elements != null)

elementsCollection.AddRange(elements);

return elementsCollection;

}

///

/// 分析Html文档,获取指定元素集第一个元素的文本内容

///

/// html文档对象

/// 选择器

/// 文本内容

protected virtual string GetFirstElementText(IHtmlContainer html, string selector)

{

var findList = html.Find(selector);

var result = findList.FirstOrDefault();

return result == null ? string.Empty : result.InnerText();

}

///

/// 分析Html文档,获取指定元素集的文本内容

///

/// html文档对象

/// 选择器

/// 自定义处理获取到的元素集,若没有,就返回第一个元素的文本内容

///

protected virtual string GetElementsText(IHtmlContainer html, string selector, Func func)

{

var findList = html.Find(selector);

if (func != null)

return func(findList);

return GetFirstElementText(html, selector);

}

}

获取产品名称的示例:

private ProductInfo AnalyzeProductInfo(string detailUrl)

{

var product = new ProductInfo();

//详情页html文档对象

var html = LoadDocument(detailUrl);

product.ProductName = GetFirstElementText(html, ".goods_particulars h1");

} 查看全部

c 抓取网页数据(封装一个简单总结(一):抓取网页文档分析

)

这两天学习了爬虫的基础知识,这里简单总结一下。

获取的网页商品数据保存在Excel表格中,效果如下:

使用Jumony Core引擎,是一个非常强大且几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并根据HTTP头自动识别。

一个抓取博客园站点导航顶部信息的例子:

var documents = new JumonyParser().LoadDocument("http://www.cnblogs.com/";).Find("#site_nav_top").FirstOrDefault();

太强大了。如果你熟悉css,你就不需要手动编写很多可读性差的正则表达式来匹配和获取数据。

封装一个简单的操作库:

public class BaseAnalyzer

{

///

/// 根据Url加载html文档对象

///

///

///

protected virtual IHtmlDocument LoadDocument(string url)

{

return new JumonyParser().LoadDocument(url);

}

///

/// 查询指定url中指定选择器的元素集

///

///

///

///

protected virtual List QueryHtmlElements(string url, string selector, Func predicate = null)

{

var elementsCollection = new List();

IEnumerable elements = LoadDocument(url).Find(selector);

if (predicate != null)

{

elements = elements.Where(predicate);

}

if (elements != null)

elementsCollection.AddRange(elements);

return elementsCollection;

}

///

/// 分析Html文档,获取指定元素集第一个元素的文本内容

///

/// html文档对象

/// 选择器

/// 文本内容

protected virtual string GetFirstElementText(IHtmlContainer html, string selector)

{

var findList = html.Find(selector);

var result = findList.FirstOrDefault();

return result == null ? string.Empty : result.InnerText();

}

///

/// 分析Html文档,获取指定元素集的文本内容

///

/// html文档对象

/// 选择器

/// 自定义处理获取到的元素集,若没有,就返回第一个元素的文本内容

///

protected virtual string GetElementsText(IHtmlContainer html, string selector, Func func)

{

var findList = html.Find(selector);

if (func != null)

return func(findList);

return GetFirstElementText(html, selector);

}

}

获取产品名称的示例:

private ProductInfo AnalyzeProductInfo(string detailUrl)

{

var product = new ProductInfo();

//详情页html文档对象

var html = LoadDocument(detailUrl);

product.ProductName = GetFirstElementText(html, ".goods_particulars h1");

}

c 抓取网页数据(常见网页抓取语言有哪些?.js最适合练习动态编码活动)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-09-10 00:05

c 抓取网页数据(常见网页抓取语言有哪些?.js最适合练习动态编码活动)

网络爬虫是从任何网站或任何其他信息源中提取数据,并以您想要查看的格式保存在您的系统中的过程。那么,常见的网络抓取语言有哪些?

1、Python 是最常见的编码语言之一。对于任何网页抓取活动,Python 被认为是网页抓取的最佳方法。

2、Node.js 是最适合练习动态编码活动的数据爬虫活动。它还支持分布式抓取实践。 Node.js 使用 Javascript 来执行非阻塞应用程序,这有助于增强多个同时发生的事件。

3、Ruby 被认为是开源编程语言之一。它具有用户友好的语法,易于理解,易于练习和应用。 Ruby 的最大特点是它由多种语言组成,如 Perl、Smalltalk、Eiffel、Ada、Lip 和另一种新语言。

4、C 和 C++ 是一个很好的实现方案,但在进行网页抓取时可能会很昂贵。

5、 创建爬虫时,PHP 可能不是理想的选择。为了提取图形、图像、视频等视觉形式的信息,最好使用 CURL 库。 curl 库的最大优点是它可以帮助传输收录 HTTP 和 FTP 在内的协议列表的文件。拥有它可以帮助您创建可用于从在线平台下载任何类型信息的网络蜘蛛。

在使用在线平台提取数据时,上面提到的前5种网络爬虫语言是一个很好的解决方案,但没有安全保障。适用的代理服务器可以进行安全有效的网络爬虫活动。 查看全部

网络爬虫是从任何网站或任何其他信息源中提取数据,并以您想要查看的格式保存在您的系统中的过程。那么,常见的网络抓取语言有哪些?

1、Python 是最常见的编码语言之一。对于任何网页抓取活动,Python 被认为是网页抓取的最佳方法。

2、Node.js 是最适合练习动态编码活动的数据爬虫活动。它还支持分布式抓取实践。 Node.js 使用 Javascript 来执行非阻塞应用程序,这有助于增强多个同时发生的事件。

3、Ruby 被认为是开源编程语言之一。它具有用户友好的语法,易于理解,易于练习和应用。 Ruby 的最大特点是它由多种语言组成,如 Perl、Smalltalk、Eiffel、Ada、Lip 和另一种新语言。

4、C 和 C++ 是一个很好的实现方案,但在进行网页抓取时可能会很昂贵。

5、 创建爬虫时,PHP 可能不是理想的选择。为了提取图形、图像、视频等视觉形式的信息,最好使用 CURL 库。 curl 库的最大优点是它可以帮助传输收录 HTTP 和 FTP 在内的协议列表的文件。拥有它可以帮助您创建可用于从在线平台下载任何类型信息的网络蜘蛛。

在使用在线平台提取数据时,上面提到的前5种网络爬虫语言是一个很好的解决方案,但没有安全保障。适用的代理服务器可以进行安全有效的网络爬虫活动。 查看全部

c 抓取网页数据(常见网页抓取语言有哪些?.js最适合练习动态编码活动)

网络爬虫是从任何网站或任何其他信息源中提取数据,并以您想要查看的格式保存在您的系统中的过程。那么,常见的网络抓取语言有哪些?

1、Python 是最常见的编码语言之一。对于任何网页抓取活动,Python 被认为是网页抓取的最佳方法。

2、Node.js 是最适合练习动态编码活动的数据爬虫活动。它还支持分布式抓取实践。 Node.js 使用 Javascript 来执行非阻塞应用程序,这有助于增强多个同时发生的事件。

3、Ruby 被认为是开源编程语言之一。它具有用户友好的语法,易于理解,易于练习和应用。 Ruby 的最大特点是它由多种语言组成,如 Perl、Smalltalk、Eiffel、Ada、Lip 和另一种新语言。

4、C 和 C++ 是一个很好的实现方案,但在进行网页抓取时可能会很昂贵。

5、 创建爬虫时,PHP 可能不是理想的选择。为了提取图形、图像、视频等视觉形式的信息,最好使用 CURL 库。 curl 库的最大优点是它可以帮助传输收录 HTTP 和 FTP 在内的协议列表的文件。拥有它可以帮助您创建可用于从在线平台下载任何类型信息的网络蜘蛛。

在使用在线平台提取数据时,上面提到的前5种网络爬虫语言是一个很好的解决方案,但没有安全保障。适用的代理服务器可以进行安全有效的网络爬虫活动。