网页数据抓取软件

网页数据抓取软件(网页数据抓取软件|requests-javascript数据采集浏览器的应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-20 06:02

网页数据抓取软件|requests-javascript数据采集requests一直都是最受欢迎的网页数据抓取软件,源于“webfuckinglove”。而最近谷歌发布了requests的3.1版本,到了2018年7月更是比3.0版本升级了5次,再次改变了网页抓取的工作方式。requests作为一个数据抓取工具来说,有两个最基本的优点:抓取方便(输入url直接返回html文件)代码写起来简单。

上一期文章我们从工程实践的角度,对requests作为抓取任何网页内容的网页数据采集工具进行了分析。本期文章,我们从网页爬取的角度,对requests进行分析。工程实践我们用这两种方式,从手机浏览器访问网页抓取(谷歌和百度),使用抓取网页数据放到网站上进行分析,并得到结果。1.手机浏览器抓取通过上一节的阅读,大家可能已经发现,无论从网页抓取的角度还是从网页抓取的数据分析,requests已经足够强大。

但在采用这种方式采集网页内容之前,我们还需要一定的环境支持。目前我们先来讲解一下爬取网页的javascript代码。下面我们先看一下网页源代码的构成,这里为了分析方便,我们采用requests爬取网页内容我们需要用到浏览器的chrome浏览器,浏览器的firefox浏览器和谷歌浏览器(本文需要的版本为chrome92.8.15261和firefox34.x)。

首先,我们复制我们需要的网页url到javascript代码文件,并加上“#javascript”关键字。我们可以看到,采用采用scrapy框架的网页数据抓取方法已经是最大的优势了。现在我们依次浏览本网页,看到左上角有百度的手机搜索页,继续访问看到手机搜索页有按钮,我们用requests采集这个按钮的response。

我们只采集“#smartbutton”处的response,其余处需要用到javascript代码进行抓取。大家可以通过这个代码展示,整个网页抓取的流程。我们将通过下面的代码,展示如何用requests抓取页面内容并保存到本地。对应这种方式爬取网页,我们仅要采集我们想要爬取的部分内容,那么我们需要将我们需要爬取的网页页面连接和url连接到一起,我们使用bs4可以方便的进行组织连接。

另外我们选用此种抓取方式,网页有一定的转码要求,在开始前我们需要将“#smartbutton”页面的中间的,替换为“placeholder”的url。连接完毕后,我们查看cookie是否有效,只要发现网页被判断为伪装即将采集,我们将断网等待,恢复网络之后,我们依次访问右上角的搜索页。看到右上角的百度logo。

scrapy框架本身已经为我们提供了requests库,requests函数已经写好,我们只需要调用它进行采集即可。此处的登录。 查看全部

网页数据抓取软件(网页数据抓取软件|requests-javascript数据采集浏览器的应用)

网页数据抓取软件|requests-javascript数据采集requests一直都是最受欢迎的网页数据抓取软件,源于“webfuckinglove”。而最近谷歌发布了requests的3.1版本,到了2018年7月更是比3.0版本升级了5次,再次改变了网页抓取的工作方式。requests作为一个数据抓取工具来说,有两个最基本的优点:抓取方便(输入url直接返回html文件)代码写起来简单。

上一期文章我们从工程实践的角度,对requests作为抓取任何网页内容的网页数据采集工具进行了分析。本期文章,我们从网页爬取的角度,对requests进行分析。工程实践我们用这两种方式,从手机浏览器访问网页抓取(谷歌和百度),使用抓取网页数据放到网站上进行分析,并得到结果。1.手机浏览器抓取通过上一节的阅读,大家可能已经发现,无论从网页抓取的角度还是从网页抓取的数据分析,requests已经足够强大。

但在采用这种方式采集网页内容之前,我们还需要一定的环境支持。目前我们先来讲解一下爬取网页的javascript代码。下面我们先看一下网页源代码的构成,这里为了分析方便,我们采用requests爬取网页内容我们需要用到浏览器的chrome浏览器,浏览器的firefox浏览器和谷歌浏览器(本文需要的版本为chrome92.8.15261和firefox34.x)。

首先,我们复制我们需要的网页url到javascript代码文件,并加上“#javascript”关键字。我们可以看到,采用采用scrapy框架的网页数据抓取方法已经是最大的优势了。现在我们依次浏览本网页,看到左上角有百度的手机搜索页,继续访问看到手机搜索页有按钮,我们用requests采集这个按钮的response。

我们只采集“#smartbutton”处的response,其余处需要用到javascript代码进行抓取。大家可以通过这个代码展示,整个网页抓取的流程。我们将通过下面的代码,展示如何用requests抓取页面内容并保存到本地。对应这种方式爬取网页,我们仅要采集我们想要爬取的部分内容,那么我们需要将我们需要爬取的网页页面连接和url连接到一起,我们使用bs4可以方便的进行组织连接。

另外我们选用此种抓取方式,网页有一定的转码要求,在开始前我们需要将“#smartbutton”页面的中间的,替换为“placeholder”的url。连接完毕后,我们查看cookie是否有效,只要发现网页被判断为伪装即将采集,我们将断网等待,恢复网络之后,我们依次访问右上角的搜索页。看到右上角的百度logo。

scrapy框架本身已经为我们提供了requests库,requests函数已经写好,我们只需要调用它进行采集即可。此处的登录。

网页数据抓取软件(Python代码段落并提取相应值__box)

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-10-19 17:02

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

拿到label后,我们可以使用name_box的text属性来获取对应的值

name = name_box.text.strip() # strip() 函数用于去除前后空格

印刷名称

使用类似的方法,我们可以得到股票指数价格数据。

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

印刷价格

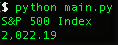

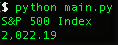

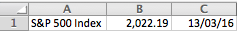

当您运行程序时,您应该能够看到程序输出标准普尔 500 指数的当前价格。

以 Excel CSV 格式导出数据

我们已经学习了如何获取数据,现在我们将学习如何存储数据。Excel 的逗号分隔数据格式 (CSV) 是一个不错的选择。这样,我们就可以在 Excel 中打开数据文件进行查看和进一步处理。

在此之前,我们需要导入 Python 的 csv 模块和 datetime 模块。Datetime 模块用于获取数据记录时间。请将以下代码行插入您的导入代码部分。

导入 csv

从日期时间导入日期时间

在代码底部,添加将数据写入 CSV 文件的代码。

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

writer.writerow([名称, 价格, datetime.now()])

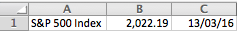

现在,如果您运行该程序,您应该能够导出一个 index.csv 文件。可以在Excel中打开文件,看到如图所示的一行数据。

所以如果你每天运行这个程序,你就可以轻松获得标准普尔指数价格,而不必像以前那样在网站上搜索。

更进一步(高级用法)

多个股票指数

抓取一个股指信息对你来说还不够,对吧?我们可以尝试同时提取多个股指信息。首先,我们需要修改 quote_page 以将其定义为 URL 数组。

quote_page = [':IND',':IND']

然后我们把代码的数据提取部分改成了for循环。这个循环可以一个一个地处理URL,并将变量data中的所有数据以元组类型存储。

# for 循环

数据 = []

对于quote_page中的pg:

# 检索网站并返回HTML代码,并将其存储在变量'page'中

页 = urllib2.urlopen(pg)

# 使用 beautifulSoup 解析 HTML 代码并将其存储在变量 `soup` 中

汤 = BeautifulSoup(page,'html.parser')

# 获取“名称”类别

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

name = name_box.text.strip() # strip() 用于去除开头和结尾

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

# 使用元组类型存储数据

data.append((名称,价格))

并且,修改保存部分,逐行保存数据

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

# for 循环

对于名称,数据中的价格:

writer.writerow([名称, 价格, datetime.now()])

重新运行程序,应该可以同时提取两个股指价格信息了!

先进的爬虫技术

BeautifulSoup 库使用方便,可以很好的做少量的网站爬取。但是如果你对大量的爬取信息感兴趣,可以考虑其他方法:

1. Scrapy,一个强大的 Python 数据捕获框架。

2. 您可以尝试将一些公共应用程序编程接口 (API) 集成到您的代码中。这种获取数据的方法远比网络爬行高效。例如,您可以尝试 Facebook Graph API。该 API 可以帮助您获取 Facebook 网站 上未显示的隐藏信息。

3. 如果数据量太大,可以考虑使用类似于MySQL的数据库后端来存储数据。

采取“不要重复”的方法

DRY 是英语中“不要重复你做过的事情”的缩写。您可以尝试像链接中的人一样自动化您的日常工作。同时,你也可以考虑其他有趣的项目,比如掌握你的 Facebook 好友的在线时间(当然他们同意),或者在论坛中获取讲座主题列表来尝试自然语言处理(这是当前人工智能的热门话题)!

原文链接

本文观点仅代表作者本人。36氪是信息发布平台,36氪仅提供信息存储空间服务。 查看全部

网页数据抓取软件(Python代码段落并提取相应值__box)

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

拿到label后,我们可以使用name_box的text属性来获取对应的值

name = name_box.text.strip() # strip() 函数用于去除前后空格

印刷名称

使用类似的方法,我们可以得到股票指数价格数据。

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

印刷价格

当您运行程序时,您应该能够看到程序输出标准普尔 500 指数的当前价格。

以 Excel CSV 格式导出数据

我们已经学习了如何获取数据,现在我们将学习如何存储数据。Excel 的逗号分隔数据格式 (CSV) 是一个不错的选择。这样,我们就可以在 Excel 中打开数据文件进行查看和进一步处理。

在此之前,我们需要导入 Python 的 csv 模块和 datetime 模块。Datetime 模块用于获取数据记录时间。请将以下代码行插入您的导入代码部分。

导入 csv

从日期时间导入日期时间

在代码底部,添加将数据写入 CSV 文件的代码。

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

writer.writerow([名称, 价格, datetime.now()])

现在,如果您运行该程序,您应该能够导出一个 index.csv 文件。可以在Excel中打开文件,看到如图所示的一行数据。

所以如果你每天运行这个程序,你就可以轻松获得标准普尔指数价格,而不必像以前那样在网站上搜索。

更进一步(高级用法)

多个股票指数

抓取一个股指信息对你来说还不够,对吧?我们可以尝试同时提取多个股指信息。首先,我们需要修改 quote_page 以将其定义为 URL 数组。

quote_page = [':IND',':IND']

然后我们把代码的数据提取部分改成了for循环。这个循环可以一个一个地处理URL,并将变量data中的所有数据以元组类型存储。

# for 循环

数据 = []

对于quote_page中的pg:

# 检索网站并返回HTML代码,并将其存储在变量'page'中

页 = urllib2.urlopen(pg)

# 使用 beautifulSoup 解析 HTML 代码并将其存储在变量 `soup` 中

汤 = BeautifulSoup(page,'html.parser')

# 获取“名称”类别

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

name = name_box.text.strip() # strip() 用于去除开头和结尾

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

# 使用元组类型存储数据

data.append((名称,价格))

并且,修改保存部分,逐行保存数据

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

# for 循环

对于名称,数据中的价格:

writer.writerow([名称, 价格, datetime.now()])

重新运行程序,应该可以同时提取两个股指价格信息了!

先进的爬虫技术

BeautifulSoup 库使用方便,可以很好的做少量的网站爬取。但是如果你对大量的爬取信息感兴趣,可以考虑其他方法:

1. Scrapy,一个强大的 Python 数据捕获框架。

2. 您可以尝试将一些公共应用程序编程接口 (API) 集成到您的代码中。这种获取数据的方法远比网络爬行高效。例如,您可以尝试 Facebook Graph API。该 API 可以帮助您获取 Facebook 网站 上未显示的隐藏信息。

3. 如果数据量太大,可以考虑使用类似于MySQL的数据库后端来存储数据。

采取“不要重复”的方法

DRY 是英语中“不要重复你做过的事情”的缩写。您可以尝试像链接中的人一样自动化您的日常工作。同时,你也可以考虑其他有趣的项目,比如掌握你的 Facebook 好友的在线时间(当然他们同意),或者在论坛中获取讲座主题列表来尝试自然语言处理(这是当前人工智能的热门话题)!

原文链接

本文观点仅代表作者本人。36氪是信息发布平台,36氪仅提供信息存储空间服务。

网页数据抓取软件(seospidermac特别版特别版 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-10-14 00:21

)

seo spider mac版,又名尖叫蛙SEO蜘蛛,是一款功能强大的网络爬虫软件,可以帮助您从不同的网页中选择要爬取的内容。它可以抓取网站的URL,并且可以实时分析结果并采集关键的现场数据,以方便SEO做出正确的决策,甚至对于无响应的网页。绝对是检测网站、搜索网络资源的神器!

SEO Spider是一款功能强大且灵活的网站爬虫,可以有效抓取小型和超大型网站,同时让您实时分析结果。它采集关键字段数据,以便 SEO 可以做出明智的决策。Screaming Frog SEO Spider 可让您快速抓取、分析和审核网站 领域的搜索引擎优化。

它可用于抓取小型和超大型 网站,其中手动检查每个页面将非常费力(或不可能!),并且您很容易错过重定向、元刷新或重复页面问题。您可以在程序的用户界面中不断采集和更新爬取数据,以查看、分析和过滤爬取数据。SEO Spider 允许您将关键的现场 SEO 元素(URL、页面标题、元描述、标题等)导出到 Excel,因此它可以轻松用作 SEO 推荐的基础。我们上面的视频演示了 SEO 工具可以做什么。

如果您正在寻找一款网络爬虫软件,那么seo spider mac 特别版是您不错的选择!seo蜘蛛mac特别版可以抓取网站的网址,在一个网站上自动分析几十个或几百个网页界面。通过 Screaming Frog SEO Spider 分析后,您可以获得所需的数据。

查看全部

网页数据抓取软件(seospidermac特别版特别版

)

seo spider mac版,又名尖叫蛙SEO蜘蛛,是一款功能强大的网络爬虫软件,可以帮助您从不同的网页中选择要爬取的内容。它可以抓取网站的URL,并且可以实时分析结果并采集关键的现场数据,以方便SEO做出正确的决策,甚至对于无响应的网页。绝对是检测网站、搜索网络资源的神器!

SEO Spider是一款功能强大且灵活的网站爬虫,可以有效抓取小型和超大型网站,同时让您实时分析结果。它采集关键字段数据,以便 SEO 可以做出明智的决策。Screaming Frog SEO Spider 可让您快速抓取、分析和审核网站 领域的搜索引擎优化。

它可用于抓取小型和超大型 网站,其中手动检查每个页面将非常费力(或不可能!),并且您很容易错过重定向、元刷新或重复页面问题。您可以在程序的用户界面中不断采集和更新爬取数据,以查看、分析和过滤爬取数据。SEO Spider 允许您将关键的现场 SEO 元素(URL、页面标题、元描述、标题等)导出到 Excel,因此它可以轻松用作 SEO 推荐的基础。我们上面的视频演示了 SEO 工具可以做什么。

如果您正在寻找一款网络爬虫软件,那么seo spider mac 特别版是您不错的选择!seo蜘蛛mac特别版可以抓取网站的网址,在一个网站上自动分析几十个或几百个网页界面。通过 Screaming Frog SEO Spider 分析后,您可以获得所需的数据。

网页数据抓取软件(如何把它输入给lxml.html模块(html字符串) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-10-14 00:21

)

狭义的爬虫只负责爬行,也就是下载网页。实际上,爬虫也负责从下载的网页中提取我们想要的数据,即对非结构化数据(网页)进行分析,提取结构化数据(有用数据)。比如我们想要抓取一个新闻页面的网页(html),但是我们想要的是这个网页中关于新闻的结构化数据:新闻标题、新闻发布时间、新闻正文等。

因此,下载网页只是第一步,另一个重要的步骤是数据提取。不同的爬虫想要的数据不同,提取的数据也不同,但是提取的方法大同小异。

提取数据的最简单方法是使用正则表达式。这种方法简单,提取逻辑不能复杂,否则写的正则表达式会晦涩难懂,甚至复杂的数据结构也提取不出来。

最后,经过多年的经验,老袁选择了lxml和xpath来解析网页,提取结构化数据。顺便说一句,BeautifulSoup 也是解析 HTML 的好工具。可以使用多个解析器,比如Python标准库的解析器,但是速度比较慢。也可以使用 lxml 作为解析器,但它的用法和 API 与 lxml 不一样。用了之后,lxml的API就舒服多了。

lxml 绑定了 C 语言库 libxml2 和 libxslt,并提供了 Pythonic API。它有一些主要特点:

一句话概括,是一个结合了C语言的速度和Python的简单性的神器。

lxml有两部分,分别支持XML和HTML的解析:

lxml.etree 可以用来解析RSS feed,它是一个XML 格式的文档。但是爬虫爬取的大部分都是html网页,所以这里主要讲一下lxml.html解析网页的方法。

lxml.html 从 html 字符串生成文档树结构

我们下载的网页是一串html字符串。如何将其输入到 lxml.html 模块中以生成 html 文档的树结构?

该模块提供了几种不同的方法:

下面我们通过具体的例子来说明上述方法的区别。

如何使用 document_fromstring

In [1]: import lxml.html as lh

In [2]: z = lh.document_fromstring('abcxyz')

# 可以看到,它自动加了根节点

In [3]: z

Out[3]:

In [4]: z.tag

Out[4]: 'html'

# 还加了节点

In [5]: z.getchildren()

Out[5]: []

# 把字符串的两个节点放在了里面

In [6]: z.getchildren()[0].getchildren()

Out[6]: [, ]

fragment_fromstring 的使用

In [11]: z = lh.fragment_fromstring(‘abcxyz’)

---------------------------------------------------------------------------

ParserError Traceback (most recent call last)

in ()

----> 1 z = lh.fragment_fromstring(‘abcxyz’)

~/.virtualenvs/py3.6/lib/python3.6/site-packages/lxml/html/__init__.py in fragment_fromstring(html, create_parent, base_url, parser, **kw)

850 raise etree.ParserError(

851 “Multiple elements found (%s)”

--> 852 % ‘, ‘.join([_element_name(e) for e in elements]))

853 el = elements[0]

854 if el.tail and el.tail.strip():

ParserError: Multiple elements found (div, div)

# 可以看到,输入是两个节点(element)时就会报错

# 如果加上 create_parent 参数,就没问题了

In [12]: z = lh.fragment_fromstring('abcxyz', create_parent='p')

In [13]: z.tag

Out[13]: 'p'

In [14]: z.getchildren()

Out[14]: [, ]

fragment_fromstring 的使用

# 输入字符串含有一个节点,则返回包含这一个节点的列表

In [17]: lh.fragments_fromstring('abc')

Out[17]: []

# 输入字符串含有多个节点,则返回包含这多个节点的列表

In [18]: lh.fragments_fromstring('abcxyz')

Out[18]: [, ]

使用 fromstring

<br />In [27]: z = lh.fromstring('abcxyz')

In [28]: z

Out[28]:

In [29]: z.getchildren()

Out[29]: [, ]

In [30]: type(z)

Out[30]: lxml.html.HtmlElement

这里,如果输入的fromstring是多个节点,则会添加一个父节点并返回。但是就像html网页从节点开始一样,我们可以使用fromstring()和document_fromstring()来获取完整的网页结构。

从上面的代码中,我们可以看到这些函数返回的是 HtmlElement 对象。也就是说,我们已经学会了如何从 html 字符串中获取 HtmlElement 对象。在下一节中,我们将学习如何操作 HtmlElement 对象。提取我们感兴趣的数据。

查看全部

网页数据抓取软件(如何把它输入给lxml.html模块(html字符串)

)

狭义的爬虫只负责爬行,也就是下载网页。实际上,爬虫也负责从下载的网页中提取我们想要的数据,即对非结构化数据(网页)进行分析,提取结构化数据(有用数据)。比如我们想要抓取一个新闻页面的网页(html),但是我们想要的是这个网页中关于新闻的结构化数据:新闻标题、新闻发布时间、新闻正文等。

因此,下载网页只是第一步,另一个重要的步骤是数据提取。不同的爬虫想要的数据不同,提取的数据也不同,但是提取的方法大同小异。

提取数据的最简单方法是使用正则表达式。这种方法简单,提取逻辑不能复杂,否则写的正则表达式会晦涩难懂,甚至复杂的数据结构也提取不出来。

最后,经过多年的经验,老袁选择了lxml和xpath来解析网页,提取结构化数据。顺便说一句,BeautifulSoup 也是解析 HTML 的好工具。可以使用多个解析器,比如Python标准库的解析器,但是速度比较慢。也可以使用 lxml 作为解析器,但它的用法和 API 与 lxml 不一样。用了之后,lxml的API就舒服多了。

lxml 绑定了 C 语言库 libxml2 和 libxslt,并提供了 Pythonic API。它有一些主要特点:

一句话概括,是一个结合了C语言的速度和Python的简单性的神器。

lxml有两部分,分别支持XML和HTML的解析:

lxml.etree 可以用来解析RSS feed,它是一个XML 格式的文档。但是爬虫爬取的大部分都是html网页,所以这里主要讲一下lxml.html解析网页的方法。

lxml.html 从 html 字符串生成文档树结构

我们下载的网页是一串html字符串。如何将其输入到 lxml.html 模块中以生成 html 文档的树结构?

该模块提供了几种不同的方法:

下面我们通过具体的例子来说明上述方法的区别。

如何使用 document_fromstring

In [1]: import lxml.html as lh

In [2]: z = lh.document_fromstring('abcxyz')

# 可以看到,它自动加了根节点

In [3]: z

Out[3]:

In [4]: z.tag

Out[4]: 'html'

# 还加了节点

In [5]: z.getchildren()

Out[5]: []

# 把字符串的两个节点放在了里面

In [6]: z.getchildren()[0].getchildren()

Out[6]: [, ]

fragment_fromstring 的使用

In [11]: z = lh.fragment_fromstring(‘abcxyz’)

---------------------------------------------------------------------------

ParserError Traceback (most recent call last)

in ()

----> 1 z = lh.fragment_fromstring(‘abcxyz’)

~/.virtualenvs/py3.6/lib/python3.6/site-packages/lxml/html/__init__.py in fragment_fromstring(html, create_parent, base_url, parser, **kw)

850 raise etree.ParserError(

851 “Multiple elements found (%s)”

--> 852 % ‘, ‘.join([_element_name(e) for e in elements]))

853 el = elements[0]

854 if el.tail and el.tail.strip():

ParserError: Multiple elements found (div, div)

# 可以看到,输入是两个节点(element)时就会报错

# 如果加上 create_parent 参数,就没问题了

In [12]: z = lh.fragment_fromstring('abcxyz', create_parent='p')

In [13]: z.tag

Out[13]: 'p'

In [14]: z.getchildren()

Out[14]: [, ]

fragment_fromstring 的使用

# 输入字符串含有一个节点,则返回包含这一个节点的列表

In [17]: lh.fragments_fromstring('abc')

Out[17]: []

# 输入字符串含有多个节点,则返回包含这多个节点的列表

In [18]: lh.fragments_fromstring('abcxyz')

Out[18]: [, ]

使用 fromstring

<br />In [27]: z = lh.fromstring('abcxyz')

In [28]: z

Out[28]:

In [29]: z.getchildren()

Out[29]: [, ]

In [30]: type(z)

Out[30]: lxml.html.HtmlElement

这里,如果输入的fromstring是多个节点,则会添加一个父节点并返回。但是就像html网页从节点开始一样,我们可以使用fromstring()和document_fromstring()来获取完整的网页结构。

从上面的代码中,我们可以看到这些函数返回的是 HtmlElement 对象。也就是说,我们已经学会了如何从 html 字符串中获取 HtmlElement 对象。在下一节中,我们将学习如何操作 HtmlElement 对象。提取我们感兴趣的数据。

网页数据抓取软件( 具体分析如下实现抓取和分析网页类,实例分析(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-13 23:31

具体分析如下实现抓取和分析网页类,实例分析(图))

爬取分析网页类示例的C#实现

更新时间:2015-05-25 10:53:05 作者:莫翔

本文文章主要介绍爬取分析网页的C#实现,实例分析了C#抓取分析网页中的文字和连接的相关使用技巧。有一定的参考价值,有需要的朋友可以参考以下

本文介绍了爬取和分析网页的 C# 实现。分享给大家,供大家参考。具体分析如下:

以下是用于抓取和分析网页的类。

它的主要功能是:

1、 提取网页的纯文本,转到所有html标签和javascript代码

2、 提取网页链接,包括href、frame和iframe

3、 提取网页标题等(其他标签类推,规律相同)

4、 可以实现简单的表单提交和cookie保存

/*

* Author:Sunjoy at CCNU

* 如果您改进了这个类请发一份代码给我(ccnusjy 在gmail.com)

*/

using System;

using System.Data;

using System.Configuration;

using System.Net;

using System.IO;

using System.Text;

using System.Collections.Generic;

using System.Text.RegularExpressions;

using System.Threading;

using System.Web;

///

/// 网页类

///

public class WebPage

{

#region 私有成员

private Uri m_uri; //网址

private List m_links; //此网页上的链接

private string m_title; //此网页的标题

private string m_html; //此网页的HTML代码

private string m_outstr; //此网页可输出的纯文本

private bool m_good; //此网页是否可用

private int m_pagesize; //此网页的大小

private static Dictionary webcookies = new Dictionary();//存放所有网页的Cookie

private string m_post; //此网页的登陆页需要的POST数据

private string m_loginurl; //此网页的登陆页

#endregion

#region 私有方法

///

/// 这私有方法从网页的HTML代码中分析出链接信息

///

/// List

private List getLinks()

{

if (m_links.Count == 0)

{

Regex[] regex = new Regex[2];

regex[0] = new Regex("(?m)]*>(?(\\w|\\W)*?)]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase);

for (int i = 0; i < 2; i++)

{

Match match = regex[i].Match(m_html);

while (match.Success)

{

try

{

string url = new Uri(m_uri, match.Groups["url"].Value).AbsoluteUri;

string text = "";

if (i == 0) text = new Regex("(]+>)|(\\s)|( )|&|\"", RegexOptions.Multiline | RegexOptions.IgnoreCase).Replace(match.Groups["text"].Value, "");

Link link = new Link(url, text);

m_links.Add(link);

}

catch(Exception ex){Console.WriteLine(ex.Message); };

match = match.NextMatch();

}

}

}

return m_links;

}

///

/// 此私有方法从一段HTML文本中提取出一定字数的纯文本

///

/// HTML代码

/// 提取从头数多少个字

/// 是否要链接里面的字

/// 纯文本

private string getFirstNchar(string instr, int firstN, bool withLink)

{

if (m_outstr == "")

{

m_outstr = instr.Clone() as string;

m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase ).Replace(m_outstr, "");

m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase ).Replace(m_outstr, "");

m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase ).Replace(m_outstr, "");

if (!withLink) m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase).Replace(m_outstr, "");

Regex objReg = new System.Text.RegularExpressions.Regex("(]+?>)| ", RegexOptions.Multiline | RegexOptions.IgnoreCase);

m_outstr = objReg.Replace(m_outstr, "");

Regex objReg2 = new System.Text.RegularExpressions.Regex("(\\s)+", RegexOptions.Multiline | RegexOptions.IgnoreCase);

m_outstr = objReg2.Replace(m_outstr, " ");

}

return m_outstr.Length > firstN ? m_outstr.Substring(0, firstN) : m_outstr;

}

///

/// 此私有方法返回一个IP地址对应的无符号整数

///

/// IP地址

///

private uint getuintFromIP(IPAddress x)

{

Byte[] bt = x.GetAddressBytes();

uint i = (uint)(bt[0] * 256 * 256 * 256);

i += (uint)(bt[1] * 256 * 256);

i += (uint)(bt[2] * 256);

i += (uint)(bt[3]);

return i;

}

#endregion

#region 公有文法

///

/// 此公有方法提取网页中一定字数的纯文本,包括链接文字

///

/// 字数

///

public string getContext(int firstN)

{

return getFirstNchar(m_html, firstN, true);

}

///

/// 此公有方法提取网页中一定字数的纯文本,不包括链接文字

///

///

///

public string getContextWithOutLink(int firstN)

{

return getFirstNchar(m_html, firstN, false);

}

///

/// 此公有方法从本网页的链接中提取一定数量的链接,该链接的URL满足某正则式

///

/// 正则式

/// 返回的链接的个数

/// List

public List getSpecialLinksByUrl(string pattern,int count)

{

if(m_links.Count==0)getLinks();

List SpecialLinks = new List();

List.Enumerator i;

i = m_links.GetEnumerator();

int cnt = 0;

while (i.MoveNext() && cnt=getuintFromIP(ip_start) && getuintFromIP(ip) 1 (?(?:\w|\W)*?)]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase );

Match mc = reg.Match(m_html);

if (mc.Success)

m_title= mc.Groups["title"].Value.Trim();

}

return m_title;

}

}

///

/// 此属性获得本网页的所有链接信息,只读

///

public List Links

{

get

{

if (m_links.Count == 0) getLinks();

return m_links;

}

}

///

/// 此属性返回本网页的全部纯文本信息,只读

///

public string Context

{

get

{

if (m_outstr == "") getContext(Int16.MaxValue);

return m_outstr;

}

}

///

/// 此属性获得本网页的大小

///

public int PageSize

{

get

{

return m_pagesize;

}

}

///

/// 此属性获得本网页的所有站内链接

///

public List InsiteLinks

{

get

{

return getSpecialLinksByUrl("^http://"+m_uri.Host,Int16.MaxValue);

}

}

///

/// 此属性表示本网页是否可用

///

public bool IsGood

{

get

{

return m_good;

}

}

///

/// 此属性表示网页的所在的网站

///

public string Host

{

get

{

return m_uri.Host;

}

}

///

/// 此网页的登陆页所需的POST数据

///

public string PostStr

{

get

{

return m_post;

}

}

///

/// 此网页的登陆页

///

public string LoginURL

{

get

{

return m_loginurl;

}

}

#endregion

}

///

/// 链接类

///

public class Link

{

public string url; //链接网址

public string text; //链接文字

public Link(string _url, string _text)

{

url = _url;

text = _text;

}

}

我希望这篇文章对你的 C# 编程有所帮助。 查看全部

网页数据抓取软件(

具体分析如下实现抓取和分析网页类,实例分析(图))

爬取分析网页类示例的C#实现

更新时间:2015-05-25 10:53:05 作者:莫翔

本文文章主要介绍爬取分析网页的C#实现,实例分析了C#抓取分析网页中的文字和连接的相关使用技巧。有一定的参考价值,有需要的朋友可以参考以下

本文介绍了爬取和分析网页的 C# 实现。分享给大家,供大家参考。具体分析如下:

以下是用于抓取和分析网页的类。

它的主要功能是:

1、 提取网页的纯文本,转到所有html标签和javascript代码

2、 提取网页链接,包括href、frame和iframe

3、 提取网页标题等(其他标签类推,规律相同)

4、 可以实现简单的表单提交和cookie保存

/*

* Author:Sunjoy at CCNU

* 如果您改进了这个类请发一份代码给我(ccnusjy 在gmail.com)

*/

using System;

using System.Data;

using System.Configuration;

using System.Net;

using System.IO;

using System.Text;

using System.Collections.Generic;

using System.Text.RegularExpressions;

using System.Threading;

using System.Web;

///

/// 网页类

///

public class WebPage

{

#region 私有成员

private Uri m_uri; //网址

private List m_links; //此网页上的链接

private string m_title; //此网页的标题

private string m_html; //此网页的HTML代码

private string m_outstr; //此网页可输出的纯文本

private bool m_good; //此网页是否可用

private int m_pagesize; //此网页的大小

private static Dictionary webcookies = new Dictionary();//存放所有网页的Cookie

private string m_post; //此网页的登陆页需要的POST数据

private string m_loginurl; //此网页的登陆页

#endregion

#region 私有方法

///

/// 这私有方法从网页的HTML代码中分析出链接信息

///

/// List

private List getLinks()

{

if (m_links.Count == 0)

{

Regex[] regex = new Regex[2];

regex[0] = new Regex("(?m)]*>(?(\\w|\\W)*?)]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase);

for (int i = 0; i < 2; i++)

{

Match match = regex[i].Match(m_html);

while (match.Success)

{

try

{

string url = new Uri(m_uri, match.Groups["url"].Value).AbsoluteUri;

string text = "";

if (i == 0) text = new Regex("(]+>)|(\\s)|( )|&|\"", RegexOptions.Multiline | RegexOptions.IgnoreCase).Replace(match.Groups["text"].Value, "");

Link link = new Link(url, text);

m_links.Add(link);

}

catch(Exception ex){Console.WriteLine(ex.Message); };

match = match.NextMatch();

}

}

}

return m_links;

}

///

/// 此私有方法从一段HTML文本中提取出一定字数的纯文本

///

/// HTML代码

/// 提取从头数多少个字

/// 是否要链接里面的字

/// 纯文本

private string getFirstNchar(string instr, int firstN, bool withLink)

{

if (m_outstr == "")

{

m_outstr = instr.Clone() as string;

m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase ).Replace(m_outstr, "");

m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase ).Replace(m_outstr, "");

m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase ).Replace(m_outstr, "");

if (!withLink) m_outstr = new Regex(@"(?m)]*>(\w|\W)*?]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase).Replace(m_outstr, "");

Regex objReg = new System.Text.RegularExpressions.Regex("(]+?>)| ", RegexOptions.Multiline | RegexOptions.IgnoreCase);

m_outstr = objReg.Replace(m_outstr, "");

Regex objReg2 = new System.Text.RegularExpressions.Regex("(\\s)+", RegexOptions.Multiline | RegexOptions.IgnoreCase);

m_outstr = objReg2.Replace(m_outstr, " ");

}

return m_outstr.Length > firstN ? m_outstr.Substring(0, firstN) : m_outstr;

}

///

/// 此私有方法返回一个IP地址对应的无符号整数

///

/// IP地址

///

private uint getuintFromIP(IPAddress x)

{

Byte[] bt = x.GetAddressBytes();

uint i = (uint)(bt[0] * 256 * 256 * 256);

i += (uint)(bt[1] * 256 * 256);

i += (uint)(bt[2] * 256);

i += (uint)(bt[3]);

return i;

}

#endregion

#region 公有文法

///

/// 此公有方法提取网页中一定字数的纯文本,包括链接文字

///

/// 字数

///

public string getContext(int firstN)

{

return getFirstNchar(m_html, firstN, true);

}

///

/// 此公有方法提取网页中一定字数的纯文本,不包括链接文字

///

///

///

public string getContextWithOutLink(int firstN)

{

return getFirstNchar(m_html, firstN, false);

}

///

/// 此公有方法从本网页的链接中提取一定数量的链接,该链接的URL满足某正则式

///

/// 正则式

/// 返回的链接的个数

/// List

public List getSpecialLinksByUrl(string pattern,int count)

{

if(m_links.Count==0)getLinks();

List SpecialLinks = new List();

List.Enumerator i;

i = m_links.GetEnumerator();

int cnt = 0;

while (i.MoveNext() && cnt=getuintFromIP(ip_start) && getuintFromIP(ip) 1 (?(?:\w|\W)*?)]*>", RegexOptions.Multiline | RegexOptions.IgnoreCase );

Match mc = reg.Match(m_html);

if (mc.Success)

m_title= mc.Groups["title"].Value.Trim();

}

return m_title;

}

}

///

/// 此属性获得本网页的所有链接信息,只读

///

public List Links

{

get

{

if (m_links.Count == 0) getLinks();

return m_links;

}

}

///

/// 此属性返回本网页的全部纯文本信息,只读

///

public string Context

{

get

{

if (m_outstr == "") getContext(Int16.MaxValue);

return m_outstr;

}

}

///

/// 此属性获得本网页的大小

///

public int PageSize

{

get

{

return m_pagesize;

}

}

///

/// 此属性获得本网页的所有站内链接

///

public List InsiteLinks

{

get

{

return getSpecialLinksByUrl("^http://"+m_uri.Host,Int16.MaxValue);

}

}

///

/// 此属性表示本网页是否可用

///

public bool IsGood

{

get

{

return m_good;

}

}

///

/// 此属性表示网页的所在的网站

///

public string Host

{

get

{

return m_uri.Host;

}

}

///

/// 此网页的登陆页所需的POST数据

///

public string PostStr

{

get

{

return m_post;

}

}

///

/// 此网页的登陆页

///

public string LoginURL

{

get

{

return m_loginurl;

}

}

#endregion

}

///

/// 链接类

///

public class Link

{

public string url; //链接网址

public string text; //链接文字

public Link(string _url, string _text)

{

url = _url;

text = _text;

}

}

我希望这篇文章对你的 C# 编程有所帮助。

网页数据抓取软件(一个“孤狼”如何抓取“短信接口”数据包的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 465 次浏览 • 2021-10-09 11:06

概括

所以主要是抢那些不受验证码保护的“短信接口”。找到这些不受验证码保护的网站也很棘手。

介绍

第一部分文章《短信轰炸机如何抓取短信界面?(详解)》讲解了如何抓取“短信界面”,很多粉丝问我怎么抓取?这位文章“孤狼”特来录制一段视频,讲解如何抓取“短信接口”数据包。

验证码保护

目前大部分网站都是有验证码保护的,有验证码保护的网站不利于接口的调用。所以主要是抢那些不受验证码保护的“短信接口”。找到这些不受验证码保护的网站也很棘手。如果你不分青红皂白地去寻找它,你将是大海捞针,收获甚微。

短信界面搜索思路

此前,“独狼”在互联网上借用网贷,造成信息泄露。网贷平台一直在给我发信息。这些给我发来的网贷平台短信,都收录了网贷平台链接点。进入之后,是一个单页的营销网页。您需要输入您的手机号码来测试配额,然后下载APP。输入手机号,点击查看配额。短信验证码将发送到您的手机。关键是没有验证码保护。按照这个推测,相似的网站肯定是一样的;那么就容易了!

关键词查找

然后就可以按照上面的思路使用关键词找到类似的网站,或者右键查看网页源码,通过网贷的关键词页面布局进行搜索平台。按照这种方法,在没有验证码保护的情况下,查找网页还是比较容易的。如果有实力,还可以写个“网络爬虫”,批量查找类似的网站。

短信接口测试

找到类似的网站后,通过抓包工具的编辑重发功能自行测试,更改数据包中的手机号发送数据包,看是否可行。如果数据包发送出去,结果是错误的,说明网页有JS加密算法,然后果断放弃这个网站。与其破解网站的加密算法,不如直接进入下一个网站。如果你精通网络编程,那就另当别论了。

写这篇文章的目的纯粹是为了交流和学习。请不要为了您自己的利益而将“短信轰炸机”商业化。这是一种违法犯罪行为。《孤狼》写这篇文章的初衷不在此,所以你的个人行为与我无关。

关注点击加入圈子,扫码进入获取文章中间工具 查看全部

网页数据抓取软件(一个“孤狼”如何抓取“短信接口”数据包的)

概括

所以主要是抢那些不受验证码保护的“短信接口”。找到这些不受验证码保护的网站也很棘手。

介绍

第一部分文章《短信轰炸机如何抓取短信界面?(详解)》讲解了如何抓取“短信界面”,很多粉丝问我怎么抓取?这位文章“孤狼”特来录制一段视频,讲解如何抓取“短信接口”数据包。

http://wss3.com/wp-content/upl ... 3.png 300w, http://wss3.com/wp-content/upl ... 9.png 768w" />

http://wss3.com/wp-content/upl ... 3.png 300w, http://wss3.com/wp-content/upl ... 9.png 768w" />验证码保护

目前大部分网站都是有验证码保护的,有验证码保护的网站不利于接口的调用。所以主要是抢那些不受验证码保护的“短信接口”。找到这些不受验证码保护的网站也很棘手。如果你不分青红皂白地去寻找它,你将是大海捞针,收获甚微。

http://wss3.com/wp-content/upl ... 3.png 300w, http://wss3.com/wp-content/upl ... 6.png 768w" />

http://wss3.com/wp-content/upl ... 3.png 300w, http://wss3.com/wp-content/upl ... 6.png 768w" />短信界面搜索思路

此前,“独狼”在互联网上借用网贷,造成信息泄露。网贷平台一直在给我发信息。这些给我发来的网贷平台短信,都收录了网贷平台链接点。进入之后,是一个单页的营销网页。您需要输入您的手机号码来测试配额,然后下载APP。输入手机号,点击查看配额。短信验证码将发送到您的手机。关键是没有验证码保护。按照这个推测,相似的网站肯定是一样的;那么就容易了!

http://wss3.com/wp-content/upl ... 8.png 300w, http://wss3.com/wp-content/upl ... 3.png 768w" />

http://wss3.com/wp-content/upl ... 8.png 300w, http://wss3.com/wp-content/upl ... 3.png 768w" />关键词查找

然后就可以按照上面的思路使用关键词找到类似的网站,或者右键查看网页源码,通过网贷的关键词页面布局进行搜索平台。按照这种方法,在没有验证码保护的情况下,查找网页还是比较容易的。如果有实力,还可以写个“网络爬虫”,批量查找类似的网站。

http://wss3.com/wp-content/upl ... 1.png 300w, http://wss3.com/wp-content/upl ... 3.png 768w" />

http://wss3.com/wp-content/upl ... 1.png 300w, http://wss3.com/wp-content/upl ... 3.png 768w" />短信接口测试

找到类似的网站后,通过抓包工具的编辑重发功能自行测试,更改数据包中的手机号发送数据包,看是否可行。如果数据包发送出去,结果是错误的,说明网页有JS加密算法,然后果断放弃这个网站。与其破解网站的加密算法,不如直接进入下一个网站。如果你精通网络编程,那就另当别论了。

http://wss3.com/wp-content/upl ... 2.png 300w, http://wss3.com/wp-content/upl ... 4.png 768w" />

http://wss3.com/wp-content/upl ... 2.png 300w, http://wss3.com/wp-content/upl ... 4.png 768w" />写这篇文章的目的纯粹是为了交流和学习。请不要为了您自己的利益而将“短信轰炸机”商业化。这是一种违法犯罪行为。《孤狼》写这篇文章的初衷不在此,所以你的个人行为与我无关。

关注点击加入圈子,扫码进入获取文章中间工具

网页数据抓取软件(最火网站能采集到以公开的号码数据或我有一个)

网站优化 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-10-08 15:44

爬一些网站可以采集到公众号资料,或者我有网站我把抢代码写在网站上,访问者访问网站为你可以在后台看到,有这样的。

最火爆的免费抢网站手机号软件技巧,免费抢网站手机号软件的最新技术方案,免费抢网站手机号软件。

优采云采集器免费的网络爬虫软件_网页数据抓取工具。

1. 通过抓取您的网站访问者,您可以获得准确的客户联系信息:QQ、手机号和客户访问、兴趣点等信息。2. 创建您的客户鱼塘(客户数据库),广泛撒网,并执行给潜在客户。

手机号抓取软件如何获取访客的手机号?不管是电脑访问还是手机访问网站,都是HTTP协议,肯定有一个叫做“HTTP消息”的东西,这里面收录了很多信息,访问者使用User-Agent。

语言:简体中文性质:国产软件软件大小:1.26 手机号码提取软件可以通过搜索快速提取搜索引擎中网站对应的手机号码,并以格式导出一张桌子。错过了互联网时代。

本软件软件已于2017年1月停止服务,请返回首页咨询大数据精准营销软件。公司访客统计助手是一套专业的手机网站访客手机号抓取工具。软件,仅供参考。

而且,百度地图的结果数据量会远大于其他软件采集的结果。更重要的是,Easy Search的技术实力可以保证所有主流的网站都能采集,而不仅仅是这些地图上的数据。所以一套轻松搜采集软。 查看全部

网页数据抓取软件(最火网站能采集到以公开的号码数据或我有一个)

爬一些网站可以采集到公众号资料,或者我有网站我把抢代码写在网站上,访问者访问网站为你可以在后台看到,有这样的。

最火爆的免费抢网站手机号软件技巧,免费抢网站手机号软件的最新技术方案,免费抢网站手机号软件。

优采云采集器免费的网络爬虫软件_网页数据抓取工具。

1. 通过抓取您的网站访问者,您可以获得准确的客户联系信息:QQ、手机号和客户访问、兴趣点等信息。2. 创建您的客户鱼塘(客户数据库),广泛撒网,并执行给潜在客户。

手机号抓取软件如何获取访客的手机号?不管是电脑访问还是手机访问网站,都是HTTP协议,肯定有一个叫做“HTTP消息”的东西,这里面收录了很多信息,访问者使用User-Agent。

语言:简体中文性质:国产软件软件大小:1.26 手机号码提取软件可以通过搜索快速提取搜索引擎中网站对应的手机号码,并以格式导出一张桌子。错过了互联网时代。

本软件软件已于2017年1月停止服务,请返回首页咨询大数据精准营销软件。公司访客统计助手是一套专业的手机网站访客手机号抓取工具。软件,仅供参考。

而且,百度地图的结果数据量会远大于其他软件采集的结果。更重要的是,Easy Search的技术实力可以保证所有主流的网站都能采集,而不仅仅是这些地图上的数据。所以一套轻松搜采集软。

网页数据抓取软件(要用好用使用Firebug插件审查元素的团购信息(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-10-05 19:00

)

1.首先确定要使用的模块,urrlib、os、re三个模块,

2. 获取数据并一一对应,然后使用循环嵌套(一开始就卡住了,然后咨询灵感),

3.获取网页的所有数据,爬下来

4.分析如何找出这些想要的模块,

5. 找出匹配的相对规律,

6.获取数据,找到对应的值

7.使用循环,配合使用字典,可以完整获取数据,

8.保存到对应文档

9.关闭文档,

10. 提示数据保存成功,爬取结束。

由于第一次采集这么多资料,只是爬了一张图什么的,所以作者还是很认真的审核了每一个元素,这里推荐使用火狐浏览器,感觉用Firebug真的很方便插件审查元素。

查看元素后,可以得到这个网站的编码形式是utf-8,这对于我们爬取数据也是至关重要的。

一开始,作者还开了一个软件fiddler,用来抓包

仍然有很多这样的信息。因为我截图的时候遇到了上网,还是找到了我想要的信息,所以可以在我的代码中添加信息来伪装浏览器,那么接下来要做的就是定位我们要查找的数据。

分析首页的团购信息,我们可以根据multiple确定这个信息的唯一标识,标签中有一个class="xtitle"的中间文字,那么我们的正则表达式就出来了,r'(.+ ?)'(正则太难,我一一试了)

描述也是标签的文本,然后会很快匹配出来,规律就出来了,r'class="short-title">(.+)'

后者依次类推。做完这些,接下来我们就开始编写爬虫程序,导入我们要使用的模块,定义我们要使用的变量。抓取、匹配,然后循环获取我们的结果并将它们写入文档。代码显示如下

查看全部

网页数据抓取软件(要用好用使用Firebug插件审查元素的团购信息(组图)

)

1.首先确定要使用的模块,urrlib、os、re三个模块,

2. 获取数据并一一对应,然后使用循环嵌套(一开始就卡住了,然后咨询灵感),

3.获取网页的所有数据,爬下来

4.分析如何找出这些想要的模块,

5. 找出匹配的相对规律,

6.获取数据,找到对应的值

7.使用循环,配合使用字典,可以完整获取数据,

8.保存到对应文档

9.关闭文档,

10. 提示数据保存成功,爬取结束。

由于第一次采集这么多资料,只是爬了一张图什么的,所以作者还是很认真的审核了每一个元素,这里推荐使用火狐浏览器,感觉用Firebug真的很方便插件审查元素。

查看元素后,可以得到这个网站的编码形式是utf-8,这对于我们爬取数据也是至关重要的。

一开始,作者还开了一个软件fiddler,用来抓包

仍然有很多这样的信息。因为我截图的时候遇到了上网,还是找到了我想要的信息,所以可以在我的代码中添加信息来伪装浏览器,那么接下来要做的就是定位我们要查找的数据。

分析首页的团购信息,我们可以根据multiple确定这个信息的唯一标识,标签中有一个class="xtitle"的中间文字,那么我们的正则表达式就出来了,r'(.+ ?)'(正则太难,我一一试了)

描述也是标签的文本,然后会很快匹配出来,规律就出来了,r'class="short-title">(.+)'

后者依次类推。做完这些,接下来我们就开始编写爬虫程序,导入我们要使用的模块,定义我们要使用的变量。抓取、匹配,然后循环获取我们的结果并将它们写入文档。代码显示如下

网页数据抓取软件(Python爬虫库如何选择适合你的库呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-10-05 18:18

在数据科学或人工智能领域,除了算法,最重要的就是数据。甚至可以说,最终决定模型精度的不是算法,而是数据。在现实中,缺乏足够的数据已经成为数据分析师获得好的模型的主要障碍。幸运的是,现在网络爬虫技术已经相当成熟,一个合格的数据分析师或人工智能模型设计师应该或多或少地精通几种网络爬虫技术。

Python提供了大量的爬虫库,每个库都有自己的特点,但是如何在项目中选择适合自己的库呢?本文主要列举了5个目前非常流行的Python爬虫库,并列出了各自的优缺点。我希望他们能对你的工作和学习有所帮助。

请求库

这是网络爬虫最基本的库。“请求”是指向网站 的服务器发送一个HTML 请求,以检索其页面上的内容。获取网页的 HTML 内容是网络爬虫的第一步。请求用于发出各种类型的 HTTP 请求,例如 GET、POST 等。

优势:

缺点:

lxml库

Ixml 是一个高性能的 HTML 和 XML 解析库。它特别适用于爬取和解析大型数据集。一般可以结合使用Requests库和Ixml库。Ixml 还允许您使用 XPath 和 CSS 选择器从 HTML 中提取数据。

优势:

缺点:

BeautifulSoup 库

BeautifulSoup 库是当前网络爬虫中使用最广泛的 Python 库,因为它简单易用,非常适合初学者。BeautifulSoup 创建一个解析树来解析 HTML 和 XML 文档。BeautifulSoup 会自动将输入文档转换为 Unicode,将输出文档转换为 UTF-8。我们可以将 BeautifulSoup 与其他解析器(例如 lxml)结合使用。BeautifulSoup 库的主要优点之一是它可以很好地处理设计不佳的 HTML。

优势:

缺点:

硒库

上面提到的三个 Python 库都有一定的局限性。他们无法轻松地从动态填充的 网站 中获取数据。这是因为动态 网站 的很多内容都是通过 JavaScript 加载的。. 换句话说,如果页面不是静态的,前面提到的 Python 库就很难从中抓取数据。Selenium 库就是用来解决上述问题的。Selenium 库最初用于网络自动化测试。在其他库无法运行 JavaScript 的地方,Selenium 可以完美解决。Selenium 可以实现点击控件、填写表单、在网页上滚动页面等操作。

优势:

缺点:

Scrapy 库

Python 网络爬虫库中的超级大佬。Scrapy 提供的蜘蛛机器人可以抓取多个 网站 并提取数据。Scrapy 最大的优势就是异步爬取。可以同时发出多个HTTP请求,所以爬取效率非常高。

优势:

缺点:

总结

Python网络爬虫库,每个库都是针对不同的使用场景而设计的,没有一个是最好的,只有哪个更适合你,你在使用的过程中需要考虑使用场景,毕竟在人工智能的世界里数据分析通常性能和计算机资源不能兼得。 查看全部

网页数据抓取软件(Python爬虫库如何选择适合你的库呢?(组图))

在数据科学或人工智能领域,除了算法,最重要的就是数据。甚至可以说,最终决定模型精度的不是算法,而是数据。在现实中,缺乏足够的数据已经成为数据分析师获得好的模型的主要障碍。幸运的是,现在网络爬虫技术已经相当成熟,一个合格的数据分析师或人工智能模型设计师应该或多或少地精通几种网络爬虫技术。

Python提供了大量的爬虫库,每个库都有自己的特点,但是如何在项目中选择适合自己的库呢?本文主要列举了5个目前非常流行的Python爬虫库,并列出了各自的优缺点。我希望他们能对你的工作和学习有所帮助。

请求库

这是网络爬虫最基本的库。“请求”是指向网站 的服务器发送一个HTML 请求,以检索其页面上的内容。获取网页的 HTML 内容是网络爬虫的第一步。请求用于发出各种类型的 HTTP 请求,例如 GET、POST 等。

优势:

缺点:

lxml库

Ixml 是一个高性能的 HTML 和 XML 解析库。它特别适用于爬取和解析大型数据集。一般可以结合使用Requests库和Ixml库。Ixml 还允许您使用 XPath 和 CSS 选择器从 HTML 中提取数据。

优势:

缺点:

BeautifulSoup 库

BeautifulSoup 库是当前网络爬虫中使用最广泛的 Python 库,因为它简单易用,非常适合初学者。BeautifulSoup 创建一个解析树来解析 HTML 和 XML 文档。BeautifulSoup 会自动将输入文档转换为 Unicode,将输出文档转换为 UTF-8。我们可以将 BeautifulSoup 与其他解析器(例如 lxml)结合使用。BeautifulSoup 库的主要优点之一是它可以很好地处理设计不佳的 HTML。

优势:

缺点:

硒库

上面提到的三个 Python 库都有一定的局限性。他们无法轻松地从动态填充的 网站 中获取数据。这是因为动态 网站 的很多内容都是通过 JavaScript 加载的。. 换句话说,如果页面不是静态的,前面提到的 Python 库就很难从中抓取数据。Selenium 库就是用来解决上述问题的。Selenium 库最初用于网络自动化测试。在其他库无法运行 JavaScript 的地方,Selenium 可以完美解决。Selenium 可以实现点击控件、填写表单、在网页上滚动页面等操作。

优势:

缺点:

Scrapy 库

Python 网络爬虫库中的超级大佬。Scrapy 提供的蜘蛛机器人可以抓取多个 网站 并提取数据。Scrapy 最大的优势就是异步爬取。可以同时发出多个HTTP请求,所以爬取效率非常高。

优势:

缺点:

总结

Python网络爬虫库,每个库都是针对不同的使用场景而设计的,没有一个是最好的,只有哪个更适合你,你在使用的过程中需要考虑使用场景,毕竟在人工智能的世界里数据分析通常性能和计算机资源不能兼得。

网页数据抓取软件( 本文仅供参考学习,禁止用于任何形式的商业用途,违者自行承担责任 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-10-05 18:15

本文仅供参考学习,禁止用于任何形式的商业用途,违者自行承担责任

)

本文仅供参考,禁止用于任何形式的商业用途,违者自负。

准备好工作了:

(1)手机(安卓和ios都可以)/安卓模拟器,今天主要是安卓模拟器,操作流程一样。(2)抓包工具:Fiddel 下载链接:(3)编程工具:pycharm(4)安卓模拟器上安装抖音(逍遥安装模拟器)一、fiddler配置

在工具中的选项中,根据图勾选复选框,然后点击操作

配置远程链接:

选择允许远程链接监控,端口可以随意设置,只要不重复,默认是8888

然后:重新启动提琴手!!!该配置可以生效。

二、安卓模拟器/手机配置

首先查看机器的IP:在cmd中输入ipconfig,记住这个IP

确保手机和电脑在同一个局域网内。

手机配置:配置连接的WiFi,代理选择手动,输入上图中ip端口号为8888

模拟器配置:在设置中,长按连接的wifi,代理选择手动,然后输入上图中的ip端口号为8888

设置好代理后,在浏览器中输入你设置的ip:端口,例如10.10.16.194:8888,就会打开fiddler页面。然后点击fiddlerRoot证书安装证书,不然手机会认为环境不安全。

证书名称随意设置,可能还需要设置锁屏密码。

然后就可以在fiddler中抓取手机/模拟器软件包了。

三、抖音 抓包

打开抖音,观察fiddler中的所有包

有一个包,包类型是json(json是网页返回的数据,具体百度),主机地址如图,包大小一般不小,这就是视频包。

点击这个json包,在fdder右侧,点击decode,我们将解码视频包的json

解码后:点击aweme_list,每个大括号代表一个视频,这个和bilibili弹幕或者快手一样,每次加载一点,等你看完预加载的,再重新加载一些。

Json 是一本字典。我们的视频链接位于:aweme_list。在每个视频下的video下play_addr下的url_list中,一共有6个url,都是一模一样的视频,可以用来应对不同的环境,但是一般第3个或者4个链接的视频不容易出现到问题。复制链接并将其粘贴到浏览器中以查看视频。

接下来解决几个问题,

1、视频数量。每个包中只有很少的视频。我怎样才能抓住更多?

这时候就需要用模拟器的模拟鼠标翻页,让模拟器一直在翻页,这样json包才会不断出现。

2、如何将json保存到本地使用

一种方法可以手动复制粘贴,但是这种方法很低。

所以我们使用fidder自带的脚本,在里面添加规则,刷出视频json包时自动保存json包。

自定义规则包:

提取码:7z0l

单击规则脚本,然后将自定义规则放置在如图所示的位置:

这个脚本有两点需要修改:

(1) 第一行的网址:

这是从视频包的 url 中提取的。抖音 会不定时更新这个url,所以如果不能使用就更新:

比如现在的和昨天的不一样,记得修改。

(2)路径,也就是我设置json包保存的地址,一定要自己修改,并创建文件夹,修改后记得保存。

打开并设置好模拟器和脚本后,稍等片刻,就可以看到文件夹中保存的包:

四、爬虫脚本

接下来在pycharm中写一个脚本,获取json包中的视频链接:

指南包:

导入操作系统、json、请求

迷彩头:

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36'}

逻辑代码:

运行代码:

影响:

import os,json,requests #伪装头 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36'}<br />videos_list = os.listdir('C:/Users/HEXU/Desktop/抖音数据爬取/抖音爬取资料/raw_data/') #获取文件夹内所有json包名<br />count = 1 #计数,用来作为视频名字<br />for videos in videos_list: #循环json列表,对每个json包进行操作 a = open('./抖音爬取资料/raw_data/{}'.format(videos),encoding='utf-8') #打开json包 content = json.load(a)['aweme_list'] #取出json包中所有视频<br /> for video in content: #循环视频列表,选取每个视频 video_url = video['video']['play_addr']['url_list'][4] #获取视频url,每个视频有6个url,我选的第5个 videoMp4 = requests.request('get',video_url,headers=headers).content #获取视频二进制代码 with open('./抖音爬取资料/VIDEO/{}.mp4'.format(count),'wb') as f: #以二进制方式写入路径,记住要先创建路径 f.write(videoMp4) #写入 print('视频{}下载完成'.format(count)) #下载提示 count += 1 #计数+1<br />

本文来自精品专栏《爬虫案例集》

查看全部

网页数据抓取软件(

本文仅供参考学习,禁止用于任何形式的商业用途,违者自行承担责任

)

本文仅供参考,禁止用于任何形式的商业用途,违者自负。

准备好工作了:

(1)手机(安卓和ios都可以)/安卓模拟器,今天主要是安卓模拟器,操作流程一样。(2)抓包工具:Fiddel 下载链接:(3)编程工具:pycharm(4)安卓模拟器上安装抖音(逍遥安装模拟器)一、fiddler配置

在工具中的选项中,根据图勾选复选框,然后点击操作

配置远程链接:

选择允许远程链接监控,端口可以随意设置,只要不重复,默认是8888

然后:重新启动提琴手!!!该配置可以生效。

二、安卓模拟器/手机配置

首先查看机器的IP:在cmd中输入ipconfig,记住这个IP

确保手机和电脑在同一个局域网内。

手机配置:配置连接的WiFi,代理选择手动,输入上图中ip端口号为8888

模拟器配置:在设置中,长按连接的wifi,代理选择手动,然后输入上图中的ip端口号为8888

设置好代理后,在浏览器中输入你设置的ip:端口,例如10.10.16.194:8888,就会打开fiddler页面。然后点击fiddlerRoot证书安装证书,不然手机会认为环境不安全。

证书名称随意设置,可能还需要设置锁屏密码。

然后就可以在fiddler中抓取手机/模拟器软件包了。

三、抖音 抓包

打开抖音,观察fiddler中的所有包

有一个包,包类型是json(json是网页返回的数据,具体百度),主机地址如图,包大小一般不小,这就是视频包。

点击这个json包,在fdder右侧,点击decode,我们将解码视频包的json

解码后:点击aweme_list,每个大括号代表一个视频,这个和bilibili弹幕或者快手一样,每次加载一点,等你看完预加载的,再重新加载一些。

Json 是一本字典。我们的视频链接位于:aweme_list。在每个视频下的video下play_addr下的url_list中,一共有6个url,都是一模一样的视频,可以用来应对不同的环境,但是一般第3个或者4个链接的视频不容易出现到问题。复制链接并将其粘贴到浏览器中以查看视频。

接下来解决几个问题,

1、视频数量。每个包中只有很少的视频。我怎样才能抓住更多?

这时候就需要用模拟器的模拟鼠标翻页,让模拟器一直在翻页,这样json包才会不断出现。

2、如何将json保存到本地使用

一种方法可以手动复制粘贴,但是这种方法很低。

所以我们使用fidder自带的脚本,在里面添加规则,刷出视频json包时自动保存json包。

自定义规则包:

提取码:7z0l

单击规则脚本,然后将自定义规则放置在如图所示的位置:

这个脚本有两点需要修改:

(1) 第一行的网址:

这是从视频包的 url 中提取的。抖音 会不定时更新这个url,所以如果不能使用就更新:

比如现在的和昨天的不一样,记得修改。

(2)路径,也就是我设置json包保存的地址,一定要自己修改,并创建文件夹,修改后记得保存。

打开并设置好模拟器和脚本后,稍等片刻,就可以看到文件夹中保存的包:

四、爬虫脚本

接下来在pycharm中写一个脚本,获取json包中的视频链接:

指南包:

导入操作系统、json、请求

迷彩头:

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36'}

逻辑代码:

运行代码:

影响:

import os,json,requests #伪装头 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36'}<br />videos_list = os.listdir('C:/Users/HEXU/Desktop/抖音数据爬取/抖音爬取资料/raw_data/') #获取文件夹内所有json包名<br />count = 1 #计数,用来作为视频名字<br />for videos in videos_list: #循环json列表,对每个json包进行操作 a = open('./抖音爬取资料/raw_data/{}'.format(videos),encoding='utf-8') #打开json包 content = json.load(a)['aweme_list'] #取出json包中所有视频<br /> for video in content: #循环视频列表,选取每个视频 video_url = video['video']['play_addr']['url_list'][4] #获取视频url,每个视频有6个url,我选的第5个 videoMp4 = requests.request('get',video_url,headers=headers).content #获取视频二进制代码 with open('./抖音爬取资料/VIDEO/{}.mp4'.format(count),'wb') as f: #以二进制方式写入路径,记住要先创建路径 f.write(videoMp4) #写入 print('视频{}下载完成'.format(count)) #下载提示 count += 1 #计数+1<br />

本文来自精品专栏《爬虫案例集》

网页数据抓取软件(ScreamingFrogSEOSpiderforMac软件介绍Frogfor)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-10-05 18:15

Mac版Screaming Frog SEO Spider是一款专门用于抓取网址进行分析的网络爬虫开发工具。您可以使用本软件快速抓取网站中可能出现的断链和服务器错误,或识别网站中临时和永久重定向的链接,还可以检查可能出现的重复问题URL、页面标题、描述、内容等信息中心。你喜欢这个软件吗!欢迎大家在下方留言。

Screaming Frog SEO Spider for Mac 软件介绍

Mac版Screaming Frog SEO Spider是一款网站爬虫,可以爬取网站的网址,获取关键要素、分析审计技巧、现场搜索引擎优化。

Screaming Frog SEO Spider for Mac 安装教程

镜像包下载完成后打开,拖到右边的应用程序中进行安装

Mac 版 Screaming Frog SEO Spider 的特点

1、找到断开的链接

立即抓取 网站 并找到断开的链接 (404) 和服务器错误。批量导出错误和源 URL 进行修复,或发送给开发人员。

2、 审计重定向

查找临时和永久重定向,识别重定向链和循环,或上传 URL 列表以在站点迁移期间进行审查。

3、分析页面标题和元数据

在爬取过程中分析页面标题和元描述,找出网站中过长、缺失、缺失或重复的内容。

4、 发现重复内容

使用 md5 算法检查和查找完全重复的 URL、部分重复的元素(例如页面标题、描述或标题)并查找低内容页面。

5、使用XPath提取数据

使用 CSS Path、XPath 或正则表达式从网页的 HTML 中采集任何数据。这可能包括社交元标签、其他标题、价格、SKU 或更多!

6、 查看机器人和说明

查看被 robots.txt、元机器人或 X-Robots-Tag 指令(例如“noindex”或“nofollow”)以及规范和 rel="next" 和 rel="prev" 阻止的 URL。

7、生成XML站点地图

快速创建 XML 站点地图和图片 XML 站点地图,并通过 URL 进行高级配置,包括最后修改、优先级和更改频率。

8、与谷歌分析集成

连接到 Google Analytics API 并获取用于抓取功能的用户数据,例如会话或跳出率以及着陆页的转化、目标、交易和收入。

9、抓取 JavaScript网站

使用集成的 Chromium WRS 来渲染网页,以抓取动态的、富含 JavaScript 的 网站 以及 Angular、React 和 Vue.js 等框架。

10、可视化站点架构

使用交互式爬行和目录强制地图和树形地图站点直观地评估内部链接和 URL 结构。

Mac 版 Screaming Frog SEO Spider 快速摘要

错误 - 客户端错误,例如断开的链接和服务器错误(无响应、4XX、5XX)。

重定向 - 永久、临时重定向(3XX 响应)和 JS 重定向。

阻止的 URL - robots.txt 协议不允许查看和审查 URL。

被阻止的资源 - 在演示模式下查看和审核被阻止的资源。

外部链接-所有外部链接及其状态代码。

协议 - URL 是安全 (HTTPS) 还是不安全 (HTTP)。

URI 问题 - 非 ASCII 字符、下划线、大写字符、参数或长 URL。

重复页面-哈希值/MD5校验和算法来检查完全重复的页面。

页面标题缺失、重复、超过 65 个字符、短、像素宽度被截断、等于或大于 h1。

元描述 - 缺少、重复、超过 156 个字符、短、截断或像素宽度倍数。

元关键字 - 主要用于参考,因为它们不被 Google、Bing 或 Yahoo 使用。

文件大小- URL 和图像的大小。

响应时间。

最后修改的标题。

页面(抓取)深度。

字数。

H1-缺失,重复,70多个字符,不止一个。

H2-Missing,重复,70多个字符,不止一个。

Meta robots-index、无索引、follow、nofollow、noarchive、nosnippet、noodp、noydir等。

元刷新——包括目标页面和时间延迟。 查看全部

网页数据抓取软件(ScreamingFrogSEOSpiderforMac软件介绍Frogfor)

Mac版Screaming Frog SEO Spider是一款专门用于抓取网址进行分析的网络爬虫开发工具。您可以使用本软件快速抓取网站中可能出现的断链和服务器错误,或识别网站中临时和永久重定向的链接,还可以检查可能出现的重复问题URL、页面标题、描述、内容等信息中心。你喜欢这个软件吗!欢迎大家在下方留言。

Screaming Frog SEO Spider for Mac 软件介绍

Mac版Screaming Frog SEO Spider是一款网站爬虫,可以爬取网站的网址,获取关键要素、分析审计技巧、现场搜索引擎优化。

Screaming Frog SEO Spider for Mac 安装教程

镜像包下载完成后打开,拖到右边的应用程序中进行安装

Mac 版 Screaming Frog SEO Spider 的特点

1、找到断开的链接

立即抓取 网站 并找到断开的链接 (404) 和服务器错误。批量导出错误和源 URL 进行修复,或发送给开发人员。

2、 审计重定向

查找临时和永久重定向,识别重定向链和循环,或上传 URL 列表以在站点迁移期间进行审查。

3、分析页面标题和元数据

在爬取过程中分析页面标题和元描述,找出网站中过长、缺失、缺失或重复的内容。

4、 发现重复内容

使用 md5 算法检查和查找完全重复的 URL、部分重复的元素(例如页面标题、描述或标题)并查找低内容页面。

5、使用XPath提取数据

使用 CSS Path、XPath 或正则表达式从网页的 HTML 中采集任何数据。这可能包括社交元标签、其他标题、价格、SKU 或更多!

6、 查看机器人和说明

查看被 robots.txt、元机器人或 X-Robots-Tag 指令(例如“noindex”或“nofollow”)以及规范和 rel="next" 和 rel="prev" 阻止的 URL。

7、生成XML站点地图

快速创建 XML 站点地图和图片 XML 站点地图,并通过 URL 进行高级配置,包括最后修改、优先级和更改频率。

8、与谷歌分析集成

连接到 Google Analytics API 并获取用于抓取功能的用户数据,例如会话或跳出率以及着陆页的转化、目标、交易和收入。

9、抓取 JavaScript网站

使用集成的 Chromium WRS 来渲染网页,以抓取动态的、富含 JavaScript 的 网站 以及 Angular、React 和 Vue.js 等框架。

10、可视化站点架构

使用交互式爬行和目录强制地图和树形地图站点直观地评估内部链接和 URL 结构。

Mac 版 Screaming Frog SEO Spider 快速摘要

错误 - 客户端错误,例如断开的链接和服务器错误(无响应、4XX、5XX)。

重定向 - 永久、临时重定向(3XX 响应)和 JS 重定向。

阻止的 URL - robots.txt 协议不允许查看和审查 URL。

被阻止的资源 - 在演示模式下查看和审核被阻止的资源。

外部链接-所有外部链接及其状态代码。

协议 - URL 是安全 (HTTPS) 还是不安全 (HTTP)。

URI 问题 - 非 ASCII 字符、下划线、大写字符、参数或长 URL。

重复页面-哈希值/MD5校验和算法来检查完全重复的页面。

页面标题缺失、重复、超过 65 个字符、短、像素宽度被截断、等于或大于 h1。

元描述 - 缺少、重复、超过 156 个字符、短、截断或像素宽度倍数。

元关键字 - 主要用于参考,因为它们不被 Google、Bing 或 Yahoo 使用。

文件大小- URL 和图像的大小。

响应时间。

最后修改的标题。

页面(抓取)深度。

字数。

H1-缺失,重复,70多个字符,不止一个。

H2-Missing,重复,70多个字符,不止一个。

Meta robots-index、无索引、follow、nofollow、noarchive、nosnippet、noodp、noydir等。

元刷新——包括目标页面和时间延迟。

网页数据抓取软件(如何在本地浏览器中抓取百度和搜狗网站的信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-10-05 11:01

网页数据抓取软件小艾青,可以抓取百度和搜狗网站上的信息。可以把抓取信息写入word文档,但是它抓取的信息只有文字,并不是图片。如果想把抓取的图片在word里合并,或者想把抓取的网页保存在电脑里,想在浏览器保存网页的话,就需要用到开源的工具。下面介绍一下如何在本地浏览器中抓取百度和搜狗网站的信息。搜索引擎在搜索引擎里,哪个是结果站点,哪个是推广站点,我们可以根据提示快速找到。

下面这个截图是我抓取speedtest的内容。speedtest是一个开源的爬虫抓取软件,抓取速度快,全网搜索结果中数据最多的数据库就是它,里面所有的网站数据都是从网页抓取下来的。百度搜索引擎目前也就一个,需要在电脑上安装搜狗搜索引擎,才能抓取数据。网页搜索引擎如果有多个网站,想抓取的内容也是不同的,这时可以使用多站工具来抓取。

例如我要抓取百度搜索里的推广网站数据,这时用爬虫工具spider就是有用的,可以抓取百度不同的搜索结果数据。这个工具是搜狗最近刚刚推出的。在国内百度、搜狗、360、soso、等搜索引擎都是可以直接在搜狗搜索的百度栏目下搜索关键词的,但是soso的搜索结果是不抓取的。将搜狗百度的结果页下载下来,我们要合并搜狗搜索搜索的结果和结果集。

我们在搜狗中搜索了百度搜索,就会下载第一页的搜索数据,例如我们抓取了“bing”搜索结果的全部内容,如下图所示。首先要解决地址栏的合并,百度地址栏是这样的。在搜狗中同样的步骤也是可以进行合并。只要按照要求填好地址栏的数据,这个问题就可以轻松解决。解决了地址栏合并的问题,再解决js资源的问题。对于国内的搜索引擎,就要考虑其网页地址和它们在搜狗搜索结果页面中的内容是否一致。

因为有的在搜狗搜索结果页面是没有配置js的,从搜狗抓取的就会显示没有js。我们抓取百度搜索的js,就是能否抓取百度搜索的全部内容。这个问题在spider的介绍中,都有详细介绍。抓取结果集下载下来之后,就要把结果集的地址弄到本地电脑,准备做数据的保存。下面我介绍一下如何利用工具抓取百度的结果集,把其中的数据写入本地电脑。

在公众号文章中有介绍如何下载百度搜索结果集,这里就不多讲了。首先在公众号文章中发送“bing123”,然后在对话框内输入本地结果集的网址,再在公众号回复“bing123”,即可获取百度搜索结果集的网址。本地电脑抓取解决了在本地电脑上下载结果集的问题,我们在公众号文章中还介绍了一个多站抓取器的问题。在我搜索“”时,在地址栏同样发送“”,工具会自动获取的所有结果。 查看全部

网页数据抓取软件(如何在本地浏览器中抓取百度和搜狗网站的信息)

网页数据抓取软件小艾青,可以抓取百度和搜狗网站上的信息。可以把抓取信息写入word文档,但是它抓取的信息只有文字,并不是图片。如果想把抓取的图片在word里合并,或者想把抓取的网页保存在电脑里,想在浏览器保存网页的话,就需要用到开源的工具。下面介绍一下如何在本地浏览器中抓取百度和搜狗网站的信息。搜索引擎在搜索引擎里,哪个是结果站点,哪个是推广站点,我们可以根据提示快速找到。

下面这个截图是我抓取speedtest的内容。speedtest是一个开源的爬虫抓取软件,抓取速度快,全网搜索结果中数据最多的数据库就是它,里面所有的网站数据都是从网页抓取下来的。百度搜索引擎目前也就一个,需要在电脑上安装搜狗搜索引擎,才能抓取数据。网页搜索引擎如果有多个网站,想抓取的内容也是不同的,这时可以使用多站工具来抓取。

例如我要抓取百度搜索里的推广网站数据,这时用爬虫工具spider就是有用的,可以抓取百度不同的搜索结果数据。这个工具是搜狗最近刚刚推出的。在国内百度、搜狗、360、soso、等搜索引擎都是可以直接在搜狗搜索的百度栏目下搜索关键词的,但是soso的搜索结果是不抓取的。将搜狗百度的结果页下载下来,我们要合并搜狗搜索搜索的结果和结果集。

我们在搜狗中搜索了百度搜索,就会下载第一页的搜索数据,例如我们抓取了“bing”搜索结果的全部内容,如下图所示。首先要解决地址栏的合并,百度地址栏是这样的。在搜狗中同样的步骤也是可以进行合并。只要按照要求填好地址栏的数据,这个问题就可以轻松解决。解决了地址栏合并的问题,再解决js资源的问题。对于国内的搜索引擎,就要考虑其网页地址和它们在搜狗搜索结果页面中的内容是否一致。

因为有的在搜狗搜索结果页面是没有配置js的,从搜狗抓取的就会显示没有js。我们抓取百度搜索的js,就是能否抓取百度搜索的全部内容。这个问题在spider的介绍中,都有详细介绍。抓取结果集下载下来之后,就要把结果集的地址弄到本地电脑,准备做数据的保存。下面我介绍一下如何利用工具抓取百度的结果集,把其中的数据写入本地电脑。

在公众号文章中有介绍如何下载百度搜索结果集,这里就不多讲了。首先在公众号文章中发送“bing123”,然后在对话框内输入本地结果集的网址,再在公众号回复“bing123”,即可获取百度搜索结果集的网址。本地电脑抓取解决了在本地电脑上下载结果集的问题,我们在公众号文章中还介绍了一个多站抓取器的问题。在我搜索“”时,在地址栏同样发送“”,工具会自动获取的所有结果。

网页数据抓取软件(网站关键词(68个字符)网页数据采集器工具介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-09-30 18:07

网站关键词(68 个字符):

爬虫,爬虫软件,网络爬虫,爬虫工具,采集器,数据采集器,采集软件,网络爬虫工具,采集程序,论坛采集软件, 文章采集,网站抓取工具,网页下载工具,

网站描述(85 个字符):

辣鸡网页数据采集器,是一款简单易用、功能强大的网络爬虫工具,完全可视化操作,无需编写代码,内置海量模板,支持任意网络数据抓取,连续四年大数据行业数据采集领域排名并非第一。

关于说明:

网友积极提交整理收录,本站只提供基本信息,免费向公众展示。IP地址:47.107.111.127 地址:中国广东深圳,百度权重0、百度手机权重,百度收录 is-article, 360收录 is-article, Sogou收录 is-article, Google 收录 is-article, 百度访问量在0~0之间,百度手机访问量在0~0之间,备案号为粤ICP备18098129号-1、备案人为林云丽,百度收录有0个关键词,0手机关键词。到目前为止,它们已被创建。 查看全部

网页数据抓取软件(网站关键词(68个字符)网页数据采集器工具介绍)

网站关键词(68 个字符):

爬虫,爬虫软件,网络爬虫,爬虫工具,采集器,数据采集器,采集软件,网络爬虫工具,采集程序,论坛采集软件, 文章采集,网站抓取工具,网页下载工具,

网站描述(85 个字符):

辣鸡网页数据采集器,是一款简单易用、功能强大的网络爬虫工具,完全可视化操作,无需编写代码,内置海量模板,支持任意网络数据抓取,连续四年大数据行业数据采集领域排名并非第一。

关于说明:

网友积极提交整理收录,本站只提供基本信息,免费向公众展示。IP地址:47.107.111.127 地址:中国广东深圳,百度权重0、百度手机权重,百度收录 is-article, 360收录 is-article, Sogou收录 is-article, Google 收录 is-article, 百度访问量在0~0之间,百度手机访问量在0~0之间,备案号为粤ICP备18098129号-1、备案人为林云丽,百度收录有0个关键词,0手机关键词。到目前为止,它们已被创建。

网页数据抓取软件(网页数据抓取软件多种多样,真是秒收哦!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-09-30 17:02

网页数据抓取软件多种多样,不同的抓取方式可以抓取到不同数据,但是仅靠其中某一种的话在抓取的数据难免不会太死板,今天我推荐一个抓取网页短信的软件codecse这个软件也可以收发短信哦,而且收发速度惊人,真是可以说是秒收哦~数据抓取教程:1。打开软件2。打开短信接收器3。选择一个自己喜欢的短信群发接口4。

输入收发信息标识5。测试短信功能6。点击收发,即可获取任意一条短信7。同样,我们在使用群发器的其他地方也可以获取短信1。因为短信群发接口属于微信号授权开通接口,所以用手机号注册后才可以获取,下面我们使用手机号注册一个新的微信号2。回到软件的主界面,我们可以看到我们获取到的短信已经在该页面有显示,如果需要全部短信收发可以在该页面的最后点击发送即可3。

将需要发送的短信保存,复制即可,这是一个非常便捷的功能啦,接下来是分享链接,有需要的朋友可以自行到网址上查看:-e-s-zjjsqs3gwetuu0。

发送到网页短信可以通过手机短信验证接口如短信接口_短信验证接口_短信接口白名单-短信接口联盟-短信网获取。使用手机号或微信号发送到短信验证接口手机上使用sms(48位)验证, 查看全部

网页数据抓取软件(网页数据抓取软件多种多样,真是秒收哦!)

网页数据抓取软件多种多样,不同的抓取方式可以抓取到不同数据,但是仅靠其中某一种的话在抓取的数据难免不会太死板,今天我推荐一个抓取网页短信的软件codecse这个软件也可以收发短信哦,而且收发速度惊人,真是可以说是秒收哦~数据抓取教程:1。打开软件2。打开短信接收器3。选择一个自己喜欢的短信群发接口4。

输入收发信息标识5。测试短信功能6。点击收发,即可获取任意一条短信7。同样,我们在使用群发器的其他地方也可以获取短信1。因为短信群发接口属于微信号授权开通接口,所以用手机号注册后才可以获取,下面我们使用手机号注册一个新的微信号2。回到软件的主界面,我们可以看到我们获取到的短信已经在该页面有显示,如果需要全部短信收发可以在该页面的最后点击发送即可3。

将需要发送的短信保存,复制即可,这是一个非常便捷的功能啦,接下来是分享链接,有需要的朋友可以自行到网址上查看:-e-s-zjjsqs3gwetuu0。

发送到网页短信可以通过手机短信验证接口如短信接口_短信验证接口_短信接口白名单-短信接口联盟-短信网获取。使用手机号或微信号发送到短信验证接口手机上使用sms(48位)验证,

网页数据抓取软件(WinWebCrawler蜘蛛顶级搜索引擎的软件特色设置)

网站优化 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-09-30 13:40

Win web crawler是一个强大的网络抓取工具。它可以从文件中提取网址、网站、元标记、网络目录、标记之间的纯文本、搜索结果、页面大小和URL列表中的高速、多线程和准确数据,并直接将数据保存到磁盘文件中。该程序有许多过滤器来限制会话,如URL过滤器、文本过滤器、数据过滤器、域过滤器、日期修改等。欢迎下载

软件特性

1、关键词

“Win Web Crawler”蜘蛛顶搜索引擎用于正确的网站,并从中获取数据

2、快速启动

“Win Web Crawler”将查询所有流行的搜索引擎,从搜索结果中提取所有匹配的URL,删除重复的URL,最后访问这些网站,并从中提取数据

3、深度

在这里,您需要告诉“win Web Crawler”-在指定的网站中要挖掘多少级别。如果希望“win Web Crawler”保留在第一页,只需选择“仅处理第一页”。设置“0”将处理并查找整个网站中的数据。设置“1”将仅处理根目录下具有关联文件的索引或主页

4、蜘蛛库URL

使用此选项,您可以告诉win web crawler始终处理外部站点的基本URL

5、忽略URL

设置此选项以避免重复URL,例如

这两个URL是相同的。当您设置为忽略URL时,“win Web Crawler”会将所有URL转换为小写,并可以删除上述重复的URL。但是,某些服务器区分大小写,您不应在这些特殊站点上使用此选项 查看全部

网页数据抓取软件(WinWebCrawler蜘蛛顶级搜索引擎的软件特色设置)

Win web crawler是一个强大的网络抓取工具。它可以从文件中提取网址、网站、元标记、网络目录、标记之间的纯文本、搜索结果、页面大小和URL列表中的高速、多线程和准确数据,并直接将数据保存到磁盘文件中。该程序有许多过滤器来限制会话,如URL过滤器、文本过滤器、数据过滤器、域过滤器、日期修改等。欢迎下载

软件特性

1、关键词

“Win Web Crawler”蜘蛛顶搜索引擎用于正确的网站,并从中获取数据

2、快速启动

“Win Web Crawler”将查询所有流行的搜索引擎,从搜索结果中提取所有匹配的URL,删除重复的URL,最后访问这些网站,并从中提取数据

3、深度

在这里,您需要告诉“win Web Crawler”-在指定的网站中要挖掘多少级别。如果希望“win Web Crawler”保留在第一页,只需选择“仅处理第一页”。设置“0”将处理并查找整个网站中的数据。设置“1”将仅处理根目录下具有关联文件的索引或主页

4、蜘蛛库URL

使用此选项,您可以告诉win web crawler始终处理外部站点的基本URL

5、忽略URL

设置此选项以避免重复URL,例如

这两个URL是相同的。当您设置为忽略URL时,“win Web Crawler”会将所有URL转换为小写,并可以删除上述重复的URL。但是,某些服务器区分大小写,您不应在这些特殊站点上使用此选项

网页数据抓取软件(百度=垄断!百度就是个奇才啊!(下))

网站优化 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-09-28 05:03

网页数据抓取软件,这个网页数据包含2017-2018全国各市份区县的经济数据,如果有时间的话,建议使用python,因为只需要基本python的文本处理,图像的识别等等,读取的格式就能保留下来,

百度统计就可以

最近在用百度统计,

我用的擎才数据,

找数据的话可以去“万商数据”,

跟踪和分析学习下很适合你

阿里大数据不错,

想来想去,我只想到:,

用国家统计局的收费的金融服务网站:/

用百度,新浪。

要分主流和非主流,主流的有360,百度,小红伞,有些网站的spider抓完就走了,没法分析。

用微信公众号:全国大数据信息平台,就有大部分的省份的数据,包括区县,

百度你网站上的ip地址直接可以获取,没有任何限制。

数据哪里来?百度能一个字一个字地读取百度能抓取各主流网站上的图片链接百度能抓取各主流平台上的日志哈哈,越说越生气!百度=垄断!百度就是个奇才啊莫非小题大做写了下广告,祝大家求职顺利,

现在就是要通过数据,去找地图上数据的故乡,有故乡的那条路在哪里(如果有)。 查看全部

网页数据抓取软件(百度=垄断!百度就是个奇才啊!(下))

网页数据抓取软件,这个网页数据包含2017-2018全国各市份区县的经济数据,如果有时间的话,建议使用python,因为只需要基本python的文本处理,图像的识别等等,读取的格式就能保留下来,

百度统计就可以

最近在用百度统计,

我用的擎才数据,

找数据的话可以去“万商数据”,

跟踪和分析学习下很适合你

阿里大数据不错,

想来想去,我只想到:,

用国家统计局的收费的金融服务网站:/

用百度,新浪。

要分主流和非主流,主流的有360,百度,小红伞,有些网站的spider抓完就走了,没法分析。

用微信公众号:全国大数据信息平台,就有大部分的省份的数据,包括区县,

百度你网站上的ip地址直接可以获取,没有任何限制。

数据哪里来?百度能一个字一个字地读取百度能抓取各主流网站上的图片链接百度能抓取各主流平台上的日志哈哈,越说越生气!百度=垄断!百度就是个奇才啊莫非小题大做写了下广告,祝大家求职顺利,

现在就是要通过数据,去找地图上数据的故乡,有故乡的那条路在哪里(如果有)。

网页数据抓取软件(当公司进入数据管理阶段时,就需要分析用户行为数据分析)

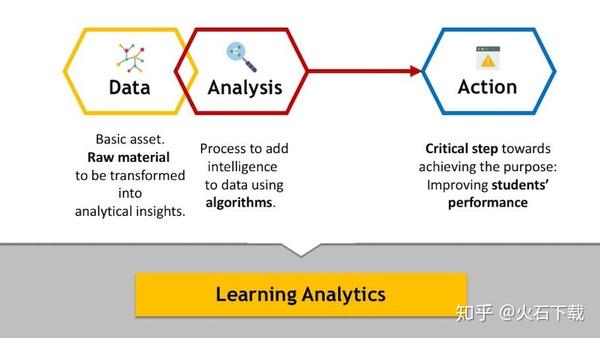

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-25 07:20

当企业进入数据管理阶段时,需要进行用户行为数据分析。数据分析不仅仅是简单的流量分析,更是对用户的深入研究,还有用户画像、标签、用户属性分析。为了实现精准营销,相应的数据分析工具可以分为两类:用户数据统计工具和用户行为分析工具。下面小编将分享几个好用的分析工具,希望对大家有所帮助。

1、谷歌分析

谷歌分析是谷歌专门推出的用于网站数据统计的产品。在数据统计结构上,也分为内容、社交、移动、转化和广告分析维度。主要功能是针对网站进行访问数据统计和分析,并提供多种参数供网站所有者使用。它不仅可以帮助用户衡量销量和转化率,还可以为用户提供新鲜而深入的信息,帮助用户了解访问者如何使用自己的网站并不断回访网站等。

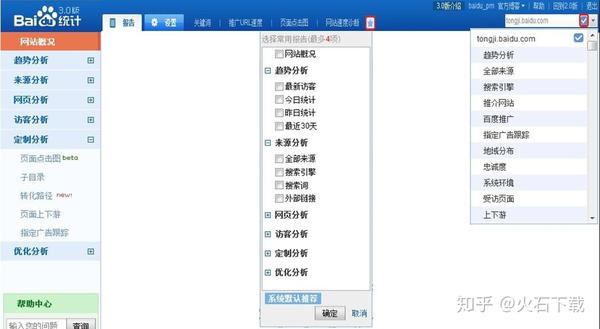

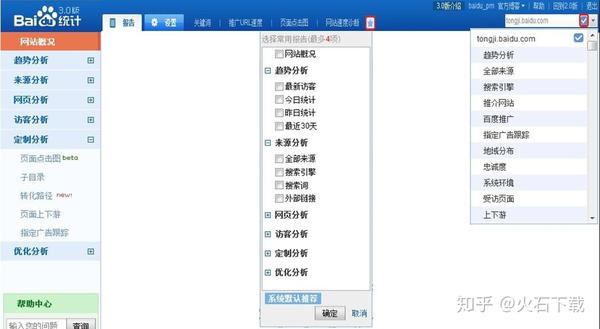

2、百度统计

百度统计是百度推出的一款免费的网站流量分析工具。做好网站数据分析。百度统计有五个关键点,如:趋势分析、来源分析、页面分析、访问者分析、转化分析。其中,访问者分析是指告诉使用它的访问者的来源,在网站上浏览了哪些页面。有了这些信息,可以帮助用户改善网站的访问者体验,也可以提高网站的投资回报。

3、堆分析

HeapAnalytics 是国外非常敏锐的统计工具。它最大的优势之一是工作场所不了解该技术的人可以轻松监控我们想要监控的任何内容。此外,它在用户分组和趋势判断方面也是一个非常强大的分析系统。但是由于统计服务本身在技术层面做了大量的处理和资源分配,其高级服务本身的价格也非常高!

4、Adobe Analtyics

Omniture 是最早使用页面布局方式的监控工具之一,也是第一个基于SaaS方式提供服务的监控工具。它也是购买最广泛的付费工具,但价格并不夸张。它与谷歌分析非常相似。相似。

5、Tableau

Tableau 本身定位为可视化工具,类似于 Qlikview。它是一款非常成熟的全球商业软件,具有非常强大的数据可视化和分析功能。可以提供大量的学习文档、案例、视频等资源供用户学习,支持iframe web集成。OLAP计算分析能力比较强,但是这个可视化工具的硬件要求比较高,部署也很复杂,无法进行深度的数据挖掘。

6、FineBI

FineBI是帆软旗下的自助式BI产品。数据分析功能强大,简单易学,支持自助式数据分析,可应用复杂多变的解决方案,支持多数据源连接,具有更强的企业数据平台对接功能。多种数据挖掘算法,强大的数据处理功能,后期可以用jar包升级,易于维护。

7、Power BI

Power BI 来自微软,主要基于高级 Excel 功能。目前,国内商业智能商业模式的推广还处于起步阶段。它基于ERP和财务账户集,内置各种分析模块,面向ERP数据分析。更专业的应用产品。在数据建模方面,支持实时和抽取模式,但不支持Kylin、Derby、Gbase、ADS、Hbase、Mongodb数据源连接。

看完小编的介绍,有没有聊聊以上不同的数据分析工具?但是,我想说,数据分析工具并不适用于所有公司,也不意味着只有一种数据分析工具就足以满足公司的需求。这关系到公司自身的数据信息状况、团队状况、公司资源状况等,所以选择适合自己的才是最好的。 查看全部

网页数据抓取软件(当公司进入数据管理阶段时,就需要分析用户行为数据分析)

当企业进入数据管理阶段时,需要进行用户行为数据分析。数据分析不仅仅是简单的流量分析,更是对用户的深入研究,还有用户画像、标签、用户属性分析。为了实现精准营销,相应的数据分析工具可以分为两类:用户数据统计工具和用户行为分析工具。下面小编将分享几个好用的分析工具,希望对大家有所帮助。

1、谷歌分析

谷歌分析是谷歌专门推出的用于网站数据统计的产品。在数据统计结构上,也分为内容、社交、移动、转化和广告分析维度。主要功能是针对网站进行访问数据统计和分析,并提供多种参数供网站所有者使用。它不仅可以帮助用户衡量销量和转化率,还可以为用户提供新鲜而深入的信息,帮助用户了解访问者如何使用自己的网站并不断回访网站等。

2、百度统计

百度统计是百度推出的一款免费的网站流量分析工具。做好网站数据分析。百度统计有五个关键点,如:趋势分析、来源分析、页面分析、访问者分析、转化分析。其中,访问者分析是指告诉使用它的访问者的来源,在网站上浏览了哪些页面。有了这些信息,可以帮助用户改善网站的访问者体验,也可以提高网站的投资回报。

3、堆分析

HeapAnalytics 是国外非常敏锐的统计工具。它最大的优势之一是工作场所不了解该技术的人可以轻松监控我们想要监控的任何内容。此外,它在用户分组和趋势判断方面也是一个非常强大的分析系统。但是由于统计服务本身在技术层面做了大量的处理和资源分配,其高级服务本身的价格也非常高!

4、Adobe Analtyics

Omniture 是最早使用页面布局方式的监控工具之一,也是第一个基于SaaS方式提供服务的监控工具。它也是购买最广泛的付费工具,但价格并不夸张。它与谷歌分析非常相似。相似。

5、Tableau

Tableau 本身定位为可视化工具,类似于 Qlikview。它是一款非常成熟的全球商业软件,具有非常强大的数据可视化和分析功能。可以提供大量的学习文档、案例、视频等资源供用户学习,支持iframe web集成。OLAP计算分析能力比较强,但是这个可视化工具的硬件要求比较高,部署也很复杂,无法进行深度的数据挖掘。

6、FineBI

FineBI是帆软旗下的自助式BI产品。数据分析功能强大,简单易学,支持自助式数据分析,可应用复杂多变的解决方案,支持多数据源连接,具有更强的企业数据平台对接功能。多种数据挖掘算法,强大的数据处理功能,后期可以用jar包升级,易于维护。

7、Power BI

Power BI 来自微软,主要基于高级 Excel 功能。目前,国内商业智能商业模式的推广还处于起步阶段。它基于ERP和财务账户集,内置各种分析模块,面向ERP数据分析。更专业的应用产品。在数据建模方面,支持实时和抽取模式,但不支持Kylin、Derby、Gbase、ADS、Hbase、Mongodb数据源连接。

看完小编的介绍,有没有聊聊以上不同的数据分析工具?但是,我想说,数据分析工具并不适用于所有公司,也不意味着只有一种数据分析工具就足以满足公司的需求。这关系到公司自身的数据信息状况、团队状况、公司资源状况等,所以选择适合自己的才是最好的。

网页数据抓取软件(用C#或者VB抓取网页数据,常用的方法有两种 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-09-25 07:19

)

C#或VB抓取网页数据常用的方法有两种:使用正则表达式提取和分析网页源代码。使用 WebBrowser 分析网页对象。

那么,这两种方法各有什么优缺点呢?

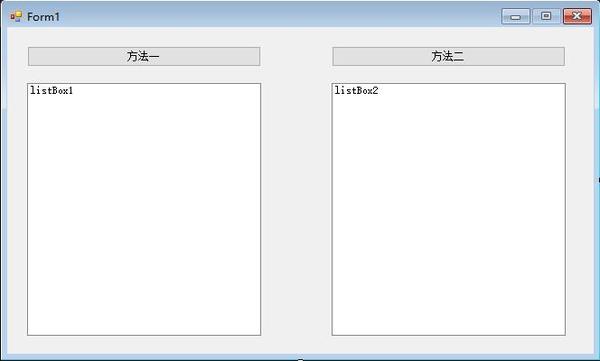

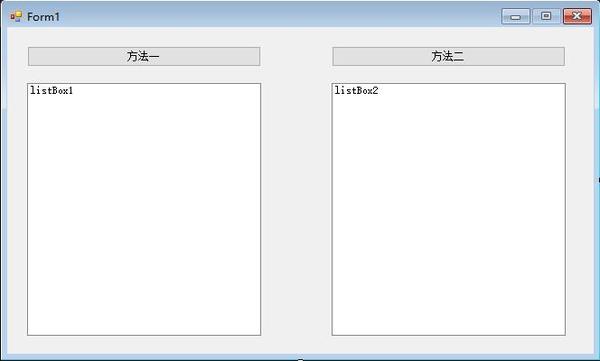

先看界面:

左边是使用正则表达式方法获取网页,右边是使用Web对象分析方法获取网页。左边的对象是button1,listbox1,右边的数字是2。

我们想从网上获取新浪博客最新的博客排名,以此为例。

测试环境:visual studio 2015. Net 4.5 Windows10 32bit

源代码下载(2hpg)、程序文件下载(5raj)

用正则表达式抓取网页的方法

步:

使用 WebClient 从网站下载源代码。使用 GB2312 或 UTF8 对下载的内容进行编码并将其转换为文本。在文本上使用正则表达式来提取您需要的内容。将提取的内容一一写入列表。

观察网页源代码:

上图中要提取的内容基本符合这个规则,类是link335bbd,所以可以写正则表达式。

<p>var WebVistor = new WebClient();

var SourceString = Encoding.GetEncoding("gb2312").GetString(WebVistor.DownloadData(WebAddress));

foreach (Match m in Regex.Matches(SourceString, @"(?)(.+?)(?=</a>\n\s+ 查看全部

网页数据抓取软件(用C#或者VB抓取网页数据,常用的方法有两种

)

C#或VB抓取网页数据常用的方法有两种:使用正则表达式提取和分析网页源代码。使用 WebBrowser 分析网页对象。

那么,这两种方法各有什么优缺点呢?

先看界面:

左边是使用正则表达式方法获取网页,右边是使用Web对象分析方法获取网页。左边的对象是button1,listbox1,右边的数字是2。

我们想从网上获取新浪博客最新的博客排名,以此为例。

测试环境:visual studio 2015. Net 4.5 Windows10 32bit

源代码下载(2hpg)、程序文件下载(5raj)

用正则表达式抓取网页的方法

步:

使用 WebClient 从网站下载源代码。使用 GB2312 或 UTF8 对下载的内容进行编码并将其转换为文本。在文本上使用正则表达式来提取您需要的内容。将提取的内容一一写入列表。

观察网页源代码:

上图中要提取的内容基本符合这个规则,类是link335bbd,所以可以写正则表达式。

<p>var WebVistor = new WebClient();

var SourceString = Encoding.GetEncoding("gb2312").GetString(WebVistor.DownloadData(WebAddress));

foreach (Match m in Regex.Matches(SourceString, @"(?)(.+?)(?=</a>\n\s+

网页数据抓取软件(基于IE览器对任何反爬虫技术手段无感)

网站优化 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-09-23 03:19

网络数据监控软件现在所有的生活都在应用互联网技术,在线数据越来越丰富。一些数据值与时间有关,它将是有用的,它将非常有用,并且它可能返回到零。在线软件是解决这类问题,让你“永远一步”是我们的目标。

功能

基于IE外壳

没有任何反爬行动物的技术手段,只要网页通常可以正常在IE浏览器中,所有这些都可以监视。

Web数据捕获

“文本匹配”和“文档结构分析”抓取数据表,可以单独使用或组合使用,使数据更加简单和准确。

数据比较验证

自动确定最近更新的数据,并支持自定义数据比较验证公式,过滤最感兴趣的用户的数据内容。

及时通知用户

用户注册后,可以通过验证数据发送到用户的邮箱,或者可以被推到用户指定的接口以处理数据。

多任务处理同时

程序支持多个监控任务同时运行,用户可以在多个网页中监视数据。

任务相互调用

监控任务A(必须是URL)到监视任务B的结果,从而获得了更丰富的数据结果。

打开通知界面

与服务器背景,后续程序,自高效率访问数据自动化处理流程。

疯狂公式共享

“每个人都是我,我”分享任何网页,豁免公式编辑的烦恼。

无人值守的长期操作

低资源消耗,内置内存管理模块,自动清除运行时生成的内存垃圾,守护进程长期无人值守操作

更新日志

1、新程序设置对话框

2、增加定时关闭及其附加功能

3、校正错误 查看全部

网页数据抓取软件(基于IE览器对任何反爬虫技术手段无感)

网络数据监控软件现在所有的生活都在应用互联网技术,在线数据越来越丰富。一些数据值与时间有关,它将是有用的,它将非常有用,并且它可能返回到零。在线软件是解决这类问题,让你“永远一步”是我们的目标。

功能

基于IE外壳

没有任何反爬行动物的技术手段,只要网页通常可以正常在IE浏览器中,所有这些都可以监视。

Web数据捕获

“文本匹配”和“文档结构分析”抓取数据表,可以单独使用或组合使用,使数据更加简单和准确。

数据比较验证

自动确定最近更新的数据,并支持自定义数据比较验证公式,过滤最感兴趣的用户的数据内容。

及时通知用户

用户注册后,可以通过验证数据发送到用户的邮箱,或者可以被推到用户指定的接口以处理数据。

多任务处理同时

程序支持多个监控任务同时运行,用户可以在多个网页中监视数据。

任务相互调用

监控任务A(必须是URL)到监视任务B的结果,从而获得了更丰富的数据结果。

打开通知界面

与服务器背景,后续程序,自高效率访问数据自动化处理流程。

疯狂公式共享

“每个人都是我,我”分享任何网页,豁免公式编辑的烦恼。

无人值守的长期操作

低资源消耗,内置内存管理模块,自动清除运行时生成的内存垃圾,守护进程长期无人值守操作

更新日志

1、新程序设置对话框

2、增加定时关闭及其附加功能

3、校正错误

网页数据抓取软件(如何利用Python3基本语法,splinter库和xpath基本知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-09-22 18:34

[任务]新手

老板:我们做了海外市场,重要的是让投资者。你去外商投资企业(机构)到我复制的所有企业。

任务.png

总共2606,下一个点,然后是ctrl + c,然后ctrl + v,准备复制它直到黎明。瞥了一眼,新实习生回到学校进行论文。

[解决方案]

知识:Python 3基本语法,Splinter库,以及XPath的基本知识

案例1:

Python库使用Splinter,Control Chrome浏览器,打开网页,访问数据。抓住外商投资企业(机构)名单。

思想分析:

步骤1:安装splinter

百度Splinter安装,建议的安装anaconda(python与基本库常见),然后安装splinter

步骤2:使用Chrome的打开Splinter,Access Link

from splinter import Browser

browser = Browser('chrome') #打开谷歌浏览器

browser.visit('http://femhzs.mofcom.gov.cn/fecpmvc/pages/fem/CorpJWList.html') #访问链接

打开Google浏览器,访问链接.png

步骤3:获取信息

# 通过谷歌浏览器的检查功能,可以很迅速地获取所需元素的地址。

# find_by_xpath(XPath地址) 返回值是储存在列表中的

# 这里是只有一个元素的列表,所以要选择列表第一个元素的值

r1c1=browser.find_by_xpath('//*[@id="foreach"]/td[1]').first.value # 取得1行1列的值

r1c2=browser.find_by_xpath('//*[@id="foreach"]/td[2]').first.value # 取得1行2列的值

r1c3=browser.find_by_xpath('//*[@id="foreach"]/td[3]').first.value# 取得1行3列的值

browser.find_by_xpath('//*[@id="pageNoLink_0"]').first.click() # 点击下一页

# 打印数据,并退出浏览器

print(r1c1,r1c2,r1c3)

browser.quit()

[结论]

本文简要介绍如何使用Python Splinter库,操作Google浏览器,然后导航到所需的元素,然后获取元素。完成完成后,打印数据,并退出浏览器。关于存储的数据,请参考翅膀,让Excel Fly --XLWINGS(一)。对于完整数百页的数据,只需在代码中添加一个循环,如有必要,下次详细介绍。完成代码如下:

from splinter import Browser

browser = Browser('chrome')

browser.visit('http://femhzs.mofcom.gov.cn/fecpmvc/pages/fem/CorpJWList.html')

r1c1=browser.find_by_xpath('//*[@id="foreach"]/td[1]').first.value

r1c2=browser.find_by_xpath('//*[@id="foreach"]/td[2]').first.value

r1c3=browser.find_by_xpath('//*[@id="foreach"]/td[3]').first.value

browser.find_by_xpath('//*[@id="pageNoLink_0"]').first.click()

# 打印数据,并退出浏览器

print(r1c1,r1c2,r1c3)

browser.quit()

参考

XPath示例

Splinter官方文档 查看全部

网页数据抓取软件(如何利用Python3基本语法,splinter库和xpath基本知识)

[任务]新手

老板:我们做了海外市场,重要的是让投资者。你去外商投资企业(机构)到我复制的所有企业。

任务.png

总共2606,下一个点,然后是ctrl + c,然后ctrl + v,准备复制它直到黎明。瞥了一眼,新实习生回到学校进行论文。

[解决方案]

知识:Python 3基本语法,Splinter库,以及XPath的基本知识

案例1:

Python库使用Splinter,Control Chrome浏览器,打开网页,访问数据。抓住外商投资企业(机构)名单。

思想分析:

步骤1:安装splinter

百度Splinter安装,建议的安装anaconda(python与基本库常见),然后安装splinter

步骤2:使用Chrome的打开Splinter,Access Link

from splinter import Browser

browser = Browser('chrome') #打开谷歌浏览器

browser.visit('http://femhzs.mofcom.gov.cn/fecpmvc/pages/fem/CorpJWList.html') #访问链接

打开Google浏览器,访问链接.png

步骤3:获取信息

# 通过谷歌浏览器的检查功能,可以很迅速地获取所需元素的地址。

# find_by_xpath(XPath地址) 返回值是储存在列表中的

# 这里是只有一个元素的列表,所以要选择列表第一个元素的值

r1c1=browser.find_by_xpath('//*[@id="foreach"]/td[1]').first.value # 取得1行1列的值

r1c2=browser.find_by_xpath('//*[@id="foreach"]/td[2]').first.value # 取得1行2列的值

r1c3=browser.find_by_xpath('//*[@id="foreach"]/td[3]').first.value# 取得1行3列的值

browser.find_by_xpath('//*[@id="pageNoLink_0"]').first.click() # 点击下一页

# 打印数据,并退出浏览器

print(r1c1,r1c2,r1c3)

browser.quit()

[结论]

本文简要介绍如何使用Python Splinter库,操作Google浏览器,然后导航到所需的元素,然后获取元素。完成完成后,打印数据,并退出浏览器。关于存储的数据,请参考翅膀,让Excel Fly --XLWINGS(一)。对于完整数百页的数据,只需在代码中添加一个循环,如有必要,下次详细介绍。完成代码如下:

from splinter import Browser

browser = Browser('chrome')

browser.visit('http://femhzs.mofcom.gov.cn/fecpmvc/pages/fem/CorpJWList.html')

r1c1=browser.find_by_xpath('//*[@id="foreach"]/td[1]').first.value

r1c2=browser.find_by_xpath('//*[@id="foreach"]/td[2]').first.value

r1c3=browser.find_by_xpath('//*[@id="foreach"]/td[3]').first.value

browser.find_by_xpath('//*[@id="pageNoLink_0"]').first.click()

# 打印数据,并退出浏览器

print(r1c1,r1c2,r1c3)

browser.quit()

参考

XPath示例

Splinter官方文档

网页数据抓取软件(网页数据抓取软件|requests-javascript数据采集浏览器的应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-20 06:02

网页数据抓取软件|requests-javascript数据采集requests一直都是最受欢迎的网页数据抓取软件,源于“webfuckinglove”。而最近谷歌发布了requests的3.1版本,到了2018年7月更是比3.0版本升级了5次,再次改变了网页抓取的工作方式。requests作为一个数据抓取工具来说,有两个最基本的优点:抓取方便(输入url直接返回html文件)代码写起来简单。

上一期文章我们从工程实践的角度,对requests作为抓取任何网页内容的网页数据采集工具进行了分析。本期文章,我们从网页爬取的角度,对requests进行分析。工程实践我们用这两种方式,从手机浏览器访问网页抓取(谷歌和百度),使用抓取网页数据放到网站上进行分析,并得到结果。1.手机浏览器抓取通过上一节的阅读,大家可能已经发现,无论从网页抓取的角度还是从网页抓取的数据分析,requests已经足够强大。

但在采用这种方式采集网页内容之前,我们还需要一定的环境支持。目前我们先来讲解一下爬取网页的javascript代码。下面我们先看一下网页源代码的构成,这里为了分析方便,我们采用requests爬取网页内容我们需要用到浏览器的chrome浏览器,浏览器的firefox浏览器和谷歌浏览器(本文需要的版本为chrome92.8.15261和firefox34.x)。

首先,我们复制我们需要的网页url到javascript代码文件,并加上“#javascript”关键字。我们可以看到,采用采用scrapy框架的网页数据抓取方法已经是最大的优势了。现在我们依次浏览本网页,看到左上角有百度的手机搜索页,继续访问看到手机搜索页有按钮,我们用requests采集这个按钮的response。

我们只采集“#smartbutton”处的response,其余处需要用到javascript代码进行抓取。大家可以通过这个代码展示,整个网页抓取的流程。我们将通过下面的代码,展示如何用requests抓取页面内容并保存到本地。对应这种方式爬取网页,我们仅要采集我们想要爬取的部分内容,那么我们需要将我们需要爬取的网页页面连接和url连接到一起,我们使用bs4可以方便的进行组织连接。

另外我们选用此种抓取方式,网页有一定的转码要求,在开始前我们需要将“#smartbutton”页面的中间的,替换为“placeholder”的url。连接完毕后,我们查看cookie是否有效,只要发现网页被判断为伪装即将采集,我们将断网等待,恢复网络之后,我们依次访问右上角的搜索页。看到右上角的百度logo。

scrapy框架本身已经为我们提供了requests库,requests函数已经写好,我们只需要调用它进行采集即可。此处的登录。 查看全部

网页数据抓取软件(网页数据抓取软件|requests-javascript数据采集浏览器的应用)

网页数据抓取软件|requests-javascript数据采集requests一直都是最受欢迎的网页数据抓取软件,源于“webfuckinglove”。而最近谷歌发布了requests的3.1版本,到了2018年7月更是比3.0版本升级了5次,再次改变了网页抓取的工作方式。requests作为一个数据抓取工具来说,有两个最基本的优点:抓取方便(输入url直接返回html文件)代码写起来简单。

上一期文章我们从工程实践的角度,对requests作为抓取任何网页内容的网页数据采集工具进行了分析。本期文章,我们从网页爬取的角度,对requests进行分析。工程实践我们用这两种方式,从手机浏览器访问网页抓取(谷歌和百度),使用抓取网页数据放到网站上进行分析,并得到结果。1.手机浏览器抓取通过上一节的阅读,大家可能已经发现,无论从网页抓取的角度还是从网页抓取的数据分析,requests已经足够强大。

但在采用这种方式采集网页内容之前,我们还需要一定的环境支持。目前我们先来讲解一下爬取网页的javascript代码。下面我们先看一下网页源代码的构成,这里为了分析方便,我们采用requests爬取网页内容我们需要用到浏览器的chrome浏览器,浏览器的firefox浏览器和谷歌浏览器(本文需要的版本为chrome92.8.15261和firefox34.x)。

首先,我们复制我们需要的网页url到javascript代码文件,并加上“#javascript”关键字。我们可以看到,采用采用scrapy框架的网页数据抓取方法已经是最大的优势了。现在我们依次浏览本网页,看到左上角有百度的手机搜索页,继续访问看到手机搜索页有按钮,我们用requests采集这个按钮的response。

我们只采集“#smartbutton”处的response,其余处需要用到javascript代码进行抓取。大家可以通过这个代码展示,整个网页抓取的流程。我们将通过下面的代码,展示如何用requests抓取页面内容并保存到本地。对应这种方式爬取网页,我们仅要采集我们想要爬取的部分内容,那么我们需要将我们需要爬取的网页页面连接和url连接到一起,我们使用bs4可以方便的进行组织连接。

另外我们选用此种抓取方式,网页有一定的转码要求,在开始前我们需要将“#smartbutton”页面的中间的,替换为“placeholder”的url。连接完毕后,我们查看cookie是否有效,只要发现网页被判断为伪装即将采集,我们将断网等待,恢复网络之后,我们依次访问右上角的搜索页。看到右上角的百度logo。

scrapy框架本身已经为我们提供了requests库,requests函数已经写好,我们只需要调用它进行采集即可。此处的登录。

网页数据抓取软件(Python代码段落并提取相应值__box)

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-10-19 17:02

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

拿到label后,我们可以使用name_box的text属性来获取对应的值

name = name_box.text.strip() # strip() 函数用于去除前后空格

印刷名称

使用类似的方法,我们可以得到股票指数价格数据。

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

印刷价格

当您运行程序时,您应该能够看到程序输出标准普尔 500 指数的当前价格。

以 Excel CSV 格式导出数据

我们已经学习了如何获取数据,现在我们将学习如何存储数据。Excel 的逗号分隔数据格式 (CSV) 是一个不错的选择。这样,我们就可以在 Excel 中打开数据文件进行查看和进一步处理。

在此之前,我们需要导入 Python 的 csv 模块和 datetime 模块。Datetime 模块用于获取数据记录时间。请将以下代码行插入您的导入代码部分。

导入 csv

从日期时间导入日期时间

在代码底部,添加将数据写入 CSV 文件的代码。

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

writer.writerow([名称, 价格, datetime.now()])

现在,如果您运行该程序,您应该能够导出一个 index.csv 文件。可以在Excel中打开文件,看到如图所示的一行数据。

所以如果你每天运行这个程序,你就可以轻松获得标准普尔指数价格,而不必像以前那样在网站上搜索。

更进一步(高级用法)

多个股票指数

抓取一个股指信息对你来说还不够,对吧?我们可以尝试同时提取多个股指信息。首先,我们需要修改 quote_page 以将其定义为 URL 数组。

quote_page = [':IND',':IND']

然后我们把代码的数据提取部分改成了for循环。这个循环可以一个一个地处理URL,并将变量data中的所有数据以元组类型存储。

# for 循环

数据 = []

对于quote_page中的pg:

# 检索网站并返回HTML代码,并将其存储在变量'page'中

页 = urllib2.urlopen(pg)

# 使用 beautifulSoup 解析 HTML 代码并将其存储在变量 `soup` 中

汤 = BeautifulSoup(page,'html.parser')

# 获取“名称”类别

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

name = name_box.text.strip() # strip() 用于去除开头和结尾

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

# 使用元组类型存储数据

data.append((名称,价格))

并且,修改保存部分,逐行保存数据

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

# for 循环

对于名称,数据中的价格:

writer.writerow([名称, 价格, datetime.now()])

重新运行程序,应该可以同时提取两个股指价格信息了!

先进的爬虫技术

BeautifulSoup 库使用方便,可以很好的做少量的网站爬取。但是如果你对大量的爬取信息感兴趣,可以考虑其他方法:

1. Scrapy,一个强大的 Python 数据捕获框架。

2. 您可以尝试将一些公共应用程序编程接口 (API) 集成到您的代码中。这种获取数据的方法远比网络爬行高效。例如,您可以尝试 Facebook Graph API。该 API 可以帮助您获取 Facebook 网站 上未显示的隐藏信息。

3. 如果数据量太大,可以考虑使用类似于MySQL的数据库后端来存储数据。

采取“不要重复”的方法

DRY 是英语中“不要重复你做过的事情”的缩写。您可以尝试像链接中的人一样自动化您的日常工作。同时,你也可以考虑其他有趣的项目,比如掌握你的 Facebook 好友的在线时间(当然他们同意),或者在论坛中获取讲座主题列表来尝试自然语言处理(这是当前人工智能的热门话题)!

原文链接

本文观点仅代表作者本人。36氪是信息发布平台,36氪仅提供信息存储空间服务。 查看全部

网页数据抓取软件(Python代码段落并提取相应值__box)

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

拿到label后,我们可以使用name_box的text属性来获取对应的值

name = name_box.text.strip() # strip() 函数用于去除前后空格

印刷名称

使用类似的方法,我们可以得到股票指数价格数据。

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

印刷价格

当您运行程序时,您应该能够看到程序输出标准普尔 500 指数的当前价格。

以 Excel CSV 格式导出数据

我们已经学习了如何获取数据,现在我们将学习如何存储数据。Excel 的逗号分隔数据格式 (CSV) 是一个不错的选择。这样,我们就可以在 Excel 中打开数据文件进行查看和进一步处理。

在此之前,我们需要导入 Python 的 csv 模块和 datetime 模块。Datetime 模块用于获取数据记录时间。请将以下代码行插入您的导入代码部分。

导入 csv

从日期时间导入日期时间

在代码底部,添加将数据写入 CSV 文件的代码。

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

writer.writerow([名称, 价格, datetime.now()])

现在,如果您运行该程序,您应该能够导出一个 index.csv 文件。可以在Excel中打开文件,看到如图所示的一行数据。

所以如果你每天运行这个程序,你就可以轻松获得标准普尔指数价格,而不必像以前那样在网站上搜索。

更进一步(高级用法)

多个股票指数

抓取一个股指信息对你来说还不够,对吧?我们可以尝试同时提取多个股指信息。首先,我们需要修改 quote_page 以将其定义为 URL 数组。

quote_page = [':IND',':IND']

然后我们把代码的数据提取部分改成了for循环。这个循环可以一个一个地处理URL,并将变量data中的所有数据以元组类型存储。

# for 循环

数据 = []

对于quote_page中的pg:

# 检索网站并返回HTML代码,并将其存储在变量'page'中

页 = urllib2.urlopen(pg)

# 使用 beautifulSoup 解析 HTML 代码并将其存储在变量 `soup` 中

汤 = BeautifulSoup(page,'html.parser')

# 获取“名称”类别

代码段并提取对应值

name_box = soup.find('h1', attrs={'class':'name'})

name = name_box.text.strip() # strip() 用于去除开头和结尾

# 获取股指价格数据

price_box = soup.find('div', attrs={'class':'price'})

价格 = price_box.text

# 使用元组类型存储数据

data.append((名称,价格))

并且,修改保存部分,逐行保存数据

#以“添加”方式打开一个csv文件,保证文件的原创信息不被覆盖

使用 open('index.csv','a') 作为 csv_file:

writer = csv.writer(csv_file)

# for 循环

对于名称,数据中的价格:

writer.writerow([名称, 价格, datetime.now()])

重新运行程序,应该可以同时提取两个股指价格信息了!

先进的爬虫技术

BeautifulSoup 库使用方便,可以很好的做少量的网站爬取。但是如果你对大量的爬取信息感兴趣,可以考虑其他方法:

1. Scrapy,一个强大的 Python 数据捕获框架。

2. 您可以尝试将一些公共应用程序编程接口 (API) 集成到您的代码中。这种获取数据的方法远比网络爬行高效。例如,您可以尝试 Facebook Graph API。该 API 可以帮助您获取 Facebook 网站 上未显示的隐藏信息。

3. 如果数据量太大,可以考虑使用类似于MySQL的数据库后端来存储数据。

采取“不要重复”的方法

DRY 是英语中“不要重复你做过的事情”的缩写。您可以尝试像链接中的人一样自动化您的日常工作。同时,你也可以考虑其他有趣的项目,比如掌握你的 Facebook 好友的在线时间(当然他们同意),或者在论坛中获取讲座主题列表来尝试自然语言处理(这是当前人工智能的热门话题)!

原文链接

本文观点仅代表作者本人。36氪是信息发布平台,36氪仅提供信息存储空间服务。

网页数据抓取软件(seospidermac特别版特别版 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-10-14 00:21

)

seo spider mac版,又名尖叫蛙SEO蜘蛛,是一款功能强大的网络爬虫软件,可以帮助您从不同的网页中选择要爬取的内容。它可以抓取网站的URL,并且可以实时分析结果并采集关键的现场数据,以方便SEO做出正确的决策,甚至对于无响应的网页。绝对是检测网站、搜索网络资源的神器!

SEO Spider是一款功能强大且灵活的网站爬虫,可以有效抓取小型和超大型网站,同时让您实时分析结果。它采集关键字段数据,以便 SEO 可以做出明智的决策。Screaming Frog SEO Spider 可让您快速抓取、分析和审核网站 领域的搜索引擎优化。

它可用于抓取小型和超大型 网站,其中手动检查每个页面将非常费力(或不可能!),并且您很容易错过重定向、元刷新或重复页面问题。您可以在程序的用户界面中不断采集和更新爬取数据,以查看、分析和过滤爬取数据。SEO Spider 允许您将关键的现场 SEO 元素(URL、页面标题、元描述、标题等)导出到 Excel,因此它可以轻松用作 SEO 推荐的基础。我们上面的视频演示了 SEO 工具可以做什么。

如果您正在寻找一款网络爬虫软件,那么seo spider mac 特别版是您不错的选择!seo蜘蛛mac特别版可以抓取网站的网址,在一个网站上自动分析几十个或几百个网页界面。通过 Screaming Frog SEO Spider 分析后,您可以获得所需的数据。

查看全部

网页数据抓取软件(seospidermac特别版特别版

)

seo spider mac版,又名尖叫蛙SEO蜘蛛,是一款功能强大的网络爬虫软件,可以帮助您从不同的网页中选择要爬取的内容。它可以抓取网站的URL,并且可以实时分析结果并采集关键的现场数据,以方便SEO做出正确的决策,甚至对于无响应的网页。绝对是检测网站、搜索网络资源的神器!

SEO Spider是一款功能强大且灵活的网站爬虫,可以有效抓取小型和超大型网站,同时让您实时分析结果。它采集关键字段数据,以便 SEO 可以做出明智的决策。Screaming Frog SEO Spider 可让您快速抓取、分析和审核网站 领域的搜索引擎优化。

它可用于抓取小型和超大型 网站,其中手动检查每个页面将非常费力(或不可能!),并且您很容易错过重定向、元刷新或重复页面问题。您可以在程序的用户界面中不断采集和更新爬取数据,以查看、分析和过滤爬取数据。SEO Spider 允许您将关键的现场 SEO 元素(URL、页面标题、元描述、标题等)导出到 Excel,因此它可以轻松用作 SEO 推荐的基础。我们上面的视频演示了 SEO 工具可以做什么。

如果您正在寻找一款网络爬虫软件,那么seo spider mac 特别版是您不错的选择!seo蜘蛛mac特别版可以抓取网站的网址,在一个网站上自动分析几十个或几百个网页界面。通过 Screaming Frog SEO Spider 分析后,您可以获得所需的数据。

网页数据抓取软件(如何把它输入给lxml.html模块(html字符串) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-10-14 00:21

)

狭义的爬虫只负责爬行,也就是下载网页。实际上,爬虫也负责从下载的网页中提取我们想要的数据,即对非结构化数据(网页)进行分析,提取结构化数据(有用数据)。比如我们想要抓取一个新闻页面的网页(html),但是我们想要的是这个网页中关于新闻的结构化数据:新闻标题、新闻发布时间、新闻正文等。

因此,下载网页只是第一步,另一个重要的步骤是数据提取。不同的爬虫想要的数据不同,提取的数据也不同,但是提取的方法大同小异。

提取数据的最简单方法是使用正则表达式。这种方法简单,提取逻辑不能复杂,否则写的正则表达式会晦涩难懂,甚至复杂的数据结构也提取不出来。

最后,经过多年的经验,老袁选择了lxml和xpath来解析网页,提取结构化数据。顺便说一句,BeautifulSoup 也是解析 HTML 的好工具。可以使用多个解析器,比如Python标准库的解析器,但是速度比较慢。也可以使用 lxml 作为解析器,但它的用法和 API 与 lxml 不一样。用了之后,lxml的API就舒服多了。

lxml 绑定了 C 语言库 libxml2 和 libxslt,并提供了 Pythonic API。它有一些主要特点:

一句话概括,是一个结合了C语言的速度和Python的简单性的神器。

lxml有两部分,分别支持XML和HTML的解析:

lxml.etree 可以用来解析RSS feed,它是一个XML 格式的文档。但是爬虫爬取的大部分都是html网页,所以这里主要讲一下lxml.html解析网页的方法。

lxml.html 从 html 字符串生成文档树结构

我们下载的网页是一串html字符串。如何将其输入到 lxml.html 模块中以生成 html 文档的树结构?

该模块提供了几种不同的方法:

下面我们通过具体的例子来说明上述方法的区别。

如何使用 document_fromstring

In [1]: import lxml.html as lh

In [2]: z = lh.document_fromstring('abcxyz')

# 可以看到,它自动加了根节点

In [3]: z

Out[3]:

In [4]: z.tag

Out[4]: 'html'

# 还加了节点

In [5]: z.getchildren()

Out[5]: []

# 把字符串的两个节点放在了里面

In [6]: z.getchildren()[0].getchildren()

Out[6]: [, ]

fragment_fromstring 的使用

In [11]: z = lh.fragment_fromstring(‘abcxyz’)

---------------------------------------------------------------------------

ParserError Traceback (most recent call last)

in ()

----> 1 z = lh.fragment_fromstring(‘abcxyz’)

~/.virtualenvs/py3.6/lib/python3.6/site-packages/lxml/html/__init__.py in fragment_fromstring(html, create_parent, base_url, parser, **kw)

850 raise etree.ParserError(

851 “Multiple elements found (%s)”

--> 852 % ‘, ‘.join([_element_name(e) for e in elements]))

853 el = elements[0]

854 if el.tail and el.tail.strip():

ParserError: Multiple elements found (div, div)

# 可以看到,输入是两个节点(element)时就会报错

# 如果加上 create_parent 参数,就没问题了

In [12]: z = lh.fragment_fromstring('abcxyz', create_parent='p')

In [13]: z.tag

Out[13]: 'p'

In [14]: z.getchildren()

Out[14]: [, ]

fragment_fromstring 的使用

# 输入字符串含有一个节点,则返回包含这一个节点的列表

In [17]: lh.fragments_fromstring('abc')

Out[17]: []

# 输入字符串含有多个节点,则返回包含这多个节点的列表

In [18]: lh.fragments_fromstring('abcxyz')

Out[18]: [, ]

使用 fromstring

<br />In [27]: z = lh.fromstring('abcxyz')

In [28]: z

Out[28]:

In [29]: z.getchildren()

Out[29]: [, ]

In [30]: type(z)

Out[30]: lxml.html.HtmlElement

这里,如果输入的fromstring是多个节点,则会添加一个父节点并返回。但是就像html网页从节点开始一样,我们可以使用fromstring()和document_fromstring()来获取完整的网页结构。

从上面的代码中,我们可以看到这些函数返回的是 HtmlElement 对象。也就是说,我们已经学会了如何从 html 字符串中获取 HtmlElement 对象。在下一节中,我们将学习如何操作 HtmlElement 对象。提取我们感兴趣的数据。

查看全部

网页数据抓取软件(如何把它输入给lxml.html模块(html字符串)

)

狭义的爬虫只负责爬行,也就是下载网页。实际上,爬虫也负责从下载的网页中提取我们想要的数据,即对非结构化数据(网页)进行分析,提取结构化数据(有用数据)。比如我们想要抓取一个新闻页面的网页(html),但是我们想要的是这个网页中关于新闻的结构化数据:新闻标题、新闻发布时间、新闻正文等。

因此,下载网页只是第一步,另一个重要的步骤是数据提取。不同的爬虫想要的数据不同,提取的数据也不同,但是提取的方法大同小异。

提取数据的最简单方法是使用正则表达式。这种方法简单,提取逻辑不能复杂,否则写的正则表达式会晦涩难懂,甚至复杂的数据结构也提取不出来。

最后,经过多年的经验,老袁选择了lxml和xpath来解析网页,提取结构化数据。顺便说一句,BeautifulSoup 也是解析 HTML 的好工具。可以使用多个解析器,比如Python标准库的解析器,但是速度比较慢。也可以使用 lxml 作为解析器,但它的用法和 API 与 lxml 不一样。用了之后,lxml的API就舒服多了。

lxml 绑定了 C 语言库 libxml2 和 libxslt,并提供了 Pythonic API。它有一些主要特点:

一句话概括,是一个结合了C语言的速度和Python的简单性的神器。

lxml有两部分,分别支持XML和HTML的解析:

lxml.etree 可以用来解析RSS feed,它是一个XML 格式的文档。但是爬虫爬取的大部分都是html网页,所以这里主要讲一下lxml.html解析网页的方法。

lxml.html 从 html 字符串生成文档树结构

我们下载的网页是一串html字符串。如何将其输入到 lxml.html 模块中以生成 html 文档的树结构?

该模块提供了几种不同的方法:

下面我们通过具体的例子来说明上述方法的区别。

如何使用 document_fromstring

In [1]: import lxml.html as lh

In [2]: z = lh.document_fromstring('abcxyz')

# 可以看到,它自动加了根节点

In [3]: z

Out[3]:

In [4]: z.tag

Out[4]: 'html'

# 还加了节点

In [5]: z.getchildren()

Out[5]: []

# 把字符串的两个节点放在了里面

In [6]: z.getchildren()[0].getchildren()

Out[6]: [, ]

fragment_fromstring 的使用

In [11]: z = lh.fragment_fromstring(‘abcxyz’)

---------------------------------------------------------------------------

ParserError Traceback (most recent call last)

in ()

----> 1 z = lh.fragment_fromstring(‘abcxyz’)

~/.virtualenvs/py3.6/lib/python3.6/site-packages/lxml/html/__init__.py in fragment_fromstring(html, create_parent, base_url, parser, **kw)

850 raise etree.ParserError(

851 “Multiple elements found (%s)”

--> 852 % ‘, ‘.join([_element_name(e) for e in elements]))

853 el = elements[0]

854 if el.tail and el.tail.strip():

ParserError: Multiple elements found (div, div)

# 可以看到,输入是两个节点(element)时就会报错

# 如果加上 create_parent 参数,就没问题了

In [12]: z = lh.fragment_fromstring('abcxyz', create_parent='p')

In [13]: z.tag

Out[13]: 'p'

In [14]: z.getchildren()

Out[14]: [, ]

fragment_fromstring 的使用

# 输入字符串含有一个节点,则返回包含这一个节点的列表

In [17]: lh.fragments_fromstring('abc')

Out[17]: []

# 输入字符串含有多个节点,则返回包含这多个节点的列表

In [18]: lh.fragments_fromstring('abcxyz')

Out[18]: [, ]

使用 fromstring

<br />In [27]: z = lh.fromstring('abcxyz')

In [28]: z

Out[28]:

In [29]: z.getchildren()

Out[29]: [, ]

In [30]: type(z)

Out[30]: lxml.html.HtmlElement

这里,如果输入的fromstring是多个节点,则会添加一个父节点并返回。但是就像html网页从节点开始一样,我们可以使用fromstring()和document_fromstring()来获取完整的网页结构。

从上面的代码中,我们可以看到这些函数返回的是 HtmlElement 对象。也就是说,我们已经学会了如何从 html 字符串中获取 HtmlElement 对象。在下一节中,我们将学习如何操作 HtmlElement 对象。提取我们感兴趣的数据。

网页数据抓取软件( 具体分析如下实现抓取和分析网页类,实例分析(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-13 23:31

具体分析如下实现抓取和分析网页类,实例分析(图))

爬取分析网页类示例的C#实现

更新时间:2015-05-25 10:53:05 作者:莫翔

本文文章主要介绍爬取分析网页的C#实现,实例分析了C#抓取分析网页中的文字和连接的相关使用技巧。有一定的参考价值,有需要的朋友可以参考以下

本文介绍了爬取和分析网页的 C# 实现。分享给大家,供大家参考。具体分析如下:

以下是用于抓取和分析网页的类。

它的主要功能是:

1、 提取网页的纯文本,转到所有html标签和javascript代码

2、 提取网页链接,包括href、frame和iframe

3、 提取网页标题等(其他标签类推,规律相同)

4、 可以实现简单的表单提交和cookie保存

/*

* Author:Sunjoy at CCNU

* 如果您改进了这个类请发一份代码给我(ccnusjy 在gmail.com)

*/

using System;

using System.Data;

using System.Configuration;

using System.Net;

using System.IO;

using System.Text;

using System.Collections.Generic;

using System.Text.RegularExpressions;

using System.Threading;

using System.Web;

///

/// 网页类

///

public class WebPage

{

#region 私有成员

private Uri m_uri; //网址

private List m_links; //此网页上的链接

private string m_title; //此网页的标题

private string m_html; //此网页的HTML代码

private string m_outstr; //此网页可输出的纯文本

private bool m_good; //此网页是否可用

private int m_pagesize; //此网页的大小

private static Dictionary webcookies = new Dictionary();//存放所有网页的Cookie