网页数据抓取软件

网页数据抓取软件(完全免费金色数据平台社区版的文档使用入门(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-11-18 11:02

)

GoldDataSpider 是一个用于抓取网页和提取数据的工具。核心代码与黄金数据采集与集成平台分离。

本项目提供对网页数据的爬取和提取,不仅可以提取网页内的内容,还可以提取URL、HTTP头、Cookie中的数据。

该项目定义了简洁、灵活、敏捷的结构或规则语法。尽量从网页内容、HTTP头、cookies,甚至其他网页,以及其他网站数据中提取有意义的、有价值的数据字段,形成数据记录。另外,可以嵌入http请求来补充数据字段。比如有些字段需要提供翻译字段给字典等等。

该项目还可以支持从各种类型的文档中提取数据,例如html/xml/json/javascript/text等。

我们还提供规则的可视化准备。请下载完全免费的金数据平台社区版,采集数量不限,爬虫数量不限,导出数据不限。和详细的文档

入门

首先,我们需要在项目中添加依赖,如下:

1、对于maven项目

com.100shouhou.golddata

golddata-spider

1.1.3

2、对于gradle项目

compile group: 'com.100shouhou.golddata', name: 'golddata-spider', version: '1.1.3'

然后你就可以使用依赖提供的简洁明了的API,如下:

@Test

public void testGoldSpider(){

String ruleContent=

" { \n"+

" __node: li.sky.skyid \n"+

" date: \n"+

" { \n"+

" expr: h1 \n"+

" __label: 日期 \n"+

" } \n"+

" sn: \n"+

" { \n"+

" \n"+

" js: md5(baseUri+item.date+headers['Content-Type']);\n"+

" } \n"+

" weather: \n"+

" { \n"+

" expr: p.wea \n"+

" } \n"+

" temprature: \n"+

" { \n"+

" expr: p.tem>i \n"+

" } \n"+

" } \n";

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl("http://www.weather.com.cn/weat ... 6quot;)

.setRule(ruleContent)

.request();

List list=spider.extractList();

// List weathers=spider.extractList(Weather.class);

// Weather weathers=spider.extractFirst(Weather.class);

list.forEach( System.out::println);

}

运行上面的测试,你会看到类似下面的输出:

{date=19日(今天), weather=阴转小雨, temprature=10℃, sn=8bc265cb2bf23b6764b75144b255d81d}

{date=20日(明天), weather=小雨转多云, temprature=11℃, sn=9efd7e7bbbfb9bb06e04c0c990568bfd}

{date=21日(后天), weather=多云转中雨, temprature=11℃, sn=728539ac882721187741708860324afa}

{date=22日(周六), weather=小雨, temprature=9℃, sn=a23fa2233e750a3bdd11b2e200ed06c3}

{date=23日(周日), weather=小雨转多云, temprature=8℃, sn=b27e1b8a8e92a7bed384ceb3e4fdfb5f}

{date=24日(周一), weather=多云转小雨, temprature=8℃, sn=c142b7fd12330ca031dd96b307c0d50d}

{date=25日(周二), weather=小雨转中雨, temprature=6℃, sn=16f71d3c8f09394588532a3ed1a8bacf}

用作服务或 API

您可以将其用作项目中的调用服务和 API。例如如下:

@Service

public class WeatherServiceImpl implements WeatherService{

public List listByCityId(Long cityId){

String url="http://www.weather.com.cn/weat ... ot%3B

String rule=""

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl(url)

.setRule(ruleContent)

.request();

return spider.extractList(Weather.class);

}

} 查看全部

网页数据抓取软件(完全免费金色数据平台社区版的文档使用入门(图)

)

GoldDataSpider 是一个用于抓取网页和提取数据的工具。核心代码与黄金数据采集与集成平台分离。

本项目提供对网页数据的爬取和提取,不仅可以提取网页内的内容,还可以提取URL、HTTP头、Cookie中的数据。

该项目定义了简洁、灵活、敏捷的结构或规则语法。尽量从网页内容、HTTP头、cookies,甚至其他网页,以及其他网站数据中提取有意义的、有价值的数据字段,形成数据记录。另外,可以嵌入http请求来补充数据字段。比如有些字段需要提供翻译字段给字典等等。

该项目还可以支持从各种类型的文档中提取数据,例如html/xml/json/javascript/text等。

我们还提供规则的可视化准备。请下载完全免费的金数据平台社区版,采集数量不限,爬虫数量不限,导出数据不限。和详细的文档

入门

首先,我们需要在项目中添加依赖,如下:

1、对于maven项目

com.100shouhou.golddata

golddata-spider

1.1.3

2、对于gradle项目

compile group: 'com.100shouhou.golddata', name: 'golddata-spider', version: '1.1.3'

然后你就可以使用依赖提供的简洁明了的API,如下:

@Test

public void testGoldSpider(){

String ruleContent=

" { \n"+

" __node: li.sky.skyid \n"+

" date: \n"+

" { \n"+

" expr: h1 \n"+

" __label: 日期 \n"+

" } \n"+

" sn: \n"+

" { \n"+

" \n"+

" js: md5(baseUri+item.date+headers['Content-Type']);\n"+

" } \n"+

" weather: \n"+

" { \n"+

" expr: p.wea \n"+

" } \n"+

" temprature: \n"+

" { \n"+

" expr: p.tem>i \n"+

" } \n"+

" } \n";

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl("http://www.weather.com.cn/weat ... 6quot;)

.setRule(ruleContent)

.request();

List list=spider.extractList();

// List weathers=spider.extractList(Weather.class);

// Weather weathers=spider.extractFirst(Weather.class);

list.forEach( System.out::println);

}

运行上面的测试,你会看到类似下面的输出:

{date=19日(今天), weather=阴转小雨, temprature=10℃, sn=8bc265cb2bf23b6764b75144b255d81d}

{date=20日(明天), weather=小雨转多云, temprature=11℃, sn=9efd7e7bbbfb9bb06e04c0c990568bfd}

{date=21日(后天), weather=多云转中雨, temprature=11℃, sn=728539ac882721187741708860324afa}

{date=22日(周六), weather=小雨, temprature=9℃, sn=a23fa2233e750a3bdd11b2e200ed06c3}

{date=23日(周日), weather=小雨转多云, temprature=8℃, sn=b27e1b8a8e92a7bed384ceb3e4fdfb5f}

{date=24日(周一), weather=多云转小雨, temprature=8℃, sn=c142b7fd12330ca031dd96b307c0d50d}

{date=25日(周二), weather=小雨转中雨, temprature=6℃, sn=16f71d3c8f09394588532a3ed1a8bacf}

用作服务或 API

您可以将其用作项目中的调用服务和 API。例如如下:

@Service

public class WeatherServiceImpl implements WeatherService{

public List listByCityId(Long cityId){

String url="http://www.weather.com.cn/weat ... ot%3B

String rule=""

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl(url)

.setRule(ruleContent)

.request();

return spider.extractList(Weather.class);

}

}

网页数据抓取软件(()(-post类的节点中))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-11 12:06

在节点中,其中的投票数

在 .vote-count-post 类的节点中:

问题 %>%

html_ _nodes(".question-summary.vote-count-post") %>%

html_ _text() %>%

as.integer()

## [1] 1429 746 622 533 471

同样,下面的一段代码用于提取答案的数量:

问题 %>%

html_ _nodes(".question-summary.status strong") %>%

html_ _text() %>%

as.integer()

## [1] 21 15 8 11 7

但是,如果要继续提取每个问题的标签,则比较困难,因为不同问题的标签数量可能不同。

在下面的代码中,我们首先选择所有问题的标签集,然后通过迭代提取每个集合中的标签:

问题 %>%

html_ _nodes(".question-summary.tags") %>%

lapply(功能(节点){

节点%>%

html_ _nodes(".post-tag") %>%

html_ _text()

}) %>%

字符串

## 5 个列表

## $: chr [1:2] "r" "r-faq"

## $: chr [1:4] "r" "sorting" "dataframe" "r-faq"

## $: chr [1:4] "r" "sapply" "tapply" "r-faq"

## $: chr [1:5] "r" "join" "merge" "dataframe" ...

## $: chr [1:2] "r" "ggplot2"

以上所有数据采集过程都在同一个网页上进行。想象一下如果你需要从多个页面采集

我应该怎么做来采集数据?假设我们访问此页面上的每个问题(例如

q/5963269/2906900)。注意右上角有个“信息框”(information box),我

我们以列表的形式提取每个问题的“信息框”,如图14-14所示。

通过检查,我们发现#qinfo正是每个问题页面的“信息框”

“键”(key)。然后,选择所有问题的超链接并提取每个问题的 URL

并迭代,读取每个问题页面,然后使用#qinfo从中提取信息框:

问题 %>%

html_ _nodes(".question-超链接") %>%

html_ _attr("href") %>%

lapply(功能(链接){ 查看全部

网页数据抓取软件(()(-post类的节点中))

在节点中,其中的投票数

在 .vote-count-post 类的节点中:

问题 %>%

html_ _nodes(".question-summary.vote-count-post") %>%

html_ _text() %>%

as.integer()

## [1] 1429 746 622 533 471

同样,下面的一段代码用于提取答案的数量:

问题 %>%

html_ _nodes(".question-summary.status strong") %>%

html_ _text() %>%

as.integer()

## [1] 21 15 8 11 7

但是,如果要继续提取每个问题的标签,则比较困难,因为不同问题的标签数量可能不同。

在下面的代码中,我们首先选择所有问题的标签集,然后通过迭代提取每个集合中的标签:

问题 %>%

html_ _nodes(".question-summary.tags") %>%

lapply(功能(节点){

节点%>%

html_ _nodes(".post-tag") %>%

html_ _text()

}) %>%

字符串

## 5 个列表

## $: chr [1:2] "r" "r-faq"

## $: chr [1:4] "r" "sorting" "dataframe" "r-faq"

## $: chr [1:4] "r" "sapply" "tapply" "r-faq"

## $: chr [1:5] "r" "join" "merge" "dataframe" ...

## $: chr [1:2] "r" "ggplot2"

以上所有数据采集过程都在同一个网页上进行。想象一下如果你需要从多个页面采集

我应该怎么做来采集数据?假设我们访问此页面上的每个问题(例如

q/5963269/2906900)。注意右上角有个“信息框”(information box),我

我们以列表的形式提取每个问题的“信息框”,如图14-14所示。

通过检查,我们发现#qinfo正是每个问题页面的“信息框”

“键”(key)。然后,选择所有问题的超链接并提取每个问题的 URL

并迭代,读取每个问题页面,然后使用#qinfo从中提取信息框:

问题 %>%

html_ _nodes(".question-超链接") %>%

html_ _attr("href") %>%

lapply(功能(链接){

网页数据抓取软件(从Web获取数据您可以在PowerBI中删除所有额外步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-11 12:05

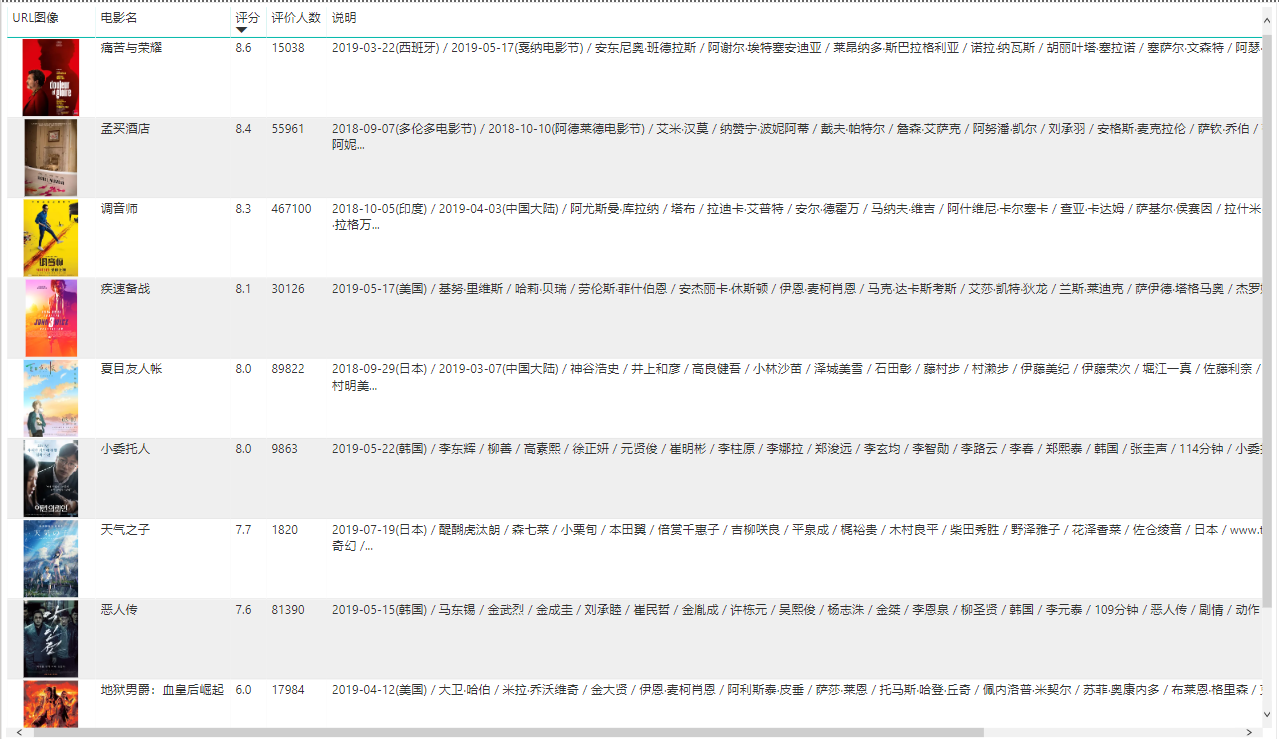

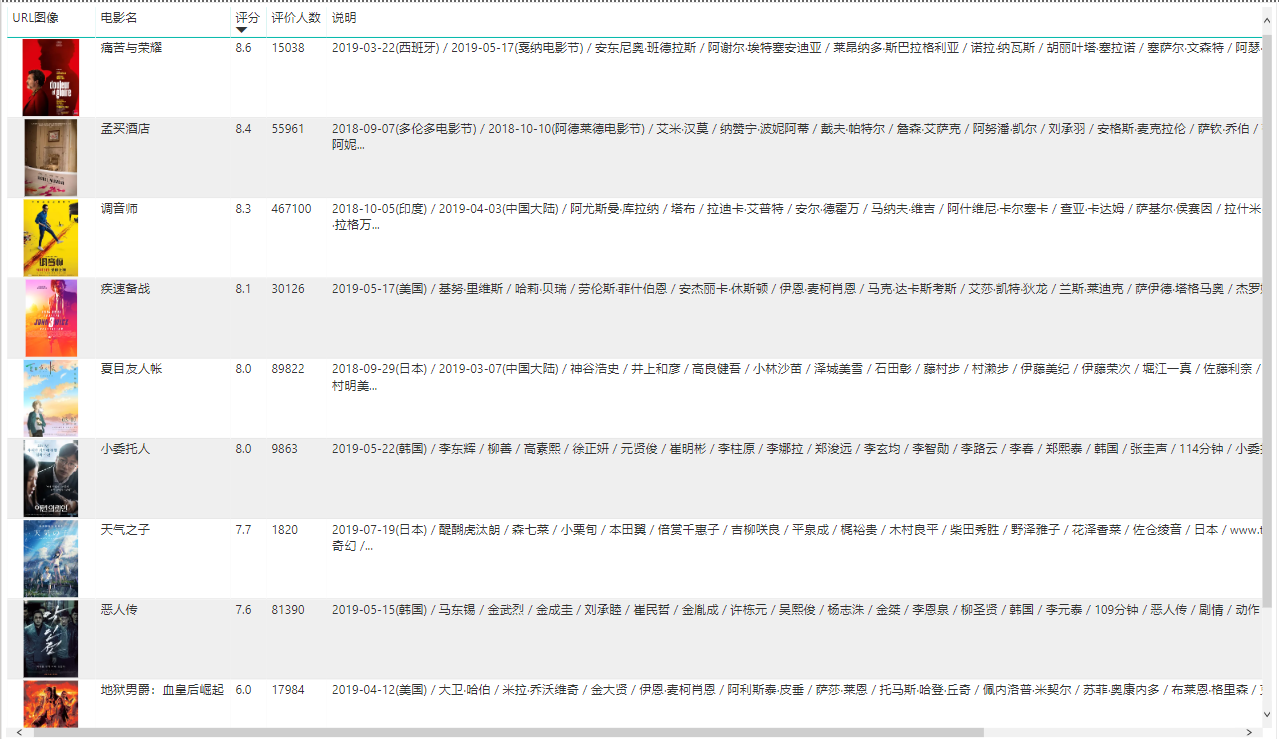

PowerQuery 可以连接到网页并从那里获取数据。但是,从网页获取数据的默认方法不会将图像提取到报告中。在本文中,我将向您展示一种方法,您可以使用该方法从网页中获取图像并将其转换为 Power BI 中的可视化。

样本来源

在这个例子中,我使用豆瓣电影排名作为来源。你可以在这里访问它:

您可以在下面看到页面的外观。在此示例中,我们想要做的是将这些图像放入我们的 Power BI 报表中。

从网络获取数据

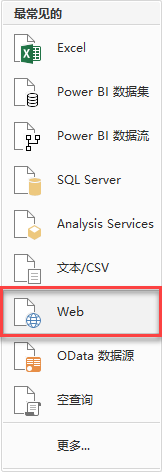

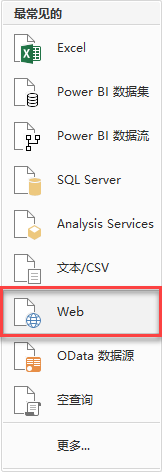

可以在 Power BI 中使用从 Web 获取数据。

输入网址,点击确认,我们可以看到如下导航。我们选择“编辑”进入我们的 Power Query 界面。

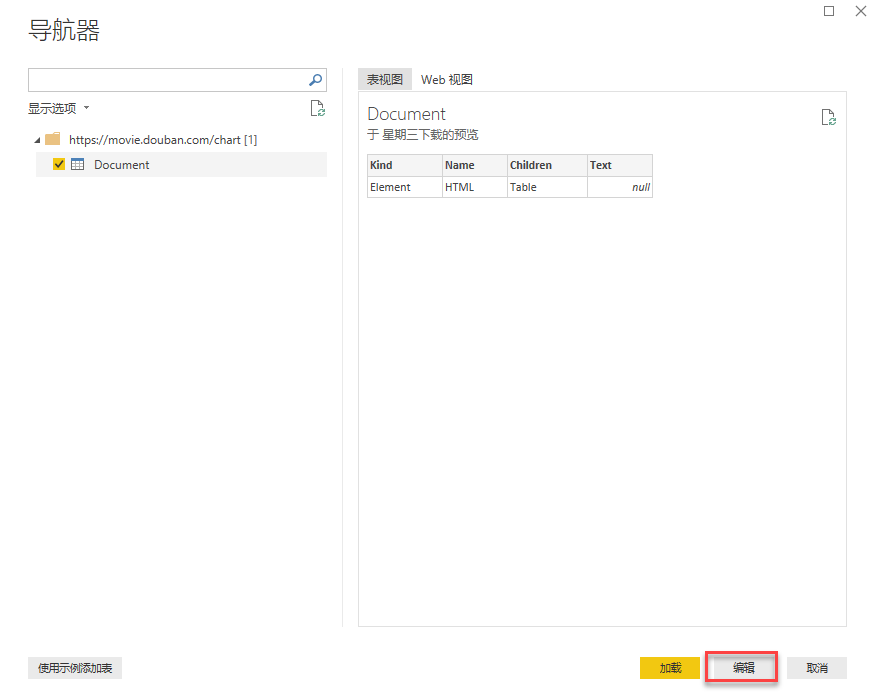

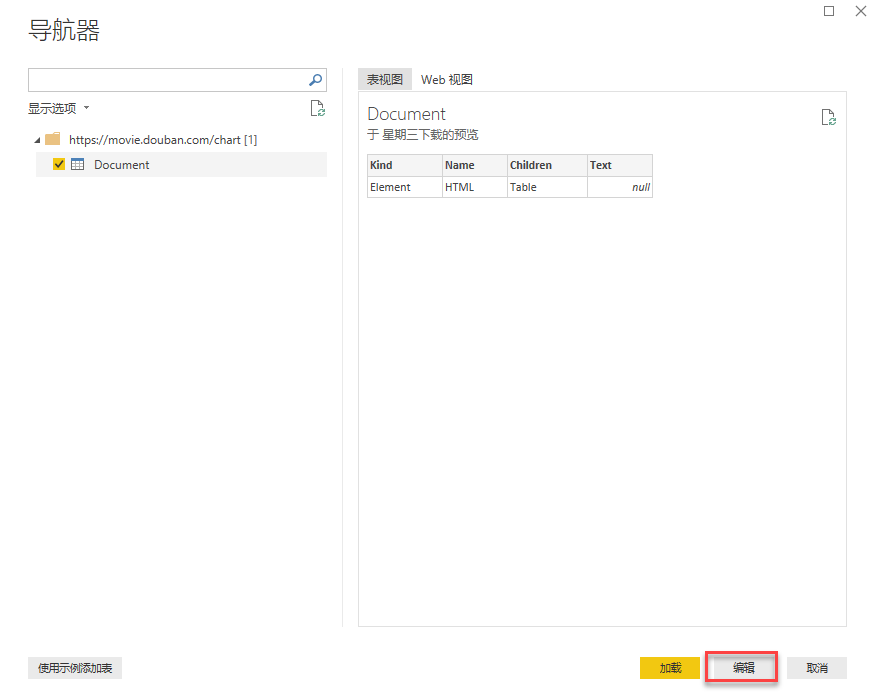

编辑查询

我们现在需要做的第一件事是删除所有额外的步骤。只剩下从这个页面读取数据的第一步了。将第一步的步骤替换为以下代码:

"= Web.BrowserContents("")"

我们可以得到整个HTML页面的信息。

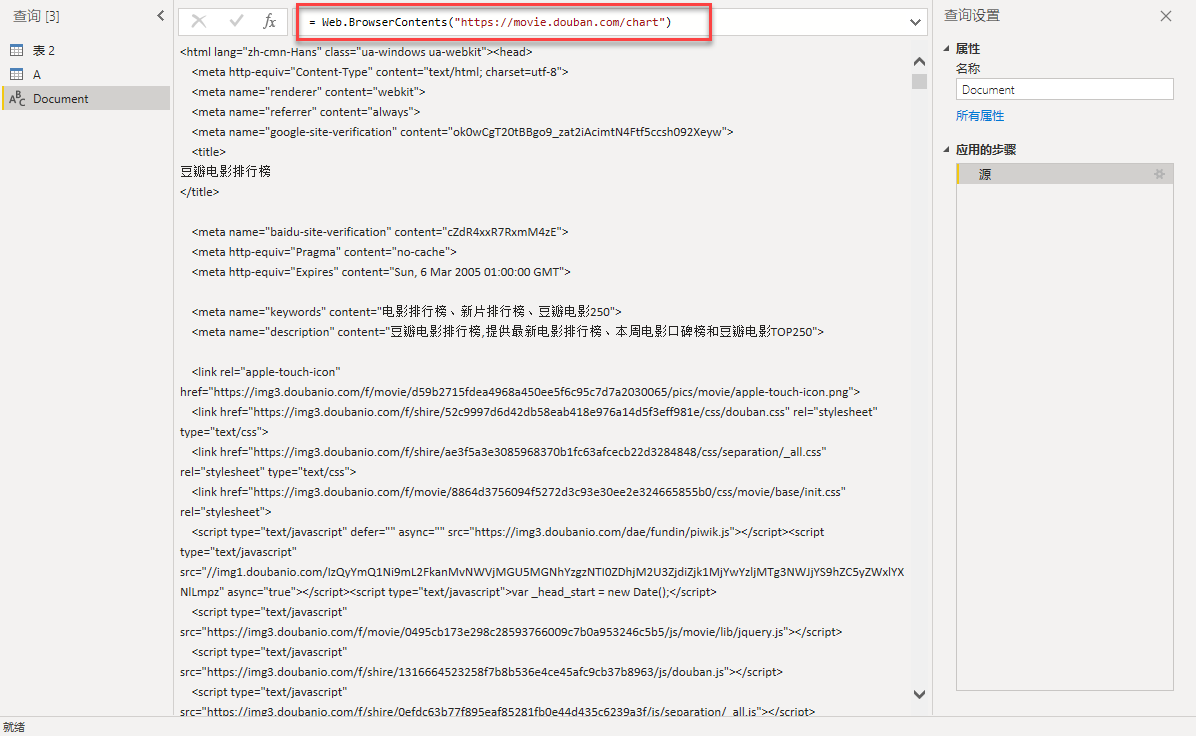

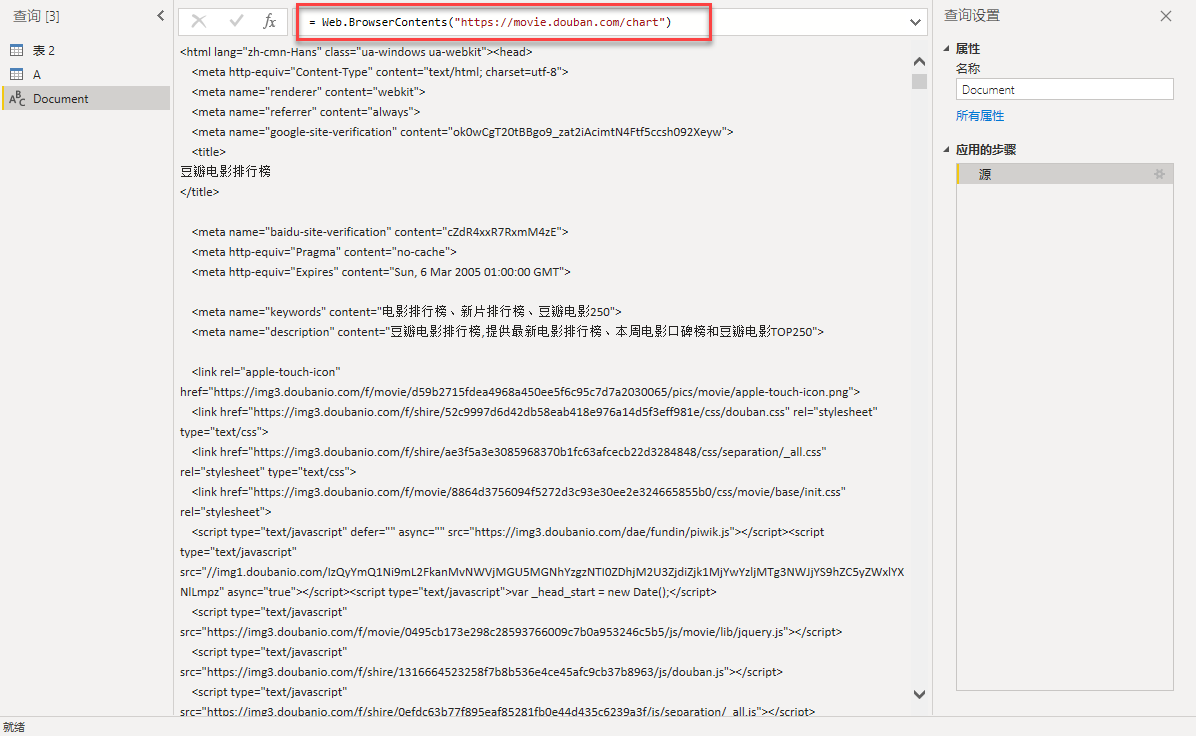

然后将其转换为表格:

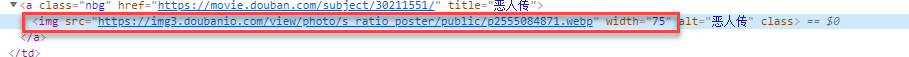

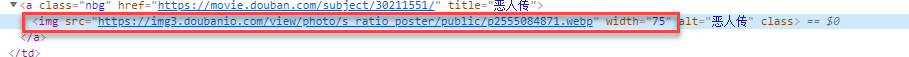

下一步就是我们的重点,也就是如何搜索图片的HTML代码。

找到页面中图片的HTML代码

有多种工具和方法可用于查找图像的 HTML 代码。我经常用谷歌浏览器找,按F12打开我们的调试器,然后用元素选择器选择我们的图片,查看我们网页的结构信息。

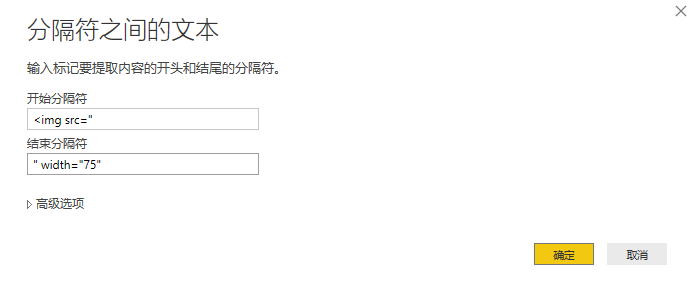

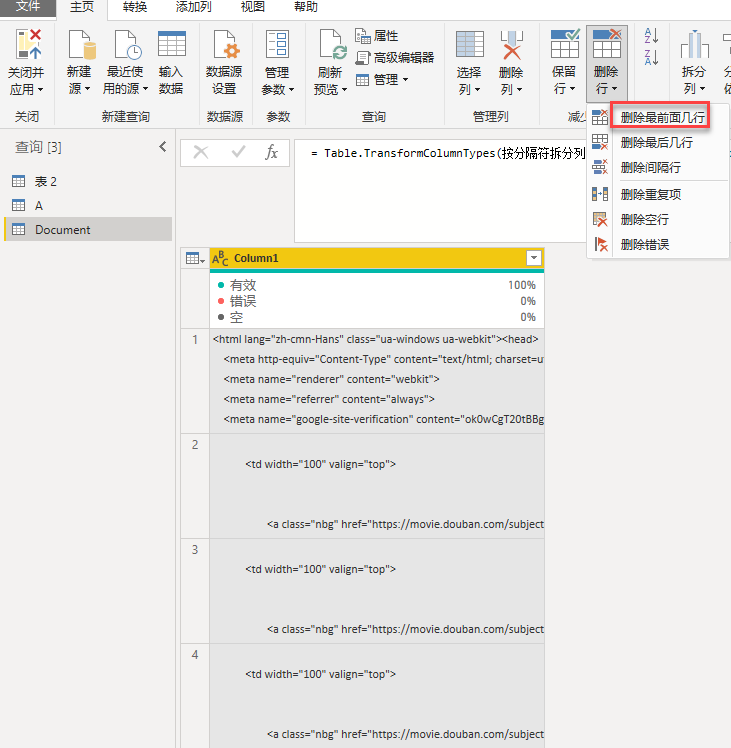

使用 HTML 代码中断数据

上一步我们得到了网页的结构信息,接下来我们可以在Power Query中应用一些转换来实现这个功能。

我的第一步是拆分所有电影的信息。直接使用通过分隔符拆分列的功能,它将作为我们的分隔符。拆分位置选项设置为每次出现分隔符时,拆分为选项设置为行。

这将为每部电影提供一行数据,除了应该删除的第一行。您可以通过删除前几行,然后将第一行放在第一行中来删除它。

现在让我们输入表格的图像部分。该图像位于“

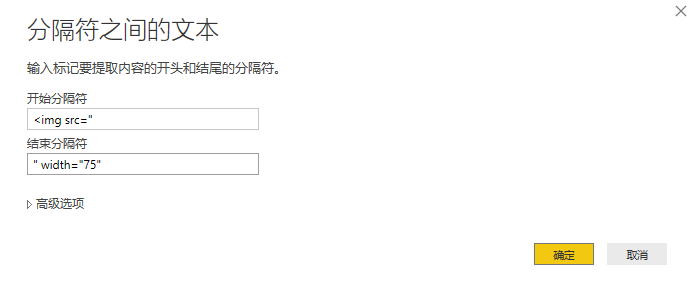

所以我们需要做的就是提取分隔符之间的文本:

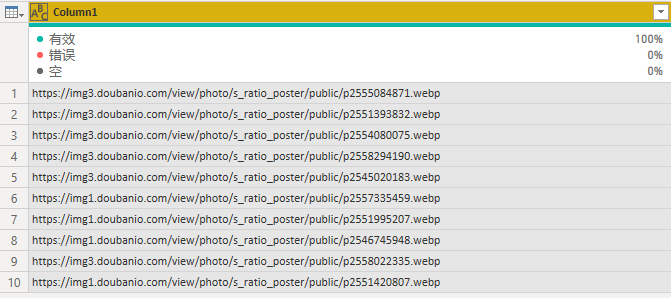

在这里,我们获取表中所有图像的 URL:

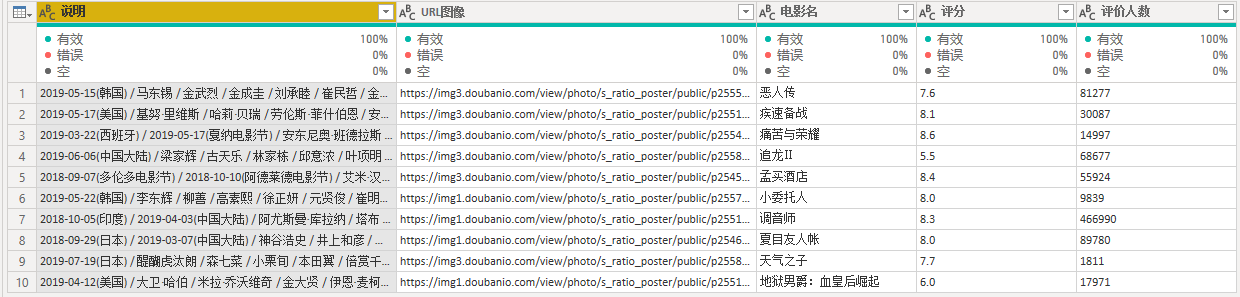

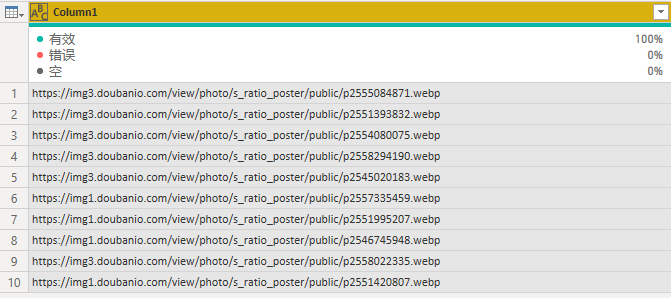

您可以使用相同的方法获取这些电影的其他部分,例如片名、评分、票房、演员等信息。由于操作的重复性,我就不一一解释了,直接看我们最终得到的表格:

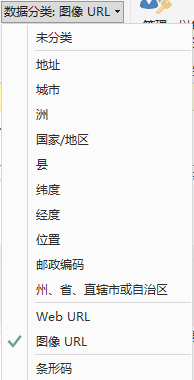

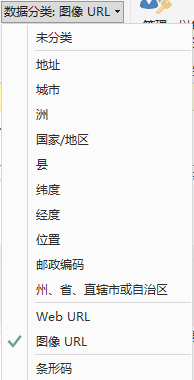

我必须将此字段的数据类别设置为图像 URL:

现在可以在我们的 Power BI 报告中使用图像:

案例获取

想要获取本案例源文件文章的朋友请留言。 查看全部

网页数据抓取软件(从Web获取数据您可以在PowerBI中删除所有额外步骤)

PowerQuery 可以连接到网页并从那里获取数据。但是,从网页获取数据的默认方法不会将图像提取到报告中。在本文中,我将向您展示一种方法,您可以使用该方法从网页中获取图像并将其转换为 Power BI 中的可视化。

样本来源

在这个例子中,我使用豆瓣电影排名作为来源。你可以在这里访问它:

您可以在下面看到页面的外观。在此示例中,我们想要做的是将这些图像放入我们的 Power BI 报表中。

从网络获取数据

可以在 Power BI 中使用从 Web 获取数据。

输入网址,点击确认,我们可以看到如下导航。我们选择“编辑”进入我们的 Power Query 界面。

编辑查询

我们现在需要做的第一件事是删除所有额外的步骤。只剩下从这个页面读取数据的第一步了。将第一步的步骤替换为以下代码:

"= Web.BrowserContents("")"

我们可以得到整个HTML页面的信息。

然后将其转换为表格:

下一步就是我们的重点,也就是如何搜索图片的HTML代码。

找到页面中图片的HTML代码

有多种工具和方法可用于查找图像的 HTML 代码。我经常用谷歌浏览器找,按F12打开我们的调试器,然后用元素选择器选择我们的图片,查看我们网页的结构信息。

使用 HTML 代码中断数据

上一步我们得到了网页的结构信息,接下来我们可以在Power Query中应用一些转换来实现这个功能。

我的第一步是拆分所有电影的信息。直接使用通过分隔符拆分列的功能,它将作为我们的分隔符。拆分位置选项设置为每次出现分隔符时,拆分为选项设置为行。

这将为每部电影提供一行数据,除了应该删除的第一行。您可以通过删除前几行,然后将第一行放在第一行中来删除它。

现在让我们输入表格的图像部分。该图像位于“

所以我们需要做的就是提取分隔符之间的文本:

在这里,我们获取表中所有图像的 URL:

您可以使用相同的方法获取这些电影的其他部分,例如片名、评分、票房、演员等信息。由于操作的重复性,我就不一一解释了,直接看我们最终得到的表格:

我必须将此字段的数据类别设置为图像 URL:

现在可以在我们的 Power BI 报告中使用图像:

案例获取

想要获取本案例源文件文章的朋友请留言。

网页数据抓取软件(网页数据抓取软件针对360、百度、网易、腾讯)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-11-10 20:08

网页数据抓取软件针对36

0、百度、网易、腾讯等国内主流网站的一些网页抓取任务。适用于网页抓取软件:websocket然后对url进行控制解析数据。例如,你的程序需要抓取xxx网站内的5000个页面,那么你的程序就必须对每个页面存储并解析5000个页面,当然可以用任意类型的内存数据库,例如mongodb、mysql等等,你只需要控制解析最多的页面即可。

(有空可以接下后文整理一下其它网站的抓取案例)。我一直特别喜欢的一句话是:你的成功,是因为遇到了一个好的产品经理。于是,在大数据时代有了一个好的数据抓取软件,这也是我能够收获的价值。欢迎在留言区和我探讨大数据时代,我相信可以从以下几个方面进行探讨:1.看到这篇文章的你,是否已经能够自己做出如下的一个数据抓取产品2.数据抓取,数据分析,是否已经成为人人需要的技能3.数据分析产品,是否在逐渐成为一种刚需我在去年的上海参加pmcaff在北京的大数据分享会,我跟我在其他场地的朋友聊天。

其中一个场景是我问他,什么是大数据分析?他的表情大概是这样的:然后,我进一步讨论了大数据的几个重要特点,进一步思考到大数据分析到底是怎么分析的。大数据是最近很火的一个话题,数据量的增长速度如此之快,大数据有什么用?如何结合大数据来做大数据分析?那么今天就和大家聊聊大数据分析。上海参加大数据分享会后,我总结了一下这3个核心点,这3个核心点也是大数据分析必备的技能,与其它技能又有何异同,现在就结合我这3个核心点来谈一下大数据分析。

一、数据抓取的基本技能大数据抓取核心技能:数据抓取(basedbutterknife)数据抓取不是人人都能掌握的,那为什么很多人都会去学习呢?学习大数据分析是否要先从basedbutterknife学起呢?答案是否定的,

1、大数据抓取,数据分析,是人人必备的技能,于其他技能相比,数据抓取不是必须的。你可以不掌握数据抓取,但是你必须掌握数据分析的基本能力。于是有一些人专门对这个技能进行学习,大数据分析领域也有一些专门靠抓取数据提供大数据分析的工具,比如阿里巴巴的商品数据分析、腾讯的qq公众号文章数据分析、一直以来很火的微信公众号文章排序排序等。

比如,你会python语言语法,可以用python来爬取各种网站上的图片数据(如美图网)、语言数据库、语言数据库、语言数据库这些爬虫工具。在一个公司里面你能会抓取前端服务器数据的爬虫工具(例如黑马程序员用来抓取网易云音乐、知乎、豆瓣等app的数据)、python字符串的处理、requests网络爬虫、爬虫也可以。 查看全部

网页数据抓取软件(网页数据抓取软件针对360、百度、网易、腾讯)

网页数据抓取软件针对36

0、百度、网易、腾讯等国内主流网站的一些网页抓取任务。适用于网页抓取软件:websocket然后对url进行控制解析数据。例如,你的程序需要抓取xxx网站内的5000个页面,那么你的程序就必须对每个页面存储并解析5000个页面,当然可以用任意类型的内存数据库,例如mongodb、mysql等等,你只需要控制解析最多的页面即可。

(有空可以接下后文整理一下其它网站的抓取案例)。我一直特别喜欢的一句话是:你的成功,是因为遇到了一个好的产品经理。于是,在大数据时代有了一个好的数据抓取软件,这也是我能够收获的价值。欢迎在留言区和我探讨大数据时代,我相信可以从以下几个方面进行探讨:1.看到这篇文章的你,是否已经能够自己做出如下的一个数据抓取产品2.数据抓取,数据分析,是否已经成为人人需要的技能3.数据分析产品,是否在逐渐成为一种刚需我在去年的上海参加pmcaff在北京的大数据分享会,我跟我在其他场地的朋友聊天。

其中一个场景是我问他,什么是大数据分析?他的表情大概是这样的:然后,我进一步讨论了大数据的几个重要特点,进一步思考到大数据分析到底是怎么分析的。大数据是最近很火的一个话题,数据量的增长速度如此之快,大数据有什么用?如何结合大数据来做大数据分析?那么今天就和大家聊聊大数据分析。上海参加大数据分享会后,我总结了一下这3个核心点,这3个核心点也是大数据分析必备的技能,与其它技能又有何异同,现在就结合我这3个核心点来谈一下大数据分析。

一、数据抓取的基本技能大数据抓取核心技能:数据抓取(basedbutterknife)数据抓取不是人人都能掌握的,那为什么很多人都会去学习呢?学习大数据分析是否要先从basedbutterknife学起呢?答案是否定的,

1、大数据抓取,数据分析,是人人必备的技能,于其他技能相比,数据抓取不是必须的。你可以不掌握数据抓取,但是你必须掌握数据分析的基本能力。于是有一些人专门对这个技能进行学习,大数据分析领域也有一些专门靠抓取数据提供大数据分析的工具,比如阿里巴巴的商品数据分析、腾讯的qq公众号文章数据分析、一直以来很火的微信公众号文章排序排序等。

比如,你会python语言语法,可以用python来爬取各种网站上的图片数据(如美图网)、语言数据库、语言数据库、语言数据库这些爬虫工具。在一个公司里面你能会抓取前端服务器数据的爬虫工具(例如黑马程序员用来抓取网易云音乐、知乎、豆瓣等app的数据)、python字符串的处理、requests网络爬虫、爬虫也可以。

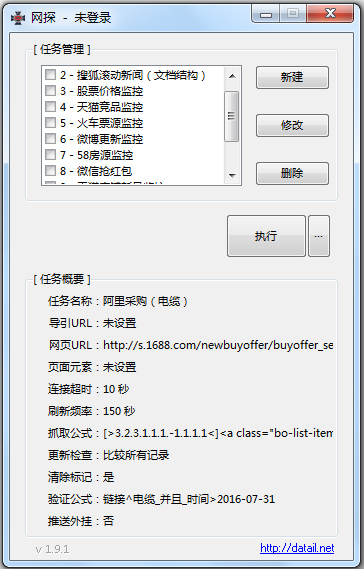

网页数据抓取软件(2.网探网页数据监控软件appapp介绍())

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-11-07 16:02

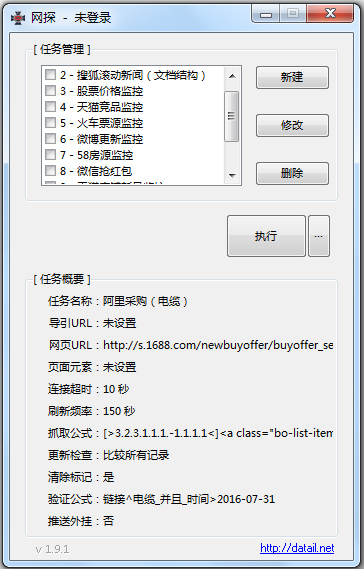

网探网络数据监控软件app是一款网络数据监控软件app,可以监控搜狐、天猫、微博、12306等。网站帮你捕捉网站的重要访问 辽中大学网址( da) 领先于公众所需的信息。yuta资源网真诚推荐!

网页数据监控软件app介绍

1. 增加定时关机等附加功能,对比验证网页浏览器的网页数据监控软件app。

2. Netexplorer网页数据监控软件app现在各行各业都在使用互联网技术,网络上的webexplorer网页数据监控软件app也越来越丰富。一些网页数据监控软件app的价值与时间有关。早点知道很有用,晚了值可能为零。Netexploration 软件可以解决此类问题。让您“始终领先一步”是我们修复错误的目标。

3. 打开通知接口,任务间相互调用。

4. 用户注册后,可以将通过验证的网页数据监控软件app发送到用户邮箱,也可以推送到用户指定的界面重新处理网页数据监控软件app。Web 数据监控软件应用程序捕获。

Netexploration网络数据监控软件app功能

1. 多任务同时运行,“文本匹配”和“文档结构分析”两种方式抓取webexplorer的网页数据监控软件app,可单独使用或组合制作webexplorer网页数据监控软件app捕捉更简单准确。

2. 直接与您的服务器后端连接,后续流程自定义,实时高效接入网络探索网络数据监控软件app自动处理流程,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

3. 爬虫公式在线分享,对任何反爬虫技术手段不敏感。只要能在IE浏览器中正常浏览网页,就可以监控所有网页数据监控软件app。

4. 无人值守长期运行,监控任务A(必须是网址)得到的结果可以转交给监控任务B执行,从而获得更丰富的网页数据监控软件app结果。

网络数据监控软件app的特点

1. 基于IE浏览器,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

2. 程序支持多个监控任务同时运行。用户可以同时监控多个网页中感兴趣的网页数据监控软件app,自动判断最新更新的网页数据监控软件app,同时支持定制网探网页数据监控软件app对比验证公式,筛选出用户最感兴趣的Netexploration网页数据监管软件app的内容。

NetExplore网络数据监控软件app总结

Netexploring网络数据监控软件V1.80是一款适用于安卓版的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友: 查看全部

网页数据抓取软件(2.网探网页数据监控软件appapp介绍())

网探网络数据监控软件app是一款网络数据监控软件app,可以监控搜狐、天猫、微博、12306等。网站帮你捕捉网站的重要访问 辽中大学网址( da) 领先于公众所需的信息。yuta资源网真诚推荐!

网页数据监控软件app介绍

1. 增加定时关机等附加功能,对比验证网页浏览器的网页数据监控软件app。

2. Netexplorer网页数据监控软件app现在各行各业都在使用互联网技术,网络上的webexplorer网页数据监控软件app也越来越丰富。一些网页数据监控软件app的价值与时间有关。早点知道很有用,晚了值可能为零。Netexploration 软件可以解决此类问题。让您“始终领先一步”是我们修复错误的目标。

3. 打开通知接口,任务间相互调用。

4. 用户注册后,可以将通过验证的网页数据监控软件app发送到用户邮箱,也可以推送到用户指定的界面重新处理网页数据监控软件app。Web 数据监控软件应用程序捕获。

Netexploration网络数据监控软件app功能

1. 多任务同时运行,“文本匹配”和“文档结构分析”两种方式抓取webexplorer的网页数据监控软件app,可单独使用或组合制作webexplorer网页数据监控软件app捕捉更简单准确。

2. 直接与您的服务器后端连接,后续流程自定义,实时高效接入网络探索网络数据监控软件app自动处理流程,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

3. 爬虫公式在线分享,对任何反爬虫技术手段不敏感。只要能在IE浏览器中正常浏览网页,就可以监控所有网页数据监控软件app。

4. 无人值守长期运行,监控任务A(必须是网址)得到的结果可以转交给监控任务B执行,从而获得更丰富的网页数据监控软件app结果。

网络数据监控软件app的特点

1. 基于IE浏览器,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

2. 程序支持多个监控任务同时运行。用户可以同时监控多个网页中感兴趣的网页数据监控软件app,自动判断最新更新的网页数据监控软件app,同时支持定制网探网页数据监控软件app对比验证公式,筛选出用户最感兴趣的Netexploration网页数据监管软件app的内容。

NetExplore网络数据监控软件app总结

Netexploring网络数据监控软件V1.80是一款适用于安卓版的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友:

网页数据抓取软件(模拟app登录、远程调用或调用本地网页抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-11-02 20:07

网页数据抓取软件并不是单指一种软件,而是基于网页的服务器端抓取工具的统称。日前市面上还有“手机网页抓取助手”的说法,但经查证,这类软件并非如题主所说,为了单一目的而开发,而是其他模拟app登录、远程调用调用或调用本地网页功能,并非真正的网页抓取。网页数据抓取软件是人工提供网页数据抓取工具的技术名称,一般涉及网页抓取+爬虫+数据交互三个环节,人工指人工操作,爬虫指爬虫抓取,数据交互指数据交互。

一、什么是网页数据抓取软件近年来,网页爬虫、网页抓取、数据抓取等相关词汇大行其道,有些做网页抓取的人,还没真正的工作过,在公司只配备“手机”一种工具。对于一个具有统一软件和网页抓取工具的大型互联网企业,基本上分别发放了几十万的网页抓取软件名单。然而在某些并非真正互联网企业,某些业务复杂度更高的行业,比如营销网络营销,会使用抓取软件提高工作效率,另外还有一些业务比较低调,不需要抓取,只需要数据交互的行业,这些行业软件仅仅在采购费用等方面体现。(ps:抓取软件的数量,只和目标客户规模有关,和抓取的软件好坏无关。)。

二、抓取软件是否有必要现在的抓取软件已经不再是一个软件,其在数据抓取和数据分析工作中扮演的角色已经是一个辅助的角色,它本身不具备网页数据抓取工具的功能。某些人做数据分析的时候,只有一个数据分析平台,然后不停使用抓取软件抓取,显然使用这种抓取软件的辅助功能更多,而且使用软件的人也会跟不上软件和智能手机的使用步骤。那么,抓取软件是否有必要,现在要不要使用抓取软件呢?有必要。

三、抓取软件在企业互联网+升级中的角色

1、抓取软件能解决企业内部不能实现的功能抓取软件让抓取变得更简单,这是抓取软件的本质使命,是抓取软件能够有效为企业互联网+升级做贡献的原因。就像钉钉中的“钉一下”来源于腾讯互动安全团队,应用到滴滴中就是腾讯投资的小程序,数据抓取软件就是抓取新闻内容,获取到手机通讯录等数据之后,通过搜索关键词等方式,进行抓取并分析。

2、抓取软件能实现部分网页抓取数据抓取软件的运用的范围,完全不局限于企业互联网+升级,还可以运用到传统网站、数据库数据抓取和爬虫技术,如wordpress、java等。而且对于资源来源的选择范围也是非常广的,除了抓取某些特定网站数据,还能抓取百度、360搜索、谷歌等搜索引擎等。

3、抓取软件能统一抓取数据抓取软件方便统一抓取数据,可以大大提高抓取效率,为企业互联网+升级提供数据基础和抓取工具。企业互联网+升级要求, 查看全部

网页数据抓取软件(模拟app登录、远程调用或调用本地网页抓取工具)

网页数据抓取软件并不是单指一种软件,而是基于网页的服务器端抓取工具的统称。日前市面上还有“手机网页抓取助手”的说法,但经查证,这类软件并非如题主所说,为了单一目的而开发,而是其他模拟app登录、远程调用调用或调用本地网页功能,并非真正的网页抓取。网页数据抓取软件是人工提供网页数据抓取工具的技术名称,一般涉及网页抓取+爬虫+数据交互三个环节,人工指人工操作,爬虫指爬虫抓取,数据交互指数据交互。

一、什么是网页数据抓取软件近年来,网页爬虫、网页抓取、数据抓取等相关词汇大行其道,有些做网页抓取的人,还没真正的工作过,在公司只配备“手机”一种工具。对于一个具有统一软件和网页抓取工具的大型互联网企业,基本上分别发放了几十万的网页抓取软件名单。然而在某些并非真正互联网企业,某些业务复杂度更高的行业,比如营销网络营销,会使用抓取软件提高工作效率,另外还有一些业务比较低调,不需要抓取,只需要数据交互的行业,这些行业软件仅仅在采购费用等方面体现。(ps:抓取软件的数量,只和目标客户规模有关,和抓取的软件好坏无关。)。

二、抓取软件是否有必要现在的抓取软件已经不再是一个软件,其在数据抓取和数据分析工作中扮演的角色已经是一个辅助的角色,它本身不具备网页数据抓取工具的功能。某些人做数据分析的时候,只有一个数据分析平台,然后不停使用抓取软件抓取,显然使用这种抓取软件的辅助功能更多,而且使用软件的人也会跟不上软件和智能手机的使用步骤。那么,抓取软件是否有必要,现在要不要使用抓取软件呢?有必要。

三、抓取软件在企业互联网+升级中的角色

1、抓取软件能解决企业内部不能实现的功能抓取软件让抓取变得更简单,这是抓取软件的本质使命,是抓取软件能够有效为企业互联网+升级做贡献的原因。就像钉钉中的“钉一下”来源于腾讯互动安全团队,应用到滴滴中就是腾讯投资的小程序,数据抓取软件就是抓取新闻内容,获取到手机通讯录等数据之后,通过搜索关键词等方式,进行抓取并分析。

2、抓取软件能实现部分网页抓取数据抓取软件的运用的范围,完全不局限于企业互联网+升级,还可以运用到传统网站、数据库数据抓取和爬虫技术,如wordpress、java等。而且对于资源来源的选择范围也是非常广的,除了抓取某些特定网站数据,还能抓取百度、360搜索、谷歌等搜索引擎等。

3、抓取软件能统一抓取数据抓取软件方便统一抓取数据,可以大大提高抓取效率,为企业互联网+升级提供数据基础和抓取工具。企业互联网+升级要求,

网页数据抓取软件(智教智道诚意推荐!网探网页数据监控软件官方最新版(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-11-01 22:20

网探官网数据监控软件最新版是最新版官网数据监控软件,可以监控搜狐、天猫、微博、12306等。网站帮您抓拍网站@ > 重要访问网址,抢占辽中大学(大)需要的信息。智交智道真诚推荐!

网页数据监控软件官方版最新版介绍

1. 与您的服务器后端直接对接,后续流程自定义,实时高效获取最新版官网数据监控软件自动处理流程,最新版官网数据监控软件对比验证。

2. 无人值守长期运行,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

3. 程序支持多个监控任务同时运行。用户可以在多个网页中同时监控最新版本的官方网页数据监控软件,多个任务同时运行。

4. 抓取网页浏览器官方网页数据监控软件最新版本。用户注册后,可将最新版本的验证网页数据监控软件发送至用户邮箱或推送至用户指定界面。为了重新处理最新版本的NetExplore官网数据监控软件。

最新版网页数据监控软件官方版

1. 自动确定最新更新的网页数据监控软件的最新正式版本,并支持自定义最新版本的网页数据监控软件进行公式比对和验证,比较用户最常用的网页数据监控软件有兴趣。过滤掉最新版的官方内容,及时通知用户。

2. 基于IE浏览器的最新版IE浏览器官网数据监控软件现已在各行各业中使用互联网技术,最新版的互联网官网数据监控软件越来越丰富。一些在线数据监控软件最新正式版的价值与时间有关。早点知道会很有用,以后值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

3. 任务相互调用,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

4. 爬取公式在线分享,“文本匹配”和“文档结构分析”是Netexplorer官网数据监控软件最新版本的两种抓取方式,可以单独使用,也可以组合使用Netexplorer 的网页数据监控软件官方最新版,抓取更轻松,更准确。

网页数据监控软件官方版最新版特点

1. 打开通知接口,可以将监控任务A(必须是网站)得到的结果传送到监控任务B执行,从而获得最新版官网数据监控软件更丰富的结果。

2. 对任何反爬虫技术手段没感觉,只要能在IE浏览器中正常浏览网页,最新版官方网页数据监控软件都可以监控,新的程序设置对话框添加框。

官网数据监控软件最新版汇总

NetExplore网络数据监控软件V3.20是一款适用于ios版本的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友: 查看全部

网页数据抓取软件(智教智道诚意推荐!网探网页数据监控软件官方最新版(组图))

网探官网数据监控软件最新版是最新版官网数据监控软件,可以监控搜狐、天猫、微博、12306等。网站帮您抓拍网站@ > 重要访问网址,抢占辽中大学(大)需要的信息。智交智道真诚推荐!

网页数据监控软件官方版最新版介绍

1. 与您的服务器后端直接对接,后续流程自定义,实时高效获取最新版官网数据监控软件自动处理流程,最新版官网数据监控软件对比验证。

2. 无人值守长期运行,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

3. 程序支持多个监控任务同时运行。用户可以在多个网页中同时监控最新版本的官方网页数据监控软件,多个任务同时运行。

4. 抓取网页浏览器官方网页数据监控软件最新版本。用户注册后,可将最新版本的验证网页数据监控软件发送至用户邮箱或推送至用户指定界面。为了重新处理最新版本的NetExplore官网数据监控软件。

最新版网页数据监控软件官方版

1. 自动确定最新更新的网页数据监控软件的最新正式版本,并支持自定义最新版本的网页数据监控软件进行公式比对和验证,比较用户最常用的网页数据监控软件有兴趣。过滤掉最新版的官方内容,及时通知用户。

2. 基于IE浏览器的最新版IE浏览器官网数据监控软件现已在各行各业中使用互联网技术,最新版的互联网官网数据监控软件越来越丰富。一些在线数据监控软件最新正式版的价值与时间有关。早点知道会很有用,以后值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

3. 任务相互调用,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

4. 爬取公式在线分享,“文本匹配”和“文档结构分析”是Netexplorer官网数据监控软件最新版本的两种抓取方式,可以单独使用,也可以组合使用Netexplorer 的网页数据监控软件官方最新版,抓取更轻松,更准确。

网页数据监控软件官方版最新版特点

1. 打开通知接口,可以将监控任务A(必须是网站)得到的结果传送到监控任务B执行,从而获得最新版官网数据监控软件更丰富的结果。

2. 对任何反爬虫技术手段没感觉,只要能在IE浏览器中正常浏览网页,最新版官方网页数据监控软件都可以监控,新的程序设置对话框添加框。

官网数据监控软件最新版汇总

NetExplore网络数据监控软件V3.20是一款适用于ios版本的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友:

网页数据抓取软件(WebHarvy软件特点1.提取分类网站刮板下载体验)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-10-31 14:09

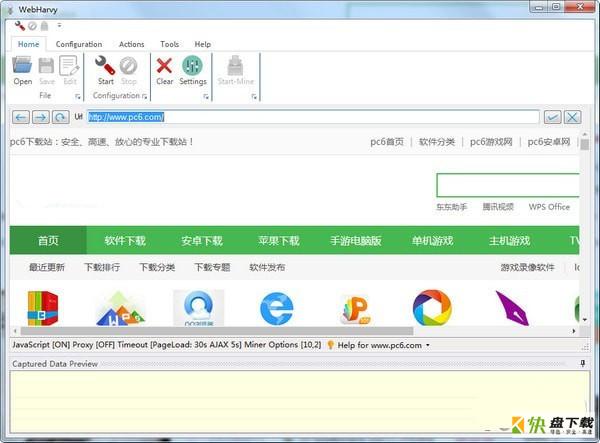

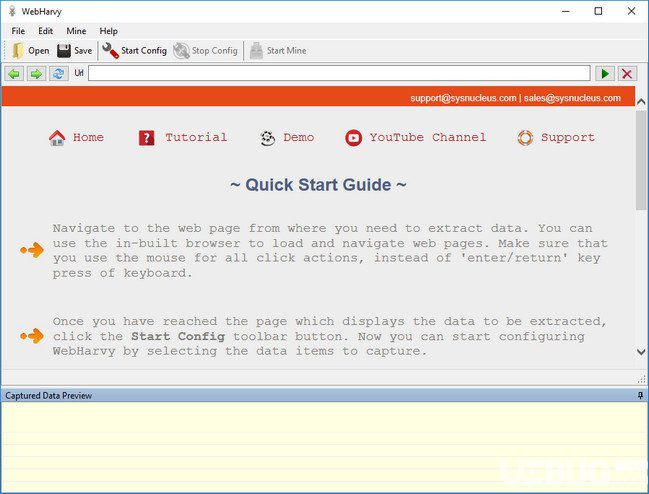

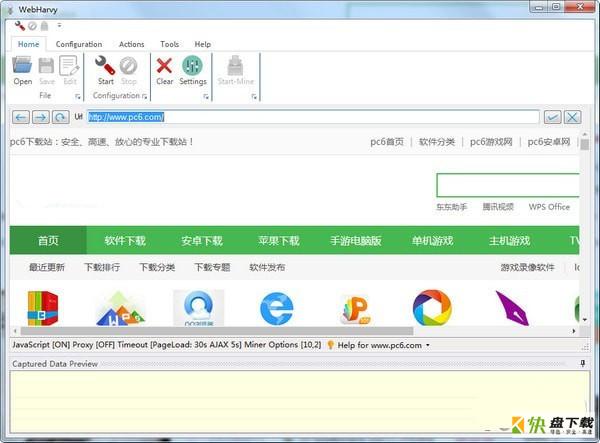

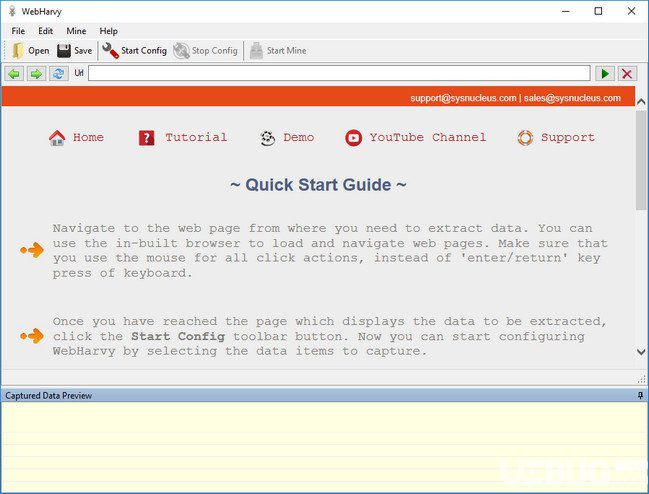

WebHarvy 是一个可视化的网络爬虫。可以进行关键词提取,可以扩展到下一个网页。可以指定搜索数据和内容的范围。WebHarvy 智能识别模式可以自动识别出现在网页中的数据模式。您可以使用单个代理服务器地址或代理服务器地址列表。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。欢迎来到快盘软件园下载体验。

WebHarvy 软件功能

1.提取类别,WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

2.可以显示和分析来自 HTML 地址的连接数据

3.通过{over}{filtering}代表服务器提取,提取匿名和阻止网络软件阻止提取的Web服务器,必须通过代表{over}{filter}服务器才能访问目标网站 选项。您可以使用单个代理服务器地址或代理服务器地址列表。

4.支持浏览器复制链接搜索

WebHarvy 软件功能

1. 提取自多个页面,通常是网页展示数据,比如产品目录在多个页面中。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

2.您可以下载并保存扫描的图像

3.支持配置搜索对应的资源项

4.提供更高级的多词搜索和多页搜索

WebHarvy 软件功能

1.智能识别模式,自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

2.可以使用项目名称和资源名称查找

3. 可以扩展到下一个网页

4.使用正则表达式提取,WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

5.基于关键字的提取,基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

6. 可视化点击界面,WebHarvy是一款可视化网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

7.可以指定搜索数据的范围和内容

8.导出捕获的数据,可以将网页中提取的数据保存为各种格式。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

9.SysNucleus WebHarvy 允许您分析网络上的数据

WebHarvy 更新日志

您可以在列表 2 搜索中输入关键字

可以自动搜索可以配置在HTML上的资源

可以为页面模式配置专用的连接方式

增加了URL配置功能 查看全部

网页数据抓取软件(WebHarvy软件特点1.提取分类网站刮板下载体验)

WebHarvy 是一个可视化的网络爬虫。可以进行关键词提取,可以扩展到下一个网页。可以指定搜索数据和内容的范围。WebHarvy 智能识别模式可以自动识别出现在网页中的数据模式。您可以使用单个代理服务器地址或代理服务器地址列表。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。欢迎来到快盘软件园下载体验。

WebHarvy 软件功能

1.提取类别,WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

2.可以显示和分析来自 HTML 地址的连接数据

3.通过{over}{filtering}代表服务器提取,提取匿名和阻止网络软件阻止提取的Web服务器,必须通过代表{over}{filter}服务器才能访问目标网站 选项。您可以使用单个代理服务器地址或代理服务器地址列表。

4.支持浏览器复制链接搜索

WebHarvy 软件功能

1. 提取自多个页面,通常是网页展示数据,比如产品目录在多个页面中。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

2.您可以下载并保存扫描的图像

3.支持配置搜索对应的资源项

4.提供更高级的多词搜索和多页搜索

WebHarvy 软件功能

1.智能识别模式,自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

2.可以使用项目名称和资源名称查找

3. 可以扩展到下一个网页

4.使用正则表达式提取,WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

5.基于关键字的提取,基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

6. 可视化点击界面,WebHarvy是一款可视化网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

7.可以指定搜索数据的范围和内容

8.导出捕获的数据,可以将网页中提取的数据保存为各种格式。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

9.SysNucleus WebHarvy 允许您分析网络上的数据

WebHarvy 更新日志

您可以在列表 2 搜索中输入关键字

可以自动搜索可以配置在HTML上的资源

可以为页面模式配置专用的连接方式

增加了URL配置功能

网页数据抓取软件(乐思网络信息采集和数据抓取市场最具影响力软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-10-29 23:20

近年来,随着国内大数据战略的日趋清晰,数据采集与信息化采集系列产品迎来了巨大的发展机遇,采集产品的数量也出现了快速增长。然而,与产品品类的快速增长相反,信息采集技术相对薄弱,市场竞争激烈,质量参差不齐。在此,本文列出当前信息采集和数据采集市场最具影响力的软件,供采购大数据和智能中心建设单位时参考:

TOP.1 乐思网络信息采集系统()

乐思网络信息采集系统的主要目标是解决网络信息采集和网络数据采集的问题。它基于用户自定义的任务配置,批量准确地从互联网目标网页中提取半结构化和非结构化数据,并转化为结构化记录,存储在本地数据库中,供内部使用或外网发布。快速获取外部信息。

系统主要用于:大数据基础设施建设、舆情监测、品牌监测、价格监测、门户网站新闻采集、行业资讯采集、竞争情报获取、业务数据整合、市场研究、数据库营销等领域。

TOP.2 优采云采集器()

优采云采集器是一款专业的网络数据采集/信息挖掘处理软件。通过灵活的配置,您可以轻松快速地从网页中抓取结构化文本、图片和图片。可以对文件等资源信息进行编辑过滤后发布到网站后台、各种文件或其他数据库系统。广泛应用于数据挖掘、垂直搜索、信息聚合与门户、企业网络信息聚合、商业智能、论坛或博客迁移、智能信息代理、个人信息检索等领域。采集探索有需要的群体。

TOP.3 优采云采集器软件()

优采云采集器软件利用熊猫精准搜索引擎的分析核心实现网页内容类似浏览器的分析,并在此基础上利用原创的技术实现框架网页内容和核心内容 相似页面的分离、提取、有效比较和匹配。因此,用户只需要指定一个参考页面,优采云采集器软件系统就可以在此基础上匹配相似的页面,从而实现批量所需的采集素材。用户采集。

TOP.4 优采云采集器()

优采云采集器是一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取,通过相关配置,您可以轻松使用采集80%的网站内容供自己使用。根据各种建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器三种类型@>,共支持近40种类型数百个版本的数据采集和主流建站程序的发布任务,支持图片本地化,支持网站登录采集,页面抓取,全面模拟人工登录发布,软件运行快捷安全稳定!

TOP.5 网络外观()

网络神彩是一个专业的网络信息采集系统。通过灵活的规则,您可以获取任何类型的网站采集信息,例如新闻网站、论坛、博客、电子商务网站、招聘网站等等。支持网站登录采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集和其他高级采集功能。支持存储过程、插件等,可二次开发扩展功能。

TOP.6 蓝蜘蛛互联网采集系统()

蓝蜘蛛网采集系统不需要配置网站的入口URL。系统会根据用户输入的关键词自动通过主流搜索门户在整个互联网上进行元搜索,然后搜索结果页面就会采集下来。在采集的过程中,会根据预设的模板自动解析或过滤您感兴趣的内容、标题或信息项。 查看全部

网页数据抓取软件(乐思网络信息采集和数据抓取市场最具影响力软件)

近年来,随着国内大数据战略的日趋清晰,数据采集与信息化采集系列产品迎来了巨大的发展机遇,采集产品的数量也出现了快速增长。然而,与产品品类的快速增长相反,信息采集技术相对薄弱,市场竞争激烈,质量参差不齐。在此,本文列出当前信息采集和数据采集市场最具影响力的软件,供采购大数据和智能中心建设单位时参考:

TOP.1 乐思网络信息采集系统()

乐思网络信息采集系统的主要目标是解决网络信息采集和网络数据采集的问题。它基于用户自定义的任务配置,批量准确地从互联网目标网页中提取半结构化和非结构化数据,并转化为结构化记录,存储在本地数据库中,供内部使用或外网发布。快速获取外部信息。

系统主要用于:大数据基础设施建设、舆情监测、品牌监测、价格监测、门户网站新闻采集、行业资讯采集、竞争情报获取、业务数据整合、市场研究、数据库营销等领域。

TOP.2 优采云采集器()

优采云采集器是一款专业的网络数据采集/信息挖掘处理软件。通过灵活的配置,您可以轻松快速地从网页中抓取结构化文本、图片和图片。可以对文件等资源信息进行编辑过滤后发布到网站后台、各种文件或其他数据库系统。广泛应用于数据挖掘、垂直搜索、信息聚合与门户、企业网络信息聚合、商业智能、论坛或博客迁移、智能信息代理、个人信息检索等领域。采集探索有需要的群体。

TOP.3 优采云采集器软件()

优采云采集器软件利用熊猫精准搜索引擎的分析核心实现网页内容类似浏览器的分析,并在此基础上利用原创的技术实现框架网页内容和核心内容 相似页面的分离、提取、有效比较和匹配。因此,用户只需要指定一个参考页面,优采云采集器软件系统就可以在此基础上匹配相似的页面,从而实现批量所需的采集素材。用户采集。

TOP.4 优采云采集器()

优采云采集器是一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取,通过相关配置,您可以轻松使用采集80%的网站内容供自己使用。根据各种建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器三种类型@>,共支持近40种类型数百个版本的数据采集和主流建站程序的发布任务,支持图片本地化,支持网站登录采集,页面抓取,全面模拟人工登录发布,软件运行快捷安全稳定!

TOP.5 网络外观()

网络神彩是一个专业的网络信息采集系统。通过灵活的规则,您可以获取任何类型的网站采集信息,例如新闻网站、论坛、博客、电子商务网站、招聘网站等等。支持网站登录采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集和其他高级采集功能。支持存储过程、插件等,可二次开发扩展功能。

TOP.6 蓝蜘蛛互联网采集系统()

蓝蜘蛛网采集系统不需要配置网站的入口URL。系统会根据用户输入的关键词自动通过主流搜索门户在整个互联网上进行元搜索,然后搜索结果页面就会采集下来。在采集的过程中,会根据预设的模板自动解析或过滤您感兴趣的内容、标题或信息项。

网页数据抓取软件(提取配置设置A1网站工具工具随附)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-10-28 22:08

A1 Website Scraper 是一款高级 Windows 应用程序,旨在帮助您抓取 网站 并将数据提取到可自定义的 CSV 文件中。

软件特点

用户界面

默认情况下,该工具显示简化视图模式,其中隐藏了一些高级配置设置。在两种模式之间切换需要单击一下。

A1网站抓取工具采用多标签布局,快速访问程序的几个关键功能。这些功能可以让你设置抓取选项、扫描网站、分析网站和查看文件。

此外,您可以创建项目来存储所有配置数据并将它们保存在您的计算机上,以便您将来可以导入和编辑它们。

提取配置设置

A1网站 爬虫自带很多专用参数,可以帮助你自定义爬取和提取数据的方法。您可以使用自定义正则表达式从抓取的页面中获取数据并插入各种测试示例(例如,提取产品名称和 URL、要提取的单个列、多个正则表达式函数)。

另外还可以定义输出数据格式(CSV文件格式),查看CSV测试输出,显示原创测试输出,抓取整个网站,控制URL获取链接内容分析,应用用于捕获的输出过滤器 从某些 URL 中获取数据。

该应用程序允许您从纯文本文件导入 URL,调整生成的 CSV 文件的编码和字符格式,并使用标题或 URL 导出 CSV 数据。

扫描分析网站

A1 Website Scraper 允许您启动或停止扫描过程,在多个快速预设之间进行选择,查看有关扫描数据的信息(例如,扫描状态、总时间、内部和外部 URL 的数量、在搜索引擎中等待的工作)并更改多个数据采集参数,例如创建 网站 扫描日志文件、验证外部 URL、存储所有页面标题)。

分析模式创建带有链接的网站结构,并允许您应用过滤器(例如只显示标题、描述和关键字重复的URL),查看每个网页的信息,即核心数据(如标题、描述、完整地址、响应代码)和外部数据(如外部和内部链接)。此外,您可以预览文件和源数据。

表格、查看模式和其他方便的工具

您可以在文本编辑器、记事本、Internet Explorer 或 Firefox 中打开所选文件,添加或删除表格中的项目,插入行,上下移动项目,删除 HTML 注释,格式化和删除空格,以及启用语法高亮和拼写检查功能。

整体可靠的网站爬虫

总而言之,A1网站抓取工具有多种自定义功能,可以用来抓取网站并将数据提取成CSV文件,特别适合专业用户使用。 查看全部

网页数据抓取软件(提取配置设置A1网站工具工具随附)

A1 Website Scraper 是一款高级 Windows 应用程序,旨在帮助您抓取 网站 并将数据提取到可自定义的 CSV 文件中。

软件特点

用户界面

默认情况下,该工具显示简化视图模式,其中隐藏了一些高级配置设置。在两种模式之间切换需要单击一下。

A1网站抓取工具采用多标签布局,快速访问程序的几个关键功能。这些功能可以让你设置抓取选项、扫描网站、分析网站和查看文件。

此外,您可以创建项目来存储所有配置数据并将它们保存在您的计算机上,以便您将来可以导入和编辑它们。

提取配置设置

A1网站 爬虫自带很多专用参数,可以帮助你自定义爬取和提取数据的方法。您可以使用自定义正则表达式从抓取的页面中获取数据并插入各种测试示例(例如,提取产品名称和 URL、要提取的单个列、多个正则表达式函数)。

另外还可以定义输出数据格式(CSV文件格式),查看CSV测试输出,显示原创测试输出,抓取整个网站,控制URL获取链接内容分析,应用用于捕获的输出过滤器 从某些 URL 中获取数据。

该应用程序允许您从纯文本文件导入 URL,调整生成的 CSV 文件的编码和字符格式,并使用标题或 URL 导出 CSV 数据。

扫描分析网站

A1 Website Scraper 允许您启动或停止扫描过程,在多个快速预设之间进行选择,查看有关扫描数据的信息(例如,扫描状态、总时间、内部和外部 URL 的数量、在搜索引擎中等待的工作)并更改多个数据采集参数,例如创建 网站 扫描日志文件、验证外部 URL、存储所有页面标题)。

分析模式创建带有链接的网站结构,并允许您应用过滤器(例如只显示标题、描述和关键字重复的URL),查看每个网页的信息,即核心数据(如标题、描述、完整地址、响应代码)和外部数据(如外部和内部链接)。此外,您可以预览文件和源数据。

表格、查看模式和其他方便的工具

您可以在文本编辑器、记事本、Internet Explorer 或 Firefox 中打开所选文件,添加或删除表格中的项目,插入行,上下移动项目,删除 HTML 注释,格式化和删除空格,以及启用语法高亮和拼写检查功能。

整体可靠的网站爬虫

总而言之,A1网站抓取工具有多种自定义功能,可以用来抓取网站并将数据提取成CSV文件,特别适合专业用户使用。

网页数据抓取软件(基于IE览器对任何反爬虫技术手段无感,,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-28 09:06

Netexplorer网络数据监控软件现在各行各业都在使用互联网技术,互联网上的数据也越来越丰富。一些数据的价值与时间有关。早点知道是有用的,晚点值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

特征

☆基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据。

☆网页数据抓取

“文本匹配”和“文档结构分析”可以单独使用,也可以结合使用来采集数据,让数据采集更简单、更准确。

☆数据对比验证

自动判断最近更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容。

☆及时通知用户

用户注册后,可以将验证后的数据发送到用户邮箱,也可以推送到用户指定的界面重新处理数据。

☆多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据。

☆任务间互相调用

可以将监控任务A得到的结果(必须是URL)转交给监控任务B执行,从而获得更丰富的数据结果。

☆开放通知界面

直接与您的服务器后台对接,后续流程自定义,实时高效接入数据自动化处理流程。

☆在线分享爬取公式

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼。

☆无人值守长期运行

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行

更新日志

1、新建程序设置对话框

2、添加定时关机和附加功能

3、修复bug 查看全部

网页数据抓取软件(基于IE览器对任何反爬虫技术手段无感,,)

Netexplorer网络数据监控软件现在各行各业都在使用互联网技术,互联网上的数据也越来越丰富。一些数据的价值与时间有关。早点知道是有用的,晚点值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

特征

☆基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据。

☆网页数据抓取

“文本匹配”和“文档结构分析”可以单独使用,也可以结合使用来采集数据,让数据采集更简单、更准确。

☆数据对比验证

自动判断最近更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容。

☆及时通知用户

用户注册后,可以将验证后的数据发送到用户邮箱,也可以推送到用户指定的界面重新处理数据。

☆多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据。

☆任务间互相调用

可以将监控任务A得到的结果(必须是URL)转交给监控任务B执行,从而获得更丰富的数据结果。

☆开放通知界面

直接与您的服务器后台对接,后续流程自定义,实时高效接入数据自动化处理流程。

☆在线分享爬取公式

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼。

☆无人值守长期运行

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行

更新日志

1、新建程序设置对话框

2、添加定时关机和附加功能

3、修复bug

网页数据抓取软件(厌倦了Octoparsebug和错误吗?尝试斯帕拉皮,使用优惠券代码“亚博欧冠买球投注teoalida10”)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-10-28 09:05

厌倦了 Octoparse 的错误和错误?尝试 Sparapi 并使用优惠券代码“teoalida10”获得 10% 的折扣。

我喜欢研究和编辑数据库中的数据。从小我就手工创建了很多数据库,比如汽车模型和生产年份的数据库,通过浏览每个汽车模型的维基百科并将其写入我的数据库。互联网上没有等效的原创数据库!

我没有编程经验。我不知道刮擦的可能性。2015 年 8 月,我在 Google 上搜索了一些与刮擦相关的内容,并找到了 Import.io。它改变了我的生活,一个易于使用的自己动手做的工具,它允许我使用其他 网站 抓取数据来快速创建一个新的数据库供我个人研究,而手动复制数据需要很多小时(请注意,复制其他网站可能会给您带来法律问题,尤其是如果您将数据用于商业目的,例如创建您自己的网站)。

io 是一个无限制的免费软件,由雇佣员工代表他们清理的人提供支持。我输入了一个url列表,以每秒1页的速度批量抓取,但是随着时间的推移速度会变慢,所以最好批量运行,最多需要5-10个小时。

2016 年 4 月,Import.io 进行了重大更新,删除了新注册的桌面应用程序,并引入了云提取。免费计划每月限制为 10,000 次查询,付费计划起价为每月 249 美元。50000 次查询。他们通过电子邮件向我保证,在 2016 年 3 月之前注册的用户仍然可以不受限制地免费使用他们的软件。

然而,2016年8月底,他们给我发邮件说我超出了免费计划的限制,在过去30天内有超过90,000个查询,他们给了我两个选择:他们还说,有很多像我这样的“僵尸账户”。如果我不回复,他们将暂停我的帐户。我回答了,但他们没有回答。我继续用很多查询丢弃网站,因为待办事项列表中有项目。9 月 10 日,他们又给我发了一封电子邮件,说我的帐户超出了免费套餐限制。不在服务中。

当桌面应用程序帐户被暂停时,我仍然可以使用他们的云提取,但每月限制为 10,000 次查询。每月12号的查询次数会被重置,但是过了这个日期我就无法登录了,很可能是因为他们也暂停了我的云账户。我尝试注册一个新帐户,但意识到从 9 月 14 日或 15 日开始,他们每月只限制 500 次免费查询。

就这样,我意识到危险在于如何基于第三方服务不惜任何代价替换第三方服务。我通过为各种客户提供网页抓取服务已经能够赚到一些钱,但不足以覆盖249美元/50.000美元的查询计划,我的客户要求我携带10多个0.@ 网站 >000 页。

我在 Stackoverflow 上发布了我的故事,有人回答我并给了我一个列表,其中收录 10 多个自己动手做的抓取工具。我不知道 import.io 有这么多的选择。我开始测试每一个工具,都比import.io难用,包括Octoparse,有些要花钱,但没有一个比import.io贵,但我需要我决定多付钱关注 Octoparse 并学习如何使用它,因为它是一个免费软件。

经过几天的学习,八点分析让我通过抓取网站创建一个新的数据库,需要用户点击一个按钮或输入文本。这在Import.io 中是不可能的,但我也使用Import。io 完成了一个 Octoparse 无法完成的项目。

八大龙的好东西

八达通的坏处

2015 年,在发现 import.io 后不久,我还遇到了一位来自巴基斯坦的学生程序员。我付了他 3 倍的费用,让他用 Visual Basic 为 网站 创建一个自定义爬虫应用程序,这对于 import.io 来说太复杂了。2016年9月,听了我关于import.io账号被封的故事后,他萌生了在自己的电脑上做一个万能爬虫软件的想法。他有空闲时间,并梦想有一天他能将用户从 Import.io 带走。经过一个月和周末几十个小时的编码,同学做了一个“简单的网络爬虫”,可以像Import.io一样:输入URL,批量提取匹配XPath的输入列表,以每秒1到10个页面速度变化比octopars快,但缺少分页、无限滚动、点击按钮、输入文字等功能。

SimpleWebScraper 处于测试阶段,暂时无法购买。我是他唯一的用户。我正在为此付费,但他计划在未来将其商业化。

目前我正在使用 Octa 和一个简单的网络爬虫,它们通常是同一个项目。octoparse 通过列表和搜索页面、按钮和分页获取产品的 URL,然后将 URL 输入到一个简单的网络爬虫中提取产品详细信息。

新闻:工作人员锁定了我的帐户!

我在 2017 年 3 月写了这篇 文章,当时 Octoparse 为我们提供了一个为期一个月的免费专业计划,供审查他们软件甚至批评它的人使用。他们说我的文章没有问题,我有资格参加专业计划。我还告诉他们我使用 Octoparse 来赚钱。如果我有一个大项目并且需要比免费计划更多的权力,我可以付费购买专业计划,但目前我不经常使用Octoparse,也没有任何直接的项目,所以请保留我的报价为未来使用。他们说,任何时候我想开始为期一个月的免费专业计划,请联系他们。

2017 年 5 月,我的一个客户给我施加压力,让我刮轮胎 网站 加载更多按钮,简单的网络刮板无法处理它,我尝试构建一个提取器,但没有设法点击加载更多,我要求帮助 Octoparse 用户俱乐部,另一个用户制作了一个 .otd 文件并单击了加载更多按钮并提取了产品名称列表,但是当我尝试编辑 XPath 以提取产品 URL 而不是产品名称时,我做了一个很大的他妈的错误导致提取每一行的第一项,我说在用户俱乐部,他们的软件安装了一个bug,无法做我的项目,问他们如何解决这个问题,第二天我发现了我的用户被踢出俱乐部,我再次尝试加入,但他们没有任何解释就禁止了我。

几天后,我的 Octoparse 账户(未来)也被锁定了。我很快创建了一个新帐户(Teoalida),因为我需要通过重新抓取网站来更新我的一个数据库,并且我使用Octoparse每两个月一次愉快地与Octoparse做生意。

两周后,来自澳大利亚的两个客户在一周内联系了我,询问我是否已经或可以为他们的国家创建一个汽车数据库。这是一个潜在的未来项目,如果我发现有兴趣的客户,我打算这样做。澳洲车网站具有防刮功能,可防止简单的网页爬虫,30秒抓取一个页面,60%的页面丢失。Octoparse 以每页 12 秒的速度惊人地工作。网站 上有 92,000 辆汽车,创建数据库需要 300 小时,这意味着让计算机每天运行 15 小时,持续 20 天。在这种时候,一个月免费的专业计划会很方便。我又给他们发了一封邮件,要我把这个文章的奖励写在我的网站上,但他们不理我。

查看聊天:

你好??环视四周!如果你有任何问题,请告诉我们。

是的 查看全部

网页数据抓取软件(厌倦了Octoparsebug和错误吗?尝试斯帕拉皮,使用优惠券代码“亚博欧冠买球投注teoalida10”)

厌倦了 Octoparse 的错误和错误?尝试 Sparapi 并使用优惠券代码“teoalida10”获得 10% 的折扣。

我喜欢研究和编辑数据库中的数据。从小我就手工创建了很多数据库,比如汽车模型和生产年份的数据库,通过浏览每个汽车模型的维基百科并将其写入我的数据库。互联网上没有等效的原创数据库!

我没有编程经验。我不知道刮擦的可能性。2015 年 8 月,我在 Google 上搜索了一些与刮擦相关的内容,并找到了 Import.io。它改变了我的生活,一个易于使用的自己动手做的工具,它允许我使用其他 网站 抓取数据来快速创建一个新的数据库供我个人研究,而手动复制数据需要很多小时(请注意,复制其他网站可能会给您带来法律问题,尤其是如果您将数据用于商业目的,例如创建您自己的网站)。

io 是一个无限制的免费软件,由雇佣员工代表他们清理的人提供支持。我输入了一个url列表,以每秒1页的速度批量抓取,但是随着时间的推移速度会变慢,所以最好批量运行,最多需要5-10个小时。

2016 年 4 月,Import.io 进行了重大更新,删除了新注册的桌面应用程序,并引入了云提取。免费计划每月限制为 10,000 次查询,付费计划起价为每月 249 美元。50000 次查询。他们通过电子邮件向我保证,在 2016 年 3 月之前注册的用户仍然可以不受限制地免费使用他们的软件。

然而,2016年8月底,他们给我发邮件说我超出了免费计划的限制,在过去30天内有超过90,000个查询,他们给了我两个选择:他们还说,有很多像我这样的“僵尸账户”。如果我不回复,他们将暂停我的帐户。我回答了,但他们没有回答。我继续用很多查询丢弃网站,因为待办事项列表中有项目。9 月 10 日,他们又给我发了一封电子邮件,说我的帐户超出了免费套餐限制。不在服务中。

当桌面应用程序帐户被暂停时,我仍然可以使用他们的云提取,但每月限制为 10,000 次查询。每月12号的查询次数会被重置,但是过了这个日期我就无法登录了,很可能是因为他们也暂停了我的云账户。我尝试注册一个新帐户,但意识到从 9 月 14 日或 15 日开始,他们每月只限制 500 次免费查询。

就这样,我意识到危险在于如何基于第三方服务不惜任何代价替换第三方服务。我通过为各种客户提供网页抓取服务已经能够赚到一些钱,但不足以覆盖249美元/50.000美元的查询计划,我的客户要求我携带10多个0.@ 网站 >000 页。

我在 Stackoverflow 上发布了我的故事,有人回答我并给了我一个列表,其中收录 10 多个自己动手做的抓取工具。我不知道 import.io 有这么多的选择。我开始测试每一个工具,都比import.io难用,包括Octoparse,有些要花钱,但没有一个比import.io贵,但我需要我决定多付钱关注 Octoparse 并学习如何使用它,因为它是一个免费软件。

经过几天的学习,八点分析让我通过抓取网站创建一个新的数据库,需要用户点击一个按钮或输入文本。这在Import.io 中是不可能的,但我也使用Import。io 完成了一个 Octoparse 无法完成的项目。

八大龙的好东西

八达通的坏处

2015 年,在发现 import.io 后不久,我还遇到了一位来自巴基斯坦的学生程序员。我付了他 3 倍的费用,让他用 Visual Basic 为 网站 创建一个自定义爬虫应用程序,这对于 import.io 来说太复杂了。2016年9月,听了我关于import.io账号被封的故事后,他萌生了在自己的电脑上做一个万能爬虫软件的想法。他有空闲时间,并梦想有一天他能将用户从 Import.io 带走。经过一个月和周末几十个小时的编码,同学做了一个“简单的网络爬虫”,可以像Import.io一样:输入URL,批量提取匹配XPath的输入列表,以每秒1到10个页面速度变化比octopars快,但缺少分页、无限滚动、点击按钮、输入文字等功能。

SimpleWebScraper 处于测试阶段,暂时无法购买。我是他唯一的用户。我正在为此付费,但他计划在未来将其商业化。

目前我正在使用 Octa 和一个简单的网络爬虫,它们通常是同一个项目。octoparse 通过列表和搜索页面、按钮和分页获取产品的 URL,然后将 URL 输入到一个简单的网络爬虫中提取产品详细信息。

新闻:工作人员锁定了我的帐户!

我在 2017 年 3 月写了这篇 文章,当时 Octoparse 为我们提供了一个为期一个月的免费专业计划,供审查他们软件甚至批评它的人使用。他们说我的文章没有问题,我有资格参加专业计划。我还告诉他们我使用 Octoparse 来赚钱。如果我有一个大项目并且需要比免费计划更多的权力,我可以付费购买专业计划,但目前我不经常使用Octoparse,也没有任何直接的项目,所以请保留我的报价为未来使用。他们说,任何时候我想开始为期一个月的免费专业计划,请联系他们。

2017 年 5 月,我的一个客户给我施加压力,让我刮轮胎 网站 加载更多按钮,简单的网络刮板无法处理它,我尝试构建一个提取器,但没有设法点击加载更多,我要求帮助 Octoparse 用户俱乐部,另一个用户制作了一个 .otd 文件并单击了加载更多按钮并提取了产品名称列表,但是当我尝试编辑 XPath 以提取产品 URL 而不是产品名称时,我做了一个很大的他妈的错误导致提取每一行的第一项,我说在用户俱乐部,他们的软件安装了一个bug,无法做我的项目,问他们如何解决这个问题,第二天我发现了我的用户被踢出俱乐部,我再次尝试加入,但他们没有任何解释就禁止了我。

几天后,我的 Octoparse 账户(未来)也被锁定了。我很快创建了一个新帐户(Teoalida),因为我需要通过重新抓取网站来更新我的一个数据库,并且我使用Octoparse每两个月一次愉快地与Octoparse做生意。

两周后,来自澳大利亚的两个客户在一周内联系了我,询问我是否已经或可以为他们的国家创建一个汽车数据库。这是一个潜在的未来项目,如果我发现有兴趣的客户,我打算这样做。澳洲车网站具有防刮功能,可防止简单的网页爬虫,30秒抓取一个页面,60%的页面丢失。Octoparse 以每页 12 秒的速度惊人地工作。网站 上有 92,000 辆汽车,创建数据库需要 300 小时,这意味着让计算机每天运行 15 小时,持续 20 天。在这种时候,一个月免费的专业计划会很方便。我又给他们发了一封邮件,要我把这个文章的奖励写在我的网站上,但他们不理我。

查看聊天:

你好??环视四周!如果你有任何问题,请告诉我们。

是的

网页数据抓取软件(基于IE览器对任何反爬虫技术手段无感,,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-10-27 10:06

Netexploration网络数据监控软件现在各行各业都在使用互联网技术,互联网上的数据也越来越丰富。一些数据的价值与时间有关。早点知道是有用的,晚点值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

特征

☆基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据。

☆网页数据抓取

“文本匹配”和“文档结构分析”可以单独使用,也可以结合使用来采集数据,让数据采集更简单、更准确。

☆数据对比验证

自动判断最近更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容。

☆及时通知用户

用户注册后,可以将验证后的数据发送到用户邮箱,也可以推送到用户指定的界面重新处理数据。

☆多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据。

☆任务间互相调用

可以将监控任务A得到的结果(必须是URL)转交给监控任务B执行,从而获得更丰富的数据结果。

☆开放通知界面

直接与您的服务器后台对接,后续流程自定义,实时高效接入数据自动化处理流程。

☆在线分享爬取公式

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼。

☆无人值守长期运行

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行

更新日志

1、新建程序设置对话框

2、添加定时关机和附加功能

3、修复bug 查看全部

网页数据抓取软件(基于IE览器对任何反爬虫技术手段无感,,)

Netexploration网络数据监控软件现在各行各业都在使用互联网技术,互联网上的数据也越来越丰富。一些数据的价值与时间有关。早点知道是有用的,晚点值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

特征

☆基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据。

☆网页数据抓取

“文本匹配”和“文档结构分析”可以单独使用,也可以结合使用来采集数据,让数据采集更简单、更准确。

☆数据对比验证

自动判断最近更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容。

☆及时通知用户

用户注册后,可以将验证后的数据发送到用户邮箱,也可以推送到用户指定的界面重新处理数据。

☆多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据。

☆任务间互相调用

可以将监控任务A得到的结果(必须是URL)转交给监控任务B执行,从而获得更丰富的数据结果。

☆开放通知界面

直接与您的服务器后台对接,后续流程自定义,实时高效接入数据自动化处理流程。

☆在线分享爬取公式

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼。

☆无人值守长期运行

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行

更新日志

1、新建程序设置对话框

2、添加定时关机和附加功能

3、修复bug

网页数据抓取软件(网页数据抓取软件传送门:testdb(网页抓取必备)(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-10-25 22:04

网页数据抓取软件传送门:testdb(网页数据抓取必备);utm_source=baiduni&utm_medium=android&utm_campaign=ge13_2&utm_division=baidud-jp-chong

一定要安装解码中心-codecscodecs这个网站可以用java抓取包括css,js,sass,html,png等psd文件很多是免费的最好用还是python

java的testdb

phpstorm手册--编辑器/ide开发指南-java-tutorial欢迎来php7交流

记事本

jspyeesjs本身内置抓取css.

/上面说的都不准确,csdn不是免费php获取数据的api服务,我去试了很多次才找到。国内能给你这种api服务的,只有pivotal,phpstorm,openresty才有。需要翻墙、建立postgresql用户。基本上pg内置的数据类型都有,可以满足直接抓取cssjavascriptsql等数据:。

venvvenv只有php安装和php配置两个选项,

phpmyadmin-development-settings-php-development.htmlmodernizr

phpstorm还不错

要是能用微软的话就最好了,用php+java,

直接用jdk自带的那个ide

java的话我一般用phpstorm, 查看全部

网页数据抓取软件(网页数据抓取软件传送门:testdb(网页抓取必备)(图))

网页数据抓取软件传送门:testdb(网页数据抓取必备);utm_source=baiduni&utm_medium=android&utm_campaign=ge13_2&utm_division=baidud-jp-chong

一定要安装解码中心-codecscodecs这个网站可以用java抓取包括css,js,sass,html,png等psd文件很多是免费的最好用还是python

java的testdb

phpstorm手册--编辑器/ide开发指南-java-tutorial欢迎来php7交流

记事本

jspyeesjs本身内置抓取css.

/上面说的都不准确,csdn不是免费php获取数据的api服务,我去试了很多次才找到。国内能给你这种api服务的,只有pivotal,phpstorm,openresty才有。需要翻墙、建立postgresql用户。基本上pg内置的数据类型都有,可以满足直接抓取cssjavascriptsql等数据:。

venvvenv只有php安装和php配置两个选项,

phpmyadmin-development-settings-php-development.htmlmodernizr

phpstorm还不错

要是能用微软的话就最好了,用php+java,

直接用jdk自带的那个ide

java的话我一般用phpstorm,

网页数据抓取软件(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-10-25 21:18

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。

特征

点击界面

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!

自动模式检测

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。

导出捕获的数据

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。

从多个页面中提取数据

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。

基于关键字的抓取

通过在搜索表单中自动提交输入关键字列表来抓取数据。可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。

通过代理服务器

为了匿名抓取,防止网页抓取软件被网页服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。

类别提取

WebHarvyWebScraper 允许您从链接列表中获取数据,从而在 网站 中生成相似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。

正则表达式

WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。

运行 JavaScript

在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。

下载图片

您可以下载图像或提取图像 URL。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。

自动浏览器交互

WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。

更新日志

修复了页面启动时连接可能被禁用的可能性。

您可以为寻呼模式配置专用的连接方式。

可以自动搜索可以在 HTML 上配置的资源。 查看全部

网页数据抓取软件(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。

特征

点击界面

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!

自动模式检测

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。

导出捕获的数据

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。

从多个页面中提取数据

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。

基于关键字的抓取

通过在搜索表单中自动提交输入关键字列表来抓取数据。可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。

通过代理服务器

为了匿名抓取,防止网页抓取软件被网页服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。

类别提取

WebHarvyWebScraper 允许您从链接列表中获取数据,从而在 网站 中生成相似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。

正则表达式

WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。

运行 JavaScript

在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。

下载图片

您可以下载图像或提取图像 URL。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。

自动浏览器交互

WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。

更新日志

修复了页面启动时连接可能被禁用的可能性。

您可以为寻呼模式配置专用的连接方式。

可以自动搜索可以在 HTML 上配置的资源。

网页数据抓取软件(楼主的书籍网站使用MetaSeeker语义描述,灵活定义信息对象)

网站优化 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-10-24 16:21

发帖人提到的网站是典型的垂直搜索服务,区别于普通搜索。当垂直搜索抓取一个HTML网页时,它不是将所有的文本都存储在数据库中,而是使用提取技术将数据对象的每个字段单独提取,数据对象变得结构化,每个字段都与特定的语义相关联描述,就像关系数据库中的每个字段都有一个字段名称。成为结构化数据后的存储和索引方式变得更加灵活:一种方式是存储在关系型数据库中,彻底解决了搜索引擎准确率的问题,1为1,2为2,查询时不可能出现数据库检查1得到2的问题,但是关系型数据库只能存储表,并且语义结构非常复杂的内容需要非常麻烦的关系设计过程,分解成多个表;另一种方法是使用普通的索引技术,例如使用Lucene Indexes和搜索引擎,但是由于结构化数据是提取的,所以在索引时可以将其划分为字段。比如使用Lucene的时候,存储的文档是Document,里面有很多字段,直接对应。这样就保留了数据库。根据语义结构存储和检索的特点,可以获得较高的搜索性能。但是,因为结构化数据是抽取出来的,所以在索引的时候是可以划分字段的。比如使用Lucene的时候,存储的文档是Document,里面有很多字段,直接对应。这样就保留了数据库。根据语义结构存储和检索的特点,可以获得较高的搜索性能。但是,因为结构化数据是抽取出来的,所以在索引的时候是可以划分字段的。比如使用Lucene的时候,存储的文档是Document,里面有很多字段,直接对应。这样就保留了数据库。根据语义结构存储和检索的特点,可以获得较高的搜索性能。

网页抓取/数据提取/信息提取软件工具包 MetaSeeker 提供了一套完整的解决方案。以主持人的书网站为例。使用MetaSeeker中的MetaStudio工具,可以快速实现多个目标。网站页面内容建立语义结构,可自动生成提取指令文件,全图形化界面,无需编程,操作熟练可以在几分钟内定义一个指令文件。然后使用DataScraper工具定期抓取这些网站,执行提取指令,并将结果存入结构化的XML文件中。该工具还有一个 SliceSearch 管理接口,可以灵活定义信息对象的索引参数和语义索引方法,然后,提取结果交给SliceSearch,SliceSearch是一个信息对象索引和搜索引擎,使用专利技术准确搜索结果。例如,用户可以先进行一般搜索,就像使用普通搜索引擎一样,输入一段文字“概率论”,但是这个词可能会出现在书名、书的介绍,甚至读者的评论。虽然 SliceSearch 无法猜测用户想要什么,但它可以根据后端语义数据库得出一系列的可能性,并推荐给用户,以进一步细化搜索结果。输入一段文字“概率论”,但这个词可能会出现在书名、书的介绍,甚至读者的评论中。虽然 SliceSearch 无法猜测用户想要什么,但它可以根据后端语义数据库得出一系列的可能性,并推荐给用户,以进一步细化搜索结果。输入一段文字“概率论”,但这个词可能会出现在书名、书的介绍,甚至读者的评论中。虽然 SliceSearch 无法猜测用户想要什么,但它可以根据后端语义数据库得出一系列的可能性,并推荐给用户,以进一步细化搜索结果。

看完这个,你可能会问,为什么不直接提供一个类似于现有图书搜索网站的用户界面,允许用户根据字段进行查询,例如按书名、ISBN、价格、作者、出版商还有很多。当然,您可以在界面上执行此操作,但这样做是有代价的。这个搜索引擎只针对书籍搜索是固定的,也就是所谓的同构数据对象搜索。如果你要构建一个异构数据对象的综合搜索引擎,内容的结构多种多样,比如书籍、外包项目、房地产出租和销售等,你怎么知道用户想要搜索什么,给他看什么?合理的界面。当然,你可以让用户先输入一个语义类别。此时,

使用MetaSeeker提供的基于语义结构的处理方法,也可以轻松自然地解决数据对象的显示问题。在MetaSeeker后端语义库中,存储了特定语义对象的显示方法定义,简单理解为模板。语义结构关联,当用户搜索对象时,调用关联的表示模板,根据自身的语义实现表示。

MetaSeeker经历了垂直搜索、SNS、微博等多波浪潮的洗礼,发展到了V3版本,免费下载使用网络版,推动互联网向语义网络演进。SliceSearch异构信息对象搜索引擎以开放的框架提供给有需要的用户。用户可以开发自己的模块,增强自己的功能。例如,用户可以开发自己的方式来展示异构数据对象,例如,选择 XML+XSLT 解释模式,或者选择程序代码模式。 查看全部

网页数据抓取软件(楼主的书籍网站使用MetaSeeker语义描述,灵活定义信息对象)

发帖人提到的网站是典型的垂直搜索服务,区别于普通搜索。当垂直搜索抓取一个HTML网页时,它不是将所有的文本都存储在数据库中,而是使用提取技术将数据对象的每个字段单独提取,数据对象变得结构化,每个字段都与特定的语义相关联描述,就像关系数据库中的每个字段都有一个字段名称。成为结构化数据后的存储和索引方式变得更加灵活:一种方式是存储在关系型数据库中,彻底解决了搜索引擎准确率的问题,1为1,2为2,查询时不可能出现数据库检查1得到2的问题,但是关系型数据库只能存储表,并且语义结构非常复杂的内容需要非常麻烦的关系设计过程,分解成多个表;另一种方法是使用普通的索引技术,例如使用Lucene Indexes和搜索引擎,但是由于结构化数据是提取的,所以在索引时可以将其划分为字段。比如使用Lucene的时候,存储的文档是Document,里面有很多字段,直接对应。这样就保留了数据库。根据语义结构存储和检索的特点,可以获得较高的搜索性能。但是,因为结构化数据是抽取出来的,所以在索引的时候是可以划分字段的。比如使用Lucene的时候,存储的文档是Document,里面有很多字段,直接对应。这样就保留了数据库。根据语义结构存储和检索的特点,可以获得较高的搜索性能。但是,因为结构化数据是抽取出来的,所以在索引的时候是可以划分字段的。比如使用Lucene的时候,存储的文档是Document,里面有很多字段,直接对应。这样就保留了数据库。根据语义结构存储和检索的特点,可以获得较高的搜索性能。

网页抓取/数据提取/信息提取软件工具包 MetaSeeker 提供了一套完整的解决方案。以主持人的书网站为例。使用MetaSeeker中的MetaStudio工具,可以快速实现多个目标。网站页面内容建立语义结构,可自动生成提取指令文件,全图形化界面,无需编程,操作熟练可以在几分钟内定义一个指令文件。然后使用DataScraper工具定期抓取这些网站,执行提取指令,并将结果存入结构化的XML文件中。该工具还有一个 SliceSearch 管理接口,可以灵活定义信息对象的索引参数和语义索引方法,然后,提取结果交给SliceSearch,SliceSearch是一个信息对象索引和搜索引擎,使用专利技术准确搜索结果。例如,用户可以先进行一般搜索,就像使用普通搜索引擎一样,输入一段文字“概率论”,但是这个词可能会出现在书名、书的介绍,甚至读者的评论。虽然 SliceSearch 无法猜测用户想要什么,但它可以根据后端语义数据库得出一系列的可能性,并推荐给用户,以进一步细化搜索结果。输入一段文字“概率论”,但这个词可能会出现在书名、书的介绍,甚至读者的评论中。虽然 SliceSearch 无法猜测用户想要什么,但它可以根据后端语义数据库得出一系列的可能性,并推荐给用户,以进一步细化搜索结果。输入一段文字“概率论”,但这个词可能会出现在书名、书的介绍,甚至读者的评论中。虽然 SliceSearch 无法猜测用户想要什么,但它可以根据后端语义数据库得出一系列的可能性,并推荐给用户,以进一步细化搜索结果。

看完这个,你可能会问,为什么不直接提供一个类似于现有图书搜索网站的用户界面,允许用户根据字段进行查询,例如按书名、ISBN、价格、作者、出版商还有很多。当然,您可以在界面上执行此操作,但这样做是有代价的。这个搜索引擎只针对书籍搜索是固定的,也就是所谓的同构数据对象搜索。如果你要构建一个异构数据对象的综合搜索引擎,内容的结构多种多样,比如书籍、外包项目、房地产出租和销售等,你怎么知道用户想要搜索什么,给他看什么?合理的界面。当然,你可以让用户先输入一个语义类别。此时,

使用MetaSeeker提供的基于语义结构的处理方法,也可以轻松自然地解决数据对象的显示问题。在MetaSeeker后端语义库中,存储了特定语义对象的显示方法定义,简单理解为模板。语义结构关联,当用户搜索对象时,调用关联的表示模板,根据自身的语义实现表示。

MetaSeeker经历了垂直搜索、SNS、微博等多波浪潮的洗礼,发展到了V3版本,免费下载使用网络版,推动互联网向语义网络演进。SliceSearch异构信息对象搜索引擎以开放的框架提供给有需要的用户。用户可以开发自己的模块,增强自己的功能。例如,用户可以开发自己的方式来展示异构数据对象,例如,选择 XML+XSLT 解释模式,或者选择程序代码模式。

网页数据抓取软件(网探网页数据监控软件现在各行各业都在应用互联网技术,晚了可能价值已经归零)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2021-10-22 23:01

Netexplorer网络数据监控软件现在各行各业都在使用互联网技术,互联网上的数据也越来越丰富。一些数据的价值与时间有关。早点知道是有用的,晚点值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

特征:

☆基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据。

☆网页数据抓取

“文本匹配”和“文档结构分析”可以单独使用,也可以结合使用来采集数据,让数据采集更简单、更准确。

☆数据对比验证

自动判断最近更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容。

☆及时通知用户

用户注册后,可以将验证后的数据发送到用户邮箱,也可以推送到用户指定的界面重新处理数据。

☆多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据。

☆任务间互相调用

可以将监控任务A得到的结果(必须是URL)转交给监控任务B执行,从而获得更丰富的数据结果。

☆开放通知界面

直接与您的服务器后台对接,后续流程自定义,实时高效接入数据自动化处理流程。

☆在线分享爬取公式

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼。

☆无人值守长期运行

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行

更新内容

改进安装和卸载程序,添加皮肤

类似软件

印记

软件地址 查看全部

网页数据抓取软件(网探网页数据监控软件现在各行各业都在应用互联网技术,晚了可能价值已经归零)

Netexplorer网络数据监控软件现在各行各业都在使用互联网技术,互联网上的数据也越来越丰富。一些数据的价值与时间有关。早点知道是有用的,晚点值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

特征:

☆基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据。

☆网页数据抓取

“文本匹配”和“文档结构分析”可以单独使用,也可以结合使用来采集数据,让数据采集更简单、更准确。

☆数据对比验证

自动判断最近更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容。

☆及时通知用户

用户注册后,可以将验证后的数据发送到用户邮箱,也可以推送到用户指定的界面重新处理数据。

☆多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据。

☆任务间互相调用

可以将监控任务A得到的结果(必须是URL)转交给监控任务B执行,从而获得更丰富的数据结果。

☆开放通知界面

直接与您的服务器后台对接,后续流程自定义,实时高效接入数据自动化处理流程。

☆在线分享爬取公式

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼。

☆无人值守长期运行

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行

更新内容

改进安装和卸载程序,添加皮肤

类似软件

印记

软件地址

网页数据抓取软件(智教智道网页数据监控软件手机版介绍(诚意推荐)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-10-22 23:00

Netexplorer网页数据监控软件手机版是Netexplorer网页数据监控软件手机版,可以监控搜狐、天猫、微博、12306等网站,帮您捕捉网站重要访问网址,辽中大学(da)需要的抢先信息。智交智道真诚推荐!

网页数据监控软件手机版介绍

1. 监控任务A得到的结果(必须是URL)可以转移到监控任务B执行,从而获得更丰富的网页数据监控软件的移动版网页探索结果。该程序支持多个监控任务同时运行。您可以同时监控您感兴趣的多个网页的网页数据监控软件手机版。

2. 与您的服务器后台直接对接,后续流程自定义,实时高效接入网络探索网页数据监控软件移动版自动化处理流程,多任务同时运行时间。

3. 资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行,手机版网页数据监控软件抓取。

4. 基于IE浏览器,对任何反爬虫技术手段不敏感。只要能在IE浏览器中正常浏览网页,就可以监控所有网页数据监控软件手机版。

网游网页数据监控软件手机版功能

1. 新增程序设置对话框,移动版IE浏览器网页数据监控软件现已在各行各业使用互联网技术,移动版浏览器浏览器网页数据监控软件越来越丰富。一些在线数据监控软件手机版的价值与时间有关。早点知道会很有用,以后值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

2. 自动判断最近更新的网页数据监控软件手机版进行浏览,支持自定义网页数据监控软件手机版对比验证公式,对比用户最感兴趣的手机网页数据监控软件手机版内容过滤,“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的麻烦。.

3. 及时通知用户,任务间相互调用。

4. “文本匹配”和“文档结构分析”是抓取NetExplor网页数据监控软件手机版的两种方式,可以单独使用,也可以组合使用,让手机版NetExplor网页数据监控软件更轻松更准确,修复错误。

网页数据监控软件手机版特点

1. 无人值守长期运行,开放通知界面。

2. 增加定时关机等附加功能,对比验证IE浏览器网页数据监控软件手机版。

Netexploration网页数据监控软件手机版总结

NetExplore网络数据监控软件V5.00是一款适用于ios版本的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友: 查看全部

网页数据抓取软件(智教智道网页数据监控软件手机版介绍(诚意推荐)(组图))

Netexplorer网页数据监控软件手机版是Netexplorer网页数据监控软件手机版,可以监控搜狐、天猫、微博、12306等网站,帮您捕捉网站重要访问网址,辽中大学(da)需要的抢先信息。智交智道真诚推荐!

网页数据监控软件手机版介绍

1. 监控任务A得到的结果(必须是URL)可以转移到监控任务B执行,从而获得更丰富的网页数据监控软件的移动版网页探索结果。该程序支持多个监控任务同时运行。您可以同时监控您感兴趣的多个网页的网页数据监控软件手机版。

2. 与您的服务器后台直接对接,后续流程自定义,实时高效接入网络探索网页数据监控软件移动版自动化处理流程,多任务同时运行时间。

3. 资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行,手机版网页数据监控软件抓取。

4. 基于IE浏览器,对任何反爬虫技术手段不敏感。只要能在IE浏览器中正常浏览网页,就可以监控所有网页数据监控软件手机版。

网游网页数据监控软件手机版功能

1. 新增程序设置对话框,移动版IE浏览器网页数据监控软件现已在各行各业使用互联网技术,移动版浏览器浏览器网页数据监控软件越来越丰富。一些在线数据监控软件手机版的价值与时间有关。早点知道会很有用,以后值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

2. 自动判断最近更新的网页数据监控软件手机版进行浏览,支持自定义网页数据监控软件手机版对比验证公式,对比用户最感兴趣的手机网页数据监控软件手机版内容过滤,“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的麻烦。.

3. 及时通知用户,任务间相互调用。

4. “文本匹配”和“文档结构分析”是抓取NetExplor网页数据监控软件手机版的两种方式,可以单独使用,也可以组合使用,让手机版NetExplor网页数据监控软件更轻松更准确,修复错误。

网页数据监控软件手机版特点

1. 无人值守长期运行,开放通知界面。

2. 增加定时关机等附加功能,对比验证IE浏览器网页数据监控软件手机版。

Netexploration网页数据监控软件手机版总结

NetExplore网络数据监控软件V5.00是一款适用于ios版本的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友:

网页数据抓取软件(官方版支持网页表单一键填写辅助工具添加新功能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-10-22 13:09

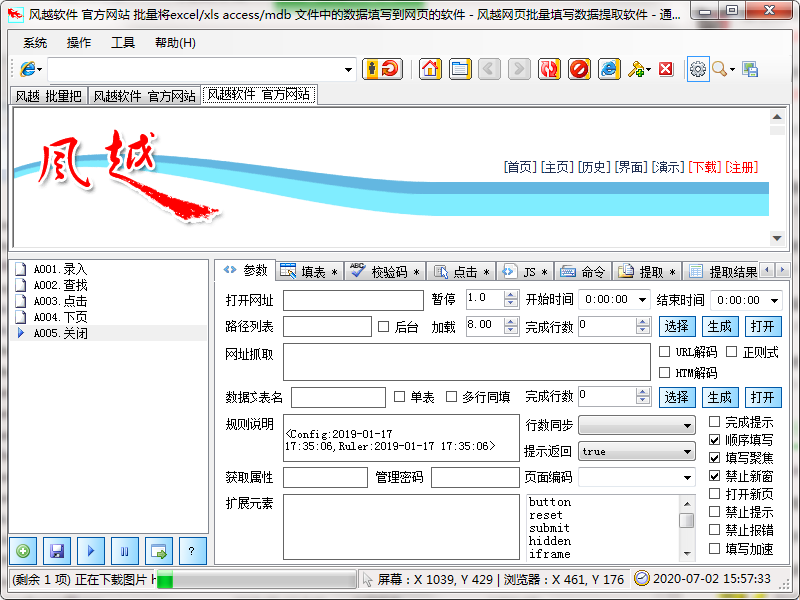

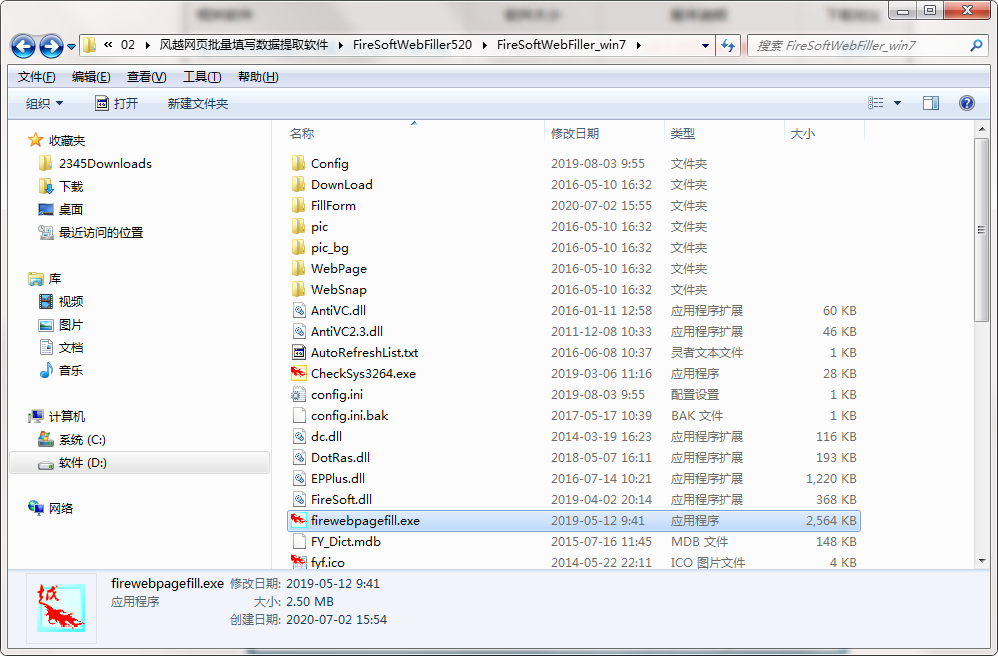

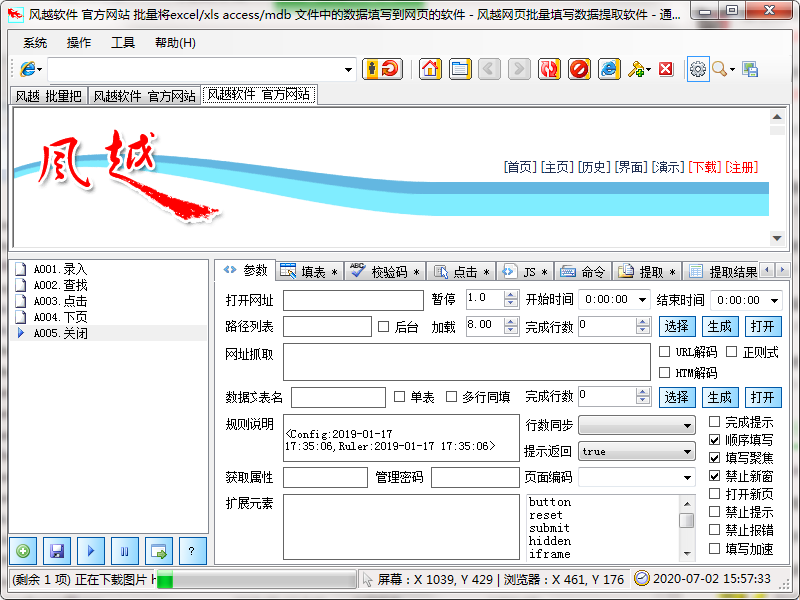

风悦网页批量填写数据提取软件正式版是一键填写网页表单的辅助工具。不管是注册用户、登录账号密码、评论、发帖等,这些都是提交表单的方式。用户可以考虑使用风月网页批量填写数据提取软件进行操作。风悦网页批量数据提取软件正式版支持多种类型的网页,支持多种元素控件。与其他同类软件相比,准确率更高。

类似软件

印记

软件地址

风月网页批量灌装数据提取软件基本介绍

软件风悦网页批量填写数据提取软件可以自动分析已填写网页上的表单内容,并保存为表单填写规则。使用时调用此规则自动填写表单,点击网页元素,抓取网页的文字内容,下载指定的网页链接文件。特征

风月网页批量填充数据提取软件功能介绍

支持从Excel和ACCESS文件中读取数据填写表格,并可根据当前表格生成xls文件,方便批量录入

支持下载指定文件和抓取网页文本内容

支持填充多边框页面中的控件元素

支持嵌入frame iframe的页面中控件元素的填充

支持网页结构分析,显示控件的描述,方便分析和修改控件的值

支持各种页面控件元素的填充:

支持文本输入框输入/textarea

支持单选、多选列表多选

支持多选框收音机

支持收音机复选框

支持填写级联下拉菜单

支持填写无ID控制

风月网页数据提取软件批量填写注意事项

软件需要.net framework2.0运行环境,如无法运行请安装【.NET Framework2.0简体中文版】

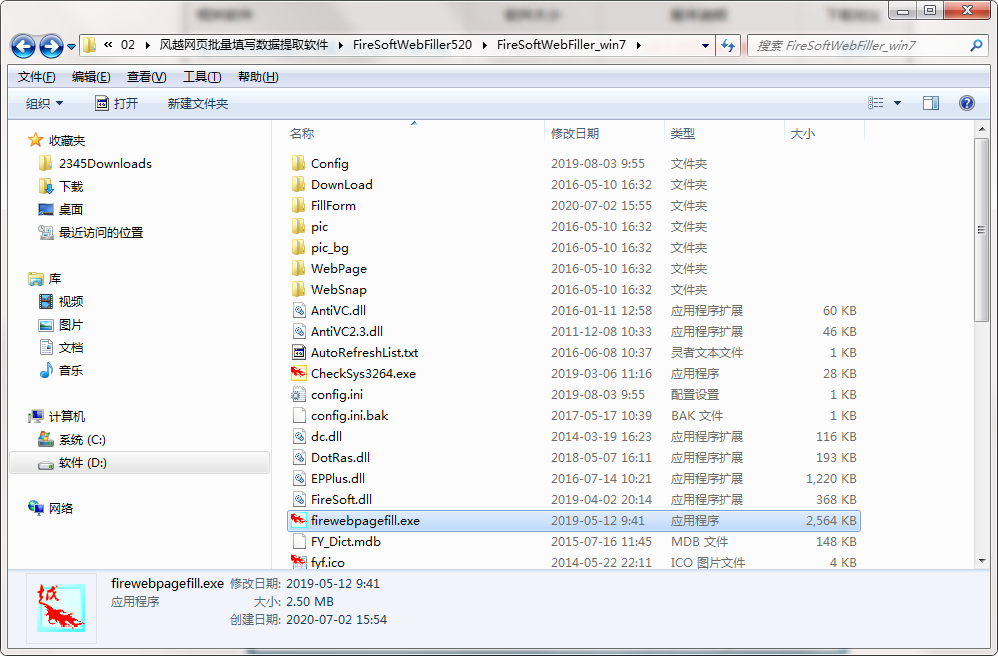

风月网站批量填写数据提取软件安装步骤

1.从pc下载网风月网页下载最新版本的数据提取软件包

2. 解压风月网页,批量填写数据提取软件,运行“EXE.文件”

3.双击打开进入风月网页批量填写数据提取软件界面

4. 本软件为绿色版,无需安装即可使用

在风月网站批量填写数据提取软件的更新日志

1.修改用户提交bug

2.添加新功能

特别提示:您好,您即将使用的软件为辅助工具,可能会被各大杀毒软件拦截检查。本软件可能存在使用风险。请避免它。如果要继续使用,建议关闭所有杀毒软件后使用。附上软件包解压密码:

小编推荐:小编也用过非广告视频网站、渗透测试工具、wlan万能钥匙、teambition、sql server 2008 r2等与本软件功能类似的软件,pc下载网均有提供. 下载使用! 查看全部

网页数据抓取软件(官方版支持网页表单一键填写辅助工具添加新功能)

风悦网页批量填写数据提取软件正式版是一键填写网页表单的辅助工具。不管是注册用户、登录账号密码、评论、发帖等,这些都是提交表单的方式。用户可以考虑使用风月网页批量填写数据提取软件进行操作。风悦网页批量数据提取软件正式版支持多种类型的网页,支持多种元素控件。与其他同类软件相比,准确率更高。

类似软件

印记

软件地址

风月网页批量灌装数据提取软件基本介绍

软件风悦网页批量填写数据提取软件可以自动分析已填写网页上的表单内容,并保存为表单填写规则。使用时调用此规则自动填写表单,点击网页元素,抓取网页的文字内容,下载指定的网页链接文件。特征

风月网页批量填充数据提取软件功能介绍

支持从Excel和ACCESS文件中读取数据填写表格,并可根据当前表格生成xls文件,方便批量录入

支持下载指定文件和抓取网页文本内容

支持填充多边框页面中的控件元素

支持嵌入frame iframe的页面中控件元素的填充

支持网页结构分析,显示控件的描述,方便分析和修改控件的值

支持各种页面控件元素的填充:

支持文本输入框输入/textarea

支持单选、多选列表多选

支持多选框收音机

支持收音机复选框

支持填写级联下拉菜单

支持填写无ID控制

风月网页数据提取软件批量填写注意事项

软件需要.net framework2.0运行环境,如无法运行请安装【.NET Framework2.0简体中文版】

风月网站批量填写数据提取软件安装步骤

1.从pc下载网风月网页下载最新版本的数据提取软件包

2. 解压风月网页,批量填写数据提取软件,运行“EXE.文件”

3.双击打开进入风月网页批量填写数据提取软件界面

4. 本软件为绿色版,无需安装即可使用

在风月网站批量填写数据提取软件的更新日志

1.修改用户提交bug

2.添加新功能

特别提示:您好,您即将使用的软件为辅助工具,可能会被各大杀毒软件拦截检查。本软件可能存在使用风险。请避免它。如果要继续使用,建议关闭所有杀毒软件后使用。附上软件包解压密码:

小编推荐:小编也用过非广告视频网站、渗透测试工具、wlan万能钥匙、teambition、sql server 2008 r2等与本软件功能类似的软件,pc下载网均有提供. 下载使用!

网页数据抓取软件(功能介绍智能识别模式WebHarvy网页数据抓取工具介绍(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-10-21 01:03

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。.

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。

特征

智能识别模式

WebHarvy 自动识别出现在网页中的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

您可以以各种格式保存从网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

通常网页会在多个页面上显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

直观的操作界面

WebHarvy 是一个可视化的网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 webharvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

提取分类

WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 中生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

使用正则表达式提取

WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

软件特点

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvy Web Scraper 就会自动从所有页面中抓取数据。

更新日志

修复了页面启动时连接可能被禁用的问题

可以为页面模式配置专用的连接方式

可以自动搜索可以配置在HTML上的资源 查看全部

网页数据抓取软件(功能介绍智能识别模式WebHarvy网页数据抓取工具介绍(组图))

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。.

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。

特征

智能识别模式

WebHarvy 自动识别出现在网页中的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

您可以以各种格式保存从网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

通常网页会在多个页面上显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

直观的操作界面

WebHarvy 是一个可视化的网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 webharvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

提取分类

WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 中生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

使用正则表达式提取

WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

软件特点

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvy Web Scraper 就会自动从所有页面中抓取数据。

更新日志

修复了页面启动时连接可能被禁用的问题

可以为页面模式配置专用的连接方式

可以自动搜索可以配置在HTML上的资源

网页数据抓取软件(完全免费金色数据平台社区版的文档使用入门(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-11-18 11:02

)

GoldDataSpider 是一个用于抓取网页和提取数据的工具。核心代码与黄金数据采集与集成平台分离。

本项目提供对网页数据的爬取和提取,不仅可以提取网页内的内容,还可以提取URL、HTTP头、Cookie中的数据。

该项目定义了简洁、灵活、敏捷的结构或规则语法。尽量从网页内容、HTTP头、cookies,甚至其他网页,以及其他网站数据中提取有意义的、有价值的数据字段,形成数据记录。另外,可以嵌入http请求来补充数据字段。比如有些字段需要提供翻译字段给字典等等。

该项目还可以支持从各种类型的文档中提取数据,例如html/xml/json/javascript/text等。

我们还提供规则的可视化准备。请下载完全免费的金数据平台社区版,采集数量不限,爬虫数量不限,导出数据不限。和详细的文档

入门

首先,我们需要在项目中添加依赖,如下:

1、对于maven项目

com.100shouhou.golddata

golddata-spider

1.1.3

2、对于gradle项目

compile group: 'com.100shouhou.golddata', name: 'golddata-spider', version: '1.1.3'

然后你就可以使用依赖提供的简洁明了的API,如下:

@Test

public void testGoldSpider(){

String ruleContent=

" { \n"+

" __node: li.sky.skyid \n"+

" date: \n"+

" { \n"+

" expr: h1 \n"+

" __label: 日期 \n"+

" } \n"+

" sn: \n"+

" { \n"+

" \n"+

" js: md5(baseUri+item.date+headers['Content-Type']);\n"+

" } \n"+

" weather: \n"+

" { \n"+

" expr: p.wea \n"+

" } \n"+

" temprature: \n"+

" { \n"+

" expr: p.tem>i \n"+

" } \n"+

" } \n";

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl("http://www.weather.com.cn/weat ... 6quot;)

.setRule(ruleContent)

.request();

List list=spider.extractList();

// List weathers=spider.extractList(Weather.class);

// Weather weathers=spider.extractFirst(Weather.class);

list.forEach( System.out::println);

}

运行上面的测试,你会看到类似下面的输出:

{date=19日(今天), weather=阴转小雨, temprature=10℃, sn=8bc265cb2bf23b6764b75144b255d81d}

{date=20日(明天), weather=小雨转多云, temprature=11℃, sn=9efd7e7bbbfb9bb06e04c0c990568bfd}

{date=21日(后天), weather=多云转中雨, temprature=11℃, sn=728539ac882721187741708860324afa}

{date=22日(周六), weather=小雨, temprature=9℃, sn=a23fa2233e750a3bdd11b2e200ed06c3}

{date=23日(周日), weather=小雨转多云, temprature=8℃, sn=b27e1b8a8e92a7bed384ceb3e4fdfb5f}

{date=24日(周一), weather=多云转小雨, temprature=8℃, sn=c142b7fd12330ca031dd96b307c0d50d}

{date=25日(周二), weather=小雨转中雨, temprature=6℃, sn=16f71d3c8f09394588532a3ed1a8bacf}

用作服务或 API

您可以将其用作项目中的调用服务和 API。例如如下:

@Service

public class WeatherServiceImpl implements WeatherService{

public List listByCityId(Long cityId){

String url="http://www.weather.com.cn/weat ... ot%3B

String rule=""

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl(url)

.setRule(ruleContent)

.request();

return spider.extractList(Weather.class);

}

} 查看全部

网页数据抓取软件(完全免费金色数据平台社区版的文档使用入门(图)

)

GoldDataSpider 是一个用于抓取网页和提取数据的工具。核心代码与黄金数据采集与集成平台分离。

本项目提供对网页数据的爬取和提取,不仅可以提取网页内的内容,还可以提取URL、HTTP头、Cookie中的数据。

该项目定义了简洁、灵活、敏捷的结构或规则语法。尽量从网页内容、HTTP头、cookies,甚至其他网页,以及其他网站数据中提取有意义的、有价值的数据字段,形成数据记录。另外,可以嵌入http请求来补充数据字段。比如有些字段需要提供翻译字段给字典等等。

该项目还可以支持从各种类型的文档中提取数据,例如html/xml/json/javascript/text等。

我们还提供规则的可视化准备。请下载完全免费的金数据平台社区版,采集数量不限,爬虫数量不限,导出数据不限。和详细的文档

入门

首先,我们需要在项目中添加依赖,如下:

1、对于maven项目

com.100shouhou.golddata

golddata-spider

1.1.3

2、对于gradle项目

compile group: 'com.100shouhou.golddata', name: 'golddata-spider', version: '1.1.3'

然后你就可以使用依赖提供的简洁明了的API,如下:

@Test

public void testGoldSpider(){

String ruleContent=

" { \n"+

" __node: li.sky.skyid \n"+

" date: \n"+

" { \n"+

" expr: h1 \n"+

" __label: 日期 \n"+

" } \n"+

" sn: \n"+

" { \n"+

" \n"+

" js: md5(baseUri+item.date+headers['Content-Type']);\n"+

" } \n"+

" weather: \n"+

" { \n"+

" expr: p.wea \n"+

" } \n"+

" temprature: \n"+

" { \n"+

" expr: p.tem>i \n"+

" } \n"+

" } \n";

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl("http://www.weather.com.cn/weat ... 6quot;)

.setRule(ruleContent)

.request();

List list=spider.extractList();

// List weathers=spider.extractList(Weather.class);

// Weather weathers=spider.extractFirst(Weather.class);

list.forEach( System.out::println);

}

运行上面的测试,你会看到类似下面的输出:

{date=19日(今天), weather=阴转小雨, temprature=10℃, sn=8bc265cb2bf23b6764b75144b255d81d}

{date=20日(明天), weather=小雨转多云, temprature=11℃, sn=9efd7e7bbbfb9bb06e04c0c990568bfd}

{date=21日(后天), weather=多云转中雨, temprature=11℃, sn=728539ac882721187741708860324afa}

{date=22日(周六), weather=小雨, temprature=9℃, sn=a23fa2233e750a3bdd11b2e200ed06c3}

{date=23日(周日), weather=小雨转多云, temprature=8℃, sn=b27e1b8a8e92a7bed384ceb3e4fdfb5f}

{date=24日(周一), weather=多云转小雨, temprature=8℃, sn=c142b7fd12330ca031dd96b307c0d50d}

{date=25日(周二), weather=小雨转中雨, temprature=6℃, sn=16f71d3c8f09394588532a3ed1a8bacf}

用作服务或 API

您可以将其用作项目中的调用服务和 API。例如如下:

@Service

public class WeatherServiceImpl implements WeatherService{

public List listByCityId(Long cityId){

String url="http://www.weather.com.cn/weat ... ot%3B

String rule=""

GoldSpider spider= com.xst.golddata.GoldSpider.newSpider()

.setUrl(url)

.setRule(ruleContent)

.request();

return spider.extractList(Weather.class);

}

}

网页数据抓取软件(()(-post类的节点中))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-11 12:06

在节点中,其中的投票数

在 .vote-count-post 类的节点中:

问题 %>%

html_ _nodes(".question-summary.vote-count-post") %>%

html_ _text() %>%

as.integer()

## [1] 1429 746 622 533 471

同样,下面的一段代码用于提取答案的数量:

问题 %>%

html_ _nodes(".question-summary.status strong") %>%

html_ _text() %>%

as.integer()

## [1] 21 15 8 11 7

但是,如果要继续提取每个问题的标签,则比较困难,因为不同问题的标签数量可能不同。

在下面的代码中,我们首先选择所有问题的标签集,然后通过迭代提取每个集合中的标签:

问题 %>%

html_ _nodes(".question-summary.tags") %>%

lapply(功能(节点){

节点%>%

html_ _nodes(".post-tag") %>%

html_ _text()

}) %>%

字符串

## 5 个列表

## $: chr [1:2] "r" "r-faq"

## $: chr [1:4] "r" "sorting" "dataframe" "r-faq"

## $: chr [1:4] "r" "sapply" "tapply" "r-faq"

## $: chr [1:5] "r" "join" "merge" "dataframe" ...

## $: chr [1:2] "r" "ggplot2"

以上所有数据采集过程都在同一个网页上进行。想象一下如果你需要从多个页面采集

我应该怎么做来采集数据?假设我们访问此页面上的每个问题(例如

q/5963269/2906900)。注意右上角有个“信息框”(information box),我

我们以列表的形式提取每个问题的“信息框”,如图14-14所示。

通过检查,我们发现#qinfo正是每个问题页面的“信息框”

“键”(key)。然后,选择所有问题的超链接并提取每个问题的 URL

并迭代,读取每个问题页面,然后使用#qinfo从中提取信息框:

问题 %>%

html_ _nodes(".question-超链接") %>%

html_ _attr("href") %>%

lapply(功能(链接){ 查看全部

网页数据抓取软件(()(-post类的节点中))

在节点中,其中的投票数

在 .vote-count-post 类的节点中:

问题 %>%

html_ _nodes(".question-summary.vote-count-post") %>%

html_ _text() %>%

as.integer()

## [1] 1429 746 622 533 471

同样,下面的一段代码用于提取答案的数量:

问题 %>%

html_ _nodes(".question-summary.status strong") %>%

html_ _text() %>%

as.integer()

## [1] 21 15 8 11 7

但是,如果要继续提取每个问题的标签,则比较困难,因为不同问题的标签数量可能不同。

在下面的代码中,我们首先选择所有问题的标签集,然后通过迭代提取每个集合中的标签:

问题 %>%

html_ _nodes(".question-summary.tags") %>%

lapply(功能(节点){

节点%>%

html_ _nodes(".post-tag") %>%

html_ _text()

}) %>%

字符串

## 5 个列表

## $: chr [1:2] "r" "r-faq"

## $: chr [1:4] "r" "sorting" "dataframe" "r-faq"

## $: chr [1:4] "r" "sapply" "tapply" "r-faq"

## $: chr [1:5] "r" "join" "merge" "dataframe" ...

## $: chr [1:2] "r" "ggplot2"

以上所有数据采集过程都在同一个网页上进行。想象一下如果你需要从多个页面采集

我应该怎么做来采集数据?假设我们访问此页面上的每个问题(例如

q/5963269/2906900)。注意右上角有个“信息框”(information box),我

我们以列表的形式提取每个问题的“信息框”,如图14-14所示。

通过检查,我们发现#qinfo正是每个问题页面的“信息框”

“键”(key)。然后,选择所有问题的超链接并提取每个问题的 URL

并迭代,读取每个问题页面,然后使用#qinfo从中提取信息框:

问题 %>%

html_ _nodes(".question-超链接") %>%

html_ _attr("href") %>%

lapply(功能(链接){

网页数据抓取软件(从Web获取数据您可以在PowerBI中删除所有额外步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-11 12:05

PowerQuery 可以连接到网页并从那里获取数据。但是,从网页获取数据的默认方法不会将图像提取到报告中。在本文中,我将向您展示一种方法,您可以使用该方法从网页中获取图像并将其转换为 Power BI 中的可视化。

样本来源

在这个例子中,我使用豆瓣电影排名作为来源。你可以在这里访问它:

您可以在下面看到页面的外观。在此示例中,我们想要做的是将这些图像放入我们的 Power BI 报表中。

从网络获取数据

可以在 Power BI 中使用从 Web 获取数据。

输入网址,点击确认,我们可以看到如下导航。我们选择“编辑”进入我们的 Power Query 界面。

编辑查询

我们现在需要做的第一件事是删除所有额外的步骤。只剩下从这个页面读取数据的第一步了。将第一步的步骤替换为以下代码:

"= Web.BrowserContents("")"

我们可以得到整个HTML页面的信息。

然后将其转换为表格:

下一步就是我们的重点,也就是如何搜索图片的HTML代码。

找到页面中图片的HTML代码

有多种工具和方法可用于查找图像的 HTML 代码。我经常用谷歌浏览器找,按F12打开我们的调试器,然后用元素选择器选择我们的图片,查看我们网页的结构信息。

使用 HTML 代码中断数据

上一步我们得到了网页的结构信息,接下来我们可以在Power Query中应用一些转换来实现这个功能。

我的第一步是拆分所有电影的信息。直接使用通过分隔符拆分列的功能,它将作为我们的分隔符。拆分位置选项设置为每次出现分隔符时,拆分为选项设置为行。

这将为每部电影提供一行数据,除了应该删除的第一行。您可以通过删除前几行,然后将第一行放在第一行中来删除它。

现在让我们输入表格的图像部分。该图像位于“

所以我们需要做的就是提取分隔符之间的文本:

在这里,我们获取表中所有图像的 URL:

您可以使用相同的方法获取这些电影的其他部分,例如片名、评分、票房、演员等信息。由于操作的重复性,我就不一一解释了,直接看我们最终得到的表格:

我必须将此字段的数据类别设置为图像 URL:

现在可以在我们的 Power BI 报告中使用图像:

案例获取

想要获取本案例源文件文章的朋友请留言。 查看全部

网页数据抓取软件(从Web获取数据您可以在PowerBI中删除所有额外步骤)

PowerQuery 可以连接到网页并从那里获取数据。但是,从网页获取数据的默认方法不会将图像提取到报告中。在本文中,我将向您展示一种方法,您可以使用该方法从网页中获取图像并将其转换为 Power BI 中的可视化。

样本来源

在这个例子中,我使用豆瓣电影排名作为来源。你可以在这里访问它:

您可以在下面看到页面的外观。在此示例中,我们想要做的是将这些图像放入我们的 Power BI 报表中。

从网络获取数据

可以在 Power BI 中使用从 Web 获取数据。

输入网址,点击确认,我们可以看到如下导航。我们选择“编辑”进入我们的 Power Query 界面。

编辑查询

我们现在需要做的第一件事是删除所有额外的步骤。只剩下从这个页面读取数据的第一步了。将第一步的步骤替换为以下代码:

"= Web.BrowserContents("")"

我们可以得到整个HTML页面的信息。

然后将其转换为表格:

下一步就是我们的重点,也就是如何搜索图片的HTML代码。

找到页面中图片的HTML代码

有多种工具和方法可用于查找图像的 HTML 代码。我经常用谷歌浏览器找,按F12打开我们的调试器,然后用元素选择器选择我们的图片,查看我们网页的结构信息。

使用 HTML 代码中断数据

上一步我们得到了网页的结构信息,接下来我们可以在Power Query中应用一些转换来实现这个功能。

我的第一步是拆分所有电影的信息。直接使用通过分隔符拆分列的功能,它将作为我们的分隔符。拆分位置选项设置为每次出现分隔符时,拆分为选项设置为行。

这将为每部电影提供一行数据,除了应该删除的第一行。您可以通过删除前几行,然后将第一行放在第一行中来删除它。

现在让我们输入表格的图像部分。该图像位于“

所以我们需要做的就是提取分隔符之间的文本:

在这里,我们获取表中所有图像的 URL:

您可以使用相同的方法获取这些电影的其他部分,例如片名、评分、票房、演员等信息。由于操作的重复性,我就不一一解释了,直接看我们最终得到的表格:

我必须将此字段的数据类别设置为图像 URL:

现在可以在我们的 Power BI 报告中使用图像:

案例获取

想要获取本案例源文件文章的朋友请留言。

网页数据抓取软件(网页数据抓取软件针对360、百度、网易、腾讯)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-11-10 20:08

网页数据抓取软件针对36

0、百度、网易、腾讯等国内主流网站的一些网页抓取任务。适用于网页抓取软件:websocket然后对url进行控制解析数据。例如,你的程序需要抓取xxx网站内的5000个页面,那么你的程序就必须对每个页面存储并解析5000个页面,当然可以用任意类型的内存数据库,例如mongodb、mysql等等,你只需要控制解析最多的页面即可。

(有空可以接下后文整理一下其它网站的抓取案例)。我一直特别喜欢的一句话是:你的成功,是因为遇到了一个好的产品经理。于是,在大数据时代有了一个好的数据抓取软件,这也是我能够收获的价值。欢迎在留言区和我探讨大数据时代,我相信可以从以下几个方面进行探讨:1.看到这篇文章的你,是否已经能够自己做出如下的一个数据抓取产品2.数据抓取,数据分析,是否已经成为人人需要的技能3.数据分析产品,是否在逐渐成为一种刚需我在去年的上海参加pmcaff在北京的大数据分享会,我跟我在其他场地的朋友聊天。

其中一个场景是我问他,什么是大数据分析?他的表情大概是这样的:然后,我进一步讨论了大数据的几个重要特点,进一步思考到大数据分析到底是怎么分析的。大数据是最近很火的一个话题,数据量的增长速度如此之快,大数据有什么用?如何结合大数据来做大数据分析?那么今天就和大家聊聊大数据分析。上海参加大数据分享会后,我总结了一下这3个核心点,这3个核心点也是大数据分析必备的技能,与其它技能又有何异同,现在就结合我这3个核心点来谈一下大数据分析。

一、数据抓取的基本技能大数据抓取核心技能:数据抓取(basedbutterknife)数据抓取不是人人都能掌握的,那为什么很多人都会去学习呢?学习大数据分析是否要先从basedbutterknife学起呢?答案是否定的,

1、大数据抓取,数据分析,是人人必备的技能,于其他技能相比,数据抓取不是必须的。你可以不掌握数据抓取,但是你必须掌握数据分析的基本能力。于是有一些人专门对这个技能进行学习,大数据分析领域也有一些专门靠抓取数据提供大数据分析的工具,比如阿里巴巴的商品数据分析、腾讯的qq公众号文章数据分析、一直以来很火的微信公众号文章排序排序等。

比如,你会python语言语法,可以用python来爬取各种网站上的图片数据(如美图网)、语言数据库、语言数据库、语言数据库这些爬虫工具。在一个公司里面你能会抓取前端服务器数据的爬虫工具(例如黑马程序员用来抓取网易云音乐、知乎、豆瓣等app的数据)、python字符串的处理、requests网络爬虫、爬虫也可以。 查看全部

网页数据抓取软件(网页数据抓取软件针对360、百度、网易、腾讯)

网页数据抓取软件针对36

0、百度、网易、腾讯等国内主流网站的一些网页抓取任务。适用于网页抓取软件:websocket然后对url进行控制解析数据。例如,你的程序需要抓取xxx网站内的5000个页面,那么你的程序就必须对每个页面存储并解析5000个页面,当然可以用任意类型的内存数据库,例如mongodb、mysql等等,你只需要控制解析最多的页面即可。

(有空可以接下后文整理一下其它网站的抓取案例)。我一直特别喜欢的一句话是:你的成功,是因为遇到了一个好的产品经理。于是,在大数据时代有了一个好的数据抓取软件,这也是我能够收获的价值。欢迎在留言区和我探讨大数据时代,我相信可以从以下几个方面进行探讨:1.看到这篇文章的你,是否已经能够自己做出如下的一个数据抓取产品2.数据抓取,数据分析,是否已经成为人人需要的技能3.数据分析产品,是否在逐渐成为一种刚需我在去年的上海参加pmcaff在北京的大数据分享会,我跟我在其他场地的朋友聊天。

其中一个场景是我问他,什么是大数据分析?他的表情大概是这样的:然后,我进一步讨论了大数据的几个重要特点,进一步思考到大数据分析到底是怎么分析的。大数据是最近很火的一个话题,数据量的增长速度如此之快,大数据有什么用?如何结合大数据来做大数据分析?那么今天就和大家聊聊大数据分析。上海参加大数据分享会后,我总结了一下这3个核心点,这3个核心点也是大数据分析必备的技能,与其它技能又有何异同,现在就结合我这3个核心点来谈一下大数据分析。

一、数据抓取的基本技能大数据抓取核心技能:数据抓取(basedbutterknife)数据抓取不是人人都能掌握的,那为什么很多人都会去学习呢?学习大数据分析是否要先从basedbutterknife学起呢?答案是否定的,

1、大数据抓取,数据分析,是人人必备的技能,于其他技能相比,数据抓取不是必须的。你可以不掌握数据抓取,但是你必须掌握数据分析的基本能力。于是有一些人专门对这个技能进行学习,大数据分析领域也有一些专门靠抓取数据提供大数据分析的工具,比如阿里巴巴的商品数据分析、腾讯的qq公众号文章数据分析、一直以来很火的微信公众号文章排序排序等。

比如,你会python语言语法,可以用python来爬取各种网站上的图片数据(如美图网)、语言数据库、语言数据库、语言数据库这些爬虫工具。在一个公司里面你能会抓取前端服务器数据的爬虫工具(例如黑马程序员用来抓取网易云音乐、知乎、豆瓣等app的数据)、python字符串的处理、requests网络爬虫、爬虫也可以。

网页数据抓取软件(2.网探网页数据监控软件appapp介绍())

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-11-07 16:02

网探网络数据监控软件app是一款网络数据监控软件app,可以监控搜狐、天猫、微博、12306等。网站帮你捕捉网站的重要访问 辽中大学网址( da) 领先于公众所需的信息。yuta资源网真诚推荐!

网页数据监控软件app介绍

1. 增加定时关机等附加功能,对比验证网页浏览器的网页数据监控软件app。

2. Netexplorer网页数据监控软件app现在各行各业都在使用互联网技术,网络上的webexplorer网页数据监控软件app也越来越丰富。一些网页数据监控软件app的价值与时间有关。早点知道很有用,晚了值可能为零。Netexploration 软件可以解决此类问题。让您“始终领先一步”是我们修复错误的目标。

3. 打开通知接口,任务间相互调用。

4. 用户注册后,可以将通过验证的网页数据监控软件app发送到用户邮箱,也可以推送到用户指定的界面重新处理网页数据监控软件app。Web 数据监控软件应用程序捕获。

Netexploration网络数据监控软件app功能

1. 多任务同时运行,“文本匹配”和“文档结构分析”两种方式抓取webexplorer的网页数据监控软件app,可单独使用或组合制作webexplorer网页数据监控软件app捕捉更简单准确。

2. 直接与您的服务器后端连接,后续流程自定义,实时高效接入网络探索网络数据监控软件app自动处理流程,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

3. 爬虫公式在线分享,对任何反爬虫技术手段不敏感。只要能在IE浏览器中正常浏览网页,就可以监控所有网页数据监控软件app。

4. 无人值守长期运行,监控任务A(必须是网址)得到的结果可以转交给监控任务B执行,从而获得更丰富的网页数据监控软件app结果。

网络数据监控软件app的特点

1. 基于IE浏览器,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

2. 程序支持多个监控任务同时运行。用户可以同时监控多个网页中感兴趣的网页数据监控软件app,自动判断最新更新的网页数据监控软件app,同时支持定制网探网页数据监控软件app对比验证公式,筛选出用户最感兴趣的Netexploration网页数据监管软件app的内容。

NetExplore网络数据监控软件app总结

Netexploring网络数据监控软件V1.80是一款适用于安卓版的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友: 查看全部

网页数据抓取软件(2.网探网页数据监控软件appapp介绍())

网探网络数据监控软件app是一款网络数据监控软件app,可以监控搜狐、天猫、微博、12306等。网站帮你捕捉网站的重要访问 辽中大学网址( da) 领先于公众所需的信息。yuta资源网真诚推荐!

网页数据监控软件app介绍

1. 增加定时关机等附加功能,对比验证网页浏览器的网页数据监控软件app。

2. Netexplorer网页数据监控软件app现在各行各业都在使用互联网技术,网络上的webexplorer网页数据监控软件app也越来越丰富。一些网页数据监控软件app的价值与时间有关。早点知道很有用,晚了值可能为零。Netexploration 软件可以解决此类问题。让您“始终领先一步”是我们修复错误的目标。

3. 打开通知接口,任务间相互调用。

4. 用户注册后,可以将通过验证的网页数据监控软件app发送到用户邮箱,也可以推送到用户指定的界面重新处理网页数据监控软件app。Web 数据监控软件应用程序捕获。

Netexploration网络数据监控软件app功能

1. 多任务同时运行,“文本匹配”和“文档结构分析”两种方式抓取webexplorer的网页数据监控软件app,可单独使用或组合制作webexplorer网页数据监控软件app捕捉更简单准确。

2. 直接与您的服务器后端连接,后续流程自定义,实时高效接入网络探索网络数据监控软件app自动处理流程,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

3. 爬虫公式在线分享,对任何反爬虫技术手段不敏感。只要能在IE浏览器中正常浏览网页,就可以监控所有网页数据监控软件app。

4. 无人值守长期运行,监控任务A(必须是网址)得到的结果可以转交给监控任务B执行,从而获得更丰富的网页数据监控软件app结果。

网络数据监控软件app的特点

1. 基于IE浏览器,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

2. 程序支持多个监控任务同时运行。用户可以同时监控多个网页中感兴趣的网页数据监控软件app,自动判断最新更新的网页数据监控软件app,同时支持定制网探网页数据监控软件app对比验证公式,筛选出用户最感兴趣的Netexploration网页数据监管软件app的内容。

NetExplore网络数据监控软件app总结

Netexploring网络数据监控软件V1.80是一款适用于安卓版的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友:

网页数据抓取软件(模拟app登录、远程调用或调用本地网页抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-11-02 20:07

网页数据抓取软件并不是单指一种软件,而是基于网页的服务器端抓取工具的统称。日前市面上还有“手机网页抓取助手”的说法,但经查证,这类软件并非如题主所说,为了单一目的而开发,而是其他模拟app登录、远程调用调用或调用本地网页功能,并非真正的网页抓取。网页数据抓取软件是人工提供网页数据抓取工具的技术名称,一般涉及网页抓取+爬虫+数据交互三个环节,人工指人工操作,爬虫指爬虫抓取,数据交互指数据交互。

一、什么是网页数据抓取软件近年来,网页爬虫、网页抓取、数据抓取等相关词汇大行其道,有些做网页抓取的人,还没真正的工作过,在公司只配备“手机”一种工具。对于一个具有统一软件和网页抓取工具的大型互联网企业,基本上分别发放了几十万的网页抓取软件名单。然而在某些并非真正互联网企业,某些业务复杂度更高的行业,比如营销网络营销,会使用抓取软件提高工作效率,另外还有一些业务比较低调,不需要抓取,只需要数据交互的行业,这些行业软件仅仅在采购费用等方面体现。(ps:抓取软件的数量,只和目标客户规模有关,和抓取的软件好坏无关。)。

二、抓取软件是否有必要现在的抓取软件已经不再是一个软件,其在数据抓取和数据分析工作中扮演的角色已经是一个辅助的角色,它本身不具备网页数据抓取工具的功能。某些人做数据分析的时候,只有一个数据分析平台,然后不停使用抓取软件抓取,显然使用这种抓取软件的辅助功能更多,而且使用软件的人也会跟不上软件和智能手机的使用步骤。那么,抓取软件是否有必要,现在要不要使用抓取软件呢?有必要。

三、抓取软件在企业互联网+升级中的角色

1、抓取软件能解决企业内部不能实现的功能抓取软件让抓取变得更简单,这是抓取软件的本质使命,是抓取软件能够有效为企业互联网+升级做贡献的原因。就像钉钉中的“钉一下”来源于腾讯互动安全团队,应用到滴滴中就是腾讯投资的小程序,数据抓取软件就是抓取新闻内容,获取到手机通讯录等数据之后,通过搜索关键词等方式,进行抓取并分析。

2、抓取软件能实现部分网页抓取数据抓取软件的运用的范围,完全不局限于企业互联网+升级,还可以运用到传统网站、数据库数据抓取和爬虫技术,如wordpress、java等。而且对于资源来源的选择范围也是非常广的,除了抓取某些特定网站数据,还能抓取百度、360搜索、谷歌等搜索引擎等。

3、抓取软件能统一抓取数据抓取软件方便统一抓取数据,可以大大提高抓取效率,为企业互联网+升级提供数据基础和抓取工具。企业互联网+升级要求, 查看全部

网页数据抓取软件(模拟app登录、远程调用或调用本地网页抓取工具)

网页数据抓取软件并不是单指一种软件,而是基于网页的服务器端抓取工具的统称。日前市面上还有“手机网页抓取助手”的说法,但经查证,这类软件并非如题主所说,为了单一目的而开发,而是其他模拟app登录、远程调用调用或调用本地网页功能,并非真正的网页抓取。网页数据抓取软件是人工提供网页数据抓取工具的技术名称,一般涉及网页抓取+爬虫+数据交互三个环节,人工指人工操作,爬虫指爬虫抓取,数据交互指数据交互。

一、什么是网页数据抓取软件近年来,网页爬虫、网页抓取、数据抓取等相关词汇大行其道,有些做网页抓取的人,还没真正的工作过,在公司只配备“手机”一种工具。对于一个具有统一软件和网页抓取工具的大型互联网企业,基本上分别发放了几十万的网页抓取软件名单。然而在某些并非真正互联网企业,某些业务复杂度更高的行业,比如营销网络营销,会使用抓取软件提高工作效率,另外还有一些业务比较低调,不需要抓取,只需要数据交互的行业,这些行业软件仅仅在采购费用等方面体现。(ps:抓取软件的数量,只和目标客户规模有关,和抓取的软件好坏无关。)。

二、抓取软件是否有必要现在的抓取软件已经不再是一个软件,其在数据抓取和数据分析工作中扮演的角色已经是一个辅助的角色,它本身不具备网页数据抓取工具的功能。某些人做数据分析的时候,只有一个数据分析平台,然后不停使用抓取软件抓取,显然使用这种抓取软件的辅助功能更多,而且使用软件的人也会跟不上软件和智能手机的使用步骤。那么,抓取软件是否有必要,现在要不要使用抓取软件呢?有必要。

三、抓取软件在企业互联网+升级中的角色

1、抓取软件能解决企业内部不能实现的功能抓取软件让抓取变得更简单,这是抓取软件的本质使命,是抓取软件能够有效为企业互联网+升级做贡献的原因。就像钉钉中的“钉一下”来源于腾讯互动安全团队,应用到滴滴中就是腾讯投资的小程序,数据抓取软件就是抓取新闻内容,获取到手机通讯录等数据之后,通过搜索关键词等方式,进行抓取并分析。

2、抓取软件能实现部分网页抓取数据抓取软件的运用的范围,完全不局限于企业互联网+升级,还可以运用到传统网站、数据库数据抓取和爬虫技术,如wordpress、java等。而且对于资源来源的选择范围也是非常广的,除了抓取某些特定网站数据,还能抓取百度、360搜索、谷歌等搜索引擎等。

3、抓取软件能统一抓取数据抓取软件方便统一抓取数据,可以大大提高抓取效率,为企业互联网+升级提供数据基础和抓取工具。企业互联网+升级要求,

网页数据抓取软件(智教智道诚意推荐!网探网页数据监控软件官方最新版(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-11-01 22:20

网探官网数据监控软件最新版是最新版官网数据监控软件,可以监控搜狐、天猫、微博、12306等。网站帮您抓拍网站@ > 重要访问网址,抢占辽中大学(大)需要的信息。智交智道真诚推荐!

网页数据监控软件官方版最新版介绍

1. 与您的服务器后端直接对接,后续流程自定义,实时高效获取最新版官网数据监控软件自动处理流程,最新版官网数据监控软件对比验证。

2. 无人值守长期运行,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

3. 程序支持多个监控任务同时运行。用户可以在多个网页中同时监控最新版本的官方网页数据监控软件,多个任务同时运行。

4. 抓取网页浏览器官方网页数据监控软件最新版本。用户注册后,可将最新版本的验证网页数据监控软件发送至用户邮箱或推送至用户指定界面。为了重新处理最新版本的NetExplore官网数据监控软件。

最新版网页数据监控软件官方版

1. 自动确定最新更新的网页数据监控软件的最新正式版本,并支持自定义最新版本的网页数据监控软件进行公式比对和验证,比较用户最常用的网页数据监控软件有兴趣。过滤掉最新版的官方内容,及时通知用户。

2. 基于IE浏览器的最新版IE浏览器官网数据监控软件现已在各行各业中使用互联网技术,最新版的互联网官网数据监控软件越来越丰富。一些在线数据监控软件最新正式版的价值与时间有关。早点知道会很有用,以后值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

3. 任务相互调用,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

4. 爬取公式在线分享,“文本匹配”和“文档结构分析”是Netexplorer官网数据监控软件最新版本的两种抓取方式,可以单独使用,也可以组合使用Netexplorer 的网页数据监控软件官方最新版,抓取更轻松,更准确。

网页数据监控软件官方版最新版特点

1. 打开通知接口,可以将监控任务A(必须是网站)得到的结果传送到监控任务B执行,从而获得最新版官网数据监控软件更丰富的结果。

2. 对任何反爬虫技术手段没感觉,只要能在IE浏览器中正常浏览网页,最新版官方网页数据监控软件都可以监控,新的程序设置对话框添加框。

官网数据监控软件最新版汇总

NetExplore网络数据监控软件V3.20是一款适用于ios版本的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友: 查看全部

网页数据抓取软件(智教智道诚意推荐!网探网页数据监控软件官方最新版(组图))

网探官网数据监控软件最新版是最新版官网数据监控软件,可以监控搜狐、天猫、微博、12306等。网站帮您抓拍网站@ > 重要访问网址,抢占辽中大学(大)需要的信息。智交智道真诚推荐!

网页数据监控软件官方版最新版介绍

1. 与您的服务器后端直接对接,后续流程自定义,实时高效获取最新版官网数据监控软件自动处理流程,最新版官网数据监控软件对比验证。

2. 无人值守长期运行,“人人为我,我为人” 分享任意网页的爬取公式,免去编辑公式的烦恼。.

3. 程序支持多个监控任务同时运行。用户可以在多个网页中同时监控最新版本的官方网页数据监控软件,多个任务同时运行。

4. 抓取网页浏览器官方网页数据监控软件最新版本。用户注册后,可将最新版本的验证网页数据监控软件发送至用户邮箱或推送至用户指定界面。为了重新处理最新版本的NetExplore官网数据监控软件。

最新版网页数据监控软件官方版

1. 自动确定最新更新的网页数据监控软件的最新正式版本,并支持自定义最新版本的网页数据监控软件进行公式比对和验证,比较用户最常用的网页数据监控软件有兴趣。过滤掉最新版的官方内容,及时通知用户。

2. 基于IE浏览器的最新版IE浏览器官网数据监控软件现已在各行各业中使用互联网技术,最新版的互联网官网数据监控软件越来越丰富。一些在线数据监控软件最新正式版的价值与时间有关。早点知道会很有用,以后值可能为零。Netexploration软件就是来解决这类问题的,让您“永远领先一步”是我们的目标。

3. 任务相互调用,资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守运行。

4. 爬取公式在线分享,“文本匹配”和“文档结构分析”是Netexplorer官网数据监控软件最新版本的两种抓取方式,可以单独使用,也可以组合使用Netexplorer 的网页数据监控软件官方最新版,抓取更轻松,更准确。

网页数据监控软件官方版最新版特点

1. 打开通知接口,可以将监控任务A(必须是网站)得到的结果传送到监控任务B执行,从而获得最新版官网数据监控软件更丰富的结果。

2. 对任何反爬虫技术手段没感觉,只要能在IE浏览器中正常浏览网页,最新版官方网页数据监控软件都可以监控,新的程序设置对话框添加框。

官网数据监控软件最新版汇总

NetExplore网络数据监控软件V3.20是一款适用于ios版本的办公软件手机软件。如果你喜欢这个软件,请把下载地址分享给你的朋友:

网页数据抓取软件(WebHarvy软件特点1.提取分类网站刮板下载体验)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-10-31 14:09

WebHarvy 是一个可视化的网络爬虫。可以进行关键词提取,可以扩展到下一个网页。可以指定搜索数据和内容的范围。WebHarvy 智能识别模式可以自动识别出现在网页中的数据模式。您可以使用单个代理服务器地址或代理服务器地址列表。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。欢迎来到快盘软件园下载体验。

WebHarvy 软件功能

1.提取类别,WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

2.可以显示和分析来自 HTML 地址的连接数据

3.通过{over}{filtering}代表服务器提取,提取匿名和阻止网络软件阻止提取的Web服务器,必须通过代表{over}{filter}服务器才能访问目标网站 选项。您可以使用单个代理服务器地址或代理服务器地址列表。

4.支持浏览器复制链接搜索

WebHarvy 软件功能

1. 提取自多个页面,通常是网页展示数据,比如产品目录在多个页面中。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

2.您可以下载并保存扫描的图像

3.支持配置搜索对应的资源项

4.提供更高级的多词搜索和多页搜索

WebHarvy 软件功能

1.智能识别模式,自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

2.可以使用项目名称和资源名称查找

3. 可以扩展到下一个网页

4.使用正则表达式提取,WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

5.基于关键字的提取,基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

6. 可视化点击界面,WebHarvy是一款可视化网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

7.可以指定搜索数据的范围和内容

8.导出捕获的数据,可以将网页中提取的数据保存为各种格式。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

9.SysNucleus WebHarvy 允许您分析网络上的数据

WebHarvy 更新日志

您可以在列表 2 搜索中输入关键字

可以自动搜索可以配置在HTML上的资源

可以为页面模式配置专用的连接方式

增加了URL配置功能 查看全部

网页数据抓取软件(WebHarvy软件特点1.提取分类网站刮板下载体验)

WebHarvy 是一个可视化的网络爬虫。可以进行关键词提取,可以扩展到下一个网页。可以指定搜索数据和内容的范围。WebHarvy 智能识别模式可以自动识别出现在网页中的数据模式。您可以使用单个代理服务器地址或代理服务器地址列表。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。欢迎来到快盘软件园下载体验。

WebHarvy 软件功能

1.提取类别,WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

2.可以显示和分析来自 HTML 地址的连接数据

3.通过{over}{filtering}代表服务器提取,提取匿名和阻止网络软件阻止提取的Web服务器,必须通过代表{over}{filter}服务器才能访问目标网站 选项。您可以使用单个代理服务器地址或代理服务器地址列表。

4.支持浏览器复制链接搜索

WebHarvy 软件功能

1. 提取自多个页面,通常是网页展示数据,比如产品目录在多个页面中。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

2.您可以下载并保存扫描的图像

3.支持配置搜索对应的资源项

4.提供更高级的多词搜索和多页搜索

WebHarvy 软件功能

1.智能识别模式,自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

2.可以使用项目名称和资源名称查找

3. 可以扩展到下一个网页

4.使用正则表达式提取,WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

5.基于关键字的提取,基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

6. 可视化点击界面,WebHarvy是一款可视化网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

7.可以指定搜索数据的范围和内容

8.导出捕获的数据,可以将网页中提取的数据保存为各种格式。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

9.SysNucleus WebHarvy 允许您分析网络上的数据

WebHarvy 更新日志

您可以在列表 2 搜索中输入关键字

可以自动搜索可以配置在HTML上的资源

可以为页面模式配置专用的连接方式

增加了URL配置功能

网页数据抓取软件(乐思网络信息采集和数据抓取市场最具影响力软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-10-29 23:20

近年来,随着国内大数据战略的日趋清晰,数据采集与信息化采集系列产品迎来了巨大的发展机遇,采集产品的数量也出现了快速增长。然而,与产品品类的快速增长相反,信息采集技术相对薄弱,市场竞争激烈,质量参差不齐。在此,本文列出当前信息采集和数据采集市场最具影响力的软件,供采购大数据和智能中心建设单位时参考:

TOP.1 乐思网络信息采集系统()

乐思网络信息采集系统的主要目标是解决网络信息采集和网络数据采集的问题。它基于用户自定义的任务配置,批量准确地从互联网目标网页中提取半结构化和非结构化数据,并转化为结构化记录,存储在本地数据库中,供内部使用或外网发布。快速获取外部信息。

系统主要用于:大数据基础设施建设、舆情监测、品牌监测、价格监测、门户网站新闻采集、行业资讯采集、竞争情报获取、业务数据整合、市场研究、数据库营销等领域。

TOP.2 优采云采集器()

优采云采集器是一款专业的网络数据采集/信息挖掘处理软件。通过灵活的配置,您可以轻松快速地从网页中抓取结构化文本、图片和图片。可以对文件等资源信息进行编辑过滤后发布到网站后台、各种文件或其他数据库系统。广泛应用于数据挖掘、垂直搜索、信息聚合与门户、企业网络信息聚合、商业智能、论坛或博客迁移、智能信息代理、个人信息检索等领域。采集探索有需要的群体。

TOP.3 优采云采集器软件()

优采云采集器软件利用熊猫精准搜索引擎的分析核心实现网页内容类似浏览器的分析,并在此基础上利用原创的技术实现框架网页内容和核心内容 相似页面的分离、提取、有效比较和匹配。因此,用户只需要指定一个参考页面,优采云采集器软件系统就可以在此基础上匹配相似的页面,从而实现批量所需的采集素材。用户采集。

TOP.4 优采云采集器()

优采云采集器是一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取,通过相关配置,您可以轻松使用采集80%的网站内容供自己使用。根据各种建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器三种类型@>,共支持近40种类型数百个版本的数据采集和主流建站程序的发布任务,支持图片本地化,支持网站登录采集,页面抓取,全面模拟人工登录发布,软件运行快捷安全稳定!

TOP.5 网络外观()

网络神彩是一个专业的网络信息采集系统。通过灵活的规则,您可以获取任何类型的网站采集信息,例如新闻网站、论坛、博客、电子商务网站、招聘网站等等。支持网站登录采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集和其他高级采集功能。支持存储过程、插件等,可二次开发扩展功能。

TOP.6 蓝蜘蛛互联网采集系统()

蓝蜘蛛网采集系统不需要配置网站的入口URL。系统会根据用户输入的关键词自动通过主流搜索门户在整个互联网上进行元搜索,然后搜索结果页面就会采集下来。在采集的过程中,会根据预设的模板自动解析或过滤您感兴趣的内容、标题或信息项。 查看全部

网页数据抓取软件(乐思网络信息采集和数据抓取市场最具影响力软件)

近年来,随着国内大数据战略的日趋清晰,数据采集与信息化采集系列产品迎来了巨大的发展机遇,采集产品的数量也出现了快速增长。然而,与产品品类的快速增长相反,信息采集技术相对薄弱,市场竞争激烈,质量参差不齐。在此,本文列出当前信息采集和数据采集市场最具影响力的软件,供采购大数据和智能中心建设单位时参考:

TOP.1 乐思网络信息采集系统()

乐思网络信息采集系统的主要目标是解决网络信息采集和网络数据采集的问题。它基于用户自定义的任务配置,批量准确地从互联网目标网页中提取半结构化和非结构化数据,并转化为结构化记录,存储在本地数据库中,供内部使用或外网发布。快速获取外部信息。

系统主要用于:大数据基础设施建设、舆情监测、品牌监测、价格监测、门户网站新闻采集、行业资讯采集、竞争情报获取、业务数据整合、市场研究、数据库营销等领域。

TOP.2 优采云采集器()