算法 自动采集列表

算法 自动采集列表( 10万个网站的采集范围是怎么样的?(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-01-19 03:14

10万个网站的采集范围是怎么样的?(组图))

昨天有网友表示,他最近采访了几家公司,被问了好几次问题,但每次的答案都不是很好。

采访者:比如有10万个网站需要采集,你是怎么快速拿到数据的?

要回答好这个问题,其实需要有足够的知识和足够的技术储备。

最近,我们也在招人。我们每周采访十几个人。只有一两个人觉得合适。大部分都和这位网友差不多。他们缺乏全局性的思考,即使是那些有三四年工作经验的老司机。. 他们有很强的解决具体问题的能力,但很少能点到点,站在新的高度,全面思考问题。

采集的10万网站s的覆盖范围已经比大多数专业舆情监测公司的数据采集还要广。为了满足面试官提出的采集要求,我们需要综合考虑从网站的采集到数据存储的方方面面,给出合适的解决方案,以节省成本,提高工作效率。的目标。

下面我们就从网站的集合到数据存储的各个方面做一个简单的介绍。

一、100,000网站 是从哪里来的?

一般来说,采集的网站是随着公司业务的发展而逐渐积累起来的。

现在让我们假设这是一家初创公司的需求。公司刚成立,那么多网站,基本可以说是冷启动。那么我们如何采集这 100,000 个 网站 呢?有几种方法:

1)历史业务的积累

不管是冷启动还是什么,既然有采集的需求,那肯定有项目或产品有这种需求。相关人员前期一定研究过一些数据源,采集了一些比较重要的网站。这些可以用作我们采集的 网站 和 采集 的原创种子。

2)协会网站

在一些网站的底部,一般都有相关的网站链接。尤其是政府类网站,一般都有下级相关部门的官网。

3)网站导航

有的网站可能会为了某些目的(比如吸引流量等)采集一些网站,分类展示,方便人们找到。这些网站可以快速为我们提供第一批种子网站。然后,我们会通过网站关联等其他方式获得更多的网站。

4)搜索引擎

也可以准备一些与公司业务相关的关键词,去百度、搜狗等搜索引擎,对搜索结果进行处理,提取出对应的网站作为我们的种子网站。

5)第三方平台

例如,一些第三方 SaaS 平台会有 7 到 15 天的免费试用期。因此,我们可以利用这段时间来采集我们业务相关的数据,然后提取其中的网站作为我们初始的采集种子。

虽然,这种方法是采集 网站 最有效和最快的方法。不过在试用期间,获得10万个网站的可能性极小,所以还是需要结合上述关联网站等方法快速获得所需的网站@ >。

通过以上五种方法,相信我们可以快速采集到我们需要的100,000个网站。但是有这么多网站,我们该如何管理呢?如何知道是否正常?

二、100,000网站如何管理?

当我们采集到100,000个网站s,我们首先要面对的是如何管理,如何配置采集规则,如何监控网站是否正常。

1)如何管理

100,000网站,如果没有专门的系统来管理,那将是一场灾难。

同时由于业务需求,比如智能推荐等,我们需要对网站进行一些预处理(比如打标签)。此时,将需要一个 网站 管理系统。

2)如何配置采集规则

前期我们采集的10万个网站只是首页。如果我们只把首页作为采集的任务,那么我们只能采集获取到很少的首页信息,泄露率非常高。

如果要基于首页URL进行全站采集,会消耗大量服务器资源,成本太高。所以,我们需要配置我们关心的列并 采集 他们。

但是,100,000 网站,如何快速高效地配置列呢?目前,我们通过自动解析HTML源代码来进行列的半自动配置。

当然,我们也尝试过机器学习的方法,但结果并不理想。

由于采集的网站的数量需要达到10万,所以对于采集绝对不要使用xpath之类的精确定位方法。否则,当你配置100,000 网站时,黄花菜会冷。

同时,数据采集必须使用通用爬虫,使用正则表达式匹配列表数据。在采集文本中,使用算法解析时间、文本等属性;

3)如何监控

由于有 100,000 个 网站s,这些 网站s 每天都会有 网站 修订,或列修订,或新/删除列等。因此,有必要根据采集的数据简要分析网站的情况。

例如,如果一个 网站 几天没有新数据,那么一定有问题。网站 的修订导致信息经常失效,或者 网站 本身存在问题。

为了提高采集的效率,可以使用单独的服务定期检查网站和列的条件。首先是检查网站和列是否可以正常访问;二是检查配置的列信息的正则表达式是否正常。以便运营商对其进行维护。

三、任务缓存

100,000 网站,配置栏目后,采集的入口URL应该达到百万级别。采集器如何高效获取采集的这些入口URL?

如果将这些URL放入数据库,无论是MySQL还是Oracle,采集器获取采集任务的操作都会浪费大量时间,大大降低采集的效率。

如何解决这个问题呢?内存数据库是首选,如Redis、Mongo DB等。一般采集使用Redis进行缓存。因此,在配置列时,可以将列信息作为采集任务缓存队列同步到Redis。

四、网站采集怎么样?

就好像你想达到一百万的年薪,大概率是去华为、阿里、腾讯等一线厂商,需要达到一定的水平。这条路注定是艰难的。

同样,如果你需要采集百万级别的列表URL,常规的方法肯定是不可能的。

必须使用分布式+多进程+多线程。同时,还需要结合内存数据库Redis和其他缓存来实现高效的任务获取,以及采集信息的重新排序;

同时,对信息的分析,如发布时间、文字等,也必须经过算法处理。比如现在比较流行的GNE,

在列表采集中可以获取一些属性,所以尽量不要和文本放在一起进行解析。例如:标题。正常情况下,从列表中得到的标题的准确度要远大于从信息html源码中算法得到的准确度。

同时,如果有一些特殊的网站,或者一些特殊的需求,我们可以使用自定义开发来处理。

五、统一数据存储接口

为了保持采集的及时性,100,000个采集的网站可能需要十几二十台服务器。同时,每台服务器上部署N个采集器,加上一些自定义开发的脚本,采集器总数将达到数百个。

如果每个采集器/custom脚本都开发了自己的数据存储接口,会浪费大量的开发调试时间。而后续的运维也将是一件不坏的事情。尤其是当业务发生变化需要调整时。因此,仍然需要统一的数据存储接口。

由于统一的数据存储接口,当我们需要对数据做一些特殊的处理,比如:清理、修正等,不需要修改每个采集存储部分,只需修改接口和重新部署它。

快,简单,快。

六、数据和采集监控

10万网站s的采集的覆盖率绝对是每天200万以上。因为无论数据解析算法多么准确,也不能总是达到 100%(90% 就很好了)。因此,数据解析中必然存在异常。例如:发布时间大于当前时间,文字收录相关新闻信息等。

但是,由于我们已经统一了数据存储接口,此时我们可以在接口处进行统一的数据质量检查。为了优化采集器,根据异常情况自定义脚本。

同时,还可以统计每个网站或列的数据采集。为了能够及时判断采集的当前网站/列信息源是否正常,从而保证始终有100000个有效采集网站 .

七、数据存储

由于每天都有大量的数据采集,普通的数据库(如mysql、Oracle等)已经无法胜任。甚至像 Mongo DB 这样的 NoSql 数据库也不再适用。这时,ES、Solr等分布式索引是目前最好的选择。

至于是否使用Hadoop、HBase等大数据平台,还要看具体情况。在预算不多的情况下,可以先搭建分布式索引集群,再考虑大数据平台。

为了保证查询的响应速度,尽量不要将body信息保存在分布式索引中。可以保存标题、发布时间、URL等信息,从而减少显示列表数据时的二次查询。

在没有大数据平台的情况下,可以将文本保存到具有固定数据标准的txt等文件系统中。在大数据平台上跟进之后,就可以转入HBASE了。

八、自动化运维

由于大量的服务器、采集器、自定义脚本,单纯依靠手动部署、启动、更新、运行监控等变得非常繁琐,容易出现人为错误。

因此,必须有一个可以部署、启动、关闭、运行采集器/脚本的自动化运维系统,以便在发生变化时能够快速响应。

“比如有10万个网站需要采集,怎么快速获取数据?” 如果你能回答这些,应该没有悬念拿到好offer。

最后希望各位找工作的朋友都能拿到满意的offer,找到一个好的平台。

#采访#数据采集 查看全部

算法 自动采集列表(

10万个网站的采集范围是怎么样的?(组图))

昨天有网友表示,他最近采访了几家公司,被问了好几次问题,但每次的答案都不是很好。

采访者:比如有10万个网站需要采集,你是怎么快速拿到数据的?

要回答好这个问题,其实需要有足够的知识和足够的技术储备。

最近,我们也在招人。我们每周采访十几个人。只有一两个人觉得合适。大部分都和这位网友差不多。他们缺乏全局性的思考,即使是那些有三四年工作经验的老司机。. 他们有很强的解决具体问题的能力,但很少能点到点,站在新的高度,全面思考问题。

采集的10万网站s的覆盖范围已经比大多数专业舆情监测公司的数据采集还要广。为了满足面试官提出的采集要求,我们需要综合考虑从网站的采集到数据存储的方方面面,给出合适的解决方案,以节省成本,提高工作效率。的目标。

下面我们就从网站的集合到数据存储的各个方面做一个简单的介绍。

一、100,000网站 是从哪里来的?

一般来说,采集的网站是随着公司业务的发展而逐渐积累起来的。

现在让我们假设这是一家初创公司的需求。公司刚成立,那么多网站,基本可以说是冷启动。那么我们如何采集这 100,000 个 网站 呢?有几种方法:

1)历史业务的积累

不管是冷启动还是什么,既然有采集的需求,那肯定有项目或产品有这种需求。相关人员前期一定研究过一些数据源,采集了一些比较重要的网站。这些可以用作我们采集的 网站 和 采集 的原创种子。

2)协会网站

在一些网站的底部,一般都有相关的网站链接。尤其是政府类网站,一般都有下级相关部门的官网。

3)网站导航

有的网站可能会为了某些目的(比如吸引流量等)采集一些网站,分类展示,方便人们找到。这些网站可以快速为我们提供第一批种子网站。然后,我们会通过网站关联等其他方式获得更多的网站。

4)搜索引擎

也可以准备一些与公司业务相关的关键词,去百度、搜狗等搜索引擎,对搜索结果进行处理,提取出对应的网站作为我们的种子网站。

5)第三方平台

例如,一些第三方 SaaS 平台会有 7 到 15 天的免费试用期。因此,我们可以利用这段时间来采集我们业务相关的数据,然后提取其中的网站作为我们初始的采集种子。

虽然,这种方法是采集 网站 最有效和最快的方法。不过在试用期间,获得10万个网站的可能性极小,所以还是需要结合上述关联网站等方法快速获得所需的网站@ >。

通过以上五种方法,相信我们可以快速采集到我们需要的100,000个网站。但是有这么多网站,我们该如何管理呢?如何知道是否正常?

二、100,000网站如何管理?

当我们采集到100,000个网站s,我们首先要面对的是如何管理,如何配置采集规则,如何监控网站是否正常。

1)如何管理

100,000网站,如果没有专门的系统来管理,那将是一场灾难。

同时由于业务需求,比如智能推荐等,我们需要对网站进行一些预处理(比如打标签)。此时,将需要一个 网站 管理系统。

2)如何配置采集规则

前期我们采集的10万个网站只是首页。如果我们只把首页作为采集的任务,那么我们只能采集获取到很少的首页信息,泄露率非常高。

如果要基于首页URL进行全站采集,会消耗大量服务器资源,成本太高。所以,我们需要配置我们关心的列并 采集 他们。

但是,100,000 网站,如何快速高效地配置列呢?目前,我们通过自动解析HTML源代码来进行列的半自动配置。

当然,我们也尝试过机器学习的方法,但结果并不理想。

由于采集的网站的数量需要达到10万,所以对于采集绝对不要使用xpath之类的精确定位方法。否则,当你配置100,000 网站时,黄花菜会冷。

同时,数据采集必须使用通用爬虫,使用正则表达式匹配列表数据。在采集文本中,使用算法解析时间、文本等属性;

3)如何监控

由于有 100,000 个 网站s,这些 网站s 每天都会有 网站 修订,或列修订,或新/删除列等。因此,有必要根据采集的数据简要分析网站的情况。

例如,如果一个 网站 几天没有新数据,那么一定有问题。网站 的修订导致信息经常失效,或者 网站 本身存在问题。

为了提高采集的效率,可以使用单独的服务定期检查网站和列的条件。首先是检查网站和列是否可以正常访问;二是检查配置的列信息的正则表达式是否正常。以便运营商对其进行维护。

三、任务缓存

100,000 网站,配置栏目后,采集的入口URL应该达到百万级别。采集器如何高效获取采集的这些入口URL?

如果将这些URL放入数据库,无论是MySQL还是Oracle,采集器获取采集任务的操作都会浪费大量时间,大大降低采集的效率。

如何解决这个问题呢?内存数据库是首选,如Redis、Mongo DB等。一般采集使用Redis进行缓存。因此,在配置列时,可以将列信息作为采集任务缓存队列同步到Redis。

四、网站采集怎么样?

就好像你想达到一百万的年薪,大概率是去华为、阿里、腾讯等一线厂商,需要达到一定的水平。这条路注定是艰难的。

同样,如果你需要采集百万级别的列表URL,常规的方法肯定是不可能的。

必须使用分布式+多进程+多线程。同时,还需要结合内存数据库Redis和其他缓存来实现高效的任务获取,以及采集信息的重新排序;

同时,对信息的分析,如发布时间、文字等,也必须经过算法处理。比如现在比较流行的GNE,

在列表采集中可以获取一些属性,所以尽量不要和文本放在一起进行解析。例如:标题。正常情况下,从列表中得到的标题的准确度要远大于从信息html源码中算法得到的准确度。

同时,如果有一些特殊的网站,或者一些特殊的需求,我们可以使用自定义开发来处理。

五、统一数据存储接口

为了保持采集的及时性,100,000个采集的网站可能需要十几二十台服务器。同时,每台服务器上部署N个采集器,加上一些自定义开发的脚本,采集器总数将达到数百个。

如果每个采集器/custom脚本都开发了自己的数据存储接口,会浪费大量的开发调试时间。而后续的运维也将是一件不坏的事情。尤其是当业务发生变化需要调整时。因此,仍然需要统一的数据存储接口。

由于统一的数据存储接口,当我们需要对数据做一些特殊的处理,比如:清理、修正等,不需要修改每个采集存储部分,只需修改接口和重新部署它。

快,简单,快。

六、数据和采集监控

10万网站s的采集的覆盖率绝对是每天200万以上。因为无论数据解析算法多么准确,也不能总是达到 100%(90% 就很好了)。因此,数据解析中必然存在异常。例如:发布时间大于当前时间,文字收录相关新闻信息等。

但是,由于我们已经统一了数据存储接口,此时我们可以在接口处进行统一的数据质量检查。为了优化采集器,根据异常情况自定义脚本。

同时,还可以统计每个网站或列的数据采集。为了能够及时判断采集的当前网站/列信息源是否正常,从而保证始终有100000个有效采集网站 .

七、数据存储

由于每天都有大量的数据采集,普通的数据库(如mysql、Oracle等)已经无法胜任。甚至像 Mongo DB 这样的 NoSql 数据库也不再适用。这时,ES、Solr等分布式索引是目前最好的选择。

至于是否使用Hadoop、HBase等大数据平台,还要看具体情况。在预算不多的情况下,可以先搭建分布式索引集群,再考虑大数据平台。

为了保证查询的响应速度,尽量不要将body信息保存在分布式索引中。可以保存标题、发布时间、URL等信息,从而减少显示列表数据时的二次查询。

在没有大数据平台的情况下,可以将文本保存到具有固定数据标准的txt等文件系统中。在大数据平台上跟进之后,就可以转入HBASE了。

八、自动化运维

由于大量的服务器、采集器、自定义脚本,单纯依靠手动部署、启动、更新、运行监控等变得非常繁琐,容易出现人为错误。

因此,必须有一个可以部署、启动、关闭、运行采集器/脚本的自动化运维系统,以便在发生变化时能够快速响应。

“比如有10万个网站需要采集,怎么快速获取数据?” 如果你能回答这些,应该没有悬念拿到好offer。

最后希望各位找工作的朋友都能拿到满意的offer,找到一个好的平台。

#采访#数据采集

算法 自动采集列表(算法自动采集列表页数据到服务器上说你多上传几个uv)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-01-18 07:03

算法自动采集列表页数据到服务器上对服务器来说你多上传几个uv,服务器就承受不了如果你要完整的采集列表页数据,

会,详见谷歌adwords。

“不管后来的事情如何发展,

您好~~如果新站的uv比老站少的话,就建议采用定向采集,这样做的目的是更有针对性,新站采用一般定向采集功能,可以持续增加客户端uv,具体的您可以参考下aol+adobe客户端大多数uv采集。希望对您有所帮助,

主要看市场情况,市场状况不一样,就会采取不一样的数据采集方式,你可以看看,主要看你的产品是面向哪类用户的,

同意楼上的看法,还有分析访客行为也很重要。

现在客户端要安全比较难,但是也有相对好的方法,比如把客户端数据放到服务器上再打包到合适的数据里,增加了定向广告的roi。

这个好理解,同时开通,

理论上可以收集,前提是要分析,通过ga等第三方工具定位客户浏览某些站点对该站点内产品、品牌、甚至隐私相关的信息。通过定向广告可以实现人群定向获取潜在客户。

要看哪些站点需要uv, 查看全部

算法 自动采集列表(算法自动采集列表页数据到服务器上说你多上传几个uv)

算法自动采集列表页数据到服务器上对服务器来说你多上传几个uv,服务器就承受不了如果你要完整的采集列表页数据,

会,详见谷歌adwords。

“不管后来的事情如何发展,

您好~~如果新站的uv比老站少的话,就建议采用定向采集,这样做的目的是更有针对性,新站采用一般定向采集功能,可以持续增加客户端uv,具体的您可以参考下aol+adobe客户端大多数uv采集。希望对您有所帮助,

主要看市场情况,市场状况不一样,就会采取不一样的数据采集方式,你可以看看,主要看你的产品是面向哪类用户的,

同意楼上的看法,还有分析访客行为也很重要。

现在客户端要安全比较难,但是也有相对好的方法,比如把客户端数据放到服务器上再打包到合适的数据里,增加了定向广告的roi。

这个好理解,同时开通,

理论上可以收集,前提是要分析,通过ga等第三方工具定位客户浏览某些站点对该站点内产品、品牌、甚至隐私相关的信息。通过定向广告可以实现人群定向获取潜在客户。

要看哪些站点需要uv,

算法 自动采集列表(《参考消息》官方网站:内容分发平台的“个性化推荐”)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-01-18 00:08

随着互联网流量红利的消失,“卖家”在交易中的主导地位逐渐被取代。各大互联网产品都放弃了过去的地毯式广告,将重点放在用户运营上。通过采集和全数据分析,基于用户画像和用户行为数据,提供针对性的精细化运营。服务。

作为精细化运营的场景之一,“个性化推荐”已成为用户与产品之间的情感纽带:如音乐平台的“心动模式”、购物平台的“猜你喜欢”、“信息流推荐” “内容平台”,这些看似普通的小功能,却能唤起用户对产品的认同感,从而增强用户对产品的依赖。

《参考新闻》作为基于图文信息流的内容分发平台,致力于连接人和信息,精选全球每日新闻和评论,全面报道国际国内新闻,拓宽读者的国际视野。《参考新闻》官方网站于2012年上线,对内容的精准高效把控是获得用户喜爱的关键。同时,这也与其背后多次尝试AB测试分不开。

案例一:调整推荐算法,增加阅读点击量

《参考新闻》APP团队在“相关阅读”板块引入了第三方推荐算法。为了对比之前的人工编辑推荐和现有的第三方推荐算法的效果,产品部使用了AppAdhoc A/B Testing平台对这两类推荐进行了推荐。进行测试的方法:

原版采用手动编辑推荐的形式,即由编辑决定是否将文章放入“相关阅读”栏目;而实验版是由第三方推荐算法自动生成的文章列表,并且为了测试结果的科学性,本次测试针对的是百度频道,即只有百度的流量渠道可以参与本次测试。

根据实验设置,分配了两个版本(包括原创版本):

由于是推荐算法测试,所以测试采用编程方式,以“相关阅读”的文章总点击次数作为优化指标。测试运行25天,得到测试数据:

实验版第三方推荐算法的“相关阅读”效果更佳,文章点击转化次数较原版提升约8%。因此,在百度频道的投放过程中,第三方推荐算法比人工更有效地提升了编辑转换效果,产品部最终选择了全推测试版。

实验还没有结束。产品部在广电通上测试了两种推荐的方法:

同理,原版是人工推荐方式,实验版是第三方推荐算法方式,只不过选择了广电通定向,结果和百度频道完全相反:推荐的“相关阅读”广电通频道手动编辑器转换。它更高,比实验版本高约 15%。因此,产品部放弃了广电通渠道中的第三方推荐算法,选择了人工编辑的推荐列表。

测试结果表明,即使设置相同,在不同的通道中效果也可能完全相反。如果没有办法通过 A/B 测试,很难想出这样的结果。精细化运营的本质是以用户为中心的运营。只有在正确的渠道中使用正确的方法,不同的用户才能感知到正确的价值,并通过科学实验进行迭代优化。这是精细化操作的必要条件。路。

案例2:调整模块位置以帮助提高转化率

关于现有页面的展示形式,《参考新闻》产品部提出了一个假设:如果先展示推荐算法生成的新闻栏目,是否能带来更多用户阅读推荐模块的信息,从而增加产品的点击次数和活跃度。程度?于是产品部使用了AppAdhoc A/B Testing平台测试了两种推荐的方法:

原版中,用户输入参考信息后,默认显示手动编辑的“热点”栏;实验版会默认显示推荐算法生成的“推荐”栏目,用户进入APP后调整默认显示栏目,将信息流文章流量作为优化指标。

相应地分配了两个版本(包括原创版本):

测试总共进行了 20 天。从测试数据的观察可以看出,测试版胜出。在95%的置信度下,推荐模块的文章点击量提升了约28%,文章的阅读时长也有明显提升。

测试结果验证了用户使用AppAdhoc AB Testing进行产品优化的猜想,结论准确有效。

以上两个测试都是推荐的算法测试,也是A/B测试中常见的测试场景。精细化运营场景还有很多实验场景:比如新老用户不同活动、不同地域、不同年龄的个性化运营、不同渠道下的推广等等,都需要我们对用户进行细分和使用过程。拆解并明确精细化经营方式。当然,这些测试需求可以通过AppAdhoc A/B Testing平台的“定向测试”、“多维分析”等小功能来实现。A/B测试帮助企业实现科学有效的增长。 查看全部

算法 自动采集列表(《参考消息》官方网站:内容分发平台的“个性化推荐”)

随着互联网流量红利的消失,“卖家”在交易中的主导地位逐渐被取代。各大互联网产品都放弃了过去的地毯式广告,将重点放在用户运营上。通过采集和全数据分析,基于用户画像和用户行为数据,提供针对性的精细化运营。服务。

作为精细化运营的场景之一,“个性化推荐”已成为用户与产品之间的情感纽带:如音乐平台的“心动模式”、购物平台的“猜你喜欢”、“信息流推荐” “内容平台”,这些看似普通的小功能,却能唤起用户对产品的认同感,从而增强用户对产品的依赖。

《参考新闻》作为基于图文信息流的内容分发平台,致力于连接人和信息,精选全球每日新闻和评论,全面报道国际国内新闻,拓宽读者的国际视野。《参考新闻》官方网站于2012年上线,对内容的精准高效把控是获得用户喜爱的关键。同时,这也与其背后多次尝试AB测试分不开。

案例一:调整推荐算法,增加阅读点击量

《参考新闻》APP团队在“相关阅读”板块引入了第三方推荐算法。为了对比之前的人工编辑推荐和现有的第三方推荐算法的效果,产品部使用了AppAdhoc A/B Testing平台对这两类推荐进行了推荐。进行测试的方法:

原版采用手动编辑推荐的形式,即由编辑决定是否将文章放入“相关阅读”栏目;而实验版是由第三方推荐算法自动生成的文章列表,并且为了测试结果的科学性,本次测试针对的是百度频道,即只有百度的流量渠道可以参与本次测试。

根据实验设置,分配了两个版本(包括原创版本):

由于是推荐算法测试,所以测试采用编程方式,以“相关阅读”的文章总点击次数作为优化指标。测试运行25天,得到测试数据:

实验版第三方推荐算法的“相关阅读”效果更佳,文章点击转化次数较原版提升约8%。因此,在百度频道的投放过程中,第三方推荐算法比人工更有效地提升了编辑转换效果,产品部最终选择了全推测试版。

实验还没有结束。产品部在广电通上测试了两种推荐的方法:

同理,原版是人工推荐方式,实验版是第三方推荐算法方式,只不过选择了广电通定向,结果和百度频道完全相反:推荐的“相关阅读”广电通频道手动编辑器转换。它更高,比实验版本高约 15%。因此,产品部放弃了广电通渠道中的第三方推荐算法,选择了人工编辑的推荐列表。

测试结果表明,即使设置相同,在不同的通道中效果也可能完全相反。如果没有办法通过 A/B 测试,很难想出这样的结果。精细化运营的本质是以用户为中心的运营。只有在正确的渠道中使用正确的方法,不同的用户才能感知到正确的价值,并通过科学实验进行迭代优化。这是精细化操作的必要条件。路。

案例2:调整模块位置以帮助提高转化率

关于现有页面的展示形式,《参考新闻》产品部提出了一个假设:如果先展示推荐算法生成的新闻栏目,是否能带来更多用户阅读推荐模块的信息,从而增加产品的点击次数和活跃度。程度?于是产品部使用了AppAdhoc A/B Testing平台测试了两种推荐的方法:

原版中,用户输入参考信息后,默认显示手动编辑的“热点”栏;实验版会默认显示推荐算法生成的“推荐”栏目,用户进入APP后调整默认显示栏目,将信息流文章流量作为优化指标。

相应地分配了两个版本(包括原创版本):

测试总共进行了 20 天。从测试数据的观察可以看出,测试版胜出。在95%的置信度下,推荐模块的文章点击量提升了约28%,文章的阅读时长也有明显提升。

测试结果验证了用户使用AppAdhoc AB Testing进行产品优化的猜想,结论准确有效。

以上两个测试都是推荐的算法测试,也是A/B测试中常见的测试场景。精细化运营场景还有很多实验场景:比如新老用户不同活动、不同地域、不同年龄的个性化运营、不同渠道下的推广等等,都需要我们对用户进行细分和使用过程。拆解并明确精细化经营方式。当然,这些测试需求可以通过AppAdhoc A/B Testing平台的“定向测试”、“多维分析”等小功能来实现。A/B测试帮助企业实现科学有效的增长。

算法 自动采集列表(图片引自算法图解1.3大O表示法是什么,厉害吧?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-01-18 00:07

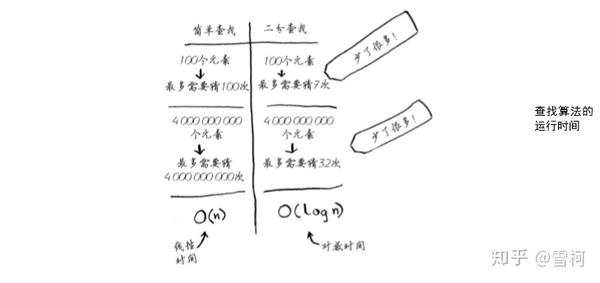

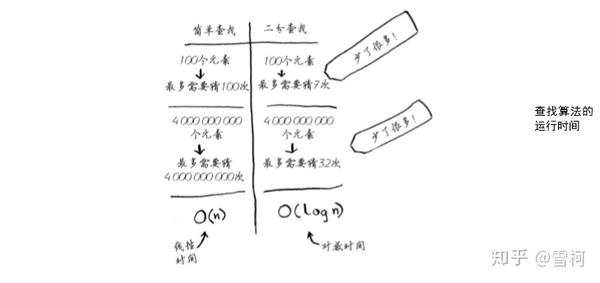

1.2.2 运行时

每次我介绍一种算法时,我都会讨论它的运行时间。通常,应选择最有效的算法以最小化运行时间或占用空间。

回到前面的二分查找。使用它可以节省多少时间?简单查找会一一检查数字,如果列表收录 100 个数字,则最多需要 100 次猜测。如果列表收录 40 亿个数字,则最多需要 40 亿次猜测。换句话说,所需的最大猜测次数与列表的长度相同,称为线性时间。二分查找不同。如果列表收录 100 个元素,则最多需要 7 次猜测;如果列表收录 40 亿个数字,则最多需要 32 次猜测。太好了,对吧?二分查找的运行时间是对数时间(或日志时间)。下表总结了我们的发现。

图片引自算法图

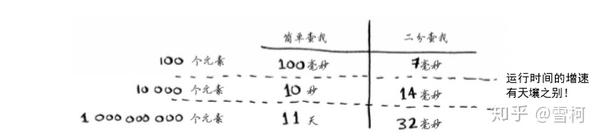

1.3 大 O 符号

大 O 表示法是一种特殊的表示法,表示算法的速度。谁在乎?在实践中,您经常不得不使用其他人编写的算法,在这种情况下,了解这些算法的速度会大有裨益。本节将介绍什么是大 O 表示法,并用它来列出一些最常见的算法运行时间。

1.3.1 算法的运行时间以不同的速率增加

Bob 将为 NASA 编写一个查找算法,该算法在火箭即将登陆月球之前启动,以帮助计算着陆点。

这个例子表明两种算法的运行时间表现出不同的增长率。Bob 需要决定是使用简单搜索还是二分搜索。使用的算法必须快速准确。一方面,二分查找更快。Bob 必须在 10 秒内找出着陆的位置,否则火箭会偏离轨道。另一方面,简单的查找算法更容易编写,因此不太可能出现错误。Bob 不希望在引导火箭着陆的代码中出现错误!为了万无一失,如果列表收录 100 个元素,Bob 决定计算两种算法需要多长时间。

假设检查一个元素需要 1ms。使用简单查找时,Bob 必须检查 100 个元素,因此完成查找需要 100ms。使用二分查找,只需要检查7个元素(log2100大约是7),所以需要7ms才能完成搜索。但是实际要搜索的列表可能收录10亿个元素,这种情况下,多长时间一个简单的搜索需要多少时间?二分搜索需要多长时间?一定要找到这两个问题的答案,然后继续阅读。

Bob 使用收录 10 亿个元素的列表运行二进制搜索,运行时间为 30 毫秒(log21 000 000 000 大约为 30)。他认为二进制搜索比简单搜索快大约 15 倍,因为列表有100个元素,简单查找需要100ms,二分查找需要7ms。所以,10亿个元素的列表,简单查找需要30×15 = 450ms,正好是10秒内完成查找的要求秒。Bob 决定使用简单查找。这是正确的选择吗?

不。事实上,鲍勃错了,而且大错特错。当列表收录 10 亿个元素时,一个简单的查找需要 10 亿毫秒,即 11 天!为什么会这样?因为二分查找和简单查找不同地加快了运行时间。

图片引自算法图

也就是说,随着元素数量的增加,二分查找不需要太多额外的时间,而简单查找则需要很多额外的时间。所以随着列表的增长,二分查找比简单查找要快得多。Bob 认为二分搜索比简单搜索快 15 倍,这是不正确的:当列表收录 10 亿个元素时,它快 3300 万倍。考虑到这一点,仅仅知道算法运行完成需要多长时间是不够的,还需要知道运行时间如何随着列表的增长而增加。这就是大 O 表示法的用武之地。

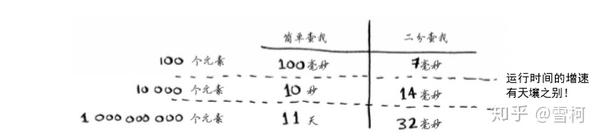

大 O 表示法表示算法的速度。例如,假设列表收录 n 个元素。一个简单的查找需要检查每个元素,所以它需要做 n 次操作。使用大 O 表示法,此运行时间为 O(n)。几秒钟后呢?否 - 大 O 符号不是指以秒为单位的速度。大 O 表示法允许您比较操作数,它指示算法运行的速度。

注意:大O表示法表示算法的增长率,记住二分法是O(logn),后面会经常用到

让我们看另一个例子。要检查长度为 n 的列表,二进制搜索需要执行 log n 操作。这个运行时间如何用大 O 表示法来表示?O(登录)。一般来说,大 O 表示法如下所示。

图片引自算法图

这表示算法需要执行的操作数。它被称为大 O 表示法,因为在操作数之前有一个大 O。这听起来像是一个笑话,但这是真的!

让我们看一些示例,看看您是否可以确定这些算法的运行时间。

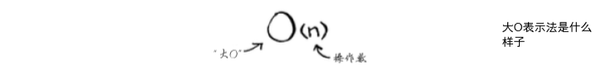

1.3.2 了解不同的 Big O 运行时

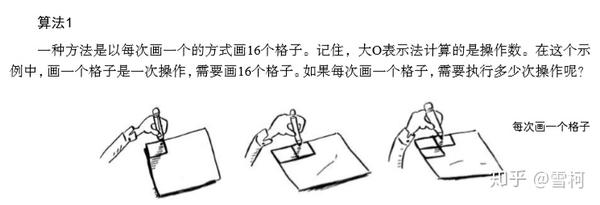

下面的例子可以在家里用纸和笔完成。假设您要绘制一个收录 16 个单元格的网格。

图片引自算法图

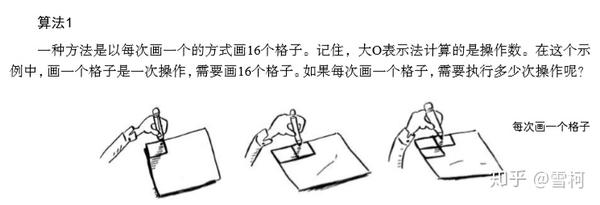

注意:先想一想,再看下面的答案,想一想:能不能用简单搜索和二分搜索?简单搜索就是一张一张的,两点呢?不记得我们小时候折纸的时候,是不是很快就能得到更多的方格呢?

图片引自算法图

绘制 16 个网格需要 16 个步骤。这个算法的运行时间是多少?

注:运行时间 O(n)=16

图片引自算法图

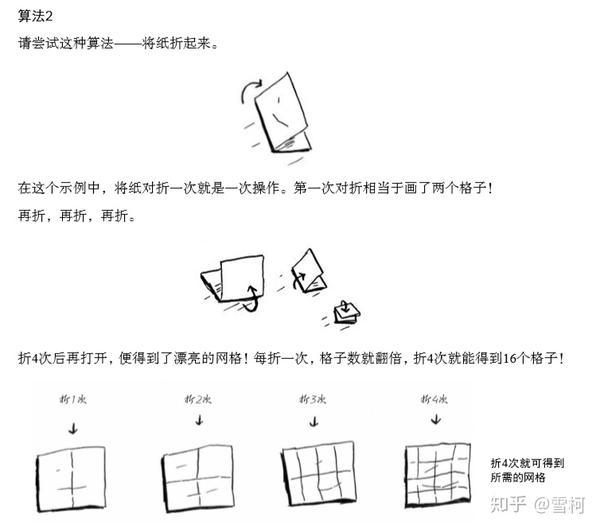

每次折叠时,绘制的方格数翻倍,因此您可以分 4 步“绘制”16 个方格。这个算法的运行时间是多少?请在弄清楚这两种算法的运行时间后继续阅读。

答案如下:算法 1 运行时间为 O(n),算法 2 运行时间为 O(log n)。

1.3.3 大 O 符号表示最坏情况的运行时间

假设您使用简单查找在电话簿中查找人员。你知道,简单的查找运行 O(n),这意味着在最坏的情况下,必须查看电话簿中的每个条目。如果您正在寻找 Adit - 电话簿中的第一个人,您可以找到它一次,而无需查看每个条目。考虑到Adit被找到一次,这个算法的运行时间是O(n)还是O(1)?简单搜索的运行时间总是O(n)。在寻找Adit的时候,找到一次是的, 这是最好的情况, 但大 O 表示法表示最坏的情况. 所以你可以说在最坏的情况下你必须查看电话簿中的每个条目, 这对应于 O (n) 的运行时间. 这是一个保证——你知道一个简单的查找运行时间不能超过 O(n)。

注意:这个概念很重要,最坏情况和平均情况,后面会有平均情况的解释

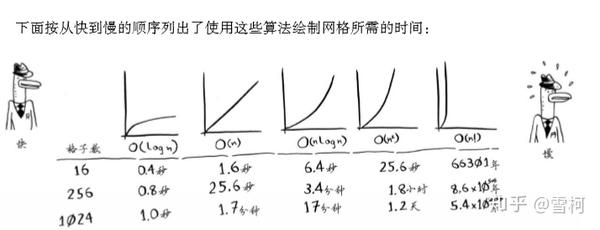

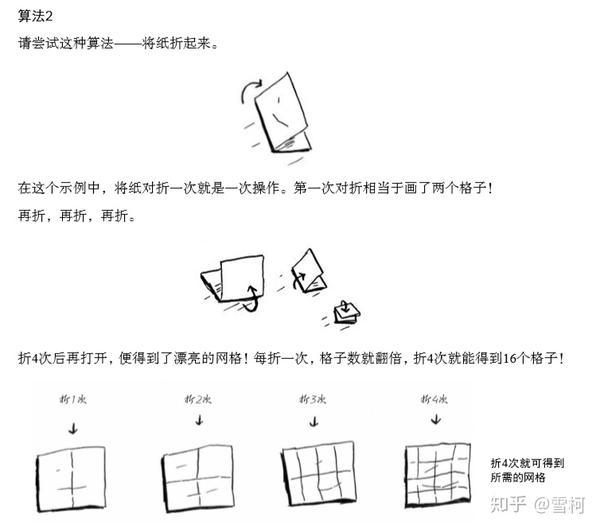

1.3.4 一些常见的 Big O 运行时

下面,按照从最快到最慢的顺序,列出了您经常会遇到的 5 个 big-O 运行时。

O(log n),也称为对数时间,此类算法包括二分查找。O(n),也称为线性时间,此类算法包括简单的查找。O(n * log n),这样的算法包括快速排序,一种更快的排序算法,在第 4 章中描述。 O(n^2),这样的算法包括选择排序,在第 2 章中描述,一种更慢的排序algorithm. O(n!),这样的算法包括接下来描述的旅行商问题的解决方案——一个非常慢的算法。

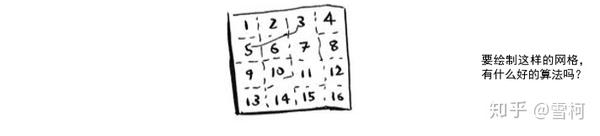

假设您要绘制一个由 16 个单元格组成的网格,并且您有 5 种不同的算法可供选择,这些算法的运行时间如上所示。如果选择第一种算法,则绘制网格所需的操作数为 4(log 16 = 4)。假设您每秒可以执行 10 次操作,那么绘制网格将需要 0.@ > 4秒。如果要绘制一个有1024个单元格的网格呢?这需要10(log 1024 = 10)次操作,也就是说,绘制这样一个网格需要1秒。这是使用第一个算法案例.

第二种算法速度较慢,运行时间为 O(n)。即绘制16个网格,需要进行16次操作;要绘制 1024 个网格,需要执行 1024 次操作。执行这些操作需要多少秒?

图片引自算法图

还有其他运行时,但这 5 个是最常见的。事实上,这里的简化并没有将 big-O 运行时转换为操作数那么干净,但就目前而言,这种准确性就足够了。在您学习了一些其他算法之后,第 4 章将再次讨论 Big-O 表示法。目前,我们得到的主要启示如下。

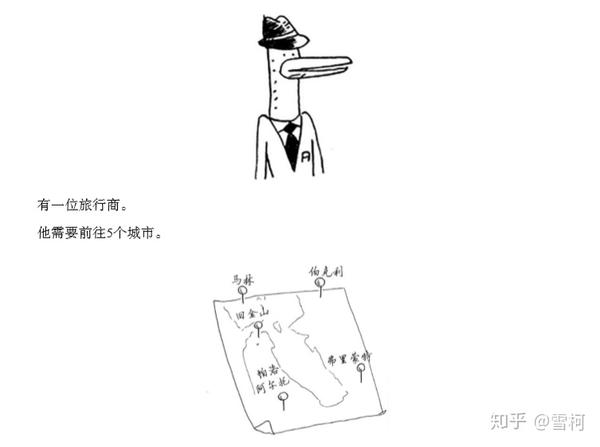

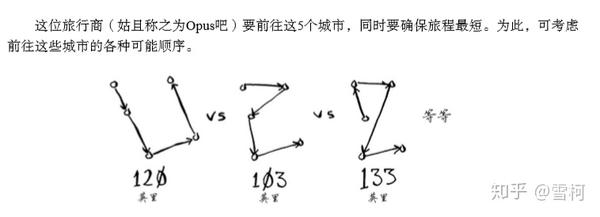

1.3.5 旅行推销员

阅读上一节时,您可能会认为根本没有 O(n!) 算法。让我证明你错了!下面是一个需要很长时间才能运行的算法。该算法解决了计算机科学中非常有名的旅行商问题,其计算时间增加非常快,一些非常聪明的人认为没有改进的余地。

图片引自算法图

图片引自算法图

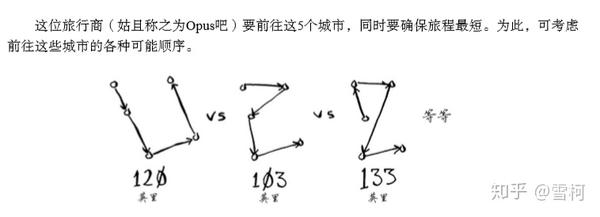

对于每个订单,他计算总行程并选择行程最短的路线。5 个城市,120 种不同的安排。所以解决这个问题需要5个城市的120个操作。当涉及 6 个城市时,需要执行 720 次操作(具有 720 种不同的排列)。当涉及7个城市时,需要5040次操作!

图片引自算法图

通过扩展,当涉及 n 个城市时,n! (n 的阶乘)运算需要计算结果。所以运行时间是 O(n!),阶乘时间。除非涉及的城市数量很少,否则需要大量的操作。如果涉及的城市数量超过 100 个,则根本无法在合理的时间内计算出结果——等到你计算出结果的时候,太阳已经消失了。这个算法很烂!Opus 应该使用另一种算法,但他别无选择。这是计算机科学中尚未解决的问题之一。对于这个问题,目前还没有更快的算法,一些很聪明的人认为根本就没有更聪明的算法来解决这个问题。面对这个问题,我们所能做的就是找到一个近似的答案,更多细节请参见第 10 章。

最后要注意的一点是,高级读者可以学习二叉树,上一章简要介绍了二叉树。

注意:旅行商问题实际上是一个NP完全问题,后面会讨论

1.4 总结

提问时间思考?

1、假设有一个收录 258 个名称的有序列表,并且您想使用二进制搜索在其中找到一个名称。需要多少步骤才能找到它?(最=最差)

2、通过电话簿中的电话号码查找人员(使用大 O 表示法给出运行时间。)

数组、链表和选择排序的先睹为快:

数组和链表:两种数据结构,区别在于数组易于查找(本质:数组有索引),链表易于插入和删除(本质:链表的每个元素都会收录下一个元素的地址)

选择排序:8个人按照身高从高到低排列。如果是选择排序,第一次从8个人中找出最高的,第二次从7个人中找出最高的,以此类推。运算为8+7+6+...+1,如果推广到n,则为n*(n+1)/2。常量在big-O记法中被忽略,所以运行时间为O (n^2),因为这个常数的问题,后面你可能会有疑惑,有些算法使用大O记法运行时间相同,但是大小有差异。记住这个常数问题!

下次更新时间:预计10月13-12日是课题组的周年纪念日。有必要向外国人报告。我会停下来几天,希望能理解。 查看全部

算法 自动采集列表(图片引自算法图解1.3大O表示法是什么,厉害吧?)

1.2.2 运行时

每次我介绍一种算法时,我都会讨论它的运行时间。通常,应选择最有效的算法以最小化运行时间或占用空间。

回到前面的二分查找。使用它可以节省多少时间?简单查找会一一检查数字,如果列表收录 100 个数字,则最多需要 100 次猜测。如果列表收录 40 亿个数字,则最多需要 40 亿次猜测。换句话说,所需的最大猜测次数与列表的长度相同,称为线性时间。二分查找不同。如果列表收录 100 个元素,则最多需要 7 次猜测;如果列表收录 40 亿个数字,则最多需要 32 次猜测。太好了,对吧?二分查找的运行时间是对数时间(或日志时间)。下表总结了我们的发现。

图片引自算法图

1.3 大 O 符号

大 O 表示法是一种特殊的表示法,表示算法的速度。谁在乎?在实践中,您经常不得不使用其他人编写的算法,在这种情况下,了解这些算法的速度会大有裨益。本节将介绍什么是大 O 表示法,并用它来列出一些最常见的算法运行时间。

1.3.1 算法的运行时间以不同的速率增加

Bob 将为 NASA 编写一个查找算法,该算法在火箭即将登陆月球之前启动,以帮助计算着陆点。

这个例子表明两种算法的运行时间表现出不同的增长率。Bob 需要决定是使用简单搜索还是二分搜索。使用的算法必须快速准确。一方面,二分查找更快。Bob 必须在 10 秒内找出着陆的位置,否则火箭会偏离轨道。另一方面,简单的查找算法更容易编写,因此不太可能出现错误。Bob 不希望在引导火箭着陆的代码中出现错误!为了万无一失,如果列表收录 100 个元素,Bob 决定计算两种算法需要多长时间。

假设检查一个元素需要 1ms。使用简单查找时,Bob 必须检查 100 个元素,因此完成查找需要 100ms。使用二分查找,只需要检查7个元素(log2100大约是7),所以需要7ms才能完成搜索。但是实际要搜索的列表可能收录10亿个元素,这种情况下,多长时间一个简单的搜索需要多少时间?二分搜索需要多长时间?一定要找到这两个问题的答案,然后继续阅读。

Bob 使用收录 10 亿个元素的列表运行二进制搜索,运行时间为 30 毫秒(log21 000 000 000 大约为 30)。他认为二进制搜索比简单搜索快大约 15 倍,因为列表有100个元素,简单查找需要100ms,二分查找需要7ms。所以,10亿个元素的列表,简单查找需要30×15 = 450ms,正好是10秒内完成查找的要求秒。Bob 决定使用简单查找。这是正确的选择吗?

不。事实上,鲍勃错了,而且大错特错。当列表收录 10 亿个元素时,一个简单的查找需要 10 亿毫秒,即 11 天!为什么会这样?因为二分查找和简单查找不同地加快了运行时间。

图片引自算法图

也就是说,随着元素数量的增加,二分查找不需要太多额外的时间,而简单查找则需要很多额外的时间。所以随着列表的增长,二分查找比简单查找要快得多。Bob 认为二分搜索比简单搜索快 15 倍,这是不正确的:当列表收录 10 亿个元素时,它快 3300 万倍。考虑到这一点,仅仅知道算法运行完成需要多长时间是不够的,还需要知道运行时间如何随着列表的增长而增加。这就是大 O 表示法的用武之地。

大 O 表示法表示算法的速度。例如,假设列表收录 n 个元素。一个简单的查找需要检查每个元素,所以它需要做 n 次操作。使用大 O 表示法,此运行时间为 O(n)。几秒钟后呢?否 - 大 O 符号不是指以秒为单位的速度。大 O 表示法允许您比较操作数,它指示算法运行的速度。

注意:大O表示法表示算法的增长率,记住二分法是O(logn),后面会经常用到

让我们看另一个例子。要检查长度为 n 的列表,二进制搜索需要执行 log n 操作。这个运行时间如何用大 O 表示法来表示?O(登录)。一般来说,大 O 表示法如下所示。

图片引自算法图

这表示算法需要执行的操作数。它被称为大 O 表示法,因为在操作数之前有一个大 O。这听起来像是一个笑话,但这是真的!

让我们看一些示例,看看您是否可以确定这些算法的运行时间。

1.3.2 了解不同的 Big O 运行时

下面的例子可以在家里用纸和笔完成。假设您要绘制一个收录 16 个单元格的网格。

图片引自算法图

注意:先想一想,再看下面的答案,想一想:能不能用简单搜索和二分搜索?简单搜索就是一张一张的,两点呢?不记得我们小时候折纸的时候,是不是很快就能得到更多的方格呢?

图片引自算法图

绘制 16 个网格需要 16 个步骤。这个算法的运行时间是多少?

注:运行时间 O(n)=16

图片引自算法图

每次折叠时,绘制的方格数翻倍,因此您可以分 4 步“绘制”16 个方格。这个算法的运行时间是多少?请在弄清楚这两种算法的运行时间后继续阅读。

答案如下:算法 1 运行时间为 O(n),算法 2 运行时间为 O(log n)。

1.3.3 大 O 符号表示最坏情况的运行时间

假设您使用简单查找在电话簿中查找人员。你知道,简单的查找运行 O(n),这意味着在最坏的情况下,必须查看电话簿中的每个条目。如果您正在寻找 Adit - 电话簿中的第一个人,您可以找到它一次,而无需查看每个条目。考虑到Adit被找到一次,这个算法的运行时间是O(n)还是O(1)?简单搜索的运行时间总是O(n)。在寻找Adit的时候,找到一次是的, 这是最好的情况, 但大 O 表示法表示最坏的情况. 所以你可以说在最坏的情况下你必须查看电话簿中的每个条目, 这对应于 O (n) 的运行时间. 这是一个保证——你知道一个简单的查找运行时间不能超过 O(n)。

注意:这个概念很重要,最坏情况和平均情况,后面会有平均情况的解释

1.3.4 一些常见的 Big O 运行时

下面,按照从最快到最慢的顺序,列出了您经常会遇到的 5 个 big-O 运行时。

O(log n),也称为对数时间,此类算法包括二分查找。O(n),也称为线性时间,此类算法包括简单的查找。O(n * log n),这样的算法包括快速排序,一种更快的排序算法,在第 4 章中描述。 O(n^2),这样的算法包括选择排序,在第 2 章中描述,一种更慢的排序algorithm. O(n!),这样的算法包括接下来描述的旅行商问题的解决方案——一个非常慢的算法。

假设您要绘制一个由 16 个单元格组成的网格,并且您有 5 种不同的算法可供选择,这些算法的运行时间如上所示。如果选择第一种算法,则绘制网格所需的操作数为 4(log 16 = 4)。假设您每秒可以执行 10 次操作,那么绘制网格将需要 0.@ > 4秒。如果要绘制一个有1024个单元格的网格呢?这需要10(log 1024 = 10)次操作,也就是说,绘制这样一个网格需要1秒。这是使用第一个算法案例.

第二种算法速度较慢,运行时间为 O(n)。即绘制16个网格,需要进行16次操作;要绘制 1024 个网格,需要执行 1024 次操作。执行这些操作需要多少秒?

图片引自算法图

还有其他运行时,但这 5 个是最常见的。事实上,这里的简化并没有将 big-O 运行时转换为操作数那么干净,但就目前而言,这种准确性就足够了。在您学习了一些其他算法之后,第 4 章将再次讨论 Big-O 表示法。目前,我们得到的主要启示如下。

1.3.5 旅行推销员

阅读上一节时,您可能会认为根本没有 O(n!) 算法。让我证明你错了!下面是一个需要很长时间才能运行的算法。该算法解决了计算机科学中非常有名的旅行商问题,其计算时间增加非常快,一些非常聪明的人认为没有改进的余地。

图片引自算法图

图片引自算法图

对于每个订单,他计算总行程并选择行程最短的路线。5 个城市,120 种不同的安排。所以解决这个问题需要5个城市的120个操作。当涉及 6 个城市时,需要执行 720 次操作(具有 720 种不同的排列)。当涉及7个城市时,需要5040次操作!

图片引自算法图

通过扩展,当涉及 n 个城市时,n! (n 的阶乘)运算需要计算结果。所以运行时间是 O(n!),阶乘时间。除非涉及的城市数量很少,否则需要大量的操作。如果涉及的城市数量超过 100 个,则根本无法在合理的时间内计算出结果——等到你计算出结果的时候,太阳已经消失了。这个算法很烂!Opus 应该使用另一种算法,但他别无选择。这是计算机科学中尚未解决的问题之一。对于这个问题,目前还没有更快的算法,一些很聪明的人认为根本就没有更聪明的算法来解决这个问题。面对这个问题,我们所能做的就是找到一个近似的答案,更多细节请参见第 10 章。

最后要注意的一点是,高级读者可以学习二叉树,上一章简要介绍了二叉树。

注意:旅行商问题实际上是一个NP完全问题,后面会讨论

1.4 总结

提问时间思考?

1、假设有一个收录 258 个名称的有序列表,并且您想使用二进制搜索在其中找到一个名称。需要多少步骤才能找到它?(最=最差)

2、通过电话簿中的电话号码查找人员(使用大 O 表示法给出运行时间。)

数组、链表和选择排序的先睹为快:

数组和链表:两种数据结构,区别在于数组易于查找(本质:数组有索引),链表易于插入和删除(本质:链表的每个元素都会收录下一个元素的地址)

选择排序:8个人按照身高从高到低排列。如果是选择排序,第一次从8个人中找出最高的,第二次从7个人中找出最高的,以此类推。运算为8+7+6+...+1,如果推广到n,则为n*(n+1)/2。常量在big-O记法中被忽略,所以运行时间为O (n^2),因为这个常数的问题,后面你可能会有疑惑,有些算法使用大O记法运行时间相同,但是大小有差异。记住这个常数问题!

下次更新时间:预计10月13-12日是课题组的周年纪念日。有必要向外国人报告。我会停下来几天,希望能理解。

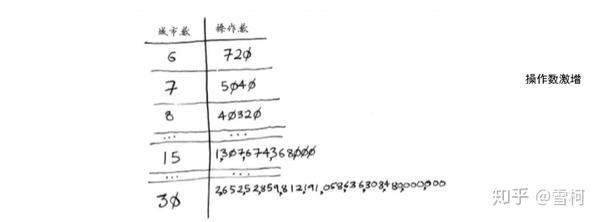

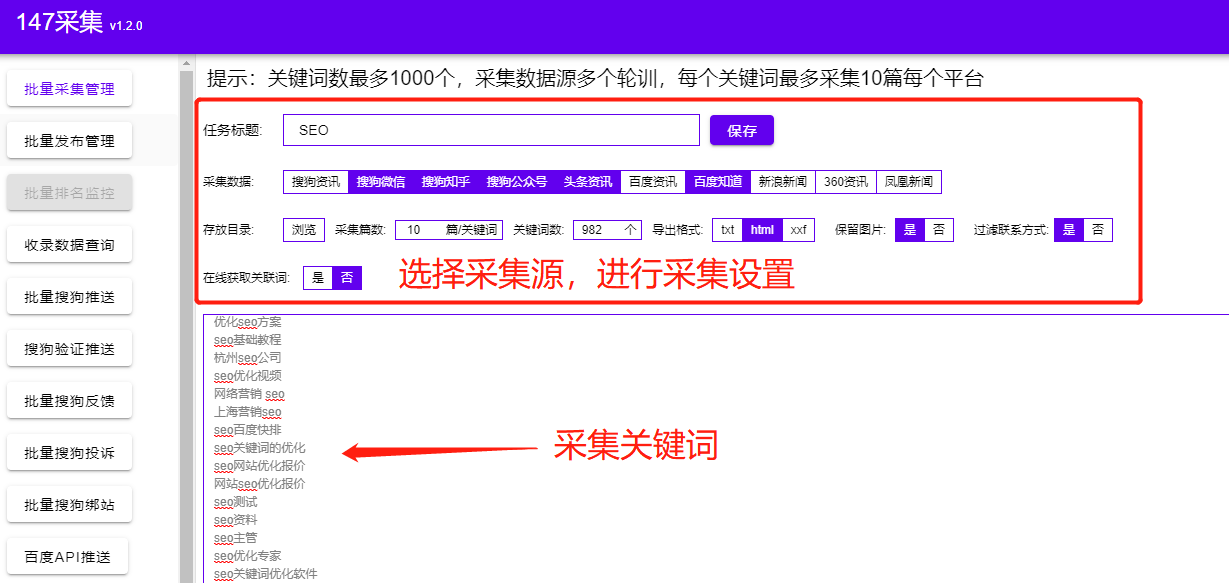

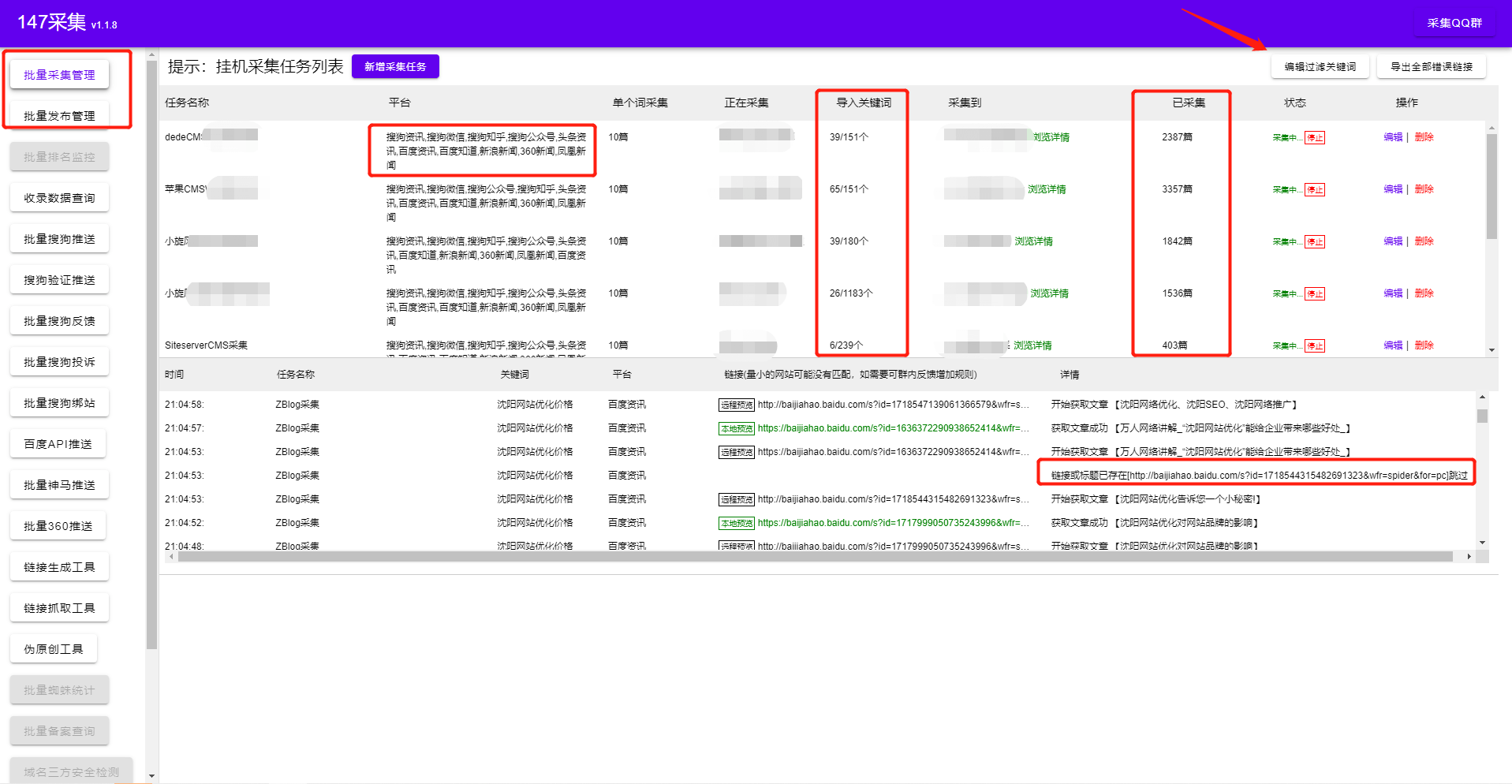

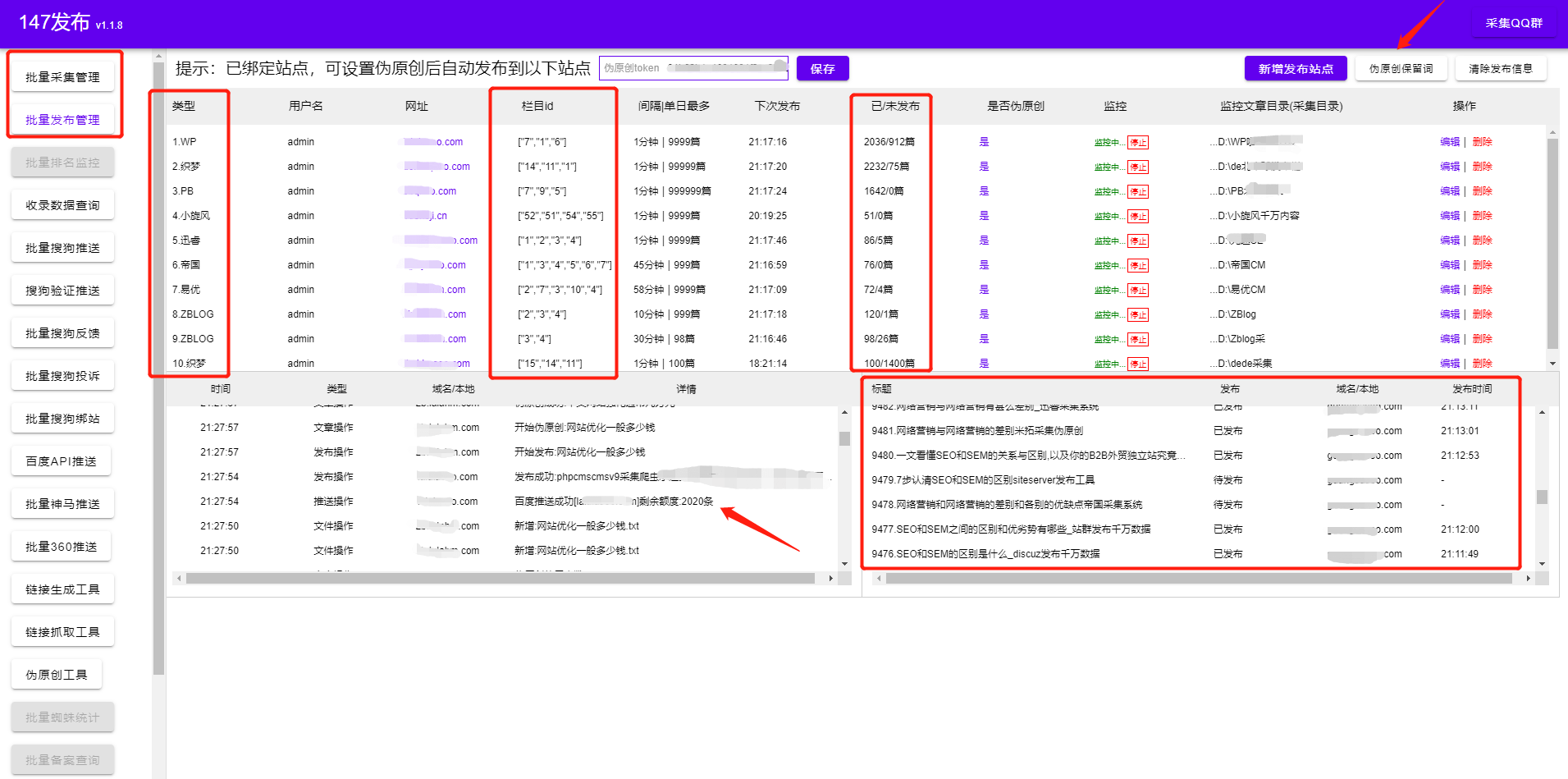

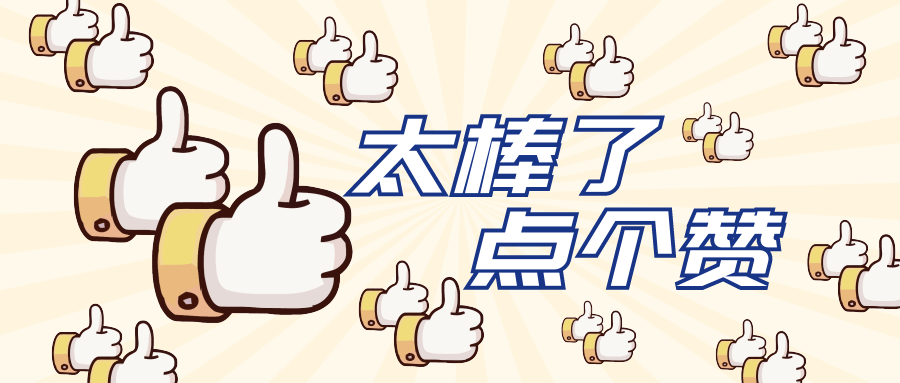

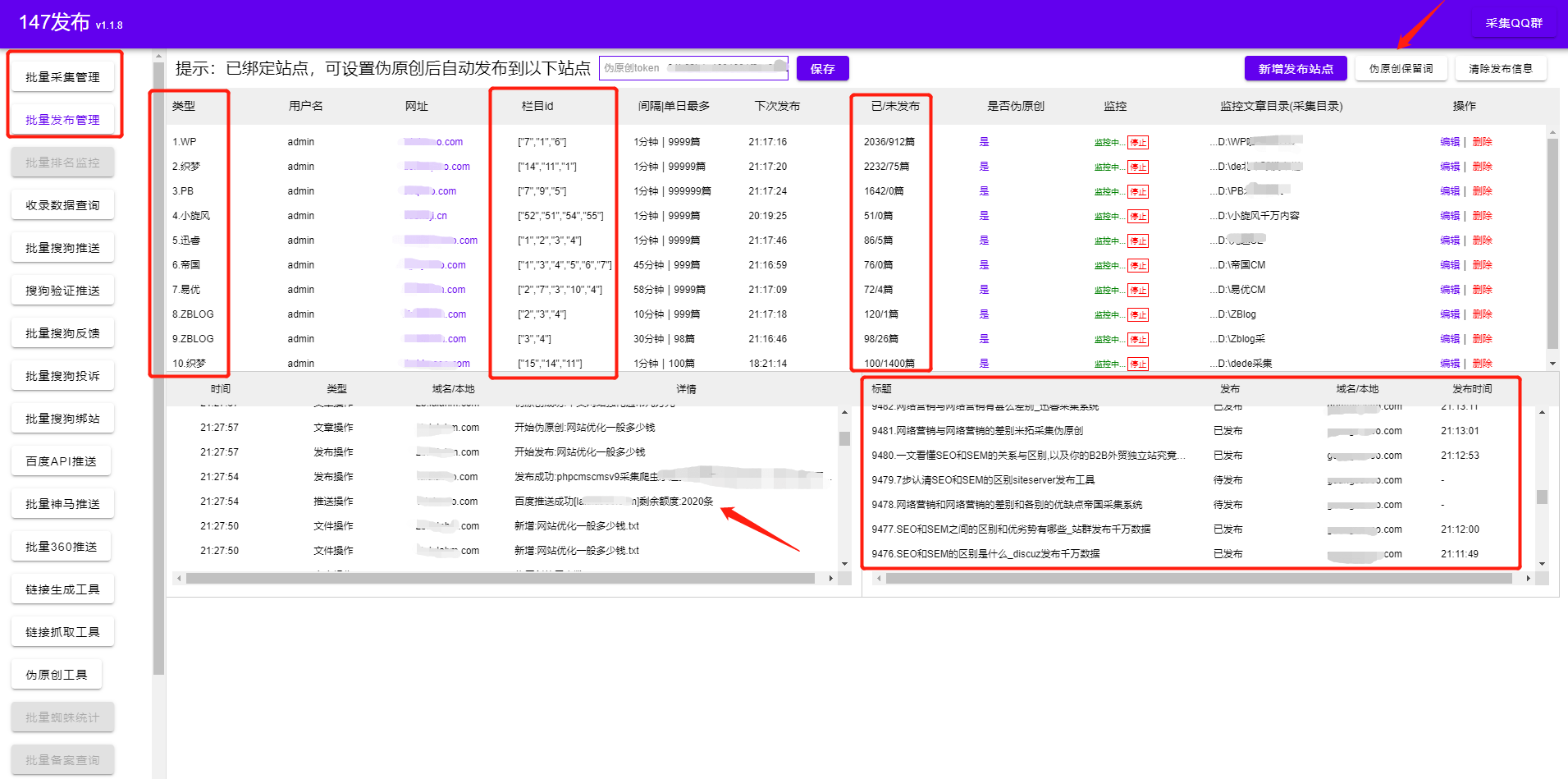

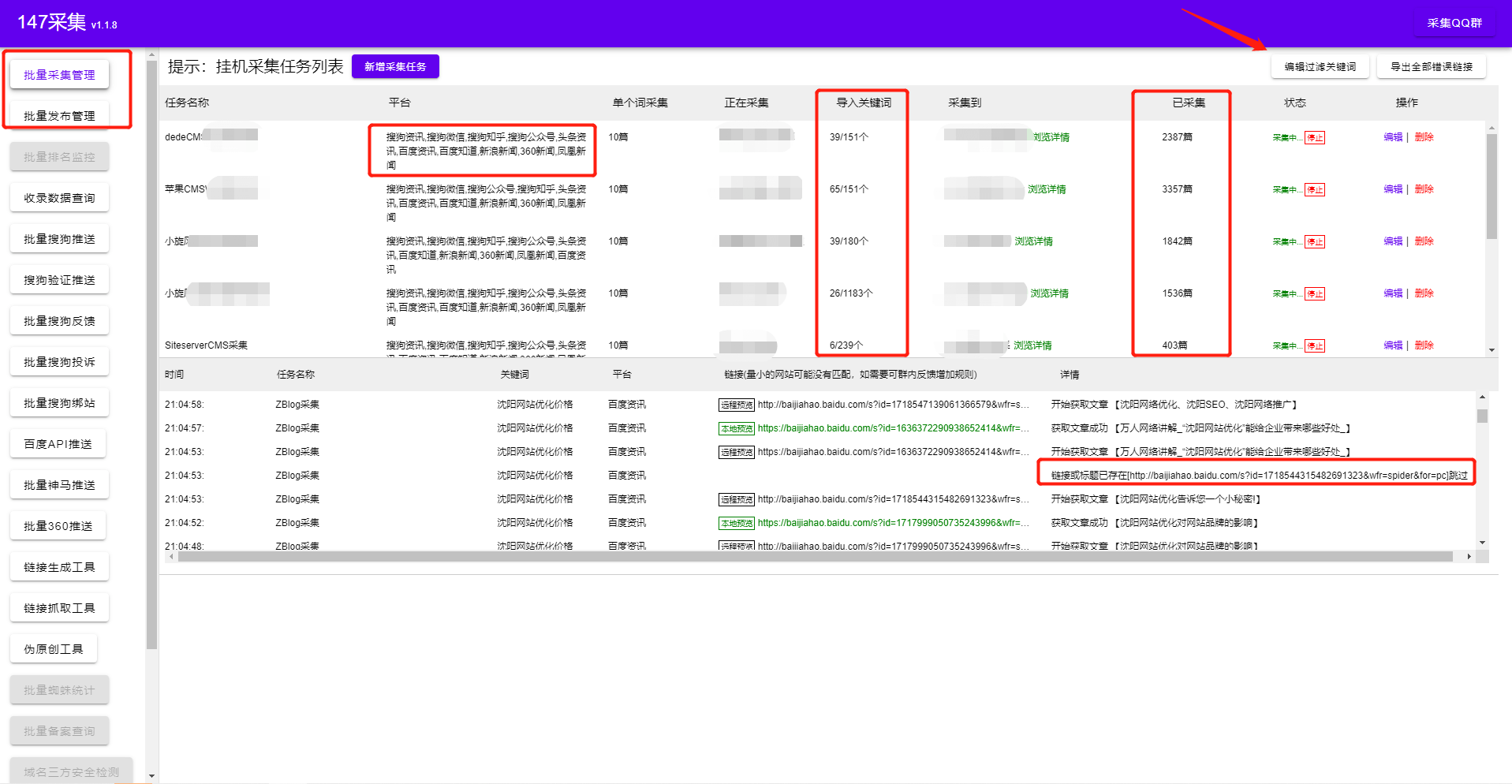

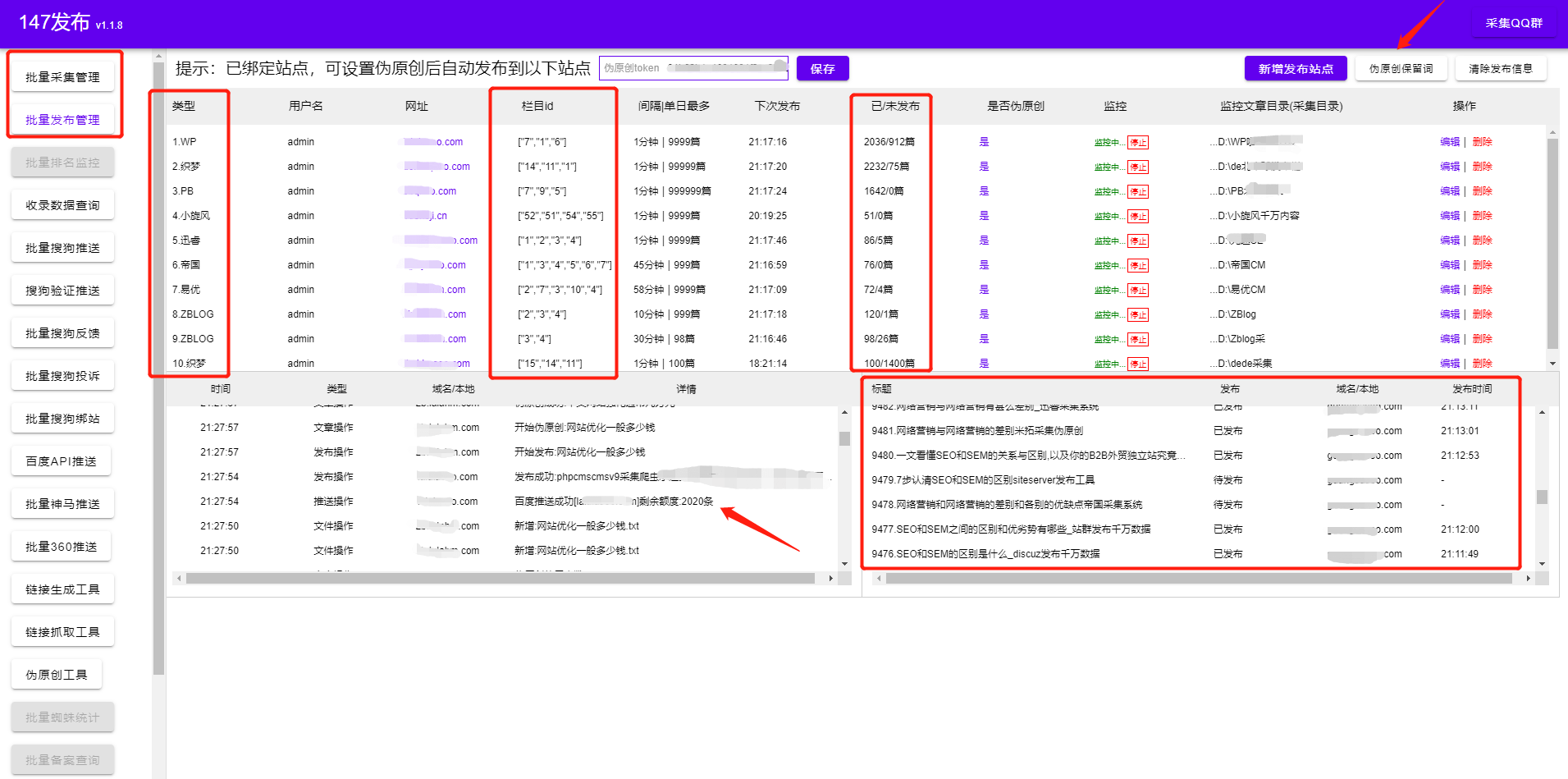

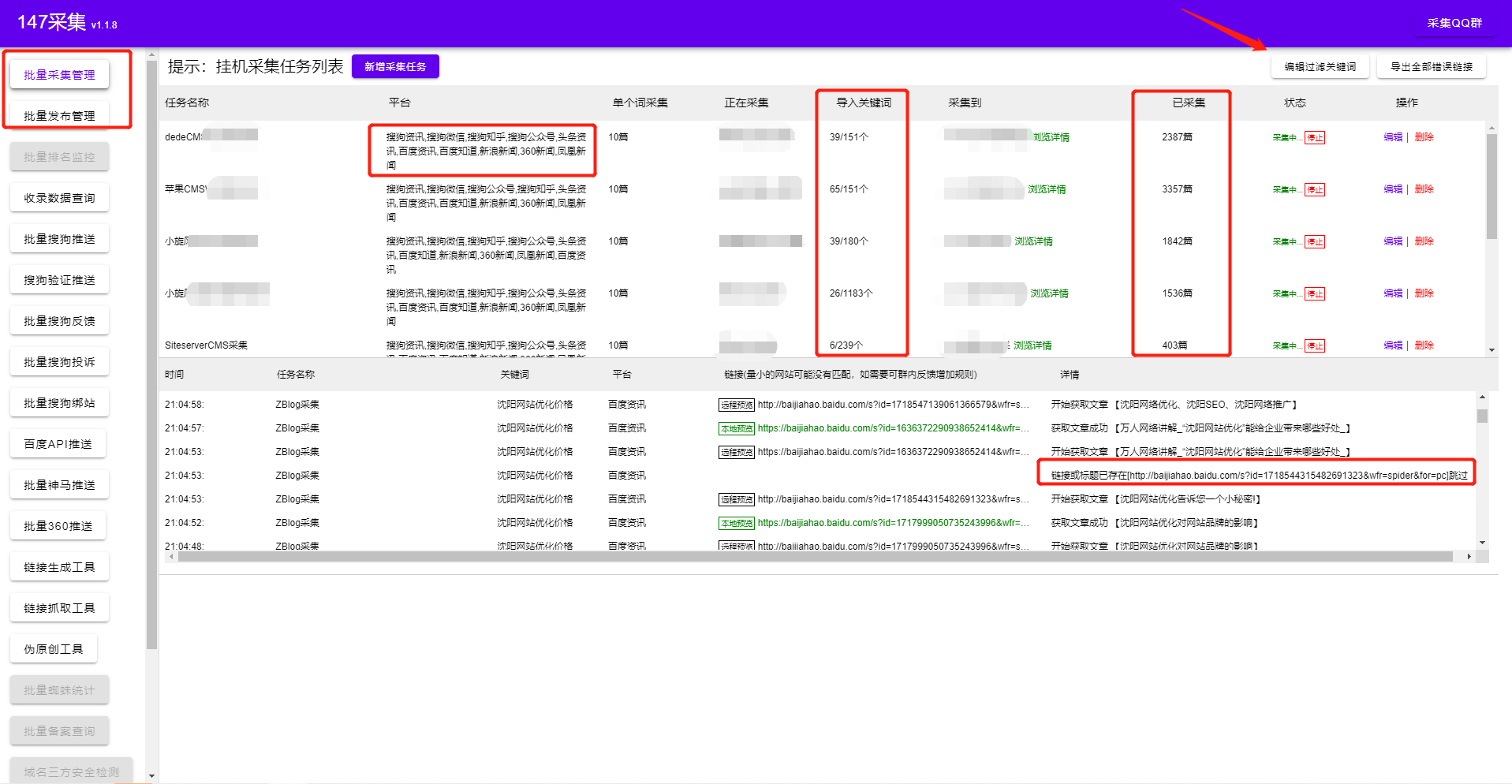

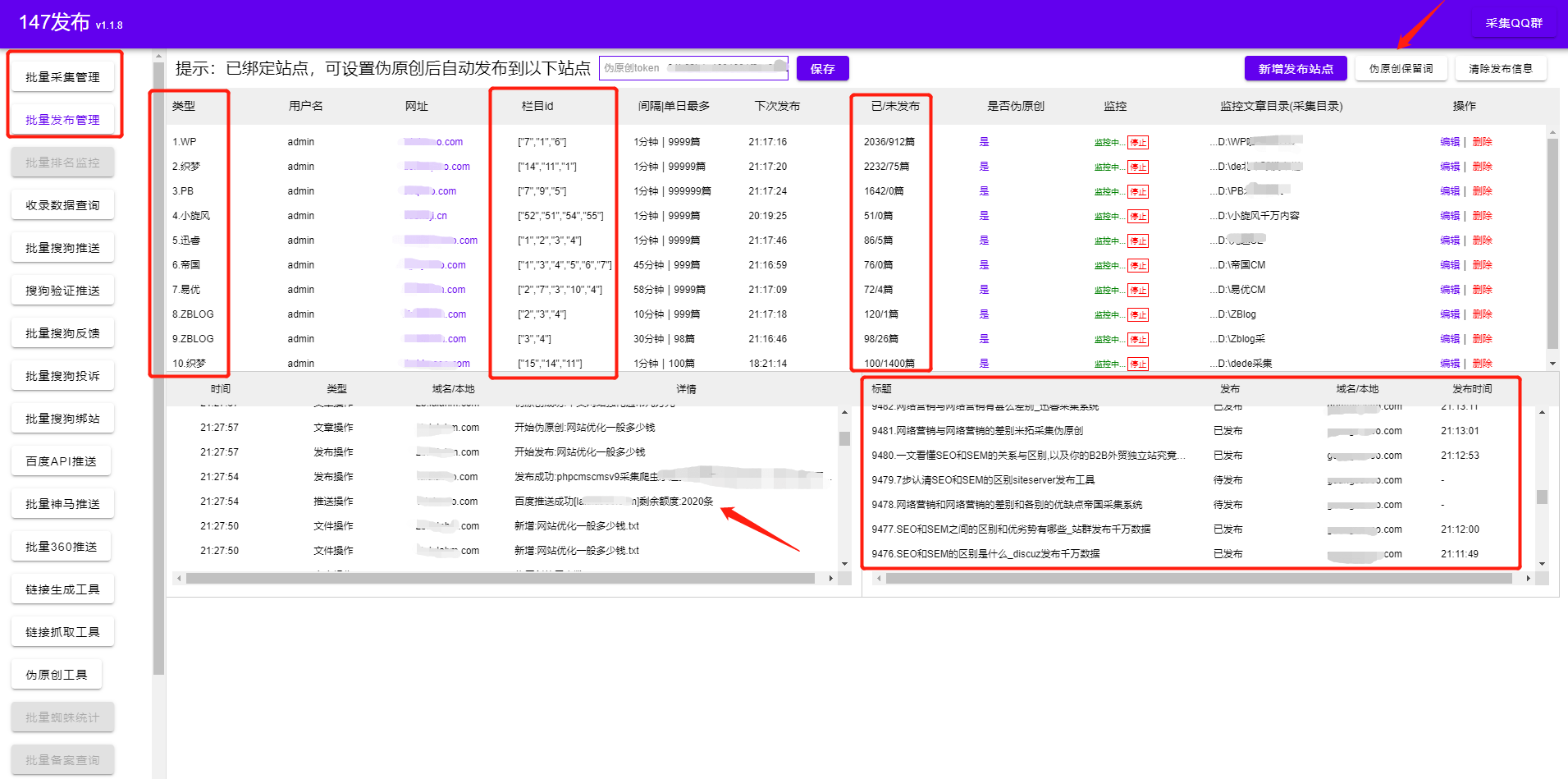

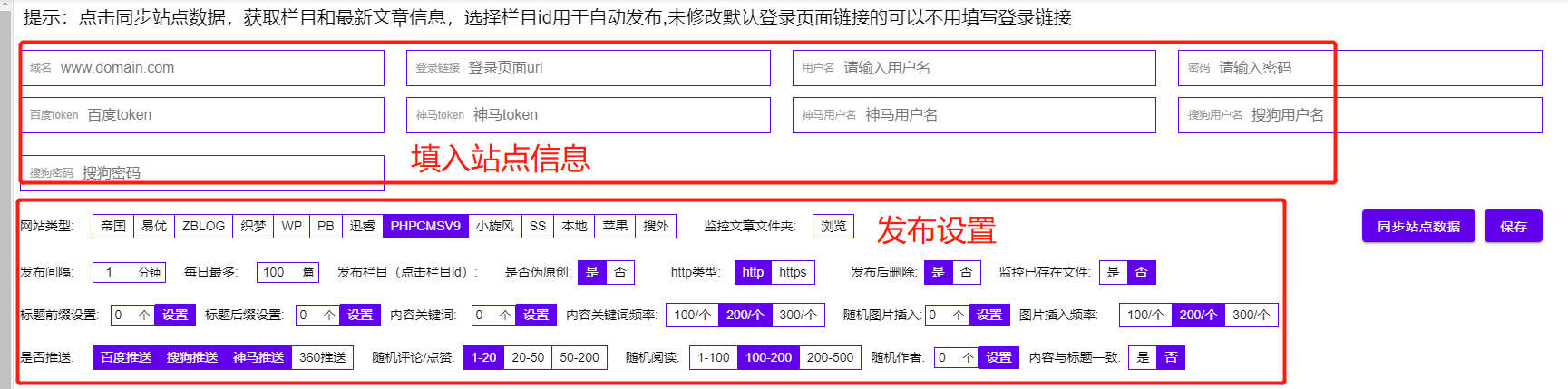

算法 自动采集列表(博主常规收费插件和免费zblog采集发布方法(简单实用) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-01-14 02:14

)

早些年,zblog ASP确实在博客时代非常流行。后来PHP普及之后,国内PHP博客程序的更新换代并没有跟上,所以PHP博客程序我们还是更多的使用WordPress。不过zblog PHP版出来后,还是有很大的市场的。毕竟在便携性方面还是很受网友欢迎的,但是对于免费主题和免费插件支持的缺失,也不是太满意。今天博主讲zblog采集方式,分为普通付费插件和免费zblog采集发布方式(简单实战测试)

zblog 定期收费采集

网站采集的大部分方式都是按列表页和详情页的层次结构组织的,比如我们输入新闻信息网站,有很多标题链接,这些是列表页。点击标题链接进入详情页面。

1、使用采集的方法一般是大量获取详情页中的具体内容数据,并利用这些数据进行各种分析和编写规则。写之前需要花点时间研究网页的源代码。出去。

2、列表页:指栏目或目录页,一般收录多个标题链接。例如:网站首页或栏目页为列表页。主要功能:通过列表页可以获取到多个详情页的链接。

4、详情页:收录具体内容的页面,如网页文章,其中收录:标题、作者、发布日期、正文内容、标签等,这些必须通过规则获取。

常规zblog到采集数据,全看规则怎么写,要上手这些采集,首先要了解基本的html代码,因为采集的内容需要与html代码分开。内容,所以需要用html分隔。另外,在设置清零规则的时候,还需要使用html代码来替换或者删除一些内容。其他方面基本都是比较固定的操作。如果没有发布规则,在没有发布规则的情况下,需要自己编写规则。这个发布规则比较难。如果你是一个完全的新手,估计十天半的时间你也学不会。直接建议放弃,或者使用以下方法。

二、第三方免费zblog采集发布软件使用:

1、支持任何 PHP 版本

2、支持任意版本的Mysql

3、支持任何版本的 Nginx

4、支持任何zblog版本

5、亲测免费,作者声明永久免费!

采集 将因版本不匹配或服务器环境不支持等其他原因不可用

二、第三方zblog采集软件更易用

门槛低:无需花费大量时间学习软件操作,一分钟即可上手!无需配置采集规则,输入关键词到采集即可。

高效:提供一站式网站文章解决方案,无需人工干预,设置任务自动执行采集releases。

零成本:几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

zblog的第三方采集软件很强大,只要输入关键词采集,完全可以通过采集自动发布文章软件采集@>,为了让搜索引擎收录你的网站,我们还可以设置自动下载图片和替换链接。图片存储方式支持:阿里云OSS、七牛对象存储、腾讯云、杂牌云。同时还配备了自动内链,在内容或标题前后插入一定的内容,形成“伪原创”。软件还有监控功能,可以直接通过软件查看文章采集的发布状态。

查看全部

算法 自动采集列表(博主常规收费插件和免费zblog采集发布方法(简单实用)

)

早些年,zblog ASP确实在博客时代非常流行。后来PHP普及之后,国内PHP博客程序的更新换代并没有跟上,所以PHP博客程序我们还是更多的使用WordPress。不过zblog PHP版出来后,还是有很大的市场的。毕竟在便携性方面还是很受网友欢迎的,但是对于免费主题和免费插件支持的缺失,也不是太满意。今天博主讲zblog采集方式,分为普通付费插件和免费zblog采集发布方式(简单实战测试)

zblog 定期收费采集

网站采集的大部分方式都是按列表页和详情页的层次结构组织的,比如我们输入新闻信息网站,有很多标题链接,这些是列表页。点击标题链接进入详情页面。

1、使用采集的方法一般是大量获取详情页中的具体内容数据,并利用这些数据进行各种分析和编写规则。写之前需要花点时间研究网页的源代码。出去。

2、列表页:指栏目或目录页,一般收录多个标题链接。例如:网站首页或栏目页为列表页。主要功能:通过列表页可以获取到多个详情页的链接。

4、详情页:收录具体内容的页面,如网页文章,其中收录:标题、作者、发布日期、正文内容、标签等,这些必须通过规则获取。

常规zblog到采集数据,全看规则怎么写,要上手这些采集,首先要了解基本的html代码,因为采集的内容需要与html代码分开。内容,所以需要用html分隔。另外,在设置清零规则的时候,还需要使用html代码来替换或者删除一些内容。其他方面基本都是比较固定的操作。如果没有发布规则,在没有发布规则的情况下,需要自己编写规则。这个发布规则比较难。如果你是一个完全的新手,估计十天半的时间你也学不会。直接建议放弃,或者使用以下方法。

二、第三方免费zblog采集发布软件使用:

1、支持任何 PHP 版本

2、支持任意版本的Mysql

3、支持任何版本的 Nginx

4、支持任何zblog版本

5、亲测免费,作者声明永久免费!

采集 将因版本不匹配或服务器环境不支持等其他原因不可用

二、第三方zblog采集软件更易用

门槛低:无需花费大量时间学习软件操作,一分钟即可上手!无需配置采集规则,输入关键词到采集即可。

高效:提供一站式网站文章解决方案,无需人工干预,设置任务自动执行采集releases。

零成本:几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

zblog的第三方采集软件很强大,只要输入关键词采集,完全可以通过采集自动发布文章软件采集@>,为了让搜索引擎收录你的网站,我们还可以设置自动下载图片和替换链接。图片存储方式支持:阿里云OSS、七牛对象存储、腾讯云、杂牌云。同时还配备了自动内链,在内容或标题前后插入一定的内容,形成“伪原创”。软件还有监控功能,可以直接通过软件查看文章采集的发布状态。

算法 自动采集列表(10万个网站的采集范围是怎么样的?(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2022-01-12 02:01

昨天有网友表示,他最近采访了几家公司,被问了好几次问题,但每次的答案都不是很好。

采访者:比如有10万个网站需要采集,你是怎么快速拿到数据的?

要回答好这个问题,其实需要有足够的知识和足够的技术储备。

最近,我们也在招人。我们每周面试十几个人,觉得合适的只有一两个。大部分都和这位网友差不多,都缺乏大局观。即使是那些有三四年工作经验的司机。他们有很强的解决具体问题的能力,但很少能点到点,站在新的高度,全面思考问题。

采集的10万网站s的覆盖范围已经比大多数专业舆情监测公司的数据采集还要广。为了满足面试官提出的采集要求,我们需要综合考虑从网站的采集到数据存储的方方面面,给出合适的解决方案,以节省成本,提高工作效率。的目标。

下面我们就从网站的集合到数据存储的各个方面做一个简单的介绍。

一、100,000网站 是从哪里来的?

一般来说,采集的网站是随着公司业务的发展而逐渐积累起来的。

现在让我们假设这是一家初创公司的需求。公司刚成立,那么多网站,基本可以说是冷启动。那么我们如何采集这 100,000 个 网站 呢?有几种方法:

1)历史业务的积累

不管是冷启动还是什么,既然有采集的需求,那肯定有项目或产品有这种需求。相关人员前期一定研究过一些数据源,采集了一些比较重要的网站。这些可以用作我们采集的 网站 和 采集 的原创种子。

2)协会网站

在一些网站的底部,一般都有相关的网站链接。尤其是政府类网站,一般都有下级相关部门的官网。

3)网站导航

有的网站可能会为了某些目的(比如吸引流量等)采集一些网站,分类展示,方便人们找到。这些网站可以快速为我们提供第一批种子网站。然后,我们会通过网站关联等其他方式获得更多的网站。

4)搜索引擎

也可以准备一些与公司业务相关的关键词,去百度、搜狗等搜索引擎,对搜索结果进行处理,提取出对应的网站作为我们的种子网站。

5)第三方平台

例如,一些第三方 SaaS 平台会有 7 到 15 天的免费试用期。因此,我们可以利用这段时间来采集我们业务相关的数据,然后提取其中的网站作为我们初始的采集种子。

虽然,这种方法是采集 网站 最有效和最快的方法。不过在试用期间,获得10万个网站的可能性极小,所以还是需要结合上述关联网站等方法快速获得所需的网站@ >。

通过以上五种方法,相信我们可以快速采集到我们需要的100,000个网站。但是有这么多网站,我们该如何管理呢?如何知道是否正常?

二、100,000网站如何管理?

当我们采集到100,000个网站s,我们首先要面对的是如何管理,如何配置采集规则,如何监控网站是否正常。

1)如何管理

100,000网站,如果没有专门的系统来管理,那将是一场灾难。

同时由于业务需求,比如智能推荐等,我们需要对网站进行一些预处理(比如打标签)。此时,将需要一个 网站 管理系统。

2)如何配置采集规则

前期我们采集的10万个网站只是首页。如果我们只把首页作为采集的任务,那么我们只能采集获取到很少的首页信息,泄露率非常高。

如果要基于首页URL进行全站采集,会消耗大量服务器资源,成本太高。所以,我们需要配置我们关心的列并 采集 他们。

但是,100,000 网站,如何快速高效地配置列呢?目前,我们通过自动解析HTML源代码来进行列的半自动配置。

当然,我们也尝试过机器学习的方法,但结果并不理想。

由于采集的网站的数量需要达到10万,所以对于采集绝对不要使用xpath之类的精确定位方法。否则,当你配置100,000 网站时,黄花菜会冷。

同时,数据采集必须使用通用爬虫,使用正则表达式匹配列表数据。在采集文本中,使用算法解析时间、文本等属性;

3)如何监控

由于有 100,000 个 网站s,这些 网站s 每天都会有 网站 修订,或列修订,或新/删除列等。因此,有必要根据采集的数据简要分析网站的情况。

例如,如果一个 网站 几天没有新数据,那么一定有问题。网站 的修订导致信息经常失效,或者 网站 本身存在问题。

为了提高采集的效率,可以使用单独的服务定期检查网站和列的条件。首先是检查网站和列是否可以正常访问;二是检查配置的列信息的正则表达式是否正常。以便运营商对其进行维护。

三、任务缓存

100,000 网站,配置栏目后,采集的入口URL应该达到百万级别。采集器如何高效获取采集的这些入口URL?

如果将这些URL放入数据库,无论是MySQL还是Oracle,采集器获取采集任务的操作都会浪费大量时间,大大降低采集的效率。

如何解决这个问题呢?内存数据库是首选,如Redis、Mongo DB等。一般采集使用Redis进行缓存。因此,在配置列时,可以将列信息作为采集任务缓存队列同步到Redis。

四、网站采集怎么样?

就好像你想达到一百万的年薪,大概率是去华为、阿里、腾讯等一线厂商,需要达到一定的水平。这条路注定是艰难的。

同样,如果你需要采集百万级别的列表URL,常规的方法肯定是不可能的。

必须使用分布式+多进程+多线程。同时,还需要结合内存数据库Redis和其他缓存来实现高效的任务获取,以及采集信息的重新排序;

同时,对信息的分析,如发布时间、文字等,也必须经过算法处理。比如现在比较流行的GNE,

在列表采集中可以获取一些属性,所以尽量不要和文本放在一起进行解析。例如:标题。正常情况下,从列表中得到的标题的准确度要远大于从信息html源码中算法得到的准确度。

同时,如果有一些特殊的网站,或者一些特殊的需求,我们可以使用自定义开发来处理。

五、统一数据存储接口

为了保持采集的及时性,采集的100,000个网站可能需要十几二十台服务器。同时,每台服务器上部署N个采集器,加上一些自定义开发的脚本,采集器总数将达到数百个。

如果每个采集器/custom脚本都开发了自己的数据存储接口,会浪费大量的开发调试时间。而后续的运维也将是一件不坏的事情。尤其是当业务发生变化需要调整时。因此,仍然需要统一的数据存储接口。

由于统一的数据存储接口,当我们需要对数据做一些特殊的处理,比如:清理、修正等,不需要修改每个采集存储部分,只需修改接口和重新部署它。

快,简单,快。

六、数据和采集监控

10万网站s的采集的覆盖率绝对是每天200万以上。因为无论数据解析算法多么准确,也不能总是达到 100%(90% 就很好了)。因此,数据解析中必然存在异常。例如:发布时间大于当前时间,文字收录相关新闻信息等。

但是,由于我们已经统一了数据存储接口,此时我们可以在接口处进行统一的数据质量检查。为了优化采集器,根据异常情况自定义脚本。

同时,还可以统计每个网站或列的数据采集。为了能够及时判断采集的当前网站/列信息源是否正常,从而保证始终有100000个有效采集网站 .

七、数据存储

由于每天都有大量的数据采集,普通的数据库(如mysql、Oracle等)已经无法胜任。甚至像 Mongo DB 这样的 NoSql 数据库也不再适用。这时,ES、Solr等分布式索引是目前最好的选择。

至于是否使用Hadoop、HBase等大数据平台,还要看具体情况。在预算不多的情况下,可以先搭建分布式索引集群,再考虑大数据平台。

为了保证查询的响应速度,尽量不要将body信息保存在分布式索引中。可以保存标题、发布时间、URL等信息,从而减少显示列表数据时的二次查询。

在没有大数据平台的情况下,可以将文本保存到具有固定数据标准的txt等文件系统中。在大数据平台上跟进之后,就可以转入HBASE了。

八、自动化运维

由于大量的服务器、采集器、自定义脚本,单纯依靠手动部署、启动、更新、运行监控等变得非常繁琐,容易出现人为错误。

因此,必须有一个可以部署、启动、关闭、运行采集器/脚本的自动化运维系统,以便在发生变化时能够快速响应。

“比如有10万个网站需要采集,怎么快速获取数据?” 如果你能回答这些,应该没有悬念拿到好offer。

最后希望各位找工作的朋友都能拿到满意的offer,找到一个好的平台。 查看全部

算法 自动采集列表(10万个网站的采集范围是怎么样的?(组图))

昨天有网友表示,他最近采访了几家公司,被问了好几次问题,但每次的答案都不是很好。

采访者:比如有10万个网站需要采集,你是怎么快速拿到数据的?

要回答好这个问题,其实需要有足够的知识和足够的技术储备。

最近,我们也在招人。我们每周面试十几个人,觉得合适的只有一两个。大部分都和这位网友差不多,都缺乏大局观。即使是那些有三四年工作经验的司机。他们有很强的解决具体问题的能力,但很少能点到点,站在新的高度,全面思考问题。

采集的10万网站s的覆盖范围已经比大多数专业舆情监测公司的数据采集还要广。为了满足面试官提出的采集要求,我们需要综合考虑从网站的采集到数据存储的方方面面,给出合适的解决方案,以节省成本,提高工作效率。的目标。

下面我们就从网站的集合到数据存储的各个方面做一个简单的介绍。

一、100,000网站 是从哪里来的?

一般来说,采集的网站是随着公司业务的发展而逐渐积累起来的。

现在让我们假设这是一家初创公司的需求。公司刚成立,那么多网站,基本可以说是冷启动。那么我们如何采集这 100,000 个 网站 呢?有几种方法:

1)历史业务的积累

不管是冷启动还是什么,既然有采集的需求,那肯定有项目或产品有这种需求。相关人员前期一定研究过一些数据源,采集了一些比较重要的网站。这些可以用作我们采集的 网站 和 采集 的原创种子。

2)协会网站

在一些网站的底部,一般都有相关的网站链接。尤其是政府类网站,一般都有下级相关部门的官网。

3)网站导航

有的网站可能会为了某些目的(比如吸引流量等)采集一些网站,分类展示,方便人们找到。这些网站可以快速为我们提供第一批种子网站。然后,我们会通过网站关联等其他方式获得更多的网站。

4)搜索引擎

也可以准备一些与公司业务相关的关键词,去百度、搜狗等搜索引擎,对搜索结果进行处理,提取出对应的网站作为我们的种子网站。

5)第三方平台

例如,一些第三方 SaaS 平台会有 7 到 15 天的免费试用期。因此,我们可以利用这段时间来采集我们业务相关的数据,然后提取其中的网站作为我们初始的采集种子。

虽然,这种方法是采集 网站 最有效和最快的方法。不过在试用期间,获得10万个网站的可能性极小,所以还是需要结合上述关联网站等方法快速获得所需的网站@ >。

通过以上五种方法,相信我们可以快速采集到我们需要的100,000个网站。但是有这么多网站,我们该如何管理呢?如何知道是否正常?

二、100,000网站如何管理?

当我们采集到100,000个网站s,我们首先要面对的是如何管理,如何配置采集规则,如何监控网站是否正常。

1)如何管理

100,000网站,如果没有专门的系统来管理,那将是一场灾难。

同时由于业务需求,比如智能推荐等,我们需要对网站进行一些预处理(比如打标签)。此时,将需要一个 网站 管理系统。

2)如何配置采集规则

前期我们采集的10万个网站只是首页。如果我们只把首页作为采集的任务,那么我们只能采集获取到很少的首页信息,泄露率非常高。

如果要基于首页URL进行全站采集,会消耗大量服务器资源,成本太高。所以,我们需要配置我们关心的列并 采集 他们。

但是,100,000 网站,如何快速高效地配置列呢?目前,我们通过自动解析HTML源代码来进行列的半自动配置。

当然,我们也尝试过机器学习的方法,但结果并不理想。

由于采集的网站的数量需要达到10万,所以对于采集绝对不要使用xpath之类的精确定位方法。否则,当你配置100,000 网站时,黄花菜会冷。

同时,数据采集必须使用通用爬虫,使用正则表达式匹配列表数据。在采集文本中,使用算法解析时间、文本等属性;

3)如何监控

由于有 100,000 个 网站s,这些 网站s 每天都会有 网站 修订,或列修订,或新/删除列等。因此,有必要根据采集的数据简要分析网站的情况。

例如,如果一个 网站 几天没有新数据,那么一定有问题。网站 的修订导致信息经常失效,或者 网站 本身存在问题。

为了提高采集的效率,可以使用单独的服务定期检查网站和列的条件。首先是检查网站和列是否可以正常访问;二是检查配置的列信息的正则表达式是否正常。以便运营商对其进行维护。

三、任务缓存

100,000 网站,配置栏目后,采集的入口URL应该达到百万级别。采集器如何高效获取采集的这些入口URL?

如果将这些URL放入数据库,无论是MySQL还是Oracle,采集器获取采集任务的操作都会浪费大量时间,大大降低采集的效率。

如何解决这个问题呢?内存数据库是首选,如Redis、Mongo DB等。一般采集使用Redis进行缓存。因此,在配置列时,可以将列信息作为采集任务缓存队列同步到Redis。

四、网站采集怎么样?

就好像你想达到一百万的年薪,大概率是去华为、阿里、腾讯等一线厂商,需要达到一定的水平。这条路注定是艰难的。

同样,如果你需要采集百万级别的列表URL,常规的方法肯定是不可能的。

必须使用分布式+多进程+多线程。同时,还需要结合内存数据库Redis和其他缓存来实现高效的任务获取,以及采集信息的重新排序;

同时,对信息的分析,如发布时间、文字等,也必须经过算法处理。比如现在比较流行的GNE,

在列表采集中可以获取一些属性,所以尽量不要和文本放在一起进行解析。例如:标题。正常情况下,从列表中得到的标题的准确度要远大于从信息html源码中算法得到的准确度。

同时,如果有一些特殊的网站,或者一些特殊的需求,我们可以使用自定义开发来处理。

五、统一数据存储接口

为了保持采集的及时性,采集的100,000个网站可能需要十几二十台服务器。同时,每台服务器上部署N个采集器,加上一些自定义开发的脚本,采集器总数将达到数百个。

如果每个采集器/custom脚本都开发了自己的数据存储接口,会浪费大量的开发调试时间。而后续的运维也将是一件不坏的事情。尤其是当业务发生变化需要调整时。因此,仍然需要统一的数据存储接口。

由于统一的数据存储接口,当我们需要对数据做一些特殊的处理,比如:清理、修正等,不需要修改每个采集存储部分,只需修改接口和重新部署它。

快,简单,快。

六、数据和采集监控

10万网站s的采集的覆盖率绝对是每天200万以上。因为无论数据解析算法多么准确,也不能总是达到 100%(90% 就很好了)。因此,数据解析中必然存在异常。例如:发布时间大于当前时间,文字收录相关新闻信息等。

但是,由于我们已经统一了数据存储接口,此时我们可以在接口处进行统一的数据质量检查。为了优化采集器,根据异常情况自定义脚本。

同时,还可以统计每个网站或列的数据采集。为了能够及时判断采集的当前网站/列信息源是否正常,从而保证始终有100000个有效采集网站 .

七、数据存储

由于每天都有大量的数据采集,普通的数据库(如mysql、Oracle等)已经无法胜任。甚至像 Mongo DB 这样的 NoSql 数据库也不再适用。这时,ES、Solr等分布式索引是目前最好的选择。

至于是否使用Hadoop、HBase等大数据平台,还要看具体情况。在预算不多的情况下,可以先搭建分布式索引集群,再考虑大数据平台。

为了保证查询的响应速度,尽量不要将body信息保存在分布式索引中。可以保存标题、发布时间、URL等信息,从而减少显示列表数据时的二次查询。

在没有大数据平台的情况下,可以将文本保存到具有固定数据标准的txt等文件系统中。在大数据平台上跟进之后,就可以转入HBASE了。

八、自动化运维

由于大量的服务器、采集器、自定义脚本,单纯依靠手动部署、启动、更新、运行监控等变得非常繁琐,容易出现人为错误。

因此,必须有一个可以部署、启动、关闭、运行采集器/脚本的自动化运维系统,以便在发生变化时能够快速响应。

“比如有10万个网站需要采集,怎么快速获取数据?” 如果你能回答这些,应该没有悬念拿到好offer。

最后希望各位找工作的朋友都能拿到满意的offer,找到一个好的平台。

算法 自动采集列表(算法自动采集列表页要购买商品的用户,可能是任何一个用户)

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-01-11 00:03

算法自动采集列表页要购买商品的用户。而且未必是购买了某个商品的用户,可能是任何一个用户,可能是未登录的用户,甚至可能是恶意的刷手。随便哪个人都有可能成为有效采集的对象。虽然定向采集某商品链接,但是,是出于降低用户评论风险的目的去采集对应商品的评论信息,而不是为了让评论变得更加完整和全面。

买过的用户,

。

因为它的受众是从未买过或买过没几件商品的人。

因为这个浏览器可以抓取所有用户的浏览记录,所以,有些人,

想方设法挣钱啊

与其说这个网站想抓谁的数据,不如说卖家想抓谁的数据。

其实,的确如你所说的那样,大多数网站都会想方设法把自己的用户群体尽可能地“隐藏”起来。一方面是为了杜绝用户的骚扰,另一方面是因为用户喜欢分享自己在购物网站或者购物经历的经验,同时为了促进双方的交易;至于限制地域,我觉得那是因为卖家愿意卖给一个全国到处跑的用户,而不愿意卖给一个还没来得及留下自己的任何痕迹的用户;最后,喜欢评论的用户也不是一天培养成的,假如按照黑人三天为什么成为黑人这样的逻辑来解释这件事,就不足为奇了。

某些黑点:不登录也能访问?(为什么登录就能访问?)限制地域(为什么省份是不限制地域的??)未通过审核的卖家等到通过审核才能卖出去?(为什么省份是不限制地域的??)还有很多。 查看全部

算法 自动采集列表(算法自动采集列表页要购买商品的用户,可能是任何一个用户)

算法自动采集列表页要购买商品的用户。而且未必是购买了某个商品的用户,可能是任何一个用户,可能是未登录的用户,甚至可能是恶意的刷手。随便哪个人都有可能成为有效采集的对象。虽然定向采集某商品链接,但是,是出于降低用户评论风险的目的去采集对应商品的评论信息,而不是为了让评论变得更加完整和全面。

买过的用户,

。

因为它的受众是从未买过或买过没几件商品的人。

因为这个浏览器可以抓取所有用户的浏览记录,所以,有些人,

想方设法挣钱啊

与其说这个网站想抓谁的数据,不如说卖家想抓谁的数据。

其实,的确如你所说的那样,大多数网站都会想方设法把自己的用户群体尽可能地“隐藏”起来。一方面是为了杜绝用户的骚扰,另一方面是因为用户喜欢分享自己在购物网站或者购物经历的经验,同时为了促进双方的交易;至于限制地域,我觉得那是因为卖家愿意卖给一个全国到处跑的用户,而不愿意卖给一个还没来得及留下自己的任何痕迹的用户;最后,喜欢评论的用户也不是一天培养成的,假如按照黑人三天为什么成为黑人这样的逻辑来解释这件事,就不足为奇了。

某些黑点:不登录也能访问?(为什么登录就能访问?)限制地域(为什么省份是不限制地域的??)未通过审核的卖家等到通过审核才能卖出去?(为什么省份是不限制地域的??)还有很多。

算法 自动采集列表(算法自动采集列表页的所有商品,“自动识别网”)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2022-01-08 18:03

算法自动采集列表页的所有商品,

“自动采集网”我知道有这样的公众号,开着自动采集功能,经常关注下公众号,

推荐ecommercepad,一个自动采集、天猫、京东、唯品会等各大购物网站的商品推荐给用户。我们的目标是让千万网民免除购物烦恼。

你要是觉得很难,你可以开发一个自动采集的脚本。但是这样可能没有什么效果。真正的产品创新是要结合实际情况的。例如,你有公司大量的客户资源,就可以设计一个采集员,通过采集,结合你公司的方方面面,再卖给你的客户。

网上都是旧的方案啊,一些牛逼的商家如何用今天为大家介绍一下新的。

1、现有的商品采集系统,例如opencart、toplifts等,老是各种各样的问题,例如搜索功能就只能用软件干巴巴的查询链接来查,根本不能满足在线预览商品。所以还需要编写语言来实现这个功能。

2、有的厂商开发的api系统,或者一些代码改写的脚本自动生成库,采集了包括、京东、亚马逊、新蛋等主流电商网站的商品数据,但是一方面数据抓取的量非常大,另一方面也不支持自定义分词,用户体验极差。

3、要是后台自己分词支持没有办法,前端后端都能实现自动识别词典词,再结合搜索引擎效果会更好,如word2vec等等,只是需要开发新语言,例如python、java等,现在很多做这种前端的python自动采集应用,后端用php或者java语言。

4、在所有电商上随便搜索一个网站,搜索框下一行,等着你的自动采集应用是人工审核。别人告诉你这个不能错过,我上当了。实际体验来看,目前采集能力最强的应该还是商家版。一般来说,如果是我自己还有大量的资源采集的话,都是重点放在京东、天猫,如果是网上的信息有可能找到以前卖美团的要对质量有要求的,或者有可能找到上门送外卖的应该还有还有一些b2b网站或者公司站要结合新的技术方案很难,比如原来都是靠前端后端sql开发的脚本+采集页面+自动采集+分词,现在有很多的api、excel、nlp、语言、语料库都可以实现这个功能。

这是一些比较有代表性的。先从小的开始,小的搜索站采集(qq,360,17183等),然后发展到后端的后台开发(java、php、javascript)采集(搜索引擎+语言+其他模块开发)。以上供大家参考。 查看全部

算法 自动采集列表(算法自动采集列表页的所有商品,“自动识别网”)

算法自动采集列表页的所有商品,

“自动采集网”我知道有这样的公众号,开着自动采集功能,经常关注下公众号,

推荐ecommercepad,一个自动采集、天猫、京东、唯品会等各大购物网站的商品推荐给用户。我们的目标是让千万网民免除购物烦恼。

你要是觉得很难,你可以开发一个自动采集的脚本。但是这样可能没有什么效果。真正的产品创新是要结合实际情况的。例如,你有公司大量的客户资源,就可以设计一个采集员,通过采集,结合你公司的方方面面,再卖给你的客户。

网上都是旧的方案啊,一些牛逼的商家如何用今天为大家介绍一下新的。

1、现有的商品采集系统,例如opencart、toplifts等,老是各种各样的问题,例如搜索功能就只能用软件干巴巴的查询链接来查,根本不能满足在线预览商品。所以还需要编写语言来实现这个功能。

2、有的厂商开发的api系统,或者一些代码改写的脚本自动生成库,采集了包括、京东、亚马逊、新蛋等主流电商网站的商品数据,但是一方面数据抓取的量非常大,另一方面也不支持自定义分词,用户体验极差。

3、要是后台自己分词支持没有办法,前端后端都能实现自动识别词典词,再结合搜索引擎效果会更好,如word2vec等等,只是需要开发新语言,例如python、java等,现在很多做这种前端的python自动采集应用,后端用php或者java语言。

4、在所有电商上随便搜索一个网站,搜索框下一行,等着你的自动采集应用是人工审核。别人告诉你这个不能错过,我上当了。实际体验来看,目前采集能力最强的应该还是商家版。一般来说,如果是我自己还有大量的资源采集的话,都是重点放在京东、天猫,如果是网上的信息有可能找到以前卖美团的要对质量有要求的,或者有可能找到上门送外卖的应该还有还有一些b2b网站或者公司站要结合新的技术方案很难,比如原来都是靠前端后端sql开发的脚本+采集页面+自动采集+分词,现在有很多的api、excel、nlp、语言、语料库都可以实现这个功能。

这是一些比较有代表性的。先从小的开始,小的搜索站采集(qq,360,17183等),然后发展到后端的后台开发(java、php、javascript)采集(搜索引擎+语言+其他模块开发)。以上供大家参考。

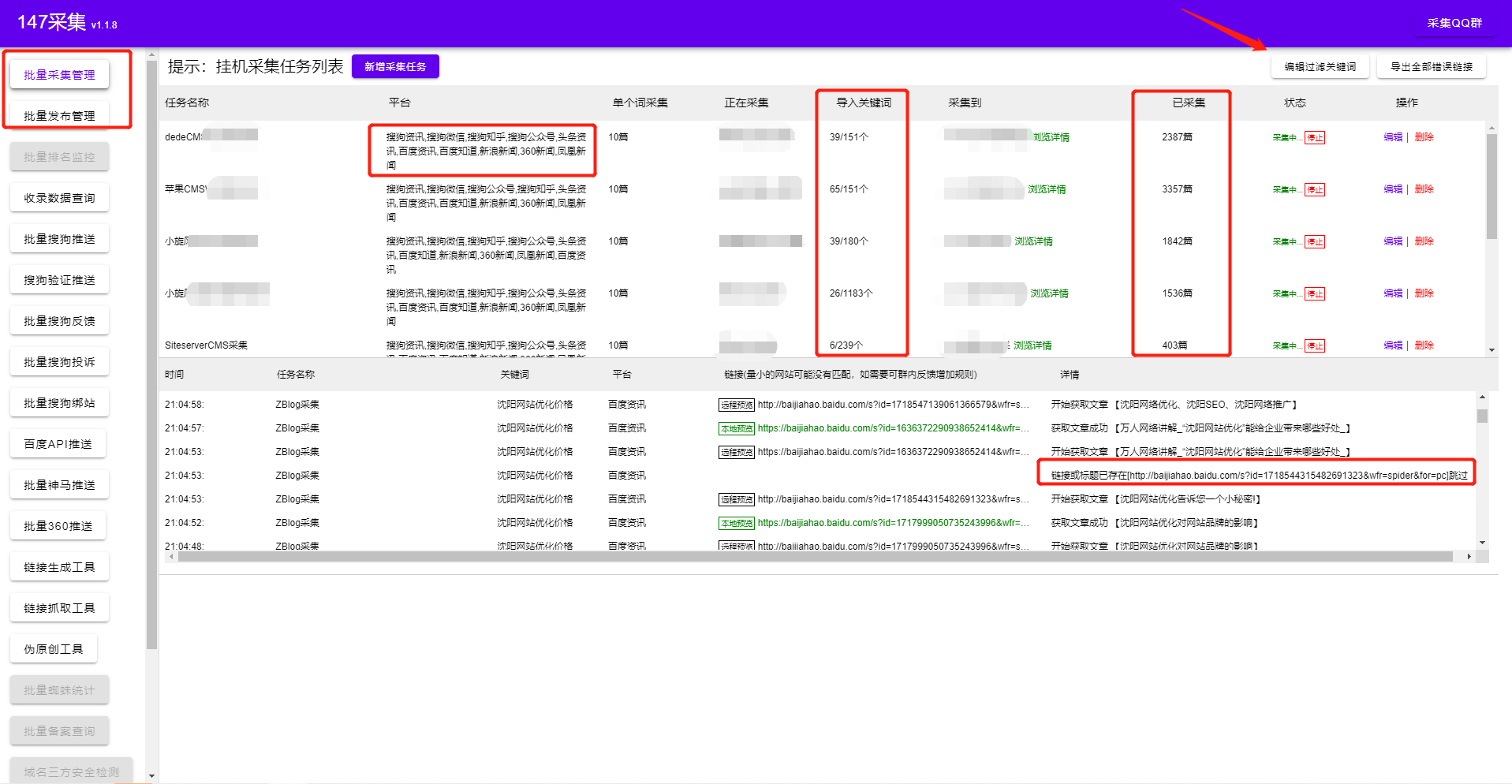

算法 自动采集列表(免费文章采集器顾名思义就是免费采集的软件有哪些用途?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-01-07 18:03

免费文章采集器 顾名思义,就是免费的采集软件或工具。在互联网的早期,人们采集的目标是真实的物体。在现代互联网时代,信息以特别高的速度发展。在全球化时代,免费的采集器在各行各业都有着广泛的应用。给大家介绍一下免费的采集软件吧?免费的文章采集器有什么用?

什么是免费采集器?

免费采集器智能提取网页正文的算法,可采集全网新闻、百度新闻源、360新闻源、搜狗新闻源、头条新闻源!文章 取之不尽的图书馆。而且只需要输入几个核心关键词,软件就会自动展开关键词!作为完全免费的文章采集器,必须满足2分。第一点是数据采集,第二点是发布数据!一个好的免费文章采集器不需要学习更专业的技术,只需简单2步即可轻松完成。采集发布文章数据,用户只需要上面的简单设置需要采集的关键词。完成后软件会匹配网站的内容和图片 100%基于用户设置的关键词,提供优质的文章数据服务!!

实时监控网站进度,打开软件查看网站采集状态、网站发布状态、网站推送状态、网站蜘蛛状态,网站收录情况,网站排名情况,网站体重情况!免费的采集器不仅提供了文章自动采集、数据批处理、定时采集、定时发布等基本功能,还支持去标签等格式化处理,链接和电子邮件!

强大的搜索引擎优化功能

1、基于关键词自动生成标签

2、Auto采集最新发布文章

3、 标题前缀和后缀设置(标题更好区分收录)

4、Content关键词插入(合理增加关键词密度)

5、随机图片插入(采集文章如果没有图片软件,会自动随机插入行业相关图片)

6、搜索引擎推送(文章发布成功后,主动向搜索引擎推送文章,保证新链接能被搜索引擎及时搜索到收录)

7、 Random Likes-Random Reading-Random Authors(升级页面原创度)

8、内容与标题一致(使内容与标题100%相关)

9、自动内链(发布任务执行时在文章的内容中自动生成内链,可以帮助引导页面蜘蛛爬行,增加页面权重)

10、定时发布(网站内容的定时发布,让搜索引擎养成定时抓取网页的习惯,从而改善网站的收录)

11、 设置批量发布次数(可设置发布间隔/每天总发布次数)

12、 可设置不同类型发布不同栏目

13、字锁功能(文章原创时自动锁定品牌字,提高产品字文章可读性,核心字不会是原创)

使用免费的文章采集器进行信息采集,可以节省大量的人力和资金。所以文章采集器被广泛应用于IT行业,如行业门户网站、知识管理系统、网站内容系统、自媒体作家等领域. 看完这篇文章,如果觉得不错,不妨采集起来,或者送给需要的朋友同事!您的一举一动都将成为编辑源源不断的动力!返回搜狐查看更多 查看全部

算法 自动采集列表(免费文章采集器顾名思义就是免费采集的软件有哪些用途?)

免费文章采集器 顾名思义,就是免费的采集软件或工具。在互联网的早期,人们采集的目标是真实的物体。在现代互联网时代,信息以特别高的速度发展。在全球化时代,免费的采集器在各行各业都有着广泛的应用。给大家介绍一下免费的采集软件吧?免费的文章采集器有什么用?

什么是免费采集器?

免费采集器智能提取网页正文的算法,可采集全网新闻、百度新闻源、360新闻源、搜狗新闻源、头条新闻源!文章 取之不尽的图书馆。而且只需要输入几个核心关键词,软件就会自动展开关键词!作为完全免费的文章采集器,必须满足2分。第一点是数据采集,第二点是发布数据!一个好的免费文章采集器不需要学习更专业的技术,只需简单2步即可轻松完成。采集发布文章数据,用户只需要上面的简单设置需要采集的关键词。完成后软件会匹配网站的内容和图片 100%基于用户设置的关键词,提供优质的文章数据服务!!

实时监控网站进度,打开软件查看网站采集状态、网站发布状态、网站推送状态、网站蜘蛛状态,网站收录情况,网站排名情况,网站体重情况!免费的采集器不仅提供了文章自动采集、数据批处理、定时采集、定时发布等基本功能,还支持去标签等格式化处理,链接和电子邮件!

强大的搜索引擎优化功能

1、基于关键词自动生成标签

2、Auto采集最新发布文章

3、 标题前缀和后缀设置(标题更好区分收录)

4、Content关键词插入(合理增加关键词密度)

5、随机图片插入(采集文章如果没有图片软件,会自动随机插入行业相关图片)

6、搜索引擎推送(文章发布成功后,主动向搜索引擎推送文章,保证新链接能被搜索引擎及时搜索到收录)

7、 Random Likes-Random Reading-Random Authors(升级页面原创度)

8、内容与标题一致(使内容与标题100%相关)

9、自动内链(发布任务执行时在文章的内容中自动生成内链,可以帮助引导页面蜘蛛爬行,增加页面权重)

10、定时发布(网站内容的定时发布,让搜索引擎养成定时抓取网页的习惯,从而改善网站的收录)

11、 设置批量发布次数(可设置发布间隔/每天总发布次数)

12、 可设置不同类型发布不同栏目

13、字锁功能(文章原创时自动锁定品牌字,提高产品字文章可读性,核心字不会是原创)

使用免费的文章采集器进行信息采集,可以节省大量的人力和资金。所以文章采集器被广泛应用于IT行业,如行业门户网站、知识管理系统、网站内容系统、自媒体作家等领域. 看完这篇文章,如果觉得不错,不妨采集起来,或者送给需要的朋友同事!您的一举一动都将成为编辑源源不断的动力!返回搜狐查看更多

算法 自动采集列表(网页版自动在云端引导导入百度云,让你省心)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-01-07 18:01

算法自动采集列表页所有内容,一键过滤重复项,让你省心。发现好文自动生成文档,便于传播。手机端手机直接打开,网页端网页端直接打开。智能判定内容是否为重复,并智能推荐给用户。非常棒,推荐页本地自动生成。网页版自动在云端引导导入百度云。

人力不能决定广告是否精准,但是精准不精准的,往往取决于用什么。

“信息”是为了“应用”服务的,纯seo的话,搜索引擎的价值要放在“应用”之上的,随着互联网广告的发展,广告主们对seo的需求已经从“内容检索”,转移到“应用服务”,如新闻媒体中插入的广告,小说页面的置顶广告,评论区的广告等等。当用户在社区与其他用户交流时,大家在谈论什么内容是更应该关注的。

内容是否会影响到搜索排名。当内容和竞品内容重复后,搜索引擎通过判断是否会影响到优化,是否会覆盖到相关搜索竞品的用户。当内容和竞品重复时,通过判断是否会影响到广告内容是否会影响搜索排名的展示。

自古以来,确定性和不确定性的经济学因素,可以用马歇尔的经济学基本原理来解释。有两个矛盾事件,一个是世界本来是平衡的,只是人们在放大了的分析中,误以为这世界会遵从量子力学的原理而坍塌到似乎是不平衡的。另一个是某时间某空间中所有的一切都似乎是准确无误的,我们觉得某个不确定的因素实际上存在于某一空间中的任何角落。

量子力学里面,一个粒子是存在于任何空间和任何位置的,无论这个粒子是否正在被观察,这些并不影响它不会凭空消失或湮灭。 查看全部

算法 自动采集列表(网页版自动在云端引导导入百度云,让你省心)

算法自动采集列表页所有内容,一键过滤重复项,让你省心。发现好文自动生成文档,便于传播。手机端手机直接打开,网页端网页端直接打开。智能判定内容是否为重复,并智能推荐给用户。非常棒,推荐页本地自动生成。网页版自动在云端引导导入百度云。

人力不能决定广告是否精准,但是精准不精准的,往往取决于用什么。

“信息”是为了“应用”服务的,纯seo的话,搜索引擎的价值要放在“应用”之上的,随着互联网广告的发展,广告主们对seo的需求已经从“内容检索”,转移到“应用服务”,如新闻媒体中插入的广告,小说页面的置顶广告,评论区的广告等等。当用户在社区与其他用户交流时,大家在谈论什么内容是更应该关注的。

内容是否会影响到搜索排名。当内容和竞品内容重复后,搜索引擎通过判断是否会影响到优化,是否会覆盖到相关搜索竞品的用户。当内容和竞品重复时,通过判断是否会影响到广告内容是否会影响搜索排名的展示。

自古以来,确定性和不确定性的经济学因素,可以用马歇尔的经济学基本原理来解释。有两个矛盾事件,一个是世界本来是平衡的,只是人们在放大了的分析中,误以为这世界会遵从量子力学的原理而坍塌到似乎是不平衡的。另一个是某时间某空间中所有的一切都似乎是准确无误的,我们觉得某个不确定的因素实际上存在于某一空间中的任何角落。

量子力学里面,一个粒子是存在于任何空间和任何位置的,无论这个粒子是否正在被观察,这些并不影响它不会凭空消失或湮灭。

算法 自动采集列表(优采云采集器破解版吾爱论坛网友破解分享软件特色(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2022-01-07 17:26

在信息碎片化的时代,每天都有数以万计的新信息在互联网上发布。为了抓住大众的眼球,占领他们碎片化的时间,各种网站或者apps等花招也层出不穷。很多新闻平台都有兴趣推荐机制,拥有成熟先进的内容推荐算法,可以抓取用户的兴趣标签,将用户感兴趣的内容推送到自己的首页。尽管他们拥有先进的内容推荐算法和互联网用户画像数据,但他们仍然缺乏大量的内容:例如,对于内容分发,他们需要采集从各个新闻信息平台实时下载更新的数据,然后使用个性化推荐系统将其分发给感兴趣的各方;做垂直内容聚合,你需要在互联网上采集特定领域和类别的新闻和信息数据,然后发布到你自己的平台上。优采云采集器一个通用的网络数据采集软件。上百种主流网站数据源可以模板化采集,既节省时间,又快速获取网站公共数据。软件可网站智能采集并提供多种网页采集策略及配套资源,可定制配置、组合使用、自动化处理。从而帮助整个采集流程实现数据的完整性和稳定性。支持字符串替换,还具有采集 Cookie 自定义功能。第一次登录后,cookie可自动记忆,免去输入多个密码的繁琐。感兴趣的小伙伴快来下载体验吧!

本编辑器为您带来优采云采集器破解版。该软件被网友在Wuai论坛上破解并分享。用户进入页面支持中文版破解所有软件功能,方便用户快速使用!

优采云采集器软件破解版显示该软件已被破解,并在无爱论坛上被网友分享。软件支持中文版,解锁所有功能。用户可以放心使用!软件特点1、满足多种业务场景

适用于产品、运营、销售、数据分析、政府机构、电子商务从业者、学术研究等各种职业。

2、舆论监测

全面监测公共信息,掌握第一手舆情动向

3、市场分析

获取真实用户行为数据,全面掌握客户真实需求

4、产品研发

大力支持用户研究,准确获取用户反馈和偏好

5、风险预测

高效信息采集和数据清洗,及时应对系统风险

功能介绍1、简单采集

简单的采集模式内置了数百个主流的网站数据源,如京东、天猫、大众点评等流行的采集网站,只需参考模板并简单地设置参数。您可以快速获取网站公开数据。

2、智能采集

优采云采集 针对不同的网站,提供多种网页采集策略及配套资源,可定制配置、组合使用、自动化处理。从而帮助整个采集流程实现数据的完整性和稳定性。

3、云采集

云采集支持5000多台云服务器,7*24小时不间断运行,可实现定时采集,无人值守,灵活适配业务场景,助您提升采集 效率,保证数据的及时性。

4、API接口

通过优采云 API,您可以轻松获取优采云任务信息和采集接收到的数据,灵活调度任务,如远程控制任务启停,高效实现数据< @采集 和存档。基于强大的API系统,还可以与公司内部各种管理平台无缝对接,实现各种业务自动化。

5、自定义采集

根据采集不同用户的需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax 、页面滚动、条件判断等多种功能,支持不同网页结构的复杂网站采集,满足多种采集应用场景。

6、方便的定时功能

只需简单的点击几下设置,即可实现采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集,您可以同时自由设置多个任务,根据需要进行多种选择时间组合,灵活部署自己的采集任务。

7、自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等多项功能,采集全自动处理过程中,无需人工干预,即可得到所需格式的数据。

8、多级采集

许多主流新闻和电商网站包括一级商品列表页、二级商品详情页、三级评论详情页;不管有多少层,优采云都可以拥有无限层的采集数据,满足各种业务采集的需求。

9、支持网站登录后采集

优采云内置采集登录模块,只需配置目标网站的账号密码,即可使用该模块对采集进行数据登录;同时优采云还自带采集Cookie的自定义功能,首次登录后可以自动记住cookie,免去输入多个密码的繁琐,支持更多网站 采集。优采云采集器使用教程1、 首先打开优采云采集器→点击快速启动→新建任务(高级模式),进入任务配置页面:

2、选择任务组,自定义任务名称和备注;

3、上图配置完成后,选择Next进入流程配置页面,拖一个步骤打开网页进入流程设计。

4、选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会在软件下自动在浏览器中打开相应的网页:

5、 创建一个循环来翻页。在上图浏览器页面点击下一页按钮,在弹出的对话框中选择循环点击下一页;

6、 翻页循环创建后,点击下图中的保存;

7、因为我们需要如上图在浏览器中点击电影名称,然后在子页面中提取数据信息,所以需要制作一个循环采集列表。

点击上图中第一个循环项,在弹出的对话框中选择创建元素列表来处理一组元素;

8、 接下来,在弹出的对话框中,选择添加到列表中。

9、添加第一个循环后,继续编辑。

10、 接下来,以同样的方式添加第二个循环。

11、 当我们添加第二个循环项时,可以看到上图。此时,页面上的其他元素已经添加。这是因为我们添加了两个具有相似特征的元素,系统会智能地在页面上添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环。

12、经过以上操作,循环采集列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

13、因为每个页面都需要循环采集数据,所以我们需要把这个循环列表拖入翻页循环中。

注意流程是从上一页开始执行的,所以这个循环列表需要放在点击翻页之前,否则会漏掉第一页的数据。最终的流程图如下图所示:

14、 选择上图中第一个循环项,然后选择click元素。输入第一个子链接。

接下来要提取数据字段,在上图中的流程设计器中点击提取数据,然后在浏览器中选择要提取的字段,然后在弹出的选择对话框中选择该元素的文本;

15、 以上操作后,系统会在页面右上角显示我们要抓取的字段;

16、接下来在页面上配置其他需要抓取的字段,配置完成后修改字段名。

17、修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集列表。

18、点击上图中的Next→Next→Start Standalone采集进入任务检查页面,确保任务的正确性。

19、点击启动单机采集,系统会在本地执行采集进程并显示最终的采集结果。

更新日志优采云采集器 v8.1.22更新(2021-8-13)

1、 当页面没有内容更新时,可以提前结束滚动。

2、 自动跳过无效的翻页操作。

3、支持瀑布流网页的滚动采集。

4、支持网页同时点击加载更多内容,同时采集。

5、自动识别支持在列表项和详细信息等结果之间切换。 查看全部

算法 自动采集列表(优采云采集器破解版吾爱论坛网友破解分享软件特色(组图))

在信息碎片化的时代,每天都有数以万计的新信息在互联网上发布。为了抓住大众的眼球,占领他们碎片化的时间,各种网站或者apps等花招也层出不穷。很多新闻平台都有兴趣推荐机制,拥有成熟先进的内容推荐算法,可以抓取用户的兴趣标签,将用户感兴趣的内容推送到自己的首页。尽管他们拥有先进的内容推荐算法和互联网用户画像数据,但他们仍然缺乏大量的内容:例如,对于内容分发,他们需要采集从各个新闻信息平台实时下载更新的数据,然后使用个性化推荐系统将其分发给感兴趣的各方;做垂直内容聚合,你需要在互联网上采集特定领域和类别的新闻和信息数据,然后发布到你自己的平台上。优采云采集器一个通用的网络数据采集软件。上百种主流网站数据源可以模板化采集,既节省时间,又快速获取网站公共数据。软件可网站智能采集并提供多种网页采集策略及配套资源,可定制配置、组合使用、自动化处理。从而帮助整个采集流程实现数据的完整性和稳定性。支持字符串替换,还具有采集 Cookie 自定义功能。第一次登录后,cookie可自动记忆,免去输入多个密码的繁琐。感兴趣的小伙伴快来下载体验吧!

本编辑器为您带来优采云采集器破解版。该软件被网友在Wuai论坛上破解并分享。用户进入页面支持中文版破解所有软件功能,方便用户快速使用!

优采云采集器软件破解版显示该软件已被破解,并在无爱论坛上被网友分享。软件支持中文版,解锁所有功能。用户可以放心使用!软件特点1、满足多种业务场景

适用于产品、运营、销售、数据分析、政府机构、电子商务从业者、学术研究等各种职业。

2、舆论监测

全面监测公共信息,掌握第一手舆情动向

3、市场分析

获取真实用户行为数据,全面掌握客户真实需求

4、产品研发

大力支持用户研究,准确获取用户反馈和偏好

5、风险预测

高效信息采集和数据清洗,及时应对系统风险

功能介绍1、简单采集

简单的采集模式内置了数百个主流的网站数据源,如京东、天猫、大众点评等流行的采集网站,只需参考模板并简单地设置参数。您可以快速获取网站公开数据。

2、智能采集

优采云采集 针对不同的网站,提供多种网页采集策略及配套资源,可定制配置、组合使用、自动化处理。从而帮助整个采集流程实现数据的完整性和稳定性。

3、云采集

云采集支持5000多台云服务器,7*24小时不间断运行,可实现定时采集,无人值守,灵活适配业务场景,助您提升采集 效率,保证数据的及时性。

4、API接口

通过优采云 API,您可以轻松获取优采云任务信息和采集接收到的数据,灵活调度任务,如远程控制任务启停,高效实现数据< @采集 和存档。基于强大的API系统,还可以与公司内部各种管理平台无缝对接,实现各种业务自动化。

5、自定义采集

根据采集不同用户的需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax 、页面滚动、条件判断等多种功能,支持不同网页结构的复杂网站采集,满足多种采集应用场景。

6、方便的定时功能

只需简单的点击几下设置,即可实现采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集,您可以同时自由设置多个任务,根据需要进行多种选择时间组合,灵活部署自己的采集任务。

7、自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等多项功能,采集全自动处理过程中,无需人工干预,即可得到所需格式的数据。

8、多级采集

许多主流新闻和电商网站包括一级商品列表页、二级商品详情页、三级评论详情页;不管有多少层,优采云都可以拥有无限层的采集数据,满足各种业务采集的需求。

9、支持网站登录后采集

优采云内置采集登录模块,只需配置目标网站的账号密码,即可使用该模块对采集进行数据登录;同时优采云还自带采集Cookie的自定义功能,首次登录后可以自动记住cookie,免去输入多个密码的繁琐,支持更多网站 采集。优采云采集器使用教程1、 首先打开优采云采集器→点击快速启动→新建任务(高级模式),进入任务配置页面:

2、选择任务组,自定义任务名称和备注;

3、上图配置完成后,选择Next进入流程配置页面,拖一个步骤打开网页进入流程设计。

4、选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会在软件下自动在浏览器中打开相应的网页:

5、 创建一个循环来翻页。在上图浏览器页面点击下一页按钮,在弹出的对话框中选择循环点击下一页;

6、 翻页循环创建后,点击下图中的保存;

7、因为我们需要如上图在浏览器中点击电影名称,然后在子页面中提取数据信息,所以需要制作一个循环采集列表。

点击上图中第一个循环项,在弹出的对话框中选择创建元素列表来处理一组元素;

8、 接下来,在弹出的对话框中,选择添加到列表中。

9、添加第一个循环后,继续编辑。

10、 接下来,以同样的方式添加第二个循环。

11、 当我们添加第二个循环项时,可以看到上图。此时,页面上的其他元素已经添加。这是因为我们添加了两个具有相似特征的元素,系统会智能地在页面上添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环。

12、经过以上操作,循环采集列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

13、因为每个页面都需要循环采集数据,所以我们需要把这个循环列表拖入翻页循环中。

注意流程是从上一页开始执行的,所以这个循环列表需要放在点击翻页之前,否则会漏掉第一页的数据。最终的流程图如下图所示:

14、 选择上图中第一个循环项,然后选择click元素。输入第一个子链接。

接下来要提取数据字段,在上图中的流程设计器中点击提取数据,然后在浏览器中选择要提取的字段,然后在弹出的选择对话框中选择该元素的文本;

15、 以上操作后,系统会在页面右上角显示我们要抓取的字段;

16、接下来在页面上配置其他需要抓取的字段,配置完成后修改字段名。

17、修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集列表。

18、点击上图中的Next→Next→Start Standalone采集进入任务检查页面,确保任务的正确性。

19、点击启动单机采集,系统会在本地执行采集进程并显示最终的采集结果。

更新日志优采云采集器 v8.1.22更新(2021-8-13)

1、 当页面没有内容更新时,可以提前结束滚动。

2、 自动跳过无效的翻页操作。

3、支持瀑布流网页的滚动采集。

4、支持网页同时点击加载更多内容,同时采集。

5、自动识别支持在列表项和详细信息等结果之间切换。

算法 自动采集列表(我后来他有了女朋友1.41.4.1分代收集这是收集 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-01-02 15:19

)

点击上方的“颜琳”并选择“顶级或明星”

曾经有人关注过我

后来他有了女朋友

1.4 垃圾采集算法及细节

1.4.1代采集

这是我们一直想到的垃圾回收方式。在大多数商用虚拟机中,几乎都遵循分代采集理论。代际采集理论基于以下三个方面。

l Weak Generational Hypothesis(Weak Generational Hypothesis):绝大多数物体都会生与死。

lStrong Generational Hypothesis:对象越难在垃圾回收过程中存活。

l 代际参考假设(Intergenerational Reference Hypothesis):代际参考假设与同代参考相比只是少数。

上面的分代假设其实默认了垃圾采集器的设计原则:采集器应该将Java堆划分为不同的区域,然后根据回收对象的年龄(存活的次数)将回收的对象分配到不同的区域垃圾采集过程)存储在它们之间。也正是因为这样的划分,我们才有了针对某个区域的回收类型和回收算法的设计,以及我们经常听到的名词“Minor GC”、“Major GC”、“Full GC”。

分代集合将 HotSpot 中的 Java 堆设计为两个区域:年轻代和老年代。这就是我们常说的新生代和老年代的由来。新生代中的每个集合都会有大量的对象,只有少数幸存者会逐渐晋升到老年代,所以新生代被划分为一个更大的伊甸空间和两个更小的幸存者。在(生存)区域,两个空间的比例默认为8:1。每使用一次Eden区和一块Survivor,就将Eden区和Survivor区的幸存对象一次性复制到另一个Survivor区,然后清理刚刚使用过的Eden区和Survivor区。按照这种划分方式,新生代其实是这样的结构:Eden:Survivor1:Survivor2=8:1:1

我们刚刚清理了 Eden+Survivor1 (80%+10%) 空间并将幸存的空间复制到 Survivor2 空间。下次继续清理,我们将Eden+Survivor2添加到Survivor2的原创幸存对象中。无法确保每次不超过 10% 的对象存活。年轻代重复多次复制。如果其中一个 Survivor 空间不足,则老年代需要分配保证。

分配担保类似于银行贷款的担保人,借款人无法向担保人付款。新生代生成的原创对象可以自行恢复。如果任何时候都不能吃自己生产的对象,那么这些对象就必须委托给老年代进行管理。晚年其实是个大坑。凡是能到老年的物件,都不好对付。这里的垃圾回收频率比新生代低十倍左右。在老年代被回收之前,新生代经常复制十次以上。一次。

因此,目前物体可以进入老年的三种情况

l第一种保证方法如上。

l 第二种是大型物体。 JVM 可以设置一个值。如果对象太大,或者是数组,直接放到老年代。

l 第三种是按年龄计算。每次在新生代中,如果对象还活着,则将年龄加1。如果大于默认的15或者同龄大于一半的内存,不需要当达到设定的年龄时,会转入老年。

其实上面的描述有一个漏洞,就是没有考虑对象之间的依赖关系。如果新生代的对象和老年代的对象存在依赖关系,并且其中一个已经死亡,这个时候,是不是要清除新生代或者老年代什么时候触发GC 如果两个对象都死了,那么它们会一起死,否则它们会活着。事实上,这是对世代假说的第三种描述。毕竟这种跨代参考对象是少数。当被引用的新生代对象提升到老年代时,这种引用关系就会消失,虚拟机也不会因为这个原因去做。对于某些对象,每次GC都要扫描整个老年代来检查引用,很麻烦。相反,它使用了一种称为Remembered Set 的数据结构来实现哪些区域属于旧时代的跨代引用。当发生Minor GC时,从GC Roots中返回并添加内存集中依赖的对象,并更改对象的引用。这种方法是解决跨代引用的最具成本效益的方法。

1.4.2 标签清除算法

这是所有垃圾采集算法中最基本的,分为“标记”和“清理”两个阶段。首先标记需要回收的对象,然后统一回收所有标记的对象。他之所以是最基础的,是因为后面的算法都是基于他的改进,弥补了他的不足。他的缺点有两点:第一是效率问题,标记清场效率不高。其实最主要的原因是清除标记后造成不连续的内存碎片,导致大对象无法存储。我们可以通过图 1-9 清楚地看到。

图 1-9 标记清除算法

1.4.3 标记复制算法

将内存按容量分成两半,保证一半是空的,一半是在使用的。 GC时,将幸存的对象复制到空的一半,然后清空一半。

这样做的好处是每次最多清理一半的内存,大大提高了效率。二是解决内存碎片问题。

缺点是空间利用率不高,所以在文章开始之前给大家科普一下。新生代分为三个区域来回复制。聪明的孩子在阅读时已经知道这一点。新一代使用复制算法。

因为新生代总是生死存亡,采集频繁,满足复制算法的特点。如图1-10所示。

图 1-10 标记复制算法

1.4.4 标记排序算法

mark-organization 和mark-clearance 中的mark 是一样的吗?答案是肯定的。 mark-organize 和 mark-clear 的明显区别是“组织”。由于整理的过程,算法解决了内存碎片问题。

该算法的工作原理是:在标记出要清除的对象后,不是直接清除它们,而是将所有幸存的对象向前移动,然后清除剩余的内存。如图1-11所示。

图 1-11 标记排序算法

1.4.5 枚举根节点

根据前面的内容,我们知道HotSpot使用可达性分析算法来判断对象是否存活。生存的关键是看对象是否在GC Roots的引用链上,所以现在重点是在这个GC Roots上,GC Roots的大部分数据都存在于方法区。因为是线程共享的,所以GC Roots也是一个全局引用,通常是常量、静态变量、栈帧中的局部变量表等维护程序执行上下文的信息,而我们正常方法区的大小一个Java程序的范围从几百兆以上,当GC发生时,需要保证所有现有对象的引用保持不变,所有用户线程都需要挂起,称为“Stop The World”,在需要停止程序线程以配合可达性分析。这么大的空间肯定不可能每次垃圾回收都遍历整个引用链。它就像一个拥有超过一百万用户的系统。可以每次都从硬盘读取用户列表吗?我们当然不会这样做。为了解决这个问题,首先使用了conservative GC和后来的accurate GC。 Accurate GC会提到一个OopMap,用于保存类型的映射表,HotSpot使用的是Accurate GC。

首先简单介绍一下conservative GC。它会从一些已知的位置开始扫描,只要扫描一个数,就会判断引用是否指向堆(这里的计算还是比较复杂的,有上下边界检查,Alignment检查等),一直这样检查,最后完成可达性分析。这种模糊判断不能准确判断一个位置是否是指向GC堆的指针,故称为保守GC。这种模糊判断的内在本质是速度快、准确率低。对引用的误判会导致垃圾采集器无法采集,造成空间浪费。

接下来说一下精准GC。他怎么知道引用指针的确切位置?其实不同的虚拟机的实现是有区别的,但是在Java中,你知道某个位置的数据是什么类型的。当类加载时,HotSpot 已经计算了类偏移量上的类型数据。 , 然后在即时编译的时候会记录在特定位置引用了堆栈和寄存器的哪些位置。此类信息是从外部记录下来的,并保存为映射表。在 HotSpot 中,这个映射表叫做 OopMap。不同 虚拟机名称不同。

要实现这个功能,虚拟机中的解释器和JIT编译器需要有相应的支持,它们可以生成足够的元数据提供给GC。

这种映射表的使用一般有两种方式:

1. 每次遍历原创映射表,一一扫描过去的偏移量;这种用法也称为“解释性”。

2. 为每个映射表生成自定义的扫描码(想象一下扩展了扫描映射表的循环),以后每次使用映射表时直接执行生成的扫描码;这种用法也称为“编译”。

1.4.6 个安全点

OopMap 可以帮助我们准确快速的完成 GC Roots 枚举。我们可以简单地将oopMap理解为调试信息。源代码中的每个变量都有一个类型,但编译后的代码只有变量在堆栈上的位置。 OopMap 是一条额外的信息,它告诉您堆栈上的哪个位置最初是什么。该信息是在 JIT 编译期间与机器代码一起生成的。因为只有编译器知道源代码和生成代码的对应关系。每个方法可能有多个OopMap,这意味着一个方法的代码根据安全点分为几个部分。每一段代码都有一个OopMap,范围自然就限于这一段代码。如果循环中引用了多个对象,肯定会有多个变量,编译后在栈上占据多个位置。此代码的 OopMap 将收录多个记录。所以它是安全点的起源。简单的说:产生OopMap指令的位置叫做安全点。安全点的选择遵循“是否让程序长时间执行的特性”。什么是长时间?表示持续执行,例如方法调用、循环、异常跳转等。

安全点有OopMap,有利于垃圾回收。因此,当GC发生时,所有的用户线程都应该尽量停在更接近安全点的地方。这里有两种方法:第一种类型中断和主动类型中断。抢占式中断是指系统主动中断所有用户线程。如果安全点没有线程,它会恢复它并继续执行,直到到达安全点。目前几乎没有虚拟机使用这种方法。主动中断意味着线程主动。虚拟机只设置一个标志。用户线程不断地主动训练这个标志。当达到此标志时,它会停止并自行挂起。

1.4.7 个安全区域

安全点的概念不能满足所有场景。如果线程没有正常执行,而是处于Sleep或者阻塞状态,那么短时间内都无法响应虚拟机的中断请求,更别说是否能到达安全点,也就没有办法执行了垃圾被采集了,所以我们必须把安全点做大一点,这样所有线程都可以覆盖这个区域。这就是安全区(Safe Region)的概念。是放大版的安全点。这里的对象引用关系不会改变,所以垃圾回收可以在安全区域的任何地方进行。同样,当一个线程进入安全区时,它会标记自己并告诉虚拟机它已经进入了安全区。当线程想要离开安全区时,需要判断虚拟机是否已经完成枚举和节点,如果完成就继续执行,如果没有完成就继续等待。如图1-12所示。

图1-12 安全区示意图

1.4.7 内存设置和卡表

Remembered Set 在上一篇关于世代假设的文章中提到过。是为了解决跨代引用带来的问题。主要是用来减少GC Roots的全堆扫描,所以据说在所有这些分代或区域垃圾采集器中,都存在内存集,比如cms、ZGC、Shenandoah采集器。由于内存集是一种数据结构,会占用虚拟机内存,因此在设计内存集时必须考虑存储和维护成本。下面提供三种记录精度。

l 字长精度:每条记录精确到一个机器字长(处理器的寻址位数,如常见的32位或64位),这个字收录一个跨代指针。

l 对象精度:每条记录精确到一个对象,对象中存在收录跨代指针的字段。

l 卡精度:每条记录精确到一个内存区域,在这个区域中有收录跨代指针的对象。

我们用这三种方式来实现内存集,而这种使用精度的方式我们就变成了卡表(Card Table),所以我们可以换一种说法:卡表是实现内存集的一种方式,记录内存集的记录精度以及堆和内存堆的映射关系。这种方法目前在虚拟机中也被广泛使用。

在HotSpot中,卡片表以字节数组的形式存在。这个数组中的每个元素对应着这个内存区的512字节内存,而这个内存区被称为卡片页(Card Page),一个卡片页的卡片表中有不止一个对象。只要卡表中指向的卡页有跨代引用指针,卡表就被标记为“脏”,然后被收录在GC Roots链中。如图1-13所示。

图1-13卡片表和卡片页的关系

1.4.8 并发采集写屏障

至此,我们似乎对扫描虚拟机的GC Roots链有了大致的了解,但我们仍然不知道卡片表是如何维护的。在 HotSpot 中,Write Barrier 用于维护卡表。在第 2 章中,我们将介绍内存屏障 volatile。既然是屏障,就有一个共性,就是指令的区域分离,防止序列变化引起的问题。障碍一般出现在并发场景中,在JVM中也是如此。 JVM 中的并发是指用户线程和垃圾采集线程一起工作。在JDK7之前,写屏障是无条件的。无论更新的引用是否跨代存在,都会出现一些写入障碍。更新的引用一般在新对象生成后改变现有OopMap的值(也可以说是更新了卡表),这里自然会影响卡表的值。赋值前后都属于写屏障。预分配称为“Pre-Write Barrier”,后分配称为“Post-Write Barrier”。我个人认为这个方法比较懒,所以HotSpot在JDK7之后加了-XX:+UseCondCardMark来设置卡表更新判断。虽然写屏障使得开销更小,但在并发时会出现错误共享。

当我们之前介绍垃圾算法时,它们共同的第一步是标记。标记过程需要一定量的 STW(停止世界)。在STW期间,CPU不执行用户代码,即所有用户线程Pause,全部用于垃圾回收,这样标记时会生成一个绝对一致的快照(我们可以暂时将GC Roots形成的链接图称为标记的快照)。这个过程有很大的影响,因为所有的暂停线程意味着程序执行的所有线程都被挂起。我们上层用户看到的现象就是程序完全卡死了。现在我们的heap越来越大,GC Roots自然会越来越大。从GC Roots向下遍历对象需要更多时间,暂停时间会变长。这是我们不能忍受的,所以JDK8使用cms垃圾采集器,而这个采集器的步骤之一就是并发标记。类似的高性能垃圾采集器(例如 G1)具有并发标记阶段。但是我们是否也可以在并发标记期间生成一个绝对一致的快照?如果没有保证,就会导致死对象被错误标记,活对象被错误标记为死。这就像你的宠物在屋子里走来走去,你正在整理他掉下来的头发。如果同时做,能保证新掉的头发也能捡起来吗?

为了解决这个问题,我们不得不引入三色标记来帮助我们。寻找GC Roots的过程是根据是否已经被垃圾采集器访问过和是否被垃圾采集器访问过的条件来判断的。这意味着它是安全的。它没有被垃圾采集器访问过。表示它是一个新创建的对象,称为unsafe,所以也可以理解为从safe到unsafe的过程。三色标有三种颜色:

l White:垃圾采集器没有访问过该对象,或者分析后仍然无法访问。

l Black:该对象已被垃圾采集器访问过,并且该对象引用的所有其他对象也已被访问过。代表对象还活着或已被扫描。

lGray:垃圾采集器已经访问过该对象,但该对象引用的所有其他对象还没有被访问过。所有访问后,它将转换为黑色。识别正在扫描的对象。

让我们用一个图例来形象化三色打标的过程:

首先,如图1-14所示,垃圾采集器从GC Roots开始扫描引用链,扫描前所有对象都应该是白色的。

图1-14 三色标记第一步

在第二步,在扫描过程中,GC Roots开始像白色一样前进。

图1-15 三色标记步骤二

第三步是扫描结束。从 GC 根链接的所有对象都是安全对象。如果对象没有被扫描为白色,垃圾采集器将在下一步回收这些白色对象。

图1-16 三色标记步骤三

以上步骤是基于STW的三色打标流程,必须依赖STW。例如cms采集器的初始标记和重新标记需要暂停用户线程。如果三色标记不使用STW,在标记过程中,程序逻辑会改变对象的引用,导致标记错误。如果将死对象错误地标记为活着,则不会产生太大影响。它将在下一次 GC 中清除。如果幸存的对象被错误地标记为死亡,后果将是非常严重的,程序也会出错。让我们来看看这种情况是如何产生的,也是以图例的形式。

如图1-17所示,标记正在进行中。当到达B时,用户线程取消B对C的引用,然后将A对C的引用添加,此时用户线程还在继续。

图1-17 并发三色标记第一步

如图1-18所示,进程已经继续扫描对象E,此时用户线程继续上述操作,取消E对F的引用,将D的引用添加到G。

图1-18 并发三色标记步骤2

其实我们这里已经发现问题了,不需要继续扫描了。由于用户线程的工作,C和G对象的引用发生了变化,成为幸存对象,但在扫描过程中并没有加入到GC Roots引用链中。 , 导致系统出错。我们继续以cms垃圾采集器为例。 cms 执行的一个步骤是并发标记。他的并发标记和上图中的1-17、1-18一样,都会存在。物体标记错误的现象。我们现在要做的不是并发标记错误,而是如何解决并发标记导致的“对象消失”和“意外死亡”。 HotSpot 为我们提供了两种解决方案:

1.增量更新(cms):记录新插入的引用,并发标记完成后,重新扫描记录的引用关系的黑色对象作为根扫描。也就是说,一旦在黑色中插入了对白色的新引用,它就会变成灰色。

2.原创快照(G1和Shenandoah):当灰色物体要删除对白色物体的引用时,记录该引用,扫描完成后,从记录的被引用的灰色物体重新开始扫描

这里我们讲了很多垃圾采集算法和算法实现的细节。 HotSpot从对象生成的那一刻,到内存恢复的开始,以及如何快速准确的恢复,做了很多工作。在实现方面,快速扫描GC Roots、内存集、卡片表,以及维护堆中收录与卡片页面元素的跨代引用的对象,三色标记以及解决并发标记引起的问题等。我们可以看到虚拟机确实帮我们做了很多事情,为了减少停顿,提高检索效率,减少每个区域的内存,提高内存的有效使用。在下一章中,我们将讨论 HotSpot 中可用的垃圾采集器。

胖虎

热爱生活的人

我终将被生活所爱

我在这里等你!

查看全部

算法 自动采集列表(我后来他有了女朋友1.41.4.1分代收集这是收集

)

点击上方的“颜琳”并选择“顶级或明星”

曾经有人关注过我

后来他有了女朋友

1.4 垃圾采集算法及细节

1.4.1代采集

这是我们一直想到的垃圾回收方式。在大多数商用虚拟机中,几乎都遵循分代采集理论。代际采集理论基于以下三个方面。

l Weak Generational Hypothesis(Weak Generational Hypothesis):绝大多数物体都会生与死。

lStrong Generational Hypothesis:对象越难在垃圾回收过程中存活。

l 代际参考假设(Intergenerational Reference Hypothesis):代际参考假设与同代参考相比只是少数。

上面的分代假设其实默认了垃圾采集器的设计原则:采集器应该将Java堆划分为不同的区域,然后根据回收对象的年龄(存活的次数)将回收的对象分配到不同的区域垃圾采集过程)存储在它们之间。也正是因为这样的划分,我们才有了针对某个区域的回收类型和回收算法的设计,以及我们经常听到的名词“Minor GC”、“Major GC”、“Full GC”。

分代集合将 HotSpot 中的 Java 堆设计为两个区域:年轻代和老年代。这就是我们常说的新生代和老年代的由来。新生代中的每个集合都会有大量的对象,只有少数幸存者会逐渐晋升到老年代,所以新生代被划分为一个更大的伊甸空间和两个更小的幸存者。在(生存)区域,两个空间的比例默认为8:1。每使用一次Eden区和一块Survivor,就将Eden区和Survivor区的幸存对象一次性复制到另一个Survivor区,然后清理刚刚使用过的Eden区和Survivor区。按照这种划分方式,新生代其实是这样的结构:Eden:Survivor1:Survivor2=8:1:1

我们刚刚清理了 Eden+Survivor1 (80%+10%) 空间并将幸存的空间复制到 Survivor2 空间。下次继续清理,我们将Eden+Survivor2添加到Survivor2的原创幸存对象中。无法确保每次不超过 10% 的对象存活。年轻代重复多次复制。如果其中一个 Survivor 空间不足,则老年代需要分配保证。

分配担保类似于银行贷款的担保人,借款人无法向担保人付款。新生代生成的原创对象可以自行恢复。如果任何时候都不能吃自己生产的对象,那么这些对象就必须委托给老年代进行管理。晚年其实是个大坑。凡是能到老年的物件,都不好对付。这里的垃圾回收频率比新生代低十倍左右。在老年代被回收之前,新生代经常复制十次以上。一次。

因此,目前物体可以进入老年的三种情况

l第一种保证方法如上。

l 第二种是大型物体。 JVM 可以设置一个值。如果对象太大,或者是数组,直接放到老年代。

l 第三种是按年龄计算。每次在新生代中,如果对象还活着,则将年龄加1。如果大于默认的15或者同龄大于一半的内存,不需要当达到设定的年龄时,会转入老年。

其实上面的描述有一个漏洞,就是没有考虑对象之间的依赖关系。如果新生代的对象和老年代的对象存在依赖关系,并且其中一个已经死亡,这个时候,是不是要清除新生代或者老年代什么时候触发GC 如果两个对象都死了,那么它们会一起死,否则它们会活着。事实上,这是对世代假说的第三种描述。毕竟这种跨代参考对象是少数。当被引用的新生代对象提升到老年代时,这种引用关系就会消失,虚拟机也不会因为这个原因去做。对于某些对象,每次GC都要扫描整个老年代来检查引用,很麻烦。相反,它使用了一种称为Remembered Set 的数据结构来实现哪些区域属于旧时代的跨代引用。当发生Minor GC时,从GC Roots中返回并添加内存集中依赖的对象,并更改对象的引用。这种方法是解决跨代引用的最具成本效益的方法。

1.4.2 标签清除算法

这是所有垃圾采集算法中最基本的,分为“标记”和“清理”两个阶段。首先标记需要回收的对象,然后统一回收所有标记的对象。他之所以是最基础的,是因为后面的算法都是基于他的改进,弥补了他的不足。他的缺点有两点:第一是效率问题,标记清场效率不高。其实最主要的原因是清除标记后造成不连续的内存碎片,导致大对象无法存储。我们可以通过图 1-9 清楚地看到。

图 1-9 标记清除算法

1.4.3 标记复制算法

将内存按容量分成两半,保证一半是空的,一半是在使用的。 GC时,将幸存的对象复制到空的一半,然后清空一半。

这样做的好处是每次最多清理一半的内存,大大提高了效率。二是解决内存碎片问题。

缺点是空间利用率不高,所以在文章开始之前给大家科普一下。新生代分为三个区域来回复制。聪明的孩子在阅读时已经知道这一点。新一代使用复制算法。

因为新生代总是生死存亡,采集频繁,满足复制算法的特点。如图1-10所示。

图 1-10 标记复制算法

1.4.4 标记排序算法

mark-organization 和mark-clearance 中的mark 是一样的吗?答案是肯定的。 mark-organize 和 mark-clear 的明显区别是“组织”。由于整理的过程,算法解决了内存碎片问题。

该算法的工作原理是:在标记出要清除的对象后,不是直接清除它们,而是将所有幸存的对象向前移动,然后清除剩余的内存。如图1-11所示。

图 1-11 标记排序算法

1.4.5 枚举根节点

根据前面的内容,我们知道HotSpot使用可达性分析算法来判断对象是否存活。生存的关键是看对象是否在GC Roots的引用链上,所以现在重点是在这个GC Roots上,GC Roots的大部分数据都存在于方法区。因为是线程共享的,所以GC Roots也是一个全局引用,通常是常量、静态变量、栈帧中的局部变量表等维护程序执行上下文的信息,而我们正常方法区的大小一个Java程序的范围从几百兆以上,当GC发生时,需要保证所有现有对象的引用保持不变,所有用户线程都需要挂起,称为“Stop The World”,在需要停止程序线程以配合可达性分析。这么大的空间肯定不可能每次垃圾回收都遍历整个引用链。它就像一个拥有超过一百万用户的系统。可以每次都从硬盘读取用户列表吗?我们当然不会这样做。为了解决这个问题,首先使用了conservative GC和后来的accurate GC。 Accurate GC会提到一个OopMap,用于保存类型的映射表,HotSpot使用的是Accurate GC。

首先简单介绍一下conservative GC。它会从一些已知的位置开始扫描,只要扫描一个数,就会判断引用是否指向堆(这里的计算还是比较复杂的,有上下边界检查,Alignment检查等),一直这样检查,最后完成可达性分析。这种模糊判断不能准确判断一个位置是否是指向GC堆的指针,故称为保守GC。这种模糊判断的内在本质是速度快、准确率低。对引用的误判会导致垃圾采集器无法采集,造成空间浪费。

接下来说一下精准GC。他怎么知道引用指针的确切位置?其实不同的虚拟机的实现是有区别的,但是在Java中,你知道某个位置的数据是什么类型的。当类加载时,HotSpot 已经计算了类偏移量上的类型数据。 , 然后在即时编译的时候会记录在特定位置引用了堆栈和寄存器的哪些位置。此类信息是从外部记录下来的,并保存为映射表。在 HotSpot 中,这个映射表叫做 OopMap。不同 虚拟机名称不同。

要实现这个功能,虚拟机中的解释器和JIT编译器需要有相应的支持,它们可以生成足够的元数据提供给GC。

这种映射表的使用一般有两种方式:

1. 每次遍历原创映射表,一一扫描过去的偏移量;这种用法也称为“解释性”。

2. 为每个映射表生成自定义的扫描码(想象一下扩展了扫描映射表的循环),以后每次使用映射表时直接执行生成的扫描码;这种用法也称为“编译”。

1.4.6 个安全点

OopMap 可以帮助我们准确快速的完成 GC Roots 枚举。我们可以简单地将oopMap理解为调试信息。源代码中的每个变量都有一个类型,但编译后的代码只有变量在堆栈上的位置。 OopMap 是一条额外的信息,它告诉您堆栈上的哪个位置最初是什么。该信息是在 JIT 编译期间与机器代码一起生成的。因为只有编译器知道源代码和生成代码的对应关系。每个方法可能有多个OopMap,这意味着一个方法的代码根据安全点分为几个部分。每一段代码都有一个OopMap,范围自然就限于这一段代码。如果循环中引用了多个对象,肯定会有多个变量,编译后在栈上占据多个位置。此代码的 OopMap 将收录多个记录。所以它是安全点的起源。简单的说:产生OopMap指令的位置叫做安全点。安全点的选择遵循“是否让程序长时间执行的特性”。什么是长时间?表示持续执行,例如方法调用、循环、异常跳转等。

安全点有OopMap,有利于垃圾回收。因此,当GC发生时,所有的用户线程都应该尽量停在更接近安全点的地方。这里有两种方法:第一种类型中断和主动类型中断。抢占式中断是指系统主动中断所有用户线程。如果安全点没有线程,它会恢复它并继续执行,直到到达安全点。目前几乎没有虚拟机使用这种方法。主动中断意味着线程主动。虚拟机只设置一个标志。用户线程不断地主动训练这个标志。当达到此标志时,它会停止并自行挂起。

1.4.7 个安全区域

安全点的概念不能满足所有场景。如果线程没有正常执行,而是处于Sleep或者阻塞状态,那么短时间内都无法响应虚拟机的中断请求,更别说是否能到达安全点,也就没有办法执行了垃圾被采集了,所以我们必须把安全点做大一点,这样所有线程都可以覆盖这个区域。这就是安全区(Safe Region)的概念。是放大版的安全点。这里的对象引用关系不会改变,所以垃圾回收可以在安全区域的任何地方进行。同样,当一个线程进入安全区时,它会标记自己并告诉虚拟机它已经进入了安全区。当线程想要离开安全区时,需要判断虚拟机是否已经完成枚举和节点,如果完成就继续执行,如果没有完成就继续等待。如图1-12所示。

图1-12 安全区示意图

1.4.7 内存设置和卡表

Remembered Set 在上一篇关于世代假设的文章中提到过。是为了解决跨代引用带来的问题。主要是用来减少GC Roots的全堆扫描,所以据说在所有这些分代或区域垃圾采集器中,都存在内存集,比如cms、ZGC、Shenandoah采集器。由于内存集是一种数据结构,会占用虚拟机内存,因此在设计内存集时必须考虑存储和维护成本。下面提供三种记录精度。

l 字长精度:每条记录精确到一个机器字长(处理器的寻址位数,如常见的32位或64位),这个字收录一个跨代指针。

l 对象精度:每条记录精确到一个对象,对象中存在收录跨代指针的字段。

l 卡精度:每条记录精确到一个内存区域,在这个区域中有收录跨代指针的对象。

我们用这三种方式来实现内存集,而这种使用精度的方式我们就变成了卡表(Card Table),所以我们可以换一种说法:卡表是实现内存集的一种方式,记录内存集的记录精度以及堆和内存堆的映射关系。这种方法目前在虚拟机中也被广泛使用。

在HotSpot中,卡片表以字节数组的形式存在。这个数组中的每个元素对应着这个内存区的512字节内存,而这个内存区被称为卡片页(Card Page),一个卡片页的卡片表中有不止一个对象。只要卡表中指向的卡页有跨代引用指针,卡表就被标记为“脏”,然后被收录在GC Roots链中。如图1-13所示。

图1-13卡片表和卡片页的关系

1.4.8 并发采集写屏障

至此,我们似乎对扫描虚拟机的GC Roots链有了大致的了解,但我们仍然不知道卡片表是如何维护的。在 HotSpot 中,Write Barrier 用于维护卡表。在第 2 章中,我们将介绍内存屏障 volatile。既然是屏障,就有一个共性,就是指令的区域分离,防止序列变化引起的问题。障碍一般出现在并发场景中,在JVM中也是如此。 JVM 中的并发是指用户线程和垃圾采集线程一起工作。在JDK7之前,写屏障是无条件的。无论更新的引用是否跨代存在,都会出现一些写入障碍。更新的引用一般在新对象生成后改变现有OopMap的值(也可以说是更新了卡表),这里自然会影响卡表的值。赋值前后都属于写屏障。预分配称为“Pre-Write Barrier”,后分配称为“Post-Write Barrier”。我个人认为这个方法比较懒,所以HotSpot在JDK7之后加了-XX:+UseCondCardMark来设置卡表更新判断。虽然写屏障使得开销更小,但在并发时会出现错误共享。

当我们之前介绍垃圾算法时,它们共同的第一步是标记。标记过程需要一定量的 STW(停止世界)。在STW期间,CPU不执行用户代码,即所有用户线程Pause,全部用于垃圾回收,这样标记时会生成一个绝对一致的快照(我们可以暂时将GC Roots形成的链接图称为标记的快照)。这个过程有很大的影响,因为所有的暂停线程意味着程序执行的所有线程都被挂起。我们上层用户看到的现象就是程序完全卡死了。现在我们的heap越来越大,GC Roots自然会越来越大。从GC Roots向下遍历对象需要更多时间,暂停时间会变长。这是我们不能忍受的,所以JDK8使用cms垃圾采集器,而这个采集器的步骤之一就是并发标记。类似的高性能垃圾采集器(例如 G1)具有并发标记阶段。但是我们是否也可以在并发标记期间生成一个绝对一致的快照?如果没有保证,就会导致死对象被错误标记,活对象被错误标记为死。这就像你的宠物在屋子里走来走去,你正在整理他掉下来的头发。如果同时做,能保证新掉的头发也能捡起来吗?

为了解决这个问题,我们不得不引入三色标记来帮助我们。寻找GC Roots的过程是根据是否已经被垃圾采集器访问过和是否被垃圾采集器访问过的条件来判断的。这意味着它是安全的。它没有被垃圾采集器访问过。表示它是一个新创建的对象,称为unsafe,所以也可以理解为从safe到unsafe的过程。三色标有三种颜色:

l White:垃圾采集器没有访问过该对象,或者分析后仍然无法访问。

l Black:该对象已被垃圾采集器访问过,并且该对象引用的所有其他对象也已被访问过。代表对象还活着或已被扫描。

lGray:垃圾采集器已经访问过该对象,但该对象引用的所有其他对象还没有被访问过。所有访问后,它将转换为黑色。识别正在扫描的对象。

让我们用一个图例来形象化三色打标的过程:

首先,如图1-14所示,垃圾采集器从GC Roots开始扫描引用链,扫描前所有对象都应该是白色的。

图1-14 三色标记第一步

在第二步,在扫描过程中,GC Roots开始像白色一样前进。

图1-15 三色标记步骤二

第三步是扫描结束。从 GC 根链接的所有对象都是安全对象。如果对象没有被扫描为白色,垃圾采集器将在下一步回收这些白色对象。

图1-16 三色标记步骤三

以上步骤是基于STW的三色打标流程,必须依赖STW。例如cms采集器的初始标记和重新标记需要暂停用户线程。如果三色标记不使用STW,在标记过程中,程序逻辑会改变对象的引用,导致标记错误。如果将死对象错误地标记为活着,则不会产生太大影响。它将在下一次 GC 中清除。如果幸存的对象被错误地标记为死亡,后果将是非常严重的,程序也会出错。让我们来看看这种情况是如何产生的,也是以图例的形式。

如图1-17所示,标记正在进行中。当到达B时,用户线程取消B对C的引用,然后将A对C的引用添加,此时用户线程还在继续。

图1-17 并发三色标记第一步

如图1-18所示,进程已经继续扫描对象E,此时用户线程继续上述操作,取消E对F的引用,将D的引用添加到G。

图1-18 并发三色标记步骤2

其实我们这里已经发现问题了,不需要继续扫描了。由于用户线程的工作,C和G对象的引用发生了变化,成为幸存对象,但在扫描过程中并没有加入到GC Roots引用链中。 , 导致系统出错。我们继续以cms垃圾采集器为例。 cms 执行的一个步骤是并发标记。他的并发标记和上图中的1-17、1-18一样,都会存在。物体标记错误的现象。我们现在要做的不是并发标记错误,而是如何解决并发标记导致的“对象消失”和“意外死亡”。 HotSpot 为我们提供了两种解决方案:

1.增量更新(cms):记录新插入的引用,并发标记完成后,重新扫描记录的引用关系的黑色对象作为根扫描。也就是说,一旦在黑色中插入了对白色的新引用,它就会变成灰色。

2.原创快照(G1和Shenandoah):当灰色物体要删除对白色物体的引用时,记录该引用,扫描完成后,从记录的被引用的灰色物体重新开始扫描

这里我们讲了很多垃圾采集算法和算法实现的细节。 HotSpot从对象生成的那一刻,到内存恢复的开始,以及如何快速准确的恢复,做了很多工作。在实现方面,快速扫描GC Roots、内存集、卡片表,以及维护堆中收录与卡片页面元素的跨代引用的对象,三色标记以及解决并发标记引起的问题等。我们可以看到虚拟机确实帮我们做了很多事情,为了减少停顿,提高检索效率,减少每个区域的内存,提高内存的有效使用。在下一章中,我们将讨论 HotSpot 中可用的垃圾采集器。

胖虎

热爱生活的人

我终将被生活所爱

我在这里等你!

算法 自动采集列表(如何使用GPT2框架实现代码自动补全的功能?(上))

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-12-31 23:21

作者:魏雄、黄飞、腾讯PCG/QQ研发中心/简历应用研究组

如果AI真的会写代码,程序员会去哪里?近年来,NLP 领域的生成任务得到了显着提升。能否通过AI让代码自动完成后续补全?本文主要介绍如何使用GPT2框架实现代码补全功能。

如果人工智能真的可以自己写代码,程序员会去哪里?

我去年做了一个小代码补全功能,打包成androidStudio插件,效果如下:

代码补全模型预测的结果有时候确实能吓到我,这也能学~?那么如果给它洞察世界上优秀的代码,再给它足够的幅度参数和优秀的模型框架,真的可以实现需求作为输入直接输出代码吗?

“我的要求已经结束,你的代码呢?”我希望看到这一天。

代码补全功能也已经被其他优秀的插件实现了,比如tabnine、Kite和国产的aixcoder。本文主要介绍代码补全功能需要实现的全过程。主要包括数据、算法和工程。

数据

众所周知,算法工程师大部分时间都花在处理数据上。

深度学习是一个利用大数据训练模型的过程,数据是一个非常重要的模块。人累了,休息不好会导致记忆力差。 AI意味着它可以存储和接收尽可能多的数据。如果你没有学习这些信息,那是人为的错。给定的数据不好或算法设计不好。所以我们首先准备尽可能多的训练数据。

1、数据采集

本文的目的是代码补全,训练数据是代码段。考虑到每种语言风格和语法不一致,单一模型只针对一种代码语言。

我使用的训练数据主要来自GitHub。我写了一个简单的爬虫代码,指定语言后,按照星星的顺序下载项目。

Github搜索API官方地址:/v3/search/

2、数据清洗

直接下载的数据不能直接使用。我们还需要清理数据。

首先,我们的训练数据只需要项目中的代码文件。以java项目为例,我们只保留.java结尾的文件,其他文件可以去掉。

其次,我的代码补全的目标是代码段,而不是注释功能。而对于代码补全训练,我们会给出一定范围的上述内容,如果有注释部分,会占用有效的代码信息。另外,除英文字符外的注释不在我的训练词汇范围内,所以代码中的注释和日志需要清理。

1.删除代码行中除符号和英文以外的字符

2.删除日志行

3.删除注释行,主要针对以下格式

/* 注释文本*/

/**

注释段落

*/

// 注释文本

code //注释

经过以上数据清洗,得到纯代码数据。

3、数据编码

得到训练数据后,需要对代码文本进行编码。本文使用bpe(byte pair encoding)字节对编码,主要用于数据压缩。 bpe简单理解为将一个单词拆分为多个字母组合,比如将tencent拆分为十分。这些组合基于大量数据和统计频率。由于我们期望的代码补全功能是在行首输入几个字母,所以这一行的内容是按照上面的来期望的。

假设tensorflow的token被编码为对应一个id,那么我希望输入十,输出tensorflow是不可能的。所以在训练过程中,我会随机打断token,比如打断tensorflow到t-en-sor-flow进行编码。打断的原则是被分割的部分必须在词汇表中。数据编码后,将编码的每个token编码成1~N个id。模型预测的id可以反向编码为token。回车符被认为是预测的终止符。经过上面的处理,我们已经准备好了训练数据,接下来就可以进入算法部分了。

模型算法

众所周知,算法工程师大部分时间都花在研究算法上。

在腾讯文档的错别字和纠错要求中,我们使用了基于LSTM的seq2seq和facebook的基于CNN的seq2seq,可以得到很好的纠错效果。直到NLP出现了“网红”-BERT,采用后准确率直接提升了8分左右,而且是google。下面简单介绍一下bert和gpt2。

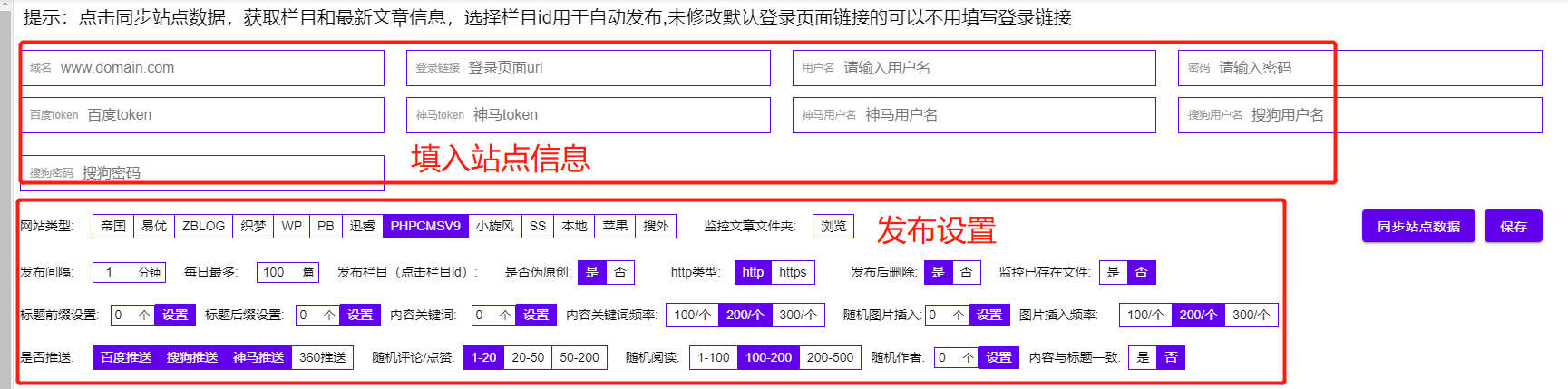

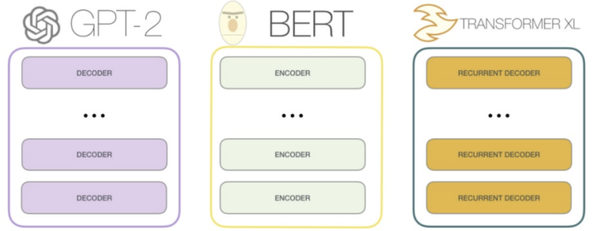

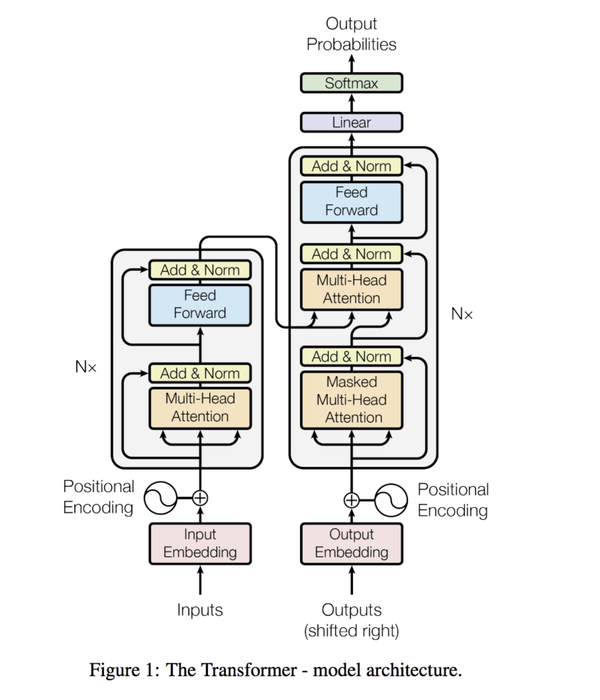

BERT 和 GPT2

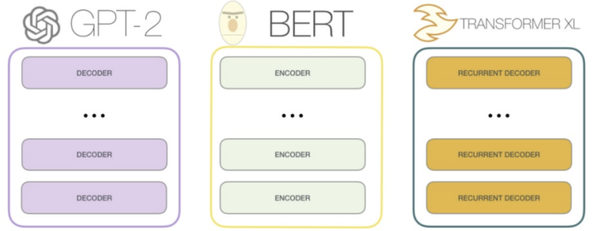

2017 年年中,google 提出了 Transformer 结构。不需要rnn,不需要cnn,引起关注就是你所需要的。 2018年openAI采用transformers结构,2018年发布GPT。同年google AI Language发布bert论文,提出的BERT模型在11个NLP任务上创下新纪录。 2019 年,openAI 推出了 GPT-2 模型。 .

BERT(Bidirectional Encoder Representation from Transformers)基于transformers框架的encoder部分,自编码语言模型,适用于N-1(如句子分类)、NN(如词性标注)任务,但不适合生成Task。

GPT(Generative Pre-Training)基于transformers的解码器部分,一种自回归语言模型,适用于生成任务。

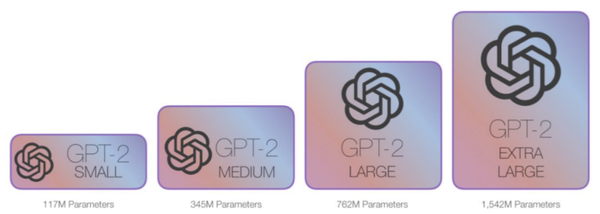

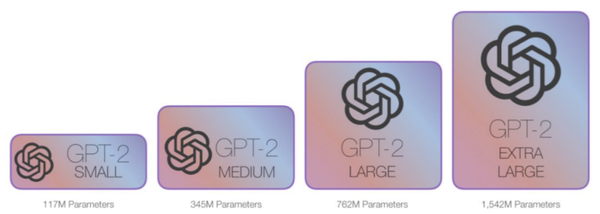

代码补全功能基于GPT2框架。 OPenAI官方提供多套GPT2预训练模型:

作为一个经常将模型部署到移动端的CVer,看到这个参数级别,我选择了最小的模型进行finetune。

关于GPT算法,/p/137350403这篇文章这篇文章很好,有兴趣的同学可以看看。

本文在训练中使用了512个文本,预测回车符会结束。模型网络使用超参数:12 层、768 个隐藏节点和 12 个头。它使用 uber 的 Horovod 分布式框架进行训练。

infer阶段使用beam-search会导致整个预测过程特别耗时,所以参考/abs/1904.09751论文,使用top-k采样,每个时间预测top3结果,然后通过概率阈值进行过滤,然后作为最终候选输出。

最终推断效果:

输入代码,预测后续代码,以回车结束。

工程

众所周知,算法工程师大部分时间都花在工程上。

模型训练好后,需要应用模型,所以需要实现一些工程工作。代码补全功能最适合的应用场景是使用IDE。 nlp模型不适合本地部署,最后选择在GPU机器上部署模型,然后终端通过http请求获得预测文本显示的解决方案。

后台部署

Flask 是一个 Web 应用程序框架,灵活、轻便且易于使用。本文简单介绍了如何使用flask启动一个web服务,以及如何访问和调用我们的功能接口。首先我们创建一个 conda 环境:

conda create -n flask python=3.6

source activate flask

pip install flask

在代码中添加一个接口函数:

from flask import Flask

from flask import request

app = Flask()

# route把一个函数绑定到对应的 url 上

@app.route("/plugin",methods=['GET',])

def send():

data = request.args.get('data')

# 模型预测逻辑

out = model_infer(data)

return out

if __name__ == '__main__':

app.run(host='0.0.0.0',port=8080, debug=False)

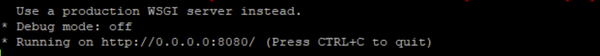

执行run.py代码,后台服务启动并运行:

客户请求:

url = http://ip:8080/plugin?data="输入"

model_infer函数需要实现模型的infer前向计算逻辑。从请求中获取数据字段作为输入,将infer预测的结果列表作为输出返回给调用者。

经过上述工作,我们提供了一个服务接口,用于返回我们代码完成的预测结果。

插件编写

最后一步是如何使用IDE上的功能。如果我们要开发AS插件,需要用到IntelliJ,首先我们需要在本机上安装配置IntelliJ IDEA

下载地址:/idea/download/

社区版源码:/JetBrains/intellij-community

一个简单易用的插件可以为程序员节省大量时间。在插件实现的时候,我还加入了一个小的git-blame功能,可以实时查看指定行的git committer,对于手机QQ等多人协同工作,更加实用。也可以通过IntelliJ自己开发一些常用的功能。

gitBlame 的主要代码:

public class GitBlame extends AnAction {

private void showPopupBalloon(final Editor editor, final String result) {

ApplicationManager.getApplication().invokeLater(new Runnable() {

public void run() {

JBPopupFactory factory = JBPopupFactory.getInstance();

factory.createHtmlTextBalloonBuilder(result, null, new JBColor(new Color(186, 238, 186), new Color(73, 117, 73)), null)

.setFadeoutTime(5000)

.createBalloon()

.show(factory.guessBestPopupLocation(editor), Balloon.Position.below);

}

});

}

@Override

public void actionPerformed(AnActionEvent e) {

// TODO: insert action logic here

//获得当前本地代码根目录

String base_path = e.getProject().getBasePath();

String file_path = e.getProject().getProjectFilePath();

//获取编辑mEditor

final Editor mEditor = e.getData(PlatformDataKeys.EDITOR);

if (null == mEditor) {

return;

}

SelectionModel model = mEditor.getSelectionModel();

final String selectedText = model.getSelectedText();

if (TextUtils.isEmpty(selectedText)) {

return;

}

//获取当前编辑文档的目录

PsiFile mPsifile = e.getData(PlatformDataKeys.PSI_FILE);

VirtualFile file = mPsifile.getContainingFile().getOriginalFile().getVirtualFile();

if (file != null && file.isInLocalFileSystem()) {

file_path = file.getCanonicalPath();

}

//gitkit工具

JGitUtil gitKit = new JGitUtil();

String filename = file_path.replace(base_path+"/","");

//得到blame信息

int line_index = mEditor.getSelectionModel().getSelectionStartPosition().getLine();

String blame_log = gitKit.git_blame(base_path,filename,line_index);

//展示

if (!blame_log.isEmpty()){

showPopupBalloon(mEditor, blame_log);

}

}

}

本文代码补全插件的主要代码逻辑是调用之前后台部署的请求。

// 请求url格式(和flask接口一致)

String baseUrl = "http://ip:8080/plugin?data=";

// 获取当前编辑位置文本

PsiFile str = position.getContainingFile();

// 根据模型上文限制获取代码端

String data = getContentCode();

String url = baseUrl+data;

// 发送请求

String result = HttpUtils.doGet(url);

// 后处理逻辑,在提示框显示预测结果

show()

最终呈现形式:

可以看出模型的预测结果还是不错的~

以上就是代码补全功能的实现和应用,可以看作是AI自动编写代码的一小步。

AI自己写代码有可能在嫌疑人追踪上达到TM的水平吗?我不敢说不可能,但以我目前的认知,是不可能实现的。毕竟,是程序员编写代码并将数据提供给算法。是程序员,算法设计师是程序员,AI连帮助人类解决bug的功能都没有! \

参考资料:

[1] /abs/1706.03762

[2] /abs/1810.04805

[3] /openai/gpt-2

[4] /abs/1904.09751 查看全部

算法 自动采集列表(如何使用GPT2框架实现代码自动补全的功能?(上))

作者:魏雄、黄飞、腾讯PCG/QQ研发中心/简历应用研究组

如果AI真的会写代码,程序员会去哪里?近年来,NLP 领域的生成任务得到了显着提升。能否通过AI让代码自动完成后续补全?本文主要介绍如何使用GPT2框架实现代码补全功能。

如果人工智能真的可以自己写代码,程序员会去哪里?

我去年做了一个小代码补全功能,打包成androidStudio插件,效果如下:

代码补全模型预测的结果有时候确实能吓到我,这也能学~?那么如果给它洞察世界上优秀的代码,再给它足够的幅度参数和优秀的模型框架,真的可以实现需求作为输入直接输出代码吗?

“我的要求已经结束,你的代码呢?”我希望看到这一天。

代码补全功能也已经被其他优秀的插件实现了,比如tabnine、Kite和国产的aixcoder。本文主要介绍代码补全功能需要实现的全过程。主要包括数据、算法和工程。

数据

众所周知,算法工程师大部分时间都花在处理数据上。

深度学习是一个利用大数据训练模型的过程,数据是一个非常重要的模块。人累了,休息不好会导致记忆力差。 AI意味着它可以存储和接收尽可能多的数据。如果你没有学习这些信息,那是人为的错。给定的数据不好或算法设计不好。所以我们首先准备尽可能多的训练数据。

1、数据采集

本文的目的是代码补全,训练数据是代码段。考虑到每种语言风格和语法不一致,单一模型只针对一种代码语言。

我使用的训练数据主要来自GitHub。我写了一个简单的爬虫代码,指定语言后,按照星星的顺序下载项目。

Github搜索API官方地址:/v3/search/

2、数据清洗

直接下载的数据不能直接使用。我们还需要清理数据。

首先,我们的训练数据只需要项目中的代码文件。以java项目为例,我们只保留.java结尾的文件,其他文件可以去掉。

其次,我的代码补全的目标是代码段,而不是注释功能。而对于代码补全训练,我们会给出一定范围的上述内容,如果有注释部分,会占用有效的代码信息。另外,除英文字符外的注释不在我的训练词汇范围内,所以代码中的注释和日志需要清理。

1.删除代码行中除符号和英文以外的字符

2.删除日志行

3.删除注释行,主要针对以下格式

/* 注释文本*/

/**

注释段落

*/

// 注释文本

code //注释

经过以上数据清洗,得到纯代码数据。

3、数据编码

得到训练数据后,需要对代码文本进行编码。本文使用bpe(byte pair encoding)字节对编码,主要用于数据压缩。 bpe简单理解为将一个单词拆分为多个字母组合,比如将tencent拆分为十分。这些组合基于大量数据和统计频率。由于我们期望的代码补全功能是在行首输入几个字母,所以这一行的内容是按照上面的来期望的。

假设tensorflow的token被编码为对应一个id,那么我希望输入十,输出tensorflow是不可能的。所以在训练过程中,我会随机打断token,比如打断tensorflow到t-en-sor-flow进行编码。打断的原则是被分割的部分必须在词汇表中。数据编码后,将编码的每个token编码成1~N个id。模型预测的id可以反向编码为token。回车符被认为是预测的终止符。经过上面的处理,我们已经准备好了训练数据,接下来就可以进入算法部分了。

模型算法

众所周知,算法工程师大部分时间都花在研究算法上。

在腾讯文档的错别字和纠错要求中,我们使用了基于LSTM的seq2seq和facebook的基于CNN的seq2seq,可以得到很好的纠错效果。直到NLP出现了“网红”-BERT,采用后准确率直接提升了8分左右,而且是google。下面简单介绍一下bert和gpt2。

BERT 和 GPT2

2017 年年中,google 提出了 Transformer 结构。不需要rnn,不需要cnn,引起关注就是你所需要的。 2018年openAI采用transformers结构,2018年发布GPT。同年google AI Language发布bert论文,提出的BERT模型在11个NLP任务上创下新纪录。 2019 年,openAI 推出了 GPT-2 模型。 .

BERT(Bidirectional Encoder Representation from Transformers)基于transformers框架的encoder部分,自编码语言模型,适用于N-1(如句子分类)、NN(如词性标注)任务,但不适合生成Task。

GPT(Generative Pre-Training)基于transformers的解码器部分,一种自回归语言模型,适用于生成任务。

代码补全功能基于GPT2框架。 OPenAI官方提供多套GPT2预训练模型:

作为一个经常将模型部署到移动端的CVer,看到这个参数级别,我选择了最小的模型进行finetune。

关于GPT算法,/p/137350403这篇文章这篇文章很好,有兴趣的同学可以看看。

本文在训练中使用了512个文本,预测回车符会结束。模型网络使用超参数:12 层、768 个隐藏节点和 12 个头。它使用 uber 的 Horovod 分布式框架进行训练。

infer阶段使用beam-search会导致整个预测过程特别耗时,所以参考/abs/1904.09751论文,使用top-k采样,每个时间预测top3结果,然后通过概率阈值进行过滤,然后作为最终候选输出。

最终推断效果:

输入代码,预测后续代码,以回车结束。

工程

众所周知,算法工程师大部分时间都花在工程上。

模型训练好后,需要应用模型,所以需要实现一些工程工作。代码补全功能最适合的应用场景是使用IDE。 nlp模型不适合本地部署,最后选择在GPU机器上部署模型,然后终端通过http请求获得预测文本显示的解决方案。

后台部署

Flask 是一个 Web 应用程序框架,灵活、轻便且易于使用。本文简单介绍了如何使用flask启动一个web服务,以及如何访问和调用我们的功能接口。首先我们创建一个 conda 环境:

conda create -n flask python=3.6

source activate flask

pip install flask

在代码中添加一个接口函数:

from flask import Flask

from flask import request

app = Flask()

# route把一个函数绑定到对应的 url 上

@app.route("/plugin",methods=['GET',])

def send():

data = request.args.get('data')

# 模型预测逻辑

out = model_infer(data)

return out

if __name__ == '__main__':

app.run(host='0.0.0.0',port=8080, debug=False)

执行run.py代码,后台服务启动并运行:

客户请求:

url = http://ip:8080/plugin?data="输入"

model_infer函数需要实现模型的infer前向计算逻辑。从请求中获取数据字段作为输入,将infer预测的结果列表作为输出返回给调用者。

经过上述工作,我们提供了一个服务接口,用于返回我们代码完成的预测结果。

插件编写

最后一步是如何使用IDE上的功能。如果我们要开发AS插件,需要用到IntelliJ,首先我们需要在本机上安装配置IntelliJ IDEA

下载地址:/idea/download/

社区版源码:/JetBrains/intellij-community

一个简单易用的插件可以为程序员节省大量时间。在插件实现的时候,我还加入了一个小的git-blame功能,可以实时查看指定行的git committer,对于手机QQ等多人协同工作,更加实用。也可以通过IntelliJ自己开发一些常用的功能。

gitBlame 的主要代码:

public class GitBlame extends AnAction {

private void showPopupBalloon(final Editor editor, final String result) {

ApplicationManager.getApplication().invokeLater(new Runnable() {

public void run() {

JBPopupFactory factory = JBPopupFactory.getInstance();

factory.createHtmlTextBalloonBuilder(result, null, new JBColor(new Color(186, 238, 186), new Color(73, 117, 73)), null)

.setFadeoutTime(5000)

.createBalloon()

.show(factory.guessBestPopupLocation(editor), Balloon.Position.below);

}

});

}

@Override

public void actionPerformed(AnActionEvent e) {

// TODO: insert action logic here

//获得当前本地代码根目录

String base_path = e.getProject().getBasePath();

String file_path = e.getProject().getProjectFilePath();

//获取编辑mEditor

final Editor mEditor = e.getData(PlatformDataKeys.EDITOR);

if (null == mEditor) {

return;

}

SelectionModel model = mEditor.getSelectionModel();

final String selectedText = model.getSelectedText();

if (TextUtils.isEmpty(selectedText)) {

return;

}

//获取当前编辑文档的目录

PsiFile mPsifile = e.getData(PlatformDataKeys.PSI_FILE);

VirtualFile file = mPsifile.getContainingFile().getOriginalFile().getVirtualFile();

if (file != null && file.isInLocalFileSystem()) {

file_path = file.getCanonicalPath();

}

//gitkit工具

JGitUtil gitKit = new JGitUtil();

String filename = file_path.replace(base_path+"/","");

//得到blame信息

int line_index = mEditor.getSelectionModel().getSelectionStartPosition().getLine();

String blame_log = gitKit.git_blame(base_path,filename,line_index);

//展示

if (!blame_log.isEmpty()){

showPopupBalloon(mEditor, blame_log);

}

}

}

本文代码补全插件的主要代码逻辑是调用之前后台部署的请求。

// 请求url格式(和flask接口一致)

String baseUrl = "http://ip:8080/plugin?data=";

// 获取当前编辑位置文本

PsiFile str = position.getContainingFile();

// 根据模型上文限制获取代码端

String data = getContentCode();

String url = baseUrl+data;

// 发送请求

String result = HttpUtils.doGet(url);

// 后处理逻辑,在提示框显示预测结果

show()

最终呈现形式:

可以看出模型的预测结果还是不错的~

以上就是代码补全功能的实现和应用,可以看作是AI自动编写代码的一小步。

AI自己写代码有可能在嫌疑人追踪上达到TM的水平吗?我不敢说不可能,但以我目前的认知,是不可能实现的。毕竟,是程序员编写代码并将数据提供给算法。是程序员,算法设计师是程序员,AI连帮助人类解决bug的功能都没有! \

参考资料:

[1] /abs/1706.03762

[2] /abs/1810.04805

[3] /openai/gpt-2

[4] /abs/1904.09751

算法 自动采集列表(内涵吧内涵段子采集入口类Neihan8Crawl实现实现)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-12-30 14:16

本博客是博客的延伸。建议在阅读本博客之前先阅读之前的博客。

上一篇博客介绍了笑话采集

网站的自动采集

。本文将展开介绍多内涵条的自动采集。

之前的博文已经详细介绍了几个基础类,现在只拿构造子类来实现内涵段的采集。

内涵栏 内涵段采集入口类Neihan8Crawl这里没有实现爬虫程序的周期性采集,这里可以根据自己的需要编写相应的线程。

<p> /**

*@Description:

*/

package cn.lulei.crawl.neihan8;

import java.io.IOException;

import java.util.ArrayList;

import java.util.HashSet;

import cn.lulei.db.neihan8.Neihan8DbOperation;

import cn.lulei.model.Neihan8;

import cn.lulei.util.ParseUtil;

import cn.lulei.util.ThreadUtil;

public class Neihan8Crawl {

//内涵吧更新列表页url格式

private static String listPageUrl = "http://www.neihan8.com/article ... 3B%3B

//两次访问页面事件间隔,单位ms

private static int sleepTime = 500;

/**

* @param start 起始页

* @param end 终止页

* @throws IOException

* @Date: 2014-2-13

* @Author: lulei

* @Description: 抓取更新列表页上的内容

*/

public void crawlMain(int start, int end) throws IOException{

start = start < 1 ? 1 : start;

Neihan8DbOperation neihan8DbOperation = new Neihan8DbOperation();

for ( ; start 查看全部

算法 自动采集列表(内涵吧内涵段子采集入口类Neihan8Crawl实现实现)

本博客是博客的延伸。建议在阅读本博客之前先阅读之前的博客。

上一篇博客介绍了笑话采集

网站的自动采集

。本文将展开介绍多内涵条的自动采集。

之前的博文已经详细介绍了几个基础类,现在只拿构造子类来实现内涵段的采集。

内涵栏 内涵段采集入口类Neihan8Crawl这里没有实现爬虫程序的周期性采集,这里可以根据自己的需要编写相应的线程。

<p> /**

*@Description:

*/

package cn.lulei.crawl.neihan8;

import java.io.IOException;

import java.util.ArrayList;

import java.util.HashSet;

import cn.lulei.db.neihan8.Neihan8DbOperation;

import cn.lulei.model.Neihan8;

import cn.lulei.util.ParseUtil;

import cn.lulei.util.ThreadUtil;

public class Neihan8Crawl {

//内涵吧更新列表页url格式

private static String listPageUrl = "http://www.neihan8.com/article ... 3B%3B

//两次访问页面事件间隔,单位ms

private static int sleepTime = 500;

/**

* @param start 起始页

* @param end 终止页

* @throws IOException

* @Date: 2014-2-13

* @Author: lulei

* @Description: 抓取更新列表页上的内容

*/

public void crawlMain(int start, int end) throws IOException{

start = start < 1 ? 1 : start;

Neihan8DbOperation neihan8DbOperation = new Neihan8DbOperation();

for ( ; start

算法 自动采集列表(【干货】如何确定是垃圾?java是怎么确定的? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2021-12-28 18:18

)

一、如何判断是垃圾?1、引用计数法

如果对象没有与之关联的引用,则计数器为 0 的对象是可回收对象。(目前使用的是python)

优点:判断效率高,实现简单。

缺点:不完全准确,无法回收循环引用的对象,容易出现内存泄漏。

2、可访问性分析(根可达性)

以一系列GC Roots对象为起点,从这些根节点开始向下搜索,一路搜索,称为引用链接。当一个对象在没有任何引用链的情况下连接到 GC Roots 时,就意味着该对象不可用。

优点:解决了相互循环引用的问题。

注意:不可达对象不等同于可回收对象。不可达对象至少需要经过两次标记过程才能成为可回收对象。你可以通过 finalize() 来拯救自己。

3、GC Roots 对象

GC Roots 对象包括:

虚拟机栈帧中局部变量表引用的对象;

方法区中的类静态属性引用;

方法区常量引用的对象;

JNI在本地方法栈中引用的对象;

同步锁持有的所有对象等;

jvm中跨代引用的对象等;

……还有其他种类,常用的前四种。

二、垃圾采集

算法?

Java自动回收内存,C、C++等必须手动回收。

1、复制算法

根据内存容量将内存分成大小相等的两块,每次使用一块。在这个块填满后,将幸存的块复制到另一个块,并清空它使用的内存。

优点:实现简单,不易产生碎片;

缺点:可用内存被压缩到原来的一半,如果存活的对象很多,这个算法的效率会大大降低。

2、标记-扫描算法(Mark-Sweep)

标记要回收的对象,回收被标记对象占用的空间。

缺点:内存碎片严重;

3、Mark-Compact

标记要回收的对象。标记后,对象没有明确标记,而是将幸存的对象移动到内存的一端,然后清除边界外的对象。

优点:不碎片化;

4、 分代采集

算法

目前JVM大多采用【新生代、老年代、永久代】

根据对象生存的不同生命周期,将内存划分为不同的域。一般情况下,垃圾回收主要是回收堆空间(因为几乎大部分对象都在堆空间,特殊情况逃逸分析:在栈上分配),所以将堆划分为新生代(1/3),老年代 (2/3).

老年:大物件直接放在老年;长寿之物进入老年;

每次只需要回收少量对象,存活率高且相对稳定。所以老年选择标记排序算法或标记清除算法。老年代的垃圾回收叫做Major GC;

新生代:储存新生物体。对象生死存亡,大量对象被回收,少数存活,所以复制成本低,所以新一代选择复制算法。新一代的垃圾回收被称为 Minor GC(copy-empty-swap)。

永久代:方法区的永久代,用于存放类、常量、方法描述等。永久代的回收主要是废弃的常量和无用的类。垃圾少,收益一般也小,所以垃圾回收主要是回收堆空间。1.8 之后称为元空间。

java内存模型

注意:Minor GC 通常在 Major GC 之前执行。Minor GC 会频繁触发,而 Major GC 不会。当无法找到足够大的连续空间分配给新创建的较大对象时,会提前触发Major GC;Major GC速度一般比Minor GC慢10倍以上;

Full GC:就是清理整个堆空间。

触发条件:

①手动使用System.gc()

②老年空间不足;

③方法区空间不足;

④Minor GC后,要移动或分配的对象的大小大于老年代的可用空间。

总结:分代回收算法是根据不同区域对象的生命周期特征选择不同的回收算法;

垃圾回收主要回收堆内存;

幸存者区晋升的年龄门槛为幸存者区的15%或50%有两种情况。

三、GC 性能测量指标1、 吞吐量:

这里测量的吞吐量是指应用程序花费的时间与系统总运行时间的比率。我们可以根据这个公式计算GC的吞吐量:系统总运行时间=应用耗时+GC耗时。如果系统运行100分钟,GC耗时1分钟,则系统吞吐量为99%。一般GC的吞吐量不能低于95%。

2、暂停时间:

指垃圾采集

器运行时应用程序的暂停时间。对于串口采集

器,暂停时间可能比较长;在使用并发采集

器时,因为垃圾采集

器和应用程序交替

运行时,程序的暂停时间会更短,但其效率很可能不如独占垃圾采集

器,系统的吞吐量很可能会下降。

3、 垃圾回收频率:

一般来说,垃圾采集

的频率越低越好。增加堆内存空间可以有效降低垃圾回收的频率,但同时也意味着要积累更多的对象进行回收,最终会增加回收过程中的暂停时间。所以我们需要适当增加堆内存空间,以保证正常的垃圾回收频率。

四、垃圾采集

器

目前7大主流:

新生代采集器

:Serial、ParNew、Parallel Scavenge;

老年采集

器:Serial Old、Parallel Old、CMS;

整桩采集

器:G1;

下面一一介绍这些采集器的特点和功能:

1、串行(单线程,复制算法,新一代)

当 Serial 采集

垃圾时,它必须挂起所有其他工作线程,直到垃圾采集

结束。对于单CPU,没有线程交互开销,效率高。

因此,Serial是Client模式下运行的java虚拟机默认的新一代垃圾回收器。

2、ParNew(Serial的并行多线程版本,复制算法,新一代)

ParNew 除了使用多个线程进行垃圾回收之外,还有和 Serial 相同的行为,它也会挂起所有的工作线程。

ParNew 默认打开具有相同 CPU 数量的线程。您可以使用参数 -XX:ParallelGCThreads 限制线程数。它是服务器模式下新一代虚拟机的默认垃圾采集

器。

3、Parallel Scavenge(并行多线程版本,复制算法,新一代)

专注于程序可以实现的可控吞吐量,通过自适应调整策略来提高用户的

经验。是1.8默认的新一代采集

器。

吞吐量=cpu运行用户代码时间/cpu总消耗时间

自适应调整策略:

Parallel Scavenge采集

器可以配合自适应调整策略将内存管理的调优任务委托给虚拟机来完成。你只需要设置基本内存数据(比如-Xmx设置最大堆),然后使用MaxGCPauseMillis参数(更多关于最大暂停时间)或GCTimeRatio参数(更多关于吞吐量)来设置优化目标虚拟机,具体参数的详细调整工作由虚拟机完成。

1),java -XX:+PrintFlagsFinal,可以看到1.8 默认是UseParallelGC

ParallelGC 默认为 Parallel Scavenge(新生代)+ Parallel Old(老年代)

** 2),自适应调整策略也是Parallel Scavenge采集

器和ParNew采集

器的重要区别。**

4、Serial Old(单线程,标签排序算法,年老)

主要运行在Client模式,java虚拟机默认的老年代垃圾采集

器,

服务器模式下的两个目的:

①:jdk1.5之前与新一代Parallel Scavenge配合使用;

②:作为老年代CMS采集

器的备用垃圾采集

方案。

5、Parallel Old (Parallel Multithreading, Marking Sorting Algorithm, Old Age)

如果还考虑老年代的吞吐量,可以考虑搭配新一代Parallel Scavenge使用。

6、CMS(Concurent Mark Sweep)(并发多线程,标记清除算法,老年代)

主要目的是获得最短的垃圾回收暂停时间,可以提高交互性高的程序的用户体验。是老年代唯一的垃圾回收器,有标记清除算法,而不是标记排序算法。

缺点:cpu敏感、浮动垃圾、内存碎片

CMS分为四个阶段:

1)初始标记(暂停):只标记GC Roots可以直接关联的对象,快速,挂起所有工作线程;