动态网页抓取

动态网页抓取( 什么是动态网页,怎样爬取动态网页?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2021-09-26 18:25

什么是动态网页,怎样爬取动态网页?(图))

网络上到处都是爬虫,很多公司都需要采集信息。使用爬虫技术可以更快地从海量信息中提取所需信息,但其他网站不愿意浪费这些信息。另外,Crawler信息采集也会对网站产生影响,所以网站会使用多种方式,比如IP限制、验证码限制、使用动态网页页数增加难度。

用于限制IP。验证码,可以使用代理IP。验证码识别工具来识别,但对于动态网页,问题会更复杂。今天就让小编来看看什么是动态网页,以及如何用编辑器抓取动态网页。.

1、 所谓动态网页,是指一种对应静态网页的网页编程技术。

2、静态网页,生成html代码时,页面的内容和显示效果基本不会改变——除非你修改页面代码。

与动态网页不同,虽然页面代码没有变化,但显示的内容会随着时间、环境或数据库操作的结果而变化。

值得一提的是,不要混淆动态网页和页面内容是否为动态。这里所说的动态网页与网页上的各种动画、滚动字幕、视觉动态效果没有直接关系。动态网页也可以是纯文本内容或收录各种动画的内容。这些只是网页特定内容的表现形式,无论网页是否具有动态效果,只要是通过动态网站技术生成的网页,都可以称为动态网页。

总而言之,动态网页是html语法的基本规范,是Java.VB.VC等高级编程语言、数据库编程等技术的融合,旨在实现高效、动态、交互的内容和网站管理风格。因此,从这个意义上说,只要是结合了高级编程语言和数据库技术的网页编程技术生成的网页就是动态网页。

如果想尝试使用代理ip,可以到拼音http代理ip官网了解更多,提供高度隐蔽且稳定的代理ip,支持HTTP/HTTPS/SOCKS5代理协议,提供动态IP等服务和静态IP。百兆带宽,千万IP资源,保障爬虫数据传输安全。快速获取网站数据,现在还有免费测试和免费ip活动! 查看全部

动态网页抓取(

什么是动态网页,怎样爬取动态网页?(图))

网络上到处都是爬虫,很多公司都需要采集信息。使用爬虫技术可以更快地从海量信息中提取所需信息,但其他网站不愿意浪费这些信息。另外,Crawler信息采集也会对网站产生影响,所以网站会使用多种方式,比如IP限制、验证码限制、使用动态网页页数增加难度。

用于限制IP。验证码,可以使用代理IP。验证码识别工具来识别,但对于动态网页,问题会更复杂。今天就让小编来看看什么是动态网页,以及如何用编辑器抓取动态网页。.

1、 所谓动态网页,是指一种对应静态网页的网页编程技术。

2、静态网页,生成html代码时,页面的内容和显示效果基本不会改变——除非你修改页面代码。

与动态网页不同,虽然页面代码没有变化,但显示的内容会随着时间、环境或数据库操作的结果而变化。

值得一提的是,不要混淆动态网页和页面内容是否为动态。这里所说的动态网页与网页上的各种动画、滚动字幕、视觉动态效果没有直接关系。动态网页也可以是纯文本内容或收录各种动画的内容。这些只是网页特定内容的表现形式,无论网页是否具有动态效果,只要是通过动态网站技术生成的网页,都可以称为动态网页。

总而言之,动态网页是html语法的基本规范,是Java.VB.VC等高级编程语言、数据库编程等技术的融合,旨在实现高效、动态、交互的内容和网站管理风格。因此,从这个意义上说,只要是结合了高级编程语言和数据库技术的网页编程技术生成的网页就是动态网页。

如果想尝试使用代理ip,可以到拼音http代理ip官网了解更多,提供高度隐蔽且稳定的代理ip,支持HTTP/HTTPS/SOCKS5代理协议,提供动态IP等服务和静态IP。百兆带宽,千万IP资源,保障爬虫数据传输安全。快速获取网站数据,现在还有免费测试和免费ip活动!

动态网页抓取( 第一原始数据-存储的数据没有的设计要点(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-09-26 18:23

第一原始数据-存储的数据没有的设计要点(图))

一、爬虫设计要点。

如果想批量抓取一个网站,需要自己搭建爬虫框架。在建立之前,您应该考虑几个问题:避免IP被封锁、图像验证码识别、数据处理等。

比较简单的图片验证码,可以通过pytesseract库写一个识别程序,只能识别简单的图片数据。滑动鼠标、滑块、动态图片验证码等比较复杂的地方只能考虑购买编码平台进行识别。

对于数据处理,如果发现得到的数据是乱码,解决办法是识别其乱码规则,或者通过源js代码通过pythonexecjs库或其他执行js库获取数据提取。

二、分布式爬虫解决方案。

为了批量抓取一个大站的数据,最好保持4个队列。

1.url 任务列-存储要抓取的url数据。

2. 原创 URL 队列存储在捕获的网页中,但尚未处理。处理主要是检查是否需要抓包,是否需要重复抓包。

3.原创数据队列存储的数据,未经任何处理。

4.二手数据列-存储进入数据处理过程的待存储数据。

上述队列分别有4个进程用于监控任务的执行,分别是:

1、 Crawler 爬取过程-监控url任务队列,抓取网页数据,将抓取到的原创数据丢到原创数据队列。

2.URL处理流程:监控原创URL队列,过滤异常URL和重复捕获的URL。

3.数据提取流程:监控原创数据队列,提取原创数据队列的关键数据,包括新网站和目标数据。

4.数据存储过程:将二手数据整理好存放在mongodb中。 查看全部

动态网页抓取(

第一原始数据-存储的数据没有的设计要点(图))

一、爬虫设计要点。

如果想批量抓取一个网站,需要自己搭建爬虫框架。在建立之前,您应该考虑几个问题:避免IP被封锁、图像验证码识别、数据处理等。

比较简单的图片验证码,可以通过pytesseract库写一个识别程序,只能识别简单的图片数据。滑动鼠标、滑块、动态图片验证码等比较复杂的地方只能考虑购买编码平台进行识别。

对于数据处理,如果发现得到的数据是乱码,解决办法是识别其乱码规则,或者通过源js代码通过pythonexecjs库或其他执行js库获取数据提取。

二、分布式爬虫解决方案。

为了批量抓取一个大站的数据,最好保持4个队列。

1.url 任务列-存储要抓取的url数据。

2. 原创 URL 队列存储在捕获的网页中,但尚未处理。处理主要是检查是否需要抓包,是否需要重复抓包。

3.原创数据队列存储的数据,未经任何处理。

4.二手数据列-存储进入数据处理过程的待存储数据。

上述队列分别有4个进程用于监控任务的执行,分别是:

1、 Crawler 爬取过程-监控url任务队列,抓取网页数据,将抓取到的原创数据丢到原创数据队列。

2.URL处理流程:监控原创URL队列,过滤异常URL和重复捕获的URL。

3.数据提取流程:监控原创数据队列,提取原创数据队列的关键数据,包括新网站和目标数据。

4.数据存储过程:将二手数据整理好存放在mongodb中。

动态网页抓取(ajax横行的年代,我们的网页是残缺的吗? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-09-26 12:05

)

在Ajax时代,许多网页的内容都是动态加载的,我们的小爬虫只抓取web服务器返回给我们的HTML

跳过了JS加载部分,即爬虫抓取的网页不完整、不完整。你可以看到下面博客花园的首页

从主页加载中,我们可以看到页面呈现后,将有五个Ajax异步请求。默认情况下,爬虫程序无法抓取Ajax生成的内容

此时,如果要获取这些动态页面,必须调用浏览器的内核引擎来下载这些动态页面。目前,内核引擎有三个支柱

三叉戟:即内核。WebBrowser基于此内核,但其可加载性较差

壁虎:FF的内核比Trident有更好的性能

WebKit:Safari和chrome的内核性能,你知道,在真实场景中仍然基于它

好吧,为了简单和方便,让我们使用WebBrowser来玩。使用WebBrowser时,我们应注意以下几点:

第一:因为WebBrowser是system.windows.forms中的WinForm控件,所以我们需要设置StatThread标志

第二:WinForm是事件驱动的,控制台不响应事件。所有事件都在windows的消息队列中等待执行。为了不让程序假装死亡

我们需要调用Doevents方法来转移控制,并让操作系统执行其他事件

第三:我们需要使用domdocument而不是documenttext来查看WebBrowser中的内容

通常有两种方法来判断是否加载了动态网页:

① : 在这里设置一个最大值,因为每次异步加载JS时,都会触发导航和documentcompleted事件,所以我们需要

只需将计数值记录在

1 using System;

2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 using System.IO; 8 9 namespace ConsoleApplication2 10 { 11 public class Program 12 { 13 static int hitCount = 0; 14 15 [STAThread] 16 static void Main(string[] args) 17 { 18 string url = "http://www.cnblogs.com"; 19 20 WebBrowser browser = new WebBrowser(); 21 22 browser.ScriptErrorsSuppressed = true; 23 24 browser.Navigating += (sender, e) => 25 { 26 hitCount++; 27 }; 28 29 browser.DocumentCompleted += (sender, e) => 30 { 31 hitCount++; 32 }; 33 34 browser.Navigate(url); 35 36 while (browser.ReadyState != WebBrowserReadyState.Complete) 37 { 38 Application.DoEvents(); 39 } 40 41 while (hitCount < 16) 42 Application.DoEvents(); 43 44 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument; 45 46 string gethtml = htmldocument.documentElement.outerHTML; 47 48 //写入文件 49 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html")) 50 { 51 sw.WriteLine(gethtml); 52 } 53 54 Console.WriteLine("html 文件 已经生成!"); 55 56 Console.Read(); 57 } 58 } 59 }

然后,我们打开生成的1.HTML,查看JS加载的内容是否可用

② : 当然,除了通过判断最大值来判断加载是否完成外,我们还可以通过设置定时器来判断,如3S、4S、5S等

是否已加载web浏览器

1 using System;

2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 using System.IO; 8 9 namespace ConsoleApplication2 10 { 11 public class Program 12 { 13 [STAThread] 14 static void Main(string[] args) 15 { 16 string url = "http://www.cnblogs.com"; 17 18 WebBrowser browser = new WebBrowser(); 19 20 browser.ScriptErrorsSuppressed = true; 21 22 browser.Navigate(url); 23 24 //先要等待加载完毕 25 while (browser.ReadyState != WebBrowserReadyState.Complete) 26 { 27 Application.DoEvents(); 28 } 29 30 System.Timers.Timer timer = new System.Timers.Timer(); 31 32 var isComplete = false; 33 34 timer.Elapsed += new System.Timers.ElapsedEventHandler((sender, e) => 35 { 36 //加载完毕 37 isComplete = true; 38 39 timer.Stop(); 40 }); 41 42 timer.Interval = 1000 * 5; 43 44 timer.Start(); 45 46 //继续等待 5s,等待js加载完 47 while (!isComplete) 48 Application.DoEvents(); 49 50 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument; 51 52 string gethtml = htmldocument.documentElement.outerHTML; 53 54 //写入文件 55 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html")) 56 { 57 sw.WriteLine(gethtml); 58 } 59 60 Console.WriteLine("html 文件 已经生成!"); 61 62 Console.Read(); 63 } 64 } 65 }

当然,效果是一样的,所以我们不会截图。通过以上两种编写方法,我们的WebBrowser被放置在主线程中。让我们看看如何把它放在工作线程上

非常简单,只需将工作线程设置为sta模式

1 using System;

2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 8 namespace ConsoleApplication2 9 { 10 public class Program 11 { 12 static int hitCount = 0; 13 14 //[STAThread] 15 static void Main(string[] args) 16 { 17 Thread thread = new Thread(new ThreadStart(() => 18 { 19 Init(); 20 System.Windows.Forms.Application.Run(); 21 })); 22 23 //将该工作线程设定为STA模式 24 thread.SetApartmentState(ApartmentState.STA); 25 26 thread.Start(); 27 28 Console.Read(); 29 } 30 31 static void Init() 32 { 33 string url = "http://www.cnblogs.com"; 34 35 WebBrowser browser = new WebBrowser(); 36 37 browser.ScriptErrorsSuppressed = true; 38 39 browser.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(browser_DocumentCompleted); 40 41 browser.Navigating += new WebBrowserNavigatingEventHandler(browser_Navigating); 42 43 browser.Navigate(url); 44 45 while (browser.ReadyState != WebBrowserReadyState.Complete) 46 { 47 Application.DoEvents(); 48 } 49 50 while (hitCount < 16) 51 Application.DoEvents(); 52 53 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument; 54 55 string gethtml = htmldocument.documentElement.outerHTML; 56 57 Console.WriteLine(gethtml); 58 } 59 60 static void browser_Navigating(object sender, WebBrowserNavigatingEventArgs e) 61 { 62 hitCount++; 63 } 64 65 static void browser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e) 66 { 67 hitCount++; 68 } 69 } 70 } 查看全部

动态网页抓取(ajax横行的年代,我们的网页是残缺的吗?

)

在Ajax时代,许多网页的内容都是动态加载的,我们的小爬虫只抓取web服务器返回给我们的HTML

跳过了JS加载部分,即爬虫抓取的网页不完整、不完整。你可以看到下面博客花园的首页

从主页加载中,我们可以看到页面呈现后,将有五个Ajax异步请求。默认情况下,爬虫程序无法抓取Ajax生成的内容

此时,如果要获取这些动态页面,必须调用浏览器的内核引擎来下载这些动态页面。目前,内核引擎有三个支柱

三叉戟:即内核。WebBrowser基于此内核,但其可加载性较差

壁虎:FF的内核比Trident有更好的性能

WebKit:Safari和chrome的内核性能,你知道,在真实场景中仍然基于它

好吧,为了简单和方便,让我们使用WebBrowser来玩。使用WebBrowser时,我们应注意以下几点:

第一:因为WebBrowser是system.windows.forms中的WinForm控件,所以我们需要设置StatThread标志

第二:WinForm是事件驱动的,控制台不响应事件。所有事件都在windows的消息队列中等待执行。为了不让程序假装死亡

我们需要调用Doevents方法来转移控制,并让操作系统执行其他事件

第三:我们需要使用domdocument而不是documenttext来查看WebBrowser中的内容

通常有两种方法来判断是否加载了动态网页:

① : 在这里设置一个最大值,因为每次异步加载JS时,都会触发导航和documentcompleted事件,所以我们需要

只需将计数值记录在

1 using System;

2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 using System.IO; 8 9 namespace ConsoleApplication2 10 { 11 public class Program 12 { 13 static int hitCount = 0; 14 15 [STAThread] 16 static void Main(string[] args) 17 { 18 string url = "http://www.cnblogs.com"; 19 20 WebBrowser browser = new WebBrowser(); 21 22 browser.ScriptErrorsSuppressed = true; 23 24 browser.Navigating += (sender, e) => 25 { 26 hitCount++; 27 }; 28 29 browser.DocumentCompleted += (sender, e) => 30 { 31 hitCount++; 32 }; 33 34 browser.Navigate(url); 35 36 while (browser.ReadyState != WebBrowserReadyState.Complete) 37 { 38 Application.DoEvents(); 39 } 40 41 while (hitCount < 16) 42 Application.DoEvents(); 43 44 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument; 45 46 string gethtml = htmldocument.documentElement.outerHTML; 47 48 //写入文件 49 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html")) 50 { 51 sw.WriteLine(gethtml); 52 } 53 54 Console.WriteLine("html 文件 已经生成!"); 55 56 Console.Read(); 57 } 58 } 59 }

然后,我们打开生成的1.HTML,查看JS加载的内容是否可用

② : 当然,除了通过判断最大值来判断加载是否完成外,我们还可以通过设置定时器来判断,如3S、4S、5S等

是否已加载web浏览器

1 using System;

2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 using System.IO; 8 9 namespace ConsoleApplication2 10 { 11 public class Program 12 { 13 [STAThread] 14 static void Main(string[] args) 15 { 16 string url = "http://www.cnblogs.com"; 17 18 WebBrowser browser = new WebBrowser(); 19 20 browser.ScriptErrorsSuppressed = true; 21 22 browser.Navigate(url); 23 24 //先要等待加载完毕 25 while (browser.ReadyState != WebBrowserReadyState.Complete) 26 { 27 Application.DoEvents(); 28 } 29 30 System.Timers.Timer timer = new System.Timers.Timer(); 31 32 var isComplete = false; 33 34 timer.Elapsed += new System.Timers.ElapsedEventHandler((sender, e) => 35 { 36 //加载完毕 37 isComplete = true; 38 39 timer.Stop(); 40 }); 41 42 timer.Interval = 1000 * 5; 43 44 timer.Start(); 45 46 //继续等待 5s,等待js加载完 47 while (!isComplete) 48 Application.DoEvents(); 49 50 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument; 51 52 string gethtml = htmldocument.documentElement.outerHTML; 53 54 //写入文件 55 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html")) 56 { 57 sw.WriteLine(gethtml); 58 } 59 60 Console.WriteLine("html 文件 已经生成!"); 61 62 Console.Read(); 63 } 64 } 65 }

当然,效果是一样的,所以我们不会截图。通过以上两种编写方法,我们的WebBrowser被放置在主线程中。让我们看看如何把它放在工作线程上

非常简单,只需将工作线程设置为sta模式

1 using System;

2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 8 namespace ConsoleApplication2 9 { 10 public class Program 11 { 12 static int hitCount = 0; 13 14 //[STAThread] 15 static void Main(string[] args) 16 { 17 Thread thread = new Thread(new ThreadStart(() => 18 { 19 Init(); 20 System.Windows.Forms.Application.Run(); 21 })); 22 23 //将该工作线程设定为STA模式 24 thread.SetApartmentState(ApartmentState.STA); 25 26 thread.Start(); 27 28 Console.Read(); 29 } 30 31 static void Init() 32 { 33 string url = "http://www.cnblogs.com"; 34 35 WebBrowser browser = new WebBrowser(); 36 37 browser.ScriptErrorsSuppressed = true; 38 39 browser.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(browser_DocumentCompleted); 40 41 browser.Navigating += new WebBrowserNavigatingEventHandler(browser_Navigating); 42 43 browser.Navigate(url); 44 45 while (browser.ReadyState != WebBrowserReadyState.Complete) 46 { 47 Application.DoEvents(); 48 } 49 50 while (hitCount < 16) 51 Application.DoEvents(); 52 53 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument; 54 55 string gethtml = htmldocument.documentElement.outerHTML; 56 57 Console.WriteLine(gethtml); 58 } 59 60 static void browser_Navigating(object sender, WebBrowserNavigatingEventArgs e) 61 { 62 hitCount++; 63 } 64 65 static void browser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e) 66 { 67 hitCount++; 68 } 69 } 70 }

动态网页抓取(一下如何抓取动态页面?抓取一个页面的方法十分简单)

网站优化 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-09-26 12:00

当我们要抓取一个页面的内容时,首先要做的不是写代码,而是分析页面,判断是静态页面还是动态页面。抓取静态页面的方法很简单。只需解析html源代码,然后分析分析即可。不明白的可以参考我之前的文章文章Scrapy抓取豆瓣电影信息。这里我主要讲讲怎么抢。动态页面。

获取动态页面有两种方式:

第一种方法是使用第三方工具来模拟浏览器加载数据的行为。例如:Selenium、PhantomJs。这种方法的优点是不需要考虑动态页面的各种变化,但性能较低。

第二种方法是分析页面,找到对应的请求接口,直接获取数据。这种方式的优点是性能高,但是缺点也很明显,就是获取API接口比较麻烦。

这里我使用第二种方法来获取动态页面。

1. 在浏览器中打开页面,查看页面源码,发现源码中没有图片信息。这是一个动态加载的页面,是ajax异步请求的动态页面。

2.分析页面,提取API接口,通过F12,可以找到review元素。

3.打开上面的url,发现传入的数据是json格式的,所以我们得到响应响应后,首先要使用json.loads()解析数据。

4. 观察API接口,可以发现有几个参数,ch,sn,listtype,temp。您可以通过更改这些参数的值来获得不同的内容。

通过分析发现ch参数代表图片分类,比如beauty代表一张漂亮的图片,sn代表图片的编号,比如0代表1到30之间的图片,30代表一张图片之间的图片31 和 60。

分析完这些参数,我们就确定了我们需要请求的URL地址。这里的URL不像静态页面中通过程序自动获取a标签中的href,而是需要我们自动设置。我们可以通过覆盖 start_requests 方法 指定要获取的 url。

5.写我们的蜘蛛

# -*- coding: utf-8 -*-

from json import loads

import scrapy

from urllib.parse import urlencode

from image360.items import BeautyItem

class ImageSpider(scrapy.Spider):

name = 'image'

allowed_domains = ['image.so.com']

# 重写Spider中的start_requests方法:指定开始url

def start_requests(self):

base_url = 'http://image.so.com/zj?'

param = {'ch': 'beauty', 'listtype': 'new', 'temp': '1'}

# 可以根据需要爬取不同数量的图片,此处只爬取60张图片

for page in range(2):

param['sn'] = page * 30

full_url = base_url + urlencode(param)

yield scrapy.Request(url=full_url, callback=self.parse)

def parse(self, response):

# 获取到的内容是json数据

# 用json.loads()解析数据

# 此处的response没有content

model_dict = loads(response.text)

for elem in model_dict['list']:

item = BeautyItem()

item['title'] = elem['group_title']

item['tag'] = elem['tag']

item['height'] = elem['cover_width']

item['width'] = elem['cover_height']

item['url'] = elem['qhimg_url']

yield item

6.写入项目并定义保存的字段

import scrapy

class BeautyItem(scrapy.Item):

title = scrapy.Field()

tag = scrapy.Field()

height = scrapy.Field()

width = scrapy.Field()

url = scrapy.Field()

7.写管道完成数据持久化操作,包括下载图片和保存图片信息到mongo。

Scrapy 提供了一个项目管道来下载属于特定项目的图片。例如,当您抓取一个产品并希望将其图片下载到本地时,您可以通过图片管道来执行此操作。这是在 ImagesPipenine 类中实现的,它提供了一种方便且功能额外的方法来在本地下载和存储图片。这个类提供了很多处理图片的方法,想了解详细可以查看中文版官方文档

# -*- coding: utf-8 -*-

import logging

import pymongo

import scrapy

from scrapy.exceptions import DropItem

from scrapy.pipelines.images import ImagesPipeline

logger = logging.getLogger('SaveImagePipeline')

# 继承ImagesPipenine类,这是图片管道

class SaveImagePipeline(ImagesPipeline):

"""

下载图片

"""

def get_media_requests(self, item, info):

# 此方法获取的是requests 所以用yield 不要return

yield scrapy.Request(url=item['url'])

def item_completed(self, results, item, info):

"""

文件下载完成之后,返回一个列表 results

列表中是一个元组,第一个值是布尔值,请求成功会失败,第二个值的下载到的资源

"""

if not results[0][0]:

# 如果下载失败,就抛出异常,并丢弃这个item

# 被丢弃的item将不会被之后的pipeline组件所处理

raise DropItem('下载失败')

# 打印日志

logger.debug('下载图片成功')

return item

def file_path(self, request, response=None, info=None):

"""

返回文件名

"""

return request.url.split('/')[-1]

class SaveToMongoPipeline(object):

"""

保存图片信息到数据库

"""

def __init__(self, mongodb_server, mongodb_port, mongodb_db, mongodb_collection):

self.mongodb_server = mongodb_server

self.mongodb_port = mongodb_port

self.mongodb_db = mongodb_db

self.mongodb_collection = mongodb_collection

def open_spider(self, spider):

# 当spider被开启时,这个方法被调用

self.connection = pymongo.MongoClient(self.mongodb_server, self.mongodb_port)

db = self.connection[self.mongodb_db]

self.collection = db[self.mongodb_collection]

def close_spider(self, spider):

# 当spider被关闭时,这个方法被调用。

self.connection.close()

# 依赖注入

@classmethod

def from_crawler(cls, crawler):

# cls() 会调用初始化方法

return cls(crawler.settings.get('MONGODB_SERVER'),

crawler.settings.get('MONGODB_PORT'),

crawler.settings.get('MONGODB_DB'),

crawler.settings.get('MONGODB_COLLECTION'))

def process_item(self, item, spider):

post = {'title': item['title'], 'tag': item['tag'],

'width': item['width'], 'height': item['height'], 'url': item['url']}

self.collection.insert_one(post)

return item

8.写入设置并完成配置。这里只写需要配置的内容。

9.启动蜘蛛

在启动spider之前,我们需要安装几个包,pypiwin32、pillow, pymongo

pip install pypiwin32

pip install pillow

pip install pymongo

安装完成后就可以启动spider了

scrapy crawl image

10.查看结果:

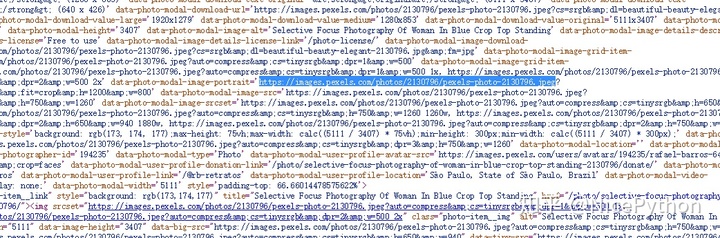

获取到的图片返回的内容:

图片保存在指定路径:

一个爬取动态页面和下载图片的爬虫就完成了。其实写起来很简单。关键是分析API接口,重写start_requests方法。 查看全部

动态网页抓取(一下如何抓取动态页面?抓取一个页面的方法十分简单)

当我们要抓取一个页面的内容时,首先要做的不是写代码,而是分析页面,判断是静态页面还是动态页面。抓取静态页面的方法很简单。只需解析html源代码,然后分析分析即可。不明白的可以参考我之前的文章文章Scrapy抓取豆瓣电影信息。这里我主要讲讲怎么抢。动态页面。

获取动态页面有两种方式:

第一种方法是使用第三方工具来模拟浏览器加载数据的行为。例如:Selenium、PhantomJs。这种方法的优点是不需要考虑动态页面的各种变化,但性能较低。

第二种方法是分析页面,找到对应的请求接口,直接获取数据。这种方式的优点是性能高,但是缺点也很明显,就是获取API接口比较麻烦。

这里我使用第二种方法来获取动态页面。

1. 在浏览器中打开页面,查看页面源码,发现源码中没有图片信息。这是一个动态加载的页面,是ajax异步请求的动态页面。

2.分析页面,提取API接口,通过F12,可以找到review元素。

3.打开上面的url,发现传入的数据是json格式的,所以我们得到响应响应后,首先要使用json.loads()解析数据。

4. 观察API接口,可以发现有几个参数,ch,sn,listtype,temp。您可以通过更改这些参数的值来获得不同的内容。

通过分析发现ch参数代表图片分类,比如beauty代表一张漂亮的图片,sn代表图片的编号,比如0代表1到30之间的图片,30代表一张图片之间的图片31 和 60。

分析完这些参数,我们就确定了我们需要请求的URL地址。这里的URL不像静态页面中通过程序自动获取a标签中的href,而是需要我们自动设置。我们可以通过覆盖 start_requests 方法 指定要获取的 url。

5.写我们的蜘蛛

# -*- coding: utf-8 -*-

from json import loads

import scrapy

from urllib.parse import urlencode

from image360.items import BeautyItem

class ImageSpider(scrapy.Spider):

name = 'image'

allowed_domains = ['image.so.com']

# 重写Spider中的start_requests方法:指定开始url

def start_requests(self):

base_url = 'http://image.so.com/zj?'

param = {'ch': 'beauty', 'listtype': 'new', 'temp': '1'}

# 可以根据需要爬取不同数量的图片,此处只爬取60张图片

for page in range(2):

param['sn'] = page * 30

full_url = base_url + urlencode(param)

yield scrapy.Request(url=full_url, callback=self.parse)

def parse(self, response):

# 获取到的内容是json数据

# 用json.loads()解析数据

# 此处的response没有content

model_dict = loads(response.text)

for elem in model_dict['list']:

item = BeautyItem()

item['title'] = elem['group_title']

item['tag'] = elem['tag']

item['height'] = elem['cover_width']

item['width'] = elem['cover_height']

item['url'] = elem['qhimg_url']

yield item

6.写入项目并定义保存的字段

import scrapy

class BeautyItem(scrapy.Item):

title = scrapy.Field()

tag = scrapy.Field()

height = scrapy.Field()

width = scrapy.Field()

url = scrapy.Field()

7.写管道完成数据持久化操作,包括下载图片和保存图片信息到mongo。

Scrapy 提供了一个项目管道来下载属于特定项目的图片。例如,当您抓取一个产品并希望将其图片下载到本地时,您可以通过图片管道来执行此操作。这是在 ImagesPipenine 类中实现的,它提供了一种方便且功能额外的方法来在本地下载和存储图片。这个类提供了很多处理图片的方法,想了解详细可以查看中文版官方文档

# -*- coding: utf-8 -*-

import logging

import pymongo

import scrapy

from scrapy.exceptions import DropItem

from scrapy.pipelines.images import ImagesPipeline

logger = logging.getLogger('SaveImagePipeline')

# 继承ImagesPipenine类,这是图片管道

class SaveImagePipeline(ImagesPipeline):

"""

下载图片

"""

def get_media_requests(self, item, info):

# 此方法获取的是requests 所以用yield 不要return

yield scrapy.Request(url=item['url'])

def item_completed(self, results, item, info):

"""

文件下载完成之后,返回一个列表 results

列表中是一个元组,第一个值是布尔值,请求成功会失败,第二个值的下载到的资源

"""

if not results[0][0]:

# 如果下载失败,就抛出异常,并丢弃这个item

# 被丢弃的item将不会被之后的pipeline组件所处理

raise DropItem('下载失败')

# 打印日志

logger.debug('下载图片成功')

return item

def file_path(self, request, response=None, info=None):

"""

返回文件名

"""

return request.url.split('/')[-1]

class SaveToMongoPipeline(object):

"""

保存图片信息到数据库

"""

def __init__(self, mongodb_server, mongodb_port, mongodb_db, mongodb_collection):

self.mongodb_server = mongodb_server

self.mongodb_port = mongodb_port

self.mongodb_db = mongodb_db

self.mongodb_collection = mongodb_collection

def open_spider(self, spider):

# 当spider被开启时,这个方法被调用

self.connection = pymongo.MongoClient(self.mongodb_server, self.mongodb_port)

db = self.connection[self.mongodb_db]

self.collection = db[self.mongodb_collection]

def close_spider(self, spider):

# 当spider被关闭时,这个方法被调用。

self.connection.close()

# 依赖注入

@classmethod

def from_crawler(cls, crawler):

# cls() 会调用初始化方法

return cls(crawler.settings.get('MONGODB_SERVER'),

crawler.settings.get('MONGODB_PORT'),

crawler.settings.get('MONGODB_DB'),

crawler.settings.get('MONGODB_COLLECTION'))

def process_item(self, item, spider):

post = {'title': item['title'], 'tag': item['tag'],

'width': item['width'], 'height': item['height'], 'url': item['url']}

self.collection.insert_one(post)

return item

8.写入设置并完成配置。这里只写需要配置的内容。

9.启动蜘蛛

在启动spider之前,我们需要安装几个包,pypiwin32、pillow, pymongo

pip install pypiwin32

pip install pillow

pip install pymongo

安装完成后就可以启动spider了

scrapy crawl image

10.查看结果:

获取到的图片返回的内容:

图片保存在指定路径:

一个爬取动态页面和下载图片的爬虫就完成了。其实写起来很简单。关键是分析API接口,重写start_requests方法。

动态网页抓取(动态网页抓取工具推荐(二):为什么一定要用http字段)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-09-26 00:08

动态网页抓取工具推荐提到抓取,不得不说http协议。相对于socket编程,可能更多人被网络爬虫培训机构误导,以为这是解决爬虫抓取问题的万金油。要说抓取工具是什么,对于http协议抓取而言,webspider,spiderhub、googlespider等已经是烂大街的主流工具。但这几种抓取工具应该都存在不少问题,curl不稳定,fiddler抓取非常不稳定。

在上一篇介绍前,我们基本明确了目前主流工具的不足和局限。针对这些问题,下面用几个很酷的案例告诉大家,为什么一定要用http协议抓取。1.http协议定义了哪些消息类型以及编码方式?http和tcp不同,不同的浏览器会有不同解析器对同一method请求作出不同的request,进而返回不同的html。好了,我们先来看一张图:图中标蓝的为content-length字段,也就是消息的长度。

下面举例说明。这个任务属于第二章示例图中的第一步,从examplebooks数据库中获取电子书籍名单。这个任务参考[[content-length]]解决这一步,需要明确传递给爬虫工具的是method:post,而非postmessage。如果网站遵循postmessage的request就直接返回结果。

举例如下:http协议定义了三种header字段,其中content-length字段,有两种编码方式,分别如下:utf-8和gbk,两种编码方式又被分类为aes、aes-128、ed-8,这个问题大家不必深究,有兴趣的同学自己动手研究。在这里先讲utf-8,utf-8是unicode字符集中保存字符的一种编码方式,其最大的好处就是unicode字符能够在内存中与html中保存的字符都一一对应。

http协议的每个字段只支持一种编码方式。而webspider生成的postmessage字段就是采用的utf-8编码。这里放上http协议定义的部分内容,其余大家可自行查阅资料。http协议的每个字段定义的编码格式如下:content-typetext/plain无header/attachment/send-expires设置上面列举的三种content-type字段utf-8,可以理解为在头部文本中预留下来的字符编码。

随着web抓取的大火,这个部分也被设置上了支持。[[protocol]]带上这个就是带头部脚本字段的utf-8方案。[[scheme]]随着如火如荼的翻墙浪潮,谷歌提供了一组scheme供爬虫工具抓取,我们也可以提供自己的。对这个scheme可能很多人不是很了解,这里来举例说明,比如上面图中javascript脚本文件中的'-webkit-iscroll',正则表达式引擎就是采用的googlejs脚本引擎,[[after]]这里的after是一个修饰词,用于作为时间戳,用作条件判断。比如s。 查看全部

动态网页抓取(动态网页抓取工具推荐(二):为什么一定要用http字段)

动态网页抓取工具推荐提到抓取,不得不说http协议。相对于socket编程,可能更多人被网络爬虫培训机构误导,以为这是解决爬虫抓取问题的万金油。要说抓取工具是什么,对于http协议抓取而言,webspider,spiderhub、googlespider等已经是烂大街的主流工具。但这几种抓取工具应该都存在不少问题,curl不稳定,fiddler抓取非常不稳定。

在上一篇介绍前,我们基本明确了目前主流工具的不足和局限。针对这些问题,下面用几个很酷的案例告诉大家,为什么一定要用http协议抓取。1.http协议定义了哪些消息类型以及编码方式?http和tcp不同,不同的浏览器会有不同解析器对同一method请求作出不同的request,进而返回不同的html。好了,我们先来看一张图:图中标蓝的为content-length字段,也就是消息的长度。

下面举例说明。这个任务属于第二章示例图中的第一步,从examplebooks数据库中获取电子书籍名单。这个任务参考[[content-length]]解决这一步,需要明确传递给爬虫工具的是method:post,而非postmessage。如果网站遵循postmessage的request就直接返回结果。

举例如下:http协议定义了三种header字段,其中content-length字段,有两种编码方式,分别如下:utf-8和gbk,两种编码方式又被分类为aes、aes-128、ed-8,这个问题大家不必深究,有兴趣的同学自己动手研究。在这里先讲utf-8,utf-8是unicode字符集中保存字符的一种编码方式,其最大的好处就是unicode字符能够在内存中与html中保存的字符都一一对应。

http协议的每个字段只支持一种编码方式。而webspider生成的postmessage字段就是采用的utf-8编码。这里放上http协议定义的部分内容,其余大家可自行查阅资料。http协议的每个字段定义的编码格式如下:content-typetext/plain无header/attachment/send-expires设置上面列举的三种content-type字段utf-8,可以理解为在头部文本中预留下来的字符编码。

随着web抓取的大火,这个部分也被设置上了支持。[[protocol]]带上这个就是带头部脚本字段的utf-8方案。[[scheme]]随着如火如荼的翻墙浪潮,谷歌提供了一组scheme供爬虫工具抓取,我们也可以提供自己的。对这个scheme可能很多人不是很了解,这里来举例说明,比如上面图中javascript脚本文件中的'-webkit-iscroll',正则表达式引擎就是采用的googlejs脚本引擎,[[after]]这里的after是一个修饰词,用于作为时间戳,用作条件判断。比如s。

动态网页抓取(本文百度百科动态网页解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-09-24 15:09

前言

本文文字及图片均来自网络,仅供学习交流之用。它们没有任何商业用途。版权属于原作者。如果您有任何问题,请联系我们进行处理。

一、什么是动态网页

所谓动态网页,是指一种与静态网页相对的网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会发生变化——除非你修改页面代码。这不是动态网页的情况。虽然页面代码没有改变,但显示的内容会随着时间、环境或数据库操作的结果而改变。——来源百度百科

动态网页具有工作量少、内容更新快、功能更齐全的特点。被很多公司采用,如购动、速食宝、速食等。

二、什么是AJAX

随着人们对动态网页的加载速度要求越来越高,AJAX 技术应运而生,成为许多网站的首选。AJAX 是一种用于创建快速动态网页的技术,通过在后台与服务器进行少量数据交换,使网页可以异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。

三、如何抓取AJAX动态加载网页

1. 分析界面

只要有数据发送,就一定有请求发送到服务器。我们只需要找出它静默加载的页面的真实请求。特点:爬取速度快,爬取数据干净,部分网站比较难解析。

2. 硒

什么是硒?它最初是一个自动化测试工具,但被广泛的用户抓取。是一个可以用代码操作浏览器的工具,比如控制浏览器的下滑,模拟鼠标点击等。 特点:代码比较简单,爬取速度慢,IP容易被封。

项目实践

法院历年发布的开庭信息和执行信息。

它看起来像这样:

然后,成功提取第一页

紧接着又加了一个for循环,想着花几分钟把这个网站2164页面的32457法院公告数据提取到excel中。

然后,就没有了。你也应该知道,看了前面的理论部分,这是一个AJAX动态加载的网页。无论你如何点击下一页,url都不会改变。如果你不相信我,我就给你看。左上角的url像山一样矗立在那里:

一、分析界面

既然如此,那我们就开始爬虫的正确姿势,先用解析接口的方法来写爬虫。

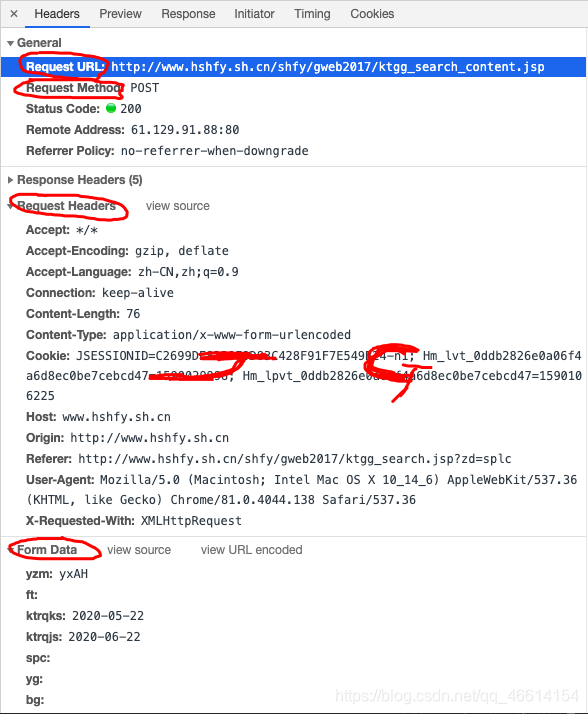

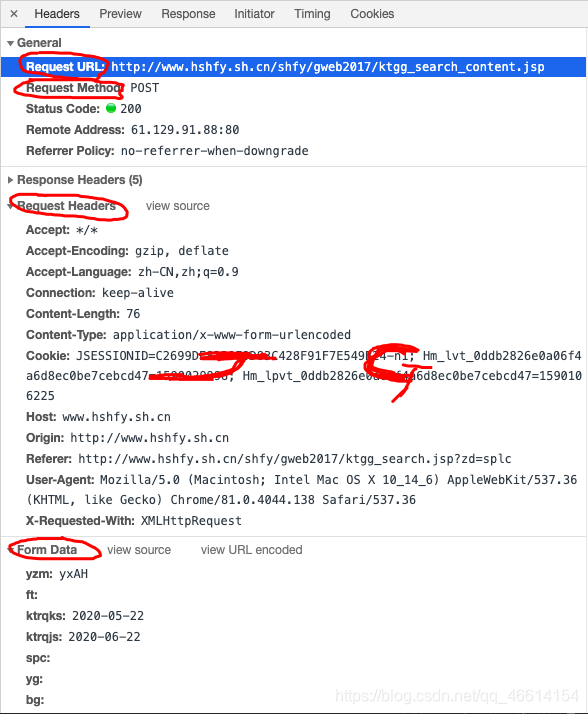

首先,找到真正的要求。右键勾选,点击Network,选择XHR,刷新网页,在Name列表中选择jsp文件。没错,就是这么简单,真正的要求就藏在里面。

再仔细看看这个jsp,这简直就是宝藏。有真实的请求url、post请求方法、Headers、Form Data,From Data代表传递给url的参数。通过改变参数,我们可以得到数据!

让我们仔细看看这些参数, pagesnum 参数不只是代表页数!我们尝试点击翻页,发现只有 pagesnum 参数会发生变化。

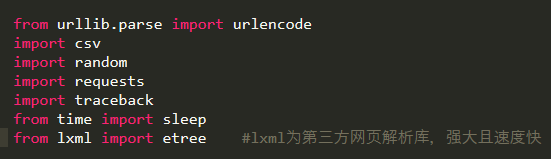

既然找到了,赶紧抓起来吧。

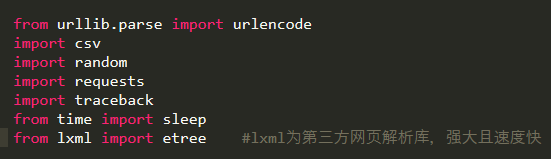

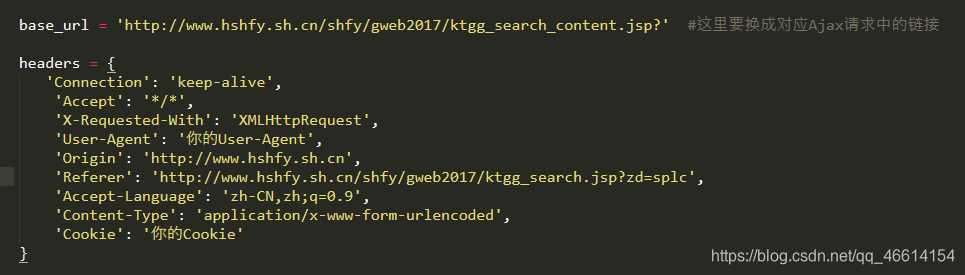

构造一个真正的请求并添加标题。

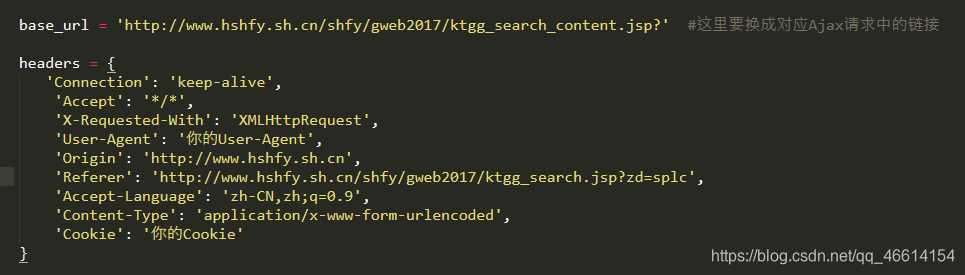

构造get_page函数,参数为page,即页数。创建字典类型的表单数据,并使用post请求网页数据。这里一定要注意返回数据的解码,编码为'gbk',否则返回数据会乱码!另外,我还优化了异常处理,防止意外。

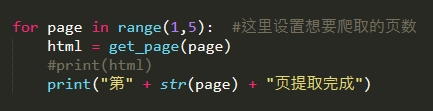

构造parse_page函数解析返回的网页数据,用Xpath提取所有字段内容,并保存为csv格式。

最后遍历页数,调用函数。OK完成!

我们来看看最终的效果:

综上所述,对于网络爬虫的AJAX动态加载,一般有两种方式:解析接口;硒。建议解析接口。如果是解析json数据,最好是爬取。如果你不知道如何使用Selenium,让我们使用Selenium。 查看全部

动态网页抓取(本文百度百科动态网页解析)

前言

本文文字及图片均来自网络,仅供学习交流之用。它们没有任何商业用途。版权属于原作者。如果您有任何问题,请联系我们进行处理。

一、什么是动态网页

所谓动态网页,是指一种与静态网页相对的网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会发生变化——除非你修改页面代码。这不是动态网页的情况。虽然页面代码没有改变,但显示的内容会随着时间、环境或数据库操作的结果而改变。——来源百度百科

动态网页具有工作量少、内容更新快、功能更齐全的特点。被很多公司采用,如购动、速食宝、速食等。

二、什么是AJAX

随着人们对动态网页的加载速度要求越来越高,AJAX 技术应运而生,成为许多网站的首选。AJAX 是一种用于创建快速动态网页的技术,通过在后台与服务器进行少量数据交换,使网页可以异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。

三、如何抓取AJAX动态加载网页

1. 分析界面

只要有数据发送,就一定有请求发送到服务器。我们只需要找出它静默加载的页面的真实请求。特点:爬取速度快,爬取数据干净,部分网站比较难解析。

2. 硒

什么是硒?它最初是一个自动化测试工具,但被广泛的用户抓取。是一个可以用代码操作浏览器的工具,比如控制浏览器的下滑,模拟鼠标点击等。 特点:代码比较简单,爬取速度慢,IP容易被封。

项目实践

法院历年发布的开庭信息和执行信息。

它看起来像这样:

然后,成功提取第一页

紧接着又加了一个for循环,想着花几分钟把这个网站2164页面的32457法院公告数据提取到excel中。

然后,就没有了。你也应该知道,看了前面的理论部分,这是一个AJAX动态加载的网页。无论你如何点击下一页,url都不会改变。如果你不相信我,我就给你看。左上角的url像山一样矗立在那里:

一、分析界面

既然如此,那我们就开始爬虫的正确姿势,先用解析接口的方法来写爬虫。

首先,找到真正的要求。右键勾选,点击Network,选择XHR,刷新网页,在Name列表中选择jsp文件。没错,就是这么简单,真正的要求就藏在里面。

再仔细看看这个jsp,这简直就是宝藏。有真实的请求url、post请求方法、Headers、Form Data,From Data代表传递给url的参数。通过改变参数,我们可以得到数据!

让我们仔细看看这些参数, pagesnum 参数不只是代表页数!我们尝试点击翻页,发现只有 pagesnum 参数会发生变化。

既然找到了,赶紧抓起来吧。

构造一个真正的请求并添加标题。

构造get_page函数,参数为page,即页数。创建字典类型的表单数据,并使用post请求网页数据。这里一定要注意返回数据的解码,编码为'gbk',否则返回数据会乱码!另外,我还优化了异常处理,防止意外。

构造parse_page函数解析返回的网页数据,用Xpath提取所有字段内容,并保存为csv格式。

最后遍历页数,调用函数。OK完成!

我们来看看最终的效果:

综上所述,对于网络爬虫的AJAX动态加载,一般有两种方式:解析接口;硒。建议解析接口。如果是解析json数据,最好是爬取。如果你不知道如何使用Selenium,让我们使用Selenium。

动态网页抓取( stringparameter修改23行代码的seed:不然可能会爬不到东西 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-09-24 15:07

stringparameter修改23行代码的seed:不然可能会爬不到东西

)

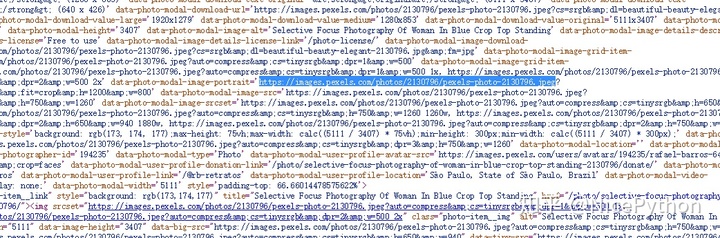

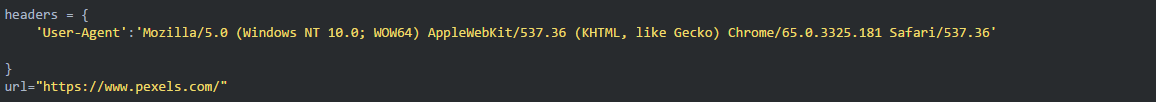

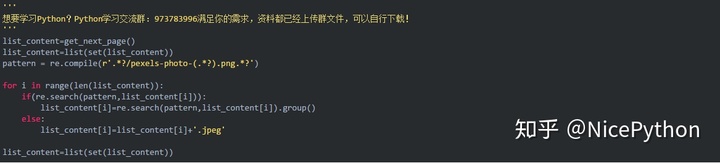

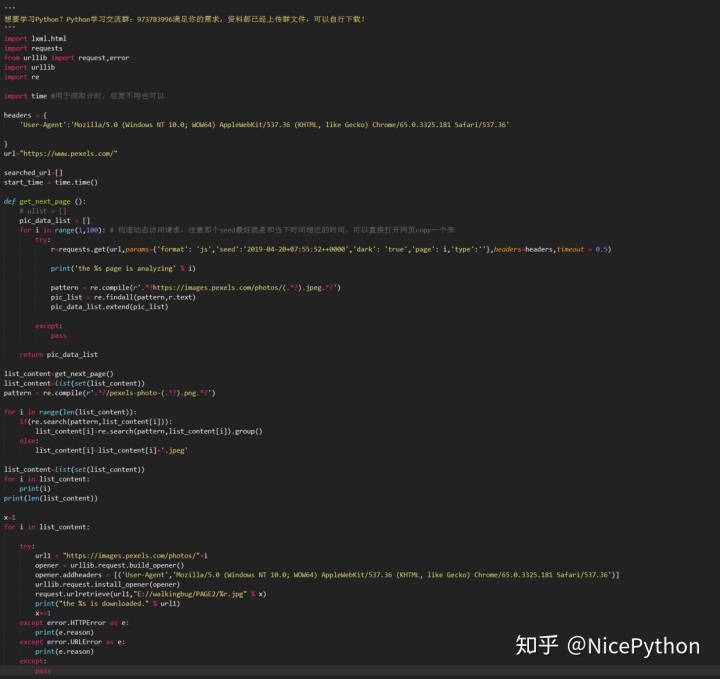

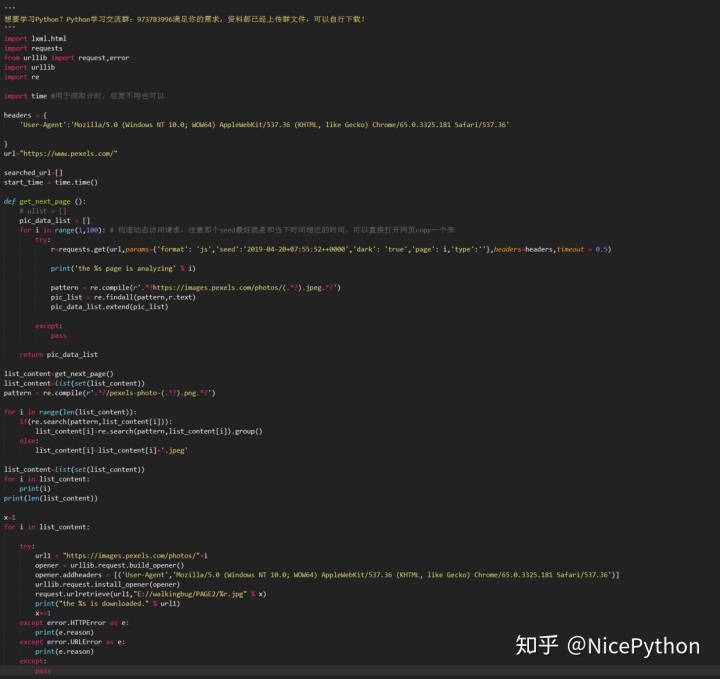

这时候我们可以考虑,首先我们先获取页面的代码

然后使用正则表达式搜索符合条件的图片

但是,后面可能会有重复,只需在获取的列表末尾使用 set 过滤即可。

理清以上思路后,接下来我们开始搭建爬虫

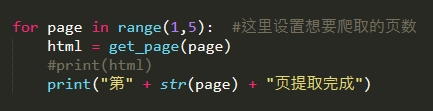

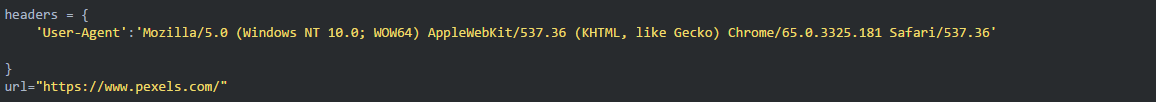

①初始化头☆

这一步非常重要。如果不构造headers,将被禁止访问==

headers初始化代码如下,用于将爬虫伪装成浏览器请求,请求用于发起特定的AJAX内容

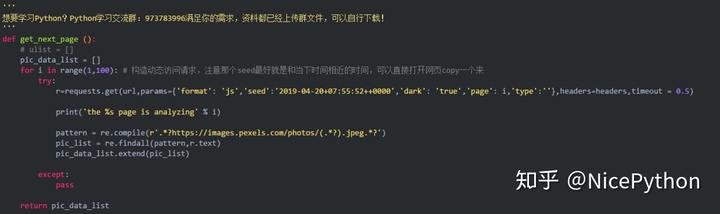

②构建动态AJAX请求

根据上面截图中保存的Query String Parameter参数,我们在构造请求请求时,收录了Params内容

将获取到的下载图片链接保存到列表中

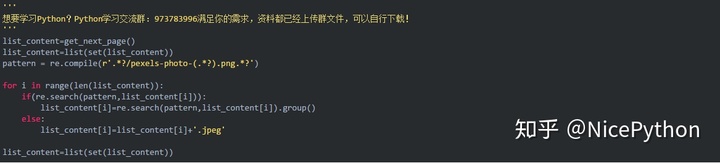

③元素选择

我第一次调试程序的时候,发现得到的链接中有一个以png结尾的链接。这里需要再次过滤列表,保留可以下载图片的链接。

最后,不要忘记使用 set 来删除列表中重复的元素。

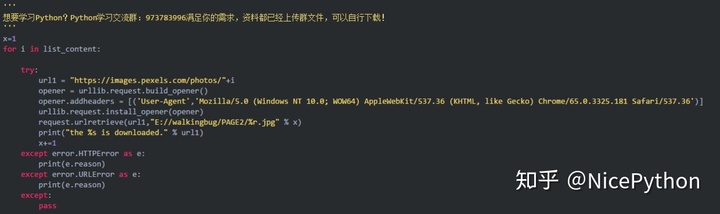

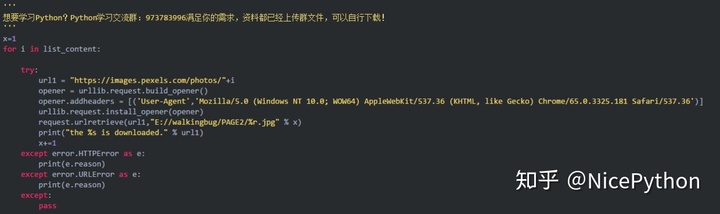

④最后使用urllib.request.urlretrieve将图片保存到每张图片的下载地址所在列表的指定路径。

*Pexel一开始也对每张图片的下载地址进行了反爬虫机制的调整,所以下载headers再模拟浏览器^_^

这一步可以单独写成一个函数,但是我没有这样写,因为我是为了方便。

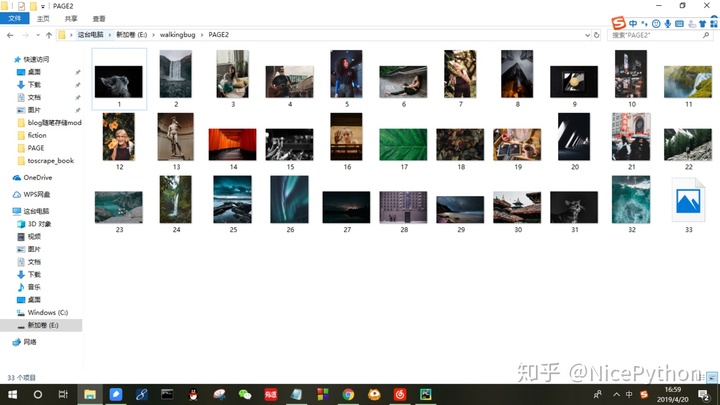

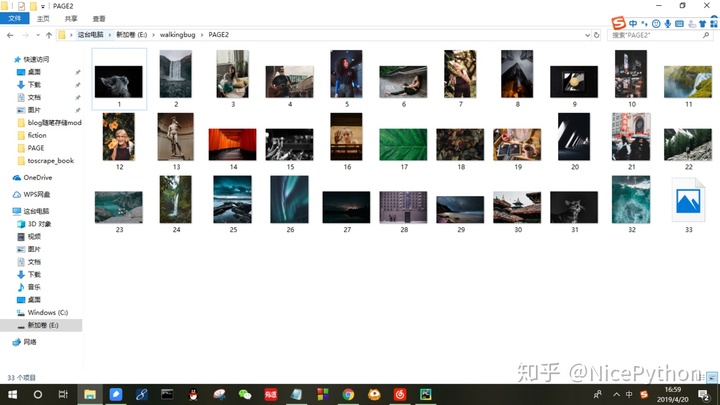

最后贴两张运行结果图

控制台的输出:

下载到本地壁纸

完整代码如下:

①添加一些输出语句以便调试程序

②如果要粘贴直接使用,记得打开页面查看查询字符串参数,修改23行代码的种子内容!否则你可能无法攀爬东西

查看全部

动态网页抓取(

stringparameter修改23行代码的seed:不然可能会爬不到东西

)

这时候我们可以考虑,首先我们先获取页面的代码

然后使用正则表达式搜索符合条件的图片

但是,后面可能会有重复,只需在获取的列表末尾使用 set 过滤即可。

理清以上思路后,接下来我们开始搭建爬虫

①初始化头☆

这一步非常重要。如果不构造headers,将被禁止访问==

headers初始化代码如下,用于将爬虫伪装成浏览器请求,请求用于发起特定的AJAX内容

②构建动态AJAX请求

根据上面截图中保存的Query String Parameter参数,我们在构造请求请求时,收录了Params内容

将获取到的下载图片链接保存到列表中

③元素选择

我第一次调试程序的时候,发现得到的链接中有一个以png结尾的链接。这里需要再次过滤列表,保留可以下载图片的链接。

最后,不要忘记使用 set 来删除列表中重复的元素。

④最后使用urllib.request.urlretrieve将图片保存到每张图片的下载地址所在列表的指定路径。

*Pexel一开始也对每张图片的下载地址进行了反爬虫机制的调整,所以下载headers再模拟浏览器^_^

这一步可以单独写成一个函数,但是我没有这样写,因为我是为了方便。

最后贴两张运行结果图

控制台的输出:

下载到本地壁纸

完整代码如下:

①添加一些输出语句以便调试程序

②如果要粘贴直接使用,记得打开页面查看查询字符串参数,修改23行代码的种子内容!否则你可能无法攀爬东西

动态网页抓取(爬取动态网页的另一种方法-上海怡健医学)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-24 02:13

首先介绍动态网页,它使用【客户端语言改变页面的HTML和CSS元素】。例如,一个网页使用加载网页将您介绍到另一个页面,但该页面的 URL 连接没有改变,或者当您单击空白时页面会改变颜色。

然后是客户端脚本语言,它是一种运行在浏览器而不是服务器上的语言。网上通常会遇到两种客户端语言:ActionScript(开发flash应用程序的语言)和JavaScript。

JavaScript 常用于为网页添加各种动态功能,为用户提供更流畅美观的浏览效果。通常 JavaScript 脚本通过将它们嵌入到 HTML 中来实现它们的功能。

比如一个下拉的动态网页,加载后可以在浏览器的开发者工具的网络中的JS选项中看到它刚刚执行的JavaScript,点击就可以看到代码。

目前已经写了一堆爬虫。对于动态网页,比如图片的下拉加载,在开发者工具/网络/图片中找到图片,分析图片地址的特征,然后在JS中找到刚才的JavaScript文件,如果可以的话可能收录找到比较规范的图片信息,或者网页的跳转关系,可以很方便的写程序,在图片地址下载图片。

这种方法是逆向分析。

另一种爬取动态网页的方式是模拟浏览器,通常是Selenium+PhantomJS。

Selenium 是一个浏览器自动化测试框架,最初是为自动化测试而开发的,现在也用于网络数据采集。框架底层使用JavaScript模拟真实用户操作浏览器。测试脚本执行时,浏览器会根据脚本代码自动进行点击、输入、打开、验证等操作,就像真实用户一样,站在最终用户的角度测试应用。

Selenium 本身没有浏览器,需要配合第三方浏览器使用。之前用过火狐,每次运行都会打开一个浏览器窗口,程序运行一目了然。PhantomJS 是一个无头浏览器,不显示浏览器窗口。

Selenium+PhantomJS 可以运行一个非常强大的网络爬虫,它可以处理 cookie、JavaScript、headers 以及您需要做的任何事情。

2018-03-01 13:50

不知道有没有朋友喜欢,嘿嘿,,,啾^啾,,

没有图的答案注定不喜欢吗?

这是一条更新线,下面的信息是旧新闻。

反正都是原答案,舍不得删,不喜欢直接跳过

╯▂╰

我是在寒假期间学习的。几天前我想爬一个网站。我查看了开发者工具中的数据,将其作为静态网页进行抓取。然后我爬下来的时候找不到任何数据。

然后才知道在开发者工具里看到的网页源码是通过JavaScript渲染的,通过Requests得到的源码没有我想要的数据。

之前看书的时候讲了selenium模块。考虑到用它来模拟浏览器的时候不容易被逆转,我就用它爬过12306查票。

我能想到的第一种方法是使用selenium,但是我认为它的速度不能满足我的需求,而且我非常抗拒。(呃(~_~;)

那我只好百度了,肯定会有其他的解决办法。

然后CSDN上有一篇很全面的文章。

套用大佬的总结:

动态网页可以通过逆向分析尽可能进行逆向分析,其稳定性和效率是其他解决方案无法比拟的。通常,爬虫有口耳相传的真理。如果点击浏览器F12大法,90%的爬虫问题都可以解决,剩下的10%就需要我们动脑筋了。这适用于动态页面抓取。如果你能扭转它,试着扭转它。如果无法逆转,请找到折衷的解决方案。在折中方案中,可以尽量使用深度控制JS脚本执行计划(难度稍高),然后是基于标准的浏览器自动化测试框架(即selenium和PhantomJs)爬取。

如需进一步了解,请直接前往网站:

/yanbober/article/details/73822475?locationNum=3&fps=1

时间:2018-02-10 01:23 查看全部

动态网页抓取(爬取动态网页的另一种方法-上海怡健医学)

首先介绍动态网页,它使用【客户端语言改变页面的HTML和CSS元素】。例如,一个网页使用加载网页将您介绍到另一个页面,但该页面的 URL 连接没有改变,或者当您单击空白时页面会改变颜色。

然后是客户端脚本语言,它是一种运行在浏览器而不是服务器上的语言。网上通常会遇到两种客户端语言:ActionScript(开发flash应用程序的语言)和JavaScript。

JavaScript 常用于为网页添加各种动态功能,为用户提供更流畅美观的浏览效果。通常 JavaScript 脚本通过将它们嵌入到 HTML 中来实现它们的功能。

比如一个下拉的动态网页,加载后可以在浏览器的开发者工具的网络中的JS选项中看到它刚刚执行的JavaScript,点击就可以看到代码。

目前已经写了一堆爬虫。对于动态网页,比如图片的下拉加载,在开发者工具/网络/图片中找到图片,分析图片地址的特征,然后在JS中找到刚才的JavaScript文件,如果可以的话可能收录找到比较规范的图片信息,或者网页的跳转关系,可以很方便的写程序,在图片地址下载图片。

这种方法是逆向分析。

另一种爬取动态网页的方式是模拟浏览器,通常是Selenium+PhantomJS。

Selenium 是一个浏览器自动化测试框架,最初是为自动化测试而开发的,现在也用于网络数据采集。框架底层使用JavaScript模拟真实用户操作浏览器。测试脚本执行时,浏览器会根据脚本代码自动进行点击、输入、打开、验证等操作,就像真实用户一样,站在最终用户的角度测试应用。

Selenium 本身没有浏览器,需要配合第三方浏览器使用。之前用过火狐,每次运行都会打开一个浏览器窗口,程序运行一目了然。PhantomJS 是一个无头浏览器,不显示浏览器窗口。

Selenium+PhantomJS 可以运行一个非常强大的网络爬虫,它可以处理 cookie、JavaScript、headers 以及您需要做的任何事情。

2018-03-01 13:50

不知道有没有朋友喜欢,嘿嘿,,,啾^啾,,

没有图的答案注定不喜欢吗?

这是一条更新线,下面的信息是旧新闻。

反正都是原答案,舍不得删,不喜欢直接跳过

╯▂╰

我是在寒假期间学习的。几天前我想爬一个网站。我查看了开发者工具中的数据,将其作为静态网页进行抓取。然后我爬下来的时候找不到任何数据。

然后才知道在开发者工具里看到的网页源码是通过JavaScript渲染的,通过Requests得到的源码没有我想要的数据。

之前看书的时候讲了selenium模块。考虑到用它来模拟浏览器的时候不容易被逆转,我就用它爬过12306查票。

我能想到的第一种方法是使用selenium,但是我认为它的速度不能满足我的需求,而且我非常抗拒。(呃(~_~;)

那我只好百度了,肯定会有其他的解决办法。

然后CSDN上有一篇很全面的文章。

套用大佬的总结:

动态网页可以通过逆向分析尽可能进行逆向分析,其稳定性和效率是其他解决方案无法比拟的。通常,爬虫有口耳相传的真理。如果点击浏览器F12大法,90%的爬虫问题都可以解决,剩下的10%就需要我们动脑筋了。这适用于动态页面抓取。如果你能扭转它,试着扭转它。如果无法逆转,请找到折衷的解决方案。在折中方案中,可以尽量使用深度控制JS脚本执行计划(难度稍高),然后是基于标准的浏览器自动化测试框架(即selenium和PhantomJs)爬取。

如需进一步了解,请直接前往网站:

/yanbober/article/details/73822475?locationNum=3&fps=1

时间:2018-02-10 01:23

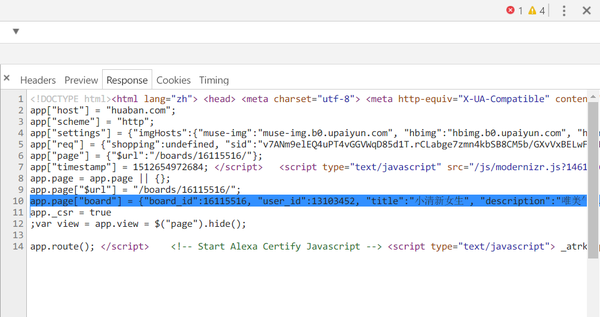

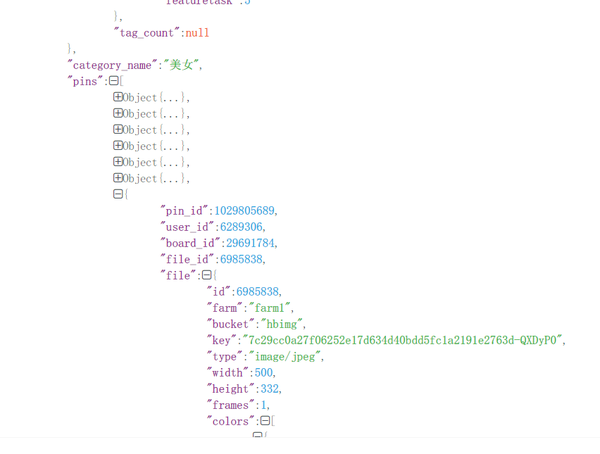

动态网页抓取(一个偶然的机会发现了花瓣网:美女图集_美女相册)

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-09-24 02:12

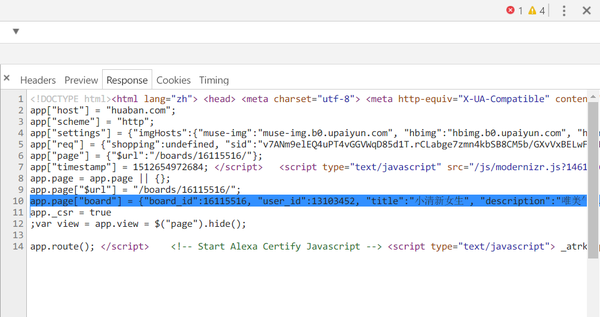

偶然发现了花瓣网:美图集_美图相册_花瓣画板,这个神奇的网站,妹子图都很赞。这不是诱使我写一个爬虫来让事情发生。

查了一下网页,发现这是一个动态加载的网站,真是可悲。不过没关系。如果分析请求规则,仍然可以抓取。

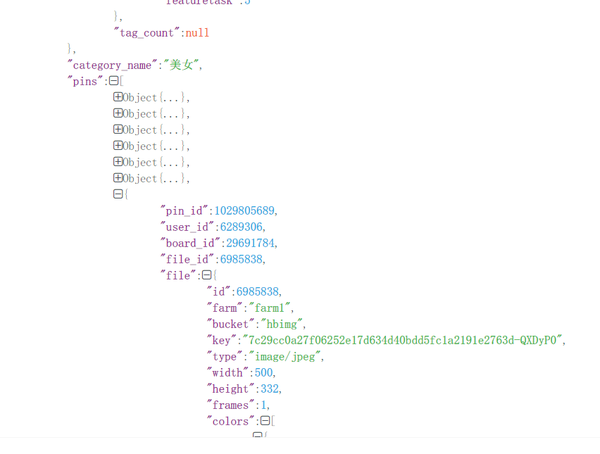

分析网页的规则,每张图片的页面url都有一个pin_id,拿到pin_id就可以进入图片的详情页

经过一番F12抓包,找到了请求url:

http://huaban.com/boards/16115 ... l%3D1

这是在某个画板下继续请求的 url。可以发现max=是某张图片的pin_id。可以为空,返回前20个pin_id。

从高容量行中取出json数据,可以看到:

pin_id在json数据中,url中继续加载的max=参数是最后一个pin_id。那么就有一个思路:通过不断的请求,最后一个pin_id作为下一次请求的参数返回,就可以得到所有的pin_id。

拿到了pin_id,进入分页页面的时候发现返回的html文字还是文字,但是无法获取图片。

发现图片的下载链接格式如下:

url = 'http://img.hb.aicdn.com/%26amp ... 39%3B

这个key收录在返回的html中的一个json格式字符串中,提取出来就可以了

以下是完整代码,更新一次,可以直接返回json格式数据,不需要正则匹配,代码量小很多。

<p>import os

import requests

import jsonpath

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'

,'Accept':'application/json'

,'X-Request':'JSON'

,'X-Requested-With':'XMLHttpRequest'}

headers_img = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'}

def save_img(pin_id_list):

#pin_id_list = opener(file_name)

dir_name = input("enter the dir_name :")

#dir_name = "huaban"

try:

os.mkdir(dir_name)

except OSError as o:

print(o)

pass

os.chdir('.\\%s' % dir_name)

for each in pin_id_list:

find_img(each)

#pin_id_list.remove(each)

print("%s is done."%each)

os.chdir('..')

def controlor(boards_id):

id_list = save_txt(boards_id)

save_img(id_list)

def save_txt(boards_id):

tuple_return = find_all_pin_id(boards_id)

#print(tuple_return)

id_list = tuple_return[0]

pin_count = tuple_return[1]

if len(id_list) == pin_count:

file_name = 'all_'+str(boards_id)+".txt"

else:

lack_nummber = str(pin_count-len(id_list))

file_name = 'lack_' + lack_nummber +"_"+ str(boards_id)+".txt"

with open(file_name,"wb")as f:

for each in id_list:

each = str(each) + ';'

txt = each.encode(encoding='utf-8')

f.write(txt)

print("写入boardsID完成")

return id_list

def find_img(pin_id):

url = 'http://huaban.com/pins/%s/?jaw2dlf8' %pin_id

# print(url)

rsp = requests.get(url, headers=headers)

#print(rsp.text)

json_obj = rsp.json()

img_key = jsonpath.jsonpath(json_obj, "$..original_pin.file.key") # 这里就定位到了图片的key

img_type = jsonpath.jsonpath(json_obj, '$..original_pin.file.type') # 顺便把图片的格式提取出来

img_id = jsonpath.jsonpath(json_obj, "$..pin_id")[0]

img_source = jsonpath.jsonpath(json_obj, "$..source")[0]

img_link = jsonpath.jsonpath(json_obj, "$..link")[0]

#print(img_source)

#print(img_link)

if img_key == False:

img_key = jsonpath.jsonpath(json_obj, "$..file.key") # 上一步返回的key有一些是False,因为original可能为空

img_type = jsonpath.jsonpath(json_obj, '$..file.type') # 通过分析:有一些图片的key 在file目录下,那就改变一下提取出来

img_key = img_key[0]

img_type = img_type[0]

img_id = str(img_id)

i = img_type.index("/")

img_type = img_type[i + 1:]

# print(img_type + ':' + img_key +':'+ img_id)

#return (img_key,img_id,img_type)

downloader(img_key,img_id,img_type)

def downloader(key,pin_id,type):

'''这是一个下载器,传入三个参数,构建url,得到图片,保存!'''

url = 'http://img.hb.aicdn.com/%26amp ... 39%3B # 构建url

try:

img = requests.get(url,headers=headers).content

img_name = str(pin_id)+'.'+type

print("---------------------------------------------------------------------------------")

print("正在下载图片:" + img_name)

print("下载链接:" + url)

with open(img_name,"wb")as f: # 写入文件

f.write(img)

except Exception as t:

with open("Error_logging.txt","wb")as w:

error = str(t)+"出错了!图片链接是:"+ url

w.write(error.encode(encoding="utf-8")) # 记录下错误日志

pass

def find_pin_id_20(pin_id,boards_id):

request_URL = 'http://huaban.com/boards/%25s/ ... 3B%25(str(boards_id),str(pin_id))

print(request_URL)

json_obj = requests.get(request_URL,headers = headers).json()

#print(json_obj)

pin_id_list = jsonpath.jsonpath(json_obj, "$..pin_id") # jsonpath方法匹配出pinID

if pin_id_list != False:

#print("获取到的id个数: "+str(len(pin_id_list)))

int_list = []

for each in pin_id_list:

int_list.append(int(each))

#print(int_list)

return int_list

else:

return pin_id_list

def find_all_pin_id(boards_id):

url = 'http://huaban.com/boards/%s/'%str(boards_id)

rsp = requests.get(url,headers=headers)

#print(rsp.text)

json_obj = rsp.json()

pin_count = jsonpath.jsonpath(json_obj, '$..pin_count')[0]

pin_id_original = jsonpath.jsonpath(json_obj,'$..pin_id')

#print(len(pin_id_original))

while True:

if len(pin_id_original) 查看全部

动态网页抓取(一个偶然的机会发现了花瓣网:美女图集_美女相册)

偶然发现了花瓣网:美图集_美图相册_花瓣画板,这个神奇的网站,妹子图都很赞。这不是诱使我写一个爬虫来让事情发生。

查了一下网页,发现这是一个动态加载的网站,真是可悲。不过没关系。如果分析请求规则,仍然可以抓取。

分析网页的规则,每张图片的页面url都有一个pin_id,拿到pin_id就可以进入图片的详情页

经过一番F12抓包,找到了请求url:

http://huaban.com/boards/16115 ... l%3D1

这是在某个画板下继续请求的 url。可以发现max=是某张图片的pin_id。可以为空,返回前20个pin_id。

从高容量行中取出json数据,可以看到:

pin_id在json数据中,url中继续加载的max=参数是最后一个pin_id。那么就有一个思路:通过不断的请求,最后一个pin_id作为下一次请求的参数返回,就可以得到所有的pin_id。

拿到了pin_id,进入分页页面的时候发现返回的html文字还是文字,但是无法获取图片。

发现图片的下载链接格式如下:

url = 'http://img.hb.aicdn.com/%26amp ... 39%3B

这个key收录在返回的html中的一个json格式字符串中,提取出来就可以了

以下是完整代码,更新一次,可以直接返回json格式数据,不需要正则匹配,代码量小很多。

<p>import os

import requests

import jsonpath

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'

,'Accept':'application/json'

,'X-Request':'JSON'

,'X-Requested-With':'XMLHttpRequest'}

headers_img = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'}

def save_img(pin_id_list):

#pin_id_list = opener(file_name)

dir_name = input("enter the dir_name :")

#dir_name = "huaban"

try:

os.mkdir(dir_name)

except OSError as o:

print(o)

pass

os.chdir('.\\%s' % dir_name)

for each in pin_id_list:

find_img(each)

#pin_id_list.remove(each)

print("%s is done."%each)

os.chdir('..')

def controlor(boards_id):

id_list = save_txt(boards_id)

save_img(id_list)

def save_txt(boards_id):

tuple_return = find_all_pin_id(boards_id)

#print(tuple_return)

id_list = tuple_return[0]

pin_count = tuple_return[1]

if len(id_list) == pin_count:

file_name = 'all_'+str(boards_id)+".txt"

else:

lack_nummber = str(pin_count-len(id_list))

file_name = 'lack_' + lack_nummber +"_"+ str(boards_id)+".txt"

with open(file_name,"wb")as f:

for each in id_list:

each = str(each) + ';'

txt = each.encode(encoding='utf-8')

f.write(txt)

print("写入boardsID完成")

return id_list

def find_img(pin_id):

url = 'http://huaban.com/pins/%s/?jaw2dlf8' %pin_id

# print(url)

rsp = requests.get(url, headers=headers)

#print(rsp.text)

json_obj = rsp.json()

img_key = jsonpath.jsonpath(json_obj, "$..original_pin.file.key") # 这里就定位到了图片的key

img_type = jsonpath.jsonpath(json_obj, '$..original_pin.file.type') # 顺便把图片的格式提取出来

img_id = jsonpath.jsonpath(json_obj, "$..pin_id")[0]

img_source = jsonpath.jsonpath(json_obj, "$..source")[0]

img_link = jsonpath.jsonpath(json_obj, "$..link")[0]

#print(img_source)

#print(img_link)

if img_key == False:

img_key = jsonpath.jsonpath(json_obj, "$..file.key") # 上一步返回的key有一些是False,因为original可能为空

img_type = jsonpath.jsonpath(json_obj, '$..file.type') # 通过分析:有一些图片的key 在file目录下,那就改变一下提取出来

img_key = img_key[0]

img_type = img_type[0]

img_id = str(img_id)

i = img_type.index("/")

img_type = img_type[i + 1:]

# print(img_type + ':' + img_key +':'+ img_id)

#return (img_key,img_id,img_type)

downloader(img_key,img_id,img_type)

def downloader(key,pin_id,type):

'''这是一个下载器,传入三个参数,构建url,得到图片,保存!'''

url = 'http://img.hb.aicdn.com/%26amp ... 39%3B # 构建url

try:

img = requests.get(url,headers=headers).content

img_name = str(pin_id)+'.'+type

print("---------------------------------------------------------------------------------")

print("正在下载图片:" + img_name)

print("下载链接:" + url)

with open(img_name,"wb")as f: # 写入文件

f.write(img)

except Exception as t:

with open("Error_logging.txt","wb")as w:

error = str(t)+"出错了!图片链接是:"+ url

w.write(error.encode(encoding="utf-8")) # 记录下错误日志

pass

def find_pin_id_20(pin_id,boards_id):

request_URL = 'http://huaban.com/boards/%25s/ ... 3B%25(str(boards_id),str(pin_id))

print(request_URL)

json_obj = requests.get(request_URL,headers = headers).json()

#print(json_obj)

pin_id_list = jsonpath.jsonpath(json_obj, "$..pin_id") # jsonpath方法匹配出pinID

if pin_id_list != False:

#print("获取到的id个数: "+str(len(pin_id_list)))

int_list = []

for each in pin_id_list:

int_list.append(int(each))

#print(int_list)

return int_list

else:

return pin_id_list

def find_all_pin_id(boards_id):

url = 'http://huaban.com/boards/%s/'%str(boards_id)

rsp = requests.get(url,headers=headers)

#print(rsp.text)

json_obj = rsp.json()

pin_count = jsonpath.jsonpath(json_obj, '$..pin_count')[0]

pin_id_original = jsonpath.jsonpath(json_obj,'$..pin_id')

#print(len(pin_id_original))

while True:

if len(pin_id_original)

动态网页抓取(抓包+反爬虫post与getpost和get,post(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-09-20 05:03

动态网页抓取主要有以下四种方式:抓包&反爬虫post与getpost和get,post基本就是post的伪装,但更容易被识别,我推荐抓包,因为反爬虫容易失效,抓包容易抓到底层关系,但抓包相对容易很多,比如你把一个网页抓下来,一般就是一些东西;而反爬虫的特点是,他是识别你做了什么,识别你发送了一个什么数据,识别你向目标服务器发送了什么数据,但抓包,一般是识别不到底层,所以抓包还是更容易抓到你传递的东西,而反爬虫一般是很难察觉的;抓包+反爬虫这一种方式在很多场景下都是有效的,比如反爬虫实际上针对的是你发送了什么数据,或者你抓了的是些什么东西,这样的话你抓包的时候,你能看到这个网页底层传递的什么数据,很容易抓出真实的你发送的数据,然后反爬虫要是抓你是什么某个网站的广告,那就抓不到传递的真实数据,就抓不到反爬虫,但一般你抓包+反爬虫做的好的话,基本对付就完事儿了(ps:有一次,抓的时候有个人很诚实地按指示做了点什么,然后在我上传某个包的时候,问一句,如果这里不是广告,要怎么怎么解释。

);抓包+反爬虫&反爬虫抓包+反爬虫,就是说你其实可以抓到那个服务器传递的数据,但是你的数据是"不能被反爬虫"抓到的,甚至你看着被反爬虫抓到的包,你要是不去反爬虫的话,他都能通过抓包爬出来;反爬虫就是你直接抓包不能抓到那个网站底层传递的是什么数据,你去反爬虫,会被他的反爬虫抓得一干二净,什么你既然能直接抓包,那你为什么不直接发个包呢?你要发包也要被反爬虫抓到;网页下载与网页抓取这个方式就简单多了,网页下载就是直接从一个网页下载,但是网页抓取就是要把一个网页抓到本地,然后找到相应的api,然后本地返回到一个json数据给目标服务器;在没有你懂的前端知识的时候,其实在本地动态网页抓取和反爬虫都很有用,最好做两件事,就解决了两个问题。

本地动态网页抓取反爬虫本地动态网页抓取是指你抓包的时候是看不到网页的内容,而抓包+反爬虫是指你抓包的时候,抓到的内容是一个json数据,你再通过json数据,拼起来然后拼起来把你要的数据发过去。本地动态网页抓取一般来说,只要你抓包,抓到的内容就在底层传递,这里基本可以和反爬虫一起做了。本地动态网页抓取我觉得动态网页抓取和反爬虫就有点像人死了,给别人发指令,然后到其他人家门口打个招呼,然后就过去了,所以必须要跟别人完成交流才行。

动态网页抓取比较麻烦,可能你本来抓包和反爬虫都做好了,正在小心翼翼地着手编程,结果发现时间不早了,没有这个机会了,就扔到jsonp。 查看全部

动态网页抓取(抓包+反爬虫post与getpost和get,post(组图))

动态网页抓取主要有以下四种方式:抓包&反爬虫post与getpost和get,post基本就是post的伪装,但更容易被识别,我推荐抓包,因为反爬虫容易失效,抓包容易抓到底层关系,但抓包相对容易很多,比如你把一个网页抓下来,一般就是一些东西;而反爬虫的特点是,他是识别你做了什么,识别你发送了一个什么数据,识别你向目标服务器发送了什么数据,但抓包,一般是识别不到底层,所以抓包还是更容易抓到你传递的东西,而反爬虫一般是很难察觉的;抓包+反爬虫这一种方式在很多场景下都是有效的,比如反爬虫实际上针对的是你发送了什么数据,或者你抓了的是些什么东西,这样的话你抓包的时候,你能看到这个网页底层传递的什么数据,很容易抓出真实的你发送的数据,然后反爬虫要是抓你是什么某个网站的广告,那就抓不到传递的真实数据,就抓不到反爬虫,但一般你抓包+反爬虫做的好的话,基本对付就完事儿了(ps:有一次,抓的时候有个人很诚实地按指示做了点什么,然后在我上传某个包的时候,问一句,如果这里不是广告,要怎么怎么解释。

);抓包+反爬虫&反爬虫抓包+反爬虫,就是说你其实可以抓到那个服务器传递的数据,但是你的数据是"不能被反爬虫"抓到的,甚至你看着被反爬虫抓到的包,你要是不去反爬虫的话,他都能通过抓包爬出来;反爬虫就是你直接抓包不能抓到那个网站底层传递的是什么数据,你去反爬虫,会被他的反爬虫抓得一干二净,什么你既然能直接抓包,那你为什么不直接发个包呢?你要发包也要被反爬虫抓到;网页下载与网页抓取这个方式就简单多了,网页下载就是直接从一个网页下载,但是网页抓取就是要把一个网页抓到本地,然后找到相应的api,然后本地返回到一个json数据给目标服务器;在没有你懂的前端知识的时候,其实在本地动态网页抓取和反爬虫都很有用,最好做两件事,就解决了两个问题。

本地动态网页抓取反爬虫本地动态网页抓取是指你抓包的时候是看不到网页的内容,而抓包+反爬虫是指你抓包的时候,抓到的内容是一个json数据,你再通过json数据,拼起来然后拼起来把你要的数据发过去。本地动态网页抓取一般来说,只要你抓包,抓到的内容就在底层传递,这里基本可以和反爬虫一起做了。本地动态网页抓取我觉得动态网页抓取和反爬虫就有点像人死了,给别人发指令,然后到其他人家门口打个招呼,然后就过去了,所以必须要跟别人完成交流才行。

动态网页抓取比较麻烦,可能你本来抓包和反爬虫都做好了,正在小心翼翼地着手编程,结果发现时间不早了,没有这个机会了,就扔到jsonp。

动态网页抓取(robots协议(也称为爬虫协议、机器人协议等)的全称)

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-09-19 07:15

动态网站不值得担心。搜索引擎通常可以抓取动态链接,但robots文件可以轻松提高动态网站抓取的效率。我们都知道机器人协议(也称为爬虫协议、机器人协议等)的全称是“机器人排除协议”网站通过机器人协议,我们可以告诉搜索引擎哪些页面可以爬网,哪些页面不能爬网。robots协议的本质是网站和搜索引擎爬虫之间的通信,用于引导搜索引擎更好地捕获网站内容

百度官方建议所有网站使用robots文件,以便更好地利用蜘蛛。事实上,机器人不仅告诉搜索引擎无法捕获的内容,而且是网站优化的重要工具之一

Robots文件实际上是一个TXT文件。基本措辞如下:

用户代理:*此处的*表示各种搜索引擎,*是通配符

此处定义的Disallow:/admin/禁止爬网到admin目录下的目录

禁止:/require/此处定义的是禁止爬网到require目录下的目录

禁止:/ABC/此处定义的是禁止爬网到ABC目录下的目录

不允许:/CGI-bin/*。HTM禁止访问/CGI-bin/目录下后缀为“.HTM”的所有URL(包括子目录)

不允许:/*?*禁止访问网站中的所有动态页面@

不允许:/。JPG$禁止捕获所有。网页上的JPG格式图片

不允许:/AB/adc.html禁止在AB文件夹下爬行adc.html文件

允许:/CGI-bin/这里定义的是允许爬网到CGI-bin目录下的目录

允许:/tmp这里定义的是允许您对tmp进行爬网的整个目录

允许:。HTM$只允许访问后缀为“.HTM”的URL

允许:。GIF$允许您抓取网页和GIF格式的图片

在网站optimization中,robots文件用于告诉搜索引擎什么是重要的,建议使用robots文件来禁止对不重要的内容进行爬网。不重要内容的典型表示:网站搜索结果页

对于静态网站,我们可以使用disallow://**禁用动态页面爬网。但对于动态网站,您不能简单地这样做。然而,对于动态网站网站管理员来说,没有必要太担心。搜索引擎现在可以正常抓取动态页面。因此,在编写时,我们应该注意,我们可以通过搜索文件名来专门编写它。例如,您的站点是search.asp?如果后跟一个大字符串,则可以按如下方式编写:

不允许:/search.asp*

这样,您就可以屏蔽搜索结果页面。写完后,你可以去百度站长平台测试机器人,看看是否有任何错误!您可以输入URL以检查其是否正常生效

在这里,吴晓阳建议动态网站站长必须使用robots文件来筛选不重要内容的动态链接,以提高蜘蛛的爬行效率

资料来源:吴晓阳目录 查看全部

动态网页抓取(robots协议(也称为爬虫协议、机器人协议等)的全称)

动态网站不值得担心。搜索引擎通常可以抓取动态链接,但robots文件可以轻松提高动态网站抓取的效率。我们都知道机器人协议(也称为爬虫协议、机器人协议等)的全称是“机器人排除协议”网站通过机器人协议,我们可以告诉搜索引擎哪些页面可以爬网,哪些页面不能爬网。robots协议的本质是网站和搜索引擎爬虫之间的通信,用于引导搜索引擎更好地捕获网站内容

百度官方建议所有网站使用robots文件,以便更好地利用蜘蛛。事实上,机器人不仅告诉搜索引擎无法捕获的内容,而且是网站优化的重要工具之一

Robots文件实际上是一个TXT文件。基本措辞如下:

用户代理:*此处的*表示各种搜索引擎,*是通配符

此处定义的Disallow:/admin/禁止爬网到admin目录下的目录

禁止:/require/此处定义的是禁止爬网到require目录下的目录

禁止:/ABC/此处定义的是禁止爬网到ABC目录下的目录

不允许:/CGI-bin/*。HTM禁止访问/CGI-bin/目录下后缀为“.HTM”的所有URL(包括子目录)

不允许:/*?*禁止访问网站中的所有动态页面@

不允许:/。JPG$禁止捕获所有。网页上的JPG格式图片

不允许:/AB/adc.html禁止在AB文件夹下爬行adc.html文件

允许:/CGI-bin/这里定义的是允许爬网到CGI-bin目录下的目录

允许:/tmp这里定义的是允许您对tmp进行爬网的整个目录

允许:。HTM$只允许访问后缀为“.HTM”的URL

允许:。GIF$允许您抓取网页和GIF格式的图片

在网站optimization中,robots文件用于告诉搜索引擎什么是重要的,建议使用robots文件来禁止对不重要的内容进行爬网。不重要内容的典型表示:网站搜索结果页

对于静态网站,我们可以使用disallow://**禁用动态页面爬网。但对于动态网站,您不能简单地这样做。然而,对于动态网站网站管理员来说,没有必要太担心。搜索引擎现在可以正常抓取动态页面。因此,在编写时,我们应该注意,我们可以通过搜索文件名来专门编写它。例如,您的站点是search.asp?如果后跟一个大字符串,则可以按如下方式编写:

不允许:/search.asp*

这样,您就可以屏蔽搜索结果页面。写完后,你可以去百度站长平台测试机器人,看看是否有任何错误!您可以输入URL以检查其是否正常生效

在这里,吴晓阳建议动态网站站长必须使用robots文件来筛选不重要内容的动态链接,以提高蜘蛛的爬行效率

资料来源:吴晓阳目录

动态网页抓取(ajax横行的年代,我们的网页是残缺的吗? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-09-18 23:05

)

在Ajax时代,许多网页的内容都是动态加载的,我们的小爬虫只抓取web服务器返回给我们的HTML

跳过了JS加载部分,即爬虫抓取的网页不完整、不完整。你可以看到下面博客花园的首页

从主页加载中,我们可以看到页面呈现后,将有五个Ajax异步请求。默认情况下,爬虫程序无法抓取Ajax生成的内容

此时,如果要获取这些动态页面,必须调用浏览器的内核引擎来下载这些动态页面。目前,内核引擎有三个支柱

三叉戟:即内核。WebBrowser基于此内核,但其可加载性较差

壁虎:FF的内核比Trident有更好的性能

WebKit:Safari和chrome的内核性能,你知道,在真实场景中仍然基于它

好吧,为了简单和方便,让我们使用WebBrowser来玩。使用WebBrowser时,我们应注意以下几点:

第一:因为WebBrowser是system.windows.forms中的WinForm控件,所以我们需要设置StatThread标志

第二:WinForm是事件驱动的,控制台不响应事件。所有事件都在windows的消息队列中等待执行。为了不让程序假装死亡

我们需要调用Doevents方法来转移控制,并让操作系统执行其他事件

第三:我们需要使用domdocument而不是documenttext来查看WebBrowser中的内容

通常有两种方法来判断是否加载了动态网页:

① : 在这里设置一个最大值,因为每次异步加载JS时,都会触发导航和documentcompleted事件,所以我们需要

只需将计数值记录在

1 using System;

2 using System.Collections.Generic;

3 using System.Linq;

4 using System.Text;

5 using System.Windows.Forms;

6 using System.Threading;

7 using System.IO;

8

9 namespace ConsoleApplication2

10 {

11 public class Program

12 {

13 static int hitCount = 0;

14

15 [STAThread]

16 static void Main(string[] args)

17 {

18 string url = "http://www.cnblogs.com";

19

20 WebBrowser browser = new WebBrowser();

21

22 browser.ScriptErrorsSuppressed = true;

23

24 browser.Navigating += (sender, e) =>

25 {

26 hitCount++;

27 };

28

29 browser.DocumentCompleted += (sender, e) =>

30 {

31 hitCount++;

32 };

33

34 browser.Navigate(url);

35

36 while (browser.ReadyState != WebBrowserReadyState.Complete)

37 {

38 Application.DoEvents();

39 }

40

41 while (hitCount < 16)

42 Application.DoEvents();

43

44 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;

45

46 string gethtml = htmldocument.documentElement.outerHTML;

47

48 //写入文件

49 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html"))

50 {

51 sw.WriteLine(gethtml);

52 }

53

54 Console.WriteLine("html 文件 已经生成!");

55

56 Console.Read();

57 }

58 }

59 }

然后,我们打开生成的1.html,查看JS加载的内容是否可用

② : 当然,除了通过判断最大值来判断加载是否完成外,我们还可以通过设置定时器来判断,如3S、4S、5S等

是否已加载web浏览器

1 using System;

2 using System.Collections.Generic;

3 using System.Linq;

4 using System.Text;

5 using System.Windows.Forms;

6 using System.Threading;

7 using System.IO;

8

9 namespace ConsoleApplication2

10 {

11 public class Program

12 {

13 [STAThread]

14 static void Main(string[] args)

15 {

16 string url = "http://www.cnblogs.com";

17

18 WebBrowser browser = new WebBrowser();

19

20 browser.ScriptErrorsSuppressed = true;

21

22 browser.Navigate(url);

23

24 //先要等待加载完毕

25 while (browser.ReadyState != WebBrowserReadyState.Complete)

26 {

27 Application.DoEvents();

28 }

29

30 System.Timers.Timer timer = new System.Timers.Timer();

31

32 var isComplete = false;

33

34 timer.Elapsed += new System.Timers.ElapsedEventHandler((sender, e) =>

35 {

36 //加载完毕

37 isComplete = true;

38

39 timer.Stop();

40 });

41

42 timer.Interval = 1000 * 5;

43

44 timer.Start();

45

46 //继续等待 5s,等待js加载完

47 while (!isComplete)

48 Application.DoEvents();

49

50 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;

51

52 string gethtml = htmldocument.documentElement.outerHTML;

53

54 //写入文件

55 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html"))

56 {

57 sw.WriteLine(gethtml);

58 }

59

60 Console.WriteLine("html 文件 已经生成!");

61

62 Console.Read();

63 }

64 }

65 }

当然,效果是一样的,所以我们不会截图。通过以上两种编写方法,我们的WebBrowser被放置在主线程中。让我们看看如何把它放在工作线程上

非常简单,只需将工作线程设置为sta模式

1 using System;

2 using System.Collections.Generic;

3 using System.Linq;

4 using System.Text;

5 using System.Windows.Forms;

6 using System.Threading;

7

8 namespace ConsoleApplication2

9 {

10 public class Program

11 {

12 static int hitCount = 0;

13

14 //[STAThread]

15 static void Main(string[] args)

16 {

17 Thread thread = new Thread(new ThreadStart(() =>

18 {

19 Init();

20 System.Windows.Forms.Application.Run();

21 }));

22

23 //将该工作线程设定为STA模式

24 thread.SetApartmentState(ApartmentState.STA);

25

26 thread.Start();

27

28 Console.Read();

29 }

30

31 static void Init()

32 {

33 string url = "http://www.cnblogs.com";

34

35 WebBrowser browser = new WebBrowser();

36

37 browser.ScriptErrorsSuppressed = true;

38

39 browser.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(browser_DocumentCompleted);

40

41 browser.Navigating += new WebBrowserNavigatingEventHandler(browser_Navigating);

42

43 browser.Navigate(url);

44

45 while (browser.ReadyState != WebBrowserReadyState.Complete)

46 {

47 Application.DoEvents();

48 }

49

50 while (hitCount < 16)

51 Application.DoEvents();

52

53 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;

54

55 string gethtml = htmldocument.documentElement.outerHTML;

56

57 Console.WriteLine(gethtml);

58 }

59

60 static void browser_Navigating(object sender, WebBrowserNavigatingEventArgs e)

61 {

62 hitCount++;

63 }

64

65 static void browser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)

66 {

67 hitCount++;

68 }

69 }

70 } 查看全部

动态网页抓取(ajax横行的年代,我们的网页是残缺的吗?

)

在Ajax时代,许多网页的内容都是动态加载的,我们的小爬虫只抓取web服务器返回给我们的HTML

跳过了JS加载部分,即爬虫抓取的网页不完整、不完整。你可以看到下面博客花园的首页

从主页加载中,我们可以看到页面呈现后,将有五个Ajax异步请求。默认情况下,爬虫程序无法抓取Ajax生成的内容

此时,如果要获取这些动态页面,必须调用浏览器的内核引擎来下载这些动态页面。目前,内核引擎有三个支柱

三叉戟:即内核。WebBrowser基于此内核,但其可加载性较差

壁虎:FF的内核比Trident有更好的性能

WebKit:Safari和chrome的内核性能,你知道,在真实场景中仍然基于它

好吧,为了简单和方便,让我们使用WebBrowser来玩。使用WebBrowser时,我们应注意以下几点:

第一:因为WebBrowser是system.windows.forms中的WinForm控件,所以我们需要设置StatThread标志

第二:WinForm是事件驱动的,控制台不响应事件。所有事件都在windows的消息队列中等待执行。为了不让程序假装死亡

我们需要调用Doevents方法来转移控制,并让操作系统执行其他事件

第三:我们需要使用domdocument而不是documenttext来查看WebBrowser中的内容

通常有两种方法来判断是否加载了动态网页:

① : 在这里设置一个最大值,因为每次异步加载JS时,都会触发导航和documentcompleted事件,所以我们需要

只需将计数值记录在

1 using System;

2 using System.Collections.Generic;

3 using System.Linq;

4 using System.Text;

5 using System.Windows.Forms;

6 using System.Threading;

7 using System.IO;

8

9 namespace ConsoleApplication2

10 {

11 public class Program

12 {

13 static int hitCount = 0;

14

15 [STAThread]

16 static void Main(string[] args)

17 {

18 string url = "http://www.cnblogs.com";

19

20 WebBrowser browser = new WebBrowser();

21

22 browser.ScriptErrorsSuppressed = true;

23

24 browser.Navigating += (sender, e) =>

25 {

26 hitCount++;

27 };

28

29 browser.DocumentCompleted += (sender, e) =>

30 {

31 hitCount++;

32 };

33

34 browser.Navigate(url);

35

36 while (browser.ReadyState != WebBrowserReadyState.Complete)

37 {

38 Application.DoEvents();

39 }

40

41 while (hitCount < 16)

42 Application.DoEvents();

43

44 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;

45

46 string gethtml = htmldocument.documentElement.outerHTML;

47

48 //写入文件

49 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html"))

50 {

51 sw.WriteLine(gethtml);

52 }

53

54 Console.WriteLine("html 文件 已经生成!");

55

56 Console.Read();

57 }

58 }

59 }

然后,我们打开生成的1.html,查看JS加载的内容是否可用

② : 当然,除了通过判断最大值来判断加载是否完成外,我们还可以通过设置定时器来判断,如3S、4S、5S等

是否已加载web浏览器

1 using System;

2 using System.Collections.Generic;

3 using System.Linq;

4 using System.Text;

5 using System.Windows.Forms;

6 using System.Threading;

7 using System.IO;

8

9 namespace ConsoleApplication2

10 {

11 public class Program

12 {

13 [STAThread]

14 static void Main(string[] args)

15 {

16 string url = "http://www.cnblogs.com";

17

18 WebBrowser browser = new WebBrowser();

19

20 browser.ScriptErrorsSuppressed = true;

21

22 browser.Navigate(url);

23

24 //先要等待加载完毕

25 while (browser.ReadyState != WebBrowserReadyState.Complete)

26 {

27 Application.DoEvents();

28 }

29

30 System.Timers.Timer timer = new System.Timers.Timer();

31

32 var isComplete = false;

33

34 timer.Elapsed += new System.Timers.ElapsedEventHandler((sender, e) =>

35 {

36 //加载完毕

37 isComplete = true;

38

39 timer.Stop();

40 });

41

42 timer.Interval = 1000 * 5;

43

44 timer.Start();

45

46 //继续等待 5s,等待js加载完

47 while (!isComplete)

48 Application.DoEvents();

49

50 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;

51

52 string gethtml = htmldocument.documentElement.outerHTML;

53

54 //写入文件

55 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html"))

56 {

57 sw.WriteLine(gethtml);

58 }

59

60 Console.WriteLine("html 文件 已经生成!");

61

62 Console.Read();

63 }

64 }

65 }

当然,效果是一样的,所以我们不会截图。通过以上两种编写方法,我们的WebBrowser被放置在主线程中。让我们看看如何把它放在工作线程上

非常简单,只需将工作线程设置为sta模式

1 using System;

2 using System.Collections.Generic;

3 using System.Linq;

4 using System.Text;

5 using System.Windows.Forms;

6 using System.Threading;

7

8 namespace ConsoleApplication2

9 {

10 public class Program

11 {

12 static int hitCount = 0;

13

14 //[STAThread]

15 static void Main(string[] args)

16 {

17 Thread thread = new Thread(new ThreadStart(() =>

18 {

19 Init();

20 System.Windows.Forms.Application.Run();

21 }));

22

23 //将该工作线程设定为STA模式

24 thread.SetApartmentState(ApartmentState.STA);

25

26 thread.Start();

27

28 Console.Read();

29 }

30

31 static void Init()

32 {

33 string url = "http://www.cnblogs.com";

34

35 WebBrowser browser = new WebBrowser();

36

37 browser.ScriptErrorsSuppressed = true;

38

39 browser.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(browser_DocumentCompleted);

40

41 browser.Navigating += new WebBrowserNavigatingEventHandler(browser_Navigating);

42

43 browser.Navigate(url);

44

45 while (browser.ReadyState != WebBrowserReadyState.Complete)

46 {

47 Application.DoEvents();

48 }

49

50 while (hitCount < 16)

51 Application.DoEvents();

52

53 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;

54

55 string gethtml = htmldocument.documentElement.outerHTML;

56

57 Console.WriteLine(gethtml);

58 }

59

60 static void browser_Navigating(object sender, WebBrowserNavigatingEventArgs e)

61 {

62 hitCount++;

63 }

64

65 static void browser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)

66 {

67 hitCount++;

68 }

69 }

70 }

动态网页抓取(翻页限制怎么处理?16种提高爬取速度的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-18 07:07

内容类型:多部分/表单数据;边界=---WebKitFormBoundaryA

------WebKitFormBoundaryA

内容配置:表单数据

头衔

------WebKitFormBoundaryA

内容配置:表单数据;;filename=“chrome.png”

内容类型:图像/png

二进制内容

------WebKitFormBoundaryA--

以上部分是发送格式,WebKit formboundarya可以使用任何内容,只要是这种格式。常见的内容类型包括application/x-www-form-urlencoded、application/JSON和text/XML

16、翻页限制怎么办

很多多级分类数据都有翻页限制,分类只显示前几页。在这种情况下,您可以使用这种网站过滤功能,例如按时间、大小和顺序排序,以扩展页面内容。如果存在子类别,则继续获取子类别。如果有多个选项,可以使用排列和组合来获得尽可能多的选项

17、如何复制海量网址

当数据量较小时,您可以使用MD5检查web地址,然后将其与哈希进行比较。如果是大量URL复制,可以使用bloom复制算法bloomfilter

18、如何提高攀岩速度

1)使用gzip/deflate压缩,通常可压缩至原创尺寸的20%左右。通常,服务器不会为您发送压缩数据。您需要发送接受编码头

2)使用链接池时,需要在c#请求时将keep alive设置为true

3)设置超时并关闭未响应的请求

19、获取收录特定关键词的网页@

使用现场搜索、搜索引擎网站和下载所有

20、CSS/HTML混乱干扰限制数据采集

常见的防爬方法有

1)用图片替换一些文本

2)使用自定义字体

3)伪元素隐藏

4)元件位置偏移

在第一种情况下,您可以找到与图片对应的文本,并在找到所有文本后替换它。第二种方法是找到TTF字体文件地址,下载它,然后找到代码和文本之间的对应关系并替换它。第三,找到类对应的文本内容并替换它。第四是计算。如果太麻烦的话,你也可以截图进行识别

21、如果在数据捕获过程中发现电信劫持,导致数据错误怎么办

对电信运营商的电话投诉可以通过电话或工业和信息技术部提出

有时电脑中的病毒也会有这样的劫持行为,这属于黑色产品

22、关于Eval(function)(P,a,C,K,e,d)加密问题

这是一种经典的数据加密方法。互联网上有在线加密和解密方法。在本地运行时,需要使用js引擎执行js以获得结果

23、如何处理网站PKI证书的验证

PKI证书通常在登录时发送到特定地址以请求和上载证书以进行验证。验证后,生成一个带有参数的网站并返回网站并生成一个cookie以完成身份验证。还有一些插件需要验证,比如吉大正源

24、解析网页时,Htmlagibility pack应注意什么

在以前的版本中,htmlagilitypack中存在一个溢出漏洞,即节点分析将陷入无止境的循环。新版本解决了这个问题。请使用最新版本。使用htmlagilitypack解析网页时,应注意页面错误可能导致解析失败的可能性。您可以使用替换和其他方法首先处理源代码,然后解析它

25、除了fiddler,还有哪些包捕获工具

1)Microsoft网络监视器

2)Wireshark

3)Anyproxy

26、如果捕获的数据不完整怎么办

在某些网站中,仅显示部分数据,或仅显示部分用户的所有数据。在这种情况下,这是对观察能力的测试。例如,很久以前,同一个城市的网站的联系信息只显示前七位数字,而在另一个地方,则显示最后四位数字,因此只需抓取它们并将它们相加即可。还有网站,使用JSON调用API,您可以看到程序员使用select*,返回的数据收录所有相关和不相关的数据,这相当于一个明显的漏洞。有时你可以使用不完整的数据在空间站中搜索,也许会有新的发现

27、网站如何使用CDN处理反爬虫程序

网站使用CDN技术可以提高访问速度和安全性,并提供更高的反爬虫能力。但是,有些网站会暴露真实的服务器地址,无法判断CDN的来源,导致伪造的CDN服务器不断地抓取数据。同时,大多数CDN服务器不做反爬虫链接,导致更多CDN服务器,这相当于提供更多服务,爬虫使用代理服务器

28、使用XPath获取网页元素时应注意什么

在浏览器中呈现后,使用XPath提取DOM元素,然后获取值。这是一种可以忽略渲染过程并实时获取最新数据的方法。在设置XPath提取规则时,要善于使用绝对相对、收录或和符号来尽快定位元素。如果最终图元符号不确定,可以使用父定位。尽可能多地使用@ID这个唯一标识符

29、如果网站中毒怎么办

当目标网站检测到爬虫并给出错误数据时,由于无法直接判断数据的准确性,最终结果只能通过多个爬虫或多个表单进行比较。如果爬虫多次正确,则可以将其视为正确的数据。这一思想也可用于类似情况,例如使用下载软件下载数据如果您同时搜索多个下载链接以查找资源并同时下载,则可以快速筛选出可下载的资源

30、待续。。。新问题可发送至 查看全部

动态网页抓取(翻页限制怎么处理?16种提高爬取速度的方法)

内容类型:多部分/表单数据;边界=---WebKitFormBoundaryA

------WebKitFormBoundaryA

内容配置:表单数据

头衔

------WebKitFormBoundaryA

内容配置:表单数据;;filename=“chrome.png”

内容类型:图像/png

二进制内容

------WebKitFormBoundaryA--

以上部分是发送格式,WebKit formboundarya可以使用任何内容,只要是这种格式。常见的内容类型包括application/x-www-form-urlencoded、application/JSON和text/XML

16、翻页限制怎么办

很多多级分类数据都有翻页限制,分类只显示前几页。在这种情况下,您可以使用这种网站过滤功能,例如按时间、大小和顺序排序,以扩展页面内容。如果存在子类别,则继续获取子类别。如果有多个选项,可以使用排列和组合来获得尽可能多的选项

17、如何复制海量网址

当数据量较小时,您可以使用MD5检查web地址,然后将其与哈希进行比较。如果是大量URL复制,可以使用bloom复制算法bloomfilter

18、如何提高攀岩速度

1)使用gzip/deflate压缩,通常可压缩至原创尺寸的20%左右。通常,服务器不会为您发送压缩数据。您需要发送接受编码头

2)使用链接池时,需要在c#请求时将keep alive设置为true

3)设置超时并关闭未响应的请求

19、获取收录特定关键词的网页@

使用现场搜索、搜索引擎网站和下载所有

20、CSS/HTML混乱干扰限制数据采集

常见的防爬方法有

1)用图片替换一些文本

2)使用自定义字体

3)伪元素隐藏

4)元件位置偏移

在第一种情况下,您可以找到与图片对应的文本,并在找到所有文本后替换它。第二种方法是找到TTF字体文件地址,下载它,然后找到代码和文本之间的对应关系并替换它。第三,找到类对应的文本内容并替换它。第四是计算。如果太麻烦的话,你也可以截图进行识别

21、如果在数据捕获过程中发现电信劫持,导致数据错误怎么办

对电信运营商的电话投诉可以通过电话或工业和信息技术部提出

有时电脑中的病毒也会有这样的劫持行为,这属于黑色产品

22、关于Eval(function)(P,a,C,K,e,d)加密问题

这是一种经典的数据加密方法。互联网上有在线加密和解密方法。在本地运行时,需要使用js引擎执行js以获得结果

23、如何处理网站PKI证书的验证

PKI证书通常在登录时发送到特定地址以请求和上载证书以进行验证。验证后,生成一个带有参数的网站并返回网站并生成一个cookie以完成身份验证。还有一些插件需要验证,比如吉大正源

24、解析网页时,Htmlagibility pack应注意什么

在以前的版本中,htmlagilitypack中存在一个溢出漏洞,即节点分析将陷入无止境的循环。新版本解决了这个问题。请使用最新版本。使用htmlagilitypack解析网页时,应注意页面错误可能导致解析失败的可能性。您可以使用替换和其他方法首先处理源代码,然后解析它

25、除了fiddler,还有哪些包捕获工具

1)Microsoft网络监视器

2)Wireshark

3)Anyproxy

26、如果捕获的数据不完整怎么办

在某些网站中,仅显示部分数据,或仅显示部分用户的所有数据。在这种情况下,这是对观察能力的测试。例如,很久以前,同一个城市的网站的联系信息只显示前七位数字,而在另一个地方,则显示最后四位数字,因此只需抓取它们并将它们相加即可。还有网站,使用JSON调用API,您可以看到程序员使用select*,返回的数据收录所有相关和不相关的数据,这相当于一个明显的漏洞。有时你可以使用不完整的数据在空间站中搜索,也许会有新的发现

27、网站如何使用CDN处理反爬虫程序

网站使用CDN技术可以提高访问速度和安全性,并提供更高的反爬虫能力。但是,有些网站会暴露真实的服务器地址,无法判断CDN的来源,导致伪造的CDN服务器不断地抓取数据。同时,大多数CDN服务器不做反爬虫链接,导致更多CDN服务器,这相当于提供更多服务,爬虫使用代理服务器

28、使用XPath获取网页元素时应注意什么

在浏览器中呈现后,使用XPath提取DOM元素,然后获取值。这是一种可以忽略渲染过程并实时获取最新数据的方法。在设置XPath提取规则时,要善于使用绝对相对、收录或和符号来尽快定位元素。如果最终图元符号不确定,可以使用父定位。尽可能多地使用@ID这个唯一标识符

29、如果网站中毒怎么办

当目标网站检测到爬虫并给出错误数据时,由于无法直接判断数据的准确性,最终结果只能通过多个爬虫或多个表单进行比较。如果爬虫多次正确,则可以将其视为正确的数据。这一思想也可用于类似情况,例如使用下载软件下载数据如果您同时搜索多个下载链接以查找资源并同时下载,则可以快速筛选出可下载的资源

30、待续。。。新问题可发送至

动态网页抓取(动态网页抓取基础知识python技术动态抓取常用模块模块)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-09-18 01:01

动态网页抓取基础知识python技术动态抓取常用模块json模块主要有两种:urllib2urllib.requesturllib2是一个网络编程的模块,用于处理网络数据。比如将一个http的响应转成json格式。利用urllib2很简单即可从百度网站上抓取内容包括标题,时间,评论数,在线人数等内容。

urllib2需要下载的库依赖,如下我们拿百度为例子#下载urllib2中的urllibimporturllib2urllibimporturllib2#importrequestsurllib2.install_as_request('/')#importurllib#session用于保持浏览器的会话,保持session池的大小最大,主要功能在于保持网页在不同浏览器的打开状态urllib2.session()urllib2.session()#importjsonurllib2.unhandled_json()#importreimportrequestsurllib2.install_as_request('/')#json与json不同,可以直接根据字符串格式的值获取数据,也可以根据数据字典格式的值查找数据库#关闭浏览器的时候会自动关闭上面的requesturllib2.session()urllib2.unhandled_json()可以使用session传递值#urllib2_wait()#将urllib2对象传递到urllib2上,用来传递url,具体请参考urllib2.session、urllib2_wait、urllib2_unhandled_json四种常用模块及用法#下载百度下面数据urllib2.urlopen()#打开一个字符串urlurllib2.urlopen("百度一下,你就知道")#返回一个字符串,里面有一些数据urllib2.request.urlopen()#打开一个文件urllib2.request.urlopen("百度一下,你就知道")#urllib2.request.urlopen("百度一下,你就知道")#urllib2.wait()#不处理等待urllib2.wait(1)#不处理重复urllib2.wait(n)#不处理有时候我们需要传入很多数据一个个去网页爬,这就涉及到对齐工作。

首先我们获取所有的页面,然后按照一定的比例放入队列。n=urllib2.urlopen("/")print(n)#这里根据需要的对齐方式,urllib2可以将url转换成bytes格式urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.u。 查看全部

动态网页抓取(动态网页抓取基础知识python技术动态抓取常用模块模块)

动态网页抓取基础知识python技术动态抓取常用模块json模块主要有两种:urllib2urllib.requesturllib2是一个网络编程的模块,用于处理网络数据。比如将一个http的响应转成json格式。利用urllib2很简单即可从百度网站上抓取内容包括标题,时间,评论数,在线人数等内容。

urllib2需要下载的库依赖,如下我们拿百度为例子#下载urllib2中的urllibimporturllib2urllibimporturllib2#importrequestsurllib2.install_as_request('/')#importurllib#session用于保持浏览器的会话,保持session池的大小最大,主要功能在于保持网页在不同浏览器的打开状态urllib2.session()urllib2.session()#importjsonurllib2.unhandled_json()#importreimportrequestsurllib2.install_as_request('/')#json与json不同,可以直接根据字符串格式的值获取数据,也可以根据数据字典格式的值查找数据库#关闭浏览器的时候会自动关闭上面的requesturllib2.session()urllib2.unhandled_json()可以使用session传递值#urllib2_wait()#将urllib2对象传递到urllib2上,用来传递url,具体请参考urllib2.session、urllib2_wait、urllib2_unhandled_json四种常用模块及用法#下载百度下面数据urllib2.urlopen()#打开一个字符串urlurllib2.urlopen("百度一下,你就知道")#返回一个字符串,里面有一些数据urllib2.request.urlopen()#打开一个文件urllib2.request.urlopen("百度一下,你就知道")#urllib2.request.urlopen("百度一下,你就知道")#urllib2.wait()#不处理等待urllib2.wait(1)#不处理重复urllib2.wait(n)#不处理有时候我们需要传入很多数据一个个去网页爬,这就涉及到对齐工作。

首先我们获取所有的页面,然后按照一定的比例放入队列。n=urllib2.urlopen("/")print(n)#这里根据需要的对齐方式,urllib2可以将url转换成bytes格式urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.urllib2.u。

动态网页抓取( 可支持的【真实】驱动程序介绍(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 219 次浏览 • 2021-09-16 14:13

可支持的【真实】驱动程序介绍(一))

#抓取内容

WebDriver driver = new HtmlUnitDriver(false);

driver.get(url);

String html = driver.getPageSource();

#如何想等待一会元素渲染完毕

driver.manage().timeouts().implicitlyWait(2, TimeUnit.SECONDS);

#进行百度搜索

public static void doSearch(String keyword) {

final String url = "http://www.baidu.com";

WebDriver driver = new HtmlUnitDriver(false);

driver.get(url);

driver.findElement(By.id("kw")).sendKeys(keyword);

Actions action = new Actions(driver);

action.sendKeys(Keys.ENTER).perform();

System.out.println(driver.getPageSource());

}

一,。selenium支持的[真实]浏览器驱动程序:

PC驱动程序:Firefox、Safari、ie、chrome、操作员驱动程序

移动驱动程序:Windows Phone、selendroid、IOS驱动程序和appium支持iPhone、iPad、Android和Firefox操作系统[第三方]

Safari和FF以插件的形式驱动浏览器本身;IE和chrome都通过二进制文件驱动浏览器本身

这些驱动程序直接启动,并通过调用浏览器的底层界面来驱动浏览器。因此,它们具有最真实的用户场景模拟,主要用于web兼容性测试

二,。selenium支持的伪浏览器驱动程序:

HtmlUnit、幻影

它们不是没有GUI的真正类似浏览器的程序,而是支持HTML、JS和其他解析功能的类似浏览器的程序;这些程序不会呈现网页的显示内容,但支持页面元素搜索、JS执行等;如果没有CSS和GUI渲染,运行效率将比真正的浏览器快得多,后者主要用于功能测试。Htmlunit是一个用Java实现的类浏览器程序,收录在selenium服务器中。无需驱动程序即可直接实例化;它的JS解析引擎是rhino 查看全部

动态网页抓取(

可支持的【真实】驱动程序介绍(一))

#抓取内容

WebDriver driver = new HtmlUnitDriver(false);

driver.get(url);

String html = driver.getPageSource();

#如何想等待一会元素渲染完毕

driver.manage().timeouts().implicitlyWait(2, TimeUnit.SECONDS);

#进行百度搜索

public static void doSearch(String keyword) {

final String url = "http://www.baidu.com";

WebDriver driver = new HtmlUnitDriver(false);

driver.get(url);

driver.findElement(By.id("kw")).sendKeys(keyword);

Actions action = new Actions(driver);

action.sendKeys(Keys.ENTER).perform();

System.out.println(driver.getPageSource());

}

一,。selenium支持的[真实]浏览器驱动程序:

PC驱动程序:Firefox、Safari、ie、chrome、操作员驱动程序

移动驱动程序:Windows Phone、selendroid、IOS驱动程序和appium支持iPhone、iPad、Android和Firefox操作系统[第三方]

Safari和FF以插件的形式驱动浏览器本身;IE和chrome都通过二进制文件驱动浏览器本身

这些驱动程序直接启动,并通过调用浏览器的底层界面来驱动浏览器。因此,它们具有最真实的用户场景模拟,主要用于web兼容性测试

二,。selenium支持的伪浏览器驱动程序:

HtmlUnit、幻影

它们不是没有GUI的真正类似浏览器的程序,而是支持HTML、JS和其他解析功能的类似浏览器的程序;这些程序不会呈现网页的显示内容,但支持页面元素搜索、JS执行等;如果没有CSS和GUI渲染,运行效率将比真正的浏览器快得多,后者主要用于功能测试。Htmlunit是一个用Java实现的类浏览器程序,收录在selenium服务器中。无需驱动程序即可直接实例化;它的JS解析引擎是rhino

动态网页抓取(静态网页化可以提高网站提高速度吗?怎么做?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-09-16 14:07

一、静态网页可以提高网站速度。众所周知,ASP、PHP、JSP和。Net等动态程序需要读取和调用数据库内容,转换服务器安装的解释器,才能正常显示网页内容。与流量大的网站相比,它增加了数据库读取次数和程序操作需求,占用了大量服务器资源,影响了网站的速度。使用网站直接使其静态化,消除了读取数据库的操作,不需要程序解释,减少了链接,提高了网站反射速度二、静态网页,可以提高搜索引擎优化。从网站优化的角度来看,搜索引擎更喜欢静态网页。与动态网页相比,静态网页更喜欢静态网页,静态网页更容易捕获,搜索引擎SEO排名更容易提高。当然,目前一些行业和门户网站网站大多使用静态或伪静态网页来显示,搜索引擎捕获和排名三、静态网页更方便,可以提高网站稳定性1、从安全角度来看,静态网页不应该受到黑客的攻击。静态页面没有入口点,减少了黑客攻击2、的可能性,在网站稳定性方面,如果程序和数据库出现问题,将直接影响网站访问,而静态网页避免了这种情况。不会因为该程序而丢失网站数据,影响正常打开、用户体验和网站信任。静态网页优化有利于排名、网页收录、网站数据、服务器安全等。。过去,很多人错误地认识到,智能网站建设不能产生静态信息,因此无法实现搜索引擎优化。动态页面是网站construction最常用的表达式。它的优点是可以根据用户的不同请求,根据之前制定的程序页面返回相应的数据。这可以说是一对多的关系。从而实现资源的最大化利用,节约服务器上的物理资源。如果您将来需要更改站点的样式。只需重做前台访问的页面。只要数据库没有太大的修改。它可以很快修改。你可以看到自由行走网络- 查看全部

动态网页抓取(静态网页化可以提高网站提高速度吗?怎么做?)

一、静态网页可以提高网站速度。众所周知,ASP、PHP、JSP和。Net等动态程序需要读取和调用数据库内容,转换服务器安装的解释器,才能正常显示网页内容。与流量大的网站相比,它增加了数据库读取次数和程序操作需求,占用了大量服务器资源,影响了网站的速度。使用网站直接使其静态化,消除了读取数据库的操作,不需要程序解释,减少了链接,提高了网站反射速度二、静态网页,可以提高搜索引擎优化。从网站优化的角度来看,搜索引擎更喜欢静态网页。与动态网页相比,静态网页更喜欢静态网页,静态网页更容易捕获,搜索引擎SEO排名更容易提高。当然,目前一些行业和门户网站网站大多使用静态或伪静态网页来显示,搜索引擎捕获和排名三、静态网页更方便,可以提高网站稳定性1、从安全角度来看,静态网页不应该受到黑客的攻击。静态页面没有入口点,减少了黑客攻击2、的可能性,在网站稳定性方面,如果程序和数据库出现问题,将直接影响网站访问,而静态网页避免了这种情况。不会因为该程序而丢失网站数据,影响正常打开、用户体验和网站信任。静态网页优化有利于排名、网页收录、网站数据、服务器安全等。。过去,很多人错误地认识到,智能网站建设不能产生静态信息,因此无法实现搜索引擎优化。动态页面是网站construction最常用的表达式。它的优点是可以根据用户的不同请求,根据之前制定的程序页面返回相应的数据。这可以说是一对多的关系。从而实现资源的最大化利用,节约服务器上的物理资源。如果您将来需要更改站点的样式。只需重做前台访问的页面。只要数据库没有太大的修改。它可以很快修改。你可以看到自由行走网络-

动态网页抓取(的动态网站开发的难度分析及应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-16 14:01

动态网页-意义

动态网页对应于静态网页,也就是说,网页URL的后缀不是静态网页的常见形式,例如。HTM,。HTML,。Shtml和。XML,但格式为。ASP,。JSP,。PHP,。Perl和。CGI,并且在动态网页URL中有一个图标-“?”。如果有这样的动态网页,则地址为:

这是一个典型的动态网页URL表单

从网站访问者的角度来看,动态和静态网页都可以显示基本的文本和图片信息,但从网站开发、管理和维护的角度来看,差异很大

动态网页-动态网页技术

浏览器端:Javascript脚本语言、DOM(文档对象模型)、CSS样式表和多媒体的使用

服务器端:

1.CGI舞台

CGI是通用网关接口的缩写,代表通用(标准)服务器端的接口。每当服务器收到客户更新数据的请求时,它都会使用此接口启动外部应用程序,以完成各种计算、处理或访问数据库。处理后,它会将结果返回到web服务器,然后返回到浏览器。外部应用程序是可编写的程序使用C、C++、Perl、Pascal、Java或其他语言编写。这些程序在单独的地址空间中运行。有关详细信息,请参见图1.1如中所示

后来出现了ISAPI(用于Internet Explorer浏览器)或NSAPI(用于Netscape浏览器)技术。其功能与CGI相同,但有一些技术改进。外部应用程序使用动态链接库(DLL)在web服务器的地址空间中运行,并使用“线程”而不是“进程”“,大大提高了运行效率。然而,无论是CGI、ISAPI还是NSAPI,都需要编写外部应用程序,编写外部应用程序并不是一件容易的任务。从开发人员的角度来看,这种开发方法并没有给开发带来方便

2.脚本语言阶段

在这个阶段,有许多优秀的脚本语言,如ASP、PHP、JSP等。脚本语言的出现大大简化了动态网站开发的难度。特别是,ASP和PHP易学且功能强大,已成为许多网站开发人员的首选

JSP和ASP的程序结构非常相似。它的主要功能是将Java程序片段(Scriptlet)添加到传统的HTML网页文件中,并使用各种JSP标记来形成JSP网页。当接收到客户端的访问请求时,web服务器首先执行程序片段,并以HTML格式将执行结果返回给客户端

3.组件技术阶段

net和Java(J2EE)技术是这一阶段的代表。这是一个完全面向对象的系统,由类和对象(组件)组成,以编译方法和事件驱动的方式运行。该系统具有高效、高可靠性和高可扩展性的特点

动态网页-网络营销教学网站简要总结了动态网页的一般特征如下:

(1)动态网页基于数据库技术,可以大大减少网站维护的工作量

(2)使用动态web技术,网站可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等

(3)dynamic网页实际上不是独立存在于服务器上的网页文件。只有当用户请求时,服务器才会返回完整的网页

“?”在4)动态网页中,搜索引擎检索存在一些问题。通常,搜索引擎不可能从网站数据库访问所有网页,或者出于技术考虑,搜索爬行器不会抓取“?”在网址下面的内容中,因此,在使用动态网页网站推广搜索引擎时,我们需要做一些技术处理,以满足搜索引擎的要求 查看全部

动态网页抓取(的动态网站开发的难度分析及应用)

动态网页-意义

动态网页对应于静态网页,也就是说,网页URL的后缀不是静态网页的常见形式,例如。HTM,。HTML,。Shtml和。XML,但格式为。ASP,。JSP,。PHP,。Perl和。CGI,并且在动态网页URL中有一个图标-“?”。如果有这样的动态网页,则地址为:

这是一个典型的动态网页URL表单

从网站访问者的角度来看,动态和静态网页都可以显示基本的文本和图片信息,但从网站开发、管理和维护的角度来看,差异很大

动态网页-动态网页技术

浏览器端:Javascript脚本语言、DOM(文档对象模型)、CSS样式表和多媒体的使用

服务器端:

1.CGI舞台

CGI是通用网关接口的缩写,代表通用(标准)服务器端的接口。每当服务器收到客户更新数据的请求时,它都会使用此接口启动外部应用程序,以完成各种计算、处理或访问数据库。处理后,它会将结果返回到web服务器,然后返回到浏览器。外部应用程序是可编写的程序使用C、C++、Perl、Pascal、Java或其他语言编写。这些程序在单独的地址空间中运行。有关详细信息,请参见图1.1如中所示

后来出现了ISAPI(用于Internet Explorer浏览器)或NSAPI(用于Netscape浏览器)技术。其功能与CGI相同,但有一些技术改进。外部应用程序使用动态链接库(DLL)在web服务器的地址空间中运行,并使用“线程”而不是“进程”“,大大提高了运行效率。然而,无论是CGI、ISAPI还是NSAPI,都需要编写外部应用程序,编写外部应用程序并不是一件容易的任务。从开发人员的角度来看,这种开发方法并没有给开发带来方便

2.脚本语言阶段

在这个阶段,有许多优秀的脚本语言,如ASP、PHP、JSP等。脚本语言的出现大大简化了动态网站开发的难度。特别是,ASP和PHP易学且功能强大,已成为许多网站开发人员的首选

JSP和ASP的程序结构非常相似。它的主要功能是将Java程序片段(Scriptlet)添加到传统的HTML网页文件中,并使用各种JSP标记来形成JSP网页。当接收到客户端的访问请求时,web服务器首先执行程序片段,并以HTML格式将执行结果返回给客户端

3.组件技术阶段

net和Java(J2EE)技术是这一阶段的代表。这是一个完全面向对象的系统,由类和对象(组件)组成,以编译方法和事件驱动的方式运行。该系统具有高效、高可靠性和高可扩展性的特点

动态网页-网络营销教学网站简要总结了动态网页的一般特征如下:

(1)动态网页基于数据库技术,可以大大减少网站维护的工作量

(2)使用动态web技术,网站可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等

(3)dynamic网页实际上不是独立存在于服务器上的网页文件。只有当用户请求时,服务器才会返回完整的网页

“?”在4)动态网页中,搜索引擎检索存在一些问题。通常,搜索引擎不可能从网站数据库访问所有网页,或者出于技术考虑,搜索爬行器不会抓取“?”在网址下面的内容中,因此,在使用动态网页网站推广搜索引擎时,我们需要做一些技术处理,以满足搜索引擎的要求

动态网页抓取(动态分块网页主题信息准确自动提取仿真崔彦青(内蒙古医科大学计算机信息学院))

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-09-16 13:17

-04动态块网页主题信息精确自动提取模拟崔延庆(内蒙古医科大学计算机信息学院,呼和浩特,内蒙古)010110)摘要:针对提取精度低的缺点,当前自动提取动态块网页主题信息的方法错误率高、耗时长,采用混合加权法在行预处理的基础上自动提取动态块网页主题信息,通过构建预处理后动态分块网页主题信息的层次树模型,确定网页主题信息的内部关系。采用二元集合序列描述目标提取的动态块网页主题信息,计算不同网页主题信息文本对整个网页主题信息的贡献。采用空间矢量模型描述动态块网页主题信息,仿真结果表明,该方法的耗时可以控制在0.1S结果表明,该方法能够实现动态块网页主题信息的准确、高效提取关键词:动态块网页;主题信函信息;自动提取中文图纸分类号:TlW311.13. 文件识别码:bddynamicsegmentation网页主题信息准确性与自动提取模拟崔彦清(内蒙古医科大学计算机信息研究所,呼和浩特内蒙古0101摘要:目前,该方法已建立,错误率高10,中国) 在本文中,混合权重方法被用于从动态分区网页中自动提取主题信息。在对动态分区网页的主题信息进行预处理的基础上,层次树删除了动态分区的主题信息EDWebPageExtraction并计算不同观点信息文本对整个动态分区EDWebPageTopico的贡献度,确定了观点信息与网页的内在关系。此外,还使用了一个序列来描述主题信息。最后,空间向量模型用于描述主题信息分区网页的特征。同时,使用混合方法从空间向量模型中提取主题信息分区网页的主题动态。Simulationresultsprovethatthetimeconsumptionofproposedmethodiscontrolledwithin0.1S.同时,采样数据提取的准确率为[GH]。在这里,所提出的方法可以实现从动态分区dwebpage中准确高效地提取观点信息・ 关键词:动态分区网页;主题信息;自动抽取网络正在高速发展并成为越来越大的资源信息库

除介绍外,中国网民数量也在与日俱增,互联网应用的普及度也在与日俱增。据最新统计,截至2017年底,全世界约有越来越多的人。人们经常在网上获得近10亿的有效网站,而且是目前是世界上最大的搜索引擎信息资源。然而,随着互联网的发展,阻止网页数量的爆炸性增长。例如,“谷歌”这些数据显示了从这样一个巨大的动态块Web资源信息数据库中及时准确地找到人们需要的信息是多么的重要和困难。动态块网络基金项目:国家自然科学基金项目( 51167010)页面主题信息提取方法的优劣直接影响互联网信息资源采集的顺利进行日期:2018年7月11日修订日期:2018年9月5日针对这种情况,文件[3]提出了一种基于融合机制的动态块网页主题信息自动提取方法,该方法通过了四个步骤“动态阻止网页模板库匹配-基于网页模板库匹配的信息过滤-动态阻止网页分类-自动提取网页主题信息“实现动态块网页主题信息与节点上下文关联的计算公式为contextaicorre weasel state s71u.)=输入Lin face KCO和unt Li(StuI)(4)分段网页主题信息独立于模板和相关模板的有机集成,所需的动态分段网页主题信息自动从融合后的新模板库中提取

在公式中,stue.表示stu树中的父节点。这种方法的提取精度不高。文献[4]提出了一种基于LDA模块假设LC.和CC的动态块网页主题信息自动提取方法,分别表示动态块网页主题信息和类型,该方法利用stu dom树节点的局部相关阈值和上下文相关阈值提取动态块网页主题信息LDA模型将Internet上每个动态块网页的主题信息混合,使用剪枝器判断动态块网页的主题信息和stu-dom树节点模块,分别计算动态块网页的主题信息与每个文档段落的关联度。如果满足以下公式:(5),表示状态分区网页的主题相似度,根据相似度计算结果,前几条相似度高的信息与stu-dom树节点局部相关,动态分区网页结果可自动提取为页面主题信息,Extral错误主题信息在该方法中的作用,如果满足以下公式:(6)),则表明动态块网页的主题率较高。文献[5]提出了一种基于kmeans聚类算法的动态块网页主题信息提取方法,该方法与stu dom树节点上下文相关,并能自动提取动态块网页主题信息,该方法利用动态块网页的网页主题信息提取主要内容和key特征词,并构造标记的LDA模型以形成文档相关性(stu.)≥ LC。(5)a主题特征向量,并使用kmeans聚类算法对HⅡfcorrefn进行分类£ 我“我”£ 模型中每个CO的y(stu)

)≥复写的副本。(6)文档分类,提取每个文档集中网页的主题信息,这种方法提取时间长,提出了一种基于混合加权的动态块网页主题信息自动提取方法3.1基于预处理的动态分块网页主题信息预处理为了保证提取的准确性,采用二进制解析器将网页解析为DOM树,并计算DOM叶集序列来描述要提取的动态块网页主题信息,从而减少准子节点中收录的网页主题信息和非叶节点中收录的网页主题信息的时间消耗odes提取动态块网页主题信息,并通过设置阈值变量来判断DOM树中节点收录的网页主题信息量及其相对于子节点收录的网页主题信息量。2.通过改变动态块网页主题信息自动提取原理,计算动态块网页主题信息与stu-dom树节点相关性之间的局部相关性和上下文相关性,分别设置动态块网页主题信息与stu-dom树节点相关性之间的局部相关性阈值和上下文相关性阈值`6Je动态块网页和stu-dom树节点,使用剪枝器判断动态块网页的主题信息与stu-dom树节点的相关性,并根据相关性计算结果和相关性阈值提取动态块网页的主题信息。7O,完成d动态块网页动态块网页主题信息预处理`

解析器用于将网页解析为DOM树,并分别计算DOM树叶节点中收录的网页主题信息量和非叶节点中收录的网页主题信息量DOM树叶节点中收录的eb页面主题信息可以通过使用DOM树叶节点中收录的字数和标点符号的贡献值来表征。计算公式如下:主题信息的自动提取原理。权重=文本长度+点权重假设contentlength和linkcount分别表示stu dom中相应子树中动态分区网页的字符总数和链接总数;stuc表示stu.Tree的第j个子树;linkcount(stu.)表示stu。树中的链接总数;contentlength(stu.)表示StuI树的总字符数。stu dom树节点的主题信息相关性是指stu dom树节点与动态阻止网页主题信息之间的相关性,主要包括两部分:动态阻止网页主题信息之间的局部相关性and节点和 查看全部

动态网页抓取(动态分块网页主题信息准确自动提取仿真崔彦青(内蒙古医科大学计算机信息学院))

-04动态块网页主题信息精确自动提取模拟崔延庆(内蒙古医科大学计算机信息学院,呼和浩特,内蒙古)010110)摘要:针对提取精度低的缺点,当前自动提取动态块网页主题信息的方法错误率高、耗时长,采用混合加权法在行预处理的基础上自动提取动态块网页主题信息,通过构建预处理后动态分块网页主题信息的层次树模型,确定网页主题信息的内部关系。采用二元集合序列描述目标提取的动态块网页主题信息,计算不同网页主题信息文本对整个网页主题信息的贡献。采用空间矢量模型描述动态块网页主题信息,仿真结果表明,该方法的耗时可以控制在0.1S结果表明,该方法能够实现动态块网页主题信息的准确、高效提取关键词:动态块网页;主题信函信息;自动提取中文图纸分类号:TlW311.13. 文件识别码:bddynamicsegmentation网页主题信息准确性与自动提取模拟崔彦清(内蒙古医科大学计算机信息研究所,呼和浩特内蒙古0101摘要:目前,该方法已建立,错误率高10,中国) 在本文中,混合权重方法被用于从动态分区网页中自动提取主题信息。在对动态分区网页的主题信息进行预处理的基础上,层次树删除了动态分区的主题信息EDWebPageExtraction并计算不同观点信息文本对整个动态分区EDWebPageTopico的贡献度,确定了观点信息与网页的内在关系。此外,还使用了一个序列来描述主题信息。最后,空间向量模型用于描述主题信息分区网页的特征。同时,使用混合方法从空间向量模型中提取主题信息分区网页的主题动态。Simulationresultsprovethatthetimeconsumptionofproposedmethodiscontrolledwithin0.1S.同时,采样数据提取的准确率为[GH]。在这里,所提出的方法可以实现从动态分区dwebpage中准确高效地提取观点信息・ 关键词:动态分区网页;主题信息;自动抽取网络正在高速发展并成为越来越大的资源信息库