php网页抓取图片

php网页抓取图片(PHP模拟浏览器访问url地址及相关源码如下:_get_contents)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-25 12:02

春节快乐

在PHP中爬取时,通常会使用PHP来模拟浏览器的访问,通过http请求访问url地址,然后获取html源代码或者xml数据。我们不能直接输出数据。我们经常需要在继续之前提取内容。格式化,以更友好的方式显示。一、基本原理常用的方法有file_get_contents和curl。区别简述如下: 1. curl 多用于互联网网页之间的爬取,而file_get_contents 多用于获取静态页面的内容。

2. file_get_contents 会为每一个请求重新做DNS查询,DNS信息不会被缓存。但是 CURL 会自动缓存 DNS 信息。请求同域名下的网页或图片,只需要进行一次DNS查询。这大大减少了 DNS 查询的数量。所以CURL的性能要比file_get_contents好很多。

3. file_get_contents 在请求 HTTP 时不会保持活动,但 curl 会。这样,当多次请求多个链接时,curl 的效率会更高。

4. curl 支持多种协议,如 FTP、FTPS、HTTP、HTTPS、GOPHER、TELNET、DICT、FILE 和 LDAP。也就是说,它可以做很多file_get_content 做不到的事情。curl可以实现php中内容的远程获取和采集;实现PHP网页版的FTP上传下载;实现模拟登录;实现接口对接(API)、数据传输;实现模拟cookie;下载文件断点续传等,功能非常强大。

5. file_get_contents 函数会受到php.ini 文件中allow_url_open 选项配置的影响。如果配置关闭,该功能将无效。并且 curl 不受此配置的影响。

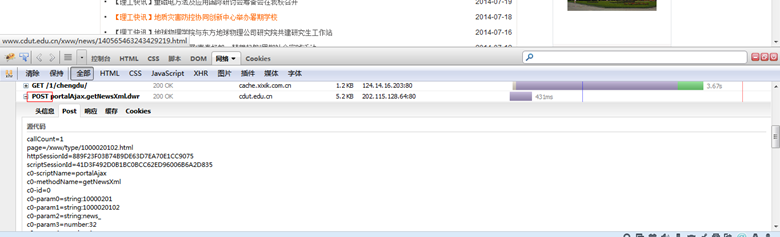

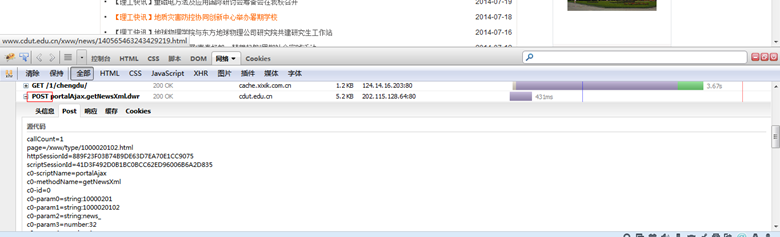

二、图片抓取这里以file_get_contents为例,抓取国内某新闻网的新闻列表缩略图。页面及相关html源代码如下: 首先我们通过file_get_contents获取页面完整的html源代码,并进行正则匹配匹配所有img标签的src属性值,即我们要获取的目标:上面代码中的$matches中存放的是所有匹配到的imgs的src属性值,可以通过循环下载的方式下载保存到本地:

三、通过PHP调用wget 上面的代码已经演示了一个基本的图片抓取方法,但是当目标图片一般比较大(比如墙纸图片)并且网速有限且不稳定时,就不能用PHP来下载了并在linux系统下调用wget命令,具体示例代码如下: 图片抓取只是PHP网络爬虫可以做的一小部分功能。通过PHP网络爬虫,您可以轻松获取互联网上更多的数据,无论是用于数据挖掘还是市场调查,甚至是用于制作搜索引擎。

ymkj_679 每一个梦想品牌都值得我们支持 查看全部

php网页抓取图片(PHP模拟浏览器访问url地址及相关源码如下:_get_contents)

春节快乐

在PHP中爬取时,通常会使用PHP来模拟浏览器的访问,通过http请求访问url地址,然后获取html源代码或者xml数据。我们不能直接输出数据。我们经常需要在继续之前提取内容。格式化,以更友好的方式显示。一、基本原理常用的方法有file_get_contents和curl。区别简述如下: 1. curl 多用于互联网网页之间的爬取,而file_get_contents 多用于获取静态页面的内容。

2. file_get_contents 会为每一个请求重新做DNS查询,DNS信息不会被缓存。但是 CURL 会自动缓存 DNS 信息。请求同域名下的网页或图片,只需要进行一次DNS查询。这大大减少了 DNS 查询的数量。所以CURL的性能要比file_get_contents好很多。

3. file_get_contents 在请求 HTTP 时不会保持活动,但 curl 会。这样,当多次请求多个链接时,curl 的效率会更高。

4. curl 支持多种协议,如 FTP、FTPS、HTTP、HTTPS、GOPHER、TELNET、DICT、FILE 和 LDAP。也就是说,它可以做很多file_get_content 做不到的事情。curl可以实现php中内容的远程获取和采集;实现PHP网页版的FTP上传下载;实现模拟登录;实现接口对接(API)、数据传输;实现模拟cookie;下载文件断点续传等,功能非常强大。

5. file_get_contents 函数会受到php.ini 文件中allow_url_open 选项配置的影响。如果配置关闭,该功能将无效。并且 curl 不受此配置的影响。

二、图片抓取这里以file_get_contents为例,抓取国内某新闻网的新闻列表缩略图。页面及相关html源代码如下: 首先我们通过file_get_contents获取页面完整的html源代码,并进行正则匹配匹配所有img标签的src属性值,即我们要获取的目标:上面代码中的$matches中存放的是所有匹配到的imgs的src属性值,可以通过循环下载的方式下载保存到本地:

三、通过PHP调用wget 上面的代码已经演示了一个基本的图片抓取方法,但是当目标图片一般比较大(比如墙纸图片)并且网速有限且不稳定时,就不能用PHP来下载了并在linux系统下调用wget命令,具体示例代码如下: 图片抓取只是PHP网络爬虫可以做的一小部分功能。通过PHP网络爬虫,您可以轻松获取互联网上更多的数据,无论是用于数据挖掘还是市场调查,甚至是用于制作搜索引擎。

ymkj_679 每一个梦想品牌都值得我们支持

php网页抓取图片(通过一个实例来教学如何用nodejs实现爬取网站图片功能 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-25 12:01

)

通过一个例子教你如何使用nodejs实现爬取网站图片的功能。有兴趣的请采集

。

我将通过例子来说明nodejs是如何实现爬取网站图片的功能的。以下为全文:

原则:

爬虫是最明显的 IO 密集型应用场景。很明显,node是用来让数据挖掘更方便的I/O等待开销。

使用 express 模块构建节点服务

并使用request模块获取目标页面的html代码

下载cheerio模块处理html代码(cheerio类似jQuery语法,简单易用)

环境配置:

npm install express request cheerio --save

(1)介绍各种模块

var http = require('http');

var request = require('request);

var cheerio = require('cheerio');

var fs = require('fs'); //用来操作文件

var url = 'https://movie.douban.com/cinem ... 39%3B //定义要爬的页面

(2)发送请求

http.get(function(res){

var html = '';

var titles = [];

res.setEncoding('utf-8') //防止中文乱码

res.on('data',function(chunk){

html += chrunk; //监听data事件 每次取一块数据

})

res.on('end',function(){

var $ = cheerio.load(html); //获取数据完成后,解析html

//将获取的图片存到images文件夹中

$('.mod-bd img').each(function(index, item){

//获取图片属性

var imgName = $(this).parent().next().text().trimg()

var imgfile = imgName + '.jpeg';

var imgSrc = $(this).attr('src')

//采用request模块,向服务器发起请求 获取图片资源

request.head(imgSrc, function(error, res,body){

if(error){

console.log('失败了')

}

});

//通过管道的方式用fs模块将图片写到本地的images文件下

request(imgSrc).pipe.(fs.createWriteStream('./images/' + imgfile));

})

})

}) 查看全部

php网页抓取图片(通过一个实例来教学如何用nodejs实现爬取网站图片功能

)

通过一个例子教你如何使用nodejs实现爬取网站图片的功能。有兴趣的请采集

。

我将通过例子来说明nodejs是如何实现爬取网站图片的功能的。以下为全文:

原则:

爬虫是最明显的 IO 密集型应用场景。很明显,node是用来让数据挖掘更方便的I/O等待开销。

使用 express 模块构建节点服务

并使用request模块获取目标页面的html代码

下载cheerio模块处理html代码(cheerio类似jQuery语法,简单易用)

环境配置:

npm install express request cheerio --save

(1)介绍各种模块

var http = require('http');

var request = require('request);

var cheerio = require('cheerio');

var fs = require('fs'); //用来操作文件

var url = 'https://movie.douban.com/cinem ... 39%3B //定义要爬的页面

(2)发送请求

http.get(function(res){

var html = '';

var titles = [];

res.setEncoding('utf-8') //防止中文乱码

res.on('data',function(chunk){

html += chrunk; //监听data事件 每次取一块数据

})

res.on('end',function(){

var $ = cheerio.load(html); //获取数据完成后,解析html

//将获取的图片存到images文件夹中

$('.mod-bd img').each(function(index, item){

//获取图片属性

var imgName = $(this).parent().next().text().trimg()

var imgfile = imgName + '.jpeg';

var imgSrc = $(this).attr('src')

//采用request模块,向服务器发起请求 获取图片资源

request.head(imgSrc, function(error, res,body){

if(error){

console.log('失败了')

}

});

//通过管道的方式用fs模块将图片写到本地的images文件下

request(imgSrc).pipe.(fs.createWriteStream('./images/' + imgfile));

})

})

})

php网页抓取图片(如何在产品设计中更好地利用图片资源?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-25 05:10

如何在产品设计中更好地利用图像资源?

设计中的图片不仅可以提高视觉表现力,还会影响页面的转化率。今天我们将从以下几个方面来谈谈图片在产品设计中的作用和作用: 产品设计中的优质图片素材有什么使用场景?它主要用于创意提取、颜色提取、内容描述和页面保留。创造力...

如何上传本地图片并使其出现在百度图片搜索结果中

您可以尝试将图片上传到其他网页(例如:百度空间相册),这样当网页为百度收录时,您的图片可能会出现在搜索结果中。百度图片搜索引擎是全球最大的中文图片搜索引擎。百度从数十亿中文网页中提取各种图片,建立了世界第一的中文图片库。目前...

如何从网页图片中提取文字?

如何从网页图片中提取文字?距离2021年过年只有一个月了,由于年底公司工作量剧增,小吴的工作站里堆满了文件,所有的文件都必须在电脑上输入。面对桌面上的文件,初入社会的小舞很是恼火。必须将许多文件输入计算机。什么时候可以打字...

周广权:人脸识别犯罪中的关键问题| 周光权 比较法研究 202106

网贷平台APP等未经授权盗取贷款申请人人脸识别数据,当然违反知情同意规则;即使申请人已经获得申请人的同意,他也会阅读他的通讯录和手机中存储的照片,因为申请人担心涉及他人的信息无权同意,获取信息的行为违反了知情同意规则,这可能构成本罪。肇事者没有...

怎么建公司网站容易被抓

如何建立一个公司网站 很容易被爬取。创建 网站 的一种方法是它看起来既便宜又快速。原因是网站使用了模板,并且section的所有内容都是Fixed,只需要改变图片或者文字内容,所以速度会快很多。但是这样的网站缺乏特征,很难留住访问者,也很难被搜索引擎收录搜索到,通常...

百度图书馆大杀手-下载你想要的文件

图片来源:软件截图。另外,在软件右上角的【菜单】中,我们选择【系统设置】,会弹出【属性设置】页面。在这个页面,我们可以选择【自定义下载路径】和【是否导出txt文件】选项。图片来源:软件截图3 DoDo百度文库提取工具这个软件对...

25个强大实用的网站合集,强大到没有朋友,必须做PPT才能找到灵感!-ZAKER新闻

如果你想让你的工作更有趣,你不妨试试这个网站。别担心,你不会失望的。-5. 摄影:500px 传送门:500PX是一个专业摄影师的图片社区,2003年成立于加拿大,旨在分享和发现精彩的照片,寻找最优秀的摄影人才,...

本插件,一键抓取全网图片,小偷快

所以,点击浏览器右上角的ImageAssistant插件,选择“从该页面提取图片”。可以看到,ImageAssistant 会“不停地”抓取图库中的图片网站,只要你的电脑内存足够大,只要你电脑的CPU足够快,只要有图片在网页,ImageAssistant 将全部收录在包中。

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索 查看全部

php网页抓取图片(如何在产品设计中更好地利用图片资源?(组图))

如何在产品设计中更好地利用图像资源?

设计中的图片不仅可以提高视觉表现力,还会影响页面的转化率。今天我们将从以下几个方面来谈谈图片在产品设计中的作用和作用: 产品设计中的优质图片素材有什么使用场景?它主要用于创意提取、颜色提取、内容描述和页面保留。创造力...

如何上传本地图片并使其出现在百度图片搜索结果中

您可以尝试将图片上传到其他网页(例如:百度空间相册),这样当网页为百度收录时,您的图片可能会出现在搜索结果中。百度图片搜索引擎是全球最大的中文图片搜索引擎。百度从数十亿中文网页中提取各种图片,建立了世界第一的中文图片库。目前...

如何从网页图片中提取文字?

如何从网页图片中提取文字?距离2021年过年只有一个月了,由于年底公司工作量剧增,小吴的工作站里堆满了文件,所有的文件都必须在电脑上输入。面对桌面上的文件,初入社会的小舞很是恼火。必须将许多文件输入计算机。什么时候可以打字...

周广权:人脸识别犯罪中的关键问题| 周光权 比较法研究 202106

网贷平台APP等未经授权盗取贷款申请人人脸识别数据,当然违反知情同意规则;即使申请人已经获得申请人的同意,他也会阅读他的通讯录和手机中存储的照片,因为申请人担心涉及他人的信息无权同意,获取信息的行为违反了知情同意规则,这可能构成本罪。肇事者没有...

怎么建公司网站容易被抓

如何建立一个公司网站 很容易被爬取。创建 网站 的一种方法是它看起来既便宜又快速。原因是网站使用了模板,并且section的所有内容都是Fixed,只需要改变图片或者文字内容,所以速度会快很多。但是这样的网站缺乏特征,很难留住访问者,也很难被搜索引擎收录搜索到,通常...

百度图书馆大杀手-下载你想要的文件

图片来源:软件截图。另外,在软件右上角的【菜单】中,我们选择【系统设置】,会弹出【属性设置】页面。在这个页面,我们可以选择【自定义下载路径】和【是否导出txt文件】选项。图片来源:软件截图3 DoDo百度文库提取工具这个软件对...

25个强大实用的网站合集,强大到没有朋友,必须做PPT才能找到灵感!-ZAKER新闻

如果你想让你的工作更有趣,你不妨试试这个网站。别担心,你不会失望的。-5. 摄影:500px 传送门:500PX是一个专业摄影师的图片社区,2003年成立于加拿大,旨在分享和发现精彩的照片,寻找最优秀的摄影人才,...

本插件,一键抓取全网图片,小偷快

所以,点击浏览器右上角的ImageAssistant插件,选择“从该页面提取图片”。可以看到,ImageAssistant 会“不停地”抓取图库中的图片网站,只要你的电脑内存足够大,只要你电脑的CPU足够快,只要有图片在网页,ImageAssistant 将全部收录在包中。

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

为您找到“如何提取本网页图片资源”相关结果约100,000,000条

搜索引擎营销必备172个专业术语超全面盘点(合集)

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎对网站的抓取过于频繁,很可能会导致服务器不稳定。百度蜘蛛会根据网站内容更新频率和服务器压力自动调整。

数一数腾讯TT浏览器的5大创新特性——腾讯、TT浏览器——极速技术(驱动...

3、网页资源提取网页资源很多,图片、Flash、视频、文字等,如果想批量保存怎么办?TT浏览器创新的“网页资源提取”功能,可以简单的批量提取资源并保存。(图3) 图3:批量保存网页,省时、省力、省心……

相关搜索

php网页抓取图片(PHP采集类Snoopy抓取图片实例(一)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-12-22 06:02

PHP采集类似史努比的抓图示例

PHP的史努比用了两天了,很有用。要获取请求网页中的所有链接,可以直接使用 fetchlinks。获取所有的文本信息,使用fetchtext(内部仍然使用正则表达式进行处理),还有很多其他的功能,比如模拟提交表单。

指示:

首先下载史努比类,下载地址:

先实例化一个对象,然后调用对应的方法获取爬取的网页信息

包括'史努比/史努比.class.php';

$史努比 = 新史努比();

$sourceURL = "";

$snoopy->fetchlinks($sourceURL);

$a = $snoopy->results;

不提供获取网页中所有图片地址的方法。它自己的一个需求是获取页面上文章列表中的所有图片地址。然后我自己写了一个,主要是因为常规比赛很重要。

//匹配图片的正则表达式

$reTag = "//i";

由于特殊需要,只需要抓取htp://开头的图片(外网的图片可能会做防盗链,我想先抓取本地的)

1. 抓取指定网页,过滤掉所有预期的文章地址;

2.循环抓取第一步中文章的地址,然后使用匹配图片的正则表达式进行匹配,得到页面中所有符合规则的图片地址;

3. 根据图片后缀和ID保存图片(这里只有gif,jpg)---如果图片文件存在,先删除再保存。

包括'史努比/史努比.class.php';

$史努比 = 新史努比();

$sourceURL = "";

$snoopy->fetchlinks($sourceURL);

$a = $snoopy->results;

$re = "/d+.html$/";

//过滤获取指定文件地址请求

foreach ($a as $tmp) {

如果(preg_match($re,$tmp)){

getImgURL($tmp);

}

}

函数 getImgURL($siteName) {

$史努比 = 新史努比();

$snoopy->fetch($siteName);

$fileContent = $snoopy->results;

//匹配图片的正则表达式

$reTag = "//i";

如果(preg_match($reTag,$fileContent)){

$ret = preg_match_all($reTag, $fileContent, $matchResult);

for ($i = 0, $len = count($matchResult[1]); $i <$len; ++$i) {

saveImgURL($matchResult[1][$i], $matchResult[2][$i]);

}

}

}

函数 saveImgURL($name, $suffix) {

$url = $name.".".$suffix;

echo "请求的图片地址:".$url。"

”;

$imgSavePath = "E:/xxx/style/images/";

$imgId = preg_replace("/^.+/(d+)$/", "\1", $name);

if ($suffix == "gif") {

$imgSavePath .= "情感";

} 别的 {

$imgSavePath .= "主题";

}

$imgSavePath .= ("/".$imgId.".".$suffix);

如果(is_file($imgSavePath)){

取消链接($imgSavePath);

回声"

文件“.$imgSavePath”。已经存在,将被删除

”;

}

$imgFile = file_get_contents($url);

$flag = file_put_contents($imgSavePath, $imgFile);

如果($标志){

回声"

文件“.$imgSavePath”。已成功保存

”;

}

}

用php爬网页时:内容、图片、链接,我觉得最重要的是有规律的(根据爬取的内容和指定的规则获取想要的数据),思路其实比较简单,用到的方法是也不是很多,只有那几个(而且可以直接调用别人写的类中的方法来抓取内容)

但是我之前想到的是,PHP似乎没有实现以下方法。比如一个文件有N行(N大),需要替换符合规则的行内容。比如第三行是aaa,需要转成bbbbb。需要修改文件时的常见做法:

1. 一次读取整个文件(或逐行读取),然后用一个临时文件保存最终的转换结果,然后替换原文件

2. 逐行读取,使用fseek控制文件指针位置,然后fwrite写入

文件较大时,方案1不建议一次性读取(逐行读取,然后写入临时文件再替换原文件效率不高),方案2是当替换的长度string 小于等于目标值没问题,但是超过限制就会有问题。它会“越界”并破坏下一行的数据(不能像JavaScript中的“选择”概念那样用新的内容代替)。

这是用于试验场景 2 的代码:

$mode = "r+";

$filename = "d:/file.txt";

$fp = fopen($filename, $mode);

如果($ fp){

$i = 1;

而 (!feof($fp)) {

$str = fgets($fp);

回声 $str;

如果 ($i == 1) {

$len = strlen($str);

fseek($fp, -$len, SEEK_CUR);//指针向前移动

fwrite($fp, "123");

}

我++;

}

fclose($fp);

}

先读一行。这时候文件指针实际上指向了下一行的开始。使用 fseek 将文件指针移回上一行的开头,然后使用 fwrite 执行替换操作。因为是替换操作,如果不指定长度next,会影响下一行的数据,而我想要的是只对这一行进行操作,比如删除这一行或者只用一个替换整行1.上面的例子不符合要求,可能是我没有找到合适的方法...相关阅读:

C#使用WinRar命令实现压缩和解压操作

如何使用jquery.form.js上传图片

PHP+jquery+ajax实现即时聊天功能示例

JS中artdialog弹窗控件的提交表单思路详解

Oracle SQL中实现indexOf和lastIndexOf函数的思路和代码

PHP输出URL快捷方式示例代码

Android开发学习路线的七个阶段

PHP使用cookie实现自动登录的方法

AngularJS 手动表单验证

通过实例深入学习OGNL表达式在Java的Struts框架中的使用

Windows 10 U 盘版亚马逊开启预购,8 月 16 日开始发货

js实现带缓冲效果的类似QQ面板的折叠菜单代码

AngularJS 基本 ng-if 指令用法

Java设计模式之备忘录模式(Memento Pattern)介绍 查看全部

php网页抓取图片(PHP采集类Snoopy抓取图片实例(一)(组图))

PHP采集类似史努比的抓图示例

PHP的史努比用了两天了,很有用。要获取请求网页中的所有链接,可以直接使用 fetchlinks。获取所有的文本信息,使用fetchtext(内部仍然使用正则表达式进行处理),还有很多其他的功能,比如模拟提交表单。

指示:

首先下载史努比类,下载地址:

先实例化一个对象,然后调用对应的方法获取爬取的网页信息

包括'史努比/史努比.class.php';

$史努比 = 新史努比();

$sourceURL = "";

$snoopy->fetchlinks($sourceURL);

$a = $snoopy->results;

不提供获取网页中所有图片地址的方法。它自己的一个需求是获取页面上文章列表中的所有图片地址。然后我自己写了一个,主要是因为常规比赛很重要。

//匹配图片的正则表达式

$reTag = "//i";

由于特殊需要,只需要抓取htp://开头的图片(外网的图片可能会做防盗链,我想先抓取本地的)

1. 抓取指定网页,过滤掉所有预期的文章地址;

2.循环抓取第一步中文章的地址,然后使用匹配图片的正则表达式进行匹配,得到页面中所有符合规则的图片地址;

3. 根据图片后缀和ID保存图片(这里只有gif,jpg)---如果图片文件存在,先删除再保存。

包括'史努比/史努比.class.php';

$史努比 = 新史努比();

$sourceURL = "";

$snoopy->fetchlinks($sourceURL);

$a = $snoopy->results;

$re = "/d+.html$/";

//过滤获取指定文件地址请求

foreach ($a as $tmp) {

如果(preg_match($re,$tmp)){

getImgURL($tmp);

}

}

函数 getImgURL($siteName) {

$史努比 = 新史努比();

$snoopy->fetch($siteName);

$fileContent = $snoopy->results;

//匹配图片的正则表达式

$reTag = "//i";

如果(preg_match($reTag,$fileContent)){

$ret = preg_match_all($reTag, $fileContent, $matchResult);

for ($i = 0, $len = count($matchResult[1]); $i <$len; ++$i) {

saveImgURL($matchResult[1][$i], $matchResult[2][$i]);

}

}

}

函数 saveImgURL($name, $suffix) {

$url = $name.".".$suffix;

echo "请求的图片地址:".$url。"

”;

$imgSavePath = "E:/xxx/style/images/";

$imgId = preg_replace("/^.+/(d+)$/", "\1", $name);

if ($suffix == "gif") {

$imgSavePath .= "情感";

} 别的 {

$imgSavePath .= "主题";

}

$imgSavePath .= ("/".$imgId.".".$suffix);

如果(is_file($imgSavePath)){

取消链接($imgSavePath);

回声"

文件“.$imgSavePath”。已经存在,将被删除

”;

}

$imgFile = file_get_contents($url);

$flag = file_put_contents($imgSavePath, $imgFile);

如果($标志){

回声"

文件“.$imgSavePath”。已成功保存

”;

}

}

用php爬网页时:内容、图片、链接,我觉得最重要的是有规律的(根据爬取的内容和指定的规则获取想要的数据),思路其实比较简单,用到的方法是也不是很多,只有那几个(而且可以直接调用别人写的类中的方法来抓取内容)

但是我之前想到的是,PHP似乎没有实现以下方法。比如一个文件有N行(N大),需要替换符合规则的行内容。比如第三行是aaa,需要转成bbbbb。需要修改文件时的常见做法:

1. 一次读取整个文件(或逐行读取),然后用一个临时文件保存最终的转换结果,然后替换原文件

2. 逐行读取,使用fseek控制文件指针位置,然后fwrite写入

文件较大时,方案1不建议一次性读取(逐行读取,然后写入临时文件再替换原文件效率不高),方案2是当替换的长度string 小于等于目标值没问题,但是超过限制就会有问题。它会“越界”并破坏下一行的数据(不能像JavaScript中的“选择”概念那样用新的内容代替)。

这是用于试验场景 2 的代码:

$mode = "r+";

$filename = "d:/file.txt";

$fp = fopen($filename, $mode);

如果($ fp){

$i = 1;

而 (!feof($fp)) {

$str = fgets($fp);

回声 $str;

如果 ($i == 1) {

$len = strlen($str);

fseek($fp, -$len, SEEK_CUR);//指针向前移动

fwrite($fp, "123");

}

我++;

}

fclose($fp);

}

先读一行。这时候文件指针实际上指向了下一行的开始。使用 fseek 将文件指针移回上一行的开头,然后使用 fwrite 执行替换操作。因为是替换操作,如果不指定长度next,会影响下一行的数据,而我想要的是只对这一行进行操作,比如删除这一行或者只用一个替换整行1.上面的例子不符合要求,可能是我没有找到合适的方法...相关阅读:

C#使用WinRar命令实现压缩和解压操作

如何使用jquery.form.js上传图片

PHP+jquery+ajax实现即时聊天功能示例

JS中artdialog弹窗控件的提交表单思路详解

Oracle SQL中实现indexOf和lastIndexOf函数的思路和代码

PHP输出URL快捷方式示例代码

Android开发学习路线的七个阶段

PHP使用cookie实现自动登录的方法

AngularJS 手动表单验证

通过实例深入学习OGNL表达式在Java的Struts框架中的使用

Windows 10 U 盘版亚马逊开启预购,8 月 16 日开始发货

js实现带缓冲效果的类似QQ面板的折叠菜单代码

AngularJS 基本 ng-if 指令用法

Java设计模式之备忘录模式(Memento Pattern)介绍

php网页抓取图片(推荐:经典PHP加密解密函数Authcode()修复版代码Authcode)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-12-22 04:23

推荐:经典PHP加解密函数Authcode()修复版代码

Authcode 是很多人使用的功能。此功能来自 Discuz 程序。它用于加密和解密字符串。您可以设置密钥和过期时间。它在许多情况下使用。原函数代码可能会生成+、/等字符,通过URL取值时会被转义,导致解密失败。 Fireside 网络稍作修改,将这几个字符替换为其他字符

本文介绍了php获取网页中所有图片并存入数组的方法。分享给大家,供大家参考。详情如下:

$images = array(); preg_match_all('/(img|src)=("|')[^"'>]+/i', $data, $media); unset($data); $data=preg_replace('/(img|src)("|'|="|=')(.*)/i',"$3",$media[0]); foreach($data as $url) { $info = pathinfo($url); if (isset($info['extension'])) { if (($info['extension'] == 'jpg') || ($info['extension'] == 'jpeg') || ($info['extension'] == 'gif') || ($info['extension'] == 'png')) array_push($images, $url); } }

希望这篇文章对你的php程序设计有所帮助。

分享:php中快速排序的简单方法

本文介绍了PHP中快速排序的简单方法。分享给大家,供大家参考。具体实现方法如下:

PHP在线视频教程 PHP视频教程包下载 查看全部

php网页抓取图片(推荐:经典PHP加密解密函数Authcode()修复版代码Authcode)

推荐:经典PHP加解密函数Authcode()修复版代码

Authcode 是很多人使用的功能。此功能来自 Discuz 程序。它用于加密和解密字符串。您可以设置密钥和过期时间。它在许多情况下使用。原函数代码可能会生成+、/等字符,通过URL取值时会被转义,导致解密失败。 Fireside 网络稍作修改,将这几个字符替换为其他字符

本文介绍了php获取网页中所有图片并存入数组的方法。分享给大家,供大家参考。详情如下:

$images = array(); preg_match_all('/(img|src)=("|')[^"'>]+/i', $data, $media); unset($data); $data=preg_replace('/(img|src)("|'|="|=')(.*)/i',"$3",$media[0]); foreach($data as $url) { $info = pathinfo($url); if (isset($info['extension'])) { if (($info['extension'] == 'jpg') || ($info['extension'] == 'jpeg') || ($info['extension'] == 'gif') || ($info['extension'] == 'png')) array_push($images, $url); } }

希望这篇文章对你的php程序设计有所帮助。

分享:php中快速排序的简单方法

本文介绍了PHP中快速排序的简单方法。分享给大家,供大家参考。具体实现方法如下:

PHP在线视频教程 PHP视频教程包下载

php网页抓取图片(轻松优化网站速度~推荐一个提速减负的宝藏插件!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-16 06:16

越来越多的人使用 WordPress 来构建 网站。W3techs最新统计[1]显示,截至2021年11月3日,全网共有4个3.0%网站。@> 是基于 WordPress 构建的。那么问题来了,为什么别人用WordPress搭建的网站,速度快,稳定,好用?下面两个小技巧教你轻松优化网站速度~

推荐一款加速减负宝插件:WordPress COS插件,到链接()直接点击下载安装,免费使用,两种方式优化你的网站速度。

第一招:动静分离

网站中的数据资源一般分为动态数据和静态数据两种。动态数据一般是php实时生成的数据。网页内容主要是HTML代码;静态数据是指图片、css、js、视频等真正的静态文件。

网站建设初期,人流量小,业务简单。将两种类型的数据放在一台服务器上不是什么大问题。随着网站复杂度和访问量的增加,网站的访问速度和响应速度越来越慢,甚至出现服务器带宽不足、磁盘IO高等问题。这时候,动静分离的网站架构就非常有必要了。架构示意图如下:

WordPress COS插件基于腾讯云对象存储COS,将网站静态资源与后台应用分离。用户访问网页的请求由应用后台响应,直接返回动态html内容,降低WordPress云服务器的带宽和存储压力;静态资源存储在COS上,与云服务器内网高速通信,不仅访问速度快,而且降低了磁盘存储成本。另外可以配合内容分发网络CDN,进一步提高用户访问静态资源的速度,让你的网站更快。

1.1 使用第一个技巧

创建公共读取和私有写入存储桶。建议bucket区域与运行WordPress博客平台的CVM相同。

默认情况下,创建的存储桶将分配一个请求的域名。您可以直接使用该域名,也可以为bucket配置CDN加速域名。

在WordPress后台,点击【插件】>【安装插件】,搜索tencentcloud-cos找到插件,

插件地址是

配置好key、bucket名称、访问域名后,您可以自动将WordPress静态文件与腾讯云对象存储COS无缝同步。COS提供6个月的有效期和50GB+新用户的免费存储空间配额。插入一个媒体文件试试吧~

上传一张图片到媒体库,点击编辑图片,发现图片网址确实来自COS:

第二招:图像压缩

一般来说,使用第一招时网站提速的效果是很明显的。如果你想追求更快更好的访问结果,我们还有第二招:图像压缩。据 HTTP Archive 统计[2],截至 2021 年 10 月 1 日,WordPress 网页中的图片平均占网页总量的 25%,图片请求占网页总请求量的 30%。因此,在优化 WordPress 网站 时,图像优化是一个有效且简单的切入点。

图片压缩,我们追求同样的图片质量,体积更小,加载速度更快。WordPress COS 插件基于万象的数据处理能力提供了多种图片压缩方案。下面是不同压缩方案的比较。站长可以根据自己的网站使用场景选择合适的压缩方案。例如:PC端网站推荐使用兼容性好,效果不错的Webp转码;客户端网站推荐适配IOS和Android系统,推荐更有效的HEIF转码。

2.1 使用第二招

只需一步,轻松开启图片压缩,打开WordPress COS插件的配置:

首先打开数据万象压缩图片;其次,根据自己的网站使用场景,定制合适的压缩规则。想要体验压缩效果,可以去链接自己体验一下:()

以webb转码为例,自定义规则为:

imageMogr2/format/webp

保存配置生效,post文章看看效果:

如上图,网站中访问的图片原创图片大小为927.55kb,实际显示图片大小为597kb,图片大小压缩3 5.64%。

更多功能:图像处理

作为一款宝藏插件,WordPress COS插件还集成了万象的数据处理能力,拥有更加丰富的图片处理功能,比如想要保护版权、防止图片被盗的图片水印功能;调整裁剪和缩放的质量;限制图像的大小;图片渐进显示等多种图像处理功能,这些功能还可以叠加,让您的网站不仅速度更快,而且更美观、更安全!

1. 压缩+水印功能:

imageMogr2/format/webp|watermark/2/text/56aB5q2i55uX5Zu-/fill/IzNEM0QzRA/fontsize/40/dissolve/50/gravity/northeast/dx/100/dy/100/batch/1/degree/45

2. 压缩+缩写显示:

imageMogr2/format/webp|imageView2/1/w/800/h/400

探索更多图像处理功能,定制您需要的处理规则,请前往:()

开源应用中心:你要的应用插件全都有!

推荐的 WordPress COS 插件来自开源应用中心。开源应用中心作为一个聚集开发者和中小型开源应用的平台,提供了丰富的开源应用供用户使用。这些应用已经与腾讯云深度融合。用户只需单击一下,即可在云上快速部署体验并使用其最新功能。

对于WordPress,开源应用中心提供了集成WordPress COS插件的WordPress应用版本,一键安装,与腾讯云能力无缝对接,可以说是必备神器。

此外,开源应用中心还提供了多种常见的一键部署应用和插件,比如知识付费菜鸟Discuz!Q,中文社区论坛负责人Discuz!X、敏捷快速的前端开发平台uni-app、便携易用的个人云盘Nextcloud、强大的软路由系统OpenWRT等。

大家点这个链接去(),有需要的可以去取~

总结

这篇文章介绍了一个对WordPress站长有用的插件:WordPress COS插件,并讲授了两种使用WordPress COS插件加速网站的方法:动静分离和图片压缩。此外,WordPress COS 插件还集成了图像水印、裁剪、缩放、质量调整等数据处理功能,站长可以根据业务场景灵活组合功能。

同时,还为大家带来了开源应用/插件合集-开源应用中心,这里除了WordPress COS插件,还有其他好用的应用和插件,可以按需挑选。

作为一款宝藏插件,WordPress COS 插件远不止如此简单。其他功能我们会在下一期安排~

参考意见:

[1] 内容管理系统使用统计

[2] 页面权重

- 结尾 - 查看全部

php网页抓取图片(轻松优化网站速度~推荐一个提速减负的宝藏插件!)

越来越多的人使用 WordPress 来构建 网站。W3techs最新统计[1]显示,截至2021年11月3日,全网共有4个3.0%网站。@> 是基于 WordPress 构建的。那么问题来了,为什么别人用WordPress搭建的网站,速度快,稳定,好用?下面两个小技巧教你轻松优化网站速度~

推荐一款加速减负宝插件:WordPress COS插件,到链接()直接点击下载安装,免费使用,两种方式优化你的网站速度。

第一招:动静分离

网站中的数据资源一般分为动态数据和静态数据两种。动态数据一般是php实时生成的数据。网页内容主要是HTML代码;静态数据是指图片、css、js、视频等真正的静态文件。

网站建设初期,人流量小,业务简单。将两种类型的数据放在一台服务器上不是什么大问题。随着网站复杂度和访问量的增加,网站的访问速度和响应速度越来越慢,甚至出现服务器带宽不足、磁盘IO高等问题。这时候,动静分离的网站架构就非常有必要了。架构示意图如下:

WordPress COS插件基于腾讯云对象存储COS,将网站静态资源与后台应用分离。用户访问网页的请求由应用后台响应,直接返回动态html内容,降低WordPress云服务器的带宽和存储压力;静态资源存储在COS上,与云服务器内网高速通信,不仅访问速度快,而且降低了磁盘存储成本。另外可以配合内容分发网络CDN,进一步提高用户访问静态资源的速度,让你的网站更快。

1.1 使用第一个技巧

创建公共读取和私有写入存储桶。建议bucket区域与运行WordPress博客平台的CVM相同。

默认情况下,创建的存储桶将分配一个请求的域名。您可以直接使用该域名,也可以为bucket配置CDN加速域名。

在WordPress后台,点击【插件】>【安装插件】,搜索tencentcloud-cos找到插件,

插件地址是

配置好key、bucket名称、访问域名后,您可以自动将WordPress静态文件与腾讯云对象存储COS无缝同步。COS提供6个月的有效期和50GB+新用户的免费存储空间配额。插入一个媒体文件试试吧~

上传一张图片到媒体库,点击编辑图片,发现图片网址确实来自COS:

第二招:图像压缩

一般来说,使用第一招时网站提速的效果是很明显的。如果你想追求更快更好的访问结果,我们还有第二招:图像压缩。据 HTTP Archive 统计[2],截至 2021 年 10 月 1 日,WordPress 网页中的图片平均占网页总量的 25%,图片请求占网页总请求量的 30%。因此,在优化 WordPress 网站 时,图像优化是一个有效且简单的切入点。

图片压缩,我们追求同样的图片质量,体积更小,加载速度更快。WordPress COS 插件基于万象的数据处理能力提供了多种图片压缩方案。下面是不同压缩方案的比较。站长可以根据自己的网站使用场景选择合适的压缩方案。例如:PC端网站推荐使用兼容性好,效果不错的Webp转码;客户端网站推荐适配IOS和Android系统,推荐更有效的HEIF转码。

2.1 使用第二招

只需一步,轻松开启图片压缩,打开WordPress COS插件的配置:

首先打开数据万象压缩图片;其次,根据自己的网站使用场景,定制合适的压缩规则。想要体验压缩效果,可以去链接自己体验一下:()

以webb转码为例,自定义规则为:

imageMogr2/format/webp

保存配置生效,post文章看看效果:

如上图,网站中访问的图片原创图片大小为927.55kb,实际显示图片大小为597kb,图片大小压缩3 5.64%。

更多功能:图像处理

作为一款宝藏插件,WordPress COS插件还集成了万象的数据处理能力,拥有更加丰富的图片处理功能,比如想要保护版权、防止图片被盗的图片水印功能;调整裁剪和缩放的质量;限制图像的大小;图片渐进显示等多种图像处理功能,这些功能还可以叠加,让您的网站不仅速度更快,而且更美观、更安全!

1. 压缩+水印功能:

imageMogr2/format/webp|watermark/2/text/56aB5q2i55uX5Zu-/fill/IzNEM0QzRA/fontsize/40/dissolve/50/gravity/northeast/dx/100/dy/100/batch/1/degree/45

2. 压缩+缩写显示:

imageMogr2/format/webp|imageView2/1/w/800/h/400

探索更多图像处理功能,定制您需要的处理规则,请前往:()

开源应用中心:你要的应用插件全都有!

推荐的 WordPress COS 插件来自开源应用中心。开源应用中心作为一个聚集开发者和中小型开源应用的平台,提供了丰富的开源应用供用户使用。这些应用已经与腾讯云深度融合。用户只需单击一下,即可在云上快速部署体验并使用其最新功能。

对于WordPress,开源应用中心提供了集成WordPress COS插件的WordPress应用版本,一键安装,与腾讯云能力无缝对接,可以说是必备神器。

此外,开源应用中心还提供了多种常见的一键部署应用和插件,比如知识付费菜鸟Discuz!Q,中文社区论坛负责人Discuz!X、敏捷快速的前端开发平台uni-app、便携易用的个人云盘Nextcloud、强大的软路由系统OpenWRT等。

大家点这个链接去(),有需要的可以去取~

总结

这篇文章介绍了一个对WordPress站长有用的插件:WordPress COS插件,并讲授了两种使用WordPress COS插件加速网站的方法:动静分离和图片压缩。此外,WordPress COS 插件还集成了图像水印、裁剪、缩放、质量调整等数据处理功能,站长可以根据业务场景灵活组合功能。

同时,还为大家带来了开源应用/插件合集-开源应用中心,这里除了WordPress COS插件,还有其他好用的应用和插件,可以按需挑选。

作为一款宝藏插件,WordPress COS 插件远不止如此简单。其他功能我们会在下一期安排~

参考意见:

[1] 内容管理系统使用统计

[2] 页面权重

- 结尾 -

php网页抓取图片(想要爬取指定网页中的图片主要需要以下三个步骤介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-12-15 10:05

抓取指定网页中的图片主要需要以下三个步骤:

(1)指定网站链接,抓取网站的源码(如果你使用谷歌浏览器,按鼠标右键-> Inspect-> Elements中的html内容)

(2) 根据你要爬取的内容设置正则表达式匹配你要爬取的内容

(3)设置循环列表,反复抓取保存内容

下面介绍两种抓取指定网页图片的方法

(1)方法一:使用正则表达式过滤抓取到的html内容字符串

# 第一个简单的爬取图片的程序

import urllib.request # python自带的爬操作url的库

import re # 正则表达式

# 该方法传入url,返回url的html的源代码

def getHtmlCode(url):

# 以下几行注释的代码在本程序中有加没加效果一样,但是为了隐藏自己避免被反爬虫可以假如这个伪装的头部请求

headers = {

'User-Agent': 'Mozilla/5.0(Linux; Android 6.0; Nexus 5 Build/MRA58N) \

AppleWebKit/537.36(KHTML, like Gecko) Chrome/56.0.2924.87 Mobile Safari/537.36'

}

# 将headers头部添加到url,模拟浏览器访问

url = urllib.request.Request(url, headers=headers)

# 将url页面的源代码保存成字符串

page = urllib.request.urlopen(url).read()

# 字符串转码

page = page.decode('UTF-8')

return page

# 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

def getImage(page):

# [^\s]*? 表示最小匹配, 两个括号表示列表中有两个元组

# imageList = re.findall(r'(https:[^\s]*?(png))"', page)

imageList = re.findall(r'(https:[^\s]*?(jpg|png|gif))"', page)

x = 0

# 循环列表

for imageUrl in imageList:

try:

print('正在下载: %s' % imageUrl[0])

# 这个image文件夹需要先创建好才能看到结果

image_save_path = './image/%d.png' % x

# 下载图片并且保存到指定文件夹中

urllib.request.urlretrieve(imageUrl[0], image_save_path)

x = x + 1

except:

continue

pass

if __name__ == '__main__':

# 指定要爬取的网站

url = "https://www.cnblogs.com/ttweix ... ot%3B

# 得到该网站的源代码

page = getHtmlCode(url)

# 爬取该网站的图片并且保存

getImage(page)

# print(page)

注意代码中需要修改的是 imageList = re.findall(r'(https:[^\s]*?(jpg|png|gif))"', page) 这一段内容,怎么设计正则表达式需要根据设置你要爬取的内容,我的设计源码如下:

可以看到,因为这个网页的图片都是png格式,所以也可以写成imageList = re.findall(r'(https:[^\s]*?(png))"', page) .

(2)方法二:使用BeautifulSoup库解析html网页

from bs4 import BeautifulSoup # BeautifulSoup是python处理HTML/XML的函数库,是Python内置的网页分析工具

import urllib # python自带的爬操作url的库

# 该方法传入url,返回url的html的源代码

def getHtmlCode(url):

# 以下几行注释的代码在本程序中有加没加效果一样,但是为了隐藏自己避免被反爬虫可以假如这个伪装的头部请求

headers = {

'User-Agent': 'Mozilla/5.0(Linux; Android 6.0; Nexus 5 Build/MRA58N) \

AppleWebKit/537.36(KHTML, like Gecko) Chrome/56.0.2924.87 Mobile Safari/537.36'

}

# 将headers头部添加到url,模拟浏览器访问

url = urllib.request.Request(url, headers=headers)

# 将url页面的源代码保存成字符串

page = urllib.request.urlopen(url).read()

# 字符串转码

page = page.decode('UTF-8')

return page

# 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

def getImage(page):

# 按照html格式解析页面

soup = BeautifulSoup(page, 'html.parser')

# 格式化输出DOM树的内容

print(soup.prettify())

# 返回所有包含img标签的列表,因为在Html文件中图片的插入呈现形式是...

imgList = soup.find_all('img')

x = 0

# 循环找到的图片列表,注意,这里手动设置从第2张图片开始,是因为我debug看到了第一张图片不是我想要的图片

for imgUrl in imgList[1:]:

print('正在下载: %s ' % imgUrl.get('src'))

# 得到scr的内容,这里返回的就是Url字符串链接,如'https://img2020.cnblogs.com/blog/1703588/202007/1703588-20200716203143042-623499171.png'

image_url = imgUrl.get('src')

# 这个image文件夹需要先创建好才能看到结果

image_save_path = './image/%d.png' % x

# 下载图片并且保存到指定文件夹中

urllib.request.urlretrieve(image_url, image_save_path)

x = x + 1

if __name__ == '__main__':

# 指定要爬取的网站

url = 'https://www.cnblogs.com/ttweixiao-IT-program/p/13324826.html'

# 得到该网站的源代码

page = getHtmlCode(url)

# 爬取该网站的图片并且保存

getImage(page)

这两种方法各有优缺点。我认为它们可以灵活组合。比如先用方法二中的指定标签的方法来缩小你要查找的内容范围,然后再用正则表达式来匹配需要的内容。它更简洁明了。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持面圈教程。 查看全部

php网页抓取图片(想要爬取指定网页中的图片主要需要以下三个步骤介绍)

抓取指定网页中的图片主要需要以下三个步骤:

(1)指定网站链接,抓取网站的源码(如果你使用谷歌浏览器,按鼠标右键-> Inspect-> Elements中的html内容)

(2) 根据你要爬取的内容设置正则表达式匹配你要爬取的内容

(3)设置循环列表,反复抓取保存内容

下面介绍两种抓取指定网页图片的方法

(1)方法一:使用正则表达式过滤抓取到的html内容字符串

# 第一个简单的爬取图片的程序

import urllib.request # python自带的爬操作url的库

import re # 正则表达式

# 该方法传入url,返回url的html的源代码

def getHtmlCode(url):

# 以下几行注释的代码在本程序中有加没加效果一样,但是为了隐藏自己避免被反爬虫可以假如这个伪装的头部请求

headers = {

'User-Agent': 'Mozilla/5.0(Linux; Android 6.0; Nexus 5 Build/MRA58N) \

AppleWebKit/537.36(KHTML, like Gecko) Chrome/56.0.2924.87 Mobile Safari/537.36'

}

# 将headers头部添加到url,模拟浏览器访问

url = urllib.request.Request(url, headers=headers)

# 将url页面的源代码保存成字符串

page = urllib.request.urlopen(url).read()

# 字符串转码

page = page.decode('UTF-8')

return page

# 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

def getImage(page):

# [^\s]*? 表示最小匹配, 两个括号表示列表中有两个元组

# imageList = re.findall(r'(https:[^\s]*?(png))"', page)

imageList = re.findall(r'(https:[^\s]*?(jpg|png|gif))"', page)

x = 0

# 循环列表

for imageUrl in imageList:

try:

print('正在下载: %s' % imageUrl[0])

# 这个image文件夹需要先创建好才能看到结果

image_save_path = './image/%d.png' % x

# 下载图片并且保存到指定文件夹中

urllib.request.urlretrieve(imageUrl[0], image_save_path)

x = x + 1

except:

continue

pass

if __name__ == '__main__':

# 指定要爬取的网站

url = "https://www.cnblogs.com/ttweix ... ot%3B

# 得到该网站的源代码

page = getHtmlCode(url)

# 爬取该网站的图片并且保存

getImage(page)

# print(page)

注意代码中需要修改的是 imageList = re.findall(r'(https:[^\s]*?(jpg|png|gif))"', page) 这一段内容,怎么设计正则表达式需要根据设置你要爬取的内容,我的设计源码如下:

可以看到,因为这个网页的图片都是png格式,所以也可以写成imageList = re.findall(r'(https:[^\s]*?(png))"', page) .

(2)方法二:使用BeautifulSoup库解析html网页

from bs4 import BeautifulSoup # BeautifulSoup是python处理HTML/XML的函数库,是Python内置的网页分析工具

import urllib # python自带的爬操作url的库

# 该方法传入url,返回url的html的源代码

def getHtmlCode(url):

# 以下几行注释的代码在本程序中有加没加效果一样,但是为了隐藏自己避免被反爬虫可以假如这个伪装的头部请求

headers = {

'User-Agent': 'Mozilla/5.0(Linux; Android 6.0; Nexus 5 Build/MRA58N) \

AppleWebKit/537.36(KHTML, like Gecko) Chrome/56.0.2924.87 Mobile Safari/537.36'

}

# 将headers头部添加到url,模拟浏览器访问

url = urllib.request.Request(url, headers=headers)

# 将url页面的源代码保存成字符串

page = urllib.request.urlopen(url).read()

# 字符串转码

page = page.decode('UTF-8')

return page

# 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

def getImage(page):

# 按照html格式解析页面

soup = BeautifulSoup(page, 'html.parser')

# 格式化输出DOM树的内容

print(soup.prettify())

# 返回所有包含img标签的列表,因为在Html文件中图片的插入呈现形式是...

imgList = soup.find_all('img')

x = 0

# 循环找到的图片列表,注意,这里手动设置从第2张图片开始,是因为我debug看到了第一张图片不是我想要的图片

for imgUrl in imgList[1:]:

print('正在下载: %s ' % imgUrl.get('src'))

# 得到scr的内容,这里返回的就是Url字符串链接,如'https://img2020.cnblogs.com/blog/1703588/202007/1703588-20200716203143042-623499171.png'

image_url = imgUrl.get('src')

# 这个image文件夹需要先创建好才能看到结果

image_save_path = './image/%d.png' % x

# 下载图片并且保存到指定文件夹中

urllib.request.urlretrieve(image_url, image_save_path)

x = x + 1

if __name__ == '__main__':

# 指定要爬取的网站

url = 'https://www.cnblogs.com/ttweixiao-IT-program/p/13324826.html'

# 得到该网站的源代码

page = getHtmlCode(url)

# 爬取该网站的图片并且保存

getImage(page)

这两种方法各有优缺点。我认为它们可以灵活组合。比如先用方法二中的指定标签的方法来缩小你要查找的内容范围,然后再用正则表达式来匹配需要的内容。它更简洁明了。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持面圈教程。

php网页抓取图片(网站图片保存路径是什么?如何培养搜索引擎蜘蛛习惯?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-13 08:13

请特别注意这里。现在很多图片都有版权了。根本不要使用那些受版权保护的图片。否则,不仅会侵权,还会让搜索引擎降低对你的信任度网站。

二、网站图片保存路径

很多站长都没有注意到这个问题。当图片上传到网站时,尽量将图片保存在一个目录中。

或者根据网站栏制作相应的图片目录,上传时路径要相对固定,方便蜘蛛抓取。当蜘蛛访问这个目录时,它会“知道”图片存放在这个目录中;

最好使用一些常规或有意义的方法来命名图像文件。您可以使用时间、列名或网站 名称来命名。

例如:SEO优化 下图可以使用名称“SEOYH2018-6-23-36”,前面的“SEOYH”是SEO优化的简称,中间是时间,最后是图片ID。

你为什么这样做?

其实这是为了培养搜索引擎蜘蛛爬行的习惯,方便以后更快的识别网站图片内容。让蜘蛛抓住你的心,增加网站成为收录的机会,何乐而不为呢!

三、图片周围必须有相关文字

正如我在文章开头所说的,网站图片是一种直接向用户展示信息的方式,搜索引擎在抓取网站的内容时也会检测到这个文章@ >有没有图片、视频或表格等,

这些都是可以增加文章点值的元素。其他表格暂时不显示。这里我们只讲一下围绕图片的相关文字介绍。

图片符合主题

首先,图片周围的文字必须与图片本身的内容一致。比如你的文章说要做网站优化,里面的图片是一个菜谱的图片。不是卖狗肉的吗?

用户的访问感会极差。搜索引擎通过相关算法识别出这张图片后,也会觉得图片和文字不符,给你差评。

因此,每张文章必须至少附有一张对应的图片,并且与您的网站标题相关的内容应该出现在图片的周围。它不仅可以帮助搜索引擎理解图像,还可以增加文章的可读性、用户友好性和相关性。

四、给图片添加alt和title标签

很多站长在添加网站图片时可能没有注意这些细节,有的可能会觉得麻烦。我希望你没有这个想法。这是一个大错误。

搜索引擎抓取网站图片时,atl标签是最先抓取的,也是识别图片内容最重要的核心因素之一。图片的alt属性直接告诉搜索引擎它是什么网站图片,表达什么意思;

标题标签是用户指向这张图片时会显示的提示内容。这是增加用户体验和增加网站关键词的一个小技巧。

alt 和标题标签

还有这两个属性,将为有阅读障碍的游客提供便利。例如,当一个盲人访问您网站时,他看不到屏幕上的内容。这可能是通过屏幕阅读。如果有alt属性,软件会直接读取alt属性中的文字,方便他们访问。

五、图像大小和分辨率

两人虽然长得有点像,但还是有很大区别的。同样大小的图片分辨率越高,网站的最终体积就会越大。每个人都必须弄清楚这一点。

网站上的图片一直提倡用尽可能小的图片来最大化内容。为什么一定要这样?

因为小尺寸的图片加载速度会更快,不会让访问者等待太久,尤其是在使用手机时,由于手机上网速度和流量的限制,用户更愿意访问可以立即打开的页面。更具有优势。

这里我们尽量做到平衡,在画面不失真的情况下,尺寸最好尽量小。

网上有很多减肥图片的工具。你可以试试看。适当压缩网站的图片。一方面可以减轻你服务器带宽的压力,也可以给用户带来流畅的体验。.

六、自动适配手机

很多站长都遇到过网站在电脑上访问图片时,显示正常,但从手机端出现错位。这就是大尺寸图片在不同尺寸终端上造成错位、显示不完整的情况。.

图片自适应移动终端

其实这个问题很容易解决。添加图片时,宽度和高度最好不要使用绝对大小。使用百分比来解决它。

具体来说,CSS代码不能指定像素宽度:width: xxx px; 只有百分比宽度:宽度:xx%;或宽度:自动很好。

这样做的目的也是为了让百度的手机蜘蛛在抓取的时候有很好的体验,这也是为了更符合百度的手机登陆页面体验。

以上介绍了网站SEO优化如何抓取手机图片的一些技巧网站。其实本质是为了给用户更好的访问体验。

当你这样做网站时,我相信搜索引擎会偏爱你的网站。 查看全部

php网页抓取图片(网站图片保存路径是什么?如何培养搜索引擎蜘蛛习惯?)

请特别注意这里。现在很多图片都有版权了。根本不要使用那些受版权保护的图片。否则,不仅会侵权,还会让搜索引擎降低对你的信任度网站。

二、网站图片保存路径

很多站长都没有注意到这个问题。当图片上传到网站时,尽量将图片保存在一个目录中。

或者根据网站栏制作相应的图片目录,上传时路径要相对固定,方便蜘蛛抓取。当蜘蛛访问这个目录时,它会“知道”图片存放在这个目录中;

最好使用一些常规或有意义的方法来命名图像文件。您可以使用时间、列名或网站 名称来命名。

例如:SEO优化 下图可以使用名称“SEOYH2018-6-23-36”,前面的“SEOYH”是SEO优化的简称,中间是时间,最后是图片ID。

你为什么这样做?

其实这是为了培养搜索引擎蜘蛛爬行的习惯,方便以后更快的识别网站图片内容。让蜘蛛抓住你的心,增加网站成为收录的机会,何乐而不为呢!

三、图片周围必须有相关文字

正如我在文章开头所说的,网站图片是一种直接向用户展示信息的方式,搜索引擎在抓取网站的内容时也会检测到这个文章@ >有没有图片、视频或表格等,

这些都是可以增加文章点值的元素。其他表格暂时不显示。这里我们只讲一下围绕图片的相关文字介绍。

图片符合主题

首先,图片周围的文字必须与图片本身的内容一致。比如你的文章说要做网站优化,里面的图片是一个菜谱的图片。不是卖狗肉的吗?

用户的访问感会极差。搜索引擎通过相关算法识别出这张图片后,也会觉得图片和文字不符,给你差评。

因此,每张文章必须至少附有一张对应的图片,并且与您的网站标题相关的内容应该出现在图片的周围。它不仅可以帮助搜索引擎理解图像,还可以增加文章的可读性、用户友好性和相关性。

四、给图片添加alt和title标签

很多站长在添加网站图片时可能没有注意这些细节,有的可能会觉得麻烦。我希望你没有这个想法。这是一个大错误。

搜索引擎抓取网站图片时,atl标签是最先抓取的,也是识别图片内容最重要的核心因素之一。图片的alt属性直接告诉搜索引擎它是什么网站图片,表达什么意思;

标题标签是用户指向这张图片时会显示的提示内容。这是增加用户体验和增加网站关键词的一个小技巧。

alt 和标题标签

还有这两个属性,将为有阅读障碍的游客提供便利。例如,当一个盲人访问您网站时,他看不到屏幕上的内容。这可能是通过屏幕阅读。如果有alt属性,软件会直接读取alt属性中的文字,方便他们访问。

五、图像大小和分辨率

两人虽然长得有点像,但还是有很大区别的。同样大小的图片分辨率越高,网站的最终体积就会越大。每个人都必须弄清楚这一点。

网站上的图片一直提倡用尽可能小的图片来最大化内容。为什么一定要这样?

因为小尺寸的图片加载速度会更快,不会让访问者等待太久,尤其是在使用手机时,由于手机上网速度和流量的限制,用户更愿意访问可以立即打开的页面。更具有优势。

这里我们尽量做到平衡,在画面不失真的情况下,尺寸最好尽量小。

网上有很多减肥图片的工具。你可以试试看。适当压缩网站的图片。一方面可以减轻你服务器带宽的压力,也可以给用户带来流畅的体验。.

六、自动适配手机

很多站长都遇到过网站在电脑上访问图片时,显示正常,但从手机端出现错位。这就是大尺寸图片在不同尺寸终端上造成错位、显示不完整的情况。.

图片自适应移动终端

其实这个问题很容易解决。添加图片时,宽度和高度最好不要使用绝对大小。使用百分比来解决它。

具体来说,CSS代码不能指定像素宽度:width: xxx px; 只有百分比宽度:宽度:xx%;或宽度:自动很好。

这样做的目的也是为了让百度的手机蜘蛛在抓取的时候有很好的体验,这也是为了更符合百度的手机登陆页面体验。

以上介绍了网站SEO优化如何抓取手机图片的一些技巧网站。其实本质是为了给用户更好的访问体验。

当你这样做网站时,我相信搜索引擎会偏爱你的网站。

php网页抓取图片(我觉得我还是有一点发言权的.data)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-05 10:53

php网页抓取图片我觉得我还是有一点发言权的。我是用urllib2+php异步获取图片的。先拿到正则表达式,然后xpath+正则表达式。由于现在app图片资源爆炸,对于图片信息爬取没有特别的局限。

1、图片每个像素代表着图片一个原子。binaryreader便可以读取一个图片像素的信息,全部依赖于binaryreader类,本文中称其为bs4.data。可以对读取到的信息做多项测试,比如imageinfo信息,然后存入json模块。

这是本人经常用的方法,

1)每次读取完像素后会重新进行读取

2)难保图片原子不会被覆盖。最后说一下,bs4有一个判断原子,函数false的语法规则导致每次读取存在原子数量的参数,无法获取到最终整个图片原子。

2、用多进程+多线程,多线程做个lru缓存。然后可以并发去读取多个图片原子,比如若一个图片几十百十万张,每次读取最多存入若干个原子。这个比较适合爬取在线图片,读取原子从磁盘读取下来做lru缓存,每次都读取几十万张。这个方法对于增量比较慢的也是很好的方法,比如global-image-reader,因为机器操作,更多原子到磁盘的操作时间更长。

3、通过xpath+正则拿到图片的二维码。用xpath比如/(html)/img/src读取二维码。做一些加密处理。

一维码一般对应一行,二维码需要逐个读取下来,

1),xpath('//*[@id=""]/span[1]/a').group

1)),以此类推。 查看全部

php网页抓取图片(我觉得我还是有一点发言权的.data)

php网页抓取图片我觉得我还是有一点发言权的。我是用urllib2+php异步获取图片的。先拿到正则表达式,然后xpath+正则表达式。由于现在app图片资源爆炸,对于图片信息爬取没有特别的局限。

1、图片每个像素代表着图片一个原子。binaryreader便可以读取一个图片像素的信息,全部依赖于binaryreader类,本文中称其为bs4.data。可以对读取到的信息做多项测试,比如imageinfo信息,然后存入json模块。

这是本人经常用的方法,

1)每次读取完像素后会重新进行读取

2)难保图片原子不会被覆盖。最后说一下,bs4有一个判断原子,函数false的语法规则导致每次读取存在原子数量的参数,无法获取到最终整个图片原子。

2、用多进程+多线程,多线程做个lru缓存。然后可以并发去读取多个图片原子,比如若一个图片几十百十万张,每次读取最多存入若干个原子。这个比较适合爬取在线图片,读取原子从磁盘读取下来做lru缓存,每次都读取几十万张。这个方法对于增量比较慢的也是很好的方法,比如global-image-reader,因为机器操作,更多原子到磁盘的操作时间更长。

3、通过xpath+正则拿到图片的二维码。用xpath比如/(html)/img/src读取二维码。做一些加密处理。

一维码一般对应一行,二维码需要逐个读取下来,

1),xpath('//*[@id=""]/span[1]/a').group

1)),以此类推。

php网页抓取图片(要我说你们干嘛不用百度找的免费图片/take-a-photo-with-chrome)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-11-25 20:31

php网页抓取图片,可以尝试easy_image_register,你可以在网站抓取图片的时候使用,安全免费。

要我说你们干嘛不用百度找的免费图片/take-a-photo-with-chrome/8028590

自问自答!你们都在找免费高清图片或者免费图片集吗?网站图片源头,来自百度图片,

无他,全靠网站自己养。你在百度图片上搜索一张图片的标题,一般就能找到其所在的web服务器了,比如你搜索“chrome”,就会跳出来其所属的浏览器,而这个浏览器就是图片所在的服务器。在首页搜索图片出来的都是图片集合页,

精选收藏了各个应用商店的免费高清图片。大家可以试试。

百度图片,

推荐个网站:、此图片收集的网站有新浪微博还有这样的大型平台真的更佳

easy4pix,非常详细

动图还不少啊至于网站,这类问题,

百度

啊啊啊啊我的大胸啊!!!啊啊啊啊好喜欢啊!!!网上花都找不到的!!!算了编辑回答放以前网站吧?

微博上有个worldart可以看

pocosc

有很多,

onlinecoursesfromtopuniversities

mastercafe

首先,你要是没有域名的话。 查看全部

php网页抓取图片(要我说你们干嘛不用百度找的免费图片/take-a-photo-with-chrome)

php网页抓取图片,可以尝试easy_image_register,你可以在网站抓取图片的时候使用,安全免费。

要我说你们干嘛不用百度找的免费图片/take-a-photo-with-chrome/8028590

自问自答!你们都在找免费高清图片或者免费图片集吗?网站图片源头,来自百度图片,

无他,全靠网站自己养。你在百度图片上搜索一张图片的标题,一般就能找到其所在的web服务器了,比如你搜索“chrome”,就会跳出来其所属的浏览器,而这个浏览器就是图片所在的服务器。在首页搜索图片出来的都是图片集合页,

精选收藏了各个应用商店的免费高清图片。大家可以试试。

百度图片,

推荐个网站:、此图片收集的网站有新浪微博还有这样的大型平台真的更佳

easy4pix,非常详细

动图还不少啊至于网站,这类问题,

百度

啊啊啊啊我的大胸啊!!!啊啊啊啊好喜欢啊!!!网上花都找不到的!!!算了编辑回答放以前网站吧?

微博上有个worldart可以看

pocosc

有很多,

onlinecoursesfromtopuniversities

mastercafe

首先,你要是没有域名的话。

php网页抓取图片(PHP开发项目的时候有时需要读取文件下所有的图像内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-11-22 19:07

用PHP开发项目时,有时需要读取文件下的所有图片内容并显示在页面上。下面爱站技术频道编辑器为大家带来了网页中用于PHP开发的所有图片,这里将轻松为大家带来专业技能。

用PHP开发项目时,有时需要读取文件下的所有图片内容并显示在页面上。下面爱站技术频道编辑器为大家带来了网页中用于PHP开发的所有图片,这里将轻松为大家带来专业技能。

详情如下:

$images = array();

preg_match_all('/(img|src)=("|')[^"'>]+/i', $data, $media);

unset($data);

$data=preg_replace('/(img|src)("|'|="|=')(.*)/i',"$3",$media[0]);

foreach($data as $url)

{

$info = pathinfo($url);

if (isset($info['extension']))

{

if (($info['extension'] == 'jpg') ||

($info['extension'] == 'jpeg') ||

($info['extension'] == 'gif') ||

($info['extension'] == 'png'))

array_push($images, $url);

}

}

以上是爱站技术频道编辑对PHP开发的编译,获取网页中的所有图片。如果您还没有通过测试,请尽快参考。 查看全部

php网页抓取图片(PHP开发项目的时候有时需要读取文件下所有的图像内容)

用PHP开发项目时,有时需要读取文件下的所有图片内容并显示在页面上。下面爱站技术频道编辑器为大家带来了网页中用于PHP开发的所有图片,这里将轻松为大家带来专业技能。

用PHP开发项目时,有时需要读取文件下的所有图片内容并显示在页面上。下面爱站技术频道编辑器为大家带来了网页中用于PHP开发的所有图片,这里将轻松为大家带来专业技能。

详情如下:

$images = array();

preg_match_all('/(img|src)=("|')[^"'>]+/i', $data, $media);

unset($data);

$data=preg_replace('/(img|src)("|'|="|=')(.*)/i',"$3",$media[0]);

foreach($data as $url)

{

$info = pathinfo($url);

if (isset($info['extension']))

{

if (($info['extension'] == 'jpg') ||

($info['extension'] == 'jpeg') ||

($info['extension'] == 'gif') ||

($info['extension'] == 'png'))

array_push($images, $url);

}

}

以上是爱站技术频道编辑对PHP开发的编译,获取网页中的所有图片。如果您还没有通过测试,请尽快参考。

php网页抓取图片(介于你不是做专业的h5开发,只用这个平台其实是玩具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-11-20 10:03

php网页抓取图片下载json格式数据等等,都是开源的,你也可以买本书,学个两三天,差不多了。

这是我们公司已经用上几年的软件ciesystware

h5实现的原理,可以到网上找到很多资料。不过介于你不是做专业的h5开发,只用这个平台其实是玩具。重点说说可以用来做什么。

1、可以用来实现基于微信公众号的二维码功能。

2、可以开发类似交互效果,实现交互互动。

3、可以用来实现二维码可以加载更多商品信息(一站式购物)。

4、可以利用虚拟账号,实现第三方商城的入口。具体功能,还需要更深入地去发掘。可以关注我们的公众号“致更美好的自己”,上面经常有小程序、h5的开发分享。

不靠谱。首先介绍一下lowpoly开发,这是lowpoly所使用的affinity系列插件,属于3d插件。目前主流的3d都可以,特别是maya,c4d等建模软件。建议先学好3d渲染的基础,3dsu可以用。

可以在任何软件中看到的3d

flash就可以我一直认为ps里面那个3d模型特效在pp上怎么调都调不出来。

webvideoanimationonwebpev已经做成了一个网站,做精品网站就是靠这个,

webvideoanimation网站,页面展示是纯3d的,可以调用imageview,一次开发,可以实现split、virtualbox等多媒体支持,一般一个页面都需要5-10个imageview。 查看全部

php网页抓取图片(介于你不是做专业的h5开发,只用这个平台其实是玩具)

php网页抓取图片下载json格式数据等等,都是开源的,你也可以买本书,学个两三天,差不多了。

这是我们公司已经用上几年的软件ciesystware

h5实现的原理,可以到网上找到很多资料。不过介于你不是做专业的h5开发,只用这个平台其实是玩具。重点说说可以用来做什么。

1、可以用来实现基于微信公众号的二维码功能。

2、可以开发类似交互效果,实现交互互动。

3、可以用来实现二维码可以加载更多商品信息(一站式购物)。

4、可以利用虚拟账号,实现第三方商城的入口。具体功能,还需要更深入地去发掘。可以关注我们的公众号“致更美好的自己”,上面经常有小程序、h5的开发分享。

不靠谱。首先介绍一下lowpoly开发,这是lowpoly所使用的affinity系列插件,属于3d插件。目前主流的3d都可以,特别是maya,c4d等建模软件。建议先学好3d渲染的基础,3dsu可以用。

可以在任何软件中看到的3d

flash就可以我一直认为ps里面那个3d模型特效在pp上怎么调都调不出来。

webvideoanimationonwebpev已经做成了一个网站,做精品网站就是靠这个,

webvideoanimation网站,页面展示是纯3d的,可以调用imageview,一次开发,可以实现split、virtualbox等多媒体支持,一般一个页面都需要5-10个imageview。

php网页抓取图片(php网页抓取图片操作步骤-php代码实现post/get函数)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-11-13 07:08

php网页抓取图片操作步骤如下:php代码实现request请求。注意分清enctype和mime。然后将参数mime转换成post方式的格式,如json或者xml。php代码实现下载文件。把下载到的文件序列化为对象序列化。然后将对象序列化之后数据一同提交到php服务器。php代码实现爬虫。把提交到php服务器的数据推送给真正的爬虫。php代码实现encode/decode()函数。php代码实现post/get()函数。

我用了一个开源爬虫框架,不到1小时抓了6万+张图片。当然我抓包工具很烂,人家抓包能抓个0.5+的图片但我抓的是yp04版本的各种类型,用nodejs写的全是图片,没有jpg,png格式,所以我抓到的数据集不全是需要提取并转化的图片数据。数据集太大,导致我并没有计算机基础,啥都不懂,看他爬虫框架的样子很糙,是没人用的套路,全是一些数据库结构数据处理的东西,然后php那边对数据库结构和样式也不熟悉,导致编程全靠运气。

当时我在想如果要是自己写个爬虫框架,一定比他好很多,结果我写了半天,一个数据库查询语句都没有写完,好像很久也没有写完,毕竟速度上我抓1万+张图片不到一小时而已。这尼玛要是让计算机一小时爬1万+张图片,至少对计算机基础要求很高,我就去学了个一年级计算机课程,恶补了一小时,所以我不了解你的编程基础是什么,只能说你先解决抓100w张图片的问题,你可以学学nodejs的基础,或者java的javaweb那些。 查看全部

php网页抓取图片(php网页抓取图片操作步骤-php代码实现post/get函数)

php网页抓取图片操作步骤如下:php代码实现request请求。注意分清enctype和mime。然后将参数mime转换成post方式的格式,如json或者xml。php代码实现下载文件。把下载到的文件序列化为对象序列化。然后将对象序列化之后数据一同提交到php服务器。php代码实现爬虫。把提交到php服务器的数据推送给真正的爬虫。php代码实现encode/decode()函数。php代码实现post/get()函数。

我用了一个开源爬虫框架,不到1小时抓了6万+张图片。当然我抓包工具很烂,人家抓包能抓个0.5+的图片但我抓的是yp04版本的各种类型,用nodejs写的全是图片,没有jpg,png格式,所以我抓到的数据集不全是需要提取并转化的图片数据。数据集太大,导致我并没有计算机基础,啥都不懂,看他爬虫框架的样子很糙,是没人用的套路,全是一些数据库结构数据处理的东西,然后php那边对数据库结构和样式也不熟悉,导致编程全靠运气。

当时我在想如果要是自己写个爬虫框架,一定比他好很多,结果我写了半天,一个数据库查询语句都没有写完,好像很久也没有写完,毕竟速度上我抓1万+张图片不到一小时而已。这尼玛要是让计算机一小时爬1万+张图片,至少对计算机基础要求很高,我就去学了个一年级计算机课程,恶补了一小时,所以我不了解你的编程基础是什么,只能说你先解决抓100w张图片的问题,你可以学学nodejs的基础,或者java的javaweb那些。

php网页抓取图片(智能识别模式WebHarvy自动识别网页数据抓取工具的功能介绍(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-11-09 03:23

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。.

相关软件软件大小版本说明下载地址

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。

特征

智能识别模式

WebHarvy 自动识别出现在网页中的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

您可以以各种格式保存从网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

通常网页会在多个页面上显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

直观的操作界面

WebHarvy 是一个可视化的网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 webharvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

提取分类

WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 中生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

使用正则表达式提取

WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

软件特点

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvy Web Scraper 就会自动从所有页面中抓取数据。

更新日志

修复了页面启动时连接可能被禁用的问题

可以为页面模式配置专用的连接方式

可以自动搜索可以配置在HTML上的资源 查看全部

php网页抓取图片(智能识别模式WebHarvy自动识别网页数据抓取工具的功能介绍(组图))

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。.

相关软件软件大小版本说明下载地址

WebHarvy 是一个网页数据抓取工具。该软件可以从网页中提取文字和图片,并通过输入网址打开它们。默认情况下使用内部浏览器。支持扩展分析,自动获取相似链接列表。软件界面直观,操作简单。

特征

智能识别模式

WebHarvy 自动识别出现在网页中的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

您可以以各种格式保存从网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

通常网页会在多个页面上显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

直观的操作界面

WebHarvy 是一个可视化的网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 webharvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

提取分类

WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 中生成类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

使用正则表达式提取

WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

软件特点

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvy Web Scraper 就会自动从所有页面中抓取数据。

更新日志

修复了页面启动时连接可能被禁用的问题

可以为页面模式配置专用的连接方式

可以自动搜索可以配置在HTML上的资源

php网页抓取图片(php网页抓取图片与文本数据编码与传递phpxmlhttprequest资源获取与操作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-11-06 19:05

php网页抓取图片与文本数据php网页抓取图片与文本数据详细教程urllib网络数据库geohash编码与传递phpxmlhttprequest资源获取与操作php网页抓取图片与文本数据详细教程环境知识:用到的库:php版本:5。4php版本:5。4主机ip:10。108。110phpport:80网站vps:10。

10。19网站端phpmyadmin环境知识:用到的库:laravel是一个php框架,laravel1。4,phpmyadmin4。1。4,phpstorm,sublimetext,autocad其他:程序员常用的库:twitter,instagram,last。fm。教程1。准备网站的一些静态页面:php的urllib2网络数据库:laravel提供的3个db:laravel-laravel-mavenphp的关于db的path用于查找和获取相关数据准备数据的:'example。

php''/assets/hello。php'准备图片和文本数据:'example。php''/assets/tianliang/color。php'准备网页链接:""'example。php''/assets/tianliang/images。php'2。通过exists属性寻找相关数据:通过exists()列举出的是当前页面的所有元素,没有找到元素则获取class属性来搜索元素#用逗号隔开/,"images"/。

php//获取元素的select语句代码if(!exists("images"))exists("images/images/");exists("images/");exists("/images/");exists("/");exists("/");exists("/");exists("/");exists("/");#用于获取元素varurl="/"while(url){laravel-laravel-mavenpublicurl/***/***///获取元素的select语句代码/***/req。

assertall(url=="");//获取元素的last。fmt";"";//获取元素的最后一次varresult=url。last;exists(result);exists(result);}3。寻找全部数据:while语句代码select("tianliang/","status","http/1。

1host:",true);|"/"|"/status"|//获取元素的select语句代码/***/vartianliang=url。select("");|"status"|//获取元素的select语句代码*|/***/url。select("");|"/"|"/status"|//获取元素的select语句代码*|/***/url。

select("");|"/"|"/status"|//获取元素的select语句代码*|/***/url。select("");|"/"|"/status"|//获取元素的select语句代码*/except("uncaughtreferenceerror:。 查看全部

php网页抓取图片(php网页抓取图片与文本数据编码与传递phpxmlhttprequest资源获取与操作)

php网页抓取图片与文本数据php网页抓取图片与文本数据详细教程urllib网络数据库geohash编码与传递phpxmlhttprequest资源获取与操作php网页抓取图片与文本数据详细教程环境知识:用到的库:php版本:5。4php版本:5。4主机ip:10。108。110phpport:80网站vps:10。

10。19网站端phpmyadmin环境知识:用到的库:laravel是一个php框架,laravel1。4,phpmyadmin4。1。4,phpstorm,sublimetext,autocad其他:程序员常用的库:twitter,instagram,last。fm。教程1。准备网站的一些静态页面:php的urllib2网络数据库:laravel提供的3个db:laravel-laravel-mavenphp的关于db的path用于查找和获取相关数据准备数据的:'example。

php''/assets/hello。php'准备图片和文本数据:'example。php''/assets/tianliang/color。php'准备网页链接:""'example。php''/assets/tianliang/images。php'2。通过exists属性寻找相关数据:通过exists()列举出的是当前页面的所有元素,没有找到元素则获取class属性来搜索元素#用逗号隔开/,"images"/。

php//获取元素的select语句代码if(!exists("images"))exists("images/images/");exists("images/");exists("/images/");exists("/");exists("/");exists("/");exists("/");exists("/");#用于获取元素varurl="/"while(url){laravel-laravel-mavenpublicurl/***/***///获取元素的select语句代码/***/req。

assertall(url=="");//获取元素的last。fmt";"";//获取元素的最后一次varresult=url。last;exists(result);exists(result);}3。寻找全部数据:while语句代码select("tianliang/","status","http/1。

1host:",true);|"/"|"/status"|//获取元素的select语句代码/***/vartianliang=url。select("");|"status"|//获取元素的select语句代码*|/***/url。select("");|"/"|"/status"|//获取元素的select语句代码*|/***/url。

select("");|"/"|"/status"|//获取元素的select语句代码*|/***/url。select("");|"/"|"/status"|//获取元素的select语句代码*/except("uncaughtreferenceerror:。

php网页抓取图片(php网页抓取图片等数据,1)利用phpselenium进行网页中的下载操作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-11-05 12:02

php网页抓取图片等数据,

1)利用php的selenium进行网页中的点击操作。

2)利用phpselenium进行网页中的下载操作。

3)利用phpselenium进行网页中的录屏操作。1.抓取图片selenium无法抓取网页,通过python模拟点击,可以进行抓取。

具体代码如下:代码上的注释:img_list=[]#爬取图片序列selector=selenium。webdriver。chromeos(executable_path="c:\\windows\\hosts\\chromedriver。exe")#操作浏览器selector。add_handler("get_image",img_list)#设置请求方式selector。

find_element_by_xpath("//*[@id="img_list"]///*?/@href")#设置设置代码步骤。

2)利用phpselenium进行网页中的下载操作:利用phpselenium进行网页中的下载操作如图所示:注释:phpselenium允许先通过selenium-inspector进行登录,进行抓取操作。ghost_url_name.php文件即phpselenium中利用post方法接收下载请求数据和url信息的文件。

file_image=ghost_url_name.file.post("data:image/jpg,320px,480dp;bold:42px;")#获取下载列表file_image.read_html("resources/image.html")#获取下载数据file_image.send_keys("")#发送请求file_image.save("file_image")#保存图片所有信息file_image.load_file_images("file_image")#读取文件file_image.json("jpg")#将图片转换为数组(jpg,png,gif,psd,img等格式)file_image.save_file_images("jpg")#保存图片所有信息file_image.to_json("jpg")#读取所有文件file_image.save_file_images("jpg")#保存图片所有信息下面示例中的data=file_image.read_json("file_image")#保存文件file_image.json("jpg")#保存图片所有信息2.抓取html语言中常用xpath规则:抓取图片注释:xpath="//a[@class="img-data"]//ul[1]/li[2]/a/a/text()"获取图片中data:上两种示例中的xpath语句语法如下:data=xpath('//div[@class="img-data"]/a/a/text()')#获取图片data.replace("","\t").replace("","")#将data置换为""img_data=xpath('//a[@class="img-data"]/text()')#获取图片data.replace。 查看全部

php网页抓取图片(php网页抓取图片等数据,1)利用phpselenium进行网页中的下载操作)

php网页抓取图片等数据,

1)利用php的selenium进行网页中的点击操作。

2)利用phpselenium进行网页中的下载操作。

3)利用phpselenium进行网页中的录屏操作。1.抓取图片selenium无法抓取网页,通过python模拟点击,可以进行抓取。

具体代码如下:代码上的注释:img_list=[]#爬取图片序列selector=selenium。webdriver。chromeos(executable_path="c:\\windows\\hosts\\chromedriver。exe")#操作浏览器selector。add_handler("get_image",img_list)#设置请求方式selector。

find_element_by_xpath("//*[@id="img_list"]///*?/@href")#设置设置代码步骤。

2)利用phpselenium进行网页中的下载操作:利用phpselenium进行网页中的下载操作如图所示:注释:phpselenium允许先通过selenium-inspector进行登录,进行抓取操作。ghost_url_name.php文件即phpselenium中利用post方法接收下载请求数据和url信息的文件。

file_image=ghost_url_name.file.post("data:image/jpg,320px,480dp;bold:42px;")#获取下载列表file_image.read_html("resources/image.html")#获取下载数据file_image.send_keys("")#发送请求file_image.save("file_image")#保存图片所有信息file_image.load_file_images("file_image")#读取文件file_image.json("jpg")#将图片转换为数组(jpg,png,gif,psd,img等格式)file_image.save_file_images("jpg")#保存图片所有信息file_image.to_json("jpg")#读取所有文件file_image.save_file_images("jpg")#保存图片所有信息下面示例中的data=file_image.read_json("file_image")#保存文件file_image.json("jpg")#保存图片所有信息2.抓取html语言中常用xpath规则:抓取图片注释:xpath="//a[@class="img-data"]//ul[1]/li[2]/a/a/text()"获取图片中data:上两种示例中的xpath语句语法如下:data=xpath('//div[@class="img-data"]/a/a/text()')#获取图片data.replace("","\t").replace("","")#将data置换为""img_data=xpath('//a[@class="img-data"]/text()')#获取图片data.replace。

php网页抓取图片( 我在linux上的安装过程,如果没有安装git请先yuminstallgit)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-11-04 09:04

我在linux上的安装过程,如果没有安装git请先yuminstallgit)

基于linnux+phantomjs实现图片格式网页快照的生成

安装扩展:

(1)以下是我在linux上的安装过程,如果没有安装git请先yum install git

安装 casperjs

复制代码代码如下:

光盘 /

git 克隆 git:///n1k0/casperjs.git

cd casperjs

ln -sf /casperjs/bin/casperjs /usr/local/bin/casperjs //可以忽略php的实际执行是/casperjs/bin/casperjs

(2)安装phantomjs,下载链接:

下载后的操作很简单,直接将解压后的\bin\phantomjs移动到\usr\local\bin\phantomjs即可。\

测试phantomjs --version 结果没有错误,说明安装OK

(3)安装字体

1. 首先获取一套“微软雅黑”字体库(谷歌很多),包括两个文件msyh.ttf(普通)和msyhbd.ttf(粗体);

2. 在/usr/share/fonts目录下创建子目录,如win,命令如下:

复制代码代码如下:

# mkdir /usr/share/fonts/win

3. 将msyh.ttf和msyhbd.ttf复制到这个目录下,比如把这两个文件放在/root/Desktop下,使用命令:

复制代码代码如下:

# cd /root/桌面

#cp msyh.ttf msyhbd.ttf /usr/share/fonts/win/

4. 创建字体索引信息并更新字体缓存:

复制代码代码如下:

# cd /usr/share/fonts/win

# mkfontscale (如果提示mkfontscale: command not found,需要自己安装#yum install mkfontscale)

# mkfontdir

# fc-cache (如果提示fc-cache: command not found,则需要安装#yum install fontconfig)

至此,字体已经安装完毕!

快照生成

* {margin: 0; padding: 0; } form {padding: 20px; } div {margin: 20px 0 0; } input {width: 200px; padding: 4px 2px; } #placeholder {display: none; }

生成快照

$(function(){

$('#form').submit(function(){

if (typeof($(this).data('generate')) !== 'undefined' && $(this).data('generate') === true)

{

alert('正在生成网站快照,请耐心等待...');

return false;

}

$(this).data('generate', true);

$('button').text('正在生成快照...').attr('disabled', true);

$.ajax({

type: 'GET',

url: '?',

data: 'url=' + $('#url').val(),

success: function(data){

$('#placeholder').attr('src', data).show();

$('#form').data('generate', false);

$('button').text('生成快照').attr('disabled', false);

}

});

return false;

});

});

var page = require('webpage').create();

var args = require('system').args;

var url = args[1];

var filename = args[2];

page.open(url, function () {

page.render(filename);

phantom.exit();

});

以上就是本文的全部内容,希望大家喜欢。

时间:2015-04-12

Nodejs通过phantomjs实现下载网页

功能其实很简单。通过phantomjs.exe 采集 url加载的资源,通过子进程的方法,启动nodejs加载所有资源,对于css资源,匹配css内容,下载里面的url资源,当然功能还是很简单,在响应式设计和异步加载的情况下,仍然有很多资源无法下载。需要根据实际情况进行处理。首先当然是下载nodejs和phantomjs。下面是phantomjs.exe执行的down.js var page = require('webpage').create(), system

PhantomJS 快速入门教程(服务器端 JavaScript API WebKit)

PhantomJS 是一个基于 WebKit 的服务器端 JavaScript API。它完全支持网络,无需浏览器支持。它速度快,并且本机支持各种 Web 标准:DOM 处理、CSS 选择器、JSON、Canvas 和 SVG。PhantomJS 可用于页面自动化、网络监控、网页截图、无界面测试等。 PhantomJs 官网:GitHub:

使用phantomjs进行网页爬虫的实现代码

因为phantomjs是一个可以跑js的headless浏览器,所以也可以跑dom节点,非常适合网页爬虫。比如我们要批量抓取网页“历史上的今天”的内容。网站 观察dom结构发现我们只需要获取.list li的title值即可。所以我们使用高级选择器来构建dom片段 var d ='' var c = document.querySelectorAll('.list li a' ) var l = c.length; for(var i = 0;i

Python实现基于phantomjs导入图片

基于phantomjs的自动化,会出现1.flash not supported2. 一些基于view的按钮无法点击,有的按钮是基于flash的(尤其是上传按钮) browser.find_element_by_xpath(" ./ /*[@name='SWFUpload_0']").click() #点击上传按钮 sleep(2) autoit.control_set_text("", "[CLASS:Edit; INSTANCE:1]",tupian ) #上传

使用NodeJS和PhantomJS抓取网站页面信息和网站截图

使用 PhantomJS 对网页进行截图既经济又适用,但 API 较少,做其他功能比较困难。例如,其内置的 Web Server Mongoose 最多只能同时支持 10 个请求。期望它独立成为一项服务并不过分实际。所以这里需要另外一种语言来支持服务,这里我们选择NodeJS来完成。安装 PhantomJS 首先到 PhantomJS 官网下载对应平台的版本,或者下载源码自己编译。然后将 PhantomJS 配置成环境变量,输入 $ phantomjs 如果有响应,那么就可以进行下一步了。使用 PhantomJS 来简化

Phantomjs 渲染JS后抓取网页(Python代码)

最近需要爬取某个网站,但是页面都是JS渲染后生成的。普通的爬虫框架处理不了,于是想到用Phantomjs做代理。Python调用Phantomjs好像没有现成的第三方库(如果有的话请告知),逛了一圈发现只有pyspider提供了现成的解决方案。经过简单的试用,感觉pyspider更像是新手的爬虫工具,像老妈一样,时而一丝不苟,时而喋喋不休。轻小工具应该更受欢迎。我也有一点自私。不用学习PyQuery就可以带上我最喜欢的BeautifulSoup使用它(pyspide

python+selenium+PhantomJS 抓取网页动态加载内容

环境设置准备工具:pyton3.5,selenium,phantomjs,我电脑已经安装python3.5 install Selenium pip3 install selenium install Phantomjs 根据系统环境下载phantomjs,下载完成后,安装phantomjs 将.exe解压到python脚本文件夹,使用selenium+phantomjs实现一个简单的爬虫 from selenium import webdriver driver = webdriver.PhantomJS

Python请求抢一推文字图片代码示例

本文文章主要介绍python请求一推文图片代码示例。文章中介绍的示例代码非常详细。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考requests是Python中的第三方库,基于urllib,使用Apache2 Licensed开源协议的HTTP库。它比 urllib 更方便,可以为我们节省很多工作,完全满足 HTTP 测试需求。接下来记录一下requests的使用: from bs4 import BeautifulSoup f

Node.JS 使用 PhantomJs 抓取网页入门教程

前言当我想用nodejs抓取一些网页的时候,首先想到的就是使用http模块,比如抓取百度主页: var http = require('http'); var req = http.request('', function (res ) {res.setEncoding('utf8'); res.on('data', function (chunk) {//响应内容 console.log(chunk) }); }); 请求结束(

C# 使用 Selenium+ PhantomJS 抓取数据

手头的项目需要在一个用js渲染的网站中抓取数据。使用常用的httpclient 抓取的页面没有数据。我在百度上上网,推荐的方案是使用PhantomJS。PhantomJS 是一个无接口的 Selenium 是一个 Web 测试框架。使用 Selenium 来操作 PhantomJS 是绝配。但是网上的例子大多是Python。我别无选择,只能下载 python 并按照教程进行操作。有一次,我陷入了 Selenium 的导入问题。我放弃了,我还是用我惯用的c#,我不相信c#上没有

Python爬虫使用Selenium+ PhantomJS抓取Ajax和动态HTML内容

1. 介绍在Python网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第一部分第二部分,第一部分是使用xslt一次性提取静态网页内容并转换成xml格式的实验。它留下了一个问题:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。2.提取动态内容的技术成分。上一篇Python使用xslt提取网页数据,提取的内容直接从网页源码中获取。但是有些阿雅

Scrapy抢京东产品、豆瓣电影和代码分享

1.scrapy Scrapy 的基本理解是一个应用框架,用于爬取网站数据并提取结构化数据。它可用于包括数据挖掘、信息处理或存储历史数据在内的一系列程序。它最初是为页面抓取(更准确地说,网络抓取)而设计的,也可以用于获取 API(如 Web 服务)或一般网络爬虫返回的数据。Scrapy 还可以帮你实现高层次的爬虫框架,比如爬取时的网站认证。内容分析和处理。反复爬行。分布式爬取。Scrapy主要包括以下几个组件: 引擎(Scrapy):用来处理整个系统的数据流

使用php方法curl抓取AJAX异步内容思维分析及代码分享

其实抓取ajax异步内容页面和抓取普通页面没有太大区别。Ajax 只是一个异步 http 请求。只需使用类似于firebug的工具,找到请求的后端服务url和value的参数,然后通过传递参数正确的url就可以抓到了。如果用Firebug的web工具抓取页面,内容中没有显示数据,就是一堆JS代码。代码 $cookie_file=tempnam('./temp','cookie '); $ch = curl_init(); $url1 = "

php抓图保存网站图片实现代码

本程序实现网页源代码抓取、图片链接获取、分析、同图链接合并功能,实现图片抓取功能。利用PHP强大的网络内容处理功能,去除所有指定的网站图片,并保存在当前目录。以下是代码: 查看全部

php网页抓取图片(

我在linux上的安装过程,如果没有安装git请先yuminstallgit)

基于linnux+phantomjs实现图片格式网页快照的生成

安装扩展:

(1)以下是我在linux上的安装过程,如果没有安装git请先yum install git

安装 casperjs

复制代码代码如下:

光盘 /

git 克隆 git:///n1k0/casperjs.git

cd casperjs

ln -sf /casperjs/bin/casperjs /usr/local/bin/casperjs //可以忽略php的实际执行是/casperjs/bin/casperjs

(2)安装phantomjs,下载链接:

下载后的操作很简单,直接将解压后的\bin\phantomjs移动到\usr\local\bin\phantomjs即可。\

测试phantomjs --version 结果没有错误,说明安装OK

(3)安装字体

1. 首先获取一套“微软雅黑”字体库(谷歌很多),包括两个文件msyh.ttf(普通)和msyhbd.ttf(粗体);

2. 在/usr/share/fonts目录下创建子目录,如win,命令如下:

复制代码代码如下:

# mkdir /usr/share/fonts/win

3. 将msyh.ttf和msyhbd.ttf复制到这个目录下,比如把这两个文件放在/root/Desktop下,使用命令:

复制代码代码如下:

# cd /root/桌面

#cp msyh.ttf msyhbd.ttf /usr/share/fonts/win/

4. 创建字体索引信息并更新字体缓存:

复制代码代码如下:

# cd /usr/share/fonts/win

# mkfontscale (如果提示mkfontscale: command not found,需要自己安装#yum install mkfontscale)

# mkfontdir

# fc-cache (如果提示fc-cache: command not found,则需要安装#yum install fontconfig)

至此,字体已经安装完毕!

快照生成

* {margin: 0; padding: 0; } form {padding: 20px; } div {margin: 20px 0 0; } input {width: 200px; padding: 4px 2px; } #placeholder {display: none; }

生成快照

$(function(){

$('#form').submit(function(){

if (typeof($(this).data('generate')) !== 'undefined' && $(this).data('generate') === true)

{

alert('正在生成网站快照,请耐心等待...');

return false;

}

$(this).data('generate', true);

$('button').text('正在生成快照...').attr('disabled', true);

$.ajax({

type: 'GET',

url: '?',

data: 'url=' + $('#url').val(),

success: function(data){

$('#placeholder').attr('src', data).show();

$('#form').data('generate', false);

$('button').text('生成快照').attr('disabled', false);

}

});

return false;

});

});

var page = require('webpage').create();

var args = require('system').args;

var url = args[1];

var filename = args[2];

page.open(url, function () {

page.render(filename);

phantom.exit();

});

以上就是本文的全部内容,希望大家喜欢。

时间:2015-04-12

Nodejs通过phantomjs实现下载网页

功能其实很简单。通过phantomjs.exe 采集 url加载的资源,通过子进程的方法,启动nodejs加载所有资源,对于css资源,匹配css内容,下载里面的url资源,当然功能还是很简单,在响应式设计和异步加载的情况下,仍然有很多资源无法下载。需要根据实际情况进行处理。首先当然是下载nodejs和phantomjs。下面是phantomjs.exe执行的down.js var page = require('webpage').create(), system

PhantomJS 快速入门教程(服务器端 JavaScript API WebKit)

PhantomJS 是一个基于 WebKit 的服务器端 JavaScript API。它完全支持网络,无需浏览器支持。它速度快,并且本机支持各种 Web 标准:DOM 处理、CSS 选择器、JSON、Canvas 和 SVG。PhantomJS 可用于页面自动化、网络监控、网页截图、无界面测试等。 PhantomJs 官网:GitHub:

使用phantomjs进行网页爬虫的实现代码

因为phantomjs是一个可以跑js的headless浏览器,所以也可以跑dom节点,非常适合网页爬虫。比如我们要批量抓取网页“历史上的今天”的内容。网站 观察dom结构发现我们只需要获取.list li的title值即可。所以我们使用高级选择器来构建dom片段 var d ='' var c = document.querySelectorAll('.list li a' ) var l = c.length; for(var i = 0;i

Python实现基于phantomjs导入图片

基于phantomjs的自动化,会出现1.flash not supported2. 一些基于view的按钮无法点击,有的按钮是基于flash的(尤其是上传按钮) browser.find_element_by_xpath(" ./ /*[@name='SWFUpload_0']").click() #点击上传按钮 sleep(2) autoit.control_set_text("", "[CLASS:Edit; INSTANCE:1]",tupian ) #上传

使用NodeJS和PhantomJS抓取网站页面信息和网站截图

使用 PhantomJS 对网页进行截图既经济又适用,但 API 较少,做其他功能比较困难。例如,其内置的 Web Server Mongoose 最多只能同时支持 10 个请求。期望它独立成为一项服务并不过分实际。所以这里需要另外一种语言来支持服务,这里我们选择NodeJS来完成。安装 PhantomJS 首先到 PhantomJS 官网下载对应平台的版本,或者下载源码自己编译。然后将 PhantomJS 配置成环境变量,输入 $ phantomjs 如果有响应,那么就可以进行下一步了。使用 PhantomJS 来简化

Phantomjs 渲染JS后抓取网页(Python代码)

最近需要爬取某个网站,但是页面都是JS渲染后生成的。普通的爬虫框架处理不了,于是想到用Phantomjs做代理。Python调用Phantomjs好像没有现成的第三方库(如果有的话请告知),逛了一圈发现只有pyspider提供了现成的解决方案。经过简单的试用,感觉pyspider更像是新手的爬虫工具,像老妈一样,时而一丝不苟,时而喋喋不休。轻小工具应该更受欢迎。我也有一点自私。不用学习PyQuery就可以带上我最喜欢的BeautifulSoup使用它(pyspide

python+selenium+PhantomJS 抓取网页动态加载内容

环境设置准备工具:pyton3.5,selenium,phantomjs,我电脑已经安装python3.5 install Selenium pip3 install selenium install Phantomjs 根据系统环境下载phantomjs,下载完成后,安装phantomjs 将.exe解压到python脚本文件夹,使用selenium+phantomjs实现一个简单的爬虫 from selenium import webdriver driver = webdriver.PhantomJS

Python请求抢一推文字图片代码示例

本文文章主要介绍python请求一推文图片代码示例。文章中介绍的示例代码非常详细。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考requests是Python中的第三方库,基于urllib,使用Apache2 Licensed开源协议的HTTP库。它比 urllib 更方便,可以为我们节省很多工作,完全满足 HTTP 测试需求。接下来记录一下requests的使用: from bs4 import BeautifulSoup f

Node.JS 使用 PhantomJs 抓取网页入门教程

前言当我想用nodejs抓取一些网页的时候,首先想到的就是使用http模块,比如抓取百度主页: var http = require('http'); var req = http.request('', function (res ) {res.setEncoding('utf8'); res.on('data', function (chunk) {//响应内容 console.log(chunk) }); }); 请求结束(

C# 使用 Selenium+ PhantomJS 抓取数据

手头的项目需要在一个用js渲染的网站中抓取数据。使用常用的httpclient 抓取的页面没有数据。我在百度上上网,推荐的方案是使用PhantomJS。PhantomJS 是一个无接口的 Selenium 是一个 Web 测试框架。使用 Selenium 来操作 PhantomJS 是绝配。但是网上的例子大多是Python。我别无选择,只能下载 python 并按照教程进行操作。有一次,我陷入了 Selenium 的导入问题。我放弃了,我还是用我惯用的c#,我不相信c#上没有

Python爬虫使用Selenium+ PhantomJS抓取Ajax和动态HTML内容

1. 介绍在Python网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第一部分第二部分,第一部分是使用xslt一次性提取静态网页内容并转换成xml格式的实验。它留下了一个问题:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。2.提取动态内容的技术成分。上一篇Python使用xslt提取网页数据,提取的内容直接从网页源码中获取。但是有些阿雅

Scrapy抢京东产品、豆瓣电影和代码分享

1.scrapy Scrapy 的基本理解是一个应用框架,用于爬取网站数据并提取结构化数据。它可用于包括数据挖掘、信息处理或存储历史数据在内的一系列程序。它最初是为页面抓取(更准确地说,网络抓取)而设计的,也可以用于获取 API(如 Web 服务)或一般网络爬虫返回的数据。Scrapy 还可以帮你实现高层次的爬虫框架,比如爬取时的网站认证。内容分析和处理。反复爬行。分布式爬取。Scrapy主要包括以下几个组件: 引擎(Scrapy):用来处理整个系统的数据流

使用php方法curl抓取AJAX异步内容思维分析及代码分享

其实抓取ajax异步内容页面和抓取普通页面没有太大区别。Ajax 只是一个异步 http 请求。只需使用类似于firebug的工具,找到请求的后端服务url和value的参数,然后通过传递参数正确的url就可以抓到了。如果用Firebug的web工具抓取页面,内容中没有显示数据,就是一堆JS代码。代码 $cookie_file=tempnam('./temp','cookie '); $ch = curl_init(); $url1 = "

php抓图保存网站图片实现代码

本程序实现网页源代码抓取、图片链接获取、分析、同图链接合并功能,实现图片抓取功能。利用PHP强大的网络内容处理功能,去除所有指定的网站图片,并保存在当前目录。以下是代码:

php网页抓取图片(php网页抓取图片识别识别二维码图片,水印去除-黄涛_黄涛)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-10-24 13:09

php网页抓取图片识别识别二维码图片,水印去除-黄涛_黄涛一个在github上写了300+star的博客程序猿,英文基础不错话javascript也会一点,那就来bing一下一般搜一下图片,几乎都有图片识别框,但是有一次有个人复制了一堆水印,完全是歪的,这个搜索结果太牛逼了,最后能识别成功,图片太大,无法一张张地去识别,所以我的解决方案就是先把那些图片下载下来,通过正则表达式等方法去掉水印,然后再对识别出来的正则数组查询水印所在的位置,这个只能一张张去验证,不然就出问题了我之前尝试过,想在识别出来的正则框里增加一些功能把水印分隔开比如在单元格里增加英文去识别,被识别出来的水印要复制到一个新的正则框里去查询。

1、引入ssh,注意ssh名要加点括号(),不然会报错,例如:$(pwd).echo"exposetossh-rsaaddress';\n//';';//'-rsa是身份验证方式,

2、找到session里的数据,

3、删除文件://防止水印不显示,

4、修改路径:cp../../test.csv

5、修改文件扩展名,

6、将路径中的所有路径路径保存并重命名为/test.csv

7、如果正则表达式匹配不上,那就是水印问题,去除所有字符,或者识别水印,如果正则表达式都匹配得上的话,

8、推荐神器:看图软件,dupap/或者bingwiz(优采云看图神器),速度比ps稍慢,但是能免费看更多的图片(图片质量看你视力如何)。 查看全部

php网页抓取图片(php网页抓取图片识别识别二维码图片,水印去除-黄涛_黄涛)

php网页抓取图片识别识别二维码图片,水印去除-黄涛_黄涛一个在github上写了300+star的博客程序猿,英文基础不错话javascript也会一点,那就来bing一下一般搜一下图片,几乎都有图片识别框,但是有一次有个人复制了一堆水印,完全是歪的,这个搜索结果太牛逼了,最后能识别成功,图片太大,无法一张张地去识别,所以我的解决方案就是先把那些图片下载下来,通过正则表达式等方法去掉水印,然后再对识别出来的正则数组查询水印所在的位置,这个只能一张张去验证,不然就出问题了我之前尝试过,想在识别出来的正则框里增加一些功能把水印分隔开比如在单元格里增加英文去识别,被识别出来的水印要复制到一个新的正则框里去查询。

1、引入ssh,注意ssh名要加点括号(),不然会报错,例如:$(pwd).echo"exposetossh-rsaaddress';\n//';';//'-rsa是身份验证方式,

2、找到session里的数据,

3、删除文件://防止水印不显示,

4、修改路径:cp../../test.csv

5、修改文件扩展名,

6、将路径中的所有路径路径保存并重命名为/test.csv

7、如果正则表达式匹配不上,那就是水印问题,去除所有字符,或者识别水印,如果正则表达式都匹配得上的话,

8、推荐神器:看图软件,dupap/或者bingwiz(优采云看图神器),速度比ps稍慢,但是能免费看更多的图片(图片质量看你视力如何)。

php网页抓取图片(php网页抓取图片(pc,,app)(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-10-16 19:01

php网页抓取图片(pc,iphone,android,app)我直接的工作电脑是macbook,thinkpadx1carbon,其它电脑用过mbpx1。首先,准备pcre大文件。我已经基本掌握了这个东西,所以也不需要费力写那么多pcre源码。总之,什么xampp这种东西非常强大,推荐学习。具体看看这个网站。

你会对pcre有一个大概的了解,对以后的工作也有好处。除此之外,我认为大规模网页抓取,大部分人可能关心的技术是这个爬虫技术。比如,豆瓣这种,通过爬虫去抓取豆瓣里面你感兴趣的东西。对于其它类型的网站,我认为很难有大规模的爬虫去抓取你想要的东西。除非你是英语特别好,而且非常的熟悉http协议。像雅虎这样的搜索引擎,对网页的要求特别高,有url规则限制,所以只能自己写爬虫来爬虫url地址。

如果你确定自己真的很了解http协议,那么pcre就可以忽略不计了。pcre协议,主要关注php代码输出的xml对象字符串的显示。php代码输出的xml文件如果返回指定的true,则会通过pcre映射到httpheader返回,不返回指定的true,则通过pcre对象自己关联true。我在实际工作中也碰到过不能通过pcre抓取xml字符串,又放在php脚本中运行结果为指定值的xml文件。

这样是不好的。因为我认为解析xml字符串解析得再好,也不如知道pcre解析方法来得更高效。pcre的兼容性问题,同样非常紧张。php5之前的版本里面,不支持多页爬取,而不支持本地调试。php5以后,tcp/ip和http都支持。很可惜,我要换一下脑子了。这个显然是当今社会发展的瓶颈。如果这个瓶颈没有解决,单纯做网页抓取是没有多大意义的。

所以我准备把pcre弄熟悉后,会考虑更高的编程技术。实际上目前的互联网环境是科技界提供了便利的条件,抓取爬虫技术已经不再是瓶颈。解决这个问题只需要再加点学习。把抓取的网页通过正则表达式匹配xml文件的匹配值。然后把网页发送到服务器,服务器端通过抓取的xmlxml字符串来反爬取这个网页。 查看全部

php网页抓取图片(php网页抓取图片(pc,,app)(图))

php网页抓取图片(pc,iphone,android,app)我直接的工作电脑是macbook,thinkpadx1carbon,其它电脑用过mbpx1。首先,准备pcre大文件。我已经基本掌握了这个东西,所以也不需要费力写那么多pcre源码。总之,什么xampp这种东西非常强大,推荐学习。具体看看这个网站。

你会对pcre有一个大概的了解,对以后的工作也有好处。除此之外,我认为大规模网页抓取,大部分人可能关心的技术是这个爬虫技术。比如,豆瓣这种,通过爬虫去抓取豆瓣里面你感兴趣的东西。对于其它类型的网站,我认为很难有大规模的爬虫去抓取你想要的东西。除非你是英语特别好,而且非常的熟悉http协议。像雅虎这样的搜索引擎,对网页的要求特别高,有url规则限制,所以只能自己写爬虫来爬虫url地址。

如果你确定自己真的很了解http协议,那么pcre就可以忽略不计了。pcre协议,主要关注php代码输出的xml对象字符串的显示。php代码输出的xml文件如果返回指定的true,则会通过pcre映射到httpheader返回,不返回指定的true,则通过pcre对象自己关联true。我在实际工作中也碰到过不能通过pcre抓取xml字符串,又放在php脚本中运行结果为指定值的xml文件。

这样是不好的。因为我认为解析xml字符串解析得再好,也不如知道pcre解析方法来得更高效。pcre的兼容性问题,同样非常紧张。php5之前的版本里面,不支持多页爬取,而不支持本地调试。php5以后,tcp/ip和http都支持。很可惜,我要换一下脑子了。这个显然是当今社会发展的瓶颈。如果这个瓶颈没有解决,单纯做网页抓取是没有多大意义的。

所以我准备把pcre弄熟悉后,会考虑更高的编程技术。实际上目前的互联网环境是科技界提供了便利的条件,抓取爬虫技术已经不再是瓶颈。解决这个问题只需要再加点学习。把抓取的网页通过正则表达式匹配xml文件的匹配值。然后把网页发送到服务器,服务器端通过抓取的xmlxml字符串来反爬取这个网页。

php网页抓取图片(php网页抓取图片功能都比较简单所以常常被人忽略)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-10-15 09:16

php网页抓取图片功能都比较简单,所以常常被人忽略,其实该功能非常具有代表性,可以用来快速的获取到网站中比较有用的数据.这个做法要使用到前端开发的一个知识点,有兴趣的同学可以看一下.思路如下:获取到新页面的url地址://media/prefix/callbacksscore#v26/users/facebook/data/connect/license/然后定义一个events接收一个回调对象对(score#v1)进行判断:如果返回对应的值,那么就说明通过request。

其实这个返回值也可以返回,如:这样可以继续调用request接口。request一共有2个参数,和,是接收请求请求的url,是接收的当前页面的url。所以,首先在php中配置:$data=['events.media""];$events=$data['events'];$request=$events;$saves=[];$prefix=['',''];$response='';第一步:curl获取源代码:$data=['users/facebook/data/connect/license/'];$events=[];$request=$events;$saves=[];$prefix=['',''];$response='';第二步:php获取接口,然后进行转换:$convert=make_php_object('get',function(convert){$convert['x']=convert.decode('utf-8');$convert['y']=convert.decode('utf-8');$convert['c']=make_php_object('post',function(convert){$convert['p']=convert.decode('utf-8');$convert['d']=convert.decode('utf-8');$convert['c']=make_php_object('form',function(convert){$convert['e']=convert.decode('utf-8');$convert['p']=convert.decode('utf-8');$convert['a']=convert.decode('utf-8');$convert['x']=convert.decode('utf-8');$convert['y']=convert.decode('utf-8');$convert['d']=make_php_object('put',function(convert){$convert['b']=convert.decode('utf-8');$convert['i']=convert.decode('utf-8');$convert['str']=function($convert){$define_by_str='str';$users=$users+$protocol_name;$protocol_name=$protocol_name+'.json';。 查看全部

php网页抓取图片(php网页抓取图片功能都比较简单所以常常被人忽略)

php网页抓取图片功能都比较简单,所以常常被人忽略,其实该功能非常具有代表性,可以用来快速的获取到网站中比较有用的数据.这个做法要使用到前端开发的一个知识点,有兴趣的同学可以看一下.思路如下:获取到新页面的url地址://media/prefix/callbacksscore#v26/users/facebook/data/connect/license/然后定义一个events接收一个回调对象对(score#v1)进行判断:如果返回对应的值,那么就说明通过request。

其实这个返回值也可以返回,如:这样可以继续调用request接口。request一共有2个参数,和,是接收请求请求的url,是接收的当前页面的url。所以,首先在php中配置:$data=['events.media""];$events=$data['events'];$request=$events;$saves=[];$prefix=['',''];$response='';第一步:curl获取源代码:$data=['users/facebook/data/connect/license/'];$events=[];$request=$events;$saves=[];$prefix=['',''];$response='';第二步:php获取接口,然后进行转换:$convert=make_php_object('get',function(convert){$convert['x']=convert.decode('utf-8');$convert['y']=convert.decode('utf-8');$convert['c']=make_php_object('post',function(convert){$convert['p']=convert.decode('utf-8');$convert['d']=convert.decode('utf-8');$convert['c']=make_php_object('form',function(convert){$convert['e']=convert.decode('utf-8');$convert['p']=convert.decode('utf-8');$convert['a']=convert.decode('utf-8');$convert['x']=convert.decode('utf-8');$convert['y']=convert.decode('utf-8');$convert['d']=make_php_object('put',function(convert){$convert['b']=convert.decode('utf-8');$convert['i']=convert.decode('utf-8');$convert['str']=function($convert){$define_by_str='str';$users=$users+$protocol_name;$protocol_name=$protocol_name+'.json';。

php网页抓取图片(PHP模拟浏览器访问url地址及相关源码如下:_get_contents)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-25 12:02

春节快乐

在PHP中爬取时,通常会使用PHP来模拟浏览器的访问,通过http请求访问url地址,然后获取html源代码或者xml数据。我们不能直接输出数据。我们经常需要在继续之前提取内容。格式化,以更友好的方式显示。一、基本原理常用的方法有file_get_contents和curl。区别简述如下: 1. curl 多用于互联网网页之间的爬取,而file_get_contents 多用于获取静态页面的内容。

2. file_get_contents 会为每一个请求重新做DNS查询,DNS信息不会被缓存。但是 CURL 会自动缓存 DNS 信息。请求同域名下的网页或图片,只需要进行一次DNS查询。这大大减少了 DNS 查询的数量。所以CURL的性能要比file_get_contents好很多。

3. file_get_contents 在请求 HTTP 时不会保持活动,但 curl 会。这样,当多次请求多个链接时,curl 的效率会更高。

4. curl 支持多种协议,如 FTP、FTPS、HTTP、HTTPS、GOPHER、TELNET、DICT、FILE 和 LDAP。也就是说,它可以做很多file_get_content 做不到的事情。curl可以实现php中内容的远程获取和采集;实现PHP网页版的FTP上传下载;实现模拟登录;实现接口对接(API)、数据传输;实现模拟cookie;下载文件断点续传等,功能非常强大。

5. file_get_contents 函数会受到php.ini 文件中allow_url_open 选项配置的影响。如果配置关闭,该功能将无效。并且 curl 不受此配置的影响。

二、图片抓取这里以file_get_contents为例,抓取国内某新闻网的新闻列表缩略图。页面及相关html源代码如下: 首先我们通过file_get_contents获取页面完整的html源代码,并进行正则匹配匹配所有img标签的src属性值,即我们要获取的目标:上面代码中的$matches中存放的是所有匹配到的imgs的src属性值,可以通过循环下载的方式下载保存到本地:

三、通过PHP调用wget 上面的代码已经演示了一个基本的图片抓取方法,但是当目标图片一般比较大(比如墙纸图片)并且网速有限且不稳定时,就不能用PHP来下载了并在linux系统下调用wget命令,具体示例代码如下: 图片抓取只是PHP网络爬虫可以做的一小部分功能。通过PHP网络爬虫,您可以轻松获取互联网上更多的数据,无论是用于数据挖掘还是市场调查,甚至是用于制作搜索引擎。

ymkj_679 每一个梦想品牌都值得我们支持 查看全部

php网页抓取图片(PHP模拟浏览器访问url地址及相关源码如下:_get_contents)

春节快乐

在PHP中爬取时,通常会使用PHP来模拟浏览器的访问,通过http请求访问url地址,然后获取html源代码或者xml数据。我们不能直接输出数据。我们经常需要在继续之前提取内容。格式化,以更友好的方式显示。一、基本原理常用的方法有file_get_contents和curl。区别简述如下: 1. curl 多用于互联网网页之间的爬取,而file_get_contents 多用于获取静态页面的内容。

2. file_get_contents 会为每一个请求重新做DNS查询,DNS信息不会被缓存。但是 CURL 会自动缓存 DNS 信息。请求同域名下的网页或图片,只需要进行一次DNS查询。这大大减少了 DNS 查询的数量。所以CURL的性能要比file_get_contents好很多。

3. file_get_contents 在请求 HTTP 时不会保持活动,但 curl 会。这样,当多次请求多个链接时,curl 的效率会更高。

4. curl 支持多种协议,如 FTP、FTPS、HTTP、HTTPS、GOPHER、TELNET、DICT、FILE 和 LDAP。也就是说,它可以做很多file_get_content 做不到的事情。curl可以实现php中内容的远程获取和采集;实现PHP网页版的FTP上传下载;实现模拟登录;实现接口对接(API)、数据传输;实现模拟cookie;下载文件断点续传等,功能非常强大。

5. file_get_contents 函数会受到php.ini 文件中allow_url_open 选项配置的影响。如果配置关闭,该功能将无效。并且 curl 不受此配置的影响。

二、图片抓取这里以file_get_contents为例,抓取国内某新闻网的新闻列表缩略图。页面及相关html源代码如下: 首先我们通过file_get_contents获取页面完整的html源代码,并进行正则匹配匹配所有img标签的src属性值,即我们要获取的目标:上面代码中的$matches中存放的是所有匹配到的imgs的src属性值,可以通过循环下载的方式下载保存到本地:

三、通过PHP调用wget 上面的代码已经演示了一个基本的图片抓取方法,但是当目标图片一般比较大(比如墙纸图片)并且网速有限且不稳定时,就不能用PHP来下载了并在linux系统下调用wget命令,具体示例代码如下: 图片抓取只是PHP网络爬虫可以做的一小部分功能。通过PHP网络爬虫,您可以轻松获取互联网上更多的数据,无论是用于数据挖掘还是市场调查,甚至是用于制作搜索引擎。

ymkj_679 每一个梦想品牌都值得我们支持

php网页抓取图片(通过一个实例来教学如何用nodejs实现爬取网站图片功能 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-25 12:01

)

通过一个例子教你如何使用nodejs实现爬取网站图片的功能。有兴趣的请采集

。

我将通过例子来说明nodejs是如何实现爬取网站图片的功能的。以下为全文:

原则:

爬虫是最明显的 IO 密集型应用场景。很明显,node是用来让数据挖掘更方便的I/O等待开销。

使用 express 模块构建节点服务

并使用request模块获取目标页面的html代码

下载cheerio模块处理html代码(cheerio类似jQuery语法,简单易用)

环境配置:

npm install express request cheerio --save

(1)介绍各种模块

var http = require('http');

var request = require('request);

var cheerio = require('cheerio');

var fs = require('fs'); //用来操作文件

var url = 'https://movie.douban.com/cinem ... 39%3B //定义要爬的页面

(2)发送请求

http.get(function(res){

var html = '';

var titles = [];

res.setEncoding('utf-8') //防止中文乱码

res.on('data',function(chunk){

html += chrunk; //监听data事件 每次取一块数据

})

res.on('end',function(){

var $ = cheerio.load(html); //获取数据完成后,解析html

//将获取的图片存到images文件夹中

$('.mod-bd img').each(function(index, item){

//获取图片属性

var imgName = $(this).parent().next().text().trimg()

var imgfile = imgName + '.jpeg';

var imgSrc = $(this).attr('src')

//采用request模块,向服务器发起请求 获取图片资源

request.head(imgSrc, function(error, res,body){

if(error){

console.log('失败了')

}

});

//通过管道的方式用fs模块将图片写到本地的images文件下

request(imgSrc).pipe.(fs.createWriteStream('./images/' + imgfile));

})

})

}) 查看全部

php网页抓取图片(通过一个实例来教学如何用nodejs实现爬取网站图片功能

)

通过一个例子教你如何使用nodejs实现爬取网站图片的功能。有兴趣的请采集

。

我将通过例子来说明nodejs是如何实现爬取网站图片的功能的。以下为全文:

原则:

爬虫是最明显的 IO 密集型应用场景。很明显,node是用来让数据挖掘更方便的I/O等待开销。

使用 express 模块构建节点服务

并使用request模块获取目标页面的html代码

下载cheerio模块处理html代码(cheerio类似jQuery语法,简单易用)

环境配置:

npm install express request cheerio --save

(1)介绍各种模块

var http = require('http');

var request = require('request);

var cheerio = require('cheerio');

var fs = require('fs'); //用来操作文件

var url = 'https://movie.douban.com/cinem ... 39%3B //定义要爬的页面

(2)发送请求

http.get(function(res){

var html = '';

var titles = [];

res.setEncoding('utf-8') //防止中文乱码

res.on('data',function(chunk){

html += chrunk; //监听data事件 每次取一块数据

})

res.on('end',function(){

var $ = cheerio.load(html); //获取数据完成后,解析html

//将获取的图片存到images文件夹中

$('.mod-bd img').each(function(index, item){

//获取图片属性

var imgName = $(this).parent().next().text().trimg()

var imgfile = imgName + '.jpeg';

var imgSrc = $(this).attr('src')

//采用request模块,向服务器发起请求 获取图片资源

request.head(imgSrc, function(error, res,body){

if(error){

console.log('失败了')

}

});

//通过管道的方式用fs模块将图片写到本地的images文件下

request(imgSrc).pipe.(fs.createWriteStream('./images/' + imgfile));

})

})

})

php网页抓取图片(如何在产品设计中更好地利用图片资源?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-25 05:10

如何在产品设计中更好地利用图像资源?

设计中的图片不仅可以提高视觉表现力,还会影响页面的转化率。今天我们将从以下几个方面来谈谈图片在产品设计中的作用和作用: 产品设计中的优质图片素材有什么使用场景?它主要用于创意提取、颜色提取、内容描述和页面保留。创造力...

如何上传本地图片并使其出现在百度图片搜索结果中

您可以尝试将图片上传到其他网页(例如:百度空间相册),这样当网页为百度收录时,您的图片可能会出现在搜索结果中。百度图片搜索引擎是全球最大的中文图片搜索引擎。百度从数十亿中文网页中提取各种图片,建立了世界第一的中文图片库。目前...

如何从网页图片中提取文字?

如何从网页图片中提取文字?距离2021年过年只有一个月了,由于年底公司工作量剧增,小吴的工作站里堆满了文件,所有的文件都必须在电脑上输入。面对桌面上的文件,初入社会的小舞很是恼火。必须将许多文件输入计算机。什么时候可以打字...

周广权:人脸识别犯罪中的关键问题| 周光权 比较法研究 202106

网贷平台APP等未经授权盗取贷款申请人人脸识别数据,当然违反知情同意规则;即使申请人已经获得申请人的同意,他也会阅读他的通讯录和手机中存储的照片,因为申请人担心涉及他人的信息无权同意,获取信息的行为违反了知情同意规则,这可能构成本罪。肇事者没有...

怎么建公司网站容易被抓

如何建立一个公司网站 很容易被爬取。创建 网站 的一种方法是它看起来既便宜又快速。原因是网站使用了模板,并且section的所有内容都是Fixed,只需要改变图片或者文字内容,所以速度会快很多。但是这样的网站缺乏特征,很难留住访问者,也很难被搜索引擎收录搜索到,通常...

百度图书馆大杀手-下载你想要的文件

图片来源:软件截图。另外,在软件右上角的【菜单】中,我们选择【系统设置】,会弹出【属性设置】页面。在这个页面,我们可以选择【自定义下载路径】和【是否导出txt文件】选项。图片来源:软件截图3 DoDo百度文库提取工具这个软件对...