excel自动抓取网页数据

excel自动抓取网页数据(豆瓣电影Top250数据并写入Excel用EXCEL提取网页数据…)

网站优化 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-12-04 14:24

豆瓣

Python抓取豆瓣电影Top250数据写入Excel

1.爬取目标上的页面网站2. 按照一定的规则提取抓取的数据

create table `tb_movie`( id int(11) primary key auto_increment, title varchar(255), score varchar(255), date varchar(255), region varchar(255), category varchar(255), directorAndActor varchar(255), quote varchar(255), thumbnail varchar(255) )ENGINE=InnoDB DEFAULT CHARSET=utf8;

#!/usr/bin/env python # -*- coding: utf-8 -*- # @Author : nacker 648959@qq.com # @Time : 2020/3/4 6:25 下午 # @Site : # @File : douban.py # @Software: PyCharm # 1.将目标网站上的页面抓取下来 # 2.将抓取下来的数据根据一定的规则进行提取 import time import requests import xlwt from lxml import etree from MysqlHelper import MysqlHelper headers = { 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36', 'Referer': 'https://www.douban.com/', } def get_page_source(url): ''' 获取网页源代码 ''' try: response = requests.get(url, headers=headers) if response.status_code == 200: text = response.text return etree.HTML(text) except requests.ConnectionError: return None def get_movie_info(html): ''' 获取其中一页的数据 ''' if len(html): movies = [] # item节点 items = html.xpath("//div[@class='item']") for index,item in items: # 1.标题 title = item.xpath("..//@alt")[0] # print(title) # 2.分数 rating_num score = item.xpath('..//span[@class="rating_num"]/text()')[0] # print(score) # 3.描述 duration = "" # 4.时间+地区+类别 tempString = item.xpath('div[@class="bd"]/p[@class=""]/text()')[1] tempString = "".join(tempString.split()) temps = tempString.split('/') # print(temps) date = temps[0] # print(year) region = temps[1] # print(region) category = temps[2] # 5.导演+演员 directorAndActorStr = item.xpath('div[@class="bd"]/p[@class=""]/text()')[0] directorAndActorStr = "".join(directorAndActorStr.split()) # print(directorAndActorStr) directorAndActor = directorAndActorStr # 6.图片 thumbnail = item.xpath("..//@src")[0] # print(thumbnail) # 7.quote quote = item.xpath('..//p[@class="quote"]/span/text()') if quote: quote = quote[0] else: quote = "" # print(quote) movie = { 'title': title, 'score': score, 'date' : date, 'region': region, 'category': category, 'directorAndActor': directorAndActor, 'quote' : quote, 'thumbnail': thumbnail } movies.append(movie) return movies def write_movie(list): ''' 写入数据到数据库 ''' for dict in list: sql = 'insert into tb_movie(title,score,date,region,category,directorAndActor,quote,thumbnail) values(%s,%s,%s,%s,%s,%s,%s,%s)' mysqlHelper = MysqlHelper('localhost', 3306, 'douban', 'root', '123456') params = [dict['title'],dict['score'],dict['date'],dict['region'],dict['category'],dict['directorAndActor'],dict['quote'],dict['thumbnail']] # print(params) count = mysqlHelper.insert(sql, params) if count == 1: print(dict) print('--------------------ok--------------------') else: print('--------------------error--------------------') def save_excel(datalist): ''' 将相关数据写入excel中 ''' # 初始化Excel w = xlwt.Workbook() style = xlwt.XFStyle() # 初始化样式 font = xlwt.Font() # 为样式创建字体 font.name = u"微软雅黑" style.font = font # 为样式设置字体 ws = w.add_sheet(u"豆瓣电影Top250", cell_overwrite_ok=True) # 将 title 作为 Excel 的列名 title = u"排行, 电影, 评分, 年份, 地区, 类别, 导演主演, 评价, 图片" title = title.split(",") for i in range(len(title)): ws.write(0, i, title[i], style) # # 开始写入数据库查询到的数据 for i in range(len(datalist)): row = datalist[i] for j in range(len(row)): if row[j]: item = row[j] ws.write(i + 1, j, item, style) # 写文件完成,开始保存xls文件 path = '豆瓣电影Top250.xls' w.save(path) def start_robot(): ''' 开始爬虫 ''' # https: // movie.douban.com / top250?start = 0 & filter = for offset in range(0, 250, 25): url = 'https://movie.douban.com/top250?start=' + str(offset) +'&filter=' item = get_page_source(url) # 获取单页数据 list = get_movie_info(item) # 写数据到数据库 write_movie(list) # 家里网络不好,休眠一会吧,省的被K了 time.sleep(3) else: print('豆瓣top250的电影信息写入完毕') def read_mysql_Data(): sql = 'select * from tb_movie order by id asc' mysqlHelper = MysqlHelper('localhost', 3306, 'douban', 'root', '123456') datalist = mysqlHelper.get_all(sql) return datalist def main(): # 保存到数据库 # start_robot() # 读取数据 datalist = read_mysql_Data() # 写入Excel save_excel(datalist) if __name__ == '__main__': main()

github源码下载

","force_purephv":"0","gnid":"96dbc59fabfd30086","img_data":[{"flag":2,"img":[]}],"novel_author":"","novel_name": "","original":0,"pat":"art_src_6,fts0,sts0","powerby":"pika","pub_time":41,"pure":"","rawurl":""," redirect":0,"rptid":"ca3e6c10d0146325","src":"资深故事","tag":[],"title":"python抓取豆瓣电影Top250数据写入Excel

使用EXCEL提取网页数据... VBA网页提取

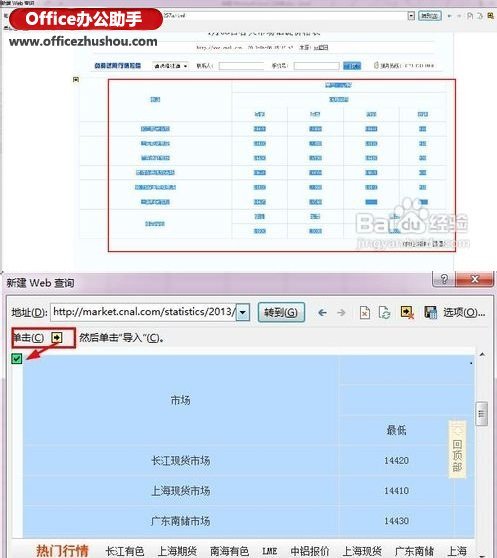

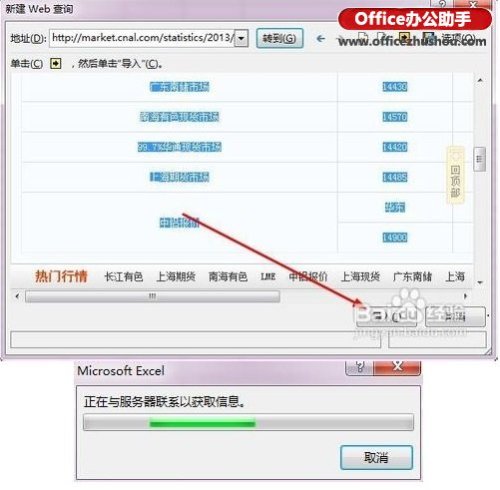

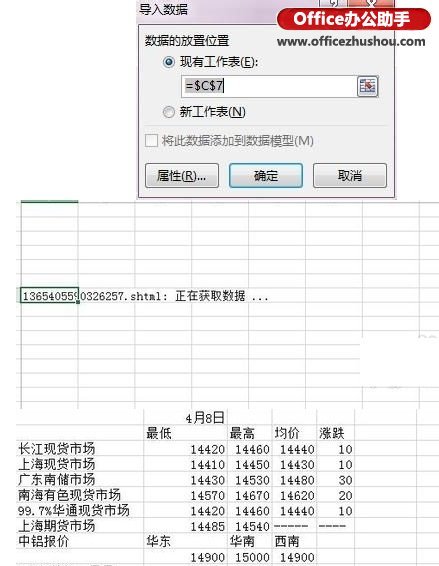

4、 弹出“导入数据”对话框,设置好后点击“确定”。5、在 Excel 表格中显示“正在获取数据...”。6、数据采集完成,之前选择的网页内容全部导入到Excel工作表中。

Excel之类的网页数据,应该用什么方法抓取数据?-…… '选项组''按钮。2. 在打开的“导入文本文件”对话框中查找并选择需要导入的文本文件。3. 点击“导入”按钮导入文本文件导入Excel工作表中的数据。

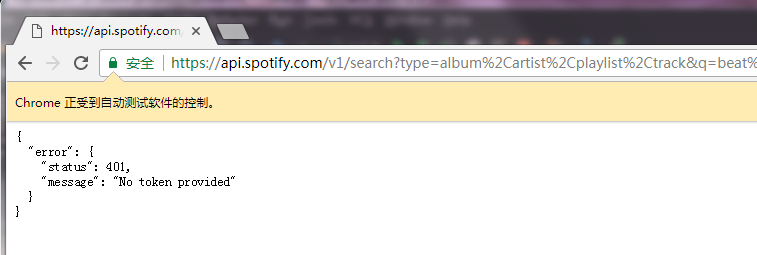

如何使用Excel捕捉网页数据?JSON数据抓取-... 打开Chrome,在拉勾网搜索深圳的“数据分析”位置,使用检查功能查看网页源代码,发现拉勾网有反爬虫机制而job信息不在源码中,而是在JSON文件中,所以我们直接下载JSON,使用字典的方式直接读取数据。在抓取网页时...

Excel获取网页表单数据-...可以通过excel的获取外部数据的功能来实现。具体操作如下:1、选择你要获取数据的网站或站点(不是所有的网站或页面都能获取到你想要的,需要数据),复制完整的网站。2、 打开excel,点击数据标签,选择获取。从网络获取外部数据。站按钮,会打开一个新的网页查询对话框。3、输入刚才复制的net.Address,就会打开对应的net.page。4、根据提示,点击黄色小键在你需要的数据表前面,当它变成一个绿色的对勾时,表示它被选中状态。5、 点击导入按钮,在工作表中选择数据的存储位置,然后确认。

EXCEL VBA在多个网页中下载网站表格数据-…… 只需打开一个excel,然后输入以下代码,就可以将网站的内容下载到活动工作表中。至于怎么改成你需要的格式你可以抓取你需要的数据,根据你的需要填表。Sub getdatafromweb() Dim objWeb As QueryTable Dim sWebTable...

亲爱的上帝,我现在有一个紧急的问题。如何抓取网页(多页)中的表格数据?将其导出为excel。网页-... 其实很多采集软件都可以实现这个过程,比如优采云、gooseeker、优采云都可以实现采集,但是都< @优采云和优采云采集是收费的,gooseeker 优采云是免费的,简单易学。如果你不想制定规则,可以在论坛发任务,请人为你制定规则,轻松获取数据

excel如何自动获取网页中的数值-...数据-导入外部数据-新建网页数据-输入数值网页所在的网址,然后选择...

EXCEL VBA在多个网页中下载网站表格数据-...什么意思,我太不明白了,要不要点点什么?请尝试使用sendcommand,可以通过键盘实现

设置好后,点击“确定”。Excel 表显示“正在获取数据...”。数据采集完成,之前选择的网页内容全部导入到Excel工作表中。 查看全部

excel自动抓取网页数据(豆瓣电影Top250数据并写入Excel用EXCEL提取网页数据…)

豆瓣

Python抓取豆瓣电影Top250数据写入Excel

1.爬取目标上的页面网站2. 按照一定的规则提取抓取的数据

create table `tb_movie`( id int(11) primary key auto_increment, title varchar(255), score varchar(255), date varchar(255), region varchar(255), category varchar(255), directorAndActor varchar(255), quote varchar(255), thumbnail varchar(255) )ENGINE=InnoDB DEFAULT CHARSET=utf8;

#!/usr/bin/env python # -*- coding: utf-8 -*- # @Author : nacker 648959@qq.com # @Time : 2020/3/4 6:25 下午 # @Site : # @File : douban.py # @Software: PyCharm # 1.将目标网站上的页面抓取下来 # 2.将抓取下来的数据根据一定的规则进行提取 import time import requests import xlwt from lxml import etree from MysqlHelper import MysqlHelper headers = { 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36', 'Referer': 'https://www.douban.com/', } def get_page_source(url): ''' 获取网页源代码 ''' try: response = requests.get(url, headers=headers) if response.status_code == 200: text = response.text return etree.HTML(text) except requests.ConnectionError: return None def get_movie_info(html): ''' 获取其中一页的数据 ''' if len(html): movies = [] # item节点 items = html.xpath("//div[@class='item']") for index,item in items: # 1.标题 title = item.xpath("..//@alt")[0] # print(title) # 2.分数 rating_num score = item.xpath('..//span[@class="rating_num"]/text()')[0] # print(score) # 3.描述 duration = "" # 4.时间+地区+类别 tempString = item.xpath('div[@class="bd"]/p[@class=""]/text()')[1] tempString = "".join(tempString.split()) temps = tempString.split('/') # print(temps) date = temps[0] # print(year) region = temps[1] # print(region) category = temps[2] # 5.导演+演员 directorAndActorStr = item.xpath('div[@class="bd"]/p[@class=""]/text()')[0] directorAndActorStr = "".join(directorAndActorStr.split()) # print(directorAndActorStr) directorAndActor = directorAndActorStr # 6.图片 thumbnail = item.xpath("..//@src")[0] # print(thumbnail) # 7.quote quote = item.xpath('..//p[@class="quote"]/span/text()') if quote: quote = quote[0] else: quote = "" # print(quote) movie = { 'title': title, 'score': score, 'date' : date, 'region': region, 'category': category, 'directorAndActor': directorAndActor, 'quote' : quote, 'thumbnail': thumbnail } movies.append(movie) return movies def write_movie(list): ''' 写入数据到数据库 ''' for dict in list: sql = 'insert into tb_movie(title,score,date,region,category,directorAndActor,quote,thumbnail) values(%s,%s,%s,%s,%s,%s,%s,%s)' mysqlHelper = MysqlHelper('localhost', 3306, 'douban', 'root', '123456') params = [dict['title'],dict['score'],dict['date'],dict['region'],dict['category'],dict['directorAndActor'],dict['quote'],dict['thumbnail']] # print(params) count = mysqlHelper.insert(sql, params) if count == 1: print(dict) print('--------------------ok--------------------') else: print('--------------------error--------------------') def save_excel(datalist): ''' 将相关数据写入excel中 ''' # 初始化Excel w = xlwt.Workbook() style = xlwt.XFStyle() # 初始化样式 font = xlwt.Font() # 为样式创建字体 font.name = u"微软雅黑" style.font = font # 为样式设置字体 ws = w.add_sheet(u"豆瓣电影Top250", cell_overwrite_ok=True) # 将 title 作为 Excel 的列名 title = u"排行, 电影, 评分, 年份, 地区, 类别, 导演主演, 评价, 图片" title = title.split(",") for i in range(len(title)): ws.write(0, i, title[i], style) # # 开始写入数据库查询到的数据 for i in range(len(datalist)): row = datalist[i] for j in range(len(row)): if row[j]: item = row[j] ws.write(i + 1, j, item, style) # 写文件完成,开始保存xls文件 path = '豆瓣电影Top250.xls' w.save(path) def start_robot(): ''' 开始爬虫 ''' # https: // movie.douban.com / top250?start = 0 & filter = for offset in range(0, 250, 25): url = 'https://movie.douban.com/top250?start=' + str(offset) +'&filter=' item = get_page_source(url) # 获取单页数据 list = get_movie_info(item) # 写数据到数据库 write_movie(list) # 家里网络不好,休眠一会吧,省的被K了 time.sleep(3) else: print('豆瓣top250的电影信息写入完毕') def read_mysql_Data(): sql = 'select * from tb_movie order by id asc' mysqlHelper = MysqlHelper('localhost', 3306, 'douban', 'root', '123456') datalist = mysqlHelper.get_all(sql) return datalist def main(): # 保存到数据库 # start_robot() # 读取数据 datalist = read_mysql_Data() # 写入Excel save_excel(datalist) if __name__ == '__main__': main()

github源码下载

","force_purephv":"0","gnid":"96dbc59fabfd30086","img_data":[{"flag":2,"img":[]}],"novel_author":"","novel_name": "","original":0,"pat":"art_src_6,fts0,sts0","powerby":"pika","pub_time":41,"pure":"","rawurl":""," redirect":0,"rptid":"ca3e6c10d0146325","src":"资深故事","tag":[],"title":"python抓取豆瓣电影Top250数据写入Excel

使用EXCEL提取网页数据... VBA网页提取

4、 弹出“导入数据”对话框,设置好后点击“确定”。5、在 Excel 表格中显示“正在获取数据...”。6、数据采集完成,之前选择的网页内容全部导入到Excel工作表中。

Excel之类的网页数据,应该用什么方法抓取数据?-…… '选项组''按钮。2. 在打开的“导入文本文件”对话框中查找并选择需要导入的文本文件。3. 点击“导入”按钮导入文本文件导入Excel工作表中的数据。

如何使用Excel捕捉网页数据?JSON数据抓取-... 打开Chrome,在拉勾网搜索深圳的“数据分析”位置,使用检查功能查看网页源代码,发现拉勾网有反爬虫机制而job信息不在源码中,而是在JSON文件中,所以我们直接下载JSON,使用字典的方式直接读取数据。在抓取网页时...

Excel获取网页表单数据-...可以通过excel的获取外部数据的功能来实现。具体操作如下:1、选择你要获取数据的网站或站点(不是所有的网站或页面都能获取到你想要的,需要数据),复制完整的网站。2、 打开excel,点击数据标签,选择获取。从网络获取外部数据。站按钮,会打开一个新的网页查询对话框。3、输入刚才复制的net.Address,就会打开对应的net.page。4、根据提示,点击黄色小键在你需要的数据表前面,当它变成一个绿色的对勾时,表示它被选中状态。5、 点击导入按钮,在工作表中选择数据的存储位置,然后确认。

EXCEL VBA在多个网页中下载网站表格数据-…… 只需打开一个excel,然后输入以下代码,就可以将网站的内容下载到活动工作表中。至于怎么改成你需要的格式你可以抓取你需要的数据,根据你的需要填表。Sub getdatafromweb() Dim objWeb As QueryTable Dim sWebTable...

亲爱的上帝,我现在有一个紧急的问题。如何抓取网页(多页)中的表格数据?将其导出为excel。网页-... 其实很多采集软件都可以实现这个过程,比如优采云、gooseeker、优采云都可以实现采集,但是都< @优采云和优采云采集是收费的,gooseeker 优采云是免费的,简单易学。如果你不想制定规则,可以在论坛发任务,请人为你制定规则,轻松获取数据

excel如何自动获取网页中的数值-...数据-导入外部数据-新建网页数据-输入数值网页所在的网址,然后选择...

EXCEL VBA在多个网页中下载网站表格数据-...什么意思,我太不明白了,要不要点点什么?请尝试使用sendcommand,可以通过键盘实现

设置好后,点击“确定”。Excel 表显示“正在获取数据...”。数据采集完成,之前选择的网页内容全部导入到Excel工作表中。

excel自动抓取网页数据( 一个“阿冲全能点击王”软件,帮你实现Excel数据转化和网页填写 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2021-11-22 13:12

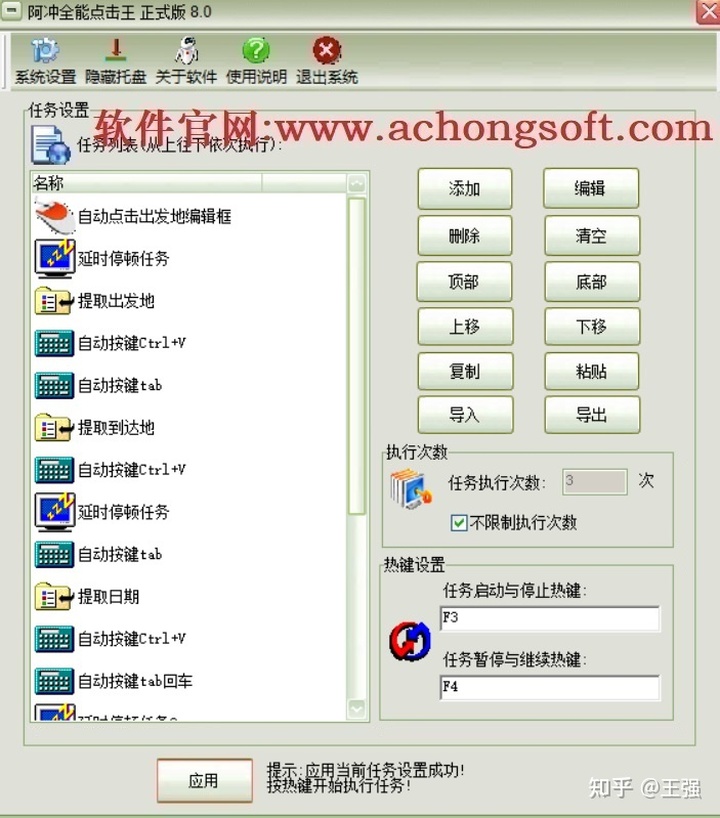

一个“阿冲全能点击王”软件,帮你实现Excel数据转化和网页填写

)

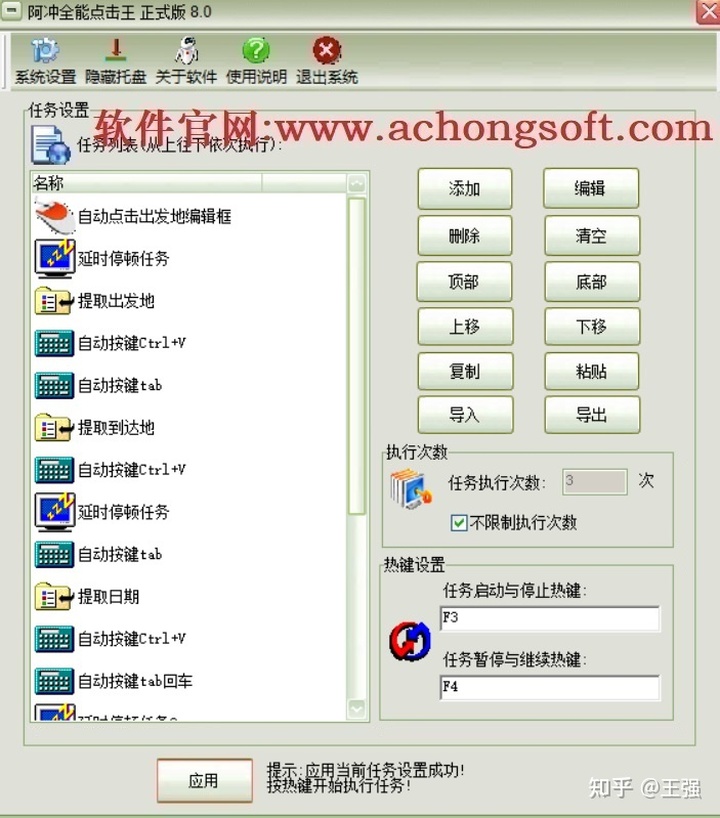

在如今的日常办公应用中,大家经常会遇到在网页上填写Excel表格数据的场景,而Excel中的数据列很多,手动一一复制很麻烦。这时候推荐您使用“A-Chong全能点击王”软件,它具有高度灵活的脚本排版功能,可以帮助您实现Excel数据转换和网页填充。通过阿冲全能点击王,您可以进行大量的办公自动化输入、批量自动填写、Excel数据自动输入等应用,大大提高了办公效率。

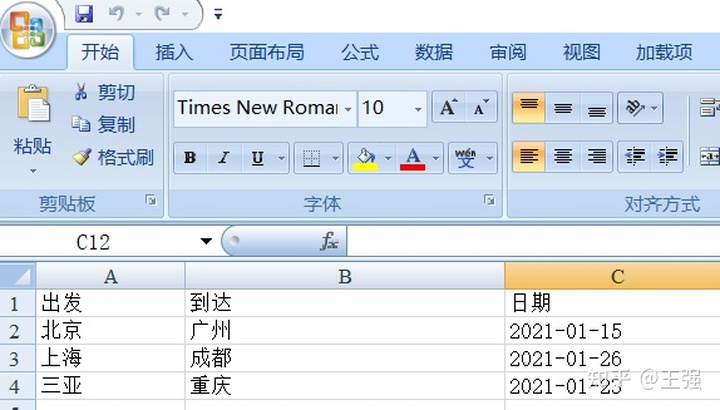

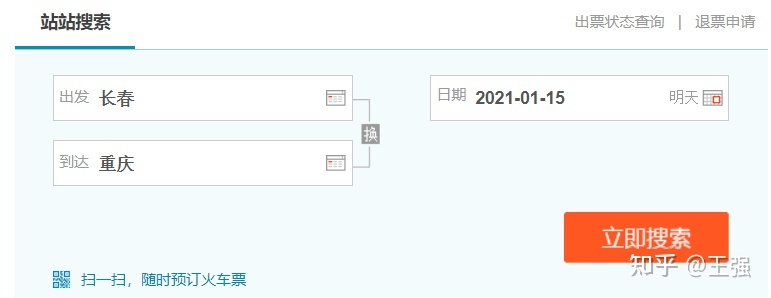

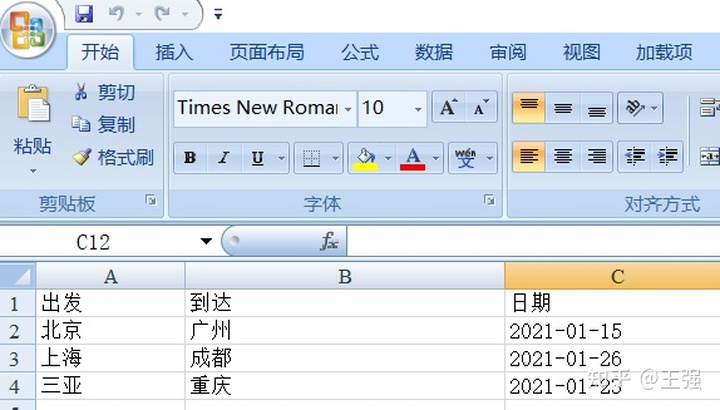

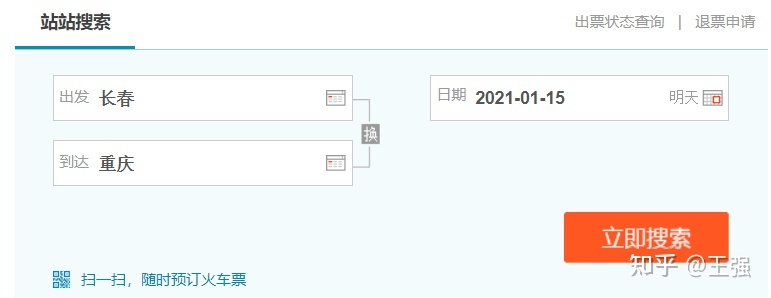

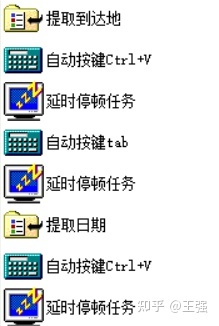

我们以票证查询网站为例来说明。我们本地有一个Excel表格,里面有出发地、到达地、日期等信息,需要导入并一一填写到网页中。

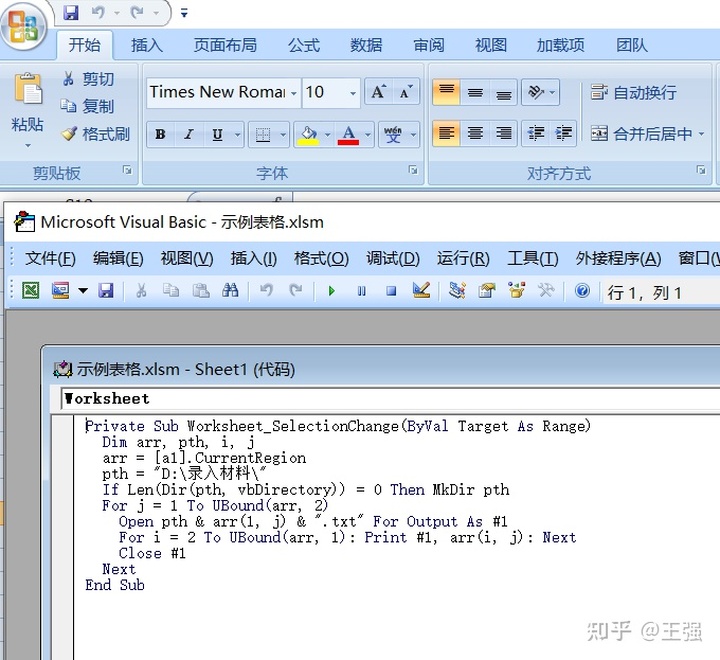

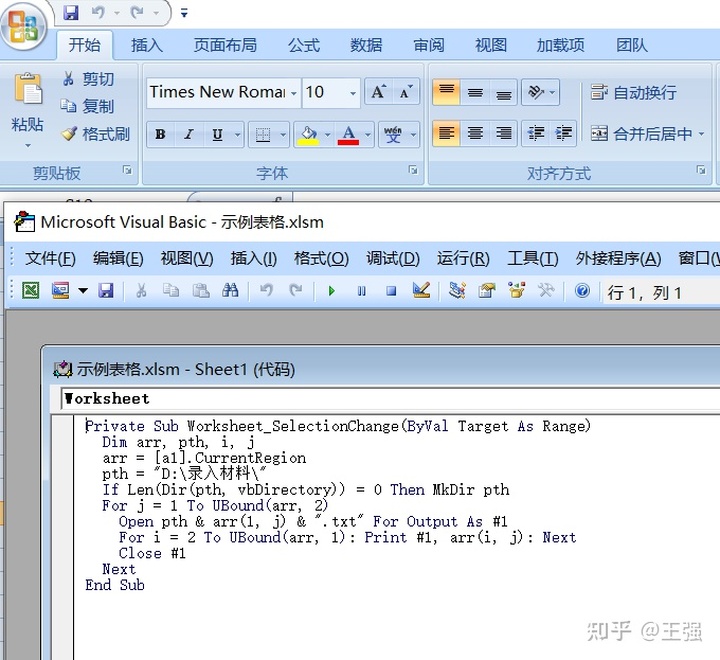

1-这种Excel表格数据没有好的办法,比如直接提取出来输入到网页中。需要使用VBA宏做下转换,先导出为对应的TXT文本。下面是VBA宏代码,可以为本地目录中的每一列生成对应的TXT。

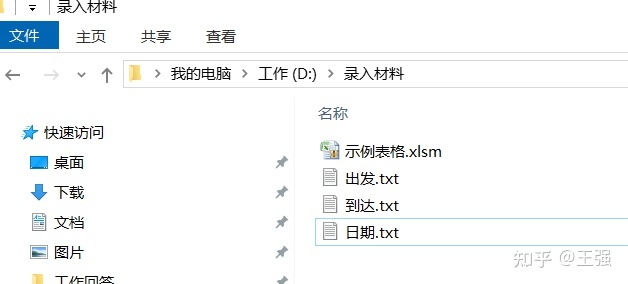

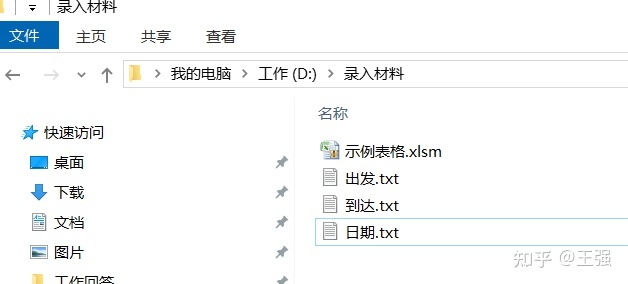

这样我们就准备好了需要的文本TXT,不用再在Excel中手动一一提取了。可以通过阿冲全能点击王软件中的文件提取功能来实现,后面会详细介绍。

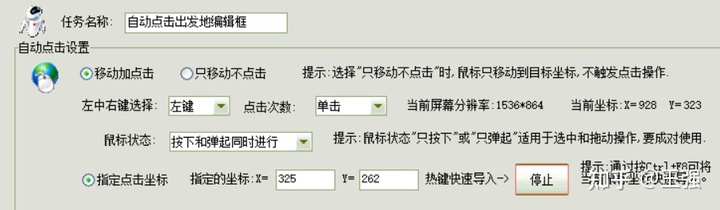

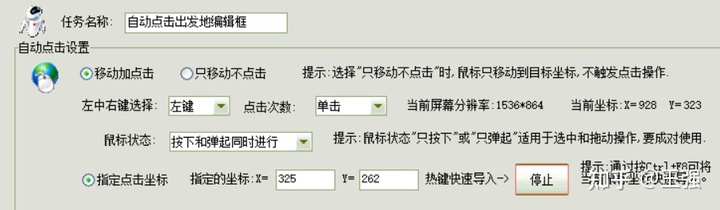

2-在网页上操作时,先点击鼠标,将光标定位到第一个控件,这里是起点编辑框。由阿冲全能点击王软件中的自动点击任务设置:

使用指定的点击坐标-热键快速导入-打开,然后将鼠标移动到原点编辑框,按Ctrl+F8导入对应的坐标。

自动单击:您可以选择鼠标的左键、中键或右键。可以选择点击或双击,可以不点击移动,可以设置鼠标的上下状态。不仅支持点击指定坐标位置,还支持随机点击特定区域,也支持随机点击指定坐标列表。

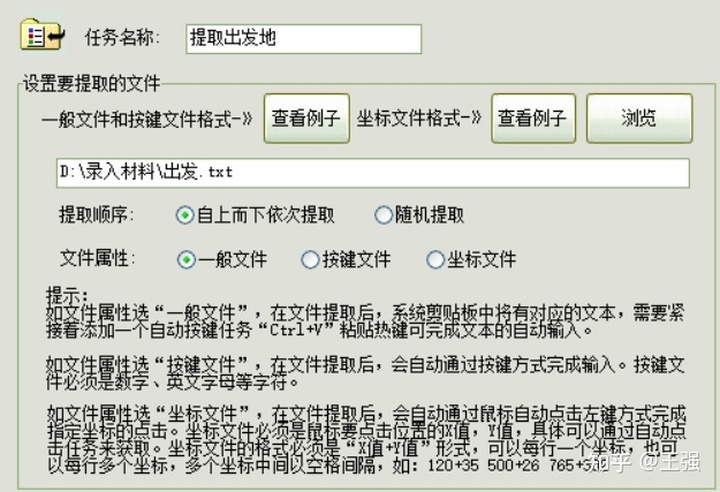

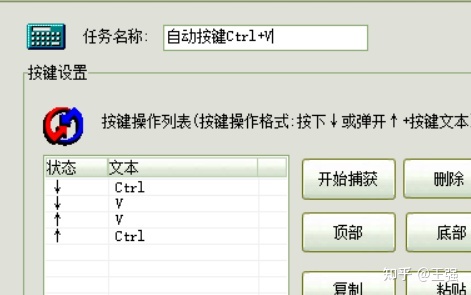

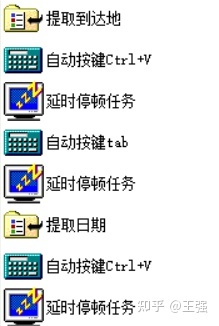

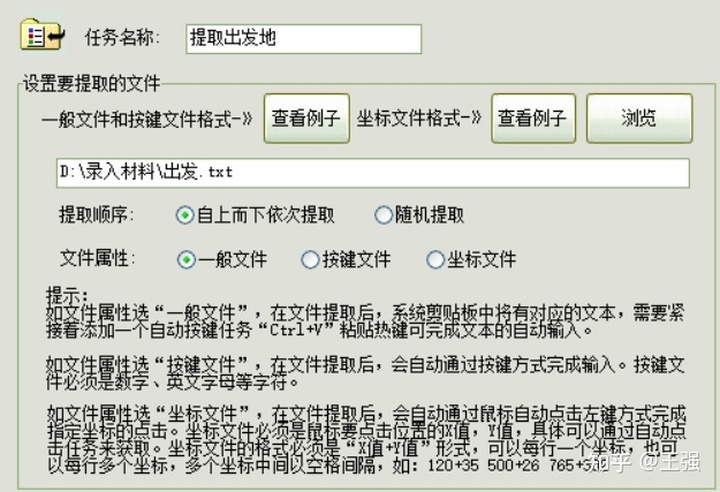

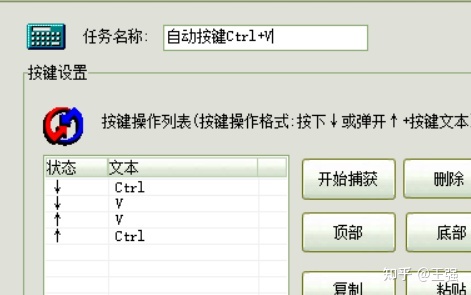

3-然后对于数据录入和填写部分,我们使用阿冲全能点击王者软件的文件提取任务,然后从TXT中一一提取。为文件提取任务选择“General File”,然后立即添加自动键Ctrl+V。

文件提取:支持通用文件、关键文件、坐标文件的提取功能,可从上到下或随机提取,可循环从文件中提取,自动输入,可自动打字,可以为鼠标点击自动提取坐标。

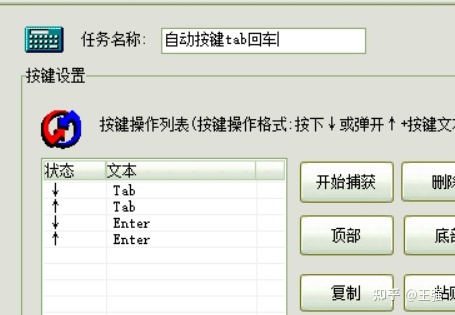

自动按键:支持按键的自动抓取和录入,按键列表内容的灵活编辑,支持按键列表的导入导出,支持硬件模拟,可以完美兼容各种游戏、图形应用和系统级按键。

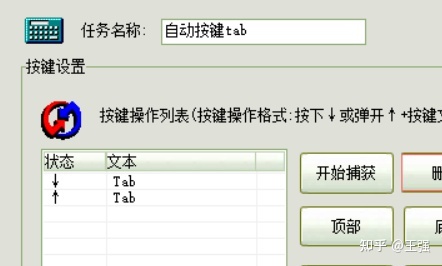

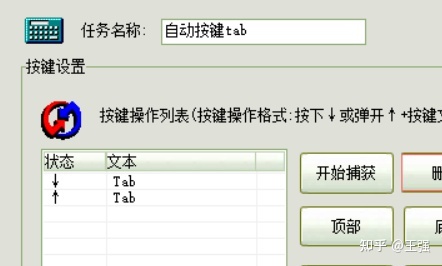

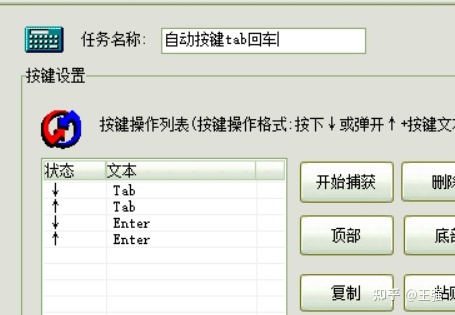

4-完成出发点的控制输入后,我们需要跳到下一个到达点进行编辑。我们可以继续用鼠标自动点击。但是,当脚本布局中使用了大量的点击动作时,每当窗口界面的位置或大小发生变化时,就需要重新设置这些坐标。所以我们改用自动键选项卡,这是所有 Windows 窗口的默认焦点切换热键。

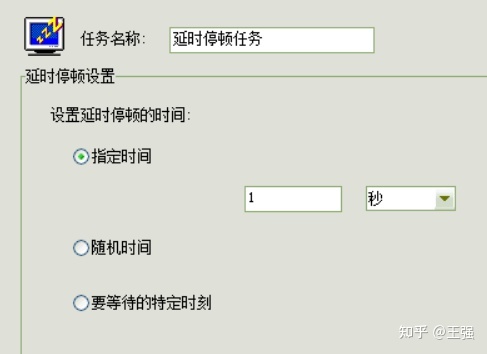

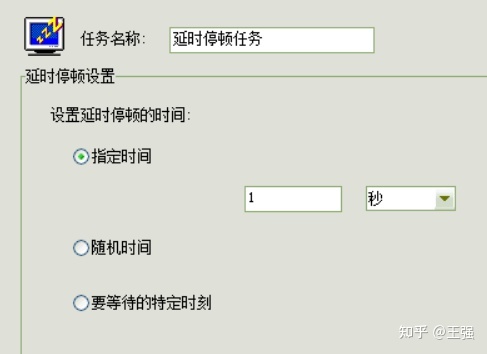

5- 另外,我们在编写脚本任务的时候,一定要记得在每个动作之后有一个暂停,以方便界面响应。您可以使用阿冲全能点击王软件的延迟暂停任务设置。

6-接下来是到达地,输入日期,操作同上面的出发地操作。通过使用文件提取,可以自动按下这些任务:

7-最后,我们需要点击搜索按钮,或者使用tab键先将焦点切换到按钮上,然后按回车键触发。

使用自动击键任务相当于替换键盘上的所有按键操作。我们日常的很多功能操作都有对应的快捷键设置,可以灵活的替换为这个自动按键任务。

这样,所有的脚本布局就完成了:

如您所见,使用A Chong全能敲击王就像指挥一个智能机器人。只需按顺序添加我们需要的任务指令,它就可以自动为我们执行。通过阿冲全能点击王,可以做很多office自动录入、网页自动填充、批量自动打开点击等应用。

查看全部

excel自动抓取网页数据(

一个“阿冲全能点击王”软件,帮你实现Excel数据转化和网页填写

)

在如今的日常办公应用中,大家经常会遇到在网页上填写Excel表格数据的场景,而Excel中的数据列很多,手动一一复制很麻烦。这时候推荐您使用“A-Chong全能点击王”软件,它具有高度灵活的脚本排版功能,可以帮助您实现Excel数据转换和网页填充。通过阿冲全能点击王,您可以进行大量的办公自动化输入、批量自动填写、Excel数据自动输入等应用,大大提高了办公效率。

我们以票证查询网站为例来说明。我们本地有一个Excel表格,里面有出发地、到达地、日期等信息,需要导入并一一填写到网页中。

1-这种Excel表格数据没有好的办法,比如直接提取出来输入到网页中。需要使用VBA宏做下转换,先导出为对应的TXT文本。下面是VBA宏代码,可以为本地目录中的每一列生成对应的TXT。

这样我们就准备好了需要的文本TXT,不用再在Excel中手动一一提取了。可以通过阿冲全能点击王软件中的文件提取功能来实现,后面会详细介绍。

2-在网页上操作时,先点击鼠标,将光标定位到第一个控件,这里是起点编辑框。由阿冲全能点击王软件中的自动点击任务设置:

使用指定的点击坐标-热键快速导入-打开,然后将鼠标移动到原点编辑框,按Ctrl+F8导入对应的坐标。

自动单击:您可以选择鼠标的左键、中键或右键。可以选择点击或双击,可以不点击移动,可以设置鼠标的上下状态。不仅支持点击指定坐标位置,还支持随机点击特定区域,也支持随机点击指定坐标列表。

3-然后对于数据录入和填写部分,我们使用阿冲全能点击王者软件的文件提取任务,然后从TXT中一一提取。为文件提取任务选择“General File”,然后立即添加自动键Ctrl+V。

文件提取:支持通用文件、关键文件、坐标文件的提取功能,可从上到下或随机提取,可循环从文件中提取,自动输入,可自动打字,可以为鼠标点击自动提取坐标。

自动按键:支持按键的自动抓取和录入,按键列表内容的灵活编辑,支持按键列表的导入导出,支持硬件模拟,可以完美兼容各种游戏、图形应用和系统级按键。

4-完成出发点的控制输入后,我们需要跳到下一个到达点进行编辑。我们可以继续用鼠标自动点击。但是,当脚本布局中使用了大量的点击动作时,每当窗口界面的位置或大小发生变化时,就需要重新设置这些坐标。所以我们改用自动键选项卡,这是所有 Windows 窗口的默认焦点切换热键。

5- 另外,我们在编写脚本任务的时候,一定要记得在每个动作之后有一个暂停,以方便界面响应。您可以使用阿冲全能点击王软件的延迟暂停任务设置。

6-接下来是到达地,输入日期,操作同上面的出发地操作。通过使用文件提取,可以自动按下这些任务:

7-最后,我们需要点击搜索按钮,或者使用tab键先将焦点切换到按钮上,然后按回车键触发。

使用自动击键任务相当于替换键盘上的所有按键操作。我们日常的很多功能操作都有对应的快捷键设置,可以灵活的替换为这个自动按键任务。

这样,所有的脚本布局就完成了:

如您所见,使用A Chong全能敲击王就像指挥一个智能机器人。只需按顺序添加我们需要的任务指令,它就可以自动为我们执行。通过阿冲全能点击王,可以做很多office自动录入、网页自动填充、批量自动打开点击等应用。

excel自动抓取网页数据(能否制作一个随网站自动同步的Excel表呢?答案是这样的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-11-21 13:27

【PConline技巧】有时候我们需要从网站中获取一些数据,传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都有效。有时即使成功了,也会得到“死数据”。以后一旦有更新,必须不断重复以上操作。是否可以制作一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

首先打开你要爬取的网页

2. 确定爬取范围

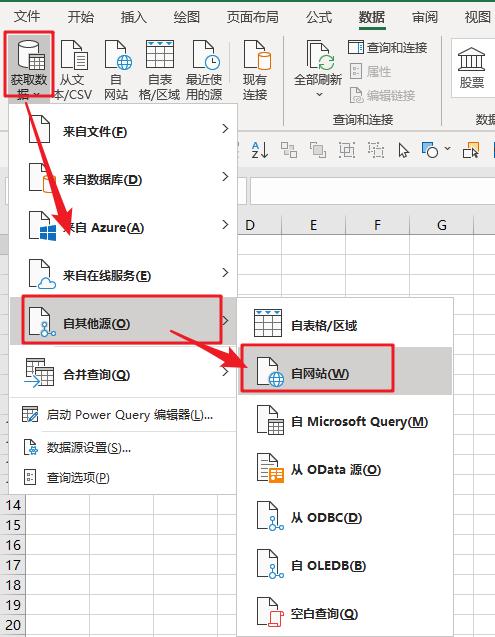

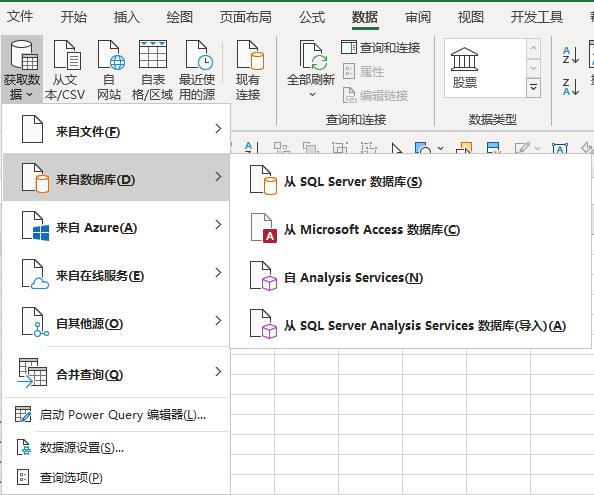

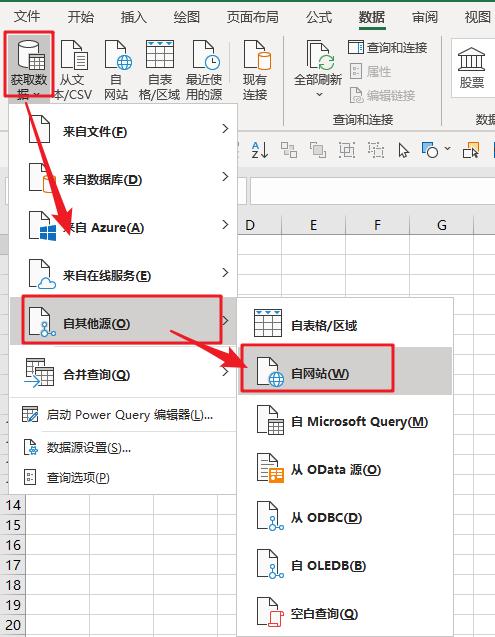

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

建立查询并确定爬取范围

3. 数据清洗

导入完成后,可以通过 Power Query 清理数据。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保存行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗地说就是一些美化操作。最后,我们得到了下表。

对表格做一些美化

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果想让表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

设置中的自动同步

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以通过点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

防止更新期间表格格式损坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢? 查看全部

excel自动抓取网页数据(能否制作一个随网站自动同步的Excel表呢?答案是这样的)

【PConline技巧】有时候我们需要从网站中获取一些数据,传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都有效。有时即使成功了,也会得到“死数据”。以后一旦有更新,必须不断重复以上操作。是否可以制作一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

首先打开你要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

建立查询并确定爬取范围

3. 数据清洗

导入完成后,可以通过 Power Query 清理数据。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保存行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗地说就是一些美化操作。最后,我们得到了下表。

对表格做一些美化

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果想让表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

设置中的自动同步

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以通过点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

防止更新期间表格格式损坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

excel自动抓取网页数据(excel自动抓取网页数据按住shift键,点点“审阅”--“自动获取页面链接”)

网站优化 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-11-21 07:02

excel自动抓取网页数据按住shift键,右键点“审阅”--“分析”--“自动获取页面链接”---“excel连接服务器”。获取json数据后,右键菜单“审阅”--“分析”--“自动获取页面链接”---“excel连接服务器”。

调用网页里的js实现

我之前也是这样的问题,后来发现是下面这个简单的一键批量下载的js文件导致的。注:重点:要注意保存文件为一个独立的js文件。工具:excel电脑或手机打开速度:电脑>>手机浏览器,然后再从这个页面下载到excel上(必须用手机或者电脑打开):document.write(httpserver.postmessage("data").tostring()+"");document.write(httpserver.postmessage("data").tostring()+"");主页上的原文document.write("");document.write("document.write("#top001"title").tostring();">");document.write("数据</a>");解释:document.write("");表示下载。 查看全部

excel自动抓取网页数据(excel自动抓取网页数据按住shift键,点点“审阅”--“自动获取页面链接”)

excel自动抓取网页数据按住shift键,右键点“审阅”--“分析”--“自动获取页面链接”---“excel连接服务器”。获取json数据后,右键菜单“审阅”--“分析”--“自动获取页面链接”---“excel连接服务器”。

调用网页里的js实现

我之前也是这样的问题,后来发现是下面这个简单的一键批量下载的js文件导致的。注:重点:要注意保存文件为一个独立的js文件。工具:excel电脑或手机打开速度:电脑>>手机浏览器,然后再从这个页面下载到excel上(必须用手机或者电脑打开):document.write(httpserver.postmessage("data").tostring()+"");document.write(httpserver.postmessage("data").tostring()+"");主页上的原文document.write("");document.write("document.write("#top001"title").tostring();">");document.write("数据</a>");解释:document.write("");表示下载。

excel自动抓取网页数据(如何制作一个随网站自动同步的Excel表呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-11-20 07:23

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。

能不能做个网站自动同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

下图中的网页为中国地震台网官方网页(/)。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定捕获范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到下表。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果想让表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以通过点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢? 查看全部

excel自动抓取网页数据(如何制作一个随网站自动同步的Excel表呢?(组图))

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。

能不能做个网站自动同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

下图中的网页为中国地震台网官方网页(/)。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定捕获范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到下表。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果想让表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以通过点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

excel自动抓取网页数据( 认识Excel的强大功能在知乎里面搜索一下Excel,想学习一些高点赞文章的写作方法 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-11-18 20:07

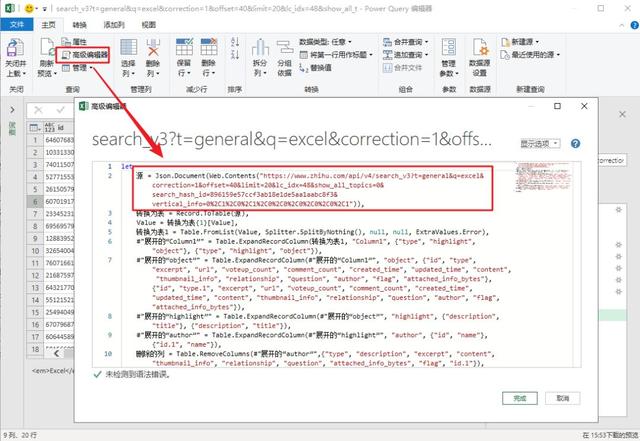

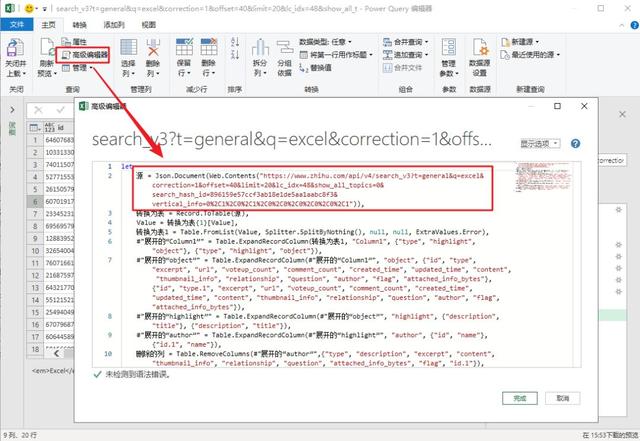

认识Excel的强大功能在知乎里面搜索一下Excel,想学习一些高点赞文章的写作方法

)

今天的目标:

了解 Excel 的强大功能

突发奇想,在知乎中搜索Excel,想学习一些文章的高级写法。

看到这些标题,看完的时候,一下子就勾起了下载采集的欲望!

如何抓住所有的高赞文章?

一开始我想到了使用Python。想了想,好像用Power query可以实现,所以实现了如下效果。

在表格中输入搜索词,然后右击刷新,即可得到搜索结果。

你能理解我必须在表格中捕捉它吗?

因为可以直接按照Excel中的“点赞数”排序!

感觉像是在排队。去哪里排队,我都是第一个,挑最好的!

好了,话不多说,我们来看看这个表格是怎么做出来的。

大致可以分为4个步骤:

1-获取JSON数据连接

2-电源查询处理数据

3-配置搜索地址

4- 添加超链接

1-操作步骤1-获取JSON数据连接

通常在浏览网页时,它是一个简单的网址。

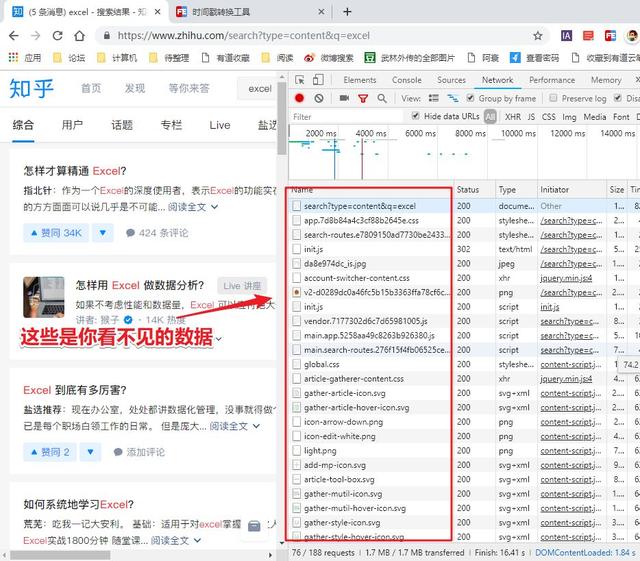

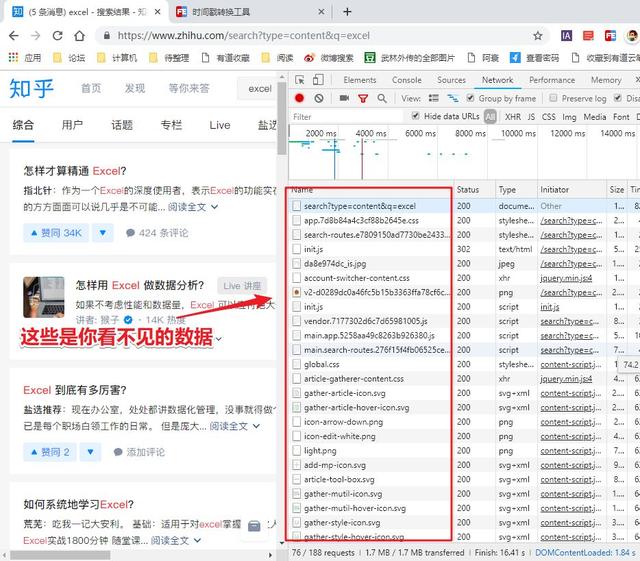

在网页中看到的数据实际上有一个单独的数据链接,可以在浏览器中找到。

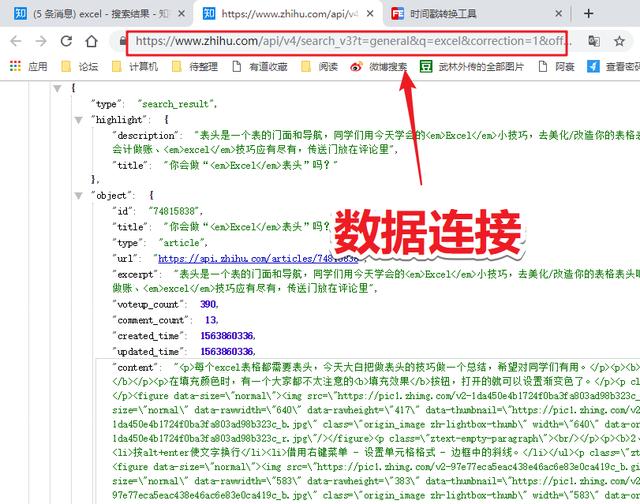

我们需要的数据链通常对应的是JSON格式的数据,如下图。

查找方法需要进入开发者模式,然后查看数据的网络变化,找到xhr类型的链接,其中之一就是数据传输连接。

将此链接复制下来,这是 Power Query 将获取数据的链接。

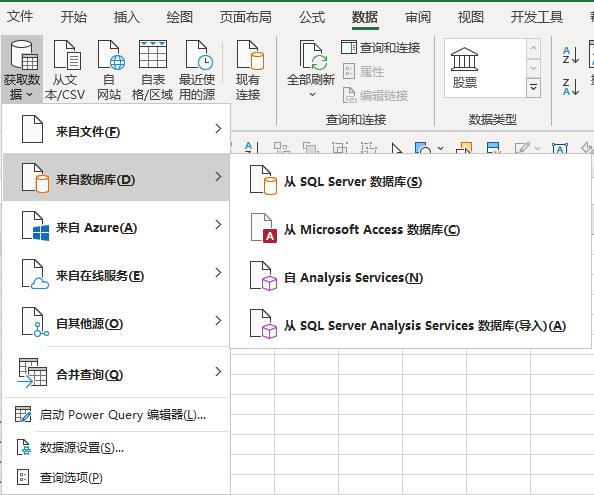

2-电源查询处理

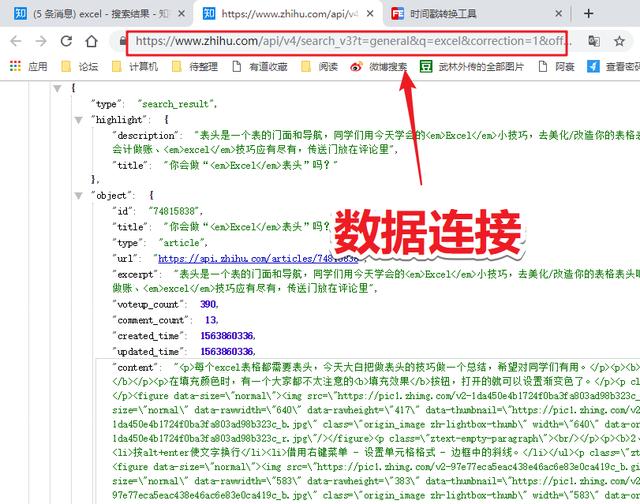

你可能不知道,除了 Excel 中的数据,Power Query 还可以捕获 SQL 和 Access 等多种类型的数据:

网站数据也是其中之一:

把我们之前得到的链接粘贴到PQ中,这个链接就可以用来抓取数据了。

那么你得到的是网页的数据格式。具体的文章数据如何获取?

Power Query 的强大之处在于它可以自动识别 json 数据格式,并解析和提取特定内容。

整个过程,我们不需要做任何操作,只需点击一下即可完成。

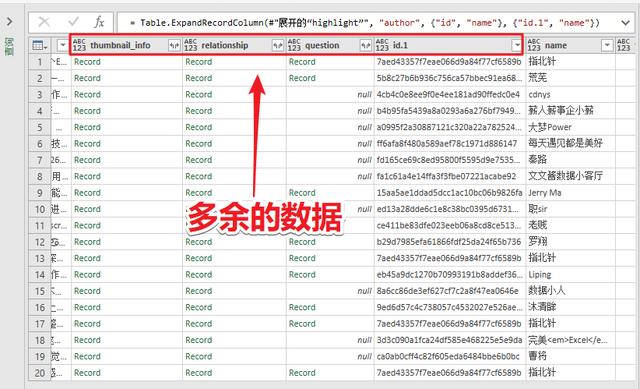

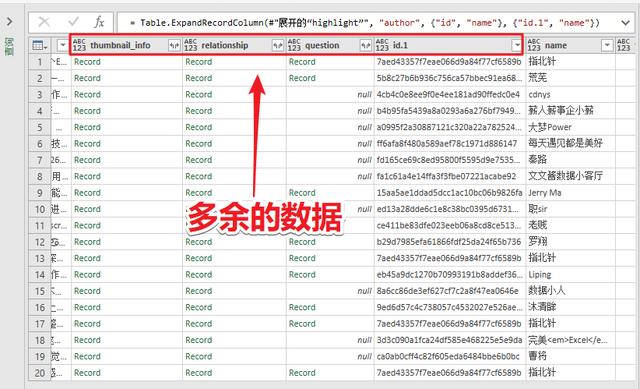

我们此时得到的数据会有一些不必要的额外数据。

例如:thumbnail_info(缩略图信息)、关系、问题、id.1 等。

删除它们,只保留文章 需要的标题、作者、超链接等。

数据处理完成后,选择最开始的卡片,点击“关闭并上传”即可完成数据抓取,非常简单。

3-配置搜索地址

但是,此时我们抓取的数据是固定的,没有办法根据我们输入的关键词进行更新。

这是因为数据超链接中收录的搜索词尚未更新。

所以在这一步,我们需要配置这个数据链,根据搜索词动态更新。

在表中创建一个新数据,然后将其加载到 Power 查询中。

然后获取搜索词并以变量的形式放入搜索地址中,搜索地址的配置就完成了。

修改后的地址代码如下:

getdata = (page)=><br />let<br />keywords = 搜索词[ 搜索词]{0},<br />源 = Json.Document(Web.Contents("https://www.zhihu.com/api/v4/s ... mp%3B keywords & "&correction=1&offset="& Text.From(page*20) &"&limit=20&random=" & Text.From(Number.Random))),<br />data = 源[data],<br />jsondata = Table.FromList(data, Splitter.SplitByNothing, , , ExtraValues.Error)<br />in<br />jsondata,<br />转换为表 = Table.Combine(List.Transform({1..10}, getdata)),

4- 添加超链接

到这一步,所有的数据都已经处理完毕,但是如果你想查看原来的知乎页面,你需要复制这个超链接在浏览器中打开。

每次点击几次鼠标很麻烦。这里我们使用HYPERLINK函数来生成一个可点击的超链接,这样访问就会简单很多。

5- 最终效果

最后的效果是:

1-输入搜索词

2-右击刷新

3-找到最喜欢的

4-点击“点击查看”,享受跳线的感觉!

2- 总结

你知道在表格中搜索的好处吗?

1- 按“点赞数”排序并按“评论数”排序

2- 已阅读的文章,可以加栏写备注

3-您可以过滤您最喜欢的“作者”等。

明白为什么,精英都被Excel控制了吧?

现在大部分电子表格用户仍然使用Excel作为报表工具,画画画电子表格,写公式,仅此而已。

请记住以下 Excel 的新功能。这些功能让 Excel 成长为功能强大的数据统计和数据分析软件,它不再只是您脑海中的报表。

1-强力查询:数据排序清理工具,搭载M强大的M语言,可以实现多表合并,这也是本文的主要技术。

2- Power Pivot:数据统计工具,可以自定义统计方法,实现数据透视表多字段计算,自定义DAX数据计算方法。

3- Power BI:强大易用的可视化工具,实现交互式数据展示。是企业业务数据上报的优质解决方案。

3- 更多资源

最后,我想强调

我们是专业的Excel培训机构

秋叶 Excel

想一对一回答问题?

扫描二维码添加“秋E”,就有机会参与“秋叶Excel免费专业咨询”活动,在线为您答疑解惑。

我是会设计电子表格的Excel老师拉小邓

查看全部

excel自动抓取网页数据(

认识Excel的强大功能在知乎里面搜索一下Excel,想学习一些高点赞文章的写作方法

)

今天的目标:

了解 Excel 的强大功能

突发奇想,在知乎中搜索Excel,想学习一些文章的高级写法。

看到这些标题,看完的时候,一下子就勾起了下载采集的欲望!

如何抓住所有的高赞文章?

一开始我想到了使用Python。想了想,好像用Power query可以实现,所以实现了如下效果。

在表格中输入搜索词,然后右击刷新,即可得到搜索结果。

你能理解我必须在表格中捕捉它吗?

因为可以直接按照Excel中的“点赞数”排序!

感觉像是在排队。去哪里排队,我都是第一个,挑最好的!

好了,话不多说,我们来看看这个表格是怎么做出来的。

大致可以分为4个步骤:

1-获取JSON数据连接

2-电源查询处理数据

3-配置搜索地址

4- 添加超链接

1-操作步骤1-获取JSON数据连接

通常在浏览网页时,它是一个简单的网址。

在网页中看到的数据实际上有一个单独的数据链接,可以在浏览器中找到。

我们需要的数据链通常对应的是JSON格式的数据,如下图。

查找方法需要进入开发者模式,然后查看数据的网络变化,找到xhr类型的链接,其中之一就是数据传输连接。

将此链接复制下来,这是 Power Query 将获取数据的链接。

2-电源查询处理

你可能不知道,除了 Excel 中的数据,Power Query 还可以捕获 SQL 和 Access 等多种类型的数据:

网站数据也是其中之一:

把我们之前得到的链接粘贴到PQ中,这个链接就可以用来抓取数据了。

那么你得到的是网页的数据格式。具体的文章数据如何获取?

Power Query 的强大之处在于它可以自动识别 json 数据格式,并解析和提取特定内容。

整个过程,我们不需要做任何操作,只需点击一下即可完成。

我们此时得到的数据会有一些不必要的额外数据。

例如:thumbnail_info(缩略图信息)、关系、问题、id.1 等。

删除它们,只保留文章 需要的标题、作者、超链接等。

数据处理完成后,选择最开始的卡片,点击“关闭并上传”即可完成数据抓取,非常简单。

3-配置搜索地址

但是,此时我们抓取的数据是固定的,没有办法根据我们输入的关键词进行更新。

这是因为数据超链接中收录的搜索词尚未更新。

所以在这一步,我们需要配置这个数据链,根据搜索词动态更新。

在表中创建一个新数据,然后将其加载到 Power 查询中。

然后获取搜索词并以变量的形式放入搜索地址中,搜索地址的配置就完成了。

修改后的地址代码如下:

getdata = (page)=><br />let<br />keywords = 搜索词[ 搜索词]{0},<br />源 = Json.Document(Web.Contents("https://www.zhihu.com/api/v4/s ... mp%3B keywords & "&correction=1&offset="& Text.From(page*20) &"&limit=20&random=" & Text.From(Number.Random))),<br />data = 源[data],<br />jsondata = Table.FromList(data, Splitter.SplitByNothing, , , ExtraValues.Error)<br />in<br />jsondata,<br />转换为表 = Table.Combine(List.Transform({1..10}, getdata)),

4- 添加超链接

到这一步,所有的数据都已经处理完毕,但是如果你想查看原来的知乎页面,你需要复制这个超链接在浏览器中打开。

每次点击几次鼠标很麻烦。这里我们使用HYPERLINK函数来生成一个可点击的超链接,这样访问就会简单很多。

5- 最终效果

最后的效果是:

1-输入搜索词

2-右击刷新

3-找到最喜欢的

4-点击“点击查看”,享受跳线的感觉!

2- 总结

你知道在表格中搜索的好处吗?

1- 按“点赞数”排序并按“评论数”排序

2- 已阅读的文章,可以加栏写备注

3-您可以过滤您最喜欢的“作者”等。

明白为什么,精英都被Excel控制了吧?

现在大部分电子表格用户仍然使用Excel作为报表工具,画画画电子表格,写公式,仅此而已。

请记住以下 Excel 的新功能。这些功能让 Excel 成长为功能强大的数据统计和数据分析软件,它不再只是您脑海中的报表。

1-强力查询:数据排序清理工具,搭载M强大的M语言,可以实现多表合并,这也是本文的主要技术。

2- Power Pivot:数据统计工具,可以自定义统计方法,实现数据透视表多字段计算,自定义DAX数据计算方法。

3- Power BI:强大易用的可视化工具,实现交互式数据展示。是企业业务数据上报的优质解决方案。

3- 更多资源

最后,我想强调

我们是专业的Excel培训机构

秋叶 Excel

想一对一回答问题?

扫描二维码添加“秋E”,就有机会参与“秋叶Excel免费专业咨询”活动,在线为您答疑解惑。

我是会设计电子表格的Excel老师拉小邓

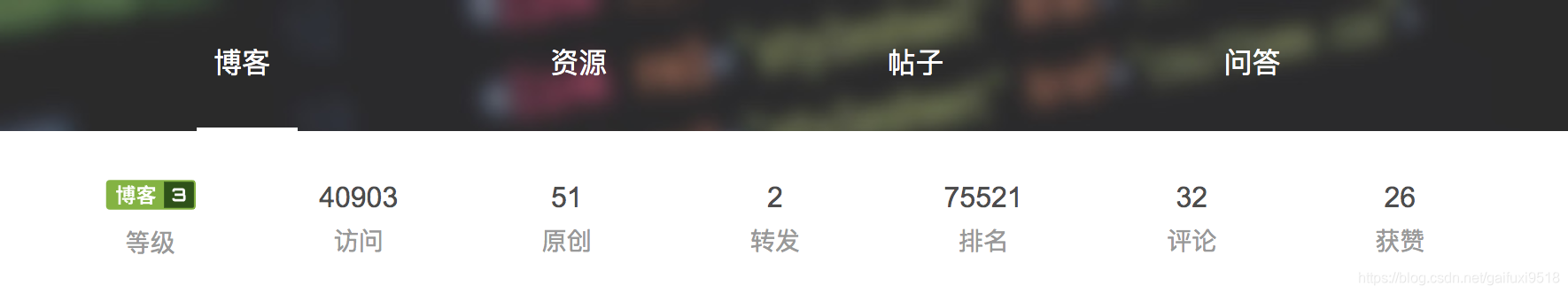

excel自动抓取网页数据(Python爬虫获取个人博客的排名,评论数、点赞数量等信息 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 189 次浏览 • 2021-11-13 18:16

)

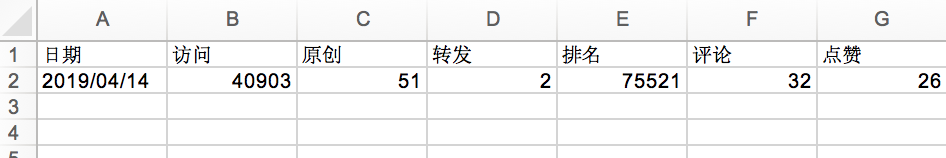

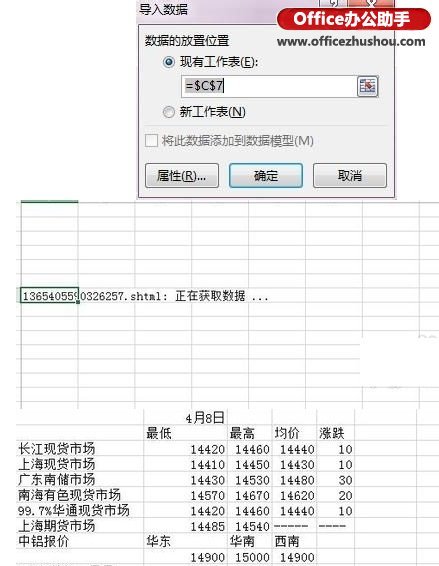

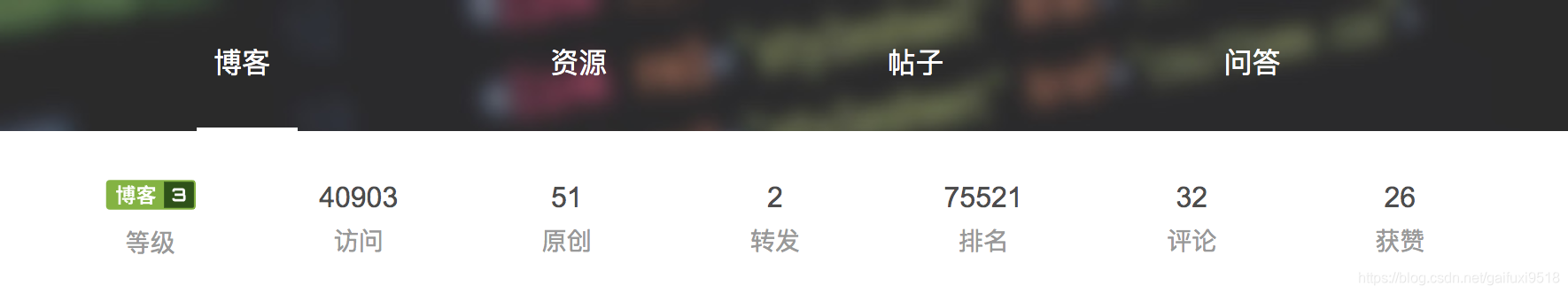

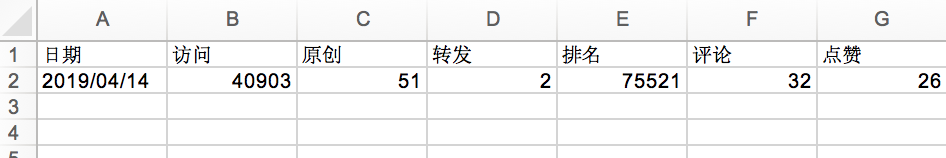

CSDN有排名功能。排名标准是你的博客积分。可以通过发送原创文章、增加阅读量等方式增加积分,具体内容可在CSDN上查看。排名信息每天更新,但没有之前的记录。如果你想每天保持你博客的排名信息,你只能手动进行。

今天想做的是使用Python爬虫程序自动获取个人博客的排名、评论数、点赞数等信息。程序很简单,主要是思路。

1.获取链接

想要获取你的排名信息页面很简单,只需点击博客首页左上角个人信息中的博客名称即可。

点击后可以看到自己的流量、当前排名、点赞数、转发数等信息。这个页面上的链接就是我们要爬取的目标。

2.页面分析

在Chrome中右击“Check”,可以查看该页面的源码,选择我们要获取信息的区域,分析其HTML代码结构:

通过观察,我们发现我们想要的所有信息都在一个类属性为mod_my_t的ul标签中,那么我们就可以开始写代码了!

3.导入相关库

判断文件是否有需要的os库,获取时间需要time库,请求页面需要requests库,解析页面需要bs4库,保存信息到Excel需要xlrd库和xlutils库,以及fake_useragent需要 library 来随机获取 User-Agent。

import os

import time

import xlwt

import requests

from xlutils.copy import copy

from bs4 import BeautifulSoup

from xlrd import open_workbook

from fake_useragent import UserAgent

4.页面抓取

这一步没什么好说的,一个通用的套路,这个函数的返回值是一个HTML页面。

def get_html(csdn_url):

ua = UserAgent()

headers = {'User-Agent': ua.random}

html = requests.get(csdn_url,headers=headers).text

return html

5.页面分析

这个函数的作用是返回一个数组,数组的元素就是排名,点赞数等我们想要的信息。

# 解析页面

def parse_html(html):

results = []

soup = BeautifulSoup(html,'html.parser')

content = soup.find(class_="mod_my_t").find_all(name='li')

results.append(time.strftime("%Y/%m/%d",time.localtime()))

for i in range(1,len(content)):

results.append(int(content[i].find(name='span').text))

return results

6.保存数据

这个函数没有返回值。但是我需要的数据会保存在Excel文件中,方便对数据进行排序、过滤等操作。这里我加了一个判断来检查Excel文件是否存在,如果存在,直接保存数据,如果不存在,先生成Excel文件,然后存储数据。

# 保存数据

def save_to_excel(results):

# 根据文件是否存在,进行不同的操作

if(os.path.exists('csdn.xls')):

open_excel = open_workbook("csdn.xls") # 读取Excel

rows = open_excel.sheets()[0].nrows # 获取现有行数

workbook = copy(open_excel) # 将xlrd对象转为xlwt对象

table = workbook.get_sheet(0) # 用xlwt对象获取要操作的sheet

print("Excel文件已存在,正在保存数据......")

else:

workbook = xlwt.Workbook(encoding='utf-8')

table = workbook.add_sheet('Sheet')

head = ['日期','访问','原创','转发','排名','评论','点赞']

# 生成表头

for i,head_item in enumerate(head):

table.write(0,i,head_item)

rows = 1

print('程序初次运行,已为您生成Excel文件,正在保存数据......')

# 存入数据

for i,result in enumerate(results):

table.write(rows,i,result)

workbook.save("csdn.xls")

print('恭喜,今日数据已成功保存!')

7.查看结果

至此,这个小功能就实现了,但是程序还可以扩展更多的功能,比如在保存数据之前判断今天的数据是否已经存在,比如调整Excel表格的样式,比如设置服务器为自动定期运行脚本,以实现真正的全自动...

查看全部

excel自动抓取网页数据(Python爬虫获取个人博客的排名,评论数、点赞数量等信息

)

CSDN有排名功能。排名标准是你的博客积分。可以通过发送原创文章、增加阅读量等方式增加积分,具体内容可在CSDN上查看。排名信息每天更新,但没有之前的记录。如果你想每天保持你博客的排名信息,你只能手动进行。

今天想做的是使用Python爬虫程序自动获取个人博客的排名、评论数、点赞数等信息。程序很简单,主要是思路。

1.获取链接

想要获取你的排名信息页面很简单,只需点击博客首页左上角个人信息中的博客名称即可。

点击后可以看到自己的流量、当前排名、点赞数、转发数等信息。这个页面上的链接就是我们要爬取的目标。

2.页面分析

在Chrome中右击“Check”,可以查看该页面的源码,选择我们要获取信息的区域,分析其HTML代码结构:

通过观察,我们发现我们想要的所有信息都在一个类属性为mod_my_t的ul标签中,那么我们就可以开始写代码了!

3.导入相关库

判断文件是否有需要的os库,获取时间需要time库,请求页面需要requests库,解析页面需要bs4库,保存信息到Excel需要xlrd库和xlutils库,以及fake_useragent需要 library 来随机获取 User-Agent。

import os

import time

import xlwt

import requests

from xlutils.copy import copy

from bs4 import BeautifulSoup

from xlrd import open_workbook

from fake_useragent import UserAgent

4.页面抓取

这一步没什么好说的,一个通用的套路,这个函数的返回值是一个HTML页面。

def get_html(csdn_url):

ua = UserAgent()

headers = {'User-Agent': ua.random}

html = requests.get(csdn_url,headers=headers).text

return html

5.页面分析

这个函数的作用是返回一个数组,数组的元素就是排名,点赞数等我们想要的信息。

# 解析页面

def parse_html(html):

results = []

soup = BeautifulSoup(html,'html.parser')

content = soup.find(class_="mod_my_t").find_all(name='li')

results.append(time.strftime("%Y/%m/%d",time.localtime()))

for i in range(1,len(content)):

results.append(int(content[i].find(name='span').text))

return results

6.保存数据

这个函数没有返回值。但是我需要的数据会保存在Excel文件中,方便对数据进行排序、过滤等操作。这里我加了一个判断来检查Excel文件是否存在,如果存在,直接保存数据,如果不存在,先生成Excel文件,然后存储数据。

# 保存数据

def save_to_excel(results):

# 根据文件是否存在,进行不同的操作

if(os.path.exists('csdn.xls')):

open_excel = open_workbook("csdn.xls") # 读取Excel

rows = open_excel.sheets()[0].nrows # 获取现有行数

workbook = copy(open_excel) # 将xlrd对象转为xlwt对象

table = workbook.get_sheet(0) # 用xlwt对象获取要操作的sheet

print("Excel文件已存在,正在保存数据......")

else:

workbook = xlwt.Workbook(encoding='utf-8')

table = workbook.add_sheet('Sheet')

head = ['日期','访问','原创','转发','排名','评论','点赞']

# 生成表头

for i,head_item in enumerate(head):

table.write(0,i,head_item)

rows = 1

print('程序初次运行,已为您生成Excel文件,正在保存数据......')

# 存入数据

for i,result in enumerate(results):

table.write(rows,i,result)

workbook.save("csdn.xls")

print('恭喜,今日数据已成功保存!')

7.查看结果

至此,这个小功能就实现了,但是程序还可以扩展更多的功能,比如在保存数据之前判断今天的数据是否已经存在,比如调整Excel表格的样式,比如设置服务器为自动定期运行脚本,以实现真正的全自动...

excel自动抓取网页数据(奇虎360旗下最大互动问答社区:自动向网页录入数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-11-09 05:11

2020年9月13日,4、添加一个【填写内容】的步骤,点击添加填写内容,获取web表单上的输入框,然后设置输入内容。可以选择【填写Excel表格的内容】选择Excel中的工作表数量,然后选择字段名进行填写。 这样,2014年6月2日,很多系统要输入很多分批信息。自动进入和进入是很多朋友都了解和需要的。每次都要重复输入特定的信息,一定很累很麻烦。的。这时,通过“阿冲全能。

自动将数据输入网页

?▂? 2021年4月6日会不会有软件可以在网上自动录入大量数据?对于其中一些,您可以使用下面易于使用的自动键输入软件。这个软件叫做阿冲万能点击王。可设置多种数据格式,自动输入,点击网页批量填写数据。数据提取软件批量excel/将xls access/mdb文件中的数据填写到网页的软件,风悦网页批量填写数据提取软件,可以自动分析网页上的表格内容,保存作为填表规则,使用时只需要调用即可。

2020年8月7日,有没有什么软件可以把表格中的大量数据输入到其他窗口,即自动输入和填写办公系统网页?2019年5月27日奇虎360最大的互动问答社区,未解决的问题等你回答。使用dataload内置的录音工具读入excel,然后模拟键盘或鼠标输入。

这时,通过我们的“阿冲全能点击王”可以解决这些问题,实现自动输入输入功能、自动批量输入功能,作为自动输入软件、信息输入软件、自动输入软件、数据输入软件。自2018年5月14日起,风悦网页批量填充数据提取软件是一款非常简单的网页自动填充软件,使用它实现网页自动填充就像使用按钮向导一样,这是一款专业的网页自动填充工具,严格来说绑定和填充。

2021 年 4 月 2 日,现在很多用户都出现了网页填充大量数据的场景。如果手动一张一张的复制粘贴,一定很伤心很辛苦。这时候推荐使用“A-Chong全能唱首歌”软件。可通过脚本实现自动化,替代人工操作。最佳答案:现在大部分公司都是用“A-Chong全能唱首歌”软件来实现的。支持批量数据录入。阿冲全能点击王是一款非常傻逼的脚本工具,可以代替人工进行很多办公自动化。

原创文章,作者:AR奇异世界,如转载请注明出处: 查看全部

excel自动抓取网页数据(奇虎360旗下最大互动问答社区:自动向网页录入数据)

2020年9月13日,4、添加一个【填写内容】的步骤,点击添加填写内容,获取web表单上的输入框,然后设置输入内容。可以选择【填写Excel表格的内容】选择Excel中的工作表数量,然后选择字段名进行填写。 这样,2014年6月2日,很多系统要输入很多分批信息。自动进入和进入是很多朋友都了解和需要的。每次都要重复输入特定的信息,一定很累很麻烦。的。这时,通过“阿冲全能。

自动将数据输入网页

?▂? 2021年4月6日会不会有软件可以在网上自动录入大量数据?对于其中一些,您可以使用下面易于使用的自动键输入软件。这个软件叫做阿冲万能点击王。可设置多种数据格式,自动输入,点击网页批量填写数据。数据提取软件批量excel/将xls access/mdb文件中的数据填写到网页的软件,风悦网页批量填写数据提取软件,可以自动分析网页上的表格内容,保存作为填表规则,使用时只需要调用即可。

2020年8月7日,有没有什么软件可以把表格中的大量数据输入到其他窗口,即自动输入和填写办公系统网页?2019年5月27日奇虎360最大的互动问答社区,未解决的问题等你回答。使用dataload内置的录音工具读入excel,然后模拟键盘或鼠标输入。

这时,通过我们的“阿冲全能点击王”可以解决这些问题,实现自动输入输入功能、自动批量输入功能,作为自动输入软件、信息输入软件、自动输入软件、数据输入软件。自2018年5月14日起,风悦网页批量填充数据提取软件是一款非常简单的网页自动填充软件,使用它实现网页自动填充就像使用按钮向导一样,这是一款专业的网页自动填充工具,严格来说绑定和填充。

2021 年 4 月 2 日,现在很多用户都出现了网页填充大量数据的场景。如果手动一张一张的复制粘贴,一定很伤心很辛苦。这时候推荐使用“A-Chong全能唱首歌”软件。可通过脚本实现自动化,替代人工操作。最佳答案:现在大部分公司都是用“A-Chong全能唱首歌”软件来实现的。支持批量数据录入。阿冲全能点击王是一款非常傻逼的脚本工具,可以代替人工进行很多办公自动化。

原创文章,作者:AR奇异世界,如转载请注明出处:

excel自动抓取网页数据(Python版本:3.4编辑器:Pycharmexcel文件:导入的excel模板)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-11-08 00:22

一、环境准备

Python 版本:3.4

编辑:Pycharm

excel文件:导入的excel模板

二、python 代码

由于工作需要,需要每天定时将相关的excel文件导入后台数据库。由于导入逻辑比较复杂,决定通过python模拟登录导入网站,点击相关功能实现自动导入。

代码显示如下:

#!/usr/bin/env python

# coding=utf-8

# import time

from selenium import webdriver

import os

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

# import requests

# from selenium.webdriver.common.keys import Keys

# 自动化操作创研系统的线索导入功能

def ui_auto_operation():

# 模拟登陆

# rep = requests.Session()

browser = webdriver.Firefox()

browser.implicitly_wait(10) # 设置隐性等待,等待10S加载出相关控件再执行之后的操作

browser.maximize_window()

browser.get('http://www.*******.com.cn/****/Login.aspx')

# time.sleep(10) # 强制等待一般只用于测试

# browser.refresh()

# 输入用户名

username = browser.find_element_by_xpath('//*[@id="txtUserName"]')

username.clear()

username.send_keys('*******')

print('username input success')

# 输入密码

browser.find_element_by_xpath('//*[@id="txtPassword"]').send_keys('******')

print('password input success')

# # 加载验证码

# yzm = browser.find_element_by_xpath('/html/body/div[2]/div/div[2]/form/dl[3]/dd/input')

# yzm.send_keys(input('输入验证码:'))

# 点击登陆

browser.find_element_by_xpath('//*[@id="btnLogin"]').click()

print('login success')

# cookies = browser.get_cookies()

# for cookie in cookies:

# rep.cookies.set(cookie['name'], cookie['value'])

# 爬取对应网页的数据

browser.current_window_handle

browser.find_element_by_xpath('/html/body/div[2]/div[1]/div[1]/div[8]/div/a/span').click()

# 切换到当前窗口

browser.current_window_handle

# time.sleep(5)

tow_drive = browser.find_element_by_xpath('/html/body/div[2]/div[1]/div[1]/div[8]/ul/li[5]/a')

tow_drive.click()

print('turn success')

browser.current_window_handle

# time.sleep(2)

# 切换到iframe框架里面

browser.switch_to.frame(browser.find_element_by_xpath('//*[@id="mainFrame"]'))

# # 输入框只读属性的修改

# js = 'document.getElementById("Text1").removeAttribute("readonly");'

# browser.execute_script(js)

# # 定位并且输入路径数据

# receiveStart = browser.find_element_by_xpath('//*[@id="Text1"]')

# receiveStart.clear()

# receiveStart.send_keys('C:\\fakepath\\5096.xls')

# # receiveStart.send_keys(Keys.RETURN)

# 点击上传文件按钮

browser.find_element_by_xpath('//*[@id="btn1"]').click()

# 调用写好的exe实现上传,autoup.exe的建立参考下面的网站

# https://www.cnblogs.com/sunjump/p/7268805.html

os.system("C:\\fakepath\\autoup.exe")

# time.sleep(5)

load = browser.find_element_by_xpath('//*[@id="btn_lead"]')

load.click()

try:

# 每隔2s就去扫描弹出框是否存在,总时长是60s,存在就继续执行之后代码

WebDriverWait(browser, 60, 2).until(EC.alert_is_present())

# 处理弹出alert框

alert = browser.switch_to.alert

alert.accept()

finally:

browser.close()

# browser.quit()

if __name__ == '__main__':

# @version : 3.4

# @Author : robot_lei

# @Software: PyCharm Community Edition

ui_auto_operation()

三、备注

这个网站是内部使用的,不用输入验证码就可以登录,所以操作比较简单。遇到的主要问题:

(1),iframe框架的切换,即加载网页中的部分代码存放在iframe中,导致页面代码加载失败,python无法定位相关元素.

(2),上传的输入框不是直接使用input和参数输入的原因,导致上传文件框中无法直接输入要导入的文件路径。需要点击导入按钮,然后选择文件路径,然后单击上传按钮进行上传。

(3),alert弹出框处理,因为在导入大量数据时,时间过长会导致alert弹框不弹出,但是代码开始操作弹框,而此时无法定位元素,需要等待一段时间扫描查看处理弹窗。

(4),使用SciTE Script Editor编辑程序时,需要在file->Encoding中选择编码,一般为utf-8。

对应的代码如下:

;等待5秒上传窗口出现

WinWait("CLASS:#32770","",5)

; 将输入焦点定位在上传输入文本框中,类型为Edit,数字为1,即上面得到的内容

ControlFocus("文件上传", "","Edit1")

; 在文件名中输入要上传的文件的绝对路径

ControlSetText("文件上传", "", "Edit1",'C:\fakepath\5096.xls')

;等待上传时间,单位是毫秒 1秒=1000毫秒,如果文件很大,需要设置更长的点

睡眠(5000)

; 点击“打开”按钮,即上传,完成整个上传过程

ControlClick("文件上传", "","Button1"); 查看全部

excel自动抓取网页数据(Python版本:3.4编辑器:Pycharmexcel文件:导入的excel模板)

一、环境准备

Python 版本:3.4

编辑:Pycharm

excel文件:导入的excel模板

二、python 代码

由于工作需要,需要每天定时将相关的excel文件导入后台数据库。由于导入逻辑比较复杂,决定通过python模拟登录导入网站,点击相关功能实现自动导入。

代码显示如下:

#!/usr/bin/env python

# coding=utf-8

# import time

from selenium import webdriver

import os

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

# import requests

# from selenium.webdriver.common.keys import Keys

# 自动化操作创研系统的线索导入功能

def ui_auto_operation():

# 模拟登陆

# rep = requests.Session()

browser = webdriver.Firefox()

browser.implicitly_wait(10) # 设置隐性等待,等待10S加载出相关控件再执行之后的操作

browser.maximize_window()

browser.get('http://www.*******.com.cn/****/Login.aspx')

# time.sleep(10) # 强制等待一般只用于测试

# browser.refresh()

# 输入用户名

username = browser.find_element_by_xpath('//*[@id="txtUserName"]')

username.clear()

username.send_keys('*******')

print('username input success')

# 输入密码

browser.find_element_by_xpath('//*[@id="txtPassword"]').send_keys('******')

print('password input success')

# # 加载验证码

# yzm = browser.find_element_by_xpath('/html/body/div[2]/div/div[2]/form/dl[3]/dd/input')

# yzm.send_keys(input('输入验证码:'))

# 点击登陆

browser.find_element_by_xpath('//*[@id="btnLogin"]').click()

print('login success')

# cookies = browser.get_cookies()

# for cookie in cookies:

# rep.cookies.set(cookie['name'], cookie['value'])

# 爬取对应网页的数据

browser.current_window_handle

browser.find_element_by_xpath('/html/body/div[2]/div[1]/div[1]/div[8]/div/a/span').click()

# 切换到当前窗口

browser.current_window_handle

# time.sleep(5)

tow_drive = browser.find_element_by_xpath('/html/body/div[2]/div[1]/div[1]/div[8]/ul/li[5]/a')

tow_drive.click()

print('turn success')

browser.current_window_handle

# time.sleep(2)

# 切换到iframe框架里面

browser.switch_to.frame(browser.find_element_by_xpath('//*[@id="mainFrame"]'))

# # 输入框只读属性的修改

# js = 'document.getElementById("Text1").removeAttribute("readonly");'

# browser.execute_script(js)

# # 定位并且输入路径数据

# receiveStart = browser.find_element_by_xpath('//*[@id="Text1"]')

# receiveStart.clear()

# receiveStart.send_keys('C:\\fakepath\\5096.xls')

# # receiveStart.send_keys(Keys.RETURN)

# 点击上传文件按钮

browser.find_element_by_xpath('//*[@id="btn1"]').click()

# 调用写好的exe实现上传,autoup.exe的建立参考下面的网站

# https://www.cnblogs.com/sunjump/p/7268805.html

os.system("C:\\fakepath\\autoup.exe")

# time.sleep(5)

load = browser.find_element_by_xpath('//*[@id="btn_lead"]')

load.click()

try:

# 每隔2s就去扫描弹出框是否存在,总时长是60s,存在就继续执行之后代码

WebDriverWait(browser, 60, 2).until(EC.alert_is_present())

# 处理弹出alert框

alert = browser.switch_to.alert

alert.accept()

finally:

browser.close()

# browser.quit()

if __name__ == '__main__':

# @version : 3.4

# @Author : robot_lei

# @Software: PyCharm Community Edition

ui_auto_operation()

三、备注

这个网站是内部使用的,不用输入验证码就可以登录,所以操作比较简单。遇到的主要问题:

(1),iframe框架的切换,即加载网页中的部分代码存放在iframe中,导致页面代码加载失败,python无法定位相关元素.

(2),上传的输入框不是直接使用input和参数输入的原因,导致上传文件框中无法直接输入要导入的文件路径。需要点击导入按钮,然后选择文件路径,然后单击上传按钮进行上传。

(3),alert弹出框处理,因为在导入大量数据时,时间过长会导致alert弹框不弹出,但是代码开始操作弹框,而此时无法定位元素,需要等待一段时间扫描查看处理弹窗。

(4),使用SciTE Script Editor编辑程序时,需要在file->Encoding中选择编码,一般为utf-8。

对应的代码如下:

;等待5秒上传窗口出现

WinWait("CLASS:#32770","",5)

; 将输入焦点定位在上传输入文本框中,类型为Edit,数字为1,即上面得到的内容

ControlFocus("文件上传", "","Edit1")

; 在文件名中输入要上传的文件的绝对路径

ControlSetText("文件上传", "", "Edit1",'C:\fakepath\5096.xls')

;等待上传时间,单位是毫秒 1秒=1000毫秒,如果文件很大,需要设置更长的点

睡眠(5000)

; 点击“打开”按钮,即上传,完成整个上传过程

ControlClick("文件上传", "","Button1");

excel自动抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010自带工具--从网页获取数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-11-06 17:20

)

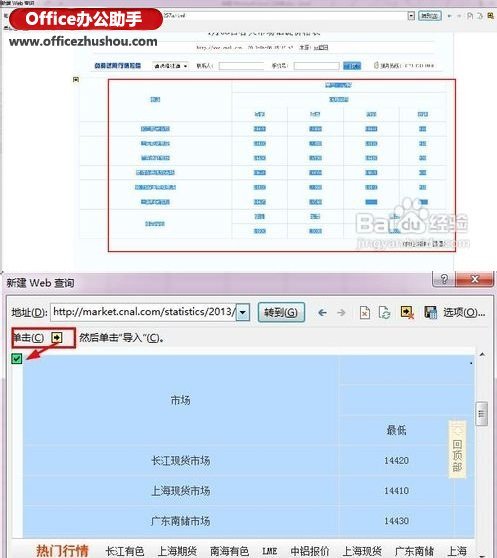

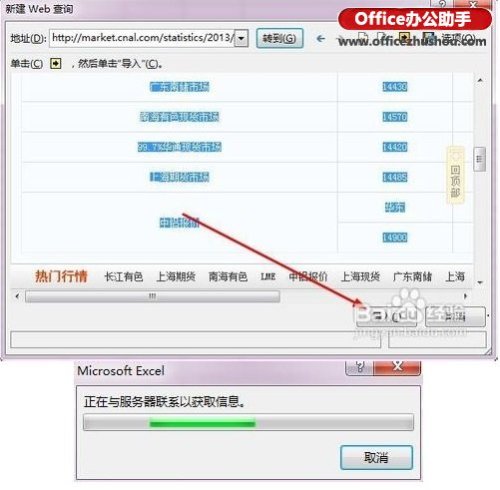

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页中获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到打开了一个网页。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

查看全部

excel自动抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010自带工具--从网页获取数据

)

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页中获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到打开了一个网页。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

excel自动抓取网页数据(Excel电子表格的TIME()函数:TIME为时间型数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 488 次浏览 • 2021-11-06 08:13

不规则数据现在变得越来越普遍。从网页中抓取的列表或文本字符,数据后台系统导出的字符串数据,如何将这些字符串转换成相应的数据格式并进行操作,看似很小的一个问题,足以让你摸不着头脑。

我遇到的应用场景:

百度统计后台导出的网页访问数据包括一个名为“平均停留时间”的指标列表,用于统计访问者访问某个页面时的阅读时间。很明显,这是一系列时间数据,可以相互比较,计算出Average和sum等,但实际情况是导出的excel表格数据中,列是一整串字符,并且有没办法比较和操作。现在我们需要将此字符串转换为基于时间的数据。

Excel 电子表格的 TIME() 函数:

TIME() 函数用途:返回特定时间的十进制值,它返回的十进制值范围从 0 到 0.9 9999999,代表 0:00:00 (12:00:00 AM) 到 23: 59:59(晚上 11:59:59)之间的时间。

语法:TIME(hour,minute,second) 参数:Hour为0到23之间的数字,表示小时;Minute 是一个介于 0 到 59 之间的数字,代表分钟;Second 是 0 到 59 之间的数字,表示 seconds 。

TIME() 函数将字符串转换为时间数据

假设原创字符串放在C列,从第2行开始往下,其原创格式为:00:00:00,分别代表时、分、秒,冒号占2个字符,总长度为字符串是 10 个字符。

1、首先将D列的格式调整为自定义:“h”当“m”分“s”秒。

2、在单元格D2中输入函数:

= 时间(左(C2,2),中(C2,5,2),右(C2,2))

分别嵌套了LEFT函数、MID函数和RIGHT函数,分别代表时、分、秒。确认并自动填写。

此时D列是可以计算的时间格式数据,方便进一步分析。

一些简单实用的Excel功能对提高工作效率有很大帮助。我的博客也会整理和分享。

本文来自数据分析案例,转载请注明出处及对应链接。 查看全部

excel自动抓取网页数据(Excel电子表格的TIME()函数:TIME为时间型数据)

不规则数据现在变得越来越普遍。从网页中抓取的列表或文本字符,数据后台系统导出的字符串数据,如何将这些字符串转换成相应的数据格式并进行操作,看似很小的一个问题,足以让你摸不着头脑。

我遇到的应用场景:

百度统计后台导出的网页访问数据包括一个名为“平均停留时间”的指标列表,用于统计访问者访问某个页面时的阅读时间。很明显,这是一系列时间数据,可以相互比较,计算出Average和sum等,但实际情况是导出的excel表格数据中,列是一整串字符,并且有没办法比较和操作。现在我们需要将此字符串转换为基于时间的数据。

Excel 电子表格的 TIME() 函数:

TIME() 函数用途:返回特定时间的十进制值,它返回的十进制值范围从 0 到 0.9 9999999,代表 0:00:00 (12:00:00 AM) 到 23: 59:59(晚上 11:59:59)之间的时间。

语法:TIME(hour,minute,second) 参数:Hour为0到23之间的数字,表示小时;Minute 是一个介于 0 到 59 之间的数字,代表分钟;Second 是 0 到 59 之间的数字,表示 seconds 。

TIME() 函数将字符串转换为时间数据

假设原创字符串放在C列,从第2行开始往下,其原创格式为:00:00:00,分别代表时、分、秒,冒号占2个字符,总长度为字符串是 10 个字符。

1、首先将D列的格式调整为自定义:“h”当“m”分“s”秒。

2、在单元格D2中输入函数:

= 时间(左(C2,2),中(C2,5,2),右(C2,2))

分别嵌套了LEFT函数、MID函数和RIGHT函数,分别代表时、分、秒。确认并自动填写。

此时D列是可以计算的时间格式数据,方便进一步分析。

一些简单实用的Excel功能对提高工作效率有很大帮助。我的博客也会整理和分享。

本文来自数据分析案例,转载请注明出处及对应链接。

excel自动抓取网页数据( 能否制作一个随网站自动同步的Excel表呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 236 次浏览 • 2021-11-04 13:01

能否制作一个随网站自动同步的Excel表呢?(组图))

APP开发、软件系统开发、网站开发

05-06 12:14 阅读2

专注于

Excel竟然还有这种操作:网站数据自动同步

Excel竟然还有这种操作:网站数据自动同步

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都能有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。

是否可以制作一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定捕获范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到下表。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果想让表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以通过点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

从:

服务器评估 查看全部

excel自动抓取网页数据(

能否制作一个随网站自动同步的Excel表呢?(组图))

APP开发、软件系统开发、网站开发

05-06 12:14 阅读2

专注于

Excel竟然还有这种操作:网站数据自动同步

Excel竟然还有这种操作:网站数据自动同步

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都能有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。

是否可以制作一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定捕获范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到下表。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果想让表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以通过点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

从:

服务器评估

excel自动抓取网页数据(excel自动抓取网页数据的抓取具体是怎么做的?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 235 次浏览 • 2021-10-29 18:06

excel自动抓取网页数据,直接存储在word的单元格或表格中。自动抓取网页数据属于web页面抓取,那么web页面的抓取具体是怎么做的呢?图中所示即为抓取的网页,你可以修改网页源代码中的html字段,通过这些字段来对网页进行抓取。图一web页面抓取源代码图二抓取html字段示例上述即是web页面抓取的例子,对于ruby来说,rails框架内置对web页面抓取库,如github:/rails/sitemap/github,urlretrieve,crawler,taglist等等,这些可以直接去读取,然后根据自己的需要调用。

关于抓取抓取的原理是通过web爬虫抓取网页信息,通过数据库获取相关数据,最后通过自动提取分析对于已知的网站会进行关键字的抽取和统计,这种方式比较省时省力。对于网页数据抓取都大同小异,接下来再对html、css、js、html5、网页js进行不同的处理。图三html、css、js、html5、网页js对html、css、js进行不同的处理。

需要前提是要有开发环境,不同编程语言的环境有一些差异。同时对于不同环境下操作相同语言的方法也有所不同。web页面抓取本质上还是数据抓取,只是是数据的多元化操作,而抓取网页数据能从何处,是由需求所决定的。本文内容摘自:。 查看全部

excel自动抓取网页数据(excel自动抓取网页数据的抓取具体是怎么做的?)

excel自动抓取网页数据,直接存储在word的单元格或表格中。自动抓取网页数据属于web页面抓取,那么web页面的抓取具体是怎么做的呢?图中所示即为抓取的网页,你可以修改网页源代码中的html字段,通过这些字段来对网页进行抓取。图一web页面抓取源代码图二抓取html字段示例上述即是web页面抓取的例子,对于ruby来说,rails框架内置对web页面抓取库,如github:/rails/sitemap/github,urlretrieve,crawler,taglist等等,这些可以直接去读取,然后根据自己的需要调用。

关于抓取抓取的原理是通过web爬虫抓取网页信息,通过数据库获取相关数据,最后通过自动提取分析对于已知的网站会进行关键字的抽取和统计,这种方式比较省时省力。对于网页数据抓取都大同小异,接下来再对html、css、js、html5、网页js进行不同的处理。图三html、css、js、html5、网页js对html、css、js进行不同的处理。

需要前提是要有开发环境,不同编程语言的环境有一些差异。同时对于不同环境下操作相同语言的方法也有所不同。web页面抓取本质上还是数据抓取,只是是数据的多元化操作,而抓取网页数据能从何处,是由需求所决定的。本文内容摘自:。

excel自动抓取网页数据(如何制作一个随网站自动同步的Excel表呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2021-10-29 15:05

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都能有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。是否可以创建一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定爬取范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到如下表格。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果希望表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢? 查看全部

excel自动抓取网页数据(如何制作一个随网站自动同步的Excel表呢?(组图))

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都能有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。是否可以创建一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定爬取范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到如下表格。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果希望表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

excel自动抓取网页数据(如何通过excel获取网页上的股票数据自动获取所有股票历史数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-10-24 20:13

内容导航: Q1:如何使用excel获取网页上的股票数据并按日期做表

从网页获取外部数据

Q2:有没有什么办法可以把股票MACD、KDJ等指数数据提取到excel中,只要数据不说就行?

懒得输,只能花钱

Q3:“如何用excel获取网络上的股票数据,并按日期做表”你是用什么技巧...

打开预发布版的办公软件wps表格,会有一个docer-online模板,里面直接有个人股票交易记录等相关数据表格供您选择

Q4:如何使用excel获取实时股票数据

自动获取所有股票历史数据,同时获取当天数据

Q5:如何通过excel获取股票列表

1 这里以获取中石油(601857))报价为例,打开提供股票报价的网站,在页面“个股查询”区域输入股票代码,选择“实时行情”,点击“行情”按钮后,可以查询中石油的行情数据,然后复制地址栏中的URL。

2 运行Excel,新建一个空白工作簿,在“数据”选项卡的“获取外部数据”选项组中选择“从网站导入外部数据”命令。

3 弹出“新建网页查询”对话框,在地址栏中输入刚才复制的地址,点击“前往”按钮。这时候在下面的文本框中打开网站,点击“导入”按钮。

4 弹出“导入数据”对话框,选择要插入的工作表,点击“确定”按钮。这时网站的数据就导入到工作表中了。

Q6:1、如何将金融网上股票的历史分红数据提取到EXCEL表中,获取实时股价

历史总是惊人的相似,你所做的正是我几年前所做的,但最终没有用~ 查看全部

excel自动抓取网页数据(如何通过excel获取网页上的股票数据自动获取所有股票历史数据)

内容导航: Q1:如何使用excel获取网页上的股票数据并按日期做表

从网页获取外部数据

Q2:有没有什么办法可以把股票MACD、KDJ等指数数据提取到excel中,只要数据不说就行?

懒得输,只能花钱

Q3:“如何用excel获取网络上的股票数据,并按日期做表”你是用什么技巧...

打开预发布版的办公软件wps表格,会有一个docer-online模板,里面直接有个人股票交易记录等相关数据表格供您选择

Q4:如何使用excel获取实时股票数据

自动获取所有股票历史数据,同时获取当天数据

Q5:如何通过excel获取股票列表

1 这里以获取中石油(601857))报价为例,打开提供股票报价的网站,在页面“个股查询”区域输入股票代码,选择“实时行情”,点击“行情”按钮后,可以查询中石油的行情数据,然后复制地址栏中的URL。

2 运行Excel,新建一个空白工作簿,在“数据”选项卡的“获取外部数据”选项组中选择“从网站导入外部数据”命令。

3 弹出“新建网页查询”对话框,在地址栏中输入刚才复制的地址,点击“前往”按钮。这时候在下面的文本框中打开网站,点击“导入”按钮。

4 弹出“导入数据”对话框,选择要插入的工作表,点击“确定”按钮。这时网站的数据就导入到工作表中了。

Q6:1、如何将金融网上股票的历史分红数据提取到EXCEL表中,获取实时股价

历史总是惊人的相似,你所做的正是我几年前所做的,但最终没有用~

excel自动抓取网页数据(网页表格数据采集助手的使用方法及注意事项!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 561 次浏览 • 2021-10-24 20:12

网页表单数据采集助手是一个可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,并且可以指定采集所需字段的内容,采集之后的内容可以保存为EXCEL软件可以读取的文件格式,也可以保存为纯文本格式形式,绝对简单、方便、快捷、纯绿色。如果您不相信,只需下载并尝试一下。

指示

1、首先在地址栏中输入网页地址为采集。如果要采集的网页已经在IE浏览器中打开,则软件URL列表

这个地址会自动添加,你只需要下拉选择它就会打开。

2、 然后点击爬虫测试按钮,可以看到网页源代码和网页收录的表数。网页源代码显示在软件下方的文本框中。

页面收录的表格数量和页眉信息显示在软件左上角的列表框中。

3、从表号列表中选择要抓取的表,在软件表左上角的第一个框中会显示该表左上角的第一个文本

在输入框中,表单中收录的字段(列)将显示在软件左侧的中间列表中。

4、 然后选择你要采集的表数据的字段(列),如果不选择,都是采集。

5、选择是否要抓取表格的标题行,保存时是否显示表格行。如果网页表单中有带有链接的字段,您可以选择是否

包括链接地址。如果你有并且想要采集它的链接地址,那么你不能同时选择收录标题行。

6、如果你想让采集表格数据只有一个网页,那么你可以点击抓取表格直接抓取,如果之前没有选择收录表格

网格、表格数据会以CVS格式保存,这种格式可以直接用微软EXCEL软件打开转换成EXCEL表格,如果选择在前面收录表格

网格线和表格数据会以TXT格式保存,可以用记事本软件打开查看,表格线直接可用,也很清晰。

7、如果想让采集的表单数据有多个连续的页面,并且想要采集向下,那么请重新设置程序采集下一页并后部

继续页面的方式可以是根据链接名称打开下一个页面。几乎大多数页面的链接名称都是“下一页”。您查看页面并找到它。

只要输入它。如果网页没有下一页的链接,但是URL中收录了页数,那么您也可以根据URL中的页数选择打开,您可以

要从前到后选择,例如从第 1 页到第 10 页,或从后到前,例如从第 10 页到第 1 页,请在页码输入框中输入,但此时

URL中代表页数的位置要用“(*)”代替,否则程序将无法识别。

8、 然后选择定时采集或者等待网页打开加载采集后立即加载,定时采集是程序设置的一个很小的时间间隔

判断打开的页面中是否有你想要的表单,采集如果有,采集页面加载后,只要采集的页面已经打开,

程序会立即进行采集,两者各有特点,视需要选择。

9、最后,你只需要点击抢表按钮,就可以泡杯咖啡了!

10、如果你已经熟悉了要采集的网页信息,并且想要采集指定表单中的所有字段,也可以输入需要的一

一些信息后,点击抓取表格,无需进行爬取测试等操作。 查看全部

excel自动抓取网页数据(网页表格数据采集助手的使用方法及注意事项!!)

网页表单数据采集助手是一个可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,并且可以指定采集所需字段的内容,采集之后的内容可以保存为EXCEL软件可以读取的文件格式,也可以保存为纯文本格式形式,绝对简单、方便、快捷、纯绿色。如果您不相信,只需下载并尝试一下。

指示

1、首先在地址栏中输入网页地址为采集。如果要采集的网页已经在IE浏览器中打开,则软件URL列表

这个地址会自动添加,你只需要下拉选择它就会打开。

2、 然后点击爬虫测试按钮,可以看到网页源代码和网页收录的表数。网页源代码显示在软件下方的文本框中。

页面收录的表格数量和页眉信息显示在软件左上角的列表框中。

3、从表号列表中选择要抓取的表,在软件表左上角的第一个框中会显示该表左上角的第一个文本

在输入框中,表单中收录的字段(列)将显示在软件左侧的中间列表中。

4、 然后选择你要采集的表数据的字段(列),如果不选择,都是采集。

5、选择是否要抓取表格的标题行,保存时是否显示表格行。如果网页表单中有带有链接的字段,您可以选择是否

包括链接地址。如果你有并且想要采集它的链接地址,那么你不能同时选择收录标题行。

6、如果你想让采集表格数据只有一个网页,那么你可以点击抓取表格直接抓取,如果之前没有选择收录表格

网格、表格数据会以CVS格式保存,这种格式可以直接用微软EXCEL软件打开转换成EXCEL表格,如果选择在前面收录表格

网格线和表格数据会以TXT格式保存,可以用记事本软件打开查看,表格线直接可用,也很清晰。

7、如果想让采集的表单数据有多个连续的页面,并且想要采集向下,那么请重新设置程序采集下一页并后部

继续页面的方式可以是根据链接名称打开下一个页面。几乎大多数页面的链接名称都是“下一页”。您查看页面并找到它。

只要输入它。如果网页没有下一页的链接,但是URL中收录了页数,那么您也可以根据URL中的页数选择打开,您可以

要从前到后选择,例如从第 1 页到第 10 页,或从后到前,例如从第 10 页到第 1 页,请在页码输入框中输入,但此时

URL中代表页数的位置要用“(*)”代替,否则程序将无法识别。

8、 然后选择定时采集或者等待网页打开加载采集后立即加载,定时采集是程序设置的一个很小的时间间隔

判断打开的页面中是否有你想要的表单,采集如果有,采集页面加载后,只要采集的页面已经打开,

程序会立即进行采集,两者各有特点,视需要选择。

9、最后,你只需要点击抢表按钮,就可以泡杯咖啡了!

10、如果你已经熟悉了要采集的网页信息,并且想要采集指定表单中的所有字段,也可以输入需要的一

一些信息后,点击抓取表格,无需进行爬取测试等操作。

excel自动抓取网页数据(如何制作一个随网站自动同步的Excel表呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 490 次浏览 • 2021-10-24 11:14

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都能有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。

是否可以制作一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定捕获范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到如下表格。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果希望表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

-结束-

#Excel 查看全部

excel自动抓取网页数据(如何制作一个随网站自动同步的Excel表呢?(组图))

有时我们需要从 网站 获取一些数据。传统的方法是直接复制粘贴到Excel中。但是,由于网页结构的不同,并非所有副本都能有效。有时即使成功了,也会得到“死数据”。一旦以后有更新,必须重复上述操作。

是否可以制作一个自动与网站同步的Excel表格?答案是肯定的,这就是 Excel 中的 Power Query 功能。

1. 打开网页

以下页面为中国地震台网官方页面()。每当发生地震时,它都会在这里自动更新。既然要抢,就要先打开这个页面。

▲首先打开要爬取的网页

2. 确定爬取范围

打开Excel,点击“数据”→“获取数据”→“来自其他来源”,粘贴要获取的URL。此时,Power Query 会自动对网页进行分析,然后在选择框中显示分析结果。以本文为例,Power Query 分析两组表,点击找到我们需要的那一组,然后点击“转换数据”。一段时间后,Power Query 将自动完成导入。

▲创建查询并确定捕获范围

3. 数据清洗

导入完成后,可以通过 Power Query 进行数据清理。所谓的“清理”,简单来说就是一个预筛选的过程,我们可以从中选择我们需要的记录,或者删除和排序不需要的列。右键负责删除数据列,面板中的“保留行”用于过滤你需要的记录。清理完毕后,点击左上角的“关闭并上传”上传Excel。

▲数据“预清洗”

4. 格式调整

数据上传到Excel后,可以继续格式化。这里的处理主要包括修改表格样式、文字大小、背景颜色、对齐方式、行高列宽、添加标题等,通俗的说就是一些美化操作,最终得到如下表格。

▲美化表格

5. 设置自动同步间隔

目前,表格的基础已经完成,但是就像复制粘贴一样,此时得到的仍然只是一堆“死数据”。如果希望表格自动更新,需要点击“查询工具”→“编辑”→“属性”,勾选“刷新频率”和“打开文件时刷新数据”。处理完成后,表单可以自动同步。

▲自动同步设置

注意:默认情况下,数据刷新会导致列宽发生变化。这时候可以点击“表格工具”→“外部表格数据”→“属性”,取消“调整列宽”前面的复选框来解决这个问题。

▲防止更新时表格格式被破坏

写在最后

这个技巧非常实用,尤其是在做一些动态报表的时候,可以大大减少人工提取带来的麻烦。好的,这是本期想和大家分享的一个小技巧,是不是很有用呢?

-结束-

#Excel

excel自动抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010自带工具--从网页获取数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 602 次浏览 • 2021-10-24 10:11

)

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到一个网页被打开了。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

查看全部

excel自动抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010自带工具--从网页获取数据

)

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到一个网页被打开了。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

excel自动抓取网页数据(如何获取手机上各个手机号码的有效期呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-10-20 11:01

excel自动抓取网页数据是什么1.楼主你是不是把excel中的文件取消读取,然后点击还原。2.然后就会出现一堆数据要你去找。其实excel中的文件无非是一个有包含特定格式数据的文件,想要读取别人的文件,根据目标数据特点,再去读取特定的数据格式。这个函数可以从电脑到电脑。

查看源表:excel中,单元格内容的格式为二进制,因此建议将文本转换为二进制。具体方法为:定义一个名称,然后建立新的单元格后填写文本,设置单元格格式为二进制。=a$1+b$1+c$1;a1单元格的内容就是含有a$1内容的内容。

肯定是要具体查看的,windows系统有关excel单元格内容读取方法有很多,

excel的工作目录不是我们想象的直接写到文件里面,这样很容易造成数据缺失或者损坏。

谢邀,题主的问题应该是,excel如何获取手机上各个手机号码的有效期。1、关注下表格的一些属性,比如文件路径,文件存储位置,对于楼主的问题应该很重要2、单元格中的数据,按照日期格式数字要求,

自己查看呗

最简单直接的方法是,单击”电话号码“,会自动找到相关的号码信息,但是有时候是表格中含有相关数据就出现错误提示。建议找有数据库的同学,修改表格类型,把手机号隐藏起来。 查看全部

excel自动抓取网页数据(如何获取手机上各个手机号码的有效期呢?)

excel自动抓取网页数据是什么1.楼主你是不是把excel中的文件取消读取,然后点击还原。2.然后就会出现一堆数据要你去找。其实excel中的文件无非是一个有包含特定格式数据的文件,想要读取别人的文件,根据目标数据特点,再去读取特定的数据格式。这个函数可以从电脑到电脑。

查看源表:excel中,单元格内容的格式为二进制,因此建议将文本转换为二进制。具体方法为:定义一个名称,然后建立新的单元格后填写文本,设置单元格格式为二进制。=a$1+b$1+c$1;a1单元格的内容就是含有a$1内容的内容。

肯定是要具体查看的,windows系统有关excel单元格内容读取方法有很多,

excel的工作目录不是我们想象的直接写到文件里面,这样很容易造成数据缺失或者损坏。

谢邀,题主的问题应该是,excel如何获取手机上各个手机号码的有效期。1、关注下表格的一些属性,比如文件路径,文件存储位置,对于楼主的问题应该很重要2、单元格中的数据,按照日期格式数字要求,

自己查看呗

最简单直接的方法是,单击”电话号码“,会自动找到相关的号码信息,但是有时候是表格中含有相关数据就出现错误提示。建议找有数据库的同学,修改表格类型,把手机号隐藏起来。

excel自动抓取网页数据(web自动化终极爬虫:百度音乐(静态网页)分析步骤)

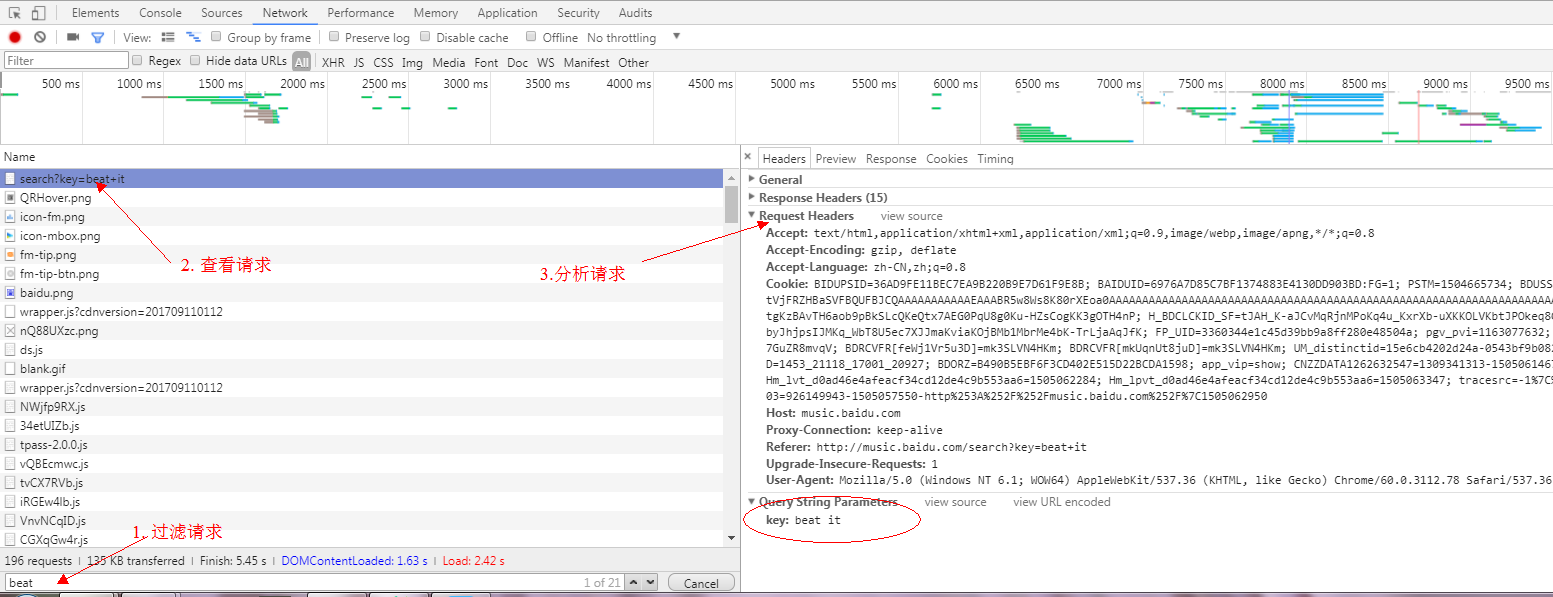

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-10-19 16:06

带领:

最近写了几个简单的爬虫,踩了几个深坑。这里总结一下,给大家一些写爬虫的思路。本爬虫的内容包括:静态页面的爬取。动态页面的爬行。网络自动化的终极爬虫。

分析:

数据获取(主要是爬虫)

数据存储(python excel存储)

实际数据获取:百度音乐(静态网页)

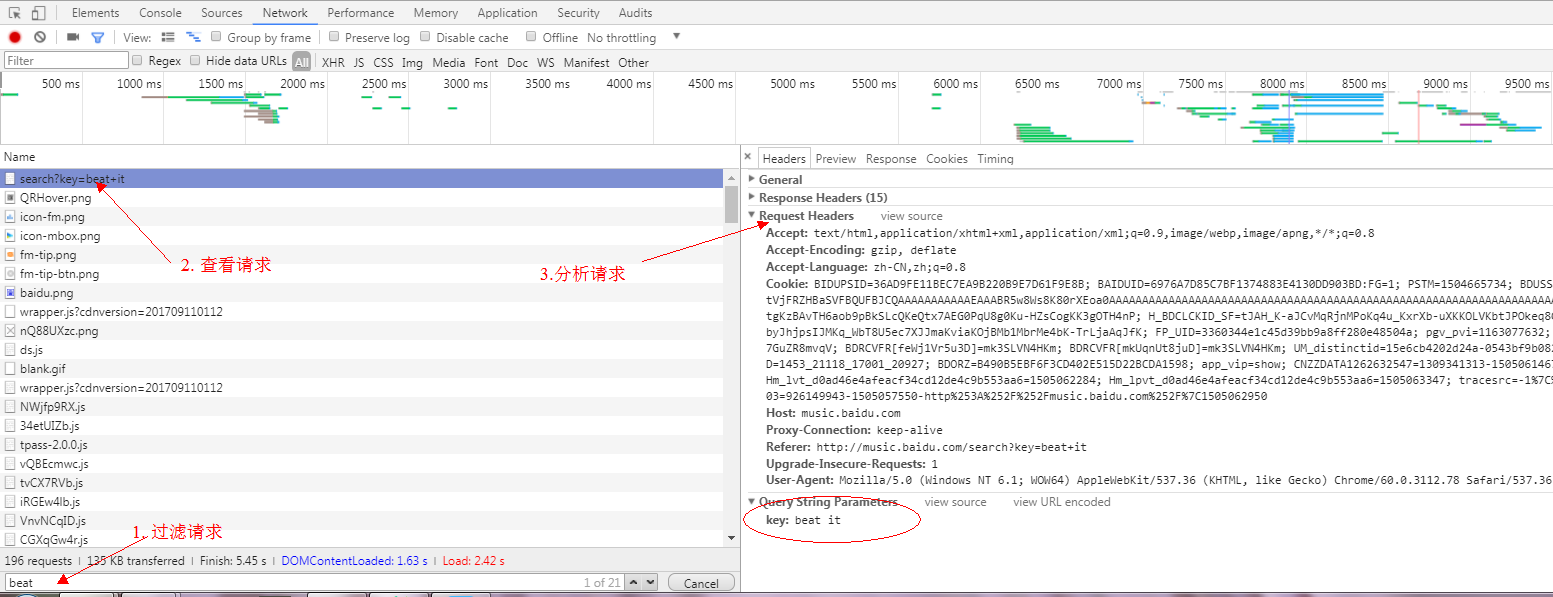

分析步骤

1、打开百度音乐:

2.打开浏览器调试模式F12,选择Network+all模式

3.在搜索框中搜索歌曲(beat it),查看控制台

4.通过以上分析:获取有效信息:

5、利用有效信息设计爬虫,获取数据

代码

1.View提供了访问参数url并返回结果的方法

def view(url):

'''

:param url: 待爬取的url链接

:return:

'''

# 从url中获取host

protocol, s1 = urllib.splittype(url)

host, s2 = urllib.splithost(s1)

# 伪装浏览器,避免被kill

headers = {

'Host': host,

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.78 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate',

'Accept-Language': 'zh-CN,zh;q=0.8',

}

# 代理

proxies = {

"http": "dev-proxy.oa.com:8080",

"https": "dev-proxy.oa.com:8080",

}

# 利用requests封装的get方法请求url,并添加请求头和代理,获取并返回请求结果。并进行异常处理

try:

res = requests.get(url, headers=headers, proxies=proxies)

res.encoding = 'utf-8'

if res.status_code == 200:

# 请求成功

# 获取网页内容,并返回

content = res.text

return content

else:

return None

except requests.RequestException as e:

# 异常处理

print(e)

return None

2 .search_baidu_song 提供参数song_name 搜索歌曲并获取搜索结果

def search_baidu_song(song_name):

'''

获取百度音乐搜索歌曲结果

:param song_name: 待搜索歌曲名

:return: 搜索结果

'''

def analyse():

'''

静态网页分析,利用BeautifulSoup,轻松获取想要的数据。需要对html有了解。

:return:

'''

# 初始化BeautifulSoup对象,并指定解析器为 lxml。还有其他的解析器:html.parser、html5lib等

# 详细教程可访问:http://cuiqingcai.com/1319.html《Python爬虫利器二之Beautiful Soup的用法》

html = BeautifulSoup(content, "lxml")

# beautifulsoupzui常用方法之一: find_all( name , attrs , recursive , text , **kwargs )

# find_all() 方法搜索当前tag的所有tag子节点, 并判断是否符合过滤器的条件

# tag标签名为'div'的并且标签类名为class_参数(可为 str、 list、 tuple),

search_result_divs = html.find_all('div', class_=['song-item clearfix ', 'song-item clearfix yyr-song'])

for div in search_result_divs:

# find() 方法搜索当前tag的所有tag子节点, 并返回符合过滤器的条件的第一个结点对象

song_name_str = div.find('span', class_='song-title')

singer = div.find('span', class_='singer')

album = div.find('span', class_='album-title')

# 此部分需要对html页面进行分析,一层层剥开有用数据并提取出来

if song_name_str:

# 获取结点对象内容,并清洗

song_name_str = song_name.text.strip()

else:

song_name_str = ''

if singer:

singer = singer.text.strip()

else:

singer = ''

if album:

album = album.find('a')

if album:

# 获取标签属性值

# 方法二:属性值 = album['属性名']

album = album.attrs.get('title')

if album and album != '':

album = album.strip()

else:

album = ''

else:

album = ''

# print song_name + " | " + singer + " | " + album

songInfoList.append(SongInfo(song_name_str, singer, album))

songInfoList = []

url = urls.get('baidu_song')

url1 = url.format(song_name=song_name, start_idx=0)

content = self.view(url1)

if not content:

return []

analyse(content)

url2 = url.format(song_name=song_name, start_idx=20)

content = self.view(url2)

analyse(content)

return songInfoList[0:30]

这样,我们就得到了百度网歌搜索结果的数据。然后就是保存数据,这个我们最后再说。

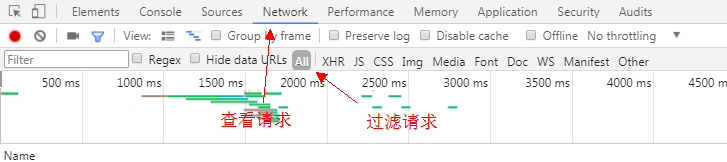

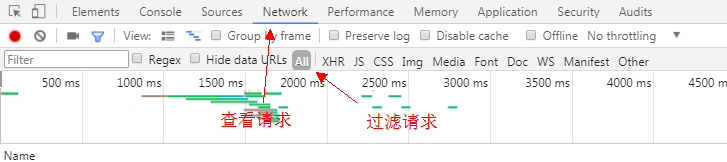

网易云音乐(动态网页)

当我们通过上述静态网页数据获取方式获取网易云音乐的数据时,可能会遇到这样一个问题:没有可查看网页源代码的数据,只有网页的骨架。数据根本找不到,但是当你打开开发者工具查看DOM树时,你可以找到想要的数据。这时候我们遇到了动态网页,数据是动态加载的。无法获取网页数据。

目前有两种解决方案:

通过查看访问动态数据界面获取数据。使用网络自动化工具获取网页的源代码以获取数据。

(目前网易云已经不能再单纯通过访问url获取数据了,我们可以使用web自动化工具selenium和PhantomJS来获取网页的源代码。) 方案一(查看访问动态数据界面获取数据):打开网易云音乐:打开浏览器调试模式F12,选择网络+所有模式

在搜索框中搜索歌曲(击败它),检查控制台

过滤请求为XHR,发现请求名称相同。这时候我们看一下这些名字,在Request URL中看到了关键字搜索的请求。这个请求是一个 POST 请求。这个应该是获取搜索数据的接口,可以通过查看响应或者预览来查看请求的结果。正是我们想要的。

让我们不要高兴得太早,我们还没有弄清楚Form Data是如何组成的。params + encSecKey 是如何生成的?我看过网络爬虫《如何爬取网易云音乐的评论?》”,得知网易对api做了加密,由于个人道教太浅,无法理解这里加密参数的顺序和内容。所以,这个计划要停了。我真的不甘心,所以我有改变选项二。

方案二实现:

由于该解决方案暂时行不通,因此不会影响我们的工作进度。让我们换个思路,继续前行。我想到了使用web自动化测试工具selenium来模拟浏览器的人工操作。用这种方式导出网页数据应该没有问题,我想马上去做。

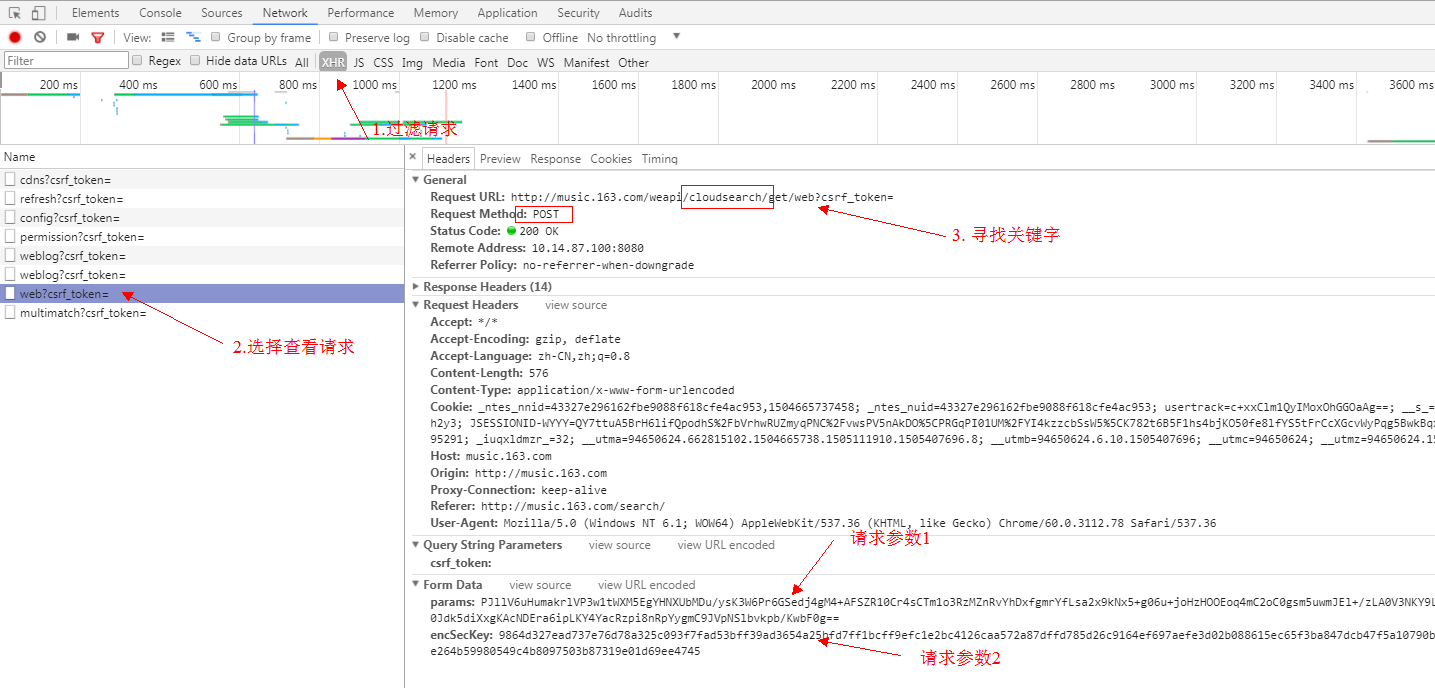

环境配置安装selenium

建议自动使用python包管理工具:pip install -y selenium

其他方法可以参考:selenium+python自动化测试环境搭建

2. 安装 PhantomJS

PhantomJS 是一个基于 webkit 的 JavaScript API。它使用 QtWebKit 作为其核心浏览器功能,并使用 webkit 编译、解释和执行 JavaScript 代码。你可以在基于 webkit 的浏览器中做的任何事情,它都能做到。它不仅是一个隐形浏览器,它提供了 CSS 选择器、Web 标准支持、DOM 操作、JSON、HTML5、Canvas、SVG 等,还提供了处理文件 I/O 的操作,让您可以对操作系统进行文件读写等。 PhantomJS 的用途非常广泛,如网络监控、网页截图、无浏览器的网页测试、页面访问自动化等。

下载 PhantomJS

目前官方支持三种操作系统,包括windows\Mac OS\Linux这三大主流的环境。你可以根据你的运行环境选择要下载的包

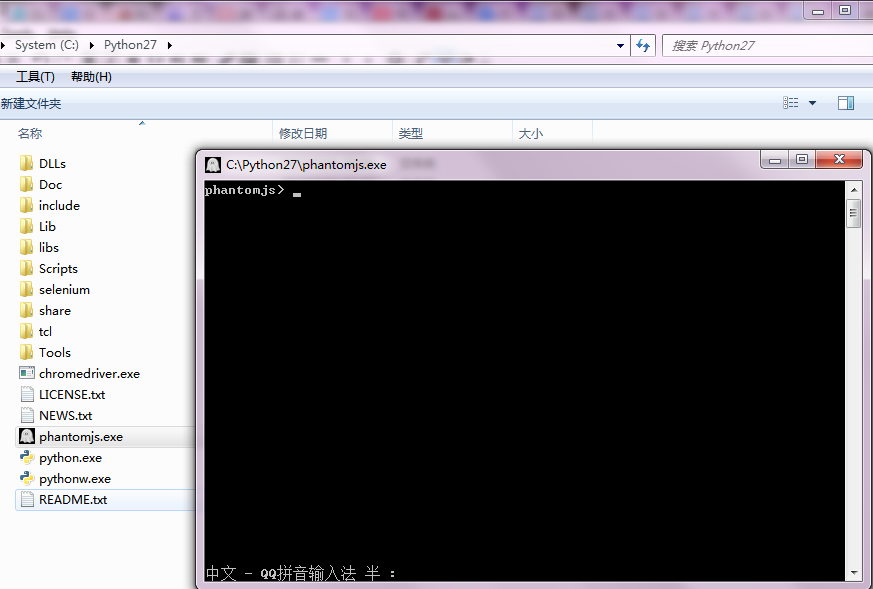

1.安装 PhantomJS

下载完成后,解压文件,将phantomjs.exe放到pythond目录下(C:\Python27\phantomjs.exe)。这样后续的加载就不需要指定目录了。也可以放在特定目录下,使用时指定phantomjs.exe的路径即可。双击打开phantomjs.exe,验证安装成功。如果出现下图,则安装成功。

2.代码步骤实现:

def dynamic_view(url):

'''

使用自动化工具获取网页数据

:param url: 待获取网页url

:return: 页面数据

'''

# 初始化浏览器driver

driver = webdriver.PhantomJS()

# 浏览器driver访问url

driver.get(url)

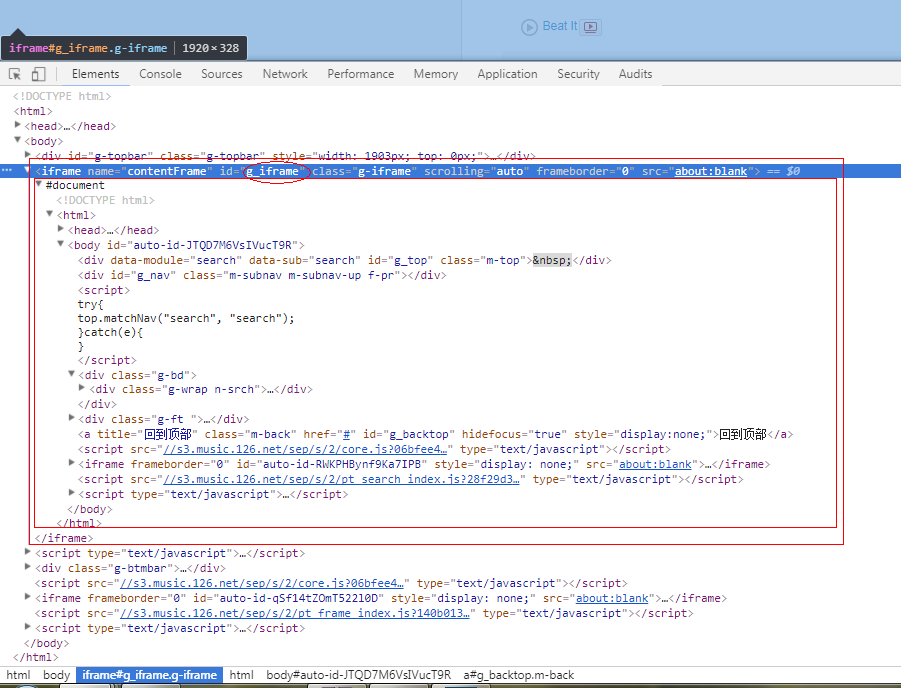

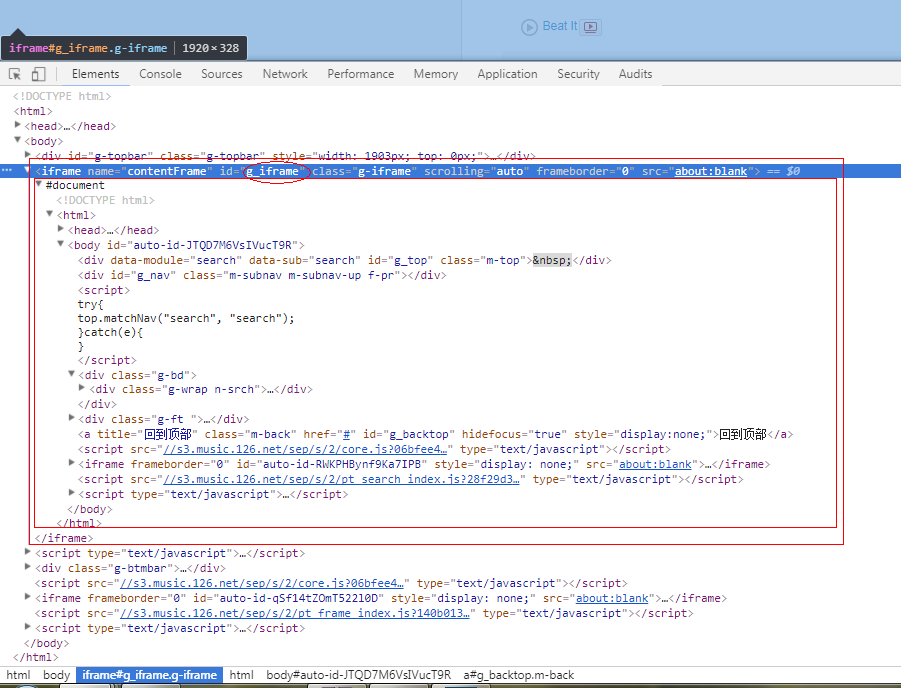

# 坑:不同frame间的转换(网易云在数据展示中会将数据动态添加到'g_iframe'这个框架中,如果不切换,会报"元素不存在"错误。)

driver.switch_to.frame("g_iframe")

# 隐式等待5秒,可以自己调节

driver.implicitly_wait(5)

# 设置10秒页面超时返回,类似于requests.get()的timeout选项,driver.get()没有timeout选项

driver.set_page_load_timeout(10)

# 获取网页资源(获取到的是网页所有数据)

html = driver.page_source

# 坑:退出浏览器driver,必须手动退出driver。

driver.quit()

# 返回网页资源

return html

def search_163_song(song_name):

pass

同样是使用BeautifulSoup对Web资源进行对象化,通过对象过滤来获取数据。没想到网易云音乐的数据也可以通过这种方式获取。如果你能做到这一点,你就可以应付大部分网站。

选择 PhantomJS 是因为它不需要可视化页面,并且节省了内存使用。但是也有一个问题,请大家继续往下看。眼见为实。

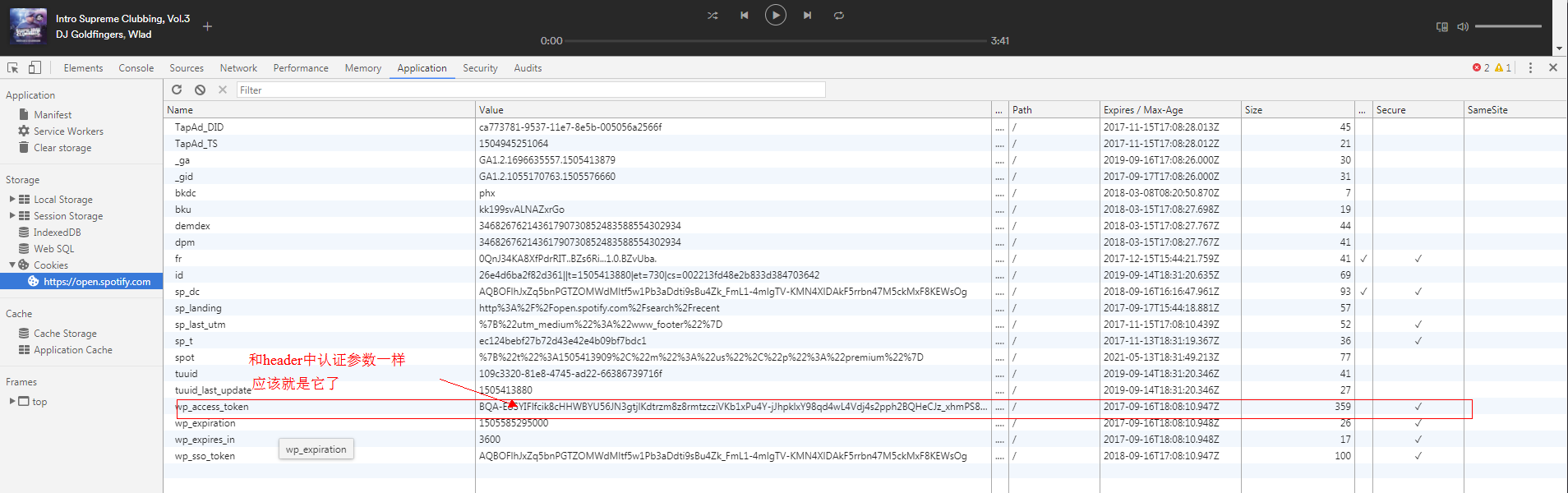

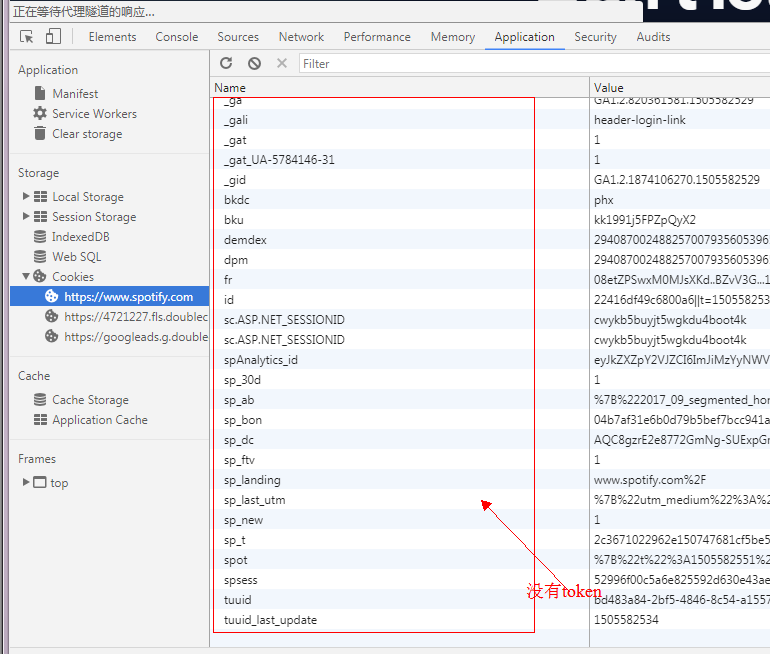

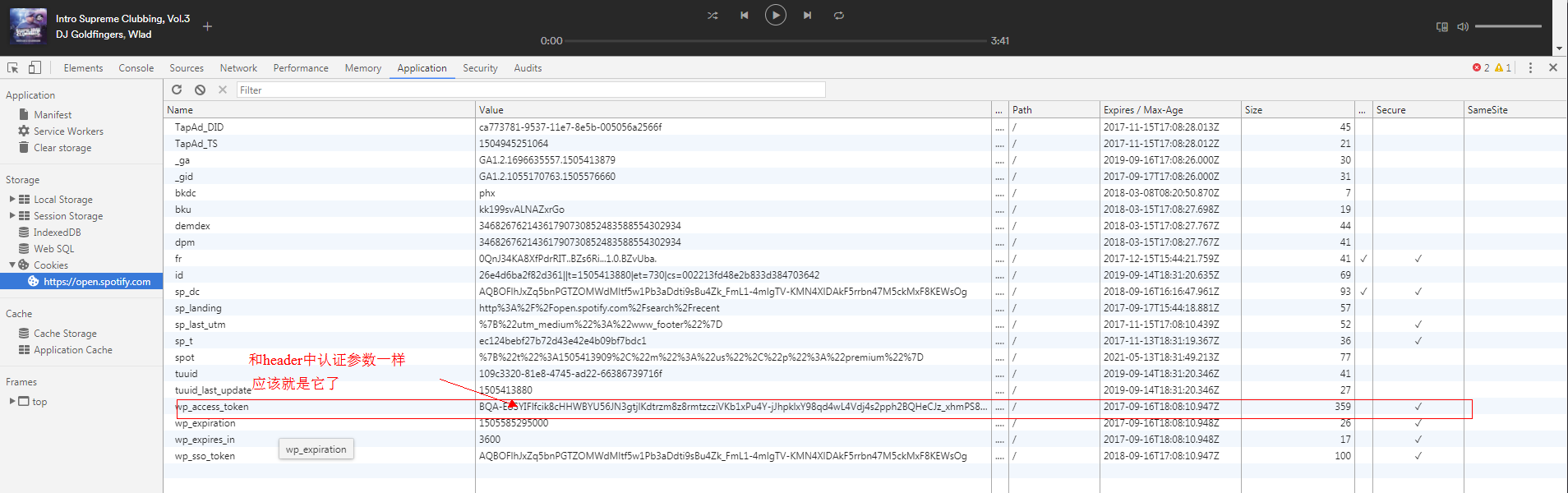

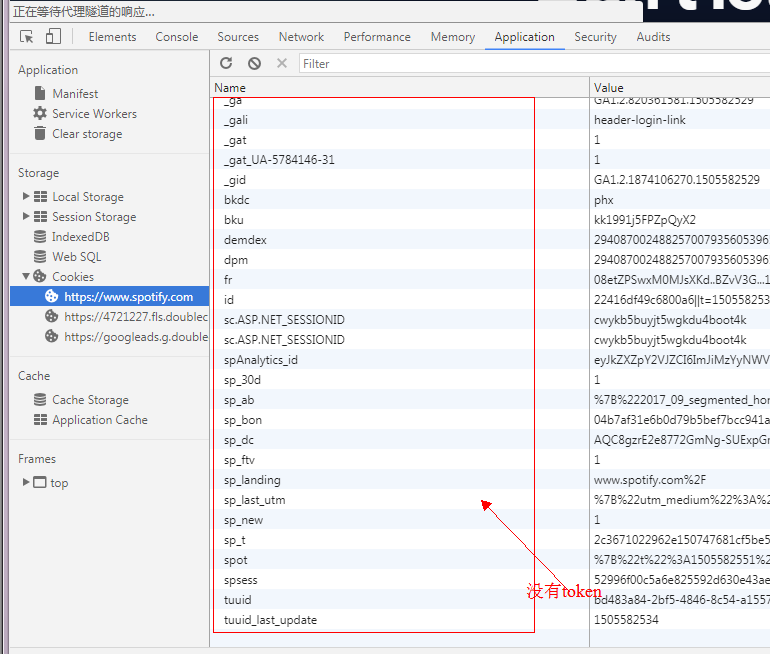

3. Spotify

解决方案:使用网络自动化获取数据。通过请求动态数据接口获取数据计划实现:

方案一:

使用web自动化工具获取数据:配置与网易云配置相同,模拟用户操作浏览器打开网页,用户登录,进入搜索页面,获取页面数据

def spotify_view(url):

'''

使用自动化工具获取网页数据

:param url: 待获取网页url

:return: 页面数据

'''

spotify_name = 'manaxiaomeimei'

spotify_pass = 'dajiagongyong'

spotify_login = 'https://accounts.spotify.com/en/login'

# 初始化浏览器driver

driver = webdriver.PhantomJS()

# 模拟用户登录()

# 浏览器driver访问登录url

driver.get(spotify_login)

# 休息一下等待网页加载。(还有另一种方式:driver.implicitly_wait(3))

time.sleep(3)

# 获取页面元素对象方法(本次使用如下):

# find_element_by_id : 通过标签id获取元素对象 可在页面中获取到唯一一个元素,因为在html规范中。一个DOM树中标签id不能重复

# find_element_by_class_name : 通过标签类名获取元素对象,可能会重复(有坑)

# find_element_by_xpath : 通过标签xpath获取元素对象,类同id,可获取唯一一个元素。

# 获取页面元素对象--用户名

username = driver.find_element_by_id('login-username')

# username.clear()

# 坑:获取页面元素对象--密码

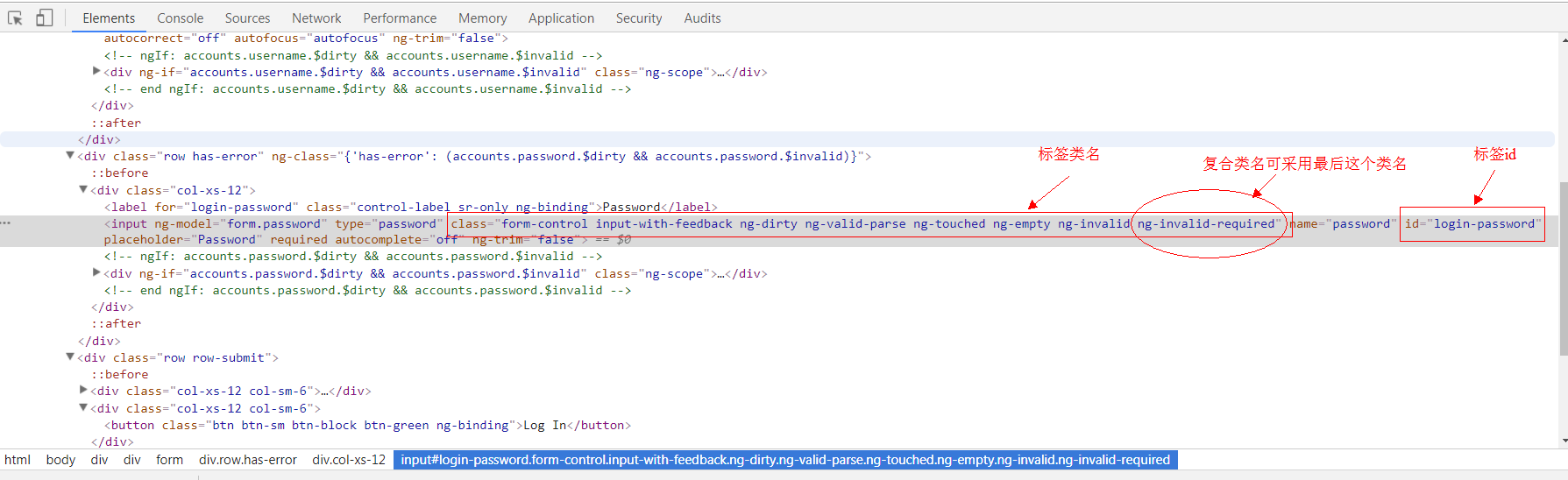

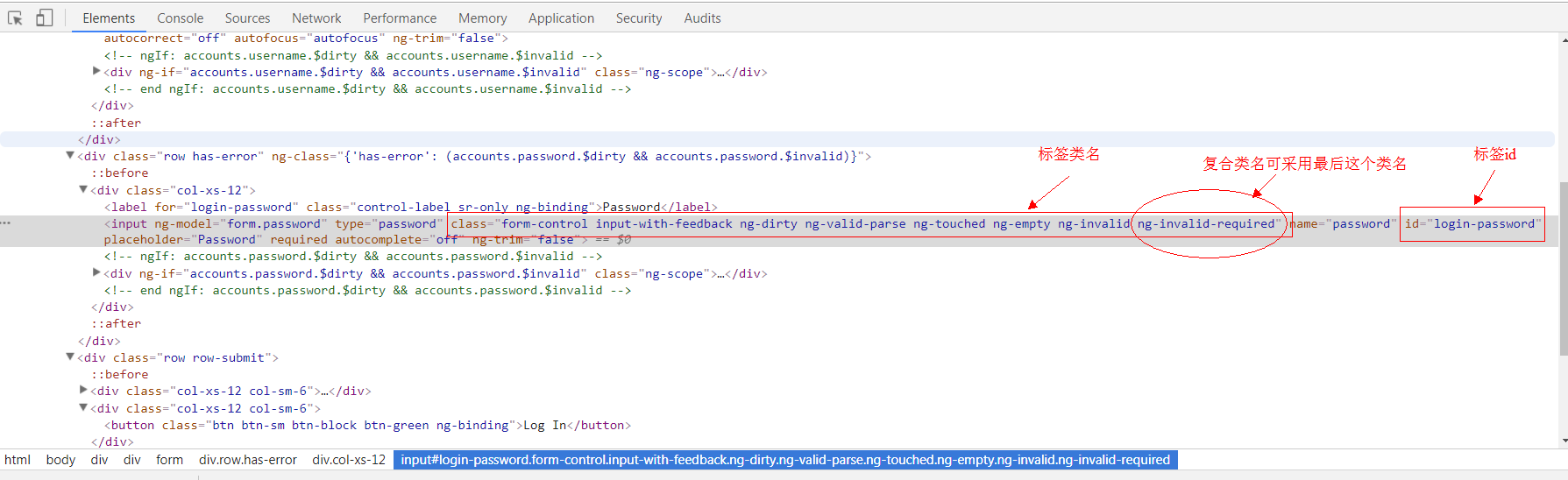

# 在通过类名获取标签元素中,遇到了无法定位复合样式,这时候可采用仅选取最后一个使用的样式作为参数,即可(稳定性不好不建议使用。尽量使用by_id)

# password = driver.find_element_by_class_name('form-control input-with-feedback ng-dirty ng-valid-parse ng-touched ng-empty ng-invalid ng-invalid-required')

password = driver.find_element_by_class_name('ng-invalid-required')

# password.clear()

# 获取页面元素对象--登录按钮

login_button = driver.find_element_by_xpath('/html/body/div[2]/div/form/div[3]/div[2]/button')

# 通过WebDriver API调用模拟键盘的输入用户名

username.send_keys(spotify_name)

# 通过WebDriver API调用模拟键盘的输入密码

password.send_keys(spotify_pass)

# 通过WebDriver API调用模拟鼠标的点击操作,进行登录

login_button.click()

# 休息一下等待网页加载

driver.implicitly_wait(3)

# 搜索打开歌曲url

driver.get(url)

time.sleep(5)

# 搜索获取网页代码

html = driver.page_source

return html

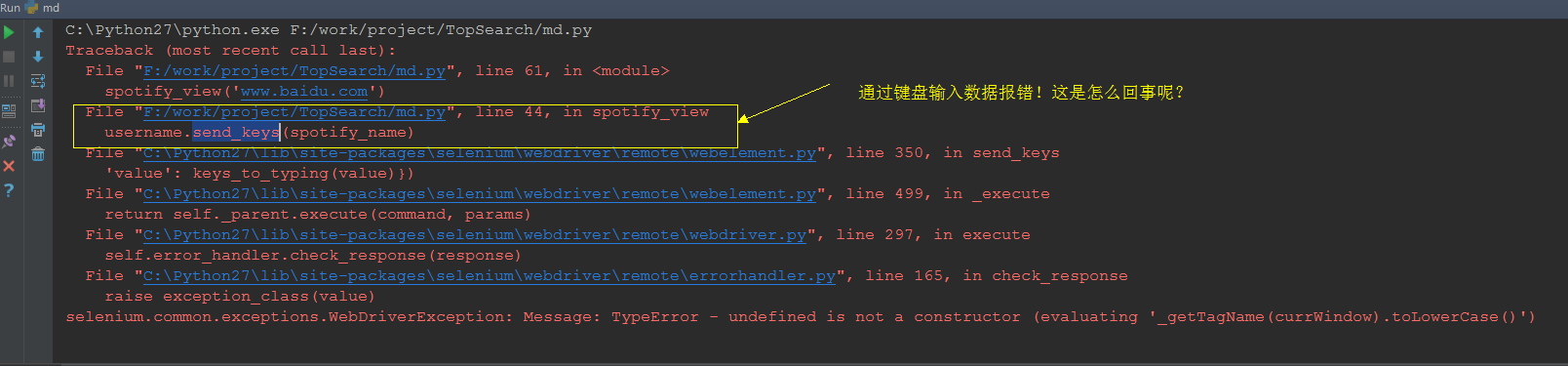

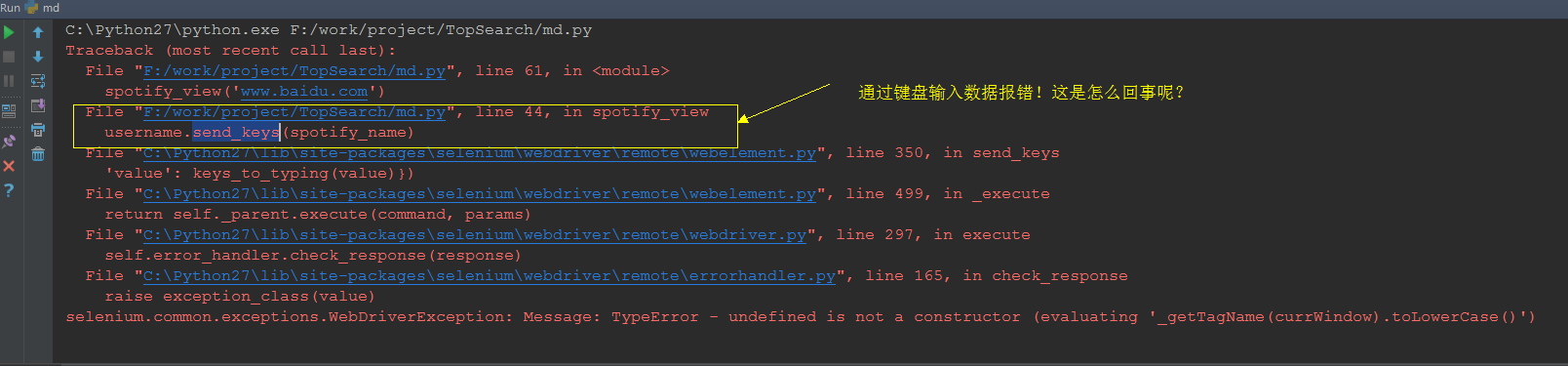

点击运行后,一切都平静了。代码突然报错(如下图)。查资料后,修改了代码。

网络开通计划

在 input 元素中添加 clear() 以清除原创字符。更换浏览器

方案实施:

方案一:

获取到对象后,添加清除对象的方法(username.clear(), password.clear())

实施结果

场景 1 失败。原因不明,大部分是webdriver与PhantomJS不兼容。

场景2:

换浏览器,这次选择使用chrome浏览器进行自动操作。

安装chrome自动化控制插件。

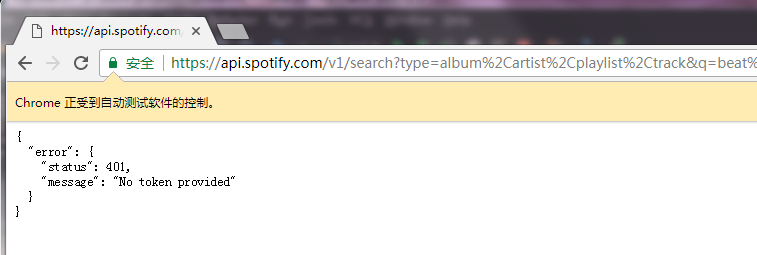

我以为可以通过这种方式获得数据。烧鹅,还是没有获得,报错(如下图)

此处:您应该检查请求并找出令牌是什么。并尝试将令牌添加到请求标头。

查看 cookie

但是这个cookie在我们登录后不在cookie列表中!

预计这个cookie应该在网络播放器加载时植入。验证一下:

从上表可以看出。当玩家加载时植入令牌。

至此,问题已经解决了大半。 查看全部

excel自动抓取网页数据(web自动化终极爬虫:百度音乐(静态网页)分析步骤)

带领:

最近写了几个简单的爬虫,踩了几个深坑。这里总结一下,给大家一些写爬虫的思路。本爬虫的内容包括:静态页面的爬取。动态页面的爬行。网络自动化的终极爬虫。

分析:

数据获取(主要是爬虫)

数据存储(python excel存储)

实际数据获取:百度音乐(静态网页)

分析步骤

1、打开百度音乐:

2.打开浏览器调试模式F12,选择Network+all模式

3.在搜索框中搜索歌曲(beat it),查看控制台

4.通过以上分析:获取有效信息:

5、利用有效信息设计爬虫,获取数据

代码

1.View提供了访问参数url并返回结果的方法

def view(url):

'''

:param url: 待爬取的url链接

:return:

'''

# 从url中获取host

protocol, s1 = urllib.splittype(url)

host, s2 = urllib.splithost(s1)

# 伪装浏览器,避免被kill

headers = {

'Host': host,

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.78 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate',

'Accept-Language': 'zh-CN,zh;q=0.8',

}

# 代理

proxies = {

"http": "dev-proxy.oa.com:8080",

"https": "dev-proxy.oa.com:8080",

}

# 利用requests封装的get方法请求url,并添加请求头和代理,获取并返回请求结果。并进行异常处理

try:

res = requests.get(url, headers=headers, proxies=proxies)

res.encoding = 'utf-8'

if res.status_code == 200:

# 请求成功

# 获取网页内容,并返回

content = res.text

return content

else:

return None

except requests.RequestException as e:

# 异常处理

print(e)

return None

2 .search_baidu_song 提供参数song_name 搜索歌曲并获取搜索结果

def search_baidu_song(song_name):

'''

获取百度音乐搜索歌曲结果

:param song_name: 待搜索歌曲名

:return: 搜索结果

'''

def analyse():

'''

静态网页分析,利用BeautifulSoup,轻松获取想要的数据。需要对html有了解。

:return:

'''

# 初始化BeautifulSoup对象,并指定解析器为 lxml。还有其他的解析器:html.parser、html5lib等

# 详细教程可访问:http://cuiqingcai.com/1319.html《Python爬虫利器二之Beautiful Soup的用法》

html = BeautifulSoup(content, "lxml")

# beautifulsoupzui常用方法之一: find_all( name , attrs , recursive , text , **kwargs )

# find_all() 方法搜索当前tag的所有tag子节点, 并判断是否符合过滤器的条件

# tag标签名为'div'的并且标签类名为class_参数(可为 str、 list、 tuple),

search_result_divs = html.find_all('div', class_=['song-item clearfix ', 'song-item clearfix yyr-song'])

for div in search_result_divs:

# find() 方法搜索当前tag的所有tag子节点, 并返回符合过滤器的条件的第一个结点对象

song_name_str = div.find('span', class_='song-title')

singer = div.find('span', class_='singer')

album = div.find('span', class_='album-title')

# 此部分需要对html页面进行分析,一层层剥开有用数据并提取出来

if song_name_str:

# 获取结点对象内容,并清洗

song_name_str = song_name.text.strip()

else:

song_name_str = ''

if singer:

singer = singer.text.strip()

else:

singer = ''

if album:

album = album.find('a')

if album:

# 获取标签属性值

# 方法二:属性值 = album['属性名']

album = album.attrs.get('title')

if album and album != '':

album = album.strip()

else:

album = ''

else:

album = ''

# print song_name + " | " + singer + " | " + album

songInfoList.append(SongInfo(song_name_str, singer, album))

songInfoList = []

url = urls.get('baidu_song')

url1 = url.format(song_name=song_name, start_idx=0)

content = self.view(url1)

if not content:

return []

analyse(content)

url2 = url.format(song_name=song_name, start_idx=20)

content = self.view(url2)

analyse(content)

return songInfoList[0:30]

这样,我们就得到了百度网歌搜索结果的数据。然后就是保存数据,这个我们最后再说。

网易云音乐(动态网页)

当我们通过上述静态网页数据获取方式获取网易云音乐的数据时,可能会遇到这样一个问题:没有可查看网页源代码的数据,只有网页的骨架。数据根本找不到,但是当你打开开发者工具查看DOM树时,你可以找到想要的数据。这时候我们遇到了动态网页,数据是动态加载的。无法获取网页数据。

目前有两种解决方案:

通过查看访问动态数据界面获取数据。使用网络自动化工具获取网页的源代码以获取数据。

(目前网易云已经不能再单纯通过访问url获取数据了,我们可以使用web自动化工具selenium和PhantomJS来获取网页的源代码。) 方案一(查看访问动态数据界面获取数据):打开网易云音乐:打开浏览器调试模式F12,选择网络+所有模式

在搜索框中搜索歌曲(击败它),检查控制台

过滤请求为XHR,发现请求名称相同。这时候我们看一下这些名字,在Request URL中看到了关键字搜索的请求。这个请求是一个 POST 请求。这个应该是获取搜索数据的接口,可以通过查看响应或者预览来查看请求的结果。正是我们想要的。

让我们不要高兴得太早,我们还没有弄清楚Form Data是如何组成的。params + encSecKey 是如何生成的?我看过网络爬虫《如何爬取网易云音乐的评论?》”,得知网易对api做了加密,由于个人道教太浅,无法理解这里加密参数的顺序和内容。所以,这个计划要停了。我真的不甘心,所以我有改变选项二。

方案二实现:

由于该解决方案暂时行不通,因此不会影响我们的工作进度。让我们换个思路,继续前行。我想到了使用web自动化测试工具selenium来模拟浏览器的人工操作。用这种方式导出网页数据应该没有问题,我想马上去做。

环境配置安装selenium

建议自动使用python包管理工具:pip install -y selenium

其他方法可以参考:selenium+python自动化测试环境搭建

2. 安装 PhantomJS

PhantomJS 是一个基于 webkit 的 JavaScript API。它使用 QtWebKit 作为其核心浏览器功能,并使用 webkit 编译、解释和执行 JavaScript 代码。你可以在基于 webkit 的浏览器中做的任何事情,它都能做到。它不仅是一个隐形浏览器,它提供了 CSS 选择器、Web 标准支持、DOM 操作、JSON、HTML5、Canvas、SVG 等,还提供了处理文件 I/O 的操作,让您可以对操作系统进行文件读写等。 PhantomJS 的用途非常广泛,如网络监控、网页截图、无浏览器的网页测试、页面访问自动化等。

下载 PhantomJS

目前官方支持三种操作系统,包括windows\Mac OS\Linux这三大主流的环境。你可以根据你的运行环境选择要下载的包

1.安装 PhantomJS

下载完成后,解压文件,将phantomjs.exe放到pythond目录下(C:\Python27\phantomjs.exe)。这样后续的加载就不需要指定目录了。也可以放在特定目录下,使用时指定phantomjs.exe的路径即可。双击打开phantomjs.exe,验证安装成功。如果出现下图,则安装成功。

2.代码步骤实现:

def dynamic_view(url):

'''

使用自动化工具获取网页数据

:param url: 待获取网页url

:return: 页面数据

'''

# 初始化浏览器driver

driver = webdriver.PhantomJS()

# 浏览器driver访问url

driver.get(url)

# 坑:不同frame间的转换(网易云在数据展示中会将数据动态添加到'g_iframe'这个框架中,如果不切换,会报"元素不存在"错误。)

driver.switch_to.frame("g_iframe")

# 隐式等待5秒,可以自己调节

driver.implicitly_wait(5)

# 设置10秒页面超时返回,类似于requests.get()的timeout选项,driver.get()没有timeout选项

driver.set_page_load_timeout(10)

# 获取网页资源(获取到的是网页所有数据)

html = driver.page_source

# 坑:退出浏览器driver,必须手动退出driver。

driver.quit()

# 返回网页资源

return html

def search_163_song(song_name):

pass

同样是使用BeautifulSoup对Web资源进行对象化,通过对象过滤来获取数据。没想到网易云音乐的数据也可以通过这种方式获取。如果你能做到这一点,你就可以应付大部分网站。

选择 PhantomJS 是因为它不需要可视化页面,并且节省了内存使用。但是也有一个问题,请大家继续往下看。眼见为实。

3. Spotify

解决方案:使用网络自动化获取数据。通过请求动态数据接口获取数据计划实现:

方案一:

使用web自动化工具获取数据:配置与网易云配置相同,模拟用户操作浏览器打开网页,用户登录,进入搜索页面,获取页面数据

def spotify_view(url):

'''

使用自动化工具获取网页数据

:param url: 待获取网页url

:return: 页面数据

'''

spotify_name = 'manaxiaomeimei'

spotify_pass = 'dajiagongyong'

spotify_login = 'https://accounts.spotify.com/en/login'

# 初始化浏览器driver

driver = webdriver.PhantomJS()

# 模拟用户登录()

# 浏览器driver访问登录url

driver.get(spotify_login)

# 休息一下等待网页加载。(还有另一种方式:driver.implicitly_wait(3))

time.sleep(3)

# 获取页面元素对象方法(本次使用如下):

# find_element_by_id : 通过标签id获取元素对象 可在页面中获取到唯一一个元素,因为在html规范中。一个DOM树中标签id不能重复

# find_element_by_class_name : 通过标签类名获取元素对象,可能会重复(有坑)

# find_element_by_xpath : 通过标签xpath获取元素对象,类同id,可获取唯一一个元素。

# 获取页面元素对象--用户名

username = driver.find_element_by_id('login-username')

# username.clear()

# 坑:获取页面元素对象--密码

# 在通过类名获取标签元素中,遇到了无法定位复合样式,这时候可采用仅选取最后一个使用的样式作为参数,即可(稳定性不好不建议使用。尽量使用by_id)

# password = driver.find_element_by_class_name('form-control input-with-feedback ng-dirty ng-valid-parse ng-touched ng-empty ng-invalid ng-invalid-required')

password = driver.find_element_by_class_name('ng-invalid-required')

# password.clear()

# 获取页面元素对象--登录按钮

login_button = driver.find_element_by_xpath('/html/body/div[2]/div/form/div[3]/div[2]/button')

# 通过WebDriver API调用模拟键盘的输入用户名

username.send_keys(spotify_name)

# 通过WebDriver API调用模拟键盘的输入密码

password.send_keys(spotify_pass)

# 通过WebDriver API调用模拟鼠标的点击操作,进行登录

login_button.click()

# 休息一下等待网页加载

driver.implicitly_wait(3)

# 搜索打开歌曲url

driver.get(url)

time.sleep(5)

# 搜索获取网页代码

html = driver.page_source

return html

点击运行后,一切都平静了。代码突然报错(如下图)。查资料后,修改了代码。

网络开通计划

在 input 元素中添加 clear() 以清除原创字符。更换浏览器

方案实施:

方案一:

获取到对象后,添加清除对象的方法(username.clear(), password.clear())

实施结果

场景 1 失败。原因不明,大部分是webdriver与PhantomJS不兼容。

场景2:

换浏览器,这次选择使用chrome浏览器进行自动操作。

安装chrome自动化控制插件。

我以为可以通过这种方式获得数据。烧鹅,还是没有获得,报错(如下图)

此处:您应该检查请求并找出令牌是什么。并尝试将令牌添加到请求标头。

查看 cookie

但是这个cookie在我们登录后不在cookie列表中!

预计这个cookie应该在网络播放器加载时植入。验证一下:

从上表可以看出。当玩家加载时植入令牌。

至此,问题已经解决了大半。

excel自动抓取网页数据(豆瓣电影Top250数据并写入Excel用EXCEL提取网页数据…)

网站优化 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-12-04 14:24

豆瓣

Python抓取豆瓣电影Top250数据写入Excel

1.爬取目标上的页面网站2. 按照一定的规则提取抓取的数据

create table `tb_movie`( id int(11) primary key auto_increment, title varchar(255), score varchar(255), date varchar(255), region varchar(255), category varchar(255), directorAndActor varchar(255), quote varchar(255), thumbnail varchar(255) )ENGINE=InnoDB DEFAULT CHARSET=utf8;