集搜客网页抓取软件

集搜客网页抓取软件( 优采云采集器大数据应用开发平台--优采云采集器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2022-04-15 04:09

优采云采集器大数据应用开发平台--优采云采集器)

优采云采集器

优采云采集器 是一款网络数据采集、处理、分析和挖掘软件。它可以灵活、快速的抓取网页上零散的信息,通过强大的处理功能,准确的挖掘出需要的数据。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

优采云采集器

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。号称免费,但实际上导出数据需要积分,做任务也可以赚取积分,但一般情况下,基本都需要购买积分。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

吉苏克

Jisoke是一款使用门槛低的小型爬虫工具。可实现完全可视化操作,无需编程基础,熟悉计算机操作即可轻松掌握。整个采集过程也是所见即所得的,遍历的链接信息、爬取结果信息、错误信息等都会及时反映在软件界面中。

优采云云爬虫

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集和实时数据监测和数据分析服务。

优势:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等。

优采云采集器

简介:优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。该软件功能强大,操作极其简单。 查看全部

集搜客网页抓取软件(

优采云采集器大数据应用开发平台--优采云采集器)

优采云采集器

优采云采集器 是一款网络数据采集、处理、分析和挖掘软件。它可以灵活、快速的抓取网页上零散的信息,通过强大的处理功能,准确的挖掘出需要的数据。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

优采云采集器

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。号称免费,但实际上导出数据需要积分,做任务也可以赚取积分,但一般情况下,基本都需要购买积分。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

吉苏克

Jisoke是一款使用门槛低的小型爬虫工具。可实现完全可视化操作,无需编程基础,熟悉计算机操作即可轻松掌握。整个采集过程也是所见即所得的,遍历的链接信息、爬取结果信息、错误信息等都会及时反映在软件界面中。

优采云云爬虫

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集和实时数据监测和数据分析服务。

优势:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等。

优采云采集器

简介:优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。该软件功能强大,操作极其简单。

集搜客网页抓取软件(配套软件版本:V9及更低集搜客网络爬虫软件新版本对应教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-04-13 01:38

配套软件版本:V9及更低版本即搜客网络爬虫软件

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《Web Data 采集 Using Nested Sorting Boxes to get Hierarchical Data》

注:GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先命名任务,然后创建规则,然后登录集合。在Sooke官网会员中心的“任务管理”中,您可以查看采集任务的执行状态,管理潜在客户的URL,进行调度设置。

如果一个网页上有很多相同结构的数据,你需要做一个样本拷贝来批量采集。但是,一些结构相同的网页的数据收录在不同的块节点中。这种情况下,需要进行两次或多次的样本复制(视实际情况而定),即多级嵌套样本复制。

以新浪新闻为例,网页上每5条新闻存储在一个区块节点中。如果只是按照样例拷贝教程拷贝样例,只会抓到当前区块节点下的5条消息。但是,页面上总共显示了 35 条新闻,分为 7 个区块节点。为了捕获页面上的所有新闻,需要复制收录新闻的区块节点。

注:本文演示的嵌套排序框样本副本可到资源库下载学习:嵌套排序框样本副本

一、创建多级嵌套组织者

图1

如图1所示,具体操作如下

1.新建一级排序框,用于复制收录新闻的区块节点样本。

2.右键单击第一级组织器并选择收录包,为每个新闻项目的样本副本创建第二级组织器。

3.右击二级排序框,选择Inclusive创建抓取内容,抓取每条新闻的标题,发布时间。

这将创建一个嵌套的排序规则框,它可以按从内到外的顺序复制两次。

二、先制作内层的样本副本

图 2

如图2所示,具体操作如下

1.点击二级组织者

2.勾选启用以启用样本复制功能。

3.分别找到第一项和第二项对应的节点。

4.在节点样本副本的“第一”对应的第一条新闻上右键,映射到样本1。

5.右击第一个新闻项对应节点样本的“第二个”副本映射到样本2。

从上图可以看出,一个UL区块节点收录5个LI节点,一个LI节点对应一条消息。现在只能在当前 UL 下捕获 UL 中 LI 的样本副本。新闻,也就是只能抓取5条新闻。为了抓住所有的新闻,让我们制作一个 UL 的样本副本。

三、制作样本副本到外层

图 3

如图3所示,具体操作如下

1.点击一级组织者

2.勾选启用以启用样本复制功能。

3.将第一个UL和第二个UL分别映射到“first”和“first”

这将抓取页面上的所有新闻。 查看全部

集搜客网页抓取软件(配套软件版本:V9及更低集搜客网络爬虫软件新版本对应教程)

配套软件版本:V9及更低版本即搜客网络爬虫软件

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《Web Data 采集 Using Nested Sorting Boxes to get Hierarchical Data》

注:GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先命名任务,然后创建规则,然后登录集合。在Sooke官网会员中心的“任务管理”中,您可以查看采集任务的执行状态,管理潜在客户的URL,进行调度设置。

如果一个网页上有很多相同结构的数据,你需要做一个样本拷贝来批量采集。但是,一些结构相同的网页的数据收录在不同的块节点中。这种情况下,需要进行两次或多次的样本复制(视实际情况而定),即多级嵌套样本复制。

以新浪新闻为例,网页上每5条新闻存储在一个区块节点中。如果只是按照样例拷贝教程拷贝样例,只会抓到当前区块节点下的5条消息。但是,页面上总共显示了 35 条新闻,分为 7 个区块节点。为了捕获页面上的所有新闻,需要复制收录新闻的区块节点。

注:本文演示的嵌套排序框样本副本可到资源库下载学习:嵌套排序框样本副本

一、创建多级嵌套组织者

图1

如图1所示,具体操作如下

1.新建一级排序框,用于复制收录新闻的区块节点样本。

2.右键单击第一级组织器并选择收录包,为每个新闻项目的样本副本创建第二级组织器。

3.右击二级排序框,选择Inclusive创建抓取内容,抓取每条新闻的标题,发布时间。

这将创建一个嵌套的排序规则框,它可以按从内到外的顺序复制两次。

二、先制作内层的样本副本

图 2

如图2所示,具体操作如下

1.点击二级组织者

2.勾选启用以启用样本复制功能。

3.分别找到第一项和第二项对应的节点。

4.在节点样本副本的“第一”对应的第一条新闻上右键,映射到样本1。

5.右击第一个新闻项对应节点样本的“第二个”副本映射到样本2。

从上图可以看出,一个UL区块节点收录5个LI节点,一个LI节点对应一条消息。现在只能在当前 UL 下捕获 UL 中 LI 的样本副本。新闻,也就是只能抓取5条新闻。为了抓住所有的新闻,让我们制作一个 UL 的样本副本。

三、制作样本副本到外层

图 3

如图3所示,具体操作如下

1.点击一级组织者

2.勾选启用以启用样本复制功能。

3.将第一个UL和第二个UL分别映射到“first”和“first”

这将抓取页面上的所有新闻。

集搜客网页抓取软件(GooSeeker网络爬虫-免费网页抓取软件-帮你轻松轻松抓取(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-04-12 18:36

网站简介:

GooSeeker网络爬虫-免费网络爬虫软件-帮助您轻松抓取网络数据-简单实用的网络爬虫软件。

Jisouke GooSeeker大数据软件开发始于2007年,2007年是语义网络商业化的时期。即搜客致力于为网页内容的语义标注和结构转换提供一套方便易用的软件。一旦有了语义结构,整个Web就变成了一个大数据库;一旦内容被赋予了意义(语义),就可以从中挖掘出有价值的知识,Jisouke创造了以下业务应用场景:

Jisouke 网络爬虫不是一个简单的网络爬虫,她可以凝聚大家的力量来提取语义标签

每个语义标签代表一个大数据知识对象的一个维度,通过多维度整合来分析这个知识对象

知识对象可以是多层次的,例如:市场竞争、消费者洞察、品牌地图、企业画像

公司:

地址:深圳市南山区南海大道花样年美年广场5栋1001D(邮编:518067)

电话:-86528616

客服:0755-26021359

邮件:

网友印象:功能强大,好用

新版网站视觉冲击力很大。该软件的第一个版本名为Jisou Ke,完全免费,有很大的想象空间。

点击进入客户采集:

返回首页-> 数字化-> 数据服务

百度收录搜狗收录可靠性查询AlexaRank SEO报告爱站查询百度体重管理投诉违法举报

此页面是 网站 描述和指南页面。如介绍不正确或URL连接错误无法打开,网站无法打开,请通知本站更正 查看全部

集搜客网页抓取软件(GooSeeker网络爬虫-免费网页抓取软件-帮你轻松轻松抓取(组图))

网站简介:

GooSeeker网络爬虫-免费网络爬虫软件-帮助您轻松抓取网络数据-简单实用的网络爬虫软件。

Jisouke GooSeeker大数据软件开发始于2007年,2007年是语义网络商业化的时期。即搜客致力于为网页内容的语义标注和结构转换提供一套方便易用的软件。一旦有了语义结构,整个Web就变成了一个大数据库;一旦内容被赋予了意义(语义),就可以从中挖掘出有价值的知识,Jisouke创造了以下业务应用场景:

Jisouke 网络爬虫不是一个简单的网络爬虫,她可以凝聚大家的力量来提取语义标签

每个语义标签代表一个大数据知识对象的一个维度,通过多维度整合来分析这个知识对象

知识对象可以是多层次的,例如:市场竞争、消费者洞察、品牌地图、企业画像

公司:

地址:深圳市南山区南海大道花样年美年广场5栋1001D(邮编:518067)

电话:-86528616

客服:0755-26021359

邮件:

网友印象:功能强大,好用

新版网站视觉冲击力很大。该软件的第一个版本名为Jisou Ke,完全免费,有很大的想象空间。

点击进入客户采集:

返回首页-> 数字化-> 数据服务

百度收录搜狗收录可靠性查询AlexaRank SEO报告爱站查询百度体重管理投诉违法举报

此页面是 网站 描述和指南页面。如介绍不正确或URL连接错误无法打开,网站无法打开,请通知本站更正

集搜客网页抓取软件( Python网络爬虫内容提取器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-04-12 06:28

Python网络爬虫内容提取器)

1 简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2. 动态内容提取技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

三、源码及实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是一个比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url="http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser=webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:可以看到网页中的手机名称和价格被正确抓取了。

4. 继续阅读

至此,我们通过两篇文章文章演示了如何爬取静态和动态网页内容,均使用xslt一次性从网页中提取需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5. Jisouke GooSeeker开源代码下载源

1.GooSeeker开源Python网络爬虫GitHub源码

6.文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加第5章:源码下载源码,并替换github源码的URL 查看全部

集搜客网页抓取软件(

Python网络爬虫内容提取器)

1 简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2. 动态内容提取技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

三、源码及实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是一个比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url="http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser=webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:可以看到网页中的手机名称和价格被正确抓取了。

4. 继续阅读

至此,我们通过两篇文章文章演示了如何爬取静态和动态网页内容,均使用xslt一次性从网页中提取需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5. Jisouke GooSeeker开源代码下载源

1.GooSeeker开源Python网络爬虫GitHub源码

6.文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加第5章:源码下载源码,并替换github源码的URL

集搜客网页抓取软件(集搜客和优采云对比一下通用网络爬虫软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-12 01:28

最近想用爬虫软件采集网页上的一些数据。根据百度推荐和相关关键词查询,我找到了两个软件:“Jisooke”和“优采云”,两个软件都有可视化界面。对于编程思维较弱的用户来说,这两款软件简单易用,通俗易懂。今天就带大家了解和对比这两款常见的网络爬虫软件。

[size=large]1.软件安装[/size]

优采云:优采云用其他软件安装,官网下载,直接点击setup.exe安装即可。

Jisooke:在Jisouke网站上下载的软件也是一个自解压的exe程序,双击开始安装,看到的是火狐浏览器的安装过程。最初的 Jisoke 软件作为 Firefox 插件发布。

[size=large]2.软件界面布局[/size]

优采云:优采云的界面布局可以归类为引导式界面。进入软件界面,用户可以看到软件使用提示信息,如图1所示,包括向导模式和高级模式,其中还列出了学习资源、采集规则、资料下载等。对于初次使用的用户,起到了很好的引导作用。

图一:优采云操作界面展示

数数客:数数客软件分为两个操作界面,MS Mouji(图片2)和DS计数器(图片3)),木书负责制定规则(网页标注) ,号机负责采集数据(网络爬虫),一搜一击,听起来更符合它的特点。位于“帮助”菜单中。

图2:几搜科谋几个界面

图3:吉搜客点钞机界面

[size=large]3.操作流程[/size]

优采云:优采云的操作流程主要分为4个步骤(如图4所示),即:设置基本信息、设计工作流程、设置采集@ >选项,完成。

图 4:优采云 操作流程

1) 设置基本信息:建立任务名称,分配任务组。它实际上只是您要制定的规则的名称。

2)设计工作流程:这一步是优采云制定规则的关键部分,包括输入URL、构建循环,翻页、循环等所有操作都在这里进行。事实上,优采云这个工作流已经为用户构建了一个预定的框架,用户只需要在其中添加元素即可。如图4所示,构造了一个大的循环框来翻页,里面也收录循环,做列表采集和分层抓取

3) 设置采集的选项:这个很简单理解,就是选择需要采集的数据,如图4右侧的方框所示,一次性获取全部数据,还需要进一步确认哪些字段是必填项和组织的。

4) 完成:规则制定完成,采集数据。

Jisouke:Jisouke 的运行没有流程的概念。看来定义采集的规则并不能遵循既定的操作顺序,而是具备“建一个盒子,把你想要的内容提取出来”的要领。所以我们称之为 4 个“块”操作(如图 6 所示),包括命名主题、创建 bin、规划爬虫路线和定义连续动作。

图6:吉索克的四大功能

1) 命名主题:为规则命名。

2) 创建排序框:吉索克提出了“盒子”的概念,即构建一个盒子,如果需要任何数据,从网页中提取相应的信息,然后扔进盒子里。输的过程中,吉索克有“映射”一词,是指将网页上的内容分配给组织者中的一个字段。

3) 爬虫路线:为 采集 任务设置页面和级别。一般来说,爬虫路由就是告诉爬虫要走哪条路由来爬取数据。

4)连续点击:这是Jisouke的高级功能,通过模拟用户点击等行为自动采集,主要针对那些需要连续点击但URL不变的网页。

综上所述,优采云的工作流特征非常明显,用户决定了软件如何行动,何时行动,在哪里应用行动,从哪里采集内容等。另一方面,Jisouke 希望用户专注于提取哪些数据。如果用户除了提取之外还想扩大范围,那么定义爬虫路由。如果他想做一些动作,那么定义连续动作。用户无需关心整个过程的细节。

[size=large]4.数据存储方式[/size]

优采云:优采云分为单机运行和云端采集,数据导出支持EXCEL、SQL、TXT等常用格式。

Jisooke:Jisouke没有云采集,因为爬虫都是在用户自己的电脑上运行的,用户想把爬虫放到云。运行数据以XML格式存储,说明这是一个中间结果。Jisoke官网提供了XML转EXCEL的工具,会员中心也提供了基于云存储的数据导入和清理功能,存储后可以导出。成EXCEL格式。

[size=large]5.充电模型[/size]

优采云: 简单来说就是软件销售模式(不包括免费版)。此外,用户需要规则积分和运行数据积分,积分可以用来购买或参与社区活动兑换积分。

Jisouke:Jisouke 只是一种服务收费模式。所有软件功能都是免费的。如果您需要一些爬虫管理和数据管理服务,您将根据服务类型、数量和时间收费。. 同样,下载规则需要积分,如果使用云存储,则根据存储量和存储时间收费。积分也可以用金钱购买,也可以通过参与社区活动赚取积分。 查看全部

集搜客网页抓取软件(集搜客和优采云对比一下通用网络爬虫软件)

最近想用爬虫软件采集网页上的一些数据。根据百度推荐和相关关键词查询,我找到了两个软件:“Jisooke”和“优采云”,两个软件都有可视化界面。对于编程思维较弱的用户来说,这两款软件简单易用,通俗易懂。今天就带大家了解和对比这两款常见的网络爬虫软件。

[size=large]1.软件安装[/size]

优采云:优采云用其他软件安装,官网下载,直接点击setup.exe安装即可。

Jisooke:在Jisouke网站上下载的软件也是一个自解压的exe程序,双击开始安装,看到的是火狐浏览器的安装过程。最初的 Jisoke 软件作为 Firefox 插件发布。

[size=large]2.软件界面布局[/size]

优采云:优采云的界面布局可以归类为引导式界面。进入软件界面,用户可以看到软件使用提示信息,如图1所示,包括向导模式和高级模式,其中还列出了学习资源、采集规则、资料下载等。对于初次使用的用户,起到了很好的引导作用。

图一:优采云操作界面展示

数数客:数数客软件分为两个操作界面,MS Mouji(图片2)和DS计数器(图片3)),木书负责制定规则(网页标注) ,号机负责采集数据(网络爬虫),一搜一击,听起来更符合它的特点。位于“帮助”菜单中。

图2:几搜科谋几个界面

图3:吉搜客点钞机界面

[size=large]3.操作流程[/size]

优采云:优采云的操作流程主要分为4个步骤(如图4所示),即:设置基本信息、设计工作流程、设置采集@ >选项,完成。

图 4:优采云 操作流程

1) 设置基本信息:建立任务名称,分配任务组。它实际上只是您要制定的规则的名称。

2)设计工作流程:这一步是优采云制定规则的关键部分,包括输入URL、构建循环,翻页、循环等所有操作都在这里进行。事实上,优采云这个工作流已经为用户构建了一个预定的框架,用户只需要在其中添加元素即可。如图4所示,构造了一个大的循环框来翻页,里面也收录循环,做列表采集和分层抓取

3) 设置采集的选项:这个很简单理解,就是选择需要采集的数据,如图4右侧的方框所示,一次性获取全部数据,还需要进一步确认哪些字段是必填项和组织的。

4) 完成:规则制定完成,采集数据。

Jisouke:Jisouke 的运行没有流程的概念。看来定义采集的规则并不能遵循既定的操作顺序,而是具备“建一个盒子,把你想要的内容提取出来”的要领。所以我们称之为 4 个“块”操作(如图 6 所示),包括命名主题、创建 bin、规划爬虫路线和定义连续动作。

图6:吉索克的四大功能

1) 命名主题:为规则命名。

2) 创建排序框:吉索克提出了“盒子”的概念,即构建一个盒子,如果需要任何数据,从网页中提取相应的信息,然后扔进盒子里。输的过程中,吉索克有“映射”一词,是指将网页上的内容分配给组织者中的一个字段。

3) 爬虫路线:为 采集 任务设置页面和级别。一般来说,爬虫路由就是告诉爬虫要走哪条路由来爬取数据。

4)连续点击:这是Jisouke的高级功能,通过模拟用户点击等行为自动采集,主要针对那些需要连续点击但URL不变的网页。

综上所述,优采云的工作流特征非常明显,用户决定了软件如何行动,何时行动,在哪里应用行动,从哪里采集内容等。另一方面,Jisouke 希望用户专注于提取哪些数据。如果用户除了提取之外还想扩大范围,那么定义爬虫路由。如果他想做一些动作,那么定义连续动作。用户无需关心整个过程的细节。

[size=large]4.数据存储方式[/size]

优采云:优采云分为单机运行和云端采集,数据导出支持EXCEL、SQL、TXT等常用格式。

Jisooke:Jisouke没有云采集,因为爬虫都是在用户自己的电脑上运行的,用户想把爬虫放到云。运行数据以XML格式存储,说明这是一个中间结果。Jisoke官网提供了XML转EXCEL的工具,会员中心也提供了基于云存储的数据导入和清理功能,存储后可以导出。成EXCEL格式。

[size=large]5.充电模型[/size]

优采云: 简单来说就是软件销售模式(不包括免费版)。此外,用户需要规则积分和运行数据积分,积分可以用来购买或参与社区活动兑换积分。

Jisouke:Jisouke 只是一种服务收费模式。所有软件功能都是免费的。如果您需要一些爬虫管理和数据管理服务,您将根据服务类型、数量和时间收费。. 同样,下载规则需要积分,如果使用云存储,则根据存储量和存储时间收费。积分也可以用金钱购买,也可以通过参与社区活动赚取积分。

集搜客网页抓取软件(大数据时代把网络爬虫领域推热了,楼主是金融从业人员)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-12 01:24

大数据时代让网络爬虫领域变得炙手可热。房东是金融从业者。获取数据的目的应该是进行数据分析和数据挖掘。这也是大数据的主要应用场景,也不同于传统的大型综合网络爬虫。在哪里。

根据我的理解,传统的网络爬虫应该专注于解决性能问题。核心问题是自适应调度和DNS预解析。单个 CPU 每秒需要处理超过 3,000 个 URL。用于数据分析的网络爬虫显然不需要这样的性能,而是需要数据获取的方便性和准确性。因此,在软件市场上,原创网页内容爬虫软件应该有更好的发展空间。

例如,研究特定人群的特征,即所谓的客户画像,需要在研究过程中不断补充多源数据。如果采用数学建模的深度挖掘方法,就会有一个不断迭代的过程。在这个过程中,会不断引入其他数据源。如果一款网页内容抓取软件能够方便、准确地实现这个目标,就会体验到一种“数据采集”的感觉。

我喜欢吉搜客网络爬虫的可视化界面和会员中心的数据管理功能。我需要从一个数据源获取数据,通过直观的注解,然后把生成的规则丢给爬虫组,这样我就可以专心处理数据了。在建模过程中,您可以在需要时从数据管理中心下载数据。

必须有效解决数据采集问题,才能专心进行数据挖掘。目前我们关注的难点是短文本的聚类分析和消费者画像、所有电商评论、新闻评论、微博消息的建模。当把短文本聚集在一起进行挖掘时,会发现很多有价值的信息,同时挑战也很大。 查看全部

集搜客网页抓取软件(大数据时代把网络爬虫领域推热了,楼主是金融从业人员)

大数据时代让网络爬虫领域变得炙手可热。房东是金融从业者。获取数据的目的应该是进行数据分析和数据挖掘。这也是大数据的主要应用场景,也不同于传统的大型综合网络爬虫。在哪里。

根据我的理解,传统的网络爬虫应该专注于解决性能问题。核心问题是自适应调度和DNS预解析。单个 CPU 每秒需要处理超过 3,000 个 URL。用于数据分析的网络爬虫显然不需要这样的性能,而是需要数据获取的方便性和准确性。因此,在软件市场上,原创网页内容爬虫软件应该有更好的发展空间。

例如,研究特定人群的特征,即所谓的客户画像,需要在研究过程中不断补充多源数据。如果采用数学建模的深度挖掘方法,就会有一个不断迭代的过程。在这个过程中,会不断引入其他数据源。如果一款网页内容抓取软件能够方便、准确地实现这个目标,就会体验到一种“数据采集”的感觉。

我喜欢吉搜客网络爬虫的可视化界面和会员中心的数据管理功能。我需要从一个数据源获取数据,通过直观的注解,然后把生成的规则丢给爬虫组,这样我就可以专心处理数据了。在建模过程中,您可以在需要时从数据管理中心下载数据。

必须有效解决数据采集问题,才能专心进行数据挖掘。目前我们关注的难点是短文本的聚类分析和消费者画像、所有电商评论、新闻评论、微博消息的建模。当把短文本聚集在一起进行挖掘时,会发现很多有价值的信息,同时挑战也很大。

集搜客网页抓取软件(五款啥好的办法,既快又省事,当然有! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2022-04-11 05:11

)

在网络信息化时代,爬虫是采集信息不可或缺的工具。对于很多小伙伴来说,只是想用爬虫进行快速的内容爬取,并不想对爬虫研究太深。

用python写爬虫程序很酷,但是学习起来需要时间和精力。学习成本非常高。有时候仅仅为了几页数据就学了几个月的爬虫,真是让人难以忍受。

有没有什么好办法,既快又省力,当然!今天,我将带领大家分享五款免费的数据抓取工具,帮助大家省时省力。

01.优采云

优采云是一款比较流行的爬虫软件,即使用户不会编程也能轻松抓取数据。优采云数据采集稳定性强,配有详细教程,可以快速上手。

我们以采集名言为例,

打开优采云软件后,打开网页,然后点击单个文本,选择右侧“全选”,软件会自动识别所有著名文本。接下来按照操作,选择 采集 文本,然后启动 采集 的软件。

采集完成后,选择文本导出的文件类型,点击确定即可导出数据。

2.吉走克

Jisouke为一些流行的网站搭建了一个快速爬虫程序,但是学习成本比优采云要高。

我们在 知乎关键词 处抓取:。首先需要根据爬取的类别进行分类,然后输入网址后,点击获取数据开始爬取。捕获的数据如下图所示:

可以看到,极速客抓取到的信息非常丰富,但是下载数据需要消耗积分,20条数据需要消耗1积分。Jisouke会给新用户20分。

以上两款都是非常好用的国产数据采集软件。接下来菜鸟哥就介绍一下chrome浏览器下的爬虫插件。

3.网络爬虫

网络爬虫插件是一个非常好用的爬虫插件。对于 Web 刮板的安装,

对于简单的数据抓取,网络抓取工具可以很好地完成这项工作。我们还以名言的 URL 数据抓取为例。

通过选中多个来获取页面中的所有引号。捕获数据后,通过单击“将数据导出为 CSV”导出所有数据。

4.AnyPapa

将网页翻到评测区,然后点击AnyPapa插件下的“本地数据”,会自动跳转到AnyPapa的数据页面。

首先,点击切换数据源,找到“京东商品评论”的数据源。此时界面会在手机评论页面显示当前所有的评论内容。点击“导出”,评论数据将以csv文件的形式下载到本地。

5.你得到

you-get 是 GitHub 上非常流行的爬虫项目。作者提供了来自网站的国内外近80个视频和图片截图,获得了40900个赞!

对于you-get的安装,可以通过命令pip install you-get来安装。

我们以B站的视频为例,

通过命令

6.总结

以上就是今天为大家带来的五款自动提取数据的工具。如果是偶尔的爬虫,或者非常低频率的爬虫需求,完全没有必要学习爬虫技术,因为学习成本非常高。比如你只想发几张图,不用学Photoshop就可以直接用美图秀秀。

如果你对爬虫有很多定制需求,需要对采集到的数据进行分析和深度挖掘,而且频繁,或者如果你想更深入地使用Python技术,通过爬虫更扎实的学习,你应该考虑在这学习时间。爬虫。

嗯,以上工具都不错,有兴趣的同学可以试试。

查看全部

集搜客网页抓取软件(五款啥好的办法,既快又省事,当然有!

)

在网络信息化时代,爬虫是采集信息不可或缺的工具。对于很多小伙伴来说,只是想用爬虫进行快速的内容爬取,并不想对爬虫研究太深。

用python写爬虫程序很酷,但是学习起来需要时间和精力。学习成本非常高。有时候仅仅为了几页数据就学了几个月的爬虫,真是让人难以忍受。

有没有什么好办法,既快又省力,当然!今天,我将带领大家分享五款免费的数据抓取工具,帮助大家省时省力。

01.优采云

优采云是一款比较流行的爬虫软件,即使用户不会编程也能轻松抓取数据。优采云数据采集稳定性强,配有详细教程,可以快速上手。

我们以采集名言为例,

打开优采云软件后,打开网页,然后点击单个文本,选择右侧“全选”,软件会自动识别所有著名文本。接下来按照操作,选择 采集 文本,然后启动 采集 的软件。

采集完成后,选择文本导出的文件类型,点击确定即可导出数据。

2.吉走克

Jisouke为一些流行的网站搭建了一个快速爬虫程序,但是学习成本比优采云要高。

我们在 知乎关键词 处抓取:。首先需要根据爬取的类别进行分类,然后输入网址后,点击获取数据开始爬取。捕获的数据如下图所示:

可以看到,极速客抓取到的信息非常丰富,但是下载数据需要消耗积分,20条数据需要消耗1积分。Jisouke会给新用户20分。

以上两款都是非常好用的国产数据采集软件。接下来菜鸟哥就介绍一下chrome浏览器下的爬虫插件。

3.网络爬虫

网络爬虫插件是一个非常好用的爬虫插件。对于 Web 刮板的安装,

对于简单的数据抓取,网络抓取工具可以很好地完成这项工作。我们还以名言的 URL 数据抓取为例。

通过选中多个来获取页面中的所有引号。捕获数据后,通过单击“将数据导出为 CSV”导出所有数据。

4.AnyPapa

将网页翻到评测区,然后点击AnyPapa插件下的“本地数据”,会自动跳转到AnyPapa的数据页面。

首先,点击切换数据源,找到“京东商品评论”的数据源。此时界面会在手机评论页面显示当前所有的评论内容。点击“导出”,评论数据将以csv文件的形式下载到本地。

5.你得到

you-get 是 GitHub 上非常流行的爬虫项目。作者提供了来自网站的国内外近80个视频和图片截图,获得了40900个赞!

对于you-get的安装,可以通过命令pip install you-get来安装。

我们以B站的视频为例,

通过命令

6.总结

以上就是今天为大家带来的五款自动提取数据的工具。如果是偶尔的爬虫,或者非常低频率的爬虫需求,完全没有必要学习爬虫技术,因为学习成本非常高。比如你只想发几张图,不用学Photoshop就可以直接用美图秀秀。

如果你对爬虫有很多定制需求,需要对采集到的数据进行分析和深度挖掘,而且频繁,或者如果你想更深入地使用Python技术,通过爬虫更扎实的学习,你应该考虑在这学习时间。爬虫。

嗯,以上工具都不错,有兴趣的同学可以试试。

集搜客网页抓取软件(神奇之处要归功于Firefox解析PDF的抓取网页pdf内容的规则 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-04-10 22:52

)

1、简介

晚上看了《Python网络数据采集》这本书,看到了阅读PDF内容的代码。记得前几天Jisouke刚刚发布了一个抓取网页PDF内容的抓取规则。 ,此规则可以将 pdf 内容视为 html 进行网页抓取。神奇之处在于Firefox解析PDF的能力,可以将pdf格式转换成html标签,比如div标签,让GooSeeker网页抓取软件可以像普通网页一样抓取结构化内容。

于是就出现了一个问题:Python爬虫能做多少事情。下面将描述一个实验过程和源代码。

2、pdf转文本的python源码

下面的python源代码读取一个pdf文件的内容(无论是在互联网上还是在本地),转换成文本,然后打印出来。这段代码主要使用第三方库PDFMiner3K将PDF读成字符串,然后使用StringIO将其转换为文件对象。 (源码下载地址见文章末尾的GitHub源码)

from urllib.request import urlopen

from pdfminer.pdfinterp import PDFResourceManager, process_pdf

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from io import StringIO

from io import open

def readPDF(pdfFile):

rsrcmgr = PDFResourceManager()

retstr = StringIO()

laparams = LAParams()

device = TextConverter(rsrcmgr, retstr, laparams=laparams)

process_pdf(rsrcmgr, device, pdfFile)

device.close()

content = retstr.getvalue()

retstr.close()

return content

pdfFile = urlopen("http://pythonscraping.com/page ... 6quot;)

outputString = readPDF(pdfFile)

print(outputString)

pdfFile.close()

如果 PDF 文件在您的计算机上,请将 urlopen 返回的 pdfFile 对象替换为正常的 open() 文件对象。

3、展望

这个实验只是把pdf转成文本,并没有像开始说的把它转成html标签,所以Python编程环境中是否有这样的能力留待以后探索。

4、Jisouke GooSeeker开源代码下载源码

GooSeeker 开源 Python 网络爬虫 GitHub 源码

5、文档修改历史

如有疑问,或

查看全部

集搜客网页抓取软件(神奇之处要归功于Firefox解析PDF的抓取网页pdf内容的规则

)

1、简介

晚上看了《Python网络数据采集》这本书,看到了阅读PDF内容的代码。记得前几天Jisouke刚刚发布了一个抓取网页PDF内容的抓取规则。 ,此规则可以将 pdf 内容视为 html 进行网页抓取。神奇之处在于Firefox解析PDF的能力,可以将pdf格式转换成html标签,比如div标签,让GooSeeker网页抓取软件可以像普通网页一样抓取结构化内容。

于是就出现了一个问题:Python爬虫能做多少事情。下面将描述一个实验过程和源代码。

2、pdf转文本的python源码

下面的python源代码读取一个pdf文件的内容(无论是在互联网上还是在本地),转换成文本,然后打印出来。这段代码主要使用第三方库PDFMiner3K将PDF读成字符串,然后使用StringIO将其转换为文件对象。 (源码下载地址见文章末尾的GitHub源码)

from urllib.request import urlopen

from pdfminer.pdfinterp import PDFResourceManager, process_pdf

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from io import StringIO

from io import open

def readPDF(pdfFile):

rsrcmgr = PDFResourceManager()

retstr = StringIO()

laparams = LAParams()

device = TextConverter(rsrcmgr, retstr, laparams=laparams)

process_pdf(rsrcmgr, device, pdfFile)

device.close()

content = retstr.getvalue()

retstr.close()

return content

pdfFile = urlopen("http://pythonscraping.com/page ... 6quot;)

outputString = readPDF(pdfFile)

print(outputString)

pdfFile.close()

如果 PDF 文件在您的计算机上,请将 urlopen 返回的 pdfFile 对象替换为正常的 open() 文件对象。

3、展望

这个实验只是把pdf转成文本,并没有像开始说的把它转成html标签,所以Python编程环境中是否有这样的能力留待以后探索。

4、Jisouke GooSeeker开源代码下载源码

GooSeeker 开源 Python 网络爬虫 GitHub 源码

5、文档修改历史

如有疑问,或

集搜客网页抓取软件(第一步:用MS谋数台建立整理箱?确定目标网页和抓取规则)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-04-10 03:06

即刻入门——三步精通即刻你对即刻的功能按键有了一定的了解之后,下面就来讲解一下即刻的实际应用。让我们从最基本的介绍开始。以规则感受Jisouke是如何使用的。按照以下三个步骤完成抓取规则的定义和抓取数据,如下图所示。Step 1:用MS搭建排序框?确定目标网页并抓取内容 确定目标网页(即样本URL)和要爬取的网页信息(即要爬取的内容),并建立Organizer,用于组织和抓取在网页上存储信息。1.示例网址:/forum/72.采集内容:采集 页面上所有帖子的主题标题和回复数。3.网页分析:示例网页是一个简单的列表结构,采集的内容是列表中的标题和回复数,以便信息点存储在可以确定分拣箱。另外,为了完整爬取网页列表的信息,会用到MS Moshutai的样本复制功能。另外,要爬取网页的所有帖子,需要设置翻页爬取,但是本章只讲解如何抓取网页列表信息和翻页的详细操作,请学习如何翻页抓取网页数据。4.规则:Jisouke_Getting Started,如果想了解更多操作方法,您可以在资源上下载Jisouke_Getting Started Rules 来查看和体验。?命名主题加载示例URL,将页面命名为主题,然后根据主题名称搜索修改页面的爬取规则,如图1所示。

图 1:命名主题?图1 步骤分解:1.点击火狐浏览器的“工具”菜单打开MS。2.在“网址框”输入或复制粘贴示例网址,回车即可自动加载网页。加载完成后,状态栏会显示“完成”标志,“页面地址”也会自动填写当前示例URL,这两个是页面加载完成的标志。3.输入主题名称,可以是中文、英文、数字和字符的组合。4.因为要求主题名唯一,所以点击“检查重复”按钮,检查主题名是否唯一有效。?创建排序框根据要抓取的网页信息,建立分类框结构来存储信息。图 2:创建一个排序框?图2 步骤分解:1.切换到“创建规则”窗口,在排序框操作区点击“新建”创建排序框,输入排序框名称并确认,这就是排序框的顶层节点,用于收录新创建的爬取内容。2.在排序框空白处右键,弹出快捷菜单,选择“添加”->“收录”,输入抓取内容的名称,创建收录抓取的内容节点为顶级节点。3.按照步骤2的方法,依次创建新的爬取内容。4.网页的关键信息(即 网页上显示的信息和可用的采集),您可以点击抓取的内容并勾选“关键内容”,它告诉DS计算机密重点采集此信息。第二步:将网页信息映射到排序框,将浏览器中红框的内容映射到排序框的“标题”。为了准确捕捉目标信息,需要在网页结构窗口中进行映射操作。定位,依次点击网页结构窗口中的HTML标签,在浏览器窗口中也可以看到闪烁的红框(如果可以一只眼看顶部,另一只眼看底部,联动效果为更明显);把网页的信息与排序框的爬取内容建立了映射关系。MS摸手会根据映射关系自动生成网页的提取程序,即爬取规则。

图3:建立映射关系?图3 步骤分解:1.点击定位:点击网页列表的第一个标题,会弹出信息的定位提示框,一般是定位模块节点(即收录多个下层节点,可以双击展开,比如A节点)2.找到网页信息对应的HTML标签:双击节点展开下一层,找到HTML标签收录标题,每个节点收录的信息都可以在“如在文本内容框中看到的”中找到,一般网页上的文本信息显示在#text节点中。3.内容映射:右击节点弹出快捷菜单,选择“内容映射”->“ ? 样本副本 为了获取完整的网页列表信息,需要制作排序框的样本副本。对于网页上结构相同的信息,使用样本复制功能,只需要定义和组织网页列表的第一个信息。框的映射关系可以捕获网页上相同结构的所有信息,如图4所示。

图 4:样本副本?图4 步骤分解:1.选中排序框的“List”节点,勾选“Sample Copy Management”框中的“Enable”按钮,在“List”节点上打样例可以应用“标题”和“回复数”之间的映射关系,从而可以提取网页上结构相同的信息。PS:通常会选择排序框中收录抓取内容的上层节点进行样本复制,已经完成“样本复制”的节点(如顶级节点“列表”)不能再被复制。 查看全部

集搜客网页抓取软件(第一步:用MS谋数台建立整理箱?确定目标网页和抓取规则)

即刻入门——三步精通即刻你对即刻的功能按键有了一定的了解之后,下面就来讲解一下即刻的实际应用。让我们从最基本的介绍开始。以规则感受Jisouke是如何使用的。按照以下三个步骤完成抓取规则的定义和抓取数据,如下图所示。Step 1:用MS搭建排序框?确定目标网页并抓取内容 确定目标网页(即样本URL)和要爬取的网页信息(即要爬取的内容),并建立Organizer,用于组织和抓取在网页上存储信息。1.示例网址:/forum/72.采集内容:采集 页面上所有帖子的主题标题和回复数。3.网页分析:示例网页是一个简单的列表结构,采集的内容是列表中的标题和回复数,以便信息点存储在可以确定分拣箱。另外,为了完整爬取网页列表的信息,会用到MS Moshutai的样本复制功能。另外,要爬取网页的所有帖子,需要设置翻页爬取,但是本章只讲解如何抓取网页列表信息和翻页的详细操作,请学习如何翻页抓取网页数据。4.规则:Jisouke_Getting Started,如果想了解更多操作方法,您可以在资源上下载Jisouke_Getting Started Rules 来查看和体验。?命名主题加载示例URL,将页面命名为主题,然后根据主题名称搜索修改页面的爬取规则,如图1所示。

图 1:命名主题?图1 步骤分解:1.点击火狐浏览器的“工具”菜单打开MS。2.在“网址框”输入或复制粘贴示例网址,回车即可自动加载网页。加载完成后,状态栏会显示“完成”标志,“页面地址”也会自动填写当前示例URL,这两个是页面加载完成的标志。3.输入主题名称,可以是中文、英文、数字和字符的组合。4.因为要求主题名唯一,所以点击“检查重复”按钮,检查主题名是否唯一有效。?创建排序框根据要抓取的网页信息,建立分类框结构来存储信息。图 2:创建一个排序框?图2 步骤分解:1.切换到“创建规则”窗口,在排序框操作区点击“新建”创建排序框,输入排序框名称并确认,这就是排序框的顶层节点,用于收录新创建的爬取内容。2.在排序框空白处右键,弹出快捷菜单,选择“添加”->“收录”,输入抓取内容的名称,创建收录抓取的内容节点为顶级节点。3.按照步骤2的方法,依次创建新的爬取内容。4.网页的关键信息(即 网页上显示的信息和可用的采集),您可以点击抓取的内容并勾选“关键内容”,它告诉DS计算机密重点采集此信息。第二步:将网页信息映射到排序框,将浏览器中红框的内容映射到排序框的“标题”。为了准确捕捉目标信息,需要在网页结构窗口中进行映射操作。定位,依次点击网页结构窗口中的HTML标签,在浏览器窗口中也可以看到闪烁的红框(如果可以一只眼看顶部,另一只眼看底部,联动效果为更明显);把网页的信息与排序框的爬取内容建立了映射关系。MS摸手会根据映射关系自动生成网页的提取程序,即爬取规则。

图3:建立映射关系?图3 步骤分解:1.点击定位:点击网页列表的第一个标题,会弹出信息的定位提示框,一般是定位模块节点(即收录多个下层节点,可以双击展开,比如A节点)2.找到网页信息对应的HTML标签:双击节点展开下一层,找到HTML标签收录标题,每个节点收录的信息都可以在“如在文本内容框中看到的”中找到,一般网页上的文本信息显示在#text节点中。3.内容映射:右击节点弹出快捷菜单,选择“内容映射”->“ ? 样本副本 为了获取完整的网页列表信息,需要制作排序框的样本副本。对于网页上结构相同的信息,使用样本复制功能,只需要定义和组织网页列表的第一个信息。框的映射关系可以捕获网页上相同结构的所有信息,如图4所示。

图 4:样本副本?图4 步骤分解:1.选中排序框的“List”节点,勾选“Sample Copy Management”框中的“Enable”按钮,在“List”节点上打样例可以应用“标题”和“回复数”之间的映射关系,从而可以提取网页上结构相同的信息。PS:通常会选择排序框中收录抓取内容的上层节点进行样本复制,已经完成“样本复制”的节点(如顶级节点“列表”)不能再被复制。

集搜客网页抓取软件(利用爬虫技术能做到哪些很酷很有趣很有用的事情?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-04-10 02:10

随着Scrapy等框架的火爆,用编程语言编写爬虫已经成为一种时尚,看来网上的每个人都对爬虫略知一二。

大神使用爬虫将学校所有重要的在线服务整合成一套JSON API,然后开发成一个App;

爬取了知乎12万用户的头像,把长得像的头像放在一起方便浏览: 然后我采集了好友的点击量,预测你(一般)最喜欢的人长什么样;

网友写了一个爬虫,根据标签爬下豆瓣上的所有书籍,根据现有标签对豆瓣书籍进行排序检索,并按照分数从高到低排序。

……

这些有趣的故事都来自知乎上的一个热门话题:爬虫技术可以做哪些酷、有趣、有用的事情?

每个人都可以是爬行动物

在互联网的早期,编写爬虫是一项技术活动。总的来说,爬虫技术是搜索引擎不可或缺的一部分。

随着互联网技术的发展,编写爬虫的门槛一降再降,一些编程语言甚至直接提供了爬虫框架,比如python的Scrapy框架,让编写爬虫进入了“老百姓的家”。

我们发现写爬虫是一件很酷的事情,但即便如此,学习爬虫还是存在一定的技术障碍。

目前主流的爬虫方式是使用Python编程。Python 的强大是毋庸置疑的,但是初学者学习 Python 还是需要一两个月的时间。

有没有更简单的方法来抓取数据?答案是肯定的。

一些可视化爬虫工具使用策略来爬取特定数据。虽然不如自己写爬虫准确,但是学习成本要低很多。下面介绍几个可视化爬虫工具。

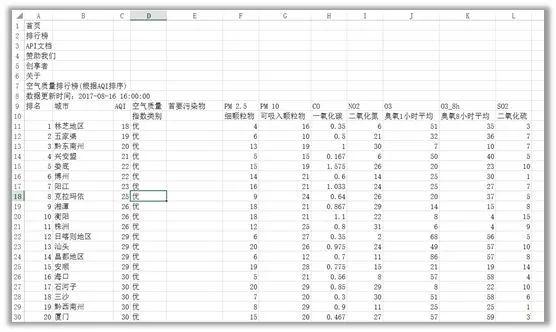

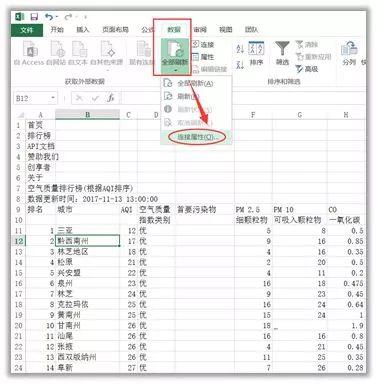

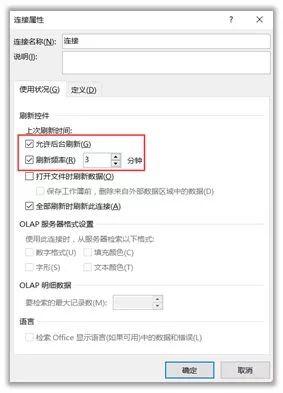

家用工具

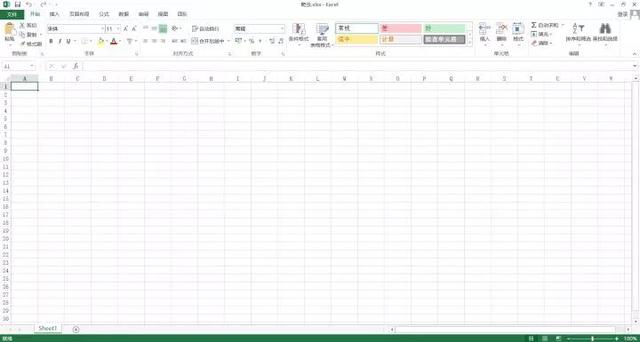

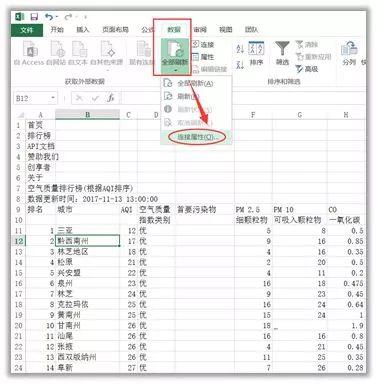

01 微软Excel

首先教大家一个使用Excel爬取数据的方法。此处使用 Microsoft Excel 2013 版本。让我们一步一步开始教学吧~

(1)新建一个Excel,打开,如下图

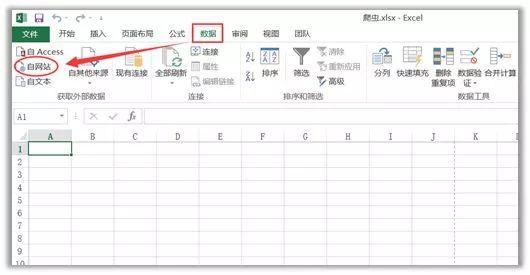

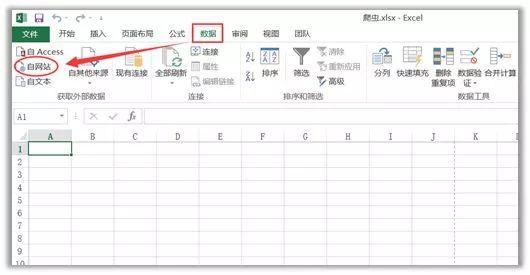

(2)点击“数据”-“来自网站”

(3)在弹出的对话框中输入目标网址,这里以全国实时空气质量为例网站,点击Go,然后导入

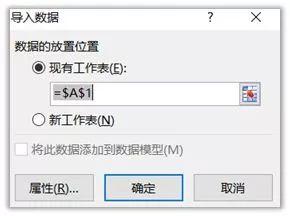

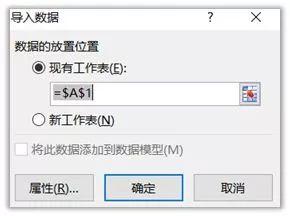

选择导入位置,OK

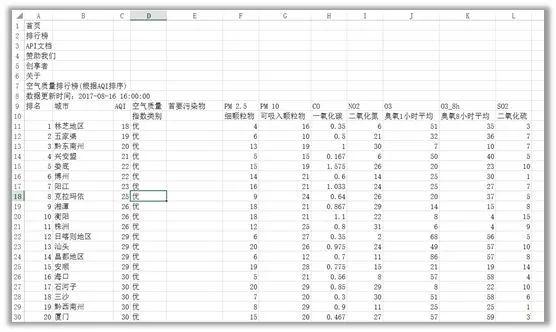

(4)结果如下图所示,怎么样,是不是很棒?

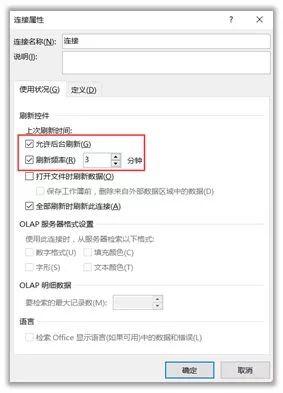

(5)如果要实时更新数据,可以在“数据”-“全部更新”-“连接属性”中设置,输入更新频率

02 优采云

一款无需可视化编程的网页采集软件,可以快速从不同的网站中提取归一化数据,帮助用户自动化采集、编辑和归一化数据,降低工作成本。

简易模式采集 步骤

是一款适合新手用户试用的采集软件。云功能强大。当然,爬虫老手也可以开发它的高级功能。

03 优采云

优采云是一款互联网数据采集、处理、分析、挖掘软件,采集功能齐全,不限于网页和内容,可以下载任何文件格式,号称采集99 % 网页。

软件定位更专业、更精准。用户需要具备基本的 HTML 基础,能够理解网页的源代码和结构。不过软件提供了相应的教程,新手可以学习上手。

04 采集客户

一款简单易用的网页信息采集软件,可以采集网页文字、图表、超链接等网页元素。

操作比较简单,适合初级用户,在功能上没有太多特色,后续支付需求也很多。

05 优采云云爬虫

一种新颖的云在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量规范化网页数据。

类似于爬虫系统框架,具体的采集也需要用户自己编写爬虫,这需要代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛<有三个类别:@采集器、cms采集器 和博客采集器。

专注于论坛和博客文字内容的抓取,采集全网数据通用性不高。

外国工具

01 谷歌表格

使用Google Sheet爬取数据前,必须保证三点:使用Chrome浏览器、有Google账号、电脑翻墙。满足这三个条件就开始吧~

(1)打开 Google 表格网站:/sheets/about/

(2)在首页点击“Go to Google Sheets”,然后登录自己的账号,可以看到如下界面,然后点击“+”新建一个sheet

新建的表格如下:

(3)打开要爬的目标网站,全国实时空气质量网站pm25.in/rank,目标上的表结构网站@ > 如下图所示

(4)回到Google sheet页面,使用函数=IMPORTHTML(URL, query, index),“URL”为抓取数据的目标网站,输入“list”或“in query “table”,这个取决于数据的具体结构类型,“index”用阿拉伯数字填充,从1开始,对应网站中定义的哪个表或列表

对于我们要抓取的 网站,我们在 Google 表格的单元格 A1 中输入函数 =IMPORTHTML("pm25.in/rank 查看全部

集搜客网页抓取软件(利用爬虫技术能做到哪些很酷很有趣很有用的事情?)

随着Scrapy等框架的火爆,用编程语言编写爬虫已经成为一种时尚,看来网上的每个人都对爬虫略知一二。

大神使用爬虫将学校所有重要的在线服务整合成一套JSON API,然后开发成一个App;

爬取了知乎12万用户的头像,把长得像的头像放在一起方便浏览: 然后我采集了好友的点击量,预测你(一般)最喜欢的人长什么样;

网友写了一个爬虫,根据标签爬下豆瓣上的所有书籍,根据现有标签对豆瓣书籍进行排序检索,并按照分数从高到低排序。

……

这些有趣的故事都来自知乎上的一个热门话题:爬虫技术可以做哪些酷、有趣、有用的事情?

每个人都可以是爬行动物

在互联网的早期,编写爬虫是一项技术活动。总的来说,爬虫技术是搜索引擎不可或缺的一部分。

随着互联网技术的发展,编写爬虫的门槛一降再降,一些编程语言甚至直接提供了爬虫框架,比如python的Scrapy框架,让编写爬虫进入了“老百姓的家”。

我们发现写爬虫是一件很酷的事情,但即便如此,学习爬虫还是存在一定的技术障碍。

目前主流的爬虫方式是使用Python编程。Python 的强大是毋庸置疑的,但是初学者学习 Python 还是需要一两个月的时间。

有没有更简单的方法来抓取数据?答案是肯定的。

一些可视化爬虫工具使用策略来爬取特定数据。虽然不如自己写爬虫准确,但是学习成本要低很多。下面介绍几个可视化爬虫工具。

家用工具

01 微软Excel

首先教大家一个使用Excel爬取数据的方法。此处使用 Microsoft Excel 2013 版本。让我们一步一步开始教学吧~

(1)新建一个Excel,打开,如下图

(2)点击“数据”-“来自网站”

(3)在弹出的对话框中输入目标网址,这里以全国实时空气质量为例网站,点击Go,然后导入

选择导入位置,OK

(4)结果如下图所示,怎么样,是不是很棒?

(5)如果要实时更新数据,可以在“数据”-“全部更新”-“连接属性”中设置,输入更新频率

02 优采云

一款无需可视化编程的网页采集软件,可以快速从不同的网站中提取归一化数据,帮助用户自动化采集、编辑和归一化数据,降低工作成本。

简易模式采集 步骤

是一款适合新手用户试用的采集软件。云功能强大。当然,爬虫老手也可以开发它的高级功能。

03 优采云

优采云是一款互联网数据采集、处理、分析、挖掘软件,采集功能齐全,不限于网页和内容,可以下载任何文件格式,号称采集99 % 网页。

软件定位更专业、更精准。用户需要具备基本的 HTML 基础,能够理解网页的源代码和结构。不过软件提供了相应的教程,新手可以学习上手。

04 采集客户

一款简单易用的网页信息采集软件,可以采集网页文字、图表、超链接等网页元素。

操作比较简单,适合初级用户,在功能上没有太多特色,后续支付需求也很多。

05 优采云云爬虫

一种新颖的云在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量规范化网页数据。

类似于爬虫系统框架,具体的采集也需要用户自己编写爬虫,这需要代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛<有三个类别:@采集器、cms采集器 和博客采集器。

专注于论坛和博客文字内容的抓取,采集全网数据通用性不高。

外国工具

01 谷歌表格

使用Google Sheet爬取数据前,必须保证三点:使用Chrome浏览器、有Google账号、电脑翻墙。满足这三个条件就开始吧~

(1)打开 Google 表格网站:/sheets/about/

(2)在首页点击“Go to Google Sheets”,然后登录自己的账号,可以看到如下界面,然后点击“+”新建一个sheet

新建的表格如下:

(3)打开要爬的目标网站,全国实时空气质量网站pm25.in/rank,目标上的表结构网站@ > 如下图所示

(4)回到Google sheet页面,使用函数=IMPORTHTML(URL, query, index),“URL”为抓取数据的目标网站,输入“list”或“in query “table”,这个取决于数据的具体结构类型,“index”用阿拉伯数字填充,从1开始,对应网站中定义的哪个表或列表

对于我们要抓取的 网站,我们在 Google 表格的单元格 A1 中输入函数 =IMPORTHTML("pm25.in/rank

集搜客网页抓取软件(神奇之处要归功于Firefox解析PDF的抓取网页pdf内容的规则 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-04-06 11:11

)

1、简介

晚上看了《Python网络数据采集》这本书,看到了阅读PDF内容的代码。记得前几天Jisouke刚刚发布了一个抓取网页PDF内容的抓取规则。 ,此规则可以将 pdf 内容视为 html 进行网页抓取。神奇之处在于Firefox解析PDF的能力,可以将pdf格式转换成html标签,比如div标签,让GooSeeker网页抓取软件可以像普通网页一样抓取结构化内容。

于是就出现了一个问题:Python爬虫能做多少事情。下面将描述一个实验过程和源代码。

2、pdf转文本的python源码

下面的python源代码读取一个pdf文件的内容(无论是在互联网上还是在本地),转换成文本,然后打印出来。这段代码主要使用第三方库PDFMiner3K将PDF读成字符串,然后使用StringIO将其转换为文件对象。 (源码下载地址见文章末尾的GitHub源码)

from urllib.request import urlopen

from pdfminer.pdfinterp import PDFResourceManager, process_pdf

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from io import StringIO

from io import open

def readPDF(pdfFile):

rsrcmgr = PDFResourceManager()

retstr = StringIO()

laparams = LAParams()

device = TextConverter(rsrcmgr, retstr, laparams=laparams)

process_pdf(rsrcmgr, device, pdfFile)

device.close()

content = retstr.getvalue()

retstr.close()

return content

pdfFile = urlopen("http://pythonscraping.com/page ... 6quot;)

outputString = readPDF(pdfFile)

print(outputString)

pdfFile.close()

如果 PDF 文件在您的计算机上,请将 urlopen 返回的 pdfFile 对象替换为正常的 open() 文件对象。

3、展望

这个实验只是把pdf转成文本,并没有像开始说的把它转成html标签,所以Python编程环境中是否有这样的能力留待以后探索。

4、Jisouke GooSeeker开源代码下载源码

GooSeeker 开源 Python 网络爬虫 GitHub 源码

5、文档修改历史

如有疑问,或

查看全部

集搜客网页抓取软件(神奇之处要归功于Firefox解析PDF的抓取网页pdf内容的规则

)

1、简介

晚上看了《Python网络数据采集》这本书,看到了阅读PDF内容的代码。记得前几天Jisouke刚刚发布了一个抓取网页PDF内容的抓取规则。 ,此规则可以将 pdf 内容视为 html 进行网页抓取。神奇之处在于Firefox解析PDF的能力,可以将pdf格式转换成html标签,比如div标签,让GooSeeker网页抓取软件可以像普通网页一样抓取结构化内容。

于是就出现了一个问题:Python爬虫能做多少事情。下面将描述一个实验过程和源代码。

2、pdf转文本的python源码

下面的python源代码读取一个pdf文件的内容(无论是在互联网上还是在本地),转换成文本,然后打印出来。这段代码主要使用第三方库PDFMiner3K将PDF读成字符串,然后使用StringIO将其转换为文件对象。 (源码下载地址见文章末尾的GitHub源码)

from urllib.request import urlopen

from pdfminer.pdfinterp import PDFResourceManager, process_pdf

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from io import StringIO

from io import open

def readPDF(pdfFile):

rsrcmgr = PDFResourceManager()

retstr = StringIO()

laparams = LAParams()

device = TextConverter(rsrcmgr, retstr, laparams=laparams)

process_pdf(rsrcmgr, device, pdfFile)

device.close()

content = retstr.getvalue()

retstr.close()

return content

pdfFile = urlopen("http://pythonscraping.com/page ... 6quot;)

outputString = readPDF(pdfFile)

print(outputString)

pdfFile.close()

如果 PDF 文件在您的计算机上,请将 urlopen 返回的 pdfFile 对象替换为正常的 open() 文件对象。

3、展望

这个实验只是把pdf转成文本,并没有像开始说的把它转成html标签,所以Python编程环境中是否有这样的能力留待以后探索。

4、Jisouke GooSeeker开源代码下载源码

GooSeeker 开源 Python 网络爬虫 GitHub 源码

5、文档修改历史

如有疑问,或

集搜客网页抓取软件(网站为什么以及如何制定反爬虫策略,可以看总结 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 478 次浏览 • 2022-04-06 11:09

)

随着大数据的普及,各种网络抓取/爬取工具涌入互联网。因此,网页数据成为大家竞争和掠夺的资源,但网站运营商不得不开始保护自己的数据资源,避免被竞争对手收购,防止更大的业务损失。下面总结一下反爬虫的策略以及如何应对。

一、什么是爬虫和反爬虫

爬虫和反爬虫是彼此的死敌。再厉害的爬虫也能被复杂的反爬虫机制发现。负键取决于双方投入了多少资源。为了更好地理解爬虫和反爬虫机制,以下是一些定义:

所以,我们可以知道爬虫最基本的特性之一就是batch size,反爬虫机制也是基于这个特性来做出判断,但是反爬虫还是一个权衡利弊的选择缺点,不仅误伤率低,还需要更高的拦截率,这也是它的弱点。 网站为什么以及如何制定反爬虫策略,可以看反爬虫经验总结。

二、反爬虫方法及其应对方法

一般网站反爬虫从三个方面进行:请求网站访问时的请求头、用户行为、目标网站的目录和数据加载方式。前两个方面可以说是最常见的反爬虫策略,而第三个方面则是使用ajax(异步加载)加载页面目录或内容,并增加爬虫访问目标后获取的数量网站 数据的难度。

但是仅仅检查请求头或者做一些IP限制显然不能满足网站运营商对反垃圾邮件的要求,所以还有很多进一步的对策。主要的大概有:Cookie限制、验证码反爬虫、Noscript。

2.1个通过Headers的反爬虫

从用户请求的标头进行反爬取是最常见的反爬取策略。由于普通用户通过浏览器访问网站,所以目标网站在收到请求时通常会检查headers中的User-Agent字段,如果没有携带正常的User-Agent信息请求会失败要求。还有一些网站为了防止上链,还要检查请求头中的Referer字段。

如果遇到这种反爬虫机制,可以直接将Headers添加到自己的爬虫中,将浏览器的User-Agent复制到爬虫的Headers中;另外,通过对请求的抓包分析,修改Referer值为目标网站域名,可以很好的绕过。

如果你使用极速客爬虫,你不需要担心如何添加或修改标头,因为极速客爬虫本身有一个浏览器嵌入了自己的标头,可以完美绕过这种反爬虫机制。

2.2 基于用户行为的反爬虫

还有一些网站会通过用户的行为来检测网站的访问者是否是爬虫,比如同一个IP在短时间内多次访问同一个页面,或者在短时间内多次使用同一帐户。做同样的事情。

大部分网站都是前一种情况,有两种策略:

1)使用代理ip。例如,可以编写一个脚本来抓取互联网上可用的代理IP,然后将抓取到的代理IP保存在代理池中供爬虫使用。当然,实际捕获的IP是免费的还是付费的,通常使用效果很一般。如果需要采集高价值数据,还可以考虑购买带宽带adsl拨号的VPS。如果ip被目标网站屏蔽,可以重新拨号。

2)降低请求频率。比如每个时间段请求一次,或者多次请求后休眠一段时间。由于网站得到的ip是一个局域网的ip,这个ip是区域内所有人共享的,所以这个间隔不需要特别长

对于第二种情况,下一个请求可以在每次请求后以几秒的随机间隔发出。对于存在逻辑漏洞的网站,可以通过多次请求、注销、重新登录、继续请求的方式,绕过同一账号短时间内不能多次发出同一个请求的限制。如果有多个账号,切换使用,效果会更好。

Jisoke Crawler 的 Firefox 插件版本安装在 Firefox 浏览器上。所有访问行为都会被加密并记录在火狐浏览器中。通过定期清理cookies、切换访问账号、控制采集速度、更改IP地址,可以避开这种反爬机制。此外,吉索客还准备开发ip代理功能,让采集数据更方便流畅。

2.3个动态页面的反爬虫

以上情况大多出现在静态页面上,但是对于动态页面,我们需要爬取的数据是通过ajax请求获取或者通过JavaScript生成的。首先使用 Firebug 或 HttpFox 分析网络请求。如果我们能找到ajax请求并分析出具体参数和响应的具体含义,就可以使用上面的方法直接使用requests或者urllib2来模拟ajax请求,分析响应json得到需要的数据。

能够直接模拟ajax请求获取数据是很棒的,但是有的网站把ajax请求的所有参数都加密了。我们根本无法构造对我们需要的数据的请求。还有一些严格守卫的网站,除了对ajax参数进行加密外,还封装了一些基础功能,都是调用自己的接口,接口参数是加密的。

遇到这样的网站,我们不能使用上面的方法。通过selenium+phantomJS框架,调用浏览器内核,使用phantomJS执行js模拟人类操作,触发页面中的js脚本。从填表到点击按钮再到页面滚动,都可以模拟,无论具体的请求和响应过程,只是完整的模拟了人们浏览页面获取数据的过程。使用这个框架几乎可以绕过大部分反爬虫,因为它不是冒充浏览器获取数据(上面提到的添加header在一定程度上是冒充浏览器),它本身就是浏览器,而且phantomJS 是一个没有界面的浏览器,但控制浏览器的不是人。

吉搜客爬虫通过设置连续动作,实现点击、输入、提交、选择、暂停、滚动等浏览行为,完全模拟人们浏览网页的操作。是真正的浏览器+智能模拟行为。可以获取大部分动态网页信息。

2.4 Cookie 限制

类似于Headers验证的反爬机制,当用户向目标网站发送请求时,请求数据中会收录cookie。检查cookie的值,判断发起访问请求的人是真实用户还是爬虫。第一次打开网页时,会生成一个随机cookie。如果再次打开网页时cookie不存在,则重新设置,第三次仍然不存在。这很可能是爬虫在工作。

Cookie验证和Headers的区别在于用户发送的Headers的内容形式是固定的,很容易被伪造,而Cookies不是。原因是我们在分析浏览器请求网站访问的过程中分析的cookies,往往是通过相关js等进程改变了域的cookies。如果直接修改爬虫携带的cookie来访问对应的网页,由于携带的cookie已经是访问后的域,而不是访问前的域,所以无法模拟整个过程成功。这种情况必然会导致爬虫无法访问页面。

分析cookie,其中可能携带大量随机哈希字符串,或者不同时间戳的字符串,根据每次访问更新域的值。对于这个限制,首先,在捕获和分析目标网站时,首先要清除浏览器的cookie,然后在第一次访问时(通常在在这个过程中,有几次301/302跳转,每次跳转网站给浏览器返回不同的cookie,最后一次跳转请求成功)。抓包并分析请求细节后,在爬虫上模拟这个过渡过程,然后将cookie截取为爬虫自身携带的cookie,这样就可以绕过对目标网站的访问cookie 的限制。 .

Jisooke 爬虫通过自己的浏览器访问网页。 采集用数据访问网页的过程和用浏览器访问网页的过程是一样的。因此,无需担心cookie限制导致访问失败,但建议定期清除cookie,这样可以更好地避免基于用户行为的反爬虫监控。

2.5 验证码限制

这是一种相当古老但有效的反爬虫策略。早先这种验证码可以通过OCR技术通过简单的图像识别来破解,但现在验证码的干扰线和噪音已经变得肉眼无法轻易识别。因此,目前由于OCR技术发展不畅,验证码技术成为了很多网站最有效的手段之一。

除了识别挑战之外,CAPTCHA 还有另一个值得注意的问题。现在很多网站都在使用第三方验证码服务。当用户打开目标网站的登录页面时,登录页面显示的验证码是从第三方(如阿里云)提供的链接中加载的。这时候,我们在模拟登录的时候,需要多提供一步从网页中获取验证码的第三方链接,而这一步往往隐含着陷阱。以阿里云提供的验证码服务为例,登录页面的源码会显示阿里云提供的第三方链接,但是当这个链接被匹配到抓取验证码时,我们会发现验证代码无效。仔细分析抓包请求数据后发现,普通浏览器在请求验证码时会多带一个ts参数,而这个参数是由当前时间戳生成的,但并不是完整的时间戳,而是一个时间戳保留九位数字后对字符串进行四舍五入。对待这种第三方服务只能小心翼翼和运气好。还有一种特殊的第三方验证码,也就是所谓的拖拽验证。互联网创业只能说有2b、2c、2vc三种模式。

吉搜客爬虫不仅可以连接打码平台,还可以自动识别滑块验证码。滑块验证码可以识别用户行为。 GooSeeker V7.0.1版本有记录用户行为功能,通过分析大量用户行为样本,提取行为特征,利用机器学习算法,实现滑块验证码的识别程序通过率高。

如有疑问,或

查看全部

集搜客网页抓取软件(网站为什么以及如何制定反爬虫策略,可以看总结

)

随着大数据的普及,各种网络抓取/爬取工具涌入互联网。因此,网页数据成为大家竞争和掠夺的资源,但网站运营商不得不开始保护自己的数据资源,避免被竞争对手收购,防止更大的业务损失。下面总结一下反爬虫的策略以及如何应对。

一、什么是爬虫和反爬虫

爬虫和反爬虫是彼此的死敌。再厉害的爬虫也能被复杂的反爬虫机制发现。负键取决于双方投入了多少资源。为了更好地理解爬虫和反爬虫机制,以下是一些定义:

所以,我们可以知道爬虫最基本的特性之一就是batch size,反爬虫机制也是基于这个特性来做出判断,但是反爬虫还是一个权衡利弊的选择缺点,不仅误伤率低,还需要更高的拦截率,这也是它的弱点。 网站为什么以及如何制定反爬虫策略,可以看反爬虫经验总结。

二、反爬虫方法及其应对方法

一般网站反爬虫从三个方面进行:请求网站访问时的请求头、用户行为、目标网站的目录和数据加载方式。前两个方面可以说是最常见的反爬虫策略,而第三个方面则是使用ajax(异步加载)加载页面目录或内容,并增加爬虫访问目标后获取的数量网站 数据的难度。

但是仅仅检查请求头或者做一些IP限制显然不能满足网站运营商对反垃圾邮件的要求,所以还有很多进一步的对策。主要的大概有:Cookie限制、验证码反爬虫、Noscript。

2.1个通过Headers的反爬虫

从用户请求的标头进行反爬取是最常见的反爬取策略。由于普通用户通过浏览器访问网站,所以目标网站在收到请求时通常会检查headers中的User-Agent字段,如果没有携带正常的User-Agent信息请求会失败要求。还有一些网站为了防止上链,还要检查请求头中的Referer字段。

如果遇到这种反爬虫机制,可以直接将Headers添加到自己的爬虫中,将浏览器的User-Agent复制到爬虫的Headers中;另外,通过对请求的抓包分析,修改Referer值为目标网站域名,可以很好的绕过。

如果你使用极速客爬虫,你不需要担心如何添加或修改标头,因为极速客爬虫本身有一个浏览器嵌入了自己的标头,可以完美绕过这种反爬虫机制。

2.2 基于用户行为的反爬虫

还有一些网站会通过用户的行为来检测网站的访问者是否是爬虫,比如同一个IP在短时间内多次访问同一个页面,或者在短时间内多次使用同一帐户。做同样的事情。

大部分网站都是前一种情况,有两种策略:

1)使用代理ip。例如,可以编写一个脚本来抓取互联网上可用的代理IP,然后将抓取到的代理IP保存在代理池中供爬虫使用。当然,实际捕获的IP是免费的还是付费的,通常使用效果很一般。如果需要采集高价值数据,还可以考虑购买带宽带adsl拨号的VPS。如果ip被目标网站屏蔽,可以重新拨号。

2)降低请求频率。比如每个时间段请求一次,或者多次请求后休眠一段时间。由于网站得到的ip是一个局域网的ip,这个ip是区域内所有人共享的,所以这个间隔不需要特别长

对于第二种情况,下一个请求可以在每次请求后以几秒的随机间隔发出。对于存在逻辑漏洞的网站,可以通过多次请求、注销、重新登录、继续请求的方式,绕过同一账号短时间内不能多次发出同一个请求的限制。如果有多个账号,切换使用,效果会更好。

Jisoke Crawler 的 Firefox 插件版本安装在 Firefox 浏览器上。所有访问行为都会被加密并记录在火狐浏览器中。通过定期清理cookies、切换访问账号、控制采集速度、更改IP地址,可以避开这种反爬机制。此外,吉索客还准备开发ip代理功能,让采集数据更方便流畅。

2.3个动态页面的反爬虫

以上情况大多出现在静态页面上,但是对于动态页面,我们需要爬取的数据是通过ajax请求获取或者通过JavaScript生成的。首先使用 Firebug 或 HttpFox 分析网络请求。如果我们能找到ajax请求并分析出具体参数和响应的具体含义,就可以使用上面的方法直接使用requests或者urllib2来模拟ajax请求,分析响应json得到需要的数据。

能够直接模拟ajax请求获取数据是很棒的,但是有的网站把ajax请求的所有参数都加密了。我们根本无法构造对我们需要的数据的请求。还有一些严格守卫的网站,除了对ajax参数进行加密外,还封装了一些基础功能,都是调用自己的接口,接口参数是加密的。

遇到这样的网站,我们不能使用上面的方法。通过selenium+phantomJS框架,调用浏览器内核,使用phantomJS执行js模拟人类操作,触发页面中的js脚本。从填表到点击按钮再到页面滚动,都可以模拟,无论具体的请求和响应过程,只是完整的模拟了人们浏览页面获取数据的过程。使用这个框架几乎可以绕过大部分反爬虫,因为它不是冒充浏览器获取数据(上面提到的添加header在一定程度上是冒充浏览器),它本身就是浏览器,而且phantomJS 是一个没有界面的浏览器,但控制浏览器的不是人。

吉搜客爬虫通过设置连续动作,实现点击、输入、提交、选择、暂停、滚动等浏览行为,完全模拟人们浏览网页的操作。是真正的浏览器+智能模拟行为。可以获取大部分动态网页信息。

2.4 Cookie 限制

类似于Headers验证的反爬机制,当用户向目标网站发送请求时,请求数据中会收录cookie。检查cookie的值,判断发起访问请求的人是真实用户还是爬虫。第一次打开网页时,会生成一个随机cookie。如果再次打开网页时cookie不存在,则重新设置,第三次仍然不存在。这很可能是爬虫在工作。

Cookie验证和Headers的区别在于用户发送的Headers的内容形式是固定的,很容易被伪造,而Cookies不是。原因是我们在分析浏览器请求网站访问的过程中分析的cookies,往往是通过相关js等进程改变了域的cookies。如果直接修改爬虫携带的cookie来访问对应的网页,由于携带的cookie已经是访问后的域,而不是访问前的域,所以无法模拟整个过程成功。这种情况必然会导致爬虫无法访问页面。

分析cookie,其中可能携带大量随机哈希字符串,或者不同时间戳的字符串,根据每次访问更新域的值。对于这个限制,首先,在捕获和分析目标网站时,首先要清除浏览器的cookie,然后在第一次访问时(通常在在这个过程中,有几次301/302跳转,每次跳转网站给浏览器返回不同的cookie,最后一次跳转请求成功)。抓包并分析请求细节后,在爬虫上模拟这个过渡过程,然后将cookie截取为爬虫自身携带的cookie,这样就可以绕过对目标网站的访问cookie 的限制。 .

Jisooke 爬虫通过自己的浏览器访问网页。 采集用数据访问网页的过程和用浏览器访问网页的过程是一样的。因此,无需担心cookie限制导致访问失败,但建议定期清除cookie,这样可以更好地避免基于用户行为的反爬虫监控。

2.5 验证码限制

这是一种相当古老但有效的反爬虫策略。早先这种验证码可以通过OCR技术通过简单的图像识别来破解,但现在验证码的干扰线和噪音已经变得肉眼无法轻易识别。因此,目前由于OCR技术发展不畅,验证码技术成为了很多网站最有效的手段之一。

除了识别挑战之外,CAPTCHA 还有另一个值得注意的问题。现在很多网站都在使用第三方验证码服务。当用户打开目标网站的登录页面时,登录页面显示的验证码是从第三方(如阿里云)提供的链接中加载的。这时候,我们在模拟登录的时候,需要多提供一步从网页中获取验证码的第三方链接,而这一步往往隐含着陷阱。以阿里云提供的验证码服务为例,登录页面的源码会显示阿里云提供的第三方链接,但是当这个链接被匹配到抓取验证码时,我们会发现验证代码无效。仔细分析抓包请求数据后发现,普通浏览器在请求验证码时会多带一个ts参数,而这个参数是由当前时间戳生成的,但并不是完整的时间戳,而是一个时间戳保留九位数字后对字符串进行四舍五入。对待这种第三方服务只能小心翼翼和运气好。还有一种特殊的第三方验证码,也就是所谓的拖拽验证。互联网创业只能说有2b、2c、2vc三种模式。

吉搜客爬虫不仅可以连接打码平台,还可以自动识别滑块验证码。滑块验证码可以识别用户行为。 GooSeeker V7.0.1版本有记录用户行为功能,通过分析大量用户行为样本,提取行为特征,利用机器学习算法,实现滑块验证码的识别程序通过率高。

如有疑问,或

集搜客网页抓取软件(import.io:大数据采集软件集搜客GooSeeker对比说明 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2022-04-06 11:06

)

最近国外大数据软件采集import.io火了。在获得90万美元天使轮融资后,近日又获得了1300万美元的一轮融资,引起了众多投资者的关注。,我也是出于好奇使用并体验了import.io的神奇功能。我是中国大数据采集软件合集GooSeeker的老用户,所以喜欢把两者放在一起比较。下面我印象最深。的几个功能对比,对应import.io的四大功能:Magic、Extractor、Crawler、Connector,分为两部分。

对data采集比较感兴趣的朋友,希望能起到吸点新意的作用,一起来分析data采集的技术亮点。

1. 魔法 (Import.io) VS 天眼和千面 (Jizouke)

Magic:就像magic这个词的本义“魔法”一样,import.io赋予了Magic一个神奇的功能。只要用户输入 URL,Magic 工具就可以神奇的将网页中的数据整齐、标准地抓取。

如图1所示,输入58同城租房信息URL后,Magic会自动采集网页数据,操作简单。但是可以看到可能会漏掉一些栏目,每页都需要点击“下一页”进行采集,无法自动翻页。当然,还有很多页面几乎没有采集可以下载,比如新浪微博。

总之,我觉得很神奇:

图 1:Magic Autocrawl 示例

上图是import.io的Magic功能截图。它是一个纯网页界面,使用起来非常方便,无需安装额外的软件。综上所述:

GooSeeker的天眼和千面系列:集搜客的天眼和千面分别针对电商和微博发布的数据采集方便的GUI界面,只要输入网址,目标数据就可以标准化、整齐采集下来。

如图2:博主的采集工具展示(微博的各种数据都有一个采集管理界面),进入博主首页的链接,可以调度爬虫,回复博主。首页下的信息为采集,如微博内容、转发、评论等数据。

图2:GooSeeker微博博主采集界面示例

界面也很简单。与 Import.io 相比,最大的不同是用户自己运行爬虫组。已结构化和转换的 XML 格式的结果文件。

从上面的分析可以看出,Magic和GooSeeker的天眼和千面操作非常简单,基本上都是纯傻瓜式操作,非常适合只想专注于业务问题而做不想被技术问题分心。用户也是纯小白学习数据采集和使用数据结果的良好起点。但是,Magic 在采集 的结果可视化方面比天眼和千眼具有更广泛的适用性。缺点是采集数据量大的场景不可控,而天眼和千面专注几个主流网站,优点主要体现在能够完成大量数据采集,例如,

2. Extractor (import.io) VS Organizer (Jizouke)

提取器:提取器是翻译中的提取器。如果从实体的角度来理解,它就是一个小程序(可能是一组脚本),从 URL 中提取出想要的信息;如果是从 采集 目标来理解它是从 采集 的角度来理解特定网页的结构规则。与Magic不同的是,import.io的Extractor(以及后面的另外两个功能)是一个可以独立运行的软件,具有非常直观的可视化界面,可以直观的展示提取出来的信息。

如图 3:import.io 的 Extractor 非常类似于修改后的浏览器。在工具栏中输入网址,网页显示出来后,在浏览器中选择要抓取的数据,然后单页就可以将结构的整列规范依次往下采集。

图 3:Extractor 提取数据的示例

GooSeeker Organizer:Jisouke 声称是“建立一个盒子,把你想要的内容放进去”。这个盒子就是所谓的组织者。原理是将需要提取的信息一个一个拖入框内,映射到组织者。Box,采集程序可以自动生成提取器(脚本程序),提取器自动存储在云服务器中,可以分发给全球的网络爬虫进行提取。

如图4所示,import.io顶部的一个工具栏在GooSeeker中展开成一个工作台,在工作台上创建一个盒子,然后通过映射操作将网页上的内容扔到盒子里。把你想要的东西扔进盒子里。原理看似简单,但面对大盒子界面和众多HTML节点,对于新手来说有点压力。当然,界面复杂,以换取能够处理更复杂的情况,因为有更多的控件可用。

图 4:分类 bin 提取数据的示例

综上所述,Extractor和排序框都具有提取信息字段的功能。Extractor操作起来比较简单直观,适用于一些简单结构化的URL,但是对于一些稍微复杂的URL,Extractor会出现无法提取的问题。这时候就突显了吉搜克排序框的优势,特别复杂的情况下,可以使用自定义的xpath来定位数据。

如有疑问,您可以或

查看全部

集搜客网页抓取软件(import.io:大数据采集软件集搜客GooSeeker对比说明

)

最近国外大数据软件采集import.io火了。在获得90万美元天使轮融资后,近日又获得了1300万美元的一轮融资,引起了众多投资者的关注。,我也是出于好奇使用并体验了import.io的神奇功能。我是中国大数据采集软件合集GooSeeker的老用户,所以喜欢把两者放在一起比较。下面我印象最深。的几个功能对比,对应import.io的四大功能:Magic、Extractor、Crawler、Connector,分为两部分。

对data采集比较感兴趣的朋友,希望能起到吸点新意的作用,一起来分析data采集的技术亮点。

1. 魔法 (Import.io) VS 天眼和千面 (Jizouke)

Magic:就像magic这个词的本义“魔法”一样,import.io赋予了Magic一个神奇的功能。只要用户输入 URL,Magic 工具就可以神奇的将网页中的数据整齐、标准地抓取。

如图1所示,输入58同城租房信息URL后,Magic会自动采集网页数据,操作简单。但是可以看到可能会漏掉一些栏目,每页都需要点击“下一页”进行采集,无法自动翻页。当然,还有很多页面几乎没有采集可以下载,比如新浪微博。

总之,我觉得很神奇:

图 1:Magic Autocrawl 示例

上图是import.io的Magic功能截图。它是一个纯网页界面,使用起来非常方便,无需安装额外的软件。综上所述:

GooSeeker的天眼和千面系列:集搜客的天眼和千面分别针对电商和微博发布的数据采集方便的GUI界面,只要输入网址,目标数据就可以标准化、整齐采集下来。

如图2:博主的采集工具展示(微博的各种数据都有一个采集管理界面),进入博主首页的链接,可以调度爬虫,回复博主。首页下的信息为采集,如微博内容、转发、评论等数据。

图2:GooSeeker微博博主采集界面示例

界面也很简单。与 Import.io 相比,最大的不同是用户自己运行爬虫组。已结构化和转换的 XML 格式的结果文件。

从上面的分析可以看出,Magic和GooSeeker的天眼和千面操作非常简单,基本上都是纯傻瓜式操作,非常适合只想专注于业务问题而做不想被技术问题分心。用户也是纯小白学习数据采集和使用数据结果的良好起点。但是,Magic 在采集 的结果可视化方面比天眼和千眼具有更广泛的适用性。缺点是采集数据量大的场景不可控,而天眼和千面专注几个主流网站,优点主要体现在能够完成大量数据采集,例如,

2. Extractor (import.io) VS Organizer (Jizouke)

提取器:提取器是翻译中的提取器。如果从实体的角度来理解,它就是一个小程序(可能是一组脚本),从 URL 中提取出想要的信息;如果是从 采集 目标来理解它是从 采集 的角度来理解特定网页的结构规则。与Magic不同的是,import.io的Extractor(以及后面的另外两个功能)是一个可以独立运行的软件,具有非常直观的可视化界面,可以直观的展示提取出来的信息。

如图 3:import.io 的 Extractor 非常类似于修改后的浏览器。在工具栏中输入网址,网页显示出来后,在浏览器中选择要抓取的数据,然后单页就可以将结构的整列规范依次往下采集。

图 3:Extractor 提取数据的示例

GooSeeker Organizer:Jisouke 声称是“建立一个盒子,把你想要的内容放进去”。这个盒子就是所谓的组织者。原理是将需要提取的信息一个一个拖入框内,映射到组织者。Box,采集程序可以自动生成提取器(脚本程序),提取器自动存储在云服务器中,可以分发给全球的网络爬虫进行提取。

如图4所示,import.io顶部的一个工具栏在GooSeeker中展开成一个工作台,在工作台上创建一个盒子,然后通过映射操作将网页上的内容扔到盒子里。把你想要的东西扔进盒子里。原理看似简单,但面对大盒子界面和众多HTML节点,对于新手来说有点压力。当然,界面复杂,以换取能够处理更复杂的情况,因为有更多的控件可用。

图 4:分类 bin 提取数据的示例

综上所述,Extractor和排序框都具有提取信息字段的功能。Extractor操作起来比较简单直观,适用于一些简单结构化的URL,但是对于一些稍微复杂的URL,Extractor会出现无法提取的问题。这时候就突显了吉搜克排序框的优势,特别复杂的情况下,可以使用自定义的xpath来定位数据。

如有疑问,您可以或

集搜客网页抓取软件(酷爱编程的老程序员,我还是启动了这个Python即时网络爬虫项目 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-04-06 11:05

)

作为一个热爱编程的老程序员,我真的受不了这种冲动。Python 真的很火,一直在激荡我的心。

我对 Python 持谨慎态度。我想,当我基于 Drupal 搭建系统,使用 php 语言的时候,语言升级的时候,老版本的很多东西都被推翻了,不得不花费大量的时间和精力去移植和升级。有一些代码埋在埋在我的某个地方。我猜Python是无法避免这个问题的(其实已经有很多声音了,比如Python 3正在摧毁Python)。

但是,无论如何,我还是开始了这个 Python 即时网络爬虫项目。我使用 C++、Java 和 Javascript 编写爬虫相关程序已经 10 多年了。追求高性能,必须只有C++。同时,有完整的标准体系,让您和您的系统非常有信心。只要充分测试,就可以按照预期的方式进行操作。在 GooSeeker 项目中,我们继续朝着一个方向努力——“收获数据”,让广大用户(不仅是专业数据采集用户)体验收获互联网数据的乐趣。“收获”的一个重要含义是大量。现在,我将启动“Instant Web Crawler”,以补充“reap”未涵盖的场景,我看到的是:

很多程序员都在玩Python爬虫,我做了一个计划:构建一个更加模块化的软件组件来解决最耗能的内容提取问题(有人总结大数据和数据分析的全链条,数据准备账户80%的工作量,我们不妨扩展一下,网络数据抓取的80%的工作量是为各种网站的各种数据结构编写抓取规则。

我把他想象成一台小机器(见上图),输入是原创网页,输出是提取出来的结构化内容,这个小机器有一个可替换的部分:一条将输入转换成输出结构块的指令,我们变成“提取器”,因此您不必担心调试正则表达式或 XPath。

这是一个开放的项目。两年前启动了手机上的实时网络爬虫项目。因为是为企业集团开发的,打开起来很不方便。一样的思路和方法会开放给这个项目,目前最火的python来做,希望大家一起参与。在实施过程中,我们会开放所有的材料和成就,以及我们遇到的坑。

最近的实验是:

如有疑问,您可以或

查看全部

集搜客网页抓取软件(酷爱编程的老程序员,我还是启动了这个Python即时网络爬虫项目

)

作为一个热爱编程的老程序员,我真的受不了这种冲动。Python 真的很火,一直在激荡我的心。

我对 Python 持谨慎态度。我想,当我基于 Drupal 搭建系统,使用 php 语言的时候,语言升级的时候,老版本的很多东西都被推翻了,不得不花费大量的时间和精力去移植和升级。有一些代码埋在埋在我的某个地方。我猜Python是无法避免这个问题的(其实已经有很多声音了,比如Python 3正在摧毁Python)。

但是,无论如何,我还是开始了这个 Python 即时网络爬虫项目。我使用 C++、Java 和 Javascript 编写爬虫相关程序已经 10 多年了。追求高性能,必须只有C++。同时,有完整的标准体系,让您和您的系统非常有信心。只要充分测试,就可以按照预期的方式进行操作。在 GooSeeker 项目中,我们继续朝着一个方向努力——“收获数据”,让广大用户(不仅是专业数据采集用户)体验收获互联网数据的乐趣。“收获”的一个重要含义是大量。现在,我将启动“Instant Web Crawler”,以补充“reap”未涵盖的场景,我看到的是:

很多程序员都在玩Python爬虫,我做了一个计划:构建一个更加模块化的软件组件来解决最耗能的内容提取问题(有人总结大数据和数据分析的全链条,数据准备账户80%的工作量,我们不妨扩展一下,网络数据抓取的80%的工作量是为各种网站的各种数据结构编写抓取规则。

我把他想象成一台小机器(见上图),输入是原创网页,输出是提取出来的结构化内容,这个小机器有一个可替换的部分:一条将输入转换成输出结构块的指令,我们变成“提取器”,因此您不必担心调试正则表达式或 XPath。

这是一个开放的项目。两年前启动了手机上的实时网络爬虫项目。因为是为企业集团开发的,打开起来很不方便。一样的思路和方法会开放给这个项目,目前最火的python来做,希望大家一起参与。在实施过程中,我们会开放所有的材料和成就,以及我们遇到的坑。

最近的实验是:

如有疑问,您可以或

集搜客网页抓取软件(图片爬虫滚动网页的处理方法有哪些?-八维教育 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-04-03 09:11

)

在做图片爬虫的时候,经常会遇到一些网站,需要鼠标滚动网页才能继续响应。这对于传统的HttpClient来说是一件非常困难的事情,至少我不知道如何处理。幸运的是,我找到了 Selenium。

硒

Selenium 是一组软件工具,每个工具都有不同的方法来支持测试自动化。大多数使用 Selenium 的 QA 工程师只关注一两个最能满足其项目需求的工具。但是,学习所有工具将为您提供更多选项来解决不同类型的测试自动化问题。这套完整的工具具有丰富的测试功能,非常适合测试各类网站应用的需求。这些操作非常灵活,在将预期测试结果与实际行为进行比较时,有多种选项可用于定位 UI 元素。Selenium 最关键的特性之一是支持在多个浏览器平台上进行测试。

在 build.gradle 中添加依赖:

<p>compile 'org.seleniumhq.selenium:selenium-java:3.7.1'

</p>

除了需要添加selenium依赖外,还需要添加webdirver。

这里我用的是chromedirver(也可以选择firefoxdriver,看个人喜好),chromedirver可以下载最新版本。对于不同的操作系统,您需要下载相应的版本。

PicCrawler

PicCrawler 是我开发的用于抓取图片的爬虫。支持User-Agent、referer、header、cookies等一些简单的自定义,有兴趣的同学可以看我之前写的基于RxJava2的简单图片爬虫文章

对于Java项目,如果使用gradle构建,由于默认不使用jcenter,需要在对应模块的build.gradle中配置

<p>repositories {

mavenCentral()

jcenter()

}

</p>

然后添加最新的 piccrawler 依赖项

<p>compile 'com.cv4j.piccrawler:crawler:0.5.1'

</p>

具体实现 1. 配置chromedriver的路径

<p> static {

System.setProperty("webdriver.chrome.driver", "crawler-selenium/chromedriver");

}

</p>

2.从网页下载图片

<p> public void downloadPic(String url) {

WebDriver driver = new ChromeDriver();

driver.get(url);

String html = driver.getPageSource();

List urls = parseHtmlToImages(html,picParser);

crawlerClient.downloadPics(urls);

}

</p>

这里通过WebDriver请求一个网页,然后解析请求的html字符串,得到一组图片,最后交给图片爬虫下载图片。

3.多次滚动网页,下载网页上的图片

<p> /**

*

* @param url

* @param scrollDownNum 模拟鼠标滚动到屏幕底部到次数

*/

public void downloadPic(String url,int scrollDownNum) {

WebDriver driver = new ChromeDriver();

driver.get(url);

String html = driver.getPageSource();

List urls = parseHtmlToImages(html,picParser);

crawlerClient.downloadPics(urls);

if (scrollDownNum>1) {

<p> for (int i=0;i 查看全部

集搜客网页抓取软件(图片爬虫滚动网页的处理方法有哪些?-八维教育

)

在做图片爬虫的时候,经常会遇到一些网站,需要鼠标滚动网页才能继续响应。这对于传统的HttpClient来说是一件非常困难的事情,至少我不知道如何处理。幸运的是,我找到了 Selenium。

硒

Selenium 是一组软件工具,每个工具都有不同的方法来支持测试自动化。大多数使用 Selenium 的 QA 工程师只关注一两个最能满足其项目需求的工具。但是,学习所有工具将为您提供更多选项来解决不同类型的测试自动化问题。这套完整的工具具有丰富的测试功能,非常适合测试各类网站应用的需求。这些操作非常灵活,在将预期测试结果与实际行为进行比较时,有多种选项可用于定位 UI 元素。Selenium 最关键的特性之一是支持在多个浏览器平台上进行测试。

在 build.gradle 中添加依赖:

<p>compile 'org.seleniumhq.selenium:selenium-java:3.7.1'

</p>

除了需要添加selenium依赖外,还需要添加webdirver。

这里我用的是chromedirver(也可以选择firefoxdriver,看个人喜好),chromedirver可以下载最新版本。对于不同的操作系统,您需要下载相应的版本。

PicCrawler

PicCrawler 是我开发的用于抓取图片的爬虫。支持User-Agent、referer、header、cookies等一些简单的自定义,有兴趣的同学可以看我之前写的基于RxJava2的简单图片爬虫文章

对于Java项目,如果使用gradle构建,由于默认不使用jcenter,需要在对应模块的build.gradle中配置

<p>repositories {

mavenCentral()

jcenter()

}

</p>

然后添加最新的 piccrawler 依赖项

<p>compile 'com.cv4j.piccrawler:crawler:0.5.1'

</p>

具体实现 1. 配置chromedriver的路径

<p> static {

System.setProperty("webdriver.chrome.driver", "crawler-selenium/chromedriver");

}

</p>

2.从网页下载图片

<p> public void downloadPic(String url) {

WebDriver driver = new ChromeDriver();

driver.get(url);

String html = driver.getPageSource();

List urls = parseHtmlToImages(html,picParser);

crawlerClient.downloadPics(urls);

}

</p>

这里通过WebDriver请求一个网页,然后解析请求的html字符串,得到一组图片,最后交给图片爬虫下载图片。

3.多次滚动网页,下载网页上的图片

<p> /**

*

* @param url

* @param scrollDownNum 模拟鼠标滚动到屏幕底部到次数

*/

public void downloadPic(String url,int scrollDownNum) {

WebDriver driver = new ChromeDriver();

driver.get(url);

String html = driver.getPageSource();

List urls = parseHtmlToImages(html,picParser);

crawlerClient.downloadPics(urls);

if (scrollDownNum>1) {

<p> for (int i=0;i

集搜客网页抓取软件( 《Python网络数据采集》一个抓取网页pdf内容的抓取规则)

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-04-01 10:03

《Python网络数据采集》一个抓取网页pdf内容的抓取规则)

1、简介

晚上看了《Python网络数据采集》这本书,看到了阅读PDF内容的代码。记得前几天Jisouke刚刚发布了一个抓取网页PDF内容的抓取规则。

,此规则可以将 pdf 内容视为 html 进行网页抓取。神奇之处在于火狐解析PDF的能力,可以将pdf格式转换成html标签,比如div标签,让GooSeeker网页抓取软件可以像普通网页一样抓取结构化内容。

于是就出现了一个问题:Python爬虫能做多少事情。下面将描述一个实验过程和源代码。

2、pdf转文本的python源码

下面的python源代码读取一个pdf文件的内容(无论是在互联网上还是在本地),转换成文本,然后打印出来。这段代码主要使用第三方库PDFMiner3K将PDF读成字符串,然后使用StringIO将其转换为文件对象。 (源码下载地址请参考文章末尾的GitHub源码)

from urllib.request import urlopen

from pdfminer.pdfinterp import PDFResourceManager, process_pdf

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from io import StringIO

from io import open

def readPDF(pdfFile):

rsrcmgr = PDFResourceManager()

retstr = StringIO()

laparams = LAParams()

device = TextConverter(rsrcmgr, retstr, laparams=laparams)

process_pdf(rsrcmgr, device, pdfFile)

device.close()

content = retstr.getvalue()

retstr.close()

return content

pdfFile = urlopen("http://pythonscraping.com/page ... 6quot;)

outputString = readPDF(pdfFile)

print(outputString)

pdfFile.close()

如果 PDF 文件在您的计算机上,请将 urlopen 返回的 pdfFile 对象替换为正常的 open() 文件对象。

3、展望

这个实验只是把pdf转成文本,并没有像开始说的把它转成html标签,所以Python编程环境中是否有这样的能力留待以后探索。

4、Jisouke GooSeeker开源代码下载源码

1.GooSeeker开源Python网络爬虫GitHub源码

5、文档修改历史

2016-05-26:V2.0,补充文字说明

2016-05-29: V2.1、增加第六章:源码下载源码,并替换github源码网址 查看全部

集搜客网页抓取软件(

《Python网络数据采集》一个抓取网页pdf内容的抓取规则)

1、简介

晚上看了《Python网络数据采集》这本书,看到了阅读PDF内容的代码。记得前几天Jisouke刚刚发布了一个抓取网页PDF内容的抓取规则。

,此规则可以将 pdf 内容视为 html 进行网页抓取。神奇之处在于火狐解析PDF的能力,可以将pdf格式转换成html标签,比如div标签,让GooSeeker网页抓取软件可以像普通网页一样抓取结构化内容。

于是就出现了一个问题:Python爬虫能做多少事情。下面将描述一个实验过程和源代码。

2、pdf转文本的python源码

下面的python源代码读取一个pdf文件的内容(无论是在互联网上还是在本地),转换成文本,然后打印出来。这段代码主要使用第三方库PDFMiner3K将PDF读成字符串,然后使用StringIO将其转换为文件对象。 (源码下载地址请参考文章末尾的GitHub源码)

from urllib.request import urlopen

from pdfminer.pdfinterp import PDFResourceManager, process_pdf

from pdfminer.converter import TextConverter

from pdfminer.layout import LAParams

from io import StringIO

from io import open

def readPDF(pdfFile):

rsrcmgr = PDFResourceManager()

retstr = StringIO()

laparams = LAParams()

device = TextConverter(rsrcmgr, retstr, laparams=laparams)

process_pdf(rsrcmgr, device, pdfFile)

device.close()

content = retstr.getvalue()

retstr.close()

return content

pdfFile = urlopen("http://pythonscraping.com/page ... 6quot;)

outputString = readPDF(pdfFile)

print(outputString)

pdfFile.close()

如果 PDF 文件在您的计算机上,请将 urlopen 返回的 pdfFile 对象替换为正常的 open() 文件对象。

3、展望

这个实验只是把pdf转成文本,并没有像开始说的把它转成html标签,所以Python编程环境中是否有这样的能力留待以后探索。

4、Jisouke GooSeeker开源代码下载源码

1.GooSeeker开源Python网络爬虫GitHub源码

5、文档修改历史

2016-05-26:V2.0,补充文字说明

2016-05-29: V2.1、增加第六章:源码下载源码,并替换github源码网址

集搜客网页抓取软件(本文给出安装和使用集搜客的检测报告(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-04-01 07:16

)

近日,吉索客技术支持中心收到了部分360安全卫士用户的反馈。在安装和使用极速客的过程中,我们遇到了一些由于360导致的误报,比如服务器连接失败、个别文件被删除、安装过程中不断出现360警告信息等问题。这些问题一直困扰着部分用户,影响了他们正常的数据采集。本文给出了应对措施,并附上Jisouke上第三方检测机构的检测报告。

1. 以下是吉索克的安装和使用指南。

1.1 安装期间的警告消息

如下所示:

当出现此警告信息时,请点击“更多”下的“允许该程序的所有操作”,如下图:

1.2 使用火狐浏览器,或者使用MS电脑/DS电脑时,会出现类似下图的警告信息:

当出现此警告信息时,请点击“更多”下的“允许该程序的所有操作”,如下图:

1.3 下载、安装或使用Jisoke的独立软件时,出现类似下图的警告信息:

请在“更多”中选择“允许该程序运行”或“信任该程序”。

或者干脆完全关闭 360 安全卫士。

1.4 360删除系统文件或与之前安装的Firefox版本冲突导致的软件使用问题

现象:

应对计划:

请注意:Vista、Win7、Win8、Win10都是这样的,WinXP没有这个目录

1.5 使用GS浏览器是360删除系统文件引起的

现象:

应对计划:

请注意:Vista、Win7、Win8、Win10都是这样的,WinXP没有这个目录

1.6 原因分析

下面的分析是基于我们长期观察得出的推论(因为观察到的对象并没有公开他们的算法): 由于360安全卫士默认开启了云网页检测,在数据抓取过程中,大量的网页或其他功能可能会被发送到 360 进行检测,也可能会导致本地 360 软件过载,从而影响整个计算机资源的过度消耗。因此,建议在采集数据时,可以

2.第三方测试

经第三方机构使用国内外数十种病毒检测引擎识别,Jisouke GooSeeker是一款安全无毒的软件,以下为测试报告(原报告可通过查看)

极速客自主软件测试报告网址:

查看全部

集搜客网页抓取软件(本文给出安装和使用集搜客的检测报告(组图)

)

近日,吉索客技术支持中心收到了部分360安全卫士用户的反馈。在安装和使用极速客的过程中,我们遇到了一些由于360导致的误报,比如服务器连接失败、个别文件被删除、安装过程中不断出现360警告信息等问题。这些问题一直困扰着部分用户,影响了他们正常的数据采集。本文给出了应对措施,并附上Jisouke上第三方检测机构的检测报告。

1. 以下是吉索克的安装和使用指南。

1.1 安装期间的警告消息

如下所示:

当出现此警告信息时,请点击“更多”下的“允许该程序的所有操作”,如下图:

1.2 使用火狐浏览器,或者使用MS电脑/DS电脑时,会出现类似下图的警告信息:

当出现此警告信息时,请点击“更多”下的“允许该程序的所有操作”,如下图:

1.3 下载、安装或使用Jisoke的独立软件时,出现类似下图的警告信息:

请在“更多”中选择“允许该程序运行”或“信任该程序”。

或者干脆完全关闭 360 安全卫士。

1.4 360删除系统文件或与之前安装的Firefox版本冲突导致的软件使用问题

现象:

应对计划:

请注意:Vista、Win7、Win8、Win10都是这样的,WinXP没有这个目录

1.5 使用GS浏览器是360删除系统文件引起的

现象:

应对计划:

请注意:Vista、Win7、Win8、Win10都是这样的,WinXP没有这个目录

1.6 原因分析

下面的分析是基于我们长期观察得出的推论(因为观察到的对象并没有公开他们的算法): 由于360安全卫士默认开启了云网页检测,在数据抓取过程中,大量的网页或其他功能可能会被发送到 360 进行检测,也可能会导致本地 360 软件过载,从而影响整个计算机资源的过度消耗。因此,建议在采集数据时,可以

2.第三方测试

经第三方机构使用国内外数十种病毒检测引擎识别,Jisouke GooSeeker是一款安全无毒的软件,以下为测试报告(原报告可通过查看)

极速客自主软件测试报告网址:

集搜客网页抓取软件(SEO优化指南之内部链接结构成功的五个seo指南)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-04-01 04:04

无论您是推出新的 网站、更新现有的 网站,还是重新组织您的内容,您的内部链接结构都将是您 SEO 成功的关键。

seo优化

内部链接是将您的网页相互连接的任何链接。

如果您没有内部链接策略,那么您将错过一个宝贵的机会来提高您的 SEO 工作并同时为您的访问者创造更人性化的 网站 体验。

最终,如果您遵循内部链接结构最佳实践,您可以为在现代 SEO 时代取得成功做好准备。

您需要了解内部链接结构成功的五个 seo 指南:

把用户放在第一位

管理内部链接的价值和流量

围绕主题内容的结构

利用独特的内容和规范

索引和优先级

本文旨在分享最新的 SEO 优化指南,帮助您了解最佳实践背后的概念,以及规划和实施内部链接结构,建立内容相关性和权威性,并帮助您进行排名。

1. 用户体验

善待您的 网站 访客。

不要为用户创建糟糕的 SEO,例如内容稀少、首屏广告过多或破坏性插页式广告。这些会将访问者弹回搜索结果页面。

无论您为 网站 访问者提供的价值主张有多好,如果他们找不到,您就不会达到您的底线目标 - 或者您为什么希望他们来您的 网站@ > 首先。

搜索引擎专注于积极的用户体验,因为他们关心最终客户——搜索者。当搜索者使用搜索引擎并在搜索结果的顶部找到他们正在寻找的内容时,此 网站 提供其用户价值。

凭借关于用户如何与搜索结果和 网站 交互的数十亿数据点,引擎可以根据用户体验因素调整算法,这些因素只能在未来预期(尤其是使用机器学习和自动算法更新)。

除了 Google 在更新中特别提到的项目之外,让您的内容与转化目标保持一致也很重要。如果您有有价值的内容自然地通过客户足迹,销售周期。您需要自行设置以让访问者留在您的 网站 上。

2. 链接价值流

当链接到达 网站 时,不要摘下链接构建的帽子。链接值按照相同的逻辑从站内页面传递到页面。

seo优化

几年前,当我们对 Google PageRank 有了更清晰的了解时,我们可以看到 网站 上每个页面的价值,并管理我们的链接结构,将 PageRank 推向我们最关心的领域。Shaped PageRank 来来去去,现在我们根本看不到 PR 分数。现在我们依靠 SEO 工具的特定指标,但您不能忘记 PageRank 仍在发挥作用。

了解来自其他来源的入站链接到达您的 网站 并构建您的 网站 以确保您不会稀释着陆页上的所有价值仍然至关重要。

通过简化导航,而不是将每个页面上的数十个链接拼接在一起,您可以将链接价值集中在最重要的页面上。这是否意味着将其传播到热门主题页面,或者将一堆内容放在一个非常具体的主题上。

您的链接构建策略应该与您所拥有的、它的结构以及您最终想要发送重要链接值的位置保持一致。

幸运的是,平板 网站 和主页感觉更像是 NASCAR 方面的日子已经结束。我们不需要进行大量清理以防止 网站 上的第一跳稀释所有链接值,因为 PageRank 值与给定页面上的所有链接按比例传递。

3. 上下文和层次结构

不要害怕让您的 网站 访问者点击并滚动。

我们不必在 网站 的第一页或第二页保留所有技术和深入的内容。围绕主题组织您的内容,并优先关注最重要的内容,而不是通过多次点击深入。

不像过去的 SEO 时代那样每个关键字都有一个页面,我们可以像学期论文大纲一样思考。我们内容的高级到具体的自然结构使我们能够在 网站 上开发主题和主题。这最终导致了从广泛的顶级到无法预见的特定和详细内容的长尾关键字的任何内容。按顺序获取内容的层次结构对用户和搜索引擎很重要。您可以通过确保您的内容井井有条且合乎逻辑来获得主题相关性。

您可能面临的最大挑战是,当您的组织中的利益相关者或客户机构中的利益相关者认为一切都很重要并且需要在主页或顶部导航中时。除了稀释前面提到的链接价值之外,主页上过多的焦点和链接可能会干扰您以正确的顺序为内容和深度构建上下文的事实。

4. 使用独特的内容和规范

要建立强大的品牌并提供优质的用户体验,您需要独特的内容。

搜索引擎过滤其结果中的重复内容。如果你拥有和其他人一样的内容,就很难打破商品地位,成为行业或利基的权威。

但是,重复内容是有正当理由的。你不能忽视它们,或者你不需要解决它们。

例如:

如果你在一个高度监管的行业,你可能有很多与其他网站类似的内容,并且不得不以某种方式打印自己的副本。

如果您是一家电子商务零售商,在多个类别中拥有相同的产品,并且您的产品描述在许多 网站 上都是相同的,那么您就没有时间为每个商店进行定制。

绘制和识别重复内容的区域很重要。您可以使用 Copyscape 之类的工具来评估网页,并使用 网站 通过批量搜索来解决重复内容的问题,如果您的 网站 中有产品内容并且其他人在网络上使用,则尤其重要。

如果您知道需要浏览哪些内容,那么您可以计划对重复和相似的内容页面、语言变体(如果您有国际内容)或 网站 上的分页使用规范标签。从那里,您可以使用站点地图作为工具来了解何时在标准页面中分层以及您希望搜索引擎发送到特定部分的 URL。

在电子商务中,这可能很棘手,因为如果您规范化更多产品而不是更重要的类别,或者如果您的产品页面的根版本与任何产品类别无关,您可能会无意中使产品类别不可见。您绝对需要仔细计划。

5. 爬取和索引

如果我们不能确保导航是可抓取的并且只有必要的主要和次要导航被编码到每个页面中,我们所有的努力都将是徒劳的。

通过在每个页面中添加不必要的导航,我们正在浪费宝贵的抓取预算和重点。关键不仅是要让搜索引擎看到我们所有的内容,还要采取简单的线性路径深入到我们主题领域的内容,还要理解基于主题相关性的页面之间的链接关联。当我们没有抓住焦点并且无法让蜘蛛到达某些页面时,我们就失去了排名更高的机会。

通过在每个页面中添加不必要的导航,我们可以浪费宝贵的抓取预算和重点。关键不仅是要让搜索引擎看到我们所有的内容,还要采取简单的线性路径深入到我们主题领域的内容,还要理解基于主题相关性的页面之间的链接关联。

当我们没有抓取焦点,并且无法让蜘蛛接收某些页面时,我们就失去了在广泛的高级到特定术语中获得高度评价的机会。此外,尽管我们努力构建高质量的内容,但我们的 网站 可能看起来很肤浅。

综上所述

虽然由于用户行为和搜索引擎优先级的变化,最佳实践会随着时间的推移而变化,但我们必须关注现在重要的事情。

从物理用户体验、管理链接价值流、捕获内容/上下文和层次结构、管理重复内容、确保正确索引,我们可以通过强大的内部链接结构成功定位 网站。

seo优化

在许多情况下,我们正在进入一个我们所做的大部分事情都是自然且符合逻辑要求的时代。如果我们从那里开始——然后了解链接价值流的更多技术方面、规范如何工作以及如何获得内容索引——那么我们会没事的。 查看全部

集搜客网页抓取软件(SEO优化指南之内部链接结构成功的五个seo指南)

无论您是推出新的 网站、更新现有的 网站,还是重新组织您的内容,您的内部链接结构都将是您 SEO 成功的关键。

seo优化

内部链接是将您的网页相互连接的任何链接。

如果您没有内部链接策略,那么您将错过一个宝贵的机会来提高您的 SEO 工作并同时为您的访问者创造更人性化的 网站 体验。

最终,如果您遵循内部链接结构最佳实践,您可以为在现代 SEO 时代取得成功做好准备。

您需要了解内部链接结构成功的五个 seo 指南:

把用户放在第一位

管理内部链接的价值和流量

围绕主题内容的结构

利用独特的内容和规范

索引和优先级

本文旨在分享最新的 SEO 优化指南,帮助您了解最佳实践背后的概念,以及规划和实施内部链接结构,建立内容相关性和权威性,并帮助您进行排名。

1. 用户体验

善待您的 网站 访客。

不要为用户创建糟糕的 SEO,例如内容稀少、首屏广告过多或破坏性插页式广告。这些会将访问者弹回搜索结果页面。

无论您为 网站 访问者提供的价值主张有多好,如果他们找不到,您就不会达到您的底线目标 - 或者您为什么希望他们来您的 网站@ > 首先。

搜索引擎专注于积极的用户体验,因为他们关心最终客户——搜索者。当搜索者使用搜索引擎并在搜索结果的顶部找到他们正在寻找的内容时,此 网站 提供其用户价值。

凭借关于用户如何与搜索结果和 网站 交互的数十亿数据点,引擎可以根据用户体验因素调整算法,这些因素只能在未来预期(尤其是使用机器学习和自动算法更新)。

除了 Google 在更新中特别提到的项目之外,让您的内容与转化目标保持一致也很重要。如果您有有价值的内容自然地通过客户足迹,销售周期。您需要自行设置以让访问者留在您的 网站 上。

2. 链接价值流

当链接到达 网站 时,不要摘下链接构建的帽子。链接值按照相同的逻辑从站内页面传递到页面。

seo优化

几年前,当我们对 Google PageRank 有了更清晰的了解时,我们可以看到 网站 上每个页面的价值,并管理我们的链接结构,将 PageRank 推向我们最关心的领域。Shaped PageRank 来来去去,现在我们根本看不到 PR 分数。现在我们依靠 SEO 工具的特定指标,但您不能忘记 PageRank 仍在发挥作用。

了解来自其他来源的入站链接到达您的 网站 并构建您的 网站 以确保您不会稀释着陆页上的所有价值仍然至关重要。

通过简化导航,而不是将每个页面上的数十个链接拼接在一起,您可以将链接价值集中在最重要的页面上。这是否意味着将其传播到热门主题页面,或者将一堆内容放在一个非常具体的主题上。

您的链接构建策略应该与您所拥有的、它的结构以及您最终想要发送重要链接值的位置保持一致。

幸运的是,平板 网站 和主页感觉更像是 NASCAR 方面的日子已经结束。我们不需要进行大量清理以防止 网站 上的第一跳稀释所有链接值,因为 PageRank 值与给定页面上的所有链接按比例传递。

3. 上下文和层次结构

不要害怕让您的 网站 访问者点击并滚动。

我们不必在 网站 的第一页或第二页保留所有技术和深入的内容。围绕主题组织您的内容,并优先关注最重要的内容,而不是通过多次点击深入。

不像过去的 SEO 时代那样每个关键字都有一个页面,我们可以像学期论文大纲一样思考。我们内容的高级到具体的自然结构使我们能够在 网站 上开发主题和主题。这最终导致了从广泛的顶级到无法预见的特定和详细内容的长尾关键字的任何内容。按顺序获取内容的层次结构对用户和搜索引擎很重要。您可以通过确保您的内容井井有条且合乎逻辑来获得主题相关性。

您可能面临的最大挑战是,当您的组织中的利益相关者或客户机构中的利益相关者认为一切都很重要并且需要在主页或顶部导航中时。除了稀释前面提到的链接价值之外,主页上过多的焦点和链接可能会干扰您以正确的顺序为内容和深度构建上下文的事实。

4. 使用独特的内容和规范

要建立强大的品牌并提供优质的用户体验,您需要独特的内容。

搜索引擎过滤其结果中的重复内容。如果你拥有和其他人一样的内容,就很难打破商品地位,成为行业或利基的权威。

但是,重复内容是有正当理由的。你不能忽视它们,或者你不需要解决它们。

例如:

如果你在一个高度监管的行业,你可能有很多与其他网站类似的内容,并且不得不以某种方式打印自己的副本。

如果您是一家电子商务零售商,在多个类别中拥有相同的产品,并且您的产品描述在许多 网站 上都是相同的,那么您就没有时间为每个商店进行定制。

绘制和识别重复内容的区域很重要。您可以使用 Copyscape 之类的工具来评估网页,并使用 网站 通过批量搜索来解决重复内容的问题,如果您的 网站 中有产品内容并且其他人在网络上使用,则尤其重要。

如果您知道需要浏览哪些内容,那么您可以计划对重复和相似的内容页面、语言变体(如果您有国际内容)或 网站 上的分页使用规范标签。从那里,您可以使用站点地图作为工具来了解何时在标准页面中分层以及您希望搜索引擎发送到特定部分的 URL。

在电子商务中,这可能很棘手,因为如果您规范化更多产品而不是更重要的类别,或者如果您的产品页面的根版本与任何产品类别无关,您可能会无意中使产品类别不可见。您绝对需要仔细计划。

5. 爬取和索引

如果我们不能确保导航是可抓取的并且只有必要的主要和次要导航被编码到每个页面中,我们所有的努力都将是徒劳的。

通过在每个页面中添加不必要的导航,我们正在浪费宝贵的抓取预算和重点。关键不仅是要让搜索引擎看到我们所有的内容,还要采取简单的线性路径深入到我们主题领域的内容,还要理解基于主题相关性的页面之间的链接关联。当我们没有抓住焦点并且无法让蜘蛛到达某些页面时,我们就失去了排名更高的机会。

通过在每个页面中添加不必要的导航,我们可以浪费宝贵的抓取预算和重点。关键不仅是要让搜索引擎看到我们所有的内容,还要采取简单的线性路径深入到我们主题领域的内容,还要理解基于主题相关性的页面之间的链接关联。

当我们没有抓取焦点,并且无法让蜘蛛接收某些页面时,我们就失去了在广泛的高级到特定术语中获得高度评价的机会。此外,尽管我们努力构建高质量的内容,但我们的 网站 可能看起来很肤浅。

综上所述

虽然由于用户行为和搜索引擎优先级的变化,最佳实践会随着时间的推移而变化,但我们必须关注现在重要的事情。

从物理用户体验、管理链接价值流、捕获内容/上下文和层次结构、管理重复内容、确保正确索引,我们可以通过强大的内部链接结构成功定位 网站。

seo优化

在许多情况下,我们正在进入一个我们所做的大部分事情都是自然且符合逻辑要求的时代。如果我们从那里开始——然后了解链接价值流的更多技术方面、规范如何工作以及如何获得内容索引——那么我们会没事的。

集搜客网页抓取软件(图标有个关注收藏夹的基本都是这种的,在单选框那,才能成功)

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-04-01 03:14

画风是这样的,只要图标有采集,基本都是采集夹

记住:要搞清楚类型,在单选框中,选择要抓取的类型,才能成功

3、详细抓拍

就是输入具体的细节和图片地址。我不会谈论这个。我以前下载过我的,我知道如何使用它。以下 *start 版本没有被删除,可以阅读。

4、索引

索引用于分页爬取。比如你下载了前50页,数据中断了,只保留50页的数据。重新抓取太费时间了。索引可以直接添加到索引中。从 50 页开始抓取。根据分类页数填写详细信息。

5、excel 合并

本软件使用本服务器专用下载,会一一生成excel文档,然后直接将excel文档导入下载器下载。

一张excel一页,全部爬取完成后会生成一个汇总文档。

所以如果中间被打断了,只取50个,后面的取数都是从50开始的。前50页的数据会从所有聚合数据中丢失。

这时候就可以使用这个功能直接合并excel了。

切记:合并时最好将生成的数据文档全部清理干净,否则可能会出现重复数据

6、下载器

下载器的功能就不多说了,说一下具体用法

1.直接填写下载文件需要存放的路径

2.导入抓取的excel文档

3.点击下载

其余功能可自行研究

如果有资源下载失败,可以点击重复下载,不会覆盖之前下载的资源 查看全部

集搜客网页抓取软件(图标有个关注收藏夹的基本都是这种的,在单选框那,才能成功)

画风是这样的,只要图标有采集,基本都是采集夹

记住:要搞清楚类型,在单选框中,选择要抓取的类型,才能成功

3、详细抓拍

就是输入具体的细节和图片地址。我不会谈论这个。我以前下载过我的,我知道如何使用它。以下 *start 版本没有被删除,可以阅读。

4、索引

索引用于分页爬取。比如你下载了前50页,数据中断了,只保留50页的数据。重新抓取太费时间了。索引可以直接添加到索引中。从 50 页开始抓取。根据分类页数填写详细信息。

5、excel 合并

本软件使用本服务器专用下载,会一一生成excel文档,然后直接将excel文档导入下载器下载。

一张excel一页,全部爬取完成后会生成一个汇总文档。

所以如果中间被打断了,只取50个,后面的取数都是从50开始的。前50页的数据会从所有聚合数据中丢失。

这时候就可以使用这个功能直接合并excel了。

切记:合并时最好将生成的数据文档全部清理干净,否则可能会出现重复数据

6、下载器

下载器的功能就不多说了,说一下具体用法

1.直接填写下载文件需要存放的路径

2.导入抓取的excel文档

3.点击下载

其余功能可自行研究

如果有资源下载失败,可以点击重复下载,不会覆盖之前下载的资源

集搜客网页抓取软件(从哪里可以下载免费版-CM软件分词和词频统计用法体验)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-03-31 11:20

ROST CM6分词软件下载安装

ROST CM6分词软件和GooSeeker在线分词工具在分词和词频统计方面非常简单易用,但是必须将ROST CM6下载到电脑上才能使用

ROST-CM软件分词和词频统计使用心得

在 GooSeeker 分词工具的开发过程中,我们学习了多款优秀的分词软件,包括 ROST-CM 内容挖掘软件。本文专门介绍分词功能,对比ROST和Jisouke分词软件的区别...

我在哪里可以下载 Rost 内容挖掘的免费版本?

看了这篇文章《ROST-CM软件分词和词频统计使用心得》,也看到很多毕业设计论文都用了ROST,但是找不到下载的地方,Jisouke分词软件可以代替ROST吗?

ROST CM情感分析是否也像Jisouke情感分析一样将一个长句子分成几个句子?

请问,ROST CM 情感分析是不是也像Jisouke 情感分析一样,把一个长句拆成几个句子?

请问各位大神!您一般如何分析来自 采集 的数据?

现在有一个困惑,数据和文字采集好吧,之前想分析一下Rost CM6,结果发现功能很全面但是实力不够。请问各位大神,这些分析用什么软件啊?

分词工具使用中遇到的问题

结果画面一团糟,很暗,画面很丑。不知道是共词数据太多还是其他原因。我也试过直接用原来的采集数据用ROSCCM软件做词频分析和社交网络分析。结果,Netdraw 无法生成图片。我不知道为什么或哪里操作错误。而且我发现ROST做的词频分析和Jisouke分词工具做的词频分析都不是很好。相同的

《基于社交媒体数据的游客空气质量感知情绪分析》如何采集微博天气评论

2017年12月,游客在新浪微博发布了2.75万条中国5A级旅游目的地的195个空气质量评价,随后又使用了Gooseeker、ROST 查看全部

集搜客网页抓取软件(从哪里可以下载免费版-CM软件分词和词频统计用法体验)

ROST CM6分词软件下载安装

ROST CM6分词软件和GooSeeker在线分词工具在分词和词频统计方面非常简单易用,但是必须将ROST CM6下载到电脑上才能使用

ROST-CM软件分词和词频统计使用心得

在 GooSeeker 分词工具的开发过程中,我们学习了多款优秀的分词软件,包括 ROST-CM 内容挖掘软件。本文专门介绍分词功能,对比ROST和Jisouke分词软件的区别...

我在哪里可以下载 Rost 内容挖掘的免费版本?

看了这篇文章《ROST-CM软件分词和词频统计使用心得》,也看到很多毕业设计论文都用了ROST,但是找不到下载的地方,Jisouke分词软件可以代替ROST吗?

ROST CM情感分析是否也像Jisouke情感分析一样将一个长句子分成几个句子?

请问,ROST CM 情感分析是不是也像Jisouke 情感分析一样,把一个长句拆成几个句子?

请问各位大神!您一般如何分析来自 采集 的数据?

现在有一个困惑,数据和文字采集好吧,之前想分析一下Rost CM6,结果发现功能很全面但是实力不够。请问各位大神,这些分析用什么软件啊?

分词工具使用中遇到的问题

结果画面一团糟,很暗,画面很丑。不知道是共词数据太多还是其他原因。我也试过直接用原来的采集数据用ROSCCM软件做词频分析和社交网络分析。结果,Netdraw 无法生成图片。我不知道为什么或哪里操作错误。而且我发现ROST做的词频分析和Jisouke分词工具做的词频分析都不是很好。相同的

《基于社交媒体数据的游客空气质量感知情绪分析》如何采集微博天气评论

2017年12月,游客在新浪微博发布了2.75万条中国5A级旅游目的地的195个空气质量评价,随后又使用了Gooseeker、ROST

集搜客网页抓取软件( 优采云采集器大数据应用开发平台--优采云采集器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2022-04-15 04:09

优采云采集器大数据应用开发平台--优采云采集器)

优采云采集器

优采云采集器 是一款网络数据采集、处理、分析和挖掘软件。它可以灵活、快速的抓取网页上零散的信息,通过强大的处理功能,准确的挖掘出需要的数据。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

优采云采集器

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。号称免费,但实际上导出数据需要积分,做任务也可以赚取积分,但一般情况下,基本都需要购买积分。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

吉苏克

Jisoke是一款使用门槛低的小型爬虫工具。可实现完全可视化操作,无需编程基础,熟悉计算机操作即可轻松掌握。整个采集过程也是所见即所得的,遍历的链接信息、爬取结果信息、错误信息等都会及时反映在软件界面中。

优采云云爬虫

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集和实时数据监测和数据分析服务。

优势:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等。

优采云采集器

简介:优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。该软件功能强大,操作极其简单。 查看全部

集搜客网页抓取软件(

优采云采集器大数据应用开发平台--优采云采集器)

优采云采集器

优采云采集器 是一款网络数据采集、处理、分析和挖掘软件。它可以灵活、快速的抓取网页上零散的信息,通过强大的处理功能,准确的挖掘出需要的数据。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

优采云采集器

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。号称免费,但实际上导出数据需要积分,做任务也可以赚取积分,但一般情况下,基本都需要购买积分。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

吉苏克

Jisoke是一款使用门槛低的小型爬虫工具。可实现完全可视化操作,无需编程基础,熟悉计算机操作即可轻松掌握。整个采集过程也是所见即所得的,遍历的链接信息、爬取结果信息、错误信息等都会及时反映在软件界面中。

优采云云爬虫

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集和实时数据监测和数据分析服务。

优势:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等。

优采云采集器

简介:优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。该软件功能强大,操作极其简单。

集搜客网页抓取软件(配套软件版本:V9及更低集搜客网络爬虫软件新版本对应教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-04-13 01:38

配套软件版本:V9及更低版本即搜客网络爬虫软件

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《Web Data 采集 Using Nested Sorting Boxes to get Hierarchical Data》

注:GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先命名任务,然后创建规则,然后登录集合。在Sooke官网会员中心的“任务管理”中,您可以查看采集任务的执行状态,管理潜在客户的URL,进行调度设置。

如果一个网页上有很多相同结构的数据,你需要做一个样本拷贝来批量采集。但是,一些结构相同的网页的数据收录在不同的块节点中。这种情况下,需要进行两次或多次的样本复制(视实际情况而定),即多级嵌套样本复制。

以新浪新闻为例,网页上每5条新闻存储在一个区块节点中。如果只是按照样例拷贝教程拷贝样例,只会抓到当前区块节点下的5条消息。但是,页面上总共显示了 35 条新闻,分为 7 个区块节点。为了捕获页面上的所有新闻,需要复制收录新闻的区块节点。

注:本文演示的嵌套排序框样本副本可到资源库下载学习:嵌套排序框样本副本

一、创建多级嵌套组织者

图1

如图1所示,具体操作如下

1.新建一级排序框,用于复制收录新闻的区块节点样本。

2.右键单击第一级组织器并选择收录包,为每个新闻项目的样本副本创建第二级组织器。

3.右击二级排序框,选择Inclusive创建抓取内容,抓取每条新闻的标题,发布时间。

这将创建一个嵌套的排序规则框,它可以按从内到外的顺序复制两次。

二、先制作内层的样本副本

图 2

如图2所示,具体操作如下

1.点击二级组织者

2.勾选启用以启用样本复制功能。

3.分别找到第一项和第二项对应的节点。

4.在节点样本副本的“第一”对应的第一条新闻上右键,映射到样本1。

5.右击第一个新闻项对应节点样本的“第二个”副本映射到样本2。

从上图可以看出,一个UL区块节点收录5个LI节点,一个LI节点对应一条消息。现在只能在当前 UL 下捕获 UL 中 LI 的样本副本。新闻,也就是只能抓取5条新闻。为了抓住所有的新闻,让我们制作一个 UL 的样本副本。

三、制作样本副本到外层

图 3

如图3所示,具体操作如下

1.点击一级组织者

2.勾选启用以启用样本复制功能。

3.将第一个UL和第二个UL分别映射到“first”和“first”

这将抓取页面上的所有新闻。 查看全部

集搜客网页抓取软件(配套软件版本:V9及更低集搜客网络爬虫软件新版本对应教程)

配套软件版本:V9及更低版本即搜客网络爬虫软件

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《Web Data 采集 Using Nested Sorting Boxes to get Hierarchical Data》

注:GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先命名任务,然后创建规则,然后登录集合。在Sooke官网会员中心的“任务管理”中,您可以查看采集任务的执行状态,管理潜在客户的URL,进行调度设置。

如果一个网页上有很多相同结构的数据,你需要做一个样本拷贝来批量采集。但是,一些结构相同的网页的数据收录在不同的块节点中。这种情况下,需要进行两次或多次的样本复制(视实际情况而定),即多级嵌套样本复制。

以新浪新闻为例,网页上每5条新闻存储在一个区块节点中。如果只是按照样例拷贝教程拷贝样例,只会抓到当前区块节点下的5条消息。但是,页面上总共显示了 35 条新闻,分为 7 个区块节点。为了捕获页面上的所有新闻,需要复制收录新闻的区块节点。

注:本文演示的嵌套排序框样本副本可到资源库下载学习:嵌套排序框样本副本

一、创建多级嵌套组织者

图1

如图1所示,具体操作如下

1.新建一级排序框,用于复制收录新闻的区块节点样本。

2.右键单击第一级组织器并选择收录包,为每个新闻项目的样本副本创建第二级组织器。

3.右击二级排序框,选择Inclusive创建抓取内容,抓取每条新闻的标题,发布时间。

这将创建一个嵌套的排序规则框,它可以按从内到外的顺序复制两次。

二、先制作内层的样本副本

图 2

如图2所示,具体操作如下

1.点击二级组织者

2.勾选启用以启用样本复制功能。

3.分别找到第一项和第二项对应的节点。

4.在节点样本副本的“第一”对应的第一条新闻上右键,映射到样本1。

5.右击第一个新闻项对应节点样本的“第二个”副本映射到样本2。

从上图可以看出,一个UL区块节点收录5个LI节点,一个LI节点对应一条消息。现在只能在当前 UL 下捕获 UL 中 LI 的样本副本。新闻,也就是只能抓取5条新闻。为了抓住所有的新闻,让我们制作一个 UL 的样本副本。

三、制作样本副本到外层

图 3

如图3所示,具体操作如下

1.点击一级组织者

2.勾选启用以启用样本复制功能。

3.将第一个UL和第二个UL分别映射到“first”和“first”

这将抓取页面上的所有新闻。

集搜客网页抓取软件(GooSeeker网络爬虫-免费网页抓取软件-帮你轻松轻松抓取(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-04-12 18:36

网站简介:

GooSeeker网络爬虫-免费网络爬虫软件-帮助您轻松抓取网络数据-简单实用的网络爬虫软件。

Jisouke GooSeeker大数据软件开发始于2007年,2007年是语义网络商业化的时期。即搜客致力于为网页内容的语义标注和结构转换提供一套方便易用的软件。一旦有了语义结构,整个Web就变成了一个大数据库;一旦内容被赋予了意义(语义),就可以从中挖掘出有价值的知识,Jisouke创造了以下业务应用场景:

Jisouke 网络爬虫不是一个简单的网络爬虫,她可以凝聚大家的力量来提取语义标签

每个语义标签代表一个大数据知识对象的一个维度,通过多维度整合来分析这个知识对象

知识对象可以是多层次的,例如:市场竞争、消费者洞察、品牌地图、企业画像

公司:

地址:深圳市南山区南海大道花样年美年广场5栋1001D(邮编:518067)

电话:-86528616

客服:0755-26021359

邮件:

网友印象:功能强大,好用

新版网站视觉冲击力很大。该软件的第一个版本名为Jisou Ke,完全免费,有很大的想象空间。

点击进入客户采集:

返回首页-> 数字化-> 数据服务

百度收录搜狗收录可靠性查询AlexaRank SEO报告爱站查询百度体重管理投诉违法举报

此页面是 网站 描述和指南页面。如介绍不正确或URL连接错误无法打开,网站无法打开,请通知本站更正 查看全部

集搜客网页抓取软件(GooSeeker网络爬虫-免费网页抓取软件-帮你轻松轻松抓取(组图))

网站简介:

GooSeeker网络爬虫-免费网络爬虫软件-帮助您轻松抓取网络数据-简单实用的网络爬虫软件。

Jisouke GooSeeker大数据软件开发始于2007年,2007年是语义网络商业化的时期。即搜客致力于为网页内容的语义标注和结构转换提供一套方便易用的软件。一旦有了语义结构,整个Web就变成了一个大数据库;一旦内容被赋予了意义(语义),就可以从中挖掘出有价值的知识,Jisouke创造了以下业务应用场景:

Jisouke 网络爬虫不是一个简单的网络爬虫,她可以凝聚大家的力量来提取语义标签

每个语义标签代表一个大数据知识对象的一个维度,通过多维度整合来分析这个知识对象

知识对象可以是多层次的,例如:市场竞争、消费者洞察、品牌地图、企业画像

公司:

地址:深圳市南山区南海大道花样年美年广场5栋1001D(邮编:518067)

电话:-86528616

客服:0755-26021359

邮件:

网友印象:功能强大,好用

新版网站视觉冲击力很大。该软件的第一个版本名为Jisou Ke,完全免费,有很大的想象空间。

点击进入客户采集:

返回首页-> 数字化-> 数据服务

百度收录搜狗收录可靠性查询AlexaRank SEO报告爱站查询百度体重管理投诉违法举报

此页面是 网站 描述和指南页面。如介绍不正确或URL连接错误无法打开,网站无法打开,请通知本站更正

集搜客网页抓取软件( Python网络爬虫内容提取器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-04-12 06:28

Python网络爬虫内容提取器)

1 简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2. 动态内容提取技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

三、源码及实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是一个比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url="http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser=webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:可以看到网页中的手机名称和价格被正确抓取了。

4. 继续阅读

至此,我们通过两篇文章文章演示了如何爬取静态和动态网页内容,均使用xslt一次性从网页中提取需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5. Jisouke GooSeeker开源代码下载源

1.GooSeeker开源Python网络爬虫GitHub源码

6.文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加第5章:源码下载源码,并替换github源码的URL 查看全部

集搜客网页抓取软件(

Python网络爬虫内容提取器)

1 简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2. 动态内容提取技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

三、源码及实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是一个比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url="http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser=webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:可以看到网页中的手机名称和价格被正确抓取了。

4. 继续阅读

至此,我们通过两篇文章文章演示了如何爬取静态和动态网页内容,均使用xslt一次性从网页中提取需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5. Jisouke GooSeeker开源代码下载源

1.GooSeeker开源Python网络爬虫GitHub源码

6.文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加第5章:源码下载源码,并替换github源码的URL

集搜客网页抓取软件(集搜客和优采云对比一下通用网络爬虫软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-12 01:28

最近想用爬虫软件采集网页上的一些数据。根据百度推荐和相关关键词查询,我找到了两个软件:“Jisooke”和“优采云”,两个软件都有可视化界面。对于编程思维较弱的用户来说,这两款软件简单易用,通俗易懂。今天就带大家了解和对比这两款常见的网络爬虫软件。

[size=large]1.软件安装[/size]

优采云:优采云用其他软件安装,官网下载,直接点击setup.exe安装即可。

Jisooke:在Jisouke网站上下载的软件也是一个自解压的exe程序,双击开始安装,看到的是火狐浏览器的安装过程。最初的 Jisoke 软件作为 Firefox 插件发布。

[size=large]2.软件界面布局[/size]

优采云:优采云的界面布局可以归类为引导式界面。进入软件界面,用户可以看到软件使用提示信息,如图1所示,包括向导模式和高级模式,其中还列出了学习资源、采集规则、资料下载等。对于初次使用的用户,起到了很好的引导作用。

图一:优采云操作界面展示

数数客:数数客软件分为两个操作界面,MS Mouji(图片2)和DS计数器(图片3)),木书负责制定规则(网页标注) ,号机负责采集数据(网络爬虫),一搜一击,听起来更符合它的特点。位于“帮助”菜单中。

图2:几搜科谋几个界面

图3:吉搜客点钞机界面

[size=large]3.操作流程[/size]

优采云:优采云的操作流程主要分为4个步骤(如图4所示),即:设置基本信息、设计工作流程、设置采集@ >选项,完成。

图 4:优采云 操作流程

1) 设置基本信息:建立任务名称,分配任务组。它实际上只是您要制定的规则的名称。

2)设计工作流程:这一步是优采云制定规则的关键部分,包括输入URL、构建循环,翻页、循环等所有操作都在这里进行。事实上,优采云这个工作流已经为用户构建了一个预定的框架,用户只需要在其中添加元素即可。如图4所示,构造了一个大的循环框来翻页,里面也收录循环,做列表采集和分层抓取

3) 设置采集的选项:这个很简单理解,就是选择需要采集的数据,如图4右侧的方框所示,一次性获取全部数据,还需要进一步确认哪些字段是必填项和组织的。

4) 完成:规则制定完成,采集数据。

Jisouke:Jisouke 的运行没有流程的概念。看来定义采集的规则并不能遵循既定的操作顺序,而是具备“建一个盒子,把你想要的内容提取出来”的要领。所以我们称之为 4 个“块”操作(如图 6 所示),包括命名主题、创建 bin、规划爬虫路线和定义连续动作。

图6:吉索克的四大功能

1) 命名主题:为规则命名。

2) 创建排序框:吉索克提出了“盒子”的概念,即构建一个盒子,如果需要任何数据,从网页中提取相应的信息,然后扔进盒子里。输的过程中,吉索克有“映射”一词,是指将网页上的内容分配给组织者中的一个字段。

3) 爬虫路线:为 采集 任务设置页面和级别。一般来说,爬虫路由就是告诉爬虫要走哪条路由来爬取数据。

4)连续点击:这是Jisouke的高级功能,通过模拟用户点击等行为自动采集,主要针对那些需要连续点击但URL不变的网页。

综上所述,优采云的工作流特征非常明显,用户决定了软件如何行动,何时行动,在哪里应用行动,从哪里采集内容等。另一方面,Jisouke 希望用户专注于提取哪些数据。如果用户除了提取之外还想扩大范围,那么定义爬虫路由。如果他想做一些动作,那么定义连续动作。用户无需关心整个过程的细节。

[size=large]4.数据存储方式[/size]

优采云:优采云分为单机运行和云端采集,数据导出支持EXCEL、SQL、TXT等常用格式。

Jisooke:Jisouke没有云采集,因为爬虫都是在用户自己的电脑上运行的,用户想把爬虫放到云。运行数据以XML格式存储,说明这是一个中间结果。Jisoke官网提供了XML转EXCEL的工具,会员中心也提供了基于云存储的数据导入和清理功能,存储后可以导出。成EXCEL格式。

[size=large]5.充电模型[/size]

优采云: 简单来说就是软件销售模式(不包括免费版)。此外,用户需要规则积分和运行数据积分,积分可以用来购买或参与社区活动兑换积分。

Jisouke:Jisouke 只是一种服务收费模式。所有软件功能都是免费的。如果您需要一些爬虫管理和数据管理服务,您将根据服务类型、数量和时间收费。. 同样,下载规则需要积分,如果使用云存储,则根据存储量和存储时间收费。积分也可以用金钱购买,也可以通过参与社区活动赚取积分。 查看全部

集搜客网页抓取软件(集搜客和优采云对比一下通用网络爬虫软件)

最近想用爬虫软件采集网页上的一些数据。根据百度推荐和相关关键词查询,我找到了两个软件:“Jisooke”和“优采云”,两个软件都有可视化界面。对于编程思维较弱的用户来说,这两款软件简单易用,通俗易懂。今天就带大家了解和对比这两款常见的网络爬虫软件。

[size=large]1.软件安装[/size]

优采云:优采云用其他软件安装,官网下载,直接点击setup.exe安装即可。

Jisooke:在Jisouke网站上下载的软件也是一个自解压的exe程序,双击开始安装,看到的是火狐浏览器的安装过程。最初的 Jisoke 软件作为 Firefox 插件发布。

[size=large]2.软件界面布局[/size]

优采云:优采云的界面布局可以归类为引导式界面。进入软件界面,用户可以看到软件使用提示信息,如图1所示,包括向导模式和高级模式,其中还列出了学习资源、采集规则、资料下载等。对于初次使用的用户,起到了很好的引导作用。

图一:优采云操作界面展示

数数客:数数客软件分为两个操作界面,MS Mouji(图片2)和DS计数器(图片3)),木书负责制定规则(网页标注) ,号机负责采集数据(网络爬虫),一搜一击,听起来更符合它的特点。位于“帮助”菜单中。

图2:几搜科谋几个界面

图3:吉搜客点钞机界面

[size=large]3.操作流程[/size]

优采云:优采云的操作流程主要分为4个步骤(如图4所示),即:设置基本信息、设计工作流程、设置采集@ >选项,完成。

图 4:优采云 操作流程

1) 设置基本信息:建立任务名称,分配任务组。它实际上只是您要制定的规则的名称。

2)设计工作流程:这一步是优采云制定规则的关键部分,包括输入URL、构建循环,翻页、循环等所有操作都在这里进行。事实上,优采云这个工作流已经为用户构建了一个预定的框架,用户只需要在其中添加元素即可。如图4所示,构造了一个大的循环框来翻页,里面也收录循环,做列表采集和分层抓取

3) 设置采集的选项:这个很简单理解,就是选择需要采集的数据,如图4右侧的方框所示,一次性获取全部数据,还需要进一步确认哪些字段是必填项和组织的。

4) 完成:规则制定完成,采集数据。

Jisouke:Jisouke 的运行没有流程的概念。看来定义采集的规则并不能遵循既定的操作顺序,而是具备“建一个盒子,把你想要的内容提取出来”的要领。所以我们称之为 4 个“块”操作(如图 6 所示),包括命名主题、创建 bin、规划爬虫路线和定义连续动作。

图6:吉索克的四大功能

1) 命名主题:为规则命名。

2) 创建排序框:吉索克提出了“盒子”的概念,即构建一个盒子,如果需要任何数据,从网页中提取相应的信息,然后扔进盒子里。输的过程中,吉索克有“映射”一词,是指将网页上的内容分配给组织者中的一个字段。

3) 爬虫路线:为 采集 任务设置页面和级别。一般来说,爬虫路由就是告诉爬虫要走哪条路由来爬取数据。

4)连续点击:这是Jisouke的高级功能,通过模拟用户点击等行为自动采集,主要针对那些需要连续点击但URL不变的网页。

综上所述,优采云的工作流特征非常明显,用户决定了软件如何行动,何时行动,在哪里应用行动,从哪里采集内容等。另一方面,Jisouke 希望用户专注于提取哪些数据。如果用户除了提取之外还想扩大范围,那么定义爬虫路由。如果他想做一些动作,那么定义连续动作。用户无需关心整个过程的细节。

[size=large]4.数据存储方式[/size]

优采云:优采云分为单机运行和云端采集,数据导出支持EXCEL、SQL、TXT等常用格式。

Jisooke:Jisouke没有云采集,因为爬虫都是在用户自己的电脑上运行的,用户想把爬虫放到云。运行数据以XML格式存储,说明这是一个中间结果。Jisoke官网提供了XML转EXCEL的工具,会员中心也提供了基于云存储的数据导入和清理功能,存储后可以导出。成EXCEL格式。

[size=large]5.充电模型[/size]

优采云: 简单来说就是软件销售模式(不包括免费版)。此外,用户需要规则积分和运行数据积分,积分可以用来购买或参与社区活动兑换积分。

Jisouke:Jisouke 只是一种服务收费模式。所有软件功能都是免费的。如果您需要一些爬虫管理和数据管理服务,您将根据服务类型、数量和时间收费。. 同样,下载规则需要积分,如果使用云存储,则根据存储量和存储时间收费。积分也可以用金钱购买,也可以通过参与社区活动赚取积分。

集搜客网页抓取软件(大数据时代把网络爬虫领域推热了,楼主是金融从业人员)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-12 01:24

大数据时代让网络爬虫领域变得炙手可热。房东是金融从业者。获取数据的目的应该是进行数据分析和数据挖掘。这也是大数据的主要应用场景,也不同于传统的大型综合网络爬虫。在哪里。

根据我的理解,传统的网络爬虫应该专注于解决性能问题。核心问题是自适应调度和DNS预解析。单个 CPU 每秒需要处理超过 3,000 个 URL。用于数据分析的网络爬虫显然不需要这样的性能,而是需要数据获取的方便性和准确性。因此,在软件市场上,原创网页内容爬虫软件应该有更好的发展空间。

例如,研究特定人群的特征,即所谓的客户画像,需要在研究过程中不断补充多源数据。如果采用数学建模的深度挖掘方法,就会有一个不断迭代的过程。在这个过程中,会不断引入其他数据源。如果一款网页内容抓取软件能够方便、准确地实现这个目标,就会体验到一种“数据采集”的感觉。

我喜欢吉搜客网络爬虫的可视化界面和会员中心的数据管理功能。我需要从一个数据源获取数据,通过直观的注解,然后把生成的规则丢给爬虫组,这样我就可以专心处理数据了。在建模过程中,您可以在需要时从数据管理中心下载数据。

必须有效解决数据采集问题,才能专心进行数据挖掘。目前我们关注的难点是短文本的聚类分析和消费者画像、所有电商评论、新闻评论、微博消息的建模。当把短文本聚集在一起进行挖掘时,会发现很多有价值的信息,同时挑战也很大。 查看全部

集搜客网页抓取软件(大数据时代把网络爬虫领域推热了,楼主是金融从业人员)

大数据时代让网络爬虫领域变得炙手可热。房东是金融从业者。获取数据的目的应该是进行数据分析和数据挖掘。这也是大数据的主要应用场景,也不同于传统的大型综合网络爬虫。在哪里。

根据我的理解,传统的网络爬虫应该专注于解决性能问题。核心问题是自适应调度和DNS预解析。单个 CPU 每秒需要处理超过 3,000 个 URL。用于数据分析的网络爬虫显然不需要这样的性能,而是需要数据获取的方便性和准确性。因此,在软件市场上,原创网页内容爬虫软件应该有更好的发展空间。

例如,研究特定人群的特征,即所谓的客户画像,需要在研究过程中不断补充多源数据。如果采用数学建模的深度挖掘方法,就会有一个不断迭代的过程。在这个过程中,会不断引入其他数据源。如果一款网页内容抓取软件能够方便、准确地实现这个目标,就会体验到一种“数据采集”的感觉。