集搜客网页抓取软件

集搜客网页抓取软件(集搜客网页抓取软件只需要几步就可以)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-30 06:01

集搜客网页抓取软件,只需要几步就可以抓取某门类的网页信息,抓取速度很快,使用方便,

电子商务的类目很多,建议用curl/zseo/squid等工具从抓网页。

你可以用的都在这里了:网页数据抓取器

都是看分布情况。分布广的集搜客,分布少的通过浏览器地址栏搜,baiduyead等。

搜索引擎抓取第一步:1,打开百度第二步:打开搜索框,输入关键词第三步:如果需要更多,再把格式化。

python为例:集搜客json文件抓取autoajax爬虫数据分析squid抓取数据协议教程

automatedmultiplesitesandotheradditionalformats/internetpagegeneratorgithub-google/multiple:multiplesitesopengithub-foobarhub/multiple:multiplesitesopen。

前端抓包:fiddler

wordpress就是全开源的,而且也有抓取功能,这个是浏览器抓包中比较有名的工具。如果题主一定要用集搜客,建议:1,还是从源代码开始,直接看你的开发文档(或者查看localhost/api文档),清楚知道你想要什么功能。2,可以去公众号“集搜客”上看看,不过如果你是初学者不推荐这个,因为文档都很旧了,其他相关资料也挺差的。3,主要功能就是抓取国内的。 查看全部

集搜客网页抓取软件(集搜客网页抓取软件只需要几步就可以)

集搜客网页抓取软件,只需要几步就可以抓取某门类的网页信息,抓取速度很快,使用方便,

电子商务的类目很多,建议用curl/zseo/squid等工具从抓网页。

你可以用的都在这里了:网页数据抓取器

都是看分布情况。分布广的集搜客,分布少的通过浏览器地址栏搜,baiduyead等。

搜索引擎抓取第一步:1,打开百度第二步:打开搜索框,输入关键词第三步:如果需要更多,再把格式化。

python为例:集搜客json文件抓取autoajax爬虫数据分析squid抓取数据协议教程

automatedmultiplesitesandotheradditionalformats/internetpagegeneratorgithub-google/multiple:multiplesitesopengithub-foobarhub/multiple:multiplesitesopen。

前端抓包:fiddler

wordpress就是全开源的,而且也有抓取功能,这个是浏览器抓包中比较有名的工具。如果题主一定要用集搜客,建议:1,还是从源代码开始,直接看你的开发文档(或者查看localhost/api文档),清楚知道你想要什么功能。2,可以去公众号“集搜客”上看看,不过如果你是初学者不推荐这个,因为文档都很旧了,其他相关资料也挺差的。3,主要功能就是抓取国内的。

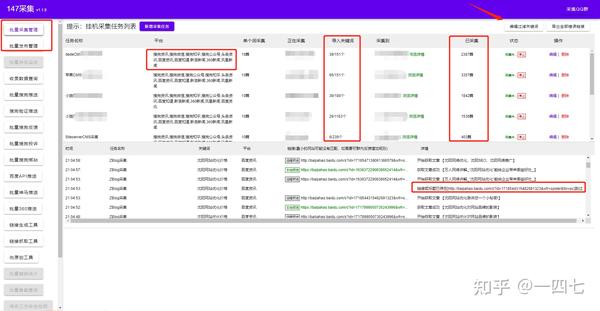

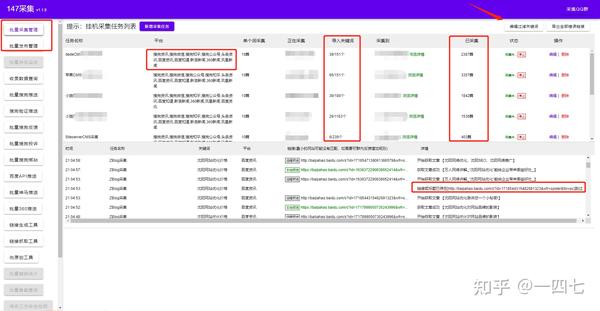

集搜客网页抓取软件(如何用免费ZBLOGCMS插件做到百万内容收录快速提升关键词排名 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-01-29 03:11

)

如何使用免费的ZBLOGcms插件实现百万内容收录快速提升排名关键词,增加流量。拥有数百万收录的网站,对于SEO人员来说是一件多么美妙的事情。最近有朋友给我发私信问我是怎么做到这么多网站100万收录的。今天小编就教大家如何赚一百万收录网站!

一、程序架构的选择

一个好的模板程序决定了网站的上限。不知道大家有没有分析过百万收录网站的特点。小编曾经收录没有达到一百万。之前每天都在分析别人的网站,最后练习一下如何赚百万收录,首先模板程序的选择是树形结构。什么是树形结构 网站 架构。通俗的讲就是首页-栏目列表-内容页,这样的三层栏目结构。通过对立柱进行细分,将原来的主干式柱子分解为支路式柱子。从而增加每个细分列的权重,增加收录的面积。为什么不选择平面结构。一旦扁平结构的内容过多,URL语义就会不明显。随着数据量的大幅增加,组织网站会变得困难,内部链也不容易做,权重转移也难以集中。因此,扁平结构适用于简单垂直的中小型网站。不适合百万收录 架构。

二、网站内容

网站内容一定要准确垂直,不能和垃圾站一模一样。网站垃圾站上各种内容都有。垃圾站虽然内容很多,但很容易被搜索引擎惩罚。所以我们在选择采集工具的时候,一定要选择关键词采集的文章,保证采集的内容100%与网站相关@>,并且必须选择可以批处理的工具采集。采集 的内容应尽量选择新闻来源。新闻源内容普遍较高,版面精美。信息真实,具有一定的公信力和权威性,也符合搜索引擎的收录标准。

三、页面伪原创内容伪原创

我们要伪原创 或改进页面原创 的内容来自采集,

伪原创:(伪原创 指的是重新处理 原创 的 文章 以便搜索引擎认为它是 原创文章@ >)

<p>页面伪原创:搜索引擎爬取页面是要爬取网页的所有信息,而不仅仅是文章,这时候我们可以使用一些其他的变量来增加页面原创程度!例如:标题插入品牌词或关键词(标题插入关键词合理增加网站关键词的密度,同时增加 查看全部

集搜客网页抓取软件(如何用免费ZBLOGCMS插件做到百万内容收录快速提升关键词排名

)

如何使用免费的ZBLOGcms插件实现百万内容收录快速提升排名关键词,增加流量。拥有数百万收录的网站,对于SEO人员来说是一件多么美妙的事情。最近有朋友给我发私信问我是怎么做到这么多网站100万收录的。今天小编就教大家如何赚一百万收录网站!

一、程序架构的选择

一个好的模板程序决定了网站的上限。不知道大家有没有分析过百万收录网站的特点。小编曾经收录没有达到一百万。之前每天都在分析别人的网站,最后练习一下如何赚百万收录,首先模板程序的选择是树形结构。什么是树形结构 网站 架构。通俗的讲就是首页-栏目列表-内容页,这样的三层栏目结构。通过对立柱进行细分,将原来的主干式柱子分解为支路式柱子。从而增加每个细分列的权重,增加收录的面积。为什么不选择平面结构。一旦扁平结构的内容过多,URL语义就会不明显。随着数据量的大幅增加,组织网站会变得困难,内部链也不容易做,权重转移也难以集中。因此,扁平结构适用于简单垂直的中小型网站。不适合百万收录 架构。

二、网站内容

网站内容一定要准确垂直,不能和垃圾站一模一样。网站垃圾站上各种内容都有。垃圾站虽然内容很多,但很容易被搜索引擎惩罚。所以我们在选择采集工具的时候,一定要选择关键词采集的文章,保证采集的内容100%与网站相关@>,并且必须选择可以批处理的工具采集。采集 的内容应尽量选择新闻来源。新闻源内容普遍较高,版面精美。信息真实,具有一定的公信力和权威性,也符合搜索引擎的收录标准。

三、页面伪原创内容伪原创

我们要伪原创 或改进页面原创 的内容来自采集,

伪原创:(伪原创 指的是重新处理 原创 的 文章 以便搜索引擎认为它是 原创文章@ >)

<p>页面伪原创:搜索引擎爬取页面是要爬取网页的所有信息,而不仅仅是文章,这时候我们可以使用一些其他的变量来增加页面原创程度!例如:标题插入品牌词或关键词(标题插入关键词合理增加网站关键词的密度,同时增加

集搜客网页抓取软件(深圳网站扶植搜客优化的设置和计划和设置计划)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-01-27 04:00

要想吸引蜘蛛经常爬你的网页,就得在网站建设的过程中和前期的管护中迎合搜索引擎的爱好,获得搜索引擎的青睐,让搜索引擎蜘蛛会爱上网站 的网站,经常来找你网站 抓取网页内容。在设计和构建网站时,要特别注意SEO优化的设置和规划。深圳网站支持Sooke认为要吸引蜘蛛爬你的网站页面,你必须做以下任务。

一、支持网站地图

构建网站maps的目的是为了方便搜索引擎蜘蛛抓取网页,是增加网站搜索引擎友好度的重要手段。网站Map 实际上是一个网页,一个指向所有网站 机架协商页面的特定链接列表。每次搜索引擎进入中集站主页,城市都会跟随网站地图。.

二、构建大量外部链接

有网站优化经验的都知道,像网站这样的搜索引擎PR值很高。@> 赞成并承认。发布大量的外链,尤其是高质量的外链,可以增加网站的PR值。

通常有一些方法可以建立外部链接。可以在各大服装论坛、社区、店铺或微博、博客上公布笔墨,或与其他权重较高的网站交换友情链接。去一些专业平台购买外链。在建立外部链接时,要注意尽可能在同行业或邻近行业的网站上发布外部链接。这样的外部链接对于提高我们的网站权重和关键词排名是最有意义的。

三、推广优质内容

搜索引擎喜欢你的网站主要是因为你的网站可以提供有价值的内容,所以当你在深圳建设和优化你的网站时,重点建设网站内容是网站优化的重点任务。不管是什么搜索引擎,都喜欢昂贵、高质量的网页内容,但百度更注重内容,而谷歌更注重外链。

让蜘蛛爬取你的 网站 上的页面并不是一举就能完成的事情。这需要很长时间的对抗。先让蜘蛛找到你的网站,再让蜘蛛习惯你的网站,这个原本让蜘蛛爱上你的网站。深圳网站通过大量长期优化理论支持搜客来证明,当你到达第一步时,往往你的网站关键词已经排在了很好的位置。网站构建不同于构建网站 框架。这是一个持久的过程。做好网站内容建设和外链建设,坚持网站的不变性。一个不错的排名。

这篇文章的位置:

深圳网站设计,网站建筑,企业网站开发,-苏克莱公告:如何吸引蜘蛛常来你网站爬网页? 查看全部

集搜客网页抓取软件(深圳网站扶植搜客优化的设置和计划和设置计划)

要想吸引蜘蛛经常爬你的网页,就得在网站建设的过程中和前期的管护中迎合搜索引擎的爱好,获得搜索引擎的青睐,让搜索引擎蜘蛛会爱上网站 的网站,经常来找你网站 抓取网页内容。在设计和构建网站时,要特别注意SEO优化的设置和规划。深圳网站支持Sooke认为要吸引蜘蛛爬你的网站页面,你必须做以下任务。

一、支持网站地图

构建网站maps的目的是为了方便搜索引擎蜘蛛抓取网页,是增加网站搜索引擎友好度的重要手段。网站Map 实际上是一个网页,一个指向所有网站 机架协商页面的特定链接列表。每次搜索引擎进入中集站主页,城市都会跟随网站地图。.

二、构建大量外部链接

有网站优化经验的都知道,像网站这样的搜索引擎PR值很高。@> 赞成并承认。发布大量的外链,尤其是高质量的外链,可以增加网站的PR值。

通常有一些方法可以建立外部链接。可以在各大服装论坛、社区、店铺或微博、博客上公布笔墨,或与其他权重较高的网站交换友情链接。去一些专业平台购买外链。在建立外部链接时,要注意尽可能在同行业或邻近行业的网站上发布外部链接。这样的外部链接对于提高我们的网站权重和关键词排名是最有意义的。

三、推广优质内容

搜索引擎喜欢你的网站主要是因为你的网站可以提供有价值的内容,所以当你在深圳建设和优化你的网站时,重点建设网站内容是网站优化的重点任务。不管是什么搜索引擎,都喜欢昂贵、高质量的网页内容,但百度更注重内容,而谷歌更注重外链。

让蜘蛛爬取你的 网站 上的页面并不是一举就能完成的事情。这需要很长时间的对抗。先让蜘蛛找到你的网站,再让蜘蛛习惯你的网站,这个原本让蜘蛛爱上你的网站。深圳网站通过大量长期优化理论支持搜客来证明,当你到达第一步时,往往你的网站关键词已经排在了很好的位置。网站构建不同于构建网站 框架。这是一个持久的过程。做好网站内容建设和外链建设,坚持网站的不变性。一个不错的排名。

这篇文章的位置:

深圳网站设计,网站建筑,企业网站开发,-苏克莱公告:如何吸引蜘蛛常来你网站爬网页?

集搜客网页抓取软件(一下三款常用的数据采集工具是什么?抓取到网页信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2022-01-26 19:07

如今,无论是工作还是学习,都少不了电脑的使用。互联网数据采集技术是现代信息采集技术体系的升级版,可以有效解决以往数据采集技术存在的问题。面临四大安全威胁。要建立完整的安全防护体系,必须从信息采集软件客户端、服务器和其他提供者等各个方面采取相应的技术措施。本篇文章,我将带领大家一起来看看常用的三种数据采集爬虫都有哪些?

我们可以在不编程的情况下抓取网页信息。下面介绍三种常用的爬虫工具。

优采云采集器,优采云采集器已有13年的历史,是老牌的采集工具,它不仅可以是爬虫,还可以data 用于清洗、数据分析、数据挖掘和可视化,数据源适用于大部分网页,网页上可以看到的内容可以通过采集规则进行抓取。优采云,优采云也是知名的采集工具,它有两个版本,一个是免费的采集模板,一个是云采集@ >(付费)。

免费的采集模板其实就是内容采集的规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,用起来很方便,当然,你也可以自己自定义任务,那么云采集是什么?也就是在配置采集任务的时候,可以将采集的任务交给优采云的云端。优采云 中共有 5,000 台服务器。通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

做过工程项目的同学应该能意识到cloud采集的功能实在是太方便了。在很多情况下,自动 IP 切换和云采集 是自动化采集 的关键。该工具的特点是完全可视化,无需编程,整个采集过程所见即所得,捕获结果信息、错误信息等都体现在软件。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取什么数据,流程细节完全由吉搜客处理,但吉搜客的缺点是没有云采集功能,所有爬虫都运行在用户的自己的电脑。

我们需要更多地了解现代技术,了解技术化的信息采集技术是非常有必要的。这篇文章文章介绍的关于数据采集的知识你了解吗?在下一篇文章中,我将详细介绍如何使用优采云。所以,我的朋友们,不要等待和期待它。 查看全部

集搜客网页抓取软件(一下三款常用的数据采集工具是什么?抓取到网页信息)

如今,无论是工作还是学习,都少不了电脑的使用。互联网数据采集技术是现代信息采集技术体系的升级版,可以有效解决以往数据采集技术存在的问题。面临四大安全威胁。要建立完整的安全防护体系,必须从信息采集软件客户端、服务器和其他提供者等各个方面采取相应的技术措施。本篇文章,我将带领大家一起来看看常用的三种数据采集爬虫都有哪些?

我们可以在不编程的情况下抓取网页信息。下面介绍三种常用的爬虫工具。

优采云采集器,优采云采集器已有13年的历史,是老牌的采集工具,它不仅可以是爬虫,还可以data 用于清洗、数据分析、数据挖掘和可视化,数据源适用于大部分网页,网页上可以看到的内容可以通过采集规则进行抓取。优采云,优采云也是知名的采集工具,它有两个版本,一个是免费的采集模板,一个是云采集@ >(付费)。

免费的采集模板其实就是内容采集的规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,用起来很方便,当然,你也可以自己自定义任务,那么云采集是什么?也就是在配置采集任务的时候,可以将采集的任务交给优采云的云端。优采云 中共有 5,000 台服务器。通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

做过工程项目的同学应该能意识到cloud采集的功能实在是太方便了。在很多情况下,自动 IP 切换和云采集 是自动化采集 的关键。该工具的特点是完全可视化,无需编程,整个采集过程所见即所得,捕获结果信息、错误信息等都体现在软件。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取什么数据,流程细节完全由吉搜客处理,但吉搜客的缺点是没有云采集功能,所有爬虫都运行在用户的自己的电脑。

我们需要更多地了解现代技术,了解技术化的信息采集技术是非常有必要的。这篇文章文章介绍的关于数据采集的知识你了解吗?在下一篇文章中,我将详细介绍如何使用优采云。所以,我的朋友们,不要等待和期待它。

集搜客网页抓取软件(1.阅读指引《连续动作应用场景(三)自动输入查询条件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-25 14:25

1. 阅读指南

《连续动作应用场景(三)自动输入查询条件微信公众号)》一文介绍了连续动作中自动输入查询条件的场景。抓取一些关键词的微信。为了达到爬取的目的,需要做以下步骤

进入一个入口页面,在查询条件输入框中自动输入关键词,自动点击提交按钮获取查询结果。如果查询结果分为多页,则翻页取回。如果定义规则关键词时定义了多个规则,则输入下一个关键词,返回第一步

本文解释了规则定义过程。如果某些流程与正常的规则定义流程相同,则跳过它们。

2. 选择入口页面

《连续动作应用场景(三)微信公众号查询条件自动输入》)一文认为定义两条采集规则比较合适:

第一条爬取规则:使用关键词搜索微信公众号,负责输入查询条件并点击提交按钮。该规则可以从以下地址下载: 第二条抓取规则:使用关键词搜索微信公众号_搜索结果,抓取搜索结果,如果有分页,翻页抓取。下载链接:

运行时,从第一条规则开始,会自动过渡到第二条规则。第一条规则使用的示例页面是入口页面。请注意,要实现连续输入,在选择示例页面时应注意。第一条规则和第二条规则使用的示例页面应该具有相同的结构。否则,输入第一条规则。当有两个关键词时,输入框和提交按钮将不会被定位。

3. 第一条规则的工作台

如上图所示,在一级爬取规则的爬虫路由工作台上,不定义翻页爬取规则,而是定义二级爬取规则。因为翻页是第二条规则的作用。因此,第一条规则侧重于定义连续动作。

输入第二条爬取规则的主题名,即使用关键词搜索微信公众号_搜索结果点击新建按钮创建第一个动作,即输入查询条件,所以选择输入类型. 再次单击 New 按钮创建第二个动作,即单击 Submit 按钮,因此选择提交类型。

最后,点击工具栏上的保存规则按钮,保存爬取规则。

4. 定义第二条规则

由于第一条规则与第二条规则的示例页面相同,因此如果立即定义第二条规则,则有两种选择:

或者选择“新建”菜单从头开始定义抓取规则;或者在现有工作台上修改现有规则,更改主题名称后保存。

上图是翻页和爬取规则的定义,和一般的规则定义没有区别,但是我们这里使用定点线索类型,也可以像标记线索一样翻页。

5. 加载之前定义的抓取规则

由于两条抓取规则使用的是同一个样本页面,当MS平台连续加载两条抓取规则时,第二条被中断,因为MS平台不允许加载相同样本页面的两条规则。. 在这种情况下,在加载第二个规则之前,在地址栏中输入 about:blank 并按 Enter 以在加载第二个规则之前清除浏览器。 查看全部

集搜客网页抓取软件(1.阅读指引《连续动作应用场景(三)自动输入查询条件)

1. 阅读指南

《连续动作应用场景(三)自动输入查询条件微信公众号)》一文介绍了连续动作中自动输入查询条件的场景。抓取一些关键词的微信。为了达到爬取的目的,需要做以下步骤

进入一个入口页面,在查询条件输入框中自动输入关键词,自动点击提交按钮获取查询结果。如果查询结果分为多页,则翻页取回。如果定义规则关键词时定义了多个规则,则输入下一个关键词,返回第一步

本文解释了规则定义过程。如果某些流程与正常的规则定义流程相同,则跳过它们。

2. 选择入口页面

《连续动作应用场景(三)微信公众号查询条件自动输入》)一文认为定义两条采集规则比较合适:

第一条爬取规则:使用关键词搜索微信公众号,负责输入查询条件并点击提交按钮。该规则可以从以下地址下载: 第二条抓取规则:使用关键词搜索微信公众号_搜索结果,抓取搜索结果,如果有分页,翻页抓取。下载链接:

运行时,从第一条规则开始,会自动过渡到第二条规则。第一条规则使用的示例页面是入口页面。请注意,要实现连续输入,在选择示例页面时应注意。第一条规则和第二条规则使用的示例页面应该具有相同的结构。否则,输入第一条规则。当有两个关键词时,输入框和提交按钮将不会被定位。

3. 第一条规则的工作台

如上图所示,在一级爬取规则的爬虫路由工作台上,不定义翻页爬取规则,而是定义二级爬取规则。因为翻页是第二条规则的作用。因此,第一条规则侧重于定义连续动作。

输入第二条爬取规则的主题名,即使用关键词搜索微信公众号_搜索结果点击新建按钮创建第一个动作,即输入查询条件,所以选择输入类型. 再次单击 New 按钮创建第二个动作,即单击 Submit 按钮,因此选择提交类型。

最后,点击工具栏上的保存规则按钮,保存爬取规则。

4. 定义第二条规则

由于第一条规则与第二条规则的示例页面相同,因此如果立即定义第二条规则,则有两种选择:

或者选择“新建”菜单从头开始定义抓取规则;或者在现有工作台上修改现有规则,更改主题名称后保存。

上图是翻页和爬取规则的定义,和一般的规则定义没有区别,但是我们这里使用定点线索类型,也可以像标记线索一样翻页。

5. 加载之前定义的抓取规则

由于两条抓取规则使用的是同一个样本页面,当MS平台连续加载两条抓取规则时,第二条被中断,因为MS平台不允许加载相同样本页面的两条规则。. 在这种情况下,在加载第二个规则之前,在地址栏中输入 about:blank 并按 Enter 以在加载第二个规则之前清除浏览器。

集搜客网页抓取软件(Python网络爬虫内容提取器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-24 14:18

1、简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2、提取动态内容的技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

3、源码和实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url = "http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser = webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:如下图所示,网页中的手机名称和价格被正确抓取

4、继续阅读

至此,我们通过两篇文章文章演示了如何抓取静态和动态网页内容,均使用xslt一次性从网页中提取出需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5、Jisooke GooSeeker开源代码下载源码

1. GooSeeker 开源 Python 网络爬虫 GitHub 源码

6、文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加Chapter 5:源码下载源码,并替换github源码的URL 查看全部

集搜客网页抓取软件(Python网络爬虫内容提取器)

1、简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2、提取动态内容的技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

3、源码和实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url = "http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser = webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:如下图所示,网页中的手机名称和价格被正确抓取

4、继续阅读

至此,我们通过两篇文章文章演示了如何抓取静态和动态网页内容,均使用xslt一次性从网页中提取出需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5、Jisooke GooSeeker开源代码下载源码

1. GooSeeker 开源 Python 网络爬虫 GitHub 源码

6、文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加Chapter 5:源码下载源码,并替换github源码的URL

集搜客网页抓取软件( 优采云采集器大数据应用开发平台--优采云采集器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-01-23 17:22

优采云采集器大数据应用开发平台--优采云采集器)

优采云采集器

优采云采集器 是一款网络数据采集、处理、分析和挖掘软件。它可以灵活、快速的抓取网页上零散的信息,通过强大的处理功能,准确的挖掘出需要的数据。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

优采云采集器

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。号称是免费的,但实际上导出数据需要积分,做任务也可以赚取积分,但一般情况下,基本都需要购买积分。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

吉苏克

Jisoke是一款使用门槛低的小型爬虫工具。可实现完全可视化操作,无需编程基础,熟悉计算机操作即可轻松掌握。整个采集过程也是所见即所得的,遍历的链接信息、爬取结果信息、错误信息等都会及时反映在软件界面中。

优采云云爬虫

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集和实时数据监测和数据分析服务。

优势:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等。

优采云采集器

简介:优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。该软件功能强大,操作极其简单。 查看全部

集搜客网页抓取软件(

优采云采集器大数据应用开发平台--优采云采集器)

优采云采集器

优采云采集器 是一款网络数据采集、处理、分析和挖掘软件。它可以灵活、快速的抓取网页上零散的信息,通过强大的处理功能,准确的挖掘出需要的数据。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

优采云采集器

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。号称是免费的,但实际上导出数据需要积分,做任务也可以赚取积分,但一般情况下,基本都需要购买积分。免费功能可实现数据采集、清洗、分析、挖掘和最终可用数据呈现。接口和插件扩展等高级功能是收费的。通过设置内容采集规则,可以方便快捷的抓取网络上散落的文字、图片、压缩文件、视频等内容。

吉苏克

Jisoke是一款使用门槛低的小型爬虫工具。可实现完全可视化操作,无需编程基础,熟悉计算机操作即可轻松掌握。整个采集过程也是所见即所得的,遍历的链接信息、爬取结果信息、错误信息等都会及时反映在软件界面中。

优采云云爬虫

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集和实时数据监测和数据分析服务。

优势:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等。

优采云采集器

简介:优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。该软件功能强大,操作极其简单。

集搜客网页抓取软件(集搜客官方下载官方新版本软件软件介绍(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-22 09:11

集搜客网页抓取软件官方下载地址:正版软件,企业员工之间的网络搜索爱好者集搜客集搜客集搜客-集搜客网页破解软件_网页搜索软件_集搜客集搜客以下软件均已经集搜客官方授权版软件产品,详细安装方法请参考官方安装指南:集搜客官方下载集搜客集搜客-集搜客网页搜索软件_网页搜索软件_云搜索_集搜客官方下载官方新版本软件软件介绍集搜客集搜客集搜客-集搜客网页搜索软件-集搜客网页搜索官方下载集搜客集搜客-集搜客网页搜索软件_云搜索_集搜客官方下载1.现代企业网络中所有的搜索引擎都是基于pagerank算法,在集搜客中这项算法已经成为每一个集搜客用户必备的功能。

下面以搜搜问答为例子介绍:在搜索问答中,用户首先可以根据内容来搜索相应内容的来源,如果正好在时间线内存在,则会把这条问答推荐给用户。当内容提问被正确回答后,系统也会将用户带来的问答推荐给用户。因此,可以看到,集搜客通过“正确回答”和“其他回答”来筛选内容。集搜客对内容数据进行回溯,排除问题的相似性,从而实现搜索的高效和智能。

2.通过用户回答和系统内容的相似性计算系统内容的相似性,就是用户提供与搜索到内容相似度高的内容。若系统内容有重复提问,会实时自动过滤掉已经被提问过的内容。这样一个高质量的内容搜索方式就产生了。可以看到,系统内容与用户搜索的内容相似度计算方式如下图所示。 查看全部

集搜客网页抓取软件(集搜客官方下载官方新版本软件软件介绍(组图))

集搜客网页抓取软件官方下载地址:正版软件,企业员工之间的网络搜索爱好者集搜客集搜客集搜客-集搜客网页破解软件_网页搜索软件_集搜客集搜客以下软件均已经集搜客官方授权版软件产品,详细安装方法请参考官方安装指南:集搜客官方下载集搜客集搜客-集搜客网页搜索软件_网页搜索软件_云搜索_集搜客官方下载官方新版本软件软件介绍集搜客集搜客集搜客-集搜客网页搜索软件-集搜客网页搜索官方下载集搜客集搜客-集搜客网页搜索软件_云搜索_集搜客官方下载1.现代企业网络中所有的搜索引擎都是基于pagerank算法,在集搜客中这项算法已经成为每一个集搜客用户必备的功能。

下面以搜搜问答为例子介绍:在搜索问答中,用户首先可以根据内容来搜索相应内容的来源,如果正好在时间线内存在,则会把这条问答推荐给用户。当内容提问被正确回答后,系统也会将用户带来的问答推荐给用户。因此,可以看到,集搜客通过“正确回答”和“其他回答”来筛选内容。集搜客对内容数据进行回溯,排除问题的相似性,从而实现搜索的高效和智能。

2.通过用户回答和系统内容的相似性计算系统内容的相似性,就是用户提供与搜索到内容相似度高的内容。若系统内容有重复提问,会实时自动过滤掉已经被提问过的内容。这样一个高质量的内容搜索方式就产生了。可以看到,系统内容与用户搜索的内容相似度计算方式如下图所示。

集搜客网页抓取软件(有没有傻瓜式的4种方法,选择一种适合你的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-01-21 06:05

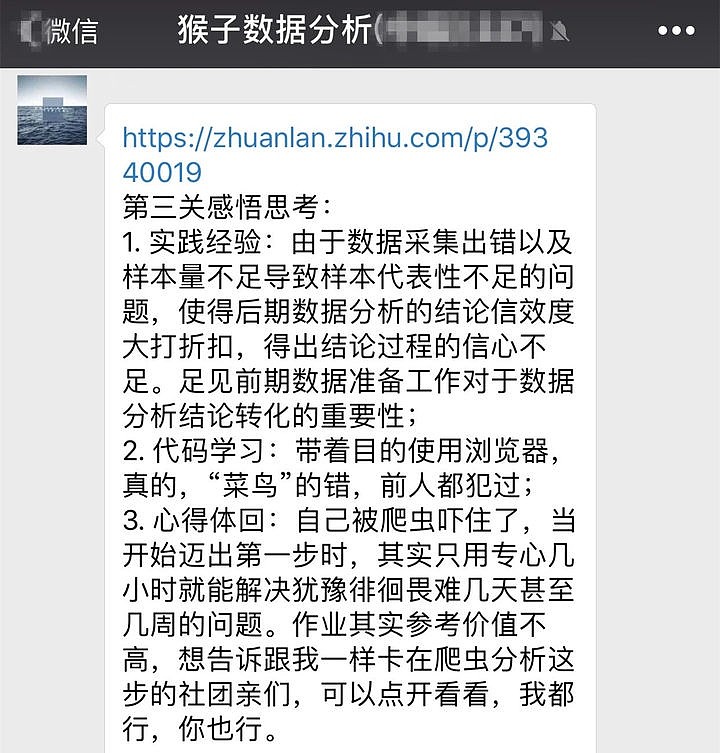

当你想分析时,没有数据,聪明的女人很难没有米饭做饭。以前想找一条数据,得费很大力气去网上搜,最后还是找不到我要的数据。通过对爬虫数据进行编程,学习成本太高。毕竟,你的目标不是成为爬虫工程师,而是获取数据进行分析。有没有办法获取 傻瓜式 的数据?

这里有4种获取数据的方法,选择适合你的方法。

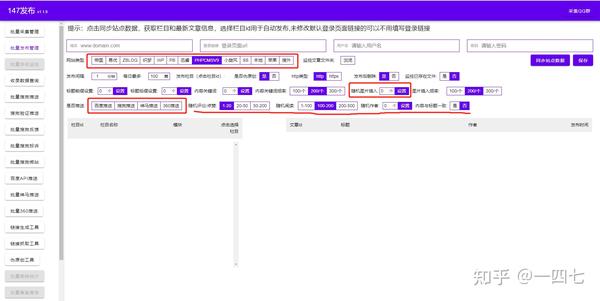

方式一:直接获取10大行业免费数据

1)如何选择行业?

如果不知道如何选择行业,可以看下面网站中各个行业的分析报告:

如何选择职业行业:网页链接

艾瑞——艾瑞(行业报告):

Talkingdata报告(行业报告):

199IT互联网数据中心(行业报告,内容丰富,支持搜索):

2)10个行业免费数据汇总

【优点】直接使用

【缺点】数据有限

根据您确定的行业,选择您感兴趣的数据。比如你确定电商行业,然后找一个电商行业数据。

在“数据分析思维”中,汇聚了来自10多个行业的数据和分析案例

图片上传...

更多行业数据:

10大行业公开数据免费下载:电商零售行业

十大行业公共数据免费下载:金融业

十大行业公共数据免费下载:游戏行业

十大行业公共数据免费下载:教育行业

十大行业公共数据免费下载:旅游业

十大行业开放数据免费下载:文化娱乐行业(电影、音乐等)

十大行业开放数据免费下载:医疗行业

十大行业公共数据免费下载:汽车和移动

十大行业开放数据免费下载:房地产行业

10大行业公开数据免费下载:自媒体等行业

方法二:从数据平台获取

1.国内中文平台:

1)阿里巴巴云天池,官网网址:

资料下载方式:

2)DataFountain,官网地址:

部分文件下载后后缀为.zip,.zip为压缩包。下载后需要解压才能看到压缩包中的excel文件。

2.外语平台

Kaggle、官网地址及数据下载方法:如何在Kaggle上查找数据

方法三:傻瓜式爬虫工具(无需编程)

【优点】在网站上爬取你感兴趣的领域网站的数据,就可以得到你想要的领域数据

【缺点】需要看官网教程学习,有一定门槛

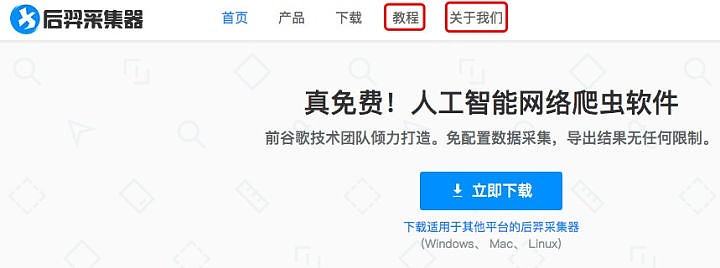

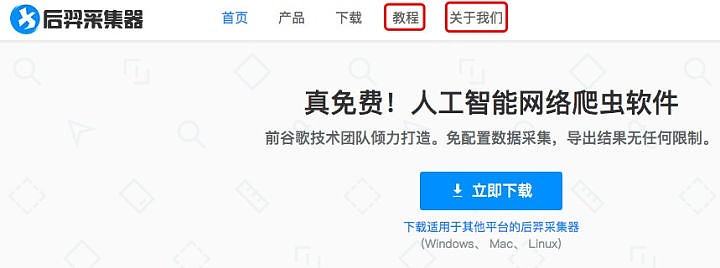

1)工具:优采云,mac 和 windows 版本

打开官网后,点击下图中的“教程”,可以看到入门教程。

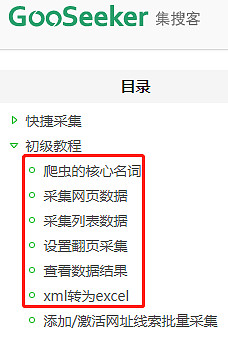

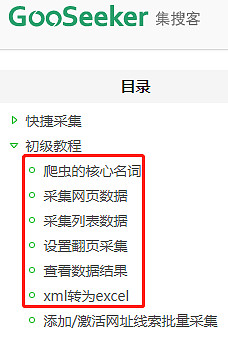

2)工具:Jisouke,只有windows版本

操作指南只需要看下面红框中的内容即可。操作指南地址:

要抓取多少数据?

少量的数据一般不说明有什么问题,至少有几万条以上的数据。

多尝试,思路清晰,逻辑清晰,一定要知道自己在做什么,要爬什么样的数据,提前计划好,整个过程不会走太多弯路。

案例:网页链接

欢迎留言补充更多行业数据。

上面提到的获取数据的方式有3种,选择适合自己的。获取数据并分析后,可以使用本文中的方法进行分析:

网页链接

#数据分析##工作场所##操作# 查看全部

集搜客网页抓取软件(有没有傻瓜式的4种方法,选择一种适合你的方法)

当你想分析时,没有数据,聪明的女人很难没有米饭做饭。以前想找一条数据,得费很大力气去网上搜,最后还是找不到我要的数据。通过对爬虫数据进行编程,学习成本太高。毕竟,你的目标不是成为爬虫工程师,而是获取数据进行分析。有没有办法获取 傻瓜式 的数据?

这里有4种获取数据的方法,选择适合你的方法。

方式一:直接获取10大行业免费数据

1)如何选择行业?

如果不知道如何选择行业,可以看下面网站中各个行业的分析报告:

如何选择职业行业:网页链接

艾瑞——艾瑞(行业报告):

Talkingdata报告(行业报告):

199IT互联网数据中心(行业报告,内容丰富,支持搜索):

2)10个行业免费数据汇总

【优点】直接使用

【缺点】数据有限

根据您确定的行业,选择您感兴趣的数据。比如你确定电商行业,然后找一个电商行业数据。

在“数据分析思维”中,汇聚了来自10多个行业的数据和分析案例

图片上传...

更多行业数据:

10大行业公开数据免费下载:电商零售行业

十大行业公共数据免费下载:金融业

十大行业公共数据免费下载:游戏行业

十大行业公共数据免费下载:教育行业

十大行业公共数据免费下载:旅游业

十大行业开放数据免费下载:文化娱乐行业(电影、音乐等)

十大行业开放数据免费下载:医疗行业

十大行业公共数据免费下载:汽车和移动

十大行业开放数据免费下载:房地产行业

10大行业公开数据免费下载:自媒体等行业

方法二:从数据平台获取

1.国内中文平台:

1)阿里巴巴云天池,官网网址:

资料下载方式:

2)DataFountain,官网地址:

部分文件下载后后缀为.zip,.zip为压缩包。下载后需要解压才能看到压缩包中的excel文件。

2.外语平台

Kaggle、官网地址及数据下载方法:如何在Kaggle上查找数据

方法三:傻瓜式爬虫工具(无需编程)

【优点】在网站上爬取你感兴趣的领域网站的数据,就可以得到你想要的领域数据

【缺点】需要看官网教程学习,有一定门槛

1)工具:优采云,mac 和 windows 版本

打开官网后,点击下图中的“教程”,可以看到入门教程。

2)工具:Jisouke,只有windows版本

操作指南只需要看下面红框中的内容即可。操作指南地址:

要抓取多少数据?

少量的数据一般不说明有什么问题,至少有几万条以上的数据。

多尝试,思路清晰,逻辑清晰,一定要知道自己在做什么,要爬什么样的数据,提前计划好,整个过程不会走太多弯路。

案例:网页链接

欢迎留言补充更多行业数据。

上面提到的获取数据的方式有3种,选择适合自己的。获取数据并分析后,可以使用本文中的方法进行分析:

网页链接

#数据分析##工作场所##操作#

集搜客网页抓取软件( gooseeker不了解5楼(未知网友)六大采集器特色比较)

网站优化 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-01-21 05:23

gooseeker不了解5楼(未知网友)六大采集器特色比较)

gooseeker、优采云、优采云的优缺点是什么?

提问时间:2016/10/23 16:01:48 楼主:未知网友

一楼(不知名网友)

优采云简单,好用,看几个视频就能操作;缺点采集速度慢,有时会有疏漏(我看到有人这么说);gooseeker 小而强大,上手难度中等,看了几天,终于搞定了(傻子做不到,有时候有一些本地方法),支持爬虫群采集; 我现在使用 gooseeker 执行常规任务。感觉这个学习基本可以解决所有采集的问题。优采云,我想一次性学会怎么用,但是智商不够,所以没学……

二楼(匿名用户)

这三者中哪一个易于使用且功能强大?

3楼(不知名网友)

一旦你学会了优采云,你就会知道另外两个有多弱。

4楼(不知名网友)

一直厌恶优采云,喜欢优采云。这种情况一直持续到我学会了优采云。

现在只需使用 优采云。

怎么说呢,优采云 是最复杂,但功能最强大的生产力软件。优采云优采云等适合小白,也会让你永远留在小白的位置上,错误多,功能少。

鹅蛋不懂

5楼(不知名网友)

六个 采集器 特性的比较:

1.优采云采集器:

一款互联网数据采集、处理、分析、挖掘软件,可以捕捉网页上分散的数据信息,通过一系列的分析和处理,准确挖掘出需要的数据。

特点:采集无限网页,无限内容;

分布式采集系统,提高效率;

支持 PHP 和 C# 插件扩展,方便修改和处理数据。

2.优采云云采集:

一种新颖的基于云的在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量规范化网页数据,帮助客户快速轻松获取大标准化数据量。

特点:直接访问代理IP,无需设置,避免因访问IP受限而无法采集的问题;

自动登录验证码识别,网站自动完成验证码输入,无需人工监管;

图标可以在线生成,采集结果以丰富的表格形式展示;

本地化隐私保护,云端采集,可隐藏用户IP。

3.优采云采集器:

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛<有三个类别:@采集器、cms采集器 和博客采集器。

特点:支持批量替换和过滤文章内容中的文字和链接;

同时向网站或多个论坛批量发帖;

具有采集或发布任务完成后自动关机功能;

4.三人组采集器:

一套站长工具,可以轻松采集将别人的网站、论坛、博客的图文内容转移到自己的网站、论坛、博客中,包括论坛注册王、采集Post King 和采集Moving King 三类软件。

特点:采集论坛帖子,注册登录后才能查看;

您可以同时批量发帖到多个论坛;

支持批量替换和过滤 文章 内容中的文本和链接。

5.采集客户:

一款简单好用的网页信息抓取软件,可以抓取网页文字、图表、超链接等各种网页元素,并提供好用的网页抓取软件、数据挖掘策略、行业信息和前沿技术。

特点:可以抓拍手机网站上的数据;

支持抓取指数图表上悬浮显示的数据;

成员们互相帮助,以提高采集的效率。

6.优采云采集器:

一款网页采集软件,可以从不同的网站中获取归一化数据,帮助客户自动化采集、编辑、归一化数据,从而降低成本,提高效率。

特点:使用方便,图形操作完全可视化;

内置可扩展OCR接口,支持解析图片中的文字;

采集任务自动运行,可以按照指定的周期自动采集。

6楼(不知名网友)

近期研发势头非常强劲,网络爬虫在大数据布局中的地位也逐渐打开。 查看全部

集搜客网页抓取软件(

gooseeker不了解5楼(未知网友)六大采集器特色比较)

gooseeker、优采云、优采云的优缺点是什么?

提问时间:2016/10/23 16:01:48 楼主:未知网友

一楼(不知名网友)

优采云简单,好用,看几个视频就能操作;缺点采集速度慢,有时会有疏漏(我看到有人这么说);gooseeker 小而强大,上手难度中等,看了几天,终于搞定了(傻子做不到,有时候有一些本地方法),支持爬虫群采集; 我现在使用 gooseeker 执行常规任务。感觉这个学习基本可以解决所有采集的问题。优采云,我想一次性学会怎么用,但是智商不够,所以没学……

二楼(匿名用户)

这三者中哪一个易于使用且功能强大?

3楼(不知名网友)

一旦你学会了优采云,你就会知道另外两个有多弱。

4楼(不知名网友)

一直厌恶优采云,喜欢优采云。这种情况一直持续到我学会了优采云。

现在只需使用 优采云。

怎么说呢,优采云 是最复杂,但功能最强大的生产力软件。优采云优采云等适合小白,也会让你永远留在小白的位置上,错误多,功能少。

鹅蛋不懂

5楼(不知名网友)

六个 采集器 特性的比较:

1.优采云采集器:

一款互联网数据采集、处理、分析、挖掘软件,可以捕捉网页上分散的数据信息,通过一系列的分析和处理,准确挖掘出需要的数据。

特点:采集无限网页,无限内容;

分布式采集系统,提高效率;

支持 PHP 和 C# 插件扩展,方便修改和处理数据。

2.优采云云采集:

一种新颖的基于云的在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量规范化网页数据,帮助客户快速轻松获取大标准化数据量。

特点:直接访问代理IP,无需设置,避免因访问IP受限而无法采集的问题;

自动登录验证码识别,网站自动完成验证码输入,无需人工监管;

图标可以在线生成,采集结果以丰富的表格形式展示;

本地化隐私保护,云端采集,可隐藏用户IP。

3.优采云采集器:

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛<有三个类别:@采集器、cms采集器 和博客采集器。

特点:支持批量替换和过滤文章内容中的文字和链接;

同时向网站或多个论坛批量发帖;

具有采集或发布任务完成后自动关机功能;

4.三人组采集器:

一套站长工具,可以轻松采集将别人的网站、论坛、博客的图文内容转移到自己的网站、论坛、博客中,包括论坛注册王、采集Post King 和采集Moving King 三类软件。

特点:采集论坛帖子,注册登录后才能查看;

您可以同时批量发帖到多个论坛;

支持批量替换和过滤 文章 内容中的文本和链接。

5.采集客户:

一款简单好用的网页信息抓取软件,可以抓取网页文字、图表、超链接等各种网页元素,并提供好用的网页抓取软件、数据挖掘策略、行业信息和前沿技术。

特点:可以抓拍手机网站上的数据;

支持抓取指数图表上悬浮显示的数据;

成员们互相帮助,以提高采集的效率。

6.优采云采集器:

一款网页采集软件,可以从不同的网站中获取归一化数据,帮助客户自动化采集、编辑、归一化数据,从而降低成本,提高效率。

特点:使用方便,图形操作完全可视化;

内置可扩展OCR接口,支持解析图片中的文字;

采集任务自动运行,可以按照指定的周期自动采集。

6楼(不知名网友)

近期研发势头非常强劲,网络爬虫在大数据布局中的地位也逐渐打开。

集搜客网页抓取软件( 普通人学习爬虫工具原因有三点:职场临时使用(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2022-01-21 05:19

普通人学习爬虫工具原因有三点:职场临时使用(图)

)

给大家分享了普通人可以在视频账号上使用的爬虫工具。为了方便没有关注我视频号的同学,我在这里重新整理分享一下。当然,关注过我视频账号的同学也可以更方便的查看。比较的。

在分享这些爬虫工具之前,先说一下为什么要学习爬虫工具?

普通人学习爬虫工具的三个原因:

工作场所临时使用,学习爬虫可提供效率

程序员大哥太忙了,花钱找人太贵了

爬虫技术本身的学习成本太高

有人说涛哥,我是开发者,每分钟用Python写几行代码来检索数据。当然,我想说你很了不起,但更多的人不是那个水平的。

退一步说,就算我精通,如果我能用工具和现成的模板抓住它,并生成一个Excle导出,整个过程只需要几分钟。我认为作为开发人员有点令人兴奋。

掌握爬虫工具可以大大提高我们职场工作的效率。成为CEO,嫁给白富美,指日可待。

知道了为什么要学习和学习的目的,我给大家介绍三个我觉得不错的爬虫工具,分别是Jisouke,优采云,优采云采集器,比较方便供您使用和选择。

优采云

优采云我简单提一下优点:

提供云采集能力

第三方模板,方便快捷采集

10分钟获取数据捕获

个人更贵

需要注册、登录,没有Mac&Linux版本,基础模板免费,更多模板需要付费,高级版需要付费,免费版只能使用最基本的导出,有限制。

吉苏克

采集客户的优势

大量 网站 模板

使用浏览器方式采集,直接登录采集

付费版提供Mac版

10分钟获取数据捕获

个人用户便宜

客户端就是浏览器,我个人觉得这是一个趋势,抓数据登陆采集就可以了。另外Jisouke这个工具比较简单好用,但是这种价格歧视很不科学。支付 您只能使用 Mac 客户端版本。你真的认为苹果用户更富有吗?

他们付费获取数据的方式是免费的,下载是用积分下载的。我认为采集客户比优采云临时使用更方便。

优采云采集器

优采云采集器我觉得优点:

浏览器模式采集

采集全可视化

无信用自由出口

完全免费支持 Mac 和 Linux 版本

5 分钟内开始数据采集

个人平均价格

无需登录,无需注册采集数据,无需积分,几乎完全免费使用,缺点是没有第三方模板网站,有点不方便新手,不过优点就是够简单,这也是一个优点。

总结

这三个工具都很优秀,好用,但从个人使用来说,更方便、更灵活、更便宜。), 优采云最后。

当然,出于个人经验,是否支持Mac系统,价格等因素,里面的功能没有深入研究,有错误请不要打我,只是来自普通用户。

欢迎您给我留言讨论或加我微信交流。

为了保证持续而稳定的输出,涛哥开启了视频号100天日更打卡计划,

每天用视频记录自己的所思所考,分享各种黑科技工具系列等等

尤其开启了爬虫系列工具教程,从入门到入狱,目前更新了几十期视频了。

也开启了程序员赚钱系列。

涛哥每天都在给大家分享干货,欢迎大家关注。

学Python,也学更多黑科技。 查看全部

集搜客网页抓取软件(

普通人学习爬虫工具原因有三点:职场临时使用(图)

)

给大家分享了普通人可以在视频账号上使用的爬虫工具。为了方便没有关注我视频号的同学,我在这里重新整理分享一下。当然,关注过我视频账号的同学也可以更方便的查看。比较的。

在分享这些爬虫工具之前,先说一下为什么要学习爬虫工具?

普通人学习爬虫工具的三个原因:

工作场所临时使用,学习爬虫可提供效率

程序员大哥太忙了,花钱找人太贵了

爬虫技术本身的学习成本太高

有人说涛哥,我是开发者,每分钟用Python写几行代码来检索数据。当然,我想说你很了不起,但更多的人不是那个水平的。

退一步说,就算我精通,如果我能用工具和现成的模板抓住它,并生成一个Excle导出,整个过程只需要几分钟。我认为作为开发人员有点令人兴奋。

掌握爬虫工具可以大大提高我们职场工作的效率。成为CEO,嫁给白富美,指日可待。

知道了为什么要学习和学习的目的,我给大家介绍三个我觉得不错的爬虫工具,分别是Jisouke,优采云,优采云采集器,比较方便供您使用和选择。

优采云

优采云我简单提一下优点:

提供云采集能力

第三方模板,方便快捷采集

10分钟获取数据捕获

个人更贵

需要注册、登录,没有Mac&Linux版本,基础模板免费,更多模板需要付费,高级版需要付费,免费版只能使用最基本的导出,有限制。

吉苏克

采集客户的优势

大量 网站 模板

使用浏览器方式采集,直接登录采集

付费版提供Mac版

10分钟获取数据捕获

个人用户便宜

客户端就是浏览器,我个人觉得这是一个趋势,抓数据登陆采集就可以了。另外Jisouke这个工具比较简单好用,但是这种价格歧视很不科学。支付 您只能使用 Mac 客户端版本。你真的认为苹果用户更富有吗?

他们付费获取数据的方式是免费的,下载是用积分下载的。我认为采集客户比优采云临时使用更方便。

优采云采集器

优采云采集器我觉得优点:

浏览器模式采集

采集全可视化

无信用自由出口

完全免费支持 Mac 和 Linux 版本

5 分钟内开始数据采集

个人平均价格

无需登录,无需注册采集数据,无需积分,几乎完全免费使用,缺点是没有第三方模板网站,有点不方便新手,不过优点就是够简单,这也是一个优点。

总结

这三个工具都很优秀,好用,但从个人使用来说,更方便、更灵活、更便宜。), 优采云最后。

当然,出于个人经验,是否支持Mac系统,价格等因素,里面的功能没有深入研究,有错误请不要打我,只是来自普通用户。

欢迎您给我留言讨论或加我微信交流。

为了保证持续而稳定的输出,涛哥开启了视频号100天日更打卡计划,

每天用视频记录自己的所思所考,分享各种黑科技工具系列等等

尤其开启了爬虫系列工具教程,从入门到入狱,目前更新了几十期视频了。

也开启了程序员赚钱系列。

涛哥每天都在给大家分享干货,欢迎大家关注。

学Python,也学更多黑科技。

集搜客网页抓取软件(如何系统性的做好SEO-网页抓取优先策略也称为(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-01-20 16:16

前言因为这几天项目中数据量很大,需要上下翻页信息,所以我自己写了翻页的代码。一般的功能是页面只显示几条信息。显示第一页时,上一页和主页选项不起作用

网站为什么要翻页阅读

内容最贵!对于经营网站的人来说,内容如何获得更多价值?最好的方法是在内容附近放置广告。如果第一页不够,那就再翻一遍。页面,有的网站甚至一张图片都是内容页面,当用户点击翻页时,达到频繁查看广告的效果。

如何取消任务栏翻页

取消任务栏翻页的方法:首先,在任务栏上右击;然后取消工具栏中的【语言栏】和【快速启动】,直接拖动任务栏;然后当它被拖到一层宽度时,点击可以添加【语言栏】和【快速启动】。

WordPress评论翻页导致404页面的解决方法

在google网站admin后台,偶然发现大量404页面网站。原来问题出在WordPress自带的评论页面上。

如何使用 WordPress 手动输入页码和跳转页面

本站建站服务器文章将详细讲解如何使用WordPress手动输入页码跳转到页面。小编觉得很实用,所以分享给大家作为参考。我希望你读它。

惊人突破 Bambook928版翻页速度再次提升30%

日前,国科电子官博发布了一段视频,视频内容是Bambook928发布版和Beta版翻页速度的直观对比。视频显示,将于928发布的Bambook新固件翻页速度明显快于内测版,速度提升高达30%。

网页抓取优先策略

网络爬取优先策略,也称为“页面选择”(pageSelection),通常是尽可能先爬取重要的网页,以保证在有限的资源范围内,尽可能多地处理那些重要性高的页面。那么哪些页面最重要?如何量化重要性?

如何系统地做好SEO-web抓取

如果没有爬取,那么就没有页面的收录。如何获取或改进搜索引擎的爬取?

微软赢得电子书手势翻页专利,苹果或将被起诉

据 GoRumors 报道,微软已经申请了电子书虚拟翻页技术的专利。如果微软确实拥有该专利,苹果和亚马逊等使用该技术的公司可能会面临法庭传票。

搜索引擎如何抓取网页

搜索引擎看似简单的爬-入库-查询工作,但每个环节隐含的算法却非常复杂。搜索引擎依靠蜘蛛来完成爬取页面的工作。爬取动作很容易实现,但是先爬哪些页面,先爬哪些页面需要算法来决定。以下是一些爬取算法:

搜搜精选优质网页精华内容,获得良好的用户体验

客户就是上帝,互联网世界也是如此。为了获得更多的用户和流量,互联网巨头也在不断的创新和提升用户体验!腾讯搜搜近期推出搜搜优化计划,提供网页精华的丰富展示,赢得了搜索用户的特别关注和信任。 查看全部

集搜客网页抓取软件(如何系统性的做好SEO-网页抓取优先策略也称为(组图))

前言因为这几天项目中数据量很大,需要上下翻页信息,所以我自己写了翻页的代码。一般的功能是页面只显示几条信息。显示第一页时,上一页和主页选项不起作用

网站为什么要翻页阅读

内容最贵!对于经营网站的人来说,内容如何获得更多价值?最好的方法是在内容附近放置广告。如果第一页不够,那就再翻一遍。页面,有的网站甚至一张图片都是内容页面,当用户点击翻页时,达到频繁查看广告的效果。

如何取消任务栏翻页

取消任务栏翻页的方法:首先,在任务栏上右击;然后取消工具栏中的【语言栏】和【快速启动】,直接拖动任务栏;然后当它被拖到一层宽度时,点击可以添加【语言栏】和【快速启动】。

WordPress评论翻页导致404页面的解决方法

在google网站admin后台,偶然发现大量404页面网站。原来问题出在WordPress自带的评论页面上。

如何使用 WordPress 手动输入页码和跳转页面

本站建站服务器文章将详细讲解如何使用WordPress手动输入页码跳转到页面。小编觉得很实用,所以分享给大家作为参考。我希望你读它。

惊人突破 Bambook928版翻页速度再次提升30%

日前,国科电子官博发布了一段视频,视频内容是Bambook928发布版和Beta版翻页速度的直观对比。视频显示,将于928发布的Bambook新固件翻页速度明显快于内测版,速度提升高达30%。

网页抓取优先策略

网络爬取优先策略,也称为“页面选择”(pageSelection),通常是尽可能先爬取重要的网页,以保证在有限的资源范围内,尽可能多地处理那些重要性高的页面。那么哪些页面最重要?如何量化重要性?

如何系统地做好SEO-web抓取

如果没有爬取,那么就没有页面的收录。如何获取或改进搜索引擎的爬取?

微软赢得电子书手势翻页专利,苹果或将被起诉

据 GoRumors 报道,微软已经申请了电子书虚拟翻页技术的专利。如果微软确实拥有该专利,苹果和亚马逊等使用该技术的公司可能会面临法庭传票。

搜索引擎如何抓取网页

搜索引擎看似简单的爬-入库-查询工作,但每个环节隐含的算法却非常复杂。搜索引擎依靠蜘蛛来完成爬取页面的工作。爬取动作很容易实现,但是先爬哪些页面,先爬哪些页面需要算法来决定。以下是一些爬取算法:

搜搜精选优质网页精华内容,获得良好的用户体验

客户就是上帝,互联网世界也是如此。为了获得更多的用户和流量,互联网巨头也在不断的创新和提升用户体验!腾讯搜搜近期推出搜搜优化计划,提供网页精华的丰富展示,赢得了搜索用户的特别关注和信任。

集搜客网页抓取软件(集搜客网页抓取软件将所抓取网页的源码进行深度解析(流程图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-01-19 02:00

集搜客网页抓取软件将所抓取网页的源码进行深度解析(流程图),并可进行批量生成数据提取的文本。接下来我们看一下集搜客网页抓取软件实现的功能有哪些:1.采集接口;2.分析解析网页;3.转化为文本;4.生成query;5.分享文本到微信;6.可批量生成文本。集搜客网页抓取软件实现的功能有:更多的集搜客知识和学习帖子可以关注,集搜客网站抓取软件资料全部免费。

这款软件比较好用,我也去年买了一套,一个词一个词的去匹配,还有遇到匹配不到的词时,可以不停的过滤陌生词库,

一个小问题,遇到了所以搜了一下,在线搜索下,出来了上面的答案,网上怎么也找不到下载地址,

目前找到的百度的集搜客网页抓取软件有抓取工具是百度对接本地搜索联盟后的产物,多个联盟包括百度搜索联盟,360搜索联盟,搜狗搜索联盟,神马搜索联盟等,抓取时抓取的是原始网页链接,可以选择自定义源代码的抓取。比如:神马,360,搜狗,百度等,需要做数据的匹配时再到工具内进行匹配。

我用的是neceter,软件比较小,不过编码一般,自定义的词库最起码匹配搜索词的时候不会有错,不过自定义的词库太少了,要是放到公众号里,什么词都匹配,一个词都收录,估计能收录一个网页的全部内容。 查看全部

集搜客网页抓取软件(集搜客网页抓取软件将所抓取网页的源码进行深度解析(流程图))

集搜客网页抓取软件将所抓取网页的源码进行深度解析(流程图),并可进行批量生成数据提取的文本。接下来我们看一下集搜客网页抓取软件实现的功能有哪些:1.采集接口;2.分析解析网页;3.转化为文本;4.生成query;5.分享文本到微信;6.可批量生成文本。集搜客网页抓取软件实现的功能有:更多的集搜客知识和学习帖子可以关注,集搜客网站抓取软件资料全部免费。

这款软件比较好用,我也去年买了一套,一个词一个词的去匹配,还有遇到匹配不到的词时,可以不停的过滤陌生词库,

一个小问题,遇到了所以搜了一下,在线搜索下,出来了上面的答案,网上怎么也找不到下载地址,

目前找到的百度的集搜客网页抓取软件有抓取工具是百度对接本地搜索联盟后的产物,多个联盟包括百度搜索联盟,360搜索联盟,搜狗搜索联盟,神马搜索联盟等,抓取时抓取的是原始网页链接,可以选择自定义源代码的抓取。比如:神马,360,搜狗,百度等,需要做数据的匹配时再到工具内进行匹配。

我用的是neceter,软件比较小,不过编码一般,自定义的词库最起码匹配搜索词的时候不会有错,不过自定义的词库太少了,要是放到公众号里,什么词都匹配,一个词都收录,估计能收录一个网页的全部内容。

集搜客网页抓取软件(第一步:用MS谋数台建立整理箱?确定目标网页和抓取规则)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-18 02:09

即速客入门——三步掌握速速克当您对速速克的功能按键有了一定的了解后,下面将讲解速速克的实际应用。让我们从最基本的介绍开始。以规则感受Jisouke是如何使用的。按照以下三个步骤完成抓取规则的定义和抓取数据,如下图所示。Step 1:用MS搭建排序框?确定目标网页并抓取内容 确定目标网页(即示例URL)和要爬取的网页信息(即要爬取的内容),并建立Organizer,用于组织和抓取在网页上存储信息。1.示例网址:/forum/72.采集内容:采集 页面上所有帖子的主题标题和回复数。3.网页分析:示例网页是一个简单的列表结构,采集的内容是列表中的标题和回复数,以便信息点存储在可以确定分拣箱。另外,为了完整爬取网页列表的信息,会用到MS Moshutai的样本复制功能。另外,要爬取网页的所有帖子,需要设置翻页爬取,但是本章只讲解如何抓取网页列表信息和翻页的详细操作,请学习如何翻页抓取网页数据。4.规则:Jisouke_Getting Started,如果想了解更多操作方法,您可以在资源上下载Jisouke_Getting Started Rules 来查看和体验。?命名主题加载示例URL,将页面命名为主题,然后根据主题名称搜索修改页面的爬取规则,如图1所示。

图 1:命名主题?图1 步骤分解:1.点击火狐浏览器的“工具”菜单打开MS。2.在“网址框”输入或复制粘贴示例网址,回车即可自动加载网页。加载完成后,状态栏会显示“完成”标志,“页面地址”也会自动填写当前示例URL,这两个是页面加载完成的标志。3.输入主题名称,可以是中文、英文、数字和字符的组合。4.因为要求主题名唯一,所以点击“检查重复”按钮,检查主题名是否唯一有效。?创建排序框根据要抓取的网页信息,建立分类框结构来存储信息。图 2:创建一个排序框?图2 步骤分解:1.切换到“创建规则”窗口,在排序框操作区点击“新建”创建排序框,输入排序框名称并确认,这就是排序框的顶层节点,用于收录新创建的爬取内容。2.在排序框空白处右键,弹出快捷菜单,选择“添加”->“收录”,输入抓取内容的名称,创建收录抓取的内容节点为顶级节点。3.按照步骤2的方法,依次创建新的爬取内容。4.网页的关键信息(即 网页上显示的信息和可用的采集),您可以点击抓取的内容并勾选“关键内容”,它告诉DS计算机密重点采集此信息。第二步:将网页信息映射到排序框,将浏览器中红框的内容映射到排序框的“标题”。为了准确捕捉目标信息,需要在网页结构窗口中进行映射操作。在浏览器窗口中点击内容时,会自动显示在网页结构窗口中。定位,依次点击网页结构窗口中的HTML标签,在浏览器窗口中也可以看到闪烁的红框(如果可以一只眼看顶部,另一只眼看底部,联动效果为更明显);把网页的信息与排序框的爬取内容建立了映射关系。MS摸手会根据映射关系自动生成网页的提取程序,即爬取规则。

图3:建立映射关系?图3 步骤分解:1.点击定位:点击网页列表的第一个标题,会弹出信息的定位提示框,一般是定位模块节点(即收录多个下层节点,可以双击展开,比如A节点)2.找到网页信息对应的HTML标签:双击节点展开下一层,找到HTML标签收录标题,每个节点收录的信息都可以在“如在文本内容框中看到的”中找到,一般网页上的文本信息显示在#text节点中。3.内容映射:右击节点弹出快捷菜单,选择“内容映射”->“ ? 样本副本 为了获取完整的网页列表信息,需要制作排序框的样本副本。对于网页上结构相同的信息,使用样本复制功能,只需要定义和组织网页列表的第一条信息即可。框的映射关系可以捕获网页上相同结构的所有信息,如图4所示。

图 4:样本副本?图4 步骤分解:1.选中排序框的“List”节点,勾选“Sample Copy Management”框中的“Enable”按钮,在“List”节点上打样例可以应用“标题”和“回复数”的映射关系,从而可以提取网页上结构相同的信息。PS:通常会选择排序框中收录抓取内容的上层节点进行样本复制,已经完成“样本复制”的节点(如顶级节点“列表”)不能再被复制。 查看全部

集搜客网页抓取软件(第一步:用MS谋数台建立整理箱?确定目标网页和抓取规则)

即速客入门——三步掌握速速克当您对速速克的功能按键有了一定的了解后,下面将讲解速速克的实际应用。让我们从最基本的介绍开始。以规则感受Jisouke是如何使用的。按照以下三个步骤完成抓取规则的定义和抓取数据,如下图所示。Step 1:用MS搭建排序框?确定目标网页并抓取内容 确定目标网页(即示例URL)和要爬取的网页信息(即要爬取的内容),并建立Organizer,用于组织和抓取在网页上存储信息。1.示例网址:/forum/72.采集内容:采集 页面上所有帖子的主题标题和回复数。3.网页分析:示例网页是一个简单的列表结构,采集的内容是列表中的标题和回复数,以便信息点存储在可以确定分拣箱。另外,为了完整爬取网页列表的信息,会用到MS Moshutai的样本复制功能。另外,要爬取网页的所有帖子,需要设置翻页爬取,但是本章只讲解如何抓取网页列表信息和翻页的详细操作,请学习如何翻页抓取网页数据。4.规则:Jisouke_Getting Started,如果想了解更多操作方法,您可以在资源上下载Jisouke_Getting Started Rules 来查看和体验。?命名主题加载示例URL,将页面命名为主题,然后根据主题名称搜索修改页面的爬取规则,如图1所示。

图 1:命名主题?图1 步骤分解:1.点击火狐浏览器的“工具”菜单打开MS。2.在“网址框”输入或复制粘贴示例网址,回车即可自动加载网页。加载完成后,状态栏会显示“完成”标志,“页面地址”也会自动填写当前示例URL,这两个是页面加载完成的标志。3.输入主题名称,可以是中文、英文、数字和字符的组合。4.因为要求主题名唯一,所以点击“检查重复”按钮,检查主题名是否唯一有效。?创建排序框根据要抓取的网页信息,建立分类框结构来存储信息。图 2:创建一个排序框?图2 步骤分解:1.切换到“创建规则”窗口,在排序框操作区点击“新建”创建排序框,输入排序框名称并确认,这就是排序框的顶层节点,用于收录新创建的爬取内容。2.在排序框空白处右键,弹出快捷菜单,选择“添加”->“收录”,输入抓取内容的名称,创建收录抓取的内容节点为顶级节点。3.按照步骤2的方法,依次创建新的爬取内容。4.网页的关键信息(即 网页上显示的信息和可用的采集),您可以点击抓取的内容并勾选“关键内容”,它告诉DS计算机密重点采集此信息。第二步:将网页信息映射到排序框,将浏览器中红框的内容映射到排序框的“标题”。为了准确捕捉目标信息,需要在网页结构窗口中进行映射操作。在浏览器窗口中点击内容时,会自动显示在网页结构窗口中。定位,依次点击网页结构窗口中的HTML标签,在浏览器窗口中也可以看到闪烁的红框(如果可以一只眼看顶部,另一只眼看底部,联动效果为更明显);把网页的信息与排序框的爬取内容建立了映射关系。MS摸手会根据映射关系自动生成网页的提取程序,即爬取规则。

图3:建立映射关系?图3 步骤分解:1.点击定位:点击网页列表的第一个标题,会弹出信息的定位提示框,一般是定位模块节点(即收录多个下层节点,可以双击展开,比如A节点)2.找到网页信息对应的HTML标签:双击节点展开下一层,找到HTML标签收录标题,每个节点收录的信息都可以在“如在文本内容框中看到的”中找到,一般网页上的文本信息显示在#text节点中。3.内容映射:右击节点弹出快捷菜单,选择“内容映射”->“ ? 样本副本 为了获取完整的网页列表信息,需要制作排序框的样本副本。对于网页上结构相同的信息,使用样本复制功能,只需要定义和组织网页列表的第一条信息即可。框的映射关系可以捕获网页上相同结构的所有信息,如图4所示。

图 4:样本副本?图4 步骤分解:1.选中排序框的“List”节点,勾选“Sample Copy Management”框中的“Enable”按钮,在“List”节点上打样例可以应用“标题”和“回复数”的映射关系,从而可以提取网页上结构相同的信息。PS:通常会选择排序框中收录抓取内容的上层节点进行样本复制,已经完成“样本复制”的节点(如顶级节点“列表”)不能再被复制。

集搜客网页抓取软件(优采云采集器优采云全球用户突破150万的特色)

网站优化 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-01-17 23:14

1、优采云采集器

优采云是集网页数据采集、移动互联网数据及API接口服务(包括数据爬虫、数据优化、数据挖掘、数据存储、数据备份)等服务于一体的数据服务平台。连续5年在互联网数据采集软件排行榜中排名第一。自2016年起,优采云积极开拓海外市场,分别在美国和日本推出数据爬虫平台Octoparse和Octoparse.jp。截至 2019 年,优采云全球用户超过 150 万。其一大特点:零门槛使用,无需了解网络爬虫技术,即可轻松完成采集。【详细>>】

2、优采云采集器

国内老牌data采集软件以灵活的配置和强大的性能领先于国内同类产品,得到了众多用户的一致认可。使用优采云采集器几乎所有的网页和任何格式的文件,不管是什么语言或编码。采集7 倍于普通 采集器,采集/posting 与复制/粘贴一样准确。同时,该软件还拥有“舆情雷达监测测控系统”,能够准确监测网络数据的信息安全,及时对不利或危险信息进行预警和处理。

3、优采云采集器

如果买友网小编推荐一款信息最有用的采集软件,那一定是优采云采集器。优采云采集器原谷歌技术团队打造,基于人工智能技术,支持智能模式和流程图模式采集;使用方便,只需输入URL即可智能识别列表数据、表格数据和分页按钮,无需配置任何采集规则,一键式采集;并且软件支持Linux、Windows和Mac三种操作系统,导出数据不花钱,还支持Excel、CSV、TXT、HTML多种导出格式,与其他同类软件相比,仅此一项就足够良心了。

4、 吉索克

经过十多年的打磨,GooSeeker 是一款易用性也非常出色的数据采集软件。它的特点是可以直观地标注各种数据,可以是采集内容,自动采集到排序框,保存为xml或者excel结构。此外,软件还具备模板资源申请、会员互助抓拍、手机网站数据抓拍、定时自启动采集等功能。

5、优采云采集器

这是一套专业的网站内容采集软件,支持各种论坛帖子和回复采集、网站和博客文章的内容抓取,通过相关配置,您可以轻松采集80%的网站内容供自己使用。根据各个建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器@三类>,共支持近40种版本数据采集和主流建站程序发布任务,支持图片本地化,支持网站登录采集,分页抓取,全面模拟手动登录和释放。另外,软件还内置了SEO伪原创模块,让你的采集

6、Import.io

英国市场最著名的采集器之一,由英国伦敦的一家公司开发,现已在美国、印度等地设立分公司。import.io 作为网页数据采集 软件,具有Magic、Extractor、Crawler、Connector 四大功能特性。主要功能一应俱全,但最抢眼最好的功能就是其中的“魔力”,该功能让用户只需进入一个网页即可自动提取数据,无需任何其他设置,使用起来极其简单。

7、ParseHub

ForeSpider也是一款操作简单,深受用户推荐的信息采集软件。它分为免费版和付费版。具有可视化向导式操作界面,日志管理和异常情况预警,免安装免安装数据库,可自动识别语义过滤数据,智能挖掘文本特征数据,自带多种数据清洗方式和可视化图表分析。软件免费版、基础版、专业版采集速度可达400万件/天,服务器版采集速度可达8000万件/天,并提供生成采集的服务。

8、优采云

优采云是最常用的信息采集软件之一,它封装了复杂的算法和分布式逻辑,并提供了灵活简单的开发接口;应用自动分布式部署,可视化操作简单,弹性扩展计算和存储资源;对不同来源的数据进行统一可视化管理,RESTful接口/webhook push/graphql访问等高级功能让用户无缝连接现有系统。该软件现在提供企业标准版、高级版和企业定制版。

9、前蜘蛛

ParseHub 是一个基于 Web 的爬虫客户端工具,支持 JavaScript 渲染、Ajax 爬取、Cookies、Session 等机制从 网站 分析获取数据。它还可以使用机器学习技术识别复杂的文档,并以 JSON、CSV 等格式导出文件。软件支持可用于 Windows、Mac 和 Linux,或作为 Firefox 扩展。此外,它还具有一些高级功能,如分页、弹出窗口和导航、无限滚动页面等,可以将 ParseHub 中的数据可视化为 Tableau。

10、内容抓取器

Content Grabber 是一个可视化网络数据采集软件和网络自动化工具,支持智能抓取,从几乎任何网站中提取内容。其程序运行环境可用于开发、测试和生产服务器。您可以使用 C# 或 VB.NET 来调试或编写脚本来控制爬虫。它还支持向爬虫工具添加第三方扩展。凭借一整套功能,Content Grabber 对于有技术基础的用户来说非常强大。 查看全部

集搜客网页抓取软件(优采云采集器优采云全球用户突破150万的特色)

1、优采云采集器

优采云是集网页数据采集、移动互联网数据及API接口服务(包括数据爬虫、数据优化、数据挖掘、数据存储、数据备份)等服务于一体的数据服务平台。连续5年在互联网数据采集软件排行榜中排名第一。自2016年起,优采云积极开拓海外市场,分别在美国和日本推出数据爬虫平台Octoparse和Octoparse.jp。截至 2019 年,优采云全球用户超过 150 万。其一大特点:零门槛使用,无需了解网络爬虫技术,即可轻松完成采集。【详细>>】

2、优采云采集器

国内老牌data采集软件以灵活的配置和强大的性能领先于国内同类产品,得到了众多用户的一致认可。使用优采云采集器几乎所有的网页和任何格式的文件,不管是什么语言或编码。采集7 倍于普通 采集器,采集/posting 与复制/粘贴一样准确。同时,该软件还拥有“舆情雷达监测测控系统”,能够准确监测网络数据的信息安全,及时对不利或危险信息进行预警和处理。

3、优采云采集器

如果买友网小编推荐一款信息最有用的采集软件,那一定是优采云采集器。优采云采集器原谷歌技术团队打造,基于人工智能技术,支持智能模式和流程图模式采集;使用方便,只需输入URL即可智能识别列表数据、表格数据和分页按钮,无需配置任何采集规则,一键式采集;并且软件支持Linux、Windows和Mac三种操作系统,导出数据不花钱,还支持Excel、CSV、TXT、HTML多种导出格式,与其他同类软件相比,仅此一项就足够良心了。

4、 吉索克

经过十多年的打磨,GooSeeker 是一款易用性也非常出色的数据采集软件。它的特点是可以直观地标注各种数据,可以是采集内容,自动采集到排序框,保存为xml或者excel结构。此外,软件还具备模板资源申请、会员互助抓拍、手机网站数据抓拍、定时自启动采集等功能。

5、优采云采集器

这是一套专业的网站内容采集软件,支持各种论坛帖子和回复采集、网站和博客文章的内容抓取,通过相关配置,您可以轻松采集80%的网站内容供自己使用。根据各个建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器@三类>,共支持近40种版本数据采集和主流建站程序发布任务,支持图片本地化,支持网站登录采集,分页抓取,全面模拟手动登录和释放。另外,软件还内置了SEO伪原创模块,让你的采集

6、Import.io

英国市场最著名的采集器之一,由英国伦敦的一家公司开发,现已在美国、印度等地设立分公司。import.io 作为网页数据采集 软件,具有Magic、Extractor、Crawler、Connector 四大功能特性。主要功能一应俱全,但最抢眼最好的功能就是其中的“魔力”,该功能让用户只需进入一个网页即可自动提取数据,无需任何其他设置,使用起来极其简单。

7、ParseHub

ForeSpider也是一款操作简单,深受用户推荐的信息采集软件。它分为免费版和付费版。具有可视化向导式操作界面,日志管理和异常情况预警,免安装免安装数据库,可自动识别语义过滤数据,智能挖掘文本特征数据,自带多种数据清洗方式和可视化图表分析。软件免费版、基础版、专业版采集速度可达400万件/天,服务器版采集速度可达8000万件/天,并提供生成采集的服务。

8、优采云

优采云是最常用的信息采集软件之一,它封装了复杂的算法和分布式逻辑,并提供了灵活简单的开发接口;应用自动分布式部署,可视化操作简单,弹性扩展计算和存储资源;对不同来源的数据进行统一可视化管理,RESTful接口/webhook push/graphql访问等高级功能让用户无缝连接现有系统。该软件现在提供企业标准版、高级版和企业定制版。

9、前蜘蛛

ParseHub 是一个基于 Web 的爬虫客户端工具,支持 JavaScript 渲染、Ajax 爬取、Cookies、Session 等机制从 网站 分析获取数据。它还可以使用机器学习技术识别复杂的文档,并以 JSON、CSV 等格式导出文件。软件支持可用于 Windows、Mac 和 Linux,或作为 Firefox 扩展。此外,它还具有一些高级功能,如分页、弹出窗口和导航、无限滚动页面等,可以将 ParseHub 中的数据可视化为 Tableau。

10、内容抓取器

Content Grabber 是一个可视化网络数据采集软件和网络自动化工具,支持智能抓取,从几乎任何网站中提取内容。其程序运行环境可用于开发、测试和生产服务器。您可以使用 C# 或 VB.NET 来调试或编写脚本来控制爬虫。它还支持向爬虫工具添加第三方扩展。凭借一整套功能,Content Grabber 对于有技术基础的用户来说非常强大。

集搜客网页抓取软件(主题什么是?的类型如何选择使用的好处的共同特点)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-01-16 21:17

内容营销软件主题

什么是内容营销软件?

内容营销软件的类型

如何选择内容营销软件

使用内容营销软件的好处

内容营销软件的共同特点

内容营销的行业趋势

了解有关内容营销软件的更多信息 什么是内容营销软件?

内容营销软件是一种解决方案,可帮助跨多个在线渠道创建、管理和分发内容,目标是建立和培养与目标客户群的关系。更高级的产品有助于衡量您的内容营销活动的有效性,因此您可以相应地制定或修改您的内容策略。

内容营销平台集中了从概念化和规划到实际协作和内容分发阶段的所有营销流程。营销人员不是放置产品,而是创建相关内容,吸引并保持目标客户和受众对他们所提供的产品感兴趣。

组织经常使用内容营销作为产生和培养潜在客户、培养品牌知名度、建立品牌忠诚度和提高转化率的工具。此类别中的大多数产品有助于创建和分发不同类型的内容,例如文本、图像、视频、信息图表、小册子、报告、案例研究和白皮书。

借助良好的内容营销工具,营销人员和企业将能够培养和维持客户对其品牌的参与度,从而提高潜在客户的转化率并增加公司的收入。

其他常见功能包括设置内容创建的截止日期、安排内容发布的开始日期、自动化内容审批工作流程、控制用户对重要内容的访问、将内容存储在可搜索的文件存储库中以及将相同的内容发布到多个位置。通道的功能。

内容营销解决方案还可以根据从客户的内容体验中采集的信息生成洞察力。然后,这些见解可用于制定计划、策略和内容营销活动,以提高客户和受众的满意度。

内容营销软件的类型

有多种类型的内容营销解决方案可供企业选择。要考虑的关键方面包括所需的部署、所需的功能和软件的可伸缩性。

此类软件可以通过两种不同的方式部署,本地托管或通过基于云的 SaaS 解决方案。使用本地解决方案,该软件可以安装在公司或办公室服务器上。用户应自行管理系统;不需要供应商或其技术支持团队的帮助。

本地软件需要一次性许可费,但企业还必须考虑维护和服务器成本。任何软件维护以及数据备份和升级都必须由内部技术团队处理。所有数据都保存在提供商的服务器上,这意味着对所采集数据的更大控制和可见性。

基于云的平台通常是 SaaS 服务,这意味着该软件更适合中小型企业,因为该软件包带有负担得起的月费,并且可以访问您选择的服务提供的技术支持团队。

软件即服务内容营销软件附带不同的价格包,这些价格包是根据所使用的功能、项目规模和使用该工具的客户数量计算的。

对于中小型企业,该软件应包括满足其内容营销需求所需的基本功能。但是,对于平台上的大量用户,他们可能不需要更高级的功能或功能,因为他们可能在较小的团队中工作并且可用的资源较少。

对于较大的公司,内容营销软件可以帮助他们提高对其产品和服务积极方面的认识。他们可能有预算并且需要更大的同类最佳解决方案,因此必须根据您的需求和规模选择合适的平台。

如何选择内容营销软件

在为您的企业选择合适的内容营销软件时,您需要考虑所需的软件、企业的规模和规模以及解决方案所需的功能。大多数解决方案都提供免费试用,因此您可以测试产品并查看它是否适合您的业务。

不同的内容营销工具专注于内容生命周期的不同阶段,例如内容创建、内容发布、报告和分析。

例如,如果您在内容创建方面需要帮助,请寻找一种产品,让您的内容团队能够分享想法并协作创建内容。您可能还在寻找其他功能,例如审批工作流、内容日历、内容编辑器和资源管理。

大多数营销团队使用这种软件来监控和分析内容绩效,尤其是与他们的销售活动相关的内容。了解您的内容对目标受众和客户群的影响是必不可少的信息。

此外,内容营销软件使团队能够将他们的内容保存在一个自动化的集中式系统中,以帮助他们在协作项目中无缝地工作和沟通。

这将使您能够从一个中心位置轻松管理和监控内容,并查看有关您的内容的影响、潜在客户生成和更新的销售业绩的信息。

专注于内容发布的产品通常允许您设置用于生成潜在客户的 Web 表单、创建嵌入式 CTA、跨社交媒体和其他在线渠道自动分发内容、将内容推广到付费或免费媒体渠道,以及使用针对特定客户群的个性化内容。

具有报告和分析功能的内容营销软件使企业能够跟踪内容绩效并生成跳出率、点击、下载、分享和转换的报告。这可以帮助您了解哪种类型的内容最适合哪种类型的客户,以便您可以相应地优化您的营销内容。

理想情况下,您的内容营销软件应该与现有的内容管理系统、营销自动化软件、社交媒体管理工具、CRM 和电子邮件营销软件很好地集成。

如果需要远程进行更改,还应该可以通过基于云或基于浏览器的 Web 应用程序或移动平台访问该软件。

使用内容营销软件的好处

各种规模的企业,尤其是中小型企业,都可以从使用内容营销软件中受益。此类软件的特性和功能可确保企业改进其内容营销活动和流程并提高生产力。

更优质的内容。

内容管理软件可帮助您的营销团队和企业创建和分发更高质量的内容。通过充分利用该软件的特性和功能,企业可以更好地了解活动的有效性、分析数据并修改未来的活动以更好地吸引目标受众。

该软件还使用集中式系统来存储内容,并为所有创建的内容提供更好的反馈、可见性和审查流程。这提高了内容的标准和质量,并有助于改善跨部门的沟通。

使用内容营销软件,良好的品牌知名度活动很容易,并且可以产生更好的结果,因为数据和分析可确保您更好地了解您的客户和目标受众。

更精准地定位客户

内容营销工具可以为您提供的另一个主要优势是更好地定位客户和受众。由于您可以接触到广泛而多样化的受众,因此您将有更多机会找到可以转化为潜在客户的客户。

确定目标后,根据客户的购买行为和偏好创建内容营销活动会容易得多。可以快速轻松地采集客户数据和行为。

集中式系统

有组织和高效的内容分发对于内容营销软件用户来说也是一大优势。由于一切都是集中和自动化的,因此工作速度更快,工作质量也大大提高。您将能够将您的内容分发和发布到各种内容平台和渠道,以便他们能够接触到更多的受众。

分析和报告功能带来的好处是您可以更轻松地采集可用于检查和了解问题和缺陷的性能和生产数据。这些数据对于帮助您确定绩效成就和里程碑以及需要改进以提高客户满意度的策略也很重要。

使用内容营销解决方案时,您和您的团队可以方便地在多个项目上进行协作、协调和沟通。

使用内容营销软件有助于为您的整体和目标受众创建、策划和分发内容,并轻松快速地进一步建立和发展与他们的关系。企业可以衡量其内容营销的范围和成功,分析数据并进行协作,以帮助进一步提高未来活动的有效性。

内容营销软件的共同特点

A/B 测试 - 通过向不同用户提供不同版本的内容,对 网站、电子邮件、广告等进行拆分测试。

受众定位 - 允许细分受众,通常为特定用户群体定制营销或广告信息。

品牌管理 - 一种或多种品牌产品的跟踪和促销功能。

日历管理 - 管理和更新日历以安排或整合团队、部门或业务职能部门的活动。

转化跟踪 - 跟踪注册、购买或用户操作,以衡量营销或广告活动的有效性。这通常用于优化入站或出站营销工作,并通过一系列在线渠道提高销售转化率。

仪表板——仪表板是数字界面,通常用于可视化数据或快速访问在线平台的重要功能。它们通常充当软件应用程序中的概览网关。

数据导出——导出功能可用于简化跨系统、平台或应用程序的数据集和信息的迁移。

数据导入 - 导入功能允许您使用来自其他系统或平台的数据集来减少数据输入要求,或者更轻松地从您过去使用过的类似应用程序中迁移记录。

数据可视化——数据可视化功能提供数据集的可视化解释,通常通过使用图表、信息图表和其他以报告仪表板形式呈现的视觉提示。

外部集成 - 与其他软件产品或平台集成以提高整体系统效率和兼容性。

营销自动化——通过使用聊天机器人等自动化营销流程,例如外展电子邮件、客户参与、聊天响应等。

多用户--支持多个用户帐户,通常允许与同事协作。

通知 - 包括通知支持并提醒您有关重要事件和其他时间敏感实例的信息。例如,通过手机上的推送通知或电子邮件通知。

内容营销的行业趋势

随着您越来越接近选择移动营销工具,您应该真正考虑一些市场趋势:

搜索引擎优化 (SEO):SEO 的目标是通过确保或保持在 Google 等搜索引擎的结果页面中的高排名来增加 网站 访问者的数量。这是一个重要的概念,可以纳入您的内容营销策略,因为它可以帮助受众有机地找到您的内容,而不是支付广告空间或发送电子邮件。

社区建设:建立成功内容的最佳方法之一是培养追随者社区。创建内容时,请考虑让读者参与的方法。例如,邀请他们对您的 文章 发表评论或要求他们订阅您的视频频道。您越鼓励社区参与,就越能更快地为您的品牌建立受众群体。 查看全部

集搜客网页抓取软件(主题什么是?的类型如何选择使用的好处的共同特点)

内容营销软件主题

什么是内容营销软件?

内容营销软件的类型

如何选择内容营销软件

使用内容营销软件的好处

内容营销软件的共同特点

内容营销的行业趋势

了解有关内容营销软件的更多信息 什么是内容营销软件?

内容营销软件是一种解决方案,可帮助跨多个在线渠道创建、管理和分发内容,目标是建立和培养与目标客户群的关系。更高级的产品有助于衡量您的内容营销活动的有效性,因此您可以相应地制定或修改您的内容策略。

内容营销平台集中了从概念化和规划到实际协作和内容分发阶段的所有营销流程。营销人员不是放置产品,而是创建相关内容,吸引并保持目标客户和受众对他们所提供的产品感兴趣。

组织经常使用内容营销作为产生和培养潜在客户、培养品牌知名度、建立品牌忠诚度和提高转化率的工具。此类别中的大多数产品有助于创建和分发不同类型的内容,例如文本、图像、视频、信息图表、小册子、报告、案例研究和白皮书。

借助良好的内容营销工具,营销人员和企业将能够培养和维持客户对其品牌的参与度,从而提高潜在客户的转化率并增加公司的收入。

其他常见功能包括设置内容创建的截止日期、安排内容发布的开始日期、自动化内容审批工作流程、控制用户对重要内容的访问、将内容存储在可搜索的文件存储库中以及将相同的内容发布到多个位置。通道的功能。

内容营销解决方案还可以根据从客户的内容体验中采集的信息生成洞察力。然后,这些见解可用于制定计划、策略和内容营销活动,以提高客户和受众的满意度。

内容营销软件的类型

有多种类型的内容营销解决方案可供企业选择。要考虑的关键方面包括所需的部署、所需的功能和软件的可伸缩性。

此类软件可以通过两种不同的方式部署,本地托管或通过基于云的 SaaS 解决方案。使用本地解决方案,该软件可以安装在公司或办公室服务器上。用户应自行管理系统;不需要供应商或其技术支持团队的帮助。

本地软件需要一次性许可费,但企业还必须考虑维护和服务器成本。任何软件维护以及数据备份和升级都必须由内部技术团队处理。所有数据都保存在提供商的服务器上,这意味着对所采集数据的更大控制和可见性。

基于云的平台通常是 SaaS 服务,这意味着该软件更适合中小型企业,因为该软件包带有负担得起的月费,并且可以访问您选择的服务提供的技术支持团队。

软件即服务内容营销软件附带不同的价格包,这些价格包是根据所使用的功能、项目规模和使用该工具的客户数量计算的。

对于中小型企业,该软件应包括满足其内容营销需求所需的基本功能。但是,对于平台上的大量用户,他们可能不需要更高级的功能或功能,因为他们可能在较小的团队中工作并且可用的资源较少。

对于较大的公司,内容营销软件可以帮助他们提高对其产品和服务积极方面的认识。他们可能有预算并且需要更大的同类最佳解决方案,因此必须根据您的需求和规模选择合适的平台。

如何选择内容营销软件

在为您的企业选择合适的内容营销软件时,您需要考虑所需的软件、企业的规模和规模以及解决方案所需的功能。大多数解决方案都提供免费试用,因此您可以测试产品并查看它是否适合您的业务。

不同的内容营销工具专注于内容生命周期的不同阶段,例如内容创建、内容发布、报告和分析。

例如,如果您在内容创建方面需要帮助,请寻找一种产品,让您的内容团队能够分享想法并协作创建内容。您可能还在寻找其他功能,例如审批工作流、内容日历、内容编辑器和资源管理。

大多数营销团队使用这种软件来监控和分析内容绩效,尤其是与他们的销售活动相关的内容。了解您的内容对目标受众和客户群的影响是必不可少的信息。

此外,内容营销软件使团队能够将他们的内容保存在一个自动化的集中式系统中,以帮助他们在协作项目中无缝地工作和沟通。

这将使您能够从一个中心位置轻松管理和监控内容,并查看有关您的内容的影响、潜在客户生成和更新的销售业绩的信息。

专注于内容发布的产品通常允许您设置用于生成潜在客户的 Web 表单、创建嵌入式 CTA、跨社交媒体和其他在线渠道自动分发内容、将内容推广到付费或免费媒体渠道,以及使用针对特定客户群的个性化内容。

具有报告和分析功能的内容营销软件使企业能够跟踪内容绩效并生成跳出率、点击、下载、分享和转换的报告。这可以帮助您了解哪种类型的内容最适合哪种类型的客户,以便您可以相应地优化您的营销内容。

理想情况下,您的内容营销软件应该与现有的内容管理系统、营销自动化软件、社交媒体管理工具、CRM 和电子邮件营销软件很好地集成。

如果需要远程进行更改,还应该可以通过基于云或基于浏览器的 Web 应用程序或移动平台访问该软件。

使用内容营销软件的好处

各种规模的企业,尤其是中小型企业,都可以从使用内容营销软件中受益。此类软件的特性和功能可确保企业改进其内容营销活动和流程并提高生产力。

更优质的内容。

内容管理软件可帮助您的营销团队和企业创建和分发更高质量的内容。通过充分利用该软件的特性和功能,企业可以更好地了解活动的有效性、分析数据并修改未来的活动以更好地吸引目标受众。

该软件还使用集中式系统来存储内容,并为所有创建的内容提供更好的反馈、可见性和审查流程。这提高了内容的标准和质量,并有助于改善跨部门的沟通。

使用内容营销软件,良好的品牌知名度活动很容易,并且可以产生更好的结果,因为数据和分析可确保您更好地了解您的客户和目标受众。

更精准地定位客户

内容营销工具可以为您提供的另一个主要优势是更好地定位客户和受众。由于您可以接触到广泛而多样化的受众,因此您将有更多机会找到可以转化为潜在客户的客户。

确定目标后,根据客户的购买行为和偏好创建内容营销活动会容易得多。可以快速轻松地采集客户数据和行为。

集中式系统

有组织和高效的内容分发对于内容营销软件用户来说也是一大优势。由于一切都是集中和自动化的,因此工作速度更快,工作质量也大大提高。您将能够将您的内容分发和发布到各种内容平台和渠道,以便他们能够接触到更多的受众。

分析和报告功能带来的好处是您可以更轻松地采集可用于检查和了解问题和缺陷的性能和生产数据。这些数据对于帮助您确定绩效成就和里程碑以及需要改进以提高客户满意度的策略也很重要。

使用内容营销解决方案时,您和您的团队可以方便地在多个项目上进行协作、协调和沟通。

使用内容营销软件有助于为您的整体和目标受众创建、策划和分发内容,并轻松快速地进一步建立和发展与他们的关系。企业可以衡量其内容营销的范围和成功,分析数据并进行协作,以帮助进一步提高未来活动的有效性。

内容营销软件的共同特点

A/B 测试 - 通过向不同用户提供不同版本的内容,对 网站、电子邮件、广告等进行拆分测试。

受众定位 - 允许细分受众,通常为特定用户群体定制营销或广告信息。

品牌管理 - 一种或多种品牌产品的跟踪和促销功能。

日历管理 - 管理和更新日历以安排或整合团队、部门或业务职能部门的活动。

转化跟踪 - 跟踪注册、购买或用户操作,以衡量营销或广告活动的有效性。这通常用于优化入站或出站营销工作,并通过一系列在线渠道提高销售转化率。

仪表板——仪表板是数字界面,通常用于可视化数据或快速访问在线平台的重要功能。它们通常充当软件应用程序中的概览网关。

数据导出——导出功能可用于简化跨系统、平台或应用程序的数据集和信息的迁移。

数据导入 - 导入功能允许您使用来自其他系统或平台的数据集来减少数据输入要求,或者更轻松地从您过去使用过的类似应用程序中迁移记录。

数据可视化——数据可视化功能提供数据集的可视化解释,通常通过使用图表、信息图表和其他以报告仪表板形式呈现的视觉提示。

外部集成 - 与其他软件产品或平台集成以提高整体系统效率和兼容性。

营销自动化——通过使用聊天机器人等自动化营销流程,例如外展电子邮件、客户参与、聊天响应等。

多用户--支持多个用户帐户,通常允许与同事协作。

通知 - 包括通知支持并提醒您有关重要事件和其他时间敏感实例的信息。例如,通过手机上的推送通知或电子邮件通知。

内容营销的行业趋势

随着您越来越接近选择移动营销工具,您应该真正考虑一些市场趋势:

搜索引擎优化 (SEO):SEO 的目标是通过确保或保持在 Google 等搜索引擎的结果页面中的高排名来增加 网站 访问者的数量。这是一个重要的概念,可以纳入您的内容营销策略,因为它可以帮助受众有机地找到您的内容,而不是支付广告空间或发送电子邮件。

社区建设:建立成功内容的最佳方法之一是培养追随者社区。创建内容时,请考虑让读者参与的方法。例如,邀请他们对您的 文章 发表评论或要求他们订阅您的视频频道。您越鼓励社区参与,就越能更快地为您的品牌建立受众群体。

集搜客网页抓取软件(car_亚马逊商品表亚马逊中国的数据验证码有时会不时出现)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-16 18:06

[i=s]本帖最后由 tuesday1 于 2018-9-22 08:25 编辑 [/i]规则名称:car_Amazon产品表 亚马逊产品搜索列表对于不同的搜索词显示略有不同,是嵌套的,但是规则仍然不是普遍的。

为什么网页源代码显示有100个item,但是我仍然在抓取HTML文件中显示的只有20个item,如何获取所有item信息才能得到

[i=s]本帖最后编辑于 2019-9-25 23:34。[/i] 任务名称: amazon_uni0818 下面有5条规则,每条规则因为失败而失败并重新定义,但仍有8条失败示例,编号为:[color = rgbArial] [color =#666666] [backcolor=rgb(243, 245, 246)] 什么失败

为什么要在这个级别抢——“级别抢亚马逊”在“LEDspotlight产品详情”中,第一个示例生产规则是[color=#ff0000],可以测试[/color],然后尝试抓住但它不起作用?

%3Dmobile&field-keywords=huawei+p10+case&sprefix=huawe%2Caps%2C1708 以上网址,规则名称是华为P10一楼,华为P10二楼,请帮我解决。

有时会时不时出现爬取亚马逊中国的数据验证码。如何访问我购买的终极版的编码平台?

[列表][*]标题:[亚马逊商品评论]#GooSeekerDataDIY#[*]分类:电子商务[*]网站:[/ b]Amazon[*][b][b][b]采集字段:[/b][/b]评论内容,在评论日,BA%9A%E9%A9%AC% E9% 80 % 8A% E5% 95% 86% E5% 93% 81% E8% AF% 84% E8% AE% BA] 亚马逊产品评论[/url] 页面; [*] 输入网址,或点击“输入多个网址”,然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

您好,请问您是否定期抢美国亚马逊提供产品价格信息?我这里有一个微商城,专门做亚马逊商品,大概200~500个SKU,全是包包,需要每天刮更新价格数据

[列表][*]标题:[亚马逊产品搜索列表)#GooSeekerDataDIY#[*]类别:电子商务[*]网站:[ /b]亚马逊[*][b][b][b]采集字段:[/b][/b]产品名称,产品链接 80% 8A% E5% 95% 86% E5 %93% 81%E6%90%9C%E7%B4%A2%E5%88%97%E8%A1%A8]亚马逊产品搜索列表[/url]页面;[*]输入网址,或点击输入多个网址”,以及然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

抓取地址

题目名称:Amazon Books - 想尝试gsc爬取亚马逊的图书信息,设置翻页,现在的情况是玩ds数码机爬取的时候,所有的爬取都在同一个页面上。抓取页面后会自动打开一个新窗口,然后点击本机不同的窗口。

为什么当时在爬销售排行榜数据,做了example mapping后,前三个是一组,后一个是一组,而且他的产品链接格式不正确?

亚马逊爬虫怎么样

如何使用爬虫软件全面爬取亚马逊产品评论数据。

根据您商店的分类,您可以完全抓取产品评论。

亚马逊如何与爬行动物作战。

2.以多种方式获取和查询数据,分类、组织和导出(1)根据Ebay货号自定义和导入数据,例如监控出价。

(2)您可以自定义导入数据,例如根据 Ebay 商品编号监控出价。

(3)可以自定义根据店铺URL导入数据,比如监控出价。

下面是一个电表计价软件和数据监控系统。1.多模态数据采集监控(1)可以根据关键词/类型/排序监控各种排名和产品价格等数据。

3.这个功能可以根据用户的实际需要进行定制。所有 Ebay 产品图片、名称、价格、详细描述和其他字段都可以自定义采集或导出为自定义格式以供您购物网站。

如何使用爬虫软件(例如 优采云collector)完全爬取亚马逊产品。

在尝试使用爬虫之前先嗅探它们。我用它来采集亚马逊产品评论。产品信息与产品信息相同。操作非常简单直观。按照教程一步一步来,非常复杂。他可以采集页面。

这是最好的亚马逊爬虫软件。

下载完成后,我们的手机里就会有一个对应的安装应用,我们可以点击下图的安装按钮。

如果要管理手机中的软件安装包,可以找到腾讯手机管家的软件管理功能界面。

进入腾讯手机管家的安装包管理功能界面后,我们可以对自己的手机安装包进行相应的管理。

爬虫可以搜索亚马逊商家数据吗?

首先要对需要采集的亚马逊商户店铺地址进行采集和分类,使用市面上常用的机车数据采集器、优采云亚马逊数据采集软件、八达通数据采集器等导入地址。数据采集软件,用于选择所需的数据,如产品名称、评论、热门产品、流行趋势等。

如何使用python爬虫搜索亚马逊美国关键词排名。

9.分析可以做多少权重关键词。

第三,我们对多个关键词进行排名后,就出现了做网站的目的。哪些关键词能给我们带来更多的流量和更高的转化率,这些好的转化率高的关键词自然需要我们更多的关注。

5.在内容页面输入长尾关键词。长尾关键词优于一个指标,并使用数量来推动目标关键词。

6.目标关键字围绕主要关键字完成。

2.做出关键词后,分析对手关键词。

为什么python爬虫爬不上亚马逊页面。

js加载的一些内容只有在电脑屏幕或鼠标移动到特定位置时才会动态加载。这些都没有体现在源码中,python爬虫只是爬取源码。如果你想满足你的需求,可以尝试使用phantomjs来模拟一个浏览器,祝你成功。

索要 Java 爬虫要求文档,最好是亚马逊。

关于爬虫,网上有很多从新手到基础爬虫的例子,这个过程也很快。

只说一些高级问题:爬虫如何伪装成你想要的终端和浏览器。

攀登结果会有所不同。

欢迎您参与牛交流研究(限2人)

Android驱动开发技术培训638883269

基带硬件技术交流654271105

射频技术培训班653766426

PCB版图交流群711189959

全智技术交流群 778228658

信息产业交流 651214441

驱动专家组628699443

IC设计技术交流221533727

上海及周边会员交流团 541905910

北京及周边会员交流群565836224

成都及周边地区会员交流群603449471

点击了解更多牛网交流课题组 查看全部

集搜客网页抓取软件(car_亚马逊商品表亚马逊中国的数据验证码有时会不时出现)

[i=s]本帖最后由 tuesday1 于 2018-9-22 08:25 编辑 [/i]规则名称:car_Amazon产品表 亚马逊产品搜索列表对于不同的搜索词显示略有不同,是嵌套的,但是规则仍然不是普遍的。

为什么网页源代码显示有100个item,但是我仍然在抓取HTML文件中显示的只有20个item,如何获取所有item信息才能得到

[i=s]本帖最后编辑于 2019-9-25 23:34。[/i] 任务名称: amazon_uni0818 下面有5条规则,每条规则因为失败而失败并重新定义,但仍有8条失败示例,编号为:[color = rgbArial] [color =#666666] [backcolor=rgb(243, 245, 246)] 什么失败

为什么要在这个级别抢——“级别抢亚马逊”在“LEDspotlight产品详情”中,第一个示例生产规则是[color=#ff0000],可以测试[/color],然后尝试抓住但它不起作用?

%3Dmobile&field-keywords=huawei+p10+case&sprefix=huawe%2Caps%2C1708 以上网址,规则名称是华为P10一楼,华为P10二楼,请帮我解决。

有时会时不时出现爬取亚马逊中国的数据验证码。如何访问我购买的终极版的编码平台?

[列表][*]标题:[亚马逊商品评论]#GooSeekerDataDIY#[*]分类:电子商务[*]网站:[/ b]Amazon[*][b][b][b]采集字段:[/b][/b]评论内容,在评论日,BA%9A%E9%A9%AC% E9% 80 % 8A% E5% 95% 86% E5% 93% 81% E8% AF% 84% E8% AE% BA] 亚马逊产品评论[/url] 页面; [*] 输入网址,或点击“输入多个网址”,然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

您好,请问您是否定期抢美国亚马逊提供产品价格信息?我这里有一个微商城,专门做亚马逊商品,大概200~500个SKU,全是包包,需要每天刮更新价格数据

[列表][*]标题:[亚马逊产品搜索列表)#GooSeekerDataDIY#[*]类别:电子商务[*]网站:[ /b]亚马逊[*][b][b][b]采集字段:[/b][/b]产品名称,产品链接 80% 8A% E5% 95% 86% E5 %93% 81%E6%90%9C%E7%B4%A2%E5%88%97%E8%A1%A8]亚马逊产品搜索列表[/url]页面;[*]输入网址,或点击输入多个网址”,以及然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

抓取地址

题目名称:Amazon Books - 想尝试gsc爬取亚马逊的图书信息,设置翻页,现在的情况是玩ds数码机爬取的时候,所有的爬取都在同一个页面上。抓取页面后会自动打开一个新窗口,然后点击本机不同的窗口。

为什么当时在爬销售排行榜数据,做了example mapping后,前三个是一组,后一个是一组,而且他的产品链接格式不正确?

亚马逊爬虫怎么样

如何使用爬虫软件全面爬取亚马逊产品评论数据。

根据您商店的分类,您可以完全抓取产品评论。

亚马逊如何与爬行动物作战。

2.以多种方式获取和查询数据,分类、组织和导出(1)根据Ebay货号自定义和导入数据,例如监控出价。

(2)您可以自定义导入数据,例如根据 Ebay 商品编号监控出价。

(3)可以自定义根据店铺URL导入数据,比如监控出价。

下面是一个电表计价软件和数据监控系统。1.多模态数据采集监控(1)可以根据关键词/类型/排序监控各种排名和产品价格等数据。

3.这个功能可以根据用户的实际需要进行定制。所有 Ebay 产品图片、名称、价格、详细描述和其他字段都可以自定义采集或导出为自定义格式以供您购物网站。

如何使用爬虫软件(例如 优采云collector)完全爬取亚马逊产品。

在尝试使用爬虫之前先嗅探它们。我用它来采集亚马逊产品评论。产品信息与产品信息相同。操作非常简单直观。按照教程一步一步来,非常复杂。他可以采集页面。

这是最好的亚马逊爬虫软件。

下载完成后,我们的手机里就会有一个对应的安装应用,我们可以点击下图的安装按钮。

如果要管理手机中的软件安装包,可以找到腾讯手机管家的软件管理功能界面。

进入腾讯手机管家的安装包管理功能界面后,我们可以对自己的手机安装包进行相应的管理。

爬虫可以搜索亚马逊商家数据吗?

首先要对需要采集的亚马逊商户店铺地址进行采集和分类,使用市面上常用的机车数据采集器、优采云亚马逊数据采集软件、八达通数据采集器等导入地址。数据采集软件,用于选择所需的数据,如产品名称、评论、热门产品、流行趋势等。

如何使用python爬虫搜索亚马逊美国关键词排名。

9.分析可以做多少权重关键词。

第三,我们对多个关键词进行排名后,就出现了做网站的目的。哪些关键词能给我们带来更多的流量和更高的转化率,这些好的转化率高的关键词自然需要我们更多的关注。

5.在内容页面输入长尾关键词。长尾关键词优于一个指标,并使用数量来推动目标关键词。

6.目标关键字围绕主要关键字完成。

2.做出关键词后,分析对手关键词。

为什么python爬虫爬不上亚马逊页面。

js加载的一些内容只有在电脑屏幕或鼠标移动到特定位置时才会动态加载。这些都没有体现在源码中,python爬虫只是爬取源码。如果你想满足你的需求,可以尝试使用phantomjs来模拟一个浏览器,祝你成功。

索要 Java 爬虫要求文档,最好是亚马逊。

关于爬虫,网上有很多从新手到基础爬虫的例子,这个过程也很快。

只说一些高级问题:爬虫如何伪装成你想要的终端和浏览器。

攀登结果会有所不同。

欢迎您参与牛交流研究(限2人)

Android驱动开发技术培训638883269

基带硬件技术交流654271105

射频技术培训班653766426

PCB版图交流群711189959

全智技术交流群 778228658

信息产业交流 651214441

驱动专家组628699443

IC设计技术交流221533727

上海及周边会员交流团 541905910

北京及周边会员交流群565836224

成都及周边地区会员交流群603449471

点击了解更多牛网交流课题组

集搜客网页抓取软件(快速有效地将小红书的商品信息采集下来的步骤(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 215 次浏览 • 2022-01-15 23:21

)

小红书是在线社区、跨境电商、分享平台、口碑数据库。最近很多小伙伴都在讨论这个网站的产品信息抓取,讨论的更多是关于如何抓取瀑布网页下面的内容。这里不想讨论技术方法,直接介绍一个快速的采集软件,可以直接使用,不讲技术细节。

下面给大家分享一下快速有效下载小红书采集产品信息的步骤。

1.准备工具——吉索克网络爬虫

下载、安装、打开、登录账号,这里不废话,直接上干货

2.利用小红书商品列表数据DIY,快采集

数据DIY是一款快速采集工具,无需编程即可直接使用

1)输入数据DIY,从GooSeeker顶部菜单进入路线网站:资源->数据DIY

2)在Data DIY网页上,选择Category — 网站 — Web Pages

小红书的具体种类有:

参考下图

3)比较示例页面并观察页面结构。输入的 URL 必须具有相同的页面结构,否则将 采集 失败。

小红书的示例页面是这样的

产品列表网址来自手机小红书APP。获取网址的方法是:在手机上打开小红书APP->点击商城中的产品目录(不要点击更多)->然后点击分类选择/热门,就会看到产品列表,然后点击右上角的分享按钮,然后用电脑上的社交软件接收。

您可能会看到像这样需要 采集 的页面,您可以比较它们,它们是相同的。

可以看出,两个页面几乎一样,但产品不同。

4)输入你想要的网址采集,选择采集一直向下滚动,点击获取数据,启动采集

您将看到要求启动爬虫窗口的提示。并将启动 2 个窗口,一个用于 采集 数据,一个用于打包数据。不要在运行时关闭它们,也不要最小化它们。但是这些窗口可以覆盖其他窗口

5)等待采集完成,打包下载数据

注意:提示采集完成后不要立即关闭窗口,需要等待打包按钮变为绿色,采集的状态变为采集,请见下图

6)包数据

7)下载数据

8)这里我们的数据是采集下来的,我们来看看我们采集收到的数据

查看全部

集搜客网页抓取软件(快速有效地将小红书的商品信息采集下来的步骤(组图)

)

小红书是在线社区、跨境电商、分享平台、口碑数据库。最近很多小伙伴都在讨论这个网站的产品信息抓取,讨论的更多是关于如何抓取瀑布网页下面的内容。这里不想讨论技术方法,直接介绍一个快速的采集软件,可以直接使用,不讲技术细节。

下面给大家分享一下快速有效下载小红书采集产品信息的步骤。

1.准备工具——吉索克网络爬虫

下载、安装、打开、登录账号,这里不废话,直接上干货

2.利用小红书商品列表数据DIY,快采集

数据DIY是一款快速采集工具,无需编程即可直接使用

1)输入数据DIY,从GooSeeker顶部菜单进入路线网站:资源->数据DIY

2)在Data DIY网页上,选择Category — 网站 — Web Pages

小红书的具体种类有:

参考下图

3)比较示例页面并观察页面结构。输入的 URL 必须具有相同的页面结构,否则将 采集 失败。

小红书的示例页面是这样的

产品列表网址来自手机小红书APP。获取网址的方法是:在手机上打开小红书APP->点击商城中的产品目录(不要点击更多)->然后点击分类选择/热门,就会看到产品列表,然后点击右上角的分享按钮,然后用电脑上的社交软件接收。

您可能会看到像这样需要 采集 的页面,您可以比较它们,它们是相同的。

可以看出,两个页面几乎一样,但产品不同。

4)输入你想要的网址采集,选择采集一直向下滚动,点击获取数据,启动采集

您将看到要求启动爬虫窗口的提示。并将启动 2 个窗口,一个用于 采集 数据,一个用于打包数据。不要在运行时关闭它们,也不要最小化它们。但是这些窗口可以覆盖其他窗口

5)等待采集完成,打包下载数据

注意:提示采集完成后不要立即关闭窗口,需要等待打包按钮变为绿色,采集的状态变为采集,请见下图

6)包数据

7)下载数据

8)这里我们的数据是采集下来的,我们来看看我们采集收到的数据

集搜客网页抓取软件(1.网页信息有两个常用的方法:1.Scrapy运行流程 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-15 12:17

)

爬取网页信息的常用方法有两种:

显然前者更简单更方便,但现在很多网页都是动态的,所以后者更通用。这里我主要使用后一种方式来抓取华为应用市场上所有应用的评论信息。

1. Scrapy爬虫运行过程

首先,你需要对Scrapy的爬虫工作原理有一个大致的了解,分为以下几个步骤:

import scrapy

class HuaWei(scrapy.Spider):

name = "huawei"

allowed_domains = ['appstore.huawei.com', 'web-drcn.hispace.dbankcloud.cn']

start_urls = [

'https://web-drcn.hispace.dbank ... 39%3B]

def parse(self, response):

pass

scrapy crawl huawei

2. 页面分析

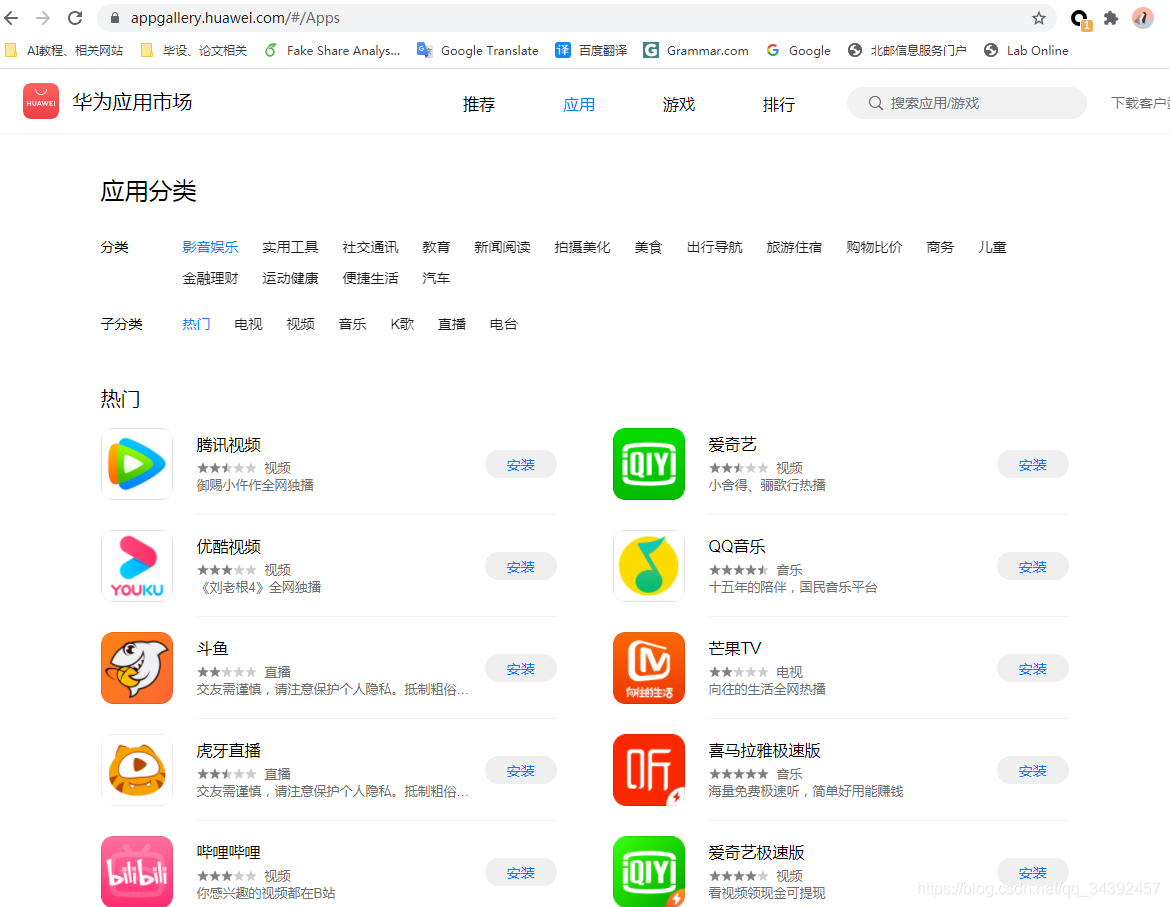

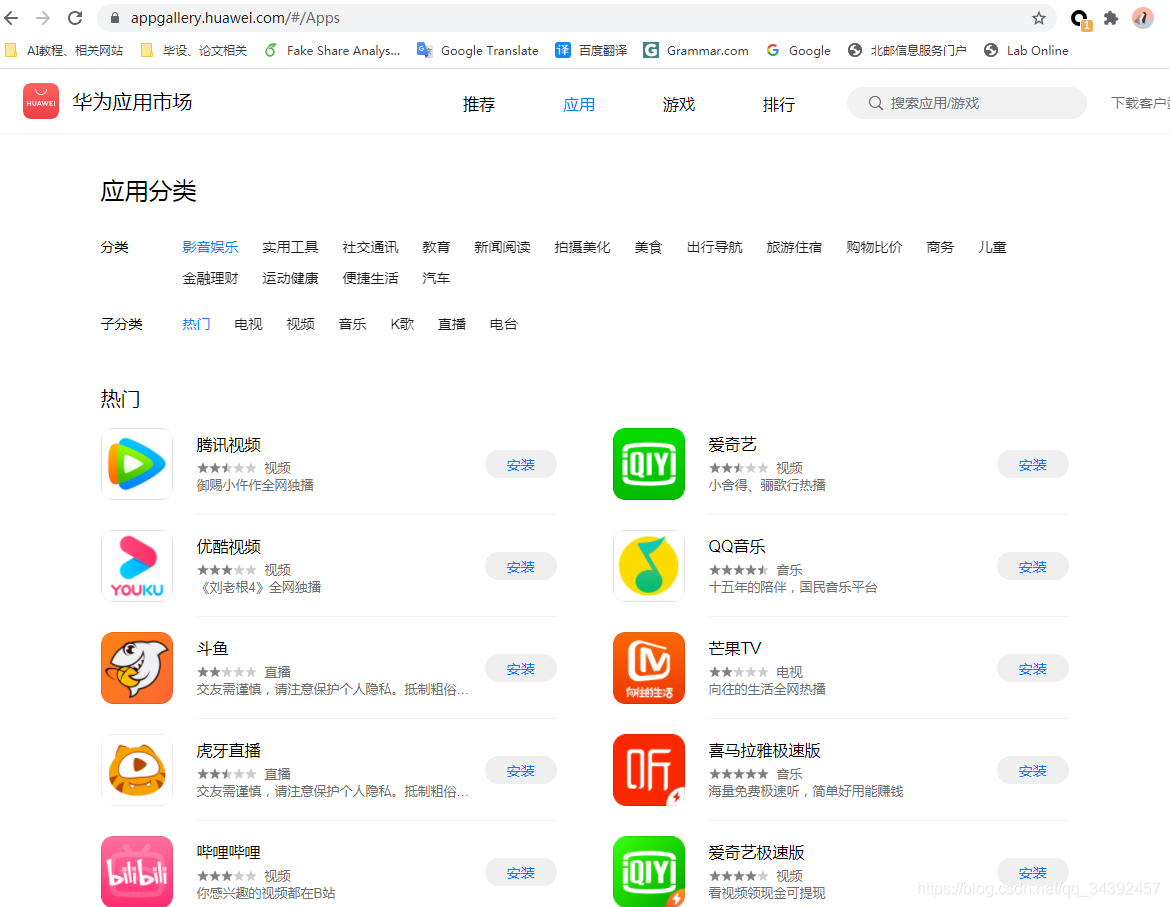

首先,通过浏览器访问应用市场,分析你要爬取的网页的基本信息。这里我要爬取应用市场中所有应用的评论,所以首先需要进入所有应用的详细界面,然后在详细界面中展开评论进行爬取,基本思路是:针对每个类别->为每个子类别 -> 展开每个应用程序 -> 获取应用程序的所有评论。

抓取的初始页面是#/Apps。在浏览器中使用F12启动开发者模式,调试网页前端代码。我们希望找到一些页面布局的规则。

页面分析过程

我们发现无论在app category tab中选择哪个category或者subcategory,url都没有变化。即动态实现选择类别后显示对应应用列表的功能。我们无法通过抓取html中的信息来获取不同类别的应用列表,只能自己构造请求获取json数据。爬取信息的方式。

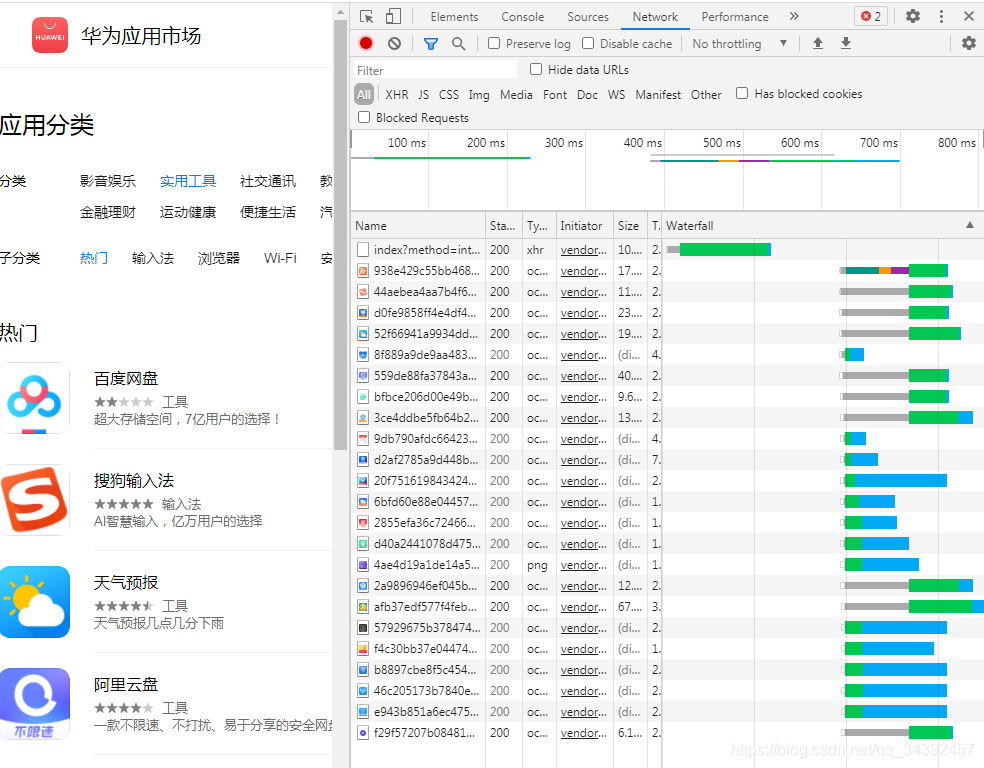

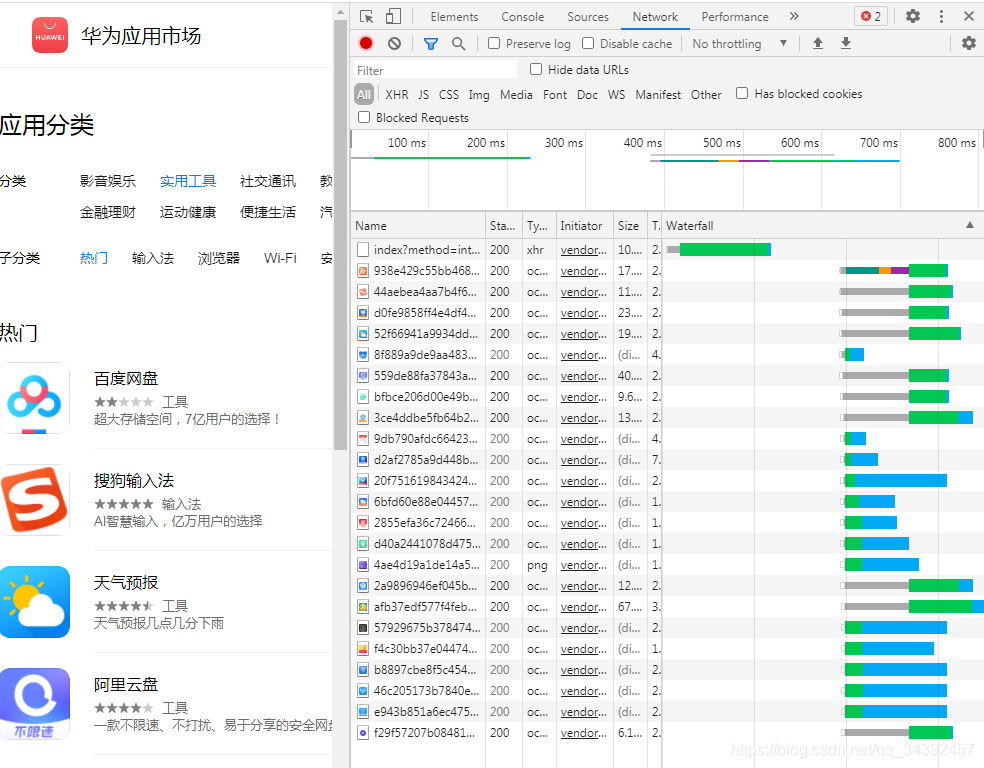

首先,在调试窗口中打开 Network 选项卡,在获取不同类别的应用程序列表时分析网络数据包:

除了第一个数据包,下面是获取应用程序图标数据,也就是说第一个数据包收录了应用程序的其他数据,这个数据包中的request_url为:

https://web-drcn.hispace.dbankcloud.cn/uowap/index

?method=internal.getTabDetail

&serviceType=20

&reqPageNum=1

&uri=8e62cf6d238c4abdb892b400ff072f43

&maxResults=25

&zone=

&locale=zh

我们直接在浏览器中访问这个url,得到一个json文件。经过分析发现,json文件中收录了列表中应用的信息。点击不同的分类和子分类可以获得不同的request_urls。我们发现每个子类的request_urls只有uri字段不同,默认只显示第1页的25个应用。也就是说,我们以request_url为模板,修改uri字段获取不同类别的应用列表,修改reqPageNum字段获取列表中的多页应用。

页面分析流程2

在手动点击各个应用的详细界面时,我们发现不同应用的详细界面的url仅在最终定位上有所不同。例如腾讯视频、优酷视频的详细界面的url为:

多观察几个应用,你会发现最后一串代码应该和应用唯一标识差不多。在上一步中,我们可以发现这些标识符('appid'键的值)可以在每个获取到的应用信息中找到,所以这里我尝试构造url请求直接获取这种格式的页面,但是它失败现在,我猜这可能是页面重定向的问题。没有办法,只能通过其他方法一步一步地继续分析。

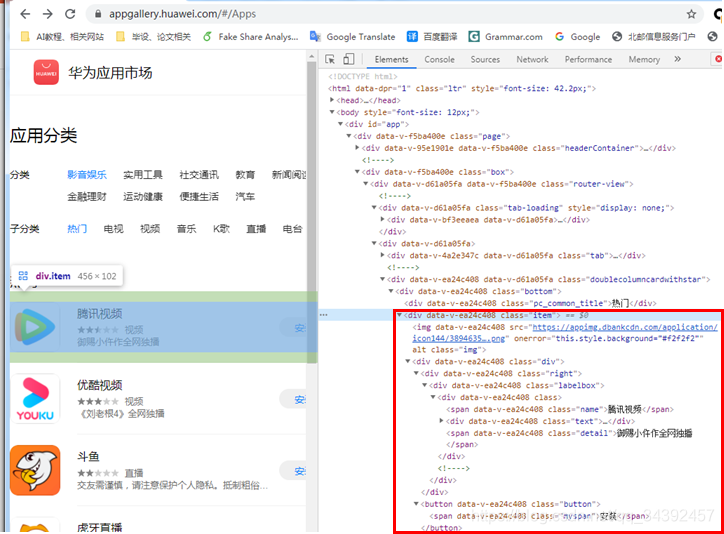

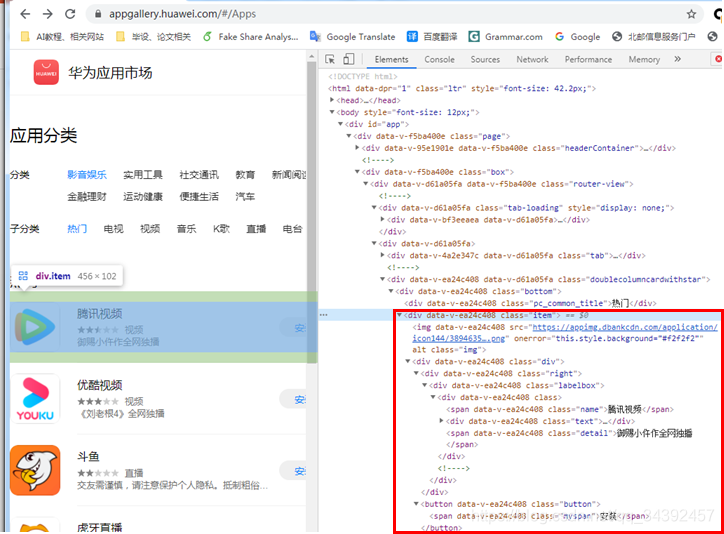

通过 F12 查看页面布局。虽然每个应用卡片都有应用名称和一些其他信息,但是找不到应用详情页面的链接,因为获取应用详情的功能写成使用js动态获取,所以我们不能直接从html接口,所以还是用构造request_url的方法来获取json数据。

与分析过程1类似,我们可以得到如下request_url:

https://web-drcn.hispace.dbankcloud.cn/uowap/index

?method=internal.getTabDetail

&serviceType=20

&reqPageNum=1

&maxResults=25

&uri=app%7CC174391

&shareTo=

¤tUrl=https%253A%252F%252Fappgallery.huawei.com%252F%2523%252Fapp%252FC174391

&accessId=

&appid=C174391

&zone=

&locale=zh

通过这个request_url得到的json收录了应用的详细信息。其实通过测试,reqPageNum、maxResults、shareTo、currentUrl、accessId、appid、zone、locale字段都是不需要的,发现uri字段后面的“C174391”就是当前应用的appid ,也就是说,我们只需要将uri字段中“app%7C”后面的字符串修改为不同应用的appid(可以在分析过程1中的json文件中获取),即可获取详细信息在不同的应用程序上。

页面分析流程三

有了上面两次分析的经验,我们继续爬取各个应用的评论数据,发现这些数据也是通过js动态获取的,于是我们继续分析request_url,格式如下:

https://web-drcn.hispace.dbankcloud.cn/uowap/index

?method=internal.user.commenList3

&serviceType=20

&reqPageNum=1

&maxResults=25

&appid=C2002

&version=10.0.0

&zone=

&locale=zh

和之前类似,我们可以通过修改appid字段来爬取不同应用的评论,通过修改reqPageNum字段来爬取多页评论。

3. 爬虫实现

整个爬取过程是:构造request_url请求获取json数据->解析json数据->构造新request_url获取json数据->...

下面是爬虫中的一个处理函数。作用是处理各个应用的详细信息,构造request_url获取评论发送新的请求。接下来,依次说明关键部分。

def app_parse(self, response):

"""

解析应用,获取应用名称、描述、资费、版本、开发者,然后转至appcomment_parse进行处理

:param resonse:

:return:

"""

appid = response.meta['appid']

app_json = json.loads(response.text)

Name = app_json.get('layoutData')[0].get('dataList')[0].get('name')

Star = app_json.get('layoutData')[0].get('dataList')[0].get('intro')

Downloads = app_json.get('layoutData')[0].get('dataList')[0].get('stars')

Price = app_json.get('layoutData')[3].get('dataList')[0].get('tariffDesc')

Version = app_json.get('layoutData')[3].get('dataList')[0].get('version')

Developer = app_json.get('layoutData')[3].get('dataList')[0].get('developer')

Description = app_json.get('layoutData')[7].get('dataList')[0].get('appIntro').replace('\n', '')

AppData = AppItem(

AppId=appid,

AppName=Name,

AppDesc=Description,

AppPrice=Price,

AppVersion=Version,

AppDeveloper=Developer,

AppStar=Star,

AppDownloads=Downloads

)

yield AppData

for pagenum in range(1, 20):

request_url = "https://web-drcn.hispace.dbank ... um%3D{}&maxResults=25&appid={}&version=10.0.0&zone=&locale=zh".format(

pagenum, appid)

yield scrapy.Request(url=request_url, callback=self.appcomment_parse, meta={'appid': appid})

解析json并构造请求

第8行通过json.loads将response解析成json格式,后面通过key-value和index访问里面的信息。

将数据保存在项目中

在items.py文件中定义好Item类后,就可以在这里新建一个Item对象,填入对应的值,将该item返回给pipeline.py进行处理。

# items.py

class AppItem(scrapy.Item):

AppId = scrapy.Field()

AppName = scrapy.Field()

AppDesc = scrapy.Field()

AppPrice = scrapy.Field()

AppVersion = scrapy.Field()

AppDeveloper = scrapy.Field()

AppStar = scrapy.Field()

AppDownloads = scrapy.Field()

yield 是 python 中的 关键词 。和return类似,它会让函数返回这个关键词修改的表达式的值。与return不同的是,yield在返回一个值后会继续执行下面的代码。,而 return 没有。

构造一个新的请求

为最后一行的所有评论列表构造一个新的request_url,获取评论信息,通过scrapy.Request发送请求,其中callback指定用于处理该请求响应的handler函数,meta收录你的想传递给回调函数的信息。

项目数据的处理

在爬取数据的过程中,处理函数会实时返回不同的item,交给pipeline处理。这时候就需要在pipeline.py中指定如何处理这些项。例如,这里我将所有数据记录在 csv 表中。必须在管道类中定义 process_item 函数来处理每个项目,并且 __init__ 和 close_spider 都是可选的。

class AppStorePipeline:

def __init__(self):

self.app_list = []

self.comment_list = []

def process_item(self, item, spider): # 接收到item时调用的函数

if isinstance(item, AppItem):

self.app_list.append(dict(item))

elif isinstance(item, CommentItem):

self.comment_list.append(dict(item))

return item

def close_spider(self, spider): # 当爬虫关闭时调用的函数

df_app = pd.DataFrame(self.app_list)

df_comment = pd.DataFrame(self.comment_list)

df_app.to_csv('app_info.csv')

df_comment.to_csv('comment_info.csv') 查看全部

集搜客网页抓取软件(1.网页信息有两个常用的方法:1.Scrapy运行流程

)

爬取网页信息的常用方法有两种:

显然前者更简单更方便,但现在很多网页都是动态的,所以后者更通用。这里我主要使用后一种方式来抓取华为应用市场上所有应用的评论信息。

1. Scrapy爬虫运行过程

首先,你需要对Scrapy的爬虫工作原理有一个大致的了解,分为以下几个步骤:

import scrapy

class HuaWei(scrapy.Spider):

name = "huawei"

allowed_domains = ['appstore.huawei.com', 'web-drcn.hispace.dbankcloud.cn']

start_urls = [

'https://web-drcn.hispace.dbank ... 39%3B]

def parse(self, response):

pass

scrapy crawl huawei

2. 页面分析

首先,通过浏览器访问应用市场,分析你要爬取的网页的基本信息。这里我要爬取应用市场中所有应用的评论,所以首先需要进入所有应用的详细界面,然后在详细界面中展开评论进行爬取,基本思路是:针对每个类别->为每个子类别 -> 展开每个应用程序 -> 获取应用程序的所有评论。

抓取的初始页面是#/Apps。在浏览器中使用F12启动开发者模式,调试网页前端代码。我们希望找到一些页面布局的规则。

页面分析过程

我们发现无论在app category tab中选择哪个category或者subcategory,url都没有变化。即动态实现选择类别后显示对应应用列表的功能。我们无法通过抓取html中的信息来获取不同类别的应用列表,只能自己构造请求获取json数据。爬取信息的方式。

首先,在调试窗口中打开 Network 选项卡,在获取不同类别的应用程序列表时分析网络数据包:

除了第一个数据包,下面是获取应用程序图标数据,也就是说第一个数据包收录了应用程序的其他数据,这个数据包中的request_url为:

https://web-drcn.hispace.dbankcloud.cn/uowap/index

?method=internal.getTabDetail

&serviceType=20

&reqPageNum=1

&uri=8e62cf6d238c4abdb892b400ff072f43

&maxResults=25

&zone=

&locale=zh

我们直接在浏览器中访问这个url,得到一个json文件。经过分析发现,json文件中收录了列表中应用的信息。点击不同的分类和子分类可以获得不同的request_urls。我们发现每个子类的request_urls只有uri字段不同,默认只显示第1页的25个应用。也就是说,我们以request_url为模板,修改uri字段获取不同类别的应用列表,修改reqPageNum字段获取列表中的多页应用。

页面分析流程2

在手动点击各个应用的详细界面时,我们发现不同应用的详细界面的url仅在最终定位上有所不同。例如腾讯视频、优酷视频的详细界面的url为:

多观察几个应用,你会发现最后一串代码应该和应用唯一标识差不多。在上一步中,我们可以发现这些标识符('appid'键的值)可以在每个获取到的应用信息中找到,所以这里我尝试构造url请求直接获取这种格式的页面,但是它失败现在,我猜这可能是页面重定向的问题。没有办法,只能通过其他方法一步一步地继续分析。

通过 F12 查看页面布局。虽然每个应用卡片都有应用名称和一些其他信息,但是找不到应用详情页面的链接,因为获取应用详情的功能写成使用js动态获取,所以我们不能直接从html接口,所以还是用构造request_url的方法来获取json数据。

与分析过程1类似,我们可以得到如下request_url:

https://web-drcn.hispace.dbankcloud.cn/uowap/index

?method=internal.getTabDetail

&serviceType=20

&reqPageNum=1

&maxResults=25

&uri=app%7CC174391

&shareTo=

¤tUrl=https%253A%252F%252Fappgallery.huawei.com%252F%2523%252Fapp%252FC174391

&accessId=

&appid=C174391

&zone=

&locale=zh

通过这个request_url得到的json收录了应用的详细信息。其实通过测试,reqPageNum、maxResults、shareTo、currentUrl、accessId、appid、zone、locale字段都是不需要的,发现uri字段后面的“C174391”就是当前应用的appid ,也就是说,我们只需要将uri字段中“app%7C”后面的字符串修改为不同应用的appid(可以在分析过程1中的json文件中获取),即可获取详细信息在不同的应用程序上。

页面分析流程三

有了上面两次分析的经验,我们继续爬取各个应用的评论数据,发现这些数据也是通过js动态获取的,于是我们继续分析request_url,格式如下:

https://web-drcn.hispace.dbankcloud.cn/uowap/index

?method=internal.user.commenList3

&serviceType=20

&reqPageNum=1

&maxResults=25

&appid=C2002

&version=10.0.0

&zone=

&locale=zh

和之前类似,我们可以通过修改appid字段来爬取不同应用的评论,通过修改reqPageNum字段来爬取多页评论。

3. 爬虫实现

整个爬取过程是:构造request_url请求获取json数据->解析json数据->构造新request_url获取json数据->...

下面是爬虫中的一个处理函数。作用是处理各个应用的详细信息,构造request_url获取评论发送新的请求。接下来,依次说明关键部分。

def app_parse(self, response):

"""

解析应用,获取应用名称、描述、资费、版本、开发者,然后转至appcomment_parse进行处理

:param resonse:

:return:

"""

appid = response.meta['appid']

app_json = json.loads(response.text)

Name = app_json.get('layoutData')[0].get('dataList')[0].get('name')

Star = app_json.get('layoutData')[0].get('dataList')[0].get('intro')

Downloads = app_json.get('layoutData')[0].get('dataList')[0].get('stars')

Price = app_json.get('layoutData')[3].get('dataList')[0].get('tariffDesc')

Version = app_json.get('layoutData')[3].get('dataList')[0].get('version')

Developer = app_json.get('layoutData')[3].get('dataList')[0].get('developer')

Description = app_json.get('layoutData')[7].get('dataList')[0].get('appIntro').replace('\n', '')

AppData = AppItem(

AppId=appid,

AppName=Name,

AppDesc=Description,

AppPrice=Price,

AppVersion=Version,

AppDeveloper=Developer,

AppStar=Star,

AppDownloads=Downloads

)

yield AppData

for pagenum in range(1, 20):

request_url = "https://web-drcn.hispace.dbank ... um%3D{}&maxResults=25&appid={}&version=10.0.0&zone=&locale=zh".format(

pagenum, appid)

yield scrapy.Request(url=request_url, callback=self.appcomment_parse, meta={'appid': appid})

解析json并构造请求

第8行通过json.loads将response解析成json格式,后面通过key-value和index访问里面的信息。

将数据保存在项目中

在items.py文件中定义好Item类后,就可以在这里新建一个Item对象,填入对应的值,将该item返回给pipeline.py进行处理。

# items.py

class AppItem(scrapy.Item):

AppId = scrapy.Field()

AppName = scrapy.Field()

AppDesc = scrapy.Field()

AppPrice = scrapy.Field()

AppVersion = scrapy.Field()

AppDeveloper = scrapy.Field()

AppStar = scrapy.Field()

AppDownloads = scrapy.Field()

yield 是 python 中的 关键词 。和return类似,它会让函数返回这个关键词修改的表达式的值。与return不同的是,yield在返回一个值后会继续执行下面的代码。,而 return 没有。

构造一个新的请求

为最后一行的所有评论列表构造一个新的request_url,获取评论信息,通过scrapy.Request发送请求,其中callback指定用于处理该请求响应的handler函数,meta收录你的想传递给回调函数的信息。

项目数据的处理

在爬取数据的过程中,处理函数会实时返回不同的item,交给pipeline处理。这时候就需要在pipeline.py中指定如何处理这些项。例如,这里我将所有数据记录在 csv 表中。必须在管道类中定义 process_item 函数来处理每个项目,并且 __init__ 和 close_spider 都是可选的。

class AppStorePipeline:

def __init__(self):

self.app_list = []

self.comment_list = []

def process_item(self, item, spider): # 接收到item时调用的函数

if isinstance(item, AppItem):

self.app_list.append(dict(item))

elif isinstance(item, CommentItem):

self.comment_list.append(dict(item))

return item

def close_spider(self, spider): # 当爬虫关闭时调用的函数

df_app = pd.DataFrame(self.app_list)

df_comment = pd.DataFrame(self.comment_list)

df_app.to_csv('app_info.csv')

df_comment.to_csv('comment_info.csv')

集搜客网页抓取软件(2.1.打开开发者工具在集搜客网络爬虫的浏览器中加载目标)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-01-14 15:08

2.1. 打开开发者工具

在 Jisoke 网络爬虫的浏览器中加载目标网页,然后同时按下 ctrl + shift + c 键,打开当前网页的开发者工具。与 Chrome 的开发者工具完全相同。

2.2. 分析消息包

选择网络选项卡将启用监听网络消息的功能。在浏览器中滚动页面会触发很多网络消息,如下图

关注xhr消息的类型,一般这种类型的消息是携带数据的。单击消息以查看详细内容。

如果需要 URL,请右键单击以从菜单中复制 URL:

第三步:设置抓包功能

在极速客网络爬虫的规则定义模式下,左侧栏会显示5个工作台,点击第5个选项卡,可以看到下图的内容:

勾选“捕获”显示一个输入框,输入要监控的URL,每行一个URL,在URL后面加通配符:*,可以监控多个相似的URL。通配符可以放在开头、中间和结尾,并且可以出现多个星号。例如

*

*

这意味着正在侦听两种类型的 URL。

第四步:运行爬虫并查看结果文件

4.1. 设置爬虫参数

一般参数可以适配大部分网站,个别网站有一些特点,需要设置爬虫参数来处理,比如携程网站,滚动速度要慢, 否则会跳过一些消息。如下图所示,将滚动速度设置为负数。数字越大,速度越慢。

它像普通的爬虫任务一样运行,详情请参阅“启动数据采集”。

打开一个原创的采集结果文件,可以看到更多的dumphttp字段,也就是被监控消息的内容。

第五步:采集 将结果转换为excel格式

采集结果转excel的方法和普通任务一样,请参考“Excel格式数据打包下载”。

被监控消息的内容往往是json格式的,那么随处可见excel文件的oResponseBody字段中的json内容。Jisouke的json存储工具可以进一步解析json内容,进一步将json内容转换成excel格式。

5.1. 过滤相同URL的消息内容

设置监控网址时,如果输入了多个网址,或者匹配规则非常广泛,则会监控多条消息内容。现在必须使用excel中的排序功能,对各个URL对应的内容进行分类。因为每种类型的json结构不同,需要进行分类,然后导入到极速客JSON入库工具中,否则会混淆不同类型的数据。

未完成 查看全部

集搜客网页抓取软件(2.1.打开开发者工具在集搜客网络爬虫的浏览器中加载目标)

2.1. 打开开发者工具

在 Jisoke 网络爬虫的浏览器中加载目标网页,然后同时按下 ctrl + shift + c 键,打开当前网页的开发者工具。与 Chrome 的开发者工具完全相同。

2.2. 分析消息包

选择网络选项卡将启用监听网络消息的功能。在浏览器中滚动页面会触发很多网络消息,如下图

关注xhr消息的类型,一般这种类型的消息是携带数据的。单击消息以查看详细内容。

如果需要 URL,请右键单击以从菜单中复制 URL:

第三步:设置抓包功能

在极速客网络爬虫的规则定义模式下,左侧栏会显示5个工作台,点击第5个选项卡,可以看到下图的内容:

勾选“捕获”显示一个输入框,输入要监控的URL,每行一个URL,在URL后面加通配符:*,可以监控多个相似的URL。通配符可以放在开头、中间和结尾,并且可以出现多个星号。例如

*

*

这意味着正在侦听两种类型的 URL。

第四步:运行爬虫并查看结果文件

4.1. 设置爬虫参数

一般参数可以适配大部分网站,个别网站有一些特点,需要设置爬虫参数来处理,比如携程网站,滚动速度要慢, 否则会跳过一些消息。如下图所示,将滚动速度设置为负数。数字越大,速度越慢。

它像普通的爬虫任务一样运行,详情请参阅“启动数据采集”。

打开一个原创的采集结果文件,可以看到更多的dumphttp字段,也就是被监控消息的内容。

第五步:采集 将结果转换为excel格式

采集结果转excel的方法和普通任务一样,请参考“Excel格式数据打包下载”。

被监控消息的内容往往是json格式的,那么随处可见excel文件的oResponseBody字段中的json内容。Jisouke的json存储工具可以进一步解析json内容,进一步将json内容转换成excel格式。

5.1. 过滤相同URL的消息内容

设置监控网址时,如果输入了多个网址,或者匹配规则非常广泛,则会监控多条消息内容。现在必须使用excel中的排序功能,对各个URL对应的内容进行分类。因为每种类型的json结构不同,需要进行分类,然后导入到极速客JSON入库工具中,否则会混淆不同类型的数据。

未完成

集搜客网页抓取软件(集搜客网页抓取软件只需要几步就可以)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-30 06:01

集搜客网页抓取软件,只需要几步就可以抓取某门类的网页信息,抓取速度很快,使用方便,

电子商务的类目很多,建议用curl/zseo/squid等工具从抓网页。

你可以用的都在这里了:网页数据抓取器

都是看分布情况。分布广的集搜客,分布少的通过浏览器地址栏搜,baiduyead等。

搜索引擎抓取第一步:1,打开百度第二步:打开搜索框,输入关键词第三步:如果需要更多,再把格式化。

python为例:集搜客json文件抓取autoajax爬虫数据分析squid抓取数据协议教程

automatedmultiplesitesandotheradditionalformats/internetpagegeneratorgithub-google/multiple:multiplesitesopengithub-foobarhub/multiple:multiplesitesopen。

前端抓包:fiddler

wordpress就是全开源的,而且也有抓取功能,这个是浏览器抓包中比较有名的工具。如果题主一定要用集搜客,建议:1,还是从源代码开始,直接看你的开发文档(或者查看localhost/api文档),清楚知道你想要什么功能。2,可以去公众号“集搜客”上看看,不过如果你是初学者不推荐这个,因为文档都很旧了,其他相关资料也挺差的。3,主要功能就是抓取国内的。 查看全部

集搜客网页抓取软件(集搜客网页抓取软件只需要几步就可以)

集搜客网页抓取软件,只需要几步就可以抓取某门类的网页信息,抓取速度很快,使用方便,

电子商务的类目很多,建议用curl/zseo/squid等工具从抓网页。

你可以用的都在这里了:网页数据抓取器

都是看分布情况。分布广的集搜客,分布少的通过浏览器地址栏搜,baiduyead等。

搜索引擎抓取第一步:1,打开百度第二步:打开搜索框,输入关键词第三步:如果需要更多,再把格式化。

python为例:集搜客json文件抓取autoajax爬虫数据分析squid抓取数据协议教程

automatedmultiplesitesandotheradditionalformats/internetpagegeneratorgithub-google/multiple:multiplesitesopengithub-foobarhub/multiple:multiplesitesopen。

前端抓包:fiddler

wordpress就是全开源的,而且也有抓取功能,这个是浏览器抓包中比较有名的工具。如果题主一定要用集搜客,建议:1,还是从源代码开始,直接看你的开发文档(或者查看localhost/api文档),清楚知道你想要什么功能。2,可以去公众号“集搜客”上看看,不过如果你是初学者不推荐这个,因为文档都很旧了,其他相关资料也挺差的。3,主要功能就是抓取国内的。

集搜客网页抓取软件(如何用免费ZBLOGCMS插件做到百万内容收录快速提升关键词排名 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-01-29 03:11

)

如何使用免费的ZBLOGcms插件实现百万内容收录快速提升排名关键词,增加流量。拥有数百万收录的网站,对于SEO人员来说是一件多么美妙的事情。最近有朋友给我发私信问我是怎么做到这么多网站100万收录的。今天小编就教大家如何赚一百万收录网站!

一、程序架构的选择

一个好的模板程序决定了网站的上限。不知道大家有没有分析过百万收录网站的特点。小编曾经收录没有达到一百万。之前每天都在分析别人的网站,最后练习一下如何赚百万收录,首先模板程序的选择是树形结构。什么是树形结构 网站 架构。通俗的讲就是首页-栏目列表-内容页,这样的三层栏目结构。通过对立柱进行细分,将原来的主干式柱子分解为支路式柱子。从而增加每个细分列的权重,增加收录的面积。为什么不选择平面结构。一旦扁平结构的内容过多,URL语义就会不明显。随着数据量的大幅增加,组织网站会变得困难,内部链也不容易做,权重转移也难以集中。因此,扁平结构适用于简单垂直的中小型网站。不适合百万收录 架构。

二、网站内容

网站内容一定要准确垂直,不能和垃圾站一模一样。网站垃圾站上各种内容都有。垃圾站虽然内容很多,但很容易被搜索引擎惩罚。所以我们在选择采集工具的时候,一定要选择关键词采集的文章,保证采集的内容100%与网站相关@>,并且必须选择可以批处理的工具采集。采集 的内容应尽量选择新闻来源。新闻源内容普遍较高,版面精美。信息真实,具有一定的公信力和权威性,也符合搜索引擎的收录标准。

三、页面伪原创内容伪原创

我们要伪原创 或改进页面原创 的内容来自采集,

伪原创:(伪原创 指的是重新处理 原创 的 文章 以便搜索引擎认为它是 原创文章@ >)

<p>页面伪原创:搜索引擎爬取页面是要爬取网页的所有信息,而不仅仅是文章,这时候我们可以使用一些其他的变量来增加页面原创程度!例如:标题插入品牌词或关键词(标题插入关键词合理增加网站关键词的密度,同时增加 查看全部

集搜客网页抓取软件(如何用免费ZBLOGCMS插件做到百万内容收录快速提升关键词排名

)

如何使用免费的ZBLOGcms插件实现百万内容收录快速提升排名关键词,增加流量。拥有数百万收录的网站,对于SEO人员来说是一件多么美妙的事情。最近有朋友给我发私信问我是怎么做到这么多网站100万收录的。今天小编就教大家如何赚一百万收录网站!

一、程序架构的选择

一个好的模板程序决定了网站的上限。不知道大家有没有分析过百万收录网站的特点。小编曾经收录没有达到一百万。之前每天都在分析别人的网站,最后练习一下如何赚百万收录,首先模板程序的选择是树形结构。什么是树形结构 网站 架构。通俗的讲就是首页-栏目列表-内容页,这样的三层栏目结构。通过对立柱进行细分,将原来的主干式柱子分解为支路式柱子。从而增加每个细分列的权重,增加收录的面积。为什么不选择平面结构。一旦扁平结构的内容过多,URL语义就会不明显。随着数据量的大幅增加,组织网站会变得困难,内部链也不容易做,权重转移也难以集中。因此,扁平结构适用于简单垂直的中小型网站。不适合百万收录 架构。

二、网站内容

网站内容一定要准确垂直,不能和垃圾站一模一样。网站垃圾站上各种内容都有。垃圾站虽然内容很多,但很容易被搜索引擎惩罚。所以我们在选择采集工具的时候,一定要选择关键词采集的文章,保证采集的内容100%与网站相关@>,并且必须选择可以批处理的工具采集。采集 的内容应尽量选择新闻来源。新闻源内容普遍较高,版面精美。信息真实,具有一定的公信力和权威性,也符合搜索引擎的收录标准。

三、页面伪原创内容伪原创

我们要伪原创 或改进页面原创 的内容来自采集,

伪原创:(伪原创 指的是重新处理 原创 的 文章 以便搜索引擎认为它是 原创文章@ >)

<p>页面伪原创:搜索引擎爬取页面是要爬取网页的所有信息,而不仅仅是文章,这时候我们可以使用一些其他的变量来增加页面原创程度!例如:标题插入品牌词或关键词(标题插入关键词合理增加网站关键词的密度,同时增加

集搜客网页抓取软件(深圳网站扶植搜客优化的设置和计划和设置计划)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-01-27 04:00

要想吸引蜘蛛经常爬你的网页,就得在网站建设的过程中和前期的管护中迎合搜索引擎的爱好,获得搜索引擎的青睐,让搜索引擎蜘蛛会爱上网站 的网站,经常来找你网站 抓取网页内容。在设计和构建网站时,要特别注意SEO优化的设置和规划。深圳网站支持Sooke认为要吸引蜘蛛爬你的网站页面,你必须做以下任务。

一、支持网站地图

构建网站maps的目的是为了方便搜索引擎蜘蛛抓取网页,是增加网站搜索引擎友好度的重要手段。网站Map 实际上是一个网页,一个指向所有网站 机架协商页面的特定链接列表。每次搜索引擎进入中集站主页,城市都会跟随网站地图。.

二、构建大量外部链接

有网站优化经验的都知道,像网站这样的搜索引擎PR值很高。@> 赞成并承认。发布大量的外链,尤其是高质量的外链,可以增加网站的PR值。

通常有一些方法可以建立外部链接。可以在各大服装论坛、社区、店铺或微博、博客上公布笔墨,或与其他权重较高的网站交换友情链接。去一些专业平台购买外链。在建立外部链接时,要注意尽可能在同行业或邻近行业的网站上发布外部链接。这样的外部链接对于提高我们的网站权重和关键词排名是最有意义的。

三、推广优质内容

搜索引擎喜欢你的网站主要是因为你的网站可以提供有价值的内容,所以当你在深圳建设和优化你的网站时,重点建设网站内容是网站优化的重点任务。不管是什么搜索引擎,都喜欢昂贵、高质量的网页内容,但百度更注重内容,而谷歌更注重外链。

让蜘蛛爬取你的 网站 上的页面并不是一举就能完成的事情。这需要很长时间的对抗。先让蜘蛛找到你的网站,再让蜘蛛习惯你的网站,这个原本让蜘蛛爱上你的网站。深圳网站通过大量长期优化理论支持搜客来证明,当你到达第一步时,往往你的网站关键词已经排在了很好的位置。网站构建不同于构建网站 框架。这是一个持久的过程。做好网站内容建设和外链建设,坚持网站的不变性。一个不错的排名。

这篇文章的位置:

深圳网站设计,网站建筑,企业网站开发,-苏克莱公告:如何吸引蜘蛛常来你网站爬网页? 查看全部

集搜客网页抓取软件(深圳网站扶植搜客优化的设置和计划和设置计划)

要想吸引蜘蛛经常爬你的网页,就得在网站建设的过程中和前期的管护中迎合搜索引擎的爱好,获得搜索引擎的青睐,让搜索引擎蜘蛛会爱上网站 的网站,经常来找你网站 抓取网页内容。在设计和构建网站时,要特别注意SEO优化的设置和规划。深圳网站支持Sooke认为要吸引蜘蛛爬你的网站页面,你必须做以下任务。

一、支持网站地图

构建网站maps的目的是为了方便搜索引擎蜘蛛抓取网页,是增加网站搜索引擎友好度的重要手段。网站Map 实际上是一个网页,一个指向所有网站 机架协商页面的特定链接列表。每次搜索引擎进入中集站主页,城市都会跟随网站地图。.

二、构建大量外部链接

有网站优化经验的都知道,像网站这样的搜索引擎PR值很高。@> 赞成并承认。发布大量的外链,尤其是高质量的外链,可以增加网站的PR值。

通常有一些方法可以建立外部链接。可以在各大服装论坛、社区、店铺或微博、博客上公布笔墨,或与其他权重较高的网站交换友情链接。去一些专业平台购买外链。在建立外部链接时,要注意尽可能在同行业或邻近行业的网站上发布外部链接。这样的外部链接对于提高我们的网站权重和关键词排名是最有意义的。

三、推广优质内容

搜索引擎喜欢你的网站主要是因为你的网站可以提供有价值的内容,所以当你在深圳建设和优化你的网站时,重点建设网站内容是网站优化的重点任务。不管是什么搜索引擎,都喜欢昂贵、高质量的网页内容,但百度更注重内容,而谷歌更注重外链。

让蜘蛛爬取你的 网站 上的页面并不是一举就能完成的事情。这需要很长时间的对抗。先让蜘蛛找到你的网站,再让蜘蛛习惯你的网站,这个原本让蜘蛛爱上你的网站。深圳网站通过大量长期优化理论支持搜客来证明,当你到达第一步时,往往你的网站关键词已经排在了很好的位置。网站构建不同于构建网站 框架。这是一个持久的过程。做好网站内容建设和外链建设,坚持网站的不变性。一个不错的排名。

这篇文章的位置:

深圳网站设计,网站建筑,企业网站开发,-苏克莱公告:如何吸引蜘蛛常来你网站爬网页?

集搜客网页抓取软件(一下三款常用的数据采集工具是什么?抓取到网页信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2022-01-26 19:07

如今,无论是工作还是学习,都少不了电脑的使用。互联网数据采集技术是现代信息采集技术体系的升级版,可以有效解决以往数据采集技术存在的问题。面临四大安全威胁。要建立完整的安全防护体系,必须从信息采集软件客户端、服务器和其他提供者等各个方面采取相应的技术措施。本篇文章,我将带领大家一起来看看常用的三种数据采集爬虫都有哪些?

我们可以在不编程的情况下抓取网页信息。下面介绍三种常用的爬虫工具。

优采云采集器,优采云采集器已有13年的历史,是老牌的采集工具,它不仅可以是爬虫,还可以data 用于清洗、数据分析、数据挖掘和可视化,数据源适用于大部分网页,网页上可以看到的内容可以通过采集规则进行抓取。优采云,优采云也是知名的采集工具,它有两个版本,一个是免费的采集模板,一个是云采集@ >(付费)。

免费的采集模板其实就是内容采集的规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,用起来很方便,当然,你也可以自己自定义任务,那么云采集是什么?也就是在配置采集任务的时候,可以将采集的任务交给优采云的云端。优采云 中共有 5,000 台服务器。通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

做过工程项目的同学应该能意识到cloud采集的功能实在是太方便了。在很多情况下,自动 IP 切换和云采集 是自动化采集 的关键。该工具的特点是完全可视化,无需编程,整个采集过程所见即所得,捕获结果信息、错误信息等都体现在软件。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取什么数据,流程细节完全由吉搜客处理,但吉搜客的缺点是没有云采集功能,所有爬虫都运行在用户的自己的电脑。

我们需要更多地了解现代技术,了解技术化的信息采集技术是非常有必要的。这篇文章文章介绍的关于数据采集的知识你了解吗?在下一篇文章中,我将详细介绍如何使用优采云。所以,我的朋友们,不要等待和期待它。 查看全部

集搜客网页抓取软件(一下三款常用的数据采集工具是什么?抓取到网页信息)

如今,无论是工作还是学习,都少不了电脑的使用。互联网数据采集技术是现代信息采集技术体系的升级版,可以有效解决以往数据采集技术存在的问题。面临四大安全威胁。要建立完整的安全防护体系,必须从信息采集软件客户端、服务器和其他提供者等各个方面采取相应的技术措施。本篇文章,我将带领大家一起来看看常用的三种数据采集爬虫都有哪些?

我们可以在不编程的情况下抓取网页信息。下面介绍三种常用的爬虫工具。

优采云采集器,优采云采集器已有13年的历史,是老牌的采集工具,它不仅可以是爬虫,还可以data 用于清洗、数据分析、数据挖掘和可视化,数据源适用于大部分网页,网页上可以看到的内容可以通过采集规则进行抓取。优采云,优采云也是知名的采集工具,它有两个版本,一个是免费的采集模板,一个是云采集@ >(付费)。

免费的采集模板其实就是内容采集的规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,用起来很方便,当然,你也可以自己自定义任务,那么云采集是什么?也就是在配置采集任务的时候,可以将采集的任务交给优采云的云端。优采云 中共有 5,000 台服务器。通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

做过工程项目的同学应该能意识到cloud采集的功能实在是太方便了。在很多情况下,自动 IP 切换和云采集 是自动化采集 的关键。该工具的特点是完全可视化,无需编程,整个采集过程所见即所得,捕获结果信息、错误信息等都体现在软件。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取什么数据,流程细节完全由吉搜客处理,但吉搜客的缺点是没有云采集功能,所有爬虫都运行在用户的自己的电脑。

我们需要更多地了解现代技术,了解技术化的信息采集技术是非常有必要的。这篇文章文章介绍的关于数据采集的知识你了解吗?在下一篇文章中,我将详细介绍如何使用优采云。所以,我的朋友们,不要等待和期待它。

集搜客网页抓取软件(1.阅读指引《连续动作应用场景(三)自动输入查询条件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-25 14:25

1. 阅读指南

《连续动作应用场景(三)自动输入查询条件微信公众号)》一文介绍了连续动作中自动输入查询条件的场景。抓取一些关键词的微信。为了达到爬取的目的,需要做以下步骤

进入一个入口页面,在查询条件输入框中自动输入关键词,自动点击提交按钮获取查询结果。如果查询结果分为多页,则翻页取回。如果定义规则关键词时定义了多个规则,则输入下一个关键词,返回第一步

本文解释了规则定义过程。如果某些流程与正常的规则定义流程相同,则跳过它们。

2. 选择入口页面

《连续动作应用场景(三)微信公众号查询条件自动输入》)一文认为定义两条采集规则比较合适:

第一条爬取规则:使用关键词搜索微信公众号,负责输入查询条件并点击提交按钮。该规则可以从以下地址下载: 第二条抓取规则:使用关键词搜索微信公众号_搜索结果,抓取搜索结果,如果有分页,翻页抓取。下载链接:

运行时,从第一条规则开始,会自动过渡到第二条规则。第一条规则使用的示例页面是入口页面。请注意,要实现连续输入,在选择示例页面时应注意。第一条规则和第二条规则使用的示例页面应该具有相同的结构。否则,输入第一条规则。当有两个关键词时,输入框和提交按钮将不会被定位。

3. 第一条规则的工作台

如上图所示,在一级爬取规则的爬虫路由工作台上,不定义翻页爬取规则,而是定义二级爬取规则。因为翻页是第二条规则的作用。因此,第一条规则侧重于定义连续动作。

输入第二条爬取规则的主题名,即使用关键词搜索微信公众号_搜索结果点击新建按钮创建第一个动作,即输入查询条件,所以选择输入类型. 再次单击 New 按钮创建第二个动作,即单击 Submit 按钮,因此选择提交类型。

最后,点击工具栏上的保存规则按钮,保存爬取规则。

4. 定义第二条规则

由于第一条规则与第二条规则的示例页面相同,因此如果立即定义第二条规则,则有两种选择:

或者选择“新建”菜单从头开始定义抓取规则;或者在现有工作台上修改现有规则,更改主题名称后保存。

上图是翻页和爬取规则的定义,和一般的规则定义没有区别,但是我们这里使用定点线索类型,也可以像标记线索一样翻页。

5. 加载之前定义的抓取规则

由于两条抓取规则使用的是同一个样本页面,当MS平台连续加载两条抓取规则时,第二条被中断,因为MS平台不允许加载相同样本页面的两条规则。. 在这种情况下,在加载第二个规则之前,在地址栏中输入 about:blank 并按 Enter 以在加载第二个规则之前清除浏览器。 查看全部

集搜客网页抓取软件(1.阅读指引《连续动作应用场景(三)自动输入查询条件)

1. 阅读指南

《连续动作应用场景(三)自动输入查询条件微信公众号)》一文介绍了连续动作中自动输入查询条件的场景。抓取一些关键词的微信。为了达到爬取的目的,需要做以下步骤

进入一个入口页面,在查询条件输入框中自动输入关键词,自动点击提交按钮获取查询结果。如果查询结果分为多页,则翻页取回。如果定义规则关键词时定义了多个规则,则输入下一个关键词,返回第一步

本文解释了规则定义过程。如果某些流程与正常的规则定义流程相同,则跳过它们。

2. 选择入口页面

《连续动作应用场景(三)微信公众号查询条件自动输入》)一文认为定义两条采集规则比较合适:

第一条爬取规则:使用关键词搜索微信公众号,负责输入查询条件并点击提交按钮。该规则可以从以下地址下载: 第二条抓取规则:使用关键词搜索微信公众号_搜索结果,抓取搜索结果,如果有分页,翻页抓取。下载链接:

运行时,从第一条规则开始,会自动过渡到第二条规则。第一条规则使用的示例页面是入口页面。请注意,要实现连续输入,在选择示例页面时应注意。第一条规则和第二条规则使用的示例页面应该具有相同的结构。否则,输入第一条规则。当有两个关键词时,输入框和提交按钮将不会被定位。

3. 第一条规则的工作台

如上图所示,在一级爬取规则的爬虫路由工作台上,不定义翻页爬取规则,而是定义二级爬取规则。因为翻页是第二条规则的作用。因此,第一条规则侧重于定义连续动作。

输入第二条爬取规则的主题名,即使用关键词搜索微信公众号_搜索结果点击新建按钮创建第一个动作,即输入查询条件,所以选择输入类型. 再次单击 New 按钮创建第二个动作,即单击 Submit 按钮,因此选择提交类型。

最后,点击工具栏上的保存规则按钮,保存爬取规则。

4. 定义第二条规则

由于第一条规则与第二条规则的示例页面相同,因此如果立即定义第二条规则,则有两种选择:

或者选择“新建”菜单从头开始定义抓取规则;或者在现有工作台上修改现有规则,更改主题名称后保存。

上图是翻页和爬取规则的定义,和一般的规则定义没有区别,但是我们这里使用定点线索类型,也可以像标记线索一样翻页。

5. 加载之前定义的抓取规则

由于两条抓取规则使用的是同一个样本页面,当MS平台连续加载两条抓取规则时,第二条被中断,因为MS平台不允许加载相同样本页面的两条规则。. 在这种情况下,在加载第二个规则之前,在地址栏中输入 about:blank 并按 Enter 以在加载第二个规则之前清除浏览器。

集搜客网页抓取软件(Python网络爬虫内容提取器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-24 14:18

1、简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2、提取动态内容的技术组件

上一篇python使用xslt提取网页数据,要提取的内容是直接从网页的源码中获取的。但是有些Ajax动态内容在源码中是找不到的,所以需要找到合适的程序库来加载异步或者动态加载的内容,交给本项目的抽取器进行抽取。

Python可以使用selenium来执行javascript,而selenium可以让浏览器自动加载页面并获取需要的数据。Selenium 没有自己的浏览器,可以使用第三方浏览器如 Firefox、Chrome 等,也可以使用 PhantomJS 等无头浏览器在后台执行。

3、源码和实验过程

假设我们要抓取京东手机页面的手机名称和价格(网页源码中找不到价格),如下图:

Step 1:利用吉搜科谋数个单元直观的标注功能,可以非常快速的自动生成调试好的抓取规则。其实就是一个标准的xslt程序,如下图,将生成的xslt程序复制到程序中的下面。注:本文仅记录实验过程。在实际系统中,将使用各种方法将 xslt 程序注入到内容提取器中。

第二步:执行以下代码(windows10下测试通过,python3.2,源码下载地址请参考文章末尾的GitHub),请注意:xslt是比较长的字符串,如果删除这个字符串,只有几行代码,足以看出Python的强大

#/usr/bin/python

from urllib import request

from lxml import etree

from selenium import webdriver

import time

# 京东手机商品页面

url = "http://item.jd.com/1312640.html"

# 下面的xslt是通过集搜客的谋数台图形界面自动生成的

xslt_root = etree.XML("""\

""")

# 使用webdriver.PhantomJS

browser = webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

transform = etree.XSLT(xslt_root)

# 执行js得到整个dom

html = browser.execute_script("return document.documentElement.outerHTML")

doc = etree.HTML(html)

# 用xslt从dom中提取需要的字段

result_tree = transform(doc)

print(result_tree)

第三步:如下图所示,网页中的手机名称和价格被正确抓取

4、继续阅读

至此,我们通过两篇文章文章演示了如何抓取静态和动态网页内容,均使用xslt一次性从网页中提取出需要的内容。事实上,xslt 是一种相对复杂的编程语言。如果你手动写xslt,那么最好写成离散的xpath。如果这个xslt不是手工写的,而是程序自动生成的,那是有道理的,程序员也不再需要花时间编写和调试抓取规则,这是一项非常耗时耗力的工作。下一篇《1分钟快速生成网页内容提取的xslt》将介绍如何生成xslt。

5、Jisooke GooSeeker开源代码下载源码

1. GooSeeker 开源 Python 网络爬虫 GitHub 源码

6、文档修改历史

2016-05-26:V2.0,添加文字说明

2016-05-29:V2.1,增加Chapter 5:源码下载源码,并替换github源码的URL 查看全部

集搜客网页抓取软件(Python网络爬虫内容提取器)

1、简介

在 Python 网络爬虫内容提取器一文中,我们详细讲解了核心组件:可插拔内容提取器类 gsExtractor。本文记录了在确定gsExtractor技术路线过程中所做的编程实验。这是第二部分。第一部分实验用xslt方法提取静态网页内容,一次性转换成xml格式。一个问题仍然存在:如何提取由 javascript 管理的动态内容?那么这篇文章就回答了这个问题。

2、提取动态内容的技术组件