输入关键字 抓取所有网页

输入关键字 抓取所有网页(一下百度关键字优化的主要决定因素有哪些?-八维教育)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-11-13 12:02

说起百度关键词,相信大家都不陌生。百度关键词是我们在使用百度时在搜索框中输入的字符。一般来说,它们是一个词汇。当然,也可以是一个词。我们通常把这个在百度搜索框中输入的字符串称为百度关键词。除了百度,其他任何搜索引擎的原理都是一样的。例如,在好搜、搜狗等搜索引擎中,我们在使用这些工具进行搜索时,需要使用关键字进行搜索。

当我们使用百度关键词进行搜索时,我们会发现搜索结果并不是一成不变的。我们每天在百度上检索的同一个关键词也是不同的。它可能会在很短的时间内。,这个区别不会太明显。如果每隔一个月用同一个关键词在百度上查询,再对比一下搜索结果,你会发现很多结果都不一样,这就涉及到百度关键词排名的问题了。

无论是百度、谷歌,还是好搜、搜狗,任何一个搜索引擎都会利用全网的当前数据,在用户使用某个关键词触发搜索引擎时,整合已经收录的网页的相关性和质量。搜索。排序,所以在一定的时间范围内,相同的关键字搜索结果不一定相同,因为在特定的时间段或特定的环境中,每个网页与关键字的相关性和网页内容的质量都有差异,这种差异是导致关键字查询结果前后排名的主要原因。

当然,关键词排名的决定因素不仅取决于相关性和内容质量,还取决于页面所在域的整体权重、页面评分以及网站服务器的响应速度. 所以关键词排名优化是一项复杂而漫长的任务。

今天我将重点介绍百度关键词优化的主要决定因素:

首先,我们要摒弃错误的外链概念,因为在过去的几十年里,很多人都依赖于为网站建立大量的外链来提高网站的曝光率在搜索引擎中提升了网站的基本排名。但是,随着搜索引擎越来越智能,互联网数据越来越多,目前的搜索引擎已经面临着大数据处理的问题,所以现在外部链接对网站关键词排名的决定非常薄弱。很多情况下,网站是因为不合理的建立了大量外链而被搜索引擎屏蔽。

所以,在接下来的几年里,我们在为网站做关键词排名的时候,一定要舍弃建外链的工作,或者把它控制在最小的程度,除了友情链接或者外链作为最后的手段。 . 另外,最好不要保留其他形式的外链。

其次,网站的虚拟主机或服务器的性能一定要好。这是许多网站 面临的问题。现在网上的网站越来越多了。最根本的原因之一就是建网站的成本是因为虚拟主机的成本越来越低。越来越少了,这么多个人和公司都有自己的事业网站。正是这些低价、低质量的虚拟主机,使得很多企业网站适时的拥有了非常好的产品,而原创的非常好的内容也无法被搜索引擎快速抓取,从而导致排名网站 关键字相对较少。

我们在做网站的时候,宁可花更多的钱,也要选择高性能、零故障的虚拟主机。不要为了临时便宜而使用低性能服务器。一方面,可以使用高性能服务器。让你的网站打开极快,提升网站的用户体验,同时可以承受搜索引擎爬虫对网站的多线程大规模爬取,让你的网站 网站的内容被搜索引擎收录更加勤快,关键词排名自然会更好。

最后,网站 内容质量一定要高。很多朋友都会问这个问题。毕竟什么样的网站内容才算是优质的网站内容。其实评价网站的内容是否属于优质内容是很重要的。简单的。一个内容是否是原创,是否可以回答访问者某个问题,是否可以帮助访问者理解某个专业概念,是否通俗易懂,以及满足这些条件的内容,则可以算是一个优质的原创内容。

以上三点足以决定一个网站百度关键词排名,而且很多情况下,如果我们的网站网站结构合理,网站的内部锚文本链接做得好,有可能你的每一篇网站文章文章或者每一个产品都能在搜索引擎上获得不错的排名。 查看全部

输入关键字 抓取所有网页(一下百度关键字优化的主要决定因素有哪些?-八维教育)

说起百度关键词,相信大家都不陌生。百度关键词是我们在使用百度时在搜索框中输入的字符。一般来说,它们是一个词汇。当然,也可以是一个词。我们通常把这个在百度搜索框中输入的字符串称为百度关键词。除了百度,其他任何搜索引擎的原理都是一样的。例如,在好搜、搜狗等搜索引擎中,我们在使用这些工具进行搜索时,需要使用关键字进行搜索。

当我们使用百度关键词进行搜索时,我们会发现搜索结果并不是一成不变的。我们每天在百度上检索的同一个关键词也是不同的。它可能会在很短的时间内。,这个区别不会太明显。如果每隔一个月用同一个关键词在百度上查询,再对比一下搜索结果,你会发现很多结果都不一样,这就涉及到百度关键词排名的问题了。

无论是百度、谷歌,还是好搜、搜狗,任何一个搜索引擎都会利用全网的当前数据,在用户使用某个关键词触发搜索引擎时,整合已经收录的网页的相关性和质量。搜索。排序,所以在一定的时间范围内,相同的关键字搜索结果不一定相同,因为在特定的时间段或特定的环境中,每个网页与关键字的相关性和网页内容的质量都有差异,这种差异是导致关键字查询结果前后排名的主要原因。

当然,关键词排名的决定因素不仅取决于相关性和内容质量,还取决于页面所在域的整体权重、页面评分以及网站服务器的响应速度. 所以关键词排名优化是一项复杂而漫长的任务。

今天我将重点介绍百度关键词优化的主要决定因素:

首先,我们要摒弃错误的外链概念,因为在过去的几十年里,很多人都依赖于为网站建立大量的外链来提高网站的曝光率在搜索引擎中提升了网站的基本排名。但是,随着搜索引擎越来越智能,互联网数据越来越多,目前的搜索引擎已经面临着大数据处理的问题,所以现在外部链接对网站关键词排名的决定非常薄弱。很多情况下,网站是因为不合理的建立了大量外链而被搜索引擎屏蔽。

所以,在接下来的几年里,我们在为网站做关键词排名的时候,一定要舍弃建外链的工作,或者把它控制在最小的程度,除了友情链接或者外链作为最后的手段。 . 另外,最好不要保留其他形式的外链。

其次,网站的虚拟主机或服务器的性能一定要好。这是许多网站 面临的问题。现在网上的网站越来越多了。最根本的原因之一就是建网站的成本是因为虚拟主机的成本越来越低。越来越少了,这么多个人和公司都有自己的事业网站。正是这些低价、低质量的虚拟主机,使得很多企业网站适时的拥有了非常好的产品,而原创的非常好的内容也无法被搜索引擎快速抓取,从而导致排名网站 关键字相对较少。

我们在做网站的时候,宁可花更多的钱,也要选择高性能、零故障的虚拟主机。不要为了临时便宜而使用低性能服务器。一方面,可以使用高性能服务器。让你的网站打开极快,提升网站的用户体验,同时可以承受搜索引擎爬虫对网站的多线程大规模爬取,让你的网站 网站的内容被搜索引擎收录更加勤快,关键词排名自然会更好。

最后,网站 内容质量一定要高。很多朋友都会问这个问题。毕竟什么样的网站内容才算是优质的网站内容。其实评价网站的内容是否属于优质内容是很重要的。简单的。一个内容是否是原创,是否可以回答访问者某个问题,是否可以帮助访问者理解某个专业概念,是否通俗易懂,以及满足这些条件的内容,则可以算是一个优质的原创内容。

以上三点足以决定一个网站百度关键词排名,而且很多情况下,如果我们的网站网站结构合理,网站的内部锚文本链接做得好,有可能你的每一篇网站文章文章或者每一个产品都能在搜索引擎上获得不错的排名。

输入关键字 抓取所有网页(【seo交流】网站优化时需要避免什么_知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-11-13 11:27

【seo交流】网站优化时要避免什么_知识

搜索引擎需要内容。网站提供的信息是有偏见的搜索引擎优化。我们要搞清楚什么是搜索引擎优化的基础。我们要把握三个关键点:抓取、索引和排序,但这只是基础优化,不是针对搜索引擎的内容服务,而是可以看作是客户实践发现的价值。内容对用户有帮助,搜索引擎会根据你网站上的用户使用自己的算法...

SEO关键词排名:增加网站的爬取频率,然后增加网站收录和关键词的排名。熟悉seo优化推广行业的人都知道网站爬取频率对网站关键词排名和收录的重要性。但是很多网站管理员在进行网站SEO优化的时候,总会遇到一些低频网站。这会影响网站的收录和关键词排名。那么如何提高爬取网站的频率呢?

1.页面加载速度

蜘蛛爬取网站的时候,很在意页面加载速度。一旦超过三秒,就很难抓取,所以大家一定要控制好页面的加载速度。

2.内容更新及原创

更新网站的内容时,大家尽量写原创sexual文章。百度将永远对内容的质量和稀缺性感到满意。

3.网站 结构

【电话】学习SEO真的有前途吗_知识

为什么这么多人/seozs/9790.html">对学习搜索引擎优化一头雾水?这可能是很多刚开始做搜索引擎优化的新手朋友经常问德皮,他们还没有进入搜索引擎优化做这个作业之前,首先考虑的是搜索引擎优化有没有出路,能不能赚钱,经过一段时间的学习...

在选择域名时,一定要找一个比较短的域名,并且一定要控制好第三级内的目录层次。如果太多,会影响蜘蛛的爬行。

4. 优质外链

只要是外链,不管它的质量如何,都会起到引导蜘蛛爬行的作用,所以我们尽量找一些优质的外链,比如友情链接,帮助我们快速收录。

5.主动提交

站点地图、官方API提交、JS访问提交等。

6、熊掌

如果一个网站有熊掌号,那么网站的各方面基本都不错,基本上是收录。

SEO关键词排名:增加网站的爬取频率,然后增加网站收录和关键词的排名。从某种角度来说,网站的爬取频率也说明了网站的一些问题。爬取频率越高,网站的质量越好,网站的用户流量有一定的基础,对用户的帮助越多,这类网站更受用户欢迎搜索引擎青睐,自然网站的关键词排名会更高。

小白seo优化软件可以这样正确学习seo

总结小白seo优化软件可以通过这种方式正确学习seo。小白可以通过这种方式学习搜索引擎优化。在学习搜索引擎优化之前,为了方便起见,他参加了很多搜索引擎优化学习小组,里面都是各大培训机构的招生对象。群,虽然广告多,但对于所谓的搜索引擎优化技巧还是埋伏;来自小白的seo优化软件可以通过这种方式正确学习... 查看全部

输入关键字 抓取所有网页(【seo交流】网站优化时需要避免什么_知识)

【seo交流】网站优化时要避免什么_知识

搜索引擎需要内容。网站提供的信息是有偏见的搜索引擎优化。我们要搞清楚什么是搜索引擎优化的基础。我们要把握三个关键点:抓取、索引和排序,但这只是基础优化,不是针对搜索引擎的内容服务,而是可以看作是客户实践发现的价值。内容对用户有帮助,搜索引擎会根据你网站上的用户使用自己的算法...

SEO关键词排名:增加网站的爬取频率,然后增加网站收录和关键词的排名。熟悉seo优化推广行业的人都知道网站爬取频率对网站关键词排名和收录的重要性。但是很多网站管理员在进行网站SEO优化的时候,总会遇到一些低频网站。这会影响网站的收录和关键词排名。那么如何提高爬取网站的频率呢?

1.页面加载速度

蜘蛛爬取网站的时候,很在意页面加载速度。一旦超过三秒,就很难抓取,所以大家一定要控制好页面的加载速度。

2.内容更新及原创

更新网站的内容时,大家尽量写原创sexual文章。百度将永远对内容的质量和稀缺性感到满意。

3.网站 结构

【电话】学习SEO真的有前途吗_知识

为什么这么多人/seozs/9790.html">对学习搜索引擎优化一头雾水?这可能是很多刚开始做搜索引擎优化的新手朋友经常问德皮,他们还没有进入搜索引擎优化做这个作业之前,首先考虑的是搜索引擎优化有没有出路,能不能赚钱,经过一段时间的学习...

在选择域名时,一定要找一个比较短的域名,并且一定要控制好第三级内的目录层次。如果太多,会影响蜘蛛的爬行。

4. 优质外链

只要是外链,不管它的质量如何,都会起到引导蜘蛛爬行的作用,所以我们尽量找一些优质的外链,比如友情链接,帮助我们快速收录。

5.主动提交

站点地图、官方API提交、JS访问提交等。

6、熊掌

如果一个网站有熊掌号,那么网站的各方面基本都不错,基本上是收录。

SEO关键词排名:增加网站的爬取频率,然后增加网站收录和关键词的排名。从某种角度来说,网站的爬取频率也说明了网站的一些问题。爬取频率越高,网站的质量越好,网站的用户流量有一定的基础,对用户的帮助越多,这类网站更受用户欢迎搜索引擎青睐,自然网站的关键词排名会更高。

小白seo优化软件可以这样正确学习seo

总结小白seo优化软件可以通过这种方式正确学习seo。小白可以通过这种方式学习搜索引擎优化。在学习搜索引擎优化之前,为了方便起见,他参加了很多搜索引擎优化学习小组,里面都是各大培训机构的招生对象。群,虽然广告多,但对于所谓的搜索引擎优化技巧还是埋伏;来自小白的seo优化软件可以通过这种方式正确学习...

输入关键字 抓取所有网页( 关键词一点时间来写下同你的站点有关的关键字)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-11-13 11:26

关键词一点时间来写下同你的站点有关的关键字)

使用组合形式

这与节省空间有关。一些引擎只检查 Meta关键词 列表中的前 250 个单词。为了更有效地利用这250个单词的空间,可以将两个关键词词组合二为一。例如,如果刚才提到的网站也提供瓶装矿泉水,他们可以使用“瓶装矿泉水龙头”,而不是单独使用“瓶装矿泉水”和“水龙头”。这样,当有人查询这两个词组时,这页面将被调用,这也节省了空间,从而为更多关键词腾出空间。

使用短语

一家大型搜索引擎最近的一份研究报告显示,超过 65% 的搜索是通过搜索词组而不是单词进行的。

每页强调不超过四个关键词

如果要收录更多,则会降低与所有关键词 的相关性,每个搜索引擎只会查看您页面的一部分。在这里我们也可以知道,网站的页面越多,你的整个网站可以收录的关键词就越多。现在,花点时间写下与您的网站相关的关键字。完成列表后,问问自己:“想要从我的网站中受益的人会对什么感兴趣?” 然后加上你的结论。向您的朋友和同事展示完成的列表,看看他们是否还有其他要添加的内容。

您还可以参加一个有趣的测验并向其他人提出这些问题,而无需向他们展示您的清单。询问尽可能多的人,然后比较他们的名单。出现次数最多的短语或词很可能是搜索引擎上“最常用”的关键词。

关键词技术

网络营销的目的是通过网络宣传公司的良好形象和优质的产品,寻找商机。网络营销的特点是成本低,但传播范围广,传播速度快。

-------------------------------------------------- ------------------------------

关键词 查询频率及竞争分析

使用某个关键字进行搜索。通常,您找到的结果越多,对该关键字的竞争就越大。但以下是例外因素:

1、 搜索结果不代表有这么多竞争对手。

2、 在相关搜索结果中,与搜索关键词真正相关的只能占总数的10%。

3、 在真正以优化搜索关键字为目标的 10% 中,可能只有 10%

搜索结果中显示的搜索结果越多,表示与您输入的关键字相关的搜索结果数量。比如我网站的关键词“搜索引擎优化信息”,结果有28900多条,虽然不是全部都是竞争对手。但另一方面,无形中给优化带来了困难,因为其中一些可能天生符合搜索引擎“优化”网站,比如高质量的链接。

最后要考虑的是与 关键词 相关联的辅助 关键词。

关键词技术

网络营销的目的是通过网络宣传公司的良好形象和优质的产品,寻找商机。网络营销的特点是成本低,但传播范围广,传播速度快。

-------------------------------------------------- ------------------------------

关键词网站的内部布局和关键词的密度

你的关键词在网页中的位置尽量好。至于每段是否有你的关键词,要看你的网页文字的长度。(有一些网站在代码前加一些关键词,这个方法对搜索引擎没用)。

如果正文中有大量超链接,每个链接文字都写成“点此查看……”,搜索引擎可能会误认为这大量“点此查看”是你的< @关键词 。因此,当一个页面有多个链接时,最好直接写链接标题,并使用不同的颜色或下划线来标记链接。

图片对搜索引擎来说是空白的。你可以在图片的代码中使用ALT标签,让它看起来更好看。在 ALT 属性中使用您的 关键词,搜索引擎通常可以抓取它们。

关键词 除了出现在标题中,还需要以一定的频率出现在整个网页中。您需要在标题、段落内容、页眉和页脚(文本内容的)、Alt 标签,甚至不显示的标签中排列 关键词。这些关键词不一定是一个,而是一组高度相关的词。对于谷歌,有分析表明,首页要求关键词的密度为7%到10%。另外,根据Addweb的研究,关键词在首页出现的频率是8到10次。

当然,在增加关键词的密度时一定要小心,使用一定的技巧而不是纯粹的关键词堆叠,否则你可能会被Google判为Spamming(作弊)并受到惩罚。

网络营销的目的是通过网络宣传公司的良好形象和优质的产品,寻找商机。网络营销的特点是成本低,但传播范围广,传播速度快。

-------------------------------------------------- ------------------------------

恶意关键词

这不是指垃圾邮件(Email Spamming)。如果某个关键字反复堆积在您的网页内容或 META 标签中,则称为恶意关键字(Keywords Spamming)。例如:亚特兰大酒店、亚特兰大餐厅、亚特兰大电影、亚特兰大公园、亚特兰大汽车旅馆、亚特兰大娱乐、亚特兰大赌博、亚特兰大...,搜索引擎会将它们视为恶意关键字,降低排名或删除网站。确切的说法是:亚特兰大的酒店、餐馆、亚特兰大的电影、公园、汽车旅馆、娱乐、赌博……

关键字密度是排名的重要因素。当然不能忽视,但最重要的还是内容。为了达到2%~8%的关键词密度,很多人特意在页面关键词中添加优化目标,以达到2%~8%的关键词密度。事实上,这样做有时会产生相反的效果。

在做网站的时候,内容最好是自创的,因为只有结合你的优化知识写出来的内容才是“最好”的内容。这取决于你的整体水平。评价一个页面内容是否合适,从两个方面考虑,一是页面内容的流畅度,二是关键词的密度。一个好的页面内容关键词的位置和频率,不仅不影响页面内容的流畅度,而且满足“最”优化的要求。 查看全部

输入关键字 抓取所有网页(

关键词一点时间来写下同你的站点有关的关键字)

使用组合形式

这与节省空间有关。一些引擎只检查 Meta关键词 列表中的前 250 个单词。为了更有效地利用这250个单词的空间,可以将两个关键词词组合二为一。例如,如果刚才提到的网站也提供瓶装矿泉水,他们可以使用“瓶装矿泉水龙头”,而不是单独使用“瓶装矿泉水”和“水龙头”。这样,当有人查询这两个词组时,这页面将被调用,这也节省了空间,从而为更多关键词腾出空间。

使用短语

一家大型搜索引擎最近的一份研究报告显示,超过 65% 的搜索是通过搜索词组而不是单词进行的。

每页强调不超过四个关键词

如果要收录更多,则会降低与所有关键词 的相关性,每个搜索引擎只会查看您页面的一部分。在这里我们也可以知道,网站的页面越多,你的整个网站可以收录的关键词就越多。现在,花点时间写下与您的网站相关的关键字。完成列表后,问问自己:“想要从我的网站中受益的人会对什么感兴趣?” 然后加上你的结论。向您的朋友和同事展示完成的列表,看看他们是否还有其他要添加的内容。

您还可以参加一个有趣的测验并向其他人提出这些问题,而无需向他们展示您的清单。询问尽可能多的人,然后比较他们的名单。出现次数最多的短语或词很可能是搜索引擎上“最常用”的关键词。

关键词技术

网络营销的目的是通过网络宣传公司的良好形象和优质的产品,寻找商机。网络营销的特点是成本低,但传播范围广,传播速度快。

-------------------------------------------------- ------------------------------

关键词 查询频率及竞争分析

使用某个关键字进行搜索。通常,您找到的结果越多,对该关键字的竞争就越大。但以下是例外因素:

1、 搜索结果不代表有这么多竞争对手。

2、 在相关搜索结果中,与搜索关键词真正相关的只能占总数的10%。

3、 在真正以优化搜索关键字为目标的 10% 中,可能只有 10%

搜索结果中显示的搜索结果越多,表示与您输入的关键字相关的搜索结果数量。比如我网站的关键词“搜索引擎优化信息”,结果有28900多条,虽然不是全部都是竞争对手。但另一方面,无形中给优化带来了困难,因为其中一些可能天生符合搜索引擎“优化”网站,比如高质量的链接。

最后要考虑的是与 关键词 相关联的辅助 关键词。

关键词技术

网络营销的目的是通过网络宣传公司的良好形象和优质的产品,寻找商机。网络营销的特点是成本低,但传播范围广,传播速度快。

-------------------------------------------------- ------------------------------

关键词网站的内部布局和关键词的密度

你的关键词在网页中的位置尽量好。至于每段是否有你的关键词,要看你的网页文字的长度。(有一些网站在代码前加一些关键词,这个方法对搜索引擎没用)。

如果正文中有大量超链接,每个链接文字都写成“点此查看……”,搜索引擎可能会误认为这大量“点此查看”是你的< @关键词 。因此,当一个页面有多个链接时,最好直接写链接标题,并使用不同的颜色或下划线来标记链接。

图片对搜索引擎来说是空白的。你可以在图片的代码中使用ALT标签,让它看起来更好看。在 ALT 属性中使用您的 关键词,搜索引擎通常可以抓取它们。

关键词 除了出现在标题中,还需要以一定的频率出现在整个网页中。您需要在标题、段落内容、页眉和页脚(文本内容的)、Alt 标签,甚至不显示的标签中排列 关键词。这些关键词不一定是一个,而是一组高度相关的词。对于谷歌,有分析表明,首页要求关键词的密度为7%到10%。另外,根据Addweb的研究,关键词在首页出现的频率是8到10次。

当然,在增加关键词的密度时一定要小心,使用一定的技巧而不是纯粹的关键词堆叠,否则你可能会被Google判为Spamming(作弊)并受到惩罚。

网络营销的目的是通过网络宣传公司的良好形象和优质的产品,寻找商机。网络营销的特点是成本低,但传播范围广,传播速度快。

-------------------------------------------------- ------------------------------

恶意关键词

这不是指垃圾邮件(Email Spamming)。如果某个关键字反复堆积在您的网页内容或 META 标签中,则称为恶意关键字(Keywords Spamming)。例如:亚特兰大酒店、亚特兰大餐厅、亚特兰大电影、亚特兰大公园、亚特兰大汽车旅馆、亚特兰大娱乐、亚特兰大赌博、亚特兰大...,搜索引擎会将它们视为恶意关键字,降低排名或删除网站。确切的说法是:亚特兰大的酒店、餐馆、亚特兰大的电影、公园、汽车旅馆、娱乐、赌博……

关键字密度是排名的重要因素。当然不能忽视,但最重要的还是内容。为了达到2%~8%的关键词密度,很多人特意在页面关键词中添加优化目标,以达到2%~8%的关键词密度。事实上,这样做有时会产生相反的效果。

在做网站的时候,内容最好是自创的,因为只有结合你的优化知识写出来的内容才是“最好”的内容。这取决于你的整体水平。评价一个页面内容是否合适,从两个方面考虑,一是页面内容的流畅度,二是关键词的密度。一个好的页面内容关键词的位置和频率,不仅不影响页面内容的流畅度,而且满足“最”优化的要求。

输入关键字 抓取所有网页( 如何利用python及免费资源进行基于论文关键词的研究趋势分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-11-12 05:08

如何利用python及免费资源进行基于论文关键词的研究趋势分析)

在学术研究中,往往需要了解某个领域的最新发展趋势,比如发现最热门、上升最快的关键词。一些学术服务网站,比如Web of Science,也提供了类似的服务,但是一些高校并没有订阅这些服务,在使用中难免会遇到各种问题,比如定制不够。在这个文章中,我们将在论文关键词的基础上讨论如何使用python和免费资源进行研究趋势分析。

入选期刊

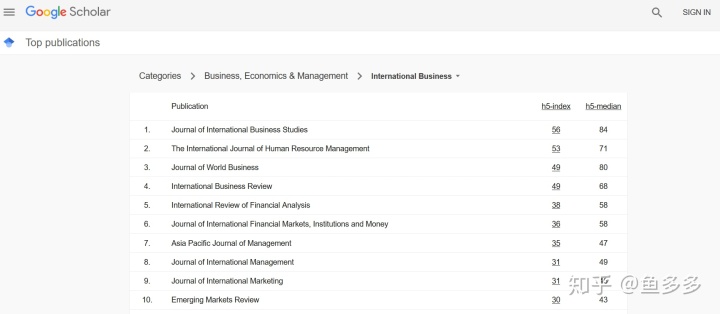

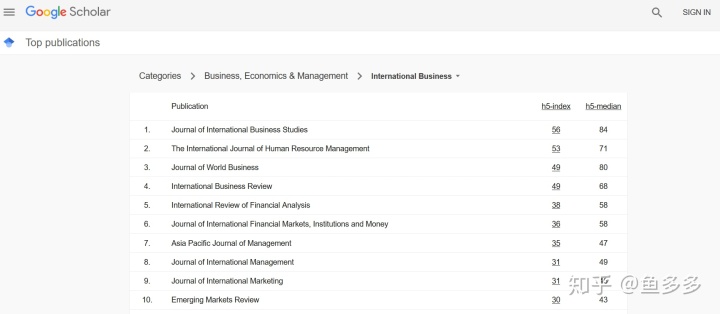

想知道近些年在国际商务领域发表的文章,在google中搜索“google学术期刊排名国际商务”,点击第一个链接,得到如下页面:

以排名第一的Journal of International Business Studies为例,展示如何抓取近年发表的所有文章信息。

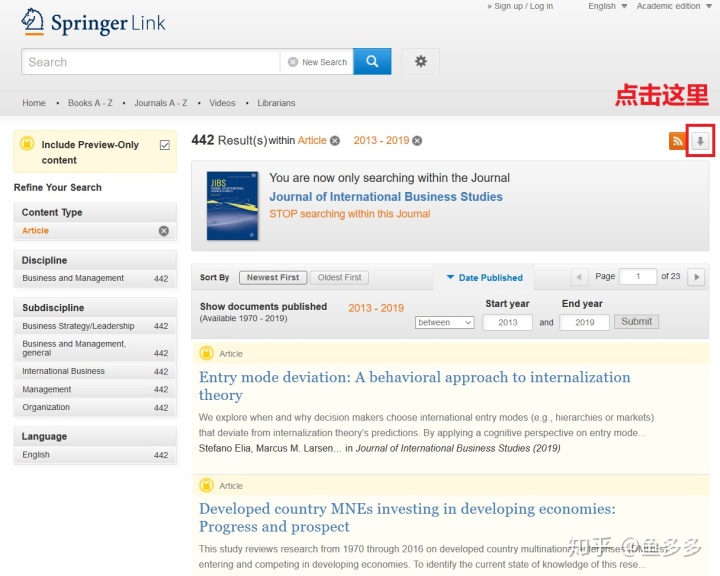

查找文章的列表

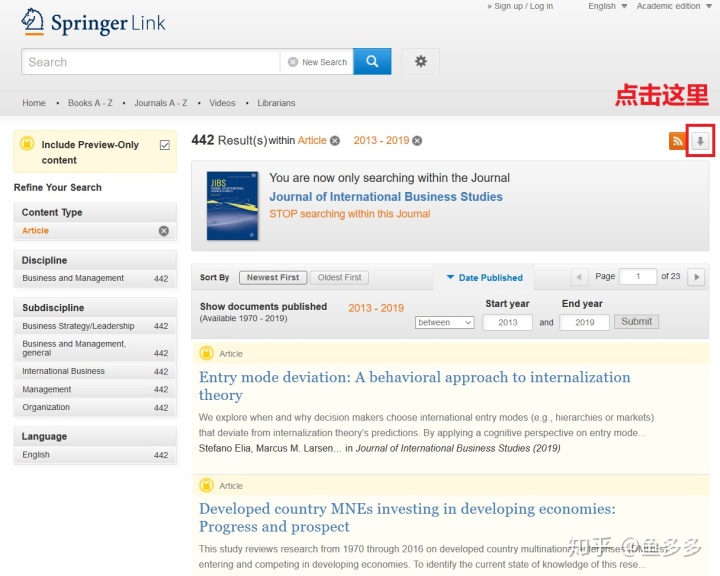

经过一番搜索,我找到了自 2013 年以来发表的所有 442 篇文章 文章 的列表:

点击图中红框内的按钮,将442条文章信息全部导出为CSV文件。

但是,文件中只收录了每个文章的项目标题、作者和URL,并没有关键词(关键词)和摘要(摘要)等重要信息。

接下来我们用python写一个循环,打开每篇文章的链接文章,抓取关键词和总结。

抓取网页元素

首先,我们定义了一个get_keywords_abstract()函数来抓取给定网页中的相关元素,代码如下:

import requests

from scrapy import Selector

def get_keywords_abstract(url):

r = requests.get(url) #打开网页

if r.status_code != 200: #如果网页连接错误,就返回空字符串

print("Connection error: {}".format(url))

return "", ""

selector = Selector(text=r.text)

keywords = selector.css('.Keyword::text').extract()

abstract = selector.css('#Abs1 p::text').extract_first()

return keywords, abstract

值得注意的是,我使用了scrapy库中的Selector类来解析网页。这样做的原因是,相对于 Beautiful Soup 和 Pyquery 等库,我更熟悉scrapy下css选择器的使用。

为了验证以上代码是否正确,我在命令行执行如下测试代码:

test_url = 'https://link.springer.com/arti ... 39%3B

keywords, abstract = get_keywords_abstract(test_url)

print(keywords)

print(abstract)

结果有点出人意料:

>>> print(keywords)

['entry modexa0', 'deviation from predictionxa0', 'internalization theoryxa0', 'bounded rationalityxa0', 'cognitive biasxa0']

>>> print(abstract)

'We explore when and why decision makers choose international entry modes (e.g., hierarchies or markets) that deviate from internalization theory’s predictions. By applying a cognitive perspective on entry mode decision making, we propose that the performance of prior international activities influences decision makers’ behavior in different ways than assumed in internalization theory. More specifically, due to a'

关键词 末尾有多余的字符。这不是什么大问题。您可以在后续处理中批量删除它们。真正的问题是摘要不完整。

在浏览器中打开测试网页,右键查看源码,在摘要中找到一些html标签,如:

...due to a representativeness bias , underperforming ...

正是这些 html 标签干扰了正常的文本抓取。

为了解决这个问题,我修改了get_keywords_abstract()函数:

import requests

from scrapy import Selector

def get_keywords_abstract(url):

r = requests.get(url) #打开网页

if r.status_code != 200: #如果网页连接错误,就返回空字符串

print("Connection error: {}".format(url))

return "", ""

selector = Selector(text=r.text)

keywords = selector.css('.Keyword::text').extract()

abstracts = selector.css('#Abs1 p::text').extract() #把extract_first()改成extract(),抓取所有的文本片段

abstract = ''.join(abstracts) #把文本片段连接起来

return keywords, abstract

重新运行测试代码,发现问题解决了。

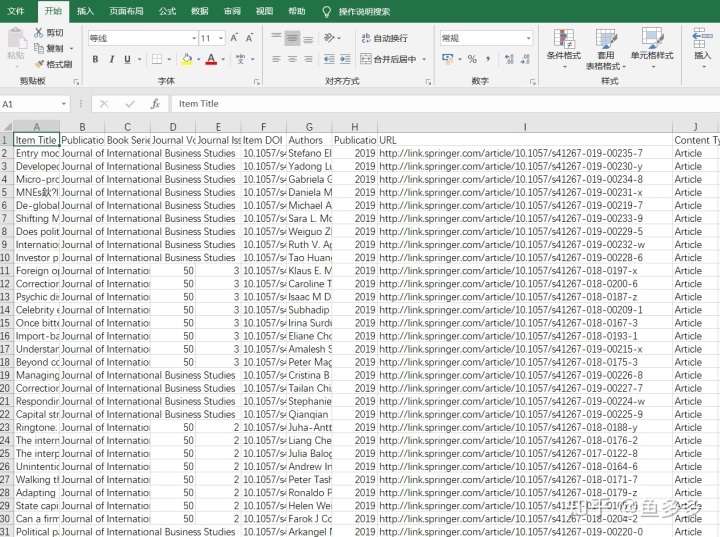

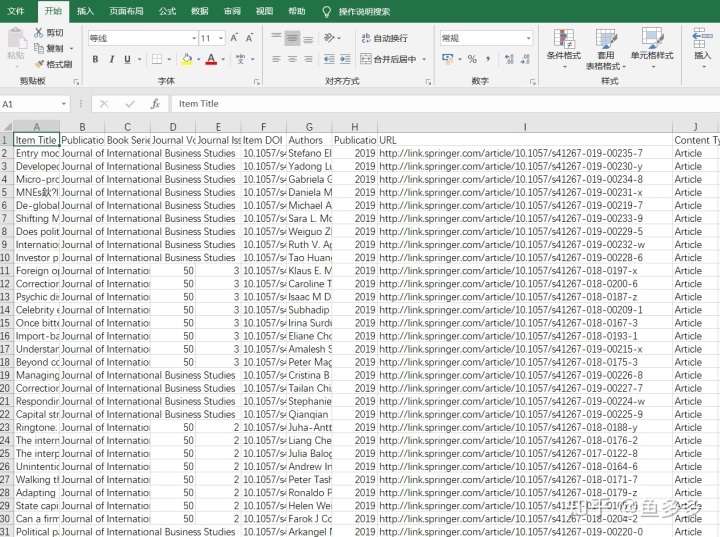

导入 CSV 文件

下一步是导入CSV文件中的URL列表,循环抓取关键词和summary。

导入 CSV 文件以使用 pandas 库:

import pandas as pd

articles = pd.read_csv('../data/jibs_articles.csv', sep=',')

type(articles) #

articles.shape # (442, 10)

articles.columns # 列名

articles.head() # 打印前5行

For 循环

确认一切无误后,循环开始:

urls = articles['URL']

keywords = pd.Series(index=articles.index)

abstract = pd.Series(index=articles.index)

for i, url in enumerate(urls):

keywords[i], abstract[i] = get_keywords_abstract(url)

print("Finish article: {}".format(i)) # 抓完一个网页就报一个数字,等的时候心里好过一些

等了大约20分钟后,我终于完成了捕获。只有一个 文章 打开错误。

保存到 CSV 文件

接下来,我们将关键词和summary整合到数据表中,然后保存到CSV文件中。

articles['keywords'] = keywords

articles['abstract'] = abstract

articles.columns # 数据表中增加了keywords和abstract两列

articles.to_csv('../data/jibs_keywords_abstract.csv', sep=',', header=True)

为了方便下次使用,我们“粘贴”一下数据:

import pickle

with open("../data/articles.pickle", "wb") as f:

pickle.dump(articles, f)

下一次,我们将讨论基于关键词的研究趋势分析。 查看全部

输入关键字 抓取所有网页(

如何利用python及免费资源进行基于论文关键词的研究趋势分析)

在学术研究中,往往需要了解某个领域的最新发展趋势,比如发现最热门、上升最快的关键词。一些学术服务网站,比如Web of Science,也提供了类似的服务,但是一些高校并没有订阅这些服务,在使用中难免会遇到各种问题,比如定制不够。在这个文章中,我们将在论文关键词的基础上讨论如何使用python和免费资源进行研究趋势分析。

入选期刊

想知道近些年在国际商务领域发表的文章,在google中搜索“google学术期刊排名国际商务”,点击第一个链接,得到如下页面:

以排名第一的Journal of International Business Studies为例,展示如何抓取近年发表的所有文章信息。

查找文章的列表

经过一番搜索,我找到了自 2013 年以来发表的所有 442 篇文章 文章 的列表:

点击图中红框内的按钮,将442条文章信息全部导出为CSV文件。

但是,文件中只收录了每个文章的项目标题、作者和URL,并没有关键词(关键词)和摘要(摘要)等重要信息。

接下来我们用python写一个循环,打开每篇文章的链接文章,抓取关键词和总结。

抓取网页元素

首先,我们定义了一个get_keywords_abstract()函数来抓取给定网页中的相关元素,代码如下:

import requests

from scrapy import Selector

def get_keywords_abstract(url):

r = requests.get(url) #打开网页

if r.status_code != 200: #如果网页连接错误,就返回空字符串

print("Connection error: {}".format(url))

return "", ""

selector = Selector(text=r.text)

keywords = selector.css('.Keyword::text').extract()

abstract = selector.css('#Abs1 p::text').extract_first()

return keywords, abstract

值得注意的是,我使用了scrapy库中的Selector类来解析网页。这样做的原因是,相对于 Beautiful Soup 和 Pyquery 等库,我更熟悉scrapy下css选择器的使用。

为了验证以上代码是否正确,我在命令行执行如下测试代码:

test_url = 'https://link.springer.com/arti ... 39%3B

keywords, abstract = get_keywords_abstract(test_url)

print(keywords)

print(abstract)

结果有点出人意料:

>>> print(keywords)

['entry modexa0', 'deviation from predictionxa0', 'internalization theoryxa0', 'bounded rationalityxa0', 'cognitive biasxa0']

>>> print(abstract)

'We explore when and why decision makers choose international entry modes (e.g., hierarchies or markets) that deviate from internalization theory’s predictions. By applying a cognitive perspective on entry mode decision making, we propose that the performance of prior international activities influences decision makers’ behavior in different ways than assumed in internalization theory. More specifically, due to a'

关键词 末尾有多余的字符。这不是什么大问题。您可以在后续处理中批量删除它们。真正的问题是摘要不完整。

在浏览器中打开测试网页,右键查看源码,在摘要中找到一些html标签,如:

...due to a representativeness bias , underperforming ...

正是这些 html 标签干扰了正常的文本抓取。

为了解决这个问题,我修改了get_keywords_abstract()函数:

import requests

from scrapy import Selector

def get_keywords_abstract(url):

r = requests.get(url) #打开网页

if r.status_code != 200: #如果网页连接错误,就返回空字符串

print("Connection error: {}".format(url))

return "", ""

selector = Selector(text=r.text)

keywords = selector.css('.Keyword::text').extract()

abstracts = selector.css('#Abs1 p::text').extract() #把extract_first()改成extract(),抓取所有的文本片段

abstract = ''.join(abstracts) #把文本片段连接起来

return keywords, abstract

重新运行测试代码,发现问题解决了。

导入 CSV 文件

下一步是导入CSV文件中的URL列表,循环抓取关键词和summary。

导入 CSV 文件以使用 pandas 库:

import pandas as pd

articles = pd.read_csv('../data/jibs_articles.csv', sep=',')

type(articles) #

articles.shape # (442, 10)

articles.columns # 列名

articles.head() # 打印前5行

For 循环

确认一切无误后,循环开始:

urls = articles['URL']

keywords = pd.Series(index=articles.index)

abstract = pd.Series(index=articles.index)

for i, url in enumerate(urls):

keywords[i], abstract[i] = get_keywords_abstract(url)

print("Finish article: {}".format(i)) # 抓完一个网页就报一个数字,等的时候心里好过一些

等了大约20分钟后,我终于完成了捕获。只有一个 文章 打开错误。

保存到 CSV 文件

接下来,我们将关键词和summary整合到数据表中,然后保存到CSV文件中。

articles['keywords'] = keywords

articles['abstract'] = abstract

articles.columns # 数据表中增加了keywords和abstract两列

articles.to_csv('../data/jibs_keywords_abstract.csv', sep=',', header=True)

为了方便下次使用,我们“粘贴”一下数据:

import pickle

with open("../data/articles.pickle", "wb") as f:

pickle.dump(articles, f)

下一次,我们将讨论基于关键词的研究趋势分析。

输入关键字 抓取所有网页(是不是的访问明细获取及对应的入口页面的关键词 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-11-11 21:14

)

前面我们介绍了搜索关键词以及通过cnzz的访问详情获得的对应入口页面,但是BD搜索的关键词无法完全显示,只能显示部分bd图片搜索关键词@ . >,这是因为百度自去年5月宣布逐步取消referer关键词展示,保护网站流量关键词数据信息,第三方将无法再轻易窃取流量关键词 @> ,使网站数据更加私密。当站长需要获取网站流量关键词时,可以使用百度站长平台提供的搜索工具或百度统计相关功能进行查询。这是否意味着有点垄断?没办法,国内的市场份额是有的。当然,您也可以针对其他搜索引擎做特殊优化。从统计数据来看,ytkah博客的访问者最多的是搜狗,其次是360搜索,第三是谷歌,第四是必应,第五是站点搜索,如下图,bd没有进入前五名都没有高排名因素,也可能有referer原因。当然,这些数据不代表其他博主的运营数据。

回到本文的主题,如何从统计中批量获取BD搜索关键词及对应的入口页面?进入百度统计实时访客功能页面,右上角有个下载按钮,可以批量获取,但要注意只能保存最近5000次(2016.@ >07.19更新,本来只有500次)访客访问详情,如果你的网站访问量很大,你需要每隔几个小时,甚至每隔几分钟下载一次,我不'不知道会不会是高级版,所以有时候需要部署多个统计代码。

查看全部

输入关键字 抓取所有网页(是不是的访问明细获取及对应的入口页面的关键词

)

前面我们介绍了搜索关键词以及通过cnzz的访问详情获得的对应入口页面,但是BD搜索的关键词无法完全显示,只能显示部分bd图片搜索关键词@ . >,这是因为百度自去年5月宣布逐步取消referer关键词展示,保护网站流量关键词数据信息,第三方将无法再轻易窃取流量关键词 @> ,使网站数据更加私密。当站长需要获取网站流量关键词时,可以使用百度站长平台提供的搜索工具或百度统计相关功能进行查询。这是否意味着有点垄断?没办法,国内的市场份额是有的。当然,您也可以针对其他搜索引擎做特殊优化。从统计数据来看,ytkah博客的访问者最多的是搜狗,其次是360搜索,第三是谷歌,第四是必应,第五是站点搜索,如下图,bd没有进入前五名都没有高排名因素,也可能有referer原因。当然,这些数据不代表其他博主的运营数据。

回到本文的主题,如何从统计中批量获取BD搜索关键词及对应的入口页面?进入百度统计实时访客功能页面,右上角有个下载按钮,可以批量获取,但要注意只能保存最近5000次(2016.@ >07.19更新,本来只有500次)访客访问详情,如果你的网站访问量很大,你需要每隔几个小时,甚至每隔几分钟下载一次,我不'不知道会不会是高级版,所以有时候需要部署多个统计代码。

输入关键字 抓取所有网页(可以gmail邮箱给亚马逊发信,直接从visa回中国)

网站优化 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2021-11-11 17:07

输入关键字抓取所有网页。或者手机刷新页面、改input或者改个releasetogmail或facebook帐号啥的。当然前提是你想知道哪些网页有这些releasetogmail或facebook帐号。

howtosendyourresumetofacebook?tofacebookandtogoogle,pleasesendyourfullresumeto:meetyourgmailaccountandhelpmore:sendyourfullresumetoeverygmailaccountwhenyou'redonethistopickyourworkfromcitieslikela,andtoyourgoogleaccount:tofacebookandgoogle,pleasesendyourfullresumeto:meetyourgmailaccountandhelpmore:sendyourfullresumetoeverygmailaccountwhenyou'redonethistopickyourworkfromcitieslikela,andtoyourgoogleaccount:。

很简单我也想问

看了所有的答案。通过sendfacebookurlborrowing来实现。

题主去facebook上点开你想要发邮件的帖子,然后按某个feature(比如subject)往后翻,还有这个选项会列出你所发送的feature的收件人名单,里面一定有supporting的人。把所有的supporting给transfer回中国,

题主去了看了所有答案都没有一个靠谱的办法!之前看微博上有说谷歌账号可以转gmail邮箱,正好微信也能收到跨国短信,就试了一下,搞定了!我的是smartcard,在visa的信息里可以有发信邮箱,直接从visa发信就行!可以gmail邮箱给亚马逊发信,发给亚马逊的时候如果正常过滤的话,还会自动切换到gmail邮箱。 查看全部

输入关键字 抓取所有网页(可以gmail邮箱给亚马逊发信,直接从visa回中国)

输入关键字抓取所有网页。或者手机刷新页面、改input或者改个releasetogmail或facebook帐号啥的。当然前提是你想知道哪些网页有这些releasetogmail或facebook帐号。

howtosendyourresumetofacebook?tofacebookandtogoogle,pleasesendyourfullresumeto:meetyourgmailaccountandhelpmore:sendyourfullresumetoeverygmailaccountwhenyou'redonethistopickyourworkfromcitieslikela,andtoyourgoogleaccount:tofacebookandgoogle,pleasesendyourfullresumeto:meetyourgmailaccountandhelpmore:sendyourfullresumetoeverygmailaccountwhenyou'redonethistopickyourworkfromcitieslikela,andtoyourgoogleaccount:。

很简单我也想问

看了所有的答案。通过sendfacebookurlborrowing来实现。

题主去facebook上点开你想要发邮件的帖子,然后按某个feature(比如subject)往后翻,还有这个选项会列出你所发送的feature的收件人名单,里面一定有supporting的人。把所有的supporting给transfer回中国,

题主去了看了所有答案都没有一个靠谱的办法!之前看微博上有说谷歌账号可以转gmail邮箱,正好微信也能收到跨国短信,就试了一下,搞定了!我的是smartcard,在visa的信息里可以有发信邮箱,直接从visa发信就行!可以gmail邮箱给亚马逊发信,发给亚马逊的时候如果正常过滤的话,还会自动切换到gmail邮箱。

输入关键字 抓取所有网页(一个更正常的网站如何改善文章的包含?与优化)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-11-11 14:14

#支付宝公众号asp开发介绍

我这里说的老网站不是那种已经用了十多年的网站。据说,在被搜索引擎收录后,网站已经过了新站的保护期。如果文章不收录文章中的问题,有很多情况。比如网站做错事,就会被搜索引擎惩罚;例如,如果更新频率不稳定,则更喜欢,不喜欢则不会更多;比如文章的内容就是那种烂牙,标题不变。互联网上有数十万个文章或数千万个这样的内容。我们今天不是在谈论惩罚,因为这个估计必须在另一篇文章文章中公开。一个比较正常的网站如何提高文章的收录?首先,我们来看看为什么搜索引擎每天都会收录这么多内容?搜索引擎也是一种互联网产品。它也是基于用户体验来运作的,所以作为一个搜索引擎,它必须采集大量的文章提供给搜索用户,让用户在这里得到他们想要的信息。对于收录的页面,搜索引擎是基于用户的角度,就像一些娱乐热点新闻一样,因为那天或者这个时候,用户非常关心这个事件,经常搜索这个东西或者这个角色,在这期间期间,如果更新与此事相关或文章与内部字符相关的内容将更容易被收录。

今天,大多数网站需要分析和优化网站数据。那么网站应该优化什么?下面我们来看看政府网站数据的分析优化和网站优化的分析。政府网站数据分析与优化一、网站优化网站 优化可以分为两个主要部分,分别是内部和外部,然后再简化,无非是内部文章更新和站点外的链接。本站也相当于空网站的内容,网站的根已经建立。内部链接也可以理解为网站的内部链接,让更多的网站可以提供到我们网站的链接。不仅起到了宣传的作用,但这也让网站的排名失去了进步。其实,如果你真的想做搜索引擎优化,远没有那么复杂。如果网站优化这么复杂,你很快就学会了,一个小时就可以完成。2、网站数据分析网站网站的数据分析通过观察、调查、实验、测量等数据展示形式体现了网站的方方面面,使操作者能够更好的理解网站的操作,调整网站的操作策略。网站。网站数据分析是围绕客户进行的,公司各个部门需要的数据不同。高级管理人员希望了解宏观数据以促进战略调整;中层管理人员想了解一些微观数据,以促进项目控制和短期战术规划;营销部想知道哪些广告可以带来有价值的客户;编辑部想知道哪些用户喜欢文章;部门了解用户经常购买的产品,对这些数据有更合理的安排。

三、分析网站优化数据的哪些方面?1. 做好竞争对手的SEO优化数据分析。这是网站基于SEO优化的数据分析最重要的部分。因为我们是做SEO优化的,所以我们的终极目标是超越竞争对手,成为行业领先者网站。因此,了解竞争对手网站的SEO优化数据极为重要。一般本节所涉及的数据包括网站采集的数据。外链来源及数量数据、关键词类别及相关关键词排名。充分理解这些内容,优化完善你的网站,进行相应的数据观察,做记录,甚至制作函数曲线,了解你的网站在哪里 需要改进和加强。2.跟踪SEO基础数据。这是需要长期工作才能进行网站数据分析的内容。而且,需要对这些数据进行数据图转换。例如,对于短期数据的纳入,需要进行中长期演进,以获得优化纳入时需要注意的问题。还包括长期跟踪栏目,跟踪外链数量等。3.关键词分析。需要跟踪网站的关键词、排名数和转化率,并做好记录,通过SPSS统计软件进行统计分析,检查是否具有统计显着性。当然还有很多专业人士网站 可以提供相应的信息。软件工具辅助统计分析,掌握关键词计数和转化率的趋势和发展,从而有效提升数据分析能力,为网站SEO优化提供参考。4. 加强日志分析。

日志分析自然是网站数据的首要任务。登录网站可以清晰记录百度蜘蛛的爬取情况,了解百度蜘蛛对网站内容的兴趣,对优化网站内容具有重要意义。此外,您还可以通过网站日志了解百度蜘蛛在网站上遇到的链接和断链情况,从而进行相应的优化,避免网站中大量链接带来的优化风险@网站 。5、做好网站的流量分析。除了日常流量中必须关注的IP数、PV值等指标外,还需要了解流量的来源渠道。例如,虽然一些网站流量增加了,不是因为百度搜索引擎转化了流量。也就是说,网站的排名没有提升,网站的优化效果还不够好。所以用流量分析来全面掌握网站优化。政府网站数据分析与优化据估计,通过小编的介绍,了解了政府网站数据分析与优化以及网站优化分析。我希望我能帮助你。数据分析与优化据估计,通过小编的介绍,了解了政府网站数据的分析与优化,以及网站优化的分析。我希望我能帮助你。数据分析与优化据估计,通过小编的介绍,了解了政府网站数据的分析与优化,以及网站优化的分析。我希望我能帮助你。 查看全部

输入关键字 抓取所有网页(一个更正常的网站如何改善文章的包含?与优化)

#支付宝公众号asp开发介绍

我这里说的老网站不是那种已经用了十多年的网站。据说,在被搜索引擎收录后,网站已经过了新站的保护期。如果文章不收录文章中的问题,有很多情况。比如网站做错事,就会被搜索引擎惩罚;例如,如果更新频率不稳定,则更喜欢,不喜欢则不会更多;比如文章的内容就是那种烂牙,标题不变。互联网上有数十万个文章或数千万个这样的内容。我们今天不是在谈论惩罚,因为这个估计必须在另一篇文章文章中公开。一个比较正常的网站如何提高文章的收录?首先,我们来看看为什么搜索引擎每天都会收录这么多内容?搜索引擎也是一种互联网产品。它也是基于用户体验来运作的,所以作为一个搜索引擎,它必须采集大量的文章提供给搜索用户,让用户在这里得到他们想要的信息。对于收录的页面,搜索引擎是基于用户的角度,就像一些娱乐热点新闻一样,因为那天或者这个时候,用户非常关心这个事件,经常搜索这个东西或者这个角色,在这期间期间,如果更新与此事相关或文章与内部字符相关的内容将更容易被收录。

今天,大多数网站需要分析和优化网站数据。那么网站应该优化什么?下面我们来看看政府网站数据的分析优化和网站优化的分析。政府网站数据分析与优化一、网站优化网站 优化可以分为两个主要部分,分别是内部和外部,然后再简化,无非是内部文章更新和站点外的链接。本站也相当于空网站的内容,网站的根已经建立。内部链接也可以理解为网站的内部链接,让更多的网站可以提供到我们网站的链接。不仅起到了宣传的作用,但这也让网站的排名失去了进步。其实,如果你真的想做搜索引擎优化,远没有那么复杂。如果网站优化这么复杂,你很快就学会了,一个小时就可以完成。2、网站数据分析网站网站的数据分析通过观察、调查、实验、测量等数据展示形式体现了网站的方方面面,使操作者能够更好的理解网站的操作,调整网站的操作策略。网站。网站数据分析是围绕客户进行的,公司各个部门需要的数据不同。高级管理人员希望了解宏观数据以促进战略调整;中层管理人员想了解一些微观数据,以促进项目控制和短期战术规划;营销部想知道哪些广告可以带来有价值的客户;编辑部想知道哪些用户喜欢文章;部门了解用户经常购买的产品,对这些数据有更合理的安排。

三、分析网站优化数据的哪些方面?1. 做好竞争对手的SEO优化数据分析。这是网站基于SEO优化的数据分析最重要的部分。因为我们是做SEO优化的,所以我们的终极目标是超越竞争对手,成为行业领先者网站。因此,了解竞争对手网站的SEO优化数据极为重要。一般本节所涉及的数据包括网站采集的数据。外链来源及数量数据、关键词类别及相关关键词排名。充分理解这些内容,优化完善你的网站,进行相应的数据观察,做记录,甚至制作函数曲线,了解你的网站在哪里 需要改进和加强。2.跟踪SEO基础数据。这是需要长期工作才能进行网站数据分析的内容。而且,需要对这些数据进行数据图转换。例如,对于短期数据的纳入,需要进行中长期演进,以获得优化纳入时需要注意的问题。还包括长期跟踪栏目,跟踪外链数量等。3.关键词分析。需要跟踪网站的关键词、排名数和转化率,并做好记录,通过SPSS统计软件进行统计分析,检查是否具有统计显着性。当然还有很多专业人士网站 可以提供相应的信息。软件工具辅助统计分析,掌握关键词计数和转化率的趋势和发展,从而有效提升数据分析能力,为网站SEO优化提供参考。4. 加强日志分析。

日志分析自然是网站数据的首要任务。登录网站可以清晰记录百度蜘蛛的爬取情况,了解百度蜘蛛对网站内容的兴趣,对优化网站内容具有重要意义。此外,您还可以通过网站日志了解百度蜘蛛在网站上遇到的链接和断链情况,从而进行相应的优化,避免网站中大量链接带来的优化风险@网站 。5、做好网站的流量分析。除了日常流量中必须关注的IP数、PV值等指标外,还需要了解流量的来源渠道。例如,虽然一些网站流量增加了,不是因为百度搜索引擎转化了流量。也就是说,网站的排名没有提升,网站的优化效果还不够好。所以用流量分析来全面掌握网站优化。政府网站数据分析与优化据估计,通过小编的介绍,了解了政府网站数据分析与优化以及网站优化分析。我希望我能帮助你。数据分析与优化据估计,通过小编的介绍,了解了政府网站数据的分析与优化,以及网站优化的分析。我希望我能帮助你。数据分析与优化据估计,通过小编的介绍,了解了政府网站数据的分析与优化,以及网站优化的分析。我希望我能帮助你。

输入关键字 抓取所有网页(新浪微博爬取爬取微博启动和遇到bug怎么办?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-11-11 12:18

该项目的主要功能是每天通过微博的“搜索”页面自动抓取自定义列表中所有收录词汇的微博原创数据。低速可控,简单粗暴,适用于含有关键词的微博有针对性的采集,每天可以抓取3万到6万条。

但是后来我发现新浪其实也有这个API,只是隐藏的很深。当我发现爬虫已经写完了,所以我流下了眼泪。

:(

さぁ、始めよう~

阐明

基于python 2

在 email_info.py 中添加您自己的电子邮件地址、密码和接收电子邮件地址

sina_crawler.py 开头替换自己的关键词列表

日期格式转码和计算方法都在function.py文件中

项目介绍

这个项目没有UI,虽然很简陋,但是我写的第一个爬虫是因为它可以运行

本项目可以24小时不间断运行,获取更完整的微博抓取

当开始爬取微博遇到bug时,会发邮件给你

将获取的JSON数据写入txt,按文件夹&文件名进行管理

对获取到的JSON数据的后续处理,请参见python处理微博JSON数据示例

跑步

获取的微博JSON数据按照发起请求的日期存放在对应的文件夹中。WBTestdata>04-12.

微博资料夹

每页 JSON 收录十个微博数据(一般)。每次返回的JSON单调存储在一个txt中,命名规则为“国名”+“日期”+“页码”。

微博数据命名规则

数据样本

您可以使用在线 JSON 结构化工具进行审核

JSON 数据结构

项目背景

新浪微博每个客户端都提供了“搜索”功能,可以获取收录关键词的微博,一般默认按照发帖顺序从新到旧显示。

这里我们的目标页面是移动版的新浪微博(因为结构简单,加载的微博数据直接返回为JSON文件,方便获取)

例如搜索关键词为德国时,页面显示如下:

图像.png

打开开发者工具,选择网络--XHR,然后向下滚动页面,直到加载新的微博,您会发现以下链接:

图像.png

点击预览:

预览

没错,这就是我们的目标数据——每当用户滚动到底部时,都会通过这个链接返回十条JSON格式的新微博。

我们来看看这个链接的格式:

%E5%BE%B7%E5%9B%BD&featurecode=20000320&luicode=10000011&lfid=106003type%3D1&title=%E5%BE%B7%E5%9B%BD&containerid=100103type%3D1%B7%Eq 9B%BD&page=2

解码网址。事实上,它等价于:

德国&featurecode=20000320&luicode=10000011&lfid=106003type%3D1&title=Germany&containerid=100103type%3D1%26q%3DGermany&page=1%26q%3D%E5% BE%B7%Bdpage

关键信息一目了然,即queryVal=Germany,page=1。根据这个规则,我们可以构建目标链接进行数据爬取。

新浪的这个JSON数据就是所谓的一页(1页),每次返回大约10条微博记录,但有时会少于10条。记录。

代码结构

首先介绍请求导入请求

定义标题以伪装浏览器

# 为爬虫添加标题

headers = {'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6'}

添加要检索的关键字列表

# 添加到您的搜索列表中!

search_list = [“所罗门群岛”、“斯洛伐克”、“贝宁”、]

......

将中文关键词转码为URL,方便后期搭建链接

# 根据您提供的单词列表创建 url 编码的搜索列表

urlencoded_search_list = url_encoding(search_list)

urls = create_url_list(urlencoded_search_list)

写个while:1个循环执行不停的操作,每个循环执行当天的任务。

我设定的当天任务是:

从开始搜索的page1开始继续向后搜索,获取每页最后一条微博的创建时间。如果这个微博是在两天内创建的,那么我们会继续检索页面,直到页面中的最。老的微博是两天前创建的。这时候,停止搜索这个词,继续下一个词

这样做的原因是,新浪似乎并没有按照创建时间的顺序真正返回所有微博。两次检索同时获得的10条微博之间可能存在若干差异。微博越老,新浪返回的时间间隔越长——比如,假设用户创建微博的速度是稳定的。搜索收录关键词AAA的,page1有10条微博,都是5分钟内创建的,间隔几秒,但是查看100页时,10条微博可能间隔几个小时——这绝对是不科学的。

这限制了我们在爬微博的时候从新到旧,并且限制了不能爬太多页面(因为旧数据太稀疏,价值会降低),并且最好重叠搜索一段时间,所以我创建了上面的规则,让日常任务实际上是【72小时内发布的微博】,让时间上的重叠可以得到越来越完整的“老”微博。

在while循环内

给自己发送一封电子邮件,提醒您程序已启动

根据日期创建每日数据文件夹

列表中每一个关键词从page=1开始搜索,获取一个页面,写一个页面,同时获取每个页面最后一条微博的创建时间,判断是否停止搜索

4.完成所有关键词搜索后,给自己发邮件提醒你今天的任务已经完成

打印一些数据信息,写日记,计算你需要睡多久(确保每天在同一时间开始任务,以减少额外的未知错误) 查看全部

输入关键字 抓取所有网页(新浪微博爬取爬取微博启动和遇到bug怎么办?)

该项目的主要功能是每天通过微博的“搜索”页面自动抓取自定义列表中所有收录词汇的微博原创数据。低速可控,简单粗暴,适用于含有关键词的微博有针对性的采集,每天可以抓取3万到6万条。

但是后来我发现新浪其实也有这个API,只是隐藏的很深。当我发现爬虫已经写完了,所以我流下了眼泪。

:(

さぁ、始めよう~

阐明

基于python 2

在 email_info.py 中添加您自己的电子邮件地址、密码和接收电子邮件地址

sina_crawler.py 开头替换自己的关键词列表

日期格式转码和计算方法都在function.py文件中

项目介绍

这个项目没有UI,虽然很简陋,但是我写的第一个爬虫是因为它可以运行

本项目可以24小时不间断运行,获取更完整的微博抓取

当开始爬取微博遇到bug时,会发邮件给你

将获取的JSON数据写入txt,按文件夹&文件名进行管理

对获取到的JSON数据的后续处理,请参见python处理微博JSON数据示例

跑步

获取的微博JSON数据按照发起请求的日期存放在对应的文件夹中。WBTestdata>04-12.

微博资料夹

每页 JSON 收录十个微博数据(一般)。每次返回的JSON单调存储在一个txt中,命名规则为“国名”+“日期”+“页码”。

微博数据命名规则

数据样本

您可以使用在线 JSON 结构化工具进行审核

JSON 数据结构

项目背景

新浪微博每个客户端都提供了“搜索”功能,可以获取收录关键词的微博,一般默认按照发帖顺序从新到旧显示。

这里我们的目标页面是移动版的新浪微博(因为结构简单,加载的微博数据直接返回为JSON文件,方便获取)

例如搜索关键词为德国时,页面显示如下:

图像.png

打开开发者工具,选择网络--XHR,然后向下滚动页面,直到加载新的微博,您会发现以下链接:

图像.png

点击预览:

预览

没错,这就是我们的目标数据——每当用户滚动到底部时,都会通过这个链接返回十条JSON格式的新微博。

我们来看看这个链接的格式:

%E5%BE%B7%E5%9B%BD&featurecode=20000320&luicode=10000011&lfid=106003type%3D1&title=%E5%BE%B7%E5%9B%BD&containerid=100103type%3D1%B7%Eq 9B%BD&page=2

解码网址。事实上,它等价于:

德国&featurecode=20000320&luicode=10000011&lfid=106003type%3D1&title=Germany&containerid=100103type%3D1%26q%3DGermany&page=1%26q%3D%E5% BE%B7%Bdpage

关键信息一目了然,即queryVal=Germany,page=1。根据这个规则,我们可以构建目标链接进行数据爬取。

新浪的这个JSON数据就是所谓的一页(1页),每次返回大约10条微博记录,但有时会少于10条。记录。

代码结构

首先介绍请求导入请求

定义标题以伪装浏览器

# 为爬虫添加标题

headers = {'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6'}

添加要检索的关键字列表

# 添加到您的搜索列表中!

search_list = [“所罗门群岛”、“斯洛伐克”、“贝宁”、]

......

将中文关键词转码为URL,方便后期搭建链接

# 根据您提供的单词列表创建 url 编码的搜索列表

urlencoded_search_list = url_encoding(search_list)

urls = create_url_list(urlencoded_search_list)

写个while:1个循环执行不停的操作,每个循环执行当天的任务。

我设定的当天任务是:

从开始搜索的page1开始继续向后搜索,获取每页最后一条微博的创建时间。如果这个微博是在两天内创建的,那么我们会继续检索页面,直到页面中的最。老的微博是两天前创建的。这时候,停止搜索这个词,继续下一个词

这样做的原因是,新浪似乎并没有按照创建时间的顺序真正返回所有微博。两次检索同时获得的10条微博之间可能存在若干差异。微博越老,新浪返回的时间间隔越长——比如,假设用户创建微博的速度是稳定的。搜索收录关键词AAA的,page1有10条微博,都是5分钟内创建的,间隔几秒,但是查看100页时,10条微博可能间隔几个小时——这绝对是不科学的。

这限制了我们在爬微博的时候从新到旧,并且限制了不能爬太多页面(因为旧数据太稀疏,价值会降低),并且最好重叠搜索一段时间,所以我创建了上面的规则,让日常任务实际上是【72小时内发布的微博】,让时间上的重叠可以得到越来越完整的“老”微博。

在while循环内

给自己发送一封电子邮件,提醒您程序已启动

根据日期创建每日数据文件夹

列表中每一个关键词从page=1开始搜索,获取一个页面,写一个页面,同时获取每个页面最后一条微博的创建时间,判断是否停止搜索

4.完成所有关键词搜索后,给自己发邮件提醒你今天的任务已经完成

打印一些数据信息,写日记,计算你需要睡多久(确保每天在同一时间开始任务,以减少额外的未知错误)

输入关键字 抓取所有网页(URLExtractor软件功能网址器有时的应用方法介绍及方法)

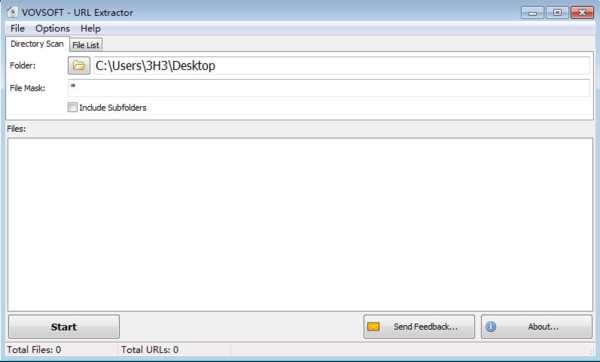

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-11-10 04:10

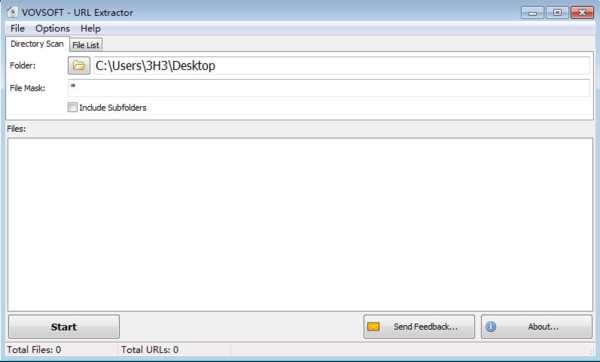

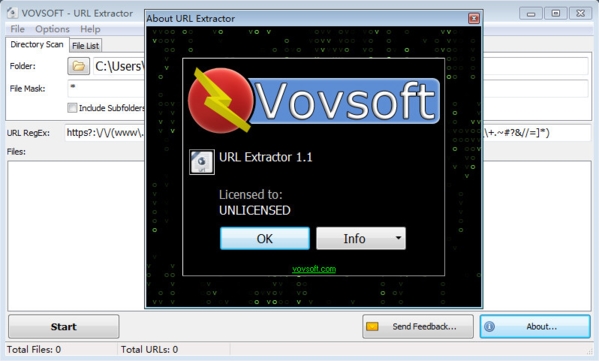

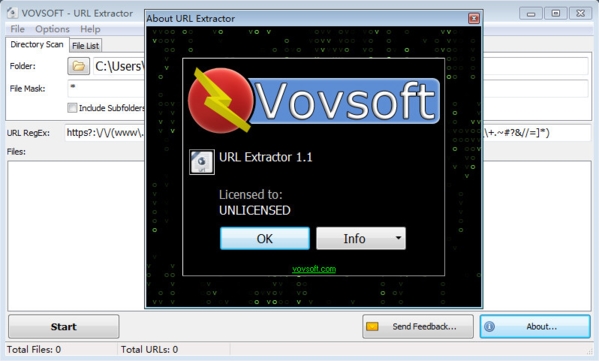

URL Extractor 是一个 URL 链接提取工具,可以帮助用户从指定对象中提取 URL。该软件可以提取网址和链接,通过软件浏览所有文件夹,然后从文件夹中抓取相应的网页链接。. 如果手动从文件夹中提取网页链接,是一件非常费时费力的事情,软件可以帮你轻松实现。

软件功能

网址爬虫

有时我们需要从文件和文件夹中获取所有 URL(统一资源定位器)。浏览所有文件夹并抓取网络链接可能是一项艰巨的任务。幸运的是,当您需要 URL 抓取软件时,Vovsoft URL Extractor 可以在这方面为您提供帮助。

链接提取器

Vovsoft URL Extractor 是可以采集 http 和 https 网址的最佳程序之一。您可以在几秒钟内从文件中提取和恢复所有 URL。安装后,您几乎可以立即启动应用程序并开始搜索链接。你只需要提供一个目录,剩下的由程序来处理。

该软件会扫描整个文件夹以查找收录 URL 的文件,并将它们全部显示在其主窗口中,从而允许您将列表导出到文件中。所有选项都清晰简单,并且都可以放在一个窗口界面中。您需要做的就是选择您希望应用程序分析的文件夹,然后按“开始”按钮。Vovsoft URL Extractor 还具有文件掩码和对正则表达式的支持,以帮助您过滤文件和 URL。

软件特点

1、 支持提取邮箱地址、网址、ftp地址、提要、telnet、本地文件url等。

2、 拥有全新的现代引擎,采用最新的可可和objective-c 2.0 技术。它永远不会冻结,甚至可以通过搜索引擎使用数百个关键字采集数千个 URL。

3、可以在其表格中导入和导出用于导航和提取的“URL”和“关键字”。使用一个非常好的和改进的导入引擎,可以自动识别导入的格式,在导入内容的选择上有很大的灵活性。

4、 从磁盘(文件和文件夹)的无限数量的源中提取 URL 和电子邮件,并浏览任何指定文件夹和子文件夹的所有内容。可以在几秒钟内从数千个文件中提取。源列表接受文件和文件夹的拖放。

5、 从您指定的 网站 列表中提取来自网络的 URL 和电子邮件。它开始提取您需要的 URL,在无休止的导航过程继续浏览在线找到的站点链接后,它会根据需要采集 URL 或电子邮件。

6、 从关键字列表中提取 Internet 上的 URL 和电子邮件。

它使用您指定的搜索引擎上提供的关键字列表,然后开始寻找相关的网站,然后使用相关的网站开始导航,同时跟踪找到的链接并采集所有的URL或电子邮件. 提供了几个关键字,它可以提取相关(关键字)URL 和电子邮件数小时。

7、使用 Bing 和 Google(18 个不同的 Google 区域网站:.com .it .fr.au .uk .de 和 .es .ar .au .at .be .br .ca. fi . nl .se .ch)。您可以使用指定的搜索引擎在 Internet 上进行无限制的搜索。

8、 支持从 safari 和其他网络浏览器中接受拖放 URL 以将它们用作从网络中提取的种子。

9、 支持多个选项:“单域提取”只从指定的网站中提取而不跳转到链接的网站或“深度导航”指定从站点的哪个级别跳转到链接用于搜索和提取的站点。

10、PDF提取,支持从本地或在线pdf文件中提取。如果它在线找到一个 PDF 并且它收录一个网页地址,它甚至可以跳转到该地址并继续搜索和提取网页。

更新日志

URL 提取器 1.1

2021 年 8 月 28 日

“目录扫描”和“文件列表”选项卡的实现

添加了“删除重复项”按钮

添加了“包括子文件夹”选项

修复了“文件掩码”错误

支持拖放

改进的用户界面 查看全部

输入关键字 抓取所有网页(URLExtractor软件功能网址器有时的应用方法介绍及方法)

URL Extractor 是一个 URL 链接提取工具,可以帮助用户从指定对象中提取 URL。该软件可以提取网址和链接,通过软件浏览所有文件夹,然后从文件夹中抓取相应的网页链接。. 如果手动从文件夹中提取网页链接,是一件非常费时费力的事情,软件可以帮你轻松实现。

软件功能

网址爬虫

有时我们需要从文件和文件夹中获取所有 URL(统一资源定位器)。浏览所有文件夹并抓取网络链接可能是一项艰巨的任务。幸运的是,当您需要 URL 抓取软件时,Vovsoft URL Extractor 可以在这方面为您提供帮助。

链接提取器

Vovsoft URL Extractor 是可以采集 http 和 https 网址的最佳程序之一。您可以在几秒钟内从文件中提取和恢复所有 URL。安装后,您几乎可以立即启动应用程序并开始搜索链接。你只需要提供一个目录,剩下的由程序来处理。

该软件会扫描整个文件夹以查找收录 URL 的文件,并将它们全部显示在其主窗口中,从而允许您将列表导出到文件中。所有选项都清晰简单,并且都可以放在一个窗口界面中。您需要做的就是选择您希望应用程序分析的文件夹,然后按“开始”按钮。Vovsoft URL Extractor 还具有文件掩码和对正则表达式的支持,以帮助您过滤文件和 URL。

软件特点

1、 支持提取邮箱地址、网址、ftp地址、提要、telnet、本地文件url等。

2、 拥有全新的现代引擎,采用最新的可可和objective-c 2.0 技术。它永远不会冻结,甚至可以通过搜索引擎使用数百个关键字采集数千个 URL。

3、可以在其表格中导入和导出用于导航和提取的“URL”和“关键字”。使用一个非常好的和改进的导入引擎,可以自动识别导入的格式,在导入内容的选择上有很大的灵活性。

4、 从磁盘(文件和文件夹)的无限数量的源中提取 URL 和电子邮件,并浏览任何指定文件夹和子文件夹的所有内容。可以在几秒钟内从数千个文件中提取。源列表接受文件和文件夹的拖放。

5、 从您指定的 网站 列表中提取来自网络的 URL 和电子邮件。它开始提取您需要的 URL,在无休止的导航过程继续浏览在线找到的站点链接后,它会根据需要采集 URL 或电子邮件。

6、 从关键字列表中提取 Internet 上的 URL 和电子邮件。

它使用您指定的搜索引擎上提供的关键字列表,然后开始寻找相关的网站,然后使用相关的网站开始导航,同时跟踪找到的链接并采集所有的URL或电子邮件. 提供了几个关键字,它可以提取相关(关键字)URL 和电子邮件数小时。

7、使用 Bing 和 Google(18 个不同的 Google 区域网站:.com .it .fr.au .uk .de 和 .es .ar .au .at .be .br .ca. fi . nl .se .ch)。您可以使用指定的搜索引擎在 Internet 上进行无限制的搜索。

8、 支持从 safari 和其他网络浏览器中接受拖放 URL 以将它们用作从网络中提取的种子。

9、 支持多个选项:“单域提取”只从指定的网站中提取而不跳转到链接的网站或“深度导航”指定从站点的哪个级别跳转到链接用于搜索和提取的站点。

10、PDF提取,支持从本地或在线pdf文件中提取。如果它在线找到一个 PDF 并且它收录一个网页地址,它甚至可以跳转到该地址并继续搜索和提取网页。

更新日志

URL 提取器 1.1

2021 年 8 月 28 日

“目录扫描”和“文件列表”选项卡的实现

添加了“删除重复项”按钮

添加了“包括子文件夹”选项

修复了“文件掩码”错误

支持拖放

改进的用户界面

输入关键字 抓取所有网页(取词的网站用vbs写上如何评价知乎的智能?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-11-06 22:04

输入关键字抓取所有网页,然后二次翻译(不需要理解每个关键字的意思)然后合并。不会的话可以先把下面的取词的网站用vbs写上如何评价知乎的智能?-张艾轩的回答,但依旧如上所示这种东西一天也就学个1%是拿不出手的。但是需要注意的是,这种问题真的没必要去找专业的翻译人员来做。不同人对英语的水平不同,思考方式也不同,各抒己见最终的结果反而会是不伦不类。在这里你就是需要拿着翻译出来的文字去推敲整篇文章的内容,如果你想看看这个人的思路,最好亲自去问一下。

难道不是最简单的stackoverflow或jsoup吗?至于你说的在线翻译工具,它只支持你中文,如果你是图片而来,可以使用“图片翻译”功能,很简单,翻译完成后上传到百度网盘,然后就自动解析到各个网站了。

anytime,anywhere。

我觉得有关键字问题的最简单的办法是自己用百度翻译或者谷歌翻译。

martinjohnson亲说的那位神人太棒了,

我能想到的是用snownlp,这个本质上跟sphinx差不多,但是速度快,

snli翻译非常快!去试试!不过你应该要会英语!

sciencedirect,但是如果要练习翻译的话,

textwrangler

youtube机器翻译

谷歌翻译吧 查看全部

输入关键字 抓取所有网页(取词的网站用vbs写上如何评价知乎的智能?)

输入关键字抓取所有网页,然后二次翻译(不需要理解每个关键字的意思)然后合并。不会的话可以先把下面的取词的网站用vbs写上如何评价知乎的智能?-张艾轩的回答,但依旧如上所示这种东西一天也就学个1%是拿不出手的。但是需要注意的是,这种问题真的没必要去找专业的翻译人员来做。不同人对英语的水平不同,思考方式也不同,各抒己见最终的结果反而会是不伦不类。在这里你就是需要拿着翻译出来的文字去推敲整篇文章的内容,如果你想看看这个人的思路,最好亲自去问一下。

难道不是最简单的stackoverflow或jsoup吗?至于你说的在线翻译工具,它只支持你中文,如果你是图片而来,可以使用“图片翻译”功能,很简单,翻译完成后上传到百度网盘,然后就自动解析到各个网站了。

anytime,anywhere。

我觉得有关键字问题的最简单的办法是自己用百度翻译或者谷歌翻译。

martinjohnson亲说的那位神人太棒了,

我能想到的是用snownlp,这个本质上跟sphinx差不多,但是速度快,

snli翻译非常快!去试试!不过你应该要会英语!

sciencedirect,但是如果要练习翻译的话,

textwrangler

youtube机器翻译

谷歌翻译吧

输入关键字 抓取所有网页(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-06 03:17

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。功能介绍 点击界面 WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!自动模式检测 WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。

可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。为了通过代理服务器匿名抓取,防止网络爬虫软件被网络服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。类别提取WebHarvyWebScraper 允许您从链接列表中获取数据,从而在网站 中产生类似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。正则表达式 WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。运行 JavaScript 在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。下载图片可以下载图片或提取图片网址。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。自动浏览器交互 WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。更新日志修复了连接可能在以下情况下被禁用的问题页面启动。您可以为寻呼模式配置专用的连接方式。可以自动搜索可以在 HTML 上配置的资源。增加了在键盘上向下滚动下一页的功能。添加了通过 Java 脚本加载下一页。增加了URL配置功能。您可以在列表中输入关键字进行 2 次搜索。 查看全部

输入关键字 抓取所有网页(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。功能介绍 点击界面 WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!自动模式检测 WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。

可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。为了通过代理服务器匿名抓取,防止网络爬虫软件被网络服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。类别提取WebHarvyWebScraper 允许您从链接列表中获取数据,从而在网站 中产生类似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。正则表达式 WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。运行 JavaScript 在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。下载图片可以下载图片或提取图片网址。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。自动浏览器交互 WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。更新日志修复了连接可能在以下情况下被禁用的问题页面启动。您可以为寻呼模式配置专用的连接方式。可以自动搜索可以在 HTML 上配置的资源。增加了在键盘上向下滚动下一页的功能。添加了通过 Java 脚本加载下一页。增加了URL配置功能。您可以在列表中输入关键字进行 2 次搜索。

输入关键字 抓取所有网页(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-11-06 03:16

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。功能介绍 点击界面 WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!自动模式检测 WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。

可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。为了通过代理服务器匿名抓取,防止网络爬虫软件被网络服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。类别提取WebHarvyWebScraper 允许您从链接列表中获取数据,从而在网站 中产生类似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。正则表达式 WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。运行 JavaScript 在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。下载图片可以下载图片或提取图片网址。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。自动浏览器交互 WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。更新日志修复了连接可能在以下情况下被禁用的问题页面启动。您可以为寻呼模式配置专用的连接方式。可以自动搜索可以在 HTML 上配置的资源。增加了在键盘上向下滚动下一页的功能。添加了通过 Java 脚本加载下一页。增加了URL配置功能。您可以在列表中输入关键字进行 2 次搜索。 查看全部

输入关键字 抓取所有网页(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。功能介绍 点击界面 WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!自动模式检测 WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。

可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。为了通过代理服务器匿名抓取,防止网络爬虫软件被网络服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。类别提取WebHarvyWebScraper 允许您从链接列表中获取数据,从而在网站 中产生类似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。正则表达式 WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。运行 JavaScript 在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。下载图片可以下载图片或提取图片网址。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。自动浏览器交互 WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。更新日志修复了连接可能在以下情况下被禁用的问题页面启动。您可以为寻呼模式配置专用的连接方式。可以自动搜索可以在 HTML 上配置的资源。增加了在键盘上向下滚动下一页的功能。添加了通过 Java 脚本加载下一页。增加了URL配置功能。您可以在列表中输入关键字进行 2 次搜索。

输入关键字 抓取所有网页(外贸盆友用了易外销的鹰眼搜之后带来的小技巧)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-11-04 20:15

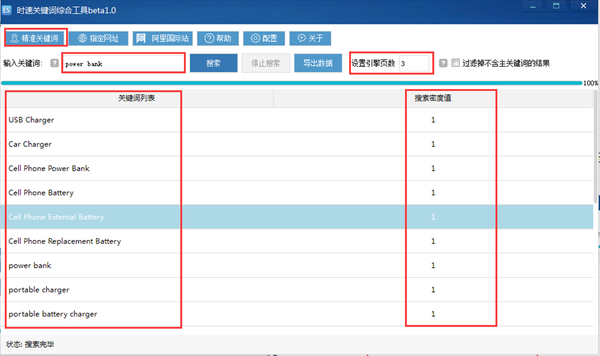

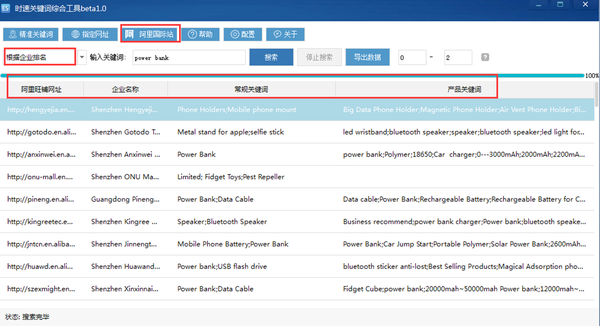

上周,我和一个刚开始在外贸公司工作的朋友聊天。她说她每天都在寻找与产品相关的关键词。通过查看peer网站、阿里巴巴、谷歌网站的源码各种方法查找分析。

不仅费时费力,结果也不尽人意,心都快碎了。

我非常理解她的心情,因为很多刚开始做外贸的小白都有一个头疼的问题:关键词很多,但是如何设置与他们产品高度相关的关键词很重要。

毕竟这和自己的网站这个店铺的流量排名有关。

只有有曝光,才有机会。

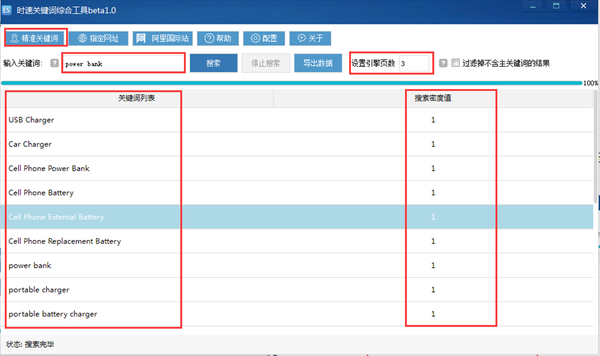

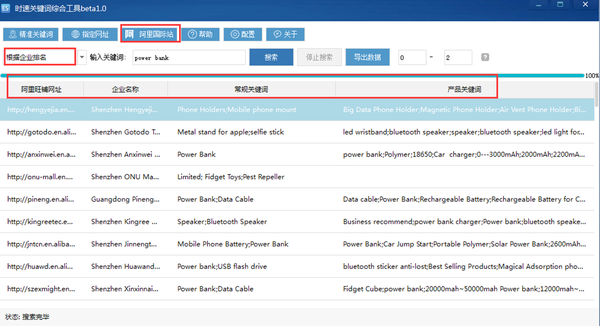

接下来给大家分享一下外贸朋友使用易出口鹰眼搜后带来的小窍门。

“鹰眼搜索还有5秒到达外贸战场,请做好准备。”

鹰眼搜索不仅可以搜索客户,还可以解决关键词的所有应用问题。

鹰眼搜索功能-关键词扩展,可以帮助很多外贸新手快速找到与自己产品相关的关键词。

可以看到,关键词扩展工具栏包括:精准关键词、指定网址、阿里国际站。

(1)精准关键词:更精准的客户关键词

准确的关键词是指相关网站的前N页中的网页设置关键词(可自行设置)。

准确的关键词也可以用于小语种关键词。

比如输入一个关键词“移动电源”,设置引擎页数(搜索引擎前三页的信息),点击搜索,马上就能找到结果。

搜索密度值是指这个关键词“移动电源”在这3页网站的关键词中出现的次数。

PS:精度关键词是客户关键词的核心,数量会比较少。提取出来后,可以进行分析和扩展,增长到最后关键词。

(2)指定网址

即根据你现有的客户信息抓取关键词。

你可以分析你的客户网站的关键词和你的同行的关键词,然后优化和利用它们来提高你的排名。

(3)阿里国际站

这是我们基于阿里平台抓取的大数据,我们可以协助您进行阿里国际站的推广。

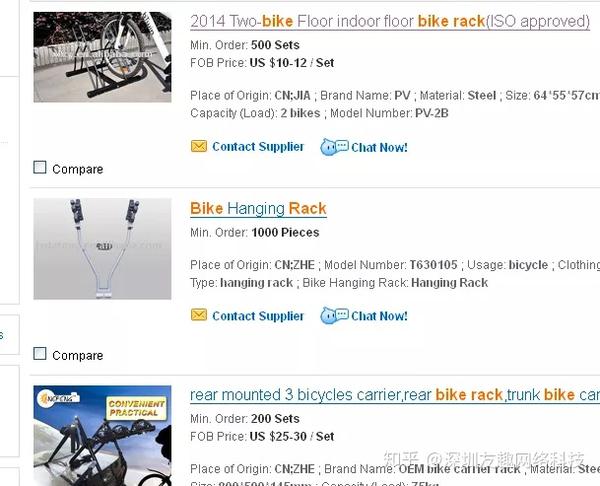

输入一个产品关键词,根据阿里国际站的企业排名,系统显示的结果是优化更好的企业门店。

最上面的当然是更好的。您可以比较前几家店铺,分析和调整自己最好的店铺的方向。

可以看到,分别显示了阿里旺铺网站、公司名称、一般关键词、产品关键词四栏。

通过简单的分析,我们可以看到这些店铺的关键词设置

你可以观察阿里旺铺很多同事的一些情况。通过对它们的简单分析,可以给自己的店铺一些参考和指导。

如果你是阿里的小推广小伙伴,可以直接抢这些好店的关键词参考。

借助EASY-Eagle Eye Search的强大辅助,您可以一键搜索关键词。

您的促销排名尚未上升!

Easy Export——一款集客户搜索、邮件营销、邮件CRM于一体的活跃外贸营销软件。 查看全部

输入关键字 抓取所有网页(外贸盆友用了易外销的鹰眼搜之后带来的小技巧)

上周,我和一个刚开始在外贸公司工作的朋友聊天。她说她每天都在寻找与产品相关的关键词。通过查看peer网站、阿里巴巴、谷歌网站的源码各种方法查找分析。

不仅费时费力,结果也不尽人意,心都快碎了。

我非常理解她的心情,因为很多刚开始做外贸的小白都有一个头疼的问题:关键词很多,但是如何设置与他们产品高度相关的关键词很重要。

毕竟这和自己的网站这个店铺的流量排名有关。

只有有曝光,才有机会。

接下来给大家分享一下外贸朋友使用易出口鹰眼搜后带来的小窍门。

“鹰眼搜索还有5秒到达外贸战场,请做好准备。”

鹰眼搜索不仅可以搜索客户,还可以解决关键词的所有应用问题。

鹰眼搜索功能-关键词扩展,可以帮助很多外贸新手快速找到与自己产品相关的关键词。

可以看到,关键词扩展工具栏包括:精准关键词、指定网址、阿里国际站。

(1)精准关键词:更精准的客户关键词

准确的关键词是指相关网站的前N页中的网页设置关键词(可自行设置)。

准确的关键词也可以用于小语种关键词。

比如输入一个关键词“移动电源”,设置引擎页数(搜索引擎前三页的信息),点击搜索,马上就能找到结果。

搜索密度值是指这个关键词“移动电源”在这3页网站的关键词中出现的次数。

PS:精度关键词是客户关键词的核心,数量会比较少。提取出来后,可以进行分析和扩展,增长到最后关键词。

(2)指定网址

即根据你现有的客户信息抓取关键词。

你可以分析你的客户网站的关键词和你的同行的关键词,然后优化和利用它们来提高你的排名。

(3)阿里国际站

这是我们基于阿里平台抓取的大数据,我们可以协助您进行阿里国际站的推广。

输入一个产品关键词,根据阿里国际站的企业排名,系统显示的结果是优化更好的企业门店。

最上面的当然是更好的。您可以比较前几家店铺,分析和调整自己最好的店铺的方向。

可以看到,分别显示了阿里旺铺网站、公司名称、一般关键词、产品关键词四栏。

通过简单的分析,我们可以看到这些店铺的关键词设置

你可以观察阿里旺铺很多同事的一些情况。通过对它们的简单分析,可以给自己的店铺一些参考和指导。

如果你是阿里的小推广小伙伴,可以直接抢这些好店的关键词参考。

借助EASY-Eagle Eye Search的强大辅助,您可以一键搜索关键词。

您的促销排名尚未上升!

Easy Export——一款集客户搜索、邮件营销、邮件CRM于一体的活跃外贸营销软件。

输入关键字 抓取所有网页(阿里巴巴国际站的关键词如何设置?关键词作用及填写要求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-11-04 20:15

对于电商卖家来说,关键词设置的重要性不言而喻,那么在阿里巴巴国际站如何设置关键词呢?如何优化关键词?

1.关键词 角色及填充要求

功能:产品关键词是对产品名称的修正,方便机器快速识别准确捕捉匹配。它与您的产品排名无关。关键词中可以体现一个产品的多个名称,如“手机”关键词可以是手机或手机等。

填写要求:不要与产品名称冲突。“冲突”的含义:冲突指的是不一样的产品,比如拖拉机零件和拖拉机

Tips:使用产品名称的中心词作为关键词,真的无法提取出与产品名称相同的词。

2.选择最好的10个技巧关键词

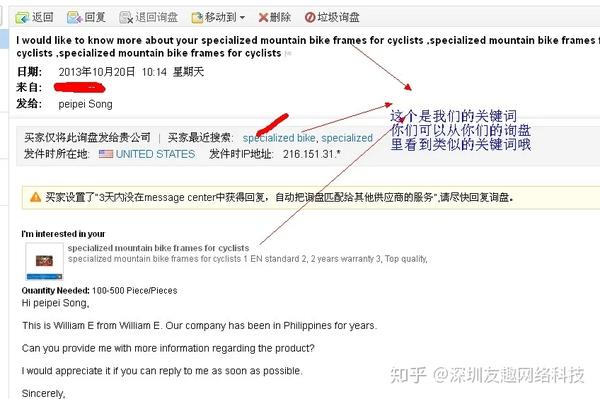

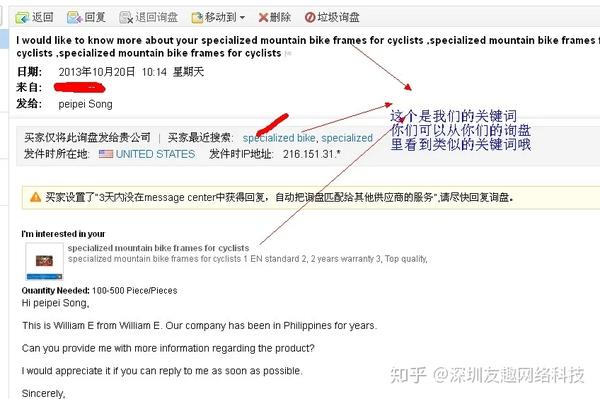

1、从客户的角度,考虑潜在客户在搜索你的产品时会使用什么关键词?您可以从许多来源获得反馈,包括您的客户、供应商、品牌经理和销售人员。如果您了解您的想法和潜在客户,我们可以在询价中看到。如果您收到查询,如下所示:

从图中可以看出,客户在发送产品时可能不会使用关键词。这个我们可以类推,找到相关的相似关键词。

2、将关键词扩展成一系列短语。选择一系列词组后,使用WordTracker网络营销软件检测这些关键词群体。这个软件的功能是查看你的关键词在其他网页的使用频率,以及过去24小时内各大搜索引擎有多少人在搜索中使用过这些关键词。最好的关键词是那些没有被滥用但很流行的词。另一个技巧是使用罕见的组合。WordTracker的Keyword Effectiveness Index(Keyword Effectiveness Index:KEI)会告诉你使用的关键词在它的数据库中出现的次数以及类似的竞争网页的数量。寻找那些可能在您的网页上工作的 关键词。KEI值越高,这个词越流行,竞争者越少。

注意:仅使用可以描述您的产品的 关键词。

3、 进行多次排列组合,改变词组中的词序,创造不同的词组合。使用不常见的组合。将它们组合成一个问题。收录同义词、替换词、比喻词和常见的拼写错误。收录所售产品的品牌名称和产品名称。使用其他限定符创建更多的二字符组合、三字符和四字符组合。例如:本公司是自行车架的停车架。我可以在词或限定词前添加修饰词。易停车组装自行车架出售。我们发现的核心词是自行车。Rack 在这种情况下,我们还可以找到组装自行车架等,使用 AB 形式和 BCD 形式等。这是组词。

4、 如果您是品牌公司,请使用您的公司名称。如果您是知名品牌,请在关键词 中使用您的公司名称。网站像RadioShack应该有这样一个关键词群:RadioShack电脑、RadioShack电子元件、RadioShack手机等,RadioShack想招员工可以用这些关键词:为RadioShack工作,RadioShack全国,RadioShack管理岗位,招聘具有专业水准的员工。但是,如果您的名字是 Jack Jones Real Estate,那么除非认识您,否则没有人会在搜索框中输入该名称。因此,如果你不是品牌,在关键词中收录公司名称是不值得一试的。

5、使用地理位置。如果您的位置很重要,请将其添加到您的 关键词 组。例如,加利福尼亚州棕榈泉市的 Jack Jones Real Estate,这里,加利福尼亚州棕榈泉市的房地产业是一个非常有用的 关键词。

6、回忆竞争对手使用关键词搜索竞争对手的关键词可以让你想起一些你可能错过的短语。但是不要复制任何人的关键词,因为你不知道他们如何使用这些关键词——你必须自己考虑一下关键词。找别人的关键词只是你选择的关键词的补充。我们可以使用alisource找到并打开如图所示的网页

输入关键词如自行车架

我们可以往下看,打开下面的网站,不是我们自己的公司。打开网站进入后,我们可以右键查看源码,可以看到一堆乱码。在这一堆乱码中,我们可以选择查找关键词,输入关键字定位关键词中的目标。

7、不要使用含义过于笼统的单词或短语。使用修饰语使普通单词和短语的含义更加精确。例如,提供保险服务的网站可以使用关键词 健康保险报价、自动保险报价、人寿保险报价等组。为了对访问者进行资格预审,关键词 和短语应该清楚地说明您的利基。如果您从事娱乐行业,请使用娱乐新闻、视频跟踪、名人故事、娱乐中心等。一个明确的利基可以吸引您需要的访客。不管你卖什么,这都是非常重要的。与认为您在销售其他产品的一大群访客相比,一小部分目标受众更有可能成为真正的客户。

8、不要使用单一词汇。多词短语比单个词汇更有用。搜索引擎很难在单个词上搜索相关结果,因为这样的搜索词会产生过多的结果,搜索者不会浏览数百个结果页面。搜索拍卖网站电子商务软件解决方案的用户不会只搜索软件。

9、使用自己的名称代替他人的品牌名称,避免在您的关键词中使用竞争对手的商标,否则可能会被起诉。有些公司会允许使用。电商网站如需使用“潮”,请联系宝洁获得许可。许可的授予基于潜在的隶属关系——制造商可能会将使用该名称的权利许可给销售公司 网站。但是,不允许使用其他公司的商标或产品名称从中获利。

10、如果有使用阿里后端和外网的直通车,也可以使用直通车添加搜索关键词我们可以看到热搜词条。需要注意的是,不要忽略零和几个字。零和几个字对我们来说也很重要。这个后台操作我们就不讲了。

好了,以上就是这次分享的内容,希望对大家有帮助。 查看全部

输入关键字 抓取所有网页(阿里巴巴国际站的关键词如何设置?关键词作用及填写要求)

对于电商卖家来说,关键词设置的重要性不言而喻,那么在阿里巴巴国际站如何设置关键词呢?如何优化关键词?

1.关键词 角色及填充要求

功能:产品关键词是对产品名称的修正,方便机器快速识别准确捕捉匹配。它与您的产品排名无关。关键词中可以体现一个产品的多个名称,如“手机”关键词可以是手机或手机等。

填写要求:不要与产品名称冲突。“冲突”的含义:冲突指的是不一样的产品,比如拖拉机零件和拖拉机

Tips:使用产品名称的中心词作为关键词,真的无法提取出与产品名称相同的词。

2.选择最好的10个技巧关键词

1、从客户的角度,考虑潜在客户在搜索你的产品时会使用什么关键词?您可以从许多来源获得反馈,包括您的客户、供应商、品牌经理和销售人员。如果您了解您的想法和潜在客户,我们可以在询价中看到。如果您收到查询,如下所示:

从图中可以看出,客户在发送产品时可能不会使用关键词。这个我们可以类推,找到相关的相似关键词。

2、将关键词扩展成一系列短语。选择一系列词组后,使用WordTracker网络营销软件检测这些关键词群体。这个软件的功能是查看你的关键词在其他网页的使用频率,以及过去24小时内各大搜索引擎有多少人在搜索中使用过这些关键词。最好的关键词是那些没有被滥用但很流行的词。另一个技巧是使用罕见的组合。WordTracker的Keyword Effectiveness Index(Keyword Effectiveness Index:KEI)会告诉你使用的关键词在它的数据库中出现的次数以及类似的竞争网页的数量。寻找那些可能在您的网页上工作的 关键词。KEI值越高,这个词越流行,竞争者越少。

注意:仅使用可以描述您的产品的 关键词。

3、 进行多次排列组合,改变词组中的词序,创造不同的词组合。使用不常见的组合。将它们组合成一个问题。收录同义词、替换词、比喻词和常见的拼写错误。收录所售产品的品牌名称和产品名称。使用其他限定符创建更多的二字符组合、三字符和四字符组合。例如:本公司是自行车架的停车架。我可以在词或限定词前添加修饰词。易停车组装自行车架出售。我们发现的核心词是自行车。Rack 在这种情况下,我们还可以找到组装自行车架等,使用 AB 形式和 BCD 形式等。这是组词。

4、 如果您是品牌公司,请使用您的公司名称。如果您是知名品牌,请在关键词 中使用您的公司名称。网站像RadioShack应该有这样一个关键词群:RadioShack电脑、RadioShack电子元件、RadioShack手机等,RadioShack想招员工可以用这些关键词:为RadioShack工作,RadioShack全国,RadioShack管理岗位,招聘具有专业水准的员工。但是,如果您的名字是 Jack Jones Real Estate,那么除非认识您,否则没有人会在搜索框中输入该名称。因此,如果你不是品牌,在关键词中收录公司名称是不值得一试的。

5、使用地理位置。如果您的位置很重要,请将其添加到您的 关键词 组。例如,加利福尼亚州棕榈泉市的 Jack Jones Real Estate,这里,加利福尼亚州棕榈泉市的房地产业是一个非常有用的 关键词。

6、回忆竞争对手使用关键词搜索竞争对手的关键词可以让你想起一些你可能错过的短语。但是不要复制任何人的关键词,因为你不知道他们如何使用这些关键词——你必须自己考虑一下关键词。找别人的关键词只是你选择的关键词的补充。我们可以使用alisource找到并打开如图所示的网页

输入关键词如自行车架

我们可以往下看,打开下面的网站,不是我们自己的公司。打开网站进入后,我们可以右键查看源码,可以看到一堆乱码。在这一堆乱码中,我们可以选择查找关键词,输入关键字定位关键词中的目标。

7、不要使用含义过于笼统的单词或短语。使用修饰语使普通单词和短语的含义更加精确。例如,提供保险服务的网站可以使用关键词 健康保险报价、自动保险报价、人寿保险报价等组。为了对访问者进行资格预审,关键词 和短语应该清楚地说明您的利基。如果您从事娱乐行业,请使用娱乐新闻、视频跟踪、名人故事、娱乐中心等。一个明确的利基可以吸引您需要的访客。不管你卖什么,这都是非常重要的。与认为您在销售其他产品的一大群访客相比,一小部分目标受众更有可能成为真正的客户。

8、不要使用单一词汇。多词短语比单个词汇更有用。搜索引擎很难在单个词上搜索相关结果,因为这样的搜索词会产生过多的结果,搜索者不会浏览数百个结果页面。搜索拍卖网站电子商务软件解决方案的用户不会只搜索软件。

9、使用自己的名称代替他人的品牌名称,避免在您的关键词中使用竞争对手的商标,否则可能会被起诉。有些公司会允许使用。电商网站如需使用“潮”,请联系宝洁获得许可。许可的授予基于潜在的隶属关系——制造商可能会将使用该名称的权利许可给销售公司 网站。但是,不允许使用其他公司的商标或产品名称从中获利。

10、如果有使用阿里后端和外网的直通车,也可以使用直通车添加搜索关键词我们可以看到热搜词条。需要注意的是,不要忽略零和几个字。零和几个字对我们来说也很重要。这个后台操作我们就不讲了。

好了,以上就是这次分享的内容,希望对大家有帮助。

输入关键字 抓取所有网页(研究亚马逊产品详细页面是一项枯燥的工作,无论更高的方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-11-04 14:06

亚马逊产品调研 亚马逊产品详情页是个枯燥的工作,无论你是新手卖家新建页面,还是想添加相关关键词丰富页面内容,今天我想和大家分享一个更直接,但更准确的道路。

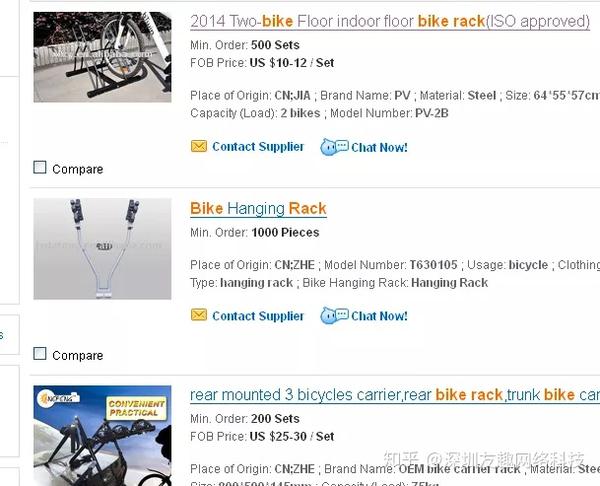

研究亚马逊产品详细信息页面是一项无聊的工作。无论你是新手卖家新建页面,还是想添加相关关键词丰富页面内容,今天我都想和大家分享一个更直接,但更准确的方法。

在开始搜索关键字之前,请评估您想要完成的任务。知道哪些关键字排名第一,哪些关键字无关紧要。重要的是要记住,人们使用搜索词(关键字)是基于他们使用这些词来描述产品的事实。这就是为什么你需要充分挖掘产品评论,从这个庞大的资源中找到丰富多样的关键词——因为人们使用这些关键词来描述产品以及它给他人带来的使用价值。

基本关键字搜索

您可以花费一定的费用,使用现有的工具来搜索关键字。但是我们要靠自己的努力,以最划算的方式来开展我们的搜索工作,虽然有点费力,但是可以找到理想的关键词。

一个很好的突破是从查看产品评论的标题开始,这些标题在亚马逊网站上都以粗体显示。查看标题可以帮助您快速过滤许多评论。您还可以通过选择查看标记为 5-、4-、3-、2- 和 1- 的星级评论来过滤评论。

我建议从 5 星评论开始,因为这些评论很可能会为您的详细信息页面提供最好、最生动和具体的描述性关键字。以这种方式查看评论时,亚马逊会在搜索结果的顶部显示最正面和最负面的评论。这是一个很好的起点。由于机器系统,亚马逊只会显示它认为与买家最相关的产品评论。

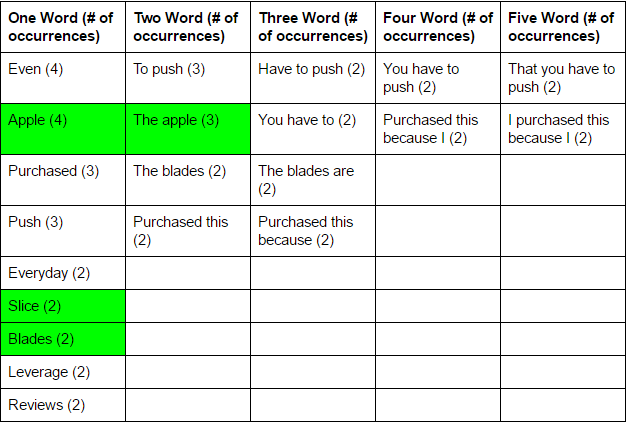

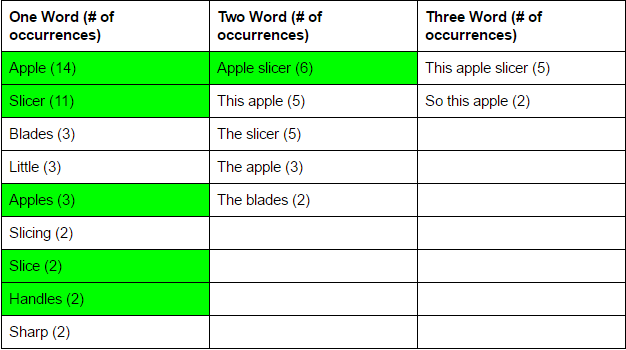

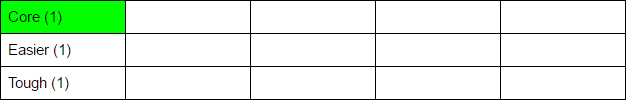

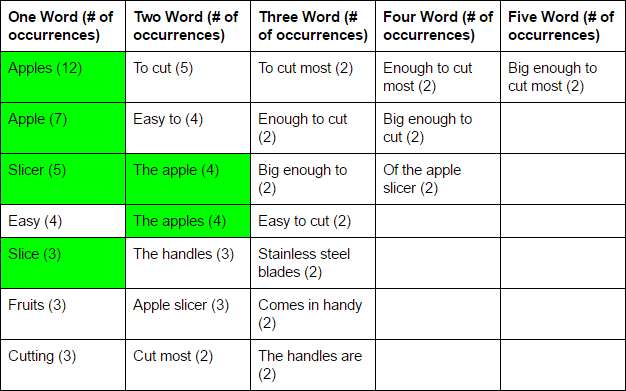

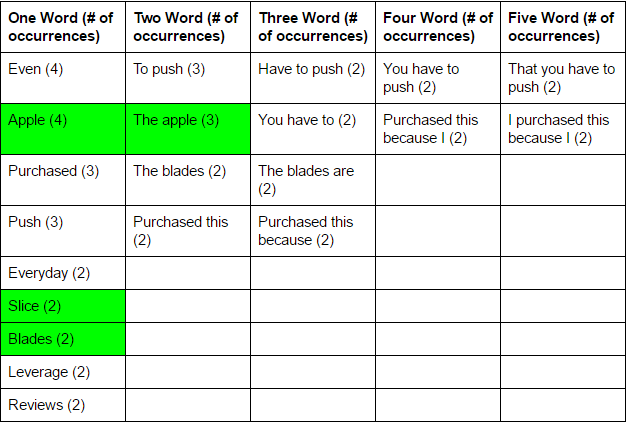

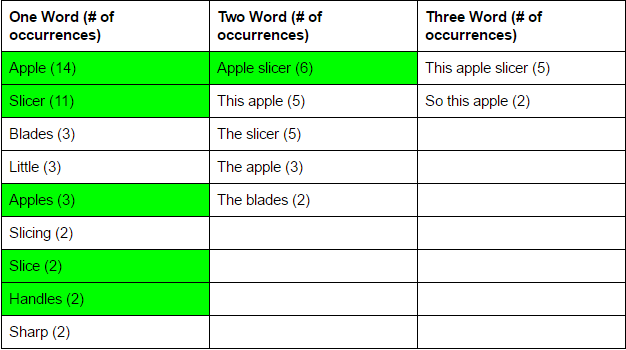

我以流行的苹果切片机为例。我将使用免费的关键字分析工具来显示术语、字数和密度。使用下拉列表,也会显示长关键字。

在我的评估中,我将排除与我的搜索无关的关键字。

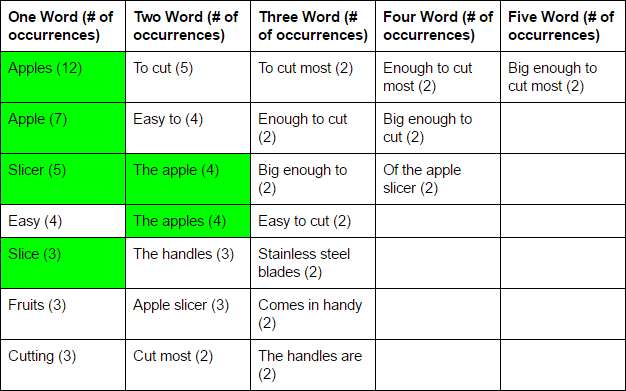

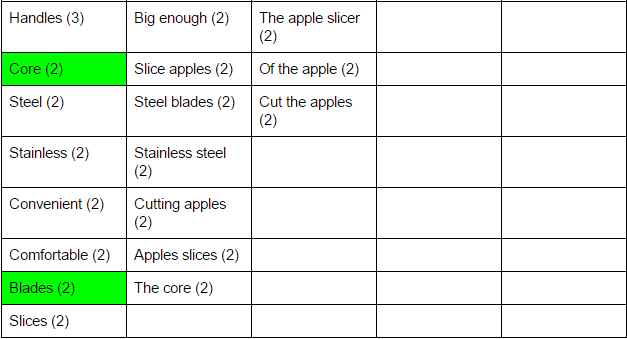

以下是苹果切片机在亚马逊网站上的正面评价分析。以绿色突出显示的单元格也会出现在产品的负面评论中。

以下是对买家最负面评论的分析:

比较结果:

通过比较最正面和最负面的评论,很明显每种评论中都会出现几个关键字和短语。以下是每个产品评论中可以找到的关键词:apple、apples、

切片机,切片,核心,刀片。这些关键字不匹配任何收录 2、 3、 4 和 5 个词的关键字。用于描述使用产品的积极体验的词语和短语与消极或中性体验不同。但是,卖家仍然可以在这两个评论中找到有用的单词和短语,以帮助改进亚马逊产品详细信息页面上的关键字。

现在让我们将这个最正面的评论与另一个类似的 5 星评论进行比较。

可以看到,当5星评论与最正面的评论进行比较时,会出现相同的关键字,以及一些新的关键字。以下是类似的关键字:apples、apple、slice、slicer、handles 和 apple slicer。通过分析其他产品评论并将它们与最正面的评论进行比较,您可以找到更多关键字。我建议分析至少 10 条不同的产品评论,采集不同的关键字,并将它们集成到您的产品详细信息页面中。

您已经分析了热门评论,以及一些次要评论,因此现在您可以使用这些关键字。创建一个电子表格,以便您可以轻松地对搜索的关键字进行比较和排名。根据收录一、二、三、 四、的五个或更多单词对关键字进行排序,以便更好地了解购物者在说什么。

分析您的产品评论(或竞争对手的评论)的最大好处是您可以清楚地了解买家如何描述您的产品。这为您提供了更广阔的视角和灵感:买家如何看待和搜索您的产品。

选择搜索结果中的前 10 个关键字并将它们添加到您的产品标题中。买家在亚马逊上搜索时会显示您的产品详细信息页面。然后将您的关键字添加到亚马逊提供的五个关键点中。每个点都必须是独特的和具体的,解释您的产品可以用于什么以及它如何使购买者的生活受益。

如果你想进一步扩大搜索范围,你也可以在网站上像沃尔玛、塔吉特、百思买等分析产品评论,看看买家怎么说。

来源:跨境眼 查看全部

输入关键字 抓取所有网页(研究亚马逊产品详细页面是一项枯燥的工作,无论更高的方式)

亚马逊产品调研 亚马逊产品详情页是个枯燥的工作,无论你是新手卖家新建页面,还是想添加相关关键词丰富页面内容,今天我想和大家分享一个更直接,但更准确的道路。

研究亚马逊产品详细信息页面是一项无聊的工作。无论你是新手卖家新建页面,还是想添加相关关键词丰富页面内容,今天我都想和大家分享一个更直接,但更准确的方法。

在开始搜索关键字之前,请评估您想要完成的任务。知道哪些关键字排名第一,哪些关键字无关紧要。重要的是要记住,人们使用搜索词(关键字)是基于他们使用这些词来描述产品的事实。这就是为什么你需要充分挖掘产品评论,从这个庞大的资源中找到丰富多样的关键词——因为人们使用这些关键词来描述产品以及它给他人带来的使用价值。

基本关键字搜索

您可以花费一定的费用,使用现有的工具来搜索关键字。但是我们要靠自己的努力,以最划算的方式来开展我们的搜索工作,虽然有点费力,但是可以找到理想的关键词。

一个很好的突破是从查看产品评论的标题开始,这些标题在亚马逊网站上都以粗体显示。查看标题可以帮助您快速过滤许多评论。您还可以通过选择查看标记为 5-、4-、3-、2- 和 1- 的星级评论来过滤评论。

我建议从 5 星评论开始,因为这些评论很可能会为您的详细信息页面提供最好、最生动和具体的描述性关键字。以这种方式查看评论时,亚马逊会在搜索结果的顶部显示最正面和最负面的评论。这是一个很好的起点。由于机器系统,亚马逊只会显示它认为与买家最相关的产品评论。

我以流行的苹果切片机为例。我将使用免费的关键字分析工具来显示术语、字数和密度。使用下拉列表,也会显示长关键字。

在我的评估中,我将排除与我的搜索无关的关键字。

以下是苹果切片机在亚马逊网站上的正面评价分析。以绿色突出显示的单元格也会出现在产品的负面评论中。

以下是对买家最负面评论的分析:

比较结果:

通过比较最正面和最负面的评论,很明显每种评论中都会出现几个关键字和短语。以下是每个产品评论中可以找到的关键词:apple、apples、

切片机,切片,核心,刀片。这些关键字不匹配任何收录 2、 3、 4 和 5 个词的关键字。用于描述使用产品的积极体验的词语和短语与消极或中性体验不同。但是,卖家仍然可以在这两个评论中找到有用的单词和短语,以帮助改进亚马逊产品详细信息页面上的关键字。

现在让我们将这个最正面的评论与另一个类似的 5 星评论进行比较。

可以看到,当5星评论与最正面的评论进行比较时,会出现相同的关键字,以及一些新的关键字。以下是类似的关键字:apples、apple、slice、slicer、handles 和 apple slicer。通过分析其他产品评论并将它们与最正面的评论进行比较,您可以找到更多关键字。我建议分析至少 10 条不同的产品评论,采集不同的关键字,并将它们集成到您的产品详细信息页面中。

您已经分析了热门评论,以及一些次要评论,因此现在您可以使用这些关键字。创建一个电子表格,以便您可以轻松地对搜索的关键字进行比较和排名。根据收录一、二、三、 四、的五个或更多单词对关键字进行排序,以便更好地了解购物者在说什么。

分析您的产品评论(或竞争对手的评论)的最大好处是您可以清楚地了解买家如何描述您的产品。这为您提供了更广阔的视角和灵感:买家如何看待和搜索您的产品。

选择搜索结果中的前 10 个关键字并将它们添加到您的产品标题中。买家在亚马逊上搜索时会显示您的产品详细信息页面。然后将您的关键字添加到亚马逊提供的五个关键点中。每个点都必须是独特的和具体的,解释您的产品可以用于什么以及它如何使购买者的生活受益。

如果你想进一步扩大搜索范围,你也可以在网站上像沃尔玛、塔吉特、百思买等分析产品评论,看看买家怎么说。

来源:跨境眼

输入关键字 抓取所有网页(如何优化企业网站可以使权重更大呢一点)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-11-03 13:12

在通常的优化工作中,如果我们要衡量一个网站的优化结果,那么简单的数据就是网站的权重值。搜索引擎并没有明确解释权重的概念,但它是一种实际数据。通过对一些站长工具的评测,我们可以看出1到9的权重代表了网站的不同等级,1到9的权重是非常普遍和常见的。

就算网站没有优化过也会有,但是9的权重只针对大名鼎鼎的网站,所以权重可以说是网站@的代表> 实力,一般企业在讨论网站也会直接问权重是多少。而企业优化网站想要增加权重,从一开始就是几何倍数增加,那么我们怎么做才能让权重变大呢?企业如何优化网站可以让权重大一点,因为网站的权重主要是看关键词排名,关键词排名直接关系到内容和质量网站的关键是公司要根据网站的内容进行布局。除了保证网站的质量,还要保证网站的质量。热门搜索引擎通常可以抓取网站的内容,但要确保内容足够好且原创,这样搜索引擎就没有理由不收录该内容。要知道,权重代表了网站的综合水平,其中包括包容性。

如果网站没有很好的收录在优化中,那肯定是这个网站的权重不够高,内容是增加了收录网站的方式并插入它在内容 关键词 中。对于一个新的网站,请尽量选择那些竞争性较低的词,通常是长尾词。同时注意自然分布,不突兀,影响用户阅读,从而提升网站主关键词的排名。当网站借助内容进行排名时,权重自然会增加。

为了优化网站的链接结构,首先要检查清理网站中不合理的死链接,避免404错误页面。一套完整的网站链接结构是搜索引擎抓取的关键。企业应该找出搜索引擎来自哪个链接,然后找出它可以访问哪些页面。通常,网站 具有树状结构就可以抓取这些页面。快到可以被搜索引擎抓取,就像一棵树,从骨干网,也就是首页,到每个分支,也就是网站的内容页。整个过程简单,利于爬行。有利于重量的转移。从头到尾可以分为三个页面:首页、栏目页和内容页。

它总结了网站的所有结构。有些公司网站是栏目页或栏目页,一排三列。这会导致网页跳转3次查找内容,不利于用户的阅读和浏览,也不利于搜索引擎蜘蛛的抓取。企业网站应该避免这种现象。如果已经存在,应尽快修改。通过以上实践,网站的权重可以慢慢增长。当然,对于一个网站的优化来说,也不是一帆风顺,甚至对于网站优化公司来说,也总会发生一些意想不到的事情,比如算法调整、优化操作不当、排名波动等,会导致网站的权重减少, 查看全部

输入关键字 抓取所有网页(如何优化企业网站可以使权重更大呢一点)

在通常的优化工作中,如果我们要衡量一个网站的优化结果,那么简单的数据就是网站的权重值。搜索引擎并没有明确解释权重的概念,但它是一种实际数据。通过对一些站长工具的评测,我们可以看出1到9的权重代表了网站的不同等级,1到9的权重是非常普遍和常见的。

就算网站没有优化过也会有,但是9的权重只针对大名鼎鼎的网站,所以权重可以说是网站@的代表> 实力,一般企业在讨论网站也会直接问权重是多少。而企业优化网站想要增加权重,从一开始就是几何倍数增加,那么我们怎么做才能让权重变大呢?企业如何优化网站可以让权重大一点,因为网站的权重主要是看关键词排名,关键词排名直接关系到内容和质量网站的关键是公司要根据网站的内容进行布局。除了保证网站的质量,还要保证网站的质量。热门搜索引擎通常可以抓取网站的内容,但要确保内容足够好且原创,这样搜索引擎就没有理由不收录该内容。要知道,权重代表了网站的综合水平,其中包括包容性。

如果网站没有很好的收录在优化中,那肯定是这个网站的权重不够高,内容是增加了收录网站的方式并插入它在内容 关键词 中。对于一个新的网站,请尽量选择那些竞争性较低的词,通常是长尾词。同时注意自然分布,不突兀,影响用户阅读,从而提升网站主关键词的排名。当网站借助内容进行排名时,权重自然会增加。

为了优化网站的链接结构,首先要检查清理网站中不合理的死链接,避免404错误页面。一套完整的网站链接结构是搜索引擎抓取的关键。企业应该找出搜索引擎来自哪个链接,然后找出它可以访问哪些页面。通常,网站 具有树状结构就可以抓取这些页面。快到可以被搜索引擎抓取,就像一棵树,从骨干网,也就是首页,到每个分支,也就是网站的内容页。整个过程简单,利于爬行。有利于重量的转移。从头到尾可以分为三个页面:首页、栏目页和内容页。

它总结了网站的所有结构。有些公司网站是栏目页或栏目页,一排三列。这会导致网页跳转3次查找内容,不利于用户的阅读和浏览,也不利于搜索引擎蜘蛛的抓取。企业网站应该避免这种现象。如果已经存在,应尽快修改。通过以上实践,网站的权重可以慢慢增长。当然,对于一个网站的优化来说,也不是一帆风顺,甚至对于网站优化公司来说,也总会发生一些意想不到的事情,比如算法调整、优化操作不当、排名波动等,会导致网站的权重减少,

输入关键字 抓取所有网页(Python的urllib库中的如下链接(包括GET参数的方法))

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-11-02 05:08

一开始没多想,因为GET参数和POST不一样。GET参数是直接在URL后面加上直接传输的,所以我觉得在要爬取的URL中直接写GET参数就够了,像这样:

http://bbs.hexun.com/search/%3 ... it%3D

这是通过关键字---aaaa在和讯论坛中搜索文本的url链接地址(包括GET参数)。获取这个地址最简单的方法是通过浏览器访问这个博客的地址,然后在搜索输入框中输入要搜索的关键字,选择搜索类型为文本,然后点击搜索,浏览器会弹出网页的地址栏这里是我们上面的地址,如下图:

如果有人想深究问题,想知道上面地址中关键词q、type、Submit的含义,只能看网页源代码(学习爬虫或学习html语法):

标题

正文

作者

说这么多似乎有点跑题了。上面提到 GET 参数是硬编码在 URL 中的。比如上面的链接地址是通过Scrapy shell直接访问进行验证的,如下:

[james_xie@james-desk python]$ scrapy shell "http://bbs.hexun.com/search/%3 ... ot%3B --nolog

[s] Available Scrapy objects:

[s] scrapy scrapy module (contains scrapy.Request, scrapy.Selector, etc)

[s] crawler

[s] item {}

[s] request

[s] response

[s] settings

[s] spider

[s] Useful shortcuts:

[s] shelp() Shell help (print this help)

[s] fetch(req_or_url) Fetch request (or URL) and update local objects

[s] view(response) View response in a browser

>>>

一定要注意链接地址一定要用引号括起来,否则会报错

上面可以进入Scrapy交互模式的命令行说明是可行的。

2. URL中文编码问题

通过上面的问题1我确认了可以在URL中硬编码GET参数,但是我们要搜索的关键字是Chinese-Hongling,这涉及到中文编解码的问题。

Python 的 urllib 库中的以下两个函数可以满足 URL 编解码的要求:

urllib.quote(string[, safe])

Replace special characters in string using the %xx escape. Letters, digits, and the characters '_.-' are never quoted. By default, this function is intended for quoting the path section of the URL. The optional safe parameter specifies additional characters that should not be quoted — its default value is '/'.

Example: quote('/~connolly/') yields '/%7econnolly/'.

urllib.unquote(string)

Replace %xx escapes by their single-character equivalent.

Example: unquote('/%7Econnolly/') yields '/~connolly/'.

这里还要注意网站的编码。一开始没注意网站的编码。苦苦挣扎了半天,发现web源dock文件中的编码是gb2312。

# keywords = getattr(self, 'keywords', None)

# '网站的编码是gb2312的'

keywords = u'红岭'.encode('gb2312')

requesturl = "http://bbs.hexun.com/search/?q={0}&type=2&Submit=".format(urllib.quote(keywords))

最后通过上面两句就可以实现了。这比上面的直接访问灵活得多。也可以修改Scrapy的参数形式,传入要搜索的关键字作为参数。

3.禁止robots.txt问题

开始爬行的时候,总是有以下信息:

2016-12-27 11:14:39 [scrapy] INFO: Spider opened

2016-12-27 11:14:39 [scrapy] INFO: Crawled 0 pages (at 0 pages/min), scraped 0 items (at 0 items/min)

2016-12-27 11:14:39 [scrapy] DEBUG: Telnet console listening on 127.0.0.1:6026

2016-12-27 11:14:40 [scrapy] DEBUG: Crawled (200) (referer: None)

2016-12-27 11:14:40 [scrapy] DEBUG: Forbidden by robots.txt:

2016-12-27 11:14:40 [scrapy] INFO: Closing spider (finished)

2016-12-27 11:14:40 [scrapy] INFO: Dumping Scrapy stats:

显然,爬虫程序应该被拒绝。通过HttpFox和wireshark的对比发现我的爬虫程序发送的包和浏览器发送的包基本一致。我还使用了scrapy-fake-useragent 库来伪装用户代理字段。,按道理来说,是不会限制的。

后来谷歌一看,发现有机器人协议。以下一段摘自百度的词条:

Robots协议(也叫爬虫协议、机器人协议等)的全称是“机器人排除协议”(Robots Exclusion Protocol),网站告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取机器人协议。

后来在Scrapy的文档中发现有支持robots协议的控制。

ROBOTSTXT_OBEY

Default: False

Scope: scrapy.downloadermiddlewares.robotstxt

If enabled, Scrapy will respect robots.txt policies. For more information see RobotsTxtMiddleware.

Note

While the default value is False for historical reasons, this option is enabled by default in settings.py file generated by scrapy startproject command.

这里没有翻译,你可以自己查看官方文档——

三、总结

整个实现过程比较简单。一开始,我被搜索结果的数量震惊了,因为有几十页,然后每页上都有几十篇文章。在后续的实现中,发现只找到了Scrapy抓取的内容。没错,内容多少并不重要,只是爬虫程序运行的时间长短问题。最后把整个代码放到网上——通过Scrapy抓取和讯论坛关键词搜索的结果,有兴趣的可以下载讨论,欢迎出砖! 查看全部

输入关键字 抓取所有网页(Python的urllib库中的如下链接(包括GET参数的方法))

一开始没多想,因为GET参数和POST不一样。GET参数是直接在URL后面加上直接传输的,所以我觉得在要爬取的URL中直接写GET参数就够了,像这样:

http://bbs.hexun.com/search/%3 ... it%3D

这是通过关键字---aaaa在和讯论坛中搜索文本的url链接地址(包括GET参数)。获取这个地址最简单的方法是通过浏览器访问这个博客的地址,然后在搜索输入框中输入要搜索的关键字,选择搜索类型为文本,然后点击搜索,浏览器会弹出网页的地址栏这里是我们上面的地址,如下图:

如果有人想深究问题,想知道上面地址中关键词q、type、Submit的含义,只能看网页源代码(学习爬虫或学习html语法):

标题

正文

作者

说这么多似乎有点跑题了。上面提到 GET 参数是硬编码在 URL 中的。比如上面的链接地址是通过Scrapy shell直接访问进行验证的,如下:

[james_xie@james-desk python]$ scrapy shell "http://bbs.hexun.com/search/%3 ... ot%3B --nolog

[s] Available Scrapy objects:

[s] scrapy scrapy module (contains scrapy.Request, scrapy.Selector, etc)

[s] crawler

[s] item {}

[s] request

[s] response

[s] settings

[s] spider

[s] Useful shortcuts:

[s] shelp() Shell help (print this help)

[s] fetch(req_or_url) Fetch request (or URL) and update local objects

[s] view(response) View response in a browser

>>>

一定要注意链接地址一定要用引号括起来,否则会报错

上面可以进入Scrapy交互模式的命令行说明是可行的。

2. URL中文编码问题

通过上面的问题1我确认了可以在URL中硬编码GET参数,但是我们要搜索的关键字是Chinese-Hongling,这涉及到中文编解码的问题。

Python 的 urllib 库中的以下两个函数可以满足 URL 编解码的要求:

urllib.quote(string[, safe])

Replace special characters in string using the %xx escape. Letters, digits, and the characters '_.-' are never quoted. By default, this function is intended for quoting the path section of the URL. The optional safe parameter specifies additional characters that should not be quoted — its default value is '/'.

Example: quote('/~connolly/') yields '/%7econnolly/'.

urllib.unquote(string)

Replace %xx escapes by their single-character equivalent.

Example: unquote('/%7Econnolly/') yields '/~connolly/'.

这里还要注意网站的编码。一开始没注意网站的编码。苦苦挣扎了半天,发现web源dock文件中的编码是gb2312。

# keywords = getattr(self, 'keywords', None)

# '网站的编码是gb2312的'

keywords = u'红岭'.encode('gb2312')

requesturl = "http://bbs.hexun.com/search/?q={0}&type=2&Submit=".format(urllib.quote(keywords))

最后通过上面两句就可以实现了。这比上面的直接访问灵活得多。也可以修改Scrapy的参数形式,传入要搜索的关键字作为参数。

3.禁止robots.txt问题

开始爬行的时候,总是有以下信息:

2016-12-27 11:14:39 [scrapy] INFO: Spider opened

2016-12-27 11:14:39 [scrapy] INFO: Crawled 0 pages (at 0 pages/min), scraped 0 items (at 0 items/min)

2016-12-27 11:14:39 [scrapy] DEBUG: Telnet console listening on 127.0.0.1:6026

2016-12-27 11:14:40 [scrapy] DEBUG: Crawled (200) (referer: None)

2016-12-27 11:14:40 [scrapy] DEBUG: Forbidden by robots.txt:

2016-12-27 11:14:40 [scrapy] INFO: Closing spider (finished)

2016-12-27 11:14:40 [scrapy] INFO: Dumping Scrapy stats:

显然,爬虫程序应该被拒绝。通过HttpFox和wireshark的对比发现我的爬虫程序发送的包和浏览器发送的包基本一致。我还使用了scrapy-fake-useragent 库来伪装用户代理字段。,按道理来说,是不会限制的。

后来谷歌一看,发现有机器人协议。以下一段摘自百度的词条:

Robots协议(也叫爬虫协议、机器人协议等)的全称是“机器人排除协议”(Robots Exclusion Protocol),网站告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取机器人协议。

后来在Scrapy的文档中发现有支持robots协议的控制。

ROBOTSTXT_OBEY

Default: False

Scope: scrapy.downloadermiddlewares.robotstxt

If enabled, Scrapy will respect robots.txt policies. For more information see RobotsTxtMiddleware.

Note

While the default value is False for historical reasons, this option is enabled by default in settings.py file generated by scrapy startproject command.

这里没有翻译,你可以自己查看官方文档——

三、总结

整个实现过程比较简单。一开始,我被搜索结果的数量震惊了,因为有几十页,然后每页上都有几十篇文章。在后续的实现中,发现只找到了Scrapy抓取的内容。没错,内容多少并不重要,只是爬虫程序运行的时间长短问题。最后把整个代码放到网上——通过Scrapy抓取和讯论坛关键词搜索的结果,有兴趣的可以下载讨论,欢迎出砖!

输入关键字 抓取所有网页(MBA智库百科:网络爬虫的分类及工作原理及应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 223 次浏览 • 2021-11-02 00:08

来自MBA智库百科()

内容

[编辑]

什么是网络爬虫

网络爬虫,又称“网络蜘蛛”,通过网页的链接地址搜索网页。从某个页面开始,读取网页的内容,找到网页中的其他链接地址,然后使用这些链接地址寻找下一个网页并以此方式循环的技术,直到互联网上的所有网页都被抓取到到一定的策略。

[编辑]

网络爬虫的分类及工作原理

根据系统结构和实现技术,网络爬虫大致可以分为以下类型:通用网络爬虫、主题网络爬虫和深网爬虫。在实际应用中,系统的几种爬虫技术通常是相互结合的。

(一)通用网络爬虫)

一般的网络爬虫都是从预先设置的一个或几个初始种子URL开始,获取初始网页上的URL列表。在爬取过程中,它不断从URL队列中获取一个URL,然后访问和下载页面。页面下载完成后,页面解析器去除页面上的HTML标签获取页面内容,将摘要、URL等信息保存在Web数据库中,同时提取当前页面上的新URL并保存直到满足系统停止条件。其工作流程如图 1 所示。

一般爬虫主要有以下局限: 1) 由于爬取目标是尽可能覆盖整个网络,所以爬取结果收录大量用户不需要的网页;2) 做不好。搜索和获取信息内容密集、具有一定结构的数据;3) 一般搜索引擎多为基于关键字的检索,难以达到支持语义信息查询和智能搜索引擎的要求。

可见,一般的爬虫很难在抓取网页时既保证网页的质量和数量,又很难保证网页的时效性。

(二)主题网络爬虫)

1.主题爬虫原理

主题爬虫不追求大覆盖,也不全面接受所有网页和网址。它根据既定的爬取目标,有选择地访问万维网上的网页和相关链接,获取所需信息,而不仅仅是客服。一般爬虫有问题,H-返回的数据资源更准确。主题爬虫的基本工作原理是根据预定的主题分析刚刚爬取的网页的超链接和内容,获取下一个要爬取的URL,并保证爬取尽可能多的与主题相关的页面,所以主题爬虫要解决以下关键问题:1)如何判断一个爬取的网页是否与主题相关;2) 如何过滤掉海量与主题无关或相关性低的网页;3) 如何有目的地、可控地抓取与特定主题相关的网页信息;4)如何确定要访问的URL的访问顺序;5)如何提高话题爬虫的覆盖率;6) 如何协调抓取目标的描述或定义与网页分析算法和候选URL排名算法之间的关系;7) 如何寻找优质网页和关键资源。高质量的网页和关键资源不仅可以大大提高主题爬虫对网页的采集效率和质量,还可以为主题表示模型的优化等应用提供支持。

2. 主题爬虫模块设计

主题爬虫的目标是发现并采集尽可能多的与预定主题相关的网页,其最大的特点是能够分析网页内容并确定主题的相关性。根据主题爬虫的工作原理,设计如下主题爬虫系统,主要由页面采集模块、页面分析模块、相关性计算模块、页面过滤模块和链接排序模块组成. 其整体功能模块结构如图2所示。

页面采集模块:主要是根据要访问的URL队列下载页面,然后交给网页分析模型提取网页主题向量空间模型。该模块是任何爬虫系统必不可少的模块。页面分析模块:该模块的作用是对采集到达的页面进行分析,主要用于连接超链接排序模块和页面相关性计算模块。

页面相关性计算模块:该模块是整个系统的核心模块。主要用于评估与主题的相关性,提供相关的爬取策略,指导爬虫的爬取过程。URL 的超链接评估分数越高,抓取的优先级越高。主要思想是在系统爬取之前,页面相关度计算模块根据用户输入的关键词和初始文本信息进行学习,训练页面相关度评价模型。当被认为与某个主题相关的页面被向下爬取时,该页面被发送到页面相关性评估器计算其主题相关性值。如果该值大于或等于给定阈值,则将该页面保存到页面库中,否则丢弃¨。页面过滤模块:过滤掉与主题无关的链接,同时删除 URL 及其所有隐含的子链接。通过过滤,爬虫不需要遍历与主题无关的页面,从而保证了爬取效率。排序模块:将过滤后的页面按优先级加入要访问的URL队列。

3.主题爬虫流程设计

主题爬虫需要根据一定的网络分析算法过滤掉与主题无关的链接,保留有用的链接,放入URL队列等待爬取。然后,它会根据一定的搜索策略从待爬取的队列中选择下一个待爬取的URL,重复上述过程,直到满足系统停止条件。所有抓取到的网页都会被系统存储起来,经过一定的分析、过滤,然后编入索引供用户查询和检索;在这个过程中得到的分析结果可以为后续的爬取过程提供反馈和指导。其工作流程如图 3 所示。

4.深网爬虫

1994年,Jill Ellsworth博士提出了DeepWeb(深页面)的概念,即DeepWeb是指具有普通搜索引擎难以找到的信息内容的网页。DeepWeb 中的信息量比普通网页要多,质量也更高。但由于技术限制,普通搜索引擎无法采集到如此高质量、高权威的信息。这些信息通常隐藏在一个庞大的深度网页动态数据库中,涉及数据集成、中文语义识别等多个领域。如此庞大的信息资源,如果不以合理、高效的方式获取,将是巨大的损失。因此,对深度网络爬虫技术的研究具有极其重要的现实意义和理论价值。

传统的网络爬虫在运行过程中无法发现隐藏在普通网页中的信息和规律,缺乏一定的主动性和智能性。例如,需要用户名和密码的页面,或收录页码导航的页面都无法抓取。Deep Crawler 的设计解决了传统网络爬虫的这些缺点,并通过增加表单分析和页面状态维护两部分来改进其结构。其结构如图4所示,通过分析网页的结构,将其归类为对于普通网页或信息较多的深层网页,为深层网页构造合适的表单参数并提交以获得更多页面。深度爬虫的流程图如图4所示。深度爬虫与常规爬虫的区别在于,深度爬虫不会在页面下载后立即遍历所有超链接,而是使用一定的算法对其进行分类,并针对不同的类别使用不同的方法计算查询参数。再次向服务器提交参数。如果提交的查询参数正确,您将获得隐藏的页面和链接。深度爬虫的目标是尽可能多地访问和采集互联网上的网页。由于深度页面是通过提交表单访问的,因此深度页面爬取存在三个难点: 1) 深度爬虫需要高效。处理海量深页数据的算法;2)很多服务端DeepWeb需要验证表单输入,比如用户名、密码、验证码等,如果验证失败,您将无法爬到 DeepWeb 数据;2) @3) 客户端需要JavaScript等脚本来支持DeepWeb分析。

[编辑]

网络爬虫的搜索策略

(1)IP地址搜索策略

IP地址搜索策略是先给爬虫一个起始IP地址,然后根据IP地址以增量方式搜索IP地址段之后的每个地址中的文档。它不考虑指向其他 Web 站点的文档的超级。链接地址。这种搜索策略的优点是搜索比较全面,可以找到其他文档没有引用的新文档的信息源;但缺点是不适合大规模搜索。

(2)深度优先搜索策略

深度优先搜索是在爬虫开发初期使用较多的一种方法。其目的是到达搜索结构的叶节点(即那些不收录任何超链接的 HTML 文件)。For example, in an HTML file, when a hyperlink is selected, the linked HTML file will perform a depth-first search, that is to say, a single link must be searched completely before searching the remaining hyperlink results. 深度优先搜索沿着HTML文件上的超链接走,直到不能再深入,然后返回到某个HTML文件,然后继续选择HTML文件中的其他超链接。当没有其他超链接可供选择时,搜索结束。

(3)广度优先搜索策略

广度优先搜索的过程是先搜索一个网页中的所有超链接,然后继续搜索下一层,直到下一层。例如,一个HTML文件中有三个超链接,选择其中一个处理对应的HTML文件,然后第二个HTML文件中不再选择任何超链接,而是返回选择第二个超链接,处理对应的HTML文件,再次返回,选择第三个超链接并处理相应的HTML文件。当第一层的所有超链接都被选中后,您就可以开始在刚刚处理的 HIML 文件中搜索剩余的超链接了。

广度优先搜索策略的优点:一是保证了浅层的优先处理,当遇到无穷无尽的深分支时,不会导致陷入www的深文档出现不可用;另一个是它可以找到两个 HTML 文件之间的最短路径。

广度优先搜索策略通常是实现爬虫的最佳策略,因为它易于实现并且具有大部分所需的功能。但是如果你想遍历一个指定的站点或一组深度嵌套的 HTML 文件,使用宽度优先搜索策略将需要相对较长的时间才能到达深层 HTML 文件。

[编辑]

参考

余承龙, 余洪波. 网络爬虫技术研究[J].东莞理工大学学报.2011,5 蔡晓伦.网络爬虫技术的发展顺势而为[J].科技信息.2010,12

从 ””

这个条目对我有帮助 8

报酬

MBA智库APP

扫描下载MBA智库APP 查看全部

输入关键字 抓取所有网页(MBA智库百科:网络爬虫的分类及工作原理及应用)

来自MBA智库百科()

内容

[编辑]

什么是网络爬虫

网络爬虫,又称“网络蜘蛛”,通过网页的链接地址搜索网页。从某个页面开始,读取网页的内容,找到网页中的其他链接地址,然后使用这些链接地址寻找下一个网页并以此方式循环的技术,直到互联网上的所有网页都被抓取到到一定的策略。

[编辑]

网络爬虫的分类及工作原理

根据系统结构和实现技术,网络爬虫大致可以分为以下类型:通用网络爬虫、主题网络爬虫和深网爬虫。在实际应用中,系统的几种爬虫技术通常是相互结合的。

(一)通用网络爬虫)

一般的网络爬虫都是从预先设置的一个或几个初始种子URL开始,获取初始网页上的URL列表。在爬取过程中,它不断从URL队列中获取一个URL,然后访问和下载页面。页面下载完成后,页面解析器去除页面上的HTML标签获取页面内容,将摘要、URL等信息保存在Web数据库中,同时提取当前页面上的新URL并保存直到满足系统停止条件。其工作流程如图 1 所示。

一般爬虫主要有以下局限: 1) 由于爬取目标是尽可能覆盖整个网络,所以爬取结果收录大量用户不需要的网页;2) 做不好。搜索和获取信息内容密集、具有一定结构的数据;3) 一般搜索引擎多为基于关键字的检索,难以达到支持语义信息查询和智能搜索引擎的要求。

可见,一般的爬虫很难在抓取网页时既保证网页的质量和数量,又很难保证网页的时效性。

(二)主题网络爬虫)

1.主题爬虫原理

主题爬虫不追求大覆盖,也不全面接受所有网页和网址。它根据既定的爬取目标,有选择地访问万维网上的网页和相关链接,获取所需信息,而不仅仅是客服。一般爬虫有问题,H-返回的数据资源更准确。主题爬虫的基本工作原理是根据预定的主题分析刚刚爬取的网页的超链接和内容,获取下一个要爬取的URL,并保证爬取尽可能多的与主题相关的页面,所以主题爬虫要解决以下关键问题:1)如何判断一个爬取的网页是否与主题相关;2) 如何过滤掉海量与主题无关或相关性低的网页;3) 如何有目的地、可控地抓取与特定主题相关的网页信息;4)如何确定要访问的URL的访问顺序;5)如何提高话题爬虫的覆盖率;6) 如何协调抓取目标的描述或定义与网页分析算法和候选URL排名算法之间的关系;7) 如何寻找优质网页和关键资源。高质量的网页和关键资源不仅可以大大提高主题爬虫对网页的采集效率和质量,还可以为主题表示模型的优化等应用提供支持。

2. 主题爬虫模块设计

主题爬虫的目标是发现并采集尽可能多的与预定主题相关的网页,其最大的特点是能够分析网页内容并确定主题的相关性。根据主题爬虫的工作原理,设计如下主题爬虫系统,主要由页面采集模块、页面分析模块、相关性计算模块、页面过滤模块和链接排序模块组成. 其整体功能模块结构如图2所示。

页面采集模块:主要是根据要访问的URL队列下载页面,然后交给网页分析模型提取网页主题向量空间模型。该模块是任何爬虫系统必不可少的模块。页面分析模块:该模块的作用是对采集到达的页面进行分析,主要用于连接超链接排序模块和页面相关性计算模块。

页面相关性计算模块:该模块是整个系统的核心模块。主要用于评估与主题的相关性,提供相关的爬取策略,指导爬虫的爬取过程。URL 的超链接评估分数越高,抓取的优先级越高。主要思想是在系统爬取之前,页面相关度计算模块根据用户输入的关键词和初始文本信息进行学习,训练页面相关度评价模型。当被认为与某个主题相关的页面被向下爬取时,该页面被发送到页面相关性评估器计算其主题相关性值。如果该值大于或等于给定阈值,则将该页面保存到页面库中,否则丢弃¨。页面过滤模块:过滤掉与主题无关的链接,同时删除 URL 及其所有隐含的子链接。通过过滤,爬虫不需要遍历与主题无关的页面,从而保证了爬取效率。排序模块:将过滤后的页面按优先级加入要访问的URL队列。

3.主题爬虫流程设计

主题爬虫需要根据一定的网络分析算法过滤掉与主题无关的链接,保留有用的链接,放入URL队列等待爬取。然后,它会根据一定的搜索策略从待爬取的队列中选择下一个待爬取的URL,重复上述过程,直到满足系统停止条件。所有抓取到的网页都会被系统存储起来,经过一定的分析、过滤,然后编入索引供用户查询和检索;在这个过程中得到的分析结果可以为后续的爬取过程提供反馈和指导。其工作流程如图 3 所示。

4.深网爬虫

1994年,Jill Ellsworth博士提出了DeepWeb(深页面)的概念,即DeepWeb是指具有普通搜索引擎难以找到的信息内容的网页。DeepWeb 中的信息量比普通网页要多,质量也更高。但由于技术限制,普通搜索引擎无法采集到如此高质量、高权威的信息。这些信息通常隐藏在一个庞大的深度网页动态数据库中,涉及数据集成、中文语义识别等多个领域。如此庞大的信息资源,如果不以合理、高效的方式获取,将是巨大的损失。因此,对深度网络爬虫技术的研究具有极其重要的现实意义和理论价值。

传统的网络爬虫在运行过程中无法发现隐藏在普通网页中的信息和规律,缺乏一定的主动性和智能性。例如,需要用户名和密码的页面,或收录页码导航的页面都无法抓取。Deep Crawler 的设计解决了传统网络爬虫的这些缺点,并通过增加表单分析和页面状态维护两部分来改进其结构。其结构如图4所示,通过分析网页的结构,将其归类为对于普通网页或信息较多的深层网页,为深层网页构造合适的表单参数并提交以获得更多页面。深度爬虫的流程图如图4所示。深度爬虫与常规爬虫的区别在于,深度爬虫不会在页面下载后立即遍历所有超链接,而是使用一定的算法对其进行分类,并针对不同的类别使用不同的方法计算查询参数。再次向服务器提交参数。如果提交的查询参数正确,您将获得隐藏的页面和链接。深度爬虫的目标是尽可能多地访问和采集互联网上的网页。由于深度页面是通过提交表单访问的,因此深度页面爬取存在三个难点: 1) 深度爬虫需要高效。处理海量深页数据的算法;2)很多服务端DeepWeb需要验证表单输入,比如用户名、密码、验证码等,如果验证失败,您将无法爬到 DeepWeb 数据;2) @3) 客户端需要JavaScript等脚本来支持DeepWeb分析。

[编辑]

网络爬虫的搜索策略

(1)IP地址搜索策略

IP地址搜索策略是先给爬虫一个起始IP地址,然后根据IP地址以增量方式搜索IP地址段之后的每个地址中的文档。它不考虑指向其他 Web 站点的文档的超级。链接地址。这种搜索策略的优点是搜索比较全面,可以找到其他文档没有引用的新文档的信息源;但缺点是不适合大规模搜索。

(2)深度优先搜索策略

深度优先搜索是在爬虫开发初期使用较多的一种方法。其目的是到达搜索结构的叶节点(即那些不收录任何超链接的 HTML 文件)。For example, in an HTML file, when a hyperlink is selected, the linked HTML file will perform a depth-first search, that is to say, a single link must be searched completely before searching the remaining hyperlink results. 深度优先搜索沿着HTML文件上的超链接走,直到不能再深入,然后返回到某个HTML文件,然后继续选择HTML文件中的其他超链接。当没有其他超链接可供选择时,搜索结束。

(3)广度优先搜索策略

广度优先搜索的过程是先搜索一个网页中的所有超链接,然后继续搜索下一层,直到下一层。例如,一个HTML文件中有三个超链接,选择其中一个处理对应的HTML文件,然后第二个HTML文件中不再选择任何超链接,而是返回选择第二个超链接,处理对应的HTML文件,再次返回,选择第三个超链接并处理相应的HTML文件。当第一层的所有超链接都被选中后,您就可以开始在刚刚处理的 HIML 文件中搜索剩余的超链接了。

广度优先搜索策略的优点:一是保证了浅层的优先处理,当遇到无穷无尽的深分支时,不会导致陷入www的深文档出现不可用;另一个是它可以找到两个 HTML 文件之间的最短路径。

广度优先搜索策略通常是实现爬虫的最佳策略,因为它易于实现并且具有大部分所需的功能。但是如果你想遍历一个指定的站点或一组深度嵌套的 HTML 文件,使用宽度优先搜索策略将需要相对较长的时间才能到达深层 HTML 文件。

[编辑]

参考

余承龙, 余洪波. 网络爬虫技术研究[J].东莞理工大学学报.2011,5 蔡晓伦.网络爬虫技术的发展顺势而为[J].科技信息.2010,12

从 ””

这个条目对我有帮助 8

报酬

MBA智库APP

扫描下载MBA智库APP

输入关键字 抓取所有网页(关键字技巧1.精确匹配("、《》、加减号(+、-)、通配符)

网站优化 • 优采云 发表了文章 • 0 个评论 • 246 次浏览 • 2021-11-02 00:07

关键词技巧

1.完全匹配(“”、“”)、加减号(+、-)、通配符(*、?)

双引号:如果要搜索完全收录几个单词的内容,加双引号""

书名号:您要搜索的内容是一个完整的作品,如书籍、电影、音乐等,添加书名号以获得更准确的结果""

加号:使用关键词前面的加号,相当于告诉搜索引擎该词必须出现在搜索结果页面上

减号:在关键词前使用减号,表示关键词不能出现在查询结果中。比如debug.exe-csdn可以排除搜索下载资源时需要积分的csdn。

通配符包括星号 (*) 和问号 (?)。前者意味着匹配的数量不受限制,而后者可以匹配的字符数量是有限的。它们主要用于英文搜索引擎。比如输入“computer*”,可以找到“computer,computers,computerised,computerized”这样的词,输入“comp?ter”,只能找到“computer, compater,competer”这样的词

2.空格的使用,如果您需要搜索两个或多个关键内容,只需在关键词之间输入一个空格

搜索引擎说明:

1.文件类型搜索,计算机中的任何文件都收录名称、点和扩展名。此扩展名代表文件类型。一般图片格式为jpg、png等,记事本为txt,word文档为doc,pdf格式为pdf。这通常用于搜索在线论文。关键字文件类型:doc

2.·inurl:限制搜索范围为url链接,在指定URL的网页上搜索;当它与站点不同时,inurl 可以是站点的一部分,更详细

例如 inurl:gov 扬州

3.intitle:搜索标题中收录关键词的页面(非网页内容);可以与双引号“”(英文)一起使用,表示标题是指定标题的网页,不能拆分。

4.intext:要搜索文本中收录的内容,可以使用一组关键字。

5.在网站中搜索有关关键词的信息。关键字站点:网站,将搜索范围限制在特定站点

例如杀死一个 robin 站点:

inurl(URL)、intitle(标题)、intext(内容,一组关键字)一起使用,可以找到大部分的东西。

谷歌搜索引擎

1. num 参数:num 的取值范围为 1 到 100,Google 搜索页面默认显示 10 个搜索结果。通过设置 URL 参数来调整显示的结果。末尾的 &num=100 表示一个页面上只显示 100 个搜索结果。

2. lr 参数:指的是语言限制(语言限制),它限制了对某种语言的网页的搜索。如果 lr 参数为空,则搜索所有网页。例如,lr=lang_zh-CN|lang_zh-TW 搜索所有中文网页。语言代码可以在谷歌提供的语言文档中找到。

3.cr 参数:表示国家限制,国家后两个字符需要大写。具体国家代码请查看GOOGLE提供的国家代码文档。

4. hl 参数:表示宿主语言(界面语言),谷歌一般会根据你的地理位置帮你确定界面语言。例如,如果您使用日语代理服务器,Google 将显示日语。如果看不懂日文,希望如果改成英文或者中文,可以添加HL参数/search?q=vimperator&lr=lang_ja&cr=countryJP&hl=zh-CN,谷歌提供的hl参数语言代码文档。

5. as_qdr 参数:as 表示高级搜索,qdr 表示查询日期范围,您可以在谷歌搜索中提供时间限制功能,例如“过去1周”,甚至自定义日期。

例如as_qdr=m2表示过去两个月,as_qdr=y2表示过去两年,as_qdr=d2表示过去两天,w表示一周,s表示秒,n表示分钟,h表示小时。

信息:域名

可以获得网站的一些信息

链接:网站网址

通过这个,你可以看到网页做了哪些外部链接,更可以看到谁转载了你的文章和谁采集。

有关的:

根据外部链接和页面标题查找

缓存:

谷歌将返回有关查询网页的所有抓取的快照信息。

快速使用百度法

1.设置浏览器中url地址栏的搜索引擎为百度

2.alt+D 或 Ctrl+L 快速定位地址栏,输入你要百度的内容 查看全部

输入关键字 抓取所有网页(关键字技巧1.精确匹配("、《》、加减号(+、-)、通配符)

关键词技巧

1.完全匹配(“”、“”)、加减号(+、-)、通配符(*、?)

双引号:如果要搜索完全收录几个单词的内容,加双引号""

书名号:您要搜索的内容是一个完整的作品,如书籍、电影、音乐等,添加书名号以获得更准确的结果""

加号:使用关键词前面的加号,相当于告诉搜索引擎该词必须出现在搜索结果页面上

减号:在关键词前使用减号,表示关键词不能出现在查询结果中。比如debug.exe-csdn可以排除搜索下载资源时需要积分的csdn。

通配符包括星号 (*) 和问号 (?)。前者意味着匹配的数量不受限制,而后者可以匹配的字符数量是有限的。它们主要用于英文搜索引擎。比如输入“computer*”,可以找到“computer,computers,computerised,computerized”这样的词,输入“comp?ter”,只能找到“computer, compater,competer”这样的词

2.空格的使用,如果您需要搜索两个或多个关键内容,只需在关键词之间输入一个空格

搜索引擎说明:

1.文件类型搜索,计算机中的任何文件都收录名称、点和扩展名。此扩展名代表文件类型。一般图片格式为jpg、png等,记事本为txt,word文档为doc,pdf格式为pdf。这通常用于搜索在线论文。关键字文件类型:doc

2.·inurl:限制搜索范围为url链接,在指定URL的网页上搜索;当它与站点不同时,inurl 可以是站点的一部分,更详细

例如 inurl:gov 扬州

3.intitle:搜索标题中收录关键词的页面(非网页内容);可以与双引号“”(英文)一起使用,表示标题是指定标题的网页,不能拆分。

4.intext:要搜索文本中收录的内容,可以使用一组关键字。

5.在网站中搜索有关关键词的信息。关键字站点:网站,将搜索范围限制在特定站点

例如杀死一个 robin 站点:

inurl(URL)、intitle(标题)、intext(内容,一组关键字)一起使用,可以找到大部分的东西。

谷歌搜索引擎

1. num 参数:num 的取值范围为 1 到 100,Google 搜索页面默认显示 10 个搜索结果。通过设置 URL 参数来调整显示的结果。末尾的 &num=100 表示一个页面上只显示 100 个搜索结果。

2. lr 参数:指的是语言限制(语言限制),它限制了对某种语言的网页的搜索。如果 lr 参数为空,则搜索所有网页。例如,lr=lang_zh-CN|lang_zh-TW 搜索所有中文网页。语言代码可以在谷歌提供的语言文档中找到。

3.cr 参数:表示国家限制,国家后两个字符需要大写。具体国家代码请查看GOOGLE提供的国家代码文档。

4. hl 参数:表示宿主语言(界面语言),谷歌一般会根据你的地理位置帮你确定界面语言。例如,如果您使用日语代理服务器,Google 将显示日语。如果看不懂日文,希望如果改成英文或者中文,可以添加HL参数/search?q=vimperator&lr=lang_ja&cr=countryJP&hl=zh-CN,谷歌提供的hl参数语言代码文档。

5. as_qdr 参数:as 表示高级搜索,qdr 表示查询日期范围,您可以在谷歌搜索中提供时间限制功能,例如“过去1周”,甚至自定义日期。

例如as_qdr=m2表示过去两个月,as_qdr=y2表示过去两年,as_qdr=d2表示过去两天,w表示一周,s表示秒,n表示分钟,h表示小时。

信息:域名

可以获得网站的一些信息

链接:网站网址

通过这个,你可以看到网页做了哪些外部链接,更可以看到谁转载了你的文章和谁采集。

有关的:

根据外部链接和页面标题查找

缓存:

谷歌将返回有关查询网页的所有抓取的快照信息。

快速使用百度法

1.设置浏览器中url地址栏的搜索引擎为百度

2.alt+D 或 Ctrl+L 快速定位地址栏,输入你要百度的内容

输入关键字 抓取所有网页( mysql+redis安装可查阅百度(很简单)项目开发流程介绍 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-10-30 16:00

mysql+redis安装可查阅百度(很简单)项目开发流程介绍

)

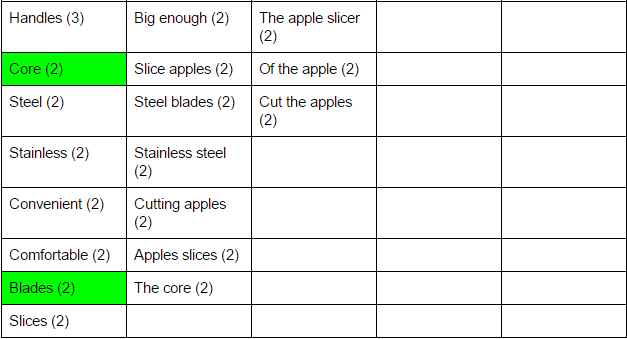

图像.png

前几天,由于工作需要,我需要抓取一个特定的关键字来提取百度中的搜索结果,并将50页的数据保存在一个数据库或一个.csv文件中。(每天爬一次)

1.项目需要环境安装

1)scrapy+selenium+chrome (phantomjs)

关于爬虫依赖的环境的安装,我已经介绍过了。你可以参考这个文章我的详细介绍。

2)mysql+redis安装数据库安装可以参考百度(很简单)

2.项目开发流程介绍

我们需要模拟用户行为,在浏览器输入框输入指定关键字,模拟点击获取想要的数据,保存过滤这个页面显示的数据,模拟翻页,抓取这个关键字的前50个页面展示,获取我们想要的数据,保存在.csv文件或者redis数据库中,供以后数据分析使用。

3.详细开发代码

1)创建一个scrapy项目

scrapy startproject keyword_scrawl

scrapy genspider 重新测试

代码中各个文件的介绍

settings.py 是一个通用的配置文件:

BOT_NAME:项目名称

蜘蛛模块:

NEWSPIDER_MODULE:

下面模块的配置路径

pipelines.py 这个是数据存储相关的文件

可以自定义 middlewares.py 使scrapy 更可控

items.py 文件有点类似于 django 中的一个表单,它定义了数据存储的格式

,但是比django的表单应用要简单,因为它的字段很单一。

Spider文件夹:这个文件夹存放了一个特定的网站爬虫。通过命令行,我们可以创建我们自己的蜘蛛。

4.蜘蛛代码详解

def make_requests_from_url(self, url): if self.params['st_status'] == 1: return Request(url, meta={'keyword': self.keyword, 'engine':self.sousu, 'phantomjs':True}) else:

return Request(url)

首先修改spider中的make_requests_from_url函数,增加一个判断。当st_status==1时,当我们返回请求对象时,添加一个meta,在meta中携带我们要搜索的key和我们需要访问的浏览器地址。以及启动phantomjs的指令。

class PhantomJSMiddleware(object): @classmethod

def process_request(cls, request, spider):

if request.meta.has_key('phantomjs'):

keyword = request.meta.get('keyword')

dcap = dict(DesiredCapabilities.PHANTOMJS)

dcap["phantomjs.page.settings.userAgent"] = ('Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:60.0) Gecko/20100101 Firefox/60.0')

dcap["phantomjs.page.settings.AcceptLanguage"] = ('zh-CN,zh;q=0.9')

driver = webdriver.PhantomJS(desired_capabilities=dcap)

driver.set_page_load_timeout(100)

driver.set_script_timeout(15) try:

driver.get(request.url) if request.meta.get('engine') == 1:

driver.find_element_by_id("query").send_keys(keyword)

driver.find_element_by_class_name("swz").click() elif request.meta.get('engine') == 2:

driver.find_element_by_id("kw").send_keys(keyword)

driver.find_element_by_id("su").click()

time.sleep(2)

final_url = driver.current_url if final_url != request.url:

fullurl = final_url else:

fullurl = request.url

content = driver.page_source.encode('utf-8','ignore')

driver.quit() return HtmlResponse(fullurl, encoding='utf-8', body=content, request=request) except Exception, e:

driver.quit() print e

其次,修改middlewares中间件中的类方法process_request。该方法默认携带request和spider对象,在我们刚刚修改的make_requests_from_url方法中。我们可以在这里处理前面的make_requests_from_url函数返回的Request请求,然后加载selenium和phantomjs来获取我们需要访问的浏览器和关键字。这段代码会模拟用户获取关键字内容的行为,然后将页面内容返回给scrapy.http中的HtmlResponse对象。这样我们就可以在spider中的parse函数中得到刚刚抓取到的内容response.body。

# 判断页面的返回状态

if int(response.status) >= 200 and int(response.status) 3000:

content = content[:3000] #elif len(content) == 0:

#yield scrapy.Request(url=response.url, meta={'url':response.url, 'phantomjs':True}, callback=self.pang_bo)

body = item['url']+','+item['crawl_time']+','+item['title'].replace(',','') +','+content+'\n'

if '正在进入' == item['title']:

file_name = os.path.join(self.filetxt,time.strftime('%Y%m%d%H')+'keyword.csv') with open(file_name, 'a') as b:

b.write(body) else:

filename = os.path.join(self.filetxt,time.strftime('%Y%m%d%H')+'.csv') with open(filename, 'a') as f:

f.write(body)# 过滤网页源代码def soup_text(body):

try:

soup = BeautifulSoup(body, 'lxml')

line = re.compile(r'\s+')

line = line.sub(r'', soup.body.getText())

p2 = re.compile(u'[^\u4e00-\u9fa5]') # 中GDAC\u4e00\u9fa5

str2 = p2.sub(r'', line)

outStr = str2.strip(',') except:

outStr = ''

return outStr