自动采集编写

最新版:勇芳文件编辑器与ET2全自动采集下载评论软件详情对比

采集交流 • 优采云 发表了文章 • 0 个评论 • 321 次浏览 • 2020-11-16 10:01

免费的采集软件EditorTools是中小型的网站自动更新工具,是全自动采集发行版,无需人工干预即可静默工作;独立软件免除网站性能消耗;安全稳定,可以连续数月无间断工作;支持任何网站和数据库采集版本,内置软件包括discuzX,phpwind,dedecms,wordpress,phpcms,empirecms,Dongyi,joomla,pbdigg,php168,bbsxp,phpbb, dvbbs,Typecho,emblog和许多其他常用系统示例。

该软件适用于需要长期更新内容的网站,不需要您对现有论坛或网站进行任何更改。

网站管理员和管理员的解放

网站要保持活跃状态,每日内容更新是基础。一个小的网站来确保每日更新,通常需要网站管理员每天进行8小时的更新工作,并在周末开放;一个介质网站来全天维护内容更新,通常一天3个班次,每个人工管理员需要2-3个班次。如果以普通月工资1500元计算,即使不包括周末加班费,小网站每月至少要花费1500元,而中型网站每月要花费10000多元。 ET的出现将为您节省这笔费用!将网站管理员和管理员从繁琐而乏味的网站更新工作中解放出来!

独特的无人值守操作

从设计伊始,ET就被设计为提高软件自动化程度的突破,以实现无人值守和自动24小时工作的目的。经过测试,ET可以长时间甚至数年自动运行。

超高稳定性

如果不使用该软件,则需要长期稳定的运行。 ET在这方面进行了很多优化,以确保软件可以稳定且连续地运行,并且不会崩溃。它甚至导致网站崩溃。

最少的资源使用量

ET独立于网站,并且不消耗宝贵的服务器WEB处理资源。它可以在服务器上或网站管理员的工作站上工作。

严格的数据和网络安全性

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,并且不直接操作网站数据库,从而避免了由ET引起的任何数据安全问题。 采集有关信息,ET使用标准的HTTP端口,这不会引起网络安全漏洞。

强大而灵活的功能

除了通用采集工具的功能外,ET还使用图像水印,防垃圾,分页采集,回复采集,登录采集,自定义项,UTF-8、UBB,支持模拟发布...使用户可以灵活地实现各种头发采集要求。

EditorTools 2功能介绍

[功能]设置计划后,它可以自动运行24小时,而无需人工干预。

[功能]与网站分开,并且可以通过独立产生的界面支持任何网站或数据库

[功能]灵活强大的采集规则不仅是采集 文章,而且可以是采集任何类型的信息

[功能]体积小,功耗低,稳定性好,非常适合在服务器上运行

[功能]可以导入和导出所有规则,灵活地重复使用资源

[功能]使用FTP上传文件,稳定又安全

[功能]下载和上传支持断点续传

[功能]高速伪原创

[采集]可以选择反向,顺序,随机的采集 文章

[采集]支持自动列表网址

[采集]支持网站的采集,数据分布在多个页面上

[采集] 采集数据项可以自由设置,每个数据项可以分别过滤和排序

[采集]支持分页内容采集

[采集]支持下载任何格式和类型的文件(包括图片,视频)

[采集]可以突破防盗文件

[采集]支持动态文件URL分析

[采集]对需要登录才能访问的网页提供采集支持

可以将[支持]设置为关键词采集

[支持]您可以设置敏感词来防止采集

[支持]可以设置图像水印

带有回复的[发布] 文章,可广泛用于论坛,博客和其他项目中

[发布]从采集数据中分离出的发布参数项可以自由地与采集数据或预设值相对应,这大大提高了发布规则的可重用性

[发布]支持随机选择发布帐户

[发布]支持发布项目的任何语言翻译

[发布]支持编码转换和UBB代码

[发布]可以选择文件上传来自动创建年,月和日目录

[发布]模拟发行版支持无法安装界面的网站发行版操作

[支持]该程序可以正常运行

[支持]防止网络运营商劫持HTTP功能

[支持]可以手动完成单个项目采集的发布

[支持]详细的工作流监控和信息反馈,使您可以快速了解工作状态 查看全部

永芳文件编辑器与ET2自动采集下载审阅软件之间的详细信息比较

免费的采集软件EditorTools是中小型的网站自动更新工具,是全自动采集发行版,无需人工干预即可静默工作;独立软件免除网站性能消耗;安全稳定,可以连续数月无间断工作;支持任何网站和数据库采集版本,内置软件包括discuzX,phpwind,dedecms,wordpress,phpcms,empirecms,Dongyi,joomla,pbdigg,php168,bbsxp,phpbb, dvbbs,Typecho,emblog和许多其他常用系统示例。

该软件适用于需要长期更新内容的网站,不需要您对现有论坛或网站进行任何更改。

网站管理员和管理员的解放

网站要保持活跃状态,每日内容更新是基础。一个小的网站来确保每日更新,通常需要网站管理员每天进行8小时的更新工作,并在周末开放;一个介质网站来全天维护内容更新,通常一天3个班次,每个人工管理员需要2-3个班次。如果以普通月工资1500元计算,即使不包括周末加班费,小网站每月至少要花费1500元,而中型网站每月要花费10000多元。 ET的出现将为您节省这笔费用!将网站管理员和管理员从繁琐而乏味的网站更新工作中解放出来!

独特的无人值守操作

从设计伊始,ET就被设计为提高软件自动化程度的突破,以实现无人值守和自动24小时工作的目的。经过测试,ET可以长时间甚至数年自动运行。

超高稳定性

如果不使用该软件,则需要长期稳定的运行。 ET在这方面进行了很多优化,以确保软件可以稳定且连续地运行,并且不会崩溃。它甚至导致网站崩溃。

最少的资源使用量

ET独立于网站,并且不消耗宝贵的服务器WEB处理资源。它可以在服务器上或网站管理员的工作站上工作。

严格的数据和网络安全性

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,并且不直接操作网站数据库,从而避免了由ET引起的任何数据安全问题。 采集有关信息,ET使用标准的HTTP端口,这不会引起网络安全漏洞。

强大而灵活的功能

除了通用采集工具的功能外,ET还使用图像水印,防垃圾,分页采集,回复采集,登录采集,自定义项,UTF-8、UBB,支持模拟发布...使用户可以灵活地实现各种头发采集要求。

EditorTools 2功能介绍

[功能]设置计划后,它可以自动运行24小时,而无需人工干预。

[功能]与网站分开,并且可以通过独立产生的界面支持任何网站或数据库

[功能]灵活强大的采集规则不仅是采集 文章,而且可以是采集任何类型的信息

[功能]体积小,功耗低,稳定性好,非常适合在服务器上运行

[功能]可以导入和导出所有规则,灵活地重复使用资源

[功能]使用FTP上传文件,稳定又安全

[功能]下载和上传支持断点续传

[功能]高速伪原创

[采集]可以选择反向,顺序,随机的采集 文章

[采集]支持自动列表网址

[采集]支持网站的采集,数据分布在多个页面上

[采集] 采集数据项可以自由设置,每个数据项可以分别过滤和排序

[采集]支持分页内容采集

[采集]支持下载任何格式和类型的文件(包括图片,视频)

[采集]可以突破防盗文件

[采集]支持动态文件URL分析

[采集]对需要登录才能访问的网页提供采集支持

可以将[支持]设置为关键词采集

[支持]您可以设置敏感词来防止采集

[支持]可以设置图像水印

带有回复的[发布] 文章,可广泛用于论坛,博客和其他项目中

[发布]从采集数据中分离出的发布参数项可以自由地与采集数据或预设值相对应,这大大提高了发布规则的可重用性

[发布]支持随机选择发布帐户

[发布]支持发布项目的任何语言翻译

[发布]支持编码转换和UBB代码

[发布]可以选择文件上传来自动创建年,月和日目录

[发布]模拟发行版支持无法安装界面的网站发行版操作

[支持]该程序可以正常运行

[支持]防止网络运营商劫持HTTP功能

[支持]可以手动完成单个项目采集的发布

[支持]详细的工作流监控和信息反馈,使您可以快速了解工作状态

技巧:网上有爬虫软件,还有必要学习代码编写爬虫吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 211 次浏览 • 2020-11-13 10:01

这取决于学习编写爬虫代码的目的吗?磨练您的技能,增加您的体验,或者只是想爬网并获取在线数据供您自己使用或研究。

如果您想成为学生聚会或准备转而使用IT技术的人,如果您拥有更多的实践经验和更多的技术技能,将来有必要找工作,则必须学习编写代码和编写爬虫。 。由于将来Internet上的信息化将会越来越多,因此爬虫可以更有效地获取Internet信息,并且爬虫的技术也在不断发展。

如果您只需要采集个Internet数据在工作或学习中应用,则可以先尝试使用市场上的通用采集器来减少用于获取数据的资源,这样您就可以专注于自己的业务。

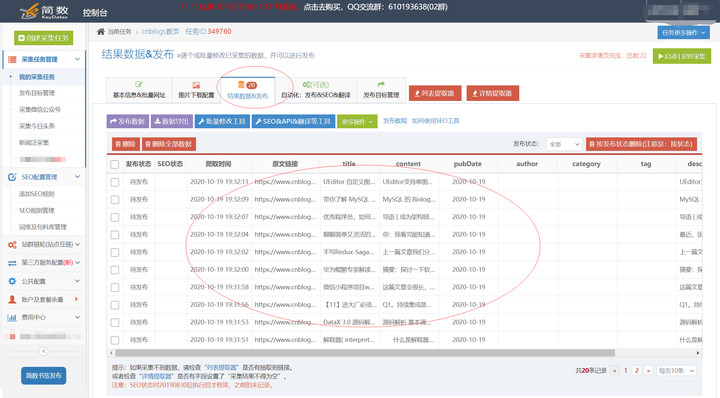

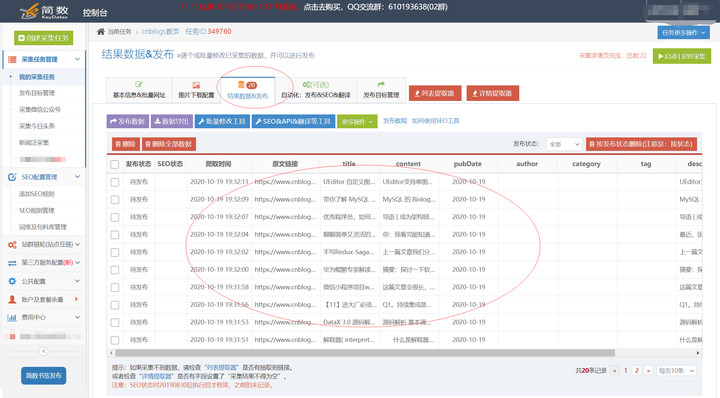

推荐自己。对于采集网页数据,您可以尝试优采云采集平台,有一个免费版本。这是采集结果数据的示例:

优采云采集是新一代的网站文章采集和发布平台,它是完全在线配置和使用云采集的平台,功能强大,操作简单,配置快捷高效。

优采云不仅提供网页文章采集,数据批处理修改,计时采集,计时和定量自动发布等基本功能,还集成了功能强大的SEO工具,并创新地实现了智能规则提取引擎和书签一键发布采集等功能大大改善了采集的配置和发布效率。

采集发布更简单:支持一键发布到WorpPress,Empire,织梦,ZBlog,Discuz,Destoon,Typecho,Emlog,Mipcms,Mituo,Yiyoucms,Applecms ],PHPcms和其他cms网站系统也可以发布到自定义Http接口。

此外,它还支持特定的文章“一键快速采集”,包括:微信官方帐户文章,今天的头条新闻,新闻窗格采集。

有需要的学生可以查看以下教程,他们可以很快上手。

采集入门教程(简体版)·优采云数据采集平台帮助中心。

查看全部

Internet上有采集器软件,是否有必要学习编码和编写采集器?

这取决于学习编写爬虫代码的目的吗?磨练您的技能,增加您的体验,或者只是想爬网并获取在线数据供您自己使用或研究。

如果您想成为学生聚会或准备转而使用IT技术的人,如果您拥有更多的实践经验和更多的技术技能,将来有必要找工作,则必须学习编写代码和编写爬虫。 。由于将来Internet上的信息化将会越来越多,因此爬虫可以更有效地获取Internet信息,并且爬虫的技术也在不断发展。

如果您只需要采集个Internet数据在工作或学习中应用,则可以先尝试使用市场上的通用采集器来减少用于获取数据的资源,这样您就可以专注于自己的业务。

推荐自己。对于采集网页数据,您可以尝试优采云采集平台,有一个免费版本。这是采集结果数据的示例:

优采云采集是新一代的网站文章采集和发布平台,它是完全在线配置和使用云采集的平台,功能强大,操作简单,配置快捷高效。

优采云不仅提供网页文章采集,数据批处理修改,计时采集,计时和定量自动发布等基本功能,还集成了功能强大的SEO工具,并创新地实现了智能规则提取引擎和书签一键发布采集等功能大大改善了采集的配置和发布效率。

采集发布更简单:支持一键发布到WorpPress,Empire,织梦,ZBlog,Discuz,Destoon,Typecho,Emlog,Mipcms,Mituo,Yiyoucms,Applecms ],PHPcms和其他cms网站系统也可以发布到自定义Http接口。

此外,它还支持特定的文章“一键快速采集”,包括:微信官方帐户文章,今天的头条新闻,新闻窗格采集。

有需要的学生可以查看以下教程,他们可以很快上手。

采集入门教程(简体版)·优采云数据采集平台帮助中心。

最新版本:Qt编写控件属性设计器7-串口采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 372 次浏览 • 2020-11-08 11:00

由二、实现的功能会自动将插件中的所有控件加载到列表中,并且默认收录120多个控件。拖到画布上以自动生成相应的控件,所见即所得。在右侧的中文属性栏上,将更改相应的属性立即应用于相应的所选控件,该控件直观,简洁,非常适合小白使用。原创的属性列文本翻译映射机制非常高效,可以非常方便地扩展其他语言的属性列。所有控件的属性将自动提取并显示在右侧的属性栏中,包括枚举值下拉框。支持手动选择插件文件和从外部导入插件文件。您可以将当前画布的所有控件配置信息导出到xml文件。您可以手动选择xml文件以打开控件布局,然后根据xml文件自动加载控件。您可以拉动滑块,选中“模拟数据”复选框,然后以三种方式输入文本框以生成数据并应用所有控件。该控件支持八个位置以调整大小,以适应任何分辨率,并且键盘可以向上,向下,向左和向右微调位置。打开串行端口采集,网络采集,数据库采集三种设置数据的方式。代码非常简洁,注释非常详细,可以用作配置的原型,以自行扩展更多功能。用纯Qt编写,支持任何Qt版本+任何编译器+任何系统。三、效果图片

四、核心代码

void frmData::initServer()

{

//实例化串口类,绑定信号槽

com = new QextSerialPort(QextSerialPort::EventDriven, this);

connect(com, SIGNAL(readyRead()), this, SLOT(readDataCom()));

//实例化网络通信客户端类,绑定信号槽

tcpClient = new QTcpSocket(this);

connect(tcpClient, SIGNAL(readyRead()), this, SLOT(readDataClient()));

//实例化网络通信服务端类,绑定信号槽

tcpSocket = NULL;

tcpServer = new QTcpServer(this);

connect(tcpServer, SIGNAL(newConnection()), this, SLOT(newConnection()));

//开启定时器读取数据库采集数据

timer = new QTimer(this);

connect(timer, SIGNAL(timeout()), this, SLOT(readDataDb()));

timer->setInterval(1000);

}

void frmData::on_btnOpenCom_clicked()

{

if (ui->btnOpenCom->text() == "打开") {

com->setPortName(App::PortName);

bool ok = com->open(QIODevice::ReadWrite);

if (ok) {

com->setBaudRate((BaudRateType)App::BaudRate);

setEnable(ui->btnOpenCom, false);

ui->btnOpenCom->setText("关闭");

}

} else {

com->close();

setEnable(ui->btnOpenCom, true);

ui->btnOpenCom->setText("打开");

}

}

void frmData::readDataCom()

{

QByteArray data = com->readAll();

if (data.length() txtValue->setText(QString::number(value));

append(1, data.toHex());

}

五、控件引入了150多种精美的控件,涵盖了各种仪表板,进度条,进度球,指南针,图形,标尺,温度计,导航栏,导航栏,flatui,高亮按钮,滑动选择商品,阴历,等等。远远超过了qwt集成的控件数量。每个类都可以独立成一个单独的控件,零耦合,每个控件都有一个头文件和一个实现文件,而不必依赖其他文件,这样就可以方便地将单个控件以源代码的形式集成到项目中,用更少的代码。 qwt的控制类是互锁的且高度耦合的。如果要使用控件之一,则必须收录所有代码。全部使用纯Qt,QWidget + QPainter绘图编写,支持从Qt4.6到Qt5.12的任何Qt版本,支持mingw,msvc,gcc和其他编译器,支持任何操作系统,例如Windows + linux + mac +嵌入式linux等,没有乱码,可以直接集成到Qt Creator中,并且像内置控件一样使用,大多数效果只需要设置一些属性,这非常方便。每个控件都有一个对应的单独DEMO,其中收录控件源代码,以方便参考和使用。它还提供了供所有控件使用的集成DEMO。每个控件的源代码都有详细的中文注释,并按照统一的设计规范编写,从而便于学习自定义控件的编写。每个控件的默认颜色匹配和演示的颜色匹配都非常漂亮。超过130个可见控件和6个不可见控件。

某些控件提供多种样式可供选择,以及多种指示器样式可供选择。所有控件都适应表单的拉伸。集成了自定义控件属性设计器,支持拖动设计,所见即所得,支持导入和导出xml格式。带有activex控件演示,所有控件都可以直接在ie浏览器中运行。集成了精美的图形字体+阿里巴巴iconfont采集的数百种图形字体,尽享图形字体的乐趣。所有控件最终都会生成一个动态库文件(dll左右等),可以将其直接集成到qtcreator中并拖动以供设计使用。已经存在qml版本,如果用户需求很大,以后将考虑pyqt版本。自定义控件插件对动态库开放使用(永久免费),没有任何后门和限制,请放心使用。当前有26个版本的dll,包括qt5.12.3 msvc2017 32 + 64 mingw 32 + 64。不时添加控件并改进控件,并不时更新SDK。欢迎任何建议,谢谢! Qt入门书籍推荐霍亚飞的“ Qt Creator快速入门”和“ Qt5编程简介”,而Qt高级书籍推荐官方的“ C ++ GUI Qt4编程”。我强烈推荐程序员的自我修养和计划系列“大谈程序员”,“程序员的成长历程”,“减轻烦恼的程序员”,这将使他们受益匪浅,终生受益! SDK下载链接:提取代码:877p 查看全部

Qt编译控件属性设计器的7串行端口采集

由二、实现的功能会自动将插件中的所有控件加载到列表中,并且默认收录120多个控件。拖到画布上以自动生成相应的控件,所见即所得。在右侧的中文属性栏上,将更改相应的属性立即应用于相应的所选控件,该控件直观,简洁,非常适合小白使用。原创的属性列文本翻译映射机制非常高效,可以非常方便地扩展其他语言的属性列。所有控件的属性将自动提取并显示在右侧的属性栏中,包括枚举值下拉框。支持手动选择插件文件和从外部导入插件文件。您可以将当前画布的所有控件配置信息导出到xml文件。您可以手动选择xml文件以打开控件布局,然后根据xml文件自动加载控件。您可以拉动滑块,选中“模拟数据”复选框,然后以三种方式输入文本框以生成数据并应用所有控件。该控件支持八个位置以调整大小,以适应任何分辨率,并且键盘可以向上,向下,向左和向右微调位置。打开串行端口采集,网络采集,数据库采集三种设置数据的方式。代码非常简洁,注释非常详细,可以用作配置的原型,以自行扩展更多功能。用纯Qt编写,支持任何Qt版本+任何编译器+任何系统。三、效果图片

四、核心代码

void frmData::initServer()

{

//实例化串口类,绑定信号槽

com = new QextSerialPort(QextSerialPort::EventDriven, this);

connect(com, SIGNAL(readyRead()), this, SLOT(readDataCom()));

//实例化网络通信客户端类,绑定信号槽

tcpClient = new QTcpSocket(this);

connect(tcpClient, SIGNAL(readyRead()), this, SLOT(readDataClient()));

//实例化网络通信服务端类,绑定信号槽

tcpSocket = NULL;

tcpServer = new QTcpServer(this);

connect(tcpServer, SIGNAL(newConnection()), this, SLOT(newConnection()));

//开启定时器读取数据库采集数据

timer = new QTimer(this);

connect(timer, SIGNAL(timeout()), this, SLOT(readDataDb()));

timer->setInterval(1000);

}

void frmData::on_btnOpenCom_clicked()

{

if (ui->btnOpenCom->text() == "打开") {

com->setPortName(App::PortName);

bool ok = com->open(QIODevice::ReadWrite);

if (ok) {

com->setBaudRate((BaudRateType)App::BaudRate);

setEnable(ui->btnOpenCom, false);

ui->btnOpenCom->setText("关闭");

}

} else {

com->close();

setEnable(ui->btnOpenCom, true);

ui->btnOpenCom->setText("打开");

}

}

void frmData::readDataCom()

{

QByteArray data = com->readAll();

if (data.length() txtValue->setText(QString::number(value));

append(1, data.toHex());

}

五、控件引入了150多种精美的控件,涵盖了各种仪表板,进度条,进度球,指南针,图形,标尺,温度计,导航栏,导航栏,flatui,高亮按钮,滑动选择商品,阴历,等等。远远超过了qwt集成的控件数量。每个类都可以独立成一个单独的控件,零耦合,每个控件都有一个头文件和一个实现文件,而不必依赖其他文件,这样就可以方便地将单个控件以源代码的形式集成到项目中,用更少的代码。 qwt的控制类是互锁的且高度耦合的。如果要使用控件之一,则必须收录所有代码。全部使用纯Qt,QWidget + QPainter绘图编写,支持从Qt4.6到Qt5.12的任何Qt版本,支持mingw,msvc,gcc和其他编译器,支持任何操作系统,例如Windows + linux + mac +嵌入式linux等,没有乱码,可以直接集成到Qt Creator中,并且像内置控件一样使用,大多数效果只需要设置一些属性,这非常方便。每个控件都有一个对应的单独DEMO,其中收录控件源代码,以方便参考和使用。它还提供了供所有控件使用的集成DEMO。每个控件的源代码都有详细的中文注释,并按照统一的设计规范编写,从而便于学习自定义控件的编写。每个控件的默认颜色匹配和演示的颜色匹配都非常漂亮。超过130个可见控件和6个不可见控件。

某些控件提供多种样式可供选择,以及多种指示器样式可供选择。所有控件都适应表单的拉伸。集成了自定义控件属性设计器,支持拖动设计,所见即所得,支持导入和导出xml格式。带有activex控件演示,所有控件都可以直接在ie浏览器中运行。集成了精美的图形字体+阿里巴巴iconfont采集的数百种图形字体,尽享图形字体的乐趣。所有控件最终都会生成一个动态库文件(dll左右等),可以将其直接集成到qtcreator中并拖动以供设计使用。已经存在qml版本,如果用户需求很大,以后将考虑pyqt版本。自定义控件插件对动态库开放使用(永久免费),没有任何后门和限制,请放心使用。当前有26个版本的dll,包括qt5.12.3 msvc2017 32 + 64 mingw 32 + 64。不时添加控件并改进控件,并不时更新SDK。欢迎任何建议,谢谢! Qt入门书籍推荐霍亚飞的“ Qt Creator快速入门”和“ Qt5编程简介”,而Qt高级书籍推荐官方的“ C ++ GUI Qt4编程”。我强烈推荐程序员的自我修养和计划系列“大谈程序员”,“程序员的成长历程”,“减轻烦恼的程序员”,这将使他们受益匪浅,终生受益! SDK下载链接:提取代码:877p

解决方案:几个Python爬虫培训案例,助你快速爱上Python编程!

采集交流 • 优采云 发表了文章 • 0 个评论 • 381 次浏览 • 2020-09-16 08:33

一、前言

该文章文章以前曾用于培训新手。每个人都觉得它很容易理解,因此我与所有人共享并学习了。如果您已经学习了一些python并想用它做点事但没有方向,那么不妨尝试完成以下案例。

二、环境准备

安装三个请求库lxml beautifulsoup4(以下代码均在python3.5环境中进行了测试)

pip install requests lxml beautifulsoup4

三、几个小履带箱

3.1获取本地公共网络IP地址

利用在公共Internet上查询IP的借口,使用python的请求库自动获取IP地址。

import requests

r = requests.get("http://2017.ip138.com/ic.asp")

r.encoding = r.apparent_encoding #使用requests的字符编码智能分析,避免中文乱码

print(r.text)

# 你还可以使用正则匹配re模块提取出IP

import re

print(re.findall("\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}",r.text))

3.2使用百度搜索界面编写url采集器

在这种情况下,我们将结合使用请求和BeautifulSoup库来完成任务。我们需要在程序中设置User-Agent标头,以绕过百度搜索引擎的反爬虫机制(您可以尝试不使用User-Agent标头来查看是否可以获取数据)。请注意百度搜索结构的URL链接规则,例如,第一页上的URL链接参数pn = 0,第二页上的URL链接参数pn = 10 ...等等。在这里,我们使用css选择器路径提取数据。

import requests

from bs4 import BeautifulSoup

# 设置User-Agent头,绕过百度搜索引擎的反爬虫机制

headers = {'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64; rv:52.0) Gecko/20100101 Firefox/52.0'}

# 注意观察百度搜索结构的URL链接规律,例如第一页pn=0,第二页pn=10.... 依次类推,下面的for循环搜索前10页结果

for i in range(0,100,10):

bd_search = "https://www.baidu.com/s%3Fwd%3 ... ot%3B % str(i)

r = requests.get(bd_search,headers=headers)

soup = BeautifulSoup(r.text,"lxml")

# 下面的select使用了css选择器路径提取数据

url_list = soup.select(".t > a")

for url in url_list:

real_url = url["href"]

r = requests.get(real_url)

print(r.url)

编写程序后,我们使用关键词inurl:/dede/login.php批量提取织梦cms的背景地址,效果如下:

3.3自动下载搜狗壁纸

在此示例中,我们将使用采集器自动下载搜索到的墙纸,并将程序中存储图片的路径更改为要存储图片的目录的路径。另一点是,我们在程序中使用了json库。这是因为我们发现观察期间搜狗的墙纸地址以json格式存储,因此我们将这组数据解析为json。

import requests

import json

#下载图片

url = "http://pic.sogou.com/pics/chan ... ot%3B

r = requests.get(url)

data = json.loads(r.text)

for i in data["all_items"]:

img_url = i["pic_url"]

# 下面这行里面的路径改成你自己想要存放图片的目录路径即可

with open("/home/evilk0/Desktop/img/%s" % img_url[-10:]+".jpg","wb") as f:

r2 = requests.get(img_url)

f.write(r2.content)

print("下载完毕:",img_url)

3.4自动填写调查表

目标官网:https://www.wjx.cn

目标问卷:https://www.wjx.cn/jq/21581199.aspx

import requests

import random

url = "https://www.wjx.cn/joinnew/pro ... ot%3B

data = {

"submitdata" : "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

}

header = {

"User-Agent" : "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko)",

"Cookie": ".ASPXANONYMOUS=iBuvxgz20wEkAAAAZGY4MDE1MjctNWU4Ni00MDUwLTgwYjQtMjFhMmZhMDE2MTA3h_bb3gNw4XRPsyh-qPh4XW1mfJ41; spiderregkey=baidu.com%c2%a7%e7%9b%b4%e8%be%be%c2%a71; UM_distinctid=1623e28d4df22d-08d0140291e4d5-102c1709-100200-1623e28d4e1141; _umdata=535523100CBE37C329C8A3EEEEE289B573446F594297CC3BB3C355F09187F5ADCC492EBB07A9CC65CD43AD3E795C914CD57017EE3799E92F0E2762C963EF0912; WjxUser=UserName=17750277425&Type=1; LastCheckUpdateDate=1; LastCheckDesign=1; DeleteQCookie=1; _cnzz_CV4478442=%E7%94%A8%E6%88%B7%E7%89%88%E6%9C%AC%7C%E5%85%8D%E8%B4%B9%E7%89%88%7C1521461468568; jac21581199=78751211; CNZZDATA4478442=cnzz_eid%3D878068609-1521456533-https%253A%252F%252Fwww.baidu.com%252F%26ntime%3D1521461319; Hm_lvt_21be24c80829bd7a683b2c536fcf520b=1521461287,1521463471; Hm_lpvt_21be24c80829bd7a683b2c536fcf520b=1521463471",

}

for i in range(0,500):

choice = (

random.randint(1, 2),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

)

data["submitdata"] = data["submitdata"] % choice

r = requests.post(url = url,headers=header,data=data)

print(r.text)

data["submitdata"] = "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

当我们使用相同的IP提交多个调查表时,将触发目标的反爬虫机制,并且验证码将显示在服务器上。

我们可以使用X-Forwarded-For伪造我们的IP,修改后的代码如下:

import requests

import random

url = "https://www.wjx.cn/joinnew/pro ... ot%3B

data = {

"submitdata" : "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

}

header = {

"User-Agent" : "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko)",

"Cookie": ".ASPXANONYMOUS=iBuvxgz20wEkAAAAZGY4MDE1MjctNWU4Ni00MDUwLTgwYjQtMjFhMmZhMDE2MTA3h_bb3gNw4XRPsyh-qPh4XW1mfJ41; spiderregkey=baidu.com%c2%a7%e7%9b%b4%e8%be%be%c2%a71; UM_distinctid=1623e28d4df22d-08d0140291e4d5-102c1709-100200-1623e28d4e1141; _umdata=535523100CBE37C329C8A3EEEEE289B573446F594297CC3BB3C355F09187F5ADCC492EBB07A9CC65CD43AD3E795C914CD57017EE3799E92F0E2762C963EF0912; WjxUser=UserName=17750277425&Type=1; LastCheckUpdateDate=1; LastCheckDesign=1; DeleteQCookie=1; _cnzz_CV4478442=%E7%94%A8%E6%88%B7%E7%89%88%E6%9C%AC%7C%E5%85%8D%E8%B4%B9%E7%89%88%7C1521461468568; jac21581199=78751211; CNZZDATA4478442=cnzz_eid%3D878068609-1521456533-https%253A%252F%252Fwww.baidu.com%252F%26ntime%3D1521461319; Hm_lvt_21be24c80829bd7a683b2c536fcf520b=1521461287,1521463471; Hm_lpvt_21be24c80829bd7a683b2c536fcf520b=1521463471",

"X-Forwarded-For" : "%s"

}

for i in range(0,500):

choice = (

random.randint(1, 2),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

)

data["submitdata"] = data["submitdata"] % choice

header["X-Forwarded-For"] = (str(random.randint(1,255))+".")+(str(random.randint(1,255))+".")+(str(random.randint(1,255))+".")+str(random.randint(1,255))

r = requests.post(url = url,headers=header,data=data)

print(header["X-Forwarded-For"],r.text)

data["submitdata"] = "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

header["X-Forwarded-For"] = "%s"

效果图:

关于这篇文章文章,因为我之前写过,所以不再重复,我对它直接感兴趣:[如何通过Python自动填写问卷]

3.5获取公共网络代理IP,判断是否可以使用以及延迟时间

<p>在此示例中,我们要在[West Spur代理]上爬网代理IP,并验证这些代理的可行性和延迟时间。 (您可以将爬网的代理IP添加到proxychain,然后执行通常的渗透任务。)在这里,我直接调用linux系统命令ping -c 1“ + ip.string +” | awk'NR == 2 {print}'-如果要在Windows中运行此程序,则需要修改倒数第二行os.popen中的命令,并将其更改为Windows可以执行的命令。 查看全部

几个Python采集器培训案例,可帮助您快速爱上Python编程!

一、前言

该文章文章以前曾用于培训新手。每个人都觉得它很容易理解,因此我与所有人共享并学习了。如果您已经学习了一些python并想用它做点事但没有方向,那么不妨尝试完成以下案例。

二、环境准备

安装三个请求库lxml beautifulsoup4(以下代码均在python3.5环境中进行了测试)

pip install requests lxml beautifulsoup4

三、几个小履带箱

3.1获取本地公共网络IP地址

利用在公共Internet上查询IP的借口,使用python的请求库自动获取IP地址。

import requests

r = requests.get("http://2017.ip138.com/ic.asp";)

r.encoding = r.apparent_encoding #使用requests的字符编码智能分析,避免中文乱码

print(r.text)

# 你还可以使用正则匹配re模块提取出IP

import re

print(re.findall("\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}",r.text))

3.2使用百度搜索界面编写url采集器

在这种情况下,我们将结合使用请求和BeautifulSoup库来完成任务。我们需要在程序中设置User-Agent标头,以绕过百度搜索引擎的反爬虫机制(您可以尝试不使用User-Agent标头来查看是否可以获取数据)。请注意百度搜索结构的URL链接规则,例如,第一页上的URL链接参数pn = 0,第二页上的URL链接参数pn = 10 ...等等。在这里,我们使用css选择器路径提取数据。

import requests

from bs4 import BeautifulSoup

# 设置User-Agent头,绕过百度搜索引擎的反爬虫机制

headers = {'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64; rv:52.0) Gecko/20100101 Firefox/52.0'}

# 注意观察百度搜索结构的URL链接规律,例如第一页pn=0,第二页pn=10.... 依次类推,下面的for循环搜索前10页结果

for i in range(0,100,10):

bd_search = "https://www.baidu.com/s%3Fwd%3 ... ot%3B % str(i)

r = requests.get(bd_search,headers=headers)

soup = BeautifulSoup(r.text,"lxml")

# 下面的select使用了css选择器路径提取数据

url_list = soup.select(".t > a")

for url in url_list:

real_url = url["href"]

r = requests.get(real_url)

print(r.url)

编写程序后,我们使用关键词inurl:/dede/login.php批量提取织梦cms的背景地址,效果如下:

3.3自动下载搜狗壁纸

在此示例中,我们将使用采集器自动下载搜索到的墙纸,并将程序中存储图片的路径更改为要存储图片的目录的路径。另一点是,我们在程序中使用了json库。这是因为我们发现观察期间搜狗的墙纸地址以json格式存储,因此我们将这组数据解析为json。

import requests

import json

#下载图片

url = "http://pic.sogou.com/pics/chan ... ot%3B

r = requests.get(url)

data = json.loads(r.text)

for i in data["all_items"]:

img_url = i["pic_url"]

# 下面这行里面的路径改成你自己想要存放图片的目录路径即可

with open("/home/evilk0/Desktop/img/%s" % img_url[-10:]+".jpg","wb") as f:

r2 = requests.get(img_url)

f.write(r2.content)

print("下载完毕:",img_url)

3.4自动填写调查表

目标官网:https://www.wjx.cn

目标问卷:https://www.wjx.cn/jq/21581199.aspx

import requests

import random

url = "https://www.wjx.cn/joinnew/pro ... ot%3B

data = {

"submitdata" : "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

}

header = {

"User-Agent" : "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko)",

"Cookie": ".ASPXANONYMOUS=iBuvxgz20wEkAAAAZGY4MDE1MjctNWU4Ni00MDUwLTgwYjQtMjFhMmZhMDE2MTA3h_bb3gNw4XRPsyh-qPh4XW1mfJ41; spiderregkey=baidu.com%c2%a7%e7%9b%b4%e8%be%be%c2%a71; UM_distinctid=1623e28d4df22d-08d0140291e4d5-102c1709-100200-1623e28d4e1141; _umdata=535523100CBE37C329C8A3EEEEE289B573446F594297CC3BB3C355F09187F5ADCC492EBB07A9CC65CD43AD3E795C914CD57017EE3799E92F0E2762C963EF0912; WjxUser=UserName=17750277425&Type=1; LastCheckUpdateDate=1; LastCheckDesign=1; DeleteQCookie=1; _cnzz_CV4478442=%E7%94%A8%E6%88%B7%E7%89%88%E6%9C%AC%7C%E5%85%8D%E8%B4%B9%E7%89%88%7C1521461468568; jac21581199=78751211; CNZZDATA4478442=cnzz_eid%3D878068609-1521456533-https%253A%252F%252Fwww.baidu.com%252F%26ntime%3D1521461319; Hm_lvt_21be24c80829bd7a683b2c536fcf520b=1521461287,1521463471; Hm_lpvt_21be24c80829bd7a683b2c536fcf520b=1521463471",

}

for i in range(0,500):

choice = (

random.randint(1, 2),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

)

data["submitdata"] = data["submitdata"] % choice

r = requests.post(url = url,headers=header,data=data)

print(r.text)

data["submitdata"] = "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

当我们使用相同的IP提交多个调查表时,将触发目标的反爬虫机制,并且验证码将显示在服务器上。

我们可以使用X-Forwarded-For伪造我们的IP,修改后的代码如下:

import requests

import random

url = "https://www.wjx.cn/joinnew/pro ... ot%3B

data = {

"submitdata" : "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

}

header = {

"User-Agent" : "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko)",

"Cookie": ".ASPXANONYMOUS=iBuvxgz20wEkAAAAZGY4MDE1MjctNWU4Ni00MDUwLTgwYjQtMjFhMmZhMDE2MTA3h_bb3gNw4XRPsyh-qPh4XW1mfJ41; spiderregkey=baidu.com%c2%a7%e7%9b%b4%e8%be%be%c2%a71; UM_distinctid=1623e28d4df22d-08d0140291e4d5-102c1709-100200-1623e28d4e1141; _umdata=535523100CBE37C329C8A3EEEEE289B573446F594297CC3BB3C355F09187F5ADCC492EBB07A9CC65CD43AD3E795C914CD57017EE3799E92F0E2762C963EF0912; WjxUser=UserName=17750277425&Type=1; LastCheckUpdateDate=1; LastCheckDesign=1; DeleteQCookie=1; _cnzz_CV4478442=%E7%94%A8%E6%88%B7%E7%89%88%E6%9C%AC%7C%E5%85%8D%E8%B4%B9%E7%89%88%7C1521461468568; jac21581199=78751211; CNZZDATA4478442=cnzz_eid%3D878068609-1521456533-https%253A%252F%252Fwww.baidu.com%252F%26ntime%3D1521461319; Hm_lvt_21be24c80829bd7a683b2c536fcf520b=1521461287,1521463471; Hm_lpvt_21be24c80829bd7a683b2c536fcf520b=1521463471",

"X-Forwarded-For" : "%s"

}

for i in range(0,500):

choice = (

random.randint(1, 2),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 4),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

)

data["submitdata"] = data["submitdata"] % choice

header["X-Forwarded-For"] = (str(random.randint(1,255))+".")+(str(random.randint(1,255))+".")+(str(random.randint(1,255))+".")+str(random.randint(1,255))

r = requests.post(url = url,headers=header,data=data)

print(header["X-Forwarded-For"],r.text)

data["submitdata"] = "1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s"

header["X-Forwarded-For"] = "%s"

效果图:

关于这篇文章文章,因为我之前写过,所以不再重复,我对它直接感兴趣:[如何通过Python自动填写问卷]

3.5获取公共网络代理IP,判断是否可以使用以及延迟时间

<p>在此示例中,我们要在[West Spur代理]上爬网代理IP,并验证这些代理的可行性和延迟时间。 (您可以将爬网的代理IP添加到proxychain,然后执行通常的渗透任务。)在这里,我直接调用linux系统命令ping -c 1“ + ip.string +” | awk'NR == 2 {print}'-如果要在Windows中运行此程序,则需要修改倒数第二行os.popen中的命令,并将其更改为Windows可以执行的命令。

技巧:怎么用5行代码写一个你自己的数据抓取程序

采集交流 • 优采云 发表了文章 • 0 个评论 • 201 次浏览 • 2020-09-15 17:22

我们平时可能会在网站上看到很多数据,我们可以自己进行分析。但是,如果需要捕获数据,则需要一个捕获程序。

通过该程序,您可以轻松地将他人网站的上一页,数百页或页面的某些内容带到您自己的本地。

当然,如果要使用5行代码,则需要做一些准备工作。例如框架,数据库等。

我们在这里使用php + mysql + PHPquery + arphp解决方案。

1、 phpquery可以查看使用计划。

2、 arphp可以查看一些使用方法。

当然,您可以编写该程序而无需阅读本文档,也可以使用其他框架,也可以不使用框架。

特定代码:

require('phpQuery/phpQuery.php');//加载这个框架

$eg1=phpQuery::newDocumentFile("http://www.whu.edu.cn/tzgg.htm");//将你需要的抓取的页面对象化

$res = pq("ul,li")->html()."

";//获取页面中某个对象的html数据

$myfile = fopen("newfile.txt", "w") or die("不能打开文件");//打开一个文件

fwrite($myfile, $res);//将页面内容写入txt

当然,您可以构建数据库,然后将内容放入数据库中。

仅需上述五行,您就可以基本完成页面内容的爬网。当然,可以更深入地研究更复杂的问题,例如多页爬网,单页内容遍历和内容过滤,https内容或反网站 IP阻止。 查看全部

如何用5行代码编写自己的数据捕获程序

我们平时可能会在网站上看到很多数据,我们可以自己进行分析。但是,如果需要捕获数据,则需要一个捕获程序。

通过该程序,您可以轻松地将他人网站的上一页,数百页或页面的某些内容带到您自己的本地。

当然,如果要使用5行代码,则需要做一些准备工作。例如框架,数据库等。

我们在这里使用php + mysql + PHPquery + arphp解决方案。

1、 phpquery可以查看使用计划。

2、 arphp可以查看一些使用方法。

当然,您可以编写该程序而无需阅读本文档,也可以使用其他框架,也可以不使用框架。

特定代码:

require('phpQuery/phpQuery.php');//加载这个框架

$eg1=phpQuery::newDocumentFile("http://www.whu.edu.cn/tzgg.htm";);//将你需要的抓取的页面对象化

$res = pq("ul,li")->html()."

";//获取页面中某个对象的html数据

$myfile = fopen("newfile.txt", "w") or die("不能打开文件");//打开一个文件

fwrite($myfile, $res);//将页面内容写入txt

当然,您可以构建数据库,然后将内容放入数据库中。

仅需上述五行,您就可以基本完成页面内容的爬网。当然,可以更深入地研究更复杂的问题,例如多页爬网,单页内容遍历和内容过滤,https内容或反网站 IP阻止。

最新版:[建站必备]-织梦dede采集侠v2.5.全自动采集文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 645 次浏览 • 2020-09-08 02:37

本文由zengqiwu1提供织梦 采集 Xia强大功能的预览:采集 Xia是专业的采集模块,具有先进的人工智能网页识别技术和出色的伪原创技术,远远超出了传统的采集软件,它具有不同的网站 采集高质量内容并自动进行原创处理,从而减少了网站维护工作量,并大大增加了收录和点击次数。一个网站基本插件。 织梦 采集夏的安装非常简单方便。只需一分钟即可立即开始采集,并结合了简单,健壮,灵活和开放源码的dede cms程序,新手可以迅速上手,并且我们有专门的客户服务为商业客户提供技术支持。与传统的采集模式不同,织梦 采集可以根据用户设置的关键词执行pan 采集。 pan 采集的优点在于通过采集和关键词进行不同的搜索。结果,可以认识到采集不在一个或几个指定的采集站点上执行,从而降低了[ 采集个站点被搜索引擎判断为镜像站点,并受到搜索引擎的惩罚。 3RSS 采集,只需输入RSS地址。 采集内容只要采集的网站提供了RSS订阅地址,就可以使用RSS进行采集,只需输入RSS地址即可轻松地采集到达目标网站内容,否需要编写采集规则,方便简单。页面监视采集仅需提供监视页面地址和文本URL规则即可指定采集来指定网站或列内容,这既方便又简单,无需编写采集规则采集就可以作为目标。自动标题,段落重新排列,高级混淆,自动内部链接,内容过滤,URL过滤,同义词替换,插入seo词,关键词添加链接和其他方法来处理采集返回的文章并增强采集 [k5 ] 原创适用于搜索引擎优化,提高搜索引擎的收录率,网站权重和关键字排名。 织梦 采集根据预设的采集任务,根据设置的采集方法采集 URL,然后自动抓取网页内容,程序通过精确计算来分析网页,丢弃不是文章的内容页面的URL,提取出色的文章内容,最后进行伪原创的导入和生成。所有这些操作都是自动完成的,无需人工干预。 织梦 采集 Xia不仅是采集插件,还是织梦必不可少的伪原创和搜索优化插件。手动发布的文章可以通过织梦 采集 Xia 伪原创进行搜索优化处理,可以对文章执行同义词替换,自动进行内部链接,随机插入关键词链接,并且文章 关键词将自动添加指定的链接等功能,是织梦必不可少的插件。定期且定量地采集 伪原创 SEO更新插件有两个触发器采集,一个是向要由用户访问权限采集更新触发的页面添加代码,另一个是我们提供的远程触发器商业用户采集服务,无需人工干预即可定期,定量地更新新站点采集。 查看全部

[建立网站必不可少]-织梦 dede 采集侠v 2. 5.全自动采集 文章

本文由zengqiwu1提供织梦 采集 Xia强大功能的预览:采集 Xia是专业的采集模块,具有先进的人工智能网页识别技术和出色的伪原创技术,远远超出了传统的采集软件,它具有不同的网站 采集高质量内容并自动进行原创处理,从而减少了网站维护工作量,并大大增加了收录和点击次数。一个网站基本插件。 织梦 采集夏的安装非常简单方便。只需一分钟即可立即开始采集,并结合了简单,健壮,灵活和开放源码的dede cms程序,新手可以迅速上手,并且我们有专门的客户服务为商业客户提供技术支持。与传统的采集模式不同,织梦 采集可以根据用户设置的关键词执行pan 采集。 pan 采集的优点在于通过采集和关键词进行不同的搜索。结果,可以认识到采集不在一个或几个指定的采集站点上执行,从而降低了[ 采集个站点被搜索引擎判断为镜像站点,并受到搜索引擎的惩罚。 3RSS 采集,只需输入RSS地址。 采集内容只要采集的网站提供了RSS订阅地址,就可以使用RSS进行采集,只需输入RSS地址即可轻松地采集到达目标网站内容,否需要编写采集规则,方便简单。页面监视采集仅需提供监视页面地址和文本URL规则即可指定采集来指定网站或列内容,这既方便又简单,无需编写采集规则采集就可以作为目标。自动标题,段落重新排列,高级混淆,自动内部链接,内容过滤,URL过滤,同义词替换,插入seo词,关键词添加链接和其他方法来处理采集返回的文章并增强采集 [k5 ] 原创适用于搜索引擎优化,提高搜索引擎的收录率,网站权重和关键字排名。 织梦 采集根据预设的采集任务,根据设置的采集方法采集 URL,然后自动抓取网页内容,程序通过精确计算来分析网页,丢弃不是文章的内容页面的URL,提取出色的文章内容,最后进行伪原创的导入和生成。所有这些操作都是自动完成的,无需人工干预。 织梦 采集 Xia不仅是采集插件,还是织梦必不可少的伪原创和搜索优化插件。手动发布的文章可以通过织梦 采集 Xia 伪原创进行搜索优化处理,可以对文章执行同义词替换,自动进行内部链接,随机插入关键词链接,并且文章 关键词将自动添加指定的链接等功能,是织梦必不可少的插件。定期且定量地采集 伪原创 SEO更新插件有两个触发器采集,一个是向要由用户访问权限采集更新触发的页面添加代码,另一个是我们提供的远程触发器商业用户采集服务,无需人工干预即可定期,定量地更新新站点采集。

解决方案:prometheus学习系列十一: Prometheus 采集器的编写

采集交流 • 优采云 发表了文章 • 0 个评论 • 414 次浏览 • 2020-09-06 01:15

上面文章中已写明了几个官方出口商的使用。在实际使用环境中,我们可能需要采集一些自定义数据。目前,我们通常需要自己写采集器。

快速开始编写介绍性示例以编写代码

from prometheus_client import Counter, Gauge, Summary, Histogram, start_http_server

# need install prometheus_client

if __name__ == '__main__':

c = Counter('cc', 'A counter')

c.inc()

g = Gauge('gg', 'A gauge')

g.set(17)

s = Summary('ss', 'A summary', ['a', 'b'])

s.labels('c', 'd').observe(17)

h = Histogram('hh', 'A histogram')

h.observe(.6)

start_http_server(8000)

import time

while True:

time.sleep(1)

只需要一个py文件。运行时,它将侦听端口8000并访问端口12 7. 0. 0. 1:8000。

效果图片

事实上,已经编写了一个导出器,就这么简单,我们只需要在prometheus中配置与采集对应的导出器。但是,我们导出的数据没有实际意义。

数据类型简介

计数器是一种累积类型,只能增加,例如记录http请求总数或网络接收和发送的数据包的累积值。

仪表盘:仪表盘类型,适用于一般的网络流量,磁盘读写,并且可能会变动。此数据类型适合上升和下降。

摘要:基于抽样,统计信息在服务器上完成。在计算平均值时,我们可能会认为异常值导致计算得出的平均值无法准确反映实际值,因此需要特定的点位置。

直方图:基于采样,统计在客户端上进行。在计算平均值时,我们可能会认为异常值导致计算得出的平均值无法准确反映实际值,因此需要特定的点位置。

采集 采集类型代码以及内存使用情况数据

from prometheus_client.core import GaugeMetricFamily, REGISTRY

from prometheus_client import start_http_server

import psutil

class CustomMemoryUsaggeCollector():

def format_metric_name(self):

return 'custom_memory_'

def collect(self):

vm = psutil.virtual_memory()

#sub_metric_list = ["free", "available", "buffers", "cached", "used", "total"]

sub_metric_list = ["free", "available", "used", "total"]

for sub_metric in sub_metric_list:

gauge = GaugeMetricFamily(self.format_metric_name() + sub_metric, '')

gauge.add_metric(labels=[], value=getattr(vm, sub_metric))

yield gauge

if __name__ == "__main__":

collector = CustomMemoryUsaggeCollector()

REGISTRY.register(collector)

start_http_server(8001)

import time

while True:

time.sleep(1)

公开数据,部署代码并集成Prometheus

# 准备python3 环境 参考: https://virtualenvwrapper.read ... test/

yum install python36 -y

pip3 install virtualenvwrapper

vim /usr/local/bin/virtualenvwrapper.sh

# 文件最前面添加如下行

# Locate the global Python where virtualenvwrapper is installed.

VIRTUALENVWRAPPER_PYTHON="/usr/bin/python3"

# 文件生效

source /usr/local/bin/virtualenvwrapper.sh

# 配置workon

[root@node01 ~]# echo "export WORKON_HOME=~/Envs" >>~/.bashrc

[root@node01 ~]# mkvirtualenv custom_memory_exporter

(custom_memory_exporter) [root@node01 ~]# pip install prometheus_client psutil

yum install python36-devel

(custom_memory_exporter) [root@node01 ~]# chmod a+x custom_memory_exporter.py

(custom_memory_exporter) [root@node01 ~]# ./custom_memory_exporter.py

# 测试是否有结果数据

[root@node00 ~]# curl http://192.168.100.11:8001/<br /><br />prometheus.yml 加入如下片段<br /> - job_name: "custom-memory-exporter"<br /> static_configs:<br /> - targets: ["192.168.100.11:8001"]<br /><br />[root@node00 prometheus]# systemctl restart prometheus <br />[root@node00 prometheus]# systemctl status prometheu

查询效果图 查看全部

普罗米修斯学习丛书11:普罗米修斯采集器准备

上面文章中已写明了几个官方出口商的使用。在实际使用环境中,我们可能需要采集一些自定义数据。目前,我们通常需要自己写采集器。

快速开始编写介绍性示例以编写代码

from prometheus_client import Counter, Gauge, Summary, Histogram, start_http_server

# need install prometheus_client

if __name__ == '__main__':

c = Counter('cc', 'A counter')

c.inc()

g = Gauge('gg', 'A gauge')

g.set(17)

s = Summary('ss', 'A summary', ['a', 'b'])

s.labels('c', 'd').observe(17)

h = Histogram('hh', 'A histogram')

h.observe(.6)

start_http_server(8000)

import time

while True:

time.sleep(1)

只需要一个py文件。运行时,它将侦听端口8000并访问端口12 7. 0. 0. 1:8000。

效果图片

事实上,已经编写了一个导出器,就这么简单,我们只需要在prometheus中配置与采集对应的导出器。但是,我们导出的数据没有实际意义。

数据类型简介

计数器是一种累积类型,只能增加,例如记录http请求总数或网络接收和发送的数据包的累积值。

仪表盘:仪表盘类型,适用于一般的网络流量,磁盘读写,并且可能会变动。此数据类型适合上升和下降。

摘要:基于抽样,统计信息在服务器上完成。在计算平均值时,我们可能会认为异常值导致计算得出的平均值无法准确反映实际值,因此需要特定的点位置。

直方图:基于采样,统计在客户端上进行。在计算平均值时,我们可能会认为异常值导致计算得出的平均值无法准确反映实际值,因此需要特定的点位置。

采集 采集类型代码以及内存使用情况数据

from prometheus_client.core import GaugeMetricFamily, REGISTRY

from prometheus_client import start_http_server

import psutil

class CustomMemoryUsaggeCollector():

def format_metric_name(self):

return 'custom_memory_'

def collect(self):

vm = psutil.virtual_memory()

#sub_metric_list = ["free", "available", "buffers", "cached", "used", "total"]

sub_metric_list = ["free", "available", "used", "total"]

for sub_metric in sub_metric_list:

gauge = GaugeMetricFamily(self.format_metric_name() + sub_metric, '')

gauge.add_metric(labels=[], value=getattr(vm, sub_metric))

yield gauge

if __name__ == "__main__":

collector = CustomMemoryUsaggeCollector()

REGISTRY.register(collector)

start_http_server(8001)

import time

while True:

time.sleep(1)

公开数据,部署代码并集成Prometheus

# 准备python3 环境 参考: https://virtualenvwrapper.read ... test/

yum install python36 -y

pip3 install virtualenvwrapper

vim /usr/local/bin/virtualenvwrapper.sh

# 文件最前面添加如下行

# Locate the global Python where virtualenvwrapper is installed.

VIRTUALENVWRAPPER_PYTHON="/usr/bin/python3"

# 文件生效

source /usr/local/bin/virtualenvwrapper.sh

# 配置workon

[root@node01 ~]# echo "export WORKON_HOME=~/Envs" >>~/.bashrc

[root@node01 ~]# mkvirtualenv custom_memory_exporter

(custom_memory_exporter) [root@node01 ~]# pip install prometheus_client psutil

yum install python36-devel

(custom_memory_exporter) [root@node01 ~]# chmod a+x custom_memory_exporter.py

(custom_memory_exporter) [root@node01 ~]# ./custom_memory_exporter.py

# 测试是否有结果数据

[root@node00 ~]# curl http://192.168.100.11:8001/<br /><br />prometheus.yml 加入如下片段<br /> - job_name: "custom-memory-exporter"<br /> static_configs:<br /> - targets: ["192.168.100.11:8001"]<br /><br />[root@node00 prometheus]# systemctl restart prometheus <br />[root@node00 prometheus]# systemctl status prometheu

查询效果图

完整的解决方案:Python实现自动化布署

采集交流 • 优采云 发表了文章 • 0 个评论 • 223 次浏览 • 2020-08-30 04:17

一. 分析需求

1. 需求说明

在项目开发过程中,我们有时会频繁的更新代码, 流程大约为:

(1) 本地git push递交代码至git托管平台

(2) 登陆到布署有网站源码的线上服务器

(3) cd到项目根目录, 执行git pull指令拉取最新代码

整个流程纯自动更新,每次历时在1分钟左右, 这样三天出来,浪费了好多时间在这种繁杂的事情上.

现在的需求是,在每次本地递交代码后,线上服务器手动拉取最新代码,完成布署更新.即所谓的自动化布署.

2. 方案

现在一些主流代码托管平台如github、 gitlab、git@osc等均已提供webhook功能,在用户push了代码后,会手动反弹一个您设定的http地址。 用户可以自己按照不同的需求,来编撰自己的脚本程序(比如发邮件,自动布署等);目前,webhook支持多种触发形式,如Push、 Tag Push、 Issue、评论、合并恳求等

附webhook的简介:

Webhook就是用户通过自定义回调函数(callback)的方法来改变Web应用的一种行为,这些回调函数可以由不是该Web应用官方的第三方用户或则开发人员来维护,修改。通过Webhook,你可以自定义一些行为通知到指定的URL去。Webhook的“自定义回调函数”通常是由一些风波触发的,比如推送代码到代码库或者博客下新增一个评论,源站点会为Webhook进行HTTP恳求的URI配置。用户通过配置,就可以让一个网站上的风波调用在另一个网站上表现下来,这些风波调用可以是任何风波,但一般应用的是系统集成和消息通知。

3. 分析怎样实现

(1) 编写一个web插口,以便于接收由webhook发出的数据恳求

(2) 在该web插口, 接收到的post消息中富含多个参数,包括分支信息,commit信息

(3) 根据分支信息和commit信息判定是否须要更新,如果无需更新,结束

(4) 需要更新,开始切换用户,获取更新权限,写入参数到文本文件中,避免因切换参数造成参数遗失

(5) 从文本文件中读取参数,传递分支参数,调用富含git pull等指令的手动布署脚本,开始执行布署操作

(6) 将收录这个插口的web服务放到你网站源码所在的服务器上,开启后台运行(使用nohup指令或supervisor守护进程)

(7) 将这个插口的url路由地址配置在代码托管平台的webhook功能中

(8) 测试更新代码,接收到webhook推送的消息数据, 执行自动化更新,完毕

二. 代码实现

特殊说明

(1) 本篇文章使用python脚本 + tornado框架搭建web服务器,用于接收git代码托管平台的webhook消息推送.

(2) git代码托管平台以Git@OSC为例,其他托管平台与之类似.

(3) 本篇文章中执行自动化布署指令的前提是早已配置了ssh

(4) 以下代码仅测试的是更新主分支,其他操作与之类似.

下图是这个脚本的整体目录

备注: 红色标记的才是关键代码,其他文件是一些日志和虚拟环境等无关紧要的文件

1. 编写一个web插口,以便于接收由webhook发出的数据恳求

2.编写一个配置文件config.json,用于储存git@osc所需的验证密码参数、需要布署的项目根目录、需要执行的git指令

3. 编写接收到webhook消息时须要执行的脚本

4. 挂载到我们布署的网站服务器上,开启后台运行(本篇文章以守护进程形式启动)

5. 将这个插口的url路由地址配置在代码托管平台的webhook功能中

6. 测试更新代码,接收到webhook推送的消息数据, 执行自动化更新,完毕 查看全部

Python实现自动化布署

一. 分析需求

1. 需求说明

在项目开发过程中,我们有时会频繁的更新代码, 流程大约为:

(1) 本地git push递交代码至git托管平台

(2) 登陆到布署有网站源码的线上服务器

(3) cd到项目根目录, 执行git pull指令拉取最新代码

整个流程纯自动更新,每次历时在1分钟左右, 这样三天出来,浪费了好多时间在这种繁杂的事情上.

现在的需求是,在每次本地递交代码后,线上服务器手动拉取最新代码,完成布署更新.即所谓的自动化布署.

2. 方案

现在一些主流代码托管平台如github、 gitlab、git@osc等均已提供webhook功能,在用户push了代码后,会手动反弹一个您设定的http地址。 用户可以自己按照不同的需求,来编撰自己的脚本程序(比如发邮件,自动布署等);目前,webhook支持多种触发形式,如Push、 Tag Push、 Issue、评论、合并恳求等

附webhook的简介:

Webhook就是用户通过自定义回调函数(callback)的方法来改变Web应用的一种行为,这些回调函数可以由不是该Web应用官方的第三方用户或则开发人员来维护,修改。通过Webhook,你可以自定义一些行为通知到指定的URL去。Webhook的“自定义回调函数”通常是由一些风波触发的,比如推送代码到代码库或者博客下新增一个评论,源站点会为Webhook进行HTTP恳求的URI配置。用户通过配置,就可以让一个网站上的风波调用在另一个网站上表现下来,这些风波调用可以是任何风波,但一般应用的是系统集成和消息通知。

3. 分析怎样实现

(1) 编写一个web插口,以便于接收由webhook发出的数据恳求

(2) 在该web插口, 接收到的post消息中富含多个参数,包括分支信息,commit信息

(3) 根据分支信息和commit信息判定是否须要更新,如果无需更新,结束

(4) 需要更新,开始切换用户,获取更新权限,写入参数到文本文件中,避免因切换参数造成参数遗失

(5) 从文本文件中读取参数,传递分支参数,调用富含git pull等指令的手动布署脚本,开始执行布署操作

(6) 将收录这个插口的web服务放到你网站源码所在的服务器上,开启后台运行(使用nohup指令或supervisor守护进程)

(7) 将这个插口的url路由地址配置在代码托管平台的webhook功能中

(8) 测试更新代码,接收到webhook推送的消息数据, 执行自动化更新,完毕

二. 代码实现

特殊说明

(1) 本篇文章使用python脚本 + tornado框架搭建web服务器,用于接收git代码托管平台的webhook消息推送.

(2) git代码托管平台以Git@OSC为例,其他托管平台与之类似.

(3) 本篇文章中执行自动化布署指令的前提是早已配置了ssh

(4) 以下代码仅测试的是更新主分支,其他操作与之类似.

下图是这个脚本的整体目录

备注: 红色标记的才是关键代码,其他文件是一些日志和虚拟环境等无关紧要的文件

1. 编写一个web插口,以便于接收由webhook发出的数据恳求

2.编写一个配置文件config.json,用于储存git@osc所需的验证密码参数、需要布署的项目根目录、需要执行的git指令

3. 编写接收到webhook消息时须要执行的脚本

4. 挂载到我们布署的网站服务器上,开启后台运行(本篇文章以守护进程形式启动)

5. 将这个插口的url路由地址配置在代码托管平台的webhook功能中

6. 测试更新代码,接收到webhook推送的消息数据, 执行自动化更新,完毕

事实:自动采集编写 最近Python这门语言太火,说是学习后会提升工作效率,是真的吗?小白能学会吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 388 次浏览 • 2020-08-28 20:26

在有关大数据分析Python API的本教程中,我们将学习怎样从远程网站检索数据以进行数据科学项目。像baidu,Twitter和Facebook之类的网站都通过其应用程序编程接口(API)向程序员提供个别数据。要使用API,你须要向远程Web服务器发出恳求,然后检索所需的数据。

但是,为什么要使用API而不是可以下载的静态数据集呢?API在以下情况下很有用:

a.数据变化很快。股票价位数据就是一个事例。重新生成数据集并每分钟下载一次并没有实际意义-这会占用大量带宽,而且速率太慢。

b.您须要一小部份更大的数据。Reddit评论就是一个事例。如果您只想在Reddit上发表自己的评论该如何办?下载整个Reddit数据库,然后仅过滤您自己的注释并没有多大意义。

c.涉及重复估算。Spotify的API可以告诉您音乐的流派。从理论上讲,您可以创建自己的分类器,并使用它对音乐进行分类,但您将永远不会拥有Spotify所拥有的数据。

在上述情况下,API是正确的解决方案。对于本数据科学教程,我们将查询一个简单的API,以检索有关国际空间站(ISS)的数据。使用API可以节约我们自己进行所有估算的时间和精力。

大数据分析Python中的API恳求

API托管在Web服务器上。当您在浏览器的地址栏中键入内容时,您的计算机实际上是在向服务器寻问网页,然后该网页返回到您的浏览器。

API的工作方式几乎相同,除了您的程序要求数据而不是您的Web浏览器寻问网页之外。这些数据一般以JSON格式返回(有关更多信息,请参阅有关使用JSON数据的教程)。

为了获取数据,我们向Web服务器发出恳求。然后,服务器将回复我们的数据。在大数据分析Python中,我们将使用恳求库来执行此操作。在此大数据剖析Python API教程中,我们将为所有示例使用大数据分析Python 3.4。

请求类型

有许多不同类型的恳求。最常用的一个GET恳求用于检索数据。

我们可以使用一个简单的GET恳求从OpenNotify API 检索信息。

OpenNotify具有多个API端点。端点是用于从API检索不同数据的服务器路由。例如,/commentsReddit API上的端点可能会检索有关注释的信息,而/users端点可能会检索有关用户的数据。要访问它们,您可以将端点添加到API 的基本URL中。

我们将在OpenNotify上见到的第一个端点是iss-now.json端点。该端点获取国际空间站的当前经度和纬度。如您所见,检索此数据不适用于数据集,因为它涉及服务器上的一些估算,并且变化很快。

您可以在此处查看OpenNotify上所有端点的列表。

OpenNotify API 的基本网址是,因此我们将其添加到所有端点的开头。

状态码

我们刚才发出的恳求的状态码为200。向Web服务器发出的每位恳求都返回状态代码。状态代码指示有关恳求发生的情况的信息。以下是与GET恳求相关的一些代码:

a)200 -一切正常,结果已返回(如果有)

b)301—服务器正在将您重定向到其他端点。当公司切换域名或修改端点名称时,可能会发生此类情况。

c)401-服务器觉得您未通过身分验证。当您没有发送正确的凭据来访问API时才会发生此类情况(我们将在之后的文章中讨论身分验证)。

d)400-服务器觉得您提出了错误的恳求。当您没有正确发送数据时,可能会发生此类情况。

e)403 —您尝试访问的资源被严禁—您没有正确的权限查看它。

f)404 -在服务器上找不到您尝试访问的资源。

现在,根据API文档,向不存在的端点发出GET恳求。

击中正确的终点

iss-pass不是有效的端点,因此我们得到了一个404状态码作为相应。.json正如API文档所述,我们忘掉在最后添加。

现在,我们将向发出GET恳求。

查询参数

您将在上一个示例中见到,我们得到了一个400状态码,表示恳求错误。如果您查看OpenNotify API的文档,我们会发觉ISS Pass端点须要两个参数。

当ISS上次通过月球上的给定位置时,将返回ISS Pass端点。为了对此进行估算,我们须要将位置的座标传递给API。为此,我们传递了两个参数-纬度和纬度。

为此,我们可以在params恳求中添加可选的关键字参数。在这些情况下,我们须要传递两个参数:

1)lat —我们想要的位置的经度。

2)lon —我们想要的位置的纬度。

我们可以使用这种参数制做字典,然后将它们传递给requests.get函数。

我们还可以通过将查询参数添加到url中来直接做同样的事情,如下所示:。

将参数设置为字典几乎总是可取的,因为requests它可以处理一些事情,例如正确设置查询参数的格式。

我们将使用纽约市的座标进行恳求,然后查看得到的答复。

b'{n "message": "success", n "request": {n "altitude": 100, n "datetime": 1441417753, n "latitude": 40.71, n "longitude": -74.0, n "passes": 5n }, n "response": [n {n "duration": 330, n "risetime": 1441445639n }, n {n "duration": 629, n "risetime": 1441451226n }, n {n "duration": 606, n "risetime": 1441457027n }, n {n "duration": 542, n "risetime": 1441462894n }, n {n "duration": 565, n "risetime": 1441468731n }n ]n}'

b'{n "message": "success", n "request": {n "altitude": 100, n "datetime": 1441417753, n "latitude": 40.71, n "longitude": -74.0, n "passes": 5n }, n "response": [n {n "duration": 329, n "risetime": 1441445639n }, n {n "duration": 629, n "risetime": 1441451226n }, n {n "duration": 606, n "risetime": 1441457027n }, n {n "duration": 542, n "risetime": 1441462894n }, n {n "duration": 565, n "risetime": 1441468731n }n ]n}'

使用JSON数据

您可能早已注意到,响应的内容之前是a string(尽管它显示为bytes对象,但是我们可以使用轻松地将内容转换为字符串response.content.decode("utf-8"))。

字符串是我们将信息来回传递给API的方法,但是很难从字符串中获取我们想要的信息。我们怎么晓得怎样解码返回的字符串并在大数据分析Python中使用它?我们怎么altitude从字符串响应中找出ISS的含意?

幸运的是,有一种名为JavaScript Object Notation(JSON)的格式。JSON是一种将列表和字典之类的数据结构编码为字符串的方式,以确保它们便于被机器读取。JSON是将数据来回传递给API的主要格式,大多数API服务器将以JSON格式发送其响应。

json套件随附大数据分析Python强悍的JSON支持。该json软件包是标准库的一部分,因此我们无需安装任何程序即可使用它。我们既可以将列表和字典转换为JSON,也可以将字符串转换为列表和字典。就我们的ISS Pass数据而言,它是一个字典,编码为JSON格式的字符串。

json库有两种主要方式:

1)dumps —接收一个大数据剖析Python对象,并将其转换为字符串。

2)loads —接收JSON字符串,并将其转换为大数据分析Python对象。

从API恳求获取JSON

通过使用.json()响应上的方式,您可以将响应的内容作为大数据分析Python对象获取。

{'response': [{'risetime': 1441456672, 'duration': 369}, {'risetime': 1441462284, 'duration': 626}, {'risetime': 1441468104, 'duration': 581}, {'risetime': 1441474000, 'duration': 482}, {'risetime': 1441479853, 'duration': 509}], 'message': 'success', 'request': {'latitude': 37.78, 'passes': 5, 'longitude': -122.41, 'altitude': 100, 'datetime': 1441417753}}

内容类型

服务器除了会在生成响应时发送状态码和数据。它还发送收录有关怎样生成数据以及怎样对其进行解码的信息的元数据。这储存在响应头中。在大数据分析Python中,我们可以使用headers响应对象的属性来访问它。

标头将显示为字典。在标题中,content-type是目前最重要的键。它告诉我们响应的格式以及怎样对其进行解码。大数据分析Python API入门教程对于OpenNotify API,格式为JSON,这就是为何我们可以json更早地使用包对其进行解码的诱因。

寻找太空中的人数

OpenNotify还有一个API端点astros.json。它告诉你当前有多少人在太空中。相应的格式可以在这里找到。

9

{'number': 9, 'people': [{'name': 'Gennady Padalka', 'craft': 'ISS'}, {'name': 'Mikhail Kornienko', 'craft': 'ISS'}, {'name': 'Scott Kelly', 'craft': 'ISS'}, {'name': 'Oleg Kononenko', 'craft': 'ISS'}, {'name': 'Kimiya Yui', 'craft': 'ISS'}, {'name': 'Kjell Lindgren', 'craft': 'ISS'}, {'name': 'Sergey Volkov', 'craft': 'ISS'}, {'name': 'Andreas Mogensen', 'craft': 'ISS'}, {'name': 'Aidyn Aimbetov', 'craft': 'ISS'}], 'message': 'success'}

大数据分析Python API数据科学教程:后续步骤

现在,您早已完成了大数据分析Python API教程,现在应当可以访问简单的API并发出get恳求了。requests在我们的dataquest API和抓取课程中,还有其他几种类型,您可以了解更多信息以及与API身分验证一起使用。

建议的其他后续步骤是阅读恳求文档,并使用Reddit API。有一个名为PRAW 的程序包,它让在大数据分析Python中使用Reddit API愈发容易,但是建议requests首先使用它来了解一切的工作原理。 查看全部

自动采集编写 最近Python这门语言太火,说是学习后会提升工作效率,是真的吗?小白能学会吗?

在有关大数据分析Python API的本教程中,我们将学习怎样从远程网站检索数据以进行数据科学项目。像baidu,Twitter和Facebook之类的网站都通过其应用程序编程接口(API)向程序员提供个别数据。要使用API,你须要向远程Web服务器发出恳求,然后检索所需的数据。

但是,为什么要使用API而不是可以下载的静态数据集呢?API在以下情况下很有用:

a.数据变化很快。股票价位数据就是一个事例。重新生成数据集并每分钟下载一次并没有实际意义-这会占用大量带宽,而且速率太慢。

b.您须要一小部份更大的数据。Reddit评论就是一个事例。如果您只想在Reddit上发表自己的评论该如何办?下载整个Reddit数据库,然后仅过滤您自己的注释并没有多大意义。

c.涉及重复估算。Spotify的API可以告诉您音乐的流派。从理论上讲,您可以创建自己的分类器,并使用它对音乐进行分类,但您将永远不会拥有Spotify所拥有的数据。

在上述情况下,API是正确的解决方案。对于本数据科学教程,我们将查询一个简单的API,以检索有关国际空间站(ISS)的数据。使用API可以节约我们自己进行所有估算的时间和精力。

大数据分析Python中的API恳求

API托管在Web服务器上。当您在浏览器的地址栏中键入内容时,您的计算机实际上是在向服务器寻问网页,然后该网页返回到您的浏览器。

API的工作方式几乎相同,除了您的程序要求数据而不是您的Web浏览器寻问网页之外。这些数据一般以JSON格式返回(有关更多信息,请参阅有关使用JSON数据的教程)。

为了获取数据,我们向Web服务器发出恳求。然后,服务器将回复我们的数据。在大数据分析Python中,我们将使用恳求库来执行此操作。在此大数据剖析Python API教程中,我们将为所有示例使用大数据分析Python 3.4。

请求类型

有许多不同类型的恳求。最常用的一个GET恳求用于检索数据。

我们可以使用一个简单的GET恳求从OpenNotify API 检索信息。

OpenNotify具有多个API端点。端点是用于从API检索不同数据的服务器路由。例如,/commentsReddit API上的端点可能会检索有关注释的信息,而/users端点可能会检索有关用户的数据。要访问它们,您可以将端点添加到API 的基本URL中。

我们将在OpenNotify上见到的第一个端点是iss-now.json端点。该端点获取国际空间站的当前经度和纬度。如您所见,检索此数据不适用于数据集,因为它涉及服务器上的一些估算,并且变化很快。

您可以在此处查看OpenNotify上所有端点的列表。

OpenNotify API 的基本网址是,因此我们将其添加到所有端点的开头。

状态码

我们刚才发出的恳求的状态码为200。向Web服务器发出的每位恳求都返回状态代码。状态代码指示有关恳求发生的情况的信息。以下是与GET恳求相关的一些代码:

a)200 -一切正常,结果已返回(如果有)

b)301—服务器正在将您重定向到其他端点。当公司切换域名或修改端点名称时,可能会发生此类情况。

c)401-服务器觉得您未通过身分验证。当您没有发送正确的凭据来访问API时才会发生此类情况(我们将在之后的文章中讨论身分验证)。

d)400-服务器觉得您提出了错误的恳求。当您没有正确发送数据时,可能会发生此类情况。

e)403 —您尝试访问的资源被严禁—您没有正确的权限查看它。

f)404 -在服务器上找不到您尝试访问的资源。

现在,根据API文档,向不存在的端点发出GET恳求。

击中正确的终点

iss-pass不是有效的端点,因此我们得到了一个404状态码作为相应。.json正如API文档所述,我们忘掉在最后添加。

现在,我们将向发出GET恳求。

查询参数

您将在上一个示例中见到,我们得到了一个400状态码,表示恳求错误。如果您查看OpenNotify API的文档,我们会发觉ISS Pass端点须要两个参数。

当ISS上次通过月球上的给定位置时,将返回ISS Pass端点。为了对此进行估算,我们须要将位置的座标传递给API。为此,我们传递了两个参数-纬度和纬度。

为此,我们可以在params恳求中添加可选的关键字参数。在这些情况下,我们须要传递两个参数:

1)lat —我们想要的位置的经度。

2)lon —我们想要的位置的纬度。

我们可以使用这种参数制做字典,然后将它们传递给requests.get函数。

我们还可以通过将查询参数添加到url中来直接做同样的事情,如下所示:。

将参数设置为字典几乎总是可取的,因为requests它可以处理一些事情,例如正确设置查询参数的格式。

我们将使用纽约市的座标进行恳求,然后查看得到的答复。

b'{n "message": "success", n "request": {n "altitude": 100, n "datetime": 1441417753, n "latitude": 40.71, n "longitude": -74.0, n "passes": 5n }, n "response": [n {n "duration": 330, n "risetime": 1441445639n }, n {n "duration": 629, n "risetime": 1441451226n }, n {n "duration": 606, n "risetime": 1441457027n }, n {n "duration": 542, n "risetime": 1441462894n }, n {n "duration": 565, n "risetime": 1441468731n }n ]n}'

b'{n "message": "success", n "request": {n "altitude": 100, n "datetime": 1441417753, n "latitude": 40.71, n "longitude": -74.0, n "passes": 5n }, n "response": [n {n "duration": 329, n "risetime": 1441445639n }, n {n "duration": 629, n "risetime": 1441451226n }, n {n "duration": 606, n "risetime": 1441457027n }, n {n "duration": 542, n "risetime": 1441462894n }, n {n "duration": 565, n "risetime": 1441468731n }n ]n}'

使用JSON数据

您可能早已注意到,响应的内容之前是a string(尽管它显示为bytes对象,但是我们可以使用轻松地将内容转换为字符串response.content.decode("utf-8"))。

字符串是我们将信息来回传递给API的方法,但是很难从字符串中获取我们想要的信息。我们怎么晓得怎样解码返回的字符串并在大数据分析Python中使用它?我们怎么altitude从字符串响应中找出ISS的含意?

幸运的是,有一种名为JavaScript Object Notation(JSON)的格式。JSON是一种将列表和字典之类的数据结构编码为字符串的方式,以确保它们便于被机器读取。JSON是将数据来回传递给API的主要格式,大多数API服务器将以JSON格式发送其响应。

json套件随附大数据分析Python强悍的JSON支持。该json软件包是标准库的一部分,因此我们无需安装任何程序即可使用它。我们既可以将列表和字典转换为JSON,也可以将字符串转换为列表和字典。就我们的ISS Pass数据而言,它是一个字典,编码为JSON格式的字符串。

json库有两种主要方式:

1)dumps —接收一个大数据剖析Python对象,并将其转换为字符串。

2)loads —接收JSON字符串,并将其转换为大数据分析Python对象。

从API恳求获取JSON

通过使用.json()响应上的方式,您可以将响应的内容作为大数据分析Python对象获取。

{'response': [{'risetime': 1441456672, 'duration': 369}, {'risetime': 1441462284, 'duration': 626}, {'risetime': 1441468104, 'duration': 581}, {'risetime': 1441474000, 'duration': 482}, {'risetime': 1441479853, 'duration': 509}], 'message': 'success', 'request': {'latitude': 37.78, 'passes': 5, 'longitude': -122.41, 'altitude': 100, 'datetime': 1441417753}}

内容类型

服务器除了会在生成响应时发送状态码和数据。它还发送收录有关怎样生成数据以及怎样对其进行解码的信息的元数据。这储存在响应头中。在大数据分析Python中,我们可以使用headers响应对象的属性来访问它。

标头将显示为字典。在标题中,content-type是目前最重要的键。它告诉我们响应的格式以及怎样对其进行解码。大数据分析Python API入门教程对于OpenNotify API,格式为JSON,这就是为何我们可以json更早地使用包对其进行解码的诱因。

寻找太空中的人数

OpenNotify还有一个API端点astros.json。它告诉你当前有多少人在太空中。相应的格式可以在这里找到。

9

{'number': 9, 'people': [{'name': 'Gennady Padalka', 'craft': 'ISS'}, {'name': 'Mikhail Kornienko', 'craft': 'ISS'}, {'name': 'Scott Kelly', 'craft': 'ISS'}, {'name': 'Oleg Kononenko', 'craft': 'ISS'}, {'name': 'Kimiya Yui', 'craft': 'ISS'}, {'name': 'Kjell Lindgren', 'craft': 'ISS'}, {'name': 'Sergey Volkov', 'craft': 'ISS'}, {'name': 'Andreas Mogensen', 'craft': 'ISS'}, {'name': 'Aidyn Aimbetov', 'craft': 'ISS'}], 'message': 'success'}

大数据分析Python API数据科学教程:后续步骤

现在,您早已完成了大数据分析Python API教程,现在应当可以访问简单的API并发出get恳求了。requests在我们的dataquest API和抓取课程中,还有其他几种类型,您可以了解更多信息以及与API身分验证一起使用。

建议的其他后续步骤是阅读恳求文档,并使用Reddit API。有一个名为PRAW 的程序包,它让在大数据分析Python中使用Reddit API愈发容易,但是建议requests首先使用它来了解一切的工作原理。

网站的产品怎样进行防采集处理?

采集交流 • 优采云 发表了文章 • 0 个评论 • 362 次浏览 • 2020-08-28 01:59

很多网站为了用户体验,通常会将一部分想听到的数据,直接加载在页面上,让用户进行查看。这时候采集器只须要解析页面的html结构,就能将页面的信息全部采集下来。百度爬虫、快照、页面采集基本上都是用了这个原理。

直接窃取web数据库这个就比较中级了,采集器一般会编撰一个爬虫,让爬虫手动发觉网站上的查询插口,并且模拟插口的数据标准,向插口传输相应的查询指令,最后将返回的数据进行整理处理,就完成了相应的资源采集。

手动采集从字面上理解,就是通过人工进行资源的采集,这种方法适用范围比较灵活,可以通过资源下载、复制等人工方法进行资源的采集。这种方法看着太low,效率太低。但常常这些采集方式,让人无比头晕。

PS:1个用户在A网站下载了一份word资料,经过简单编辑后,上传到自己的网站上进行使用。这个过程就难以通过技术手段进行跟踪(整个过程全是用户的真实操作),即使发觉了这些现象,也难以确定对方窃取了自己的资源,因为你没有切实可行的证据。此处你们可以思索一下,百度文库的一部分内容是如何来的。

防采集方法策略

上文中简单介绍了部份采集器的采集手段,接下来我们说说该怎样进行防采集处理。

应对下载链接泄漏的策略

通过这个流程,我们发觉,如果采集器可以直接领到步骤3的下载链接,是可以不需要经过步骤2的验证,直接下载资源。这样我们就清楚了,要避免这些采集方式的话,我们的重点在于不使用户领到资源的下载链接。那我们就可以根据下边的形式进行处理:

将下载链接进行加密

程序猿在开发过程中,基本就会进行下载链接的加密处理。加密就好比一把锁匙,没有锁匙就开不了锁,加密一样的,不知道揭秘形式,是难以破解你的下载链接,这样便实现了资源的防采集。

解密是须要晓得加密规则的,所以在做加密处理的时侯,最好不要使用第三方机加密规则,自己做最安全。定期维护加密规则,也是有必要的。

防止采集器拦截下载链接

有一部分采集器,会在步骤3与步骤4之间,拦截传输出去的下载链接。这样他不需要经过步骤2,一样能领到我们返回的下载链接进行下载。遇到这些情况的时侯,我们可以考虑在下载url加入用户验证。在浏览器解析url的时侯,验证当前用户是否是我们的下载用户,达到防采集的目的。除非用户能领到我们的帐户信息,否则是不能采集到我们的内容。但是这些方式难以支持断点下载。 查看全部

网站的产品怎样进行防采集处理?

很多网站为了用户体验,通常会将一部分想听到的数据,直接加载在页面上,让用户进行查看。这时候采集器只须要解析页面的html结构,就能将页面的信息全部采集下来。百度爬虫、快照、页面采集基本上都是用了这个原理。

直接窃取web数据库这个就比较中级了,采集器一般会编撰一个爬虫,让爬虫手动发觉网站上的查询插口,并且模拟插口的数据标准,向插口传输相应的查询指令,最后将返回的数据进行整理处理,就完成了相应的资源采集。

手动采集从字面上理解,就是通过人工进行资源的采集,这种方法适用范围比较灵活,可以通过资源下载、复制等人工方法进行资源的采集。这种方法看着太low,效率太低。但常常这些采集方式,让人无比头晕。

PS:1个用户在A网站下载了一份word资料,经过简单编辑后,上传到自己的网站上进行使用。这个过程就难以通过技术手段进行跟踪(整个过程全是用户的真实操作),即使发觉了这些现象,也难以确定对方窃取了自己的资源,因为你没有切实可行的证据。此处你们可以思索一下,百度文库的一部分内容是如何来的。

防采集方法策略

上文中简单介绍了部份采集器的采集手段,接下来我们说说该怎样进行防采集处理。

应对下载链接泄漏的策略

通过这个流程,我们发觉,如果采集器可以直接领到步骤3的下载链接,是可以不需要经过步骤2的验证,直接下载资源。这样我们就清楚了,要避免这些采集方式的话,我们的重点在于不使用户领到资源的下载链接。那我们就可以根据下边的形式进行处理:

将下载链接进行加密

程序猿在开发过程中,基本就会进行下载链接的加密处理。加密就好比一把锁匙,没有锁匙就开不了锁,加密一样的,不知道揭秘形式,是难以破解你的下载链接,这样便实现了资源的防采集。

解密是须要晓得加密规则的,所以在做加密处理的时侯,最好不要使用第三方机加密规则,自己做最安全。定期维护加密规则,也是有必要的。

防止采集器拦截下载链接

有一部分采集器,会在步骤3与步骤4之间,拦截传输出去的下载链接。这样他不需要经过步骤2,一样能领到我们返回的下载链接进行下载。遇到这些情况的时侯,我们可以考虑在下载url加入用户验证。在浏览器解析url的时侯,验证当前用户是否是我们的下载用户,达到防采集的目的。除非用户能领到我们的帐户信息,否则是不能采集到我们的内容。但是这些方式难以支持断点下载。

V站信息采集工具最新绿色版

采集交流 • 优采云 发表了文章 • 0 个评论 • 295 次浏览 • 2020-08-28 01:11

V站信息采集工具可以采集网站的信息以及文件,能够手动辨识js脚本语言,还能够多页面采集,能够用于搜集素材以及资源所使用。

软件功能

1.信息采集添加全手动

网站抓取的目的主要是添加到您的网站中,软件可以实现采集添加全手动完成。其它网站刚刚更新的信息五分钟之内都会手动挪到您的网站中.

2.需要登入的网站也照抓

对于须要登陆能够听到信息内容的网站,网站优采云采集器可以实现轻松登陆并采集,即使有验证码也可以穿过登陆采集到您须要的信息。

3.任意类型的文件都能下载

如果须要采集图片等二进制文件,经过简单设置网站优采云采集器就可以把任意类型的文件保存到本地。

4.多级页面采集

可以同时采集到多级页面的内容。如果一条信息分布在好多不同的页面上,网站优采云采集器也能手动识

别多级页面实现采集

5.自动辨识Javascript等特殊网址

不少网站的网页联接是类似javascript:openwin('1234')这样的特殊网址,不是一般的开头的,软件也能手动辨识并抓到内容

软件如何用

1、在关键词页面输入你所须要的网站信息,点击搜索

2、就会出现相应的网站了,只须要点击进去就可以了

注意事项

该软件为易语言所编撰安杀软会针对小软件报毒,所以通常都是误报,只须要添加信任去即可。 查看全部

V站信息采集工具最新绿色版

V站信息采集工具可以采集网站的信息以及文件,能够手动辨识js脚本语言,还能够多页面采集,能够用于搜集素材以及资源所使用。

软件功能

1.信息采集添加全手动

网站抓取的目的主要是添加到您的网站中,软件可以实现采集添加全手动完成。其它网站刚刚更新的信息五分钟之内都会手动挪到您的网站中.

2.需要登入的网站也照抓

对于须要登陆能够听到信息内容的网站,网站优采云采集器可以实现轻松登陆并采集,即使有验证码也可以穿过登陆采集到您须要的信息。

3.任意类型的文件都能下载

如果须要采集图片等二进制文件,经过简单设置网站优采云采集器就可以把任意类型的文件保存到本地。

4.多级页面采集

可以同时采集到多级页面的内容。如果一条信息分布在好多不同的页面上,网站优采云采集器也能手动识

别多级页面实现采集

5.自动辨识Javascript等特殊网址

不少网站的网页联接是类似javascript:openwin('1234')这样的特殊网址,不是一般的开头的,软件也能手动辨识并抓到内容

软件如何用

1、在关键词页面输入你所须要的网站信息,点击搜索

2、就会出现相应的网站了,只须要点击进去就可以了

注意事项

该软件为易语言所编撰安杀软会针对小软件报毒,所以通常都是误报,只须要添加信任去即可。

黑客基础 编写Python爬虫入门步骤

采集交流 • 优采云 发表了文章 • 0 个评论 • 263 次浏览 • 2020-08-27 23:40

信息时代,数据就是宝藏。数据的背后蕴藏着无穷的宝藏,这些宝藏其实就是信息量所带来的商业价值,而大数据本身也将成为桌面上的筹码。

黑客花无涯 带你走入黑客世界系列文章

学习黑客精典书籍 网络黑白 某宝有售

通过编写者两个小爬虫,我渐渐感受到了爬虫的一些作用,对其的一些巧妙应用,多线程的处理有时候会大大提升做事的效率,而一个功能强悍的爬虫系统所能做的远不止这种。

说了那么多数据的重要性,本篇文章所提及爬取的数据不包括超过传统数据库系统处理能力的数据。而是从一个简单的爬虫程序上讲起,讲怎么编撰属于自己的爬虫,获取想要的简单数据,并使程序对数据进行剖析进而得到我们想要的信息。

逻辑剖析

编写爬虫首先要有个简单的逻辑思路,无非是发送恳求-加载页面-获取页面的信息-提取想要的数据-数据可视化、以表格的方式呈现或则依据需求批量下载到本地。

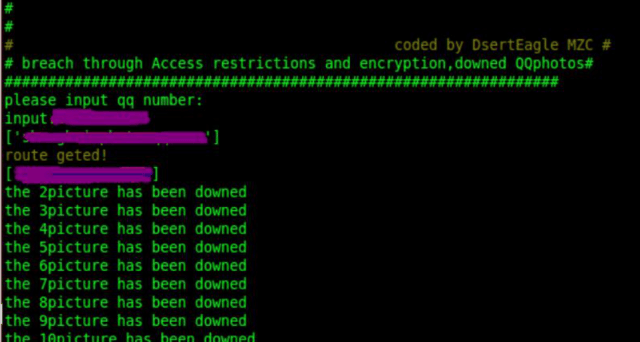

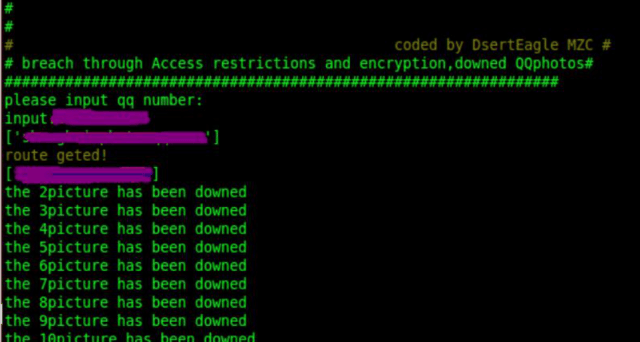

所以这儿我们不妨写两个工程程序进行测试,一是批量数据下载到本地,我们可以把腾讯服务器里用户QQ空间中的相册批量下载出来,寻找规律随机下载,或借助一些插口从服务器上爬取。二是对特定数据爬取,最好以可视化表格的方式表现下来,我们可以采集网站上一些数据,然后以表格显示。

案例一代码剖析

现在我们开始写代码,用Python来实现这一功能,首先是发送恳求信息。Python的Urllib模块提供了读取web页面数据的插口,我们可以读取万维网、FTP上的数据。用urllib.urlopen()方法用于打开一个URL地址。用read()方法可以读取URL上的数据。其间对字符串的处理自定义了函数,为获取想要的数据,编写了正则表达式。简单基础的Python编程,附上核心代码。

//自定义函数获取指定两个字符串之间的数据

defsfinds(start_str,end,html):start=html.find(start_str)ifstart=0:start+=len(start_str)end=html.find(end,start)ifend=0:returnhtml[start:end].strip()//自定义函数getHtml()用来读取网页数据defgetHtml(url):p=urllib.urlopen(url)html=p.read()returnhtml//自定义函数构造正则表达式来获取网路图片defgetImg(html):reg=rurl[^]*[^u]*[^r]*[^l]*[^]*/urlimgae=pile(reg)imglist=re.findall(imgae,str(html))returnimglist

有了以上定义的基本函数,就可以进行好多实战测试了。利用腾讯已有的一些插口来访问服务器空间上保存的数据,下面就是一个网络爬虫爬取数据,相册批量下载的测试效果图,可以下载任意QQ的相册,即使对方设置了权限限制。

图1软件打开效果图

接下来输入我们要下载相册的QQ号,可以看见程序会手动获取相册信息:

图2相册信息获取截图

然后我们的爬虫系统会手动下载保存图片,我们只须要耐心等待。

图3相片下载成果后提示截图

出去转了一圈,回头再来看的时侯所有相册早已下载完毕,到程序文件夹里可以见到下载的相片。

图4下载的图片

接着又测试了一个QQ号,效果如图。

案例二逻辑剖析

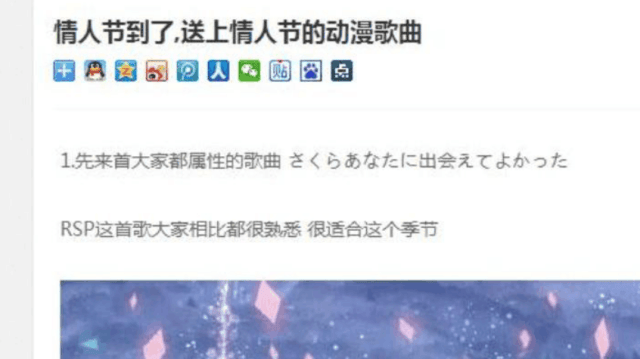

作为学习来讲,在案例中学我们涉及html数据解析。欧尼酱这个网站我之前没有听过,一次碰巧发觉上面有首还不错的日系音乐,于是决定拿这个网站为反例,爬取o站里部份音乐信息。首先打开一个页面,查看其源代码,如图7所示。

图7

从这个源代码中我们可以看见divcalss=”contentmarkitup-box”这个html标签中保存的是歌曲的名子,我们可以获取所有这个标签中收录的内容,以此来爬取页面所推荐的情人春节漫歌曲名子。

我们可以先获取页面的html数据信息,然后通过class或则ID查找特定的标签,接着对标签的内容进行获取,列表显示,核心代码如下:

//首先还是读取页面信息

学习黑客精典书籍 黑客技术攻守入门到精通 网络黑白书 某宝有售

中国黑客协会 普及网路安全知识,让更多的人学习并注重网路安全和信息安全。

中国黑客协会是一种精神的弘扬,黑客代表是一种精神,它是一种热爱祖国、坚持正义、开拓进取的精神。

接着对读取的信息进行处理,我们晓得我们爬到的信息是有大幅度的html标签,我们要对数据进行html解析。对此我们有很多方式,HTMLParser模块、BeautifulSoup、SGMLParser,这里我们用SGMLParser,理由不多讲了,好用。 查看全部

黑客基础 编写Python爬虫入门步骤

信息时代,数据就是宝藏。数据的背后蕴藏着无穷的宝藏,这些宝藏其实就是信息量所带来的商业价值,而大数据本身也将成为桌面上的筹码。

黑客花无涯 带你走入黑客世界系列文章

学习黑客精典书籍 网络黑白 某宝有售

通过编写者两个小爬虫,我渐渐感受到了爬虫的一些作用,对其的一些巧妙应用,多线程的处理有时候会大大提升做事的效率,而一个功能强悍的爬虫系统所能做的远不止这种。

说了那么多数据的重要性,本篇文章所提及爬取的数据不包括超过传统数据库系统处理能力的数据。而是从一个简单的爬虫程序上讲起,讲怎么编撰属于自己的爬虫,获取想要的简单数据,并使程序对数据进行剖析进而得到我们想要的信息。

逻辑剖析

编写爬虫首先要有个简单的逻辑思路,无非是发送恳求-加载页面-获取页面的信息-提取想要的数据-数据可视化、以表格的方式呈现或则依据需求批量下载到本地。

所以这儿我们不妨写两个工程程序进行测试,一是批量数据下载到本地,我们可以把腾讯服务器里用户QQ空间中的相册批量下载出来,寻找规律随机下载,或借助一些插口从服务器上爬取。二是对特定数据爬取,最好以可视化表格的方式表现下来,我们可以采集网站上一些数据,然后以表格显示。

案例一代码剖析

现在我们开始写代码,用Python来实现这一功能,首先是发送恳求信息。Python的Urllib模块提供了读取web页面数据的插口,我们可以读取万维网、FTP上的数据。用urllib.urlopen()方法用于打开一个URL地址。用read()方法可以读取URL上的数据。其间对字符串的处理自定义了函数,为获取想要的数据,编写了正则表达式。简单基础的Python编程,附上核心代码。

//自定义函数获取指定两个字符串之间的数据

defsfinds(start_str,end,html):start=html.find(start_str)ifstart=0:start+=len(start_str)end=html.find(end,start)ifend=0:returnhtml[start:end].strip()//自定义函数getHtml()用来读取网页数据defgetHtml(url):p=urllib.urlopen(url)html=p.read()returnhtml//自定义函数构造正则表达式来获取网路图片defgetImg(html):reg=rurl[^]*[^u]*[^r]*[^l]*[^]*/urlimgae=pile(reg)imglist=re.findall(imgae,str(html))returnimglist

有了以上定义的基本函数,就可以进行好多实战测试了。利用腾讯已有的一些插口来访问服务器空间上保存的数据,下面就是一个网络爬虫爬取数据,相册批量下载的测试效果图,可以下载任意QQ的相册,即使对方设置了权限限制。

图1软件打开效果图

接下来输入我们要下载相册的QQ号,可以看见程序会手动获取相册信息:

图2相册信息获取截图

然后我们的爬虫系统会手动下载保存图片,我们只须要耐心等待。

图3相片下载成果后提示截图

出去转了一圈,回头再来看的时侯所有相册早已下载完毕,到程序文件夹里可以见到下载的相片。

图4下载的图片

接着又测试了一个QQ号,效果如图。

案例二逻辑剖析

作为学习来讲,在案例中学我们涉及html数据解析。欧尼酱这个网站我之前没有听过,一次碰巧发觉上面有首还不错的日系音乐,于是决定拿这个网站为反例,爬取o站里部份音乐信息。首先打开一个页面,查看其源代码,如图7所示。

图7

从这个源代码中我们可以看见divcalss=”contentmarkitup-box”这个html标签中保存的是歌曲的名子,我们可以获取所有这个标签中收录的内容,以此来爬取页面所推荐的情人春节漫歌曲名子。

我们可以先获取页面的html数据信息,然后通过class或则ID查找特定的标签,接着对标签的内容进行获取,列表显示,核心代码如下:

//首先还是读取页面信息

学习黑客精典书籍 黑客技术攻守入门到精通 网络黑白书 某宝有售

中国黑客协会 普及网路安全知识,让更多的人学习并注重网路安全和信息安全。

中国黑客协会是一种精神的弘扬,黑客代表是一种精神,它是一种热爱祖国、坚持正义、开拓进取的精神。

接着对读取的信息进行处理,我们晓得我们爬到的信息是有大幅度的html标签,我们要对数据进行html解析。对此我们有很多方式,HTMLParser模块、BeautifulSoup、SGMLParser,这里我们用SGMLParser,理由不多讲了,好用。

学会这个技能,一键爬取全网资源,10分钟搞定!

采集交流 • 优采云 发表了文章 • 0 个评论 • 293 次浏览 • 2020-08-27 17:04

学会这个技能,一键爬取全网资源,10分钟搞定!

网易云课堂

study163

实用技能学习平台,帮你发觉感兴趣的课程,成为更好的自己。

在现今互联网信息爆燃的时代,经常会面临各类与信息采集有关的事情,但是信息来源网站多,信息量大,如果采用常规的人工搜索+office软件整理,往往要耗费大量的时间。

因此门槛低、易上手的工具——Python成了必备的辅助技能。由Python编程语言编撰的网路爬虫是一种“自动化浏览网路”程序,或者说是一种网路机器人。它可以手动采集所有才能访问到的页面内容,获取海量信息。很多须要人工三天完成的事情,Python只需1分钟甚至几秒钟就搞定了。

百度搜索、谷歌搜索等搜索工具,通过Python爬虫来补充和实时更新海量搜索结果。

各种比价网站,利用Python爬虫,实时监控各电商平台的价钱浮动,采集商品价钱、型号、配置等信息,然后再做处理、分析、反馈。

……

也许你们会觉得,Python编程、爬虫都是程序员的事,但似乎不然。现在,越来越多的人借助Python完成自动化办公、表格处理、信息采集、数据剖析、图表制做等工作。如果你会Python的话,至少可以释放80%的重复劳动,让你拥有更多时间和精力去提高自己。高效工作,开心生活!

但是这三年,找工作越来越难了,每到秋招季/毕业季/转业季/年末回去季/大概在夏季,就会收到许多读者朋友们的提问:

现在还可以上车学 Python吗?

Python 开发是不是很难就业啊?

想要入行 Python须要哪些技能啊?

收到了好多同类型的咨询后,我认为学IT的真的太难了!

为此,大家假如想用业余时间来学习python的话,可以瞧瞧下边网易云课堂这种免费的直播课,零碎时间也能借助上去!

No.2

Python全栈开发 视频资料

No.3

Python全栈开发 网易独家文档

扫描下方二维码发放

免费资源,先到先得~ 查看全部

学会这个技能,一键爬取全网资源,10分钟搞定!

学会这个技能,一键爬取全网资源,10分钟搞定!

网易云课堂

study163

实用技能学习平台,帮你发觉感兴趣的课程,成为更好的自己。

在现今互联网信息爆燃的时代,经常会面临各类与信息采集有关的事情,但是信息来源网站多,信息量大,如果采用常规的人工搜索+office软件整理,往往要耗费大量的时间。

因此门槛低、易上手的工具——Python成了必备的辅助技能。由Python编程语言编撰的网路爬虫是一种“自动化浏览网路”程序,或者说是一种网路机器人。它可以手动采集所有才能访问到的页面内容,获取海量信息。很多须要人工三天完成的事情,Python只需1分钟甚至几秒钟就搞定了。

百度搜索、谷歌搜索等搜索工具,通过Python爬虫来补充和实时更新海量搜索结果。

各种比价网站,利用Python爬虫,实时监控各电商平台的价钱浮动,采集商品价钱、型号、配置等信息,然后再做处理、分析、反馈。

……

也许你们会觉得,Python编程、爬虫都是程序员的事,但似乎不然。现在,越来越多的人借助Python完成自动化办公、表格处理、信息采集、数据剖析、图表制做等工作。如果你会Python的话,至少可以释放80%的重复劳动,让你拥有更多时间和精力去提高自己。高效工作,开心生活!

但是这三年,找工作越来越难了,每到秋招季/毕业季/转业季/年末回去季/大概在夏季,就会收到许多读者朋友们的提问:

现在还可以上车学 Python吗?

Python 开发是不是很难就业啊?

想要入行 Python须要哪些技能啊?

收到了好多同类型的咨询后,我认为学IT的真的太难了!

为此,大家假如想用业余时间来学习python的话,可以瞧瞧下边网易云课堂这种免费的直播课,零碎时间也能借助上去!

No.2

Python全栈开发 视频资料

No.3

Python全栈开发 网易独家文档

扫描下方二维码发放

免费资源,先到先得~

Qt编撰控件属性设计器6-动态属性

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2020-08-27 06:13

一、前言

之前就提过,Qt的属性机制强悍到爆,这次的动态属性功能就是要使他爆,很难想像只要一行代码即可widget->setProperty("value", value);没错就那么简单,调用弱属性机制,可以直接控制控件中的所有属性,设计这个机制的人绝对是天才,直接跪了。至于具体底层是如何实现的,这个可以先不管,也没有太多精力再去研究Qt的源码了,那个源码十分庞大,研究源码的时侯最快的办法是搜索直接定位对应文件。本设计器不仅提供文本框输入值进行动态改变控件属性以外,还提供了了滑动条、随机模拟数据、串口采集数据、网络采集数据、数据库采集数据等多种方法获取数据源。 这里不得不提下一个牛逼的方法:QLabel有三种设置文本的方式,掌握好Qt的属性系统,举一反三,可以作出好多疗效。

ui->label->setStyleSheet("qproperty-text:hello;");

ui->label->setProperty("text", "hello");

ui->label->setText("hello");

体验地址:/s/1A5Gd77kExm8Co5ckT51vvQ 提取码:877p 文件:可执行文件.zip

二、实现的功能手动加载插件文件中的所有控件生成列表,默认自带的控件超过120个。拖曳到画布手动生成对应的控件,所见即所得。右侧英文属性栏,改变对应的属性立刻应用到对应选中控件,直观简约,非常适宜小白使用。独创属性栏文字翻译映射机制,效率极高,可以十分便捷拓展其他语言的属性栏。所有控件的属性手动提取并显示在左侧属性栏,包括枚举值下拉框等。支持自动选择插件文件,外部导出插件文件。可以将当前画布的所有控件配置信息导入到xml文件。可以自动选择xml文件打开控件布局,自动按照xml文件加载控件。可带动滑动条、勾选模拟数据复选框、文本框输入,三种形式来生成数据应用所有控件。控件支持八个方位带动调整大小,自适应任意帧率,可按键上下左右微调位置。打通了并口采集、网络采集、数据库采集三种形式设置数据。代码非常精简,注释十分详尽,可以作为组态的雏型,自行拓展更多的功能。纯Qt编撰,支持任意Qt版本+任意编译器+任意系统。三、效果图

四、核心代码

void frmMain::initForm()

{

//初始化中英属性对照表

QtPropertyName::initMap();

//设置没有关闭按钮

ui->dockWidgetControl->setFixedWidth(200);

ui->dockWidgetData->setFixedWidth(200);

ui->dockWidgetProperty->setFixedWidth(220);

ui->dockWidgetControl->setFeatures(QDockWidget::DockWidgetMovable | QDockWidget::DockWidgetFloatable);

ui->dockWidgetProperty->setFeatures(QDockWidget::DockWidgetMovable | QDockWidget::DockWidgetFloatable);

ui->dockWidgetData->setFeatures(QDockWidget::DockWidgetMovable | QDockWidget::DockWidgetFloatable);

this->tabifyDockWidget(ui->dockWidgetControl, ui->dockWidgetData);

ui->dockWidgetControl->raise();

//绑定数据源窗体的数值改变信号

connect(ui->dockWidgetContentsData, SIGNAL(valueChanged(int)), this, SLOT(valueChanged(int)));

//允许拖曳接收

this->setAcceptDrops(true);

bgPix = QPixmap(":/image/bg.png");

//居中显示窗体

int frmX = this->width();

int frmY = this->height();

QDesktopWidget w;

int deskWidth = w.availableGeometry().width();

int deskHeight = w.availableGeometry().height();

QPoint movePoint(deskWidth / 2 - frmX / 2, deskHeight / 2 - frmY / 2);

this->move(movePoint);

//初始化随机数种子

QTime t = QTime::currentTime();

qsrand(t.msec() + t.second() * 1000);

//定时器模拟随机值赋值给控件

timer = new QTimer(this);

connect(timer, SIGNAL(timeout()), this, SLOT(setValue()));

timer->setInterval(2000);

}

void frmMain::setValue()

{

int value = qrand() % 100;

valueChanged(value);

}

void frmMain::valueChanged(int value)

{

QList widgets = ui->centralwidget->findChildren();

foreach (QWidget *widget, widgets) {

widget->setProperty("value", value);

}

}

五、控件介绍超过150个精致控件,涵盖了各类仪表盘、进度条、进度球、指南针、曲线图、标尺、温度计、导航条、导航栏,flatui、高亮按键、滑动选择器、农历等。远超qwt集成的控件数目。每个类都可以独立成一个单独的控件,零耦合,每个控件一个头文件和一个实现文件,不依赖其他文件,方便单个控件以源码方式集成到项目中,较少代码量。qwt的控件类环环相扣,高度耦合,想要使用其中一个控件,必须收录所有的代码。全部纯Qt编撰,QWidget+QPainter勾画,支持Qt4.6到Qt5.12的任何Qt版本,支持mingw、msvc、gcc等编译器,支持任意操作系统例如windows+linux+mac+嵌入式linux等,不乱码,可直接集成到Qt Creator中,和自带的控件一样使用,大部分疗效只要设置几个属性即可,极为便捷。每个控件都有一个对应的单独的收录该控件源码的DEMO,方便参考使用。同时还提供一个所有控件使用的集成的DEMO。每个控件的源代码都有详尽英文注释,都依照统一设计规范编撰,方便学习自定义控件的编撰。每个控件默认配色和demo对应的配色都十分精致。超过130个可见控件,6个不可见控件。

部分控件提供多种款式风格选择,多种指示器款式选择。所有控件自适应窗体拉伸变化。集成自定义控件属性设计器,支持拖曳设计,所见即所得,支持导出导入xml格式。自带activex控件demo,所有控件可以直接运行在ie浏览器中。集成fontawesome图形字体+阿里巴巴iconfont采集的几百个图形字体,享受图形字体带来的乐趣。所有控件最后生成一个动态库文件(dll或则so等),可以直接集成到qtcreator中拖曳设计使用。目前早已有qml版本,后期会考虑出pyqt版本,如果用户需求量很大的话。自定义控件插件开放动态库使用(永久免费),无任何侧门和限制,请放心使用。目前已提供26个版本的dll,其中包括了qt5.12.3 msvc2017 32+64 mingw 32+64 的。不定期降低控件和建立控件,不定期更新SDK,欢迎诸位提出建议,谢谢! Qt入门书籍推荐霍亚飞的《Qt Creator快速入门》《Qt5编程入门》,Qt进阶书籍推荐官方的《C++ GUI Qt4编程》。强烈推荐程序员自我修养和规划系列书《大话程序员》《程序员的成长课》《解忧程序员》,受益匪浅,受益终身!SDK下载链接:/s/1A5Gd77kExm8Co5ckT51vvQ 提取码:877p 查看全部

Qt编撰控件属性设计器6-动态属性

一、前言

之前就提过,Qt的属性机制强悍到爆,这次的动态属性功能就是要使他爆,很难想像只要一行代码即可widget->setProperty("value", value);没错就那么简单,调用弱属性机制,可以直接控制控件中的所有属性,设计这个机制的人绝对是天才,直接跪了。至于具体底层是如何实现的,这个可以先不管,也没有太多精力再去研究Qt的源码了,那个源码十分庞大,研究源码的时侯最快的办法是搜索直接定位对应文件。本设计器不仅提供文本框输入值进行动态改变控件属性以外,还提供了了滑动条、随机模拟数据、串口采集数据、网络采集数据、数据库采集数据等多种方法获取数据源。 这里不得不提下一个牛逼的方法:QLabel有三种设置文本的方式,掌握好Qt的属性系统,举一反三,可以作出好多疗效。

ui->label->setStyleSheet("qproperty-text:hello;");

ui->label->setProperty("text", "hello");

ui->label->setText("hello");

体验地址:/s/1A5Gd77kExm8Co5ckT51vvQ 提取码:877p 文件:可执行文件.zip

二、实现的功能手动加载插件文件中的所有控件生成列表,默认自带的控件超过120个。拖曳到画布手动生成对应的控件,所见即所得。右侧英文属性栏,改变对应的属性立刻应用到对应选中控件,直观简约,非常适宜小白使用。独创属性栏文字翻译映射机制,效率极高,可以十分便捷拓展其他语言的属性栏。所有控件的属性手动提取并显示在左侧属性栏,包括枚举值下拉框等。支持自动选择插件文件,外部导出插件文件。可以将当前画布的所有控件配置信息导入到xml文件。可以自动选择xml文件打开控件布局,自动按照xml文件加载控件。可带动滑动条、勾选模拟数据复选框、文本框输入,三种形式来生成数据应用所有控件。控件支持八个方位带动调整大小,自适应任意帧率,可按键上下左右微调位置。打通了并口采集、网络采集、数据库采集三种形式设置数据。代码非常精简,注释十分详尽,可以作为组态的雏型,自行拓展更多的功能。纯Qt编撰,支持任意Qt版本+任意编译器+任意系统。三、效果图

四、核心代码

void frmMain::initForm()

{

//初始化中英属性对照表

QtPropertyName::initMap();

//设置没有关闭按钮

ui->dockWidgetControl->setFixedWidth(200);

ui->dockWidgetData->setFixedWidth(200);

ui->dockWidgetProperty->setFixedWidth(220);

ui->dockWidgetControl->setFeatures(QDockWidget::DockWidgetMovable | QDockWidget::DockWidgetFloatable);

ui->dockWidgetProperty->setFeatures(QDockWidget::DockWidgetMovable | QDockWidget::DockWidgetFloatable);

ui->dockWidgetData->setFeatures(QDockWidget::DockWidgetMovable | QDockWidget::DockWidgetFloatable);

this->tabifyDockWidget(ui->dockWidgetControl, ui->dockWidgetData);

ui->dockWidgetControl->raise();

//绑定数据源窗体的数值改变信号

connect(ui->dockWidgetContentsData, SIGNAL(valueChanged(int)), this, SLOT(valueChanged(int)));

//允许拖曳接收

this->setAcceptDrops(true);

bgPix = QPixmap(":/image/bg.png");

//居中显示窗体

int frmX = this->width();

int frmY = this->height();

QDesktopWidget w;

int deskWidth = w.availableGeometry().width();

int deskHeight = w.availableGeometry().height();

QPoint movePoint(deskWidth / 2 - frmX / 2, deskHeight / 2 - frmY / 2);

this->move(movePoint);

//初始化随机数种子

QTime t = QTime::currentTime();

qsrand(t.msec() + t.second() * 1000);

//定时器模拟随机值赋值给控件

timer = new QTimer(this);

connect(timer, SIGNAL(timeout()), this, SLOT(setValue()));

timer->setInterval(2000);

}

void frmMain::setValue()

{

int value = qrand() % 100;

valueChanged(value);

}

void frmMain::valueChanged(int value)

{

QList widgets = ui->centralwidget->findChildren();

foreach (QWidget *widget, widgets) {

widget->setProperty("value", value);

}

}

五、控件介绍超过150个精致控件,涵盖了各类仪表盘、进度条、进度球、指南针、曲线图、标尺、温度计、导航条、导航栏,flatui、高亮按键、滑动选择器、农历等。远超qwt集成的控件数目。每个类都可以独立成一个单独的控件,零耦合,每个控件一个头文件和一个实现文件,不依赖其他文件,方便单个控件以源码方式集成到项目中,较少代码量。qwt的控件类环环相扣,高度耦合,想要使用其中一个控件,必须收录所有的代码。全部纯Qt编撰,QWidget+QPainter勾画,支持Qt4.6到Qt5.12的任何Qt版本,支持mingw、msvc、gcc等编译器,支持任意操作系统例如windows+linux+mac+嵌入式linux等,不乱码,可直接集成到Qt Creator中,和自带的控件一样使用,大部分疗效只要设置几个属性即可,极为便捷。每个控件都有一个对应的单独的收录该控件源码的DEMO,方便参考使用。同时还提供一个所有控件使用的集成的DEMO。每个控件的源代码都有详尽英文注释,都依照统一设计规范编撰,方便学习自定义控件的编撰。每个控件默认配色和demo对应的配色都十分精致。超过130个可见控件,6个不可见控件。

部分控件提供多种款式风格选择,多种指示器款式选择。所有控件自适应窗体拉伸变化。集成自定义控件属性设计器,支持拖曳设计,所见即所得,支持导出导入xml格式。自带activex控件demo,所有控件可以直接运行在ie浏览器中。集成fontawesome图形字体+阿里巴巴iconfont采集的几百个图形字体,享受图形字体带来的乐趣。所有控件最后生成一个动态库文件(dll或则so等),可以直接集成到qtcreator中拖曳设计使用。目前早已有qml版本,后期会考虑出pyqt版本,如果用户需求量很大的话。自定义控件插件开放动态库使用(永久免费),无任何侧门和限制,请放心使用。目前已提供26个版本的dll,其中包括了qt5.12.3 msvc2017 32+64 mingw 32+64 的。不定期降低控件和建立控件,不定期更新SDK,欢迎诸位提出建议,谢谢! Qt入门书籍推荐霍亚飞的《Qt Creator快速入门》《Qt5编程入门》,Qt进阶书籍推荐官方的《C++ GUI Qt4编程》。强烈推荐程序员自我修养和规划系列书《大话程序员》《程序员的成长课》《解忧程序员》,受益匪浅,受益终身!SDK下载链接:/s/1A5Gd77kExm8Co5ckT51vvQ 提取码:877p

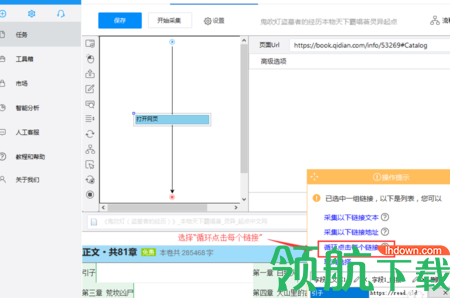

优采云采集器破解版 v2.0

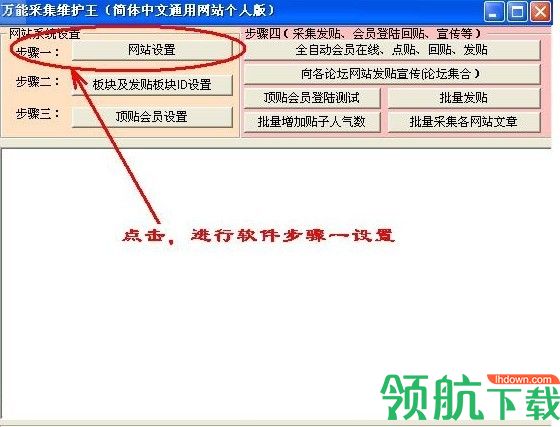

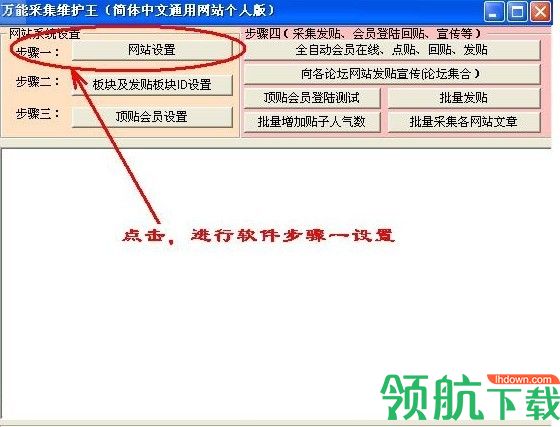

采集交流 • 优采云 发表了文章 • 0 个评论 • 310 次浏览 • 2020-08-26 02:52

优采云采集器是一款专门在网站上和文章进行数据采集,同时还可以手动维护峰会的一个发帖量以及手动顶帖、和贴子观看人数,是一款非常好用的一款采集器,它支持可视化点选,可以一键快速抓取网页内容。软件兼容性挺好,软件体积小,消耗很少笔记本资源,有须要同学赶快下载吧。

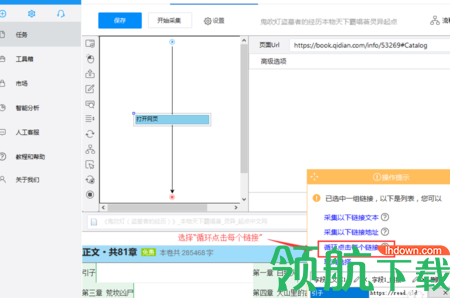

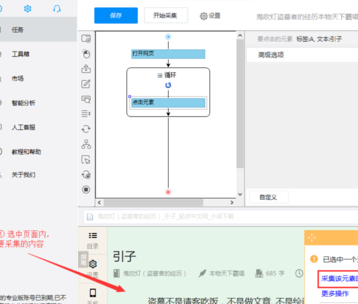

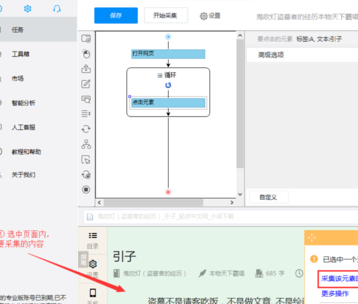

如何采集网络文章教程

步骤1:在页面右上角,打开“流程”,以突显出“流程设计器”和“定制当前操作”两个蓝筹股。选中页面里的第一条链接,系统会手动辨识页面内的同类链接,选择“选中全部”。

步骤2:选择“循环点击每位链接”。

步骤3:选中页面内要采集的小说内容(被选中的内容会弄成红色),选择“采集该元素的文本”。

步骤4:选择“启动本地采集”。

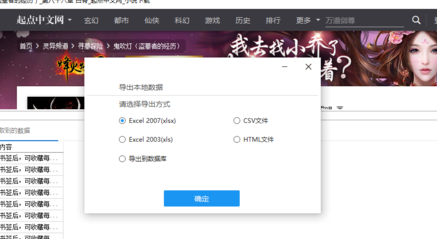

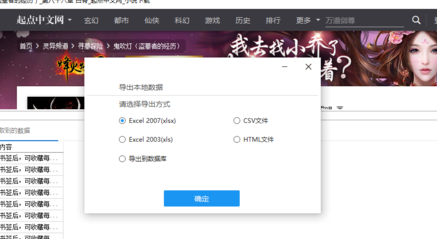

步骤5:采集完成后,会跳出提示,选择“导出数据。选择“合适的导入方法”,将采集好的评论信息数据导入。

优采云采集器软件特色

可以在短时间内给你的峰会注册几千到几万个会员账号

可以使会员在设定的时间内同时上线,实现万人同时在线疗效

可以采集网站和峰会的主题和回复内容,支持把文章内容保存到本地后再发觉

支持将某网站论坛A蓝筹股或栏目内容批量采集转发到自己峰会指定蓝筹股

软件支持按UBB代码和源代码以及UBB和源代码相结合的三种形式编撰采集规则

软件可以同时向峰会的多个版块一起批量发帖

软件可以针对峰会的某一主题分类进行发贴

软件具备万能破解功能,对于富含干扰码的文章、帖子,可以对它们内容中的干扰码进行屏蔽 查看全部

优采云采集器破解版 v2.0

优采云采集器是一款专门在网站上和文章进行数据采集,同时还可以手动维护峰会的一个发帖量以及手动顶帖、和贴子观看人数,是一款非常好用的一款采集器,它支持可视化点选,可以一键快速抓取网页内容。软件兼容性挺好,软件体积小,消耗很少笔记本资源,有须要同学赶快下载吧。

如何采集网络文章教程

步骤1:在页面右上角,打开“流程”,以突显出“流程设计器”和“定制当前操作”两个蓝筹股。选中页面里的第一条链接,系统会手动辨识页面内的同类链接,选择“选中全部”。

步骤2:选择“循环点击每位链接”。

步骤3:选中页面内要采集的小说内容(被选中的内容会弄成红色),选择“采集该元素的文本”。

步骤4:选择“启动本地采集”。

步骤5:采集完成后,会跳出提示,选择“导出数据。选择“合适的导入方法”,将采集好的评论信息数据导入。

优采云采集器软件特色

可以在短时间内给你的峰会注册几千到几万个会员账号

可以使会员在设定的时间内同时上线,实现万人同时在线疗效

可以采集网站和峰会的主题和回复内容,支持把文章内容保存到本地后再发觉

支持将某网站论坛A蓝筹股或栏目内容批量采集转发到自己峰会指定蓝筹股

软件支持按UBB代码和源代码以及UBB和源代码相结合的三种形式编撰采集规则

软件可以同时向峰会的多个版块一起批量发帖

软件可以针对峰会的某一主题分类进行发贴

软件具备万能破解功能,对于富含干扰码的文章、帖子,可以对它们内容中的干扰码进行屏蔽

手把手教你怎样从互联网采集海量数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 571 次浏览 • 2020-08-26 02:48

互联网是一张大网,采集数据的小程序可以形象地称之为爬虫或则蜘蛛。

爬虫的原理很简单,我们在访问网页时,会点击翻页按键和超链接,浏览器会帮我们恳请所有的资源和图片。所以,你可以设计一个程序,能够模拟人在浏览器上的操作,让网站误觉得爬虫是正常访问者,它还会把所需的数据乖乖送回去。

爬虫分为两种,一种象百度(黑)那样哪些都抓的搜索引擎爬虫。另一种就是开发的,只精确地抓取所需的内容:比如我只要二手房信息,旁边的广告和新闻一律不要。

爬虫这样的名子并不好听,所以我给这套软件取名为Hawk,指代为"鹰",能够精确,快速地捕捉猎物。 基本不需编程,通过图形化拖放的操作来快速设计爬虫,有点像Photoshop。它能在20分钟内编撰大众点评的爬虫(简化版只需3分钟),然后使它运行就好啦、

下面是使用Hawk抓取二手房的视频,建议在wifi环境下观看:

自动将网页导入为Excel

那么,一个页面这么大,爬虫如何晓得我想要哪些呢?

人其实可以很容易地看出,上图的红框是二手房信息,但机器不知道。

网页是一种有结构的树,而重要信息所在的节点,往往枝繁叶茂。 举个不恰当的比方,一大伙子人构成树形世系,谁最厉害?当然是:

孩子多,最好一生20个

孩子各个都太争气(生的孙子多)

最好每位儿子还都太象(清一色的优采云八)

大家都会认为这一家子太厉害了!

我们对整个树结构进行打分,自然能够找到哪个最牛的节点,就是我们要的表格。找到最牛父亲以后,儿子们其实相像:个子高,长得帅,两条手指两条腿,但这种都是共性,没有信息量,我们关心的是特点。大女儿锥子脸,跟其他人都不一样,那脸部就是重要信息;三女儿最有钱——钱也是我们关心的。 因此,对比儿子们的不同属性,我们能够晓得什么信息是重要的了。

回到网页采集这个反例,通过一套有趣的算法,给一个网页的地址,软件都会手动地把它转成Excel! (听不懂吧?听不懂正常, 不要在乎那些细节!)

◆◆ ◆

破解翻页限制

获取了一页的数据,这还不够,我们要获取所有页面的数据!这简单,我们使程序依次地恳求第1页,第2页...数据就搜集回去了

就那么简单吗?网站怎么可能使自己宝贵的数据被如此轻松地捉住呢?所以它只能翻到第50页或第100页。链家就是这样:

这也难不倒我们,每页有30个数据,100页最多能呈现3000条数据。北京有16个区县两万个新村,但每位县的新村数目就没有3000个了,我们可分别获取每位县的新村列表。每个新村最多有300多套在售二手房,这样才能获取链家的所有二手房了。

然后我们启动抓取器,Hawk都会给每位子线程(可以理解为机器人)分配任务:给我抓取这个新村的所有二手房! 然后你才会看见壮丽的场面:一堆小机器人,同心协力地从网站上搬数据,超牛迅雷有没有?同时100个任务!!上个公厕回去就抓完了!!!

◆◆ ◆

清洗:识别并转换内容

获取的数据大约长这样:

但你会看见,里面会有些奇怪的字符应当去去除。xx平米应当都把数字提取下来。而售价,有的是2130000元,有的是373万元,这些都很难处理。

发现面积那一列的乱码,自动除去

识别价钱,并把所有的价钱都转换为亿元单位

发现港元,转换为人民币

发现日期,比如2014.12或2014年12.31,都能转换为2014年12月31日

哈哈,然后你能够够轻松地把这种数据拿去作剖析了,纯净无污染!

◆◆ ◆

破解须要登陆的网站

此处的意思其实不是去破解用户名密码,还没强到哪个程度。 有些网站的数据,都须要登陆能够访问。这也难不倒我们。

当你开启了Hawk外置了嗅探功能时,Hawk如同一个录音机一样,会记录你对目标网站的访问操作。之后它还会将其重放下来,从而实现手动登入。

你会不会害怕Hawk保存你的用户名密码?不保存如何手动登入呢?但是Hawk是开源的,所有代码都经过了审查,是安全的。你的私密信息,只会躺在你自己的硬碟里。

(我们就这样手动登入了大众点评)

◆◆ ◆

是不是我也可以抓数据了

理论上是的。但道高一尺魔高一丈,不同的网站千差万别,对抗爬虫的技术也有很多种。而且虫子虫对细节十分敏感,只要错一点,后面的步骤就可能进行不下去了。

怎么办呢?沙漠君把之前的操作保存并分享下来,你只要加载这种文件才能快速获取数据了。

如果你有其他网站的获取需求,可以去找你身边的程序员朋友,让她们来帮忙抓数据,或使她们来试试Hawk,看看谁的效率更高。

如果你是文科生姑娘,那还是建议你多看看东野奎吾和村上春树,直接上手如此复杂的软件会使你郁闷的。那该找谁帮忙抓数据呢?嘿嘿嘿...

◆◆ ◆

在哪里获取软件和教程?

Hawk: Advanced Crawler& ETL tool written in C#/WPF 软件介绍

HAWK是一种数据采集和清洗工具,依据GPL协议开源,能够灵活,有效地采集来自网页,数据库,文件, 并通过可视化地拖放,快速地进行生成,过滤,转换等操作。其功能最适宜的领域,是爬虫和数据清洗。

Hawk的含意为“鹰”,能够高效,准确地猎杀猎物。

HAWK使用C# 编写,其后端界面使用WPF开发,支持插件扩充。通过图形化操作,能够快速构建解决方案。

GitHub地址:

其Python等价的实现是etlpy:

笔者专门为其开发的工程文件已公开在GitHub:

使用时,点击文件,加载工程即可加载。

不想编译的话,可执行文件在:

密码:4iy0

编译路径在:

Hawk.Core\Hawk.Core.sln

国内一站式数据智能剖析平台ETHINK提供本文

ETHINK官网 查看全部

手把手教你怎样从互联网采集海量数据

互联网是一张大网,采集数据的小程序可以形象地称之为爬虫或则蜘蛛。

爬虫的原理很简单,我们在访问网页时,会点击翻页按键和超链接,浏览器会帮我们恳请所有的资源和图片。所以,你可以设计一个程序,能够模拟人在浏览器上的操作,让网站误觉得爬虫是正常访问者,它还会把所需的数据乖乖送回去。

爬虫分为两种,一种象百度(黑)那样哪些都抓的搜索引擎爬虫。另一种就是开发的,只精确地抓取所需的内容:比如我只要二手房信息,旁边的广告和新闻一律不要。

爬虫这样的名子并不好听,所以我给这套软件取名为Hawk,指代为"鹰",能够精确,快速地捕捉猎物。 基本不需编程,通过图形化拖放的操作来快速设计爬虫,有点像Photoshop。它能在20分钟内编撰大众点评的爬虫(简化版只需3分钟),然后使它运行就好啦、

下面是使用Hawk抓取二手房的视频,建议在wifi环境下观看:

自动将网页导入为Excel

那么,一个页面这么大,爬虫如何晓得我想要哪些呢?

人其实可以很容易地看出,上图的红框是二手房信息,但机器不知道。

网页是一种有结构的树,而重要信息所在的节点,往往枝繁叶茂。 举个不恰当的比方,一大伙子人构成树形世系,谁最厉害?当然是:

孩子多,最好一生20个

孩子各个都太争气(生的孙子多)

最好每位儿子还都太象(清一色的优采云八)

大家都会认为这一家子太厉害了!

我们对整个树结构进行打分,自然能够找到哪个最牛的节点,就是我们要的表格。找到最牛父亲以后,儿子们其实相像:个子高,长得帅,两条手指两条腿,但这种都是共性,没有信息量,我们关心的是特点。大女儿锥子脸,跟其他人都不一样,那脸部就是重要信息;三女儿最有钱——钱也是我们关心的。 因此,对比儿子们的不同属性,我们能够晓得什么信息是重要的了。

回到网页采集这个反例,通过一套有趣的算法,给一个网页的地址,软件都会手动地把它转成Excel! (听不懂吧?听不懂正常, 不要在乎那些细节!)

◆◆ ◆

破解翻页限制

获取了一页的数据,这还不够,我们要获取所有页面的数据!这简单,我们使程序依次地恳求第1页,第2页...数据就搜集回去了

就那么简单吗?网站怎么可能使自己宝贵的数据被如此轻松地捉住呢?所以它只能翻到第50页或第100页。链家就是这样:

这也难不倒我们,每页有30个数据,100页最多能呈现3000条数据。北京有16个区县两万个新村,但每位县的新村数目就没有3000个了,我们可分别获取每位县的新村列表。每个新村最多有300多套在售二手房,这样才能获取链家的所有二手房了。

然后我们启动抓取器,Hawk都会给每位子线程(可以理解为机器人)分配任务:给我抓取这个新村的所有二手房! 然后你才会看见壮丽的场面:一堆小机器人,同心协力地从网站上搬数据,超牛迅雷有没有?同时100个任务!!上个公厕回去就抓完了!!!

◆◆ ◆

清洗:识别并转换内容

获取的数据大约长这样:

但你会看见,里面会有些奇怪的字符应当去去除。xx平米应当都把数字提取下来。而售价,有的是2130000元,有的是373万元,这些都很难处理。

发现面积那一列的乱码,自动除去

识别价钱,并把所有的价钱都转换为亿元单位

发现港元,转换为人民币

发现日期,比如2014.12或2014年12.31,都能转换为2014年12月31日

哈哈,然后你能够够轻松地把这种数据拿去作剖析了,纯净无污染!

◆◆ ◆

破解须要登陆的网站

此处的意思其实不是去破解用户名密码,还没强到哪个程度。 有些网站的数据,都须要登陆能够访问。这也难不倒我们。

当你开启了Hawk外置了嗅探功能时,Hawk如同一个录音机一样,会记录你对目标网站的访问操作。之后它还会将其重放下来,从而实现手动登入。

你会不会害怕Hawk保存你的用户名密码?不保存如何手动登入呢?但是Hawk是开源的,所有代码都经过了审查,是安全的。你的私密信息,只会躺在你自己的硬碟里。

(我们就这样手动登入了大众点评)

◆◆ ◆

是不是我也可以抓数据了

理论上是的。但道高一尺魔高一丈,不同的网站千差万别,对抗爬虫的技术也有很多种。而且虫子虫对细节十分敏感,只要错一点,后面的步骤就可能进行不下去了。

怎么办呢?沙漠君把之前的操作保存并分享下来,你只要加载这种文件才能快速获取数据了。

如果你有其他网站的获取需求,可以去找你身边的程序员朋友,让她们来帮忙抓数据,或使她们来试试Hawk,看看谁的效率更高。

如果你是文科生姑娘,那还是建议你多看看东野奎吾和村上春树,直接上手如此复杂的软件会使你郁闷的。那该找谁帮忙抓数据呢?嘿嘿嘿...

◆◆ ◆

在哪里获取软件和教程?

Hawk: Advanced Crawler& ETL tool written in C#/WPF 软件介绍

HAWK是一种数据采集和清洗工具,依据GPL协议开源,能够灵活,有效地采集来自网页,数据库,文件, 并通过可视化地拖放,快速地进行生成,过滤,转换等操作。其功能最适宜的领域,是爬虫和数据清洗。

Hawk的含意为“鹰”,能够高效,准确地猎杀猎物。

HAWK使用C# 编写,其后端界面使用WPF开发,支持插件扩充。通过图形化操作,能够快速构建解决方案。

GitHub地址:

其Python等价的实现是etlpy:

笔者专门为其开发的工程文件已公开在GitHub:

使用时,点击文件,加载工程即可加载。

不想编译的话,可执行文件在:

密码:4iy0

编译路径在:

Hawk.Core\Hawk.Core.sln

国内一站式数据智能剖析平台ETHINK提供本文

ETHINK官网

数据采集的工作就是复制粘贴吗?完全没有技术浓度吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 390 次浏览 • 2020-08-26 01:01

这个要看情况了,如果数据量小,且比较集中,可以直接复制黏贴,没有任何问题,但假如数据量多,且比较分散,那就显著不合适了,耗时耗力,且不利于数据规整,这里介绍3个特别不错的数据采集软件,分别是优采云采集器、优采云采集器和优采云采集器,对于大部分网页数据来说,都可以轻松采集,感兴趣的同学可以尝试一下:

简单易用优采云采集器

这是一个完全免费、跨平台的数据采集软件,基于强悍人工智能技术,只须要输入网页地址,即可手动辨识网页中的数据和内容(包括表格、列表、链接等),支持手动翻页和数据导入(txt、excel、mysql等),操作简单、易学易用,零基础小白也可以轻松把握,如果你缺乏一个免费、跨平台、简单易用的数据采集软件,可以使用一下优采云采集器,总体疗效来说特别不错:

专业强悍优采云采集器

这是一款比较强悍、也比较专业的数据采集软件,集成了数据从采集、处理到剖析的全过程,不需编撰一行代码即可采集任意网页数据,规则设置上更灵活也更强悍,只需输入网页地址,设置采集规则,自定义采集字段,软件便会手动开始采集过程,支持数据导入和翻页功能,如果你缺乏一个专业强悍的数据采集工具,可以使用一下优采云采集器,效率来说特别不错,官方也自带有特别详尽的入门教程,非常适宜初学者:

国产软件优采云采集器

这是一个纯粹国产的数据采集软件,目前仅支持windows平台(比较局限),功能来说也十分强悍,支持简易采集和自定义采集2种模式,只需输入网页地址,选择采集字段,软件便会手动开始数据采集过程,支持翻页和数据导入功能,而且官方自带有特别多的数据采集模板,只需简单改建适配,即可轻松采集某宝评论内容,且不需要编撰一行代码,如果你缺乏一个国产强悍的数据采集软件,可以使用一下优采云采集器,效果来说也十分不错: 查看全部

数据采集的工作就是复制粘贴吗?完全没有技术浓度吗?

这个要看情况了,如果数据量小,且比较集中,可以直接复制黏贴,没有任何问题,但假如数据量多,且比较分散,那就显著不合适了,耗时耗力,且不利于数据规整,这里介绍3个特别不错的数据采集软件,分别是优采云采集器、优采云采集器和优采云采集器,对于大部分网页数据来说,都可以轻松采集,感兴趣的同学可以尝试一下:

简单易用优采云采集器

这是一个完全免费、跨平台的数据采集软件,基于强悍人工智能技术,只须要输入网页地址,即可手动辨识网页中的数据和内容(包括表格、列表、链接等),支持手动翻页和数据导入(txt、excel、mysql等),操作简单、易学易用,零基础小白也可以轻松把握,如果你缺乏一个免费、跨平台、简单易用的数据采集软件,可以使用一下优采云采集器,总体疗效来说特别不错:

专业强悍优采云采集器

这是一款比较强悍、也比较专业的数据采集软件,集成了数据从采集、处理到剖析的全过程,不需编撰一行代码即可采集任意网页数据,规则设置上更灵活也更强悍,只需输入网页地址,设置采集规则,自定义采集字段,软件便会手动开始采集过程,支持数据导入和翻页功能,如果你缺乏一个专业强悍的数据采集工具,可以使用一下优采云采集器,效率来说特别不错,官方也自带有特别详尽的入门教程,非常适宜初学者:

国产软件优采云采集器

这是一个纯粹国产的数据采集软件,目前仅支持windows平台(比较局限),功能来说也十分强悍,支持简易采集和自定义采集2种模式,只需输入网页地址,选择采集字段,软件便会手动开始数据采集过程,支持翻页和数据导入功能,而且官方自带有特别多的数据采集模板,只需简单改建适配,即可轻松采集某宝评论内容,且不需要编撰一行代码,如果你缺乏一个国产强悍的数据采集软件,可以使用一下优采云采集器,效果来说也十分不错:

侠客站群采集系统采集模块全流程编撰

采集交流 • 优采云 发表了文章 • 0 个评论 • 366 次浏览 • 2020-08-25 19:45

首先先介绍下侠客站群系统的流程。第一,我要写个采集游戏功略的模块发布到我的网站,我的网站是织梦做的。第二其实是打算工作了,这次主要是说采集模块,发布模块有机会的吧,要不内容太多发布模块官方有很多,各种cms的发布模块侠客都为我们打算的太充分,功能也太健全。第三 最好学习下侠客为我们打算的学习视频。官方学习网址:,规则测试工具下载地址可以侠客官方峰会下载。

我用的发布模块id=1173. 大家可以上在线获取。好吧,下面我就要开始了。

我们可以制做新模块,抓取和发布。单击即可。这个是构建模块的界面。当然要先更改模块信息,不要手懒哦,有利于自己的管理的。选择自己须要的抓取模式,四种采集,自由选择。模块参数,自定义和关键词抓取有三个流程,蜘蛛和同步追踪模式有两个流程。

先说明一下其它的地方:1 侠客可以保存自己的模块到本地,同时支持导出导入,推荐在本地保存。2 自定义抓取模式,顾名思义,当然是自己可以自由采集你须要的内容,推荐 学习下正则。 关键词抓取,根据定义好的关键词库进行抓取,可以获取相关的内容主题。 蜘蛛爬行,模仿蜘蛛,给出入口地址,则可以在全站无妨碍抓取。 同步追踪,及时跟踪目标站,根据目标站来进行及时抓取。 语料库手动重组,自动原创高质量文章。 这个部份,是用于第三方网站发布内容。

流程1 部分。选择自己的抓取编码,填写自己的抓取网站,即目标站。注意各个地方的编码格式要统一哦。

第一步:填写测试网址,用于测试规则。第二步:有两种方法提取,第一种,为可视化的,不会正则的同学可以尝试,我们使用第二种。第三步:选择安装规则提取。第四步:为添加规则的面板。这上面按照第一步的选择不同,添加的规则会不同。

说明:提取分页的正则形式。找到分页的地方,使用regextest (上面有下载地址)进行测试。说明:\d 匹配数字。第二流程:内容链接的提取。

说明:我们找到内容代码部份。写出采集规则。我提供了两种,第二种使我贴到了规则描述 的地方。大家可以参考下。我这儿选择的是正则形式提取,对应的是正则规则。第三流程:具体内容获得部份:

说明:填写基本信息。提取模式两种,规则和智能,我们为了说明问题,使用规则提取方法,让你们了解下正则。也可以提取分页,这里分页流程一的列表分页设置类似,这里不在赘语。

说明:提取标题,使用正则,同样,我们发觉还有b标签,一会在提取后处理过滤掉即可。本来准备使用可视化引擎方法提取标题了,下次吧。

说明:正文内容的提取,找到正文的开始和结尾,写出正则,即可。方法一样。具体正则学习,在腹部早已贴出侠客视频教程。

提取后处理,让我们过滤下正文内容。几个重要的标签过滤。说明:标签过滤。包括链接,脚本等影响网页布局和采集网站信息的内容,使用正则我们过滤掉。

流程四:现在我们保存我们的抓取规则,建立站点,添加任务。进行测试吧。

说明:一个站点可以设置多个任务,一个任务可以对应个采集模块,任务对应一个发布模块。

说明:采集开始了! 先获取列表,在获取内容。

说明:这个事文章库的信息,我们看下文章质量,如果有质量不好,我们可以选择替换库过滤或则重新修正采集规则,进行重新采集。站点设置:采集的质量,还行,我们这儿不需要重新在来。下面是发布的具体设置:

说明:三个部份:第一部分为基本库。第二部份为模块设置。第三部份为测试发布。先登入在分类,在发布,如果发布成功,几乎差不多可以了。如果不成功,我们可以更改下发布模块或则重新获取下其它发布模块。

说明:测试登陆

说明:测试获取分类

说明:测试发布文章,如果正常,即为侠客测试文章一篇。

说明:测试发布文章成功。

说明:侠客发布过程!

说明:发布成功网页。已经成功发布。

这个教程早已一步步带着你们进行了侠客的全流程采集过程。侠客还有其他强悍的功能。我这个只是冰山一角,希望你们多多指导,提供宝贵意见,谢谢你们!

好推达人 抖音、小红书推广利器

购买短视频粉丝/网店/网站 到a5交易

10W+新媒体资源 低投入高转化 查看全部

侠客站群采集系统采集模块全流程编撰

首先先介绍下侠客站群系统的流程。第一,我要写个采集游戏功略的模块发布到我的网站,我的网站是织梦做的。第二其实是打算工作了,这次主要是说采集模块,发布模块有机会的吧,要不内容太多发布模块官方有很多,各种cms的发布模块侠客都为我们打算的太充分,功能也太健全。第三 最好学习下侠客为我们打算的学习视频。官方学习网址:,规则测试工具下载地址可以侠客官方峰会下载。

我用的发布模块id=1173. 大家可以上在线获取。好吧,下面我就要开始了。

我们可以制做新模块,抓取和发布。单击即可。这个是构建模块的界面。当然要先更改模块信息,不要手懒哦,有利于自己的管理的。选择自己须要的抓取模式,四种采集,自由选择。模块参数,自定义和关键词抓取有三个流程,蜘蛛和同步追踪模式有两个流程。

先说明一下其它的地方:1 侠客可以保存自己的模块到本地,同时支持导出导入,推荐在本地保存。2 自定义抓取模式,顾名思义,当然是自己可以自由采集你须要的内容,推荐 学习下正则。 关键词抓取,根据定义好的关键词库进行抓取,可以获取相关的内容主题。 蜘蛛爬行,模仿蜘蛛,给出入口地址,则可以在全站无妨碍抓取。 同步追踪,及时跟踪目标站,根据目标站来进行及时抓取。 语料库手动重组,自动原创高质量文章。 这个部份,是用于第三方网站发布内容。

流程1 部分。选择自己的抓取编码,填写自己的抓取网站,即目标站。注意各个地方的编码格式要统一哦。

第一步:填写测试网址,用于测试规则。第二步:有两种方法提取,第一种,为可视化的,不会正则的同学可以尝试,我们使用第二种。第三步:选择安装规则提取。第四步:为添加规则的面板。这上面按照第一步的选择不同,添加的规则会不同。

说明:提取分页的正则形式。找到分页的地方,使用regextest (上面有下载地址)进行测试。说明:\d 匹配数字。第二流程:内容链接的提取。

说明:我们找到内容代码部份。写出采集规则。我提供了两种,第二种使我贴到了规则描述 的地方。大家可以参考下。我这儿选择的是正则形式提取,对应的是正则规则。第三流程:具体内容获得部份:

说明:填写基本信息。提取模式两种,规则和智能,我们为了说明问题,使用规则提取方法,让你们了解下正则。也可以提取分页,这里分页流程一的列表分页设置类似,这里不在赘语。

说明:提取标题,使用正则,同样,我们发觉还有b标签,一会在提取后处理过滤掉即可。本来准备使用可视化引擎方法提取标题了,下次吧。

说明:正文内容的提取,找到正文的开始和结尾,写出正则,即可。方法一样。具体正则学习,在腹部早已贴出侠客视频教程。

提取后处理,让我们过滤下正文内容。几个重要的标签过滤。说明:标签过滤。包括链接,脚本等影响网页布局和采集网站信息的内容,使用正则我们过滤掉。

流程四:现在我们保存我们的抓取规则,建立站点,添加任务。进行测试吧。

说明:一个站点可以设置多个任务,一个任务可以对应个采集模块,任务对应一个发布模块。

说明:采集开始了! 先获取列表,在获取内容。

说明:这个事文章库的信息,我们看下文章质量,如果有质量不好,我们可以选择替换库过滤或则重新修正采集规则,进行重新采集。站点设置:采集的质量,还行,我们这儿不需要重新在来。下面是发布的具体设置:

说明:三个部份:第一部分为基本库。第二部份为模块设置。第三部份为测试发布。先登入在分类,在发布,如果发布成功,几乎差不多可以了。如果不成功,我们可以更改下发布模块或则重新获取下其它发布模块。

说明:测试登陆

说明:测试获取分类

说明:测试发布文章,如果正常,即为侠客测试文章一篇。

说明:测试发布文章成功。

说明:侠客发布过程!

说明:发布成功网页。已经成功发布。

这个教程早已一步步带着你们进行了侠客的全流程采集过程。侠客还有其他强悍的功能。我这个只是冰山一角,希望你们多多指导,提供宝贵意见,谢谢你们!

好推达人 抖音、小红书推广利器

购买短视频粉丝/网店/网站 到a5交易

10W+新媒体资源 低投入高转化

一种web数据手动采集系统的制做方式

采集交流 • 优采云 发表了文章 • 0 个评论 • 366 次浏览 • 2020-08-25 18:24

一种web数据手动采集系统的制做方式

【专利摘要】本发明公开一种WEB数据手动采集系统,包括WEB 客户端、WEB 服务器和应用服务器,所述WEB 客户端包括索引图,所述索引图保存图形和数据与链接之间的对应关系,所述WEB 客户端将顾客点击的图形或数据对应的链接发送至WEB 服务器,所述WEB 服务器从应用服务器采集链接对应的图形或数据,并将采集到的图形或数据转换成SVG 文件后返回至WEB 客户端。本发明可以将半结构化和非结构化的数据变为结构化的元数据,实现班机数据的动态跟踪与检测。

【专利说明】一种WEB数据手动采集系统

【技术领域】

[0001]本发明涉及一种数据采集系统,更准确地说是一种WEB数据手动采集系统。

【背景技术】

[0002]Web服务系统主要实现信息发布功能,是配网自动化系统的基本功能之一,客户使用浏览器通过Web服务系统对配电网运行状况进行了解和剖析。目前在线运行的配网自动化系统基本上都是运行于EMS (Energy Manage System,能量管理系统)系统的I控制县,然后通过隔离装置将数据同步到非控制III县,通过非控制III县对外提供Web月艮务。配网自动化系统对外提供的Web服务,大多是基于ActiveX控件技术或则Java控件技术,不管是基于哪种控件技术,都须要用户下装相应的控件,控件将配网自动化系统某一时刻的图形与数据全部下载到客户端,这样用户的查看恳求可以快速得到响应,但用户听到的并不是当前配网自动化系统的运行状况。另外,为了系统安全,需要配网自动化系统在保护模式运行该控件,如果运行的权限没有设置正确,会导致这种控件的功能失效,从而造成客户端的用户体验不佳。

【发明内容】

[0003]本发明的目的是提供一种WEB数据手动采集系统,其可以解决现有技术产的上述缺点。

[0004]本发明采用以下技术方案:

[0005]一种WEB数据手动采集系统,包括WEB客户端、WEB服务器和应用服务器,所述WEB客户端包括索引图,所述索引图保存图形和数据与链接之间的对应关系,所述WEB客户端将顾客点击的图形或数据对应的链接发送至WEB服务器,所述WEB服务器从应用服务器采集链接对应的图形或数据,并将采集到的图形或数据转换成SVG文件后返回至WEB客户端;还包括一 Web无线数据采集控制系统,Web无线数据采集控制系统由数据采集发送模块和数据接收模块组成,数据采集发送模块包括信号调理模块、A/D转换模块、微控制器和无线模块,采集到的讯号经过信号调理模块传送到A/D转换模块,A/D转换模块联接微控制器;数据接收模块包括无线模块和微控制器,无线模块输入端联接数据采集发送模块中的微控制器,无线模块输出端联接数据接收模块中的微控制器,微处理器与PC联接。

[0006]所述WEB服务器包括: