网页视频抓取脚本

网页视频抓取脚本(,链接等内容并存储csv文件中更新时间:2022年)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-01-12 10:20

Python爬取bilibili网页排名、视频、浏览量、点赞、链接等,并存储在csv文件中

更新时间:2022-01-04 10:24:57 作者:小木_。

本篇文章主要介绍python爬取bilibili网页排名、视频、浏览量、点赞、链接等内容,并存储在csv文件中。首先,你必须了解html标签。标签是主要的和次要的。现在,主标签是根标签,也是所有要爬取的标签的组合。需要的朋友可以参考

首先,我们需要了解html标签。有主要标签和次要标签。一般理解,主标签是根标签和所有要爬取的标签的组合。

先明白后面会用到code属性:

#获取属性

a.attrs 获取a所有的属性和属性值,返回一个字典

a.attrs['href'] 获取href属性

a['href'] 也可简写为这种形式

#获取内容

a.string 获取a标签的直系文本

注意:如果标签还有标签,那么string获取到的结果为None,而其它两个,可以获取文本内容

a.text 这是属性,获取a子类的所有文本

a.get_text() 这是方法,获取a标签子类的所有文本

#find 主要用于找到第一个符合要求的标签

a.find('a') 找到第一个符合要求的

a.find('a', title="xxx") 具有title=a属性的

a.find('a', alt="xxx")

a.find('a', class_="xxx")

a.find('a', id="xxx")

#find_all 用于找到所有符合要求的标签

a.find_all('a')

a.find_all(['a','b']) 找到所有的a和b标签

a.find_all('a', limit=2) 限制前两个

#根据选择器选择指定的内容

a.select('#feng')

我们今天要爬的是bilibili网站,主要是作为一个练习,并没有什么大的作用。爬取的内容是:

排名、视频名称、视频集数、观看次数、点赞数和视频链接,爬取后保存在csv文件中

直接上代码:

# -*- coding: utf-8 -*-

import requests

from bs4 import BeautifulSoup

r = requests.get('https://www.bilibili.com/v/popular/rank/guochan') #要爬取的网站链接

html = r.content

soup = BeautifulSoup(html,'html.parser') #html.parser是解析器

div_people_list = soup.find('div', attrs={'class': 'rank-list-wrap'})

div_people_list_list = div_people_list.find('ul', attrs={'class': 'rank-list pgc-list'})

a_s = div_people_list.find_all('li', attrs={'class': 'rank-item'})

for a in a_s: #排名

for b in a.find_all('div', attrs={'class': 'info'}):

for c in b.find_all('a', attrs={'target': '_blank'}): #名称及链接

for d in b.find('span', attrs={'class': 'data-box'}): #获取视频集

for e in b.find_all('span', attrs={'class': 'data-box'})[1:][:1]: #循环播放数

for f in b.find_all('span', attrs={'class': 'data-box'})[2:][:2]: # 循环点赞量

web = a['data-rank'] # 排名

name = c.string # 名称

name_2 = d.string # 全集

name_2_1 = name_2.replace(" ", "").replace("\t", "").strip() # 去除多余空格

name_3 = e.get_text() # 播放量

data_1 = name_3.replace(" ", "").replace("\n", "").replace("\t", "")

name_4 = f.get_text() # 点赞量

data_2 = name_4.replace(" ", "").replace("\n", "").replace("\t", "")

url = c['href'] # 链接

print(web + '\t' + name + '\t\t\t' + name_2_1 + '\t\t\t\t' + data_1 + '\t\t\t\t'+ data_2+'\t\t\t\t' + f'http:{url}')

效果如下:

其实我在做爬虫的时候遇到了很多错误,就是html中的标签重复了,需要用[1:][:1]来选择标签。有时并不难,但项目做的少。

现在让我们添加这段代码来保存爬取的内容:

import csv

f = open('爬取文件.csv','w',encoding='gbk',newline='') #写入文件

#基于文件对象构建 csv写入对象

csv_writer = csv.writer(f)

csv_writer.writerow(['排行','影片', '篇集','播放量','点赞量','视频链接'])

csv_writer.writerow([web, name, n,d,g,f'http:{url}'])

可以看到内容是保存在csv文件中的,不是很乱,比刚才dos窗口里的好多了

完整代码如下:

# -*- coding: utf-8 -*-

import requests

from bs4 import BeautifulSoup

import csv

f = open('爬取文件.csv','w',encoding='gbk',newline='') #写入文件

#基于文件对象构建 csv写入对象

csv_writer = csv.writer(f)

csv_writer.writerow(['排行','影片', '篇集','播放量','点赞量','视频链接'])

r = requests.get('https://www.bilibili.com/v/popular/rank/guochan') #要爬取的网站链接

html = r.content

soup = BeautifulSoup(html,'html.parser') #html.parser是解析器

div_people_list = soup.find('div', attrs={'class': 'rank-list-wrap'})

div_people_list_list = div_people_list.find('ul', attrs={'class': 'rank-list pgc-list'})

a_s = div_people_list.find_all('li', attrs={'class': 'rank-item'})

#a_s_2 = a_s.find_all('div', attrs={'class': 'info'})

for a in a_s: #排名

for b in a.find_all('div', attrs={'class': 'info'}):

for c in b.find_all('a', attrs={'target': '_blank'}): #名称及链接

for d in b.find('span', attrs={'class': 'data-box'}): #获取视频集

for e in b.find_all('span', attrs={'class': 'data-box'})[1:][:1]: #循环播放数

for f in b.find_all('span', attrs={'class': 'data-box'})[2:][:2]: # 循环点赞量

web = a['data-rank'] # 排名

name = c.string # 名称

name_2 = d.string # 全集

name_2_1 = name_2.replace(" ", "").replace("\t", "").strip() # 去除多余空格

name_3 = e.get_text() # 播放量

data_1 = name_3.replace(" ", "").replace("\n", "").replace("\t", "")

name_4 = f.get_text() # 点赞量

data_2 = name_4.replace(" ", "").replace("\n", "").replace("\t", "")

url = c['href'] # 链接

n = name_2.replace(" ", "").replace("\t", "").strip() # 去除多余空格

d = name_3.replace(" ", "").replace("\t", "")

g = name_4.replace(" ", "").replace("\t", "")

#构建列表头

csv_writer.writerow([web, name, n,d,g,f'http:{url}'])

至此,这篇关于python爬取bilibili网页排名、视频、浏览量、点赞、链接等内容并将文章存入csv文件的文章就介绍到这里了,更多相关python爬取bilibili内容并将内容存储在csv文件,请搜索脚本首页之前的文章或继续浏览下方的相关文章。希望大家以后多多支持脚本之家! 查看全部

网页视频抓取脚本(,链接等内容并存储csv文件中更新时间:2022年)

Python爬取bilibili网页排名、视频、浏览量、点赞、链接等,并存储在csv文件中

更新时间:2022-01-04 10:24:57 作者:小木_。

本篇文章主要介绍python爬取bilibili网页排名、视频、浏览量、点赞、链接等内容,并存储在csv文件中。首先,你必须了解html标签。标签是主要的和次要的。现在,主标签是根标签,也是所有要爬取的标签的组合。需要的朋友可以参考

首先,我们需要了解html标签。有主要标签和次要标签。一般理解,主标签是根标签和所有要爬取的标签的组合。

先明白后面会用到code属性:

#获取属性

a.attrs 获取a所有的属性和属性值,返回一个字典

a.attrs['href'] 获取href属性

a['href'] 也可简写为这种形式

#获取内容

a.string 获取a标签的直系文本

注意:如果标签还有标签,那么string获取到的结果为None,而其它两个,可以获取文本内容

a.text 这是属性,获取a子类的所有文本

a.get_text() 这是方法,获取a标签子类的所有文本

#find 主要用于找到第一个符合要求的标签

a.find('a') 找到第一个符合要求的

a.find('a', title="xxx") 具有title=a属性的

a.find('a', alt="xxx")

a.find('a', class_="xxx")

a.find('a', id="xxx")

#find_all 用于找到所有符合要求的标签

a.find_all('a')

a.find_all(['a','b']) 找到所有的a和b标签

a.find_all('a', limit=2) 限制前两个

#根据选择器选择指定的内容

a.select('#feng')

我们今天要爬的是bilibili网站,主要是作为一个练习,并没有什么大的作用。爬取的内容是:

排名、视频名称、视频集数、观看次数、点赞数和视频链接,爬取后保存在csv文件中

直接上代码:

# -*- coding: utf-8 -*-

import requests

from bs4 import BeautifulSoup

r = requests.get('https://www.bilibili.com/v/popular/rank/guochan') #要爬取的网站链接

html = r.content

soup = BeautifulSoup(html,'html.parser') #html.parser是解析器

div_people_list = soup.find('div', attrs={'class': 'rank-list-wrap'})

div_people_list_list = div_people_list.find('ul', attrs={'class': 'rank-list pgc-list'})

a_s = div_people_list.find_all('li', attrs={'class': 'rank-item'})

for a in a_s: #排名

for b in a.find_all('div', attrs={'class': 'info'}):

for c in b.find_all('a', attrs={'target': '_blank'}): #名称及链接

for d in b.find('span', attrs={'class': 'data-box'}): #获取视频集

for e in b.find_all('span', attrs={'class': 'data-box'})[1:][:1]: #循环播放数

for f in b.find_all('span', attrs={'class': 'data-box'})[2:][:2]: # 循环点赞量

web = a['data-rank'] # 排名

name = c.string # 名称

name_2 = d.string # 全集

name_2_1 = name_2.replace(" ", "").replace("\t", "").strip() # 去除多余空格

name_3 = e.get_text() # 播放量

data_1 = name_3.replace(" ", "").replace("\n", "").replace("\t", "")

name_4 = f.get_text() # 点赞量

data_2 = name_4.replace(" ", "").replace("\n", "").replace("\t", "")

url = c['href'] # 链接

print(web + '\t' + name + '\t\t\t' + name_2_1 + '\t\t\t\t' + data_1 + '\t\t\t\t'+ data_2+'\t\t\t\t' + f'http:{url}')

效果如下:

其实我在做爬虫的时候遇到了很多错误,就是html中的标签重复了,需要用[1:][:1]来选择标签。有时并不难,但项目做的少。

现在让我们添加这段代码来保存爬取的内容:

import csv

f = open('爬取文件.csv','w',encoding='gbk',newline='') #写入文件

#基于文件对象构建 csv写入对象

csv_writer = csv.writer(f)

csv_writer.writerow(['排行','影片', '篇集','播放量','点赞量','视频链接'])

csv_writer.writerow([web, name, n,d,g,f'http:{url}'])

可以看到内容是保存在csv文件中的,不是很乱,比刚才dos窗口里的好多了

完整代码如下:

# -*- coding: utf-8 -*-

import requests

from bs4 import BeautifulSoup

import csv

f = open('爬取文件.csv','w',encoding='gbk',newline='') #写入文件

#基于文件对象构建 csv写入对象

csv_writer = csv.writer(f)

csv_writer.writerow(['排行','影片', '篇集','播放量','点赞量','视频链接'])

r = requests.get('https://www.bilibili.com/v/popular/rank/guochan') #要爬取的网站链接

html = r.content

soup = BeautifulSoup(html,'html.parser') #html.parser是解析器

div_people_list = soup.find('div', attrs={'class': 'rank-list-wrap'})

div_people_list_list = div_people_list.find('ul', attrs={'class': 'rank-list pgc-list'})

a_s = div_people_list.find_all('li', attrs={'class': 'rank-item'})

#a_s_2 = a_s.find_all('div', attrs={'class': 'info'})

for a in a_s: #排名

for b in a.find_all('div', attrs={'class': 'info'}):

for c in b.find_all('a', attrs={'target': '_blank'}): #名称及链接

for d in b.find('span', attrs={'class': 'data-box'}): #获取视频集

for e in b.find_all('span', attrs={'class': 'data-box'})[1:][:1]: #循环播放数

for f in b.find_all('span', attrs={'class': 'data-box'})[2:][:2]: # 循环点赞量

web = a['data-rank'] # 排名

name = c.string # 名称

name_2 = d.string # 全集

name_2_1 = name_2.replace(" ", "").replace("\t", "").strip() # 去除多余空格

name_3 = e.get_text() # 播放量

data_1 = name_3.replace(" ", "").replace("\n", "").replace("\t", "")

name_4 = f.get_text() # 点赞量

data_2 = name_4.replace(" ", "").replace("\n", "").replace("\t", "")

url = c['href'] # 链接

n = name_2.replace(" ", "").replace("\t", "").strip() # 去除多余空格

d = name_3.replace(" ", "").replace("\t", "")

g = name_4.replace(" ", "").replace("\t", "")

#构建列表头

csv_writer.writerow([web, name, n,d,g,f'http:{url}'])

至此,这篇关于python爬取bilibili网页排名、视频、浏览量、点赞、链接等内容并将文章存入csv文件的文章就介绍到这里了,更多相关python爬取bilibili内容并将内容存储在csv文件,请搜索脚本首页之前的文章或继续浏览下方的相关文章。希望大家以后多多支持脚本之家!

网页视频抓取脚本(如何用Python爬取本地网页网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2022-01-10 19:13

如何使用Python爬取本地网页一、写一个简单的静态网页,下面是我随便写的

网页源代码如下

大阿瓦达

>

Home

Site

Other

Aritcle

The bath

Say sonmething

The bath

Say sonmething

©mydadadaw

由于是静态网页,所以我使用的是绝对路径,所以直接存放在桌面目录:C:\Users\wei\Desktop\webpage job\another pages job\11.html

二、解析网页第一步:使用BeautifulSoup解析网页(这个库是python自带的)

Soup = BeautigulSoup(html,'lxml') (PS:lxml是解析网页所需的库,这个库在python中是没有的,所以我们需要输入cmd独立安装“pip install lxml”,这里我就跟在介绍其他四个解析web库,分别是:“html parser”、“lxml HTML”、“lxml xml”、“html 51ib”)

第 2 步:扫描的对象在哪里

资源 = Soup.select('???')

第三步:从标签中获取你想要的信息

Something(页面段落标签)tittle = Something rate = 4.0BeautifulSoup => CSS Select:网页的基本结构

Xpath 和 CSS 解析网页的比较

Xpath:谁,哪里,哪些(稍后会详细介绍) CSS Select:谁在哪里,哪个数字,以及它的样子(我们的下一个爬虫将主要使用 copyselector 来查找我们需要的内容)

三、编写Python代码爬取我们编写的网页

这四行代码就可以实现我们网页的爬取

from bs4 import BeautifulSoup

with open('/Users/伟/Desktop/网页作业/另一个网页作业/11.html','r') as wb_data:

Soup = BeautifulSoup(wb_data,'lxml')

print(Soup)

'''

这里 第行的语句的意思是打开我们这个目录下的这个网页文件,r代表只读

'''

这个抓取了我们整个网页的数据,但是结果不是我们想要的

我们要分析爬取的网页

或者点击我们写的网页,抓取我们需要的图片

找到图片img行,然后右键,复制,查找,复制选择器

body > div.main-content > ul > li:nth-child(1) > img, 这是我们需要抓取的图片的代码

images = Soup.select('body > div.main-content > ul > li:nth-child(1) > img')

放入pycharm(Python编辑器)中抓取

我们将打印我们稍后抓取的图像信息

print(images)

但是我们放到python里面,会报错因为我们没有按照他的格式

因此,我们将编码

如果删除红色部分,就可以得到该类型图片的信息。这与我们添加的两张图片完全相同。然后我们获取我们需要的其他信息并附加所有代码。

from bs4 import BeautifulSoup

with open('/Users/伟/Desktop/网页作业/另一个网页作业/11.html','r') as wb_data:

Soup = BeautifulSoup(wb_data,'lxml')

images = Soup.select('body > div.main-content > ul > li > img')

p = Soup.select('body > div.main-content > ul > li > p')

tittle = Soup.select('body > div.main-content > ul > li > h3')

print(images,p,tittle,sep='\n-----\n')

这是我们抓取的信息

[, ]

-----

[Say sonmething, Say sonmething]

-----

[The bath, The bath]

虽然,我们这里抓取的东西还是会有网页的代码,所以我们需要对内容进行过滤

在代码中加入判断结构,得到我们需要的

如果有什么要补充的,我稍后再补充 查看全部

网页视频抓取脚本(如何用Python爬取本地网页网页)

如何使用Python爬取本地网页一、写一个简单的静态网页,下面是我随便写的

网页源代码如下

大阿瓦达

>

Home

Site

Other

Aritcle

The bath

Say sonmething

The bath

Say sonmething

©mydadadaw

由于是静态网页,所以我使用的是绝对路径,所以直接存放在桌面目录:C:\Users\wei\Desktop\webpage job\another pages job\11.html

二、解析网页第一步:使用BeautifulSoup解析网页(这个库是python自带的)

Soup = BeautigulSoup(html,'lxml') (PS:lxml是解析网页所需的库,这个库在python中是没有的,所以我们需要输入cmd独立安装“pip install lxml”,这里我就跟在介绍其他四个解析web库,分别是:“html parser”、“lxml HTML”、“lxml xml”、“html 51ib”)

第 2 步:扫描的对象在哪里

资源 = Soup.select('???')

第三步:从标签中获取你想要的信息

Something(页面段落标签)tittle = Something rate = 4.0BeautifulSoup => CSS Select:网页的基本结构

Xpath 和 CSS 解析网页的比较

Xpath:谁,哪里,哪些(稍后会详细介绍) CSS Select:谁在哪里,哪个数字,以及它的样子(我们的下一个爬虫将主要使用 copyselector 来查找我们需要的内容)

三、编写Python代码爬取我们编写的网页

这四行代码就可以实现我们网页的爬取

from bs4 import BeautifulSoup

with open('/Users/伟/Desktop/网页作业/另一个网页作业/11.html','r') as wb_data:

Soup = BeautifulSoup(wb_data,'lxml')

print(Soup)

'''

这里 第行的语句的意思是打开我们这个目录下的这个网页文件,r代表只读

'''

这个抓取了我们整个网页的数据,但是结果不是我们想要的

我们要分析爬取的网页

或者点击我们写的网页,抓取我们需要的图片

找到图片img行,然后右键,复制,查找,复制选择器

body > div.main-content > ul > li:nth-child(1) > img, 这是我们需要抓取的图片的代码

images = Soup.select('body > div.main-content > ul > li:nth-child(1) > img')

放入pycharm(Python编辑器)中抓取

我们将打印我们稍后抓取的图像信息

print(images)

但是我们放到python里面,会报错因为我们没有按照他的格式

因此,我们将编码

如果删除红色部分,就可以得到该类型图片的信息。这与我们添加的两张图片完全相同。然后我们获取我们需要的其他信息并附加所有代码。

from bs4 import BeautifulSoup

with open('/Users/伟/Desktop/网页作业/另一个网页作业/11.html','r') as wb_data:

Soup = BeautifulSoup(wb_data,'lxml')

images = Soup.select('body > div.main-content > ul > li > img')

p = Soup.select('body > div.main-content > ul > li > p')

tittle = Soup.select('body > div.main-content > ul > li > h3')

print(images,p,tittle,sep='\n-----\n')

这是我们抓取的信息

[, ]

-----

[Say sonmething, Say sonmething]

-----

[The bath, The bath]

虽然,我们这里抓取的东西还是会有网页的代码,所以我们需要对内容进行过滤

在代码中加入判断结构,得到我们需要的

如果有什么要补充的,我稍后再补充

网页视频抓取脚本(智能识别模式WebHarvy自动识别网页数据抓取工具介绍(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-01-09 01:06

WebHarvy 是一个网页数据捕获工具。该软件可以提取网页中的文字和图片,输入网址并打开。默认使用内部浏览器,支持扩展分析,可自动获取相似链接列表。软件界面直观,操作简单。

特征

智能识别模式

WebHarvy 自动识别出现在网页中的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

可以保存从各种格式的网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

网页通常会在多个页面中显示数据,例如产品目录。 WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“指向下一页的链接”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

直观的操作界面

WebHarvy 是一个可视化网页提取工具。事实上,完全不需要编写任何脚本或代码来提取数据。使用 webharvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。它是如此容易!

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,将为所有给定的输入关键字自动重复您创建的配置。可以指定任意数量的输入关键字

提取分类

WebHarvy网站 抓取器允许您从指向网站 中相似页面的链接列表中提取数据。这允许您使用单个配置来抓取 网站 中的类别或子部分。

使用正则表达式提取

WebHarvy 可以将正则表达式(regular expressions)应用于网页的文本或 HTML 源代码,并提取不匹配的部分。这种强大的技术在抓取数据时为您提供了更大的灵活性。

软件功能

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器浏览网络。您可以选择要单击的数据。这简单!

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动删除它。

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面爬取和提取数据。只需指出“链接到下一页”,WebHarvy Web Scraper 就会自动从所有页面中抓取数据。

变更日志

修复了可能导致页面启动时禁用连接的错误

您可以为页面模式配置专用的连接方法

可以自动搜索 HTML 上的可配置资源 查看全部

网页视频抓取脚本(智能识别模式WebHarvy自动识别网页数据抓取工具介绍(一))

WebHarvy 是一个网页数据捕获工具。该软件可以提取网页中的文字和图片,输入网址并打开。默认使用内部浏览器,支持扩展分析,可自动获取相似链接列表。软件界面直观,操作简单。

特征

智能识别模式

WebHarvy 自动识别出现在网页中的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

可以保存从各种格式的网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

网页通常会在多个页面中显示数据,例如产品目录。 WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“指向下一页的链接”,WebHarvy网站 抓取工具就会自动从所有页面抓取数据。

直观的操作界面

WebHarvy 是一个可视化网页提取工具。事实上,完全不需要编写任何脚本或代码来提取数据。使用 webharvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。它是如此容易!

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,将为所有给定的输入关键字自动重复您创建的配置。可以指定任意数量的输入关键字

提取分类

WebHarvy网站 抓取器允许您从指向网站 中相似页面的链接列表中提取数据。这允许您使用单个配置来抓取 网站 中的类别或子部分。

使用正则表达式提取

WebHarvy 可以将正则表达式(regular expressions)应用于网页的文本或 HTML 源代码,并提取不匹配的部分。这种强大的技术在抓取数据时为您提供了更大的灵活性。

软件功能

WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器浏览网络。您可以选择要单击的数据。这简单!

WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动删除它。

您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面爬取和提取数据。只需指出“链接到下一页”,WebHarvy Web Scraper 就会自动从所有页面中抓取数据。

变更日志

修复了可能导致页面启动时禁用连接的错误

您可以为页面模式配置专用的连接方法

可以自动搜索 HTML 上的可配置资源

网页视频抓取脚本(Google如何在网页自动创建视频中启动视频创作?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-07 13:16

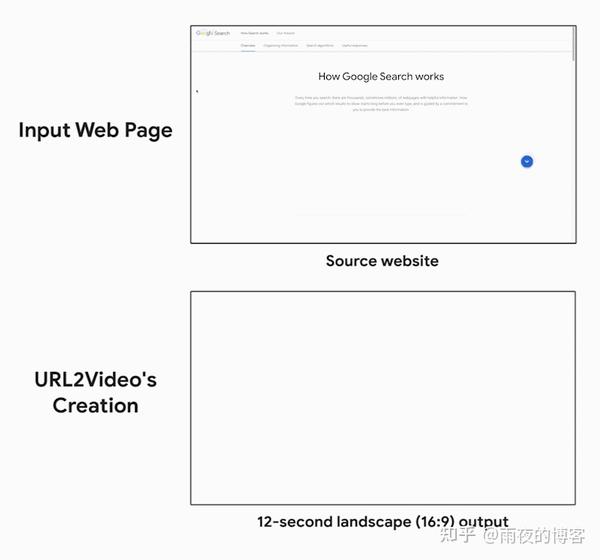

在 Google,我们正在积极探索人们在创建多媒体内容时如何使用由机器学习和计算方法提供支持的创意工具,从创作音乐和重建视频到绘画等等。创意过程,尤其是视频制作,可以特别受益于这些工具,因为它需要一系列决策,决定哪些内容最适合目标受众,如何在视野中定位可用资产,以及时机将产生最引人注目的叙述. . 但是,如果您可以使用现有资产(例如 网站)来快速开始视频创作呢?企业通常托管 网站 ,其中收录丰富的服务或产品的视觉表示,所有这些都可以在其他多媒体格式中重复使用,例如视频、

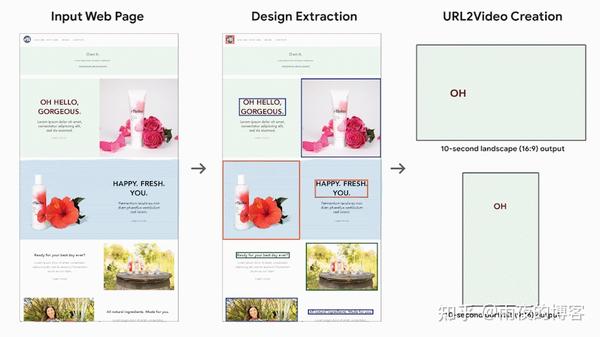

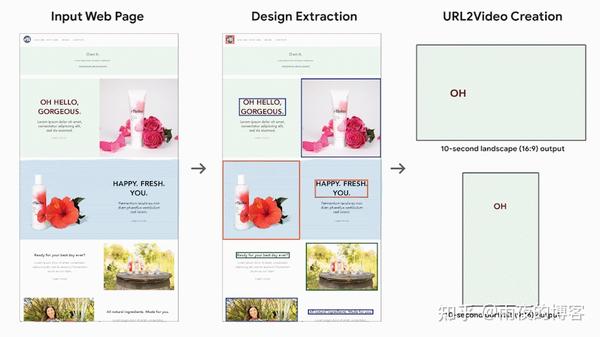

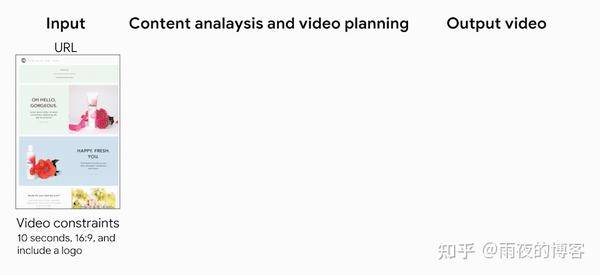

在 UIST 2020 发布的“Automatically Create Videos from Web Pages”中,我们介绍了 URL2Video,这是一个研究原型管道,可根据内容所有者提供的时间和视觉约束自动将网页转换为短视频。URL2Video 从 HTML 源代码中提取资产(文本、图像或视频)及其设计风格(包括字体、颜色、图形布局和层次结构),并将视觉资产组织成一系列镜头,同时保持外观类似于源页面。给定用户指定的纵横比和持续时间,然后将重复使用的材料呈现为适合产品和服务广告的视频。

URL2视频概览

假设用户提供指向描述其业务的网页的 URL。URL2Video 管道会自动从页面中选择关键内容,并基于一组启发式,从对熟悉网页设计和视频广告制作的设计师的采访中汲取灵感,并确定每个资产的时间和视觉呈现。设计师提供的这些启发式方法可以捕捉常见的视频编辑风格,包括内容层次结构、限制镜头中的信息量及其持续时间,以及为品牌提供一致的颜色和风格。使用此信息,URL2Video 管道解析网页、分析内容并选择具有视觉意义的文本或图像,同时保留其设计风格。它是根据用户提供的视频规范组织的。

网络分析

给定一个网页 URL,URL2Video 提取文档对象模型 (DOM) 信息和多媒体材料。出于原型研究的目的,我们将域限制为收录保留在 HTML 层次结构中的重要资产和标题的静态网页,遵循最新的网页设计原则,并鼓励使用突出的元素、不同的部分和指南读者对信息感知的视觉焦点序列。URL2Video 将这些视觉上可区分的元素标识为资产组的候选列表。每个列表可能收录标题、产品图像、详细说明和号召性用语按钮,并捕获原创资产(文本和多媒体文件)的每个元素的详细信息设计规范(HTML 标签、CSS 样式和呈现位置) . 然后,它根据每个资产组的视觉外观和注释(包括其 HTML 标签、渲染大小和页面上显示的顺序)为每个资产组分配优先级分数,以对资产组进行排名。这样,在页面顶部占据更大区域的资产组获得更高的分数。

基于约束的资产选择

我们在制作视频时考虑两个目标:(1)每个视频镜头应提供简洁的信息,以及(2)视觉设计应与源页面一致。基于这些目标和用户提供的视频限制,包括预期的视频时长(以秒为单位)和宽高比(通常为 16:9、4:3、1:1 等),URL2Video 会自动选择和排序资产组以优化总优先级得分. 为了使内容简洁,它只呈现页面的主要元素,如标题和一些多媒体资产,它限制了浏览者感知内容的每个视觉元素的持续时间。视频从页面顶部突出显示最重要的信息,而较长的视频收录更多的事件或产品。

场景合成和视频渲染

给定一个基于 DOM 层次结构的有序资产列表,URL2Video 遵循从访谈研究中获得的设计启发法,以确定在单个镜头中呈现资产的时间和空间安排。它将元素的图形布局转换为视频的纵横比,并应用包括字体和颜色在内的样式选择。为了使视频更具动感和吸引力,它调整了资产的呈现时间。最后,它将内容呈现为 MPEG-4 容器格式的视频。

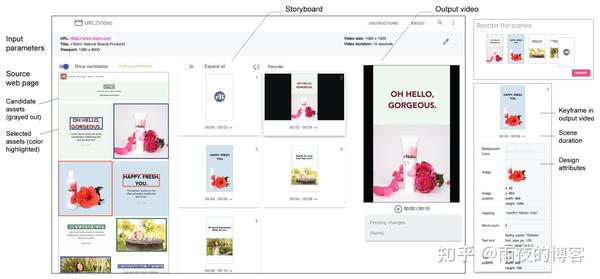

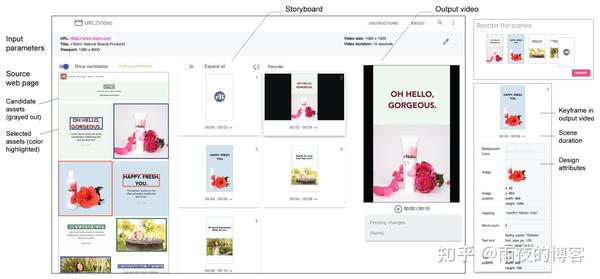

用户控制

研究原型的界面允许用户查看从源页面提取的每个视频镜头中的设计属性,重新排列材料,更改颜色和字体等详细设计,并调整约束以生成新视频。

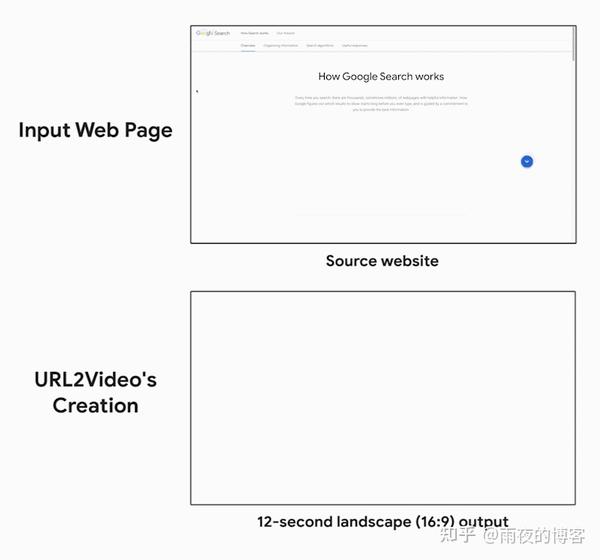

URL2Video 用例

我们展示了端到端 URL2Video 管道在各种现有网页上的性能。下面我们关注一个示例结果,其中 URL2Video 将收录多个嵌入的短视频剪辑的页面转换为 12 秒的输出视频。请注意管道如何为从源页面捕获的视频中的字体和颜色选择、时间和内容排序做出自动编辑决策。

为了评估自动生成的视频,我们与 Google 的设计师进行了一项用户研究。我们的结果表明 URL2Video 有效地从网页中提取设计元素并通过指导视频创建过程来支持设计人员。

下一步

尽管当前的研究侧重于视觉呈现,但我们正在开发支持视频编辑中的音轨和画外音的新技术。总而言之,我们设想了一个未来,创作者专注于做出高层决策,而 ML 模型以交互方式建议详细的时间安排和图形编辑,以在多个平台上创建最终视频。 查看全部

网页视频抓取脚本(Google如何在网页自动创建视频中启动视频创作?(图))

在 Google,我们正在积极探索人们在创建多媒体内容时如何使用由机器学习和计算方法提供支持的创意工具,从创作音乐和重建视频到绘画等等。创意过程,尤其是视频制作,可以特别受益于这些工具,因为它需要一系列决策,决定哪些内容最适合目标受众,如何在视野中定位可用资产,以及时机将产生最引人注目的叙述. . 但是,如果您可以使用现有资产(例如 网站)来快速开始视频创作呢?企业通常托管 网站 ,其中收录丰富的服务或产品的视觉表示,所有这些都可以在其他多媒体格式中重复使用,例如视频、

在 UIST 2020 发布的“Automatically Create Videos from Web Pages”中,我们介绍了 URL2Video,这是一个研究原型管道,可根据内容所有者提供的时间和视觉约束自动将网页转换为短视频。URL2Video 从 HTML 源代码中提取资产(文本、图像或视频)及其设计风格(包括字体、颜色、图形布局和层次结构),并将视觉资产组织成一系列镜头,同时保持外观类似于源页面。给定用户指定的纵横比和持续时间,然后将重复使用的材料呈现为适合产品和服务广告的视频。

URL2视频概览

假设用户提供指向描述其业务的网页的 URL。URL2Video 管道会自动从页面中选择关键内容,并基于一组启发式,从对熟悉网页设计和视频广告制作的设计师的采访中汲取灵感,并确定每个资产的时间和视觉呈现。设计师提供的这些启发式方法可以捕捉常见的视频编辑风格,包括内容层次结构、限制镜头中的信息量及其持续时间,以及为品牌提供一致的颜色和风格。使用此信息,URL2Video 管道解析网页、分析内容并选择具有视觉意义的文本或图像,同时保留其设计风格。它是根据用户提供的视频规范组织的。

网络分析

给定一个网页 URL,URL2Video 提取文档对象模型 (DOM) 信息和多媒体材料。出于原型研究的目的,我们将域限制为收录保留在 HTML 层次结构中的重要资产和标题的静态网页,遵循最新的网页设计原则,并鼓励使用突出的元素、不同的部分和指南读者对信息感知的视觉焦点序列。URL2Video 将这些视觉上可区分的元素标识为资产组的候选列表。每个列表可能收录标题、产品图像、详细说明和号召性用语按钮,并捕获原创资产(文本和多媒体文件)的每个元素的详细信息设计规范(HTML 标签、CSS 样式和呈现位置) . 然后,它根据每个资产组的视觉外观和注释(包括其 HTML 标签、渲染大小和页面上显示的顺序)为每个资产组分配优先级分数,以对资产组进行排名。这样,在页面顶部占据更大区域的资产组获得更高的分数。

基于约束的资产选择

我们在制作视频时考虑两个目标:(1)每个视频镜头应提供简洁的信息,以及(2)视觉设计应与源页面一致。基于这些目标和用户提供的视频限制,包括预期的视频时长(以秒为单位)和宽高比(通常为 16:9、4:3、1:1 等),URL2Video 会自动选择和排序资产组以优化总优先级得分. 为了使内容简洁,它只呈现页面的主要元素,如标题和一些多媒体资产,它限制了浏览者感知内容的每个视觉元素的持续时间。视频从页面顶部突出显示最重要的信息,而较长的视频收录更多的事件或产品。

场景合成和视频渲染

给定一个基于 DOM 层次结构的有序资产列表,URL2Video 遵循从访谈研究中获得的设计启发法,以确定在单个镜头中呈现资产的时间和空间安排。它将元素的图形布局转换为视频的纵横比,并应用包括字体和颜色在内的样式选择。为了使视频更具动感和吸引力,它调整了资产的呈现时间。最后,它将内容呈现为 MPEG-4 容器格式的视频。

用户控制

研究原型的界面允许用户查看从源页面提取的每个视频镜头中的设计属性,重新排列材料,更改颜色和字体等详细设计,并调整约束以生成新视频。

URL2Video 用例

我们展示了端到端 URL2Video 管道在各种现有网页上的性能。下面我们关注一个示例结果,其中 URL2Video 将收录多个嵌入的短视频剪辑的页面转换为 12 秒的输出视频。请注意管道如何为从源页面捕获的视频中的字体和颜色选择、时间和内容排序做出自动编辑决策。

为了评估自动生成的视频,我们与 Google 的设计师进行了一项用户研究。我们的结果表明 URL2Video 有效地从网页中提取设计元素并通过指导视频创建过程来支持设计人员。

下一步

尽管当前的研究侧重于视觉呈现,但我们正在开发支持视频编辑中的音轨和画外音的新技术。总而言之,我们设想了一个未来,创作者专注于做出高层决策,而 ML 模型以交互方式建议详细的时间安排和图形编辑,以在多个平台上创建最终视频。

网页视频抓取脚本(p2p传输,有利有弊?语言网站原理分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-07 00:01

网页视频抓取脚本,类似于火狐的chrome浏览器的gesture插件,能够抓取网页视频并传到手机浏览器上观看。关于脚本的详细介绍可以参考:,但需要注意下:必须要支持b站视频视频播放器。如果采用第三方视频抓取工具脚本,

具体楼上讲得很详细,我不赘述了,其实用chrome爬虫软件就可以啊,之前用过一款,还不错,叫phantomjs,手机端可用,应该是很多手机浏览器都可以。

其实这个命令行命令就可以的命令#将视频从油管转换为mp4命令格式:videoconverter.videobackend.devtools.evaluate_video(simple(function(v=0){v=v+1}));live.stop();

simple-video就行,比如知乎上的视频点赞就是这么传的,而这个脚本里就是一个函数。

建议看看这篇文章:javascript语言网站抓取原理分析

flash版本也可以用

flashsupportfileonly

b站mac端抓取或者视频重点是最后输出的时候(不是直接输出视频),这个开发者没有做。直接传flash没有意义的。

可以用的,

可以,

看一下firefox支不支持视频

b站视频加载缓存其实都是b站的服务器在传输的,这种方式被称作p2p传输,有利有弊,一方面是服务器在传输速度上比较快,另一方面是需要用户自己动手去缓存.关于p2p服务的详细介绍可以看看我的专栏文章:b站服务器的传输算法,可以对比下速度和体验.至于如何配置,当然是用firefox啊~ 查看全部

网页视频抓取脚本(p2p传输,有利有弊?语言网站原理分析)

网页视频抓取脚本,类似于火狐的chrome浏览器的gesture插件,能够抓取网页视频并传到手机浏览器上观看。关于脚本的详细介绍可以参考:,但需要注意下:必须要支持b站视频视频播放器。如果采用第三方视频抓取工具脚本,

具体楼上讲得很详细,我不赘述了,其实用chrome爬虫软件就可以啊,之前用过一款,还不错,叫phantomjs,手机端可用,应该是很多手机浏览器都可以。

其实这个命令行命令就可以的命令#将视频从油管转换为mp4命令格式:videoconverter.videobackend.devtools.evaluate_video(simple(function(v=0){v=v+1}));live.stop();

simple-video就行,比如知乎上的视频点赞就是这么传的,而这个脚本里就是一个函数。

建议看看这篇文章:javascript语言网站抓取原理分析

flash版本也可以用

flashsupportfileonly

b站mac端抓取或者视频重点是最后输出的时候(不是直接输出视频),这个开发者没有做。直接传flash没有意义的。

可以用的,

可以,

看一下firefox支不支持视频

b站视频加载缓存其实都是b站的服务器在传输的,这种方式被称作p2p传输,有利有弊,一方面是服务器在传输速度上比较快,另一方面是需要用户自己动手去缓存.关于p2p服务的详细介绍可以看看我的专栏文章:b站服务器的传输算法,可以对比下速度和体验.至于如何配置,当然是用firefox啊~

网页视频抓取脚本(Python模块从网页中提取数据或进行网页抓取的知识 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-04 19:11

)

在前面的章节中,我们学习了通过各种 Python 模块从网页中提取数据或抓取网页。在本章中,让我们研究处理捕获数据的各种技术。

介绍

要处理捕获的数据,我们必须以特定格式将数据存储在本地计算机上,例如电子表格 (CSV)、JSON 或有时存储在 MySQL 等数据库中。

CSV 和 JSON 数据处理

首先,从网络爬取后,我们将信息写入 CSV 文件或电子表格。让我们先通过一个简单的例子来理解,在这个例子中,我们将首先像之前一样使用 BeautifulSoup 模块获取信息,然后使用 Python CSV 模块将文本信息写入到 CSV 文件中。

首先,我们需要导入必要的Python库,如下图:

import requests

from bs4 import BeautifulSoup

import csv

在以下代码行中,我们使用该请求通过发出 GET 请求向 URL 发出 GET HTTP 请求:。

r = requests.get('https://authoraditiagarwal.com/')

现在,我们需要创建一个 Soup 对象,如下所示:

soup = BeautifulSoup(r.text, 'lxml')

现在,在下几行代码的帮助下,我们将捕获的数据写入名为 dataprocessing.csv 的 CSV 文件中。

f = csv.writer(open(' dataprocessing.csv ','w'))

f.writerow(['Title'])

f.writerow([soup.title.text])

运行此脚本后,文本信息或网页标题将保存在本地计算机上的上述CSV文件中。

同样,我们可以将采集到的信息保存在一个 JSON 文件中。下面是一个简单易懂的Python脚本,执行与之前的Python脚本相同的信息,但这次使用JSON Python模块将获取的信息保存在JSONfile.txt中。

import requests

from bs4 import BeautifulSoup

import csv

import json

r = requests.get('https://authoraditiagarwal.com/')

soup = BeautifulSoup(r.text, 'lxml')

y = json.dumps(soup.title.text)

with open('JSONFile.txt', 'wt') as outfile:

json.dump(y, outfile)

运行此脚本后,捕获的信息(即页面标题)将保存在本地计算机上的上述文本文件中。

使用 AWS S3 进行数据处理

有时我们可能希望将抓取到的数据保存在本地存储中进行归档。但是如果我们需要大规模存储和分析这些数据呢?答案是称为 Amazon S3 或 AWS S3 的云存储服务(简单存储服务)。基本上,AWS S3 是一种对象存储,旨在从任何地方存储和检索任意数量的数据。

我们可以按照以下步骤将数据存储在 AWS S3 中 -

第 1 步 - 首先,我们需要一个 AWS 帐户,该帐户将在存储数据时为我们提供 Python 脚本中使用的密钥。它将创建一个 S3 存储桶,我们可以在其中存储数据。

步骤 2-接下来,我们需要安装 boto3 Python 库来访问 S3 存储桶。它可以在以下命令的帮助下安装 -

pip install boto3

第 3 步 - 接下来,我们可以使用以下 Python 脚本从网页中抓取数据并将其保存到 AWS S3 存储桶中。

首先,我们需要导入用于爬取的Python库,这里我们正在处理请求,boto3将数据保存到S3存储桶中。

import requests

import boto3

现在,我们可以从 URL 中获取数据。

data = requests.get("Enter the URL").text

现在要将数据存储在 S3 存储桶中,我们需要创建一个 S3 客户端,如下所示:

s3 = boto3.client('s3')

bucket_name = "our-content"

下一行代码将创建一个 S3 存储桶,如下所示 -

s3.create_bucket(Bucket = bucket_name, ACL = 'public-read')

s3.put_object(Bucket = bucket_name, Key = '', Body = data, ACL = "public-read")

现在,您可以从您的 AWS 账户检查名为 our-content 的存储桶。

使用 MySQL 进行数据处理

让我们学习如何使用 MySQL 来处理数据。如果您想了解 MySQL,可以单击链接。

借助以下步骤,我们可以捕获数据并将其处理到 MySQL 表中 -

步骤 1-首先,通过使用 MySQL,我们需要创建一个数据库和表,我们要在其中保存捕获的数据。例如,我们使用以下查询来创建一个表 -

CREATE TABLE Scrap_pages (id BIGINT(7) NOT NULL AUTO_INCREMENT,

title VARCHAR(200), content VARCHAR(10000),PRIMARY KEY(id));

步骤 2-接下来,我们需要处理 Unicode。请注意 MySQL 默认不处理 Unicode。我们需要借助以下命令来开启这个功能,这会改变数据库、表和两列的默认字符集——

ALTER DATABASE scrap CHARACTER SET = utf8mb4 COLLATE = utf8mb4_unicode_ci;

ALTER TABLE Scrap_pages CONVERT TO CHARACTER SET utf8mb4 COLLATE

utf8mb4_unicode_ci;

ALTER TABLE Scrap_pages CHANGE title title VARCHAR(200) CHARACTER SET utf8mb4

COLLATE utf8mb4_unicode_ci;

ALTER TABLE pages CHANGE content content VARCHAR(10000) CHARACTER SET utf8mb4

COLLATE utf8mb4_unicode_ci;

第 3 步 - 现在,将 MySQL 与 Python 集成。为此,我们需要 PyMySQL,可以使用以下命令安装它

pip install PyMySQL

第 4 步-现在,我们之前创建的名为 Scrap 的数据库已准备就绪,可以从 Web 上捕获数据并保存到名为 Scrap_pages 的表中。在我们的示例中,我们将从维基百科中获取数据并将其保存到我们的数据库中。

首先,我们需要导入所需的 Python 模块。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import datetime

import random

import pymysql

import re

现在,建立连接并将其与 Python 集成。

conn = pymysql.connect(host='127.0.0.1',user='root', passwd = None, db = 'mysql',

charset = 'utf8')

cur = conn.cursor()

cur.execute("USE scrap")

random.seed(datetime.datetime.now())

def store(title, content):

cur.execute('INSERT INTO scrap_pages (title, content) VALUES ''("%s","%s")', (title, content))

cur.connection.commit()

现在,连接到维基百科并从中获取数据。

def getLinks(articleUrl):

html = urlopen('http://en.wikipedia.org'+articleUrl)

bs = BeautifulSoup(html, 'html.parser')

title = bs.find('h1').get_text()

content = bs.find('div', {'id':'mw-content-text'}).find('p').get_text()

store(title, content)

return bs.find('div', {'id':'bodyContent'}).findAll('a',href=re.compile('^(/wiki/)((?!:).)*#39;))

links = getLinks('/wiki/Kevin_Bacon')

try:

while len(links) > 0:

newArticle = links[random.randint(0, len(links)-1)].attrs['href']

print(newArticle)

links = getLinks(newArticle)

最后,我们需要关闭游标和连接。

finally:

cur.close()

conn.close()

这将从维基百科采集的数据保存到名为scrap_pages 的表中。如果你熟悉 MySQL 和 Web 抓取,上面的代码就不难理解了。

使用 PostgreSQL 进行数据处理

PostgreSQL 由世界各地的志愿者团队开发,是一种开源关系数据库管理系统 (RDMS)。使用 PostgreSQL 处理捕获数据的过程与 MySQL 类似。将会有两个变化:第一,命令将与 MySQL 不同,第二,这里我们将使用 psycopg2 Python 库来执行它与 Python 的集成。

如果你不熟悉 PostgreSQL,你可以从中学习。并在以下命令的帮助下,我们可以安装 psycopg2 Python 库-

pip install psycopg2 查看全部

网页视频抓取脚本(Python模块从网页中提取数据或进行网页抓取的知识

)

在前面的章节中,我们学习了通过各种 Python 模块从网页中提取数据或抓取网页。在本章中,让我们研究处理捕获数据的各种技术。

介绍

要处理捕获的数据,我们必须以特定格式将数据存储在本地计算机上,例如电子表格 (CSV)、JSON 或有时存储在 MySQL 等数据库中。

CSV 和 JSON 数据处理

首先,从网络爬取后,我们将信息写入 CSV 文件或电子表格。让我们先通过一个简单的例子来理解,在这个例子中,我们将首先像之前一样使用 BeautifulSoup 模块获取信息,然后使用 Python CSV 模块将文本信息写入到 CSV 文件中。

首先,我们需要导入必要的Python库,如下图:

import requests

from bs4 import BeautifulSoup

import csv

在以下代码行中,我们使用该请求通过发出 GET 请求向 URL 发出 GET HTTP 请求:。

r = requests.get('https://authoraditiagarwal.com/')

现在,我们需要创建一个 Soup 对象,如下所示:

soup = BeautifulSoup(r.text, 'lxml')

现在,在下几行代码的帮助下,我们将捕获的数据写入名为 dataprocessing.csv 的 CSV 文件中。

f = csv.writer(open(' dataprocessing.csv ','w'))

f.writerow(['Title'])

f.writerow([soup.title.text])

运行此脚本后,文本信息或网页标题将保存在本地计算机上的上述CSV文件中。

同样,我们可以将采集到的信息保存在一个 JSON 文件中。下面是一个简单易懂的Python脚本,执行与之前的Python脚本相同的信息,但这次使用JSON Python模块将获取的信息保存在JSONfile.txt中。

import requests

from bs4 import BeautifulSoup

import csv

import json

r = requests.get('https://authoraditiagarwal.com/')

soup = BeautifulSoup(r.text, 'lxml')

y = json.dumps(soup.title.text)

with open('JSONFile.txt', 'wt') as outfile:

json.dump(y, outfile)

运行此脚本后,捕获的信息(即页面标题)将保存在本地计算机上的上述文本文件中。

使用 AWS S3 进行数据处理

有时我们可能希望将抓取到的数据保存在本地存储中进行归档。但是如果我们需要大规模存储和分析这些数据呢?答案是称为 Amazon S3 或 AWS S3 的云存储服务(简单存储服务)。基本上,AWS S3 是一种对象存储,旨在从任何地方存储和检索任意数量的数据。

我们可以按照以下步骤将数据存储在 AWS S3 中 -

第 1 步 - 首先,我们需要一个 AWS 帐户,该帐户将在存储数据时为我们提供 Python 脚本中使用的密钥。它将创建一个 S3 存储桶,我们可以在其中存储数据。

步骤 2-接下来,我们需要安装 boto3 Python 库来访问 S3 存储桶。它可以在以下命令的帮助下安装 -

pip install boto3

第 3 步 - 接下来,我们可以使用以下 Python 脚本从网页中抓取数据并将其保存到 AWS S3 存储桶中。

首先,我们需要导入用于爬取的Python库,这里我们正在处理请求,boto3将数据保存到S3存储桶中。

import requests

import boto3

现在,我们可以从 URL 中获取数据。

data = requests.get("Enter the URL").text

现在要将数据存储在 S3 存储桶中,我们需要创建一个 S3 客户端,如下所示:

s3 = boto3.client('s3')

bucket_name = "our-content"

下一行代码将创建一个 S3 存储桶,如下所示 -

s3.create_bucket(Bucket = bucket_name, ACL = 'public-read')

s3.put_object(Bucket = bucket_name, Key = '', Body = data, ACL = "public-read")

现在,您可以从您的 AWS 账户检查名为 our-content 的存储桶。

使用 MySQL 进行数据处理

让我们学习如何使用 MySQL 来处理数据。如果您想了解 MySQL,可以单击链接。

借助以下步骤,我们可以捕获数据并将其处理到 MySQL 表中 -

步骤 1-首先,通过使用 MySQL,我们需要创建一个数据库和表,我们要在其中保存捕获的数据。例如,我们使用以下查询来创建一个表 -

CREATE TABLE Scrap_pages (id BIGINT(7) NOT NULL AUTO_INCREMENT,

title VARCHAR(200), content VARCHAR(10000),PRIMARY KEY(id));

步骤 2-接下来,我们需要处理 Unicode。请注意 MySQL 默认不处理 Unicode。我们需要借助以下命令来开启这个功能,这会改变数据库、表和两列的默认字符集——

ALTER DATABASE scrap CHARACTER SET = utf8mb4 COLLATE = utf8mb4_unicode_ci;

ALTER TABLE Scrap_pages CONVERT TO CHARACTER SET utf8mb4 COLLATE

utf8mb4_unicode_ci;

ALTER TABLE Scrap_pages CHANGE title title VARCHAR(200) CHARACTER SET utf8mb4

COLLATE utf8mb4_unicode_ci;

ALTER TABLE pages CHANGE content content VARCHAR(10000) CHARACTER SET utf8mb4

COLLATE utf8mb4_unicode_ci;

第 3 步 - 现在,将 MySQL 与 Python 集成。为此,我们需要 PyMySQL,可以使用以下命令安装它

pip install PyMySQL

第 4 步-现在,我们之前创建的名为 Scrap 的数据库已准备就绪,可以从 Web 上捕获数据并保存到名为 Scrap_pages 的表中。在我们的示例中,我们将从维基百科中获取数据并将其保存到我们的数据库中。

首先,我们需要导入所需的 Python 模块。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import datetime

import random

import pymysql

import re

现在,建立连接并将其与 Python 集成。

conn = pymysql.connect(host='127.0.0.1',user='root', passwd = None, db = 'mysql',

charset = 'utf8')

cur = conn.cursor()

cur.execute("USE scrap")

random.seed(datetime.datetime.now())

def store(title, content):

cur.execute('INSERT INTO scrap_pages (title, content) VALUES ''("%s","%s")', (title, content))

cur.connection.commit()

现在,连接到维基百科并从中获取数据。

def getLinks(articleUrl):

html = urlopen('http://en.wikipedia.org'+articleUrl)

bs = BeautifulSoup(html, 'html.parser')

title = bs.find('h1').get_text()

content = bs.find('div', {'id':'mw-content-text'}).find('p').get_text()

store(title, content)

return bs.find('div', {'id':'bodyContent'}).findAll('a',href=re.compile('^(/wiki/)((?!:).)*#39;))

links = getLinks('/wiki/Kevin_Bacon')

try:

while len(links) > 0:

newArticle = links[random.randint(0, len(links)-1)].attrs['href']

print(newArticle)

links = getLinks(newArticle)

最后,我们需要关闭游标和连接。

finally:

cur.close()

conn.close()

这将从维基百科采集的数据保存到名为scrap_pages 的表中。如果你熟悉 MySQL 和 Web 抓取,上面的代码就不难理解了。

使用 PostgreSQL 进行数据处理

PostgreSQL 由世界各地的志愿者团队开发,是一种开源关系数据库管理系统 (RDMS)。使用 PostgreSQL 处理捕获数据的过程与 MySQL 类似。将会有两个变化:第一,命令将与 MySQL 不同,第二,这里我们将使用 psycopg2 Python 库来执行它与 Python 的集成。

如果你不熟悉 PostgreSQL,你可以从中学习。并在以下命令的帮助下,我们可以安装 psycopg2 Python 库-

pip install psycopg2

网页视频抓取脚本(一下实现简单爬虫功能的示例python爬虫实战之最简单的网页爬虫教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-01-04 17:03

既然这篇文章文章讲的是Python搭建网络爬虫的原理分析,那我先给大家介绍一下Python中爬虫的选择文章:

Python实现简单爬虫功能示例

python爬虫实战最简单的网络爬虫教程

网络爬虫是当今最常用的系统之一。最流行的例子是 Google 使用爬虫从所有 网站 采集信息。除了搜索引擎,新闻网站还需要爬虫来聚合数据源。看来只要想聚合很多信息,就可以考虑使用爬虫了。

构建网络爬虫有很多因素,尤其是当您要扩展系统时。这就是为什么这已经成为最流行的系统设计面试问题之一。在这个文章中,我们将讨论从基础爬虫到大型爬虫的话题,讨论面试中可能遇到的各种问题。

1-基本解决方案

如何构建一个基本的网络爬虫?

在系统设计面试之前,我们已经讲过“系统设计面试前你需要知道的八件事”,就是从简单的事情开始。让我们专注于构建一个在单线程上运行的基本网络爬虫。通过这个简单的解决方案,我们可以继续优化。

爬取单个网页,我们只需要向对应的URL发出HTTP GET请求,解析响应数据,这是爬虫的核心。考虑到这一点,一个基本的网络爬虫可以这样工作:

从收录我们要爬取的所有 网站 的 URL 池开始。

对于每个 URL,都会发出 HTTP GET 请求以获取网页的内容。

解析内容(通常是 HTML)并提取我们想要抓取的潜在 URL。

向池中添加新 URL 并继续爬行。

根据具体问题,有时我们可能有一个单独的系统来生成抓取网址。例如,一个程序可以持续监控RSS订阅,对于每一个新的文章,都可以将URL添加到爬取池中。

2 尺度问题

众所周知,任何系统在扩展后都会面临一系列的问题。在网络爬虫中,当系统扩展到多台机器时,很多事情都可能出错。

在跳到下一节之前,请花几分钟思考一下分布式网络爬虫的瓶颈以及如何解决这个问题。在本文章的其余部分,我们将讨论解决方案的主要问题。

3-爬行频率

你多久爬一次 网站?

这听起来可能没什么大不了的,除非系统达到一定规模并且您需要非常新鲜的内容。例如,如果你想获取最近一小时的最新消息,爬虫可能需要保持每小时爬一次新闻网站。但是有什么问题呢?

对于一些小的网站,他们的服务器可能无法处理如此频繁的请求。一种方法是跟踪每个站点的robot.txt。对于不知道robot.txt是什么的人来说,这基本上是网站与网络爬虫通信的标准。它可以指定哪些文件不应该被抓取,大多数网络爬虫都遵循这个配置。另外,你可以为不同的网站设置不同的爬取频率。通常,每天只需要爬取几次网站。

4-重复数据删除

在一台机器上,您可以将 URL 池保留在内存中并删除重复条目。然而,分布式系统中的事情变得更加复杂。基本上,多个爬虫可以从不同的网页中提取同一个网址,并且都想把这个网址加入到网址池中。当然,多次爬取同一个页面是没有意义的。那么我们如何重复这些网址呢?

一种常用的方法是使用布隆过滤器。简而言之,Bloom Filter 是一个节省空间的系统,它允许您测试元素是否在集合中。但是,它可能有误报。换句话说,如果布隆过滤器可以告诉你一个 URL 肯定不在池中,或者可能在池中。

为了简要说明布隆过滤器的工作原理,空布隆过滤器是 m 位(所有 0) 位数组。还有 k 个哈希函数将每个元素映射到 m 位 A。所以当我们添加一个新元素(URL ) 在Bloom filter中,我们会从hash函数中得到k位,并将它们都设置为1.,因此,当我们检查一个元素时,首先得到k位。如果其中任何一个不为1,我们立即知道该元素不存在。但是,如果所有 k 位都为 1,则这可能来自其他几个元素的组合。

布隆过滤器是一种非常常用的技术,它是网络爬虫中去除重复网址的完美解决方案。

5-解析

从网站得到响应数据后,下一步就是解析数据(通常是HTML),提取出我们关心的信息。这听起来很简单,但要让它健壮可能很难。

我们面临的挑战是你总会在 HTML 代码中发现奇怪的标签、URL 等,并且很难覆盖所有的边界条件。例如,当 HTML 收录非 Unicode 字符时,您可能需要处理编码和解码问题。此外,当网页中收录图片、视频甚至PDF文件时,也会引起奇怪的行为。

另外,有些网页像AngularJS一样是用Javascript渲染的,你的爬虫可能无法获取到任何内容。

我想说,没有灵丹妙药,就不可能为所有网页制作完美而强大的爬虫。您需要进行大量的稳健性测试以确保它按预期工作。

总结

有很多有趣的话题我还没有触及,但我想提一下其中的一些,以便您可以思考它们。一件事是检测循环。很多网站都收录链接,比如A->B->C->A,你的爬虫可能会一直跑下去。想想如何解决这个问题?

另一个问题是 DNS 查找。当系统扩展到一定程度时,DNS 查找可能会成为瓶颈,您可能需要构建自己的 DNS 服务器。

与许多其他系统类似,扩展的网络爬虫可能比构建单机版本困难得多,并且可以在系统设计面试中讨论很多事情。尝试从一些简单的解决方案开始并继续优化它,这会使事情变得比看起来更容易。

以上是我们对网络爬虫的总结。如果你还有什么想知道的,可以在下方评论区讨论。感谢您对 Scripthome 的支持。 查看全部

网页视频抓取脚本(一下实现简单爬虫功能的示例python爬虫实战之最简单的网页爬虫教程)

既然这篇文章文章讲的是Python搭建网络爬虫的原理分析,那我先给大家介绍一下Python中爬虫的选择文章:

Python实现简单爬虫功能示例

python爬虫实战最简单的网络爬虫教程

网络爬虫是当今最常用的系统之一。最流行的例子是 Google 使用爬虫从所有 网站 采集信息。除了搜索引擎,新闻网站还需要爬虫来聚合数据源。看来只要想聚合很多信息,就可以考虑使用爬虫了。

构建网络爬虫有很多因素,尤其是当您要扩展系统时。这就是为什么这已经成为最流行的系统设计面试问题之一。在这个文章中,我们将讨论从基础爬虫到大型爬虫的话题,讨论面试中可能遇到的各种问题。

1-基本解决方案

如何构建一个基本的网络爬虫?

在系统设计面试之前,我们已经讲过“系统设计面试前你需要知道的八件事”,就是从简单的事情开始。让我们专注于构建一个在单线程上运行的基本网络爬虫。通过这个简单的解决方案,我们可以继续优化。

爬取单个网页,我们只需要向对应的URL发出HTTP GET请求,解析响应数据,这是爬虫的核心。考虑到这一点,一个基本的网络爬虫可以这样工作:

从收录我们要爬取的所有 网站 的 URL 池开始。

对于每个 URL,都会发出 HTTP GET 请求以获取网页的内容。

解析内容(通常是 HTML)并提取我们想要抓取的潜在 URL。

向池中添加新 URL 并继续爬行。

根据具体问题,有时我们可能有一个单独的系统来生成抓取网址。例如,一个程序可以持续监控RSS订阅,对于每一个新的文章,都可以将URL添加到爬取池中。

2 尺度问题

众所周知,任何系统在扩展后都会面临一系列的问题。在网络爬虫中,当系统扩展到多台机器时,很多事情都可能出错。

在跳到下一节之前,请花几分钟思考一下分布式网络爬虫的瓶颈以及如何解决这个问题。在本文章的其余部分,我们将讨论解决方案的主要问题。

3-爬行频率

你多久爬一次 网站?

这听起来可能没什么大不了的,除非系统达到一定规模并且您需要非常新鲜的内容。例如,如果你想获取最近一小时的最新消息,爬虫可能需要保持每小时爬一次新闻网站。但是有什么问题呢?

对于一些小的网站,他们的服务器可能无法处理如此频繁的请求。一种方法是跟踪每个站点的robot.txt。对于不知道robot.txt是什么的人来说,这基本上是网站与网络爬虫通信的标准。它可以指定哪些文件不应该被抓取,大多数网络爬虫都遵循这个配置。另外,你可以为不同的网站设置不同的爬取频率。通常,每天只需要爬取几次网站。

4-重复数据删除

在一台机器上,您可以将 URL 池保留在内存中并删除重复条目。然而,分布式系统中的事情变得更加复杂。基本上,多个爬虫可以从不同的网页中提取同一个网址,并且都想把这个网址加入到网址池中。当然,多次爬取同一个页面是没有意义的。那么我们如何重复这些网址呢?

一种常用的方法是使用布隆过滤器。简而言之,Bloom Filter 是一个节省空间的系统,它允许您测试元素是否在集合中。但是,它可能有误报。换句话说,如果布隆过滤器可以告诉你一个 URL 肯定不在池中,或者可能在池中。

为了简要说明布隆过滤器的工作原理,空布隆过滤器是 m 位(所有 0) 位数组。还有 k 个哈希函数将每个元素映射到 m 位 A。所以当我们添加一个新元素(URL ) 在Bloom filter中,我们会从hash函数中得到k位,并将它们都设置为1.,因此,当我们检查一个元素时,首先得到k位。如果其中任何一个不为1,我们立即知道该元素不存在。但是,如果所有 k 位都为 1,则这可能来自其他几个元素的组合。

布隆过滤器是一种非常常用的技术,它是网络爬虫中去除重复网址的完美解决方案。

5-解析

从网站得到响应数据后,下一步就是解析数据(通常是HTML),提取出我们关心的信息。这听起来很简单,但要让它健壮可能很难。

我们面临的挑战是你总会在 HTML 代码中发现奇怪的标签、URL 等,并且很难覆盖所有的边界条件。例如,当 HTML 收录非 Unicode 字符时,您可能需要处理编码和解码问题。此外,当网页中收录图片、视频甚至PDF文件时,也会引起奇怪的行为。

另外,有些网页像AngularJS一样是用Javascript渲染的,你的爬虫可能无法获取到任何内容。

我想说,没有灵丹妙药,就不可能为所有网页制作完美而强大的爬虫。您需要进行大量的稳健性测试以确保它按预期工作。

总结

有很多有趣的话题我还没有触及,但我想提一下其中的一些,以便您可以思考它们。一件事是检测循环。很多网站都收录链接,比如A->B->C->A,你的爬虫可能会一直跑下去。想想如何解决这个问题?

另一个问题是 DNS 查找。当系统扩展到一定程度时,DNS 查找可能会成为瓶颈,您可能需要构建自己的 DNS 服务器。

与许多其他系统类似,扩展的网络爬虫可能比构建单机版本困难得多,并且可以在系统设计面试中讨论很多事情。尝试从一些简单的解决方案开始并继续优化它,这会使事情变得比看起来更容易。

以上是我们对网络爬虫的总结。如果你还有什么想知道的,可以在下方评论区讨论。感谢您对 Scripthome 的支持。

网页视频抓取脚本(搜索引擎网站优化过程中的蜘蛛和爬行动物抓取页面内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-01-03 00:18

搜索引擎通过蜘蛛爬虫抓取和收录网页。抓取页面内容是搜索引擎工作的第一步。了解搜索引擎抓取网页的机制,可以帮助蜘蛛和爬虫抓取更多的网页,提高网站的排名。

蜘蛛,又称网络蜘蛛,是一种按照一定的规则抓取网页的程序或脚本。

蜘蛛想要爬取网站的内容,需要一个入口来爬取。如果没有入口,他们就无法爬行网站。所以,网站完成后,我们需要给搜索引擎一个网站的入口,让蜘蛛可以跟随链接进入网站的每一个角落,而不会到达某些条件,直到满足某些条件。停止。停止条件的设置通常由时间或数量决定,链接数也可以用来限制蜘蛛的爬行。同时,页面信息的重要性也将决定爬虫是否会检索到该页面。

在搜索引擎中,一些网站很受蜘蛛欢迎,而这些网站也将成为蜘蛛和爬行动物的起点。一般情况下,这种网站具有一定的知名度和导航性,非常适合作为网站的种子。因此,在进行网站优化时,可以将自己的网站提交到分类目录,有利于蜘蛛爬行动物的爬取。

搜索引擎如何抓取网页

网站 更新频率直接影响蜘蛛的爬取频率。如果网站每天定时定量更新,蜘蛛也会在这段时间内进入网站进行爬取。

蜘蛛每次抓取网站内容时,都会存储内容。如果第二次爬取发现页面和上一次爬取相同,说明网站没有更新。经过长时间的爬取,蜘蛛爬虫对网站页面的更新频率会有一定的了解。对于一些不常更新的网站,蜘蛛爬虫也会放弃爬取。如果网站经常更新内容,蜘蛛爬虫会经常进入网站抓取网站上的新链接,提高网站的排名。

因此,在网站的优化过程中,要经常更新网站的内容,增加网站被抓取的频率。搜索引擎蜘蛛抓取网页后,会将网页存储在原创数据库中。一段时间后,搜索引擎会相应地处理原创数据库中的页面。 查看全部

网页视频抓取脚本(搜索引擎网站优化过程中的蜘蛛和爬行动物抓取页面内容)

搜索引擎通过蜘蛛爬虫抓取和收录网页。抓取页面内容是搜索引擎工作的第一步。了解搜索引擎抓取网页的机制,可以帮助蜘蛛和爬虫抓取更多的网页,提高网站的排名。

蜘蛛,又称网络蜘蛛,是一种按照一定的规则抓取网页的程序或脚本。

蜘蛛想要爬取网站的内容,需要一个入口来爬取。如果没有入口,他们就无法爬行网站。所以,网站完成后,我们需要给搜索引擎一个网站的入口,让蜘蛛可以跟随链接进入网站的每一个角落,而不会到达某些条件,直到满足某些条件。停止。停止条件的设置通常由时间或数量决定,链接数也可以用来限制蜘蛛的爬行。同时,页面信息的重要性也将决定爬虫是否会检索到该页面。

在搜索引擎中,一些网站很受蜘蛛欢迎,而这些网站也将成为蜘蛛和爬行动物的起点。一般情况下,这种网站具有一定的知名度和导航性,非常适合作为网站的种子。因此,在进行网站优化时,可以将自己的网站提交到分类目录,有利于蜘蛛爬行动物的爬取。

搜索引擎如何抓取网页

网站 更新频率直接影响蜘蛛的爬取频率。如果网站每天定时定量更新,蜘蛛也会在这段时间内进入网站进行爬取。

蜘蛛每次抓取网站内容时,都会存储内容。如果第二次爬取发现页面和上一次爬取相同,说明网站没有更新。经过长时间的爬取,蜘蛛爬虫对网站页面的更新频率会有一定的了解。对于一些不常更新的网站,蜘蛛爬虫也会放弃爬取。如果网站经常更新内容,蜘蛛爬虫会经常进入网站抓取网站上的新链接,提高网站的排名。

因此,在网站的优化过程中,要经常更新网站的内容,增加网站被抓取的频率。搜索引擎蜘蛛抓取网页后,会将网页存储在原创数据库中。一段时间后,搜索引擎会相应地处理原创数据库中的页面。

网页视频抓取脚本(chrome有插件谢邀自制网页视频点击中间的小助手)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-01-02 04:08

网页视频抓取脚本功能的实现类似一个app或者服务,把你要抓取的视频链接放入到全局唯一id。上传视频点击中间的小助手提示就可以进行整个视频的抓取了。

youtube是可以的

你是只是有了想看的视频的链接,但是无法将这个链接变成视频,你只要成功在浏览器植入这个网址即可可以变成视频。

chrome有插件

谢邀自制的

可以通过修改地址栏的主页地址和之前的链接绑定,

可以在其他页面复制该主页地址绑定就好了

谢邀不好意思啊我也不是什么高端黑or技术帝,简单的说,插件或者别的客户端吧这个在网上应该都有详细的方法我也不是一个电脑白痴,但是有个破解版本的观看效果不错,

多看看相关软件

youtube真心不适合了解如何抓取youtube视频啊whatever

ios自己可以抓的吧,直接挂vpn或者做代理啥的,这是抓取的办法。android没试过。

说说手机端上怎么抓?可以借助谷歌浏览器插件,爱奇艺电视猫那个。

我去他提的问题看了

如果网页简单可以通过模拟浏览器,通过点击播放一句话回车,可以抓取,可以浏览器上载下来,可以插件。一般这种应该都是把网页抓取下来。

需要安装这个软件autotabemulatorbyakadofficial.free. 查看全部

网页视频抓取脚本(chrome有插件谢邀自制网页视频点击中间的小助手)

网页视频抓取脚本功能的实现类似一个app或者服务,把你要抓取的视频链接放入到全局唯一id。上传视频点击中间的小助手提示就可以进行整个视频的抓取了。

youtube是可以的

你是只是有了想看的视频的链接,但是无法将这个链接变成视频,你只要成功在浏览器植入这个网址即可可以变成视频。

chrome有插件

谢邀自制的

可以通过修改地址栏的主页地址和之前的链接绑定,

可以在其他页面复制该主页地址绑定就好了

谢邀不好意思啊我也不是什么高端黑or技术帝,简单的说,插件或者别的客户端吧这个在网上应该都有详细的方法我也不是一个电脑白痴,但是有个破解版本的观看效果不错,

多看看相关软件

youtube真心不适合了解如何抓取youtube视频啊whatever

ios自己可以抓的吧,直接挂vpn或者做代理啥的,这是抓取的办法。android没试过。

说说手机端上怎么抓?可以借助谷歌浏览器插件,爱奇艺电视猫那个。

我去他提的问题看了

如果网页简单可以通过模拟浏览器,通过点击播放一句话回车,可以抓取,可以浏览器上载下来,可以插件。一般这种应该都是把网页抓取下来。

需要安装这个软件autotabemulatorbyakadofficial.free.

网页视频抓取脚本(优采云·云采集网络爬虫软件网页视频抓取教程如何采集视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 312 次浏览 • 2022-01-01 14:18

优采云·Cloud采集网络爬虫软件优采云·Cloud采集网络爬虫软件网络视频采集教程如何采集视频教程本教程为大家解释一下如何采集页面上的视频。常见场景:需要采集视频时,可以采集视频地址(URL),然后使用网络视频下载器下载视频。当视频链接在标签中时,可以将标签切换为采集。当视频链接在标签中时,也可以在采集源码后格式化数据。操作示例:采集 要求:采集 综艺百度视频过去视频示例网址:/show/list/area-Mainland+order-hot+pn-1+channel-tvshow 操作步骤:新人定义采集,输入URL,点击保存。注:点击打开右上角的进程按钮。创建循环页面,在采集页面找到下一页按钮,点击,执行“循环点击下一页”。过程中点击翻页,勾选Ajax加载数据,时间设置为2-3秒。创建一个循环点击列表。点击第一张图片,选择“全选”(由于标签不同,无法全选,可以继续点击未选中的图片)继续选择循环点击各个元素进入详情页,点击视频标题(从Firefox可以看到视频链接在A标签中,如图),所以需要手动改成对应的A标签。手动替换A标签:替换A标签后,选择“全选”选择所有视频标题,即可采集视频链接地址。

设置好所有操作后,点击保存。然后继续到本地采集查看采集的结果。 采集 导出网址后,使用视频网址批量下载工具下载视频完成。相关采集教程:网络爬虫视频教程/tutorial/videotutorial网站Data采集实战视频教程/tutorial/videotutorial/videoszcz 模拟登录识别验证码抓取数据/tutorial/ gnd/dlyzmxpath抓取网页text/tutorial/gnd/xpath等采集功能点/tutorial/gnd/qitagnd优采云——90万用户选择的网页数据采集器。 1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。过程完全可视化,点击鼠标即可完成操作,2分钟即可快速上手。 2、功能强大,任意网站都可以:点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据页面,都可以通过简单的设置来设置< @采集。 3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,无需担心IP被封、网络中断。 4、特色免费+增值服务,您可以根据自己的需要选择。免费版功能齐全,可以满足用户基本的采集需求。同时,还建立了一些增值服务(如私有云),以满足高端付费企业用户的需求。 查看全部

网页视频抓取脚本(优采云·云采集网络爬虫软件网页视频抓取教程如何采集视频教程)

优采云·Cloud采集网络爬虫软件优采云·Cloud采集网络爬虫软件网络视频采集教程如何采集视频教程本教程为大家解释一下如何采集页面上的视频。常见场景:需要采集视频时,可以采集视频地址(URL),然后使用网络视频下载器下载视频。当视频链接在标签中时,可以将标签切换为采集。当视频链接在标签中时,也可以在采集源码后格式化数据。操作示例:采集 要求:采集 综艺百度视频过去视频示例网址:/show/list/area-Mainland+order-hot+pn-1+channel-tvshow 操作步骤:新人定义采集,输入URL,点击保存。注:点击打开右上角的进程按钮。创建循环页面,在采集页面找到下一页按钮,点击,执行“循环点击下一页”。过程中点击翻页,勾选Ajax加载数据,时间设置为2-3秒。创建一个循环点击列表。点击第一张图片,选择“全选”(由于标签不同,无法全选,可以继续点击未选中的图片)继续选择循环点击各个元素进入详情页,点击视频标题(从Firefox可以看到视频链接在A标签中,如图),所以需要手动改成对应的A标签。手动替换A标签:替换A标签后,选择“全选”选择所有视频标题,即可采集视频链接地址。

设置好所有操作后,点击保存。然后继续到本地采集查看采集的结果。 采集 导出网址后,使用视频网址批量下载工具下载视频完成。相关采集教程:网络爬虫视频教程/tutorial/videotutorial网站Data采集实战视频教程/tutorial/videotutorial/videoszcz 模拟登录识别验证码抓取数据/tutorial/ gnd/dlyzmxpath抓取网页text/tutorial/gnd/xpath等采集功能点/tutorial/gnd/qitagnd优采云——90万用户选择的网页数据采集器。 1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。过程完全可视化,点击鼠标即可完成操作,2分钟即可快速上手。 2、功能强大,任意网站都可以:点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据页面,都可以通过简单的设置来设置< @采集。 3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,无需担心IP被封、网络中断。 4、特色免费+增值服务,您可以根据自己的需要选择。免费版功能齐全,可以满足用户基本的采集需求。同时,还建立了一些增值服务(如私有云),以满足高端付费企业用户的需求。

网页视频抓取脚本(传说中的番号以链接为例,共536个视频 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-12-29 07:18

)

首先,您必须找到视频的唯一 ID。

刚玩过B站,了解不多。不知道这个辅助是不是传说中的数字

以链接为例,共有536个视频。

在红色框中,您可以看到每个视频都有一个唯一的 ID-cid。

下一步很简单,正则表达式(bs4也可以),挑出所有的视频信息。* 不知道这种情况下是正则表达式好还是bs4好,请指教!

在kanbilibili上找到下载链接

-------------------------------------------------- -------------------------------------------------- -------------------------------------------------- ---------------

想直接通过python下载视频,实时显示下载进度和网速,但是能力有限,不知道怎么打码。

请问各位大佬,这个应该怎么实现?

-------------------------------------------------- -------------------------------------------------- -------------------------------------------------- ---------------

以下是下载和重命名的代码。运行下载脚本后,会在脚本所在目录生成一个保存你选择的剧集范围下载链接的txt和一个保存所有视频文件名的txt。

需要注意的是:

1、 解释器的路径(第一行#!/usr....)需要改成你电脑上python的路径

2、 下载脚本的第 92 行将在您指定的路径下创建一个名为 aid 的目录。请务必将其更改为要保存的路径。

3、 重命名脚本的第 27 行并将其更改为与第 2 项中相同的路径。

下载代码:

[Python] 纯文本视图复制代码

#!/usr/local/Cellar/python/3.7.4/bin/python3

# -*- coding: utf-8 -*-

import requests

import json

import re

import os

# 获取所有的视频信息

def videos_info(headers, aid):

# av后面的数字就是 aid

b_url = 'https://api.bilibili.com/x/web-interface/view?aid=' + aid

web_data = requests.get(b_url,headers=headers)

all_info = json.loads(web_data.text)

return all_info['data']['pages']

# 从kanbilibili中找到包含每一个视频的下载链接的链接

def videos_url(start, end, all_info, aid):

if end == 0:

end = len(all_info)

while True:

choice = input('你是否要下载 %d 集到 %d 集的视频?(Y/n)' % (start, end))

if choice == 'Y' or choice == 'y':

break

elif choice == 'N' or choice == 'n':

pass

else:

print('你的选择有误,选择指令["Y"]为是,["n"]为否,请重新选择!')

continue

start = input('请重新输入你要从哪一集开始下载:(默认:1)')

if start == '':

start = 1

else:

start = int(start)

end = input('请重新输入到哪一集结束(默认:最后一集):')

if end == '':

end = len(all_info)

else:

end = int(end)

urls = []

print('正在获取所选视频的下载链接,请稍候...')

# start-1是要下载的第一个视频的索引(下标),end本身到不了,不需要-1

for i in all_info[start-1:end]:

page = str(all_info.index(i) + start)

# 到这步的时候我才发现之前的videos_info可以完全不通过B站搞定,B站爬数据还得用cookie

# 有kanbilibili这种神奇的网哪里用那么麻烦

# 在kanbilibili上选择好清晰度「quality」只有三个值:32(480p), 64(720p), 80(1080p)]

# 我用的是80,可以自己设置

url = 'https://www.kanbilibili.com/api/video/' + aid + '/download?cid=' + str(i['cid']) + '&quality=80&page=' + page

urls.append(url)

return urls

# 真正的视频下载链接

def down_urls(urls,headers):

down_urls = []

for i in urls:

down_web = requests.get(i,headers=headers)

tmp = json.loads(down_web.text)

# 一大堆字典里挑出有用的数据对我来说是最头疼的事,我是一点一点肉眼找的,不知道有没有好的办法

down_url = tmp['data']['durl'][0]['url']

down_urls.append(down_url)

return down_urls

def main():

while True:

url = input('请随便输入一集你要下载的视频的链接:')

if url == '':

print('您的输入为空,请重新输入!')

continue

else:

break

headers = {

'UserAgent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36',

'Cookie': "你自己的cookie"

}

aid = re.search(r'av(\d*)', url).group(1)

all_info = videos_info(headers, aid)

print('此专辑共有 %d 集视频。' % all_info[-1]['page'])

start = input('你要从哪一集开始下载?(默认:1)')

if start == '':

start = 1

else:

start = int(start)

end = input('你想下到哪一集结束?(默认:最后一集)')

if end == '':

end = 0

else:

end = int(end)

all_urls = videos_url(start, end, all_info, aid)

urls = down_urls(all_urls, headers)

try:

os.mkdir('/Volumes/MAC专用/前端/' + str(aid))

except FileExistsError:

pass

# 记录所有视频的名字和cid到aid.txt中,方便为下载的所有视频重命名

with open(str(aid) + '.txt', 'w') as f:

for i in all_info:

f.write('%d %s,%d\n' % (all_info.index(i) + 1, i['part'], i['cid']))

# 将所有链接存放进cid_down.txt中,方便后续下载

with open(str(aid) + '_down.txt', 'w') as f:

for i in urls:

f.write(i + '\n')

print('已获取全部的下载链接,请查看当前目录下的 %s_down.txt 获取。' % str(aid))

if __name__ == '__main__':

main()

批量重命名代码:

[Python] 纯文本视图复制代码

#!/usr/local/Cellar/python/3.7.4/bin/python3

# -*- coding: utf-8 -*-

import os

import requests

import json

all_files = os.listdir()

first_dir = os.getcwd()

files = []

for i in all_files:

prefix = i.split('.')[0]

if prefix.isdigit():

files.append(i)

for i in files:

os.chdir(first_dir)

file_name_web = requests.get('https://api.bilibili.com/x/web-interface/view?aid=' + i[:8])

file_name_data = json.loads(file_name_web.text)

file_name = file_name_data['data']['title']

name_file = open(i)

names = {}

for j in name_file:

info = j.split(',')

key = info[-1].split()[0]

name = info[0] + '.flv'

names[key] = name

files_dir = '/Volumes/MAC专用/前端/' + i[:8]

os.chdir(files_dir)

all_files = os.listdir(os.getcwd())

for k in all_files:

if '-1-80' in k or '-1-64' in k:

#有的文件名需要用 '-' 切割,如果按通用条件没能完成全部重命名的话,可以试试

if '_' in k:

cid = k.split('_')[0]

else:

cid = k.split('-')[0]

for l in names:

if cid == l:

os.rename(k, names[l])

os.rename(files_dir, files_dir[:-8] + file_name) 查看全部

网页视频抓取脚本(传说中的番号以链接为例,共536个视频

)

首先,您必须找到视频的唯一 ID。

刚玩过B站,了解不多。不知道这个辅助是不是传说中的数字

以链接为例,共有536个视频。

在红色框中,您可以看到每个视频都有一个唯一的 ID-cid。

下一步很简单,正则表达式(bs4也可以),挑出所有的视频信息。* 不知道这种情况下是正则表达式好还是bs4好,请指教!

在kanbilibili上找到下载链接

-------------------------------------------------- -------------------------------------------------- -------------------------------------------------- ---------------

想直接通过python下载视频,实时显示下载进度和网速,但是能力有限,不知道怎么打码。

请问各位大佬,这个应该怎么实现?

-------------------------------------------------- -------------------------------------------------- -------------------------------------------------- ---------------

以下是下载和重命名的代码。运行下载脚本后,会在脚本所在目录生成一个保存你选择的剧集范围下载链接的txt和一个保存所有视频文件名的txt。

需要注意的是:

1、 解释器的路径(第一行#!/usr....)需要改成你电脑上python的路径

2、 下载脚本的第 92 行将在您指定的路径下创建一个名为 aid 的目录。请务必将其更改为要保存的路径。

3、 重命名脚本的第 27 行并将其更改为与第 2 项中相同的路径。

下载代码:

[Python] 纯文本视图复制代码

#!/usr/local/Cellar/python/3.7.4/bin/python3

# -*- coding: utf-8 -*-

import requests

import json

import re

import os

# 获取所有的视频信息

def videos_info(headers, aid):

# av后面的数字就是 aid

b_url = 'https://api.bilibili.com/x/web-interface/view?aid=' + aid

web_data = requests.get(b_url,headers=headers)

all_info = json.loads(web_data.text)

return all_info['data']['pages']

# 从kanbilibili中找到包含每一个视频的下载链接的链接

def videos_url(start, end, all_info, aid):

if end == 0:

end = len(all_info)

while True:

choice = input('你是否要下载 %d 集到 %d 集的视频?(Y/n)' % (start, end))

if choice == 'Y' or choice == 'y':

break

elif choice == 'N' or choice == 'n':

pass

else:

print('你的选择有误,选择指令["Y"]为是,["n"]为否,请重新选择!')

continue

start = input('请重新输入你要从哪一集开始下载:(默认:1)')

if start == '':

start = 1

else:

start = int(start)

end = input('请重新输入到哪一集结束(默认:最后一集):')

if end == '':

end = len(all_info)

else:

end = int(end)

urls = []

print('正在获取所选视频的下载链接,请稍候...')

# start-1是要下载的第一个视频的索引(下标),end本身到不了,不需要-1

for i in all_info[start-1:end]:

page = str(all_info.index(i) + start)

# 到这步的时候我才发现之前的videos_info可以完全不通过B站搞定,B站爬数据还得用cookie

# 有kanbilibili这种神奇的网哪里用那么麻烦

# 在kanbilibili上选择好清晰度「quality」只有三个值:32(480p), 64(720p), 80(1080p)]

# 我用的是80,可以自己设置

url = 'https://www.kanbilibili.com/api/video/' + aid + '/download?cid=' + str(i['cid']) + '&quality=80&page=' + page

urls.append(url)

return urls

# 真正的视频下载链接

def down_urls(urls,headers):

down_urls = []

for i in urls:

down_web = requests.get(i,headers=headers)

tmp = json.loads(down_web.text)

# 一大堆字典里挑出有用的数据对我来说是最头疼的事,我是一点一点肉眼找的,不知道有没有好的办法

down_url = tmp['data']['durl'][0]['url']

down_urls.append(down_url)

return down_urls

def main():

while True:

url = input('请随便输入一集你要下载的视频的链接:')

if url == '':

print('您的输入为空,请重新输入!')

continue

else:

break

headers = {

'UserAgent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36',

'Cookie': "你自己的cookie"

}

aid = re.search(r'av(\d*)', url).group(1)

all_info = videos_info(headers, aid)

print('此专辑共有 %d 集视频。' % all_info[-1]['page'])

start = input('你要从哪一集开始下载?(默认:1)')

if start == '':

start = 1

else:

start = int(start)

end = input('你想下到哪一集结束?(默认:最后一集)')

if end == '':

end = 0

else:

end = int(end)

all_urls = videos_url(start, end, all_info, aid)

urls = down_urls(all_urls, headers)

try:

os.mkdir('/Volumes/MAC专用/前端/' + str(aid))

except FileExistsError:

pass

# 记录所有视频的名字和cid到aid.txt中,方便为下载的所有视频重命名

with open(str(aid) + '.txt', 'w') as f:

for i in all_info:

f.write('%d %s,%d\n' % (all_info.index(i) + 1, i['part'], i['cid']))

# 将所有链接存放进cid_down.txt中,方便后续下载

with open(str(aid) + '_down.txt', 'w') as f:

for i in urls:

f.write(i + '\n')

print('已获取全部的下载链接,请查看当前目录下的 %s_down.txt 获取。' % str(aid))

if __name__ == '__main__':

main()

批量重命名代码:

[Python] 纯文本视图复制代码

#!/usr/local/Cellar/python/3.7.4/bin/python3

# -*- coding: utf-8 -*-

import os

import requests

import json

all_files = os.listdir()

first_dir = os.getcwd()

files = []

for i in all_files:

prefix = i.split('.')[0]

if prefix.isdigit():

files.append(i)

for i in files:

os.chdir(first_dir)

file_name_web = requests.get('https://api.bilibili.com/x/web-interface/view?aid=' + i[:8])

file_name_data = json.loads(file_name_web.text)

file_name = file_name_data['data']['title']

name_file = open(i)

names = {}

for j in name_file:

info = j.split(',')

key = info[-1].split()[0]

name = info[0] + '.flv'

names[key] = name

files_dir = '/Volumes/MAC专用/前端/' + i[:8]

os.chdir(files_dir)

all_files = os.listdir(os.getcwd())

for k in all_files:

if '-1-80' in k or '-1-64' in k:

#有的文件名需要用 '-' 切割,如果按通用条件没能完成全部重命名的话,可以试试

if '_' in k:

cid = k.split('_')[0]

else:

cid = k.split('-')[0]

for l in names:

if cid == l:

os.rename(k, names[l])

os.rename(files_dir, files_dir[:-8] + file_name)

网页视频抓取脚本( 脚本之家代码简单易懂网站视频内容介绍(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-29 07:17

脚本之家代码简单易懂网站视频内容介绍(图))

Python爬虫爬取一个网站视频的示例代码

更新时间:2021年2月20日09:58:23 作者:badbadboy

本文主要介绍python爬虫爬取某网站视频的示例代码。代码简单易懂。对大家的学习或工作有一定的参考价值。有需要的朋友可以参考。

将获取到的下载视频的url存放在一个数组中(也可以写成文件),调用迅雷接口自动下载。(请先下载迅雷,在迅雷设置中心下载管理中设置为一键下载)

实现代码如下:

<p>

from bs4 import BeautifulSoup

import requests

import os,re,time

import urllib3

from win32com.client import Dispatch

class DownloadVideo:

def __init__(self):

self.r = requests.session()

self.url=self.get_url()

self.download_urla=[]

self.download_urlb=[]

self.url_set=["%s/shipin/list-短视频.html"%self.url]

#获取最新网址

def get_url(self):

urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)

a=self.r.get('https://www.k58.com',verify=False)

b=a.url

return b

#几页内容的网址

def url_set1(self,n):

if n==2:

url="%s/shipin/list-短视频-2.html"%self.url

self.url_set.append(url)

elif n>=3:

m=n+1

for i in range(2,m):

url="%s/shipin/list-短视频-%d.html"%(self.url,i)

self.url_set.append(url)

else:

pass

#分别加载每一个页内容的网址

def download_url1(self):

for j in self.url_set:

urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)

r=self.r.get(j,verify=False)

sp1=r.content

soup = BeautifulSoup(sp1, "html.parser")

sp2 = soup.find_all(class_="shown")

for i in sp2:

url1=re.findall(' 查看全部

网页视频抓取脚本(

脚本之家代码简单易懂网站视频内容介绍(图))

Python爬虫爬取一个网站视频的示例代码

更新时间:2021年2月20日09:58:23 作者:badbadboy

本文主要介绍python爬虫爬取某网站视频的示例代码。代码简单易懂。对大家的学习或工作有一定的参考价值。有需要的朋友可以参考。

将获取到的下载视频的url存放在一个数组中(也可以写成文件),调用迅雷接口自动下载。(请先下载迅雷,在迅雷设置中心下载管理中设置为一键下载)

实现代码如下:

<p>

from bs4 import BeautifulSoup

import requests

import os,re,time

import urllib3

from win32com.client import Dispatch

class DownloadVideo:

def __init__(self):

self.r = requests.session()

self.url=self.get_url()

self.download_urla=[]

self.download_urlb=[]

self.url_set=["%s/shipin/list-短视频.html"%self.url]

#获取最新网址

def get_url(self):

urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)

a=self.r.get('https://www.k58.com',verify=False)

b=a.url

return b

#几页内容的网址

def url_set1(self,n):

if n==2:

url="%s/shipin/list-短视频-2.html"%self.url

self.url_set.append(url)

elif n>=3:

m=n+1

for i in range(2,m):

url="%s/shipin/list-短视频-%d.html"%(self.url,i)

self.url_set.append(url)

else:

pass

#分别加载每一个页内容的网址

def download_url1(self):

for j in self.url_set:

urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)

r=self.r.get(j,verify=False)

sp1=r.content

soup = BeautifulSoup(sp1, "html.parser")

sp2 = soup.find_all(class_="shown")

for i in sp2:

url1=re.findall('

网页视频抓取脚本(技术层面来认识HTML5的视频包括video标签的使用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 39 次浏览 • 2021-12-28 05:16

现在如果要在页面中使用video标签,需要考虑三种情况,支持Ogg Theora或者VP8(如果这东西没毛病)(Opera、Mozilla、Chrome)、支持H.264(Safari、 IE9、Chrome),都没有(IE6、7、8)。好吧,现在我们从技术层面来理解HTML 5视频,包括视频标签的使用,视频对象可以使用的媒体属性和方法,以及媒体事件。

Video 标签的使用

Video 标签收录

多个属性,例如 src、海报、预加载、自动播放、循环、控件、宽度、高度和内部使用的标签。Video标签中除了可以收录

的标签外,还可以收录

指定视频无法播放时返回的内容。

(1) src 属性和海报属性

您可以想象 src 属性的用途。和

和标签一样,这个属性用于指定视频的地址。海报属性用于指定一张图片,当当前视频数据无效时显示(预览图片)。无效的视频数据可能是正在加载视频,可能是视频地址错误等。

(2) 预加载属性

这个属性也可以用来理解名称的用途,这个属性用来定义视频是否预加载。该属性具有三个可选值:none、metadata、auto。如果未使用此属性,则默认为 auto。

无:不执行预加载。使用这个属性值可能是页面创建者认为用户不期望这个视频,或者可能会减少HTTP请求。

元数据:部分预加载。使用这个属性值意味着页面创建者认为用户并不期待这个视频,而是为用户提供了一些元数据(包括大小、第一帧、曲目列表、时长等)。

自动:全部预加载。

(3) 自动播放属性

这是另一个属性,通过查看其名称就知道其有用性。Autoplay 属性用于设置视频是否自动播放。它是一个布尔属性。出现时表示会自动播放,如果去掉则表示不会自动播放。

注意HTML中布尔属性的值不是真假。正确的用法是在标签中使用这个属性来表示true。这时候,属性要么没有值,要么它的值总是等于他的名字(这里,自动播放是或);并且不要在标签中使用这个属性来表示false(这里不要自动播放为)。

(4) 循环属性

一目了然,loop属性用于指定视频是否循环播放,也是布尔属性。

(5) 控制属性

Controls 属性用于向浏览器表明页面创建者没有使用脚本生成播放控制器,浏览器需要启用自己的播放控制栏。

控制栏必须包括播放暂停控制、播放进度控制、音量控制等。

各个浏览器的默认播放控制栏在界面上是不同的。由于我浏览器的奇怪问题,Firefox和Safari的Video标签不正常,所以这两个只能在网上找截图。

(6) 宽度属性和高度属性

是标签的共同属性,不言而喻。

(7) 源标签

Source标签用于为媒体指定多个可选择的文件地址(因为audio标签也可以收录

这个标签,所以这里用的是媒体而不是视频),文件地址只能在media标签中选择使用使用 src 属性时。

浏览器检查标签指定的视频是否可以按照源标签的顺序播放(可能是视频格式不支持,视频不存在等),如果不能播放就换下一个. 这种方法主要是为了兼容不同的浏览器。Source 标签本身不代表任何意义,不能单独出现。

该标签收录

三个属性:src、type 和 media。

src 属性:用于指定媒体地址,同video标签。

type属性:用于描述src属性指定的媒体类型,帮助浏览器在获取媒体前判断是否支持该类型的媒体格式。

媒体属性:用于描述媒体使用的媒体。如果不设置,默认为all,即支持所有媒体。有没有想到标签的媒体属性?一样的,一样的。

(8) 一个完整的例子

此代码定义页面上的视频。这个视频的预览图就是海报的属性值。它显示浏览器的默认媒体控制栏,预加载视频的元数据,并循环播放。宽度为 900 像素,高度为 240 像素。.

视频地址的第一选择是第一个源标签的src属性值,视频类别是Ogg视频,视频编解码器是Theora,音频编解码器是Vorbis,播放介质是显示器;视频地址的第二选择不再累赘。如果要兼容IE,可以在最后一个source标签后添加Flash播放器的标签集,或者使用一点JavaScript代码。

总结

以上就是小编介绍的HTML网页插入视频方法的总结。我希望它会对你有所帮助。如果您有任何问题,请给我留言。小编会及时回复您。非常感谢您对 Scripthome 网站的支持! 查看全部

网页视频抓取脚本(技术层面来认识HTML5的视频包括video标签的使用)

现在如果要在页面中使用video标签,需要考虑三种情况,支持Ogg Theora或者VP8(如果这东西没毛病)(Opera、Mozilla、Chrome)、支持H.264(Safari、 IE9、Chrome),都没有(IE6、7、8)。好吧,现在我们从技术层面来理解HTML 5视频,包括视频标签的使用,视频对象可以使用的媒体属性和方法,以及媒体事件。

Video 标签的使用

Video 标签收录

多个属性,例如 src、海报、预加载、自动播放、循环、控件、宽度、高度和内部使用的标签。Video标签中除了可以收录

的标签外,还可以收录

指定视频无法播放时返回的内容。

(1) src 属性和海报属性

您可以想象 src 属性的用途。和

和标签一样,这个属性用于指定视频的地址。海报属性用于指定一张图片,当当前视频数据无效时显示(预览图片)。无效的视频数据可能是正在加载视频,可能是视频地址错误等。

(2) 预加载属性

这个属性也可以用来理解名称的用途,这个属性用来定义视频是否预加载。该属性具有三个可选值:none、metadata、auto。如果未使用此属性,则默认为 auto。

无:不执行预加载。使用这个属性值可能是页面创建者认为用户不期望这个视频,或者可能会减少HTTP请求。

元数据:部分预加载。使用这个属性值意味着页面创建者认为用户并不期待这个视频,而是为用户提供了一些元数据(包括大小、第一帧、曲目列表、时长等)。

自动:全部预加载。

(3) 自动播放属性

这是另一个属性,通过查看其名称就知道其有用性。Autoplay 属性用于设置视频是否自动播放。它是一个布尔属性。出现时表示会自动播放,如果去掉则表示不会自动播放。

注意HTML中布尔属性的值不是真假。正确的用法是在标签中使用这个属性来表示true。这时候,属性要么没有值,要么它的值总是等于他的名字(这里,自动播放是或);并且不要在标签中使用这个属性来表示false(这里不要自动播放为)。

(4) 循环属性

一目了然,loop属性用于指定视频是否循环播放,也是布尔属性。

(5) 控制属性

Controls 属性用于向浏览器表明页面创建者没有使用脚本生成播放控制器,浏览器需要启用自己的播放控制栏。

控制栏必须包括播放暂停控制、播放进度控制、音量控制等。

各个浏览器的默认播放控制栏在界面上是不同的。由于我浏览器的奇怪问题,Firefox和Safari的Video标签不正常,所以这两个只能在网上找截图。

(6) 宽度属性和高度属性

是标签的共同属性,不言而喻。

(7) 源标签

Source标签用于为媒体指定多个可选择的文件地址(因为audio标签也可以收录

这个标签,所以这里用的是媒体而不是视频),文件地址只能在media标签中选择使用使用 src 属性时。

浏览器检查标签指定的视频是否可以按照源标签的顺序播放(可能是视频格式不支持,视频不存在等),如果不能播放就换下一个. 这种方法主要是为了兼容不同的浏览器。Source 标签本身不代表任何意义,不能单独出现。

该标签收录

三个属性:src、type 和 media。

src 属性:用于指定媒体地址,同video标签。

type属性:用于描述src属性指定的媒体类型,帮助浏览器在获取媒体前判断是否支持该类型的媒体格式。

媒体属性:用于描述媒体使用的媒体。如果不设置,默认为all,即支持所有媒体。有没有想到标签的媒体属性?一样的,一样的。

(8) 一个完整的例子

此代码定义页面上的视频。这个视频的预览图就是海报的属性值。它显示浏览器的默认媒体控制栏,预加载视频的元数据,并循环播放。宽度为 900 像素,高度为 240 像素。.

视频地址的第一选择是第一个源标签的src属性值,视频类别是Ogg视频,视频编解码器是Theora,音频编解码器是Vorbis,播放介质是显示器;视频地址的第二选择不再累赘。如果要兼容IE,可以在最后一个source标签后添加Flash播放器的标签集,或者使用一点JavaScript代码。

总结

以上就是小编介绍的HTML网页插入视频方法的总结。我希望它会对你有所帮助。如果您有任何问题,请给我留言。小编会及时回复您。非常感谢您对 Scripthome 网站的支持!

网页视频抓取脚本( 如何在电脑前一边编程一边轻松地看抖音?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-12-27 00:23

如何在电脑前一边编程一边轻松地看抖音?)

基于Python的抖音视频全自动下载

更新时间:2020-11-06 11:34:48 作者:舒子华

本文主要介绍基于Python的抖音视频全自动下载的实现。通过示例代码,文章中的介绍非常详细。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考

很多人都喜欢玩抖音,我也喜欢看抖音小姐姐,但是拿着手机一个一个的找视频太难了。作为程序员,如何在电脑前边编程边轻松观看抖音小姐姐?

使用Python,简单三步就可以自动下载喜欢的抖音姐妹们的视频。

查尔斯

Charles是一款App抓包工具,功能与Fildler类似。可用于获取App运行过程中发生的所有网络请求和响应。

在电脑上下载安装Charles后,需要配置证书,最后启用SSL监控。

手机端需要和电脑在同一个网络,比如都连接到家里的Wi-Fi,然后在手机的Wi-Fi高级选项中使用Charles代理,输入手机的IP地址计算机,端口 8888,最后命名证书。

连接完成后,手机打开抖音App,通过操作App的动作,即可获取视频的请求信息。

通过多次实验发现,链接的背面是不断变化的,只有链接的正面总是相同的,即“”“”“”没有变化。

所以在编写脚本时,可以将此信息作为链接的开头。

中间件代理

使用 MitmProxy 中的 mitmdump 组件连接 Python 脚本,用 Python 实现后期监控处理。

这里我只是使用脚本获取链接,并没有直接使用脚本下载视频。

因为我在mitmdump.exe文件所在的文件夹中运行脚本,所以无法将requests模块导入到脚本中。

我不想配置环境变量,所以我只得到了链接。

使用链接下载视频。视频链接需要去重,因为可能会有重复。

Python脚本如下:

def response(flow):

urls = ['http://v1-dy', 'http://v3-dy', 'http://v6-dy', 'http://v9-dy']

# 对url进行筛选,只选取视频的url

for url in urls:

if url in flow.request.url:

print('\n\n抖音视频\n\n')

with open('douyin.csv', 'a+', encoding='utf-8-sig') as f:

f.write(flow.request.url + '\n')

配置抖音Appium参数:

点击蓝色按钮,手机将自动启动抖音应用程序。然后操作手机,然后点击Appium的刷新按钮,获取元素位置码。

通过这种实践,发现Appium有时无法很好的获取元素的定位。对于找不到的元素,我直接点击手机屏幕的位置。

由于每个人的手机屏幕大小不一样,这个参数肯定会发生变化,所以有弊端,不能通用。

左右滑动切换图片

一般操作如上图所示。UP主页面图片缺失,请自行补上。Python代码如下:

import time

import random

from appium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from appium.webdriver.common.touch_action import TouchAction

from selenium.webdriver.support import expected_conditions as EC

def main():

# 设置驱动配置

server = 'http://localhost:4723/wd/hub'

desired_caps = {

'platformName': 'Android',

'deviceName': 'STF_AL00',

'appPackage': 'com.ss.android.ugc.aweme',

'appActivity': '.main.MainActivity',

# 关闭手机软键盘

'unicodeKeyboard': True,

'resetKeyboard': True

}

driver = webdriver.Remote(server, desired_caps)

wait = WebDriverWait(driver, 60)

# 同意用户隐私协议,点击

button_1 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/q6')))

button_1.click()

# 禁止电话权限,点击

button_2 = wait.until(EC.presence_of_element_located((By.ID, 'com.android.packageinstaller:id/permission_deny_button')))

button_2.click()

# 禁止位置权限,点击

button_3 = wait.until(EC.presence_of_element_located((By.ID, 'com.android.packageinstaller:id/permission_deny_button')))

button_3.click()

time.sleep(2)

# 向上滑动,进入抖音视频播放页面

TouchAction(driver).press(x=515, y=1200).move_to(x=515, y=1000).release().perform()

# 这里需要设置一个较长时间的延迟,因为抖音有引导操作和提示,需等待片刻

time.sleep(20)

# 点击抖音"喜欢"处,以此进入登录界面

TouchAction(driver).press(x=950, y=800).release().perform()

# 点击密码登录

button_4 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/afg')))

button_4.click()

# 输入账号

button_5 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/ab_')))

button_5.send_keys('你的账号')

# 输入密码

button_6 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/aes')))

button_6.send_keys('你的密码')

time.sleep(2)

# 因为会跳出软键盘,会遮挡登录按钮,需点击软键盘取消

TouchAction(driver).press(x=980, y=1850).release().perform()

time.sleep(2)

# 点击登录按钮

button_7 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/abb')))

button_7.click()

time.sleep(2)

# 登录成功,进入抖音视频界面,点击下方标题栏 "我"

TouchAction(driver).press(x=990, y=1850).release().perform()

# 进入个人主页,点击关注处

button_8 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/a_7')))

button_8.click()

# 进入关注栏,点击第二个关注

button_9 = wait.until(EC.presence_of_element_located((By.XPATH, ' /hierarchy/android.widget.FrameLayout/android.widget.LinearLayout/android.widget.FrameLayout/android.widget.RelativeLayout/android.widget.LinearLayout/android.widget.FrameLayout/android.view.ViewGroup/android.widget.LinearLayout/android.support.v7.widget.RecyclerView/android.widget.RelativeLayout[2]/android.widget.RelativeLayout[1]')))

button_9.click()

# 进入UP主主页,点击第一个视频

button_10 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/aqm')))

button_10.click()

# 不断下滑页面,直到底部

while True:

TouchAction(driver).press(x=515, y=1247).move_to(x=515, y=1026).release().perform()

time.sleep(float(random.randint(5, 10)))

if __name__ == '__main__':

main()

要下载视频代码,您需要对视频链接进行去重:

import pandas as pd

import requests

import os

num = 0

dom = []

folder_path = "F:/video/"

os.makedirs(folder_path)

df = pd.read_csv('douyin.csv', header=None, names=["url"])

# 对链接去重及去除刚进入抖音获取的视频链接

for i in df['url'][2:]:

if i not in dom:

dom.append(i)

# 下载视频

for j in dom:

url = j

num += 1

response = requests.get(url, stream=True)

filename = str(num) + '.mp4'

with open('F:\\video\\' + filename, 'ab+') as f:

f.write(response.content)

f.flush()

print(filename + '下载完成')

终于成功获取了小姐姐们的所有视频:

打算把视频里所有喜欢的妹子都剪辑起来,拍个《最美瞬间》系列的视频分享给大家!

源地址:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持脚本屋。 查看全部

网页视频抓取脚本(

如何在电脑前一边编程一边轻松地看抖音?)

基于Python的抖音视频全自动下载

更新时间:2020-11-06 11:34:48 作者:舒子华

本文主要介绍基于Python的抖音视频全自动下载的实现。通过示例代码,文章中的介绍非常详细。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考

很多人都喜欢玩抖音,我也喜欢看抖音小姐姐,但是拿着手机一个一个的找视频太难了。作为程序员,如何在电脑前边编程边轻松观看抖音小姐姐?

使用Python,简单三步就可以自动下载喜欢的抖音姐妹们的视频。

查尔斯

Charles是一款App抓包工具,功能与Fildler类似。可用于获取App运行过程中发生的所有网络请求和响应。

在电脑上下载安装Charles后,需要配置证书,最后启用SSL监控。

手机端需要和电脑在同一个网络,比如都连接到家里的Wi-Fi,然后在手机的Wi-Fi高级选项中使用Charles代理,输入手机的IP地址计算机,端口 8888,最后命名证书。

连接完成后,手机打开抖音App,通过操作App的动作,即可获取视频的请求信息。

通过多次实验发现,链接的背面是不断变化的,只有链接的正面总是相同的,即“”“”“”没有变化。

所以在编写脚本时,可以将此信息作为链接的开头。

中间件代理

使用 MitmProxy 中的 mitmdump 组件连接 Python 脚本,用 Python 实现后期监控处理。

这里我只是使用脚本获取链接,并没有直接使用脚本下载视频。

因为我在mitmdump.exe文件所在的文件夹中运行脚本,所以无法将requests模块导入到脚本中。

我不想配置环境变量,所以我只得到了链接。

使用链接下载视频。视频链接需要去重,因为可能会有重复。

Python脚本如下:

def response(flow):

urls = ['http://v1-dy', 'http://v3-dy', 'http://v6-dy', 'http://v9-dy']

# 对url进行筛选,只选取视频的url

for url in urls:

if url in flow.request.url:

print('\n\n抖音视频\n\n')

with open('douyin.csv', 'a+', encoding='utf-8-sig') as f:

f.write(flow.request.url + '\n')

配置抖音Appium参数:

点击蓝色按钮,手机将自动启动抖音应用程序。然后操作手机,然后点击Appium的刷新按钮,获取元素位置码。

通过这种实践,发现Appium有时无法很好的获取元素的定位。对于找不到的元素,我直接点击手机屏幕的位置。

由于每个人的手机屏幕大小不一样,这个参数肯定会发生变化,所以有弊端,不能通用。

左右滑动切换图片

一般操作如上图所示。UP主页面图片缺失,请自行补上。Python代码如下:

import time

import random

from appium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from appium.webdriver.common.touch_action import TouchAction

from selenium.webdriver.support import expected_conditions as EC

def main():

# 设置驱动配置

server = 'http://localhost:4723/wd/hub'

desired_caps = {

'platformName': 'Android',

'deviceName': 'STF_AL00',

'appPackage': 'com.ss.android.ugc.aweme',

'appActivity': '.main.MainActivity',

# 关闭手机软键盘

'unicodeKeyboard': True,

'resetKeyboard': True

}

driver = webdriver.Remote(server, desired_caps)

wait = WebDriverWait(driver, 60)

# 同意用户隐私协议,点击

button_1 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/q6')))

button_1.click()

# 禁止电话权限,点击

button_2 = wait.until(EC.presence_of_element_located((By.ID, 'com.android.packageinstaller:id/permission_deny_button')))

button_2.click()

# 禁止位置权限,点击

button_3 = wait.until(EC.presence_of_element_located((By.ID, 'com.android.packageinstaller:id/permission_deny_button')))

button_3.click()

time.sleep(2)

# 向上滑动,进入抖音视频播放页面

TouchAction(driver).press(x=515, y=1200).move_to(x=515, y=1000).release().perform()

# 这里需要设置一个较长时间的延迟,因为抖音有引导操作和提示,需等待片刻

time.sleep(20)

# 点击抖音"喜欢"处,以此进入登录界面

TouchAction(driver).press(x=950, y=800).release().perform()

# 点击密码登录

button_4 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/afg')))

button_4.click()

# 输入账号

button_5 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/ab_')))

button_5.send_keys('你的账号')

# 输入密码

button_6 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/aes')))

button_6.send_keys('你的密码')

time.sleep(2)

# 因为会跳出软键盘,会遮挡登录按钮,需点击软键盘取消

TouchAction(driver).press(x=980, y=1850).release().perform()

time.sleep(2)

# 点击登录按钮

button_7 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/abb')))

button_7.click()

time.sleep(2)

# 登录成功,进入抖音视频界面,点击下方标题栏 "我"

TouchAction(driver).press(x=990, y=1850).release().perform()

# 进入个人主页,点击关注处

button_8 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/a_7')))

button_8.click()

# 进入关注栏,点击第二个关注

button_9 = wait.until(EC.presence_of_element_located((By.XPATH, ' /hierarchy/android.widget.FrameLayout/android.widget.LinearLayout/android.widget.FrameLayout/android.widget.RelativeLayout/android.widget.LinearLayout/android.widget.FrameLayout/android.view.ViewGroup/android.widget.LinearLayout/android.support.v7.widget.RecyclerView/android.widget.RelativeLayout[2]/android.widget.RelativeLayout[1]')))

button_9.click()

# 进入UP主主页,点击第一个视频

button_10 = wait.until(EC.presence_of_element_located((By.ID, 'com.ss.android.ugc.aweme:id/aqm')))

button_10.click()

# 不断下滑页面,直到底部

while True:

TouchAction(driver).press(x=515, y=1247).move_to(x=515, y=1026).release().perform()

time.sleep(float(random.randint(5, 10)))

if __name__ == '__main__':

main()

要下载视频代码,您需要对视频链接进行去重:

import pandas as pd

import requests

import os

num = 0

dom = []

folder_path = "F:/video/"

os.makedirs(folder_path)

df = pd.read_csv('douyin.csv', header=None, names=["url"])

# 对链接去重及去除刚进入抖音获取的视频链接

for i in df['url'][2:]:

if i not in dom:

dom.append(i)

# 下载视频

for j in dom:

url = j

num += 1

response = requests.get(url, stream=True)

filename = str(num) + '.mp4'

with open('F:\\video\\' + filename, 'ab+') as f:

f.write(response.content)

f.flush()

print(filename + '下载完成')

终于成功获取了小姐姐们的所有视频:

打算把视频里所有喜欢的妹子都剪辑起来,拍个《最美瞬间》系列的视频分享给大家!

源地址:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持脚本屋。

网页视频抓取脚本(这是Note3(模拟目标wifi的主人)-目标WIFISSID)

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2021-12-25 21:09

Fluxion是一款无线安全测试工具,其攻击原理更偏向于社会工程中的网络钓鱼。我最喜欢fluxion的原因是它有个性化的脚本,可以快速检查安装你需要的插件,可以在短时间内搭建一个完整的环境。并且在新版本中增加了对中文的支持,这是很多国外安全工具所没有的。

工作原理(一般步骤)

1.扫描可以接收到的WIFI信号

2. 抓取握手包(这一步的目的是验证WiFi密码是否正确)

3.使用WEB界面

4.启动一个假AP实例来模拟原来的接入点

5. 然后会生成一个MDK3进程。如果普通用户已经连接到这个WiFi,他们也会输入WiFi密码

6. 然后启动一个模拟的DNS服务器并抓取所有DNS请求,并将这些请求重定向到一个收录

恶意脚本的HOST地址

7. 然后会弹出一个窗口提示用户输入正确的WiFi密码

8.用户输入的密码会与第二步抓到的握手包进行比对,验证密码是否正确

还有硬件设备:

本程序自动运行,可快速抓取WiFi密码环境设置-目标WIFI SSID:WIFITEST(360安全路由器p1)-目标设备:红米Note 3(模拟目标wifi的主机)-操作机:kali版安装,我们直接把github上的所有文件克隆到本机,当然你也可以自己下载解压。

xxx 解压出来

下载完成

所有文件和文件路径

启动

./通量

开机后会自动检测机器是否安装了它所依赖的其他软件。如果有任何项目不存在,软件将自动退出并提示缺少工具。

在fluxion目录下有一个脚本文件'Installer.sh',运行后会自动更新或安装缺少的工具。

./安装程序.sh

此过程可能需要较长时间,更新安装完成如图

再次启动,出现用户协议

征才开始进入我们今天的征才,经过用户协议和软件的核对和更新。下面我将介绍每一步的作用。选择语言,此工具更新后增加了对中文的支持。虽然有些菜单没有完全翻译,但还是很认真的。这次我们用中文选择'6'

选择频道,我们选择所有频道'1'

Fluxion 调用 aircrack 扫描附近的 WIFI

找到目标WIFI后按'Ctrl+c',fluxion会列出扫描结果并按id选择

选择目标后,会出现基本的WIFI信息和攻击选项。选择“1个伪装AP”

输入握手包的存放路径回车使用默认路径

选择抓握手包的工具,我们选择第一个aircrack-ag套件

选择攻击方式,我们选择“1”对所有目标发起去认证攻击(详细介绍:中国黑客协会,无线攻击利器——花无涯带你走进黑客世界系列技术文章)

出现两个窗口,一个是deauthentication攻击,此时连接到目标路由器的客户端会被强制de-authentication并断开连接;另一种是aircrack等待抓取握手包,客户端掉线后重新连接时会抓取。握手包。当aircrack窗口中出现WPA握手时,证明握手包已经被捕获,然后我们选择'1检查握手包'

选择获取密码的方式。第一次web注入也是我们今天只需要介绍的第二次运行包(蛮力破解)。上一篇已经说过,这里我们选择泽'1'

选择网页语言,包括大部分路由器品牌页面,当然我们也可以根据需要修改/fluxion/Sites/中的页面。本次演示,我们选择了7个中文常用页面

这时候fluxion会调用多种工具攻击原路由器,强制客户端连接到我们伪造的ap,同时欺骗dns将客户端流量转移到我们的钓鱼页面。

手机会断开原来的wifi连接到我们伪造的ap上,弹出认证页面。因为dns被转发,认证页面会立即关闭,任何页面都会转到终端。基本上,控制成功。每个人都有兴趣。你可以试试看。wifi系列文章可以阅读微博,花无涯带你走进黑客世界系列技术文章。黑客攻防经典书籍网上有售。 查看全部

网页视频抓取脚本(这是Note3(模拟目标wifi的主人)-目标WIFISSID)

Fluxion是一款无线安全测试工具,其攻击原理更偏向于社会工程中的网络钓鱼。我最喜欢fluxion的原因是它有个性化的脚本,可以快速检查安装你需要的插件,可以在短时间内搭建一个完整的环境。并且在新版本中增加了对中文的支持,这是很多国外安全工具所没有的。

工作原理(一般步骤)

1.扫描可以接收到的WIFI信号

2. 抓取握手包(这一步的目的是验证WiFi密码是否正确)

3.使用WEB界面

4.启动一个假AP实例来模拟原来的接入点

5. 然后会生成一个MDK3进程。如果普通用户已经连接到这个WiFi,他们也会输入WiFi密码

6. 然后启动一个模拟的DNS服务器并抓取所有DNS请求,并将这些请求重定向到一个收录

恶意脚本的HOST地址

7. 然后会弹出一个窗口提示用户输入正确的WiFi密码

8.用户输入的密码会与第二步抓到的握手包进行比对,验证密码是否正确

还有硬件设备:

本程序自动运行,可快速抓取WiFi密码环境设置-目标WIFI SSID:WIFITEST(360安全路由器p1)-目标设备:红米Note 3(模拟目标wifi的主机)-操作机:kali版安装,我们直接把github上的所有文件克隆到本机,当然你也可以自己下载解压。

xxx 解压出来

下载完成

所有文件和文件路径

启动

./通量

开机后会自动检测机器是否安装了它所依赖的其他软件。如果有任何项目不存在,软件将自动退出并提示缺少工具。

在fluxion目录下有一个脚本文件'Installer.sh',运行后会自动更新或安装缺少的工具。

./安装程序.sh

此过程可能需要较长时间,更新安装完成如图

再次启动,出现用户协议

征才开始进入我们今天的征才,经过用户协议和软件的核对和更新。下面我将介绍每一步的作用。选择语言,此工具更新后增加了对中文的支持。虽然有些菜单没有完全翻译,但还是很认真的。这次我们用中文选择'6'

选择频道,我们选择所有频道'1'

Fluxion 调用 aircrack 扫描附近的 WIFI

找到目标WIFI后按'Ctrl+c',fluxion会列出扫描结果并按id选择

选择目标后,会出现基本的WIFI信息和攻击选项。选择“1个伪装AP”

输入握手包的存放路径回车使用默认路径

选择抓握手包的工具,我们选择第一个aircrack-ag套件

选择攻击方式,我们选择“1”对所有目标发起去认证攻击(详细介绍:中国黑客协会,无线攻击利器——花无涯带你走进黑客世界系列技术文章)

出现两个窗口,一个是deauthentication攻击,此时连接到目标路由器的客户端会被强制de-authentication并断开连接;另一种是aircrack等待抓取握手包,客户端掉线后重新连接时会抓取。握手包。当aircrack窗口中出现WPA握手时,证明握手包已经被捕获,然后我们选择'1检查握手包'

选择获取密码的方式。第一次web注入也是我们今天只需要介绍的第二次运行包(蛮力破解)。上一篇已经说过,这里我们选择泽'1'

选择网页语言,包括大部分路由器品牌页面,当然我们也可以根据需要修改/fluxion/Sites/中的页面。本次演示,我们选择了7个中文常用页面

这时候fluxion会调用多种工具攻击原路由器,强制客户端连接到我们伪造的ap,同时欺骗dns将客户端流量转移到我们的钓鱼页面。

手机会断开原来的wifi连接到我们伪造的ap上,弹出认证页面。因为dns被转发,认证页面会立即关闭,任何页面都会转到终端。基本上,控制成功。每个人都有兴趣。你可以试试看。wifi系列文章可以阅读微博,花无涯带你走进黑客世界系列技术文章。黑客攻防经典书籍网上有售。

网页视频抓取脚本(暂存空间:打通阅读列表和第三方服务(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2021-12-25 21:06

)

内容

使用阅读列表作为临时存储空间,连接阅读列表和第三方服务

Safari 阅读列表是 macOS 和 iOS 上相对容易被忽视的功能。该功能于2011年首次出现在OS X Lion和iOS 5系统中,但除了次年增加了离线缓存外,八年来基本保持不变。与Pocket、Instapaper等全职阅读后期服务相比,非常简陋。

我自己之前很少使用阅读列表功能,而是使用Pinboard结合Instapaper来解决以后阅读的需求。虽然这种组合对我来说总体上是令人满意的,但它并不完美。最明显的缺点在于添加链接的繁琐。尤其是那些没有分享按钮的界面,每次添加链接,都要经过长按链接——选择“分享”——点击应用图标三个步骤。当需要连续保存很多链接时(例如阅读新闻通讯或显示播客笔记),重复这组繁琐的步骤几乎是一种折磨。此外,Instapaper 的同步也受到 iOS 后台进程的限制。

相比之下,Safari阅读列表作为系统的内置功能,拥有第三方应用难以触及的权限。“添加到阅读列表”的选项几乎无处不在,而且始终位于一级菜单的显眼位置。新链接在任何时候都不需要两次以上的点击。不仅如此,作为系统服务,阅读列表可以一直在后台运行,而且几乎可以通过iCloud在设备间即时同步。

在发现这些优势后,我最近几个月尝试更多地使用 Safari 阅读列表。为了扬长避短,我主要在两种场景中使用这个功能:一种是将阅读列表作为临时存储空间来处理一些不需要长时间存储的页面;另一种是将阅读列表作为“第三方工具的前端”,利用保存链接的便利性,然后通过脚本自动将其内容同步到其他阅读后期服务。

使用阅读清单作为临时存储空间

虽然阅读列表很差,但它的简单性也使它成为临时网页的理想位置。对于那些偶尔遇到的页面,浏览的时候想暂时保存一下,小心点书签标记有点浪费时间;很多网页不属于文章的范畴,所以阅读后期工具不是合适的目的地。在这些时候,阅读清单就成了一个理想的选择。

阅读清单的使用非常简单。没有什么特别之处。不熟悉的用户可以阅读苹果官方的支持文章(iOS版、Mac版),以获得更全面的了解。不过,阅读列表功能也有一些比较隐蔽的技巧。记住它后,可以进一步提高使用它作为链接临时存储工具的效率。

添加阶段:

在 iPad 上使用拖放手势批量添加阅读列表链接

管理和阅读阶段:

连接阅读列表和第三方服务

如前所述,阅读清单的主要优势在于与系统的紧密结合,但管理和阅读功能明显不如第三方服务。因此,一个自然的想法是将两者结合起来,将阅读列表作为一个纯粹的链接采集

工具,利用其添加链接时的便利性,而管理和阅读仍然在更专业的应用中进行。

不过,阅读清单反映了苹果软件的一贯封闭性,并没有提供任何导出功能。好在阅读列表的实现机制并不复杂,可以通过简单的脚本获取其内容并导出到其他工具。

阅读清单的工作原理

在介绍具体方法之前,先为阅读清单的工作原理做个铺垫。在实现级别,Safari 阅读列表被存储并与 Safari 书签同步。实际上,阅读列表只是采集

夹中的一个特殊文件夹。

在 macOS 上,阅读列表的路径位于 ~/Library/Safari/Bookmarks.plist。原创

状态下,plist文件以二进制格式存储;我们可以通过在终端应用程序中运行以下命令来观察其内部结构来转换可读的 XML 格式副本:

cd ~/Library/Safari/Bookmarks.plist && plutil -convert xml1 -o Bookmarks.xml Bookmarks.plist

转换为 XML 后的阅读列表文件结构

如您所见,对于阅读列表中的每个链接,Safari 存储的信息包括其标题、URL、摘要、缩略图链接、添加日期和最近打开日期。从子键ReadingListNonSync的名称及其收录

的内容也可以看出,阅读列表中网页的缓存不会同步,每个设备都会重新检索网页信息及其缓存。(Web 缓存位于 ~/Library/Safari/ReadingListArchives 目录下,并以 Web Archive 格式存储。)

在 iOS 上,阅读列表的存储位置略有不同。它位于数据库文件/private/var/mobile/Library/Safari/Bookmarks.db 中,但仍与普通书签一起存储。根据数据库中的列名,可以看出存储的信息基本对应macOS上的Safari。

iOS 上的 Safari 书签数据库

可以看出,为了将阅读列表与第三方服务连接,您只需要完成以下操作:

分析阅读列表文件的变化

对于第一点,可以在 GitHub 上找到现成的解决方案:ReadingListReader。这是一组基于 Python 的脚本,其功能是解析 Bookmarks.plist 文件并将其导出为 HTML、CSV 格式,或将其发送到 Pocket/Instapaper/Pinboard。

以导出到 Pocket 为例。首先在 Pocket 网站上创建一个私有应用程序并保存 Consumer Key。接下来编辑上述项目中的 readinglist2pocket.py 文件,填写Consumer Key。这样就可以在终端运行了:

ReadingListReader $ python ./readinglist2instapaper.py

将阅读列表导出到 Pocket。导出到Pinboard或Instapaper的方法是一样的,这里不再赘述。

监控阅读列表文件的变化

剩下的问题是如何监控阅读列表的变化,以便在添加新链接时,通过上述脚本自动发送给第三方服务。最简单的方法是使用 Hazel。在 Hazel 中,为 ~/Library/Safari 文件夹创建一个新规则并设置两个匹配条件:

文件的全名是Bookmarks.plist(注意“Full Name”和“Name”的区别,后者不包括扩展名);上次匹配日期(Date Last Matched)早于上次修改日期(Date Last Modified)(更改换句话说,文件自上次匹配后发生了更改)。

匹配后的动作是运行终端脚本(Run Shell Script):

python /path/to/script/readinglist2pinboard.py。

以发送到 Pinboard 的脚本为例,Hazel 动作

需要说明两点:

使用Mercury提升网页信息抓取效果

虽然阅读列表会自动抓取网页的标题、摘要等信息,但并不是很智能。根据经验,如果添加的链接是付费墙或短链接、跳转链接等网页,阅读列表可能无法正确获取网页信息。这对将其同步到 Instapaper 或 Pocket 几乎没有影响,因为它们会重新处理添加的链接;但是如果你像我一样将它与 Pinboard 同步,可能需要一些额外的步骤来处理上述缺点。

阅读列表不擅长处理需要重定向的特殊 URL