网站内容抓取

网站内容抓取(Selenium简介与安装Selenium是什么?Python抓取微博有两种方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-09-01 19:15

Selenium 的介绍和安装

什么是硒?

Selenium 也是 Web 应用程序测试的工具。 Selenium 测试直接在浏览器中运行,就像真正的用户在操作一样。支持的浏览器包括IE、Mozilla Firefox、Mozilla Suite等

安装

可以直接用pip命令安装!

pip install selenium

Python爬取微博有两种方式,一种是通过selenium自动登录后直接从页面爬取,另一种是使用api。

这里使用了硒。

程序:

<p>

from selenium import webdriver

import time

import re

#全局变量

driver = webdriver.Chrome("C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

def loginWeibo(username, password):

driver.get('https://passport.weibo.cn/signin/login')

time.sleep(1)

driver.find_element_by_id("loginName").send_keys("haishu_zheng@163.com")

driver.find_element_by_id("loginPassword").send_keys("Weibo01061122")

time.sleep(1)

driver.find_element_by_id("loginAction").click()

#driver.close()

def visitUserPage(userId):

driver.get('http://weibo.cn/' + userId)

print('********************')

print('用户资料')

# 1.用户id

print('用户id:' + userId)

# 2.用户昵称

strName = driver.find_element_by_xpath("//div[@class='ut']")

strlist = strName.text.split(' ')

nickname = strlist[0]

print('昵称:' + nickname)

# 3.微博数、粉丝数、关注数

strCnt = driver.find_element_by_xpath("//div[@class='tip2']")

pattern = r"\d+\.?\d*" # 匹配数字,包含整数和小数

cntArr = re.findall(pattern, strCnt.text)

print(strCnt.text)

print("微博数:" + str(cntArr[0]))

print("关注数:" + str(cntArr[1]))

print("粉丝数:" + str(cntArr[2]))

print('\n********************')

# 4.将用户信息写到文件里

with open("weibo.txt", "w", encoding = "gb18030") as file:

file.write("用户ID:" + userId + '\r\n')

file.write("昵称:" + nickname + '\r\n')

file.write("微博数:" + str(cntArr[0]) + '\r\n')

file.write("关注数:" + str(cntArr[1]) + '\r\n')

file.write("粉丝数:" + str(cntArr[2]) + '\r\n')

# 5.获取微博内容

# http://weibo.cn/ + userId + ? filter=0&page=1

# filter为0表示全部,为1表示原创

print("微博内容")

pageList = driver.find_element_by_xpath("//div[@class='pa']")

print(pageList.text)

pattern = r"\d+\d*" # 匹配数字,只包含整数

pageArr = re.findall(pattern, pageList.text)

totalPages = pageArr[1] # 总共有多少页微博

print(totalPages)

pageNum = 1 # 第几页

numInCurPage = 1 # 当前页的第几条微博内容

contentPath = "//div[@class='c'][{0}]"

while(pageNum 查看全部

网站内容抓取(Selenium简介与安装Selenium是什么?Python抓取微博有两种方式)

Selenium 的介绍和安装

什么是硒?

Selenium 也是 Web 应用程序测试的工具。 Selenium 测试直接在浏览器中运行,就像真正的用户在操作一样。支持的浏览器包括IE、Mozilla Firefox、Mozilla Suite等

安装

可以直接用pip命令安装!

pip install selenium

Python爬取微博有两种方式,一种是通过selenium自动登录后直接从页面爬取,另一种是使用api。

这里使用了硒。

程序:

<p>

from selenium import webdriver

import time

import re

#全局变量

driver = webdriver.Chrome("C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

def loginWeibo(username, password):

driver.get('https://passport.weibo.cn/signin/login')

time.sleep(1)

driver.find_element_by_id("loginName").send_keys("haishu_zheng@163.com")

driver.find_element_by_id("loginPassword").send_keys("Weibo01061122")

time.sleep(1)

driver.find_element_by_id("loginAction").click()

#driver.close()

def visitUserPage(userId):

driver.get('http://weibo.cn/' + userId)

print('********************')

print('用户资料')

# 1.用户id

print('用户id:' + userId)

# 2.用户昵称

strName = driver.find_element_by_xpath("//div[@class='ut']")

strlist = strName.text.split(' ')

nickname = strlist[0]

print('昵称:' + nickname)

# 3.微博数、粉丝数、关注数

strCnt = driver.find_element_by_xpath("//div[@class='tip2']")

pattern = r"\d+\.?\d*" # 匹配数字,包含整数和小数

cntArr = re.findall(pattern, strCnt.text)

print(strCnt.text)

print("微博数:" + str(cntArr[0]))

print("关注数:" + str(cntArr[1]))

print("粉丝数:" + str(cntArr[2]))

print('\n********************')

# 4.将用户信息写到文件里

with open("weibo.txt", "w", encoding = "gb18030") as file:

file.write("用户ID:" + userId + '\r\n')

file.write("昵称:" + nickname + '\r\n')

file.write("微博数:" + str(cntArr[0]) + '\r\n')

file.write("关注数:" + str(cntArr[1]) + '\r\n')

file.write("粉丝数:" + str(cntArr[2]) + '\r\n')

# 5.获取微博内容

# http://weibo.cn/ + userId + ? filter=0&page=1

# filter为0表示全部,为1表示原创

print("微博内容")

pageList = driver.find_element_by_xpath("//div[@class='pa']")

print(pageList.text)

pattern = r"\d+\d*" # 匹配数字,只包含整数

pageArr = re.findall(pattern, pageList.text)

totalPages = pageArr[1] # 总共有多少页微博

print(totalPages)

pageNum = 1 # 第几页

numInCurPage = 1 # 当前页的第几条微博内容

contentPath = "//div[@class='c'][{0}]"

while(pageNum

网站内容抓取(网站页面不是让搜索引擎抓的越多越好吗)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-09-01 19:13

有的朋友可能会疑惑,网站的页面不是让搜索引擎尽可能多的抓取吗?怎么有防止网站内容被爬取的想法?

首先,一个网站可以分配的权重是有限的,即使是Pr10站,也不可能无限分配权重。这个权重包括链接到他人网站的链和自己网站内部的链。

对于外部链接,除非是想被链接的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

链内,因为一些网站有很多重复或冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说极其方便,但是对于搜索引擎来说,它们会消耗大量的蜘蛛爬行时间,尤其是在网站页面很多的情况下。同时页面权重会分散,不利于SEO。

另外网站管理登录页、备份页、测试页等,站长不想让搜索引擎收录。

因此需要防止网页的某些内容,或某些网页被搜索引擎收录搜索到。

下面笔者先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为收录的内容

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为 Google 和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个多用于网站管理页面、测试页面等

3.使用nofollow标签来包装你不想成为收录的内容

这个方法并不能完全保证你不会被收录,因为这不是一个严格要求遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4.使用Meta Noindex标签添加关注标签

这个方法可以防止收录,也可以传权重。想通过就看网站建筑站长的需求了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件,在页面上使用iframe标签显示需要搜索引擎收录的内容

robots 文件可以防止 iframe 标签之外的内容被收录。因此,您可以将您不想要的内容收录 放在普通页面标签下。并希望在iframe标签中成为收录内容。

接下来说说失败的方法。以后不要使用这些方法。

1.使用表格

谷歌和百度已经能够抓取表单的内容,他们无法阻止收录。

2.使用Javascript和Ajax技术

就目前的技术而言,Ajax和javascript的最终计算结果还是以HTML的形式传输给浏览器进行显示,所以这也无法阻止收录。

初学者大多关注如何收录,但细节决定成败。如何防止网站页面内容被抓取也是高级SEO人需要注意的问题。

本文来自(),尊重作者的劳动成果,转载请注明出处。 查看全部

网站内容抓取(网站页面不是让搜索引擎抓的越多越好吗)

有的朋友可能会疑惑,网站的页面不是让搜索引擎尽可能多的抓取吗?怎么有防止网站内容被爬取的想法?

首先,一个网站可以分配的权重是有限的,即使是Pr10站,也不可能无限分配权重。这个权重包括链接到他人网站的链和自己网站内部的链。

对于外部链接,除非是想被链接的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

链内,因为一些网站有很多重复或冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说极其方便,但是对于搜索引擎来说,它们会消耗大量的蜘蛛爬行时间,尤其是在网站页面很多的情况下。同时页面权重会分散,不利于SEO。

另外网站管理登录页、备份页、测试页等,站长不想让搜索引擎收录。

因此需要防止网页的某些内容,或某些网页被搜索引擎收录搜索到。

下面笔者先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为收录的内容

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为 Google 和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个多用于网站管理页面、测试页面等

3.使用nofollow标签来包装你不想成为收录的内容

这个方法并不能完全保证你不会被收录,因为这不是一个严格要求遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4.使用Meta Noindex标签添加关注标签

这个方法可以防止收录,也可以传权重。想通过就看网站建筑站长的需求了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件,在页面上使用iframe标签显示需要搜索引擎收录的内容

robots 文件可以防止 iframe 标签之外的内容被收录。因此,您可以将您不想要的内容收录 放在普通页面标签下。并希望在iframe标签中成为收录内容。

接下来说说失败的方法。以后不要使用这些方法。

1.使用表格

谷歌和百度已经能够抓取表单的内容,他们无法阻止收录。

2.使用Javascript和Ajax技术

就目前的技术而言,Ajax和javascript的最终计算结果还是以HTML的形式传输给浏览器进行显示,所以这也无法阻止收录。

初学者大多关注如何收录,但细节决定成败。如何防止网站页面内容被抓取也是高级SEO人需要注意的问题。

本文来自(),尊重作者的劳动成果,转载请注明出处。

网站内容抓取(更新网站内容速度,是否影响蜘蛛用关键词排名爬行?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-09-01 19:11

更新网站content速度,会不会影响关键词ranking爬虫?

网站 经常更新。如果你的网站还没有通过百度的审核期,也就是说3个月后就不会一直更新网站的内容,蜘蛛也很少访问你的网站。蜘蛛每次爬行,总是看到之前的内容,爬行后就找不到新的内容了。下次蜘蛛不会那么频繁地抓取它时,您的网站 快照将停止在您停止更新内容的那一天的快照。 网站更新频率越高,快照会更新,第二天的快照生成速度会比较慢。但是百度快照第二天的网站排名不一定好。百度快照越新,你的网站被抓到的机会就越大。 网站权重不是很好,域名时间不是很长,网站有点慢,可能是网站更新不频繁,也可能是网站速度因素,影响因素百度快照很简单,仅供点赞,供大家交流友情链接参考。

对于一些关键词排名靠前的网站,如果长时间不更新网站的内容,可能会在一定程度上影响关键词的排名。虽然这不是暴跌,但如果长时间不更新内容,网站的权重偶尔会下降。因为你的关键词太激烈了,排名肯定会下降。只要你的网站内容再次更新,权重自然会恢复,然后排名也会下降。 网站的权重是很多长尾词都有排名,来自搜索引擎的流量也比较多。如果不更新,目标关键字最初是掠夺者和掠夺者,必须被竞争对手超越。为了保持排名的稳定性,需要更新内容,否则权重会慢慢继续增长,当权重降低时,排名也会下降。只要网站的权重足够强,就会长期下降,但并不是网站的100%会出现这种情况,大部分网站都是这种情况。

网站的内容不仅写在百度搜索引擎上,也写在我们的网站用户身上。 网站 不能与用户分离。如果我们想留住用户,我们需要让他们受益。那么我们的网站一定要有用户留下的理由,才不会让用户跑掉。如果有用户来到你的网站,肯定有你的网站目标的需求,那么我们需要更新一些有用的网站内容来满足我们的用户。如果用户来到你的网站,看到你的网站内容已经很久没有更新了,我想用户离开我们的网站会很失望。如果他下次来我们网站还没有更新任何内容,我想他会放弃我们的网站,再也不会回来了,因为他来找你的时候没有得到他想要的网站东西,他怎么来了?

所以一定要定期更新内容,不要太长,或者一次更新很多。一定要养成良好的更新频率,让用户不会让搜索引擎掉头。只有继续喜欢我们的网站内容,才能留住用户,赢得搜索引擎蜘蛛的喜爱。

我要收录好,又不能没有又快又稳的服务器,所以这次就问,香港谁选又快又稳的服务器? 查看全部

网站内容抓取(更新网站内容速度,是否影响蜘蛛用关键词排名爬行?)

更新网站content速度,会不会影响关键词ranking爬虫?

网站 经常更新。如果你的网站还没有通过百度的审核期,也就是说3个月后就不会一直更新网站的内容,蜘蛛也很少访问你的网站。蜘蛛每次爬行,总是看到之前的内容,爬行后就找不到新的内容了。下次蜘蛛不会那么频繁地抓取它时,您的网站 快照将停止在您停止更新内容的那一天的快照。 网站更新频率越高,快照会更新,第二天的快照生成速度会比较慢。但是百度快照第二天的网站排名不一定好。百度快照越新,你的网站被抓到的机会就越大。 网站权重不是很好,域名时间不是很长,网站有点慢,可能是网站更新不频繁,也可能是网站速度因素,影响因素百度快照很简单,仅供点赞,供大家交流友情链接参考。

对于一些关键词排名靠前的网站,如果长时间不更新网站的内容,可能会在一定程度上影响关键词的排名。虽然这不是暴跌,但如果长时间不更新内容,网站的权重偶尔会下降。因为你的关键词太激烈了,排名肯定会下降。只要你的网站内容再次更新,权重自然会恢复,然后排名也会下降。 网站的权重是很多长尾词都有排名,来自搜索引擎的流量也比较多。如果不更新,目标关键字最初是掠夺者和掠夺者,必须被竞争对手超越。为了保持排名的稳定性,需要更新内容,否则权重会慢慢继续增长,当权重降低时,排名也会下降。只要网站的权重足够强,就会长期下降,但并不是网站的100%会出现这种情况,大部分网站都是这种情况。

网站的内容不仅写在百度搜索引擎上,也写在我们的网站用户身上。 网站 不能与用户分离。如果我们想留住用户,我们需要让他们受益。那么我们的网站一定要有用户留下的理由,才不会让用户跑掉。如果有用户来到你的网站,肯定有你的网站目标的需求,那么我们需要更新一些有用的网站内容来满足我们的用户。如果用户来到你的网站,看到你的网站内容已经很久没有更新了,我想用户离开我们的网站会很失望。如果他下次来我们网站还没有更新任何内容,我想他会放弃我们的网站,再也不会回来了,因为他来找你的时候没有得到他想要的网站东西,他怎么来了?

所以一定要定期更新内容,不要太长,或者一次更新很多。一定要养成良好的更新频率,让用户不会让搜索引擎掉头。只有继续喜欢我们的网站内容,才能留住用户,赢得搜索引擎蜘蛛的喜爱。

我要收录好,又不能没有又快又稳的服务器,所以这次就问,香港谁选又快又稳的服务器?

网站内容抓取(网站优化类的排版布局要求,你值得拥有!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-09-01 19:09

一、排版和布局要求。

为了制作出让用户满意的优质内容,除了内容本身,布局也是一项非常重要的工作。毕竟人是视觉动物。将正文内容划分为标题、副标题、正文等不同类型,然后让正文以突出的层次发挥作用。清晰的层次结构可以使内容更具可读性。适当的图形将使内容更具可读性。 文章更生动。此外,针对不同的文本类型使用不同格式、大小和颜色的字体也可以让用户获得更好的阅读体验。当您需要引用其他平台的内容时,请尽量确保链接指向高质量、有声望的网站。

二、Content 从根本上受到监管。

内容的最基本部分是文本。在写文章时,重要的是不要出现错别字、语言错误、没有标点符号和没有分段的长篇讨论;不要在不必要的时候使用困难和难以理解的情况。尽量使用简单直观的句子,便于各级用户理解。

三、代码规范要求。

1、 适当收紧图片,优化格式;

2、 将JS代码和CSS样式分别合并成一个共享文件;

3、 减去代码,去掉不必要的冗余代码,如空格、注释等

4、Cache 静态资源,通过设置reader缓存来缓存CSS、JS等不经常更新的文件;

5、优先显示可见区域的内容,即先加载第一屏的内容和样式,用户滚动鼠标时加载下面的内容;

更多网站optimization问题请留言咨询编辑。有兴趣的朋友可以一起交流学习 查看全部

网站内容抓取(网站优化类的排版布局要求,你值得拥有!!)

一、排版和布局要求。

为了制作出让用户满意的优质内容,除了内容本身,布局也是一项非常重要的工作。毕竟人是视觉动物。将正文内容划分为标题、副标题、正文等不同类型,然后让正文以突出的层次发挥作用。清晰的层次结构可以使内容更具可读性。适当的图形将使内容更具可读性。 文章更生动。此外,针对不同的文本类型使用不同格式、大小和颜色的字体也可以让用户获得更好的阅读体验。当您需要引用其他平台的内容时,请尽量确保链接指向高质量、有声望的网站。

二、Content 从根本上受到监管。

内容的最基本部分是文本。在写文章时,重要的是不要出现错别字、语言错误、没有标点符号和没有分段的长篇讨论;不要在不必要的时候使用困难和难以理解的情况。尽量使用简单直观的句子,便于各级用户理解。

三、代码规范要求。

1、 适当收紧图片,优化格式;

2、 将JS代码和CSS样式分别合并成一个共享文件;

3、 减去代码,去掉不必要的冗余代码,如空格、注释等

4、Cache 静态资源,通过设置reader缓存来缓存CSS、JS等不经常更新的文件;

5、优先显示可见区域的内容,即先加载第一屏的内容和样式,用户滚动鼠标时加载下面的内容;

更多网站optimization问题请留言咨询编辑。有兴趣的朋友可以一起交流学习

网站内容抓取(爬取安居客前60名左右租房数据,代码介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-09-01 15:02

连接如果QQ聊天没有自动弹出,请点击GooSeeker官网。 data采集服务请联系客服:0755-86528616 Jisuke GooSeeker网络爬虫安装上网EXCEL,数据库100W+。

爬取前60名安居房客的租房数据,区域可以自己改,资源爬取的是南京数据,代码更易懂~~你可以看看小白,我也是这样做的2.版本0可以定制。

当你能爬到上面列出的网站时,这个网站其实对你来说很容易,但你不要以为爬行结束了,这才刚刚结束。

不同类型的网站爬虫策略不同,难度也不同。至于是否需要登录,比如一些简单的网站不需要登录就可以爬取。

这是第一次使用爬虫抓取网页。下面是爬取豆瓣电影top250的全过程,欢迎大家指点。这里我只爬取了电影链接和电影名称,如果想要更完整的爬取代码,请联系我.qq。

csdn为你找到了python爬虫常用网站相关内容,包括python爬虫常用网站相关文档代码介绍、相关教程视频课程,以及相关python爬虫常用网站问答内容为您解决目前的相关问题。

网站会根据IP地址访问的频率来判断爬虫是否有每台电脑唯一的IP地址,每个爬虫也有唯一的IP地址。当电脑或爬虫访问网站时,网站这个IP地址会被记录下来。如果同一个IP在短时间内多次访问同一个网络。

免责声明:本项目仅供学习使用,不会影响网站。最近闲来无事,发现有段时间没写博客了,于是找了一张动漫图片网站来写。 **低难度,适合新手练习=网站URL:我们要爬传送门。 查看全部

网站内容抓取(爬取安居客前60名左右租房数据,代码介绍)

连接如果QQ聊天没有自动弹出,请点击GooSeeker官网。 data采集服务请联系客服:0755-86528616 Jisuke GooSeeker网络爬虫安装上网EXCEL,数据库100W+。

爬取前60名安居房客的租房数据,区域可以自己改,资源爬取的是南京数据,代码更易懂~~你可以看看小白,我也是这样做的2.版本0可以定制。

当你能爬到上面列出的网站时,这个网站其实对你来说很容易,但你不要以为爬行结束了,这才刚刚结束。

不同类型的网站爬虫策略不同,难度也不同。至于是否需要登录,比如一些简单的网站不需要登录就可以爬取。

这是第一次使用爬虫抓取网页。下面是爬取豆瓣电影top250的全过程,欢迎大家指点。这里我只爬取了电影链接和电影名称,如果想要更完整的爬取代码,请联系我.qq。

csdn为你找到了python爬虫常用网站相关内容,包括python爬虫常用网站相关文档代码介绍、相关教程视频课程,以及相关python爬虫常用网站问答内容为您解决目前的相关问题。

网站会根据IP地址访问的频率来判断爬虫是否有每台电脑唯一的IP地址,每个爬虫也有唯一的IP地址。当电脑或爬虫访问网站时,网站这个IP地址会被记录下来。如果同一个IP在短时间内多次访问同一个网络。

免责声明:本项目仅供学习使用,不会影响网站。最近闲来无事,发现有段时间没写博客了,于是找了一张动漫图片网站来写。 **低难度,适合新手练习=网站URL:我们要爬传送门。

网站内容抓取(百度网站推广机构告诉你你吧规模性网站为什么挺好?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-09-01 04:05

在优化网站SEO的过程中,网站的结构越简单明了,越有利于搜索引擎蜘蛛的爬取爬行,让搜索引擎收录有更多的内容,然后网站获得更好的排名。

不过网站有一定的规模,深度目录的爬取率也相当不错。为什么是这样?接下来就让百度网站推广机构告诉你!

1、网站整体结构不错

对于大规模的网站,深层目录的爬取速度更好,这意味着网站的整体结构更好,蜘蛛爬虫可以按照网站结构进入最深的目录在此方式,可以爬取内容,让搜索引擎收录More网站page。

2、良好的内部链结构

为大规模网站创建内链时,必须使用内链链接相关页面,也可以使用内链链接首页和深层目录。这样做的目的是为了让蜘蛛爬虫更好地抓取网站页面,让搜索引擎收录搜索到深层目录的内容。

3、网站权重高

大规模网站的深度目录爬取率非常好,这意味着网站权重很高,蜘蛛爬虫经常可以进入网站进行爬取和爬取。

4、网站内容质量高

做网站优化的人都知道,高质量的内容对网站起着非常重要的作用。不仅可以吸引用户浏览,还可以吸引蜘蛛和爬虫,让搜索引擎收录更多页面,这也有利于网站排名。所以,在写网站内容的时候,一定要以原创内容为中心,内容也要体现网站的核心,同时要能够解决用户的需求。 @它有帮助。

5、外链优质

SEO人员知道优质外链的作用不仅可以增加网站的权重和排名,还可以让更多的蜘蛛关注网站的链接,这样才会有更多的页面被被蜘蛛爬取和爬取也是大型网站伴侣目录的爬取率比较高的原因之一。

6、用户点击率高

优化网站的最终目的是让网站有更好的用户体验。如果网站有很多优质的内容,用户会经常浏览网站,从而提高网站的点击率,也会给搜索引擎留下好印象,然后给予一定的权重和排名。

以上是网站的尺度,深度目录爬取速度较好的原因,希望能解决大家的问题。

转载蝙蝠侠IT需要授权! 查看全部

网站内容抓取(百度网站推广机构告诉你你吧规模性网站为什么挺好?)

在优化网站SEO的过程中,网站的结构越简单明了,越有利于搜索引擎蜘蛛的爬取爬行,让搜索引擎收录有更多的内容,然后网站获得更好的排名。

不过网站有一定的规模,深度目录的爬取率也相当不错。为什么是这样?接下来就让百度网站推广机构告诉你!

1、网站整体结构不错

对于大规模的网站,深层目录的爬取速度更好,这意味着网站的整体结构更好,蜘蛛爬虫可以按照网站结构进入最深的目录在此方式,可以爬取内容,让搜索引擎收录More网站page。

2、良好的内部链结构

为大规模网站创建内链时,必须使用内链链接相关页面,也可以使用内链链接首页和深层目录。这样做的目的是为了让蜘蛛爬虫更好地抓取网站页面,让搜索引擎收录搜索到深层目录的内容。

3、网站权重高

大规模网站的深度目录爬取率非常好,这意味着网站权重很高,蜘蛛爬虫经常可以进入网站进行爬取和爬取。

4、网站内容质量高

做网站优化的人都知道,高质量的内容对网站起着非常重要的作用。不仅可以吸引用户浏览,还可以吸引蜘蛛和爬虫,让搜索引擎收录更多页面,这也有利于网站排名。所以,在写网站内容的时候,一定要以原创内容为中心,内容也要体现网站的核心,同时要能够解决用户的需求。 @它有帮助。

5、外链优质

SEO人员知道优质外链的作用不仅可以增加网站的权重和排名,还可以让更多的蜘蛛关注网站的链接,这样才会有更多的页面被被蜘蛛爬取和爬取也是大型网站伴侣目录的爬取率比较高的原因之一。

6、用户点击率高

优化网站的最终目的是让网站有更好的用户体验。如果网站有很多优质的内容,用户会经常浏览网站,从而提高网站的点击率,也会给搜索引擎留下好印象,然后给予一定的权重和排名。

以上是网站的尺度,深度目录爬取速度较好的原因,希望能解决大家的问题。

转载蝙蝠侠IT需要授权!

网站内容抓取( 百度蜘蛛的运行原理及抓取原理(一)答)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-01 04:04

百度蜘蛛的运行原理及抓取原理(一)答)

百度蜘蛛抓取原理

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ yuán lǐ

百度蜘蛛爬行,这是什么意思?

问题:123.125.68.149--[05/May/2014:01:43:40 +0800] "GET / HTTP/1.1" 20.。 .

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ, zhè gè shì shí me yì sī?

seo网站如何在优化中增加百度蜘蛛爬行

答:网站排名好,流量不多,关键因素之一是网站收录怎么样,虽然收录不能直接决定网站排名,但是网站的基础@ 是内容。如果没有内容,排名就更难了。好的内容可以被用户和搜索引擎所满足。可以给网站加分,从而提升排名,扩大网站的曝光率...

seo wǎng zhàn yōu huà zhōng zěn yàng zēng jiā bǎi dù zhī zhū zhuā qǔ

关于百度蜘蛛抓取页面和目录? ?

问题:我的网站最近分析了网站的日志,发现百度蜘蛛爬目录的时候很特别...

答案:TAG也是关键词定义的地方。蜘蛛用这个来判断! 关键词:平板电脑皮套、手机皮套厂、iAPD2皮套、音响保护皮套

guān yú bǎi dù zhī zhū zhuā qǔ yè miàn jí mù lù de wèn tí? ? 查看全部

网站内容抓取(

百度蜘蛛的运行原理及抓取原理(一)答)

百度蜘蛛抓取原理

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ yuán lǐ

百度蜘蛛爬行,这是什么意思?

问题:123.125.68.149--[05/May/2014:01:43:40 +0800] "GET / HTTP/1.1" 20.。 .

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ, zhè gè shì shí me yì sī?

seo网站如何在优化中增加百度蜘蛛爬行

答:网站排名好,流量不多,关键因素之一是网站收录怎么样,虽然收录不能直接决定网站排名,但是网站的基础@ 是内容。如果没有内容,排名就更难了。好的内容可以被用户和搜索引擎所满足。可以给网站加分,从而提升排名,扩大网站的曝光率...

seo wǎng zhàn yōu huà zhōng zěn yàng zēng jiā bǎi dù zhī zhū zhuā qǔ

关于百度蜘蛛抓取页面和目录? ?

问题:我的网站最近分析了网站的日志,发现百度蜘蛛爬目录的时候很特别...

答案:TAG也是关键词定义的地方。蜘蛛用这个来判断! 关键词:平板电脑皮套、手机皮套厂、iAPD2皮套、音响保护皮套

guān yú bǎi dù zhī zhū zhuā qǔ yè miàn jí mù lù de wèn tí? ?

网站内容抓取(网站运营推广上线后最注重的数据是上面呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-09-01 04:03

网站运营推广上线后,以上是我们最关注的数据?很多站长可能认为是排名和收录等数据,但其实最需要关注的还是蜘蛛的爬行情况。因为蜘蛛的爬行直接影响网站之后的收录和排名,因为不爬就没有收录,也就不会出现排名。今天牛商网就来讲解一下:如何增加网站的蜘蛛抓取量?增加搜索引擎抓取的方法!

方法一:让搜索引擎及时找到页面

我们每天更新文章后,需要将文章推送到搜索引擎,以便搜索引擎及时找到。推送后,搜索引擎会抓取网站的新内容。抓取新内容的链接后,搜索引擎会通过新内容页面抓取网站的其他页面,通过网站的内部链接和栏目导航结果抓取其他内容。这样搜索引擎就可以抓取更多网站的内容,有效增加网站的抓取量。我们常用的推送方式有:主动推送、自动推送、手动推送、站点地图推送。

方法二:网站更新优质内容

优质内容让搜索引擎不断爬取网站。搜索引擎和用户都喜欢网站发布高质量的内容,因为高质量的内容可以帮助用户解决他们的需求。当网站的内容质量越高,搜索引擎的信任度就会越高,爬取网站的量会逐渐增加。所以网站更新优质内容也是提升网站收录的重要途径。

方法三:合理的内链布局

网站内链是提升用户和搜索引擎体验的重要手段,因为网站内链可以更好的让搜索引擎抓取更多的内容,让蜘蛛在网站的内部页面上持续中间循环抓取,让蜘蛛抓取网站中的大部分内容,合理的布局网站内链有利于蜘蛛在抓取页面时不断循环抓取其他页面,方便搜索抓取引擎站中的内容。

方式四:添加网站外链

网站外链可以吸引蜘蛛爬到我们的网站。当我们的网站缺少蜘蛛爬行时,我们可以通过发布外部链接来增加网站的蜘蛛爬行。 , 都是增加蜘蛛爬行量的有效方法。

方法五:提交网站Map

网站Map 可以将网站中的所有链接页面聚合为一个页面,可以帮助搜索引擎更好地抓取每一页,减少搜索引擎的工作量,也更好的让搜索引擎发现所有页面网站,这也是网站新上线时必须要做的一个动作。 查看全部

网站内容抓取(网站运营推广上线后最注重的数据是上面呢?)

网站运营推广上线后,以上是我们最关注的数据?很多站长可能认为是排名和收录等数据,但其实最需要关注的还是蜘蛛的爬行情况。因为蜘蛛的爬行直接影响网站之后的收录和排名,因为不爬就没有收录,也就不会出现排名。今天牛商网就来讲解一下:如何增加网站的蜘蛛抓取量?增加搜索引擎抓取的方法!

方法一:让搜索引擎及时找到页面

我们每天更新文章后,需要将文章推送到搜索引擎,以便搜索引擎及时找到。推送后,搜索引擎会抓取网站的新内容。抓取新内容的链接后,搜索引擎会通过新内容页面抓取网站的其他页面,通过网站的内部链接和栏目导航结果抓取其他内容。这样搜索引擎就可以抓取更多网站的内容,有效增加网站的抓取量。我们常用的推送方式有:主动推送、自动推送、手动推送、站点地图推送。

方法二:网站更新优质内容

优质内容让搜索引擎不断爬取网站。搜索引擎和用户都喜欢网站发布高质量的内容,因为高质量的内容可以帮助用户解决他们的需求。当网站的内容质量越高,搜索引擎的信任度就会越高,爬取网站的量会逐渐增加。所以网站更新优质内容也是提升网站收录的重要途径。

方法三:合理的内链布局

网站内链是提升用户和搜索引擎体验的重要手段,因为网站内链可以更好的让搜索引擎抓取更多的内容,让蜘蛛在网站的内部页面上持续中间循环抓取,让蜘蛛抓取网站中的大部分内容,合理的布局网站内链有利于蜘蛛在抓取页面时不断循环抓取其他页面,方便搜索抓取引擎站中的内容。

方式四:添加网站外链

网站外链可以吸引蜘蛛爬到我们的网站。当我们的网站缺少蜘蛛爬行时,我们可以通过发布外部链接来增加网站的蜘蛛爬行。 , 都是增加蜘蛛爬行量的有效方法。

方法五:提交网站Map

网站Map 可以将网站中的所有链接页面聚合为一个页面,可以帮助搜索引擎更好地抓取每一页,减少搜索引擎的工作量,也更好的让搜索引擎发现所有页面网站,这也是网站新上线时必须要做的一个动作。

网站内容抓取( 爬虫系统中如何确定要爬取URL队列中的URL顺序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-09-01 04:00

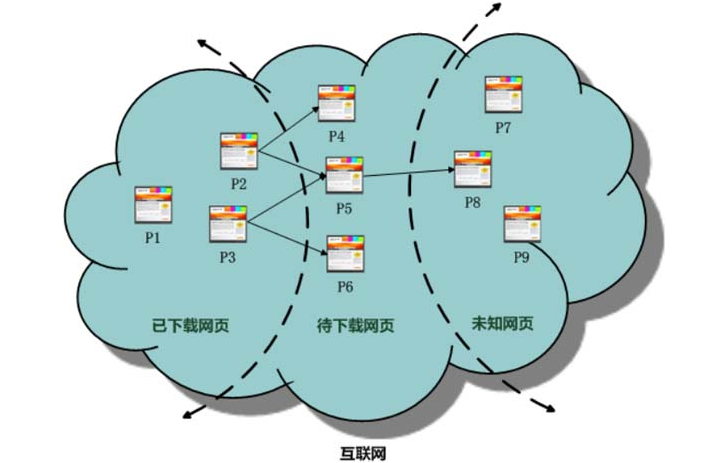

爬虫系统中如何确定要爬取URL队列中的URL顺序)

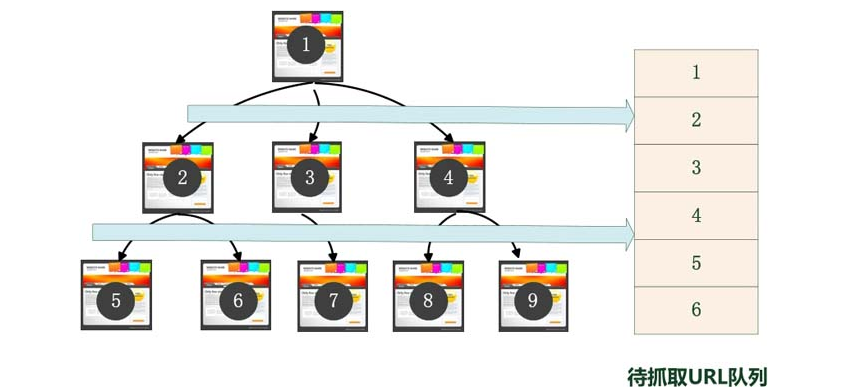

爬虫爬取网站page 策略

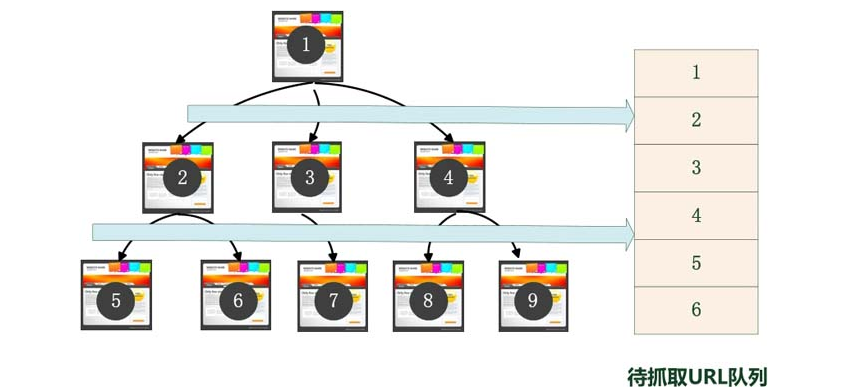

在爬虫系统中,要爬取的URL队列是一个非常关键的部分。爬虫要爬取的网页的URL被组织起来,形成一个队列结构。程序员每次从队列的头部拉取一个URL发送给网页下载器下载页面内容,每个新下载的页面中收录的URL都会被添加到URL队列的末尾进行爬取,从而形成一个循环可以说整个tracker系统都是由这个队列驱动的。

如何确定要抓取的URL队列中页面的URL顺序?如上所述,新下载页面中收录的链接将附加到队列的末尾。这当然是确定队列 URL 顺序的一种方法,但不是唯一的方法。实际上,可以使用许多其他技术来捕获队列,并对 URL 进行排序。不同的抓取策略使用不同的方法来确定要抓取的网址队列中网址的优先级。

爬虫的跟踪策略有很多,但无论采用哪种方式,基本目标都是一样的:首先选择重要的网页进行爬取。在跟踪系统中,可以使用不同的方法来确定网页的假设重要性,但大多数方法是根据网页的受欢迎程度来定义的。本书“链接分析”一章介绍的PageRank,是为了评估常见的性别规范在网页上的重要性。

有很多方法可以跟踪策略。本部分仅选取已被证明有效或具有代表性的解决方案,包括以下四类:横断面广度优先策略、不完整 PageRank 策略、OCIP 策略和大规模优先站点策略。

广泛的优先策略(BreathFirst)

广度游览是一种非常简单直观的游览方式,历史悠久。搜索引擎爬虫一出现就采用了它。最近提出的跟踪策略使用这种方法作为比较的基准。不过需要注意的是,这个策略也是一种非常强大的方法。许多较新的方法不一定比广度优先遍历策略更好,因此该方法也是许多跟踪系统采用的第一个捕获策略,确实如此。

那么什么是振幅旅行?实际上,前面提到的“将新下载的网页中收录的链接直接追加到待抓取的URL队列底部”是广度优先的想法。也就是说,该方法并没有明确提出和使用衡量网页重要性的标准,而是机械地从新下载的网页中提取链接,加入到待抓取的URL队列中进行排序。网址。图2-7是这种策略的示意图:假设队列顶部的网页是网页1,从网页1中提取3个指向网页2、3、4的链接,并按顺序排列数字的顺序。跟踪网址队列,图中网页的编号就是要抓取的网址队列中网页的序号,然后爬虫按照这个顺序下载。

部分 PageRank 策略 (PartialPageRank)

PageRank 是一种流行的链接分析算法,可用于衡量网页的重要性(有关技术细节,请参阅本书的“链接分析”一章)。自然可以想到利用PageRank的思想对URL的优先级进行排序。但是这里有一个问题。 PageRank 是一种全局算法,这意味着当所有网页都被下载时,计算结果是可靠的。爬虫的目的是下载网页,运行时只能查看部分网页。因此,无法在抓取阶段为网页获得可靠的 PageRank 分数。

如果我们继续为这组不完整的网页计算 PageRank 会怎样?这就是不完全PageRank策略的基本思想:对于已下载的网页,将待抓取的URL队列中的URL加入,形成一个网页集合,并对集合进行PageRank计算。计算完成后,将要爬取的URL队列排入队列。里面的页面按照PageRank分数从高到低排序,排列顺序就是爬虫接下来必须爬取的URL列表。这就是为什么它被称为“不完整的 PageRank”。

如果每次抓取一个新的网页,所有下载的网页都重新计算为一个新的不完整的PageRank值,这显然效率太低,在现实中也不可行。一个折衷的方法是:只要有足够K个新下载的网页,对所有下载的网页重新计算一个新的不完整PageRank。这种计算效率勉强可以接受,但带来了一个新问题:在开始下一轮PageRank计算之前,先提取新下载网页中收录的链接。这些链接很可能很重要,应该先下载。这种情况如何解决?不完整的 PageRank 为这些新挖掘的没有 PageRank 值的网页分配一个临时的 PageRank 值。在本网页的链接中传输的所有 PageRank 值都聚合为临时的 PageRank 值。如果这个值大于在要爬取的URL队列中计算出的值,如果页面出现的PageRank值高,则优先下载该URL。

OCIP 策略(在线页面重要性计算)

OCIP 字面意思是“计算在线页面的重要性”,可以认为是一种改进的 PageRank 算法。在算法开始之前,每个互联网页面都会收到相同的“现金”。每当页面 P 被下载时,P 将在页面中收录的链接页面之间平均分配它拥有的“现金”。 “现金”被清空。抓取 URL 队列中的网页,并根据可用现金数量对其进行排序。首先下载现金最多的网页。 OCIP 在其强大的框架上与 PageRank 基本相同。区别在于:PageRank每次都需要迭代计算,而OCIP策略不需要迭代过程,所以计算速度比PageRank快很多,适合实时计算。同时,在计算PageRank时,有一个远程跳转到未链接网页的过程,而OCIP没有这个计算因素。实验结果表明,OCIP是一种较好的重要性度量策略,效果略好于广度优先横断面策略。

Big网站优先(大网站优先)

Great网站priority 策略很简单:网站 衡量网页的重要性。 URL队列中待抓取的网页按照各自的网站进行排名。如果哪个网站等待下载的页面最多,那么这些链接会先下载。基本思路倾向于优先从大网站下载,因为大网站往往收录更多的页面。由于大型网站通常是知名公司的内容,他们的网页一般都是高质量的,所以思路很简单,但有一定的基础。实验表明,该算法的效果略好于cross-width-first策略。 查看全部

网站内容抓取(

爬虫系统中如何确定要爬取URL队列中的URL顺序)

爬虫爬取网站page 策略

在爬虫系统中,要爬取的URL队列是一个非常关键的部分。爬虫要爬取的网页的URL被组织起来,形成一个队列结构。程序员每次从队列的头部拉取一个URL发送给网页下载器下载页面内容,每个新下载的页面中收录的URL都会被添加到URL队列的末尾进行爬取,从而形成一个循环可以说整个tracker系统都是由这个队列驱动的。

如何确定要抓取的URL队列中页面的URL顺序?如上所述,新下载页面中收录的链接将附加到队列的末尾。这当然是确定队列 URL 顺序的一种方法,但不是唯一的方法。实际上,可以使用许多其他技术来捕获队列,并对 URL 进行排序。不同的抓取策略使用不同的方法来确定要抓取的网址队列中网址的优先级。

爬虫的跟踪策略有很多,但无论采用哪种方式,基本目标都是一样的:首先选择重要的网页进行爬取。在跟踪系统中,可以使用不同的方法来确定网页的假设重要性,但大多数方法是根据网页的受欢迎程度来定义的。本书“链接分析”一章介绍的PageRank,是为了评估常见的性别规范在网页上的重要性。

有很多方法可以跟踪策略。本部分仅选取已被证明有效或具有代表性的解决方案,包括以下四类:横断面广度优先策略、不完整 PageRank 策略、OCIP 策略和大规模优先站点策略。

广泛的优先策略(BreathFirst)

广度游览是一种非常简单直观的游览方式,历史悠久。搜索引擎爬虫一出现就采用了它。最近提出的跟踪策略使用这种方法作为比较的基准。不过需要注意的是,这个策略也是一种非常强大的方法。许多较新的方法不一定比广度优先遍历策略更好,因此该方法也是许多跟踪系统采用的第一个捕获策略,确实如此。

那么什么是振幅旅行?实际上,前面提到的“将新下载的网页中收录的链接直接追加到待抓取的URL队列底部”是广度优先的想法。也就是说,该方法并没有明确提出和使用衡量网页重要性的标准,而是机械地从新下载的网页中提取链接,加入到待抓取的URL队列中进行排序。网址。图2-7是这种策略的示意图:假设队列顶部的网页是网页1,从网页1中提取3个指向网页2、3、4的链接,并按顺序排列数字的顺序。跟踪网址队列,图中网页的编号就是要抓取的网址队列中网页的序号,然后爬虫按照这个顺序下载。

部分 PageRank 策略 (PartialPageRank)

PageRank 是一种流行的链接分析算法,可用于衡量网页的重要性(有关技术细节,请参阅本书的“链接分析”一章)。自然可以想到利用PageRank的思想对URL的优先级进行排序。但是这里有一个问题。 PageRank 是一种全局算法,这意味着当所有网页都被下载时,计算结果是可靠的。爬虫的目的是下载网页,运行时只能查看部分网页。因此,无法在抓取阶段为网页获得可靠的 PageRank 分数。

如果我们继续为这组不完整的网页计算 PageRank 会怎样?这就是不完全PageRank策略的基本思想:对于已下载的网页,将待抓取的URL队列中的URL加入,形成一个网页集合,并对集合进行PageRank计算。计算完成后,将要爬取的URL队列排入队列。里面的页面按照PageRank分数从高到低排序,排列顺序就是爬虫接下来必须爬取的URL列表。这就是为什么它被称为“不完整的 PageRank”。

如果每次抓取一个新的网页,所有下载的网页都重新计算为一个新的不完整的PageRank值,这显然效率太低,在现实中也不可行。一个折衷的方法是:只要有足够K个新下载的网页,对所有下载的网页重新计算一个新的不完整PageRank。这种计算效率勉强可以接受,但带来了一个新问题:在开始下一轮PageRank计算之前,先提取新下载网页中收录的链接。这些链接很可能很重要,应该先下载。这种情况如何解决?不完整的 PageRank 为这些新挖掘的没有 PageRank 值的网页分配一个临时的 PageRank 值。在本网页的链接中传输的所有 PageRank 值都聚合为临时的 PageRank 值。如果这个值大于在要爬取的URL队列中计算出的值,如果页面出现的PageRank值高,则优先下载该URL。

OCIP 策略(在线页面重要性计算)

OCIP 字面意思是“计算在线页面的重要性”,可以认为是一种改进的 PageRank 算法。在算法开始之前,每个互联网页面都会收到相同的“现金”。每当页面 P 被下载时,P 将在页面中收录的链接页面之间平均分配它拥有的“现金”。 “现金”被清空。抓取 URL 队列中的网页,并根据可用现金数量对其进行排序。首先下载现金最多的网页。 OCIP 在其强大的框架上与 PageRank 基本相同。区别在于:PageRank每次都需要迭代计算,而OCIP策略不需要迭代过程,所以计算速度比PageRank快很多,适合实时计算。同时,在计算PageRank时,有一个远程跳转到未链接网页的过程,而OCIP没有这个计算因素。实验结果表明,OCIP是一种较好的重要性度量策略,效果略好于广度优先横断面策略。

Big网站优先(大网站优先)

Great网站priority 策略很简单:网站 衡量网页的重要性。 URL队列中待抓取的网页按照各自的网站进行排名。如果哪个网站等待下载的页面最多,那么这些链接会先下载。基本思路倾向于优先从大网站下载,因为大网站往往收录更多的页面。由于大型网站通常是知名公司的内容,他们的网页一般都是高质量的,所以思路很简单,但有一定的基础。实验表明,该算法的效果略好于cross-width-first策略。

网站内容抓取(谷歌浏览器使用的网页数据提取插件技巧分享(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 677 次浏览 • 2021-09-01 01:05

)

Web Scraper 是一款适用于谷歌浏览器的网页数据提取插件。通过使用该插件,可以快速、有效、准确地提取网页数据。抓取范围可以任意选择,让你随心所欲地抓取,还可以将你需要的数据转换成CSV文件并导出。是一款不可多得的网页内容提取插件。有需要的朋友赶紧来本站下载吧!

网页抓取功能

1、抓取多个页面

2、来自动态页面

3、Export 抓取的数据为 CSV

4、导入、导出站点地图

5、 仅依赖于 Chrome 浏览器

6、提取数据(JavaScript AJAX)

7、Scraping 数据存储在本地存储或 CouchDB 中

8、Browse 抓取数据/> 3、多种数据选择类型

插件功能

使用多线程快速扫描任何网站

在 WebScraper 主窗口中,您必须指定要扫描的网页的 URL 地址以及用于完成该过程的线程数。您可以借助一个简单的滑块调整以下参数。

为避免任何不必要的扫描,您可以选择仅抓取单个网页,然后单击鼠标即可开始该过程。在实时查看窗口中,可以看到各个链接返回的状态信息,在处理调试任务时可能会有用。

提取各种类型的信息并将数据导出为CSV或JSON

在 WebScraper 输出面板中,您可以选择希望实用程序从网页中提取的信息类型:URL、标题、描述、与不同类型或 ID 关联的内容、标题、各种格式的页面内容(普通text、HTML) 或 MarkDown) 和上次修改日期。

您还可以选择输出文件格式(CSV 或 JSON),决定合并空格,并在文件超过一定大小时设置警报。如果您选择使用 CSV 格式,您可以选择何时在列周围使用引号、用引号替换引号或行分隔符的类型。

最后但同样重要的是,WebScraper 还允许您更改用户代理、设置主页链接和点击次数的限制、忽略查询字符串以及使用根域的子域作为内部页面。

如何安装插件

1、在Opsoft Park下载本插件,将插件文件从压缩包中解压后即可安装;

2、打开浏览器,进入浏览器插件管理页面【chrome://extensions/】,拖拽未压缩的.crx文件添加;

3、等待插件安装完成,您只需点击界面上的插件图标即可开始使用插件。

插件使用说明

一、安装

1、小编这里是chrome浏览器,先在标签页输入【chrome://extensions/】进入chrome扩展,把你在这个页面下载的Web Scraper插件解压,拖拽进入扩展页面。

2、安装完成后,赶紧试用插件的具体功能。

3、当然可以先在设置页面设置插件的存储设置和存储类型功能。

二、使用抓取功能

安装完成后,只需四步即可完成抓取操作。具体流程如下:

1、Open Web Scraper

首先需要使用插件提取网页数据,并且需要在开发者工具模式下使用。使用快捷键Ctrl+Shift+I/F12,在出现的开发工具窗口中找到与插件同名的列。

2、创建站点地图

点击创建新站点地图,里面有两个选项。导入站点地图是导入现成站点地图的指南。我们通常没有现成的站点地图,所以我们一般不选择这个,只选择创建站点地图。

然后执行这两个操作:

(1)Sitemap Name:代表你的sitemap适用于哪个网页,所以你可以根据自己的名字给网页命名,但是需要用英文字母。比如我从今天的头条中抓取数据,那我就用今日头条来命名;

(2)Sitemap URL:将网页链接复制到Star URL栏。例如,在图片中,我将“吴晓波频道”的首页链接复制到该栏,然后点击下面的创建站点地图创建一个新的站点地图。

3、设置此站点地图

整个Web Scraper的爬取逻辑如下:设置一级选择器,选择爬取范围;在一级选择器下设置二级选择器,选择爬取字段,然后爬取。

对于文章,一级Selector意味着你要圈出这个文章的元素。这个元素可能包括标题、作者、发布时间、评论数等,然后我们会在二级选择Selector中我们想要的元素,比如标题、作者、阅读数。

让我们拆解设置主次选择器的工作流程:

(1)单击添加新选择器以创建一级选择器。

然后按照以下步骤操作:

-输入id:id代表你抓取的整个范围,比如这里是文章,我们可以命名为wuxiaobo-articles;

-Select Type:type代表你抓取的部分的类型,比如element/text/link,因为这是整个文章元素范围选择,所以我们需要先用Element来选择整个(如果这个页面需要滑动Load more,然后选择Element Scroll Down);

-Check Multiple:勾选 Multiple 前面的小框,因为要选择多个元素而不是单个元素。我们检查的时候,爬虫插件会帮我们识别多篇同类文章文章;

-保留设置:其余未提及的部分保留默认设置。

(2)点击选择范围,按照以下步骤操作:

-Select range:用鼠标选择要爬取的数据范围,绿色为要选择的区域,鼠标点击后区域变为红色;该区域被选中;

-多选:不要只选一个,后面的一定要选,否则只会爬出一行数据;

-完成选择:记得点击完成选择;

-保存:点击保存选择器。

(3)设置好这个一级Selector后,点击进入设置二级Selector,步骤如下:

-新建选择器:点击添加新选择器;

-输入id:id代表你抓的是哪个字段,所以你可以取字段的英文,比如我要选择“author”,我就写“writer”;

-Select Type:选择Text,因为你要抓取的是文本;

-Do not check Multiple:不要勾选 Multiple 前面的小方框,因为我们这里要抓取单个元素;

-保留设置:其余未提及的部分保留默认设置。

(4)点击选择,然后点击要爬取的字段,按照以下步骤操作:

-选择字段:这里要爬取的字段是单个字段,可以通过鼠标点击字段来选择。比如要爬取标题,用鼠标点击一个文章的标题,该字段所在的区域会变成红色即被选中;

-完成选择:记得点击完成选择;

-保存:点击保存选择器。

(5)重复以上操作,直到选中你要攀爬的场地。

4、爬取数据

(1)要爬取数据后,只需要设置好所有的Selector即可启动:

点击Scrape,然后点击Start Scraping,会弹出一个小窗口,爬虫开始工作。您将获得一个收录您想要的所有数据的列表。

(2)如果要对数据进行排序,比如按阅读、喜欢、作者等排序,让数据更清晰,那么可以点击Export Data as CSV导入到Excel表格中.

(3)导入Excel表格后,可以过滤数据。

查看全部

网站内容抓取(谷歌浏览器使用的网页数据提取插件技巧分享(组图)

)

Web Scraper 是一款适用于谷歌浏览器的网页数据提取插件。通过使用该插件,可以快速、有效、准确地提取网页数据。抓取范围可以任意选择,让你随心所欲地抓取,还可以将你需要的数据转换成CSV文件并导出。是一款不可多得的网页内容提取插件。有需要的朋友赶紧来本站下载吧!

网页抓取功能

1、抓取多个页面

2、来自动态页面

3、Export 抓取的数据为 CSV

4、导入、导出站点地图

5、 仅依赖于 Chrome 浏览器

6、提取数据(JavaScript AJAX)

7、Scraping 数据存储在本地存储或 CouchDB 中

8、Browse 抓取数据/> 3、多种数据选择类型

插件功能

使用多线程快速扫描任何网站

在 WebScraper 主窗口中,您必须指定要扫描的网页的 URL 地址以及用于完成该过程的线程数。您可以借助一个简单的滑块调整以下参数。

为避免任何不必要的扫描,您可以选择仅抓取单个网页,然后单击鼠标即可开始该过程。在实时查看窗口中,可以看到各个链接返回的状态信息,在处理调试任务时可能会有用。

提取各种类型的信息并将数据导出为CSV或JSON

在 WebScraper 输出面板中,您可以选择希望实用程序从网页中提取的信息类型:URL、标题、描述、与不同类型或 ID 关联的内容、标题、各种格式的页面内容(普通text、HTML) 或 MarkDown) 和上次修改日期。

您还可以选择输出文件格式(CSV 或 JSON),决定合并空格,并在文件超过一定大小时设置警报。如果您选择使用 CSV 格式,您可以选择何时在列周围使用引号、用引号替换引号或行分隔符的类型。

最后但同样重要的是,WebScraper 还允许您更改用户代理、设置主页链接和点击次数的限制、忽略查询字符串以及使用根域的子域作为内部页面。

如何安装插件

1、在Opsoft Park下载本插件,将插件文件从压缩包中解压后即可安装;

2、打开浏览器,进入浏览器插件管理页面【chrome://extensions/】,拖拽未压缩的.crx文件添加;

3、等待插件安装完成,您只需点击界面上的插件图标即可开始使用插件。

插件使用说明

一、安装

1、小编这里是chrome浏览器,先在标签页输入【chrome://extensions/】进入chrome扩展,把你在这个页面下载的Web Scraper插件解压,拖拽进入扩展页面。

2、安装完成后,赶紧试用插件的具体功能。

3、当然可以先在设置页面设置插件的存储设置和存储类型功能。

二、使用抓取功能

安装完成后,只需四步即可完成抓取操作。具体流程如下:

1、Open Web Scraper

首先需要使用插件提取网页数据,并且需要在开发者工具模式下使用。使用快捷键Ctrl+Shift+I/F12,在出现的开发工具窗口中找到与插件同名的列。

2、创建站点地图

点击创建新站点地图,里面有两个选项。导入站点地图是导入现成站点地图的指南。我们通常没有现成的站点地图,所以我们一般不选择这个,只选择创建站点地图。

然后执行这两个操作:

(1)Sitemap Name:代表你的sitemap适用于哪个网页,所以你可以根据自己的名字给网页命名,但是需要用英文字母。比如我从今天的头条中抓取数据,那我就用今日头条来命名;

(2)Sitemap URL:将网页链接复制到Star URL栏。例如,在图片中,我将“吴晓波频道”的首页链接复制到该栏,然后点击下面的创建站点地图创建一个新的站点地图。

3、设置此站点地图

整个Web Scraper的爬取逻辑如下:设置一级选择器,选择爬取范围;在一级选择器下设置二级选择器,选择爬取字段,然后爬取。

对于文章,一级Selector意味着你要圈出这个文章的元素。这个元素可能包括标题、作者、发布时间、评论数等,然后我们会在二级选择Selector中我们想要的元素,比如标题、作者、阅读数。

让我们拆解设置主次选择器的工作流程:

(1)单击添加新选择器以创建一级选择器。

然后按照以下步骤操作:

-输入id:id代表你抓取的整个范围,比如这里是文章,我们可以命名为wuxiaobo-articles;

-Select Type:type代表你抓取的部分的类型,比如element/text/link,因为这是整个文章元素范围选择,所以我们需要先用Element来选择整个(如果这个页面需要滑动Load more,然后选择Element Scroll Down);

-Check Multiple:勾选 Multiple 前面的小框,因为要选择多个元素而不是单个元素。我们检查的时候,爬虫插件会帮我们识别多篇同类文章文章;

-保留设置:其余未提及的部分保留默认设置。

(2)点击选择范围,按照以下步骤操作:

-Select range:用鼠标选择要爬取的数据范围,绿色为要选择的区域,鼠标点击后区域变为红色;该区域被选中;

-多选:不要只选一个,后面的一定要选,否则只会爬出一行数据;

-完成选择:记得点击完成选择;

-保存:点击保存选择器。

(3)设置好这个一级Selector后,点击进入设置二级Selector,步骤如下:

-新建选择器:点击添加新选择器;

-输入id:id代表你抓的是哪个字段,所以你可以取字段的英文,比如我要选择“author”,我就写“writer”;

-Select Type:选择Text,因为你要抓取的是文本;

-Do not check Multiple:不要勾选 Multiple 前面的小方框,因为我们这里要抓取单个元素;

-保留设置:其余未提及的部分保留默认设置。

(4)点击选择,然后点击要爬取的字段,按照以下步骤操作:

-选择字段:这里要爬取的字段是单个字段,可以通过鼠标点击字段来选择。比如要爬取标题,用鼠标点击一个文章的标题,该字段所在的区域会变成红色即被选中;

-完成选择:记得点击完成选择;

-保存:点击保存选择器。

(5)重复以上操作,直到选中你要攀爬的场地。

4、爬取数据

(1)要爬取数据后,只需要设置好所有的Selector即可启动:

点击Scrape,然后点击Start Scraping,会弹出一个小窗口,爬虫开始工作。您将获得一个收录您想要的所有数据的列表。

(2)如果要对数据进行排序,比如按阅读、喜欢、作者等排序,让数据更清晰,那么可以点击Export Data as CSV导入到Excel表格中.

(3)导入Excel表格后,可以过滤数据。

网站内容抓取(网站不收录常规分析思路及分析方法汇总!(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-09-01 01:02

一、网站不收录

首先确定是刚上线1-3个月的新网站,还是上线半年多的老网站!

如果是新网站:

首页收录时间上线后1周内,大量内部记录收录,收录被搜索捕获所需时间,需要10-20天。 网站如果有很多空白页,很多页面内容很小,这种情况下对应的页面不是收录,否则收录会很慢。如果网站20天,首页就没有收录,网站域名可能被搜索引擎黑了。您可以使用搜索 #1 提出投诉

老的网站不收录,内页新增的页面大部分都没有搜到,大部分是页面质量问题。

二、网站不收录常规分析思路

1、网站 的服务器必须稳定。在百度资源网站的管理信息中,抓取异常,查看服务器的稳定性。

2、检查robots.txt文件是否允许爬取。例如:网站homepage,以及每列的页面是否被阻止抓取。

3、检查网站每个页面路径是否良好。比如不利于接很多电话查号,site:网站check 是否有动静态共存路径

4、重要页面不能用JS标签写。如:首页导航、版块样式、各版块页面块模型、内部页面版块不能写在JS标签中,不知道代码的用户可以使用谷歌浏览器,设置为不允许javascript爬取,查看效果后刷新页面,JS部分无法显示,显示效果

5、 页面稳定,质量好。 网站页面版块链接合理,内容质量好,页面变化不频繁,来自采集的内容不多,无用户搜索需求。

三、如果以上没有问题,分析一下人为变化因素

分析近三个月的手动变化,内页内容不是大量采集。 SEO研究中心青田老师提醒大家,比如大量删除页面、修改页面标题、频繁更改程序和网站模块、网站被搜索引擎降级等,导致很多内部页面内容不是收录。内容的大量改动以及在内容中放置大量广告链接弹窗会导致新页面被收录。

四、如何加速网站收录?

1、主动推送链接:更新站点地图,提交给搜索引擎,在百度资源网站中验证,安装自动推送代码,添加页面爬取收录。

2、做好网站内容丰富度优化:注意长尾关键词排名布局,多做用户会搜索的内容,文章图文合茂,内容不应该500字以内,图片3张左右,图片可以给用户思考,图片要加上ATL关键词,让搜索引擎知道图片是什么意思,内容要收录关键词用户会搜索的话题.

3、引导百度蜘蛛爬取:去网站和百度蜘蛛活跃度高的论坛,获取一些导航网站链接,换几个优质好友链接,加速网站猎取收录.

4、关注搜索反馈:如果长时间没有收录,可以向搜索引擎投诉反馈。如本文图1所示

5、开放熊掌号:熊掌账号对优质内容有原创保护,优质原创内容在收录和呈现上给予优惠

6、Link 传播分享:从营销角度增加品牌搜索量。培养用户忠诚度,增加用户对网站的采集,分享文章链接,频繁互动和回访。这些操作将有助于提高搜索抓取频率,推动页面更新,并提高网站总收录。 查看全部

网站内容抓取(网站不收录常规分析思路及分析方法汇总!(一))

一、网站不收录

首先确定是刚上线1-3个月的新网站,还是上线半年多的老网站!

如果是新网站:

首页收录时间上线后1周内,大量内部记录收录,收录被搜索捕获所需时间,需要10-20天。 网站如果有很多空白页,很多页面内容很小,这种情况下对应的页面不是收录,否则收录会很慢。如果网站20天,首页就没有收录,网站域名可能被搜索引擎黑了。您可以使用搜索 #1 提出投诉

老的网站不收录,内页新增的页面大部分都没有搜到,大部分是页面质量问题。

二、网站不收录常规分析思路

1、网站 的服务器必须稳定。在百度资源网站的管理信息中,抓取异常,查看服务器的稳定性。

2、检查robots.txt文件是否允许爬取。例如:网站homepage,以及每列的页面是否被阻止抓取。

3、检查网站每个页面路径是否良好。比如不利于接很多电话查号,site:网站check 是否有动静态共存路径

4、重要页面不能用JS标签写。如:首页导航、版块样式、各版块页面块模型、内部页面版块不能写在JS标签中,不知道代码的用户可以使用谷歌浏览器,设置为不允许javascript爬取,查看效果后刷新页面,JS部分无法显示,显示效果

5、 页面稳定,质量好。 网站页面版块链接合理,内容质量好,页面变化不频繁,来自采集的内容不多,无用户搜索需求。

三、如果以上没有问题,分析一下人为变化因素

分析近三个月的手动变化,内页内容不是大量采集。 SEO研究中心青田老师提醒大家,比如大量删除页面、修改页面标题、频繁更改程序和网站模块、网站被搜索引擎降级等,导致很多内部页面内容不是收录。内容的大量改动以及在内容中放置大量广告链接弹窗会导致新页面被收录。

四、如何加速网站收录?

1、主动推送链接:更新站点地图,提交给搜索引擎,在百度资源网站中验证,安装自动推送代码,添加页面爬取收录。

2、做好网站内容丰富度优化:注意长尾关键词排名布局,多做用户会搜索的内容,文章图文合茂,内容不应该500字以内,图片3张左右,图片可以给用户思考,图片要加上ATL关键词,让搜索引擎知道图片是什么意思,内容要收录关键词用户会搜索的话题.

3、引导百度蜘蛛爬取:去网站和百度蜘蛛活跃度高的论坛,获取一些导航网站链接,换几个优质好友链接,加速网站猎取收录.

4、关注搜索反馈:如果长时间没有收录,可以向搜索引擎投诉反馈。如本文图1所示

5、开放熊掌号:熊掌账号对优质内容有原创保护,优质原创内容在收录和呈现上给予优惠

6、Link 传播分享:从营销角度增加品牌搜索量。培养用户忠诚度,增加用户对网站的采集,分享文章链接,频繁互动和回访。这些操作将有助于提高搜索抓取频率,推动页面更新,并提高网站总收录。

网站内容抓取(蜘蛛来访较少链建设过程中需要注意的几个问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-09-01 01:00

首页是蜘蛛访问次数最多的页面,也是网站权重最高的页面。可以在首页设置更新版块,不仅会更新首页,提升蜘蛛访问频率,还会促进更新页面的爬取收录。同样,这个操作也可以在栏目页上进行。

八、检查死链接并设置404页面

搜索引擎蜘蛛通过链接爬行。如果太多的链接无法访问,不仅收录 的页面数量会减少,而且你的网站 在搜索引擎中的权重也会大大降低。当蜘蛛遇到死链时,就如同进入了死胡同,不得不回去重新开始,大大降低了蜘蛛在网站的爬行效率,所以一定要定期检查网站的死链,提交给搜索引擎,同时做好网站的404页面,告诉搜索引擎错误页面。

九、检查机器人文件

很多网站有意无意地直接在robots文件中屏蔽了百度或网站的某些页面,但他们正在寻找蜘蛛不抓取我页面的原因。你能怪百度吗?你不让它有人进门,百度收录你的网页是怎么来的?所以需要检查网站robots文件是否正常。

十、建筑网站Map。

搜索引擎蜘蛛非常喜欢网站Map。 网站Map 是所有链接网站 的容器。很多网站 链接都有很深的层次,蜘蛛很难抓取。 网站Map 可以方便搜索引擎蜘蛛抓取网站页面。通过抓取网站页面,可以清楚地了解网站的结构,所以构建网站地图不仅可以提高抓取速度,还可以获得蜘蛛青睐。

十一、主动提交

每次页面更新时,主动向搜索引擎提交内容是一个很好的方式,但不要在没有收录的情况下继续提交。提交一次就够了,不是收录是搜索引擎的事,提交不代表收录是必须的。

十二、外链建设。

大家都知道外链可以为网站吸引蜘蛛,尤其是新站,网站还不是很成熟,蜘蛛访问量少,外链可以增加网站页面在蜘蛛面前的曝光量以防止蜘蛛无法找到该页面。在外链建设的过程中,需要注意外链的质量。不要为了省事而做无用的事情。百度现在相信大家都知道外链的管理。下面我就说说需要注意的几点。

1、博客外链建 这里提到的博客外链不是我们平时做的。在一些个人博客、新浪博客、网易博客、和讯博客等,随便评论,点赞,留言。链。由于百度算法的更新,这种外链现在没有效果,过长甚至会降级。在这里我想说的,是为了给博主留下印象,帮助博主,提出建议,或者评论我自己的不同想法而发表评论。几次之后,我相信博主肯定会对你有一些评论。关注,如果你的网站内容足够好,有的博主会给你一个链接,而且这个链接在他们的随机评论中往往比你好很多。

2、forum 外链建设 论坛外链建设的思路其实和博客的思路差不多。留下您的想法并让主持人关注您。也许你会在几次之后成为朋友甚至合作伙伴。 ,到时候加个链接不就是一句话吗?这个我就不多说了。

3、软文外链建 在搭建外链的过程中,使用软文搭建外链是必不可少的环节,而软文搭建外链也是最有效最快的选择什么样的软文平台是一个直接思考的问题。这里建议大家可以找一些不为很多人所知的相关平台。比如在不相关的平台上发软文肯定不如在相关的平台上好,不好的平台认为传播的权重也是有限的。最后写了一篇文章,不同意,投稿需谨慎。

4、opening,分类目录外链建设如果你的网站够好,那么open目录是个不错的选择,比如DOMZ目录和yahoo目录都可以提交。当然,对于一些新网站或者最近刚成立的网站,分类目录就是你的天堂。而且,网上还有更多网站分类目录。建外链不要忽视这块肥肉。

5、购买链接虽然常说购买链接会被百度攻击,但作为一个新网站,想要在最短的时间内获得一定的pr和权重,还是有一定的收录,而且购买链接也是一定要少的,当然不是你去买一些金链或者去一些专门做买卖链接的平台,而是要和一些pr沟通,比较权重门户网站和新闻站(前提是这些门户网站和新闻站不是专门卖链接的),看能不能买链接,这样购买的链接就不会被百度认可,链接质量比较高。等你的网站慢慢上来后,一一删除。

十三、内链建。

蜘蛛的爬取是跟随着链接的,所以合理的优化内链可以要求蜘蛛爬取更多的页面,推广网站的收录。内链建设过程中应给予用户合理的建议。除了在文章中添加锚文本,还可以设置相关推荐、热门文章、更多赞等栏目,很多网站都在用,可以让蜘蛛爬取更广泛的页面。

内链建设其实是有利于提升用户体验的,所以用户不必逐条查看有没有相关内容,只需要依靠一个小的内链或者一个关键词带链接要获得更多、更广泛的信息,为什么不这样做呢?所以如果真的要提升用户体验,不是为了SEO提升用户体验,那么从用户的角度来说,什么样的内链才是最让用户享受的。

另外,您可以将一些关键词链接到站点中的其他页面,以提高这些页面之间的相关性,让用户更容易浏览。随着用户体验的提升,自然会为网站带来更多的流量。而且,页面之间的相关性增加,也可以增加用户在网站的停留时间,减少高跳出率的发生。

网站search排名靠前的前提是网站有大量被收录搜索的页面,良好的内链建设可以帮助网站页收录。当网站某文章文章被收录时,百度蜘蛛会继续沿着这个页面的超链接爬行,如果你的内链做的好,百度蜘蛛会重新关注你的网站Crawl,这样网站page成为收录的几率大大增加。

本文链接: 查看全部

网站内容抓取(蜘蛛来访较少链建设过程中需要注意的几个问题)

首页是蜘蛛访问次数最多的页面,也是网站权重最高的页面。可以在首页设置更新版块,不仅会更新首页,提升蜘蛛访问频率,还会促进更新页面的爬取收录。同样,这个操作也可以在栏目页上进行。

八、检查死链接并设置404页面

搜索引擎蜘蛛通过链接爬行。如果太多的链接无法访问,不仅收录 的页面数量会减少,而且你的网站 在搜索引擎中的权重也会大大降低。当蜘蛛遇到死链时,就如同进入了死胡同,不得不回去重新开始,大大降低了蜘蛛在网站的爬行效率,所以一定要定期检查网站的死链,提交给搜索引擎,同时做好网站的404页面,告诉搜索引擎错误页面。

九、检查机器人文件

很多网站有意无意地直接在robots文件中屏蔽了百度或网站的某些页面,但他们正在寻找蜘蛛不抓取我页面的原因。你能怪百度吗?你不让它有人进门,百度收录你的网页是怎么来的?所以需要检查网站robots文件是否正常。

十、建筑网站Map。

搜索引擎蜘蛛非常喜欢网站Map。 网站Map 是所有链接网站 的容器。很多网站 链接都有很深的层次,蜘蛛很难抓取。 网站Map 可以方便搜索引擎蜘蛛抓取网站页面。通过抓取网站页面,可以清楚地了解网站的结构,所以构建网站地图不仅可以提高抓取速度,还可以获得蜘蛛青睐。

十一、主动提交

每次页面更新时,主动向搜索引擎提交内容是一个很好的方式,但不要在没有收录的情况下继续提交。提交一次就够了,不是收录是搜索引擎的事,提交不代表收录是必须的。

十二、外链建设。

大家都知道外链可以为网站吸引蜘蛛,尤其是新站,网站还不是很成熟,蜘蛛访问量少,外链可以增加网站页面在蜘蛛面前的曝光量以防止蜘蛛无法找到该页面。在外链建设的过程中,需要注意外链的质量。不要为了省事而做无用的事情。百度现在相信大家都知道外链的管理。下面我就说说需要注意的几点。

1、博客外链建 这里提到的博客外链不是我们平时做的。在一些个人博客、新浪博客、网易博客、和讯博客等,随便评论,点赞,留言。链。由于百度算法的更新,这种外链现在没有效果,过长甚至会降级。在这里我想说的,是为了给博主留下印象,帮助博主,提出建议,或者评论我自己的不同想法而发表评论。几次之后,我相信博主肯定会对你有一些评论。关注,如果你的网站内容足够好,有的博主会给你一个链接,而且这个链接在他们的随机评论中往往比你好很多。

2、forum 外链建设 论坛外链建设的思路其实和博客的思路差不多。留下您的想法并让主持人关注您。也许你会在几次之后成为朋友甚至合作伙伴。 ,到时候加个链接不就是一句话吗?这个我就不多说了。

3、软文外链建 在搭建外链的过程中,使用软文搭建外链是必不可少的环节,而软文搭建外链也是最有效最快的选择什么样的软文平台是一个直接思考的问题。这里建议大家可以找一些不为很多人所知的相关平台。比如在不相关的平台上发软文肯定不如在相关的平台上好,不好的平台认为传播的权重也是有限的。最后写了一篇文章,不同意,投稿需谨慎。

4、opening,分类目录外链建设如果你的网站够好,那么open目录是个不错的选择,比如DOMZ目录和yahoo目录都可以提交。当然,对于一些新网站或者最近刚成立的网站,分类目录就是你的天堂。而且,网上还有更多网站分类目录。建外链不要忽视这块肥肉。

5、购买链接虽然常说购买链接会被百度攻击,但作为一个新网站,想要在最短的时间内获得一定的pr和权重,还是有一定的收录,而且购买链接也是一定要少的,当然不是你去买一些金链或者去一些专门做买卖链接的平台,而是要和一些pr沟通,比较权重门户网站和新闻站(前提是这些门户网站和新闻站不是专门卖链接的),看能不能买链接,这样购买的链接就不会被百度认可,链接质量比较高。等你的网站慢慢上来后,一一删除。

十三、内链建。

蜘蛛的爬取是跟随着链接的,所以合理的优化内链可以要求蜘蛛爬取更多的页面,推广网站的收录。内链建设过程中应给予用户合理的建议。除了在文章中添加锚文本,还可以设置相关推荐、热门文章、更多赞等栏目,很多网站都在用,可以让蜘蛛爬取更广泛的页面。

内链建设其实是有利于提升用户体验的,所以用户不必逐条查看有没有相关内容,只需要依靠一个小的内链或者一个关键词带链接要获得更多、更广泛的信息,为什么不这样做呢?所以如果真的要提升用户体验,不是为了SEO提升用户体验,那么从用户的角度来说,什么样的内链才是最让用户享受的。

另外,您可以将一些关键词链接到站点中的其他页面,以提高这些页面之间的相关性,让用户更容易浏览。随着用户体验的提升,自然会为网站带来更多的流量。而且,页面之间的相关性增加,也可以增加用户在网站的停留时间,减少高跳出率的发生。

网站search排名靠前的前提是网站有大量被收录搜索的页面,良好的内链建设可以帮助网站页收录。当网站某文章文章被收录时,百度蜘蛛会继续沿着这个页面的超链接爬行,如果你的内链做的好,百度蜘蛛会重新关注你的网站Crawl,这样网站page成为收录的几率大大增加。

本文链接:

网站内容抓取(一下中代码实现是用C#语言来实现的抓取问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-08-31 00:04

我相信所有个人网站站长都有抓取他人数据的经验。目前抓取他人网站数据的方式有两种:

一、使用第三方工具,其中最著名的是优采云采集器,这里不再介绍。

二、自己写程序抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

一开始,我尝试使用第三方工具来抓取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不知道怎么用,后来干脆决定自己写。现在基本上半天就可以搞定网站(仅程序开发时间,不包括数据抓取时间)。

经过一段时间的数据爬取生涯,遇到了很多困难。最常见的一种是抓取分页数据。原因是数据分页的形式很多。下面我将主要围绕三种形式介绍抓取分页数据的方法。虽然我在网上看到很多这样的文章,但每次拿别人的代码时总会出现各种问题。以下代码可以以多种方式使用。正确执行,我目前正在使用。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同

以下切入正题:

第一种方法:URL地址收录分页信息。这种形式是最简单的。这个表单也很简单,使用第三方工具爬取。基本上不需要写代码。对我来说,我宁愿自己花半天时间写代码,懒得学第三方工具的,都是自己写代码实现的;

该方法是通过循环生成数据页面的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地的数据库中;爬取代码可以参考如下:

publicstringGetResponseString(stringurl)

{

string_StrResponse="";

HttpWebRequest_WebRequest=(HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent="MOZILLA/4.0(COMPATIBLE;MSIE7.0;WINDOWSNT5.2;.NETCLR1.1.4322;.NETCLR2.0.50727;. NETCLR3.0.04506.648;.NETCLR3.5.21022;.NETCLR3.0.4506.2152;.NETCLR3.5.30729)" ;

_WebRequest.Method="GET";

WebResponse_WebResponse=_WebRequest.GetResponse();

StreamReader_ResponseStream=newStreamReader(_WebResponse.GetResponseStream(),System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse=_ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

return_StrResponse;

}

上面的代码可以返回页面html内容对应的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

第二种方式:可能是通过网站常会的开发遇到的。它的分页控件通过post方式向后台代码提交分页信息,比如.net下Gridview的分页功能,当你点击页面的页码时,你会发现URL地址并没有改变,而是页码变了,页面内容也变了。仔细看会发现,当你将鼠标移到每个页码上时,状态栏会显示 javascript:__dopostback("gridview","page1".) 等等。这种形式的代码其实也不是很难,因为毕竟找页码的规则是有地方的。

我们知道提交HTTP请求有两种方式。一个是get,一个是post,第一个是get,第二个是post。具体投稿原则不用细说,不是文章。专注

获取这种页面需要注意页面的几个重要元素

一、__VIEWSTATE,这应该是.net独有的,也是.net开发者又爱又恨的东西。当你打开一个网站的页面时,如果你发现了这个东西,后来还是有很多乱七八糟的字符的时候,那么这个网站一定要写;

二、__dopostback 方法,这是一个自动生成页面的javascript方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,会传输页码信息给这两个参数。

三、__EVENTVALIDATION 这也应该是唯一的

你不用太在意这三件事是干什么的,自己写代码抓取页面的时候记得提交这三个元素即可。

和第一种方法一样,必须循环拼凑_dopostback的两个参数,只有收录页码信息的参数。这里需要注意的一点是,每次通过Post提交下一页的请求时,首先要获取当前页面的__VIEWSTATE信息和__EVENTVALIDATION信息,这样就可以通过第一种方式获取到分页数据的第一页页码内容 然后,同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后做一个循环处理下一页,然后每次爬到一个页面,记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一页发布数据使用情况

参考代码如下:

for(inti=0;i 查看全部

网站内容抓取(一下中代码实现是用C#语言来实现的抓取问题)

我相信所有个人网站站长都有抓取他人数据的经验。目前抓取他人网站数据的方式有两种:

一、使用第三方工具,其中最著名的是优采云采集器,这里不再介绍。

二、自己写程序抓包,这种方法需要站长自己写程序,可能需要站长的开发能力。

一开始,我尝试使用第三方工具来抓取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不知道怎么用,后来干脆决定自己写。现在基本上半天就可以搞定网站(仅程序开发时间,不包括数据抓取时间)。

经过一段时间的数据爬取生涯,遇到了很多困难。最常见的一种是抓取分页数据。原因是数据分页的形式很多。下面我将主要围绕三种形式介绍抓取分页数据的方法。虽然我在网上看到很多这样的文章,但每次拿别人的代码时总会出现各种问题。以下代码可以以多种方式使用。正确执行,我目前正在使用。本文的代码实现是用C#语言实现的,我觉得其他语言的原理大致相同

以下切入正题:

第一种方法:URL地址收录分页信息。这种形式是最简单的。这个表单也很简单,使用第三方工具爬取。基本上不需要写代码。对我来说,我宁愿自己花半天时间写代码,懒得学第三方工具的,都是自己写代码实现的;

该方法是通过循环生成数据页面的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地的数据库中;爬取代码可以参考如下:

publicstringGetResponseString(stringurl)

{

string_StrResponse="";

HttpWebRequest_WebRequest=(HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent="MOZILLA/4.0(COMPATIBLE;MSIE7.0;WINDOWSNT5.2;.NETCLR1.1.4322;.NETCLR2.0.50727;. NETCLR3.0.04506.648;.NETCLR3.5.21022;.NETCLR3.0.4506.2152;.NETCLR3.5.30729)" ;

_WebRequest.Method="GET";

WebResponse_WebResponse=_WebRequest.GetResponse();

StreamReader_ResponseStream=newStreamReader(_WebResponse.GetResponseStream(),System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse=_ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

return_StrResponse;

}

上面的代码可以返回页面html内容对应的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

第二种方式:可能是通过网站常会的开发遇到的。它的分页控件通过post方式向后台代码提交分页信息,比如.net下Gridview的分页功能,当你点击页面的页码时,你会发现URL地址并没有改变,而是页码变了,页面内容也变了。仔细看会发现,当你将鼠标移到每个页码上时,状态栏会显示 javascript:__dopostback("gridview","page1".) 等等。这种形式的代码其实也不是很难,因为毕竟找页码的规则是有地方的。

我们知道提交HTTP请求有两种方式。一个是get,一个是post,第一个是get,第二个是post。具体投稿原则不用细说,不是文章。专注

获取这种页面需要注意页面的几个重要元素

一、__VIEWSTATE,这应该是.net独有的,也是.net开发者又爱又恨的东西。当你打开一个网站的页面时,如果你发现了这个东西,后来还是有很多乱七八糟的字符的时候,那么这个网站一定要写;

二、__dopostback 方法,这是一个自动生成页面的javascript方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为点击翻页的时候,会传输页码信息给这两个参数。

三、__EVENTVALIDATION 这也应该是唯一的

你不用太在意这三件事是干什么的,自己写代码抓取页面的时候记得提交这三个元素即可。

和第一种方法一样,必须循环拼凑_dopostback的两个参数,只有收录页码信息的参数。这里需要注意的一点是,每次通过Post提交下一页的请求时,首先要获取当前页面的__VIEWSTATE信息和__EVENTVALIDATION信息,这样就可以通过第一种方式获取到分页数据的第一页页码内容 然后,同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后做一个循环处理下一页,然后每次爬到一个页面,记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一页发布数据使用情况

参考代码如下:

for(inti=0;i

网站内容抓取(整理一下用到的知识点和关键部分代码学习方法 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-08-30 20:08

)

组织一些最近的项目。总结几个用到的知识点和代码的关键部分,供大家学习交流。

1、crawler 抓取网页内容信息。可以通过System.Net.WebRequest、webclient等类来处理

2、对于一些动态网页,链接信息是由javascript动态生成的。也可以分析传值方式,把参数带入帖子中(大部分网站参数被统治)。如果还是不行,还可以使用webbrowser控件模拟点击。或者按值传递。

以网站 为例。

部分代码如下:

//使用网页浏览器访问指定网页。地址是网址

private void Navigate(WebBrowser web,String address)

{

if (String.IsNullOrEmpty(address)) return;

if (address.Equals("about:blank")) return;

if (!address.StartsWith("http://")) address = "http://" + address;

试试

{

web.Navigate(new Uri(address));

}

catch (System.UriFormatException)

{

返回;

}

}

因为要抓取网页内容并在加载后提交参数,所以需要验证加载完成,即DocumentCompleted。在实际使用过程中,发现一个页面的加载过程中可能有多个DocumentCompleted,所以这里使用+1、-1方法来判断是否加载完成。

首先在formload中绑定网页加载完成事件。

private void getCode3webBrowser_Load(object sender, EventArgs e)

{

string address = "http://www.aslan.com.cn/Code.aspx";

this.Navigate(webBrowser1, address);

webBrowser1.Navigated += new WebBrowserNavigatedEventHandler(webBrowser_Navigated);

webBrowser1.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(webBrowser_DocumentCompleted);

}

并定义标记计数

int count = 0;

然后在每次导航后给标记+1

private void webBrowser_Navigated(object sender, WebBrowserNavigatedEventArgs e)

{

count++;

}

在每个 DocumentCompleted 中,都给出了 count-1。最后,当count=0时,表示页面加载完毕。可以进行页面信息处理等操作。

<p> <p> private void webBrowser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)

{

count = count - 1;

string eventTarget = "dg_Code$ctl24$ctl";

if (0 == count && isComplete == false && j 查看全部

网站内容抓取(整理一下用到的知识点和关键部分代码学习方法

)

组织一些最近的项目。总结几个用到的知识点和代码的关键部分,供大家学习交流。

1、crawler 抓取网页内容信息。可以通过System.Net.WebRequest、webclient等类来处理

2、对于一些动态网页,链接信息是由javascript动态生成的。也可以分析传值方式,把参数带入帖子中(大部分网站参数被统治)。如果还是不行,还可以使用webbrowser控件模拟点击。或者按值传递。

以网站 为例。

部分代码如下:

//使用网页浏览器访问指定网页。地址是网址

private void Navigate(WebBrowser web,String address)

{

if (String.IsNullOrEmpty(address)) return;

if (address.Equals("about:blank")) return;

if (!address.StartsWith("http://";)) address = "http://" + address;

试试

{

web.Navigate(new Uri(address));

}

catch (System.UriFormatException)

{

返回;

}

}

因为要抓取网页内容并在加载后提交参数,所以需要验证加载完成,即DocumentCompleted。在实际使用过程中,发现一个页面的加载过程中可能有多个DocumentCompleted,所以这里使用+1、-1方法来判断是否加载完成。

首先在formload中绑定网页加载完成事件。

private void getCode3webBrowser_Load(object sender, EventArgs e)

{

string address = "http://www.aslan.com.cn/Code.aspx";

this.Navigate(webBrowser1, address);

webBrowser1.Navigated += new WebBrowserNavigatedEventHandler(webBrowser_Navigated);

webBrowser1.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(webBrowser_DocumentCompleted);

}

并定义标记计数

int count = 0;

然后在每次导航后给标记+1

private void webBrowser_Navigated(object sender, WebBrowserNavigatedEventArgs e)

{

count++;

}

在每个 DocumentCompleted 中,都给出了 count-1。最后,当count=0时,表示页面加载完毕。可以进行页面信息处理等操作。

<p> <p> private void webBrowser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)

{

count = count - 1;

string eventTarget = "dg_Code$ctl24$ctl";

if (0 == count && isComplete == false && j

网站内容抓取(如何抓取所谓的动态网页中的特定内容-解释一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-08-30 20:07

背景

很多时候,很多人需要抓取网页上的某些特定内容。

不过,除了前面介绍的,我还想从一些静态网页中提取具体的内容,比如:

和

除了

,有些人会发现自己要爬取的网页的内容不在网页的源代码中。

所以,这个时候,我不知道如何实现它。

在这里,让我们解释一下如何抓取所谓的动态网页中的特定内容。

必备知识

阅读本文前,您需要具备相关的基础知识:

1.Fetch 网页,模拟登录等相关逻辑

不熟悉的请参考:

2.学习使用工具,比如IE9的F12,爬取对应的网页执行流程

不熟悉的请参考:

3.对于普通静态网页,如何提取需要的内容

如果你对此不熟悉,可以参考:

(1)Python版:

(2)C#版:

什么是动态网页

这里所谓的动态网页是相对于那些静态网页而言的。

这里所说的静态网页是指在浏览器中查看网页源代码时所看到的网页源代码中的内容以及网页上显示的内容。

也就是说,当我想在网页上显示某个内容时,可以通过搜索网页的源代码来找到相应的部分。

对于动态网页,则相反,如果想获取动态网页中的具体内容,直接查看网页源代码是找不到的。

动态网页中的动态内容从何而来?

所以,这里有一个问题:

所谓动态网页中的动态内容从何而来?

简而言之,它是通过其他方式生成或获得的。

目前,我学到了几件事:

由本地 Javascript 脚本生成

如果你用IE9的F12来分析访问一个url的过程,你会发现很可能会涉及到,

在网页正常显示之前,这段时间会访问很多javascript脚本,简称js脚本或js。

这些js脚本实现了很多动态的交互内容。

其中,对于一些想要抓取的内容,有时这些js脚本是动态执行最后计算出来的。

通过访问另一个 url 地址获得

很多时候,有些内容是访问另一个url地址后返回的数据;

如何获取我要爬取的动态内容

其实,关于如何抓取需要的动态内容,简单来说,有一个解决方案:

根据自己通过工具分析的结果,自己找到对应的数据,提取出来;

只是这样,有时可以在分析结果的过程中直接提取这些数据,有时可能会通过js进行计算。

如果要抓取数据,由js脚本生成

虽然最终的一些动态内容是通过js脚本的执行产生的,但是对于你想要抓取的数据:

如果你要抓取的内容与js的执行逻辑有关:你要自己分析,调试js执行的过程,最后找出你需要的最终值如何计算;

如果你要抓取的内容与js的执行无关:也就是说,虽然你要抓取的内容是由js的执行生成的,但最终可以直接在其他一些js文件或其他返回的html代码得到了,那么自然可以直接提取,不用关系数据是怎么来的,也就是从特定的字符串中提取出你想要的对应内容。

你要抓取的数据是通过访问另一个url获取的

如果对应你要抓取的内容,需要访问另外一个url地址和返回的数据,那么就很简单了,你也需要单独访问这个url,然后获取对应的返回内容,并提取你从它得到你想要的数据。

总结

同一句话,不管你访问的内容是怎么生成的,最后还是可以用工具分析一下对应的内容是怎么从头生成的。

然后用代码模拟这个过程,最后提取出你需要的; 查看全部

网站内容抓取(如何抓取所谓的动态网页中的特定内容-解释一下)

背景

很多时候,很多人需要抓取网页上的某些特定内容。

不过,除了前面介绍的,我还想从一些静态网页中提取具体的内容,比如:

和

除了

,有些人会发现自己要爬取的网页的内容不在网页的源代码中。

所以,这个时候,我不知道如何实现它。

在这里,让我们解释一下如何抓取所谓的动态网页中的特定内容。

必备知识

阅读本文前,您需要具备相关的基础知识:

1.Fetch 网页,模拟登录等相关逻辑

不熟悉的请参考:

2.学习使用工具,比如IE9的F12,爬取对应的网页执行流程

不熟悉的请参考:

3.对于普通静态网页,如何提取需要的内容

如果你对此不熟悉,可以参考:

(1)Python版:

(2)C#版:

什么是动态网页

这里所谓的动态网页是相对于那些静态网页而言的。

这里所说的静态网页是指在浏览器中查看网页源代码时所看到的网页源代码中的内容以及网页上显示的内容。

也就是说,当我想在网页上显示某个内容时,可以通过搜索网页的源代码来找到相应的部分。

对于动态网页,则相反,如果想获取动态网页中的具体内容,直接查看网页源代码是找不到的。

动态网页中的动态内容从何而来?

所以,这里有一个问题:

所谓动态网页中的动态内容从何而来?

简而言之,它是通过其他方式生成或获得的。

目前,我学到了几件事:

由本地 Javascript 脚本生成

如果你用IE9的F12来分析访问一个url的过程,你会发现很可能会涉及到,

在网页正常显示之前,这段时间会访问很多javascript脚本,简称js脚本或js。

这些js脚本实现了很多动态的交互内容。

其中,对于一些想要抓取的内容,有时这些js脚本是动态执行最后计算出来的。

通过访问另一个 url 地址获得

很多时候,有些内容是访问另一个url地址后返回的数据;

如何获取我要爬取的动态内容

其实,关于如何抓取需要的动态内容,简单来说,有一个解决方案:

根据自己通过工具分析的结果,自己找到对应的数据,提取出来;

只是这样,有时可以在分析结果的过程中直接提取这些数据,有时可能会通过js进行计算。

如果要抓取数据,由js脚本生成

虽然最终的一些动态内容是通过js脚本的执行产生的,但是对于你想要抓取的数据:

如果你要抓取的内容与js的执行逻辑有关:你要自己分析,调试js执行的过程,最后找出你需要的最终值如何计算;

如果你要抓取的内容与js的执行无关:也就是说,虽然你要抓取的内容是由js的执行生成的,但最终可以直接在其他一些js文件或其他返回的html代码得到了,那么自然可以直接提取,不用关系数据是怎么来的,也就是从特定的字符串中提取出你想要的对应内容。

你要抓取的数据是通过访问另一个url获取的

如果对应你要抓取的内容,需要访问另外一个url地址和返回的数据,那么就很简单了,你也需要单独访问这个url,然后获取对应的返回内容,并提取你从它得到你想要的数据。

总结

同一句话,不管你访问的内容是怎么生成的,最后还是可以用工具分析一下对应的内容是怎么从头生成的。

然后用代码模拟这个过程,最后提取出你需要的;

网站内容抓取(如何从网站爬网数据中获取结构化数据?() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-08-30 20:06

)

原文出处:作品(从网站抓取数据的3种最佳方式)/网站名(Octoparse)

原创链接:从网站抓取数据的最佳 3 种方法

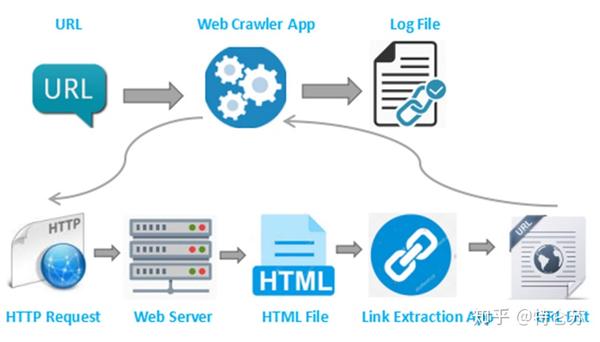

这几年,爬取数据的需求越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以用来从网站抓取数据的三种方法。

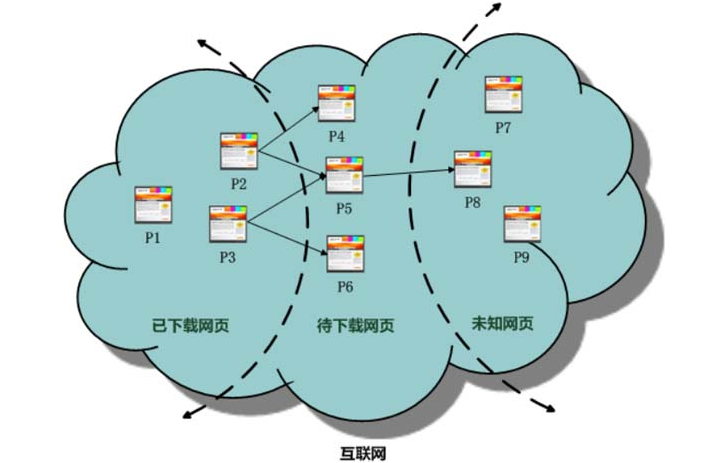

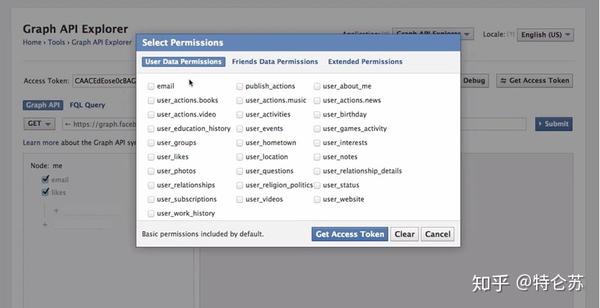

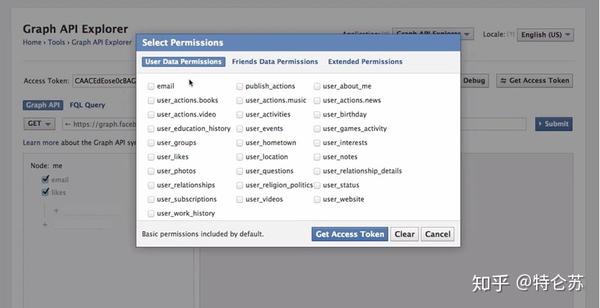

1.use网站API

许多大型社交媒体网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问其数据。有时,您可以选择官方 API 来获取结构化数据。如下面的 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。要了解更多信息,请参阅 /docs/graph-api/using-graph-api。

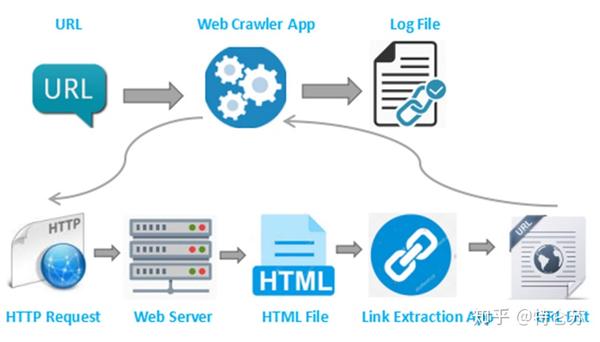

2.创建自己的搜索引擎

然而,并非所有网站 都为用户提供 API。一些网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出RSS提要,但由于它们的使用受到限制,我不会对其提出建议或评论。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

搜索引擎是如何工作的?换句话说,爬虫是一种生成可以由提取程序提供的 URL 列表的方法。 爬虫可以定义为查找 URL 的工具。首先,您需要为爬虫提供一个要启动的网页,它们将跟踪该页面上的所有这些链接。然后,这个过程会继续循环下去。

然后,我们可以继续构建自己的爬虫。众所周知,Python是一门开源的编程语言,你可以找到很多有用的函数库。在这里,我推荐使用 BeautifulSoup(Python 库),因为它易于使用且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取网页。这就是我将 urllib2 与 BeautifulSoup 库结合使用的原因。然后,我们需要处理 HTML 标记以找到页面标记和右侧表格中的所有链接。之后,遍历每一行 (tr),然后将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。首先让我们看一下表格的HTML结构(我不会从表格标题中提取信息)。

通过使用这种方法,您的搜索引擎是定制的。它可以处理API提取中遇到的某些困难。您可以使用代理来防止它被某些网站等阻止,整个过程都在您的掌控之中。这种方法对于具有编码技能的人来说应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式抓取网站 可能很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些搜索引擎工具。

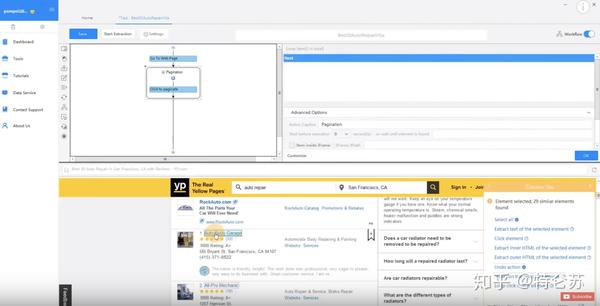

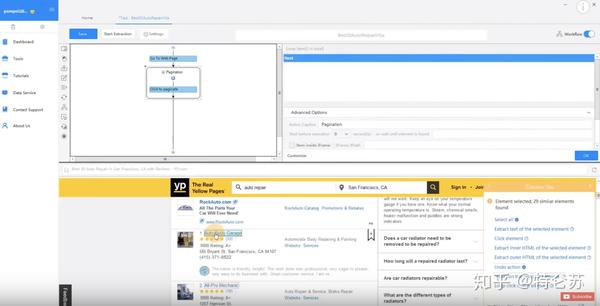

八度分析

Octoparse 是一个强大的基于 Visual Windows 的 Web 数据搜索器。用户可以通过其简单友好的用户界面轻松掌握该工具。要使用它,您需要在本地桌面上下载此应用程序。

如下图所示,您可以在 Workflow Designer 窗格中单击并拖动这些块来自定义您自己的任务。 Octoparse 提供两种版本的爬虫服务订阅计划免费版和付费版。两者都可以满足用户的基本爬取或爬取需求。使用免费版本,您可以在本地运行任务。

如果您从免费版本切换到付费版本,您可以通过将任务上传到云平台来使用基于云的服务。 6 到 14 台云服务器将同时以更高的速度运行您的任务,并执行更大范围的抓取。此外,您可以使用 Octoparse 的匿名代理功能自动提取数据,不留任何痕迹。该功能可以轮流使用大量IP,可以防止你被某些网站屏蔽。这是一个介绍 Octoparse 云提取的视频。

Octoparse 还提供 API 以将您的系统实时连接到您的抓取数据。您可以将 Octoparse 数据导入您自己的数据库,也可以使用 API 请求访问您的帐户数据。完成任务配置后,可以将数据导出为CSV、Excel、HTML、TXT、数据库(MySQL、SQL Server、Oracle)等多种格式。

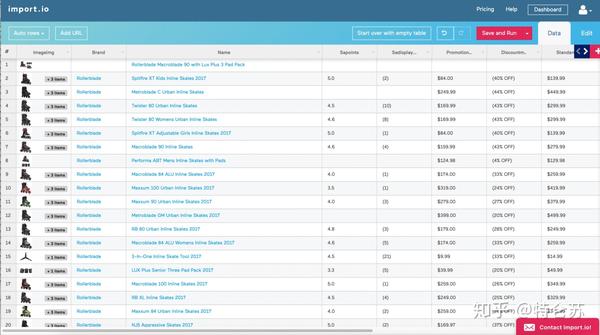

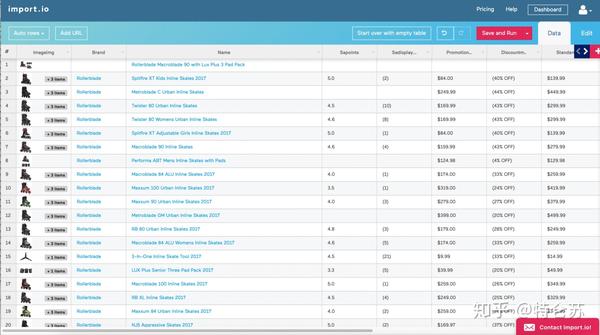

导入

Import.io 也被称为网络爬虫,涵盖所有不同级别的搜索需求。它提供了一个神奇的工具,无需任何培训即可将站点转换为表格。如果需要抓取更复杂的网站,建议用户下载自己的桌面应用。构建 API 后,他们将提供许多简单的集成选项,例如 Google Sheets、Plot.ly、Excel 以及 GET 和 POST 请求。当您认为所有这些都带有终身免费价格标签和强大的支持团队时,import.io 无疑是那些寻找结构化数据的人的首选。它们还为寻求更大或更复杂数据提取的公司提供企业级支付选项。

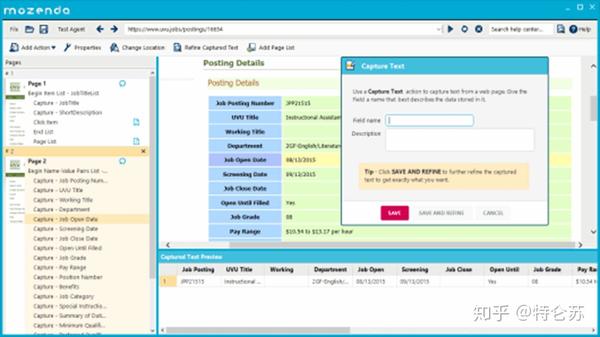

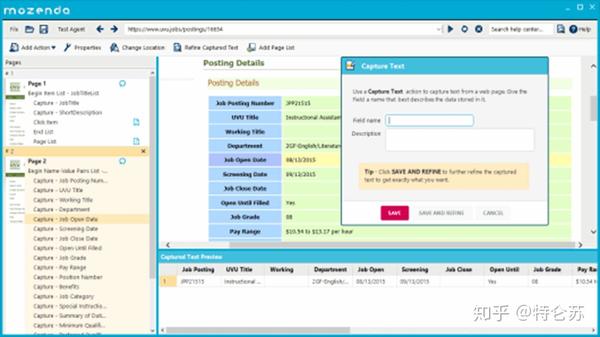

本善达

Mozenda 是另一个用户友好的网络数据提取器。它有一个指向用户的点击式 UI,无需任何编码技能即可使用。 Mozenda 还消除了自动化和发布提取数据的麻烦。一次告诉Mozenda你想要什么数据,然后不管你需要多少次都可以得到。此外,它还允许使用 REST API 进行高级编程,用户可以直接连接 Mozenda 帐户。它还提供基于云的服务和 IP 轮换。

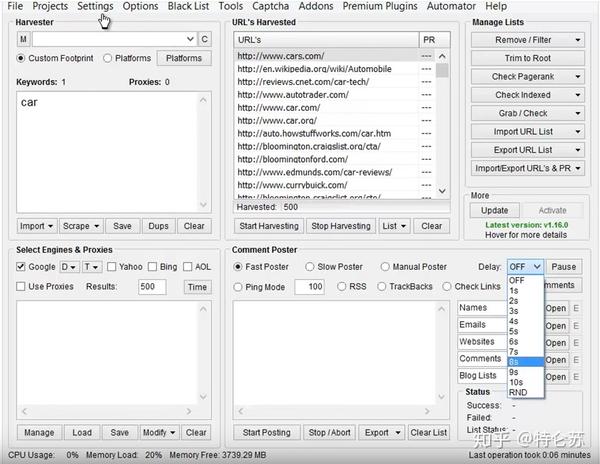

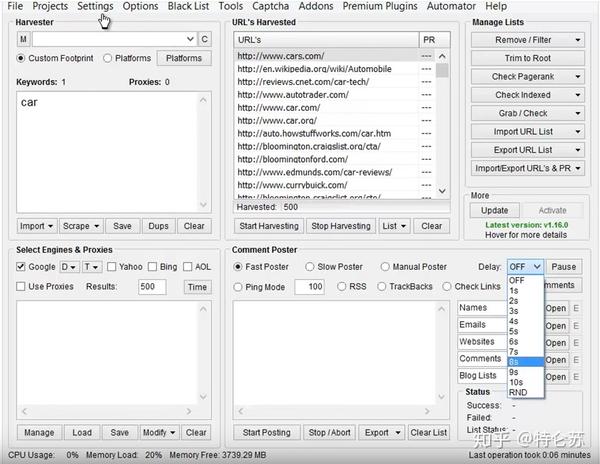

抓取框架

SEO 专家、在线营销人员甚至垃圾邮件发送者都应该非常熟悉 ScrapeBox,它具有非常用户友好的界面。用户可以轻松地从网站 采集数据以获取电子邮件、查看页面排名、验证工作代理和 RSS 提交。通过使用数以千计的轮换代理,您将能够向竞争对手隐藏网站keywords、对 .gov网站 进行研究、采集数据并发表评论而不会被阻止或检测。

Google Web Scraper 插件

如果人们只是想以简单的方式抓取数据,我建议您选择 Google Web Scraper 插件。它是一种基于浏览器的网页抓取工具,其工作方式类似于 Firefox 的 Outwit Hub。您可以将其作为扩展下载并安装在浏览器中。您需要突出显示要抓取的数据字段,右键单击并选择“Scrape like...”。与您突出显示的内容类似的任何内容都将显示在准备导出的表格中,并且与 Google Docs 兼容。最新版本的电子表格仍有一些错误。虽然操作简单,应该会吸引所有用户的注意力,但不能抓取图片,抓取大量数据。

查看全部

网站内容抓取(如何从网站爬网数据中获取结构化数据?()

)

原文出处:作品(从网站抓取数据的3种最佳方式)/网站名(Octoparse)

原创链接:从网站抓取数据的最佳 3 种方法

这几年,爬取数据的需求越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以用来从网站抓取数据的三种方法。

1.use网站API

许多大型社交媒体网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问其数据。有时,您可以选择官方 API 来获取结构化数据。如下面的 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。要了解更多信息,请参阅 /docs/graph-api/using-graph-api。

2.创建自己的搜索引擎

然而,并非所有网站 都为用户提供 API。一些网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出RSS提要,但由于它们的使用受到限制,我不会对其提出建议或评论。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

搜索引擎是如何工作的?换句话说,爬虫是一种生成可以由提取程序提供的 URL 列表的方法。 爬虫可以定义为查找 URL 的工具。首先,您需要为爬虫提供一个要启动的网页,它们将跟踪该页面上的所有这些链接。然后,这个过程会继续循环下去。

然后,我们可以继续构建自己的爬虫。众所周知,Python是一门开源的编程语言,你可以找到很多有用的函数库。在这里,我推荐使用 BeautifulSoup(Python 库),因为它易于使用且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取网页。这就是我将 urllib2 与 BeautifulSoup 库结合使用的原因。然后,我们需要处理 HTML 标记以找到页面标记和右侧表格中的所有链接。之后,遍历每一行 (tr),然后将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。首先让我们看一下表格的HTML结构(我不会从表格标题中提取信息)。

通过使用这种方法,您的搜索引擎是定制的。它可以处理API提取中遇到的某些困难。您可以使用代理来防止它被某些网站等阻止,整个过程都在您的掌控之中。这种方法对于具有编码技能的人来说应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式抓取网站 可能很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些搜索引擎工具。

八度分析

Octoparse 是一个强大的基于 Visual Windows 的 Web 数据搜索器。用户可以通过其简单友好的用户界面轻松掌握该工具。要使用它,您需要在本地桌面上下载此应用程序。

如下图所示,您可以在 Workflow Designer 窗格中单击并拖动这些块来自定义您自己的任务。 Octoparse 提供两种版本的爬虫服务订阅计划免费版和付费版。两者都可以满足用户的基本爬取或爬取需求。使用免费版本,您可以在本地运行任务。

如果您从免费版本切换到付费版本,您可以通过将任务上传到云平台来使用基于云的服务。 6 到 14 台云服务器将同时以更高的速度运行您的任务,并执行更大范围的抓取。此外,您可以使用 Octoparse 的匿名代理功能自动提取数据,不留任何痕迹。该功能可以轮流使用大量IP,可以防止你被某些网站屏蔽。这是一个介绍 Octoparse 云提取的视频。

Octoparse 还提供 API 以将您的系统实时连接到您的抓取数据。您可以将 Octoparse 数据导入您自己的数据库,也可以使用 API 请求访问您的帐户数据。完成任务配置后,可以将数据导出为CSV、Excel、HTML、TXT、数据库(MySQL、SQL Server、Oracle)等多种格式。

导入

Import.io 也被称为网络爬虫,涵盖所有不同级别的搜索需求。它提供了一个神奇的工具,无需任何培训即可将站点转换为表格。如果需要抓取更复杂的网站,建议用户下载自己的桌面应用。构建 API 后,他们将提供许多简单的集成选项,例如 Google Sheets、Plot.ly、Excel 以及 GET 和 POST 请求。当您认为所有这些都带有终身免费价格标签和强大的支持团队时,import.io 无疑是那些寻找结构化数据的人的首选。它们还为寻求更大或更复杂数据提取的公司提供企业级支付选项。

本善达

Mozenda 是另一个用户友好的网络数据提取器。它有一个指向用户的点击式 UI,无需任何编码技能即可使用。 Mozenda 还消除了自动化和发布提取数据的麻烦。一次告诉Mozenda你想要什么数据,然后不管你需要多少次都可以得到。此外,它还允许使用 REST API 进行高级编程,用户可以直接连接 Mozenda 帐户。它还提供基于云的服务和 IP 轮换。

抓取框架

SEO 专家、在线营销人员甚至垃圾邮件发送者都应该非常熟悉 ScrapeBox,它具有非常用户友好的界面。用户可以轻松地从网站 采集数据以获取电子邮件、查看页面排名、验证工作代理和 RSS 提交。通过使用数以千计的轮换代理,您将能够向竞争对手隐藏网站keywords、对 .gov网站 进行研究、采集数据并发表评论而不会被阻止或检测。

Google Web Scraper 插件

如果人们只是想以简单的方式抓取数据,我建议您选择 Google Web Scraper 插件。它是一种基于浏览器的网页抓取工具,其工作方式类似于 Firefox 的 Outwit Hub。您可以将其作为扩展下载并安装在浏览器中。您需要突出显示要抓取的数据字段,右键单击并选择“Scrape like...”。与您突出显示的内容类似的任何内容都将显示在准备导出的表格中,并且与 Google Docs 兼容。最新版本的电子表格仍有一些错误。虽然操作简单,应该会吸引所有用户的注意力,但不能抓取图片,抓取大量数据。

网站内容抓取(爬虫四处抓取网站内容瘫痪百度也没有这么折腾的!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-08-30 13:04

近日,有站长在网上发表评论称,字节跳动为了快速发展搜索业务,派出爬虫抓取网站内容,给中小网站站长造成很大损失和困扰,影响网站普通用户访问。

<p>站长说,今年7月,突然发现公司的网站经常打不开,网页加载极慢,有时甚至直接瘫痪。经过一系列调查,在服务器日志中发现了bytespider爬虫的踪迹。这个爬虫每天的爬虫频率达到几百万次,高达几千万次,服务器带宽负载暴涨到100%,完全不遵守网站的robots协议。 查看全部

网站内容抓取(爬虫四处抓取网站内容瘫痪百度也没有这么折腾的!)

近日,有站长在网上发表评论称,字节跳动为了快速发展搜索业务,派出爬虫抓取网站内容,给中小网站站长造成很大损失和困扰,影响网站普通用户访问。

<p>站长说,今年7月,突然发现公司的网站经常打不开,网页加载极慢,有时甚至直接瘫痪。经过一系列调查,在服务器日志中发现了bytespider爬虫的踪迹。这个爬虫每天的爬虫频率达到几百万次,高达几千万次,服务器带宽负载暴涨到100%,完全不遵守网站的robots协议。

网站内容抓取(SEO专员绞尽脑汁进行网站优化,创建原创内容的抓取习惯)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-08-30 13:03

SEO专家绞尽脑汁优化网站、布局关键词、发布外链、创建原创内容,都是为了吸引搜索引擎对网站爬取、抓取网站内容,从而收录网站,提升网站的排名。

但是搜索引擎抓取网站内容的技术是什么?其实,只要分析一下搜索引擎抓取到的内容的数据,就可以了解搜索引擎的抓取习惯。具体分析建议应从搜索引擎对整个网站的抓取频率、搜索引擎对页面的抓取频率、搜索引擎抓取的网站内容分布、搜索引擎。抓取各种类型的网页。

一、搜索引擎定位网站crawl 频率

了解这个频率,分析数据,就可以大致了解网站在搜索引擎眼中的整体形象。如果网站的内容更新正常,并且网站没有明显变化,但是突然出现整个网站被搜索引擎抓取的频率突然下降,那么只有两个原因,或者网站Run出故障,或者搜索引擎认为网站有漏洞,质量不好。如果爬取的频率突然增加,可能是随着网站内容的不断增加和权重的积累,一直受到搜索引擎的青睐,但会逐渐趋于稳定。

二、搜索引擎对页面的抓取频率

了解此频率有助于调整网络内容的更新频率。搜索引擎为用户显示的每一个搜索结果都对应于互联网上的一个页面。每个搜索结果从生成到被搜索引擎展示给用户,都需要经过四个过程:抓取、过滤、索引和输出结果。

三、搜索引擎抓取的内容分布

<p>搜索引擎对网站内容的爬取分布,结合搜索引擎收录网站的情况。搜索引擎通过了解网站中各个频道的内容更新状态、搜索引擎的收录状态以及搜索引擎每天对该频道的抓取是否成正比来确定网站内容抓取的分布。 查看全部

网站内容抓取(SEO专员绞尽脑汁进行网站优化,创建原创内容的抓取习惯)

SEO专家绞尽脑汁优化网站、布局关键词、发布外链、创建原创内容,都是为了吸引搜索引擎对网站爬取、抓取网站内容,从而收录网站,提升网站的排名。

但是搜索引擎抓取网站内容的技术是什么?其实,只要分析一下搜索引擎抓取到的内容的数据,就可以了解搜索引擎的抓取习惯。具体分析建议应从搜索引擎对整个网站的抓取频率、搜索引擎对页面的抓取频率、搜索引擎抓取的网站内容分布、搜索引擎。抓取各种类型的网页。

一、搜索引擎定位网站crawl 频率

了解这个频率,分析数据,就可以大致了解网站在搜索引擎眼中的整体形象。如果网站的内容更新正常,并且网站没有明显变化,但是突然出现整个网站被搜索引擎抓取的频率突然下降,那么只有两个原因,或者网站Run出故障,或者搜索引擎认为网站有漏洞,质量不好。如果爬取的频率突然增加,可能是随着网站内容的不断增加和权重的积累,一直受到搜索引擎的青睐,但会逐渐趋于稳定。

二、搜索引擎对页面的抓取频率

了解此频率有助于调整网络内容的更新频率。搜索引擎为用户显示的每一个搜索结果都对应于互联网上的一个页面。每个搜索结果从生成到被搜索引擎展示给用户,都需要经过四个过程:抓取、过滤、索引和输出结果。

三、搜索引擎抓取的内容分布

<p>搜索引擎对网站内容的爬取分布,结合搜索引擎收录网站的情况。搜索引擎通过了解网站中各个频道的内容更新状态、搜索引擎的收录状态以及搜索引擎每天对该频道的抓取是否成正比来确定网站内容抓取的分布。

网站内容抓取(网站建设要做好SEO优化,提高网站在搜索引擎的排名)

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-08-30 13:02

[摘要]网站building一定要做好SEO优化,提高网站在搜索引擎中的排名。使用软文文章做网站的SEO排名,是Seoer做排名的必要手段。一篇用于对关键词进行排名的文章网站文章有几个我们需要注意的核心点:第一,网站title;二、网站文章内容;三、网站文章结构。

网站construction一定要做好SEO优化,提高网站在搜索引擎中的排名。使用软文文章做网站的SEO排名,是Seoer做排名的必要手段。一篇用于对关键词进行排名的文章网站文章有几个我们需要注意的核心点:第一,网站title;二、网站文章内容;三、网站文章结构。下面我们来详细分析一下网站content 构建的这三个因素:

首先,网站titles 的重要性。以“广州应用开发公司”这个词为例,百度蜘蛛首先会判断标题中出现文章:“广州,应用,开发,公司”这个词文章曾经出现过,有没有好的组合如果是这样,那么百度蜘蛛就会认为这个文章有一定的关联性。再者,如果网站文章对于核心词的相关性和内容的丰富性足够好,那么这个文章无论是在网站的内页还是对外排名,都有良好的排名效果。

其次,网站的文章内容。在网站的文章内容方面,关键是紧跟文章标题,处理好语言的相关性、内容丰富性、扩展性和自然性。处理好这些关系,无论是对用户还是百度蜘蛛,都会是一个高质量的网站文章。

三、网站的文章结构。使用软文进行排名和文章的结构非常重要。一是让网站的文章井井有条,观看舒适。其次,在网站的文章添加排序码可以加快蜘蛛对文章质量的审核,间接加快帖子和收录的排名。

Seoer在做网站SEO优化建设的时候,如果想通过网站内部文章提升网站的排名,需要关注网站的质量内文章,优质的文章不仅会加快百度蜘蛛的收录速度,而且对于用户来说也是一个有价值的文章,更有利于网站获得好的排名。所以seoer应该从上面提到的三点来做文章关键词排名。 查看全部

网站内容抓取(网站建设要做好SEO优化,提高网站在搜索引擎的排名)

[摘要]网站building一定要做好SEO优化,提高网站在搜索引擎中的排名。使用软文文章做网站的SEO排名,是Seoer做排名的必要手段。一篇用于对关键词进行排名的文章网站文章有几个我们需要注意的核心点:第一,网站title;二、网站文章内容;三、网站文章结构。

网站construction一定要做好SEO优化,提高网站在搜索引擎中的排名。使用软文文章做网站的SEO排名,是Seoer做排名的必要手段。一篇用于对关键词进行排名的文章网站文章有几个我们需要注意的核心点:第一,网站title;二、网站文章内容;三、网站文章结构。下面我们来详细分析一下网站content 构建的这三个因素:

首先,网站titles 的重要性。以“广州应用开发公司”这个词为例,百度蜘蛛首先会判断标题中出现文章:“广州,应用,开发,公司”这个词文章曾经出现过,有没有好的组合如果是这样,那么百度蜘蛛就会认为这个文章有一定的关联性。再者,如果网站文章对于核心词的相关性和内容的丰富性足够好,那么这个文章无论是在网站的内页还是对外排名,都有良好的排名效果。

其次,网站的文章内容。在网站的文章内容方面,关键是紧跟文章标题,处理好语言的相关性、内容丰富性、扩展性和自然性。处理好这些关系,无论是对用户还是百度蜘蛛,都会是一个高质量的网站文章。

三、网站的文章结构。使用软文进行排名和文章的结构非常重要。一是让网站的文章井井有条,观看舒适。其次,在网站的文章添加排序码可以加快蜘蛛对文章质量的审核,间接加快帖子和收录的排名。

Seoer在做网站SEO优化建设的时候,如果想通过网站内部文章提升网站的排名,需要关注网站的质量内文章,优质的文章不仅会加快百度蜘蛛的收录速度,而且对于用户来说也是一个有价值的文章,更有利于网站获得好的排名。所以seoer应该从上面提到的三点来做文章关键词排名。

网站内容抓取(如何解决网站频次频次太低的问题?-成都蔡江)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-08-29 19:01

在优化网站的过程中,我们经常会分析网站的优化效果。绑定百度站长工具的SEOer有没有观察到抓取频率降低,增加索引的问题?很多站长解决不了问题,一脸懵逼。他们没有任何不正规的操作,但他们就是这样。说说成都彩江SEO吧。

网站的爬取频率是多少?

其实这个问题很好理解。它是爬到网站 的蜘蛛数量。通俗的说,你的网站里面的蜘蛛不多,吸引还是不吸引蜘蛛。

高抓取频率是一种好现象吗?

不是,蜘蛛爬行频率太高了,但是说明你的网站可能开始出现问题了,比如:自己网站被挂黑链,被别人镜像了等等。网站蜘蛛的爬取频率,成都seo觉得还是和你的网站体量有关。如果你是企业网站,网页只有150,那么你的抓取频率永远不会超过一百,除非设置了网站优化,优质内容。这样的网站可以有这么多蜘蛛。如果不是这样,老铁,你应该检查你的网站!

如何解决网站抓取频率过低的问题?

1、坚持每天向百度站长提交网站链接

您可以在百度站长工具中提交链接。这是最简单粗暴的方式,也是最及时有效的方式。如果您有更多新网站的链接,可以提交网站的sitmap.txt网站的地图,也可以提交单个链接。

2、做好网站内链环

a.文章内链.包括文中的内部链接以及相关的文章推荐等,这是基本的操作方法,我就不多说了。

B.侧边栏推荐。比如热门阅读、最新内容、标签采集标签推荐等。页面链接暴露的越多,被蜘蛛爬取的几率就越大。这是一个非常简单的事实。

c.文章list。这是一个重要的解释点。一般情况下,列表中的文章是按时间倒序排列的,也就是说,后面发布的文章会排在最前面。这里有问题。同一个文章列表下每天更新的文章数量有限,分页被蜘蛛爬取的次数会比较多,浪费了链接展示的机会。

3、做好内容更新频率

新站可以每天多更新一点,一天三五篇,老站可以少更新一点,一天一两篇。但它必须是定期的。不能说三天钓鱼两天上网,今天一口气更新了几十篇文章,然后一个星期都没动静。百度蜘蛛更喜欢常规的东西。只有控制网站的更新频率,蜘蛛才会更喜欢你的网站。

4、做好内容质量

内容质量分为原创、伪原创和抄袭。建议无论走到哪里都使用原创文章,因为原创的内容会更吸引蜘蛛。如果实在没时间或者文采不好,可以贴一些别人的文章进行修改,拼凑伪原创。这并不是说原创的文章会好,伪原创一定不如原创文章,这只是一个建议。比如写一篇关于办公家具的软文,我对它一无所知,根本写不出理由,所以更明智的选择是选择伪原创。关于抄袭,强烈不推荐!

无论是网站还是收录的排名,成都seo告诉你,这与蜘蛛的爬行频率有一定的关系。 网站的质量是达标的,有利于用户体验,自然对蜘蛛有利。敏感度,增加蜘蛛的信任度,那么有利于网站和收录的后续排名。 查看全部

网站内容抓取(如何解决网站频次频次太低的问题?-成都蔡江)

在优化网站的过程中,我们经常会分析网站的优化效果。绑定百度站长工具的SEOer有没有观察到抓取频率降低,增加索引的问题?很多站长解决不了问题,一脸懵逼。他们没有任何不正规的操作,但他们就是这样。说说成都彩江SEO吧。

网站的爬取频率是多少?

其实这个问题很好理解。它是爬到网站 的蜘蛛数量。通俗的说,你的网站里面的蜘蛛不多,吸引还是不吸引蜘蛛。

高抓取频率是一种好现象吗?

不是,蜘蛛爬行频率太高了,但是说明你的网站可能开始出现问题了,比如:自己网站被挂黑链,被别人镜像了等等。网站蜘蛛的爬取频率,成都seo觉得还是和你的网站体量有关。如果你是企业网站,网页只有150,那么你的抓取频率永远不会超过一百,除非设置了网站优化,优质内容。这样的网站可以有这么多蜘蛛。如果不是这样,老铁,你应该检查你的网站!

如何解决网站抓取频率过低的问题?

1、坚持每天向百度站长提交网站链接

您可以在百度站长工具中提交链接。这是最简单粗暴的方式,也是最及时有效的方式。如果您有更多新网站的链接,可以提交网站的sitmap.txt网站的地图,也可以提交单个链接。

2、做好网站内链环

a.文章内链.包括文中的内部链接以及相关的文章推荐等,这是基本的操作方法,我就不多说了。

B.侧边栏推荐。比如热门阅读、最新内容、标签采集标签推荐等。页面链接暴露的越多,被蜘蛛爬取的几率就越大。这是一个非常简单的事实。

c.文章list。这是一个重要的解释点。一般情况下,列表中的文章是按时间倒序排列的,也就是说,后面发布的文章会排在最前面。这里有问题。同一个文章列表下每天更新的文章数量有限,分页被蜘蛛爬取的次数会比较多,浪费了链接展示的机会。

3、做好内容更新频率

新站可以每天多更新一点,一天三五篇,老站可以少更新一点,一天一两篇。但它必须是定期的。不能说三天钓鱼两天上网,今天一口气更新了几十篇文章,然后一个星期都没动静。百度蜘蛛更喜欢常规的东西。只有控制网站的更新频率,蜘蛛才会更喜欢你的网站。

4、做好内容质量

内容质量分为原创、伪原创和抄袭。建议无论走到哪里都使用原创文章,因为原创的内容会更吸引蜘蛛。如果实在没时间或者文采不好,可以贴一些别人的文章进行修改,拼凑伪原创。这并不是说原创的文章会好,伪原创一定不如原创文章,这只是一个建议。比如写一篇关于办公家具的软文,我对它一无所知,根本写不出理由,所以更明智的选择是选择伪原创。关于抄袭,强烈不推荐!

无论是网站还是收录的排名,成都seo告诉你,这与蜘蛛的爬行频率有一定的关系。 网站的质量是达标的,有利于用户体验,自然对蜘蛛有利。敏感度,增加蜘蛛的信任度,那么有利于网站和收录的后续排名。

网站内容抓取(Selenium简介与安装Selenium是什么?Python抓取微博有两种方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-09-01 19:15

Selenium 的介绍和安装

什么是硒?

Selenium 也是 Web 应用程序测试的工具。 Selenium 测试直接在浏览器中运行,就像真正的用户在操作一样。支持的浏览器包括IE、Mozilla Firefox、Mozilla Suite等

安装

可以直接用pip命令安装!

pip install selenium

Python爬取微博有两种方式,一种是通过selenium自动登录后直接从页面爬取,另一种是使用api。

这里使用了硒。

程序:

<p>

from selenium import webdriver

import time

import re

#全局变量

driver = webdriver.Chrome("C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

def loginWeibo(username, password):

driver.get('https://passport.weibo.cn/signin/login')

time.sleep(1)

driver.find_element_by_id("loginName").send_keys("haishu_zheng@163.com")

driver.find_element_by_id("loginPassword").send_keys("Weibo01061122")

time.sleep(1)

driver.find_element_by_id("loginAction").click()

#driver.close()

def visitUserPage(userId):

driver.get('http://weibo.cn/' + userId)

print('********************')

print('用户资料')

# 1.用户id

print('用户id:' + userId)

# 2.用户昵称

strName = driver.find_element_by_xpath("//div[@class='ut']")

strlist = strName.text.split(' ')

nickname = strlist[0]

print('昵称:' + nickname)

# 3.微博数、粉丝数、关注数

strCnt = driver.find_element_by_xpath("//div[@class='tip2']")

pattern = r"\d+\.?\d*" # 匹配数字,包含整数和小数

cntArr = re.findall(pattern, strCnt.text)

print(strCnt.text)

print("微博数:" + str(cntArr[0]))

print("关注数:" + str(cntArr[1]))

print("粉丝数:" + str(cntArr[2]))

print('\n********************')

# 4.将用户信息写到文件里

with open("weibo.txt", "w", encoding = "gb18030") as file:

file.write("用户ID:" + userId + '\r\n')

file.write("昵称:" + nickname + '\r\n')

file.write("微博数:" + str(cntArr[0]) + '\r\n')

file.write("关注数:" + str(cntArr[1]) + '\r\n')

file.write("粉丝数:" + str(cntArr[2]) + '\r\n')

# 5.获取微博内容

# http://weibo.cn/ + userId + ? filter=0&page=1

# filter为0表示全部,为1表示原创

print("微博内容")

pageList = driver.find_element_by_xpath("//div[@class='pa']")

print(pageList.text)

pattern = r"\d+\d*" # 匹配数字,只包含整数

pageArr = re.findall(pattern, pageList.text)

totalPages = pageArr[1] # 总共有多少页微博

print(totalPages)

pageNum = 1 # 第几页

numInCurPage = 1 # 当前页的第几条微博内容

contentPath = "//div[@class='c'][{0}]"

while(pageNum 查看全部

网站内容抓取(Selenium简介与安装Selenium是什么?Python抓取微博有两种方式)

Selenium 的介绍和安装

什么是硒?

Selenium 也是 Web 应用程序测试的工具。 Selenium 测试直接在浏览器中运行,就像真正的用户在操作一样。支持的浏览器包括IE、Mozilla Firefox、Mozilla Suite等

安装

可以直接用pip命令安装!

pip install selenium

Python爬取微博有两种方式,一种是通过selenium自动登录后直接从页面爬取,另一种是使用api。

这里使用了硒。

程序:

<p>

from selenium import webdriver

import time

import re

#全局变量

driver = webdriver.Chrome("C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

def loginWeibo(username, password):

driver.get('https://passport.weibo.cn/signin/login')

time.sleep(1)

driver.find_element_by_id("loginName").send_keys("haishu_zheng@163.com")

driver.find_element_by_id("loginPassword").send_keys("Weibo01061122")

time.sleep(1)

driver.find_element_by_id("loginAction").click()

#driver.close()

def visitUserPage(userId):

driver.get('http://weibo.cn/' + userId)

print('********************')

print('用户资料')

# 1.用户id

print('用户id:' + userId)

# 2.用户昵称

strName = driver.find_element_by_xpath("//div[@class='ut']")

strlist = strName.text.split(' ')

nickname = strlist[0]

print('昵称:' + nickname)

# 3.微博数、粉丝数、关注数

strCnt = driver.find_element_by_xpath("//div[@class='tip2']")

pattern = r"\d+\.?\d*" # 匹配数字,包含整数和小数

cntArr = re.findall(pattern, strCnt.text)

print(strCnt.text)

print("微博数:" + str(cntArr[0]))

print("关注数:" + str(cntArr[1]))

print("粉丝数:" + str(cntArr[2]))

print('\n********************')

# 4.将用户信息写到文件里

with open("weibo.txt", "w", encoding = "gb18030") as file:

file.write("用户ID:" + userId + '\r\n')

file.write("昵称:" + nickname + '\r\n')

file.write("微博数:" + str(cntArr[0]) + '\r\n')

file.write("关注数:" + str(cntArr[1]) + '\r\n')

file.write("粉丝数:" + str(cntArr[2]) + '\r\n')

# 5.获取微博内容

# http://weibo.cn/ + userId + ? filter=0&page=1

# filter为0表示全部,为1表示原创

print("微博内容")

pageList = driver.find_element_by_xpath("//div[@class='pa']")

print(pageList.text)

pattern = r"\d+\d*" # 匹配数字,只包含整数

pageArr = re.findall(pattern, pageList.text)

totalPages = pageArr[1] # 总共有多少页微博

print(totalPages)

pageNum = 1 # 第几页

numInCurPage = 1 # 当前页的第几条微博内容

contentPath = "//div[@class='c'][{0}]"

while(pageNum

网站内容抓取(网站页面不是让搜索引擎抓的越多越好吗)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-09-01 19:13

有的朋友可能会疑惑,网站的页面不是让搜索引擎尽可能多的抓取吗?怎么有防止网站内容被爬取的想法?

首先,一个网站可以分配的权重是有限的,即使是Pr10站,也不可能无限分配权重。这个权重包括链接到他人网站的链和自己网站内部的链。

对于外部链接,除非是想被链接的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

链内,因为一些网站有很多重复或冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说极其方便,但是对于搜索引擎来说,它们会消耗大量的蜘蛛爬行时间,尤其是在网站页面很多的情况下。同时页面权重会分散,不利于SEO。

另外网站管理登录页、备份页、测试页等,站长不想让搜索引擎收录。

因此需要防止网页的某些内容,或某些网页被搜索引擎收录搜索到。

下面笔者先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为收录的内容

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为 Google 和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个多用于网站管理页面、测试页面等

3.使用nofollow标签来包装你不想成为收录的内容

这个方法并不能完全保证你不会被收录,因为这不是一个严格要求遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4.使用Meta Noindex标签添加关注标签

这个方法可以防止收录,也可以传权重。想通过就看网站建筑站长的需求了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件,在页面上使用iframe标签显示需要搜索引擎收录的内容

robots 文件可以防止 iframe 标签之外的内容被收录。因此,您可以将您不想要的内容收录 放在普通页面标签下。并希望在iframe标签中成为收录内容。

接下来说说失败的方法。以后不要使用这些方法。

1.使用表格

谷歌和百度已经能够抓取表单的内容,他们无法阻止收录。

2.使用Javascript和Ajax技术

就目前的技术而言,Ajax和javascript的最终计算结果还是以HTML的形式传输给浏览器进行显示,所以这也无法阻止收录。

初学者大多关注如何收录,但细节决定成败。如何防止网站页面内容被抓取也是高级SEO人需要注意的问题。

本文来自(),尊重作者的劳动成果,转载请注明出处。 查看全部

网站内容抓取(网站页面不是让搜索引擎抓的越多越好吗)

有的朋友可能会疑惑,网站的页面不是让搜索引擎尽可能多的抓取吗?怎么有防止网站内容被爬取的想法?

首先,一个网站可以分配的权重是有限的,即使是Pr10站,也不可能无限分配权重。这个权重包括链接到他人网站的链和自己网站内部的链。

对于外部链接,除非是想被链接的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

链内,因为一些网站有很多重复或冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说极其方便,但是对于搜索引擎来说,它们会消耗大量的蜘蛛爬行时间,尤其是在网站页面很多的情况下。同时页面权重会分散,不利于SEO。

另外网站管理登录页、备份页、测试页等,站长不想让搜索引擎收录。

因此需要防止网页的某些内容,或某些网页被搜索引擎收录搜索到。

下面笔者先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为收录的内容

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为 Google 和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个多用于网站管理页面、测试页面等

3.使用nofollow标签来包装你不想成为收录的内容

这个方法并不能完全保证你不会被收录,因为这不是一个严格要求遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4.使用Meta Noindex标签添加关注标签

这个方法可以防止收录,也可以传权重。想通过就看网站建筑站长的需求了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件,在页面上使用iframe标签显示需要搜索引擎收录的内容

robots 文件可以防止 iframe 标签之外的内容被收录。因此,您可以将您不想要的内容收录 放在普通页面标签下。并希望在iframe标签中成为收录内容。

接下来说说失败的方法。以后不要使用这些方法。

1.使用表格

谷歌和百度已经能够抓取表单的内容,他们无法阻止收录。

2.使用Javascript和Ajax技术

就目前的技术而言,Ajax和javascript的最终计算结果还是以HTML的形式传输给浏览器进行显示,所以这也无法阻止收录。

初学者大多关注如何收录,但细节决定成败。如何防止网站页面内容被抓取也是高级SEO人需要注意的问题。

本文来自(),尊重作者的劳动成果,转载请注明出处。

网站内容抓取(更新网站内容速度,是否影响蜘蛛用关键词排名爬行?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-09-01 19:11

更新网站content速度,会不会影响关键词ranking爬虫?

网站 经常更新。如果你的网站还没有通过百度的审核期,也就是说3个月后就不会一直更新网站的内容,蜘蛛也很少访问你的网站。蜘蛛每次爬行,总是看到之前的内容,爬行后就找不到新的内容了。下次蜘蛛不会那么频繁地抓取它时,您的网站 快照将停止在您停止更新内容的那一天的快照。 网站更新频率越高,快照会更新,第二天的快照生成速度会比较慢。但是百度快照第二天的网站排名不一定好。百度快照越新,你的网站被抓到的机会就越大。 网站权重不是很好,域名时间不是很长,网站有点慢,可能是网站更新不频繁,也可能是网站速度因素,影响因素百度快照很简单,仅供点赞,供大家交流友情链接参考。

对于一些关键词排名靠前的网站,如果长时间不更新网站的内容,可能会在一定程度上影响关键词的排名。虽然这不是暴跌,但如果长时间不更新内容,网站的权重偶尔会下降。因为你的关键词太激烈了,排名肯定会下降。只要你的网站内容再次更新,权重自然会恢复,然后排名也会下降。 网站的权重是很多长尾词都有排名,来自搜索引擎的流量也比较多。如果不更新,目标关键字最初是掠夺者和掠夺者,必须被竞争对手超越。为了保持排名的稳定性,需要更新内容,否则权重会慢慢继续增长,当权重降低时,排名也会下降。只要网站的权重足够强,就会长期下降,但并不是网站的100%会出现这种情况,大部分网站都是这种情况。

网站的内容不仅写在百度搜索引擎上,也写在我们的网站用户身上。 网站 不能与用户分离。如果我们想留住用户,我们需要让他们受益。那么我们的网站一定要有用户留下的理由,才不会让用户跑掉。如果有用户来到你的网站,肯定有你的网站目标的需求,那么我们需要更新一些有用的网站内容来满足我们的用户。如果用户来到你的网站,看到你的网站内容已经很久没有更新了,我想用户离开我们的网站会很失望。如果他下次来我们网站还没有更新任何内容,我想他会放弃我们的网站,再也不会回来了,因为他来找你的时候没有得到他想要的网站东西,他怎么来了?

所以一定要定期更新内容,不要太长,或者一次更新很多。一定要养成良好的更新频率,让用户不会让搜索引擎掉头。只有继续喜欢我们的网站内容,才能留住用户,赢得搜索引擎蜘蛛的喜爱。

我要收录好,又不能没有又快又稳的服务器,所以这次就问,香港谁选又快又稳的服务器? 查看全部

网站内容抓取(更新网站内容速度,是否影响蜘蛛用关键词排名爬行?)

更新网站content速度,会不会影响关键词ranking爬虫?

网站 经常更新。如果你的网站还没有通过百度的审核期,也就是说3个月后就不会一直更新网站的内容,蜘蛛也很少访问你的网站。蜘蛛每次爬行,总是看到之前的内容,爬行后就找不到新的内容了。下次蜘蛛不会那么频繁地抓取它时,您的网站 快照将停止在您停止更新内容的那一天的快照。 网站更新频率越高,快照会更新,第二天的快照生成速度会比较慢。但是百度快照第二天的网站排名不一定好。百度快照越新,你的网站被抓到的机会就越大。 网站权重不是很好,域名时间不是很长,网站有点慢,可能是网站更新不频繁,也可能是网站速度因素,影响因素百度快照很简单,仅供点赞,供大家交流友情链接参考。

对于一些关键词排名靠前的网站,如果长时间不更新网站的内容,可能会在一定程度上影响关键词的排名。虽然这不是暴跌,但如果长时间不更新内容,网站的权重偶尔会下降。因为你的关键词太激烈了,排名肯定会下降。只要你的网站内容再次更新,权重自然会恢复,然后排名也会下降。 网站的权重是很多长尾词都有排名,来自搜索引擎的流量也比较多。如果不更新,目标关键字最初是掠夺者和掠夺者,必须被竞争对手超越。为了保持排名的稳定性,需要更新内容,否则权重会慢慢继续增长,当权重降低时,排名也会下降。只要网站的权重足够强,就会长期下降,但并不是网站的100%会出现这种情况,大部分网站都是这种情况。

网站的内容不仅写在百度搜索引擎上,也写在我们的网站用户身上。 网站 不能与用户分离。如果我们想留住用户,我们需要让他们受益。那么我们的网站一定要有用户留下的理由,才不会让用户跑掉。如果有用户来到你的网站,肯定有你的网站目标的需求,那么我们需要更新一些有用的网站内容来满足我们的用户。如果用户来到你的网站,看到你的网站内容已经很久没有更新了,我想用户离开我们的网站会很失望。如果他下次来我们网站还没有更新任何内容,我想他会放弃我们的网站,再也不会回来了,因为他来找你的时候没有得到他想要的网站东西,他怎么来了?

所以一定要定期更新内容,不要太长,或者一次更新很多。一定要养成良好的更新频率,让用户不会让搜索引擎掉头。只有继续喜欢我们的网站内容,才能留住用户,赢得搜索引擎蜘蛛的喜爱。

我要收录好,又不能没有又快又稳的服务器,所以这次就问,香港谁选又快又稳的服务器?

网站内容抓取(网站优化类的排版布局要求,你值得拥有!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-09-01 19:09

一、排版和布局要求。

为了制作出让用户满意的优质内容,除了内容本身,布局也是一项非常重要的工作。毕竟人是视觉动物。将正文内容划分为标题、副标题、正文等不同类型,然后让正文以突出的层次发挥作用。清晰的层次结构可以使内容更具可读性。适当的图形将使内容更具可读性。 文章更生动。此外,针对不同的文本类型使用不同格式、大小和颜色的字体也可以让用户获得更好的阅读体验。当您需要引用其他平台的内容时,请尽量确保链接指向高质量、有声望的网站。

二、Content 从根本上受到监管。

内容的最基本部分是文本。在写文章时,重要的是不要出现错别字、语言错误、没有标点符号和没有分段的长篇讨论;不要在不必要的时候使用困难和难以理解的情况。尽量使用简单直观的句子,便于各级用户理解。

三、代码规范要求。

1、 适当收紧图片,优化格式;

2、 将JS代码和CSS样式分别合并成一个共享文件;

3、 减去代码,去掉不必要的冗余代码,如空格、注释等

4、Cache 静态资源,通过设置reader缓存来缓存CSS、JS等不经常更新的文件;

5、优先显示可见区域的内容,即先加载第一屏的内容和样式,用户滚动鼠标时加载下面的内容;

更多网站optimization问题请留言咨询编辑。有兴趣的朋友可以一起交流学习 查看全部

网站内容抓取(网站优化类的排版布局要求,你值得拥有!!)

一、排版和布局要求。

为了制作出让用户满意的优质内容,除了内容本身,布局也是一项非常重要的工作。毕竟人是视觉动物。将正文内容划分为标题、副标题、正文等不同类型,然后让正文以突出的层次发挥作用。清晰的层次结构可以使内容更具可读性。适当的图形将使内容更具可读性。 文章更生动。此外,针对不同的文本类型使用不同格式、大小和颜色的字体也可以让用户获得更好的阅读体验。当您需要引用其他平台的内容时,请尽量确保链接指向高质量、有声望的网站。

二、Content 从根本上受到监管。

内容的最基本部分是文本。在写文章时,重要的是不要出现错别字、语言错误、没有标点符号和没有分段的长篇讨论;不要在不必要的时候使用困难和难以理解的情况。尽量使用简单直观的句子,便于各级用户理解。

三、代码规范要求。

1、 适当收紧图片,优化格式;

2、 将JS代码和CSS样式分别合并成一个共享文件;

3、 减去代码,去掉不必要的冗余代码,如空格、注释等

4、Cache 静态资源,通过设置reader缓存来缓存CSS、JS等不经常更新的文件;

5、优先显示可见区域的内容,即先加载第一屏的内容和样式,用户滚动鼠标时加载下面的内容;

更多网站optimization问题请留言咨询编辑。有兴趣的朋友可以一起交流学习

网站内容抓取(爬取安居客前60名左右租房数据,代码介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-09-01 15:02

连接如果QQ聊天没有自动弹出,请点击GooSeeker官网。 data采集服务请联系客服:0755-86528616 Jisuke GooSeeker网络爬虫安装上网EXCEL,数据库100W+。

爬取前60名安居房客的租房数据,区域可以自己改,资源爬取的是南京数据,代码更易懂~~你可以看看小白,我也是这样做的2.版本0可以定制。

当你能爬到上面列出的网站时,这个网站其实对你来说很容易,但你不要以为爬行结束了,这才刚刚结束。

不同类型的网站爬虫策略不同,难度也不同。至于是否需要登录,比如一些简单的网站不需要登录就可以爬取。

这是第一次使用爬虫抓取网页。下面是爬取豆瓣电影top250的全过程,欢迎大家指点。这里我只爬取了电影链接和电影名称,如果想要更完整的爬取代码,请联系我.qq。

csdn为你找到了python爬虫常用网站相关内容,包括python爬虫常用网站相关文档代码介绍、相关教程视频课程,以及相关python爬虫常用网站问答内容为您解决目前的相关问题。

网站会根据IP地址访问的频率来判断爬虫是否有每台电脑唯一的IP地址,每个爬虫也有唯一的IP地址。当电脑或爬虫访问网站时,网站这个IP地址会被记录下来。如果同一个IP在短时间内多次访问同一个网络。

免责声明:本项目仅供学习使用,不会影响网站。最近闲来无事,发现有段时间没写博客了,于是找了一张动漫图片网站来写。 **低难度,适合新手练习=网站URL:我们要爬传送门。 查看全部

网站内容抓取(爬取安居客前60名左右租房数据,代码介绍)

连接如果QQ聊天没有自动弹出,请点击GooSeeker官网。 data采集服务请联系客服:0755-86528616 Jisuke GooSeeker网络爬虫安装上网EXCEL,数据库100W+。

爬取前60名安居房客的租房数据,区域可以自己改,资源爬取的是南京数据,代码更易懂~~你可以看看小白,我也是这样做的2.版本0可以定制。

当你能爬到上面列出的网站时,这个网站其实对你来说很容易,但你不要以为爬行结束了,这才刚刚结束。

不同类型的网站爬虫策略不同,难度也不同。至于是否需要登录,比如一些简单的网站不需要登录就可以爬取。

这是第一次使用爬虫抓取网页。下面是爬取豆瓣电影top250的全过程,欢迎大家指点。这里我只爬取了电影链接和电影名称,如果想要更完整的爬取代码,请联系我.qq。

csdn为你找到了python爬虫常用网站相关内容,包括python爬虫常用网站相关文档代码介绍、相关教程视频课程,以及相关python爬虫常用网站问答内容为您解决目前的相关问题。

网站会根据IP地址访问的频率来判断爬虫是否有每台电脑唯一的IP地址,每个爬虫也有唯一的IP地址。当电脑或爬虫访问网站时,网站这个IP地址会被记录下来。如果同一个IP在短时间内多次访问同一个网络。

免责声明:本项目仅供学习使用,不会影响网站。最近闲来无事,发现有段时间没写博客了,于是找了一张动漫图片网站来写。 **低难度,适合新手练习=网站URL:我们要爬传送门。

网站内容抓取(百度网站推广机构告诉你你吧规模性网站为什么挺好?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-09-01 04:05

在优化网站SEO的过程中,网站的结构越简单明了,越有利于搜索引擎蜘蛛的爬取爬行,让搜索引擎收录有更多的内容,然后网站获得更好的排名。

不过网站有一定的规模,深度目录的爬取率也相当不错。为什么是这样?接下来就让百度网站推广机构告诉你!

1、网站整体结构不错

对于大规模的网站,深层目录的爬取速度更好,这意味着网站的整体结构更好,蜘蛛爬虫可以按照网站结构进入最深的目录在此方式,可以爬取内容,让搜索引擎收录More网站page。

2、良好的内部链结构

为大规模网站创建内链时,必须使用内链链接相关页面,也可以使用内链链接首页和深层目录。这样做的目的是为了让蜘蛛爬虫更好地抓取网站页面,让搜索引擎收录搜索到深层目录的内容。

3、网站权重高

大规模网站的深度目录爬取率非常好,这意味着网站权重很高,蜘蛛爬虫经常可以进入网站进行爬取和爬取。

4、网站内容质量高

做网站优化的人都知道,高质量的内容对网站起着非常重要的作用。不仅可以吸引用户浏览,还可以吸引蜘蛛和爬虫,让搜索引擎收录更多页面,这也有利于网站排名。所以,在写网站内容的时候,一定要以原创内容为中心,内容也要体现网站的核心,同时要能够解决用户的需求。 @它有帮助。

5、外链优质

SEO人员知道优质外链的作用不仅可以增加网站的权重和排名,还可以让更多的蜘蛛关注网站的链接,这样才会有更多的页面被被蜘蛛爬取和爬取也是大型网站伴侣目录的爬取率比较高的原因之一。

6、用户点击率高

优化网站的最终目的是让网站有更好的用户体验。如果网站有很多优质的内容,用户会经常浏览网站,从而提高网站的点击率,也会给搜索引擎留下好印象,然后给予一定的权重和排名。

以上是网站的尺度,深度目录爬取速度较好的原因,希望能解决大家的问题。

转载蝙蝠侠IT需要授权! 查看全部

网站内容抓取(百度网站推广机构告诉你你吧规模性网站为什么挺好?)

在优化网站SEO的过程中,网站的结构越简单明了,越有利于搜索引擎蜘蛛的爬取爬行,让搜索引擎收录有更多的内容,然后网站获得更好的排名。

不过网站有一定的规模,深度目录的爬取率也相当不错。为什么是这样?接下来就让百度网站推广机构告诉你!

1、网站整体结构不错

对于大规模的网站,深层目录的爬取速度更好,这意味着网站的整体结构更好,蜘蛛爬虫可以按照网站结构进入最深的目录在此方式,可以爬取内容,让搜索引擎收录More网站page。

2、良好的内部链结构

为大规模网站创建内链时,必须使用内链链接相关页面,也可以使用内链链接首页和深层目录。这样做的目的是为了让蜘蛛爬虫更好地抓取网站页面,让搜索引擎收录搜索到深层目录的内容。

3、网站权重高

大规模网站的深度目录爬取率非常好,这意味着网站权重很高,蜘蛛爬虫经常可以进入网站进行爬取和爬取。

4、网站内容质量高

做网站优化的人都知道,高质量的内容对网站起着非常重要的作用。不仅可以吸引用户浏览,还可以吸引蜘蛛和爬虫,让搜索引擎收录更多页面,这也有利于网站排名。所以,在写网站内容的时候,一定要以原创内容为中心,内容也要体现网站的核心,同时要能够解决用户的需求。 @它有帮助。

5、外链优质

SEO人员知道优质外链的作用不仅可以增加网站的权重和排名,还可以让更多的蜘蛛关注网站的链接,这样才会有更多的页面被被蜘蛛爬取和爬取也是大型网站伴侣目录的爬取率比较高的原因之一。

6、用户点击率高

优化网站的最终目的是让网站有更好的用户体验。如果网站有很多优质的内容,用户会经常浏览网站,从而提高网站的点击率,也会给搜索引擎留下好印象,然后给予一定的权重和排名。

以上是网站的尺度,深度目录爬取速度较好的原因,希望能解决大家的问题。

转载蝙蝠侠IT需要授权!

网站内容抓取( 百度蜘蛛的运行原理及抓取原理(一)答)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-01 04:04

百度蜘蛛的运行原理及抓取原理(一)答)

百度蜘蛛抓取原理

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ yuán lǐ

百度蜘蛛爬行,这是什么意思?

问题:123.125.68.149--[05/May/2014:01:43:40 +0800] "GET / HTTP/1.1" 20.。 .

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ, zhè gè shì shí me yì sī?

seo网站如何在优化中增加百度蜘蛛爬行

答:网站排名好,流量不多,关键因素之一是网站收录怎么样,虽然收录不能直接决定网站排名,但是网站的基础@ 是内容。如果没有内容,排名就更难了。好的内容可以被用户和搜索引擎所满足。可以给网站加分,从而提升排名,扩大网站的曝光率...

seo wǎng zhàn yōu huà zhōng zěn yàng zēng jiā bǎi dù zhī zhū zhuā qǔ

关于百度蜘蛛抓取页面和目录? ?

问题:我的网站最近分析了网站的日志,发现百度蜘蛛爬目录的时候很特别...

答案:TAG也是关键词定义的地方。蜘蛛用这个来判断! 关键词:平板电脑皮套、手机皮套厂、iAPD2皮套、音响保护皮套

guān yú bǎi dù zhī zhū zhuā qǔ yè miàn jí mù lù de wèn tí? ? 查看全部

网站内容抓取(

百度蜘蛛的运行原理及抓取原理(一)答)

百度蜘蛛抓取原理

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ yuán lǐ

百度蜘蛛爬行,这是什么意思?

问题:123.125.68.149--[05/May/2014:01:43:40 +0800] "GET / HTTP/1.1" 20.。 .

答:百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后按类别建立索引数据库,让用户可以搜索到你的网站网页、图片、视频等内容。百度搜索引擎。 一、百度蜘蛛的运行原理。 (1)通过百度...

bǎi dù zhī zhū zhuā qǔ, zhè gè shì shí me yì sī?

seo网站如何在优化中增加百度蜘蛛爬行

答:网站排名好,流量不多,关键因素之一是网站收录怎么样,虽然收录不能直接决定网站排名,但是网站的基础@ 是内容。如果没有内容,排名就更难了。好的内容可以被用户和搜索引擎所满足。可以给网站加分,从而提升排名,扩大网站的曝光率...

seo wǎng zhàn yōu huà zhōng zěn yàng zēng jiā bǎi dù zhī zhū zhuā qǔ

关于百度蜘蛛抓取页面和目录? ?

问题:我的网站最近分析了网站的日志,发现百度蜘蛛爬目录的时候很特别...

答案:TAG也是关键词定义的地方。蜘蛛用这个来判断! 关键词:平板电脑皮套、手机皮套厂、iAPD2皮套、音响保护皮套

guān yú bǎi dù zhī zhū zhuā qǔ yè miàn jí mù lù de wèn tí? ?

网站内容抓取(网站运营推广上线后最注重的数据是上面呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-09-01 04:03

网站运营推广上线后,以上是我们最关注的数据?很多站长可能认为是排名和收录等数据,但其实最需要关注的还是蜘蛛的爬行情况。因为蜘蛛的爬行直接影响网站之后的收录和排名,因为不爬就没有收录,也就不会出现排名。今天牛商网就来讲解一下:如何增加网站的蜘蛛抓取量?增加搜索引擎抓取的方法!

方法一:让搜索引擎及时找到页面

我们每天更新文章后,需要将文章推送到搜索引擎,以便搜索引擎及时找到。推送后,搜索引擎会抓取网站的新内容。抓取新内容的链接后,搜索引擎会通过新内容页面抓取网站的其他页面,通过网站的内部链接和栏目导航结果抓取其他内容。这样搜索引擎就可以抓取更多网站的内容,有效增加网站的抓取量。我们常用的推送方式有:主动推送、自动推送、手动推送、站点地图推送。

方法二:网站更新优质内容

优质内容让搜索引擎不断爬取网站。搜索引擎和用户都喜欢网站发布高质量的内容,因为高质量的内容可以帮助用户解决他们的需求。当网站的内容质量越高,搜索引擎的信任度就会越高,爬取网站的量会逐渐增加。所以网站更新优质内容也是提升网站收录的重要途径。

方法三:合理的内链布局

网站内链是提升用户和搜索引擎体验的重要手段,因为网站内链可以更好的让搜索引擎抓取更多的内容,让蜘蛛在网站的内部页面上持续中间循环抓取,让蜘蛛抓取网站中的大部分内容,合理的布局网站内链有利于蜘蛛在抓取页面时不断循环抓取其他页面,方便搜索抓取引擎站中的内容。

方式四:添加网站外链

网站外链可以吸引蜘蛛爬到我们的网站。当我们的网站缺少蜘蛛爬行时,我们可以通过发布外部链接来增加网站的蜘蛛爬行。 , 都是增加蜘蛛爬行量的有效方法。

方法五:提交网站Map

网站Map 可以将网站中的所有链接页面聚合为一个页面,可以帮助搜索引擎更好地抓取每一页,减少搜索引擎的工作量,也更好的让搜索引擎发现所有页面网站,这也是网站新上线时必须要做的一个动作。 查看全部

网站内容抓取(网站运营推广上线后最注重的数据是上面呢?)

网站运营推广上线后,以上是我们最关注的数据?很多站长可能认为是排名和收录等数据,但其实最需要关注的还是蜘蛛的爬行情况。因为蜘蛛的爬行直接影响网站之后的收录和排名,因为不爬就没有收录,也就不会出现排名。今天牛商网就来讲解一下:如何增加网站的蜘蛛抓取量?增加搜索引擎抓取的方法!

方法一:让搜索引擎及时找到页面

我们每天更新文章后,需要将文章推送到搜索引擎,以便搜索引擎及时找到。推送后,搜索引擎会抓取网站的新内容。抓取新内容的链接后,搜索引擎会通过新内容页面抓取网站的其他页面,通过网站的内部链接和栏目导航结果抓取其他内容。这样搜索引擎就可以抓取更多网站的内容,有效增加网站的抓取量。我们常用的推送方式有:主动推送、自动推送、手动推送、站点地图推送。

方法二:网站更新优质内容

优质内容让搜索引擎不断爬取网站。搜索引擎和用户都喜欢网站发布高质量的内容,因为高质量的内容可以帮助用户解决他们的需求。当网站的内容质量越高,搜索引擎的信任度就会越高,爬取网站的量会逐渐增加。所以网站更新优质内容也是提升网站收录的重要途径。

方法三:合理的内链布局

网站内链是提升用户和搜索引擎体验的重要手段,因为网站内链可以更好的让搜索引擎抓取更多的内容,让蜘蛛在网站的内部页面上持续中间循环抓取,让蜘蛛抓取网站中的大部分内容,合理的布局网站内链有利于蜘蛛在抓取页面时不断循环抓取其他页面,方便搜索抓取引擎站中的内容。

方式四:添加网站外链

网站外链可以吸引蜘蛛爬到我们的网站。当我们的网站缺少蜘蛛爬行时,我们可以通过发布外部链接来增加网站的蜘蛛爬行。 , 都是增加蜘蛛爬行量的有效方法。

方法五:提交网站Map

网站Map 可以将网站中的所有链接页面聚合为一个页面,可以帮助搜索引擎更好地抓取每一页,减少搜索引擎的工作量,也更好的让搜索引擎发现所有页面网站,这也是网站新上线时必须要做的一个动作。

网站内容抓取( 爬虫系统中如何确定要爬取URL队列中的URL顺序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-09-01 04:00

爬虫系统中如何确定要爬取URL队列中的URL顺序)

爬虫爬取网站page 策略

在爬虫系统中,要爬取的URL队列是一个非常关键的部分。爬虫要爬取的网页的URL被组织起来,形成一个队列结构。程序员每次从队列的头部拉取一个URL发送给网页下载器下载页面内容,每个新下载的页面中收录的URL都会被添加到URL队列的末尾进行爬取,从而形成一个循环可以说整个tracker系统都是由这个队列驱动的。

如何确定要抓取的URL队列中页面的URL顺序?如上所述,新下载页面中收录的链接将附加到队列的末尾。这当然是确定队列 URL 顺序的一种方法,但不是唯一的方法。实际上,可以使用许多其他技术来捕获队列,并对 URL 进行排序。不同的抓取策略使用不同的方法来确定要抓取的网址队列中网址的优先级。

爬虫的跟踪策略有很多,但无论采用哪种方式,基本目标都是一样的:首先选择重要的网页进行爬取。在跟踪系统中,可以使用不同的方法来确定网页的假设重要性,但大多数方法是根据网页的受欢迎程度来定义的。本书“链接分析”一章介绍的PageRank,是为了评估常见的性别规范在网页上的重要性。

有很多方法可以跟踪策略。本部分仅选取已被证明有效或具有代表性的解决方案,包括以下四类:横断面广度优先策略、不完整 PageRank 策略、OCIP 策略和大规模优先站点策略。

广泛的优先策略(BreathFirst)

广度游览是一种非常简单直观的游览方式,历史悠久。搜索引擎爬虫一出现就采用了它。最近提出的跟踪策略使用这种方法作为比较的基准。不过需要注意的是,这个策略也是一种非常强大的方法。许多较新的方法不一定比广度优先遍历策略更好,因此该方法也是许多跟踪系统采用的第一个捕获策略,确实如此。