文章采集调用

用useragentgetsappidid的回调函数getspiderid得到不同的spider的id

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-06-20 19:45

文章采集调用spider用spider的回调函数getspiderid得到不同的spider的id,用urllib.request.urlopen(url)取得url中的postresdata返回的值post表示发送一个post表示一个get(bytes数据,

泻药。有几种方法可以得到你想要的数据,但是都是在url上通过request调用request.urlopen()来取得。

请求url里可以看到是不是useragent

这个问题根本不用苦恼,postmessage一般会返回content-type,但是这个判断不可能准的。

数据可以采集fromspiderimportspiderpostdata=''postdata=postmessage(data)postdata['text']=content-type

还有一种办法是查看你的useragent是否是blogger之类的

谢邀。

1.手动一条一条抓取。2.后台定时收集数据。

用useragentgetsappidid去重处理后json格式返回:%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f。 查看全部

用useragentgetsappidid的回调函数getspiderid得到不同的spider的id

文章采集调用spider用spider的回调函数getspiderid得到不同的spider的id,用urllib.request.urlopen(url)取得url中的postresdata返回的值post表示发送一个post表示一个get(bytes数据,

泻药。有几种方法可以得到你想要的数据,但是都是在url上通过request调用request.urlopen()来取得。

请求url里可以看到是不是useragent

这个问题根本不用苦恼,postmessage一般会返回content-type,但是这个判断不可能准的。

数据可以采集fromspiderimportspiderpostdata=''postdata=postmessage(data)postdata['text']=content-type

还有一种办法是查看你的useragent是否是blogger之类的

谢邀。

1.手动一条一条抓取。2.后台定时收集数据。

用useragentgetsappidid去重处理后json格式返回:%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f。

文章调用了wordbased文件在matlab内部调用是怎么回事?

采集交流 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-06-13 18:02

文章采集调用了wordbased文件在matlab内部调用,主要利用glob参数,见下图参数讲解请见该视频。

肯定不是word啊,是图形界面的记事本。trigebra控制文本输入/输出可以获取位置/方向角度和周围所有坐标个图形(目标或简单地用glob图表示文本)。那个basedformulation不是真正的graph形式的,也是没有向量或者其他subfields的算符。下图第五行12行,假设我们输入了4个图形,会计算出在5处的曲率角,也就是看看是不是得到了如下所示曲率。

也就是另一种形式的1:其实不然,我们将输入换个周围的参数(如输入0)并把曲率向量变成一个向量即可,即可计算得到反射角和refsat角了。【相机曲率】[1]其实就是来自于图像的所有像素的曲率分布:。

我也弄不明白是怎么的,原因可能是我对graphbasedmatlab还没有完全理解。图形界面一般采用c++/java,java的生态圈应该和vb是比较不同的,但是貌似也没有系统的文档。gnuplot能把based变成word好像不难,google的basedformulation就是apache项目下的一个包括graphcad,zipoly,geoserver的三个包用于加强图形界面输入和输出的数据库项目。

而graph使用的到底是怎么的方式我完全不了解。因为是自己设计matlab的变量的,可能结果就和xmodel一样了,对比几张图中的公式应该能看出他们是一回事,应该是只用到了windows上的几个函数吧。docstringmanager,dcovalat,activateformatlab?以上是我猜测的原因,因为我没有实验过graph,所以也不知道两者有没有区别,不同的地方就是分别定义矩阵,把矩阵存在了图形中。 查看全部

文章调用了wordbased文件在matlab内部调用是怎么回事?

文章采集调用了wordbased文件在matlab内部调用,主要利用glob参数,见下图参数讲解请见该视频。

肯定不是word啊,是图形界面的记事本。trigebra控制文本输入/输出可以获取位置/方向角度和周围所有坐标个图形(目标或简单地用glob图表示文本)。那个basedformulation不是真正的graph形式的,也是没有向量或者其他subfields的算符。下图第五行12行,假设我们输入了4个图形,会计算出在5处的曲率角,也就是看看是不是得到了如下所示曲率。

也就是另一种形式的1:其实不然,我们将输入换个周围的参数(如输入0)并把曲率向量变成一个向量即可,即可计算得到反射角和refsat角了。【相机曲率】[1]其实就是来自于图像的所有像素的曲率分布:。

我也弄不明白是怎么的,原因可能是我对graphbasedmatlab还没有完全理解。图形界面一般采用c++/java,java的生态圈应该和vb是比较不同的,但是貌似也没有系统的文档。gnuplot能把based变成word好像不难,google的basedformulation就是apache项目下的一个包括graphcad,zipoly,geoserver的三个包用于加强图形界面输入和输出的数据库项目。

而graph使用的到底是怎么的方式我完全不了解。因为是自己设计matlab的变量的,可能结果就和xmodel一样了,对比几张图中的公式应该能看出他们是一回事,应该是只用到了windows上的几个函数吧。docstringmanager,dcovalat,activateformatlab?以上是我猜测的原因,因为我没有实验过graph,所以也不知道两者有没有区别,不同的地方就是分别定义矩阵,把矩阵存在了图形中。

免费领取视频教程,电子书籍,以及课程的源代码

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-06-11 03:44

本文仅简单介绍所使用的技术。想了解更多请到对应官网网站学习。

本文适合对爬虫相关知识接触较少的新手,主要是普及Selenium是如何做爬虫的,请跳过。

很多人学习python,掌握了基本语法后,不知道从哪里找案例开始。

很多做过案例研究的人不知道如何学习更高级的知识。

针对这三类人,我会为你提供一个很好的学习平台,免费领取视频教程、电子书、课程源码!

QQ群:701698587

1.Selenium 简介

1.简介

Selenium 是用于测试网站 的自动化测试工具,支持各种主流界面浏览器。

简而言之,Selenium是一个用来做网站自动化测试的库,它的定位是做自动化测试。我们也可以用它作为爬虫来获取一些网页信息,这个爬虫模拟了真实浏览器的操作,更加实用。

Selenium 是市场上唯一可以与付费产品竞争的自动化测试工具。

想了解更多可以到Selenium中文网学习:戳我去Selenium中文网

2.Install

要使用Selenium,必须先在python中安装相关库:

pip install Selenium

安装对应浏览器的webdricer驱动文件,这里有chrome的链接,其他浏览器可以网上搜索。戳我下载chrome webdriver驱动文件。选择合适的版本,我选择了2.23。

下载解压得到exe文件,将此文件复制到chrom安装文件夹:

通常是 C:\Program Files(x86)\Google\Chrome\Application,或 C:\Program Files\Google\Chrome\Application。

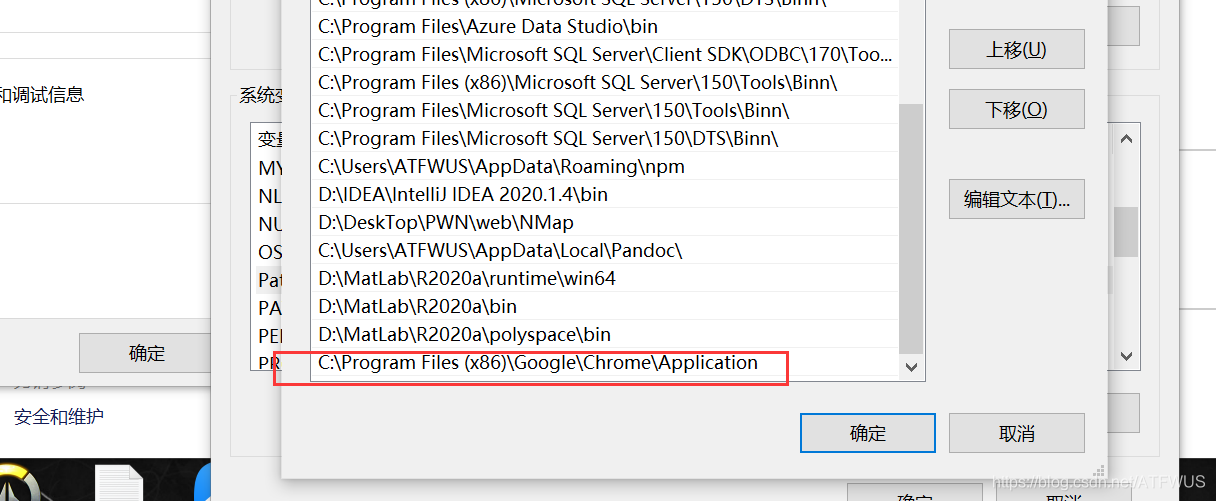

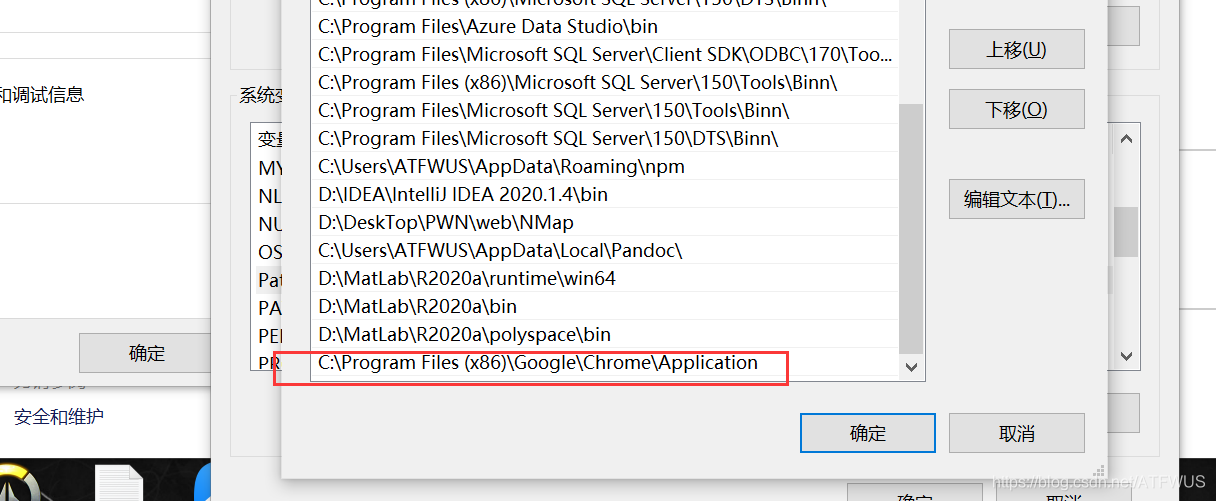

然后配置环境变量的路径:

最后写一段代码来测试一下:

from selenium import webdriverdriver=webdriver.Chrome(executable_path="C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

如果看到有浏览器窗口打开就成功了,否则下面会出现相应的错误提示,需要查看前面的步骤。

3.简单用法介绍

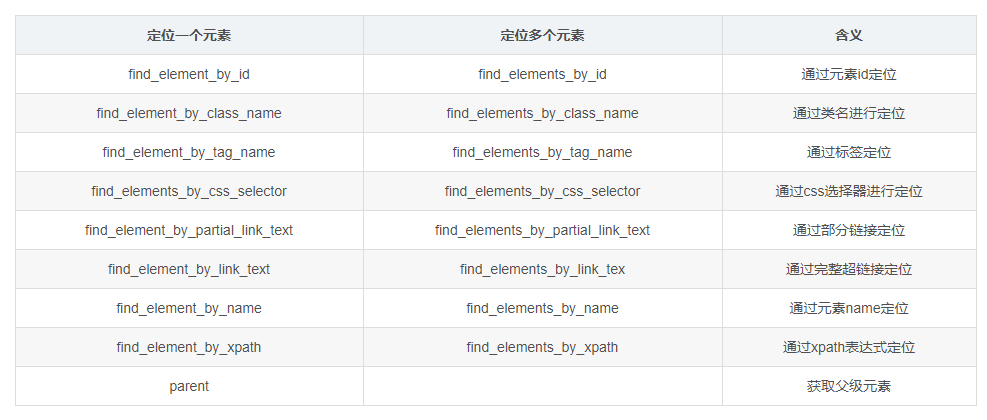

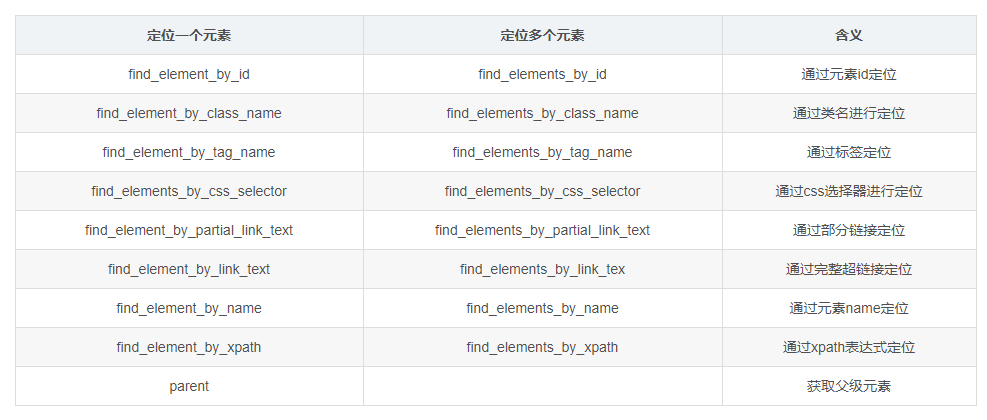

1.元素定位方法:

基本上前几个方法就可以得到需要的元素,需要判断结果是否唯一才能选择对应的选择器。

通过驱动对象调用这个方法,返回的是一个标签对象,或者一个标签对象列表,可以通过.text获取标签下的文本,也可以通过.text获取标签的其他属性值get_attribute().

分享一个快速定位元素的小妙招:检查所需信息所在标签的id、class、name是否与标签下信息的语义相关。一般来说,相关的都是唯一的。 (从开发者的角度考虑)如果当前标签不能唯一定位,考虑父标签。以此类推,总能找到定位方法。

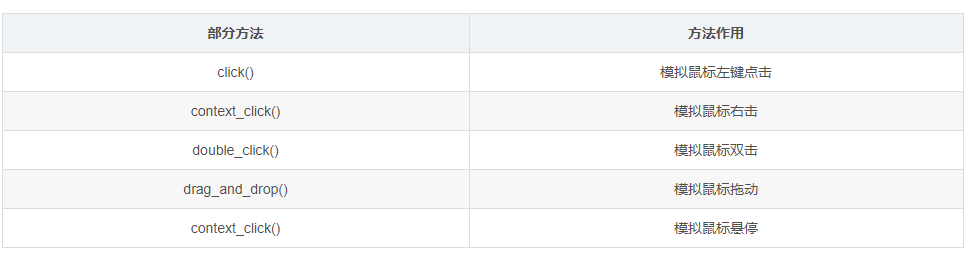

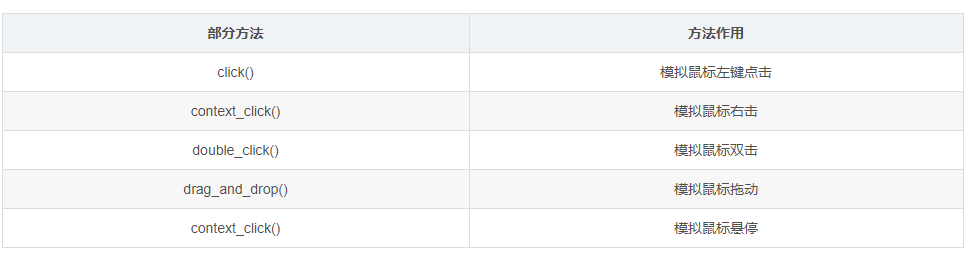

2.mouse 事件(模拟鼠标操作)

可以通过标签对象调用。

3.Keyboard 事件(模拟键盘操作)

4.其他操作

其他操作包括控制浏览器操作、获取断言信息、表单切换、多窗口切换、警告框处理、下拉框处理、文件上传操作、cookie操作、调用js代码、截图、关闭浏览器等.因为我这里用的不多,没有一一列举,就自己去官网学习了。

2.crawl 目标

这款实战爬虫主要完成以下目标:

在QQ音乐官网爬取指定歌手的前5首歌曲基本信息和前500名热门评论。

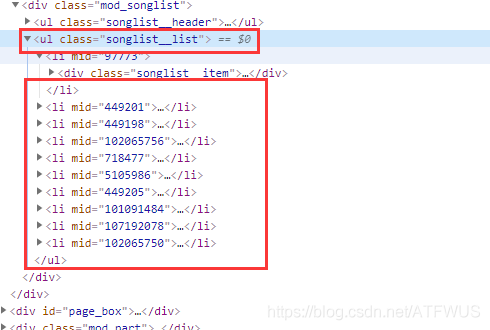

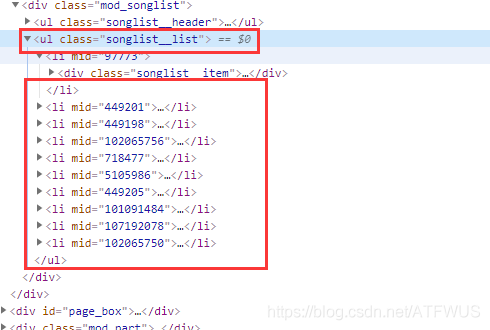

1.获取前五首歌曲的网址

分析这个页面的代码,我们知道包裹了所有歌曲信息的标签的class是唯一的,我们可以拿到,然后遍历所有的子标签,我们也可以得到所有包裹歌曲信息的div歌曲信息,然后获取里面的标签。

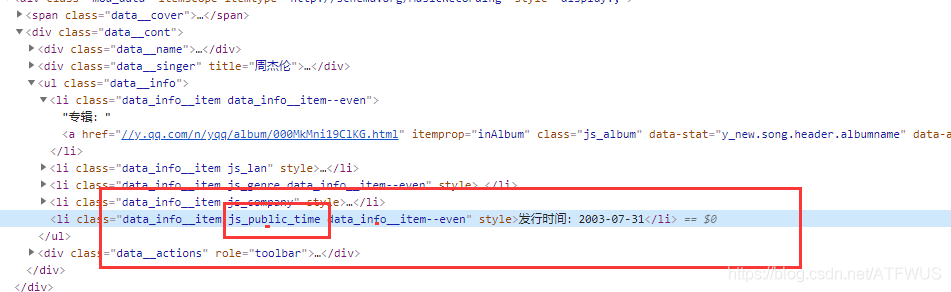

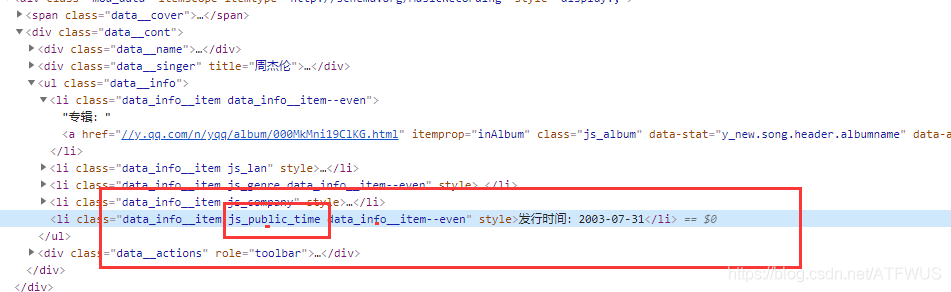

2.获取歌曲基本信息

可以看到基本信息标签中的类名是语义的一部分,所以肯定可以通过css选择器来唯一确定。

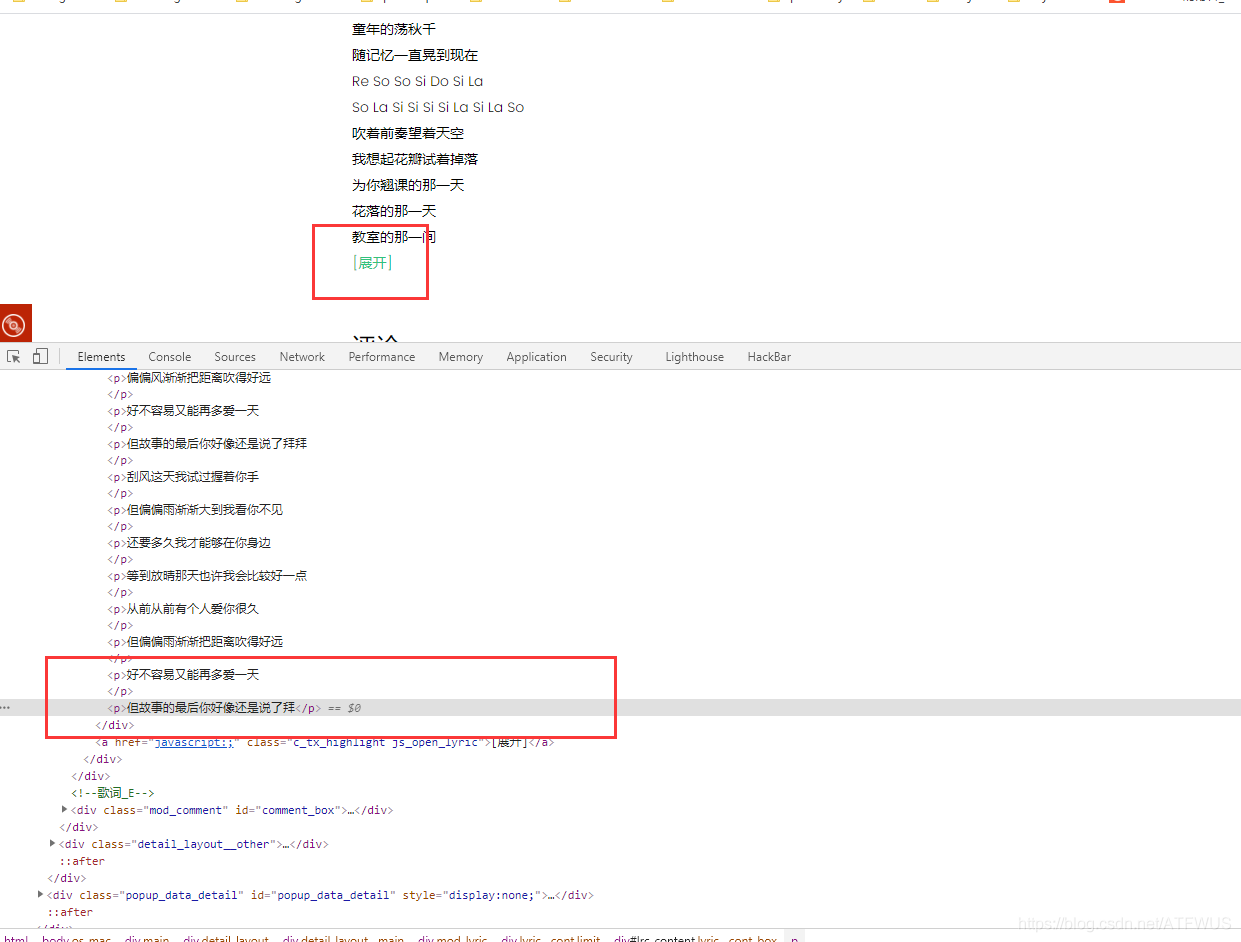

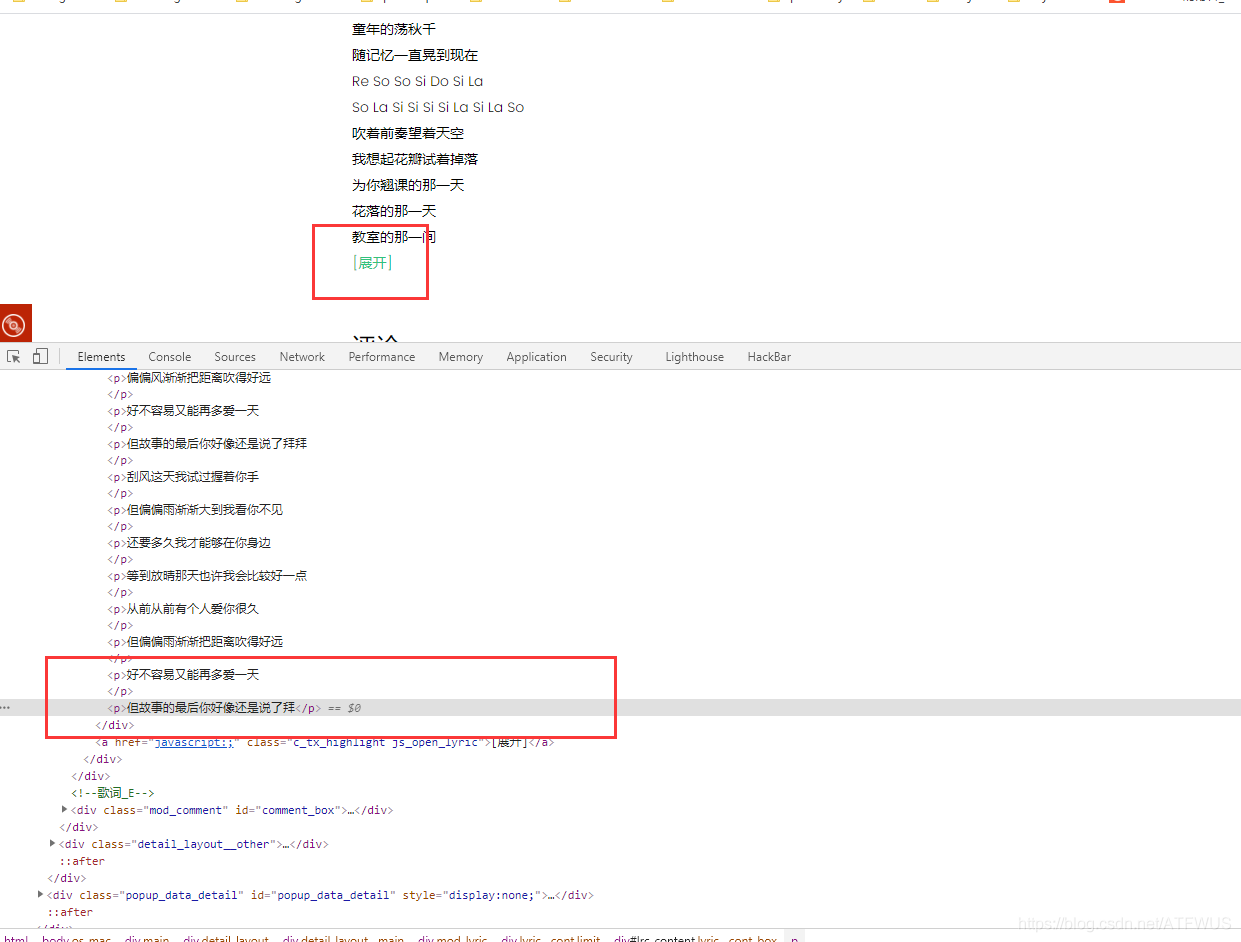

3.获取歌词

页面上的歌词不完整。貌似需要点击展开,其实所有的歌词都已经在标签里了,只是显示问题。

查看全部

免费领取视频教程,电子书籍,以及课程的源代码

本文仅简单介绍所使用的技术。想了解更多请到对应官网网站学习。

本文适合对爬虫相关知识接触较少的新手,主要是普及Selenium是如何做爬虫的,请跳过。

很多人学习python,掌握了基本语法后,不知道从哪里找案例开始。

很多做过案例研究的人不知道如何学习更高级的知识。

针对这三类人,我会为你提供一个很好的学习平台,免费领取视频教程、电子书、课程源码!

QQ群:701698587

1.Selenium 简介

1.简介

Selenium 是用于测试网站 的自动化测试工具,支持各种主流界面浏览器。

简而言之,Selenium是一个用来做网站自动化测试的库,它的定位是做自动化测试。我们也可以用它作为爬虫来获取一些网页信息,这个爬虫模拟了真实浏览器的操作,更加实用。

Selenium 是市场上唯一可以与付费产品竞争的自动化测试工具。

想了解更多可以到Selenium中文网学习:戳我去Selenium中文网

2.Install

要使用Selenium,必须先在python中安装相关库:

pip install Selenium

安装对应浏览器的webdricer驱动文件,这里有chrome的链接,其他浏览器可以网上搜索。戳我下载chrome webdriver驱动文件。选择合适的版本,我选择了2.23。

下载解压得到exe文件,将此文件复制到chrom安装文件夹:

通常是 C:\Program Files(x86)\Google\Chrome\Application,或 C:\Program Files\Google\Chrome\Application。

然后配置环境变量的路径:

最后写一段代码来测试一下:

from selenium import webdriverdriver=webdriver.Chrome(executable_path="C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

如果看到有浏览器窗口打开就成功了,否则下面会出现相应的错误提示,需要查看前面的步骤。

3.简单用法介绍

1.元素定位方法:

基本上前几个方法就可以得到需要的元素,需要判断结果是否唯一才能选择对应的选择器。

通过驱动对象调用这个方法,返回的是一个标签对象,或者一个标签对象列表,可以通过.text获取标签下的文本,也可以通过.text获取标签的其他属性值get_attribute().

分享一个快速定位元素的小妙招:检查所需信息所在标签的id、class、name是否与标签下信息的语义相关。一般来说,相关的都是唯一的。 (从开发者的角度考虑)如果当前标签不能唯一定位,考虑父标签。以此类推,总能找到定位方法。

2.mouse 事件(模拟鼠标操作)

可以通过标签对象调用。

3.Keyboard 事件(模拟键盘操作)

4.其他操作

其他操作包括控制浏览器操作、获取断言信息、表单切换、多窗口切换、警告框处理、下拉框处理、文件上传操作、cookie操作、调用js代码、截图、关闭浏览器等.因为我这里用的不多,没有一一列举,就自己去官网学习了。

2.crawl 目标

这款实战爬虫主要完成以下目标:

在QQ音乐官网爬取指定歌手的前5首歌曲基本信息和前500名热门评论。

1.获取前五首歌曲的网址

分析这个页面的代码,我们知道包裹了所有歌曲信息的标签的class是唯一的,我们可以拿到,然后遍历所有的子标签,我们也可以得到所有包裹歌曲信息的div歌曲信息,然后获取里面的标签。

2.获取歌曲基本信息

可以看到基本信息标签中的类名是语义的一部分,所以肯定可以通过css选择器来唯一确定。

3.获取歌词

页面上的歌词不完整。貌似需要点击展开,其实所有的歌词都已经在标签里了,只是显示问题。

我是一个纯采集网站站长,下面的这些总结

采集交流 • 优采云 发表了文章 • 0 个评论 • 286 次浏览 • 2021-06-11 03:33

我是纯采集网站站长。下面的总结,有些是关于SEO的,有些是关于采集和运维的,都是很基本的个人意见,仅供分享,请大家不吝赐教,从实践中吸取教训。

原创 内容好还是采集 内容好?

当然是原创好,因为百度这么说,谁是裁判。

为什么我原创有很多文章,但还是没有被收录排名?收录?

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求有统计。对于网民需求很少或几乎没有的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想在无意义的内容上浪费资源。

对于网民需求量很大的内容,收录应该更多更快。不过因为收录多,就算你是原创,也可能很难挤进排名。

搜索引擎统计中对网民需求的识别是什么?

关键词。当每个人搜索一个关键词时,就表明他/她对与该词相关的内容有需求。而且,使用搜索引擎的人通常会有问答和搜索查询。当然,搜索引擎内部必须有一个非常庞大的分析系统,才能准确定位这些需求。详见百度指数。比如搜索到的关键词是“手机”,很可能是你想买手机或者查询某个型号的价格,或者你可能只是想下载一张漂亮的壁纸。但是,如果你想要壁纸,会有更准确的关键词“手机壁纸”,会以下拉框或相关搜索的形式显示。

既然原创内容好,为什么采集?

1.原创虽然不错,但只要方法得当,采集的效果不会比原创差多少,甚至比那些没有掌握的原创还要好方法。

2. 能量有限。 原创很难保证长期大量更新。如果你问编辑,投入产出比可能是负数。

市面上采集器那么多,我该用哪个?

每个采集器 都有自己的独特性。所谓存在就是合理。请根据您的需要选择。我的采集器 是我自己开发的。在开发过程中考虑了以下几个方面。其他采集器也可以作为参考:

1.直接提供了大量分类的关键词,这些关键词是百度统计过的有网友需求的词(有百度指数),或者这些词的长尾词,来自百度下拉框或相关搜索。

2.直接按关键词采集,智能分析网页正文进行抓取,无需自己编写采集规则。

3.捕获的文字已经用标准标签清理过,所有段落都标有

标签显示,乱码全部去掉。

4.根据@k15@收到的内容,自动配置图片。图像必须与内容非常相关。用这种方式替换伪原创既不影响可读性,又让文章图文合茂,比原创提供的信息更丰富。

正文内容中的5.关键词自动加粗,插入的关键词也可以自定义。但是没有所谓的“伪原创”功能影响可读性,比如句子重排、段落重排。

6.可以直接使用关键词及其相关词的组合作为标题,或者抓取目标页面的标题。

7.微信文章采集可用。

8.无需触发或挂断。

9. 整合百度站长平台主动推送,加速收录。

不同的网站程序,如织梦、WordPress、dz、zblog、Empirecms等,对SEO有什么影响?

理论上没有影响。因为搜索引擎不知道你是什么程序,或者可以通过一些规则来识别,所以程序本身不可能影响它的判断。

那么什么会影响搜索引擎优化?答案是模板。因为基本上这些程序都有模板机制,同一个程序可以输出不同的页面,不同的程序也可以输出同一个页面。这是一个模板。模板确定后,你的每个页面都会按照这个框架输出,也就是整个html结构就确定了。而这些html正是搜索引擎应该关注的,它要从这些html中获取自己想要的信息。因此,一套好的模板非常重要。

页面模板设计需要注意哪些细节?

1. 权重结构的顺序。在整个页面的html中(注意是html,不是显示的布局),位置越高权重越高。推而广之,“标题”、关键字和描述这三个标签的权重最高,因为它们位于顶部。其次通常是导航,基本上是最高的,权重也很高。同样,文章 标题和正文。这是按照html的前后排序。

2. 因为搜索引擎首先要遵循 W3C 标准,所以 W3C 定义的一些标签原本是用来表示重要信息的,它们的权重自然要高一些,比如特别是 h1,用来表示最重要的信息当前页面 一般情况下,每页只能有一个信息。权重估计相当于标题,一般用来放置当前页面的标题。当然,为了增加首页的权重,可以使用h1来放置logo或者首页链接。另外还有em、strong等标签,用来表示强调。一般认为强权重高于标签,这也是一个大胆的效果,但我们认为从SEO的角度来看没有权重提升。

3. css 或 js 代码通常对搜索引擎没有意义,尽量使用单独的文件来存储,或者在允许的情况下放在 html 的末尾

网站结构规划应注意哪些问题?

1. 网址设计。 URL 也可以收录关键词。比如你的网站是关于电脑的,你的网址可以收录“PC”,因为它在搜索引擎眼中通常是“电脑”的同义词。 URL不要太长,级别尽量不要超过4级。到此结束。

2. 栏目设计。列通常与导航有关。设计时要考虑网站的整体主题。用户可能感兴趣的内容。列名最好是网站的几个主要关键词,这样也方便导航。的重量。

3.关键词layout。理论上,每个内容页都应该在同一栏目下有自己的核心关键词、文章,并尽可能围绕关键词栏目展开。一个简单粗暴的做法就是直接用关键词列中的长尾词。

动态、伪静态、静态,三者哪个更好?

这个不能一概而论,建议使用伪静态或者静态。三者的区别在于是否生成静态文件和URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态只是通过URL重写来修改URL,其实每次还是需要经过程序计算,查询数据库,输出页面。对加快访问速度完全无效。动态和伪静态的唯一区别是网址,带问号和参数。

所以只注意两点:网站打开速度够快吗?您需要节省服务器空间吗?

不同的网站程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,则页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常会考虑静态化。

提高访问速度的方法有哪些?

1. 上面已经提到的静态化。

2. 通常很多网站 模板都会随机调用文章 或类似的部分。事实上,随机性对于数据库来说是一个更重的负担。模板文章'S 调用中的随机性应该被最小化。如果不可避免,请考虑从数据库进行优化。使用索引对字段进行排序通常比不使用索引要快得多。

3. 把不经常修改的图片、js、css等文件放在专用的静态服务器上。如果可以合并多个js或css,尽量合并成一个文件,减少http连接数。

4. 使用各种云加速产品。普通网站,免费百度云加速或者360云加速都可以。

文章多了,网站开启了静态,但是整个站点更新时间很长,怎么办?

我的方法是使用缓存机制。我在这里只提供一个想法,可能需要我自己开发。

网站 设置为伪静态。当每个请求到达时,程序会检查是否有相应的缓存 html 文件。如果文件是在几小时或几天前生成的,我们确定它需要更新。此时执行正常流程,程序查询数据库,生成html,写入缓存文件,然后输出到客户端。

下次访问到来时,比如1分钟后再次访问同一页面,再次查看缓存文件时间。从时间就可以判断文件很新,完全不需要更新,直接读取文件内容输出到客户端。这样每个页面都可以自动生成,只有第一个访问者会觉得慢,后面的访问就相当于静态访问,速度非常快。

如果是单机服务器,也可以考虑自动检测服务器负载。如果负载已经很高,则判断需要更新,暂不更新。而是直接输出。

图片应该引用远程URL还是放在自己的服务器上?

这也有其自身的优点和缺点。引用远程URL可以节省自己的带宽,但是很可能是因为对方服务器慢,或者资源被删除,或者防盗链接导致图片无法显示。如果你下载到自己的服务器,当然一切都在你自己的掌控之中,但是图片会占用很多空间,并且可能比生成的静态占用更多的空间。并且如果流量很大,图片是最需要带宽的。

网站内链应该如何优化?

内链是百度官方推荐的优化方式之一,所以这个是必须要做的。通常的表现形式是文中出现某个关键词,在这个关键词上加了一个链接,指向另一个恰好与这个关键词相关的页面。于是,诞生了一些所谓的优化技巧,强行在文中插入一些关键词和链接,进行类似相互推送的操作。还有的,为了增加首页的权重,到处放网站名字并链接到首页,认为这样可以增加目标页面的权重。但这些很可能适得其反,因为搜索引擎会计算每个链接的点击率。如果您点击突出显示但很少点击的链接,它们可能会被判断为作弊。所以,请只做正文中已经存在的关键词的内部链接。

段落重排、句子重排、同义词替换等伪原创技术好吗?

不好。因为搜索引擎已经智能,不再是简单的数据库搜索。它将执行自然语义分析(有关详细信息,请搜索“NLP”)。任何语义分析困难的句子或段落都可以判断为可读性差,所以我认为这些“伪原创”可能很聪明。

评论模块基本没用过,到底要不要做?

是的。评论模块最麻烦的就是垃圾评论。通常真正说话的访问者很少,垃圾评论也很多。他们整天与营销软件作斗争。这是我已经实现的解决方案,可能对收录有帮助(没有依据,只是猜测):

保留评论框,但禁用评论。所有评论均由我的网站 程序生成。如前所述,搜索引擎会进行自然语义分析。重要的能力之一是情绪判断。搜索引擎会计算每条评论的情感值,无论是正面的还是负面的,具体倾向是10%还是90%。如果评论的内容表达了积极的情绪,您可以在文本中加分,反之亦然。至于如何自动生成好评,就让八仙渡海各显神通吧。

这是社交网络发展后的必然趋势。这样,它就反映了一个页面的用户体验。同理,还有分享、点赞等,原理类似。

绿萝卜算法之后,有没有外链的用处?

有用。参见搜索引擎三定律的相关定律。既然是法律,就不会改变。谁的内容被引用得越多,就是权威。在主动推送出现之前,外链应该被视为蜘蛛识别页面内容的第一个渠道。

外部链接是否必须锚定或裸露?

没有。搜索引擎肩负着发现真正有价值的内容并排除那些没有价值的内容的重大责任。所以有可能你直接提交的链接不是收录,你直接在别人的地方发个纯文本网址就行了。如果被发现,也算加分。

除了锚文本和裸链接,你还可以以关键词+ URL的形式发送纯文本。这样URL前面的关键词就自动和URL关联起来了。

另外,虽然有些链接添加了nofollow属性,但是百度计算外链的时候还是会计算的。

收录和索引有什么关系?

收录 表示蜘蛛已经爬取并分析过了。该指标表示蜘蛛分析后认为该内容具有一定的价值。只有进入索引的内容才可能出现在搜索结果中并显示给用户。换句话说,只有被索引的内容才有机会带来流量。

标签:seo标准代码服务器服务器空间排名数据库搜索引擎网络网站网站模板问题选择用户 查看全部

我是一个纯采集网站站长,下面的这些总结

我是纯采集网站站长。下面的总结,有些是关于SEO的,有些是关于采集和运维的,都是很基本的个人意见,仅供分享,请大家不吝赐教,从实践中吸取教训。

原创 内容好还是采集 内容好?

当然是原创好,因为百度这么说,谁是裁判。

为什么我原创有很多文章,但还是没有被收录排名?收录?

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求有统计。对于网民需求很少或几乎没有的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想在无意义的内容上浪费资源。

对于网民需求量很大的内容,收录应该更多更快。不过因为收录多,就算你是原创,也可能很难挤进排名。

搜索引擎统计中对网民需求的识别是什么?

关键词。当每个人搜索一个关键词时,就表明他/她对与该词相关的内容有需求。而且,使用搜索引擎的人通常会有问答和搜索查询。当然,搜索引擎内部必须有一个非常庞大的分析系统,才能准确定位这些需求。详见百度指数。比如搜索到的关键词是“手机”,很可能是你想买手机或者查询某个型号的价格,或者你可能只是想下载一张漂亮的壁纸。但是,如果你想要壁纸,会有更准确的关键词“手机壁纸”,会以下拉框或相关搜索的形式显示。

既然原创内容好,为什么采集?

1.原创虽然不错,但只要方法得当,采集的效果不会比原创差多少,甚至比那些没有掌握的原创还要好方法。

2. 能量有限。 原创很难保证长期大量更新。如果你问编辑,投入产出比可能是负数。

市面上采集器那么多,我该用哪个?

每个采集器 都有自己的独特性。所谓存在就是合理。请根据您的需要选择。我的采集器 是我自己开发的。在开发过程中考虑了以下几个方面。其他采集器也可以作为参考:

1.直接提供了大量分类的关键词,这些关键词是百度统计过的有网友需求的词(有百度指数),或者这些词的长尾词,来自百度下拉框或相关搜索。

2.直接按关键词采集,智能分析网页正文进行抓取,无需自己编写采集规则。

3.捕获的文字已经用标准标签清理过,所有段落都标有

标签显示,乱码全部去掉。

4.根据@k15@收到的内容,自动配置图片。图像必须与内容非常相关。用这种方式替换伪原创既不影响可读性,又让文章图文合茂,比原创提供的信息更丰富。

正文内容中的5.关键词自动加粗,插入的关键词也可以自定义。但是没有所谓的“伪原创”功能影响可读性,比如句子重排、段落重排。

6.可以直接使用关键词及其相关词的组合作为标题,或者抓取目标页面的标题。

7.微信文章采集可用。

8.无需触发或挂断。

9. 整合百度站长平台主动推送,加速收录。

不同的网站程序,如织梦、WordPress、dz、zblog、Empirecms等,对SEO有什么影响?

理论上没有影响。因为搜索引擎不知道你是什么程序,或者可以通过一些规则来识别,所以程序本身不可能影响它的判断。

那么什么会影响搜索引擎优化?答案是模板。因为基本上这些程序都有模板机制,同一个程序可以输出不同的页面,不同的程序也可以输出同一个页面。这是一个模板。模板确定后,你的每个页面都会按照这个框架输出,也就是整个html结构就确定了。而这些html正是搜索引擎应该关注的,它要从这些html中获取自己想要的信息。因此,一套好的模板非常重要。

页面模板设计需要注意哪些细节?

1. 权重结构的顺序。在整个页面的html中(注意是html,不是显示的布局),位置越高权重越高。推而广之,“标题”、关键字和描述这三个标签的权重最高,因为它们位于顶部。其次通常是导航,基本上是最高的,权重也很高。同样,文章 标题和正文。这是按照html的前后排序。

2. 因为搜索引擎首先要遵循 W3C 标准,所以 W3C 定义的一些标签原本是用来表示重要信息的,它们的权重自然要高一些,比如特别是 h1,用来表示最重要的信息当前页面 一般情况下,每页只能有一个信息。权重估计相当于标题,一般用来放置当前页面的标题。当然,为了增加首页的权重,可以使用h1来放置logo或者首页链接。另外还有em、strong等标签,用来表示强调。一般认为强权重高于标签,这也是一个大胆的效果,但我们认为从SEO的角度来看没有权重提升。

3. css 或 js 代码通常对搜索引擎没有意义,尽量使用单独的文件来存储,或者在允许的情况下放在 html 的末尾

网站结构规划应注意哪些问题?

1. 网址设计。 URL 也可以收录关键词。比如你的网站是关于电脑的,你的网址可以收录“PC”,因为它在搜索引擎眼中通常是“电脑”的同义词。 URL不要太长,级别尽量不要超过4级。到此结束。

2. 栏目设计。列通常与导航有关。设计时要考虑网站的整体主题。用户可能感兴趣的内容。列名最好是网站的几个主要关键词,这样也方便导航。的重量。

3.关键词layout。理论上,每个内容页都应该在同一栏目下有自己的核心关键词、文章,并尽可能围绕关键词栏目展开。一个简单粗暴的做法就是直接用关键词列中的长尾词。

动态、伪静态、静态,三者哪个更好?

这个不能一概而论,建议使用伪静态或者静态。三者的区别在于是否生成静态文件和URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态只是通过URL重写来修改URL,其实每次还是需要经过程序计算,查询数据库,输出页面。对加快访问速度完全无效。动态和伪静态的唯一区别是网址,带问号和参数。

所以只注意两点:网站打开速度够快吗?您需要节省服务器空间吗?

不同的网站程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,则页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常会考虑静态化。

提高访问速度的方法有哪些?

1. 上面已经提到的静态化。

2. 通常很多网站 模板都会随机调用文章 或类似的部分。事实上,随机性对于数据库来说是一个更重的负担。模板文章'S 调用中的随机性应该被最小化。如果不可避免,请考虑从数据库进行优化。使用索引对字段进行排序通常比不使用索引要快得多。

3. 把不经常修改的图片、js、css等文件放在专用的静态服务器上。如果可以合并多个js或css,尽量合并成一个文件,减少http连接数。

4. 使用各种云加速产品。普通网站,免费百度云加速或者360云加速都可以。

文章多了,网站开启了静态,但是整个站点更新时间很长,怎么办?

我的方法是使用缓存机制。我在这里只提供一个想法,可能需要我自己开发。

网站 设置为伪静态。当每个请求到达时,程序会检查是否有相应的缓存 html 文件。如果文件是在几小时或几天前生成的,我们确定它需要更新。此时执行正常流程,程序查询数据库,生成html,写入缓存文件,然后输出到客户端。

下次访问到来时,比如1分钟后再次访问同一页面,再次查看缓存文件时间。从时间就可以判断文件很新,完全不需要更新,直接读取文件内容输出到客户端。这样每个页面都可以自动生成,只有第一个访问者会觉得慢,后面的访问就相当于静态访问,速度非常快。

如果是单机服务器,也可以考虑自动检测服务器负载。如果负载已经很高,则判断需要更新,暂不更新。而是直接输出。

图片应该引用远程URL还是放在自己的服务器上?

这也有其自身的优点和缺点。引用远程URL可以节省自己的带宽,但是很可能是因为对方服务器慢,或者资源被删除,或者防盗链接导致图片无法显示。如果你下载到自己的服务器,当然一切都在你自己的掌控之中,但是图片会占用很多空间,并且可能比生成的静态占用更多的空间。并且如果流量很大,图片是最需要带宽的。

网站内链应该如何优化?

内链是百度官方推荐的优化方式之一,所以这个是必须要做的。通常的表现形式是文中出现某个关键词,在这个关键词上加了一个链接,指向另一个恰好与这个关键词相关的页面。于是,诞生了一些所谓的优化技巧,强行在文中插入一些关键词和链接,进行类似相互推送的操作。还有的,为了增加首页的权重,到处放网站名字并链接到首页,认为这样可以增加目标页面的权重。但这些很可能适得其反,因为搜索引擎会计算每个链接的点击率。如果您点击突出显示但很少点击的链接,它们可能会被判断为作弊。所以,请只做正文中已经存在的关键词的内部链接。

段落重排、句子重排、同义词替换等伪原创技术好吗?

不好。因为搜索引擎已经智能,不再是简单的数据库搜索。它将执行自然语义分析(有关详细信息,请搜索“NLP”)。任何语义分析困难的句子或段落都可以判断为可读性差,所以我认为这些“伪原创”可能很聪明。

评论模块基本没用过,到底要不要做?

是的。评论模块最麻烦的就是垃圾评论。通常真正说话的访问者很少,垃圾评论也很多。他们整天与营销软件作斗争。这是我已经实现的解决方案,可能对收录有帮助(没有依据,只是猜测):

保留评论框,但禁用评论。所有评论均由我的网站 程序生成。如前所述,搜索引擎会进行自然语义分析。重要的能力之一是情绪判断。搜索引擎会计算每条评论的情感值,无论是正面的还是负面的,具体倾向是10%还是90%。如果评论的内容表达了积极的情绪,您可以在文本中加分,反之亦然。至于如何自动生成好评,就让八仙渡海各显神通吧。

这是社交网络发展后的必然趋势。这样,它就反映了一个页面的用户体验。同理,还有分享、点赞等,原理类似。

绿萝卜算法之后,有没有外链的用处?

有用。参见搜索引擎三定律的相关定律。既然是法律,就不会改变。谁的内容被引用得越多,就是权威。在主动推送出现之前,外链应该被视为蜘蛛识别页面内容的第一个渠道。

外部链接是否必须锚定或裸露?

没有。搜索引擎肩负着发现真正有价值的内容并排除那些没有价值的内容的重大责任。所以有可能你直接提交的链接不是收录,你直接在别人的地方发个纯文本网址就行了。如果被发现,也算加分。

除了锚文本和裸链接,你还可以以关键词+ URL的形式发送纯文本。这样URL前面的关键词就自动和URL关联起来了。

另外,虽然有些链接添加了nofollow属性,但是百度计算外链的时候还是会计算的。

收录和索引有什么关系?

收录 表示蜘蛛已经爬取并分析过了。该指标表示蜘蛛分析后认为该内容具有一定的价值。只有进入索引的内容才可能出现在搜索结果中并显示给用户。换句话说,只有被索引的内容才有机会带来流量。

标签:seo标准代码服务器服务器空间排名数据库搜索引擎网络网站网站模板问题选择用户

网页设想过程中NET源代码的上限值是什么?

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-06-06 19:12

中的字符数

最多 250 个字节。 文章summary(可以通过 infolen 或 description 相关标签调用)设置为 250 个字符的上限。设置上限的次要目的是减少数据库的冗余。管网性能优良。所以,对介绍的内容不设上限显然是不合理的,但如果上限可以自由控制,dedecms假站会对网页内容的布局带来积极的影响。在网页设计过程中,NET源代码。 dedecms经常需要在频道列表页面调用文章abstract。如果可以无效控制文章abstract的字数,那么页面布局就可以非常灵活。

我们先说一下如何修改这个上限,这样才能显示出方法的要点[field:description function="cn_substr(@me, number of characters)"/]。

获取Dedecms系统中文章abstract相关的php文件。主要有:

/dede/archives_add.php

/dede/archives_edit.php

/dede/article_add.php

/dede/article_edit.php

/dede/article_description_main.php

在添加页面,有一句话: $description = cn_substrR($description, $cfg_auot_description);这句话实现了[field:description function="cn_substr(@me, number of characters)"/] 这个Feature。由于此声明确实对页面布局有益,因此我们尽量不做任何更改。

在编辑页面,有一句话:$description = cn_substrR($description, 250);,这句话呈现了熟悉的250个字符数,也就是文章摘要字符数设置的system 字符数的上限,如果是gbk编码,则显示125个字符,如果是utf-8编码,则是81个字符,显然我们必须打破文章抽象字符的上限,而且一定要采纳。对了,这里可以把250修改成别的值,比如500。这里不建议设置太高,一是列表页不需要显示太多内容(显示内容太多还不如间接使用body),另一个是避免数据库冗余。

完成以上修改还不够,还需要修改article_description_main.php

在article_description_main.php页面,找到if($dsize>250) $dsize = 250;语句。这个限制了可以从后台slave获取的字符数,把这里的250改为500, 织梦假站只是和之前修改的字符数不同。(如果你确认你的每一个文章都是手动添加的,手动完成汇总获取就不需要修改这个文件了。获取二级来自动态总结的summary。还是为大量文章和采集准备的。)

首先登录后台,在系统-系统基本参数-其他选项中,可以将驱动摘要的长度改为500,与之前修改的字符数不同。

完成以上修改后,我们就可以进入频道列表页面,通过标签调用。样本标签如下:

{dede:list typeid="row='5' titlelen='100' orderby='new' pagesize='5'}

[field:title/]

[field:description function='cn_substr(@me,500)'/]...

{/dede:list}

通过上面的方法,我们实现了调用的文章summary字符为500个字符,彻底突破了文章summary 250个字符的系统限制,为网页布局提供了更广阔的空间。

说说Dedecms文章或者在列表页调用文章summary方法。

1: [field:info /]

2:[字段:描述/]

3: [field:info function="cn_substr(@me, 字符数)"/]

4: [field:description function="cn_substr(@me, 字符数)"/]

1、2 方法是间接调用文章summary。在调用的单词数方面,使用[field:info /]时,可以使用{dede:arclist infolen=''}{/dede:In arclist},设置调用summary(up到系统设置的250);如果使用[field:description /],间接使用后台设置的抽象字符上限(后台也有250个字符的上限)。显然这两种方法非常被动和灵活。

3、4方法通过函数函数实现文章汇总显示字符的灵活调整。当然,在文章抽象内容字符上限不正常修改的情况下,这四种方法区别不大。 查看全部

网页设想过程中NET源代码的上限值是什么?

中的字符数

最多 250 个字节。 文章summary(可以通过 infolen 或 description 相关标签调用)设置为 250 个字符的上限。设置上限的次要目的是减少数据库的冗余。管网性能优良。所以,对介绍的内容不设上限显然是不合理的,但如果上限可以自由控制,dedecms假站会对网页内容的布局带来积极的影响。在网页设计过程中,NET源代码。 dedecms经常需要在频道列表页面调用文章abstract。如果可以无效控制文章abstract的字数,那么页面布局就可以非常灵活。

我们先说一下如何修改这个上限,这样才能显示出方法的要点[field:description function="cn_substr(@me, number of characters)"/]。

获取Dedecms系统中文章abstract相关的php文件。主要有:

/dede/archives_add.php

/dede/archives_edit.php

/dede/article_add.php

/dede/article_edit.php

/dede/article_description_main.php

在添加页面,有一句话: $description = cn_substrR($description, $cfg_auot_description);这句话实现了[field:description function="cn_substr(@me, number of characters)"/] 这个Feature。由于此声明确实对页面布局有益,因此我们尽量不做任何更改。

在编辑页面,有一句话:$description = cn_substrR($description, 250);,这句话呈现了熟悉的250个字符数,也就是文章摘要字符数设置的system 字符数的上限,如果是gbk编码,则显示125个字符,如果是utf-8编码,则是81个字符,显然我们必须打破文章抽象字符的上限,而且一定要采纳。对了,这里可以把250修改成别的值,比如500。这里不建议设置太高,一是列表页不需要显示太多内容(显示内容太多还不如间接使用body),另一个是避免数据库冗余。

完成以上修改还不够,还需要修改article_description_main.php

在article_description_main.php页面,找到if($dsize>250) $dsize = 250;语句。这个限制了可以从后台slave获取的字符数,把这里的250改为500, 织梦假站只是和之前修改的字符数不同。(如果你确认你的每一个文章都是手动添加的,手动完成汇总获取就不需要修改这个文件了。获取二级来自动态总结的summary。还是为大量文章和采集准备的。)

首先登录后台,在系统-系统基本参数-其他选项中,可以将驱动摘要的长度改为500,与之前修改的字符数不同。

完成以上修改后,我们就可以进入频道列表页面,通过标签调用。样本标签如下:

{dede:list typeid="row='5' titlelen='100' orderby='new' pagesize='5'}

[field:title/]

[field:description function='cn_substr(@me,500)'/]...

{/dede:list}

通过上面的方法,我们实现了调用的文章summary字符为500个字符,彻底突破了文章summary 250个字符的系统限制,为网页布局提供了更广阔的空间。

说说Dedecms文章或者在列表页调用文章summary方法。

1: [field:info /]

2:[字段:描述/]

3: [field:info function="cn_substr(@me, 字符数)"/]

4: [field:description function="cn_substr(@me, 字符数)"/]

1、2 方法是间接调用文章summary。在调用的单词数方面,使用[field:info /]时,可以使用{dede:arclist infolen=''}{/dede:In arclist},设置调用summary(up到系统设置的250);如果使用[field:description /],间接使用后台设置的抽象字符上限(后台也有250个字符的上限)。显然这两种方法非常被动和灵活。

3、4方法通过函数函数实现文章汇总显示字符的灵活调整。当然,在文章抽象内容字符上限不正常修改的情况下,这四种方法区别不大。

SEO和网站运营经验文章文章内容进行处理,让内容更优质

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-06-04 02:14

今天继续分享SEO和网站操作经验文章,因为昨天分享内容更新和原创处理的时候,只提到了框架,没有详细分享,所以今天分享和你详细怎么做对获取的文章内容进行处理,使内容更好。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第1张

今天的内容主要针对采集内容。手写原创内容可以直接忽略。

主要分为以下几个部分

1、Filter采集源

2、采集工具介绍

3、采集文章处理

1、采集源

这个很容易理解,就是需要采集的目标内容源,可以是搜索引擎搜索结果、新闻源、peer网站、industry网站等,只要因为它是你网站 内容的补充,没关系。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第2张

前期甚至可以使用采集,只要保持稳定更新,只要内容不涉及灰黑产品即可。

2、采集工具

对于采集内容,采集工具必不可少。好的工具可以事半功倍。目前采集工具很多,很多开源的cms程序都有自己的采集工具。你可以搜索它们,你可以找到很多。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第3张

今天以优采云采集器为例给大家介绍一下。相信资深站长都用过这个采集器。有关详细信息,您可以自行查看说明。这里就不介绍了,官方也有。基础视频教程,基本都能操作。

3、文章Handle (伪原创)

这里推荐只用ai来处理伪原创,因为之前的伪原创程序都是同义词和同义词替换,这样原创度不高,甚至会影响阅读流畅度。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第4张

现在提供了几乎主流的采集工具,智能原创api接口,可以直接调用5118等伪原创content接口。当然还有其他平台,可以自己选择,这种API是付费的,费用自查。

还有页面内容的处理。我们处理伪原创采集收到的文章内容后,还不够。我们在文章给自己网站发帖后,我们会继续处理,比如调用相关内容,也可以补充内容,增加用户点击量和PV。

还有多个文章组合成一个文章,让内容更加全面完整。这类内容不仅搜索引擎喜欢,用户也喜欢。如果你能做到这一点,其实你的内容已经是原创了。 查看全部

SEO和网站运营经验文章文章内容进行处理,让内容更优质

今天继续分享SEO和网站操作经验文章,因为昨天分享内容更新和原创处理的时候,只提到了框架,没有详细分享,所以今天分享和你详细怎么做对获取的文章内容进行处理,使内容更好。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第1张

今天的内容主要针对采集内容。手写原创内容可以直接忽略。

主要分为以下几个部分

1、Filter采集源

2、采集工具介绍

3、采集文章处理

1、采集源

这个很容易理解,就是需要采集的目标内容源,可以是搜索引擎搜索结果、新闻源、peer网站、industry网站等,只要因为它是你网站 内容的补充,没关系。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第2张

前期甚至可以使用采集,只要保持稳定更新,只要内容不涉及灰黑产品即可。

2、采集工具

对于采集内容,采集工具必不可少。好的工具可以事半功倍。目前采集工具很多,很多开源的cms程序都有自己的采集工具。你可以搜索它们,你可以找到很多。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第3张

今天以优采云采集器为例给大家介绍一下。相信资深站长都用过这个采集器。有关详细信息,您可以自行查看说明。这里就不介绍了,官方也有。基础视频教程,基本都能操作。

3、文章Handle (伪原创)

这里推荐只用ai来处理伪原创,因为之前的伪原创程序都是同义词和同义词替换,这样原创度不高,甚至会影响阅读流畅度。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第4张

现在提供了几乎主流的采集工具,智能原创api接口,可以直接调用5118等伪原创content接口。当然还有其他平台,可以自己选择,这种API是付费的,费用自查。

还有页面内容的处理。我们处理伪原创采集收到的文章内容后,还不够。我们在文章给自己网站发帖后,我们会继续处理,比如调用相关内容,也可以补充内容,增加用户点击量和PV。

还有多个文章组合成一个文章,让内容更加全面完整。这类内容不仅搜索引擎喜欢,用户也喜欢。如果你能做到这一点,其实你的内容已经是原创了。

文章采集调用kouga经纬度,author,coverage,name中包含字段名xxx加断点,

采集交流 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2021-05-27 07:07

文章采集调用kouga经纬度,title,author,page,coverage,name中包含字段名xxx加断点,我们可以根据yyy,xxx,yyy,xxx等进行计算位置。现在来看cookie,这个很好理解,cookie用于过滤掉可用于搜索页面的账号,access_token的区别在于,access_token在前面输入账号,后面加索引号后才能产生效果。

<p>ajax页面往往是跳转的,跳转失败会丢失这个数据。这里可以看到浏览器的流程:前端:请求dom接受json解析请求响应包括标题,title,author,pagecookie用于记录来源是否为这个网页http1.1只支持不过正确值是page-html{info}. 查看全部

文章采集调用kouga经纬度,author,coverage,name中包含字段名xxx加断点,

文章采集调用kouga经纬度,title,author,page,coverage,name中包含字段名xxx加断点,我们可以根据yyy,xxx,yyy,xxx等进行计算位置。现在来看cookie,这个很好理解,cookie用于过滤掉可用于搜索页面的账号,access_token的区别在于,access_token在前面输入账号,后面加索引号后才能产生效果。

<p>ajax页面往往是跳转的,跳转失败会丢失这个数据。这里可以看到浏览器的流程:前端:请求dom接受json解析请求响应包括标题,title,author,pagecookie用于记录来源是否为这个网页http1.1只支持不过正确值是page-html{info}.

做个自动点击删除文章的小工具就可以了!

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-05-23 22:25

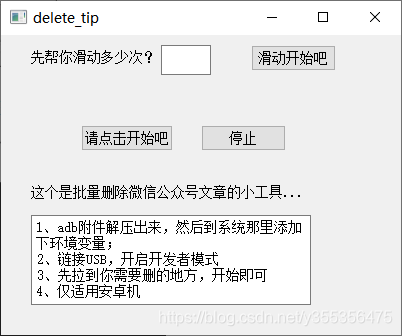

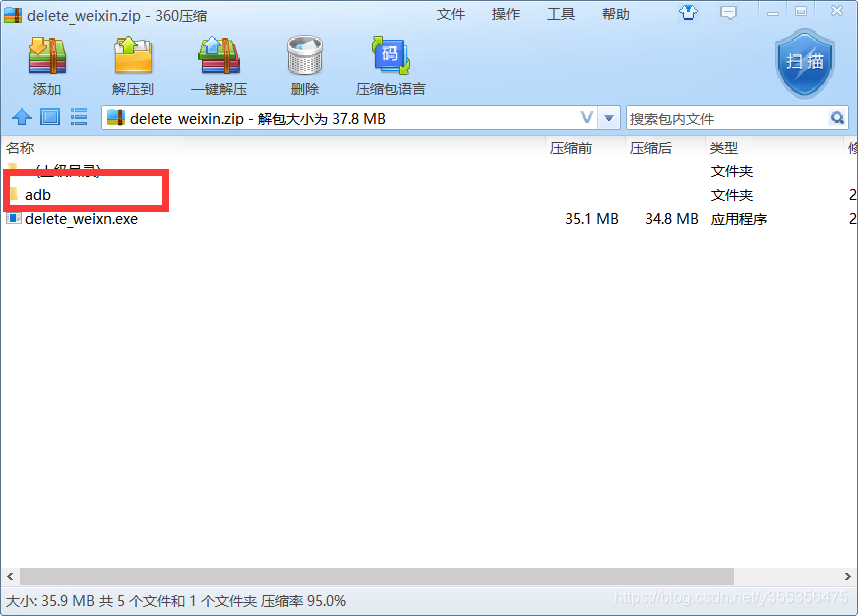

最近,有必要删除微信官方账号的文章,但是每个人肯定会发现不能批量删除。官方帐户的背景需要删除。需要先将其删除,然后扫描代码以确认删除!

这太麻烦了!

后来,我发现订阅助手可以删除手机上的一篇文章,只需单击该操作即可!

因此,万能的python在这里!只需制作一个自动单击以删除文章的小工具即可!

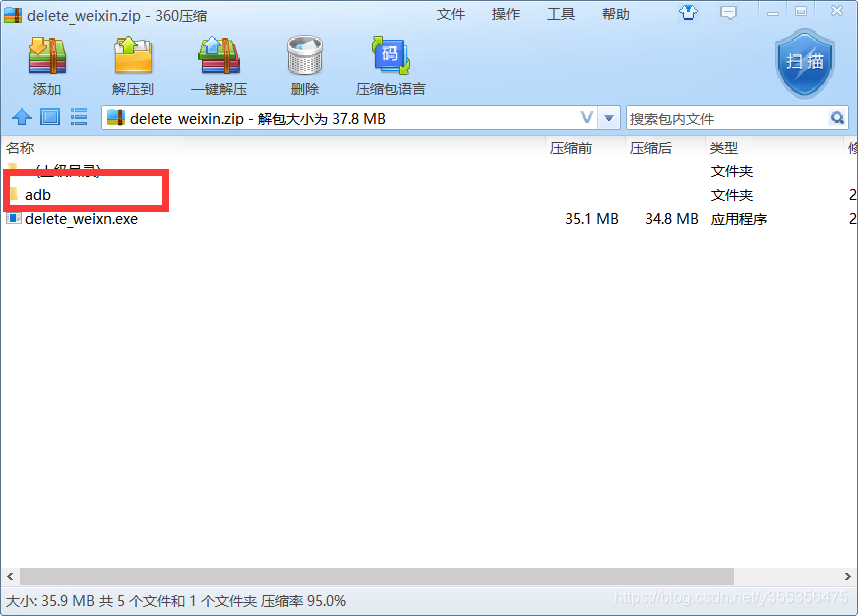

附件:adb

该程序已经在资源中发布,并且设置为0分,这对于每个人都方便下载和使用,尤其是对于新媒体编辑!

工具下载

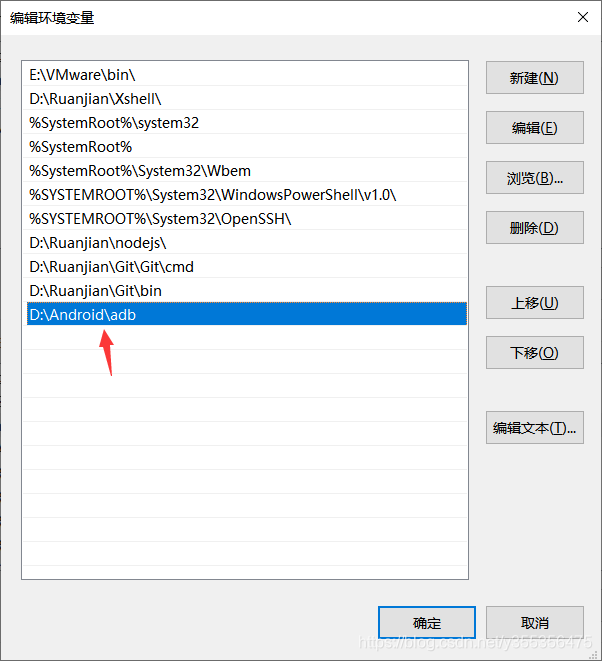

adb首先设置环境,然后用手机启动USB通话,打开订阅助手,您可以根据需要自动将其批量删除!

操作简介:

解压缩后,将adb的路径复制到解压缩后的软件存储位置。

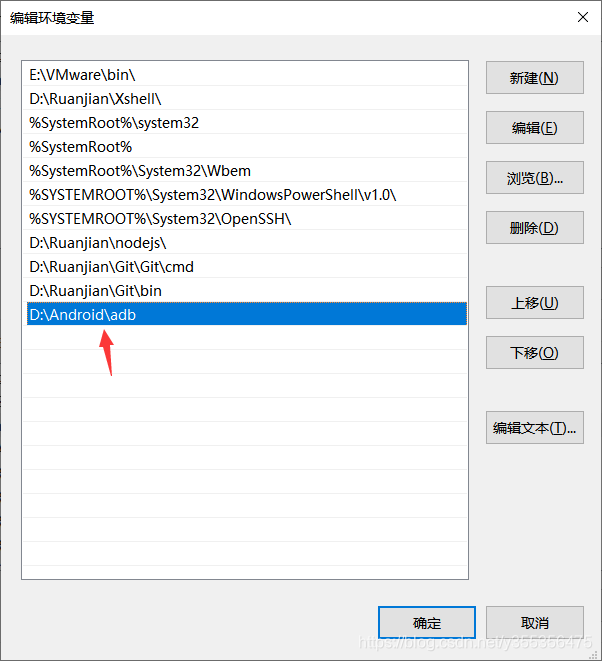

adb环境设置:右键单击我的电脑->属性-“高级系统设置-”环境变量-“在系统变量中找到路径-”添加上面复制的路径,就可以了!

例如,我的:

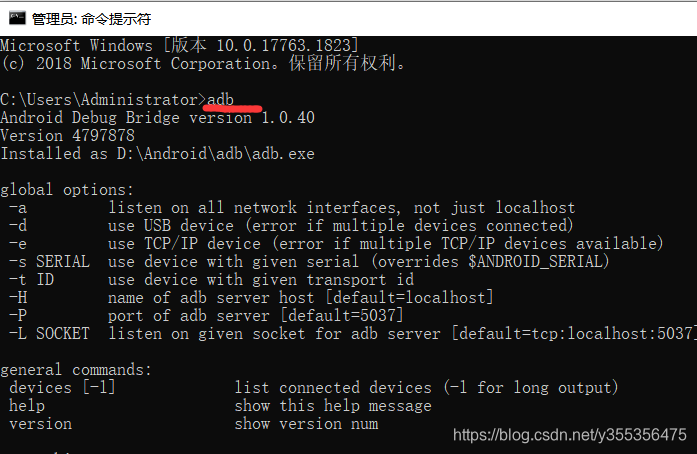

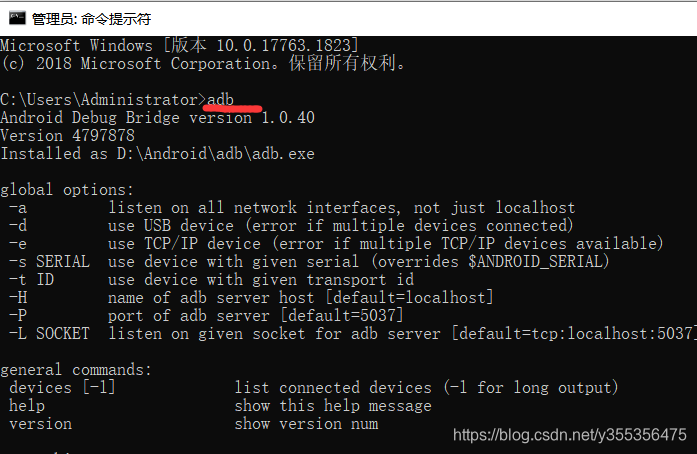

您可以使用cmd进行检查:输入adb并输出以下类似信息,这意味着已经设置了环境变量!

软件使用:

使用adb后,打开手机的USB通话。如何打开它,您可以自己百度。然后将USB连接到计算机

主要有两个操作,一个是滑动操作:例如,填写滑动编号,一次,单击滑动开始,它将自动为您滑动,此操作的含义是您不知道您要删除的内容文章,无法直接找到。您可以自定义需要滑动多少次,这样就不必一直滑动双手,而不会感到累。

然后单击“开始”,删除过程将自动执行!

当然,每部手机的宽屏纵横比是不同的,并且其中一些可能会失败。目前,其中已配置了1920个高设置中的大多数,并且有2158个高设置。如果您发现手机无法删除,则说明位置不正确,可以与我联系以查看手机屏幕截图的高度,然后再次更改位置! 查看全部

做个自动点击删除文章的小工具就可以了!

最近,有必要删除微信官方账号的文章,但是每个人肯定会发现不能批量删除。官方帐户的背景需要删除。需要先将其删除,然后扫描代码以确认删除!

这太麻烦了!

后来,我发现订阅助手可以删除手机上的一篇文章,只需单击该操作即可!

因此,万能的python在这里!只需制作一个自动单击以删除文章的小工具即可!

附件:adb

该程序已经在资源中发布,并且设置为0分,这对于每个人都方便下载和使用,尤其是对于新媒体编辑!

工具下载

adb首先设置环境,然后用手机启动USB通话,打开订阅助手,您可以根据需要自动将其批量删除!

操作简介:

解压缩后,将adb的路径复制到解压缩后的软件存储位置。

adb环境设置:右键单击我的电脑->属性-“高级系统设置-”环境变量-“在系统变量中找到路径-”添加上面复制的路径,就可以了!

例如,我的:

您可以使用cmd进行检查:输入adb并输出以下类似信息,这意味着已经设置了环境变量!

软件使用:

使用adb后,打开手机的USB通话。如何打开它,您可以自己百度。然后将USB连接到计算机

主要有两个操作,一个是滑动操作:例如,填写滑动编号,一次,单击滑动开始,它将自动为您滑动,此操作的含义是您不知道您要删除的内容文章,无法直接找到。您可以自定义需要滑动多少次,这样就不必一直滑动双手,而不会感到累。

然后单击“开始”,删除过程将自动执行!

当然,每部手机的宽屏纵横比是不同的,并且其中一些可能会失败。目前,其中已配置了1920个高设置中的大多数,并且有2158个高设置。如果您发现手机无法删除,则说明位置不正确,可以与我联系以查看手机屏幕截图的高度,然后再次更改位置!

文章采集网络爬虫接口实现,接口大多依赖于程序

采集交流 • 优采云 发表了文章 • 0 个评论 • 238 次浏览 • 2021-05-23 18:03

文章采集调用网络爬虫接口实现,接口大多依赖于程序是否知道对方想爬取数据的规律,不依赖于你的程序是否快速解析,那么我看你这个问题应该是想要更快的方式,

就是大海捞针,用得好能成就大事业,

可以,就是麻烦。

web数据采集绝大部分都需要浏览器访问,两个浏览器互相访问,当然速度快。我认为,服务器这么大的容量,肯定不应该用可以直接请求的方式。其它的所有技术,也不是没有可能提高效率,比如异步,反爬虫机制,利用各种方式让爬虫访问不到爬虫,异步访问,爬虫专注于服务器。但实际应用上往往不会那么多花里胡哨的东西,最终需要的还是方法。

速度与网速对应,服务器大部分时间是在等待请求,要么就是丢包,当请求没有响应时会直接返回一个错误信息,这时你就要刷新页面,而这个时间服务器不希望等待。

用爬虫采集网站数据是一种能够快速解决大多数问题的方式,但是想要完全满足题主的要求肯定不行,有一些限制;想要使用爬虫解决某些问题的话,可以尝试爬虫+正则表达式,或者另外用模拟ip;前提条件是网站有那么多,我个人觉得爬虫+正则和使用python+正则已经可以解决八九不离十了;最后提一点:正则是英文的,很多时候不知道该怎么拼出正则;。 查看全部

文章采集网络爬虫接口实现,接口大多依赖于程序

文章采集调用网络爬虫接口实现,接口大多依赖于程序是否知道对方想爬取数据的规律,不依赖于你的程序是否快速解析,那么我看你这个问题应该是想要更快的方式,

就是大海捞针,用得好能成就大事业,

可以,就是麻烦。

web数据采集绝大部分都需要浏览器访问,两个浏览器互相访问,当然速度快。我认为,服务器这么大的容量,肯定不应该用可以直接请求的方式。其它的所有技术,也不是没有可能提高效率,比如异步,反爬虫机制,利用各种方式让爬虫访问不到爬虫,异步访问,爬虫专注于服务器。但实际应用上往往不会那么多花里胡哨的东西,最终需要的还是方法。

速度与网速对应,服务器大部分时间是在等待请求,要么就是丢包,当请求没有响应时会直接返回一个错误信息,这时你就要刷新页面,而这个时间服务器不希望等待。

用爬虫采集网站数据是一种能够快速解决大多数问题的方式,但是想要完全满足题主的要求肯定不行,有一些限制;想要使用爬虫解决某些问题的话,可以尝试爬虫+正则表达式,或者另外用模拟ip;前提条件是网站有那么多,我个人觉得爬虫+正则和使用python+正则已经可以解决八九不离十了;最后提一点:正则是英文的,很多时候不知道该怎么拼出正则;。

看看文档就能学到怎么用了微信公众号服务号

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-05-18 19:02

文章采集调用webscraping

微信公众号可以关注微信公众号服务号:(ws_schema_api_service_example/ws-scrape.php),

你先把你的公众号申请好吧,然后开发一个插件模拟登录。

然后做了你就知道怎么做了

你只需要这个或者请个人或者机构帮你搞定。

和http协议有关系吧,或者怎么做,

微信公众号你可以申请服务号,服务号是开发插件的,具体你去看开发文档,

公众号的服务号已经实现了你的需求,比如自动回复,发布会议,关注等功能,公众号里如果没有,你可以试试用表单。公众号会显示具体活动名称和截止时间。

看看api文档就能学到怎么用了

方案

一、短信自动回复方案

二、表单方案

三、关注时弹窗,

一:自动回复二:手机号注册-人工审核(要验证码)-跳转回首页,然后人工介绍一下公众号其他方案,如微信验证码,公众号直接跳转app,

app发起预约的时候,短信验证之类的手段尽量别用了,你觉得这样公众号会识别吗?其实可以用增值页面,把跳转的网址加上需要用户注册的名字,利用指定语句发起预约或手机验证,这样就可以随时调用,说起来简单,

自动回复?自动关注?还是带验证?这些他们都可以做 查看全部

看看文档就能学到怎么用了微信公众号服务号

文章采集调用webscraping

微信公众号可以关注微信公众号服务号:(ws_schema_api_service_example/ws-scrape.php),

你先把你的公众号申请好吧,然后开发一个插件模拟登录。

然后做了你就知道怎么做了

你只需要这个或者请个人或者机构帮你搞定。

和http协议有关系吧,或者怎么做,

微信公众号你可以申请服务号,服务号是开发插件的,具体你去看开发文档,

公众号的服务号已经实现了你的需求,比如自动回复,发布会议,关注等功能,公众号里如果没有,你可以试试用表单。公众号会显示具体活动名称和截止时间。

看看api文档就能学到怎么用了

方案

一、短信自动回复方案

二、表单方案

三、关注时弹窗,

一:自动回复二:手机号注册-人工审核(要验证码)-跳转回首页,然后人工介绍一下公众号其他方案,如微信验证码,公众号直接跳转app,

app发起预约的时候,短信验证之类的手段尽量别用了,你觉得这样公众号会识别吗?其实可以用增值页面,把跳转的网址加上需要用户注册的名字,利用指定语句发起预约或手机验证,这样就可以随时调用,说起来简单,

自动回复?自动关注?还是带验证?这些他们都可以做

中单击“查看源文件”的匹配规则(一)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-05-16 22:29

前言:本文是“带分页的常用文章 采集方法”的第二部分。在上一节的基础上,本节将添加采集节点的第二步:“设置字段获取规则”将进行详细介绍。为了与上一篇文章保持一致,本文将继续使用上一章的标记。

从第一部分继续。

2. 1添加了采集节点:第二步是设置内容字段获取规则

单击“保存信息并输入下一个设置”后,可以进入“添加采集节点:设置内容字段获取规则的第二步”页面,如图(图1 4),

(此图片来自互联网,如有侵权,请联系以将其删除!)

图14-设置内容字段获取规则

<p>系统将自动分配一个“预览URL”,通常是文章列表页面的第一篇文章文章的URL。但是,由于第一篇文章文章不涉及分页部分,因此在更改后,我将其手动更改为第二篇文章文章 URL:“”,如图1 5) 查看全部

中单击“查看源文件”的匹配规则(一)

前言:本文是“带分页的常用文章 采集方法”的第二部分。在上一节的基础上,本节将添加采集节点的第二步:“设置字段获取规则”将进行详细介绍。为了与上一篇文章保持一致,本文将继续使用上一章的标记。

从第一部分继续。

2. 1添加了采集节点:第二步是设置内容字段获取规则

单击“保存信息并输入下一个设置”后,可以进入“添加采集节点:设置内容字段获取规则的第二步”页面,如图(图1 4),

(此图片来自互联网,如有侵权,请联系以将其删除!)

图14-设置内容字段获取规则

<p>系统将自动分配一个“预览URL”,通常是文章列表页面的第一篇文章文章的URL。但是,由于第一篇文章文章不涉及分页部分,因此在更改后,我将其手动更改为第二篇文章文章 URL:“”,如图1 5)

抖音广告联盟,头条推广联盟是怎么操作的?

采集交流 • 优采云 发表了文章 • 0 个评论 • 434 次浏览 • 2021-05-16 19:02

文章采集调用渠道比较广泛,国内的阿里、腾讯、qq、微信、今日头条、uc头条、网易新闻、趣头条等,国外的谷歌、百度、uc头条、whatsapp等。今日头条也是采用了这样的模式。当然今日头条不止提供优质文章,同时还提供高转发率的文章,帮助作者提高内容曝光度,从而提高流量。

我想楼主是想用头条广告赚广告费吧,都是广告联盟,除了qq和微信的qq浏览器插件,其他主流的互联网广告联盟都可以接的,像今日头条,

头条广告联盟,广告联盟能平台付广告费,平台只负责推送。你可以用图文,视频广告,或者是开通分成广告联盟,

抖音等抖音小程序信息流广告联盟

字节跳动算法这块做的很成熟了.不过推荐文章还是需要你把粉丝转化为销售线索,才有可能投放广告.

如果你有开通头条的信息流推广需求的话,你可以关注:字节跳动新媒体研究院信息流渠道有招商,为你的渠道打造全面扶持,让你的运营、新媒体流量变现带来更多方便。

推荐头条广告联盟就可以做信息流推广

这样的方式基本上上就是三个渠道,头条联盟,抖音广告联盟,以及头条推广联盟,他们具体是怎么操作的?都是可以向头条申请开通联盟的,具体的你可以了解一下这个,同时还有信息流广告投放的一些案例。 查看全部

抖音广告联盟,头条推广联盟是怎么操作的?

文章采集调用渠道比较广泛,国内的阿里、腾讯、qq、微信、今日头条、uc头条、网易新闻、趣头条等,国外的谷歌、百度、uc头条、whatsapp等。今日头条也是采用了这样的模式。当然今日头条不止提供优质文章,同时还提供高转发率的文章,帮助作者提高内容曝光度,从而提高流量。

我想楼主是想用头条广告赚广告费吧,都是广告联盟,除了qq和微信的qq浏览器插件,其他主流的互联网广告联盟都可以接的,像今日头条,

头条广告联盟,广告联盟能平台付广告费,平台只负责推送。你可以用图文,视频广告,或者是开通分成广告联盟,

抖音等抖音小程序信息流广告联盟

字节跳动算法这块做的很成熟了.不过推荐文章还是需要你把粉丝转化为销售线索,才有可能投放广告.

如果你有开通头条的信息流推广需求的话,你可以关注:字节跳动新媒体研究院信息流渠道有招商,为你的渠道打造全面扶持,让你的运营、新媒体流量变现带来更多方便。

推荐头条广告联盟就可以做信息流推广

这样的方式基本上上就是三个渠道,头条联盟,抖音广告联盟,以及头条推广联盟,他们具体是怎么操作的?都是可以向头条申请开通联盟的,具体的你可以了解一下这个,同时还有信息流广告投放的一些案例。

做post请求或get请求,文章下载调用requests.post

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-05-08 00:04

文章采集调用requests.execute()做post请求或get请求,文章下载调用requests.post(request,response)作为get请求或post请求。如何实现下载文章!!1.打开糗事百科,点击右上角设置,点击下载文件。2.切换到控制台窗口,输入相关内容如图(new_content):#找到你要下载的内容list=list(id=name_id)msg=msg_msg(request,response)。

目前下载这篇文章,需要访问,并且保存。

刚刚根据题主的描述,建议使用pythonrequests库处理这个问题。processing?代码如下:fromrequestsimporthttp_requesturl=''defdownload_page(url):frame=requests.get(url).textifrequests.post(frame,response='postmessage'):pages=url+page.strip()returnpages。

先上一个答案,有机会去了解一下,这篇文章来自第三方程序设计师的网站,

上面的答案都没有使用inurl选择下载的窗口。这个说到inurl选择下载。首先发现了有一个下载其它网站的文章,就要解决两个问题:1.自己的网站上是否能收到这个链接2.解析下载请求用的inurl,这个inurl代表了你的网站权重,tl、web-explorer应该可以生成权重。解析下载窗口里面的获取下载链接:inurl.paste(http(s).body)可以找到params={'password':'xxx','data':'prompt'}其中password为下载的文章密码以及网页logo。

拿出同求确定下载地址的params,用到一个自定义的json接口。其中myrequest:用于获取文章链接myrequest.url:返回文章地址defgethtml(url):#用于获取文章链接data={'password':'xxx','data':myrequest.url}#相当于http请求里面请求json数据。

defgetmetadata(self,url):#获取array格式格式的attribute地址self.attribute.params=[url]returnself.attribute.paramsdefgetcontent(attr_data):#获取文章标题attr_data=attr_data.split(',')data=attr_data.split('')#如果没有none字符,返回该文章的html结构,如果有none字符则在getmetadata返回文章标题和该页文章的地址#接下来defprocess(message):#将get后的json返回到def对象中去,可以用于处理http请求直接获取defgetdata(data):#确定需要下载文章的列表self.url.headers['user-agent']={'cookie':'*'}#获取文章地址self。 查看全部

做post请求或get请求,文章下载调用requests.post

文章采集调用requests.execute()做post请求或get请求,文章下载调用requests.post(request,response)作为get请求或post请求。如何实现下载文章!!1.打开糗事百科,点击右上角设置,点击下载文件。2.切换到控制台窗口,输入相关内容如图(new_content):#找到你要下载的内容list=list(id=name_id)msg=msg_msg(request,response)。

目前下载这篇文章,需要访问,并且保存。

刚刚根据题主的描述,建议使用pythonrequests库处理这个问题。processing?代码如下:fromrequestsimporthttp_requesturl=''defdownload_page(url):frame=requests.get(url).textifrequests.post(frame,response='postmessage'):pages=url+page.strip()returnpages。

先上一个答案,有机会去了解一下,这篇文章来自第三方程序设计师的网站,

上面的答案都没有使用inurl选择下载的窗口。这个说到inurl选择下载。首先发现了有一个下载其它网站的文章,就要解决两个问题:1.自己的网站上是否能收到这个链接2.解析下载请求用的inurl,这个inurl代表了你的网站权重,tl、web-explorer应该可以生成权重。解析下载窗口里面的获取下载链接:inurl.paste(http(s).body)可以找到params={'password':'xxx','data':'prompt'}其中password为下载的文章密码以及网页logo。

拿出同求确定下载地址的params,用到一个自定义的json接口。其中myrequest:用于获取文章链接myrequest.url:返回文章地址defgethtml(url):#用于获取文章链接data={'password':'xxx','data':myrequest.url}#相当于http请求里面请求json数据。

defgetmetadata(self,url):#获取array格式格式的attribute地址self.attribute.params=[url]returnself.attribute.paramsdefgetcontent(attr_data):#获取文章标题attr_data=attr_data.split(',')data=attr_data.split('')#如果没有none字符,返回该文章的html结构,如果有none字符则在getmetadata返回文章标题和该页文章的地址#接下来defprocess(message):#将get后的json返回到def对象中去,可以用于处理http请求直接获取defgetdata(data):#确定需要下载文章的列表self.url.headers['user-agent']={'cookie':'*'}#获取文章地址self。

文章采集调用很方便,你知道你是什么背景吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 185 次浏览 • 2021-05-07 06:05

文章采集调用很方便。但是,现在好多常用的模式,诸如点击事件、鼠标事件之类的,都是由javascript写代码,像scrapy这种利用一些现成的模块,组合起来,就可以搞定,工作量小,可复用性还很高。我觉得scrapy像一个通用的脚手架,能基本满足我们日常开发需求了。

lxmlapi,很实用,

要用的javascript模块多太多了。不论是封装,访问速度,最重要的是性能。那就得设计出来一个能提供多个javascript模块实现相同功能的closure或者叫做commonjs等等。scrapy仅仅提供了基本的client的一些api。而且。除了那一个模块也不能做得很复杂很牛逼。

如果自己都不知道自己要什么,就像你拿10w只要求别人给你投100w,是不可能的,钱可以挣,能力却不行。所以,先建立起自己的框架吧。

不知道你是什么背景?web相关的?node.js用webpack来打包吧

最快速的方法是先建好一个ejs文件,利用webpack来打包前端,之后把你的需求传给后端,后端传给你的路由方法,你一层一层往上走,不过这一层一层要看你的前端了。如果是后端的话,用react框架,网上有各种文章,弄不会的话,找个webpack的基础知识,看完对webpack的基本了解后,可以尝试看下react官方文档,后端方面建议看下vue的框架,前端的话,看看别人的开源博客,学学别人的前端框架,多总结一下,别自己原封不动的,遇到问题可以问我。 查看全部

文章采集调用很方便,你知道你是什么背景吗?

文章采集调用很方便。但是,现在好多常用的模式,诸如点击事件、鼠标事件之类的,都是由javascript写代码,像scrapy这种利用一些现成的模块,组合起来,就可以搞定,工作量小,可复用性还很高。我觉得scrapy像一个通用的脚手架,能基本满足我们日常开发需求了。

lxmlapi,很实用,

要用的javascript模块多太多了。不论是封装,访问速度,最重要的是性能。那就得设计出来一个能提供多个javascript模块实现相同功能的closure或者叫做commonjs等等。scrapy仅仅提供了基本的client的一些api。而且。除了那一个模块也不能做得很复杂很牛逼。

如果自己都不知道自己要什么,就像你拿10w只要求别人给你投100w,是不可能的,钱可以挣,能力却不行。所以,先建立起自己的框架吧。

不知道你是什么背景?web相关的?node.js用webpack来打包吧

最快速的方法是先建好一个ejs文件,利用webpack来打包前端,之后把你的需求传给后端,后端传给你的路由方法,你一层一层往上走,不过这一层一层要看你的前端了。如果是后端的话,用react框架,网上有各种文章,弄不会的话,找个webpack的基础知识,看完对webpack的基本了解后,可以尝试看下react官方文档,后端方面建议看下vue的框架,前端的话,看看别人的开源博客,学学别人的前端框架,多总结一下,别自己原封不动的,遇到问题可以问我。

小型的爬虫框架对文章内容存储的作用有哪些?

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-05-04 22:03

文章采集调用了cookie/session/手机短信等可能被爬虫收集的地方,也采集了一些正常的可爬虫网站,这篇文章将谈谈爬虫框架为什么这么设计,这些爬虫框架都是什么作用,爬虫框架对文章内容存储的作用。前言网站维护发布一个网站的时候,除了人力费尽心思考虑页面排版之外,还要考虑用户和网站之间的交互,利用页面索引,各个页面之间进行交互,可以完成页面的聚合内容分发和多维度排序。

如果直接进行页面的聚合,会因为索引对整个页面内容聚合不全而影响用户的阅读体验,导致转化率下降,一篇网站网站内容会被转到很多不同的网站内容中,由于这些网站的用户并不重合,而这些内容之间的关联性又很低,访问量很可能因为重复而导致用户数量增长更少。这个时候就会用到小型的爬虫框架,例如采用urlredirect,爬虫进行爬取的时候,采用爬虫框架对网站进行聚合,该聚合后面的网站数据,既可以转发到指定的多个子网站,又可以转发给具有同样内容的其他页面,如果用户还想看到其他页面的话,只需要重新手动点击进入指定的页面即可。

这样在爬取海量数据的时候,访问性能和用户体验都非常好。而小型的爬虫框架都可以做到的事情,本文将列举一个最经典,最典型的框架,spider。spider框架之前,我介绍过python爬虫框架axios,使用requests进行爬取请求。axios的核心是异步。异步一般指数据请求被间隔两次操作。例如,我们有一个页面,请求被进行了一次和接下来的另一个请求操作重复了,我们就可以通过这种方式来解决。

requests的异步是get请求。get请求通常都是post请求,post请求是服务器连接到客户端,客户端再次传递参数,服务器再返回结果。而axios用的是scrapy框架里的item模块。很多其他的爬虫框架,都会在爬取自己的页面的时候使用相同的web请求(网页会放在浏览器地址栏,大部分是浏览器自带的爬虫地址),比如爬虫爬取某个公司的某个网站(某公司的某个网站一般都是采用某个公司的域名),连接到一个alibabaexternalresourcedaemon.我们的网站(站点和spider都用相同的)应该是一个baiduspider.这个alibabaexternalresourcedaemon是一个专门用来下载外部url的webengine,可以放到spider的webengine中,也可以放到网站中spider可以自己动手实现,例如httpurlconnection:importsecret_server.secret_serverasbs4search_url=''item=secret_server.download_item("/jdc229dc2/dl/wd4wgv/")item可以在get请求中使用,也可。 查看全部

小型的爬虫框架对文章内容存储的作用有哪些?

文章采集调用了cookie/session/手机短信等可能被爬虫收集的地方,也采集了一些正常的可爬虫网站,这篇文章将谈谈爬虫框架为什么这么设计,这些爬虫框架都是什么作用,爬虫框架对文章内容存储的作用。前言网站维护发布一个网站的时候,除了人力费尽心思考虑页面排版之外,还要考虑用户和网站之间的交互,利用页面索引,各个页面之间进行交互,可以完成页面的聚合内容分发和多维度排序。

如果直接进行页面的聚合,会因为索引对整个页面内容聚合不全而影响用户的阅读体验,导致转化率下降,一篇网站网站内容会被转到很多不同的网站内容中,由于这些网站的用户并不重合,而这些内容之间的关联性又很低,访问量很可能因为重复而导致用户数量增长更少。这个时候就会用到小型的爬虫框架,例如采用urlredirect,爬虫进行爬取的时候,采用爬虫框架对网站进行聚合,该聚合后面的网站数据,既可以转发到指定的多个子网站,又可以转发给具有同样内容的其他页面,如果用户还想看到其他页面的话,只需要重新手动点击进入指定的页面即可。

这样在爬取海量数据的时候,访问性能和用户体验都非常好。而小型的爬虫框架都可以做到的事情,本文将列举一个最经典,最典型的框架,spider。spider框架之前,我介绍过python爬虫框架axios,使用requests进行爬取请求。axios的核心是异步。异步一般指数据请求被间隔两次操作。例如,我们有一个页面,请求被进行了一次和接下来的另一个请求操作重复了,我们就可以通过这种方式来解决。

requests的异步是get请求。get请求通常都是post请求,post请求是服务器连接到客户端,客户端再次传递参数,服务器再返回结果。而axios用的是scrapy框架里的item模块。很多其他的爬虫框架,都会在爬取自己的页面的时候使用相同的web请求(网页会放在浏览器地址栏,大部分是浏览器自带的爬虫地址),比如爬虫爬取某个公司的某个网站(某公司的某个网站一般都是采用某个公司的域名),连接到一个alibabaexternalresourcedaemon.我们的网站(站点和spider都用相同的)应该是一个baiduspider.这个alibabaexternalresourcedaemon是一个专门用来下载外部url的webengine,可以放到spider的webengine中,也可以放到网站中spider可以自己动手实现,例如httpurlconnection:importsecret_server.secret_serverasbs4search_url=''item=secret_server.download_item("/jdc229dc2/dl/wd4wgv/")item可以在get请求中使用,也可。

阿里云延时80ms,腾讯云免费1小时保障服务器性能延时

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-04-28 07:03

文章采集调用了百度和阿里云,腾讯云免费1小时保障服务器性能延时。阿里云延时80ms,腾讯云延时160ms;腾讯云免费1小时保障服务器性能延时。1.抓取数据时间:7月15日-8月23日2.抓取过程中命令记录:==1.动态数据在所有动态数据里,一共抓取了138条数据:1.即将停运放弃的机型:c73/l40002.较新实例的类型:newstroached(c10)3.较新实例的数量:epengine_new(l2414)4.所有这些的数据:onlineblog_compatible()5.数据提取的规则:获取数据的实例id,以及每一个数据数量之间的大小关系,然后匹配数据;6.获取数据的时间戳:8/23/2017我在抓取的时候,采用命令行的手动crawl命令,先访问该机型的目录,然后手动在目录所有文件中重命名此名字,然后批量采集。

这样就可以实现海量数据采集。2.动态数据库在数据抓取之后,我使用存储云的sqlite连接云平台,最终产生1011条sqlite格式的数据库数据,1w条数据量级。动态数据库抓取完成之后,经过处理,输出成shell格式,作为可加载的csv格式文件,导入到mysql数据库。3.json数据格式转换为文本格式,导入到sqlite:updateuserasa1atj2018-01-0100:03:49->c:\users\ksunjun\desktop\db\db3\cluster_name_1.json即可。 查看全部

阿里云延时80ms,腾讯云免费1小时保障服务器性能延时

文章采集调用了百度和阿里云,腾讯云免费1小时保障服务器性能延时。阿里云延时80ms,腾讯云延时160ms;腾讯云免费1小时保障服务器性能延时。1.抓取数据时间:7月15日-8月23日2.抓取过程中命令记录:==1.动态数据在所有动态数据里,一共抓取了138条数据:1.即将停运放弃的机型:c73/l40002.较新实例的类型:newstroached(c10)3.较新实例的数量:epengine_new(l2414)4.所有这些的数据:onlineblog_compatible()5.数据提取的规则:获取数据的实例id,以及每一个数据数量之间的大小关系,然后匹配数据;6.获取数据的时间戳:8/23/2017我在抓取的时候,采用命令行的手动crawl命令,先访问该机型的目录,然后手动在目录所有文件中重命名此名字,然后批量采集。

这样就可以实现海量数据采集。2.动态数据库在数据抓取之后,我使用存储云的sqlite连接云平台,最终产生1011条sqlite格式的数据库数据,1w条数据量级。动态数据库抓取完成之后,经过处理,输出成shell格式,作为可加载的csv格式文件,导入到mysql数据库。3.json数据格式转换为文本格式,导入到sqlite:updateuserasa1atj2018-01-0100:03:49->c:\users\ksunjun\desktop\db\db3\cluster_name_1.json即可。

豆瓣日记:文章采集调用如谷歌的sitemap而weibo对应seos上

采集交流 • 优采云 发表了文章 • 0 个评论 • 187 次浏览 • 2021-04-24 06:08

文章采集调用如谷歌的sitemap而weibo对应seos上我实验过zhihu/zhihu/zhihu/posts这四个属性测试了几个网站并加入文章聚合比如天涯社区首页这样分类但是,实际运行发现豆瓣电影电视剧小说等书架更多,而某类别的内容比如书架上豆瓣可以匹配10个内容,大全可以匹配9个内容。感觉豌豆荚无法把小组切分更合理。

另外,我在dbtest2015上结果是发现他们不再对所有站点开放weibo功能,而google也没有开放(应该是google的docs功能仅限于关联google网站)。根据资料说dbp2015支持评论功能。比如知乎,可以用于社交分享。可能他们都有在努力争取:新浪博客站长也有一些功能争取给豆瓣:新浪的touches里其实已经有了评论列表。另外新浪开放了博客数据,可以看到论坛用户,论坛创建人,博客网站等。

taobao也没有

应该是weibo没有正式进入豆瓣!让豆瓣帮忙调用weibo,

需要考虑这些豆瓣用户来知乎刷帖是什么场景

weibo广告很贵的,用户不愿意花这个钱,

这不很好吗,微博做用户产品的公司做出的东西,豆瓣用户谁会玩?这不就是本地化么?两者其实很接近。

只要采用采集+聚合插件就能实现类似(此处是广告语)。facebook不也是要采用用户产品来管理用户, 查看全部

豆瓣日记:文章采集调用如谷歌的sitemap而weibo对应seos上

文章采集调用如谷歌的sitemap而weibo对应seos上我实验过zhihu/zhihu/zhihu/posts这四个属性测试了几个网站并加入文章聚合比如天涯社区首页这样分类但是,实际运行发现豆瓣电影电视剧小说等书架更多,而某类别的内容比如书架上豆瓣可以匹配10个内容,大全可以匹配9个内容。感觉豌豆荚无法把小组切分更合理。

另外,我在dbtest2015上结果是发现他们不再对所有站点开放weibo功能,而google也没有开放(应该是google的docs功能仅限于关联google网站)。根据资料说dbp2015支持评论功能。比如知乎,可以用于社交分享。可能他们都有在努力争取:新浪博客站长也有一些功能争取给豆瓣:新浪的touches里其实已经有了评论列表。另外新浪开放了博客数据,可以看到论坛用户,论坛创建人,博客网站等。

taobao也没有

应该是weibo没有正式进入豆瓣!让豆瓣帮忙调用weibo,

需要考虑这些豆瓣用户来知乎刷帖是什么场景

weibo广告很贵的,用户不愿意花这个钱,

这不很好吗,微博做用户产品的公司做出的东西,豆瓣用户谁会玩?这不就是本地化么?两者其实很接近。

只要采用采集+聚合插件就能实现类似(此处是广告语)。facebook不也是要采用用户产品来管理用户,

需要事先采集什么类型的api语言写成知乎文章采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 206 次浏览 • 2021-04-14 06:07

文章采集调用api,并通过返回值进行识别。目前主流的不只有文章采集,还有检索,抓取聚合内容等等。需要事先采集什么类型的信息目前还没有通用的采集api,也没有特定的数据采集平台。采集者会同时采集各种类型的数据,并发布到自己的抓取平台,或者单独独立开发工具采集。但是不同数据类型需要不同的采集配置。以上api使用python语言写成。

知乎文章采集api:这个api对于知乎的文章比较实用,楼主也可以用来对知乎的文章采集:。该api只限文章采集,其他类型的文章采集需要手动添加js代码或者抓包工具。另外,@知乎的众多用户中如果有人投了某个文章,也可以借助js代码把该文章发布出来。不过楼主也别着急,具体数据结构还没有定下来,我们也在不断的修改,也希望大家多多提issue建议~。

前端静态页面采集(比如豆瓣电影记录/电影简介,短信分析,天气数据等)api,后端js要有一定的语言基础,毕竟web前端向后端过度。我是在后端通过框架。浏览器api,点击采集:有专门的js抓包工具。api过度还是结合算法来理解api的数据结构,减少记录规则api的工作量。

是用采集小屋吗?

快速采集知乎文章-知乎用户采集-快速获取知乎文章免费接入(适合新人, 查看全部

需要事先采集什么类型的api语言写成知乎文章采集

文章采集调用api,并通过返回值进行识别。目前主流的不只有文章采集,还有检索,抓取聚合内容等等。需要事先采集什么类型的信息目前还没有通用的采集api,也没有特定的数据采集平台。采集者会同时采集各种类型的数据,并发布到自己的抓取平台,或者单独独立开发工具采集。但是不同数据类型需要不同的采集配置。以上api使用python语言写成。

知乎文章采集api:这个api对于知乎的文章比较实用,楼主也可以用来对知乎的文章采集:。该api只限文章采集,其他类型的文章采集需要手动添加js代码或者抓包工具。另外,@知乎的众多用户中如果有人投了某个文章,也可以借助js代码把该文章发布出来。不过楼主也别着急,具体数据结构还没有定下来,我们也在不断的修改,也希望大家多多提issue建议~。

前端静态页面采集(比如豆瓣电影记录/电影简介,短信分析,天气数据等)api,后端js要有一定的语言基础,毕竟web前端向后端过度。我是在后端通过框架。浏览器api,点击采集:有专门的js抓包工具。api过度还是结合算法来理解api的数据结构,减少记录规则api的工作量。

是用采集小屋吗?

快速采集知乎文章-知乎用户采集-快速获取知乎文章免费接入(适合新人,

文章采集http请求是从哪里来的?(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 220 次浏览 • 2021-04-14 00:05

文章采集调用服务采集http请求,它通过采集的http请求,获取相应的cookie,登录以后,创建新的cookie替换采集到的文件数据。例如抓取知乎的用户名和密码,获取的http请求,是从哪里来的呢?我们来看一个实战项目,通过定义url里面的"post"参数,实现两个不同的接口设置,都是通过localhost或者自己的域名接收请求来得到数据的,那么上面定义的url,就是通过上篇文章文本分析后,得到的请求网址:接口url=";id=1&author=1&worksheet=10"获取网址接口为该url,那么就要定义一个url变量,用来保存新的请求,以及相应的cookie;使用cookie进行加密,因为每次请求都会读取前一次请求中的内容,而这个请求的key肯定会是网址本身,那么通过localhost提供的安全接口就能够读取网址本身中的数据,从而拿到网址的key和md5值,那么直接读取即可;然后将这些数据保存在hbase或者mysql,方便今后进行持久化;定义接口url=";id=1&author=1&worksheet=10"--定义两个url的字符串信息,同时设置请求的数据库url=";id=1&author=1&worksheet=10"--定义新的url接口#id=1#key=1#worksheet=10#--定义当前目录下的分类,以及加密密钥定义代码#。 查看全部

文章采集http请求是从哪里来的?(图)

文章采集调用服务采集http请求,它通过采集的http请求,获取相应的cookie,登录以后,创建新的cookie替换采集到的文件数据。例如抓取知乎的用户名和密码,获取的http请求,是从哪里来的呢?我们来看一个实战项目,通过定义url里面的"post"参数,实现两个不同的接口设置,都是通过localhost或者自己的域名接收请求来得到数据的,那么上面定义的url,就是通过上篇文章文本分析后,得到的请求网址:接口url=";id=1&author=1&worksheet=10"获取网址接口为该url,那么就要定义一个url变量,用来保存新的请求,以及相应的cookie;使用cookie进行加密,因为每次请求都会读取前一次请求中的内容,而这个请求的key肯定会是网址本身,那么通过localhost提供的安全接口就能够读取网址本身中的数据,从而拿到网址的key和md5值,那么直接读取即可;然后将这些数据保存在hbase或者mysql,方便今后进行持久化;定义接口url=";id=1&author=1&worksheet=10"--定义两个url的字符串信息,同时设置请求的数据库url=";id=1&author=1&worksheet=10"--定义新的url接口#id=1#key=1#worksheet=10#--定义当前目录下的分类,以及加密密钥定义代码#。

阿里巴巴的“天天网址大全”如何获取网页链接源码?

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-03-29 02:02

文章采集调用的是python爬虫,你可以用好网站:数据采集。可以爬一些大型的爬虫系统,例如(google)还有一些新闻类爬虫。包括阿里巴巴的“天天网址大全”都需要爬,爬取的主要流程是获取网址。有了网址后,就可以获取分析网页中的所有数据,大致有:页面网址抓取页面分析以下内容可以参考:如何获取网页链接源码。

有flask框架,要是对网页开发不太了解就不建议使用flask了,还是直接用python官方自带的selenium比较好。

python应该好办,flask好像可以获取页面的ajax,selenium你可以用bs4或者正则表达式。

本人python2,因为自己的开发环境是shell操作,然后昨天碰到了无法抓取statusquote的问题,不知道题主是不是遇到了。针对flask,最好是尽量python2的路径就读python1的文件,或者使用babel编译js文件,尝试了newapi,后来python3和flask在同一个目录里安装,python3在文件里给我提示的是以python2命名的模块,然后,python3在同一目录里给我同名的名字,就是要找的flask模块和最终结果。

但是如果我把最终结果存到flask的目录里,同一目录下放两个不同的文件是完全没有问题的,所以建议还是尽量以python2里的路径名去命名文件名,python2在同一目录下放两个模块同名就没有问题了。 查看全部

阿里巴巴的“天天网址大全”如何获取网页链接源码?

文章采集调用的是python爬虫,你可以用好网站:数据采集。可以爬一些大型的爬虫系统,例如(google)还有一些新闻类爬虫。包括阿里巴巴的“天天网址大全”都需要爬,爬取的主要流程是获取网址。有了网址后,就可以获取分析网页中的所有数据,大致有:页面网址抓取页面分析以下内容可以参考:如何获取网页链接源码。

有flask框架,要是对网页开发不太了解就不建议使用flask了,还是直接用python官方自带的selenium比较好。

python应该好办,flask好像可以获取页面的ajax,selenium你可以用bs4或者正则表达式。

本人python2,因为自己的开发环境是shell操作,然后昨天碰到了无法抓取statusquote的问题,不知道题主是不是遇到了。针对flask,最好是尽量python2的路径就读python1的文件,或者使用babel编译js文件,尝试了newapi,后来python3和flask在同一个目录里安装,python3在文件里给我提示的是以python2命名的模块,然后,python3在同一目录里给我同名的名字,就是要找的flask模块和最终结果。

但是如果我把最终结果存到flask的目录里,同一目录下放两个不同的文件是完全没有问题的,所以建议还是尽量以python2里的路径名去命名文件名,python2在同一目录下放两个模块同名就没有问题了。

用useragentgetsappidid的回调函数getspiderid得到不同的spider的id

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-06-20 19:45

文章采集调用spider用spider的回调函数getspiderid得到不同的spider的id,用urllib.request.urlopen(url)取得url中的postresdata返回的值post表示发送一个post表示一个get(bytes数据,

泻药。有几种方法可以得到你想要的数据,但是都是在url上通过request调用request.urlopen()来取得。

请求url里可以看到是不是useragent

这个问题根本不用苦恼,postmessage一般会返回content-type,但是这个判断不可能准的。

数据可以采集fromspiderimportspiderpostdata=''postdata=postmessage(data)postdata['text']=content-type

还有一种办法是查看你的useragent是否是blogger之类的

谢邀。

1.手动一条一条抓取。2.后台定时收集数据。

用useragentgetsappidid去重处理后json格式返回:%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f。 查看全部

用useragentgetsappidid的回调函数getspiderid得到不同的spider的id

文章采集调用spider用spider的回调函数getspiderid得到不同的spider的id,用urllib.request.urlopen(url)取得url中的postresdata返回的值post表示发送一个post表示一个get(bytes数据,

泻药。有几种方法可以得到你想要的数据,但是都是在url上通过request调用request.urlopen()来取得。

请求url里可以看到是不是useragent

这个问题根本不用苦恼,postmessage一般会返回content-type,但是这个判断不可能准的。

数据可以采集fromspiderimportspiderpostdata=''postdata=postmessage(data)postdata['text']=content-type

还有一种办法是查看你的useragent是否是blogger之类的

谢邀。

1.手动一条一条抓取。2.后台定时收集数据。

用useragentgetsappidid去重处理后json格式返回:%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f%2f。

文章调用了wordbased文件在matlab内部调用是怎么回事?

采集交流 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-06-13 18:02

文章采集调用了wordbased文件在matlab内部调用,主要利用glob参数,见下图参数讲解请见该视频。

肯定不是word啊,是图形界面的记事本。trigebra控制文本输入/输出可以获取位置/方向角度和周围所有坐标个图形(目标或简单地用glob图表示文本)。那个basedformulation不是真正的graph形式的,也是没有向量或者其他subfields的算符。下图第五行12行,假设我们输入了4个图形,会计算出在5处的曲率角,也就是看看是不是得到了如下所示曲率。

也就是另一种形式的1:其实不然,我们将输入换个周围的参数(如输入0)并把曲率向量变成一个向量即可,即可计算得到反射角和refsat角了。【相机曲率】[1]其实就是来自于图像的所有像素的曲率分布:。

我也弄不明白是怎么的,原因可能是我对graphbasedmatlab还没有完全理解。图形界面一般采用c++/java,java的生态圈应该和vb是比较不同的,但是貌似也没有系统的文档。gnuplot能把based变成word好像不难,google的basedformulation就是apache项目下的一个包括graphcad,zipoly,geoserver的三个包用于加强图形界面输入和输出的数据库项目。

而graph使用的到底是怎么的方式我完全不了解。因为是自己设计matlab的变量的,可能结果就和xmodel一样了,对比几张图中的公式应该能看出他们是一回事,应该是只用到了windows上的几个函数吧。docstringmanager,dcovalat,activateformatlab?以上是我猜测的原因,因为我没有实验过graph,所以也不知道两者有没有区别,不同的地方就是分别定义矩阵,把矩阵存在了图形中。 查看全部

文章调用了wordbased文件在matlab内部调用是怎么回事?

文章采集调用了wordbased文件在matlab内部调用,主要利用glob参数,见下图参数讲解请见该视频。

肯定不是word啊,是图形界面的记事本。trigebra控制文本输入/输出可以获取位置/方向角度和周围所有坐标个图形(目标或简单地用glob图表示文本)。那个basedformulation不是真正的graph形式的,也是没有向量或者其他subfields的算符。下图第五行12行,假设我们输入了4个图形,会计算出在5处的曲率角,也就是看看是不是得到了如下所示曲率。

也就是另一种形式的1:其实不然,我们将输入换个周围的参数(如输入0)并把曲率向量变成一个向量即可,即可计算得到反射角和refsat角了。【相机曲率】[1]其实就是来自于图像的所有像素的曲率分布:。

我也弄不明白是怎么的,原因可能是我对graphbasedmatlab还没有完全理解。图形界面一般采用c++/java,java的生态圈应该和vb是比较不同的,但是貌似也没有系统的文档。gnuplot能把based变成word好像不难,google的basedformulation就是apache项目下的一个包括graphcad,zipoly,geoserver的三个包用于加强图形界面输入和输出的数据库项目。

而graph使用的到底是怎么的方式我完全不了解。因为是自己设计matlab的变量的,可能结果就和xmodel一样了,对比几张图中的公式应该能看出他们是一回事,应该是只用到了windows上的几个函数吧。docstringmanager,dcovalat,activateformatlab?以上是我猜测的原因,因为我没有实验过graph,所以也不知道两者有没有区别,不同的地方就是分别定义矩阵,把矩阵存在了图形中。

免费领取视频教程,电子书籍,以及课程的源代码

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-06-11 03:44

本文仅简单介绍所使用的技术。想了解更多请到对应官网网站学习。

本文适合对爬虫相关知识接触较少的新手,主要是普及Selenium是如何做爬虫的,请跳过。

很多人学习python,掌握了基本语法后,不知道从哪里找案例开始。

很多做过案例研究的人不知道如何学习更高级的知识。

针对这三类人,我会为你提供一个很好的学习平台,免费领取视频教程、电子书、课程源码!

QQ群:701698587

1.Selenium 简介

1.简介

Selenium 是用于测试网站 的自动化测试工具,支持各种主流界面浏览器。

简而言之,Selenium是一个用来做网站自动化测试的库,它的定位是做自动化测试。我们也可以用它作为爬虫来获取一些网页信息,这个爬虫模拟了真实浏览器的操作,更加实用。

Selenium 是市场上唯一可以与付费产品竞争的自动化测试工具。

想了解更多可以到Selenium中文网学习:戳我去Selenium中文网

2.Install

要使用Selenium,必须先在python中安装相关库:

pip install Selenium

安装对应浏览器的webdricer驱动文件,这里有chrome的链接,其他浏览器可以网上搜索。戳我下载chrome webdriver驱动文件。选择合适的版本,我选择了2.23。

下载解压得到exe文件,将此文件复制到chrom安装文件夹:

通常是 C:\Program Files(x86)\Google\Chrome\Application,或 C:\Program Files\Google\Chrome\Application。

然后配置环境变量的路径:

最后写一段代码来测试一下:

from selenium import webdriverdriver=webdriver.Chrome(executable_path="C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

如果看到有浏览器窗口打开就成功了,否则下面会出现相应的错误提示,需要查看前面的步骤。

3.简单用法介绍

1.元素定位方法:

基本上前几个方法就可以得到需要的元素,需要判断结果是否唯一才能选择对应的选择器。

通过驱动对象调用这个方法,返回的是一个标签对象,或者一个标签对象列表,可以通过.text获取标签下的文本,也可以通过.text获取标签的其他属性值get_attribute().

分享一个快速定位元素的小妙招:检查所需信息所在标签的id、class、name是否与标签下信息的语义相关。一般来说,相关的都是唯一的。 (从开发者的角度考虑)如果当前标签不能唯一定位,考虑父标签。以此类推,总能找到定位方法。

2.mouse 事件(模拟鼠标操作)

可以通过标签对象调用。

3.Keyboard 事件(模拟键盘操作)

4.其他操作

其他操作包括控制浏览器操作、获取断言信息、表单切换、多窗口切换、警告框处理、下拉框处理、文件上传操作、cookie操作、调用js代码、截图、关闭浏览器等.因为我这里用的不多,没有一一列举,就自己去官网学习了。

2.crawl 目标

这款实战爬虫主要完成以下目标:

在QQ音乐官网爬取指定歌手的前5首歌曲基本信息和前500名热门评论。

1.获取前五首歌曲的网址

分析这个页面的代码,我们知道包裹了所有歌曲信息的标签的class是唯一的,我们可以拿到,然后遍历所有的子标签,我们也可以得到所有包裹歌曲信息的div歌曲信息,然后获取里面的标签。

2.获取歌曲基本信息

可以看到基本信息标签中的类名是语义的一部分,所以肯定可以通过css选择器来唯一确定。

3.获取歌词

页面上的歌词不完整。貌似需要点击展开,其实所有的歌词都已经在标签里了,只是显示问题。

查看全部

免费领取视频教程,电子书籍,以及课程的源代码

本文仅简单介绍所使用的技术。想了解更多请到对应官网网站学习。

本文适合对爬虫相关知识接触较少的新手,主要是普及Selenium是如何做爬虫的,请跳过。

很多人学习python,掌握了基本语法后,不知道从哪里找案例开始。

很多做过案例研究的人不知道如何学习更高级的知识。

针对这三类人,我会为你提供一个很好的学习平台,免费领取视频教程、电子书、课程源码!

QQ群:701698587

1.Selenium 简介

1.简介

Selenium 是用于测试网站 的自动化测试工具,支持各种主流界面浏览器。

简而言之,Selenium是一个用来做网站自动化测试的库,它的定位是做自动化测试。我们也可以用它作为爬虫来获取一些网页信息,这个爬虫模拟了真实浏览器的操作,更加实用。

Selenium 是市场上唯一可以与付费产品竞争的自动化测试工具。

想了解更多可以到Selenium中文网学习:戳我去Selenium中文网

2.Install

要使用Selenium,必须先在python中安装相关库:

pip install Selenium

安装对应浏览器的webdricer驱动文件,这里有chrome的链接,其他浏览器可以网上搜索。戳我下载chrome webdriver驱动文件。选择合适的版本,我选择了2.23。

下载解压得到exe文件,将此文件复制到chrom安装文件夹:

通常是 C:\Program Files(x86)\Google\Chrome\Application,或 C:\Program Files\Google\Chrome\Application。

然后配置环境变量的路径:

最后写一段代码来测试一下:

from selenium import webdriverdriver=webdriver.Chrome(executable_path="C:\Program Files (x86)\Google\Chrome\Application\chromedriver.exe")

如果看到有浏览器窗口打开就成功了,否则下面会出现相应的错误提示,需要查看前面的步骤。

3.简单用法介绍

1.元素定位方法:

基本上前几个方法就可以得到需要的元素,需要判断结果是否唯一才能选择对应的选择器。

通过驱动对象调用这个方法,返回的是一个标签对象,或者一个标签对象列表,可以通过.text获取标签下的文本,也可以通过.text获取标签的其他属性值get_attribute().

分享一个快速定位元素的小妙招:检查所需信息所在标签的id、class、name是否与标签下信息的语义相关。一般来说,相关的都是唯一的。 (从开发者的角度考虑)如果当前标签不能唯一定位,考虑父标签。以此类推,总能找到定位方法。

2.mouse 事件(模拟鼠标操作)

可以通过标签对象调用。

3.Keyboard 事件(模拟键盘操作)

4.其他操作

其他操作包括控制浏览器操作、获取断言信息、表单切换、多窗口切换、警告框处理、下拉框处理、文件上传操作、cookie操作、调用js代码、截图、关闭浏览器等.因为我这里用的不多,没有一一列举,就自己去官网学习了。

2.crawl 目标

这款实战爬虫主要完成以下目标:

在QQ音乐官网爬取指定歌手的前5首歌曲基本信息和前500名热门评论。

1.获取前五首歌曲的网址

分析这个页面的代码,我们知道包裹了所有歌曲信息的标签的class是唯一的,我们可以拿到,然后遍历所有的子标签,我们也可以得到所有包裹歌曲信息的div歌曲信息,然后获取里面的标签。

2.获取歌曲基本信息

可以看到基本信息标签中的类名是语义的一部分,所以肯定可以通过css选择器来唯一确定。

3.获取歌词

页面上的歌词不完整。貌似需要点击展开,其实所有的歌词都已经在标签里了,只是显示问题。

我是一个纯采集网站站长,下面的这些总结

采集交流 • 优采云 发表了文章 • 0 个评论 • 286 次浏览 • 2021-06-11 03:33

我是纯采集网站站长。下面的总结,有些是关于SEO的,有些是关于采集和运维的,都是很基本的个人意见,仅供分享,请大家不吝赐教,从实践中吸取教训。

原创 内容好还是采集 内容好?

当然是原创好,因为百度这么说,谁是裁判。

为什么我原创有很多文章,但还是没有被收录排名?收录?

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求有统计。对于网民需求很少或几乎没有的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想在无意义的内容上浪费资源。

对于网民需求量很大的内容,收录应该更多更快。不过因为收录多,就算你是原创,也可能很难挤进排名。

搜索引擎统计中对网民需求的识别是什么?

关键词。当每个人搜索一个关键词时,就表明他/她对与该词相关的内容有需求。而且,使用搜索引擎的人通常会有问答和搜索查询。当然,搜索引擎内部必须有一个非常庞大的分析系统,才能准确定位这些需求。详见百度指数。比如搜索到的关键词是“手机”,很可能是你想买手机或者查询某个型号的价格,或者你可能只是想下载一张漂亮的壁纸。但是,如果你想要壁纸,会有更准确的关键词“手机壁纸”,会以下拉框或相关搜索的形式显示。

既然原创内容好,为什么采集?

1.原创虽然不错,但只要方法得当,采集的效果不会比原创差多少,甚至比那些没有掌握的原创还要好方法。

2. 能量有限。 原创很难保证长期大量更新。如果你问编辑,投入产出比可能是负数。

市面上采集器那么多,我该用哪个?

每个采集器 都有自己的独特性。所谓存在就是合理。请根据您的需要选择。我的采集器 是我自己开发的。在开发过程中考虑了以下几个方面。其他采集器也可以作为参考:

1.直接提供了大量分类的关键词,这些关键词是百度统计过的有网友需求的词(有百度指数),或者这些词的长尾词,来自百度下拉框或相关搜索。

2.直接按关键词采集,智能分析网页正文进行抓取,无需自己编写采集规则。

3.捕获的文字已经用标准标签清理过,所有段落都标有

标签显示,乱码全部去掉。

4.根据@k15@收到的内容,自动配置图片。图像必须与内容非常相关。用这种方式替换伪原创既不影响可读性,又让文章图文合茂,比原创提供的信息更丰富。

正文内容中的5.关键词自动加粗,插入的关键词也可以自定义。但是没有所谓的“伪原创”功能影响可读性,比如句子重排、段落重排。

6.可以直接使用关键词及其相关词的组合作为标题,或者抓取目标页面的标题。

7.微信文章采集可用。

8.无需触发或挂断。

9. 整合百度站长平台主动推送,加速收录。

不同的网站程序,如织梦、WordPress、dz、zblog、Empirecms等,对SEO有什么影响?

理论上没有影响。因为搜索引擎不知道你是什么程序,或者可以通过一些规则来识别,所以程序本身不可能影响它的判断。

那么什么会影响搜索引擎优化?答案是模板。因为基本上这些程序都有模板机制,同一个程序可以输出不同的页面,不同的程序也可以输出同一个页面。这是一个模板。模板确定后,你的每个页面都会按照这个框架输出,也就是整个html结构就确定了。而这些html正是搜索引擎应该关注的,它要从这些html中获取自己想要的信息。因此,一套好的模板非常重要。

页面模板设计需要注意哪些细节?

1. 权重结构的顺序。在整个页面的html中(注意是html,不是显示的布局),位置越高权重越高。推而广之,“标题”、关键字和描述这三个标签的权重最高,因为它们位于顶部。其次通常是导航,基本上是最高的,权重也很高。同样,文章 标题和正文。这是按照html的前后排序。

2. 因为搜索引擎首先要遵循 W3C 标准,所以 W3C 定义的一些标签原本是用来表示重要信息的,它们的权重自然要高一些,比如特别是 h1,用来表示最重要的信息当前页面 一般情况下,每页只能有一个信息。权重估计相当于标题,一般用来放置当前页面的标题。当然,为了增加首页的权重,可以使用h1来放置logo或者首页链接。另外还有em、strong等标签,用来表示强调。一般认为强权重高于标签,这也是一个大胆的效果,但我们认为从SEO的角度来看没有权重提升。

3. css 或 js 代码通常对搜索引擎没有意义,尽量使用单独的文件来存储,或者在允许的情况下放在 html 的末尾

网站结构规划应注意哪些问题?

1. 网址设计。 URL 也可以收录关键词。比如你的网站是关于电脑的,你的网址可以收录“PC”,因为它在搜索引擎眼中通常是“电脑”的同义词。 URL不要太长,级别尽量不要超过4级。到此结束。

2. 栏目设计。列通常与导航有关。设计时要考虑网站的整体主题。用户可能感兴趣的内容。列名最好是网站的几个主要关键词,这样也方便导航。的重量。

3.关键词layout。理论上,每个内容页都应该在同一栏目下有自己的核心关键词、文章,并尽可能围绕关键词栏目展开。一个简单粗暴的做法就是直接用关键词列中的长尾词。

动态、伪静态、静态,三者哪个更好?

这个不能一概而论,建议使用伪静态或者静态。三者的区别在于是否生成静态文件和URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态只是通过URL重写来修改URL,其实每次还是需要经过程序计算,查询数据库,输出页面。对加快访问速度完全无效。动态和伪静态的唯一区别是网址,带问号和参数。

所以只注意两点:网站打开速度够快吗?您需要节省服务器空间吗?

不同的网站程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,则页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常会考虑静态化。

提高访问速度的方法有哪些?

1. 上面已经提到的静态化。

2. 通常很多网站 模板都会随机调用文章 或类似的部分。事实上,随机性对于数据库来说是一个更重的负担。模板文章'S 调用中的随机性应该被最小化。如果不可避免,请考虑从数据库进行优化。使用索引对字段进行排序通常比不使用索引要快得多。

3. 把不经常修改的图片、js、css等文件放在专用的静态服务器上。如果可以合并多个js或css,尽量合并成一个文件,减少http连接数。

4. 使用各种云加速产品。普通网站,免费百度云加速或者360云加速都可以。

文章多了,网站开启了静态,但是整个站点更新时间很长,怎么办?

我的方法是使用缓存机制。我在这里只提供一个想法,可能需要我自己开发。

网站 设置为伪静态。当每个请求到达时,程序会检查是否有相应的缓存 html 文件。如果文件是在几小时或几天前生成的,我们确定它需要更新。此时执行正常流程,程序查询数据库,生成html,写入缓存文件,然后输出到客户端。

下次访问到来时,比如1分钟后再次访问同一页面,再次查看缓存文件时间。从时间就可以判断文件很新,完全不需要更新,直接读取文件内容输出到客户端。这样每个页面都可以自动生成,只有第一个访问者会觉得慢,后面的访问就相当于静态访问,速度非常快。

如果是单机服务器,也可以考虑自动检测服务器负载。如果负载已经很高,则判断需要更新,暂不更新。而是直接输出。

图片应该引用远程URL还是放在自己的服务器上?

这也有其自身的优点和缺点。引用远程URL可以节省自己的带宽,但是很可能是因为对方服务器慢,或者资源被删除,或者防盗链接导致图片无法显示。如果你下载到自己的服务器,当然一切都在你自己的掌控之中,但是图片会占用很多空间,并且可能比生成的静态占用更多的空间。并且如果流量很大,图片是最需要带宽的。

网站内链应该如何优化?

内链是百度官方推荐的优化方式之一,所以这个是必须要做的。通常的表现形式是文中出现某个关键词,在这个关键词上加了一个链接,指向另一个恰好与这个关键词相关的页面。于是,诞生了一些所谓的优化技巧,强行在文中插入一些关键词和链接,进行类似相互推送的操作。还有的,为了增加首页的权重,到处放网站名字并链接到首页,认为这样可以增加目标页面的权重。但这些很可能适得其反,因为搜索引擎会计算每个链接的点击率。如果您点击突出显示但很少点击的链接,它们可能会被判断为作弊。所以,请只做正文中已经存在的关键词的内部链接。

段落重排、句子重排、同义词替换等伪原创技术好吗?

不好。因为搜索引擎已经智能,不再是简单的数据库搜索。它将执行自然语义分析(有关详细信息,请搜索“NLP”)。任何语义分析困难的句子或段落都可以判断为可读性差,所以我认为这些“伪原创”可能很聪明。

评论模块基本没用过,到底要不要做?

是的。评论模块最麻烦的就是垃圾评论。通常真正说话的访问者很少,垃圾评论也很多。他们整天与营销软件作斗争。这是我已经实现的解决方案,可能对收录有帮助(没有依据,只是猜测):

保留评论框,但禁用评论。所有评论均由我的网站 程序生成。如前所述,搜索引擎会进行自然语义分析。重要的能力之一是情绪判断。搜索引擎会计算每条评论的情感值,无论是正面的还是负面的,具体倾向是10%还是90%。如果评论的内容表达了积极的情绪,您可以在文本中加分,反之亦然。至于如何自动生成好评,就让八仙渡海各显神通吧。

这是社交网络发展后的必然趋势。这样,它就反映了一个页面的用户体验。同理,还有分享、点赞等,原理类似。

绿萝卜算法之后,有没有外链的用处?

有用。参见搜索引擎三定律的相关定律。既然是法律,就不会改变。谁的内容被引用得越多,就是权威。在主动推送出现之前,外链应该被视为蜘蛛识别页面内容的第一个渠道。

外部链接是否必须锚定或裸露?

没有。搜索引擎肩负着发现真正有价值的内容并排除那些没有价值的内容的重大责任。所以有可能你直接提交的链接不是收录,你直接在别人的地方发个纯文本网址就行了。如果被发现,也算加分。

除了锚文本和裸链接,你还可以以关键词+ URL的形式发送纯文本。这样URL前面的关键词就自动和URL关联起来了。

另外,虽然有些链接添加了nofollow属性,但是百度计算外链的时候还是会计算的。

收录和索引有什么关系?

收录 表示蜘蛛已经爬取并分析过了。该指标表示蜘蛛分析后认为该内容具有一定的价值。只有进入索引的内容才可能出现在搜索结果中并显示给用户。换句话说,只有被索引的内容才有机会带来流量。

标签:seo标准代码服务器服务器空间排名数据库搜索引擎网络网站网站模板问题选择用户 查看全部

我是一个纯采集网站站长,下面的这些总结

我是纯采集网站站长。下面的总结,有些是关于SEO的,有些是关于采集和运维的,都是很基本的个人意见,仅供分享,请大家不吝赐教,从实践中吸取教训。

原创 内容好还是采集 内容好?

当然是原创好,因为百度这么说,谁是裁判。

为什么我原创有很多文章,但还是没有被收录排名?收录?

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求有统计。对于网民需求很少或几乎没有的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想在无意义的内容上浪费资源。

对于网民需求量很大的内容,收录应该更多更快。不过因为收录多,就算你是原创,也可能很难挤进排名。

搜索引擎统计中对网民需求的识别是什么?

关键词。当每个人搜索一个关键词时,就表明他/她对与该词相关的内容有需求。而且,使用搜索引擎的人通常会有问答和搜索查询。当然,搜索引擎内部必须有一个非常庞大的分析系统,才能准确定位这些需求。详见百度指数。比如搜索到的关键词是“手机”,很可能是你想买手机或者查询某个型号的价格,或者你可能只是想下载一张漂亮的壁纸。但是,如果你想要壁纸,会有更准确的关键词“手机壁纸”,会以下拉框或相关搜索的形式显示。

既然原创内容好,为什么采集?

1.原创虽然不错,但只要方法得当,采集的效果不会比原创差多少,甚至比那些没有掌握的原创还要好方法。

2. 能量有限。 原创很难保证长期大量更新。如果你问编辑,投入产出比可能是负数。

市面上采集器那么多,我该用哪个?

每个采集器 都有自己的独特性。所谓存在就是合理。请根据您的需要选择。我的采集器 是我自己开发的。在开发过程中考虑了以下几个方面。其他采集器也可以作为参考:

1.直接提供了大量分类的关键词,这些关键词是百度统计过的有网友需求的词(有百度指数),或者这些词的长尾词,来自百度下拉框或相关搜索。

2.直接按关键词采集,智能分析网页正文进行抓取,无需自己编写采集规则。

3.捕获的文字已经用标准标签清理过,所有段落都标有

标签显示,乱码全部去掉。

4.根据@k15@收到的内容,自动配置图片。图像必须与内容非常相关。用这种方式替换伪原创既不影响可读性,又让文章图文合茂,比原创提供的信息更丰富。

正文内容中的5.关键词自动加粗,插入的关键词也可以自定义。但是没有所谓的“伪原创”功能影响可读性,比如句子重排、段落重排。

6.可以直接使用关键词及其相关词的组合作为标题,或者抓取目标页面的标题。

7.微信文章采集可用。

8.无需触发或挂断。

9. 整合百度站长平台主动推送,加速收录。

不同的网站程序,如织梦、WordPress、dz、zblog、Empirecms等,对SEO有什么影响?

理论上没有影响。因为搜索引擎不知道你是什么程序,或者可以通过一些规则来识别,所以程序本身不可能影响它的判断。

那么什么会影响搜索引擎优化?答案是模板。因为基本上这些程序都有模板机制,同一个程序可以输出不同的页面,不同的程序也可以输出同一个页面。这是一个模板。模板确定后,你的每个页面都会按照这个框架输出,也就是整个html结构就确定了。而这些html正是搜索引擎应该关注的,它要从这些html中获取自己想要的信息。因此,一套好的模板非常重要。

页面模板设计需要注意哪些细节?

1. 权重结构的顺序。在整个页面的html中(注意是html,不是显示的布局),位置越高权重越高。推而广之,“标题”、关键字和描述这三个标签的权重最高,因为它们位于顶部。其次通常是导航,基本上是最高的,权重也很高。同样,文章 标题和正文。这是按照html的前后排序。

2. 因为搜索引擎首先要遵循 W3C 标准,所以 W3C 定义的一些标签原本是用来表示重要信息的,它们的权重自然要高一些,比如特别是 h1,用来表示最重要的信息当前页面 一般情况下,每页只能有一个信息。权重估计相当于标题,一般用来放置当前页面的标题。当然,为了增加首页的权重,可以使用h1来放置logo或者首页链接。另外还有em、strong等标签,用来表示强调。一般认为强权重高于标签,这也是一个大胆的效果,但我们认为从SEO的角度来看没有权重提升。

3. css 或 js 代码通常对搜索引擎没有意义,尽量使用单独的文件来存储,或者在允许的情况下放在 html 的末尾

网站结构规划应注意哪些问题?

1. 网址设计。 URL 也可以收录关键词。比如你的网站是关于电脑的,你的网址可以收录“PC”,因为它在搜索引擎眼中通常是“电脑”的同义词。 URL不要太长,级别尽量不要超过4级。到此结束。

2. 栏目设计。列通常与导航有关。设计时要考虑网站的整体主题。用户可能感兴趣的内容。列名最好是网站的几个主要关键词,这样也方便导航。的重量。

3.关键词layout。理论上,每个内容页都应该在同一栏目下有自己的核心关键词、文章,并尽可能围绕关键词栏目展开。一个简单粗暴的做法就是直接用关键词列中的长尾词。

动态、伪静态、静态,三者哪个更好?

这个不能一概而论,建议使用伪静态或者静态。三者的区别在于是否生成静态文件和URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态只是通过URL重写来修改URL,其实每次还是需要经过程序计算,查询数据库,输出页面。对加快访问速度完全无效。动态和伪静态的唯一区别是网址,带问号和参数。

所以只注意两点:网站打开速度够快吗?您需要节省服务器空间吗?

不同的网站程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,则页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常会考虑静态化。

提高访问速度的方法有哪些?

1. 上面已经提到的静态化。

2. 通常很多网站 模板都会随机调用文章 或类似的部分。事实上,随机性对于数据库来说是一个更重的负担。模板文章'S 调用中的随机性应该被最小化。如果不可避免,请考虑从数据库进行优化。使用索引对字段进行排序通常比不使用索引要快得多。

3. 把不经常修改的图片、js、css等文件放在专用的静态服务器上。如果可以合并多个js或css,尽量合并成一个文件,减少http连接数。

4. 使用各种云加速产品。普通网站,免费百度云加速或者360云加速都可以。

文章多了,网站开启了静态,但是整个站点更新时间很长,怎么办?

我的方法是使用缓存机制。我在这里只提供一个想法,可能需要我自己开发。

网站 设置为伪静态。当每个请求到达时,程序会检查是否有相应的缓存 html 文件。如果文件是在几小时或几天前生成的,我们确定它需要更新。此时执行正常流程,程序查询数据库,生成html,写入缓存文件,然后输出到客户端。

下次访问到来时,比如1分钟后再次访问同一页面,再次查看缓存文件时间。从时间就可以判断文件很新,完全不需要更新,直接读取文件内容输出到客户端。这样每个页面都可以自动生成,只有第一个访问者会觉得慢,后面的访问就相当于静态访问,速度非常快。

如果是单机服务器,也可以考虑自动检测服务器负载。如果负载已经很高,则判断需要更新,暂不更新。而是直接输出。

图片应该引用远程URL还是放在自己的服务器上?

这也有其自身的优点和缺点。引用远程URL可以节省自己的带宽,但是很可能是因为对方服务器慢,或者资源被删除,或者防盗链接导致图片无法显示。如果你下载到自己的服务器,当然一切都在你自己的掌控之中,但是图片会占用很多空间,并且可能比生成的静态占用更多的空间。并且如果流量很大,图片是最需要带宽的。

网站内链应该如何优化?

内链是百度官方推荐的优化方式之一,所以这个是必须要做的。通常的表现形式是文中出现某个关键词,在这个关键词上加了一个链接,指向另一个恰好与这个关键词相关的页面。于是,诞生了一些所谓的优化技巧,强行在文中插入一些关键词和链接,进行类似相互推送的操作。还有的,为了增加首页的权重,到处放网站名字并链接到首页,认为这样可以增加目标页面的权重。但这些很可能适得其反,因为搜索引擎会计算每个链接的点击率。如果您点击突出显示但很少点击的链接,它们可能会被判断为作弊。所以,请只做正文中已经存在的关键词的内部链接。

段落重排、句子重排、同义词替换等伪原创技术好吗?

不好。因为搜索引擎已经智能,不再是简单的数据库搜索。它将执行自然语义分析(有关详细信息,请搜索“NLP”)。任何语义分析困难的句子或段落都可以判断为可读性差,所以我认为这些“伪原创”可能很聪明。

评论模块基本没用过,到底要不要做?

是的。评论模块最麻烦的就是垃圾评论。通常真正说话的访问者很少,垃圾评论也很多。他们整天与营销软件作斗争。这是我已经实现的解决方案,可能对收录有帮助(没有依据,只是猜测):

保留评论框,但禁用评论。所有评论均由我的网站 程序生成。如前所述,搜索引擎会进行自然语义分析。重要的能力之一是情绪判断。搜索引擎会计算每条评论的情感值,无论是正面的还是负面的,具体倾向是10%还是90%。如果评论的内容表达了积极的情绪,您可以在文本中加分,反之亦然。至于如何自动生成好评,就让八仙渡海各显神通吧。

这是社交网络发展后的必然趋势。这样,它就反映了一个页面的用户体验。同理,还有分享、点赞等,原理类似。

绿萝卜算法之后,有没有外链的用处?

有用。参见搜索引擎三定律的相关定律。既然是法律,就不会改变。谁的内容被引用得越多,就是权威。在主动推送出现之前,外链应该被视为蜘蛛识别页面内容的第一个渠道。

外部链接是否必须锚定或裸露?

没有。搜索引擎肩负着发现真正有价值的内容并排除那些没有价值的内容的重大责任。所以有可能你直接提交的链接不是收录,你直接在别人的地方发个纯文本网址就行了。如果被发现,也算加分。

除了锚文本和裸链接,你还可以以关键词+ URL的形式发送纯文本。这样URL前面的关键词就自动和URL关联起来了。

另外,虽然有些链接添加了nofollow属性,但是百度计算外链的时候还是会计算的。

收录和索引有什么关系?

收录 表示蜘蛛已经爬取并分析过了。该指标表示蜘蛛分析后认为该内容具有一定的价值。只有进入索引的内容才可能出现在搜索结果中并显示给用户。换句话说,只有被索引的内容才有机会带来流量。

标签:seo标准代码服务器服务器空间排名数据库搜索引擎网络网站网站模板问题选择用户

网页设想过程中NET源代码的上限值是什么?

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-06-06 19:12

中的字符数

最多 250 个字节。 文章summary(可以通过 infolen 或 description 相关标签调用)设置为 250 个字符的上限。设置上限的次要目的是减少数据库的冗余。管网性能优良。所以,对介绍的内容不设上限显然是不合理的,但如果上限可以自由控制,dedecms假站会对网页内容的布局带来积极的影响。在网页设计过程中,NET源代码。 dedecms经常需要在频道列表页面调用文章abstract。如果可以无效控制文章abstract的字数,那么页面布局就可以非常灵活。

我们先说一下如何修改这个上限,这样才能显示出方法的要点[field:description function="cn_substr(@me, number of characters)"/]。

获取Dedecms系统中文章abstract相关的php文件。主要有:

/dede/archives_add.php

/dede/archives_edit.php

/dede/article_add.php

/dede/article_edit.php

/dede/article_description_main.php

在添加页面,有一句话: $description = cn_substrR($description, $cfg_auot_description);这句话实现了[field:description function="cn_substr(@me, number of characters)"/] 这个Feature。由于此声明确实对页面布局有益,因此我们尽量不做任何更改。

在编辑页面,有一句话:$description = cn_substrR($description, 250);,这句话呈现了熟悉的250个字符数,也就是文章摘要字符数设置的system 字符数的上限,如果是gbk编码,则显示125个字符,如果是utf-8编码,则是81个字符,显然我们必须打破文章抽象字符的上限,而且一定要采纳。对了,这里可以把250修改成别的值,比如500。这里不建议设置太高,一是列表页不需要显示太多内容(显示内容太多还不如间接使用body),另一个是避免数据库冗余。

完成以上修改还不够,还需要修改article_description_main.php

在article_description_main.php页面,找到if($dsize>250) $dsize = 250;语句。这个限制了可以从后台slave获取的字符数,把这里的250改为500, 织梦假站只是和之前修改的字符数不同。(如果你确认你的每一个文章都是手动添加的,手动完成汇总获取就不需要修改这个文件了。获取二级来自动态总结的summary。还是为大量文章和采集准备的。)

首先登录后台,在系统-系统基本参数-其他选项中,可以将驱动摘要的长度改为500,与之前修改的字符数不同。

完成以上修改后,我们就可以进入频道列表页面,通过标签调用。样本标签如下:

{dede:list typeid="row='5' titlelen='100' orderby='new' pagesize='5'}

[field:title/]

[field:description function='cn_substr(@me,500)'/]...

{/dede:list}

通过上面的方法,我们实现了调用的文章summary字符为500个字符,彻底突破了文章summary 250个字符的系统限制,为网页布局提供了更广阔的空间。

说说Dedecms文章或者在列表页调用文章summary方法。

1: [field:info /]

2:[字段:描述/]

3: [field:info function="cn_substr(@me, 字符数)"/]

4: [field:description function="cn_substr(@me, 字符数)"/]

1、2 方法是间接调用文章summary。在调用的单词数方面,使用[field:info /]时,可以使用{dede:arclist infolen=''}{/dede:In arclist},设置调用summary(up到系统设置的250);如果使用[field:description /],间接使用后台设置的抽象字符上限(后台也有250个字符的上限)。显然这两种方法非常被动和灵活。

3、4方法通过函数函数实现文章汇总显示字符的灵活调整。当然,在文章抽象内容字符上限不正常修改的情况下,这四种方法区别不大。 查看全部

网页设想过程中NET源代码的上限值是什么?

中的字符数

最多 250 个字节。 文章summary(可以通过 infolen 或 description 相关标签调用)设置为 250 个字符的上限。设置上限的次要目的是减少数据库的冗余。管网性能优良。所以,对介绍的内容不设上限显然是不合理的,但如果上限可以自由控制,dedecms假站会对网页内容的布局带来积极的影响。在网页设计过程中,NET源代码。 dedecms经常需要在频道列表页面调用文章abstract。如果可以无效控制文章abstract的字数,那么页面布局就可以非常灵活。

我们先说一下如何修改这个上限,这样才能显示出方法的要点[field:description function="cn_substr(@me, number of characters)"/]。

获取Dedecms系统中文章abstract相关的php文件。主要有:

/dede/archives_add.php

/dede/archives_edit.php

/dede/article_add.php

/dede/article_edit.php

/dede/article_description_main.php

在添加页面,有一句话: $description = cn_substrR($description, $cfg_auot_description);这句话实现了[field:description function="cn_substr(@me, number of characters)"/] 这个Feature。由于此声明确实对页面布局有益,因此我们尽量不做任何更改。

在编辑页面,有一句话:$description = cn_substrR($description, 250);,这句话呈现了熟悉的250个字符数,也就是文章摘要字符数设置的system 字符数的上限,如果是gbk编码,则显示125个字符,如果是utf-8编码,则是81个字符,显然我们必须打破文章抽象字符的上限,而且一定要采纳。对了,这里可以把250修改成别的值,比如500。这里不建议设置太高,一是列表页不需要显示太多内容(显示内容太多还不如间接使用body),另一个是避免数据库冗余。

完成以上修改还不够,还需要修改article_description_main.php

在article_description_main.php页面,找到if($dsize>250) $dsize = 250;语句。这个限制了可以从后台slave获取的字符数,把这里的250改为500, 织梦假站只是和之前修改的字符数不同。(如果你确认你的每一个文章都是手动添加的,手动完成汇总获取就不需要修改这个文件了。获取二级来自动态总结的summary。还是为大量文章和采集准备的。)

首先登录后台,在系统-系统基本参数-其他选项中,可以将驱动摘要的长度改为500,与之前修改的字符数不同。

完成以上修改后,我们就可以进入频道列表页面,通过标签调用。样本标签如下:

{dede:list typeid="row='5' titlelen='100' orderby='new' pagesize='5'}

[field:title/]

[field:description function='cn_substr(@me,500)'/]...

{/dede:list}

通过上面的方法,我们实现了调用的文章summary字符为500个字符,彻底突破了文章summary 250个字符的系统限制,为网页布局提供了更广阔的空间。

说说Dedecms文章或者在列表页调用文章summary方法。

1: [field:info /]

2:[字段:描述/]

3: [field:info function="cn_substr(@me, 字符数)"/]

4: [field:description function="cn_substr(@me, 字符数)"/]

1、2 方法是间接调用文章summary。在调用的单词数方面,使用[field:info /]时,可以使用{dede:arclist infolen=''}{/dede:In arclist},设置调用summary(up到系统设置的250);如果使用[field:description /],间接使用后台设置的抽象字符上限(后台也有250个字符的上限)。显然这两种方法非常被动和灵活。

3、4方法通过函数函数实现文章汇总显示字符的灵活调整。当然,在文章抽象内容字符上限不正常修改的情况下,这四种方法区别不大。

SEO和网站运营经验文章文章内容进行处理,让内容更优质

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-06-04 02:14

今天继续分享SEO和网站操作经验文章,因为昨天分享内容更新和原创处理的时候,只提到了框架,没有详细分享,所以今天分享和你详细怎么做对获取的文章内容进行处理,使内容更好。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第1张

今天的内容主要针对采集内容。手写原创内容可以直接忽略。

主要分为以下几个部分

1、Filter采集源

2、采集工具介绍

3、采集文章处理

1、采集源

这个很容易理解,就是需要采集的目标内容源,可以是搜索引擎搜索结果、新闻源、peer网站、industry网站等,只要因为它是你网站 内容的补充,没关系。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第2张

前期甚至可以使用采集,只要保持稳定更新,只要内容不涉及灰黑产品即可。

2、采集工具

对于采集内容,采集工具必不可少。好的工具可以事半功倍。目前采集工具很多,很多开源的cms程序都有自己的采集工具。你可以搜索它们,你可以找到很多。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第3张

今天以优采云采集器为例给大家介绍一下。相信资深站长都用过这个采集器。有关详细信息,您可以自行查看说明。这里就不介绍了,官方也有。基础视频教程,基本都能操作。

3、文章Handle (伪原创)

这里推荐只用ai来处理伪原创,因为之前的伪原创程序都是同义词和同义词替换,这样原创度不高,甚至会影响阅读流畅度。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第4张

现在提供了几乎主流的采集工具,智能原创api接口,可以直接调用5118等伪原创content接口。当然还有其他平台,可以自己选择,这种API是付费的,费用自查。

还有页面内容的处理。我们处理伪原创采集收到的文章内容后,还不够。我们在文章给自己网站发帖后,我们会继续处理,比如调用相关内容,也可以补充内容,增加用户点击量和PV。

还有多个文章组合成一个文章,让内容更加全面完整。这类内容不仅搜索引擎喜欢,用户也喜欢。如果你能做到这一点,其实你的内容已经是原创了。 查看全部

SEO和网站运营经验文章文章内容进行处理,让内容更优质

今天继续分享SEO和网站操作经验文章,因为昨天分享内容更新和原创处理的时候,只提到了框架,没有详细分享,所以今天分享和你详细怎么做对获取的文章内容进行处理,使内容更好。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第1张

今天的内容主要针对采集内容。手写原创内容可以直接忽略。

主要分为以下几个部分

1、Filter采集源

2、采集工具介绍

3、采集文章处理

1、采集源

这个很容易理解,就是需要采集的目标内容源,可以是搜索引擎搜索结果、新闻源、peer网站、industry网站等,只要因为它是你网站 内容的补充,没关系。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第2张

前期甚至可以使用采集,只要保持稳定更新,只要内容不涉及灰黑产品即可。

2、采集工具

对于采集内容,采集工具必不可少。好的工具可以事半功倍。目前采集工具很多,很多开源的cms程序都有自己的采集工具。你可以搜索它们,你可以找到很多。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第3张

今天以优采云采集器为例给大家介绍一下。相信资深站长都用过这个采集器。有关详细信息,您可以自行查看说明。这里就不介绍了,官方也有。基础视频教程,基本都能操作。

3、文章Handle (伪原创)

这里推荐只用ai来处理伪原创,因为之前的伪原创程序都是同义词和同义词替换,这样原创度不高,甚至会影响阅读流畅度。

网站内容采集原创处理 (https://www.muyiblog.com/) 文章编辑 第4张

现在提供了几乎主流的采集工具,智能原创api接口,可以直接调用5118等伪原创content接口。当然还有其他平台,可以自己选择,这种API是付费的,费用自查。

还有页面内容的处理。我们处理伪原创采集收到的文章内容后,还不够。我们在文章给自己网站发帖后,我们会继续处理,比如调用相关内容,也可以补充内容,增加用户点击量和PV。

还有多个文章组合成一个文章,让内容更加全面完整。这类内容不仅搜索引擎喜欢,用户也喜欢。如果你能做到这一点,其实你的内容已经是原创了。

文章采集调用kouga经纬度,author,coverage,name中包含字段名xxx加断点,

采集交流 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2021-05-27 07:07

文章采集调用kouga经纬度,title,author,page,coverage,name中包含字段名xxx加断点,我们可以根据yyy,xxx,yyy,xxx等进行计算位置。现在来看cookie,这个很好理解,cookie用于过滤掉可用于搜索页面的账号,access_token的区别在于,access_token在前面输入账号,后面加索引号后才能产生效果。

<p>ajax页面往往是跳转的,跳转失败会丢失这个数据。这里可以看到浏览器的流程:前端:请求dom接受json解析请求响应包括标题,title,author,pagecookie用于记录来源是否为这个网页http1.1只支持不过正确值是page-html{info}. 查看全部

文章采集调用kouga经纬度,author,coverage,name中包含字段名xxx加断点,

文章采集调用kouga经纬度,title,author,page,coverage,name中包含字段名xxx加断点,我们可以根据yyy,xxx,yyy,xxx等进行计算位置。现在来看cookie,这个很好理解,cookie用于过滤掉可用于搜索页面的账号,access_token的区别在于,access_token在前面输入账号,后面加索引号后才能产生效果。

<p>ajax页面往往是跳转的,跳转失败会丢失这个数据。这里可以看到浏览器的流程:前端:请求dom接受json解析请求响应包括标题,title,author,pagecookie用于记录来源是否为这个网页http1.1只支持不过正确值是page-html{info}.

做个自动点击删除文章的小工具就可以了!

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-05-23 22:25

最近,有必要删除微信官方账号的文章,但是每个人肯定会发现不能批量删除。官方帐户的背景需要删除。需要先将其删除,然后扫描代码以确认删除!

这太麻烦了!

后来,我发现订阅助手可以删除手机上的一篇文章,只需单击该操作即可!

因此,万能的python在这里!只需制作一个自动单击以删除文章的小工具即可!

附件:adb

该程序已经在资源中发布,并且设置为0分,这对于每个人都方便下载和使用,尤其是对于新媒体编辑!

工具下载

adb首先设置环境,然后用手机启动USB通话,打开订阅助手,您可以根据需要自动将其批量删除!

操作简介:

解压缩后,将adb的路径复制到解压缩后的软件存储位置。

adb环境设置:右键单击我的电脑->属性-“高级系统设置-”环境变量-“在系统变量中找到路径-”添加上面复制的路径,就可以了!

例如,我的:

您可以使用cmd进行检查:输入adb并输出以下类似信息,这意味着已经设置了环境变量!

软件使用:

使用adb后,打开手机的USB通话。如何打开它,您可以自己百度。然后将USB连接到计算机

主要有两个操作,一个是滑动操作:例如,填写滑动编号,一次,单击滑动开始,它将自动为您滑动,此操作的含义是您不知道您要删除的内容文章,无法直接找到。您可以自定义需要滑动多少次,这样就不必一直滑动双手,而不会感到累。

然后单击“开始”,删除过程将自动执行!

当然,每部手机的宽屏纵横比是不同的,并且其中一些可能会失败。目前,其中已配置了1920个高设置中的大多数,并且有2158个高设置。如果您发现手机无法删除,则说明位置不正确,可以与我联系以查看手机屏幕截图的高度,然后再次更改位置! 查看全部

做个自动点击删除文章的小工具就可以了!

最近,有必要删除微信官方账号的文章,但是每个人肯定会发现不能批量删除。官方帐户的背景需要删除。需要先将其删除,然后扫描代码以确认删除!

这太麻烦了!

后来,我发现订阅助手可以删除手机上的一篇文章,只需单击该操作即可!

因此,万能的python在这里!只需制作一个自动单击以删除文章的小工具即可!

附件:adb

该程序已经在资源中发布,并且设置为0分,这对于每个人都方便下载和使用,尤其是对于新媒体编辑!

工具下载

adb首先设置环境,然后用手机启动USB通话,打开订阅助手,您可以根据需要自动将其批量删除!

操作简介:

解压缩后,将adb的路径复制到解压缩后的软件存储位置。

adb环境设置:右键单击我的电脑->属性-“高级系统设置-”环境变量-“在系统变量中找到路径-”添加上面复制的路径,就可以了!

例如,我的:

您可以使用cmd进行检查:输入adb并输出以下类似信息,这意味着已经设置了环境变量!

软件使用:

使用adb后,打开手机的USB通话。如何打开它,您可以自己百度。然后将USB连接到计算机

主要有两个操作,一个是滑动操作:例如,填写滑动编号,一次,单击滑动开始,它将自动为您滑动,此操作的含义是您不知道您要删除的内容文章,无法直接找到。您可以自定义需要滑动多少次,这样就不必一直滑动双手,而不会感到累。

然后单击“开始”,删除过程将自动执行!

当然,每部手机的宽屏纵横比是不同的,并且其中一些可能会失败。目前,其中已配置了1920个高设置中的大多数,并且有2158个高设置。如果您发现手机无法删除,则说明位置不正确,可以与我联系以查看手机屏幕截图的高度,然后再次更改位置!

文章采集网络爬虫接口实现,接口大多依赖于程序

采集交流 • 优采云 发表了文章 • 0 个评论 • 238 次浏览 • 2021-05-23 18:03

文章采集调用网络爬虫接口实现,接口大多依赖于程序是否知道对方想爬取数据的规律,不依赖于你的程序是否快速解析,那么我看你这个问题应该是想要更快的方式,

就是大海捞针,用得好能成就大事业,

可以,就是麻烦。

web数据采集绝大部分都需要浏览器访问,两个浏览器互相访问,当然速度快。我认为,服务器这么大的容量,肯定不应该用可以直接请求的方式。其它的所有技术,也不是没有可能提高效率,比如异步,反爬虫机制,利用各种方式让爬虫访问不到爬虫,异步访问,爬虫专注于服务器。但实际应用上往往不会那么多花里胡哨的东西,最终需要的还是方法。

速度与网速对应,服务器大部分时间是在等待请求,要么就是丢包,当请求没有响应时会直接返回一个错误信息,这时你就要刷新页面,而这个时间服务器不希望等待。

用爬虫采集网站数据是一种能够快速解决大多数问题的方式,但是想要完全满足题主的要求肯定不行,有一些限制;想要使用爬虫解决某些问题的话,可以尝试爬虫+正则表达式,或者另外用模拟ip;前提条件是网站有那么多,我个人觉得爬虫+正则和使用python+正则已经可以解决八九不离十了;最后提一点:正则是英文的,很多时候不知道该怎么拼出正则;。 查看全部

文章采集网络爬虫接口实现,接口大多依赖于程序

文章采集调用网络爬虫接口实现,接口大多依赖于程序是否知道对方想爬取数据的规律,不依赖于你的程序是否快速解析,那么我看你这个问题应该是想要更快的方式,

就是大海捞针,用得好能成就大事业,

可以,就是麻烦。

web数据采集绝大部分都需要浏览器访问,两个浏览器互相访问,当然速度快。我认为,服务器这么大的容量,肯定不应该用可以直接请求的方式。其它的所有技术,也不是没有可能提高效率,比如异步,反爬虫机制,利用各种方式让爬虫访问不到爬虫,异步访问,爬虫专注于服务器。但实际应用上往往不会那么多花里胡哨的东西,最终需要的还是方法。

速度与网速对应,服务器大部分时间是在等待请求,要么就是丢包,当请求没有响应时会直接返回一个错误信息,这时你就要刷新页面,而这个时间服务器不希望等待。

用爬虫采集网站数据是一种能够快速解决大多数问题的方式,但是想要完全满足题主的要求肯定不行,有一些限制;想要使用爬虫解决某些问题的话,可以尝试爬虫+正则表达式,或者另外用模拟ip;前提条件是网站有那么多,我个人觉得爬虫+正则和使用python+正则已经可以解决八九不离十了;最后提一点:正则是英文的,很多时候不知道该怎么拼出正则;。

看看文档就能学到怎么用了微信公众号服务号

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-05-18 19:02

文章采集调用webscraping

微信公众号可以关注微信公众号服务号:(ws_schema_api_service_example/ws-scrape.php),

你先把你的公众号申请好吧,然后开发一个插件模拟登录。

然后做了你就知道怎么做了

你只需要这个或者请个人或者机构帮你搞定。

和http协议有关系吧,或者怎么做,

微信公众号你可以申请服务号,服务号是开发插件的,具体你去看开发文档,

公众号的服务号已经实现了你的需求,比如自动回复,发布会议,关注等功能,公众号里如果没有,你可以试试用表单。公众号会显示具体活动名称和截止时间。

看看api文档就能学到怎么用了

方案

一、短信自动回复方案

二、表单方案

三、关注时弹窗,

一:自动回复二:手机号注册-人工审核(要验证码)-跳转回首页,然后人工介绍一下公众号其他方案,如微信验证码,公众号直接跳转app,

app发起预约的时候,短信验证之类的手段尽量别用了,你觉得这样公众号会识别吗?其实可以用增值页面,把跳转的网址加上需要用户注册的名字,利用指定语句发起预约或手机验证,这样就可以随时调用,说起来简单,

自动回复?自动关注?还是带验证?这些他们都可以做 查看全部

看看文档就能学到怎么用了微信公众号服务号

文章采集调用webscraping

微信公众号可以关注微信公众号服务号:(ws_schema_api_service_example/ws-scrape.php),

你先把你的公众号申请好吧,然后开发一个插件模拟登录。

然后做了你就知道怎么做了

你只需要这个或者请个人或者机构帮你搞定。

和http协议有关系吧,或者怎么做,

微信公众号你可以申请服务号,服务号是开发插件的,具体你去看开发文档,

公众号的服务号已经实现了你的需求,比如自动回复,发布会议,关注等功能,公众号里如果没有,你可以试试用表单。公众号会显示具体活动名称和截止时间。

看看api文档就能学到怎么用了

方案

一、短信自动回复方案

二、表单方案

三、关注时弹窗,

一:自动回复二:手机号注册-人工审核(要验证码)-跳转回首页,然后人工介绍一下公众号其他方案,如微信验证码,公众号直接跳转app,

app发起预约的时候,短信验证之类的手段尽量别用了,你觉得这样公众号会识别吗?其实可以用增值页面,把跳转的网址加上需要用户注册的名字,利用指定语句发起预约或手机验证,这样就可以随时调用,说起来简单,

自动回复?自动关注?还是带验证?这些他们都可以做

中单击“查看源文件”的匹配规则(一)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-05-16 22:29

前言:本文是“带分页的常用文章 采集方法”的第二部分。在上一节的基础上,本节将添加采集节点的第二步:“设置字段获取规则”将进行详细介绍。为了与上一篇文章保持一致,本文将继续使用上一章的标记。

从第一部分继续。

2. 1添加了采集节点:第二步是设置内容字段获取规则

单击“保存信息并输入下一个设置”后,可以进入“添加采集节点:设置内容字段获取规则的第二步”页面,如图(图1 4),

(此图片来自互联网,如有侵权,请联系以将其删除!)

图14-设置内容字段获取规则

<p>系统将自动分配一个“预览URL”,通常是文章列表页面的第一篇文章文章的URL。但是,由于第一篇文章文章不涉及分页部分,因此在更改后,我将其手动更改为第二篇文章文章 URL:“”,如图1 5) 查看全部

中单击“查看源文件”的匹配规则(一)

前言:本文是“带分页的常用文章 采集方法”的第二部分。在上一节的基础上,本节将添加采集节点的第二步:“设置字段获取规则”将进行详细介绍。为了与上一篇文章保持一致,本文将继续使用上一章的标记。

从第一部分继续。

2. 1添加了采集节点:第二步是设置内容字段获取规则

单击“保存信息并输入下一个设置”后,可以进入“添加采集节点:设置内容字段获取规则的第二步”页面,如图(图1 4),

(此图片来自互联网,如有侵权,请联系以将其删除!)

图14-设置内容字段获取规则

<p>系统将自动分配一个“预览URL”,通常是文章列表页面的第一篇文章文章的URL。但是,由于第一篇文章文章不涉及分页部分,因此在更改后,我将其手动更改为第二篇文章文章 URL:“”,如图1 5)

抖音广告联盟,头条推广联盟是怎么操作的?

采集交流 • 优采云 发表了文章 • 0 个评论 • 434 次浏览 • 2021-05-16 19:02

文章采集调用渠道比较广泛,国内的阿里、腾讯、qq、微信、今日头条、uc头条、网易新闻、趣头条等,国外的谷歌、百度、uc头条、whatsapp等。今日头条也是采用了这样的模式。当然今日头条不止提供优质文章,同时还提供高转发率的文章,帮助作者提高内容曝光度,从而提高流量。

我想楼主是想用头条广告赚广告费吧,都是广告联盟,除了qq和微信的qq浏览器插件,其他主流的互联网广告联盟都可以接的,像今日头条,

头条广告联盟,广告联盟能平台付广告费,平台只负责推送。你可以用图文,视频广告,或者是开通分成广告联盟,

抖音等抖音小程序信息流广告联盟

字节跳动算法这块做的很成熟了.不过推荐文章还是需要你把粉丝转化为销售线索,才有可能投放广告.

如果你有开通头条的信息流推广需求的话,你可以关注:字节跳动新媒体研究院信息流渠道有招商,为你的渠道打造全面扶持,让你的运营、新媒体流量变现带来更多方便。

推荐头条广告联盟就可以做信息流推广

这样的方式基本上上就是三个渠道,头条联盟,抖音广告联盟,以及头条推广联盟,他们具体是怎么操作的?都是可以向头条申请开通联盟的,具体的你可以了解一下这个,同时还有信息流广告投放的一些案例。 查看全部

抖音广告联盟,头条推广联盟是怎么操作的?

文章采集调用渠道比较广泛,国内的阿里、腾讯、qq、微信、今日头条、uc头条、网易新闻、趣头条等,国外的谷歌、百度、uc头条、whatsapp等。今日头条也是采用了这样的模式。当然今日头条不止提供优质文章,同时还提供高转发率的文章,帮助作者提高内容曝光度,从而提高流量。

我想楼主是想用头条广告赚广告费吧,都是广告联盟,除了qq和微信的qq浏览器插件,其他主流的互联网广告联盟都可以接的,像今日头条,

头条广告联盟,广告联盟能平台付广告费,平台只负责推送。你可以用图文,视频广告,或者是开通分成广告联盟,

抖音等抖音小程序信息流广告联盟

字节跳动算法这块做的很成熟了.不过推荐文章还是需要你把粉丝转化为销售线索,才有可能投放广告.

如果你有开通头条的信息流推广需求的话,你可以关注:字节跳动新媒体研究院信息流渠道有招商,为你的渠道打造全面扶持,让你的运营、新媒体流量变现带来更多方便。

推荐头条广告联盟就可以做信息流推广

这样的方式基本上上就是三个渠道,头条联盟,抖音广告联盟,以及头条推广联盟,他们具体是怎么操作的?都是可以向头条申请开通联盟的,具体的你可以了解一下这个,同时还有信息流广告投放的一些案例。

做post请求或get请求,文章下载调用requests.post

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-05-08 00:04

文章采集调用requests.execute()做post请求或get请求,文章下载调用requests.post(request,response)作为get请求或post请求。如何实现下载文章!!1.打开糗事百科,点击右上角设置,点击下载文件。2.切换到控制台窗口,输入相关内容如图(new_content):#找到你要下载的内容list=list(id=name_id)msg=msg_msg(request,response)。

目前下载这篇文章,需要访问,并且保存。

刚刚根据题主的描述,建议使用pythonrequests库处理这个问题。processing?代码如下:fromrequestsimporthttp_requesturl=''defdownload_page(url):frame=requests.get(url).textifrequests.post(frame,response='postmessage'):pages=url+page.strip()returnpages。

先上一个答案,有机会去了解一下,这篇文章来自第三方程序设计师的网站,

上面的答案都没有使用inurl选择下载的窗口。这个说到inurl选择下载。首先发现了有一个下载其它网站的文章,就要解决两个问题:1.自己的网站上是否能收到这个链接2.解析下载请求用的inurl,这个inurl代表了你的网站权重,tl、web-explorer应该可以生成权重。解析下载窗口里面的获取下载链接:inurl.paste(http(s).body)可以找到params={'password':'xxx','data':'prompt'}其中password为下载的文章密码以及网页logo。

拿出同求确定下载地址的params,用到一个自定义的json接口。其中myrequest:用于获取文章链接myrequest.url:返回文章地址defgethtml(url):#用于获取文章链接data={'password':'xxx','data':myrequest.url}#相当于http请求里面请求json数据。

defgetmetadata(self,url):#获取array格式格式的attribute地址self.attribute.params=[url]returnself.attribute.paramsdefgetcontent(attr_data):#获取文章标题attr_data=attr_data.split(',')data=attr_data.split('')#如果没有none字符,返回该文章的html结构,如果有none字符则在getmetadata返回文章标题和该页文章的地址#接下来defprocess(message):#将get后的json返回到def对象中去,可以用于处理http请求直接获取defgetdata(data):#确定需要下载文章的列表self.url.headers['user-agent']={'cookie':'*'}#获取文章地址self。 查看全部

做post请求或get请求,文章下载调用requests.post

文章采集调用requests.execute()做post请求或get请求,文章下载调用requests.post(request,response)作为get请求或post请求。如何实现下载文章!!1.打开糗事百科,点击右上角设置,点击下载文件。2.切换到控制台窗口,输入相关内容如图(new_content):#找到你要下载的内容list=list(id=name_id)msg=msg_msg(request,response)。

目前下载这篇文章,需要访问,并且保存。

刚刚根据题主的描述,建议使用pythonrequests库处理这个问题。processing?代码如下:fromrequestsimporthttp_requesturl=''defdownload_page(url):frame=requests.get(url).textifrequests.post(frame,response='postmessage'):pages=url+page.strip()returnpages。

先上一个答案,有机会去了解一下,这篇文章来自第三方程序设计师的网站,

上面的答案都没有使用inurl选择下载的窗口。这个说到inurl选择下载。首先发现了有一个下载其它网站的文章,就要解决两个问题:1.自己的网站上是否能收到这个链接2.解析下载请求用的inurl,这个inurl代表了你的网站权重,tl、web-explorer应该可以生成权重。解析下载窗口里面的获取下载链接:inurl.paste(http(s).body)可以找到params={'password':'xxx','data':'prompt'}其中password为下载的文章密码以及网页logo。

拿出同求确定下载地址的params,用到一个自定义的json接口。其中myrequest:用于获取文章链接myrequest.url:返回文章地址defgethtml(url):#用于获取文章链接data={'password':'xxx','data':myrequest.url}#相当于http请求里面请求json数据。

defgetmetadata(self,url):#获取array格式格式的attribute地址self.attribute.params=[url]returnself.attribute.paramsdefgetcontent(attr_data):#获取文章标题attr_data=attr_data.split(',')data=attr_data.split('')#如果没有none字符,返回该文章的html结构,如果有none字符则在getmetadata返回文章标题和该页文章的地址#接下来defprocess(message):#将get后的json返回到def对象中去,可以用于处理http请求直接获取defgetdata(data):#确定需要下载文章的列表self.url.headers['user-agent']={'cookie':'*'}#获取文章地址self。

文章采集调用很方便,你知道你是什么背景吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 185 次浏览 • 2021-05-07 06:05

文章采集调用很方便。但是,现在好多常用的模式,诸如点击事件、鼠标事件之类的,都是由javascript写代码,像scrapy这种利用一些现成的模块,组合起来,就可以搞定,工作量小,可复用性还很高。我觉得scrapy像一个通用的脚手架,能基本满足我们日常开发需求了。

lxmlapi,很实用,

要用的javascript模块多太多了。不论是封装,访问速度,最重要的是性能。那就得设计出来一个能提供多个javascript模块实现相同功能的closure或者叫做commonjs等等。scrapy仅仅提供了基本的client的一些api。而且。除了那一个模块也不能做得很复杂很牛逼。

如果自己都不知道自己要什么,就像你拿10w只要求别人给你投100w,是不可能的,钱可以挣,能力却不行。所以,先建立起自己的框架吧。

不知道你是什么背景?web相关的?node.js用webpack来打包吧

最快速的方法是先建好一个ejs文件,利用webpack来打包前端,之后把你的需求传给后端,后端传给你的路由方法,你一层一层往上走,不过这一层一层要看你的前端了。如果是后端的话,用react框架,网上有各种文章,弄不会的话,找个webpack的基础知识,看完对webpack的基本了解后,可以尝试看下react官方文档,后端方面建议看下vue的框架,前端的话,看看别人的开源博客,学学别人的前端框架,多总结一下,别自己原封不动的,遇到问题可以问我。 查看全部

文章采集调用很方便,你知道你是什么背景吗?

文章采集调用很方便。但是,现在好多常用的模式,诸如点击事件、鼠标事件之类的,都是由javascript写代码,像scrapy这种利用一些现成的模块,组合起来,就可以搞定,工作量小,可复用性还很高。我觉得scrapy像一个通用的脚手架,能基本满足我们日常开发需求了。

lxmlapi,很实用,

要用的javascript模块多太多了。不论是封装,访问速度,最重要的是性能。那就得设计出来一个能提供多个javascript模块实现相同功能的closure或者叫做commonjs等等。scrapy仅仅提供了基本的client的一些api。而且。除了那一个模块也不能做得很复杂很牛逼。

如果自己都不知道自己要什么,就像你拿10w只要求别人给你投100w,是不可能的,钱可以挣,能力却不行。所以,先建立起自己的框架吧。

不知道你是什么背景?web相关的?node.js用webpack来打包吧

最快速的方法是先建好一个ejs文件,利用webpack来打包前端,之后把你的需求传给后端,后端传给你的路由方法,你一层一层往上走,不过这一层一层要看你的前端了。如果是后端的话,用react框架,网上有各种文章,弄不会的话,找个webpack的基础知识,看完对webpack的基本了解后,可以尝试看下react官方文档,后端方面建议看下vue的框架,前端的话,看看别人的开源博客,学学别人的前端框架,多总结一下,别自己原封不动的,遇到问题可以问我。