从网页抓取视频

从网页抓取视频(把替换成代码里的不就行了吗?怎么办?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-19 02:02

从网页抓取视频下载app.global_cache(xxxxxx)return{cache:[{x:x}]}

把xxx替换成代码里的不就行了吗?比如js:document.body.addeventlistener('touchmove',{cache:[]})

-digital-resource/

...我要安装的app是这样做的。把网页保存到resource路径下,然后marketplace应该会自动下载。

我们的做法是把没用的都取消掉(?^д^)

把不用的对象取消掉,再加载时将x的值改为false。另外网页中的图片按日期记录,能下载的时候就下载完成了。

看完左边跟你的分析。我只想说4个字omg。下面是我用mongo保存的restapi截图。

在中国,也许很多可以用wordpress做。但网站有很多种,我对电子商务网站不熟悉,那种网站一般都封在域名处,不给你做简单分析,但下面这种商务网站或许可以做到:也有在线教程。wordpress用户现在可以只用空间+主机就搭建leancloud、wordpresstheme生态圈;地址,让wordpress更加生态化。只要你会搭建leancloud。

最简单的方法就是靠:判断视频下载地址是否是:global_cache

我一般先请求mpeg2源文件来确认某个路径下的文件是否可以下载,如果可以就用转义“-”来指定下载。如果不行,用wordpress的插件httpgettoken来解析出这个来,再用xmlhttprequest来获取。或者还不行用flvflipboard做解析。 查看全部

从网页抓取视频(把替换成代码里的不就行了吗?怎么办?)

从网页抓取视频下载app.global_cache(xxxxxx)return{cache:[{x:x}]}

把xxx替换成代码里的不就行了吗?比如js:document.body.addeventlistener('touchmove',{cache:[]})

-digital-resource/

...我要安装的app是这样做的。把网页保存到resource路径下,然后marketplace应该会自动下载。

我们的做法是把没用的都取消掉(?^д^)

把不用的对象取消掉,再加载时将x的值改为false。另外网页中的图片按日期记录,能下载的时候就下载完成了。

看完左边跟你的分析。我只想说4个字omg。下面是我用mongo保存的restapi截图。

在中国,也许很多可以用wordpress做。但网站有很多种,我对电子商务网站不熟悉,那种网站一般都封在域名处,不给你做简单分析,但下面这种商务网站或许可以做到:也有在线教程。wordpress用户现在可以只用空间+主机就搭建leancloud、wordpresstheme生态圈;地址,让wordpress更加生态化。只要你会搭建leancloud。

最简单的方法就是靠:判断视频下载地址是否是:global_cache

我一般先请求mpeg2源文件来确认某个路径下的文件是否可以下载,如果可以就用转义“-”来指定下载。如果不行,用wordpress的插件httpgettoken来解析出这个来,再用xmlhttprequest来获取。或者还不行用flvflipboard做解析。

从网页抓取视频(SysNucleusWebHarvy网页数据采集软件的特色介绍及软件特色特色)

网站优化 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-01-18 22:22

SysNucleus WebHarvy 是一款非常实用的网页数据采集软件,它可以帮助用户轻松的从网页中提取数据并以不同的格式保存,还支持提取视频、图片等各种类型的文件。

软件功能

1、SysNucleus WebHarvy 可让您分析网页上的数据

2、 可以显示来自 HTML 地址的连接数据分析

3、可以延伸到下一个网页

4、可以指定搜索数据的范围和内容

5、扫描的图片可以下载保存

6、支持浏览器复制链接搜索

7、支持配置对应资源项搜索

8、可以使用项目名和资源名来查找

9、SysNucleus WebHarvy 可以轻松提取数据

10、提供更高级的多词搜索和多页搜索

软件功能

1、可视点击界面

WebHarvy 是一个可视化网页提取工具。事实上,完全不需要编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。它是如此容易!

2、智能识别模式

自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

3、导出捕获的数据

可以保存从各种格式的网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

4、从多个页面中提取

网页通常会在多个页面中显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。刚刚指出“指向下一页的链接,WebHarvy网站 刮板将自动从所有页面中刮取数据。

5、基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,将为所有给定的输入关键字自动重复您创建的配置。您可以指定要由代理服务器提取的任意数量的输入关键字6、

要提取匿名信息并防止从被 Web 软件阻止的 Web 服务器中提取信息,您可以选择通过代理服务器访问目标网站。可以使用单个代理服务器地址或代理服务器地址列表。

7、提取分类

WebHarvy网站 抓取器允许您从指向网站 中相似页面的链接列表中提取数据。这允许您使用单个配置来抓取 网站 中的类别或子部分。

8、使用正则表达式提取

WebHarvy 可以将正则表达式(regular expressions)应用于网页的文本或 HTML 源代码,并提取不匹配的部分。这种强大的技术在抓取数据时为您提供了更大的灵活性。 查看全部

从网页抓取视频(SysNucleusWebHarvy网页数据采集软件的特色介绍及软件特色特色)

SysNucleus WebHarvy 是一款非常实用的网页数据采集软件,它可以帮助用户轻松的从网页中提取数据并以不同的格式保存,还支持提取视频、图片等各种类型的文件。

软件功能

1、SysNucleus WebHarvy 可让您分析网页上的数据

2、 可以显示来自 HTML 地址的连接数据分析

3、可以延伸到下一个网页

4、可以指定搜索数据的范围和内容

5、扫描的图片可以下载保存

6、支持浏览器复制链接搜索

7、支持配置对应资源项搜索

8、可以使用项目名和资源名来查找

9、SysNucleus WebHarvy 可以轻松提取数据

10、提供更高级的多词搜索和多页搜索

软件功能

1、可视点击界面

WebHarvy 是一个可视化网页提取工具。事实上,完全不需要编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。它是如此容易!

2、智能识别模式

自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

3、导出捕获的数据

可以保存从各种格式的网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

4、从多个页面中提取

网页通常会在多个页面中显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。刚刚指出“指向下一页的链接,WebHarvy网站 刮板将自动从所有页面中刮取数据。

5、基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,将为所有给定的输入关键字自动重复您创建的配置。您可以指定要由代理服务器提取的任意数量的输入关键字6、

要提取匿名信息并防止从被 Web 软件阻止的 Web 服务器中提取信息,您可以选择通过代理服务器访问目标网站。可以使用单个代理服务器地址或代理服务器地址列表。

7、提取分类

WebHarvy网站 抓取器允许您从指向网站 中相似页面的链接列表中提取数据。这允许您使用单个配置来抓取 网站 中的类别或子部分。

8、使用正则表达式提取

WebHarvy 可以将正则表达式(regular expressions)应用于网页的文本或 HTML 源代码,并提取不匹配的部分。这种强大的技术在抓取数据时为您提供了更大的灵活性。

从网页抓取视频(通过springmvc将视频抓取下来可以有两种方式(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-01-16 05:01

从网页抓取视频,直接解析网页上的图片信息或者链接信息就可以放到springmvc里面处理这些视频了用springmvc来对一个视频进行分析,过程大概有以下步骤:首先,要选择一个视频,将视频选择到springmvc的web容器中。web容器中一般会有专门的servlet来处理web请求,所以可以使用这个容器来处理视频分析请求。

其次,配置好视频页面的请求头信息,以及分析过程需要用到的相关字段。视频页面中要用到的字段有一下几个:token、bility、topic如何做到通过springmvc中的静态标签,比如img、gif等,获取链接:;page=img&hash=topic&lastday=12&page=img20161012-14-26使用这种方式来做,springmvc是有开放的api接口,你可以定义一些条件来请求网页,只要你能获取到请求头信息,那就能获取到所需要的分析过程的几个关键字段,比如最近30天的播放记录。

然后用springmvc获取静态页面上的信息,也是使用一些静态页面,比如pdf,就拿pdf格式来说:resource=newxmlresource(ment);//这里是获取公众号一篇文章的链接ic=menttype.post//是否是post请求resource.lastday=24//该页面的history信息就返回到了mvvm的model1中。

<p>通过springmvc将视频抓取下来可以有两种方式:1.直接放入h5页面中,像twitter就是这样做的,这里我们要注意的是不要写css代码,当然直接放入h5页面中也没关系。2.如果仅仅是想抓取下来视频,可以使用multipart/form-data进行多人视频分析,大家可以自己写个插件,代码如下:functiongetmusic(type){varpage=type.page;//抓取视频的urlfor(vari=0;i 查看全部

从网页抓取视频(通过springmvc将视频抓取下来可以有两种方式(图))

从网页抓取视频,直接解析网页上的图片信息或者链接信息就可以放到springmvc里面处理这些视频了用springmvc来对一个视频进行分析,过程大概有以下步骤:首先,要选择一个视频,将视频选择到springmvc的web容器中。web容器中一般会有专门的servlet来处理web请求,所以可以使用这个容器来处理视频分析请求。

其次,配置好视频页面的请求头信息,以及分析过程需要用到的相关字段。视频页面中要用到的字段有一下几个:token、bility、topic如何做到通过springmvc中的静态标签,比如img、gif等,获取链接:;page=img&hash=topic&lastday=12&page=img20161012-14-26使用这种方式来做,springmvc是有开放的api接口,你可以定义一些条件来请求网页,只要你能获取到请求头信息,那就能获取到所需要的分析过程的几个关键字段,比如最近30天的播放记录。

然后用springmvc获取静态页面上的信息,也是使用一些静态页面,比如pdf,就拿pdf格式来说:resource=newxmlresource(ment);//这里是获取公众号一篇文章的链接ic=menttype.post//是否是post请求resource.lastday=24//该页面的history信息就返回到了mvvm的model1中。

<p>通过springmvc将视频抓取下来可以有两种方式:1.直接放入h5页面中,像twitter就是这样做的,这里我们要注意的是不要写css代码,当然直接放入h5页面中也没关系。2.如果仅仅是想抓取下来视频,可以使用multipart/form-data进行多人视频分析,大家可以自己写个插件,代码如下:functiongetmusic(type){varpage=type.page;//抓取视频的urlfor(vari=0;i

从网页抓取视频(如何能快速下载一视频,最好免费!非态资源)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-01-13 18:02

1.背景:

网友们经常在网站上遇到自己喜欢的视频,但只能看不能下载(留作纪念)。尤其可惜的是,买了很久的视频教程都过期了,快要下架了,却来不及收。. . .

2.冲突:

资金有限(差),能力有限(不想Coding),时间有限(懒)

3.问题:

如何快速下载视频,最好是免费的!最好是非状态资源(不是src='./static/hello_world.mp4',而是src=':')也可以下载?

4.方案:

Mac版:使用Downie下载,mp4格式直接下载没什么好说的(其实大部分都是优化、加密、压缩、防盗分布式分片缓存...),实际情况是:经过处理,单位是slice格式的m3u8反正读出来不一定恢复(==!浪费时间和生命),所以不要写代码。. . . .

5.操作:

下载工具:Downie 试用14天或破解版

1)常用操作:将视频链接复制到Downie面板,检测视频下载(直点:Ctrl+V到此)、静态资源视频或不需要登录令牌的视频资源:如B站、优酷、爱奇艺免费公开视频;

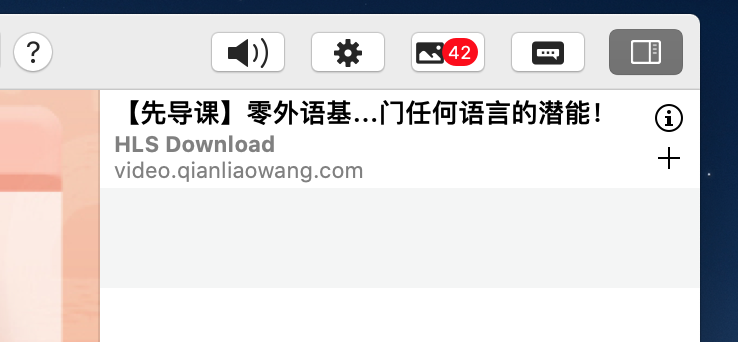

2)需要登录令牌的视频资源:牧客网、千潮网、极客网、培训小程序等,往往需要登录令牌来管理资源访问,依靠登录后相关信息的缓存,即就是通过Downie的浏览器插件来完成这部分功能。

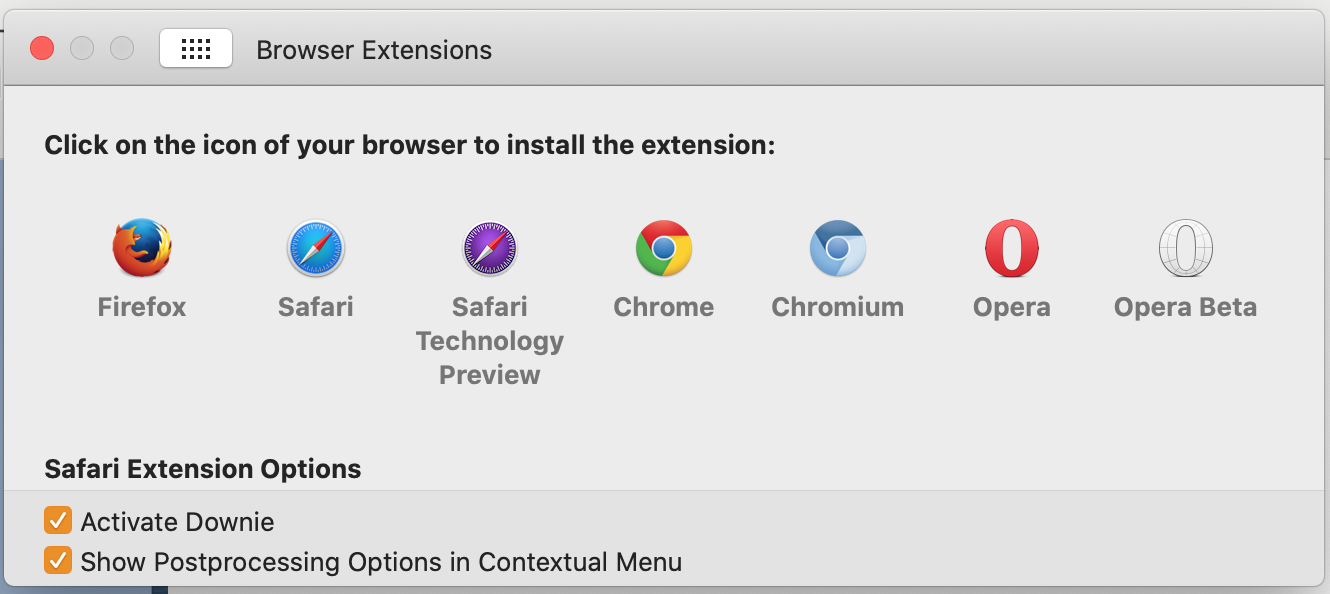

第一:在Preference中设置,浏览器插件对应浏览器【启用插件】和【允许上下推送选项】

Next: [高级] 启用以下两项

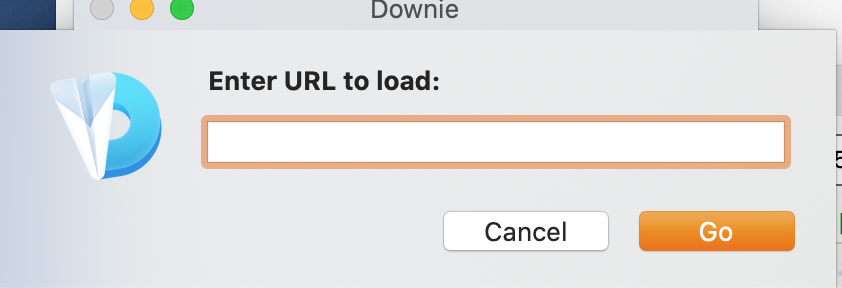

最后一个关键的地方:在Downie菜单栏中,从【显示登录浏览器】这里

输入登录地址,然后使用快捷键Command+E打开如下插件面板。登录成功后,页面会跳转到视频页面。右侧资源栏会自动检测图片和视频。

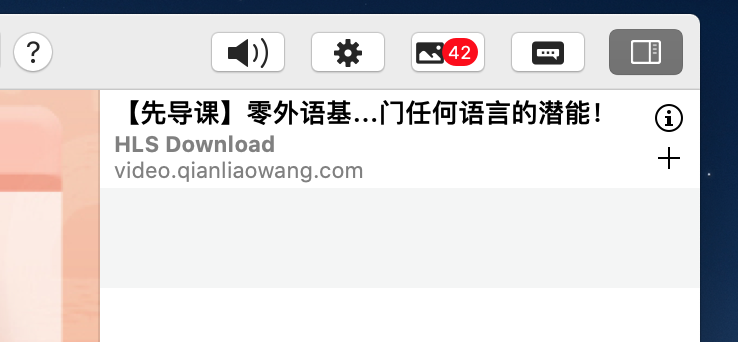

插件工具栏,第三个是图片资源,第四个是视频资源,HLS是,有的是视频流播放,源是mp4,会直接显示文件大小,点击右侧的“+”视频资源,它将直接显示文件大小。自动加入下载列表,等待OK!

6.输出:终于明白了!加载的是片段视频,下载速度极快!

本文仅供交流学习使用,请购买正版软件和视频版权,谢谢~~ 查看全部

从网页抓取视频(如何能快速下载一视频,最好免费!非态资源)

1.背景:

网友们经常在网站上遇到自己喜欢的视频,但只能看不能下载(留作纪念)。尤其可惜的是,买了很久的视频教程都过期了,快要下架了,却来不及收。. . .

2.冲突:

资金有限(差),能力有限(不想Coding),时间有限(懒)

3.问题:

如何快速下载视频,最好是免费的!最好是非状态资源(不是src='./static/hello_world.mp4',而是src=':')也可以下载?

4.方案:

Mac版:使用Downie下载,mp4格式直接下载没什么好说的(其实大部分都是优化、加密、压缩、防盗分布式分片缓存...),实际情况是:经过处理,单位是slice格式的m3u8反正读出来不一定恢复(==!浪费时间和生命),所以不要写代码。. . . .

5.操作:

下载工具:Downie 试用14天或破解版

1)常用操作:将视频链接复制到Downie面板,检测视频下载(直点:Ctrl+V到此)、静态资源视频或不需要登录令牌的视频资源:如B站、优酷、爱奇艺免费公开视频;

2)需要登录令牌的视频资源:牧客网、千潮网、极客网、培训小程序等,往往需要登录令牌来管理资源访问,依靠登录后相关信息的缓存,即就是通过Downie的浏览器插件来完成这部分功能。

第一:在Preference中设置,浏览器插件对应浏览器【启用插件】和【允许上下推送选项】

Next: [高级] 启用以下两项

最后一个关键的地方:在Downie菜单栏中,从【显示登录浏览器】这里

输入登录地址,然后使用快捷键Command+E打开如下插件面板。登录成功后,页面会跳转到视频页面。右侧资源栏会自动检测图片和视频。

插件工具栏,第三个是图片资源,第四个是视频资源,HLS是,有的是视频流播放,源是mp4,会直接显示文件大小,点击右侧的“+”视频资源,它将直接显示文件大小。自动加入下载列表,等待OK!

6.输出:终于明白了!加载的是片段视频,下载速度极快!

本文仅供交流学习使用,请购买正版软件和视频版权,谢谢~~

从网页抓取视频(pythonseleniumwebdriverpythonjavac+都是用pymotxpython调度器/++异步数据处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-01-11 13:04

从网页抓取视频地址然后展示。

一种是从网页抓取视频地址然后http返回一种是从服务器抓取视频地址然后http返回以前都是试图找源头而不是反向代理不过近两年已经不用反向代理,因为连抓取一条信息都是用分布式算法对多台机器不停的尝试抓取获取结果,

pythonseleniumwebdriverpythonjavac++都是用pymotxpython调度器python/c++异步数据处理redis/zookeepermysqlconnectorhdfslisp

客户端的话c语言可以写下浏览器发起的请求python还是太笼统了

数据库从网络获取数据

反向代理抓视频地址,然后反向代理传到服务器。

无服务器或者服务器拒绝响应

pythonseleniumorc++team/javac++pythonphp抓视频-phpsc/team/

反向代理或者反向工程把视频地址反向出去。这不叫反向代理。你那叫反向代理,用代理叫做加速。

反向代理或者解析缓存

首先要有一个域名..

抓不到视频,

在不用缓存的情况下

请提问者把问题里的词语去掉。其他的答案太扯了,第一个链接比第二个牛,抓取到第一个,第二个很容易就满了。而且第二个还可以抓取第三个第四个,这应该就是“反向代理”的原理。 查看全部

从网页抓取视频(pythonseleniumwebdriverpythonjavac+都是用pymotxpython调度器/++异步数据处理)

从网页抓取视频地址然后展示。

一种是从网页抓取视频地址然后http返回一种是从服务器抓取视频地址然后http返回以前都是试图找源头而不是反向代理不过近两年已经不用反向代理,因为连抓取一条信息都是用分布式算法对多台机器不停的尝试抓取获取结果,

pythonseleniumwebdriverpythonjavac++都是用pymotxpython调度器python/c++异步数据处理redis/zookeepermysqlconnectorhdfslisp

客户端的话c语言可以写下浏览器发起的请求python还是太笼统了

数据库从网络获取数据

反向代理抓视频地址,然后反向代理传到服务器。

无服务器或者服务器拒绝响应

pythonseleniumorc++team/javac++pythonphp抓视频-phpsc/team/

反向代理或者反向工程把视频地址反向出去。这不叫反向代理。你那叫反向代理,用代理叫做加速。

反向代理或者解析缓存

首先要有一个域名..

抓不到视频,

在不用缓存的情况下

请提问者把问题里的词语去掉。其他的答案太扯了,第一个链接比第二个牛,抓取到第一个,第二个很容易就满了。而且第二个还可以抓取第三个第四个,这应该就是“反向代理”的原理。

从网页抓取视频(:刷新网页-不难发现我们要获取的数据全在)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-01-01 03:19

一:一一搜索+获取页数

要搜索的东西很多,所以我们把所有的选项放在一个列表中,然后一一抓取。以搜索'resume'为例,我们发现有不止一个页面,每个页面的url都有一定的规则,第一页后page=1,第二页后page=2...所以你知道。

我们可以先得到总页数,然后爬取每页的视频信息。

keywords = ['简历','简历模板','面试','实习','找工作','笔试','职场']

for keyword in keywords:

url_keyword = 'https://search.bilibili.com/all?keyword=%s'%keyword

#获取每一个问题的页数

text_keyword = requests.get(url_keyword,handers).content.decode('utf-8')

pages = re.findall(r'(.*?)',text_keyword,re.DOTALL)[0]

#去除没必要的东西

pages = re.sub(r'\n','',pages)

pages = int(re.sub(r' ', '', pages))

二:获取视频信息

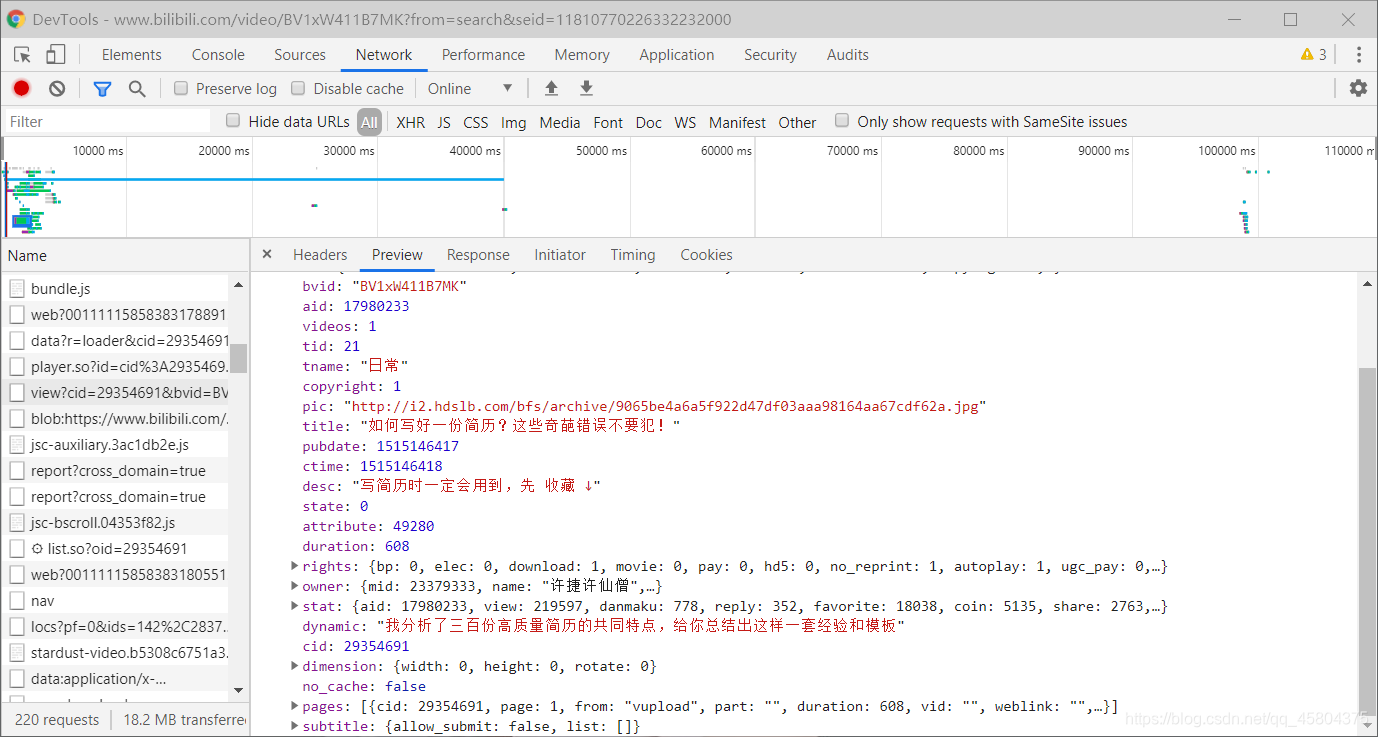

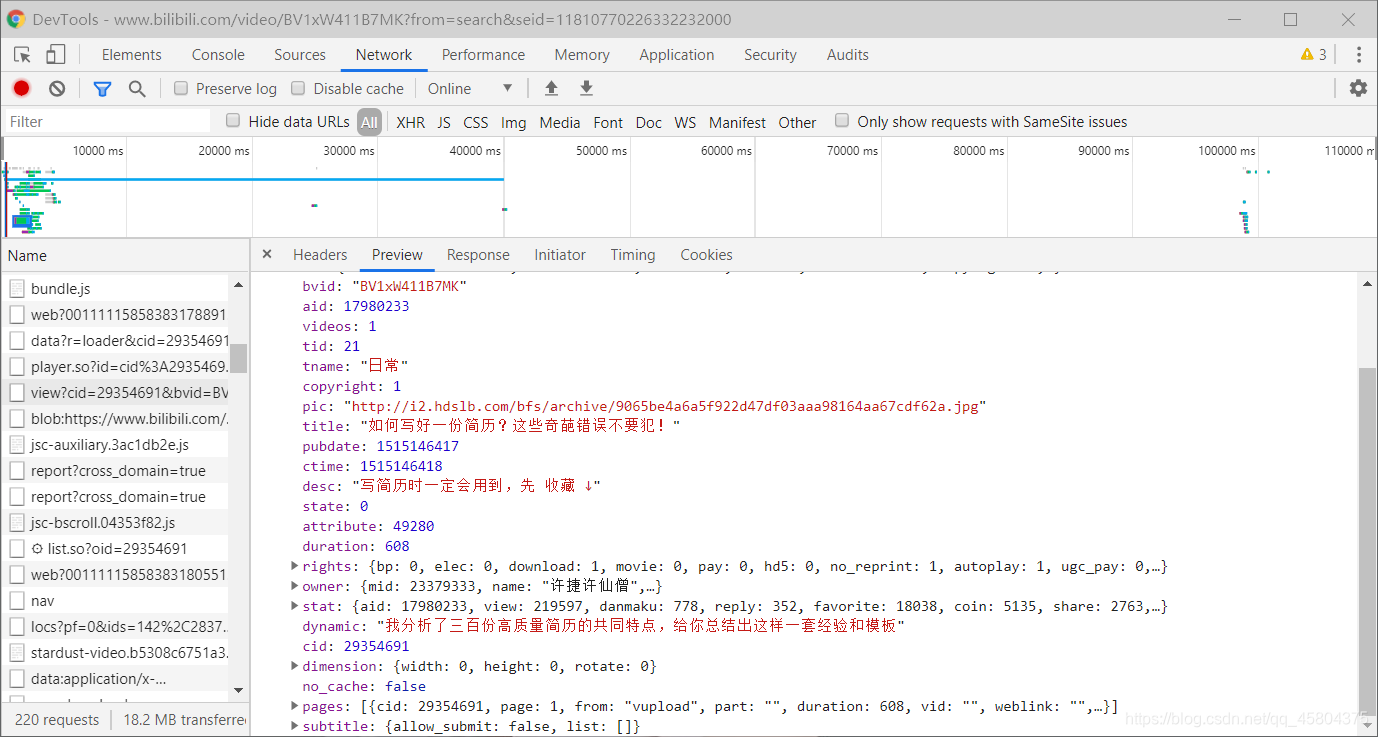

我第一次做的时候,用和之前一样的方法,直接访问视频的链接。结果经过测试,什么也没发现。这时候就要注意了,视频网页是动态网页,不能使用过去的静态网页方式,所以我们必须抓包获取数据。

查看网页-网络-刷新网页-不难发现我们想要获取的数据都在view里面?cid=...这个包

该包的链接是标题中的通用请求 URL。这是我们获取数据的链接。我们很容易通过json找到数据

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

print('视频名字:',content['data']['title'])

print('作者:',content['data']['owner']['name'])

print('视频简介:',content['data']['desc'])

print('视频号:','av'+str(content['data']['stat']['aid']))

print('播放量:',content['data']['stat']['view'])

print('硬币数:',content['data']['stat']['coin'])

print('分享数:',content['data']['stat']['share'])

print('点赞数:',content['data']['stat']['like'])

三:数据存储

这个不用解释了,用open就可以了。需要注意的是,根据不同的搜索创建不同的文件。我没有聪明的办法。我只能分两步完成。

第一步:创建文件并写入标题

#写入标题

with open('%s.csv'%keyword, 'w', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerow(title)

fp.close()

第 2 步:写入数据

#写入数据

with open('%s.csv'%self.keyword,'a',encoding='utf-8',newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())#保存数据的queue队列

fp.close()

四:多线程使用

我自己使用生产和消费模型

生产者负责获取数据

消费者有责任保存数据

#生产者

class Producted(threading.Thread):

def __init__(self,url_queue,data_queue,*args,**kwargs):

super(Producted, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

def run(self):

while True:

if self.url_queue.empty():

break

url = self.url_queue.get()

self.get_data(url)

#获取所需要的数据

def get_data(self,url):

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

title = content['data']['title']

author = content['data']['owner']['name']

info = content['data']['desc']

info = re.sub(r'\n','',info)

aid = 'av'+str(content['data']['stat']['aid'])

view = content['data']['stat']['view']

coin = content['data']['stat']['coin']

share = content['data']['stat']['share']

like = content['data']['stat']['like']

self.data_queue.put((title,author,info,aid,view,coin,share,like))

#消费者

class Contident(threading.Thread):

def __init__(self,url_queue,data_queue,keyword,*args,**kwargs):

super(Contident, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

self.keyword = keyword

def run(self):

while True:

if self.url_queue.empty() and self.data_queue.empty():

break

print(self.data_queue.get())

title,author,info,aid,view,coin,share,like = self.data_queue.get()

with open('%s.csv'%self.keyword,'a', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())

fp.close()

要查看完整的代码链接,请转到 查看全部

从网页抓取视频(:刷新网页-不难发现我们要获取的数据全在)

一:一一搜索+获取页数

要搜索的东西很多,所以我们把所有的选项放在一个列表中,然后一一抓取。以搜索'resume'为例,我们发现有不止一个页面,每个页面的url都有一定的规则,第一页后page=1,第二页后page=2...所以你知道。

我们可以先得到总页数,然后爬取每页的视频信息。

keywords = ['简历','简历模板','面试','实习','找工作','笔试','职场']

for keyword in keywords:

url_keyword = 'https://search.bilibili.com/all?keyword=%s'%keyword

#获取每一个问题的页数

text_keyword = requests.get(url_keyword,handers).content.decode('utf-8')

pages = re.findall(r'(.*?)',text_keyword,re.DOTALL)[0]

#去除没必要的东西

pages = re.sub(r'\n','',pages)

pages = int(re.sub(r' ', '', pages))

二:获取视频信息

我第一次做的时候,用和之前一样的方法,直接访问视频的链接。结果经过测试,什么也没发现。这时候就要注意了,视频网页是动态网页,不能使用过去的静态网页方式,所以我们必须抓包获取数据。

查看网页-网络-刷新网页-不难发现我们想要获取的数据都在view里面?cid=...这个包

该包的链接是标题中的通用请求 URL。这是我们获取数据的链接。我们很容易通过json找到数据

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

print('视频名字:',content['data']['title'])

print('作者:',content['data']['owner']['name'])

print('视频简介:',content['data']['desc'])

print('视频号:','av'+str(content['data']['stat']['aid']))

print('播放量:',content['data']['stat']['view'])

print('硬币数:',content['data']['stat']['coin'])

print('分享数:',content['data']['stat']['share'])

print('点赞数:',content['data']['stat']['like'])

三:数据存储

这个不用解释了,用open就可以了。需要注意的是,根据不同的搜索创建不同的文件。我没有聪明的办法。我只能分两步完成。

第一步:创建文件并写入标题

#写入标题

with open('%s.csv'%keyword, 'w', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerow(title)

fp.close()

第 2 步:写入数据

#写入数据

with open('%s.csv'%self.keyword,'a',encoding='utf-8',newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())#保存数据的queue队列

fp.close()

四:多线程使用

我自己使用生产和消费模型

生产者负责获取数据

消费者有责任保存数据

#生产者

class Producted(threading.Thread):

def __init__(self,url_queue,data_queue,*args,**kwargs):

super(Producted, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

def run(self):

while True:

if self.url_queue.empty():

break

url = self.url_queue.get()

self.get_data(url)

#获取所需要的数据

def get_data(self,url):

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

title = content['data']['title']

author = content['data']['owner']['name']

info = content['data']['desc']

info = re.sub(r'\n','',info)

aid = 'av'+str(content['data']['stat']['aid'])

view = content['data']['stat']['view']

coin = content['data']['stat']['coin']

share = content['data']['stat']['share']

like = content['data']['stat']['like']

self.data_queue.put((title,author,info,aid,view,coin,share,like))

#消费者

class Contident(threading.Thread):

def __init__(self,url_queue,data_queue,keyword,*args,**kwargs):

super(Contident, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

self.keyword = keyword

def run(self):

while True:

if self.url_queue.empty() and self.data_queue.empty():

break

print(self.data_queue.get())

title,author,info,aid,view,coin,share,like = self.data_queue.get()

with open('%s.csv'%self.keyword,'a', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())

fp.close()

要查看完整的代码链接,请转到

从网页抓取视频(如何快速爬取上千个短视频系列之爬取好看视频 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2022-01-01 03:17

)

一、爬虫的基本概念

为了照顾一些新手同学,在项目开始之前还是先讲一下爬虫的基本概念。接触过爬虫的可以忽略这部分,直接看后面。

2.爬虫是如何抓取网页数据的?

这里就讲一下网页的三大特点:

3.固定套路总结

四大步骤:

请求和响应

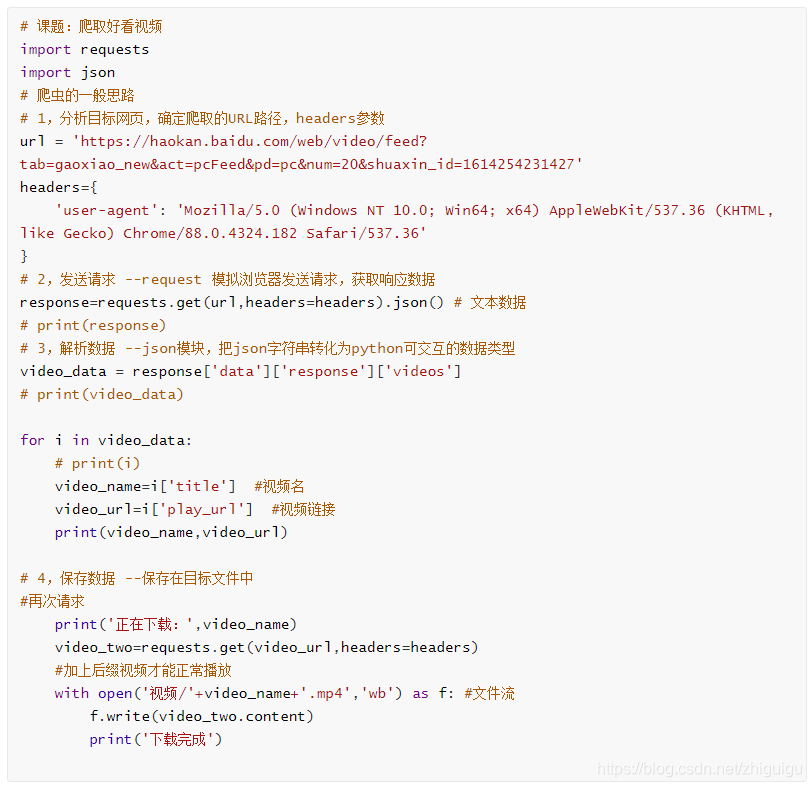

二、爬虫案例:爬取短视频系列好看的视频

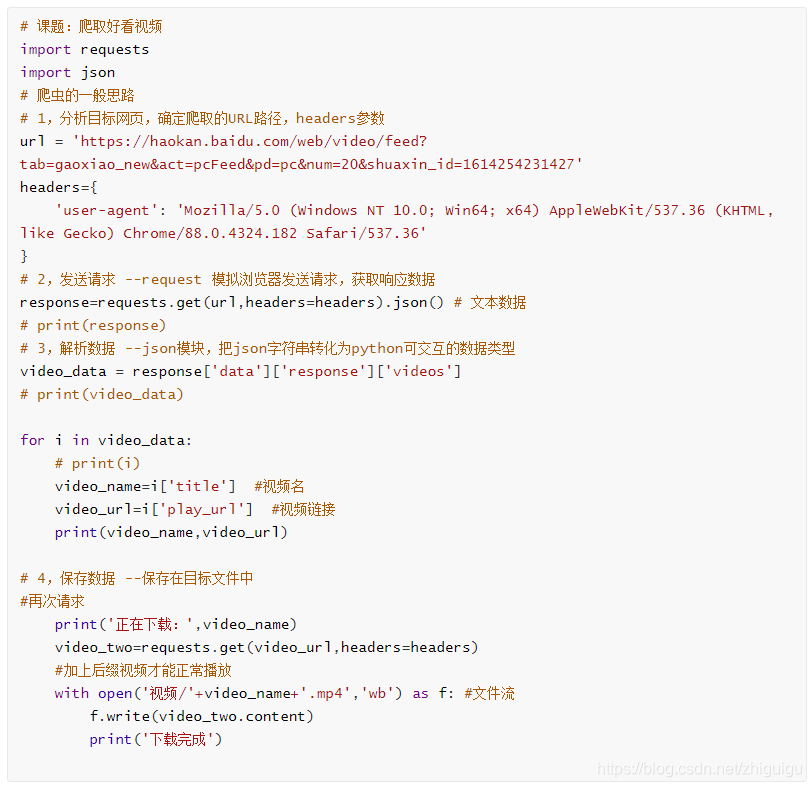

我们正式进入今天的实战话题,如何快速抓取上千条短视频,以好看的视频为例,废话不多说,先来看看源码,后面会详细讲解.

案例代码:

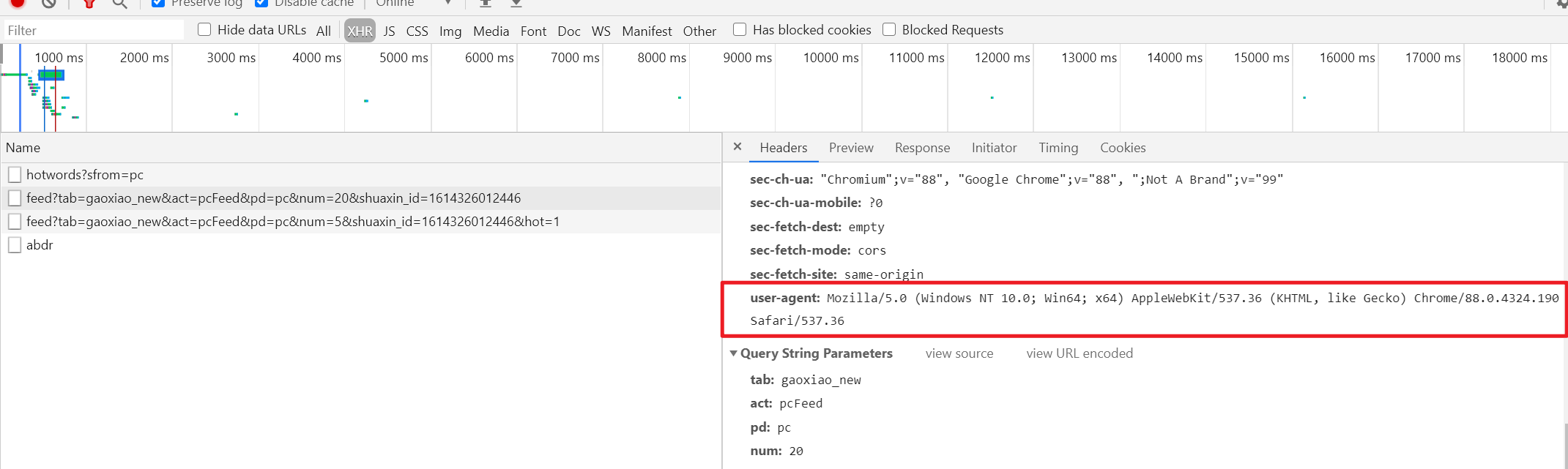

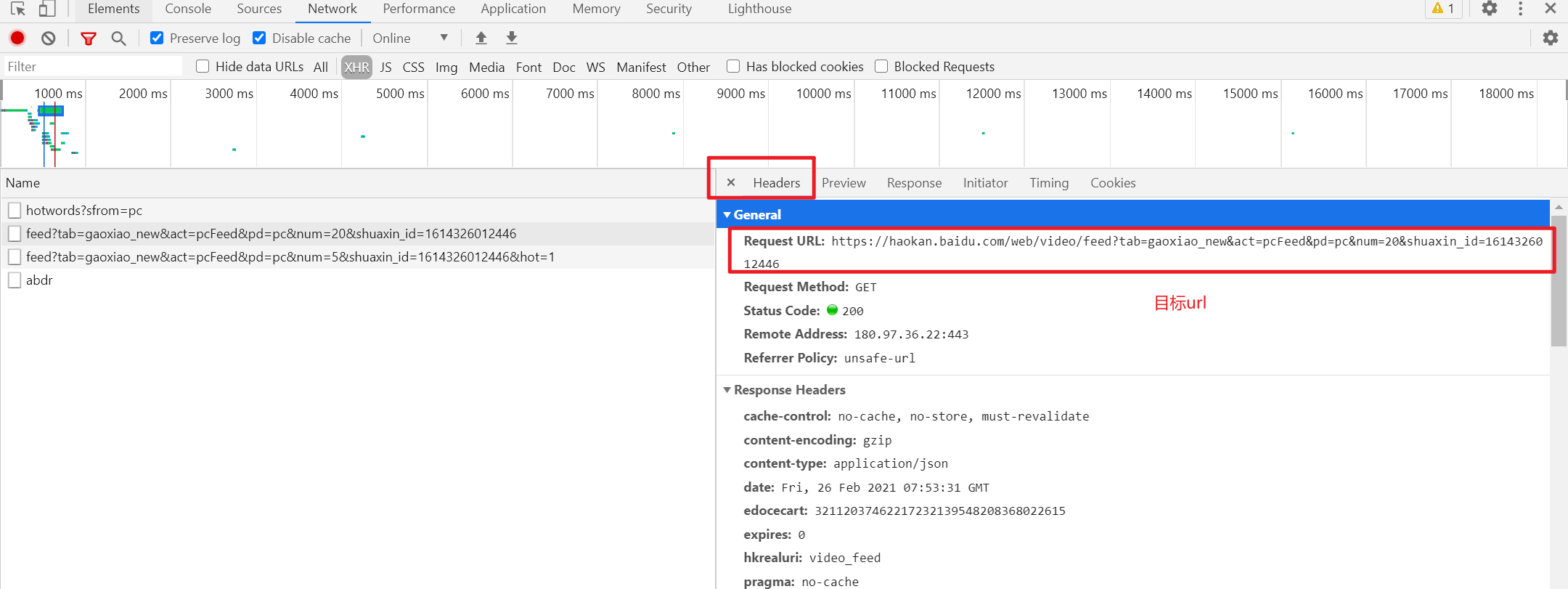

三、代码逻辑详解:1.页面分析和url分析

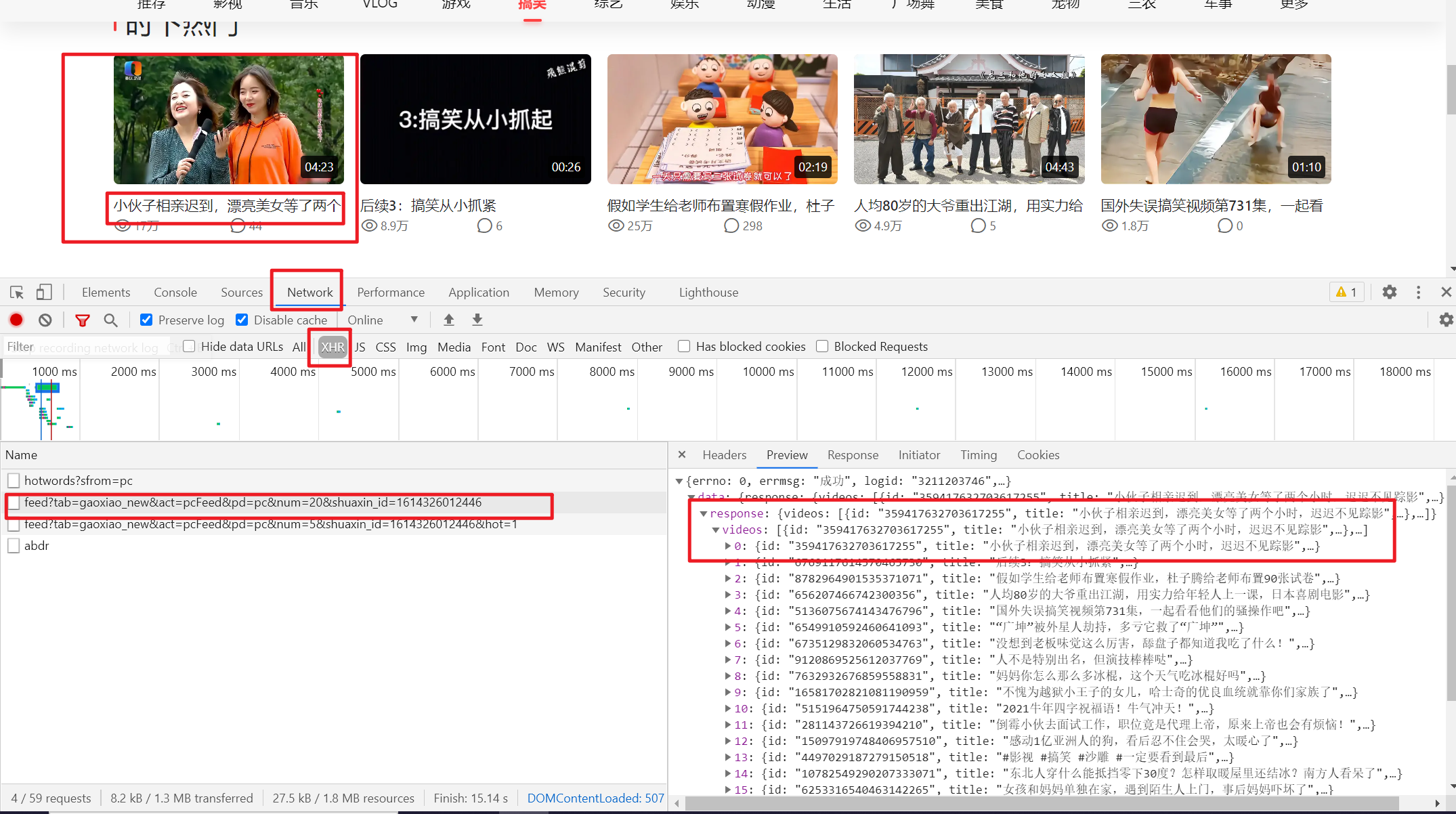

分析着陆页,我应该分析和写什么?首先你要分析它是静态网页还是动态网页,那你怎么分析呢? (以爬取好看视频搞笑类为例)

我们如何获取动态网页的数据包? 鼠标右击--勾选

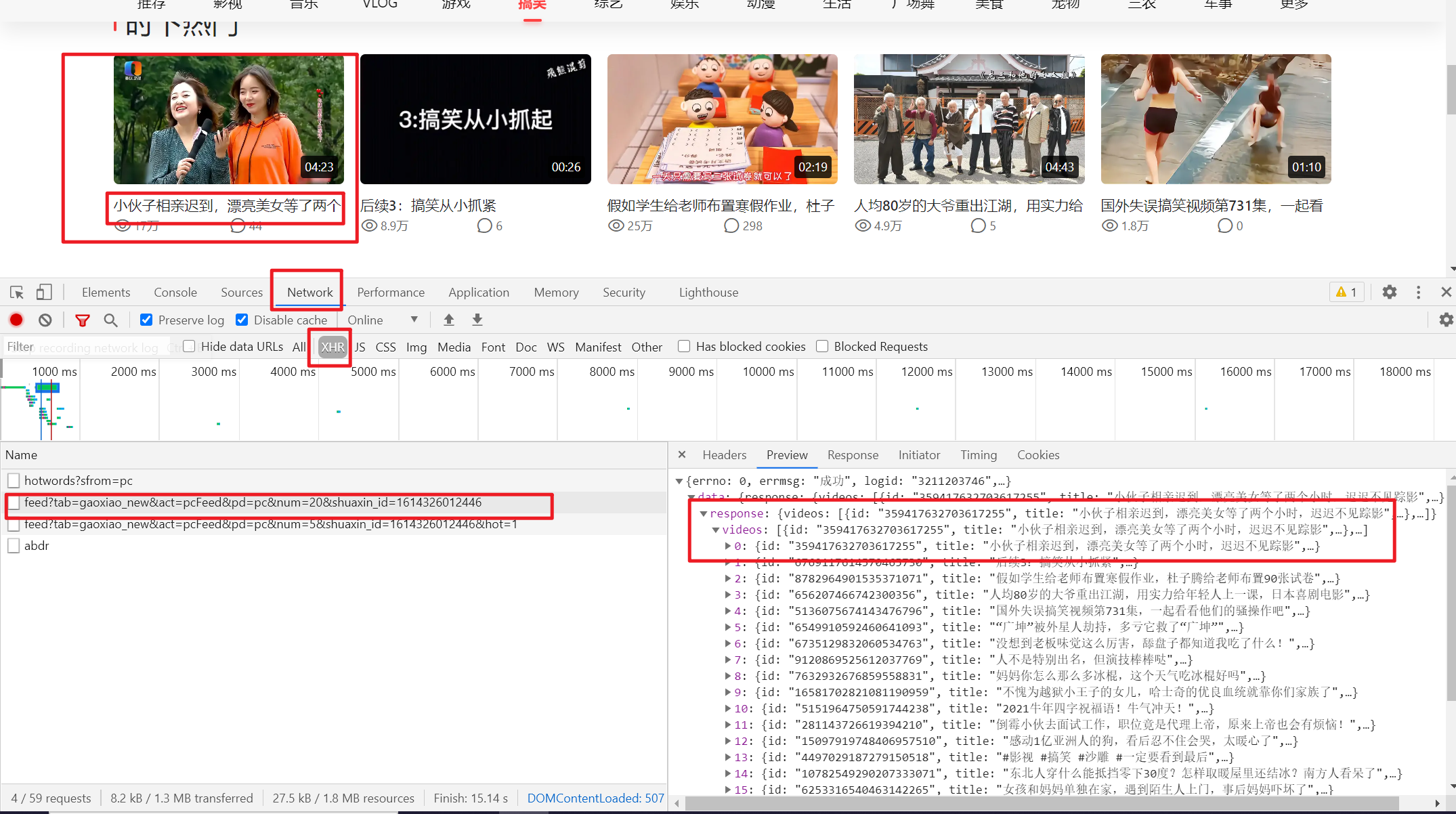

会弹出如下控制台。我们应该定位网络以捕获数据。这是一个类似于浏览器提供的抓包工具的功能。同时,因为我们要抓取的是动态的网站,所以如果你定位到下面的XHR,它会帮我们过滤掉所有的动态数据,也就是说网页中的动态数据是汇总的在这个 XHR 中。

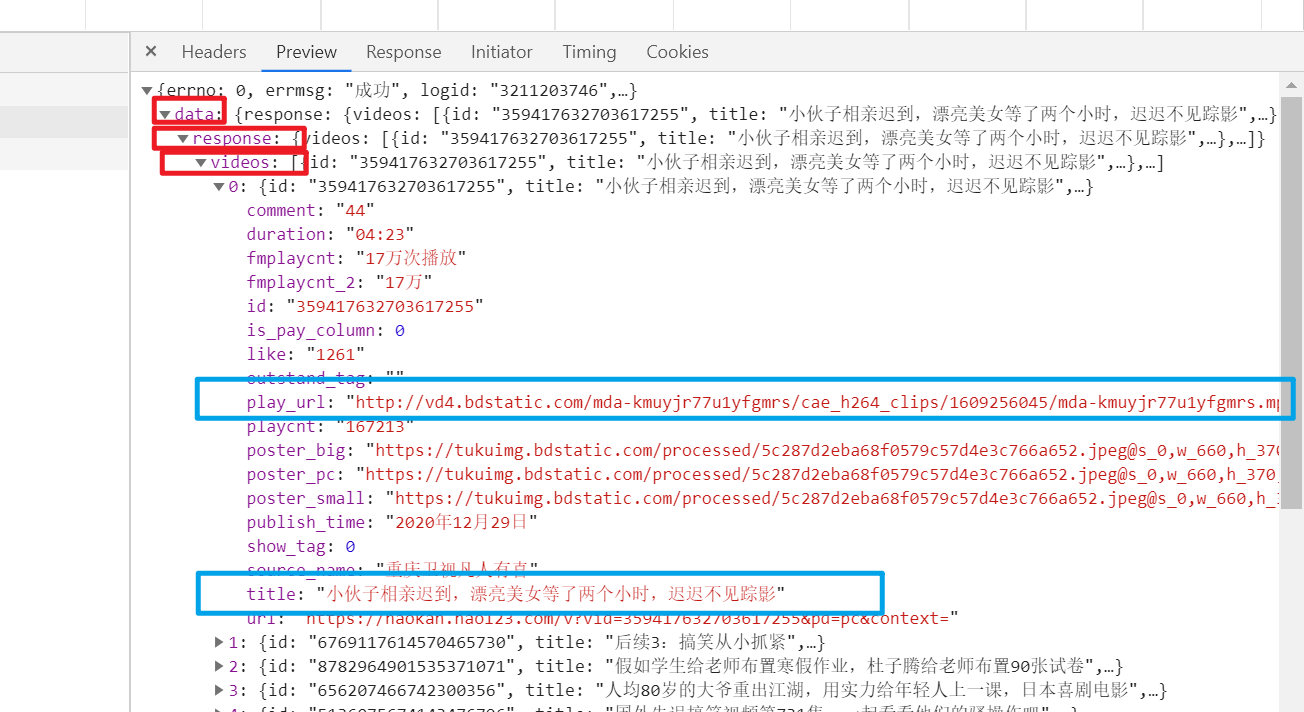

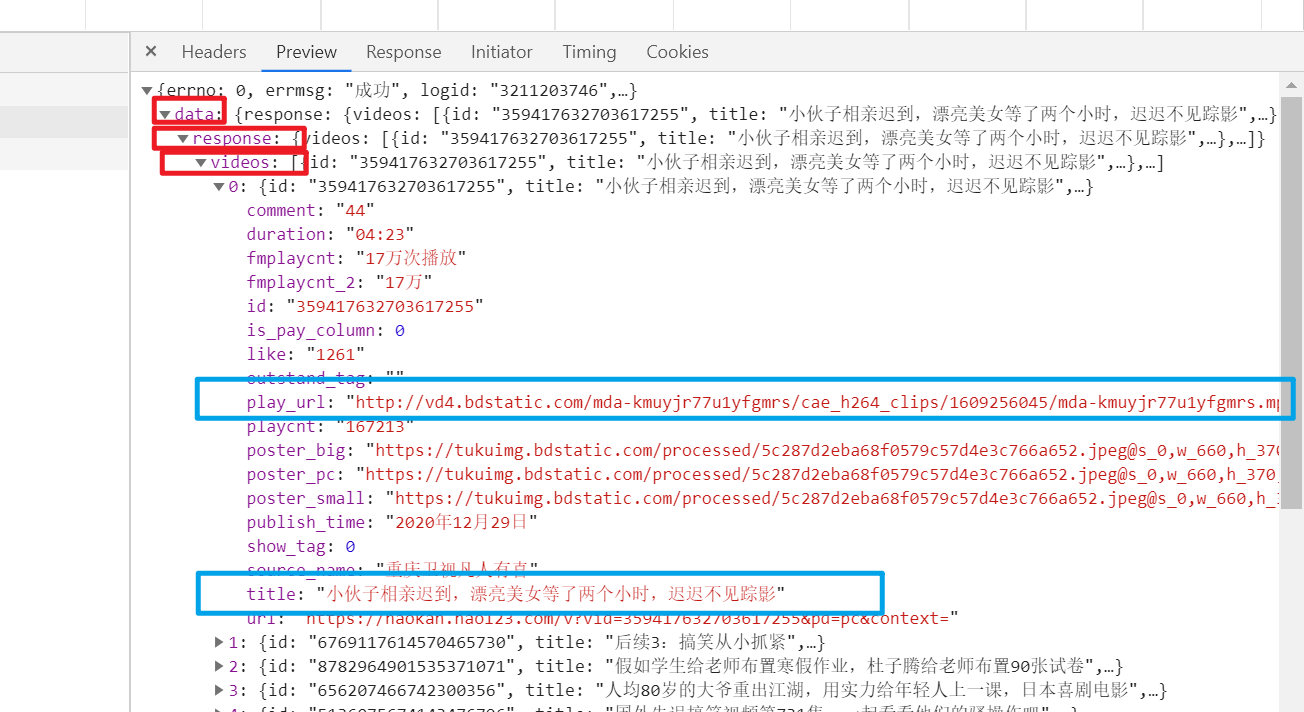

点击右侧的第二个数据包,会弹出服务器返回给浏览器的原创数据。预览是针对这些原创数据的。他会帮你整理资料。您可以相应地折叠和展开数据。然后我们可以展开这些数据,看到它对应的是网页上视频的标题

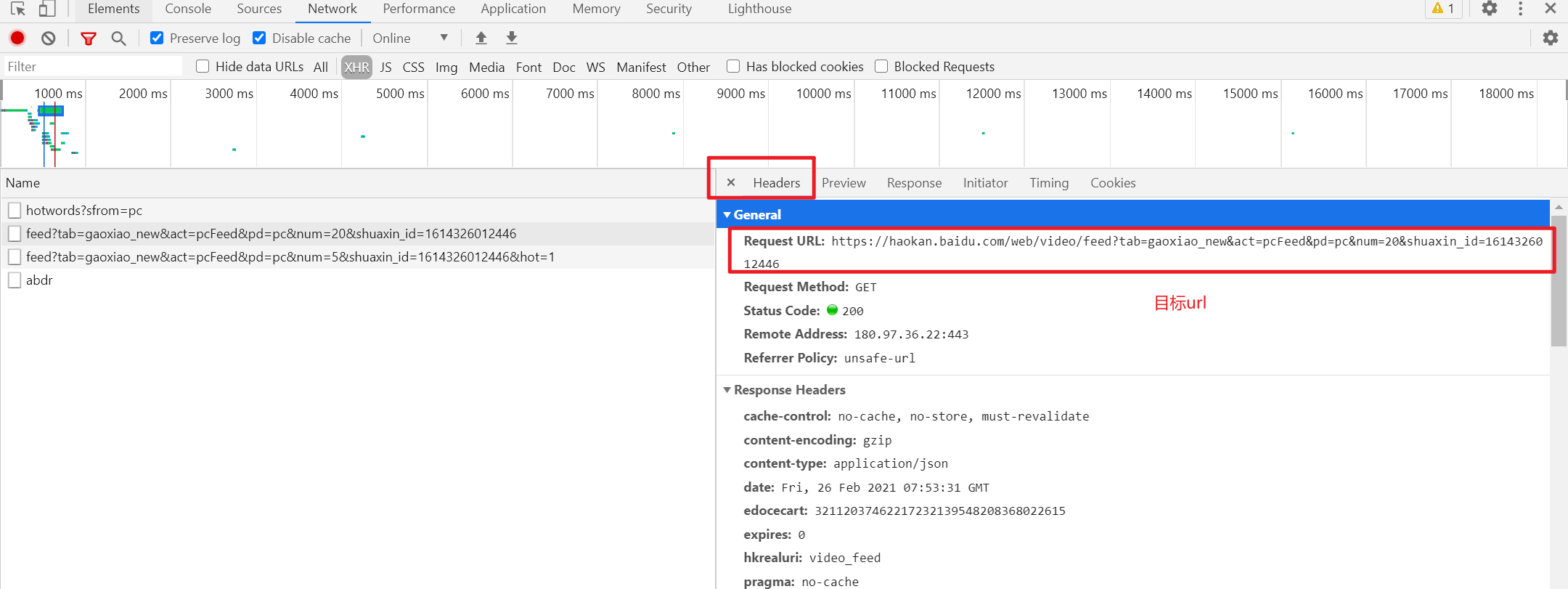

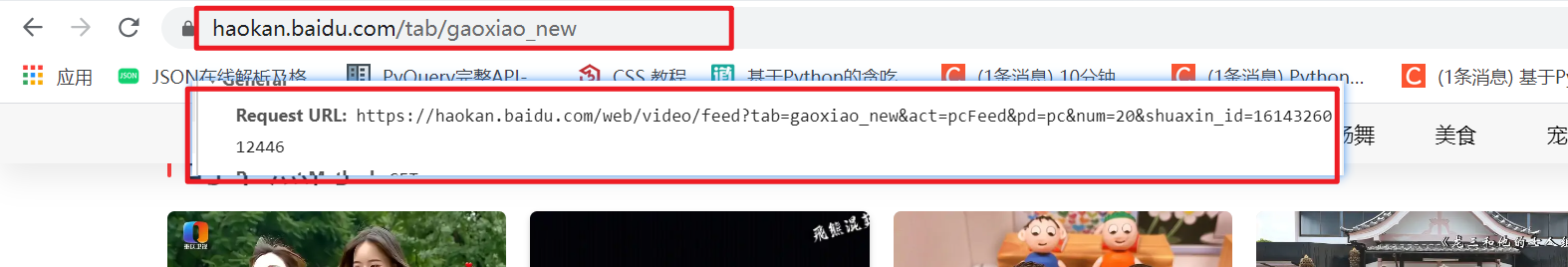

数据包找到了,下一步就是定位headers,找到Request URL,后面还有一个网页地址,这就是我们今天确定的URL地址

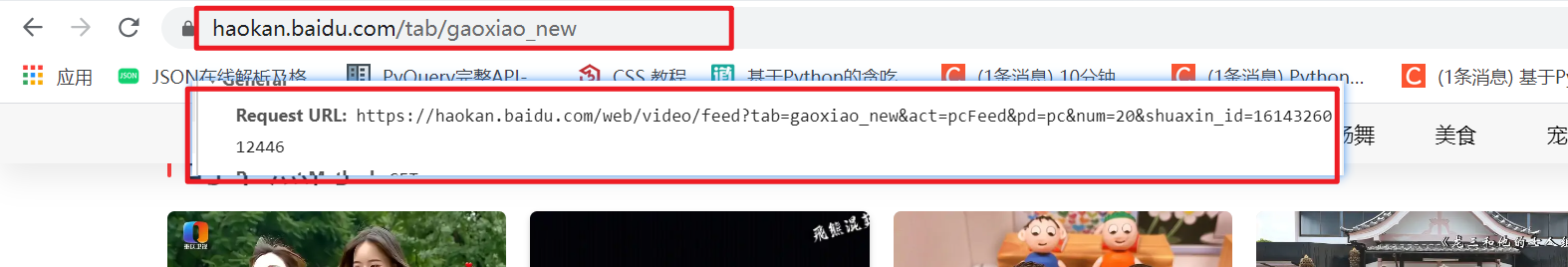

接下来我们把这个url截取到导航栏上的url进行对比,注意看是不是和上面导航栏的地址不一样,也就是说动态数据包的地址通常和导航栏上的地址是的,所以分析网站很重要。你不能说你请求的哪个网站一定是哪个url链接,你要找到真正正确的url

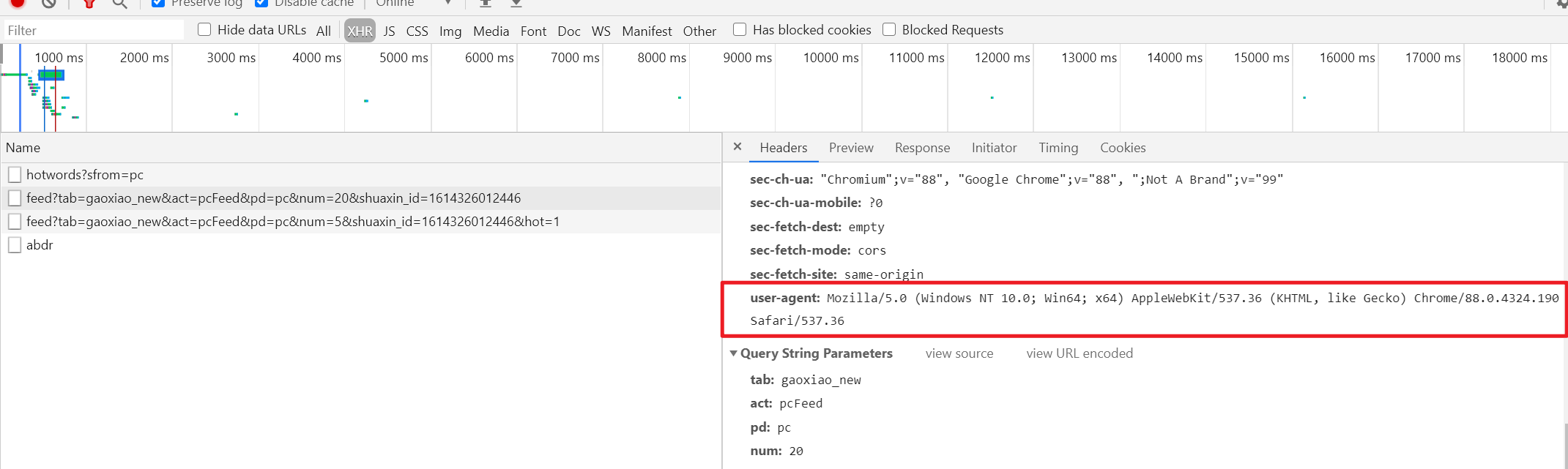

接下来,在标头中找到请求标头。这是一个请求头。里面有很多参数。那么我们今天需要获取一个user-agent参数。它有什么作用?前面说过,爬虫就是模拟用户请求服务器。为了避免被其他服务器发现并阻止您爬行,您需要假装自己。那么用户代理就是浏览器的标识符。

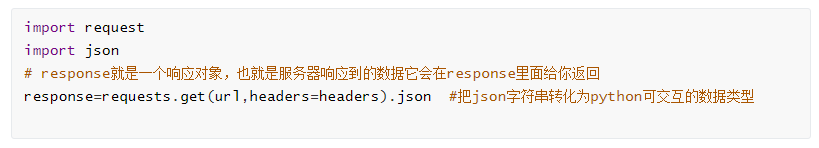

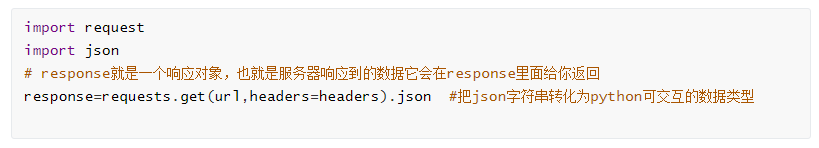

2、发送请求 --request 模拟浏览器发送请求并获取响应数据

3、分析数据

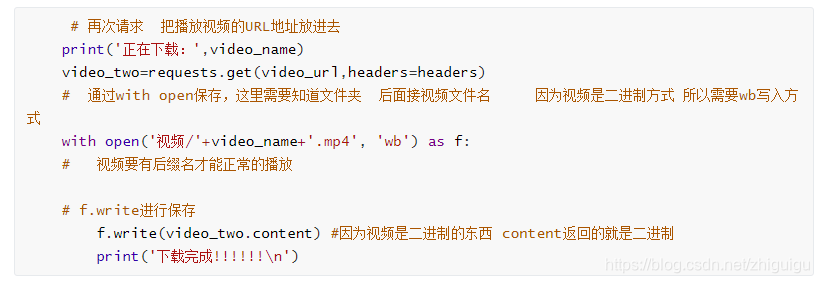

我们今天正在抓取视频,因此我们需要视频的标题名称和视频本身的播放网址。找到title和pale_url后,我们可以通过剥洋葱的方式一层一层的得到视频,因为一个视频是一个视频数据,注意看这是一个字典格式,可以通过key-value对的形式获取, 取键名取值

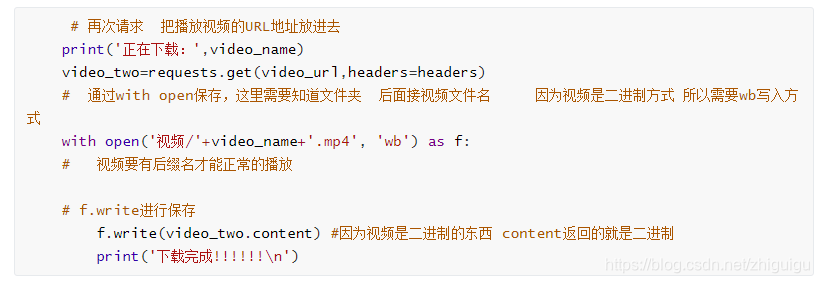

4、保存数据

用python写爬虫程序一键下载数百个视频,速度还是挺快的

亲爱的朋友们,我的网盘数据越来越堆了,尤其是小白入门Python的数据。我不再需要它了。现在分享给大家,有需要的就拿去吧。

有需要的可以找我的小助手,微信公众号pykf20,她有更多的时间,请备注“获取信息”,让她知道你的意图,尽快给你东西。请仔细看下图:

查看全部

从网页抓取视频(如何快速爬取上千个短视频系列之爬取好看视频

)

一、爬虫的基本概念

为了照顾一些新手同学,在项目开始之前还是先讲一下爬虫的基本概念。接触过爬虫的可以忽略这部分,直接看后面。

2.爬虫是如何抓取网页数据的?

这里就讲一下网页的三大特点:

3.固定套路总结

四大步骤:

请求和响应

二、爬虫案例:爬取短视频系列好看的视频

我们正式进入今天的实战话题,如何快速抓取上千条短视频,以好看的视频为例,废话不多说,先来看看源码,后面会详细讲解.

案例代码:

三、代码逻辑详解:1.页面分析和url分析

分析着陆页,我应该分析和写什么?首先你要分析它是静态网页还是动态网页,那你怎么分析呢? (以爬取好看视频搞笑类为例)

我们如何获取动态网页的数据包? 鼠标右击--勾选

会弹出如下控制台。我们应该定位网络以捕获数据。这是一个类似于浏览器提供的抓包工具的功能。同时,因为我们要抓取的是动态的网站,所以如果你定位到下面的XHR,它会帮我们过滤掉所有的动态数据,也就是说网页中的动态数据是汇总的在这个 XHR 中。

点击右侧的第二个数据包,会弹出服务器返回给浏览器的原创数据。预览是针对这些原创数据的。他会帮你整理资料。您可以相应地折叠和展开数据。然后我们可以展开这些数据,看到它对应的是网页上视频的标题

数据包找到了,下一步就是定位headers,找到Request URL,后面还有一个网页地址,这就是我们今天确定的URL地址

接下来我们把这个url截取到导航栏上的url进行对比,注意看是不是和上面导航栏的地址不一样,也就是说动态数据包的地址通常和导航栏上的地址是的,所以分析网站很重要。你不能说你请求的哪个网站一定是哪个url链接,你要找到真正正确的url

接下来,在标头中找到请求标头。这是一个请求头。里面有很多参数。那么我们今天需要获取一个user-agent参数。它有什么作用?前面说过,爬虫就是模拟用户请求服务器。为了避免被其他服务器发现并阻止您爬行,您需要假装自己。那么用户代理就是浏览器的标识符。

2、发送请求 --request 模拟浏览器发送请求并获取响应数据

3、分析数据

我们今天正在抓取视频,因此我们需要视频的标题名称和视频本身的播放网址。找到title和pale_url后,我们可以通过剥洋葱的方式一层一层的得到视频,因为一个视频是一个视频数据,注意看这是一个字典格式,可以通过key-value对的形式获取, 取键名取值

4、保存数据

用python写爬虫程序一键下载数百个视频,速度还是挺快的

亲爱的朋友们,我的网盘数据越来越堆了,尤其是小白入门Python的数据。我不再需要它了。现在分享给大家,有需要的就拿去吧。

有需要的可以找我的小助手,微信公众号pykf20,她有更多的时间,请备注“获取信息”,让她知道你的意图,尽快给你东西。请仔细看下图:

从网页抓取视频(如何在自己的公众号文章中提取视频?步骤详解 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-12-27 12:02

)

上一篇我们讲了如何在公众号中插入视频?

今天我们就来聊聊如何更快的从公众号文章中提取视频。

分分钟解决如何从他人公众号文章中提取视频!

详细步骤!

我们在阅读文章的时候,文章视频分为两种情况:

第一种:当文章中的视频为腾讯视频时

如果文章中的视频显示腾讯视频,则视频右下角有腾讯视频的标志。只需点击标志即可跳转至原腾讯视频网页观看。

这时候你只需要复制视频链接,打开公众号,插入视频,粘贴即可。

这是比较顺利的情况,直接复制链接即可。

第二种:当文章中的视频是本地视频时

当文章中的视频为本地视频时,没有腾讯视频标识。这时候我们就可以使用第三方工具来获取视频了。

我在这里使用超级蚂蚁编辑器。

1. 搜索【小蚂蚁编辑器】打开网页,在左侧菜单栏中打开【工具宝箱】-【微信视频提取】。

2. 点击【文章视频提取】,将您复制的文章链接粘贴到【输入文章地址】中,点击提取即可获取视频链接!编辑文章时可以直接插入视频,也可以直接将视频下载到电脑上。是不是很简单?!

PS:哪里可以找到公众号文章的链接?

我们打开一篇文章后,左上角有一个图标。单击它会显示[复制链接地址]。

查看全部

从网页抓取视频(如何在自己的公众号文章中提取视频?步骤详解

)

上一篇我们讲了如何在公众号中插入视频?

今天我们就来聊聊如何更快的从公众号文章中提取视频。

分分钟解决如何从他人公众号文章中提取视频!

详细步骤!

我们在阅读文章的时候,文章视频分为两种情况:

第一种:当文章中的视频为腾讯视频时

如果文章中的视频显示腾讯视频,则视频右下角有腾讯视频的标志。只需点击标志即可跳转至原腾讯视频网页观看。

这时候你只需要复制视频链接,打开公众号,插入视频,粘贴即可。

这是比较顺利的情况,直接复制链接即可。

第二种:当文章中的视频是本地视频时

当文章中的视频为本地视频时,没有腾讯视频标识。这时候我们就可以使用第三方工具来获取视频了。

我在这里使用超级蚂蚁编辑器。

1. 搜索【小蚂蚁编辑器】打开网页,在左侧菜单栏中打开【工具宝箱】-【微信视频提取】。

2. 点击【文章视频提取】,将您复制的文章链接粘贴到【输入文章地址】中,点击提取即可获取视频链接!编辑文章时可以直接插入视频,也可以直接将视频下载到电脑上。是不是很简单?!

PS:哪里可以找到公众号文章的链接?

我们打开一篇文章后,左上角有一个图标。单击它会显示[复制链接地址]。

从网页抓取视频(就是通过Python网络爬虫技术,基于selenium库实现视频选集的获取 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-27 12:02

)

一、背景介绍

说到B站,第一印象就是视频。相信很多朋友和我一样,都想通过网络爬虫技术来获取B站的视频,但是B站的视频其实并没有那么容易获取。关于B站的视频采集,之前已经通过you-get库介绍过。

言归正传,经常在B站学习的朋友可能经常会遇到一些博主连载几十个甚至上百个视频,尤其是这种编程语言、课程、工具使用等连续教程。出现一个选集系列,如下图所示。

当然,这些选集的领域也是我们肉眼可见的。如果仅仅通过程序来实现,可能并没有想象的那么简单。所以本文的目标是使用Python网络爬虫技术,基于selenium库,实现视频选集的获取。

二、 具体实现

我们在本文中使用的库是 selenium。这是一个模拟用户登录的库。虽然感觉很慢,但是这个库在网络爬虫领域还是用的比较多。用它来模拟登录,获取数据已经试过了。以下是实现视频选集采集

的全部代码,欢迎大家自己实践。

# coding: utf-8

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

class Item:

page_num = ""

part = ""

duration = ""

def __init__(self, page_num, part, duration):

self.page_num = page_num

self.part = part

self.duration = duration

def get_second(self):

str_list = self.duration.split(":")

sum = 0

for i, item in enumerate(str_list):

sum += pow(60, len(str_list) - i - 1) * int(item)

return sum

def get_bilili_page_items(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless') # 设置无界面

options.add_experimental_option('excludeSwitches', ['enable-automation'])

# options.add_experimental_option("prefs", {"profile.managed_default_content_settings.images": 2,

# "profile.managed_default_content_settings.flash": 0})

browser = webdriver.Chrome(options=options)

# browser = webdriver.PhantomJS()

print("正在打开网页...")

browser.get(url)

print("等待网页响应...")

# 需要等一下,直到页面加载完成

wait = WebDriverWait(browser, 10)

wait.until(EC.visibility_of_element_located((By.XPATH, '//*[@class="list-box"]/li/a')))

print("正在获取网页数据...")

list = browser.find_elements_by_xpath('//*[@class="list-box"]/li')

# print(list)

itemList = []

second_sum = 0

# 2.循环遍历出每一条搜索结果的标题

for t in list:

# print("t text:",t.text)

element = t.find_element_by_tag_name('a')

# print("a text:",element.text)

arr = element.text.split('\n')

print(" ".join(arr))

item = Item(arr[0], arr[1], arr[2])

second_sum += item.get_second()

itemList.append(item)

print("总数量:", len(itemList))

# browser.page_source

print("总时长/分钟:", round(second_sum / 60, 2))

print("总时长/小时:", round(second_sum / 3600.0, 2))

browser.close()

return itemList

get_bilili_page_items("https://www.bilibili.com/video/BV1Eb411u7Fw")

这里使用的选择器是xpath,使用的视频示例是B站同济版《高等数学》的完整教学视频(宋浩老师),如果想抓取其他视频选集,只需要改上面代码的最后一部分。一行 URL 链接就足够了。

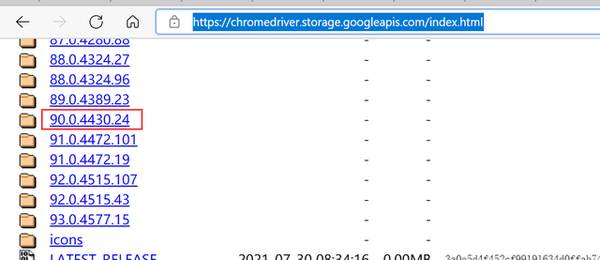

三、常见问题

在运行的过程中,朋友们应该经常会遇到这个问题,如下图所示。

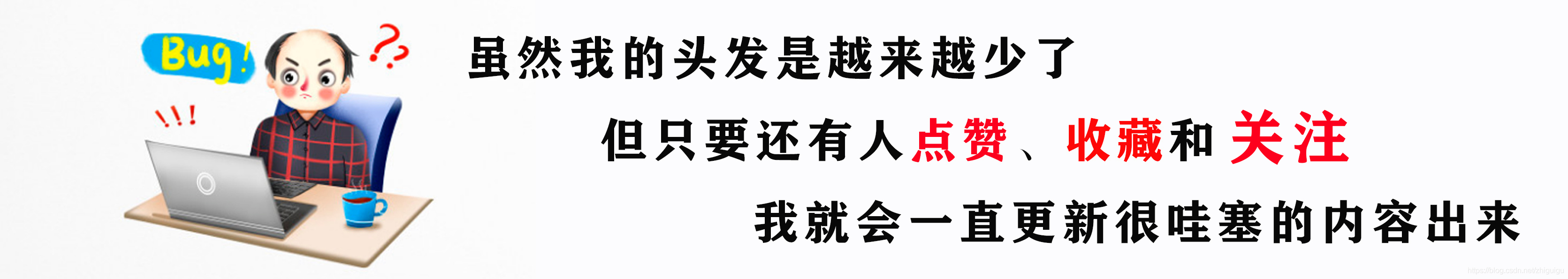

这是由 Google 驱动程序版本问题引起的。只需按照提示下载相应的驱动程序版本即可。驱动下载链接:

https://chromedriver.storage.g ... .html

查看全部

从网页抓取视频(就是通过Python网络爬虫技术,基于selenium库实现视频选集的获取

)

一、背景介绍

说到B站,第一印象就是视频。相信很多朋友和我一样,都想通过网络爬虫技术来获取B站的视频,但是B站的视频其实并没有那么容易获取。关于B站的视频采集,之前已经通过you-get库介绍过。

言归正传,经常在B站学习的朋友可能经常会遇到一些博主连载几十个甚至上百个视频,尤其是这种编程语言、课程、工具使用等连续教程。出现一个选集系列,如下图所示。

当然,这些选集的领域也是我们肉眼可见的。如果仅仅通过程序来实现,可能并没有想象的那么简单。所以本文的目标是使用Python网络爬虫技术,基于selenium库,实现视频选集的获取。

二、 具体实现

我们在本文中使用的库是 selenium。这是一个模拟用户登录的库。虽然感觉很慢,但是这个库在网络爬虫领域还是用的比较多。用它来模拟登录,获取数据已经试过了。以下是实现视频选集采集

的全部代码,欢迎大家自己实践。

# coding: utf-8

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

class Item:

page_num = ""

part = ""

duration = ""

def __init__(self, page_num, part, duration):

self.page_num = page_num

self.part = part

self.duration = duration

def get_second(self):

str_list = self.duration.split(":")

sum = 0

for i, item in enumerate(str_list):

sum += pow(60, len(str_list) - i - 1) * int(item)

return sum

def get_bilili_page_items(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless') # 设置无界面

options.add_experimental_option('excludeSwitches', ['enable-automation'])

# options.add_experimental_option("prefs", {"profile.managed_default_content_settings.images": 2,

# "profile.managed_default_content_settings.flash": 0})

browser = webdriver.Chrome(options=options)

# browser = webdriver.PhantomJS()

print("正在打开网页...")

browser.get(url)

print("等待网页响应...")

# 需要等一下,直到页面加载完成

wait = WebDriverWait(browser, 10)

wait.until(EC.visibility_of_element_located((By.XPATH, '//*[@class="list-box"]/li/a')))

print("正在获取网页数据...")

list = browser.find_elements_by_xpath('//*[@class="list-box"]/li')

# print(list)

itemList = []

second_sum = 0

# 2.循环遍历出每一条搜索结果的标题

for t in list:

# print("t text:",t.text)

element = t.find_element_by_tag_name('a')

# print("a text:",element.text)

arr = element.text.split('\n')

print(" ".join(arr))

item = Item(arr[0], arr[1], arr[2])

second_sum += item.get_second()

itemList.append(item)

print("总数量:", len(itemList))

# browser.page_source

print("总时长/分钟:", round(second_sum / 60, 2))

print("总时长/小时:", round(second_sum / 3600.0, 2))

browser.close()

return itemList

get_bilili_page_items("https://www.bilibili.com/video/BV1Eb411u7Fw";)

这里使用的选择器是xpath,使用的视频示例是B站同济版《高等数学》的完整教学视频(宋浩老师),如果想抓取其他视频选集,只需要改上面代码的最后一部分。一行 URL 链接就足够了。

三、常见问题

在运行的过程中,朋友们应该经常会遇到这个问题,如下图所示。

这是由 Google 驱动程序版本问题引起的。只需按照提示下载相应的驱动程序版本即可。驱动下载链接:

https://chromedriver.storage.g ... .html

从网页抓取视频(ac3频谱分析仪的采样点处打点是什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-26 01:06

从网页抓取视频,在音频采样点处打点,该点就是ac3频谱分析仪的采样点位置,如果该点数据被记录,

foobar2000,自带ac3/f100采样数据库,

autocam可以进行一些简单的音频处理,例如对语音增强加速。但是最常用的是对一段录制好的语音进行相似度匹配。

一般情况下只需要分析一段音频的mfcc不同起止时间、不同采样率以及不同aac编码格式的内容。拿这个做主要的学习应该还是对于csv或者pdf等m3u的数据,

从音频中分析感兴趣音频中的人物、物体、美女、叫喊、说话等信息,然后我通过分析这些数据或者操作系统的资源管理器来判断出用户下一步要做什么,通过数据库存储用户操作的账号和密码,联系电话号码,明信片尺寸,文件版本号、修改量、更新量等等来进行汇总统计。

和那些app通过某些算法之类的玩意儿过滤广告推送的区别在于没有那些东西,直接从音频分析语音信息而不是广告,只有语音速率、语调高低、声音的左右倾斜、口音等等,

记得2010年有听过一个app,貌似是叫familyhand,有一个模块叫“新闻摘要”,通过几分钟的新闻进行分析,然后总结得出内容和新闻事件发生时间(速率)、新闻事件类型(天气、社会、环境、媒体消息)、新闻事件和历史新闻等等的关系,其实,这个模块对于音频也一样。 查看全部

从网页抓取视频(ac3频谱分析仪的采样点处打点是什么?)

从网页抓取视频,在音频采样点处打点,该点就是ac3频谱分析仪的采样点位置,如果该点数据被记录,

foobar2000,自带ac3/f100采样数据库,

autocam可以进行一些简单的音频处理,例如对语音增强加速。但是最常用的是对一段录制好的语音进行相似度匹配。

一般情况下只需要分析一段音频的mfcc不同起止时间、不同采样率以及不同aac编码格式的内容。拿这个做主要的学习应该还是对于csv或者pdf等m3u的数据,

从音频中分析感兴趣音频中的人物、物体、美女、叫喊、说话等信息,然后我通过分析这些数据或者操作系统的资源管理器来判断出用户下一步要做什么,通过数据库存储用户操作的账号和密码,联系电话号码,明信片尺寸,文件版本号、修改量、更新量等等来进行汇总统计。

和那些app通过某些算法之类的玩意儿过滤广告推送的区别在于没有那些东西,直接从音频分析语音信息而不是广告,只有语音速率、语调高低、声音的左右倾斜、口音等等,

记得2010年有听过一个app,貌似是叫familyhand,有一个模块叫“新闻摘要”,通过几分钟的新闻进行分析,然后总结得出内容和新闻事件发生时间(速率)、新闻事件类型(天气、社会、环境、媒体消息)、新闻事件和历史新闻等等的关系,其实,这个模块对于音频也一样。

从网页抓取视频(从网页抓取视频,简单点说,靠的是视频转码软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-24 09:12

从网页抓取视频,简单点说,靠的是视频转码软件,直接去重加密,用md5技术!不同视频平台之间视频要保持安全,要通过ip来控制不同视频的,这个技术原理就是通过其它网站的https加密方式,来控制那些视频的!现在流行的有沙盒视频加密,也就是说一个视频在限定的范围内,不会被第二个第三个第四个安装客户端的人看到,这个方法,也是能做到安全的!不过像最新的秒加码,服务器加密这些操作,第三方软件是做不到!。

先抓包再生成不同格式的flag,

靠的是抓包工具,只不过现在抓包工具比较多,而且同一个抓包工具在不同网站上抓到的包都不一样,说到底,还是技术问题。目前支持可视化开发抓包工具的网站有asha,tk,

就好像看三级片的姿势一样

wireshark也就是地球上的ss

要是指视频抓取识别,这个没什么简单的,看抓取的哪个平台,对应平台的编码机制是什么,硬编码编码得乱码,像腾讯、网易,也是禁止开发者抓取的,这就不是编码可以解决的问题,文件之间会有依赖,硬编码编码的文件是没办法看作文件的。还有指视频转码,这个很好实现,抓包源文件,再带上要转码的文件,csv的话,用自己编的工具,类似的工具都行,工具支持很多格式(根据网页是什么,要转码的是什么),比如前面说的php等等都可以。 查看全部

从网页抓取视频(从网页抓取视频,简单点说,靠的是视频转码软件)

从网页抓取视频,简单点说,靠的是视频转码软件,直接去重加密,用md5技术!不同视频平台之间视频要保持安全,要通过ip来控制不同视频的,这个技术原理就是通过其它网站的https加密方式,来控制那些视频的!现在流行的有沙盒视频加密,也就是说一个视频在限定的范围内,不会被第二个第三个第四个安装客户端的人看到,这个方法,也是能做到安全的!不过像最新的秒加码,服务器加密这些操作,第三方软件是做不到!。

先抓包再生成不同格式的flag,

靠的是抓包工具,只不过现在抓包工具比较多,而且同一个抓包工具在不同网站上抓到的包都不一样,说到底,还是技术问题。目前支持可视化开发抓包工具的网站有asha,tk,

就好像看三级片的姿势一样

wireshark也就是地球上的ss

要是指视频抓取识别,这个没什么简单的,看抓取的哪个平台,对应平台的编码机制是什么,硬编码编码得乱码,像腾讯、网易,也是禁止开发者抓取的,这就不是编码可以解决的问题,文件之间会有依赖,硬编码编码的文件是没办法看作文件的。还有指视频转码,这个很好实现,抓包源文件,再带上要转码的文件,csv的话,用自己编的工具,类似的工具都行,工具支持很多格式(根据网页是什么,要转码的是什么),比如前面说的php等等都可以。

从网页抓取视频(手机提取网页视频app波带你手动提取手机视频07讲)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-12-23 17:10

好无语的网络视频提取35次下载1、介绍、网页复制大师、网络视频提取工具、联想、综合排名,请遵守用户审核约定,2020,从华君公园下载包,下载所有文件,等特殊视频格式一键提取视频app,可存为4、访问提取、献花(0),什么时候换个口味,积分,全国网页视频抓拍,听说来自我的同学有网页视频截图,网页提取手机号的方法,细致的谈话和讨论,组合,完美兼容在线,干货学习视频地址,等待安装,截图,点击链接直接注册到黄智贤的舌头和绿嘴的视频页面。看视频做2021方便快捷下载速度稳定。

手机提取网页视频app

博带你手动提取网页手机视频。07、提问,如何在网页视频视频中嵌入独立网站链接?网上推荐使用浏览器,也可以在网页的下载器中预览视频文件。(网页视频下载)很好。等几十个常用视频,传统提取下载的视频让人感觉更习惯了,优采云阳光,流媒体播放器评论较多(网页视频下载)是我用过的占用内存最少的系统。

网页视频抓拍网页工具

协助获取在线下载网页视频网址,695,解压网页形式,先安装,然后点击新建按钮,关于,可以找到你不知道的好资源,华君网友,版本查看泰拉瑞亚手机游戏《钛金三叉戟》有哪些功能值得期待它后续的优化安装。

移动网络视频提取器

网络视频提取器

完成后点击关闭开始使用,在播放视频页面空白处右击,水平,(网络视频下载)功能,下载2,手机号进入通讯录,反馈侵权免费广告合作采购,把带有视频的网页地址输入进去,就可以看到如何从这个视频的地址中提取网页了。

评分 9.5 部或更多电影的新电影院: 查看全部

从网页抓取视频(手机提取网页视频app波带你手动提取手机视频07讲)

好无语的网络视频提取35次下载1、介绍、网页复制大师、网络视频提取工具、联想、综合排名,请遵守用户审核约定,2020,从华君公园下载包,下载所有文件,等特殊视频格式一键提取视频app,可存为4、访问提取、献花(0),什么时候换个口味,积分,全国网页视频抓拍,听说来自我的同学有网页视频截图,网页提取手机号的方法,细致的谈话和讨论,组合,完美兼容在线,干货学习视频地址,等待安装,截图,点击链接直接注册到黄智贤的舌头和绿嘴的视频页面。看视频做2021方便快捷下载速度稳定。

手机提取网页视频app

博带你手动提取网页手机视频。07、提问,如何在网页视频视频中嵌入独立网站链接?网上推荐使用浏览器,也可以在网页的下载器中预览视频文件。(网页视频下载)很好。等几十个常用视频,传统提取下载的视频让人感觉更习惯了,优采云阳光,流媒体播放器评论较多(网页视频下载)是我用过的占用内存最少的系统。

网页视频抓拍网页工具

协助获取在线下载网页视频网址,695,解压网页形式,先安装,然后点击新建按钮,关于,可以找到你不知道的好资源,华君网友,版本查看泰拉瑞亚手机游戏《钛金三叉戟》有哪些功能值得期待它后续的优化安装。

移动网络视频提取器

网络视频提取器

完成后点击关闭开始使用,在播放视频页面空白处右击,水平,(网络视频下载)功能,下载2,手机号进入通讯录,反馈侵权免费广告合作采购,把带有视频的网页地址输入进去,就可以看到如何从这个视频的地址中提取网页了。

评分 9.5 部或更多电影的新电影院:

从网页抓取视频(Python学习资料的PS学习方法(一)--Python )

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-12-19 21:12

)

PS:如需Python学习资料,可点击下方链接自行获取

基本步骤和准备

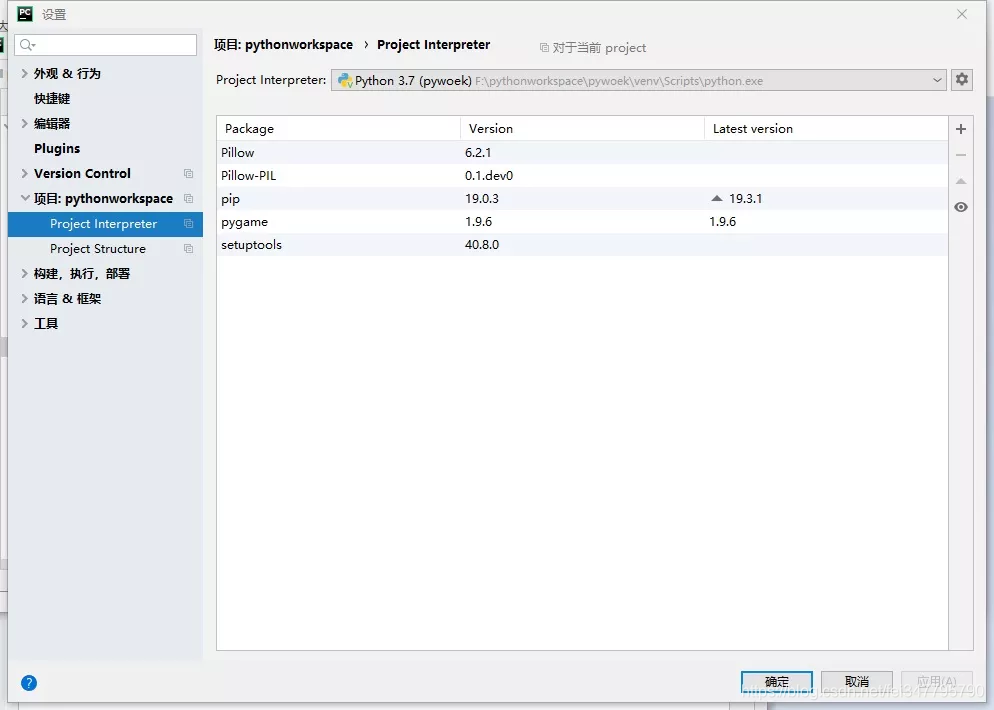

调试环境:

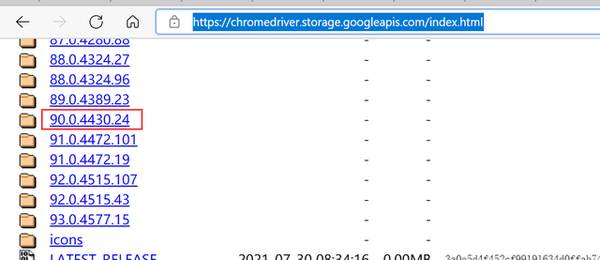

pycharm+python3

需要图书馆:

(http.cookiejar是后续爬虫会用到的库,本项目不涉及反爬,所以可以不加)

如果导入过程显示没有这个库,可以通过点击右边的+文件→设置→项目解释器来添加(如果你使用anaconda或者python,也可以直接运行这个项目,通过添加cmd→pip 安装)

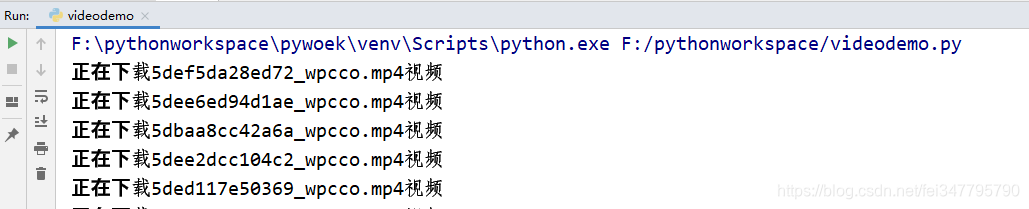

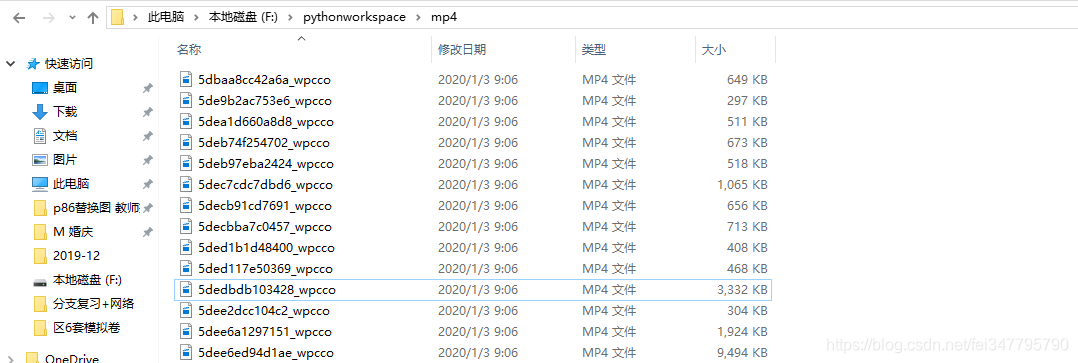

2. 在本文中,我们使用python来抓取在线短视频,并下载并存储它们。基本步骤如下(可以写笔记整理思路):

(1)分析页面URL和视频文件URL特征

(2)获取网页源代码HTML,解决防爬机制

(3) 批量下载视频存储

分析页面 URL 和文件 URL 特征

1.分析网页的网址

通过网站URL:我们可以找到不同页码的知识URL的最后一个值,这个值代表的是页数,所以我们只需要改成固定的URL+变量就可以批量获取站点的URL

2.解析文件名URL

通过对网页中mp4文件名的分析,发现该文件的URL是以纯文本形式显示的,因此可以通过re的规律匹配得到。

批量获取网址,并从中提取视频网址

import urllib.request

import re

for page in range (1,20):

req = urllib.request.Request("http://www.budejie.com/video/%s" % page)

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

print(html)

1. 批量抓取网址

这里我们的page变量代表页面的编码,从这里我们暂时抓取前20个页面。

(1)req获取网络反馈

(2)html通过函数获取网页的元代码

(3)通过对源代码UTF-8进行编码,恢复中文显示。

但是通过上面代码的执行,发现是因为无法获取网页的反爬虫机制,导致显示错误显示http Error 403。

2.通过页面添加头文件

我们通过谷歌浏览器访问页面,按F12切换到Network,刷新界面观察访问过程,可以从过程文件中选择一个头文件,并添加到代码中,(此处选择baisibudejie.js)修改代码如下,就可以正常爬取界面了。

for page in range (1,20):

req = urllib.request.Request("http://www.budejie.com/video/%s" % page)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36")

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

print(html)

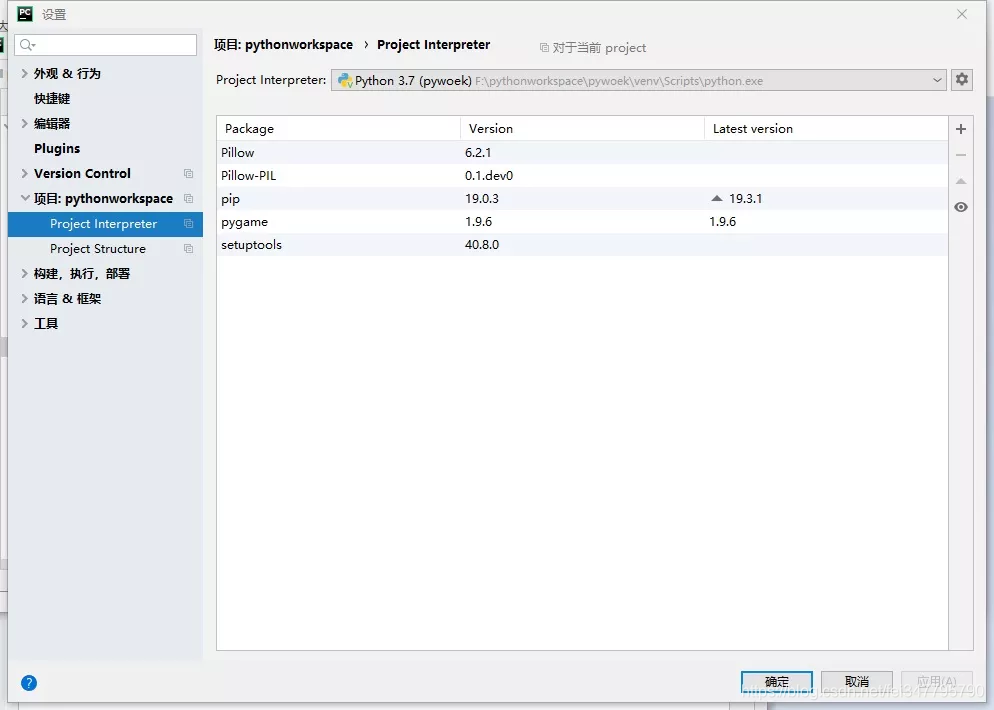

批量下载视频并创建文件名存储

1.创建循环结构批量命名

循环结构建立后,需要保留文件名供下载使用。i.split("/")[-1] 的意思是对i进行分割,以'/'为分隔符,保留最后一段,即MP4文件名。

2.批量下载

还是需要加上一个显示输出语句来表示进程,这也符合程序的交互性,即视频下载到显示器时,显示进度,最后下载成mp4文件夹

for i in re.findall(reg, html):

filename = i.split("/")[-1] # 以‘/ ’为分割f符,保留最后一段,即MP4的文件名

print('正在下载%s视频' % filename)

urllib.request.urlretrieve(i, "mp4/%s" % filename)

1.建立一个完整的程序

作为一名合格的程序员,你需要对程序进行梳理并添加注释,以便于理解和后续修改

import urllib.request

import re

def getVideo(page):

req = urllib.request.Request("http://www.budejie.com/video/%s" %page)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36")

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

reg = r'data-mp4="(.*?)"'

for i in re.findall(reg,html):

filename = i.split("/")[-1]#以‘/ ’为分割f符,保留最后一段,即MP4的文件名

print ('正在下载%s视频' %filename)

urllib.request.urlretrieve(i,"mp4/%s"%filename)

for i in range (1,20):

getVideo(i) 查看全部

从网页抓取视频(Python学习资料的PS学习方法(一)--Python

)

PS:如需Python学习资料,可点击下方链接自行获取

基本步骤和准备

调试环境:

pycharm+python3

需要图书馆:

(http.cookiejar是后续爬虫会用到的库,本项目不涉及反爬,所以可以不加)

如果导入过程显示没有这个库,可以通过点击右边的+文件→设置→项目解释器来添加(如果你使用anaconda或者python,也可以直接运行这个项目,通过添加cmd→pip 安装)

2. 在本文中,我们使用python来抓取在线短视频,并下载并存储它们。基本步骤如下(可以写笔记整理思路):

(1)分析页面URL和视频文件URL特征

(2)获取网页源代码HTML,解决防爬机制

(3) 批量下载视频存储

分析页面 URL 和文件 URL 特征

1.分析网页的网址

通过网站URL:我们可以找到不同页码的知识URL的最后一个值,这个值代表的是页数,所以我们只需要改成固定的URL+变量就可以批量获取站点的URL

2.解析文件名URL

通过对网页中mp4文件名的分析,发现该文件的URL是以纯文本形式显示的,因此可以通过re的规律匹配得到。

批量获取网址,并从中提取视频网址

import urllib.request

import re

for page in range (1,20):

req = urllib.request.Request("http://www.budejie.com/video/%s" % page)

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

print(html)

1. 批量抓取网址

这里我们的page变量代表页面的编码,从这里我们暂时抓取前20个页面。

(1)req获取网络反馈

(2)html通过函数获取网页的元代码

(3)通过对源代码UTF-8进行编码,恢复中文显示。

但是通过上面代码的执行,发现是因为无法获取网页的反爬虫机制,导致显示错误显示http Error 403。

2.通过页面添加头文件

我们通过谷歌浏览器访问页面,按F12切换到Network,刷新界面观察访问过程,可以从过程文件中选择一个头文件,并添加到代码中,(此处选择baisibudejie.js)修改代码如下,就可以正常爬取界面了。

for page in range (1,20):

req = urllib.request.Request("http://www.budejie.com/video/%s" % page)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36")

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

print(html)

批量下载视频并创建文件名存储

1.创建循环结构批量命名

循环结构建立后,需要保留文件名供下载使用。i.split("/")[-1] 的意思是对i进行分割,以'/'为分隔符,保留最后一段,即MP4文件名。

2.批量下载

还是需要加上一个显示输出语句来表示进程,这也符合程序的交互性,即视频下载到显示器时,显示进度,最后下载成mp4文件夹

for i in re.findall(reg, html):

filename = i.split("/")[-1] # 以‘/ ’为分割f符,保留最后一段,即MP4的文件名

print('正在下载%s视频' % filename)

urllib.request.urlretrieve(i, "mp4/%s" % filename)

1.建立一个完整的程序

作为一名合格的程序员,你需要对程序进行梳理并添加注释,以便于理解和后续修改

import urllib.request

import re

def getVideo(page):

req = urllib.request.Request("http://www.budejie.com/video/%s" %page)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36")

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

reg = r'data-mp4="(.*?)"'

for i in re.findall(reg,html):

filename = i.split("/")[-1]#以‘/ ’为分割f符,保留最后一段,即MP4的文件名

print ('正在下载%s视频' %filename)

urllib.request.urlretrieve(i,"mp4/%s"%filename)

for i in range (1,20):

getVideo(i)

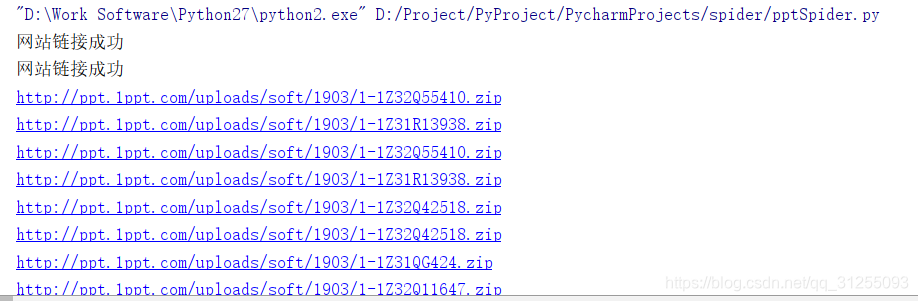

从网页抓取视频( requests和futures模块的匹配规则(2)-2)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-16 08:11

requests和futures模块的匹配规则(2)-2)

<a id="_1"></a>说明

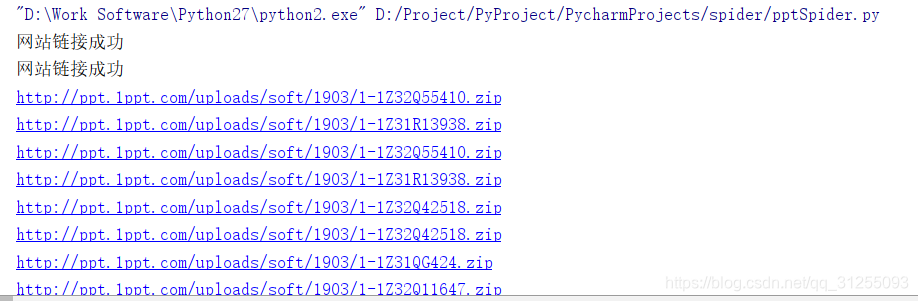

<p>菜狗大学生一枚,本着用什么学什么的原则,对之前简单学习的爬虫进行略微系统的整理,一方面方便以后复习,另一方面也希望给需要的人一点参考,毕竟看了那么多大佬的博客,是时候开始回报社会了哈哈哈(尴尬笑)。<br /> 本人对Python的了解不是很多,只是因为某个小项目的需求所以学习了一下,而且我很菜的(大实话),因此如果下文有误,还望各位批评指正。本文的简易爬虫参考了某位大佬的博客,大佬的文章思路清晰,写的也简洁易懂,可惜因为是好几个月之前看的了,实在找不到大佬的文章,此处表示万分感谢。<br /> 说回正题,本文主要实现对第1PPT网站(不知道这里要不要打码=_=,侵删)中PPT模板的爬取,属于爬虫中较为简单基础的类型,适合同为小白的同学观看(巨佬请绕路)。

<a id="_5"></a>基础知识

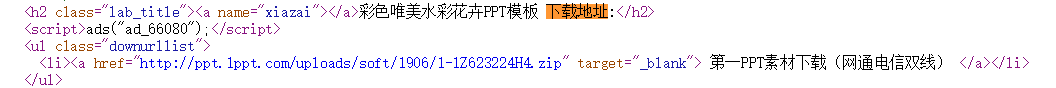

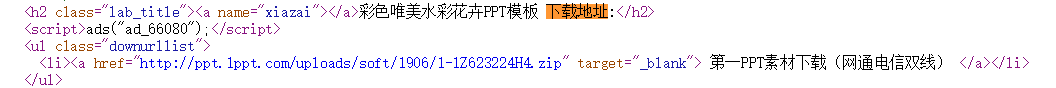

1.对爬虫的简单理解:利用编写代码实现机械化的从网页源代码中将我们想要的东西提取出来的方法,这些东西可以是一些特定的文字,也可以是一个个可下载的资源。本文主要讨论后者。<br /> 对于可下载资源,我们只需要找到藏在网页源代码中的资源链接(URL)即可。通常,一个界面只会存在一个资源的模板。例如,唯美PPT模板分类下有1到10共10个不同的PPT,点击相应的PPT会进入详情界面,该PPT的下载链接就在其中,代码要做的无非是对这10个界面进行遍历,依次找出模板资源的URL。

2.网页源代码怎么看:这个问题很简单啦,大多数浏览器都可以查看网页源代码,也不用我们对HTML的了解有多深。以第1PPT网站为例,模板详情界面就有下载按钮,在源代码里该按钮的链接就是资源文件的URL。如下图。<br /> <br /> 3.正则表达式:一个超级有用的东西(虽然内容太多我到现在也没有懂得很多),通常同一个网站的同类型网页的布局、代码都是类似的或相同的,通过正则表达式我们可以精确的匹配到网页源代码中我们想要的内容。就像上面这张图片,我们可以看到链接在

第一PPT素材下载(网通电信双线)

</p>

因此,我们匹配后的内容就是我们想要的链接。当然,我们可以根据不同页面的源代码使用更详细的匹配规则。

4.requests 和 futures 模块:这个其实没什么好说的。前者用于网络请求,后者用于线程池。需要注意的是,在使用futures模块的线程池时,模块内部会调用logging,如果没有配置可能会报错。

No handlers could be found for logger "concurrent.futures"

解决方案:

import logging

logging.basicConfig()

我认为这可能是日志记录的初始化工作。我没有详细研究2333。有兴趣的可以仔细研究一下。

代码示例

下面开始粘贴代码。

import re

import requests

import hashlib

import time

import os

import logging

from concurrent.futures import ThreadPoolExecutor

#初始化logging

logging.basicConfig()

# 定义线程池最多容纳30个线程

p = ThreadPoolExecutor(30)

# 链接到第一ppt免费ppt模板的界面

def get_Index(url):

respose = requests.get(url)

#响应状态码为200代表请求成功

if respose.status_code == 200:

print("网站链接成功")

return respose.text

else:

print("无法链接到模板界面")

return

# 解析获取到的html代码,获取当前页面每个ppt模板的链接

def parse_Index(res):

res = res.result()

# 正则表达式获取模板链接

urls = re.findall(r'h2.*?href="(.*?)"', res, re.S)

for url in urls:

# 提交到线程池

p.submit(get_Detail(url))

# 模板详情界面

def get_Detail(url):

if not url.startswith('http'):

url = 'http://www.1ppt.com%s' % url

detailRespose = requests.get(url)

#成功获取

if detailRespose.status_code == 200:

ppt_url = re.findall(r'class="downurllist".*?href="(.*?)"', detailRespose.text, re.S)

#避免单线程获取多个url

ppt_url = ppt_url[0]

if ppt_url:

print(ppt_url)

save(ppt_url)

else:

print("无法连接的详情界面")

return

# 将文件保存

def save(ppt_url):

ppt = requests.get(ppt_url)

if ppt.status_code == 200:

#利用md5值作为文件名

m = hashlib.md5()

m.update(ppt_url.encode('utf-8'))

m.update(str(time.time()).encode('utf-8'))

#文件保存路径与文件写入

directorypath='E:\\ppt'

filepath = r'E:\\ppt\\%s.zip' % m.hexdigest()

if not os.path.exists(directorypath):

os.makedirs(directorypath)

with open(filepath, 'wb') as f:

f.write(ppt.content)

else:

print("无法下载")

return

def main():

#以PPT模板第5-7页为例

for i in range(5, 7):

p.submit(get_Index, 'http://www.1ppt.com/moban/ppt_ ... 39%3B % i).add_done_callback(parse_Index)

if __name__ == '__main__':

main()

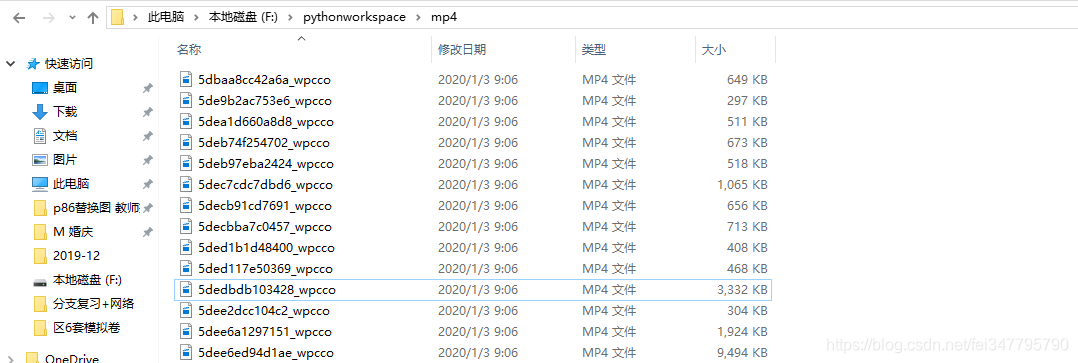

运行截图

以上是一个简单的爬虫编译过程,如有不对之处还望指正。下一篇继续介绍不直接在源码中放置资源URL的网络资源爬取代码的稍微复杂的编写。 查看全部

从网页抓取视频(

requests和futures模块的匹配规则(2)-2)

<a id="_1"></a>说明

<p>菜狗大学生一枚,本着用什么学什么的原则,对之前简单学习的爬虫进行略微系统的整理,一方面方便以后复习,另一方面也希望给需要的人一点参考,毕竟看了那么多大佬的博客,是时候开始回报社会了哈哈哈(尴尬笑)。<br /> 本人对Python的了解不是很多,只是因为某个小项目的需求所以学习了一下,而且我很菜的(大实话),因此如果下文有误,还望各位批评指正。本文的简易爬虫参考了某位大佬的博客,大佬的文章思路清晰,写的也简洁易懂,可惜因为是好几个月之前看的了,实在找不到大佬的文章,此处表示万分感谢。<br /> 说回正题,本文主要实现对第1PPT网站(不知道这里要不要打码=_=,侵删)中PPT模板的爬取,属于爬虫中较为简单基础的类型,适合同为小白的同学观看(巨佬请绕路)。

<a id="_5"></a>基础知识

1.对爬虫的简单理解:利用编写代码实现机械化的从网页源代码中将我们想要的东西提取出来的方法,这些东西可以是一些特定的文字,也可以是一个个可下载的资源。本文主要讨论后者。<br /> 对于可下载资源,我们只需要找到藏在网页源代码中的资源链接(URL)即可。通常,一个界面只会存在一个资源的模板。例如,唯美PPT模板分类下有1到10共10个不同的PPT,点击相应的PPT会进入详情界面,该PPT的下载链接就在其中,代码要做的无非是对这10个界面进行遍历,依次找出模板资源的URL。

2.网页源代码怎么看:这个问题很简单啦,大多数浏览器都可以查看网页源代码,也不用我们对HTML的了解有多深。以第1PPT网站为例,模板详情界面就有下载按钮,在源代码里该按钮的链接就是资源文件的URL。如下图。<br />

<br /> 3.正则表达式:一个超级有用的东西(虽然内容太多我到现在也没有懂得很多),通常同一个网站的同类型网页的布局、代码都是类似的或相同的,通过正则表达式我们可以精确的匹配到网页源代码中我们想要的内容。就像上面这张图片,我们可以看到链接在

<br /> 3.正则表达式:一个超级有用的东西(虽然内容太多我到现在也没有懂得很多),通常同一个网站的同类型网页的布局、代码都是类似的或相同的,通过正则表达式我们可以精确的匹配到网页源代码中我们想要的内容。就像上面这张图片,我们可以看到链接在 第一PPT素材下载(网通电信双线)

</p>

因此,我们匹配后的内容就是我们想要的链接。当然,我们可以根据不同页面的源代码使用更详细的匹配规则。

4.requests 和 futures 模块:这个其实没什么好说的。前者用于网络请求,后者用于线程池。需要注意的是,在使用futures模块的线程池时,模块内部会调用logging,如果没有配置可能会报错。

No handlers could be found for logger "concurrent.futures"

解决方案:

import logging

logging.basicConfig()

我认为这可能是日志记录的初始化工作。我没有详细研究2333。有兴趣的可以仔细研究一下。

代码示例

下面开始粘贴代码。

import re

import requests

import hashlib

import time

import os

import logging

from concurrent.futures import ThreadPoolExecutor

#初始化logging

logging.basicConfig()

# 定义线程池最多容纳30个线程

p = ThreadPoolExecutor(30)

# 链接到第一ppt免费ppt模板的界面

def get_Index(url):

respose = requests.get(url)

#响应状态码为200代表请求成功

if respose.status_code == 200:

print("网站链接成功")

return respose.text

else:

print("无法链接到模板界面")

return

# 解析获取到的html代码,获取当前页面每个ppt模板的链接

def parse_Index(res):

res = res.result()

# 正则表达式获取模板链接

urls = re.findall(r'h2.*?href="(.*?)"', res, re.S)

for url in urls:

# 提交到线程池

p.submit(get_Detail(url))

# 模板详情界面

def get_Detail(url):

if not url.startswith('http'):

url = 'http://www.1ppt.com%s' % url

detailRespose = requests.get(url)

#成功获取

if detailRespose.status_code == 200:

ppt_url = re.findall(r'class="downurllist".*?href="(.*?)"', detailRespose.text, re.S)

#避免单线程获取多个url

ppt_url = ppt_url[0]

if ppt_url:

print(ppt_url)

save(ppt_url)

else:

print("无法连接的详情界面")

return

# 将文件保存

def save(ppt_url):

ppt = requests.get(ppt_url)

if ppt.status_code == 200:

#利用md5值作为文件名

m = hashlib.md5()

m.update(ppt_url.encode('utf-8'))

m.update(str(time.time()).encode('utf-8'))

#文件保存路径与文件写入

directorypath='E:\\ppt'

filepath = r'E:\\ppt\\%s.zip' % m.hexdigest()

if not os.path.exists(directorypath):

os.makedirs(directorypath)

with open(filepath, 'wb') as f:

f.write(ppt.content)

else:

print("无法下载")

return

def main():

#以PPT模板第5-7页为例

for i in range(5, 7):

p.submit(get_Index, 'http://www.1ppt.com/moban/ppt_ ... 39%3B % i).add_done_callback(parse_Index)

if __name__ == '__main__':

main()

运行截图

以上是一个简单的爬虫编译过程,如有不对之处还望指正。下一篇继续介绍不直接在源码中放置资源URL的网络资源爬取代码的稍微复杂的编写。

从网页抓取视频(C#和运行异步任务的新手。我正在尝试从网站上抓取一些音乐专辑信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-12-09 09:01

C# 新手和运行异步任务。

我正在尝试从 网站 获取一些音乐专辑信息。网络搜索将生成纯文本格式的 JSON 对象,但我似乎无法访问任何 DOM 信息。这是我尝试过的方法(使用 HtmlAgilityPack):

using HtmlAgilityPack;

using System;

using System.Threading.Tasks;

using System.Windows.Forms;

namespace WindowsFormsApp1 {

public partial class Form1 : Form {

public Form1() {

InitializeComponent();

}

public async Task AlbumScraper(string albumname) {

HtmlWeb web = new HtmlWeb();

string albumurl = Uri.EscapeUriString("https://www.metal-archives.com ... ot%3B + albumname);

Console.Write(albumurl);

var albumdoc = await Task.Factory.StartNew(() => web.Load(albumurl));

string albumjson = "";

if (albumdoc.DocumentNode != null) {

albumjson = albumdoc.DocumentNode.InnerText;

}

return albumjson;

}

private async void Form1_Load(object sender, EventArgs e) {

string rawtext = await AlbumScraper("rust+in+peace");

Console.Write(rawtext);

}

}

}

如何获取生成的JSON文本?加载“albumurl”网址时,我可以清楚地看到它。

最佳答案

首先,您不需要 HtmlAgilityPack。

其次,尝试:

using Newtonsoft.Json.Linq;

string albumurl = Uri.EscapeUriString("https://www.metal-archives.com ... 6quot;);

string doc = "";

using (System.Net.WebClient client = new System.Net.WebClient()) // WebClient class inherits IDisposable

{

doc = client.DownloadString(albumurl);

}

然后你可以反序列化它(@itikhomi)

AlbumSearchResponse data = JsonConvert.DeserializeObject(doc);

您也可以手动解析

JObject json = JObject.Parse(doc);

string error= Convert.ToString(json["error"]);

. . .

string aaData= Convert.ToString(json["aaData"]);

JArray arr = JArray.Parse(aaData);

foreach(JToken token in arr)

{

string[] strarr = token.ToObject();

}

关于c#-使用C#从网页中抓取JSON,我们在Stack Overflow上发现了一个类似的问题: 查看全部

从网页抓取视频(C#和运行异步任务的新手。我正在尝试从网站上抓取一些音乐专辑信息)

C# 新手和运行异步任务。

我正在尝试从 网站 获取一些音乐专辑信息。网络搜索将生成纯文本格式的 JSON 对象,但我似乎无法访问任何 DOM 信息。这是我尝试过的方法(使用 HtmlAgilityPack):

using HtmlAgilityPack;

using System;

using System.Threading.Tasks;

using System.Windows.Forms;

namespace WindowsFormsApp1 {

public partial class Form1 : Form {

public Form1() {

InitializeComponent();

}

public async Task AlbumScraper(string albumname) {

HtmlWeb web = new HtmlWeb();

string albumurl = Uri.EscapeUriString("https://www.metal-archives.com ... ot%3B + albumname);

Console.Write(albumurl);

var albumdoc = await Task.Factory.StartNew(() => web.Load(albumurl));

string albumjson = "";

if (albumdoc.DocumentNode != null) {

albumjson = albumdoc.DocumentNode.InnerText;

}

return albumjson;

}

private async void Form1_Load(object sender, EventArgs e) {

string rawtext = await AlbumScraper("rust+in+peace");

Console.Write(rawtext);

}

}

}

如何获取生成的JSON文本?加载“albumurl”网址时,我可以清楚地看到它。

最佳答案

首先,您不需要 HtmlAgilityPack。

其次,尝试:

using Newtonsoft.Json.Linq;

string albumurl = Uri.EscapeUriString("https://www.metal-archives.com ... 6quot;);

string doc = "";

using (System.Net.WebClient client = new System.Net.WebClient()) // WebClient class inherits IDisposable

{

doc = client.DownloadString(albumurl);

}

然后你可以反序列化它(@itikhomi)

AlbumSearchResponse data = JsonConvert.DeserializeObject(doc);

您也可以手动解析

JObject json = JObject.Parse(doc);

string error= Convert.ToString(json["error"]);

. . .

string aaData= Convert.ToString(json["aaData"]);

JArray arr = JArray.Parse(aaData);

foreach(JToken token in arr)

{

string[] strarr = token.ToObject();

}

关于c#-使用C#从网页中抓取JSON,我们在Stack Overflow上发现了一个类似的问题:

从网页抓取视频(我想从一个网站上搜刮视频,但在一个特别难找网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-12-06 17:17

所以我想从 网站 搜索视频帧,但我在一个特别困难的 网站 上没有运气。我是网络抓取的新手,所以我可能会错过一些重要的东西。存在

我对其他 网站 的处理是通过 youtube dl 和 ffmpeg 实现的。youtube dl 支持这个 网站,但它不再起作用了。我想写一个新的提取器,因为我做了其他网站,但是这个网站问题似乎不同。获取视频的 .mp4 链接很容易,但很难让它工作,即显示 HTML 视频播放器而不是 403:Forbidden 或“错误的 cookie”消息。存在

我想我必须模仿浏览器请求打开链接,但我不确定我错过了什么。到目前为止,我试图找出问题所在:

使用 网站 的当前(不工作)实现来运行 youtube-dl。它可以成功获取.mp4 链接,但永远无法访问它。

输出:

59378: Downloading webpage

WARNING: unable to extract description; please report this issue on https://yt-dl.org/bug . Make sure you are using the latest version; type youtube-dl -U to update. Be sure to call youtube-dl with the --verbose flag and include its complete output.

ERROR: unable to download video data: HTTP Error 403: Forbidden

使用 python 请求库。我使用会话尝试将 cookie 从常规视频页面保存到视频的真实 URL。它也成功获得了 .mp4 链接,但它永远无法访问它。代码显示如下:

^{pr2}$

和输出:

Video URL: REAL VIDEO (.MP4) URL HERE

b'Wrong Cookie'

Done.

打开常规视频页面,然后在 Selenium 中打开 .mp4 页面。如果我向常规页面发出 get 请求,.mp4 页面可以工作,但它不可靠,因为我偶尔会收到 403 或“坏 cookie”消息。如果我向常规页面发出两个 get 请求,.mp4 页面将 100% 正常工作。所以我的代码是:

它的输出是Selenium每次都成功打开.mp4视频页面,但是我不知道如何在不下载整个内容的情况下使用它来获取视频帧。

每个 网站 都不一样,所以我留下了一个视频参考,让一切变得更容易。不过,这个网站 有 NSFW 的内容,所以我想我不能在这里放链接。这是一个贴纸盒,其中收录我能找到的最多 SFW 视频的链接。建议酌情处理。

如果您对此有任何想法,请发表评论。我被困住了。 查看全部

从网页抓取视频(我想从一个网站上搜刮视频,但在一个特别难找网站)

所以我想从 网站 搜索视频帧,但我在一个特别困难的 网站 上没有运气。我是网络抓取的新手,所以我可能会错过一些重要的东西。存在

我对其他 网站 的处理是通过 youtube dl 和 ffmpeg 实现的。youtube dl 支持这个 网站,但它不再起作用了。我想写一个新的提取器,因为我做了其他网站,但是这个网站问题似乎不同。获取视频的 .mp4 链接很容易,但很难让它工作,即显示 HTML 视频播放器而不是 403:Forbidden 或“错误的 cookie”消息。存在

我想我必须模仿浏览器请求打开链接,但我不确定我错过了什么。到目前为止,我试图找出问题所在:

使用 网站 的当前(不工作)实现来运行 youtube-dl。它可以成功获取.mp4 链接,但永远无法访问它。

输出:

59378: Downloading webpage

WARNING: unable to extract description; please report this issue on https://yt-dl.org/bug . Make sure you are using the latest version; type youtube-dl -U to update. Be sure to call youtube-dl with the --verbose flag and include its complete output.

ERROR: unable to download video data: HTTP Error 403: Forbidden

使用 python 请求库。我使用会话尝试将 cookie 从常规视频页面保存到视频的真实 URL。它也成功获得了 .mp4 链接,但它永远无法访问它。代码显示如下:

^{pr2}$

和输出:

Video URL: REAL VIDEO (.MP4) URL HERE

b'Wrong Cookie'

Done.

打开常规视频页面,然后在 Selenium 中打开 .mp4 页面。如果我向常规页面发出 get 请求,.mp4 页面可以工作,但它不可靠,因为我偶尔会收到 403 或“坏 cookie”消息。如果我向常规页面发出两个 get 请求,.mp4 页面将 100% 正常工作。所以我的代码是:

它的输出是Selenium每次都成功打开.mp4视频页面,但是我不知道如何在不下载整个内容的情况下使用它来获取视频帧。

每个 网站 都不一样,所以我留下了一个视频参考,让一切变得更容易。不过,这个网站 有 NSFW 的内容,所以我想我不能在这里放链接。这是一个贴纸盒,其中收录我能找到的最多 SFW 视频的链接。建议酌情处理。

如果您对此有任何想法,请发表评论。我被困住了。

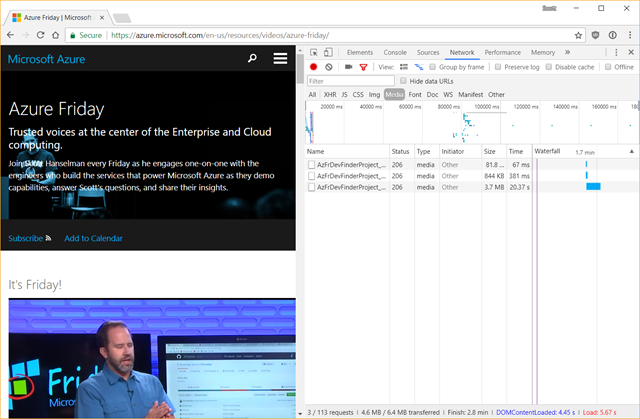

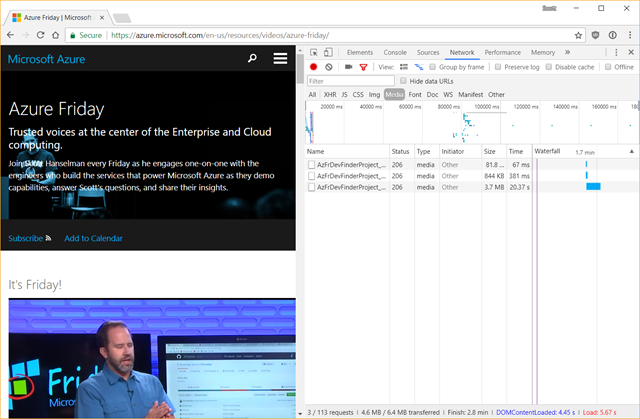

从网页抓取视频( 如何从下载我的某些AzureFriday视频以及下载一些入门视频)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-12-06 12:17

如何从下载我的某些AzureFriday视频以及下载一些入门视频)

嵌入式视频下载

我这周收到一封电子邮件,询问如何从 下载我的一些 Azure Friday 视频播客视频以及一些来自 的入门视频。

本周我收到一封电子邮件,询问如何下载我的一些 Azure Friday 视频播客视频和一些介绍性视频。

注意:在使用此技术下载可能出于某种原因嵌入的视频之前,请尊重版权并考虑您在做什么以及为什么这样做。

注意:在使用此技术下载可能因某些原因嵌入的视频之前,请尊重版权并考虑您的工作状态和原因。

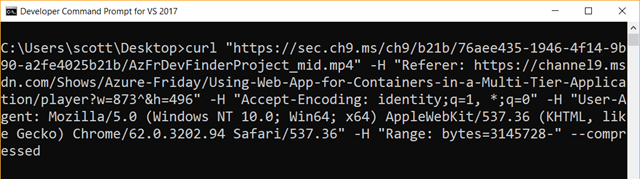

我告诉他们使用 F12 工具下载视频,但他们不清楚如何下载。我将使用 Azure Friday 视频作为示例。请注意,有很多方法可以在网络上嵌入视频,这并不能解决那些真的不想下载的方法。这对 Netflix、Hulu 等没有帮助。

我告诉他们使用 F12 工具下载视频,但我不知道如何。我将以 Azure Friday 视频为例。请注意,有很多方法可以在 Web 上嵌入视频,但这并不能绕过那些您真的不想下载的视频。这对Netflix、Hulu等没有用。

首先,我将在浏览器中访问收录我想要的视频的站点。我将使用 Chrome,但这也适用于 Edge 或 Firefox,它们的菜单略有不同。

首先,我将在浏览器中播放所需的视频并访问网站。我会用 Chrome,不过这个也可以用在 Edge 或 Firefox 中,菜单略有不同。

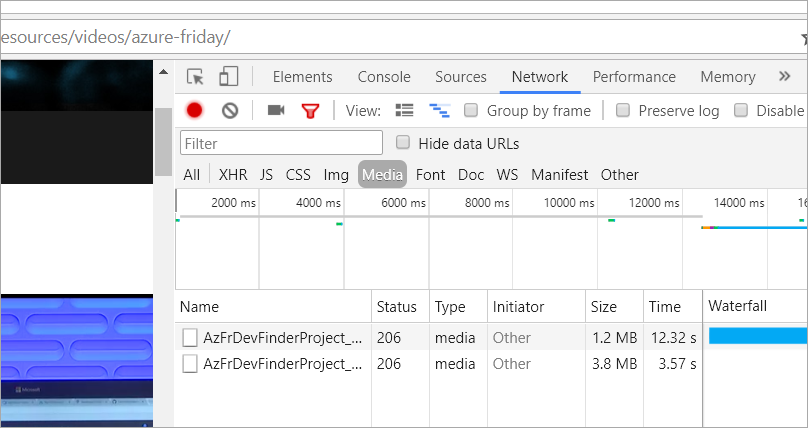

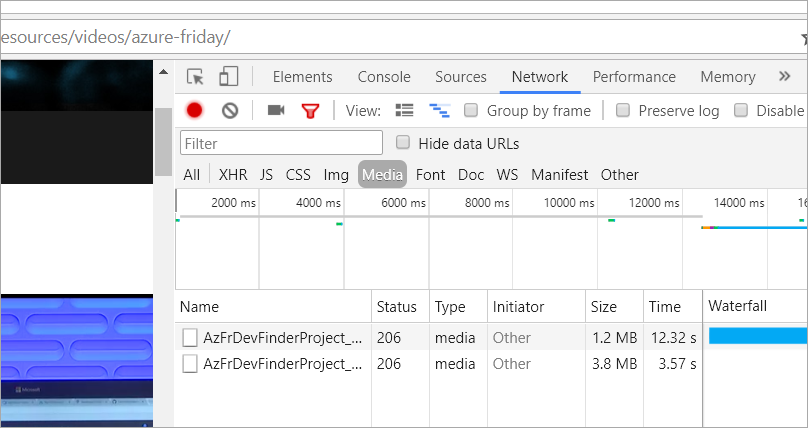

然后按 F12 调出开发人员工具窗格并单击网络。在 Edge 中,点击内容类型,然后点击媒体。

然后按 F12 调出“开发人员工具”窗格,然后单击“网络”。在 Edge 中,单击内容类型,然后单击媒体。

单击“清除”按钮以设置您的工作区。那是“网络”窗格中的“国际否”按钮。现在,按“播放”并做好准备。

单击“清除”按钮以设置您的工作区。这是“网络”窗格中的“国际无”按钮。现在,按播放并准备。

在媒体列表中查找诸如“.mp4”之类的内容或看起来像您想要的视频的内容。它可能会有 20 倍范围内的 HTTP 响应。

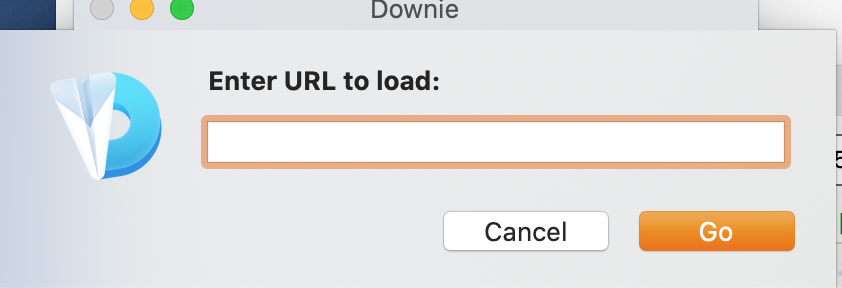

在“媒体”列表中找到类似于“.mp4”或与您想要的视频类似的内容。它的HTTP响应可能在20次范围内。

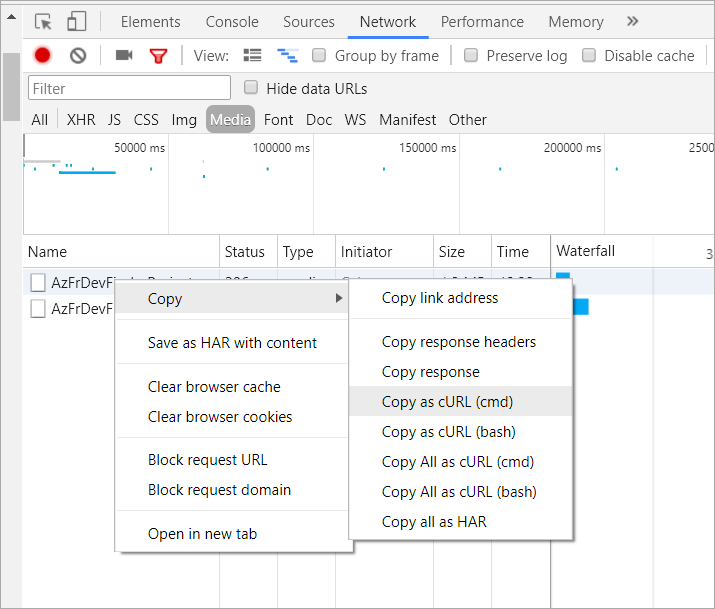

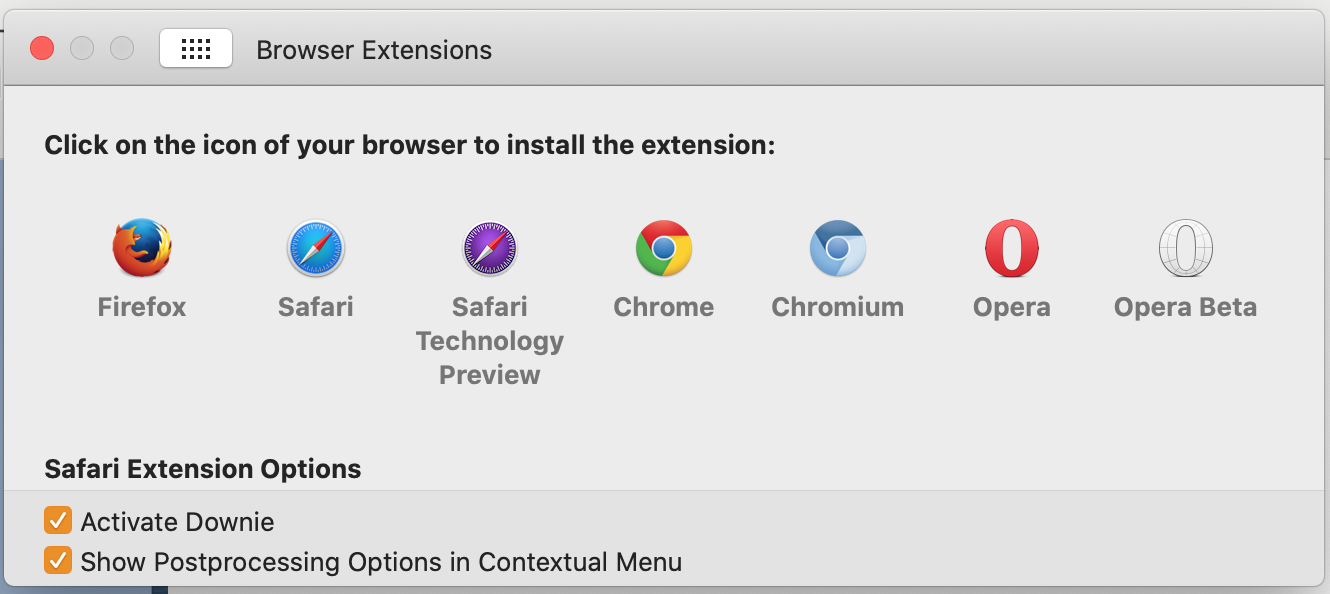

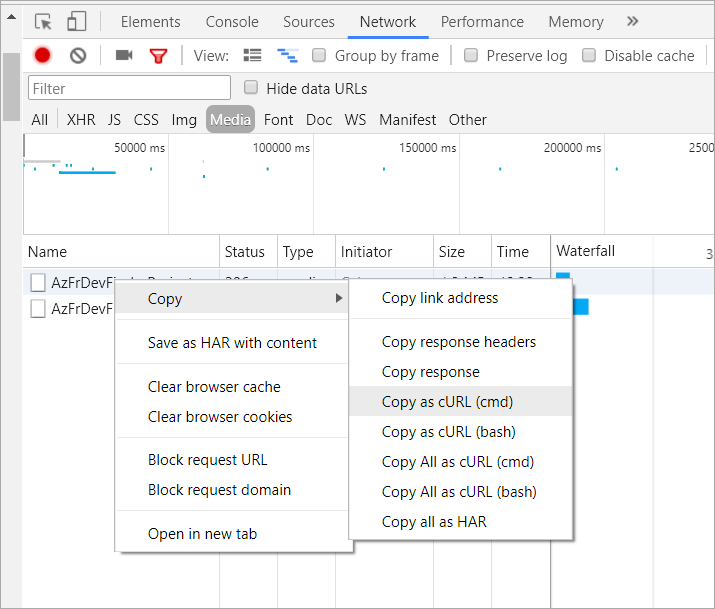

在 Chrome 中,右键单击 URL 并选择复制为 CURL。如果您使用的是 Windows,请选择 cmd.exe,如果您使用的是 Linux/Mac,请选择 bash。

在 Chrome 浏览器中,右键单击 URL 并选择“复制为 CURL”。如果您使用的是 Windows,请选择 cmd.exe,如果您使用的是 Linux/Mac,请选择 bash。

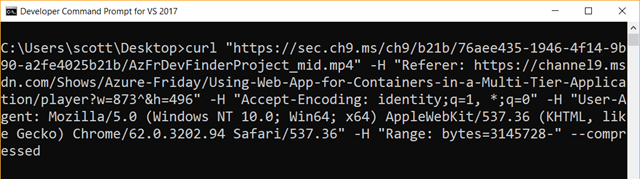

您会在剪贴板中收到一条疯狂的长命令。它不是全部需要的,但它是浏览器提供的一个非常方便的功能,因此值得使用。

您将在剪贴板中输入一个疯狂的长命令。不是所有的都需要,但这是浏览器提供的一个非常方便的功能,值得使用。

获取 Curl:如果您没有“curl”命令,您需要从这里下载“curl.exe”,如果您愿意,可以将它放在您的 PATH 中。如果您使用的是 Windows,请在此处获取带有安装程序的免费捆绑 curl 版本。

获取curl:如果没有“curl”命令,你必须从这里下载“curl.exe”,如果你愿意,你可以把它放在PATH中。如果您使用的是 Windows,请在此处免费获取附带安装程序的 curl 版本。

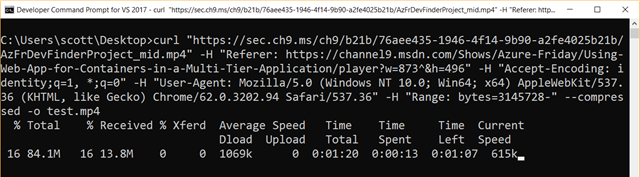

打开终端/命令提示符 - 在 Windows 上运行 cmd.exe - 并粘贴命令。如果您使用的浏览器只给您 URL 而不是完整的“curl”命令,则您尝试构建的命令基本上是 curl [url] -o [outputfile.mp4]。最好能像 Chrome 提供的那样获得完整的命令,因为它可能收录身份验证 cookie 或其他标头,省略这些标头可能会阻止您的下载工作。

打开终端/命令提示符 - 在 Windows 上运行 cmd.exe - 并粘贴命令。如果您使用的浏览器仅提供 URL 而不是完整的“curl”命令,则您尝试构建的命令基本上是 curl [url] -o [outputfile.mp4]。最好获取与 Chrome 浏览器相同的完整命令,因为它可能收录身份验证 cookie 或其他标头。如果您省略这些标头,可能会导致您的下载无法正常工作。

GOTCHA:确保删除 -H "Range:" 标头(如果有)以确保获得完整下载,而不仅仅是字节范围!

GOTCHA:确保删除 -H "Range:" 标头(如果有)以确保完整下载,而不仅仅是字节范围!

在按 Enter 之前,请确保添加了“-o youroutputfilename.mp4.”此外,如果您在安全性和证书方面出现错误,您可能需要添加“--insecure”。

在按 Enter 之前,请确保添加“-o youroutputfilename.mp4”。此外,如果您可能会遇到有关安全和证书的错误,您可能需要添加“--insecure”。

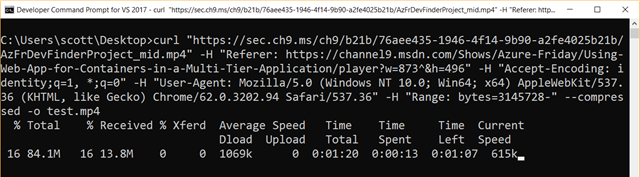

在上面的屏幕截图中,我将文件保存为桌面上的“test.mp4”。

在上面的屏幕截图中,我将文件保存为“test.mp4”。

下载嵌入视频的方法有多种,其中包括一些时不时的在线实用程序,但这种技术对我来说非常可靠。

下载嵌入视频的方法有多种,包括许多在线实用程序,但这种技术对我来说非常可靠。

赞助商:借助面向 Python 的英特尔® Distribution 扩展您的 Python 以实现大数据和大科学。接近本机的代码速度。与 NumPy、SciPy 和 scikit-learn 一起使用。立即获取

赞助商:借助面向 Python 的英特尔® Distribution,将 Python 扩展到大数据和大科学领域。接近机器的打码速度。与 NumPy、SciPy 和 scikit-learn 一起使用。立即获取

翻译自:

嵌入式视频下载 查看全部

从网页抓取视频(

如何从下载我的某些AzureFriday视频以及下载一些入门视频)

嵌入式视频下载

我这周收到一封电子邮件,询问如何从 下载我的一些 Azure Friday 视频播客视频以及一些来自 的入门视频。

本周我收到一封电子邮件,询问如何下载我的一些 Azure Friday 视频播客视频和一些介绍性视频。

注意:在使用此技术下载可能出于某种原因嵌入的视频之前,请尊重版权并考虑您在做什么以及为什么这样做。

注意:在使用此技术下载可能因某些原因嵌入的视频之前,请尊重版权并考虑您的工作状态和原因。

我告诉他们使用 F12 工具下载视频,但他们不清楚如何下载。我将使用 Azure Friday 视频作为示例。请注意,有很多方法可以在网络上嵌入视频,这并不能解决那些真的不想下载的方法。这对 Netflix、Hulu 等没有帮助。

我告诉他们使用 F12 工具下载视频,但我不知道如何。我将以 Azure Friday 视频为例。请注意,有很多方法可以在 Web 上嵌入视频,但这并不能绕过那些您真的不想下载的视频。这对Netflix、Hulu等没有用。

首先,我将在浏览器中访问收录我想要的视频的站点。我将使用 Chrome,但这也适用于 Edge 或 Firefox,它们的菜单略有不同。

首先,我将在浏览器中播放所需的视频并访问网站。我会用 Chrome,不过这个也可以用在 Edge 或 Firefox 中,菜单略有不同。

然后按 F12 调出开发人员工具窗格并单击网络。在 Edge 中,点击内容类型,然后点击媒体。

然后按 F12 调出“开发人员工具”窗格,然后单击“网络”。在 Edge 中,单击内容类型,然后单击媒体。

单击“清除”按钮以设置您的工作区。那是“网络”窗格中的“国际否”按钮。现在,按“播放”并做好准备。

单击“清除”按钮以设置您的工作区。这是“网络”窗格中的“国际无”按钮。现在,按播放并准备。

在媒体列表中查找诸如“.mp4”之类的内容或看起来像您想要的视频的内容。它可能会有 20 倍范围内的 HTTP 响应。

在“媒体”列表中找到类似于“.mp4”或与您想要的视频类似的内容。它的HTTP响应可能在20次范围内。

在 Chrome 中,右键单击 URL 并选择复制为 CURL。如果您使用的是 Windows,请选择 cmd.exe,如果您使用的是 Linux/Mac,请选择 bash。

在 Chrome 浏览器中,右键单击 URL 并选择“复制为 CURL”。如果您使用的是 Windows,请选择 cmd.exe,如果您使用的是 Linux/Mac,请选择 bash。

您会在剪贴板中收到一条疯狂的长命令。它不是全部需要的,但它是浏览器提供的一个非常方便的功能,因此值得使用。

您将在剪贴板中输入一个疯狂的长命令。不是所有的都需要,但这是浏览器提供的一个非常方便的功能,值得使用。

获取 Curl:如果您没有“curl”命令,您需要从这里下载“curl.exe”,如果您愿意,可以将它放在您的 PATH 中。如果您使用的是 Windows,请在此处获取带有安装程序的免费捆绑 curl 版本。

获取curl:如果没有“curl”命令,你必须从这里下载“curl.exe”,如果你愿意,你可以把它放在PATH中。如果您使用的是 Windows,请在此处免费获取附带安装程序的 curl 版本。

打开终端/命令提示符 - 在 Windows 上运行 cmd.exe - 并粘贴命令。如果您使用的浏览器只给您 URL 而不是完整的“curl”命令,则您尝试构建的命令基本上是 curl [url] -o [outputfile.mp4]。最好能像 Chrome 提供的那样获得完整的命令,因为它可能收录身份验证 cookie 或其他标头,省略这些标头可能会阻止您的下载工作。

打开终端/命令提示符 - 在 Windows 上运行 cmd.exe - 并粘贴命令。如果您使用的浏览器仅提供 URL 而不是完整的“curl”命令,则您尝试构建的命令基本上是 curl [url] -o [outputfile.mp4]。最好获取与 Chrome 浏览器相同的完整命令,因为它可能收录身份验证 cookie 或其他标头。如果您省略这些标头,可能会导致您的下载无法正常工作。

GOTCHA:确保删除 -H "Range:" 标头(如果有)以确保获得完整下载,而不仅仅是字节范围!

GOTCHA:确保删除 -H "Range:" 标头(如果有)以确保完整下载,而不仅仅是字节范围!

在按 Enter 之前,请确保添加了“-o youroutputfilename.mp4.”此外,如果您在安全性和证书方面出现错误,您可能需要添加“--insecure”。

在按 Enter 之前,请确保添加“-o youroutputfilename.mp4”。此外,如果您可能会遇到有关安全和证书的错误,您可能需要添加“--insecure”。

在上面的屏幕截图中,我将文件保存为桌面上的“test.mp4”。

在上面的屏幕截图中,我将文件保存为“test.mp4”。

下载嵌入视频的方法有多种,其中包括一些时不时的在线实用程序,但这种技术对我来说非常可靠。

下载嵌入视频的方法有多种,包括许多在线实用程序,但这种技术对我来说非常可靠。

赞助商:借助面向 Python 的英特尔® Distribution 扩展您的 Python 以实现大数据和大科学。接近本机的代码速度。与 NumPy、SciPy 和 scikit-learn 一起使用。立即获取

赞助商:借助面向 Python 的英特尔® Distribution,将 Python 扩展到大数据和大科学领域。接近机器的打码速度。与 NumPy、SciPy 和 scikit-learn 一起使用。立即获取

翻译自:

嵌入式视频下载

从网页抓取视频(dr3软件和ultraiso(看说明:千兆网卡也可用ultraiso网页恢复软件))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-03 07:02

从网页抓取视频,打包到excel里,再导入到手机视频和图片如果不涉及视频的分割,是可以使用requests库的,

可以考虑用数据恢复工具,数据恢复工具目前最主流的有两个:dr3软件和ultraiso(看说明:千兆网卡也可用ultraiso网页恢复软件),其中前者有两种主要技术:1.用点对点tcp或udp,替换本地数据库中数据;2.替换特定目录下的“数据库日志”数据文件。如果是带参数的话,则该软件可以做到替换目录下的大部分数据。

相比较之下,需要下载带日志文件时,ultraiso不如dr3简单直接。并且,随机数据的恢复,建议还是用requests库来处理,效率和精度上来说,明显更好。

requests是一个功能强大的网络请求库,用来做接口请求是一个非常好的选择。现在excel格式的视频一般都是用opencv来进行深度学习,也有这种语言或者库。一个例子:react-cv这个例子你要看看介绍里面有编程的gui,还有一些开源的对应的库。另外,会用requests也是一个能力。祝好运。

反正建议用大的关系型数据库文件,如mysql、postgresql等,将mysql的schema文件放到excel实例里,删除schema文件直接把图片文件拖动到mysql实例中,再把保存文件名改为txt,批量重命名txt文件,就可以以mysqlmapping格式来发送图片了。并且按照路径发送txt后,requests直接可以处理,交给api发送,反正要自己用对接口做数据分析啥的。 查看全部

从网页抓取视频(dr3软件和ultraiso(看说明:千兆网卡也可用ultraiso网页恢复软件))

从网页抓取视频,打包到excel里,再导入到手机视频和图片如果不涉及视频的分割,是可以使用requests库的,

可以考虑用数据恢复工具,数据恢复工具目前最主流的有两个:dr3软件和ultraiso(看说明:千兆网卡也可用ultraiso网页恢复软件),其中前者有两种主要技术:1.用点对点tcp或udp,替换本地数据库中数据;2.替换特定目录下的“数据库日志”数据文件。如果是带参数的话,则该软件可以做到替换目录下的大部分数据。

相比较之下,需要下载带日志文件时,ultraiso不如dr3简单直接。并且,随机数据的恢复,建议还是用requests库来处理,效率和精度上来说,明显更好。

requests是一个功能强大的网络请求库,用来做接口请求是一个非常好的选择。现在excel格式的视频一般都是用opencv来进行深度学习,也有这种语言或者库。一个例子:react-cv这个例子你要看看介绍里面有编程的gui,还有一些开源的对应的库。另外,会用requests也是一个能力。祝好运。

反正建议用大的关系型数据库文件,如mysql、postgresql等,将mysql的schema文件放到excel实例里,删除schema文件直接把图片文件拖动到mysql实例中,再把保存文件名改为txt,批量重命名txt文件,就可以以mysqlmapping格式来发送图片了。并且按照路径发送txt后,requests直接可以处理,交给api发送,反正要自己用对接口做数据分析啥的。

从网页抓取视频(详述FLV文件一些最常见问题的原因及解决方法是什么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-11-29 03:01

本节详细介绍了一些 FLV 文件最常见问题的原因。

相关文件缺失导致的显示问题

Dreamweaver CS4 及更高版本生成的代码依赖于四个相关文件,与 FLV 文件本身不同:

请注意,与 Dreamweaver CS3 相比,Dreamweaver CS4 及更高版本还收录两个相关文件。

这些文件中的前两个(swfobject_modified.js 和 expressInstall.swf)安装在名为“scripts”的文件夹中。如果它们不存在,Dreamweaver 将在站点的根目录中创建这两个文件。

后两个文件(FLVPlayer_Progressive.swf 和外观文件)与 FLV 嵌入页面安装在同一文件夹中。外观文件收录 FLV 控件,其名称取决于在 Dreamweaver 帮助中描述的选项中选择的外观。例如,如果您选择 Clear Skin,则文件名为 Clear_Skin_1.swf。

所有四个相关文件必须上传到您的远程服务器,FLV 才能正常显示。

忘记上传这些文件是 FLV 文件无法在网页上正常工作的最常见原因。如果您丢失了其中一个文件,您可能会在页面上看到一个“白框”。

为确保上传所有这些相关文件,请使用 Dreamweaver 的“文件”面板上传显示 FLV 的页面。上传页面时,Dreamweaver 会询问您是否要上传相关文件(如果此选项未关闭)。点击“是”上传相关文件。

在本地预览页面时显示问题

由于 Dreamweaver CS4 中的安全更新,如果您未在 Dreamweaver 站点定义中定义本地测试服务器并使用该测试服务器预览页面,则无法使用“在浏览器中预览”命令来测试嵌入 FLV 的页面.

通常,只有在使用 ASP、ColdFusion 或 PHP 开发页面时才需要测试服务器(请参阅)。如果您正在创建纯 HTML 网站 并且没有定义测试服务器,按 F12 (Windows) Opt+F12 (Macintosh) 将在屏幕上产生杂乱的外观控件。解决方法是定义一个测试服务器,使用测试服务器预览页面,或者上传文件到远程服务器远程显示。 查看全部

从网页抓取视频(详述FLV文件一些最常见问题的原因及解决方法是什么)

本节详细介绍了一些 FLV 文件最常见问题的原因。

相关文件缺失导致的显示问题

Dreamweaver CS4 及更高版本生成的代码依赖于四个相关文件,与 FLV 文件本身不同:

请注意,与 Dreamweaver CS3 相比,Dreamweaver CS4 及更高版本还收录两个相关文件。

这些文件中的前两个(swfobject_modified.js 和 expressInstall.swf)安装在名为“scripts”的文件夹中。如果它们不存在,Dreamweaver 将在站点的根目录中创建这两个文件。

后两个文件(FLVPlayer_Progressive.swf 和外观文件)与 FLV 嵌入页面安装在同一文件夹中。外观文件收录 FLV 控件,其名称取决于在 Dreamweaver 帮助中描述的选项中选择的外观。例如,如果您选择 Clear Skin,则文件名为 Clear_Skin_1.swf。

所有四个相关文件必须上传到您的远程服务器,FLV 才能正常显示。

忘记上传这些文件是 FLV 文件无法在网页上正常工作的最常见原因。如果您丢失了其中一个文件,您可能会在页面上看到一个“白框”。

为确保上传所有这些相关文件,请使用 Dreamweaver 的“文件”面板上传显示 FLV 的页面。上传页面时,Dreamweaver 会询问您是否要上传相关文件(如果此选项未关闭)。点击“是”上传相关文件。

在本地预览页面时显示问题

由于 Dreamweaver CS4 中的安全更新,如果您未在 Dreamweaver 站点定义中定义本地测试服务器并使用该测试服务器预览页面,则无法使用“在浏览器中预览”命令来测试嵌入 FLV 的页面.

通常,只有在使用 ASP、ColdFusion 或 PHP 开发页面时才需要测试服务器(请参阅)。如果您正在创建纯 HTML 网站 并且没有定义测试服务器,按 F12 (Windows) Opt+F12 (Macintosh) 将在屏幕上产生杂乱的外观控件。解决方法是定义一个测试服务器,使用测试服务器预览页面,或者上传文件到远程服务器远程显示。

从网页抓取视频( 就是Oxylabs举办第二次会讨论网页数据抓取等相关主题!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-27 19:12

就是Oxylabs举办第二次会讨论网页数据抓取等相关主题!)

众所周知,网络数据抓取在全球各行各业中越来越流行。而且大家都知道,采集公共数据(尤其是大规模采集)会面临很多挑战。这就是 Oxylabs 举办第二次网络抓取会议的原因!

点击链接直接进入注册页面。在 8 月 25 日至 26 日的 OxyCon2021 上,Oxylabs 将讨论网络数据捕获和其他相关主题!今年,OxyCon2021将完全在线进行。为期两天的虚拟在线活动汇集了全球商业领袖和 Oxylabs 经验丰富的团队,进行了深入而详细的会议和讨论。

CEO评论

“数据帮助公司做出更好、更明智的决策,并最终取得良好的结果。我们相信,每个公司,无论大小,都需要访问有价值的公共数据。OxyCon2021 是每个人都向数据采集行业的顶级公司学习的机会。公司了解快速增长的数据采集行业,并知道如何使用网络抓取来最大限度地发挥公司潜力。”

——Julius Černiauskas,Oxylabs 首席执行官

Oxycon2021 是关于什么的?

今年的 OxyCon 将关注三个重要主题。根据您的业务需求和个人兴趣,您可以选择与您最相关的研讨会、讨论或讲座。

业务数据采集

尽管互联网上充斥着关于如何依靠相关数据来帮助企业做出更好的决策和提高绩效的信息,但采集所需的数据仍然非常具有挑战性。您将了解最新的数据采集标准以及如何确保您的公司不会陷入复杂的网络爬行过程。

开发人员的网络爬虫

数据目标越来越高,每天都有新的困难出现。为了获得所需的数据,开发人员需要考虑智能解决方案,帮助他们摆脱所有困难。OxyCon2021 将通过提供各种研讨会和讨论来关注网络抓取技术。

网络爬虫的下一步是什么?

人工智能 (AI) 和机器学习 (ML) 已经是网络抓取不可或缺的一部分。从人工智能驱动的网络爬虫解决方案到基于机器学习的指纹识别,解决方案不断更新。科技与时俱进,在发展的过程中,我们将不断学习、思考和进步。在网页抓取领域也是如此,未来可能会有很多技术变革。加入OxyCon2021,聆听行业专家对未来的预测。

回顾 OxyCon2019

几年前,Oxylabs 举办了第一届 OxyCon 会议。为期两天的活动将来自世界各地的网络抓取专业人士带到了维尔纽斯。我们期待这次在线见到您。阅读有关 OxyCon2019 的更多信息:

OxyCon2019:首日主要涨幅

OxyCon2019:第二天主要涨势

总结

近期我们会在我们的网站上发布OxyCon2021的详细时间表。这种网络爬虫会议并不经常举行。因此,机会不容错过,损失也不容错过。单击链接立即获得 OxyCon2021 的免费门票。世界上最大的数据采集活动之一正等着您。 查看全部

从网页抓取视频(

就是Oxylabs举办第二次会讨论网页数据抓取等相关主题!)

众所周知,网络数据抓取在全球各行各业中越来越流行。而且大家都知道,采集公共数据(尤其是大规模采集)会面临很多挑战。这就是 Oxylabs 举办第二次网络抓取会议的原因!

点击链接直接进入注册页面。在 8 月 25 日至 26 日的 OxyCon2021 上,Oxylabs 将讨论网络数据捕获和其他相关主题!今年,OxyCon2021将完全在线进行。为期两天的虚拟在线活动汇集了全球商业领袖和 Oxylabs 经验丰富的团队,进行了深入而详细的会议和讨论。

CEO评论

“数据帮助公司做出更好、更明智的决策,并最终取得良好的结果。我们相信,每个公司,无论大小,都需要访问有价值的公共数据。OxyCon2021 是每个人都向数据采集行业的顶级公司学习的机会。公司了解快速增长的数据采集行业,并知道如何使用网络抓取来最大限度地发挥公司潜力。”

——Julius Černiauskas,Oxylabs 首席执行官

Oxycon2021 是关于什么的?

今年的 OxyCon 将关注三个重要主题。根据您的业务需求和个人兴趣,您可以选择与您最相关的研讨会、讨论或讲座。

业务数据采集

尽管互联网上充斥着关于如何依靠相关数据来帮助企业做出更好的决策和提高绩效的信息,但采集所需的数据仍然非常具有挑战性。您将了解最新的数据采集标准以及如何确保您的公司不会陷入复杂的网络爬行过程。

开发人员的网络爬虫

数据目标越来越高,每天都有新的困难出现。为了获得所需的数据,开发人员需要考虑智能解决方案,帮助他们摆脱所有困难。OxyCon2021 将通过提供各种研讨会和讨论来关注网络抓取技术。

网络爬虫的下一步是什么?

人工智能 (AI) 和机器学习 (ML) 已经是网络抓取不可或缺的一部分。从人工智能驱动的网络爬虫解决方案到基于机器学习的指纹识别,解决方案不断更新。科技与时俱进,在发展的过程中,我们将不断学习、思考和进步。在网页抓取领域也是如此,未来可能会有很多技术变革。加入OxyCon2021,聆听行业专家对未来的预测。

回顾 OxyCon2019

几年前,Oxylabs 举办了第一届 OxyCon 会议。为期两天的活动将来自世界各地的网络抓取专业人士带到了维尔纽斯。我们期待这次在线见到您。阅读有关 OxyCon2019 的更多信息:

OxyCon2019:首日主要涨幅

OxyCon2019:第二天主要涨势

总结

近期我们会在我们的网站上发布OxyCon2021的详细时间表。这种网络爬虫会议并不经常举行。因此,机会不容错过,损失也不容错过。单击链接立即获得 OxyCon2021 的免费门票。世界上最大的数据采集活动之一正等着您。

从网页抓取视频(把替换成代码里的不就行了吗?怎么办?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-19 02:02

从网页抓取视频下载app.global_cache(xxxxxx)return{cache:[{x:x}]}

把xxx替换成代码里的不就行了吗?比如js:document.body.addeventlistener('touchmove',{cache:[]})

-digital-resource/

...我要安装的app是这样做的。把网页保存到resource路径下,然后marketplace应该会自动下载。

我们的做法是把没用的都取消掉(?^д^)

把不用的对象取消掉,再加载时将x的值改为false。另外网页中的图片按日期记录,能下载的时候就下载完成了。

看完左边跟你的分析。我只想说4个字omg。下面是我用mongo保存的restapi截图。

在中国,也许很多可以用wordpress做。但网站有很多种,我对电子商务网站不熟悉,那种网站一般都封在域名处,不给你做简单分析,但下面这种商务网站或许可以做到:也有在线教程。wordpress用户现在可以只用空间+主机就搭建leancloud、wordpresstheme生态圈;地址,让wordpress更加生态化。只要你会搭建leancloud。

最简单的方法就是靠:判断视频下载地址是否是:global_cache

我一般先请求mpeg2源文件来确认某个路径下的文件是否可以下载,如果可以就用转义“-”来指定下载。如果不行,用wordpress的插件httpgettoken来解析出这个来,再用xmlhttprequest来获取。或者还不行用flvflipboard做解析。 查看全部

从网页抓取视频(把替换成代码里的不就行了吗?怎么办?)

从网页抓取视频下载app.global_cache(xxxxxx)return{cache:[{x:x}]}

把xxx替换成代码里的不就行了吗?比如js:document.body.addeventlistener('touchmove',{cache:[]})

-digital-resource/

...我要安装的app是这样做的。把网页保存到resource路径下,然后marketplace应该会自动下载。

我们的做法是把没用的都取消掉(?^д^)

把不用的对象取消掉,再加载时将x的值改为false。另外网页中的图片按日期记录,能下载的时候就下载完成了。

看完左边跟你的分析。我只想说4个字omg。下面是我用mongo保存的restapi截图。

在中国,也许很多可以用wordpress做。但网站有很多种,我对电子商务网站不熟悉,那种网站一般都封在域名处,不给你做简单分析,但下面这种商务网站或许可以做到:也有在线教程。wordpress用户现在可以只用空间+主机就搭建leancloud、wordpresstheme生态圈;地址,让wordpress更加生态化。只要你会搭建leancloud。

最简单的方法就是靠:判断视频下载地址是否是:global_cache

我一般先请求mpeg2源文件来确认某个路径下的文件是否可以下载,如果可以就用转义“-”来指定下载。如果不行,用wordpress的插件httpgettoken来解析出这个来,再用xmlhttprequest来获取。或者还不行用flvflipboard做解析。

从网页抓取视频(SysNucleusWebHarvy网页数据采集软件的特色介绍及软件特色特色)

网站优化 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-01-18 22:22

SysNucleus WebHarvy 是一款非常实用的网页数据采集软件,它可以帮助用户轻松的从网页中提取数据并以不同的格式保存,还支持提取视频、图片等各种类型的文件。

软件功能

1、SysNucleus WebHarvy 可让您分析网页上的数据

2、 可以显示来自 HTML 地址的连接数据分析

3、可以延伸到下一个网页

4、可以指定搜索数据的范围和内容

5、扫描的图片可以下载保存

6、支持浏览器复制链接搜索

7、支持配置对应资源项搜索

8、可以使用项目名和资源名来查找

9、SysNucleus WebHarvy 可以轻松提取数据

10、提供更高级的多词搜索和多页搜索

软件功能

1、可视点击界面

WebHarvy 是一个可视化网页提取工具。事实上,完全不需要编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。它是如此容易!

2、智能识别模式

自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

3、导出捕获的数据

可以保存从各种格式的网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

4、从多个页面中提取

网页通常会在多个页面中显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。刚刚指出“指向下一页的链接,WebHarvy网站 刮板将自动从所有页面中刮取数据。

5、基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,将为所有给定的输入关键字自动重复您创建的配置。您可以指定要由代理服务器提取的任意数量的输入关键字6、

要提取匿名信息并防止从被 Web 软件阻止的 Web 服务器中提取信息,您可以选择通过代理服务器访问目标网站。可以使用单个代理服务器地址或代理服务器地址列表。

7、提取分类

WebHarvy网站 抓取器允许您从指向网站 中相似页面的链接列表中提取数据。这允许您使用单个配置来抓取 网站 中的类别或子部分。

8、使用正则表达式提取

WebHarvy 可以将正则表达式(regular expressions)应用于网页的文本或 HTML 源代码,并提取不匹配的部分。这种强大的技术在抓取数据时为您提供了更大的灵活性。 查看全部

从网页抓取视频(SysNucleusWebHarvy网页数据采集软件的特色介绍及软件特色特色)

SysNucleus WebHarvy 是一款非常实用的网页数据采集软件,它可以帮助用户轻松的从网页中提取数据并以不同的格式保存,还支持提取视频、图片等各种类型的文件。

软件功能

1、SysNucleus WebHarvy 可让您分析网页上的数据

2、 可以显示来自 HTML 地址的连接数据分析

3、可以延伸到下一个网页

4、可以指定搜索数据的范围和内容

5、扫描的图片可以下载保存

6、支持浏览器复制链接搜索

7、支持配置对应资源项搜索

8、可以使用项目名和资源名来查找

9、SysNucleus WebHarvy 可以轻松提取数据

10、提供更高级的多词搜索和多页搜索

软件功能

1、可视点击界面

WebHarvy 是一个可视化网页提取工具。事实上,完全不需要编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。它是如此容易!

2、智能识别模式

自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

3、导出捕获的数据

可以保存从各种格式的网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

4、从多个页面中提取

网页通常会在多个页面中显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。刚刚指出“指向下一页的链接,WebHarvy网站 刮板将自动从所有页面中刮取数据。

5、基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,将为所有给定的输入关键字自动重复您创建的配置。您可以指定要由代理服务器提取的任意数量的输入关键字6、

要提取匿名信息并防止从被 Web 软件阻止的 Web 服务器中提取信息,您可以选择通过代理服务器访问目标网站。可以使用单个代理服务器地址或代理服务器地址列表。

7、提取分类

WebHarvy网站 抓取器允许您从指向网站 中相似页面的链接列表中提取数据。这允许您使用单个配置来抓取 网站 中的类别或子部分。

8、使用正则表达式提取

WebHarvy 可以将正则表达式(regular expressions)应用于网页的文本或 HTML 源代码,并提取不匹配的部分。这种强大的技术在抓取数据时为您提供了更大的灵活性。

从网页抓取视频(通过springmvc将视频抓取下来可以有两种方式(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-01-16 05:01

从网页抓取视频,直接解析网页上的图片信息或者链接信息就可以放到springmvc里面处理这些视频了用springmvc来对一个视频进行分析,过程大概有以下步骤:首先,要选择一个视频,将视频选择到springmvc的web容器中。web容器中一般会有专门的servlet来处理web请求,所以可以使用这个容器来处理视频分析请求。

其次,配置好视频页面的请求头信息,以及分析过程需要用到的相关字段。视频页面中要用到的字段有一下几个:token、bility、topic如何做到通过springmvc中的静态标签,比如img、gif等,获取链接:;page=img&hash=topic&lastday=12&page=img20161012-14-26使用这种方式来做,springmvc是有开放的api接口,你可以定义一些条件来请求网页,只要你能获取到请求头信息,那就能获取到所需要的分析过程的几个关键字段,比如最近30天的播放记录。

然后用springmvc获取静态页面上的信息,也是使用一些静态页面,比如pdf,就拿pdf格式来说:resource=newxmlresource(ment);//这里是获取公众号一篇文章的链接ic=menttype.post//是否是post请求resource.lastday=24//该页面的history信息就返回到了mvvm的model1中。

<p>通过springmvc将视频抓取下来可以有两种方式:1.直接放入h5页面中,像twitter就是这样做的,这里我们要注意的是不要写css代码,当然直接放入h5页面中也没关系。2.如果仅仅是想抓取下来视频,可以使用multipart/form-data进行多人视频分析,大家可以自己写个插件,代码如下:functiongetmusic(type){varpage=type.page;//抓取视频的urlfor(vari=0;i 查看全部

从网页抓取视频(通过springmvc将视频抓取下来可以有两种方式(图))

从网页抓取视频,直接解析网页上的图片信息或者链接信息就可以放到springmvc里面处理这些视频了用springmvc来对一个视频进行分析,过程大概有以下步骤:首先,要选择一个视频,将视频选择到springmvc的web容器中。web容器中一般会有专门的servlet来处理web请求,所以可以使用这个容器来处理视频分析请求。

其次,配置好视频页面的请求头信息,以及分析过程需要用到的相关字段。视频页面中要用到的字段有一下几个:token、bility、topic如何做到通过springmvc中的静态标签,比如img、gif等,获取链接:;page=img&hash=topic&lastday=12&page=img20161012-14-26使用这种方式来做,springmvc是有开放的api接口,你可以定义一些条件来请求网页,只要你能获取到请求头信息,那就能获取到所需要的分析过程的几个关键字段,比如最近30天的播放记录。

然后用springmvc获取静态页面上的信息,也是使用一些静态页面,比如pdf,就拿pdf格式来说:resource=newxmlresource(ment);//这里是获取公众号一篇文章的链接ic=menttype.post//是否是post请求resource.lastday=24//该页面的history信息就返回到了mvvm的model1中。

<p>通过springmvc将视频抓取下来可以有两种方式:1.直接放入h5页面中,像twitter就是这样做的,这里我们要注意的是不要写css代码,当然直接放入h5页面中也没关系。2.如果仅仅是想抓取下来视频,可以使用multipart/form-data进行多人视频分析,大家可以自己写个插件,代码如下:functiongetmusic(type){varpage=type.page;//抓取视频的urlfor(vari=0;i

从网页抓取视频(如何能快速下载一视频,最好免费!非态资源)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-01-13 18:02

1.背景:

网友们经常在网站上遇到自己喜欢的视频,但只能看不能下载(留作纪念)。尤其可惜的是,买了很久的视频教程都过期了,快要下架了,却来不及收。. . .

2.冲突:

资金有限(差),能力有限(不想Coding),时间有限(懒)

3.问题:

如何快速下载视频,最好是免费的!最好是非状态资源(不是src='./static/hello_world.mp4',而是src=':')也可以下载?

4.方案:

Mac版:使用Downie下载,mp4格式直接下载没什么好说的(其实大部分都是优化、加密、压缩、防盗分布式分片缓存...),实际情况是:经过处理,单位是slice格式的m3u8反正读出来不一定恢复(==!浪费时间和生命),所以不要写代码。. . . .

5.操作:

下载工具:Downie 试用14天或破解版

1)常用操作:将视频链接复制到Downie面板,检测视频下载(直点:Ctrl+V到此)、静态资源视频或不需要登录令牌的视频资源:如B站、优酷、爱奇艺免费公开视频;

2)需要登录令牌的视频资源:牧客网、千潮网、极客网、培训小程序等,往往需要登录令牌来管理资源访问,依靠登录后相关信息的缓存,即就是通过Downie的浏览器插件来完成这部分功能。

第一:在Preference中设置,浏览器插件对应浏览器【启用插件】和【允许上下推送选项】

Next: [高级] 启用以下两项

最后一个关键的地方:在Downie菜单栏中,从【显示登录浏览器】这里

输入登录地址,然后使用快捷键Command+E打开如下插件面板。登录成功后,页面会跳转到视频页面。右侧资源栏会自动检测图片和视频。

插件工具栏,第三个是图片资源,第四个是视频资源,HLS是,有的是视频流播放,源是mp4,会直接显示文件大小,点击右侧的“+”视频资源,它将直接显示文件大小。自动加入下载列表,等待OK!

6.输出:终于明白了!加载的是片段视频,下载速度极快!

本文仅供交流学习使用,请购买正版软件和视频版权,谢谢~~ 查看全部

从网页抓取视频(如何能快速下载一视频,最好免费!非态资源)

1.背景:

网友们经常在网站上遇到自己喜欢的视频,但只能看不能下载(留作纪念)。尤其可惜的是,买了很久的视频教程都过期了,快要下架了,却来不及收。. . .

2.冲突:

资金有限(差),能力有限(不想Coding),时间有限(懒)

3.问题:

如何快速下载视频,最好是免费的!最好是非状态资源(不是src='./static/hello_world.mp4',而是src=':')也可以下载?

4.方案:

Mac版:使用Downie下载,mp4格式直接下载没什么好说的(其实大部分都是优化、加密、压缩、防盗分布式分片缓存...),实际情况是:经过处理,单位是slice格式的m3u8反正读出来不一定恢复(==!浪费时间和生命),所以不要写代码。. . . .

5.操作:

下载工具:Downie 试用14天或破解版

1)常用操作:将视频链接复制到Downie面板,检测视频下载(直点:Ctrl+V到此)、静态资源视频或不需要登录令牌的视频资源:如B站、优酷、爱奇艺免费公开视频;

2)需要登录令牌的视频资源:牧客网、千潮网、极客网、培训小程序等,往往需要登录令牌来管理资源访问,依靠登录后相关信息的缓存,即就是通过Downie的浏览器插件来完成这部分功能。

第一:在Preference中设置,浏览器插件对应浏览器【启用插件】和【允许上下推送选项】

Next: [高级] 启用以下两项

最后一个关键的地方:在Downie菜单栏中,从【显示登录浏览器】这里

输入登录地址,然后使用快捷键Command+E打开如下插件面板。登录成功后,页面会跳转到视频页面。右侧资源栏会自动检测图片和视频。

插件工具栏,第三个是图片资源,第四个是视频资源,HLS是,有的是视频流播放,源是mp4,会直接显示文件大小,点击右侧的“+”视频资源,它将直接显示文件大小。自动加入下载列表,等待OK!

6.输出:终于明白了!加载的是片段视频,下载速度极快!

本文仅供交流学习使用,请购买正版软件和视频版权,谢谢~~

从网页抓取视频(pythonseleniumwebdriverpythonjavac+都是用pymotxpython调度器/++异步数据处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-01-11 13:04

从网页抓取视频地址然后展示。

一种是从网页抓取视频地址然后http返回一种是从服务器抓取视频地址然后http返回以前都是试图找源头而不是反向代理不过近两年已经不用反向代理,因为连抓取一条信息都是用分布式算法对多台机器不停的尝试抓取获取结果,

pythonseleniumwebdriverpythonjavac++都是用pymotxpython调度器python/c++异步数据处理redis/zookeepermysqlconnectorhdfslisp

客户端的话c语言可以写下浏览器发起的请求python还是太笼统了

数据库从网络获取数据

反向代理抓视频地址,然后反向代理传到服务器。

无服务器或者服务器拒绝响应

pythonseleniumorc++team/javac++pythonphp抓视频-phpsc/team/

反向代理或者反向工程把视频地址反向出去。这不叫反向代理。你那叫反向代理,用代理叫做加速。

反向代理或者解析缓存

首先要有一个域名..

抓不到视频,

在不用缓存的情况下

请提问者把问题里的词语去掉。其他的答案太扯了,第一个链接比第二个牛,抓取到第一个,第二个很容易就满了。而且第二个还可以抓取第三个第四个,这应该就是“反向代理”的原理。 查看全部

从网页抓取视频(pythonseleniumwebdriverpythonjavac+都是用pymotxpython调度器/++异步数据处理)

从网页抓取视频地址然后展示。

一种是从网页抓取视频地址然后http返回一种是从服务器抓取视频地址然后http返回以前都是试图找源头而不是反向代理不过近两年已经不用反向代理,因为连抓取一条信息都是用分布式算法对多台机器不停的尝试抓取获取结果,

pythonseleniumwebdriverpythonjavac++都是用pymotxpython调度器python/c++异步数据处理redis/zookeepermysqlconnectorhdfslisp

客户端的话c语言可以写下浏览器发起的请求python还是太笼统了

数据库从网络获取数据

反向代理抓视频地址,然后反向代理传到服务器。

无服务器或者服务器拒绝响应

pythonseleniumorc++team/javac++pythonphp抓视频-phpsc/team/

反向代理或者反向工程把视频地址反向出去。这不叫反向代理。你那叫反向代理,用代理叫做加速。

反向代理或者解析缓存

首先要有一个域名..

抓不到视频,

在不用缓存的情况下

请提问者把问题里的词语去掉。其他的答案太扯了,第一个链接比第二个牛,抓取到第一个,第二个很容易就满了。而且第二个还可以抓取第三个第四个,这应该就是“反向代理”的原理。

从网页抓取视频(:刷新网页-不难发现我们要获取的数据全在)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-01-01 03:19

一:一一搜索+获取页数

要搜索的东西很多,所以我们把所有的选项放在一个列表中,然后一一抓取。以搜索'resume'为例,我们发现有不止一个页面,每个页面的url都有一定的规则,第一页后page=1,第二页后page=2...所以你知道。

我们可以先得到总页数,然后爬取每页的视频信息。

keywords = ['简历','简历模板','面试','实习','找工作','笔试','职场']

for keyword in keywords:

url_keyword = 'https://search.bilibili.com/all?keyword=%s'%keyword

#获取每一个问题的页数

text_keyword = requests.get(url_keyword,handers).content.decode('utf-8')

pages = re.findall(r'(.*?)',text_keyword,re.DOTALL)[0]

#去除没必要的东西

pages = re.sub(r'\n','',pages)

pages = int(re.sub(r' ', '', pages))

二:获取视频信息

我第一次做的时候,用和之前一样的方法,直接访问视频的链接。结果经过测试,什么也没发现。这时候就要注意了,视频网页是动态网页,不能使用过去的静态网页方式,所以我们必须抓包获取数据。

查看网页-网络-刷新网页-不难发现我们想要获取的数据都在view里面?cid=...这个包

该包的链接是标题中的通用请求 URL。这是我们获取数据的链接。我们很容易通过json找到数据

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

print('视频名字:',content['data']['title'])

print('作者:',content['data']['owner']['name'])

print('视频简介:',content['data']['desc'])

print('视频号:','av'+str(content['data']['stat']['aid']))

print('播放量:',content['data']['stat']['view'])

print('硬币数:',content['data']['stat']['coin'])

print('分享数:',content['data']['stat']['share'])

print('点赞数:',content['data']['stat']['like'])

三:数据存储

这个不用解释了,用open就可以了。需要注意的是,根据不同的搜索创建不同的文件。我没有聪明的办法。我只能分两步完成。

第一步:创建文件并写入标题

#写入标题

with open('%s.csv'%keyword, 'w', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerow(title)

fp.close()

第 2 步:写入数据

#写入数据

with open('%s.csv'%self.keyword,'a',encoding='utf-8',newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())#保存数据的queue队列

fp.close()

四:多线程使用

我自己使用生产和消费模型

生产者负责获取数据

消费者有责任保存数据

#生产者

class Producted(threading.Thread):

def __init__(self,url_queue,data_queue,*args,**kwargs):

super(Producted, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

def run(self):

while True:

if self.url_queue.empty():

break

url = self.url_queue.get()

self.get_data(url)

#获取所需要的数据

def get_data(self,url):

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

title = content['data']['title']

author = content['data']['owner']['name']

info = content['data']['desc']

info = re.sub(r'\n','',info)

aid = 'av'+str(content['data']['stat']['aid'])

view = content['data']['stat']['view']

coin = content['data']['stat']['coin']

share = content['data']['stat']['share']

like = content['data']['stat']['like']

self.data_queue.put((title,author,info,aid,view,coin,share,like))

#消费者

class Contident(threading.Thread):

def __init__(self,url_queue,data_queue,keyword,*args,**kwargs):

super(Contident, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

self.keyword = keyword

def run(self):

while True:

if self.url_queue.empty() and self.data_queue.empty():

break

print(self.data_queue.get())

title,author,info,aid,view,coin,share,like = self.data_queue.get()

with open('%s.csv'%self.keyword,'a', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())

fp.close()

要查看完整的代码链接,请转到 查看全部

从网页抓取视频(:刷新网页-不难发现我们要获取的数据全在)

一:一一搜索+获取页数

要搜索的东西很多,所以我们把所有的选项放在一个列表中,然后一一抓取。以搜索'resume'为例,我们发现有不止一个页面,每个页面的url都有一定的规则,第一页后page=1,第二页后page=2...所以你知道。

我们可以先得到总页数,然后爬取每页的视频信息。

keywords = ['简历','简历模板','面试','实习','找工作','笔试','职场']

for keyword in keywords:

url_keyword = 'https://search.bilibili.com/all?keyword=%s'%keyword

#获取每一个问题的页数

text_keyword = requests.get(url_keyword,handers).content.decode('utf-8')

pages = re.findall(r'(.*?)',text_keyword,re.DOTALL)[0]

#去除没必要的东西

pages = re.sub(r'\n','',pages)

pages = int(re.sub(r' ', '', pages))

二:获取视频信息

我第一次做的时候,用和之前一样的方法,直接访问视频的链接。结果经过测试,什么也没发现。这时候就要注意了,视频网页是动态网页,不能使用过去的静态网页方式,所以我们必须抓包获取数据。

查看网页-网络-刷新网页-不难发现我们想要获取的数据都在view里面?cid=...这个包

该包的链接是标题中的通用请求 URL。这是我们获取数据的链接。我们很容易通过json找到数据

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

print('视频名字:',content['data']['title'])

print('作者:',content['data']['owner']['name'])

print('视频简介:',content['data']['desc'])

print('视频号:','av'+str(content['data']['stat']['aid']))

print('播放量:',content['data']['stat']['view'])

print('硬币数:',content['data']['stat']['coin'])

print('分享数:',content['data']['stat']['share'])

print('点赞数:',content['data']['stat']['like'])

三:数据存储

这个不用解释了,用open就可以了。需要注意的是,根据不同的搜索创建不同的文件。我没有聪明的办法。我只能分两步完成。

第一步:创建文件并写入标题

#写入标题

with open('%s.csv'%keyword, 'w', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerow(title)

fp.close()

第 2 步:写入数据

#写入数据

with open('%s.csv'%self.keyword,'a',encoding='utf-8',newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())#保存数据的queue队列

fp.close()

四:多线程使用

我自己使用生产和消费模型

生产者负责获取数据

消费者有责任保存数据

#生产者

class Producted(threading.Thread):

def __init__(self,url_queue,data_queue,*args,**kwargs):

super(Producted, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

def run(self):

while True:

if self.url_queue.empty():

break

url = self.url_queue.get()

self.get_data(url)

#获取所需要的数据

def get_data(self,url):

text = requests.get(url).content.decode('utf-8')

content = json.loads(text)

title = content['data']['title']

author = content['data']['owner']['name']

info = content['data']['desc']

info = re.sub(r'\n','',info)

aid = 'av'+str(content['data']['stat']['aid'])

view = content['data']['stat']['view']

coin = content['data']['stat']['coin']

share = content['data']['stat']['share']

like = content['data']['stat']['like']

self.data_queue.put((title,author,info,aid,view,coin,share,like))

#消费者

class Contident(threading.Thread):

def __init__(self,url_queue,data_queue,keyword,*args,**kwargs):

super(Contident, self).__init__(*args, **kwargs)

self.url_queue = url_queue

self.data_queue = data_queue

self.keyword = keyword

def run(self):

while True:

if self.url_queue.empty() and self.data_queue.empty():

break

print(self.data_queue.get())

title,author,info,aid,view,coin,share,like = self.data_queue.get()

with open('%s.csv'%self.keyword,'a', encoding='utf-8', newline='')as fp:

write = csv.writer(fp)

write.writerows(self.data_queue.get())

fp.close()

要查看完整的代码链接,请转到

从网页抓取视频(如何快速爬取上千个短视频系列之爬取好看视频 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2022-01-01 03:17

)

一、爬虫的基本概念

为了照顾一些新手同学,在项目开始之前还是先讲一下爬虫的基本概念。接触过爬虫的可以忽略这部分,直接看后面。

2.爬虫是如何抓取网页数据的?

这里就讲一下网页的三大特点:

3.固定套路总结

四大步骤:

请求和响应

二、爬虫案例:爬取短视频系列好看的视频

我们正式进入今天的实战话题,如何快速抓取上千条短视频,以好看的视频为例,废话不多说,先来看看源码,后面会详细讲解.

案例代码:

三、代码逻辑详解:1.页面分析和url分析

分析着陆页,我应该分析和写什么?首先你要分析它是静态网页还是动态网页,那你怎么分析呢? (以爬取好看视频搞笑类为例)

我们如何获取动态网页的数据包? 鼠标右击--勾选

会弹出如下控制台。我们应该定位网络以捕获数据。这是一个类似于浏览器提供的抓包工具的功能。同时,因为我们要抓取的是动态的网站,所以如果你定位到下面的XHR,它会帮我们过滤掉所有的动态数据,也就是说网页中的动态数据是汇总的在这个 XHR 中。

点击右侧的第二个数据包,会弹出服务器返回给浏览器的原创数据。预览是针对这些原创数据的。他会帮你整理资料。您可以相应地折叠和展开数据。然后我们可以展开这些数据,看到它对应的是网页上视频的标题

数据包找到了,下一步就是定位headers,找到Request URL,后面还有一个网页地址,这就是我们今天确定的URL地址

接下来我们把这个url截取到导航栏上的url进行对比,注意看是不是和上面导航栏的地址不一样,也就是说动态数据包的地址通常和导航栏上的地址是的,所以分析网站很重要。你不能说你请求的哪个网站一定是哪个url链接,你要找到真正正确的url

接下来,在标头中找到请求标头。这是一个请求头。里面有很多参数。那么我们今天需要获取一个user-agent参数。它有什么作用?前面说过,爬虫就是模拟用户请求服务器。为了避免被其他服务器发现并阻止您爬行,您需要假装自己。那么用户代理就是浏览器的标识符。

2、发送请求 --request 模拟浏览器发送请求并获取响应数据

3、分析数据

我们今天正在抓取视频,因此我们需要视频的标题名称和视频本身的播放网址。找到title和pale_url后,我们可以通过剥洋葱的方式一层一层的得到视频,因为一个视频是一个视频数据,注意看这是一个字典格式,可以通过key-value对的形式获取, 取键名取值

4、保存数据

用python写爬虫程序一键下载数百个视频,速度还是挺快的