php可以抓取网页数据吗

php可以抓取网页数据吗(requiresPHP4Beta4+)$maxframes允许追踪的框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2022-03-17 11:28

$error 报告在哪里,如果有的话

$response_code 服务器返回的响应码

从服务器返回的 $headers 标头

$maxlength 最长返回数据长度

$read_timeout 读取超时(需要 PHP 4 Beta 4+)

设置为 0 表示没有超时

$timed_out 如果读取操作超时,此属性返回 true(需要 PHP 4 Beta 4+)

$maxframes 允许跟踪的最大帧数

$status 获取 http 状态

Web 服务器可以写入的临时文件的 $temp_dir 目录 (/tmp)

cURL二进制的$curl_path目录,如果没有cURL二进制则设置为false

以下是演示

复制代码代码如下:

包括“Snoopy.class.php”;

$snoopy = 新史努比;

$snoopy->proxy_host = "";

$snoopy->proxy_port = "8080";

$snoopy->agent = "(兼容;MSIE 4.01;MSN 2.5;AOL 4.0;Windows 98)";

$snoopy->referer = "";

$snoopy->cookies["SessionID"] = 238472834723489l;

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext(""))

{

回声“

".htmlspecialchars($snoopy->results)."

\n";

}

其他

echo "获取文档时出错:".$snoopy->error."\n";

////////////////////////////////////// //////////

Snoopy 的特点是“大”和“满”,一次 fetch 可以拾取一切,可以作为 采集 的第一步。接下来,您需要使用 simple_html_dom 扣除所需的部分。当然,如果你特别擅长规律,喜欢规律,也可以用规律来搭配抢。

simple_html_dom 实际上是一个 dom 解析过程。 PHP也提供了一些解析方法,不过这个simple_html_dom可以说是比较专业的一个类,满足了很多你想要的功能。

////////////////////////////////////// ///////////

// 使用URL或文件名创建目标文档对象,即目标网页

$html = file_get_html ('' );

//$html = file_get_html('test.htm');

//使用字符串作为登陆页面。可以通过Snoopy获取页面,然后在这里获取处理

$myhtml = str_get_html ('你好!' );

// 查找所有图片并返回一个数组

foreach($html->find ('img' ) as $element)

echo $element->src 。 '

' ;

// 查找所有链接

foreach($html->find ('a') as $element)

echo $element->href 。 '

' ;

find 方法效果很好,通常它返回一个对象数组。在查找目标元素时,可以通过class或者id,或者其他属性来获取目标字符串。

//通过目标div的class属性搜索div。 find 方法中的第二个参数是返回数组中的数字。从0开始是第一个

$target_div = $html->find('div.targetclass',0 );

//检查结果是不是你想要的,直接echo就行了

回声 $target_div;

//关键是这个采集对象创建后一定要销毁,否则php页面可能会“卡住”30秒左右,这取决于你服务器的时间限制。销毁的方法是:

$html->clear();

未设置($html);

我觉得simple_html_dom的优势在于采集和JS一样容易控制。下面提供的下载包中有英文说明书

simplehtmldom_1_11/simplehtmldom/manual/manual.htm

数组

$e->getAllAttributes()

数组

$e->属性

字符串

$e->getAttribute($name)

字符串

$e->属性

无效

$e->setAttribute($name, $value)

无效

$value = $e->属性

布尔

$e->hasAttribute($name)

布尔

isset($e->属性)

无效

$e->removeAttribute ($name)

无效

$e->attribute=null

元素

$e->getElementById($id)

混合

$e->find ("#$id", 0)

混合

$e->getElementsById($id [,$index])

混合

$e->find ("#$id" [, int $index])

元素

$e->getElementByTagName ($name)

混合

$e->find ($name, 0)

混合

$e->getElementsByTagName ($name [, $index])

混合

$e->find ($name [, int $index])

元素

$e->parentNode()

元素

$e->parent()

混合

$e->childNodes ([$index])

混合

$e->children ([int $index])

元素

$e->firstChild()

元素

$e->first_child()

元素

$e->lastChild()

元素

$e->last_child()

元素

$e->nextSibling()

元素

$e->next_sibling()

元素

$e->previousSibling()

元素

$e->prev_sibling()

相关文章 查看全部

php可以抓取网页数据吗(requiresPHP4Beta4+)$maxframes允许追踪的框架)

$error 报告在哪里,如果有的话

$response_code 服务器返回的响应码

从服务器返回的 $headers 标头

$maxlength 最长返回数据长度

$read_timeout 读取超时(需要 PHP 4 Beta 4+)

设置为 0 表示没有超时

$timed_out 如果读取操作超时,此属性返回 true(需要 PHP 4 Beta 4+)

$maxframes 允许跟踪的最大帧数

$status 获取 http 状态

Web 服务器可以写入的临时文件的 $temp_dir 目录 (/tmp)

cURL二进制的$curl_path目录,如果没有cURL二进制则设置为false

以下是演示

复制代码代码如下:

包括“Snoopy.class.php”;

$snoopy = 新史努比;

$snoopy->proxy_host = "";

$snoopy->proxy_port = "8080";

$snoopy->agent = "(兼容;MSIE 4.01;MSN 2.5;AOL 4.0;Windows 98)";

$snoopy->referer = "";

$snoopy->cookies["SessionID"] = 238472834723489l;

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext(""))

{

回声“

".htmlspecialchars($snoopy->results)."

\n";

}

其他

echo "获取文档时出错:".$snoopy->error."\n";

////////////////////////////////////// //////////

Snoopy 的特点是“大”和“满”,一次 fetch 可以拾取一切,可以作为 采集 的第一步。接下来,您需要使用 simple_html_dom 扣除所需的部分。当然,如果你特别擅长规律,喜欢规律,也可以用规律来搭配抢。

simple_html_dom 实际上是一个 dom 解析过程。 PHP也提供了一些解析方法,不过这个simple_html_dom可以说是比较专业的一个类,满足了很多你想要的功能。

////////////////////////////////////// ///////////

// 使用URL或文件名创建目标文档对象,即目标网页

$html = file_get_html ('' );

//$html = file_get_html('test.htm');

//使用字符串作为登陆页面。可以通过Snoopy获取页面,然后在这里获取处理

$myhtml = str_get_html ('你好!' );

// 查找所有图片并返回一个数组

foreach($html->find ('img' ) as $element)

echo $element->src 。 '

' ;

// 查找所有链接

foreach($html->find ('a') as $element)

echo $element->href 。 '

' ;

find 方法效果很好,通常它返回一个对象数组。在查找目标元素时,可以通过class或者id,或者其他属性来获取目标字符串。

//通过目标div的class属性搜索div。 find 方法中的第二个参数是返回数组中的数字。从0开始是第一个

$target_div = $html->find('div.targetclass',0 );

//检查结果是不是你想要的,直接echo就行了

回声 $target_div;

//关键是这个采集对象创建后一定要销毁,否则php页面可能会“卡住”30秒左右,这取决于你服务器的时间限制。销毁的方法是:

$html->clear();

未设置($html);

我觉得simple_html_dom的优势在于采集和JS一样容易控制。下面提供的下载包中有英文说明书

simplehtmldom_1_11/simplehtmldom/manual/manual.htm

数组

$e->getAllAttributes()

数组

$e->属性

字符串

$e->getAttribute($name)

字符串

$e->属性

无效

$e->setAttribute($name, $value)

无效

$value = $e->属性

布尔

$e->hasAttribute($name)

布尔

isset($e->属性)

无效

$e->removeAttribute ($name)

无效

$e->attribute=null

元素

$e->getElementById($id)

混合

$e->find ("#$id", 0)

混合

$e->getElementsById($id [,$index])

混合

$e->find ("#$id" [, int $index])

元素

$e->getElementByTagName ($name)

混合

$e->find ($name, 0)

混合

$e->getElementsByTagName ($name [, $index])

混合

$e->find ($name [, int $index])

元素

$e->parentNode()

元素

$e->parent()

混合

$e->childNodes ([$index])

混合

$e->children ([int $index])

元素

$e->firstChild()

元素

$e->first_child()

元素

$e->lastChild()

元素

$e->last_child()

元素

$e->nextSibling()

元素

$e->next_sibling()

元素

$e->previousSibling()

元素

$e->prev_sibling()

相关文章

php可以抓取网页数据吗(4年前1737前端安全系列之二:如何防止CSRF攻击?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-03-16 00:20

PHP爬取网页和解析HTML的常用方法总结

PHP 使用 QueryList 抓取网页内容

原文:PHP使用QueryList来抓取网页内容。之前用Java Jsoup爬取网页数据。前几天听说用PHP爬取比较方便。今天研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQuery 的泛型 list采集 类,简单、灵活、强大

陈杰克 6年前 1527

PHP 使用 QueryList 抓取网页内容

以前,我使用Java Jsoup 来捕获网页数据。前几天听说用PHP比较方便。今天简单研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQ 的

thinkyoung6 年前1544

Python爬虫框架-PySpider

From: From: PySpider PySpider github地址PySpider官方文档PySpi

shadowcat4 年前7965

前端面试题集

一、理论知识1.1、前端MV*框架的含义早期的前端比较简单,基本上以页面为工作单位,内容主要是浏览,偶尔也有简单的表单操作,基本不需要框架。随着AJAX的出现和Web2.0的兴起,人们可以在页面上做更复杂的事情,然后前端框架才真正出现

科技胖子4年前 1737

前端安全系列二:如何防范CSRF攻击?

背景随着互联网的飞速发展,信息安全已经成为企业关注的焦点之一,而前端则是引发企业安全问题的高风险基地。移动互联网时代,除了XSS、CSRF等传统安全问题外,前端人员经常会遇到网络劫持、非法调用Hybrid API等新的安全问题。当然,浏览

技术小能手3年前 2211

国内大公司开源项目清单

奇虎3601.MySQL 中间层Atlas Atlas是Web平台部基础架构团队奇虎360开发维护的基于MySQL协议的数据中间层项目。在 MySQL MySQL-Prox 中正式上线

double2li4 年前2877

大公司都有哪些开源项目~~~阿里、百度、腾讯、360、新浪、网易、小米等

红色字体现阶段比较流行------------------------------------------ --- ------------------------------------------------------------ -----------奇虎36

徐茂君3 年前3896

老式 - 从输入 url 到页面显示发生了什么

读取目录 输入地址 浏览器查找域名的 IP 地址 浏览器向 Web 服务器发送 HTTP 请求 服务器的永久重定向响应 浏览器跟随重定向地址 服务器处理请求 服务器返回 HTTP 响应浏览器显示 HTML 浏览器发送请求以获取 HTML 中的嵌入资源

沃克武松4年前2156 查看全部

php可以抓取网页数据吗(4年前1737前端安全系列之二:如何防止CSRF攻击?)

PHP爬取网页和解析HTML的常用方法总结

PHP 使用 QueryList 抓取网页内容

原文:PHP使用QueryList来抓取网页内容。之前用Java Jsoup爬取网页数据。前几天听说用PHP爬取比较方便。今天研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQuery 的泛型 list采集 类,简单、灵活、强大

陈杰克 6年前 1527

PHP 使用 QueryList 抓取网页内容

以前,我使用Java Jsoup 来捕获网页数据。前几天听说用PHP比较方便。今天简单研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQ 的

thinkyoung6 年前1544

Python爬虫框架-PySpider

From: From: PySpider PySpider github地址PySpider官方文档PySpi

shadowcat4 年前7965

前端面试题集

一、理论知识1.1、前端MV*框架的含义早期的前端比较简单,基本上以页面为工作单位,内容主要是浏览,偶尔也有简单的表单操作,基本不需要框架。随着AJAX的出现和Web2.0的兴起,人们可以在页面上做更复杂的事情,然后前端框架才真正出现

科技胖子4年前 1737

前端安全系列二:如何防范CSRF攻击?

背景随着互联网的飞速发展,信息安全已经成为企业关注的焦点之一,而前端则是引发企业安全问题的高风险基地。移动互联网时代,除了XSS、CSRF等传统安全问题外,前端人员经常会遇到网络劫持、非法调用Hybrid API等新的安全问题。当然,浏览

技术小能手3年前 2211

国内大公司开源项目清单

奇虎3601.MySQL 中间层Atlas Atlas是Web平台部基础架构团队奇虎360开发维护的基于MySQL协议的数据中间层项目。在 MySQL MySQL-Prox 中正式上线

double2li4 年前2877

大公司都有哪些开源项目~~~阿里、百度、腾讯、360、新浪、网易、小米等

红色字体现阶段比较流行------------------------------------------ --- ------------------------------------------------------------ -----------奇虎36

徐茂君3 年前3896

老式 - 从输入 url 到页面显示发生了什么

读取目录 输入地址 浏览器查找域名的 IP 地址 浏览器向 Web 服务器发送 HTTP 请求 服务器的永久重定向响应 浏览器跟随重定向地址 服务器处理请求 服务器返回 HTTP 响应浏览器显示 HTML 浏览器发送请求以获取 HTML 中的嵌入资源

沃克武松4年前2156

php可以抓取网页数据吗(PHP爱好者的操作环境-快照系统、Dell“网页快照”)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-03-13 21:00

今天,PHP爱好者为大家带来快照的使用。快照也称为“网页快照”。当搜索引擎在 收录 网页上时,它会备份该网页并将其存储在自己的服务器缓存中。当点击“网页快照”链接时,搜索引擎会显示当时蜘蛛系统抓取并保存的网页内容。我希望能有所帮助。

本文运行环境:Windows7系统,戴尔G3电脑。

当搜索引擎在 收录 网页上时,它会备份该网页并将其存储在自己的服务器缓存中。当用户点击搜索引擎中的“网页快照”链接时,搜索引擎将抓取当时Spider系统抓取并保存的网页。显示内容,称为“页面快照”。

由于网页快照存储在搜索引擎服务器中,因此查看网页快照的速度往往比直接访问网页要快。在网页截图中,搜索到的关键词以亮色显示,用户可以点击亮色的关键词直接找到关键词的位置,方便快速查找所需的信息和提高搜索效率。当搜索到的网页被删除或链接失效时,可以通过网页快照查看网页的原创内容。

原则

为什么我们只是在搜索引擎的搜索框中输入我们要查询的关键词,搜索引擎会立即扫过浩瀚的互联网上包括关键词在内的所有网页,呈现在前面我们。如果您了解搜索引擎的工作原理,您不会这么认为。每个网页上都有很多超链接,链接到其他网页,而这些网页还有很多超链接,可以链接到其他网页。大量网页被逐渐爬取。

搜索引擎的老大哥 Google 的名字来源于一个数学上几乎无法逾越的数字:googol,它是 10 的 100 次方,在其网页数据库中存储了数十亿个网页。网页通过上述方法被Net Spider系统抓取并保存。所有这些页面,当显示在搜索引擎结果中时,都称为页面快照。

快照抓取

当用户使用搜索引擎在互联网上搜索网页时,实际上是在搜索引擎的网页数据库中进行搜索。用户误以为搜索引擎在互联网上一下子找到了收录关键词的网页。

Internet 上的网页不是静态的,而是不断添加、删除和更改的。因此,搜索引擎网页数据库中的网页也需要及时更新,即重新复制互联网上的网页。如果你在你的网站上删除了一个网页,那么搜索引擎数据库中的副本——网页快照不会立即被删除,而是会在一段时间后被删除。但是,谷歌的网页快照显示了快照的存档时间,所以在这个时间点上,网页必须仍然存在。示例:打开2008 年7 月20 日Google 网页的快照,该快照显示Google 在7 月10 日搜索并归档。这是什么意思?这意味着:在 2008 年 7 月 20 日,此页面可能已被删除或更新,但在 2008 年 7 月 10 日,

搜索引擎和快照

搜索引擎还尝试采集所有可以找到的 URL,并将收录相同 关键词 的页面排入队列。纯商业搜索引擎采用纯商业原则,根据点击率对页面进行排名,保证用户搜索效率最高。

搜索引擎只是一个工具,你可以通过熟练的驱动在互联网上找到非常丰富的资源。

目前,最人性化的网页快照是“百度”。除了谷歌快照的所有功能外,“百度快照”还增加了关键词定位功能,为用户提供更快、更高效的关键词搜索方式,更方便“百度快照”已大大超越其他同类搜索引擎。

影响

网页快照的作用:

1、网页快照可以保留修改前网页的内容信息。

2、网页快照显示蜘蛛爬行的频率网站。

3、网页快照可用作现有网站 内容和爬取内容的参考。

4、网页快照可以反映网站定期内容更新。

5、网页快照可以反映搜索引擎的信任程度。

以上是快照含义的详细内容。更多信息请关注PHP爱好者的其他相关话题文章! 查看全部

php可以抓取网页数据吗(PHP爱好者的操作环境-快照系统、Dell“网页快照”)

今天,PHP爱好者为大家带来快照的使用。快照也称为“网页快照”。当搜索引擎在 收录 网页上时,它会备份该网页并将其存储在自己的服务器缓存中。当点击“网页快照”链接时,搜索引擎会显示当时蜘蛛系统抓取并保存的网页内容。我希望能有所帮助。

本文运行环境:Windows7系统,戴尔G3电脑。

当搜索引擎在 收录 网页上时,它会备份该网页并将其存储在自己的服务器缓存中。当用户点击搜索引擎中的“网页快照”链接时,搜索引擎将抓取当时Spider系统抓取并保存的网页。显示内容,称为“页面快照”。

由于网页快照存储在搜索引擎服务器中,因此查看网页快照的速度往往比直接访问网页要快。在网页截图中,搜索到的关键词以亮色显示,用户可以点击亮色的关键词直接找到关键词的位置,方便快速查找所需的信息和提高搜索效率。当搜索到的网页被删除或链接失效时,可以通过网页快照查看网页的原创内容。

原则

为什么我们只是在搜索引擎的搜索框中输入我们要查询的关键词,搜索引擎会立即扫过浩瀚的互联网上包括关键词在内的所有网页,呈现在前面我们。如果您了解搜索引擎的工作原理,您不会这么认为。每个网页上都有很多超链接,链接到其他网页,而这些网页还有很多超链接,可以链接到其他网页。大量网页被逐渐爬取。

搜索引擎的老大哥 Google 的名字来源于一个数学上几乎无法逾越的数字:googol,它是 10 的 100 次方,在其网页数据库中存储了数十亿个网页。网页通过上述方法被Net Spider系统抓取并保存。所有这些页面,当显示在搜索引擎结果中时,都称为页面快照。

快照抓取

当用户使用搜索引擎在互联网上搜索网页时,实际上是在搜索引擎的网页数据库中进行搜索。用户误以为搜索引擎在互联网上一下子找到了收录关键词的网页。

Internet 上的网页不是静态的,而是不断添加、删除和更改的。因此,搜索引擎网页数据库中的网页也需要及时更新,即重新复制互联网上的网页。如果你在你的网站上删除了一个网页,那么搜索引擎数据库中的副本——网页快照不会立即被删除,而是会在一段时间后被删除。但是,谷歌的网页快照显示了快照的存档时间,所以在这个时间点上,网页必须仍然存在。示例:打开2008 年7 月20 日Google 网页的快照,该快照显示Google 在7 月10 日搜索并归档。这是什么意思?这意味着:在 2008 年 7 月 20 日,此页面可能已被删除或更新,但在 2008 年 7 月 10 日,

搜索引擎和快照

搜索引擎还尝试采集所有可以找到的 URL,并将收录相同 关键词 的页面排入队列。纯商业搜索引擎采用纯商业原则,根据点击率对页面进行排名,保证用户搜索效率最高。

搜索引擎只是一个工具,你可以通过熟练的驱动在互联网上找到非常丰富的资源。

目前,最人性化的网页快照是“百度”。除了谷歌快照的所有功能外,“百度快照”还增加了关键词定位功能,为用户提供更快、更高效的关键词搜索方式,更方便“百度快照”已大大超越其他同类搜索引擎。

影响

网页快照的作用:

1、网页快照可以保留修改前网页的内容信息。

2、网页快照显示蜘蛛爬行的频率网站。

3、网页快照可用作现有网站 内容和爬取内容的参考。

4、网页快照可以反映网站定期内容更新。

5、网页快照可以反映搜索引擎的信任程度。

以上是快照含义的详细内容。更多信息请关注PHP爱好者的其他相关话题文章!

php可以抓取网页数据吗(爬虫在数据分析领域的应用,如何帮助我们提升数据分析质量)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-09 18:12

在当今信息化和数字化的时代,人们离不开网络搜索,但想想看,在搜索过程中,你真的可以得到相关信息,因为有人在帮你过滤相关内容,呈现在你面前。

就像在餐馆里一样,你点了土豆然后得到它们,因为有人帮你在土豆、萝卜、西红柿等中找到它们,然后有人把它们带到你的餐桌上。在网上,这两个动作是一个叫爬虫的同学为你实现的。

也就是说,没有爬虫,就没有今天的检索,就无法准确查找信息和高效获取数据。今天DataHunter就来谈谈爬虫在数据分析领域的应用,以及它如何帮助我们提高数据分析的质量。

一、数据时代,爬虫的本质是提高效率

网络爬虫,又称网络机器人,可以代替人自动浏览网络信息,采集和组织数据。

它是一个程序,其基本原理是向网站/网络发起请求,获取资源后分析提取有用数据。从技术上讲,就是通过程序模拟浏览器请求站点的行为,将站点返回的HTML代码/JSON数据/二进制数据(图片、视频)爬取到本地,然后提取您需要的数据并将其存储以供使用。

每个程序都有自己的规则,网络爬虫也不例外。它穿梭于世界各地的各种网站之间,根据人们强加的规则将采集信息。我们称这些规则为网络爬虫算法。规则是人定的,是人根据自己的目的和需要设计的。因此,根据用户的目的,爬虫可以有不同的功能。但所有爬虫的本质是方便人们在海量的互联网信息中找到并下载自己想要的信息类型,从而提高信息获取效率。

二、爬虫的应用:搜索并帮助企业做强业务

1.搜索引擎:爬取网站为网络用户提供便利

在互联网的早期,能够提供全球范围内信息的网站并不多,用户也不多。Internet 只是文件传输协议 (FTP) 站点的集合,用户可以在其中导航以查找特定的共享文件,并查找和组合 Internet 上可用的分布式数据,创建了一个称为网络爬虫的自动化程序 /Robot,它可以爬取网络上的所有网页,然后将所有页面的内容复制到数据库中进行索引。这也是最早的搜索引擎。

如今,随着互联网的飞速发展,我们可以在任何搜索引擎中看到来自世界各地各种网站的信息。百度搜索引擎的爬虫叫百度蜘蛛,360的爬虫叫360Spider,搜狗的爬虫叫搜狗蜘蛛,必应的爬虫叫Bingbot。搜索引擎离不开爬虫。

比如百度蜘蛛每天都会抓取大量的互联网信息,抓取优质信息和收录。当用户在百度搜索引擎上搜索对应的关键词时,百度会对关键词进行分析处理,从收录的网页中找出相关网页,按照一定的排名规则和结果展示给用户,工作原理如图。现在,我们可以大胆地说,你每天都在免费享受爬虫的好处。

2.企业:监控舆情,高效获取有价值信息

我们说过爬虫的本质是提高效率,而爬虫的规则是由人决定的;那么企业就可以完全根据自己的业务需求设计爬虫,第一时间获取网络上的相关信息,并进行清理整合。

做大数据时代的数据分析,首先要有数据源,网络爬虫可以让我们获取更多的数据源,同时根据我们的目的进行采集,从而去除很多的无关数据。

例如,在进行大数据分析或数据挖掘时,可以从一些提供数据统计的网站s,或者从某些文档或内部资料中获取数据源。但是,这些获取数据的方式有时很难满足我们的数据需求。此时,我们可以利用爬虫技术从互联网上自动获取更多我们感兴趣的数据内容,从而进行更深入的数据分析,获取更多有价值的信息。

此外,网络爬虫还可用于财务分析,对财务数据进行采集进行投资分析;可应用于舆情监测分析、精准客户精准营销等各个领域。

三、企业常用的4种网络爬虫

网络爬虫根据实现的技术和结构可以分为一般网络爬虫、聚焦网络爬虫、增量网络爬虫和深度网络爬虫。但由于网络环境复杂,实际的网络爬虫通常是这几种爬虫的组合。

1.万能网络爬虫

通用网络爬虫也称为全网络爬虫。顾名思义,要爬取的目标资源在整个互联网上,要爬取的目标数据是巨大的,爬取的范围也很大。正是因为爬取的数据是海量数据,所以对于这种爬虫来说,对爬取的性能要求是非常高的。这种网络爬虫主要用于大型搜索引擎,具有很高的应用价值。

一般的网络爬虫主要由初始URL采集、URL队列、页面爬取模块、页面分析模块、页面数据库、链接过滤模块等组成。一般网络爬虫在爬取时会采用一定的爬取策略,主要包括深度优先爬取策略和广度优先爬取策略。具体细节将在后面介绍。

2.专注于网络爬虫

聚焦网络爬虫,也称为主题网络爬虫,是根据预先定义的主题有选择地爬取网页的爬虫。聚焦网络爬虫主要用于爬取特定信息,主要为特定类型的人提供服务。

聚焦网络爬虫也是由初始URL集合、URL队列、页面爬取模块、页面分析模块、页面数据库、链接过滤模块、内容评价模块、链接评价模块等组成。内容评估模块和链接评估模块可以根据链接和内容的重要性确定优先访问哪些页面。专注于网络爬虫的爬取策略主要有四种,如图:

由于专注的网络爬虫可以有目的地根据相应的主题进行爬取,在实际应用过程中可以节省大量的服务器资源和宽带资源,因此具有很强的实用性。这里我们以网络爬虫为例来了解爬虫运行的工作原理和过程。

如图所示,焦点网络爬虫有一个控制中心,负责管理和监控整个爬虫系统,包括控制用户交互、初始化爬虫、确定主题、协调各个模块之间的工作以及控制整个爬虫系统。爬行过程。等等:

(1)控制中心将初始URL集合传递给URL队列,页面爬取模块会从URL队列中读取第一批URL列表;

(2)根据这些URL地址,从网上爬取对应的页面;爬取后,将爬取的内容发送到页面数据库进行存储;

(3)在爬取过程中,会爬取一些新的URL,此时需要使用链接过滤模块,根据指定的主题过滤掉不相关的链接,然后使用链接评价模块进行根据主题剩余的URL链接。或者内容评估模块进行优先排序,完成后将新的URL地址传递给URL队列,供页面爬取模块使用;

(4)爬取并存入页面数据库后,需要使用页面分析模块,根据主题对爬取的页面进行分析处理,并根据处理结果建立索引库。当用户检索到相应的信息,就可以从索引数据库中进行相应的检索,得到相应的结果。

3.增量网络爬虫

这里的“incremental”对应于增量更新,意思是在更新过程中只更新变化的地方,不变的地方不更新。

增量网络爬虫,在爬取网页时,只爬取内容发生变化的网页或新生成的网页,不会爬取内容未发生变化的网页。增量网络爬虫可以在一定程度上保证爬取的页面尽可能的新。

4.深网爬虫

在互联网中,网页根据存在的程度可以分为表层页面和深层页面。表面页面是指无需提交表单,使用静态链接即可到达的静态页面;而深页是提交某个关键词后才能获得的页面。在 Internet 中,深层页面的数量通常远大于表面页面的数量。

深网爬虫可以爬取互联网中的深层页面,而要爬取深层页面,就需要想办法自动填写相应的表格。深网爬虫主要由 URL 列表、LVS 列表(LVS 指标签/值集合,即填充表单的数据源)、爬取控制器、解析器、LVS 控制器、表单分析器、表单处理器、响应分析仪等部件。

四、网络爬虫的爬取策略

前面我们说过,网络爬虫算法是基于人对采集信息施加的规则,由于网络环境复杂,算法也多种多样,也就是爬取策略。这里主要介绍爬取的顺序和频率。

1.爬取顺序

网络爬虫在爬取过程中,可能会出现在爬取的URL列表中的多个URL地址,因此爬虫会依次对这些URL地址进行爬取。

与一般的网络爬虫相比,爬取的顺序并不那么重要。但专注于网络爬虫,爬取的顺序与服务器资源和宽带资源有关,所以非常重要,一般由爬取策略决定。爬取策略主要包括深度优先爬取策略、广度优先爬取策略、大站点优先策略、反链策略等爬取策略。

如图,假设有一个网站,ABCDEFG为站点下的网页,网页的层次结构如图所示。如果此时网页ABCDEFG都在爬取队列中,那么根据不同的爬取策略,爬取的顺序是不同的。

深度优先爬取策略:A→D→E→B→C→F→G

广度优先爬取策略:A→B→C→D→E→F→G

除了以上两种爬取策略外,还可以使用大站点爬取策略。可以根据相应网页所属的站点进行分类。如果某个网站有大量的网页,则称为大站点。按照这个策略,网站拥有的网页越多,则越大,优先抓取该网页在大站点中的URL地址。

此外,还有反向链接策略。一个网页的反向链接数是指该网页被其他网页指向的次数。这个次数代表了该网页在一定程度上被其他网页推荐的次数。因此,如果按照反向链接策略进行爬取,那么哪个网页的反向链接多,就会先爬到哪个页面。

但是,在实际情况中,如果一个网页的优先级只是简单地由反向链接策略来决定的话,就可能会出现很多作弊的情况。因此,采用反向链接策略需要考虑可靠反向链接的数量。除了以上的爬取策略,实践中还有很多其他的爬取策略,比如OPIC策略、Partial PageRank策略等等。

2.爬取频率

网站 网页经常更新。作为爬虫,网站的更新频率越接近爬虫访问网站的频率,效果越好。当然,在爬虫服务器资源有限的情况下,爬虫还需要根据相应的策略,让不同的网页有不同的更新优先级。优先级高的网页会更新得更快,爬取响应也会更快。常见的网页更新策略有以下三种:

(1)用户体验策略:大部分用户使用搜索引擎查询某个关键词时,只会关注排名靠前的网页。因此,当爬虫服务器的资源处于有限,爬虫会优先更新排名靠前的页面。

(2)历史数据策略:是指根据一个网页的历史更新数据,通过泊松过程建模等手段,预测该网页下次更新时间的能力,从而确定下一次更新时间。抓取网页所花费的时间。

(3)聚类分析策略:网页可能有不同的内容,但一般来说,属性相似的网页更新频率相似,所以可以对大量网页进行聚类。爬取的频率是根据设定的同类型网页的平均更新值。

五、网络爬虫的实现技术

对于实现技术,本文不展开,只为有兴趣的同学提供几种常用语言:Python、Java、PHP、Node.JS、C++、Go语言(另外还有很多开发语言用于网络爬虫)。

Python:爬虫框架非常丰富,多线程处理能力强,而且易学,代码简洁,优点很多。

Java:适合开发大型爬虫项目。

PHP:后端处理能力很强,代码很简洁,模块丰富,但是并发能力比较弱。

Node.JS:支持高并发和多线程。

C++:运行速度快,适合开发大型爬虫项目,成本高。

Go语言:同样的高并发能力很强。

六、总结

说到爬虫,很多人认为它们是网络世界中不可能存在的灰色地带。恭喜你,看完这篇文章,你比很多人都知道。

因为爬虫分为良性爬虫和恶意爬虫,比如搜索引擎爬虫。Goodwill爬虫严格遵守Robots协议规范爬取网页数据(如URL),它的存在可以增加网站的曝光度,给网站带来流量;

恶意爬虫,无视Robots协议,肆意爬取网站中一些深度不情愿的数据,包括个人隐私或商业机密等重要信息。而恶意爬虫的用户想要多次大量地从网站获取信息,所以通常会在目标网站上投放大量爬虫。如果大量爬虫同时访问网站,很容易导致网站服务器超载或崩溃,导致网站算子丢失。

据统计,2017年我国42.2%的互联网流量是由网络机器人创造的,其中恶意机器(主要是恶意爬虫)占21.80%。我们应该合法合理地使用网络爬虫,这样才能用科技为企业带来长远发展,用科学为社会创造更高的价值。

关于数据猎人

DataHunter是一家专业的数据分析和商业智能服务商,注册于2014年,团队核心成员来自IBM、Oracle、SAP等知名企业,深耕大数据分析领域,拥有十余年丰富的企业服务经验。

DataHunter的核心产品Data Analytics智能数据分析平台和数据大屏设计配置工具Data MAX在行业中形成了自己的独特优势,在各行业积累了众多标杆客户和成功案例.

自成立以来,DataHunter一直致力于为客户提供实时、高效、智能的数据分析与展示解决方案,帮助企业查看和分析数据并改善业务,成为最值得信赖的数据业务公司。 查看全部

php可以抓取网页数据吗(爬虫在数据分析领域的应用,如何帮助我们提升数据分析质量)

在当今信息化和数字化的时代,人们离不开网络搜索,但想想看,在搜索过程中,你真的可以得到相关信息,因为有人在帮你过滤相关内容,呈现在你面前。

就像在餐馆里一样,你点了土豆然后得到它们,因为有人帮你在土豆、萝卜、西红柿等中找到它们,然后有人把它们带到你的餐桌上。在网上,这两个动作是一个叫爬虫的同学为你实现的。

也就是说,没有爬虫,就没有今天的检索,就无法准确查找信息和高效获取数据。今天DataHunter就来谈谈爬虫在数据分析领域的应用,以及它如何帮助我们提高数据分析的质量。

一、数据时代,爬虫的本质是提高效率

网络爬虫,又称网络机器人,可以代替人自动浏览网络信息,采集和组织数据。

它是一个程序,其基本原理是向网站/网络发起请求,获取资源后分析提取有用数据。从技术上讲,就是通过程序模拟浏览器请求站点的行为,将站点返回的HTML代码/JSON数据/二进制数据(图片、视频)爬取到本地,然后提取您需要的数据并将其存储以供使用。

每个程序都有自己的规则,网络爬虫也不例外。它穿梭于世界各地的各种网站之间,根据人们强加的规则将采集信息。我们称这些规则为网络爬虫算法。规则是人定的,是人根据自己的目的和需要设计的。因此,根据用户的目的,爬虫可以有不同的功能。但所有爬虫的本质是方便人们在海量的互联网信息中找到并下载自己想要的信息类型,从而提高信息获取效率。

二、爬虫的应用:搜索并帮助企业做强业务

1.搜索引擎:爬取网站为网络用户提供便利

在互联网的早期,能够提供全球范围内信息的网站并不多,用户也不多。Internet 只是文件传输协议 (FTP) 站点的集合,用户可以在其中导航以查找特定的共享文件,并查找和组合 Internet 上可用的分布式数据,创建了一个称为网络爬虫的自动化程序 /Robot,它可以爬取网络上的所有网页,然后将所有页面的内容复制到数据库中进行索引。这也是最早的搜索引擎。

如今,随着互联网的飞速发展,我们可以在任何搜索引擎中看到来自世界各地各种网站的信息。百度搜索引擎的爬虫叫百度蜘蛛,360的爬虫叫360Spider,搜狗的爬虫叫搜狗蜘蛛,必应的爬虫叫Bingbot。搜索引擎离不开爬虫。

比如百度蜘蛛每天都会抓取大量的互联网信息,抓取优质信息和收录。当用户在百度搜索引擎上搜索对应的关键词时,百度会对关键词进行分析处理,从收录的网页中找出相关网页,按照一定的排名规则和结果展示给用户,工作原理如图。现在,我们可以大胆地说,你每天都在免费享受爬虫的好处。

2.企业:监控舆情,高效获取有价值信息

我们说过爬虫的本质是提高效率,而爬虫的规则是由人决定的;那么企业就可以完全根据自己的业务需求设计爬虫,第一时间获取网络上的相关信息,并进行清理整合。

做大数据时代的数据分析,首先要有数据源,网络爬虫可以让我们获取更多的数据源,同时根据我们的目的进行采集,从而去除很多的无关数据。

例如,在进行大数据分析或数据挖掘时,可以从一些提供数据统计的网站s,或者从某些文档或内部资料中获取数据源。但是,这些获取数据的方式有时很难满足我们的数据需求。此时,我们可以利用爬虫技术从互联网上自动获取更多我们感兴趣的数据内容,从而进行更深入的数据分析,获取更多有价值的信息。

此外,网络爬虫还可用于财务分析,对财务数据进行采集进行投资分析;可应用于舆情监测分析、精准客户精准营销等各个领域。

三、企业常用的4种网络爬虫

网络爬虫根据实现的技术和结构可以分为一般网络爬虫、聚焦网络爬虫、增量网络爬虫和深度网络爬虫。但由于网络环境复杂,实际的网络爬虫通常是这几种爬虫的组合。

1.万能网络爬虫

通用网络爬虫也称为全网络爬虫。顾名思义,要爬取的目标资源在整个互联网上,要爬取的目标数据是巨大的,爬取的范围也很大。正是因为爬取的数据是海量数据,所以对于这种爬虫来说,对爬取的性能要求是非常高的。这种网络爬虫主要用于大型搜索引擎,具有很高的应用价值。

一般的网络爬虫主要由初始URL采集、URL队列、页面爬取模块、页面分析模块、页面数据库、链接过滤模块等组成。一般网络爬虫在爬取时会采用一定的爬取策略,主要包括深度优先爬取策略和广度优先爬取策略。具体细节将在后面介绍。

2.专注于网络爬虫

聚焦网络爬虫,也称为主题网络爬虫,是根据预先定义的主题有选择地爬取网页的爬虫。聚焦网络爬虫主要用于爬取特定信息,主要为特定类型的人提供服务。

聚焦网络爬虫也是由初始URL集合、URL队列、页面爬取模块、页面分析模块、页面数据库、链接过滤模块、内容评价模块、链接评价模块等组成。内容评估模块和链接评估模块可以根据链接和内容的重要性确定优先访问哪些页面。专注于网络爬虫的爬取策略主要有四种,如图:

由于专注的网络爬虫可以有目的地根据相应的主题进行爬取,在实际应用过程中可以节省大量的服务器资源和宽带资源,因此具有很强的实用性。这里我们以网络爬虫为例来了解爬虫运行的工作原理和过程。

如图所示,焦点网络爬虫有一个控制中心,负责管理和监控整个爬虫系统,包括控制用户交互、初始化爬虫、确定主题、协调各个模块之间的工作以及控制整个爬虫系统。爬行过程。等等:

(1)控制中心将初始URL集合传递给URL队列,页面爬取模块会从URL队列中读取第一批URL列表;

(2)根据这些URL地址,从网上爬取对应的页面;爬取后,将爬取的内容发送到页面数据库进行存储;

(3)在爬取过程中,会爬取一些新的URL,此时需要使用链接过滤模块,根据指定的主题过滤掉不相关的链接,然后使用链接评价模块进行根据主题剩余的URL链接。或者内容评估模块进行优先排序,完成后将新的URL地址传递给URL队列,供页面爬取模块使用;

(4)爬取并存入页面数据库后,需要使用页面分析模块,根据主题对爬取的页面进行分析处理,并根据处理结果建立索引库。当用户检索到相应的信息,就可以从索引数据库中进行相应的检索,得到相应的结果。

3.增量网络爬虫

这里的“incremental”对应于增量更新,意思是在更新过程中只更新变化的地方,不变的地方不更新。

增量网络爬虫,在爬取网页时,只爬取内容发生变化的网页或新生成的网页,不会爬取内容未发生变化的网页。增量网络爬虫可以在一定程度上保证爬取的页面尽可能的新。

4.深网爬虫

在互联网中,网页根据存在的程度可以分为表层页面和深层页面。表面页面是指无需提交表单,使用静态链接即可到达的静态页面;而深页是提交某个关键词后才能获得的页面。在 Internet 中,深层页面的数量通常远大于表面页面的数量。

深网爬虫可以爬取互联网中的深层页面,而要爬取深层页面,就需要想办法自动填写相应的表格。深网爬虫主要由 URL 列表、LVS 列表(LVS 指标签/值集合,即填充表单的数据源)、爬取控制器、解析器、LVS 控制器、表单分析器、表单处理器、响应分析仪等部件。

四、网络爬虫的爬取策略

前面我们说过,网络爬虫算法是基于人对采集信息施加的规则,由于网络环境复杂,算法也多种多样,也就是爬取策略。这里主要介绍爬取的顺序和频率。

1.爬取顺序

网络爬虫在爬取过程中,可能会出现在爬取的URL列表中的多个URL地址,因此爬虫会依次对这些URL地址进行爬取。

与一般的网络爬虫相比,爬取的顺序并不那么重要。但专注于网络爬虫,爬取的顺序与服务器资源和宽带资源有关,所以非常重要,一般由爬取策略决定。爬取策略主要包括深度优先爬取策略、广度优先爬取策略、大站点优先策略、反链策略等爬取策略。

如图,假设有一个网站,ABCDEFG为站点下的网页,网页的层次结构如图所示。如果此时网页ABCDEFG都在爬取队列中,那么根据不同的爬取策略,爬取的顺序是不同的。

深度优先爬取策略:A→D→E→B→C→F→G

广度优先爬取策略:A→B→C→D→E→F→G

除了以上两种爬取策略外,还可以使用大站点爬取策略。可以根据相应网页所属的站点进行分类。如果某个网站有大量的网页,则称为大站点。按照这个策略,网站拥有的网页越多,则越大,优先抓取该网页在大站点中的URL地址。

此外,还有反向链接策略。一个网页的反向链接数是指该网页被其他网页指向的次数。这个次数代表了该网页在一定程度上被其他网页推荐的次数。因此,如果按照反向链接策略进行爬取,那么哪个网页的反向链接多,就会先爬到哪个页面。

但是,在实际情况中,如果一个网页的优先级只是简单地由反向链接策略来决定的话,就可能会出现很多作弊的情况。因此,采用反向链接策略需要考虑可靠反向链接的数量。除了以上的爬取策略,实践中还有很多其他的爬取策略,比如OPIC策略、Partial PageRank策略等等。

2.爬取频率

网站 网页经常更新。作为爬虫,网站的更新频率越接近爬虫访问网站的频率,效果越好。当然,在爬虫服务器资源有限的情况下,爬虫还需要根据相应的策略,让不同的网页有不同的更新优先级。优先级高的网页会更新得更快,爬取响应也会更快。常见的网页更新策略有以下三种:

(1)用户体验策略:大部分用户使用搜索引擎查询某个关键词时,只会关注排名靠前的网页。因此,当爬虫服务器的资源处于有限,爬虫会优先更新排名靠前的页面。

(2)历史数据策略:是指根据一个网页的历史更新数据,通过泊松过程建模等手段,预测该网页下次更新时间的能力,从而确定下一次更新时间。抓取网页所花费的时间。

(3)聚类分析策略:网页可能有不同的内容,但一般来说,属性相似的网页更新频率相似,所以可以对大量网页进行聚类。爬取的频率是根据设定的同类型网页的平均更新值。

五、网络爬虫的实现技术

对于实现技术,本文不展开,只为有兴趣的同学提供几种常用语言:Python、Java、PHP、Node.JS、C++、Go语言(另外还有很多开发语言用于网络爬虫)。

Python:爬虫框架非常丰富,多线程处理能力强,而且易学,代码简洁,优点很多。

Java:适合开发大型爬虫项目。

PHP:后端处理能力很强,代码很简洁,模块丰富,但是并发能力比较弱。

Node.JS:支持高并发和多线程。

C++:运行速度快,适合开发大型爬虫项目,成本高。

Go语言:同样的高并发能力很强。

六、总结

说到爬虫,很多人认为它们是网络世界中不可能存在的灰色地带。恭喜你,看完这篇文章,你比很多人都知道。

因为爬虫分为良性爬虫和恶意爬虫,比如搜索引擎爬虫。Goodwill爬虫严格遵守Robots协议规范爬取网页数据(如URL),它的存在可以增加网站的曝光度,给网站带来流量;

恶意爬虫,无视Robots协议,肆意爬取网站中一些深度不情愿的数据,包括个人隐私或商业机密等重要信息。而恶意爬虫的用户想要多次大量地从网站获取信息,所以通常会在目标网站上投放大量爬虫。如果大量爬虫同时访问网站,很容易导致网站服务器超载或崩溃,导致网站算子丢失。

据统计,2017年我国42.2%的互联网流量是由网络机器人创造的,其中恶意机器(主要是恶意爬虫)占21.80%。我们应该合法合理地使用网络爬虫,这样才能用科技为企业带来长远发展,用科学为社会创造更高的价值。

关于数据猎人

DataHunter是一家专业的数据分析和商业智能服务商,注册于2014年,团队核心成员来自IBM、Oracle、SAP等知名企业,深耕大数据分析领域,拥有十余年丰富的企业服务经验。

DataHunter的核心产品Data Analytics智能数据分析平台和数据大屏设计配置工具Data MAX在行业中形成了自己的独特优势,在各行业积累了众多标杆客户和成功案例.

自成立以来,DataHunter一直致力于为客户提供实时、高效、智能的数据分析与展示解决方案,帮助企业查看和分析数据并改善业务,成为最值得信赖的数据业务公司。

php可以抓取网页数据吗(学哪一个好呀?能不能介绍一下ASP,,CGI,PHP)

网站优化 • 优采云 发表了文章 • 0 个评论 • 40 次浏览 • 2022-03-07 07:17

他们可以将会话保存到文件或数据库中,然后一起读取会话文件

好像不能直接得到

只需直接使用超全局变量 $_SESSION 即可。

比如你在上一页 $_SESSION['abc'] = 5;

在另一个页面上,可以直接 echo $_SESSION['abc'];

输出5.

在 php 的所有输出之前调用 session_start();

然后您可以将会话用作超级数组。

例如

赋值:$_SESSION['username'] = ''berryblue;

值:$username = $_SESSION['username'];

判断:isset($_SESSION['username']),,empty($_SESSION['username']);

破坏:unset($_SESSION['username']);

在asp1.asp中给session赋值后,需要response.write session("variable")检查赋值是否成功。

应该是不可能的。这种形式的参数可以通过url传递

login.php?username=xx&pwd=xxx

密码部分最好加密

如何将asp网站采集的数据传到php网站-:一种是直接传数据库,用php写一个程序连接两个数据库,然后找出来asp 并将其写入您自己的数据库中。另一种是写一个采集规则,访问asp的网站,然后写入自己的数据库,看看别人怎么说。

如果把asp文件传给php空间,能执行吗?网易有个php空间:应该是不可能的,因为一般空间支持asp的是windows主机,php支持的是unix主机。您可以在那里放置一个 PHP 程序。没有 网站

哪一个比较好学?能介绍一下 ASP、JSP、CGI 和 PHP 吗?建议学习PHP。国内的ASP爱好者很多,再学一遍就枯燥了。当然,你也可以学习它。更多,但有点难。如果你很强大,你就是一个独特的人。JSP 是一个新事物。如果您有兴趣,不妨一试。

php中可以asp获取session值吗:可以将自己的session保存到文件或者数据库中,然后一起读取一个session文件直接获取,貌似不可能

ASP中如何使用PHP获取会话值,接口文件:写数据库或写文件,让PHP访问..

asp如何获取php传递的参数:只能将php中生成的ationid值再次提交给ASP页面。

是否可以在 ASP 中调用 PHP 文件 - : 当然,但是如果这两个文件在同一台服务器上,那么服务器需要同时支持两种背景语言环境。

asp 如何从 php 获取 cookie - PHP 进阶讨论:你可以获取相同 网站 的 cookie。站下可以用php脚本设置cookie,然后用asp脚本获取cookie。

如何在 ASP 页面上获取传递的 Session 值 - : string name=session.getsession["sessionname"] 查看全部

php可以抓取网页数据吗(学哪一个好呀?能不能介绍一下ASP,,CGI,PHP)

他们可以将会话保存到文件或数据库中,然后一起读取会话文件

好像不能直接得到

只需直接使用超全局变量 $_SESSION 即可。

比如你在上一页 $_SESSION['abc'] = 5;

在另一个页面上,可以直接 echo $_SESSION['abc'];

输出5.

在 php 的所有输出之前调用 session_start();

然后您可以将会话用作超级数组。

例如

赋值:$_SESSION['username'] = ''berryblue;

值:$username = $_SESSION['username'];

判断:isset($_SESSION['username']),,empty($_SESSION['username']);

破坏:unset($_SESSION['username']);

在asp1.asp中给session赋值后,需要response.write session("variable")检查赋值是否成功。

应该是不可能的。这种形式的参数可以通过url传递

login.php?username=xx&pwd=xxx

密码部分最好加密

如何将asp网站采集的数据传到php网站-:一种是直接传数据库,用php写一个程序连接两个数据库,然后找出来asp 并将其写入您自己的数据库中。另一种是写一个采集规则,访问asp的网站,然后写入自己的数据库,看看别人怎么说。

如果把asp文件传给php空间,能执行吗?网易有个php空间:应该是不可能的,因为一般空间支持asp的是windows主机,php支持的是unix主机。您可以在那里放置一个 PHP 程序。没有 网站

哪一个比较好学?能介绍一下 ASP、JSP、CGI 和 PHP 吗?建议学习PHP。国内的ASP爱好者很多,再学一遍就枯燥了。当然,你也可以学习它。更多,但有点难。如果你很强大,你就是一个独特的人。JSP 是一个新事物。如果您有兴趣,不妨一试。

php中可以asp获取session值吗:可以将自己的session保存到文件或者数据库中,然后一起读取一个session文件直接获取,貌似不可能

ASP中如何使用PHP获取会话值,接口文件:写数据库或写文件,让PHP访问..

asp如何获取php传递的参数:只能将php中生成的ationid值再次提交给ASP页面。

是否可以在 ASP 中调用 PHP 文件 - : 当然,但是如果这两个文件在同一台服务器上,那么服务器需要同时支持两种背景语言环境。

asp 如何从 php 获取 cookie - PHP 进阶讨论:你可以获取相同 网站 的 cookie。站下可以用php脚本设置cookie,然后用asp脚本获取cookie。

如何在 ASP 页面上获取传递的 Session 值 - : string name=session.getsession["sessionname"]

php可以抓取网页数据吗(Web站点数据采集程序的基本流程及流程图详解 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-03-04 14:02

)

首先需要明确:网站的任何页面,无论是php、jsp、aspx等动态页面还是后台程序生成的静态页面,都可以在浏览器。

所以当你要开发一个数据采集程序的时候,你首先要知道你要采集网站解开的网站的首页结构(HTML)。

一旦熟悉了 网站 中的 HTML 源文件的内容,其中数据是 采集,程序的其余部分就很容易了。因为C#在网站上执行数据采集,原理是“下载你想要的页面的HTML源文件到采集,分析HTML代码然后抓取你需要的数据,最后保存数据。到本地文件”。

基本流程如下图所示:

1.页面源文件下载

首先引用 System.Net 命名空间

使用 System.Net;

冰峰卡联赛

还需要引用

使用 System.Text;

使用下载十二生肖每日星座运势系统.IO;

引用后实例化一个 WebClient 对象

私人 WebClient wc = new WebClient();

调用DownloadData方法从指定网页的源文件中下载一组BYTE数据,然后将BYTE数组转换为字符串。

//下载页面源文件并转换为UTF8编码格式的STRING

string mainData = Encoding.UTF8.GetString(wc.DownloadData(string.Format("你要的网页地址采集")));

或者也可以调用DownloadFile方法,先将源文件下载到本地再读取其字符串

//下载网页源文件到本地

wc.DownloadFile("你要访问的网页的URL采集", "保存源文件的本地文件路径");

//读取下载的源文件HTML格式字符串

string mainData = File.ReadAllText("保存源文件的本地文件路径",Encoding.UTF8);

使用网页 HTML 格式字符串,您可以分析 采集 网页并抓取您需要的内容。

2.页面分析采集

页面分析就是用网页源文件中的一个特定的或唯一的字符(字符串)作为一个抓取点,从这个抓取点开始截取你想要的页面上的数据。

水花文胸

以博客园为栏目为例,如果我想要采集博客园首页列出的文章的标题和链接,我必须以"开头

代码:

//经过”

mainData=mainData.Substring(mainData.IndexOf("

//获取文章页面的链接地址

字符串 articleAddr = mainData.Substring(0,mainData.IndexOf("""));

//获取文章标题

字符串文章标题 = mainData.Substring(mainData.IndexOf("target="_blank">") + 16,

mainData.IndexOf("") - mainData.IndexOf("target="_blank">") - 16);

注意:当你要采集的网页首页的HTML格式发生变化时,作为抓取点的字符也要相应的改变,否则采集什么都得不到

3.数据存储

从网页中截取需要的数据后,将程序中的数据组织起来,保存到本地文件中(或者插入到自己的本地数据库中)。这样,整个采集的工作就会在一个段落中完成。

// 输出数据到本地文件

File.AppendAllText(CreateFolderIfNot(Settings.Default.OutPath) + articleTitle + ".李云天九月星座txt",

文章数据,

编码.UTF8);

另外附上我自己写的采集博客园主页文章的小程序代码。该程序的作用是将博客园主页上的文章采集全部发布下来。

下载地址:CnBlogCollector.rar

当然,如果博客园首页的格式调整了,程序的采集功能肯定会失效,而继续采集的唯一办法就是重新调整程序自己一个人,呵呵。. .

程序效果如下:

查看全部

php可以抓取网页数据吗(Web站点数据采集程序的基本流程及流程图详解

)

首先需要明确:网站的任何页面,无论是php、jsp、aspx等动态页面还是后台程序生成的静态页面,都可以在浏览器。

所以当你要开发一个数据采集程序的时候,你首先要知道你要采集网站解开的网站的首页结构(HTML)。

一旦熟悉了 网站 中的 HTML 源文件的内容,其中数据是 采集,程序的其余部分就很容易了。因为C#在网站上执行数据采集,原理是“下载你想要的页面的HTML源文件到采集,分析HTML代码然后抓取你需要的数据,最后保存数据。到本地文件”。

基本流程如下图所示:

1.页面源文件下载

首先引用 System.Net 命名空间

使用 System.Net;

冰峰卡联赛

还需要引用

使用 System.Text;

使用下载十二生肖每日星座运势系统.IO;

引用后实例化一个 WebClient 对象

私人 WebClient wc = new WebClient();

调用DownloadData方法从指定网页的源文件中下载一组BYTE数据,然后将BYTE数组转换为字符串。

//下载页面源文件并转换为UTF8编码格式的STRING

string mainData = Encoding.UTF8.GetString(wc.DownloadData(string.Format("你要的网页地址采集")));

或者也可以调用DownloadFile方法,先将源文件下载到本地再读取其字符串

//下载网页源文件到本地

wc.DownloadFile("你要访问的网页的URL采集", "保存源文件的本地文件路径");

//读取下载的源文件HTML格式字符串

string mainData = File.ReadAllText("保存源文件的本地文件路径",Encoding.UTF8);

使用网页 HTML 格式字符串,您可以分析 采集 网页并抓取您需要的内容。

2.页面分析采集

页面分析就是用网页源文件中的一个特定的或唯一的字符(字符串)作为一个抓取点,从这个抓取点开始截取你想要的页面上的数据。

水花文胸

以博客园为栏目为例,如果我想要采集博客园首页列出的文章的标题和链接,我必须以"开头

代码:

//经过”

mainData=mainData.Substring(mainData.IndexOf("

//获取文章页面的链接地址

字符串 articleAddr = mainData.Substring(0,mainData.IndexOf("""));

//获取文章标题

字符串文章标题 = mainData.Substring(mainData.IndexOf("target="_blank">") + 16,

mainData.IndexOf("") - mainData.IndexOf("target="_blank">") - 16);

注意:当你要采集的网页首页的HTML格式发生变化时,作为抓取点的字符也要相应的改变,否则采集什么都得不到

3.数据存储

从网页中截取需要的数据后,将程序中的数据组织起来,保存到本地文件中(或者插入到自己的本地数据库中)。这样,整个采集的工作就会在一个段落中完成。

// 输出数据到本地文件

File.AppendAllText(CreateFolderIfNot(Settings.Default.OutPath) + articleTitle + ".李云天九月星座txt",

文章数据,

编码.UTF8);

另外附上我自己写的采集博客园主页文章的小程序代码。该程序的作用是将博客园主页上的文章采集全部发布下来。

下载地址:CnBlogCollector.rar

当然,如果博客园首页的格式调整了,程序的采集功能肯定会失效,而继续采集的唯一办法就是重新调整程序自己一个人,呵呵。. .

程序效果如下:

php可以抓取网页数据吗(PHP的curl()设置相关选项执行curl_RETURNTRANSFER)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-03-02 07:19

PHP 的 curl() 爬取网页的效率相对较高,并且支持多线程,而 file_get_contents.jpg() 的效率略低。当然,使用 curl 时需要打开 curl 扩展。

我们先看登录部分的代码:

login_post()函数首先初始化curl_init(),然后使用curl_setopt()设置相关选项信息,包括要提交的url地址、保存的cookie文件、post数据(用户名和密码等)、是否提交返回信息等,然后curl_exec执行curl,最后curl_close()释放资源。注意,PHP 自带的 http_build_query() 可以将数组转换成拼接字符串。

接下来,如果登录成功,我们需要获取登录成功后的页面信息。代码如下:

函数get_content()也是先初始化curl,然后设置相关选项,执行curl,释放资源。我们将CURLOPT_RETURNTRANSFER设置为1自动返回信息,CURLOPT_COOKIEFILE可以读取登录时保存的cookie信息,最后返回页面内容。.

我们的最终目标是获取模拟登录后的信息,即只有正常登录成功后才能获取的有用信息。下面我们以开源中国手机版为例,看看登录成功后如何抓取信息。信息。

运行上述代码后,我们会看到最终得到了登录用户的头像。

使用总结:1、初始化curl;2、使用 curl_setopt 设置目标 url 等选项;3、curl_exec,执行curl;4、执行后关闭curl;5、 输出数据。

教程地址:

欢迎转载!但请带上文章地址^^ 查看全部

php可以抓取网页数据吗(PHP的curl()设置相关选项执行curl_RETURNTRANSFER)

PHP 的 curl() 爬取网页的效率相对较高,并且支持多线程,而 file_get_contents.jpg() 的效率略低。当然,使用 curl 时需要打开 curl 扩展。

我们先看登录部分的代码:

login_post()函数首先初始化curl_init(),然后使用curl_setopt()设置相关选项信息,包括要提交的url地址、保存的cookie文件、post数据(用户名和密码等)、是否提交返回信息等,然后curl_exec执行curl,最后curl_close()释放资源。注意,PHP 自带的 http_build_query() 可以将数组转换成拼接字符串。

接下来,如果登录成功,我们需要获取登录成功后的页面信息。代码如下:

函数get_content()也是先初始化curl,然后设置相关选项,执行curl,释放资源。我们将CURLOPT_RETURNTRANSFER设置为1自动返回信息,CURLOPT_COOKIEFILE可以读取登录时保存的cookie信息,最后返回页面内容。.

我们的最终目标是获取模拟登录后的信息,即只有正常登录成功后才能获取的有用信息。下面我们以开源中国手机版为例,看看登录成功后如何抓取信息。信息。

运行上述代码后,我们会看到最终得到了登录用户的头像。

使用总结:1、初始化curl;2、使用 curl_setopt 设置目标 url 等选项;3、curl_exec,执行curl;4、执行后关闭curl;5、 输出数据。

教程地址:

欢迎转载!但请带上文章地址^^

php可以抓取网页数据吗(php可以抓取网页数据吗?建议亲们这两天先了解下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-02-27 14:05

php可以抓取网页数据吗??建议亲们这两天先了解下php的基本知识,可以先学习先下会节省一些学习时间。不要心急。网络爬虫需要写爬虫代码,但你要先掌握php语言基础。如果你连基础也不会,跟别说去掌握网络爬虫。

php可以获取网页,但是这需要一些前置技能,1php基础语法2oracle数据库3asp,access数据库4iis一般是这样,剩下要看你是个什么目的。

php可以抓取网页数据,也可以读取文件,具体如何实现的,建议你先学习一下网络爬虫,

可以通过requests库来抓取网页源代码通过get方法来拿到链接

可以抓取网页,但有时候抓取的不是你想要的数据,

php可以抓取网页,至于要抓取哪一部分的数据,因为你刚入门也只能爬一些常用的数据,比如新闻,

php可以抓取网页,用你提问里面讲的方法,有办法写出很好的页面解析语言,爬取效果很好。

现在的工作以及大部分人都会选择php这个语言做为编程语言,可以从php5.x和6.x开始学习,不过现在随着发展php7.x取代php5.x,可以先看看廖雪峰老师的教程,在基础会语句的情况下再看视频教程,先学会编程语言。如果想要详细了解php的话可以看一下神程php教程。如果对其他编程语言感兴趣,可以再继续关注下。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?建议亲们这两天先了解下)

php可以抓取网页数据吗??建议亲们这两天先了解下php的基本知识,可以先学习先下会节省一些学习时间。不要心急。网络爬虫需要写爬虫代码,但你要先掌握php语言基础。如果你连基础也不会,跟别说去掌握网络爬虫。

php可以获取网页,但是这需要一些前置技能,1php基础语法2oracle数据库3asp,access数据库4iis一般是这样,剩下要看你是个什么目的。

php可以抓取网页数据,也可以读取文件,具体如何实现的,建议你先学习一下网络爬虫,

可以通过requests库来抓取网页源代码通过get方法来拿到链接

可以抓取网页,但有时候抓取的不是你想要的数据,

php可以抓取网页,至于要抓取哪一部分的数据,因为你刚入门也只能爬一些常用的数据,比如新闻,

php可以抓取网页,用你提问里面讲的方法,有办法写出很好的页面解析语言,爬取效果很好。

现在的工作以及大部分人都会选择php这个语言做为编程语言,可以从php5.x和6.x开始学习,不过现在随着发展php7.x取代php5.x,可以先看看廖雪峰老师的教程,在基础会语句的情况下再看视频教程,先学会编程语言。如果想要详细了解php的话可以看一下神程php教程。如果对其他编程语言感兴趣,可以再继续关注下。

php可以抓取网页数据吗(php可以抓取网页数据吗?可以看看下面的例子$result=request)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-02-25 08:00

php可以抓取网页数据吗?可以看看下面的例子$result=request。urlopen('index。php');result。data=array(float(each_name));$header=preg_replace('user-agent','mozilla/5。0(windowsnt10。

0;win64;x64;rv:57。0)gecko/20100101firefox/57。0','');$url_replace='';print_r($header);line_tail='';str_replace('text:','',$header);str_split('{}',$result);echo"[{}。php{}。asp'。($result);}'。$result;。

-friend/using-the-php-page-lookup-for-array-html-script-content-for-simple-javascript-web-applications-at-php?silent=1

php无法做网页抓取。只能通过正则匹配。

好久没上知乎了,不知道回答的你还能看到吗?如果你需要爬取网页的内容,建议你去专业的网页抓取网站,不用谢。

php可以抓取吗?可以看看下面的例子$result=request。urlopen('index。php');$header=preg_replace('user-agent','mozilla/5。0(windowsnt10。0;win64;x64;rv:57。0)gecko/20100101firefox/57。

0','');$url_replace='';print_r($header);line_tail='';str_replace('text:','',$header);str_split('{}',$result);echo"[{}。php{}。asp'。($result);"。$result;。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?可以看看下面的例子$result=request)

php可以抓取网页数据吗?可以看看下面的例子$result=request。urlopen('index。php');result。data=array(float(each_name));$header=preg_replace('user-agent','mozilla/5。0(windowsnt10。

0;win64;x64;rv:57。0)gecko/20100101firefox/57。0','');$url_replace='';print_r($header);line_tail='';str_replace('text:','',$header);str_split('{}',$result);echo"[{}。php{}。asp'。($result);}'。$result;。

-friend/using-the-php-page-lookup-for-array-html-script-content-for-simple-javascript-web-applications-at-php?silent=1

php无法做网页抓取。只能通过正则匹配。

好久没上知乎了,不知道回答的你还能看到吗?如果你需要爬取网页的内容,建议你去专业的网页抓取网站,不用谢。

php可以抓取吗?可以看看下面的例子$result=request。urlopen('index。php');$header=preg_replace('user-agent','mozilla/5。0(windowsnt10。0;win64;x64;rv:57。0)gecko/20100101firefox/57。

0','');$url_replace='';print_r($header);line_tail='';str_replace('text:','',$header);str_split('{}',$result);echo"[{}。php{}。asp'。($result);"。$result;。

php可以抓取网页数据吗(,获取访问的最佳方法是什么?(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-02-20 14:16

)

例如,这是一个“页面”:

该页面有一个 RSS 提要(理想情况下我想使用它),但是 a) 它的浏览器嗅探意味着我需要从脚本中伪造用户代理来获取它 - 这感觉非常脆弱 b) 的质量返回的数据真的很糟糕。

我可以使用图形 api 来获取相同的数据吗?这个网址:

暗示我可以,json 对我来说很好,尽管我是从 PHP 脚本而不是客户端获取它。但是,当我为我的实际页面尝试该 URL 时,我得到以下信息:

1{

2 "error": {

3 "type": "OAuthAccessTokenException",

4 "message": "An access token is required to request this resource."

5 }

6}

7

我不明白为什么我的页面需要访问令牌,而其他页面“更公开” - 这是页面上的一些配置吗?如果不是,那么获取访问密钥的最佳方式是什么 - 请注意,这不是一个需要页面所有者进行身份验证的交互式脚本。

如果我尝试通过 CURL 访问 URL,它在 PHP 中对我来说很好。

1$curlResponse = http('https://graph.facebook.com/facebook/feed');

2$facebookFeed = json_decode($curlResponse['data'], true);

3

4var_dump($facebookFeed);

5

使用这个 PHP 函数:

1function http($url) {

2 $timeout = 30;

3 $connectTimeout = 30;

4 $sslVerifyPeer = false;

5

6 $response = array();

7 $ci = curl_init();

8

9 /* Curl settings */

10 curl_setopt($ci, CURLOPT_CONNECTTIMEOUT, $connectTimeout);

11 curl_setopt($ci, CURLOPT_TIMEOUT, $timeout);

12 curl_setopt($ci, CURLOPT_RETURNTRANSFER, true);

13 curl_setopt($ci, CURLOPT_HTTPHEADER, array('Expect:'));

14 curl_setopt($ci, CURLOPT_SSL_VERIFYPEER, $sslVerifyPeer);

15 curl_setopt($ci, CURLOPT_URL, $url);

16

17 $response['http_code'] = curl_getinfo($ci, CURLINFO_HTTP_CODE);

18 $response['api_call'] = $url;

19 $response['data'] = curl_exec($ci);

20

21 curl_close ($ci);

22

23 return $response;

24}

25 查看全部

php可以抓取网页数据吗(,获取访问的最佳方法是什么?(图)

)

例如,这是一个“页面”:

该页面有一个 RSS 提要(理想情况下我想使用它),但是 a) 它的浏览器嗅探意味着我需要从脚本中伪造用户代理来获取它 - 这感觉非常脆弱 b) 的质量返回的数据真的很糟糕。

我可以使用图形 api 来获取相同的数据吗?这个网址:

暗示我可以,json 对我来说很好,尽管我是从 PHP 脚本而不是客户端获取它。但是,当我为我的实际页面尝试该 URL 时,我得到以下信息:

1{

2 "error": {

3 "type": "OAuthAccessTokenException",

4 "message": "An access token is required to request this resource."

5 }

6}

7

我不明白为什么我的页面需要访问令牌,而其他页面“更公开” - 这是页面上的一些配置吗?如果不是,那么获取访问密钥的最佳方式是什么 - 请注意,这不是一个需要页面所有者进行身份验证的交互式脚本。

如果我尝试通过 CURL 访问 URL,它在 PHP 中对我来说很好。

1$curlResponse = http('https://graph.facebook.com/facebook/feed');

2$facebookFeed = json_decode($curlResponse['data'], true);

3

4var_dump($facebookFeed);

5

使用这个 PHP 函数:

1function http($url) {

2 $timeout = 30;

3 $connectTimeout = 30;

4 $sslVerifyPeer = false;

5

6 $response = array();

7 $ci = curl_init();

8

9 /* Curl settings */

10 curl_setopt($ci, CURLOPT_CONNECTTIMEOUT, $connectTimeout);

11 curl_setopt($ci, CURLOPT_TIMEOUT, $timeout);

12 curl_setopt($ci, CURLOPT_RETURNTRANSFER, true);

13 curl_setopt($ci, CURLOPT_HTTPHEADER, array('Expect:'));

14 curl_setopt($ci, CURLOPT_SSL_VERIFYPEER, $sslVerifyPeer);

15 curl_setopt($ci, CURLOPT_URL, $url);

16

17 $response['http_code'] = curl_getinfo($ci, CURLINFO_HTTP_CODE);

18 $response['api_call'] = $url;

19 $response['data'] = curl_exec($ci);

20

21 curl_close ($ci);

22

23 return $response;

24}

25

php可以抓取网页数据吗(htmlsnoopy()、file_get_contents())

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-19 10:16

curl()、file_get_contents()、snoopy.class.php是远程页面爬取或采集中使用的三个工具。它们的功能至关重要。它们的优点和缺点是什么?我们来一一介绍:html

snoopy.class.phpweb

Snoopy 是使用 fsockopen 的自研类,效率高,不需要服务器特定的配置支持。可以在普通的虚拟主机上使用,但是经常会出现问题。官方下载地址:浏览器

Snoopy是一个模拟浏览器功能的php类,可以获取网页内容和发送表单。服务器

史努比的特点:饼干

一、 抓取网页内容获取多线程

二、获取网页文本内容(去掉HTML标签)fetchtext框架

三、抓取网页的链接,form fetchlinks fetchformcurl

四、支持代理主机ide

五、支持基本的用户名/密码认证

六、支持设置user_agent、referer(来)、cookies和header内容(头文件)

七、支持浏览器重定向,可以控制重定向深度

八、 可以将网页中的链接扩展为高质量的url(默认)

九、提交数据并获取返回值

十、支持跟踪 HTML 帧

10一、支持重定向时传递cookie

需要php4以上就够了,因为是php的一个类,不需要扩展支持,服务器不支持curl的时候最好的选择。

随附的:

史努比中文说明书:

使用示例:

史努比的缺陷和 CURL 的威力:

文件获取内容()

file_get_contents 是 fsockopen 函数的简单封装,效率略低,但是抓取成功率很高,所以我一般在 snoopy 有问题的时候打电话给他。5.0.0 增加了对context的支持,有了context,他还可以发送header信息,自定义user agent,referer,cookies都是一个问题。5.1.0 添加了 offset 和 maxlen 参数以只读部分文件。

卷曲()

curl通常用于抓取网页,二是获取或发布数据,三是在PHP中实现多线程任务。

最强大的,几乎能够模拟浏览器的方方面面,几乎像真的一样。效率也很高,支持多线程,但是需要开启curl扩展。

cURL 是一个使用 URL 语法传输文件和数据的工具,支持多种协议,例如 HTTP、FTP、TELNET 等。PHP 还支持 cURL 库,我们经常使用它进行远程页面抓取和 采集 .

它还支持从断点恢复 Range 的代码:

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.spiegel.de/');

curl_setopt($ch, CURLOPT_RANGE, '0-500');

curl_setopt($ch, CURLOPT_BINARYTRANSFER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

$result = curl_exec($ch);

curl_close($ch);

echo $result;

/**

*But as noted before if the server doesn't honor this header but sends the whole file curl will download all of it. E.g. http://www.php.net ignores the header. But you can (in addition) set a write function callback and abort the request when more data is received, e.g.

* php 5.3+ only

* use function writefn($ch, $chunk) { ... } for earlier versions

*/

$writefn = function($ch, $chunk) {

static $data='';

static $limit = 500; // 500 bytes, it's only a test

$len = strlen($data) + strlen($chunk);

if ($len >= $limit ) {

$data .= substr($chunk, 0, $limit-strlen($data));

echo strlen($data) , ' ', $data;

return -1;

}

$data .= $chunk;

return strlen($chunk);

};

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.php.net/');

curl_setopt($ch, CURLOPT_RANGE, '0-500');

curl_setopt($ch, CURLOPT_BINARYTRANSFER, 1);

curl_setopt($ch, CURLOPT_WRITEFUNCTION, $writefn);

$result = curl_exec($ch);

curl_close($ch);

使用教程地址: 查看全部

php可以抓取网页数据吗(htmlsnoopy()、file_get_contents())

curl()、file_get_contents()、snoopy.class.php是远程页面爬取或采集中使用的三个工具。它们的功能至关重要。它们的优点和缺点是什么?我们来一一介绍:html

snoopy.class.phpweb

Snoopy 是使用 fsockopen 的自研类,效率高,不需要服务器特定的配置支持。可以在普通的虚拟主机上使用,但是经常会出现问题。官方下载地址:浏览器

Snoopy是一个模拟浏览器功能的php类,可以获取网页内容和发送表单。服务器

史努比的特点:饼干

一、 抓取网页内容获取多线程

二、获取网页文本内容(去掉HTML标签)fetchtext框架

三、抓取网页的链接,form fetchlinks fetchformcurl

四、支持代理主机ide

五、支持基本的用户名/密码认证

六、支持设置user_agent、referer(来)、cookies和header内容(头文件)

七、支持浏览器重定向,可以控制重定向深度

八、 可以将网页中的链接扩展为高质量的url(默认)

九、提交数据并获取返回值

十、支持跟踪 HTML 帧

10一、支持重定向时传递cookie

需要php4以上就够了,因为是php的一个类,不需要扩展支持,服务器不支持curl的时候最好的选择。

随附的:

史努比中文说明书:

使用示例:

史努比的缺陷和 CURL 的威力:

文件获取内容()

file_get_contents 是 fsockopen 函数的简单封装,效率略低,但是抓取成功率很高,所以我一般在 snoopy 有问题的时候打电话给他。5.0.0 增加了对context的支持,有了context,他还可以发送header信息,自定义user agent,referer,cookies都是一个问题。5.1.0 添加了 offset 和 maxlen 参数以只读部分文件。

卷曲()

curl通常用于抓取网页,二是获取或发布数据,三是在PHP中实现多线程任务。

最强大的,几乎能够模拟浏览器的方方面面,几乎像真的一样。效率也很高,支持多线程,但是需要开启curl扩展。

cURL 是一个使用 URL 语法传输文件和数据的工具,支持多种协议,例如 HTTP、FTP、TELNET 等。PHP 还支持 cURL 库,我们经常使用它进行远程页面抓取和 采集 .

它还支持从断点恢复 Range 的代码:

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.spiegel.de/');

curl_setopt($ch, CURLOPT_RANGE, '0-500');

curl_setopt($ch, CURLOPT_BINARYTRANSFER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

$result = curl_exec($ch);

curl_close($ch);

echo $result;

/**

*But as noted before if the server doesn't honor this header but sends the whole file curl will download all of it. E.g. http://www.php.net ignores the header. But you can (in addition) set a write function callback and abort the request when more data is received, e.g.

* php 5.3+ only

* use function writefn($ch, $chunk) { ... } for earlier versions

*/

$writefn = function($ch, $chunk) {

static $data='';

static $limit = 500; // 500 bytes, it's only a test

$len = strlen($data) + strlen($chunk);

if ($len >= $limit ) {

$data .= substr($chunk, 0, $limit-strlen($data));

echo strlen($data) , ' ', $data;

return -1;

}

$data .= $chunk;

return strlen($chunk);

};

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.php.net/');

curl_setopt($ch, CURLOPT_RANGE, '0-500');

curl_setopt($ch, CURLOPT_BINARYTRANSFER, 1);

curl_setopt($ch, CURLOPT_WRITEFUNCTION, $writefn);

$result = curl_exec($ch);

curl_close($ch);

使用教程地址:

php可以抓取网页数据吗(思路有点天马行空,渴望理性探讨是否可行?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-02-18 11:22

我是一名三年级软件工程专业的学生。最近突然想到一个问题:为什么前端连接不上数据库?产生这个想法的原因是我最近在开发一个简单的小项目,使用的是gin和vue的前后端分离结构。然后我发现后端做的事情,归根结底就是访问和操作数据库(可能因为我在做一个小项目),这些事情前端能做吗?于是我想了想是否可行。首先,需要对数据库中的数据进行处理。也许js的执行效率不如后端开发语言,但我觉得应该有瓶颈。那么以后会不会有节点,让js数据处理能够满足大众的需求。然后,存在数据库连接和数据传输问题。可能需要开发一种新协议以允许网页与数据库连接。但是有一个新的问题,因为网页是静态资源,用户可以随意修改,而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。可能需要开发一种新协议以允许网页与数据库连接。但是有一个新的问题,因为网页是静态资源,用户可以随意修改,而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。可能需要开发一种新协议以允许网页与数据库连接。但是有一个新的问题,因为网页是静态资源,用户可以随意修改,而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。

你的诉求是,如果后端只做增删改查,能做吗?

答案是肯定的,而且这个想法是合乎逻辑的。

但是有很多方法可以杀死

1. 浏览器直接与数据库打交道。

这个想法已经存在了很长时间,甚至在富浏览器出现之前。Microsoft 在其 IE 浏览器中提供了一个 ActiveX 扩展,允许您安装插件。此时,如果您安装相同的 Microsoft Access 数据库插件。您可以直接在浏览器中操作数据库。

2. 使用轻量级数据库将其嵌入前端。

富客户端概念兴起后,在前端存储数据已经不是什么新鲜事了。只是前端不认为它是数据库,它更像是一个缓存。因为最终避免数据丢失、安全性和一致性仍然需要后端。此外,将类似 sqlite 的数据库嵌入到应用程序中是很常见的,但应用程序可能不被视为“前端”。

3.打不过就加入,前端实现轻服务器。

让我们谈谈这个。这无疑是去除烦人服务器的未来发展方向。前端编程在nodejs、graphQL等框架的帮助下变得非常流行,也建议题主看看Prisma。坚定自己的想法,前端走遍世界都是可行的。

用 HTML 编写的网页如何与数据库交互?

“我是悠悠鸿科技,专注于数据网络的解答,欢迎大家与我交流数据网络问题”

例如,HTML 网页如何与数据库交互?

HTML网页一般以静态方式呈现,不支持动态数据交互。如果要呈现动态网页,需要通过php、java等语言从数据库中获取,然后生成静态html发送给浏览器。

另一种方法是通过AJAX技术来实现,即浏览器下载静态页面并显示出来后,还可以通过网页中的javascript脚本再次请求服务器获取一些数据内容,然后更新部分页面内容。,最终达到与数据库交互的目的。

下面简单介绍一下AJAX的工作流程:

AJAX(Asynchronous JavaScript and XML,异步 JavaScript 和 XML)是一种用于实现交互式 Web 应用程序的开发技术。

1、客户端生成js事件;

.

尽管腾讯官方多次强调不会私下查看用户的聊天记录,但这仍然是我们非常担心的问题。网上甚至有传言称,因为害怕泄露公司机密,所以不使用腾讯社交平台。

一般来说,我们的微信聊天记录和文件会存档在两个地方,一个是我们的终端,比如手机和电脑。第二个词存储在腾讯的服务器上,但是使用微信的人太多,腾讯的服务器很难承载如此庞大的数据。腾讯的所有机制都是7天访问,所以我们发现我们的一些文件,如果不及时下载,7天后就会消失。

所以,远程查看微信记录之类的事情,一方面确实需要国家层面的监管,另一方面也需要腾讯的官方管控。

为什么其他人可以知道他们与其他人的微信聊天记录?

首先要确定别人真的知道你和别人的微信聊天记录吗?你知道你和每个人的聊天记录吗?如果他只知道您与某人的聊天记录,请考虑与您聊天的人是否泄露了聊天记录。

如果其他人确实知道您与微信好友中所有人的聊天记录。嗯,我认为有两个主要原因。

一.问题出在你的手机上。其他人在您的手机上安装了监控软件,特别是如果您使用的是 Android 手机。因为是开源的安卓软件,所以很容易有人安装监控软件。这一点在技术层面上是完全可以实现的。您需要完全格式化您的软件并更改您的手机密码。不要让别人玩你的手机,这些可能会让别人在你的手机上安装监控软件。

二.看你手机微信界面的搜索框下面,有没有Windows微信登录,或者IPAD登录提示。因为现在微信可以允许双终端登录了。也就是你在手机上用微信登录后,你也可以在电脑或iPad上登录。这样一来,自然而然,你在手机微信上聊什么,和谁聊天,别人就能看的一清二楚。曾经在电脑上登录微信忘记退出,和手机上的MM聊天被老婆看的一清二楚,引来一场战斗,哎,深刻的教训。

除了以上两点,基本没有其他泄露微信聊天记录的可能。

如何防止P2P终结者攻击 下面是修改方法: 1:在开始菜单的运行中输入regedit,打开注册表编辑器,将注册表展开为:HKEY_LOCAL_MACHINESystem CurrentControlSetControlClass{4D36E9E}子项,0000,0001下的子项,0002和其他分支找到DriverDesc(如果你有多个网卡,有0001,0002......你的网卡信息保存在这里,DriverDesc的内容是网卡说明,比如我的网卡是Intel 210 41 based Ethernet Controller),这里假设你的网卡在0000子项中。在 0000 子项下添加一个字符串并将其命名为 NetworkAddress。键值为修改后的 MAC 地址,要求为 12 个连续的十六进制数。然后在 0000 子键下的 NDIparams 中新建一个名为 NetworkAddress 的子键,在子键下添加一个名为 default 的字符串,键值为修改后的 MAC 地址。继续在NetworkAddress的子键下创建一个名为ParamDesc的字符串,用于指定Network Address的描述,其值可以是MAC Address。这样以后打开网上邻居的属性,双击对应的网卡,你会发现有一个高级设置,下面有一个MACAddress的选项,就是你在注册表中新增的一项NetworkAddress ,以后只需要在此处修改MAC地址即可。. 关闭注册表,重启,你的网卡地址已经改了。打开网上邻居的属性,双击对应的网卡项,会找到MAC地址的高级设置项,用于直接修改MAC地址。2:第二种方法是修改IP到MAC的映射,使P2P攻击的ARP欺骗失效,突破其局限性。方法是在cmd下使用ARP -a命令获取网关的MAC地址,最后使用ARP -s IP网卡MAC地址命令映射网关的IP地址和它的MAC地址。

"

如何解除网速限制?

1.打开电脑后,首先打开开始菜单,点击运行。

2.在运行中输入 gpedit.msc 并单击确定打开本地策略组编辑器。

3.打开本地策略组编辑器,双击右侧菜单中的计算机配置。

4.再次双击管理模块。

5.然后双击网络。

6.其次,双击QoS Packet Scheduler。

7.接下来,双击限制以预留带宽。

8.当弹出限制可预留带宽的界面时,点击下图中红色箭头所示的已激活,将其选中。

9.这时候我们会发现下面的带宽限制是20%,这是系统默认的。

10. 手动将20改为0,最后点击OK,网速限制解除。

" 查看全部

php可以抓取网页数据吗(思路有点天马行空,渴望理性探讨是否可行?(组图))

我是一名三年级软件工程专业的学生。最近突然想到一个问题:为什么前端连接不上数据库?产生这个想法的原因是我最近在开发一个简单的小项目,使用的是gin和vue的前后端分离结构。然后我发现后端做的事情,归根结底就是访问和操作数据库(可能因为我在做一个小项目),这些事情前端能做吗?于是我想了想是否可行。首先,需要对数据库中的数据进行处理。也许js的执行效率不如后端开发语言,但我觉得应该有瓶颈。那么以后会不会有节点,让js数据处理能够满足大众的需求。然后,存在数据库连接和数据传输问题。可能需要开发一种新协议以允许网页与数据库连接。但是有一个新的问题,因为网页是静态资源,用户可以随意修改,而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。可能需要开发一种新协议以允许网页与数据库连接。但是有一个新的问题,因为网页是静态资源,用户可以随意修改,而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。可能需要开发一种新协议以允许网页与数据库连接。但是有一个新的问题,因为网页是静态资源,用户可以随意修改,而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。而且数据库的安全性也有问题,不知道怎么解决。最后,我这个想法的实际意义可能并不大,因为像我这样的小项目毕竟是少数,而且大部分项目肯定是原架构能更好的实现功能。这是我第一次提出问题,我的想法有点想象力。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。我渴望理性地讨论它。如有逻辑上的瑕疵,希望老板指出。

你的诉求是,如果后端只做增删改查,能做吗?

答案是肯定的,而且这个想法是合乎逻辑的。

但是有很多方法可以杀死

1. 浏览器直接与数据库打交道。

这个想法已经存在了很长时间,甚至在富浏览器出现之前。Microsoft 在其 IE 浏览器中提供了一个 ActiveX 扩展,允许您安装插件。此时,如果您安装相同的 Microsoft Access 数据库插件。您可以直接在浏览器中操作数据库。

2. 使用轻量级数据库将其嵌入前端。

富客户端概念兴起后,在前端存储数据已经不是什么新鲜事了。只是前端不认为它是数据库,它更像是一个缓存。因为最终避免数据丢失、安全性和一致性仍然需要后端。此外,将类似 sqlite 的数据库嵌入到应用程序中是很常见的,但应用程序可能不被视为“前端”。

3.打不过就加入,前端实现轻服务器。

让我们谈谈这个。这无疑是去除烦人服务器的未来发展方向。前端编程在nodejs、graphQL等框架的帮助下变得非常流行,也建议题主看看Prisma。坚定自己的想法,前端走遍世界都是可行的。

用 HTML 编写的网页如何与数据库交互?

“我是悠悠鸿科技,专注于数据网络的解答,欢迎大家与我交流数据网络问题”

例如,HTML 网页如何与数据库交互?

HTML网页一般以静态方式呈现,不支持动态数据交互。如果要呈现动态网页,需要通过php、java等语言从数据库中获取,然后生成静态html发送给浏览器。

另一种方法是通过AJAX技术来实现,即浏览器下载静态页面并显示出来后,还可以通过网页中的javascript脚本再次请求服务器获取一些数据内容,然后更新部分页面内容。,最终达到与数据库交互的目的。

下面简单介绍一下AJAX的工作流程:

AJAX(Asynchronous JavaScript and XML,异步 JavaScript 和 XML)是一种用于实现交互式 Web 应用程序的开发技术。

1、客户端生成js事件;

.

尽管腾讯官方多次强调不会私下查看用户的聊天记录,但这仍然是我们非常担心的问题。网上甚至有传言称,因为害怕泄露公司机密,所以不使用腾讯社交平台。

一般来说,我们的微信聊天记录和文件会存档在两个地方,一个是我们的终端,比如手机和电脑。第二个词存储在腾讯的服务器上,但是使用微信的人太多,腾讯的服务器很难承载如此庞大的数据。腾讯的所有机制都是7天访问,所以我们发现我们的一些文件,如果不及时下载,7天后就会消失。

所以,远程查看微信记录之类的事情,一方面确实需要国家层面的监管,另一方面也需要腾讯的官方管控。

为什么其他人可以知道他们与其他人的微信聊天记录?

首先要确定别人真的知道你和别人的微信聊天记录吗?你知道你和每个人的聊天记录吗?如果他只知道您与某人的聊天记录,请考虑与您聊天的人是否泄露了聊天记录。

如果其他人确实知道您与微信好友中所有人的聊天记录。嗯,我认为有两个主要原因。

一.问题出在你的手机上。其他人在您的手机上安装了监控软件,特别是如果您使用的是 Android 手机。因为是开源的安卓软件,所以很容易有人安装监控软件。这一点在技术层面上是完全可以实现的。您需要完全格式化您的软件并更改您的手机密码。不要让别人玩你的手机,这些可能会让别人在你的手机上安装监控软件。

二.看你手机微信界面的搜索框下面,有没有Windows微信登录,或者IPAD登录提示。因为现在微信可以允许双终端登录了。也就是你在手机上用微信登录后,你也可以在电脑或iPad上登录。这样一来,自然而然,你在手机微信上聊什么,和谁聊天,别人就能看的一清二楚。曾经在电脑上登录微信忘记退出,和手机上的MM聊天被老婆看的一清二楚,引来一场战斗,哎,深刻的教训。

除了以上两点,基本没有其他泄露微信聊天记录的可能。

如何防止P2P终结者攻击 下面是修改方法: 1:在开始菜单的运行中输入regedit,打开注册表编辑器,将注册表展开为:HKEY_LOCAL_MACHINESystem CurrentControlSetControlClass{4D36E9E}子项,0000,0001下的子项,0002和其他分支找到DriverDesc(如果你有多个网卡,有0001,0002......你的网卡信息保存在这里,DriverDesc的内容是网卡说明,比如我的网卡是Intel 210 41 based Ethernet Controller),这里假设你的网卡在0000子项中。在 0000 子项下添加一个字符串并将其命名为 NetworkAddress。键值为修改后的 MAC 地址,要求为 12 个连续的十六进制数。然后在 0000 子键下的 NDIparams 中新建一个名为 NetworkAddress 的子键,在子键下添加一个名为 default 的字符串,键值为修改后的 MAC 地址。继续在NetworkAddress的子键下创建一个名为ParamDesc的字符串,用于指定Network Address的描述,其值可以是MAC Address。这样以后打开网上邻居的属性,双击对应的网卡,你会发现有一个高级设置,下面有一个MACAddress的选项,就是你在注册表中新增的一项NetworkAddress ,以后只需要在此处修改MAC地址即可。. 关闭注册表,重启,你的网卡地址已经改了。打开网上邻居的属性,双击对应的网卡项,会找到MAC地址的高级设置项,用于直接修改MAC地址。2:第二种方法是修改IP到MAC的映射,使P2P攻击的ARP欺骗失效,突破其局限性。方法是在cmd下使用ARP -a命令获取网关的MAC地址,最后使用ARP -s IP网卡MAC地址命令映射网关的IP地址和它的MAC地址。

"

如何解除网速限制?

1.打开电脑后,首先打开开始菜单,点击运行。

2.在运行中输入 gpedit.msc 并单击确定打开本地策略组编辑器。

3.打开本地策略组编辑器,双击右侧菜单中的计算机配置。

4.再次双击管理模块。

5.然后双击网络。

6.其次,双击QoS Packet Scheduler。

7.接下来,双击限制以预留带宽。

8.当弹出限制可预留带宽的界面时,点击下图中红色箭头所示的已激活,将其选中。

9.这时候我们会发现下面的带宽限制是20%,这是系统默认的。

10. 手动将20改为0,最后点击OK,网速限制解除。

"

php可以抓取网页数据吗(php可以抓取网页数据吗?我们已经在php抓取历史记录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-02-18 01:02

php可以抓取网页数据吗?我们已经在php抓取网页数据之前进行了一下数据分析,网页数据抓取有两种:url导向型抓取和词频抓取型抓取。抓取网页数据完整代码见底部附件。导向型抓取是纯面向网页的抓取,抓取结果存储在html网页中;词频抓取是对给定的一个或多个url提供的某个关键词进行抓取,并根据抓取的实际抓取数进行统计。

php抓取网页数据可以使用以下的方法,从本地执行抓取ftp文件一般需要使用ftp和ftpserver,在windows下可以使用lsponitor和webserver或者直接在bin目录下面安装,在mac下需要安装triglopper,在这里同时给大家介绍一下ftp和ftpserver常用命令。本系列文章中不涉及此方法,和mac下安装了triglopper也不影响运行此方法。

不需要抓取网页内容如果抓取网页的内容(html),这里采用当前浏览器的抓取模式和查看模式,打开浏览器页面控制台,点击ftp/ftpserver,如下图所示,如果此前页面已经抓取过,那么就有抓取历史记录。打开抓取历史记录,如下图所示,此时我们看到的抓取网页数据都在observer_list中。抓取文件名和文件描述格式之后将会抓取出相应的字符串,字符串结构为:user-agent:vim、vim_accept:accept-encoding:gzip,deflatevim_accept:disable-soft-cache:cache-essential_cache:occurrence,omissionvim_accept:auto-options:cookie,from_user:root,from_passwd:password,now_domain:domainvim_accept:auto-options:cookie,from_user:root,from_passwd:passwordparam_type:value,from_all:all最后我们查看是否抓取成功。ftp服务器下所有抓取网页数据。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?我们已经在php抓取历史记录)

php可以抓取网页数据吗?我们已经在php抓取网页数据之前进行了一下数据分析,网页数据抓取有两种:url导向型抓取和词频抓取型抓取。抓取网页数据完整代码见底部附件。导向型抓取是纯面向网页的抓取,抓取结果存储在html网页中;词频抓取是对给定的一个或多个url提供的某个关键词进行抓取,并根据抓取的实际抓取数进行统计。

php抓取网页数据可以使用以下的方法,从本地执行抓取ftp文件一般需要使用ftp和ftpserver,在windows下可以使用lsponitor和webserver或者直接在bin目录下面安装,在mac下需要安装triglopper,在这里同时给大家介绍一下ftp和ftpserver常用命令。本系列文章中不涉及此方法,和mac下安装了triglopper也不影响运行此方法。

不需要抓取网页内容如果抓取网页的内容(html),这里采用当前浏览器的抓取模式和查看模式,打开浏览器页面控制台,点击ftp/ftpserver,如下图所示,如果此前页面已经抓取过,那么就有抓取历史记录。打开抓取历史记录,如下图所示,此时我们看到的抓取网页数据都在observer_list中。抓取文件名和文件描述格式之后将会抓取出相应的字符串,字符串结构为:user-agent:vim、vim_accept:accept-encoding:gzip,deflatevim_accept:disable-soft-cache:cache-essential_cache:occurrence,omissionvim_accept:auto-options:cookie,from_user:root,from_passwd:password,now_domain:domainvim_accept:auto-options:cookie,from_user:root,from_passwd:passwordparam_type:value,from_all:all最后我们查看是否抓取成功。ftp服务器下所有抓取网页数据。

php可以抓取网页数据吗(php可以抓取网页数据吗?有很多人在问php)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-02-16 08:03

php可以抓取网页数据吗?有很多人在问php可以抓取网页数据吗?今天大家推荐一个简单的方法来抓取网页,如果你不想手动去抓取,那么这个方法非常适合你。开始之前必须要有php语言基础,因为我不推荐大家使用模拟浏览器的程序代替php进行操作,php是脚本语言,你可以看到整个页面的前端页面,但是如果你去抓取网页就要做很多事情,会很麻烦。

首先安装一个php:php:php,它并不是一个浏览器端运行的程序,但是php程序已经被浏览器内置于地址栏中。当我们加载数据时,会将页面上的每一个数据链接读取、预处理和写入文档。因此,在php中可以用pre_sql语句等扩展开发。php常用设置:默认的php是不支持sql功能的,我们这里给它加上一个内置的数据库语句:php_database='mysql',然后再在header的时候写上:php_database='***',这样在你点击“获取数据”之后,它的内置数据库就会自动帮你上传你之前保存好的数据到数据库,当然你可以选择这样再配置一个php扩展:php_database_support='mysql',把你的数据库保存在php_databases目录下,这样你从数据库里读取时,不会显示php_database_support中存在这个数据库,而是直接从php_databases目录里找到你想要的数据。

这个php扩展不需要你自己再安装了,我通过phpmyadmin下载安装了一个,然后再phpmyadmin中可以查看用户名和密码,要的话自己去安装试一下,不要怕。好,接下来,我们抓取网页的方法就有了。第一步:打开phpmyadmin。打开要抓取的网页:我这里抓取了2013年-2014年的天猫“连衣裙”店铺数据。

第二步:安装header。输入我们要抓取的要抓取的header:php_database='***'php_auth='mysql'进入到phpmyadmin里,在它的左侧有个“phpmyadmin设置”按钮,点击进去后,选择数据库选项,我在这里选择mysql数据库,点击开始抓取:再选择条件操作,在这里我们要选择要抓取的网页,这里我选择抓取的网页选择2013年-2014年“连衣裙”店铺的数据:在弹出的对话框里,点击"开始抓取”即可把要抓取的网页放到我们刚才写好的文件夹中。

最后的结果是这样的:然后我们回到我们写好的代码区,在开始时加入页面的代码即可看到我们所要抓取的网页,代码如下:后面再对源码修改的时候只需要把auth项改成你自己的账号密码就可以对这个页面进行抓取了。即可进行抓取全部天猫店铺,抓取所有商品,而不用ctrl+c,ctrl+v.这样就搞定了。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?有很多人在问php)

php可以抓取网页数据吗?有很多人在问php可以抓取网页数据吗?今天大家推荐一个简单的方法来抓取网页,如果你不想手动去抓取,那么这个方法非常适合你。开始之前必须要有php语言基础,因为我不推荐大家使用模拟浏览器的程序代替php进行操作,php是脚本语言,你可以看到整个页面的前端页面,但是如果你去抓取网页就要做很多事情,会很麻烦。

首先安装一个php:php:php,它并不是一个浏览器端运行的程序,但是php程序已经被浏览器内置于地址栏中。当我们加载数据时,会将页面上的每一个数据链接读取、预处理和写入文档。因此,在php中可以用pre_sql语句等扩展开发。php常用设置:默认的php是不支持sql功能的,我们这里给它加上一个内置的数据库语句:php_database='mysql',然后再在header的时候写上:php_database='***',这样在你点击“获取数据”之后,它的内置数据库就会自动帮你上传你之前保存好的数据到数据库,当然你可以选择这样再配置一个php扩展:php_database_support='mysql',把你的数据库保存在php_databases目录下,这样你从数据库里读取时,不会显示php_database_support中存在这个数据库,而是直接从php_databases目录里找到你想要的数据。

这个php扩展不需要你自己再安装了,我通过phpmyadmin下载安装了一个,然后再phpmyadmin中可以查看用户名和密码,要的话自己去安装试一下,不要怕。好,接下来,我们抓取网页的方法就有了。第一步:打开phpmyadmin。打开要抓取的网页:我这里抓取了2013年-2014年的天猫“连衣裙”店铺数据。

第二步:安装header。输入我们要抓取的要抓取的header:php_database='***'php_auth='mysql'进入到phpmyadmin里,在它的左侧有个“phpmyadmin设置”按钮,点击进去后,选择数据库选项,我在这里选择mysql数据库,点击开始抓取:再选择条件操作,在这里我们要选择要抓取的网页,这里我选择抓取的网页选择2013年-2014年“连衣裙”店铺的数据:在弹出的对话框里,点击"开始抓取”即可把要抓取的网页放到我们刚才写好的文件夹中。

最后的结果是这样的:然后我们回到我们写好的代码区,在开始时加入页面的代码即可看到我们所要抓取的网页,代码如下:后面再对源码修改的时候只需要把auth项改成你自己的账号密码就可以对这个页面进行抓取了。即可进行抓取全部天猫店铺,抓取所有商品,而不用ctrl+c,ctrl+v.这样就搞定了。

php可以抓取网页数据吗(WickedFoldersPro支持TablePress开发的DataTablesJavaScript库!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-02-15 16:33

描述

TablePress 使您能够轻松创建和管理漂亮的表格。您可以使用简码在 文章、页面或小部件中显示表格。表格可以用常用的电子表格软件进行编辑,因此无需编程。表格可以收录各种类型的数据,甚至支持公式计算。TablePress 使用额外的 JavaScript 库为 网站 访问者提供额外的功能,例如排序、分页、过滤等。表格可以以 Excel、CSV、HTML 和 JSON 等文件格式导入或导出。

更多信息

请访问插件网站 了解更多信息或查看演示。有关最新更新,请在 Twitter 上关注@TablePress。

捐款支持发展

如果您喜欢 TablePress,请在 WordPress 插件目录中评价 TablePress 并写下您的评论,或者捐赠以支持 TablePress 的开发。谢谢!

TablePress 扩展

附加功能和一些有用的增强功能通过附加插件提供,即 TablePress 扩展,可通过 plugins网站 获得。

你有很多表格吗?您可以将它们分组到文件夹中!Wicked Folders Pro 支持 TablePress,可能是适合您的解决方案。

用法

安装插件后,您可以从 WordPress 控制面板的“TablePress”页面创建或管理表格。

要在 文章 或页面中显示表格,请将表格的简码 [table id= /] 嵌入到块编辑器中适当位置的“简码”块中。每个表单都有一个唯一的 ID,需要与简码中的 ID 对应。

然后,您可能想要更改表格的样式。您可以通过在插件选项页面上的自定义 CSS 文本框中输入 CSS 代码来完成此操作。一些常见的样式修改示例可以在 TablePress 常见问题页面上找到。

您还可以通过勾选表格编辑页面上的相应复选框来添加排序、分页、过滤、交替行背景颜色、突出显示行、显示表格名称和/或表格描述等功能。

谢谢

特别感谢 Allan Jardine 的 DataTables JavaScript 库。

感谢所有语言文件的翻译人员!

感谢每一位赞助商、支持者和问题记者!

授权

该插件是免费软件,根据 GPL 版本 2() 许可发布和许可。

您可以出于任何目的自由使用该软件。 查看全部

php可以抓取网页数据吗(WickedFoldersPro支持TablePress开发的DataTablesJavaScript库!!)

描述

TablePress 使您能够轻松创建和管理漂亮的表格。您可以使用简码在 文章、页面或小部件中显示表格。表格可以用常用的电子表格软件进行编辑,因此无需编程。表格可以收录各种类型的数据,甚至支持公式计算。TablePress 使用额外的 JavaScript 库为 网站 访问者提供额外的功能,例如排序、分页、过滤等。表格可以以 Excel、CSV、HTML 和 JSON 等文件格式导入或导出。

更多信息

请访问插件网站 了解更多信息或查看演示。有关最新更新,请在 Twitter 上关注@TablePress。

捐款支持发展

如果您喜欢 TablePress,请在 WordPress 插件目录中评价 TablePress 并写下您的评论,或者捐赠以支持 TablePress 的开发。谢谢!

TablePress 扩展

附加功能和一些有用的增强功能通过附加插件提供,即 TablePress 扩展,可通过 plugins网站 获得。

你有很多表格吗?您可以将它们分组到文件夹中!Wicked Folders Pro 支持 TablePress,可能是适合您的解决方案。

用法

安装插件后,您可以从 WordPress 控制面板的“TablePress”页面创建或管理表格。

要在 文章 或页面中显示表格,请将表格的简码 [table id= /] 嵌入到块编辑器中适当位置的“简码”块中。每个表单都有一个唯一的 ID,需要与简码中的 ID 对应。

然后,您可能想要更改表格的样式。您可以通过在插件选项页面上的自定义 CSS 文本框中输入 CSS 代码来完成此操作。一些常见的样式修改示例可以在 TablePress 常见问题页面上找到。

您还可以通过勾选表格编辑页面上的相应复选框来添加排序、分页、过滤、交替行背景颜色、突出显示行、显示表格名称和/或表格描述等功能。

谢谢

特别感谢 Allan Jardine 的 DataTables JavaScript 库。

感谢所有语言文件的翻译人员!

感谢每一位赞助商、支持者和问题记者!

授权

该插件是免费软件,根据 GPL 版本 2() 许可发布和许可。

您可以出于任何目的自由使用该软件。

php可以抓取网页数据吗(用本地服务器打开html分几种的html中的静态资源)

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2022-02-12 11:14

尽量简单解释一下,希望你能明白: 是否需要使用本地服务器打开html分为几种情况: html是否为纯静态模板页面 纯静态模板页面表示没有页面中的“请求服务器”获取数据,显示是为了版面核算。位临时写入的“假”数据。例如,对于“姓名”和“年龄”,后端数据尚未完成。前端会先写模板页面,随便写“姓名:张三”和“年龄:18”,然后先完成页面布局和样式。在这个阶段,不需要打开本地服务器html中引用的静态资源是否需要通过构建工具打包编译。例如,js 使用 ES6 新特性,css 使用较少的编写等,这时候可能需要使用 Webpack 等工具进行编译。这时候一般需要启动一个本地的node.js服务进行编译,预览开发中是否使用“实时刷新,同步预览”。如果不想在开发的时候每次修改文件都点击刷新或者按F5,保存的时候会自动刷新,可以用一些工具,比如livereload、browserSync等。有了这些工具,就需要启动本地服务开发。静态页面开发中是否使用多端调试,如果想在某品牌真机上看显示效果,调试兼容性问题,除了最笨的, 查看全部

php可以抓取网页数据吗(用本地服务器打开html分几种的html中的静态资源)

尽量简单解释一下,希望你能明白: 是否需要使用本地服务器打开html分为几种情况: html是否为纯静态模板页面 纯静态模板页面表示没有页面中的“请求服务器”获取数据,显示是为了版面核算。位临时写入的“假”数据。例如,对于“姓名”和“年龄”,后端数据尚未完成。前端会先写模板页面,随便写“姓名:张三”和“年龄:18”,然后先完成页面布局和样式。在这个阶段,不需要打开本地服务器html中引用的静态资源是否需要通过构建工具打包编译。例如,js 使用 ES6 新特性,css 使用较少的编写等,这时候可能需要使用 Webpack 等工具进行编译。这时候一般需要启动一个本地的node.js服务进行编译,预览开发中是否使用“实时刷新,同步预览”。如果不想在开发的时候每次修改文件都点击刷新或者按F5,保存的时候会自动刷新,可以用一些工具,比如livereload、browserSync等。有了这些工具,就需要启动本地服务开发。静态页面开发中是否使用多端调试,如果想在某品牌真机上看显示效果,调试兼容性问题,除了最笨的,

php可以抓取网页数据吗(百度搜索引擎怎么用ajax加载数据?豆瓣怎么办? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-02-11 07:05

)

过去可以通过豆瓣的API接口获取数据,但近几年豆瓣已经关闭了几乎所有的API,我们只能想其他办法了。搜索引擎应该是比较新的数据,我们可以抓取百度搜索引擎来实现这个我们的效果。

我使用eggjs作为后台,抓取的数据每24小时更新一次。每次访问都会先从缓存中获取数据,如果没有就直接抓取百度的数据。

获取目标 HTML

在百度搜索最新电影是这样的:

首先使用curl下载我们要爬取的整个页面

let html = await this.ctx.curl(baiduUrl);

html = html.data.toString();

解析 HTML

我们可以直接匹配上面截图的html代码,但是我发现如果电影名太长会自动转换成省略号而不是全名,这样不好。

注意下面的页码翻了,应该是用ajax加载数据的。我们可以从这里开始抓取我们想要的数据并使用浏览器调试工具:

响应结果:

正是我们想要的结果,其中还包括电影的封面和评分等信息,相当全面。

https://sp0.baidu.com/8aQDcjqpAAV3otqbppnN2DJv/api.php?resource_id=28286&from_mid=1&=&

format=json&ie=utf-8&oe=utf-8&query=最新电影&sort_key=17&

sort_type=1&stat0=&stat1=&stat2=&stat3=&pn=8&rn=8&

cb=jQuery1102026705352123140547_1611809868163&_=1611809868164

仔细查看上面的网址,发现有一个字符串(8aQDcjqpAAV3otqbppnN2DJv)不知道从哪里弄到,而且这个字符串肯定不一样。打开HTML搜索后,第4000行有一个JS配置:

但是后来我通过服务器抓取网页的时候,这些字段都是空的,可能是因为没有设置user-agent,但是我找到了字段fbtext,这不是我想要的列表吗?为什么需要做其他的分页之类的,直接去正则:

// 网页匹配

let hotMove = [];

const regReturn = html.match(/fbtext: '(.*),'/gi);

if (regReturn) {

hotMove = regReturn[0].replace("fbtext: '", '').replace(",'", '').split(',');

}

完整代码

async getBaiduMovie(type) {

let baiduUrl = 'http://www.baidu.com/s?wd=最新电影';

if (type === 2) {

baiduUrl = 'http://www.baidu.com/s?wd=热门电影';

}

let html = await this.ctx.curl(baiduUrl);

html = html.data.toString();

let hotMove = [];

// 网页匹配

const regReturn = html.match(/fbtext: '(.*),'/gi);

if (regReturn) {

hotMove = regReturn[0].replace("fbtext: '", '').replace(",'", '').split(',');

}

return hotMove;

}

最终效果

查看全部

php可以抓取网页数据吗(百度搜索引擎怎么用ajax加载数据?豆瓣怎么办?

)

过去可以通过豆瓣的API接口获取数据,但近几年豆瓣已经关闭了几乎所有的API,我们只能想其他办法了。搜索引擎应该是比较新的数据,我们可以抓取百度搜索引擎来实现这个我们的效果。

我使用eggjs作为后台,抓取的数据每24小时更新一次。每次访问都会先从缓存中获取数据,如果没有就直接抓取百度的数据。

获取目标 HTML

在百度搜索最新电影是这样的:

首先使用curl下载我们要爬取的整个页面

let html = await this.ctx.curl(baiduUrl);

html = html.data.toString();

解析 HTML

我们可以直接匹配上面截图的html代码,但是我发现如果电影名太长会自动转换成省略号而不是全名,这样不好。

注意下面的页码翻了,应该是用ajax加载数据的。我们可以从这里开始抓取我们想要的数据并使用浏览器调试工具:

响应结果:

正是我们想要的结果,其中还包括电影的封面和评分等信息,相当全面。

https://sp0.baidu.com/8aQDcjqpAAV3otqbppnN2DJv/api.php?resource_id=28286&from_mid=1&=&

format=json&ie=utf-8&oe=utf-8&query=最新电影&sort_key=17&

sort_type=1&stat0=&stat1=&stat2=&stat3=&pn=8&rn=8&

cb=jQuery1102026705352123140547_1611809868163&_=1611809868164

仔细查看上面的网址,发现有一个字符串(8aQDcjqpAAV3otqbppnN2DJv)不知道从哪里弄到,而且这个字符串肯定不一样。打开HTML搜索后,第4000行有一个JS配置:

但是后来我通过服务器抓取网页的时候,这些字段都是空的,可能是因为没有设置user-agent,但是我找到了字段fbtext,这不是我想要的列表吗?为什么需要做其他的分页之类的,直接去正则:

// 网页匹配

let hotMove = [];

const regReturn = html.match(/fbtext: '(.*),'/gi);

if (regReturn) {

hotMove = regReturn[0].replace("fbtext: '", '').replace(",'", '').split(',');

}

完整代码

async getBaiduMovie(type) {

let baiduUrl = 'http://www.baidu.com/s?wd=最新电影';

if (type === 2) {

baiduUrl = 'http://www.baidu.com/s?wd=热门电影';

}

let html = await this.ctx.curl(baiduUrl);

html = html.data.toString();

let hotMove = [];

// 网页匹配

const regReturn = html.match(/fbtext: '(.*),'/gi);

if (regReturn) {

hotMove = regReturn[0].replace("fbtext: '", '').replace(",'", '').split(',');

}

return hotMove;

}

最终效果

php可以抓取网页数据吗(看图网站的无限滚动脚本是怎么写出来的?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-02-10 18:24

最近为一张图片网站写了一个无限滚动脚本。这个网站的特点是服务端渲染,所以我们不能简单的访问界面,给页面添加数据来实现无限滚动。我在写之前参考了这个脚本,但是我的具体实现方法和这个脚本完全不同。

对于服务端渲染的网页,实现无限滚动的基本思路是在滚动条滚动到页面底部时获取下一页,然后提取获取的网页中需要显示的部分(例如图像容器),并将其添加到页面上。(个人总结)

思路一:获取

这里我使用 fetch 方法来获取新页面:

fetch('src').then(resp => resp.text()).then(text => {

const dummyHTML = document.createElement('html');

// 将获取到的 html 文本转成 DOM,以便查找元素

dummyHTML.innerHTML = text;

const container = dummyHTML.querySelector('选取图片container') ;

document.querySelector('图片container').append(container);

})

获取和展示数据的基本思路如代码所示。实际操作中发现目标网站的HTML结构不统一,所以需要根据情况选择容器部分的选择器。

思路二:iframe + 采用节点

这个思路就是上面列出的脚本的思路。兼容性好,代码少。推荐使用此方法。具体思路是:

const iframe = document.createElement('iframe');

iframe.src = src;

// 隐藏 iframe

iframe.style.height = 0;

iframe.style.width = 0;

// 把 iframe 添加到页面中,此时数据才开始加载

document.body.appendChild(iframe);

// 获取 iframe 的页面内容,功能和用 fetch 请求网页一样,但是更简单

const iframeContent = iframe.contentDocument

// document.adoptNode 的功能是删除原 DOM 子树并返回

// 这里就是删除原 iframe 的 container 并赋值给 container

const container = document.adoptNode(iframeContent.querySelector('图片container'));

// 把取出的 container 添加到当前页面

document.querySelector('.container').append(container);

iframe.remove()

总结iframe的作用和使用,主要注意src和contentDocument的作用,document.adoptNode的使用,fetch的使用

以上所有功能的详细文档可以在 mdn 上找到。

最后附上我花了几个小时写的G站无限滚动脚本的地址:

使用了更多新的 API,例如 URL 和 URLSearchParams。如果您有兴趣,请参考以下内容。 查看全部

php可以抓取网页数据吗(看图网站的无限滚动脚本是怎么写出来的?(一))

最近为一张图片网站写了一个无限滚动脚本。这个网站的特点是服务端渲染,所以我们不能简单的访问界面,给页面添加数据来实现无限滚动。我在写之前参考了这个脚本,但是我的具体实现方法和这个脚本完全不同。

对于服务端渲染的网页,实现无限滚动的基本思路是在滚动条滚动到页面底部时获取下一页,然后提取获取的网页中需要显示的部分(例如图像容器),并将其添加到页面上。(个人总结)

思路一:获取

这里我使用 fetch 方法来获取新页面:

fetch('src').then(resp => resp.text()).then(text => {

const dummyHTML = document.createElement('html');

// 将获取到的 html 文本转成 DOM,以便查找元素

dummyHTML.innerHTML = text;

const container = dummyHTML.querySelector('选取图片container') ;

document.querySelector('图片container').append(container);

})

获取和展示数据的基本思路如代码所示。实际操作中发现目标网站的HTML结构不统一,所以需要根据情况选择容器部分的选择器。

思路二:iframe + 采用节点

这个思路就是上面列出的脚本的思路。兼容性好,代码少。推荐使用此方法。具体思路是:

const iframe = document.createElement('iframe');

iframe.src = src;

// 隐藏 iframe

iframe.style.height = 0;

iframe.style.width = 0;

// 把 iframe 添加到页面中,此时数据才开始加载

document.body.appendChild(iframe);

// 获取 iframe 的页面内容,功能和用 fetch 请求网页一样,但是更简单

const iframeContent = iframe.contentDocument

// document.adoptNode 的功能是删除原 DOM 子树并返回

// 这里就是删除原 iframe 的 container 并赋值给 container

const container = document.adoptNode(iframeContent.querySelector('图片container'));

// 把取出的 container 添加到当前页面

document.querySelector('.container').append(container);

iframe.remove()

总结iframe的作用和使用,主要注意src和contentDocument的作用,document.adoptNode的使用,fetch的使用

以上所有功能的详细文档可以在 mdn 上找到。

最后附上我花了几个小时写的G站无限滚动脚本的地址:

使用了更多新的 API,例如 URL 和 URLSearchParams。如果您有兴趣,请参考以下内容。

php可以抓取网页数据吗(1.爬虫概述可能上面的说明还是难以具体地描述爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-02-09 14:14

爬虫,也就是网络爬虫,我们可以把互联网比作一个大网,而爬虫就是在网上爬行的蜘蛛,我们可以把网页的节点比作网页,爬它就相当于访问了page 获取其信息后,可以将节点之间的连接比作网页之间的链接关系,这样蜘蛛就可以在经过一个节点后继续沿着该节点连接爬行到下一个节点,即继续获取后续网页通过一个网页,让蜘蛛爬取整个网络的节点,从而抓取网站的数据。

1. 爬虫概述

在上面的描述中可能很难描述爬虫是什么。简而言之,爬虫是获取网页并提取和保存信息的自动化程序。接下来,我们将解释每一点:

获取网页

爬虫要做的第一个工作就是获取网页。这里,获取网页就是获取网页的源代码。源代码中一定收录了网页的一些有用信息,所以只要得到源代码,我们就可以从中提取出我们想要的东西。信息。

前面我们谈到了请求和响应的概念。我们向网站的服务器发送一个Request,返回的Response的body就是网页的源代码。所以最关键的部分就是构造一个Request并发送给服务器,然后接收Response并解析出来。这个过程如何实施?不能手动截取网页源代码?

不用担心,Python提供了很多库来帮助我们实现这个操作,比如Urllib、Requests等,我们可以利用这些库来帮助我们实现HTTP请求操作。Request 和 Response 可以用类库提供的数据结构来表示。拿到Response之后,我们只需要解析数据结构的Body部分,也就是得到网页的源码,这样我们就可以用程序来实现获取网页的过程了。

行

我们在第一步得到了网页的源代码后,接下来的工作就是分析网页的源代码,提取出我们想要的数据。最常用的方法是使用正则表达式进行提取,这是一种通用的方法。但是构造正则表达式是复杂且容易出错的。

另外,由于网页的结构有一定的规则,也有一些库是根据网页节点属性、CSS选择器或者XPath来提取网页信息的,比如BeautifulSoup、PyQuery、LXML等,这些库都可以使用高效快速地提取网页。信息,例如节点属性、文本值等。

提取信息是爬虫非常重要的一个环节,它可以让杂乱无章的数据变得清晰有条理,方便我们后期对数据进行处理和分析。

保存数据

提取信息后,我们一般将提取的数据保存在某处,以供后续数据处理。保存有多种形式,比如简单的保存为TXT文本或者Json文本,或者保存到数据库,比如MySQL、MongoDB等,或者保存到远程服务器,比如使用Sftp操作。

自动化程序

谈到自动化,这意味着爬虫可以代替人类执行这些操作。首先,我们可以手动提取这些信息,但是如果当量特别大或者想要快速获取大量数据,还是得使用程序。因此,爬虫是一个自动化的程序,它代表我们完成爬取数据的工作。可以在爬取过程中进行各种异常处理、错误重试等操作,保证爬取持续高效运行。

2. 我可以捕获什么样的数据

我们可以在网页中看到各种各样的信息,最常见的是常规网页,它们都对应着HTML代码,而最常见的爬取就是爬取HTML源代码。

此外,某些网页可能会返回 Json 字符串而不是 HTML 代码。大多数API接口都采用这种形式,方便数据传输和分析。这种数据也可以抓取,数据提取更方便。

此外,我们还可以看到各种二进制数据,比如图片、视频、音频等,我们可以使用爬虫抓取它们的二进制数据,并保存为对应的文件名。

此外,我们还可以看到各种扩展名的文件,比如CSS、JavaScript、配置文件等,这些其实是最常见的文件,只要在浏览器中访问,我们就可以抓取。

以上内容其实是对应各自的URL,是基于HTTP或HTTPS协议的。只要是这种数据爬虫,都可以爬取。

3. JavaScript 渲染页面

有时当我们用 Urllib 或 Requests 抓取网页时,我们得到的源代码实际上与我们在浏览器中看到的不同。

这个问题是一个非常普遍的问题。现在越来越多的网页使用Ajax和前端模块化工具来构建网页。整个网页可能会被 JavaScript 渲染,这意味着原创的 HTML 代码是一个空壳。例如:

这是一个演示

Python资源分享qun 784758214,包括安装包、PDF、学习视频,这里是Python学习者的聚集地,零基础,进阶,欢迎大家

body节点中只有一个id为container的节点,但是注意在body节点之后引入了一个app.js,负责渲染整个网站。

浏览器在打开这个页面的时候会先加载html内容,然后浏览器会发现里面已经引入了一个app.js文件,然后浏览器就会请求这个文件,获取到后执行文件。JavaScript 代码,而 JavaScript 会改变 HTML 中的节点,向内添加内容,最终得到完整的页面。

但是当使用 Urllib 或 Requests 等库请求当前页面时,我们得到的只是这段 HTML 代码,它不会帮助我们继续加载 JavaScript 文件,所以我们不会在浏览器中看到我们看到的内容。

这也解释了为什么有时我们得到的源代码与我们在浏览器中看到的不同。

所以使用基本的HTTP请求库得到的结果源代码可能与浏览器中的页面源代码不一样。在这种情况下,我们可以分析它的后台 Ajax 接口,或者使用 Selenium 和 Splash 等库来模拟 JavaScript 渲染,这样我们就可以爬取 JavaScript 渲染的网页内容。

稍后我们将详细介绍 JavaScript 渲染页面的 采集 方法。

4. 结论

本节介绍爬虫的一些基本原理,了解以上内容可以帮助我们以后编写爬虫时更加得心应手。 查看全部

php可以抓取网页数据吗(1.爬虫概述可能上面的说明还是难以具体地描述爬虫)

爬虫,也就是网络爬虫,我们可以把互联网比作一个大网,而爬虫就是在网上爬行的蜘蛛,我们可以把网页的节点比作网页,爬它就相当于访问了page 获取其信息后,可以将节点之间的连接比作网页之间的链接关系,这样蜘蛛就可以在经过一个节点后继续沿着该节点连接爬行到下一个节点,即继续获取后续网页通过一个网页,让蜘蛛爬取整个网络的节点,从而抓取网站的数据。

1. 爬虫概述

在上面的描述中可能很难描述爬虫是什么。简而言之,爬虫是获取网页并提取和保存信息的自动化程序。接下来,我们将解释每一点:

获取网页

爬虫要做的第一个工作就是获取网页。这里,获取网页就是获取网页的源代码。源代码中一定收录了网页的一些有用信息,所以只要得到源代码,我们就可以从中提取出我们想要的东西。信息。

前面我们谈到了请求和响应的概念。我们向网站的服务器发送一个Request,返回的Response的body就是网页的源代码。所以最关键的部分就是构造一个Request并发送给服务器,然后接收Response并解析出来。这个过程如何实施?不能手动截取网页源代码?

不用担心,Python提供了很多库来帮助我们实现这个操作,比如Urllib、Requests等,我们可以利用这些库来帮助我们实现HTTP请求操作。Request 和 Response 可以用类库提供的数据结构来表示。拿到Response之后,我们只需要解析数据结构的Body部分,也就是得到网页的源码,这样我们就可以用程序来实现获取网页的过程了。

行

我们在第一步得到了网页的源代码后,接下来的工作就是分析网页的源代码,提取出我们想要的数据。最常用的方法是使用正则表达式进行提取,这是一种通用的方法。但是构造正则表达式是复杂且容易出错的。

另外,由于网页的结构有一定的规则,也有一些库是根据网页节点属性、CSS选择器或者XPath来提取网页信息的,比如BeautifulSoup、PyQuery、LXML等,这些库都可以使用高效快速地提取网页。信息,例如节点属性、文本值等。

提取信息是爬虫非常重要的一个环节,它可以让杂乱无章的数据变得清晰有条理,方便我们后期对数据进行处理和分析。

保存数据

提取信息后,我们一般将提取的数据保存在某处,以供后续数据处理。保存有多种形式,比如简单的保存为TXT文本或者Json文本,或者保存到数据库,比如MySQL、MongoDB等,或者保存到远程服务器,比如使用Sftp操作。

自动化程序

谈到自动化,这意味着爬虫可以代替人类执行这些操作。首先,我们可以手动提取这些信息,但是如果当量特别大或者想要快速获取大量数据,还是得使用程序。因此,爬虫是一个自动化的程序,它代表我们完成爬取数据的工作。可以在爬取过程中进行各种异常处理、错误重试等操作,保证爬取持续高效运行。

2. 我可以捕获什么样的数据

我们可以在网页中看到各种各样的信息,最常见的是常规网页,它们都对应着HTML代码,而最常见的爬取就是爬取HTML源代码。

此外,某些网页可能会返回 Json 字符串而不是 HTML 代码。大多数API接口都采用这种形式,方便数据传输和分析。这种数据也可以抓取,数据提取更方便。

此外,我们还可以看到各种二进制数据,比如图片、视频、音频等,我们可以使用爬虫抓取它们的二进制数据,并保存为对应的文件名。

此外,我们还可以看到各种扩展名的文件,比如CSS、JavaScript、配置文件等,这些其实是最常见的文件,只要在浏览器中访问,我们就可以抓取。

以上内容其实是对应各自的URL,是基于HTTP或HTTPS协议的。只要是这种数据爬虫,都可以爬取。

3. JavaScript 渲染页面

有时当我们用 Urllib 或 Requests 抓取网页时,我们得到的源代码实际上与我们在浏览器中看到的不同。

这个问题是一个非常普遍的问题。现在越来越多的网页使用Ajax和前端模块化工具来构建网页。整个网页可能会被 JavaScript 渲染,这意味着原创的 HTML 代码是一个空壳。例如:

这是一个演示

Python资源分享qun 784758214,包括安装包、PDF、学习视频,这里是Python学习者的聚集地,零基础,进阶,欢迎大家

body节点中只有一个id为container的节点,但是注意在body节点之后引入了一个app.js,负责渲染整个网站。

浏览器在打开这个页面的时候会先加载html内容,然后浏览器会发现里面已经引入了一个app.js文件,然后浏览器就会请求这个文件,获取到后执行文件。JavaScript 代码,而 JavaScript 会改变 HTML 中的节点,向内添加内容,最终得到完整的页面。

但是当使用 Urllib 或 Requests 等库请求当前页面时,我们得到的只是这段 HTML 代码,它不会帮助我们继续加载 JavaScript 文件,所以我们不会在浏览器中看到我们看到的内容。

这也解释了为什么有时我们得到的源代码与我们在浏览器中看到的不同。

所以使用基本的HTTP请求库得到的结果源代码可能与浏览器中的页面源代码不一样。在这种情况下,我们可以分析它的后台 Ajax 接口,或者使用 Selenium 和 Splash 等库来模拟 JavaScript 渲染,这样我们就可以爬取 JavaScript 渲染的网页内容。

稍后我们将详细介绍 JavaScript 渲染页面的 采集 方法。

4. 结论

本节介绍爬虫的一些基本原理,了解以上内容可以帮助我们以后编写爬虫时更加得心应手。

php可以抓取网页数据吗(Python网络库库的基本堆栈--代理云爬虫的小伙伴)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-08 20:22

网络抓取是一种采集项目和工作数据的通用且有效的方法。在本指南中,我们将介绍 Python Web 抓取库的基本堆栈。

首先,如果你想做一个好的爬虫,一个好的代理IP是必不可少的

这里推荐一个适合爬虫的代理ip---代理云

爬虫小伙伴可以去获取免费代理IP试试

国产优质动态IP。限时2-10分钟,现在注册即可免费领取10000个代理IP

为什么只有5包?

有几十个用于网络抓取的软件包......但你只需要几个就可以抓取几乎所有的网站。这是一个自我认同的声明。在这里,我们决定将我们最喜欢的 5 个 Python 库用于网络抓取。它们一起涵盖了所有重要的基础,并且有据可查。

我需要学习下面的每个包吗?

不,但每个人都需要它,因为这是您与 网站 交流的方式。其余的取决于您的用例。经验法则如下:

您应该至少学习 BeautifulSoup 或 lxml 之一。选择哪个对您来说更直观(见下文)。

如果您需要使用 JavaScript 采集的数据来抓取 网站,请学习 Selenium。

如果您需要构建一个真正的蜘蛛或网络爬虫,而不仅仅是在这里和那里刮几页,学习 Scrapy。

哪一种更适合你的用餐?

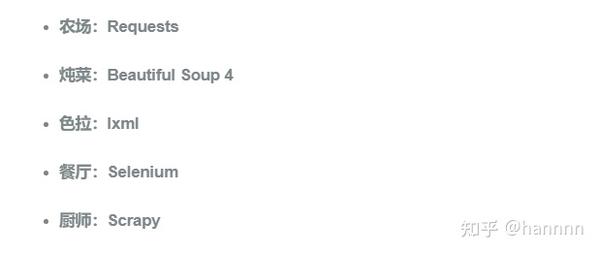

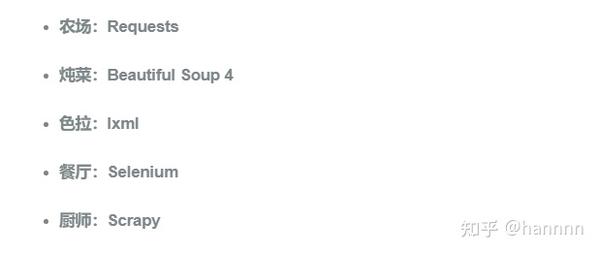

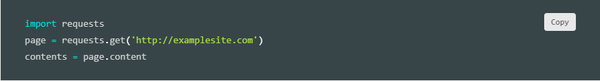

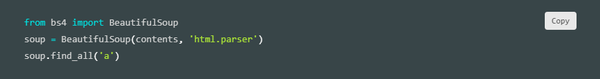

农场/请求

必不可少的添加到您的数据科学工具箱。这是一个简单但功能强大的 HTTP 包,这意味着您可以使用它来访问网页。我们称其为“农场”,因为您将使用它来获取菜肴的成分(即原创 HTML)(即可用数据)。它的简单性绝对是它最大的优势。它非常易于使用,您无需阅读文档即可直接使用。比如要获取一个页面的内容,就这么简单。: 但这不仅仅是 Requests 可以做的。它可以访问 API、发布到表单等。此外,它还具有……唯一自称非基因、有机和纯素的袋子。你会喜欢的。

炖菜/美汤 4

有了原料之后,接下来呢?现在你把它们做成炖菜……一道漂亮的炖菜。Beautiful Soup (BS4) 是一个解析包,可以使用不同的解析器。解析器只是一个可以从 HTML 和 XML 文本文件中提取数据的程序。Beautiful Soup 的默认解析器来自 Python 的标准库。它灵活和宽容,但有点慢。好消息是,如果你需要速度,它的解析器可以换成更快的解析器。BS4 的优点之一是它能够自动检测编码。带有特殊字符的 HTML 文档。在此外,BS4 可以帮助您浏览解析后的文档并找到您需要的内容。这使得构建通用应用程序变得快速和容易。例如,如果您想找到我们之前的网页中的所有链接,只需下面几行,

沙拉/lxml

Lxml 是一个高性能、生产质量的 HTML 和 XML 解析包。我们称它为“沙拉”,因为无论您选择哪种饮食,您都可以指望它对您有好处。在所有 Python 网页抓取包中,我们最喜欢使用 lxml。它简单、快速且功能丰富。即便如此,如果您有使用 XPath 或 CSS 的经验,也很容易上手。它的原创速度和力量也帮助它在行业中获得广泛采用。

BeautifulSoup 与 lxml

从历史上看,经验法则是:如果您需要速度,请使用 lxml。如果您需要处理凌乱的文档,请选择 BeautifulSoup。然而,这种区别不再成立。Beautiful Soup 现在支持使用 lxml 解析器,反之亦然。一旦你学会了另一个,就很容易学习另一个。因此,在开始时,我们建议您尝试并选择一个对您来说更直观的选项。我们更喜欢lxml,但很多人都和Beautiful Soup一致。

. HTML Scraping with lxml and Requests - 关于使用请求提取网页然后使用 XPath 选择器挖掘所需数据的简短而有趣的教程。比官方文档更适合初学者。

餐厅 / Selenium

有时,您确实需要去餐馆吃某些菜肴。农场很棒,但你不会在那里找到一切。

此外,有时 Requests 包不足以获取 网站。一些网站使用 JavaScript 来提供内容。例如,在您向下滚动页面或单击按钮之前,它们可能不会加载某些内容。其他网站可能要求您单击表单以查看其内容。或者从下拉菜单中选择一个选项。或者来一场部落雨舞……对于这些 网站,你将需要更强大的东西。您将需要 Selenium(可以处理除部落雨舞之外的所有事情)。Selenium 是一种用于自动化浏览器的工具,也称为 Web 驱动程序。有了它,您实际上可以打开一个 Google Chrome 窗口,访问 网站,然后单击一个链接。很酷,对吧?它还带有 Python 绑定,可以直接在您的应用程序中控制它。与您选择的解析库集成是轻而易举的事。

厨师/刮板

好吧,我们刚才谈了很多。你已经有 Requests 和 Selenium 来从网页获取 HTML/XML。然后,您可以使用 Beautiful Soup 或 lxml 将其解析为有用的数据。但是如果你需要更多呢?如果您需要一个可以系统地爬取整个 网站 的完整爬虫怎么办?刮!从技术上讲,Scrapy 甚至不是一个包……它是一个完整的网络抓取框架。这意味着您可以使用它来管理请求、保留用户会话、遵循重置指示和处理输出管道。这也意味着您可以与其他 Python Web 抓取包交换单个模块。例如,如果您需要插入 Selenium 来抓取动态网页。因此,如果您需要重用爬虫、扩展它、管理复杂的数据管道或制作其他复杂的爬虫,Scrapy 适合您。

——————————————— 查看全部

php可以抓取网页数据吗(Python网络库库的基本堆栈--代理云爬虫的小伙伴)

网络抓取是一种采集项目和工作数据的通用且有效的方法。在本指南中,我们将介绍 Python Web 抓取库的基本堆栈。

首先,如果你想做一个好的爬虫,一个好的代理IP是必不可少的

这里推荐一个适合爬虫的代理ip---代理云

爬虫小伙伴可以去获取免费代理IP试试

国产优质动态IP。限时2-10分钟,现在注册即可免费领取10000个代理IP

为什么只有5包?

有几十个用于网络抓取的软件包......但你只需要几个就可以抓取几乎所有的网站。这是一个自我认同的声明。在这里,我们决定将我们最喜欢的 5 个 Python 库用于网络抓取。它们一起涵盖了所有重要的基础,并且有据可查。

我需要学习下面的每个包吗?

不,但每个人都需要它,因为这是您与 网站 交流的方式。其余的取决于您的用例。经验法则如下:

您应该至少学习 BeautifulSoup 或 lxml 之一。选择哪个对您来说更直观(见下文)。

如果您需要使用 JavaScript 采集的数据来抓取 网站,请学习 Selenium。

如果您需要构建一个真正的蜘蛛或网络爬虫,而不仅仅是在这里和那里刮几页,学习 Scrapy。

哪一种更适合你的用餐?

农场/请求

必不可少的添加到您的数据科学工具箱。这是一个简单但功能强大的 HTTP 包,这意味着您可以使用它来访问网页。我们称其为“农场”,因为您将使用它来获取菜肴的成分(即原创 HTML)(即可用数据)。它的简单性绝对是它最大的优势。它非常易于使用,您无需阅读文档即可直接使用。比如要获取一个页面的内容,就这么简单。: 但这不仅仅是 Requests 可以做的。它可以访问 API、发布到表单等。此外,它还具有……唯一自称非基因、有机和纯素的袋子。你会喜欢的。

炖菜/美汤 4

有了原料之后,接下来呢?现在你把它们做成炖菜……一道漂亮的炖菜。Beautiful Soup (BS4) 是一个解析包,可以使用不同的解析器。解析器只是一个可以从 HTML 和 XML 文本文件中提取数据的程序。Beautiful Soup 的默认解析器来自 Python 的标准库。它灵活和宽容,但有点慢。好消息是,如果你需要速度,它的解析器可以换成更快的解析器。BS4 的优点之一是它能够自动检测编码。带有特殊字符的 HTML 文档。在此外,BS4 可以帮助您浏览解析后的文档并找到您需要的内容。这使得构建通用应用程序变得快速和容易。例如,如果您想找到我们之前的网页中的所有链接,只需下面几行,

沙拉/lxml

Lxml 是一个高性能、生产质量的 HTML 和 XML 解析包。我们称它为“沙拉”,因为无论您选择哪种饮食,您都可以指望它对您有好处。在所有 Python 网页抓取包中,我们最喜欢使用 lxml。它简单、快速且功能丰富。即便如此,如果您有使用 XPath 或 CSS 的经验,也很容易上手。它的原创速度和力量也帮助它在行业中获得广泛采用。

BeautifulSoup 与 lxml

从历史上看,经验法则是:如果您需要速度,请使用 lxml。如果您需要处理凌乱的文档,请选择 BeautifulSoup。然而,这种区别不再成立。Beautiful Soup 现在支持使用 lxml 解析器,反之亦然。一旦你学会了另一个,就很容易学习另一个。因此,在开始时,我们建议您尝试并选择一个对您来说更直观的选项。我们更喜欢lxml,但很多人都和Beautiful Soup一致。

. HTML Scraping with lxml and Requests - 关于使用请求提取网页然后使用 XPath 选择器挖掘所需数据的简短而有趣的教程。比官方文档更适合初学者。

餐厅 / Selenium

有时,您确实需要去餐馆吃某些菜肴。农场很棒,但你不会在那里找到一切。

此外,有时 Requests 包不足以获取 网站。一些网站使用 JavaScript 来提供内容。例如,在您向下滚动页面或单击按钮之前,它们可能不会加载某些内容。其他网站可能要求您单击表单以查看其内容。或者从下拉菜单中选择一个选项。或者来一场部落雨舞……对于这些 网站,你将需要更强大的东西。您将需要 Selenium(可以处理除部落雨舞之外的所有事情)。Selenium 是一种用于自动化浏览器的工具,也称为 Web 驱动程序。有了它,您实际上可以打开一个 Google Chrome 窗口,访问 网站,然后单击一个链接。很酷,对吧?它还带有 Python 绑定,可以直接在您的应用程序中控制它。与您选择的解析库集成是轻而易举的事。

厨师/刮板

好吧,我们刚才谈了很多。你已经有 Requests 和 Selenium 来从网页获取 HTML/XML。然后,您可以使用 Beautiful Soup 或 lxml 将其解析为有用的数据。但是如果你需要更多呢?如果您需要一个可以系统地爬取整个 网站 的完整爬虫怎么办?刮!从技术上讲,Scrapy 甚至不是一个包……它是一个完整的网络抓取框架。这意味着您可以使用它来管理请求、保留用户会话、遵循重置指示和处理输出管道。这也意味着您可以与其他 Python Web 抓取包交换单个模块。例如,如果您需要插入 Selenium 来抓取动态网页。因此,如果您需要重用爬虫、扩展它、管理复杂的数据管道或制作其他复杂的爬虫,Scrapy 适合您。

———————————————

php可以抓取网页数据吗(requiresPHP4Beta4+)$maxframes允许追踪的框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2022-03-17 11:28

$error 报告在哪里,如果有的话

$response_code 服务器返回的响应码

从服务器返回的 $headers 标头

$maxlength 最长返回数据长度

$read_timeout 读取超时(需要 PHP 4 Beta 4+)

设置为 0 表示没有超时

$timed_out 如果读取操作超时,此属性返回 true(需要 PHP 4 Beta 4+)

$maxframes 允许跟踪的最大帧数

$status 获取 http 状态

Web 服务器可以写入的临时文件的 $temp_dir 目录 (/tmp)

cURL二进制的$curl_path目录,如果没有cURL二进制则设置为false

以下是演示

复制代码代码如下:

包括“Snoopy.class.php”;

$snoopy = 新史努比;

$snoopy->proxy_host = "";

$snoopy->proxy_port = "8080";

$snoopy->agent = "(兼容;MSIE 4.01;MSN 2.5;AOL 4.0;Windows 98)";

$snoopy->referer = "";

$snoopy->cookies["SessionID"] = 238472834723489l;

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext(""))

{

回声“

".htmlspecialchars($snoopy->results)."

\n";

}

其他

echo "获取文档时出错:".$snoopy->error."\n";

////////////////////////////////////// //////////

Snoopy 的特点是“大”和“满”,一次 fetch 可以拾取一切,可以作为 采集 的第一步。接下来,您需要使用 simple_html_dom 扣除所需的部分。当然,如果你特别擅长规律,喜欢规律,也可以用规律来搭配抢。

simple_html_dom 实际上是一个 dom 解析过程。 PHP也提供了一些解析方法,不过这个simple_html_dom可以说是比较专业的一个类,满足了很多你想要的功能。

////////////////////////////////////// ///////////

// 使用URL或文件名创建目标文档对象,即目标网页

$html = file_get_html ('' );

//$html = file_get_html('test.htm');

//使用字符串作为登陆页面。可以通过Snoopy获取页面,然后在这里获取处理

$myhtml = str_get_html ('你好!' );

// 查找所有图片并返回一个数组

foreach($html->find ('img' ) as $element)

echo $element->src 。 '

' ;

// 查找所有链接

foreach($html->find ('a') as $element)

echo $element->href 。 '

' ;

find 方法效果很好,通常它返回一个对象数组。在查找目标元素时,可以通过class或者id,或者其他属性来获取目标字符串。

//通过目标div的class属性搜索div。 find 方法中的第二个参数是返回数组中的数字。从0开始是第一个

$target_div = $html->find('div.targetclass',0 );

//检查结果是不是你想要的,直接echo就行了

回声 $target_div;

//关键是这个采集对象创建后一定要销毁,否则php页面可能会“卡住”30秒左右,这取决于你服务器的时间限制。销毁的方法是:

$html->clear();

未设置($html);

我觉得simple_html_dom的优势在于采集和JS一样容易控制。下面提供的下载包中有英文说明书

simplehtmldom_1_11/simplehtmldom/manual/manual.htm

数组

$e->getAllAttributes()

数组

$e->属性

字符串

$e->getAttribute($name)

字符串

$e->属性

无效

$e->setAttribute($name, $value)

无效

$value = $e->属性

布尔

$e->hasAttribute($name)

布尔

isset($e->属性)

无效

$e->removeAttribute ($name)

无效

$e->attribute=null

元素

$e->getElementById($id)

混合

$e->find ("#$id", 0)

混合

$e->getElementsById($id [,$index])

混合