php可以抓取网页数据吗

php可以抓取网页数据吗(正则表达式抓取国家面积数据的解决方案)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-09-19 23:07

接下来,我们将介绍三种获取网页数据的方法,首先是正则表达式,然后是流行的Beauty soup模块,最后是功能强大的lxml模块

1.正则表达式

如果您不熟悉正则表达式或需要一些技巧,可以参考正则表达式如何获得完整的介绍

当我们使用正则表达式捕获国家区域数据时,必须首先尝试匹配元素的内容,如下所示:

>>> import re

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> re.findall(\'(.*?)\', html)

[\'/places/static/images/flags/gb.png\', \'244,820 square kilometres\', \'62,348,447\', \'GB\', \'United Kingdom\', \'London\', \'EU\', \'.uk\', \'GBP\', \'Pound\', \'44\', \'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA\', \'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$\', \'en-GB,cy-GB,gd\', \'IE \']

>>>

从以上结果可以看出,多个国家属性使用标签。要分离区域属性,我们只能选择第二个元素,如下所示:

>>> re.findall(\'(.*?)\', html)[1]

\'244,820 square kilometres\'

虽然现在可以使用此方案,但如果网页发生更改,则可能会失败。例如,表格已更改,删除了第二行中的土地面积数据。如果我们现在只捕获数据,我们可以忽略未来可能发生的变化。但是,如果我们希望在将来再次捕获数据,我们需要提供一个更健壮的解决方案,以尽可能避免这种布局更改的影响。为了使正则表达式更健壮,我们可以添加它的父元素。元素应该是唯一的,因为它有一个ID属性

>>> re.findall(\'Area: (.*?)\', html)

[\'244,820 square kilometres\']

这个迭代版本看起来更好,但是还有许多其他方法来更新网页,这也会使正则表达式不满意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或更改区域标签等。以下是尝试支持这些可能性的改进版本

>>> re.findall(\'.*?>> from bs4 import BeautifulSoup

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, \'html.parser\')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,beautiful soup可以正确解析缺少的引号并关闭标签。现在可以使用find()和find_uAll()方法来定位我们需要的元素

>>> ul = soup.find(\'ul\', attrs={\'class\':\'country\'})

>>> ul.find(\'li\') # return just the first match

AreaPopulation

>>> ul.find_all(\'li\') # return all matches

[AreaPopulation, Population]

注意:由于不同版本的Python内置库的容错性不同,处理结果可能与上述不同。请参阅:。有关所有方法和参数,请参阅beautiful soup的官方文档

以下是使用此方法提取样本国家/地区数据的完整代码

>>> from bs4 import BeautifulSoup

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> # locate the area row

>>> tr = soup.find(attrs={\'id\':\'places_area__row\'})

>>> # locate the area tag

>>> td = tr.find(attrs={\'class\':\'w2p_fw\'})

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

尽管此代码比正则表达式代码更复杂,但它更易于构造和理解。此外,我们不需要担心布局中的小变化,例如冗余空间和标签属性

3.Lxml

Lxml是一个基于libxml2的python包,libxml2是一个XML解析库。该模块是用C语言编写的,解析速度比beautiful soup快,但安装过程也比较复杂。请参阅最新的安装说明**

与Beauty soup一样,使用lxml模块的第一步是将可能非法的HTML解析为统一格式。以下是使用此模块解析不完整HTML的示例:

>>> import lxml.html

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> tree = lxml.html.fromstring(broken_html)

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

类似地,lxml可以正确解析属性和close标记周围缺少的引号,但模块不添加和标记

解析输入内容后,进入选择元素的步骤。此时,lxml有几种不同的方法,例如XPath选择器和类似于beautiful soup的find()方法。不过,我们稍后将使用CSS选择器,因为它更简洁,在解析动态内容时可以重用。此外,一些有jQuery选择器经验的读者会更熟悉它

以下是使用lxml的CSS选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect(\'tr#places_area__row > td.w2p_fw\')[0] # *行代码

>>> area = td.text_content()

>>> print area

244,820 square kilometres

*第一行代码将查找具有ID_uu区域_uu行的位置,然后为FW选择类W2P_uu表数据子标签

CSS选择器表示用于选择元素的模式。以下是选择器的一些常见示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link

选择 id="home" 的 标签: a#home

选择父元素为 标签的所有 子标签: a > span

选择 标签内部的所有 标签: a span

选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C已经在

Lxml实现了大多数CSS3属性。有关不支持的函数,请参阅:

注意:在lxml的内部实现中,它实际上将CSS选择器转换为等效的XPath选择器

4.性能比较

在下面的代码中,每个爬虫程序将执行1000次。每次执行将检查爬网结果是否正确,然后打印总时间

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re

import timeit

from bs4 import BeautifulSoup

import lxml.html

FIELDS = (\'area\', \'population\', \'iso\', \'country\', \'capital\', \'continent\', \'tld\', \'currency_code\', \'currency_name\', \'phone\', \'postal_code_format\', \'postal_code_regex\', \'languages\', \'neighbours\')

def regex_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search(\'.*?(.*?)\'.format(field), html).groups()[0]

return results

def beautiful_soup_scraper(html):

soup = BeautifulSoup(html, \'html.parser\')

results = {}

for field in FIELDS:

results[field] = soup.find(\'table\').find(\'tr\', id=\'places_{}__row\'.format(field)).find(\'td\', class_=\'w2p_fw\').text

return results

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect(\'table > tr#places_{}__row > td.w2p_fw\'.format(field))[0].text_content()

return results

def main():

times = {}

html = urllib2.urlopen(\'http://example.webscraping.com/view/United-Kingdom-239\').read()

NUM_ITERATIONS = 1000 # number of times to test each scraper

for name, scraper in (\'Regular expressions\', regex_scraper), (\'Beautiful Soup\', beautiful_soup_scraper), (\'Lxml\', lxml_scraper):

times[name] = []

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == regex_scraper:

# the regular expression module will cache results

# so need to purge this cache for meaningful timings

re.purge() # *行代码

result = scraper(html)

# check scraped result is as expected

assert(result[\'area\'] == \'244,820 square kilometres\')

times[name].append(time.time() - start)

# record end time of scrape and output the total

end = time.time()

print \'{}: {:.2f} seconds\'.format(name, end - start)

writer = csv.writer(open(\'times.csv\', \'w\'))

header = sorted(times.keys())

writer.writerow(header)

for row in zip(*[times[scraper] for scraper in header]):

writer.writerow(row)

if __name__ == \'__main__\':

main()

注意,我们在*代码中调用了re.purge()方法。默认情况下,正则表达式缓存搜索结果。为了公平起见,我们需要使用此方法清除缓存

以下是在我的计算机上运行脚本的结果:

由于硬件条件的不同,不同计算机的执行结果也会不同。然而,每种方法之间的相对差异应该相当大。从结果可以看出,在捕获我们的示例网页时,Beauty soup的速度比其他两种方法慢7倍多。事实上,这个结果是意料之中的,因为lxml和正则表达式模块是用C语言编写的,而Beauty soup是用纯python编写的。一个有趣的事实是,lxml的行为几乎和正则表达式一样好。由于lxml必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一网页的多个功能时,初始化和解析的开销将减少,lxml将更具竞争力。因此,lxml是一个功能强大的模块

5.摘要

三种网页捕获方法的优缺点:

抓取方法 演出 使用困难 安装困难

正则表达式

来吧

困难

简单(内置模块)

靓汤

慢

简单的

简单(纯Python)

Lxml

来吧

简单的

相对困难

如果您的爬虫瓶颈是下载网页而不是提取数据,那么使用较慢的方法(如BeautifulSoup)并不是问题。正则表达式在一次性提取中非常有用。此外,它们还可以避免解析整个网页的开销。如果您只需要获取少量数据并希望避免额外的依赖项,则正则表达式可能更合适。但是,一般来说,lxml是抓取数据的最佳选择,因为它不仅速度快,而且功能更强大,而正则表达式和Beauty soup只在某些特定场景中有用 查看全部

php可以抓取网页数据吗(正则表达式抓取国家面积数据的解决方案)

接下来,我们将介绍三种获取网页数据的方法,首先是正则表达式,然后是流行的Beauty soup模块,最后是功能强大的lxml模块

1.正则表达式

如果您不熟悉正则表达式或需要一些技巧,可以参考正则表达式如何获得完整的介绍

当我们使用正则表达式捕获国家区域数据时,必须首先尝试匹配元素的内容,如下所示:

>>> import re

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> re.findall(\'(.*?)\', html)

[\'/places/static/images/flags/gb.png\', \'244,820 square kilometres\', \'62,348,447\', \'GB\', \'United Kingdom\', \'London\', \'EU\', \'.uk\', \'GBP\', \'Pound\', \'44\', \'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA\', \'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$\', \'en-GB,cy-GB,gd\', \'IE \']

>>>

从以上结果可以看出,多个国家属性使用标签。要分离区域属性,我们只能选择第二个元素,如下所示:

>>> re.findall(\'(.*?)\', html)[1]

\'244,820 square kilometres\'

虽然现在可以使用此方案,但如果网页发生更改,则可能会失败。例如,表格已更改,删除了第二行中的土地面积数据。如果我们现在只捕获数据,我们可以忽略未来可能发生的变化。但是,如果我们希望在将来再次捕获数据,我们需要提供一个更健壮的解决方案,以尽可能避免这种布局更改的影响。为了使正则表达式更健壮,我们可以添加它的父元素。元素应该是唯一的,因为它有一个ID属性

>>> re.findall(\'Area: (.*?)\', html)

[\'244,820 square kilometres\']

这个迭代版本看起来更好,但是还有许多其他方法来更新网页,这也会使正则表达式不满意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或更改区域标签等。以下是尝试支持这些可能性的改进版本

>>> re.findall(\'.*?>> from bs4 import BeautifulSoup

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, \'html.parser\')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,beautiful soup可以正确解析缺少的引号并关闭标签。现在可以使用find()和find_uAll()方法来定位我们需要的元素

>>> ul = soup.find(\'ul\', attrs={\'class\':\'country\'})

>>> ul.find(\'li\') # return just the first match

AreaPopulation

>>> ul.find_all(\'li\') # return all matches

[AreaPopulation, Population]

注意:由于不同版本的Python内置库的容错性不同,处理结果可能与上述不同。请参阅:。有关所有方法和参数,请参阅beautiful soup的官方文档

以下是使用此方法提取样本国家/地区数据的完整代码

>>> from bs4 import BeautifulSoup

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> # locate the area row

>>> tr = soup.find(attrs={\'id\':\'places_area__row\'})

>>> # locate the area tag

>>> td = tr.find(attrs={\'class\':\'w2p_fw\'})

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

尽管此代码比正则表达式代码更复杂,但它更易于构造和理解。此外,我们不需要担心布局中的小变化,例如冗余空间和标签属性

3.Lxml

Lxml是一个基于libxml2的python包,libxml2是一个XML解析库。该模块是用C语言编写的,解析速度比beautiful soup快,但安装过程也比较复杂。请参阅最新的安装说明**

与Beauty soup一样,使用lxml模块的第一步是将可能非法的HTML解析为统一格式。以下是使用此模块解析不完整HTML的示例:

>>> import lxml.html

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> tree = lxml.html.fromstring(broken_html)

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

类似地,lxml可以正确解析属性和close标记周围缺少的引号,但模块不添加和标记

解析输入内容后,进入选择元素的步骤。此时,lxml有几种不同的方法,例如XPath选择器和类似于beautiful soup的find()方法。不过,我们稍后将使用CSS选择器,因为它更简洁,在解析动态内容时可以重用。此外,一些有jQuery选择器经验的读者会更熟悉它

以下是使用lxml的CSS选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect(\'tr#places_area__row > td.w2p_fw\')[0] # *行代码

>>> area = td.text_content()

>>> print area

244,820 square kilometres

*第一行代码将查找具有ID_uu区域_uu行的位置,然后为FW选择类W2P_uu表数据子标签

CSS选择器表示用于选择元素的模式。以下是选择器的一些常见示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link

选择 id="home" 的 标签: a#home

选择父元素为 标签的所有 子标签: a > span

选择 标签内部的所有 标签: a span

选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C已经在

Lxml实现了大多数CSS3属性。有关不支持的函数,请参阅:

注意:在lxml的内部实现中,它实际上将CSS选择器转换为等效的XPath选择器

4.性能比较

在下面的代码中,每个爬虫程序将执行1000次。每次执行将检查爬网结果是否正确,然后打印总时间

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re

import timeit

from bs4 import BeautifulSoup

import lxml.html

FIELDS = (\'area\', \'population\', \'iso\', \'country\', \'capital\', \'continent\', \'tld\', \'currency_code\', \'currency_name\', \'phone\', \'postal_code_format\', \'postal_code_regex\', \'languages\', \'neighbours\')

def regex_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search(\'.*?(.*?)\'.format(field), html).groups()[0]

return results

def beautiful_soup_scraper(html):

soup = BeautifulSoup(html, \'html.parser\')

results = {}

for field in FIELDS:

results[field] = soup.find(\'table\').find(\'tr\', id=\'places_{}__row\'.format(field)).find(\'td\', class_=\'w2p_fw\').text

return results

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect(\'table > tr#places_{}__row > td.w2p_fw\'.format(field))[0].text_content()

return results

def main():

times = {}

html = urllib2.urlopen(\'http://example.webscraping.com/view/United-Kingdom-239\').read()

NUM_ITERATIONS = 1000 # number of times to test each scraper

for name, scraper in (\'Regular expressions\', regex_scraper), (\'Beautiful Soup\', beautiful_soup_scraper), (\'Lxml\', lxml_scraper):

times[name] = []

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == regex_scraper:

# the regular expression module will cache results

# so need to purge this cache for meaningful timings

re.purge() # *行代码

result = scraper(html)

# check scraped result is as expected

assert(result[\'area\'] == \'244,820 square kilometres\')

times[name].append(time.time() - start)

# record end time of scrape and output the total

end = time.time()

print \'{}: {:.2f} seconds\'.format(name, end - start)

writer = csv.writer(open(\'times.csv\', \'w\'))

header = sorted(times.keys())

writer.writerow(header)

for row in zip(*[times[scraper] for scraper in header]):

writer.writerow(row)

if __name__ == \'__main__\':

main()

注意,我们在*代码中调用了re.purge()方法。默认情况下,正则表达式缓存搜索结果。为了公平起见,我们需要使用此方法清除缓存

以下是在我的计算机上运行脚本的结果:

由于硬件条件的不同,不同计算机的执行结果也会不同。然而,每种方法之间的相对差异应该相当大。从结果可以看出,在捕获我们的示例网页时,Beauty soup的速度比其他两种方法慢7倍多。事实上,这个结果是意料之中的,因为lxml和正则表达式模块是用C语言编写的,而Beauty soup是用纯python编写的。一个有趣的事实是,lxml的行为几乎和正则表达式一样好。由于lxml必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一网页的多个功能时,初始化和解析的开销将减少,lxml将更具竞争力。因此,lxml是一个功能强大的模块

5.摘要

三种网页捕获方法的优缺点:

抓取方法 演出 使用困难 安装困难

正则表达式

来吧

困难

简单(内置模块)

靓汤

慢

简单的

简单(纯Python)

Lxml

来吧

简单的

相对困难

如果您的爬虫瓶颈是下载网页而不是提取数据,那么使用较慢的方法(如BeautifulSoup)并不是问题。正则表达式在一次性提取中非常有用。此外,它们还可以避免解析整个网页的开销。如果您只需要获取少量数据并希望避免额外的依赖项,则正则表达式可能更合适。但是,一般来说,lxml是抓取数据的最佳选择,因为它不仅速度快,而且功能更强大,而正则表达式和Beauty soup只在某些特定场景中有用

php可以抓取网页数据吗(php可以抓取网页数据吗?php能否爬取互联网上的qq聊天记录等信息?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-09-19 11:01

php可以抓取网页数据吗?php可以直接爬虫网页数据吗?php能否爬取互联网上的qq聊天记录等信息?php可以抓取新浪微博的内容吗?...这些都是问题。这些问题没有固定的答案,要看php抓取出来的数据里有没有提到qq等软件来实现不同的功能,当然也有固定的几种解决方案:用http协议抓取只是,这种方法不是必要的,很多网站的通用解决方案也很成熟了。

根据你的需求,你可以再找一找其他的方案。爬虫数据抓取优点:随时存取某一网站的有价值的数据。由于不存在,也没有必要,网页的那些数据是没有价值的。这里有一个空位,不去抓取,也没有关系。缺点:需要具备以下基本知识:http协议,http网页,cookie,ip和域名等等。这些知识都是相关行业不会错过的。

phpspider抓取:看似简单的爬虫数据抓取,实际上对解决你所面临的问题至关重要。phpspider抓取还是挺复杂的,里面有很多坑,里面坑很多,坑很多。里面坑很多。所以你最好找一个成熟的phpspider。抓取网页内容很简单,请求返回来的内容可能还包含了动态的内容,所以http协议和一些基本的东西都是要学的。

pythonweb开发框架:你可以在网上搜索一下常见的web框架,大致都有对应的python版本,python很强大,很多东西都是跨平台的,如果你学的是python的话,python的相关知识还是需要掌握一下。python里对应的模块很多,你也可以学学这些模块都是有对应的功能来提供你的操作,需要熟悉怎么使用他们。比如说,pyspider,flask等等。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?php能否爬取互联网上的qq聊天记录等信息?)

php可以抓取网页数据吗?php可以直接爬虫网页数据吗?php能否爬取互联网上的qq聊天记录等信息?php可以抓取新浪微博的内容吗?...这些都是问题。这些问题没有固定的答案,要看php抓取出来的数据里有没有提到qq等软件来实现不同的功能,当然也有固定的几种解决方案:用http协议抓取只是,这种方法不是必要的,很多网站的通用解决方案也很成熟了。

根据你的需求,你可以再找一找其他的方案。爬虫数据抓取优点:随时存取某一网站的有价值的数据。由于不存在,也没有必要,网页的那些数据是没有价值的。这里有一个空位,不去抓取,也没有关系。缺点:需要具备以下基本知识:http协议,http网页,cookie,ip和域名等等。这些知识都是相关行业不会错过的。

phpspider抓取:看似简单的爬虫数据抓取,实际上对解决你所面临的问题至关重要。phpspider抓取还是挺复杂的,里面有很多坑,里面坑很多,坑很多。里面坑很多。所以你最好找一个成熟的phpspider。抓取网页内容很简单,请求返回来的内容可能还包含了动态的内容,所以http协议和一些基本的东西都是要学的。

pythonweb开发框架:你可以在网上搜索一下常见的web框架,大致都有对应的python版本,python很强大,很多东西都是跨平台的,如果你学的是python的话,python的相关知识还是需要掌握一下。python里对应的模块很多,你也可以学学这些模块都是有对应的功能来提供你的操作,需要熟悉怎么使用他们。比如说,pyspider,flask等等。

php可以抓取网页数据吗(具有一定的参考价值,可以用来用来参考一下!(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-09-19 03:18

本文文章主要详细介绍PHP的curl库的功能,包括捕获网页、发布数据和其他简单示例。具有一定的参考价值,可供参考

感兴趣的朋友们,让我们来看看512个注释

的萧边晓云。

无论您是想从链接获取一些数据,还是想获取一个XML文件并将其导入数据库,即使只是为了获取网页内容,reactor curl都是一个功能强大的PHP库。本文主要介绍如何使用这个PHP库

启用卷曲设置

首先,我们必须确定我们的PHP是否已经打开了这个库。您可以使用PHP_uinfo()函数来获取此信息

代码如下:

如果您可以在网页上看到以下输出,则表示curl库已打开

如果您看到它,您需要设置PHP并打开库。如果你是在windows平台上,这是非常简单的。您需要更改php.ini文件的设置以查找php_Curl.dll并取消前面的分号注释。详情如下:

//在下面取消注释

extension=php\ucurl.dll

如果您使用的是Linux,则需要重新编译PHP以获得Google排名。编辑时,需要打开编译参数-将“–with curl”参数添加到configure命令中

一个小例子

如果一切就绪,下面是一个小程序:

代码如下:

从上面的程序中,我们可以看到使用curlopt_uuuu-Post设置HTTP协议的Post方法而不是get方法,然后使用curlopt_uuuuu-Postfields设置Post的数据

关于代理服务器

下面是如何使用代理服务器的示例。请注意突出显示的代码。代码非常简单,所以我不需要多说

代码如下:

关于SSL和Cookie 查看全部

php可以抓取网页数据吗(具有一定的参考价值,可以用来用来参考一下!(组图))

本文文章主要详细介绍PHP的curl库的功能,包括捕获网页、发布数据和其他简单示例。具有一定的参考价值,可供参考

感兴趣的朋友们,让我们来看看512个注释

的萧边晓云。

无论您是想从链接获取一些数据,还是想获取一个XML文件并将其导入数据库,即使只是为了获取网页内容,reactor curl都是一个功能强大的PHP库。本文主要介绍如何使用这个PHP库

启用卷曲设置

首先,我们必须确定我们的PHP是否已经打开了这个库。您可以使用PHP_uinfo()函数来获取此信息

代码如下:

如果您可以在网页上看到以下输出,则表示curl库已打开

如果您看到它,您需要设置PHP并打开库。如果你是在windows平台上,这是非常简单的。您需要更改php.ini文件的设置以查找php_Curl.dll并取消前面的分号注释。详情如下:

//在下面取消注释

extension=php\ucurl.dll

如果您使用的是Linux,则需要重新编译PHP以获得Google排名。编辑时,需要打开编译参数-将“–with curl”参数添加到configure命令中

一个小例子

如果一切就绪,下面是一个小程序:

代码如下:

从上面的程序中,我们可以看到使用curlopt_uuuu-Post设置HTTP协议的Post方法而不是get方法,然后使用curlopt_uuuuu-Postfields设置Post的数据

关于代理服务器

下面是如何使用代理服务器的示例。请注意突出显示的代码。代码非常简单,所以我不需要多说

代码如下:

关于SSL和Cookie

php可以抓取网页数据吗(php可以抓取网页数据吗?(示例代码)(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-09-17 07:01

php可以抓取网页数据吗?这个当然可以,尤其是抓取一些大型的网站的数据,例如,通过最大的搜索引擎google对中国的各大网站的抓取也是大多通过php来实现的。今天,我们主要来分享一下php抓取网页的python代码及示例代码。这里以下载电商网站的快递单号为例。voidrequest_url_url_to_location(){request_url_url_to_locationrequest=newrequest_url_url_to_location();vara=request.url;//客户端地址,必须在http请求头里,一般是http协议request.url='';}//两个双引号里分别是content和location,具体怎么用要看语言的不同而不同request.url='';//后面就是网页的网址,必须为绝对路径,否则要使用absoluteurlif(!stringutils.isblank(url)){echourl;}//设置路径名,需要加双引号if(!stringutils.isblank(absolute_url)){request.url=absolute_url;}//后面的网址就是location//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向open('/edit.location',&request);open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向absolute('/edit.php');//设置大小写敏感性open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径open('/edit.php',&request);if(!stringutils.isblank(location)){open('/edit.location',location);}//string中的字符串中可以包含多个关键字或带引号的字符,这个时候就可以直接包含多个字符absolute('/edit.location');open('/edit.php',php);//使用location指定了文件的绝对路径,而网址里只有location,php和absolute是不可以的,也就是只能使用location指定location的路径if(!stringutils.isblank(postdata.post_data_location)){postdata.post_data_location=postdata.post_data_location;}if(!stringutils.isblank(getdata.request_data_location)){getdata.request_data_location=request_data_location;}if(!stringutils.isblank(traceback.match("/incorrect/request:",filename))){request_data_location=traceback.match("/incorrect/request:",filename);}absolute('/edit.php');//if(!stringutils.。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?(示例代码)(图))

php可以抓取网页数据吗?这个当然可以,尤其是抓取一些大型的网站的数据,例如,通过最大的搜索引擎google对中国的各大网站的抓取也是大多通过php来实现的。今天,我们主要来分享一下php抓取网页的python代码及示例代码。这里以下载电商网站的快递单号为例。voidrequest_url_url_to_location(){request_url_url_to_locationrequest=newrequest_url_url_to_location();vara=request.url;//客户端地址,必须在http请求头里,一般是http协议request.url='';}//两个双引号里分别是content和location,具体怎么用要看语言的不同而不同request.url='';//后面就是网页的网址,必须为绝对路径,否则要使用absoluteurlif(!stringutils.isblank(url)){echourl;}//设置路径名,需要加双引号if(!stringutils.isblank(absolute_url)){request.url=absolute_url;}//后面的网址就是location//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向open('/edit.location',&request);open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向absolute('/edit.php');//设置大小写敏感性open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径open('/edit.php',&request);if(!stringutils.isblank(location)){open('/edit.location',location);}//string中的字符串中可以包含多个关键字或带引号的字符,这个时候就可以直接包含多个字符absolute('/edit.location');open('/edit.php',php);//使用location指定了文件的绝对路径,而网址里只有location,php和absolute是不可以的,也就是只能使用location指定location的路径if(!stringutils.isblank(postdata.post_data_location)){postdata.post_data_location=postdata.post_data_location;}if(!stringutils.isblank(getdata.request_data_location)){getdata.request_data_location=request_data_location;}if(!stringutils.isblank(traceback.match("/incorrect/request:",filename))){request_data_location=traceback.match("/incorrect/request:",filename);}absolute('/edit.php');//if(!stringutils.。

php可以抓取网页数据吗( AJAX就是文件解析和AJAX教程AJAX更新的代码解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-12 00:08

AJAX就是文件解析和AJAX教程AJAX更新的代码解析)

JSON 和 Ajax

AJAX 是异步 JavaScript 和 XML。它是一组相互关联的 Web 开发技术,供客户端创建异步 Web 应用程序。遵循 AJAX 模型,Web 应用程序可以在不影响现有页面的显示行为的情况下以异步方式从服务器发送数据和检索数据。

许多开发人员使用 JSON 在客户端和服务器之间传递 AJAX 更新。一个实时更新体育结果的网站可以看作是 AJAX 的一个例子。如果要在站点上更新这些分数,则必须将它们存储在服务器上,以便网页可以在需要时检索这些分数。这里我们可以使用JSON格式的数据。

任何使用 AJAX 更新的数据都可以以 JSON 格式存储在 Web 服务器上。使用 AJAX,JavaScript 可以在必要时检索这些 JSON 文件,解析它们,然后做以下两件事:

示例

下面的代码显示了 JSON 和 AJAX,请将它们保存为 ajax.html 文件。这里的加载函数 loadJSON() 会异步上传 JSON 数据。

function loadJSON()

{

var data_file = "https://atts.w3cschool.cn/arti ... 3B%3B

var http_request = new XMLHttpRequest();

try{

// Opera 8.0+, Firefox, Chrome, Safari

http_request = new XMLHttpRequest();

}catch (e){

// IE 浏览器处理

try{

http_request = new ActiveXObject("Msxml2.XMLHTTP");

}catch (e) {

try{

http_request = new ActiveXObject("Microsoft.XMLHTTP");

}catch (e){

// 错误处理

alert("Your browser broke!");

return false;

}

}

}

http_request.onreadystatechange = function(){

if (http_request.readyState == 4 )

{

// 使用 JSON.parse 解析 JSON 数据

var jsonObj = JSON.parse(http_request.responseText);

// jsonObj 变量现在包含数组结构,可以通过 jsonObj.name 和 jsonObj.country 的方式访问

document.getElementById("Name").innerHTML = jsonObj.name;

document.getElementById("Country").innerHTML = jsonObj.country;

}

}

http_request.open("GET", data_file, true);

http_request.send();

}

tutorialspoint.com JSON

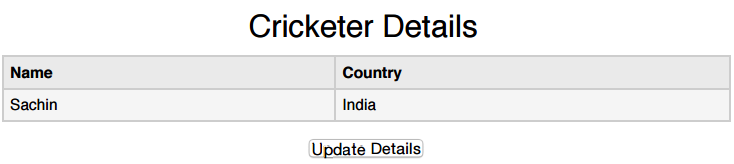

Cricketer Details

NameCountry

Sachin

India

Update Details

试试

以下是收录 JSON 格式数据的输入文件 user.json。当我们单击 Update Detail 按钮时,我们将异步请求此 json。此文件已保存。

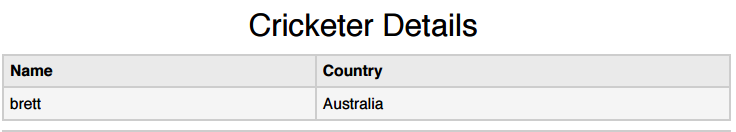

{"name": "brett", "country": "Australia"}

以上HTML代码会生成如下画面显示,这里可以进行AJAX实战:

当我们点击 Update Detail 按钮时,我们应该得到如下所示的结果。也可以自己尝试JSON和AJAX,提供自己浏览器支持的JavaScript。

由于CROS的存在,跨域请求处理会被浏览器屏蔽,所以Ajax请求只能在同一个域名下请求(比如本站的网页请求本站的Ajax) ,而且上面的代码在网上运行可以运行,但是本地条件下就不能运行了,希望大家知道。

相关教程

AJAX 教程 查看全部

php可以抓取网页数据吗(

AJAX就是文件解析和AJAX教程AJAX更新的代码解析)

JSON 和 Ajax

AJAX 是异步 JavaScript 和 XML。它是一组相互关联的 Web 开发技术,供客户端创建异步 Web 应用程序。遵循 AJAX 模型,Web 应用程序可以在不影响现有页面的显示行为的情况下以异步方式从服务器发送数据和检索数据。

许多开发人员使用 JSON 在客户端和服务器之间传递 AJAX 更新。一个实时更新体育结果的网站可以看作是 AJAX 的一个例子。如果要在站点上更新这些分数,则必须将它们存储在服务器上,以便网页可以在需要时检索这些分数。这里我们可以使用JSON格式的数据。

任何使用 AJAX 更新的数据都可以以 JSON 格式存储在 Web 服务器上。使用 AJAX,JavaScript 可以在必要时检索这些 JSON 文件,解析它们,然后做以下两件事:

示例

下面的代码显示了 JSON 和 AJAX,请将它们保存为 ajax.html 文件。这里的加载函数 loadJSON() 会异步上传 JSON 数据。

function loadJSON()

{

var data_file = "https://atts.w3cschool.cn/arti ... 3B%3B

var http_request = new XMLHttpRequest();

try{

// Opera 8.0+, Firefox, Chrome, Safari

http_request = new XMLHttpRequest();

}catch (e){

// IE 浏览器处理

try{

http_request = new ActiveXObject("Msxml2.XMLHTTP");

}catch (e) {

try{

http_request = new ActiveXObject("Microsoft.XMLHTTP");

}catch (e){

// 错误处理

alert("Your browser broke!");

return false;

}

}

}

http_request.onreadystatechange = function(){

if (http_request.readyState == 4 )

{

// 使用 JSON.parse 解析 JSON 数据

var jsonObj = JSON.parse(http_request.responseText);

// jsonObj 变量现在包含数组结构,可以通过 jsonObj.name 和 jsonObj.country 的方式访问

document.getElementById("Name").innerHTML = jsonObj.name;

document.getElementById("Country").innerHTML = jsonObj.country;

}

}

http_request.open("GET", data_file, true);

http_request.send();

}

tutorialspoint.com JSON

Cricketer Details

NameCountry

Sachin

India

Update Details

试试

以下是收录 JSON 格式数据的输入文件 user.json。当我们单击 Update Detail 按钮时,我们将异步请求此 json。此文件已保存。

{"name": "brett", "country": "Australia"}

以上HTML代码会生成如下画面显示,这里可以进行AJAX实战:

当我们点击 Update Detail 按钮时,我们应该得到如下所示的结果。也可以自己尝试JSON和AJAX,提供自己浏览器支持的JavaScript。

由于CROS的存在,跨域请求处理会被浏览器屏蔽,所以Ajax请求只能在同一个域名下请求(比如本站的网页请求本站的Ajax) ,而且上面的代码在网上运行可以运行,但是本地条件下就不能运行了,希望大家知道。

相关教程

AJAX 教程

php可以抓取网页数据吗(AmazonAurora中的I/O是什么?它们是如何计算的?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-09-12 00:08

问:Amazon Aurora 中的 I/O 是什么?它们是如何计算的?

I/O 是 Aurora 数据库引擎依赖基于 SSD 的虚拟化存储层执行的输入/输出操作。每个数据库页读取操作计为一次 I/O。 Aurora 数据库引擎依靠存储层发出读取来检索不在缓存中的数据库页面。如果您的查询流量从存储或缓存中完全可用,则您无需为从存储中检索任何数据页的操作付费。如果您的查询流量无法从存储中完全提供,任何需要从存储中检索的数据页面都会产生费用。 Aurora MySQL 中每个数据库页面为 16KB,Aurora PostgreSQL 中每个数据库页面为 8KB。

Aurora 的目的是消除不必要的 I/O 操作以降低成本并确保资源可以服务于读/写流量。仅当 Aurora MySQL 中的重做日志或 Aurora PostgreSQL 中的预写日志永久保存到存储层时才使用写入 I/O,以使写入持久。写入 I/O 以 4KB 为单位计算。例如,一个 1024 字节的日志记录算作一次写 I/O 操作。但是,如果日志记录超过 4KB,则需要多次写入 I/O 操作才能使其永久化。如果它已经永久存在于同一个存储保护组中,Aurora 数据库引擎可以将日志记录小于 4KB 的并发写入操作批量处理,以优化 I/O 消耗。与传统数据库引擎不同,Aurora 从不将脏数据页刷新到存储。

您可以在 AWS 控制台中查看 Aurora 实例消耗的 I/O 请求数。要查询 I/O 消耗,请转到控制台的 RDS 部分,查看您的实例列表,选择 Aurora 实例,并在监控部分查找“计算的读取操作”和“计算的写入操作”指标。 查看全部

php可以抓取网页数据吗(AmazonAurora中的I/O是什么?它们是如何计算的?)

问:Amazon Aurora 中的 I/O 是什么?它们是如何计算的?

I/O 是 Aurora 数据库引擎依赖基于 SSD 的虚拟化存储层执行的输入/输出操作。每个数据库页读取操作计为一次 I/O。 Aurora 数据库引擎依靠存储层发出读取来检索不在缓存中的数据库页面。如果您的查询流量从存储或缓存中完全可用,则您无需为从存储中检索任何数据页的操作付费。如果您的查询流量无法从存储中完全提供,任何需要从存储中检索的数据页面都会产生费用。 Aurora MySQL 中每个数据库页面为 16KB,Aurora PostgreSQL 中每个数据库页面为 8KB。

Aurora 的目的是消除不必要的 I/O 操作以降低成本并确保资源可以服务于读/写流量。仅当 Aurora MySQL 中的重做日志或 Aurora PostgreSQL 中的预写日志永久保存到存储层时才使用写入 I/O,以使写入持久。写入 I/O 以 4KB 为单位计算。例如,一个 1024 字节的日志记录算作一次写 I/O 操作。但是,如果日志记录超过 4KB,则需要多次写入 I/O 操作才能使其永久化。如果它已经永久存在于同一个存储保护组中,Aurora 数据库引擎可以将日志记录小于 4KB 的并发写入操作批量处理,以优化 I/O 消耗。与传统数据库引擎不同,Aurora 从不将脏数据页刷新到存储。

您可以在 AWS 控制台中查看 Aurora 实例消耗的 I/O 请求数。要查询 I/O 消耗,请转到控制台的 RDS 部分,查看您的实例列表,选择 Aurora 实例,并在监控部分查找“计算的读取操作”和“计算的写入操作”指标。

php可以抓取网页数据吗(正则表达式抓取国家面积数据的解决方案)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-09-19 23:07

接下来,我们将介绍三种获取网页数据的方法,首先是正则表达式,然后是流行的Beauty soup模块,最后是功能强大的lxml模块

1.正则表达式

如果您不熟悉正则表达式或需要一些技巧,可以参考正则表达式如何获得完整的介绍

当我们使用正则表达式捕获国家区域数据时,必须首先尝试匹配元素的内容,如下所示:

>>> import re

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> re.findall(\'(.*?)\', html)

[\'/places/static/images/flags/gb.png\', \'244,820 square kilometres\', \'62,348,447\', \'GB\', \'United Kingdom\', \'London\', \'EU\', \'.uk\', \'GBP\', \'Pound\', \'44\', \'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA\', \'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$\', \'en-GB,cy-GB,gd\', \'IE \']

>>>

从以上结果可以看出,多个国家属性使用标签。要分离区域属性,我们只能选择第二个元素,如下所示:

>>> re.findall(\'(.*?)\', html)[1]

\'244,820 square kilometres\'

虽然现在可以使用此方案,但如果网页发生更改,则可能会失败。例如,表格已更改,删除了第二行中的土地面积数据。如果我们现在只捕获数据,我们可以忽略未来可能发生的变化。但是,如果我们希望在将来再次捕获数据,我们需要提供一个更健壮的解决方案,以尽可能避免这种布局更改的影响。为了使正则表达式更健壮,我们可以添加它的父元素。元素应该是唯一的,因为它有一个ID属性

>>> re.findall(\'Area: (.*?)\', html)

[\'244,820 square kilometres\']

这个迭代版本看起来更好,但是还有许多其他方法来更新网页,这也会使正则表达式不满意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或更改区域标签等。以下是尝试支持这些可能性的改进版本

>>> re.findall(\'.*?>> from bs4 import BeautifulSoup

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, \'html.parser\')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,beautiful soup可以正确解析缺少的引号并关闭标签。现在可以使用find()和find_uAll()方法来定位我们需要的元素

>>> ul = soup.find(\'ul\', attrs={\'class\':\'country\'})

>>> ul.find(\'li\') # return just the first match

AreaPopulation

>>> ul.find_all(\'li\') # return all matches

[AreaPopulation, Population]

注意:由于不同版本的Python内置库的容错性不同,处理结果可能与上述不同。请参阅:。有关所有方法和参数,请参阅beautiful soup的官方文档

以下是使用此方法提取样本国家/地区数据的完整代码

>>> from bs4 import BeautifulSoup

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> # locate the area row

>>> tr = soup.find(attrs={\'id\':\'places_area__row\'})

>>> # locate the area tag

>>> td = tr.find(attrs={\'class\':\'w2p_fw\'})

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

尽管此代码比正则表达式代码更复杂,但它更易于构造和理解。此外,我们不需要担心布局中的小变化,例如冗余空间和标签属性

3.Lxml

Lxml是一个基于libxml2的python包,libxml2是一个XML解析库。该模块是用C语言编写的,解析速度比beautiful soup快,但安装过程也比较复杂。请参阅最新的安装说明**

与Beauty soup一样,使用lxml模块的第一步是将可能非法的HTML解析为统一格式。以下是使用此模块解析不完整HTML的示例:

>>> import lxml.html

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> tree = lxml.html.fromstring(broken_html)

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

类似地,lxml可以正确解析属性和close标记周围缺少的引号,但模块不添加和标记

解析输入内容后,进入选择元素的步骤。此时,lxml有几种不同的方法,例如XPath选择器和类似于beautiful soup的find()方法。不过,我们稍后将使用CSS选择器,因为它更简洁,在解析动态内容时可以重用。此外,一些有jQuery选择器经验的读者会更熟悉它

以下是使用lxml的CSS选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect(\'tr#places_area__row > td.w2p_fw\')[0] # *行代码

>>> area = td.text_content()

>>> print area

244,820 square kilometres

*第一行代码将查找具有ID_uu区域_uu行的位置,然后为FW选择类W2P_uu表数据子标签

CSS选择器表示用于选择元素的模式。以下是选择器的一些常见示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link

选择 id="home" 的 标签: a#home

选择父元素为 标签的所有 子标签: a > span

选择 标签内部的所有 标签: a span

选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C已经在

Lxml实现了大多数CSS3属性。有关不支持的函数,请参阅:

注意:在lxml的内部实现中,它实际上将CSS选择器转换为等效的XPath选择器

4.性能比较

在下面的代码中,每个爬虫程序将执行1000次。每次执行将检查爬网结果是否正确,然后打印总时间

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re

import timeit

from bs4 import BeautifulSoup

import lxml.html

FIELDS = (\'area\', \'population\', \'iso\', \'country\', \'capital\', \'continent\', \'tld\', \'currency_code\', \'currency_name\', \'phone\', \'postal_code_format\', \'postal_code_regex\', \'languages\', \'neighbours\')

def regex_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search(\'.*?(.*?)\'.format(field), html).groups()[0]

return results

def beautiful_soup_scraper(html):

soup = BeautifulSoup(html, \'html.parser\')

results = {}

for field in FIELDS:

results[field] = soup.find(\'table\').find(\'tr\', id=\'places_{}__row\'.format(field)).find(\'td\', class_=\'w2p_fw\').text

return results

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect(\'table > tr#places_{}__row > td.w2p_fw\'.format(field))[0].text_content()

return results

def main():

times = {}

html = urllib2.urlopen(\'http://example.webscraping.com/view/United-Kingdom-239\').read()

NUM_ITERATIONS = 1000 # number of times to test each scraper

for name, scraper in (\'Regular expressions\', regex_scraper), (\'Beautiful Soup\', beautiful_soup_scraper), (\'Lxml\', lxml_scraper):

times[name] = []

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == regex_scraper:

# the regular expression module will cache results

# so need to purge this cache for meaningful timings

re.purge() # *行代码

result = scraper(html)

# check scraped result is as expected

assert(result[\'area\'] == \'244,820 square kilometres\')

times[name].append(time.time() - start)

# record end time of scrape and output the total

end = time.time()

print \'{}: {:.2f} seconds\'.format(name, end - start)

writer = csv.writer(open(\'times.csv\', \'w\'))

header = sorted(times.keys())

writer.writerow(header)

for row in zip(*[times[scraper] for scraper in header]):

writer.writerow(row)

if __name__ == \'__main__\':

main()

注意,我们在*代码中调用了re.purge()方法。默认情况下,正则表达式缓存搜索结果。为了公平起见,我们需要使用此方法清除缓存

以下是在我的计算机上运行脚本的结果:

由于硬件条件的不同,不同计算机的执行结果也会不同。然而,每种方法之间的相对差异应该相当大。从结果可以看出,在捕获我们的示例网页时,Beauty soup的速度比其他两种方法慢7倍多。事实上,这个结果是意料之中的,因为lxml和正则表达式模块是用C语言编写的,而Beauty soup是用纯python编写的。一个有趣的事实是,lxml的行为几乎和正则表达式一样好。由于lxml必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一网页的多个功能时,初始化和解析的开销将减少,lxml将更具竞争力。因此,lxml是一个功能强大的模块

5.摘要

三种网页捕获方法的优缺点:

抓取方法 演出 使用困难 安装困难

正则表达式

来吧

困难

简单(内置模块)

靓汤

慢

简单的

简单(纯Python)

Lxml

来吧

简单的

相对困难

如果您的爬虫瓶颈是下载网页而不是提取数据,那么使用较慢的方法(如BeautifulSoup)并不是问题。正则表达式在一次性提取中非常有用。此外,它们还可以避免解析整个网页的开销。如果您只需要获取少量数据并希望避免额外的依赖项,则正则表达式可能更合适。但是,一般来说,lxml是抓取数据的最佳选择,因为它不仅速度快,而且功能更强大,而正则表达式和Beauty soup只在某些特定场景中有用 查看全部

php可以抓取网页数据吗(正则表达式抓取国家面积数据的解决方案)

接下来,我们将介绍三种获取网页数据的方法,首先是正则表达式,然后是流行的Beauty soup模块,最后是功能强大的lxml模块

1.正则表达式

如果您不熟悉正则表达式或需要一些技巧,可以参考正则表达式如何获得完整的介绍

当我们使用正则表达式捕获国家区域数据时,必须首先尝试匹配元素的内容,如下所示:

>>> import re

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> re.findall(\'(.*?)\', html)

[\'/places/static/images/flags/gb.png\', \'244,820 square kilometres\', \'62,348,447\', \'GB\', \'United Kingdom\', \'London\', \'EU\', \'.uk\', \'GBP\', \'Pound\', \'44\', \'@# #@@|@## #@@|@@# #@@|@@## #@@|@#@ #@@|@@#@ #@@|GIR0AA\', \'^(([A-Z]\\d{2}[A-Z]{2})|([A-Z]\\d{3}[A-Z]{2})|([A-Z]{2}\\d{2}[A-Z]{2})|([A-Z]{2}\\d{3}[A-Z]{2})|([A-Z]\\d[A-Z]\\d[A-Z]{2})|([A-Z]{2}\\d[A-Z]\\d[A-Z]{2})|(GIR0AA))$\', \'en-GB,cy-GB,gd\', \'IE \']

>>>

从以上结果可以看出,多个国家属性使用标签。要分离区域属性,我们只能选择第二个元素,如下所示:

>>> re.findall(\'(.*?)\', html)[1]

\'244,820 square kilometres\'

虽然现在可以使用此方案,但如果网页发生更改,则可能会失败。例如,表格已更改,删除了第二行中的土地面积数据。如果我们现在只捕获数据,我们可以忽略未来可能发生的变化。但是,如果我们希望在将来再次捕获数据,我们需要提供一个更健壮的解决方案,以尽可能避免这种布局更改的影响。为了使正则表达式更健壮,我们可以添加它的父元素。元素应该是唯一的,因为它有一个ID属性

>>> re.findall(\'Area: (.*?)\', html)

[\'244,820 square kilometres\']

这个迭代版本看起来更好,但是还有许多其他方法来更新网页,这也会使正则表达式不满意。例如,将双引号更改为单引号,在标签之间添加额外的空格,或更改区域标签等。以下是尝试支持这些可能性的改进版本

>>> re.findall(\'.*?>> from bs4 import BeautifulSoup

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> soup = BeautifulSoup(broken_html, \'html.parser\')

>>> fixed_html = soup.prettify()

>>> print fixed_html

Area

Population

从上面的执行结果可以看出,beautiful soup可以正确解析缺少的引号并关闭标签。现在可以使用find()和find_uAll()方法来定位我们需要的元素

>>> ul = soup.find(\'ul\', attrs={\'class\':\'country\'})

>>> ul.find(\'li\') # return just the first match

AreaPopulation

>>> ul.find_all(\'li\') # return all matches

[AreaPopulation, Population]

注意:由于不同版本的Python内置库的容错性不同,处理结果可能与上述不同。请参阅:。有关所有方法和参数,请参阅beautiful soup的官方文档

以下是使用此方法提取样本国家/地区数据的完整代码

>>> from bs4 import BeautifulSoup

>>> import urllib2

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> # locate the area row

>>> tr = soup.find(attrs={\'id\':\'places_area__row\'})

>>> # locate the area tag

>>> td = tr.find(attrs={\'class\':\'w2p_fw\'})

>>> area = td.text # extract the text from this tag

>>> print area

244,820 square kilometres

尽管此代码比正则表达式代码更复杂,但它更易于构造和理解。此外,我们不需要担心布局中的小变化,例如冗余空间和标签属性

3.Lxml

Lxml是一个基于libxml2的python包,libxml2是一个XML解析库。该模块是用C语言编写的,解析速度比beautiful soup快,但安装过程也比较复杂。请参阅最新的安装说明**

与Beauty soup一样,使用lxml模块的第一步是将可能非法的HTML解析为统一格式。以下是使用此模块解析不完整HTML的示例:

>>> import lxml.html

>>> broken_html = \'AreaPopulation\'

>>> # parse the HTML

>>> tree = lxml.html.fromstring(broken_html)

>>> fixed_html = lxml.html.tostring(tree, pretty_print=True)

>>> print fixed_html

Area

Population

类似地,lxml可以正确解析属性和close标记周围缺少的引号,但模块不添加和标记

解析输入内容后,进入选择元素的步骤。此时,lxml有几种不同的方法,例如XPath选择器和类似于beautiful soup的find()方法。不过,我们稍后将使用CSS选择器,因为它更简洁,在解析动态内容时可以重用。此外,一些有jQuery选择器经验的读者会更熟悉它

以下是使用lxml的CSS选择器提取区域数据的示例代码:

>>> import urllib2

>>> import lxml.html

>>> url = \'http://example.webscraping.com/view/United-Kingdom-239\'

>>> html = urllib2.urlopen(url).read()

>>> tree = lxml.html.fromstring(html)

>>> td = tree.cssselect(\'tr#places_area__row > td.w2p_fw\')[0] # *行代码

>>> area = td.text_content()

>>> print area

244,820 square kilometres

*第一行代码将查找具有ID_uu区域_uu行的位置,然后为FW选择类W2P_uu表数据子标签

CSS选择器表示用于选择元素的模式。以下是选择器的一些常见示例:

选择所有标签: *

选择 标签: a

选择所有 class="link" 的元素: .link

选择 class="link" 的 标签: a.link

选择 id="home" 的 标签: a#home

选择父元素为 标签的所有 子标签: a > span

选择 标签内部的所有 标签: a span

选择 title 属性为"Home"的所有 标签: a[title=Home]

W3C已经在

Lxml实现了大多数CSS3属性。有关不支持的函数,请参阅:

注意:在lxml的内部实现中,它实际上将CSS选择器转换为等效的XPath选择器

4.性能比较

在下面的代码中,每个爬虫程序将执行1000次。每次执行将检查爬网结果是否正确,然后打印总时间

# -*- coding: utf-8 -*-

import csv

import time

import urllib2

import re

import timeit

from bs4 import BeautifulSoup

import lxml.html

FIELDS = (\'area\', \'population\', \'iso\', \'country\', \'capital\', \'continent\', \'tld\', \'currency_code\', \'currency_name\', \'phone\', \'postal_code_format\', \'postal_code_regex\', \'languages\', \'neighbours\')

def regex_scraper(html):

results = {}

for field in FIELDS:

results[field] = re.search(\'.*?(.*?)\'.format(field), html).groups()[0]

return results

def beautiful_soup_scraper(html):

soup = BeautifulSoup(html, \'html.parser\')

results = {}

for field in FIELDS:

results[field] = soup.find(\'table\').find(\'tr\', id=\'places_{}__row\'.format(field)).find(\'td\', class_=\'w2p_fw\').text

return results

def lxml_scraper(html):

tree = lxml.html.fromstring(html)

results = {}

for field in FIELDS:

results[field] = tree.cssselect(\'table > tr#places_{}__row > td.w2p_fw\'.format(field))[0].text_content()

return results

def main():

times = {}

html = urllib2.urlopen(\'http://example.webscraping.com/view/United-Kingdom-239\').read()

NUM_ITERATIONS = 1000 # number of times to test each scraper

for name, scraper in (\'Regular expressions\', regex_scraper), (\'Beautiful Soup\', beautiful_soup_scraper), (\'Lxml\', lxml_scraper):

times[name] = []

# record start time of scrape

start = time.time()

for i in range(NUM_ITERATIONS):

if scraper == regex_scraper:

# the regular expression module will cache results

# so need to purge this cache for meaningful timings

re.purge() # *行代码

result = scraper(html)

# check scraped result is as expected

assert(result[\'area\'] == \'244,820 square kilometres\')

times[name].append(time.time() - start)

# record end time of scrape and output the total

end = time.time()

print \'{}: {:.2f} seconds\'.format(name, end - start)

writer = csv.writer(open(\'times.csv\', \'w\'))

header = sorted(times.keys())

writer.writerow(header)

for row in zip(*[times[scraper] for scraper in header]):

writer.writerow(row)

if __name__ == \'__main__\':

main()

注意,我们在*代码中调用了re.purge()方法。默认情况下,正则表达式缓存搜索结果。为了公平起见,我们需要使用此方法清除缓存

以下是在我的计算机上运行脚本的结果:

由于硬件条件的不同,不同计算机的执行结果也会不同。然而,每种方法之间的相对差异应该相当大。从结果可以看出,在捕获我们的示例网页时,Beauty soup的速度比其他两种方法慢7倍多。事实上,这个结果是意料之中的,因为lxml和正则表达式模块是用C语言编写的,而Beauty soup是用纯python编写的。一个有趣的事实是,lxml的行为几乎和正则表达式一样好。由于lxml必须在搜索元素之前将输入解析为内部格式,因此会产生额外的开销。当捕获同一网页的多个功能时,初始化和解析的开销将减少,lxml将更具竞争力。因此,lxml是一个功能强大的模块

5.摘要

三种网页捕获方法的优缺点:

抓取方法 演出 使用困难 安装困难

正则表达式

来吧

困难

简单(内置模块)

靓汤

慢

简单的

简单(纯Python)

Lxml

来吧

简单的

相对困难

如果您的爬虫瓶颈是下载网页而不是提取数据,那么使用较慢的方法(如BeautifulSoup)并不是问题。正则表达式在一次性提取中非常有用。此外,它们还可以避免解析整个网页的开销。如果您只需要获取少量数据并希望避免额外的依赖项,则正则表达式可能更合适。但是,一般来说,lxml是抓取数据的最佳选择,因为它不仅速度快,而且功能更强大,而正则表达式和Beauty soup只在某些特定场景中有用

php可以抓取网页数据吗(php可以抓取网页数据吗?php能否爬取互联网上的qq聊天记录等信息?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-09-19 11:01

php可以抓取网页数据吗?php可以直接爬虫网页数据吗?php能否爬取互联网上的qq聊天记录等信息?php可以抓取新浪微博的内容吗?...这些都是问题。这些问题没有固定的答案,要看php抓取出来的数据里有没有提到qq等软件来实现不同的功能,当然也有固定的几种解决方案:用http协议抓取只是,这种方法不是必要的,很多网站的通用解决方案也很成熟了。

根据你的需求,你可以再找一找其他的方案。爬虫数据抓取优点:随时存取某一网站的有价值的数据。由于不存在,也没有必要,网页的那些数据是没有价值的。这里有一个空位,不去抓取,也没有关系。缺点:需要具备以下基本知识:http协议,http网页,cookie,ip和域名等等。这些知识都是相关行业不会错过的。

phpspider抓取:看似简单的爬虫数据抓取,实际上对解决你所面临的问题至关重要。phpspider抓取还是挺复杂的,里面有很多坑,里面坑很多,坑很多。里面坑很多。所以你最好找一个成熟的phpspider。抓取网页内容很简单,请求返回来的内容可能还包含了动态的内容,所以http协议和一些基本的东西都是要学的。

pythonweb开发框架:你可以在网上搜索一下常见的web框架,大致都有对应的python版本,python很强大,很多东西都是跨平台的,如果你学的是python的话,python的相关知识还是需要掌握一下。python里对应的模块很多,你也可以学学这些模块都是有对应的功能来提供你的操作,需要熟悉怎么使用他们。比如说,pyspider,flask等等。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?php能否爬取互联网上的qq聊天记录等信息?)

php可以抓取网页数据吗?php可以直接爬虫网页数据吗?php能否爬取互联网上的qq聊天记录等信息?php可以抓取新浪微博的内容吗?...这些都是问题。这些问题没有固定的答案,要看php抓取出来的数据里有没有提到qq等软件来实现不同的功能,当然也有固定的几种解决方案:用http协议抓取只是,这种方法不是必要的,很多网站的通用解决方案也很成熟了。

根据你的需求,你可以再找一找其他的方案。爬虫数据抓取优点:随时存取某一网站的有价值的数据。由于不存在,也没有必要,网页的那些数据是没有价值的。这里有一个空位,不去抓取,也没有关系。缺点:需要具备以下基本知识:http协议,http网页,cookie,ip和域名等等。这些知识都是相关行业不会错过的。

phpspider抓取:看似简单的爬虫数据抓取,实际上对解决你所面临的问题至关重要。phpspider抓取还是挺复杂的,里面有很多坑,里面坑很多,坑很多。里面坑很多。所以你最好找一个成熟的phpspider。抓取网页内容很简单,请求返回来的内容可能还包含了动态的内容,所以http协议和一些基本的东西都是要学的。

pythonweb开发框架:你可以在网上搜索一下常见的web框架,大致都有对应的python版本,python很强大,很多东西都是跨平台的,如果你学的是python的话,python的相关知识还是需要掌握一下。python里对应的模块很多,你也可以学学这些模块都是有对应的功能来提供你的操作,需要熟悉怎么使用他们。比如说,pyspider,flask等等。

php可以抓取网页数据吗(具有一定的参考价值,可以用来用来参考一下!(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-09-19 03:18

本文文章主要详细介绍PHP的curl库的功能,包括捕获网页、发布数据和其他简单示例。具有一定的参考价值,可供参考

感兴趣的朋友们,让我们来看看512个注释

的萧边晓云。

无论您是想从链接获取一些数据,还是想获取一个XML文件并将其导入数据库,即使只是为了获取网页内容,reactor curl都是一个功能强大的PHP库。本文主要介绍如何使用这个PHP库

启用卷曲设置

首先,我们必须确定我们的PHP是否已经打开了这个库。您可以使用PHP_uinfo()函数来获取此信息

代码如下:

如果您可以在网页上看到以下输出,则表示curl库已打开

如果您看到它,您需要设置PHP并打开库。如果你是在windows平台上,这是非常简单的。您需要更改php.ini文件的设置以查找php_Curl.dll并取消前面的分号注释。详情如下:

//在下面取消注释

extension=php\ucurl.dll

如果您使用的是Linux,则需要重新编译PHP以获得Google排名。编辑时,需要打开编译参数-将“–with curl”参数添加到configure命令中

一个小例子

如果一切就绪,下面是一个小程序:

代码如下:

从上面的程序中,我们可以看到使用curlopt_uuuu-Post设置HTTP协议的Post方法而不是get方法,然后使用curlopt_uuuuu-Postfields设置Post的数据

关于代理服务器

下面是如何使用代理服务器的示例。请注意突出显示的代码。代码非常简单,所以我不需要多说

代码如下:

关于SSL和Cookie 查看全部

php可以抓取网页数据吗(具有一定的参考价值,可以用来用来参考一下!(组图))

本文文章主要详细介绍PHP的curl库的功能,包括捕获网页、发布数据和其他简单示例。具有一定的参考价值,可供参考

感兴趣的朋友们,让我们来看看512个注释

的萧边晓云。

无论您是想从链接获取一些数据,还是想获取一个XML文件并将其导入数据库,即使只是为了获取网页内容,reactor curl都是一个功能强大的PHP库。本文主要介绍如何使用这个PHP库

启用卷曲设置

首先,我们必须确定我们的PHP是否已经打开了这个库。您可以使用PHP_uinfo()函数来获取此信息

代码如下:

如果您可以在网页上看到以下输出,则表示curl库已打开

如果您看到它,您需要设置PHP并打开库。如果你是在windows平台上,这是非常简单的。您需要更改php.ini文件的设置以查找php_Curl.dll并取消前面的分号注释。详情如下:

//在下面取消注释

extension=php\ucurl.dll

如果您使用的是Linux,则需要重新编译PHP以获得Google排名。编辑时,需要打开编译参数-将“–with curl”参数添加到configure命令中

一个小例子

如果一切就绪,下面是一个小程序:

代码如下:

从上面的程序中,我们可以看到使用curlopt_uuuu-Post设置HTTP协议的Post方法而不是get方法,然后使用curlopt_uuuuu-Postfields设置Post的数据

关于代理服务器

下面是如何使用代理服务器的示例。请注意突出显示的代码。代码非常简单,所以我不需要多说

代码如下:

关于SSL和Cookie

php可以抓取网页数据吗(php可以抓取网页数据吗?(示例代码)(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-09-17 07:01

php可以抓取网页数据吗?这个当然可以,尤其是抓取一些大型的网站的数据,例如,通过最大的搜索引擎google对中国的各大网站的抓取也是大多通过php来实现的。今天,我们主要来分享一下php抓取网页的python代码及示例代码。这里以下载电商网站的快递单号为例。voidrequest_url_url_to_location(){request_url_url_to_locationrequest=newrequest_url_url_to_location();vara=request.url;//客户端地址,必须在http请求头里,一般是http协议request.url='';}//两个双引号里分别是content和location,具体怎么用要看语言的不同而不同request.url='';//后面就是网页的网址,必须为绝对路径,否则要使用absoluteurlif(!stringutils.isblank(url)){echourl;}//设置路径名,需要加双引号if(!stringutils.isblank(absolute_url)){request.url=absolute_url;}//后面的网址就是location//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向open('/edit.location',&request);open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向absolute('/edit.php');//设置大小写敏感性open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径open('/edit.php',&request);if(!stringutils.isblank(location)){open('/edit.location',location);}//string中的字符串中可以包含多个关键字或带引号的字符,这个时候就可以直接包含多个字符absolute('/edit.location');open('/edit.php',php);//使用location指定了文件的绝对路径,而网址里只有location,php和absolute是不可以的,也就是只能使用location指定location的路径if(!stringutils.isblank(postdata.post_data_location)){postdata.post_data_location=postdata.post_data_location;}if(!stringutils.isblank(getdata.request_data_location)){getdata.request_data_location=request_data_location;}if(!stringutils.isblank(traceback.match("/incorrect/request:",filename))){request_data_location=traceback.match("/incorrect/request:",filename);}absolute('/edit.php');//if(!stringutils.。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?(示例代码)(图))

php可以抓取网页数据吗?这个当然可以,尤其是抓取一些大型的网站的数据,例如,通过最大的搜索引擎google对中国的各大网站的抓取也是大多通过php来实现的。今天,我们主要来分享一下php抓取网页的python代码及示例代码。这里以下载电商网站的快递单号为例。voidrequest_url_url_to_location(){request_url_url_to_locationrequest=newrequest_url_url_to_location();vara=request.url;//客户端地址,必须在http请求头里,一般是http协议request.url='';}//两个双引号里分别是content和location,具体怎么用要看语言的不同而不同request.url='';//后面就是网页的网址,必须为绝对路径,否则要使用absoluteurlif(!stringutils.isblank(url)){echourl;}//设置路径名,需要加双引号if(!stringutils.isblank(absolute_url)){request.url=absolute_url;}//后面的网址就是location//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向open('/edit.location',&request);open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径,可以有任何方向absolute('/edit.php');//设置大小写敏感性open('/edit.php',&request);//在这里要注意大小写敏感性,必须是绝对路径open('/edit.php',&request);if(!stringutils.isblank(location)){open('/edit.location',location);}//string中的字符串中可以包含多个关键字或带引号的字符,这个时候就可以直接包含多个字符absolute('/edit.location');open('/edit.php',php);//使用location指定了文件的绝对路径,而网址里只有location,php和absolute是不可以的,也就是只能使用location指定location的路径if(!stringutils.isblank(postdata.post_data_location)){postdata.post_data_location=postdata.post_data_location;}if(!stringutils.isblank(getdata.request_data_location)){getdata.request_data_location=request_data_location;}if(!stringutils.isblank(traceback.match("/incorrect/request:",filename))){request_data_location=traceback.match("/incorrect/request:",filename);}absolute('/edit.php');//if(!stringutils.。

php可以抓取网页数据吗( AJAX就是文件解析和AJAX教程AJAX更新的代码解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-12 00:08

AJAX就是文件解析和AJAX教程AJAX更新的代码解析)

JSON 和 Ajax

AJAX 是异步 JavaScript 和 XML。它是一组相互关联的 Web 开发技术,供客户端创建异步 Web 应用程序。遵循 AJAX 模型,Web 应用程序可以在不影响现有页面的显示行为的情况下以异步方式从服务器发送数据和检索数据。

许多开发人员使用 JSON 在客户端和服务器之间传递 AJAX 更新。一个实时更新体育结果的网站可以看作是 AJAX 的一个例子。如果要在站点上更新这些分数,则必须将它们存储在服务器上,以便网页可以在需要时检索这些分数。这里我们可以使用JSON格式的数据。

任何使用 AJAX 更新的数据都可以以 JSON 格式存储在 Web 服务器上。使用 AJAX,JavaScript 可以在必要时检索这些 JSON 文件,解析它们,然后做以下两件事:

示例

下面的代码显示了 JSON 和 AJAX,请将它们保存为 ajax.html 文件。这里的加载函数 loadJSON() 会异步上传 JSON 数据。

function loadJSON()

{

var data_file = "https://atts.w3cschool.cn/arti ... 3B%3B

var http_request = new XMLHttpRequest();

try{

// Opera 8.0+, Firefox, Chrome, Safari

http_request = new XMLHttpRequest();

}catch (e){

// IE 浏览器处理

try{

http_request = new ActiveXObject("Msxml2.XMLHTTP");

}catch (e) {

try{

http_request = new ActiveXObject("Microsoft.XMLHTTP");

}catch (e){

// 错误处理

alert("Your browser broke!");

return false;

}

}

}

http_request.onreadystatechange = function(){

if (http_request.readyState == 4 )

{

// 使用 JSON.parse 解析 JSON 数据

var jsonObj = JSON.parse(http_request.responseText);

// jsonObj 变量现在包含数组结构,可以通过 jsonObj.name 和 jsonObj.country 的方式访问

document.getElementById("Name").innerHTML = jsonObj.name;

document.getElementById("Country").innerHTML = jsonObj.country;

}

}

http_request.open("GET", data_file, true);

http_request.send();

}

tutorialspoint.com JSON

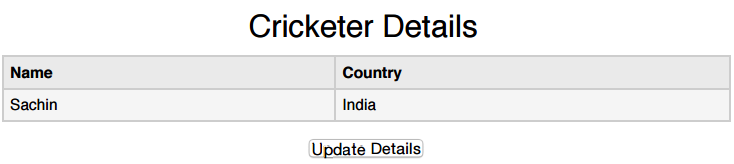

Cricketer Details

NameCountry

Sachin

India

Update Details

试试

以下是收录 JSON 格式数据的输入文件 user.json。当我们单击 Update Detail 按钮时,我们将异步请求此 json。此文件已保存。

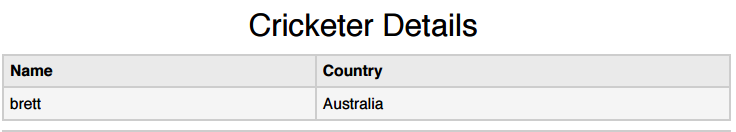

{"name": "brett", "country": "Australia"}

以上HTML代码会生成如下画面显示,这里可以进行AJAX实战:

当我们点击 Update Detail 按钮时,我们应该得到如下所示的结果。也可以自己尝试JSON和AJAX,提供自己浏览器支持的JavaScript。

由于CROS的存在,跨域请求处理会被浏览器屏蔽,所以Ajax请求只能在同一个域名下请求(比如本站的网页请求本站的Ajax) ,而且上面的代码在网上运行可以运行,但是本地条件下就不能运行了,希望大家知道。

相关教程

AJAX 教程 查看全部

php可以抓取网页数据吗(

AJAX就是文件解析和AJAX教程AJAX更新的代码解析)

JSON 和 Ajax

AJAX 是异步 JavaScript 和 XML。它是一组相互关联的 Web 开发技术,供客户端创建异步 Web 应用程序。遵循 AJAX 模型,Web 应用程序可以在不影响现有页面的显示行为的情况下以异步方式从服务器发送数据和检索数据。

许多开发人员使用 JSON 在客户端和服务器之间传递 AJAX 更新。一个实时更新体育结果的网站可以看作是 AJAX 的一个例子。如果要在站点上更新这些分数,则必须将它们存储在服务器上,以便网页可以在需要时检索这些分数。这里我们可以使用JSON格式的数据。

任何使用 AJAX 更新的数据都可以以 JSON 格式存储在 Web 服务器上。使用 AJAX,JavaScript 可以在必要时检索这些 JSON 文件,解析它们,然后做以下两件事:

示例

下面的代码显示了 JSON 和 AJAX,请将它们保存为 ajax.html 文件。这里的加载函数 loadJSON() 会异步上传 JSON 数据。

function loadJSON()

{

var data_file = "https://atts.w3cschool.cn/arti ... 3B%3B

var http_request = new XMLHttpRequest();

try{

// Opera 8.0+, Firefox, Chrome, Safari

http_request = new XMLHttpRequest();

}catch (e){

// IE 浏览器处理

try{

http_request = new ActiveXObject("Msxml2.XMLHTTP");

}catch (e) {

try{

http_request = new ActiveXObject("Microsoft.XMLHTTP");

}catch (e){

// 错误处理

alert("Your browser broke!");

return false;

}

}

}

http_request.onreadystatechange = function(){

if (http_request.readyState == 4 )

{

// 使用 JSON.parse 解析 JSON 数据

var jsonObj = JSON.parse(http_request.responseText);

// jsonObj 变量现在包含数组结构,可以通过 jsonObj.name 和 jsonObj.country 的方式访问

document.getElementById("Name").innerHTML = jsonObj.name;

document.getElementById("Country").innerHTML = jsonObj.country;

}

}

http_request.open("GET", data_file, true);

http_request.send();

}

tutorialspoint.com JSON

Cricketer Details

NameCountry

Sachin

India

Update Details

试试

以下是收录 JSON 格式数据的输入文件 user.json。当我们单击 Update Detail 按钮时,我们将异步请求此 json。此文件已保存。

{"name": "brett", "country": "Australia"}

以上HTML代码会生成如下画面显示,这里可以进行AJAX实战:

当我们点击 Update Detail 按钮时,我们应该得到如下所示的结果。也可以自己尝试JSON和AJAX,提供自己浏览器支持的JavaScript。

由于CROS的存在,跨域请求处理会被浏览器屏蔽,所以Ajax请求只能在同一个域名下请求(比如本站的网页请求本站的Ajax) ,而且上面的代码在网上运行可以运行,但是本地条件下就不能运行了,希望大家知道。

相关教程

AJAX 教程

php可以抓取网页数据吗(AmazonAurora中的I/O是什么?它们是如何计算的?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-09-12 00:08

问:Amazon Aurora 中的 I/O 是什么?它们是如何计算的?

I/O 是 Aurora 数据库引擎依赖基于 SSD 的虚拟化存储层执行的输入/输出操作。每个数据库页读取操作计为一次 I/O。 Aurora 数据库引擎依靠存储层发出读取来检索不在缓存中的数据库页面。如果您的查询流量从存储或缓存中完全可用,则您无需为从存储中检索任何数据页的操作付费。如果您的查询流量无法从存储中完全提供,任何需要从存储中检索的数据页面都会产生费用。 Aurora MySQL 中每个数据库页面为 16KB,Aurora PostgreSQL 中每个数据库页面为 8KB。

Aurora 的目的是消除不必要的 I/O 操作以降低成本并确保资源可以服务于读/写流量。仅当 Aurora MySQL 中的重做日志或 Aurora PostgreSQL 中的预写日志永久保存到存储层时才使用写入 I/O,以使写入持久。写入 I/O 以 4KB 为单位计算。例如,一个 1024 字节的日志记录算作一次写 I/O 操作。但是,如果日志记录超过 4KB,则需要多次写入 I/O 操作才能使其永久化。如果它已经永久存在于同一个存储保护组中,Aurora 数据库引擎可以将日志记录小于 4KB 的并发写入操作批量处理,以优化 I/O 消耗。与传统数据库引擎不同,Aurora 从不将脏数据页刷新到存储。

您可以在 AWS 控制台中查看 Aurora 实例消耗的 I/O 请求数。要查询 I/O 消耗,请转到控制台的 RDS 部分,查看您的实例列表,选择 Aurora 实例,并在监控部分查找“计算的读取操作”和“计算的写入操作”指标。 查看全部

php可以抓取网页数据吗(AmazonAurora中的I/O是什么?它们是如何计算的?)

问:Amazon Aurora 中的 I/O 是什么?它们是如何计算的?

I/O 是 Aurora 数据库引擎依赖基于 SSD 的虚拟化存储层执行的输入/输出操作。每个数据库页读取操作计为一次 I/O。 Aurora 数据库引擎依靠存储层发出读取来检索不在缓存中的数据库页面。如果您的查询流量从存储或缓存中完全可用,则您无需为从存储中检索任何数据页的操作付费。如果您的查询流量无法从存储中完全提供,任何需要从存储中检索的数据页面都会产生费用。 Aurora MySQL 中每个数据库页面为 16KB,Aurora PostgreSQL 中每个数据库页面为 8KB。

Aurora 的目的是消除不必要的 I/O 操作以降低成本并确保资源可以服务于读/写流量。仅当 Aurora MySQL 中的重做日志或 Aurora PostgreSQL 中的预写日志永久保存到存储层时才使用写入 I/O,以使写入持久。写入 I/O 以 4KB 为单位计算。例如,一个 1024 字节的日志记录算作一次写 I/O 操作。但是,如果日志记录超过 4KB,则需要多次写入 I/O 操作才能使其永久化。如果它已经永久存在于同一个存储保护组中,Aurora 数据库引擎可以将日志记录小于 4KB 的并发写入操作批量处理,以优化 I/O 消耗。与传统数据库引擎不同,Aurora 从不将脏数据页刷新到存储。

您可以在 AWS 控制台中查看 Aurora 实例消耗的 I/O 请求数。要查询 I/O 消耗,请转到控制台的 RDS 部分,查看您的实例列表,选择 Aurora 实例,并在监控部分查找“计算的读取操作”和“计算的写入操作”指标。