js 抓取网页内容

js 抓取网页内容(抓取时选用它,主要是Selenium可以渲染页面,相对于requests+BeautifulSoup会慢 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-11-11 03:03

)

我们在爬取的时候选择它,主要是因为Selenium可以渲染页面,运行页面中的JS,点击按钮,提交表单等操作。

但是因为Selenium会渲染页面,所以会比requests+BeautifulSoup慢。

关于 PhantomJs

PhantomJs 可以看作是一个没有页面的浏览器,有一个渲染引擎(QtWebkit)和一个 JS 引擎(JavascriptCore)。 PhantomJs具有DOM渲染、JS运行、网络访问、网页截图等多种功能。

使用 PhantomJS 而不是 Chromedriver 和 firefox,主要是因为 PhantomJS 的静音模式(无需打开浏览器在后台运行)。

抓取示例的小测试-抓取标题

首先尝试一个简单的例子。以前这类内容一般都是用requests+BeautifulSoup或者Scrapy来处理的。

from selenium import webdriverbrowser = webdriver.PhantomJS('D:\phantomjs.exe') #浏览器初始化;Win下需要设置phantomjs路径,linux下置空即可url = ' # 设置访问路径browser.get(url) # 打开网页title = browser.find_elements_by_xpath('//h2') # 用xpath获取元素for t in title: # 遍历输出 print t.text # 输出其中文本 print t.get_attribute('class') # 输出属性值browser.quit() # 关闭浏览器。当出现异常时记得在任务浏览器中关闭PhantomJS,因为会有多个PhantomJS在运行状态,影响电脑性能 查看全部

js 抓取网页内容(抓取时选用它,主要是Selenium可以渲染页面,相对于requests+BeautifulSoup会慢

)

我们在爬取的时候选择它,主要是因为Selenium可以渲染页面,运行页面中的JS,点击按钮,提交表单等操作。

但是因为Selenium会渲染页面,所以会比requests+BeautifulSoup慢。

关于 PhantomJs

PhantomJs 可以看作是一个没有页面的浏览器,有一个渲染引擎(QtWebkit)和一个 JS 引擎(JavascriptCore)。 PhantomJs具有DOM渲染、JS运行、网络访问、网页截图等多种功能。

使用 PhantomJS 而不是 Chromedriver 和 firefox,主要是因为 PhantomJS 的静音模式(无需打开浏览器在后台运行)。

抓取示例的小测试-抓取标题

首先尝试一个简单的例子。以前这类内容一般都是用requests+BeautifulSoup或者Scrapy来处理的。

from selenium import webdriverbrowser = webdriver.PhantomJS('D:\phantomjs.exe') #浏览器初始化;Win下需要设置phantomjs路径,linux下置空即可url = ' # 设置访问路径browser.get(url) # 打开网页title = browser.find_elements_by_xpath('//h2') # 用xpath获取元素for t in title: # 遍历输出 print t.text # 输出其中文本 print t.get_attribute('class') # 输出属性值browser.quit() # 关闭浏览器。当出现异常时记得在任务浏览器中关闭PhantomJS,因为会有多个PhantomJS在运行状态,影响电脑性能

js 抓取网页内容(以上仅为一个小测试上海SEO()十分欢迎与大家一起交流学习探讨)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-11-11 03:02

经过半个多月的观察和分析,网页文件中的JAVASCRIPT(JS)代码被搜索引擎抓取,性能终于成功!2大搜索引擎成功抓取网页JS代码!测试的SE(搜索引擎)是YAHOO和Google百度暂时没有收入!(搜索引擎上报因为忙,最近才看到!实在抱歉!)

自从10-20号网站开通以来,我在25号做了一个小实验。如果你在网站上关注它,你会在右边的导航栏中看到红色标记的“JS代码抓取实验”可以抓取结果。显示YAHOO网站是当天收到的,GOOGLE是31号才被抓的,也就是6天后!(上海SEO成立于2007-10-20!)

这是GOOGLE的收入页面。如需查看详情,请输入::Ljul4S5KPSMJ:+site:

这是YAHOO的类似上面的细节!

结果告诉我们:搜索引擎不仅改变了排名算法,还升级了蜘蛛!从原来的静态页面爬取到现在的JS脚本语言也能爬!做网站还是做内容,做用户不做搜索引擎!以上只是一个小测试

上海SEO()非常欢迎与您交流,学习和讨论SEO技术策略和网站策划相关内容!^_^ 查看全部

js 抓取网页内容(以上仅为一个小测试上海SEO()十分欢迎与大家一起交流学习探讨)

经过半个多月的观察和分析,网页文件中的JAVASCRIPT(JS)代码被搜索引擎抓取,性能终于成功!2大搜索引擎成功抓取网页JS代码!测试的SE(搜索引擎)是YAHOO和Google百度暂时没有收入!(搜索引擎上报因为忙,最近才看到!实在抱歉!)

自从10-20号网站开通以来,我在25号做了一个小实验。如果你在网站上关注它,你会在右边的导航栏中看到红色标记的“JS代码抓取实验”可以抓取结果。显示YAHOO网站是当天收到的,GOOGLE是31号才被抓的,也就是6天后!(上海SEO成立于2007-10-20!)

这是GOOGLE的收入页面。如需查看详情,请输入::Ljul4S5KPSMJ:+site:

这是YAHOO的类似上面的细节!

结果告诉我们:搜索引擎不仅改变了排名算法,还升级了蜘蛛!从原来的静态页面爬取到现在的JS脚本语言也能爬!做网站还是做内容,做用户不做搜索引擎!以上只是一个小测试

上海SEO()非常欢迎与您交流,学习和讨论SEO技术策略和网站策划相关内容!^_^

js 抓取网页内容(《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-11-10 09:19

)

《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理,也介绍了Xpath的语法,Xpath的一些语法对于定位还是很有用的。

第10章介绍:

1. 首先介绍一下主要用于网页的javascript库,jquery\Google Analytics\Google Map。爬取JavaScript生成的页面,必须了解javascript库的基本操作。

2.接下来就是如何使用selenium()通过selenium模拟浏览器操作,然后读取页面内容。

Selenium 可以调用不同浏览器的核心操作。文章中的介绍主要使用了phantomjs()工具。

安装操作:

硒安装:

pip install selenium

只需下载并解压phantomjs,下载地址:

建议添加到PATH路径

sudo ln -sf /pythontest/tool/phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin/phantomjs

XPath 语法介绍:

Selenium 还支持 XPath 定位方法(BeautifulSoup 不支持)

XPath 的一些语法比较有用,也列出来了:

: 根节点和非根节点

--/div 根节点上的div

--//div所有div节点

:定位属性

--//@Href 所有 href 属性

--//A[@href='://'] 所有href都指向天山的属性

: 按位置选择

--//A[3] 第三个节点

--//Table[last()] 最后一个表

--//A[position() <3] 前3张表

: 通配符 (*)

--//Table/tr/* 所有表的所有内容

--//div[@*] div标签的所有属性

示例代码:

1-seleniumBasic.py<br />

2-waitForLoad.py<br />

3-javascriptRedirect.py

例子比较简单,自己看吧。

但是,有一点需要修改。我修改了示例1的代码,制作了不同的浏览器和具体的执行路径:

-------<br />

#1-seleniumBasic.py<br />

from selenium import webdriver<br />

import time<br />

driver = webdriver.Firefox(executable_path='')<br />

#driver = webdriver.PhantomJS() #这个也可以<br />

#driver = webdriver.PhantomJS(executable_path='/usr/local/bin/phantomjs')#这个也可以<br />

driver.get("http://pythonscraping.com/page ... 6quot;)<br />

time.sleep(3)<br />

print(driver.find_element_by_id("content").text)<br />

driver.close() 查看全部

js 抓取网页内容(《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理

)

《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理,也介绍了Xpath的语法,Xpath的一些语法对于定位还是很有用的。

第10章介绍:

1. 首先介绍一下主要用于网页的javascript库,jquery\Google Analytics\Google Map。爬取JavaScript生成的页面,必须了解javascript库的基本操作。

2.接下来就是如何使用selenium()通过selenium模拟浏览器操作,然后读取页面内容。

Selenium 可以调用不同浏览器的核心操作。文章中的介绍主要使用了phantomjs()工具。

安装操作:

硒安装:

pip install selenium

只需下载并解压phantomjs,下载地址:

建议添加到PATH路径

sudo ln -sf /pythontest/tool/phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin/phantomjs

XPath 语法介绍:

Selenium 还支持 XPath 定位方法(BeautifulSoup 不支持)

XPath 的一些语法比较有用,也列出来了:

: 根节点和非根节点

--/div 根节点上的div

--//div所有div节点

:定位属性

--//@Href 所有 href 属性

--//A[@href='://'] 所有href都指向天山的属性

: 按位置选择

--//A[3] 第三个节点

--//Table[last()] 最后一个表

--//A[position() <3] 前3张表

: 通配符 (*)

--//Table/tr/* 所有表的所有内容

--//div[@*] div标签的所有属性

示例代码:

1-seleniumBasic.py<br />

2-waitForLoad.py<br />

3-javascriptRedirect.py

例子比较简单,自己看吧。

但是,有一点需要修改。我修改了示例1的代码,制作了不同的浏览器和具体的执行路径:

-------<br />

#1-seleniumBasic.py<br />

from selenium import webdriver<br />

import time<br />

driver = webdriver.Firefox(executable_path='')<br />

#driver = webdriver.PhantomJS() #这个也可以<br />

#driver = webdriver.PhantomJS(executable_path='/usr/local/bin/phantomjs')#这个也可以<br />

driver.get("http://pythonscraping.com/page ... 6quot;)<br />

time.sleep(3)<br />

print(driver.find_element_by_id("content").text)<br />

driver.close()

js 抓取网页内容(一天就能上线一个微信小程序,你准备好了吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-11-09 14:10

最近在研究微信小程序的云开发功能。云开发的最大优势是不需要在前端搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序,免去购买服务器的成本,对于个人来说尝试从前台到后台练习微信小程序。发展还是不错的选择。一个微信小程序一天就可以上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三个基本能力:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个JSON数据库,可以在小程序前端操作,也可以读写云功能。小程序前端直接上传/下载云文件,在云开发控制台可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复的工作估计贴10次左右就放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。Node 的 fs 模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(非必需)。用于抓取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

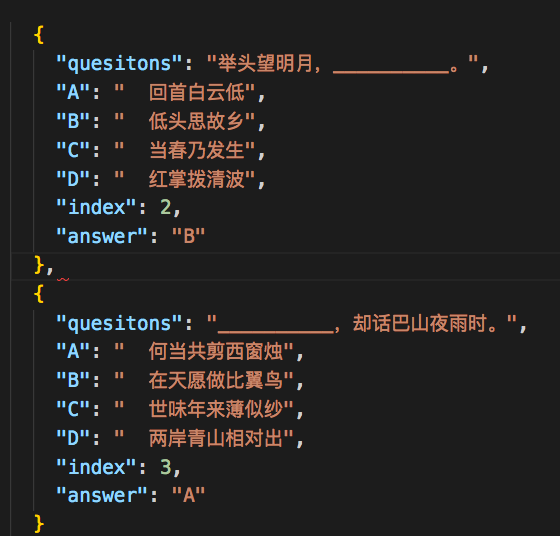

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

//我的html结构大致如下,数据很多

const 问题 = `

`;

const $ =cheerio.load(questions);

var arr = [];

对于 (var i = 0; i

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

obj.answer =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, JSON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已经成功保存!);

});

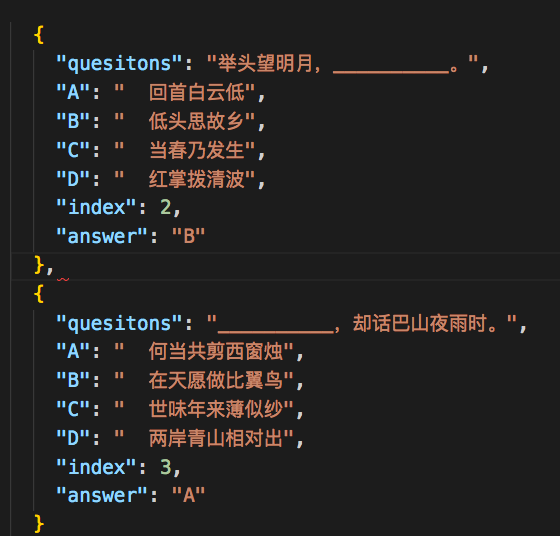

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前也提示过格式错误,后来发现JSON数据不是数组,而是类似于JSON Lines,即每条记录对象之间用n分隔,而不是逗号。所以需要对node写的json文件做一点处理,才能上传成功。 查看全部

js 抓取网页内容(一天就能上线一个微信小程序,你准备好了吗?)

最近在研究微信小程序的云开发功能。云开发的最大优势是不需要在前端搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序,免去购买服务器的成本,对于个人来说尝试从前台到后台练习微信小程序。发展还是不错的选择。一个微信小程序一天就可以上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三个基本能力:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个JSON数据库,可以在小程序前端操作,也可以读写云功能。小程序前端直接上传/下载云文件,在云开发控制台可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复的工作估计贴10次左右就放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。Node 的 fs 模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(非必需)。用于抓取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

//我的html结构大致如下,数据很多

const 问题 = `

`;

const $ =cheerio.load(questions);

var arr = [];

对于 (var i = 0; i

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

obj.answer =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, JSON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已经成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前也提示过格式错误,后来发现JSON数据不是数组,而是类似于JSON Lines,即每条记录对象之间用n分隔,而不是逗号。所以需要对node写的json文件做一点处理,才能上传成功。

js 抓取网页内容(一天就能上线一个微信小程序,你准备好了吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-11-09 14:10

最近在研究微信小程序的云开发功能。云开发的最大优势是不需要在前端搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序,免去购买服务器的成本,对于个人来说尝试从前台到后台练习微信小程序。发展还是不错的选择。一个微信小程序一天就可以上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三个基本能力:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个JSON数据库,可以在小程序前端操作,也可以读写云功能。小程序前端直接上传/下载云文件,在云开发控制台可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复的工作估计贴10次左右就放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。Node 的 fs 模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(非必需)。用于抓取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

//我的html结构大致如下,数据很多

const 问题 = `

`;

const $ =cheerio.load(questions);

var arr = [];

对于 (var i = 0; i

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

obj.answer =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, JSON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已经成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前也提示过格式错误,后来发现JSON数据不是数组,而是类似于JSON Lines,即每条记录对象之间用n分隔,而不是逗号。所以需要对node写的json文件做一点处理,才能上传成功。 查看全部

js 抓取网页内容(一天就能上线一个微信小程序,你准备好了吗?)

最近在研究微信小程序的云开发功能。云开发的最大优势是不需要在前端搭建服务器,可以利用云能力编写一个可以从头启动的微信小程序,免去购买服务器的成本,对于个人来说尝试从前台到后台练习微信小程序。发展还是不错的选择。一个微信小程序一天就可以上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三个基本能力:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个JSON数据库,可以在小程序前端操作,也可以读写云功能。小程序前端直接上传/下载云文件,在云开发控制台可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复的工作估计贴10次左右就放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。Node 的 fs 模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(非必需)。用于抓取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

//我的html结构大致如下,数据很多

const 问题 = `

`;

const $ =cheerio.load(questions);

var arr = [];

对于 (var i = 0; i

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

obj.answer =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, JSON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已经成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前也提示过格式错误,后来发现JSON数据不是数组,而是类似于JSON Lines,即每条记录对象之间用n分隔,而不是逗号。所以需要对node写的json文件做一点处理,才能上传成功。

js 抓取网页内容(基于网页分析的钓鱼网站过滤技术进行验证。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-11-08 01:12

0 简介 随着电子邮件的广泛使用,随之而来的垃圾邮件问题也越来越严重。它不仅消耗网络资源,占用网络带宽,浪费用户宝贵的时间和上网费用,还诱使用户泄露个人信息,从而对网络安全和财务安全构成严重威胁。网络钓鱼电子邮件是典型的垃圾邮件类型。他们通过伪装的电子邮件引导收件人连接到特制的网页,从而达到窃取用户信息的目的。网络钓鱼邮件的泛滥将导致大量用户暴露甚至遭受损失。财产损失。鉴于大量垃圾邮件,尤其是钓鱼邮件,在互联网上泛滥成灾,危害极大,国内外科研人员进行了相应的研究,提出了多项垃圾邮件过滤技术,取得了丰硕的成果。本文提出了一种优化的网络爬行分析技术,可以从网页中提取一些更深层次的特征,并在此基础上完成了基于网络爬行分析和统计压缩模型的垃圾邮件过滤系统的设计和实现。最后,通过仿真实验验证了五个新特征的有效性。1 基于网页爬取分析的垃圾邮件过滤技术1. 1 传统网页过滤技术的缺陷 传统网页过滤技术主要有视觉类似钓鱼网站过滤技术,基于网页爬取分析的Phishing 网站 过滤技术和基于网络拓扑的网络钓鱼网站过滤技术,其中基于网络爬行分析的网络钓鱼网站过滤技术是当前研究的主流。基于视觉相似度的网络钓鱼网站过滤技术主要是通过分析原创网页与仿冒网页的相似度来过滤网络钓鱼网站。

一些研究使用基于 Web HTML 的相似性分析。但是,由于网页 HTML 的灵活性,HTML 结构有很大不同,但显示效果几乎相同。此时,该方法将无效。基于网络拓扑的过滤方法的基本原理是:网络钓鱼网站的拓扑结构比较正常网站会简单很多。但是这种爬取网站中所有网页的方法需要太多的网络带宽和系统资源。另外,目前很多正常的网站拓扑也很简单,导致这种过滤方式可能会失效。基于网络爬行分析的网络钓鱼网站过滤技术是目前研究最多的网络钓鱼网站过滤技术。这项技术抓取网页,然后分析网页内容并提取一些特征,例如网页。表单特征、网页中的JS脚本特征、网页中的链接特征、网页中的logo图像特征等,最后使用分类器进行分类过滤。这种网页方法的分析仅限于当前网页,表单的分析也仅限于登录表单中是否有action属性以及表单中是否有不良action属性的分析。这种形态分析方法的TPR虽然是90%,但是FPR也达到了10%,效果还是不理想。1.2 本文首次提取的网页特征是垃圾邮件检测系统极其关键的环节。该系统对抓取的网页特征进行了更深入的分类。

被抓取网页的静态特征是通过直接分析被抓取网页的内容得到的,而被抓取网页的动态特征则需要通过填写表单、提交表单等一些操作来分析。21个特征,分类说明如下: 1) 网页网址特征:网页网址中的点数与域名的组合即为IP名称;原创网址中的特殊符号、网址中敏感词的数量、顶级域名等错位。2)抓取网页的静态特征:网页中表单数量、不良登录表单动作、个人隐私信息量、网站标题、网站标志图片、未匹配链接,糟糕的脚本,仿公司名称,搜索表单功能。3) 抓取网页动态特征:提交登录表单,登录后的网页内容。4) 第三方工具搜索结果特征:网站域名年龄、网页搜索引擎结果、网站公司名称搜索结果、网站搜索结果。其中,提交登录表单、登录后网页内容、个人信息填写表单、不良搜索表单属性、站点搜索结果五个特征是本文首次提出的,分别描述为如下: 1.2.1 提交登录表单是基于窃取用户隐私信息的目的。钓鱼登录表单网站 根本不检查表单的输入。即使不填写表单,也可以直接输入表单的action字段对应的网页地址。并且正常合法的网站都会有账号 查看全部

js 抓取网页内容(基于网页分析的钓鱼网站过滤技术进行验证。)

0 简介 随着电子邮件的广泛使用,随之而来的垃圾邮件问题也越来越严重。它不仅消耗网络资源,占用网络带宽,浪费用户宝贵的时间和上网费用,还诱使用户泄露个人信息,从而对网络安全和财务安全构成严重威胁。网络钓鱼电子邮件是典型的垃圾邮件类型。他们通过伪装的电子邮件引导收件人连接到特制的网页,从而达到窃取用户信息的目的。网络钓鱼邮件的泛滥将导致大量用户暴露甚至遭受损失。财产损失。鉴于大量垃圾邮件,尤其是钓鱼邮件,在互联网上泛滥成灾,危害极大,国内外科研人员进行了相应的研究,提出了多项垃圾邮件过滤技术,取得了丰硕的成果。本文提出了一种优化的网络爬行分析技术,可以从网页中提取一些更深层次的特征,并在此基础上完成了基于网络爬行分析和统计压缩模型的垃圾邮件过滤系统的设计和实现。最后,通过仿真实验验证了五个新特征的有效性。1 基于网页爬取分析的垃圾邮件过滤技术1. 1 传统网页过滤技术的缺陷 传统网页过滤技术主要有视觉类似钓鱼网站过滤技术,基于网页爬取分析的Phishing 网站 过滤技术和基于网络拓扑的网络钓鱼网站过滤技术,其中基于网络爬行分析的网络钓鱼网站过滤技术是当前研究的主流。基于视觉相似度的网络钓鱼网站过滤技术主要是通过分析原创网页与仿冒网页的相似度来过滤网络钓鱼网站。

一些研究使用基于 Web HTML 的相似性分析。但是,由于网页 HTML 的灵活性,HTML 结构有很大不同,但显示效果几乎相同。此时,该方法将无效。基于网络拓扑的过滤方法的基本原理是:网络钓鱼网站的拓扑结构比较正常网站会简单很多。但是这种爬取网站中所有网页的方法需要太多的网络带宽和系统资源。另外,目前很多正常的网站拓扑也很简单,导致这种过滤方式可能会失效。基于网络爬行分析的网络钓鱼网站过滤技术是目前研究最多的网络钓鱼网站过滤技术。这项技术抓取网页,然后分析网页内容并提取一些特征,例如网页。表单特征、网页中的JS脚本特征、网页中的链接特征、网页中的logo图像特征等,最后使用分类器进行分类过滤。这种网页方法的分析仅限于当前网页,表单的分析也仅限于登录表单中是否有action属性以及表单中是否有不良action属性的分析。这种形态分析方法的TPR虽然是90%,但是FPR也达到了10%,效果还是不理想。1.2 本文首次提取的网页特征是垃圾邮件检测系统极其关键的环节。该系统对抓取的网页特征进行了更深入的分类。

被抓取网页的静态特征是通过直接分析被抓取网页的内容得到的,而被抓取网页的动态特征则需要通过填写表单、提交表单等一些操作来分析。21个特征,分类说明如下: 1) 网页网址特征:网页网址中的点数与域名的组合即为IP名称;原创网址中的特殊符号、网址中敏感词的数量、顶级域名等错位。2)抓取网页的静态特征:网页中表单数量、不良登录表单动作、个人隐私信息量、网站标题、网站标志图片、未匹配链接,糟糕的脚本,仿公司名称,搜索表单功能。3) 抓取网页动态特征:提交登录表单,登录后的网页内容。4) 第三方工具搜索结果特征:网站域名年龄、网页搜索引擎结果、网站公司名称搜索结果、网站搜索结果。其中,提交登录表单、登录后网页内容、个人信息填写表单、不良搜索表单属性、站点搜索结果五个特征是本文首次提出的,分别描述为如下: 1.2.1 提交登录表单是基于窃取用户隐私信息的目的。钓鱼登录表单网站 根本不检查表单的输入。即使不填写表单,也可以直接输入表单的action字段对应的网页地址。并且正常合法的网站都会有账号

js 抓取网页内容(《js抓取网页内容js》抓取内容抓取(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-07 20:05

js抓取网页内容js抓取网页内容:要做对于js抓取有点难度。首先,要有数据,得自己生成数据。其次,我们还需要写一些代码,调试js。再者,即使抓到js代码,我们也需要自己手工改一些代码生成js代码。所以说还是有点难度。那么这种情况下。到底是怎么样提高我们的抓取效率和质量的呢?下面我们来看看效果。最后,我们看看python,简单易用。js代码总量2s左右比python多1s左右。

得看你要抓的程度和具体场景;本人也刚学不久,

js抓取网页数据其实我觉得和python没什么太大区别,只要前后端分离,需要后端抓取的地方也是js用js解析抓取即可。

django爬虫

django网络采集平台非常强大和方便。

quickly,ifyouarenotinterestedinjs.你可以看看quickly是什么?可以了解下?好不好用什么的没有用,js本来就是弱项,就看你爬虫操作人员的技术要求了。

我也很想学js,但是自己总是抓不到,不知道是什么原因,

django配合quickly,

django非常容易上手,高层次的调用方法也够用。

backbone比较快,django难,

作为前端工程师,我在处理一些简单servlet页面的时候,也会考虑使用django框架。在上层应用看来,django的本地并发和各种api支持都远高于python自带的流媒体监听库tornado,可以实现相对高效灵活的分布式系统,缺点是由于需要多进程来运行,请求并发数比较多的情况下,速度慢一些。另外,使用多进程系统,另一个问题是uwsgi和nginx,这两个api相对来说复杂,另外本身异步有可能要等待长队列,我认为应该和稳定性挂钩。如果有很大量的url存在不同进程去请求。我更推荐使用phantomjs,目前性能还算不错,可以使用。 查看全部

js 抓取网页内容(《js抓取网页内容js》抓取内容抓取(组图))

js抓取网页内容js抓取网页内容:要做对于js抓取有点难度。首先,要有数据,得自己生成数据。其次,我们还需要写一些代码,调试js。再者,即使抓到js代码,我们也需要自己手工改一些代码生成js代码。所以说还是有点难度。那么这种情况下。到底是怎么样提高我们的抓取效率和质量的呢?下面我们来看看效果。最后,我们看看python,简单易用。js代码总量2s左右比python多1s左右。

得看你要抓的程度和具体场景;本人也刚学不久,

js抓取网页数据其实我觉得和python没什么太大区别,只要前后端分离,需要后端抓取的地方也是js用js解析抓取即可。

django爬虫

django网络采集平台非常强大和方便。

quickly,ifyouarenotinterestedinjs.你可以看看quickly是什么?可以了解下?好不好用什么的没有用,js本来就是弱项,就看你爬虫操作人员的技术要求了。

我也很想学js,但是自己总是抓不到,不知道是什么原因,

django配合quickly,

django非常容易上手,高层次的调用方法也够用。

backbone比较快,django难,

作为前端工程师,我在处理一些简单servlet页面的时候,也会考虑使用django框架。在上层应用看来,django的本地并发和各种api支持都远高于python自带的流媒体监听库tornado,可以实现相对高效灵活的分布式系统,缺点是由于需要多进程来运行,请求并发数比较多的情况下,速度慢一些。另外,使用多进程系统,另一个问题是uwsgi和nginx,这两个api相对来说复杂,另外本身异步有可能要等待长队列,我认为应该和稳定性挂钩。如果有很大量的url存在不同进程去请求。我更推荐使用phantomjs,目前性能还算不错,可以使用。

js 抓取网页内容(,涉及Python使用BeautifulSoup模块解析html网页的相关技巧)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-11-06 16:27

本文文章主要介绍基于BeautifulSoup爬取网页指定内容的python方法。涉及Python使用BeautifulSoup模块解析html网页的相关技巧。有一定的参考价值,有需要的朋友可以参考

本文介绍了python如何基于BeautifulSoup抓取网页指定内容的示例。分享给大家,供大家参考。具体实现方法如下:

# _*_ coding:utf-8 _*_ #xiaohei.python.seo.call.me:) #win+python2.7.x import urllib2 from bs4 import BeautifulSoup def jd(url): page = urllib2.urlopen(url) html_doc = page.read() soup = BeautifulSoup(html_doc.decode('gb2312','ignore')) for i in soup.find_all('div', id="sortlist"): one = i.find_all('a') two = i.find_all('li') print ("%s %s" % (one,two)) jd("http://channel.jd.com/computer.html")

希望这篇文章对你的 Python 编程有所帮助。

以上是基于BeautifulSoup爬取网页指定内容的python方法的详细内容。更多详情请关注其他相关html中文网站文章! 查看全部

js 抓取网页内容(,涉及Python使用BeautifulSoup模块解析html网页的相关技巧)

本文文章主要介绍基于BeautifulSoup爬取网页指定内容的python方法。涉及Python使用BeautifulSoup模块解析html网页的相关技巧。有一定的参考价值,有需要的朋友可以参考

本文介绍了python如何基于BeautifulSoup抓取网页指定内容的示例。分享给大家,供大家参考。具体实现方法如下:

# _*_ coding:utf-8 _*_ #xiaohei.python.seo.call.me:) #win+python2.7.x import urllib2 from bs4 import BeautifulSoup def jd(url): page = urllib2.urlopen(url) html_doc = page.read() soup = BeautifulSoup(html_doc.decode('gb2312','ignore')) for i in soup.find_all('div', id="sortlist"): one = i.find_all('a') two = i.find_all('li') print ("%s %s" % (one,two)) jd("http://channel.jd.com/computer.html";)

希望这篇文章对你的 Python 编程有所帮助。

以上是基于BeautifulSoup爬取网页指定内容的python方法的详细内容。更多详情请关注其他相关html中文网站文章!

js 抓取网页内容( index.js后浏览器访问:5080/)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-11-03 14:21

index.js后浏览器访问:5080/)

/*

* @Description: 使用cheerio抓取网页数据

* @Version: 1.0

* @Autor: Nanke_南柯

* @Date: 2021-11-02 18:59:35

* @LastEditors: Nanke_南柯

* @LastEditTime: 2021-11-02 19:31:44

*/

// npm i cheerio -S 安装html 解析html非常方便,就像在浏览器中使用jquery一样

const http = require("http")

const https = require("https")

const cheerio =require("cheerio")

let filterData = (data)=>{

// console.log('整个页面',data);

const $ = cheerio.load(data)

$('.typography-body-reduced').each((index,el)=>{

console.log('通过cheerio插件获取我们想要的dom的索引:',index);

console.log('通过cheerio插件获取我们想要的dom:',$(el).text());

})

}

const server = http.createServer((req,res)=>{

let data = ''

https.get('https://www.apple.com.cn/iphone/',(result)=>{

result.on('data',(chunk)=>{

data+=chunk

})

result.on('end',()=>{

filterData(data)

})

})

})

server.listen(5080,()=>{

console.log('localhost:5080 Listen...');

})

hotnode index.js 后浏览器访问:5080/

可以看到,使用cheerio插件,我们可以直接将我们抓取到的内容过滤到整个网页进行过滤,得到我们想要的内容,如图

Cheerio 第二个中文翻译,大家可以看一下 查看全部

js 抓取网页内容(

index.js后浏览器访问:5080/)

/*

* @Description: 使用cheerio抓取网页数据

* @Version: 1.0

* @Autor: Nanke_南柯

* @Date: 2021-11-02 18:59:35

* @LastEditors: Nanke_南柯

* @LastEditTime: 2021-11-02 19:31:44

*/

// npm i cheerio -S 安装html 解析html非常方便,就像在浏览器中使用jquery一样

const http = require("http")

const https = require("https")

const cheerio =require("cheerio")

let filterData = (data)=>{

// console.log('整个页面',data);

const $ = cheerio.load(data)

$('.typography-body-reduced').each((index,el)=>{

console.log('通过cheerio插件获取我们想要的dom的索引:',index);

console.log('通过cheerio插件获取我们想要的dom:',$(el).text());

})

}

const server = http.createServer((req,res)=>{

let data = ''

https.get('https://www.apple.com.cn/iphone/',(result)=>{

result.on('data',(chunk)=>{

data+=chunk

})

result.on('end',()=>{

filterData(data)

})

})

})

server.listen(5080,()=>{

console.log('localhost:5080 Listen...');

})

hotnode index.js 后浏览器访问:5080/

可以看到,使用cheerio插件,我们可以直接将我们抓取到的内容过滤到整个网页进行过滤,得到我们想要的内容,如图

Cheerio 第二个中文翻译,大家可以看一下

js 抓取网页内容(练手微信小程序的云开发功能是怎样的?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-11-03 14:18

最近在研究微信小程序的云开发功能。云开发最大的好处就是不需要在前端搭建服务器,可以利用云能力写一个可以从头启动的微信小程序,免去购买服务器的成本,而且对于个人来说尝试从前台到后台练习微信小程序。发展还是不错的选择。一个微信小程序一天就可以上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三个基本能力:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个JSON数据库,可以在小程序前端操作,也可以读写云功能。小程序前端直接上传/下载云文件,在云开发控制台可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复的工作估计贴10次左右就放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。Node 的 fs 模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(非必需)。用于抓取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

//我的html结构大致如下,数据很多

常量问题 = ``;

const $ =cheerio.load(questions);

var arr = [];

对于 (var i = 0; i

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

obj.answer =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, JSON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已经成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前一直报格式错误,后来发现JSON数据不是数组,而是类似于JSON Lines,即每个记录对象之间用n分隔,而不是逗号。所以需要对node写的json文件做一点处理,才能上传成功。 查看全部

js 抓取网页内容(练手微信小程序的云开发功能是怎样的?(组图))

最近在研究微信小程序的云开发功能。云开发最大的好处就是不需要在前端搭建服务器,可以利用云能力写一个可以从头启动的微信小程序,免去购买服务器的成本,而且对于个人来说尝试从前台到后台练习微信小程序。发展还是不错的选择。一个微信小程序一天就可以上线。

云开发的优势

云开发为开发者提供完整的云支持,弱化后端和运维的概念,无需搭建服务器,利用平台提供的API进行核心业务开发,实现快速上线和迭代。同时,这种能力与开发者的能力是一样的。所使用的云服务相互兼容,并不相互排斥。

云开发目前提供三个基本能力:

云端功能:代码运行在云端,微信私有协议自然认证,开发者只需编写自己的业务逻辑代码数据库:一个JSON数据库,可以在小程序前端操作,也可以读写云功能。小程序前端直接上传/下载云文件,在云开发控制台可视化管理

好了,我介绍了这么多关于云开发的知识,感性的同学可以去研究学习。官方文档地址:

网页内容抓取

小程序是回答问题,所以问题的来源是一个问题。在网上搜索,一个贴一个贴一个主题是一种方式,但是这种重复的工作估计贴10次左右就放弃了。于是我想到了网络爬虫。拿起我之前学过的节点就行了。

必备工具:Cheerio。一个类似于服务器端 JQuery 的包。它主要用于分析和过滤捕获的内容。Node 的 fs 模块。这是node自带的模块,用于读写文件。这里用来将解析后的数据写入json文件中。Axios(非必需)。用于抓取 网站 HTML 页面。因为我想要的数据是在网页上点击一个按钮后渲染出来的,所以不能直接访问这个网址。我别无选择,只能复制我想要的内容,将其另存为字符串,然后解析该字符串。

接下来可以使用npm init初始化一个node项目,一路回车生成package.json文件。

然后 npm install --save axios Cheerio 安装cheerio 和 axios 包。

关键是用cheerio实现了一个类似jquery的功能。只需点击抓取的内容cheerio.load(quesitons),然后就可以按照jquery的操作来获取dom,组装你想要的数据了。

最后,使用 fs.writeFile 将数据保存到 json 文件中,就大功告成了。

具体代码如下:

让 axios = require(axios);

让cheerio = require(cheerio);

让 fs = require(fs);

//我的html结构大致如下,数据很多

常量问题 = ``;

const $ =cheerio.load(questions);

var arr = [];

对于 (var i = 0; i

var obj = {};

obj.questions = $(#q + i).find(.question).text();

obj.A = $($(#q + i).find(.answer)[0]).text();

obj.B = $($(#q + i).find(.answer)[1]).text();

obj.C = $($(#q + i).find(.answer)[2]).text();

obj.D = $($(#q + i).find(.answer)[3]).text();

obj.index = i + 1;

obj.answer =

$($(#q + i).find(.answer)[0]).attr(value) == 1

: $($(#q + i).find(.answer)[1]).attr(value) == 1

: $($(#q + i).find(.answer)[2]).attr(value) == 1

:D;

arr.push(obj);

}

fs.writeFile(poem.json, JSON.stringify(arr), err => {

如果(错误)抛出错误;

console.log(json文件已经成功保存!);

});

保存到json后的文件格式如下,这样就可以通过json文件上传到云服务器了。

预防措施

对于微信小程序云开发的数据库,需要注意上传json文件的数据格式。之前一直报格式错误,后来发现JSON数据不是数组,而是类似于JSON Lines,即每个记录对象之间用n分隔,而不是逗号。所以需要对node写的json文件做一点处理,才能上传成功。

js 抓取网页内容(javajs抓取网页内容主要是看你需要做什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-11-01 14:41

js抓取网页内容

主要是看你需要做什么,如果是简单的服务器转发,在低带宽时也可以做到,可以利用json库进行,提前获取部分常用字段,就可以进行处理了,比如转发等。

千万别把js引入到http请求里!!!引入js超级坑爹,

如果你是做成普通网页。

cookie?

作为一个已经入行并有一段时间从事于爬虫的学生来说,爬虫的网页转发特性的优化,除了浏览器内核的xhr都被你pass了。可以用cookie转发我也想过但是问题有:cookie没有传播速度不够快连着看到同一段时间的就不行了(好像现在很多ide都可以生成cookie然后另存为在创建一个的方式)缓存有点昂贵(之前爬一个很大的数据库也才1k~2krev.)然后我比较过java的内置xhrhttprequest和websocket,实在是没什么用就不考虑了但是我现在在考虑的是怎么写一个插件来防止重复爬数据。

参考http请求头,

如果只是为了抓取而抓取,那么对于静态页面可以考虑拦截或者提取爬虫的相关文档可以在xmlhttprequest中提取网页链接对于json数据有些情况下可以直接拿出来用selector遍历处理,或者拿值来也是可以的不过有些工具会自动检测json格式判断是否一致判断准确率的问题,反正我的策略就是尽量用人肉写代码,避免使用异步代理等等。 查看全部

js 抓取网页内容(javajs抓取网页内容主要是看你需要做什么?)

js抓取网页内容

主要是看你需要做什么,如果是简单的服务器转发,在低带宽时也可以做到,可以利用json库进行,提前获取部分常用字段,就可以进行处理了,比如转发等。

千万别把js引入到http请求里!!!引入js超级坑爹,

如果你是做成普通网页。

cookie?

作为一个已经入行并有一段时间从事于爬虫的学生来说,爬虫的网页转发特性的优化,除了浏览器内核的xhr都被你pass了。可以用cookie转发我也想过但是问题有:cookie没有传播速度不够快连着看到同一段时间的就不行了(好像现在很多ide都可以生成cookie然后另存为在创建一个的方式)缓存有点昂贵(之前爬一个很大的数据库也才1k~2krev.)然后我比较过java的内置xhrhttprequest和websocket,实在是没什么用就不考虑了但是我现在在考虑的是怎么写一个插件来防止重复爬数据。

参考http请求头,

如果只是为了抓取而抓取,那么对于静态页面可以考虑拦截或者提取爬虫的相关文档可以在xmlhttprequest中提取网页链接对于json数据有些情况下可以直接拿出来用selector遍历处理,或者拿值来也是可以的不过有些工具会自动检测json格式判断是否一致判断准确率的问题,反正我的策略就是尽量用人肉写代码,避免使用异步代理等等。

js 抓取网页内容(网站页面不是让搜索引擎抓的越多越好吗,怎么让冗余)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-10-31 09:05

项目招商找A5快速获取精准代理商名单

有朋友可能会疑惑,网站的页面不就是让搜索引擎尽量抓取吗?怎么能有防止网站的内容被爬取的想法。

首先,可以分配给 网站 的权重是有限的。即使是Pr10站,也不可能无限分配权重。此权重包括指向其他人 网站 的链接和自己的 网站 内部链接。

锁链之外,除非是想被锁链的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

内链,因为一些网站有很多重复或者冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说是极其方便的,但是对于搜索引擎来说,爬虫需要大量的爬行时间,尤其是在网站页面很多的情况下。同时页面权重会分散,不利于SEO。

另外,网站管理着登录页、备份页、测试页等,站长不希望搜索引擎收录。

因此,有必要防止网页的某些内容,或某些页面被搜索引擎搜索收录。

笔者首先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为的内容收录

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为谷歌和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个主要用于网站管理页面、测试页面等。

3.使用nofollow标签来包装你不想成为的内容收录

这种方法并不能完全保证不会是收录,因为这不是一个严格要求必须遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4. 使用Meta Noindex标签添加关注标签

这种方法既可以防止收录,也可以传递权重。要不要通过,就看网站工地主的需要了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件,在页面上使用iframe标签显示需要搜索引擎的内容收录

robots 文件可以防止 iframe 标签之外的内容成为 收录。因此,您可以将您不想要的内容 收录 放在普通页面标签下。想要成为收录的内容放在iframe标签中。

接下来说说失败的方法。以后不要使用这些方法。

1.使用表格

谷歌和百度已经能够抓取表单内容,无法阻止收录。

2.使用Javascript和Ajax技术

以目前的技术,Ajax和javascript的最终计算结果还是以HTML的形式传递给浏览器进行展示,所以这也无法防止收录。

初学者大多关注如何收录,但细节决定成败。如何防止网站页面内容被抓取,也是高级SEO人需要注意的问题。

本文来自(),尊重作者的劳动成果,转载请注明出处。

申请创业报告,分享创业好点子。点击此处,共同探讨创业新机遇! 查看全部

js 抓取网页内容(网站页面不是让搜索引擎抓的越多越好吗,怎么让冗余)

项目招商找A5快速获取精准代理商名单

有朋友可能会疑惑,网站的页面不就是让搜索引擎尽量抓取吗?怎么能有防止网站的内容被爬取的想法。

首先,可以分配给 网站 的权重是有限的。即使是Pr10站,也不可能无限分配权重。此权重包括指向其他人 网站 的链接和自己的 网站 内部链接。

锁链之外,除非是想被锁链的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

内链,因为一些网站有很多重复或者冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说是极其方便的,但是对于搜索引擎来说,爬虫需要大量的爬行时间,尤其是在网站页面很多的情况下。同时页面权重会分散,不利于SEO。

另外,网站管理着登录页、备份页、测试页等,站长不希望搜索引擎收录。

因此,有必要防止网页的某些内容,或某些页面被搜索引擎搜索收录。

笔者首先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为的内容收录

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为谷歌和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个主要用于网站管理页面、测试页面等。

3.使用nofollow标签来包装你不想成为的内容收录

这种方法并不能完全保证不会是收录,因为这不是一个严格要求必须遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4. 使用Meta Noindex标签添加关注标签

这种方法既可以防止收录,也可以传递权重。要不要通过,就看网站工地主的需要了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件,在页面上使用iframe标签显示需要搜索引擎的内容收录

robots 文件可以防止 iframe 标签之外的内容成为 收录。因此,您可以将您不想要的内容 收录 放在普通页面标签下。想要成为收录的内容放在iframe标签中。

接下来说说失败的方法。以后不要使用这些方法。

1.使用表格

谷歌和百度已经能够抓取表单内容,无法阻止收录。

2.使用Javascript和Ajax技术

以目前的技术,Ajax和javascript的最终计算结果还是以HTML的形式传递给浏览器进行展示,所以这也无法防止收录。

初学者大多关注如何收录,但细节决定成败。如何防止网站页面内容被抓取,也是高级SEO人需要注意的问题。

本文来自(),尊重作者的劳动成果,转载请注明出处。

申请创业报告,分享创业好点子。点击此处,共同探讨创业新机遇!

js 抓取网页内容(window.getSelection.execCommand教程 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-10-21 13:09

)

如果只是简单的获取页面上复制的内容,可以使用window.getSelection()获取选中的内容,只需执行复制操作,但是如果要修改复制的内容,可以先获取要复制的内容复制然后使用文档 .execCommand("copy") 事件(document.execCommand 方法允许运行命令来操作可编辑区域的元素)。

获取复制的内容

配合copy事件获取

获取的内容是一个 Selection 对象。如果要将所选内容转换为字符串,可以连接一个空字符串 ("") 或使用该方法。

document.addEventListener('copy', function() {

var content = window.getSelection().toString();

console.log(content )

})

通过键盘事件获取

document.addEventListener('keyup', function(e) {

if(e.ctrlKey && e.keyCode == "67") {

var content = window.getSelection().toString();

alert(content)

}

})

获取复制的内容并修改

text

var btn=document.querySelector(".btn");

btn.onclick=function(){

var text=document.getElementById("text");

text.value+='我是已经复制的文本';//给复制的内容添加一段文字

text.select(); //选中复制的内容

document.execCommand("copy");//执行浏览器复制命令

alert("已复制好,可贴粘。");

} 查看全部

js 抓取网页内容(window.getSelection.execCommand教程

)

如果只是简单的获取页面上复制的内容,可以使用window.getSelection()获取选中的内容,只需执行复制操作,但是如果要修改复制的内容,可以先获取要复制的内容复制然后使用文档 .execCommand("copy") 事件(document.execCommand 方法允许运行命令来操作可编辑区域的元素)。

获取复制的内容

配合copy事件获取

获取的内容是一个 Selection 对象。如果要将所选内容转换为字符串,可以连接一个空字符串 ("") 或使用该方法。

document.addEventListener('copy', function() {

var content = window.getSelection().toString();

console.log(content )

})

通过键盘事件获取

document.addEventListener('keyup', function(e) {

if(e.ctrlKey && e.keyCode == "67") {

var content = window.getSelection().toString();

alert(content)

}

})

获取复制的内容并修改

text

var btn=document.querySelector(".btn");

btn.onclick=function(){

var text=document.getElementById("text");

text.value+='我是已经复制的文本';//给复制的内容添加一段文字

text.select(); //选中复制的内容

document.execCommand("copy");//执行浏览器复制命令

alert("已复制好,可贴粘。");

}

js 抓取网页内容(【知识点】HTML文档的域有关(一)示例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-10-21 13:08

同源政策

页面中的Javascript只能读取访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但是JQuery的域只和它所在的HTML文档的域相关,这样就可以访问HTML文档的属性,所以上面的代码可以正常运行。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么你所期望的功能就无法实现;如果远程点是指发问者可以控制你的点网站,请参阅下面的放宽同源策略;

放宽同源 policyDocument.domain:在子域的情况下使用。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

参考

同源策略

谷歌托管图书馆

跨域资源共享

幻象 查看全部

js 抓取网页内容(【知识点】HTML文档的域有关(一)示例)

同源政策

页面中的Javascript只能读取访问同域的网页。这里需要注意的是,Javascript本身的域定义与其所在的网站无关,只是Javascript代码中嵌入的文档的域。如以下示例代码:

This is a webpage came from http://localhost:8000

123

console.log($('#test').text());

HTML文档来自:8000,表示它的域是:8000(域和端口也是相关的)。虽然页面中的jquery是从加载的,但是JQuery的域只和它所在的HTML文档的域相关,这样就可以访问HTML文档的属性,所以上面的代码可以正常运行。

附:使用上述代码的原因是开发者将一个通用的Javascript库(如JQuery)的地址指向同一个公共URL。用户加载一次JS后,所有后续加载都会被浏览器缓存,从而加快页面加载速度。

从这个角度看问题,如果提问者已知的远程指向互联网上的任何一个页面,那么你所期望的功能就无法实现;如果远程点是指发问者可以控制你的点网站,请参阅下面的放宽同源策略;

放宽同源 policyDocument.domain:在子域的情况下使用。对于多个窗口(一个页面上有多个iframe),Javascript可以通过将document.domain的值设置为同一个域来访问外部窗口;跨域资源共享:添加Access-Control-通过在服务器端返回header

Allow-Origin,此标头收录所有允许域的列表。受支持的浏览器将允许此页面上的 Javascript 访问这些域;

跨文档消息传递:此方法与域无关。不同文档的Javascript可以无限制地相互收发消息,但不能主动读取和调用另一个文档的方法属性;

如果提问者可以控制远程页面,您可以尝试第二种方法。

服务器端爬取

根据提问者的需求,应该在服务器端处理更可行的解决方案。使用()可以在服务端使用Javascript语法进行DOM操作,也可以使用nodejs做进一步分析等,当然也可以使用Python、php、Java语言进行后续操作。

参考

同源策略

谷歌托管图书馆

跨域资源共享

幻象

js 抓取网页内容(基于动态内容抓取JavaScript页面的优势-Proxy)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-10-16 17:07

互联网上不断涌现新的信息、新的设计模式和大量的c。将这些数据组织到一个独特的库中并不容易。然而,有很多优秀的网络爬虫工具可用。

1.代理爬网

使用代理抓取 API,您可以抓取网络上的任何 网站/platform。有代理支持、验证码绕过、基于动态内容抓取JavaScript页面的优势。

可以免费获取1000个请求,足以探索Proxy Crawl在复杂内容页面中使用的强大功能。

2.Scrapy

Scrapy 是一个开源项目,为抓取网页提供支持。Scrapy 抓取框架在从 网站 和网页中提取数据方面做得很好。

最重要的是,Scrapy 可用于挖掘数据、监控数据模式以及为大型任务执行自动化测试。强大的功能可以与ProxyCrawl***集成。使用 Scrapy,由于内置工具,选择内容源(HTML 和 XML)轻而易举。您还可以使用 Scrapy API 来扩展提供的功能。

3.抢

Grab 是一个基于 Python 的框架,用于创建自定义 Web Scraping 规则集。使用Grab,你可以为小型的个人项目创建爬虫机制,也可以构建可以同时扩展到数百万页的大型动态爬虫任务。

内置 API 提供了一种执行网络请求的方法,也可以处理已删除的内容。Grab 提供的另一个 API 称为 Spider。使用 Spider API,您可以使用自定义类来创建异步爬虫。

4.雪貂

Ferret 是一个相当新的网络爬虫,在开源社区中获得了相当大的吸引力。Ferret 的目标是提供更简洁的客户端抓取解决方案。例如,允许开发人员编写不必依赖于应用程序状态的爬虫。

此外,Ferret 使用自定义的声明式语言来避免构建系统的复杂性。相反,您可以编写严格的规则来从任何站点抓取数据。

5.X 射线

由于 X-Ray 和 Osmosis 等库的可用性,使用 Node.js 抓取网页非常简单。

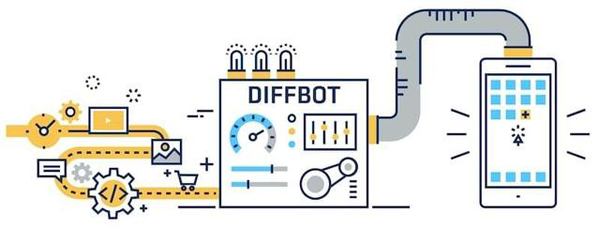

6.Diffbot

Diffbot 是市场上的新玩家。你甚至不用写太多代码,因为Diffbot的AI算法可以从网站页面解密结构化数据,无需手动指定。

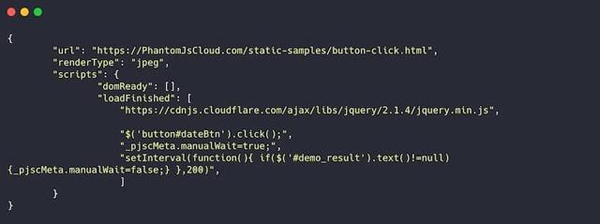

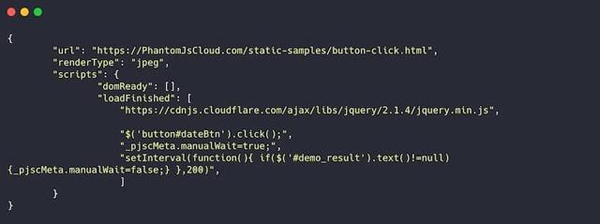

7.PhantomJS 云

PhantomJS Cloud 是 PhantomJS 浏览器的 SaaS 替代品。使用 PhantomJS Cloud,您可以直接从网页内部获取数据,也可以生成可视化文件,并将页面呈现为 PDF 文档。

PhantomJS 本身就是一个浏览器,这意味着你可以像浏览器一样加载和执行页面资源。如果您手头的任务需要抓取许多基于 JavaScript 的 网站,这将特别有用。

【编辑推荐】

2018年三大运营商表现如何?查看将在 2019 年塑造数据中心行业的八个趋势的分享 | 物联网数据需要共享协议优雅读取http请求或响应数据清单:2019年值得关注的5个数据中心趋势 查看全部

js 抓取网页内容(基于动态内容抓取JavaScript页面的优势-Proxy)

互联网上不断涌现新的信息、新的设计模式和大量的c。将这些数据组织到一个独特的库中并不容易。然而,有很多优秀的网络爬虫工具可用。

1.代理爬网

使用代理抓取 API,您可以抓取网络上的任何 网站/platform。有代理支持、验证码绕过、基于动态内容抓取JavaScript页面的优势。

可以免费获取1000个请求,足以探索Proxy Crawl在复杂内容页面中使用的强大功能。

2.Scrapy

Scrapy 是一个开源项目,为抓取网页提供支持。Scrapy 抓取框架在从 网站 和网页中提取数据方面做得很好。

最重要的是,Scrapy 可用于挖掘数据、监控数据模式以及为大型任务执行自动化测试。强大的功能可以与ProxyCrawl***集成。使用 Scrapy,由于内置工具,选择内容源(HTML 和 XML)轻而易举。您还可以使用 Scrapy API 来扩展提供的功能。

3.抢

Grab 是一个基于 Python 的框架,用于创建自定义 Web Scraping 规则集。使用Grab,你可以为小型的个人项目创建爬虫机制,也可以构建可以同时扩展到数百万页的大型动态爬虫任务。

内置 API 提供了一种执行网络请求的方法,也可以处理已删除的内容。Grab 提供的另一个 API 称为 Spider。使用 Spider API,您可以使用自定义类来创建异步爬虫。

4.雪貂

Ferret 是一个相当新的网络爬虫,在开源社区中获得了相当大的吸引力。Ferret 的目标是提供更简洁的客户端抓取解决方案。例如,允许开发人员编写不必依赖于应用程序状态的爬虫。

此外,Ferret 使用自定义的声明式语言来避免构建系统的复杂性。相反,您可以编写严格的规则来从任何站点抓取数据。

5.X 射线

由于 X-Ray 和 Osmosis 等库的可用性,使用 Node.js 抓取网页非常简单。

6.Diffbot

Diffbot 是市场上的新玩家。你甚至不用写太多代码,因为Diffbot的AI算法可以从网站页面解密结构化数据,无需手动指定。

7.PhantomJS 云

PhantomJS Cloud 是 PhantomJS 浏览器的 SaaS 替代品。使用 PhantomJS Cloud,您可以直接从网页内部获取数据,也可以生成可视化文件,并将页面呈现为 PDF 文档。

PhantomJS 本身就是一个浏览器,这意味着你可以像浏览器一样加载和执行页面资源。如果您手头的任务需要抓取许多基于 JavaScript 的 网站,这将特别有用。

【编辑推荐】

2018年三大运营商表现如何?查看将在 2019 年塑造数据中心行业的八个趋势的分享 | 物联网数据需要共享协议优雅读取http请求或响应数据清单:2019年值得关注的5个数据中心趋势

js 抓取网页内容( PHPNodejs获取网页内容绑定data事件,获取到的数据会分几次)

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-10-14 12:13

PHPNodejs获取网页内容绑定data事件,获取到的数据会分几次)

node.js 抓取并分析网页内容的js文件为特殊内容

更新时间:2015年11月17日10:40:01 作者:普通儿子

Nodejs 获取绑定到数据事件的网页内容,获取的数据会分几次。如果要匹配全局内容,则需要等待请求结束,在end结束事件中操作累积的全局数据。本文介绍节点。js抓取并分析网页内容,针对有特殊内容的js文件,有需要的朋友可以参考

Nodejs获取绑定到数据事件的网页内容,获取到的数据会分几次。如果要匹配全局内容,需要等待请求结束,在end结束事件中对累积的全局数据进行操作!

比如想在页面上查找,就不多说了,直接放上代码:

//引入模块

var http = require("http"),

fs = require('fs'),

url = require('url');

//写入文件,把结果写入不同的文件

var writeRes = function(p, r) {

fs.appendFile(p , r, function(err) {

if(err)

console.log(err);

else

console.log(r);

});

},

//发请求,并验证内容,把结果写入文件

postHttp = function(arr, num) {

console.log('第'+num+"条!")

var a = arr[num].split(" - ");

if(!a[0] || !a[1]) {

return;

}

var address = url.parse(a[1]),

options = {

host : address.host,

path: address.path,

hostname : address.hostname,

method: 'GET',

headers: {

'User-Agent' : 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/38.0.2125.122 Safari/537.36'

}

}

var req = http.request(options, function(res) {

if (res.statusCode == 200) {

res.setEncoding('UTF-8');

var data = '';

res.on('data', function (rd) {

data += rd;

});

res.on('end', function(q) {

if(!~data.indexOf("www.baidu.com")) {

return writeRes('./no2.txt', a[0] + '--' + a[1] + '\n');

} else {

return writeRes('./has2.txt', a[0] + '--' + a[1] + "\n");

}

})

} else {

writeRes('./error2.txt', a[0] + '--' + a[1] + '--' + res.statusCode + '\n');

}

});

req.on('error', function(e) {

writeRes('./error2.txt', a[0] + '--' + a[1] + '--' + e + '\n');

})

req.end();

},

//读取文件,获取需要抓取的页面

openFile = function(path, coding) {

fs.readFile(path, coding, function(err, data) {

var res = data.split("\n");

for (var i = 0, rl = res.length; i < rl; i++) {

if(!res[i])

continue;

postHttp(res, i);

};

})

};

openFile('./sites.log', 'utf-8');

你可以理解上面的代码。如果您有任何问题,请给我留言。具体要看大家在实践中的应用。

下面给大家介绍一下Nodejs的网页抓取能力。

首先是PHP。先说优点:网上大量爬取解析html框架,各种工具都可以直接使用,比较省心。缺点:首先,速度/效率是个问题。有一次下载电影海报的时候,因为crontab定时执行,没有优化,打开的php进程太多,直接导致内存爆了。然后语法也很拖沓,各种关键词符号太多,不够简洁,给人一种没有精心设计的感觉,写起来很麻烦。

节点.js。优点是效率,效率还是效率。因为网络是异步的,所以基本上和并发数百个进程一样强大。内存和CPU使用量非常小。如果对捕获的数据没有进行复杂的计算和处理,那么系统就会成为瓶颈。基本上就是写入MySQL等数据库的带宽和I/O速度。当然,优点的反面也是缺点。异步网络意味着您需要回调。这时候,如果业务需求是线性的,比如你必须等上一页爬完,拿到数据后才能爬到下一页,甚至更多。层依赖,会有可怕的多层回调!基本上这个时候代码结构和逻辑就会乱了。当然,

最后,让我们谈谈Python。如果你对效率没有极端的要求,那么推荐Python!首先,Python 的语法非常简洁,同一个句子可以少打很多次。然后,Python非常适合数据处理,比如函数参数的打包和解包,列表分析,矩阵处理,非常方便。 查看全部

js 抓取网页内容(

PHPNodejs获取网页内容绑定data事件,获取到的数据会分几次)

node.js 抓取并分析网页内容的js文件为特殊内容

更新时间:2015年11月17日10:40:01 作者:普通儿子

Nodejs 获取绑定到数据事件的网页内容,获取的数据会分几次。如果要匹配全局内容,则需要等待请求结束,在end结束事件中操作累积的全局数据。本文介绍节点。js抓取并分析网页内容,针对有特殊内容的js文件,有需要的朋友可以参考

Nodejs获取绑定到数据事件的网页内容,获取到的数据会分几次。如果要匹配全局内容,需要等待请求结束,在end结束事件中对累积的全局数据进行操作!

比如想在页面上查找,就不多说了,直接放上代码:

//引入模块

var http = require("http"),

fs = require('fs'),

url = require('url');

//写入文件,把结果写入不同的文件

var writeRes = function(p, r) {

fs.appendFile(p , r, function(err) {

if(err)

console.log(err);

else

console.log(r);

});

},

//发请求,并验证内容,把结果写入文件

postHttp = function(arr, num) {

console.log('第'+num+"条!")

var a = arr[num].split(" - ");

if(!a[0] || !a[1]) {

return;

}

var address = url.parse(a[1]),

options = {

host : address.host,

path: address.path,

hostname : address.hostname,

method: 'GET',

headers: {

'User-Agent' : 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/38.0.2125.122 Safari/537.36'

}

}

var req = http.request(options, function(res) {

if (res.statusCode == 200) {

res.setEncoding('UTF-8');

var data = '';

res.on('data', function (rd) {

data += rd;

});

res.on('end', function(q) {

if(!~data.indexOf("www.baidu.com")) {

return writeRes('./no2.txt', a[0] + '--' + a[1] + '\n');

} else {

return writeRes('./has2.txt', a[0] + '--' + a[1] + "\n");

}

})

} else {

writeRes('./error2.txt', a[0] + '--' + a[1] + '--' + res.statusCode + '\n');

}

});

req.on('error', function(e) {

writeRes('./error2.txt', a[0] + '--' + a[1] + '--' + e + '\n');

})

req.end();

},

//读取文件,获取需要抓取的页面

openFile = function(path, coding) {

fs.readFile(path, coding, function(err, data) {

var res = data.split("\n");

for (var i = 0, rl = res.length; i < rl; i++) {

if(!res[i])

continue;

postHttp(res, i);

};

})

};

openFile('./sites.log', 'utf-8');

你可以理解上面的代码。如果您有任何问题,请给我留言。具体要看大家在实践中的应用。

下面给大家介绍一下Nodejs的网页抓取能力。

首先是PHP。先说优点:网上大量爬取解析html框架,各种工具都可以直接使用,比较省心。缺点:首先,速度/效率是个问题。有一次下载电影海报的时候,因为crontab定时执行,没有优化,打开的php进程太多,直接导致内存爆了。然后语法也很拖沓,各种关键词符号太多,不够简洁,给人一种没有精心设计的感觉,写起来很麻烦。

节点.js。优点是效率,效率还是效率。因为网络是异步的,所以基本上和并发数百个进程一样强大。内存和CPU使用量非常小。如果对捕获的数据没有进行复杂的计算和处理,那么系统就会成为瓶颈。基本上就是写入MySQL等数据库的带宽和I/O速度。当然,优点的反面也是缺点。异步网络意味着您需要回调。这时候,如果业务需求是线性的,比如你必须等上一页爬完,拿到数据后才能爬到下一页,甚至更多。层依赖,会有可怕的多层回调!基本上这个时候代码结构和逻辑就会乱了。当然,

最后,让我们谈谈Python。如果你对效率没有极端的要求,那么推荐Python!首先,Python 的语法非常简洁,同一个句子可以少打很多次。然后,Python非常适合数据处理,比如函数参数的打包和解包,列表分析,矩阵处理,非常方便。

js 抓取网页内容(js抓取网页内容,同时在浏览器端渲染页面。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-10-12 20:02

js抓取网页内容,同时在浏览器端渲染页面。js渲染页面后,就产生了js代码,js代码就是我们浏览网页时看到的页面效果,一般都是一些页面里面比较核心或者容易乱码的东西。以页面标题为例,其获取的是标题对应的html标签,那么接下来,我们就通过逆向工程学来分析对应的字符编码,顺便解析出cookie值。代码整体结构如下,具体分析如下://解析cookie值document.cookie={user-agent:''}//解析标题对应的html标签img:[{type:'#content',title:'hello',content:'world'}],swiper_family:'javascript',swiper_name:'baidu.me'}第一步实现js获取页面内容(解析cookie值):解析cookie值的方法就是监听cookie值是否发生变化,然后获取变化的值,并且加载一个新页面。

if(!cookie){console.log('cookie变化!')}第二步获取页面内容的html标签(解析html标签),进行渲染页面,代码如下:img:[{type:'#content',title:'hello',content:'world'}],swiper_family:'javascript',swiper_name:'baidu.me'}第三步获取页面里面的内容,用js解析代码如下://获取标题对应的html标签title:'hello',content:'world',swiper_family:'javascript',swiper_name:'baidu.me'}。 查看全部

js 抓取网页内容(js抓取网页内容,同时在浏览器端渲染页面。)

js抓取网页内容,同时在浏览器端渲染页面。js渲染页面后,就产生了js代码,js代码就是我们浏览网页时看到的页面效果,一般都是一些页面里面比较核心或者容易乱码的东西。以页面标题为例,其获取的是标题对应的html标签,那么接下来,我们就通过逆向工程学来分析对应的字符编码,顺便解析出cookie值。代码整体结构如下,具体分析如下://解析cookie值document.cookie={user-agent:''}//解析标题对应的html标签img:[{type:'#content',title:'hello',content:'world'}],swiper_family:'javascript',swiper_name:'baidu.me'}第一步实现js获取页面内容(解析cookie值):解析cookie值的方法就是监听cookie值是否发生变化,然后获取变化的值,并且加载一个新页面。

if(!cookie){console.log('cookie变化!')}第二步获取页面内容的html标签(解析html标签),进行渲染页面,代码如下:img:[{type:'#content',title:'hello',content:'world'}],swiper_family:'javascript',swiper_name:'baidu.me'}第三步获取页面里面的内容,用js解析代码如下://获取标题对应的html标签title:'hello',content:'world',swiper_family:'javascript',swiper_name:'baidu.me'}。

js 抓取网页内容(3.详细代码(1)基础内容分析本次使用的是vscode演示)

网站优化 • 优采云 发表了文章 • 0 个评论 • 261 次浏览 • 2021-10-11 05:37

1.前言

最近由于公司项目开发需要,研究了一段时间chrome扩展开发。使用chrome扩展开发的好处是学习门槛很低,主要使用js、css、html。最常用的三个前端的东西,除了研究chrome提供的界面,还可以用。开发起来非常方便。但是,也有缺点。开发的控件只能在部分使用 webkit 的浏览器中使用。(chrome的内核正是Chromium引擎。它使用苹果的WebKit作为浏览器内核原型,也就是WebKit内核的一个分支)***

一般来说,只要有前端开发经验,花一天时间阅读文档,就可以快速上手chrome扩展。这是帖子文档的链接:

360文档 360文档其实就是chrome文档的翻译版,一模一样,只是有些年头了,里面可能没有更新的内容。Chrome 官方文档 这是官方文档。提供各种界面演示,但您需要克服障碍并具有良好的英语水平。2.实现内容

这主要是通过从一个 网站 抓取所需的数据并将其放在另一个页面上来实现的。需要对chrome扩展api和结构有一定的了解。如果你不知道,先去文档学习。

3.详细代码(1)基本内容分析

这次使用了vs code开发工具演示,首先来看一下结构图

左边的是目录结构。我在这里详细说一下:

第一个是在图像文件夹下。放置图标文件,最好在 19 像素左右。如果它们太大,它们将被压缩。

然后是js文件夹,里面的文件是主要实现功能的文件:

1.background.js 是一个常驻页面。它的生命周期是插件所有类型页面中最长的。它在浏览器打开时打开,在浏览器关闭时关闭,所以一般需要一直运行的全局代码,启动时运行,全局代码放在后台,一般也是一个文件用于数据交互。

2.content-script.js 这个文件其实就是我们插入打开页面的js代码。它与打开的页面共享相同的DOM,但与页面的js隔离,不能相互调用。每次打开页面时,都会生成并运行一个 content-script.js。

3.jquery.js (非必须) 这个看个人喜好,方便以后写代码。

4.popuop.js 这是我们运行的扩展的js文件,它只能控制扩展。

接下来是 manifest.json。这个文件是整个程序的配置文件。这是非常重要的。这是下面的图片。

"姓名": "XXXXXXX",

"版本": "XXXXXXX",

"Manifest_version": 2,

这些字段是必需的。请注意, manifest_version 值必须为 2。

描述:是程序的描述。

browser_action:这里使用浏览器,也可以使用page、app等。里面的属性对应图片地址提示信息扩展程序的显示页面。

后台:如上所述,是程序驻留在后台的代码。

content_script:matches 表示匹配的地址是指所有,js是指注入页面的js文件。

最后是里面的扩展程序的popup.html显示页面。

还不明白的朋友,这里调整一下,解释manifest.json的属性

(2)代码实现

现在您了解了结构,下一步是开始开发。

一、文件配置:manifest.json

{

"name": "Copy Data Extension",

"manifest_version": 2,

"version": "1.0",

"description": "The extension for copy data.",

"browser_action": {

"default_icon": "image/showpicture.png",

"default_title": "Copy Data",

"default_popup": "popup.html"

},

"background": {

"scripts": ["js/background.js"]

},

"content_scripts": [

{

"matches": [ "" ],

"js": [ "js/jquery-1.12.4.min.js", "js/content-script.js" ]

}

]

}

这里没什么特别的,正常配置,上面已经解释过了。

扩展页面:popup.html

button {width:100px;}

button ~ button {margin-top:10px;}

Copy

Paste

这里引用了需要的js文件,两个按钮用来操作抓包和放置数据。

这个文件决定了我们的程序是什么样的:

后台页面:background.js

window.data = null;

只需提供一段数据供公众使用。

由于数据抓取和放置比较繁琐,我们拆解说明,最后有合并的代码

数据捕获:popuo.js && content-script.js

************************** popup.js *****************************

$(function () {

$("#btnCopy").click(function () {

// chrome.tabs.query可以通过回调函数获得当前页面的信息tabs

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

// 发送一个copy消息出去

chrome.tabs.sendMessage(tabs[0].id, { action: "copy" }, function (response) {

// 这里的回调函数接收到了要抓取的值,获取值得操作在下方content-script.js

// 将值存在background.js的data属性里面。

var win = chrome.extension.getBackgroundPage();

win.data=response;

console.log(response);

});

});

});

});

************************** content-script.js *****************************

//监听消息

chrome.extension.onMessage.addListener(

function (request, sender, sendResponse) {

if (request.action === "copy") {

//收到copy信息,开始获取当前页面id为sb_form_q的值

var ctrl = $("#sb_form_q");

if (ctrl.length > 0) {

// 如果获取的值不为空则返回数据到popup.js的回调函数

if (sendResponse) sendResponse(ctrl.val());

} else {

alert("No data");

}

}

}

);

以上是抓取部分,可以获取需要的数据并保存。不好理解的也有注释,基本都能看懂。

将数据放在另一个页面上:popuo.js && content-script.js

************************** popup.js *****************************

$(function () {

$("#btnPaste").click(function () {

// 将之前抓取到的并保存的data数据从background.js取出

var win = chrome.extension.getBackgroundPage();

if (win.data) {

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

// 将之前抓取的数据发送

chrome.tabs.sendMessage(tabs[0].id, { action: "paste", data: win.data }, function (response) {

console.log(response);

});

});

}

});

});

************************** content-script.js *****************************

chrome.extension.onMessage.addListener(

function (request, sender, sendResponse) {

if (request.action === "paste") {

// 收到paste消息和之前抓取的值

var ctrl = $("#input");

if (ctrl.length > 0) {

// 将值放入目标网页的id为input的输入框中

ctrl.val(request.data);

sendResponse("OK");

} else {

alert("No data");

}

}

}

);

其实放数据就是抓起来翻过来,然后放整体代码。

弹出窗口.js

$(function () {

$("#btnCopy").click(function () {

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

chrome.tabs.sendMessage(tabs[0].id, { action: "copy" }, function (response) {

var win = chrome.extension.getBackgroundPage();

win.data=response;

console.log(response);

});

});

});

$("#btnPaste").click(function () {

var win = chrome.extension.getBackgroundPage();

if (win.data) {

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

chrome.tabs.sendMessage(tabs[0].id, { action: "paste", data: win.data }, function (response) {

console.log(response);

});

});

}

});

});

内容脚本.js

chrome.extension.onMessage.addListener(

function (request, sender, sendResponse) {

if (request.action === "copy") {

var ctrl = $("#sb_form_q");

if (ctrl.length > 0) {

if (sendResponse) sendResponse(ctrl.val());

} else {

alert("No data");

}

} else if (request.action === "paste") {

var ctrl = $("#input");

if (ctrl.length > 0) {

ctrl.val(request.data);

sendResponse("OK");

} else {

alert("No data");

}

}

}

);

4.添加到chrome和效果演示

经过上面的代码,功能就完成了。接下来,将扩展添加到 chrome 并显示效果。

添加到 chrome 将所有文件放在文件夹中。打开谷歌浏览器,在地址栏输入 chrome://extensions/ 勾选开发者模式,点击加载解压后的扩展程序选择文件夹

使用控件

我们控件获取数据的URL是微软必应搜索,放置数据的URL是360搜索

想要抓取或放置其他网址的,只需将用于获取数据或赋值的代码部分的id替换为您需要抓取或放置页面输入的id即可。

1.首先在爬取网址(微软必应搜索)的目标输入框中输入点数据,点击右上角添加的扩展名,选择复制。

2. 然后找到展示位置网页(360搜索),点击粘贴,我们的数据就会自动上传。

写在最后

chrome加载扩展时,有时可能会出现bug。如果你是小伙伴,写完代码后功能无法实现。. 你可以尝试打开扩展页面Ctrl+R(重新加载),同时刷新你的抓取页面和展示位置页面,会有效果!! 查看全部

js 抓取网页内容(3.详细代码(1)基础内容分析本次使用的是vscode演示)

1.前言

最近由于公司项目开发需要,研究了一段时间chrome扩展开发。使用chrome扩展开发的好处是学习门槛很低,主要使用js、css、html。最常用的三个前端的东西,除了研究chrome提供的界面,还可以用。开发起来非常方便。但是,也有缺点。开发的控件只能在部分使用 webkit 的浏览器中使用。(chrome的内核正是Chromium引擎。它使用苹果的WebKit作为浏览器内核原型,也就是WebKit内核的一个分支)***

一般来说,只要有前端开发经验,花一天时间阅读文档,就可以快速上手chrome扩展。这是帖子文档的链接:

360文档 360文档其实就是chrome文档的翻译版,一模一样,只是有些年头了,里面可能没有更新的内容。Chrome 官方文档 这是官方文档。提供各种界面演示,但您需要克服障碍并具有良好的英语水平。2.实现内容

这主要是通过从一个 网站 抓取所需的数据并将其放在另一个页面上来实现的。需要对chrome扩展api和结构有一定的了解。如果你不知道,先去文档学习。

3.详细代码(1)基本内容分析

这次使用了vs code开发工具演示,首先来看一下结构图

左边的是目录结构。我在这里详细说一下:

第一个是在图像文件夹下。放置图标文件,最好在 19 像素左右。如果它们太大,它们将被压缩。

然后是js文件夹,里面的文件是主要实现功能的文件:

1.background.js 是一个常驻页面。它的生命周期是插件所有类型页面中最长的。它在浏览器打开时打开,在浏览器关闭时关闭,所以一般需要一直运行的全局代码,启动时运行,全局代码放在后台,一般也是一个文件用于数据交互。

2.content-script.js 这个文件其实就是我们插入打开页面的js代码。它与打开的页面共享相同的DOM,但与页面的js隔离,不能相互调用。每次打开页面时,都会生成并运行一个 content-script.js。

3.jquery.js (非必须) 这个看个人喜好,方便以后写代码。

4.popuop.js 这是我们运行的扩展的js文件,它只能控制扩展。

接下来是 manifest.json。这个文件是整个程序的配置文件。这是非常重要的。这是下面的图片。

"姓名": "XXXXXXX",

"版本": "XXXXXXX",

"Manifest_version": 2,

这些字段是必需的。请注意, manifest_version 值必须为 2。

描述:是程序的描述。

browser_action:这里使用浏览器,也可以使用page、app等。里面的属性对应图片地址提示信息扩展程序的显示页面。

后台:如上所述,是程序驻留在后台的代码。

content_script:matches 表示匹配的地址是指所有,js是指注入页面的js文件。

最后是里面的扩展程序的popup.html显示页面。

还不明白的朋友,这里调整一下,解释manifest.json的属性

(2)代码实现

现在您了解了结构,下一步是开始开发。

一、文件配置:manifest.json

{

"name": "Copy Data Extension",

"manifest_version": 2,

"version": "1.0",

"description": "The extension for copy data.",

"browser_action": {

"default_icon": "image/showpicture.png",

"default_title": "Copy Data",

"default_popup": "popup.html"

},

"background": {

"scripts": ["js/background.js"]

},

"content_scripts": [

{

"matches": [ "" ],

"js": [ "js/jquery-1.12.4.min.js", "js/content-script.js" ]

}

]

}

这里没什么特别的,正常配置,上面已经解释过了。

扩展页面:popup.html

button {width:100px;}

button ~ button {margin-top:10px;}

Copy

Paste

这里引用了需要的js文件,两个按钮用来操作抓包和放置数据。

这个文件决定了我们的程序是什么样的:

后台页面:background.js

window.data = null;

只需提供一段数据供公众使用。

由于数据抓取和放置比较繁琐,我们拆解说明,最后有合并的代码

数据捕获:popuo.js && content-script.js

************************** popup.js *****************************

$(function () {

$("#btnCopy").click(function () {

// chrome.tabs.query可以通过回调函数获得当前页面的信息tabs

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

// 发送一个copy消息出去

chrome.tabs.sendMessage(tabs[0].id, { action: "copy" }, function (response) {

// 这里的回调函数接收到了要抓取的值,获取值得操作在下方content-script.js

// 将值存在background.js的data属性里面。

var win = chrome.extension.getBackgroundPage();

win.data=response;

console.log(response);

});

});

});

});

************************** content-script.js *****************************

//监听消息

chrome.extension.onMessage.addListener(

function (request, sender, sendResponse) {

if (request.action === "copy") {

//收到copy信息,开始获取当前页面id为sb_form_q的值

var ctrl = $("#sb_form_q");

if (ctrl.length > 0) {

// 如果获取的值不为空则返回数据到popup.js的回调函数

if (sendResponse) sendResponse(ctrl.val());

} else {

alert("No data");

}

}

}

);

以上是抓取部分,可以获取需要的数据并保存。不好理解的也有注释,基本都能看懂。

将数据放在另一个页面上:popuo.js && content-script.js

************************** popup.js *****************************

$(function () {

$("#btnPaste").click(function () {

// 将之前抓取到的并保存的data数据从background.js取出

var win = chrome.extension.getBackgroundPage();

if (win.data) {

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

// 将之前抓取的数据发送

chrome.tabs.sendMessage(tabs[0].id, { action: "paste", data: win.data }, function (response) {

console.log(response);

});

});

}

});

});

************************** content-script.js *****************************

chrome.extension.onMessage.addListener(

function (request, sender, sendResponse) {

if (request.action === "paste") {

// 收到paste消息和之前抓取的值

var ctrl = $("#input");

if (ctrl.length > 0) {

// 将值放入目标网页的id为input的输入框中

ctrl.val(request.data);

sendResponse("OK");

} else {

alert("No data");

}

}

}

);

其实放数据就是抓起来翻过来,然后放整体代码。

弹出窗口.js

$(function () {

$("#btnCopy").click(function () {

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

chrome.tabs.sendMessage(tabs[0].id, { action: "copy" }, function (response) {

var win = chrome.extension.getBackgroundPage();

win.data=response;

console.log(response);

});

});

});

$("#btnPaste").click(function () {

var win = chrome.extension.getBackgroundPage();

if (win.data) {

chrome.tabs.query({ active: true, currentWindow: true }, function (tabs) {

chrome.tabs.sendMessage(tabs[0].id, { action: "paste", data: win.data }, function (response) {

console.log(response);

});

});

}

});

});

内容脚本.js

chrome.extension.onMessage.addListener(

function (request, sender, sendResponse) {

if (request.action === "copy") {

var ctrl = $("#sb_form_q");

if (ctrl.length > 0) {

if (sendResponse) sendResponse(ctrl.val());

} else {

alert("No data");

}

} else if (request.action === "paste") {

var ctrl = $("#input");

if (ctrl.length > 0) {

ctrl.val(request.data);

sendResponse("OK");

} else {

alert("No data");

}

}

}

);

4.添加到chrome和效果演示

经过上面的代码,功能就完成了。接下来,将扩展添加到 chrome 并显示效果。

添加到 chrome 将所有文件放在文件夹中。打开谷歌浏览器,在地址栏输入 chrome://extensions/ 勾选开发者模式,点击加载解压后的扩展程序选择文件夹

使用控件

我们控件获取数据的URL是微软必应搜索,放置数据的URL是360搜索

想要抓取或放置其他网址的,只需将用于获取数据或赋值的代码部分的id替换为您需要抓取或放置页面输入的id即可。

1.首先在爬取网址(微软必应搜索)的目标输入框中输入点数据,点击右上角添加的扩展名,选择复制。

2. 然后找到展示位置网页(360搜索),点击粘贴,我们的数据就会自动上传。

写在最后

chrome加载扩展时,有时可能会出现bug。如果你是小伙伴,写完代码后功能无法实现。. 你可以尝试打开扩展页面Ctrl+R(重新加载),同时刷新你的抓取页面和展示位置页面,会有效果!!

js 抓取网页内容(谷歌能DOM是如何抓取JavaScript的?Google不能处理JavaScript)

网站优化 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-10-11 03:14

我们测试了 Google 爬虫如何抓取 JavaScript,这是我们从中学到的东西。认为谷歌不能

我们测试了 Google 爬虫如何抓取 JavaScript,这是我们从中学到的东西。

认为 Google 无法处理 JavaScript?再想想。Audette Audette 分享了一系列测试结果。他和他的同事测试了 Google 和 收录 会抓取哪些类型的 JavaScript 函数。

长话短说

1. 我们进行了一系列测试,并确认谷歌可以以多种方式执行和收录 JavaScript。我们还确认了 Google 可以渲染整个页面并读取 DOM,从而可以收录 动态生成内容。

2. DOM 中的 SEO 信号(页面标题、元描述、规范标签、元机器人标签等)都受到关注。动态插入到DOM中的内容也可以被爬取和收录。此外,在某些情况下,DOM 甚至可能优先于 HTML 源代码语句。虽然这需要更多的工作,但这是我们的几个测试之一。

简介:Google 执行 JavaScript 并读取 DOM

早在 2008 年,Google 就成功抓取了 JavaScript,但很可能仅限于某种方式。

今天,很明显,Google 不仅可以制定自己的抓取和 收录 JavaScript 类型,而且在渲染整个网页方面也取得了重大进展(尤其是最近 12 到 18 个月)。

在 Merkle,我们的 SEO 技术团队希望更好地了解 Google 爬虫可以抓取哪些类型的 JavaScript 事件和 收录。经过研究,我们发现了惊人的结果,并确认 Google 不仅可以执行各种 JavaScript 事件,还可以动态生成收录 内容。怎么做?Google 可以读取 DOM。

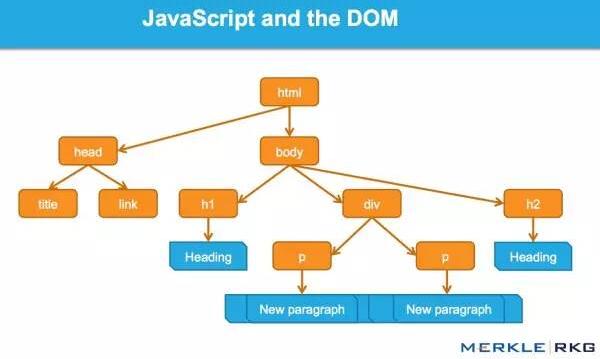

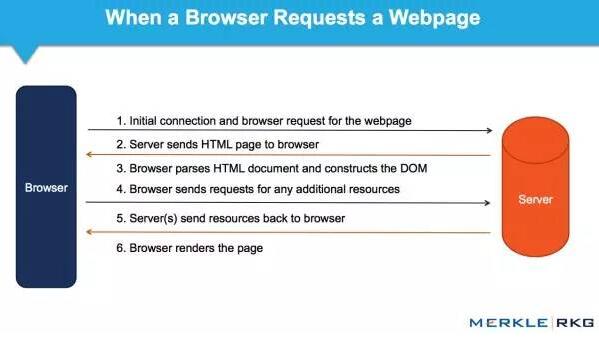

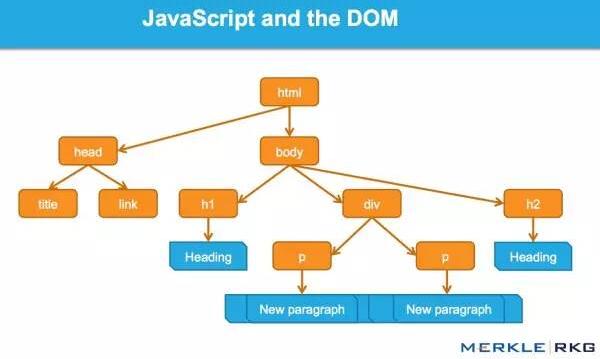

什么是DOM?

很多从事SEO的人不了解什么是文档对象模型(DOM)。

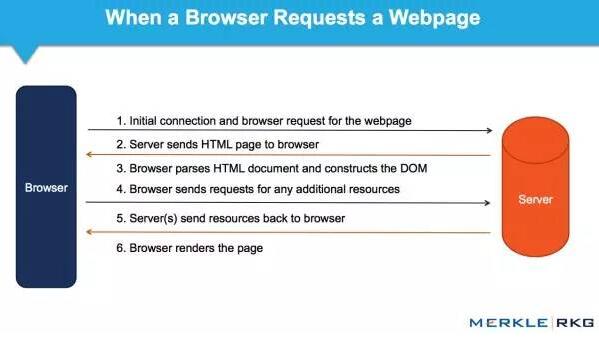

当浏览器请求一个页面时会发生什么,DOM 是如何参与的?

在 Web 浏览器中使用时,DOM 本质上是一个应用程序接口或 API,用于标记和构建数据(例如 HTML 和 XML)。该接口允许 Web 浏览器将它们组合成一个文档。

DOM 还定义了如何获取和操作结构。尽管 DOM 是一种独立于语言的 API(不依赖于特定的编程语言或库),但它通常用于 Web 应用程序中的 JavaScript 和动态内容。

DOM 代表接口或“桥”,将网页与编程语言连接起来。解析 HTML 并执行 JavaScript 的结果就是 DOM。网页的内容不仅(不仅)是源代码,而且是 DOM。这使它变得非常重要。

JavaScript 如何通过 DOM 接口工作。

我们很高兴地发现 Google 可以读取 DOM,并且可以解析信号和动态插入的内容,例如标题标签、页面文本、标题标签和元注释(例如:rel = canonical)。您可以阅读完整的详细信息。

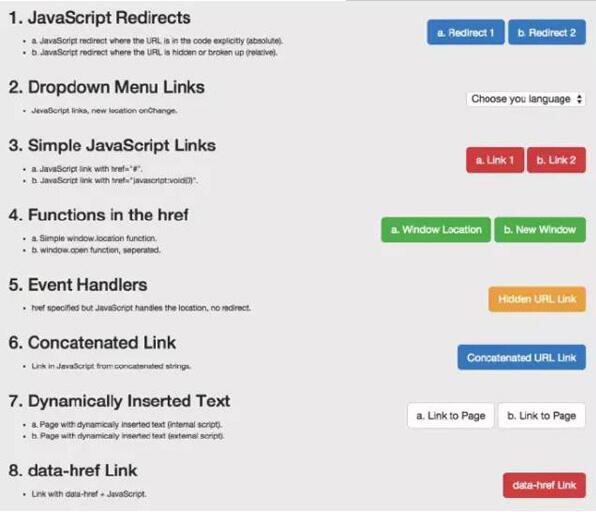

这一系列的测试和结果

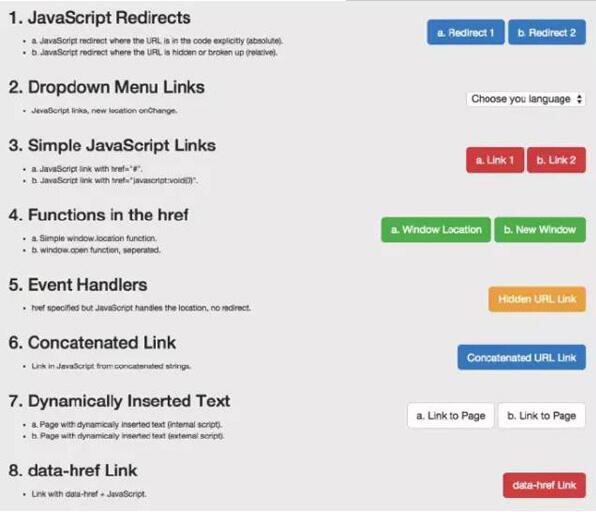

因为想知道会爬取哪些JavaScript特性和收录,所以分别在谷歌爬虫上创建了一系列测试。通过创建控件,确保可以独立理解 URL 活动。下面,让我们详细介绍一些有趣的测试结果。它们分为5类:

1、JavaScript 重定向2、JavaScript 链接3、动态插入内容4、动态插入元数据和页面元素5、rel = "nofollow" 的一个重要例子

示例:用于测试 Google 抓取工具理解 JavaScript 能力的页面。

1. JavaScript 重定向

我们首先测试了常见的 JavaScript 重定向。URL 以不同方式表达的结果是什么?我们为两个测试选择了 window.location 对象:测试 A 使用绝对路径 URL 调用 window.location,测试 B 使用它。相对路径。

结果:重定向很快就被谷歌跟踪了。从收录的角度来看,它们被解释为301——最终状态URL,而不是谷歌收录中的重定向URL。

在随后的测试中,我们在权威网页上使用完全相同的内容来完成使用 JavaScript 重定向到同一站点的新页面。原创网址在 Google 热门查询的主页上排名。

结果:果然,重定向被谷歌跟踪了,但是原创页面不是收录。新的URL是收录,它立即在同一个查询页面的同一个位置上排名。这让我们感到惊讶。从排名的角度来看,JavaScript 重定向行为(有时)与永久性 301 重定向非常相似。

下次,您的客户想要为他们的 网站 完成 JavaScript 重定向动作,您可能不需要回答,或者回答:“请不要”。因为这好像有转职排名信号的关系。引用谷歌指南支持这一结论:

使用 JavaScript 重定向用户可能是一种合法的做法。例如,如果您将登录用户重定向到内部页面,则可以使用 JavaScript 来完成此操作。在仔细检查 JavaScript 或其他重定向方法时,请确保您的网站遵循我们的指南并考虑其意图。请记住,将 301 重定向重定向到您的 网站 是最好的,但如果您没有访问您的 网站 服务器的权限,您可以为此使用 JavaScript 重定向。

2. JavaScript 链接 我们用各种编码方法测试了不同类型的 JS 链接。

我们测试下拉菜单的链接。历史搜索引擎一直无法跟踪这种类型的链接。我们要确定是否会跟踪 onchange 事件处理程序。重要的是,这只是一种特定的执行类型,而我们需要的是:其他变化的影响,而不是像上面JavaScript重定向的强制操作。

示例:Google Work 页面上的语言选择下拉菜单。

结果:链接被完全抓取和跟踪。

我们还测试了常见的 JavaScript 链接。以下是最常见的 JavaScript 链接类型,而传统 SEO 推荐纯文本。这些测试包括 JavaScript 链接代码:

作用于外部 href 键值对 (AVP),但在标签内(“onClick”)

使用 href 内部 AVP("javascript: window.location")

在 a 标签之外执行,但在 href 中调用 AVP("javascript: openlink()")

还有很多

结果:链接被完全抓取和跟踪。

我们接下来的测试是进一步测试事件处理程序,比如上面的onchange测试。具体来说,我们要使用鼠标移动的事件处理程序,然后隐藏 URL 变量,该变量仅在事件处理程序函数(在本例中为 onmousedown 和 onmouseout)被触发时执行。

结果:链接被完全抓取和跟踪。

构造链接:我们知道谷歌可以执行JavaScript,但我们想确认他们是否可以读取代码中的变量。所以在这个测试中,我们连接可以构造 URL 字符串的字符。结果:链接被完全抓取和跟踪。

3. 动态插入内容

显然,这些是要点:动态插入文本、图像、链接和导航。高质量的文本内容对于搜索引擎理解网页的主题和内容至关重要。在这个充满活力的网站时代,它的重要性毋庸置疑。

这些测试旨在检查在两种不同场景中动态插入文本的结果。

1)。测试搜索引擎是否可以统计动态插入的文本,文本来自页面的HTML源代码。2)。测试搜索引擎是否可以统计动态插入的文本,并且文本来自页面的HTML源代码之外(在外部JavaScript文件中)。

结果:两种情况下都可以抓取文本和收录,页面根据内容排名。凉爽的!

为了深入了解,我们测试了一个用JavaScript编写的客户端全局导航,导航中的链接是通过document.writeIn函数插入的,确认可以完全爬取和跟踪。需要指出的是,Google 可以解释网站 使用AngularJS 框架和HTML5 History API (pushState) 构建,可以渲染和收录 它,并且可以像传统静态网页一样进行排名。这就是不禁止 Google 爬虫获取外部文件和 JavaScript 的重要性,这可能也是 Google 将其从 Ajax Supporting SEO Guide 中删除的原因。当您可以简单地呈现整个页面时,谁需要 HTML 快照?

经过测试,发现无论是什么类型的内容,结果都是一样的。比如图片加载到DOM后,会被抓取并收录。我们甚至做了这样的测试:通过动态生成结构数据来制作面包屑(breadcrumb navigation),并插入到DOM中。结果?成功插入后的面包屑出现在搜索结果中(搜索引擎结果页面)。

值得注意的是,Google 现在推荐使用 JSON-LD 标签来形成结构化数据。我相信未来会有更多基于此的东西。

4. 动态插入元数据和页面元素

我们动态地将各种对 SEO 至关重要的标签插入到 DOM 中:

标题元素元描述元机器人规范标签

结果:在所有情况下,标签都可以被抓取并表现得像 HTML 源代码中的元素。

一个有趣的补充实验可以帮助我们理解优先级的顺序。当出现相互矛盾的信号时,哪一个会获胜?如果源代码中没有index,nofollow标签,DOM中没有index,follow标签,会发生什么?在这个协议中,HTTP x-robots 响应头如何作为另一个变量使用行为?这将是未来全面测试的一部分。但是,我们的测试表明,当发生冲突时,Google 会忽略源代码中的标签并支持 DOM。

5. rel="nofollow" 的一个重要例子

我们想测试谷歌如何响应出现在源代码和 DOM 链接级别的 nofollow 属性。我们还创建了一个没有 nofollow 的控件。

对于nofollow,我们分别测试了源代码和DOM生成的注解。

源代码中的 nofollow 按预期工作(不跟踪链接)。但是DOM中的nofollow无效(链接被跟踪,页面为收录)。为什么?因为修改 DOM 中 href 元素的操作发生得太晚了:谷歌在执行添加 rel="nofollow" 的 JavaScript 函数之前,已经准备好抓取链接并排队等待 URL。但是,如果将带有 href="nofollow" 的 a 元素插入到 DOM 中,nofollow 和链接将被跟踪,因为它们是同时插入的。

结果

从历史的角度来看,各种 SEO 建议都尽可能关注“纯文本”内容。动态生成的内容、AJAX 和 JavaScript 链接会损害主流搜索引擎的 SEO。显然,这对谷歌来说不再是问题。JavaScript 链接的操作方式类似于普通的 HTML 链接(这只是表面,我们不知道程序在幕后做了什么)。JavaScript 重定向的处理方式与 301 重定向类似。

动态插入的内容,即使是元标记,例如 rel 规范注释,无论是在 HTML 源代码中,还是在解析初始 HTML 后触发 JavaScript 生成 DOM,都以相同的方式处理。

Google 依赖于完全呈现页面和理解 DOM,而不仅仅是源代码。太不可思议了!(请记住允许 Google 爬虫获取这些外部文件和 JavaScript。)

谷歌已经以惊人的速度在创新方面将其他搜索引擎甩在了后面。我们希望在其他搜索引擎中看到相同类型的创新。如果他们要在新的网络时代保持竞争力并取得实质性进展,就意味着他们必须更好地支持 HTML5、JavaScript 和动态网站。

对于SEO,不了解上述基本概念和谷歌技术的人应该学习学习,以追赶当前的技术。如果你不考虑 DOM,你可能会失去一半的份额。

并非本文所表达的所有观点均由 Search Engine Land(搜索引擎 网站)提供,部分观点由客座作者提供。所有作者的名单。 查看全部

js 抓取网页内容(谷歌能DOM是如何抓取JavaScript的?Google不能处理JavaScript)

我们测试了 Google 爬虫如何抓取 JavaScript,这是我们从中学到的东西。认为谷歌不能

我们测试了 Google 爬虫如何抓取 JavaScript,这是我们从中学到的东西。

认为 Google 无法处理 JavaScript?再想想。Audette Audette 分享了一系列测试结果。他和他的同事测试了 Google 和 收录 会抓取哪些类型的 JavaScript 函数。

长话短说

1. 我们进行了一系列测试,并确认谷歌可以以多种方式执行和收录 JavaScript。我们还确认了 Google 可以渲染整个页面并读取 DOM,从而可以收录 动态生成内容。

2. DOM 中的 SEO 信号(页面标题、元描述、规范标签、元机器人标签等)都受到关注。动态插入到DOM中的内容也可以被爬取和收录。此外,在某些情况下,DOM 甚至可能优先于 HTML 源代码语句。虽然这需要更多的工作,但这是我们的几个测试之一。

简介:Google 执行 JavaScript 并读取 DOM

早在 2008 年,Google 就成功抓取了 JavaScript,但很可能仅限于某种方式。

今天,很明显,Google 不仅可以制定自己的抓取和 收录 JavaScript 类型,而且在渲染整个网页方面也取得了重大进展(尤其是最近 12 到 18 个月)。

在 Merkle,我们的 SEO 技术团队希望更好地了解 Google 爬虫可以抓取哪些类型的 JavaScript 事件和 收录。经过研究,我们发现了惊人的结果,并确认 Google 不仅可以执行各种 JavaScript 事件,还可以动态生成收录 内容。怎么做?Google 可以读取 DOM。

什么是DOM?

很多从事SEO的人不了解什么是文档对象模型(DOM)。

当浏览器请求一个页面时会发生什么,DOM 是如何参与的?

在 Web 浏览器中使用时,DOM 本质上是一个应用程序接口或 API,用于标记和构建数据(例如 HTML 和 XML)。该接口允许 Web 浏览器将它们组合成一个文档。

DOM 还定义了如何获取和操作结构。尽管 DOM 是一种独立于语言的 API(不依赖于特定的编程语言或库),但它通常用于 Web 应用程序中的 JavaScript 和动态内容。

DOM 代表接口或“桥”,将网页与编程语言连接起来。解析 HTML 并执行 JavaScript 的结果就是 DOM。网页的内容不仅(不仅)是源代码,而且是 DOM。这使它变得非常重要。

JavaScript 如何通过 DOM 接口工作。

我们很高兴地发现 Google 可以读取 DOM,并且可以解析信号和动态插入的内容,例如标题标签、页面文本、标题标签和元注释(例如:rel = canonical)。您可以阅读完整的详细信息。

这一系列的测试和结果

因为想知道会爬取哪些JavaScript特性和收录,所以分别在谷歌爬虫上创建了一系列测试。通过创建控件,确保可以独立理解 URL 活动。下面,让我们详细介绍一些有趣的测试结果。它们分为5类:

1、JavaScript 重定向2、JavaScript 链接3、动态插入内容4、动态插入元数据和页面元素5、rel = "nofollow" 的一个重要例子

示例:用于测试 Google 抓取工具理解 JavaScript 能力的页面。

1. JavaScript 重定向

我们首先测试了常见的 JavaScript 重定向。URL 以不同方式表达的结果是什么?我们为两个测试选择了 window.location 对象:测试 A 使用绝对路径 URL 调用 window.location,测试 B 使用它。相对路径。

结果:重定向很快就被谷歌跟踪了。从收录的角度来看,它们被解释为301——最终状态URL,而不是谷歌收录中的重定向URL。

在随后的测试中,我们在权威网页上使用完全相同的内容来完成使用 JavaScript 重定向到同一站点的新页面。原创网址在 Google 热门查询的主页上排名。

结果:果然,重定向被谷歌跟踪了,但是原创页面不是收录。新的URL是收录,它立即在同一个查询页面的同一个位置上排名。这让我们感到惊讶。从排名的角度来看,JavaScript 重定向行为(有时)与永久性 301 重定向非常相似。

下次,您的客户想要为他们的 网站 完成 JavaScript 重定向动作,您可能不需要回答,或者回答:“请不要”。因为这好像有转职排名信号的关系。引用谷歌指南支持这一结论:

使用 JavaScript 重定向用户可能是一种合法的做法。例如,如果您将登录用户重定向到内部页面,则可以使用 JavaScript 来完成此操作。在仔细检查 JavaScript 或其他重定向方法时,请确保您的网站遵循我们的指南并考虑其意图。请记住,将 301 重定向重定向到您的 网站 是最好的,但如果您没有访问您的 网站 服务器的权限,您可以为此使用 JavaScript 重定向。

2. JavaScript 链接 我们用各种编码方法测试了不同类型的 JS 链接。

我们测试下拉菜单的链接。历史搜索引擎一直无法跟踪这种类型的链接。我们要确定是否会跟踪 onchange 事件处理程序。重要的是,这只是一种特定的执行类型,而我们需要的是:其他变化的影响,而不是像上面JavaScript重定向的强制操作。

示例:Google Work 页面上的语言选择下拉菜单。

结果:链接被完全抓取和跟踪。

我们还测试了常见的 JavaScript 链接。以下是最常见的 JavaScript 链接类型,而传统 SEO 推荐纯文本。这些测试包括 JavaScript 链接代码:

作用于外部 href 键值对 (AVP),但在标签内(“onClick”)

使用 href 内部 AVP("javascript: window.location")

在 a 标签之外执行,但在 href 中调用 AVP("javascript: openlink()")

还有很多

结果:链接被完全抓取和跟踪。

我们接下来的测试是进一步测试事件处理程序,比如上面的onchange测试。具体来说,我们要使用鼠标移动的事件处理程序,然后隐藏 URL 变量,该变量仅在事件处理程序函数(在本例中为 onmousedown 和 onmouseout)被触发时执行。

结果:链接被完全抓取和跟踪。

构造链接:我们知道谷歌可以执行JavaScript,但我们想确认他们是否可以读取代码中的变量。所以在这个测试中,我们连接可以构造 URL 字符串的字符。结果:链接被完全抓取和跟踪。

3. 动态插入内容

显然,这些是要点:动态插入文本、图像、链接和导航。高质量的文本内容对于搜索引擎理解网页的主题和内容至关重要。在这个充满活力的网站时代,它的重要性毋庸置疑。

这些测试旨在检查在两种不同场景中动态插入文本的结果。

1)。测试搜索引擎是否可以统计动态插入的文本,文本来自页面的HTML源代码。2)。测试搜索引擎是否可以统计动态插入的文本,并且文本来自页面的HTML源代码之外(在外部JavaScript文件中)。

结果:两种情况下都可以抓取文本和收录,页面根据内容排名。凉爽的!

为了深入了解,我们测试了一个用JavaScript编写的客户端全局导航,导航中的链接是通过document.writeIn函数插入的,确认可以完全爬取和跟踪。需要指出的是,Google 可以解释网站 使用AngularJS 框架和HTML5 History API (pushState) 构建,可以渲染和收录 它,并且可以像传统静态网页一样进行排名。这就是不禁止 Google 爬虫获取外部文件和 JavaScript 的重要性,这可能也是 Google 将其从 Ajax Supporting SEO Guide 中删除的原因。当您可以简单地呈现整个页面时,谁需要 HTML 快照?

经过测试,发现无论是什么类型的内容,结果都是一样的。比如图片加载到DOM后,会被抓取并收录。我们甚至做了这样的测试:通过动态生成结构数据来制作面包屑(breadcrumb navigation),并插入到DOM中。结果?成功插入后的面包屑出现在搜索结果中(搜索引擎结果页面)。

值得注意的是,Google 现在推荐使用 JSON-LD 标签来形成结构化数据。我相信未来会有更多基于此的东西。

4. 动态插入元数据和页面元素

我们动态地将各种对 SEO 至关重要的标签插入到 DOM 中:

标题元素元描述元机器人规范标签

结果:在所有情况下,标签都可以被抓取并表现得像 HTML 源代码中的元素。

一个有趣的补充实验可以帮助我们理解优先级的顺序。当出现相互矛盾的信号时,哪一个会获胜?如果源代码中没有index,nofollow标签,DOM中没有index,follow标签,会发生什么?在这个协议中,HTTP x-robots 响应头如何作为另一个变量使用行为?这将是未来全面测试的一部分。但是,我们的测试表明,当发生冲突时,Google 会忽略源代码中的标签并支持 DOM。

5. rel="nofollow" 的一个重要例子

我们想测试谷歌如何响应出现在源代码和 DOM 链接级别的 nofollow 属性。我们还创建了一个没有 nofollow 的控件。

对于nofollow,我们分别测试了源代码和DOM生成的注解。

源代码中的 nofollow 按预期工作(不跟踪链接)。但是DOM中的nofollow无效(链接被跟踪,页面为收录)。为什么?因为修改 DOM 中 href 元素的操作发生得太晚了:谷歌在执行添加 rel="nofollow" 的 JavaScript 函数之前,已经准备好抓取链接并排队等待 URL。但是,如果将带有 href="nofollow" 的 a 元素插入到 DOM 中,nofollow 和链接将被跟踪,因为它们是同时插入的。

结果

从历史的角度来看,各种 SEO 建议都尽可能关注“纯文本”内容。动态生成的内容、AJAX 和 JavaScript 链接会损害主流搜索引擎的 SEO。显然,这对谷歌来说不再是问题。JavaScript 链接的操作方式类似于普通的 HTML 链接(这只是表面,我们不知道程序在幕后做了什么)。JavaScript 重定向的处理方式与 301 重定向类似。

动态插入的内容,即使是元标记,例如 rel 规范注释,无论是在 HTML 源代码中,还是在解析初始 HTML 后触发 JavaScript 生成 DOM,都以相同的方式处理。

Google 依赖于完全呈现页面和理解 DOM,而不仅仅是源代码。太不可思议了!(请记住允许 Google 爬虫获取这些外部文件和 JavaScript。)

谷歌已经以惊人的速度在创新方面将其他搜索引擎甩在了后面。我们希望在其他搜索引擎中看到相同类型的创新。如果他们要在新的网络时代保持竞争力并取得实质性进展,就意味着他们必须更好地支持 HTML5、JavaScript 和动态网站。

对于SEO,不了解上述基本概念和谷歌技术的人应该学习学习,以追赶当前的技术。如果你不考虑 DOM,你可能会失去一半的份额。

并非本文所表达的所有观点均由 Search Engine Land(搜索引擎 网站)提供,部分观点由客座作者提供。所有作者的名单。

js 抓取网页内容(在这篇文章中,我们将学习使用浏览器自动化和JavaScript来网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-10-08 15:45

在这个文章中,我们将学习使用浏览器自动化和JavaScript来抓取网页。我们将使用 puppeteer。

Puppeteer 是一个节点库 API,允许我们控制无头 Chrome。Headless Chrome 是一种无需实际运行 Chrome 即可运行 Chrome 浏览器的方法。

如何进行

一般来说,网络爬虫分为“通过HTTP请求获取数据”和“通过解析HTML DOM提取重要数据”两部分

库和工具

“傀儡师”和“Nodejs”

我们想要捕捉的

我们将通过这个网站提供Scrape Book的价格和标题。这是一家专门为帮助人们练习刮痧而设立的书店。

设置

我们的设置非常简单。只需创建一个文件夹并安装 puppeteer。要创建文件夹并安装库,请键入以下命令。我假设你已经安装了 Node.js。

现在,在该文件夹中创建一个您喜欢的任何名称的文件。我用的名字是scraping.js

准备食物

现在,在 scraping.js 中插入以下样板代码

让我们逐行浏览此示例。第 1 行:我们需要之前安装的 Puppeteer 依赖项;第 3-7 行:这是我们的主要功能抓取。这个函数会保存我们所有的自动化代码;第 9 行:在这里,我们调用了 scrape() 函数(以运行该函数)。

需要注意的重要一点是,我们的 scrape() 函数是一个异步函数,并利用了 ES 2017 新的 async/await 函数。由于该函数是异步的,因此在调用该函数时将返回一个 Promise。当 async 函数最终返回一个值时,Promise 将解析(如果有错误,则拒绝)。

由于我们使用的是 async 函数,我们可以使用 await 表达式,它会暂停函数执行并等待 Promise 解析完成,然后再继续。随着本教程的继续,它会变得更加清晰。

我们可以通过在scrape函数中添加一行代码来测试上面的代码。试试看:

现在 node scrape.js 正在控制台中运行。测试退出!完美,我们返回的值正在记录到控制台。现在我们可以开始填充我们的刮取功能。

第 1 步:设置

我们需要做的第一件事是创建浏览器的实例。打开一个新页面并导航到一个 URL。我们的操作方法如下:

让我们逐行分解:首先,我们创建浏览器并将无头模式设置为 false。这使我们能够准确地观察发生了什么:

然后,我们在浏览器中创建一个新页面:

接下来,我们转到 URL:

(可选)我添加了 1,000 毫秒的延迟。虽然通常没有必要,但这将确保页面上的所有内容都已加载:

最后,当一切都完成后,我们将关闭浏览器并返回

设置完成。现在,让我们开始刮吧!

第2步:刮

现在您可能对我们将要捕获的内容有所了解。我们将获取一本书的书名及其价格。

查看 Puppeteer API,我们可以找到一种方法,可以让我们从页面中获取 HTML。为了检索这些值,我们将使用 page.evaluate() 方法。这个方法允许我们使用内置的 DOM 选择器,比如 querySelector()。

我们需要做的第一件事是创建 page.evaluate() 函数并将返回值保存到名称 result 中:

在我们的职能范围内,我们可以选择所需的元素。我们将再次使用 Google Developers 工具来解决这个问题。右键单击标题并选择检查:

正如您将在 Elements 面板中看到的,标题只是一个 h1 元素。现在,我们可以使用以下代码选择此元素:

由于我们希望文本收录在此元素中,因此我们需要添加插件 .innerText。最终代码如下:

同样,我们可以通过右键单击并检查元素来选择价格:

如您所见,我们的价格是 price_color。我们可以使用这种类型的选择元素及其内部文本。这是代码:

现在我们有了所需的文本,我们可以将它返回给一个对象:

奇妙!现在,我们选择标题和价格,将其保存到对象中,然后将对象的值返回到结果变量中。放在一起看起来是这样的:

剩下要做的就是返回我们的代码 result 以便它可以记录在控制台中:返回结果。

您的最终代码应如下所示:

现在,您可以通过在控制台中键入以下内容来运行 Node 文件:

如果没有问题,您应该会在屏幕上看到所选书籍的书名和价格。

让它完美

现在,初学者从主页本身爬取所有书名变得更加困难。但是,这为您提供了一个练习新爬行技能的绝佳机会!

提示:这个挑战和前面的例子的主要区别是需要遍历的结果数量很多。您可以通过如下设置代码来做到这一点:

最后

在本文中,我们学习了如何使用 Nodejs & Puppeteer 抓取数据。不管网站的类型,我们都可以爬取我们想要的资源。 查看全部

js 抓取网页内容(在这篇文章中,我们将学习使用浏览器自动化和JavaScript来网页)

在这个文章中,我们将学习使用浏览器自动化和JavaScript来抓取网页。我们将使用 puppeteer。

Puppeteer 是一个节点库 API,允许我们控制无头 Chrome。Headless Chrome 是一种无需实际运行 Chrome 即可运行 Chrome 浏览器的方法。

如何进行

一般来说,网络爬虫分为“通过HTTP请求获取数据”和“通过解析HTML DOM提取重要数据”两部分

库和工具

“傀儡师”和“Nodejs”

我们想要捕捉的

我们将通过这个网站提供Scrape Book的价格和标题。这是一家专门为帮助人们练习刮痧而设立的书店。

设置

我们的设置非常简单。只需创建一个文件夹并安装 puppeteer。要创建文件夹并安装库,请键入以下命令。我假设你已经安装了 Node.js。

现在,在该文件夹中创建一个您喜欢的任何名称的文件。我用的名字是scraping.js

准备食物

现在,在 scraping.js 中插入以下样板代码

让我们逐行浏览此示例。第 1 行:我们需要之前安装的 Puppeteer 依赖项;第 3-7 行:这是我们的主要功能抓取。这个函数会保存我们所有的自动化代码;第 9 行:在这里,我们调用了 scrape() 函数(以运行该函数)。

需要注意的重要一点是,我们的 scrape() 函数是一个异步函数,并利用了 ES 2017 新的 async/await 函数。由于该函数是异步的,因此在调用该函数时将返回一个 Promise。当 async 函数最终返回一个值时,Promise 将解析(如果有错误,则拒绝)。

由于我们使用的是 async 函数,我们可以使用 await 表达式,它会暂停函数执行并等待 Promise 解析完成,然后再继续。随着本教程的继续,它会变得更加清晰。

我们可以通过在scrape函数中添加一行代码来测试上面的代码。试试看:

现在 node scrape.js 正在控制台中运行。测试退出!完美,我们返回的值正在记录到控制台。现在我们可以开始填充我们的刮取功能。

第 1 步:设置

我们需要做的第一件事是创建浏览器的实例。打开一个新页面并导航到一个 URL。我们的操作方法如下:

让我们逐行分解:首先,我们创建浏览器并将无头模式设置为 false。这使我们能够准确地观察发生了什么:

然后,我们在浏览器中创建一个新页面:

接下来,我们转到 URL:

(可选)我添加了 1,000 毫秒的延迟。虽然通常没有必要,但这将确保页面上的所有内容都已加载:

最后,当一切都完成后,我们将关闭浏览器并返回

设置完成。现在,让我们开始刮吧!

第2步:刮

现在您可能对我们将要捕获的内容有所了解。我们将获取一本书的书名及其价格。

查看 Puppeteer API,我们可以找到一种方法,可以让我们从页面中获取 HTML。为了检索这些值,我们将使用 page.evaluate() 方法。这个方法允许我们使用内置的 DOM 选择器,比如 querySelector()。

我们需要做的第一件事是创建 page.evaluate() 函数并将返回值保存到名称 result 中:

在我们的职能范围内,我们可以选择所需的元素。我们将再次使用 Google Developers 工具来解决这个问题。右键单击标题并选择检查:

正如您将在 Elements 面板中看到的,标题只是一个 h1 元素。现在,我们可以使用以下代码选择此元素:

由于我们希望文本收录在此元素中,因此我们需要添加插件 .innerText。最终代码如下:

同样,我们可以通过右键单击并检查元素来选择价格:

如您所见,我们的价格是 price_color。我们可以使用这种类型的选择元素及其内部文本。这是代码:

现在我们有了所需的文本,我们可以将它返回给一个对象:

奇妙!现在,我们选择标题和价格,将其保存到对象中,然后将对象的值返回到结果变量中。放在一起看起来是这样的:

剩下要做的就是返回我们的代码 result 以便它可以记录在控制台中:返回结果。

您的最终代码应如下所示:

现在,您可以通过在控制台中键入以下内容来运行 Node 文件:

如果没有问题,您应该会在屏幕上看到所选书籍的书名和价格。

让它完美

现在,初学者从主页本身爬取所有书名变得更加困难。但是,这为您提供了一个练习新爬行技能的绝佳机会!

提示:这个挑战和前面的例子的主要区别是需要遍历的结果数量很多。您可以通过如下设置代码来做到这一点:

最后

在本文中,我们学习了如何使用 Nodejs & Puppeteer 抓取数据。不管网站的类型,我们都可以爬取我们想要的资源。

js 抓取网页内容(抓取时选用它,主要是Selenium可以渲染页面,相对于requests+BeautifulSoup会慢 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-11-11 03:03

)

我们在爬取的时候选择它,主要是因为Selenium可以渲染页面,运行页面中的JS,点击按钮,提交表单等操作。

但是因为Selenium会渲染页面,所以会比requests+BeautifulSoup慢。

关于 PhantomJs

PhantomJs 可以看作是一个没有页面的浏览器,有一个渲染引擎(QtWebkit)和一个 JS 引擎(JavascriptCore)。 PhantomJs具有DOM渲染、JS运行、网络访问、网页截图等多种功能。

使用 PhantomJS 而不是 Chromedriver 和 firefox,主要是因为 PhantomJS 的静音模式(无需打开浏览器在后台运行)。

抓取示例的小测试-抓取标题

首先尝试一个简单的例子。以前这类内容一般都是用requests+BeautifulSoup或者Scrapy来处理的。

from selenium import webdriverbrowser = webdriver.PhantomJS('D:\phantomjs.exe') #浏览器初始化;Win下需要设置phantomjs路径,linux下置空即可url = ' # 设置访问路径browser.get(url) # 打开网页title = browser.find_elements_by_xpath('//h2') # 用xpath获取元素for t in title: # 遍历输出 print t.text # 输出其中文本 print t.get_attribute('class') # 输出属性值browser.quit() # 关闭浏览器。当出现异常时记得在任务浏览器中关闭PhantomJS,因为会有多个PhantomJS在运行状态,影响电脑性能 查看全部

js 抓取网页内容(抓取时选用它,主要是Selenium可以渲染页面,相对于requests+BeautifulSoup会慢

)

我们在爬取的时候选择它,主要是因为Selenium可以渲染页面,运行页面中的JS,点击按钮,提交表单等操作。

但是因为Selenium会渲染页面,所以会比requests+BeautifulSoup慢。

关于 PhantomJs

PhantomJs 可以看作是一个没有页面的浏览器,有一个渲染引擎(QtWebkit)和一个 JS 引擎(JavascriptCore)。 PhantomJs具有DOM渲染、JS运行、网络访问、网页截图等多种功能。

使用 PhantomJS 而不是 Chromedriver 和 firefox,主要是因为 PhantomJS 的静音模式(无需打开浏览器在后台运行)。

抓取示例的小测试-抓取标题

首先尝试一个简单的例子。以前这类内容一般都是用requests+BeautifulSoup或者Scrapy来处理的。

from selenium import webdriverbrowser = webdriver.PhantomJS('D:\phantomjs.exe') #浏览器初始化;Win下需要设置phantomjs路径,linux下置空即可url = ' # 设置访问路径browser.get(url) # 打开网页title = browser.find_elements_by_xpath('//h2') # 用xpath获取元素for t in title: # 遍历输出 print t.text # 输出其中文本 print t.get_attribute('class') # 输出属性值browser.quit() # 关闭浏览器。当出现异常时记得在任务浏览器中关闭PhantomJS,因为会有多个PhantomJS在运行状态,影响电脑性能

js 抓取网页内容(以上仅为一个小测试上海SEO()十分欢迎与大家一起交流学习探讨)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-11-11 03:02

经过半个多月的观察和分析,网页文件中的JAVASCRIPT(JS)代码被搜索引擎抓取,性能终于成功!2大搜索引擎成功抓取网页JS代码!测试的SE(搜索引擎)是YAHOO和Google百度暂时没有收入!(搜索引擎上报因为忙,最近才看到!实在抱歉!)

自从10-20号网站开通以来,我在25号做了一个小实验。如果你在网站上关注它,你会在右边的导航栏中看到红色标记的“JS代码抓取实验”可以抓取结果。显示YAHOO网站是当天收到的,GOOGLE是31号才被抓的,也就是6天后!(上海SEO成立于2007-10-20!)

这是GOOGLE的收入页面。如需查看详情,请输入::Ljul4S5KPSMJ:+site:

这是YAHOO的类似上面的细节!

结果告诉我们:搜索引擎不仅改变了排名算法,还升级了蜘蛛!从原来的静态页面爬取到现在的JS脚本语言也能爬!做网站还是做内容,做用户不做搜索引擎!以上只是一个小测试

上海SEO()非常欢迎与您交流,学习和讨论SEO技术策略和网站策划相关内容!^_^ 查看全部

js 抓取网页内容(以上仅为一个小测试上海SEO()十分欢迎与大家一起交流学习探讨)

经过半个多月的观察和分析,网页文件中的JAVASCRIPT(JS)代码被搜索引擎抓取,性能终于成功!2大搜索引擎成功抓取网页JS代码!测试的SE(搜索引擎)是YAHOO和Google百度暂时没有收入!(搜索引擎上报因为忙,最近才看到!实在抱歉!)

自从10-20号网站开通以来,我在25号做了一个小实验。如果你在网站上关注它,你会在右边的导航栏中看到红色标记的“JS代码抓取实验”可以抓取结果。显示YAHOO网站是当天收到的,GOOGLE是31号才被抓的,也就是6天后!(上海SEO成立于2007-10-20!)

这是GOOGLE的收入页面。如需查看详情,请输入::Ljul4S5KPSMJ:+site:

这是YAHOO的类似上面的细节!

结果告诉我们:搜索引擎不仅改变了排名算法,还升级了蜘蛛!从原来的静态页面爬取到现在的JS脚本语言也能爬!做网站还是做内容,做用户不做搜索引擎!以上只是一个小测试

上海SEO()非常欢迎与您交流,学习和讨论SEO技术策略和网站策划相关内容!^_^

js 抓取网页内容(《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-11-10 09:19

)

《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理,也介绍了Xpath的语法,Xpath的一些语法对于定位还是很有用的。

第10章介绍:

1. 首先介绍一下主要用于网页的javascript库,jquery\Google Analytics\Google Map。爬取JavaScript生成的页面,必须了解javascript库的基本操作。

2.接下来就是如何使用selenium()通过selenium模拟浏览器操作,然后读取页面内容。

Selenium 可以调用不同浏览器的核心操作。文章中的介绍主要使用了phantomjs()工具。

安装操作:

硒安装:

pip install selenium

只需下载并解压phantomjs,下载地址:

建议添加到PATH路径

sudo ln -sf /pythontest/tool/phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin/phantomjs

XPath 语法介绍:

Selenium 还支持 XPath 定位方法(BeautifulSoup 不支持)

XPath 的一些语法比较有用,也列出来了:

: 根节点和非根节点

--/div 根节点上的div

--//div所有div节点

:定位属性

--//@Href 所有 href 属性

--//A[@href='://'] 所有href都指向天山的属性

: 按位置选择

--//A[3] 第三个节点

--//Table[last()] 最后一个表

--//A[position() <3] 前3张表

: 通配符 (*)

--//Table/tr/* 所有表的所有内容

--//div[@*] div标签的所有属性

示例代码:

1-seleniumBasic.py<br />

2-waitForLoad.py<br />

3-javascriptRedirect.py

例子比较简单,自己看吧。

但是,有一点需要修改。我修改了示例1的代码,制作了不同的浏览器和具体的执行路径:

-------<br />

#1-seleniumBasic.py<br />

from selenium import webdriver<br />

import time<br />

driver = webdriver.Firefox(executable_path='')<br />

#driver = webdriver.PhantomJS() #这个也可以<br />

#driver = webdriver.PhantomJS(executable_path='/usr/local/bin/phantomjs')#这个也可以<br />

driver.get("http://pythonscraping.com/page ... 6quot;)<br />

time.sleep(3)<br />

print(driver.find_element_by_id("content").text)<br />

driver.close() 查看全部

js 抓取网页内容(《Python网络数据采集》第10章介绍了如何抓取JavaScript生成的页面的基本原理

)