java爬虫抓取动态网页

java爬虫抓取动态网页(Selenium+Chrome:运用到爬虫中的思路是什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-09-21 14:10

爬虫:动态网页的处理方法(第2部分)——模拟浏览器行为前言:

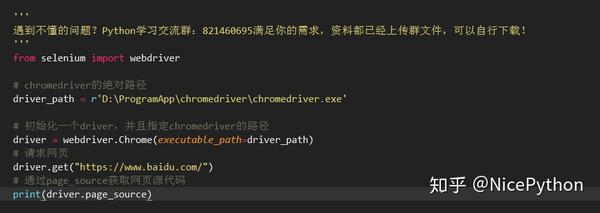

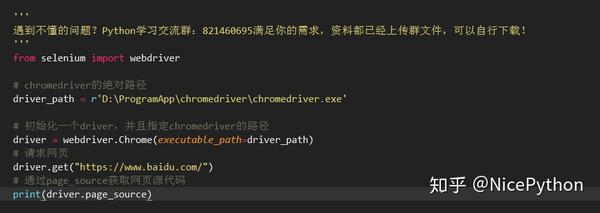

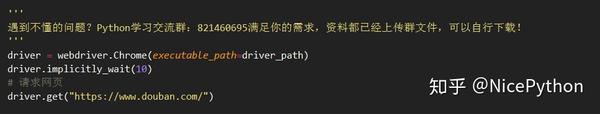

在上一个示例中,我们使用WebKit库自定义浏览器渲染引擎,以便完全控制要执行的行为。如果您不需要如此多的灵活性,那么有一个很好的替代方案来替代selenium,它提供了一个API接口来自动化浏览器

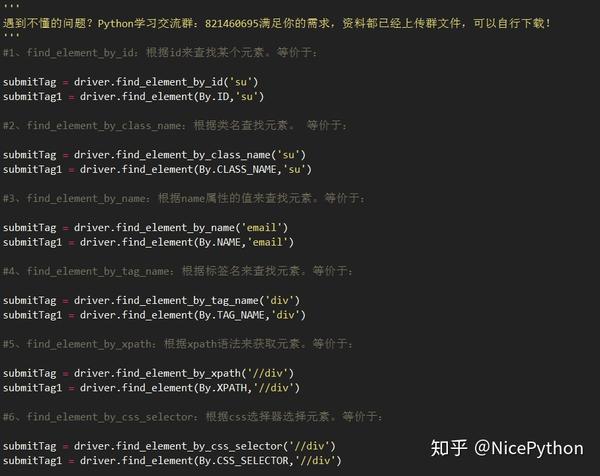

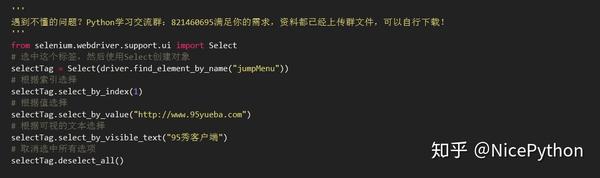

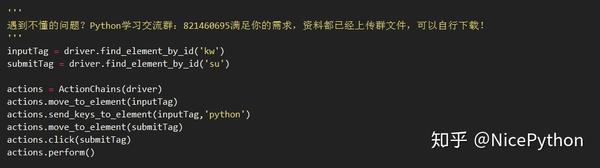

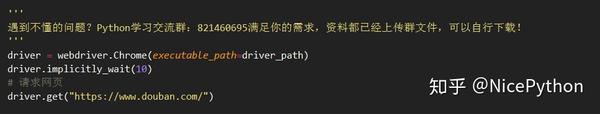

硒简介:

Selenium是一种用于测试web应用程序的工具。Selenium测试直接在浏览器中运行,就像真实用户一样。支持市场上几乎所有主流浏览器

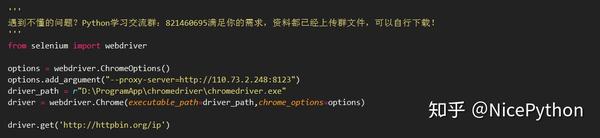

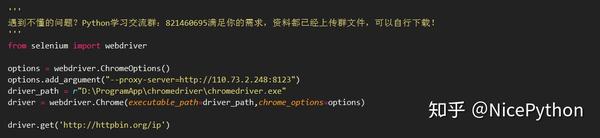

最初,我打算使用selenium+phantom JS的组合,但我发现chrome和Firefox也相继推出了无头浏览器模式,我更喜欢chrome。本文采用硒+铬的组合

例如:

适用于爬行动物的想法是:

以新浪阅读图书节选网站为例。目标是获取列表中每个文章详细页面的地址。直接参见示例代码:

# coding=utf-8

import time

from selenium import webdriver

class SinaBookSpider(object):

# 创建可见的Chrome浏览器, 方便调试

driver = webdriver.Chrome()

# 创建Chrome的无头浏览器

# opt = webdriver.ChromeOptions()

# opt.set_headless()

# driver = webdriver.Chrome(options=opt)

driver.implicitly_wait(10)

total = 1526 # 预先计算的总数据量

count = 0 # 已爬取的数据量

# 记录解析以及翻页位置

location = 0

click_times = 0

def run(self):

"""

开始爬虫

:return:

"""

# get方式打开网页

self.driver.get("http://book.sina.com.cn/excerpt/rwws/")

self.parselist()

while self.count < self.total:

if self.click_times is 2:

self.driver.find_element_by_css_selector('#subShowContent1_page > span:nth-child(6) > a').click()

# 等待页面加载完成

time.sleep(5)

self.click_times = 0

self.location = 0

else:

self.driver.find_element_by_css_selector('#subShowContent1_loadMore').click()

# 等待页面加载完成

time.sleep(3)

self.click_times += 1

# 分析加载的新内容,从location开始

self.parselist()

self.driver.quit()

def parselist(self):

"""

解析列表

:return:

"""

divs = self.driver.find_elements_by_class_name("item")

for i in range(self.location, len(divs)):

link = divs[i].find_element_by_tag_name('a').get_attribute("href")

print link

self.location += 1

self.count += 1

print self.count

if __name__ == '__main__':

spider = SinaBookSpider()

spider.run()

代码地址:动态web进程--GitHub

如果要实际运行上述代码,请确保在运行之前安装了与浏览器版本对应的驱动程序,并将其正确添加到环境变量中

这里可以看到对这三种方法的解释:Python selenium——必须能够使用selenium进行等待,以及对这三种等待方法的解释——gray和blue博客

总结:

在这里,我们介绍两种动态页面处理方法:

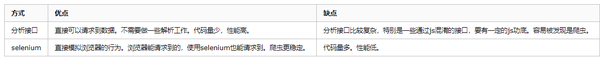

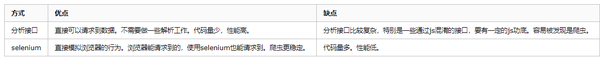

做一个简单的比较:

使用哪种方法取决于爬行动物活动的具体情况:

就我个人而言,我认为应该尽可能避免模拟浏览器的方法,因为浏览器环境会消耗大量内存和CPU,这可以作为短期解决方案。此时,长期性能和可靠性并不重要;作为一个长期的解决方案,我将尽最大努力网站进行逆向工程

欢迎指出本文中的任何错误或不足之处 查看全部

java爬虫抓取动态网页(Selenium+Chrome:运用到爬虫中的思路是什么?)

爬虫:动态网页的处理方法(第2部分)——模拟浏览器行为前言:

在上一个示例中,我们使用WebKit库自定义浏览器渲染引擎,以便完全控制要执行的行为。如果您不需要如此多的灵活性,那么有一个很好的替代方案来替代selenium,它提供了一个API接口来自动化浏览器

硒简介:

Selenium是一种用于测试web应用程序的工具。Selenium测试直接在浏览器中运行,就像真实用户一样。支持市场上几乎所有主流浏览器

最初,我打算使用selenium+phantom JS的组合,但我发现chrome和Firefox也相继推出了无头浏览器模式,我更喜欢chrome。本文采用硒+铬的组合

例如:

适用于爬行动物的想法是:

以新浪阅读图书节选网站为例。目标是获取列表中每个文章详细页面的地址。直接参见示例代码:

# coding=utf-8

import time

from selenium import webdriver

class SinaBookSpider(object):

# 创建可见的Chrome浏览器, 方便调试

driver = webdriver.Chrome()

# 创建Chrome的无头浏览器

# opt = webdriver.ChromeOptions()

# opt.set_headless()

# driver = webdriver.Chrome(options=opt)

driver.implicitly_wait(10)

total = 1526 # 预先计算的总数据量

count = 0 # 已爬取的数据量

# 记录解析以及翻页位置

location = 0

click_times = 0

def run(self):

"""

开始爬虫

:return:

"""

# get方式打开网页

self.driver.get("http://book.sina.com.cn/excerpt/rwws/";)

self.parselist()

while self.count < self.total:

if self.click_times is 2:

self.driver.find_element_by_css_selector('#subShowContent1_page > span:nth-child(6) > a').click()

# 等待页面加载完成

time.sleep(5)

self.click_times = 0

self.location = 0

else:

self.driver.find_element_by_css_selector('#subShowContent1_loadMore').click()

# 等待页面加载完成

time.sleep(3)

self.click_times += 1

# 分析加载的新内容,从location开始

self.parselist()

self.driver.quit()

def parselist(self):

"""

解析列表

:return:

"""

divs = self.driver.find_elements_by_class_name("item")

for i in range(self.location, len(divs)):

link = divs[i].find_element_by_tag_name('a').get_attribute("href")

print link

self.location += 1

self.count += 1

print self.count

if __name__ == '__main__':

spider = SinaBookSpider()

spider.run()

代码地址:动态web进程--GitHub

如果要实际运行上述代码,请确保在运行之前安装了与浏览器版本对应的驱动程序,并将其正确添加到环境变量中

这里可以看到对这三种方法的解释:Python selenium——必须能够使用selenium进行等待,以及对这三种等待方法的解释——gray和blue博客

总结:

在这里,我们介绍两种动态页面处理方法:

做一个简单的比较:

使用哪种方法取决于爬行动物活动的具体情况:

就我个人而言,我认为应该尽可能避免模拟浏览器的方法,因为浏览器环境会消耗大量内存和CPU,这可以作为短期解决方案。此时,长期性能和可靠性并不重要;作为一个长期的解决方案,我将尽最大努力网站进行逆向工程

欢迎指出本文中的任何错误或不足之处

java爬虫抓取动态网页(关于Java使用PhantomJs的一些事儿,你了解多少?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-09-21 14:08

让我们先离题。当我刚开始学习爬行动物时,有一次一位大四的学生让我需要捕捉京东图书的相关信息。因为我刚刚开始学习爬行动物和练习豆瓣菜,所以我抓取了大约500篇电影评论并存储在MySQL中。当时,我觉得自己不够强壮,所以很容易就接受了这个要求

然后自信地开始工作。。首先查看网页源代码。。。???我需要的不是源代码!!!然后我去问大四。前辈告诉我这是由Ajax生成的数据。听了之后,我去检查数据。人们发现,互联网上的大量信息正在解释一个事实。对于动态页面,使用phantom JS进行捕获,但这种效率非常低。作为一名优秀的程序员,我当时看到了四个低效字,这在我心里是绝对不允许的,所以我使用捕获数据包的方式查看ajax数据所在的URL。模拟浏览器的方法一直被搁置至今

但是现在你知道了这件事,没有理由不去学习。因此,我花了一些时间阅读了有关在Java中使用phantom JS的信息,现在我将与您分享

顺便说一句,作为一个网络爬虫,页面上90%的数据可以通过捕获数据包获得。因此,我鼓励您直接请求所需数据的URL。毕竟,尽管这种方法很方便,但效率很低

JS渲染与ajax

在学习这件事之前,我们必须首先了解什么是JS渲染,什么是Ajax,以及为什么我们不能在web源代码中获取这两种数据

据我了解,JS渲染和Ajax是相辅相成的。AJAX负责从服务器异步获取数据,获取数据后用JS进行渲染,最后将数据呈现给用户。在Java中,httpclient只能请求简单的静态页面,不能在页面完全加载后请求JS调用相关代码生成的异步数据。因此,我们无法通过httpclient直接获取Ajax和JS渲染生成的数据。此时,建议您直接捕获网络数据包以获取ajax数据所在的URL,或者使用本文中描述的phantom JS呈现引擎

三种JS渲染引擎的比较

在互联网上查阅信息时,我们常常被各种各样的答案所淹没。此时,首先要保持平静的心情,其次,我们应该考虑搜索问题的相关姿势,我们需要在必要时科学地上网。

更不用说本文中提到的JS呈现引擎,Java爬虫中的HTTP请求库可以用多种方式描述。Java的本机httpurlconnection类、httpclient第三方库等等。。。当然,网络上有太多可用的方法,我们必须选择,因此我们当然希望选择一个功能强大且简单的类库。此时,我们应该在互联网上搜索并比较两个类库,以做出更好的选择,而不是仅仅选择一个来学习。这样,学习成本很可能与回报不成正比

所以我相信,当您准备使用JS引擎来模拟浏览器时,您不仅看到了phantom JS,还看到了selenium和htmlunit,它们具有相同的功能。那么我们如何选择呢?下图摘自其他网友的博客:

HtmlUnitSeleniumPhantomJs

内置rhinojs浏览器引擎,没有浏览器使用此内核,解析速度平均,解析JS/CSS较差,没有浏览器界面

Selenium+webdriver=Selenium基于本地安装的浏览器。需要打开浏览器,引用相应的webdriver,并正确配置webdriver的路径参数。在抓取大量JS呈现的页面时,这显然是不合适的

工件简短而简洁,可以在本地运行,也可以作为服务器运行。它基于WebKit内核,具有良好的性能和性能,能够完美解析大多数页面

这就是为什么我选择谈论幻影JS

在互联网上,phantom JS和selenium经常成对出现。原因是selenium封装了phantom JS的一些函数,并且selenium提供了Python接口模块。Selenium可以在Python语言中很好地使用,phantom JS可以间接使用。然而,是时候放弃selenium+phantom JS了。一个原因是封装的接口很长时间没有更新(没有人维护它)。另一个原因是selenium只实现了一些phantom JS函数,而且非常不完善

幻影JS的使用

我用Ubuntu16.04开发环境。关于phantom JS+selenium的环境部署,网络上有很多信息。我将在这里介绍一个链接。我不会详细解释:Ubuntu安装phantomjs

我不会详细介绍phantom JS和selenium的介绍。你可以直接去百度。让我们直接看看幻像JS应该如何在java

中使用

如果您不使用maven,请在Internet上下载第三方jar包。我们需要的Maven依赖项如下:

org.seleniumhq.selenium

selenium-java

2.53.1

com.github.detro.ghostdriver

phantomjsdriver

1.1.0

接下来,让我们看看程序应该如何编写:

1.set请求头

//设置必要参数

DesiredCapabilities dcaps = new DesiredCapabilities();

//ssl证书支持

dcaps.setCapability("acceptSslCerts", true);

//截屏支持

dcaps.setCapability("takesScreenshot", true);

//css搜索支持

dcaps.setCapability("cssSelectorsEnabled", true);

//js支持

dcaps.setJavascriptEnabled(true);

//驱动支持(第二参数表明的是你的phantomjs引擎所在的路径,使用whereis phantomjs可以查看)

dcaps.setCapability(PhantomJSDriverService.PHANTOMJS_EXECUTABLE_PATH_PROPERTY, "/usr/local/bin/phantomjs");

2.create phantomjs浏览器对象

//创建无界面浏览器对象

PhantomJSDriver driver = new PhantomJSDriver(dcaps);

3.set隐藏等待

//设置隐性等待

driver.manage().timeouts().implicitlyWait(1, TimeUnit.SECONDS);

由于加载页面需要一段时间,如果在加载页面之前查找元素,则一定无法找到它们。最好的方法是设置默认等待时间。如果找不到页面元素,请等待一段时间,直到它超时

使用phantomjs时应注意以上三点。您可以查看一般的总体程序:

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.phantomjs.PhantomJSDriver;

import org.openqa.selenium.phantomjs.PhantomJSDriverService;

import org.openqa.selenium.remote.DesiredCapabilities;

import java.util.concurrent.TimeUnit;

/**

* Created by hg_yi on 17-10-11.

*/

public class phantomjs {

public static void main(String[] args) {

//设置必要参数

DesiredCapabilities dcaps = new DesiredCapabilities();

//ssl证书支持

dcaps.setCapability("acceptSslCerts", true);

//截屏支持

dcaps.setCapability("takesScreenshot", true);

//css搜索支持

dcaps.setCapability("cssSelectorsEnabled", true);

//js支持

dcaps.setJavascriptEnabled(true);

//驱动支持(第二参数表明的是你的phantomjs引擎所在的路径)

dcaps.setCapability(PhantomJSDriverService.PHANTOMJS_EXECUTABLE_PATH_PROPERTY,

"/usr/bin/phantomjs-2.1.1-linux-x86_64/bin/phantomjs");

//创建无界面浏览器对象

PhantomJSDriver driver = new PhantomJSDriver(dcaps);

//设置隐性等待(作用于全局)

driver.manage().timeouts().implicitlyWait(1, TimeUnit.SECONDS);

//打开页面

driver.get("--------------------------------");

//查找元素

WebElement element = driver.findElement(By.id("img_valiCode"));

System.out.println(element.getAttribute("src"));

}

}

我成功捕获了网页源代码中没有的数据~

对于上面使用的phantomjsdriver类的相关API,您可以直接查看此资料,它应该满足您的日常需要:webdriver API中文版(webdriver API也适用于phantomjsdriver)

phantom JS的性能优化

我们都知道,使用phantom JS等无头浏览器捕获web源代码非常耗时,因此当我们决定使用此工具并对捕获速度有一定要求时,我们需要掌握优化phantom JS性能的能力

1.设置参数

谷歌和百度已经阅读了很长时间的一些官方文档,但是他们仍然找不到与phantomjs相关的Java调用API文档。好吧,先抛出一篇python文章,然后找到这方面的内容并加以补充~~~

[phantom JS series]硒+phantom JS性能优化

旁白:事实上,对于java网络爬虫。。。真想吐槽,建议刚开始抱怨爬行动物或与Python爬虫搏斗的人~~对Java爬虫来说,只要说一句话:学习很难,学习周期很长,扔东西和收入不成正比!!!p> 查看全部

java爬虫抓取动态网页(关于Java使用PhantomJs的一些事儿,你了解多少?)

让我们先离题。当我刚开始学习爬行动物时,有一次一位大四的学生让我需要捕捉京东图书的相关信息。因为我刚刚开始学习爬行动物和练习豆瓣菜,所以我抓取了大约500篇电影评论并存储在MySQL中。当时,我觉得自己不够强壮,所以很容易就接受了这个要求

然后自信地开始工作。。首先查看网页源代码。。。???我需要的不是源代码!!!然后我去问大四。前辈告诉我这是由Ajax生成的数据。听了之后,我去检查数据。人们发现,互联网上的大量信息正在解释一个事实。对于动态页面,使用phantom JS进行捕获,但这种效率非常低。作为一名优秀的程序员,我当时看到了四个低效字,这在我心里是绝对不允许的,所以我使用捕获数据包的方式查看ajax数据所在的URL。模拟浏览器的方法一直被搁置至今

但是现在你知道了这件事,没有理由不去学习。因此,我花了一些时间阅读了有关在Java中使用phantom JS的信息,现在我将与您分享

顺便说一句,作为一个网络爬虫,页面上90%的数据可以通过捕获数据包获得。因此,我鼓励您直接请求所需数据的URL。毕竟,尽管这种方法很方便,但效率很低

JS渲染与ajax

在学习这件事之前,我们必须首先了解什么是JS渲染,什么是Ajax,以及为什么我们不能在web源代码中获取这两种数据

据我了解,JS渲染和Ajax是相辅相成的。AJAX负责从服务器异步获取数据,获取数据后用JS进行渲染,最后将数据呈现给用户。在Java中,httpclient只能请求简单的静态页面,不能在页面完全加载后请求JS调用相关代码生成的异步数据。因此,我们无法通过httpclient直接获取Ajax和JS渲染生成的数据。此时,建议您直接捕获网络数据包以获取ajax数据所在的URL,或者使用本文中描述的phantom JS呈现引擎

三种JS渲染引擎的比较

在互联网上查阅信息时,我们常常被各种各样的答案所淹没。此时,首先要保持平静的心情,其次,我们应该考虑搜索问题的相关姿势,我们需要在必要时科学地上网。

更不用说本文中提到的JS呈现引擎,Java爬虫中的HTTP请求库可以用多种方式描述。Java的本机httpurlconnection类、httpclient第三方库等等。。。当然,网络上有太多可用的方法,我们必须选择,因此我们当然希望选择一个功能强大且简单的类库。此时,我们应该在互联网上搜索并比较两个类库,以做出更好的选择,而不是仅仅选择一个来学习。这样,学习成本很可能与回报不成正比

所以我相信,当您准备使用JS引擎来模拟浏览器时,您不仅看到了phantom JS,还看到了selenium和htmlunit,它们具有相同的功能。那么我们如何选择呢?下图摘自其他网友的博客:

HtmlUnitSeleniumPhantomJs

内置rhinojs浏览器引擎,没有浏览器使用此内核,解析速度平均,解析JS/CSS较差,没有浏览器界面

Selenium+webdriver=Selenium基于本地安装的浏览器。需要打开浏览器,引用相应的webdriver,并正确配置webdriver的路径参数。在抓取大量JS呈现的页面时,这显然是不合适的

工件简短而简洁,可以在本地运行,也可以作为服务器运行。它基于WebKit内核,具有良好的性能和性能,能够完美解析大多数页面

这就是为什么我选择谈论幻影JS

在互联网上,phantom JS和selenium经常成对出现。原因是selenium封装了phantom JS的一些函数,并且selenium提供了Python接口模块。Selenium可以在Python语言中很好地使用,phantom JS可以间接使用。然而,是时候放弃selenium+phantom JS了。一个原因是封装的接口很长时间没有更新(没有人维护它)。另一个原因是selenium只实现了一些phantom JS函数,而且非常不完善

幻影JS的使用

我用Ubuntu16.04开发环境。关于phantom JS+selenium的环境部署,网络上有很多信息。我将在这里介绍一个链接。我不会详细解释:Ubuntu安装phantomjs

我不会详细介绍phantom JS和selenium的介绍。你可以直接去百度。让我们直接看看幻像JS应该如何在java

中使用

如果您不使用maven,请在Internet上下载第三方jar包。我们需要的Maven依赖项如下:

org.seleniumhq.selenium

selenium-java

2.53.1

com.github.detro.ghostdriver

phantomjsdriver

1.1.0

接下来,让我们看看程序应该如何编写:

1.set请求头

//设置必要参数

DesiredCapabilities dcaps = new DesiredCapabilities();

//ssl证书支持

dcaps.setCapability("acceptSslCerts", true);

//截屏支持

dcaps.setCapability("takesScreenshot", true);

//css搜索支持

dcaps.setCapability("cssSelectorsEnabled", true);

//js支持

dcaps.setJavascriptEnabled(true);

//驱动支持(第二参数表明的是你的phantomjs引擎所在的路径,使用whereis phantomjs可以查看)

dcaps.setCapability(PhantomJSDriverService.PHANTOMJS_EXECUTABLE_PATH_PROPERTY, "/usr/local/bin/phantomjs");

2.create phantomjs浏览器对象

//创建无界面浏览器对象

PhantomJSDriver driver = new PhantomJSDriver(dcaps);

3.set隐藏等待

//设置隐性等待

driver.manage().timeouts().implicitlyWait(1, TimeUnit.SECONDS);

由于加载页面需要一段时间,如果在加载页面之前查找元素,则一定无法找到它们。最好的方法是设置默认等待时间。如果找不到页面元素,请等待一段时间,直到它超时

使用phantomjs时应注意以上三点。您可以查看一般的总体程序:

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.phantomjs.PhantomJSDriver;

import org.openqa.selenium.phantomjs.PhantomJSDriverService;

import org.openqa.selenium.remote.DesiredCapabilities;

import java.util.concurrent.TimeUnit;

/**

* Created by hg_yi on 17-10-11.

*/

public class phantomjs {

public static void main(String[] args) {

//设置必要参数

DesiredCapabilities dcaps = new DesiredCapabilities();

//ssl证书支持

dcaps.setCapability("acceptSslCerts", true);

//截屏支持

dcaps.setCapability("takesScreenshot", true);

//css搜索支持

dcaps.setCapability("cssSelectorsEnabled", true);

//js支持

dcaps.setJavascriptEnabled(true);

//驱动支持(第二参数表明的是你的phantomjs引擎所在的路径)

dcaps.setCapability(PhantomJSDriverService.PHANTOMJS_EXECUTABLE_PATH_PROPERTY,

"/usr/bin/phantomjs-2.1.1-linux-x86_64/bin/phantomjs");

//创建无界面浏览器对象

PhantomJSDriver driver = new PhantomJSDriver(dcaps);

//设置隐性等待(作用于全局)

driver.manage().timeouts().implicitlyWait(1, TimeUnit.SECONDS);

//打开页面

driver.get("--------------------------------");

//查找元素

WebElement element = driver.findElement(By.id("img_valiCode"));

System.out.println(element.getAttribute("src"));

}

}

我成功捕获了网页源代码中没有的数据~

对于上面使用的phantomjsdriver类的相关API,您可以直接查看此资料,它应该满足您的日常需要:webdriver API中文版(webdriver API也适用于phantomjsdriver)

phantom JS的性能优化

我们都知道,使用phantom JS等无头浏览器捕获web源代码非常耗时,因此当我们决定使用此工具并对捕获速度有一定要求时,我们需要掌握优化phantom JS性能的能力

1.设置参数

谷歌和百度已经阅读了很长时间的一些官方文档,但是他们仍然找不到与phantomjs相关的Java调用API文档。好吧,先抛出一篇python文章,然后找到这方面的内容并加以补充~~~

[phantom JS series]硒+phantom JS性能优化

旁白:事实上,对于java网络爬虫。。。真想吐槽,建议刚开始抱怨爬行动物或与Python爬虫搏斗的人~~对Java爬虫来说,只要说一句话:学习很难,学习周期很长,扔东西和收入不成正比!!!p>

java爬虫抓取动态网页(soup()需要爬取的网站数据及分析方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 206 次浏览 • 2021-09-21 14:07

参考原文:

需要爬网的网站数据:共165页,可通过将page=1改为其他数字进行访问

获取所有URL:URL=(“{}”。范围(1)中的I的格式(I),166))

使用Firefox浏览器打开要爬网的网页,右键单击查看页面源代码,Ctrl+F查找并输入293。此值在源代码中不存在,表示它是动态加载的数据

对于动态加载的数据,我熟悉两种方法:一种是使用selenium,另一种是分析网页元素,找出原创网页中的数据,提交表单,并获取不同的数据以达到爬行的目的

方法1:

#coding=utf-8

from bs4 import BeautifulSoup

from selenium import webdriver

urls = ('http://gkcx.eol.cn/soudaxue/qu ... ge%3D{}'.format(i) for i in range(1,166))

driver=webdriver.Firefox()

driver.maximize_window()

for url in urls:

#print ("正在访问{}".format(url))

driver.get(url)

data = driver.page_source

soup = BeautifulSoup(data, 'lxml')

grades = soup.find_all('tr')

for grade in grades:

if '' in str(grade):

print(grade.get_text())

代码说明:

从BS4导入Beauty soup使用Beauty soup解析网页数据

从selenium导入webdriver使用selenium抓取动态数据

URL=('{}'。范围(1)中的i的格式(i),166))收录需要爬网的所有数据的网站生成器

Driver=webdriver.Firefox()打开Firefox浏览器

Driver.maximize_window()最大化窗口

driver.get(URL)浏览器会自动跳转到URL链接

Data=driver.page\u source获取页面元素,其中收录要爬网的数据

soup=BeautifulSoup(数据'lxml')

等级=汤。查找所有('tr'))

按年级划分的年级:

如果str(年级)中有“”:

打印(grade.get_text())

通过分析数据并写出上述搜索方法,您可以获得所有数据

通过这种方法获取数据简单直观,但缺点是速度太慢

现在,第二种方法是获取数据

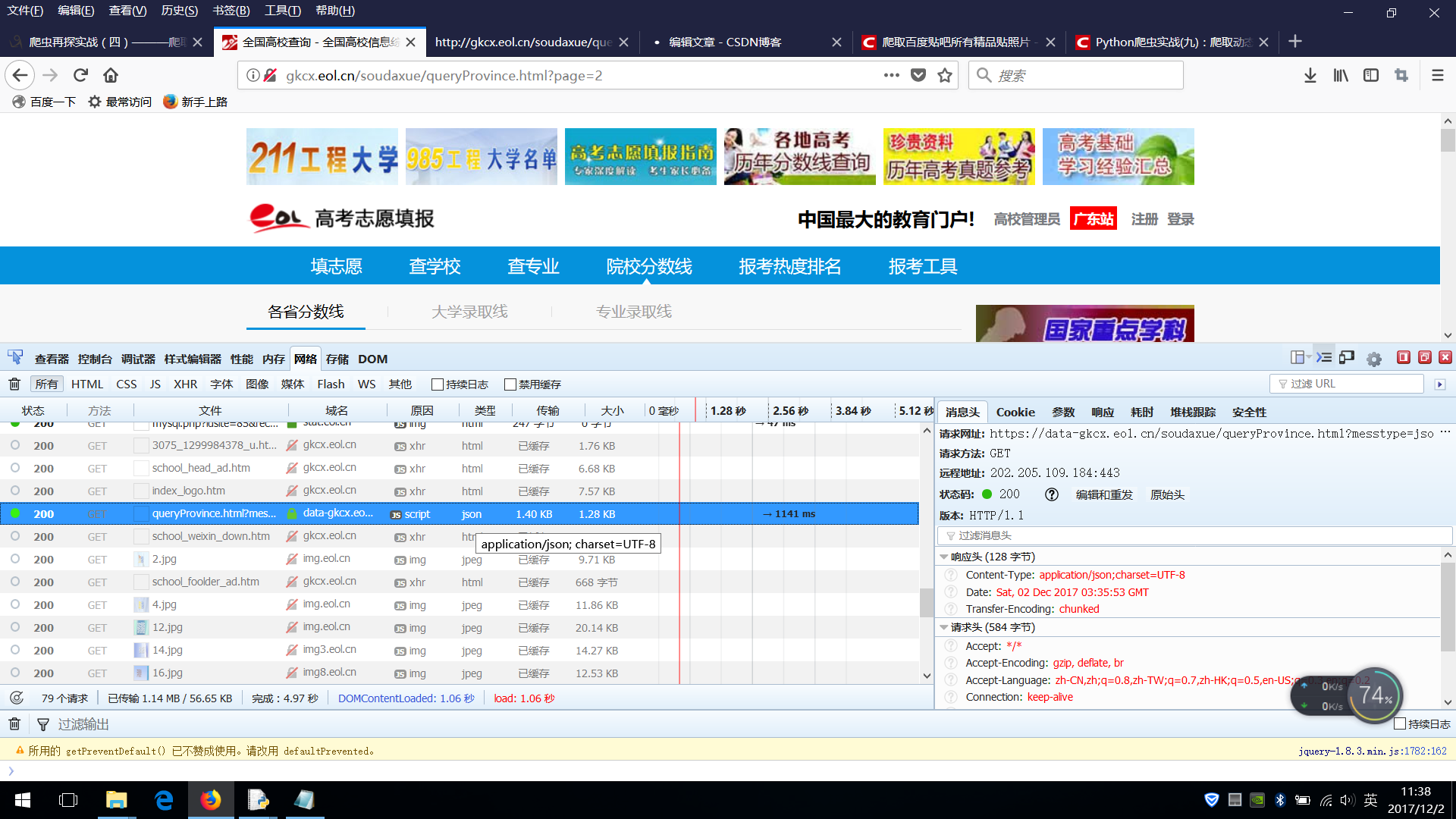

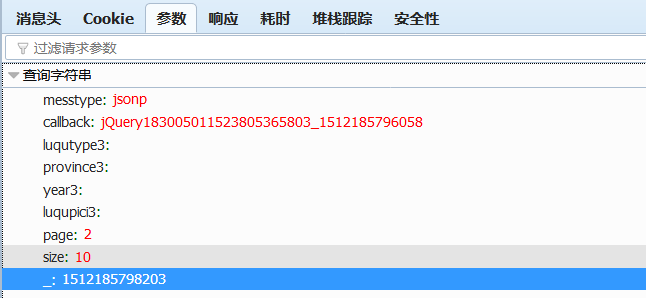

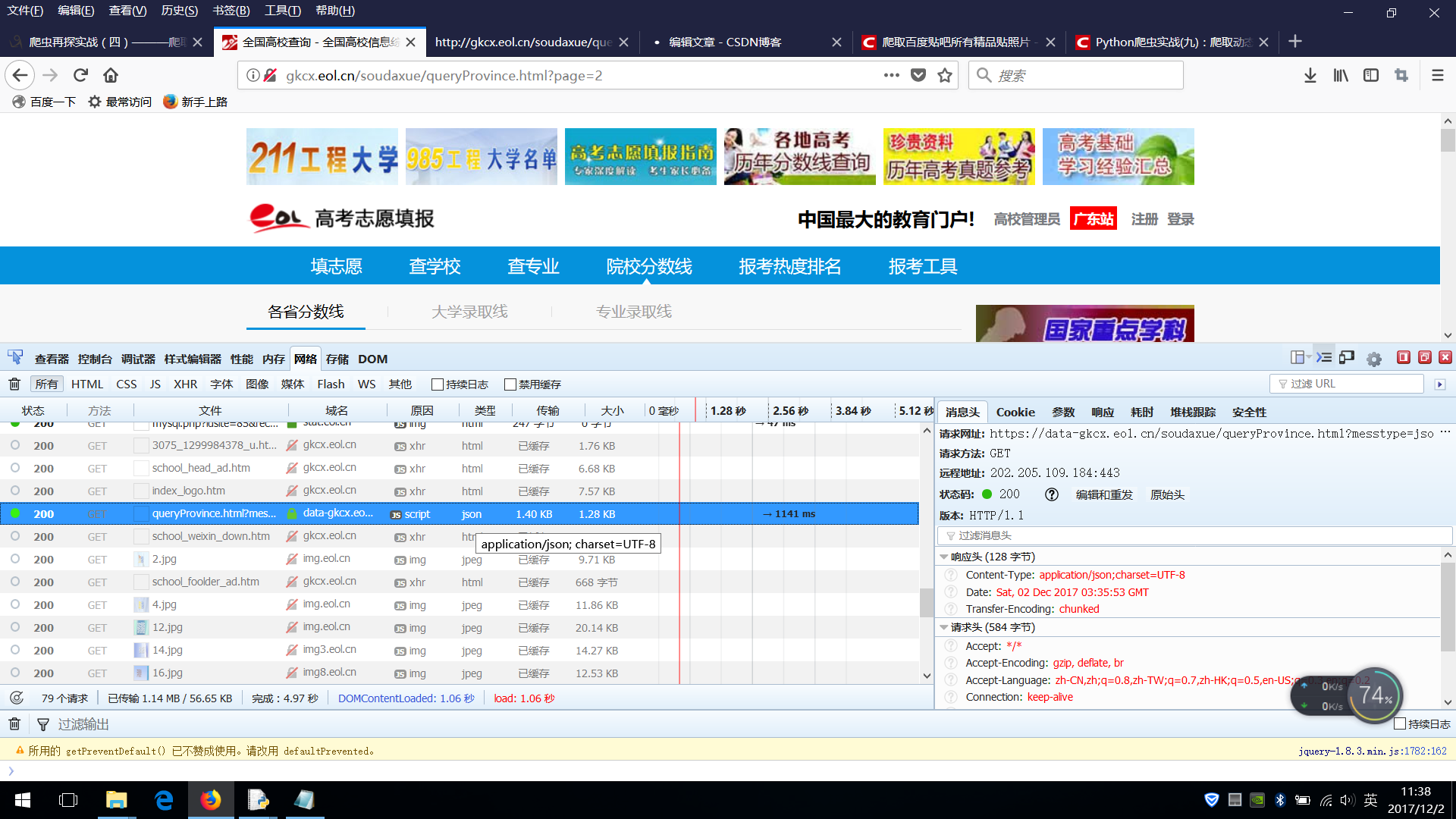

使用Firefox浏览器打开要爬网的网页,右键单击查看元素,然后选择“网络”。默认情况下,该功能正常

(一些旧版本的Firefox可能需要安装firebug插件)

单击第二页以查看加载了哪些页面和数据

分析如下:

分析表明,JSON类型的列就是我们需要的数据

在消息头网站中查看请求@

实际请求网站

参数mestype=jsonp&;callback=jquery3805365803&;luqutype3=&;province3=&;year3=&;luqupici3=&;page=2&;size=10&;03

也可以单击右侧的参数栏以查看参数

Page表示当前的页数

大小表示每页显示的项目数

编写代码

#coding=utf-8

import requests

import json

from prettytable import PrettyTable

if __name__=='__main__':

url = 'https://data-gkcx.eol.cn/souda ... 39%3B

row = PrettyTable()

row.field_names = ["地区", "年份", "考生类别", "批次","分数线"]

for i in range(1,34):

data ={"messtype":"json",

"page":i,

"size":50,

"callback":

"jQuery1830426658582613074_1469201131959",

"_":"1469201133189",

}

school_datas = requests.post(url,data = data).json()

datas = school_datas["school"]

for data in datas:

row.add_row((data["province"] ,data["year"],data["bath"],data["type"], data["score"]))

print(row)

代码描述

对于范围(1,34):

共有1644个条目。每页上显示的最大条目数为50,1600/50=32,44个条目为33页,因此范围应为(1,34)

数据={“messtype”:“json”

“页面”:我

“尺寸”:50

“回调”:

“jQuery82613074_59”

":"89"

}

分析提交的数据并使用post方法 查看全部

java爬虫抓取动态网页(soup()需要爬取的网站数据及分析方法)

参考原文:

需要爬网的网站数据:共165页,可通过将page=1改为其他数字进行访问

获取所有URL:URL=(“{}”。范围(1)中的I的格式(I),166))

使用Firefox浏览器打开要爬网的网页,右键单击查看页面源代码,Ctrl+F查找并输入293。此值在源代码中不存在,表示它是动态加载的数据

对于动态加载的数据,我熟悉两种方法:一种是使用selenium,另一种是分析网页元素,找出原创网页中的数据,提交表单,并获取不同的数据以达到爬行的目的

方法1:

#coding=utf-8

from bs4 import BeautifulSoup

from selenium import webdriver

urls = ('http://gkcx.eol.cn/soudaxue/qu ... ge%3D{}'.format(i) for i in range(1,166))

driver=webdriver.Firefox()

driver.maximize_window()

for url in urls:

#print ("正在访问{}".format(url))

driver.get(url)

data = driver.page_source

soup = BeautifulSoup(data, 'lxml')

grades = soup.find_all('tr')

for grade in grades:

if '' in str(grade):

print(grade.get_text())

代码说明:

从BS4导入Beauty soup使用Beauty soup解析网页数据

从selenium导入webdriver使用selenium抓取动态数据

URL=('{}'。范围(1)中的i的格式(i),166))收录需要爬网的所有数据的网站生成器

Driver=webdriver.Firefox()打开Firefox浏览器

Driver.maximize_window()最大化窗口

driver.get(URL)浏览器会自动跳转到URL链接

Data=driver.page\u source获取页面元素,其中收录要爬网的数据

soup=BeautifulSoup(数据'lxml')

等级=汤。查找所有('tr'))

按年级划分的年级:

如果str(年级)中有“”:

打印(grade.get_text())

通过分析数据并写出上述搜索方法,您可以获得所有数据

通过这种方法获取数据简单直观,但缺点是速度太慢

现在,第二种方法是获取数据

使用Firefox浏览器打开要爬网的网页,右键单击查看元素,然后选择“网络”。默认情况下,该功能正常

(一些旧版本的Firefox可能需要安装firebug插件)

单击第二页以查看加载了哪些页面和数据

分析如下:

分析表明,JSON类型的列就是我们需要的数据

在消息头网站中查看请求@

实际请求网站

参数mestype=jsonp&;callback=jquery3805365803&;luqutype3=&;province3=&;year3=&;luqupici3=&;page=2&;size=10&;03

也可以单击右侧的参数栏以查看参数

Page表示当前的页数

大小表示每页显示的项目数

编写代码

#coding=utf-8

import requests

import json

from prettytable import PrettyTable

if __name__=='__main__':

url = 'https://data-gkcx.eol.cn/souda ... 39%3B

row = PrettyTable()

row.field_names = ["地区", "年份", "考生类别", "批次","分数线"]

for i in range(1,34):

data ={"messtype":"json",

"page":i,

"size":50,

"callback":

"jQuery1830426658582613074_1469201131959",

"_":"1469201133189",

}

school_datas = requests.post(url,data = data).json()

datas = school_datas["school"]

for data in datas:

row.add_row((data["province"] ,data["year"],data["bath"],data["type"], data["score"]))

print(row)

代码描述

对于范围(1,34):

共有1644个条目。每页上显示的最大条目数为50,1600/50=32,44个条目为33页,因此范围应为(1,34)

数据={“messtype”:“json”

“页面”:我

“尺寸”:50

“回调”:

“jQuery82613074_59”

":"89"

}

分析提交的数据并使用post方法

java爬虫抓取动态网页(豆瓣View:headlessbrowser网页抓取(网络爬虫)的应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-09-21 14:05

CasperJS是一个导航脚本&;用于PhantomJS(WebKit)和SlimerJS(Gecko)无头浏览器的测试实用程序,用Javascript编写

Phantom JS是一款基于WebKit内核的无头浏览器

Slimerjs是一款基于gecko内核的无头浏览器

无头浏览器:没有界面显示的浏览器。它可以用于自动测试、网页截图、JS注入、DOM操作等。它是一个非常新的web应用工具。虽然该浏览器没有任何界面输出,但它可以在许多方面得到广泛的应用。整篇文章文章将介绍使用casperjs的web页面爬行(web crawler)的应用。这篇文章只是起到了吸引翡翠的作用。事实上,无头浏览器技术的应用将非常广泛,甚至可能会深刻地影响web前端和后端技术的发展

本文使用了著名的网站[]“operation”(仅供研究、学习和使用。我希望该站不会打扰我

),以测试功能强大的无头浏览器网页捕获技术的威力

第一步是安装casperjs,打开casperjs官网,下载并安装最新稳定版本的casperjs,官网上有非常详细的文档,这是学习casperjs最好的第一手资料,当然如果安装了NPM,也可以通过NPM直接安装。同时,这也是官方推荐的安装方法。关于安装的内容不多。官方文件非常详细

1 npm install casperjs

2 node_modules/casperjs/bin/casperjs selftest

视图代码

第二步是分析target网站.一般来说,内容类网站分为列表页和详细内容页。Douban也不例外。先看看豆瓣列表的页长。经过分析,发现豆瓣电影网站的列表页像T。他的。首先,你可以点击排序规则。翻页不像翻过传统的页码,而是点击最后一页来加载更多。对于这样一个页面,传统的爬虫程序通常会停止烹饪,或者实现非常复杂。但是,对于无头浏览器技术,这是一个很小的例子分析网页,你可以看到点击这个[load more]位置可以持续显示更多的电影信息

第三步是开始编写代码获取电影详情页面的链接信息。我们不礼貌。模拟点击此处采集超链接列表。以下代码是获取链接的代码。引用并创建casperjs对象。如果网页需要插入脚本,您可以引用要插入的脚本生成Casper对象时,注入到clientscript部分的网页中。为了加快网页的加载速度,我们禁止下载图片和插件:

1 pageSettings: {

2 loadImages: false, // The WebPage instance used by Casper will

3 loadPlugins: false // use these settings

4 },

视图代码

)

完成获取详细信息页面链接的代码。单击[load more]并循环50次。事实上,可以通过[判断while(而不是“loading more”)然后(stop)]来改进循环。获取后,使用require('utils')。Dump(…)要输出链接列表,请将以下代码另存为getdoublanlist.js,然后运行casperjs getdoublanlist.js以获取并输出该类别下的所有详细页面链接

1 1 phantom.outputEncoding="uft8";

2 var casper = require('casper').create({

3 // clientScripts: [

4 // 'includes/jquery.js', // These two scripts will be injected in remote

5 // 'includes/underscore.js' // DOM on every request

6 // ],

7 pageSettings: {

8 loadImages: false, // The WebPage instance used by Casper will

9 loadPlugins: false // use these settings

10 },

11 logLevel: "info", // Only "info" level messages will be logged

12 verbose: false // log messages will be printed out to the console

13 });

14

15 casper.start("https://movie.douban.com/explo ... ot%3B, function () {

16 this.capture("1.png");

17 });

18

19 casper.then(function () {

20 this.click("a.more",10,10);

21 var i = 0;

22 do

23 {

24 i ++;

25 casper.waitForText('加载更多', function() {

26 this.click("a.more",10,10);//this.capture("2.png"); // read data from popup

27 });

28 }

29 while (i {

15 console.log(data.toString());

16 strUrls = strUrls + data.toString();

17

18 });

19

20 urllist.stderr.on('data', (data) => {

21 console.log(data);

22 });

23

24 urllist.on('exit', (code) => {

25 console.log(`Child exited with code ${code}`);

26 var urlData = JSON.parse(strUrls);

27 var content2 = "";

28 for(var key in urlData){

29 if (content2 != "") {

30 content2 = content2 + "\r\n" + urlData[key];

31 }

32 else {

33 content2 = urlData[key];

34 }

35 }

36 var recordurl = new record.RecordAllUrl();

37 recordurl.RecordUrlInText(content2);

38 console.log(content2);

39 });

40

GetAllUrls

引用的recordurl模块不是用mongodb编写的,您可以自己完成

1 exports.RecordAllUrl = RecordUrl;

2 var fs = require('fs');

3 function RecordUrl() {

4 var file = "d:/urllog.txt";

5 var RecordUrlInFile = function(theurl) {

6

9 fs.appendFile(file, theurl, function(err){

10 if(err)

11 console.log("fail " + err);

12 else

13 console.log("写入文件ok");

14 });

15 };

16 var RecordUrlInMongo = function() {

17 console.log('Hello ' + name);

18 };

19 return {

20 RecordUrlInDB: RecordUrlInMongo,

21 RecordUrlInText: RecordUrlInFile

22 } ;

23 };

记录URL

第四步是分析细节页面并编写细节页面捕获程序

在这一步中,您已经获得了要捕获的详细页面列表。现在让我们打开一个电影详细页面,看看结构如何,并分析如何捕获每个信息。对于信息捕获,我们必须综合使用DOM、文本处理、JS脚本和其他技术。我想获得这部分的信息,包括di校长、编剧、乐谱等等。我们在本文中不再重复。这里我们只提取一些信息项的示例

1.grab director list:domcss选择器'div#info span:nth child(1)span.Attrs a')的director列表。我们使用函数gettexcontent(strule,strmesg)方法来获取内容

1 phantom.outputEncoding="GBK";

2 var S = require("string");

3 var casper = require('casper').create({

4 clientScripts: [

5 'includes/jquery.js', // These two scripts will be injected in remote

6 'includes/underscore.js' // DOM on every request

7 ],

8 pageSettings: {

9 loadImages: false, // The WebPage instance used by Casper will

10 loadPlugins: false // use these settings

11 },

12 logLevel: "info", // Only "info" level messages will be logged

13 verbose: false // log messages will be printed out to the console

14 });

15

16 //casper.echo(casper.cli.get(0));

17 var fetchUrl='https://movie.douban.com/subject/25662329/', fetchNumber;

18 if(casper.cli.has('url'))

19 fetchUrl = casper.cli.get('url');

20 else if(casper.cli.has('number'))

21 fetchNumber = casper.cli.get('number');

22 casper.echo(fetchUrl);

23

24 casper.start(fetchUrl, function () {

25 this.capture("1.png");

26 //this.echo("启动程序....");

27 //this.echo(this.getHTML('div#info span:nth-child(3) a'));

28 //this.echo(this.fetchText('div#info span:nth-child(1) a'));

29

30 //抓取导演

31 getTextContent('div#info span:nth-child(1) span.attrs a','抓取导演');

32

33

34 });

35

36 //get the text content of tag

37 function getTextContent(strRule, strMesg)

38 {

39 //给evaluate传入参数

40 var textinfo = casper.evaluate(function(rule) {

41 var valArr = '';

42 $(rule).each(function(index,item){

43 valArr = valArr + $(this).text() + ',';

44 });

45 return valArr.substring(0,valArr.length-1);

46 }, strRule);

47 casper.echo(strMesg);

48 require('utils').dump(textinfo.split(','));

49 return textinfo.split(',');

50 };

51

52 //get the attribute content of tag

53 function getAttrContent(strRule, strMesg, Attr)

54 {

55 //给evaluate传入参数

56 var textinfo = casper.evaluate(function(rule, attrname) {

57 var valArr = '';

58 $(rule).each(function(index,item){

59 valArr = valArr + $(this).attr(attrname) + ',';

60 });

61 return valArr.substring(0,valArr.length-1);

62 }, strRule, Attr);

63 casper.echo(strMesg);

64 require('utils').dump(textinfo.split(','));

65 return textinfo.split(',');

66 };

67

68 casper.run();

获得董事

2.使用CSS选择器很难捕捉生产国家和地区。分析网页后,我们可以发现,首先,信息没有放置在标签中,文本“America”直接位于标签中

在这个高级元素中。对于此类信息,我们使用另一种方法,文本分析和截取。首先,映射字符串模块var s=require(“字符串”);此模块也将单独安装。然后获取整个信息,然后用文本截取:

1 //影片信息全文字抓取

2 nameCount = casper.evaluate(function() {

3 var valArr = '';

4 $('div#info').each(function(index,item){

5 valArr = valArr + $(this).text() + ',';

6 });

7 return valArr.substring(0,valArr.length-1);

8 });

9 this.echo("影片信息全文字抓取");

10 this.echo(nameCount);

11 //this.echo(nameCount.indexOf("制片国家/地区:"));

12

13 //抓取国家

14 this.echo(S(nameCount).between("制片国家/地区:","\n"));

GetCountry

其他信息也可以类似地获得

第五步:存储捕获的信息并将其作为分析源,建议使用NoSQL数据库存储,如mongodb,更适合存储此类非结构化数据,性能更好 查看全部

java爬虫抓取动态网页(豆瓣View:headlessbrowser网页抓取(网络爬虫)的应用)

CasperJS是一个导航脚本&;用于PhantomJS(WebKit)和SlimerJS(Gecko)无头浏览器的测试实用程序,用Javascript编写

Phantom JS是一款基于WebKit内核的无头浏览器

Slimerjs是一款基于gecko内核的无头浏览器

无头浏览器:没有界面显示的浏览器。它可以用于自动测试、网页截图、JS注入、DOM操作等。它是一个非常新的web应用工具。虽然该浏览器没有任何界面输出,但它可以在许多方面得到广泛的应用。整篇文章文章将介绍使用casperjs的web页面爬行(web crawler)的应用。这篇文章只是起到了吸引翡翠的作用。事实上,无头浏览器技术的应用将非常广泛,甚至可能会深刻地影响web前端和后端技术的发展

本文使用了著名的网站[]“operation”(仅供研究、学习和使用。我希望该站不会打扰我

),以测试功能强大的无头浏览器网页捕获技术的威力

第一步是安装casperjs,打开casperjs官网,下载并安装最新稳定版本的casperjs,官网上有非常详细的文档,这是学习casperjs最好的第一手资料,当然如果安装了NPM,也可以通过NPM直接安装。同时,这也是官方推荐的安装方法。关于安装的内容不多。官方文件非常详细

1 npm install casperjs

2 node_modules/casperjs/bin/casperjs selftest

视图代码

第二步是分析target网站.一般来说,内容类网站分为列表页和详细内容页。Douban也不例外。先看看豆瓣列表的页长。经过分析,发现豆瓣电影网站的列表页像T。他的。首先,你可以点击排序规则。翻页不像翻过传统的页码,而是点击最后一页来加载更多。对于这样一个页面,传统的爬虫程序通常会停止烹饪,或者实现非常复杂。但是,对于无头浏览器技术,这是一个很小的例子分析网页,你可以看到点击这个[load more]位置可以持续显示更多的电影信息

第三步是开始编写代码获取电影详情页面的链接信息。我们不礼貌。模拟点击此处采集超链接列表。以下代码是获取链接的代码。引用并创建casperjs对象。如果网页需要插入脚本,您可以引用要插入的脚本生成Casper对象时,注入到clientscript部分的网页中。为了加快网页的加载速度,我们禁止下载图片和插件:

1 pageSettings: {

2 loadImages: false, // The WebPage instance used by Casper will

3 loadPlugins: false // use these settings

4 },

视图代码

)

完成获取详细信息页面链接的代码。单击[load more]并循环50次。事实上,可以通过[判断while(而不是“loading more”)然后(stop)]来改进循环。获取后,使用require('utils')。Dump(…)要输出链接列表,请将以下代码另存为getdoublanlist.js,然后运行casperjs getdoublanlist.js以获取并输出该类别下的所有详细页面链接

1 1 phantom.outputEncoding="uft8";

2 var casper = require('casper').create({

3 // clientScripts: [

4 // 'includes/jquery.js', // These two scripts will be injected in remote

5 // 'includes/underscore.js' // DOM on every request

6 // ],

7 pageSettings: {

8 loadImages: false, // The WebPage instance used by Casper will

9 loadPlugins: false // use these settings

10 },

11 logLevel: "info", // Only "info" level messages will be logged

12 verbose: false // log messages will be printed out to the console

13 });

14

15 casper.start("https://movie.douban.com/explo ... ot%3B, function () {

16 this.capture("1.png");

17 });

18

19 casper.then(function () {

20 this.click("a.more",10,10);

21 var i = 0;

22 do

23 {

24 i ++;

25 casper.waitForText('加载更多', function() {

26 this.click("a.more",10,10);//this.capture("2.png"); // read data from popup

27 });

28 }

29 while (i {

15 console.log(data.toString());

16 strUrls = strUrls + data.toString();

17

18 });

19

20 urllist.stderr.on('data', (data) => {

21 console.log(data);

22 });

23

24 urllist.on('exit', (code) => {

25 console.log(`Child exited with code ${code}`);

26 var urlData = JSON.parse(strUrls);

27 var content2 = "";

28 for(var key in urlData){

29 if (content2 != "") {

30 content2 = content2 + "\r\n" + urlData[key];

31 }

32 else {

33 content2 = urlData[key];

34 }

35 }

36 var recordurl = new record.RecordAllUrl();

37 recordurl.RecordUrlInText(content2);

38 console.log(content2);

39 });

40

GetAllUrls

引用的recordurl模块不是用mongodb编写的,您可以自己完成

1 exports.RecordAllUrl = RecordUrl;

2 var fs = require('fs');

3 function RecordUrl() {

4 var file = "d:/urllog.txt";

5 var RecordUrlInFile = function(theurl) {

6

9 fs.appendFile(file, theurl, function(err){

10 if(err)

11 console.log("fail " + err);

12 else

13 console.log("写入文件ok");

14 });

15 };

16 var RecordUrlInMongo = function() {

17 console.log('Hello ' + name);

18 };

19 return {

20 RecordUrlInDB: RecordUrlInMongo,

21 RecordUrlInText: RecordUrlInFile

22 } ;

23 };

记录URL

第四步是分析细节页面并编写细节页面捕获程序

在这一步中,您已经获得了要捕获的详细页面列表。现在让我们打开一个电影详细页面,看看结构如何,并分析如何捕获每个信息。对于信息捕获,我们必须综合使用DOM、文本处理、JS脚本和其他技术。我想获得这部分的信息,包括di校长、编剧、乐谱等等。我们在本文中不再重复。这里我们只提取一些信息项的示例

1.grab director list:domcss选择器'div#info span:nth child(1)span.Attrs a')的director列表。我们使用函数gettexcontent(strule,strmesg)方法来获取内容

1 phantom.outputEncoding="GBK";

2 var S = require("string");

3 var casper = require('casper').create({

4 clientScripts: [

5 'includes/jquery.js', // These two scripts will be injected in remote

6 'includes/underscore.js' // DOM on every request

7 ],

8 pageSettings: {

9 loadImages: false, // The WebPage instance used by Casper will

10 loadPlugins: false // use these settings

11 },

12 logLevel: "info", // Only "info" level messages will be logged

13 verbose: false // log messages will be printed out to the console

14 });

15

16 //casper.echo(casper.cli.get(0));

17 var fetchUrl='https://movie.douban.com/subject/25662329/', fetchNumber;

18 if(casper.cli.has('url'))

19 fetchUrl = casper.cli.get('url');

20 else if(casper.cli.has('number'))

21 fetchNumber = casper.cli.get('number');

22 casper.echo(fetchUrl);

23

24 casper.start(fetchUrl, function () {

25 this.capture("1.png");

26 //this.echo("启动程序....");

27 //this.echo(this.getHTML('div#info span:nth-child(3) a'));

28 //this.echo(this.fetchText('div#info span:nth-child(1) a'));

29

30 //抓取导演

31 getTextContent('div#info span:nth-child(1) span.attrs a','抓取导演');

32

33

34 });

35

36 //get the text content of tag

37 function getTextContent(strRule, strMesg)

38 {

39 //给evaluate传入参数

40 var textinfo = casper.evaluate(function(rule) {

41 var valArr = '';

42 $(rule).each(function(index,item){

43 valArr = valArr + $(this).text() + ',';

44 });

45 return valArr.substring(0,valArr.length-1);

46 }, strRule);

47 casper.echo(strMesg);

48 require('utils').dump(textinfo.split(','));

49 return textinfo.split(',');

50 };

51

52 //get the attribute content of tag

53 function getAttrContent(strRule, strMesg, Attr)

54 {

55 //给evaluate传入参数

56 var textinfo = casper.evaluate(function(rule, attrname) {

57 var valArr = '';

58 $(rule).each(function(index,item){

59 valArr = valArr + $(this).attr(attrname) + ',';

60 });

61 return valArr.substring(0,valArr.length-1);

62 }, strRule, Attr);

63 casper.echo(strMesg);

64 require('utils').dump(textinfo.split(','));

65 return textinfo.split(',');

66 };

67

68 casper.run();

获得董事

2.使用CSS选择器很难捕捉生产国家和地区。分析网页后,我们可以发现,首先,信息没有放置在标签中,文本“America”直接位于标签中

在这个高级元素中。对于此类信息,我们使用另一种方法,文本分析和截取。首先,映射字符串模块var s=require(“字符串”);此模块也将单独安装。然后获取整个信息,然后用文本截取:

1 //影片信息全文字抓取

2 nameCount = casper.evaluate(function() {

3 var valArr = '';

4 $('div#info').each(function(index,item){

5 valArr = valArr + $(this).text() + ',';

6 });

7 return valArr.substring(0,valArr.length-1);

8 });

9 this.echo("影片信息全文字抓取");

10 this.echo(nameCount);

11 //this.echo(nameCount.indexOf("制片国家/地区:"));

12

13 //抓取国家

14 this.echo(S(nameCount).between("制片国家/地区:","\n"));

GetCountry

其他信息也可以类似地获得

第五步:存储捕获的信息并将其作为分析源,建议使用NoSQL数据库存储,如mongodb,更适合存储此类非结构化数据,性能更好

java爬虫抓取动态网页(基于微内核+插件式架构的JAVA爬虫框架(内核))

网站优化 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-09-21 14:05

1、Gecco

GitHub地址:xtuhcy/GECCO

GECCO是一个用Java语言开发的轻量级且易于使用的web爬虫程序。它集成了jsoup、httpclient、fastjson、spring、htmlunit、再分配和其他框架。通过配置一些jQuery样式选择器,可以快速编写爬虫程序。GECCO框架具有良好的可扩展性。框架根据开闭原理设计,关闭修改,打开扩展

2、WebCollector

GitHub地址:crawlscript/webcollector

Webcollector是一个Java爬虫框架(内核),不需要配置,便于二次开发。它提供了一个简化的API,只需少量代码即可实现强大的爬虫程序。Webcollector Hadoop是Webcollector的Hadoop版本,支持分布式爬网

3、Spiderman

代码云地址:l-weiwei/spiderman2-代码云-开源中国

用例:演示垂直爬虫的能力–自由如风

蜘蛛侠是一种基于微内核+插件架构的网络蜘蛛。它的目标是通过简单的方法捕获复杂的目标网页信息并将其解析为业务数据

4、WebMagic

代码云地址:flashsword20/webmagic-代码云-开源中国

Webmagic是一个无配置的爬虫框架,便于二次开发。它提供了一个简单灵活的API,只需少量代码即可实现爬虫程序。Webmagic采用全模块化设计,覆盖爬虫的整个生命周期(链接提取、页面下载、内容提取、持久化),支持多线程爬虫、分布式爬虫、自动重试、自定义UA/cookie等功能

5、Heritrix

GitHub地址:InternetArchive/Heritrix 3

Heritrix是一个开源、可扩展的网络爬虫项目。用户可以使用它从互联网上获取所需的资源。Heritrix的设计严格遵循robots.txt文件和meta robots标签的排除说明。其最大的特点是具有良好的可扩展性,方便用户实现自己的爬网逻辑

6、crawler4j

GitHub地址:yasserg/crawler4j·GitHub

Crawler4j是一个用Java实现的开源web爬虫程序。提供一个易于使用的界面,以便在几分钟内创建多线程web爬虫程序

7、Nutch

GitHub地址:Apache/nutch

Nutch是一个用Java实现的开源搜索引擎。它提供了我们运行自己的搜索引擎所需的所有工具。包括全文搜索和网络爬虫

在nutch的发展过程中,出现了四个Java开源项目,Hadoop、Tika、Gora和crawler commons。如今,这四个项目发展迅速,非常流行,尤其是Hadoop,它已经成为大规模数据处理的事实标准。Tika使用各种现有的开源内容解析项目从各种格式的文件中提取元数据和结构化文本。Gora支持将大数据持久化到各种存储实现中。Crawler Commons是一个通用的web爬虫组件

8、SeimiCrawler

GitHub地址:哲格晓霍兹/赛米克罗勒

Seimicrawler是一个灵活、独立部署和分布式Java爬虫框架。希望最大限度地降低新手开发高可用性、高性能爬虫系统的门槛,提高爬虫系统的开发效率。在seimi crawler的世界中,大多数人只需要关心编写捕获的业务逻辑,其余的seimi将帮助您。在设计理念上,seimicrawler受到Python的crawler框架scripy的启发,融合了Java语言和spring的特点,希望在中国使用更方便高效的XPath解析HTML。因此,seimicrawler的默认HTML解析器是JSOUPPATH(独立扩展项目,不是jsoup提供的),默认情况下,解析和提取HTML数据是使用XPath完成的(当然,数据处理也可以选择其他解析器)。它与seimiagent相结合,全面、完美地解决了复杂动态页面的渲染和抓取问题

9、Jsoup

GitHub地址:jhy/jsoup

中文指南:jsoup开发指南、jsoup中文文档

Jsoup是一个Java HTML解析器,它可以直接解析URL地址和HTML文本内容。它提供了一个非常省力的API,可以通过DOM、CSS和类似于jQuery的操作方法获取和操作数据 查看全部

java爬虫抓取动态网页(基于微内核+插件式架构的JAVA爬虫框架(内核))

1、Gecco

GitHub地址:xtuhcy/GECCO

GECCO是一个用Java语言开发的轻量级且易于使用的web爬虫程序。它集成了jsoup、httpclient、fastjson、spring、htmlunit、再分配和其他框架。通过配置一些jQuery样式选择器,可以快速编写爬虫程序。GECCO框架具有良好的可扩展性。框架根据开闭原理设计,关闭修改,打开扩展

2、WebCollector

GitHub地址:crawlscript/webcollector

Webcollector是一个Java爬虫框架(内核),不需要配置,便于二次开发。它提供了一个简化的API,只需少量代码即可实现强大的爬虫程序。Webcollector Hadoop是Webcollector的Hadoop版本,支持分布式爬网

3、Spiderman

代码云地址:l-weiwei/spiderman2-代码云-开源中国

用例:演示垂直爬虫的能力–自由如风

蜘蛛侠是一种基于微内核+插件架构的网络蜘蛛。它的目标是通过简单的方法捕获复杂的目标网页信息并将其解析为业务数据

4、WebMagic

代码云地址:flashsword20/webmagic-代码云-开源中国

Webmagic是一个无配置的爬虫框架,便于二次开发。它提供了一个简单灵活的API,只需少量代码即可实现爬虫程序。Webmagic采用全模块化设计,覆盖爬虫的整个生命周期(链接提取、页面下载、内容提取、持久化),支持多线程爬虫、分布式爬虫、自动重试、自定义UA/cookie等功能

5、Heritrix

GitHub地址:InternetArchive/Heritrix 3

Heritrix是一个开源、可扩展的网络爬虫项目。用户可以使用它从互联网上获取所需的资源。Heritrix的设计严格遵循robots.txt文件和meta robots标签的排除说明。其最大的特点是具有良好的可扩展性,方便用户实现自己的爬网逻辑

6、crawler4j

GitHub地址:yasserg/crawler4j·GitHub

Crawler4j是一个用Java实现的开源web爬虫程序。提供一个易于使用的界面,以便在几分钟内创建多线程web爬虫程序

7、Nutch

GitHub地址:Apache/nutch

Nutch是一个用Java实现的开源搜索引擎。它提供了我们运行自己的搜索引擎所需的所有工具。包括全文搜索和网络爬虫

在nutch的发展过程中,出现了四个Java开源项目,Hadoop、Tika、Gora和crawler commons。如今,这四个项目发展迅速,非常流行,尤其是Hadoop,它已经成为大规模数据处理的事实标准。Tika使用各种现有的开源内容解析项目从各种格式的文件中提取元数据和结构化文本。Gora支持将大数据持久化到各种存储实现中。Crawler Commons是一个通用的web爬虫组件

8、SeimiCrawler

GitHub地址:哲格晓霍兹/赛米克罗勒

Seimicrawler是一个灵活、独立部署和分布式Java爬虫框架。希望最大限度地降低新手开发高可用性、高性能爬虫系统的门槛,提高爬虫系统的开发效率。在seimi crawler的世界中,大多数人只需要关心编写捕获的业务逻辑,其余的seimi将帮助您。在设计理念上,seimicrawler受到Python的crawler框架scripy的启发,融合了Java语言和spring的特点,希望在中国使用更方便高效的XPath解析HTML。因此,seimicrawler的默认HTML解析器是JSOUPPATH(独立扩展项目,不是jsoup提供的),默认情况下,解析和提取HTML数据是使用XPath完成的(当然,数据处理也可以选择其他解析器)。它与seimiagent相结合,全面、完美地解决了复杂动态页面的渲染和抓取问题

9、Jsoup

GitHub地址:jhy/jsoup

中文指南:jsoup开发指南、jsoup中文文档

Jsoup是一个Java HTML解析器,它可以直接解析URL地址和HTML文本内容。它提供了一个非常省力的API,可以通过DOM、CSS和类似于jQuery的操作方法获取和操作数据

java爬虫抓取动态网页(Python编程修改程序函数式编程的实战二抓取您想要的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-09-19 22:08

实战一

抓取所需的网页并将其保存到本地计算机

首先,我们简要分析了要编写的爬虫程序,它可以分为以下三个部分:

在澄清逻辑之后,我们可以正式编写爬虫程序

导入所需模块

from urllib import request, parse

拼接URL地址

定义URL变量和拼接URL地址。代码如下:

url = 'http://www.baidu.com/s?wd={}'

word = input('请输入想要搜索的内容:')

params = parse.quote(word)

full_url = url.format(params)

向URL发送请求

发送请求主要分为以下步骤:

代码如下:

# 重构请求头

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0'

}

# 创建请求对应

req = request.Request(url=full_url, headers=headers)

# 获取响应对象

res = request.urlopen(req)

# 获取响应内容

html = res.read().decode('utf-8')

另存为本地文件

将已爬网的照片保存到本地。这里需要使用python编程的文件IO操作。代码如下:

filename = word + '.html'

with open(filename, 'w', encoding='utf-8') as f:

f.write(html)

整个程序如下:

from urllib import request, parse

# 1.拼url地址

url = 'http://www.baidu.com/s?wd={}'

word = input('请输入想要搜索的内容:')

params = parse.quote(word)

full_url = url.format(params)

# 2.发请求保存到本地

# 重构请求头

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0'

}

# 创建请求对应

req = request.Request(url=full_url, headers=headers)

# 获取响应对象

res = request.urlopen(req)

# 获取响应内容

html = res.read().decode('utf-8')

# 3.保存文件至当前目录

filename = word + '.html'

with open(filename, 'w', encoding='utf-8') as f:

f.write(html)

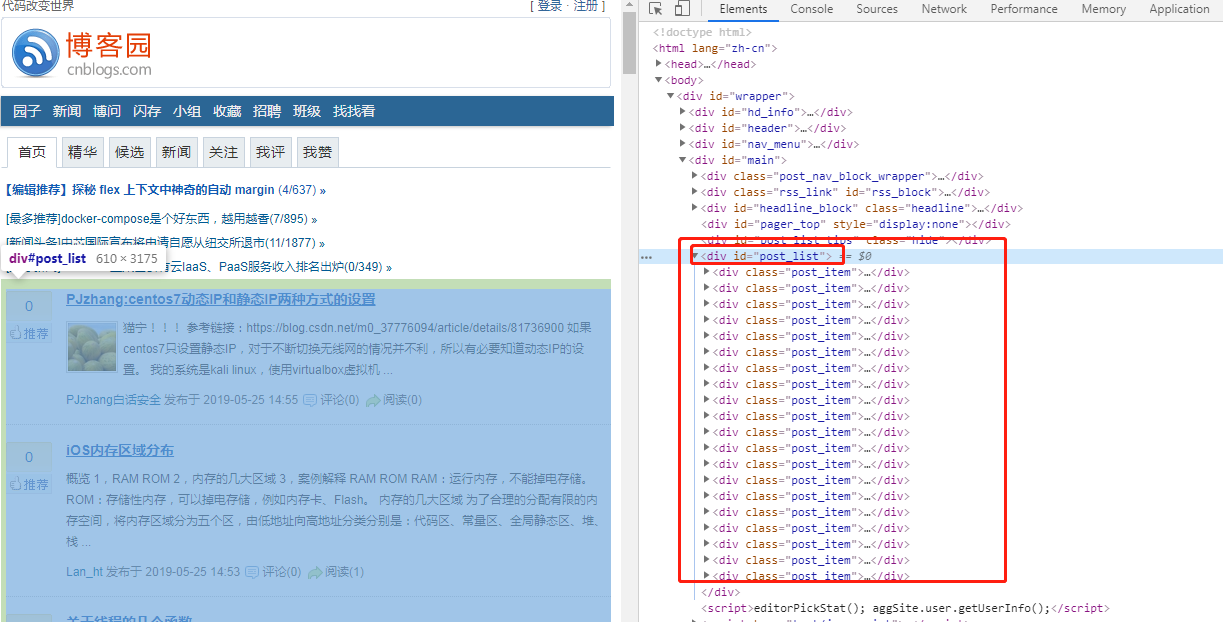

尝试运行该程序,进入riotian blog Park,确认搜索,然后您将在当前工作目录中找到“riotian blog Park.HTML”文件

函数式编程修改器

Python函数式编程可以使程序的思想更清晰、更容易理解。接下来,使用函数式编程的思想更改上述代码

定义相应的函数并通过调用函数执行爬虫程序。修改后的代码如下:

from urllib import request, parse

# 拼接URL地址

def get_url(word):

url = 'http://www.baidu.com/s?{}'

# 此处使用urlencode()进行编码

params = parse.urlencode({'wd': word})

url = url.format(params)

return url

# 发请求,保存本地文件

def request_url(url, filename):

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0'

}

# 请求对象 + 响应对象 + 提取内容

req = request.Request(url=url, headers=headers)

res = request.urlopen(req)

html = res.read().decode('utf-8')

# 保存文件至本地

with open(filename, 'w', encoding='utf-8') as f:

f.write(html)

# 主程序入口

if __name__ == '__main__':

word = input('请输入搜索内容:')

url = get_url(word)

filename = word + '.html'

request_url(url, filename)

除了函数式编程外,还可以使用面向对象的编程方法(actual Combation二),将在后续内容中介绍)

实战二

抓取百度贴吧()页面,如Python爬虫栏和编程栏。只需抓取贴吧的前五页即可@

确定页面类型

通过简单的分析,我们可以知道要抓取的百度贴吧页面属于静态网页,分析方法非常简单:打开百度贴吧,搜索“Python爬虫”,复制页面中的任何部分信息,如“爬虫为什么需要HTTP代理”然后右键单击以查看源代码,并使用Ctrl+F搜索刚刚复制到源代码页上的数据,如下所示:

从上图可以看出,页面中的所有信息都收录在源页面中,不需要从数据库中加载数据,因此该页面是一个静态页面

查找URL更改规则

接下来,找到要爬网的页面的URL规则,搜索“Python爬虫”后,贴吧first页面的URL如下:

https://tieba.baidu.com/f?ie=utf-8&kw=python爬虫&fr=search

点击第二页,URL信息如下:

https://tieba.baidu.com/f?kw=python爬虫&ie=utf-8&pn=50

点击第三页,URL信息如下:

https://tieba.baidu.com/f?kw=python爬虫&ie=utf-8&pn=100

再次点击第一页,URL信息如下:

https://tieba.baidu.com/f?kw=python爬虫&ie=utf-8&pn=0

如果您不确定,可以继续浏览更多页面。最后,您发现URL有两个查询参数kW和PN,PN参数是常规的,如下所示:

第n页:pn=(n-1)*50

#参数params

pn=(page-1)*50

params={

'kw':name,

'pn':str(pn)

}

URL地址可以缩写为:

https://tieba.baidu.com/f?kw=python爬虫&pn=450

写爬虫

爬虫程序以类的形式编写,类下编写不同的函数,代码如下:

from urllib import request,parse

import time

import random

from ua_info import ua_list #使用自定义的ua池

#定义一个爬虫类

class TiebaSpider(object):

#初始化url属性

def __init__(self):

self.url='http://tieba.baidu.com/f?{}'

# 1.请求函数,得到页面,传统三步

def get_html(self,url):

req=request.Request(url=url,headers={'User-Agent':random.choice(ua_list)})

res=request.urlopen(req)

#windows会存在乱码问题,需要使用 gbk解码,并使用ignore忽略不能处理的字节

#linux不会存在上述问题,可以直接使用decode('utf-8')解码

html=res.read().decode("gbk","ignore")

return html

# 2.解析函数,此处代码暂时省略,还没介绍解析模块

def parse_html(self):

pass

# 3.保存文件函数

def save_html(self,filename,html):

with open(filename,'w') as f:

f.write(html)

# 4.入口函数

def run(self):

name=input('输入贴吧名:')

begin=int(input('输入起始页:'))

stop=int(input('输入终止页:'))

# +1 操作保证能够取到整数

for page in range(begin,stop+1):

pn=(page-1)*50

params={

'kw':name,

'pn':str(pn)

}

#拼接URL地址

params=parse.urlencode(params)

url=self.url.format(params)

#发请求

html=self.get_html(url)

#定义路径

filename='{}-{}页.html'.format(name,page)

self.save_html(filename,html)

#提示

print('第%d页抓取成功'%page)

#每爬取一个页面随机休眠1-2秒钟的时间

time.sleep(random.randint(1,2))

#以脚本的形式启动爬虫

if __name__=='__main__':

start=time.time()

spider=TiebaSpider() #实例化一个对象spider

spider.run() #调用入口函数

end=time.time()

#查看程序执行时间

print('执行时间:%.2f'%(end-start)) #爬虫执行时间

程序执行后,爬网文件将保存到pychart当前工作目录,输出结果如下:

输入贴吧名:python爬虫

输入起始页:1

输入终止页:2

第1页抓取成功

第2页抓取成功

执行时间:12.25

用面向对象的方法编写爬虫程序时,思路简单,逻辑清晰易懂,以上代码主要包括四个功能,分别负责不同的功能,总结如下:

1)request函数

请求函数的最终结果是返回一个HTML对象,以方便后续函数调用

2)解析函数

解析功能用于解析HTML页面,常用的解析模块包括常规解析模块和BS4解析模块,通过对页面的分析提取所需的数据,在后续内容中详细描述

3)保存数据功能

此功能负责将捕获的数据保存到数据库中,如mysql、mongodb等,或以文件格式保存,如CSV、TXT、Excel等

4)entry函数

entry函数的主要任务是组织数据,例如要搜索的贴吧名称、编码URL参数、拼接URL地址以及定义文件保存路径

履带结构

采用面向对象方法编译爬虫程序时,逻辑结构相对固定,概括如下:

# 程序结构

class xxxSpider(object):

def __init__(self):

# 定义常用变量,比如url或计数变量等

def get_html(self):

# 获取响应内容函数,使用随机User-Agent

def parse_html(self):

# 使用正则表达式来解析页面,提取数据

def write_html(self):

# 将提取的数据按要求保存,csv、MySQL数据库等

def run(self):

# 主函数,用来控制整体逻辑

if __name__ == '__main__':

# 程序开始运行时间

spider = xxxSpider()

spider.run()

注意:掌握上述编程逻辑有助于后续学习

爬虫随机睡眠

在输入功能代码中,包括以下代码:

# 每爬取一个页面随机休眠1-2秒钟的时间

time.sleep(random.randint(1,2))

爬虫访问网站的速度非常快,这与正常人的点击行为非常不一致。因此,通过随机睡眠,爬虫可以像成年人一样点击网站,因此网站不容易被检测到是爬虫访问网站,但这样做的代价是影响程序的执行效率

聚焦爬虫(Focused crawler)是一种执行效率较低的程序,提高其性能一直是业界关注的问题,这也催生了高效的python爬虫框架scripy

程序员灯塔

转载请注明原链接:[网络爬虫学习]实战、抓取网页和贴吧数据 查看全部

java爬虫抓取动态网页(Python编程修改程序函数式编程的实战二抓取您想要的)

实战一

抓取所需的网页并将其保存到本地计算机

首先,我们简要分析了要编写的爬虫程序,它可以分为以下三个部分:

在澄清逻辑之后,我们可以正式编写爬虫程序

导入所需模块

from urllib import request, parse

拼接URL地址

定义URL变量和拼接URL地址。代码如下:

url = 'http://www.baidu.com/s?wd={}'

word = input('请输入想要搜索的内容:')

params = parse.quote(word)

full_url = url.format(params)

向URL发送请求

发送请求主要分为以下步骤:

代码如下:

# 重构请求头

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0'

}

# 创建请求对应

req = request.Request(url=full_url, headers=headers)

# 获取响应对象

res = request.urlopen(req)

# 获取响应内容

html = res.read().decode('utf-8')

另存为本地文件

将已爬网的照片保存到本地。这里需要使用python编程的文件IO操作。代码如下:

filename = word + '.html'

with open(filename, 'w', encoding='utf-8') as f:

f.write(html)

整个程序如下:

from urllib import request, parse

# 1.拼url地址

url = 'http://www.baidu.com/s?wd={}'

word = input('请输入想要搜索的内容:')

params = parse.quote(word)

full_url = url.format(params)

# 2.发请求保存到本地

# 重构请求头

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0'

}

# 创建请求对应

req = request.Request(url=full_url, headers=headers)

# 获取响应对象

res = request.urlopen(req)

# 获取响应内容

html = res.read().decode('utf-8')

# 3.保存文件至当前目录

filename = word + '.html'

with open(filename, 'w', encoding='utf-8') as f:

f.write(html)

尝试运行该程序,进入riotian blog Park,确认搜索,然后您将在当前工作目录中找到“riotian blog Park.HTML”文件

函数式编程修改器

Python函数式编程可以使程序的思想更清晰、更容易理解。接下来,使用函数式编程的思想更改上述代码

定义相应的函数并通过调用函数执行爬虫程序。修改后的代码如下:

from urllib import request, parse

# 拼接URL地址

def get_url(word):

url = 'http://www.baidu.com/s?{}'

# 此处使用urlencode()进行编码

params = parse.urlencode({'wd': word})

url = url.format(params)

return url

# 发请求,保存本地文件

def request_url(url, filename):

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0'

}

# 请求对象 + 响应对象 + 提取内容

req = request.Request(url=url, headers=headers)

res = request.urlopen(req)

html = res.read().decode('utf-8')

# 保存文件至本地

with open(filename, 'w', encoding='utf-8') as f:

f.write(html)

# 主程序入口

if __name__ == '__main__':

word = input('请输入搜索内容:')

url = get_url(word)

filename = word + '.html'

request_url(url, filename)

除了函数式编程外,还可以使用面向对象的编程方法(actual Combation二),将在后续内容中介绍)

实战二

抓取百度贴吧()页面,如Python爬虫栏和编程栏。只需抓取贴吧的前五页即可@

确定页面类型

通过简单的分析,我们可以知道要抓取的百度贴吧页面属于静态网页,分析方法非常简单:打开百度贴吧,搜索“Python爬虫”,复制页面中的任何部分信息,如“爬虫为什么需要HTTP代理”然后右键单击以查看源代码,并使用Ctrl+F搜索刚刚复制到源代码页上的数据,如下所示:

https://cdn.jsdelivr.net/gh/Ri ... 49.png" />

https://cdn.jsdelivr.net/gh/Ri ... 49.png" />从上图可以看出,页面中的所有信息都收录在源页面中,不需要从数据库中加载数据,因此该页面是一个静态页面

查找URL更改规则

接下来,找到要爬网的页面的URL规则,搜索“Python爬虫”后,贴吧first页面的URL如下:

https://tieba.baidu.com/f?ie=utf-8&kw=python爬虫&fr=search

点击第二页,URL信息如下:

https://tieba.baidu.com/f?kw=python爬虫&ie=utf-8&pn=50

点击第三页,URL信息如下:

https://tieba.baidu.com/f?kw=python爬虫&ie=utf-8&pn=100

再次点击第一页,URL信息如下:

https://tieba.baidu.com/f?kw=python爬虫&ie=utf-8&pn=0

如果您不确定,可以继续浏览更多页面。最后,您发现URL有两个查询参数kW和PN,PN参数是常规的,如下所示:

第n页:pn=(n-1)*50

#参数params

pn=(page-1)*50

params={

'kw':name,

'pn':str(pn)

}

URL地址可以缩写为:

https://tieba.baidu.com/f?kw=python爬虫&pn=450

写爬虫

爬虫程序以类的形式编写,类下编写不同的函数,代码如下:

from urllib import request,parse

import time

import random

from ua_info import ua_list #使用自定义的ua池

#定义一个爬虫类

class TiebaSpider(object):

#初始化url属性

def __init__(self):

self.url='http://tieba.baidu.com/f?{}'

# 1.请求函数,得到页面,传统三步

def get_html(self,url):

req=request.Request(url=url,headers={'User-Agent':random.choice(ua_list)})

res=request.urlopen(req)

#windows会存在乱码问题,需要使用 gbk解码,并使用ignore忽略不能处理的字节

#linux不会存在上述问题,可以直接使用decode('utf-8')解码

html=res.read().decode("gbk","ignore")

return html

# 2.解析函数,此处代码暂时省略,还没介绍解析模块

def parse_html(self):

pass

# 3.保存文件函数

def save_html(self,filename,html):

with open(filename,'w') as f:

f.write(html)

# 4.入口函数

def run(self):

name=input('输入贴吧名:')

begin=int(input('输入起始页:'))

stop=int(input('输入终止页:'))

# +1 操作保证能够取到整数

for page in range(begin,stop+1):

pn=(page-1)*50

params={

'kw':name,

'pn':str(pn)

}

#拼接URL地址

params=parse.urlencode(params)

url=self.url.format(params)

#发请求

html=self.get_html(url)

#定义路径

filename='{}-{}页.html'.format(name,page)

self.save_html(filename,html)

#提示

print('第%d页抓取成功'%page)

#每爬取一个页面随机休眠1-2秒钟的时间

time.sleep(random.randint(1,2))

#以脚本的形式启动爬虫

if __name__=='__main__':

start=time.time()

spider=TiebaSpider() #实例化一个对象spider

spider.run() #调用入口函数

end=time.time()

#查看程序执行时间

print('执行时间:%.2f'%(end-start)) #爬虫执行时间

程序执行后,爬网文件将保存到pychart当前工作目录,输出结果如下:

输入贴吧名:python爬虫

输入起始页:1

输入终止页:2

第1页抓取成功

第2页抓取成功

执行时间:12.25

用面向对象的方法编写爬虫程序时,思路简单,逻辑清晰易懂,以上代码主要包括四个功能,分别负责不同的功能,总结如下:

1)request函数

请求函数的最终结果是返回一个HTML对象,以方便后续函数调用

2)解析函数

解析功能用于解析HTML页面,常用的解析模块包括常规解析模块和BS4解析模块,通过对页面的分析提取所需的数据,在后续内容中详细描述

3)保存数据功能

此功能负责将捕获的数据保存到数据库中,如mysql、mongodb等,或以文件格式保存,如CSV、TXT、Excel等

4)entry函数

entry函数的主要任务是组织数据,例如要搜索的贴吧名称、编码URL参数、拼接URL地址以及定义文件保存路径

履带结构

采用面向对象方法编译爬虫程序时,逻辑结构相对固定,概括如下:

# 程序结构

class xxxSpider(object):

def __init__(self):

# 定义常用变量,比如url或计数变量等

def get_html(self):

# 获取响应内容函数,使用随机User-Agent

def parse_html(self):

# 使用正则表达式来解析页面,提取数据

def write_html(self):

# 将提取的数据按要求保存,csv、MySQL数据库等

def run(self):

# 主函数,用来控制整体逻辑

if __name__ == '__main__':

# 程序开始运行时间

spider = xxxSpider()

spider.run()

注意:掌握上述编程逻辑有助于后续学习

爬虫随机睡眠

在输入功能代码中,包括以下代码:

# 每爬取一个页面随机休眠1-2秒钟的时间

time.sleep(random.randint(1,2))

爬虫访问网站的速度非常快,这与正常人的点击行为非常不一致。因此,通过随机睡眠,爬虫可以像成年人一样点击网站,因此网站不容易被检测到是爬虫访问网站,但这样做的代价是影响程序的执行效率

聚焦爬虫(Focused crawler)是一种执行效率较低的程序,提高其性能一直是业界关注的问题,这也催生了高效的python爬虫框架scripy

程序员灯塔

转载请注明原链接:[网络爬虫学习]实战、抓取网页和贴吧数据

java爬虫抓取动态网页(Java爬虫Jsoup+httpclient获取动态生成的数据(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 217 次浏览 • 2021-09-19 22:05

您想知道Java爬虫jsup+httpclient获取动态生成数据的相关内容吗?在本文中,我们将仔细解释Java爬虫的相关知识和一些代码示例。欢迎阅读并更正。让我们首先关注:Java爬虫jsup+httpclient获取动态生成的数据,Java爬虫,Java爬虫jsup。让我们一起学习

Java爬虫程序jsup+httpclient获取动态生成的数据

我们之前详细讨论过,发现事情就是这样。只要它是一个可以访问的静态资源页面,您就可以直接使用它来获取所需的数据。细节跳跃——jsup爬虫的详细解释,但很多时候网站为了防止数据被恶意爬虫,有很多掩码,比如加密和动态加载,这实际上给我们编写的爬虫程序带来了很多麻烦,那么,我们如何突破这一限制,获得我们迫切需要的数据呢

让我们详细解释一下如何获得

String startPage="https://item.jd.com/11476104681.html";

Document document = Jsoup.connect(startPage).userAgent

("Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome/52.0.2743.116 Safari/537.36").get();

此时,已经获取了整个页面的数据,但商品价格是通过回调函数获取并填写的。因此,编写爬虫程序的开发人员必须非常耐心地找到价格数据的回调接口。我们可以直接访问此界面获取价格。以下是一个演示:

从这个截图中,我们可以看到他传递的只是一个静态资源页面,根本没有价格参数。那么价格是怎么来的呢?继续查找此接口:

您会发现许多参数都拼接在这个接口中,所以我们需要做的是分析所有参数是否有用

https://p.3.cn/prices/mgets%3F ... tk%3D

pduid=14930020970791835891856&pdpin=jd_6738608ee8eed&pdbp=0&skuIds=J_11476104681&source=item-pc

您可以尝试删除一些参数,发现接口所需的参数其实非常简单:

https://p.3.cn/prices/mgets%3F ... em-pc

在这里看电影不是很刺激吗?事实上,您可以更改其他一些JD产品ID以获取当前价格和最高价格。我不知道价格是多少。我们需要做的就是编写一个httpclient模拟请求接口

String doGet = HttpUtils.doGet("https://p.3.cn/prices/mgets%3F ... ot%3B, null);

System.out.println(doGet);

结果是:

jQuery9734926([{"id":"J_11476104681","p":"880.00","m":"980.00","op":"980.00"}]);

对于以下内容,您可以直接解析JSON字符串,获得您想要的数据

注意

这是对回调请求的数据的重新请求获取,这只是对先前商品价格动态获取的补充。在这种情况下,价格本身不会通过主链接带到页面,而是在加载过程中由异步请求填写。有时候会带来数据,但是相关的JS处理后我们还是无法得到,这个时候我们要通过其他的方式来获得这个数据,后面会解释 查看全部

java爬虫抓取动态网页(Java爬虫Jsoup+httpclient获取动态生成的数据(组图))

您想知道Java爬虫jsup+httpclient获取动态生成数据的相关内容吗?在本文中,我们将仔细解释Java爬虫的相关知识和一些代码示例。欢迎阅读并更正。让我们首先关注:Java爬虫jsup+httpclient获取动态生成的数据,Java爬虫,Java爬虫jsup。让我们一起学习

Java爬虫程序jsup+httpclient获取动态生成的数据

我们之前详细讨论过,发现事情就是这样。只要它是一个可以访问的静态资源页面,您就可以直接使用它来获取所需的数据。细节跳跃——jsup爬虫的详细解释,但很多时候网站为了防止数据被恶意爬虫,有很多掩码,比如加密和动态加载,这实际上给我们编写的爬虫程序带来了很多麻烦,那么,我们如何突破这一限制,获得我们迫切需要的数据呢

让我们详细解释一下如何获得

String startPage="https://item.jd.com/11476104681.html";

Document document = Jsoup.connect(startPage).userAgent

("Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome/52.0.2743.116 Safari/537.36").get();

此时,已经获取了整个页面的数据,但商品价格是通过回调函数获取并填写的。因此,编写爬虫程序的开发人员必须非常耐心地找到价格数据的回调接口。我们可以直接访问此界面获取价格。以下是一个演示:

从这个截图中,我们可以看到他传递的只是一个静态资源页面,根本没有价格参数。那么价格是怎么来的呢?继续查找此接口:

您会发现许多参数都拼接在这个接口中,所以我们需要做的是分析所有参数是否有用

https://p.3.cn/prices/mgets%3F ... tk%3D

pduid=14930020970791835891856&pdpin=jd_6738608ee8eed&pdbp=0&skuIds=J_11476104681&source=item-pc

您可以尝试删除一些参数,发现接口所需的参数其实非常简单:

https://p.3.cn/prices/mgets%3F ... em-pc

在这里看电影不是很刺激吗?事实上,您可以更改其他一些JD产品ID以获取当前价格和最高价格。我不知道价格是多少。我们需要做的就是编写一个httpclient模拟请求接口

String doGet = HttpUtils.doGet("https://p.3.cn/prices/mgets%3F ... ot%3B, null);

System.out.println(doGet);

结果是:

jQuery9734926([{"id":"J_11476104681","p":"880.00","m":"980.00","op":"980.00"}]);

对于以下内容,您可以直接解析JSON字符串,获得您想要的数据

注意

这是对回调请求的数据的重新请求获取,这只是对先前商品价格动态获取的补充。在这种情况下,价格本身不会通过主链接带到页面,而是在加载过程中由异步请求填写。有时候会带来数据,但是相关的JS处理后我们还是无法得到,这个时候我们要通过其他的方式来获得这个数据,后面会解释

java爬虫抓取动态网页(【学习】morestories模拟点击按钮行为比phantomjs更稳定)

网站优化 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-19 16:14

在上一期中,我们说过phantomjs可以模拟单击按钮的行为,并通过单击所有“加载更多”按钮来获取所有内容。例如,此网页

我们需要抓取红线标记的超链接,存储URL,然后单击“查看更多故事”以显示更多列表。但是,对于某些网页,“查看更多故事”按钮在所有隐藏内容出现后仍然存在,这使得很难判断模拟点击行为何时终止。也许聪明的朋友会说:“有什么困难?模拟单击行为,抓取网页,并从下到上获取列表项的URL。当URL与数据库中已捕获的URL重复时,停止获取。当从下到上获取的第一个URL与数据库中的URL重复时,这意味着整个网页的所有内容都已获取,模拟点击行为可以停止”。这确实是一种方法,但网页有很多判断和重复爬行。我们有一个更优雅的解决方案。为什么不呢??(此外,如果我们真的想模拟,selenium比phantomjs更稳定…)

你一定已经知道我接下来想通过标题说什么,所谓的更优雅的方式……没错

打开控制台的网络模块

单击“查看更多故事”按钮,将显示以下网络请求。请注意,此类型为XHR的网络请求是从后台请求更多列表项的原因。请观察请求标题

请求有两个参数,因此请尝试按如下方式拼接URL

我们得到了13个列表项,但是当我们点击load more按钮时,添加了15个新项,只缺少了两个列表项,这并不影响抓取的整体效果,所以我们使用这种方法抓取它们。当页面参数大于实际最大页数时,一些网页不会出现“查看更多故事”“按钮,某些按钮仍会出现,但会显示最大页数的页面内容。根据不同情况判断是否停止爬网。”

代码如下:(大部分基本代码已经在前面解释过了,所以我不再重复)

package edu.nju.opsource.vnexpress.linktype;

import java.io.InputStream;

import java.util.Date;

import java.util.LinkedList;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import com.onezetta.downloader.EasyHttpDownloader;

import edu.nju.opensource.common.beans.ELinkState;

import edu.nju.opensource.common.beans.Link;

import edu.nju.opensource.common.beans.LinkType;

import edu.nju.opensource.common.beans.Site;

import edu.nju.opsource.vnexpress.utils.IdXmlUtil;

public class LinkType_NewsList extends LinkType {

private Document doc = null;

private Site site = null;

private LinkedList newItems = null;

private Link nextPage = null;

public LinkType_NewsList() {

super();

// TODO Auto-generated constructor stub

}

public LinkType_NewsList(String linkTypeName) {

super.setLinkTypeName(linkTypeName);

}

public LinkType_NewsList(Site site) {

super.setLinkTypeName("vnexpress.newslist");

this.site = site;

}

public void get(String url) {

super.get(url);

String content = new EasyHttpDownloader(url).run();

if (content != null) {

this.doc = Jsoup.parse(content, this.site.getUrl().getUrl());

System.out.println(" ... has Crawled.");

} else {

setState(ELinkState.CRAWLFAILED);

System.out.println(" ... crawled failed.");

}

}

// 把新闻列表条目的链接插入表

// 在总项目中被调用的核心函数handle()

@Override

public boolean handle(Link parentlink) throws Exception {

if (getState() == ELinkState.CRAWLFAILED)

return false;

Elements news = this.doc.select("div.list_news_folder.col_720 h4.title_news_site");

this.newItems = new LinkedList();

boolean flag = false;

for (Element newItem : news) {

Elements tmp = newItem.select("a");

if ((tmp != null) && (tmp.size() != 0)) {

Link link = new Link(tmp.first().attr("abs:href"), new LinkType_News(), ELinkState.UNCRAWL, parentlink,

this.site).setLinkDate( new java.sql.Date(new Date().getTime()));

// System.out.println(tmp.first().attr("abs:href"));

int rst = link.insert();

if (rst == -1)

flag = true;// link exist

}

}

if (flag) {

setState(ELinkState.CRAWLED);

return false;

}

Elements nextPageE = this.doc.select("a#vnexpress_folder_load_more");

String url = getNextPageUrl();

if ((nextPageE != null) && (nextPageE.size() != 0)) {

System.out.println(url);

this.nextPage = new Link(url, new LinkType_NewsList(this.site), ELinkState.UNCRAWL, parentlink, this.site).setLinkDate( new java.sql.Date(new Date().getTime()));

this.nextPage.insert();

}

else {

IdXmlUtil.setIdByName("news", 2 + "");

}

setState(ELinkState.CRAWLED);

return true;

}

public static String getNextPageUrl() {

int id = IdXmlUtil.getIdByName("news");

// IdXmlUtil用来存储当前已抓取的pageid其实这个工具完全没必要,因为数据库的//url有此参数啊。。。当时脑抽没想到,搞麻烦了。。。

IdXmlUtil.setIdByName("news", (id + 1) + "");

//此文章的精髓

String url = "http://e.vnexpress.net/news/ne ... ot%3B + id;

return url;

}

@Override

public String getLinkTextData() {

// TODO Auto-generated method stub

return null;

}

@Override

public InputStream getLinkBinaryData() {

// TODO Auto-generated method stub

return null;

}

@Override

public String getLinkUniqeID(String paramString) {

// TODO Auto-generated method stub

return null;

}

@Override

public Date getLinkDate() {

// TODO Auto-generated method stub

return null;

}

public Site getSite() {

return this.site;

}

@Override

public void setSite(Site site) {

// TODO Auto-generated method stub

this.site = site;

}

public LinkedList getNewItems() {

return this.newItems;

}

public void setNewItems(LinkedList newItems) {

this.newItems = newItems;

}

public Link getNextPage() {

return this.nextPage;

}

public void setNextPage(Link nextPage) {

this.nextPage = nextPage;

}

@Override

public String toString() {

return "LinkType_newsList [doc=" + doc + ", site=" + site + ", newItems=" + newItems + ", nextPage="

+ nextPage + "]";

}

}

我原以为爬虫系列将在这里结束。事实上,另一个问题是我们在浏览器上尝试URL以查看效果。但是,一些网站尝试以这种方式看不到任何内容。这是因为浏览器将URL作为get请求输入,而一些网站后台内容不接受get请求。在这种情况下,我们如何处理ck拼接URL的效果如何

<p>期待下一期>0 查看全部

java爬虫抓取动态网页(【学习】morestories模拟点击按钮行为比phantomjs更稳定)

在上一期中,我们说过phantomjs可以模拟单击按钮的行为,并通过单击所有“加载更多”按钮来获取所有内容。例如,此网页

我们需要抓取红线标记的超链接,存储URL,然后单击“查看更多故事”以显示更多列表。但是,对于某些网页,“查看更多故事”按钮在所有隐藏内容出现后仍然存在,这使得很难判断模拟点击行为何时终止。也许聪明的朋友会说:“有什么困难?模拟单击行为,抓取网页,并从下到上获取列表项的URL。当URL与数据库中已捕获的URL重复时,停止获取。当从下到上获取的第一个URL与数据库中的URL重复时,这意味着整个网页的所有内容都已获取,模拟点击行为可以停止”。这确实是一种方法,但网页有很多判断和重复爬行。我们有一个更优雅的解决方案。为什么不呢??(此外,如果我们真的想模拟,selenium比phantomjs更稳定…)

你一定已经知道我接下来想通过标题说什么,所谓的更优雅的方式……没错

打开控制台的网络模块

单击“查看更多故事”按钮,将显示以下网络请求。请注意,此类型为XHR的网络请求是从后台请求更多列表项的原因。请观察请求标题

请求有两个参数,因此请尝试按如下方式拼接URL

我们得到了13个列表项,但是当我们点击load more按钮时,添加了15个新项,只缺少了两个列表项,这并不影响抓取的整体效果,所以我们使用这种方法抓取它们。当页面参数大于实际最大页数时,一些网页不会出现“查看更多故事”“按钮,某些按钮仍会出现,但会显示最大页数的页面内容。根据不同情况判断是否停止爬网。”

代码如下:(大部分基本代码已经在前面解释过了,所以我不再重复)

package edu.nju.opsource.vnexpress.linktype;

import java.io.InputStream;

import java.util.Date;

import java.util.LinkedList;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import com.onezetta.downloader.EasyHttpDownloader;

import edu.nju.opensource.common.beans.ELinkState;

import edu.nju.opensource.common.beans.Link;

import edu.nju.opensource.common.beans.LinkType;

import edu.nju.opensource.common.beans.Site;

import edu.nju.opsource.vnexpress.utils.IdXmlUtil;

public class LinkType_NewsList extends LinkType {

private Document doc = null;

private Site site = null;

private LinkedList newItems = null;

private Link nextPage = null;

public LinkType_NewsList() {

super();

// TODO Auto-generated constructor stub

}

public LinkType_NewsList(String linkTypeName) {

super.setLinkTypeName(linkTypeName);

}

public LinkType_NewsList(Site site) {

super.setLinkTypeName("vnexpress.newslist");

this.site = site;

}

public void get(String url) {

super.get(url);

String content = new EasyHttpDownloader(url).run();

if (content != null) {

this.doc = Jsoup.parse(content, this.site.getUrl().getUrl());

System.out.println(" ... has Crawled.");

} else {

setState(ELinkState.CRAWLFAILED);

System.out.println(" ... crawled failed.");

}

}

// 把新闻列表条目的链接插入表

// 在总项目中被调用的核心函数handle()

@Override

public boolean handle(Link parentlink) throws Exception {

if (getState() == ELinkState.CRAWLFAILED)

return false;

Elements news = this.doc.select("div.list_news_folder.col_720 h4.title_news_site");

this.newItems = new LinkedList();

boolean flag = false;

for (Element newItem : news) {

Elements tmp = newItem.select("a");

if ((tmp != null) && (tmp.size() != 0)) {

Link link = new Link(tmp.first().attr("abs:href"), new LinkType_News(), ELinkState.UNCRAWL, parentlink,

this.site).setLinkDate( new java.sql.Date(new Date().getTime()));

// System.out.println(tmp.first().attr("abs:href"));

int rst = link.insert();

if (rst == -1)

flag = true;// link exist

}

}

if (flag) {

setState(ELinkState.CRAWLED);

return false;

}

Elements nextPageE = this.doc.select("a#vnexpress_folder_load_more");

String url = getNextPageUrl();

if ((nextPageE != null) && (nextPageE.size() != 0)) {

System.out.println(url);

this.nextPage = new Link(url, new LinkType_NewsList(this.site), ELinkState.UNCRAWL, parentlink, this.site).setLinkDate( new java.sql.Date(new Date().getTime()));

this.nextPage.insert();

}

else {

IdXmlUtil.setIdByName("news", 2 + "");

}

setState(ELinkState.CRAWLED);

return true;

}

public static String getNextPageUrl() {

int id = IdXmlUtil.getIdByName("news");

// IdXmlUtil用来存储当前已抓取的pageid其实这个工具完全没必要,因为数据库的//url有此参数啊。。。当时脑抽没想到,搞麻烦了。。。

IdXmlUtil.setIdByName("news", (id + 1) + "");

//此文章的精髓

String url = "http://e.vnexpress.net/news/ne ... ot%3B + id;

return url;

}

@Override

public String getLinkTextData() {

// TODO Auto-generated method stub

return null;

}

@Override

public InputStream getLinkBinaryData() {

// TODO Auto-generated method stub

return null;

}

@Override

public String getLinkUniqeID(String paramString) {

// TODO Auto-generated method stub

return null;

}

@Override

public Date getLinkDate() {

// TODO Auto-generated method stub

return null;

}

public Site getSite() {

return this.site;

}

@Override

public void setSite(Site site) {

// TODO Auto-generated method stub

this.site = site;

}

public LinkedList getNewItems() {

return this.newItems;

}

public void setNewItems(LinkedList newItems) {

this.newItems = newItems;

}

public Link getNextPage() {

return this.nextPage;

}

public void setNextPage(Link nextPage) {

this.nextPage = nextPage;

}

@Override

public String toString() {

return "LinkType_newsList [doc=" + doc + ", site=" + site + ", newItems=" + newItems + ", nextPage="

+ nextPage + "]";

}

}

我原以为爬虫系列将在这里结束。事实上,另一个问题是我们在浏览器上尝试URL以查看效果。但是,一些网站尝试以这种方式看不到任何内容。这是因为浏览器将URL作为get请求输入,而一些网站后台内容不接受get请求。在这种情况下,我们如何处理ck拼接URL的效果如何

<p>期待下一期>0

java爬虫抓取动态网页(通过案例展示如何使用Jsoup进行解析案例中将获取博客园首页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-09-19 16:11

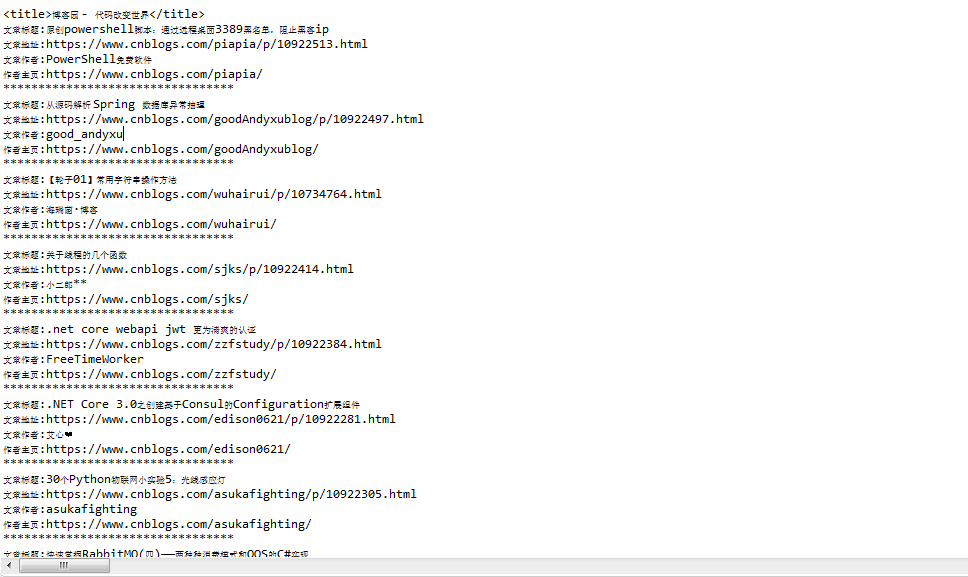

下面是一个案例,演示如何使用jsup进行解析。在这种情况下,将获得博客花园第一页的标题和第一页上的博客文章列表

请查看代码(在前面代码的基础上操作。如果您不知道如何使用httpclient,请跳转到页面阅读):

引入依赖关系

org.jsoup

jsoup

1.12.1

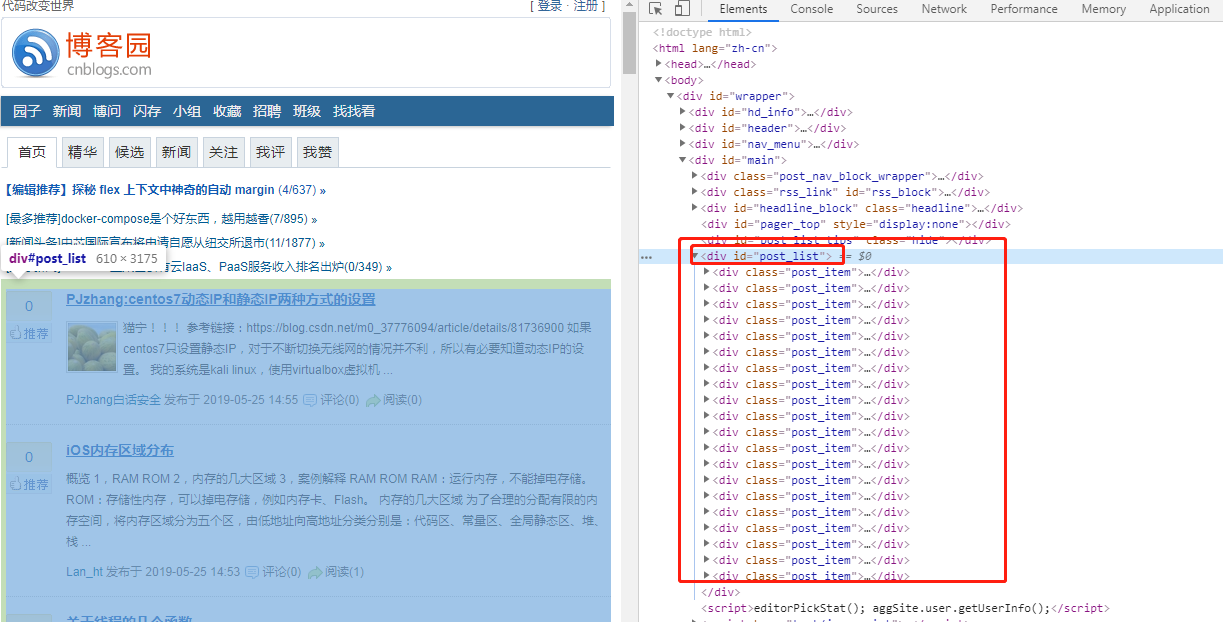

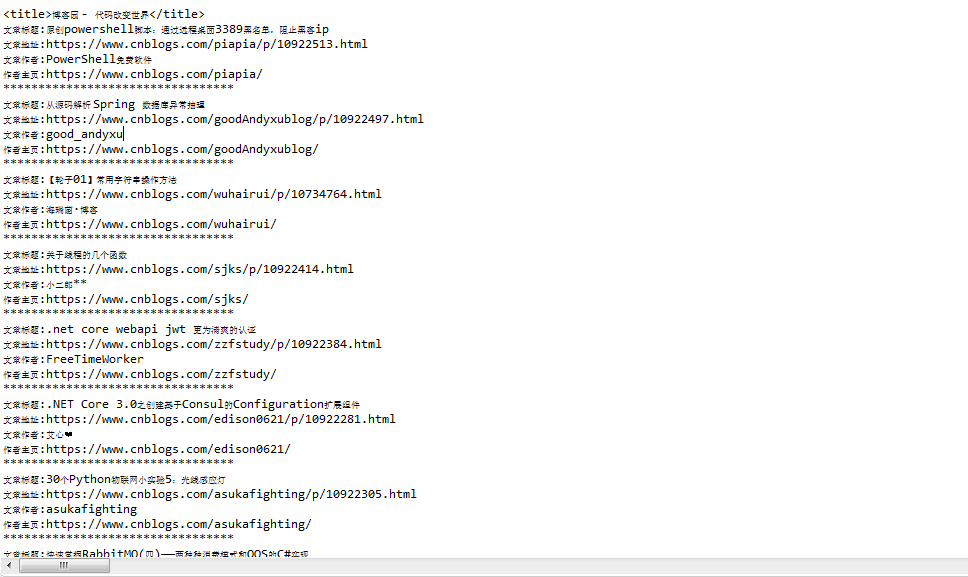

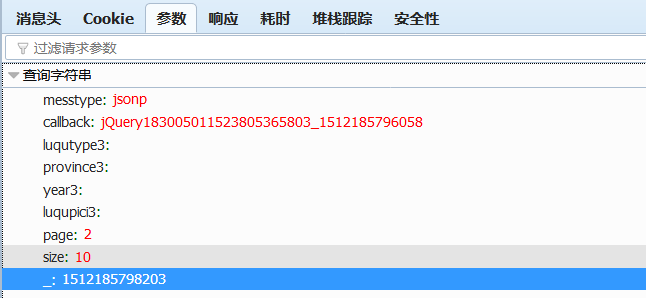

实现代码。在实现代码之前,首先分析HTML结构。不用说,那么文章列表呢?按浏览器的F12键查看页面元素源代码。您会发现列表是一个大div,id=“post\u list”,而每个文章文章都是一个小div,class=“post\u item”

接下来,您可以启动代码。jsup的核心代码如下(整体源代码将在文章末尾给出):

/**

* 下面是Jsoup展现自我的平台

*/

//6.Jsoup解析html

Document document = Jsoup.parse(html);

//像js一样,通过标签获取title

System.out.println(document.getElementsByTag("title").first());

//像js一样,通过id 获取文章列表元素对象

Element postList = document.getElementById("post_list");

//像js一样,通过class 获取列表下的所有博客

Elements postItems = postList.getElementsByClass("post_item");

//循环处理每篇博客

for (Element postItem : postItems) {

//像jquery选择器一样,获取文章标题元素

Elements titleEle = postItem.select(".post_item_body a[class='titlelnk']");

System.out.println("文章标题:" + titleEle.text());;

System.out.println("文章地址:" + titleEle.attr("href"));

//像jquery选择器一样,获取文章作者元素

Elements footEle = postItem.select(".post_item_foot a[class='lightblue']");

System.out.println("文章作者:" + footEle.text());;

System.out.println("作者主页:" + footEle.attr("href"));

System.out.println("*********************************");

}

根据上面的代码,您会发现我通过jsup.parse(string HTML)方法解析httpclient获取的HTML内容来获取文档,然后文档可以通过两种方式获取其子元素:类似JS的getelementxxxx和类似jQuery选择器的select()。两种方法都可以。我个人建议使用select方法。对于元素中的属性,例如超链接地址,可以使用元素。Attr(string)方法获取,对于元素的文本内容,可以使用元素。要获取的Text()方法

执行代码并检查结果(我不得不感叹博客公园的朋友们真的很棒。从上面对主页HTML结构的分析到jsup分析的代码的执行,这段时间文章有这么多主页)

因为新的文章版本太快了,上面的屏幕截图与这里的输出有些不同

三、Jsoup其他用途

一、 jsup不仅可以在httpclient的工作成果中发挥作用,还可以独立工作,抓取页面,自己分析。分析能力已在上面显示。现在让我们展示如何抓取页面。事实上,这很简单。区别在于我直接获取文档,不需要通过jsup解析它。Parse()方法

除了直接访问在线资源外,我还可以解析本地资源:

代码:

public static void main(String[] args) {

try {

Document document = Jsoup.parse(new File("d://1.html"), "utf-8");

System.out.println(document);

} catch (IOException e) {

e.printStackTrace();

}

}

四、Jsoup另一个值得一提的特点

你一定有过这种经历。如果在页面文本框中输入HTML元素并在保存后查看它们,则页面布局很可能会混乱。如果你能过滤这些内容,它将是完美的

只是为了让我能做

通过jsup.clean方法使用白名单进行过滤。执行结果:

unsafe: <p>博客园

safe:

<a rel="nofollow">博客园</a></p>

五、结论

通过以上,我相信我是非常强大的。我不仅可以解析httpclient捕获的HTML元素,还可以自己抓取页面DOM。我还可以加载和解析本地保存的HTML文件

此外,我可以通过白名单过滤字符串,以筛选出一些不安全的字符

最重要的是,上述所有函数的API调用都相对简单

===============华丽的分界线=============

编写代码并不容易。就像你走之前那样~~

最后,本案例中分析博客公园主页文章列表的完整源代码附于后文:

package httpclient_learn;

import java.io.IOException;

import org.apache.http.HttpEntity;

import org.apache.http.HttpStatus;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.client.utils.HttpClientUtils;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class HttpClientTest {

public static void main(String[] args) {

//1.生成httpclient,相当于该打开一个浏览器

CloseableHttpClient httpClient = HttpClients.createDefault();

CloseableHttpResponse response = null;

//2.创建get请求,相当于在浏览器地址栏输入 网址

HttpGet request = new HttpGet("https://www.cnblogs.com/");

//设置请求头,将爬虫伪装成浏览器

request.setHeader("User-Agent","Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.169 Safari/537.36");

// HttpHost proxy = new HttpHost("60.13.42.232", 9999);

// RequestConfig config = RequestConfig.custom().setProxy(proxy).build();

// request.setConfig(config);

try {

//3.执行get请求,相当于在输入地址栏后敲回车键

response = httpClient.execute(request);

//4.判断响应状态为200,进行处理

if(response.getStatusLine().getStatusCode() == HttpStatus.SC_OK) {

//5.获取响应内容

HttpEntity httpEntity = response.getEntity();

String html = EntityUtils.toString(httpEntity, "utf-8");

System.out.println(html);

/**

* 下面是Jsoup展现自我的平台

*/

//6.Jsoup解析html

Document document = Jsoup.parse(html);

//像js一样,通过标签获取title

System.out.println(document.getElementsByTag("title").first());

//像js一样,通过id 获取文章列表元素对象

Element postList = document.getElementById("post_list");

//像js一样,通过class 获取列表下的所有博客

Elements postItems = postList.getElementsByClass("post_item");

//循环处理每篇博客

for (Element postItem : postItems) {

//像jquery选择器一样,获取文章标题元素

Elements titleEle = postItem.select(".post_item_body a[class='titlelnk']");

System.out.println("文章标题:" + titleEle.text());;

System.out.println("文章地址:" + titleEle.attr("href"));

//像jquery选择器一样,获取文章作者元素

Elements footEle = postItem.select(".post_item_foot a[class='lightblue']");

System.out.println("文章作者:" + footEle.text());;

System.out.println("作者主页:" + footEle.attr("href"));

System.out.println("*********************************");

}

} else {

//如果返回状态不是200,比如404(页面不存在)等,根据情况做处理,这里略

System.out.println("返回状态不是200");

System.out.println(EntityUtils.toString(response.getEntity(), "utf-8"));

}

} catch (ClientProtocolException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} finally {

//6.关闭

HttpClientUtils.closeQuietly(response);

HttpClientUtils.closeQuietly(httpClient);

}

}

}

视图代码 查看全部

java爬虫抓取动态网页(通过案例展示如何使用Jsoup进行解析案例中将获取博客园首页)

下面是一个案例,演示如何使用jsup进行解析。在这种情况下,将获得博客花园第一页的标题和第一页上的博客文章列表

请查看代码(在前面代码的基础上操作。如果您不知道如何使用httpclient,请跳转到页面阅读):

引入依赖关系

org.jsoup

jsoup

1.12.1

实现代码。在实现代码之前,首先分析HTML结构。不用说,那么文章列表呢?按浏览器的F12键查看页面元素源代码。您会发现列表是一个大div,id=“post\u list”,而每个文章文章都是一个小div,class=“post\u item”

接下来,您可以启动代码。jsup的核心代码如下(整体源代码将在文章末尾给出):

/**

* 下面是Jsoup展现自我的平台

*/

//6.Jsoup解析html

Document document = Jsoup.parse(html);

//像js一样,通过标签获取title

System.out.println(document.getElementsByTag("title").first());

//像js一样,通过id 获取文章列表元素对象

Element postList = document.getElementById("post_list");

//像js一样,通过class 获取列表下的所有博客

Elements postItems = postList.getElementsByClass("post_item");

//循环处理每篇博客

for (Element postItem : postItems) {

//像jquery选择器一样,获取文章标题元素

Elements titleEle = postItem.select(".post_item_body a[class='titlelnk']");

System.out.println("文章标题:" + titleEle.text());;

System.out.println("文章地址:" + titleEle.attr("href"));

//像jquery选择器一样,获取文章作者元素

Elements footEle = postItem.select(".post_item_foot a[class='lightblue']");

System.out.println("文章作者:" + footEle.text());;

System.out.println("作者主页:" + footEle.attr("href"));

System.out.println("*********************************");

}

根据上面的代码,您会发现我通过jsup.parse(string HTML)方法解析httpclient获取的HTML内容来获取文档,然后文档可以通过两种方式获取其子元素:类似JS的getelementxxxx和类似jQuery选择器的select()。两种方法都可以。我个人建议使用select方法。对于元素中的属性,例如超链接地址,可以使用元素。Attr(string)方法获取,对于元素的文本内容,可以使用元素。要获取的Text()方法

执行代码并检查结果(我不得不感叹博客公园的朋友们真的很棒。从上面对主页HTML结构的分析到jsup分析的代码的执行,这段时间文章有这么多主页)

因为新的文章版本太快了,上面的屏幕截图与这里的输出有些不同

三、Jsoup其他用途

一、 jsup不仅可以在httpclient的工作成果中发挥作用,还可以独立工作,抓取页面,自己分析。分析能力已在上面显示。现在让我们展示如何抓取页面。事实上,这很简单。区别在于我直接获取文档,不需要通过jsup解析它。Parse()方法

除了直接访问在线资源外,我还可以解析本地资源:

代码:

public static void main(String[] args) {

try {

Document document = Jsoup.parse(new File("d://1.html"), "utf-8");

System.out.println(document);

} catch (IOException e) {

e.printStackTrace();

}

}

四、Jsoup另一个值得一提的特点

你一定有过这种经历。如果在页面文本框中输入HTML元素并在保存后查看它们,则页面布局很可能会混乱。如果你能过滤这些内容,它将是完美的

只是为了让我能做

通过jsup.clean方法使用白名单进行过滤。执行结果:

unsafe: <p>博客园

safe:

<a rel="nofollow">博客园</a></p>

五、结论

通过以上,我相信我是非常强大的。我不仅可以解析httpclient捕获的HTML元素,还可以自己抓取页面DOM。我还可以加载和解析本地保存的HTML文件

此外,我可以通过白名单过滤字符串,以筛选出一些不安全的字符

最重要的是,上述所有函数的API调用都相对简单

===============华丽的分界线=============

编写代码并不容易。就像你走之前那样~~

最后,本案例中分析博客公园主页文章列表的完整源代码附于后文:

package httpclient_learn;

import java.io.IOException;

import org.apache.http.HttpEntity;

import org.apache.http.HttpStatus;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.client.utils.HttpClientUtils;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class HttpClientTest {

public static void main(String[] args) {

//1.生成httpclient,相当于该打开一个浏览器

CloseableHttpClient httpClient = HttpClients.createDefault();

CloseableHttpResponse response = null;

//2.创建get请求,相当于在浏览器地址栏输入 网址

HttpGet request = new HttpGet("https://www.cnblogs.com/";);

//设置请求头,将爬虫伪装成浏览器

request.setHeader("User-Agent","Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.169 Safari/537.36");

// HttpHost proxy = new HttpHost("60.13.42.232", 9999);

// RequestConfig config = RequestConfig.custom().setProxy(proxy).build();

// request.setConfig(config);

try {

//3.执行get请求,相当于在输入地址栏后敲回车键

response = httpClient.execute(request);

//4.判断响应状态为200,进行处理

if(response.getStatusLine().getStatusCode() == HttpStatus.SC_OK) {

//5.获取响应内容

HttpEntity httpEntity = response.getEntity();

String html = EntityUtils.toString(httpEntity, "utf-8");

System.out.println(html);

/**

* 下面是Jsoup展现自我的平台

*/

//6.Jsoup解析html

Document document = Jsoup.parse(html);

//像js一样,通过标签获取title

System.out.println(document.getElementsByTag("title").first());

//像js一样,通过id 获取文章列表元素对象

Element postList = document.getElementById("post_list");

//像js一样,通过class 获取列表下的所有博客

Elements postItems = postList.getElementsByClass("post_item");

//循环处理每篇博客

for (Element postItem : postItems) {

//像jquery选择器一样,获取文章标题元素

Elements titleEle = postItem.select(".post_item_body a[class='titlelnk']");

System.out.println("文章标题:" + titleEle.text());;

System.out.println("文章地址:" + titleEle.attr("href"));

//像jquery选择器一样,获取文章作者元素

Elements footEle = postItem.select(".post_item_foot a[class='lightblue']");

System.out.println("文章作者:" + footEle.text());;

System.out.println("作者主页:" + footEle.attr("href"));

System.out.println("*********************************");

}

} else {

//如果返回状态不是200,比如404(页面不存在)等,根据情况做处理,这里略

System.out.println("返回状态不是200");

System.out.println(EntityUtils.toString(response.getEntity(), "utf-8"));

}

} catch (ClientProtocolException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} finally {

//6.关闭

HttpClientUtils.closeQuietly(response);

HttpClientUtils.closeQuietly(httpClient);

}

}

}

视图代码

java爬虫抓取动态网页(大数据时代爬虫工作者开发框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-09-19 15:15

如今,在大数据时代,爬虫已经成为互联网数据公司的关键位置。他们不仅要精通数据采集和分析,还要熟悉搜索引擎和相关检索算法,并对各种算法有一定的了解。合理安排工作流程

爬虫有很多种方式,但是Java爬虫是开发中应用最广泛的一种网页获取技术。它具有一流的速度和性能,功能支持水平相对较低。Jsoup是一个Java HTML解析器,它可以直接解析URL地址和HTML文本内容。它提供了一个非常省力的API,可以通过DOM、CSS和类似于jQuery的操作方法获取和操作数据

对于爬虫行业,我们推出了用于动态转发的高质量代理IP解决方案,完美解决了爬虫行业的难点。动态转发使用简单方便,不限制机器的使用,更适合项目的快速启动。最简单的方法如下:

import java.io.IOException;

import java.net.Authenticator;

import java.net.InetSocketAddress;

import java.net.PasswordAuthentication;

import java.net.Proxy;

import org.jsoup.Jsoup;