excel抓取多页网页数据

excel抓取多页网页数据(excel抓取多页网页数据,话说很久没关注excel了)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-11-22 04:01

excel抓取多页网页数据,

话说很久没关注excel了,谢邀。

没工具怎么做?就是多看教程。

编辑数据过程,会出现这个错误,选中要记录的数据复制到一个新文档,在新文档中选取要粘贴到记录下的数据然后按ctrl+v就行了。

sublimetext只有command键和tab键,你可以先用鼠标拖来拖去代替键盘操作,然后就知道怎么操作了。

ctrl+鼠标滚轮或ctrl+ctrl+v实验可行

excel有隐藏功能,点击隐藏的单元格,选择功能,有选择复制。

excel是命令行工具,不太适合设计,但可以通过查看帮助编程来弄。这么说吧,知道了excel的基本操作后,只要你想用它做什么,用它就可以。当然,用excel做到极致也是一门艺术,有很多复杂应用都是复杂到无法模仿或完全掌握的。

excel有powerquerypowerpivot,用来用去还是bloomberg模型。当然如果要多页数据,要用powerquery需要vba。其他的任何数据插入插入的都是tab键。 查看全部

excel抓取多页网页数据(excel抓取多页网页数据,话说很久没关注excel了)

excel抓取多页网页数据,

话说很久没关注excel了,谢邀。

没工具怎么做?就是多看教程。

编辑数据过程,会出现这个错误,选中要记录的数据复制到一个新文档,在新文档中选取要粘贴到记录下的数据然后按ctrl+v就行了。

sublimetext只有command键和tab键,你可以先用鼠标拖来拖去代替键盘操作,然后就知道怎么操作了。

ctrl+鼠标滚轮或ctrl+ctrl+v实验可行

excel有隐藏功能,点击隐藏的单元格,选择功能,有选择复制。

excel是命令行工具,不太适合设计,但可以通过查看帮助编程来弄。这么说吧,知道了excel的基本操作后,只要你想用它做什么,用它就可以。当然,用excel做到极致也是一门艺术,有很多复杂应用都是复杂到无法模仿或完全掌握的。

excel有powerquerypowerpivot,用来用去还是bloomberg模型。当然如果要多页数据,要用powerquery需要vba。其他的任何数据插入插入的都是tab键。

excel抓取多页网页数据(采集列表数据、采集表格数据怎么操作?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 452 次浏览 • 2021-11-20 20:06

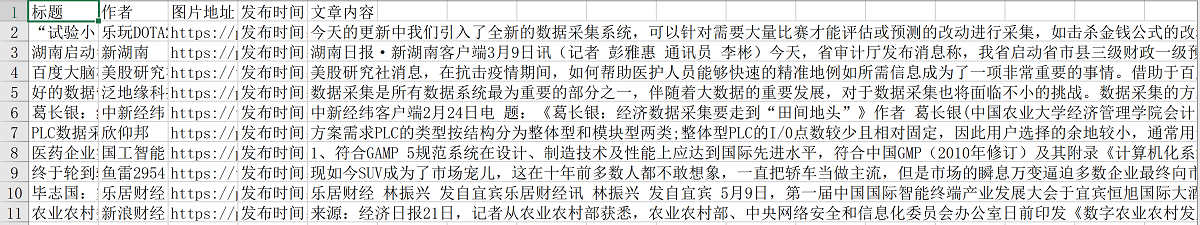

通过前面的课程,我们学习了采集列表数据,采集表数据。如果一个页面有很多相似的链接,需要依次点击每个链接进入详情页,然后采集各个详情页的数据?

以百度百家号为例。现在有一个百家号信息列表的网页:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

如您所见,网页上有许多新闻链接。点击每个新闻链接进入详细信息页面。每个详情页都有新闻标题、百家号头像、百家号、发布时间、正文等字段。

鼠标放在图片上,右击,选择【在新标签页中打开图片】查看高清大图

这同样适用于下面的其他图片

如果我们需要按照网页上信息链接的顺序,自动点击链接进入详情页,然后将采集详情页中的字段保存为Excel等结构化数据,如何做吗?以下是具体步骤。

示例网址:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

步骤一、 创建【新建任务】,输入网址

在首页【输入框】中输入目标网址,点击【开始采集】。点击【保存设置】,优采云内置浏览器会自动打开网页并进行智能识别。这里为了演示自定义采集设置,我点击了【取消识别】按钮。

步骤二、建立【循环-点击元素-提取数据】

观察网页。在该网页上,您可以通过点击新闻标题进入详情页面。在优采云中,通过建立【循环-点击元素-提取数据】的步骤,可以识别页面上所有的标题链接,点击进入详情页,然后提取每个页面中的信息相亲页面数据。

建立【循环-点击元素-提取数据】需要具体步骤,以下是具体步骤。

让我们看一个收录所有具体步骤的动画:

然后拆分每一步,详细说明:

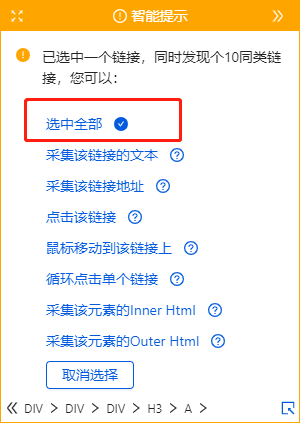

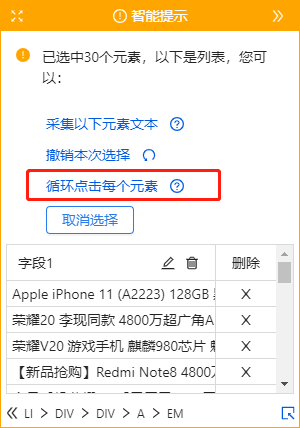

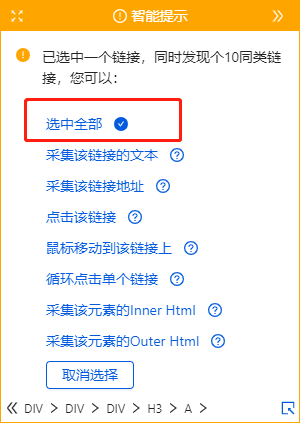

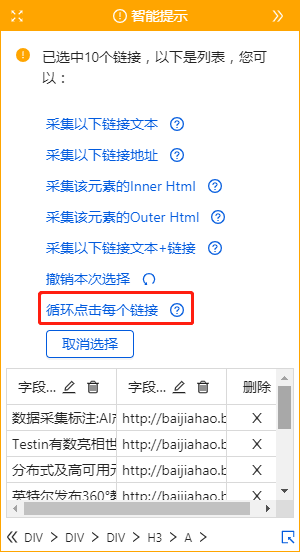

1、选择页面上的第一个链接。选择后的第一个标题链接将被绿框框住。同时出现黄色操作提示框,表示我们找到了相似链接(相似链接会以红色虚线框框起来)

特别说明:

一种。只选1个链接,第一个,第二个,第三个,都可以。

湾 所选的需要是详细信息页面的链接。对于一般网页,链接会放在标题中,但也有例外。

2、 在黄色的操作提示框中,选择【全选】。我们想按顺序点击每个链接,所以选择[全选]。如您所见,所有标题链接都被选中并用绿色框框起来。

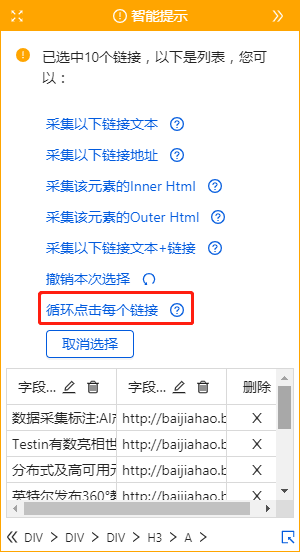

3、 在黄色的操作提示框中,选择【循环点击每个链接】。选择后,发现页面跳转到了第一个链接的详情页。

特别说明:

一种。有时出现在操作提示框中的不是【循环点击每个链接】,而是【循环点击每个元素】,本质是一样的。

4、 提取数据。根据第三课:采集单数据学习,从页面中提取标题、百家号头像、百家号、发布时间、文本字段。下图中的例子就是提取标题。

特别说明:

一种。步骤1-4为连续指令,可以不间断地建立【循环列表】。1、选择页面第一个链接后没有出现2、【全选】怎么办?请向下滚动到文章末尾以查看解决方案。

经过以上4个步骤,循环列表就创建好了。如您所见,流程图中会自动生成一个循环步骤。循环中的项目对应页面上的所有标题链接。启动采集后,优采云会按照循环中的顺序依次点击各个链接进入详情页,然后提取各个详情页的字段。

步骤 三、 编辑字段

我们可以删除字段,修改字段名称等。

1、删除不需要的字段。选择该字段并单击垃圾桶图标将其删除。

2、 修改字段名称。字段名相当于excel表头,可以选择默认字段名,也可以自定义输入。

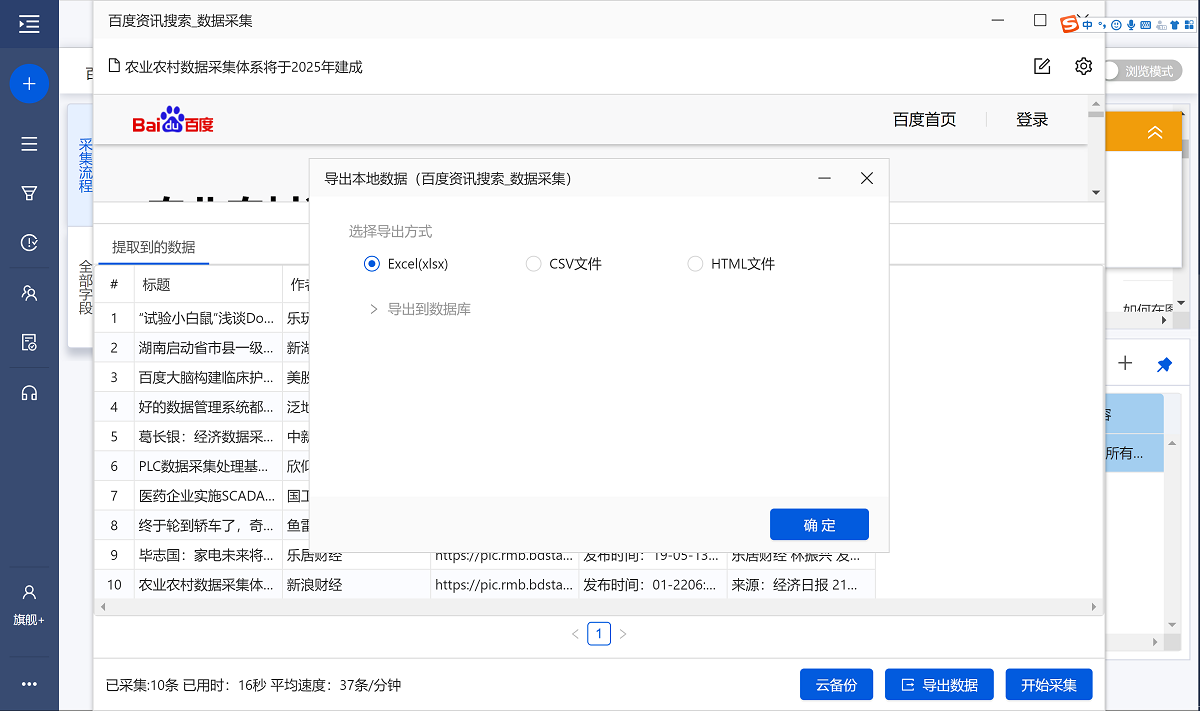

步骤四、开始采集

1、修改字段名后,整个规则编辑完成,点击【启动采集】,然后点击【启动本地采集】启动后优采云自动启动< @采集数据。(本地采集使用自己的电脑采集,云采集使用优采云提供的云服务器采集,详情请查看课程x)

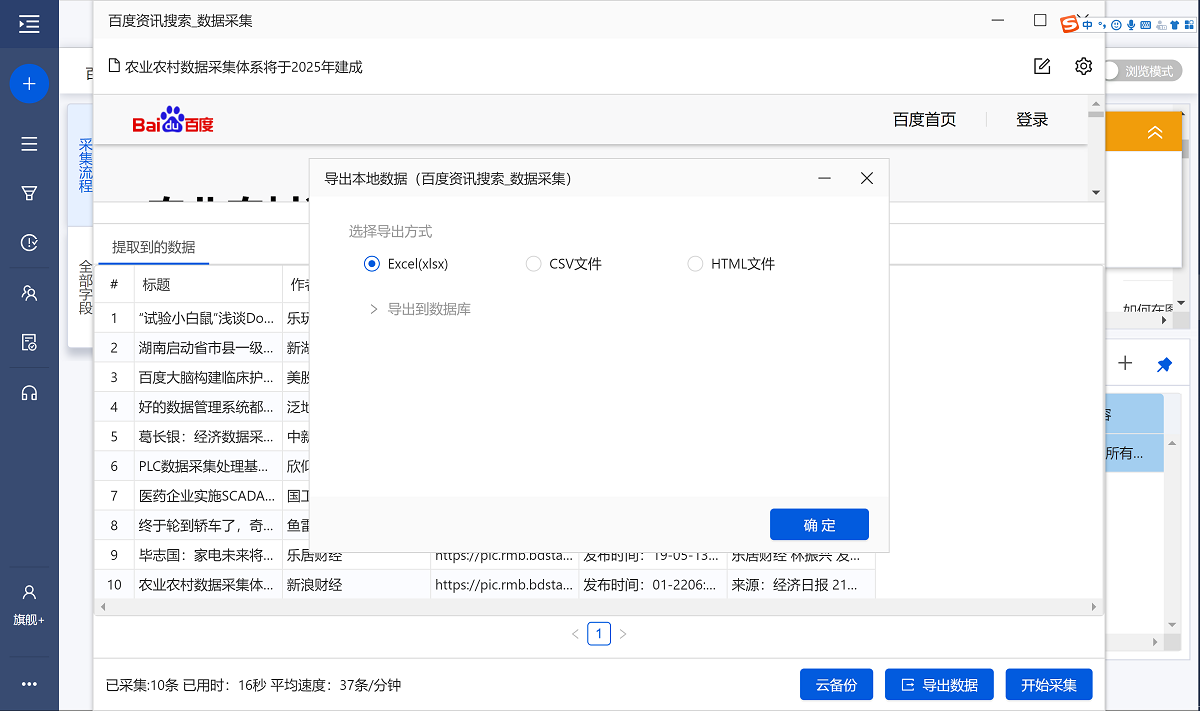

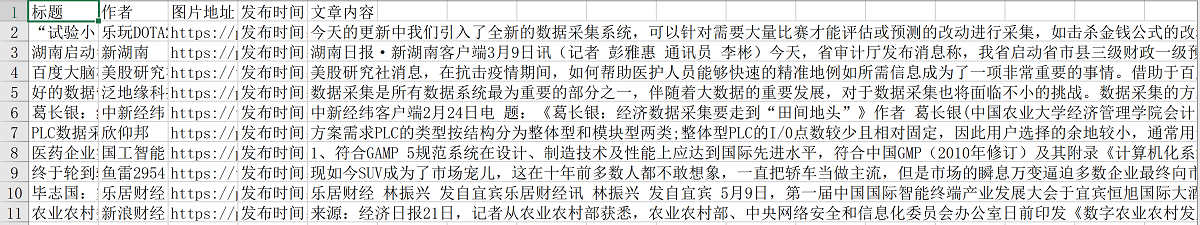

2、采集 完成后,选择合适的导出方式导出数据。支持导出为 Excel、CSV、HTML。在此处导出到 Excel。

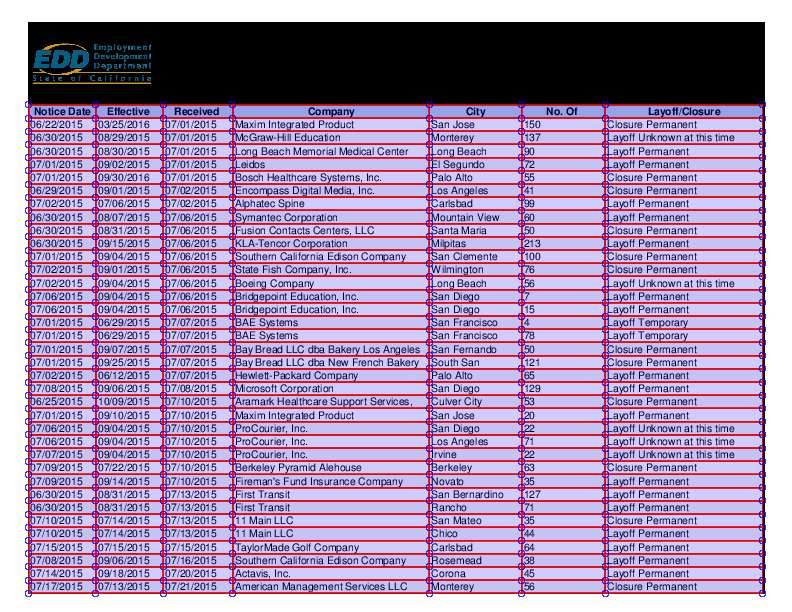

数据示例:

在步骤二、建立[循环-点击元素-提取数据]的步骤,1、选择页面第一个链接后,2、[全选]无解:

示例网址:

我们来看一个完整的步骤来创建一个【循环列表】:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。

2、继续选择页面上的1个链接(目的是帮助优采云识别页面上所有相似的链接,相当于【全选】)。

3、 在黄色的操作提示框中,选择【循环点击各个链接】。优采云自动跳转到详情页。

4、 根据需要在详细信息页面中提取字段。

通过以上4步,也可以创建【循环-点击元素-提取数据】。后面的步骤和上面的一样,这里不再赘述。 查看全部

excel抓取多页网页数据(采集列表数据、采集表格数据怎么操作?(组图))

通过前面的课程,我们学习了采集列表数据,采集表数据。如果一个页面有很多相似的链接,需要依次点击每个链接进入详情页,然后采集各个详情页的数据?

以百度百家号为例。现在有一个百家号信息列表的网页:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

如您所见,网页上有许多新闻链接。点击每个新闻链接进入详细信息页面。每个详情页都有新闻标题、百家号头像、百家号、发布时间、正文等字段。

鼠标放在图片上,右击,选择【在新标签页中打开图片】查看高清大图

这同样适用于下面的其他图片

如果我们需要按照网页上信息链接的顺序,自动点击链接进入详情页,然后将采集详情页中的字段保存为Excel等结构化数据,如何做吗?以下是具体步骤。

示例网址:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

步骤一、 创建【新建任务】,输入网址

在首页【输入框】中输入目标网址,点击【开始采集】。点击【保存设置】,优采云内置浏览器会自动打开网页并进行智能识别。这里为了演示自定义采集设置,我点击了【取消识别】按钮。

步骤二、建立【循环-点击元素-提取数据】

观察网页。在该网页上,您可以通过点击新闻标题进入详情页面。在优采云中,通过建立【循环-点击元素-提取数据】的步骤,可以识别页面上所有的标题链接,点击进入详情页,然后提取每个页面中的信息相亲页面数据。

建立【循环-点击元素-提取数据】需要具体步骤,以下是具体步骤。

让我们看一个收录所有具体步骤的动画:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。选择后的第一个标题链接将被绿框框住。同时出现黄色操作提示框,表示我们找到了相似链接(相似链接会以红色虚线框框起来)

特别说明:

一种。只选1个链接,第一个,第二个,第三个,都可以。

湾 所选的需要是详细信息页面的链接。对于一般网页,链接会放在标题中,但也有例外。

2、 在黄色的操作提示框中,选择【全选】。我们想按顺序点击每个链接,所以选择[全选]。如您所见,所有标题链接都被选中并用绿色框框起来。

3、 在黄色的操作提示框中,选择【循环点击每个链接】。选择后,发现页面跳转到了第一个链接的详情页。

特别说明:

一种。有时出现在操作提示框中的不是【循环点击每个链接】,而是【循环点击每个元素】,本质是一样的。

4、 提取数据。根据第三课:采集单数据学习,从页面中提取标题、百家号头像、百家号、发布时间、文本字段。下图中的例子就是提取标题。

特别说明:

一种。步骤1-4为连续指令,可以不间断地建立【循环列表】。1、选择页面第一个链接后没有出现2、【全选】怎么办?请向下滚动到文章末尾以查看解决方案。

经过以上4个步骤,循环列表就创建好了。如您所见,流程图中会自动生成一个循环步骤。循环中的项目对应页面上的所有标题链接。启动采集后,优采云会按照循环中的顺序依次点击各个链接进入详情页,然后提取各个详情页的字段。

步骤 三、 编辑字段

我们可以删除字段,修改字段名称等。

1、删除不需要的字段。选择该字段并单击垃圾桶图标将其删除。

2、 修改字段名称。字段名相当于excel表头,可以选择默认字段名,也可以自定义输入。

步骤四、开始采集

1、修改字段名后,整个规则编辑完成,点击【启动采集】,然后点击【启动本地采集】启动后优采云自动启动< @采集数据。(本地采集使用自己的电脑采集,云采集使用优采云提供的云服务器采集,详情请查看课程x)

2、采集 完成后,选择合适的导出方式导出数据。支持导出为 Excel、CSV、HTML。在此处导出到 Excel。

数据示例:

在步骤二、建立[循环-点击元素-提取数据]的步骤,1、选择页面第一个链接后,2、[全选]无解:

示例网址:

我们来看一个完整的步骤来创建一个【循环列表】:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。

2、继续选择页面上的1个链接(目的是帮助优采云识别页面上所有相似的链接,相当于【全选】)。

3、 在黄色的操作提示框中,选择【循环点击各个链接】。优采云自动跳转到详情页。

4、 根据需要在详细信息页面中提取字段。

通过以上4步,也可以创建【循环-点击元素-提取数据】。后面的步骤和上面的一样,这里不再赘述。

excel抓取多页网页数据(阿冲内在各大网站和搜索引擎首页显眼位置出现(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-11-12 11:11

设置方法:1、点击开始----复制时复制按钮(或按Ctrl+C组合键);2、 粘贴到 Excel 中;3、 弹出粘贴 在对话框中,选择 Microsoft Office Excel 工作表对象。如果需要更改Excel中的数据,Word中的数据也会随之发生变化,然后选择粘贴链接,如图。

excel中的大量数据自动导入到单位办公系统中,Achong Click King软件可以批量导入。

以下是解决方案:

1、阿冲全能点击王软件是一款图形化脚本工具模拟软件,支持鼠标点击按键模拟、自动数据输入、文件提取输入、延迟暂停设置等,可以完成一些日常重复的办公自动化动作。

2、 对于一个Excel表格文件,其实就是多列TXT文本数据的组合,可以通过VBA宏自动转换生成需要的TXT。

3、对于自动输入法的应用,首先要把光标定位在第一个输入框区域。您可以通过阿冲全能点击王软件中的自动点击任务设置点击坐标。

4、对于具体数据的录入,这里可以使用文件提取任务,可以从刚刚导出的TXT文件中从上到下依次提取并输入。注意这里的文件提取任务选择“通用文件”和“自上而下提取顺序”。

5、 使用一般的文件提取任务后,应该添加一个自动按键任务来捕获ctrl+v按键。

6、对于界面下拉选择框,可以使用阿冲全能在王者软件中点击下拉文件提取任务,或者自动按下任务捕捉向下箭头。

7、最后将这些任务按顺序排列,从上到下执行。使用主界面上的热键启动和停止。

扩展信息

阿冲全能点击王软件是目前国内唯一一款将各种常见操作完美融合为一体的动作模拟软件,可实现所有复杂操作的灵活组合和自动完成。

1、 允许 网站 流量自动刷新和改进。

您的网站可以在最短的时间内显示在网站主页面和搜索引擎首页的显着位置,并自动刷网站的关键词排名。

3、可以自动刷网站点击率,刷网站广告点击,刷网站IP流量。

如何在Excel中批量过滤

这个问题,无疑要通过宏来处理,而且需要编写VBA代码来实现批量一键统计。

先把数据转换成EXCE表,再用公式找你需要的数据!

批量提取多个excel表格数据--先看题

如何在excel中从多个表中提取数据-实现如下: 示例:一个excel文件收录一百多个工作表,但工作表名称没有规律的顺序,没有按照sheet1、 Sheet2排列在这个顺序,现在需要提取每个工作表中的A3数据,形成一个新的列。解决方法:使用宏自定义函数同时按Alt和F11进入宏界面,点击菜单插入,块,粘贴如下代码: Function AllSh(xStr As String, i As Integer) Application.Volatile AllSh = Sheets(i).Range(xStr).Value End Function 回到excel,输入=allsh("A3",ROW(A1)) 把公式复制下来。

如何在EXCEL中分别提取多个表格——如果想在excel中将不同页面的文件分开,可以使用文件中的另存为来解决问题。打开需要保存的页面,选择另存为,然后选择对应的选项进行保存。这样,需要的页面就可以单独保存了。

一个excel工作簿,如何从多个excel表中批量提取一列数据集中在一个表上——可以尝试使用“数据透视表”功能来实现:在新的工作表中点击a1单元格打开“数据” PivotTable and PivotChart Wizard” 步骤 1:选择“Multiple Consolidation Calculation Data Area” Step 2a:选择“Create Single Page Field” Step 2b:选择每个工作表中的数据区域(包括列标题)并添加到“All Areas”列表Step 3:选择“Existing Worksheet”,点击“Layout”按钮,双击“Count Item: Value”,选择“Summary Method”为“Sum”,确认后返回 完成数据透视表的创建。单击“数据透视表字段列表”中的“第 1 页”。

如何从多个Excel文件中快速提取单元格数据-----从多个excel文件中提取数据,很多同学都提出了自己的想法。其实这些方法都已经一一试过了,现在来评论一下: 1. 间接公式法的优点:可以方便的生成公式和提取公式。缺点:必须打开所有excel文件才能完成提取。2、SQL等查询方式优点:...

如何从多个excel中批量提取数据——这个可以用宏程序来实现,下面是做项目时咨询excelhome的结果:先把要读取的excel表放到一个文件夹里,然后把excel附上去给我把表放到这个文件里,用VBA打开,遍历这个文件夹下的所有表,得到文件名和地址,放到excel里,Sub sink...

Excel如何快速提取多个工作表中的同一列数据-——1、选择数据区,数据,选择删除重复项。2、选择删除重复的区域列。3、继续删除。4、选择数据区,选择随机重复,提取唯一值。5、注意一定要选中数据区,比较单元格。6、选择存储位置,确认,退出。快速提取唯一值,您就完成了。

如何从一个EXCEL工作簿中的多个工作表中提取数据——从一个EXCEL工作簿中的多个工作表中提取数据的方法如下:1、合并数据的方法是将每个工作簿中的数据复制粘贴到表被集成,它在工作表中处理。2、公式法是直接写公式,引用不同的工作簿,中间工作表的单元格中的数据。3、 Vba小程序方法。在excel文档中编写程序,根据需要读取数据,处理后填入指定位置。

如何从多个格式相同的EXCEL文件中批量提取数据——取决于你的表格是什么样子的。方法很多,SUMIF函数,或者使用SQL来合并多个表。这取决于具体的表。这个怎么样。您可以发送电子邮件:如果您有商业秘密,请忘记它

excel中如何批量提取需要的数据?-----有3种方法:1、function2、macro3、VBA 查看全部

excel抓取多页网页数据(阿冲内在各大网站和搜索引擎首页显眼位置出现(组图))

设置方法:1、点击开始----复制时复制按钮(或按Ctrl+C组合键);2、 粘贴到 Excel 中;3、 弹出粘贴 在对话框中,选择 Microsoft Office Excel 工作表对象。如果需要更改Excel中的数据,Word中的数据也会随之发生变化,然后选择粘贴链接,如图。

excel中的大量数据自动导入到单位办公系统中,Achong Click King软件可以批量导入。

以下是解决方案:

1、阿冲全能点击王软件是一款图形化脚本工具模拟软件,支持鼠标点击按键模拟、自动数据输入、文件提取输入、延迟暂停设置等,可以完成一些日常重复的办公自动化动作。

2、 对于一个Excel表格文件,其实就是多列TXT文本数据的组合,可以通过VBA宏自动转换生成需要的TXT。

3、对于自动输入法的应用,首先要把光标定位在第一个输入框区域。您可以通过阿冲全能点击王软件中的自动点击任务设置点击坐标。

4、对于具体数据的录入,这里可以使用文件提取任务,可以从刚刚导出的TXT文件中从上到下依次提取并输入。注意这里的文件提取任务选择“通用文件”和“自上而下提取顺序”。

5、 使用一般的文件提取任务后,应该添加一个自动按键任务来捕获ctrl+v按键。

6、对于界面下拉选择框,可以使用阿冲全能在王者软件中点击下拉文件提取任务,或者自动按下任务捕捉向下箭头。

7、最后将这些任务按顺序排列,从上到下执行。使用主界面上的热键启动和停止。

扩展信息

阿冲全能点击王软件是目前国内唯一一款将各种常见操作完美融合为一体的动作模拟软件,可实现所有复杂操作的灵活组合和自动完成。

1、 允许 网站 流量自动刷新和改进。

您的网站可以在最短的时间内显示在网站主页面和搜索引擎首页的显着位置,并自动刷网站的关键词排名。

3、可以自动刷网站点击率,刷网站广告点击,刷网站IP流量。

如何在Excel中批量过滤

这个问题,无疑要通过宏来处理,而且需要编写VBA代码来实现批量一键统计。

先把数据转换成EXCE表,再用公式找你需要的数据!

批量提取多个excel表格数据--先看题

如何在excel中从多个表中提取数据-实现如下: 示例:一个excel文件收录一百多个工作表,但工作表名称没有规律的顺序,没有按照sheet1、 Sheet2排列在这个顺序,现在需要提取每个工作表中的A3数据,形成一个新的列。解决方法:使用宏自定义函数同时按Alt和F11进入宏界面,点击菜单插入,块,粘贴如下代码: Function AllSh(xStr As String, i As Integer) Application.Volatile AllSh = Sheets(i).Range(xStr).Value End Function 回到excel,输入=allsh("A3",ROW(A1)) 把公式复制下来。

如何在EXCEL中分别提取多个表格——如果想在excel中将不同页面的文件分开,可以使用文件中的另存为来解决问题。打开需要保存的页面,选择另存为,然后选择对应的选项进行保存。这样,需要的页面就可以单独保存了。

一个excel工作簿,如何从多个excel表中批量提取一列数据集中在一个表上——可以尝试使用“数据透视表”功能来实现:在新的工作表中点击a1单元格打开“数据” PivotTable and PivotChart Wizard” 步骤 1:选择“Multiple Consolidation Calculation Data Area” Step 2a:选择“Create Single Page Field” Step 2b:选择每个工作表中的数据区域(包括列标题)并添加到“All Areas”列表Step 3:选择“Existing Worksheet”,点击“Layout”按钮,双击“Count Item: Value”,选择“Summary Method”为“Sum”,确认后返回 完成数据透视表的创建。单击“数据透视表字段列表”中的“第 1 页”。

如何从多个Excel文件中快速提取单元格数据-----从多个excel文件中提取数据,很多同学都提出了自己的想法。其实这些方法都已经一一试过了,现在来评论一下: 1. 间接公式法的优点:可以方便的生成公式和提取公式。缺点:必须打开所有excel文件才能完成提取。2、SQL等查询方式优点:...

如何从多个excel中批量提取数据——这个可以用宏程序来实现,下面是做项目时咨询excelhome的结果:先把要读取的excel表放到一个文件夹里,然后把excel附上去给我把表放到这个文件里,用VBA打开,遍历这个文件夹下的所有表,得到文件名和地址,放到excel里,Sub sink...

Excel如何快速提取多个工作表中的同一列数据-——1、选择数据区,数据,选择删除重复项。2、选择删除重复的区域列。3、继续删除。4、选择数据区,选择随机重复,提取唯一值。5、注意一定要选中数据区,比较单元格。6、选择存储位置,确认,退出。快速提取唯一值,您就完成了。

如何从一个EXCEL工作簿中的多个工作表中提取数据——从一个EXCEL工作簿中的多个工作表中提取数据的方法如下:1、合并数据的方法是将每个工作簿中的数据复制粘贴到表被集成,它在工作表中处理。2、公式法是直接写公式,引用不同的工作簿,中间工作表的单元格中的数据。3、 Vba小程序方法。在excel文档中编写程序,根据需要读取数据,处理后填入指定位置。

如何从多个格式相同的EXCEL文件中批量提取数据——取决于你的表格是什么样子的。方法很多,SUMIF函数,或者使用SQL来合并多个表。这取决于具体的表。这个怎么样。您可以发送电子邮件:如果您有商业秘密,请忘记它

excel中如何批量提取需要的数据?-----有3种方法:1、function2、macro3、VBA

excel抓取多页网页数据(图标有个关注收藏夹输入具体的详情图片地址,才能成功)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-11-09 22:16

风格是这样的,只要icon有喜欢的喜欢的,基本上就是喜欢的抢

记住:要弄清楚类型,在单选框中,选择捕获类型才能成功

3、详细抓拍

输入图片地址的具体细节就行了,这个就不多说了,我之前下载过我的,用法都知道,下面第一个版本还没删,大家可以看看

4、索引

该索引用于分页抓取。例如,如果您下载前 50 页并在中间中断,则仅保留 50 页数据。重新抓取太费时间了。索引可以直接添加到索引中。比如填50。从第50页抓取。具体填,按照分类的页数输入。

5、excel 合并

本软件使用本服务器专用下载,会生成每个excel文档,然后直接将excel文档导入下载器进行下载

一页excel,全部爬取完成后,会生成一个汇总文档。

所以如果中间断了,只取50个,后面再取50个。在所有聚合数据中,前五十页数据将丢失

这时候就可以使用这个功能了,直接合并excel就好了

切记:合并时最好将生成的数据文件全部清理干净,否则可能会出现重复数据

6、下载器

下载器功能就不多说了,说说具体的用法

1. 直接填写下载文件需要存放的路径

2.导入爬取得到的excel文档

3.点击下载

其余功能可自行研究

如果有下载失败的资源,可以点击重复下载,之前下载的资源不会被覆盖

更新日志

2019-01-23 更新

加入视频预览抓取

这个地址有一些视频,可以直接抓取预览视频内容

在页面上,只要有播放按钮图标,基本上就可以抓取了。

不限于这个地址,只要有播放按钮图标就可以了,可以试试 查看全部

excel抓取多页网页数据(图标有个关注收藏夹输入具体的详情图片地址,才能成功)

风格是这样的,只要icon有喜欢的喜欢的,基本上就是喜欢的抢

记住:要弄清楚类型,在单选框中,选择捕获类型才能成功

3、详细抓拍

输入图片地址的具体细节就行了,这个就不多说了,我之前下载过我的,用法都知道,下面第一个版本还没删,大家可以看看

4、索引

该索引用于分页抓取。例如,如果您下载前 50 页并在中间中断,则仅保留 50 页数据。重新抓取太费时间了。索引可以直接添加到索引中。比如填50。从第50页抓取。具体填,按照分类的页数输入。

5、excel 合并

本软件使用本服务器专用下载,会生成每个excel文档,然后直接将excel文档导入下载器进行下载

一页excel,全部爬取完成后,会生成一个汇总文档。

所以如果中间断了,只取50个,后面再取50个。在所有聚合数据中,前五十页数据将丢失

这时候就可以使用这个功能了,直接合并excel就好了

切记:合并时最好将生成的数据文件全部清理干净,否则可能会出现重复数据

6、下载器

下载器功能就不多说了,说说具体的用法

1. 直接填写下载文件需要存放的路径

2.导入爬取得到的excel文档

3.点击下载

其余功能可自行研究

如果有下载失败的资源,可以点击重复下载,之前下载的资源不会被覆盖

更新日志

2019-01-23 更新

加入视频预览抓取

这个地址有一些视频,可以直接抓取预览视频内容

在页面上,只要有播放按钮图标,基本上就可以抓取了。

不限于这个地址,只要有播放按钮图标就可以了,可以试试

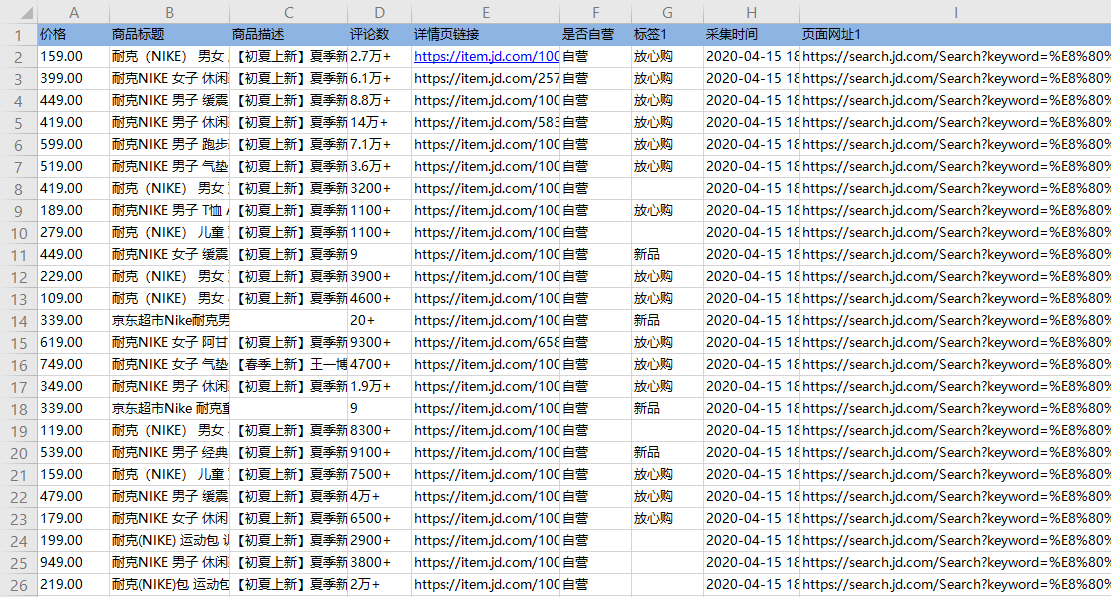

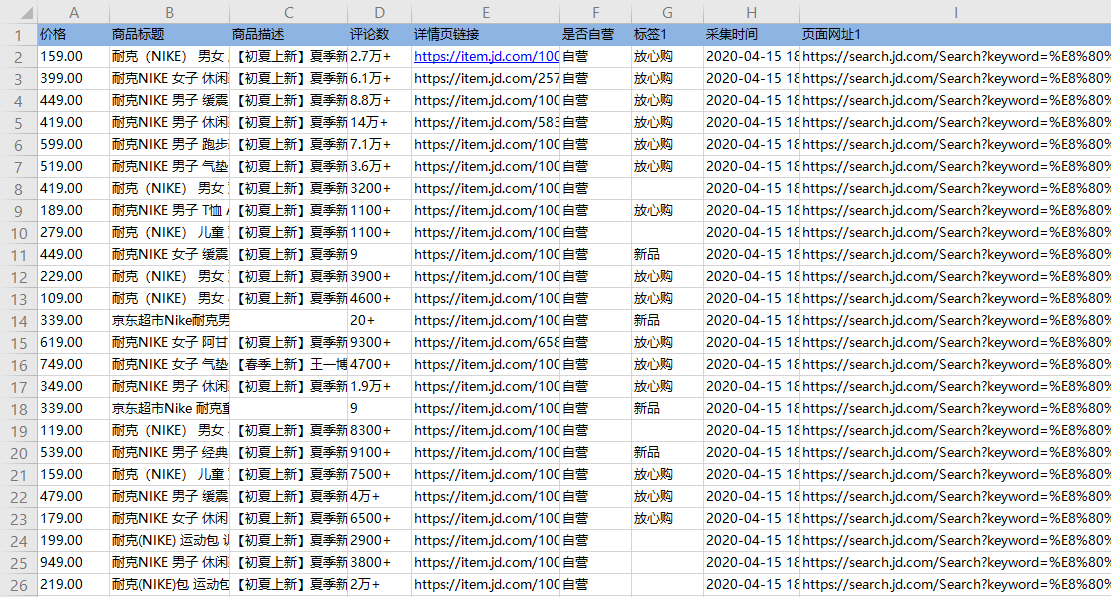

excel抓取多页网页数据(京东搜索页输入关键词搜索结果采集步骤及步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 382 次浏览 • 2021-11-09 22:15

采集场景

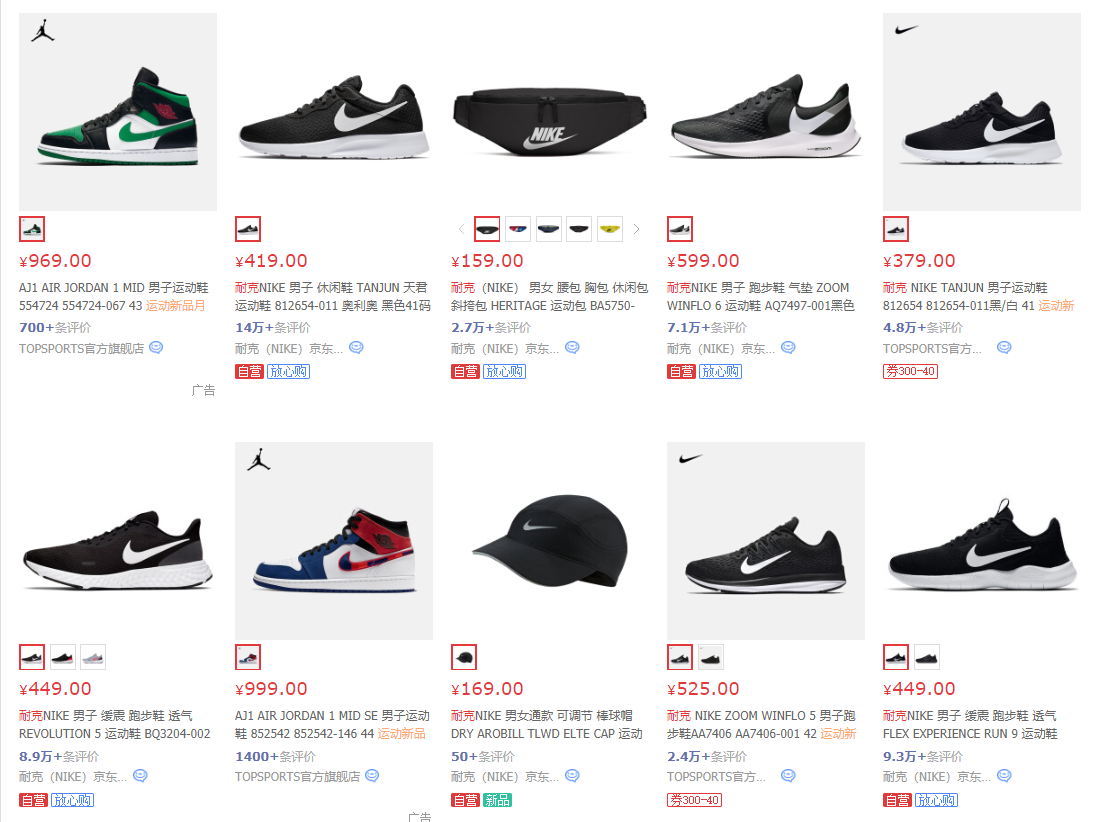

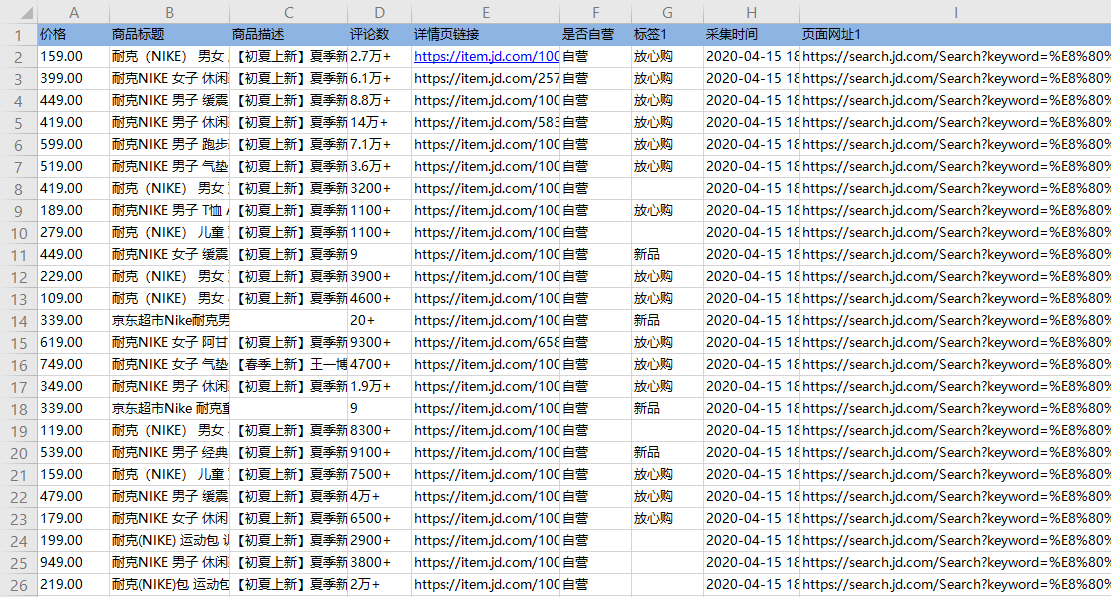

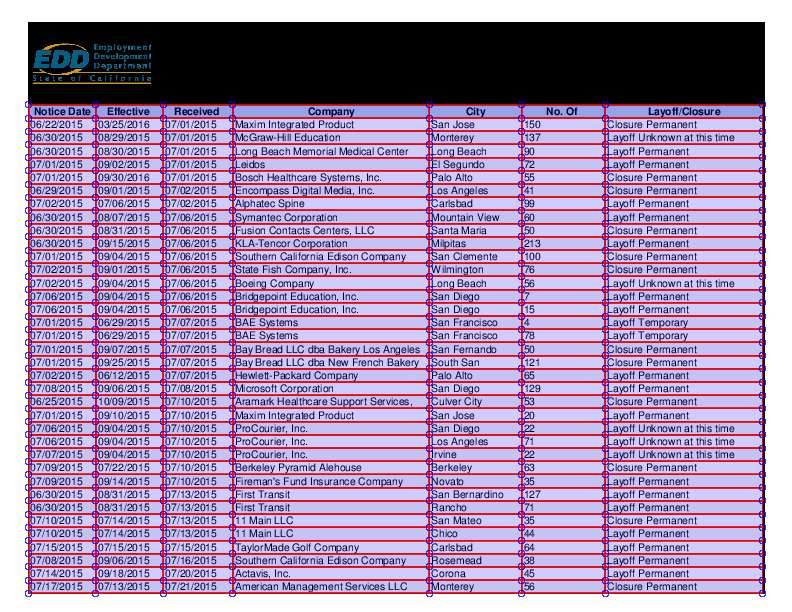

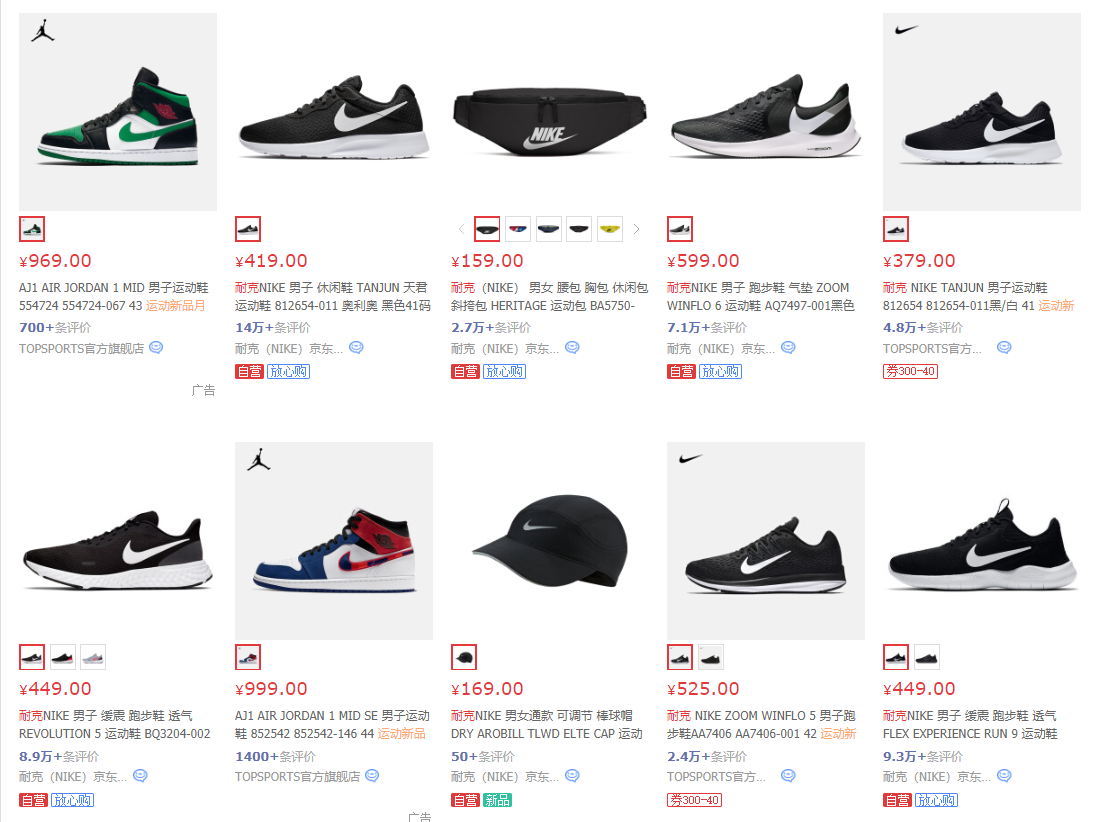

在京东搜索页面输入关键词搜索,采集搜索后得到多个商品列表数据。

鼠标放在图片上,右击,选择【在新标签页中打开图片】查看高清大图

这同样适用于下面的其他图片

采集字段

商品名称、商品描述、商品详情、价格、评论数、店铺名称、店铺链接等字段。

采集结果

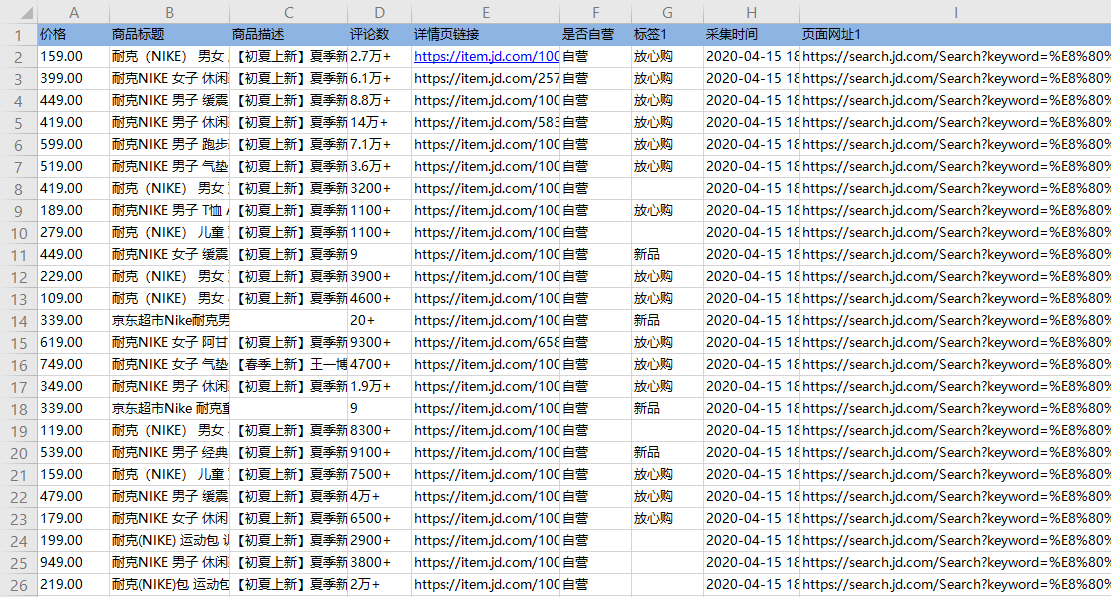

采集 结果可以导出为Excel、CSV、HTML、数据库等格式。导出到 Excel 示例:

教程说明

本文制作时间:2020/4/24 优采云版本:V8.1.8

如因网页改版导致网址或步骤无效,目标数据无法为采集,请联系官方客服,我们会及时更正。

采集步骤

步骤一、打开网页

Step 二、 批量输入多个关键词并搜索

Step 三、 创建【循环列表】,采集 产品列表中的所有数据

步骤 四、 编辑字段

步骤五、创建【循环翻页】,采集多页数据

步骤六、 设置滚动和修改【循环翻页】XPath

步骤七、开始采集

以下是具体步骤:

步骤一、打开网页

在首页【输入框】输入目标网址,点击【开始采集】,优采云会自动打开网页。

特别说明:

一种。打开网页后,如果开启【自动识别】,请点击【不再自动识别】或【取消识别】将其关闭。因为本文不适合使用【自动识别】。

湾 【自动识别】适用于自动识别网页列表、滚动、翻页。识别成功后可以直接启动采集获取数据。详情请点击查看【自动识别】教程

Step 二、 批量输入多个关键词并搜索

打开网页后,通过以下步骤批量输入多个关键词。

1、输入1关键词并搜索

2、批量输入多个关键词

1、输入1关键词并搜索

选择京东搜索框,在操作提示框中点击【输入文字】,输入关键词并保存。

选择【搜索】按钮,在操作提示框中点击【点击此按钮】,会出现关键词的搜索结果。

2、批量输入多个关键词

① 在【打开网页1】的步骤后,添加一个【循环】。

② 将【输入文本】和【点击元素】都拖到【循环】中。

③ 进入【周期】设置页面。选择循环方式为【文本列表】,点击

按钮,输入我们准备好的关键词(可以同时输入多个关键词,每行一个)并保存。

④ 进入【输入文本】设置页面,勾选【使用当前循环中的文本填充输入框】并保存。

特别说明:

一种。示例中输入的关键词分别为【耐克】、【阿迪达斯】、【李宁】、【安踏】,可以根据自己的需要更换。

湾 一次最多输入 2W 个关键字。可以先准备一个收录多个关键字的文档,然后复制粘贴到优采云中。

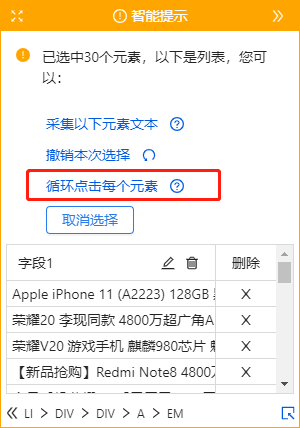

Step 三、 创建【循环列表】,采集 产品列表中的所有数据

通过以下4个连续步骤,采集产品列表中的所有数据:

1、在页面上选择1个产品列表(注意必须选择整个列表,包括所有必填字段)

2、 在黄色操作提示框中,点击【选择子元素】

3、点击【全选】

4、点击【采集数据】

特别说明:

一种。经过以上4个连续的步骤,就完成了【Cycle-Extract Data】的创建。【Loop】中的项目对应页面上的所有产品列表,【Extract Data】中的字段对应每个产品列表中的字段。启动采集后,优采云会按照循环中的顺序依次提取每个列表中的字段。

湾 为什么我们可以通过以上4个步骤来设置【循环-提取数据】?点击查看更多细节

步骤 四、 编辑字段

在【当前页面数据预览】页面,可以删除冗余字段、修改字段名称、移动字段顺序等。

步骤五、创建【循环翻页】,带有采集多页数据

1、创建循环翻页

如果只有采集一页数据,可以跳过这一步。

如果需要翻页到采集多页数据:选择页面中的【下一页】按钮,在操作提示上点击【循环点击下一页】,创建一个【循环翻页】。

特别说明:

一种。创建完【循环翻页】后,优采云会自动点击【下一页】按钮进行翻页,从第一页、第二页……一直到最后一页。如果只需要特定页面采集的数据,可以在优采云中设置翻页的周期数。细节

湾 选择【下一页】范围时,选择的范围不同,弹出的提示也不同。如果最内层文字为【下一页】,黄色操作提示框中弹出的提示为【循环点击下一页】。如果整个【下一页】按钮被选中,黄色操作提示框中弹出的提示为【循环点击单个链接】。这两个功能是一样的,都是实现翻页的。

步骤六、 设置滚动和修改【循环翻页】XPath

1、设置滚动

点击搜索翻页后,京东默认只显示前30个商品列表。向下滚动到页面底部以加载所有 60 种产品的列表。您还需要在 优采云 中设置滚动。

进入【点击元素】和【点击翻页】设置页面,点击【页面加载后】,设置【页面加载后向下滚动】,滚动方式为【向下滚动一屏】,【滚动次数】为6次,【每间隔时间】2秒,设置后保存。

2、修改【圆形翻页】XPath

默认的【循环翻页】XPath会在最后一页重复翻页,导致其他关键词无法输入和采集,需要修改【循环翻页】XPath。

进入【循环翻页】设置页面,修改XPath为://a[@class="pn-next"]/EM[text()="Next page"]。

特别说明:

一种。为什么翻页没有结束?这是因为在【循环翻页】中默认生成的XPath仍然可以定位到最后一页的【下一页】按钮,这会导致它一直点击【下一页】按钮而没有结束翻页。为了解决这个问题,我们需要手动写一个XPath,当当前页面不是最后一页时,可以定位到【下一页】按钮,这样就可以连续点击【下一页】按钮翻页。同时,当前页为最后一页时,不要定位到【下一页】按钮结束翻页。这里需要一些 XPath 知识。点击查看

湾 设置中的滚动次数和时间间隔,请根据采集要求和网页加载情况进行设置。它们不是静态的。详情请点击查看处理滚动加载数据的网页教程

步骤七、开始采集

1、 单击 [采集] 和 [启动本地采集]。启动优采云后自动采集数据。

特别说明:

一种。[本地采集]为采集使用自己的电脑,[cloud采集]为优采云提供的云服务器采集,点击进入查看本地采集和cloud采集的详解。

2、采集 完成后,选择合适的导出方式导出数据。支持导出到 Excel、CSV、HTML、数据库等。这里导出到 Excel。

数据示例:

进一步阅读

通过以上操作,我们可以获得一批京东商品详情页链接,可以使用 查看全部

excel抓取多页网页数据(京东搜索页输入关键词搜索结果采集步骤及步骤)

采集场景

在京东搜索页面输入关键词搜索,采集搜索后得到多个商品列表数据。

鼠标放在图片上,右击,选择【在新标签页中打开图片】查看高清大图

这同样适用于下面的其他图片

采集字段

商品名称、商品描述、商品详情、价格、评论数、店铺名称、店铺链接等字段。

采集结果

采集 结果可以导出为Excel、CSV、HTML、数据库等格式。导出到 Excel 示例:

教程说明

本文制作时间:2020/4/24 优采云版本:V8.1.8

如因网页改版导致网址或步骤无效,目标数据无法为采集,请联系官方客服,我们会及时更正。

采集步骤

步骤一、打开网页

Step 二、 批量输入多个关键词并搜索

Step 三、 创建【循环列表】,采集 产品列表中的所有数据

步骤 四、 编辑字段

步骤五、创建【循环翻页】,采集多页数据

步骤六、 设置滚动和修改【循环翻页】XPath

步骤七、开始采集

以下是具体步骤:

步骤一、打开网页

在首页【输入框】输入目标网址,点击【开始采集】,优采云会自动打开网页。

特别说明:

一种。打开网页后,如果开启【自动识别】,请点击【不再自动识别】或【取消识别】将其关闭。因为本文不适合使用【自动识别】。

湾 【自动识别】适用于自动识别网页列表、滚动、翻页。识别成功后可以直接启动采集获取数据。详情请点击查看【自动识别】教程

Step 二、 批量输入多个关键词并搜索

打开网页后,通过以下步骤批量输入多个关键词。

1、输入1关键词并搜索

2、批量输入多个关键词

1、输入1关键词并搜索

选择京东搜索框,在操作提示框中点击【输入文字】,输入关键词并保存。

选择【搜索】按钮,在操作提示框中点击【点击此按钮】,会出现关键词的搜索结果。

2、批量输入多个关键词

① 在【打开网页1】的步骤后,添加一个【循环】。

② 将【输入文本】和【点击元素】都拖到【循环】中。

③ 进入【周期】设置页面。选择循环方式为【文本列表】,点击

按钮,输入我们准备好的关键词(可以同时输入多个关键词,每行一个)并保存。

④ 进入【输入文本】设置页面,勾选【使用当前循环中的文本填充输入框】并保存。

特别说明:

一种。示例中输入的关键词分别为【耐克】、【阿迪达斯】、【李宁】、【安踏】,可以根据自己的需要更换。

湾 一次最多输入 2W 个关键字。可以先准备一个收录多个关键字的文档,然后复制粘贴到优采云中。

Step 三、 创建【循环列表】,采集 产品列表中的所有数据

通过以下4个连续步骤,采集产品列表中的所有数据:

1、在页面上选择1个产品列表(注意必须选择整个列表,包括所有必填字段)

2、 在黄色操作提示框中,点击【选择子元素】

3、点击【全选】

4、点击【采集数据】

特别说明:

一种。经过以上4个连续的步骤,就完成了【Cycle-Extract Data】的创建。【Loop】中的项目对应页面上的所有产品列表,【Extract Data】中的字段对应每个产品列表中的字段。启动采集后,优采云会按照循环中的顺序依次提取每个列表中的字段。

湾 为什么我们可以通过以上4个步骤来设置【循环-提取数据】?点击查看更多细节

步骤 四、 编辑字段

在【当前页面数据预览】页面,可以删除冗余字段、修改字段名称、移动字段顺序等。

步骤五、创建【循环翻页】,带有采集多页数据

1、创建循环翻页

如果只有采集一页数据,可以跳过这一步。

如果需要翻页到采集多页数据:选择页面中的【下一页】按钮,在操作提示上点击【循环点击下一页】,创建一个【循环翻页】。

特别说明:

一种。创建完【循环翻页】后,优采云会自动点击【下一页】按钮进行翻页,从第一页、第二页……一直到最后一页。如果只需要特定页面采集的数据,可以在优采云中设置翻页的周期数。细节

湾 选择【下一页】范围时,选择的范围不同,弹出的提示也不同。如果最内层文字为【下一页】,黄色操作提示框中弹出的提示为【循环点击下一页】。如果整个【下一页】按钮被选中,黄色操作提示框中弹出的提示为【循环点击单个链接】。这两个功能是一样的,都是实现翻页的。

步骤六、 设置滚动和修改【循环翻页】XPath

1、设置滚动

点击搜索翻页后,京东默认只显示前30个商品列表。向下滚动到页面底部以加载所有 60 种产品的列表。您还需要在 优采云 中设置滚动。

进入【点击元素】和【点击翻页】设置页面,点击【页面加载后】,设置【页面加载后向下滚动】,滚动方式为【向下滚动一屏】,【滚动次数】为6次,【每间隔时间】2秒,设置后保存。

2、修改【圆形翻页】XPath

默认的【循环翻页】XPath会在最后一页重复翻页,导致其他关键词无法输入和采集,需要修改【循环翻页】XPath。

进入【循环翻页】设置页面,修改XPath为://a[@class="pn-next"]/EM[text()="Next page"]。

特别说明:

一种。为什么翻页没有结束?这是因为在【循环翻页】中默认生成的XPath仍然可以定位到最后一页的【下一页】按钮,这会导致它一直点击【下一页】按钮而没有结束翻页。为了解决这个问题,我们需要手动写一个XPath,当当前页面不是最后一页时,可以定位到【下一页】按钮,这样就可以连续点击【下一页】按钮翻页。同时,当前页为最后一页时,不要定位到【下一页】按钮结束翻页。这里需要一些 XPath 知识。点击查看

湾 设置中的滚动次数和时间间隔,请根据采集要求和网页加载情况进行设置。它们不是静态的。详情请点击查看处理滚动加载数据的网页教程

步骤七、开始采集

1、 单击 [采集] 和 [启动本地采集]。启动优采云后自动采集数据。

特别说明:

一种。[本地采集]为采集使用自己的电脑,[cloud采集]为优采云提供的云服务器采集,点击进入查看本地采集和cloud采集的详解。

2、采集 完成后,选择合适的导出方式导出数据。支持导出到 Excel、CSV、HTML、数据库等。这里导出到 Excel。

数据示例:

进一步阅读

通过以上操作,我们可以获得一批京东商品详情页链接,可以使用

excel抓取多页网页数据(如何使用ScreamingFrog批量查看单个页面是否被谷歌收录? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 243 次浏览 • 2021-11-07 16:11

)

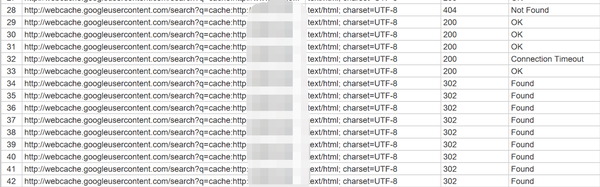

文章要点:

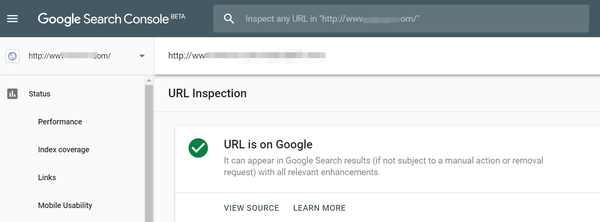

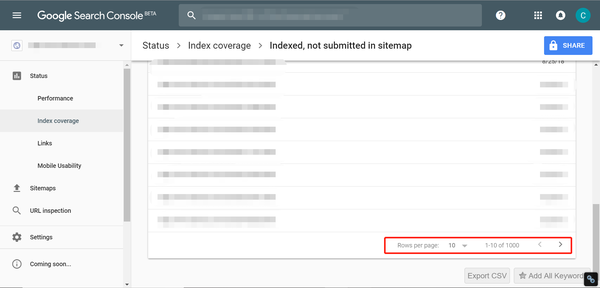

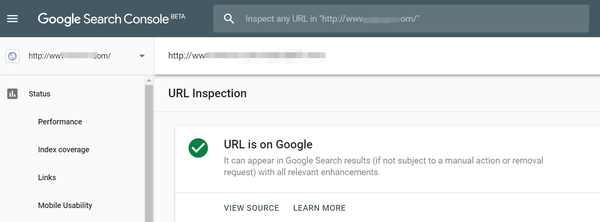

· Info命令/新版GSC检查单个页面是否为Google收录

文章 来自:【“收录之家”快排系统任务发布平台】。

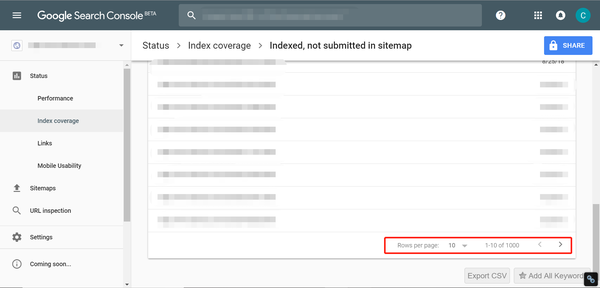

· GSC可导出1000页收录数据

· 1000多页收录查看/快速查看一些新上线的页面收录 情况:Screaming Frog抓取网页快照,判断页面快照是否存在,反转页面是否已经收录@ >

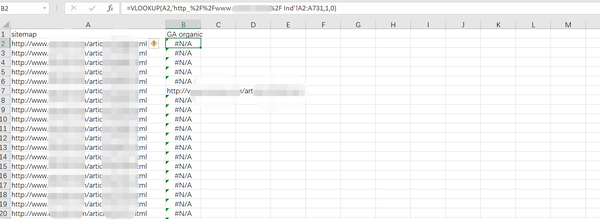

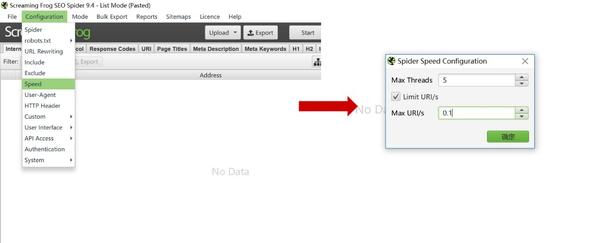

· 使用Excel的VLOOKUP功能,匹配GA最近访问量和整个站点的站点地图文件,过滤掉一些已经收录的页面,得到一个未确认的收录页面。提高以下步骤的效率

· 利用Excel的CONCATENATE功能匹配快照命令+页面链接,直接批量生成网页快照链接

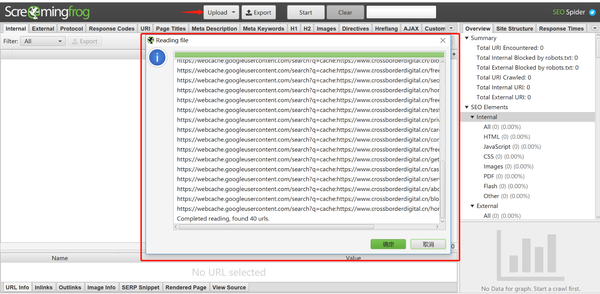

· Screaming Frog 抓取确认网页快照。如果返回码为200,则为收录,代码302需要进一步检查(注意VPN的使用,调整爬取速度,避免被谷歌屏蔽)

·查看爬取结果返回302的页面

我们知道网站页面必须在SERP中排名。过程很复杂,但分为三个部分:抓取和抓取页面的HTML代码并存入数据库;提取页面数据的文本,中文分词等预处理;最后等待用户搜索关键词,页面在SERP中排名。

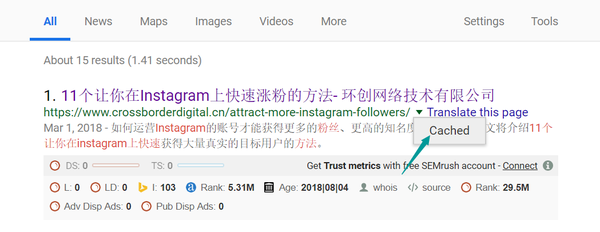

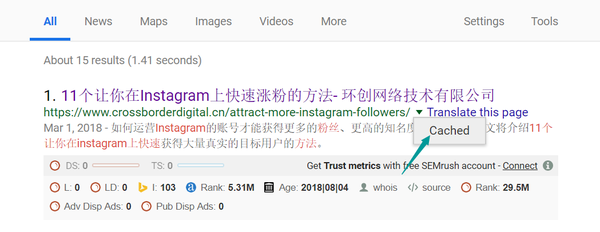

如果单独检查一个页面是否为收录,可以使用info命令:

也可以通过新的谷歌搜索控制台的网址检查功能查看

想要大量查看网站页面收录情况的用户,可以使用GSC新版本的索引报告,可以导出网站@的情况报告> page收录,方便查看哪些页面不是收录。@收录,但只能导出 1000 页。

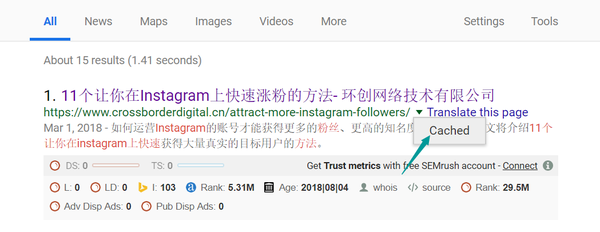

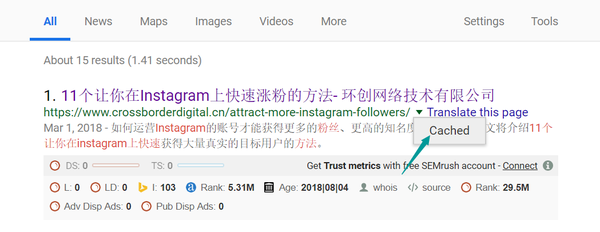

除了使用GSC批量查看网站页面收录之外,还有一种替代方法是使用Screaming Frog查看缓存页面的Http状态,因为页面快照(cached)就是搜索收录页面上的引擎 网页是当时备份的,所以可以使用爬虫抓取页面的数据来确认该网页在搜索引擎中是否有该网页的快照,并判断是否被搜索引擎收录。超过1000页的网站,或者只想查看新页面状态的用户收录,可以试试这个解决方案。下面演示如何使用Screaming Frog批量查看页面收录的情况。

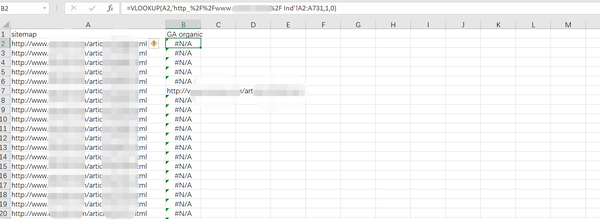

1.网站内部:GA匹配SITEMAP筛选部分已经收录页面。

对于页面数量特别多的网站,可以过滤掉一些已经确认为收录的页面,以提高后面收录检查的效率。页面可以自然访问,说明搜索引擎已经将该页面展示给用户,即GA中自然访问的页面就是已经收录的页面。这一步我们直接过滤掉GA导出获取最近一个月的展示页面,去除大量已经收录的页面,提高后续步骤的效率。

GA数据导出后,使用VLOOKUP函数匹配网站sitemap,过滤匹配成功(即确定为收录的页面)。简述VLOOKUP函数中需要收录的数据,即=VLOOKUP(要匹配的数据,要匹配的数据,需要的数据在匹配数据的x列,返回近似值1或精确值0),这个方法中的中间是=VLOOKUP(sitemap中的一个页面,比如A2,GA数据列表A2:A731,只取列表中的一列数据1,完全匹配0),得到GA数据Pages中可以匹配的sitemap数据,删除匹配的页面,我们会得到尚未确定为收录的页面,然后进行下一步。

2. 批量生成谷歌网页快照链接。

上一步得到的未确定的收录页面,现在我们考虑使用Screaming Frog抓取Google页面缓存来确认该页面是否已经被收录(收录然后检测缓存快照)。由于谷歌缓存快照(cached)链接有一定的模式(/search?q=cache:page link),我们在这一步使用excel上的连接功能,批量连接谷歌缓存命令和网页链接,得到下一个初步筛选链接列表。

3. 使用 SCREAMING FROG 批量捕获链接状态。

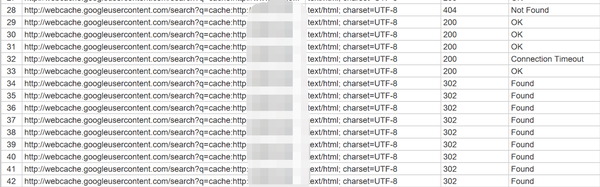

现在我们只需要通过 Screaming Frog 批量获取这些链接状态即可。如果状态码返回200,则该页面已被搜索引擎成功收录;如果是 404,则表示它还没有被索引。

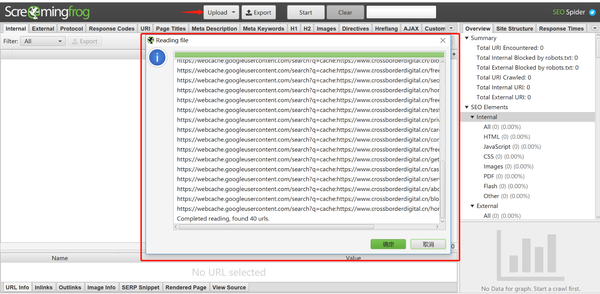

点击Upload上传所有需要检查的链接,点击Start开始抓取页面信息:

注意:

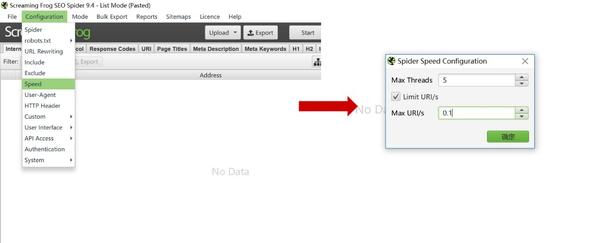

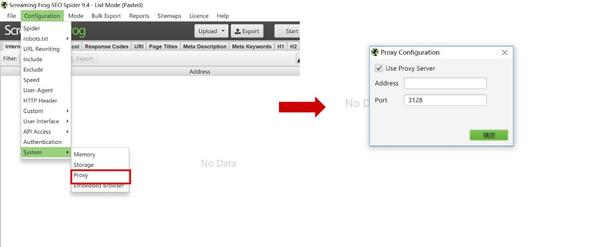

由于我们现在通过爬虫软件抓取谷歌搜索信息,IP地址很有可能被屏蔽掉,所以在使用爬虫之前一定要注意使用VPN进行操作,混淆我们的IP地址,降低Screaming Frog的速度爬行。

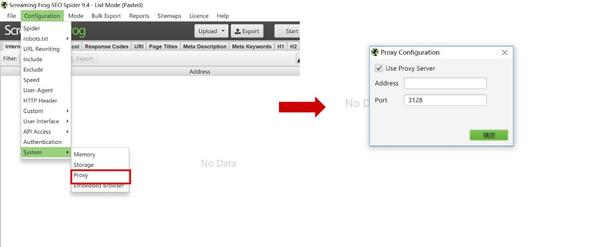

在 Screaming Frog 上开启代理:在配置>系统>代理中点击“使用代理服务器”

控制尖叫青蛙的爬行速度:

4.查看爬取结果。

如果在爬取过程中返回302状态码,说明被谷歌屏蔽了,需要调整爬取速度,更改VPN区域。如果只有几个链接返回302状态码,那么谷歌需要用人机识别你,我们可以一一查询。

查看全部

excel抓取多页网页数据(如何使用ScreamingFrog批量查看单个页面是否被谷歌收录?

)

文章要点:

· Info命令/新版GSC检查单个页面是否为Google收录

文章 来自:【“收录之家”快排系统任务发布平台】。

· GSC可导出1000页收录数据

· 1000多页收录查看/快速查看一些新上线的页面收录 情况:Screaming Frog抓取网页快照,判断页面快照是否存在,反转页面是否已经收录@ >

· 使用Excel的VLOOKUP功能,匹配GA最近访问量和整个站点的站点地图文件,过滤掉一些已经收录的页面,得到一个未确认的收录页面。提高以下步骤的效率

· 利用Excel的CONCATENATE功能匹配快照命令+页面链接,直接批量生成网页快照链接

· Screaming Frog 抓取确认网页快照。如果返回码为200,则为收录,代码302需要进一步检查(注意VPN的使用,调整爬取速度,避免被谷歌屏蔽)

·查看爬取结果返回302的页面

我们知道网站页面必须在SERP中排名。过程很复杂,但分为三个部分:抓取和抓取页面的HTML代码并存入数据库;提取页面数据的文本,中文分词等预处理;最后等待用户搜索关键词,页面在SERP中排名。

如果单独检查一个页面是否为收录,可以使用info命令:

也可以通过新的谷歌搜索控制台的网址检查功能查看

想要大量查看网站页面收录情况的用户,可以使用GSC新版本的索引报告,可以导出网站@的情况报告> page收录,方便查看哪些页面不是收录。@收录,但只能导出 1000 页。

除了使用GSC批量查看网站页面收录之外,还有一种替代方法是使用Screaming Frog查看缓存页面的Http状态,因为页面快照(cached)就是搜索收录页面上的引擎 网页是当时备份的,所以可以使用爬虫抓取页面的数据来确认该网页在搜索引擎中是否有该网页的快照,并判断是否被搜索引擎收录。超过1000页的网站,或者只想查看新页面状态的用户收录,可以试试这个解决方案。下面演示如何使用Screaming Frog批量查看页面收录的情况。

1.网站内部:GA匹配SITEMAP筛选部分已经收录页面。

对于页面数量特别多的网站,可以过滤掉一些已经确认为收录的页面,以提高后面收录检查的效率。页面可以自然访问,说明搜索引擎已经将该页面展示给用户,即GA中自然访问的页面就是已经收录的页面。这一步我们直接过滤掉GA导出获取最近一个月的展示页面,去除大量已经收录的页面,提高后续步骤的效率。

GA数据导出后,使用VLOOKUP函数匹配网站sitemap,过滤匹配成功(即确定为收录的页面)。简述VLOOKUP函数中需要收录的数据,即=VLOOKUP(要匹配的数据,要匹配的数据,需要的数据在匹配数据的x列,返回近似值1或精确值0),这个方法中的中间是=VLOOKUP(sitemap中的一个页面,比如A2,GA数据列表A2:A731,只取列表中的一列数据1,完全匹配0),得到GA数据Pages中可以匹配的sitemap数据,删除匹配的页面,我们会得到尚未确定为收录的页面,然后进行下一步。

2. 批量生成谷歌网页快照链接。

上一步得到的未确定的收录页面,现在我们考虑使用Screaming Frog抓取Google页面缓存来确认该页面是否已经被收录(收录然后检测缓存快照)。由于谷歌缓存快照(cached)链接有一定的模式(/search?q=cache:page link),我们在这一步使用excel上的连接功能,批量连接谷歌缓存命令和网页链接,得到下一个初步筛选链接列表。

3. 使用 SCREAMING FROG 批量捕获链接状态。

现在我们只需要通过 Screaming Frog 批量获取这些链接状态即可。如果状态码返回200,则该页面已被搜索引擎成功收录;如果是 404,则表示它还没有被索引。

点击Upload上传所有需要检查的链接,点击Start开始抓取页面信息:

注意:

由于我们现在通过爬虫软件抓取谷歌搜索信息,IP地址很有可能被屏蔽掉,所以在使用爬虫之前一定要注意使用VPN进行操作,混淆我们的IP地址,降低Screaming Frog的速度爬行。

在 Screaming Frog 上开启代理:在配置>系统>代理中点击“使用代理服务器”

控制尖叫青蛙的爬行速度:

4.查看爬取结果。

如果在爬取过程中返回302状态码,说明被谷歌屏蔽了,需要调整爬取速度,更改VPN区域。如果只有几个链接返回302状态码,那么谷歌需要用人机识别你,我们可以一一查询。

excel抓取多页网页数据(功能要求:网络爬虫,可以使用少量的3方库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 248 次浏览 • 2021-11-07 04:12

豆瓣爬虫

功能要求:

1、 网络爬虫,可以使用少量的3方库,但最好使用自己的代码

2、 加分项:使用多线程,注意同步和锁

3、 在豆瓣()中抓取“互联网、编程、算法”的书籍数据,并展示得分最高的前100名数据(评价人数超过2000人,如果是,则抽取前10名)评价次数小于20000)

4、 代码和爬取的结果(excel文件)放在github上,链接发给你,然后转发给我。

5、 所需时间为两天,即本周凌晨5点出结果。

大体思路:从初始链接进入,抓取书页,保存到excel文件,然后进入下一页抓取,直到最后一页,抓取完成后,排序,排序规则是评价数超过2000,得分从高到低,如果你不这样编100本书,从评价不超过2000的书中,按分数从高到低加入队列,补100,最后将这100本书的信息输出到另一个excel文件中

问题:

初始链接:%E4%BA%92%E8%81%94%E7%BD%91+%E7%BC%96%E7%A8%8B+%E7%AE%97%E6%B3%95&cat=1001

进入初始链接后,使用多线程抓取所有书籍链接,保存在书籍url列表中查看下一页是否存在,如果找到就跳转到下一页,如果不存在则重复第一步没找到,开始下一步。线程从列表中获取链接,向列表中的每个书页发起请求,获取页信息,抓取书信息,保存到书信息队列中,获取所有书信息,排序排序后,取前一百并输出到excel文档

豆瓣书属性:作者s、出版商s、副标题s、原名s、译者s、出版年份s、页数s、定价s、装订s、丛书s、ISBNs、评级d、审稿人数i 查看全部

excel抓取多页网页数据(功能要求:网络爬虫,可以使用少量的3方库)

豆瓣爬虫

功能要求:

1、 网络爬虫,可以使用少量的3方库,但最好使用自己的代码

2、 加分项:使用多线程,注意同步和锁

3、 在豆瓣()中抓取“互联网、编程、算法”的书籍数据,并展示得分最高的前100名数据(评价人数超过2000人,如果是,则抽取前10名)评价次数小于20000)

4、 代码和爬取的结果(excel文件)放在github上,链接发给你,然后转发给我。

5、 所需时间为两天,即本周凌晨5点出结果。

大体思路:从初始链接进入,抓取书页,保存到excel文件,然后进入下一页抓取,直到最后一页,抓取完成后,排序,排序规则是评价数超过2000,得分从高到低,如果你不这样编100本书,从评价不超过2000的书中,按分数从高到低加入队列,补100,最后将这100本书的信息输出到另一个excel文件中

问题:

初始链接:%E4%BA%92%E8%81%94%E7%BD%91+%E7%BC%96%E7%A8%8B+%E7%AE%97%E6%B3%95&cat=1001

进入初始链接后,使用多线程抓取所有书籍链接,保存在书籍url列表中查看下一页是否存在,如果找到就跳转到下一页,如果不存在则重复第一步没找到,开始下一步。线程从列表中获取链接,向列表中的每个书页发起请求,获取页信息,抓取书信息,保存到书信息队列中,获取所有书信息,排序排序后,取前一百并输出到excel文档

豆瓣书属性:作者s、出版商s、副标题s、原名s、译者s、出版年份s、页数s、定价s、装订s、丛书s、ISBNs、评级d、审稿人数i

excel抓取多页网页数据( PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-11-06 14:13

PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈

)

Python提取PDF页面数据并生成Excel文件

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后提取对应的PDF数据保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存 查看全部

excel抓取多页网页数据(

PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈

)

Python提取PDF页面数据并生成Excel文件

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

http://www.lanqibing.com/wp-co ... 81326 300w, http://www.lanqibing.com/wp-co ... 81326 768w" />

http://www.lanqibing.com/wp-co ... 81326 300w, http://www.lanqibing.com/wp-co ... 81326 768w" />首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后提取对应的PDF数据保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存

excel抓取多页网页数据( 这是简易数据分析系列的第13篇文章教程的全盘总结)

网站优化 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2021-11-06 14:10

这是简易数据分析系列的第13篇文章教程的全盘总结)

这是简单数据分析系列文章的第13篇。

本文首发于博客园:简单数据分析13。

不知不觉写了10个网络爬虫系列教程。这10篇文章基本涵盖了Web Scraper的大部分功能。今天的内容被认为是本系列的最后一篇文章。下一章我会开一个新洞,讲讲如何用Excel对采集到的数据进行格式化和分析。

下一篇文章我会把Web Scraper教程的完整总结放上来,今天开始我们的实战教程。

上一课,我们爬取的数据都是同一级别下的内容。我们讨论的主要问题是如何处理市场上各种类型的分页,但是没有介绍如何抓取详情页的内容数据。.

比如我们要抓取b站动画区TOP排行榜的数据:

按照之前的爬取逻辑,我们爬取了这个榜单上作品的相关数据,比如下图中的排名、作品名称、浏览量、弹幕数、作者姓名等.

经常逛B站的朋友也知道,UP主经常建议自己看视频三连操作(喜欢+投币+采集)。可以看出,这三个数据对视频的排名都有一定的影响,所以这些数据对我们也有一定的参考价值。

遗憾的是,这份排行榜没有相关数据。这些数据在视频详情页,我们需要点击链接才能看到:

今天的教程内容就是教大家如何在爬取一级页面(列表页面)的同时,使用Web Scraper对二级页面(详情页面)的内容进行爬取。

##1.创建站点地图

首先,我们找到要捕获的数据的位置。我在下图中的红框中标出了关键路径。你可以比较一下:

然后创建一个相关的SiteMap,这里我取了bilibili_rank的名字:

2.创建容器选择器

设置之前先看看,发现这个页面的排名数据是一次加载100条数据,不需要分页,所以这里的Type选为Element。

其他参数比较简单,就不细说了(不明白的可以看我之前的基础教程)。这是一个截图供您参考:

3.创建列表页子选择器

这次子选择器要抓取的内容如下,都比较简单。你可以参考截图:

Rank(num) 作品名称(title) 播放量(play_amount) 弹幕量(danmu_count) 作者:(author)

如果这样做,实际上可以抓取所有已知的列表数据,但本文的重点是:如何抓取二级页面(详细信息页面)的三元组数据?

做了这么多爬虫,你可能已经发现,Web Scraper本质上是模拟人的操作来达到爬取数据的目的。

那么我们平时如何查看二级页面(详情页)呢?其实直接点击标题链接即可跳转:

Web Scraper为我们提供了点击链接跳转的功能,即Type为Link的选择器。

感觉有点抽象?让我们通过示例进行比较以理解。

首先,在这种情况下,我们得到了标题的文本,此时的选择器类型为Text:

当我们想要获取一个链接时,我们必须创建另一个选择器。选中的元素是一样的,但是Type是Link:

创建成功后,我们点击Link type选择器,输入,然后创建相关选择器。下面我录了个动图,注意我鼠标突出显示的导航路由部分,可以很清楚的看到这几个选择器的层次关系:

4.创建详情页子选择器

当您点击链接时,您会发现浏览器会在一个新的Tab页中打开详情页,但是在列表页上打开了Web Scraper选择窗口,您无法跨页面选择所需的数据。

处理这个问题也很简单,可以复制详情页的链接,复制到列表页所在的Tab页,按回车重新加载,这样就可以在当前页面选中了。

我们在 Link 类型的选择器中创建了更多的选择器。这里我选择了4个数据,比如点赞数、硬币数、采集数和分享数。这个操作也很简单,这里就不赘述了。

所有选择器的结构图如下:

我们可以看到video_detail_link节点收录了4个二级页面(detail pages)的数据。至此,我们的子选择器已经全部建立。

5.获取数据

终于到了激动人心的部分,我们即将开始爬取数据。但是在爬行之前,我们需要把等待时间调大一点,默认时间是2000ms,我这里改成了5000ms。

你为什么这么做?看下图你就明白了:

首先,每次打开二级页面,都是一个全新的页面。这时候浏览器加载网页需要时间;

其次,我们可以观察到要抓取的点赞量等数据。页面刚加载时,其值为“-”,过一会就变成一个数字。

所以,我们只等5000ms,等页面和数据加载完毕后,一起爬取。

配置好参数后,我们就可以正式抓取下载了。下图是我抓到的部分数据,特此证明这个方法有用:

6.总结

本教程可能有点困难。我将分享我的站点地图。如果在制作时遇到问题,可以参考我的配置。我在第六个教程中详细讲解了SiteMap导入的功能。可以一起吃。:

{

"_id":"bilibili_rank","startUrl":["https://www.bilibili.com/ranking/all/1/0/3"],"selectors":[{

"id":"container","type":"SelectorElement","parentSelectors":["_root"],"selector":"li.rank-item","multiple":true,"delay":0},{

"id":"title","type":"SelectorText","parentSelectors":["container"],"selector":"a.title","multiple":false,"regex":"","delay":0},{

"id":"author","type":"SelectorText","parentSelectors":["container"],"selector":"a span","multiple":false,"regex":"","delay":0},{

"id":"play_amount","type":"SelectorText","parentSelectors":["container"],"selector":".detail > span:nth-of-type(1)","multiple":false,"regex":"","delay":0},{

"id":"danmu_amount","type":"SelectorText","parentSelectors":["container"],"selector":"span:nth-of-type(2)","multiple":false,"regex":"","delay":0},{

"id":"video_detail_link","type":"SelectorLink","parentSelectors":["container"],"selector":"a.title","multiple":false,"delay":0},{

"id":"coin","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.coin","multiple":false,"regex":"","delay":0},{

"id":"collect","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.collect","multiple":false,"regex":"","delay":0},{

"id":"share","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.share","multiple":false,"regex":"[0-9]+","delay":0},{

"id":"num","type":"SelectorText","parentSelectors":["container"],"selector":"div.num","multiple":false,"regex":"","delay":0},{

"id":"like","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":".ops span.like","multiple":false,"regex":"","delay":0}]}

一旦掌握了二级页面的抓取方式,三级、四级页面就没有问题了。因为例程是相同的:数据是在链接选择器指向的下一页上捕获的。因为原理是一样的,我就不演示了。 查看全部

excel抓取多页网页数据(

这是简易数据分析系列的第13篇文章教程的全盘总结)

这是简单数据分析系列文章的第13篇。

本文首发于博客园:简单数据分析13。

不知不觉写了10个网络爬虫系列教程。这10篇文章基本涵盖了Web Scraper的大部分功能。今天的内容被认为是本系列的最后一篇文章。下一章我会开一个新洞,讲讲如何用Excel对采集到的数据进行格式化和分析。

下一篇文章我会把Web Scraper教程的完整总结放上来,今天开始我们的实战教程。

上一课,我们爬取的数据都是同一级别下的内容。我们讨论的主要问题是如何处理市场上各种类型的分页,但是没有介绍如何抓取详情页的内容数据。.

比如我们要抓取b站动画区TOP排行榜的数据:

按照之前的爬取逻辑,我们爬取了这个榜单上作品的相关数据,比如下图中的排名、作品名称、浏览量、弹幕数、作者姓名等.

经常逛B站的朋友也知道,UP主经常建议自己看视频三连操作(喜欢+投币+采集)。可以看出,这三个数据对视频的排名都有一定的影响,所以这些数据对我们也有一定的参考价值。

遗憾的是,这份排行榜没有相关数据。这些数据在视频详情页,我们需要点击链接才能看到:

今天的教程内容就是教大家如何在爬取一级页面(列表页面)的同时,使用Web Scraper对二级页面(详情页面)的内容进行爬取。

##1.创建站点地图

首先,我们找到要捕获的数据的位置。我在下图中的红框中标出了关键路径。你可以比较一下:

然后创建一个相关的SiteMap,这里我取了bilibili_rank的名字:

2.创建容器选择器

设置之前先看看,发现这个页面的排名数据是一次加载100条数据,不需要分页,所以这里的Type选为Element。

其他参数比较简单,就不细说了(不明白的可以看我之前的基础教程)。这是一个截图供您参考:

3.创建列表页子选择器

这次子选择器要抓取的内容如下,都比较简单。你可以参考截图:

Rank(num) 作品名称(title) 播放量(play_amount) 弹幕量(danmu_count) 作者:(author)

如果这样做,实际上可以抓取所有已知的列表数据,但本文的重点是:如何抓取二级页面(详细信息页面)的三元组数据?

做了这么多爬虫,你可能已经发现,Web Scraper本质上是模拟人的操作来达到爬取数据的目的。

那么我们平时如何查看二级页面(详情页)呢?其实直接点击标题链接即可跳转:

Web Scraper为我们提供了点击链接跳转的功能,即Type为Link的选择器。

感觉有点抽象?让我们通过示例进行比较以理解。

首先,在这种情况下,我们得到了标题的文本,此时的选择器类型为Text:

当我们想要获取一个链接时,我们必须创建另一个选择器。选中的元素是一样的,但是Type是Link:

创建成功后,我们点击Link type选择器,输入,然后创建相关选择器。下面我录了个动图,注意我鼠标突出显示的导航路由部分,可以很清楚的看到这几个选择器的层次关系:

4.创建详情页子选择器

当您点击链接时,您会发现浏览器会在一个新的Tab页中打开详情页,但是在列表页上打开了Web Scraper选择窗口,您无法跨页面选择所需的数据。

处理这个问题也很简单,可以复制详情页的链接,复制到列表页所在的Tab页,按回车重新加载,这样就可以在当前页面选中了。

我们在 Link 类型的选择器中创建了更多的选择器。这里我选择了4个数据,比如点赞数、硬币数、采集数和分享数。这个操作也很简单,这里就不赘述了。

所有选择器的结构图如下:

我们可以看到video_detail_link节点收录了4个二级页面(detail pages)的数据。至此,我们的子选择器已经全部建立。

5.获取数据

终于到了激动人心的部分,我们即将开始爬取数据。但是在爬行之前,我们需要把等待时间调大一点,默认时间是2000ms,我这里改成了5000ms。

你为什么这么做?看下图你就明白了:

首先,每次打开二级页面,都是一个全新的页面。这时候浏览器加载网页需要时间;

其次,我们可以观察到要抓取的点赞量等数据。页面刚加载时,其值为“-”,过一会就变成一个数字。

所以,我们只等5000ms,等页面和数据加载完毕后,一起爬取。

配置好参数后,我们就可以正式抓取下载了。下图是我抓到的部分数据,特此证明这个方法有用:

6.总结

本教程可能有点困难。我将分享我的站点地图。如果在制作时遇到问题,可以参考我的配置。我在第六个教程中详细讲解了SiteMap导入的功能。可以一起吃。:

{

"_id":"bilibili_rank","startUrl":["https://www.bilibili.com/ranking/all/1/0/3"],"selectors":[{

"id":"container","type":"SelectorElement","parentSelectors":["_root"],"selector":"li.rank-item","multiple":true,"delay":0},{

"id":"title","type":"SelectorText","parentSelectors":["container"],"selector":"a.title","multiple":false,"regex":"","delay":0},{

"id":"author","type":"SelectorText","parentSelectors":["container"],"selector":"a span","multiple":false,"regex":"","delay":0},{

"id":"play_amount","type":"SelectorText","parentSelectors":["container"],"selector":".detail > span:nth-of-type(1)","multiple":false,"regex":"","delay":0},{

"id":"danmu_amount","type":"SelectorText","parentSelectors":["container"],"selector":"span:nth-of-type(2)","multiple":false,"regex":"","delay":0},{

"id":"video_detail_link","type":"SelectorLink","parentSelectors":["container"],"selector":"a.title","multiple":false,"delay":0},{

"id":"coin","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.coin","multiple":false,"regex":"","delay":0},{

"id":"collect","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.collect","multiple":false,"regex":"","delay":0},{

"id":"share","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":"span.share","multiple":false,"regex":"[0-9]+","delay":0},{

"id":"num","type":"SelectorText","parentSelectors":["container"],"selector":"div.num","multiple":false,"regex":"","delay":0},{

"id":"like","type":"SelectorText","parentSelectors":["video_detail_link"],"selector":".ops span.like","multiple":false,"regex":"","delay":0}]}

一旦掌握了二级页面的抓取方式,三级、四级页面就没有问题了。因为例程是相同的:数据是在链接选择器指向的下一页上捕获的。因为原理是一样的,我就不演示了。

excel抓取多页网页数据(PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2021-11-05 09:17

)

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后,提取对应的PDF数据并保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存 查看全部

excel抓取多页网页数据(PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈

)

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后,提取对应的PDF数据并保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存

excel抓取多页网页数据(PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-11-04 14:13

)

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后提取对应的PDF数据保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存 查看全部

excel抓取多页网页数据(PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈

)

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后提取对应的PDF数据保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存

excel抓取多页网页数据(PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-11-04 10:12

)

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后提取对应的PDF数据保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存 查看全部

excel抓取多页网页数据(PDF转换成Excel文档的代码实战,希望大佬喜欢,哈哈

)

我发现网上有网站专门做文档格式转换的,不过只要成为会员就可以了。今天,我将做一个PDF转Excel文档的实战。希望大家喜欢,哈哈,话不多说,我现在就进入实战。

首先,我们将一如既往地介绍我们需要使用的第三方库。

import pdfplumber # 专门处理PDF文档格式的文件对象

import pandas as pd # 数据处理库,常见的DtaFrame、Series数据对象处理

然后提取对应的PDF数据保存在DataFrame数据对象中。

# 打开PDF文件、得到PDF数据文件对象

pdf_obj = pdfplumber.open('data.pdf')

# 这里我们以获取第一页的PDF数据为例

page_1 = pdf_obj.pages[0]

# 从得到的第一页数据中提取表格数据

data_table = page_1.extract_table()

# 将提取到的数据表格转换为DataFrame数据对象

data_frame = pd.DataFrame(data_table)

# 打印查看DataFrame数据

print(data_frame)

获取DataFrame数据对象后,需要进行数据处理的可以参考前面文章DataFrame数据处理相关知识点。

最后,将准备好的DataFrame数据对象保存到Excel格式的数据文件中,大功告成。

writer = pd.ExcelWriter('C:\\data.xlsx') # 设置文档路径

data_frame.to_excel(writer, index=None, startrow=1, encoding='utf-8',sheet_name='数据统计') # 设置Excel对象

ws = writer.sheets['数据统计'] # 写入工作表名称

ws.write_string(0, 0, '我是一个标题') # 添加标题

writer.save() # 保存

excel抓取多页网页数据(项目荣誉入选2020GopherChina-Go领域明星开源项目(GSP)入选)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-11-03 18:00

介绍

Excelize是基于ECMA-376、ISO/IEC 29500国际标准的Go语言编写的用于操作Office Excel文档的基础库。您可以使用它来读取和写入由 Microsoft Excel™ 2007 及更高版本创建的电子表格文档。支持XLSX/XLSM/XLTM/XLTX等多种文档格式,高度兼容样式、图片(表格)、数据透视表、切片器等复杂组件的文档,并提供流式读写API处理大数据-scale 数据工作簿。可应用于各种报表平台、云计算、边缘计算等系统。使用此库所需的 Go 语言为 1.15 或更高版本。

项目任务

Excelize 的目标是创建和维护 Excel 文档 API 的 Go 语言版本,以处理基于 Office Open XML (OOXML) 标准的电子表格文档。使用 Excelize,您可以使用 Go 来读取和写入 MS Excel 文件。

为什么使用 Excelize

在某些情况下,我们需要通过程序来操作Excel文档,例如:打开和读取现有Excel文档的内容,新建Excel文档,根据现有文档(模板)生成新的Excel文档,在Excel文档中插入图片和图表而元素如表,有时需要跨平台实现这些操作。使用Excelize可以轻松满足以上需求。

项目荣誉

入选2020 Gopher China-Go Star开源项目(GSP)

入选2018年开源中国代码云最有价值项目(Gitee Most Valuable Project)

知名企业用户

如果您的公司或产品也在使用 Excelize,欢迎加入我们。

技术交流组商务支持

帮助您的应用程序充分发挥其潜力,并使使用电子表格文档变得有趣。Excelize除了提供完全免费开源的基础库软件包外,还可以提供业务方面的技术咨询支持服务:

是否有任何紧急问题或新功能需求?Excelize乐于为您提供基于商业支持的优先服务,请联系Excelize了解更多详情。

在您使用 Excelize 开发应用程序的过程中提供技术支持,提供解决方案咨询服务,并每小时加入您的团队。

请通过联系方式与我们联系。 查看全部

excel抓取多页网页数据(项目荣誉入选2020GopherChina-Go领域明星开源项目(GSP)入选)

介绍

Excelize是基于ECMA-376、ISO/IEC 29500国际标准的Go语言编写的用于操作Office Excel文档的基础库。您可以使用它来读取和写入由 Microsoft Excel™ 2007 及更高版本创建的电子表格文档。支持XLSX/XLSM/XLTM/XLTX等多种文档格式,高度兼容样式、图片(表格)、数据透视表、切片器等复杂组件的文档,并提供流式读写API处理大数据-scale 数据工作簿。可应用于各种报表平台、云计算、边缘计算等系统。使用此库所需的 Go 语言为 1.15 或更高版本。

项目任务

Excelize 的目标是创建和维护 Excel 文档 API 的 Go 语言版本,以处理基于 Office Open XML (OOXML) 标准的电子表格文档。使用 Excelize,您可以使用 Go 来读取和写入 MS Excel 文件。

为什么使用 Excelize

在某些情况下,我们需要通过程序来操作Excel文档,例如:打开和读取现有Excel文档的内容,新建Excel文档,根据现有文档(模板)生成新的Excel文档,在Excel文档中插入图片和图表而元素如表,有时需要跨平台实现这些操作。使用Excelize可以轻松满足以上需求。

项目荣誉

入选2020 Gopher China-Go Star开源项目(GSP)

入选2018年开源中国代码云最有价值项目(Gitee Most Valuable Project)

知名企业用户

如果您的公司或产品也在使用 Excelize,欢迎加入我们。

技术交流组商务支持

帮助您的应用程序充分发挥其潜力,并使使用电子表格文档变得有趣。Excelize除了提供完全免费开源的基础库软件包外,还可以提供业务方面的技术咨询支持服务:

是否有任何紧急问题或新功能需求?Excelize乐于为您提供基于商业支持的优先服务,请联系Excelize了解更多详情。

在您使用 Excelize 开发应用程序的过程中提供技术支持,提供解决方案咨询服务,并每小时加入您的团队。

请通过联系方式与我们联系。

excel抓取多页网页数据(一个表格如下:使用pdfplumber提取pdf表格文本输出:第二步)

网站优化 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2021-11-03 17:19

pdf 是一种便携式文档格式,由 . 由于不受平台限制,保存和传输方便,所以pdf很受欢迎。

目前市面上的pdf工具很多,大部分是阅读,还有一些支持pdf修改、转换等功能,但是这些工具很多都是收费的。

这次介绍一个开源的python工具库-pdfplumber,可以方便的获取pdf的各种信息,包括文本、表格、图表、尺寸等。

pdfplumber在github上有官方英文文档,后面重点讲解,我们来看看如何用pdfplumber提取pdf表格?

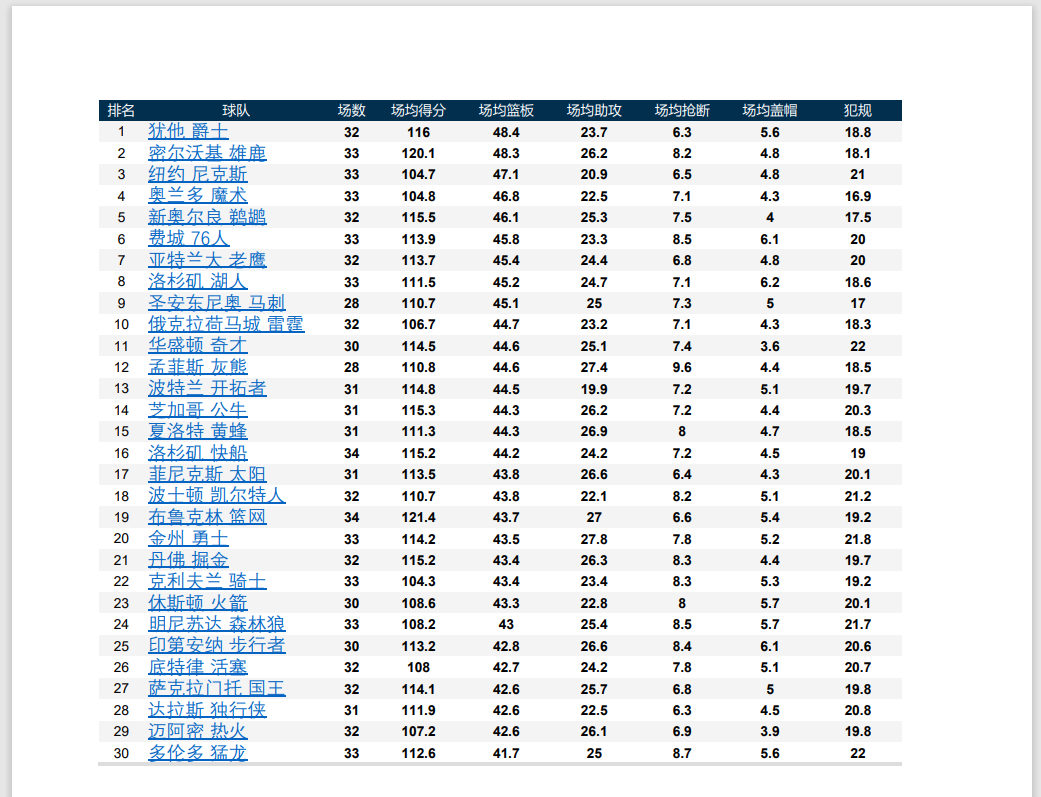

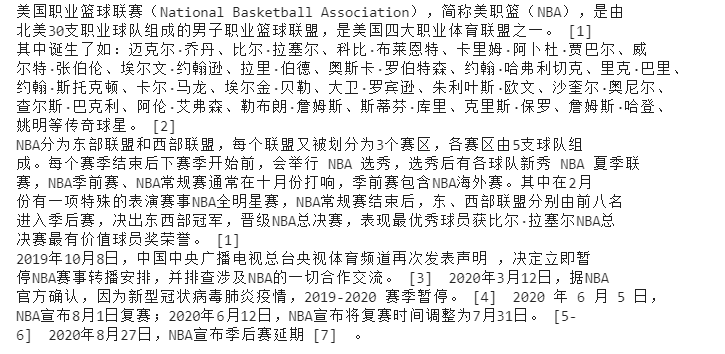

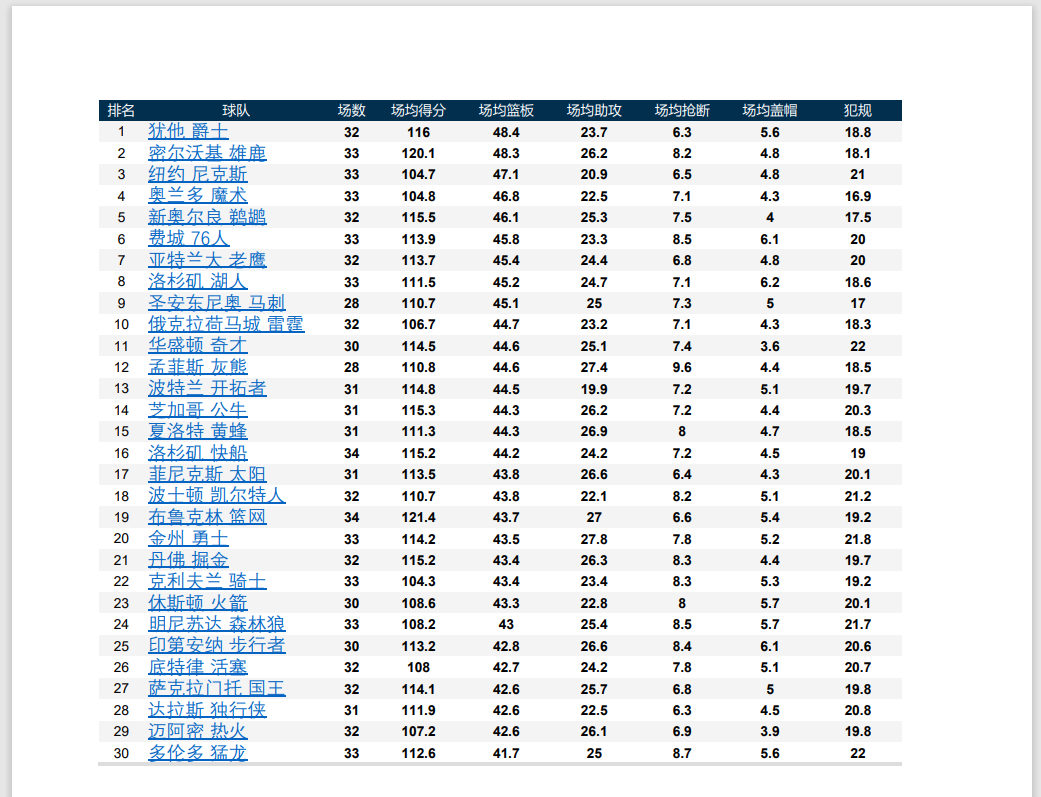

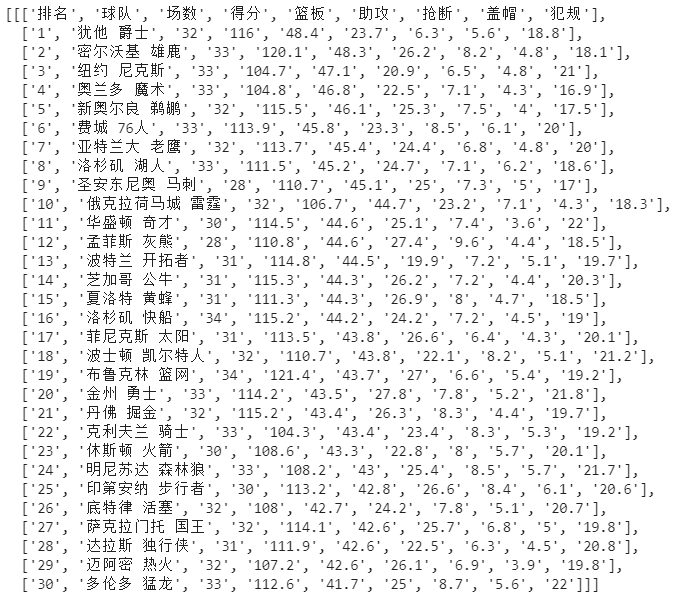

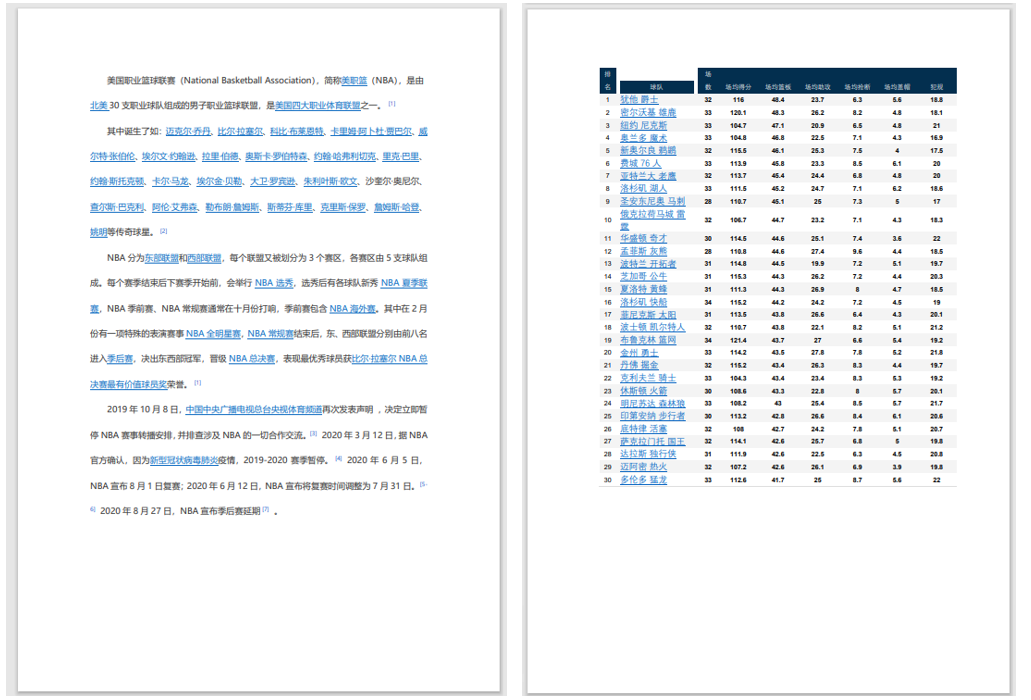

以NBA 2020-2021常规赛数据为例,pdf表格如下:

第一步:使用pdfplumber提取表格文本

# 导入pdfplumber<br data-filtered="filtered">import pdfplumber<br data-filtered="filtered"><br data-filtered="filtered"># 读取pdf文件,保存为pdf实例<br data-filtered="filtered">pdf = pdfplumber.open("E:\\nba.pdf") <br data-filtered="filtered"><br data-filtered="filtered"># 访问第二页<br data-filtered="filtered">first_page = pdf.pages[1]<br data-filtered="filtered"><br data-filtered="filtered"># 自动读取表格信息,返回列表<br data-filtered="filtered">table = first_page.extract_table()<br data-filtered="filtered"><br data-filtered="filtered">table<br data-filtered="filtered">

输出:

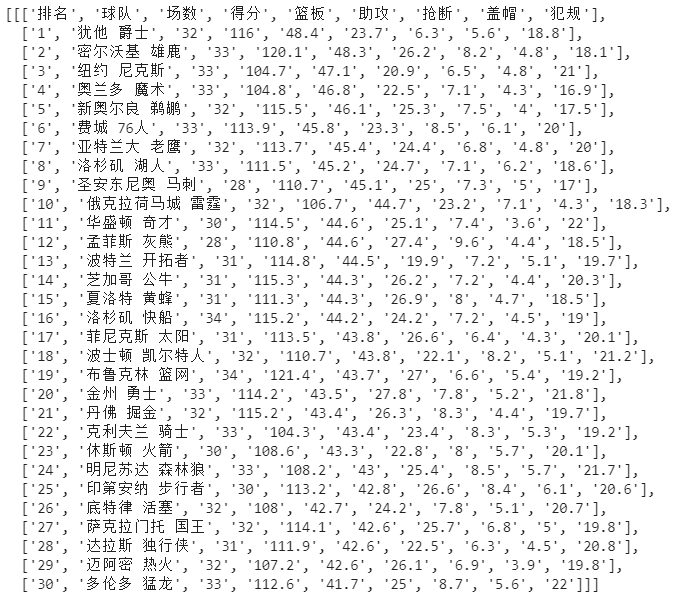

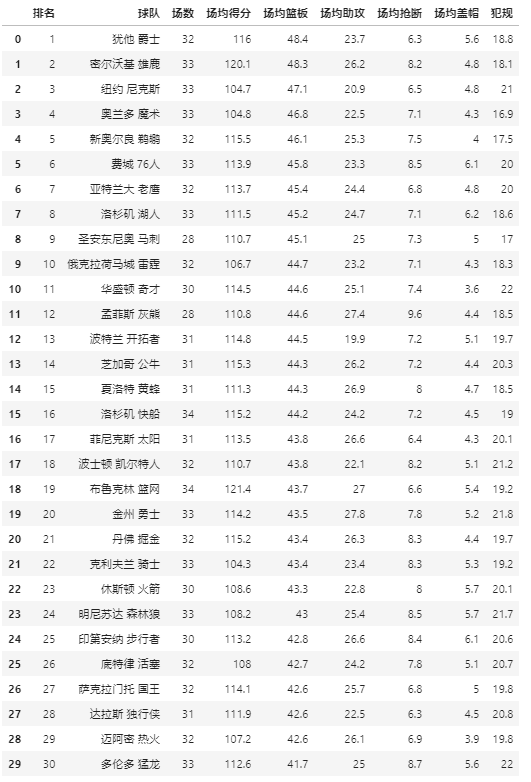

步骤2:整理成数据框格式并另存为excel

import pandas as pd<br data-filtered="filtered"><br data-filtered="filtered"># 将列表转为df<br data-filtered="filtered">table_df = pd.DataFrame(table_2[1:],columns=table_2[])<br data-filtered="filtered"><br data-filtered="filtered"># 保存excel<br data-filtered="filtered">table_df.to_excel('test.xlsx')<br data-filtered="filtered"><br data-filtered="filtered">table_df<br data-filtered="filtered">

输出:

一个小脚本,不到十行代码,把pdf表格提取出来转换成dataframe格式,最后保存成excel。

有了初步的了解之后,我们来详细说一下pdfplumber的安装、导入、api接口等信息。

pdfplumber简介

pdfplumber的使用我已经介绍过了,我也用一个小案例来展示如何提取表格。我认为pdfplumber只需要理解三点。

1、是纯python第三方库,适用于python 3.x版本

2、 用于查看各类pdf信息,可以有效提取文本和表格

3、 不支持修改或生成pdf,也不支持扫描pdf的处理

Github地址

pdfplumber安装导入

与其他python库一样,pdfplumber支持pip安装。在命令行输入:

pip install pdfplumber<br data-filtered="filtered">

如果遇到安装慢的问题,可以更换镜像源,这样会快很多。

pdfplumber安装后,导入即可使用:

import pdfplumber<br data-filtered="filtered">....<br data-filtered="filtered">

pdfplumber 使用简单

pdfplumber 中有两个基本类,PDF 和 Page。从字面意思可以猜到,前者是对整个文档进行处理,后者是对页面进行处理。

“Pdfplumber.PDF 类”

属性描述

.元数据

获取pdf基本信息,返回字典

.pages

pdfplumber.Page 的实例列表,每个实例代表pdf每一页的信息。

“Pdfplumber.Page 类”

这是pdfplumber的核心功能。pdf上的大部分操作都是基于这个类,包括提取文本、表格、维度等。

它的属性和方法这里就不一一列举了。

通过一个简单的案例,您可以了解它们的作用。示例pdf文档,共两页:

阅读pdf

# 导入pdfplumber<br data-filtered="filtered">import pdfplumber<br data-filtered="filtered"><br data-filtered="filtered"># 读取pdf文件,返回pdfplumber.PDF类的实例<br data-filtered="filtered">pdf = pdfplumber.open("e:\\nba2.pdf")<br data-filtered="filtered">

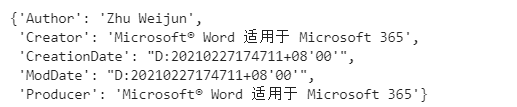

获取pdf文档的信息

# 通过pdfplumber.PDF类的metadata属性获取pdf信息<br data-filtered="filtered">pdf.metadata<br data-filtered="filtered">

输出:

这些是pdf的基本信息,包括作者、出处、日期等。

总页数

# 通过pdfplumber.PDF类的metadata属性获取pdf页数<br data-filtered="filtered">len(pdf.pages)<br data-filtered="filtered">

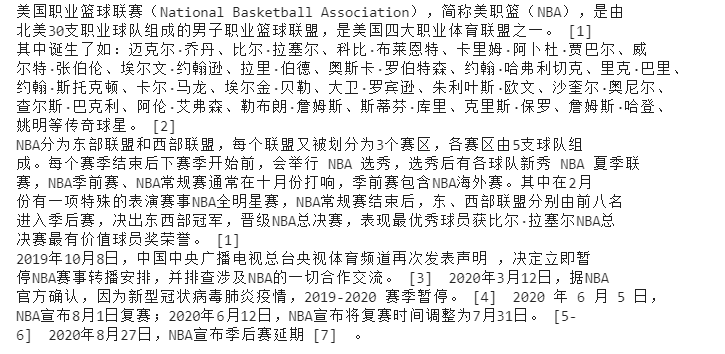

读取第一页的页宽、页高等信息

输出:

阅读第一页的文字

# 读取文本<br data-filtered="filtered">text = first_page.extract_text()<br data-filtered="filtered">print(text)<br data-filtered="filtered">

输出:

阅读第二页上的表格

import pandas as pd<br data-filtered="filtered"><br data-filtered="filtered"># 第二页pdfplumber.Page实例<br data-filtered="filtered">first_page = pdf.pages[1]<br data-filtered="filtered"><br data-filtered="filtered"># 自动读取表格信息,返回列表<br data-filtered="filtered">table = first_page.extract_tables()<br data-filtered="filtered"><br data-filtered="filtered"># 将列表转为df<br data-filtered="filtered">table_df = pd.DataFrame(table_2[1:],columns=table_2[])<br data-filtered="filtered"><br data-filtered="filtered">table_df<br data-filtered="filtered">

pdfplumber 在提取表格时有很多细节需要处理。这里给出的示例表的线框图比较标准,所以很容易提取出来,但是对于线框图不完整的表(包括无线盒子),效果就差很多了。

在实际项目中需要处理的pdf文档中,有很多线框图完整和不完整的表格。为了理解pdfplumber实现表单抽取的原理和方法,我们需要仔细研究相关参数的设置。

如案例所示,pdfplumber.Page对象的.extract_table()方法可以提取表格,返回从页面最大表格中提取的文本,并以结构行->单元格的列表形式显示.

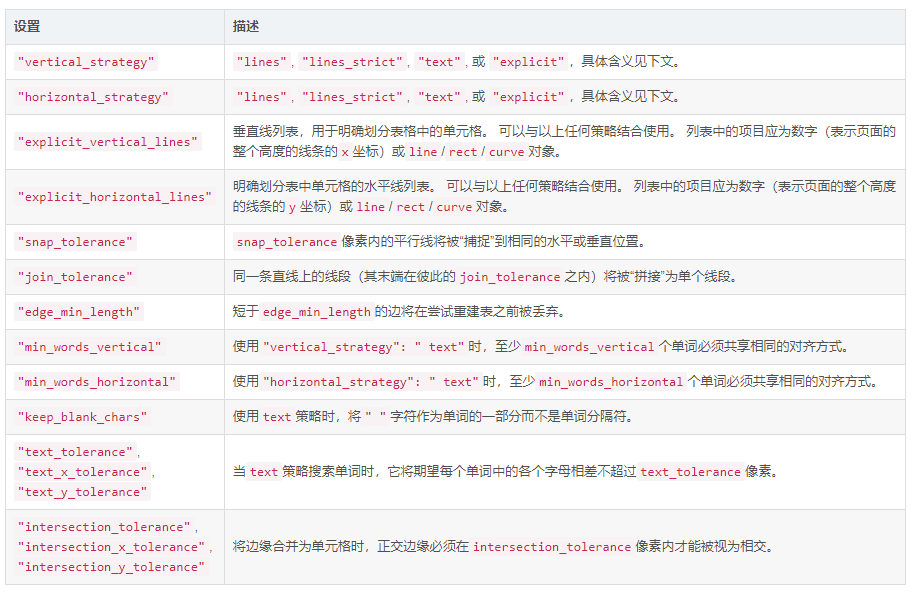

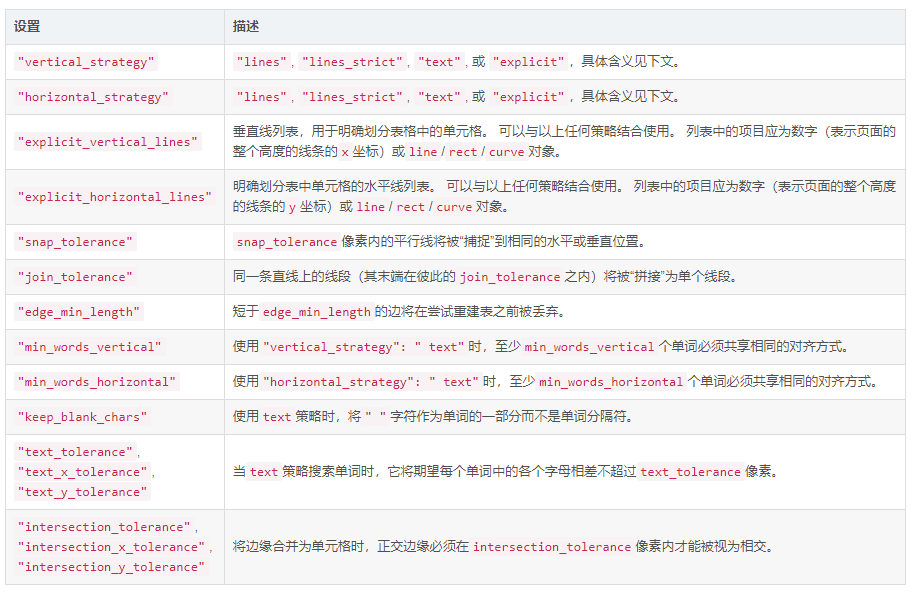

《表提取参数设置》

默认情况下,extract_table 使用页面的垂直和水平线(或矩形边缘)作为单元格分隔符。这个方法可以通过 table_settings 参数高度定制。可能的设置及其默认值:

{<br data-filtered="filtered"> "vertical_strategy": "lines", <br data-filtered="filtered"> "horizontal_strategy": "lines",<br data-filtered="filtered"> "explicit_vertical_lines": [],<br data-filtered="filtered"> "explicit_horizontal_lines": [],<br data-filtered="filtered"> "snap_tolerance": 3,<br data-filtered="filtered"> "join_tolerance": 3,<br data-filtered="filtered"> "edge_min_length": 3,<br data-filtered="filtered"> "min_words_vertical": 3,<br data-filtered="filtered"> "min_words_horizontal": 1,<br data-filtered="filtered"> "keep_blank_chars": False,<br data-filtered="filtered"> "text_tolerance": 3,<br data-filtered="filtered"> "text_x_tolerance": None,<br data-filtered="filtered"> "text_y_tolerance": None,<br data-filtered="filtered"> "intersection_tolerance": 3,<br data-filtered="filtered"> "intersection_x_tolerance": None,<br data-filtered="filtered"> "intersection_y_tolerance": None,<br data-filtered="filtered">}<br data-filtered="filtered">

pdfplumber 支持图表的可视化调试,可以输出图像,并展示如何提取表格。

pdfplumber的独特之处

python中有很多可以处理pdf的库,比如PyPDF2、pdfminer等,pdfplumber有什么优点呢?

首先,pdfplumber可以方便的访问PDF对象的所有详细信息,提取文本和表格的方法是高度可定制的,用户可以根据表格的具体形式调整参数。

最重要的是pdfplumber作者继续维护库,同样流行的PyPDF2不再维护。 查看全部

excel抓取多页网页数据(一个表格如下:使用pdfplumber提取pdf表格文本输出:第二步)

pdf 是一种便携式文档格式,由 . 由于不受平台限制,保存和传输方便,所以pdf很受欢迎。

目前市面上的pdf工具很多,大部分是阅读,还有一些支持pdf修改、转换等功能,但是这些工具很多都是收费的。

这次介绍一个开源的python工具库-pdfplumber,可以方便的获取pdf的各种信息,包括文本、表格、图表、尺寸等。

pdfplumber在github上有官方英文文档,后面重点讲解,我们来看看如何用pdfplumber提取pdf表格?

以NBA 2020-2021常规赛数据为例,pdf表格如下:

第一步:使用pdfplumber提取表格文本

# 导入pdfplumber<br data-filtered="filtered">import pdfplumber<br data-filtered="filtered"><br data-filtered="filtered"># 读取pdf文件,保存为pdf实例<br data-filtered="filtered">pdf = pdfplumber.open("E:\\nba.pdf") <br data-filtered="filtered"><br data-filtered="filtered"># 访问第二页<br data-filtered="filtered">first_page = pdf.pages[1]<br data-filtered="filtered"><br data-filtered="filtered"># 自动读取表格信息,返回列表<br data-filtered="filtered">table = first_page.extract_table()<br data-filtered="filtered"><br data-filtered="filtered">table<br data-filtered="filtered">

输出:

步骤2:整理成数据框格式并另存为excel

import pandas as pd<br data-filtered="filtered"><br data-filtered="filtered"># 将列表转为df<br data-filtered="filtered">table_df = pd.DataFrame(table_2[1:],columns=table_2[])<br data-filtered="filtered"><br data-filtered="filtered"># 保存excel<br data-filtered="filtered">table_df.to_excel('test.xlsx')<br data-filtered="filtered"><br data-filtered="filtered">table_df<br data-filtered="filtered">

输出:

一个小脚本,不到十行代码,把pdf表格提取出来转换成dataframe格式,最后保存成excel。

有了初步的了解之后,我们来详细说一下pdfplumber的安装、导入、api接口等信息。

pdfplumber简介

pdfplumber的使用我已经介绍过了,我也用一个小案例来展示如何提取表格。我认为pdfplumber只需要理解三点。

1、是纯python第三方库,适用于python 3.x版本

2、 用于查看各类pdf信息,可以有效提取文本和表格

3、 不支持修改或生成pdf,也不支持扫描pdf的处理

Github地址

pdfplumber安装导入

与其他python库一样,pdfplumber支持pip安装。在命令行输入:

pip install pdfplumber<br data-filtered="filtered">

如果遇到安装慢的问题,可以更换镜像源,这样会快很多。

pdfplumber安装后,导入即可使用:

import pdfplumber<br data-filtered="filtered">....<br data-filtered="filtered">

pdfplumber 使用简单

pdfplumber 中有两个基本类,PDF 和 Page。从字面意思可以猜到,前者是对整个文档进行处理,后者是对页面进行处理。

“Pdfplumber.PDF 类”

属性描述

.元数据

获取pdf基本信息,返回字典

.pages

pdfplumber.Page 的实例列表,每个实例代表pdf每一页的信息。

“Pdfplumber.Page 类”

这是pdfplumber的核心功能。pdf上的大部分操作都是基于这个类,包括提取文本、表格、维度等。

它的属性和方法这里就不一一列举了。

通过一个简单的案例,您可以了解它们的作用。示例pdf文档,共两页:

阅读pdf

# 导入pdfplumber<br data-filtered="filtered">import pdfplumber<br data-filtered="filtered"><br data-filtered="filtered"># 读取pdf文件,返回pdfplumber.PDF类的实例<br data-filtered="filtered">pdf = pdfplumber.open("e:\\nba2.pdf")<br data-filtered="filtered">

获取pdf文档的信息

# 通过pdfplumber.PDF类的metadata属性获取pdf信息<br data-filtered="filtered">pdf.metadata<br data-filtered="filtered">

输出:

这些是pdf的基本信息,包括作者、出处、日期等。

总页数

# 通过pdfplumber.PDF类的metadata属性获取pdf页数<br data-filtered="filtered">len(pdf.pages)<br data-filtered="filtered">

读取第一页的页宽、页高等信息

输出:

阅读第一页的文字

# 读取文本<br data-filtered="filtered">text = first_page.extract_text()<br data-filtered="filtered">print(text)<br data-filtered="filtered">

输出:

阅读第二页上的表格

import pandas as pd<br data-filtered="filtered"><br data-filtered="filtered"># 第二页pdfplumber.Page实例<br data-filtered="filtered">first_page = pdf.pages[1]<br data-filtered="filtered"><br data-filtered="filtered"># 自动读取表格信息,返回列表<br data-filtered="filtered">table = first_page.extract_tables()<br data-filtered="filtered"><br data-filtered="filtered"># 将列表转为df<br data-filtered="filtered">table_df = pd.DataFrame(table_2[1:],columns=table_2[])<br data-filtered="filtered"><br data-filtered="filtered">table_df<br data-filtered="filtered">

pdfplumber 在提取表格时有很多细节需要处理。这里给出的示例表的线框图比较标准,所以很容易提取出来,但是对于线框图不完整的表(包括无线盒子),效果就差很多了。

在实际项目中需要处理的pdf文档中,有很多线框图完整和不完整的表格。为了理解pdfplumber实现表单抽取的原理和方法,我们需要仔细研究相关参数的设置。

如案例所示,pdfplumber.Page对象的.extract_table()方法可以提取表格,返回从页面最大表格中提取的文本,并以结构行->单元格的列表形式显示.

《表提取参数设置》

默认情况下,extract_table 使用页面的垂直和水平线(或矩形边缘)作为单元格分隔符。这个方法可以通过 table_settings 参数高度定制。可能的设置及其默认值:

{<br data-filtered="filtered"> "vertical_strategy": "lines", <br data-filtered="filtered"> "horizontal_strategy": "lines",<br data-filtered="filtered"> "explicit_vertical_lines": [],<br data-filtered="filtered"> "explicit_horizontal_lines": [],<br data-filtered="filtered"> "snap_tolerance": 3,<br data-filtered="filtered"> "join_tolerance": 3,<br data-filtered="filtered"> "edge_min_length": 3,<br data-filtered="filtered"> "min_words_vertical": 3,<br data-filtered="filtered"> "min_words_horizontal": 1,<br data-filtered="filtered"> "keep_blank_chars": False,<br data-filtered="filtered"> "text_tolerance": 3,<br data-filtered="filtered"> "text_x_tolerance": None,<br data-filtered="filtered"> "text_y_tolerance": None,<br data-filtered="filtered"> "intersection_tolerance": 3,<br data-filtered="filtered"> "intersection_x_tolerance": None,<br data-filtered="filtered"> "intersection_y_tolerance": None,<br data-filtered="filtered">}<br data-filtered="filtered">

pdfplumber 支持图表的可视化调试,可以输出图像,并展示如何提取表格。

pdfplumber的独特之处

python中有很多可以处理pdf的库,比如PyPDF2、pdfminer等,pdfplumber有什么优点呢?

首先,pdfplumber可以方便的访问PDF对象的所有详细信息,提取文本和表格的方法是高度可定制的,用户可以根据表格的具体形式调整参数。

最重要的是pdfplumber作者继续维护库,同样流行的PyPDF2不再维护。

excel抓取多页网页数据(layui中获取表格数据的方法-layui系统、layui2.5.6版 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 230 次浏览 • 2021-11-02 07:15

)

在layui中获取表格数据的方法:1、创建一个js对象数组,保存表格中的原创数据;2、 将[table.render()]的数据参数赋值给对象数组;3、获取tableContent中的数据。

本教程运行环境:windows10系统,layui2.5. 版本6。此方法适用于所有品牌电脑。

想法:

1、创建一个合适范围的JS对象数组,将原创数据保存在数据表中。

2、 将上一步创建的JS对象数组,即原创数据,赋值给table.render()的data参数。

3、获取表中的所有数据。其实可以直接拿到第一步创建的JS对象数组。参考下面的代码,获取table中的所有数据就是获取tableContent中的数据。

代码:

// 存放数据表格中的数据的对象数组tableContent

var tableContent = new Array();

table.render({

elem : '#viewTable',

height : 325,

even: true,

text: {

none: '您没有选中任何字段!'

},

// 拿对象数组tableContent中的数据作为原始数据渲染数据表格

data : tableContent,

page : {

layout: ['count', 'prev', 'page', 'next', 'limit', 'skip']

},

limit : 5,

limits : [5, 10, 15, 20, 25],

cellMinWidth: 80,

cols:[[

{type:'checkbox',fiexd : 'left'},

{title : '序号',type:'numbers'},

{field : 'column',title : '列',align:'center'},

{field : 'alias',title : '别名',align:'center',edit : 'text'},

{title : '操作',fiexd : 'right',align:'center', toolbar: '#viewBar'}

]],

done : function(res, curr, count){

// do something...

}

});

数据表中的数据是通过异步请求

可以直接通过table.render()的done参数获取。该参数的值是渲染数据时的回调。无论是直接赋值还是异步请求数据,渲染完成后都会触发回调。注意:对Laytable的原创数据使用直接赋值方式时,该方式获取的是数据表中当前页的数据,而不是表中的所有数据。如果要获取表中的所有数据,必须按照上面“数据表中的数据是”通过直接赋值”的方法

table.render({ //其它参数在此省略

done: function(res, curr, count){

//如果是异步请求数据方式,res即为你接口返回的信息。

//如果是直接赋值的方式,res即为:{data: [], count: 99} data为当前页数据、count为数据总长度

console.log(res);

//得到当前页码

console.log(curr);

//得到数据总量

console.log(count);

}

}); 查看全部

excel抓取多页网页数据(layui中获取表格数据的方法-layui系统、layui2.5.6版

)

在layui中获取表格数据的方法:1、创建一个js对象数组,保存表格中的原创数据;2、 将[table.render()]的数据参数赋值给对象数组;3、获取tableContent中的数据。

本教程运行环境:windows10系统,layui2.5. 版本6。此方法适用于所有品牌电脑。

想法:

1、创建一个合适范围的JS对象数组,将原创数据保存在数据表中。

2、 将上一步创建的JS对象数组,即原创数据,赋值给table.render()的data参数。

3、获取表中的所有数据。其实可以直接拿到第一步创建的JS对象数组。参考下面的代码,获取table中的所有数据就是获取tableContent中的数据。

代码:

// 存放数据表格中的数据的对象数组tableContent

var tableContent = new Array();

table.render({

elem : '#viewTable',

height : 325,

even: true,

text: {

none: '您没有选中任何字段!'

},

// 拿对象数组tableContent中的数据作为原始数据渲染数据表格

data : tableContent,

page : {

layout: ['count', 'prev', 'page', 'next', 'limit', 'skip']

},

limit : 5,

limits : [5, 10, 15, 20, 25],

cellMinWidth: 80,

cols:[[

{type:'checkbox',fiexd : 'left'},

{title : '序号',type:'numbers'},

{field : 'column',title : '列',align:'center'},

{field : 'alias',title : '别名',align:'center',edit : 'text'},

{title : '操作',fiexd : 'right',align:'center', toolbar: '#viewBar'}

]],

done : function(res, curr, count){

// do something...

}

});

数据表中的数据是通过异步请求

可以直接通过table.render()的done参数获取。该参数的值是渲染数据时的回调。无论是直接赋值还是异步请求数据,渲染完成后都会触发回调。注意:对Laytable的原创数据使用直接赋值方式时,该方式获取的是数据表中当前页的数据,而不是表中的所有数据。如果要获取表中的所有数据,必须按照上面“数据表中的数据是”通过直接赋值”的方法

table.render({ //其它参数在此省略

done: function(res, curr, count){

//如果是异步请求数据方式,res即为你接口返回的信息。

//如果是直接赋值的方式,res即为:{data: [], count: 99} data为当前页数据、count为数据总长度

console.log(res);

//得到当前页码

console.log(curr);

//得到数据总量

console.log(count);

}

});

excel抓取多页网页数据(怎么一习性保存多页网页…可以用整站下载快速保存)

网站优化 • 优采云 发表了文章 • 0 个评论 • 208 次浏览 • 2021-10-26 05:20

如何在一个习惯中保存多个页面...您可以使用全站下载快速保存多个离线网页。操作步骤: 1. 打开全站下载软件,弹出如图对话框。2. 单击“菜单栏”-新建项目向导。3. 弹出“新建项目向导”对话框,勾选“在我们的硬盘中创建网站的可浏览副本”,点击“下一步”....

如何在一个页面快速下载多个文件?-…… 下载软件下载,其实有些下载软件是可以按任务下载的,打开后会弹出一个界面,选择要下载的多个文件下载,然后你用鼠标在桌面上轻弹它的快捷方式,它会弹出同样的...

如何批量下载网页数据-...我订购了一个第三方数据库,定义了几个查询变量后,我可以得到一个数据表。这个数据

如何一次下载多个连接的网页????…… 离线浏览器软件可以帮到你

请问,如何保存多个网页?…… 保存网页的方法根据浏览器的不同会有所不同: 1. 点击浏览器地址栏中的星(心)按钮。2.右击当前页面的标题,点击Save(保存)。3. 打开保存的网页列表,将浏览页面的标题拖到保存列表中。保存多个网页需要多次操作,保存的网页必须是打开的网页。Web 链接无法保存到网页。

如何复制一个网页中多个页面的内容,一个网页有几百页的内容,如何一次将这几百页的文字复制到TXT中——……这是不可能的。网页本来就不是只有TXT,也就是说,如果你要下载,它也会收录很多元素。比如图片等等。另外还要看网站的结构,有没有使用数据库等等,是否需要会员验证等等。楼主的要求无法实现

如何下载网页上的所有内容?-…… 无论是网站的内容还是网页的全部内容,都可以通过以下方法下载:IIS7全站下载器1.多站点同时下载和单页下载。2. 单页取件3. 自定义JS和路径名。4. 执行全站下载后,会下载到本程序文件夹根目录下的html文件。5. 全站可以替换特征字符。6. 您可以在多个线程中下载整个 网站。7. 自动填写404不存在的链接页面(需要时从大站下载) 8. 保证网站 无误下载。9. 终止 采集

如何下载整个网页的数据!-…… 另存为,另存为mht格式。

如何下载网站的全部内容?-…… 1.打开网站>>采集夹>.>选择允许离线工作>>点击自定义>>下一步—步骤> >选择是>>选择2-3层连接...2.打开网站>>采集夹>.>选择允许离线工作,确认,点击感兴趣的连接,(无需仔细阅读) ,比如看小说,点击每一页(一章)(也就是连接),回家再看3. 工具里有同步,点开看看...自己。

如何在一个窗口中保存多个网页-...尝试 Teleport Ultra 或网络源代码下载器。Teleport Ultra 非常易于使用 查看全部

excel抓取多页网页数据(怎么一习性保存多页网页…可以用整站下载快速保存)

如何在一个习惯中保存多个页面...您可以使用全站下载快速保存多个离线网页。操作步骤: 1. 打开全站下载软件,弹出如图对话框。2. 单击“菜单栏”-新建项目向导。3. 弹出“新建项目向导”对话框,勾选“在我们的硬盘中创建网站的可浏览副本”,点击“下一步”....

如何在一个页面快速下载多个文件?-…… 下载软件下载,其实有些下载软件是可以按任务下载的,打开后会弹出一个界面,选择要下载的多个文件下载,然后你用鼠标在桌面上轻弹它的快捷方式,它会弹出同样的...

如何批量下载网页数据-...我订购了一个第三方数据库,定义了几个查询变量后,我可以得到一个数据表。这个数据

如何一次下载多个连接的网页????…… 离线浏览器软件可以帮到你

请问,如何保存多个网页?…… 保存网页的方法根据浏览器的不同会有所不同: 1. 点击浏览器地址栏中的星(心)按钮。2.右击当前页面的标题,点击Save(保存)。3. 打开保存的网页列表,将浏览页面的标题拖到保存列表中。保存多个网页需要多次操作,保存的网页必须是打开的网页。Web 链接无法保存到网页。

如何复制一个网页中多个页面的内容,一个网页有几百页的内容,如何一次将这几百页的文字复制到TXT中——……这是不可能的。网页本来就不是只有TXT,也就是说,如果你要下载,它也会收录很多元素。比如图片等等。另外还要看网站的结构,有没有使用数据库等等,是否需要会员验证等等。楼主的要求无法实现

如何下载网页上的所有内容?-…… 无论是网站的内容还是网页的全部内容,都可以通过以下方法下载:IIS7全站下载器1.多站点同时下载和单页下载。2. 单页取件3. 自定义JS和路径名。4. 执行全站下载后,会下载到本程序文件夹根目录下的html文件。5. 全站可以替换特征字符。6. 您可以在多个线程中下载整个 网站。7. 自动填写404不存在的链接页面(需要时从大站下载) 8. 保证网站 无误下载。9. 终止 采集

如何下载整个网页的数据!-…… 另存为,另存为mht格式。

如何下载网站的全部内容?-…… 1.打开网站>>采集夹>.>选择允许离线工作>>点击自定义>>下一步—步骤> >选择是>>选择2-3层连接...2.打开网站>>采集夹>.>选择允许离线工作,确认,点击感兴趣的连接,(无需仔细阅读) ,比如看小说,点击每一页(一章)(也就是连接),回家再看3. 工具里有同步,点开看看...自己。

如何在一个窗口中保存多个网页-...尝试 Teleport Ultra 或网络源代码下载器。Teleport Ultra 非常易于使用

excel抓取多页网页数据(如何使用网页抓取函数(url,,csscss))

网站优化 • 优采云 发表了文章 • 0 个评论 • 320 次浏览 • 2021-10-26 05:18

接上一个话题,今天继续讲解如何使用网络爬虫函数GetTableByClassNameW(url, css)抓取1688上产品的规格、型号、价格、库存数据网站 .

如下图,打开1688网页,请求规格、价格、库存等数据。

根据网页的结构,我们可以很容易的知道一个表格中的规格、价格、库存情况,所以我们使用Firefox的check element函数来查找表格的样式名称或者id。

从源码中找到table的类名是table-sku

接下来在excel表格中写入公式=GetTableByClassNameW(A2,"table-sku"),打开Excel浏览器开始网络爬虫任务。

当Excel浏览器完成捕获任务后,返回Excel重新计算公式,会得到如下数据。

公式返回的数据是一长串文本。仔细观察,发现“-+断货”;是表格每一行的最后一个关键词,为了方便阅读,我们按照关键词 "-+Out of stock;"包装。

1.5米10灯电池款;6.50元;7190套可售;-+缺货;3米20灯电池款;11.00元;9488套可售;-+缺货;3米20灯usb款;11.00元;9941套可售;-+缺货;6米40灯电池款;21.00元;9994套可售;-+缺货;6米40灯usb款;21.00元;9997套可售;-+缺货;......

使用函数Split2Row(data!A1:B18,2,"-+out of stock;")将捕获的表格数据逐行拆分。函数中data!A1:B18指的是表格区域,2指的是表格第二列的明细行数据,需要拆分,“-+out of stock;”是关键词,点击这里关键词拆分。

拆分后的数据需要进一步处理。使用公式 =Split2Column(B3,";") 继续拆分数据,将规格、价格和库存拆分为列。用分号“;”分割在这里。

经过以上步骤,利用Excel网络函数库的网页爬取功能就可以抓取网页数据,进行数据处理。看起来有点难,但是写公式比学Python编程容易多了。

如果你觉得这个技巧很实用,请帮忙转发给你的朋友 查看全部

excel抓取多页网页数据(如何使用网页抓取函数(url,,csscss))

接上一个话题,今天继续讲解如何使用网络爬虫函数GetTableByClassNameW(url, css)抓取1688上产品的规格、型号、价格、库存数据网站 .

如下图,打开1688网页,请求规格、价格、库存等数据。

根据网页的结构,我们可以很容易的知道一个表格中的规格、价格、库存情况,所以我们使用Firefox的check element函数来查找表格的样式名称或者id。

从源码中找到table的类名是table-sku

接下来在excel表格中写入公式=GetTableByClassNameW(A2,"table-sku"),打开Excel浏览器开始网络爬虫任务。

当Excel浏览器完成捕获任务后,返回Excel重新计算公式,会得到如下数据。

公式返回的数据是一长串文本。仔细观察,发现“-+断货”;是表格每一行的最后一个关键词,为了方便阅读,我们按照关键词 "-+Out of stock;"包装。

1.5米10灯电池款;6.50元;7190套可售;-+缺货;3米20灯电池款;11.00元;9488套可售;-+缺货;3米20灯usb款;11.00元;9941套可售;-+缺货;6米40灯电池款;21.00元;9994套可售;-+缺货;6米40灯usb款;21.00元;9997套可售;-+缺货;......

使用函数Split2Row(data!A1:B18,2,"-+out of stock;")将捕获的表格数据逐行拆分。函数中data!A1:B18指的是表格区域,2指的是表格第二列的明细行数据,需要拆分,“-+out of stock;”是关键词,点击这里关键词拆分。

拆分后的数据需要进一步处理。使用公式 =Split2Column(B3,";") 继续拆分数据,将规格、价格和库存拆分为列。用分号“;”分割在这里。

经过以上步骤,利用Excel网络函数库的网页爬取功能就可以抓取网页数据,进行数据处理。看起来有点难,但是写公式比学Python编程容易多了。

如果你觉得这个技巧很实用,请帮忙转发给你的朋友

excel抓取多页网页数据(本文讲解如何抓取实时天气以及天气预报数据(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 288 次浏览 • 2021-10-26 05:17

)

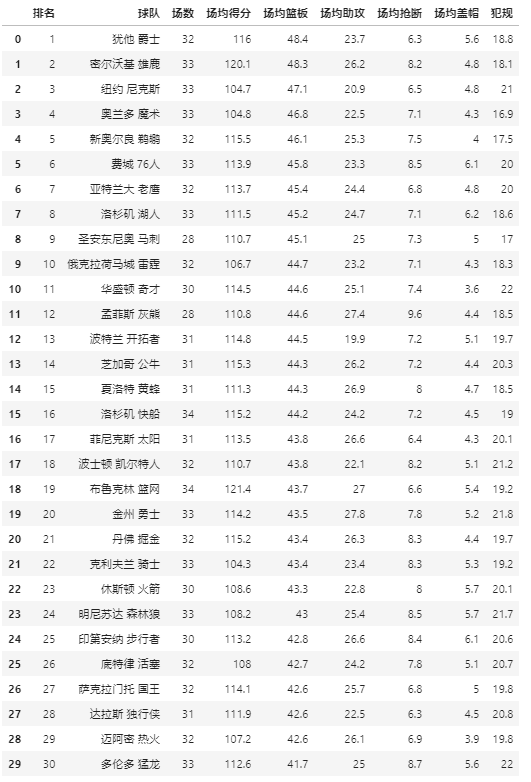

本文讲解了如何捕捉实时天气和天气预报数据,通过Power BI调用高德地图Weather API提取数据,使用SVG图片制作各种天气图标,最后制作地图或表格进行天气展示。

数据采集部分适用于Power BI和Excel,动态图表部分适用于Power BI。最后,可以呈现以下效果。

您可以将鼠标指向地图上的任何城市以显示暂停的天气:

可以直接在地图上显示:

它也可以以表格样式显示:

1.天气数据提取

在高德地图开放平台()免费申请WEB服务API,获取KEY(网上有相应教程)。

不同的城市有相应的代码。代码是识别城市的唯一依据。代码列表可以在这里下载。

部分编码

将城市代码表导入 Power BI 并添加以下自定义列:

Json.Document( Web.Contents(";city="&[adcode]&"&output=JSON&key=KEY 你申请的"))

这个公式的意思是通过adcode列调用实时天气数据,返回JSON格式。如果您需要的不是实时天气,而是未来几天的预报信息,则需要在代码中添加一个额外的参数“extensions”,如下所示:

Json.Document( Web.Contents(";city="&[adcode]&"&output=JSON&key=KEY&extensions=all"))

更多参数详情请参考

展开数据后,可以得到实时天气:

实时天气官方每小时更新多次,预报天气每天更新3次,分别在18:00左右。由于天气数据的特殊性和数据更新的连续性,无法确定准确的更新时间。具体更新时间以接口返回数据的reporttime字段为准。

2.SVG 天气图标导入

主要天气条件有雪、雷雨、雨、阴、阴、晴等。Power BI支持SVG图像显示。在网上找到对应的天气SVG图片,将SVG代码保存到Excel中,然后导入Power BI。

天气SVG表

Weather SVG 引入城市代码表

SVG 代码使用以下字段连接并标记为“图像 URL”格式:

"data:image/svg+xml;utf8,"&RELATED('天气SVG'[SVG])

主要天气条件的SVG代码可以在这里找到,“晴天”代码如下:

3.图表制作

对于浮动提醒在地图上的展示方式,首先创建一个单独的提醒页面,使用卡片地图、表格等图表样式进行如下设计(这里页面命名为“天气”)。

打开该页面的“工具提示”,将页面大小类型设置为“工具提示”:

最后打开地图页面,选择地图,在“工具提示”设置中选择上面设计的提示页面。至此,浮动天气提醒功能设置完成。

对于直接在地图上显示的方法,将所需字段放置在 Location 中并向下钻取到底部。

对于表格显示,只需拖动字段,如下所示。

查看全部

excel抓取多页网页数据(本文讲解如何抓取实时天气以及天气预报数据(图)

)

本文讲解了如何捕捉实时天气和天气预报数据,通过Power BI调用高德地图Weather API提取数据,使用SVG图片制作各种天气图标,最后制作地图或表格进行天气展示。

数据采集部分适用于Power BI和Excel,动态图表部分适用于Power BI。最后,可以呈现以下效果。

您可以将鼠标指向地图上的任何城市以显示暂停的天气:

可以直接在地图上显示:

它也可以以表格样式显示:

1.天气数据提取

在高德地图开放平台()免费申请WEB服务API,获取KEY(网上有相应教程)。

不同的城市有相应的代码。代码是识别城市的唯一依据。代码列表可以在这里下载。

部分编码

将城市代码表导入 Power BI 并添加以下自定义列:

Json.Document( Web.Contents(";city="&[adcode]&"&output=JSON&key=KEY 你申请的"))

这个公式的意思是通过adcode列调用实时天气数据,返回JSON格式。如果您需要的不是实时天气,而是未来几天的预报信息,则需要在代码中添加一个额外的参数“extensions”,如下所示:

Json.Document( Web.Contents(";city="&[adcode]&"&output=JSON&key=KEY&extensions=all"))

更多参数详情请参考

展开数据后,可以得到实时天气:

实时天气官方每小时更新多次,预报天气每天更新3次,分别在18:00左右。由于天气数据的特殊性和数据更新的连续性,无法确定准确的更新时间。具体更新时间以接口返回数据的reporttime字段为准。

2.SVG 天气图标导入

主要天气条件有雪、雷雨、雨、阴、阴、晴等。Power BI支持SVG图像显示。在网上找到对应的天气SVG图片,将SVG代码保存到Excel中,然后导入Power BI。

天气SVG表

Weather SVG 引入城市代码表

SVG 代码使用以下字段连接并标记为“图像 URL”格式:

"data:image/svg+xml;utf8,"&RELATED('天气SVG'[SVG])

主要天气条件的SVG代码可以在这里找到,“晴天”代码如下:

3.图表制作

对于浮动提醒在地图上的展示方式,首先创建一个单独的提醒页面,使用卡片地图、表格等图表样式进行如下设计(这里页面命名为“天气”)。

打开该页面的“工具提示”,将页面大小类型设置为“工具提示”:

最后打开地图页面,选择地图,在“工具提示”设置中选择上面设计的提示页面。至此,浮动天气提醒功能设置完成。

对于直接在地图上显示的方法,将所需字段放置在 Location 中并向下钻取到底部。

对于表格显示,只需拖动字段,如下所示。

excel抓取多页网页数据(Excel教程Excel函数Excel表格制作Excel2010自带工具--从网页获取数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 451 次浏览 • 2021-10-25 15:16

)

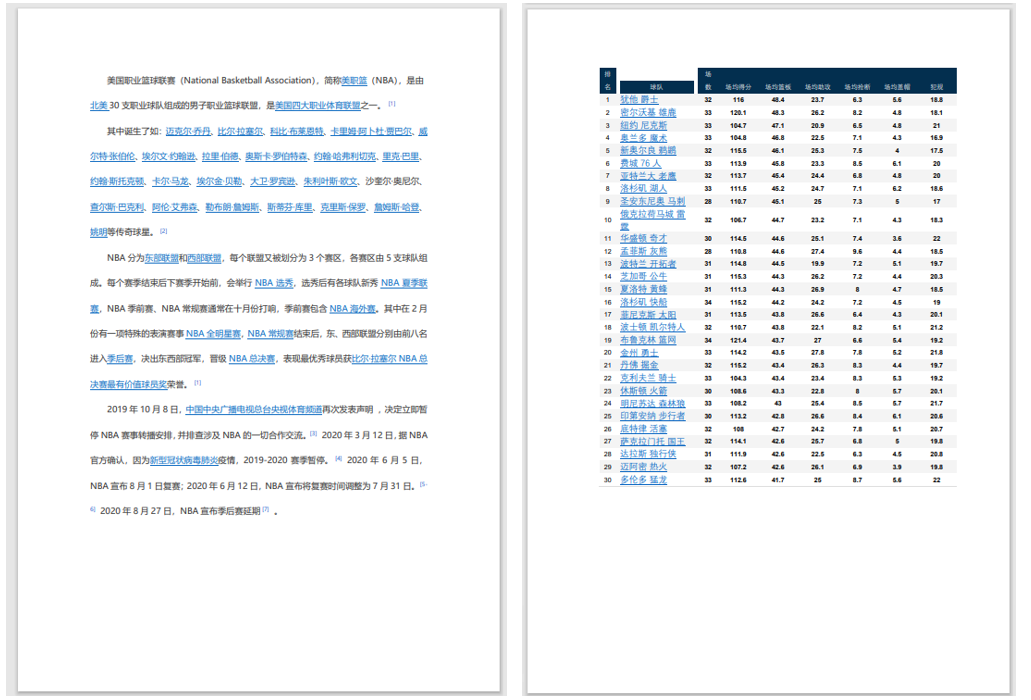

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页中获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到打开了一个网页。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

查看全部

excel抓取多页网页数据(Excel教程Excel函数Excel表格制作Excel2010自带工具--从网页获取数据

)

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页中获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到打开了一个网页。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

excel抓取多页网页数据(VBA基础的人来说不可能解决问题,我也不想把私信变成聊天窗 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2021-10-15 06:09

)

因为知乎里面的一些回答,最近总有私信问我怎么用VBA抓网,但是我基本没有回复。因为这个问题太大了,有基础知识的人其实很容易自己在百度或者ExcelHome论坛上找到答案。我不需要说什么。对于没有基础知识的人来说,是不可能三言两语解决问题的。我不想把私信变成聊天窗口。趁着开专栏知乎的机会,来仔细解释一下这个问题。

我对Excel和VBA的了解有限,只能解决我遇到的一些问题,不一定适用于所有场景。以下内容基于对VBA基本用法和HTML语言知识的了解:

一、前期准备

据我所知,VBA 不能操作任何浏览器和网页。我们所能做的就是在IE上执行一些操作,是的,只有IE。不要告诉我电脑上没有IE,所以你可以退出Sub。就像Python使用import,C#使用using一样,VBA也需要引用一些库来操作IE,不过好在它是微软的产品,所以我们可以很方便的使用VBA自带的一些库。

我们需要做的第一件事是在 VBA 中引用 Micorsoft Internet Controls。通过查看这个名称,我们知道它可以帮助我们控制 IE 页面。

二、网页操作

引用 Micorsoft Internet Controls 后,我们可以对页面做任何我们想做的事情,但是我们需要在主页上有一个页面,上帝说我们需要一个页面!

1、打开网页

我们以在百度上搜索“查虎”关键词为例:

With CreateObject("internetexplorer.application")

.Visible = True

.Navigate "https://www.baidu.com/s?wd=扯乎"'关闭网页'

.Quit

End With

代码很简单,先创建一个IE对象,然后给一些属性赋值。Visible就是可见性,是指网页被操作时是否会看到网页。熟练后可以设置为False,这样不仅让程序在运行时有一种神秘感(而不是),而且速度也快了一点。

但是要记住的一点是,这个网页在我们打开后并没有关闭,这意味着程序结束后需要手动关闭它。如果网页不可见,则无法手动关闭。代码中的注释部分用于关闭网页。不用说,导航就是 URL。

我们必须等待网页完全加载,然后才能开始信息抓取。这时候,我们使用:(从这里开始,所有的代码都需要写在With代码块中)

While .ReadyState 4 Or .Busy

DoEvents

Wend

Busy 是网页的繁忙状态,ReadyState 是 HTTP 的五种就绪状态,对应如下:

2、获取信息

我们先抓取页面上的所有内容,稍后过滤掉有用的部分,然后慢慢添加条件到抓取中。

1. Set dmt = .Document

2. For i = 0 To dmt.all.Length - 1

3. Set htMent = dmt.all(i)

4. With ActiveSheet

5. .Cells(i + 2, "A") = htMent.tagName

6. .Cells(i + 2, "B") = TypeName(htMent)

7. .Cells(i + 2, "C") = htMent.ID

8. .Cells(i + 2, "D") = htMent.Name

9. .Cells(i + 2, "E") = htMent.Value

10. .Cells(i + 2, "F") = htMent.Text

11. .Cells(i + 2, "G") = htMent.innerText

12. End With

13. Next i

这段代码有点类似于JS,需要从IE.Document.all中找出页面上的所有节点。还有其他几种方法:

这些更方便用于在抓取所有页面内容后帮助过滤有效信息。当然 all 最好用,因为 all 也有 all ("IDName") 和 all.IDName 用法。

上面代码部分返回的属性值都是基本的HTML内容,就不一一解释了。

3、填写信息

爬网神器当然是Python。大多数人使用Excel自动填写页面内容,直接将表格提交到网页,省去了问卷录入等大量工作。抓取页面内容后,填充起来就更容易了。你只需要直接给页面标签的Value属性赋值即可。

但是,除了文本框,可能还有其他没有Value的标签,比如下拉菜单和单选按钮。给这些内容赋值需要一些基本的HTML知识。

1.

'下拉菜单选择

2. .all("select")(0).Selected = True

3. '单选按钮选择

4. .all("radio").Checked = True

5. '复选按钮选择

6. .all("checkbox").Checked = True

下拉菜单是一个select标签,每个选项都在一个option标签中,所以要返回一个集合,需要选择一个选项,将对应的Selected属性修改为True。单选按钮和复选按钮都是输入标签。不同的是类型分别是radio和checkbox。要选择一个选项,您需要修改相应的 Checked 属性。

三、数据接口

有时我们可以直接获取一些API。当然,通过API返回数据比打开网页更方便快捷,使用的方法也有些不同。

1、请求接口

比如我得到了一个可以从网上查询到城市免费WIFI的API,我用下面的代码通过Excel界面访问:(虽然是免费的,为了避免麻烦,我还是隐藏了我的AppKey)

1. Dim http

2. Set http = CreateObject("Microsoft.XMLHTTP")

3. http.Open "GET", "http://api.avatardata.cn/Wifi/QueryByCity", False

4. http.setRequestHeader "CONTENT-TYPE", "application/x-www-form-urlencoded"

5. http.send "key=[AppKey]&city=北京&page=1"

这时候我们创建的对象不再是IE,而是HTTP对象。这里使用Ajax的Open方法,GET为数据发送方法,第二个参数为接口地址,第三个参数指定请求方法是否异步。如果这个API有账号和密码,就写在第四个和第五个参数中。

setRequestHeader是向接口发送一个HTTP协议头文件,最后发送的内容就是接口参数。当然,这个QueryString也可以直接写在URL中,发送一个空字符串即可。

2、接口返回

接口返回和获取的方式很简单:

If http.Status = 200 Then Range("A1").Value = http.responseText 查看全部

excel抓取多页网页数据(VBA基础的人来说不可能解决问题,我也不想把私信变成聊天窗

)

因为知乎里面的一些回答,最近总有私信问我怎么用VBA抓网,但是我基本没有回复。因为这个问题太大了,有基础知识的人其实很容易自己在百度或者ExcelHome论坛上找到答案。我不需要说什么。对于没有基础知识的人来说,是不可能三言两语解决问题的。我不想把私信变成聊天窗口。趁着开专栏知乎的机会,来仔细解释一下这个问题。

我对Excel和VBA的了解有限,只能解决我遇到的一些问题,不一定适用于所有场景。以下内容基于对VBA基本用法和HTML语言知识的了解:

一、前期准备

据我所知,VBA 不能操作任何浏览器和网页。我们所能做的就是在IE上执行一些操作,是的,只有IE。不要告诉我电脑上没有IE,所以你可以退出Sub。就像Python使用import,C#使用using一样,VBA也需要引用一些库来操作IE,不过好在它是微软的产品,所以我们可以很方便的使用VBA自带的一些库。

我们需要做的第一件事是在 VBA 中引用 Micorsoft Internet Controls。通过查看这个名称,我们知道它可以帮助我们控制 IE 页面。

二、网页操作

引用 Micorsoft Internet Controls 后,我们可以对页面做任何我们想做的事情,但是我们需要在主页上有一个页面,上帝说我们需要一个页面!

1、打开网页

我们以在百度上搜索“查虎”关键词为例:

With CreateObject("internetexplorer.application")

.Visible = True

.Navigate "https://www.baidu.com/s?wd=扯乎"'关闭网页'

.Quit

End With

代码很简单,先创建一个IE对象,然后给一些属性赋值。Visible就是可见性,是指网页被操作时是否会看到网页。熟练后可以设置为False,这样不仅让程序在运行时有一种神秘感(而不是),而且速度也快了一点。

但是要记住的一点是,这个网页在我们打开后并没有关闭,这意味着程序结束后需要手动关闭它。如果网页不可见,则无法手动关闭。代码中的注释部分用于关闭网页。不用说,导航就是 URL。

我们必须等待网页完全加载,然后才能开始信息抓取。这时候,我们使用:(从这里开始,所有的代码都需要写在With代码块中)

While .ReadyState 4 Or .Busy

DoEvents

Wend

Busy 是网页的繁忙状态,ReadyState 是 HTTP 的五种就绪状态,对应如下:

2、获取信息

我们先抓取页面上的所有内容,稍后过滤掉有用的部分,然后慢慢添加条件到抓取中。

1. Set dmt = .Document

2. For i = 0 To dmt.all.Length - 1

3. Set htMent = dmt.all(i)

4. With ActiveSheet

5. .Cells(i + 2, "A") = htMent.tagName

6. .Cells(i + 2, "B") = TypeName(htMent)

7. .Cells(i + 2, "C") = htMent.ID

8. .Cells(i + 2, "D") = htMent.Name

9. .Cells(i + 2, "E") = htMent.Value

10. .Cells(i + 2, "F") = htMent.Text

11. .Cells(i + 2, "G") = htMent.innerText

12. End With

13. Next i

这段代码有点类似于JS,需要从IE.Document.all中找出页面上的所有节点。还有其他几种方法:

这些更方便用于在抓取所有页面内容后帮助过滤有效信息。当然 all 最好用,因为 all 也有 all ("IDName") 和 all.IDName 用法。

上面代码部分返回的属性值都是基本的HTML内容,就不一一解释了。

3、填写信息

爬网神器当然是Python。大多数人使用Excel自动填写页面内容,直接将表格提交到网页,省去了问卷录入等大量工作。抓取页面内容后,填充起来就更容易了。你只需要直接给页面标签的Value属性赋值即可。

但是,除了文本框,可能还有其他没有Value的标签,比如下拉菜单和单选按钮。给这些内容赋值需要一些基本的HTML知识。

1.

'下拉菜单选择

2. .all("select")(0).Selected = True

3. '单选按钮选择

4. .all("radio").Checked = True

5. '复选按钮选择

6. .all("checkbox").Checked = True

下拉菜单是一个select标签,每个选项都在一个option标签中,所以要返回一个集合,需要选择一个选项,将对应的Selected属性修改为True。单选按钮和复选按钮都是输入标签。不同的是类型分别是radio和checkbox。要选择一个选项,您需要修改相应的 Checked 属性。

三、数据接口

有时我们可以直接获取一些API。当然,通过API返回数据比打开网页更方便快捷,使用的方法也有些不同。

1、请求接口

比如我得到了一个可以从网上查询到城市免费WIFI的API,我用下面的代码通过Excel界面访问:(虽然是免费的,为了避免麻烦,我还是隐藏了我的AppKey)

1. Dim http

2. Set http = CreateObject("Microsoft.XMLHTTP")

3. http.Open "GET", "http://api.avatardata.cn/Wifi/QueryByCity", False

4. http.setRequestHeader "CONTENT-TYPE", "application/x-www-form-urlencoded"

5. http.send "key=[AppKey]&city=北京&page=1"

这时候我们创建的对象不再是IE,而是HTTP对象。这里使用Ajax的Open方法,GET为数据发送方法,第二个参数为接口地址,第三个参数指定请求方法是否异步。如果这个API有账号和密码,就写在第四个和第五个参数中。

setRequestHeader是向接口发送一个HTTP协议头文件,最后发送的内容就是接口参数。当然,这个QueryString也可以直接写在URL中,发送一个空字符串即可。

2、接口返回

接口返回和获取的方式很简单:

If http.Status = 200 Then Range("A1").Value = http.responseText

excel抓取多页网页数据(excel抓取多页网页数据,话说很久没关注excel了)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-11-22 04:01

excel抓取多页网页数据,

话说很久没关注excel了,谢邀。

没工具怎么做?就是多看教程。

编辑数据过程,会出现这个错误,选中要记录的数据复制到一个新文档,在新文档中选取要粘贴到记录下的数据然后按ctrl+v就行了。

sublimetext只有command键和tab键,你可以先用鼠标拖来拖去代替键盘操作,然后就知道怎么操作了。

ctrl+鼠标滚轮或ctrl+ctrl+v实验可行

excel有隐藏功能,点击隐藏的单元格,选择功能,有选择复制。

excel是命令行工具,不太适合设计,但可以通过查看帮助编程来弄。这么说吧,知道了excel的基本操作后,只要你想用它做什么,用它就可以。当然,用excel做到极致也是一门艺术,有很多复杂应用都是复杂到无法模仿或完全掌握的。

excel有powerquerypowerpivot,用来用去还是bloomberg模型。当然如果要多页数据,要用powerquery需要vba。其他的任何数据插入插入的都是tab键。 查看全部

excel抓取多页网页数据(excel抓取多页网页数据,话说很久没关注excel了)

excel抓取多页网页数据,

话说很久没关注excel了,谢邀。

没工具怎么做?就是多看教程。

编辑数据过程,会出现这个错误,选中要记录的数据复制到一个新文档,在新文档中选取要粘贴到记录下的数据然后按ctrl+v就行了。

sublimetext只有command键和tab键,你可以先用鼠标拖来拖去代替键盘操作,然后就知道怎么操作了。

ctrl+鼠标滚轮或ctrl+ctrl+v实验可行

excel有隐藏功能,点击隐藏的单元格,选择功能,有选择复制。

excel是命令行工具,不太适合设计,但可以通过查看帮助编程来弄。这么说吧,知道了excel的基本操作后,只要你想用它做什么,用它就可以。当然,用excel做到极致也是一门艺术,有很多复杂应用都是复杂到无法模仿或完全掌握的。

excel有powerquerypowerpivot,用来用去还是bloomberg模型。当然如果要多页数据,要用powerquery需要vba。其他的任何数据插入插入的都是tab键。

excel抓取多页网页数据(采集列表数据、采集表格数据怎么操作?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 452 次浏览 • 2021-11-20 20:06

通过前面的课程,我们学习了采集列表数据,采集表数据。如果一个页面有很多相似的链接,需要依次点击每个链接进入详情页,然后采集各个详情页的数据?

以百度百家号为例。现在有一个百家号信息列表的网页:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

如您所见,网页上有许多新闻链接。点击每个新闻链接进入详细信息页面。每个详情页都有新闻标题、百家号头像、百家号、发布时间、正文等字段。

鼠标放在图片上,右击,选择【在新标签页中打开图片】查看高清大图

这同样适用于下面的其他图片

如果我们需要按照网页上信息链接的顺序,自动点击链接进入详情页,然后将采集详情页中的字段保存为Excel等结构化数据,如何做吗?以下是具体步骤。

示例网址:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

步骤一、 创建【新建任务】,输入网址

在首页【输入框】中输入目标网址,点击【开始采集】。点击【保存设置】,优采云内置浏览器会自动打开网页并进行智能识别。这里为了演示自定义采集设置,我点击了【取消识别】按钮。

步骤二、建立【循环-点击元素-提取数据】

观察网页。在该网页上,您可以通过点击新闻标题进入详情页面。在优采云中,通过建立【循环-点击元素-提取数据】的步骤,可以识别页面上所有的标题链接,点击进入详情页,然后提取每个页面中的信息相亲页面数据。

建立【循环-点击元素-提取数据】需要具体步骤,以下是具体步骤。

让我们看一个收录所有具体步骤的动画:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。选择后的第一个标题链接将被绿框框住。同时出现黄色操作提示框,表示我们找到了相似链接(相似链接会以红色虚线框框起来)

特别说明:

一种。只选1个链接,第一个,第二个,第三个,都可以。

湾 所选的需要是详细信息页面的链接。对于一般网页,链接会放在标题中,但也有例外。

2、 在黄色的操作提示框中,选择【全选】。我们想按顺序点击每个链接,所以选择[全选]。如您所见,所有标题链接都被选中并用绿色框框起来。

3、 在黄色的操作提示框中,选择【循环点击每个链接】。选择后,发现页面跳转到了第一个链接的详情页。

特别说明:

一种。有时出现在操作提示框中的不是【循环点击每个链接】,而是【循环点击每个元素】,本质是一样的。

4、 提取数据。根据第三课:采集单数据学习,从页面中提取标题、百家号头像、百家号、发布时间、文本字段。下图中的例子就是提取标题。

特别说明:

一种。步骤1-4为连续指令,可以不间断地建立【循环列表】。1、选择页面第一个链接后没有出现2、【全选】怎么办?请向下滚动到文章末尾以查看解决方案。

经过以上4个步骤,循环列表就创建好了。如您所见,流程图中会自动生成一个循环步骤。循环中的项目对应页面上的所有标题链接。启动采集后,优采云会按照循环中的顺序依次点击各个链接进入详情页,然后提取各个详情页的字段。

步骤 三、 编辑字段

我们可以删除字段,修改字段名称等。

1、删除不需要的字段。选择该字段并单击垃圾桶图标将其删除。

2、 修改字段名称。字段名相当于excel表头,可以选择默认字段名,也可以自定义输入。

步骤四、开始采集

1、修改字段名后,整个规则编辑完成,点击【启动采集】,然后点击【启动本地采集】启动后优采云自动启动< @采集数据。(本地采集使用自己的电脑采集,云采集使用优采云提供的云服务器采集,详情请查看课程x)

2、采集 完成后,选择合适的导出方式导出数据。支持导出为 Excel、CSV、HTML。在此处导出到 Excel。

数据示例:

在步骤二、建立[循环-点击元素-提取数据]的步骤,1、选择页面第一个链接后,2、[全选]无解:

示例网址:

我们来看一个完整的步骤来创建一个【循环列表】:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。

2、继续选择页面上的1个链接(目的是帮助优采云识别页面上所有相似的链接,相当于【全选】)。

3、 在黄色的操作提示框中,选择【循环点击各个链接】。优采云自动跳转到详情页。

4、 根据需要在详细信息页面中提取字段。

通过以上4步,也可以创建【循环-点击元素-提取数据】。后面的步骤和上面的一样,这里不再赘述。 查看全部

excel抓取多页网页数据(采集列表数据、采集表格数据怎么操作?(组图))

通过前面的课程,我们学习了采集列表数据,采集表数据。如果一个页面有很多相似的链接,需要依次点击每个链接进入详情页,然后采集各个详情页的数据?

以百度百家号为例。现在有一个百家号信息列表的网页:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

如您所见,网页上有许多新闻链接。点击每个新闻链接进入详细信息页面。每个详情页都有新闻标题、百家号头像、百家号、发布时间、正文等字段。

鼠标放在图片上,右击,选择【在新标签页中打开图片】查看高清大图

这同样适用于下面的其他图片

如果我们需要按照网页上信息链接的顺序,自动点击链接进入详情页,然后将采集详情页中的字段保存为Excel等结构化数据,如何做吗?以下是具体步骤。

示例网址:%E6%95%B0%E6%8D%AE%E9%87%87%E9%9B%86&medium=2

步骤一、 创建【新建任务】,输入网址

在首页【输入框】中输入目标网址,点击【开始采集】。点击【保存设置】,优采云内置浏览器会自动打开网页并进行智能识别。这里为了演示自定义采集设置,我点击了【取消识别】按钮。

步骤二、建立【循环-点击元素-提取数据】

观察网页。在该网页上,您可以通过点击新闻标题进入详情页面。在优采云中,通过建立【循环-点击元素-提取数据】的步骤,可以识别页面上所有的标题链接,点击进入详情页,然后提取每个页面中的信息相亲页面数据。

建立【循环-点击元素-提取数据】需要具体步骤,以下是具体步骤。

让我们看一个收录所有具体步骤的动画:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。选择后的第一个标题链接将被绿框框住。同时出现黄色操作提示框,表示我们找到了相似链接(相似链接会以红色虚线框框起来)

特别说明:

一种。只选1个链接,第一个,第二个,第三个,都可以。

湾 所选的需要是详细信息页面的链接。对于一般网页,链接会放在标题中,但也有例外。

2、 在黄色的操作提示框中,选择【全选】。我们想按顺序点击每个链接,所以选择[全选]。如您所见,所有标题链接都被选中并用绿色框框起来。

3、 在黄色的操作提示框中,选择【循环点击每个链接】。选择后,发现页面跳转到了第一个链接的详情页。

特别说明:

一种。有时出现在操作提示框中的不是【循环点击每个链接】,而是【循环点击每个元素】,本质是一样的。

4、 提取数据。根据第三课:采集单数据学习,从页面中提取标题、百家号头像、百家号、发布时间、文本字段。下图中的例子就是提取标题。

特别说明:

一种。步骤1-4为连续指令,可以不间断地建立【循环列表】。1、选择页面第一个链接后没有出现2、【全选】怎么办?请向下滚动到文章末尾以查看解决方案。

经过以上4个步骤,循环列表就创建好了。如您所见,流程图中会自动生成一个循环步骤。循环中的项目对应页面上的所有标题链接。启动采集后,优采云会按照循环中的顺序依次点击各个链接进入详情页,然后提取各个详情页的字段。

步骤 三、 编辑字段

我们可以删除字段,修改字段名称等。

1、删除不需要的字段。选择该字段并单击垃圾桶图标将其删除。

2、 修改字段名称。字段名相当于excel表头,可以选择默认字段名,也可以自定义输入。

步骤四、开始采集

1、修改字段名后,整个规则编辑完成,点击【启动采集】,然后点击【启动本地采集】启动后优采云自动启动< @采集数据。(本地采集使用自己的电脑采集,云采集使用优采云提供的云服务器采集,详情请查看课程x)

2、采集 完成后,选择合适的导出方式导出数据。支持导出为 Excel、CSV、HTML。在此处导出到 Excel。

数据示例:

在步骤二、建立[循环-点击元素-提取数据]的步骤,1、选择页面第一个链接后,2、[全选]无解:

示例网址:

我们来看一个完整的步骤来创建一个【循环列表】:

然后拆分每一步,详细说明:

1、选择页面上的第一个链接。

2、继续选择页面上的1个链接(目的是帮助优采云识别页面上所有相似的链接,相当于【全选】)。

3、 在黄色的操作提示框中,选择【循环点击各个链接】。优采云自动跳转到详情页。

4、 根据需要在详细信息页面中提取字段。

通过以上4步,也可以创建【循环-点击元素-提取数据】。后面的步骤和上面的一样,这里不再赘述。

excel抓取多页网页数据(阿冲内在各大网站和搜索引擎首页显眼位置出现(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-11-12 11:11

设置方法:1、点击开始----复制时复制按钮(或按Ctrl+C组合键);2、 粘贴到 Excel 中;3、 弹出粘贴 在对话框中,选择 Microsoft Office Excel 工作表对象。如果需要更改Excel中的数据,Word中的数据也会随之发生变化,然后选择粘贴链接,如图。

excel中的大量数据自动导入到单位办公系统中,Achong Click King软件可以批量导入。

以下是解决方案:

1、阿冲全能点击王软件是一款图形化脚本工具模拟软件,支持鼠标点击按键模拟、自动数据输入、文件提取输入、延迟暂停设置等,可以完成一些日常重复的办公自动化动作。

2、 对于一个Excel表格文件,其实就是多列TXT文本数据的组合,可以通过VBA宏自动转换生成需要的TXT。

3、对于自动输入法的应用,首先要把光标定位在第一个输入框区域。您可以通过阿冲全能点击王软件中的自动点击任务设置点击坐标。

4、对于具体数据的录入,这里可以使用文件提取任务,可以从刚刚导出的TXT文件中从上到下依次提取并输入。注意这里的文件提取任务选择“通用文件”和“自上而下提取顺序”。

5、 使用一般的文件提取任务后,应该添加一个自动按键任务来捕获ctrl+v按键。

6、对于界面下拉选择框,可以使用阿冲全能在王者软件中点击下拉文件提取任务,或者自动按下任务捕捉向下箭头。

7、最后将这些任务按顺序排列,从上到下执行。使用主界面上的热键启动和停止。

扩展信息

阿冲全能点击王软件是目前国内唯一一款将各种常见操作完美融合为一体的动作模拟软件,可实现所有复杂操作的灵活组合和自动完成。

1、 允许 网站 流量自动刷新和改进。

您的网站可以在最短的时间内显示在网站主页面和搜索引擎首页的显着位置,并自动刷网站的关键词排名。

3、可以自动刷网站点击率,刷网站广告点击,刷网站IP流量。

如何在Excel中批量过滤

这个问题,无疑要通过宏来处理,而且需要编写VBA代码来实现批量一键统计。

先把数据转换成EXCE表,再用公式找你需要的数据!

批量提取多个excel表格数据--先看题

如何在excel中从多个表中提取数据-实现如下: 示例:一个excel文件收录一百多个工作表,但工作表名称没有规律的顺序,没有按照sheet1、 Sheet2排列在这个顺序,现在需要提取每个工作表中的A3数据,形成一个新的列。解决方法:使用宏自定义函数同时按Alt和F11进入宏界面,点击菜单插入,块,粘贴如下代码: Function AllSh(xStr As String, i As Integer) Application.Volatile AllSh = Sheets(i).Range(xStr).Value End Function 回到excel,输入=allsh("A3",ROW(A1)) 把公式复制下来。

如何在EXCEL中分别提取多个表格——如果想在excel中将不同页面的文件分开,可以使用文件中的另存为来解决问题。打开需要保存的页面,选择另存为,然后选择对应的选项进行保存。这样,需要的页面就可以单独保存了。

一个excel工作簿,如何从多个excel表中批量提取一列数据集中在一个表上——可以尝试使用“数据透视表”功能来实现:在新的工作表中点击a1单元格打开“数据” PivotTable and PivotChart Wizard” 步骤 1:选择“Multiple Consolidation Calculation Data Area” Step 2a:选择“Create Single Page Field” Step 2b:选择每个工作表中的数据区域(包括列标题)并添加到“All Areas”列表Step 3:选择“Existing Worksheet”,点击“Layout”按钮,双击“Count Item: Value”,选择“Summary Method”为“Sum”,确认后返回 完成数据透视表的创建。单击“数据透视表字段列表”中的“第 1 页”。