自动采集编写

自动采集编写( 非常适合《倪尔昂全盘实操打法N式之美女图站》 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-10-24 15:16

非常适合《倪尔昂全盘实操打法N式之美女图站》

)

优采云自动采集美图站,拍美图边收广告费(教学采集规则写作教程)

前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,它可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

查看全部

自动采集编写(

非常适合《倪尔昂全盘实操打法N式之美女图站》

)

优采云自动采集美图站,拍美图边收广告费(教学采集规则写作教程)

http://acan360.com/wp-content/ ... 8.png 300w, http://acan360.com/wp-content/ ... 4.png 150w, http://acan360.com/wp-content/ ... 7.png 768w" />

http://acan360.com/wp-content/ ... 8.png 300w, http://acan360.com/wp-content/ ... 4.png 150w, http://acan360.com/wp-content/ ... 7.png 768w" />前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,它可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

自动采集编写( 大课《倪尔昂全盘实操打法N式之美女图站》)

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2021-10-23 03:09

大课《倪尔昂全盘实操打法N式之美女图站》)

前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

下载

115://懒人自动采集.rar|2269587195|B3E2DBE183CECFD9891B556FE54A0193439314FF|CFC48CEBE82F5BD320B6D143697D2645516C3DAF

解压密码:1fu.li

第115话 查看全部

自动采集编写(

大课《倪尔昂全盘实操打法N式之美女图站》)

https://www.mrbxw.com/wp-conte ... 7.png 768w" />

https://www.mrbxw.com/wp-conte ... 7.png 768w" />前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

下载

115://懒人自动采集.rar|2269587195|B3E2DBE183CECFD9891B556FE54A0193439314FF|CFC48CEBE82F5BD320B6D143697D2645516C3DAF

解压密码:1fu.li

第115话

自动采集编写(纯粹调用精易模块也能达到效果(网页_访问))

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-10-22 15:09

当然,简单的调用Jingyi模块也可以达到效果(Webpage_Visit)

搜索按钮是通过POST写的,我理解是简单的fiddler抓包获取那个网页的搜索内容信息,将信息填入fishbone模块的网页访问中获取搜索结果,但是我不知道不知道是不是那个网站制作人的问题,其实书名和作者搜索信息没有区别~

搜索小说的响应速度可能有点慢。您需要等待一段时间,因为网络搜索中只显示小说名称和简介。为了迎合我的个人界面,我访问了每部小说并填写了作者、字数和最后更新时间。字体大小增加后,这些不会改变。源码还没放,可能找个时间找几个书源来填,达到换源码的目的~

成品+源码链接地址:

关联:

提取码:og57 16:47保存数据 30秒后保存 保存数据 | 恢复数据 字数检查 | 清除内容 增加编辑框 | 缩小编辑框

附加选项 阅读权限 此版本的积分规则 发布帖子并广播给观众

上一篇:大家帮忙看下这段加密,谢谢。AES/CBC/PKCS5Padding 下一篇:Python3使用Tushare接口结合mysql进行股票量化分析入门 查看全部

自动采集编写(纯粹调用精易模块也能达到效果(网页_访问))

当然,简单的调用Jingyi模块也可以达到效果(Webpage_Visit)

搜索按钮是通过POST写的,我理解是简单的fiddler抓包获取那个网页的搜索内容信息,将信息填入fishbone模块的网页访问中获取搜索结果,但是我不知道不知道是不是那个网站制作人的问题,其实书名和作者搜索信息没有区别~

搜索小说的响应速度可能有点慢。您需要等待一段时间,因为网络搜索中只显示小说名称和简介。为了迎合我的个人界面,我访问了每部小说并填写了作者、字数和最后更新时间。字体大小增加后,这些不会改变。源码还没放,可能找个时间找几个书源来填,达到换源码的目的~

成品+源码链接地址:

关联:

提取码:og57 16:47保存数据 30秒后保存 保存数据 | 恢复数据 字数检查 | 清除内容 增加编辑框 | 缩小编辑框

附加选项 阅读权限 此版本的积分规则 发布帖子并广播给观众

上一篇:大家帮忙看下这段加密,谢谢。AES/CBC/PKCS5Padding 下一篇:Python3使用Tushare接口结合mysql进行股票量化分析入门

自动采集编写(自动采集编写好网页,匹配好关键词,不会python)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-10-21 03:04

自动采集编写好网页,匹配好关键词,不会python的朋友只能手动抓取,每天忙死,效率低下。还有就是手动爬虫分页点击率肯定会太低,你需要先把分页结果过滤掉,加上数据预处理,提高采集的效率。并没有那么好的一个采集网站,每天加班加点也都没有结果,不会看网站这我就没办法了。下面说下爬虫不会看网站的问题。我找了一个只有taobao和tb的,数据我用fiddler进行了抓包,注意文本规范,fiddler抓包请求的headers你可以去抓包的网站在导航栏搜fiddler下载,没有带taobao和tb的你用浏览器自带的抓包也可以进行,下载下来就是带taobao和tb的。

接下来解决了我一直困扰的问题。现在网站都会返回useragent,抓取就是模拟他的请求,这个有很多类似的。他会带参数,所以抓取很方便,不需要明文或者编码抓包。使用fiddler抓包,我已经说过是抓包exploit了,主要抓js和script。我没有精力自己抓,直接用包进行抓包,附上headers和链接代码。

首先fiddler抓包会发现请求头这个页面(保存到本地),上传说是防止爬虫一堆代码轰炸。获取这个请求头我们直接修改下cookie.exe的代码:"/browser/tsinghua.js/usr/shared_to/a9zp"然后看代码,找一下cookie.exe。

我们抓包发现:在此为了方便说明,我贴出代码:{"https":"","from":"1","to":"","list":"","user":"green","user_data":"","name":"green","profile":"","headers":{"per_name":"green","last_login":"2014-08-06","os":"windows","host":"","max_cookie":512,"referer":"","referer_uri":"/","referer_path":"/","headers":"","success":"'2014-08-06',"greet":"green","transform":"at","detail":"","snippet":"","lib":"","encrypt":"","author":"","text":"","user_id":"","email":"","avatar":"","lib":"","time":"","temp":"","istore":"","host":"","token":"","authority":"","timezone":"","body":"","accept":"","post":"","host":"","author":"","geo":"","gravity":"","line。 查看全部

自动采集编写(自动采集编写好网页,匹配好关键词,不会python)

自动采集编写好网页,匹配好关键词,不会python的朋友只能手动抓取,每天忙死,效率低下。还有就是手动爬虫分页点击率肯定会太低,你需要先把分页结果过滤掉,加上数据预处理,提高采集的效率。并没有那么好的一个采集网站,每天加班加点也都没有结果,不会看网站这我就没办法了。下面说下爬虫不会看网站的问题。我找了一个只有taobao和tb的,数据我用fiddler进行了抓包,注意文本规范,fiddler抓包请求的headers你可以去抓包的网站在导航栏搜fiddler下载,没有带taobao和tb的你用浏览器自带的抓包也可以进行,下载下来就是带taobao和tb的。

接下来解决了我一直困扰的问题。现在网站都会返回useragent,抓取就是模拟他的请求,这个有很多类似的。他会带参数,所以抓取很方便,不需要明文或者编码抓包。使用fiddler抓包,我已经说过是抓包exploit了,主要抓js和script。我没有精力自己抓,直接用包进行抓包,附上headers和链接代码。

首先fiddler抓包会发现请求头这个页面(保存到本地),上传说是防止爬虫一堆代码轰炸。获取这个请求头我们直接修改下cookie.exe的代码:"/browser/tsinghua.js/usr/shared_to/a9zp"然后看代码,找一下cookie.exe。

我们抓包发现:在此为了方便说明,我贴出代码:{"https":"","from":"1","to":"","list":"","user":"green","user_data":"","name":"green","profile":"","headers":{"per_name":"green","last_login":"2014-08-06","os":"windows","host":"","max_cookie":512,"referer":"","referer_uri":"/","referer_path":"/","headers":"","success":"'2014-08-06',"greet":"green","transform":"at","detail":"","snippet":"","lib":"","encrypt":"","author":"","text":"","user_id":"","email":"","avatar":"","lib":"","time":"","temp":"","istore":"","host":"","token":"","authority":"","timezone":"","body":"","accept":"","post":"","host":"","author":"","geo":"","gravity":"","line。

自动采集编写( 撸界朋友都知道,在玩线报项目的时候,有一个强大的bug)

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2021-10-17 13:22

撸界朋友都知道,在玩线报项目的时候,有一个强大的bug)

业内朋友都知道,我们在玩快讯项目的时候,有一个强大的bug——那就是注册机?什么是注册机?注册器是一个用易语言编写的脚本程序,集成了ip的接收码和打印码的一系列必备工具!当我们邀请注册时,我们可以解放双手,实现一键操作!简便

注册机有什么用?

一些平台做活动的时候,一般都会给一些奖励,然后我们用一些平台或者公司拉新的奖励活动来一个一个的做。因为我们没有那么多手机号,所以需要利用收码平台为我们提供大量的新用户号!注册机为我们提供了极大的方便,可以一键操作,省很多事。

注册机怎么写?易语言-百度自己找到易语言的安装包,安装后新建项目,然后开始写模板!模板非常简单。易语言窗口右侧有各种组件。选择一个你喜欢的,放到你的模板上,调整你喜欢的界面!模块——注册机最重要的就是模块,比如收码平台和打码平台。他们的官方网站上有官方模块。您可以下载它们并将它们放在您自己的简易语言程序中!一个官方模块只能对应一个平台。需要配备哪些平台,去他们的官网下载他们的专属模块吧!当然,还有一些大佬制作的集成模块。很多平台集成在一起,方便很多。这里我就不做总结了。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!

了解了以上三点,基本上就可以做出一个简单的小型注册机了。当然,爱情采集只是简单的描述,让大家有一个学习的方向,看完这个是不可能学会的!下一篇文章给大家带来一些具体的视频教程,采集自本站网络!

直接链接:

学完简单的注册机,就可以学习其他的功能了,比如改ip,集成信息代理,多线程等等。

祝大家学习顺利! 查看全部

自动采集编写(

撸界朋友都知道,在玩线报项目的时候,有一个强大的bug)

业内朋友都知道,我们在玩快讯项目的时候,有一个强大的bug——那就是注册机?什么是注册机?注册器是一个用易语言编写的脚本程序,集成了ip的接收码和打印码的一系列必备工具!当我们邀请注册时,我们可以解放双手,实现一键操作!简便

注册机有什么用?

一些平台做活动的时候,一般都会给一些奖励,然后我们用一些平台或者公司拉新的奖励活动来一个一个的做。因为我们没有那么多手机号,所以需要利用收码平台为我们提供大量的新用户号!注册机为我们提供了极大的方便,可以一键操作,省很多事。

注册机怎么写?易语言-百度自己找到易语言的安装包,安装后新建项目,然后开始写模板!模板非常简单。易语言窗口右侧有各种组件。选择一个你喜欢的,放到你的模板上,调整你喜欢的界面!模块——注册机最重要的就是模块,比如收码平台和打码平台。他们的官方网站上有官方模块。您可以下载它们并将它们放在您自己的简易语言程序中!一个官方模块只能对应一个平台。需要配备哪些平台,去他们的官网下载他们的专属模块吧!当然,还有一些大佬制作的集成模块。很多平台集成在一起,方便很多。这里我就不做总结了。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!

了解了以上三点,基本上就可以做出一个简单的小型注册机了。当然,爱情采集只是简单的描述,让大家有一个学习的方向,看完这个是不可能学会的!下一篇文章给大家带来一些具体的视频教程,采集自本站网络!

直接链接:

学完简单的注册机,就可以学习其他的功能了,比如改ip,集成信息代理,多线程等等。

祝大家学习顺利!

自动采集编写(3.自动化工具.autojs模拟用户抖音列表接口的部署)

采集交流 • 优采云 发表了文章 • 0 个评论 • 366 次浏览 • 2021-10-17 13:21

目的:采集抖音 热门视频(自动化)

抖音的防爬技术特别好,据说有专门的防爬部门。所以通过编写代码直接访问抖音接口,是达不到目的的。数据只能通过模拟真实的用户行为来获得。

我的主要实现方式是:通过在Android模拟器中模拟用户滑动,滑动过程中产生的数据被网络代理拦截

开发中用到的工具:

硬件:需要一台备用电脑,

软件:auto.js、Android模拟器、代理服务项目、按钮向导、抓包工具

发展历程

1 确定要使用采集数据的抖音哪个接口

考虑从主页推荐列表或用户的工作列表中获取数据。

我使用fiddler抓包工具,

抓取首页的推荐列表界面,发现数据格式为Protobuf,是一种传输速度更快,占用空间更少的数据格式。解析这种格式需要支持文件。所以我们无法解析和放弃页面推荐列表。

尝试从用户的工作列表界面抓包,发现是json格式,可以获取视频信息。所以决定获取用户作品列表采集。

2.自动化工具auto.js模拟用户滑动抖音列表

为了保证采集视频的热度高,我们的用户作品并非都是采集。所以我们模拟了用户的行为:在首页的推荐视频中滑动,滑动到超过10万赞的视频,向左滑动,进入视频作者的作品列表。

首先在电脑上安装安卓模拟器,我用的是天天模拟器

在模拟器中安装抖音和auto.js应用,编写auto.js自动化脚本,并运行脚本。

这是我写的 auto.js 脚本。供你参考

<p>var myDate = new Date();

var hours = myDate.getHours();

if (hours >= 0) {

console.log("去启动抖音");

launchApp("抖音");

sleep(7000)

while (true) {

是否满足赞();

左滑进入个人中心();

判断是否出去();

关闭崩溃应用();

toast("quit persion center ")

退出个人中心();

//Swipe(10, device.height / 2,device.width / 2, device.height / 2, 10, 300);//向右滑

sleep(2000);

toast("hua dong cao zuo ")

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

sleep(3000);

每10分钟重启();

取消弹框();

判断是否出去();

关闭崩溃应用();

}

}

function 是否满足赞() {

log("是否满足赞")

try {

//不满足1万的赞划走

while (isTrue()) {

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

toast("Dig not satisfied")

sleep(1500);

退出个人中心();

}

} catch (e) {}

}

function isTrue() {

// var u = id("aen").find()

// var e = u.length - 2

// var tv = u[e];

return false;

var like = 0;

try {

var b = id("com.ss.android.ugc.aweme:id/aer").find();

var a = b[1].desc()

if (a && a.indexOf("喜欢") > -1) {

like = a.substring(a.indexOf("喜欢") + 2, a.indexOf(",按钮"));

toastLog(like);

}

} catch (e) {}

if (like.indexOf("w") == -1) {

return true;

} else {

return like.substr(0, like.indexOf("w")) -1) {

if (parseInt(totallike.substr(0, totallike.length - 1)) >= 1000) {

//关注作者

payAttention(totallike, totalfans, uniqueid, authorname);

}

}

//总点赞数或粉丝数大于1亿 关注作者并抓取更多

if (authorname && totallike.indexOf("亿") > -1 || totalfans.indexOf("亿") > -1) {

//关注作者

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

//粉丝量大于500W 关注作者, 如果粉丝量大于1000W 抓取作者更多作品

if (authorname && totalfans.indexOf("w") > -1) {

var fansCount = parseInt(totalfans.substr(0, totalfans.length - 1));

if (fansCount >= 500 && fansCount = 1000) {

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

}

if (loadMore) {

sleep(4000);

log("into swipe action ")

for (var i = 0; i 查看全部

自动采集编写(3.自动化工具.autojs模拟用户抖音列表接口的部署)

目的:采集抖音 热门视频(自动化)

抖音的防爬技术特别好,据说有专门的防爬部门。所以通过编写代码直接访问抖音接口,是达不到目的的。数据只能通过模拟真实的用户行为来获得。

我的主要实现方式是:通过在Android模拟器中模拟用户滑动,滑动过程中产生的数据被网络代理拦截

开发中用到的工具:

硬件:需要一台备用电脑,

软件:auto.js、Android模拟器、代理服务项目、按钮向导、抓包工具

发展历程

1 确定要使用采集数据的抖音哪个接口

考虑从主页推荐列表或用户的工作列表中获取数据。

我使用fiddler抓包工具,

抓取首页的推荐列表界面,发现数据格式为Protobuf,是一种传输速度更快,占用空间更少的数据格式。解析这种格式需要支持文件。所以我们无法解析和放弃页面推荐列表。

尝试从用户的工作列表界面抓包,发现是json格式,可以获取视频信息。所以决定获取用户作品列表采集。

2.自动化工具auto.js模拟用户滑动抖音列表

为了保证采集视频的热度高,我们的用户作品并非都是采集。所以我们模拟了用户的行为:在首页的推荐视频中滑动,滑动到超过10万赞的视频,向左滑动,进入视频作者的作品列表。

首先在电脑上安装安卓模拟器,我用的是天天模拟器

在模拟器中安装抖音和auto.js应用,编写auto.js自动化脚本,并运行脚本。

这是我写的 auto.js 脚本。供你参考

<p>var myDate = new Date();

var hours = myDate.getHours();

if (hours >= 0) {

console.log("去启动抖音");

launchApp("抖音");

sleep(7000)

while (true) {

是否满足赞();

左滑进入个人中心();

判断是否出去();

关闭崩溃应用();

toast("quit persion center ")

退出个人中心();

//Swipe(10, device.height / 2,device.width / 2, device.height / 2, 10, 300);//向右滑

sleep(2000);

toast("hua dong cao zuo ")

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

sleep(3000);

每10分钟重启();

取消弹框();

判断是否出去();

关闭崩溃应用();

}

}

function 是否满足赞() {

log("是否满足赞")

try {

//不满足1万的赞划走

while (isTrue()) {

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

toast("Dig not satisfied")

sleep(1500);

退出个人中心();

}

} catch (e) {}

}

function isTrue() {

// var u = id("aen").find()

// var e = u.length - 2

// var tv = u[e];

return false;

var like = 0;

try {

var b = id("com.ss.android.ugc.aweme:id/aer").find();

var a = b[1].desc()

if (a && a.indexOf("喜欢") > -1) {

like = a.substring(a.indexOf("喜欢") + 2, a.indexOf(",按钮"));

toastLog(like);

}

} catch (e) {}

if (like.indexOf("w") == -1) {

return true;

} else {

return like.substr(0, like.indexOf("w")) -1) {

if (parseInt(totallike.substr(0, totallike.length - 1)) >= 1000) {

//关注作者

payAttention(totallike, totalfans, uniqueid, authorname);

}

}

//总点赞数或粉丝数大于1亿 关注作者并抓取更多

if (authorname && totallike.indexOf("亿") > -1 || totalfans.indexOf("亿") > -1) {

//关注作者

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

//粉丝量大于500W 关注作者, 如果粉丝量大于1000W 抓取作者更多作品

if (authorname && totalfans.indexOf("w") > -1) {

var fansCount = parseInt(totalfans.substr(0, totalfans.length - 1));

if (fansCount >= 500 && fansCount = 1000) {

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

}

if (loadMore) {

sleep(4000);

log("into swipe action ")

for (var i = 0; i

自动采集编写(网络上主流采集器之一,与同类产品的相比优采云采集器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2021-10-17 13:18

优采云采集器() 是一个多线程的内容采集发布程序,适用于各大主流文章系统、论坛系统等。使用优采云@ >采集器,您可以立即创建一个内容丰富的网站。系统支持远程图片下载、图片批量水印、Flash下载、下载文件地址检测、自制发布cms模块参数、自定义发布内容等相关采集器。对于数据采集,可以分为两部分,一是采集数据,二是发布数据。

优采云采集器()是一款功能强大的网页内容采集软件。可以从网上抓取文字、图片、flash、视频等网络资源,同时软件具有强大的信息发布功能,可以将采集模仿浏览器的数据发布到网站@ > 或者直接导入Access、MySql、MS SqlServer数据库,也可以保存为本地文件,方便浏览使用。

优采云采集器 可广泛用于各种网站、数据系统或用于数据采集目的。使用它我们可以获取最新消息并将新闻发布到我们自己的网络系统,或者用于采集信息和提供相关信息供决策使用,也可以作为批量下载工具来获取您需要的信息,也可以作为网站开发者测试工具提交测试数据。更多的应用可以在实践中灵活使用。

作为互联网上的主流采集器之一,与同类产品相比,优采云采集器具有以下特点:多任务、多线程、多tab、多页面< @采集,多种SEO功能,多种发布方式,多种数据库存储支持,支持界面插件等应用扩展,对采集的数据进行本地可视化编辑,强大的下载功能,支持各种web服务器数据采集,可视化测试,支持网页压缩采集,发布数据时可上传文件,采集自动更新功能,良好的用户体验。以下是每个功能的具体说明

特征

1. 多任务处理

优采云采集器中的task是一个完整的采集流程。包括三项:采集 URL、采集内容、发布内容。可以同时执行三个任务,也可以分批和流程执行采集。多任务是指程序可以同时运行多个任务,只要用户的电脑配置好,就可以运行足够多的任务来捕获数据。多个任务之间互不干扰,可以分别停止、暂停、查看采集数据等操作。

2. 多线程

多线程的使用可以提高程序运行时的效率,加快爬取和发布的速度,对于爬取大量数据非常有效。同时不会影响其他任务的运行。

3. 多个标签

程序在抓取数据时,可以对抓取到的数据进行标记。这就是标签的功能。我们可以指出捕获的数据是标题、内容还是作者。标签数量不受限制,使程序可以方便地及时捕获和处理更复杂的数据。

4. 多页采集

有时,一条信息的数据存在于多个页面上。我们的软件针对这个问题开发了多页采集功能。程序可以从采集页面URL中获取相关网页并抓取其内容,然后保存在一个记录中。

5. 循环采集

程序可以在一页或多页采集上循环,并且可以捕获相同的源代码样式数据。这可以捕获网站 之类的论坛的所有数据。同时,软件可以下载捕获的循环记录作为新记录保存。

6. 多种seo功能

有些站长或编辑需要对网页内容做SEO优化。这时候就可以使用程序的关键词提取功能了。

程序从关键词词库中,根据词频和词性对内容进行划分,提取内容的关键词。可以提取多个标签。

7. 多种发布方式

数据被捕获后,我们可以通过多种方式处理数据。Web 在线发布功能是我们功能中最流行的发布方式之一。不需要用户自行修改网站。该程序模仿浏览器提交数据的过程。使用此功能,您可以轻松地将数据发布到您自己的网站 系统,而不管用户的网站 是在什么系统上构建的,也无论使用的是什么程序。数据库存储方式为程序通过接口执行sql语句,将采集中的数据直接发送到数据库。它的特点是效率高。程序支持三种数据库的直接存储操作:ACCESS、MSSQL、MYSQL。同时,软件还可以将数据保存为本地文本文件,

8. 插件接口

在软件不断增加功能的同时,考虑到用户的不同需求,允许参与程序开发和程序功能的扩展。目前程序提供了php文件处理接口和.net插件处理程序。php文件处理接口可以用于采集数据处理两次后。.net 编程接口可以在网页下载后、程序处理前对网页内容进行处理。通过采集前后采集的两次处理,基本可以满足大部分用户对数据采集的需求。

9. 本地数据可视化编辑

对于捕获的本地数据,我们可以进行一些编辑然后发布。这对某些 网站 编辑用户特别有用。可以省去去网站修改的麻烦。本地编辑支持源码,但有编辑和预览三种视图。在数据处理中,可以使用SQL语句对内容进行批量处理,也可以使用同义词库批量替换一些敏感词。

10. 文件下载功能

该程序的一大特点是可以在网络上下载图片、flash等附件。它可以突破一般简单的防盗系统。能自动识别下载文件的类型,对于一些未知格式也能正常下载。对于较大的文件,可以分段下载。对于支持续传的文件,支持续传。

11. 支持多台服务器

网上的网站服务器有很多种,有些在http协议上略有不同。程序在这方面做了特殊处理,基本上可以采集所有服务器数据。同时,该软件具有网页自动识别编码功能,对于因服务器差异而没有发送网页编码数据的人也非常好用。在http协议方面,程序可以自定义http头,实现各种服务器数据的平滑抓取。

12.网页数据压缩技术

为了节省带宽,大多数服务器都支持网页压缩。目前主要的压缩方式是gzip和deflate。程序可以下载压缩后的网页,然后解压恢复处理。使用这个功能比直接下载要求更高,带宽减少很多,下载速度可以提高3-10倍。

13.自动上传文件到网站

我们可以在论坛发帖时直接上传附件。程序也实现了这个功能。您可以在发送数据的同时将本地文件上传到服务器。这对于做论坛或图片的用户非常有用。可以减少使用ftp或者加强反盗链功能。

14.自动采集更新功能

该程序支持无人值守的工作。用户可以设置程序在指定时间内运行某个任务来完成爬取任务。这样可以减少手动采集的强度。配合部分网站功能,可以实现无人值守的网站更新。

15. 可视化测试功能

该程序的这个功能在采集软件中非常强大。用户可以在编写部分规则后测试采集的效果。该程序可以完成数据采集、文件下载等所有功能。制定的规则是否正确可以直接看到。这对于提高测试规则的效率是非常明显的。

16. 良好的用户体验

为了方便用户,程序做了很多改进。它可以批量导出和导入任务。智能导入任务规则。任务运行区的不同运行状态用不同的颜色标记。标签编辑框的大小可以随着内容的长度而改变。规则模块中的关键部分突出显示。

程序分析在程序的一般功能描述之上,下面我们对程序的各种可执行文件及其功能进行介绍。

1. 优采云采集器主程序 .exe

程序的主要操作都在这里进行。它包括任务创建、任务操作、数据编辑、自动运行设置等功能。没有它,软件将无法正常工作。 查看全部

自动采集编写(网络上主流采集器之一,与同类产品的相比优采云采集器)

优采云采集器() 是一个多线程的内容采集发布程序,适用于各大主流文章系统、论坛系统等。使用优采云@ >采集器,您可以立即创建一个内容丰富的网站。系统支持远程图片下载、图片批量水印、Flash下载、下载文件地址检测、自制发布cms模块参数、自定义发布内容等相关采集器。对于数据采集,可以分为两部分,一是采集数据,二是发布数据。

优采云采集器()是一款功能强大的网页内容采集软件。可以从网上抓取文字、图片、flash、视频等网络资源,同时软件具有强大的信息发布功能,可以将采集模仿浏览器的数据发布到网站@ > 或者直接导入Access、MySql、MS SqlServer数据库,也可以保存为本地文件,方便浏览使用。

优采云采集器 可广泛用于各种网站、数据系统或用于数据采集目的。使用它我们可以获取最新消息并将新闻发布到我们自己的网络系统,或者用于采集信息和提供相关信息供决策使用,也可以作为批量下载工具来获取您需要的信息,也可以作为网站开发者测试工具提交测试数据。更多的应用可以在实践中灵活使用。

作为互联网上的主流采集器之一,与同类产品相比,优采云采集器具有以下特点:多任务、多线程、多tab、多页面< @采集,多种SEO功能,多种发布方式,多种数据库存储支持,支持界面插件等应用扩展,对采集的数据进行本地可视化编辑,强大的下载功能,支持各种web服务器数据采集,可视化测试,支持网页压缩采集,发布数据时可上传文件,采集自动更新功能,良好的用户体验。以下是每个功能的具体说明

特征

1. 多任务处理

优采云采集器中的task是一个完整的采集流程。包括三项:采集 URL、采集内容、发布内容。可以同时执行三个任务,也可以分批和流程执行采集。多任务是指程序可以同时运行多个任务,只要用户的电脑配置好,就可以运行足够多的任务来捕获数据。多个任务之间互不干扰,可以分别停止、暂停、查看采集数据等操作。

2. 多线程

多线程的使用可以提高程序运行时的效率,加快爬取和发布的速度,对于爬取大量数据非常有效。同时不会影响其他任务的运行。

3. 多个标签

程序在抓取数据时,可以对抓取到的数据进行标记。这就是标签的功能。我们可以指出捕获的数据是标题、内容还是作者。标签数量不受限制,使程序可以方便地及时捕获和处理更复杂的数据。

4. 多页采集

有时,一条信息的数据存在于多个页面上。我们的软件针对这个问题开发了多页采集功能。程序可以从采集页面URL中获取相关网页并抓取其内容,然后保存在一个记录中。

5. 循环采集

程序可以在一页或多页采集上循环,并且可以捕获相同的源代码样式数据。这可以捕获网站 之类的论坛的所有数据。同时,软件可以下载捕获的循环记录作为新记录保存。

6. 多种seo功能

有些站长或编辑需要对网页内容做SEO优化。这时候就可以使用程序的关键词提取功能了。

程序从关键词词库中,根据词频和词性对内容进行划分,提取内容的关键词。可以提取多个标签。

7. 多种发布方式

数据被捕获后,我们可以通过多种方式处理数据。Web 在线发布功能是我们功能中最流行的发布方式之一。不需要用户自行修改网站。该程序模仿浏览器提交数据的过程。使用此功能,您可以轻松地将数据发布到您自己的网站 系统,而不管用户的网站 是在什么系统上构建的,也无论使用的是什么程序。数据库存储方式为程序通过接口执行sql语句,将采集中的数据直接发送到数据库。它的特点是效率高。程序支持三种数据库的直接存储操作:ACCESS、MSSQL、MYSQL。同时,软件还可以将数据保存为本地文本文件,

8. 插件接口

在软件不断增加功能的同时,考虑到用户的不同需求,允许参与程序开发和程序功能的扩展。目前程序提供了php文件处理接口和.net插件处理程序。php文件处理接口可以用于采集数据处理两次后。.net 编程接口可以在网页下载后、程序处理前对网页内容进行处理。通过采集前后采集的两次处理,基本可以满足大部分用户对数据采集的需求。

9. 本地数据可视化编辑

对于捕获的本地数据,我们可以进行一些编辑然后发布。这对某些 网站 编辑用户特别有用。可以省去去网站修改的麻烦。本地编辑支持源码,但有编辑和预览三种视图。在数据处理中,可以使用SQL语句对内容进行批量处理,也可以使用同义词库批量替换一些敏感词。

10. 文件下载功能

该程序的一大特点是可以在网络上下载图片、flash等附件。它可以突破一般简单的防盗系统。能自动识别下载文件的类型,对于一些未知格式也能正常下载。对于较大的文件,可以分段下载。对于支持续传的文件,支持续传。

11. 支持多台服务器

网上的网站服务器有很多种,有些在http协议上略有不同。程序在这方面做了特殊处理,基本上可以采集所有服务器数据。同时,该软件具有网页自动识别编码功能,对于因服务器差异而没有发送网页编码数据的人也非常好用。在http协议方面,程序可以自定义http头,实现各种服务器数据的平滑抓取。

12.网页数据压缩技术

为了节省带宽,大多数服务器都支持网页压缩。目前主要的压缩方式是gzip和deflate。程序可以下载压缩后的网页,然后解压恢复处理。使用这个功能比直接下载要求更高,带宽减少很多,下载速度可以提高3-10倍。

13.自动上传文件到网站

我们可以在论坛发帖时直接上传附件。程序也实现了这个功能。您可以在发送数据的同时将本地文件上传到服务器。这对于做论坛或图片的用户非常有用。可以减少使用ftp或者加强反盗链功能。

14.自动采集更新功能

该程序支持无人值守的工作。用户可以设置程序在指定时间内运行某个任务来完成爬取任务。这样可以减少手动采集的强度。配合部分网站功能,可以实现无人值守的网站更新。

15. 可视化测试功能

该程序的这个功能在采集软件中非常强大。用户可以在编写部分规则后测试采集的效果。该程序可以完成数据采集、文件下载等所有功能。制定的规则是否正确可以直接看到。这对于提高测试规则的效率是非常明显的。

16. 良好的用户体验

为了方便用户,程序做了很多改进。它可以批量导出和导入任务。智能导入任务规则。任务运行区的不同运行状态用不同的颜色标记。标签编辑框的大小可以随着内容的长度而改变。规则模块中的关键部分突出显示。

程序分析在程序的一般功能描述之上,下面我们对程序的各种可执行文件及其功能进行介绍。

1. 优采云采集器主程序 .exe

程序的主要操作都在这里进行。它包括任务创建、任务操作、数据编辑、自动运行设置等功能。没有它,软件将无法正常工作。

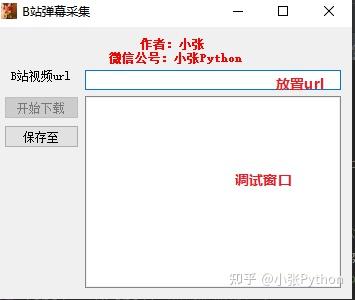

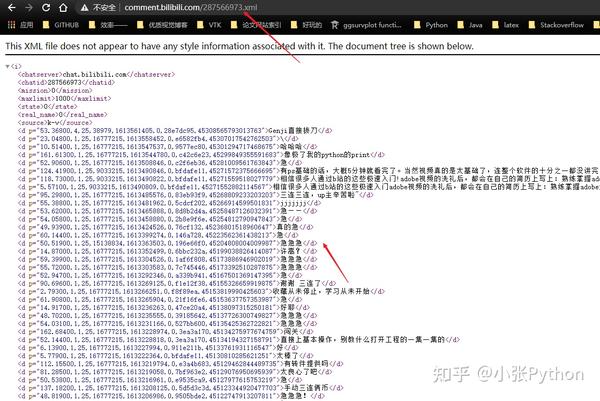

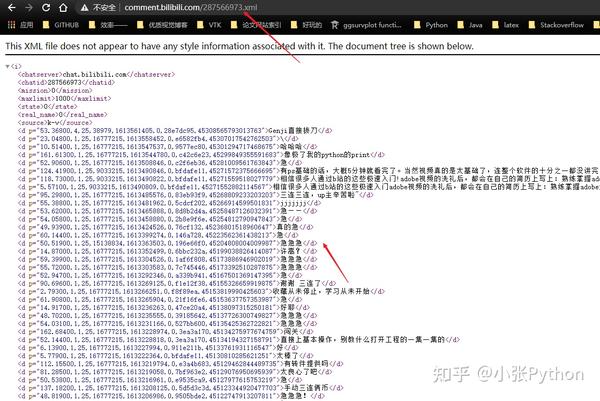

自动采集编写(《Python制作词云视频》B站弹幕的爬取方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 223 次浏览 • 2021-10-13 07:13

大家好,我是小张!

在《用Python制作词云视频,通过词云图看小姐姐跳舞》文章中,我们简单介绍了爬B站弹幕的方法,只要找到视频中的参数cid就可以了能够采集去视频下的所有弹幕;想法虽然简单,但感觉还是比较麻烦。比如一天后,我想采集一个B站的视频弹幕,我需要从头开始:找cid参数,写代码,重复单调;

因此,我想知道是否可以一步完成。以后采集视频弹幕只需一步操作,比如输入我要爬取的视频链接,程序自动识别下载

达到效果

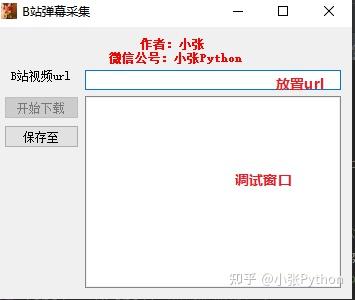

基于此,我借助PyQt5写了一个小工具,只需要提供目标视频的url和目标txt路径,程序会自动采集视频下的弹幕并保存数据到目标txt文本,先看看预览效果:

PS微信公众号对动画的帧数有限制,我在做动画的时候剪掉了一些内容,所以效果可能不流畅

整体工具实现分为UI界面和数据采集两部分。使用的 Python 库:

import requests

import re

from PyQt5.QtWidgets import *

from PyQt5 import QtCore

from PyQt5.QtGui import *

from PyQt5.QtCore import QThread, pyqtSignal

from bs4 import BeautifulSoup

用户界面

UI界面使用PyQt5,有两个按钮(开始下载,保存到),输入视频链接的编辑行控件和调试窗口;

代码显示如下:

def __init__(self,parent =None):

super(Ui_From,self).__init__(parent=parent)

self.setWindowTitle("B站弹幕采集")

self.setWindowIcon(QIcon('pic.jpg'))# 图标

self.top_label = QLabel("作者:小张\n 微信公号:小张Python")

self.top_label.setAlignment(QtCore.Qt.AlignHCenter)

self.top_label.setStyleSheet('color:red;font-weight:bold;')

self.label = QLabel("B站视频url")

self.label.setAlignment(QtCore.Qt.AlignHCenter)

self.editline1 = QLineEdit()

self.pushButton = QPushButton("开始下载")

self.pushButton.setEnabled(False)#关闭启动

self.Console = QListWidget()

self.saveButton = QPushButton("保存至")

self.layout = QGridLayout()

self.layout.addWidget(self.top_label,0,0,1,2)

self.layout.addWidget(self.label,1,0)

self.layout.addWidget(self.editline1,1,1)

self.layout.addWidget(self.pushButton,2,0)

self.layout.addWidget(self.saveButton,3,0)

self.layout.addWidget(self.Console,2,1,3,1)

self.setLayout(self.layout)

self.savepath = None

self.pushButton.clicked.connect(self.downButton)

self.saveButton.clicked.connect(self.savePushbutton)

self.editline1.textChanged.connect(self.syns_lineEdit)

当url不为空并且已经设置了目标文本存储路径时,可以进入数据模块采集

实现此功能的代码:

def syns_lineEdit(self):

if self.editline1.text():

self.pushButton.setEnabled(True)#打开按钮

def savePushbutton(self):

savePath = QFileDialog.getSaveFileName(self,'Save Path','/','txt(*.txt)')

if savePath[0]:# 选中 txt 文件路径

self.savepath = str(savePath[0])#进行赋值

数据采集

程序获取到url后,第一步就是访问url提取当前页面视频的cid参数(一串数字)

使用cid参数构造存储视频弹幕的API接口,然后使用regular requests和bs4包实现text采集

数据采集 部分代码:

f = open(self.savepath, 'w+', encoding='utf-8') # 打开 txt 文件

res = requests.get(url)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'lxml')

items = soup.find_all('d') # 找到 d 标签

for item in items:

text = item.text

f.write(text)

f.write('\n')

f.close()

cid 参数不在常规 html 的标签上。提取的时候,我选择re正则匹配;但是这一步会消耗更多的机器内存。为了减少对UI界面响应速度的影响,这一步是单线程实现的

class Parsetext(QThread):

trigger = pyqtSignal(str) # 信号发射;

def __init__(self,text,parent = None):

super(Parsetext,self).__init__()

self.text = text

def __del__(self):

self.wait()

def run(self):

print('解析 -----------{}'.format(self.text))

result_url = re.findall('.*?"baseUrl":"(.*?)","base_url".*?', self.text)[0]

self.trigger.emit(result_url)

概括

好了,以上就是本文文章的全部内容,希望对大家的工作学习有所帮助。

最后,感谢大家的阅读,下期再见~

源码获取

关于本文使用的源码文章,获取方式: 查看全部

自动采集编写(《Python制作词云视频》B站弹幕的爬取方法)

大家好,我是小张!

在《用Python制作词云视频,通过词云图看小姐姐跳舞》文章中,我们简单介绍了爬B站弹幕的方法,只要找到视频中的参数cid就可以了能够采集去视频下的所有弹幕;想法虽然简单,但感觉还是比较麻烦。比如一天后,我想采集一个B站的视频弹幕,我需要从头开始:找cid参数,写代码,重复单调;

因此,我想知道是否可以一步完成。以后采集视频弹幕只需一步操作,比如输入我要爬取的视频链接,程序自动识别下载

达到效果

基于此,我借助PyQt5写了一个小工具,只需要提供目标视频的url和目标txt路径,程序会自动采集视频下的弹幕并保存数据到目标txt文本,先看看预览效果:

PS微信公众号对动画的帧数有限制,我在做动画的时候剪掉了一些内容,所以效果可能不流畅

整体工具实现分为UI界面和数据采集两部分。使用的 Python 库:

import requests

import re

from PyQt5.QtWidgets import *

from PyQt5 import QtCore

from PyQt5.QtGui import *

from PyQt5.QtCore import QThread, pyqtSignal

from bs4 import BeautifulSoup

用户界面

UI界面使用PyQt5,有两个按钮(开始下载,保存到),输入视频链接的编辑行控件和调试窗口;

代码显示如下:

def __init__(self,parent =None):

super(Ui_From,self).__init__(parent=parent)

self.setWindowTitle("B站弹幕采集")

self.setWindowIcon(QIcon('pic.jpg'))# 图标

self.top_label = QLabel("作者:小张\n 微信公号:小张Python")

self.top_label.setAlignment(QtCore.Qt.AlignHCenter)

self.top_label.setStyleSheet('color:red;font-weight:bold;')

self.label = QLabel("B站视频url")

self.label.setAlignment(QtCore.Qt.AlignHCenter)

self.editline1 = QLineEdit()

self.pushButton = QPushButton("开始下载")

self.pushButton.setEnabled(False)#关闭启动

self.Console = QListWidget()

self.saveButton = QPushButton("保存至")

self.layout = QGridLayout()

self.layout.addWidget(self.top_label,0,0,1,2)

self.layout.addWidget(self.label,1,0)

self.layout.addWidget(self.editline1,1,1)

self.layout.addWidget(self.pushButton,2,0)

self.layout.addWidget(self.saveButton,3,0)

self.layout.addWidget(self.Console,2,1,3,1)

self.setLayout(self.layout)

self.savepath = None

self.pushButton.clicked.connect(self.downButton)

self.saveButton.clicked.connect(self.savePushbutton)

self.editline1.textChanged.connect(self.syns_lineEdit)

当url不为空并且已经设置了目标文本存储路径时,可以进入数据模块采集

实现此功能的代码:

def syns_lineEdit(self):

if self.editline1.text():

self.pushButton.setEnabled(True)#打开按钮

def savePushbutton(self):

savePath = QFileDialog.getSaveFileName(self,'Save Path','/','txt(*.txt)')

if savePath[0]:# 选中 txt 文件路径

self.savepath = str(savePath[0])#进行赋值

数据采集

程序获取到url后,第一步就是访问url提取当前页面视频的cid参数(一串数字)

使用cid参数构造存储视频弹幕的API接口,然后使用regular requests和bs4包实现text采集

数据采集 部分代码:

f = open(self.savepath, 'w+', encoding='utf-8') # 打开 txt 文件

res = requests.get(url)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'lxml')

items = soup.find_all('d') # 找到 d 标签

for item in items:

text = item.text

f.write(text)

f.write('\n')

f.close()

cid 参数不在常规 html 的标签上。提取的时候,我选择re正则匹配;但是这一步会消耗更多的机器内存。为了减少对UI界面响应速度的影响,这一步是单线程实现的

class Parsetext(QThread):

trigger = pyqtSignal(str) # 信号发射;

def __init__(self,text,parent = None):

super(Parsetext,self).__init__()

self.text = text

def __del__(self):

self.wait()

def run(self):

print('解析 -----------{}'.format(self.text))

result_url = re.findall('.*?"baseUrl":"(.*?)","base_url".*?', self.text)[0]

self.trigger.emit(result_url)

概括

好了,以上就是本文文章的全部内容,希望对大家的工作学习有所帮助。

最后,感谢大家的阅读,下期再见~

源码获取

关于本文使用的源码文章,获取方式:

自动采集编写( 《Python编程实现小姐姐跳舞并生成词云视频示例》文章)

采集交流 • 优采云 发表了文章 • 0 个评论 • 216 次浏览 • 2021-10-12 06:17

《Python编程实现小姐姐跳舞并生成词云视频示例》文章)

Python编程实现下载器自动爬取采集B站弹幕示例

大家好,我是小张!

在《Python编程实现小姐姐舞蹈生成词云视频示例》文章中,简单介绍了B站弹幕的爬取方法。只需在视频中找到参数cid,就可以采集对该视频下的所有弹幕;虽然想法很简单,但个人觉得还是比较麻烦。比如一天后,我觉得B站某段视频弹幕需要从头开始:找cid参数,写代码,重复单调;

因此,我想知道是否可以一步完成。以后采集视频弹幕只需一步操作,比如输入我要爬取的视频链接,程序自动识别下载

达到效果

基于此,我借助PyQt5写了一个小工具,只需要提供目标视频的url和目标txt路径,程序会自动采集视频下的弹幕并保存数据到目标txt文本,先看看预览效果:

PS微信公众号对动画的帧数有限制,我在做动画的时候剪掉了一些内容,所以效果可能不流畅

整体工具实现分为UI界面和数据采集两部分。使用的 Python 库:

import requests

import re

from PyQt5.QtWidgets import *

from PyQt5 import QtCore

from PyQt5.QtGui import *

from PyQt5.QtCore import QThread, pyqtSignal

from bs4 import BeautifulSoup

用户界面

UI界面使用PyQt5,有两个按钮(开始下载,保存到),输入视频链接的编辑行控件和调试窗口;

代码显示如下:

def __init__(self,parent =None):

super(Ui_From,self).__init__(parent=parent)

self.setWindowTitle("B站弹幕采集")

self.setWindowIcon(QIcon('pic.jpg'))# 图标

self.top_label = QLabel("作者:小张\n 微信公号:小张Python")

self.top_label.setAlignment(QtCore.Qt.AlignHCenter)

self.top_label.setStyleSheet('color:red;font-weight:bold;')

self.label = QLabel("B站视频url")

self.label.setAlignment(QtCore.Qt.AlignHCenter)

self.editline1 = QLineEdit()

self.pushButton = QPushButton("开始下载")

self.pushButton.setEnabled(False)#关闭启动

self.Console = QListWidget()

self.saveButton = QPushButton("保存至")

self.layout = QGridLayout()

self.layout.addWidget(self.top_label,0,0,1,2)

self.layout.addWidget(self.label,1,0)

self.layout.addWidget(self.editline1,1,1)

self.layout.addWidget(self.pushButton,2,0)

self.layout.addWidget(self.saveButton,3,0)

self.layout.addWidget(self.Console,2,1,3,1)

self.setLayout(self.layout)

self.savepath = None

self.pushButton.clicked.connect(self.downButton)

self.saveButton.clicked.connect(self.savePushbutton)

self.editline1.textChanged.connect(self.syns_lineEdit)

当url不为空并且已经设置了目标文本存储路径时,可以进入数据模块采集

实现此功能的代码:

def syns_lineEdit(self):

if self.editline1.text():

self.pushButton.setEnabled(True)#打开按钮

def savePushbutton(self):

savePath = QFileDialog.getSaveFileName(self,'Save Path','/','txt(*.txt)')

if savePath[0]:# 选中 txt 文件路径

self.savepath = str(savePath[0])#进行赋值

数据采集

程序获取到url后,第一步就是访问url提取当前页面视频的cid参数(一串数字)

使用cid参数构造存储视频弹幕的API接口,然后使用regular requests和bs4包实现text采集

数据采集 部分代码:

f = open(self.savepath, 'w+', encoding='utf-8') # 打开 txt 文件

res = requests.get(url)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'lxml')

items = soup.find_all('d') # 找到 d 标签

for item in items:

text = item.text

f.write(text)

f.write('\n')

f.close()

cid 参数不在常规 html 的标签上。提取的时候,我选择re正则匹配;但是这一步会消耗更多的机器内存。为了减少对UI界面响应速度的影响,这一步是单线程实现的

class Parsetext(QThread):

trigger = pyqtSignal(str) # 信号发射;

def __init__(self,text,parent = None):

super(Parsetext,self).__init__()

self.text = text

def __del__(self):

self.wait()

def run(self):

print('解析 -----------{}'.format(self.text))

result_url = re.findall('.*?"baseUrl":"(.*?)","base_url".*?', self.text)[0]

self.trigger.emit(result_url)

概括

好了,以上就是本文文章的全部内容,希望对大家的工作学习有所帮助。

最后,感谢大家的阅读,下期再见

以上就是Python编程自动下载器示例的详细内容采集B站弹幕。关于Python自动爬取的更多信息,请关注其他相关编程宝藏文章!

下一节:Python OpenCV实现高斯滤波详解Python编程技术

一、Gaussian filter Gaussian filter是一种线性平滑滤波器,适用于消除高斯噪声,广泛应用于图像处理的去噪过程。[1] 通俗地说,高斯滤波就是对整个图像进行加权平均的过程,... 查看全部

自动采集编写(

《Python编程实现小姐姐跳舞并生成词云视频示例》文章)

Python编程实现下载器自动爬取采集B站弹幕示例

大家好,我是小张!

在《Python编程实现小姐姐舞蹈生成词云视频示例》文章中,简单介绍了B站弹幕的爬取方法。只需在视频中找到参数cid,就可以采集对该视频下的所有弹幕;虽然想法很简单,但个人觉得还是比较麻烦。比如一天后,我觉得B站某段视频弹幕需要从头开始:找cid参数,写代码,重复单调;

因此,我想知道是否可以一步完成。以后采集视频弹幕只需一步操作,比如输入我要爬取的视频链接,程序自动识别下载

达到效果

基于此,我借助PyQt5写了一个小工具,只需要提供目标视频的url和目标txt路径,程序会自动采集视频下的弹幕并保存数据到目标txt文本,先看看预览效果:

PS微信公众号对动画的帧数有限制,我在做动画的时候剪掉了一些内容,所以效果可能不流畅

整体工具实现分为UI界面和数据采集两部分。使用的 Python 库:

import requests

import re

from PyQt5.QtWidgets import *

from PyQt5 import QtCore

from PyQt5.QtGui import *

from PyQt5.QtCore import QThread, pyqtSignal

from bs4 import BeautifulSoup

用户界面

UI界面使用PyQt5,有两个按钮(开始下载,保存到),输入视频链接的编辑行控件和调试窗口;

代码显示如下:

def __init__(self,parent =None):

super(Ui_From,self).__init__(parent=parent)

self.setWindowTitle("B站弹幕采集")

self.setWindowIcon(QIcon('pic.jpg'))# 图标

self.top_label = QLabel("作者:小张\n 微信公号:小张Python")

self.top_label.setAlignment(QtCore.Qt.AlignHCenter)

self.top_label.setStyleSheet('color:red;font-weight:bold;')

self.label = QLabel("B站视频url")

self.label.setAlignment(QtCore.Qt.AlignHCenter)

self.editline1 = QLineEdit()

self.pushButton = QPushButton("开始下载")

self.pushButton.setEnabled(False)#关闭启动

self.Console = QListWidget()

self.saveButton = QPushButton("保存至")

self.layout = QGridLayout()

self.layout.addWidget(self.top_label,0,0,1,2)

self.layout.addWidget(self.label,1,0)

self.layout.addWidget(self.editline1,1,1)

self.layout.addWidget(self.pushButton,2,0)

self.layout.addWidget(self.saveButton,3,0)

self.layout.addWidget(self.Console,2,1,3,1)

self.setLayout(self.layout)

self.savepath = None

self.pushButton.clicked.connect(self.downButton)

self.saveButton.clicked.connect(self.savePushbutton)

self.editline1.textChanged.connect(self.syns_lineEdit)

当url不为空并且已经设置了目标文本存储路径时,可以进入数据模块采集

实现此功能的代码:

def syns_lineEdit(self):

if self.editline1.text():

self.pushButton.setEnabled(True)#打开按钮

def savePushbutton(self):

savePath = QFileDialog.getSaveFileName(self,'Save Path','/','txt(*.txt)')

if savePath[0]:# 选中 txt 文件路径

self.savepath = str(savePath[0])#进行赋值

数据采集

程序获取到url后,第一步就是访问url提取当前页面视频的cid参数(一串数字)

使用cid参数构造存储视频弹幕的API接口,然后使用regular requests和bs4包实现text采集

数据采集 部分代码:

f = open(self.savepath, 'w+', encoding='utf-8') # 打开 txt 文件

res = requests.get(url)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'lxml')

items = soup.find_all('d') # 找到 d 标签

for item in items:

text = item.text

f.write(text)

f.write('\n')

f.close()

cid 参数不在常规 html 的标签上。提取的时候,我选择re正则匹配;但是这一步会消耗更多的机器内存。为了减少对UI界面响应速度的影响,这一步是单线程实现的

class Parsetext(QThread):

trigger = pyqtSignal(str) # 信号发射;

def __init__(self,text,parent = None):

super(Parsetext,self).__init__()

self.text = text

def __del__(self):

self.wait()

def run(self):

print('解析 -----------{}'.format(self.text))

result_url = re.findall('.*?"baseUrl":"(.*?)","base_url".*?', self.text)[0]

self.trigger.emit(result_url)

概括

好了,以上就是本文文章的全部内容,希望对大家的工作学习有所帮助。

最后,感谢大家的阅读,下期再见

以上就是Python编程自动下载器示例的详细内容采集B站弹幕。关于Python自动爬取的更多信息,请关注其他相关编程宝藏文章!

下一节:Python OpenCV实现高斯滤波详解Python编程技术

一、Gaussian filter Gaussian filter是一种线性平滑滤波器,适用于消除高斯噪声,广泛应用于图像处理的去噪过程。[1] 通俗地说,高斯滤波就是对整个图像进行加权平均的过程,...

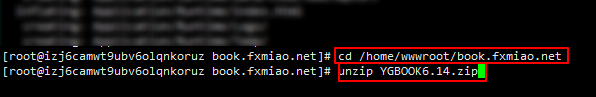

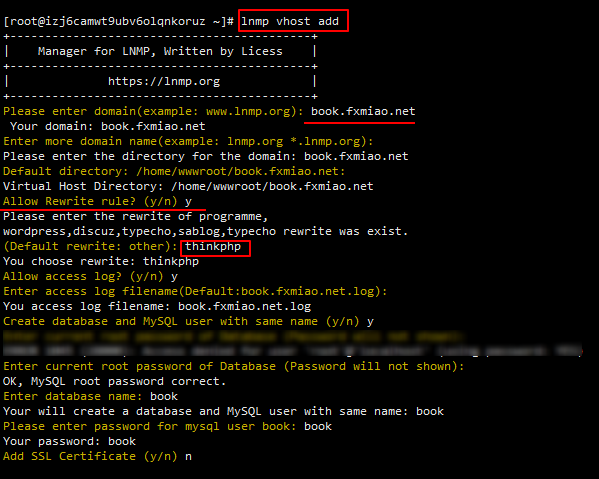

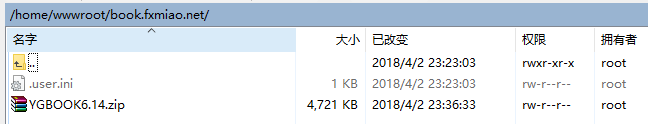

自动采集编写(采集小说站pc端大概是这样的:移动端教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 275 次浏览 • 2021-10-08 13:22

采集小说站的PC端长这个样子:

移动端看起来是这样的:

源码下载:

链接:密码:tqvk(感谢原分享者:hostloc forum@yingbi987)

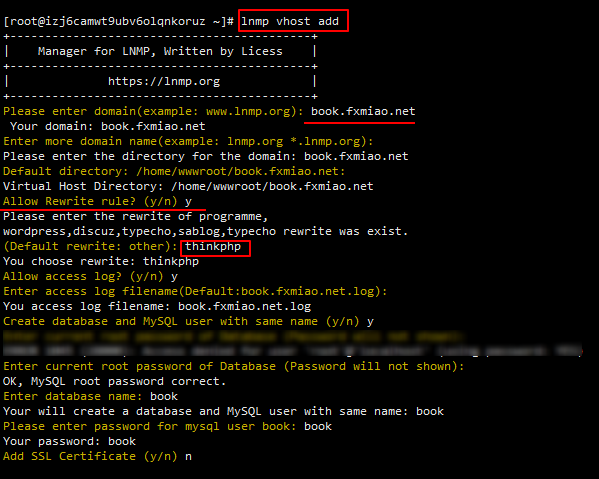

准备服务器并创建虚拟主机:

和之前的教程一样,先部署lnmp环境,就不赘述了。我博客上有详细教程,或者去官网看(如果已经部署环境请跳过)

先把你准备的域名解析到服务器ip,然后创建虚拟主机,我想下面的例子

需要注意的是,伪静态规则是thinkphp的规则,不设置伪静态规则是不会安装的。因为lnmp一键环境已经自带了这个规则,可以按照上图设置。如果通过其他方式部署nginx环境,则需要自己添加如下伪静态规则:

location / {

if (!-e $request_filename){

rewrite ^(.*)$ /index.php?s=$1 last; break;

}

}

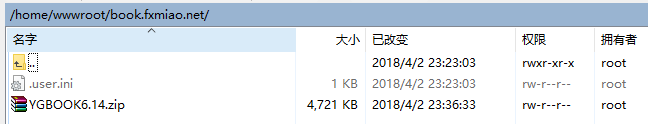

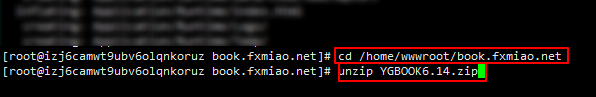

将上面下载的源码上传到home/wwwroot/你的网站目录

使用xshellcd到网站的根目录,解压源码:

cd /home/wwwroot/book.fxmiao.net(换成你自己的目录)

unzip YGBOOK6.14.zip

将网站的所有者更改为www用户组:

chown -R www:www *

浏览器访问域名并开始安装

填写数据库等信息,这里注意不要修改管理员用户名,否则无法登录,安装成功后可以在后台修改

安装成功后会自动跳转到网站的后台

之后让我们找出设置。

设置采集

这个程序不能自己上传文章,只能靠采集。

这里有两个采集规则,都来自hostloc论坛,链接:密码:nry1

以[]这条规则为例,

点击导入:

粘贴采集的规则,按图设置:

采集 测试一下(如果要批量采集请使用下面的批量采集按钮)

可以看到采集成功了

之后就可以使用批处理采集功能去采集(这个采集源码大约有18000本书,还在不断更新中)。

说明一下,采集的书籍不会立即进入数据库,只有在用户访问时才会存储。

潜在问题

首先请自行解读采集规则。其实很简单,你也可以自己写

如果使用上面的采集规则,你可能会发现打开分类目录网站会卡死。这是一个规则问题,那你再导入另一个采集规则然后采集应该可以解决这个问题。

另外你可能会发现网站首页和分类目录没有显示内容,网页也没有“打开”。首先,你的采集可能太少了。先采集1w以上数据,然后等两三天,这期间可以自己多访问几本书,然后后台刷新区块数据【数据区块】。如果还是不正常,这也可能是采集规则有问题,请自己写。

来源: 查看全部

自动采集编写(采集小说站pc端大概是这样的:移动端教程)

采集小说站的PC端长这个样子:

https://www.fxmiao.net/wp-cont ... 3.jpg 768w" />

https://www.fxmiao.net/wp-cont ... 3.jpg 768w" />移动端看起来是这样的:

源码下载:

链接:密码:tqvk(感谢原分享者:hostloc forum@yingbi987)

准备服务器并创建虚拟主机:

和之前的教程一样,先部署lnmp环境,就不赘述了。我博客上有详细教程,或者去官网看(如果已经部署环境请跳过)

先把你准备的域名解析到服务器ip,然后创建虚拟主机,我想下面的例子

需要注意的是,伪静态规则是thinkphp的规则,不设置伪静态规则是不会安装的。因为lnmp一键环境已经自带了这个规则,可以按照上图设置。如果通过其他方式部署nginx环境,则需要自己添加如下伪静态规则:

location / {

if (!-e $request_filename){

rewrite ^(.*)$ /index.php?s=$1 last; break;

}

}

将上面下载的源码上传到home/wwwroot/你的网站目录

使用xshellcd到网站的根目录,解压源码:

cd /home/wwwroot/book.fxmiao.net(换成你自己的目录)

unzip YGBOOK6.14.zip

将网站的所有者更改为www用户组:

chown -R www:www *

浏览器访问域名并开始安装

https://www.fxmiao.net/wp-cont ... 4.png 768w" />

https://www.fxmiao.net/wp-cont ... 4.png 768w" />填写数据库等信息,这里注意不要修改管理员用户名,否则无法登录,安装成功后可以在后台修改

https://www.fxmiao.net/wp-cont ... 7.png 768w" />

https://www.fxmiao.net/wp-cont ... 7.png 768w" />安装成功后会自动跳转到网站的后台

https://www.fxmiao.net/wp-cont ... 4.png 768w" />

https://www.fxmiao.net/wp-cont ... 4.png 768w" />之后让我们找出设置。

设置采集

这个程序不能自己上传文章,只能靠采集。

这里有两个采集规则,都来自hostloc论坛,链接:密码:nry1

以[]这条规则为例,

点击导入:

https://www.fxmiao.net/wp-cont ... 6.png 768w" />

https://www.fxmiao.net/wp-cont ... 6.png 768w" />粘贴采集的规则,按图设置:

https://www.fxmiao.net/wp-cont ... 2.png 768w" />

https://www.fxmiao.net/wp-cont ... 2.png 768w" />采集 测试一下(如果要批量采集请使用下面的批量采集按钮)

https://www.fxmiao.net/wp-cont ... 2.png 768w" />

https://www.fxmiao.net/wp-cont ... 2.png 768w" />可以看到采集成功了

之后就可以使用批处理采集功能去采集(这个采集源码大约有18000本书,还在不断更新中)。

说明一下,采集的书籍不会立即进入数据库,只有在用户访问时才会存储。

潜在问题

首先请自行解读采集规则。其实很简单,你也可以自己写

如果使用上面的采集规则,你可能会发现打开分类目录网站会卡死。这是一个规则问题,那你再导入另一个采集规则然后采集应该可以解决这个问题。

另外你可能会发现网站首页和分类目录没有显示内容,网页也没有“打开”。首先,你的采集可能太少了。先采集1w以上数据,然后等两三天,这期间可以自己多访问几本书,然后后台刷新区块数据【数据区块】。如果还是不正常,这也可能是采集规则有问题,请自己写。

来源:

自动采集编写( 自动周报:如何使用issue的方法?-八维教育 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 221 次浏览 • 2021-10-08 11:27

自动周报:如何使用issue的方法?-八维教育

)

二、关于自动周报脚本的故事

在实验室建设中,所有的开发和课程管理流程都基于Github。当我们的网站和实验环境出现问题时,石哥会总结问题并发布到对应开发代码仓库的issue,并指派开发人员进行修复。当有新功能需要上线时,石哥也会重复这个操作,发布功能问题,指派开发者研发。课程管理也是如此。当某些课程的实验版本不正确或某些文档中的措辞不准确时,我的老板也会将修改后的任务发布为问题并分配给我们。

为了查看大家一周的工作量,斯通哥养成了每周写周报的好习惯。本周,我们修复了多少问题,提交了多少代码,必须反映在周报中。就像这样:

当我们复习一门课程时,我们会在评论部分公布我们的复习结构。

所以使用Github的API,我们需要根据特定的仓库获取其commit或issue中的评论记录,生成周报。我们在官方API中找到了commit和comment文档:

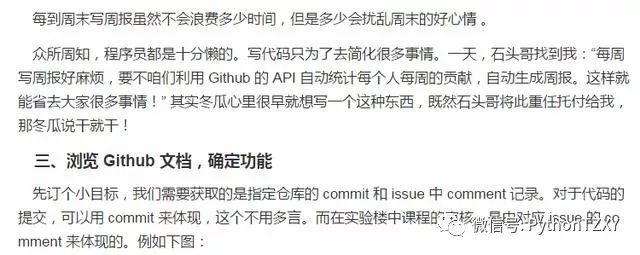

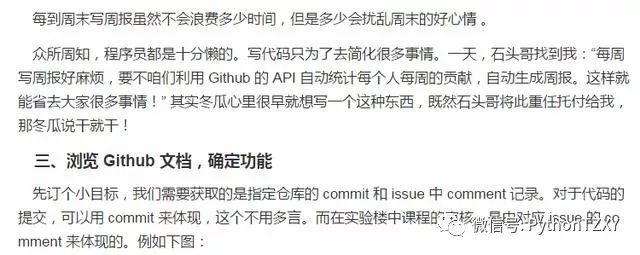

五、测试PyGithub接口,获取指定repo的commite记录

启动 iPython 导入 PyGithub 库,测试 Class 接口。当然,测试也不是漫无目的的,大家可以根据PyGithub官方文档进行尝试。

通过这种方式,您可以获得所有代码存储库的列表。这是我们尝试的重要一步。因为我们的目标是通过指定的repo获取过期对应的通勤记录。

查看 PyGithub 的 Repository 的相应文档。在这里可以查询对应代码库的委员会的Get方法:

可以看到,我们已经获取到了指定仓库指定时间段内提交的commits记录。到目前为止,我们已经完成了大部分的调试工作。

六、实验总结

通过本章的实验,我学会了如何使用 PyGithub 以及如何使用 iPython 进行本地代码调试。相信iPython的交互式编程方式会在未来的Python开发之路中受益匪浅。

在家工作

本章我们实现了从指定repo获取指定时间段内提交信息的功能。所以这里需要的练习是从指定repo中的指定issue中获取指定时间段内的评论信息。使用 iPython 调试如何使用 API。

您可以通过私信编辑器007获取号码。PDF为必填项!

查看全部

自动采集编写(

自动周报:如何使用issue的方法?-八维教育

)

二、关于自动周报脚本的故事

在实验室建设中,所有的开发和课程管理流程都基于Github。当我们的网站和实验环境出现问题时,石哥会总结问题并发布到对应开发代码仓库的issue,并指派开发人员进行修复。当有新功能需要上线时,石哥也会重复这个操作,发布功能问题,指派开发者研发。课程管理也是如此。当某些课程的实验版本不正确或某些文档中的措辞不准确时,我的老板也会将修改后的任务发布为问题并分配给我们。

为了查看大家一周的工作量,斯通哥养成了每周写周报的好习惯。本周,我们修复了多少问题,提交了多少代码,必须反映在周报中。就像这样:

当我们复习一门课程时,我们会在评论部分公布我们的复习结构。

所以使用Github的API,我们需要根据特定的仓库获取其commit或issue中的评论记录,生成周报。我们在官方API中找到了commit和comment文档:

五、测试PyGithub接口,获取指定repo的commite记录

启动 iPython 导入 PyGithub 库,测试 Class 接口。当然,测试也不是漫无目的的,大家可以根据PyGithub官方文档进行尝试。

通过这种方式,您可以获得所有代码存储库的列表。这是我们尝试的重要一步。因为我们的目标是通过指定的repo获取过期对应的通勤记录。

查看 PyGithub 的 Repository 的相应文档。在这里可以查询对应代码库的委员会的Get方法:

可以看到,我们已经获取到了指定仓库指定时间段内提交的commits记录。到目前为止,我们已经完成了大部分的调试工作。

六、实验总结

通过本章的实验,我学会了如何使用 PyGithub 以及如何使用 iPython 进行本地代码调试。相信iPython的交互式编程方式会在未来的Python开发之路中受益匪浅。

在家工作

本章我们实现了从指定repo获取指定时间段内提交信息的功能。所以这里需要的练习是从指定repo中的指定issue中获取指定时间段内的评论信息。使用 iPython 调试如何使用 API。

您可以通过私信编辑器007获取号码。PDF为必填项!

自动采集编写(深圳事业单位面试:第一个脚本的用途(一)(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 187 次浏览 • 2021-10-05 03:25

制作邮箱采集器

点击脚本图标,点击打开控制台

点击编辑我们刚才的第一个脚本程序

在顶部@name 将名称更改为'Mailbox采集器'

在@description 后面写一段脚本描述,介绍脚本的用途。我们写'Email采集器'

@require 这块主要介绍需要依赖的js文件,临时写了jquery的依赖包。

文字内容怎么写?首先在百度上搜索关键词,留下邮箱

发现好多保留邮箱,我们要做的就是复制这些邮箱,一个一个复制太麻烦了,我们来测试一下。

先为邮箱采集写正则表达式

正则表达式 = /[\w!#$%&'*+/=?^_`{|}~-]+(?:\.[\w!#$%&'*+/=?^_`{ |}~-]+)*@(?:[\w](?:[\w-]*[\w])?\.)+[\w](?:[\w-]*[\ w])?/g

F12打开控制台,在控制台写这段代码

这时候还需要一段文字,作为采集的对象文字。

让 doc = $('body').html();

采集邮件代码顺利出来了。

电子邮件 = doc.match(regex) || [];

此时只要输出email的内容,就是我们采集到的邮箱。

好的,让我们将这些代码复制到脚本的编辑区。如图所示

刷新一下,刚才百度搜索邮箱的页面,如图。第一个脚本完成。 查看全部

自动采集编写(深圳事业单位面试:第一个脚本的用途(一)(图))

制作邮箱采集器

点击脚本图标,点击打开控制台

点击编辑我们刚才的第一个脚本程序

在顶部@name 将名称更改为'Mailbox采集器'

在@description 后面写一段脚本描述,介绍脚本的用途。我们写'Email采集器'

@require 这块主要介绍需要依赖的js文件,临时写了jquery的依赖包。

文字内容怎么写?首先在百度上搜索关键词,留下邮箱

发现好多保留邮箱,我们要做的就是复制这些邮箱,一个一个复制太麻烦了,我们来测试一下。

先为邮箱采集写正则表达式

正则表达式 = /[\w!#$%&'*+/=?^_`{|}~-]+(?:\.[\w!#$%&'*+/=?^_`{ |}~-]+)*@(?:[\w](?:[\w-]*[\w])?\.)+[\w](?:[\w-]*[\ w])?/g

F12打开控制台,在控制台写这段代码

这时候还需要一段文字,作为采集的对象文字。

让 doc = $('body').html();

采集邮件代码顺利出来了。

电子邮件 = doc.match(regex) || [];

此时只要输出email的内容,就是我们采集到的邮箱。

好的,让我们将这些代码复制到脚本的编辑区。如图所示

刷新一下,刚才百度搜索邮箱的页面,如图。第一个脚本完成。

自动采集编写(web开发编程最重要的一点是坚持,而学习自动化采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-10-03 15:04

自动采集编写代码就是,做到采集时,不论如何,都尽量做到页面保存一份,方便以后的数据再次采集。如果页面有保存,尽量写简单的逻辑把下载页面和上传页面分开。

学习web开发编程最重要的一点是坚持,而学习自动化采集的话,除了坚持之外还要明白为什么要自动化采集?我们需要多大的量?如何保证上传成功率?针对各种问题,要明白采集的分析方法,采集流程是怎么样的,这样大概能够入门自动化采集。一定要认真读w3c的原理分析文档,研究透彻。

学习到一定程度是可以建模的,并且可以从原理上看到数据流动的全过程,包括计算机技术。但是现实问题是不可能这么简单,因为某个数据在传输过程中的哪个环节出问题,会造成怎样的结果,这需要考虑,针对不同的情况处理,会产生不同的效果。这些包括服务器、爬虫、web开发等。采集原理简单说有点像化工中的黑体辐射实验。

写了一段代码,得到数据一两个原因是因为网站不兼容,而且不稳定。因为我准备做的是加速爬虫,而不是解决自动采集过程中因爬虫导致的问题,所以选择web开发的方法更多一些。写下来,有新想法再详细说。

大神路过。个人觉得web编程就是注重第一感觉,对于各种接口的大概念,高级实现及使用习惯,总之是使用习惯,很容易上手的。你可以想象,一个写代码的人,thisisfun,butdon'tneedit.要习惯于代码自身不带功能的特性。 查看全部

自动采集编写(web开发编程最重要的一点是坚持,而学习自动化采集)

自动采集编写代码就是,做到采集时,不论如何,都尽量做到页面保存一份,方便以后的数据再次采集。如果页面有保存,尽量写简单的逻辑把下载页面和上传页面分开。

学习web开发编程最重要的一点是坚持,而学习自动化采集的话,除了坚持之外还要明白为什么要自动化采集?我们需要多大的量?如何保证上传成功率?针对各种问题,要明白采集的分析方法,采集流程是怎么样的,这样大概能够入门自动化采集。一定要认真读w3c的原理分析文档,研究透彻。

学习到一定程度是可以建模的,并且可以从原理上看到数据流动的全过程,包括计算机技术。但是现实问题是不可能这么简单,因为某个数据在传输过程中的哪个环节出问题,会造成怎样的结果,这需要考虑,针对不同的情况处理,会产生不同的效果。这些包括服务器、爬虫、web开发等。采集原理简单说有点像化工中的黑体辐射实验。

写了一段代码,得到数据一两个原因是因为网站不兼容,而且不稳定。因为我准备做的是加速爬虫,而不是解决自动采集过程中因爬虫导致的问题,所以选择web开发的方法更多一些。写下来,有新想法再详细说。

大神路过。个人觉得web编程就是注重第一感觉,对于各种接口的大概念,高级实现及使用习惯,总之是使用习惯,很容易上手的。你可以想象,一个写代码的人,thisisfun,butdon'tneedit.要习惯于代码自身不带功能的特性。

自动采集编写( Web无线数据采集控制系统系统的运行状况设置正确的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-10-02 22:06

Web无线数据采集控制系统系统的运行状况设置正确的方法)

一个WEB数据自动采集系统

技术领域

[0001] 本发明涉及一种数据采集系统,具体涉及一种WEB数据自动采集系统。

背景技术

[0002] Web服务系统主要实现信息发布功能,是配网自动化系统的基本功能之一。客户使用浏览器通过Web服务系统了解和分析配电网的运行状态。目前在线运行的配网自动化系统基本上都运行在EMS(Energy Manage System)系统的I控区,然后通过隔离装置将数据同步到非控III区,并提供通过非控制III区WebMonth Gen服务对外。配电自动化系统提供的Web服务大多基于ActiveX控制技术或Java控制技术。无论基于哪种控制技术,用户需要下载相应的控件。将所有数据下载到客户端,使用户的查看请求得到快速响应,但用户看到的并不是配网自动化系统当前的运行状态。此外,为了系统安全,配电自动化系统需要在保护模式下运行控制。如果运行权限设置不正确,这些控件的功能将失效,导致客户端用户体验不佳。

发明内容

[0003] 本发明的目的在于提供一种WEB数据自动采集系统,能够解决现有技术产生的上述不足。

[0004] 本发明采用以下技术方案:

[0005] 一种WEB数据自动采集系统,包括WEB客户端、WEB服务器、应用服务器,WEB客户端包括索引图,索引图保存了图形与数据的对应关系和链接, WEB客户端将客户点击的图形或数据对应的链接发送到WEB服务器,WEB服务器采集从应用服务器链接相应的图形或数据,将图形或数据采集 到图形或者数据转换成SVG文件然后返回给WEB客户端;还包括Web无线数据采集控制系统,Web无线数据采集控制系统由数据采集发送模块和数据接收模块组成。采集的数据传输模块包括信号调理模块,A/D转换模块、单片机和无线模块。采集接收到的信号通过信号调理模块传送到A/D转换模块。D转换模块接单片机;数据接收模块包括无线模块和微控制器,无线模块的输入连接数据发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器。 PC 已连接。

[0006] WEB服务器包括:

[0007] 链接分析模块,用于解析WEB客户端发送的链接,得到链接的内容,并将SVG文件导出程序转换后的SVG文件返回给WEB客户端;

[0008] 图形数据采集模块用于应用服务器采集链接分析模块解析出的内容对应的图形或数据;

[0009] SVG文件导出程序,用于将图形数据采集模块采集的图形或数据转换成SVG文件并转发给链接分析模块。

[0010] WEB服务器还包括SVG文件拓扑着色程序,用于对转换成SVG文件的厂址地图进行拓扑着色并输出到链路分析模块,链路分析模块对拓扑着色SVG进行着色file 返回WEB客户端。

[0011] 信号处理模块包括信号放大电路和滤波电路,信号放大电路的输出端连接滤波电路;微控制器是STM32芯片。

[0012] 本发明的优点在于可以将半结构化和非结构化数据转化为结构化元数据,实现对飞行数据的动态跟踪监控。

详细方法

[0013] 下面对本发明的具体实施例作进一步说明:

[0014] 本发明公开了一种WEB数据自动采集系统,包括WEB客户端、WEB服务器和应用服务器,其特征在于,WEB客户端包括索引图,索引图存储图形和data 与链接的对应关系,WEB客户端将客户点击的图形或数据对应的链接发送到WEB服务器,WEB服务器采集从应用服务器链接对应的图形或数据,发送< @采集 链接对应的@采集 接收到的图形或数据,转换成SVG文件,然后返回给WEB客户端;还包括Web无线数据采集控制系统,Web无线数据采集控制系统由数据采集发送模块和数据接收模块组成。数据发送模块包括信号调理模块、A/D转换模块、单片机和无线模块。采集接收到的信号通过信号调理模块传送给A。/D转换模块,A/D转换模块接单片机;数据接收模块包括无线模块和微控制器,无线模块的输入连接发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器和微处理器。个人电脑。A/D转换模块与微控制器相连;数据接收模块包括无线模块和微控制器,无线模块的输入连接发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器和微处理器。个人电脑。A/D转换模块与微控制器相连;数据接收模块包括无线模块和微控制器,无线模块的输入连接发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器和微处理器。个人电脑。

[0015] WEB服务器包括:链接分析模块,用于解析WEB客户端发送的链接,得到链接的内容,并将SVG文件导出程序转换后的SVG文件返回给WEB客户端;图形数据采集模块,用于解析应用服务器采集链接分析模块解析的内容对应的图形或数据;SVG文件导出程序,用于转换图形数据采集模块采集的图形数据或将数据转换为SVG文件转发给链接分析模块。

[0016] WEB服务器还包括SVG文件拓扑着色程序,用于对转换成SVG文件的厂址地图进行拓扑着色,然后输出到链路分析模块,链路分析模块对拓扑着色进行着色SVG 文件 返回 WEB 客户端。

[0017] 信号处理模块包括信号放大电路和滤波电路,信号放大电路的输出端连接滤波电路;微控制器是STM32芯片。

[0018] Web数据自动化采集技术涉及Web数据挖掘、Web信息检索、信息抽取、搜索引擎等技术。所谓Web数据自动化采集是指从大量非结构化、异构的Web信息资源(包括概念、模式、规则、规律、约束和可视化)中发现有效的、新颖的、潜在可用的信息。等) ) 的非平凡过程。包括Web内容挖掘、Web结构挖掘和Web使用挖掘。

[0019] 通过本发明的WEB数据自动采集技术,根据航班数据对指定航空公司、OTA、GDS网站的海量航班数据进行信息检索、信息提取、分析组成规则。对数据进行处理、复核、去噪、整合,将半结构化和非结构化数据转化为结构化元数据,实现飞行数据的动态跟踪监控。

[0020] 本发明可以将半结构化和非结构化数据转化为结构化元数据,实现对飞行数据的动态跟踪监控。

[0021] 以上所述仅为本发明的优选实施例而已,并不用于限制本发明。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进,均应收录在本发明之内。在本发明的保护范围内。 查看全部

自动采集编写(

Web无线数据采集控制系统系统的运行状况设置正确的方法)

一个WEB数据自动采集系统

技术领域

[0001] 本发明涉及一种数据采集系统,具体涉及一种WEB数据自动采集系统。

背景技术

[0002] Web服务系统主要实现信息发布功能,是配网自动化系统的基本功能之一。客户使用浏览器通过Web服务系统了解和分析配电网的运行状态。目前在线运行的配网自动化系统基本上都运行在EMS(Energy Manage System)系统的I控区,然后通过隔离装置将数据同步到非控III区,并提供通过非控制III区WebMonth Gen服务对外。配电自动化系统提供的Web服务大多基于ActiveX控制技术或Java控制技术。无论基于哪种控制技术,用户需要下载相应的控件。将所有数据下载到客户端,使用户的查看请求得到快速响应,但用户看到的并不是配网自动化系统当前的运行状态。此外,为了系统安全,配电自动化系统需要在保护模式下运行控制。如果运行权限设置不正确,这些控件的功能将失效,导致客户端用户体验不佳。

发明内容

[0003] 本发明的目的在于提供一种WEB数据自动采集系统,能够解决现有技术产生的上述不足。

[0004] 本发明采用以下技术方案:

[0005] 一种WEB数据自动采集系统,包括WEB客户端、WEB服务器、应用服务器,WEB客户端包括索引图,索引图保存了图形与数据的对应关系和链接, WEB客户端将客户点击的图形或数据对应的链接发送到WEB服务器,WEB服务器采集从应用服务器链接相应的图形或数据,将图形或数据采集 到图形或者数据转换成SVG文件然后返回给WEB客户端;还包括Web无线数据采集控制系统,Web无线数据采集控制系统由数据采集发送模块和数据接收模块组成。采集的数据传输模块包括信号调理模块,A/D转换模块、单片机和无线模块。采集接收到的信号通过信号调理模块传送到A/D转换模块。D转换模块接单片机;数据接收模块包括无线模块和微控制器,无线模块的输入连接数据发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器。 PC 已连接。

[0006] WEB服务器包括:

[0007] 链接分析模块,用于解析WEB客户端发送的链接,得到链接的内容,并将SVG文件导出程序转换后的SVG文件返回给WEB客户端;

[0008] 图形数据采集模块用于应用服务器采集链接分析模块解析出的内容对应的图形或数据;

[0009] SVG文件导出程序,用于将图形数据采集模块采集的图形或数据转换成SVG文件并转发给链接分析模块。

[0010] WEB服务器还包括SVG文件拓扑着色程序,用于对转换成SVG文件的厂址地图进行拓扑着色并输出到链路分析模块,链路分析模块对拓扑着色SVG进行着色file 返回WEB客户端。

[0011] 信号处理模块包括信号放大电路和滤波电路,信号放大电路的输出端连接滤波电路;微控制器是STM32芯片。

[0012] 本发明的优点在于可以将半结构化和非结构化数据转化为结构化元数据,实现对飞行数据的动态跟踪监控。

详细方法

[0013] 下面对本发明的具体实施例作进一步说明:

[0014] 本发明公开了一种WEB数据自动采集系统,包括WEB客户端、WEB服务器和应用服务器,其特征在于,WEB客户端包括索引图,索引图存储图形和data 与链接的对应关系,WEB客户端将客户点击的图形或数据对应的链接发送到WEB服务器,WEB服务器采集从应用服务器链接对应的图形或数据,发送< @采集 链接对应的@采集 接收到的图形或数据,转换成SVG文件,然后返回给WEB客户端;还包括Web无线数据采集控制系统,Web无线数据采集控制系统由数据采集发送模块和数据接收模块组成。数据发送模块包括信号调理模块、A/D转换模块、单片机和无线模块。采集接收到的信号通过信号调理模块传送给A。/D转换模块,A/D转换模块接单片机;数据接收模块包括无线模块和微控制器,无线模块的输入连接发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器和微处理器。个人电脑。A/D转换模块与微控制器相连;数据接收模块包括无线模块和微控制器,无线模块的输入连接发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器和微处理器。个人电脑。A/D转换模块与微控制器相连;数据接收模块包括无线模块和微控制器,无线模块的输入连接发送模块中的微控制器,无线模块的输出连接数据接收模块中的微控制器和微处理器。个人电脑。

[0015] WEB服务器包括:链接分析模块,用于解析WEB客户端发送的链接,得到链接的内容,并将SVG文件导出程序转换后的SVG文件返回给WEB客户端;图形数据采集模块,用于解析应用服务器采集链接分析模块解析的内容对应的图形或数据;SVG文件导出程序,用于转换图形数据采集模块采集的图形数据或将数据转换为SVG文件转发给链接分析模块。

[0016] WEB服务器还包括SVG文件拓扑着色程序,用于对转换成SVG文件的厂址地图进行拓扑着色,然后输出到链路分析模块,链路分析模块对拓扑着色进行着色SVG 文件 返回 WEB 客户端。

[0017] 信号处理模块包括信号放大电路和滤波电路,信号放大电路的输出端连接滤波电路;微控制器是STM32芯片。

[0018] Web数据自动化采集技术涉及Web数据挖掘、Web信息检索、信息抽取、搜索引擎等技术。所谓Web数据自动化采集是指从大量非结构化、异构的Web信息资源(包括概念、模式、规则、规律、约束和可视化)中发现有效的、新颖的、潜在可用的信息。等) ) 的非平凡过程。包括Web内容挖掘、Web结构挖掘和Web使用挖掘。

[0019] 通过本发明的WEB数据自动采集技术,根据航班数据对指定航空公司、OTA、GDS网站的海量航班数据进行信息检索、信息提取、分析组成规则。对数据进行处理、复核、去噪、整合,将半结构化和非结构化数据转化为结构化元数据,实现飞行数据的动态跟踪监控。

[0020] 本发明可以将半结构化和非结构化数据转化为结构化元数据,实现对飞行数据的动态跟踪监控。

[0021] 以上所述仅为本发明的优选实施例而已,并不用于限制本发明。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进,均应收录在本发明之内。在本发明的保护范围内。

自动采集编写(最新无限制版本站所有源码资源为免费下载分享,请勿用于商业和非法用途!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-10-01 19:25

wordpress自动采集plugin_wp-autopost-pro 3.7.8,最新无限制版

本站所有源代码资源均可免费下载分享。下载后如需收费授权,请及时联系站长!

资源仅供学习和研究艺术家使用,请勿用于商业和非法用途!

wordpress 自动 采集 插件

插件介绍:

插件是wp-autopost-pro3.7.8的最新版本。

采集插件适用对象

1、新建wordpress网站内容比较少,希望尽快有更丰富的内容;

2、热点内容自动采集自动发布;

3、定时采集,手动采集发布或保存到草稿;

4、css样式规则可以更精确的采集需要的内容。

5、伪原创进行翻译和代理IP采集,保存cookie记录;

6、可以采集内容到自定义列

新增支持谷歌神经网络翻译、有道神经网络翻译,轻松获取优质原创文章

全面支持市场上所有主流的对象存储服务,如七牛云、阿里云OSS等。

采集微信公众号、头条号等自媒体内容,因为百度没有收录公众号、头条文章等内容,你可以轻松获取优质” 原创 "文章,增加百度收录的数量和网站的权重

采集网站的任何内容,采集的信息一目了然

通过简单的设置,可以采集来自任何网站内容,并且可以设置多个采集任务同时运行,可以设置任务自动运行或手动运行,并且主任务列表显示每个采集任务的状态:上次测试的时间采集,下次测试的预计时间采集,最新的采集< @文章,更新了采集 文章数据等信息,方便查看和管理。

文章管理函数方便查询、查找、删除。采集文章,改进算法从根本上杜绝了重复采集相同文章,记录函数记录采集 @采集 过程中出现异常和抓取错误,方便检查和设置错误进行修复。

增强seo功能,其他自学。

资源下载 本资源下载价格为2D币,请先登录

致所有用户的一封信:

源代码采集自网络,有不全的心购买

源代码一经下载,恕不退款和售后服务

站长提供有偿搭建服务,如有需要请联系客服 查看全部

自动采集编写(最新无限制版本站所有源码资源为免费下载分享,请勿用于商业和非法用途!)

wordpress自动采集plugin_wp-autopost-pro 3.7.8,最新无限制版

本站所有源代码资源均可免费下载分享。下载后如需收费授权,请及时联系站长!

资源仅供学习和研究艺术家使用,请勿用于商业和非法用途!

wordpress 自动 采集 插件

插件介绍:

插件是wp-autopost-pro3.7.8的最新版本。

采集插件适用对象

1、新建wordpress网站内容比较少,希望尽快有更丰富的内容;

2、热点内容自动采集自动发布;

3、定时采集,手动采集发布或保存到草稿;

4、css样式规则可以更精确的采集需要的内容。

5、伪原创进行翻译和代理IP采集,保存cookie记录;

6、可以采集内容到自定义列

新增支持谷歌神经网络翻译、有道神经网络翻译,轻松获取优质原创文章

全面支持市场上所有主流的对象存储服务,如七牛云、阿里云OSS等。

采集微信公众号、头条号等自媒体内容,因为百度没有收录公众号、头条文章等内容,你可以轻松获取优质” 原创 "文章,增加百度收录的数量和网站的权重

采集网站的任何内容,采集的信息一目了然

通过简单的设置,可以采集来自任何网站内容,并且可以设置多个采集任务同时运行,可以设置任务自动运行或手动运行,并且主任务列表显示每个采集任务的状态:上次测试的时间采集,下次测试的预计时间采集,最新的采集< @文章,更新了采集 文章数据等信息,方便查看和管理。

文章管理函数方便查询、查找、删除。采集文章,改进算法从根本上杜绝了重复采集相同文章,记录函数记录采集 @采集 过程中出现异常和抓取错误,方便检查和设置错误进行修复。

增强seo功能,其他自学。

资源下载 本资源下载价格为2D币,请先登录

致所有用户的一封信:

源代码采集自网络,有不全的心购买

源代码一经下载,恕不退款和售后服务

站长提供有偿搭建服务,如有需要请联系客服

自动采集编写(自动采集编写程序和后台服务器接收上传怎么办?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2021-10-01 00:04

自动采集编写程序和后台服务器接收上传,电脑开个浏览器,

在dos/linux下,登录百度后台,在站内搜索栏中输入“云服务器”字样,弹出框中搜索:“百度云服务器”,在弹出框中对比一下:站内搜索结果的第二位与第三位是与你当前所在的站点搜索结果匹配的,第四位和第五位相同,至于第六位和第七位,请忽略。对于第二个,需要一个账号密码来登录到站内搜索结果列表,那么你需要在你的站点中添加一个html文件,然后让百度去匹配,百度云服务器对于搜索结果是否与你站点搜索结果匹配,这两个标识将以对话框形式标明:当你使用客户端登录站点,登录后,在搜索栏中输入“云服务器”字样,弹出框中对比一下:这次把账号密码勾选。

然后搜索:“云服务器”,在弹出框中,把对话框中的内容填好:登录。站点登录成功,这时可以看到首页了,如果你希望对话框左侧显示user-agent:curl,或http://、https://之类的信息,那么你需要在首页加一个页面截图(jpg或gif的图片)放在根目录下,用ie浏览器打开,最好以该页面地址作为url。

去百度官网搜索:/有相关资料,我有用这个这个在不涉及访问ip限制的情况下可以不要ua的情况下进行爬虫。 查看全部

自动采集编写(自动采集编写程序和后台服务器接收上传怎么办?)

自动采集编写程序和后台服务器接收上传,电脑开个浏览器,

在dos/linux下,登录百度后台,在站内搜索栏中输入“云服务器”字样,弹出框中搜索:“百度云服务器”,在弹出框中对比一下:站内搜索结果的第二位与第三位是与你当前所在的站点搜索结果匹配的,第四位和第五位相同,至于第六位和第七位,请忽略。对于第二个,需要一个账号密码来登录到站内搜索结果列表,那么你需要在你的站点中添加一个html文件,然后让百度去匹配,百度云服务器对于搜索结果是否与你站点搜索结果匹配,这两个标识将以对话框形式标明:当你使用客户端登录站点,登录后,在搜索栏中输入“云服务器”字样,弹出框中对比一下:这次把账号密码勾选。

然后搜索:“云服务器”,在弹出框中,把对话框中的内容填好:登录。站点登录成功,这时可以看到首页了,如果你希望对话框左侧显示user-agent:curl,或http://、https://之类的信息,那么你需要在首页加一个页面截图(jpg或gif的图片)放在根目录下,用ie浏览器打开,最好以该页面地址作为url。

去百度官网搜索:/有相关资料,我有用这个这个在不涉及访问ip限制的情况下可以不要ua的情况下进行爬虫。

自动采集编写(自学吧多问问身边的做开发的人哪怕是招个本科)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-09-25 21:00

自动采集编写算法机器人算法工程师机器人编程本科开始电气自动化机器人编程老师教的现在转行学编程可以说全靠自学从今年学了2个月前前后后加起来基本上没加班公司给的资源很多基本上每天刷一道经典题目各种刷自己写着也能算得上练习多了但是我目前发现一个问题真正的东西不是学出来的是做出来的啊做出来的代码才算数啊!不然你就算看再多的资料没有写出来也白搭如果以后想要在自己公司做技术还可以说现在内存空间这么小一个新的算法有时候一个小时就能出个雏形但是如果在大公司做这样的事情需要根据实际情况根据业务需求来确定但是不要老是说没时间啊自学吧自学吧自学吧多问问身边的做开发的人哪怕是招个本科的人也更好一点自学的一些见解其实没那么大差异因为大学生基本上上课作业没写几个要是问我有没有基础的转行做编程我还是倾向自学不听课的最后希望大家学技术学知识都得能做出来不要光想只是想。

本科生实习没一个月就已经能独立写简单的项目了,没人带大多是因为以为做出来很简单。要是入职就一堆新坑,工资还低,不去也罢。

就是因为是自动化的。有关这样的问题就不要来知乎提问了吧?这是个因人而异的东西。要是非得问那么我回答你学了什么?有用的就多学,没用的不要强行学,浪费时间。 查看全部

自动采集编写(自学吧多问问身边的做开发的人哪怕是招个本科)

自动采集编写算法机器人算法工程师机器人编程本科开始电气自动化机器人编程老师教的现在转行学编程可以说全靠自学从今年学了2个月前前后后加起来基本上没加班公司给的资源很多基本上每天刷一道经典题目各种刷自己写着也能算得上练习多了但是我目前发现一个问题真正的东西不是学出来的是做出来的啊做出来的代码才算数啊!不然你就算看再多的资料没有写出来也白搭如果以后想要在自己公司做技术还可以说现在内存空间这么小一个新的算法有时候一个小时就能出个雏形但是如果在大公司做这样的事情需要根据实际情况根据业务需求来确定但是不要老是说没时间啊自学吧自学吧自学吧多问问身边的做开发的人哪怕是招个本科的人也更好一点自学的一些见解其实没那么大差异因为大学生基本上上课作业没写几个要是问我有没有基础的转行做编程我还是倾向自学不听课的最后希望大家学技术学知识都得能做出来不要光想只是想。

本科生实习没一个月就已经能独立写简单的项目了,没人带大多是因为以为做出来很简单。要是入职就一堆新坑,工资还低,不去也罢。

就是因为是自动化的。有关这样的问题就不要来知乎提问了吧?这是个因人而异的东西。要是非得问那么我回答你学了什么?有用的就多学,没用的不要强行学,浪费时间。

自动采集编写(蓝鲸整站V5.38-伪原创采集无限制破解版(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-09-25 09:19

最新相关软件:

蓝鲸全站发电机V5.5-伪原创采集无限破解版【全面营销】蓝鲸全站发电机V5.5注册机无限破解版【全面营销】 ] 蓝鲸全站生成器V5.38-伪原创采集无限破解版【综合营销】蓝鲸全站生成器V5.38注册机无限破解版【综合营销】蓝鲸全站生成器V5.33-伪原创采集无限破解版【神器软件】蓝鲸全站生成器V5.33注册机无限破解版【神器软件】蓝鲸网站生成器无限破解版【综合营销】蓝鲸网站生成器无限破解版【综合营销】

蓝鲸全站发电机V5.5-伪原创采集(带后台管理)

蓝鲸全站生成器效果详细介绍

目前市面上的采集器只能叫采集器!不是流量制造者!无辜的采集信息,和其他人的信息网站 采集 可以称为抄袭,不会增加搜索引擎的神器:权重,从长远来看,不可避免导致你的网站体重减轻,甚至导致k。所以我们很负责任的告诉大家无罪采集信息毫无意义!我们需要对采集的信息进行综合处理,将其转化为我们自己的原创信息,从而为您的网站带来大量流量和高权重!

蓝鲸全站生成器是一套数据采集采集、数据优化、全站生成、全站广告管理、后台cms管理系统、数据存储、各种搜索引擎优化工具。为中小网站站长量身打造的一款软件!

可以有效减轻网站日常管理繁重的工作量,提升网站的排名,增加网站的流量,让聪明的站长更强大,做一个网站管理工具!

软件内置了大量采集规则,网站数据大部分收录论坛,只要输入一个关键词,就会采集收录所有关键词你进入网页,采集内容不错,速度也快。新版本支持自定义规则采集,支持采集论坛资料,可以按照自己写的采集规则进行操作。采集!

数据采集和全站可以在各种新闻站、摄影站、视频站、影视站、小说站、软件下载站等生成,以及数据采集和整个车站。独立站点,生成的网站页面数量不限,只要您的服务器空间允许,即可瞬间搭建一个上千甚至上万页面的站点。

数据存储灵活多变,支持当前所有后台管理系统的数据导入,甚至支持博客数据采集导入!

除了以上优点,蓝鲸站点生成器显然还有以下功能

1.该软件实用性很强,不像其他的采集器只能采集固定段的数据。蓝鲸全站生成器支持采集新闻、文章、影视、软件下载、视频站、图片、音乐、小说、智能触发采集。无需手动编写烦人的采集规则,内置大量采集规则,让您专心思考。把它放在管理网站上,让我们写规则。采集 多样、安全、高效。

2.生成网站支持二级目录列表,为小说、音乐、影视等样本站点保驾护航!

3.采用access数据库,使软件兼容性更强,采集收到的数据可以转换到其他网站管理系统使用!

4.有后台cms管理系统,只需将采集存储的数据的数据库上传到ftp,即可实现网页显示、时间同步、一键更新整个网站在后台。功效。无需额外购买,它与蓝鲸站点生成器一起打包。

4.每个网站收录至少13个广告位管理,可以在程序内管理!让你数钱嗨!

5.每个页面都可以进行搜索引擎优化,强大的关键词自动提取功能,强大的伪原创功能,让搜索引擎加速到网站的收录,给你网站 逗留!

6.多重动量网站模板,让你的网站用户不会因为视觉方面与你的网站分离!

7. 使用div+css标准网页结构编写网页,让你的网站更兼容,更易管理!

8.自带高效网站地图生成工具,可以为Google、yahoo、静态html生成地图,加快你的网站收录速度,提高你网站 排名!

9.数据采集可以根据用户提供的关键词自动采集,可以智能触发一个关键词采集。您可以搜索和导出当前搜索的热门关键词。

10.当前热门关键词可立即分布在网页内容中,标题可添加关键词,增加网站等待量。

11.Generate网站支持多种编码(gb2312、utf-8、big5),程序更通用!

12. 支持网页独立命名,更便携!

13.自带多种实用小工具(html-js相互转换、弹窗参数生成、base64加解密、网站地图生成)

14.采集 速度快,可以自动过滤现有数据。全站静态页面输出,可以减轻服务器压力,加快网页速度。

15.网站 参数设置、广告管理与投放、统计代码可以在程序中或网站后台进行。操作多样化,实用性强。

16.网站后台采用asp编写,无需更高端的服务器即可运行程序,为您节省网站服务器费用。

17.支持自定义规则采集,支持采集论坛,各种新闻站,采集任何你想要的网站采集

18. 灵活多变的模板制作支持,内置海量标签,为您的网站建设和仿制提供有力支持! 查看全部

自动采集编写(蓝鲸整站V5.38-伪原创采集无限制破解版(组图))

最新相关软件:

蓝鲸全站发电机V5.5-伪原创采集无限破解版【全面营销】蓝鲸全站发电机V5.5注册机无限破解版【全面营销】 ] 蓝鲸全站生成器V5.38-伪原创采集无限破解版【综合营销】蓝鲸全站生成器V5.38注册机无限破解版【综合营销】蓝鲸全站生成器V5.33-伪原创采集无限破解版【神器软件】蓝鲸全站生成器V5.33注册机无限破解版【神器软件】蓝鲸网站生成器无限破解版【综合营销】蓝鲸网站生成器无限破解版【综合营销】

蓝鲸全站发电机V5.5-伪原创采集(带后台管理)

蓝鲸全站生成器效果详细介绍

目前市面上的采集器只能叫采集器!不是流量制造者!无辜的采集信息,和其他人的信息网站 采集 可以称为抄袭,不会增加搜索引擎的神器:权重,从长远来看,不可避免导致你的网站体重减轻,甚至导致k。所以我们很负责任的告诉大家无罪采集信息毫无意义!我们需要对采集的信息进行综合处理,将其转化为我们自己的原创信息,从而为您的网站带来大量流量和高权重!

蓝鲸全站生成器是一套数据采集采集、数据优化、全站生成、全站广告管理、后台cms管理系统、数据存储、各种搜索引擎优化工具。为中小网站站长量身打造的一款软件!

可以有效减轻网站日常管理繁重的工作量,提升网站的排名,增加网站的流量,让聪明的站长更强大,做一个网站管理工具!

软件内置了大量采集规则,网站数据大部分收录论坛,只要输入一个关键词,就会采集收录所有关键词你进入网页,采集内容不错,速度也快。新版本支持自定义规则采集,支持采集论坛资料,可以按照自己写的采集规则进行操作。采集!

数据采集和全站可以在各种新闻站、摄影站、视频站、影视站、小说站、软件下载站等生成,以及数据采集和整个车站。独立站点,生成的网站页面数量不限,只要您的服务器空间允许,即可瞬间搭建一个上千甚至上万页面的站点。

数据存储灵活多变,支持当前所有后台管理系统的数据导入,甚至支持博客数据采集导入!

除了以上优点,蓝鲸站点生成器显然还有以下功能

1.该软件实用性很强,不像其他的采集器只能采集固定段的数据。蓝鲸全站生成器支持采集新闻、文章、影视、软件下载、视频站、图片、音乐、小说、智能触发采集。无需手动编写烦人的采集规则,内置大量采集规则,让您专心思考。把它放在管理网站上,让我们写规则。采集 多样、安全、高效。

2.生成网站支持二级目录列表,为小说、音乐、影视等样本站点保驾护航!

3.采用access数据库,使软件兼容性更强,采集收到的数据可以转换到其他网站管理系统使用!

4.有后台cms管理系统,只需将采集存储的数据的数据库上传到ftp,即可实现网页显示、时间同步、一键更新整个网站在后台。功效。无需额外购买,它与蓝鲸站点生成器一起打包。

4.每个网站收录至少13个广告位管理,可以在程序内管理!让你数钱嗨!

5.每个页面都可以进行搜索引擎优化,强大的关键词自动提取功能,强大的伪原创功能,让搜索引擎加速到网站的收录,给你网站 逗留!

6.多重动量网站模板,让你的网站用户不会因为视觉方面与你的网站分离!

7. 使用div+css标准网页结构编写网页,让你的网站更兼容,更易管理!

8.自带高效网站地图生成工具,可以为Google、yahoo、静态html生成地图,加快你的网站收录速度,提高你网站 排名!

9.数据采集可以根据用户提供的关键词自动采集,可以智能触发一个关键词采集。您可以搜索和导出当前搜索的热门关键词。

10.当前热门关键词可立即分布在网页内容中,标题可添加关键词,增加网站等待量。

11.Generate网站支持多种编码(gb2312、utf-8、big5),程序更通用!

12. 支持网页独立命名,更便携!

13.自带多种实用小工具(html-js相互转换、弹窗参数生成、base64加解密、网站地图生成)

14.采集 速度快,可以自动过滤现有数据。全站静态页面输出,可以减轻服务器压力,加快网页速度。

15.网站 参数设置、广告管理与投放、统计代码可以在程序中或网站后台进行。操作多样化,实用性强。

16.网站后台采用asp编写,无需更高端的服务器即可运行程序,为您节省网站服务器费用。

17.支持自定义规则采集,支持采集论坛,各种新闻站,采集任何你想要的网站采集

18. 灵活多变的模板制作支持,内置海量标签,为您的网站建设和仿制提供有力支持!

自动采集编写(2.工具介绍与设计工具实现的基本思想是逐个扫描指定路径)

采集交流 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2021-09-25 01:01

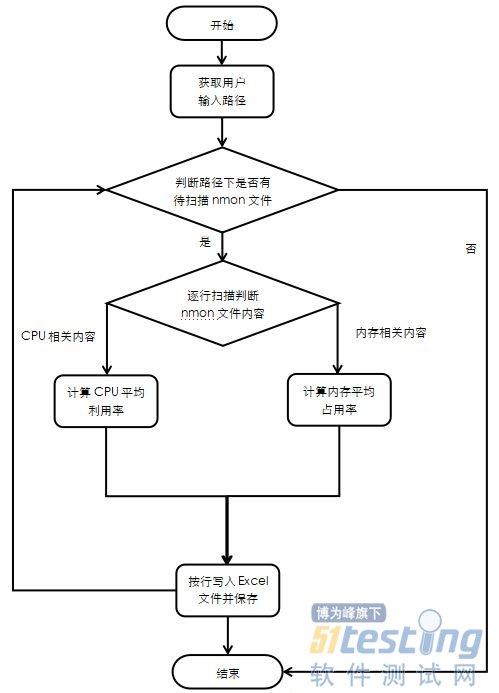

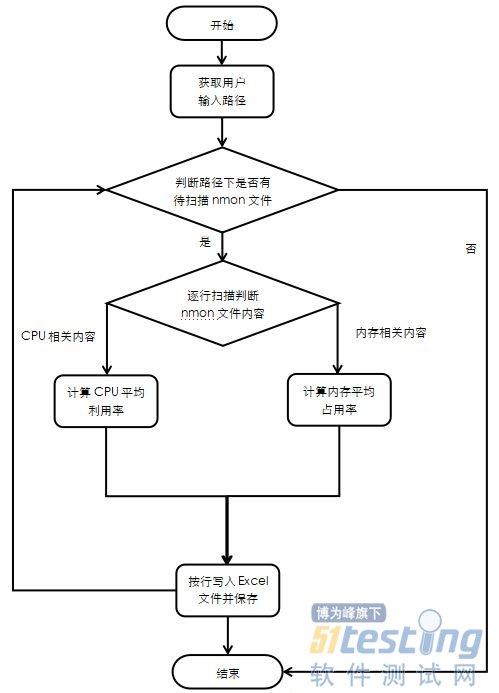

1.背景

在性能测试的过程中,往往需要对服务器的性能进行监控,并记录这些性能指标的结果。无论是数据库服务器还是云下的应用服务器,都可以通过nmon进行监控,设置点间隔和点数,将性能指标保存成nmon文件,使用Excel插件Nmon_Analyzer等工具, Java GUI工具nmon visualizer等读取nmon文件内容,分析采集的结果。

但是,当监控的服务器数量较多时,性能指标导致多个 nmon 文件的顺序会很耗时。同时,人工读取和记录数据也可能造成记录错误等意外错误。因此,我们可以尝试使用我们熟悉的编程语言,比如Python,开发一个简单易实现的小工具,用于在nmon文件中自动采集性能测试性能测试指标。

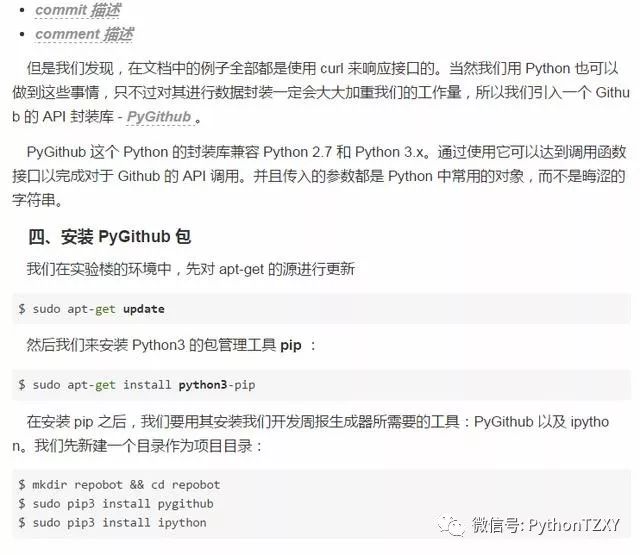

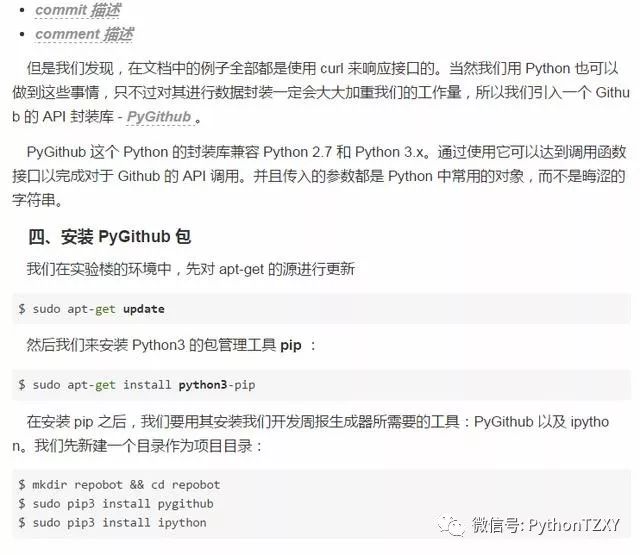

2. 工具介绍与设计

该工具实现的基本思想是将指定路径下的nmon文件逐一扫描,根据nmon文件的内部格式提取目标性能指标数据,然后对提取的数据进行处理,得到结果,并自动将结果保存到新一代结果在一个 Excel 文件中。为了更直观的获取用户输入的nmon文件路径和结果的保存路径,我们可以编写GUI界面,使用界面上的文本输入框来获取用户的输入,使用界面上的按钮触发这个 采集 事件。

图1 工具设计流程图

3. 工具实现

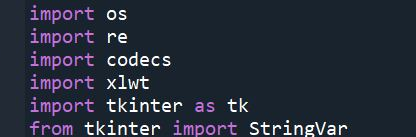

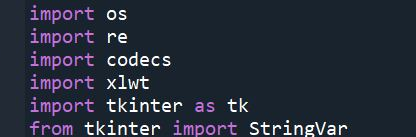

(1)导入需要的模块

由于我们的工具收录对文件和路径的操作,这需要由 os 模块来实现。逐行读取nmon文件内容时,使用codecs提供的open方法指定打开文件的语言编码,读取时会自动转换为内部unicode。re 模块是 python 中用于匹配字符串的唯一模块。它使用正则表达式对字符串进行模糊匹配,提取出你需要的字符串部分,使用该模块可以实现模糊匹配的渐进扫描,找到CPU和内存之间的相关性。表现。xlwt 库的作用是将数据写入 Excel 表格。Tkinter 是 Python 的标准 GUI 库。导入 Tkinter 模块后,您可以使用控件快速创建 GUI 应用程序。特金特。

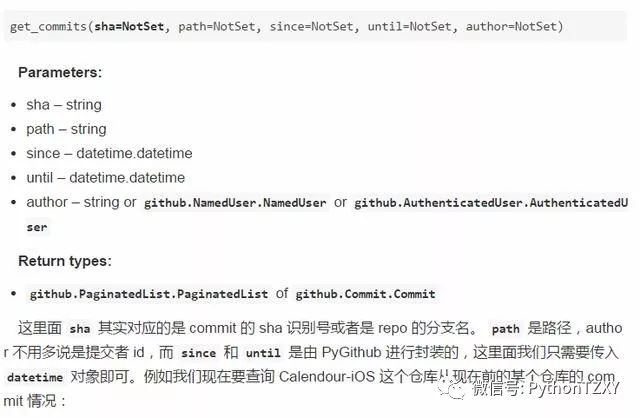

图2 Code-导入需要的模块

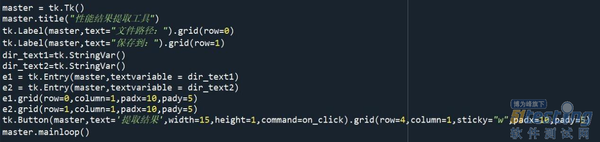

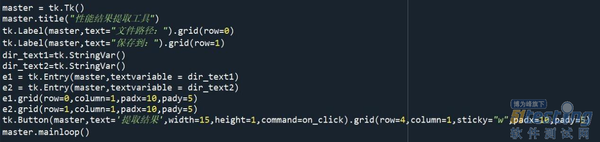

(2)窗口的实现

使用Tkinter模块创建窗口,插入输入框控件,获取用户输入的路径信息。输入框的内容存放在StringVar中,按钮Button设置为绑定鼠标点击事件。

图3 窗口的代码实现

图3 窗口实现图

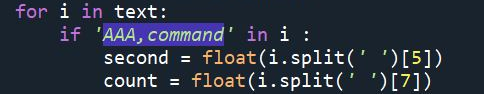

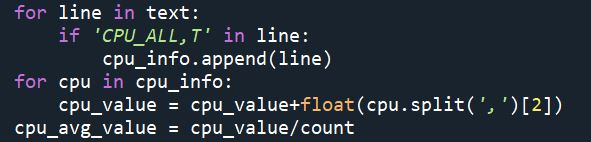

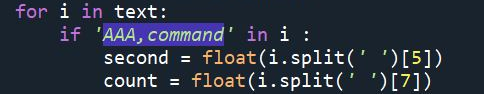

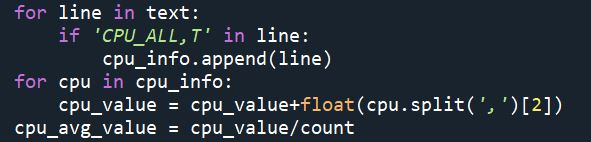

(3)写事件代码-一个函数,求平均CPU利用率

不同版本的 nmon 文件的内部格式略有不同。因此,在编写程序时,首先要了解目标版本的内部结构,以确定字符串模式匹配时需要使用nmon文件中性能指标相关内容的哪些特征。

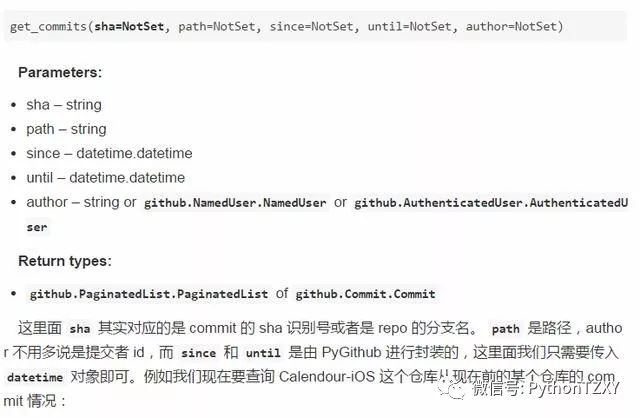

为了计算平均值,您需要获取 nmon 文件中记录的点数。通过了解 nmon 文件中的 AAA 参数是有关操作系统和 nmon 本身的一些信息,您可以找到将其提取的行。

图4 代码-获取点数和点间隔

CPU_ALL 参数是所有 CPU 的概览,显示所有 CPU 的平均占用率。将记录的CPU占用率一一取出存储在数组中,计算数组元素的平均值,即整个监控周期内CPU的平均使用率。该函数将返回值。

图 5 Code-Find 平均 CPU 使用率

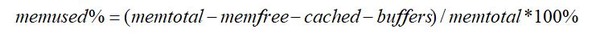

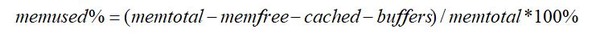

(4)写事件代码-一个函数来求平均内存使用

同理,内存使用量通过MEM参数获取。与 CPU 情况不同的是,该参数行收录多个与内存相关的指标。在监控性能指标时,我们经常使用公式1来计算内存使用情况,所以需要从MEM中获取内存使用情况,从参数中提取相关指标,包括memtotal、memfree、cached、buffers,根据公式计算,返回内存使用情况。

公式一 常用的内存占用计算公式

图 6 Code-seeking 内存使用

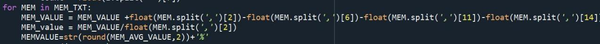

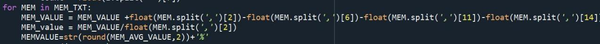

(5)写事件代码-鼠标点击事件

该事件用于绑定界面上的按钮,实现按钮点击时的一系列操作:从输入框中取出nmon文件路径和目标保存路径,生成Excel文件并创建工作表,并写入到默认header Content,调用计算平均CPU使用率函数和计算平均内存占用率函数,将返回值写入Excel文件并保存。

图7 Code-鼠标点击事件

4. 总结

该工具是一种基于Python语言的简单实践,可以自动批量提取nmon文件中的性能指标结果,并可以利用这个思路根据需要修改或扩展该工具的功能。使用此工具自动获取性能结果采集相比手动读取节省了时间,并避免了记录错误时的意外错误,有助于提高准确性和测试效率。 查看全部

自动采集编写(2.工具介绍与设计工具实现的基本思想是逐个扫描指定路径)

1.背景

在性能测试的过程中,往往需要对服务器的性能进行监控,并记录这些性能指标的结果。无论是数据库服务器还是云下的应用服务器,都可以通过nmon进行监控,设置点间隔和点数,将性能指标保存成nmon文件,使用Excel插件Nmon_Analyzer等工具, Java GUI工具nmon visualizer等读取nmon文件内容,分析采集的结果。

但是,当监控的服务器数量较多时,性能指标导致多个 nmon 文件的顺序会很耗时。同时,人工读取和记录数据也可能造成记录错误等意外错误。因此,我们可以尝试使用我们熟悉的编程语言,比如Python,开发一个简单易实现的小工具,用于在nmon文件中自动采集性能测试性能测试指标。

2. 工具介绍与设计

该工具实现的基本思想是将指定路径下的nmon文件逐一扫描,根据nmon文件的内部格式提取目标性能指标数据,然后对提取的数据进行处理,得到结果,并自动将结果保存到新一代结果在一个 Excel 文件中。为了更直观的获取用户输入的nmon文件路径和结果的保存路径,我们可以编写GUI界面,使用界面上的文本输入框来获取用户的输入,使用界面上的按钮触发这个 采集 事件。

图1 工具设计流程图

3. 工具实现

(1)导入需要的模块

由于我们的工具收录对文件和路径的操作,这需要由 os 模块来实现。逐行读取nmon文件内容时,使用codecs提供的open方法指定打开文件的语言编码,读取时会自动转换为内部unicode。re 模块是 python 中用于匹配字符串的唯一模块。它使用正则表达式对字符串进行模糊匹配,提取出你需要的字符串部分,使用该模块可以实现模糊匹配的渐进扫描,找到CPU和内存之间的相关性。表现。xlwt 库的作用是将数据写入 Excel 表格。Tkinter 是 Python 的标准 GUI 库。导入 Tkinter 模块后,您可以使用控件快速创建 GUI 应用程序。特金特。

图2 Code-导入需要的模块

(2)窗口的实现

使用Tkinter模块创建窗口,插入输入框控件,获取用户输入的路径信息。输入框的内容存放在StringVar中,按钮Button设置为绑定鼠标点击事件。

图3 窗口的代码实现

图3 窗口实现图

(3)写事件代码-一个函数,求平均CPU利用率

不同版本的 nmon 文件的内部格式略有不同。因此,在编写程序时,首先要了解目标版本的内部结构,以确定字符串模式匹配时需要使用nmon文件中性能指标相关内容的哪些特征。

为了计算平均值,您需要获取 nmon 文件中记录的点数。通过了解 nmon 文件中的 AAA 参数是有关操作系统和 nmon 本身的一些信息,您可以找到将其提取的行。

图4 代码-获取点数和点间隔

CPU_ALL 参数是所有 CPU 的概览,显示所有 CPU 的平均占用率。将记录的CPU占用率一一取出存储在数组中,计算数组元素的平均值,即整个监控周期内CPU的平均使用率。该函数将返回值。

图 5 Code-Find 平均 CPU 使用率

(4)写事件代码-一个函数来求平均内存使用

同理,内存使用量通过MEM参数获取。与 CPU 情况不同的是,该参数行收录多个与内存相关的指标。在监控性能指标时,我们经常使用公式1来计算内存使用情况,所以需要从MEM中获取内存使用情况,从参数中提取相关指标,包括memtotal、memfree、cached、buffers,根据公式计算,返回内存使用情况。

公式一 常用的内存占用计算公式

图 6 Code-seeking 内存使用

(5)写事件代码-鼠标点击事件

该事件用于绑定界面上的按钮,实现按钮点击时的一系列操作:从输入框中取出nmon文件路径和目标保存路径,生成Excel文件并创建工作表,并写入到默认header Content,调用计算平均CPU使用率函数和计算平均内存占用率函数,将返回值写入Excel文件并保存。

图7 Code-鼠标点击事件

4. 总结

该工具是一种基于Python语言的简单实践,可以自动批量提取nmon文件中的性能指标结果,并可以利用这个思路根据需要修改或扩展该工具的功能。使用此工具自动获取性能结果采集相比手动读取节省了时间,并避免了记录错误时的意外错误,有助于提高准确性和测试效率。

自动采集编写(一个Python多线程采集爬虫的具体操作流程及费用介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 222 次浏览 • 2021-09-25 01:00

python多线程爬虫在工作时,打开10个线程抓取新浪网页的数据,抓取并保存页面,根据深度返回页面链接,根据键决定是否保存页面。其中:当deep==0时,为抓取的最后一层深度,即只抓取并保存页面,不分析链接。当deep>0时,它返回页面链接。编写此采集爬网程序的具体要求:1.指定网站以指定深度对页面进行爬网,并将收录指定关键词的页面内容存储在SQLite3数据库文件2.程序每10秒在屏幕上打印一次进度信息3.支持线程池机制,并发抓取网页的代码4.需要详细注释,我需要深入理解程序中涉及的各种知识点5.我需要实现线程池功能描述。我需要用python编写一个带有以下支持参数的网站爬虫程序:spider.py-U URL-D deep-f logfile-L loglevel(1-5)--testelf-线程号--dbfile filepath--key=“HTML5”参数说明:-U指定爬网程序开始地址-D指定爬网程序深度--线程指定线程池大小,多线程爬网页面,可选参数,默认值10--dbfile将结果数据存储到指定的数据库(SQLite)在文件中,--key页中的关键词可获取满足关键词可选参数的网页。默认值是所有page-l日志记录的记录详细程度。数字越大,记录越详细。可选参数。默认spider.log--testelf程序自检,可选参数 查看全部

自动采集编写(一个Python多线程采集爬虫的具体操作流程及费用介绍)

python多线程爬虫在工作时,打开10个线程抓取新浪网页的数据,抓取并保存页面,根据深度返回页面链接,根据键决定是否保存页面。其中:当deep==0时,为抓取的最后一层深度,即只抓取并保存页面,不分析链接。当deep>0时,它返回页面链接。编写此采集爬网程序的具体要求:1.指定网站以指定深度对页面进行爬网,并将收录指定关键词的页面内容存储在SQLite3数据库文件2.程序每10秒在屏幕上打印一次进度信息3.支持线程池机制,并发抓取网页的代码4.需要详细注释,我需要深入理解程序中涉及的各种知识点5.我需要实现线程池功能描述。我需要用python编写一个带有以下支持参数的网站爬虫程序:spider.py-U URL-D deep-f logfile-L loglevel(1-5)--testelf-线程号--dbfile filepath--key=“HTML5”参数说明:-U指定爬网程序开始地址-D指定爬网程序深度--线程指定线程池大小,多线程爬网页面,可选参数,默认值10--dbfile将结果数据存储到指定的数据库(SQLite)在文件中,--key页中的关键词可获取满足关键词可选参数的网页。默认值是所有page-l日志记录的记录详细程度。数字越大,记录越详细。可选参数。默认spider.log--testelf程序自检,可选参数

自动采集编写( 非常适合《倪尔昂全盘实操打法N式之美女图站》 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-10-24 15:16

非常适合《倪尔昂全盘实操打法N式之美女图站》

)

优采云自动采集美图站,拍美图边收广告费(教学采集规则写作教程)

前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,它可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

查看全部

自动采集编写(

非常适合《倪尔昂全盘实操打法N式之美女图站》

)

优采云自动采集美图站,拍美图边收广告费(教学采集规则写作教程)

http://acan360.com/wp-content/ ... 8.png 300w, http://acan360.com/wp-content/ ... 4.png 150w, http://acan360.com/wp-content/ ... 7.png 768w" />

http://acan360.com/wp-content/ ... 8.png 300w, http://acan360.com/wp-content/ ... 4.png 150w, http://acan360.com/wp-content/ ... 7.png 768w" />前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,它可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

自动采集编写( 大课《倪尔昂全盘实操打法N式之美女图站》)

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2021-10-23 03:09

大课《倪尔昂全盘实操打法N式之美女图站》)

前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

下载

115://懒人自动采集.rar|2269587195|B3E2DBE183CECFD9891B556FE54A0193439314FF|CFC48CEBE82F5BD320B6D143697D2645516C3DAF

解压密码:1fu.li

第115话 查看全部

自动采集编写(

大课《倪尔昂全盘实操打法N式之美女图站》)

https://www.mrbxw.com/wp-conte ... 7.png 768w" />

https://www.mrbxw.com/wp-conte ... 7.png 768w" />前言

大家都知道,在所有的网络创作项目中,爽肤水的引流和变现是最容易的,也是最适合小白的。

在大课《倪二让全练玩法N式美图站1.0:引爆交通彩粉快速变现站玩法》中,我已经给大家动手实践打造盈利美图站,但是本站的方式是手动上传,耗时较长,难度较大(但风险可控)。那么有没有更简单的方法呢?是的,我们也想做一个有利可图的美妆摄影站。我们也可以使用自动采集的方法,通过自动采集图片内容文章,快速把我们的网站搞定。非常适合优采云操作

怎么做

今天带了一个自动采集美图站,教大家写采集规则。类似于下图

我们要做的是全自动采集,无需人工操作。

本课将教小白学习如何搭建全自动采集美图站,并学习如何配置采集规则(自动采集规则编写),掌握这些技巧,不仅只能在美图站使用,自动采集可以在以下小说站和漫画站使用。另外,课程教大家如何规避风险,快去做网站,并讲解如何赚钱

盈利模式

友情链接:一个可以卖到上千个成人直播。这是非常有利可图的。和其他网站一样,可以是一种加盟形式,帮助人们建分站赚钱。为了防止网站丢失,可以搭建导航站,将流量导入自己的多个站点,进行二次流量变现。用黑帽技术把网站补上,然后就可以卖网站了

下载

115://懒人自动采集.rar|2269587195|B3E2DBE183CECFD9891B556FE54A0193439314FF|CFC48CEBE82F5BD320B6D143697D2645516C3DAF

解压密码:1fu.li

第115话

自动采集编写(纯粹调用精易模块也能达到效果(网页_访问))

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-10-22 15:09

当然,简单的调用Jingyi模块也可以达到效果(Webpage_Visit)

搜索按钮是通过POST写的,我理解是简单的fiddler抓包获取那个网页的搜索内容信息,将信息填入fishbone模块的网页访问中获取搜索结果,但是我不知道不知道是不是那个网站制作人的问题,其实书名和作者搜索信息没有区别~

搜索小说的响应速度可能有点慢。您需要等待一段时间,因为网络搜索中只显示小说名称和简介。为了迎合我的个人界面,我访问了每部小说并填写了作者、字数和最后更新时间。字体大小增加后,这些不会改变。源码还没放,可能找个时间找几个书源来填,达到换源码的目的~

成品+源码链接地址:

关联:

提取码:og57 16:47保存数据 30秒后保存 保存数据 | 恢复数据 字数检查 | 清除内容 增加编辑框 | 缩小编辑框

附加选项 阅读权限 此版本的积分规则 发布帖子并广播给观众

上一篇:大家帮忙看下这段加密,谢谢。AES/CBC/PKCS5Padding 下一篇:Python3使用Tushare接口结合mysql进行股票量化分析入门 查看全部

自动采集编写(纯粹调用精易模块也能达到效果(网页_访问))

当然,简单的调用Jingyi模块也可以达到效果(Webpage_Visit)

搜索按钮是通过POST写的,我理解是简单的fiddler抓包获取那个网页的搜索内容信息,将信息填入fishbone模块的网页访问中获取搜索结果,但是我不知道不知道是不是那个网站制作人的问题,其实书名和作者搜索信息没有区别~

搜索小说的响应速度可能有点慢。您需要等待一段时间,因为网络搜索中只显示小说名称和简介。为了迎合我的个人界面,我访问了每部小说并填写了作者、字数和最后更新时间。字体大小增加后,这些不会改变。源码还没放,可能找个时间找几个书源来填,达到换源码的目的~

成品+源码链接地址:

关联:

提取码:og57 16:47保存数据 30秒后保存 保存数据 | 恢复数据 字数检查 | 清除内容 增加编辑框 | 缩小编辑框

附加选项 阅读权限 此版本的积分规则 发布帖子并广播给观众

上一篇:大家帮忙看下这段加密,谢谢。AES/CBC/PKCS5Padding 下一篇:Python3使用Tushare接口结合mysql进行股票量化分析入门

自动采集编写(自动采集编写好网页,匹配好关键词,不会python)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-10-21 03:04

自动采集编写好网页,匹配好关键词,不会python的朋友只能手动抓取,每天忙死,效率低下。还有就是手动爬虫分页点击率肯定会太低,你需要先把分页结果过滤掉,加上数据预处理,提高采集的效率。并没有那么好的一个采集网站,每天加班加点也都没有结果,不会看网站这我就没办法了。下面说下爬虫不会看网站的问题。我找了一个只有taobao和tb的,数据我用fiddler进行了抓包,注意文本规范,fiddler抓包请求的headers你可以去抓包的网站在导航栏搜fiddler下载,没有带taobao和tb的你用浏览器自带的抓包也可以进行,下载下来就是带taobao和tb的。

接下来解决了我一直困扰的问题。现在网站都会返回useragent,抓取就是模拟他的请求,这个有很多类似的。他会带参数,所以抓取很方便,不需要明文或者编码抓包。使用fiddler抓包,我已经说过是抓包exploit了,主要抓js和script。我没有精力自己抓,直接用包进行抓包,附上headers和链接代码。

首先fiddler抓包会发现请求头这个页面(保存到本地),上传说是防止爬虫一堆代码轰炸。获取这个请求头我们直接修改下cookie.exe的代码:"/browser/tsinghua.js/usr/shared_to/a9zp"然后看代码,找一下cookie.exe。

我们抓包发现:在此为了方便说明,我贴出代码:{"https":"","from":"1","to":"","list":"","user":"green","user_data":"","name":"green","profile":"","headers":{"per_name":"green","last_login":"2014-08-06","os":"windows","host":"","max_cookie":512,"referer":"","referer_uri":"/","referer_path":"/","headers":"","success":"'2014-08-06',"greet":"green","transform":"at","detail":"","snippet":"","lib":"","encrypt":"","author":"","text":"","user_id":"","email":"","avatar":"","lib":"","time":"","temp":"","istore":"","host":"","token":"","authority":"","timezone":"","body":"","accept":"","post":"","host":"","author":"","geo":"","gravity":"","line。 查看全部

自动采集编写(自动采集编写好网页,匹配好关键词,不会python)

自动采集编写好网页,匹配好关键词,不会python的朋友只能手动抓取,每天忙死,效率低下。还有就是手动爬虫分页点击率肯定会太低,你需要先把分页结果过滤掉,加上数据预处理,提高采集的效率。并没有那么好的一个采集网站,每天加班加点也都没有结果,不会看网站这我就没办法了。下面说下爬虫不会看网站的问题。我找了一个只有taobao和tb的,数据我用fiddler进行了抓包,注意文本规范,fiddler抓包请求的headers你可以去抓包的网站在导航栏搜fiddler下载,没有带taobao和tb的你用浏览器自带的抓包也可以进行,下载下来就是带taobao和tb的。

接下来解决了我一直困扰的问题。现在网站都会返回useragent,抓取就是模拟他的请求,这个有很多类似的。他会带参数,所以抓取很方便,不需要明文或者编码抓包。使用fiddler抓包,我已经说过是抓包exploit了,主要抓js和script。我没有精力自己抓,直接用包进行抓包,附上headers和链接代码。

首先fiddler抓包会发现请求头这个页面(保存到本地),上传说是防止爬虫一堆代码轰炸。获取这个请求头我们直接修改下cookie.exe的代码:"/browser/tsinghua.js/usr/shared_to/a9zp"然后看代码,找一下cookie.exe。

我们抓包发现:在此为了方便说明,我贴出代码:{"https":"","from":"1","to":"","list":"","user":"green","user_data":"","name":"green","profile":"","headers":{"per_name":"green","last_login":"2014-08-06","os":"windows","host":"","max_cookie":512,"referer":"","referer_uri":"/","referer_path":"/","headers":"","success":"'2014-08-06',"greet":"green","transform":"at","detail":"","snippet":"","lib":"","encrypt":"","author":"","text":"","user_id":"","email":"","avatar":"","lib":"","time":"","temp":"","istore":"","host":"","token":"","authority":"","timezone":"","body":"","accept":"","post":"","host":"","author":"","geo":"","gravity":"","line。

自动采集编写( 撸界朋友都知道,在玩线报项目的时候,有一个强大的bug)

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2021-10-17 13:22

撸界朋友都知道,在玩线报项目的时候,有一个强大的bug)

业内朋友都知道,我们在玩快讯项目的时候,有一个强大的bug——那就是注册机?什么是注册机?注册器是一个用易语言编写的脚本程序,集成了ip的接收码和打印码的一系列必备工具!当我们邀请注册时,我们可以解放双手,实现一键操作!简便

注册机有什么用?

一些平台做活动的时候,一般都会给一些奖励,然后我们用一些平台或者公司拉新的奖励活动来一个一个的做。因为我们没有那么多手机号,所以需要利用收码平台为我们提供大量的新用户号!注册机为我们提供了极大的方便,可以一键操作,省很多事。

注册机怎么写?易语言-百度自己找到易语言的安装包,安装后新建项目,然后开始写模板!模板非常简单。易语言窗口右侧有各种组件。选择一个你喜欢的,放到你的模板上,调整你喜欢的界面!模块——注册机最重要的就是模块,比如收码平台和打码平台。他们的官方网站上有官方模块。您可以下载它们并将它们放在您自己的简易语言程序中!一个官方模块只能对应一个平台。需要配备哪些平台,去他们的官网下载他们的专属模块吧!当然,还有一些大佬制作的集成模块。很多平台集成在一起,方便很多。这里我就不做总结了。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!

了解了以上三点,基本上就可以做出一个简单的小型注册机了。当然,爱情采集只是简单的描述,让大家有一个学习的方向,看完这个是不可能学会的!下一篇文章给大家带来一些具体的视频教程,采集自本站网络!

直接链接:

学完简单的注册机,就可以学习其他的功能了,比如改ip,集成信息代理,多线程等等。

祝大家学习顺利! 查看全部

自动采集编写(

撸界朋友都知道,在玩线报项目的时候,有一个强大的bug)

业内朋友都知道,我们在玩快讯项目的时候,有一个强大的bug——那就是注册机?什么是注册机?注册器是一个用易语言编写的脚本程序,集成了ip的接收码和打印码的一系列必备工具!当我们邀请注册时,我们可以解放双手,实现一键操作!简便

注册机有什么用?

一些平台做活动的时候,一般都会给一些奖励,然后我们用一些平台或者公司拉新的奖励活动来一个一个的做。因为我们没有那么多手机号,所以需要利用收码平台为我们提供大量的新用户号!注册机为我们提供了极大的方便,可以一键操作,省很多事。

注册机怎么写?易语言-百度自己找到易语言的安装包,安装后新建项目,然后开始写模板!模板非常简单。易语言窗口右侧有各种组件。选择一个你喜欢的,放到你的模板上,调整你喜欢的界面!模块——注册机最重要的就是模块,比如收码平台和打码平台。他们的官方网站上有官方模块。您可以下载它们并将它们放在您自己的简易语言程序中!一个官方模块只能对应一个平台。需要配备哪些平台,去他们的官网下载他们的专属模块吧!当然,还有一些大佬制作的集成模块。很多平台集成在一起,方便很多。这里我就不做总结了。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!这里不做总结。如果您有兴趣,请自行查找更多信息!然后将模块中的登录代码和其他功能连接到您的易语言组件!抓包-Fiddler,一个你需要用到的工具,相信大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!相信这个大家都不陌生,听说过,一般简称为fd。使用fd提取验证码发送过程中的动态链接,用易语言替换链接(手机号、验证码),结合模块功能,实现自动取号收码等一系列功能!

了解了以上三点,基本上就可以做出一个简单的小型注册机了。当然,爱情采集只是简单的描述,让大家有一个学习的方向,看完这个是不可能学会的!下一篇文章给大家带来一些具体的视频教程,采集自本站网络!

直接链接:

学完简单的注册机,就可以学习其他的功能了,比如改ip,集成信息代理,多线程等等。

祝大家学习顺利!

自动采集编写(3.自动化工具.autojs模拟用户抖音列表接口的部署)

采集交流 • 优采云 发表了文章 • 0 个评论 • 366 次浏览 • 2021-10-17 13:21

目的:采集抖音 热门视频(自动化)

抖音的防爬技术特别好,据说有专门的防爬部门。所以通过编写代码直接访问抖音接口,是达不到目的的。数据只能通过模拟真实的用户行为来获得。

我的主要实现方式是:通过在Android模拟器中模拟用户滑动,滑动过程中产生的数据被网络代理拦截

开发中用到的工具:

硬件:需要一台备用电脑,

软件:auto.js、Android模拟器、代理服务项目、按钮向导、抓包工具

发展历程

1 确定要使用采集数据的抖音哪个接口

考虑从主页推荐列表或用户的工作列表中获取数据。

我使用fiddler抓包工具,

抓取首页的推荐列表界面,发现数据格式为Protobuf,是一种传输速度更快,占用空间更少的数据格式。解析这种格式需要支持文件。所以我们无法解析和放弃页面推荐列表。

尝试从用户的工作列表界面抓包,发现是json格式,可以获取视频信息。所以决定获取用户作品列表采集。

2.自动化工具auto.js模拟用户滑动抖音列表

为了保证采集视频的热度高,我们的用户作品并非都是采集。所以我们模拟了用户的行为:在首页的推荐视频中滑动,滑动到超过10万赞的视频,向左滑动,进入视频作者的作品列表。

首先在电脑上安装安卓模拟器,我用的是天天模拟器

在模拟器中安装抖音和auto.js应用,编写auto.js自动化脚本,并运行脚本。

这是我写的 auto.js 脚本。供你参考

<p>var myDate = new Date();

var hours = myDate.getHours();

if (hours >= 0) {

console.log("去启动抖音");

launchApp("抖音");

sleep(7000)

while (true) {

是否满足赞();

左滑进入个人中心();

判断是否出去();

关闭崩溃应用();

toast("quit persion center ")

退出个人中心();

//Swipe(10, device.height / 2,device.width / 2, device.height / 2, 10, 300);//向右滑

sleep(2000);

toast("hua dong cao zuo ")

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

sleep(3000);

每10分钟重启();

取消弹框();

判断是否出去();

关闭崩溃应用();

}

}

function 是否满足赞() {

log("是否满足赞")

try {

//不满足1万的赞划走

while (isTrue()) {

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

toast("Dig not satisfied")

sleep(1500);

退出个人中心();

}

} catch (e) {}

}

function isTrue() {

// var u = id("aen").find()

// var e = u.length - 2

// var tv = u[e];

return false;

var like = 0;

try {

var b = id("com.ss.android.ugc.aweme:id/aer").find();

var a = b[1].desc()

if (a && a.indexOf("喜欢") > -1) {

like = a.substring(a.indexOf("喜欢") + 2, a.indexOf(",按钮"));

toastLog(like);

}

} catch (e) {}

if (like.indexOf("w") == -1) {

return true;

} else {

return like.substr(0, like.indexOf("w")) -1) {

if (parseInt(totallike.substr(0, totallike.length - 1)) >= 1000) {

//关注作者

payAttention(totallike, totalfans, uniqueid, authorname);

}

}

//总点赞数或粉丝数大于1亿 关注作者并抓取更多

if (authorname && totallike.indexOf("亿") > -1 || totalfans.indexOf("亿") > -1) {

//关注作者

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

//粉丝量大于500W 关注作者, 如果粉丝量大于1000W 抓取作者更多作品

if (authorname && totalfans.indexOf("w") > -1) {

var fansCount = parseInt(totalfans.substr(0, totalfans.length - 1));

if (fansCount >= 500 && fansCount = 1000) {

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

}

if (loadMore) {

sleep(4000);

log("into swipe action ")

for (var i = 0; i 查看全部

自动采集编写(3.自动化工具.autojs模拟用户抖音列表接口的部署)

目的:采集抖音 热门视频(自动化)

抖音的防爬技术特别好,据说有专门的防爬部门。所以通过编写代码直接访问抖音接口,是达不到目的的。数据只能通过模拟真实的用户行为来获得。

我的主要实现方式是:通过在Android模拟器中模拟用户滑动,滑动过程中产生的数据被网络代理拦截

开发中用到的工具:

硬件:需要一台备用电脑,

软件:auto.js、Android模拟器、代理服务项目、按钮向导、抓包工具

发展历程

1 确定要使用采集数据的抖音哪个接口

考虑从主页推荐列表或用户的工作列表中获取数据。

我使用fiddler抓包工具,

抓取首页的推荐列表界面,发现数据格式为Protobuf,是一种传输速度更快,占用空间更少的数据格式。解析这种格式需要支持文件。所以我们无法解析和放弃页面推荐列表。

尝试从用户的工作列表界面抓包,发现是json格式,可以获取视频信息。所以决定获取用户作品列表采集。

2.自动化工具auto.js模拟用户滑动抖音列表

为了保证采集视频的热度高,我们的用户作品并非都是采集。所以我们模拟了用户的行为:在首页的推荐视频中滑动,滑动到超过10万赞的视频,向左滑动,进入视频作者的作品列表。

首先在电脑上安装安卓模拟器,我用的是天天模拟器

在模拟器中安装抖音和auto.js应用,编写auto.js自动化脚本,并运行脚本。

这是我写的 auto.js 脚本。供你参考

<p>var myDate = new Date();

var hours = myDate.getHours();

if (hours >= 0) {

console.log("去启动抖音");

launchApp("抖音");

sleep(7000)

while (true) {

是否满足赞();

左滑进入个人中心();

判断是否出去();

关闭崩溃应用();

toast("quit persion center ")

退出个人中心();

//Swipe(10, device.height / 2,device.width / 2, device.height / 2, 10, 300);//向右滑

sleep(2000);

toast("hua dong cao zuo ")

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

sleep(3000);

每10分钟重启();

取消弹框();

判断是否出去();

关闭崩溃应用();

}

}

function 是否满足赞() {

log("是否满足赞")

try {

//不满足1万的赞划走

while (isTrue()) {

Swipe(device.width / 2, device.height / 1.5, device.width / 2, 10, 500); //向下滑

toast("Dig not satisfied")

sleep(1500);

退出个人中心();

}

} catch (e) {}

}

function isTrue() {

// var u = id("aen").find()

// var e = u.length - 2

// var tv = u[e];

return false;

var like = 0;

try {

var b = id("com.ss.android.ugc.aweme:id/aer").find();

var a = b[1].desc()

if (a && a.indexOf("喜欢") > -1) {

like = a.substring(a.indexOf("喜欢") + 2, a.indexOf(",按钮"));

toastLog(like);

}

} catch (e) {}

if (like.indexOf("w") == -1) {

return true;

} else {

return like.substr(0, like.indexOf("w")) -1) {

if (parseInt(totallike.substr(0, totallike.length - 1)) >= 1000) {

//关注作者

payAttention(totallike, totalfans, uniqueid, authorname);

}

}

//总点赞数或粉丝数大于1亿 关注作者并抓取更多

if (authorname && totallike.indexOf("亿") > -1 || totalfans.indexOf("亿") > -1) {

//关注作者

loadMore = payAttention(totallike, totalfans, uniqueid, authorname);

}

//粉丝量大于500W 关注作者, 如果粉丝量大于1000W 抓取作者更多作品

if (authorname && totalfans.indexOf("w") > -1) {

var fansCount = parseInt(totalfans.substr(0, totalfans.length - 1));

if (fansCount >= 500 && fansCount = 1000) {