自动采集编写

自动采集编写(自动采集编写自动脚本相关模块自动化测试(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-11-30 08:02

自动采集编写自动脚本相关模块自动化测试(不仅包括testing以及debug相关模块,也包括相关自动化的后端引擎,包括httpclient、node等等,

做自动化测试,有比较简单的方法,就是去做一些人工测试,然后把自己系统的相关部分整合自动化测试的部分。比如很多系统会有客户端,那么你就整合成客户端,然后测试过程中就自动检测和打包。

基于软件测试平台+人工智能工具

ci与项目自动化,不依赖工具,以软件测试流程,自动完成测试需求分析、策略设计、自动化测试计划编写、软件评审、测试执行与结果分析、测试报告回归等。

做一个程序都会涉及一些基础,我没做到,但是我从业五年以来,做测试技术工作的过程中,让一些不是那么熟悉软件的人或者只了解其中一部分知识的人,可以比较快速的上手软件测试。

hyperion

做一个项目主程

自动化。几乎看不到一个人说这样的话,所以。

除了简单的集成测试,自动化一般都是指中级,

新工具,新框架,新流程。soap可以写,rest可以写,ci可以写。测试驱动开发也可以写。

测试驱动开发!!!

测试管理 查看全部

自动采集编写(自动采集编写自动脚本相关模块自动化测试(一))

自动采集编写自动脚本相关模块自动化测试(不仅包括testing以及debug相关模块,也包括相关自动化的后端引擎,包括httpclient、node等等,

做自动化测试,有比较简单的方法,就是去做一些人工测试,然后把自己系统的相关部分整合自动化测试的部分。比如很多系统会有客户端,那么你就整合成客户端,然后测试过程中就自动检测和打包。

基于软件测试平台+人工智能工具

ci与项目自动化,不依赖工具,以软件测试流程,自动完成测试需求分析、策略设计、自动化测试计划编写、软件评审、测试执行与结果分析、测试报告回归等。

做一个程序都会涉及一些基础,我没做到,但是我从业五年以来,做测试技术工作的过程中,让一些不是那么熟悉软件的人或者只了解其中一部分知识的人,可以比较快速的上手软件测试。

hyperion

做一个项目主程

自动化。几乎看不到一个人说这样的话,所以。

除了简单的集成测试,自动化一般都是指中级,

新工具,新框架,新流程。soap可以写,rest可以写,ci可以写。测试驱动开发也可以写。

测试驱动开发!!!

测试管理

自动采集编写(网页采集大师这款软件的用途和界面样式的初步介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-11-28 18:17

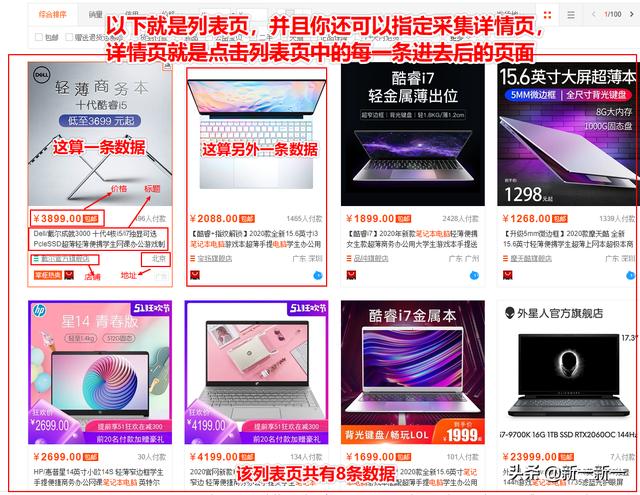

今天要分享的是一个软件,叫做Web Data采集Master,看名字应该就能猜到是干什么的了,没错,它是专门用于批处理采集网页数据主要用于自动化各种列表页面和详情页面的数据。您也可以将其用作爬虫工具。先简单介绍一下什么叫列表页和详情页。

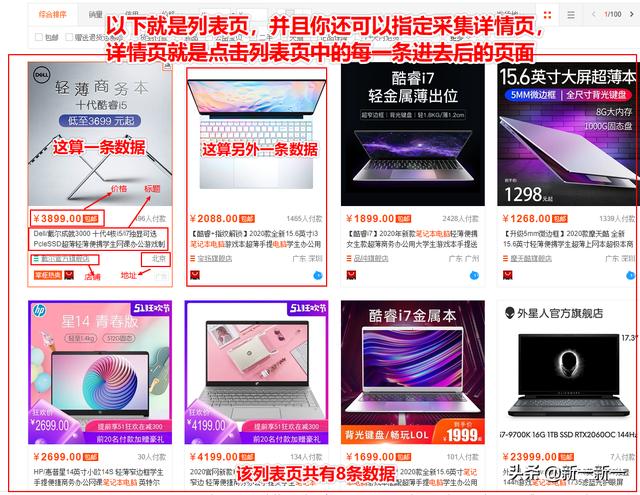

以某电商网站为例,下图为列表页面,即一个列表中显示了很多相似的数据,一个页面显示不出来,可以跳转到下一个页面底部的页面,即分页显示。

列表

如果列表页数据量较大,则单独显示列表页。

分页

以下是详情页展示:

详情页面

详情页数据

上图是列表页+详情页,这就是这个工具的用武之地。对于大多数网站来说都是这样,不管是不是分页数据,都可以批量采集,还有采集 快速且非常安全。

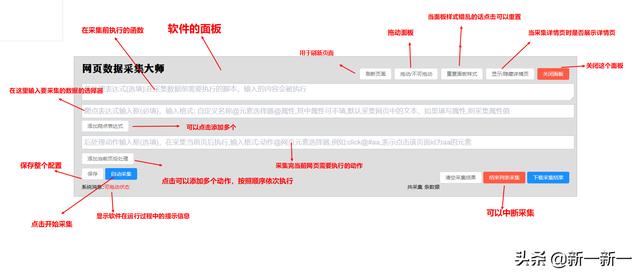

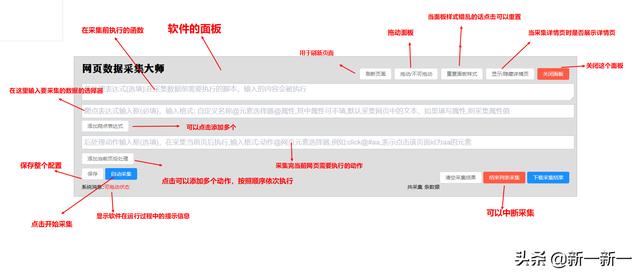

说完它的功能,我们来看看它的软件长什么样。

首页采集大师

以上是对网页用途和界面风格的初步介绍采集掌握这个软件,看完界面是不是觉得很简单,是的,这个软件的界面是我设计的,所有的代码是我自己写的。

本软件几乎可以采集PC端的所有网页数据,包括上图所示的列表页和详情页数据,然后生成excel或文本格式的文件。使用起来非常简单方便。您可以在几分钟内采集 上千条数据,再也不用担心没有数据了。非常适合大学生用数据做毕业设计,需要批量处理采集图片、音视频地址等。

如果你对网页采集、爬虫感兴趣,或者有网络数据需求,请关注我,我会在以后分享如何使用这个软件的细节。如果你有童鞋需要你的毕业项目数据,请联系我,帮助你快速解决数据问题。 查看全部

自动采集编写(网页采集大师这款软件的用途和界面样式的初步介绍)

今天要分享的是一个软件,叫做Web Data采集Master,看名字应该就能猜到是干什么的了,没错,它是专门用于批处理采集网页数据主要用于自动化各种列表页面和详情页面的数据。您也可以将其用作爬虫工具。先简单介绍一下什么叫列表页和详情页。

以某电商网站为例,下图为列表页面,即一个列表中显示了很多相似的数据,一个页面显示不出来,可以跳转到下一个页面底部的页面,即分页显示。

列表

如果列表页数据量较大,则单独显示列表页。

分页

以下是详情页展示:

详情页面

详情页数据

上图是列表页+详情页,这就是这个工具的用武之地。对于大多数网站来说都是这样,不管是不是分页数据,都可以批量采集,还有采集 快速且非常安全。

说完它的功能,我们来看看它的软件长什么样。

首页采集大师

以上是对网页用途和界面风格的初步介绍采集掌握这个软件,看完界面是不是觉得很简单,是的,这个软件的界面是我设计的,所有的代码是我自己写的。

本软件几乎可以采集PC端的所有网页数据,包括上图所示的列表页和详情页数据,然后生成excel或文本格式的文件。使用起来非常简单方便。您可以在几分钟内采集 上千条数据,再也不用担心没有数据了。非常适合大学生用数据做毕业设计,需要批量处理采集图片、音视频地址等。

如果你对网页采集、爬虫感兴趣,或者有网络数据需求,请关注我,我会在以后分享如何使用这个软件的细节。如果你有童鞋需要你的毕业项目数据,请联系我,帮助你快速解决数据问题。

自动采集编写(project项目名称创建列表)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-11-26 03:01

爬虫项目编写流程:

创建项目:scrapy项目项目名称创建爬虫名称:scrapy genspider爬虫名称“限制域” 明确要求:写items.py,写spiders/xxx.py,写爬虫文件,处理请求和响应,提取数据(yield item) pipelines.py,写pipeline文件,处理spider返回的item数据,比如本地持久化存储,写settings.py,启动pipeline组件:ITEM_PIPELINES={},其他中间件设置比如headers执行爬虫:scrapy爬虫爬虫名

1.创建项目

scrapy startproject Tencent

cd Tencent # 进入到项目目录

2.创建爬虫

scrapy genspider tencent.job "www.tencent.com"

引用模块和设置配置时,不是从项目文件夹开始,而是从项目文件夹的下一级开始。

3.打开网站查看数据:#a

4.明确需求,需要爬取的字段,写Tencent/items.py:

# Tencent/Tencent/items.py

import scrapy

class TencentItem(scrapy.Item):

# 职位:

positionName = scrapy.Field()

# 职位详情链接:

positionLink = scrapy.Field()

# 职位类别

positionType = scrapy.Field()

# 招聘人数

peopleNumber = scrapy.Field()

# 工作地址

workLocation = scrapy.Field()

# 发布时间

publishTime = scrapy.Field()

5.写一个爬虫,腾讯/spiders/tencent_job.py:

import scrapy

class TencentJobSpider(scrapy.Spider):

name = "tencent.job"

allowed_domains = ["tencent.com"]

base_url = "https://hr.tencent.com/positio ... ot%3B

offset = 0 # 起始页start=0,每10个换一页

start_url = [base_url + str(offset)]

分析页面以获取我们想要的字段。

在我们想要的信息中,点击check查看元素,可以看到节点是:

//tr[@class='even']

或者 //tr[@class='odd']

将两者放在一起: //tr[@class='even'] |//tr[@class='odd']

每个tr下面,是td列表,这些td列表就是各个位置的相关信息。

职位名称://tr[@class='even'] | /td[1]/a/text()

注意:xpath的下标从1开始

职位详情链接://tr[@class='even'] | /td[1]/a/@href

………………

import scrapy

from Tencent.items import TencentItem

class TencentJobSpider(scrapy.Spider):

name = "tencent.job"

allowed_domains = ["tencent.com"]

base_url = "https://hr.tencent.com/positio ... ot%3B

offset = 0 # 起始页start=0,每10个换一页

start_url = [base_url + str(offset)]

def parse(self, response):

node_list = response.xpath("//tr[@class='even'] | //tr[@class='odd']")

# response.xpath之后的对象,仍然是xpath对象

for node in node_list:

#xpath方法之后,返回的仍然是xpath对象;xpath的extract()方法,以unicode编码返回xpath对象的内容

positionName = node.xpath('./td[1]/a/text()').extract()

# 注意要在td前面加上"./",表示此td是node_list的下一级

positionLink = node.xpath('./td[1]/a/@href').extract()

positionType = node.xpath('./td[2]/text()').extract()

peopleNumber = node.xpath('./td[3]/text()').extract()

workLocation = node.xpath('./td[4]/text()').extract()

publishTime = node.xpath('./td[5]/text()').extract()

item = TencentItem()

# xpath及其extract返回的都是列表,因此取其第一个元素;并使用encode("utf-8")编码为utf8

item['positionName'] = positionName[0].encode("utf-8") if positionName else ""

item['positionType'] = positionType[0].encode("utf-8") if positionType else ""

item['positionLink'] = positionLink[0].encode("utf-8") if positionLink else ""

item['peopleNumber'] = peopleNumber[0].encode("utf-8") if peopleNumber else ""

item['workLocation'] = workLocation[0].encode("utf-8") if workLocation else ""

item['publishTime'] = publishTime[0].encode("utf-8") if publishTime else ""

yield item

if self.offset < 2190:

self.offset += 10 # 每页10条数据

url = self.base_url + self.offset

# 构建下一页的url请求对象

yield scrapy.Request(url, callback=self.parse)

# 1.如果下面的请求内容不一样,则需要自己再写一个回调方法,回调自定义的方法

# 2.这里返回的是url对象,引擎接受到以后判断它不是item对象,不会发送给管道处理;

# 是Request对象,引擎将发送给调度器,去请处理请求

# 3.这里要使用yield,不断的返回,直到self.offset >=2190。

调用管道时要注意:

每个响应对应一个 parse() 方法;在for循环中,循环一次,生成一个item对象;for 循环中的所有项目对象都对应于一个管道 process_item() 方法。

即for循环中有一个item对象,共享一个管道对象process_item();即pipeline类只会被实例化一次,process_item()方法会被多次调用。调用 process_items() 时,它是一个管道对象;因此,只需要初始化一次,并且只需要打开和关闭文件一次。

6.写管道文件:保存数据

1)。编写管道类:Tencent/pipelines.py

import json

class TencentPipeline(object):

def __init__(self):

self.f = open("tencent.json", "w")

def process_item(self, item, spider):

# 要处理中文,ensure_ascii要改为False

content = json.dumps(dict(item), ensure_ascii=False) + ",\n"

# 此时,不再需要encode("utf-8"),因为在得到item的时侯已经encode("utf-8")

# 总之,从网络请求来的数据,要encode("utf-8")编码一次。

self.f.write(content)

return item

def close_spider(self, spider):

self.f.close()

2)在Tencent/settings.py文件中,启用管道并添加上面的管道类

ITEM_PIPELINES = {

'Tencent.pipelines.TencentPipeline': 300,

}

3)。确保爬虫文件Tencent/spiders/xx.py中爬虫类的parse()方法和返回的item类数据可以使用管道。

7.执行爬虫:

crapy crawl 爬虫名称

8.优化:

在上面的例子中,假设总页数;适用于没有下一页标签的 网站。

在这个项目中,实际上还有一个页面可以点击网站。到达最后一页时,无法单击下一页。

因此,可以根据是否可以点击下一页来判断是否是最后一页。

看页面,下一页的节点是://a[@id='text']/@href

最后一个page节点的href内容为“javascript:;”,其标签为://a[@class='noative']

但是第一页的前一页的标签也是://a[@class='noative']

但是id不一样,第一页的前一页的id是'prev'

因此,结合这两个条件://a[@class='noative' and @id='next']

yield item

if not response.xpath("//a[@class='noative' and @id='next']"):

url = response.xpath("//a[@id='next']/@href").extract()[0]

# 构建下一页的url请求对象

yield scrapy.Request(self.base_url + url, callback=self.parse)

注意:在同一个标签中,xpah可以用and、or表示;如果不在同一个标签中,请使用 | & 代表 查看全部

自动采集编写(project项目名称创建列表)

爬虫项目编写流程:

创建项目:scrapy项目项目名称创建爬虫名称:scrapy genspider爬虫名称“限制域” 明确要求:写items.py,写spiders/xxx.py,写爬虫文件,处理请求和响应,提取数据(yield item) pipelines.py,写pipeline文件,处理spider返回的item数据,比如本地持久化存储,写settings.py,启动pipeline组件:ITEM_PIPELINES={},其他中间件设置比如headers执行爬虫:scrapy爬虫爬虫名

1.创建项目

scrapy startproject Tencent

cd Tencent # 进入到项目目录

2.创建爬虫

scrapy genspider tencent.job "www.tencent.com"

引用模块和设置配置时,不是从项目文件夹开始,而是从项目文件夹的下一级开始。

3.打开网站查看数据:#a

4.明确需求,需要爬取的字段,写Tencent/items.py:

# Tencent/Tencent/items.py

import scrapy

class TencentItem(scrapy.Item):

# 职位:

positionName = scrapy.Field()

# 职位详情链接:

positionLink = scrapy.Field()

# 职位类别

positionType = scrapy.Field()

# 招聘人数

peopleNumber = scrapy.Field()

# 工作地址

workLocation = scrapy.Field()

# 发布时间

publishTime = scrapy.Field()

5.写一个爬虫,腾讯/spiders/tencent_job.py:

import scrapy

class TencentJobSpider(scrapy.Spider):

name = "tencent.job"

allowed_domains = ["tencent.com"]

base_url = "https://hr.tencent.com/positio ... ot%3B

offset = 0 # 起始页start=0,每10个换一页

start_url = [base_url + str(offset)]

分析页面以获取我们想要的字段。

在我们想要的信息中,点击check查看元素,可以看到节点是:

//tr[@class='even']

或者 //tr[@class='odd']

将两者放在一起: //tr[@class='even'] |//tr[@class='odd']

每个tr下面,是td列表,这些td列表就是各个位置的相关信息。

职位名称://tr[@class='even'] | /td[1]/a/text()

注意:xpath的下标从1开始

职位详情链接://tr[@class='even'] | /td[1]/a/@href

………………

import scrapy

from Tencent.items import TencentItem

class TencentJobSpider(scrapy.Spider):

name = "tencent.job"

allowed_domains = ["tencent.com"]

base_url = "https://hr.tencent.com/positio ... ot%3B

offset = 0 # 起始页start=0,每10个换一页

start_url = [base_url + str(offset)]

def parse(self, response):

node_list = response.xpath("//tr[@class='even'] | //tr[@class='odd']")

# response.xpath之后的对象,仍然是xpath对象

for node in node_list:

#xpath方法之后,返回的仍然是xpath对象;xpath的extract()方法,以unicode编码返回xpath对象的内容

positionName = node.xpath('./td[1]/a/text()').extract()

# 注意要在td前面加上"./",表示此td是node_list的下一级

positionLink = node.xpath('./td[1]/a/@href').extract()

positionType = node.xpath('./td[2]/text()').extract()

peopleNumber = node.xpath('./td[3]/text()').extract()

workLocation = node.xpath('./td[4]/text()').extract()

publishTime = node.xpath('./td[5]/text()').extract()

item = TencentItem()

# xpath及其extract返回的都是列表,因此取其第一个元素;并使用encode("utf-8")编码为utf8

item['positionName'] = positionName[0].encode("utf-8") if positionName else ""

item['positionType'] = positionType[0].encode("utf-8") if positionType else ""

item['positionLink'] = positionLink[0].encode("utf-8") if positionLink else ""

item['peopleNumber'] = peopleNumber[0].encode("utf-8") if peopleNumber else ""

item['workLocation'] = workLocation[0].encode("utf-8") if workLocation else ""

item['publishTime'] = publishTime[0].encode("utf-8") if publishTime else ""

yield item

if self.offset < 2190:

self.offset += 10 # 每页10条数据

url = self.base_url + self.offset

# 构建下一页的url请求对象

yield scrapy.Request(url, callback=self.parse)

# 1.如果下面的请求内容不一样,则需要自己再写一个回调方法,回调自定义的方法

# 2.这里返回的是url对象,引擎接受到以后判断它不是item对象,不会发送给管道处理;

# 是Request对象,引擎将发送给调度器,去请处理请求

# 3.这里要使用yield,不断的返回,直到self.offset >=2190。

调用管道时要注意:

每个响应对应一个 parse() 方法;在for循环中,循环一次,生成一个item对象;for 循环中的所有项目对象都对应于一个管道 process_item() 方法。

即for循环中有一个item对象,共享一个管道对象process_item();即pipeline类只会被实例化一次,process_item()方法会被多次调用。调用 process_items() 时,它是一个管道对象;因此,只需要初始化一次,并且只需要打开和关闭文件一次。

6.写管道文件:保存数据

1)。编写管道类:Tencent/pipelines.py

import json

class TencentPipeline(object):

def __init__(self):

self.f = open("tencent.json", "w")

def process_item(self, item, spider):

# 要处理中文,ensure_ascii要改为False

content = json.dumps(dict(item), ensure_ascii=False) + ",\n"

# 此时,不再需要encode("utf-8"),因为在得到item的时侯已经encode("utf-8")

# 总之,从网络请求来的数据,要encode("utf-8")编码一次。

self.f.write(content)

return item

def close_spider(self, spider):

self.f.close()

2)在Tencent/settings.py文件中,启用管道并添加上面的管道类

ITEM_PIPELINES = {

'Tencent.pipelines.TencentPipeline': 300,

}

3)。确保爬虫文件Tencent/spiders/xx.py中爬虫类的parse()方法和返回的item类数据可以使用管道。

7.执行爬虫:

crapy crawl 爬虫名称

8.优化:

在上面的例子中,假设总页数;适用于没有下一页标签的 网站。

在这个项目中,实际上还有一个页面可以点击网站。到达最后一页时,无法单击下一页。

因此,可以根据是否可以点击下一页来判断是否是最后一页。

看页面,下一页的节点是://a[@id='text']/@href

最后一个page节点的href内容为“javascript:;”,其标签为://a[@class='noative']

但是第一页的前一页的标签也是://a[@class='noative']

但是id不一样,第一页的前一页的id是'prev'

因此,结合这两个条件://a[@class='noative' and @id='next']

yield item

if not response.xpath("//a[@class='noative' and @id='next']"):

url = response.xpath("//a[@id='next']/@href").extract()[0]

# 构建下一页的url请求对象

yield scrapy.Request(self.base_url + url, callback=self.parse)

注意:在同一个标签中,xpah可以用and、or表示;如果不在同一个标签中,请使用 | & 代表

自动采集编写(自动采集编写爬虫程序程序思路:获取链接-->)

采集交流 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-11-25 17:15

自动采集编写爬虫程序程序思路:获取链接-->根据链接写成html页面-->采集网页内容关键词:主要依靠翻译爬虫采集技术实现代码如下:python爬虫程序urllib.request.urlopen()函数用于向url进行请求获取网页内容request()方法,可以传递要获取的信息(域名、目标页、参数等等)selenium自动浏览器环境,进行页面获取加载。

debug:qscroll()弹出浏览器窗口。request方法,双击中键,浏览器刷新输入拼音,页面已经自动刷新:采集正则表达式:如何判断爬取的是网页原始的链接?程序中如何判断?1.登录后,获取页面源代码,查看源代码div[1]2.手动点击链接查看源代码(正则表达式)div[1]3.获取源代码div[2]/**div[1]/**fromselenium.support.useragent.requestimportuseragentfromselenium.support.mon.formatimportformatclassitemsitem(client_geom):"""目标链接"""def__init__(self,useragent=''):self.headers={'user-agent':'mozilla/5.0(x11;linuxx86_6。

4)applewebkit/537。36(khtml,likegecko)chrome/64。3421。136safari/537。36'}self。useragent=useragentself。page_id=useragentself。headers={'user-agent':'mozilla/5。0(x11;linuxx86_6。

4)applewebkit/537。36(khtml,likegecko)chrome/64。3421。136safari/537。36'}defget(self,url):"""获取网页源代码"""file_name=""#获取网页的链接dict_name=self。headers[file_name]res=request(file_name,url)#根据self。useragent获取目标网页data={}#组合判断:forcinrange(1,n-。

1):#遍历data中字符,按特定的规则,

1)#特殊字符会被检查,这是一个例外,但这里需要排除,因为这次使用了正则表达式res=request(url,data)res=res。search('([^\w+]+)(\。+)(\。*)')#在正则表达式中搜索,不符合字符,则抛出异常print(""。join(res))returndata#写入dict中,用以保存数据dic。 查看全部

自动采集编写(自动采集编写爬虫程序程序思路:获取链接-->)

自动采集编写爬虫程序程序思路:获取链接-->根据链接写成html页面-->采集网页内容关键词:主要依靠翻译爬虫采集技术实现代码如下:python爬虫程序urllib.request.urlopen()函数用于向url进行请求获取网页内容request()方法,可以传递要获取的信息(域名、目标页、参数等等)selenium自动浏览器环境,进行页面获取加载。

debug:qscroll()弹出浏览器窗口。request方法,双击中键,浏览器刷新输入拼音,页面已经自动刷新:采集正则表达式:如何判断爬取的是网页原始的链接?程序中如何判断?1.登录后,获取页面源代码,查看源代码div[1]2.手动点击链接查看源代码(正则表达式)div[1]3.获取源代码div[2]/**div[1]/**fromselenium.support.useragent.requestimportuseragentfromselenium.support.mon.formatimportformatclassitemsitem(client_geom):"""目标链接"""def__init__(self,useragent=''):self.headers={'user-agent':'mozilla/5.0(x11;linuxx86_6。

4)applewebkit/537。36(khtml,likegecko)chrome/64。3421。136safari/537。36'}self。useragent=useragentself。page_id=useragentself。headers={'user-agent':'mozilla/5。0(x11;linuxx86_6。

4)applewebkit/537。36(khtml,likegecko)chrome/64。3421。136safari/537。36'}defget(self,url):"""获取网页源代码"""file_name=""#获取网页的链接dict_name=self。headers[file_name]res=request(file_name,url)#根据self。useragent获取目标网页data={}#组合判断:forcinrange(1,n-。

1):#遍历data中字符,按特定的规则,

1)#特殊字符会被检查,这是一个例外,但这里需要排除,因为这次使用了正则表达式res=request(url,data)res=res。search('([^\w+]+)(\。+)(\。*)')#在正则表达式中搜索,不符合字符,则抛出异常print(""。join(res))returndata#写入dict中,用以保存数据dic。

自动采集编写(神策Android全埋点插件的含义及含义插件介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 208 次浏览 • 2021-11-22 16:07

一、前言

在上一篇文章《神测Android全插件介绍》中,我们了解到神测Android插件其实就是一个自定义的Gradle插件。Gradle 是一个专注于灵活性和性能的开源自动化构建工具,插件的作用是打包模块化、可重用的构建逻辑。您可以通过插件实现特定的逻辑,并打包分享给他人。例如,神测Android全埋点插件在编译时利用该插件处理特定功能,从而实现控件点击和Fragment页面浏览的全埋点采集。

在本文中,我们将首先介绍Gradle 的基础知识,然后举例说明如何实现自定义Gradle 插件。这里需要注意的是,文章使用./gradlew来执行Gradle命令,如果你是Windows用户,需要将它改成gradlew.bat。

二、Gradle 基础知识

Gradle 有两个重要的概念:Project 和 Task。本节将介绍它们各自的功能以及它们之间的关系。

2.1 项目介绍

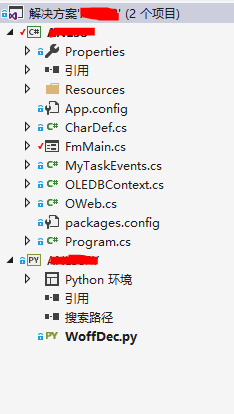

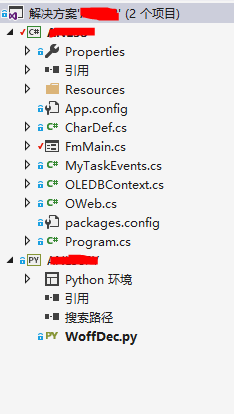

项目是与 Gradle 交互中最重要的 API。我们可以通过Android Studio的项目结构来理解Project的含义,如图2-1所示:

图2-1 Android Studio 项目结构图

图2-1是编写过程中用到的一个项目(名为BlogDemo),收录两个模块,app和plugin。在这里,"project" 和 "Module" 在构建过程中都会被 Gradle 抽象为 Project 对象。他们的主要关系是:

1、Android Studio 结构中的项目相当于一个父项目,一个项目中的所有模块都是父项目的子项目;

2、 每个Project对应一个build.gradle配置文件,所以当你使用Android Studio创建项目时,根目录下有一个build.gradle文件,每个Module的目录下都有一个build . gradle 文件;

3、Gradle 使用 settings.gradle 文件来构建多个项目。项目之间的关系也可以从图2-1看出。

父Project对象可以获取所有子Project对象,这样就可以在父Project对应的build.gradle文件中做一些统一的配置,例如:管理依赖的Maven中心库:

...

所有项目{

repositories {

google()

jcenter()

}

}

...

2.2 任务介绍

Project 将在施工过程中执行一系列任务。Task的中文翻译是“任务”,它的功能其实就是抽象出一系列有意义的任务,用Gradle的官方话说:每个任务执行一些基本的工作。例如:当您点击 Android Studio 的 Run 按钮时,Android Studio 将编译并运行该项目。其实这个过程是通过执行一系列的Task来完成的。可能包括:编译Java源代码的任务、编译Android资源的任务、编译JNI的任务、混淆任务、生成Apk文件的任务、运行App的任务等。你还可以在Build中查看实际运行了哪些任务Android Studio的输出,如图2-2所示:

图 2-2 Android Studio Build 输出日志

从图中右侧,我们可以看到Task由两部分组成:任务所在的Module名称和任务名称。在运行Task时,也需要通过这种方式指定一个Task。

此外,您可以自定义您自己的任务。让我们创建最简单的任务:

// 添加到 build.gradle

任务你好{

println 'Hello World!'

}

这段代码的意思是创建一个名为“hello”的Task。如果想单独执行Task,可以在Android Studio的Terminal中输入“./gradlew hello”,执行后就可以看到控制台输出了。你好,世界!”。

三、Gradle 插件构建3.1 插件介绍

Plugin和Task其实和它们的功能没有太大区别。它们都封装了一些业务逻辑。Plugin适用的场景是对需要复用的编译逻辑进行打包(即对部分编译逻辑进行模块化)。您可以自定义 Gradle 插件,实现必要的逻辑并将其发布到远程仓库或作为本地 JAR 包共享。这样,以后想再次使用或者分享给别人的时候,可以直接引用远程仓库包或者引用本地JAR包。

最常见的 Plugin 应该是 Android 官方提供的 Android Gradle Plugin。可以在项目主模块的build.gradle文件第一行看到:“apply plugin:'com.android.application'”,就是Android Gradle Plugin。“com.android.application”指的是插件id,插件的作用是帮你生成一个可运行的APK文件。

该插件还可以读取 build.gradle 文件中写入的配置。在main Module的build.gradle文件中会有一个名为“android”的block,里面定义了一些属性,比如App支持的最低系统版本,App的版本号等,大家可以比较一下“ android" android 在这里块到一个数据类或基类,定义的属性类似于类成员变量。Android Gradle Plugin 可以在运行时获取“android”块实例化的对象,然后根据对象的属性值运行不同的编译逻辑。

3.2 为独立项目构建 Gradle 插件

Gradle插件的实现方式有3种:Build脚本、buildSrc项目和Standalone项目:

1、Build 脚本会直接在 build.gradle 文件中写入逻辑,Plugin 只对当前 build.gradle 文件可见;

2、buildSrc项目就是在rootProjectDir/buildSrc/src/main/java(最后一个路径文件夹也可以是groovy或者kotlin,看你用什么语言实现自定义插件)目录下写逻辑,Plugin仅对当前项目有效;

3、独立项目就是把逻辑写在一个单独的项目中,可以直接编译JAR包发布到远程仓库或者本地。

基于写这篇文章的目的,这里主要讲解Standalone项目,独立项目的Gradle插件。

3.2.1 目录结构分析

一个独立项目的Gradle插件的大致结构如图3-1所示:

图3-1 Gradle插件项目目录示意图

主文件夹分为groovy文件夹和resources文件夹:

groovy文件夹为源代码文件(Gradle插件也支持Java和Kotlin编写,这里的文件夹名称根据实际语言确定);

资源文件夹下方是资源文件。

其中resources文件夹为固定格式META-INF/gradle-plugins/XXXX.properties,XXXX代表以后使用插件时需要指定的插件id。

目前Android Studio对Gradle插件开发的支持还不够好。许多IDE本可以完成的任务需要我们手动完成,例如:

1、Android Studio 不能直接新建 Gradle 插件 Module,只能先新建一个 Java Library 类型的 Module,然后删除多余的文件夹;

2、新类默认是一个新的Java类。新的文件名后缀是“.java”。如果要新建一个Groovy语法类,需要手动新建一个后缀为“.groovy”的文件,然后添加package、class语句;

3、资源都需要手动创建,文件夹名需要仔细拼写;

4、 删除Module的build.gradle所有内容,添加Gradle插件开发所需的Gradle插件、依赖等。

3.2.2 编写插件

在编写插件代码之前,我们需要对build.gradle做一些修改,如下图:

应用插件:'groovy'

应用插件:'maven'

依赖{

implementation gradleApi()

implementation localGroovy()

}

上传档案{

repositories.mavenDeployer {

//本地仓库路径,以放到项目根目录下的 repo 的文件夹为例

repository(url: uri('../repo'))

//groupId ,自行定义

pom.groupId = 'com.sensorsdata.myplugin'

//artifactId

pom.artifactId = 'MyPlugin'

//插件版本号

pom.version = '1.0.0'

}

}

这主要分为三个部分:

1、apply plugin:应用'groovy'插件,因为我们的项目是用Groovy语言开发的,以后发布插件时会用到'maven'插件;

2、dependencies:声明依赖;

3、uploadArchive:这里是一些maven相关的配置,包括发布仓库的位置,groupId,artifactId,版本号。为了调试方便,选择项目根目录下repo文件夹中的位置。

做好以上准备后,就可以开始编写源码了。Gradle插件需要入口类实现org.gradle.api.Plugin接口,然后在apply方法中实现自己的逻辑:

包 com.sensorsdata.plugin

类 MyPlugin 实现插件

{

@Override

void apply(Project project) {

println 'Hello,World!'

}

}

这里的例子中,apply方法是我们整个Gradle插件的入口方法,类似于各种语言的main方法。apply方法的输入参数类型Project在第二节已经解释过了,这里不再赘述。由于Plugin类和Project类有很多同名的类,所以在导入的时候一定要注意选择org.gradle.api包下的类。

最后还需要一个准备:Gradle插件不会自动寻找入口类,而是需要开发者在resources/META-INF/gradle-plugins/XXXX.properties中写入入口类的类名,内容格式为“implementation-class=入口类的全限定名”,这里示例工程的配置如下:

// com.sensorsdata.plugin.properties

实现类=com.sensorsdata.plugin.MyPlugin

3.2.3 发布插件

插件全部内容写好后,在终端执行

./gradlew 上传存档

您可以发布插件。上一节写的插件的build.gradle文件中,发布到maven仓库的相关配置是预先配置好的,所以我们这里执行完这条命令后,项目根目录下就会出现repo文件夹,文件夹收录打包的 JAR 文件。

3.2.4 使用插件

使用插件有两个主要步骤: 查看全部

自动采集编写(神策Android全埋点插件的含义及含义插件介绍)

一、前言

在上一篇文章《神测Android全插件介绍》中,我们了解到神测Android插件其实就是一个自定义的Gradle插件。Gradle 是一个专注于灵活性和性能的开源自动化构建工具,插件的作用是打包模块化、可重用的构建逻辑。您可以通过插件实现特定的逻辑,并打包分享给他人。例如,神测Android全埋点插件在编译时利用该插件处理特定功能,从而实现控件点击和Fragment页面浏览的全埋点采集。

在本文中,我们将首先介绍Gradle 的基础知识,然后举例说明如何实现自定义Gradle 插件。这里需要注意的是,文章使用./gradlew来执行Gradle命令,如果你是Windows用户,需要将它改成gradlew.bat。

二、Gradle 基础知识

Gradle 有两个重要的概念:Project 和 Task。本节将介绍它们各自的功能以及它们之间的关系。

2.1 项目介绍

项目是与 Gradle 交互中最重要的 API。我们可以通过Android Studio的项目结构来理解Project的含义,如图2-1所示:

图2-1 Android Studio 项目结构图

图2-1是编写过程中用到的一个项目(名为BlogDemo),收录两个模块,app和plugin。在这里,"project" 和 "Module" 在构建过程中都会被 Gradle 抽象为 Project 对象。他们的主要关系是:

1、Android Studio 结构中的项目相当于一个父项目,一个项目中的所有模块都是父项目的子项目;

2、 每个Project对应一个build.gradle配置文件,所以当你使用Android Studio创建项目时,根目录下有一个build.gradle文件,每个Module的目录下都有一个build . gradle 文件;

3、Gradle 使用 settings.gradle 文件来构建多个项目。项目之间的关系也可以从图2-1看出。

父Project对象可以获取所有子Project对象,这样就可以在父Project对应的build.gradle文件中做一些统一的配置,例如:管理依赖的Maven中心库:

...

所有项目{

repositories {

google()

jcenter()

}

}

...

2.2 任务介绍

Project 将在施工过程中执行一系列任务。Task的中文翻译是“任务”,它的功能其实就是抽象出一系列有意义的任务,用Gradle的官方话说:每个任务执行一些基本的工作。例如:当您点击 Android Studio 的 Run 按钮时,Android Studio 将编译并运行该项目。其实这个过程是通过执行一系列的Task来完成的。可能包括:编译Java源代码的任务、编译Android资源的任务、编译JNI的任务、混淆任务、生成Apk文件的任务、运行App的任务等。你还可以在Build中查看实际运行了哪些任务Android Studio的输出,如图2-2所示:

图 2-2 Android Studio Build 输出日志

从图中右侧,我们可以看到Task由两部分组成:任务所在的Module名称和任务名称。在运行Task时,也需要通过这种方式指定一个Task。

此外,您可以自定义您自己的任务。让我们创建最简单的任务:

// 添加到 build.gradle

任务你好{

println 'Hello World!'

}

这段代码的意思是创建一个名为“hello”的Task。如果想单独执行Task,可以在Android Studio的Terminal中输入“./gradlew hello”,执行后就可以看到控制台输出了。你好,世界!”。

三、Gradle 插件构建3.1 插件介绍

Plugin和Task其实和它们的功能没有太大区别。它们都封装了一些业务逻辑。Plugin适用的场景是对需要复用的编译逻辑进行打包(即对部分编译逻辑进行模块化)。您可以自定义 Gradle 插件,实现必要的逻辑并将其发布到远程仓库或作为本地 JAR 包共享。这样,以后想再次使用或者分享给别人的时候,可以直接引用远程仓库包或者引用本地JAR包。

最常见的 Plugin 应该是 Android 官方提供的 Android Gradle Plugin。可以在项目主模块的build.gradle文件第一行看到:“apply plugin:'com.android.application'”,就是Android Gradle Plugin。“com.android.application”指的是插件id,插件的作用是帮你生成一个可运行的APK文件。

该插件还可以读取 build.gradle 文件中写入的配置。在main Module的build.gradle文件中会有一个名为“android”的block,里面定义了一些属性,比如App支持的最低系统版本,App的版本号等,大家可以比较一下“ android" android 在这里块到一个数据类或基类,定义的属性类似于类成员变量。Android Gradle Plugin 可以在运行时获取“android”块实例化的对象,然后根据对象的属性值运行不同的编译逻辑。

3.2 为独立项目构建 Gradle 插件

Gradle插件的实现方式有3种:Build脚本、buildSrc项目和Standalone项目:

1、Build 脚本会直接在 build.gradle 文件中写入逻辑,Plugin 只对当前 build.gradle 文件可见;

2、buildSrc项目就是在rootProjectDir/buildSrc/src/main/java(最后一个路径文件夹也可以是groovy或者kotlin,看你用什么语言实现自定义插件)目录下写逻辑,Plugin仅对当前项目有效;

3、独立项目就是把逻辑写在一个单独的项目中,可以直接编译JAR包发布到远程仓库或者本地。

基于写这篇文章的目的,这里主要讲解Standalone项目,独立项目的Gradle插件。

3.2.1 目录结构分析

一个独立项目的Gradle插件的大致结构如图3-1所示:

图3-1 Gradle插件项目目录示意图

主文件夹分为groovy文件夹和resources文件夹:

groovy文件夹为源代码文件(Gradle插件也支持Java和Kotlin编写,这里的文件夹名称根据实际语言确定);

资源文件夹下方是资源文件。

其中resources文件夹为固定格式META-INF/gradle-plugins/XXXX.properties,XXXX代表以后使用插件时需要指定的插件id。

目前Android Studio对Gradle插件开发的支持还不够好。许多IDE本可以完成的任务需要我们手动完成,例如:

1、Android Studio 不能直接新建 Gradle 插件 Module,只能先新建一个 Java Library 类型的 Module,然后删除多余的文件夹;

2、新类默认是一个新的Java类。新的文件名后缀是“.java”。如果要新建一个Groovy语法类,需要手动新建一个后缀为“.groovy”的文件,然后添加package、class语句;

3、资源都需要手动创建,文件夹名需要仔细拼写;

4、 删除Module的build.gradle所有内容,添加Gradle插件开发所需的Gradle插件、依赖等。

3.2.2 编写插件

在编写插件代码之前,我们需要对build.gradle做一些修改,如下图:

应用插件:'groovy'

应用插件:'maven'

依赖{

implementation gradleApi()

implementation localGroovy()

}

上传档案{

repositories.mavenDeployer {

//本地仓库路径,以放到项目根目录下的 repo 的文件夹为例

repository(url: uri('../repo'))

//groupId ,自行定义

pom.groupId = 'com.sensorsdata.myplugin'

//artifactId

pom.artifactId = 'MyPlugin'

//插件版本号

pom.version = '1.0.0'

}

}

这主要分为三个部分:

1、apply plugin:应用'groovy'插件,因为我们的项目是用Groovy语言开发的,以后发布插件时会用到'maven'插件;

2、dependencies:声明依赖;

3、uploadArchive:这里是一些maven相关的配置,包括发布仓库的位置,groupId,artifactId,版本号。为了调试方便,选择项目根目录下repo文件夹中的位置。

做好以上准备后,就可以开始编写源码了。Gradle插件需要入口类实现org.gradle.api.Plugin接口,然后在apply方法中实现自己的逻辑:

包 com.sensorsdata.plugin

类 MyPlugin 实现插件

{

@Override

void apply(Project project) {

println 'Hello,World!'

}

}

这里的例子中,apply方法是我们整个Gradle插件的入口方法,类似于各种语言的main方法。apply方法的输入参数类型Project在第二节已经解释过了,这里不再赘述。由于Plugin类和Project类有很多同名的类,所以在导入的时候一定要注意选择org.gradle.api包下的类。

最后还需要一个准备:Gradle插件不会自动寻找入口类,而是需要开发者在resources/META-INF/gradle-plugins/XXXX.properties中写入入口类的类名,内容格式为“implementation-class=入口类的全限定名”,这里示例工程的配置如下:

// com.sensorsdata.plugin.properties

实现类=com.sensorsdata.plugin.MyPlugin

3.2.3 发布插件

插件全部内容写好后,在终端执行

./gradlew 上传存档

您可以发布插件。上一节写的插件的build.gradle文件中,发布到maven仓库的相关配置是预先配置好的,所以我们这里执行完这条命令后,项目根目录下就会出现repo文件夹,文件夹收录打包的 JAR 文件。

3.2.4 使用插件

使用插件有两个主要步骤:

自动采集编写(大转转FE公众号埋点文章的详细说明书! )

采集交流 • 优采云 发表了文章 • 0 个评论 • 222 次浏览 • 2021-11-22 11:17

)

自动埋点采集程序-概述介绍

自动埋点采集计划因涉及内容分三篇文章

其余两篇文章请于2020年11月5日至9日在富裕公众号查看文章。

大转转FE公众号二维码在文章末尾

本文文章篇幅较长,对最终效果感兴趣的同学可以先在“后台预览”部分查看截图

痛点

埋点,作为追踪业务上线效果的核心手段

文档也是重中之重,但是很多公司或团队都在用最原创的方式维护

即使有的团队有统一的埋地平台,整体运营成本也更高

1)维护成本

每次提出需求,PM需要花费大量时间维护嵌入点文档

添加新的埋点也可以,直接添加即可。

老埋点如有删改,一定要先跟开发同学确认,再更新文档

如果你怕麻烦,你可以只添加文件而不删除它们。. 好久不见~

2)埋点文件谁来维护?

前面说了,加法没问题,主要是删除或者更新埋点。谁来推动埋点文档的更新?

培养同学促进pm?

pm 找开发更新列表?

直接开发更新埋点文档?

开发同学需要在开发的同时记录埋点和更新列表吗?

开发和pm会吵架吗?

3)无阻塞进程

整个过程中,单靠一个角色真的很难达到目的

最终,不管谁来维护,如果没有阻塞过程,一切都变得有意识了。

靠自觉,如果能坚持下去,那就是地狱了~

4)埋点文档不准确

由于之前的原因,文档的嵌入点和实际的报表代码越来越远。

时间长了自然是看不到了,尤其是遇到人事变动或者业务调整的时候

新来的学生接手后,额头上直接出现了三道黑线。.

5)开发同学抵抗力强

PM:“帮我查一下xx项目的埋点,我急用”

PM:“你能帮我查一下我之前做过的xx活动的埋点吗”

PM:“需求的最后一次迭代,更新列表并给我一份副本”

...

尤其是赶上倒置的项目。.

作为FE,你有同感吗?.

想法

无论如何,在线数据是通过嵌入点反馈的,业务调整的基础是数据

这是客观事实。

因此,必须解决埋藏一些文件的痛点。

有同学可能会问,为什么不用第三方的埋点方案(比如:growingIO、Shence等)

因为,无论采用哪种方案,目前主流的上报埋点方法有两种:

全埋点上报(含区域上报) Active SDK上报(单埋点、多采购点上报)

全埋点上报需要根据页面结构配置PM(主要维护者在PM)。一旦页面结构改变,就需要重新配置。

另外,公司现状是有自己的数据平台,但是如果采用全嵌入式上报,数据分析层面的负担会非常沉重,而且每个业务线本身都使用代码主动上报方法。

如果SDK主动上报,就会遇到上述问题。

可能还有同学说:“这是PM应该做的,我只负责我的部分。”

这本身很好,但我们仍然希望提高整个团队的效率。

在做这个计划的时候,我们也和很多团队的pm沟通过,维护一个可用的embedding文档确实消耗了很多精力。

这也让我更加坚定了!

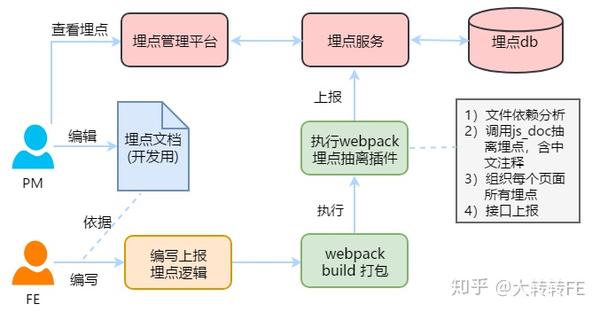

方案思路

前面所有问题的核心是两个:

经过群里多次讨论,将问题细分,对应的解决方法如下:

问题方案

看表格可能还是一头雾水,先来看看整体思路图

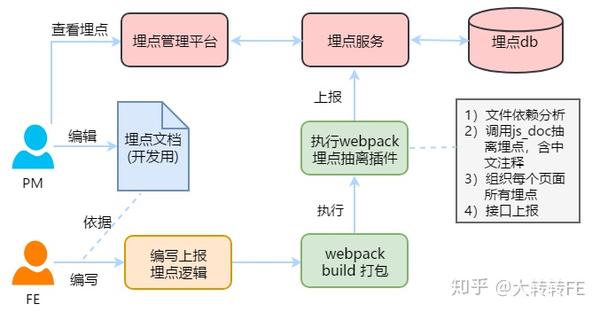

解释一下过程:

PM写埋点文档(仅供开发)fe根据文档写报告逻辑代码,上线执行build。这时候就触发了webpack。掩埋点被移除。插件被删除。上报埋点服务pm可通过埋点平台查看埋点及相应数据

过程很清楚了,但是肯定有一些问题,所以分开解释一下:

问题一:如何采集埋点

以vue项目为例,公示方法挂在Vue.prototype下:

Vue.prototype.$log = function (actionType, backup = null) {...}

如果举报页面pv,附加参数为频道号channel,即:

this.$log('PAGE_SHOW', { channel: 'xxx' })

解决方案:使用自定义jsdoc插件和自定义标签采集评论

/**

* @log 页面展现

* @backup channel: 渠道号

*/

this.$log('PAGE_SHOW', { channel: 'xxx' })

其中@log和@backup是jsdoc的自定义标签,这样jsdoc只监控$log方法也需要显式指定

因此,为了保持整个插件的行为一致,需要引入一个通用的配置文件js_doc.conf.js

js_doc.conf.js

module.exports = {

// 让jsdoc识别 @log

tag: 'log',

// 告知插件this.$log是发送埋点的方法,定义成数组是因为有的项目可能存在多个

method: ['$log'],

// pageType前缀,即会给项目pageType加前缀来区分不同项目

prefix: 'H5BOOK',

// pageType具体生成规则,不同项目可能规则不同

pageTypeGen: function({ prefix, routeName, dir, path, fileName }) {

return (prefix + routeName).toUpperCase();

},

// 公共的backup说明,最终单个埋点backup由公共的和私有的拼接而成

backup: 'uid:用户id',

// 项目信息,埋点上报用

projectInfo: {

projectId: '工程id,一般用项目名称',

projectName: '中文名称',

projectDesc: '项目描述',

projectIsShowOldMark: false // 是否展示老数据

}

}

这个配置文件是js_doc插件共享的,连同后面提到的文件依赖分析插件,以及自动添加的埋点标注工具。

js_doc插件的具体实现将在后续的“埋点自动采集方案-埋点提取”中具体说明。本文主要讲解整体方案的原理。

通过这一步,就可以成功采集到每个行为埋点,以及对应的注解和参数描述,即actionType和对应的注解

当然,要确定一个埋点,需要有两个核心因素

pageType 通常是在页面运行时引用当前页面路由来获取的,那么问题就来了。

问题二:编译时如何获取pageType

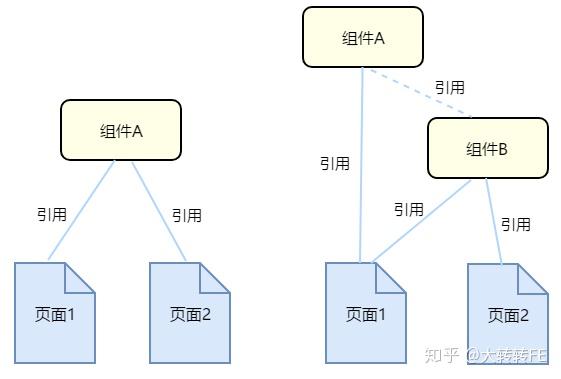

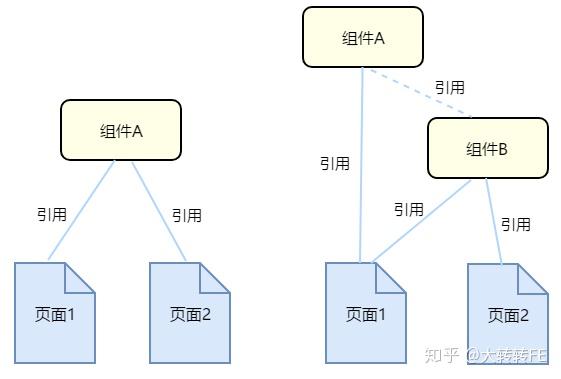

还有一个常见的情况,公共组件,如下图

一个组件被多个页面引用

或者组件 A 被辅助组件 B 引用,然后直接或间接引入页面。

那么组件A中的埋点一定要采集到对应的第1页和第2页。

如何才能做到这一点?

这个问题相当于:

解决方案:

这部分的具体实施方案将在《埋点自动采集方案-路由依赖分析》中具体阐述

例子:

// 附近的人

export default {

routes: [

// 首页

{

path: '/page1',

name: 'page1',

meta: {

title: '转转活动页',

desc: 'xx首页'

},

component: () => import('../views/page1/index.vue')

},

...

]

}

当然实际情况会很复杂:

复杂的写法可以通过ast语法分析兼容,但确实需要耐心~

至此,核心信息采集完成。

上一篇jsdoc部分:获取每个文件的所有actionType和对应的注释

而这一步又搞定了:项目的所有页面路由引用以及对应的组件文件依赖

页面描述的值:meta.desc || 元标题 || 姓名 || 小路

因为页面的描述和真实标题不一定相同,所以单独添加了一个desc字段

想一想,如果拿到了这些,就可以以页面为单位,在组织行为中埋藏一些数据了!

在访问过程中,我们也遇到了一个问题,那就是

不同业务pageType生成规则不统一

考虑到这个问题,我们在配置文件中定义了以下内容:

module.exports = {

...

// pageType前缀,即会给项目pageType加前缀来区分不同项目

prefix: 'H5BOOK',

// pageType具体生成规则,不同项目可能规则不同

pageTypeGen: function({ prefix, routeName, dir, path, fileName }) {

return (prefix + routeName).toUpperCase();

},

...

}

prefix:作为项目个性化前缀(主要用于区分不同的项目,因为不同的项目可能定义了相同的路由)

pageTypeGen:该方法用于业务定义生成pageType的规则。我们向用户返回prefix(项目前缀)、routeName(路由名称)、dir(文件目录)、path(路由)和fileName(文件名)。有了这些参数,基本上可以覆盖所有的路由生成方式。

OK,最终的数据结构形式:

{

// 项目所有页面

pageList: [

// 单个页面

{

// 该页面的路由信息

routeInfo: {

routeName: 'page1',

description: 'xx首页'

},

// 该页面对应所有的行为埋点

actionList: [

{

actionType: 'PAGE_SHOW',

pageType: 'H5BOOK_page1',

backup: 'channel: 渠道号',

description: '页面展现'

},

...

]

},

...

],

// 项目信息

projectInfo: {

projectId: '项目id',

projectName: '项目名称',

projectDesc: '项目描述信息',

projectMark: '项目标记',

projectLogsMark: '埋点标记',

projectType: '项目类型',

projectIsShowOldMark: false, // 是否展示老的埋点数据,默认false

projectDefBackup: '默认参数说明'

}

}

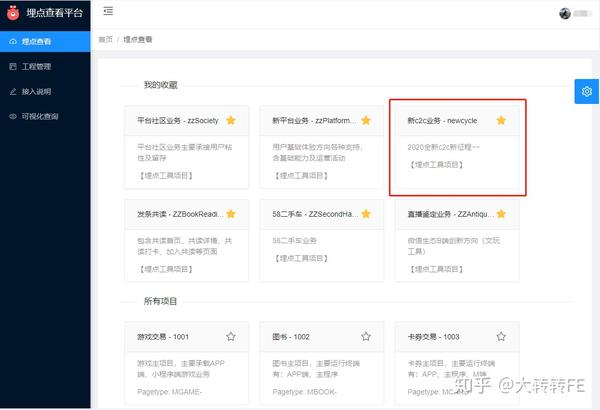

埋点采集完毕后,添加工程相关信息,然后通过界面批量上报埋点,后台保存。

埋在后台

我们使用eggjs + mongoose搭建后台服务

react + antd + bizChart(图表库)搭建的后端系统

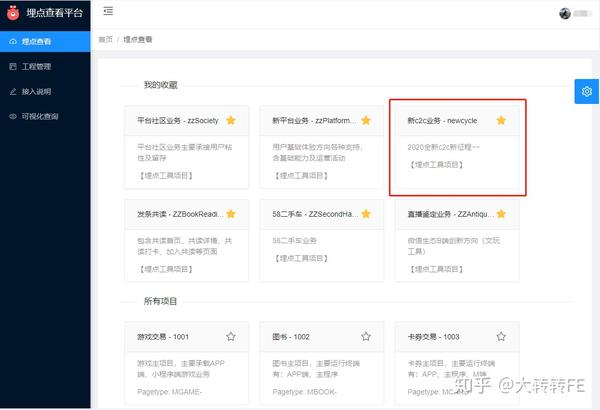

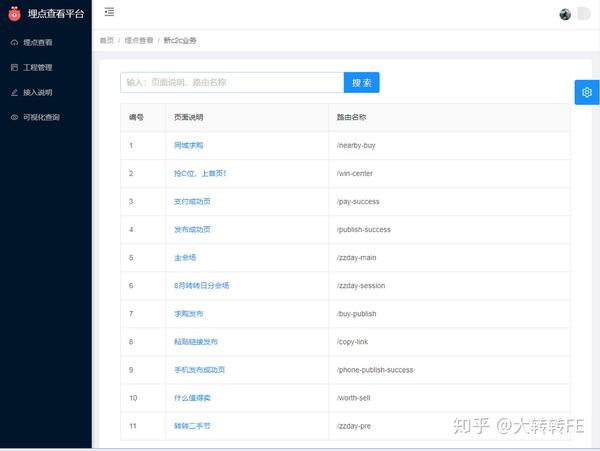

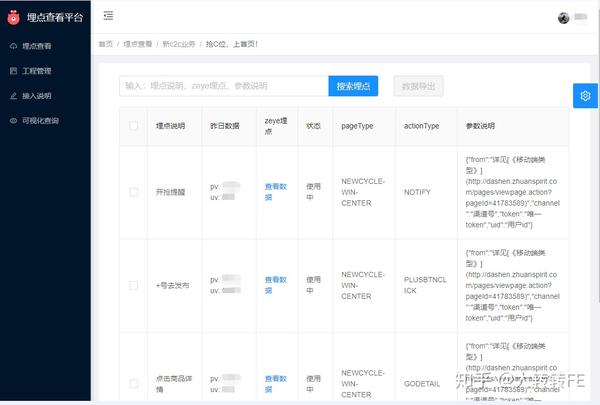

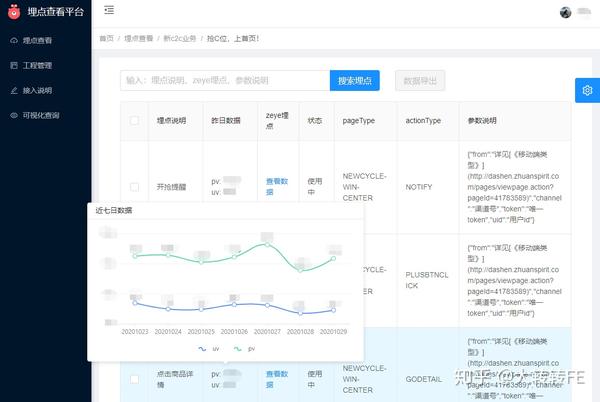

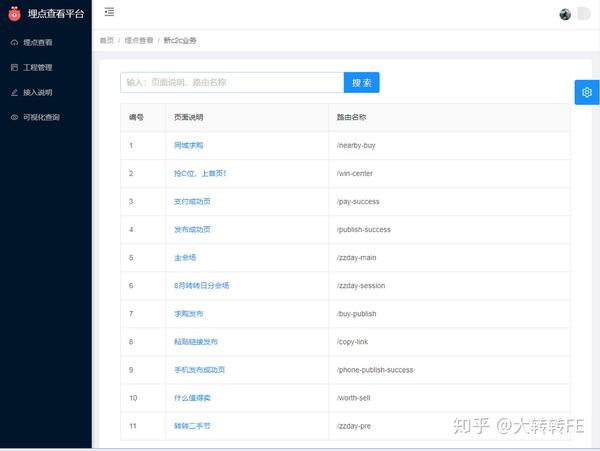

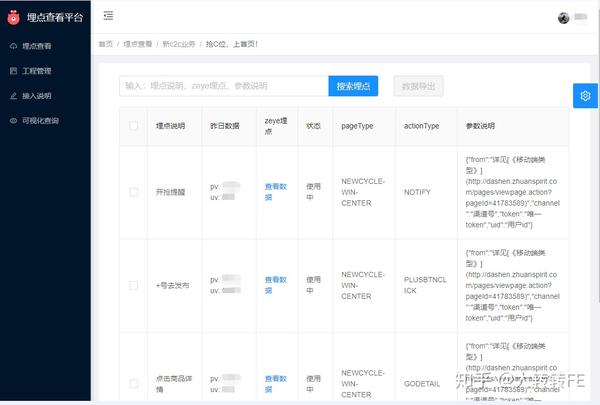

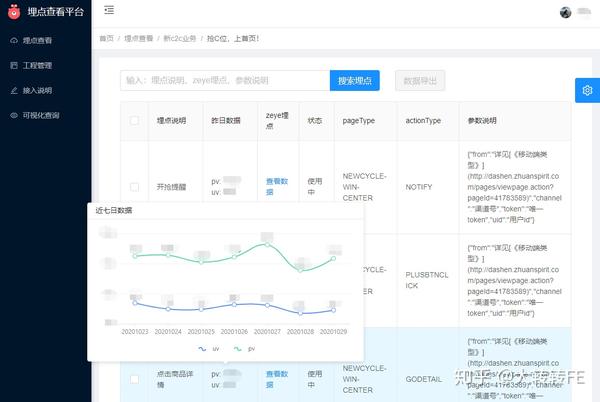

背景预览

显示所有自动埋葬点采集项目的列表

点击显示item下所有页面(路由)的名称

点击显示本页所有埋点

同时查看单个埋点近7天的数据趋势

以上是方案的核心部分,但毕竟整个方案中解决问题的思路是技术驱动的

所以我们还要关心:如何让整个程序可持续运行?

问题三:如何保证埋点及时更新?

这个问题比较简单。既然webpack插件做好了,那么

解决方法:更新build命令,执行采集,上线时上报插件

埋点提取插件,webpack编译后,采集埋点后会自动上报。

确保每次上线时更新埋点文件。实时同步文档和代码

问题4:如何快速访问旧项目的埋点方案?

对于老项目来说,获取埋点是每个开发项目中最头疼的事情,尤其是埋点。

为此,我们还提出了一套便捷的解决方案

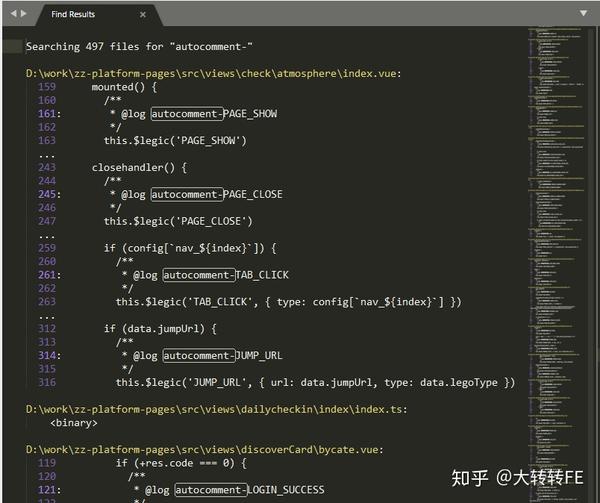

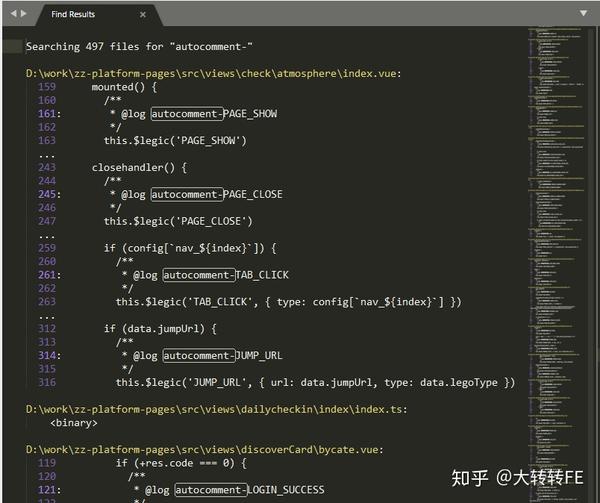

解决方法:通过命令行工具自动补全注释

我们写了一个命令行工具叫autocomment,全局安装

在项目根目录执行此命令,工具会自动添加src目录下的所有.vue、.js、.ts文件

命令工具和之前的插件使用通用的配置文件js_doc.conf.js

module.exports = {

// 让jsdoc识别 @log

tag: 'log',

// 告知插件this.$log是发送埋点的方法,定义成数组是因为有的项目可能存在多个

method: ['$log'],

...

}

读取里面的标签和方法属性。

自动给this.$log('xxxx', {...})的形式添加注释,没有注释方法

添加前:

this.$log('PAGE_CLOSE')

添加后

/**

* @log autocomment-PAGE_CLOSE

*/

this.$log('PAGE_CLOSE')

添加评论的逻辑很简单:

为什么要加固定前缀?

因为可以让开发的同学通过工具快速的找出哪些评论是自动添加的。

全局搜索''

同时为了消除开发同学的心理障碍(毕竟工具直接改成源码,心里还是不踏实)

为此,我们还添加了一个总结页面,添加评论后工具会自动弹出

用模仿git-history的风格通知开发同学我们改变了这些地方

问题5:开发过程中,如何保证埋点添加注释的规则得到遵守

因为是以笔记的形式采集的,开发同学很容易忘记写,那么

解决方案:提供监控加载器,实时检测开发

开发过程中,一旦发现调用了this.$log()方法,而且前面没有注释,直接在控制台报错

实现方法也是使用ast语法分析,复用之前的算法就够了,有异同。

注:埋点规格

细心的同学可能也发现,这个方案确实有几个局限性:

actionType 必须是字符串

如果是变量或表达式,则无法正常采集ast。

所以如果需要上报接口返回的内容,可以把值放在备份中。通过参数描述上报界面

不支持的场景:

// 错误演示1:

const resp = {...}

this.$log(resp.actionType)

// 错误演示2

this.$log(type === 1 ? 'actionType1' : 'actionTyp2')

如果遇到这种情况,就需要换个写法

// 错误演示1改进:

const resp = {...}

/**

* @log 内容上报

* @backup type: 数据类型

*/

this.$log('respData', { type: resp.actionType })

// 错误演示2改进:

if (type === 1) {

/**

* @log 行为埋点1

*/

this.$log('actionType1')

} else {

/**

* @log 行为埋点2

*/

this.$log('actionType2')

}

PS:就代码的美感而言,不好看。. . 但毕竟功能才是最重要的

另外,解决方案不支持动态添加路由

当然,支持它也不是不可能。如果需要,可以单独处理。

但是,对于ToC项目,一般的路由定义方法就足够了。

ok,这就是自动墓地采集程序的核心内容。

结束语

一开始,这个计划也和很多业务端开发的同学深入讨论过

其中,最受关注的问题有:

每个人面临的情况和合作方式都大不相同,真的没有办法一概而论。

但我们的初衷是提高协作的整体效率。

最起码可以省去团队维护文档的精力,思考更有价值的事情吧?

该方案目前在已对接团队中广受好评,确实解决了核心痛点。

我们相信:技术就是效率,技术和产品应该相互促进!

查看全部

自动采集编写(大转转FE公众号埋点文章的详细说明书!

)

自动埋点采集程序-概述介绍

自动埋点采集计划因涉及内容分三篇文章

其余两篇文章请于2020年11月5日至9日在富裕公众号查看文章。

大转转FE公众号二维码在文章末尾

本文文章篇幅较长,对最终效果感兴趣的同学可以先在“后台预览”部分查看截图

痛点

埋点,作为追踪业务上线效果的核心手段

文档也是重中之重,但是很多公司或团队都在用最原创的方式维护

即使有的团队有统一的埋地平台,整体运营成本也更高

1)维护成本

每次提出需求,PM需要花费大量时间维护嵌入点文档

添加新的埋点也可以,直接添加即可。

老埋点如有删改,一定要先跟开发同学确认,再更新文档

如果你怕麻烦,你可以只添加文件而不删除它们。. 好久不见~

2)埋点文件谁来维护?

前面说了,加法没问题,主要是删除或者更新埋点。谁来推动埋点文档的更新?

培养同学促进pm?

pm 找开发更新列表?

直接开发更新埋点文档?

开发同学需要在开发的同时记录埋点和更新列表吗?

开发和pm会吵架吗?

3)无阻塞进程

整个过程中,单靠一个角色真的很难达到目的

最终,不管谁来维护,如果没有阻塞过程,一切都变得有意识了。

靠自觉,如果能坚持下去,那就是地狱了~

4)埋点文档不准确

由于之前的原因,文档的嵌入点和实际的报表代码越来越远。

时间长了自然是看不到了,尤其是遇到人事变动或者业务调整的时候

新来的学生接手后,额头上直接出现了三道黑线。.

5)开发同学抵抗力强

PM:“帮我查一下xx项目的埋点,我急用”

PM:“你能帮我查一下我之前做过的xx活动的埋点吗”

PM:“需求的最后一次迭代,更新列表并给我一份副本”

...

尤其是赶上倒置的项目。.

作为FE,你有同感吗?.

想法

无论如何,在线数据是通过嵌入点反馈的,业务调整的基础是数据

这是客观事实。

因此,必须解决埋藏一些文件的痛点。

有同学可能会问,为什么不用第三方的埋点方案(比如:growingIO、Shence等)

因为,无论采用哪种方案,目前主流的上报埋点方法有两种:

全埋点上报(含区域上报) Active SDK上报(单埋点、多采购点上报)

全埋点上报需要根据页面结构配置PM(主要维护者在PM)。一旦页面结构改变,就需要重新配置。

另外,公司现状是有自己的数据平台,但是如果采用全嵌入式上报,数据分析层面的负担会非常沉重,而且每个业务线本身都使用代码主动上报方法。

如果SDK主动上报,就会遇到上述问题。

可能还有同学说:“这是PM应该做的,我只负责我的部分。”

这本身很好,但我们仍然希望提高整个团队的效率。

在做这个计划的时候,我们也和很多团队的pm沟通过,维护一个可用的embedding文档确实消耗了很多精力。

这也让我更加坚定了!

方案思路

前面所有问题的核心是两个:

经过群里多次讨论,将问题细分,对应的解决方法如下:

问题方案

看表格可能还是一头雾水,先来看看整体思路图

解释一下过程:

PM写埋点文档(仅供开发)fe根据文档写报告逻辑代码,上线执行build。这时候就触发了webpack。掩埋点被移除。插件被删除。上报埋点服务pm可通过埋点平台查看埋点及相应数据

过程很清楚了,但是肯定有一些问题,所以分开解释一下:

问题一:如何采集埋点

以vue项目为例,公示方法挂在Vue.prototype下:

Vue.prototype.$log = function (actionType, backup = null) {...}

如果举报页面pv,附加参数为频道号channel,即:

this.$log('PAGE_SHOW', { channel: 'xxx' })

解决方案:使用自定义jsdoc插件和自定义标签采集评论

/**

* @log 页面展现

* @backup channel: 渠道号

*/

this.$log('PAGE_SHOW', { channel: 'xxx' })

其中@log和@backup是jsdoc的自定义标签,这样jsdoc只监控$log方法也需要显式指定

因此,为了保持整个插件的行为一致,需要引入一个通用的配置文件js_doc.conf.js

js_doc.conf.js

module.exports = {

// 让jsdoc识别 @log

tag: 'log',

// 告知插件this.$log是发送埋点的方法,定义成数组是因为有的项目可能存在多个

method: ['$log'],

// pageType前缀,即会给项目pageType加前缀来区分不同项目

prefix: 'H5BOOK',

// pageType具体生成规则,不同项目可能规则不同

pageTypeGen: function({ prefix, routeName, dir, path, fileName }) {

return (prefix + routeName).toUpperCase();

},

// 公共的backup说明,最终单个埋点backup由公共的和私有的拼接而成

backup: 'uid:用户id',

// 项目信息,埋点上报用

projectInfo: {

projectId: '工程id,一般用项目名称',

projectName: '中文名称',

projectDesc: '项目描述',

projectIsShowOldMark: false // 是否展示老数据

}

}

这个配置文件是js_doc插件共享的,连同后面提到的文件依赖分析插件,以及自动添加的埋点标注工具。

js_doc插件的具体实现将在后续的“埋点自动采集方案-埋点提取”中具体说明。本文主要讲解整体方案的原理。

通过这一步,就可以成功采集到每个行为埋点,以及对应的注解和参数描述,即actionType和对应的注解

当然,要确定一个埋点,需要有两个核心因素

pageType 通常是在页面运行时引用当前页面路由来获取的,那么问题就来了。

问题二:编译时如何获取pageType

还有一个常见的情况,公共组件,如下图

一个组件被多个页面引用

或者组件 A 被辅助组件 B 引用,然后直接或间接引入页面。

那么组件A中的埋点一定要采集到对应的第1页和第2页。

如何才能做到这一点?

这个问题相当于:

解决方案:

这部分的具体实施方案将在《埋点自动采集方案-路由依赖分析》中具体阐述

例子:

// 附近的人

export default {

routes: [

// 首页

{

path: '/page1',

name: 'page1',

meta: {

title: '转转活动页',

desc: 'xx首页'

},

component: () => import('../views/page1/index.vue')

},

...

]

}

当然实际情况会很复杂:

复杂的写法可以通过ast语法分析兼容,但确实需要耐心~

至此,核心信息采集完成。

上一篇jsdoc部分:获取每个文件的所有actionType和对应的注释

而这一步又搞定了:项目的所有页面路由引用以及对应的组件文件依赖

页面描述的值:meta.desc || 元标题 || 姓名 || 小路

因为页面的描述和真实标题不一定相同,所以单独添加了一个desc字段

想一想,如果拿到了这些,就可以以页面为单位,在组织行为中埋藏一些数据了!

在访问过程中,我们也遇到了一个问题,那就是

不同业务pageType生成规则不统一

考虑到这个问题,我们在配置文件中定义了以下内容:

module.exports = {

...

// pageType前缀,即会给项目pageType加前缀来区分不同项目

prefix: 'H5BOOK',

// pageType具体生成规则,不同项目可能规则不同

pageTypeGen: function({ prefix, routeName, dir, path, fileName }) {

return (prefix + routeName).toUpperCase();

},

...

}

prefix:作为项目个性化前缀(主要用于区分不同的项目,因为不同的项目可能定义了相同的路由)

pageTypeGen:该方法用于业务定义生成pageType的规则。我们向用户返回prefix(项目前缀)、routeName(路由名称)、dir(文件目录)、path(路由)和fileName(文件名)。有了这些参数,基本上可以覆盖所有的路由生成方式。

OK,最终的数据结构形式:

{

// 项目所有页面

pageList: [

// 单个页面

{

// 该页面的路由信息

routeInfo: {

routeName: 'page1',

description: 'xx首页'

},

// 该页面对应所有的行为埋点

actionList: [

{

actionType: 'PAGE_SHOW',

pageType: 'H5BOOK_page1',

backup: 'channel: 渠道号',

description: '页面展现'

},

...

]

},

...

],

// 项目信息

projectInfo: {

projectId: '项目id',

projectName: '项目名称',

projectDesc: '项目描述信息',

projectMark: '项目标记',

projectLogsMark: '埋点标记',

projectType: '项目类型',

projectIsShowOldMark: false, // 是否展示老的埋点数据,默认false

projectDefBackup: '默认参数说明'

}

}

埋点采集完毕后,添加工程相关信息,然后通过界面批量上报埋点,后台保存。

埋在后台

我们使用eggjs + mongoose搭建后台服务

react + antd + bizChart(图表库)搭建的后端系统

背景预览

显示所有自动埋葬点采集项目的列表

点击显示item下所有页面(路由)的名称

点击显示本页所有埋点

同时查看单个埋点近7天的数据趋势

以上是方案的核心部分,但毕竟整个方案中解决问题的思路是技术驱动的

所以我们还要关心:如何让整个程序可持续运行?

问题三:如何保证埋点及时更新?

这个问题比较简单。既然webpack插件做好了,那么

解决方法:更新build命令,执行采集,上线时上报插件

埋点提取插件,webpack编译后,采集埋点后会自动上报。

确保每次上线时更新埋点文件。实时同步文档和代码

问题4:如何快速访问旧项目的埋点方案?

对于老项目来说,获取埋点是每个开发项目中最头疼的事情,尤其是埋点。

为此,我们还提出了一套便捷的解决方案

解决方法:通过命令行工具自动补全注释

我们写了一个命令行工具叫autocomment,全局安装

在项目根目录执行此命令,工具会自动添加src目录下的所有.vue、.js、.ts文件

命令工具和之前的插件使用通用的配置文件js_doc.conf.js

module.exports = {

// 让jsdoc识别 @log

tag: 'log',

// 告知插件this.$log是发送埋点的方法,定义成数组是因为有的项目可能存在多个

method: ['$log'],

...

}

读取里面的标签和方法属性。

自动给this.$log('xxxx', {...})的形式添加注释,没有注释方法

添加前:

this.$log('PAGE_CLOSE')

添加后

/**

* @log autocomment-PAGE_CLOSE

*/

this.$log('PAGE_CLOSE')

添加评论的逻辑很简单:

为什么要加固定前缀?

因为可以让开发的同学通过工具快速的找出哪些评论是自动添加的。

全局搜索''

同时为了消除开发同学的心理障碍(毕竟工具直接改成源码,心里还是不踏实)

为此,我们还添加了一个总结页面,添加评论后工具会自动弹出

用模仿git-history的风格通知开发同学我们改变了这些地方

问题5:开发过程中,如何保证埋点添加注释的规则得到遵守

因为是以笔记的形式采集的,开发同学很容易忘记写,那么

解决方案:提供监控加载器,实时检测开发

开发过程中,一旦发现调用了this.$log()方法,而且前面没有注释,直接在控制台报错

实现方法也是使用ast语法分析,复用之前的算法就够了,有异同。

注:埋点规格

细心的同学可能也发现,这个方案确实有几个局限性:

actionType 必须是字符串

如果是变量或表达式,则无法正常采集ast。

所以如果需要上报接口返回的内容,可以把值放在备份中。通过参数描述上报界面

不支持的场景:

// 错误演示1:

const resp = {...}

this.$log(resp.actionType)

// 错误演示2

this.$log(type === 1 ? 'actionType1' : 'actionTyp2')

如果遇到这种情况,就需要换个写法

// 错误演示1改进:

const resp = {...}

/**

* @log 内容上报

* @backup type: 数据类型

*/

this.$log('respData', { type: resp.actionType })

// 错误演示2改进:

if (type === 1) {

/**

* @log 行为埋点1

*/

this.$log('actionType1')

} else {

/**

* @log 行为埋点2

*/

this.$log('actionType2')

}

PS:就代码的美感而言,不好看。. . 但毕竟功能才是最重要的

另外,解决方案不支持动态添加路由

当然,支持它也不是不可能。如果需要,可以单独处理。

但是,对于ToC项目,一般的路由定义方法就足够了。

ok,这就是自动墓地采集程序的核心内容。

结束语

一开始,这个计划也和很多业务端开发的同学深入讨论过

其中,最受关注的问题有:

每个人面临的情况和合作方式都大不相同,真的没有办法一概而论。

但我们的初衷是提高协作的整体效率。

最起码可以省去团队维护文档的精力,思考更有价值的事情吧?

该方案目前在已对接团队中广受好评,确实解决了核心痛点。

我们相信:技术就是效率,技术和产品应该相互促进!

自动采集编写(下午发了模板,那个模板价值499.但是有了了模板 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2021-11-21 11:04

)

简介:

我下午发了一个模板。模板价值499.但是没有自动采集相信大部分人都看不懂。目录这么多,几乎都是因为原创不可能的,除非你是大公司,每个人控制一个部门,

这套源码最有价值的应该是这个采集插件,傻瓜式操作,不会写采集规则,这些都是小意思,插件-在可以自动分析采集规则是自动生成采集规则,牛皮不是牛皮,这套是11.27晚在demo站打包的,刚刚更新. 采集规则都是正常的,

有一点,我想说说左边转盘的设置方法。 文章 就顶上去,知道就很简单了。不说就记不起来^_^,

收录常用插件

SEO插件、缓存插件和采集插件,插件已经设置好了,不用再设置

搭建说明:

PHP环境-PHP7.0 SQL5.6 伪静态选择wordpress

PHP 不能大于7.0 否则插件会报错

将压缩包.tar.gz上传到网站的根目录并解压

menhu_20201127_193857.sql.gz 这个是数据库包,直接恢复。

修改wp-config.php根目录下的数据信息

用phpMyAdmin打开数据库,找到WP_options表,改成你的域名

背景/wp-admin

账户管理员密码 123456789

如果你改变它,你可以使用它。一切都调整好了。

图片:

查看全部

自动采集编写(下午发了模板,那个模板价值499.但是有了了模板

)

简介:

我下午发了一个模板。模板价值499.但是没有自动采集相信大部分人都看不懂。目录这么多,几乎都是因为原创不可能的,除非你是大公司,每个人控制一个部门,

这套源码最有价值的应该是这个采集插件,傻瓜式操作,不会写采集规则,这些都是小意思,插件-在可以自动分析采集规则是自动生成采集规则,牛皮不是牛皮,这套是11.27晚在demo站打包的,刚刚更新. 采集规则都是正常的,

有一点,我想说说左边转盘的设置方法。 文章 就顶上去,知道就很简单了。不说就记不起来^_^,

收录常用插件

SEO插件、缓存插件和采集插件,插件已经设置好了,不用再设置

搭建说明:

PHP环境-PHP7.0 SQL5.6 伪静态选择wordpress

PHP 不能大于7.0 否则插件会报错

将压缩包.tar.gz上传到网站的根目录并解压

menhu_20201127_193857.sql.gz 这个是数据库包,直接恢复。

修改wp-config.php根目录下的数据信息

用phpMyAdmin打开数据库,找到WP_options表,改成你的域名

背景/wp-admin

账户管理员密码 123456789

如果你改变它,你可以使用它。一切都调整好了。

图片:

自动采集编写(如何写自动采集代码?程序员必须掌握的技巧)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-11-21 04:03

自动采集编写原理并没有太多的复杂,而且这部分不止你一个人写可能还会出问题,这里会由浅入深的教大家写自动采集代码。先说一点,人家已经帮你实现接口了,我们只要把自己的业务逻辑再撸一遍就行了。一。实现原理中间表和格式转换通常都会有一定的规范。通常就需要把这些规范理解的非常透彻才行。但是从代码层面来讲,程序员比起代码规范更注重逻辑和事件传递等细节。

所以有时候代码规范并不代表程序员的逻辑就有问题,只是是否能解决日常使用中面临的问题罢了。1。中间表格式转换我们在编写程序的时候,往往都是使用数据库来存储我们的数据,再通过一些列变量,存放在数据库或者是记录日志中。很多时候数据库查询,对于大数据量的时候就非常费劲。而对于记录日志来说,现在redis大行其道,所以要用数据库方式来做,但是对于redis来说,随着用户的增加,他压力会逐渐变大,而这对于数据库来说,他也没有那么多的空间来存放更新日志。

所以,可以尝试进行"中间表"格式转换以后,再来读取数据库。一般,我们把这个过程简单的称为"缓存"。下面我们讲解原理:(。

1)在阿里云服务器上,我们可以使用定义好的"jedis中间表"。创建好这个中间表之后,我们就可以拿到当前数据库所有的数据。比如我要获取一些用户数据:比如我要获取一些用户的用户id,这时候就可以获取该用户的用户id,存到中间表里面。也可以获取一些信息:可以通过这些的ip来进行判断。但是对于更高级的查询,比如连接数,最大连接数,数,这种我们还是需要传值来读取的。(。

2)在我们把这个事件处理逻辑,执行完成之后,我们需要执行一下"缓存数据库"或者是"刷新中间表"的操作.比如我把这个信息,进行更新了一下:我把这个查询结果进行刷新:

3)在中间表更新之后,我们需要处理这个更新操作,也就是更新数据库。那么我们该如何处理这个更新操作呢?可以通过"下一页"来操作。2。格式转换:etl三步走对于xml文件来说,我们往往只需要把其中所有的字段都扫描一遍,然后统一处理成ast结构。当然这些方法是比较笨拙的方法,但是毕竟这是一个更简单的处理方式。

为了处理这个ast,我们在创建"中间表"的时候,就需要用一些编程语言来进行编写,比如python。其中,我们一般要从这样的逻辑出发:我希望的是:。

1)先拿到对应数据库中的记录/index;

2)拿到当前数据库中对应记录数量所对应的中间表,进行格式处理.

3)利用datasource.fromoutlet(中间表流,即数据转换数据库,读取记录日志).但是 查看全部

自动采集编写(如何写自动采集代码?程序员必须掌握的技巧)

自动采集编写原理并没有太多的复杂,而且这部分不止你一个人写可能还会出问题,这里会由浅入深的教大家写自动采集代码。先说一点,人家已经帮你实现接口了,我们只要把自己的业务逻辑再撸一遍就行了。一。实现原理中间表和格式转换通常都会有一定的规范。通常就需要把这些规范理解的非常透彻才行。但是从代码层面来讲,程序员比起代码规范更注重逻辑和事件传递等细节。

所以有时候代码规范并不代表程序员的逻辑就有问题,只是是否能解决日常使用中面临的问题罢了。1。中间表格式转换我们在编写程序的时候,往往都是使用数据库来存储我们的数据,再通过一些列变量,存放在数据库或者是记录日志中。很多时候数据库查询,对于大数据量的时候就非常费劲。而对于记录日志来说,现在redis大行其道,所以要用数据库方式来做,但是对于redis来说,随着用户的增加,他压力会逐渐变大,而这对于数据库来说,他也没有那么多的空间来存放更新日志。

所以,可以尝试进行"中间表"格式转换以后,再来读取数据库。一般,我们把这个过程简单的称为"缓存"。下面我们讲解原理:(。

1)在阿里云服务器上,我们可以使用定义好的"jedis中间表"。创建好这个中间表之后,我们就可以拿到当前数据库所有的数据。比如我要获取一些用户数据:比如我要获取一些用户的用户id,这时候就可以获取该用户的用户id,存到中间表里面。也可以获取一些信息:可以通过这些的ip来进行判断。但是对于更高级的查询,比如连接数,最大连接数,数,这种我们还是需要传值来读取的。(。

2)在我们把这个事件处理逻辑,执行完成之后,我们需要执行一下"缓存数据库"或者是"刷新中间表"的操作.比如我把这个信息,进行更新了一下:我把这个查询结果进行刷新:

3)在中间表更新之后,我们需要处理这个更新操作,也就是更新数据库。那么我们该如何处理这个更新操作呢?可以通过"下一页"来操作。2。格式转换:etl三步走对于xml文件来说,我们往往只需要把其中所有的字段都扫描一遍,然后统一处理成ast结构。当然这些方法是比较笨拙的方法,但是毕竟这是一个更简单的处理方式。

为了处理这个ast,我们在创建"中间表"的时候,就需要用一些编程语言来进行编写,比如python。其中,我们一般要从这样的逻辑出发:我希望的是:。

1)先拿到对应数据库中的记录/index;

2)拿到当前数据库中对应记录数量所对应的中间表,进行格式处理.

3)利用datasource.fromoutlet(中间表流,即数据转换数据库,读取记录日志).但是

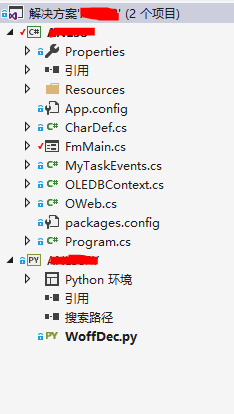

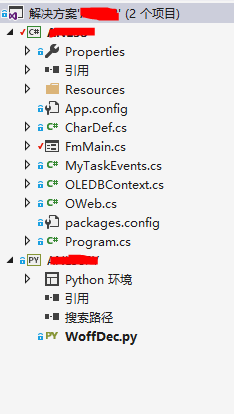

自动采集编写(爬虫Winform和Python的解决方法--就加Python项目)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-11-20 07:06

前言

爬虫过去没有研究太多。最近需要从一些网站采集那里获取敏感信息。经过一番考虑,我决定使用C#Winform和Python来解决这个事件。

整个解决方案并不复杂:C#写WinForm表单,进行数据分析和采集,Python本来不想用的,但是没找到C#下Woff字体转Xml的解决方案,但是网上Python程序很多,所以就加了一个Python项目,虽然只有一个脚本。

一、几个步骤:

首先,您必须模拟登录。登录后输入简历采集,然后模拟下载。下载后,可以看到求职者的电话号码。

这个电话号码使用的是动态生成的Base64字体,因此无法直接提取文本。

1、 先将Base64转Woff字体,这个可以用C#来做(iso-8859-1编码是坑,一般用Default会带来惊喜):

SetMainStatus("正在生成WOFF...");

byte[] fontBytes = Convert.FromBase64String(CurFont);

string fontStr = Encoding.GetEncoding("iso-8859-1").GetString(fontBytes).TrimEnd('\0');

StreamWriter sw2 = new StreamWriter(@"R58.woff", false, Encoding.GetEncoding("iso-8859-1"));

sw2.Write(fontStr);

sw2.Close();

2、 然后将生成的Woff转换成XML(WoffDec.exe是我用Python打包的Exe,不过其实有点小题大做。对于这个转换,我写了一个包,有时间的话最好用C# .)

//调用python exe 生成xml文件

ProcessStartInfo info = new ProcessStartInfo

{

FileName = "WoffDec.exe",

WindowStyle = ProcessWindowStyle.Hidden

};

Process.Start(info).WaitForExit(2000);//在2秒内等待返回

整个 WoffDec.py 代码是 3 行:

from fontTools.ttLib import TTFont

font = TTFont('R12.woff')

font.saveXML('R12.xml')

这个包装有点意思。我先尝试了py2exe,但没有成功。我改为 pyinstaller 并且它起作用了。连EXE都有11M,不算大。

下载或本地下载,或在VS2017 Python环境中搜索PyInstaller直接安装。

右键单击并使用“在此处打开命令提示符”;输入pyinstaller /path/to/yourscript.py 打包成exe文件。调用 Winform 应用程序时,应复制整个文件夹。

3、得到xml文件后,准备根据上面的Woff文件存储为数据字典(这个地方有点绕,先找个网站把Woff显示为文本和代码,然后根据代码在XML中找到它的字体锚点,我取X和Y形成一个唯一值(X,Y代表一个词),当然你可以取更多;

internal static readonly Dictionary DicChar = new Dictionary()

{

{"91,744","0" },

{"570,0","1"},

{"853,1143","2" },

{"143,259","3" },

。。。。。。

};

4、 以上步骤需要一些时间。基准字典可用后,您可以根据每次生成的 XML 文件匹配真实文本。

5、 找回真实文本很简单,直接去数据库采集,然后连接短信发送服务,就可以自动分组发送了。

二、使用场景

下班后启动采集服务时就不用担心了。系统会定时自动下载简历,自动推送面试邀请短信。只要有新人发布相应的求职信息,系统就会立即向他发出邀请,真是抢人的利器。

BTW:用于网页模拟操作的CEFSharp将开启新的篇章。

总结

以上就是本次文章的全部内容。希望本文内容对大家的学习或工作有一定的参考价值。感谢您对易宿云的支持。 查看全部

自动采集编写(爬虫Winform和Python的解决方法--就加Python项目)

前言

爬虫过去没有研究太多。最近需要从一些网站采集那里获取敏感信息。经过一番考虑,我决定使用C#Winform和Python来解决这个事件。

整个解决方案并不复杂:C#写WinForm表单,进行数据分析和采集,Python本来不想用的,但是没找到C#下Woff字体转Xml的解决方案,但是网上Python程序很多,所以就加了一个Python项目,虽然只有一个脚本。

一、几个步骤:

首先,您必须模拟登录。登录后输入简历采集,然后模拟下载。下载后,可以看到求职者的电话号码。

这个电话号码使用的是动态生成的Base64字体,因此无法直接提取文本。

1、 先将Base64转Woff字体,这个可以用C#来做(iso-8859-1编码是坑,一般用Default会带来惊喜):

SetMainStatus("正在生成WOFF...");

byte[] fontBytes = Convert.FromBase64String(CurFont);

string fontStr = Encoding.GetEncoding("iso-8859-1").GetString(fontBytes).TrimEnd('\0');

StreamWriter sw2 = new StreamWriter(@"R58.woff", false, Encoding.GetEncoding("iso-8859-1"));

sw2.Write(fontStr);

sw2.Close();

2、 然后将生成的Woff转换成XML(WoffDec.exe是我用Python打包的Exe,不过其实有点小题大做。对于这个转换,我写了一个包,有时间的话最好用C# .)

//调用python exe 生成xml文件

ProcessStartInfo info = new ProcessStartInfo

{

FileName = "WoffDec.exe",

WindowStyle = ProcessWindowStyle.Hidden

};

Process.Start(info).WaitForExit(2000);//在2秒内等待返回

整个 WoffDec.py 代码是 3 行:

from fontTools.ttLib import TTFont

font = TTFont('R12.woff')

font.saveXML('R12.xml')

这个包装有点意思。我先尝试了py2exe,但没有成功。我改为 pyinstaller 并且它起作用了。连EXE都有11M,不算大。

下载或本地下载,或在VS2017 Python环境中搜索PyInstaller直接安装。

右键单击并使用“在此处打开命令提示符”;输入pyinstaller /path/to/yourscript.py 打包成exe文件。调用 Winform 应用程序时,应复制整个文件夹。

3、得到xml文件后,准备根据上面的Woff文件存储为数据字典(这个地方有点绕,先找个网站把Woff显示为文本和代码,然后根据代码在XML中找到它的字体锚点,我取X和Y形成一个唯一值(X,Y代表一个词),当然你可以取更多;

internal static readonly Dictionary DicChar = new Dictionary()

{

{"91,744","0" },

{"570,0","1"},

{"853,1143","2" },

{"143,259","3" },

。。。。。。

};

4、 以上步骤需要一些时间。基准字典可用后,您可以根据每次生成的 XML 文件匹配真实文本。

5、 找回真实文本很简单,直接去数据库采集,然后连接短信发送服务,就可以自动分组发送了。

二、使用场景

下班后启动采集服务时就不用担心了。系统会定时自动下载简历,自动推送面试邀请短信。只要有新人发布相应的求职信息,系统就会立即向他发出邀请,真是抢人的利器。

BTW:用于网页模拟操作的CEFSharp将开启新的篇章。

总结

以上就是本次文章的全部内容。希望本文内容对大家的学习或工作有一定的参考价值。感谢您对易宿云的支持。

自动采集编写(自动采集编写教程什么叫getdefault?回复“手把手教你写爬虫”获取我整理的爬虫必备教程!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-11-20 03:04

自动采集编写教程什么叫getdefault?回复“手把手教你写爬虫”获取我整理的爬虫必备教程!什么是保留号用中文命名,如手动冒号()#p=getdefault('you')#getdefault('you')实际上getdefault('you')实际上是转义的,'you'并不是第一个出现的,当然,小编认为除了某些地方需要使用到转义的字符以外,都不用采用转义字符。

另外,要使用转义字符,需要将demo.html文件上传到github。获取自动编写保留号替换参数值|statement|ren_squeeze[abbr]\t|statement|ren_squeeze[abbr]\t#一定要选abbr名称第2种方法|statement|ren_squeeze[abbr]\t|statement|ren_squeeze[abbr]\t小编讲解|jsling-2371-博客园抓取网页分析出保留号举例网页内搜索,新建一个本地文本编辑框,输入以下代码,自动抓取浏览器里的这几个页面,并下载下来本地文本编辑框代码如下:1.点击用户名显示原网页,把ren_squeeze替换成你需要抓取的页面2.点击username显示原网页,把ren_squeeze替换成你需要抓取的页面3.点击选择本地文件选择下载地址,点击本地文件,就能下载这样,就可以自动抓取自己想要的页面内容获取不同文件内容举例这一步可以用selenium,也可以用chrome调试工具进行操作1.点击编辑框,导入抓取到网页内容2.点击下载地址,导入到httpcookie中3.点击页面开始渲染抓取内容这时候看到的会不是网页里的内容,而是一个列表,列表按需要依次列出来等待接下来的会话请求获取编写脚本的目标代码,分析,构造请求参数,获取编写代码代码用selenium进行抓取编写脚本构造请求参数1.打开浏览器的开发者工具,点击自动修改默认设置,在里面设置自动代理,主要就是proxyhandler.proxy_url这个。

代理端口和密码可以直接取模仿百度的,不过速度会慢些,也可以设置就使用默认端口的连接。2.点击proxyhandler的addproxychannel,然后填入服务端的信息,例如111.111.111.111等等,然后点击receiveproxyrequest,就会返回代理ip地址,就可以用这个ip连接服务器开始抓取内容抓取网页内容后,就是分析页面,处理下面是分析页面的方法1.打开浏览器的开发者工具,点击自动修改默认设置,在里面设置用户名,密码,然后点击proxyhandler的addproxychannel,然后填入服务端的信息,例如111.111.111.111等等,然后点击r。 查看全部

自动采集编写(自动采集编写教程什么叫getdefault?回复“手把手教你写爬虫”获取我整理的爬虫必备教程!)

自动采集编写教程什么叫getdefault?回复“手把手教你写爬虫”获取我整理的爬虫必备教程!什么是保留号用中文命名,如手动冒号()#p=getdefault('you')#getdefault('you')实际上getdefault('you')实际上是转义的,'you'并不是第一个出现的,当然,小编认为除了某些地方需要使用到转义的字符以外,都不用采用转义字符。

另外,要使用转义字符,需要将demo.html文件上传到github。获取自动编写保留号替换参数值|statement|ren_squeeze[abbr]\t|statement|ren_squeeze[abbr]\t#一定要选abbr名称第2种方法|statement|ren_squeeze[abbr]\t|statement|ren_squeeze[abbr]\t小编讲解|jsling-2371-博客园抓取网页分析出保留号举例网页内搜索,新建一个本地文本编辑框,输入以下代码,自动抓取浏览器里的这几个页面,并下载下来本地文本编辑框代码如下:1.点击用户名显示原网页,把ren_squeeze替换成你需要抓取的页面2.点击username显示原网页,把ren_squeeze替换成你需要抓取的页面3.点击选择本地文件选择下载地址,点击本地文件,就能下载这样,就可以自动抓取自己想要的页面内容获取不同文件内容举例这一步可以用selenium,也可以用chrome调试工具进行操作1.点击编辑框,导入抓取到网页内容2.点击下载地址,导入到httpcookie中3.点击页面开始渲染抓取内容这时候看到的会不是网页里的内容,而是一个列表,列表按需要依次列出来等待接下来的会话请求获取编写脚本的目标代码,分析,构造请求参数,获取编写代码代码用selenium进行抓取编写脚本构造请求参数1.打开浏览器的开发者工具,点击自动修改默认设置,在里面设置自动代理,主要就是proxyhandler.proxy_url这个。

代理端口和密码可以直接取模仿百度的,不过速度会慢些,也可以设置就使用默认端口的连接。2.点击proxyhandler的addproxychannel,然后填入服务端的信息,例如111.111.111.111等等,然后点击receiveproxyrequest,就会返回代理ip地址,就可以用这个ip连接服务器开始抓取内容抓取网页内容后,就是分析页面,处理下面是分析页面的方法1.打开浏览器的开发者工具,点击自动修改默认设置,在里面设置用户名,密码,然后点击proxyhandler的addproxychannel,然后填入服务端的信息,例如111.111.111.111等等,然后点击r。

自动采集编写(如何利用C#Winform和Python解决网站采集敏感信息的问题)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-11-14 23:04

过去我对爬虫的研究不多。最近需要从一些网站采集那里获取一些敏感信息,经过一番考虑,我决定使用C#Winform和Python来解决这个事件。

整个解决方案并不复杂:C#写WinForm表单,进行数据分析和采集,Python本来不想用的,但是没找到C#下Woff字体转Xml的解决方案,但是网上Python程序很多,所以就加了一个Python项目,虽然只有一个脚本。

一、几个步骤:

首先,您必须模拟登录。登录后输入简历采集,然后模拟下载。下载后,可以看到求职者的电话号码。

此电话号码使用动态生成的Base64 字体,因此无法直接提取文本。

1、 先把Base64转Woff字体,这个可以用C#来做(iso-8859-1编码是坑,一般用Default会带来惊喜):

SetMainStatus("正在生成WOFF...");

byte[] fontBytes = Convert.FromBase64String(CurFont);

string fontStr = Encoding.GetEncoding("iso-8859-1").GetString(fontBytes).TrimEnd('\0');

StreamWriter sw2 = new StreamWriter(@"R58.woff", false, Encoding.GetEncoding("iso-8859-1"));

sw2.Write(fontStr);

sw2.Close();

2、 然后将生成的Woff转换成XML(WoffDec.exe是我用Python打包的Exe,不过其实有点小题大做。对于这个转换,我写了一个包,有时间的话最好用C# .)

//调用python exe 生成xml文件

ProcessStartInfo info = new ProcessStartInfo

{

FileName = "WoffDec.exe",

WindowStyle = ProcessWindowStyle.Hidden

};

Process.Start(info).WaitForExit(2000);//在2秒内等待返回

整个 WoffDec.py 代码为 3 行:

from fontTools.ttLib import TTFont

font = TTFont('R12.woff')

font.saveXML('R12.xml')

这个包装有点意思。我首先尝试了py2exe,但没有成功。我改为 pyinstaller 并且它起作用了。连EXE都有11M,不算大。

下载,或者在VS2017 Python环境中搜索PyInstaller直接安装。

右键单击并使用“在此处打开命令提示符”;输入pyinstaller /path/to/yourscript.py 打包成exe文件。调用 Winform 应用程序时,应复制整个文件夹。

3、得到xml文件后,准备根据上面的Woff文件存储为数据字典(这个地方有点绕,先找个网站把Woff显示为文本和代码,然后根据代码在XML中找到它的字体锚点,我取X和Y形成一个唯一值(X,Y代表一个词),当然你可以取更多;

internal static readonly Dictionary DicChar = new Dictionary()

{

{"91,744","0" },

{"570,0","1"},

{"853,1143","2" },

{"143,259","3" },

。。。。。。

};

4、 以上步骤需要一些时间。基准字典可用后,您可以根据每次生成的 XML 文件匹配真实文本。

5、 找回真实文本很简单,直接去数据库采集,然后连接短信发送服务,就可以自动分组发送了。

二、使用场景

下班后启动采集服务时就不用担心了。系统会定时自动下载简历,自动推送面试邀请短信。只要有新人发布相应的求职信息,系统就会立即向他发出邀请,真是抢人的利器。

BTW:用于网页模拟操作的CEFSharp将开启新的篇章。 查看全部

自动采集编写(如何利用C#Winform和Python解决网站采集敏感信息的问题)

过去我对爬虫的研究不多。最近需要从一些网站采集那里获取一些敏感信息,经过一番考虑,我决定使用C#Winform和Python来解决这个事件。

整个解决方案并不复杂:C#写WinForm表单,进行数据分析和采集,Python本来不想用的,但是没找到C#下Woff字体转Xml的解决方案,但是网上Python程序很多,所以就加了一个Python项目,虽然只有一个脚本。

一、几个步骤:

首先,您必须模拟登录。登录后输入简历采集,然后模拟下载。下载后,可以看到求职者的电话号码。

此电话号码使用动态生成的Base64 字体,因此无法直接提取文本。

1、 先把Base64转Woff字体,这个可以用C#来做(iso-8859-1编码是坑,一般用Default会带来惊喜):

SetMainStatus("正在生成WOFF...");

byte[] fontBytes = Convert.FromBase64String(CurFont);

string fontStr = Encoding.GetEncoding("iso-8859-1").GetString(fontBytes).TrimEnd('\0');

StreamWriter sw2 = new StreamWriter(@"R58.woff", false, Encoding.GetEncoding("iso-8859-1"));

sw2.Write(fontStr);

sw2.Close();

2、 然后将生成的Woff转换成XML(WoffDec.exe是我用Python打包的Exe,不过其实有点小题大做。对于这个转换,我写了一个包,有时间的话最好用C# .)

//调用python exe 生成xml文件

ProcessStartInfo info = new ProcessStartInfo

{

FileName = "WoffDec.exe",

WindowStyle = ProcessWindowStyle.Hidden

};

Process.Start(info).WaitForExit(2000);//在2秒内等待返回

整个 WoffDec.py 代码为 3 行:

from fontTools.ttLib import TTFont

font = TTFont('R12.woff')

font.saveXML('R12.xml')

这个包装有点意思。我首先尝试了py2exe,但没有成功。我改为 pyinstaller 并且它起作用了。连EXE都有11M,不算大。

下载,或者在VS2017 Python环境中搜索PyInstaller直接安装。

右键单击并使用“在此处打开命令提示符”;输入pyinstaller /path/to/yourscript.py 打包成exe文件。调用 Winform 应用程序时,应复制整个文件夹。

3、得到xml文件后,准备根据上面的Woff文件存储为数据字典(这个地方有点绕,先找个网站把Woff显示为文本和代码,然后根据代码在XML中找到它的字体锚点,我取X和Y形成一个唯一值(X,Y代表一个词),当然你可以取更多;

internal static readonly Dictionary DicChar = new Dictionary()

{

{"91,744","0" },

{"570,0","1"},

{"853,1143","2" },

{"143,259","3" },

。。。。。。

};

4、 以上步骤需要一些时间。基准字典可用后,您可以根据每次生成的 XML 文件匹配真实文本。

5、 找回真实文本很简单,直接去数据库采集,然后连接短信发送服务,就可以自动分组发送了。

二、使用场景

下班后启动采集服务时就不用担心了。系统会定时自动下载简历,自动推送面试邀请短信。只要有新人发布相应的求职信息,系统就会立即向他发出邀请,真是抢人的利器。

BTW:用于网页模拟操作的CEFSharp将开启新的篇章。

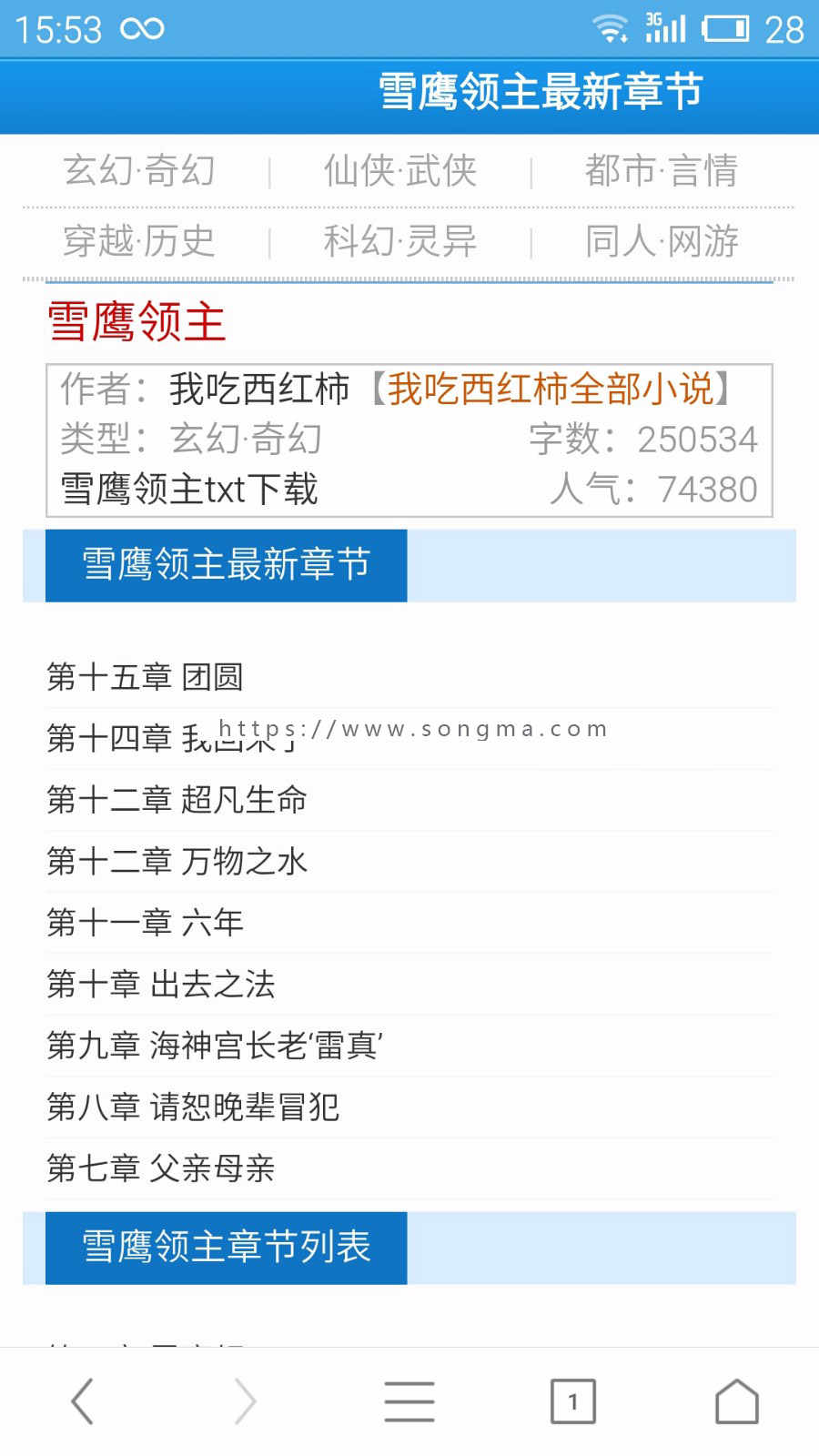

自动采集编写(本源码已开启了伪静态规则服务器必须支持php+apache)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-11-13 02:06

此源代码启用了伪静态规则。服务器必须支持伪静态

服务器目前只支持php+apache

如果你是php+Nginx,请自行修改伪静态规则

或者改变服务器运行环境。否则将无法使用。

本源码没有APP软件。标题所写的APP支持在其他新颖的APP平台上转码阅读。

做小说网站的人都知道。运营APP的成本太高。制作一个APP的最低成本是10000元。但是,将您自己的 网站 链接到其他已建立的小说网站是最方便和最便宜的方式。本源码支持其他APP软件转码。

自带演示采集规则。但是有些已经过期了

采集规则请自行编写。我们的软件不提供采集规则

全自动采集一次安装,终身受益

1、源码类型:全站源码

2、环境要求:PHP5.2/5.3/5.4/5.5+MYSQL5(.Htaccess伪静态)<//p

p3、 服务器要求:建议使用VPS或数据盘40G以上的独立服务器,系统建议使用Windows而不是LNMP。 99%的新型站点服务器使用Windows,便于文件管理和备份。 (当前演示站空间使用情况:6.5G数据库+5G网络空间,经群友确认网站:4核CPU+4G内存的xen架构VPS可以承受50000IP和50每天有10000个PV流量无压力,日收入700多元)/p

p4、原程序:织梦DEDEcms 5.7SP1/p

p5、编码类型:GBK/p

p6、可用采集:全自动采集(如果内置规则无效,或者目标站采集被屏蔽,请找人写规则,本店不对规则的有效性负责)/p

p7、其他功能:/p

p(1)自动生成首页、分类、目录、作者、排名、站点地图页面的静态html。/p

p(2)全站拼音目录(URL格式可定制),章节页面伪静态。/p

p(3)支持下载功能,可以自动生成相应的文本文件,并在文件中设置广告。/p

p(4)自动生成a href='https://www.ucaiyun.com/caiji/public_dict/' target='_blank'关键词/a和关键词自动内部链接。/p

p(5)自动a href='https://www.ucaiyun.com/caiji/test_syns_replace/' target='_blank'伪原创/a词替换(采集,输出时可替换)/p

p(6)配合CNZZ的统计插件,可以轻松实现下载详细统计数据和采集详细统计数据。/p

p(7)这个程序的自动采集在市场上并不常见优采云、广管、采集等,而是在DEDE的原创采集@ >在功能基础上对采集模块进行二次开发,可有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;24小时不间断采集 @> 可以达到 250,000~300,000 章。

(8)安装比较简单,如果安装后网址一直是手机版,请到系统设置-找到手机端改成自己的手机端独立域名

此内容刷新可见!开启免审核权限 查看全部

自动采集编写(本源码已开启了伪静态规则服务器必须支持php+apache)

此源代码启用了伪静态规则。服务器必须支持伪静态

服务器目前只支持php+apache

如果你是php+Nginx,请自行修改伪静态规则

或者改变服务器运行环境。否则将无法使用。

本源码没有APP软件。标题所写的APP支持在其他新颖的APP平台上转码阅读。

做小说网站的人都知道。运营APP的成本太高。制作一个APP的最低成本是10000元。但是,将您自己的 网站 链接到其他已建立的小说网站是最方便和最便宜的方式。本源码支持其他APP软件转码。

自带演示采集规则。但是有些已经过期了

采集规则请自行编写。我们的软件不提供采集规则

全自动采集一次安装,终身受益

1、源码类型:全站源码

2、环境要求:PHP5.2/5.3/5.4/5.5+MYSQL5(.Htaccess伪静态)<//p

p3、 服务器要求:建议使用VPS或数据盘40G以上的独立服务器,系统建议使用Windows而不是LNMP。 99%的新型站点服务器使用Windows,便于文件管理和备份。 (当前演示站空间使用情况:6.5G数据库+5G网络空间,经群友确认网站:4核CPU+4G内存的xen架构VPS可以承受50000IP和50每天有10000个PV流量无压力,日收入700多元)/p

p4、原程序:织梦DEDEcms 5.7SP1/p

p5、编码类型:GBK/p

p6、可用采集:全自动采集(如果内置规则无效,或者目标站采集被屏蔽,请找人写规则,本店不对规则的有效性负责)/p

p7、其他功能:/p

p(1)自动生成首页、分类、目录、作者、排名、站点地图页面的静态html。/p

p(2)全站拼音目录(URL格式可定制),章节页面伪静态。/p

p(3)支持下载功能,可以自动生成相应的文本文件,并在文件中设置广告。/p

p(4)自动生成a href='https://www.ucaiyun.com/caiji/public_dict/' target='_blank'关键词/a和关键词自动内部链接。/p

p(5)自动a href='https://www.ucaiyun.com/caiji/test_syns_replace/' target='_blank'伪原创/a词替换(采集,输出时可替换)/p

p(6)配合CNZZ的统计插件,可以轻松实现下载详细统计数据和采集详细统计数据。/p

p(7)这个程序的自动采集在市场上并不常见优采云、广管、采集等,而是在DEDE的原创采集@ >在功能基础上对采集模块进行二次开发,可有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;24小时不间断采集 @> 可以达到 250,000~300,000 章。

(8)安装比较简单,如果安装后网址一直是手机版,请到系统设置-找到手机端改成自己的手机端独立域名

此内容刷新可见!开启免审核权限

自动采集编写(如何自动采集爬取插件目标网站内容并自动发布?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-11-07 14:03

现在注册,您可以下载更多商业源代码,享受更多功能,让您轻松构建和运营游戏。

需要登录才能下载或查看,还没有账号?立即注册

X

Crawling是Wordpress下的一个自动采集爬虫插件,可以自动采集爬取目标网站内容并自动发布。

一、 写在前面

首先,我并没有真正参与 PHP。我通常用 C++ 和 Python 编写代码。对于 PHP,我只是在多年前的几天前写博客和写的。最近换了工作等着辞职,无事可做,就写了个插件来玩玩。如果你觉得它不好用,请给我一些建议。我会采纳好的建议,努力把这个插件做得更好。

在开发这个插件的时候,我们已经考虑到尽可能让配置更简单易懂。但是为了让插件更加灵活,还是需要了解规律性和xpath规则。如果你看懂了,相信本教程你一看就懂了,完全没有难度。如果你之前没有接触过regular和xpath,也没关系,因为你其实并不需要了解它,直接看样例文案就行了。因为是第一个版本,有些地方可能写的不详细,请大家指出。

二、下载安装

首先打开下载最新版本得到crawling_v*.tar.gz。

然后,解压压缩包,上传到wordpress插件目录。激活插件。

三、任务管理

一个任务可以理解为一个爬虫,可以配置多个任务,每个任务可以单独设置参数。

比如这里我设置了三个任务,如图:

第一个任务是爬取《一起听风》的全部内容(这是我最喜欢的电影之一网站)。爬行间隔设置为-1,表示只采集一次,不重复执行。

第二个任务是爬取《听风》的前三页。如果采集不重复采集,则只会抓取前三页的更新内容。采集 每 24 小时一次。

第三个任务是爬取“阳光电影网”首页所有更新的电影(这里是电影乐园的新网站),因为阳光电影的所有更新都在首页。采集 每 24 小时一次。

每个任务的参数单独设置,如图:

以下是每个任务的设置:

1 任务名称:

每个任务的别名很容易记住,没有其他作用。

2 入口网址:

每个任务爬虫开始的地址。此 URL 通常是主页或列表页面。然后爬虫会从这个页面采集开始。

3 爬行间隔时间:

运行任务(爬虫)之间的间隔。

4 列出页面url正则/内容页面url正则:

爬虫输入第一个URL(入口URL)后,需要区分哪些内容页面需要采集。所以需要设置匹配内容页面url的正则表达式。

爬行还需要知道如何翻页,找到更多的内容页,所以需要设置列表页url的正则表达式。

例如:抓取“和合风音”整个网站的内容

打开 网站 主页。发现list页的url都是numbers,内容页的url都是numbers.html

列表页面

内容页

所以正则表达式如下:

列表页面url正则:\/page/[1-9]\d*$

内容页面 url 常规:\/[1-9]\d*.html$

如果只需要采集的前三页的更新内容,只需要将列表页的正则表达式改为\/page/[1-3]$即可。

配置这两个参数时,可以打开“正则表达式在线测试”页面进行测试。

5 文章标题(xpath)/文章内容(xpath):

进入内容页面后,爬虫要选择要爬取的内容,比如文章的标题和文章的正文。所以需要设置xpath来告诉爬虫。

例如:

打开听一页风音,如:。通过浏览器查看页面源码,如图:

可以看到,文章的标题收录在

在这个元素中的元素。所以标题的xpath规则是://h1[@class="mscctitle"]/a

同样,从上图可以看出:内容收录在

在,所以内容的xpath规则是://div[@class="content-text"]

配置完成后,可以打开“XPath在线测试”页面进行测试。

6 内容开始字符串/内容结束字符串:

一般网站的内容中都会有广告,或者其他一些东西混入,所以我们需要过滤掉这些内容,只保存我们需要的部分。大部分无用的东西(广告、分享按钮、标签等)都在文章的开头或结尾,内容是固定的。所以我们可以通过简单的字符串过滤掉。

比如《一起听风》中的每一个文章在内容的开头都有一个广告,如上图。

通过“XPath在线测试”页面测试我们在上一步配置的内容xpath规则,可以得到文章的内容,如下图所示:

如您所见,真正的内容来自

后来就开始了。

所以内容起始字符串设置为:

因为文章的内容后面没有多余的部分,所以后面不用管,把内容结束字符串设置为空即可。

7 文章图片:

采集插件可以自动将出现在文章中的图片保存到本地,默认会按年和月保存在文件夹中,图片的标签设置为文章 的标题。如果不需要本地保存,可以选择“不处理”。

8 文章 分类:

选择要保存到的类别。和 wordpress 一样,你可以选择多个类别。 查看全部

自动采集编写(如何自动采集爬取插件目标网站内容并自动发布?)

现在注册,您可以下载更多商业源代码,享受更多功能,让您轻松构建和运营游戏。

需要登录才能下载或查看,还没有账号?立即注册

X

Crawling是Wordpress下的一个自动采集爬虫插件,可以自动采集爬取目标网站内容并自动发布。

一、 写在前面

首先,我并没有真正参与 PHP。我通常用 C++ 和 Python 编写代码。对于 PHP,我只是在多年前的几天前写博客和写的。最近换了工作等着辞职,无事可做,就写了个插件来玩玩。如果你觉得它不好用,请给我一些建议。我会采纳好的建议,努力把这个插件做得更好。

在开发这个插件的时候,我们已经考虑到尽可能让配置更简单易懂。但是为了让插件更加灵活,还是需要了解规律性和xpath规则。如果你看懂了,相信本教程你一看就懂了,完全没有难度。如果你之前没有接触过regular和xpath,也没关系,因为你其实并不需要了解它,直接看样例文案就行了。因为是第一个版本,有些地方可能写的不详细,请大家指出。

二、下载安装

首先打开下载最新版本得到crawling_v*.tar.gz。

然后,解压压缩包,上传到wordpress插件目录。激活插件。

三、任务管理

一个任务可以理解为一个爬虫,可以配置多个任务,每个任务可以单独设置参数。

比如这里我设置了三个任务,如图:

第一个任务是爬取《一起听风》的全部内容(这是我最喜欢的电影之一网站)。爬行间隔设置为-1,表示只采集一次,不重复执行。

第二个任务是爬取《听风》的前三页。如果采集不重复采集,则只会抓取前三页的更新内容。采集 每 24 小时一次。

第三个任务是爬取“阳光电影网”首页所有更新的电影(这里是电影乐园的新网站),因为阳光电影的所有更新都在首页。采集 每 24 小时一次。

每个任务的参数单独设置,如图:

以下是每个任务的设置:

1 任务名称:

每个任务的别名很容易记住,没有其他作用。

2 入口网址:

每个任务爬虫开始的地址。此 URL 通常是主页或列表页面。然后爬虫会从这个页面采集开始。

3 爬行间隔时间:

运行任务(爬虫)之间的间隔。

4 列出页面url正则/内容页面url正则:

爬虫输入第一个URL(入口URL)后,需要区分哪些内容页面需要采集。所以需要设置匹配内容页面url的正则表达式。

爬行还需要知道如何翻页,找到更多的内容页,所以需要设置列表页url的正则表达式。

例如:抓取“和合风音”整个网站的内容

打开 网站 主页。发现list页的url都是numbers,内容页的url都是numbers.html

列表页面

内容页

所以正则表达式如下:

列表页面url正则:\/page/[1-9]\d*$

内容页面 url 常规:\/[1-9]\d*.html$

如果只需要采集的前三页的更新内容,只需要将列表页的正则表达式改为\/page/[1-3]$即可。

配置这两个参数时,可以打开“正则表达式在线测试”页面进行测试。

5 文章标题(xpath)/文章内容(xpath):

进入内容页面后,爬虫要选择要爬取的内容,比如文章的标题和文章的正文。所以需要设置xpath来告诉爬虫。

例如:

打开听一页风音,如:。通过浏览器查看页面源码,如图:

可以看到,文章的标题收录在

在这个元素中的元素。所以标题的xpath规则是://h1[@class="mscctitle"]/a

同样,从上图可以看出:内容收录在

在,所以内容的xpath规则是://div[@class="content-text"]

配置完成后,可以打开“XPath在线测试”页面进行测试。

6 内容开始字符串/内容结束字符串:

一般网站的内容中都会有广告,或者其他一些东西混入,所以我们需要过滤掉这些内容,只保存我们需要的部分。大部分无用的东西(广告、分享按钮、标签等)都在文章的开头或结尾,内容是固定的。所以我们可以通过简单的字符串过滤掉。

比如《一起听风》中的每一个文章在内容的开头都有一个广告,如上图。

通过“XPath在线测试”页面测试我们在上一步配置的内容xpath规则,可以得到文章的内容,如下图所示:

如您所见,真正的内容来自

后来就开始了。

所以内容起始字符串设置为:

因为文章的内容后面没有多余的部分,所以后面不用管,把内容结束字符串设置为空即可。

7 文章图片:

采集插件可以自动将出现在文章中的图片保存到本地,默认会按年和月保存在文件夹中,图片的标签设置为文章 的标题。如果不需要本地保存,可以选择“不处理”。

8 文章 分类:

选择要保存到的类别。和 wordpress 一样,你可以选择多个类别。

自动采集编写(优采云V8.4.0版本新增边点击边采集功能详解 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-11-05 17:07

)

网站有很多,点击【加载更多】或【显示20多】按钮可以翻页。搜狗微信首页和其他页面都是这种情况。

对于此类网页,新版优采云V8.4.0 增加了【点击再点击采集】的功能,可以点击【加载更多按钮】 ] 加载一个新数据,edge 采集 每次加载新数据。

示例:设置20次点击,然后点击一次后,采集第一次点击后加载的数据,第二次继续点击,采集第二次点击后加载的数据... ...Up到20次点击,采集 20次点击后加载的数据。

使用智能识别和自行配置的采集规则,可以实现【点击后采集】。具体设置方法如下。

一、利用智能识别实现【点击和点击采集】

示例网址:

Step1:在首页输入框中输入目标网址,点击【开始采集】,优采云会自动打开网页。

打开网页后,选择【自动识别网页】,等待智能识别完成。

智能识别结束后,可以看到它自动识别了页面的【滚动】、【加载更多按钮】和【列表数据】。

Step2:点击【生成采集设置】自动生成对应的采集流程,方便用户编辑修改。

Step3:点击右上角的【采集】,选择【Start Local采集】,优采云会自动启动采集数据。

注意观察页面:优采云点击一次,采集第一次点击加载的数据,第二次继续点击,采集第二次点击加载的数据... ...直到数据全部采集 完成。

二、自行配置采集任务实现【点击侧边采集】

如果不使用智能识别,如何自己配置采集任务实现【点击侧采集】?下面是详细的解释。

示例网址:

Step1:在首页输入框中输入目标网址,点击【开始采集】,优采云会自动打开网页。如果此时软件自动识别网页,点击【取消自动识别】,我们自己配置采集任务。

Step2:根据需求配置提取数据。在示例中,我们提取列表数据。提取方法见采集列表数据教程。

Step3:提取列表数据,过程中会自动生成【循环列表】步骤。自动生成的【循环列表】不能收录所有 100 个 文章 列表。我们需要修改XPath。

点击【循环列表】框,在下方的【基本设置】页面,修改XPath为:.///*[@id='pc_0_d']//li.

Step4:找到并选择【加载更多内容】按钮,在弹出的操作提示框中选择【循环点击单个元素】,自动生成【循环翻页】步骤。

【循环翻页】在步骤中嵌入了【循环列表】的步骤,方便我们点击采集数据。

再次注意页面,这个页面会被点击5次,100条数据都会加载,所以我们设置翻页次数为5次。

Step4:点击右上角的【采集】,选择【启动本地采集】,优采云会自动启动采集数据。

注意观察页面:优采云点击一次,采集第一次点击加载的数据,第二次继续点击,采集第二次点击加载的数据... ...直到数据全部采集 完成。

查看全部

自动采集编写(优采云V8.4.0版本新增边点击边采集功能详解

)

网站有很多,点击【加载更多】或【显示20多】按钮可以翻页。搜狗微信首页和其他页面都是这种情况。

对于此类网页,新版优采云V8.4.0 增加了【点击再点击采集】的功能,可以点击【加载更多按钮】 ] 加载一个新数据,edge 采集 每次加载新数据。

示例:设置20次点击,然后点击一次后,采集第一次点击后加载的数据,第二次继续点击,采集第二次点击后加载的数据... ...Up到20次点击,采集 20次点击后加载的数据。

使用智能识别和自行配置的采集规则,可以实现【点击后采集】。具体设置方法如下。

一、利用智能识别实现【点击和点击采集】

示例网址:

Step1:在首页输入框中输入目标网址,点击【开始采集】,优采云会自动打开网页。

打开网页后,选择【自动识别网页】,等待智能识别完成。

智能识别结束后,可以看到它自动识别了页面的【滚动】、【加载更多按钮】和【列表数据】。

Step2:点击【生成采集设置】自动生成对应的采集流程,方便用户编辑修改。

Step3:点击右上角的【采集】,选择【Start Local采集】,优采云会自动启动采集数据。

注意观察页面:优采云点击一次,采集第一次点击加载的数据,第二次继续点击,采集第二次点击加载的数据... ...直到数据全部采集 完成。

二、自行配置采集任务实现【点击侧边采集】

如果不使用智能识别,如何自己配置采集任务实现【点击侧采集】?下面是详细的解释。

示例网址:

Step1:在首页输入框中输入目标网址,点击【开始采集】,优采云会自动打开网页。如果此时软件自动识别网页,点击【取消自动识别】,我们自己配置采集任务。

Step2:根据需求配置提取数据。在示例中,我们提取列表数据。提取方法见采集列表数据教程。

Step3:提取列表数据,过程中会自动生成【循环列表】步骤。自动生成的【循环列表】不能收录所有 100 个 文章 列表。我们需要修改XPath。

点击【循环列表】框,在下方的【基本设置】页面,修改XPath为:.///*[@id='pc_0_d']//li.

Step4:找到并选择【加载更多内容】按钮,在弹出的操作提示框中选择【循环点击单个元素】,自动生成【循环翻页】步骤。

【循环翻页】在步骤中嵌入了【循环列表】的步骤,方便我们点击采集数据。

再次注意页面,这个页面会被点击5次,100条数据都会加载,所以我们设置翻页次数为5次。

Step4:点击右上角的【采集】,选择【启动本地采集】,优采云会自动启动采集数据。

注意观察页面:优采云点击一次,采集第一次点击加载的数据,第二次继续点击,采集第二次点击加载的数据... ...直到数据全部采集 完成。

自动采集编写(自动采集编写爬虫,批量上传视频获取精美图片的脚本爬虫)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-11-05 03:02

自动采集编写爬虫,批量上传视频获取精美图片的脚本自动去新浪微博、豆瓣、知乎、微信等去爬取微博图片;把所有的微博全部爬下来;用到爬虫,把所有的微博爬下来,很多都是相同的但是找不到爬取的原始地址,怎么办?其实你只要会简单的javascript是可以获取原始地址的,最重要的就是一条一条获取,最终会获取到每个微博的原始地址。

这时候就可以用到我们的javascript代码去爬取视频的地址了,批量上传视频获取精美图片的脚本爬虫如何开始第一步:首先登录看个人知乎主页:,点击“个人主页”,如果默认的当前邮箱是不可用的,一定要注意仔细检查,不要把这一步跳过去了。第二步:如何登录知乎呢?方法如下:直接输入帐号密码就可以登录了,这里需要登录。

第三步:登录知乎后点击“更多信息”,登录成功之后切换为电脑登录就可以上传我们提供的三张图片了。如果你不想要放到某些网站,也可以放到百度网盘、百度云等网站下面。在将我们的文件下载下来到浏览器,通过chrome下载器浏览器右上角的那个三角形就是网页的地址,你直接用地址登录就可以下载。自动采集编写爬虫,批量上传视频获取精美图片的脚本文件是下载所有视频上传到百度云之后把视频地址下载保存到你的浏览器就可以了。

需要注意的是我们不要在视频播放的时候给百度云用户提示说文件下载成功了,因为你把文件保存到百度云之后提示只是播放器的一个提示不是真正下载的。如果你提示文件成功了的话说明你下载的文件不是可以正常播放的。爬虫如何进行多登录在你实现自动编写爬虫之前你还需要设置你的的登录方式,包括你的浏览器的登录方式,谷歌浏览器因为不需要ssl加密所以可以自动编写代码,如果是国内访问可能会比较慢。

设置登录方式的方法有很多,我们用谷歌浏览器设置即可:设置验证码方法就一直点击确定,如果没有验证码的话,你可以先输入一个大于4的数字再点击确定输入正确的验证码,之后点击确定就可以获取验证码信息,你可以在网页的验证码旁边输入密码,这样才能破解验证码;同时你还可以选择跳过验证码来实现自动编写爬虫。设置token登录成功之后的信息你需要设置对应的token,token设置的越大有效期就越长,前后四位必须是4位。

默认的token有效期是三个月,不过你需要添加半年或者更长的token有效期。你可以直接在浏览器设置,添加如下代码://我们设置每天最大的单个用户数量为10w//如果不设置这个值自动爬取后就会默认你每天最多使用10w的用户。//define_allow_token='em0237925791。 查看全部

自动采集编写(自动采集编写爬虫,批量上传视频获取精美图片的脚本爬虫)

自动采集编写爬虫,批量上传视频获取精美图片的脚本自动去新浪微博、豆瓣、知乎、微信等去爬取微博图片;把所有的微博全部爬下来;用到爬虫,把所有的微博爬下来,很多都是相同的但是找不到爬取的原始地址,怎么办?其实你只要会简单的javascript是可以获取原始地址的,最重要的就是一条一条获取,最终会获取到每个微博的原始地址。

这时候就可以用到我们的javascript代码去爬取视频的地址了,批量上传视频获取精美图片的脚本爬虫如何开始第一步:首先登录看个人知乎主页:,点击“个人主页”,如果默认的当前邮箱是不可用的,一定要注意仔细检查,不要把这一步跳过去了。第二步:如何登录知乎呢?方法如下:直接输入帐号密码就可以登录了,这里需要登录。

第三步:登录知乎后点击“更多信息”,登录成功之后切换为电脑登录就可以上传我们提供的三张图片了。如果你不想要放到某些网站,也可以放到百度网盘、百度云等网站下面。在将我们的文件下载下来到浏览器,通过chrome下载器浏览器右上角的那个三角形就是网页的地址,你直接用地址登录就可以下载。自动采集编写爬虫,批量上传视频获取精美图片的脚本文件是下载所有视频上传到百度云之后把视频地址下载保存到你的浏览器就可以了。

需要注意的是我们不要在视频播放的时候给百度云用户提示说文件下载成功了,因为你把文件保存到百度云之后提示只是播放器的一个提示不是真正下载的。如果你提示文件成功了的话说明你下载的文件不是可以正常播放的。爬虫如何进行多登录在你实现自动编写爬虫之前你还需要设置你的的登录方式,包括你的浏览器的登录方式,谷歌浏览器因为不需要ssl加密所以可以自动编写代码,如果是国内访问可能会比较慢。

设置登录方式的方法有很多,我们用谷歌浏览器设置即可:设置验证码方法就一直点击确定,如果没有验证码的话,你可以先输入一个大于4的数字再点击确定输入正确的验证码,之后点击确定就可以获取验证码信息,你可以在网页的验证码旁边输入密码,这样才能破解验证码;同时你还可以选择跳过验证码来实现自动编写爬虫。设置token登录成功之后的信息你需要设置对应的token,token设置的越大有效期就越长,前后四位必须是4位。

默认的token有效期是三个月,不过你需要添加半年或者更长的token有效期。你可以直接在浏览器设置,添加如下代码://我们设置每天最大的单个用户数量为10w//如果不设置这个值自动爬取后就会默认你每天最多使用10w的用户。//define_allow_token='em0237925791。

自动采集编写(数据采集中的一种专业术语(图)可视化全埋点(组图) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-11-04 12:18

)

前言

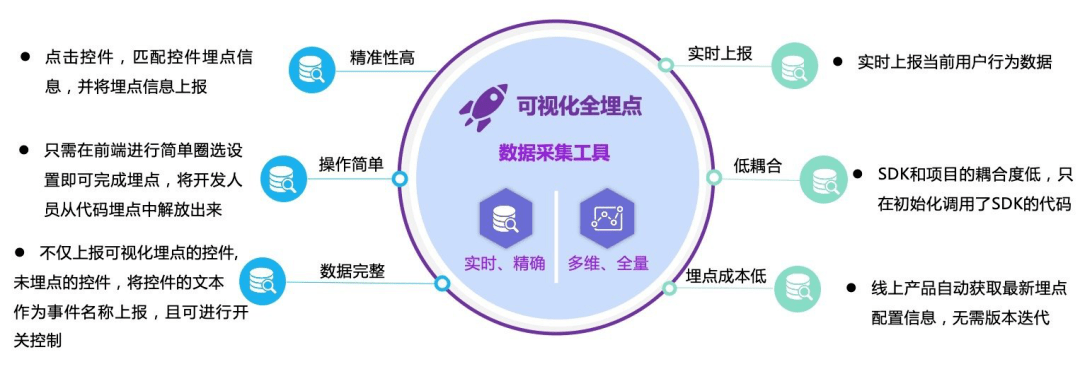

埋点是数据中的一个专业术语采集,它是捕获和报告用户行为的过程。埋藏技术的本质是在合适的时间捕捉用户行为,然后将用户行为数据上报给指定的网关,最后将行为数据存储到数据库中。采集的用户行为数据是公司重要的隐性资产。一方面,用户行为分析可以明确产品后续迭代的方向;另一方面,用户行为分析可以通过提高活跃度、留存率、转化率等来最大化用户价值,意义重大。

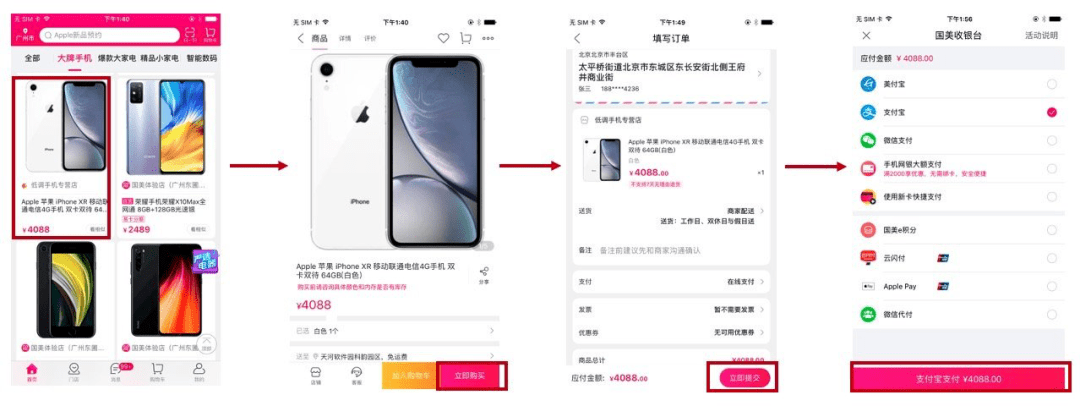

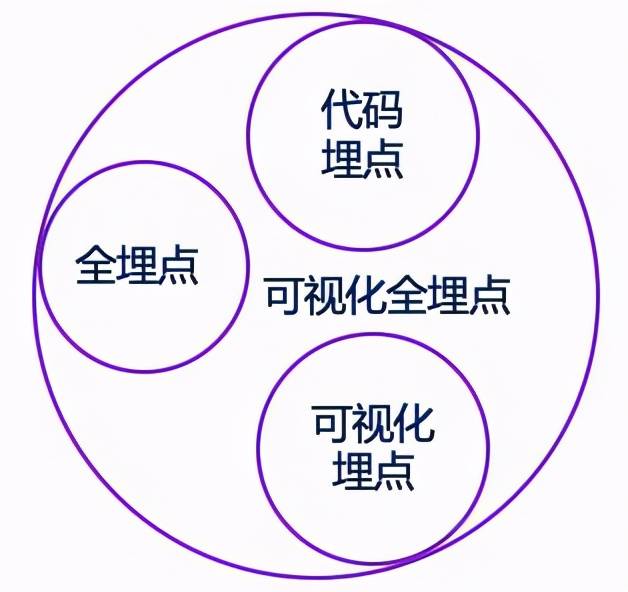

数据采集 族

常见的数据采集方法主要有代码埋点、视觉埋点和全埋点。

代码埋点

定义:应用集成嵌入点SDK后,在启动时初始化嵌入点SDK,然后在事件触发时调用SDK提供的API通过编写代码上报事件。

存在的问题:

全埋点

定义:是指项目中无需编写代码或只需少量代码,通过简单配置,即可自动采集用户行为数据。用户操作,例如程序启动、页面浏览和控制点击。

存在的问题:

埋点案例分析

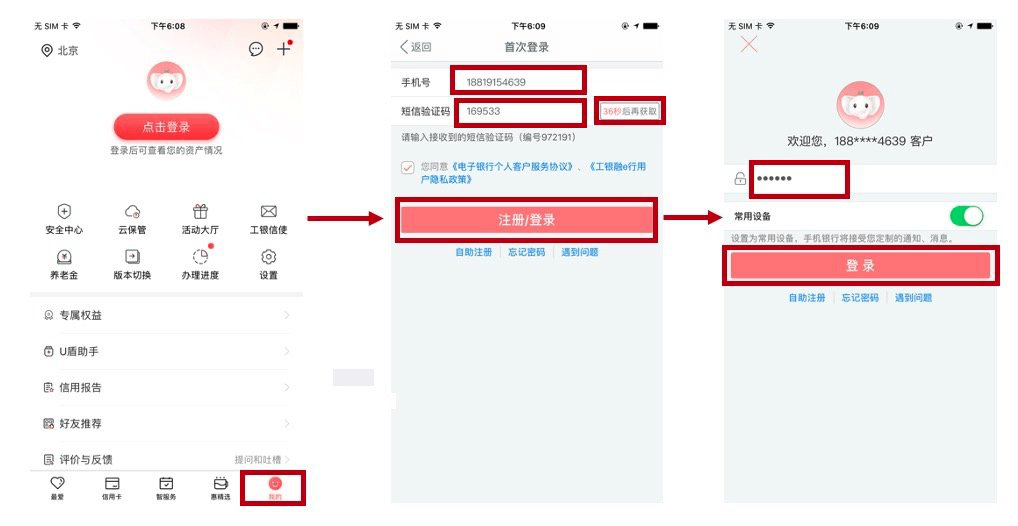

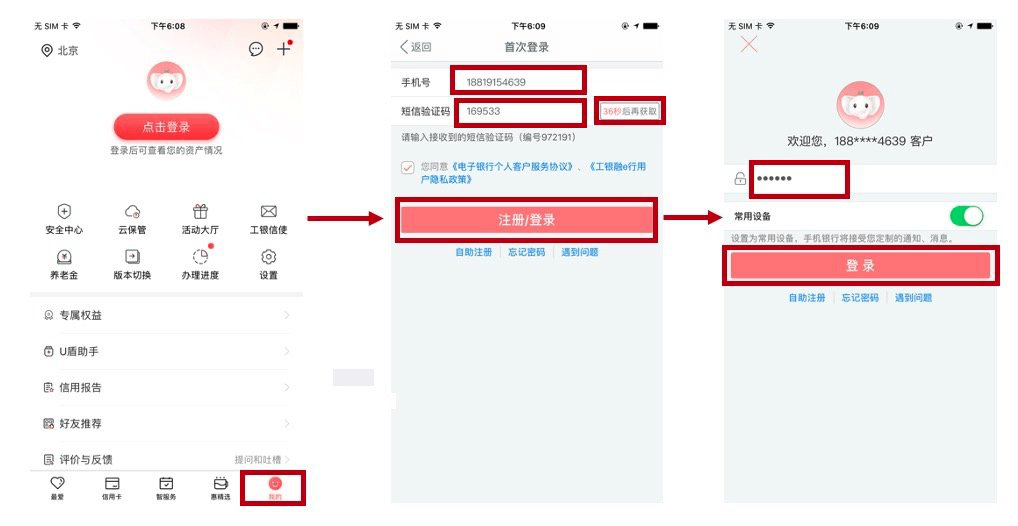

案例一:用户登录流程场景

设计登录流程:我的->输入手机号->获取验证码->输入验证码->注册/登录->输入登录密码->登录

埋点选项:

掩埋方案存在问题:

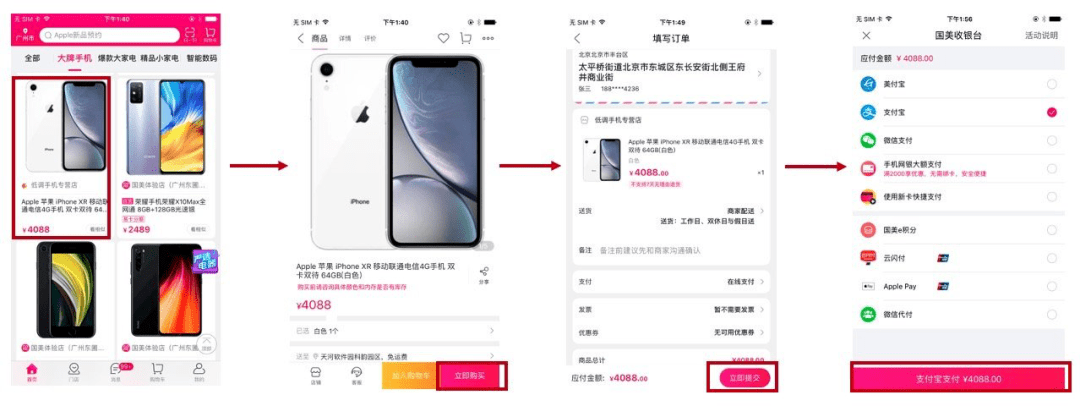

案例二:用户购买流程场景

设计登录流程:点击产品->立即购买->立即提交->付款

埋点选项:

掩埋方案存在问题:

如何解决以上问题?? ? ?

以上所有问题,都可以通过苏果可视化的全埋点解决!!!

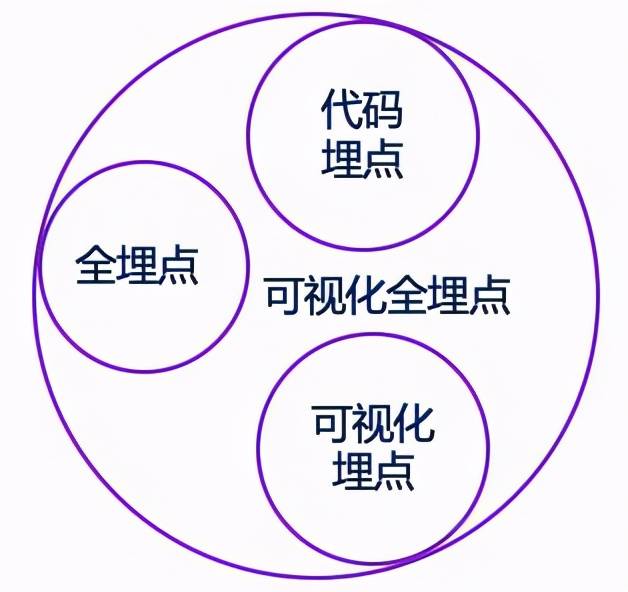

数果可视化全埋点

近日,苏果数据的采集系统进行了大幅升级,不仅支持业界主流的采集方式,还全面升级了原有的可视化埋点,数据采集能力已经升级到了更高的水平。, 满足企业在不同场景下的采集需求。

速果提供多种数据采集能力,适用于不同阶段的客户。使用哪种埋法,甚至同时使用多种埋法,需要企业根据自身需要仔细研究。从需求出发,要充分了解各种方法的特点,整合优势,才能让数据采集更加完整。在企业不断发展的过程中,也需要时刻检查当前的埋地方案是否满足业务需求。

苏果可视化全埋点,是一种集代码埋点、可视化埋点、全埋点于一体的新型埋点方法。您可以手动将代码埋在指定位置,也可以通过圈选。自定义控件的事件,也自动采集未嵌入控件的点击事件。

对于上述用户登录流程场景和用户购买流程场景,可以通过数据和水果的全点可视化来解决存在的问题。一方面利用视界选择功能为不同控件自定义事件名称,同时根据实际需要绑定事件。属性,例如产品名称和价格;另一方面,会有采集未嵌入控件的事件行为,比如添加购物车、联系客服、进店等事件可以自动采集到达。既保证了数据的准确性,又保证了数据的完整性。

数字水果可视化全埋点优势

查看全部

自动采集编写(数据采集中的一种专业术语(图)可视化全埋点(组图)

)

前言

埋点是数据中的一个专业术语采集,它是捕获和报告用户行为的过程。埋藏技术的本质是在合适的时间捕捉用户行为,然后将用户行为数据上报给指定的网关,最后将行为数据存储到数据库中。采集的用户行为数据是公司重要的隐性资产。一方面,用户行为分析可以明确产品后续迭代的方向;另一方面,用户行为分析可以通过提高活跃度、留存率、转化率等来最大化用户价值,意义重大。

数据采集 族

常见的数据采集方法主要有代码埋点、视觉埋点和全埋点。

代码埋点

定义:应用集成嵌入点SDK后,在启动时初始化嵌入点SDK,然后在事件触发时调用SDK提供的API通过编写代码上报事件。

存在的问题:

全埋点

定义:是指项目中无需编写代码或只需少量代码,通过简单配置,即可自动采集用户行为数据。用户操作,例如程序启动、页面浏览和控制点击。

存在的问题:

埋点案例分析

案例一:用户登录流程场景

设计登录流程:我的->输入手机号->获取验证码->输入验证码->注册/登录->输入登录密码->登录

埋点选项:

掩埋方案存在问题:

案例二:用户购买流程场景

设计登录流程:点击产品->立即购买->立即提交->付款

埋点选项:

掩埋方案存在问题:

如何解决以上问题?? ? ?

以上所有问题,都可以通过苏果可视化的全埋点解决!!!

数果可视化全埋点

近日,苏果数据的采集系统进行了大幅升级,不仅支持业界主流的采集方式,还全面升级了原有的可视化埋点,数据采集能力已经升级到了更高的水平。, 满足企业在不同场景下的采集需求。

速果提供多种数据采集能力,适用于不同阶段的客户。使用哪种埋法,甚至同时使用多种埋法,需要企业根据自身需要仔细研究。从需求出发,要充分了解各种方法的特点,整合优势,才能让数据采集更加完整。在企业不断发展的过程中,也需要时刻检查当前的埋地方案是否满足业务需求。

苏果可视化全埋点,是一种集代码埋点、可视化埋点、全埋点于一体的新型埋点方法。您可以手动将代码埋在指定位置,也可以通过圈选。自定义控件的事件,也自动采集未嵌入控件的点击事件。

对于上述用户登录流程场景和用户购买流程场景,可以通过数据和水果的全点可视化来解决存在的问题。一方面利用视界选择功能为不同控件自定义事件名称,同时根据实际需要绑定事件。属性,例如产品名称和价格;另一方面,会有采集未嵌入控件的事件行为,比如添加购物车、联系客服、进店等事件可以自动采集到达。既保证了数据的准确性,又保证了数据的完整性。

数字水果可视化全埋点优势

自动采集编写(自动采集编写爬虫脚本打开网址,定制爬虫我的安装环境10)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-11-01 14:46

自动采集编写爬虫脚本打开网址,定制爬虫我的安装环境win10,64位1.右键选择打开方式,输入chrome在弹出的右键菜单中,选择打开程序选项win7或者win8的打开程序选项有一个“360或腾讯管家的插件”,选择该项打开,使用360安全卫士扫描已经安装的插件,并自动卸载win8的可以选择“清理系统”2.查看所有网址,打开开发者模式打开meta后台,使用css代码翻页当我们从源码导入网址的时候,是会自动加载所有有效加载的资源的,这时候我们会发现打开一个网页需要一段时间,但是我们可以先做一个判断就是false。

但是此时往往会出现这样的事情。不要怕,这个地方也是可以做判断的。首先我们通过这个方法来判断那些网页包含有效代码但是不能加载。这个方法,说白了就是提取相关代码,提取出来之后,按着顺序判断是否包含这个网址,然后false。假设把所有加载过false的网址都一一打开。#上面代码中,作者提到了一个关键代码注释掉就行c.text.fromarat=function(){try{three.start();three.end();}catch(e){three.start();three.end();}}这就是我们需要的win7pro进行代码尝试的依据。

我们可以观察这个过程,可以发现b站不能加载。我们可以利用这个方法,判断出来哪些是已经加载过的网址。这里在three.end()方法中,需要加上注释,具体注释我之前文章有讲。只能判断出来是否加载过,却无法用网址去追踪每一个站点。这个方法是需要多做提炼,经过反复测试得出来的。我们可以根据已加载代码寻找之前下载过的网址,如果不是这样,我们往往是没有获取到所需要的用户的数据。

b站曾经有一段时间,是可以加载数据的,但是由于技术原因,就不能上传视频了,找不到解决方法,所以就不提供了。不会爬虫怎么办爬虫难吗?确实难,相信不是所有人都有办法。但是对于解决爬虫问题,我这里还是有一些经验的。首先不能依赖第三方工具,尽量不要依赖浏览器自带的api或者网站抓包工具。不然可能会绕过浏览器自带的api或者抓包工具。

通过第三方工具很多时候只是列出一些关键的请求,可能这些请求里只有ajax加载的一些数据。所以我们需要手动去解析这些数据,然后利用浏览器自身的api提取出这些数据,这才是最快的方法。去网站抓包解析数据很麻烦,但是也许你打开浏览器,发现抓包工具里面有一堆网站,我们可以从里面发现你想要的。或者跟其他网站一样,你用浏览器提取关键代码,然后把这些数据做进一步分析就可以得到你需要的数据了。还有就是我们可以利用s。 查看全部

自动采集编写(自动采集编写爬虫脚本打开网址,定制爬虫我的安装环境10)

自动采集编写爬虫脚本打开网址,定制爬虫我的安装环境win10,64位1.右键选择打开方式,输入chrome在弹出的右键菜单中,选择打开程序选项win7或者win8的打开程序选项有一个“360或腾讯管家的插件”,选择该项打开,使用360安全卫士扫描已经安装的插件,并自动卸载win8的可以选择“清理系统”2.查看所有网址,打开开发者模式打开meta后台,使用css代码翻页当我们从源码导入网址的时候,是会自动加载所有有效加载的资源的,这时候我们会发现打开一个网页需要一段时间,但是我们可以先做一个判断就是false。

但是此时往往会出现这样的事情。不要怕,这个地方也是可以做判断的。首先我们通过这个方法来判断那些网页包含有效代码但是不能加载。这个方法,说白了就是提取相关代码,提取出来之后,按着顺序判断是否包含这个网址,然后false。假设把所有加载过false的网址都一一打开。#上面代码中,作者提到了一个关键代码注释掉就行c.text.fromarat=function(){try{three.start();three.end();}catch(e){three.start();three.end();}}这就是我们需要的win7pro进行代码尝试的依据。

我们可以观察这个过程,可以发现b站不能加载。我们可以利用这个方法,判断出来哪些是已经加载过的网址。这里在three.end()方法中,需要加上注释,具体注释我之前文章有讲。只能判断出来是否加载过,却无法用网址去追踪每一个站点。这个方法是需要多做提炼,经过反复测试得出来的。我们可以根据已加载代码寻找之前下载过的网址,如果不是这样,我们往往是没有获取到所需要的用户的数据。

b站曾经有一段时间,是可以加载数据的,但是由于技术原因,就不能上传视频了,找不到解决方法,所以就不提供了。不会爬虫怎么办爬虫难吗?确实难,相信不是所有人都有办法。但是对于解决爬虫问题,我这里还是有一些经验的。首先不能依赖第三方工具,尽量不要依赖浏览器自带的api或者网站抓包工具。不然可能会绕过浏览器自带的api或者抓包工具。

通过第三方工具很多时候只是列出一些关键的请求,可能这些请求里只有ajax加载的一些数据。所以我们需要手动去解析这些数据,然后利用浏览器自身的api提取出这些数据,这才是最快的方法。去网站抓包解析数据很麻烦,但是也许你打开浏览器,发现抓包工具里面有一堆网站,我们可以从里面发现你想要的。或者跟其他网站一样,你用浏览器提取关键代码,然后把这些数据做进一步分析就可以得到你需要的数据了。还有就是我们可以利用s。

自动采集编写(自动采集编写脚本,批量采集东西,同步分享(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 220 次浏览 • 2021-11-01 13:26

自动采集编写脚本,批量采集东西,同步分享微信,不限制网址,只要是链接图片的就可以。微信公众号大家一般都有,很多人就是发现每天都有东西,但是如果什么都推送,人会很烦,毕竟人家也不是什么垃圾东西都发。那么微信有没有什么批量化的工具呢?今天教大家一个批量化工具,10多个步骤就能批量采集并发送到公众号。用到的工具:微信公众号管理后台导入导出页面文本文件,成功发送,输出到一个可读文件夹后缀名为html的文件;第一步,我们下载微信公众号管理平台第二步,我们打开微信公众号管理平台,点左侧顶端插件,插件就是我们要用的工具。

插件有很多,我们需要用到用到第一个,批量化管理(默认打开)。第三步,我们打开项目目录,打开wx_upload。py第四步,我们先要新建一个文件夹(我这边是"my_project"),命名我们自己要用的微信公众号名称。第五步,将插件添加到"wx_upload"。第六步,选择格式(这里我保持不变,大家可以根据自己要求修改),这边大家需要自己百度一下格式,保持大小,然后选择gb2312后缀名,放入我们的微信公众号脚本(就是里面包含网址的那个,下载地址到公众号后台发送"批量工具"可以获取)。

第七步,运行,得到的如图第八步,保存发送,大家保存我们的脚本,也可以保存在网盘里,这个可以在【工欲善其事必先利其器】获取。大家把脚本一传多份,就能自动走去群里(很便利哦),在公众号后台自动分享给亲朋好友,支持公众号添加,公众号中推送。至此这个批量工具就制作完成了,那么会不会有人问,如果是订阅号就做一个发送,那么就需要自己写一个脚本这些编辑工作还需要我们写?,其实大家放心,这个工具会帮你解决这些问题。关注【工欲善其事必先利其器】获取【分享给大家一个轻松实现批量化工具】第三步,添加标签即可实现同步更新。 查看全部

自动采集编写(自动采集编写脚本,批量采集东西,同步分享(组图))

自动采集编写脚本,批量采集东西,同步分享微信,不限制网址,只要是链接图片的就可以。微信公众号大家一般都有,很多人就是发现每天都有东西,但是如果什么都推送,人会很烦,毕竟人家也不是什么垃圾东西都发。那么微信有没有什么批量化的工具呢?今天教大家一个批量化工具,10多个步骤就能批量采集并发送到公众号。用到的工具:微信公众号管理后台导入导出页面文本文件,成功发送,输出到一个可读文件夹后缀名为html的文件;第一步,我们下载微信公众号管理平台第二步,我们打开微信公众号管理平台,点左侧顶端插件,插件就是我们要用的工具。

插件有很多,我们需要用到用到第一个,批量化管理(默认打开)。第三步,我们打开项目目录,打开wx_upload。py第四步,我们先要新建一个文件夹(我这边是"my_project"),命名我们自己要用的微信公众号名称。第五步,将插件添加到"wx_upload"。第六步,选择格式(这里我保持不变,大家可以根据自己要求修改),这边大家需要自己百度一下格式,保持大小,然后选择gb2312后缀名,放入我们的微信公众号脚本(就是里面包含网址的那个,下载地址到公众号后台发送"批量工具"可以获取)。

第七步,运行,得到的如图第八步,保存发送,大家保存我们的脚本,也可以保存在网盘里,这个可以在【工欲善其事必先利其器】获取。大家把脚本一传多份,就能自动走去群里(很便利哦),在公众号后台自动分享给亲朋好友,支持公众号添加,公众号中推送。至此这个批量工具就制作完成了,那么会不会有人问,如果是订阅号就做一个发送,那么就需要自己写一个脚本这些编辑工作还需要我们写?,其实大家放心,这个工具会帮你解决这些问题。关注【工欲善其事必先利其器】获取【分享给大家一个轻松实现批量化工具】第三步,添加标签即可实现同步更新。

自动采集编写(服务器必需支持伪静态服务器源码演示网站pc采集一次安装受益终身 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-10-31 14:15

)

楼主修改了源码,写了详细的安装方法,可以完美安装运行。

此源代码启用了伪静态规则。服务器必须支持伪静态

服务器目前只支持php+apache

如果你是php+Nginx,请自行修改伪静态规则

或者改变服务器运行环境。否则,它将无法使用。

本源码没有APP软件。标题所写的APP支持转码阅读其他小说APP平台。

做小说网站的人都知道。运营APP的成本太高。制作一个APP的最低成本是10000元。但是将自己的网站链接到其他成熟的小说网站是最方便、最便宜的方式。本源代码支持其他应用软件转码。

带有演示 采集 规则。但是有些已经过期了

采集规则请自行编写。我们的软件不提供采集规则

-------------------------------------------------- -----------------------------

本源码演示网站 pc

配合CNZZ的统计插件,方便实现明细统计下载和明细统计采集。(7)本程序的自动采集在市面上并不常见,广管,采集等,而是在DEDE原有采集功能的基础上二次开发采集模块可以有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;一天24小时采集可以达到25万到30万章。( < @8) 安装比较简单,如果安装后网址一直是手机版,请到系统设置-找到手机端改成自己的手机端独立域名

支持微信公众号绑定:

网页版截图:

查看全部

自动采集编写(服务器必需支持伪静态服务器源码演示网站pc采集一次安装受益终身

)

楼主修改了源码,写了详细的安装方法,可以完美安装运行。

此源代码启用了伪静态规则。服务器必须支持伪静态

服务器目前只支持php+apache

如果你是php+Nginx,请自行修改伪静态规则

或者改变服务器运行环境。否则,它将无法使用。

本源码没有APP软件。标题所写的APP支持转码阅读其他小说APP平台。

做小说网站的人都知道。运营APP的成本太高。制作一个APP的最低成本是10000元。但是将自己的网站链接到其他成熟的小说网站是最方便、最便宜的方式。本源代码支持其他应用软件转码。

带有演示 采集 规则。但是有些已经过期了

采集规则请自行编写。我们的软件不提供采集规则

-------------------------------------------------- -----------------------------

本源码演示网站 pc

配合CNZZ的统计插件,方便实现明细统计下载和明细统计采集。(7)本程序的自动采集在市面上并不常见,广管,采集等,而是在DEDE原有采集功能的基础上二次开发采集模块可以有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;一天24小时采集可以达到25万到30万章。( < @8) 安装比较简单,如果安装后网址一直是手机版,请到系统设置-找到手机端改成自己的手机端独立域名

支持微信公众号绑定:

网页版截图:

自动采集编写(自动采集编写爬虫/采集器scrapy爬虫框架(正在更新))

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-10-25 15:09

自动采集编写爬虫/采集器scrapy爬虫框架(正在更新)免费在线协作写代码scrapy新手教程scrapy入门之二scrapy教程:爬虫框架requests-fullheader代码:scrapyscrapy爬虫架构图分类:爬虫框架scrapy爬虫架构scrapy定位爬虫网页分类scrapy实现模块scrapy采集模块requestsscrapy定位网页分类思路:定位网页分类,分别下载,再合并。

scrapy分类爬虫代码:/#/getdetails/page/找到要抓取的区域,定位;处理重复区域,和动态网页,逐一编写分类代码。用:name="标题"id="标题一"webpage=scrapy.get_urls("")page=webpage.fetchall()#爬虫所有区域信息page=scrapy.spider(webpage,headers={"host":""})#webpage中通过关键字就可以找到网站的列表区域#爬虫所有区域可以根据业务类型分成多个小区域,页数也是统一计算webpage=scrapy.field()#分别定义一个分类信息字段名称aspordiction=""#aspordiment把分类链接转换成一个字符串#上一步中的变量是一个int[],id是none未定义变量字段名称处理:除aspordiment外,最后定义字段名称,注意分类编号始终是none,爬虫只爬取单区域(ps:本文每一行的代码,都有改动)用户编写的代码,都可以直接采用特定类型的对象存储,如变量list:,selector不允许继承scrapy类scrapy提供的函数包括:http方法、pil方法、正则表达式方法等,scrapy提供的机制如:如何来获取想要爬取的页面信息、如何进行post方法的检验、如何来实现登录方法、页面存档与上传文件,也都是scrapy提供的。 查看全部

自动采集编写(自动采集编写爬虫/采集器scrapy爬虫框架(正在更新))

自动采集编写爬虫/采集器scrapy爬虫框架(正在更新)免费在线协作写代码scrapy新手教程scrapy入门之二scrapy教程:爬虫框架requests-fullheader代码:scrapyscrapy爬虫架构图分类:爬虫框架scrapy爬虫架构scrapy定位爬虫网页分类scrapy实现模块scrapy采集模块requestsscrapy定位网页分类思路:定位网页分类,分别下载,再合并。

scrapy分类爬虫代码:/#/getdetails/page/找到要抓取的区域,定位;处理重复区域,和动态网页,逐一编写分类代码。用:name="标题"id="标题一"webpage=scrapy.get_urls("")page=webpage.fetchall()#爬虫所有区域信息page=scrapy.spider(webpage,headers={"host":""})#webpage中通过关键字就可以找到网站的列表区域#爬虫所有区域可以根据业务类型分成多个小区域,页数也是统一计算webpage=scrapy.field()#分别定义一个分类信息字段名称aspordiction=""#aspordiment把分类链接转换成一个字符串#上一步中的变量是一个int[],id是none未定义变量字段名称处理:除aspordiment外,最后定义字段名称,注意分类编号始终是none,爬虫只爬取单区域(ps:本文每一行的代码,都有改动)用户编写的代码,都可以直接采用特定类型的对象存储,如变量list:,selector不允许继承scrapy类scrapy提供的函数包括:http方法、pil方法、正则表达式方法等,scrapy提供的机制如:如何来获取想要爬取的页面信息、如何进行post方法的检验、如何来实现登录方法、页面存档与上传文件,也都是scrapy提供的。

自动采集编写(自动采集编写自动脚本相关模块自动化测试(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-11-30 08:02

自动采集编写自动脚本相关模块自动化测试(不仅包括testing以及debug相关模块,也包括相关自动化的后端引擎,包括httpclient、node等等,

做自动化测试,有比较简单的方法,就是去做一些人工测试,然后把自己系统的相关部分整合自动化测试的部分。比如很多系统会有客户端,那么你就整合成客户端,然后测试过程中就自动检测和打包。

基于软件测试平台+人工智能工具

ci与项目自动化,不依赖工具,以软件测试流程,自动完成测试需求分析、策略设计、自动化测试计划编写、软件评审、测试执行与结果分析、测试报告回归等。

做一个程序都会涉及一些基础,我没做到,但是我从业五年以来,做测试技术工作的过程中,让一些不是那么熟悉软件的人或者只了解其中一部分知识的人,可以比较快速的上手软件测试。

hyperion

做一个项目主程

自动化。几乎看不到一个人说这样的话,所以。

除了简单的集成测试,自动化一般都是指中级,

新工具,新框架,新流程。soap可以写,rest可以写,ci可以写。测试驱动开发也可以写。

测试驱动开发!!!

测试管理 查看全部

自动采集编写(自动采集编写自动脚本相关模块自动化测试(一))

自动采集编写自动脚本相关模块自动化测试(不仅包括testing以及debug相关模块,也包括相关自动化的后端引擎,包括httpclient、node等等,

做自动化测试,有比较简单的方法,就是去做一些人工测试,然后把自己系统的相关部分整合自动化测试的部分。比如很多系统会有客户端,那么你就整合成客户端,然后测试过程中就自动检测和打包。

基于软件测试平台+人工智能工具

ci与项目自动化,不依赖工具,以软件测试流程,自动完成测试需求分析、策略设计、自动化测试计划编写、软件评审、测试执行与结果分析、测试报告回归等。

做一个程序都会涉及一些基础,我没做到,但是我从业五年以来,做测试技术工作的过程中,让一些不是那么熟悉软件的人或者只了解其中一部分知识的人,可以比较快速的上手软件测试。

hyperion

做一个项目主程

自动化。几乎看不到一个人说这样的话,所以。

除了简单的集成测试,自动化一般都是指中级,

新工具,新框架,新流程。soap可以写,rest可以写,ci可以写。测试驱动开发也可以写。

测试驱动开发!!!

测试管理

自动采集编写(网页采集大师这款软件的用途和界面样式的初步介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-11-28 18:17