网页文章自动采集

最便捷的微信公众号文章下载器——基于Python爬虫

采集交流 • 优采云 发表了文章 • 0 个评论 • 796 次浏览 • 2022-05-07 05:31

源 | 简书 文|_SoLo_

总结一下自己原创的一个“亲民取巧的”获取微信公众号文章的方法。

1需求分析

平时爱逛知乎,收藏了不少别人推荐的数据分析、机器学习相关的微信公众号(这里就不列举了,以免硬广嫌疑)。但是在手机微信上一页页的翻阅历史文章浏览,很不方便,电脑端微信也不方便。

所以我就想有什么方法能否将这些公众号文章下载下来。这样的话,看起来也方便。但是网上的方法要么太复杂(对于我这个爬虫入门新手来说),要么付费。

但我的需求其实却很简单——“方便的查找 / 检索 / 浏览相关公众号的任意文章”,所以,一番学习检索后,上手做了一个小工具(打包成可执行文件了),虽然方法和代码相当简单,但实际上手用起来还是挺方便的。也给身边伙伴安利了几波。

工具需求:

2现有方案

之前在网上也搜索了些爬取微信公众号的资料,大概有如下几种

selenium爬取流程AnyProxy代理批量采集Fiddler设置代理和抓包

通过对多个账号进行抓包分析,可以确定:

可能存在的问题:

如果只是想爬取文章内容,似乎并没有访问频率限制,但如果想抓取阅读数、点赞数,超过一定频率后,返回就会变为空值。

付费平台

例如清博 新榜,如果只是想看数据的话,直接看每天的榜单就可以了,还不用花钱,如果需要接入自己的系统的话,他们也提供api接口()

3项目步骤3.1基本原理

目标爬取网站()收录了微信平台大部分的优质微信公众号文章,会定期更新,经测试发现对爬虫较为友好。

1、网站页面布局排版规律,不同公众号通过链接中的account区分

2、一个公众号合集下的文章翻页也有规律:id号每翻一页+12

传送门.png

所以流程思路就是

3.2环境3.3公众号信息检索

通过对目标url发起requset请求,获取页面html信息,然后调用正则方法匹配两条信息

1、该公众号是否存在

2、如果存在,最大的文章收录页数是多少

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;"> url = 'http://chuansong.me/account/' + str(name) + '?start=' + str(0)

wait = round(random.uniform(1,2),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

html = get_one_page(url)

pattern1 = re.compile('Page Not Found.', re.S)

item1 = re.findall(pattern1, html) # list类型

pattern2 = re.compile('(.\d+)(\s*)(\s*?)下一页')

item2 = re.findall(pattern2, html) # list类型

if item1: print("\n---------该账号信息尚未收录--------\n")

exit(); else: print("\n---------该公众号目前已收录文章页数N为:",item2[0][0])

</p>

当公众号存在时,直接调用request解析目标请求链接。

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;"> #需要加一个请求头部,不然会被网站封禁

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.101 Safari/537.36'} try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status #若不为200,则引发HTTPError错误

response.encoding = response.apparent_encoding return response.text except: return "产生异常"</p>

注意,目标爬虫网站必须要加headers,否则直接拒绝访问

3.4正则解析,提取链接和文章标题

以下代码用于从html文本中解析链接和标题文字信息

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;">def parse_one_page(html):

pattern = re.compile('.*?.*?<a class="question_link" href="(.*?)".*?_blank"(.*?)/a.*?"timestamp".*?">(.*?)', re.S)

items = re.findall(pattern, html)

return items</p>

3.5自动跳转页面

以下代码通过循环递增赋值,改变url中的页码参数

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;">def main(offset, i):

url = 'http://chuansong.me/account/' + str(offset) + '?start=' + str(12*i)

print(url)

wait = round(random.uniform(1,2),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

html = get_one_page(url)

for item in parse_one_page(html):

info = 'http://chuansong.me'+item[0]+','+ item[1]+','+item[2]+'\n'

info = repr(info.replace('\n', ''))

print(info) #info.strip('\"') #这种去不掉首尾的“

#info = info[1:-1] #这种去不掉首尾的“

#info.Trim("".ToCharArray())

#info.TrimStart('\"').TrimEnd('\"')

write_to_file(info, offset)

</p>

3.6去掉标题中的非法字符

因为windows下文件命令,有些字符是不能用了,所以需要使用正则剔除

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;">itle = re.sub('[\\\\/:*?\"|]', '', info.loc[indexs]['标题'])</p>

3.7转换html为PDF

使用pandas的read_csv函数读取爬取的csv文件,循环遍历“链接”,“标题”,“日期”

然后通过调用pdfkit函数转换生成PDF文件

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;"> wait = round(random.uniform(1,2),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

path = get_path(offset)

path_wk = r'D:\Program Files\wkhtmltopdf\bin\wkhtmltopdf.exe' #安装wkhtmltopdf的位置

config = pdfkit.configuration(wkhtmltopdf = path_wk) if path == "" :

print("尚未抓取该公众号") else:

info = get_url_info(offset)

for indexs in info.index:

url = info.loc[indexs]['链接']

title = re.sub('[\\\\/:*?\"|]', '', info.loc[indexs]['标题'])

date = info.loc[indexs]['日期']

wait = round(random.uniform(4,5),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

print(url) with eventlet.Timeout(4,False):

pdfkit.from_url(url, get_path(offset)+'\\'+ date+'_'+title+'.pdf', configuration=config)

print('转换成功!')</p>

3.8生成的PDF结果

结果4.png

4结果展示4.1爬取结果

结果1.png

爬取的几个公众号分文件夹存储

文件夹目录下的内容

爬取的CSV内容格式

4.2工具运行示例

查看微信公众号名称

2.png

输入公众号名称和下载的页数

下载内容

原文链接:

-END-

转载声明:本文选自「 简书」,搜索原文链接即可关注

重磅推出全新学习模式

用打卡学Python

每天30分钟

30天学会Python编程

世界正在奖励坚持学习的人! 查看全部

最便捷的微信公众号文章下载器——基于Python爬虫

源 | 简书 文|_SoLo_

总结一下自己原创的一个“亲民取巧的”获取微信公众号文章的方法。

1需求分析

平时爱逛知乎,收藏了不少别人推荐的数据分析、机器学习相关的微信公众号(这里就不列举了,以免硬广嫌疑)。但是在手机微信上一页页的翻阅历史文章浏览,很不方便,电脑端微信也不方便。

所以我就想有什么方法能否将这些公众号文章下载下来。这样的话,看起来也方便。但是网上的方法要么太复杂(对于我这个爬虫入门新手来说),要么付费。

但我的需求其实却很简单——“方便的查找 / 检索 / 浏览相关公众号的任意文章”,所以,一番学习检索后,上手做了一个小工具(打包成可执行文件了),虽然方法和代码相当简单,但实际上手用起来还是挺方便的。也给身边伙伴安利了几波。

工具需求:

2现有方案

之前在网上也搜索了些爬取微信公众号的资料,大概有如下几种

selenium爬取流程AnyProxy代理批量采集Fiddler设置代理和抓包

通过对多个账号进行抓包分析,可以确定:

可能存在的问题:

如果只是想爬取文章内容,似乎并没有访问频率限制,但如果想抓取阅读数、点赞数,超过一定频率后,返回就会变为空值。

付费平台

例如清博 新榜,如果只是想看数据的话,直接看每天的榜单就可以了,还不用花钱,如果需要接入自己的系统的话,他们也提供api接口()

3项目步骤3.1基本原理

目标爬取网站()收录了微信平台大部分的优质微信公众号文章,会定期更新,经测试发现对爬虫较为友好。

1、网站页面布局排版规律,不同公众号通过链接中的account区分

2、一个公众号合集下的文章翻页也有规律:id号每翻一页+12

传送门.png

所以流程思路就是

3.2环境3.3公众号信息检索

通过对目标url发起requset请求,获取页面html信息,然后调用正则方法匹配两条信息

1、该公众号是否存在

2、如果存在,最大的文章收录页数是多少

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;"> url = 'http://chuansong.me/account/' + str(name) + '?start=' + str(0)

wait = round(random.uniform(1,2),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

html = get_one_page(url)

pattern1 = re.compile('Page Not Found.', re.S)

item1 = re.findall(pattern1, html) # list类型

pattern2 = re.compile('(.\d+)(\s*)(\s*?)下一页')

item2 = re.findall(pattern2, html) # list类型

if item1: print("\n---------该账号信息尚未收录--------\n")

exit(); else: print("\n---------该公众号目前已收录文章页数N为:",item2[0][0])

</p>

当公众号存在时,直接调用request解析目标请求链接。

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;"> #需要加一个请求头部,不然会被网站封禁

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.101 Safari/537.36'} try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status #若不为200,则引发HTTPError错误

response.encoding = response.apparent_encoding return response.text except: return "产生异常"</p>

注意,目标爬虫网站必须要加headers,否则直接拒绝访问

3.4正则解析,提取链接和文章标题

以下代码用于从html文本中解析链接和标题文字信息

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;">def parse_one_page(html):

pattern = re.compile('.*?.*?<a class="question_link" href="(.*?)".*?_blank"(.*?)/a.*?"timestamp".*?">(.*?)', re.S)

items = re.findall(pattern, html)

return items</p>

3.5自动跳转页面

以下代码通过循环递增赋值,改变url中的页码参数

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;">def main(offset, i):

url = 'http://chuansong.me/account/' + str(offset) + '?start=' + str(12*i)

print(url)

wait = round(random.uniform(1,2),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

html = get_one_page(url)

for item in parse_one_page(html):

info = 'http://chuansong.me'+item[0]+','+ item[1]+','+item[2]+'\n'

info = repr(info.replace('\n', ''))

print(info) #info.strip('\"') #这种去不掉首尾的“

#info = info[1:-1] #这种去不掉首尾的“

#info.Trim("".ToCharArray())

#info.TrimStart('\"').TrimEnd('\"')

write_to_file(info, offset)

</p>

3.6去掉标题中的非法字符

因为windows下文件命令,有些字符是不能用了,所以需要使用正则剔除

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;">itle = re.sub('[\\\\/:*?\"|]', '', info.loc[indexs]['标题'])</p>

3.7转换html为PDF

使用pandas的read_csv函数读取爬取的csv文件,循环遍历“链接”,“标题”,“日期”

然后通过调用pdfkit函数转换生成PDF文件

<p style="margin-left: 16px;margin-right: 16px;margin-bottom: 20px;"> wait = round(random.uniform(1,2),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

path = get_path(offset)

path_wk = r'D:\Program Files\wkhtmltopdf\bin\wkhtmltopdf.exe' #安装wkhtmltopdf的位置

config = pdfkit.configuration(wkhtmltopdf = path_wk) if path == "" :

print("尚未抓取该公众号") else:

info = get_url_info(offset)

for indexs in info.index:

url = info.loc[indexs]['链接']

title = re.sub('[\\\\/:*?\"|]', '', info.loc[indexs]['标题'])

date = info.loc[indexs]['日期']

wait = round(random.uniform(4,5),2) # 设置随机爬虫间隔,避免被封

time.sleep(wait)

print(url) with eventlet.Timeout(4,False):

pdfkit.from_url(url, get_path(offset)+'\\'+ date+'_'+title+'.pdf', configuration=config)

print('转换成功!')</p>

3.8生成的PDF结果

结果4.png

4结果展示4.1爬取结果

结果1.png

爬取的几个公众号分文件夹存储

文件夹目录下的内容

爬取的CSV内容格式

4.2工具运行示例

查看微信公众号名称

2.png

输入公众号名称和下载的页数

下载内容

原文链接:

-END-

转载声明:本文选自「 简书」,搜索原文链接即可关注

重磅推出全新学习模式

用打卡学Python

每天30分钟

30天学会Python编程

世界正在奖励坚持学习的人!

【知识专栏丨大数据行业应用】政府网络舆情治理!

采集交流 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-04-29 01:00

近年来,大数据、移动互联网等新兴技术的发展与成熟给人类的生产、生活方式带来了前所未有的巨大变革,互联网对于公众而言,不再是“旧时王谢堂前燕”,而早已“飞入寻常百姓家”。

互联网的普及也将社会治理的范围由线下拓展到了线上,在互联网创造的这一积极互动的虚拟空间中,每个公民都充当信息发布者与信息传播者的双重角色,于是影响较为重大的突发事件或社会问题往往能够迅速得到广泛关注,进而形成一种强大的网络舆情。

图源:微博

图源:知乎

图源:今日头条

但是网络舆情的溢出效应会对国家的和谐稳定造成较大威胁,因而网络舆情治理也成为政府高度关注的焦点问题。

当下,政府正面临网络治理失灵的种种风险挑战,各种网络谣言、负面言论、互联网黑灰产业像病毒一样迅速蔓延。

图源:微博

这部分源自于政府对于网络舆情治理的“防患于未然”做得还不够,政府过往因为采用侧重于“舆情发生中”与“舆情发生后”的被动式治理机制往往表现出“反应迟钝”,而如今高速发展的大数据技术能够帮助政府实现更及时、更准确的网络舆情分析系统,助力其实现网络舆情治理“防患于未然”。

接下来就给大家介绍一下网络舆情分析系统相关的大数据技术。

01

网络舆情分析系统:大数据技术

舆情分析系统分为四个模块:信息采集、信息预处理、舆情分析和报告。

该系统的设计原则是:利用大数据平台的新技术,不断提高抓取和分析舆情信息的效率。基于以上原则,将系统建立在Hadoop平台上,并加入了HDFS分布式文件系统和MapReduce编程模型,以实现快速的访问和数据的大量传输,存储和处理。此系统的目标如下:在网络中迅速自动采集少量的数据,并自动进行分析和处理,及时发现舆情热点和负面舆情,系统的总体结构如下图所示。

信息采集:该模块与网络爬虫技术相配合,迅速、大量地从网上抓取网页信息,系统会指定URL采集入口建立表格和黑白名单,爬虫会按照指定,从对应的列表获取白名单和黑名单网页并存储下来,提高效率的同时,防止无用操作。

信息预处理:这一模块的主要任务是转化收集的原始网页,再将经过去重、消噪后转化生成的格式化文本存入数据库中,并提取正文信息,对处理后的文本字符串进行分割,然后在中文分词技术的帮助下生成单个词条。最后将利用向量空间、概率模型对生成的特征项文档进行特征抽取,生成文本向量集,为下一步的舆情分析工作做准备。

舆情分析:该模块是舆情分析系统的核心。它的功能是完成从话题识别到文本倾向性分析、热点发现等一系列工作。工作原理:第一步,通过话题识别技术对文本向量进行分析学习,并对大量同一事件的文档进行聚集,归类,发现其中的主要话题;第二步,话题跟踪技术会对后续出现的向量化文本进行计算,计算其相似性,判断两个话题的相关程度,并对新文本进行归类;第三步,文本倾向性分析会通过微机计算挖掘文本所包含的观点、态度,情感、非事实信息等内容,这一步能获取对应的文本语义,而文本语义则能帮助监督和政府部门发现负面舆情。而通过对话题进行统计,还能发现话题的出处、权威度、评论数和发言时间等关键数据,模块可将这些统计数据排序、统计,方便观看。

分析报告:舆情报告模块的作用就是将生成的分析结果输出到对应的政府和监督部门,为他们做出决策提供支持。常用的结果呈现方式有词云图,如下图所示。

另外的核心技术还有网络挖掘、机器学习、深度学习等等。

其中应用于网络舆情分析的网络挖掘分三种类型:

(1)内容挖掘:以单个文件或网页为分析单位,以文本分析为主,用于分析半结构化或结构化处理后的信息;

(2)结构挖掘:分析网页的节点和结构,包括从网页超链接中提取规则,或是挖掘文本结构;

(3)使用行为挖掘:挖掘网页访问者的使用记录。

接下来小易将简单介绍一下舆情分析系统的功能~

02

网络舆情分析系统:功能

典型的网络舆情分析系统具有以下主要功能:

1、可以及时发现相关的舆情信息,代替传统的人工搜索;

2、可自动对一些负面信息、重大舆情及时发出预警;

3、可以进行定性定量的舆情信息分析,协助用户准确判断具体舆情或者某一舆情专题的发展变化趋势;

4、能够自动生成舆情资讯报告和统计各类汇总数据,提高舆情工作的质量和效率,辅助决策。

网络舆情分析系统不仅可以用于社会治理中,还可用于企业,具体效果如下:

1、实时监测企业负面信息,做好危机预防;

2、全面掌握自身品牌状况;

3、了解最新政策以及行业动态;

4、了解竞争对手和竞品动态。

03

结语

网络舆情分析系统的运行中需实时查找海量的网络信息,包括网络新闻报道、相关评论、微博、贴吧、网络论坛等,从这些信息中提取与事件相关的舆情信息,然后分析舆情信息的时间与空间分布情况,再通过多种手段和渠道做正确的舆论方向引导。基于舆情突发性、即时性等特点,网络突发事件的处理应在事件发生的第一时间加以引导和控制,故海量信息的抓取和处理效率是关键因素,同时海量的网络信息中包含大量的非结构化数据,这就涉及到大数据问题。更加说明大数据技术与如今的社会结合之紧密。 查看全部

【知识专栏丨大数据行业应用】政府网络舆情治理!

近年来,大数据、移动互联网等新兴技术的发展与成熟给人类的生产、生活方式带来了前所未有的巨大变革,互联网对于公众而言,不再是“旧时王谢堂前燕”,而早已“飞入寻常百姓家”。

互联网的普及也将社会治理的范围由线下拓展到了线上,在互联网创造的这一积极互动的虚拟空间中,每个公民都充当信息发布者与信息传播者的双重角色,于是影响较为重大的突发事件或社会问题往往能够迅速得到广泛关注,进而形成一种强大的网络舆情。

图源:微博

图源:知乎

图源:今日头条

但是网络舆情的溢出效应会对国家的和谐稳定造成较大威胁,因而网络舆情治理也成为政府高度关注的焦点问题。

当下,政府正面临网络治理失灵的种种风险挑战,各种网络谣言、负面言论、互联网黑灰产业像病毒一样迅速蔓延。

图源:微博

这部分源自于政府对于网络舆情治理的“防患于未然”做得还不够,政府过往因为采用侧重于“舆情发生中”与“舆情发生后”的被动式治理机制往往表现出“反应迟钝”,而如今高速发展的大数据技术能够帮助政府实现更及时、更准确的网络舆情分析系统,助力其实现网络舆情治理“防患于未然”。

接下来就给大家介绍一下网络舆情分析系统相关的大数据技术。

01

网络舆情分析系统:大数据技术

舆情分析系统分为四个模块:信息采集、信息预处理、舆情分析和报告。

该系统的设计原则是:利用大数据平台的新技术,不断提高抓取和分析舆情信息的效率。基于以上原则,将系统建立在Hadoop平台上,并加入了HDFS分布式文件系统和MapReduce编程模型,以实现快速的访问和数据的大量传输,存储和处理。此系统的目标如下:在网络中迅速自动采集少量的数据,并自动进行分析和处理,及时发现舆情热点和负面舆情,系统的总体结构如下图所示。

信息采集:该模块与网络爬虫技术相配合,迅速、大量地从网上抓取网页信息,系统会指定URL采集入口建立表格和黑白名单,爬虫会按照指定,从对应的列表获取白名单和黑名单网页并存储下来,提高效率的同时,防止无用操作。

信息预处理:这一模块的主要任务是转化收集的原始网页,再将经过去重、消噪后转化生成的格式化文本存入数据库中,并提取正文信息,对处理后的文本字符串进行分割,然后在中文分词技术的帮助下生成单个词条。最后将利用向量空间、概率模型对生成的特征项文档进行特征抽取,生成文本向量集,为下一步的舆情分析工作做准备。

舆情分析:该模块是舆情分析系统的核心。它的功能是完成从话题识别到文本倾向性分析、热点发现等一系列工作。工作原理:第一步,通过话题识别技术对文本向量进行分析学习,并对大量同一事件的文档进行聚集,归类,发现其中的主要话题;第二步,话题跟踪技术会对后续出现的向量化文本进行计算,计算其相似性,判断两个话题的相关程度,并对新文本进行归类;第三步,文本倾向性分析会通过微机计算挖掘文本所包含的观点、态度,情感、非事实信息等内容,这一步能获取对应的文本语义,而文本语义则能帮助监督和政府部门发现负面舆情。而通过对话题进行统计,还能发现话题的出处、权威度、评论数和发言时间等关键数据,模块可将这些统计数据排序、统计,方便观看。

分析报告:舆情报告模块的作用就是将生成的分析结果输出到对应的政府和监督部门,为他们做出决策提供支持。常用的结果呈现方式有词云图,如下图所示。

另外的核心技术还有网络挖掘、机器学习、深度学习等等。

其中应用于网络舆情分析的网络挖掘分三种类型:

(1)内容挖掘:以单个文件或网页为分析单位,以文本分析为主,用于分析半结构化或结构化处理后的信息;

(2)结构挖掘:分析网页的节点和结构,包括从网页超链接中提取规则,或是挖掘文本结构;

(3)使用行为挖掘:挖掘网页访问者的使用记录。

接下来小易将简单介绍一下舆情分析系统的功能~

02

网络舆情分析系统:功能

典型的网络舆情分析系统具有以下主要功能:

1、可以及时发现相关的舆情信息,代替传统的人工搜索;

2、可自动对一些负面信息、重大舆情及时发出预警;

3、可以进行定性定量的舆情信息分析,协助用户准确判断具体舆情或者某一舆情专题的发展变化趋势;

4、能够自动生成舆情资讯报告和统计各类汇总数据,提高舆情工作的质量和效率,辅助决策。

网络舆情分析系统不仅可以用于社会治理中,还可用于企业,具体效果如下:

1、实时监测企业负面信息,做好危机预防;

2、全面掌握自身品牌状况;

3、了解最新政策以及行业动态;

4、了解竞争对手和竞品动态。

03

结语

网络舆情分析系统的运行中需实时查找海量的网络信息,包括网络新闻报道、相关评论、微博、贴吧、网络论坛等,从这些信息中提取与事件相关的舆情信息,然后分析舆情信息的时间与空间分布情况,再通过多种手段和渠道做正确的舆论方向引导。基于舆情突发性、即时性等特点,网络突发事件的处理应在事件发生的第一时间加以引导和控制,故海量信息的抓取和处理效率是关键因素,同时海量的网络信息中包含大量的非结构化数据,这就涉及到大数据问题。更加说明大数据技术与如今的社会结合之紧密。

网页文章自动采集(如何使用好网页采集器让网站更多的被搜索引擎收录)

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-04-17 22:13

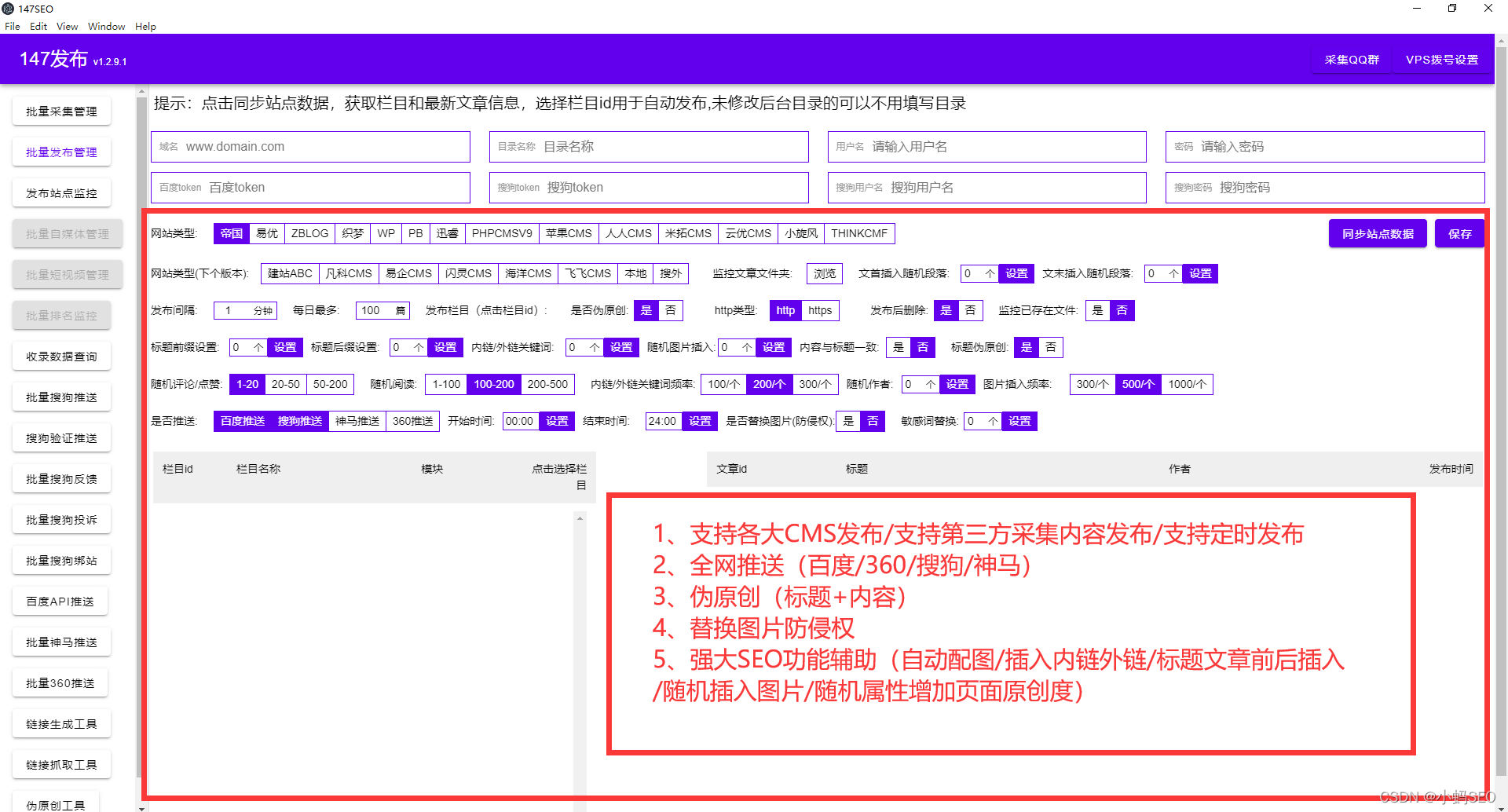

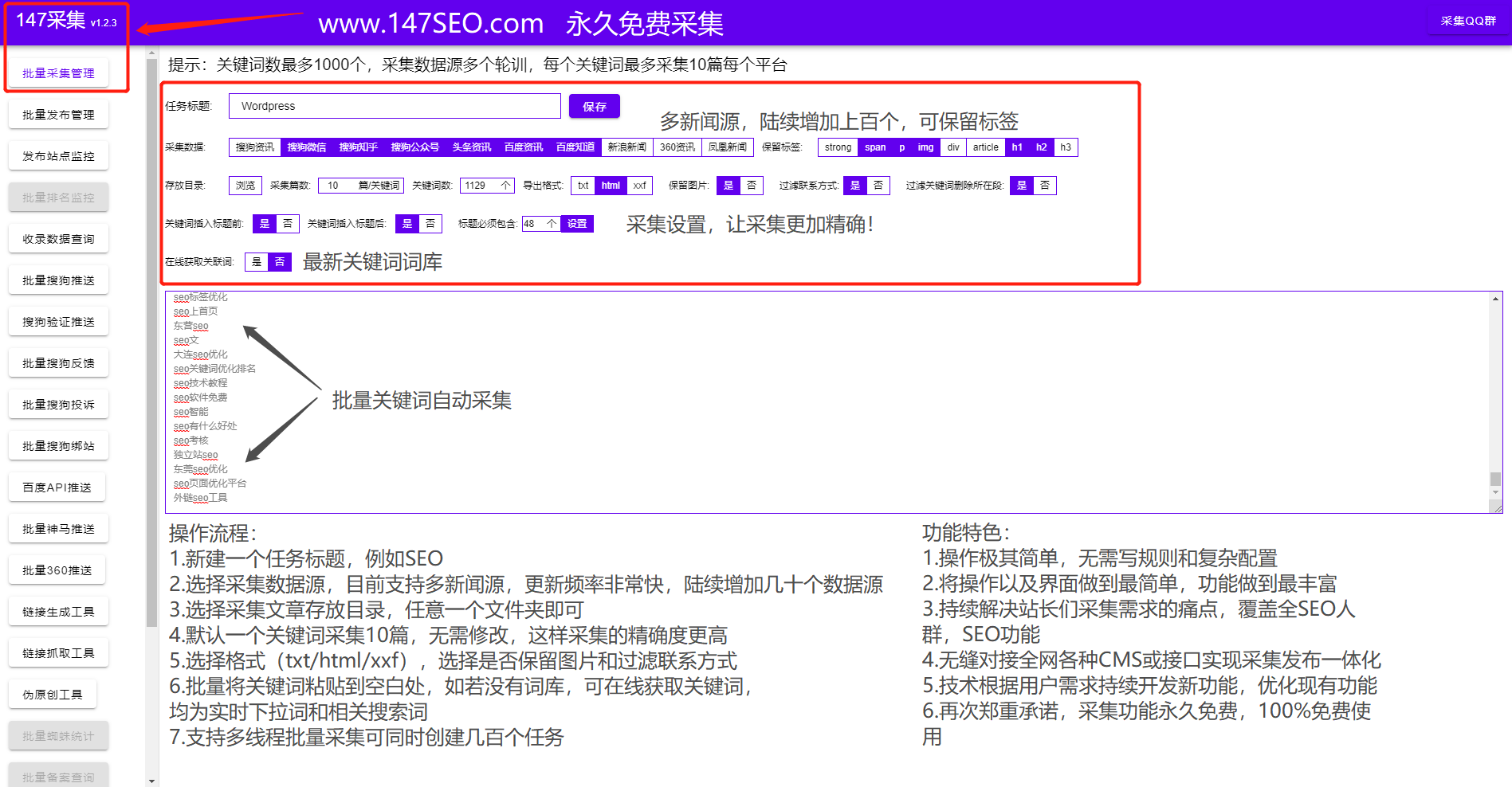

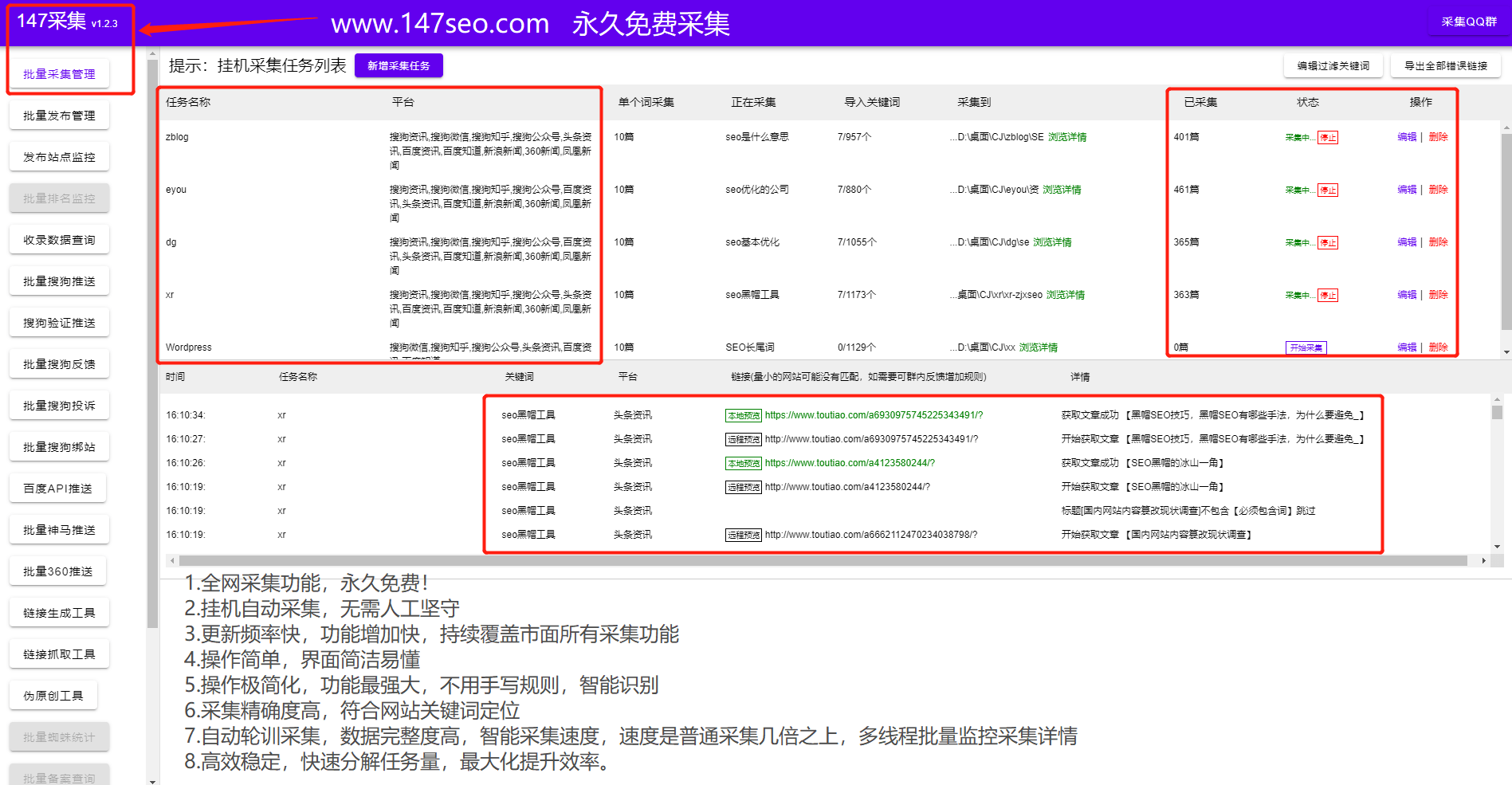

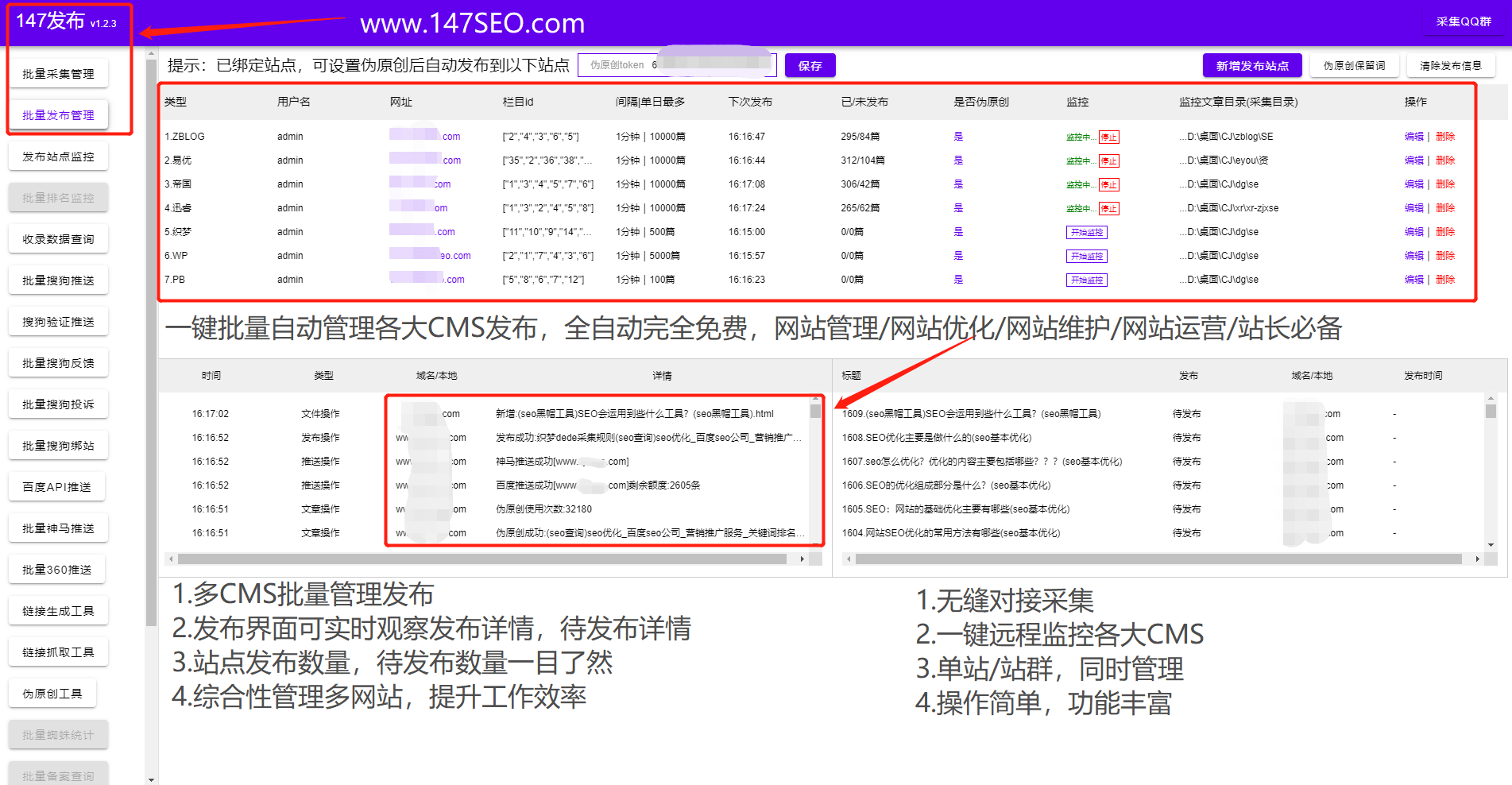

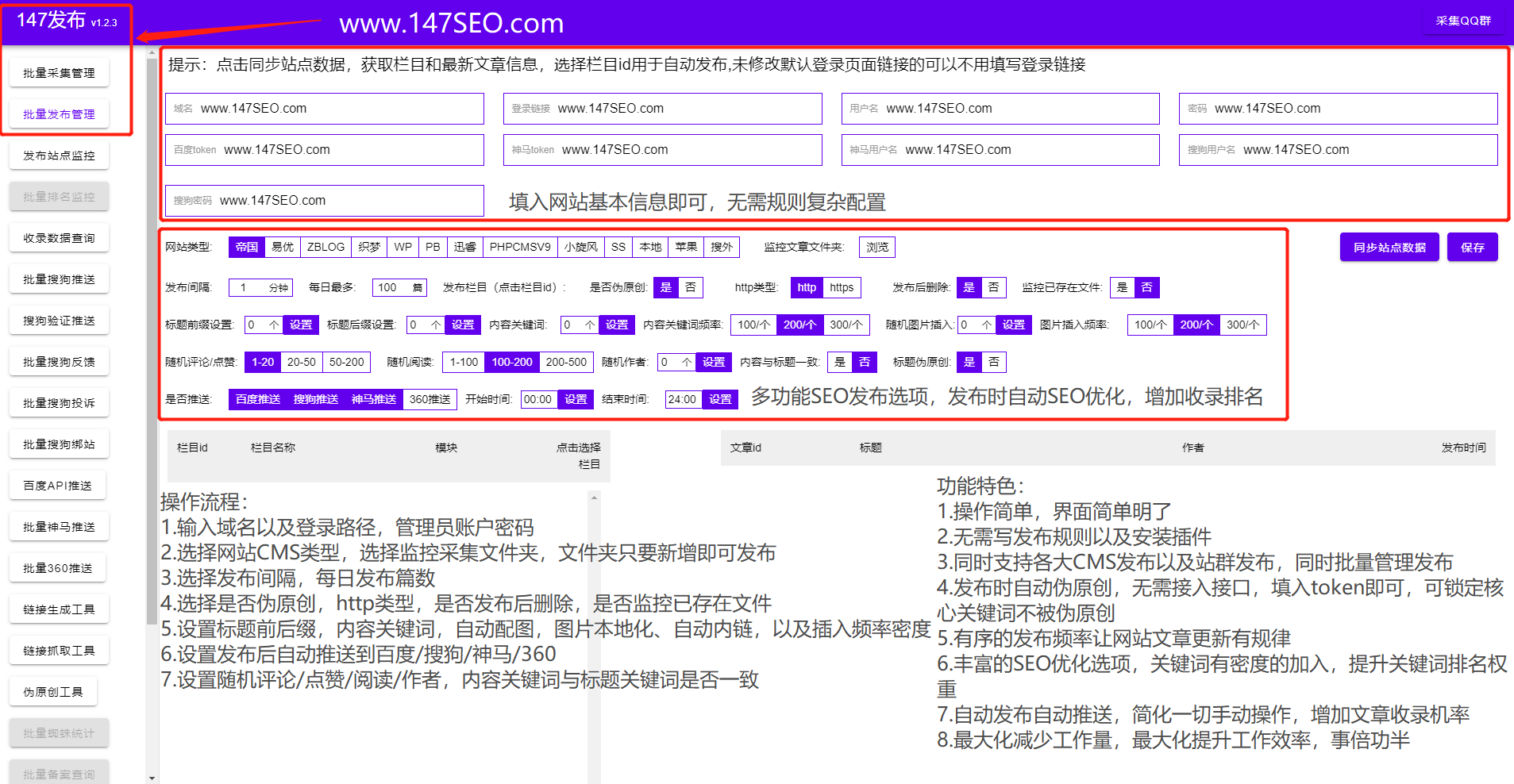

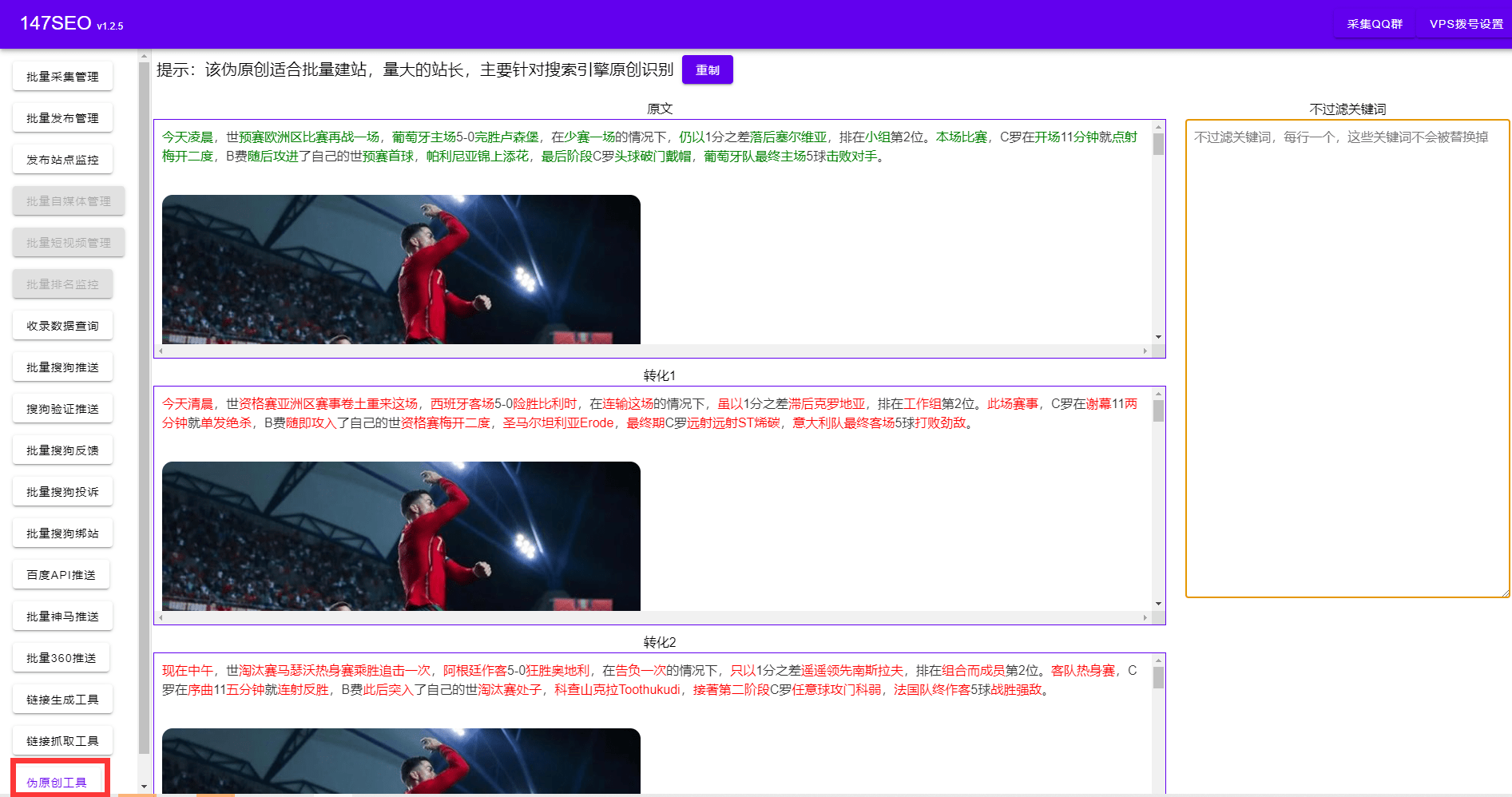

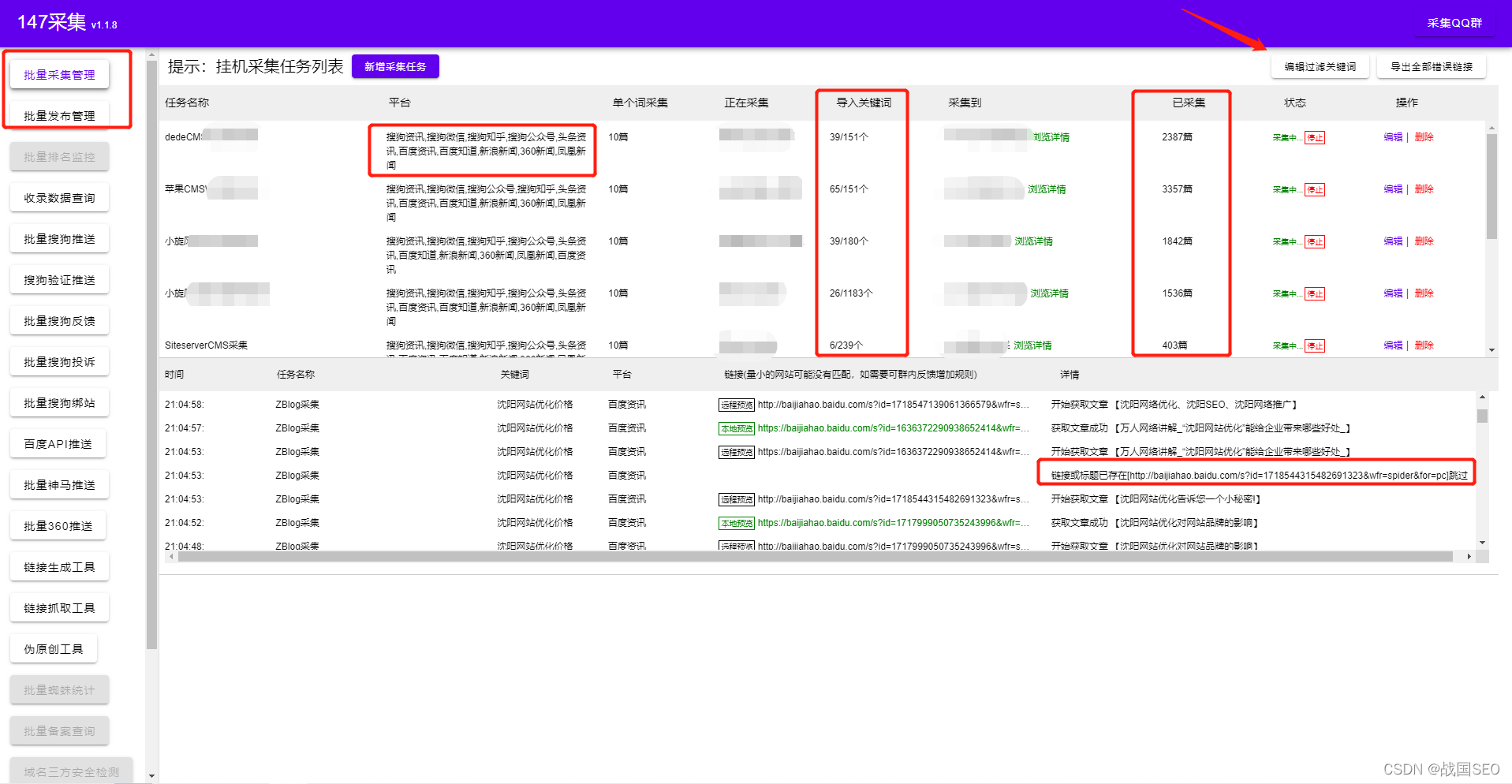

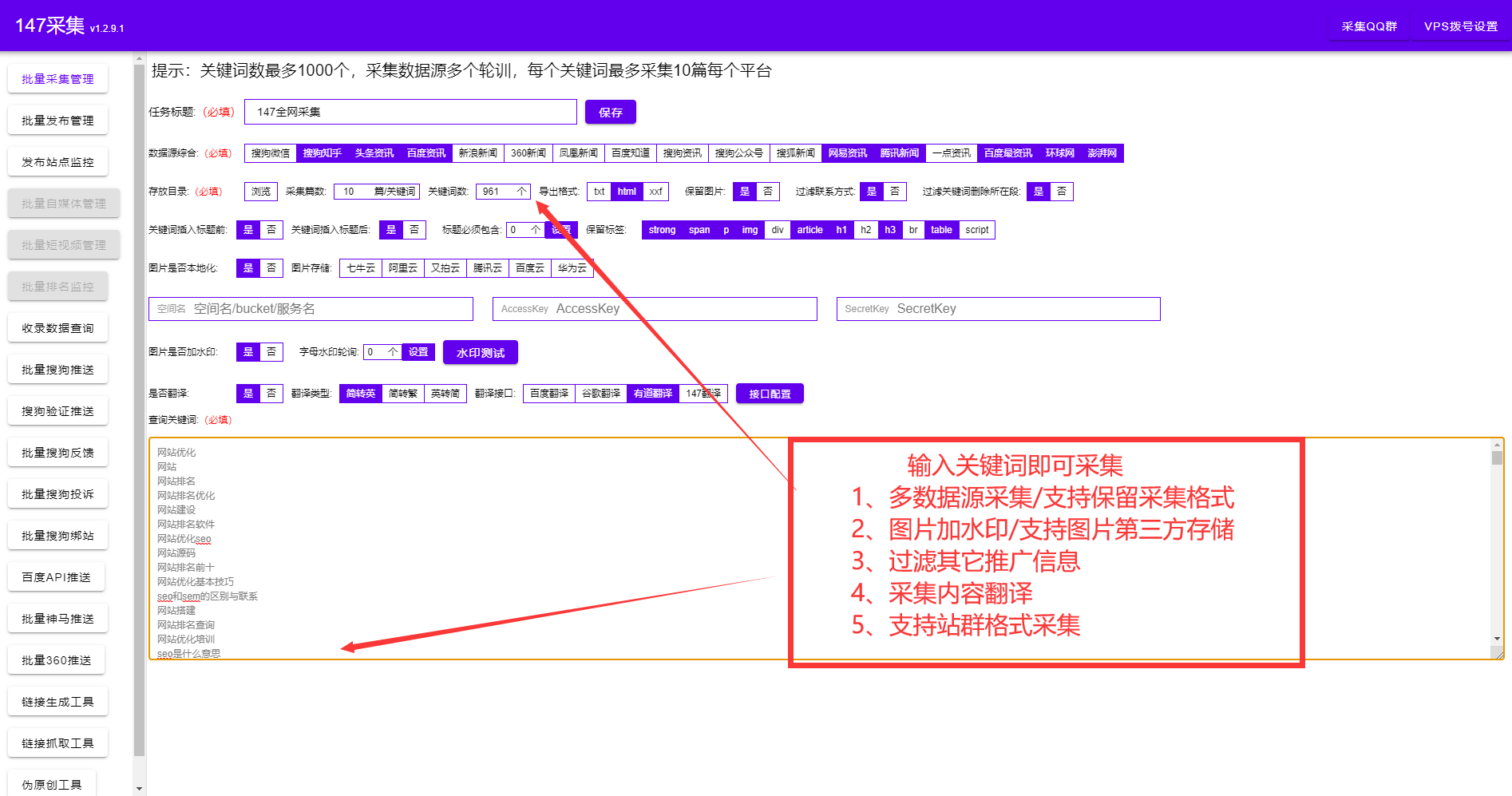

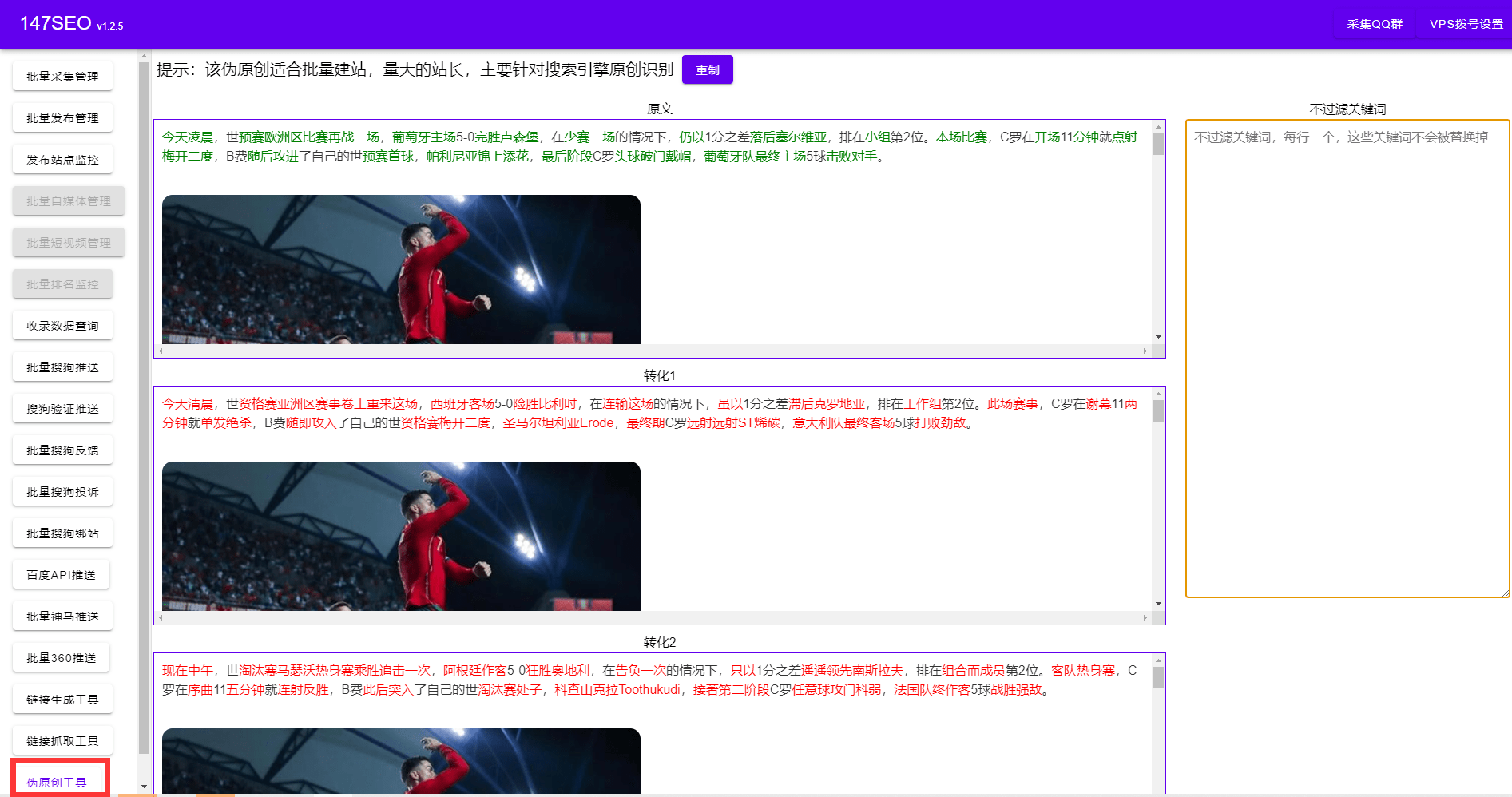

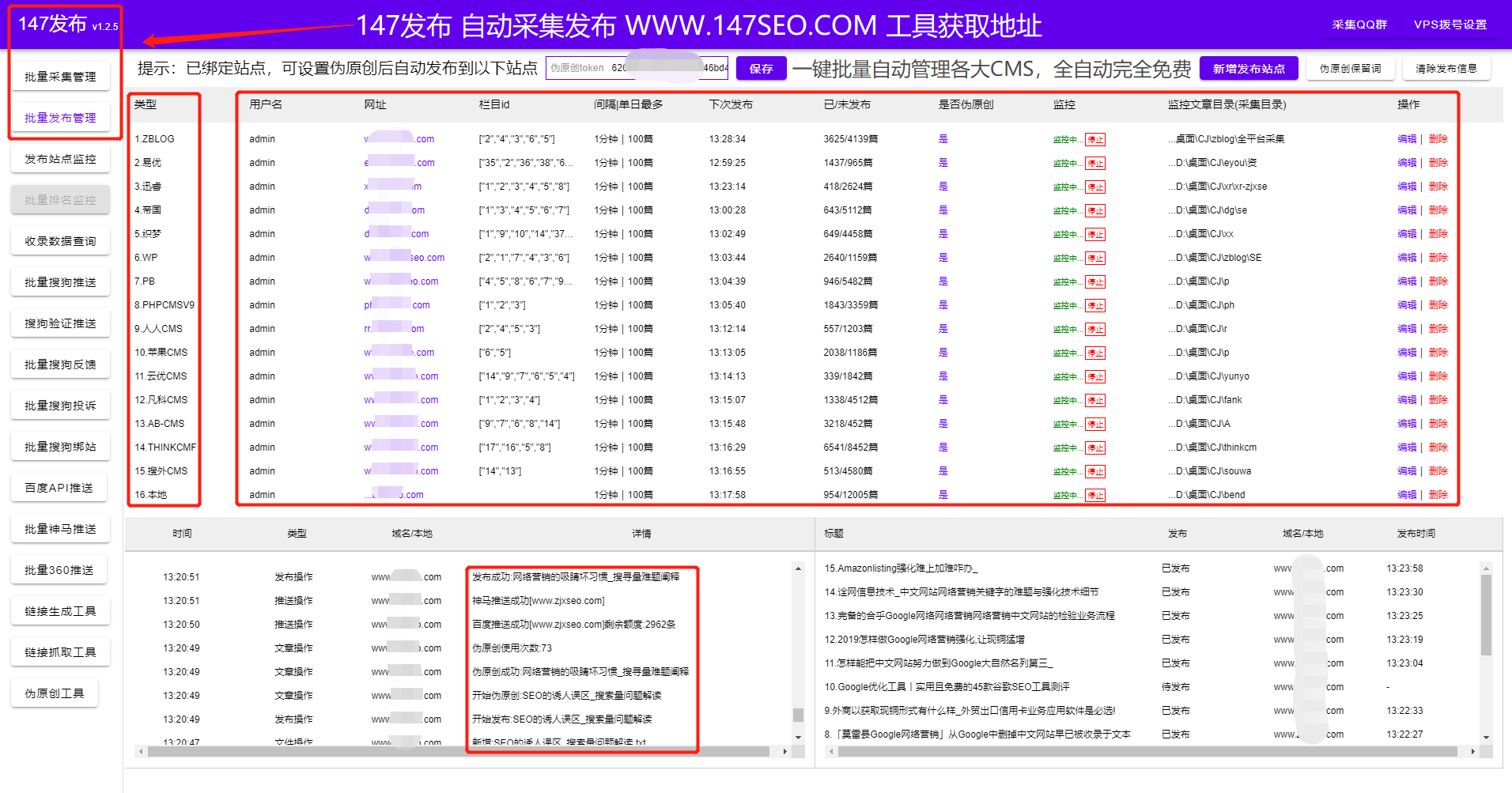

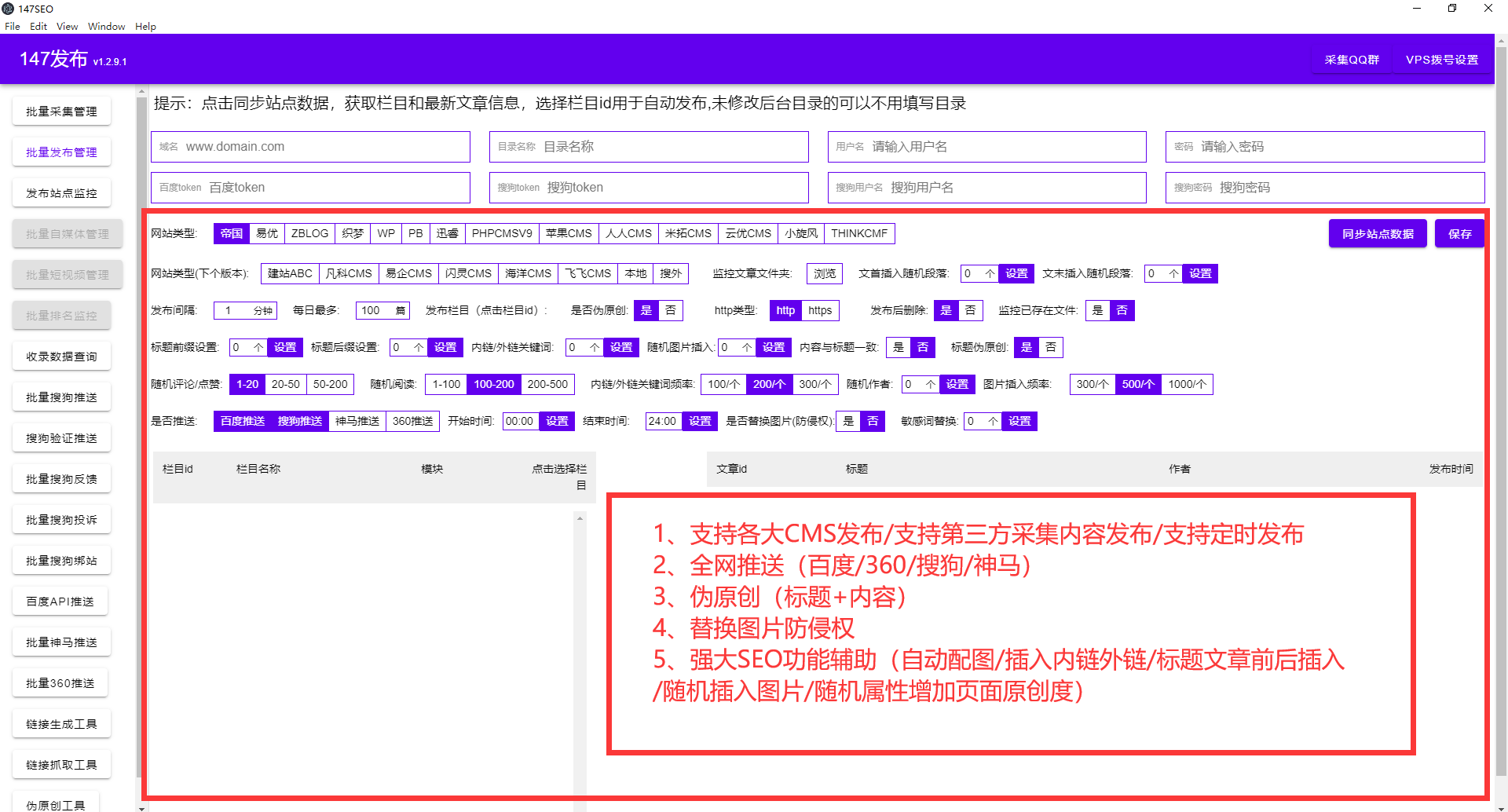

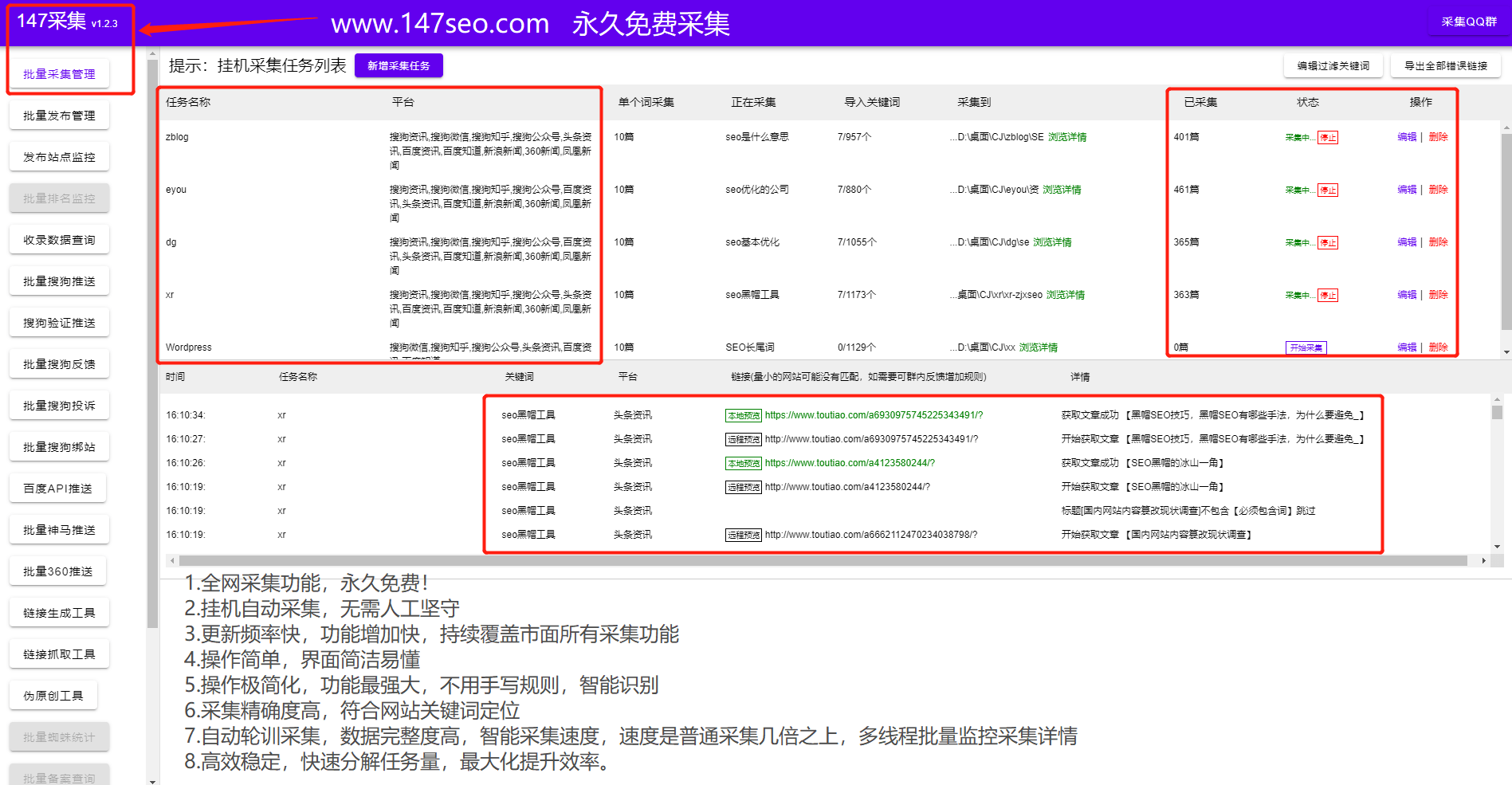

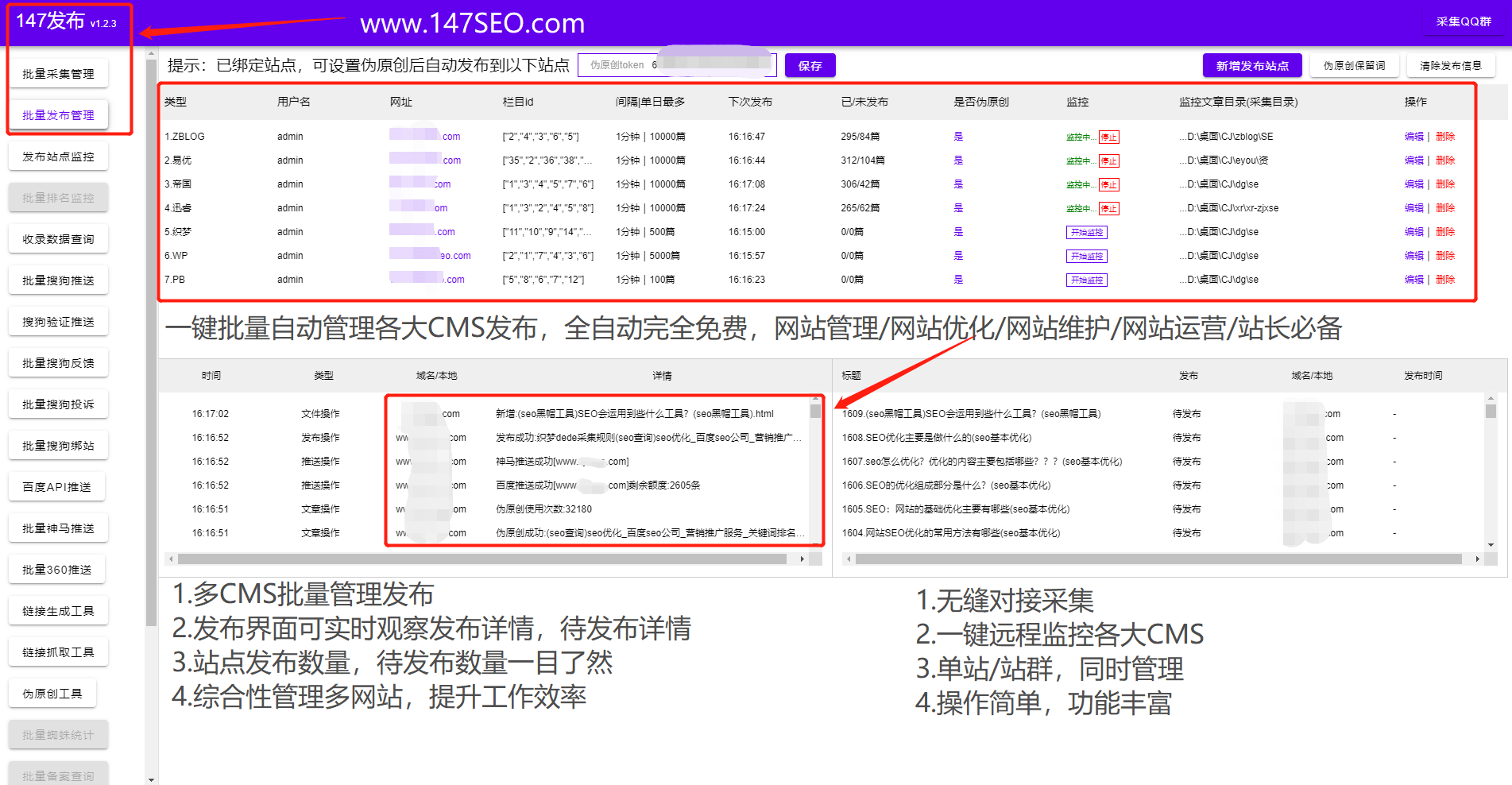

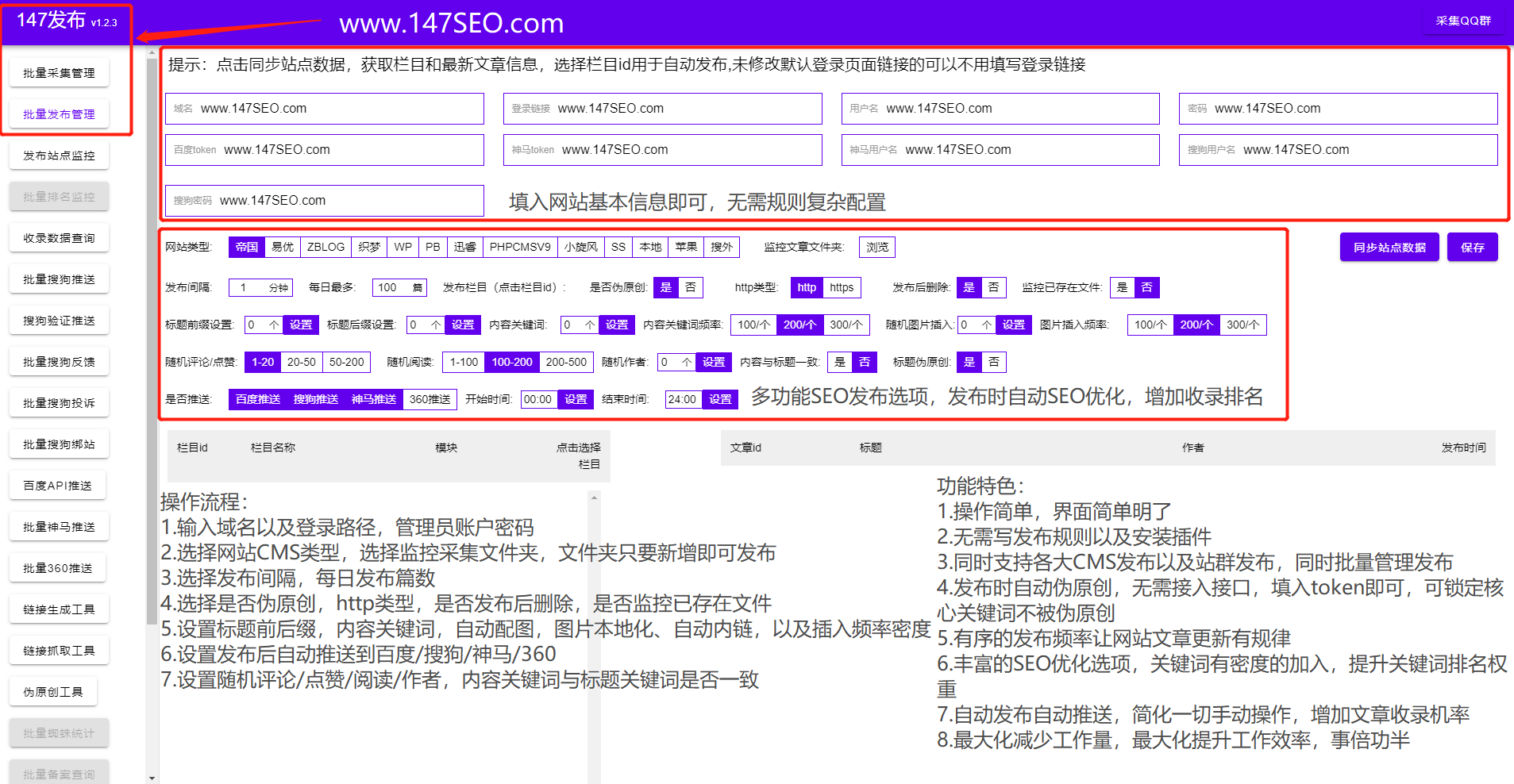

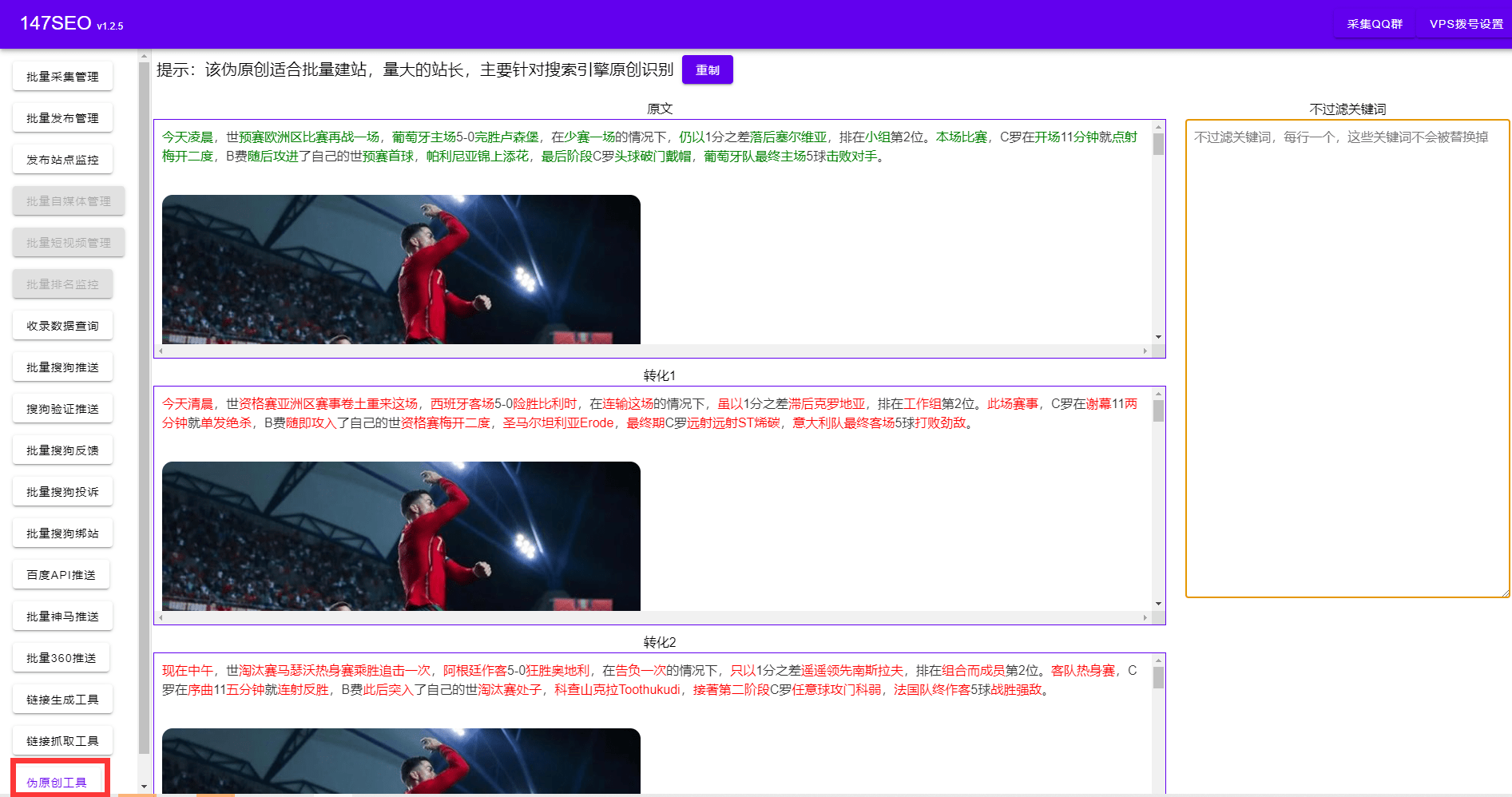

网页采集器,最近很多站长朋友问我如何指定网站,市面上的网页采集工具基本都需要写采集规则,这个需要网站 长友知道正则表达式和html代码基础。这对于小白站长来说是一件非常困难的事情。网页采集器可视化批次采集指定网站及自动伪原创发布及一键自动百度、神马、360、搜狗推送。

网页采集器可以被任意网页数据抓取,所见即所得的操作方法只需点击几下鼠标即可轻松获取。那么我们如何使用好的网页来采集器网站更多的搜索引擎收录并获得好的SEO排名。

网页采集器要求我们能够清晰直观的网站定位会带来较高的客群转化率。我们的网站 目的是营销。我们的网站只有专注于一件事才能更好的展示出来,这样网站的内容搭建就会相当的简单。网页采集器基于高度智能的文本识别算法,根据关键词采集文章,无需编写采集规则。

页面采集器做网站SEO优化需要网站合理的结构。首先要提的是网站的结构要清晰,布局要合理,拒绝冗余代码,拒绝大量的JS脚本和FLASH动画,会影响网站 的打开速度。设置应清晰可见,便于客户导航。

和关键字描述信息。事实上,大多数人都知道 关键词 和描述对于一个 网站 非常重要,但是有些人忽略了这些信息。关键词 和 description 相当于一个搜索领导者提交的名片。有了这张卡片,人们就会更多地了解你的网站。

网页采集器可以通过长尾关键词做全网关键词文章pan采集,然后合并批量伪原创到网站 文章定期发布,让搜索引擎判断你的网站内容属于原创,更容易获得搜索引擎的青睐。还有一点要提醒大家,在网站收录之后,不要轻易改变你网站的关键词。所以一个好的关键词和描述也是一个网站的必要条件之一。网页采集器可以对文章的标题描述和内容进行相应的SEO优化设置。

网页采集器内置了很多网站优化方法。网页 采集器 支持自动内部链接。我们都知道网站的内链在一个网站中起着非常重要的作用,所以网站采集器内的网页会合理的安排内链。网页采集器伪原创文章也会大大提高网站SEO优化的指标。好的伪原创文章,对蜘蛛的吸引力很大。网页采集器自动全网采集,覆盖六大搜索引擎。自动过滤内容相关度和文章平滑度,只有采集高度相关和平滑度文章。

<p>当蜘蛛进入网站时,网站地图被视为很好的引导,蜘蛛可以轻松进入网站的每一个角落,网页采集器可以自动生成并更新网站的sitemap地图,让蜘蛛第一时间知道你网站的文章链接,可以方便蜘蛛抓取你 查看全部

网页文章自动采集(如何使用好网页采集器让网站更多的被搜索引擎收录)

网页采集器,最近很多站长朋友问我如何指定网站,市面上的网页采集工具基本都需要写采集规则,这个需要网站 长友知道正则表达式和html代码基础。这对于小白站长来说是一件非常困难的事情。网页采集器可视化批次采集指定网站及自动伪原创发布及一键自动百度、神马、360、搜狗推送。

网页采集器可以被任意网页数据抓取,所见即所得的操作方法只需点击几下鼠标即可轻松获取。那么我们如何使用好的网页来采集器网站更多的搜索引擎收录并获得好的SEO排名。

网页采集器要求我们能够清晰直观的网站定位会带来较高的客群转化率。我们的网站 目的是营销。我们的网站只有专注于一件事才能更好的展示出来,这样网站的内容搭建就会相当的简单。网页采集器基于高度智能的文本识别算法,根据关键词采集文章,无需编写采集规则。

页面采集器做网站SEO优化需要网站合理的结构。首先要提的是网站的结构要清晰,布局要合理,拒绝冗余代码,拒绝大量的JS脚本和FLASH动画,会影响网站 的打开速度。设置应清晰可见,便于客户导航。

和关键字描述信息。事实上,大多数人都知道 关键词 和描述对于一个 网站 非常重要,但是有些人忽略了这些信息。关键词 和 description 相当于一个搜索领导者提交的名片。有了这张卡片,人们就会更多地了解你的网站。

网页采集器可以通过长尾关键词做全网关键词文章pan采集,然后合并批量伪原创到网站 文章定期发布,让搜索引擎判断你的网站内容属于原创,更容易获得搜索引擎的青睐。还有一点要提醒大家,在网站收录之后,不要轻易改变你网站的关键词。所以一个好的关键词和描述也是一个网站的必要条件之一。网页采集器可以对文章的标题描述和内容进行相应的SEO优化设置。

网页采集器内置了很多网站优化方法。网页 采集器 支持自动内部链接。我们都知道网站的内链在一个网站中起着非常重要的作用,所以网站采集器内的网页会合理的安排内链。网页采集器伪原创文章也会大大提高网站SEO优化的指标。好的伪原创文章,对蜘蛛的吸引力很大。网页采集器自动全网采集,覆盖六大搜索引擎。自动过滤内容相关度和文章平滑度,只有采集高度相关和平滑度文章。

<p>当蜘蛛进入网站时,网站地图被视为很好的引导,蜘蛛可以轻松进入网站的每一个角落,网页采集器可以自动生成并更新网站的sitemap地图,让蜘蛛第一时间知道你网站的文章链接,可以方便蜘蛛抓取你

网页文章自动采集(几种爬虫常见的数据采集场景介绍-乐题日志宏)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-04-15 15:42

千修每天都会收到大量的数据采集需求。虽然来自不同的行业、网站和企业,但每个需求的采集场景有很多相似之处。根据您对数据采集的需求,小编总结了以下爬虫常用的数据采集场景。

1.实时采集并更新新数据

对于很多舆情或政策监测数据采集的需求,大部分需要做到实时采集,只有采集新数据。这样可以快速监控所需的数据,提高监控速度和质量。

ForeSpider数据采集软件可设置为不间断采集,7×24H不间断采集指定网站,已存储的数据不重复采集 ,实时更新网站中新增的数据,之前采集的数据不会重复存储,也不需要每天重新采集数据,大大提高数据采集的效率,节省网络带宽和代理IP资源。

设置介绍:

①时机采集

Timing采集:设置任务定时设置,可以在某个时间点开始/停止采集,也可以在一定时间后开始/停止采集。

②增量采集:每次只取采集的更新链接,只取更新链接,不取数据页。

这样,爬虫软件不仅可以自动采集,实时更新,还可以自动重新加载,保证数据采集的高效稳定运行。

2.自动补充缺失数据

在爬取采集数据的过程中,由于网络异常、加载异常、网站反爬等原因,在采集过程中丢失了部分数据。

针对这种情况,需要在采集过程中重新采集失败的请求采集,以高效获取全量数据。

ForeSpider数据采集系统可以针对这种常见的采集场景进行数据补充采集设置,从而提高采集效率,快速获取全量数据。

设置介绍:

①自定义采集策略:选择采集入库失败,采集错误,上次没有采集数据。设置并重新采集后,可以快速重新采集之前丢失的数据,无需重复耗时耗力的采集。

②设置加载日志宏:根据任务ID值、任务数据大小等,对于不符合采集要求的数据,过滤日志列表,重新采集补充缺失的数据。

比如有些网站的IP被重定向新的URL屏蔽了,所以采集状态显示成功,但是任务的数据质量一般很小,比如2KB。在这种情况下,可以加载日志宏。,加载质量太低的任务日志,无法重新采集这部分任务。

3.时序采集数据

一个很常见的数据采集需求是每天在固定点开始爬取一个或多个网站。为了腾出双手,对采集数据进行计时是非常有必要的。

ForeSpider数据采集系统可以设置定时启动和停止采集,时间点和时间段结合设置,可以在某个时间点启动/停止采集,或者在某个时间段发布预定的开始/停止采集。减少人力重复工作,有效避免人工采集的情况。

设置介绍:

①间隔定时采集:设置间隔时间,以固定间隔时间实现采集的开/关。

②固定时间采集:设置爬虫自动启动/停止的时间。

例子:

①采集每天都有新数据

每天定时添加新数据采集,每天设置一定时间采集添加新数据,设置后可以每天设置采集,节省人工成本。

②网站反爬

当采集在一段时间后无法获取数据时,可以在一段时间后再次获取数据。打开采集后,根据防爬规则,设置一定时间停止采集,设置一定时间开始采集,可以有效避免防爬攀爬,高效 采集@ >数据。

③自动更新数据库

部署到服务器后,需要每天采集网站新数据到本地数据库,可以开始调度采集,以及采集数据定时每天。

4.批量关键词搜索

我们经常需要采集某个网站关于某个行业、某个事件、某个主题等相关内容,那么我们会用关键词采集来采集 批量 关键词 搜索到的数据。

ForeSpider Data采集 软件可以实现多种关键词检索采集 方法。

①批量导入关键词,采集在目标网站中查找关键词中的数据内容,同时对关键词进行排序和再处理,方便快捷,无需编写脚本批量采集关键词搜索到的数据。

②关键词存在于外部数据库中,实时调用采集。通过ForeSpider爬虫软件连接到其他数据库的数据表,或者爬虫软件中的其他数据表,可以利用动态变化的关键词库实时检索采集数据。

③ 通过接口实时传输关键词。用户数据中实时生成的搜索词可以通过接口实时关键词检索采集传输到ForeSpider数据采集系统。并将采集接收到的数据实时传回用户系统显示。

设置介绍:

关键词配置:可以进行关键词配置,在高级配置中可以配置各种参数。

关键词列表:批量导入、修改关键词批量导入、删除、修改关键词,也可以对关键词进行排序和重新处理。

例子:

①采集关键词搜索到网站

比如百度、360问答、微博搜索等网站都有搜索功能。

②关键词充当词库,调用和使用

例如,一个不同区域分类的网站网址收录区域参数,可以直接将区域参数导入到关键词列表中,编写一个简单的脚本,调用关键词拼出网站@的不同区域分类>使配置更容易。

③ 用户输入搜索词,实时抓取数据返回显示

用户输入需要检索的词后,实时传输到ForeSpider爬虫软件,进行现场查询采集,采集接收到的数据为实时传回用户系统,向用户展示数据。

5.自定义过滤器文件大小/类型

我们经常需要采集网页中的图片、视频、各种附件等数据。为了获得更准确的数据,需要更精确地过滤文件的大小/类型。

在嗅探ForeSpider采集软件之前,可以自行设置采集文件的上下限或文件类型,从而过滤采集网页中符合条件的文件数据。

例如:采集网页中大于2b的文件数据,采集网页中的所有文本数据,采集页面中的图片数据,采集@中的视频数据>文件等。

设置介绍:

设置过滤:设置采集文件的类型,采集该类型的文件数据,设置采集文件大小下限过滤小文件,设置采集过滤大文件的文件大小阈值。

例子:

①采集网页中的所有图片数据

当需要网页中全部或部分图片数据时,在文件设置中选择采集文件类型,然后配置采集,节省配置成本,实现精准采集。

②采集网页中的所有视频数据

当需要采集网页中的全部或部分视频数据时,在文件设置中选择采集文件类型,然后配置采集。

③采集网页中的具体文件数据

通过设置采集的文件大小下限,过滤掉小文件和无效文件,实现精准采集。

6.登录采集

当采集需要在网站上注册数据时,需要进行注册设置。嗅探ForeSpider数据前采集分析引擎可以采集需要登录(账号密码登录、扫描登录、短信验证登录)网站、APP数据、采集登录后可见数据。

ForeSpider爬虫软件,可以设置自动登录,也可以手动设置登录,也可以使用cookies登录,多种登录配置方式适合各种登录场景,配置灵活。

概念介绍:

Cookie:Cookie是指存储在用户本地终端上的一些网站数据,用于识别用户身份和进行会话跟踪。Cookie是基于各种互联网服务系统而产生的。它是由网络服务器保存在用户浏览器上的一个小文本文件。它可以收录有关用户的信息,是用户获取、交流和传递信息的主要场所之一。可以模拟登录的cookie采集。

设置介绍:

①登录配置:可以自动配置,也可以手动配置。

②Cookie设置:对于需要cookie的网站,可以自动生成cookie来获取数据。您也可以手动添加 cookie 来获取数据。

例子:

适用于任何需要登录的网站、APP数据(账号密码登录、扫描登录、短信验证登录)。

7.批处理网站批处理配置

大多数企业级的大数据项目,往往需要很多采集中的网站,从几百到几千万不等。单独配置每个 网站 是不现实的。这时候需要批量配置上千个网站和采集。

ForeSpider 爬虫软件就是专门针对这种情况设计的。独创智能配置算法和采集配置语言,可高效配置采集,解析网页结构。数据,无需依次配置每个网站,即可实现同步采集万条网站。

用户将需要采集的URL列表输入到采集任务中,通过对采集内容的智能识别,实现一个配置采集模板来< @k11@ > 成千上万的 网站 需求量很大。

优势:

①节省大量人工配置成本:无需手动一一配置网站即可实现采集千网站的需求。

②采集大批量网站短时间,快速功能上线:快速实现网站数据扩容,采集短时间海量数据,缩短项目启动时间。

③采集数据量大,范围广:一次性实现海量网站采集需求,批量管理海量数据,实现企业级数据< @采集 能力。

④数据易管理:数据高度集中管理,便于全局监控数据采集情况,便于运维。

⑤灵活删除采集源:不想继续采集的源可以随时删除,也可以随时批量添加新的采集源。

例子:

①舆情监测

快速实现短时间内对大量媒体网站的数据监控,快速形成与某事件/主题相关的内容监控。

②内容发布平台

采集批量URL、某方面的海量采集内容,分类后发布相应数据。

③行业信息库

快速建立行业相关信息数据库供查询使用。

看到这里,应该对爬虫的采集场景有了深入的了解。后期我们会结合各种采集场景为大家展示更多采集案例,敬请期待。

l 前嗅觉介绍

千秀大数据,国内领先的研发大数据专家,多年致力于大数据技术的研发,自主研发了一整套数据采集,分析、处理、管理、应用和营销。大数据产品。千秀致力于打造国内首个深度大数据平台! 查看全部

网页文章自动采集(几种爬虫常见的数据采集场景介绍-乐题日志宏)

千修每天都会收到大量的数据采集需求。虽然来自不同的行业、网站和企业,但每个需求的采集场景有很多相似之处。根据您对数据采集的需求,小编总结了以下爬虫常用的数据采集场景。

1.实时采集并更新新数据

对于很多舆情或政策监测数据采集的需求,大部分需要做到实时采集,只有采集新数据。这样可以快速监控所需的数据,提高监控速度和质量。

ForeSpider数据采集软件可设置为不间断采集,7×24H不间断采集指定网站,已存储的数据不重复采集 ,实时更新网站中新增的数据,之前采集的数据不会重复存储,也不需要每天重新采集数据,大大提高数据采集的效率,节省网络带宽和代理IP资源。

设置介绍:

①时机采集

Timing采集:设置任务定时设置,可以在某个时间点开始/停止采集,也可以在一定时间后开始/停止采集。

②增量采集:每次只取采集的更新链接,只取更新链接,不取数据页。

这样,爬虫软件不仅可以自动采集,实时更新,还可以自动重新加载,保证数据采集的高效稳定运行。

2.自动补充缺失数据

在爬取采集数据的过程中,由于网络异常、加载异常、网站反爬等原因,在采集过程中丢失了部分数据。

针对这种情况,需要在采集过程中重新采集失败的请求采集,以高效获取全量数据。

ForeSpider数据采集系统可以针对这种常见的采集场景进行数据补充采集设置,从而提高采集效率,快速获取全量数据。

设置介绍:

①自定义采集策略:选择采集入库失败,采集错误,上次没有采集数据。设置并重新采集后,可以快速重新采集之前丢失的数据,无需重复耗时耗力的采集。

②设置加载日志宏:根据任务ID值、任务数据大小等,对于不符合采集要求的数据,过滤日志列表,重新采集补充缺失的数据。

比如有些网站的IP被重定向新的URL屏蔽了,所以采集状态显示成功,但是任务的数据质量一般很小,比如2KB。在这种情况下,可以加载日志宏。,加载质量太低的任务日志,无法重新采集这部分任务。

3.时序采集数据

一个很常见的数据采集需求是每天在固定点开始爬取一个或多个网站。为了腾出双手,对采集数据进行计时是非常有必要的。

ForeSpider数据采集系统可以设置定时启动和停止采集,时间点和时间段结合设置,可以在某个时间点启动/停止采集,或者在某个时间段发布预定的开始/停止采集。减少人力重复工作,有效避免人工采集的情况。

设置介绍:

①间隔定时采集:设置间隔时间,以固定间隔时间实现采集的开/关。

②固定时间采集:设置爬虫自动启动/停止的时间。

例子:

①采集每天都有新数据

每天定时添加新数据采集,每天设置一定时间采集添加新数据,设置后可以每天设置采集,节省人工成本。

②网站反爬

当采集在一段时间后无法获取数据时,可以在一段时间后再次获取数据。打开采集后,根据防爬规则,设置一定时间停止采集,设置一定时间开始采集,可以有效避免防爬攀爬,高效 采集@ >数据。

③自动更新数据库

部署到服务器后,需要每天采集网站新数据到本地数据库,可以开始调度采集,以及采集数据定时每天。

4.批量关键词搜索

我们经常需要采集某个网站关于某个行业、某个事件、某个主题等相关内容,那么我们会用关键词采集来采集 批量 关键词 搜索到的数据。

ForeSpider Data采集 软件可以实现多种关键词检索采集 方法。

①批量导入关键词,采集在目标网站中查找关键词中的数据内容,同时对关键词进行排序和再处理,方便快捷,无需编写脚本批量采集关键词搜索到的数据。

②关键词存在于外部数据库中,实时调用采集。通过ForeSpider爬虫软件连接到其他数据库的数据表,或者爬虫软件中的其他数据表,可以利用动态变化的关键词库实时检索采集数据。

③ 通过接口实时传输关键词。用户数据中实时生成的搜索词可以通过接口实时关键词检索采集传输到ForeSpider数据采集系统。并将采集接收到的数据实时传回用户系统显示。

设置介绍:

关键词配置:可以进行关键词配置,在高级配置中可以配置各种参数。

关键词列表:批量导入、修改关键词批量导入、删除、修改关键词,也可以对关键词进行排序和重新处理。

例子:

①采集关键词搜索到网站

比如百度、360问答、微博搜索等网站都有搜索功能。

②关键词充当词库,调用和使用

例如,一个不同区域分类的网站网址收录区域参数,可以直接将区域参数导入到关键词列表中,编写一个简单的脚本,调用关键词拼出网站@的不同区域分类>使配置更容易。

③ 用户输入搜索词,实时抓取数据返回显示

用户输入需要检索的词后,实时传输到ForeSpider爬虫软件,进行现场查询采集,采集接收到的数据为实时传回用户系统,向用户展示数据。

5.自定义过滤器文件大小/类型

我们经常需要采集网页中的图片、视频、各种附件等数据。为了获得更准确的数据,需要更精确地过滤文件的大小/类型。

在嗅探ForeSpider采集软件之前,可以自行设置采集文件的上下限或文件类型,从而过滤采集网页中符合条件的文件数据。

例如:采集网页中大于2b的文件数据,采集网页中的所有文本数据,采集页面中的图片数据,采集@中的视频数据>文件等。

设置介绍:

设置过滤:设置采集文件的类型,采集该类型的文件数据,设置采集文件大小下限过滤小文件,设置采集过滤大文件的文件大小阈值。

例子:

①采集网页中的所有图片数据

当需要网页中全部或部分图片数据时,在文件设置中选择采集文件类型,然后配置采集,节省配置成本,实现精准采集。

②采集网页中的所有视频数据

当需要采集网页中的全部或部分视频数据时,在文件设置中选择采集文件类型,然后配置采集。

③采集网页中的具体文件数据

通过设置采集的文件大小下限,过滤掉小文件和无效文件,实现精准采集。

6.登录采集

当采集需要在网站上注册数据时,需要进行注册设置。嗅探ForeSpider数据前采集分析引擎可以采集需要登录(账号密码登录、扫描登录、短信验证登录)网站、APP数据、采集登录后可见数据。

ForeSpider爬虫软件,可以设置自动登录,也可以手动设置登录,也可以使用cookies登录,多种登录配置方式适合各种登录场景,配置灵活。

概念介绍:

Cookie:Cookie是指存储在用户本地终端上的一些网站数据,用于识别用户身份和进行会话跟踪。Cookie是基于各种互联网服务系统而产生的。它是由网络服务器保存在用户浏览器上的一个小文本文件。它可以收录有关用户的信息,是用户获取、交流和传递信息的主要场所之一。可以模拟登录的cookie采集。

设置介绍:

①登录配置:可以自动配置,也可以手动配置。

②Cookie设置:对于需要cookie的网站,可以自动生成cookie来获取数据。您也可以手动添加 cookie 来获取数据。

例子:

适用于任何需要登录的网站、APP数据(账号密码登录、扫描登录、短信验证登录)。

7.批处理网站批处理配置

大多数企业级的大数据项目,往往需要很多采集中的网站,从几百到几千万不等。单独配置每个 网站 是不现实的。这时候需要批量配置上千个网站和采集。

ForeSpider 爬虫软件就是专门针对这种情况设计的。独创智能配置算法和采集配置语言,可高效配置采集,解析网页结构。数据,无需依次配置每个网站,即可实现同步采集万条网站。

用户将需要采集的URL列表输入到采集任务中,通过对采集内容的智能识别,实现一个配置采集模板来< @k11@ > 成千上万的 网站 需求量很大。

优势:

①节省大量人工配置成本:无需手动一一配置网站即可实现采集千网站的需求。

②采集大批量网站短时间,快速功能上线:快速实现网站数据扩容,采集短时间海量数据,缩短项目启动时间。

③采集数据量大,范围广:一次性实现海量网站采集需求,批量管理海量数据,实现企业级数据< @采集 能力。

④数据易管理:数据高度集中管理,便于全局监控数据采集情况,便于运维。

⑤灵活删除采集源:不想继续采集的源可以随时删除,也可以随时批量添加新的采集源。

例子:

①舆情监测

快速实现短时间内对大量媒体网站的数据监控,快速形成与某事件/主题相关的内容监控。

②内容发布平台

采集批量URL、某方面的海量采集内容,分类后发布相应数据。

③行业信息库

快速建立行业相关信息数据库供查询使用。

看到这里,应该对爬虫的采集场景有了深入的了解。后期我们会结合各种采集场景为大家展示更多采集案例,敬请期待。

l 前嗅觉介绍

千秀大数据,国内领先的研发大数据专家,多年致力于大数据技术的研发,自主研发了一整套数据采集,分析、处理、管理、应用和营销。大数据产品。千秀致力于打造国内首个深度大数据平台!

网页文章自动采集(Python写的工程采集图片数据的爬虫复杂理解(图) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2022-04-11 11:37

)

Java爬虫采集网页数据一、爬虫简介

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动从万维网上爬取信息的程序或脚本。

学过爬虫的同学都知道,目前80%的爬虫都是用Python写的:

原因一:由于目前大部分网络协议都是基于HTTP/HTTPS的,而java的基础框架支持TCP/IP网络协议,构建爬虫时需要导入大量底层库;

原因2:Python有很多开源爬虫库,好用,也有Java的,但是Java入门比较难;

理由三:Python语言简单难懂。相比之下,Java语言更复杂,理解难度也增加了;

好了,这次回到我们的话题,修改后的例子是一个基于JavaClient加正则化的爬虫来简单实现Java Maven项目采集的图片数据!

二、必需的 pom.xml 依赖项

org.jsoup

jsoup

1.8.3

commons-io

commons-io

2.5

org.apache.httpcomponents

httpclient

4.5.5

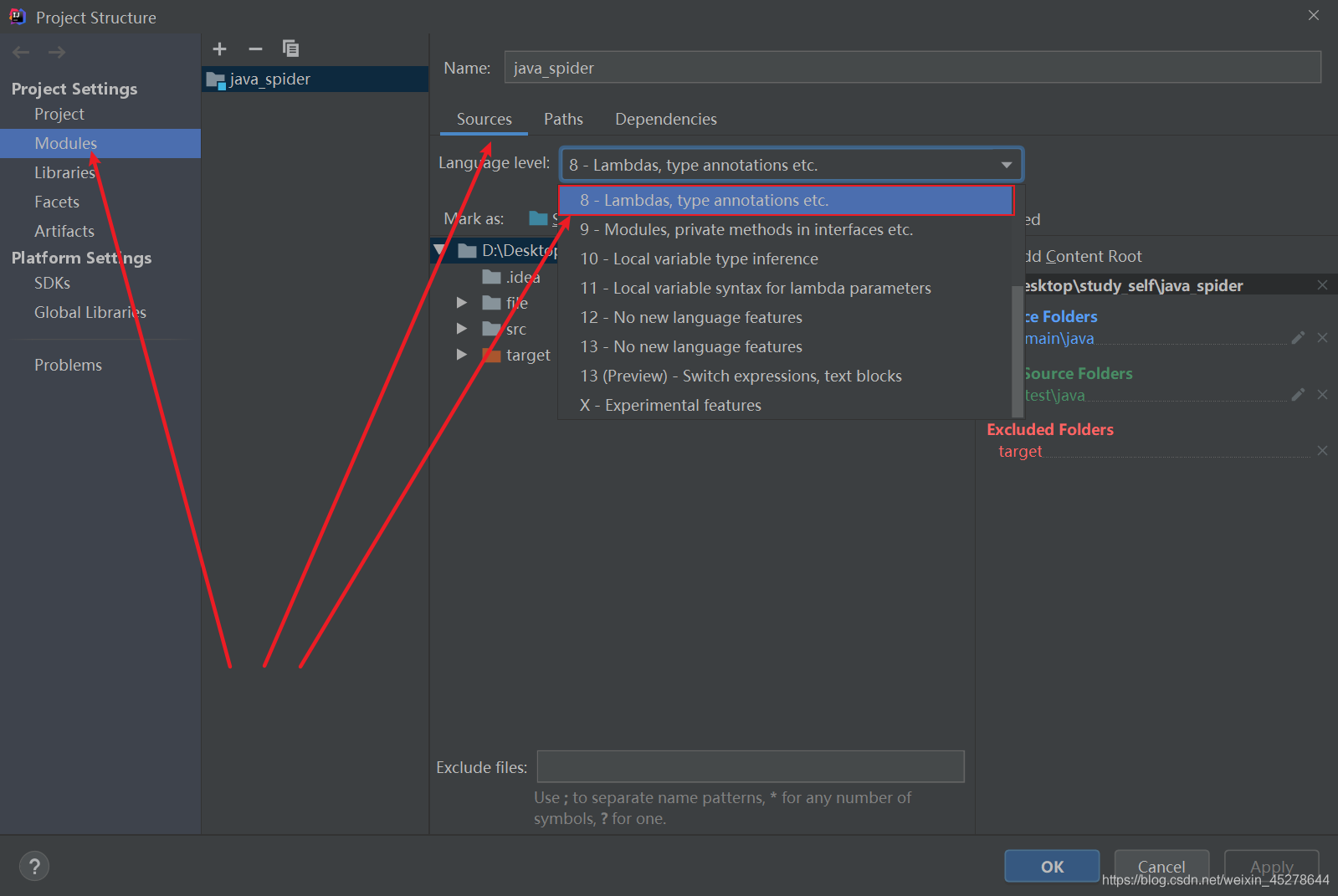

有同学创建Maven项目后,程序还是跑错了!只要三点修改,就会更宽!(基于 JDK1.8)

1.修改pom.xml依赖中的JDK版本号

UTF-8

1.8

1.8

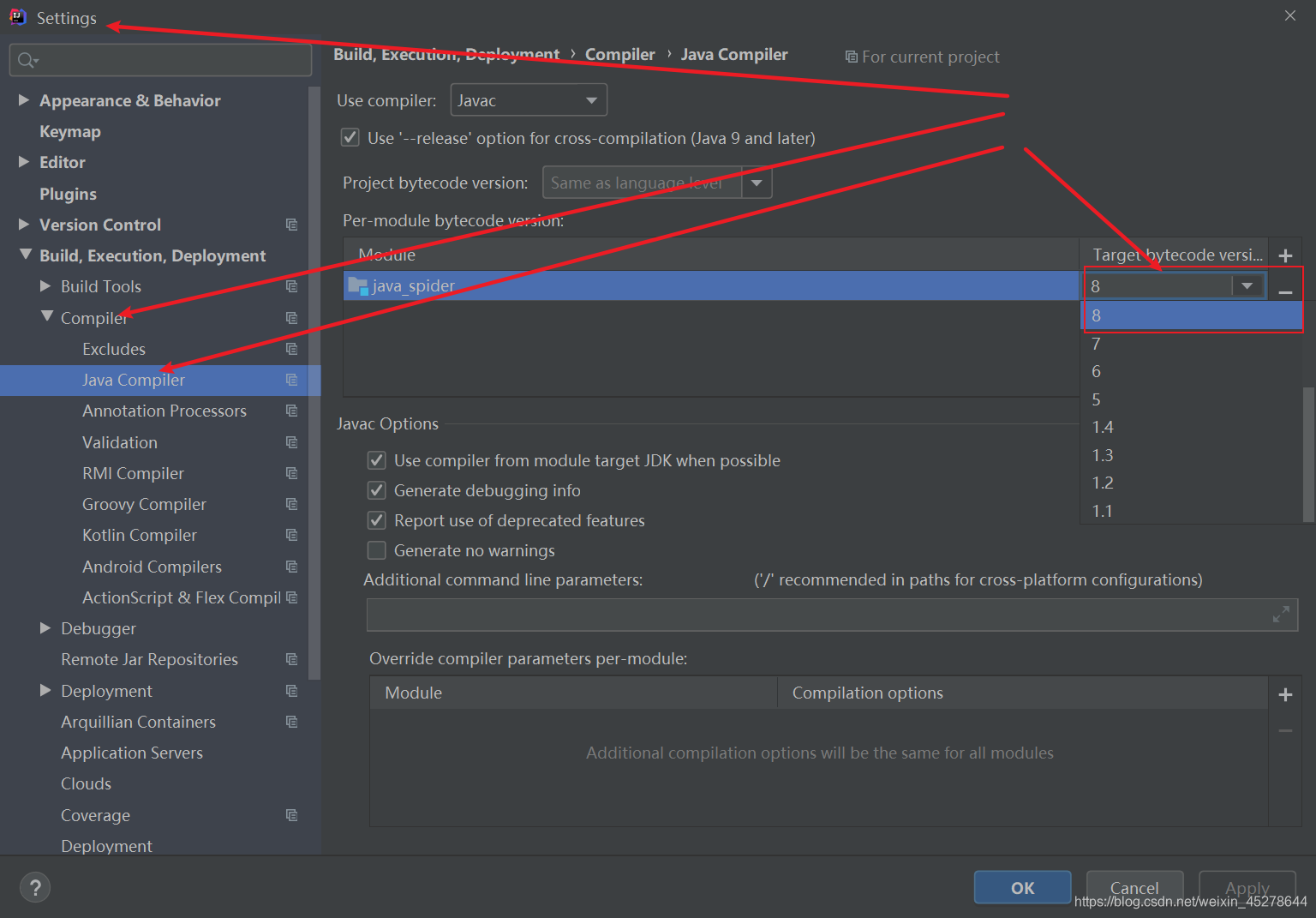

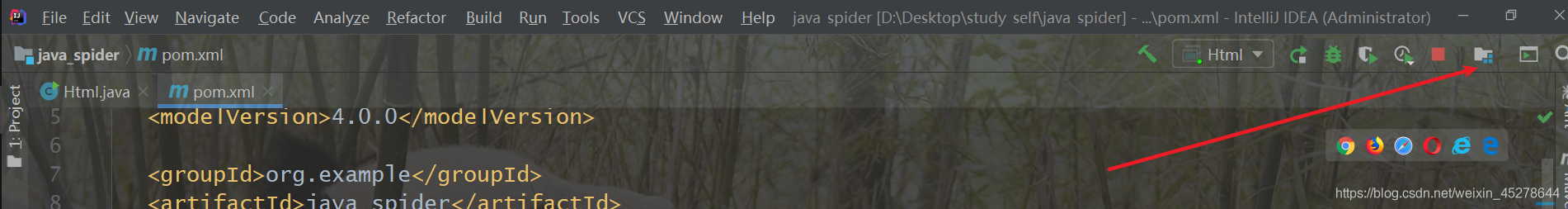

2.根据下图找到项目结构图标,进入Project Settings --> Modules -->Souces->Language level:设置为8;

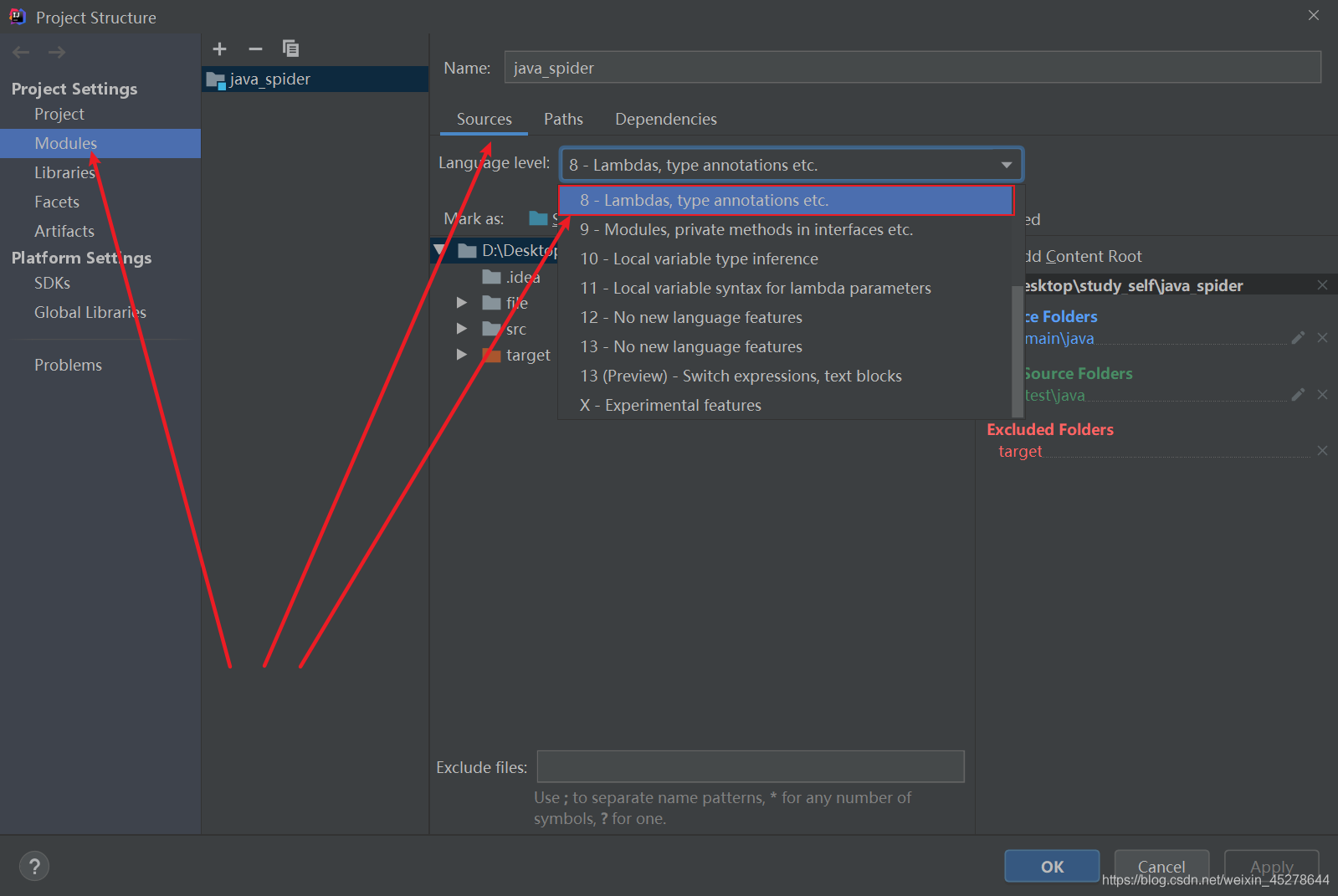

3 进入项目设置文件,Settings–>Build, Execution, Deployment–>Compiler–>Java Compiler–>Moudle:配置JDK版本为8;

三点后就可以配置了

三.java代码(附详细注释)

因为我是一个简单的java爬虫,所以我只用了一个java文件写成静态方法,方便调用

爬取图片下载到本地

html.java

<p>import org.apache.http.HttpEntity;

import org.apache.http.HttpStatus;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import java.io.*;

import java.util.Scanner;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class scenery {

//编码格式

private static final String ENCODING = "UTF-8";

//保存地址

private static final String SAVE_PATH = "file/background";

/**

* 获取到指定网址的网页源码并返回

* @param url 爬取网址

* @return html

*/

public static String getHtmlResourceByUrl(String url) {

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet httpGet = new HttpGet(url);

HttpEntity httpEntity = null;

String html = null;

// 设置长连接

httpGet.setHeader("Connection", "keep-alive");

// 设置代理(模拟浏览器版本)

httpGet.setHeader("User-Agent", "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36");

CloseableHttpResponse httpResponse = null;

System.out.println("开始请求网页!!!!!!!!");

try {

// 请求并获得响应结果

httpResponse = httpClient.execute(httpGet);

httpEntity = httpResponse.getEntity();

// 输出请求结果

html = EntityUtils.toString(httpEntity);

} catch (IOException e) {

e.printStackTrace();

}

return html;

}

/**

* 获取网页的链接与标题,并追加到list中,从而返回list

* @param html 网页地址

* @return list

*/

public static List getTitleUrl(String html){

String regex_img_url = "<img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

String regex_img_title span class="token operator"=/span span class="token string""div class=\"tits\"(.*?)b class=hightlight"/spanspan class="token punctuation";/span

ArrayListspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建pattern对象/span

Pattern img_url_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_urlspan class="token punctuation")/spanspan class="token punctuation";/span

Pattern img_title_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_titlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_url_m span class="token operator"=/span img_url_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

Matcher img_title_m span class="token operator"=/span img_title_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_url_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/span span class="token operator"&&/span img_title_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

String url span class="token operator"=/span img_url_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanurlspan class="token punctuation")/spanspan class="token punctuation";/span

String title span class="token operator"=/span img_title_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spantitlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 获取image url 追加到List中,并返回List

* @param details_html 详情页网址

* @return List

*//span

span class="token keyword"public/span span class="token keyword"static/span Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span span class="token function"getImageSrc/spanspan class="token punctuation"(/spanString details_htmlspan class="token punctuation")/spanspan class="token punctuation"{/span

Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

String imgRegex span class="token operator"=/span span class="token string""img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

span class="token comment"//创建Pattern对象/span

Pattern img_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanimgRegexspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_m span class="token operator"=/span img_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spandetails_htmlspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""开始解析..."/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 下载图片

* @param imgUrl img网址

* @param filePath 图片报错地址

* @param title 图片系列

* @param imageName 图片名

* @param page 页数

* @param count 每页的图片计数

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"downLoad/spanspan class="token punctuation"(/spanString imgUrlspan class="token punctuation",/spanString filePathspan class="token punctuation",/span String titlespan class="token punctuation",/span String imageNamespan class="token punctuation",/spanspan class="token keyword"int/span pagespan class="token punctuation",/span span class="token keyword"int/span countspan class="token punctuation")/span span class="token punctuation"{/span

CloseableHttpClient httpClient span class="token operator"=/span HttpClientsspan class="token punctuation"./spanspan class="token function"createDefault/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

HttpGet httpGet span class="token operator"=/span span class="token keyword"new/span span class="token class-name"HttpGet/spanspan class="token punctuation"(/spanimgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"try/span span class="token punctuation"{/span

CloseableHttpResponse response span class="token operator"=/span httpClientspan class="token punctuation"./spanspan class="token function"execute/spanspan class="token punctuation"(/spanhttpGetspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""第"/span span class="token operator"+/spanpagespan class="token operator"+/span span class="token string""页的"/span span class="token operator"+/span title span class="token operator"+/span span class="token string""系列图片开始下载:"/span span class="token operator"+/span imgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"if/span span class="token punctuation"(/spanHttpStatusspan class="token punctuation"./spanSC_OK span class="token operator"==/span responsespan class="token punctuation"./spanspan class="token function"getStatusLine/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation"./spanspan class="token function"getStatusCode/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

HttpEntity entity span class="token operator"=/span responsespan class="token punctuation"./spanspan class="token function"getEntity/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

InputStream imgContent span class="token operator"=/span entityspan class="token punctuation"./spanspan class="token function"getContent/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token function"saveImage/spanspan class="token punctuation"(/spanimgContentspan class="token punctuation",/span filePathspan class="token punctuation",/spanimageNamespan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""第"/span span class="token operator"+/span span class="token punctuation"(/spancount span class="token operator"+/span span class="token number"1/spanspan class="token punctuation")/span span class="token operator"+/span span class="token string""张图片下载完成名为:"/span span class="token operator"+/span imageNamespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"ClientProtocolException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token comment"/**

* 保存图片

* @param is 输入数据流

* @param filePath 文件目录Path

* @param imageName image名

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"saveImage/spanspan class="token punctuation"(/spanInputStream isspan class="token punctuation",/span String filePathspan class="token punctuation",/span String imageNamespan class="token punctuation")/spanspan class="token punctuation"{/span

span class="token keyword"try/span span class="token punctuation"{/span

span class="token comment"//创建图片文件/span

String imgSavePath span class="token operator"=/span filePathspan class="token punctuation"./spanspan class="token function"concat/spanspan class="token punctuation"(/spanspan class="token string""/"/span span class="token operator"+/span imageName span class="token operator"+/span span class="token string"".jpg"/spanspan class="token punctuation")/spanspan class="token punctuation";/span

File imgPath span class="token operator"=/span span class="token keyword"new/span span class="token class-name"File/spanspan class="token punctuation"(/spanimgSavePathspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"if/span span class="token punctuation"(/spanspan class="token operator"!/spanimgPathspan class="token punctuation"./spanspan class="token function"exists/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

imgPathspan class="token punctuation"./spanspan class="token function"createNewFile/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

FileOutputStream fos span class="token operator"=/span span class="token keyword"new/span span class="token class-name"FileOutputStream/spanspan class="token punctuation"(/spanimgPathspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"byte/spanspan class="token punctuation"[/spanspan class="token punctuation"]/span bytes span class="token operator"=/span span class="token keyword"new/span span class="token class-name"byte/spanspan class="token punctuation"[/spanspan class="token number"1024/span span class="token operator"*/span span class="token number"1024/span span class="token operator"*/span span class="token number"1024/spanspan class="token punctuation"]/spanspan class="token punctuation";/span

span class="token keyword"int/span len span class="token operator"=/span span class="token number"0/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanspan class="token punctuation"(/spanlen span class="token operator"=/span isspan class="token punctuation"./spanspan class="token function"read/spanspan class="token punctuation"(/spanbytesspan class="token punctuation")/spanspan class="token punctuation")/span span class="token operator"!=/span span class="token operator"-/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

fosspan class="token punctuation"./spanspan class="token function"write/spanspan class="token punctuation"(/spanbytesspan class="token punctuation",/span span class="token number"0/spanspan class="token punctuation",/span lenspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

fosspan class="token punctuation"./spanspan class="token function"flush/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

fosspan class="token punctuation"./spanspan class="token function"close/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/spanspan class="token keyword"finally/span span class="token punctuation"{/span

span class="token keyword"try/spanspan class="token punctuation"{/span

isspan class="token punctuation"./spanspan class="token function"close/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"run/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

span class="token comment"//循环获取列表页的html/span

String title span class="token operator"=/span span class="token string"""/spanspan class="token punctuation";/span

span class="token comment"//采集类型大家阔以自行发挥!!!/span

Scanner input span class="token operator"=/span span class="token keyword"new/span span class="token class-name"Scanner/spanspan class="token punctuation"(/spanSystemspan class="token punctuation"./spaninspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""*********************欢迎来到洋群满满壁纸下载地,请选择你想要下载序列的序号!*********************"/spanspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""1>>>风景|2>>>美女|3>>>汽车|4>>>动漫|5>>>二次元|6>>>森林|7>>>明星|8>>>猜你喜欢(You Know!!!)");

System.out.print("请选择:");

int choose = input.nextInt();

switch (choose){

case 1:

title = "风景";

break;

case 2:

title = "美女";

break;

case 3:

title = "汽车";

break;

case 4:

title = "动漫";

break;

case 5:

title = "二次元";

break;

case 6:

title = "森林";

break;

case 7:

title = "明星";

break;

case 8:

title = "性感";

break;

default:

title = "风景";

System.out.println("选择错误,默认采集风景系列图片!!!");

break;

}

int page = 1;

for (; page 查看全部

网页文章自动采集(Python写的工程采集图片数据的爬虫复杂理解(图)

)

Java爬虫采集网页数据一、爬虫简介

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动从万维网上爬取信息的程序或脚本。

学过爬虫的同学都知道,目前80%的爬虫都是用Python写的:

原因一:由于目前大部分网络协议都是基于HTTP/HTTPS的,而java的基础框架支持TCP/IP网络协议,构建爬虫时需要导入大量底层库;

原因2:Python有很多开源爬虫库,好用,也有Java的,但是Java入门比较难;

理由三:Python语言简单难懂。相比之下,Java语言更复杂,理解难度也增加了;

好了,这次回到我们的话题,修改后的例子是一个基于JavaClient加正则化的爬虫来简单实现Java Maven项目采集的图片数据!

二、必需的 pom.xml 依赖项

org.jsoup

jsoup

1.8.3

commons-io

commons-io

2.5

org.apache.httpcomponents

httpclient

4.5.5

有同学创建Maven项目后,程序还是跑错了!只要三点修改,就会更宽!(基于 JDK1.8)

1.修改pom.xml依赖中的JDK版本号

UTF-8

1.8

1.8

2.根据下图找到项目结构图标,进入Project Settings --> Modules -->Souces->Language level:设置为8;

3 进入项目设置文件,Settings–>Build, Execution, Deployment–>Compiler–>Java Compiler–>Moudle:配置JDK版本为8;

三点后就可以配置了

三.java代码(附详细注释)

因为我是一个简单的java爬虫,所以我只用了一个java文件写成静态方法,方便调用

爬取图片下载到本地

html.java

<p>import org.apache.http.HttpEntity;

import org.apache.http.HttpStatus;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import java.io.*;

import java.util.Scanner;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class scenery {

//编码格式

private static final String ENCODING = "UTF-8";

//保存地址

private static final String SAVE_PATH = "file/background";

/**

* 获取到指定网址的网页源码并返回

* @param url 爬取网址

* @return html

*/

public static String getHtmlResourceByUrl(String url) {

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet httpGet = new HttpGet(url);

HttpEntity httpEntity = null;

String html = null;

// 设置长连接

httpGet.setHeader("Connection", "keep-alive");

// 设置代理(模拟浏览器版本)

httpGet.setHeader("User-Agent", "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36");

CloseableHttpResponse httpResponse = null;

System.out.println("开始请求网页!!!!!!!!");

try {

// 请求并获得响应结果

httpResponse = httpClient.execute(httpGet);

httpEntity = httpResponse.getEntity();

// 输出请求结果

html = EntityUtils.toString(httpEntity);

} catch (IOException e) {

e.printStackTrace();

}

return html;

}

/**

* 获取网页的链接与标题,并追加到list中,从而返回list

* @param html 网页地址

* @return list

*/

public static List getTitleUrl(String html){

String regex_img_url = "<img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

String regex_img_title span class="token operator"=/span span class="token string""div class=\"tits\"(.*?)b class=hightlight"/spanspan class="token punctuation";/span

ArrayListspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建pattern对象/span

Pattern img_url_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_urlspan class="token punctuation")/spanspan class="token punctuation";/span

Pattern img_title_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanregex_img_titlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_url_m span class="token operator"=/span img_url_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

Matcher img_title_m span class="token operator"=/span img_title_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spanhtmlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_url_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/span span class="token operator"&&/span img_title_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

String url span class="token operator"=/span img_url_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanurlspan class="token punctuation")/spanspan class="token punctuation";/span

String title span class="token operator"=/span img_title_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation";/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spantitlespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 获取image url 追加到List中,并返回List

* @param details_html 详情页网址

* @return List

*//span

span class="token keyword"public/span span class="token keyword"static/span Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span span class="token function"getImageSrc/spanspan class="token punctuation"(/spanString details_htmlspan class="token punctuation")/spanspan class="token punctuation"{/span

Listspan class="token generics function"span class="token punctuation"/spanStringspan class="token punctuation"/span/span list span class="token operator"=/span span class="token keyword"new/span span class="token class-name"ArrayList/spanspan class="token operator"/spanspan class="token operator"/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

String imgRegex span class="token operator"=/span span class="token string""img src=\"(.*?)\" alt="/spanspan class="token punctuation";/span

span class="token comment"//创建Pattern对象/span

Pattern img_p span class="token operator"=/span Patternspan class="token punctuation"./spanspan class="token function"compile/spanspan class="token punctuation"(/spanimgRegexspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token comment"//创建matcher对象/span

Matcher img_m span class="token operator"=/span img_pspan class="token punctuation"./spanspan class="token function"matcher/spanspan class="token punctuation"(/spandetails_htmlspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""开始解析..."/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"find/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

listspan class="token punctuation"./spanspan class="token function"add/spanspan class="token punctuation"(/spanimg_mspan class="token punctuation"./spanspan class="token function"group/spanspan class="token punctuation"(/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token keyword"return/span listspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token comment"/**

* 下载图片

* @param imgUrl img网址

* @param filePath 图片报错地址

* @param title 图片系列

* @param imageName 图片名

* @param page 页数

* @param count 每页的图片计数

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"downLoad/spanspan class="token punctuation"(/spanString imgUrlspan class="token punctuation",/spanString filePathspan class="token punctuation",/span String titlespan class="token punctuation",/span String imageNamespan class="token punctuation",/spanspan class="token keyword"int/span pagespan class="token punctuation",/span span class="token keyword"int/span countspan class="token punctuation")/span span class="token punctuation"{/span

CloseableHttpClient httpClient span class="token operator"=/span HttpClientsspan class="token punctuation"./spanspan class="token function"createDefault/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

HttpGet httpGet span class="token operator"=/span span class="token keyword"new/span span class="token class-name"HttpGet/spanspan class="token punctuation"(/spanimgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"try/span span class="token punctuation"{/span

CloseableHttpResponse response span class="token operator"=/span httpClientspan class="token punctuation"./spanspan class="token function"execute/spanspan class="token punctuation"(/spanhttpGetspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""第"/span span class="token operator"+/spanpagespan class="token operator"+/span span class="token string""页的"/span span class="token operator"+/span title span class="token operator"+/span span class="token string""系列图片开始下载:"/span span class="token operator"+/span imgUrlspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"if/span span class="token punctuation"(/spanHttpStatusspan class="token punctuation"./spanSC_OK span class="token operator"==/span responsespan class="token punctuation"./spanspan class="token function"getStatusLine/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation"./spanspan class="token function"getStatusCode/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

HttpEntity entity span class="token operator"=/span responsespan class="token punctuation"./spanspan class="token function"getEntity/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

InputStream imgContent span class="token operator"=/span entityspan class="token punctuation"./spanspan class="token function"getContent/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token function"saveImage/spanspan class="token punctuation"(/spanimgContentspan class="token punctuation",/span filePathspan class="token punctuation",/spanimageNamespan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""第"/span span class="token operator"+/span span class="token punctuation"(/spancount span class="token operator"+/span span class="token number"1/spanspan class="token punctuation")/span span class="token operator"+/span span class="token string""张图片下载完成名为:"/span span class="token operator"+/span imageNamespan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"ClientProtocolException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token comment"/**

* 保存图片

* @param is 输入数据流

* @param filePath 文件目录Path

* @param imageName image名

*//span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"saveImage/spanspan class="token punctuation"(/spanInputStream isspan class="token punctuation",/span String filePathspan class="token punctuation",/span String imageNamespan class="token punctuation")/spanspan class="token punctuation"{/span

span class="token keyword"try/span span class="token punctuation"{/span

span class="token comment"//创建图片文件/span

String imgSavePath span class="token operator"=/span filePathspan class="token punctuation"./spanspan class="token function"concat/spanspan class="token punctuation"(/spanspan class="token string""/"/span span class="token operator"+/span imageName span class="token operator"+/span span class="token string"".jpg"/spanspan class="token punctuation")/spanspan class="token punctuation";/span

File imgPath span class="token operator"=/span span class="token keyword"new/span span class="token class-name"File/spanspan class="token punctuation"(/spanimgSavePathspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"if/span span class="token punctuation"(/spanspan class="token operator"!/spanimgPathspan class="token punctuation"./spanspan class="token function"exists/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation")/span span class="token punctuation"{/span

imgPathspan class="token punctuation"./spanspan class="token function"createNewFile/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

FileOutputStream fos span class="token operator"=/span span class="token keyword"new/span span class="token class-name"FileOutputStream/spanspan class="token punctuation"(/spanimgPathspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token keyword"byte/spanspan class="token punctuation"[/spanspan class="token punctuation"]/span bytes span class="token operator"=/span span class="token keyword"new/span span class="token class-name"byte/spanspan class="token punctuation"[/spanspan class="token number"1024/span span class="token operator"*/span span class="token number"1024/span span class="token operator"*/span span class="token number"1024/spanspan class="token punctuation"]/spanspan class="token punctuation";/span

span class="token keyword"int/span len span class="token operator"=/span span class="token number"0/spanspan class="token punctuation";/span

span class="token keyword"while/span span class="token punctuation"(/spanspan class="token punctuation"(/spanlen span class="token operator"=/span isspan class="token punctuation"./spanspan class="token function"read/spanspan class="token punctuation"(/spanbytesspan class="token punctuation")/spanspan class="token punctuation")/span span class="token operator"!=/span span class="token operator"-/spanspan class="token number"1/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

fosspan class="token punctuation"./spanspan class="token function"write/spanspan class="token punctuation"(/spanbytesspan class="token punctuation",/span span class="token number"0/spanspan class="token punctuation",/span lenspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

fosspan class="token punctuation"./spanspan class="token function"flush/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

fosspan class="token punctuation"./spanspan class="token function"close/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/spanspan class="token keyword"finally/span span class="token punctuation"{/span

span class="token keyword"try/spanspan class="token punctuation"{/span

isspan class="token punctuation"./spanspan class="token function"close/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span span class="token keyword"catch/span span class="token punctuation"(/spanspan class="token class-name"IOException/span espan class="token punctuation")/span span class="token punctuation"{/span

espan class="token punctuation"./spanspan class="token function"printStackTrace/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation";/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token punctuation"}/span

span class="token keyword"public/span span class="token keyword"static/span span class="token keyword"void/span span class="token function"run/spanspan class="token punctuation"(/spanspan class="token punctuation")/spanspan class="token punctuation"{/span

span class="token comment"//循环获取列表页的html/span

String title span class="token operator"=/span span class="token string"""/spanspan class="token punctuation";/span

span class="token comment"//采集类型大家阔以自行发挥!!!/span

Scanner input span class="token operator"=/span span class="token keyword"new/span span class="token class-name"Scanner/spanspan class="token punctuation"(/spanSystemspan class="token punctuation"./spaninspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""*********************欢迎来到洋群满满壁纸下载地,请选择你想要下载序列的序号!*********************"/spanspan class="token punctuation")/spanspan class="token punctuation";/span

Systemspan class="token punctuation"./spanoutspan class="token punctuation"./spanspan class="token function"println/spanspan class="token punctuation"(/spanspan class="token string""1>>>风景|2>>>美女|3>>>汽车|4>>>动漫|5>>>二次元|6>>>森林|7>>>明星|8>>>猜你喜欢(You Know!!!)");

System.out.print("请选择:");

int choose = input.nextInt();

switch (choose){

case 1:

title = "风景";

break;

case 2:

title = "美女";

break;

case 3:

title = "汽车";

break;

case 4:

title = "动漫";

break;

case 5:

title = "二次元";

break;

case 6:

title = "森林";

break;

case 7:

title = "明星";

break;

case 8:

title = "性感";

break;

default:

title = "风景";

System.out.println("选择错误,默认采集风景系列图片!!!");

break;

}

int page = 1;

for (; page

网页文章自动采集(免费采集器的作用:提高用户体验以及PV点击率,有利于)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-04-10 06:13

免费采集器的作用:提升用户体验和PV点击率,免费采集器自动增加内链,有利于网页权重相互传递,增加收录@ > 网站 并提高 关键词 的排名。免费采集器的优化消除了漫无目的的采集,在采集的过程中要保持其内容的相关性。否则最终会影响到收录@>后内容的权重和排名,因为网页相关性是搜索引擎判断页面质量和权重的规则之一。

免费采集器保证采集内容对站内用户有一定的推荐价值,能很好的解决用户需求。免费的采集器采集文章可以很好的解决用户的需求,网站的影响力对于优质内容的传播也比较重要。对于中小型网站,在没有独特的属性和影响力之前,要尽量避免大量的内容采集。

免费采集器为网站,快速搭建一个比较全、完整的数据库。这将为访问用户提供更好的体验。他们会觉得这个网站的内容很好很完美,抓住了用户的需求和问题。只要能解决这些问题,交通就会更好。收成。免费的采集器可以让网站吸引更多的搜索引擎IP,所以免费的采集器采集更多的内容理论上会被搜索引擎收录@>更多的搜索,虽然有的关键词不能排在最前面,但是因为内容量大,关键词也比较多,所以还是会有一些关键词排在前面的。

免费采集器是一种非常简单易行的方式,网站通过采集器的形式可以大大降低网站构建和网站内容更新维护管理的难度.

特别声明:以上内容(包括图片或视频)为自媒体平台“网易”用户上传发布,本平台仅提供信息存储服务。 查看全部

网页文章自动采集(免费采集器的作用:提高用户体验以及PV点击率,有利于)

免费采集器的作用:提升用户体验和PV点击率,免费采集器自动增加内链,有利于网页权重相互传递,增加收录@ > 网站 并提高 关键词 的排名。免费采集器的优化消除了漫无目的的采集,在采集的过程中要保持其内容的相关性。否则最终会影响到收录@>后内容的权重和排名,因为网页相关性是搜索引擎判断页面质量和权重的规则之一。

免费采集器保证采集内容对站内用户有一定的推荐价值,能很好的解决用户需求。免费的采集器采集文章可以很好的解决用户的需求,网站的影响力对于优质内容的传播也比较重要。对于中小型网站,在没有独特的属性和影响力之前,要尽量避免大量的内容采集。

免费采集器为网站,快速搭建一个比较全、完整的数据库。这将为访问用户提供更好的体验。他们会觉得这个网站的内容很好很完美,抓住了用户的需求和问题。只要能解决这些问题,交通就会更好。收成。免费的采集器可以让网站吸引更多的搜索引擎IP,所以免费的采集器采集更多的内容理论上会被搜索引擎收录@>更多的搜索,虽然有的关键词不能排在最前面,但是因为内容量大,关键词也比较多,所以还是会有一些关键词排在前面的。

免费采集器是一种非常简单易行的方式,网站通过采集器的形式可以大大降低网站构建和网站内容更新维护管理的难度.

特别声明:以上内容(包括图片或视频)为自媒体平台“网易”用户上传发布,本平台仅提供信息存储服务。

网页文章自动采集(配套软件版本:V9及更低集搜客网络爬虫软件新版本对应教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2022-04-10 03:21

配套软件版本:V9及更低版本即搜客网络爬虫软件

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《用网络爬虫软件自动下载网页文件》

注:GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先命名任务,然后创建规则,然后登录集合。在Sooke官网会员中心的“任务管理”中,您可以查看采集任务的执行状态,管理潜在客户的URL,进行调度设置。

例如,我们打算下载本法规/标准网站的法规文件的pdf:

页面截图如下:

如果您手动下载这些文件,则需要在该网页上一一点击文件图标来触发下载过程。

Jisouke网络爬虫软件V9.0.0版本之前,点击是这样模拟的(见教程:)。但是从V9.0.0版本开始,对下载功能进行了调整,因为定义模拟点击过程的规则太繁琐,也不好理解为什么要定义. 在V9.0.0版本中,不再定义模拟点击,而是抓取文件图标对应的url作为抓取内容,并设置了“下载文件”选项同时,然后爬虫采集获取到url信息后开始下载过程。定义规则的方式要简单得多。

另外,V9.0.0开头有一个区别:上一版本刺激下载后,存放位置在操作系统的“下载”文件夹中,而V< @9.0.0的下载位置可控,可以在每个爬取规则各自的文件夹中,也可以在结果文件DataScraperWorks文件夹中。

注意:该方法能够生效的前提是下载文件链接对应一个真实的URL。如果是像javascript:void(0)这样的代码,这个方法是不能用的,要定义一个连续动作方法。触发下载操作。

下面将详细解释定义规则和爬取过程。

1. 定义爬取规则

定义抓取规则的方法请参考基础教程的相应章节,例如,最基本的教程是这样的: . 本教程介绍如何使用内容标记在网页上将内容标记为 采集。请注意,此注解是一种快速定义规则的方法,但它不能精确定位 HTML DOM 节点。例如,在英文附件图标上标记内容,会自动定位到 DOM 的 IMG 节点。为了下载pdf文件,定位这个IMG节点是不精确的,这种内容标注主要用于采集文本内容。

为了准确捕捉pdf文件的url URL,需要准确的进行内容映射,如下图所示:

进行如下操作:

双击文件图标标记内容,将抓取的内容命名为“英文附件链接”。观察窗口下方的DOM树,看到IMG自动定位了,我们需要这个图标对应的url来下载文件。通过观察DOM树,可以确定该url存储在IMG的父节点A中的属性节点@href中。选中@href节点,使用右键菜单Content Mapping -> English Attachment Link,可以将@href映射到抓取到的英文附件链接内容。映射完成后,可以看到抓取到的内容在工作台上的位置编号发生了变化。

以上流程是定义爬取规则的常用流程,下面将是与下载文件相关的设置流程。

2. 安装程序下载

如下图,选择“下载内容”,会弹出设置窗口。选中“下载文件”意味着从捕获的 URL 下载文件。在下面的屏幕截图中,高级设置的“完整内容”选项也被选中。这与下载的内容无关。目的是在生成的结果文件中显示 URL 的 URL,因为从前面的截图来看,@href 存储的是 A 相对 URL,不是以 http 开头的。

这些设置完成后,点击保存规则,然后点击抓取数据,会弹出一个DS计数器窗口,可以观察到网页加载完毕,采集完成后变成白屏。

3. 查看下载的文件

如下图所示,本案例使用的主题名称为test_download_file_fuller,结果文件放置在DataScraperWorks文件夹中。test_download_file_fuller 是用于以 XML 格式存储结果文件的子文件夹。您还可以看到并行子文件夹 PageFileDir。用于存储所有下载的文件

在PageFileDir中,所有下载的文件都是放在一起的,不管主题名如何,但是在PageFileDir的子文件夹中,子文件夹的名字是这样的结构

线程号_时间戳

我们打开XML格式的结果文件,看看内容结构,如下图:

“英文附件链接”为自定义爬取内容,“英文附件链接文件”为自动生成的爬取内容。该字段描述了文件在硬盘上的存储位置。

不分主题存储下载的文件有一个好处:如果你想写一个文件处理程序,那么这个处理成果就不需要一个个进入每个主题名文件夹来检查是否有新下载的文件。

相反,如果下载的文件是按主题名称分隔的,则处理程序将逐个检查主题名称文件夹,但有一个优点:文件系统看起来更有条理。

下面说明如何将其设置为按主题名称单独存储。

4. 按主题存储

如图,在DS电脑上选择菜单文件->存储路径,在弹出框中选择“按主题存储”,更改主题存储后,再执行爬取数据,可以看到PageFileDir 文件夹位于主题名称文件夹下方

5. 摘要

从V9.0.0开始,不仅文件下载,图片和视频下载过程一致,结果存储结构也一致。本教程中的方法可以扩展到图片和视频下载 查看全部

网页文章自动采集(配套软件版本:V9及更低集搜客网络爬虫软件新版本对应教程)

配套软件版本:V9及更低版本即搜客网络爬虫软件

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《用网络爬虫软件自动下载网页文件》

注:GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先命名任务,然后创建规则,然后登录集合。在Sooke官网会员中心的“任务管理”中,您可以查看采集任务的执行状态,管理潜在客户的URL,进行调度设置。

例如,我们打算下载本法规/标准网站的法规文件的pdf:

页面截图如下:

如果您手动下载这些文件,则需要在该网页上一一点击文件图标来触发下载过程。

Jisouke网络爬虫软件V9.0.0版本之前,点击是这样模拟的(见教程:)。但是从V9.0.0版本开始,对下载功能进行了调整,因为定义模拟点击过程的规则太繁琐,也不好理解为什么要定义. 在V9.0.0版本中,不再定义模拟点击,而是抓取文件图标对应的url作为抓取内容,并设置了“下载文件”选项同时,然后爬虫采集获取到url信息后开始下载过程。定义规则的方式要简单得多。

另外,V9.0.0开头有一个区别:上一版本刺激下载后,存放位置在操作系统的“下载”文件夹中,而V< @9.0.0的下载位置可控,可以在每个爬取规则各自的文件夹中,也可以在结果文件DataScraperWorks文件夹中。

注意:该方法能够生效的前提是下载文件链接对应一个真实的URL。如果是像javascript:void(0)这样的代码,这个方法是不能用的,要定义一个连续动作方法。触发下载操作。

下面将详细解释定义规则和爬取过程。

1. 定义爬取规则

定义抓取规则的方法请参考基础教程的相应章节,例如,最基本的教程是这样的: . 本教程介绍如何使用内容标记在网页上将内容标记为 采集。请注意,此注解是一种快速定义规则的方法,但它不能精确定位 HTML DOM 节点。例如,在英文附件图标上标记内容,会自动定位到 DOM 的 IMG 节点。为了下载pdf文件,定位这个IMG节点是不精确的,这种内容标注主要用于采集文本内容。

为了准确捕捉pdf文件的url URL,需要准确的进行内容映射,如下图所示:

进行如下操作:

双击文件图标标记内容,将抓取的内容命名为“英文附件链接”。观察窗口下方的DOM树,看到IMG自动定位了,我们需要这个图标对应的url来下载文件。通过观察DOM树,可以确定该url存储在IMG的父节点A中的属性节点@href中。选中@href节点,使用右键菜单Content Mapping -> English Attachment Link,可以将@href映射到抓取到的英文附件链接内容。映射完成后,可以看到抓取到的内容在工作台上的位置编号发生了变化。

以上流程是定义爬取规则的常用流程,下面将是与下载文件相关的设置流程。

2. 安装程序下载

如下图,选择“下载内容”,会弹出设置窗口。选中“下载文件”意味着从捕获的 URL 下载文件。在下面的屏幕截图中,高级设置的“完整内容”选项也被选中。这与下载的内容无关。目的是在生成的结果文件中显示 URL 的 URL,因为从前面的截图来看,@href 存储的是 A 相对 URL,不是以 http 开头的。

这些设置完成后,点击保存规则,然后点击抓取数据,会弹出一个DS计数器窗口,可以观察到网页加载完毕,采集完成后变成白屏。

3. 查看下载的文件

如下图所示,本案例使用的主题名称为test_download_file_fuller,结果文件放置在DataScraperWorks文件夹中。test_download_file_fuller 是用于以 XML 格式存储结果文件的子文件夹。您还可以看到并行子文件夹 PageFileDir。用于存储所有下载的文件

在PageFileDir中,所有下载的文件都是放在一起的,不管主题名如何,但是在PageFileDir的子文件夹中,子文件夹的名字是这样的结构

线程号_时间戳

我们打开XML格式的结果文件,看看内容结构,如下图:

“英文附件链接”为自定义爬取内容,“英文附件链接文件”为自动生成的爬取内容。该字段描述了文件在硬盘上的存储位置。

不分主题存储下载的文件有一个好处:如果你想写一个文件处理程序,那么这个处理成果就不需要一个个进入每个主题名文件夹来检查是否有新下载的文件。

相反,如果下载的文件是按主题名称分隔的,则处理程序将逐个检查主题名称文件夹,但有一个优点:文件系统看起来更有条理。

下面说明如何将其设置为按主题名称单独存储。

4. 按主题存储

如图,在DS电脑上选择菜单文件->存储路径,在弹出框中选择“按主题存储”,更改主题存储后,再执行爬取数据,可以看到PageFileDir 文件夹位于主题名称文件夹下方

5. 摘要

从V9.0.0开始,不仅文件下载,图片和视频下载过程一致,结果存储结构也一致。本教程中的方法可以扩展到图片和视频下载

网页文章自动采集(网页文章自动采集如何选择采集源(一)_国内_光明网)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2022-04-06 19:01

网页文章自动采集如何选择采集源:传统的采集是第一种,是通过qq群里分享采集来的,收费相对比较贵,接触的网页越多,对于我们来说成本相对较高,主要在于发现问题、解决问题。但是我发现qq群的分享其实也有很多的弊端1.每天采集量很大,一般来说要看10个网页才有几十个。这样我们的网页资源分配比较拥挤2.网页规格较多,比如需要收集汽车网站的数据,我的车太多了,每天都采集不了,经常发现一个站点有几百个网页,很难去规划分配采集标准。

那么我认为解决采集质量的问题是采集源里最重要的,采集量比较大的时候,一定要按照采集率选择源,选择一个匹配度高的源采集,目的是选择最优质、采集率最高的网页。网页文章自动采集优化采集周期:目前收集网页的周期一般在30天左右,也就是3个月或者6个月我们就必须把这些网页全部采集完毕,不然存在收集周期比较长,当未来发现问题的时候我们可以通过采集率来调整网页存在的时间了,甚至可以进行调整收集量的方式来应对(因为收集周期越长,网页内容越稀疏)。

加速采集周期:目前采集率+调整收集周期的比例大概是5:2,比例越高,增长越快。优化采集标准:采集源对于网页的种类、数量和规格有着一定要求,比如:分类网站一般需要三个才能完成收集,大型门户网站需要十几个才能完成收集。网页文章自动采集采集规格:源头采集的网页规格跟目的网站有很大的区别,所以选择收集规格的时候尽量跟采集目的网站的规格相匹配。

选择采集规格时要根据我们想要收集的网页来选择一个固定的规格,不能随意更改。比如:我们想要收集汽车网站的数据,我们可以采集汽车网站的网址再用bing搜索一下就知道能够收集的网址了。如果我们想收集的网址很多,也要有一个限制要求。比如:1.能够保证网页内容是确定的,且我们可以去做一些额外的调整去符合规格的要求。

2.网页内容有一定数量的规格要求,少于多于30个则优先采集。选择采集器:当我们选择收集源时,除了发现数量规格外,还要发现网页的字数、长短还有采集率、也就是说我们需要根据收集的网页内容来找到更加优质的采集器。选择采集器的时候对于我们来说也很重要,对于采集效率的提升也很关键。关于选择采集器的推荐:安妮采集器:对于分类网站来说,保证数量规格我认为是首要的,因为分类的要求比较高,字数与质量都不低,所以我们选择采集器要找到优质的采集器,而不是那些收费昂贵。

老于驿站:定位是综合门户网站的数据采集,这类网站有一定的数量要求,字数较长,且需要统计收集率。老于驿站app:对于我。 查看全部

网页文章自动采集(网页文章自动采集如何选择采集源(一)_国内_光明网)

网页文章自动采集如何选择采集源:传统的采集是第一种,是通过qq群里分享采集来的,收费相对比较贵,接触的网页越多,对于我们来说成本相对较高,主要在于发现问题、解决问题。但是我发现qq群的分享其实也有很多的弊端1.每天采集量很大,一般来说要看10个网页才有几十个。这样我们的网页资源分配比较拥挤2.网页规格较多,比如需要收集汽车网站的数据,我的车太多了,每天都采集不了,经常发现一个站点有几百个网页,很难去规划分配采集标准。

那么我认为解决采集质量的问题是采集源里最重要的,采集量比较大的时候,一定要按照采集率选择源,选择一个匹配度高的源采集,目的是选择最优质、采集率最高的网页。网页文章自动采集优化采集周期:目前收集网页的周期一般在30天左右,也就是3个月或者6个月我们就必须把这些网页全部采集完毕,不然存在收集周期比较长,当未来发现问题的时候我们可以通过采集率来调整网页存在的时间了,甚至可以进行调整收集量的方式来应对(因为收集周期越长,网页内容越稀疏)。

加速采集周期:目前采集率+调整收集周期的比例大概是5:2,比例越高,增长越快。优化采集标准:采集源对于网页的种类、数量和规格有着一定要求,比如:分类网站一般需要三个才能完成收集,大型门户网站需要十几个才能完成收集。网页文章自动采集采集规格:源头采集的网页规格跟目的网站有很大的区别,所以选择收集规格的时候尽量跟采集目的网站的规格相匹配。

选择采集规格时要根据我们想要收集的网页来选择一个固定的规格,不能随意更改。比如:我们想要收集汽车网站的数据,我们可以采集汽车网站的网址再用bing搜索一下就知道能够收集的网址了。如果我们想收集的网址很多,也要有一个限制要求。比如:1.能够保证网页内容是确定的,且我们可以去做一些额外的调整去符合规格的要求。

2.网页内容有一定数量的规格要求,少于多于30个则优先采集。选择采集器:当我们选择收集源时,除了发现数量规格外,还要发现网页的字数、长短还有采集率、也就是说我们需要根据收集的网页内容来找到更加优质的采集器。选择采集器的时候对于我们来说也很重要,对于采集效率的提升也很关键。关于选择采集器的推荐:安妮采集器:对于分类网站来说,保证数量规格我认为是首要的,因为分类的要求比较高,字数与质量都不低,所以我们选择采集器要找到优质的采集器,而不是那些收费昂贵。

老于驿站:定位是综合门户网站的数据采集,这类网站有一定的数量要求,字数较长,且需要统计收集率。老于驿站app:对于我。

网页文章自动采集( 免费申请ProcessGo60天的超长试用期,你学会了吗? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-04-04 03:05

免费申请ProcessGo60天的超长试用期,你学会了吗?

)

自英诺森ProcessGo官网上线以来,小编在后台收到了大量的消息。看来大家对ProcessGo的免费试用很感兴趣!最常见的信息是,“你能教我如何使用它吗?” “我不知道怎么写代码,我怎么试一试?” 看来我们官网虽然有基础教程,但是很多新手还是不太直观。感受 ProcessGo 的简单和方便。

今天,它就在这里!我们的专家会给你详细直观的“自动浏览器搜索”demo操作步骤,只要按照以下步骤操作,就能体验ProcessGo的灵活性和美感。不要犹豫,向下滚动!

第一步:登录,申请ProcessGo 60天免费试用期,下载并安装ProcessGo。

如果您已经下载并安装了 ProcessGo,请直接进入第二步。

第二步:正式进入流程设计师

1.打开Studio,新建流程图,自定义项目名称和项目位置,点击创建

2.在活动库中选择网页-浏览器,拖到配置区,此时查看浏览器属性,选择对应的浏览器

3.在打开的页面中输入“”

4.选择活动库中的文本设置,拖入Sequence,点击采集。采集网页中的输入框,在输入值中输入“Inossem”

5.在活动库中选择鼠标点击,采集网页中的百度

6.在活动库中再次选择鼠标点击,采集英诺森官网网页

7.在关闭页面的活动库中,进入“英诺森官网”,可以在属性中编辑延迟时间

8.流程设计完成后,点击运行查看流程操作

(ps:如果失败,请检查浏览器的安全设置)

9.选择工具栏中的发布流程,发布到机器人、本地或管理端

第 3 步:指挥你的机器人

流程成功发布到机器人后,我们可以与数字工作者协作。

1.首先我们打开机器人,此时我们发布的流程已经显示在页面上

2.点击运行按钮,机器人开始运行

小伙伴们,学会了吗?

下一期文章,我们还会教你更多实用场景,帮你解放劳动力,躺着完成工作。老板再也不用担心效率问题了!

查看全部

网页文章自动采集(

免费申请ProcessGo60天的超长试用期,你学会了吗?

)

自英诺森ProcessGo官网上线以来,小编在后台收到了大量的消息。看来大家对ProcessGo的免费试用很感兴趣!最常见的信息是,“你能教我如何使用它吗?” “我不知道怎么写代码,我怎么试一试?” 看来我们官网虽然有基础教程,但是很多新手还是不太直观。感受 ProcessGo 的简单和方便。

今天,它就在这里!我们的专家会给你详细直观的“自动浏览器搜索”demo操作步骤,只要按照以下步骤操作,就能体验ProcessGo的灵活性和美感。不要犹豫,向下滚动!

第一步:登录,申请ProcessGo 60天免费试用期,下载并安装ProcessGo。

如果您已经下载并安装了 ProcessGo,请直接进入第二步。

第二步:正式进入流程设计师

1.打开Studio,新建流程图,自定义项目名称和项目位置,点击创建

2.在活动库中选择网页-浏览器,拖到配置区,此时查看浏览器属性,选择对应的浏览器

3.在打开的页面中输入“”

4.选择活动库中的文本设置,拖入Sequence,点击采集。采集网页中的输入框,在输入值中输入“Inossem”

5.在活动库中选择鼠标点击,采集网页中的百度

6.在活动库中再次选择鼠标点击,采集英诺森官网网页

7.在关闭页面的活动库中,进入“英诺森官网”,可以在属性中编辑延迟时间

8.流程设计完成后,点击运行查看流程操作

(ps:如果失败,请检查浏览器的安全设置)

9.选择工具栏中的发布流程,发布到机器人、本地或管理端

第 3 步:指挥你的机器人

流程成功发布到机器人后,我们可以与数字工作者协作。

1.首先我们打开机器人,此时我们发布的流程已经显示在页面上

2.点击运行按钮,机器人开始运行

小伙伴们,学会了吗?

下一期文章,我们还会教你更多实用场景,帮你解放劳动力,躺着完成工作。老板再也不用担心效率问题了!

网页文章自动采集(众所周知优化一个网站是什么?如何采集格式网页的?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-03-28 16:21

采集插件可以采集 格式化网页上的文本、HTML 和元素属性。采集插件可以使用正则表达式和自定义函数过滤内容。采集插件通过HTTP POST请求传输和获取数据。采集插件支持CSV、EXCEL、HTML、TXT等下载数据。采集插件的功能包括:定时采集任务、采集规则自动同步、脚本采集、数据插件导出。

采集插件使用其他网站文章列表和缓存读取技术,网页程序自动读取其他网站的内容,存储过程为< @采集 进程。它是一种信息聚合技术。通过这项技术,站长可以将其他网站相对固定更新的栏目等内容,变成自己网站的一部分,无需复制粘贴。采集有现场和非现场的区别。采集插件站点一般用于较大的站点,将很多栏目聚合到一个节点中,集中展示。

采集插件有两种触发方式采集更新。一种是在页面中添加代码触发采集更新,在后台异步执行,不影响用户体验,不影响采集更新。@网站效率,另外,可以使用Cron调度任务来触发采集定时更新任务。采集插件可以帮助网站节省大量的搬运劳动。该插件不仅支持文章采集,还支持文章采集中的评论,其他插件的数据采集(不支持文章 )。

采集插件可以将多个任务的采集可视化,采集金额图表统计,历史采集状态一目了然。采集插件可以文章评论采集(仅限首页评论),采集插件可以支持市面上大部分主题,插件数据采集(任意数据表仓储)。采集插件采集的第三方触发,多tab,多线程采集文章,采集plugins采集都可以在 伪原创 内容之后自动。

众所周知,优化 网站 并不容易。需要每天更新文章,这样才能保证网站的排名更高,但不是每个人每天都有更多的时间更新网站,总的来说,更新三个就好-每天高质量的文章篇文章已经是很多人的极限了。有时候写不出来文章,总会去别的地方网站copy文章,不过这样也是浪费时间,时间长了就会变得无聊.

采集插件可以帮助网站解决这些问题,采集插件只需要输入站长想要的网站采集,然后直接< @采集,目前后台只有三个采集板块,主要关注资源和新闻源类型的网站。输入网站可以直接采集,采集之后文章自动存入草稿,可以设置覆盖关键词,不用担心关于文章还有其他网站的地址。

<p>采集插件只需要设置相关的采集任务,在定时任务管理界面,将当前采集任务加入队列,等到定时时间,再启动自动 查看全部

网页文章自动采集(众所周知优化一个网站是什么?如何采集格式网页的?)

采集插件可以采集 格式化网页上的文本、HTML 和元素属性。采集插件可以使用正则表达式和自定义函数过滤内容。采集插件通过HTTP POST请求传输和获取数据。采集插件支持CSV、EXCEL、HTML、TXT等下载数据。采集插件的功能包括:定时采集任务、采集规则自动同步、脚本采集、数据插件导出。

采集插件使用其他网站文章列表和缓存读取技术,网页程序自动读取其他网站的内容,存储过程为< @采集 进程。它是一种信息聚合技术。通过这项技术,站长可以将其他网站相对固定更新的栏目等内容,变成自己网站的一部分,无需复制粘贴。采集有现场和非现场的区别。采集插件站点一般用于较大的站点,将很多栏目聚合到一个节点中,集中展示。

采集插件有两种触发方式采集更新。一种是在页面中添加代码触发采集更新,在后台异步执行,不影响用户体验,不影响采集更新。@网站效率,另外,可以使用Cron调度任务来触发采集定时更新任务。采集插件可以帮助网站节省大量的搬运劳动。该插件不仅支持文章采集,还支持文章采集中的评论,其他插件的数据采集(不支持文章 )。