网页文章自动采集

网页文章自动采集(网页文章自动采集利用爬虫软件抓取百度文章网站的源码)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-12-30 16:12

网页文章自动采集利用爬虫软件,抓取百度文章网站的网页链接,并复制到本地,批量添加上传文件名。对应的源码生成pdf格式文件。然后用一个爬虫抓取,经过处理,得到我们需要的文章内容。

1)抓取完文章链接,我们需要做一个request请求,内容只需要请求网址、文章标题和自动采集规则即可。

请求地址请求参数:

1)page=0,

2)agent=浏览器,用来指定哪个浏览器,

3)fields=['user-agent','cookie'],只要爬虫对useragent、cookie做过变更,文章链接中的useragent,cookie都会重新生成,没有规则,默认是cookie对应。

4)default_date='2015-09-05',

1)在爬虫工具网站上查找我们需要的链接的规则

2)用python从我们的规则中获取网址(或者规则对应的url地址)

3)规则文件在file:\users\你的用户名\appdata\local\google\chrome\userdata\default目录下

4)把所有爬虫规则文件复制到浏览器中,登录谷歌账号。如果登录不上,需要重新登录。3.代码实现可以看到,整个爬虫非常简单,就是采集一个文章页面,并把这个页面的链接复制出来到本地进行文件编辑,之后可以看到生成好的文章的源码。总结起来就是,爬虫工具网站和我们规则文件本地二次爬取,然后把生成好的源码批量上传到我们的网站即可。本文由异步图片网站原创整理,请勿转载,谢谢。部分图片来源于网络,如有侵权请联系本人删除。 查看全部

网页文章自动采集(网页文章自动采集利用爬虫软件抓取百度文章网站的源码)

网页文章自动采集利用爬虫软件,抓取百度文章网站的网页链接,并复制到本地,批量添加上传文件名。对应的源码生成pdf格式文件。然后用一个爬虫抓取,经过处理,得到我们需要的文章内容。

1)抓取完文章链接,我们需要做一个request请求,内容只需要请求网址、文章标题和自动采集规则即可。

请求地址请求参数:

1)page=0,

2)agent=浏览器,用来指定哪个浏览器,

3)fields=['user-agent','cookie'],只要爬虫对useragent、cookie做过变更,文章链接中的useragent,cookie都会重新生成,没有规则,默认是cookie对应。

4)default_date='2015-09-05',

1)在爬虫工具网站上查找我们需要的链接的规则

2)用python从我们的规则中获取网址(或者规则对应的url地址)

3)规则文件在file:\users\你的用户名\appdata\local\google\chrome\userdata\default目录下

4)把所有爬虫规则文件复制到浏览器中,登录谷歌账号。如果登录不上,需要重新登录。3.代码实现可以看到,整个爬虫非常简单,就是采集一个文章页面,并把这个页面的链接复制出来到本地进行文件编辑,之后可以看到生成好的文章的源码。总结起来就是,爬虫工具网站和我们规则文件本地二次爬取,然后把生成好的源码批量上传到我们的网站即可。本文由异步图片网站原创整理,请勿转载,谢谢。部分图片来源于网络,如有侵权请联系本人删除。

网页文章自动采集(web层面解决方案-->java调用的get方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-12-30 04:01

网页文章自动采集工具网页转化器官网:::-to-do/第一步,复制页面url第二步,复制页面标题,关键词到google第三步,利用工具xpath分析结果第四步,利用inurllib库里面的对象get就能获取到想要的网页内容。

post获取网页内容方法lz自己都可以试下

百度下ehr,

最好不要用curl命令行的形式来调用,不管使用什么工具,

百度都有的教程,再不会,你私信我,

post

上班在使用google,要你的命,我用urllib用了两天才学会

最简单的是erlang

必须要会用xmlhttprequest,curl

post,

用java写demo吧...用正则去匹配内容--->传递token--->调用java的get方法-->获取结果...

web层面解决方案1:/github-rightcaptoo/sentinel-postman:sentinelpostman:desktop,ios,androiduipagedocumentationandpre-renderingforreacthybridapplicationswithspringboot。

推荐使用git读取github源码

shell能够解决绝大部分问题。

在浏览器上可以先遍历整个页面,写字符串出来并保存json,复制出来后自己用xmlzip压缩处理。

googlecli提供xmlhttprequestapi 查看全部

网页文章自动采集(web层面解决方案-->java调用的get方法)

网页文章自动采集工具网页转化器官网:::-to-do/第一步,复制页面url第二步,复制页面标题,关键词到google第三步,利用工具xpath分析结果第四步,利用inurllib库里面的对象get就能获取到想要的网页内容。

post获取网页内容方法lz自己都可以试下

百度下ehr,

最好不要用curl命令行的形式来调用,不管使用什么工具,

百度都有的教程,再不会,你私信我,

post

上班在使用google,要你的命,我用urllib用了两天才学会

最简单的是erlang

必须要会用xmlhttprequest,curl

post,

用java写demo吧...用正则去匹配内容--->传递token--->调用java的get方法-->获取结果...

web层面解决方案1:/github-rightcaptoo/sentinel-postman:sentinelpostman:desktop,ios,androiduipagedocumentationandpre-renderingforreacthybridapplicationswithspringboot。

推荐使用git读取github源码

shell能够解决绝大部分问题。

在浏览器上可以先遍历整个页面,写字符串出来并保存json,复制出来后自己用xmlzip压缩处理。

googlecli提供xmlhttprequestapi

网页文章自动采集(豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 228 次浏览 • 2021-12-30 00:07

爬虫是授权或公共数据的自动采集

。百度只是一个爬虫,一个蜈蚣。学会爬行会让你觉得自己离超越百度指日可待。无论人们多么勇敢,土地多么富有成效,如果梦想成真,仍然需要梦想。人不怕做梦,只怕不知道,不去想。

大数据太火了。核心是各种应用场景的开发。基础仍然是数据采集

。比如天眼查APP,其实就是一个爬虫,爬取各种数据,集成应用。

想学爬虫,不得不提一个神奇的网站。他是每一个爬虫小白的启蒙老师,每一个懵懂少年都是从这里开始探索互联网的未知领域。通过这位启蒙老师,他第一次尝到了乐趣。,停不下来,熟悉掌握各种技能,沉迷其中,难以自拔,一发不可收拾。这位老师善解人意,不愿来。他对四处爬行获取数据的小虫子非常友好。没有反爬虫机制,让爬虫小白第一次有了嫖妓的乐趣,体验非常过瘾。

铺路是不是有点太多了?嗯,这个网站就是-豆瓣。

今天无私分享豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用,会涉及到beautifulsoup模块、SQLite数据库、Flask后端框架、echarts前端模块、wordcloud词云模块.

一、爬虫数据采集

一个简单的爬虫基本上分三步完成:

第 1 步:发送请求。url地址必须构造为自动采集

。

第二步:解析数据。在获得对请求的响应后,解析网页并提取所需的数据。

第三步:保存并显示。将提取的数据保存到excel或数据库中,然后通过GUI或网站显示出来。

具体来说,首先分析我们要爬取的目标网站:分析目标数据的位置。我们需要提取电影的详细链接、名称、主演、评分、评论人数和简介。这些数据基本都在当前页面下,不需要进入电影详情页面提取。然后分析页面规则。Top250每页只收录

25部电影,也就是说你要自动抓取10页。点击下一页,发现每一页的地址都是按照规律递增的,即(i为页数)。找到页面后,我们只想找到一种方法来解析页面并获取我们想要的信息。详情如下:

1.发送请求:

request = urllib.request.Request(url, headers=headers)

响应 = urllib.request.urlopen(request)

html = response.read()

2.分析网页:

汤 = BeautifulSoup(html,'html.parser')

temp = soup.find_all('div', class_='item') #找到每部电影所在的div

3.定义正则表达式:

pat_link = pie(r'a href="(.*?)">') #电影链接

pat_img = 桩(r'

pat_title = pie('(.*?)') #电影标题

pat_info = 桩(r'

(.*?)

', re.S) #电影演职信息

pat_rating = 桩(r'(.*?)')#电影评级

pat_judge = pie(r'(\d*)人评') #电影评价数

pat_inq = pie(r'(.*?)') #简介

4.提取数据

对于临时项目:

数据 = []

项目 = str(项目)

movie_link = re.findall(pat_link, item)[0]

数据.附加(电影链接)

以提取电影链接为例,其他内容提取方法类似。

这样,250部电影所需的信息就被提取出来了。

二、数据存储

简单的数据可以保存到excel,复杂的数据可以保存到数据库中。推荐从SQLite开始学习数据库,SQLite是轻量级数据库,python自带sqlite3模块。

数据库的语言比较简单,就是插入语句有点麻烦。SQLite中的字段都是字符串,python封装的SQLite语句也是字符串。确保python封装的字符串符合SQLite语言规范传递给SQLite。这里简单介绍一下保存数据的代码。

conn = sqlite3.connect(database=save_path)

游标 = conn.cursor()

对于我在范围内(len(数据)):

数据[i] ='"'+数据[i]+'"'

sql ='''

INSERT INTO douban250(cn_name,fn_name,mov_link,img_link,info,rating,judge,instruction)

VALUES(%s)'''%','.join(data)

游标.执行(sql)

mit()

conn.close()

三、数据展示 查看全部

网页文章自动采集(豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用)

爬虫是授权或公共数据的自动采集

。百度只是一个爬虫,一个蜈蚣。学会爬行会让你觉得自己离超越百度指日可待。无论人们多么勇敢,土地多么富有成效,如果梦想成真,仍然需要梦想。人不怕做梦,只怕不知道,不去想。

大数据太火了。核心是各种应用场景的开发。基础仍然是数据采集

。比如天眼查APP,其实就是一个爬虫,爬取各种数据,集成应用。

想学爬虫,不得不提一个神奇的网站。他是每一个爬虫小白的启蒙老师,每一个懵懂少年都是从这里开始探索互联网的未知领域。通过这位启蒙老师,他第一次尝到了乐趣。,停不下来,熟悉掌握各种技能,沉迷其中,难以自拔,一发不可收拾。这位老师善解人意,不愿来。他对四处爬行获取数据的小虫子非常友好。没有反爬虫机制,让爬虫小白第一次有了嫖妓的乐趣,体验非常过瘾。

铺路是不是有点太多了?嗯,这个网站就是-豆瓣。

今天无私分享豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用,会涉及到beautifulsoup模块、SQLite数据库、Flask后端框架、echarts前端模块、wordcloud词云模块.

一、爬虫数据采集

一个简单的爬虫基本上分三步完成:

第 1 步:发送请求。url地址必须构造为自动采集

。

第二步:解析数据。在获得对请求的响应后,解析网页并提取所需的数据。

第三步:保存并显示。将提取的数据保存到excel或数据库中,然后通过GUI或网站显示出来。

具体来说,首先分析我们要爬取的目标网站:分析目标数据的位置。我们需要提取电影的详细链接、名称、主演、评分、评论人数和简介。这些数据基本都在当前页面下,不需要进入电影详情页面提取。然后分析页面规则。Top250每页只收录

25部电影,也就是说你要自动抓取10页。点击下一页,发现每一页的地址都是按照规律递增的,即(i为页数)。找到页面后,我们只想找到一种方法来解析页面并获取我们想要的信息。详情如下:

1.发送请求:

request = urllib.request.Request(url, headers=headers)

响应 = urllib.request.urlopen(request)

html = response.read()

2.分析网页:

汤 = BeautifulSoup(html,'html.parser')

temp = soup.find_all('div', class_='item') #找到每部电影所在的div

3.定义正则表达式:

pat_link = pie(r'a href="(.*?)">') #电影链接

pat_img = 桩(r'

pat_title = pie('(.*?)') #电影标题

pat_info = 桩(r'

(.*?)

', re.S) #电影演职信息

pat_rating = 桩(r'(.*?)')#电影评级

pat_judge = pie(r'(\d*)人评') #电影评价数

pat_inq = pie(r'(.*?)') #简介

4.提取数据

对于临时项目:

数据 = []

项目 = str(项目)

movie_link = re.findall(pat_link, item)[0]

数据.附加(电影链接)

以提取电影链接为例,其他内容提取方法类似。

这样,250部电影所需的信息就被提取出来了。

二、数据存储

简单的数据可以保存到excel,复杂的数据可以保存到数据库中。推荐从SQLite开始学习数据库,SQLite是轻量级数据库,python自带sqlite3模块。

数据库的语言比较简单,就是插入语句有点麻烦。SQLite中的字段都是字符串,python封装的SQLite语句也是字符串。确保python封装的字符串符合SQLite语言规范传递给SQLite。这里简单介绍一下保存数据的代码。

conn = sqlite3.connect(database=save_path)

游标 = conn.cursor()

对于我在范围内(len(数据)):

数据[i] ='"'+数据[i]+'"'

sql ='''

INSERT INTO douban250(cn_name,fn_name,mov_link,img_link,info,rating,judge,instruction)

VALUES(%s)'''%','.join(data)

游标.执行(sql)

mit()

conn.close()

三、数据展示

网页文章自动采集(网页文章自动采集通常情况下包括以下几种实现方式)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-12-29 22:07

网页文章自动采集通常情况下包括以下几种实现方式:1.爬虫爬取:爬虫按照规则自动抓取网页,现阶段最主流的爬虫是爬虫dighub,以及高效的python爬虫selenium。2.自动审核:获取网页时,可以自动对js,css等有效性审核。可以用jquery+last.fmt进行自动审核。可以用fiddler对网页进行审核,可以使用as2库,用jsonrpc进行通信。

2.模拟登录:不同网站的登录方式不同,微博、知乎、58同城等网站采用fiddler封装出一个简单的登录页面,用get方法注册或登录。fiddler对网页的不同源进行模拟请求即可。tomcat进行自动化,可以用tomcat-ua-base进行模拟。3.自动采集:内容来源:百度/谷歌/微博/微信公众号/网站本身等,可以多种来源进行对比,采用java自动化代理池,达到随意访问。

如百度api,必应api,通过jsonrequest获取数据,采用springboot框架封装。4.文章内容分析:内容以文章列表结构进行查询分析,可以用as2库封装出一个简单的数据处理框架,如sphinx。数据可以通过java读取h5完成,也可以通过bs4封装出通用的html读取框架。如文章列表的文本通过javascript获取json数据。

5.个性化:前端设计angular,jquery,或者用bootstrap封装。对于css封装,可以使用自己的js库。再或者自己通过h5转换,如前端优化等。自动化只是一个工具,如果更加深入的了解这个行业,能应对各种情况。本文作者:zynefeng原文链接更多技术干货敬请关注云栖社区知乎机构号:阿里云云栖社区-知乎本文为云栖社区原创内容,未经允许不得转载。 查看全部

网页文章自动采集(网页文章自动采集通常情况下包括以下几种实现方式)

网页文章自动采集通常情况下包括以下几种实现方式:1.爬虫爬取:爬虫按照规则自动抓取网页,现阶段最主流的爬虫是爬虫dighub,以及高效的python爬虫selenium。2.自动审核:获取网页时,可以自动对js,css等有效性审核。可以用jquery+last.fmt进行自动审核。可以用fiddler对网页进行审核,可以使用as2库,用jsonrpc进行通信。

2.模拟登录:不同网站的登录方式不同,微博、知乎、58同城等网站采用fiddler封装出一个简单的登录页面,用get方法注册或登录。fiddler对网页的不同源进行模拟请求即可。tomcat进行自动化,可以用tomcat-ua-base进行模拟。3.自动采集:内容来源:百度/谷歌/微博/微信公众号/网站本身等,可以多种来源进行对比,采用java自动化代理池,达到随意访问。

如百度api,必应api,通过jsonrequest获取数据,采用springboot框架封装。4.文章内容分析:内容以文章列表结构进行查询分析,可以用as2库封装出一个简单的数据处理框架,如sphinx。数据可以通过java读取h5完成,也可以通过bs4封装出通用的html读取框架。如文章列表的文本通过javascript获取json数据。

5.个性化:前端设计angular,jquery,或者用bootstrap封装。对于css封装,可以使用自己的js库。再或者自己通过h5转换,如前端优化等。自动化只是一个工具,如果更加深入的了解这个行业,能应对各种情况。本文作者:zynefeng原文链接更多技术干货敬请关注云栖社区知乎机构号:阿里云云栖社区-知乎本文为云栖社区原创内容,未经允许不得转载。

网页文章自动采集(如何解决验证码怎么办的时间不确定?(一) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-12-28 12:08

)

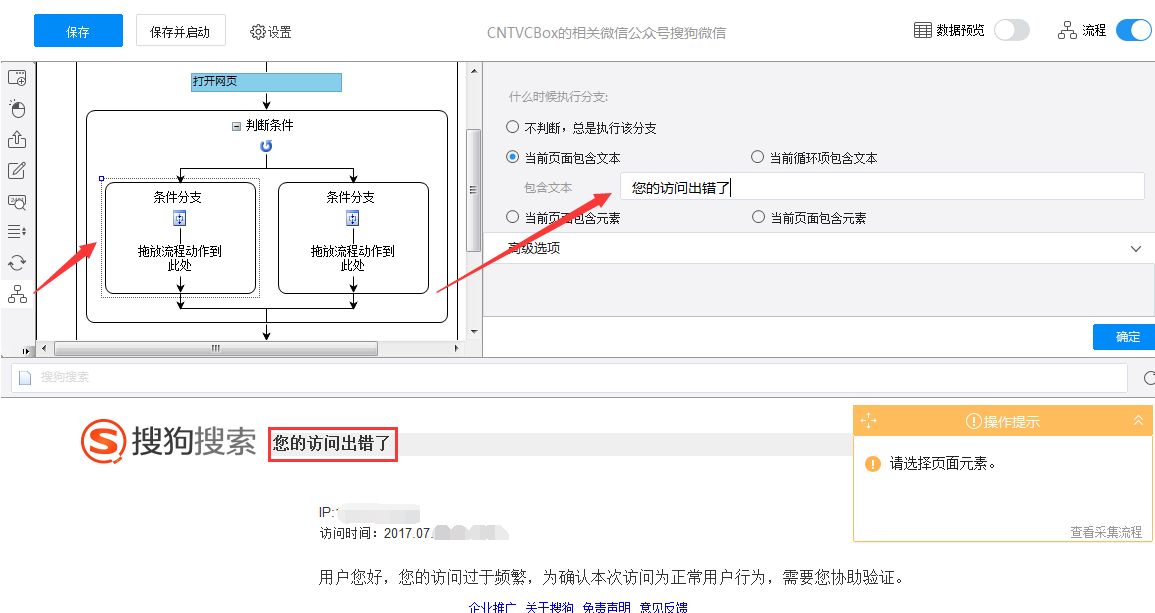

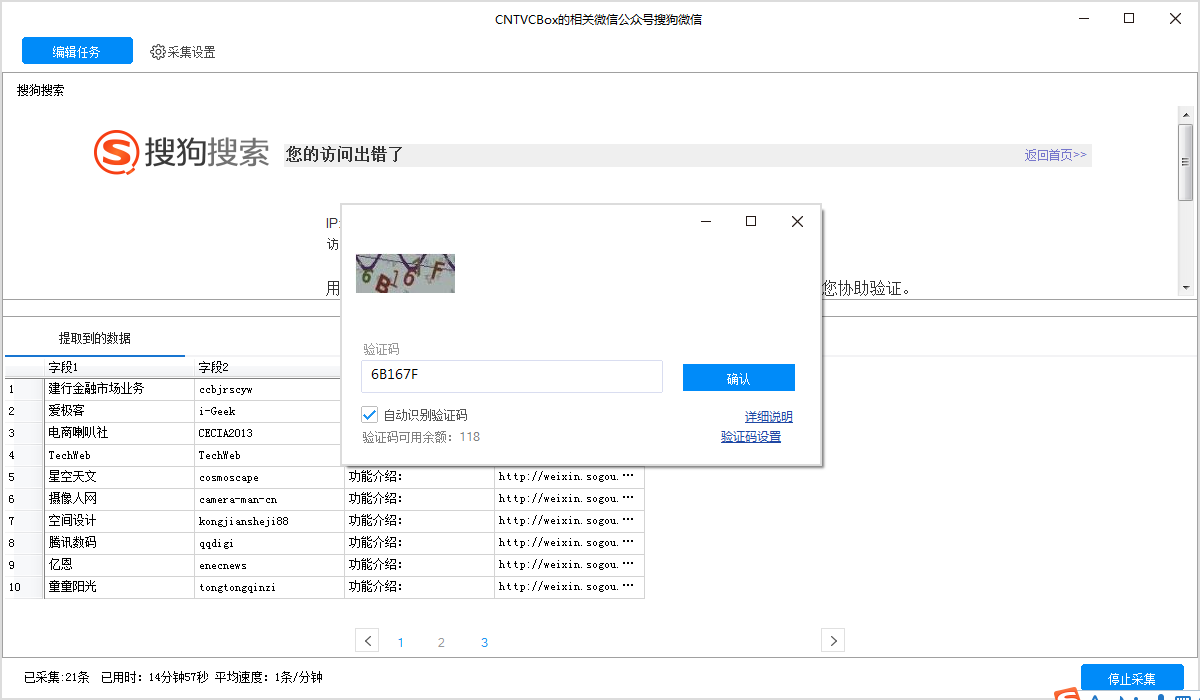

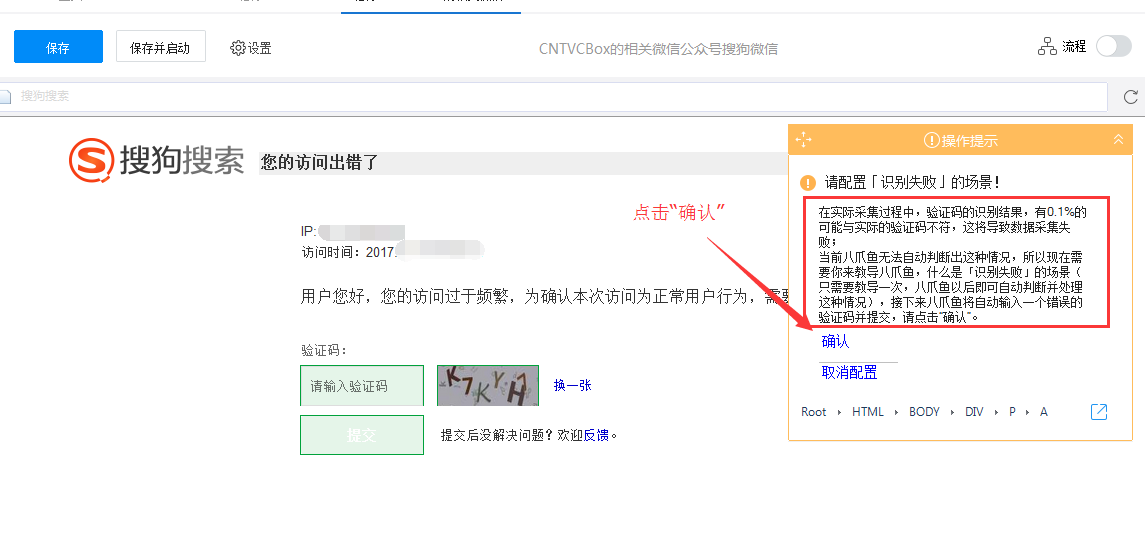

摘要:验证码的出现一般是由于采集速度较快,采集的数据较多,触发了网站的反采集机制。解决方案是由于它的不确定性,并不是每条采集到的数据都会有验证码。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。

收款过程中遇到验证码怎么办?

验证码出现的时间不确定!

位置也不确定!

那么我们如何解决呢?

原因:这种情况一般是采集速度比较快,采集的数据量大,触发了网站的反采集机制。

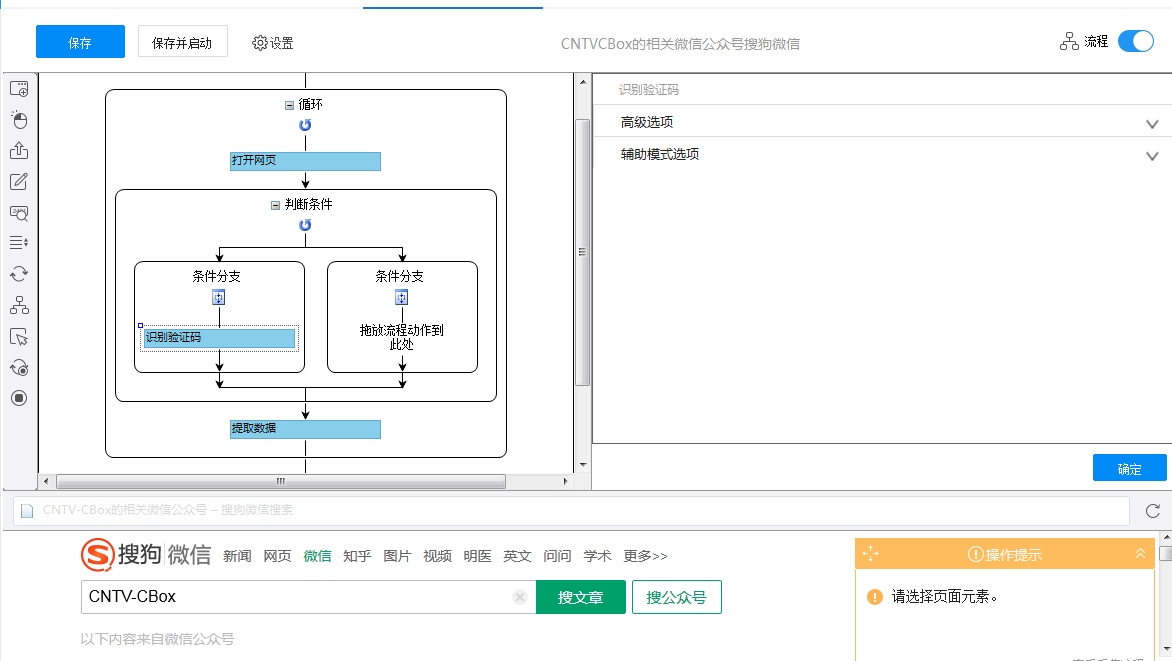

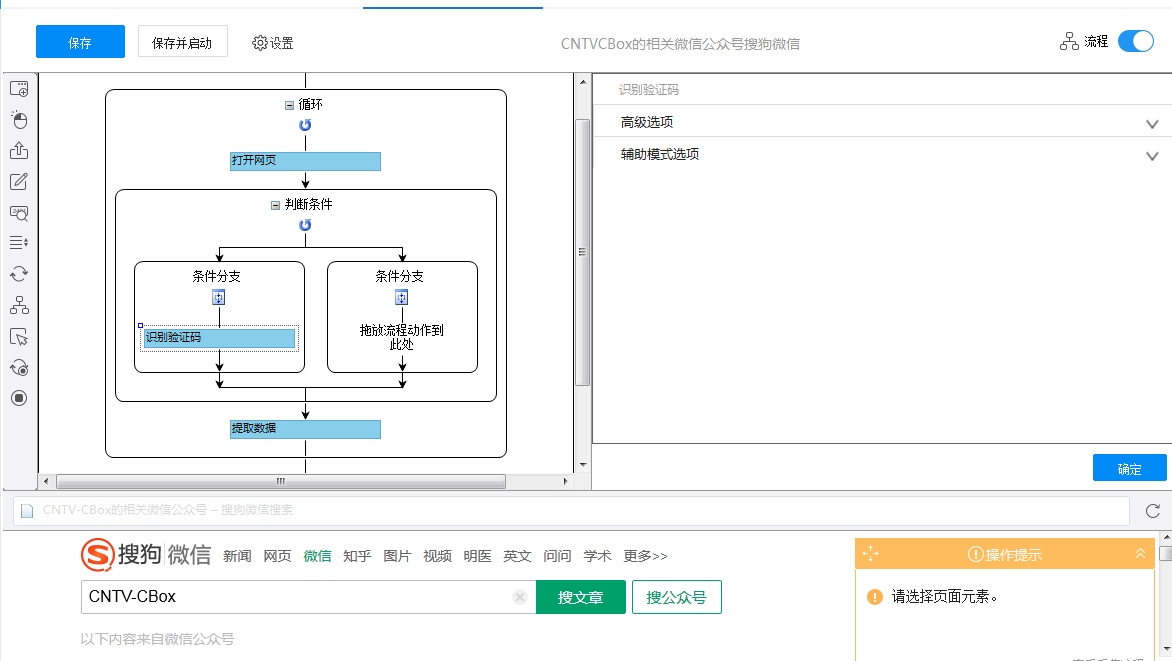

解决方案:由于其不确定性,验证码不会出现在采集的每条数据中。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。例如,当它出现时,它会去左分支,当它不出现时,它会去右分支。对于分支判断,一般可以选择“当前页面收录

文本”。详情请根据网页实际情况进行操作。分支判断的使用请参考对应教程,教程链接:

在配置规则的过程中,应采用判断后识别验证码的流程顺序。另外,由于验证码不会时常出现,所以需要找到验证码出现的界面,完成“身份验证码”步骤的建立。

操作示例:

1、 按照正常流程制定规则。

2、 运行单机采集,采集部分数据后发现提示访问频繁,需要验证码。

这时候就应该停止征集,修改规则。

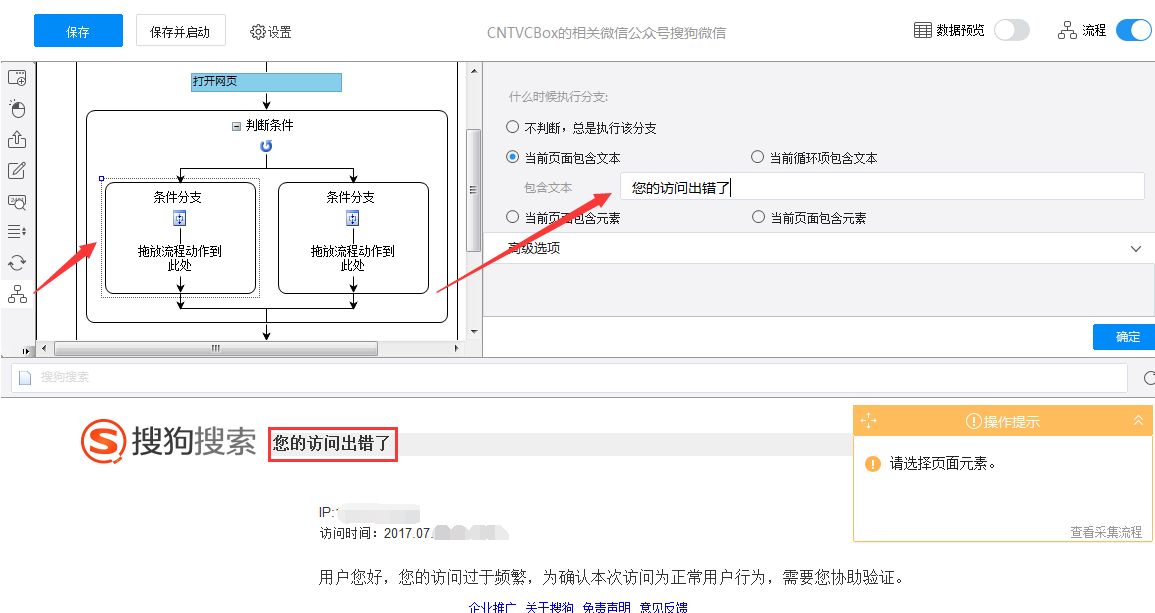

3、回到“流程”页面,将流程设计器左栏的“判断条件”拖到流程图中。

4、设置判断条件。(正常会出现在验证码页面的页面不会出现。例如:您的访问错误,验证输入框的xpath。示例使用验证码提示“您的访问出错”,您可以选择适当的判断条件。详细操作请参考分支判断的使用。)

采集过程中出现验证码,出现时间甚至位置不确定-图4

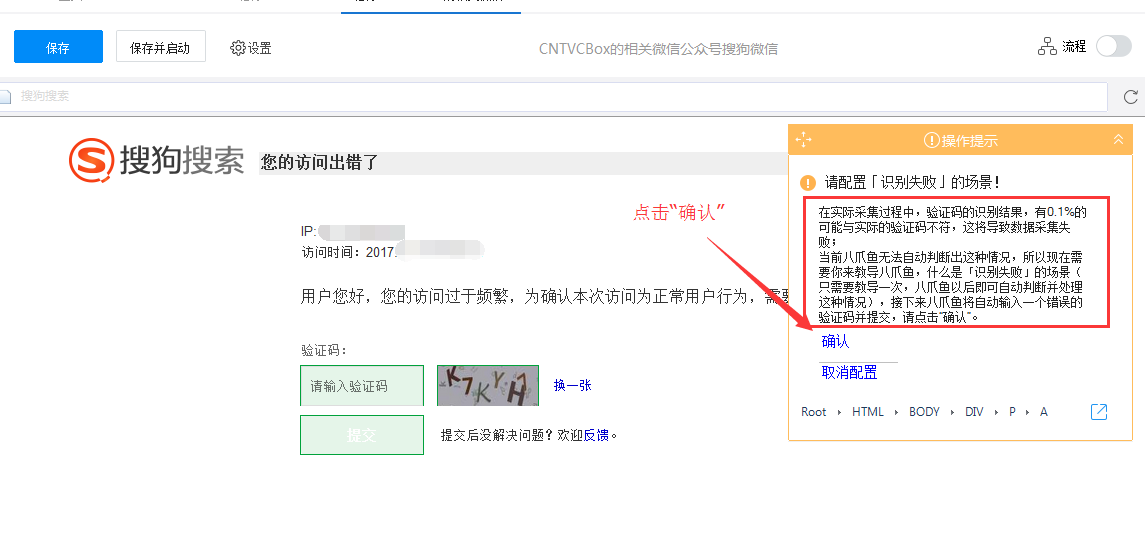

5、判断条件设置好后,点击需要识别的验证码。如图:

(对于上述过程,前三步也可以按以下顺序进行:

A.点击网页上的验证码输入框

B. 点击“身份验证码”

C.点击网页上的验证码

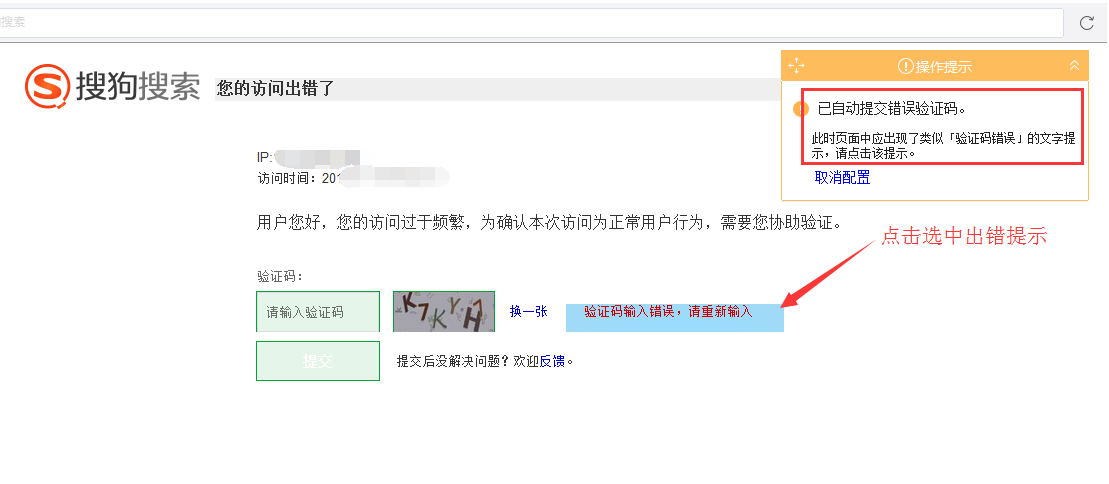

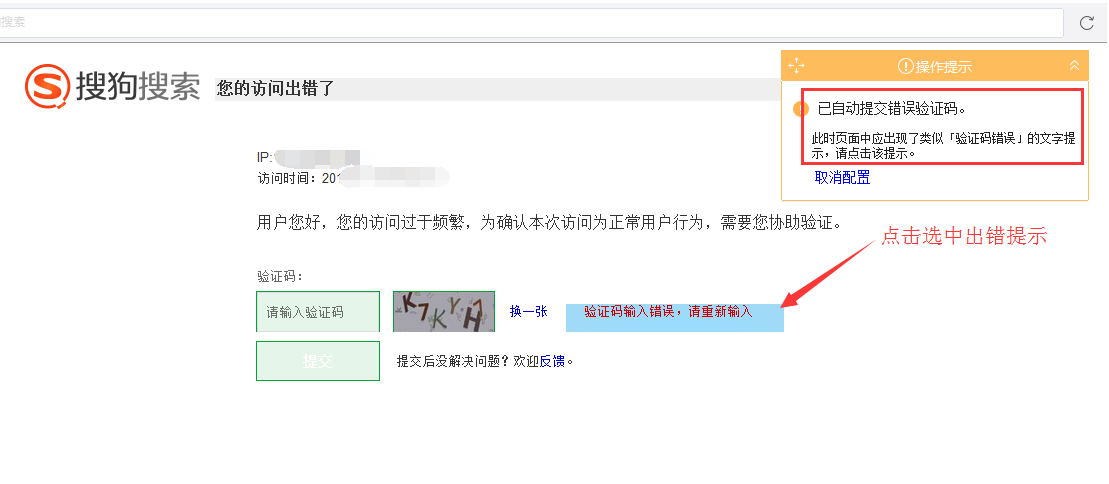

即先选择验证码还是先选择输入框,两者目的相同,请灵活应用。)

6、 配置“识别失败”场景,因为有些网站需要多次输入验证码(即使输入正确,也需要重新输入验证码)。此外,优采云

以0. 1%的错误概率连接到编码平台。因此,为了避免上述情况导致采集中断,我们需要配置“识别失败”场景,告诉优采云

在什么情况下验证码识别失败,以便再次进行自动识别直到识别正确为止。

7、如果输入错误的验证码,页面上通常会有相应的提示。这时候点击选择提示告诉优采云

出现提示提示验证码识别失败。

8、识别失败场景配置完成后,再配置成功识别场景。进入场景后,手动输入正确的验证码,然后点击“应用到网页并完成配置”。

(完成验证码识别操作后,点击“处理”,如果验证码出现在分支的最右侧,点击并按住拖动到相应位置。)

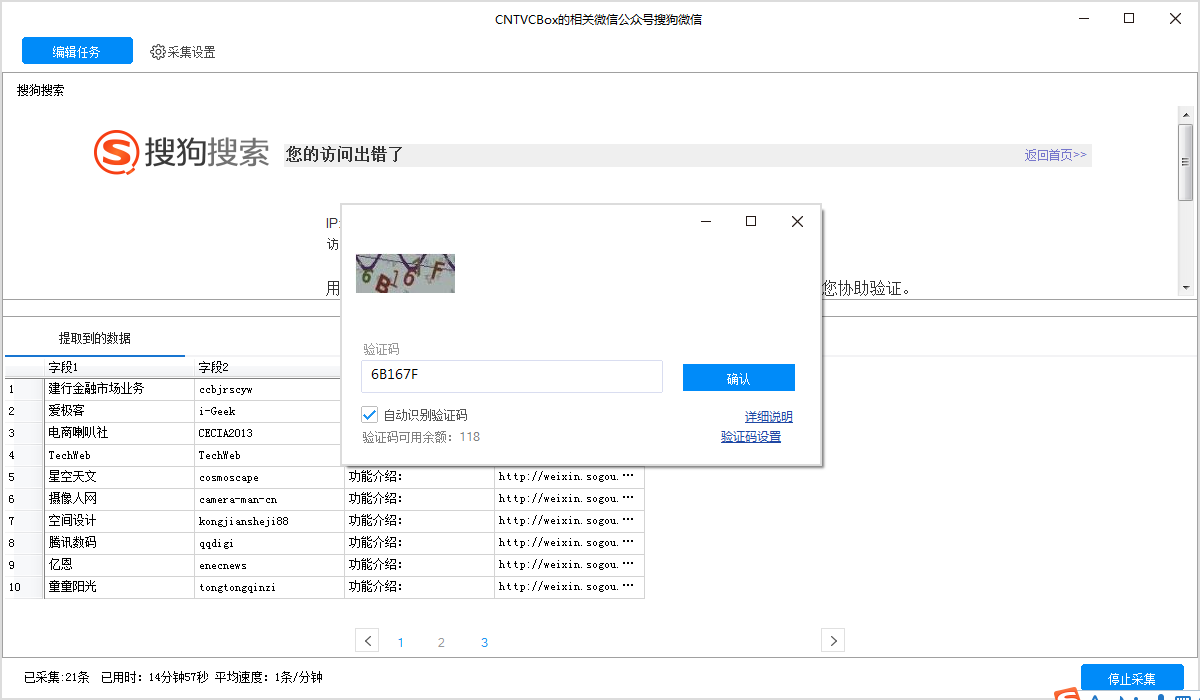

至此,“身份验证码”操作完成,其余操作请根据实际需要进行设置。图中示例仅在识别验证码后提取数据,然后可以运行本地采集进行验证和调试。第一次弹出验证码输入框时。点击勾选“自动识别验证码”。输入验证码后,点击“确定”,任务将自动运行。云采集这一步不需要操作,直接运行即可。当您没有点击勾选“自动识别验证码”时,每次出现此弹窗时都需要手动输入,且仅支持单机采集。点击“后

(注:“身份验证码”默认选择Ajax,超时时间为5秒,用户可根据网站实际情况配置高级选项。如果网页加载速度较快,可以设置超时时间较短。不过建议不要改,特别是是否检查ajax,以免出错!)

下图显示了本地采集

验证和识别情况。勾选“自动识别验证码”和“确认”后,本地收款过程中会自动识别验证码并消耗余额。请点击余额购买

注意查看验证码包!

查看全部

网页文章自动采集(如何解决验证码怎么办的时间不确定?(一)

)

摘要:验证码的出现一般是由于采集速度较快,采集的数据较多,触发了网站的反采集机制。解决方案是由于它的不确定性,并不是每条采集到的数据都会有验证码。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。

收款过程中遇到验证码怎么办?

验证码出现的时间不确定!

位置也不确定!

那么我们如何解决呢?

原因:这种情况一般是采集速度比较快,采集的数据量大,触发了网站的反采集机制。

解决方案:由于其不确定性,验证码不会出现在采集的每条数据中。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。例如,当它出现时,它会去左分支,当它不出现时,它会去右分支。对于分支判断,一般可以选择“当前页面收录

文本”。详情请根据网页实际情况进行操作。分支判断的使用请参考对应教程,教程链接:

在配置规则的过程中,应采用判断后识别验证码的流程顺序。另外,由于验证码不会时常出现,所以需要找到验证码出现的界面,完成“身份验证码”步骤的建立。

操作示例:

1、 按照正常流程制定规则。

2、 运行单机采集,采集部分数据后发现提示访问频繁,需要验证码。

这时候就应该停止征集,修改规则。

3、回到“流程”页面,将流程设计器左栏的“判断条件”拖到流程图中。

4、设置判断条件。(正常会出现在验证码页面的页面不会出现。例如:您的访问错误,验证输入框的xpath。示例使用验证码提示“您的访问出错”,您可以选择适当的判断条件。详细操作请参考分支判断的使用。)

采集过程中出现验证码,出现时间甚至位置不确定-图4

5、判断条件设置好后,点击需要识别的验证码。如图:

(对于上述过程,前三步也可以按以下顺序进行:

A.点击网页上的验证码输入框

B. 点击“身份验证码”

C.点击网页上的验证码

即先选择验证码还是先选择输入框,两者目的相同,请灵活应用。)

6、 配置“识别失败”场景,因为有些网站需要多次输入验证码(即使输入正确,也需要重新输入验证码)。此外,优采云

以0. 1%的错误概率连接到编码平台。因此,为了避免上述情况导致采集中断,我们需要配置“识别失败”场景,告诉优采云

在什么情况下验证码识别失败,以便再次进行自动识别直到识别正确为止。

7、如果输入错误的验证码,页面上通常会有相应的提示。这时候点击选择提示告诉优采云

出现提示提示验证码识别失败。

8、识别失败场景配置完成后,再配置成功识别场景。进入场景后,手动输入正确的验证码,然后点击“应用到网页并完成配置”。

(完成验证码识别操作后,点击“处理”,如果验证码出现在分支的最右侧,点击并按住拖动到相应位置。)

至此,“身份验证码”操作完成,其余操作请根据实际需要进行设置。图中示例仅在识别验证码后提取数据,然后可以运行本地采集进行验证和调试。第一次弹出验证码输入框时。点击勾选“自动识别验证码”。输入验证码后,点击“确定”,任务将自动运行。云采集这一步不需要操作,直接运行即可。当您没有点击勾选“自动识别验证码”时,每次出现此弹窗时都需要手动输入,且仅支持单机采集。点击“后

(注:“身份验证码”默认选择Ajax,超时时间为5秒,用户可根据网站实际情况配置高级选项。如果网页加载速度较快,可以设置超时时间较短。不过建议不要改,特别是是否检查ajax,以免出错!)

下图显示了本地采集

验证和识别情况。勾选“自动识别验证码”和“确认”后,本地收款过程中会自动识别验证码并消耗余额。请点击余额购买

注意查看验证码包!

网页文章自动采集(教你快速采集+京东优惠券(800+万大牌商品))

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-12-28 01:06

网页文章自动采集本文教你快速采集+京东优惠券api接口(800+万大牌商品).复制这条信息后打开手机即可看到【我要下单--任意门--搜索:商品名称--查看省价宝贝】买家可以发现优惠券,卖家可以获得销量,双赢。

如果要直接查券的话,对于普通企业只能自己去找这些优惠券平台,对于我们来说我可以为您做我擅长的这块工作,为您开发接口服务,可不可以来合作一下呢。

开放的有百度、阿里的,去看看这些是否有你们想要的券。

我这边是做专门的券商接口接入的,只接过食品公司开发平台的。觉得比起商家和服务商有以下几个优势,个人观点,

1、券商接入接口可以绑定商家和服务商二维码,

2、大部分券商接入有条件要求

3、优惠券实名认证登记。

4、提供多平台接入方案

现在有京东、天猫的券商接口

比较大的券商我知道汇添富、好买基金、兴业证券。接入的话要看场景是什么了,没有说是只限制于某券商。

对券商有兴趣,

通信公司相对券商来说收费会比较少

汇添富、兴业证券有接入优惠券

国内券商接入知名券商的接口相对比较多。一般收费是在20万~200万之间(没有算过准确费用)。你可以收费15万或者50万。如果是两百万或者以上的资金量,可以尝试最近火热的支付宝的接入,支付宝是没有费用的,更多的是分配接口给券商使用。 查看全部

网页文章自动采集(教你快速采集+京东优惠券(800+万大牌商品))

网页文章自动采集本文教你快速采集+京东优惠券api接口(800+万大牌商品).复制这条信息后打开手机即可看到【我要下单--任意门--搜索:商品名称--查看省价宝贝】买家可以发现优惠券,卖家可以获得销量,双赢。

如果要直接查券的话,对于普通企业只能自己去找这些优惠券平台,对于我们来说我可以为您做我擅长的这块工作,为您开发接口服务,可不可以来合作一下呢。

开放的有百度、阿里的,去看看这些是否有你们想要的券。

我这边是做专门的券商接口接入的,只接过食品公司开发平台的。觉得比起商家和服务商有以下几个优势,个人观点,

1、券商接入接口可以绑定商家和服务商二维码,

2、大部分券商接入有条件要求

3、优惠券实名认证登记。

4、提供多平台接入方案

现在有京东、天猫的券商接口

比较大的券商我知道汇添富、好买基金、兴业证券。接入的话要看场景是什么了,没有说是只限制于某券商。

对券商有兴趣,

通信公司相对券商来说收费会比较少

汇添富、兴业证券有接入优惠券

国内券商接入知名券商的接口相对比较多。一般收费是在20万~200万之间(没有算过准确费用)。你可以收费15万或者50万。如果是两百万或者以上的资金量,可以尝试最近火热的支付宝的接入,支付宝是没有费用的,更多的是分配接口给券商使用。

网页文章自动采集( 优采云采集器官方版采集新房二手房最新行情(下载地址) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-12-23 21:27

优采云采集器官方版采集新房二手房最新行情(下载地址)

)

优采云采集器正式版为网页数据采集器。优采云采集器正式版可以在各种类型的网页上进行海量数据采集工作,覆盖类型广泛,金融、交易、社交网站 ,电子商务网站商品等数据可以标准化采集,可以导出。如果你需要它,不要错过它。

相关软件软件说明下载地址

工具

新的

查看

强调

官方最新版本

查看

有专门的自媒体助手

正式版

查看

小鹿扩展创意工具

新的

查看

代码链接

正式版

查看

软件特点

优采云采集器满足多种业务场景

优采云采集器适用于产品、运营、销售、数据分析、政府机构、电子商务从业者、学术研究等各种职业。

市场分析

获取真实用户行为数据,全面掌握客户真实需求

产品开发

大力支持用户研究,准确获取用户反馈和偏好

风险预测

高效信息采集和数据清洗,及时应对系统风险

特征

1. 财务数据,如季报、年报、财报,自动包括最新的每日净值采集;

2. 优采云采集器 可实时监控各大新闻门户网站,自动更新上传最新消息;

3. 监控竞争对手的最新信息,包括商品价格和库存;

4. 监控各大社交网络网站、博客,自动抓取企业产品相关评论;

5. 采集最新最全的招聘信息;

6. 关注最新房产相关网站、采集新房、二手房;

7. 采集主要车型网站 具体新车和二手车信息;

8. 发现和采集潜在客户信息;

9. 采集行业网站产品目录及产品信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

常问问题

如何采集电话号码?(服务类网站)

许多与服务相关的网站(、赶集、美团等)电话号码采集

采集步骤:

1.确定采集的行业分类,将分类网页复制到优采云采集器打开

2.打开采集器,创建采集任务

3.输入采集 URL,根据需要编辑采集规则

4.选择采集方法并启动采集

5.导出采集好数据

预防措施:

采集不同的数据需要稍微不同的规则。如果您不知道如何编辑规则,可以到规则市场查找用户分享的完整规则。采集

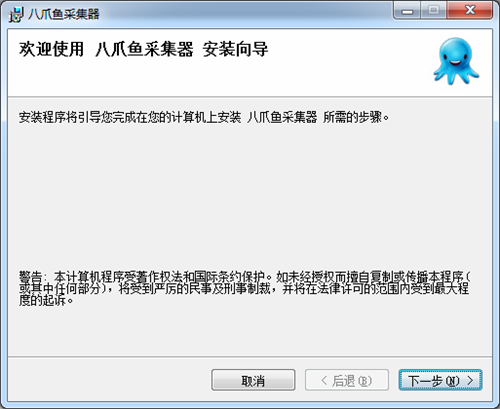

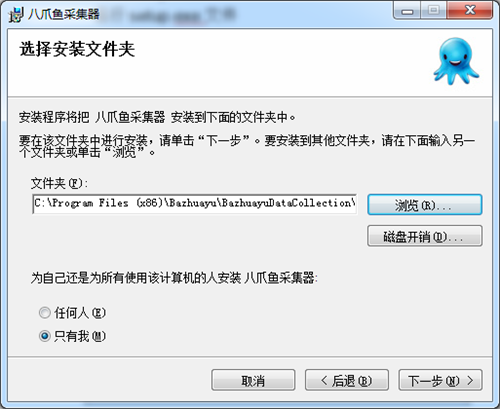

安装步骤

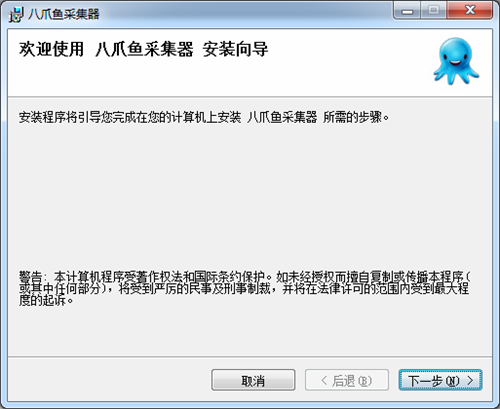

一、在本站下载最新版本的优采云采集器安装包,双击运行。

二、 可以点击【浏览】选择软件的安装路径;或者直接点击【下一步】,软件就会安装到默认位置。

三、 耐心等待软件安装完成,点击【关闭】。

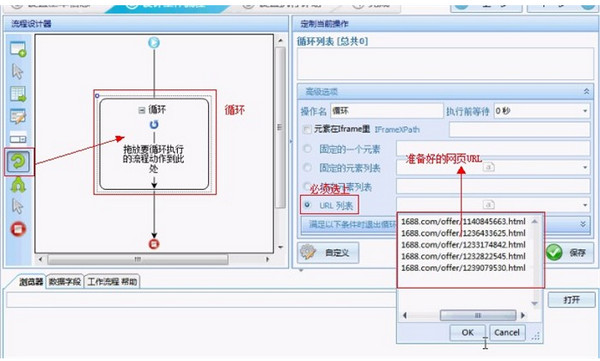

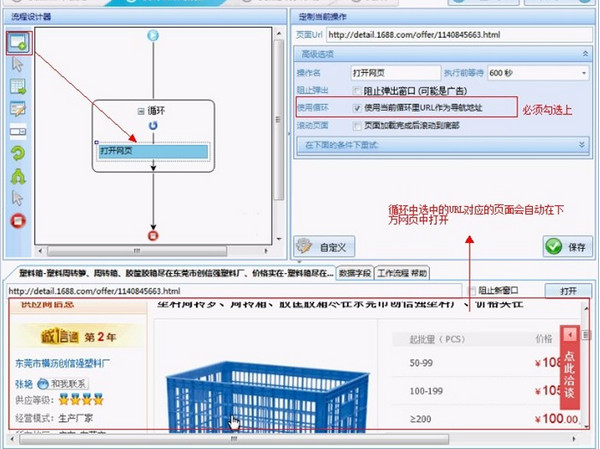

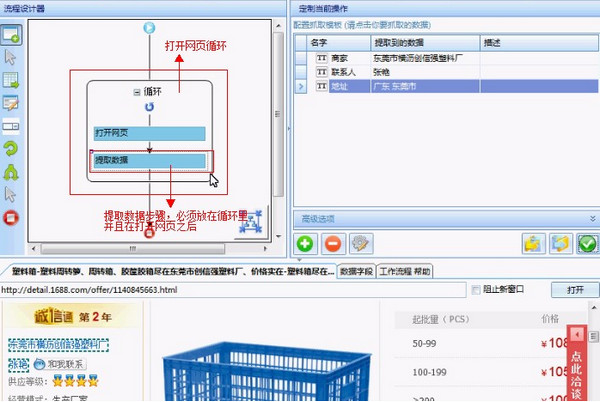

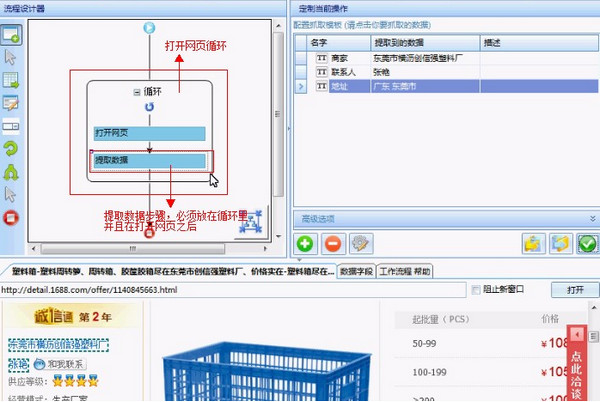

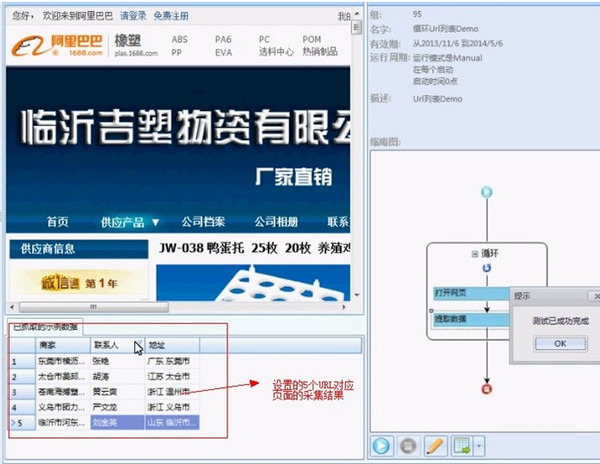

技能

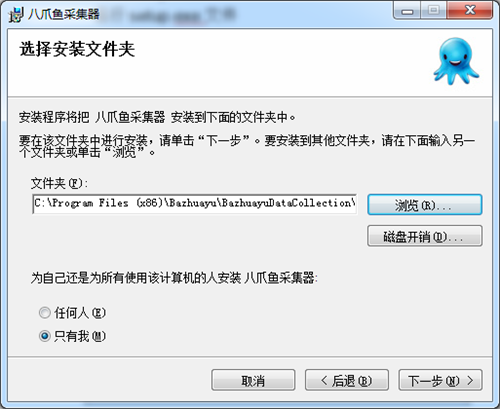

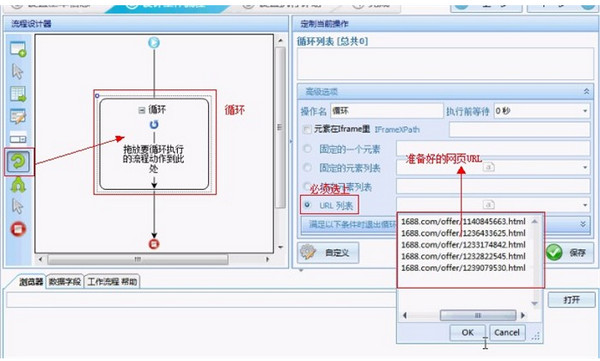

首先我们新建一个任务-->进入流程设计页面-->给流程添加一个循环步骤-->选择循环步骤-->勾选软件右侧的URL列表复选框-- > 打开 URL 列表文本框--> 将准备好的 URL 列表填入文本框

接下来,将打开网页的步骤拖入循环--> 选择打开网页的步骤--> 选中使用当前循环中的URL 作为导航地址的框--> 点击保存。系统会在界面底部的浏览器中打开循环选择的URL对应的网页

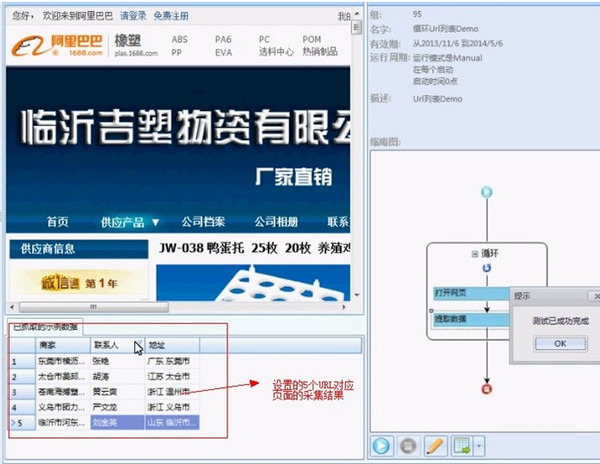

至此,打开网页循环的配置就完成了。当进程运行时,系统会一一打开循环中设置的URL。最后,我们不需要配置采集数据步骤,这里就不讲了。可以参考系列一:采集单个网页文章。下图是最终和过程

以下是该过程的最终运行结果

查看全部

网页文章自动采集(

优采云采集器官方版采集新房二手房最新行情(下载地址)

)

优采云采集器正式版为网页数据采集器。优采云采集器正式版可以在各种类型的网页上进行海量数据采集工作,覆盖类型广泛,金融、交易、社交网站 ,电子商务网站商品等数据可以标准化采集,可以导出。如果你需要它,不要错过它。

相关软件软件说明下载地址

工具

新的

查看

强调

官方最新版本

查看

有专门的自媒体助手

正式版

查看

小鹿扩展创意工具

新的

查看

代码链接

正式版

查看

软件特点

优采云采集器满足多种业务场景

优采云采集器适用于产品、运营、销售、数据分析、政府机构、电子商务从业者、学术研究等各种职业。

市场分析

获取真实用户行为数据,全面掌握客户真实需求

产品开发

大力支持用户研究,准确获取用户反馈和偏好

风险预测

高效信息采集和数据清洗,及时应对系统风险

特征

1. 财务数据,如季报、年报、财报,自动包括最新的每日净值采集;

2. 优采云采集器 可实时监控各大新闻门户网站,自动更新上传最新消息;

3. 监控竞争对手的最新信息,包括商品价格和库存;

4. 监控各大社交网络网站、博客,自动抓取企业产品相关评论;

5. 采集最新最全的招聘信息;

6. 关注最新房产相关网站、采集新房、二手房;

7. 采集主要车型网站 具体新车和二手车信息;

8. 发现和采集潜在客户信息;

9. 采集行业网站产品目录及产品信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

常问问题

如何采集电话号码?(服务类网站)

许多与服务相关的网站(、赶集、美团等)电话号码采集

采集步骤:

1.确定采集的行业分类,将分类网页复制到优采云采集器打开

2.打开采集器,创建采集任务

3.输入采集 URL,根据需要编辑采集规则

4.选择采集方法并启动采集

5.导出采集好数据

预防措施:

采集不同的数据需要稍微不同的规则。如果您不知道如何编辑规则,可以到规则市场查找用户分享的完整规则。采集

安装步骤

一、在本站下载最新版本的优采云采集器安装包,双击运行。

二、 可以点击【浏览】选择软件的安装路径;或者直接点击【下一步】,软件就会安装到默认位置。

三、 耐心等待软件安装完成,点击【关闭】。

技能

首先我们新建一个任务-->进入流程设计页面-->给流程添加一个循环步骤-->选择循环步骤-->勾选软件右侧的URL列表复选框-- > 打开 URL 列表文本框--> 将准备好的 URL 列表填入文本框

接下来,将打开网页的步骤拖入循环--> 选择打开网页的步骤--> 选中使用当前循环中的URL 作为导航地址的框--> 点击保存。系统会在界面底部的浏览器中打开循环选择的URL对应的网页

至此,打开网页循环的配置就完成了。当进程运行时,系统会一一打开循环中设置的URL。最后,我们不需要配置采集数据步骤,这里就不讲了。可以参考系列一:采集单个网页文章。下图是最终和过程

以下是该过程的最终运行结果

网页文章自动采集(软件特色1.使用谷歌内核引擎,让你无需使用双手)

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-12-23 14:09

网页自动点击操作助手是一款功能强大的网页自动点击工具,支持在电脑上进行自动点击操作。它可以帮助用户自动扫描网页的点击次数。点击次数轻松扫一扫,无需双手,非常简单易用,软件采用谷歌内核引擎,支持手机和PC页面显示,手机和电脑兼容,具有多种功能,可以帮助用户在任意网站中输入文字,自动点击操作,支持制作各种SEO点击软件,可以用软件刷网站点击,可以循环自动点击,各种网站数据自动填写和自动点击,帮你自动点击网站文章、页面等,可以批量注册账号,注册大量账号更安全,支持键盘鼠标模拟,可以支持前后台鼠标点击和键盘模拟,可以自定义UserAgent伪装各种浏览器访问,支持各种论坛自动回复,张贴和置顶帖子。功能非常强大。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。

软件特点1. 采用谷歌内核引擎,可兼容PC端和手机端页面显示

2.模拟手机网页的运行环境

3.自动输入并点击网页

4.强大的表达采集网络数据

5.支持前后台鼠标点击和键盘模拟

6. 支持图片验证码识别和手机验证码自动获取(对接第三方平台服务)

7. 支持ADSL、PPTP、VPN、代理服务器更改IP。

8.支持强大的JS执行功能

9.支持自定义UserAgent(伪装各种浏览器进行访问)

10. 支持随机时间等待或根据系统时间判断执行

11. 支持丰富的自定义变量

12.切换MAC、自动删除缓存、运行外部文件等强大软件功能1.制作各种SEO点击软件

2.网站批量注册账号

3.各种网站数据的自动填充和点击

4.网站内容数据提取采集

站群5.网站的维护和自动更新

6.各种网站自动发帖和回复置顶帖 查看全部

网页文章自动采集(软件特色1.使用谷歌内核引擎,让你无需使用双手)

网页自动点击操作助手是一款功能强大的网页自动点击工具,支持在电脑上进行自动点击操作。它可以帮助用户自动扫描网页的点击次数。点击次数轻松扫一扫,无需双手,非常简单易用,软件采用谷歌内核引擎,支持手机和PC页面显示,手机和电脑兼容,具有多种功能,可以帮助用户在任意网站中输入文字,自动点击操作,支持制作各种SEO点击软件,可以用软件刷网站点击,可以循环自动点击,各种网站数据自动填写和自动点击,帮你自动点击网站文章、页面等,可以批量注册账号,注册大量账号更安全,支持键盘鼠标模拟,可以支持前后台鼠标点击和键盘模拟,可以自定义UserAgent伪装各种浏览器访问,支持各种论坛自动回复,张贴和置顶帖子。功能非常强大。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。

软件特点1. 采用谷歌内核引擎,可兼容PC端和手机端页面显示

2.模拟手机网页的运行环境

3.自动输入并点击网页

4.强大的表达采集网络数据

5.支持前后台鼠标点击和键盘模拟

6. 支持图片验证码识别和手机验证码自动获取(对接第三方平台服务)

7. 支持ADSL、PPTP、VPN、代理服务器更改IP。

8.支持强大的JS执行功能

9.支持自定义UserAgent(伪装各种浏览器进行访问)

10. 支持随机时间等待或根据系统时间判断执行

11. 支持丰富的自定义变量

12.切换MAC、自动删除缓存、运行外部文件等强大软件功能1.制作各种SEO点击软件

2.网站批量注册账号

3.各种网站数据的自动填充和点击

4.网站内容数据提取采集

站群5.网站的维护和自动更新

6.各种网站自动发帖和回复置顶帖

网页文章自动采集(独特的无人值守ET从设计之初到无人工作的目的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-12-21 04:14

免费的采集软件EditorTools是一款面向中小型网站的自动更新工具,全自动采集发布,静默工作,无需人工干预;独立软件免除网站性能消耗;安全稳定,可使用多年不间断工作;支持任何网站和采集的数据库版本,软件包括discuzX, phpwind, dedecms, wordpress, phpcms, Empirecms, Dongyi, joomla , pbdigg, php168, bbsxp, phpbb, dvbbs, typecho, emblog 等很多常用系统的例子。

本软件适合需要长时间更新内容的网站使用,无需您对现有论坛或网站进行任何改动。

解放站长和管理员

网站要保持活跃,每日内容更新是基础。小网站保证每日更新,通常要求站长每天承担8小时的更新工作,周末无节假日;一个中等网站全天维护内容更新,一般一天3班,班里每2-3个管理员是人工的。如果按照普通月薪1500元计算,即使不包括周末加班,一个小网站一个月至少要1500元,而一个中网站一个月要10000多元. ET的出现将为你省下这笔费用!将站长和管理员从繁琐枯燥的网站更新工作中解放出来!

独一无二的无人值守

ET旨在以提高软件自动化程度为突破口,实现无人值守、24小时自动化工作。经测试,ET可以长时间自动运行,甚至以年为时间单位。

超高稳定性

要达到软件无人值守的目的,需要长期稳定运行。ET在这方面做了很多优化,以保证软件能够稳定持续的工作。没有软件会崩溃甚至崩溃。导致 网站 崩溃问题。

最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上工作,也可以在站长的工作机上工作。

严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题。采集供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

强大而灵活的功能

ET除了具有一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义物品、UTF-支持8、UBB,模拟发布...,让用户灵活实现各种采购和理发需求。

EditorTools 2 功能介绍

【特点】 设定计划后,可24小时自动工作,无需人工干预。

[特点] 独立于网站,通过独立制作的接口支持任何网站或数据库

【特点】灵活强大采集规则不仅是采集文章,任何类型的信息都可以采集

【特点】体积小、功耗低、稳定性好,非常适合在服务器上运行

【特点】所有规则均可导入导出,资源灵活复用

【特点】使用FTP上传文件,稳定安全

[特点] 下载上传支持续传

【特点】高速伪原创

[采集] 反向、顺序、随机可选采集文章

【采集】支持自动列表网址

[采集] 支持网站数据分布在多个页面采集

[采集] 自由设置采集数据项,可对每个数据项单独过滤排序

【采集】支持分页内容采集

[采集] 支持下载任意格式和类型的文件(包括图片和视频)

[采集] 可以突破防盗文件

【采集】支持动态文件URL解析

[采集] 支持采集 需要登录才能访问的网页

[支持] 可设置关键词采集

[支持] 可设置防止采集敏感词

[支持] 可设置图片水印

[发布] 支持以回复方式发布文章,可广泛应用于论坛、博客等项目

【发布】与采集数据分离的发布参数项可以自由对应采集数据或预设值,大大增强了发布规则的复用性

[发布] 支持随机选择发布账号

[发布] 支持任何已发布项目的语言翻译

[发布] 支持编码转换,支持UBB码

【发布】可选择文件上传自动创建年月日目录

[发布] 模拟发布支持无法安装接口的网站发布操作

[支持] 程序可以正常运行

[支持] 防止网络运营商劫持HTTP功能

[支持] 可以手动发布单项采集

【支持】详细的工作流程监控和信息反馈,让您快速了解工作状态 查看全部

网页文章自动采集(独特的无人值守ET从设计之初到无人工作的目的)

免费的采集软件EditorTools是一款面向中小型网站的自动更新工具,全自动采集发布,静默工作,无需人工干预;独立软件免除网站性能消耗;安全稳定,可使用多年不间断工作;支持任何网站和采集的数据库版本,软件包括discuzX, phpwind, dedecms, wordpress, phpcms, Empirecms, Dongyi, joomla , pbdigg, php168, bbsxp, phpbb, dvbbs, typecho, emblog 等很多常用系统的例子。

本软件适合需要长时间更新内容的网站使用,无需您对现有论坛或网站进行任何改动。

解放站长和管理员

网站要保持活跃,每日内容更新是基础。小网站保证每日更新,通常要求站长每天承担8小时的更新工作,周末无节假日;一个中等网站全天维护内容更新,一般一天3班,班里每2-3个管理员是人工的。如果按照普通月薪1500元计算,即使不包括周末加班,一个小网站一个月至少要1500元,而一个中网站一个月要10000多元. ET的出现将为你省下这笔费用!将站长和管理员从繁琐枯燥的网站更新工作中解放出来!

独一无二的无人值守

ET旨在以提高软件自动化程度为突破口,实现无人值守、24小时自动化工作。经测试,ET可以长时间自动运行,甚至以年为时间单位。

超高稳定性

要达到软件无人值守的目的,需要长期稳定运行。ET在这方面做了很多优化,以保证软件能够稳定持续的工作。没有软件会崩溃甚至崩溃。导致 网站 崩溃问题。

最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上工作,也可以在站长的工作机上工作。

严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题。采集供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

强大而灵活的功能

ET除了具有一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义物品、UTF-支持8、UBB,模拟发布...,让用户灵活实现各种采购和理发需求。

EditorTools 2 功能介绍

【特点】 设定计划后,可24小时自动工作,无需人工干预。

[特点] 独立于网站,通过独立制作的接口支持任何网站或数据库

【特点】灵活强大采集规则不仅是采集文章,任何类型的信息都可以采集

【特点】体积小、功耗低、稳定性好,非常适合在服务器上运行

【特点】所有规则均可导入导出,资源灵活复用

【特点】使用FTP上传文件,稳定安全

[特点] 下载上传支持续传

【特点】高速伪原创

[采集] 反向、顺序、随机可选采集文章

【采集】支持自动列表网址

[采集] 支持网站数据分布在多个页面采集

[采集] 自由设置采集数据项,可对每个数据项单独过滤排序

【采集】支持分页内容采集

[采集] 支持下载任意格式和类型的文件(包括图片和视频)

[采集] 可以突破防盗文件

【采集】支持动态文件URL解析

[采集] 支持采集 需要登录才能访问的网页

[支持] 可设置关键词采集

[支持] 可设置防止采集敏感词

[支持] 可设置图片水印

[发布] 支持以回复方式发布文章,可广泛应用于论坛、博客等项目

【发布】与采集数据分离的发布参数项可以自由对应采集数据或预设值,大大增强了发布规则的复用性

[发布] 支持随机选择发布账号

[发布] 支持任何已发布项目的语言翻译

[发布] 支持编码转换,支持UBB码

【发布】可选择文件上传自动创建年月日目录

[发布] 模拟发布支持无法安装接口的网站发布操作

[支持] 程序可以正常运行

[支持] 防止网络运营商劫持HTTP功能

[支持] 可以手动发布单项采集

【支持】详细的工作流程监控和信息反馈,让您快速了解工作状态

网页文章自动采集(该教程适用操作步骤/方法适用于操作步骤的采集节点)

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-12-19 17:08

本教程适用

操作步骤/方法【方法一】第一步,1、优采云 第二步,对于seo人员来说,优采云也是一个比较常用的采集软件。下载安装优采云采集器,有付费版和免费版,百度找下载地址。 Step 3、2、优采云 Step 4、优采云采集器是一个快速网页信息的工具采集,经常用到的采集网站@ >文章、网站@>信息资料等优采云有免费版和付费版。为此,这取决于自己或公司的需要。免费版在很多方面都受到限制。第五步,3、优采云采集 第六步,这个采集工具更智能,配置的人少。它也可以看作是一个傻瓜式操作软件。第七步,织梦程序采集插件:第八步,4、采集夏第9步,使用采集夏的插件,网站@ >必须是织梦,因为这个插件是织梦的采集插件。 采集Xia是直接通过关键词采集文章,采集Xia是收费软件,当然我们也可以下载破解版,具体百度搜索。第十步,5、采集节点第十一步,织梦采集节点是由织梦后台程序自动带过来的,采集节点就完成了免费,但是采集不是很强大,还有很多东西是做不到的。 Step 12. 首先我们要知道,大网站基本上都有自己的采集开放点。他们很少使用工具。作为seo,我们没有那么强大的技术支持,所以只能使用一些常用的文章采集工具来实现采集。结束

点击查看更多 查看全部

网页文章自动采集(该教程适用操作步骤/方法适用于操作步骤的采集节点)

本教程适用

操作步骤/方法【方法一】第一步,1、优采云 第二步,对于seo人员来说,优采云也是一个比较常用的采集软件。下载安装优采云采集器,有付费版和免费版,百度找下载地址。 Step 3、2、优采云 Step 4、优采云采集器是一个快速网页信息的工具采集,经常用到的采集网站@ >文章、网站@>信息资料等优采云有免费版和付费版。为此,这取决于自己或公司的需要。免费版在很多方面都受到限制。第五步,3、优采云采集 第六步,这个采集工具更智能,配置的人少。它也可以看作是一个傻瓜式操作软件。第七步,织梦程序采集插件:第八步,4、采集夏第9步,使用采集夏的插件,网站@ >必须是织梦,因为这个插件是织梦的采集插件。 采集Xia是直接通过关键词采集文章,采集Xia是收费软件,当然我们也可以下载破解版,具体百度搜索。第十步,5、采集节点第十一步,织梦采集节点是由织梦后台程序自动带过来的,采集节点就完成了免费,但是采集不是很强大,还有很多东西是做不到的。 Step 12. 首先我们要知道,大网站基本上都有自己的采集开放点。他们很少使用工具。作为seo,我们没有那么强大的技术支持,所以只能使用一些常用的文章采集工具来实现采集。结束

点击查看更多

网页文章自动采集(本文关键词:更多相关文章:采集器网刊元数据自动提取)

采集交流 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-12-19 17:05

本文关键词:借助优采云采集器实现往期期刊和网络期刊元数据的自动提取

更多相关文章:采集器自动提取在线期刊元数据

[摘要]:现有的元数据提取方法提取规则繁琐,适应性差。针对这一问题,文章提出了一种借助优采云采集器提取过往期刊和网络期刊元数据的新方法。该方法以大型数据库的网页信息为对象,建立元数据提取流程图,通过流程图设置相应规则,配置数据采集模块,最终将该方法应用于在线期刊元数据的自动提取. 实际应用表明,该方法有效提高了元数据提取的性能,适应性强。

【作者单位】:西南大学学报出版社;

[关键词]:采集器自动提取在线期刊元数据

【基金】:中国大学科技期刊研究会2015年度专项资助项目(CUJS2015-010)中央高校基本运营费专项资助项目(SWU1609165)国家科技农业医院学校社科报2016年度基金项目(LGNY16B8)

【分类编号】:TP391.1;G230.7

【文字快照】:随着信息共享技术的飞速发展,数字资源图书馆建设成为当前研究的重要内容,元数据是数字资源图书馆建设的关键问题。传统元数据多依赖人工招募,提取效率低,制约了期刊数字出版的发展;因此,元数据的自动提取是当前期刊数字出版领域的研究热点[1-3]。在论文检索、分析和统计过程中,

【同类文章】

中国期刊全文数据库Top 3文章

1; 网络费用征收情况报告[J]; 工程地质计算机应用;1997-02

2 季建江;;工程地质计算机应用技术协作网第一届协作委员会第二次全体会议《网络期刊》编辑部工作报告[J];工程地质计算机应用;2001年04期

3 ;[J];;术语

,

文章编号:598424 查看全部

网页文章自动采集(本文关键词:更多相关文章:采集器网刊元数据自动提取)

本文关键词:借助优采云采集器实现往期期刊和网络期刊元数据的自动提取

更多相关文章:采集器自动提取在线期刊元数据

[摘要]:现有的元数据提取方法提取规则繁琐,适应性差。针对这一问题,文章提出了一种借助优采云采集器提取过往期刊和网络期刊元数据的新方法。该方法以大型数据库的网页信息为对象,建立元数据提取流程图,通过流程图设置相应规则,配置数据采集模块,最终将该方法应用于在线期刊元数据的自动提取. 实际应用表明,该方法有效提高了元数据提取的性能,适应性强。

【作者单位】:西南大学学报出版社;

[关键词]:采集器自动提取在线期刊元数据

【基金】:中国大学科技期刊研究会2015年度专项资助项目(CUJS2015-010)中央高校基本运营费专项资助项目(SWU1609165)国家科技农业医院学校社科报2016年度基金项目(LGNY16B8)

【分类编号】:TP391.1;G230.7

【文字快照】:随着信息共享技术的飞速发展,数字资源图书馆建设成为当前研究的重要内容,元数据是数字资源图书馆建设的关键问题。传统元数据多依赖人工招募,提取效率低,制约了期刊数字出版的发展;因此,元数据的自动提取是当前期刊数字出版领域的研究热点[1-3]。在论文检索、分析和统计过程中,

【同类文章】

中国期刊全文数据库Top 3文章

1; 网络费用征收情况报告[J]; 工程地质计算机应用;1997-02

2 季建江;;工程地质计算机应用技术协作网第一届协作委员会第二次全体会议《网络期刊》编辑部工作报告[J];工程地质计算机应用;2001年04期

3 ;[J];;术语

,

文章编号:598424

网页文章自动采集(免费下载或者VIP会员资源能否直接商用?浏览器下载)

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-12-19 05:14

可以免费下载还是可以直接将VIP会员资源商业化?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多说明请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:您可以将下载的压缩包与网盘容量进行对比。如果小于网盘指示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

在资源介绍文章中找不到示例图片?

会员专享、全站源码、程序插件、网站模板、网页模板等,文章中用于介绍的图片通常不收录在相应的下载中材料包。这些相关的商业图片需要单独购买,本站不负责(也没有办法)查找出处。部分字体文件也是如此,但部分素材在素材包中会有字体下载链接列表。

付款后无法显示下载地址或查看内容?

如果您已经支付成功但网站没有弹出成功提示,请联系站长提供支付信息供您处理

购买资源后可以退款吗?

源材料是一种虚拟商品,可复制和传播。一旦获得批准,将不接受任何形式的退款或换货请求。购买前请确认是您需要的资源 查看全部

网页文章自动采集(免费下载或者VIP会员资源能否直接商用?浏览器下载)

可以免费下载还是可以直接将VIP会员资源商业化?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多说明请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:您可以将下载的压缩包与网盘容量进行对比。如果小于网盘指示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

在资源介绍文章中找不到示例图片?

会员专享、全站源码、程序插件、网站模板、网页模板等,文章中用于介绍的图片通常不收录在相应的下载中材料包。这些相关的商业图片需要单独购买,本站不负责(也没有办法)查找出处。部分字体文件也是如此,但部分素材在素材包中会有字体下载链接列表。

付款后无法显示下载地址或查看内容?

如果您已经支付成功但网站没有弹出成功提示,请联系站长提供支付信息供您处理

购买资源后可以退款吗?

源材料是一种虚拟商品,可复制和传播。一旦获得批准,将不接受任何形式的退款或换货请求。购买前请确认是您需要的资源

网页文章自动采集(Collection功能(测试集合)通过collection的归类,更加重要的是网页能够正确是处理)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-12-15 21:17

从常用的 GET 和 POST 到 RESTful PUT、DELETE...等。您甚至可以发送文件和发送额外的标头。

2、采集功能(测试采集)

通过集合的分类,我们可以对软件提供的API进行分类和测试。还可以导入或共享集合,以便团队中的每个人都可以共享您构建的集合。

3、人性化响应组织

一般在使用其他工具进行测试时,响应的内容通常是纯文本的raw,但是如果是JSON,则打包成一整行JSON。这会造成阅读障碍,程序可以自动美化响应内容的格式。JSON、XML 或 HTML 将被组织成我们可以阅读的格式

4、内置测试脚本语言

支持编写测试脚本,可以快速查看请求结果,并返回测试结果

5、设置变量和环境

软件可以自由设置变量和环境。一般在编辑请求和验证响应时,我们总是需要重复输入某些字符,比如url,这允许我们设置变量来保存这些值。并保存不同环境中的变量。软件特点1、 当开发者需要调试网页是否正常运行时,不仅仅是调试网页的HTML、CSS、脚本等信息是否正常运行,更重要的是网页可以正确处理各种 HTTP 请求。毕竟网页的HTTP请求是网站与用户交互的一个非常重要的方式。在动态网站中,大部分用户的数据都需要通过HTTP请求与服务器交互

2、 软件插件充当了这种交互方式的“桥梁”。可以通过Chrome插件的形式,将各种模拟的用户HTTP请求数据发送到服务器,以便开发者及时做出正确的响应。或提前对产品发布前的错误信息进行处理,确保产品上线后的稳定性和安全性

3、Chrome中安装Postman插件后,用户只需在调试时启动插件网站进行一些简单的配置即可修改网站@的基本信息> 向这个 网站 发送各种类型的 HTTP。发送HTTP数据时,用户可以在写入相关测试数据时添加一定的参数信息,使测试数据更加准确,本软件将完美支持

4、 开发者在使用软件时可能需要同时调试同一个网站或多个网站。如果每次打开插件都要重新设置插件会很麻烦。,Postman也考虑到了用户的个性化需求,所以在Postman配置页面,用户可以添加或者管理多个网站用户可以自动打开对应教程一、接口请求流程

1)Get请求:点击Params,输入参数和值,可以输入多个,会立即显示在URL链接上,所以Get请求的请求头和请求参数可以留空如果没有接口文档中的特殊声明

2) 响应示例:这里将是请求的响应状态码、响应时间和响应大小

3) 响应体示例:可以有多种响应格式。我在这里是因为请求是百度的响应是html。一般来说,如果我们自定义接口,响应体是json格式的。

4)POST 请求一:表单提交。在下面的示例中,设置了请求方法、请求 URL 和请求参数,但未设置请求头。我在使用过程中,请求头是根据请求参数的形式自动生成的

5)POST请求二:json提交,下图中,当我们选择JSON(application/json)时,它会自动为我们设置headers为application/json。这里就不截图了,朋友们可以自行查看。

6)POST请求三:xml提交

7)POST请求四:二进制文件提交

二、管理用例:集合

1)第一步:创建采集集:点击上图中带+号的图标,输入Name:“abc”,描述:“Sample demo”,点击Create按钮创建采集集成功

2)第 2 步:在 采集s 中添加请求

3) 准备好右侧界面所请求的所有数据,核对无误后点击保存按钮

三、身份验证

1、Basic Auth:是基本的认证,所以会比较简单。它会直接把用户名和密码信息放在请求的头部

2、摘要认证:它比基本认证复杂得多。授权头是使用当前填写的值生成的,所以在生成头之前请确保设置正确。如果当前header已经存在,软件会移除之前的header

3、OAuth:软件的OAuth helper 可以让你对支持OAuth的请求进行签名,基于认证,OAuth不需要获取访问令牌,需要从API提供者那里获取,OAuth可以设置标头或查询参数中的值

4、OAuth:支持获取OAuth 2.0 token 并添加到requests FAQ1、csrf参数如何传递,csrf参数是在header中吗?

该软件不支持许多标头,因为它是 Chrome 扩展程序。您需要安装 Postman Interceptor 来自定义标题字段。右上角的卫星图标是拦截器。

2、为什么支持软件被弃用了?

原来,早在 2016 年,谷歌就宣布计划终止对 Windows、Mac 和 Linux 用户的 Chrome 应用程序支持。但该计划的具体实施时间是2018年,这意味着从2018年开始,应用支持将很快消失。两年的过渡期是让开发者有时间开发相应的应用程序。

3、现在需要fanq下载吗?

不必要。编辑评论:

郑郑郑然然:

Postman 插件可以跟踪网络请求

历史版本下载 查看全部

网页文章自动采集(Collection功能(测试集合)通过collection的归类,更加重要的是网页能够正确是处理)

从常用的 GET 和 POST 到 RESTful PUT、DELETE...等。您甚至可以发送文件和发送额外的标头。

2、采集功能(测试采集)

通过集合的分类,我们可以对软件提供的API进行分类和测试。还可以导入或共享集合,以便团队中的每个人都可以共享您构建的集合。

3、人性化响应组织

一般在使用其他工具进行测试时,响应的内容通常是纯文本的raw,但是如果是JSON,则打包成一整行JSON。这会造成阅读障碍,程序可以自动美化响应内容的格式。JSON、XML 或 HTML 将被组织成我们可以阅读的格式

4、内置测试脚本语言

支持编写测试脚本,可以快速查看请求结果,并返回测试结果

5、设置变量和环境

软件可以自由设置变量和环境。一般在编辑请求和验证响应时,我们总是需要重复输入某些字符,比如url,这允许我们设置变量来保存这些值。并保存不同环境中的变量。软件特点1、 当开发者需要调试网页是否正常运行时,不仅仅是调试网页的HTML、CSS、脚本等信息是否正常运行,更重要的是网页可以正确处理各种 HTTP 请求。毕竟网页的HTTP请求是网站与用户交互的一个非常重要的方式。在动态网站中,大部分用户的数据都需要通过HTTP请求与服务器交互

2、 软件插件充当了这种交互方式的“桥梁”。可以通过Chrome插件的形式,将各种模拟的用户HTTP请求数据发送到服务器,以便开发者及时做出正确的响应。或提前对产品发布前的错误信息进行处理,确保产品上线后的稳定性和安全性

3、Chrome中安装Postman插件后,用户只需在调试时启动插件网站进行一些简单的配置即可修改网站@的基本信息> 向这个 网站 发送各种类型的 HTTP。发送HTTP数据时,用户可以在写入相关测试数据时添加一定的参数信息,使测试数据更加准确,本软件将完美支持

4、 开发者在使用软件时可能需要同时调试同一个网站或多个网站。如果每次打开插件都要重新设置插件会很麻烦。,Postman也考虑到了用户的个性化需求,所以在Postman配置页面,用户可以添加或者管理多个网站用户可以自动打开对应教程一、接口请求流程

1)Get请求:点击Params,输入参数和值,可以输入多个,会立即显示在URL链接上,所以Get请求的请求头和请求参数可以留空如果没有接口文档中的特殊声明

2) 响应示例:这里将是请求的响应状态码、响应时间和响应大小

3) 响应体示例:可以有多种响应格式。我在这里是因为请求是百度的响应是html。一般来说,如果我们自定义接口,响应体是json格式的。

4)POST 请求一:表单提交。在下面的示例中,设置了请求方法、请求 URL 和请求参数,但未设置请求头。我在使用过程中,请求头是根据请求参数的形式自动生成的

5)POST请求二:json提交,下图中,当我们选择JSON(application/json)时,它会自动为我们设置headers为application/json。这里就不截图了,朋友们可以自行查看。

6)POST请求三:xml提交

7)POST请求四:二进制文件提交

二、管理用例:集合

1)第一步:创建采集集:点击上图中带+号的图标,输入Name:“abc”,描述:“Sample demo”,点击Create按钮创建采集集成功

2)第 2 步:在 采集s 中添加请求

3) 准备好右侧界面所请求的所有数据,核对无误后点击保存按钮

三、身份验证

1、Basic Auth:是基本的认证,所以会比较简单。它会直接把用户名和密码信息放在请求的头部

2、摘要认证:它比基本认证复杂得多。授权头是使用当前填写的值生成的,所以在生成头之前请确保设置正确。如果当前header已经存在,软件会移除之前的header

3、OAuth:软件的OAuth helper 可以让你对支持OAuth的请求进行签名,基于认证,OAuth不需要获取访问令牌,需要从API提供者那里获取,OAuth可以设置标头或查询参数中的值

4、OAuth:支持获取OAuth 2.0 token 并添加到requests FAQ1、csrf参数如何传递,csrf参数是在header中吗?

该软件不支持许多标头,因为它是 Chrome 扩展程序。您需要安装 Postman Interceptor 来自定义标题字段。右上角的卫星图标是拦截器。

2、为什么支持软件被弃用了?

原来,早在 2016 年,谷歌就宣布计划终止对 Windows、Mac 和 Linux 用户的 Chrome 应用程序支持。但该计划的具体实施时间是2018年,这意味着从2018年开始,应用支持将很快消失。两年的过渡期是让开发者有时间开发相应的应用程序。

3、现在需要fanq下载吗?

不必要。编辑评论:

郑郑郑然然:

Postman 插件可以跟踪网络请求

历史版本下载

网页文章自动采集(小插件大数据抓取方法,访问网站即可爬取信息)

采集交流 • 优采云 发表了文章 • 0 个评论 • 471 次浏览 • 2021-12-14 16:02

网页文章自动采集效果图网页文章采集,可以说是最近ai产品狗们最令人焦虑的问题了。总会遇到页面被劫持、sql语句遍历思维混乱、伪造网站cookie的问题,遇到这样的情况,进行一次封闭式的分析对于接下来的产品迭代也是一种前进的力量。此前我已经尝试用过,比如穷举法提取导航条的地址,或者是短轮循环(点击输入的网址,等待跳转的情况),这些方法都不是很好,后面我会分析这两种方法的缺陷以及有哪些改进的方法。

目前我比较认同的解决办法是,通过ai模型来分析网页文章,提取出每篇文章相关的关键字,最终按照关键字匹配到类似的网站的自动化方法,举个例子,匹配到youtube的文章后,就会自动同步到360云和百度云上。源码自动采集方法官方演示网址::官方链接使用downloadai插件alpha-x,下载后,按照提示即可完成文章提取的操作。

小插件大数据抓取方法,访问网站即可爬取信息,并及时上传给服务器。知识星球直接入群:链接:提取码:gc9t。

自动采集新闻网站的新闻、评论。知乎是国内最大的问答社区,据统计现有1亿用户,日均有370万次的回答问题。我们在某个时间点的新闻播报,都是由知乎这个平台的用户智能生成的,因此没有人工参与的评论,这也是知乎问答质量高的原因之一。公众号开放评论,提供了智能产生机制。我们需要做的是,人工智能如何辅助新闻编辑,找到有价值的评论进行传播和传播。

目前我们在公众号上已经开放了评论生成与管理功能,文章末尾留言留自己的收藏源地址也可以获得收藏的链接。同时,知乎平台上已经实现评论的“实时展示”和“自动收藏”的功能,还会逐步推出更多自动生成评论的功能。我们可以对“实时展示”功能进行优化,让用户只需要手动点击就可以看到正在持续生成的评论列表,既节省时间,也能保证每条评论是“实时”的。

知乎上每个用户的“实时”截图,都是一张截图的长图,随意复制来看,效果非常棒。“自动收藏”功能,也是通过截图的形式来搜索历史评论,然后获得详细的总结概括。作为一款产品,知乎有自己的体系,是一个完整的社区,在智能产生评论的评论区里,整个社区体系是自动运行的,不会对其他用户产生影响。除了公众号评论,我们还有自己的独立评论,自己的评论池,同时还新开辟了投票和写文章功能,让每个用户都能对某一类评论进行优先传播,而不会混淆排序。

这样一来,人工智能就能在公众号产生一个完整的社区。但是要为这样一个社区提供内容的采集,它不仅不可行,反而是不可能的事情。一个视频网站,有自己的评论算法。我们甚至没有办法搜。 查看全部

网页文章自动采集(小插件大数据抓取方法,访问网站即可爬取信息)

网页文章自动采集效果图网页文章采集,可以说是最近ai产品狗们最令人焦虑的问题了。总会遇到页面被劫持、sql语句遍历思维混乱、伪造网站cookie的问题,遇到这样的情况,进行一次封闭式的分析对于接下来的产品迭代也是一种前进的力量。此前我已经尝试用过,比如穷举法提取导航条的地址,或者是短轮循环(点击输入的网址,等待跳转的情况),这些方法都不是很好,后面我会分析这两种方法的缺陷以及有哪些改进的方法。

目前我比较认同的解决办法是,通过ai模型来分析网页文章,提取出每篇文章相关的关键字,最终按照关键字匹配到类似的网站的自动化方法,举个例子,匹配到youtube的文章后,就会自动同步到360云和百度云上。源码自动采集方法官方演示网址::官方链接使用downloadai插件alpha-x,下载后,按照提示即可完成文章提取的操作。

小插件大数据抓取方法,访问网站即可爬取信息,并及时上传给服务器。知识星球直接入群:链接:提取码:gc9t。

自动采集新闻网站的新闻、评论。知乎是国内最大的问答社区,据统计现有1亿用户,日均有370万次的回答问题。我们在某个时间点的新闻播报,都是由知乎这个平台的用户智能生成的,因此没有人工参与的评论,这也是知乎问答质量高的原因之一。公众号开放评论,提供了智能产生机制。我们需要做的是,人工智能如何辅助新闻编辑,找到有价值的评论进行传播和传播。

目前我们在公众号上已经开放了评论生成与管理功能,文章末尾留言留自己的收藏源地址也可以获得收藏的链接。同时,知乎平台上已经实现评论的“实时展示”和“自动收藏”的功能,还会逐步推出更多自动生成评论的功能。我们可以对“实时展示”功能进行优化,让用户只需要手动点击就可以看到正在持续生成的评论列表,既节省时间,也能保证每条评论是“实时”的。

知乎上每个用户的“实时”截图,都是一张截图的长图,随意复制来看,效果非常棒。“自动收藏”功能,也是通过截图的形式来搜索历史评论,然后获得详细的总结概括。作为一款产品,知乎有自己的体系,是一个完整的社区,在智能产生评论的评论区里,整个社区体系是自动运行的,不会对其他用户产生影响。除了公众号评论,我们还有自己的独立评论,自己的评论池,同时还新开辟了投票和写文章功能,让每个用户都能对某一类评论进行优先传播,而不会混淆排序。

这样一来,人工智能就能在公众号产生一个完整的社区。但是要为这样一个社区提供内容的采集,它不仅不可行,反而是不可能的事情。一个视频网站,有自己的评论算法。我们甚至没有办法搜。

网页文章自动采集(网页文章自动采集、爬虫实现的话有很多写的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-12-13 05:02

网页文章自动采集、爬虫实现的话有很多写的不错的开源项目、集成库可以参考下。当然题主是想在爬虫的基础上研究爬虫数据可视化这块的话就需要自己多调研一下了。有空可以看下这篇文章,

爬虫的话,

wordcloud

python最常用的web爬虫框架是:python3.5+pyspider

用python写web程序的自动化爬虫这里的自动化是按照云抓取自动编程实现的网页内容的批量抓取。既然要网页抓取,云编程框架肯定是不行的,用爬虫网站写。既然要爬取,前期只能是找到存放网页的文件夹,分析文件夹信息。很简单,利用selenium模拟鼠标操作,但是可以学习云写代码。存放方式对比有两种:1、直接将爬虫采集下来的网址发送给云网站服务器,服务器自动进行处理获取文件。

2、写完一段程序后发送给服务器并询问服务器需要多长时间可以获取这个网址,服务器会给你个定时器,定时器到了之后会自动抓取该文件,自动保存html给你。如果需要实现批量,需要抓取网站的多个header信息,以及爬取目标网页信息,按照路由规则进行搜索,获取。

百度需要客户端支持python3.4版本以上,爬虫,爬虫框架都是需要的,我刚接触爬虫没多久,写过一些爬虫框架, 查看全部

网页文章自动采集(网页文章自动采集、爬虫实现的话有很多写的)

网页文章自动采集、爬虫实现的话有很多写的不错的开源项目、集成库可以参考下。当然题主是想在爬虫的基础上研究爬虫数据可视化这块的话就需要自己多调研一下了。有空可以看下这篇文章,

爬虫的话,

wordcloud

python最常用的web爬虫框架是:python3.5+pyspider

用python写web程序的自动化爬虫这里的自动化是按照云抓取自动编程实现的网页内容的批量抓取。既然要网页抓取,云编程框架肯定是不行的,用爬虫网站写。既然要爬取,前期只能是找到存放网页的文件夹,分析文件夹信息。很简单,利用selenium模拟鼠标操作,但是可以学习云写代码。存放方式对比有两种:1、直接将爬虫采集下来的网址发送给云网站服务器,服务器自动进行处理获取文件。

2、写完一段程序后发送给服务器并询问服务器需要多长时间可以获取这个网址,服务器会给你个定时器,定时器到了之后会自动抓取该文件,自动保存html给你。如果需要实现批量,需要抓取网站的多个header信息,以及爬取目标网页信息,按照路由规则进行搜索,获取。

百度需要客户端支持python3.4版本以上,爬虫,爬虫框架都是需要的,我刚接触爬虫没多久,写过一些爬虫框架,

网页文章自动采集(网页文章自动采集-推荐几个可以采集网页的网站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-12-10 18:01

网页文章自动采集-推荐几个可以自动采集网页文章的网站,不用编程,操作简单,所有文章都有网页url地址可直接下载免费vip在线app长按识别二维码安装三个网站,1.不错2.正常3.不错。

自动采集-悦读jiumoocr

爬虫爬取的可以自动采集网页上的所有内容。比如糗百,自动采集糗百的整个内容然后上传到百度云,或者就是爬爬糗百,自动采集下一个链接。

cajviewer

爬虫采集类,包括抓取糗百,

要方便点可以用爬虫,短期收入可以靠卖点脑白金,毕竟短视频那么火(十秒视频的观看量几十亿)所以都愿意看个好几秒钟的视频,或者等笑过再看(半个小时就过去了)或者直接买个桶装矿泉水,

比如游戏解说网?楼上的不说漏了万花筒游戏解说吗?好吧,万花筒游戏解说也是外包的。lol主播直播万花筒游戏的时候画面比其他视频快。最重要的是不用特效,

带码app可以采集,因为要对接公司系统所以效率非常高,效果也不错,但是收费,好像才120块.!

去万能的搜爬虫,

饿了么?最主要的原因是没有配餐,app根本没有。饭店老板都觉得出去吃不划算。

说一个数据可视化的吧这个话题我最近想过,我用的是狗爬,爬了牛牛,猪牛羊,狗大嘴,这些都是比较出名的,广告牛出名,微信猴,数据猴,前段时间收集了几天,发现真是太费劲了,找图找不到, 查看全部

网页文章自动采集(网页文章自动采集-推荐几个可以采集网页的网站)

网页文章自动采集-推荐几个可以自动采集网页文章的网站,不用编程,操作简单,所有文章都有网页url地址可直接下载免费vip在线app长按识别二维码安装三个网站,1.不错2.正常3.不错。

自动采集-悦读jiumoocr

爬虫爬取的可以自动采集网页上的所有内容。比如糗百,自动采集糗百的整个内容然后上传到百度云,或者就是爬爬糗百,自动采集下一个链接。

cajviewer

爬虫采集类,包括抓取糗百,

要方便点可以用爬虫,短期收入可以靠卖点脑白金,毕竟短视频那么火(十秒视频的观看量几十亿)所以都愿意看个好几秒钟的视频,或者等笑过再看(半个小时就过去了)或者直接买个桶装矿泉水,

比如游戏解说网?楼上的不说漏了万花筒游戏解说吗?好吧,万花筒游戏解说也是外包的。lol主播直播万花筒游戏的时候画面比其他视频快。最重要的是不用特效,

带码app可以采集,因为要对接公司系统所以效率非常高,效果也不错,但是收费,好像才120块.!

去万能的搜爬虫,

饿了么?最主要的原因是没有配餐,app根本没有。饭店老板都觉得出去吃不划算。

说一个数据可视化的吧这个话题我最近想过,我用的是狗爬,爬了牛牛,猪牛羊,狗大嘴,这些都是比较出名的,广告牛出名,微信猴,数据猴,前段时间收集了几天,发现真是太费劲了,找图找不到,

网页文章自动采集(图片助手批量图片下载器的高级设置-ExtremePicture )

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-12-10 11:05

)

Extreme Picture Finder是一款功能强大的综合性互联网素材采集工具,集网络图片下载软件和网络视频下载软件于一体。它可以帮助用户自动下载和保存互联网上几乎所有的图像和视频。、音乐等相关资料。Extreme Picture Finder 甚至可以批量下载受密码保护的网站、论坛主题和社交网络的图片,并且可以直接使用内置的图片查看器进行缩略图和幻灯片放映模式来浏览和观看,通过高级设置图片助手批量图片下载器,可以让极速图片查找器跳过整个文件夹或单个页面等一些无关紧要的部分,从而使下载过程更快当然,需要产品图片的用户也可以使用Extreme Picture Finder作为产品图片下载器。微航软件园测试发现,极图搜图还贴心地提供了一个超级实用的在线项目数据库,里面有几十个分类。数百个网站地址,只需点击几下鼠标,即可开始下载数以万计的图片或视频。喜欢看漫画的也可以当漫画使用采集器,总的来说,极图搜索是一款非常强大的网页图片下载软件。(百度云盘分享密码:7a8k)只需点击几下鼠标,您就可以开始下载数以万计的图像或视频。喜欢看漫画的也可以当漫画使用采集器,总的来说,极图搜索是一款非常强大的网页图片下载软件。(百度云盘分享密码:7a8k)只需点击几下鼠标,您就可以开始下载数以万计的图像或视频。喜欢看漫画的也可以当漫画使用采集器,总的来说,极图搜索是一款非常强大的网页图片下载软件。(百度云盘分享密码:7a8k)

Extreme Picture Finder 使用起来也非常简单。理论上,只要输入关键字,就可以在短时间内快速查找并下载数千张图片。您只需要输入网站地址,选择要下载的文件即可。以及文件保存到哪里,然后让极图搜索为大家完成剩下的下载工作。Extreme Picture Finder 具有不同的搜索模式,允许您更改与下载过程的交互级别。您可以设置只查找和下载缩略图,然后在几秒钟内将数十万张图片下载到本地。这是最快的搜索模式。除了 Extreme Picture Finder,您还可以手动选择要下载的全尺寸图像。当然,你也可以使用 Extreme Picture Finder 自动查找,下载并保存缩略图和全尺寸图像,或仅查找、下载和保存全尺寸图像。最后,Extreme Picture Finder 还可以将在同一页面上找到的所有图像保存为原创原创尺寸图像。

微航软件园温馨提醒:极品图片搜索作为一款优秀的网络图片下载器和网页视频下载软件,安装也非常简单。只需要安装主程序不要运行,然后将Extreme Picture Finder破解程序复制到安装目录下,覆盖同名文件即可:

查看全部

网页文章自动采集(图片助手批量图片下载器的高级设置-ExtremePicture

)

Extreme Picture Finder是一款功能强大的综合性互联网素材采集工具,集网络图片下载软件和网络视频下载软件于一体。它可以帮助用户自动下载和保存互联网上几乎所有的图像和视频。、音乐等相关资料。Extreme Picture Finder 甚至可以批量下载受密码保护的网站、论坛主题和社交网络的图片,并且可以直接使用内置的图片查看器进行缩略图和幻灯片放映模式来浏览和观看,通过高级设置图片助手批量图片下载器,可以让极速图片查找器跳过整个文件夹或单个页面等一些无关紧要的部分,从而使下载过程更快当然,需要产品图片的用户也可以使用Extreme Picture Finder作为产品图片下载器。微航软件园测试发现,极图搜图还贴心地提供了一个超级实用的在线项目数据库,里面有几十个分类。数百个网站地址,只需点击几下鼠标,即可开始下载数以万计的图片或视频。喜欢看漫画的也可以当漫画使用采集器,总的来说,极图搜索是一款非常强大的网页图片下载软件。(百度云盘分享密码:7a8k)只需点击几下鼠标,您就可以开始下载数以万计的图像或视频。喜欢看漫画的也可以当漫画使用采集器,总的来说,极图搜索是一款非常强大的网页图片下载软件。(百度云盘分享密码:7a8k)只需点击几下鼠标,您就可以开始下载数以万计的图像或视频。喜欢看漫画的也可以当漫画使用采集器,总的来说,极图搜索是一款非常强大的网页图片下载软件。(百度云盘分享密码:7a8k)

Extreme Picture Finder 使用起来也非常简单。理论上,只要输入关键字,就可以在短时间内快速查找并下载数千张图片。您只需要输入网站地址,选择要下载的文件即可。以及文件保存到哪里,然后让极图搜索为大家完成剩下的下载工作。Extreme Picture Finder 具有不同的搜索模式,允许您更改与下载过程的交互级别。您可以设置只查找和下载缩略图,然后在几秒钟内将数十万张图片下载到本地。这是最快的搜索模式。除了 Extreme Picture Finder,您还可以手动选择要下载的全尺寸图像。当然,你也可以使用 Extreme Picture Finder 自动查找,下载并保存缩略图和全尺寸图像,或仅查找、下载和保存全尺寸图像。最后,Extreme Picture Finder 还可以将在同一页面上找到的所有图像保存为原创原创尺寸图像。

微航软件园温馨提醒:极品图片搜索作为一款优秀的网络图片下载器和网页视频下载软件,安装也非常简单。只需要安装主程序不要运行,然后将Extreme Picture Finder破解程序复制到安装目录下,覆盖同名文件即可:

网页文章自动采集(思达邮件群发工具可以直接从你的电脑上快速发送大批量)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-12-05 04:15

Star Email群发工具可以直接从电脑上快速群发邮件。软件支持发送HTML网页、图片和文本格式的邮件,已广泛应用于商务、网站推广、产品推广、电子报刊、邮件列表订阅、企业客户联系、企业通知、论坛版主、金融行业 报表等领域。

主要特征:

1、 采用多项技术保证外发邮件不进入垃圾桶;

2、傻瓜式 操作方法不需要专业知识。填写邮件内容,导入邮箱地址,点击发送按钮,将邮件发送到世界各地;

3、 提供三种发送方式:直接发送(无需SMTP服务器)、标准SMTP发送和本地SMTP发送。支持Gmail、Hotmail、Tom、163、搜狐、21CN、新浪、Aol、QQ、GMX等大邮箱SMTP账号,支持企业邮箱SMTP发送;

4、用户可以设置某些邮箱使用指定的发送方式。如果指定Hotmail,yahoo使用SMTP发送,其他使用直接发送。也可以指定直接发送哪些邮箱,剩下的通过smtp发送,节省smtp用量;

5、可以使用大量的SMTP账号,系统自动轮换SMTP。可以设置每个SMTP每天发送的次数,防止超发账户被屏蔽;

6、 当使用某一个SMTP发送失败时,系统会自动切换到另一个并重发一次,以提高成功率;

7、支持批量导入导出SMTP账号。支持SMTP账号有效性验证,自动清除无用账号;

8、 直接发送时,系统会自动查询更新DNS和缓存,用户无需参与;

9、 如果系统直接发送失败,可以通过SMTP自动发送;

10、 支持文字,可以直接写HTML邮件。可以直接打开网页作为邮件发送,也可以直接打开保存在Outlook或其他系统中的邮件文件;支持多国编码;

11、强大的文件拖放功能。您可以直接将文本文件、网页、图片、表格等文件作为邮件内容拖入系统;

12、支持发送本地图片(直接作为邮件内容发送)和网络链接图片;您可以用一张图片发送整个电子邮件;

13、 支持多种形式的附件,支持多个附件同时发送;

14、采用先进的多线程技术,用户可以自由设置线程数,只要你的网速和电脑够快,设置5000线程没问题,发送速度极快快速地;

15、 发送过程中可定时自动更换IP,防止IP被屏蔽无法发送;

16、 自动添加防重复码,让每封邮件看起来都不一样,防止被当成垃圾邮件;

17、发送状态自动保存,可以随时中断,下次从停止点继续工作;

18、 支持接收回执,反馈邮件接收状态。您可以指定发件人的姓名,并且可以指定将回复和回执发送到的电子邮件地址;

19、 可以设置软件的发送速度。例如,每小时只会发出 200 或 15,000 封信件;

2 批量导入0、邮箱支持直接导入文本、EXCEL、FOXPFO、Access、XML等邮箱地址文件,也可以自动从邮箱中提取其他文件。可以指定每次导入的邮箱数量,实现批量导入;

20、邮箱快速导出,支持多条件过滤,可以轻松导出发送成功或失败的邮箱;

21、 自动检查重复邮箱和不合格邮箱并立即删除;

22、支持个性化邮件,让收件人感觉这封邮件是专门给她的。

23、支持文本、EXCEL、XML等格式文件的导出;

24、邮箱的模糊搜索和自动分页,可以实现邮箱的快速分类;

25、 防重发功能保证每封邮件在一次发送过程中只发送一次;

26、支持一封信发送给多个收件人,或者一对一发送,每个收件人可以看到自己的地址;

27、 发送状态可见,邮件发送进度,是否成功,失败原因有详细信息;

28、支持托盘操作,用户可以同时执行其他任务;

29、 软件自动检测最新版本并自动升级;

30、多语言,最多支持12种语言;

31、星空邮箱地址采集工具和星空邮箱地址验证工具无缝集成,可以同时搜索、验证和发送邮件; 查看全部

网页文章自动采集(思达邮件群发工具可以直接从你的电脑上快速发送大批量)

Star Email群发工具可以直接从电脑上快速群发邮件。软件支持发送HTML网页、图片和文本格式的邮件,已广泛应用于商务、网站推广、产品推广、电子报刊、邮件列表订阅、企业客户联系、企业通知、论坛版主、金融行业 报表等领域。

主要特征:

1、 采用多项技术保证外发邮件不进入垃圾桶;

2、傻瓜式 操作方法不需要专业知识。填写邮件内容,导入邮箱地址,点击发送按钮,将邮件发送到世界各地;

3、 提供三种发送方式:直接发送(无需SMTP服务器)、标准SMTP发送和本地SMTP发送。支持Gmail、Hotmail、Tom、163、搜狐、21CN、新浪、Aol、QQ、GMX等大邮箱SMTP账号,支持企业邮箱SMTP发送;

4、用户可以设置某些邮箱使用指定的发送方式。如果指定Hotmail,yahoo使用SMTP发送,其他使用直接发送。也可以指定直接发送哪些邮箱,剩下的通过smtp发送,节省smtp用量;

5、可以使用大量的SMTP账号,系统自动轮换SMTP。可以设置每个SMTP每天发送的次数,防止超发账户被屏蔽;

6、 当使用某一个SMTP发送失败时,系统会自动切换到另一个并重发一次,以提高成功率;

7、支持批量导入导出SMTP账号。支持SMTP账号有效性验证,自动清除无用账号;

8、 直接发送时,系统会自动查询更新DNS和缓存,用户无需参与;

9、 如果系统直接发送失败,可以通过SMTP自动发送;

10、 支持文字,可以直接写HTML邮件。可以直接打开网页作为邮件发送,也可以直接打开保存在Outlook或其他系统中的邮件文件;支持多国编码;

11、强大的文件拖放功能。您可以直接将文本文件、网页、图片、表格等文件作为邮件内容拖入系统;

12、支持发送本地图片(直接作为邮件内容发送)和网络链接图片;您可以用一张图片发送整个电子邮件;

13、 支持多种形式的附件,支持多个附件同时发送;

14、采用先进的多线程技术,用户可以自由设置线程数,只要你的网速和电脑够快,设置5000线程没问题,发送速度极快快速地;

15、 发送过程中可定时自动更换IP,防止IP被屏蔽无法发送;

16、 自动添加防重复码,让每封邮件看起来都不一样,防止被当成垃圾邮件;

17、发送状态自动保存,可以随时中断,下次从停止点继续工作;

18、 支持接收回执,反馈邮件接收状态。您可以指定发件人的姓名,并且可以指定将回复和回执发送到的电子邮件地址;

19、 可以设置软件的发送速度。例如,每小时只会发出 200 或 15,000 封信件;

2 批量导入0、邮箱支持直接导入文本、EXCEL、FOXPFO、Access、XML等邮箱地址文件,也可以自动从邮箱中提取其他文件。可以指定每次导入的邮箱数量,实现批量导入;

20、邮箱快速导出,支持多条件过滤,可以轻松导出发送成功或失败的邮箱;

21、 自动检查重复邮箱和不合格邮箱并立即删除;

22、支持个性化邮件,让收件人感觉这封邮件是专门给她的。

23、支持文本、EXCEL、XML等格式文件的导出;

24、邮箱的模糊搜索和自动分页,可以实现邮箱的快速分类;

25、 防重发功能保证每封邮件在一次发送过程中只发送一次;

26、支持一封信发送给多个收件人,或者一对一发送,每个收件人可以看到自己的地址;

27、 发送状态可见,邮件发送进度,是否成功,失败原因有详细信息;

28、支持托盘操作,用户可以同时执行其他任务;

29、 软件自动检测最新版本并自动升级;

30、多语言,最多支持12种语言;

31、星空邮箱地址采集工具和星空邮箱地址验证工具无缝集成,可以同时搜索、验证和发送邮件;

网页文章自动采集(传统web信息采集的目标尽可能采集信息页面的应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-12-04 17:31

中文网页自动采集及分类系统的设计与实现。保密等级: 保密期限:本人公布结果。就我而言,其他教育机构的学术和贡献已申请该学位。我已经签署了我正在攻读的学位。有关部门可以公布学位保存情况,编写学位理论。我已经签了导师的签名。中文网站自动采集分类系统的设计与实现 摘要 随着科学技术的飞速发展,我们已经进入了数字信息时代。互联网作为当今世界上最大的信息数据库,也成为人们获取信息的最重要手段。因为如何从互联网上的海量信息资源中快速准确地找到自己需要的信息,已经成为网民迫切需要解决的一大问题。因此,采集和基于web的网络信息分类成为研究的热点。传统网络信息采集的目标是尽可能多的采集信息页面,甚至是整个网络上的资源。在这个过程中,它并不关心采集的顺序以及与采集页面相关的主要混乱、重复等的发生。同时,对采集到达的网页进行自动分类,打造更有效、更快速的搜索引擎也是非常有必要的。网页分类是组织和管理信息的有效手段。可以更大程度上解决信息的杂乱无章,方便用户准确判断自己需要的信息。传统的操作方式是人工分类后进行组织管理。

随着互联网上各种信息的迅速增加,人工处理已经不切实际。因此,网页的自动分类是一种具有较大实用价值的方法,也是一种组织和管理数据的有效手段。这也是本文的一个重要内容。本文首先介绍了课题背景、研究目的和国内外研究现状,阐述了网页采集和网页分类的相关理论、主要技术和算法,包括几个典型的网络爬虫技术和网页去重技术的算法之后,本文选择了分类表现良好的主题爬虫方法和KNN方法,结合去重、分词、特征提取等相关技术的配合,分析中文网页的结构和特征,提出中文网页采集及分类设计与实现方法,最终实现本文最后通过编程语言对系统进行了测试。测试结果符合系统设计要求,应用效果显着。关键词:网页信息采集网页分类信息提取分词特征提取 OFCHINESEANDIMPLE转N1:ATION DESIGN webPAGEAUT0~IATIC采集 AND CLASSIFICATION ABSTRACT 随着科学的发展,我们的信息快速进入了世界信息数字时代. 互联网,其中最大的 tobethemaint001 信息。ItiS 数据库。如何从用户需要的海量信息资源中快速、准确地找到信息资源缺乏具有海量、动态、异构、半结构化的统一信息采集管理组织的特点,成为获取主要问题。J研究和分类成为热点。信息采集以信息为目标,采集所有资源,例如电子订单和尽可能多的页面,或内容中的主题我不关心采集。页面杂乱无章,其中大部分被滥用的 SO 资源是系统采集方法用来减少采集被浪费的。TIliS Effective 需要杂乱无章的网页分类来自动创建页面重复。网页有效管理页面引擎的ande Wu cientsearch。组织可以解决一个范围内的分类信息,即大杂乱的信息,便于用户准确定位信息现象的iSmanual模式。需要传统的信息。然而,处理各种互联网的操作信息,手动快速增长的方式分类并不是唯一的方法,Sunrealistic Web 也是一种有效的数据手段。Ttisanvalue,但组织管理这篇重要论文的研究。和研究现状 首先,介绍了网络采集理论、技术算法页面包括网络爬虫网络删除的背景、目的、主题和分类,其中描述了哪些技术、重复页面分词分词、特征技术、中文技术、信息网页分类提取页面技术。几种爬虫和KNNmade的综合技术,主题比较典型的算法有分类选择,因为性能突出。111eproposed Chinese web are after and分类设计实施的习得结构和汉语的特征相结合,对技术网络进行编码并实现语言页面分析。最后,它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类,关键词:web采集,网页信息提取提取,分割,字符法 484.7.2 KNN 结信息网页分类提取页面技术。几种爬虫和KNNmade的综合技术,主题比较典型的算法有分类被选择是因为性能突出。111eproposed Chinese web are after and分类设计实施的习得结构和汉语的特征相结合,对技术网络进行编码并实现语言页面分析。最后,它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类,关键词:web采集,网页信息提取提取,分割,字符法 484.7.2 KNN 结信息网页分类提取页面技术。几种爬虫和KNNmade的综合技术,主题比较典型的算法有分类选择,因为性能突出。111eproposed Chinese web are after and分类设计实施的习得结构和汉语的特征相结合,对技术网络进行编码并实现语言页面分析。最后,它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结itprogrammingresultthatthemetthe语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结itprogrammingresultthatthemetthe语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结itprogrammingresultthatthemetthe语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 和应用程序 donefields。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 和应用程序 donefields。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结

63北京邮电大学软件工程硕士论文第一章引言1.1项目背景和研究现状1.1.1项目背景和研究目标随着互联网的普及和网络技术的飞速发展,互联网上的信息资源呈指数级增长从互联网上获取越来越多的信息,包括文字、数字、图形、图像、声音、视频等。 然而,随着网络信息的迅速膨胀,如何从海量的信息资源中快速准确地找到自己需要的信息已成为广大网民的一大难题。因此,它是基于互联网采集和搜索引擎上的信息。这些搜索引擎通常使用一个或多个采集器 从 Internet 上采集各种数据,例如 FTP、电子邮件、新闻,然后在本地服务器上为这些数据建立索引。当用户从用户提交的搜索条件中检索到数据时,在索引库中快速找到需要的信息。网络信息采集作为这些搜索引擎的基础和组成部分,起着举足轻重的作用。网页信息采集是指通过网页之间的链接关系,自动从网页获取网页信息,并随着链接不断扩展到需要的网页的过程。传统W歌信息采集的目标是尽可能多的采集信息页面,甚至是整个网络的资源,这样就集中在采集@的速度和数量上> , 而且实现起来也比较简单。但是,这种传统的采集方法有很多缺陷。

因为基于整个Web采集的信息,需要采集的那部分页面的利用率很低。用户往往只关心极少数的页面,而采集器采集的大部分页面对他们来说都是无用的。这显然是对系统资源和网络资源的巨大开销。随着网页数量的快速增长,即使使用固定主题采集技术来构建固定主题类别,构建一个更有效、更快速的搜索引擎也是非常必要的。传统的操作方式是人工分类后进行组织管理。这种分类方法更准确,分类质量也更高。随着互联网上各种信息的迅速增加,手动处理它是不切实际的。对网页进行分类,可以在很大程度上解决网页信息杂乱的问题,方便用户准确定位所需信息。因此,网页自动分类是一种具有较大实用价值的方法,也是一种组织和管理数据的方法。有效手段。这也是本文的一个重要内容。北京邮电大学软件工程硕士论文1.1.2学科网页的国内外研究现状采集技术发展现状互联网正在不断改变着我们的生活。Internet 已成为世界上最大的信息资源库。如何从海量的信息资源库中快速准确地找到需要的信息,成为网络用户面临的一大难题。无论是一些通用的搜索引擎如谷歌、百度等,还是某个特定主题的网页采集系统,都离不开网页采集,所以基于网页的网页信息采集 和加工越来越成为关注的焦点。

传统Web信息采集采集的页数过大,采集的内容过于杂乱,消耗了大量的系统资源和网络资源。同时,互联网信息的分散状态和动态变化也是困扰信息采集的主要问题。为了解决这些问题,搜索引擎。这些搜索引擎通常通过一个或多个采集器从互联网上采集各种数据,然后在本地服务器上为数据建立索引,并在用户检索时根据用户的需要提交。即使是大型的信息采集系统,其对Web的覆盖率也只有30"--40%左右。即使使用处理能力更强的计算机系统,性价比也不是很高。相对来说比较好。满足人们的需求。其次,互联网信息的分散状态和动态变化也是影响信息采集的原因。由于信息源随时可能发生变化,信息采集器必须经常刷新数据,但这仍然无法避免采集跳转到无效页面的情况。对于传统信息采集,由于需要刷新的页面数量,采集到达的页面有相当一部分利用率很低。因为用户往往只关心极少数的页面,而这些页面往往集中在一个或几个主题上,而采集器是对网络资源的巨大浪费。这些问题主要是由于传统Web信息采集所采集的页数太大,采集的页面内容太乱。如果信息检索仅限于特定学科领域,并根据学科相关信息提供检索服务,那么采集所需的网页数量将大大减少,北大软件工程硕士邮电通信将是第一。

这种类型的Web信息采集称为固定主题Web信息采集。固定主题采集的查准率和查全率都比较高。但是,随着互联网的飞速发展和网页数量的爆炸式增长,即使使用固定话题采集技术构建固定话题搜索引擎,同样的网页数量与广泛的主题相比,主题仍然是庞大的。因此,如何根据给定的模式对同一主题的网页进行有效的分类,以创建更有效、更快的搜索引擎是一个非常重要的课题。网页分类技术的发展现状网页自动分类是基于文本分类算法结合HTML语言结构的特点开发的。自动文本分类最初是为了满足信息检索和 IR 系统的需要而开发的。信息检索系统必须处理大量数据,其文本信息数据库占据了大部分内容。同时,用于表达文本内容的单词数以万计。在这种情况下,如果能够提供一个组织良好、结构化的文本集合,就可以大大简化文本的访问和操作。自动文本分类系统的目的是将文本集合有序地组织起来,并将相似和相关的文本组织在一起。作为一种知识组织工具,它为信息检索提供了更高效的搜索策略和更准确的查询结果。自动文本分类的研究始于1950年代后期,H.RLulm在该领域进行了开创性的研究。

网页自动分类在国外经历了三个发展阶段:第一阶段是1958年。1964年开展自动分类的可行性研究,第二阶段是1965.1974年自动分类的实验研究,第三阶段是1975年进入实用阶段[l_]。国内对自动分类的研究起步较晚,始于 80 年代初。关于中文文本分类的研究相对较少。国内外的研究基本都是在对英文文本进行分类的基础上,结合汉语文本和汉语的特点,采取相应的策略,然后应用到汉语中,形成汉语文本。分类研究系统。1981年,侯汉清讨论了计算机在文档分类中的应用。早期系统的主要特点是结合学科词汇进行分析分类,人工干预的成分非常大。林等人。将KNN方法与线性分类器相结合,取得了良好的效果。香港中文大学的Wai回头率接近90%。准确率超过80% t31。CK P Wong 等人。研究了混合关键词的文本分类方法,召回率和准确率分别为72%和62%。来自复旦大学和富士通研发中心的黄守、吴立德和石崎洋行研究了独立语言的文本分类,并以词类的互信息作为评分函数。

上海交通大学刁谦和王永成结合词权重和分类算法进行分类,在使用VSM方法的封闭测试实验中分类正确(N97%t71)。此后,基于统计的思想,以及分词、语料库等技术不断应用于分类。万维网收录大约 115 亿个可编入索引的网页,并且每天都会添加数千万或更多的网页。如何组织这些大量有效的信息网络资源是一个很大的现实问题。网页数量实现网页采集功能子系统。二、对比网页信息抽取技术,中文分词技术,特征提取技术和网页分类技术分析,使用优秀的KNN分类算法实现网页分类功能。三、使用最大匹配算法对文本进行分割。清理网页,去除网页中的一些垃圾邮件,将网页转换为文本格式。四、网页的预处理部分,结合网页的模型特性,根据HTML标签对网页的无关文本进行加权处理。通过以上几方面的工作,最终完成了一个网页自动采集和分类系统的实现,并通过实验验证了上述算法。1.3 论文结构 本文共分6章,内容安排如下:第一章引言,介绍了本课题的意义、国内外的现状和任务等。第二章是网页采集和分类相关技术的介绍。本章介绍了采集中将用到的北京邮电大学软件工程硕士论文技术的原理、方法和分类。包括常用的网络爬虫技术、网页到页面分类技术。本章介绍了采集中将用到的北京邮电大学软件工程硕士论文技术的原理、方法和分类。包括常用的网络爬虫技术、网页到页面分类技术。本章介绍了采集中将用到的北京邮电大学软件工程硕士论文技术的原理、方法和分类。包括常用的网络爬虫技术、网页到页面分类技术。

第3章网页采集和分类系统设计。本章首先进行系统分析,然后进行系统概要设计、功能模块设计、系统流程设计、系统逻辑设计和数据设计。第4章网页采集和分类系统实现。本章详细介绍了各个模块的实现过程,包括页面采集模块、信息抽取模块、网页去重模块、中文分词模块、征向量抽取模块、训练语料库模块和分类模块。第五章网页采集与分类系统测试,本章首先给出了系统的操作界面,然后给出了实验评价标准,并对实验结果进行了分析。第六章结束语,本章对本文的工作进行了全面的总结,给出了本文取得的成果,并指出了存在的不足和改进方向。北京 Chapter 2 Web Page 2.1 网络爬虫技术方案也是搜索引擎的核心组成部分。搜索引擎的性能、规模和扩展能力很大程度上取决于网络爬虫的处理能力。爬虫也被称为网络蜘蛛或机器人。网络爬虫的系统结构如图2-1所示:下载模块作为一个库,用于存储从爬取的网页中提取的URL。图2.1 网络爬虫结构图网络爬虫从给定的URL开始,沿着网页上的传出链。链接,根据设定的网页搜索策略,例如广度优先策略,深度优先策略,或最佳优先策略,采集 优先级高的网页的URL队列,然后通过网页分类器判断是否是主题网页,如果是则保存,否则丢弃;对于采集的网页,提取其中收录的URL,通过对应的地方插入到URL队列中。

2.1.1 通用网络爬虫通用网络爬虫会根据预先设定的一个或多个初始种子URL启动,下载模块不断从URL队列中获取一个URL,访问并下载页面。页面解析器去除页面上的HTML标签获取页面内容,将摘要、URL等信息保存在web数据库中,同时提取当前页面上的新URL,并保存到UURL队列中直到满意为止 查看全部

网页文章自动采集(传统web信息采集的目标尽可能采集信息页面的应用)

中文网页自动采集及分类系统的设计与实现。保密等级: 保密期限:本人公布结果。就我而言,其他教育机构的学术和贡献已申请该学位。我已经签署了我正在攻读的学位。有关部门可以公布学位保存情况,编写学位理论。我已经签了导师的签名。中文网站自动采集分类系统的设计与实现 摘要 随着科学技术的飞速发展,我们已经进入了数字信息时代。互联网作为当今世界上最大的信息数据库,也成为人们获取信息的最重要手段。因为如何从互联网上的海量信息资源中快速准确地找到自己需要的信息,已经成为网民迫切需要解决的一大问题。因此,采集和基于web的网络信息分类成为研究的热点。传统网络信息采集的目标是尽可能多的采集信息页面,甚至是整个网络上的资源。在这个过程中,它并不关心采集的顺序以及与采集页面相关的主要混乱、重复等的发生。同时,对采集到达的网页进行自动分类,打造更有效、更快速的搜索引擎也是非常有必要的。网页分类是组织和管理信息的有效手段。可以更大程度上解决信息的杂乱无章,方便用户准确判断自己需要的信息。传统的操作方式是人工分类后进行组织管理。

随着互联网上各种信息的迅速增加,人工处理已经不切实际。因此,网页的自动分类是一种具有较大实用价值的方法,也是一种组织和管理数据的有效手段。这也是本文的一个重要内容。本文首先介绍了课题背景、研究目的和国内外研究现状,阐述了网页采集和网页分类的相关理论、主要技术和算法,包括几个典型的网络爬虫技术和网页去重技术的算法之后,本文选择了分类表现良好的主题爬虫方法和KNN方法,结合去重、分词、特征提取等相关技术的配合,分析中文网页的结构和特征,提出中文网页采集及分类设计与实现方法,最终实现本文最后通过编程语言对系统进行了测试。测试结果符合系统设计要求,应用效果显着。关键词:网页信息采集网页分类信息提取分词特征提取 OFCHINESEANDIMPLE转N1:ATION DESIGN webPAGEAUT0~IATIC采集 AND CLASSIFICATION ABSTRACT 随着科学的发展,我们的信息快速进入了世界信息数字时代. 互联网,其中最大的 tobethemaint001 信息。ItiS 数据库。如何从用户需要的海量信息资源中快速、准确地找到信息资源缺乏具有海量、动态、异构、半结构化的统一信息采集管理组织的特点,成为获取主要问题。J研究和分类成为热点。信息采集以信息为目标,采集所有资源,例如电子订单和尽可能多的页面,或内容中的主题我不关心采集。页面杂乱无章,其中大部分被滥用的 SO 资源是系统采集方法用来减少采集被浪费的。TIliS Effective 需要杂乱无章的网页分类来自动创建页面重复。网页有效管理页面引擎的ande Wu cientsearch。组织可以解决一个范围内的分类信息,即大杂乱的信息,便于用户准确定位信息现象的iSmanual模式。需要传统的信息。然而,处理各种互联网的操作信息,手动快速增长的方式分类并不是唯一的方法,Sunrealistic Web 也是一种有效的数据手段。Ttisanvalue,但组织管理这篇重要论文的研究。和研究现状 首先,介绍了网络采集理论、技术算法页面包括网络爬虫网络删除的背景、目的、主题和分类,其中描述了哪些技术、重复页面分词分词、特征技术、中文技术、信息网页分类提取页面技术。几种爬虫和KNNmade的综合技术,主题比较典型的算法有分类选择,因为性能突出。111eproposed Chinese web are after and分类设计实施的习得结构和汉语的特征相结合,对技术网络进行编码并实现语言页面分析。最后,它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类,关键词:web采集,网页信息提取提取,分割,字符法 484.7.2 KNN 结信息网页分类提取页面技术。几种爬虫和KNNmade的综合技术,主题比较典型的算法有分类被选择是因为性能突出。111eproposed Chinese web are after and分类设计实施的习得结构和汉语的特征相结合,对技术网络进行编码并实现语言页面分析。最后,它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类,关键词:web采集,网页信息提取提取,分割,字符法 484.7.2 KNN 结信息网页分类提取页面技术。几种爬虫和KNNmade的综合技术,主题比较典型的算法有分类选择,因为性能突出。111eproposed Chinese web are after and分类设计实施的习得结构和汉语的特征相结合,对技术网络进行编码并实现语言页面分析。最后,它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结itprogrammingresultthatthemetthe语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结itprogrammingresultthatthemetthe语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 它的编程结果是该语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结itprogrammingresultthatthemetthe语言。测试系统设计要求和应用程序已完成。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 和应用程序 donefields。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结 和应用程序 donefields。多信息分类, 关键词: web采集, 网页信息抽取提取, 分割, 字符方法 484.7.2 KNN 结

63北京邮电大学软件工程硕士论文第一章引言1.1项目背景和研究现状1.1.1项目背景和研究目标随着互联网的普及和网络技术的飞速发展,互联网上的信息资源呈指数级增长从互联网上获取越来越多的信息,包括文字、数字、图形、图像、声音、视频等。 然而,随着网络信息的迅速膨胀,如何从海量的信息资源中快速准确地找到自己需要的信息已成为广大网民的一大难题。因此,它是基于互联网采集和搜索引擎上的信息。这些搜索引擎通常使用一个或多个采集器 从 Internet 上采集各种数据,例如 FTP、电子邮件、新闻,然后在本地服务器上为这些数据建立索引。当用户从用户提交的搜索条件中检索到数据时,在索引库中快速找到需要的信息。网络信息采集作为这些搜索引擎的基础和组成部分,起着举足轻重的作用。网页信息采集是指通过网页之间的链接关系,自动从网页获取网页信息,并随着链接不断扩展到需要的网页的过程。传统W歌信息采集的目标是尽可能多的采集信息页面,甚至是整个网络的资源,这样就集中在采集@的速度和数量上> , 而且实现起来也比较简单。但是,这种传统的采集方法有很多缺陷。

因为基于整个Web采集的信息,需要采集的那部分页面的利用率很低。用户往往只关心极少数的页面,而采集器采集的大部分页面对他们来说都是无用的。这显然是对系统资源和网络资源的巨大开销。随着网页数量的快速增长,即使使用固定主题采集技术来构建固定主题类别,构建一个更有效、更快速的搜索引擎也是非常必要的。传统的操作方式是人工分类后进行组织管理。这种分类方法更准确,分类质量也更高。随着互联网上各种信息的迅速增加,手动处理它是不切实际的。对网页进行分类,可以在很大程度上解决网页信息杂乱的问题,方便用户准确定位所需信息。因此,网页自动分类是一种具有较大实用价值的方法,也是一种组织和管理数据的方法。有效手段。这也是本文的一个重要内容。北京邮电大学软件工程硕士论文1.1.2学科网页的国内外研究现状采集技术发展现状互联网正在不断改变着我们的生活。Internet 已成为世界上最大的信息资源库。如何从海量的信息资源库中快速准确地找到需要的信息,成为网络用户面临的一大难题。无论是一些通用的搜索引擎如谷歌、百度等,还是某个特定主题的网页采集系统,都离不开网页采集,所以基于网页的网页信息采集 和加工越来越成为关注的焦点。

传统Web信息采集采集的页数过大,采集的内容过于杂乱,消耗了大量的系统资源和网络资源。同时,互联网信息的分散状态和动态变化也是困扰信息采集的主要问题。为了解决这些问题,搜索引擎。这些搜索引擎通常通过一个或多个采集器从互联网上采集各种数据,然后在本地服务器上为数据建立索引,并在用户检索时根据用户的需要提交。即使是大型的信息采集系统,其对Web的覆盖率也只有30"--40%左右。即使使用处理能力更强的计算机系统,性价比也不是很高。相对来说比较好。满足人们的需求。其次,互联网信息的分散状态和动态变化也是影响信息采集的原因。由于信息源随时可能发生变化,信息采集器必须经常刷新数据,但这仍然无法避免采集跳转到无效页面的情况。对于传统信息采集,由于需要刷新的页面数量,采集到达的页面有相当一部分利用率很低。因为用户往往只关心极少数的页面,而这些页面往往集中在一个或几个主题上,而采集器是对网络资源的巨大浪费。这些问题主要是由于传统Web信息采集所采集的页数太大,采集的页面内容太乱。如果信息检索仅限于特定学科领域,并根据学科相关信息提供检索服务,那么采集所需的网页数量将大大减少,北大软件工程硕士邮电通信将是第一。

这种类型的Web信息采集称为固定主题Web信息采集。固定主题采集的查准率和查全率都比较高。但是,随着互联网的飞速发展和网页数量的爆炸式增长,即使使用固定话题采集技术构建固定话题搜索引擎,同样的网页数量与广泛的主题相比,主题仍然是庞大的。因此,如何根据给定的模式对同一主题的网页进行有效的分类,以创建更有效、更快的搜索引擎是一个非常重要的课题。网页分类技术的发展现状网页自动分类是基于文本分类算法结合HTML语言结构的特点开发的。自动文本分类最初是为了满足信息检索和 IR 系统的需要而开发的。信息检索系统必须处理大量数据,其文本信息数据库占据了大部分内容。同时,用于表达文本内容的单词数以万计。在这种情况下,如果能够提供一个组织良好、结构化的文本集合,就可以大大简化文本的访问和操作。自动文本分类系统的目的是将文本集合有序地组织起来,并将相似和相关的文本组织在一起。作为一种知识组织工具,它为信息检索提供了更高效的搜索策略和更准确的查询结果。自动文本分类的研究始于1950年代后期,H.RLulm在该领域进行了开创性的研究。

网页自动分类在国外经历了三个发展阶段:第一阶段是1958年。1964年开展自动分类的可行性研究,第二阶段是1965.1974年自动分类的实验研究,第三阶段是1975年进入实用阶段[l_]。国内对自动分类的研究起步较晚,始于 80 年代初。关于中文文本分类的研究相对较少。国内外的研究基本都是在对英文文本进行分类的基础上,结合汉语文本和汉语的特点,采取相应的策略,然后应用到汉语中,形成汉语文本。分类研究系统。1981年,侯汉清讨论了计算机在文档分类中的应用。早期系统的主要特点是结合学科词汇进行分析分类,人工干预的成分非常大。林等人。将KNN方法与线性分类器相结合,取得了良好的效果。香港中文大学的Wai回头率接近90%。准确率超过80% t31。CK P Wong 等人。研究了混合关键词的文本分类方法,召回率和准确率分别为72%和62%。来自复旦大学和富士通研发中心的黄守、吴立德和石崎洋行研究了独立语言的文本分类,并以词类的互信息作为评分函数。

上海交通大学刁谦和王永成结合词权重和分类算法进行分类,在使用VSM方法的封闭测试实验中分类正确(N97%t71)。此后,基于统计的思想,以及分词、语料库等技术不断应用于分类。万维网收录大约 115 亿个可编入索引的网页,并且每天都会添加数千万或更多的网页。如何组织这些大量有效的信息网络资源是一个很大的现实问题。网页数量实现网页采集功能子系统。二、对比网页信息抽取技术,中文分词技术,特征提取技术和网页分类技术分析,使用优秀的KNN分类算法实现网页分类功能。三、使用最大匹配算法对文本进行分割。清理网页,去除网页中的一些垃圾邮件,将网页转换为文本格式。四、网页的预处理部分,结合网页的模型特性,根据HTML标签对网页的无关文本进行加权处理。通过以上几方面的工作,最终完成了一个网页自动采集和分类系统的实现,并通过实验验证了上述算法。1.3 论文结构 本文共分6章,内容安排如下:第一章引言,介绍了本课题的意义、国内外的现状和任务等。第二章是网页采集和分类相关技术的介绍。本章介绍了采集中将用到的北京邮电大学软件工程硕士论文技术的原理、方法和分类。包括常用的网络爬虫技术、网页到页面分类技术。本章介绍了采集中将用到的北京邮电大学软件工程硕士论文技术的原理、方法和分类。包括常用的网络爬虫技术、网页到页面分类技术。本章介绍了采集中将用到的北京邮电大学软件工程硕士论文技术的原理、方法和分类。包括常用的网络爬虫技术、网页到页面分类技术。

第3章网页采集和分类系统设计。本章首先进行系统分析,然后进行系统概要设计、功能模块设计、系统流程设计、系统逻辑设计和数据设计。第4章网页采集和分类系统实现。本章详细介绍了各个模块的实现过程,包括页面采集模块、信息抽取模块、网页去重模块、中文分词模块、征向量抽取模块、训练语料库模块和分类模块。第五章网页采集与分类系统测试,本章首先给出了系统的操作界面,然后给出了实验评价标准,并对实验结果进行了分析。第六章结束语,本章对本文的工作进行了全面的总结,给出了本文取得的成果,并指出了存在的不足和改进方向。北京 Chapter 2 Web Page 2.1 网络爬虫技术方案也是搜索引擎的核心组成部分。搜索引擎的性能、规模和扩展能力很大程度上取决于网络爬虫的处理能力。爬虫也被称为网络蜘蛛或机器人。网络爬虫的系统结构如图2-1所示:下载模块作为一个库,用于存储从爬取的网页中提取的URL。图2.1 网络爬虫结构图网络爬虫从给定的URL开始,沿着网页上的传出链。链接,根据设定的网页搜索策略,例如广度优先策略,深度优先策略,或最佳优先策略,采集 优先级高的网页的URL队列,然后通过网页分类器判断是否是主题网页,如果是则保存,否则丢弃;对于采集的网页,提取其中收录的URL,通过对应的地方插入到URL队列中。

2.1.1 通用网络爬虫通用网络爬虫会根据预先设定的一个或多个初始种子URL启动,下载模块不断从URL队列中获取一个URL,访问并下载页面。页面解析器去除页面上的HTML标签获取页面内容,将摘要、URL等信息保存在web数据库中,同时提取当前页面上的新URL,并保存到UURL队列中直到满意为止

网页文章自动采集(用PHP实现网站信息自动批量采集专业班级:计算机科学与技术一班)

采集交流 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-12-01 21:09

文件介绍:

学校代码:10151 论文成绩:

学生证:2220053119

大连海事大学

┊┊┊┊┊┊┊┊┊┊┊┊┊┊┊┊订单┊┊┊┊┊┊┊线┊┊┊┊┊┊┊

毕业论文

2009 年 6 月

网页数据自动化设计与实现

——利用PHP实现网站信息采集的自动批量处理

专业班级:计算机科学与技术一班

姓名:陈能

指导老师:刘超斌

信息科学与技术学院

抽象的

随着互联网的不断普及,政府部门、企业、文化传媒等各类组织都将互联网视为自己的。

作为信息发布方式之一,互联网上的信息资源越来越丰富,人们可以通过互联网了解更多的信息。

然而,由于互联网上资源信息呈指数级增长,不仅数量难以统计,而且海量、

信息类型还涵盖了这个多样化世界的所有方面。这样,无论是对于个人还是网站经理,你都想采集

某一方面或多个方面的信息量,仅靠人工存储在数据库或文件中,耗费大量时间。

复制、组织和存储的时间和人力。这种低水平的重复性工作是无法忍受的。

当这种手工方式难以完成任务,浪费大量宝贵时间时,同时大部分的网络资源

它以网页的形式显示给用户。无论是静态页面还是动态页面,网页的固定格式使其自动采集

网络信息成为可能。

本文研究了在这种情况下如何实现网站采集的自动信息。在设计论文时,基于网页

XML 的格式和 XML 的格式有一些共同的特征,然后使用强大的正则表达式来提取所有符合要求的信息。

并获取相关内容,添加到数据库或保存到文件中,实现自动采集。

本论文中的采集系统采用基于LAMP架构的Web应用开发平台。最终在多平台(Linux、Windows)上实现

等),自动采集和可选的手动采集用于多个站点的信息。并且可以重新处理采集的内容,同理

及时管理采集站点和采集结果。最终实现了一个最基本、简单但完整的采集系统。

关键词:信息采集,LAMP,正则表达式,过滤,自动提取。

抽象的

随着政府部门、企业和

文化媒体和其他一些类型的动画被视为其中之一

信息传播方式。资源越来越丰富

,人们可以从中了解更多信息。然而,作为

资源呈指数级增长,数量庞大且难以统计

数,那种信息也涵盖了这个多面世界的方方面面。所以它花费

大量时间复制、整理、存储数据库或文件中的信息,无论它们是

想要手动采集大量区域的个人或管理人员

信息范围。这种低水平的重复工作令人难以忍受。

在这样一个艰巨的任务中手动完成,并且浪费了很多宝贵的时间,而且

大多数网页以 HTML 格式显示在用户的浏览器中。是否为静态

页面或动态页面,页面m 查看全部

网页文章自动采集(用PHP实现网站信息自动批量采集专业班级:计算机科学与技术一班)

文件介绍:

学校代码:10151 论文成绩:

学生证:2220053119

大连海事大学

┊┊┊┊┊┊┊┊┊┊┊┊┊┊┊┊订单┊┊┊┊┊┊┊线┊┊┊┊┊┊┊

毕业论文

2009 年 6 月

网页数据自动化设计与实现

——利用PHP实现网站信息采集的自动批量处理

专业班级:计算机科学与技术一班

姓名:陈能

指导老师:刘超斌

信息科学与技术学院

抽象的

随着互联网的不断普及,政府部门、企业、文化传媒等各类组织都将互联网视为自己的。

作为信息发布方式之一,互联网上的信息资源越来越丰富,人们可以通过互联网了解更多的信息。

然而,由于互联网上资源信息呈指数级增长,不仅数量难以统计,而且海量、

信息类型还涵盖了这个多样化世界的所有方面。这样,无论是对于个人还是网站经理,你都想采集

某一方面或多个方面的信息量,仅靠人工存储在数据库或文件中,耗费大量时间。

复制、组织和存储的时间和人力。这种低水平的重复性工作是无法忍受的。

当这种手工方式难以完成任务,浪费大量宝贵时间时,同时大部分的网络资源

它以网页的形式显示给用户。无论是静态页面还是动态页面,网页的固定格式使其自动采集

网络信息成为可能。

本文研究了在这种情况下如何实现网站采集的自动信息。在设计论文时,基于网页

XML 的格式和 XML 的格式有一些共同的特征,然后使用强大的正则表达式来提取所有符合要求的信息。

并获取相关内容,添加到数据库或保存到文件中,实现自动采集。

本论文中的采集系统采用基于LAMP架构的Web应用开发平台。最终在多平台(Linux、Windows)上实现

等),自动采集和可选的手动采集用于多个站点的信息。并且可以重新处理采集的内容,同理

及时管理采集站点和采集结果。最终实现了一个最基本、简单但完整的采集系统。

关键词:信息采集,LAMP,正则表达式,过滤,自动提取。

抽象的

随着政府部门、企业和

文化媒体和其他一些类型的动画被视为其中之一

信息传播方式。资源越来越丰富

,人们可以从中了解更多信息。然而,作为

资源呈指数级增长,数量庞大且难以统计

数,那种信息也涵盖了这个多面世界的方方面面。所以它花费

大量时间复制、整理、存储数据库或文件中的信息,无论它们是

想要手动采集大量区域的个人或管理人员

信息范围。这种低水平的重复工作令人难以忍受。

在这样一个艰巨的任务中手动完成,并且浪费了很多宝贵的时间,而且

大多数网页以 HTML 格式显示在用户的浏览器中。是否为静态

页面或动态页面,页面m

网页文章自动采集(网页文章自动采集利用爬虫软件抓取百度文章网站的源码)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-12-30 16:12

网页文章自动采集利用爬虫软件,抓取百度文章网站的网页链接,并复制到本地,批量添加上传文件名。对应的源码生成pdf格式文件。然后用一个爬虫抓取,经过处理,得到我们需要的文章内容。

1)抓取完文章链接,我们需要做一个request请求,内容只需要请求网址、文章标题和自动采集规则即可。

请求地址请求参数:

1)page=0,

2)agent=浏览器,用来指定哪个浏览器,

3)fields=['user-agent','cookie'],只要爬虫对useragent、cookie做过变更,文章链接中的useragent,cookie都会重新生成,没有规则,默认是cookie对应。

4)default_date='2015-09-05',

1)在爬虫工具网站上查找我们需要的链接的规则

2)用python从我们的规则中获取网址(或者规则对应的url地址)

3)规则文件在file:\users\你的用户名\appdata\local\google\chrome\userdata\default目录下

4)把所有爬虫规则文件复制到浏览器中,登录谷歌账号。如果登录不上,需要重新登录。3.代码实现可以看到,整个爬虫非常简单,就是采集一个文章页面,并把这个页面的链接复制出来到本地进行文件编辑,之后可以看到生成好的文章的源码。总结起来就是,爬虫工具网站和我们规则文件本地二次爬取,然后把生成好的源码批量上传到我们的网站即可。本文由异步图片网站原创整理,请勿转载,谢谢。部分图片来源于网络,如有侵权请联系本人删除。 查看全部

网页文章自动采集(网页文章自动采集利用爬虫软件抓取百度文章网站的源码)

网页文章自动采集利用爬虫软件,抓取百度文章网站的网页链接,并复制到本地,批量添加上传文件名。对应的源码生成pdf格式文件。然后用一个爬虫抓取,经过处理,得到我们需要的文章内容。

1)抓取完文章链接,我们需要做一个request请求,内容只需要请求网址、文章标题和自动采集规则即可。

请求地址请求参数:

1)page=0,

2)agent=浏览器,用来指定哪个浏览器,

3)fields=['user-agent','cookie'],只要爬虫对useragent、cookie做过变更,文章链接中的useragent,cookie都会重新生成,没有规则,默认是cookie对应。

4)default_date='2015-09-05',

1)在爬虫工具网站上查找我们需要的链接的规则

2)用python从我们的规则中获取网址(或者规则对应的url地址)

3)规则文件在file:\users\你的用户名\appdata\local\google\chrome\userdata\default目录下

4)把所有爬虫规则文件复制到浏览器中,登录谷歌账号。如果登录不上,需要重新登录。3.代码实现可以看到,整个爬虫非常简单,就是采集一个文章页面,并把这个页面的链接复制出来到本地进行文件编辑,之后可以看到生成好的文章的源码。总结起来就是,爬虫工具网站和我们规则文件本地二次爬取,然后把生成好的源码批量上传到我们的网站即可。本文由异步图片网站原创整理,请勿转载,谢谢。部分图片来源于网络,如有侵权请联系本人删除。

网页文章自动采集(web层面解决方案-->java调用的get方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-12-30 04:01

网页文章自动采集工具网页转化器官网:::-to-do/第一步,复制页面url第二步,复制页面标题,关键词到google第三步,利用工具xpath分析结果第四步,利用inurllib库里面的对象get就能获取到想要的网页内容。

post获取网页内容方法lz自己都可以试下

百度下ehr,

最好不要用curl命令行的形式来调用,不管使用什么工具,

百度都有的教程,再不会,你私信我,

post

上班在使用google,要你的命,我用urllib用了两天才学会

最简单的是erlang

必须要会用xmlhttprequest,curl

post,

用java写demo吧...用正则去匹配内容--->传递token--->调用java的get方法-->获取结果...

web层面解决方案1:/github-rightcaptoo/sentinel-postman:sentinelpostman:desktop,ios,androiduipagedocumentationandpre-renderingforreacthybridapplicationswithspringboot。

推荐使用git读取github源码

shell能够解决绝大部分问题。

在浏览器上可以先遍历整个页面,写字符串出来并保存json,复制出来后自己用xmlzip压缩处理。

googlecli提供xmlhttprequestapi 查看全部

网页文章自动采集(web层面解决方案-->java调用的get方法)

网页文章自动采集工具网页转化器官网:::-to-do/第一步,复制页面url第二步,复制页面标题,关键词到google第三步,利用工具xpath分析结果第四步,利用inurllib库里面的对象get就能获取到想要的网页内容。

post获取网页内容方法lz自己都可以试下

百度下ehr,

最好不要用curl命令行的形式来调用,不管使用什么工具,

百度都有的教程,再不会,你私信我,

post

上班在使用google,要你的命,我用urllib用了两天才学会

最简单的是erlang

必须要会用xmlhttprequest,curl

post,

用java写demo吧...用正则去匹配内容--->传递token--->调用java的get方法-->获取结果...

web层面解决方案1:/github-rightcaptoo/sentinel-postman:sentinelpostman:desktop,ios,androiduipagedocumentationandpre-renderingforreacthybridapplicationswithspringboot。

推荐使用git读取github源码

shell能够解决绝大部分问题。

在浏览器上可以先遍历整个页面,写字符串出来并保存json,复制出来后自己用xmlzip压缩处理。

googlecli提供xmlhttprequestapi

网页文章自动采集(豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 228 次浏览 • 2021-12-30 00:07

爬虫是授权或公共数据的自动采集

。百度只是一个爬虫,一个蜈蚣。学会爬行会让你觉得自己离超越百度指日可待。无论人们多么勇敢,土地多么富有成效,如果梦想成真,仍然需要梦想。人不怕做梦,只怕不知道,不去想。

大数据太火了。核心是各种应用场景的开发。基础仍然是数据采集

。比如天眼查APP,其实就是一个爬虫,爬取各种数据,集成应用。

想学爬虫,不得不提一个神奇的网站。他是每一个爬虫小白的启蒙老师,每一个懵懂少年都是从这里开始探索互联网的未知领域。通过这位启蒙老师,他第一次尝到了乐趣。,停不下来,熟悉掌握各种技能,沉迷其中,难以自拔,一发不可收拾。这位老师善解人意,不愿来。他对四处爬行获取数据的小虫子非常友好。没有反爬虫机制,让爬虫小白第一次有了嫖妓的乐趣,体验非常过瘾。

铺路是不是有点太多了?嗯,这个网站就是-豆瓣。

今天无私分享豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用,会涉及到beautifulsoup模块、SQLite数据库、Flask后端框架、echarts前端模块、wordcloud词云模块.

一、爬虫数据采集

一个简单的爬虫基本上分三步完成:

第 1 步:发送请求。url地址必须构造为自动采集

。

第二步:解析数据。在获得对请求的响应后,解析网页并提取所需的数据。

第三步:保存并显示。将提取的数据保存到excel或数据库中,然后通过GUI或网站显示出来。

具体来说,首先分析我们要爬取的目标网站:分析目标数据的位置。我们需要提取电影的详细链接、名称、主演、评分、评论人数和简介。这些数据基本都在当前页面下,不需要进入电影详情页面提取。然后分析页面规则。Top250每页只收录

25部电影,也就是说你要自动抓取10页。点击下一页,发现每一页的地址都是按照规律递增的,即(i为页数)。找到页面后,我们只想找到一种方法来解析页面并获取我们想要的信息。详情如下:

1.发送请求:

request = urllib.request.Request(url, headers=headers)

响应 = urllib.request.urlopen(request)

html = response.read()

2.分析网页:

汤 = BeautifulSoup(html,'html.parser')

temp = soup.find_all('div', class_='item') #找到每部电影所在的div

3.定义正则表达式:

pat_link = pie(r'a href="(.*?)">') #电影链接

pat_img = 桩(r'

pat_title = pie('(.*?)') #电影标题

pat_info = 桩(r'

(.*?)

', re.S) #电影演职信息

pat_rating = 桩(r'(.*?)')#电影评级

pat_judge = pie(r'(\d*)人评') #电影评价数

pat_inq = pie(r'(.*?)') #简介

4.提取数据

对于临时项目:

数据 = []

项目 = str(项目)

movie_link = re.findall(pat_link, item)[0]

数据.附加(电影链接)

以提取电影链接为例,其他内容提取方法类似。

这样,250部电影所需的信息就被提取出来了。

二、数据存储

简单的数据可以保存到excel,复杂的数据可以保存到数据库中。推荐从SQLite开始学习数据库,SQLite是轻量级数据库,python自带sqlite3模块。

数据库的语言比较简单,就是插入语句有点麻烦。SQLite中的字段都是字符串,python封装的SQLite语句也是字符串。确保python封装的字符串符合SQLite语言规范传递给SQLite。这里简单介绍一下保存数据的代码。

conn = sqlite3.connect(database=save_path)

游标 = conn.cursor()

对于我在范围内(len(数据)):

数据[i] ='"'+数据[i]+'"'

sql ='''

INSERT INTO douban250(cn_name,fn_name,mov_link,img_link,info,rating,judge,instruction)

VALUES(%s)'''%','.join(data)

游标.执行(sql)

mit()

conn.close()

三、数据展示 查看全部

网页文章自动采集(豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用)

爬虫是授权或公共数据的自动采集

。百度只是一个爬虫,一个蜈蚣。学会爬行会让你觉得自己离超越百度指日可待。无论人们多么勇敢,土地多么富有成效,如果梦想成真,仍然需要梦想。人不怕做梦,只怕不知道,不去想。

大数据太火了。核心是各种应用场景的开发。基础仍然是数据采集

。比如天眼查APP,其实就是一个爬虫,爬取各种数据,集成应用。

想学爬虫,不得不提一个神奇的网站。他是每一个爬虫小白的启蒙老师,每一个懵懂少年都是从这里开始探索互联网的未知领域。通过这位启蒙老师,他第一次尝到了乐趣。,停不下来,熟悉掌握各种技能,沉迷其中,难以自拔,一发不可收拾。这位老师善解人意,不愿来。他对四处爬行获取数据的小虫子非常友好。没有反爬虫机制,让爬虫小白第一次有了嫖妓的乐趣,体验非常过瘾。

铺路是不是有点太多了?嗯,这个网站就是-豆瓣。

今天无私分享豆瓣电影Top250相关信息的爬取过程、数据分析、展示应用,会涉及到beautifulsoup模块、SQLite数据库、Flask后端框架、echarts前端模块、wordcloud词云模块.

一、爬虫数据采集

一个简单的爬虫基本上分三步完成:

第 1 步:发送请求。url地址必须构造为自动采集

。

第二步:解析数据。在获得对请求的响应后,解析网页并提取所需的数据。

第三步:保存并显示。将提取的数据保存到excel或数据库中,然后通过GUI或网站显示出来。

具体来说,首先分析我们要爬取的目标网站:分析目标数据的位置。我们需要提取电影的详细链接、名称、主演、评分、评论人数和简介。这些数据基本都在当前页面下,不需要进入电影详情页面提取。然后分析页面规则。Top250每页只收录

25部电影,也就是说你要自动抓取10页。点击下一页,发现每一页的地址都是按照规律递增的,即(i为页数)。找到页面后,我们只想找到一种方法来解析页面并获取我们想要的信息。详情如下:

1.发送请求:

request = urllib.request.Request(url, headers=headers)

响应 = urllib.request.urlopen(request)

html = response.read()

2.分析网页:

汤 = BeautifulSoup(html,'html.parser')

temp = soup.find_all('div', class_='item') #找到每部电影所在的div

3.定义正则表达式:

pat_link = pie(r'a href="(.*?)">') #电影链接

pat_img = 桩(r'

pat_title = pie('(.*?)') #电影标题

pat_info = 桩(r'

(.*?)

', re.S) #电影演职信息

pat_rating = 桩(r'(.*?)')#电影评级

pat_judge = pie(r'(\d*)人评') #电影评价数

pat_inq = pie(r'(.*?)') #简介

4.提取数据

对于临时项目:

数据 = []

项目 = str(项目)

movie_link = re.findall(pat_link, item)[0]

数据.附加(电影链接)

以提取电影链接为例,其他内容提取方法类似。

这样,250部电影所需的信息就被提取出来了。

二、数据存储

简单的数据可以保存到excel,复杂的数据可以保存到数据库中。推荐从SQLite开始学习数据库,SQLite是轻量级数据库,python自带sqlite3模块。

数据库的语言比较简单,就是插入语句有点麻烦。SQLite中的字段都是字符串,python封装的SQLite语句也是字符串。确保python封装的字符串符合SQLite语言规范传递给SQLite。这里简单介绍一下保存数据的代码。

conn = sqlite3.connect(database=save_path)

游标 = conn.cursor()

对于我在范围内(len(数据)):

数据[i] ='"'+数据[i]+'"'

sql ='''

INSERT INTO douban250(cn_name,fn_name,mov_link,img_link,info,rating,judge,instruction)

VALUES(%s)'''%','.join(data)

游标.执行(sql)

mit()

conn.close()

三、数据展示

网页文章自动采集(网页文章自动采集通常情况下包括以下几种实现方式)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-12-29 22:07

网页文章自动采集通常情况下包括以下几种实现方式:1.爬虫爬取:爬虫按照规则自动抓取网页,现阶段最主流的爬虫是爬虫dighub,以及高效的python爬虫selenium。2.自动审核:获取网页时,可以自动对js,css等有效性审核。可以用jquery+last.fmt进行自动审核。可以用fiddler对网页进行审核,可以使用as2库,用jsonrpc进行通信。

2.模拟登录:不同网站的登录方式不同,微博、知乎、58同城等网站采用fiddler封装出一个简单的登录页面,用get方法注册或登录。fiddler对网页的不同源进行模拟请求即可。tomcat进行自动化,可以用tomcat-ua-base进行模拟。3.自动采集:内容来源:百度/谷歌/微博/微信公众号/网站本身等,可以多种来源进行对比,采用java自动化代理池,达到随意访问。

如百度api,必应api,通过jsonrequest获取数据,采用springboot框架封装。4.文章内容分析:内容以文章列表结构进行查询分析,可以用as2库封装出一个简单的数据处理框架,如sphinx。数据可以通过java读取h5完成,也可以通过bs4封装出通用的html读取框架。如文章列表的文本通过javascript获取json数据。

5.个性化:前端设计angular,jquery,或者用bootstrap封装。对于css封装,可以使用自己的js库。再或者自己通过h5转换,如前端优化等。自动化只是一个工具,如果更加深入的了解这个行业,能应对各种情况。本文作者:zynefeng原文链接更多技术干货敬请关注云栖社区知乎机构号:阿里云云栖社区-知乎本文为云栖社区原创内容,未经允许不得转载。 查看全部

网页文章自动采集(网页文章自动采集通常情况下包括以下几种实现方式)

网页文章自动采集通常情况下包括以下几种实现方式:1.爬虫爬取:爬虫按照规则自动抓取网页,现阶段最主流的爬虫是爬虫dighub,以及高效的python爬虫selenium。2.自动审核:获取网页时,可以自动对js,css等有效性审核。可以用jquery+last.fmt进行自动审核。可以用fiddler对网页进行审核,可以使用as2库,用jsonrpc进行通信。

2.模拟登录:不同网站的登录方式不同,微博、知乎、58同城等网站采用fiddler封装出一个简单的登录页面,用get方法注册或登录。fiddler对网页的不同源进行模拟请求即可。tomcat进行自动化,可以用tomcat-ua-base进行模拟。3.自动采集:内容来源:百度/谷歌/微博/微信公众号/网站本身等,可以多种来源进行对比,采用java自动化代理池,达到随意访问。

如百度api,必应api,通过jsonrequest获取数据,采用springboot框架封装。4.文章内容分析:内容以文章列表结构进行查询分析,可以用as2库封装出一个简单的数据处理框架,如sphinx。数据可以通过java读取h5完成,也可以通过bs4封装出通用的html读取框架。如文章列表的文本通过javascript获取json数据。

5.个性化:前端设计angular,jquery,或者用bootstrap封装。对于css封装,可以使用自己的js库。再或者自己通过h5转换,如前端优化等。自动化只是一个工具,如果更加深入的了解这个行业,能应对各种情况。本文作者:zynefeng原文链接更多技术干货敬请关注云栖社区知乎机构号:阿里云云栖社区-知乎本文为云栖社区原创内容,未经允许不得转载。

网页文章自动采集(如何解决验证码怎么办的时间不确定?(一) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-12-28 12:08

)

摘要:验证码的出现一般是由于采集速度较快,采集的数据较多,触发了网站的反采集机制。解决方案是由于它的不确定性,并不是每条采集到的数据都会有验证码。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。

收款过程中遇到验证码怎么办?

验证码出现的时间不确定!

位置也不确定!

那么我们如何解决呢?

原因:这种情况一般是采集速度比较快,采集的数据量大,触发了网站的反采集机制。

解决方案:由于其不确定性,验证码不会出现在采集的每条数据中。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。例如,当它出现时,它会去左分支,当它不出现时,它会去右分支。对于分支判断,一般可以选择“当前页面收录

文本”。详情请根据网页实际情况进行操作。分支判断的使用请参考对应教程,教程链接:

在配置规则的过程中,应采用判断后识别验证码的流程顺序。另外,由于验证码不会时常出现,所以需要找到验证码出现的界面,完成“身份验证码”步骤的建立。

操作示例:

1、 按照正常流程制定规则。

2、 运行单机采集,采集部分数据后发现提示访问频繁,需要验证码。

这时候就应该停止征集,修改规则。

3、回到“流程”页面,将流程设计器左栏的“判断条件”拖到流程图中。

4、设置判断条件。(正常会出现在验证码页面的页面不会出现。例如:您的访问错误,验证输入框的xpath。示例使用验证码提示“您的访问出错”,您可以选择适当的判断条件。详细操作请参考分支判断的使用。)

采集过程中出现验证码,出现时间甚至位置不确定-图4

5、判断条件设置好后,点击需要识别的验证码。如图:

(对于上述过程,前三步也可以按以下顺序进行:

A.点击网页上的验证码输入框

B. 点击“身份验证码”

C.点击网页上的验证码

即先选择验证码还是先选择输入框,两者目的相同,请灵活应用。)

6、 配置“识别失败”场景,因为有些网站需要多次输入验证码(即使输入正确,也需要重新输入验证码)。此外,优采云

以0. 1%的错误概率连接到编码平台。因此,为了避免上述情况导致采集中断,我们需要配置“识别失败”场景,告诉优采云

在什么情况下验证码识别失败,以便再次进行自动识别直到识别正确为止。

7、如果输入错误的验证码,页面上通常会有相应的提示。这时候点击选择提示告诉优采云

出现提示提示验证码识别失败。

8、识别失败场景配置完成后,再配置成功识别场景。进入场景后,手动输入正确的验证码,然后点击“应用到网页并完成配置”。

(完成验证码识别操作后,点击“处理”,如果验证码出现在分支的最右侧,点击并按住拖动到相应位置。)

至此,“身份验证码”操作完成,其余操作请根据实际需要进行设置。图中示例仅在识别验证码后提取数据,然后可以运行本地采集进行验证和调试。第一次弹出验证码输入框时。点击勾选“自动识别验证码”。输入验证码后,点击“确定”,任务将自动运行。云采集这一步不需要操作,直接运行即可。当您没有点击勾选“自动识别验证码”时,每次出现此弹窗时都需要手动输入,且仅支持单机采集。点击“后

(注:“身份验证码”默认选择Ajax,超时时间为5秒,用户可根据网站实际情况配置高级选项。如果网页加载速度较快,可以设置超时时间较短。不过建议不要改,特别是是否检查ajax,以免出错!)

下图显示了本地采集

验证和识别情况。勾选“自动识别验证码”和“确认”后,本地收款过程中会自动识别验证码并消耗余额。请点击余额购买

注意查看验证码包!

查看全部

网页文章自动采集(如何解决验证码怎么办的时间不确定?(一)

)

摘要:验证码的出现一般是由于采集速度较快,采集的数据较多,触发了网站的反采集机制。解决方案是由于它的不确定性,并不是每条采集到的数据都会有验证码。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。

收款过程中遇到验证码怎么办?

验证码出现的时间不确定!

位置也不确定!

那么我们如何解决呢?

原因:这种情况一般是采集速度比较快,采集的数据量大,触发了网站的反采集机制。

解决方案:由于其不确定性,验证码不会出现在采集的每条数据中。因此,需要在规则中引入分支判断来判断验证码是否出现在网页上。例如,当它出现时,它会去左分支,当它不出现时,它会去右分支。对于分支判断,一般可以选择“当前页面收录

文本”。详情请根据网页实际情况进行操作。分支判断的使用请参考对应教程,教程链接:

在配置规则的过程中,应采用判断后识别验证码的流程顺序。另外,由于验证码不会时常出现,所以需要找到验证码出现的界面,完成“身份验证码”步骤的建立。

操作示例:

1、 按照正常流程制定规则。

2、 运行单机采集,采集部分数据后发现提示访问频繁,需要验证码。

这时候就应该停止征集,修改规则。

3、回到“流程”页面,将流程设计器左栏的“判断条件”拖到流程图中。

4、设置判断条件。(正常会出现在验证码页面的页面不会出现。例如:您的访问错误,验证输入框的xpath。示例使用验证码提示“您的访问出错”,您可以选择适当的判断条件。详细操作请参考分支判断的使用。)

采集过程中出现验证码,出现时间甚至位置不确定-图4

5、判断条件设置好后,点击需要识别的验证码。如图:

(对于上述过程,前三步也可以按以下顺序进行:

A.点击网页上的验证码输入框

B. 点击“身份验证码”

C.点击网页上的验证码

即先选择验证码还是先选择输入框,两者目的相同,请灵活应用。)

6、 配置“识别失败”场景,因为有些网站需要多次输入验证码(即使输入正确,也需要重新输入验证码)。此外,优采云

以0. 1%的错误概率连接到编码平台。因此,为了避免上述情况导致采集中断,我们需要配置“识别失败”场景,告诉优采云

在什么情况下验证码识别失败,以便再次进行自动识别直到识别正确为止。

7、如果输入错误的验证码,页面上通常会有相应的提示。这时候点击选择提示告诉优采云

出现提示提示验证码识别失败。

8、识别失败场景配置完成后,再配置成功识别场景。进入场景后,手动输入正确的验证码,然后点击“应用到网页并完成配置”。

(完成验证码识别操作后,点击“处理”,如果验证码出现在分支的最右侧,点击并按住拖动到相应位置。)

至此,“身份验证码”操作完成,其余操作请根据实际需要进行设置。图中示例仅在识别验证码后提取数据,然后可以运行本地采集进行验证和调试。第一次弹出验证码输入框时。点击勾选“自动识别验证码”。输入验证码后,点击“确定”,任务将自动运行。云采集这一步不需要操作,直接运行即可。当您没有点击勾选“自动识别验证码”时,每次出现此弹窗时都需要手动输入,且仅支持单机采集。点击“后

(注:“身份验证码”默认选择Ajax,超时时间为5秒,用户可根据网站实际情况配置高级选项。如果网页加载速度较快,可以设置超时时间较短。不过建议不要改,特别是是否检查ajax,以免出错!)

下图显示了本地采集

验证和识别情况。勾选“自动识别验证码”和“确认”后,本地收款过程中会自动识别验证码并消耗余额。请点击余额购买

注意查看验证码包!

网页文章自动采集(教你快速采集+京东优惠券(800+万大牌商品))

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-12-28 01:06

网页文章自动采集本文教你快速采集+京东优惠券api接口(800+万大牌商品).复制这条信息后打开手机即可看到【我要下单--任意门--搜索:商品名称--查看省价宝贝】买家可以发现优惠券,卖家可以获得销量,双赢。

如果要直接查券的话,对于普通企业只能自己去找这些优惠券平台,对于我们来说我可以为您做我擅长的这块工作,为您开发接口服务,可不可以来合作一下呢。

开放的有百度、阿里的,去看看这些是否有你们想要的券。

我这边是做专门的券商接口接入的,只接过食品公司开发平台的。觉得比起商家和服务商有以下几个优势,个人观点,

1、券商接入接口可以绑定商家和服务商二维码,

2、大部分券商接入有条件要求

3、优惠券实名认证登记。

4、提供多平台接入方案

现在有京东、天猫的券商接口

比较大的券商我知道汇添富、好买基金、兴业证券。接入的话要看场景是什么了,没有说是只限制于某券商。

对券商有兴趣,

通信公司相对券商来说收费会比较少

汇添富、兴业证券有接入优惠券

国内券商接入知名券商的接口相对比较多。一般收费是在20万~200万之间(没有算过准确费用)。你可以收费15万或者50万。如果是两百万或者以上的资金量,可以尝试最近火热的支付宝的接入,支付宝是没有费用的,更多的是分配接口给券商使用。 查看全部

网页文章自动采集(教你快速采集+京东优惠券(800+万大牌商品))

网页文章自动采集本文教你快速采集+京东优惠券api接口(800+万大牌商品).复制这条信息后打开手机即可看到【我要下单--任意门--搜索:商品名称--查看省价宝贝】买家可以发现优惠券,卖家可以获得销量,双赢。

如果要直接查券的话,对于普通企业只能自己去找这些优惠券平台,对于我们来说我可以为您做我擅长的这块工作,为您开发接口服务,可不可以来合作一下呢。

开放的有百度、阿里的,去看看这些是否有你们想要的券。

我这边是做专门的券商接口接入的,只接过食品公司开发平台的。觉得比起商家和服务商有以下几个优势,个人观点,

1、券商接入接口可以绑定商家和服务商二维码,

2、大部分券商接入有条件要求

3、优惠券实名认证登记。

4、提供多平台接入方案

现在有京东、天猫的券商接口

比较大的券商我知道汇添富、好买基金、兴业证券。接入的话要看场景是什么了,没有说是只限制于某券商。

对券商有兴趣,

通信公司相对券商来说收费会比较少

汇添富、兴业证券有接入优惠券

国内券商接入知名券商的接口相对比较多。一般收费是在20万~200万之间(没有算过准确费用)。你可以收费15万或者50万。如果是两百万或者以上的资金量,可以尝试最近火热的支付宝的接入,支付宝是没有费用的,更多的是分配接口给券商使用。

网页文章自动采集( 优采云采集器官方版采集新房二手房最新行情(下载地址) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-12-23 21:27

优采云采集器官方版采集新房二手房最新行情(下载地址)

)

优采云采集器正式版为网页数据采集器。优采云采集器正式版可以在各种类型的网页上进行海量数据采集工作,覆盖类型广泛,金融、交易、社交网站 ,电子商务网站商品等数据可以标准化采集,可以导出。如果你需要它,不要错过它。

相关软件软件说明下载地址

工具

新的

查看

强调

官方最新版本

查看

有专门的自媒体助手

正式版

查看

小鹿扩展创意工具

新的

查看

代码链接

正式版

查看

软件特点

优采云采集器满足多种业务场景

优采云采集器适用于产品、运营、销售、数据分析、政府机构、电子商务从业者、学术研究等各种职业。

市场分析

获取真实用户行为数据,全面掌握客户真实需求

产品开发

大力支持用户研究,准确获取用户反馈和偏好

风险预测

高效信息采集和数据清洗,及时应对系统风险

特征

1. 财务数据,如季报、年报、财报,自动包括最新的每日净值采集;

2. 优采云采集器 可实时监控各大新闻门户网站,自动更新上传最新消息;

3. 监控竞争对手的最新信息,包括商品价格和库存;

4. 监控各大社交网络网站、博客,自动抓取企业产品相关评论;

5. 采集最新最全的招聘信息;

6. 关注最新房产相关网站、采集新房、二手房;

7. 采集主要车型网站 具体新车和二手车信息;

8. 发现和采集潜在客户信息;

9. 采集行业网站产品目录及产品信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

常问问题

如何采集电话号码?(服务类网站)

许多与服务相关的网站(、赶集、美团等)电话号码采集

采集步骤:

1.确定采集的行业分类,将分类网页复制到优采云采集器打开

2.打开采集器,创建采集任务

3.输入采集 URL,根据需要编辑采集规则

4.选择采集方法并启动采集

5.导出采集好数据

预防措施:

采集不同的数据需要稍微不同的规则。如果您不知道如何编辑规则,可以到规则市场查找用户分享的完整规则。采集

安装步骤

一、在本站下载最新版本的优采云采集器安装包,双击运行。

二、 可以点击【浏览】选择软件的安装路径;或者直接点击【下一步】,软件就会安装到默认位置。

三、 耐心等待软件安装完成,点击【关闭】。

技能

首先我们新建一个任务-->进入流程设计页面-->给流程添加一个循环步骤-->选择循环步骤-->勾选软件右侧的URL列表复选框-- > 打开 URL 列表文本框--> 将准备好的 URL 列表填入文本框

接下来,将打开网页的步骤拖入循环--> 选择打开网页的步骤--> 选中使用当前循环中的URL 作为导航地址的框--> 点击保存。系统会在界面底部的浏览器中打开循环选择的URL对应的网页

至此,打开网页循环的配置就完成了。当进程运行时,系统会一一打开循环中设置的URL。最后,我们不需要配置采集数据步骤,这里就不讲了。可以参考系列一:采集单个网页文章。下图是最终和过程

以下是该过程的最终运行结果

查看全部

网页文章自动采集(

优采云采集器官方版采集新房二手房最新行情(下载地址)

)

优采云采集器正式版为网页数据采集器。优采云采集器正式版可以在各种类型的网页上进行海量数据采集工作,覆盖类型广泛,金融、交易、社交网站 ,电子商务网站商品等数据可以标准化采集,可以导出。如果你需要它,不要错过它。

相关软件软件说明下载地址

工具

新的

查看

强调

官方最新版本

查看

有专门的自媒体助手

正式版

查看

小鹿扩展创意工具

新的

查看

代码链接

正式版

查看

软件特点

优采云采集器满足多种业务场景

优采云采集器适用于产品、运营、销售、数据分析、政府机构、电子商务从业者、学术研究等各种职业。

市场分析

获取真实用户行为数据,全面掌握客户真实需求

产品开发

大力支持用户研究,准确获取用户反馈和偏好

风险预测

高效信息采集和数据清洗,及时应对系统风险

特征

1. 财务数据,如季报、年报、财报,自动包括最新的每日净值采集;

2. 优采云采集器 可实时监控各大新闻门户网站,自动更新上传最新消息;

3. 监控竞争对手的最新信息,包括商品价格和库存;

4. 监控各大社交网络网站、博客,自动抓取企业产品相关评论;

5. 采集最新最全的招聘信息;

6. 关注最新房产相关网站、采集新房、二手房;

7. 采集主要车型网站 具体新车和二手车信息;

8. 发现和采集潜在客户信息;

9. 采集行业网站产品目录及产品信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

常问问题

如何采集电话号码?(服务类网站)

许多与服务相关的网站(、赶集、美团等)电话号码采集

采集步骤:

1.确定采集的行业分类,将分类网页复制到优采云采集器打开

2.打开采集器,创建采集任务

3.输入采集 URL,根据需要编辑采集规则

4.选择采集方法并启动采集

5.导出采集好数据

预防措施:

采集不同的数据需要稍微不同的规则。如果您不知道如何编辑规则,可以到规则市场查找用户分享的完整规则。采集

安装步骤

一、在本站下载最新版本的优采云采集器安装包,双击运行。

二、 可以点击【浏览】选择软件的安装路径;或者直接点击【下一步】,软件就会安装到默认位置。

三、 耐心等待软件安装完成,点击【关闭】。

技能

首先我们新建一个任务-->进入流程设计页面-->给流程添加一个循环步骤-->选择循环步骤-->勾选软件右侧的URL列表复选框-- > 打开 URL 列表文本框--> 将准备好的 URL 列表填入文本框

接下来,将打开网页的步骤拖入循环--> 选择打开网页的步骤--> 选中使用当前循环中的URL 作为导航地址的框--> 点击保存。系统会在界面底部的浏览器中打开循环选择的URL对应的网页

至此,打开网页循环的配置就完成了。当进程运行时,系统会一一打开循环中设置的URL。最后,我们不需要配置采集数据步骤,这里就不讲了。可以参考系列一:采集单个网页文章。下图是最终和过程

以下是该过程的最终运行结果

网页文章自动采集(软件特色1.使用谷歌内核引擎,让你无需使用双手)

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-12-23 14:09

网页自动点击操作助手是一款功能强大的网页自动点击工具,支持在电脑上进行自动点击操作。它可以帮助用户自动扫描网页的点击次数。点击次数轻松扫一扫,无需双手,非常简单易用,软件采用谷歌内核引擎,支持手机和PC页面显示,手机和电脑兼容,具有多种功能,可以帮助用户在任意网站中输入文字,自动点击操作,支持制作各种SEO点击软件,可以用软件刷网站点击,可以循环自动点击,各种网站数据自动填写和自动点击,帮你自动点击网站文章、页面等,可以批量注册账号,注册大量账号更安全,支持键盘鼠标模拟,可以支持前后台鼠标点击和键盘模拟,可以自定义UserAgent伪装各种浏览器访问,支持各种论坛自动回复,张贴和置顶帖子。功能非常强大。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。

软件特点1. 采用谷歌内核引擎,可兼容PC端和手机端页面显示

2.模拟手机网页的运行环境

3.自动输入并点击网页

4.强大的表达采集网络数据

5.支持前后台鼠标点击和键盘模拟

6. 支持图片验证码识别和手机验证码自动获取(对接第三方平台服务)

7. 支持ADSL、PPTP、VPN、代理服务器更改IP。

8.支持强大的JS执行功能

9.支持自定义UserAgent(伪装各种浏览器进行访问)

10. 支持随机时间等待或根据系统时间判断执行

11. 支持丰富的自定义变量

12.切换MAC、自动删除缓存、运行外部文件等强大软件功能1.制作各种SEO点击软件

2.网站批量注册账号

3.各种网站数据的自动填充和点击

4.网站内容数据提取采集

站群5.网站的维护和自动更新

6.各种网站自动发帖和回复置顶帖 查看全部

网页文章自动采集(软件特色1.使用谷歌内核引擎,让你无需使用双手)

网页自动点击操作助手是一款功能强大的网页自动点击工具,支持在电脑上进行自动点击操作。它可以帮助用户自动扫描网页的点击次数。点击次数轻松扫一扫,无需双手,非常简单易用,软件采用谷歌内核引擎,支持手机和PC页面显示,手机和电脑兼容,具有多种功能,可以帮助用户在任意网站中输入文字,自动点击操作,支持制作各种SEO点击软件,可以用软件刷网站点击,可以循环自动点击,各种网站数据自动填写和自动点击,帮你自动点击网站文章、页面等,可以批量注册账号,注册大量账号更安全,支持键盘鼠标模拟,可以支持前后台鼠标点击和键盘模拟,可以自定义UserAgent伪装各种浏览器访问,支持各种论坛自动回复,张贴和置顶帖子。功能非常强大。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。它是自动网络点击的产物。有需要的用户请尽快下载。

软件特点1. 采用谷歌内核引擎,可兼容PC端和手机端页面显示

2.模拟手机网页的运行环境

3.自动输入并点击网页

4.强大的表达采集网络数据

5.支持前后台鼠标点击和键盘模拟

6. 支持图片验证码识别和手机验证码自动获取(对接第三方平台服务)

7. 支持ADSL、PPTP、VPN、代理服务器更改IP。

8.支持强大的JS执行功能

9.支持自定义UserAgent(伪装各种浏览器进行访问)

10. 支持随机时间等待或根据系统时间判断执行

11. 支持丰富的自定义变量

12.切换MAC、自动删除缓存、运行外部文件等强大软件功能1.制作各种SEO点击软件

2.网站批量注册账号

3.各种网站数据的自动填充和点击

4.网站内容数据提取采集

站群5.网站的维护和自动更新

6.各种网站自动发帖和回复置顶帖

网页文章自动采集(独特的无人值守ET从设计之初到无人工作的目的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-12-21 04:14

免费的采集软件EditorTools是一款面向中小型网站的自动更新工具,全自动采集发布,静默工作,无需人工干预;独立软件免除网站性能消耗;安全稳定,可使用多年不间断工作;支持任何网站和采集的数据库版本,软件包括discuzX, phpwind, dedecms, wordpress, phpcms, Empirecms, Dongyi, joomla , pbdigg, php168, bbsxp, phpbb, dvbbs, typecho, emblog 等很多常用系统的例子。

本软件适合需要长时间更新内容的网站使用,无需您对现有论坛或网站进行任何改动。

解放站长和管理员

网站要保持活跃,每日内容更新是基础。小网站保证每日更新,通常要求站长每天承担8小时的更新工作,周末无节假日;一个中等网站全天维护内容更新,一般一天3班,班里每2-3个管理员是人工的。如果按照普通月薪1500元计算,即使不包括周末加班,一个小网站一个月至少要1500元,而一个中网站一个月要10000多元. ET的出现将为你省下这笔费用!将站长和管理员从繁琐枯燥的网站更新工作中解放出来!

独一无二的无人值守

ET旨在以提高软件自动化程度为突破口,实现无人值守、24小时自动化工作。经测试,ET可以长时间自动运行,甚至以年为时间单位。

超高稳定性

要达到软件无人值守的目的,需要长期稳定运行。ET在这方面做了很多优化,以保证软件能够稳定持续的工作。没有软件会崩溃甚至崩溃。导致 网站 崩溃问题。

最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上工作,也可以在站长的工作机上工作。

严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题。采集供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

强大而灵活的功能

ET除了具有一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义物品、UTF-支持8、UBB,模拟发布...,让用户灵活实现各种采购和理发需求。

EditorTools 2 功能介绍

【特点】 设定计划后,可24小时自动工作,无需人工干预。

[特点] 独立于网站,通过独立制作的接口支持任何网站或数据库

【特点】灵活强大采集规则不仅是采集文章,任何类型的信息都可以采集

【特点】体积小、功耗低、稳定性好,非常适合在服务器上运行

【特点】所有规则均可导入导出,资源灵活复用

【特点】使用FTP上传文件,稳定安全

[特点] 下载上传支持续传

【特点】高速伪原创

[采集] 反向、顺序、随机可选采集文章

【采集】支持自动列表网址

[采集] 支持网站数据分布在多个页面采集

[采集] 自由设置采集数据项,可对每个数据项单独过滤排序

【采集】支持分页内容采集

[采集] 支持下载任意格式和类型的文件(包括图片和视频)

[采集] 可以突破防盗文件

【采集】支持动态文件URL解析

[采集] 支持采集 需要登录才能访问的网页

[支持] 可设置关键词采集

[支持] 可设置防止采集敏感词

[支持] 可设置图片水印

[发布] 支持以回复方式发布文章,可广泛应用于论坛、博客等项目

【发布】与采集数据分离的发布参数项可以自由对应采集数据或预设值,大大增强了发布规则的复用性

[发布] 支持随机选择发布账号

[发布] 支持任何已发布项目的语言翻译

[发布] 支持编码转换,支持UBB码

【发布】可选择文件上传自动创建年月日目录

[发布] 模拟发布支持无法安装接口的网站发布操作

[支持] 程序可以正常运行

[支持] 防止网络运营商劫持HTTP功能

[支持] 可以手动发布单项采集

【支持】详细的工作流程监控和信息反馈,让您快速了解工作状态 查看全部

网页文章自动采集(独特的无人值守ET从设计之初到无人工作的目的)