seo文章采集工具

seo文章采集工具(SEO人手必备的一个工具,你知道几个?!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-12-09 17:12

SEO现在已经进入了工具时代,小编认可这个说法。SEO工具从最原创的链接工厂进化到了现在的各种SEO便捷工具,给SEOER带来了方便。SEO工具(Seo tools)是在搜索引擎优化过程中使用的辅助软件,如查询工具、排名工具、流量分析软件、站群软件等,以提高SEOER的效率。SEO工具是搜索引擎优化过程中使用的辅助软件,可以事半功倍,即提高工作效率。同时,一些工具更加准确,与手动查询数据基本一致。如查询工具、排名工具、流量分析软件、站群软件等。SEO工具是搜索引擎优化的工具。我们会在排名优化中使用各种辅助工具来提高我们的工作效率。使用这些常用的SEO工具,可以帮助我们了解网站的情况,让搜索引擎优化更容易操作。常用的SEO工具有很多,每个平台都有自己的特点,应该根据自己的需要合理使用。给大家介绍一下SEO过程中经常用到的一些工具。

采集Tool,基本上是SEO人员必备的工具。因为网站每天需要填很多的内容,一个站长要同时管理这么多的网站,所以我会利用采集的功能来帮助自己提高网站的内容,以达到长期更新的目的。大多数SEO人员使用免费的采集工具来完成采集的工作,主要是操作简单,不需要写规则,不需要复杂的配置,可以挂采集,< @采集 是完全免费的。

发布工具与采集相同,相辅相成。网站采集这么多内容需要发布给我们网站。对于站长来说,为了更好的增加收录和网站的权重,提升网站的排名需要相对较高的频率来丰富网站的内容,但是站长也有很多cms网站(帝国cms、WordPress、织梦cms、易游cms等)难以同时同步管理,每个cms背景都不一样。所以我们需要使用发布工具来完成这项工作。操作步骤非常简单,定时发布,同时无缝对接各大cms发布。 查看全部

seo文章采集工具(SEO人手必备的一个工具,你知道几个?!)

SEO现在已经进入了工具时代,小编认可这个说法。SEO工具从最原创的链接工厂进化到了现在的各种SEO便捷工具,给SEOER带来了方便。SEO工具(Seo tools)是在搜索引擎优化过程中使用的辅助软件,如查询工具、排名工具、流量分析软件、站群软件等,以提高SEOER的效率。SEO工具是搜索引擎优化过程中使用的辅助软件,可以事半功倍,即提高工作效率。同时,一些工具更加准确,与手动查询数据基本一致。如查询工具、排名工具、流量分析软件、站群软件等。SEO工具是搜索引擎优化的工具。我们会在排名优化中使用各种辅助工具来提高我们的工作效率。使用这些常用的SEO工具,可以帮助我们了解网站的情况,让搜索引擎优化更容易操作。常用的SEO工具有很多,每个平台都有自己的特点,应该根据自己的需要合理使用。给大家介绍一下SEO过程中经常用到的一些工具。

采集Tool,基本上是SEO人员必备的工具。因为网站每天需要填很多的内容,一个站长要同时管理这么多的网站,所以我会利用采集的功能来帮助自己提高网站的内容,以达到长期更新的目的。大多数SEO人员使用免费的采集工具来完成采集的工作,主要是操作简单,不需要写规则,不需要复杂的配置,可以挂采集,< @采集 是完全免费的。

发布工具与采集相同,相辅相成。网站采集这么多内容需要发布给我们网站。对于站长来说,为了更好的增加收录和网站的权重,提升网站的排名需要相对较高的频率来丰富网站的内容,但是站长也有很多cms网站(帝国cms、WordPress、织梦cms、易游cms等)难以同时同步管理,每个cms背景都不一样。所以我们需要使用发布工具来完成这项工作。操作步骤非常简单,定时发布,同时无缝对接各大cms发布。

seo文章采集工具(算法的每次改进都会导致一些seo工具失效,怎么办)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-12-05 00:07

算法的每一次改进都会导致一些seo工具失效。在过去三年的seo中,人们发现,以前的seo软件随着时间的推移,已经慢慢淡出了人们的视野。很多朋友也在盲目找seo软件,投机做排名。其实以前seo软件只是某种辅助功能,并不能完全替代人工,使用时需要非常谨慎,只有当网站有一定程度的权重时,软件可适当使用,效果更佳;现在,软件优化可能毫无意义(百度一直在控制这种作弊方式,而且效果只是昙花一现),除非你能做出一个写出高质量原创文章的软件.

一、伪原创工具

伪原创工具可以快速打乱一篇文章文章的顺序,达到了“原创”的效果,但是伪原创产生的文章质量@> 担心,内容基本不能让用户看清楚意思;2010年seo优化中,使用伪原创工具是一种很常见的优化方式,软件的种类数不胜数,除了网站文章除了伪原创之外,我们还使用< @伪原创 以节省在外部链发布中编辑 文章 的时间。

随着算法的改进,k掉了很多这样的“原创但质量不高”文章。许多 Seoer 从经验和教训中学习。本站手动更新,但是外链一如既往。伪原创,因为我们知道外链是发到别人的网站,别人是不是k1是别人的事,我们只问对于外链发帖和伪原创0@>提升排名,这是一种很自私的想法和做法,其实是很不合理的seo优化方法,因为当别人网站被惩罚的时候,我们的伪原创7@ > 必然会产生一定的影响,但影响的大小不同。当别人的网站是k时,你自己的网站没有降级的迹象,不要高兴得太早,

随着搜索引擎的完善,搜索引擎不断对内容质量差的内容进行处罚,同时提醒站长内容质量是网站的本质,好的内容质量会带来好的排名;如果你现在一如既往地为互联网制造垃圾,那么恭喜你,你离惩罚的目标不远了。我们要知道,SEO下链的发布是一个互利的过程,实现双赢的下链才是最有价值的。

二、数据伪原创1@>工具

数据伪原创1@>是创建内容最快的方式。一个新网站可以立即从“苗条”变为“丰满”。以前,伪原创1@>的方式很流行,尤其是搞交通信息类的网站,因为网站需要大量的内容支持,使用人工发布,需要大量的人力和时间,有了“优采云”伪原创1@>,就剩下很多进程了;记得之前有朋友用过伪原创1@>工具伪原创1@>soso问,百度知道等平台文章,虽然伪原创0@>达到了百万,但很快就被k掉了。

随着搜索引擎对原创文章的要求越来越高,批量伪原创1@>的方式显得华而不实,昔日的“优采云”一去不复返了!

三、外链群发工具

内容和外链是Seoer最关心的话题,因为这两者曾经主导着排名趋势。外链群发工具也已经在seo界流行起来。记得比较流行的优利得博客群发工具、bug群发工具、博客精灵等等,10年也用博客群发工具优化了一批网站。一开始排名很强,但随着百度的大更新,网站是“没有完整皮肤的k的身体”。经过那段时间的教训,我意识到seo软件只能辅助人,不能代替人。现在,或许援助太过牵强。

外链群发工具在百度优化中被淘汰,但在外贸优化中还是比较常见的网站。大量的链接或许能够支撑一段时间的排名。当然,能在短期内带来效益的优化,百度和谷歌都可以尝试。

四、浏览交通工具

刷流量工具可以让网站的流量暴涨,但这只是虚的。听别人说刷流量对我的排名有好处,但是我试过了。它并没有我想象的那么神奇。也许seo软件就是这个。如果使用太多,事情就会失败。

五、 刷排名软件

以前有朋友扫描ALEXA排名,最近更新了关键词排名,不过百度还是可以应付这些不好的优化方式的。百度的网址改进可能会对排名起到防御作用,排名软件正在逐渐失去快速排名一次的效果。

六、滑动下拉框,相关搜索

扫一扫网站品牌名称的相关搜索,可以宣传你的网站品牌,引导一定的流量到你的网站。不过,百度官方明确指出,这是一种作弊形式。刷机肯定会有一定的影响,但是百度除了防止自己刷机之外,肯定还会防止一些恶意行为网站。

总结:软件可以节省很多精力,但软件在seo优化中永远不会比手动更好。除了以上工具,百度索引工具也是最近比较火的。其实这东西是为了增加自己的百度权重。价值和网站流量,但这不是真正的用户访问,只是为了安慰自己,也许在友情链接交流中能起到一点作用。文章作者:曾宇文(家视·家居商城)原创,exchange-449-165,欢迎大家交流讨论!

红酒有助于保持体形

网站我对优化“购买链接”的看法

红酒木瓜汤助女性丰盈美颜

网络营销不仅仅是销售产品

红酒配鱼

浅谈如何建设农村互联网体系增加农民收入

红酒木瓜汤白蒂丽娜打造D杯性感少女

隆力奇小拉菲干红葡萄酒法国红酒新上市,赠品,欢迎选购批发零售

浅谈如何快速恢复百度快照

判断网站是否被降级的方法及原因 查看全部

seo文章采集工具(算法的每次改进都会导致一些seo工具失效,怎么办)

算法的每一次改进都会导致一些seo工具失效。在过去三年的seo中,人们发现,以前的seo软件随着时间的推移,已经慢慢淡出了人们的视野。很多朋友也在盲目找seo软件,投机做排名。其实以前seo软件只是某种辅助功能,并不能完全替代人工,使用时需要非常谨慎,只有当网站有一定程度的权重时,软件可适当使用,效果更佳;现在,软件优化可能毫无意义(百度一直在控制这种作弊方式,而且效果只是昙花一现),除非你能做出一个写出高质量原创文章的软件.

一、伪原创工具

伪原创工具可以快速打乱一篇文章文章的顺序,达到了“原创”的效果,但是伪原创产生的文章质量@> 担心,内容基本不能让用户看清楚意思;2010年seo优化中,使用伪原创工具是一种很常见的优化方式,软件的种类数不胜数,除了网站文章除了伪原创之外,我们还使用< @伪原创 以节省在外部链发布中编辑 文章 的时间。

随着算法的改进,k掉了很多这样的“原创但质量不高”文章。许多 Seoer 从经验和教训中学习。本站手动更新,但是外链一如既往。伪原创,因为我们知道外链是发到别人的网站,别人是不是k1是别人的事,我们只问对于外链发帖和伪原创0@>提升排名,这是一种很自私的想法和做法,其实是很不合理的seo优化方法,因为当别人网站被惩罚的时候,我们的伪原创7@ > 必然会产生一定的影响,但影响的大小不同。当别人的网站是k时,你自己的网站没有降级的迹象,不要高兴得太早,

随着搜索引擎的完善,搜索引擎不断对内容质量差的内容进行处罚,同时提醒站长内容质量是网站的本质,好的内容质量会带来好的排名;如果你现在一如既往地为互联网制造垃圾,那么恭喜你,你离惩罚的目标不远了。我们要知道,SEO下链的发布是一个互利的过程,实现双赢的下链才是最有价值的。

二、数据伪原创1@>工具

数据伪原创1@>是创建内容最快的方式。一个新网站可以立即从“苗条”变为“丰满”。以前,伪原创1@>的方式很流行,尤其是搞交通信息类的网站,因为网站需要大量的内容支持,使用人工发布,需要大量的人力和时间,有了“优采云”伪原创1@>,就剩下很多进程了;记得之前有朋友用过伪原创1@>工具伪原创1@>soso问,百度知道等平台文章,虽然伪原创0@>达到了百万,但很快就被k掉了。

随着搜索引擎对原创文章的要求越来越高,批量伪原创1@>的方式显得华而不实,昔日的“优采云”一去不复返了!

三、外链群发工具

内容和外链是Seoer最关心的话题,因为这两者曾经主导着排名趋势。外链群发工具也已经在seo界流行起来。记得比较流行的优利得博客群发工具、bug群发工具、博客精灵等等,10年也用博客群发工具优化了一批网站。一开始排名很强,但随着百度的大更新,网站是“没有完整皮肤的k的身体”。经过那段时间的教训,我意识到seo软件只能辅助人,不能代替人。现在,或许援助太过牵强。

外链群发工具在百度优化中被淘汰,但在外贸优化中还是比较常见的网站。大量的链接或许能够支撑一段时间的排名。当然,能在短期内带来效益的优化,百度和谷歌都可以尝试。

四、浏览交通工具

刷流量工具可以让网站的流量暴涨,但这只是虚的。听别人说刷流量对我的排名有好处,但是我试过了。它并没有我想象的那么神奇。也许seo软件就是这个。如果使用太多,事情就会失败。

五、 刷排名软件

以前有朋友扫描ALEXA排名,最近更新了关键词排名,不过百度还是可以应付这些不好的优化方式的。百度的网址改进可能会对排名起到防御作用,排名软件正在逐渐失去快速排名一次的效果。

六、滑动下拉框,相关搜索

扫一扫网站品牌名称的相关搜索,可以宣传你的网站品牌,引导一定的流量到你的网站。不过,百度官方明确指出,这是一种作弊形式。刷机肯定会有一定的影响,但是百度除了防止自己刷机之外,肯定还会防止一些恶意行为网站。

总结:软件可以节省很多精力,但软件在seo优化中永远不会比手动更好。除了以上工具,百度索引工具也是最近比较火的。其实这东西是为了增加自己的百度权重。价值和网站流量,但这不是真正的用户访问,只是为了安慰自己,也许在友情链接交流中能起到一点作用。文章作者:曾宇文(家视·家居商城)原创,exchange-449-165,欢迎大家交流讨论!

红酒有助于保持体形

网站我对优化“购买链接”的看法

红酒木瓜汤助女性丰盈美颜

网络营销不仅仅是销售产品

红酒配鱼

浅谈如何建设农村互联网体系增加农民收入

红酒木瓜汤白蒂丽娜打造D杯性感少女

隆力奇小拉菲干红葡萄酒法国红酒新上市,赠品,欢迎选购批发零售

浅谈如何快速恢复百度快照

判断网站是否被降级的方法及原因

seo文章采集工具(“流量是怎么来的”从0基础怎么获得流量?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-12-03 15:17

“流量是怎么来的?”从流量到网站建设,往后推:流量→关键词排名→收录→蜘蛛爬行→推送→海量内容→网站Build)

如何从0基获取流量:网站TDK布局→大内容→收录→关键词rank→流量

一、网站TDK 布局:

使用关键词或站点命令查询优秀同行网页的数量和排名收录。可以直观的看到自己在百度/搜狗/今日头条的同行网站的收录的排名情况,通过大量优秀同行的关键词布局经验确定自己网站 布局,优化方向!您也可以通过关键词搜索了解更多关于您的网站关键词排名和收录情况!

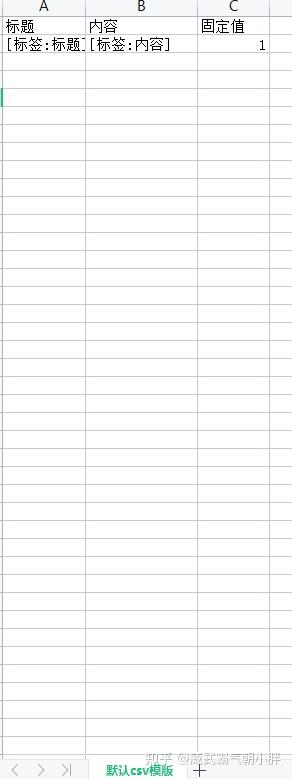

通过site:域名,查询网站有多少收录,收录有多少关键词?我们可以直接导出软件上的Excel表格做进一步分析!

查询工具能做什么:防止网站被黑(通过观察收录的情况,检查收录是否有不良信息)-网站修改(通过工具提取收录链接并将新链接URL路径更改提交到百度资源搜索平台)-关键词排名(通过关键词查看网站的排名,并重点关注关键词Ranking)-网站Push(通过查询收录的链接--only push not收录网站)

二、内容丰富

发布很多内容到我自己的网站。第一个用于填充数据,第二个用于更新网站。第三,保证更多的关键词有流量排名。这里的很多内容也有点特别,一定是关键词相关的文章(通过设置几千个关键词采集-创建几十个采集任务实现挂机采集发布-可以直接在软件上查看,采集状态和查看采集内容质量极其方便!)

三、伪原创

什么是伪原创? 伪原创是指对现有的文章进行再加工,使搜索引擎认为它是一个原创文章,从而提高收录和网站的排名。

四、cms释放函数

什么是发布功能?意思是将伪原创的内容或内容快速发布到网站并监控数据,节省更多时间

cms 发布:目前市场上唯一同时支持Empire、Yiyou、ZBLOG、织梦、WP、PB、Apple、搜外等主流< @cms,可以同时批量管理和发布工具

对应栏目:不同的文章可以发布不同的栏目

定时发布:控制发表一篇文章的分钟数/总共发表多少篇文章

监控数据:发布、待发布、是否伪原创、发布状态、URL、程序等

好了,今天的分享就到这里。剩下的就是主动提交网站的链接给搜索引擎,主要是增加蜘蛛爬行的频率。让您的网站更快收录获得排名。 查看全部

seo文章采集工具(“流量是怎么来的”从0基础怎么获得流量?)

“流量是怎么来的?”从流量到网站建设,往后推:流量→关键词排名→收录→蜘蛛爬行→推送→海量内容→网站Build)

如何从0基获取流量:网站TDK布局→大内容→收录→关键词rank→流量

一、网站TDK 布局:

使用关键词或站点命令查询优秀同行网页的数量和排名收录。可以直观的看到自己在百度/搜狗/今日头条的同行网站的收录的排名情况,通过大量优秀同行的关键词布局经验确定自己网站 布局,优化方向!您也可以通过关键词搜索了解更多关于您的网站关键词排名和收录情况!

通过site:域名,查询网站有多少收录,收录有多少关键词?我们可以直接导出软件上的Excel表格做进一步分析!

查询工具能做什么:防止网站被黑(通过观察收录的情况,检查收录是否有不良信息)-网站修改(通过工具提取收录链接并将新链接URL路径更改提交到百度资源搜索平台)-关键词排名(通过关键词查看网站的排名,并重点关注关键词Ranking)-网站Push(通过查询收录的链接--only push not收录网站)

二、内容丰富

发布很多内容到我自己的网站。第一个用于填充数据,第二个用于更新网站。第三,保证更多的关键词有流量排名。这里的很多内容也有点特别,一定是关键词相关的文章(通过设置几千个关键词采集-创建几十个采集任务实现挂机采集发布-可以直接在软件上查看,采集状态和查看采集内容质量极其方便!)

三、伪原创

什么是伪原创? 伪原创是指对现有的文章进行再加工,使搜索引擎认为它是一个原创文章,从而提高收录和网站的排名。

四、cms释放函数

什么是发布功能?意思是将伪原创的内容或内容快速发布到网站并监控数据,节省更多时间

cms 发布:目前市场上唯一同时支持Empire、Yiyou、ZBLOG、织梦、WP、PB、Apple、搜外等主流< @cms,可以同时批量管理和发布工具

对应栏目:不同的文章可以发布不同的栏目

定时发布:控制发表一篇文章的分钟数/总共发表多少篇文章

监控数据:发布、待发布、是否伪原创、发布状态、URL、程序等

好了,今天的分享就到这里。剩下的就是主动提交网站的链接给搜索引擎,主要是增加蜘蛛爬行的频率。让您的网站更快收录获得排名。

seo文章采集工具(企业站和流量站的两种情况来分析,文章需不需要每天发?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-12-03 15:14

大家好~这几天有几个朋友过来咨询,“文章需要天天发帖吗?” 这个问题

今天我们就详细聊一聊,接下来分别分析企业站和流量站的两种情况。

企业站

在上线之前,我们要做的就是填写网站的整体内容。一般企业网站上都有产品页面和文章页面。

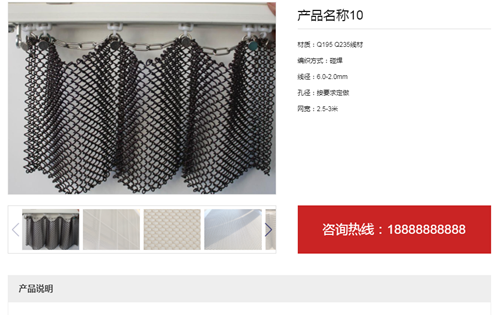

优先完整填写商品页面,特别是商品页面的内容可以更加丰富,比如商品参数、图片、价格、评论等,可以给用户带来更多的信息

示例产品页面

文章页面,建议先发100篇。原创文章,上来澄清一下我们要做什么关键词然后展开一些长尾词写文章

那么我们现在有100篇文章文章的产品文章和原创,然后在网站上线后,我们可以提交站点地图供蜘蛛抓取

记录网站一般收录会更快更好。未备案的网站可能不是收录

那么在日常的优化过程中,我们还需要继续发送文章吗?

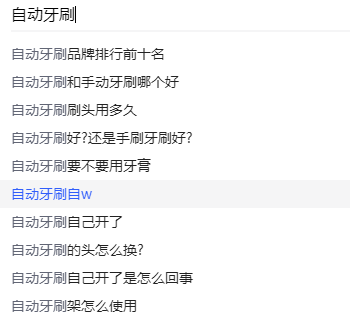

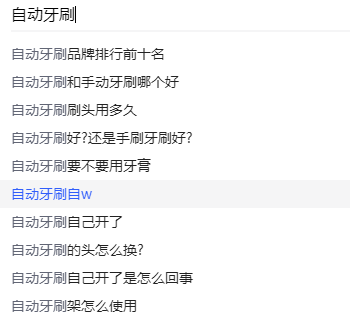

是的,因为客户的搜索行为会发生变化,我们可以以一个关键词为例,比如“自动牙刷”

百度的下拉和相关搜索,今天你可能看到这些,明天你可能又换了几个词。

相关搜索示例

下拉内容

因此,我们更新了文章来满足需求,并让百度知道我们正在不断优化一个网站

还有一个操作,就是网站的内容在上线后三四个月内不会是收录。好的,这个时候我们不用更新了,直接去佛系,改域名改模板重新开始,之前的网站放在那里,别用了

别管它,别挂在树上

注:企业网站每日可少发文章,如放假通知、公司团建活动等。

流量站

交通站需要很多文章,所以交通站必须发送文章,可以经常更新

网站 定位取决于peer如何操作。有些交通站是一个团队运营的,但是我们没法比较,看后面的站点是怎么做的,了解你自己和你的对手

流量站依赖文章页面或聚合页面获取相应流量

我们用关键词《王者荣耀》搜索一下,有视频和文章页面弹出。那么如果你制作这个页面,就会有指南、视频和排名。会更好吗?

搜索结果显示

是的,因为你从多个角度解决了用户需求,增加了用户留存时间

好,让我们回到刚才的问题。有多少文章需要更新?

采集每天推荐采集50+。当然,你需要找到更好的采集来源。那些排名高的大网站不推荐采集

伪原创,每天用工具,伪原创 10篇左右应该不是问题吧?

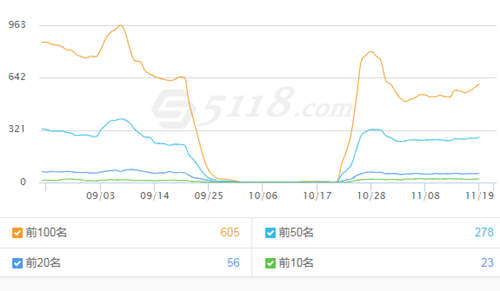

我之前做过一个网站。不知什么原因,几个月没更新了,百度索引爬疯了,然后又开始更新了。趋势如下图所示。

而且你要明白交通站需要很多文章堆,很多文章不会收录,比如你采集100w+的文章 , 可能只有10w+收录,甚至更少

如果你坚持能做到100%收录,那你就真的很厉害了,你是个什么样的站长,明天直接向百度汇报。年薪低于1000w的请见谅。 查看全部

seo文章采集工具(企业站和流量站的两种情况来分析,文章需不需要每天发?)

大家好~这几天有几个朋友过来咨询,“文章需要天天发帖吗?” 这个问题

今天我们就详细聊一聊,接下来分别分析企业站和流量站的两种情况。

企业站

在上线之前,我们要做的就是填写网站的整体内容。一般企业网站上都有产品页面和文章页面。

优先完整填写商品页面,特别是商品页面的内容可以更加丰富,比如商品参数、图片、价格、评论等,可以给用户带来更多的信息

示例产品页面

文章页面,建议先发100篇。原创文章,上来澄清一下我们要做什么关键词然后展开一些长尾词写文章

那么我们现在有100篇文章文章的产品文章和原创,然后在网站上线后,我们可以提交站点地图供蜘蛛抓取

记录网站一般收录会更快更好。未备案的网站可能不是收录

那么在日常的优化过程中,我们还需要继续发送文章吗?

是的,因为客户的搜索行为会发生变化,我们可以以一个关键词为例,比如“自动牙刷”

百度的下拉和相关搜索,今天你可能看到这些,明天你可能又换了几个词。

相关搜索示例

下拉内容

因此,我们更新了文章来满足需求,并让百度知道我们正在不断优化一个网站

还有一个操作,就是网站的内容在上线后三四个月内不会是收录。好的,这个时候我们不用更新了,直接去佛系,改域名改模板重新开始,之前的网站放在那里,别用了

别管它,别挂在树上

注:企业网站每日可少发文章,如放假通知、公司团建活动等。

流量站

交通站需要很多文章,所以交通站必须发送文章,可以经常更新

网站 定位取决于peer如何操作。有些交通站是一个团队运营的,但是我们没法比较,看后面的站点是怎么做的,了解你自己和你的对手

流量站依赖文章页面或聚合页面获取相应流量

我们用关键词《王者荣耀》搜索一下,有视频和文章页面弹出。那么如果你制作这个页面,就会有指南、视频和排名。会更好吗?

搜索结果显示

是的,因为你从多个角度解决了用户需求,增加了用户留存时间

好,让我们回到刚才的问题。有多少文章需要更新?

采集每天推荐采集50+。当然,你需要找到更好的采集来源。那些排名高的大网站不推荐采集

伪原创,每天用工具,伪原创 10篇左右应该不是问题吧?

我之前做过一个网站。不知什么原因,几个月没更新了,百度索引爬疯了,然后又开始更新了。趋势如下图所示。

而且你要明白交通站需要很多文章堆,很多文章不会收录,比如你采集100w+的文章 , 可能只有10w+收录,甚至更少

如果你坚持能做到100%收录,那你就真的很厉害了,你是个什么样的站长,明天直接向百度汇报。年薪低于1000w的请见谅。

seo文章采集工具( 关于Empire收藏和网站创建的SEO技巧和问题解决方法 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-12-02 14:14

关于Empire收藏和网站创建的SEO技巧和问题解决方法

)

今天小编就继续和大家分享网站 seo搜索引擎优化基础教程胡宝杰的Empire采集和创作的一些SEO技巧和解题方法,以及如何使用Empirecms创作更多超过 100,000 通过采集采集网站。Empire cms 是一个成熟的内容管理系统,拥有大量用户。但是,很多用户都遇到了同样的问题。一开始,他们正在探索帝国的内置采集器。后来,他们觉得自己不够强大,采集的速度很慢。即如果不能存入库,则留在导入临时库页面,不动,超时。编辑是如何解决这些问题的?然后我们可以切换到第三方采集 软件,不仅解决了上述问题,还建立了网站。目前指数稳定在12万左右。

帝国典藏对于网站SEO优化应该怎么做?学会选择关键词很重要。SEO最重要的是关键词优化,包括如何选择核心关键词和长尾关键词;如何查看关键词的流行度和竞争度,以及一些分词技巧。内容优化,包括文章中关键词的密度、位置、内部链接等。了解什么样的网站结构容易被搜索引擎搜索到收录、网站域名基础知识、网站静态和动态URL、优缺点等. 做网站SEO优化的站长都知道,有些文章每天都会定期在网站上发布,但是如果有少数网站 照样可以这样发布,如果网站多了,手动更新难免,效率难免会低一些。有什么问题可以提高效率吗?内置的Empire 采集只是说实在满足不了我们的采集需求。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件是: 永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要导入批量关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览采集文章,支持关键词 过滤。错误的方法能提高效率吗?内置的Empire 采集只是说实在满足不了我们的采集需求。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件有:永久免费seo搜索引擎优化基础教程胡宝洁,可以同时选择多个数据源采集

错误的方法能提高效率吗?内置的Empire 采集只是说实在满足不了我们的采集需求。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件是: 永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要导入批量关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览采集文章,支持关键词 过滤。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件为:永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要批量导入关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览采集文章,支持关键词过滤。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件是: 永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要导入批量关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览<

这样可以解决Empirecms用户获取困难的问题。只有解决了内容问题,才有时间和精力去优化网站的SEO。对于编辑来说,三个月轻松打造一个10万网站。一般SEO优化网站一个多月就会看到结果。三个月左右建一个10万网站不值一提。的。用全网免费采集软件将文章内容采集回来。你必须知道用什么方法优化才能达到这个效果。首先在网站SEO优化方面有一些内容和大家分享:首先,我觉得首页的标题和描述还是很重要的。对于编辑器中的每个 网站,我会认真考虑怎么写标题和描述,把标题写好。更有效的优化。147采集是一款优秀的御用采集工具。构建站群简单方便。因此,我们需要在标题中收录我们正在做的行业等关键词。包括标题和描述。所以目前这个网站可以轻松采集超过100,000。其次,关键词的密度也是需要考虑的问题。关键词出现在网站首页的频率,关键词的密度为2-8%,在关键词密度访问的合理范围内。SEO的关键词内链是提升关键词排名的重要途径之一。

先分享一些Empire 采集的经验。当然,网站收录是可以加的,不仅仅是小编提到的几点,SEO是一个多维度、长期的过程。网站SEO优化需要做的太多。这可能看起来深奥,但实际上非常简单。搜索引擎已经给出了相应的规则。我们只需要按照这些规则做SEO优化,网站自然会进入排名!

查看全部

seo文章采集工具(

关于Empire收藏和网站创建的SEO技巧和问题解决方法

)

今天小编就继续和大家分享网站 seo搜索引擎优化基础教程胡宝杰的Empire采集和创作的一些SEO技巧和解题方法,以及如何使用Empirecms创作更多超过 100,000 通过采集采集网站。Empire cms 是一个成熟的内容管理系统,拥有大量用户。但是,很多用户都遇到了同样的问题。一开始,他们正在探索帝国的内置采集器。后来,他们觉得自己不够强大,采集的速度很慢。即如果不能存入库,则留在导入临时库页面,不动,超时。编辑是如何解决这些问题的?然后我们可以切换到第三方采集 软件,不仅解决了上述问题,还建立了网站。目前指数稳定在12万左右。

帝国典藏对于网站SEO优化应该怎么做?学会选择关键词很重要。SEO最重要的是关键词优化,包括如何选择核心关键词和长尾关键词;如何查看关键词的流行度和竞争度,以及一些分词技巧。内容优化,包括文章中关键词的密度、位置、内部链接等。了解什么样的网站结构容易被搜索引擎搜索到收录、网站域名基础知识、网站静态和动态URL、优缺点等. 做网站SEO优化的站长都知道,有些文章每天都会定期在网站上发布,但是如果有少数网站 照样可以这样发布,如果网站多了,手动更新难免,效率难免会低一些。有什么问题可以提高效率吗?内置的Empire 采集只是说实在满足不了我们的采集需求。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件是: 永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要导入批量关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览采集文章,支持关键词 过滤。错误的方法能提高效率吗?内置的Empire 采集只是说实在满足不了我们的采集需求。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件有:永久免费seo搜索引擎优化基础教程胡宝洁,可以同时选择多个数据源采集

错误的方法能提高效率吗?内置的Empire 采集只是说实在满足不了我们的采集需求。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件是: 永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要导入批量关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览采集文章,支持关键词 过滤。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件为:永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要批量导入关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览采集文章,支持关键词过滤。我们可以通过全网免费的采集软件完成网站的采集任务。主要软件是: 永久免费,可以同时选择多个数据源采集,可以同时创建几十个或几百个采集任务,每个任务只需要导入批量关键词挂机采集,操作简单,使用方便,实时查看采集数据,本地或远程预览<

这样可以解决Empirecms用户获取困难的问题。只有解决了内容问题,才有时间和精力去优化网站的SEO。对于编辑来说,三个月轻松打造一个10万网站。一般SEO优化网站一个多月就会看到结果。三个月左右建一个10万网站不值一提。的。用全网免费采集软件将文章内容采集回来。你必须知道用什么方法优化才能达到这个效果。首先在网站SEO优化方面有一些内容和大家分享:首先,我觉得首页的标题和描述还是很重要的。对于编辑器中的每个 网站,我会认真考虑怎么写标题和描述,把标题写好。更有效的优化。147采集是一款优秀的御用采集工具。构建站群简单方便。因此,我们需要在标题中收录我们正在做的行业等关键词。包括标题和描述。所以目前这个网站可以轻松采集超过100,000。其次,关键词的密度也是需要考虑的问题。关键词出现在网站首页的频率,关键词的密度为2-8%,在关键词密度访问的合理范围内。SEO的关键词内链是提升关键词排名的重要途径之一。

先分享一些Empire 采集的经验。当然,网站收录是可以加的,不仅仅是小编提到的几点,SEO是一个多维度、长期的过程。网站SEO优化需要做的太多。这可能看起来深奥,但实际上非常简单。搜索引擎已经给出了相应的规则。我们只需要按照这些规则做SEO优化,网站自然会进入排名!

seo文章采集工具(算法的每次改进都会导致一些seo工具失效,怎么办)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-12-01 09:17

算法的每一次改进都会导致一些seo工具失效。在过去三年的seo中,人们发现,以前的seo软件随着时间的推移,已经慢慢淡出了人们的视野。很多朋友也是盲目搜索seo软件,靠炒作做排名。其实,过去seo软件只是起到了一定的辅助功能,并不能完全替代人工,使用时需要非常谨慎。只有当网站有一定程度的权重时,才能适当使用软件,才能有更好的效果;现在,软件优化可能毫无意义(百度一直在控制这种作弊方式,而且效果只是昙花一现),除非你能做出一个写出高质量原创文章的软件.

一、伪原创工具

伪原创该工具可以快速打乱一篇文章文章的顺序,达到了“原创”的效果,但是伪原创@产生的文章的质量> 令人担忧,内容基本无法让用户看清意思;2010年seo优化中,使用伪原创工具是一种很常见的优化方式,软件的种类数不胜数,除了网站文章除了伪原创之外,我们还使用< @伪原创 以节省在外部链发布中编辑 文章 的时间。

随着算法的改进,k掉了很多这样的“原创但质量不高”文章。许多 Seoer 从经验和教训中学习。本站手动更新,但是外链照常。伪原创,因为我们知道外链发到别人的网站,别人是不是k1是别人的事,我们只问对于外链发帖和伪原创0@>提升排名,这是一种很自私的想法和做法,其实是很不合理的seo优化方法,因为当别人网站被惩罚的时候,我们的伪原创7@ > 必然会产生一定的影响,但影响的大小不同。当别人的网站是k时,你自己的网站没有降级的迹象,不要高兴得太早,

随着搜索引擎的完善,搜索引擎不断对内容质量差的内容进行处罚,同时提醒站长内容质量是网站的本质,好的内容质量会带来好的排名;如果你现在和往常一样,伪原创 正在为互联网制造垃圾,那么恭喜你,你离惩罚的目标不远了。你要知道,SEO下链的发布是一个互利的过程,实现双赢的下链才是最有价值的。

二、数据伪原创1@>工具

数据伪原创1@>是创建内容最快的方式。一个新网站可以立即从“浪费”变为“充实”。以前,伪原创1@>的方式很流行,尤其是搞交通信息类的网站,因为网站需要大量的内容支持,使用人工发布,需要大量的人力和时间,用 "优采云"伪原创1@> 剩下很多进程;记得之前有朋友用过伪原创1@>工具伪原创1@>搜搜问、百度知道等平台文章,虽然伪原创0@>达到了百万,但很快就被K掉了。

随着搜索引擎对原创文章的要求越来越高,批量伪原创1@>的方式显得华而不实,昔日的“优采云”一去不复返了!

三、外链群发工具

内容和外链是Seoer最关心的话题,因为这两个曾经主导着排名趋势。外链群发工具也已经在seo界流行起来。记得比较流行的优利得博客群发工具、bug群发工具、博客精灵等等,10年也用博客群发工具优化了一批网站。一开始排名很强,但随着百度的大更新,网站是“没有完整皮肤的k的身体”。经过那段时间的教训,我意识到seo软件只能辅助人,不能代替人。现在,或许援助太过牵强。

外链群发工具在百度优化中被淘汰,但在外贸优化中还是比较常见的网站。大量的链接或许能够支撑一段时间的排名。当然,能在短期内带来效益的优化,百度和谷歌都可以尝试。

四、浏览交通工具

流量刷刷工具可以让网站的流量暴涨,但这只是虚的。听别人说刷流量对我的排名有好处,但是我试过了。它并没有我想象的那么神奇。也许seo软件就是这个。如果使用太多,事情就会失败。

五、 刷排名软件

以前有朋友扫描ALEXA排名,最近更新了关键词排名,不过百度还是可以应付这些不好的优化方式的。百度的网址改进可能会对排名起到防御作用,排名软件正在逐渐失去快速排名一次的效果。

六、滑动下拉框,相关搜索

扫一扫网站品牌名称的相关搜索,可以宣传你的网站品牌,引导一定的流量到你的网站。不过,百度官方明确指出,这是一种作弊形式。刷机肯定会有一定的影响,但是百度除了防止自己刷机之外,肯定还会防止一些恶意行为网站。

总结:软件可以节省很多精力,但软件在seo优化中永远不会比手动更好。除了以上工具,百度索引工具也是最近比较火的。其实这东西是为了增加自己的百度权重。价值和网站流量,但这不是真正的用户访问,只是为了安慰自己,或许在友情链接交流中能起到一点作用。 查看全部

seo文章采集工具(算法的每次改进都会导致一些seo工具失效,怎么办)

算法的每一次改进都会导致一些seo工具失效。在过去三年的seo中,人们发现,以前的seo软件随着时间的推移,已经慢慢淡出了人们的视野。很多朋友也是盲目搜索seo软件,靠炒作做排名。其实,过去seo软件只是起到了一定的辅助功能,并不能完全替代人工,使用时需要非常谨慎。只有当网站有一定程度的权重时,才能适当使用软件,才能有更好的效果;现在,软件优化可能毫无意义(百度一直在控制这种作弊方式,而且效果只是昙花一现),除非你能做出一个写出高质量原创文章的软件.

一、伪原创工具

伪原创该工具可以快速打乱一篇文章文章的顺序,达到了“原创”的效果,但是伪原创@产生的文章的质量> 令人担忧,内容基本无法让用户看清意思;2010年seo优化中,使用伪原创工具是一种很常见的优化方式,软件的种类数不胜数,除了网站文章除了伪原创之外,我们还使用< @伪原创 以节省在外部链发布中编辑 文章 的时间。

随着算法的改进,k掉了很多这样的“原创但质量不高”文章。许多 Seoer 从经验和教训中学习。本站手动更新,但是外链照常。伪原创,因为我们知道外链发到别人的网站,别人是不是k1是别人的事,我们只问对于外链发帖和伪原创0@>提升排名,这是一种很自私的想法和做法,其实是很不合理的seo优化方法,因为当别人网站被惩罚的时候,我们的伪原创7@ > 必然会产生一定的影响,但影响的大小不同。当别人的网站是k时,你自己的网站没有降级的迹象,不要高兴得太早,

随着搜索引擎的完善,搜索引擎不断对内容质量差的内容进行处罚,同时提醒站长内容质量是网站的本质,好的内容质量会带来好的排名;如果你现在和往常一样,伪原创 正在为互联网制造垃圾,那么恭喜你,你离惩罚的目标不远了。你要知道,SEO下链的发布是一个互利的过程,实现双赢的下链才是最有价值的。

二、数据伪原创1@>工具

数据伪原创1@>是创建内容最快的方式。一个新网站可以立即从“浪费”变为“充实”。以前,伪原创1@>的方式很流行,尤其是搞交通信息类的网站,因为网站需要大量的内容支持,使用人工发布,需要大量的人力和时间,用 "优采云"伪原创1@> 剩下很多进程;记得之前有朋友用过伪原创1@>工具伪原创1@>搜搜问、百度知道等平台文章,虽然伪原创0@>达到了百万,但很快就被K掉了。

随着搜索引擎对原创文章的要求越来越高,批量伪原创1@>的方式显得华而不实,昔日的“优采云”一去不复返了!

三、外链群发工具

内容和外链是Seoer最关心的话题,因为这两个曾经主导着排名趋势。外链群发工具也已经在seo界流行起来。记得比较流行的优利得博客群发工具、bug群发工具、博客精灵等等,10年也用博客群发工具优化了一批网站。一开始排名很强,但随着百度的大更新,网站是“没有完整皮肤的k的身体”。经过那段时间的教训,我意识到seo软件只能辅助人,不能代替人。现在,或许援助太过牵强。

外链群发工具在百度优化中被淘汰,但在外贸优化中还是比较常见的网站。大量的链接或许能够支撑一段时间的排名。当然,能在短期内带来效益的优化,百度和谷歌都可以尝试。

四、浏览交通工具

流量刷刷工具可以让网站的流量暴涨,但这只是虚的。听别人说刷流量对我的排名有好处,但是我试过了。它并没有我想象的那么神奇。也许seo软件就是这个。如果使用太多,事情就会失败。

五、 刷排名软件

以前有朋友扫描ALEXA排名,最近更新了关键词排名,不过百度还是可以应付这些不好的优化方式的。百度的网址改进可能会对排名起到防御作用,排名软件正在逐渐失去快速排名一次的效果。

六、滑动下拉框,相关搜索

扫一扫网站品牌名称的相关搜索,可以宣传你的网站品牌,引导一定的流量到你的网站。不过,百度官方明确指出,这是一种作弊形式。刷机肯定会有一定的影响,但是百度除了防止自己刷机之外,肯定还会防止一些恶意行为网站。

总结:软件可以节省很多精力,但软件在seo优化中永远不会比手动更好。除了以上工具,百度索引工具也是最近比较火的。其实这东西是为了增加自己的百度权重。价值和网站流量,但这不是真正的用户访问,只是为了安慰自己,或许在友情链接交流中能起到一点作用。

seo文章采集工具(SEO优化师每天最多只能照顾好20个站。。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-11-25 21:26

一直有很多用户担心一个问题,说他们每天有很多不同的cms站点(帝国、WP、DEDE、易游等)难以管理,而且每个cms后台不一样,每天都要登录查询。有些cms有插件比较好,但是插件只能对应一个站,不同站收费不同。采集 的东西很乱。, 手动修改要很多,有的cms还得用优采云采集,只是找采集的地址要花很长时间,几乎每次都加班夜晚。遇到一个新同事不明白,有同事采集后伪原创去当地一一贴出来,一直在网上找相关软件,想要一个可以批量管理的。与cms软件不同的是,市场上从未发现过这样的工具。定制软件成本太高,公司不同意。更多使用插件和手册。直到遇到了147SEO工具。

相信很多公司员工和个人站长也遇到过类似的问题,因为我们看不懂代码。自己写一套模板太费时间了。很多都是在网上找不同的模板,但是对应的都是不同的cms,而且每个站都在更新,所以你会遇到不同的cms,公司里每个人的习惯都不一样,有的喜欢用优采云,还有人喜欢用优采云等等,优采云要找到对应的cms发布者,帝国也要写一个release模块(通用的还好,个别的cms就是简单的找优采云用到底。伪原创之后也是有问题的,就像我们用同义词伪原创,市场使用优采云 同义词表收录太多,效果不太好。你必须每天一遍又一遍地更新规则,你必须检查。每个站需要大量文章来更新,我们普通的SEO优化器一天最多只能照顾20个站。

直到看到147SEO工具,批量监控采集+batch伪原创+批量多站发布cms!网站配置一次,挂一年不用担心伪原创和发布相关事宜!

147SEO各种cms批量发布工具功能:

伪原创工具:与优采云、优采云等采集软件无缝对接,支持本地批量伪原创+支持网站API接口

cms发布:支持Empire、易游、ZBLOG、织梦、WP、PB、Apple、搜外等各大cms,可同时管理和发布

对应栏目:不同的文章可以发布不同的栏目

定时发布:可以控制多少分钟发表一篇文章

监控数据:发布、待发布、是否伪原创、发布状态、URL、程序等。

功能齐全,简直就是我们这些人的救星。提高效率、降低成本、有用的东西,没有理由不分享!!!!!! 查看全部

seo文章采集工具(SEO优化师每天最多只能照顾好20个站。。)

一直有很多用户担心一个问题,说他们每天有很多不同的cms站点(帝国、WP、DEDE、易游等)难以管理,而且每个cms后台不一样,每天都要登录查询。有些cms有插件比较好,但是插件只能对应一个站,不同站收费不同。采集 的东西很乱。, 手动修改要很多,有的cms还得用优采云采集,只是找采集的地址要花很长时间,几乎每次都加班夜晚。遇到一个新同事不明白,有同事采集后伪原创去当地一一贴出来,一直在网上找相关软件,想要一个可以批量管理的。与cms软件不同的是,市场上从未发现过这样的工具。定制软件成本太高,公司不同意。更多使用插件和手册。直到遇到了147SEO工具。

相信很多公司员工和个人站长也遇到过类似的问题,因为我们看不懂代码。自己写一套模板太费时间了。很多都是在网上找不同的模板,但是对应的都是不同的cms,而且每个站都在更新,所以你会遇到不同的cms,公司里每个人的习惯都不一样,有的喜欢用优采云,还有人喜欢用优采云等等,优采云要找到对应的cms发布者,帝国也要写一个release模块(通用的还好,个别的cms就是简单的找优采云用到底。伪原创之后也是有问题的,就像我们用同义词伪原创,市场使用优采云 同义词表收录太多,效果不太好。你必须每天一遍又一遍地更新规则,你必须检查。每个站需要大量文章来更新,我们普通的SEO优化器一天最多只能照顾20个站。

直到看到147SEO工具,批量监控采集+batch伪原创+批量多站发布cms!网站配置一次,挂一年不用担心伪原创和发布相关事宜!

147SEO各种cms批量发布工具功能:

伪原创工具:与优采云、优采云等采集软件无缝对接,支持本地批量伪原创+支持网站API接口

cms发布:支持Empire、易游、ZBLOG、织梦、WP、PB、Apple、搜外等各大cms,可同时管理和发布

对应栏目:不同的文章可以发布不同的栏目

定时发布:可以控制多少分钟发表一篇文章

监控数据:发布、待发布、是否伪原创、发布状态、URL、程序等。

功能齐全,简直就是我们这些人的救星。提高效率、降低成本、有用的东西,没有理由不分享!!!!!!

seo文章采集工具(本渣渣就是第二次360搜索相关关键词关键源码可参考学习)

采集交流 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-11-23 23:19

搜索引擎相关搜索词应该是很多seoer正在寻找和选择使用的关键词扩展类别,除了流行的百度相关搜索词采集,当然还有360搜索搜索引擎和搜狗搜索引擎,当然知道方法之后,python的实现基本一致,唯一需要关心的就是单词本身和反爬的限制!

不,这已经是这个人渣第二次在360搜翻车了。请注意,这是第二次。处女座第一次在采集360搜索问答中翻车。这很棒。伤疤忘记疼了,太长了!!

360搜索大力出奇迹,不,大力出验证码。.

这里的渣实现了,相关关键词的获取是有规律的,参考了很多源码。采用常规规则更方便快捷!

360搜索相关关键词关键源码

re.findall(r'(.+?)', html, re.S | re.I)

搜狗搜索相关关键词关键源码

re.findall(r'<p>(.+?)', html, re.S | re.I)

</p>

大家可以自己参考学习,毕竟没什么好说的!

附上360搜索相关关键词采集的源码供大家参考学习!PS:我没有写代码。顽固的学习被废除。怎么写?!

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

360相关搜索词挖掘脚本(多线程版)

基于python3.8

需要安装requests模块

@author:微信/huguo00289

"""

import re

from queue import Queue

from threading import Thread

import requests,random

class Qh360Spider(Thread):

result = {} # 保存结果字典

seen = set() # 表示在队列中的关键词(已抓取或待抓取)

def __init__(self, kw_queue, loop, failed):

super(Qh360Spider, self).__init__()

self.kw_queue = kw_queue # 关键词队列

self.loop = loop # 循环挖词拓展次数

self.failed = failed # 保存查询失败的关键词文件

self.ua_list = [

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36Chrome 17.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0Firefox 4.0.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1',

'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11',

]

def run(self): # 程序的执行流程

while True:

# 从队列里面获取一个关键词及其对应的当前拓展次数

kw, cloop = self.kw_queue.get()

print('CurLoop:{} Checking: {}'.format(cloop, kw))

query = 'https://www.so.com/s?q={}'.format(kw) # 构建含关键词的url

try:

source = self.download(query, timeout=10)

# source = self.download(query,timeout=10,user_agent=self.ua)

if source:

kw_list = self.extract(source)

print(kw_list)

self.filter(cloop, kw_list)

else:

# 获取源码失败,保存查询失败的关键词

self.failed.write('{}\n'.format(kw))

finally:

self.kw_queue.task_done()

def download(self, url, timeout=5, proxy=None, num_retries=5):

"""

通用网页源码下载函数

:param url: 要下载的url

:param timeout: 请求超时时间,单位/秒。可能某些网站的反应速度很慢,所以需要一个连接超时变量来处理。

:param user_agent: 用户代理信息,可以自定义是爬虫还是模拟用户

:param proxy: ip代理(http代理),访问某些国外网站的时候需要用到。必须是双元素元组或列表(‘ip:端口’,‘http/https’)

:param num_retries: 失败重试次数

:return: HTML网页源码

"""

headers = {

"Cookie": "QiHooGUID=41F80B0CCE5D43A22EEF0305A12CDE3F.1596003342506; __guid=15484592.2994995584481314300.1596003341831.5723; soid=TjzBKt3zrO-Rh1S7fXSb0S!6kmX5TlEerB2URZz9v4; __md=667cb161f9515972323507763d8fa7dd643a65bd2e88034.9; dpr=1; isafe=1; webp=1; _uc_m2=886a48052dbb9e2291f80055746e0d4f1f110f922b2f; _uc_mid=7cb161f953d8fa7dd643a65bd2e88034; __huid=11xZqhEl%2FfVeqclI4j%2BdQeQvX63Oph%2F%2BCVM5vxqYGxQI4%3D; Q=u%3Duhthb002%26n%3D%26le%3DAwH0ZGV5ZGR3WGDjpKRhL29g%26m%3DZGH5WGWOWGWOWGWOWGWOWGWOZGL0%26qid%3D144048053%26im%3D1_t018c25fbb66797efb2%26src%3D360chrome%26t%3D1; T=s%3D2afa764886f737dd5d23421c30f87a1f%26t%3D1595934758%26lm%3D0-1%26lf%3D2%26sk%3De485bbde46ac34fc27fc40215de76c44%26mt%3D1595934758%26rc%3D1%26v%3D2.0%26a%3D1; _S=tg75a7e3fmv0mfdfkt8jlpfpj6; stc_ls_sohome=RRzRSR!RTR(RUR_RVR; gtHuid=1; homeopenad=1; _pp_wd=1; _ga=GA1.2.607533084.1598082638; _gid=GA1.2.1887117715.1598082638; count=6; erules=p1-9%7Cp2-11%7Cp4-3%7Cecl-2%7Ckd-1%7Cp3-2",

'User-Agent': random.choice(self.ua_list)

}

try:

# 打开网页并读取内容存入html变量中

resp = requests.get(url, headers=headers, proxies=proxy, timeout=timeout)

print(resp.status_code)

except requests.RequestException as err:

print('Download error:', err)

html = None # 如果有异常,那么html肯定是没获取到的,所以赋值None

if num_retries > 0:

return self.download(url, timeout, proxy, num_retries - 1)

else:

html = resp.content.decode('utf-8')

#print(html)

return html

@staticmethod

def extract(html):

'''

提取关键词

:param html:搜索结果源码

:return:提取出来的相关关键词列表

'''

return re.findall(r'(.+?)', html, re.S | re.I)

def filter(self, current_loop, kwlist):

'''

关键词过滤和统计函数

:param current_loop: 当前拓展的次数

:param kwlist: 提取出来的关键词列表

:return: None

'''

for kw in kwlist:

# 判断关键词是不是已经被抓取或者已经存在关键词队列

# 判断当前的拓展次数是否已经超过指定值

if current_loop < self.loop and kw not in self.seen:

# 同时满足关键词的拓展次数小于目标次数,而且关键词不在seen里面时才把kw放到待抓取队列内

self.kw_queue.put((kw, current_loop+1))

Qh360Spider.seen.add(kw)

# 将关键词放到结果字典内,并统计出现次数

if kw in self.result:

Qh360Spider.result[kw] += 1

else:

Qh360Spider.result[kw] = 1

if __name__ == '__main__':

# 创建关键词队列实例

k_queue = Queue()

# 将待抓取关键词放入队列已经类的seen属性中

with open('keywords.txt', encoding="GBK") as kwfile:

for key in kwfile:

key = key.strip()

k_queue.put((key, 1))

Qh360Spider.seen.add(key)

# 创建查询失败保存文件

check_failed = open('faileds.txt', 'w')

# 创建线程

for i in range(15):

bds = Qh360Spider(k_queue, 3, check_failed)

bds.setDaemon(True)

bds.start()

# 阻塞关键词队列,直到完成

k_queue.join()

# 关闭查询失败的文件

check_failed.close()

# 对结果进行排序及写入文件

sort_list = sorted(Qh360Spider.result.items(), key=lambda x: x[1], reverse=True)

with open('ah360key.txt', 'w', encoding='utf8') as save:

for item in sort_list:

# 关键词+次数的文件输出方式

line = '%s\n' % (item[0])

if len(line) > 0:

print("有东西")

print('111')

save.write(line)

save.flush() # 刷新缓存,避免中途出错

save.close()

print('done,完成挖掘')

如果没有ip代理,调和起来超级容易。毕竟,你会大力获取验证码。试了一下,速度还是可以的,就是太容易被360搜索和反爬了。要想正常稳定运行,不知道访问代理的ip状态。怎么样,必须同时有cookies库! 查看全部

seo文章采集工具(本渣渣就是第二次360搜索相关关键词关键源码可参考学习)

搜索引擎相关搜索词应该是很多seoer正在寻找和选择使用的关键词扩展类别,除了流行的百度相关搜索词采集,当然还有360搜索搜索引擎和搜狗搜索引擎,当然知道方法之后,python的实现基本一致,唯一需要关心的就是单词本身和反爬的限制!

不,这已经是这个人渣第二次在360搜翻车了。请注意,这是第二次。处女座第一次在采集360搜索问答中翻车。这很棒。伤疤忘记疼了,太长了!!

360搜索大力出奇迹,不,大力出验证码。.

这里的渣实现了,相关关键词的获取是有规律的,参考了很多源码。采用常规规则更方便快捷!

360搜索相关关键词关键源码

re.findall(r'(.+?)', html, re.S | re.I)

搜狗搜索相关关键词关键源码

re.findall(r'<p>(.+?)', html, re.S | re.I)

</p>

大家可以自己参考学习,毕竟没什么好说的!

附上360搜索相关关键词采集的源码供大家参考学习!PS:我没有写代码。顽固的学习被废除。怎么写?!

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

360相关搜索词挖掘脚本(多线程版)

基于python3.8

需要安装requests模块

@author:微信/huguo00289

"""

import re

from queue import Queue

from threading import Thread

import requests,random

class Qh360Spider(Thread):

result = {} # 保存结果字典

seen = set() # 表示在队列中的关键词(已抓取或待抓取)

def __init__(self, kw_queue, loop, failed):

super(Qh360Spider, self).__init__()

self.kw_queue = kw_queue # 关键词队列

self.loop = loop # 循环挖词拓展次数

self.failed = failed # 保存查询失败的关键词文件

self.ua_list = [

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36Chrome 17.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0Firefox 4.0.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1',

'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11',

]

def run(self): # 程序的执行流程

while True:

# 从队列里面获取一个关键词及其对应的当前拓展次数

kw, cloop = self.kw_queue.get()

print('CurLoop:{} Checking: {}'.format(cloop, kw))

query = 'https://www.so.com/s?q={}'.format(kw) # 构建含关键词的url

try:

source = self.download(query, timeout=10)

# source = self.download(query,timeout=10,user_agent=self.ua)

if source:

kw_list = self.extract(source)

print(kw_list)

self.filter(cloop, kw_list)

else:

# 获取源码失败,保存查询失败的关键词

self.failed.write('{}\n'.format(kw))

finally:

self.kw_queue.task_done()

def download(self, url, timeout=5, proxy=None, num_retries=5):

"""

通用网页源码下载函数

:param url: 要下载的url

:param timeout: 请求超时时间,单位/秒。可能某些网站的反应速度很慢,所以需要一个连接超时变量来处理。

:param user_agent: 用户代理信息,可以自定义是爬虫还是模拟用户

:param proxy: ip代理(http代理),访问某些国外网站的时候需要用到。必须是双元素元组或列表(‘ip:端口’,‘http/https’)

:param num_retries: 失败重试次数

:return: HTML网页源码

"""

headers = {

"Cookie": "QiHooGUID=41F80B0CCE5D43A22EEF0305A12CDE3F.1596003342506; __guid=15484592.2994995584481314300.1596003341831.5723; soid=TjzBKt3zrO-Rh1S7fXSb0S!6kmX5TlEerB2URZz9v4; __md=667cb161f9515972323507763d8fa7dd643a65bd2e88034.9; dpr=1; isafe=1; webp=1; _uc_m2=886a48052dbb9e2291f80055746e0d4f1f110f922b2f; _uc_mid=7cb161f953d8fa7dd643a65bd2e88034; __huid=11xZqhEl%2FfVeqclI4j%2BdQeQvX63Oph%2F%2BCVM5vxqYGxQI4%3D; Q=u%3Duhthb002%26n%3D%26le%3DAwH0ZGV5ZGR3WGDjpKRhL29g%26m%3DZGH5WGWOWGWOWGWOWGWOWGWOZGL0%26qid%3D144048053%26im%3D1_t018c25fbb66797efb2%26src%3D360chrome%26t%3D1; T=s%3D2afa764886f737dd5d23421c30f87a1f%26t%3D1595934758%26lm%3D0-1%26lf%3D2%26sk%3De485bbde46ac34fc27fc40215de76c44%26mt%3D1595934758%26rc%3D1%26v%3D2.0%26a%3D1; _S=tg75a7e3fmv0mfdfkt8jlpfpj6; stc_ls_sohome=RRzRSR!RTR(RUR_RVR; gtHuid=1; homeopenad=1; _pp_wd=1; _ga=GA1.2.607533084.1598082638; _gid=GA1.2.1887117715.1598082638; count=6; erules=p1-9%7Cp2-11%7Cp4-3%7Cecl-2%7Ckd-1%7Cp3-2",

'User-Agent': random.choice(self.ua_list)

}

try:

# 打开网页并读取内容存入html变量中

resp = requests.get(url, headers=headers, proxies=proxy, timeout=timeout)

print(resp.status_code)

except requests.RequestException as err:

print('Download error:', err)

html = None # 如果有异常,那么html肯定是没获取到的,所以赋值None

if num_retries > 0:

return self.download(url, timeout, proxy, num_retries - 1)

else:

html = resp.content.decode('utf-8')

#print(html)

return html

@staticmethod

def extract(html):

'''

提取关键词

:param html:搜索结果源码

:return:提取出来的相关关键词列表

'''

return re.findall(r'(.+?)', html, re.S | re.I)

def filter(self, current_loop, kwlist):

'''

关键词过滤和统计函数

:param current_loop: 当前拓展的次数

:param kwlist: 提取出来的关键词列表

:return: None

'''

for kw in kwlist:

# 判断关键词是不是已经被抓取或者已经存在关键词队列

# 判断当前的拓展次数是否已经超过指定值

if current_loop < self.loop and kw not in self.seen:

# 同时满足关键词的拓展次数小于目标次数,而且关键词不在seen里面时才把kw放到待抓取队列内

self.kw_queue.put((kw, current_loop+1))

Qh360Spider.seen.add(kw)

# 将关键词放到结果字典内,并统计出现次数

if kw in self.result:

Qh360Spider.result[kw] += 1

else:

Qh360Spider.result[kw] = 1

if __name__ == '__main__':

# 创建关键词队列实例

k_queue = Queue()

# 将待抓取关键词放入队列已经类的seen属性中

with open('keywords.txt', encoding="GBK") as kwfile:

for key in kwfile:

key = key.strip()

k_queue.put((key, 1))

Qh360Spider.seen.add(key)

# 创建查询失败保存文件

check_failed = open('faileds.txt', 'w')

# 创建线程

for i in range(15):

bds = Qh360Spider(k_queue, 3, check_failed)

bds.setDaemon(True)

bds.start()

# 阻塞关键词队列,直到完成

k_queue.join()

# 关闭查询失败的文件

check_failed.close()

# 对结果进行排序及写入文件

sort_list = sorted(Qh360Spider.result.items(), key=lambda x: x[1], reverse=True)

with open('ah360key.txt', 'w', encoding='utf8') as save:

for item in sort_list:

# 关键词+次数的文件输出方式

line = '%s\n' % (item[0])

if len(line) > 0:

print("有东西")

print('111')

save.write(line)

save.flush() # 刷新缓存,避免中途出错

save.close()

print('done,完成挖掘')

如果没有ip代理,调和起来超级容易。毕竟,你会大力获取验证码。试了一下,速度还是可以的,就是太容易被360搜索和反爬了。要想正常稳定运行,不知道访问代理的ip状态。怎么样,必须同时有cookies库!

seo文章采集工具(六种实用的SEO工具,可以大大方便各个站长来优化)

采集交流 • 优采云 发表了文章 • 0 个评论 • 421 次浏览 • 2021-11-17 16:16

今天给大家介绍六款好用的SEO工具,可以大大方便各路站长优化网站,废话不多说,直接上正题

爱站工具包

做网站工具必不可少,收录的功能也很全面

爱站工具包

可用于挖掘精度关键词

制作网站地图,这个功能很方便,可以直接导出

还可用于分析日志和查看蜘蛛爬行类型

5118、爱站、站长工具

可以看到网站权重,收录排名变化

关键词排名情况

体重情况

方便站长记录网站的动向,做更有针对性的优化

橙色搜索引擎优化

可用于检查域名状态的工具

域名历史建站记录、外链数量、当前评级等

域名情况

您可以在买卖网站时进行咨询,对网站有更深入的了解

网站采集工具

一般用于交通站。当然,企业站可以尽量使用原创,因为文章的数量很少。

采集界面

优采云采集器,运行稳定,效率高采集,需要写采集流程,需要系统学习掌握

优采云采集器、采集操作比较简单、稳定、高效

优采云采集器,可视化操作,更适合新手小白使用

伪原创工具

大家都知道伪原创是一种常用的写文章的方法,比如换句、换同义词等

伪原创界面

5118伪原创工具,每天都需要文章如果数量比较多,建议充值会员,总体文章质量还不错

写猫,替换大量同义词,调整词序等,可读性比较强,每天可以免费处理2w字内容

之前有人把文章放到百度上翻译成英文再翻译回中文,但是翻译回来后,整体文章的内容质量很低,帮助< @收录 不明显

云锁工具

主要目的是保证网站的安全,避免网站被黑或篡改部分内容

云锁功能

市面上的云锁种类很多,可以根据自己的预算选择

个人站长可以直接使用免费的 查看全部

seo文章采集工具(六种实用的SEO工具,可以大大方便各个站长来优化)

今天给大家介绍六款好用的SEO工具,可以大大方便各路站长优化网站,废话不多说,直接上正题

爱站工具包

做网站工具必不可少,收录的功能也很全面

爱站工具包

可用于挖掘精度关键词

制作网站地图,这个功能很方便,可以直接导出

还可用于分析日志和查看蜘蛛爬行类型

5118、爱站、站长工具

可以看到网站权重,收录排名变化

关键词排名情况

体重情况

方便站长记录网站的动向,做更有针对性的优化

橙色搜索引擎优化

可用于检查域名状态的工具

域名历史建站记录、外链数量、当前评级等

域名情况

您可以在买卖网站时进行咨询,对网站有更深入的了解

网站采集工具

一般用于交通站。当然,企业站可以尽量使用原创,因为文章的数量很少。

采集界面

优采云采集器,运行稳定,效率高采集,需要写采集流程,需要系统学习掌握

优采云采集器、采集操作比较简单、稳定、高效

优采云采集器,可视化操作,更适合新手小白使用

伪原创工具

大家都知道伪原创是一种常用的写文章的方法,比如换句、换同义词等

伪原创界面

5118伪原创工具,每天都需要文章如果数量比较多,建议充值会员,总体文章质量还不错

写猫,替换大量同义词,调整词序等,可读性比较强,每天可以免费处理2w字内容

之前有人把文章放到百度上翻译成英文再翻译回中文,但是翻译回来后,整体文章的内容质量很低,帮助< @收录 不明显

云锁工具

主要目的是保证网站的安全,避免网站被黑或篡改部分内容

云锁功能

市面上的云锁种类很多,可以根据自己的预算选择

个人站长可以直接使用免费的

seo文章采集工具(现如今做SEO最难的不是技术,而是网站内容谱)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-11-13 10:02

现在做SEO最难的不是技术,而是内容。拥有高质量的 文章 对 SEO 排名有很大帮助。很多人认为原创文章就是高质量文章,于是就有了很多文章原创度检测工具,还有一些采集软件脱离上下文组合不同的 文章 段落。这种操作方式确实对网站SEO没有帮助,完全不靠谱。

曾经在公司发过外链的同事说,使用原创度检测工具的文章收录情况并不好。一开始以为外链发布平台不行,后来自己做了。用了几次,测试的文章确实是收录不理想,排名也没有上升。经过研究,发现文章原创度工具检测的原理并不可靠。,以及原创文章被别人盗用的风险,大致如下:

首先:文章原创度检测工具只能检测前十几个字。

目前我用的文章检测工具只能检测文章的前十几个汉字。即便如此,检测速度还是很慢。比如我们的文章有800个汉字,检测工具只能检测50个汉字。那么我们需要把这个文章分成16个段分别进行测试。如果文章字数多,那我们就需要分成更多的段落,这个工作原理简直太不科学了,因为:

1、操作太麻烦

如果将文章分成多个小段单独测试,不用于记忆和比较,过程繁琐,操作时间长。如果采集在一个段中测试,那么平均写文章可能比自己写一篇文章要花更长的时间。随着时间的推移,您可能会对 SEO 工作感到厌烦,并且您将失去的比获得的更多。

2、检测速度慢

无论是逐段测试还是整个文章测试,这些文章测试工具的响应速度都无法超过百度。把文章放到百度上搜索一下,基本上是秒出结果。百度拥有强大的数据计算能力,这些检测工具的检测结果也是来自百度,所以你可以直接在百度搜索要检测的内容。

二、原创文章 可以由相似度检测工具本身使用采集。

我写的这么辛苦的原创文章,被他们采集用检测工具检测后,第一个发表在其他网站,但真正的作者成了伪原创,这是多么令人恼火的事情。当然,以上只是个别网站的行为,完全有可能发生某些网站被黑客利用的情况。因此,仅仅为了检测文章的相似性而冒这个风险是完全没有价值的。我们之前测试过的文章收录并不好,可能是我们太相信这个工具了。

建议您在写文章时用自己的语言表达您想表达的信息,突出主题,有效解决读者的实际需求,让用户理解文章中的内容一目了然,不谈。这样,相同的文章内容一般不会出现在互联网上,不仅提升了用户体验,也有助于蜘蛛爬取和收录。

最后,不能依赖检测工具,因为原创文章不代表高质量文章。

<p>我们之所以追求原创文章,是为了默认像原创这样的高质量。在搜索引擎超级智能的今天,如果我们用检测工具发布垃圾原创文章,不如直接采集。以前网上有一些同义词替换,标点替换和空格,文章内容顺序交换的方法写的文章,检测工具上的结果是 查看全部

seo文章采集工具(现如今做SEO最难的不是技术,而是网站内容谱)

现在做SEO最难的不是技术,而是内容。拥有高质量的 文章 对 SEO 排名有很大帮助。很多人认为原创文章就是高质量文章,于是就有了很多文章原创度检测工具,还有一些采集软件脱离上下文组合不同的 文章 段落。这种操作方式确实对网站SEO没有帮助,完全不靠谱。

曾经在公司发过外链的同事说,使用原创度检测工具的文章收录情况并不好。一开始以为外链发布平台不行,后来自己做了。用了几次,测试的文章确实是收录不理想,排名也没有上升。经过研究,发现文章原创度工具检测的原理并不可靠。,以及原创文章被别人盗用的风险,大致如下:

首先:文章原创度检测工具只能检测前十几个字。

目前我用的文章检测工具只能检测文章的前十几个汉字。即便如此,检测速度还是很慢。比如我们的文章有800个汉字,检测工具只能检测50个汉字。那么我们需要把这个文章分成16个段分别进行测试。如果文章字数多,那我们就需要分成更多的段落,这个工作原理简直太不科学了,因为:

1、操作太麻烦

如果将文章分成多个小段单独测试,不用于记忆和比较,过程繁琐,操作时间长。如果采集在一个段中测试,那么平均写文章可能比自己写一篇文章要花更长的时间。随着时间的推移,您可能会对 SEO 工作感到厌烦,并且您将失去的比获得的更多。

2、检测速度慢

无论是逐段测试还是整个文章测试,这些文章测试工具的响应速度都无法超过百度。把文章放到百度上搜索一下,基本上是秒出结果。百度拥有强大的数据计算能力,这些检测工具的检测结果也是来自百度,所以你可以直接在百度搜索要检测的内容。

二、原创文章 可以由相似度检测工具本身使用采集。

我写的这么辛苦的原创文章,被他们采集用检测工具检测后,第一个发表在其他网站,但真正的作者成了伪原创,这是多么令人恼火的事情。当然,以上只是个别网站的行为,完全有可能发生某些网站被黑客利用的情况。因此,仅仅为了检测文章的相似性而冒这个风险是完全没有价值的。我们之前测试过的文章收录并不好,可能是我们太相信这个工具了。

建议您在写文章时用自己的语言表达您想表达的信息,突出主题,有效解决读者的实际需求,让用户理解文章中的内容一目了然,不谈。这样,相同的文章内容一般不会出现在互联网上,不仅提升了用户体验,也有助于蜘蛛爬取和收录。

最后,不能依赖检测工具,因为原创文章不代表高质量文章。

<p>我们之所以追求原创文章,是为了默认像原创这样的高质量。在搜索引擎超级智能的今天,如果我们用检测工具发布垃圾原创文章,不如直接采集。以前网上有一些同义词替换,标点替换和空格,文章内容顺序交换的方法写的文章,检测工具上的结果是

seo文章采集工具(如何使用好采集垃圾网站一种的感觉呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-11-06 08:23

相信很多朋友都用过采集网站项目,有的是手动复制的,有的是使用采集软件和插件来快速获取内容的。即使搜索引擎引入了各种算法来处理采集junk网站,也有人做得更好。当然,这些肯定没有我们想象的那么简单。不仅仅是我们需要搭建网站,然后手动复制,软件采集,或者伪原创等等,包括我们看到群里很多网友都做得很好. 网站 已经卖了几万的出价,很是羡慕。

一、网站如何进行采集内容

采集,有人喜欢,有人避而远之!说爱它,因为它真的可以帮助我们节省更多的时间和精力,让我们有更多的时间去推广它。网站; 说要避免,因为搜索引擎不喜欢采集和网站的数据,有些站长提到采集不会摇头。那么,如何用好采集,既节省时间又给搜索引擎耳目一新的感觉呢?

1、采集器的选择

目前大部分cms(PHPcms、Empire、织梦、心云等)都有采集的功能,如果你用得好,也是一个省钱的好方法;但是这些内置的采集功能,个人觉得鸡肋,虽然能用,但功能不强大。如果资金允许,建议购买专业的采集器。

2、了解采集器的特点

俗话说,磨刀不误砍柴。只有当你了解了采集器的所有功能并且能够熟练的使用它时,你才能谈论采集。

3、选择源网站

这个没什么好说的,如果你想挂在树上,就为所欲为。. . 最好选择多个网站,每个网站的内容为原创。记住,不要收录每个网站 采集 的内容过来,最好是每个采集 部分的数据。

4、数据采集

(1), 采集 规则编写

根据预先采集的采集对象,分别为每个网站编写采集规则。请记住,采集 数据应包括以下项目:标题、来源、作者、内容,不要选择其他内容,例如关键字、摘要和时间。

(2),阐明采集的原理和流程

所有 采集器 基本上都按照以下步骤工作:

一种。根据采集规则采集数据,并将数据保存在临时数据库中,功能更强大的采集器也会附上相应的附件(如图片、文件、软件等)。 ) 保存在预先指定的文件中,这些数据和文件有的保存在本地计算机中,有的保存在服务器中;

湾 按照指定的接口发布已经采集的数据,即将临时数据库中的数据发布到网站的数据库中;

(3), 编辑数据

当数据采集到达临时数据库时,很多人因为麻烦直接进入数据库发布数据。这种方式相当于复制粘贴,没有意义。如果您这样做,搜索引擎可能不会惩罚您。小的。因此,当数据采集在临时数据库中时,无论多麻烦,都必须对数据进行编辑,具体有以下几个方面:

一种。修改标题(必填)

湾 添加关键词(手动获取,但部分采集器可以自动获取)

C。写描述或摘要,最好手动

d. 适当修改文章的头部和底部信息

5、发布数据

这一步没什么好说的,就是将编辑好的数据发布到网站。

最后,有的朋友可能会问哪个采集器合适,因为时间关系,也因为不想被人误认为我是马甲。这辈子最难过的事,就是你深深地坠入爱河。一个陌生人突然偷偷告诉你他曾经很喜欢你的人。,这里就不多说了。如果你采集做过,你心中应该有一个最喜欢的。一会儿给大家一个分析表,对目前主流的采集器做一个全面的对比,方便大家轻松辨别选择。

其实我们看到的网站采集项目很简单吧?

如果单纯的模仿、抄袭,甚至是软件采集,你是不是发现效果并不明显,甚至根本不会是收录。问题是什么?前段时间还找了几个专攻采集网站的朋友,聊的不错。事实上,我们表面上似乎做得很好,平时没什么可做的,吹牛而已。聊天,但实际上,人们也付出了很多。

在这个文章中,我将简要介绍一下采集网站项目的正确流程。我可以告诉你的是,它实际上没有那么简单,如果它那么简单。我们都跟风吗?我们的效率和建站速度肯定会超过大多数用户,为什么不去做呢?这说明还是有一定的门槛的。

二、优质内容

如果是优质内容,我绝对不会去采集内容。这里的优质内容,不允许我们自己写文章的每一篇文章原创。就是我们在选择内容的时候要垂直,如果我们在选择内容的时候选择流量词。比如我以前有朋友采集tribe网站技术含量。事实上,技术内容的用户基数很小,词库中根本无法生成词,所以流量基本很小。

如果我们选择影视、游戏等内容,一旦出现收录这个词,就很容易带来流量。因为以后我们做网站无论是卖还是贴自己的广告,都需要获得流量,有流量的话,卖的单价比较高。当然,买家还需要在站长工具中查看您的网站数据信息。如果选择没有字号的内容,基本上是很难卖的。

而我们在做内容的时候,不管是你原创,采集,抄袭还是别的什么,都必须进行二次加工。直接复制是很难成功的。毕竟你的网站质量肯定不如原版内容。

三、 推广权重

任何网站我们做了之后肯定不会自然带来重量和流量,还需要推广。根据网友反馈,即使是采集网站,他们也开始更新内容和推广,和普通的网站一样,只有达到一定的权重值和效果将大量更新和推广。采集。如果开始很多采集,可能会直接被罚网站还没开始。

同时,在我们后续的网站操作中,有网友告诉他们,他们每个月要花几十万元购买资源,比如连接和软文来增加软文的权重。 @网站。我们看到了吗,或者我们为什么不做?其实不是这样的。

四、时期效果

我们很多人都认为采集网站很容易做到,是的,很容易做到,但需要一定的时间才能见效。比如前几天我们看到几个网站效果很好,也是采集或者集成内容。然而,它们需要半年到一年的时间才能生效。所以我们在准备做采集网站项目的时候,也需要考虑时间段,不可能几个月就见效。

就算能用几个月,当你卖网站的时候,买家会分析你的网站是否被骗了,如果是,你的价格不会高或者对方是不需要的. 当然,如果我们通过上述一系列流程来操作,几个月后是不会见效的。我们不应该有任何猜测。

网站如何进行SEO采集,正确的网站采集项目操作流程

五、加权域名

我们网站的朋友应该知道,如果我们注册一个新的域名,至少要等3到6个月才有一定的权重。你一开始更新的任何内容,除非你的内容绝对有价值,否则需要这么长时间才能被搜索引擎认可。这就是所谓的累积重量,甚至有的网站需要好几年才能达到一定的重量。

在这里我们可以看到,做采集网站的站长很多,而且都是购买优质的加权域名。有的直接买别人的网站,有的买旧域名,预注册一些已经过期的域名。我写了几篇关于抢注旧域名的文章,专门针对这些朋友的需求。事实上,他们想购买一些旧域名,以减少域名评估期。

最近几个月,我们会发现很多网友都在运营采集网站,流量上升的非常快。甚至还有一些个人博客和个人网站,一年前都没有更新。通过 采集 获得更大的流量。包括我们在一些网络营销培训团队中也有类似的培训项目。其实采集一直都有,只是最近几个月百度好像出现了算法问题,赋予了采集网站更大的权重效果。

最重要的是域名。如果是老域名,效果会更好。前段时间很多网友都在讨论买旧域名。当时也有两篇关于自己买旧域名的文章文章。如果有网友的需求,我们也可以参考。

过去我们在哪里寻找旧域名购买?大部分网友可能从国内一些域名交易平台、论坛、网友看到,相对域名价格比较高,平均几百元。这些老域名,大多也是通过大多数网友不知道的域名渠道抢注获得,然后赚取差价。

因此,如果我们需要寻找旧域名,我们可以直接从旧域名等平台购买,包括我们其他的域名抢注平台。只是我之前用过这两个平台,成功率很高,有的甚至可以直接购买。购买旧域名需要注意哪些问题?

1、检查域名是否被屏蔽

由于不确定性,我们可以在购买该域名之前使用PING测试工具查看这些域名是否被DNS拦截或污染。如果我们看到一个被阻止或被污染的域名,如果你重新注册它就没有用了。包括我们以后新注册的域名也需要检查。很有可能我们购买的域名之前已经被用户使用过,因为被屏蔽而被丢弃了。

2、查看域名详情

查找旧域名的目的是什么?有的是因为要让用户看到网站开得更早,有的是外贸网站需要更早的时间,包括一些有一定权重的域名,比new更有效域名。我们可以先看看它是否满足我们的需求再购买。

3、域名交易安全

对于我们在平台上购买的旧域名,付款后不会立即收到,需要一定的时间才能到账到我们的账户使用。如果原持有人以高价赎回,我们支付的费用也将退还。如果我们通过其他中介平台交易旧域名,一定要注意不要私下交易。即使是最优秀的网民,如果他们不觉得自己像个骗子,也不会可信。

每个用户找旧域名的渠道可能不同,目的也不同。不能说老域名一定有预期的效果,我们要根据实际需要来选择。

最后我要说的是,当我们采集网站时,我们也需要注意版权问题。部分网站声明内容版权。你不能去采集 或复制它。目前我们的版权意识也在加强,很多站长都收到了律师的来信。 查看全部

seo文章采集工具(如何使用好采集垃圾网站一种的感觉呢?)

相信很多朋友都用过采集网站项目,有的是手动复制的,有的是使用采集软件和插件来快速获取内容的。即使搜索引擎引入了各种算法来处理采集junk网站,也有人做得更好。当然,这些肯定没有我们想象的那么简单。不仅仅是我们需要搭建网站,然后手动复制,软件采集,或者伪原创等等,包括我们看到群里很多网友都做得很好. 网站 已经卖了几万的出价,很是羡慕。

https://www.yanxinet.com/wp-co ... 5.png 300w" />

https://www.yanxinet.com/wp-co ... 5.png 300w" />一、网站如何进行采集内容

采集,有人喜欢,有人避而远之!说爱它,因为它真的可以帮助我们节省更多的时间和精力,让我们有更多的时间去推广它。网站; 说要避免,因为搜索引擎不喜欢采集和网站的数据,有些站长提到采集不会摇头。那么,如何用好采集,既节省时间又给搜索引擎耳目一新的感觉呢?

1、采集器的选择

目前大部分cms(PHPcms、Empire、织梦、心云等)都有采集的功能,如果你用得好,也是一个省钱的好方法;但是这些内置的采集功能,个人觉得鸡肋,虽然能用,但功能不强大。如果资金允许,建议购买专业的采集器。

2、了解采集器的特点

俗话说,磨刀不误砍柴。只有当你了解了采集器的所有功能并且能够熟练的使用它时,你才能谈论采集。

3、选择源网站

这个没什么好说的,如果你想挂在树上,就为所欲为。. . 最好选择多个网站,每个网站的内容为原创。记住,不要收录每个网站 采集 的内容过来,最好是每个采集 部分的数据。

4、数据采集

(1), 采集 规则编写

根据预先采集的采集对象,分别为每个网站编写采集规则。请记住,采集 数据应包括以下项目:标题、来源、作者、内容,不要选择其他内容,例如关键字、摘要和时间。

(2),阐明采集的原理和流程

所有 采集器 基本上都按照以下步骤工作:

一种。根据采集规则采集数据,并将数据保存在临时数据库中,功能更强大的采集器也会附上相应的附件(如图片、文件、软件等)。 ) 保存在预先指定的文件中,这些数据和文件有的保存在本地计算机中,有的保存在服务器中;

湾 按照指定的接口发布已经采集的数据,即将临时数据库中的数据发布到网站的数据库中;

(3), 编辑数据

当数据采集到达临时数据库时,很多人因为麻烦直接进入数据库发布数据。这种方式相当于复制粘贴,没有意义。如果您这样做,搜索引擎可能不会惩罚您。小的。因此,当数据采集在临时数据库中时,无论多麻烦,都必须对数据进行编辑,具体有以下几个方面:

一种。修改标题(必填)

湾 添加关键词(手动获取,但部分采集器可以自动获取)

C。写描述或摘要,最好手动

d. 适当修改文章的头部和底部信息

5、发布数据

这一步没什么好说的,就是将编辑好的数据发布到网站。

最后,有的朋友可能会问哪个采集器合适,因为时间关系,也因为不想被人误认为我是马甲。这辈子最难过的事,就是你深深地坠入爱河。一个陌生人突然偷偷告诉你他曾经很喜欢你的人。,这里就不多说了。如果你采集做过,你心中应该有一个最喜欢的。一会儿给大家一个分析表,对目前主流的采集器做一个全面的对比,方便大家轻松辨别选择。

其实我们看到的网站采集项目很简单吧?

如果单纯的模仿、抄袭,甚至是软件采集,你是不是发现效果并不明显,甚至根本不会是收录。问题是什么?前段时间还找了几个专攻采集网站的朋友,聊的不错。事实上,我们表面上似乎做得很好,平时没什么可做的,吹牛而已。聊天,但实际上,人们也付出了很多。

在这个文章中,我将简要介绍一下采集网站项目的正确流程。我可以告诉你的是,它实际上没有那么简单,如果它那么简单。我们都跟风吗?我们的效率和建站速度肯定会超过大多数用户,为什么不去做呢?这说明还是有一定的门槛的。

二、优质内容

如果是优质内容,我绝对不会去采集内容。这里的优质内容,不允许我们自己写文章的每一篇文章原创。就是我们在选择内容的时候要垂直,如果我们在选择内容的时候选择流量词。比如我以前有朋友采集tribe网站技术含量。事实上,技术内容的用户基数很小,词库中根本无法生成词,所以流量基本很小。

如果我们选择影视、游戏等内容,一旦出现收录这个词,就很容易带来流量。因为以后我们做网站无论是卖还是贴自己的广告,都需要获得流量,有流量的话,卖的单价比较高。当然,买家还需要在站长工具中查看您的网站数据信息。如果选择没有字号的内容,基本上是很难卖的。

而我们在做内容的时候,不管是你原创,采集,抄袭还是别的什么,都必须进行二次加工。直接复制是很难成功的。毕竟你的网站质量肯定不如原版内容。

三、 推广权重

任何网站我们做了之后肯定不会自然带来重量和流量,还需要推广。根据网友反馈,即使是采集网站,他们也开始更新内容和推广,和普通的网站一样,只有达到一定的权重值和效果将大量更新和推广。采集。如果开始很多采集,可能会直接被罚网站还没开始。

同时,在我们后续的网站操作中,有网友告诉他们,他们每个月要花几十万元购买资源,比如连接和软文来增加软文的权重。 @网站。我们看到了吗,或者我们为什么不做?其实不是这样的。

四、时期效果

我们很多人都认为采集网站很容易做到,是的,很容易做到,但需要一定的时间才能见效。比如前几天我们看到几个网站效果很好,也是采集或者集成内容。然而,它们需要半年到一年的时间才能生效。所以我们在准备做采集网站项目的时候,也需要考虑时间段,不可能几个月就见效。

就算能用几个月,当你卖网站的时候,买家会分析你的网站是否被骗了,如果是,你的价格不会高或者对方是不需要的. 当然,如果我们通过上述一系列流程来操作,几个月后是不会见效的。我们不应该有任何猜测。

网站如何进行SEO采集,正确的网站采集项目操作流程

五、加权域名

我们网站的朋友应该知道,如果我们注册一个新的域名,至少要等3到6个月才有一定的权重。你一开始更新的任何内容,除非你的内容绝对有价值,否则需要这么长时间才能被搜索引擎认可。这就是所谓的累积重量,甚至有的网站需要好几年才能达到一定的重量。

在这里我们可以看到,做采集网站的站长很多,而且都是购买优质的加权域名。有的直接买别人的网站,有的买旧域名,预注册一些已经过期的域名。我写了几篇关于抢注旧域名的文章,专门针对这些朋友的需求。事实上,他们想购买一些旧域名,以减少域名评估期。

最近几个月,我们会发现很多网友都在运营采集网站,流量上升的非常快。甚至还有一些个人博客和个人网站,一年前都没有更新。通过 采集 获得更大的流量。包括我们在一些网络营销培训团队中也有类似的培训项目。其实采集一直都有,只是最近几个月百度好像出现了算法问题,赋予了采集网站更大的权重效果。

最重要的是域名。如果是老域名,效果会更好。前段时间很多网友都在讨论买旧域名。当时也有两篇关于自己买旧域名的文章文章。如果有网友的需求,我们也可以参考。

过去我们在哪里寻找旧域名购买?大部分网友可能从国内一些域名交易平台、论坛、网友看到,相对域名价格比较高,平均几百元。这些老域名,大多也是通过大多数网友不知道的域名渠道抢注获得,然后赚取差价。

因此,如果我们需要寻找旧域名,我们可以直接从旧域名等平台购买,包括我们其他的域名抢注平台。只是我之前用过这两个平台,成功率很高,有的甚至可以直接购买。购买旧域名需要注意哪些问题?

1、检查域名是否被屏蔽

由于不确定性,我们可以在购买该域名之前使用PING测试工具查看这些域名是否被DNS拦截或污染。如果我们看到一个被阻止或被污染的域名,如果你重新注册它就没有用了。包括我们以后新注册的域名也需要检查。很有可能我们购买的域名之前已经被用户使用过,因为被屏蔽而被丢弃了。

2、查看域名详情

查找旧域名的目的是什么?有的是因为要让用户看到网站开得更早,有的是外贸网站需要更早的时间,包括一些有一定权重的域名,比new更有效域名。我们可以先看看它是否满足我们的需求再购买。

3、域名交易安全

对于我们在平台上购买的旧域名,付款后不会立即收到,需要一定的时间才能到账到我们的账户使用。如果原持有人以高价赎回,我们支付的费用也将退还。如果我们通过其他中介平台交易旧域名,一定要注意不要私下交易。即使是最优秀的网民,如果他们不觉得自己像个骗子,也不会可信。

每个用户找旧域名的渠道可能不同,目的也不同。不能说老域名一定有预期的效果,我们要根据实际需要来选择。

最后我要说的是,当我们采集网站时,我们也需要注意版权问题。部分网站声明内容版权。你不能去采集 或复制它。目前我们的版权意识也在加强,很多站长都收到了律师的来信。

seo文章采集工具(国内首款权重优化软件,网站关键词排名最佳辅助软件!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-11-04 15:02

蜗牛精灵seo工具可以有效跟踪企业网站的SEO状态,分析企业网站在各大搜索引擎的排名变化趋势,分析竞争对手在搜索引擎中的表现,智能诊断网站SEO问题,根据相关诊断报告,提升网站在SEO各方面的质量,从而达到其网站关键词的良好排名结果搜索引擎。国内第一款权重优化软件,网站关键词排名最佳辅助优化软件!

无蜗牛精灵seo工具软件特点:

1、快速有效提升网站关键词在各大搜索引擎的自然排名。

2、SEO诊断:快速发现网站SEO状态,自动给出合理建议,及时调整。

3、关键词深度挖掘,关键词变化追踪,快速增加关键词所在页面的权重。

4、强大的SEO预警功能,让网站维护者第一时间发现网站SEO状态。

5、竞争对手分析,智能对比分析竞争对手网站SEO状态。

6、智能优化网站的搜索引擎关注度和友好度。

7、智能优化网站搜索引擎中收录的数量;和更新频率。

8、 真正有效增加网站访问量;即增加访问IP和PV。

9、搜索引擎相关搜索智能优化(在底层相关搜索中显示优化的关键词)。

10、 智能优化搜索引擎下拉框,快速占领十大最热门、最抢眼的搜索下拉位置。

11、快速提交网站各大搜索引擎。同时管理多个网站,减少重复时间。

蜗牛精灵免费seo工具软件特点:

1、成熟的系统,可靠的品质:

蜗牛精灵SEO营销系统是拥有国家认证的自主知识产权。它是经过多年实践开发的SEO系统。现已被众多用户使用,正式注册用户数以万计。

2、省力、省时、省心:

蜗牛精灵是一个智能的seo优化系统,无人值守,用户只需花一点时间操作,同时蜗牛精灵SEO营销系统可以让您闲置的电脑成为“营销推广者”。

3、 排名提升效果稳定:

360度优化网站,以“提升”的方式提升您网站的SEO潜力。蜗牛精灵50大功能服务体系,帮你把网站从里到外,从下到上“提升”,让你的网站自然排在搜索引擎前10 . 如果你“加注”得好,你仍然有机会进入前三名。

4、 给你最强大的网络营销效果:

蜗牛精灵是一款以营销为目标的SEO营销系统,集成SEO工具功能,让用户获得更多的网络营销效果和营销成本。

5、技术到位,让您更放心:

蜗牛精灵专职SEO技术团队为您提供在线技术支持,帮助您解决推广问题,让您的推广更有效。

6、操作简单,用户拥有较高的自主控制权:

时尚精致的操作画面,可视化的操作按钮,操作简单方便。

7、用户可以独立叠加推广效果:

蜗牛精灵SEO营销系统为开放式设计,支持多台电脑同时操作,效果可叠加。

8、安全、绿色、环保:

蜗牛精灵SEO营销系统桌面端为绿色软件,无需安装直接使用,节省用户电脑资源,帮助用户省电,减少电脑对人才的影响。 查看全部

seo文章采集工具(国内首款权重优化软件,网站关键词排名最佳辅助软件!)

蜗牛精灵seo工具可以有效跟踪企业网站的SEO状态,分析企业网站在各大搜索引擎的排名变化趋势,分析竞争对手在搜索引擎中的表现,智能诊断网站SEO问题,根据相关诊断报告,提升网站在SEO各方面的质量,从而达到其网站关键词的良好排名结果搜索引擎。国内第一款权重优化软件,网站关键词排名最佳辅助优化软件!

无蜗牛精灵seo工具软件特点:

1、快速有效提升网站关键词在各大搜索引擎的自然排名。

2、SEO诊断:快速发现网站SEO状态,自动给出合理建议,及时调整。

3、关键词深度挖掘,关键词变化追踪,快速增加关键词所在页面的权重。

4、强大的SEO预警功能,让网站维护者第一时间发现网站SEO状态。

5、竞争对手分析,智能对比分析竞争对手网站SEO状态。

6、智能优化网站的搜索引擎关注度和友好度。

7、智能优化网站搜索引擎中收录的数量;和更新频率。

8、 真正有效增加网站访问量;即增加访问IP和PV。

9、搜索引擎相关搜索智能优化(在底层相关搜索中显示优化的关键词)。

10、 智能优化搜索引擎下拉框,快速占领十大最热门、最抢眼的搜索下拉位置。

11、快速提交网站各大搜索引擎。同时管理多个网站,减少重复时间。

蜗牛精灵免费seo工具软件特点:

1、成熟的系统,可靠的品质:

蜗牛精灵SEO营销系统是拥有国家认证的自主知识产权。它是经过多年实践开发的SEO系统。现已被众多用户使用,正式注册用户数以万计。

2、省力、省时、省心:

蜗牛精灵是一个智能的seo优化系统,无人值守,用户只需花一点时间操作,同时蜗牛精灵SEO营销系统可以让您闲置的电脑成为“营销推广者”。

3、 排名提升效果稳定:

360度优化网站,以“提升”的方式提升您网站的SEO潜力。蜗牛精灵50大功能服务体系,帮你把网站从里到外,从下到上“提升”,让你的网站自然排在搜索引擎前10 . 如果你“加注”得好,你仍然有机会进入前三名。

4、 给你最强大的网络营销效果:

蜗牛精灵是一款以营销为目标的SEO营销系统,集成SEO工具功能,让用户获得更多的网络营销效果和营销成本。

5、技术到位,让您更放心:

蜗牛精灵专职SEO技术团队为您提供在线技术支持,帮助您解决推广问题,让您的推广更有效。

6、操作简单,用户拥有较高的自主控制权:

时尚精致的操作画面,可视化的操作按钮,操作简单方便。

7、用户可以独立叠加推广效果:

蜗牛精灵SEO营销系统为开放式设计,支持多台电脑同时操作,效果可叠加。

8、安全、绿色、环保:

蜗牛精灵SEO营销系统桌面端为绿色软件,无需安装直接使用,节省用户电脑资源,帮助用户省电,减少电脑对人才的影响。

seo文章采集工具(优采云系列的软件真是SEO工作者的福音!(图) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 467 次浏览 • 2021-10-29 07:08

)

简介:

群里有小伙伴需要关键词采集内容对应的软件,正好自己用的那个优采云很不错,分享给大家大家好,优采云系列的软件真是SEO作品读者的福音!

优采云通用文章采集器是一款可以批量下载指定关键词文章采集的工具,主要是为了帮助用户< @采集各大平台文章,也可以采集指定网站文章,非常方便快捷,给做网站推广的朋友和优化 不可多得的工具。

只需在采集中输入关键词,软件操作简单,可以准确提取网页正文部分并保存为文章,并支持tag、链接、电子邮件等。只需几分钟即可采集任何你想要的文章。

用户可以设置搜索间隔、采集类型、时间语言等选项,还可以过滤采集的文章、插入关键词等,可以大大提高我们的工作效率是一个非常好的文章采集工具,双击打开即可使用。软件已完美破解,无需注册码激活即可免费使用。

loading="lazy" title="自动草稿" src="/static/pic/3/21_04_01/1617260832_92180.jpg" alt="自动草稿">

2、点击确定,打开软件就可以直接开始使用软件了。填写采集的文章关键词的关键词栏。

loading="lazy" title="自动草稿" src="/static/pic/3/21_04_01/1617260832_78172.jpg" alt="自动草稿">

3、输入关键字后,选择文章保存地址和保存选项。

loading="lazy" title="自动草稿" src="/static/pic/3/21_04_01/1617260832_38745.jpg" alt="自动草稿">

4、确认信息,点击采集获取您想要的信息。

网盘下载地址:

图片:

查看全部

seo文章采集工具(优采云系列的软件真是SEO工作者的福音!(图)

)

简介:

群里有小伙伴需要关键词采集内容对应的软件,正好自己用的那个优采云很不错,分享给大家大家好,优采云系列的软件真是SEO作品读者的福音!

优采云通用文章采集器是一款可以批量下载指定关键词文章采集的工具,主要是为了帮助用户< @采集各大平台文章,也可以采集指定网站文章,非常方便快捷,给做网站推广的朋友和优化 不可多得的工具。

只需在采集中输入关键词,软件操作简单,可以准确提取网页正文部分并保存为文章,并支持tag、链接、电子邮件等。只需几分钟即可采集任何你想要的文章。

用户可以设置搜索间隔、采集类型、时间语言等选项,还可以过滤采集的文章、插入关键词等,可以大大提高我们的工作效率是一个非常好的文章采集工具,双击打开即可使用。软件已完美破解,无需注册码激活即可免费使用。

loading="lazy" title="自动草稿" src="/static/pic/3/21_04_01/1617260832_92180.jpg" alt="自动草稿">

2、点击确定,打开软件就可以直接开始使用软件了。填写采集的文章关键词的关键词栏。

loading="lazy" title="自动草稿" src="/static/pic/3/21_04_01/1617260832_78172.jpg" alt="自动草稿">

3、输入关键字后,选择文章保存地址和保存选项。

loading="lazy" title="自动草稿" src="/static/pic/3/21_04_01/1617260832_38745.jpg" alt="自动草稿">

4、确认信息,点击采集获取您想要的信息。

网盘下载地址:

图片:

seo文章采集工具(如何解决尽可能获取全量数据?工具采集地址数据回顾)

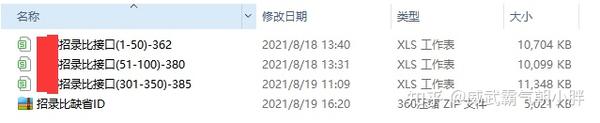

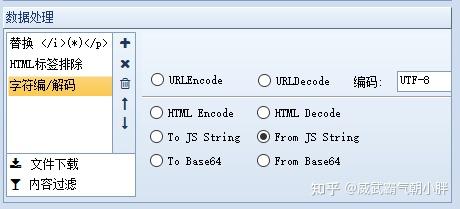

采集交流 • 优采云 发表了文章 • 0 个评论 • 729 次浏览 • 2021-10-28 16:19

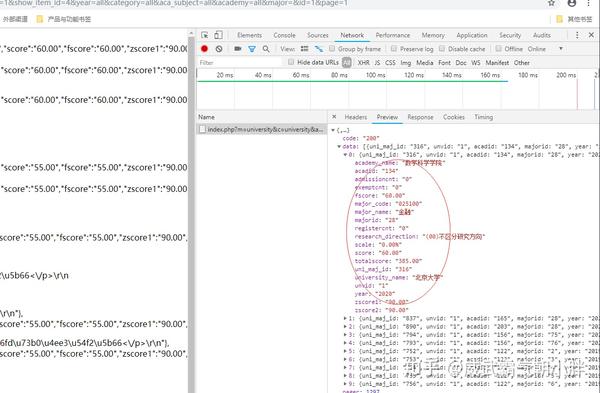

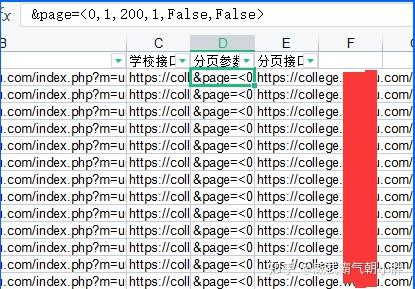

本帖主要是记录采集大数据使用优采云采集软件时遇到的坑和规避指南。

为了更好地引导避坑,尽可能的修复坑,指定了工具和环境。

系统环境:win10

工具:优采云7.6 版本

.net 4.1 版本

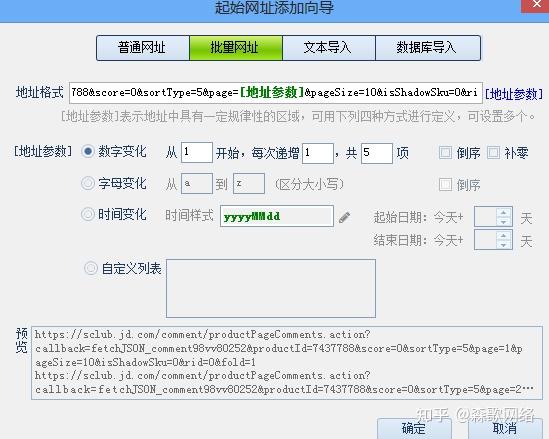

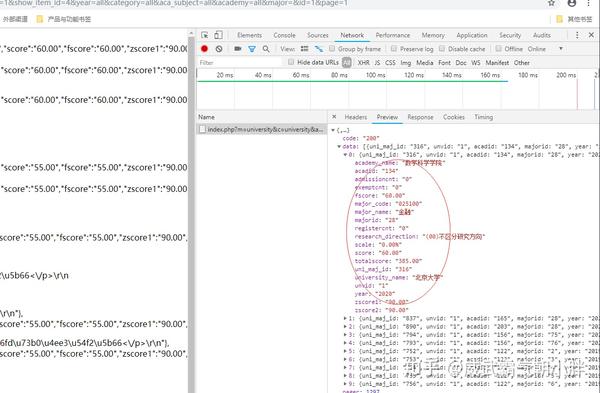

目标数据样式为非HTML静态页面内容,即动态url参数post请求界面反馈数据。

这一块就是我们需要得到的数据

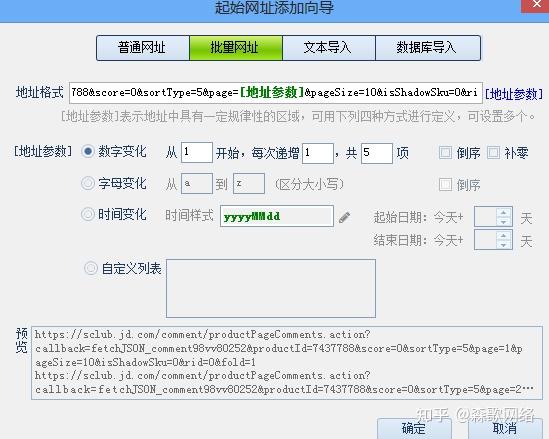

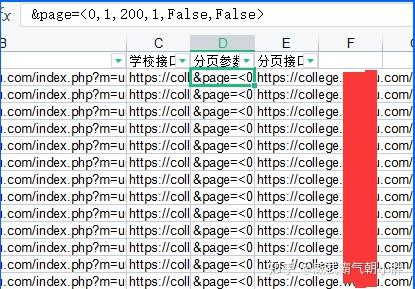

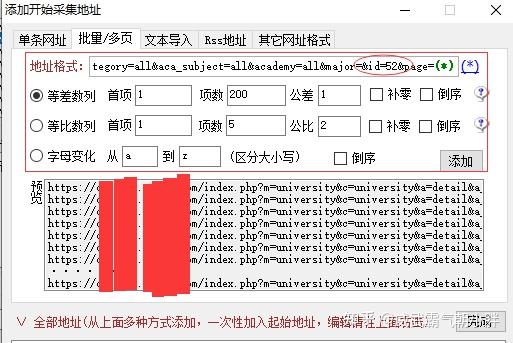

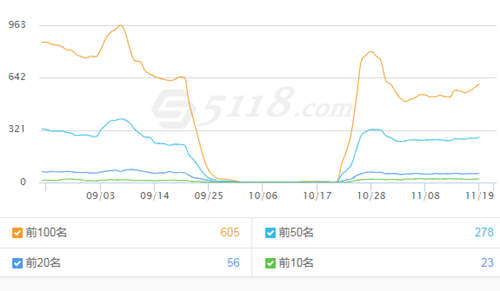

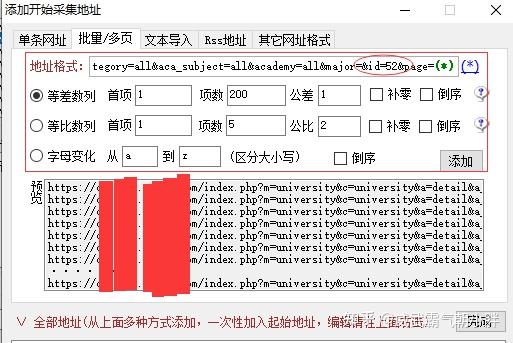

事件回顾:由于是动态的接口反馈数据,需要不同的参数请求才能得到结果。单个ID参数得到的结果其实是有分页参数的。. 通过前端其他数据接口获取的已知ID参数有975个。可以获取每个ID请求获取的结果总量,但是不能获取分页值。但是当我需要获取975个ID的全量数据时,无法为每个ID单独创建一个任务执行。通过表单导入ID,然后通过批量插入分页规则组合分页接口查询URL,批量导入任务。

坑一:分页不能自动滚动查找。

这里是第一个坑。优采云工具采集 分页地址数据必须由规则定义。如初始参数、增量参数、间距参数、前序、闪回等。但是没有规则可以让变量参数自动滚动直到结果为空。

为了解决问题,尽可能获取全量数据。我只能设置更大的分页参数。这样做的结果就是ID很多,结果很少,但同样需要请求这么多次。这会导致更多的任务分页结果。我选择了几个数据量大的ID参数进行观察,最后为了保证数据量比较完整。分页变量设置为 200。

坑2:本地数据存储问题

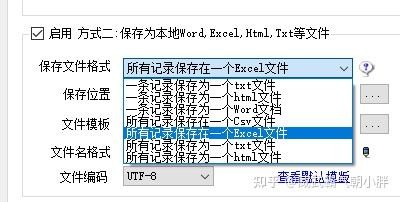

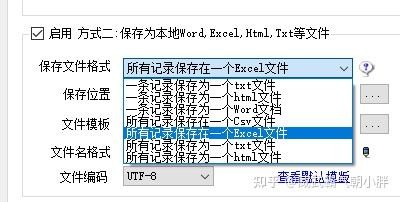

优采云 保存数据到本地的文件格式为TXT/excel/html/CSV

Subpit 1:EXCEL是导出xls而不是xlsx

Subpit 2:CSV 自定义模块仅支持 5 个标签

子坑3:CSV数据导出编码强制UTF-8

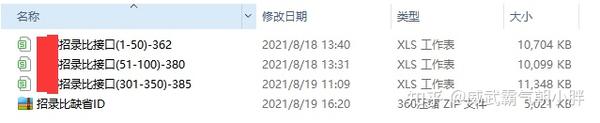

任务估计:请求的任务数为 975X200=195 000 个请求。每个请求的结果大约有20行,其中一行需要获取26-32个标签。因为是研究生院/专业/分数线/招生比例的图书馆功能。排除前端显示的数据。该接口还收录其他参数,用于关联库与库之间的对应关系。

优采云 任务完成后估计结果超过200W,一条线等于一条线。此请求是针对无代理 IP 池的。对于没有访问UA库的优采云7.6版本,运行了40多个小时。幸运的是。目标接口没有反爬虫设置,不需要验证密钥。

子项 1:

最后,当我查看并保存文件XXXX.xls 时,发现最多的结果只有65536 行。通过估计的任务数。我知道如果我踩到它,数据是不完整的。优采云 保存文件只有两种选择:一结果一表,多任务一表。当然,您不必考虑将其保存在表中。然后当数据导出超过xls可以承担的任务时,我什至不知道保存了多个表。. .

子航2:

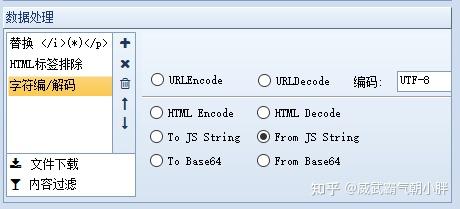

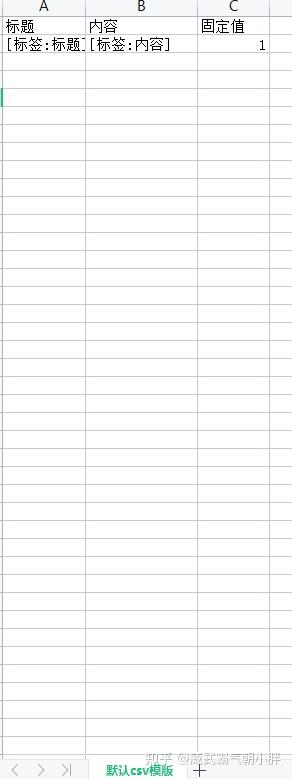

然后我想,数据量太大了,没有办法导出为CSV数据库格式。新建一个CSV模板,将需要导出的标签添加到要导出的模板中。打开本地结果:XXXX.CSV,你会看到除了前5列数据正常之外,其他列都没有数据。没办法,那我把标签单独导出到总公司。一次导出 5 列标签数据。

默认CSV模板标签数量不满足

新创建的 CSV 模板| 收录 20 个标签,其他接口标签不与此模板一起导出。采集,可以设置30多个标签采集来获取,但是导出的数据可以根据需要在模板中导出。

子项 3:

当我修改模板导出接下来5列标签的对应数据时。打开一看,发现汉字的编码乱了。引用的标签直接翻译和乱码。晚上查了一些教程,下载了相应的工具来修改CSV文件的编码。虽然显示中文,但是没有获取到对应标签的数据。没有办法在 CSV 中存储数据,它不起作用。而此时,又是24小时过去了。这个项目的重点是数据库结构,建一个数据库最重要的就是保证数据的完整性。写一个采集规则真的花了半个小时。拿到这部分数据花了3天时间,还没搞定。.

避坑指南:

1、多任务多线程,提高速度,保证效率。

基于XLS形式只能保存6W+数据。我把975的请求ID分成20个任务

通过定义分页规则Ping出20个任务

大概url:1-50ID创建任务

?id=1&page=&XX&22

?id=2&page=&XX&22

?id=3&page=&XX&22

?id=4&page=&XX&22

?id=*&page=&XX&22

?id=*&page=&XX&22

?id=*&page=&XX&22

?id=50&page=&XX&22

此外,ID在现实中并不总是在增加。但是总数是975,我在请求之前通过一个接口获取了所有的ID。将ID放入表中,按序号递增,结果为975个ID。1-50 Ping出一组任务的url,批量添加任务

那么优采云支持的最大线程是5.,也就是说可以同时执行5个任务。

下载效率提高了5倍。用了 2 天时间完成运行,现在运行所有任务大约需要 8 小时。

2、小数据多任务,适合修改和发现问题。

20个任务运行后,有4个任务数据超出表容量报错,其他任务正常完成。

图中表格为采集的优化数据,原创数据大小为0。

将报错的task拆分为2个task,比如1-25ID,26-50ID为一组,并且为了保证数据的完整性,将list分页值增加到250.

3、excel模板支持多标签获取和导出。

还是选择xls格式保存数据,这样可以保证一行中所有的标签数据是完整的和相关的。

4、添加内容编码转换规则,解决内容编码问题。

总结:当采集中数据量过大时,可以多任务多线程,先测试少量采集数据本地存储,看是否成功获取标签,然后批量多任务获取数据。为内容添加编码功能。确保内容数据的编码与导出文件的编码一致。 查看全部

seo文章采集工具(如何解决尽可能获取全量数据?工具采集地址数据回顾)

本帖主要是记录采集大数据使用优采云采集软件时遇到的坑和规避指南。

为了更好地引导避坑,尽可能的修复坑,指定了工具和环境。

系统环境:win10

工具:优采云7.6 版本

.net 4.1 版本

目标数据样式为非HTML静态页面内容,即动态url参数post请求界面反馈数据。

这一块就是我们需要得到的数据

事件回顾:由于是动态的接口反馈数据,需要不同的参数请求才能得到结果。单个ID参数得到的结果其实是有分页参数的。. 通过前端其他数据接口获取的已知ID参数有975个。可以获取每个ID请求获取的结果总量,但是不能获取分页值。但是当我需要获取975个ID的全量数据时,无法为每个ID单独创建一个任务执行。通过表单导入ID,然后通过批量插入分页规则组合分页接口查询URL,批量导入任务。

坑一:分页不能自动滚动查找。

这里是第一个坑。优采云工具采集 分页地址数据必须由规则定义。如初始参数、增量参数、间距参数、前序、闪回等。但是没有规则可以让变量参数自动滚动直到结果为空。

为了解决问题,尽可能获取全量数据。我只能设置更大的分页参数。这样做的结果就是ID很多,结果很少,但同样需要请求这么多次。这会导致更多的任务分页结果。我选择了几个数据量大的ID参数进行观察,最后为了保证数据量比较完整。分页变量设置为 200。

坑2:本地数据存储问题

优采云 保存数据到本地的文件格式为TXT/excel/html/CSV

Subpit 1:EXCEL是导出xls而不是xlsx

Subpit 2:CSV 自定义模块仅支持 5 个标签

子坑3:CSV数据导出编码强制UTF-8

任务估计:请求的任务数为 975X200=195 000 个请求。每个请求的结果大约有20行,其中一行需要获取26-32个标签。因为是研究生院/专业/分数线/招生比例的图书馆功能。排除前端显示的数据。该接口还收录其他参数,用于关联库与库之间的对应关系。

优采云 任务完成后估计结果超过200W,一条线等于一条线。此请求是针对无代理 IP 池的。对于没有访问UA库的优采云7.6版本,运行了40多个小时。幸运的是。目标接口没有反爬虫设置,不需要验证密钥。

子项 1:

最后,当我查看并保存文件XXXX.xls 时,发现最多的结果只有65536 行。通过估计的任务数。我知道如果我踩到它,数据是不完整的。优采云 保存文件只有两种选择:一结果一表,多任务一表。当然,您不必考虑将其保存在表中。然后当数据导出超过xls可以承担的任务时,我什至不知道保存了多个表。. .

子航2:

然后我想,数据量太大了,没有办法导出为CSV数据库格式。新建一个CSV模板,将需要导出的标签添加到要导出的模板中。打开本地结果:XXXX.CSV,你会看到除了前5列数据正常之外,其他列都没有数据。没办法,那我把标签单独导出到总公司。一次导出 5 列标签数据。

默认CSV模板标签数量不满足

新创建的 CSV 模板| 收录 20 个标签,其他接口标签不与此模板一起导出。采集,可以设置30多个标签采集来获取,但是导出的数据可以根据需要在模板中导出。

子项 3:

当我修改模板导出接下来5列标签的对应数据时。打开一看,发现汉字的编码乱了。引用的标签直接翻译和乱码。晚上查了一些教程,下载了相应的工具来修改CSV文件的编码。虽然显示中文,但是没有获取到对应标签的数据。没有办法在 CSV 中存储数据,它不起作用。而此时,又是24小时过去了。这个项目的重点是数据库结构,建一个数据库最重要的就是保证数据的完整性。写一个采集规则真的花了半个小时。拿到这部分数据花了3天时间,还没搞定。.

避坑指南:

1、多任务多线程,提高速度,保证效率。

基于XLS形式只能保存6W+数据。我把975的请求ID分成20个任务

通过定义分页规则Ping出20个任务

大概url:1-50ID创建任务

?id=1&page=&XX&22

?id=2&page=&XX&22

?id=3&page=&XX&22

?id=4&page=&XX&22

?id=*&page=&XX&22

?id=*&page=&XX&22

?id=*&page=&XX&22

?id=50&page=&XX&22

此外,ID在现实中并不总是在增加。但是总数是975,我在请求之前通过一个接口获取了所有的ID。将ID放入表中,按序号递增,结果为975个ID。1-50 Ping出一组任务的url,批量添加任务

那么优采云支持的最大线程是5.,也就是说可以同时执行5个任务。

下载效率提高了5倍。用了 2 天时间完成运行,现在运行所有任务大约需要 8 小时。

2、小数据多任务,适合修改和发现问题。

20个任务运行后,有4个任务数据超出表容量报错,其他任务正常完成。

图中表格为采集的优化数据,原创数据大小为0。

将报错的task拆分为2个task,比如1-25ID,26-50ID为一组,并且为了保证数据的完整性,将list分页值增加到250.

3、excel模板支持多标签获取和导出。

还是选择xls格式保存数据,这样可以保证一行中所有的标签数据是完整的和相关的。

4、添加内容编码转换规则,解决内容编码问题。

总结:当采集中数据量过大时,可以多任务多线程,先测试少量采集数据本地存储,看是否成功获取标签,然后批量多任务获取数据。为内容添加编码功能。确保内容数据的编码与导出文件的编码一致。

seo文章采集工具( Python与数据采集SEO的系列文章之2.本系列)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-10-25 14:19

Python与数据采集SEO的系列文章之2.本系列)

1.本系列前言

一直想写一系列Python和SEO文章,因为随着SEO工作的发展和自身Python水平的提高,Python在SEO中的使用越来越多,范围也越来越广用途也越来越广泛。

这个系列暂时计划分为几个主题,将在接下来的几周内完成:

适用人群:有Python基础的SEOer(没有Python基础的直接下拉,看推荐的Python教程)

2. SEO 和数据采集

SEO工作离不开数据采集。获取某个频道的所有URL,查询一批网页的收录/排名状态,以及采集竞争对手的具体数据,都需要用到数据采集。

特别是对于个人站长来说,只有通过数据采集才能得到大量的数据并生成网页。

3.原创爬虫

最原创的爬虫可以只发送一个HTTP请求并获得返回的响应数据。你可以用三行请求写一个简单的爬虫。代码如下:

import requests

r = requests.get('http://www.zhidaow.com')

print r.content

注意:

4. 高级爬虫

升级几个技能到原来的爬虫就可以使用了。我经常升级以下功能。

4.1 获取特定字段:BeautifulSoup+Requests

BeautifulSoup 可以将 HTML 解析成 DOM 树,然后获取特定字段。关于 BeautifulSoup 的详细信息,请看这个 文章,这里只是一个简单的例子。

以下是途牛播放页面的部分代码

玉渊潭樱花节

地 址:

游玩时间:预计4小时

可以通过此功能获取4小时字段:

import requests

from bs4 import BeautifulSoup as bs

url = 'http://www.tuniu.com/play/9232/'

r = requests.get(url)

soup = bs(r.content)

print soup.find('b', class_='c_f80').string

#输出字段有空格,可以通过strip()函数来过滤多余的空格和换行

注意:您也可以使用 requests 和 lxml 进行捕获。

4.2 使用代理

为了避免阻塞,爬取的时候通常需要一个proxy,这个效果可以通过Requests的proxys参数来实现。按照上面的代码:

proxies = {

"http": "http://10.10.1.10:3128",

"https": "http://10.10.1.10:1080",

}

r = requests.get(url, proxies=proxies)

如果代理需要账号和密码,需要这样:

proxies = {

"http": "http://user:pass@10.10.1.10:3128/",

}

4.3 模拟百度蜘蛛

在爬行时模拟搜索引擎蜘蛛是个好主意。这里,User-Agent 尝试模仿百度蜘蛛抓取:

headers = {

'User-Agent': 'Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)',

}

r = requests.get(url, headers=headers)

4.4 多线程爬取

为了提高爬取速度,一般采用多线程爬取。在本文中,我使用了第三方库线程池来实现多线程。这里我采用另一种形式,使用标准库multiprocessing来实现:

import requests

from bs4 import BeautifulSoup as bs

from multiprocessing.dummy import Pool as ThreadPool

#URL列表

urls = [

'http://www.tuniu.com/play/9232/',

'http://www.tuniu.com/play/9231/',

'http://www.tuniu.com/play/9237/',

'http://www.tuniu.com/play/9234/',

# etc..

]

#提取字段函数

def get_play_time(url):

r = requests.get(url)

soup = bs(r.content)

print soup.find('b', class_='c_f80').string.strip()

#设置线程数

pool = ThreadPool(4)

#开启多线程

results = pool.map(get_play_time, urls)

#关闭线程并等待结束

pool.close()

pool.join()

注意:这个多线程的实现主要是指这个文章。

4.5 个请求+常规

有时如果需要的字段出现在 DOM 树之外比如 JS,可以通过常规方式直接获取。有时速度会更快。

4.6 抓取网页JS内容

很多网站会专注于JS,增加了爬虫的难度。这可以通过Selenium+PhantomJS+Xpath 捕获。

5.终极爬行者

终极爬虫是 Scrapy。 Scrapy可以理解为搜索引擎爬虫的原型,可以沿着初始的URL列表进行爬取,可以设置爬取深度、爬取字段、爬取URL、爬取频率等。

此外,还可以添加随机代理、随机UA、分布式捕获、存储等高级功能,还可以结合selenium来捕获JS生成的元素。许多价格比较网站 使用 Scrapy 作为商店爬虫。 Scrapy也是爬虫工程师必备的技能之一。

我修改了官方教程中的基础示例,演示基础爬虫的代码:

import scrapy

class TuniuSpider(scrapy.Spider):

name = 'tuniu' # 设置爬虫名称,这里没卵用

start_urls = ['http://www.tuniu.com/guide/d-b ... 39%3B] # 设置初始抓取链接

def parse(self, response):

for href in response.css('.mgl_pic a::attr(href)'): # 用CSS提取链接,也可以用xpath,beautifulsoup提取

yield scrapy.Request(href.extract(), callback=self.parse_poi) # 提出的链接用parse_poi函数处理

def parse_poi(self, response):

yield {

'name': response.css('h1 a::text').extract()[0], # 用CSS规则从网页中提取字段

'english': response.css('.english::text').extract()[0],

}

之后就可以使用scrapy runspider tuniu_spider.py -o tuniu_poi.json 来爬取了。

推荐教程:

注意:Scrapy依赖很多其他的库,比如lxml和Twist,安装起来会比较麻烦。以后我可能会单独写一篇关于 Scrapy 的文章。

6. Python 教程推荐7. 备注 查看全部

seo文章采集工具(

Python与数据采集SEO的系列文章之2.本系列)

1.本系列前言

一直想写一系列Python和SEO文章,因为随着SEO工作的发展和自身Python水平的提高,Python在SEO中的使用越来越多,范围也越来越广用途也越来越广泛。

这个系列暂时计划分为几个主题,将在接下来的几周内完成:

适用人群:有Python基础的SEOer(没有Python基础的直接下拉,看推荐的Python教程)

2. SEO 和数据采集

SEO工作离不开数据采集。获取某个频道的所有URL,查询一批网页的收录/排名状态,以及采集竞争对手的具体数据,都需要用到数据采集。

特别是对于个人站长来说,只有通过数据采集才能得到大量的数据并生成网页。

3.原创爬虫

最原创的爬虫可以只发送一个HTTP请求并获得返回的响应数据。你可以用三行请求写一个简单的爬虫。代码如下:

import requests

r = requests.get('http://www.zhidaow.com')

print r.content

注意:

4. 高级爬虫

升级几个技能到原来的爬虫就可以使用了。我经常升级以下功能。

4.1 获取特定字段:BeautifulSoup+Requests

BeautifulSoup 可以将 HTML 解析成 DOM 树,然后获取特定字段。关于 BeautifulSoup 的详细信息,请看这个 文章,这里只是一个简单的例子。

以下是途牛播放页面的部分代码

玉渊潭樱花节

地 址:

游玩时间:预计4小时

可以通过此功能获取4小时字段:

import requests

from bs4 import BeautifulSoup as bs

url = 'http://www.tuniu.com/play/9232/'

r = requests.get(url)

soup = bs(r.content)

print soup.find('b', class_='c_f80').string

#输出字段有空格,可以通过strip()函数来过滤多余的空格和换行

注意:您也可以使用 requests 和 lxml 进行捕获。

4.2 使用代理

为了避免阻塞,爬取的时候通常需要一个proxy,这个效果可以通过Requests的proxys参数来实现。按照上面的代码:

proxies = {

"http": "http://10.10.1.10:3128",

"https": "http://10.10.1.10:1080",

}

r = requests.get(url, proxies=proxies)

如果代理需要账号和密码,需要这样:

proxies = {

"http": "http://user:pass@10.10.1.10:3128/",

}

4.3 模拟百度蜘蛛

在爬行时模拟搜索引擎蜘蛛是个好主意。这里,User-Agent 尝试模仿百度蜘蛛抓取:

headers = {

'User-Agent': 'Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)',

}

r = requests.get(url, headers=headers)

4.4 多线程爬取

为了提高爬取速度,一般采用多线程爬取。在本文中,我使用了第三方库线程池来实现多线程。这里我采用另一种形式,使用标准库multiprocessing来实现:

import requests

from bs4 import BeautifulSoup as bs

from multiprocessing.dummy import Pool as ThreadPool

#URL列表

urls = [

'http://www.tuniu.com/play/9232/',

'http://www.tuniu.com/play/9231/',

'http://www.tuniu.com/play/9237/',

'http://www.tuniu.com/play/9234/',

# etc..

]

#提取字段函数

def get_play_time(url):

r = requests.get(url)

soup = bs(r.content)

print soup.find('b', class_='c_f80').string.strip()

#设置线程数

pool = ThreadPool(4)

#开启多线程

results = pool.map(get_play_time, urls)

#关闭线程并等待结束

pool.close()

pool.join()

注意:这个多线程的实现主要是指这个文章。

4.5 个请求+常规

有时如果需要的字段出现在 DOM 树之外比如 JS,可以通过常规方式直接获取。有时速度会更快。

4.6 抓取网页JS内容

很多网站会专注于JS,增加了爬虫的难度。这可以通过Selenium+PhantomJS+Xpath 捕获。

5.终极爬行者

终极爬虫是 Scrapy。 Scrapy可以理解为搜索引擎爬虫的原型,可以沿着初始的URL列表进行爬取,可以设置爬取深度、爬取字段、爬取URL、爬取频率等。

此外,还可以添加随机代理、随机UA、分布式捕获、存储等高级功能,还可以结合selenium来捕获JS生成的元素。许多价格比较网站 使用 Scrapy 作为商店爬虫。 Scrapy也是爬虫工程师必备的技能之一。

我修改了官方教程中的基础示例,演示基础爬虫的代码:

import scrapy

class TuniuSpider(scrapy.Spider):

name = 'tuniu' # 设置爬虫名称,这里没卵用

start_urls = ['http://www.tuniu.com/guide/d-b ... 39%3B] # 设置初始抓取链接

def parse(self, response):

for href in response.css('.mgl_pic a::attr(href)'): # 用CSS提取链接,也可以用xpath,beautifulsoup提取

yield scrapy.Request(href.extract(), callback=self.parse_poi) # 提出的链接用parse_poi函数处理

def parse_poi(self, response):

yield {

'name': response.css('h1 a::text').extract()[0], # 用CSS规则从网页中提取字段

'english': response.css('.english::text').extract()[0],

}

之后就可以使用scrapy runspider tuniu_spider.py -o tuniu_poi.json 来爬取了。

推荐教程:

注意:Scrapy依赖很多其他的库,比如lxml和Twist,安装起来会比较麻烦。以后我可能会单独写一篇关于 Scrapy 的文章。

6. Python 教程推荐7. 备注

seo文章采集工具(做好好的内容采集站来说是重中之重吗?采集工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-10-22 04:01

做好采集网站,前提是做好内容处理,内容处理离不开搜索引擎已有的内容。搜索引擎上的内容处理是许多采集站长中最重要的。头痛之一;一般采集站都离不开采集工具,好的内容采集处理工具是采集站的重中之重!

一、 采集 站必须

1、旧域名

2、网站 匹配搜索引擎的程序

3、采集工具

4、快速行点击

为采集做好老域名是必不可少的。什么样的老域名才是好域名?

1、老域名(DR)评级

2、旧域名外链数量

3、旧域名反向链接

4、旧域名历史外链

5、网站的前任历史快照查询

以上数据可以通过Orange SEO找到!

市面上的cms程序很多,比较常见和常用的有织梦、Empire、WordPress、ZBLOG等,选择哪个程序就看你自己了。

采集工具

市面上的SEO采集工具很多,例如:优采云、优采云、优采云采集、优采云采集 、采集Xia、采集节点等,多用于优采云。

1、优采云

对于seo人员来说,优采云是一个比较常见的采集软件。下载安装优采云采集器,有付费版和免费版,百度找下载地址。

2、优采云

优采云采集器是一个快速的网页信息工具采集,常用来采集网站文章,网站信息数据,等等。 。优采云有免费版和付费版。这取决于自己或公司的需要。免费版在很多方面都受到限制。

3、优采云采集

优采云采集完全在线使用采集器,无需安装客户端,功能强大,操作简单,多处默认配置。此外,还有强大的SEO工具和数据批处理工具。采集的数据也可以快速发布到各种开源的cms系统。优采云采集 有一个免费版本。免费版涵盖了从采集到发布的主线功能。

织梦程序采集插件:

4、采集侠

要使用采集侠的插件,网站必须是织梦,因为这个插件是织梦的采集插件。采集Xia是直接通过关键词采集文章,采集Xia是收费软件,当然我们也可以下载破解版,具体百度搜索。

5、采集 节点

织梦采集 该节点由织梦的后台程序自动带入。采集节点是完全免费的,但是采集不是很强大,还有很多东西是做不到的。.

不过随着python的出现,现在市面上的站长已经比较多,开始使用爬虫python来采集来处理内容,这对于大部分程序站长来说并不难!

比如站长自己用的是【采集python编写的程序】,可以同时处理【标题】和【内容】,相当方便和智能。

快速点击,你不用说那么多,你知道你知道的!

说说2021年站长使用python采集工具的原理,更好的采集站!主要讲内容处理,不细说。

1、 采集流量词(重量词)

2、 python清洗和采集长尾词(相关词)

3、 Python 处理标题

4、 python采集 内容清理

5、 编写对应的cms网站发布接口

6、使用接口设置部署自动发布文章

一、采集流量词(重量词)

根据你的行业采集流量词(权重词),在爱站或5118中导出关键词并保存为TXT文本。一般站长采集的关键词数量在20万以上。

二、python清洗和采集长尾词(相关词)

根据采集good关键词的文字,导入python采集工具,对违禁词进行清理过滤。根据清理后的关键词采集长尾词(相关词)保存为文本。

三、python处理标题

根据采集好的长尾词文本,使用python程序预先做关键词,处理成文章内容的标题。标题中会有关键词和长尾词。类似的例子:学什么手艺最赚钱(女生最喜欢的十大手艺)上海手机行情(手机行情每日行情)

四、python采集内容清理

使用python爬虫根据处理后的内容清理全网内容。这一步需要很多时间和更多细节。我不会在这里透露它们。采集 好的内容打包成数据库保存在电脑本地。

五、设置部署和自动发布文章

将电脑本地打包好的数据库上传到宝塔,使用自动发布接口部署自动发布文章和百度推送设置。自动发布接口,部署过程不一一公开,大家都知道。返回搜狐查看更多 查看全部

seo文章采集工具(做好好的内容采集站来说是重中之重吗?采集工具)

做好采集网站,前提是做好内容处理,内容处理离不开搜索引擎已有的内容。搜索引擎上的内容处理是许多采集站长中最重要的。头痛之一;一般采集站都离不开采集工具,好的内容采集处理工具是采集站的重中之重!

一、 采集 站必须

1、旧域名

2、网站 匹配搜索引擎的程序

3、采集工具

4、快速行点击

为采集做好老域名是必不可少的。什么样的老域名才是好域名?

1、老域名(DR)评级

2、旧域名外链数量

3、旧域名反向链接

4、旧域名历史外链

5、网站的前任历史快照查询

以上数据可以通过Orange SEO找到!

市面上的cms程序很多,比较常见和常用的有织梦、Empire、WordPress、ZBLOG等,选择哪个程序就看你自己了。

采集工具

市面上的SEO采集工具很多,例如:优采云、优采云、优采云采集、优采云采集 、采集Xia、采集节点等,多用于优采云。

1、优采云

对于seo人员来说,优采云是一个比较常见的采集软件。下载安装优采云采集器,有付费版和免费版,百度找下载地址。

2、优采云

优采云采集器是一个快速的网页信息工具采集,常用来采集网站文章,网站信息数据,等等。 。优采云有免费版和付费版。这取决于自己或公司的需要。免费版在很多方面都受到限制。

3、优采云采集

优采云采集完全在线使用采集器,无需安装客户端,功能强大,操作简单,多处默认配置。此外,还有强大的SEO工具和数据批处理工具。采集的数据也可以快速发布到各种开源的cms系统。优采云采集 有一个免费版本。免费版涵盖了从采集到发布的主线功能。

织梦程序采集插件:

4、采集侠

要使用采集侠的插件,网站必须是织梦,因为这个插件是织梦的采集插件。采集Xia是直接通过关键词采集文章,采集Xia是收费软件,当然我们也可以下载破解版,具体百度搜索。

5、采集 节点

织梦采集 该节点由织梦的后台程序自动带入。采集节点是完全免费的,但是采集不是很强大,还有很多东西是做不到的。.

不过随着python的出现,现在市面上的站长已经比较多,开始使用爬虫python来采集来处理内容,这对于大部分程序站长来说并不难!

比如站长自己用的是【采集python编写的程序】,可以同时处理【标题】和【内容】,相当方便和智能。

快速点击,你不用说那么多,你知道你知道的!

说说2021年站长使用python采集工具的原理,更好的采集站!主要讲内容处理,不细说。

1、 采集流量词(重量词)

2、 python清洗和采集长尾词(相关词)

3、 Python 处理标题

4、 python采集 内容清理

5、 编写对应的cms网站发布接口

6、使用接口设置部署自动发布文章

一、采集流量词(重量词)

根据你的行业采集流量词(权重词),在爱站或5118中导出关键词并保存为TXT文本。一般站长采集的关键词数量在20万以上。

二、python清洗和采集长尾词(相关词)

根据采集good关键词的文字,导入python采集工具,对违禁词进行清理过滤。根据清理后的关键词采集长尾词(相关词)保存为文本。

三、python处理标题

根据采集好的长尾词文本,使用python程序预先做关键词,处理成文章内容的标题。标题中会有关键词和长尾词。类似的例子:学什么手艺最赚钱(女生最喜欢的十大手艺)上海手机行情(手机行情每日行情)

四、python采集内容清理

使用python爬虫根据处理后的内容清理全网内容。这一步需要很多时间和更多细节。我不会在这里透露它们。采集 好的内容打包成数据库保存在电脑本地。

五、设置部署和自动发布文章

将电脑本地打包好的数据库上传到宝塔,使用自动发布接口部署自动发布文章和百度推送设置。自动发布接口,部署过程不一一公开,大家都知道。返回搜狐查看更多

seo文章采集工具(站长网志挑选出来了几十个谷歌SEO优化工具(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-22 00:29

站长博客精选了几十款谷歌SEO&SEM优质外链建设工具与大家分享。不管你要研究什么竞争对手,掌握内容营销,删除网站的死链。我保证新手和有经验的数字营销人员都能找到您想要的工具。现在的外链建设已经不再像以前那样做一些低质量的垃圾外链。我们需要建立高质量的外部链接。所以学习和使用这些外链工具

谷歌搜索引擎优化工具

一:灵芝

Linkio 是一款功能强大的外链自动化工具,用于反向链接规划,可以在设置链接构建活动时执行重复和繁琐的工作。

除了简化品牌和代理商的流程外,该工具还不同于复杂的分析引擎,该引擎主动推荐您需要排名最高的下一个链接。

您可以在系统中输入 URL 和一些关键字,软件会分析您现有的反向链接以计算理想的锚文本百分比。然后,它将为您的个人资料建模,而不是从排名靠前的 网站 开始,并告诉您接下来应该建立哪种类型的链接。

例如,如果您建立反向链接以节省时间,并希望该软件提供有效的建议——Linkio 可能就是您一直在寻找的。

二:Linkio 的锚文本生成器

Linkio 的锚文本生成器工具是一款免费工具,可以为您提供目标关键词的锚文本写作。

Linkio 研究了排名靠前的 网站 的反向链接配置文件,以识别锚文本模式,并使用这些数据创建一种算法来提供锚文本推荐。

无论您是要为主页、产品页面还是博客 文章 构建链接,它们都有自然的锚文本建议,可以帮助您更快地构建更自然的链接。

谷歌目录的经验认为,为了避免谷歌的算法惩罚,需要不同的锚文本配置文件,所以在你的工具包中使用锚文本生成器这样的工具对于任何有上进心的外链专家来说都是成功的第一步。

三:SE排名

SE Ranking目前是semrush的主要竞争对手之一。看看他们的网站,不难知道这是一个比较强大的工具。89美元的价格比较亲民。但是,对 Google SEO 工作者的帮助非常全面。可以提供全面的链接跟踪和排名跟踪。

四:SEMRUSH

SEMrush 可以定位为您的“一体化”SEO 工具包。无论是关键词挖矿,排名监控,竞争对手付费流量分析。这是外链分析的好工具

五:Ahrefs

目前我认为最强的外链分析工具比较贵。这也是谷歌目录中经常使用的工具。我个人认为ahrefs在外链分析中比任何其他工具都更完美。但是与 semrush 相比,排名跟踪感觉不是很准确。

六:雄伟

这个工具是帮我徒弟买的,他是做国内百度seo的,价格不贵。不过外链数据库已经足够强大了。更新速度也比较快,这个工具的优势主要在外链的分析上。当然,你也可以利用他来规划你的网站内容,了解用户更喜欢什么样的内容。

七:打开站点浏览器

以目前的外部数据平台,没有一家公司可以做到完美的数据。如果你没有Open Site Explorer,你得到的外链数据就不会完美。在国外SEO圈的调查中,Open Site Explorer排名第三。

八:乌鸦工具

Raven Tools 可以提供全面的竞争对手分析,并且可以发现你的网站 链接配置的缺点,让你纠正他。

九:MozPro

Moz Pro 为我们提供了证明我们的项目和策略所需的数据。它帮助我们跟踪我们工作的投资回报,并为我们的行业带来显着的透明度。

十:MozBar

MozBar 拥有近 500,000 次安装,是市场上领先的 SEO 工具之一,为您提供与所有主要浏览器兼容的完整 SEO 工具栏。

基本上任何与您相关的 SEO 相关数据点都需要点击两次。页面元素、HTTP 状态代码、链接指示器、结构标签、关键字难度……只需单击两次!MozBar 是我工具箱中最有用的项目之一,而且它一直在变得越来越好。不要浪费你的时间,下载 MozBar!~Beacon Ray,数字营销专家

与 Mozbar Google 目录相比,我更喜欢 SEOquake。

十一:Ontolo

如果你想挖掘数据,没有什么比 Ontolo 更强大的了。Ontolo 的定制软件可以帮助查找潜在客户难以获取的信息。包括联系方式、页面和页面的出站链接。并且可以根据数据进行分类。

十二:链接浏览器

在外链建设方面,获取链接的方式有很多种。不管你做什么行业,为了排名好,稳定。Link Prospector 可以通过研究分析大量数据,列出更多潜在的链接伙伴,大大缩短您的搜索时间。

十三:罗莫夫

如果您想尽快删除您的网站垃圾链接,即对您的网站Google排名有不良影响的链接,那么Rmoov会帮您处理这一切。

十四:认知SEO

它是一个权威工具,可以帮助您快速轻松地找到反向链接活动中的弱点和漏洞。

它会分析您的链接配置文件以查找可能导致处罚的不自然链接,并为您提供快速解决问题所需的工具。

十五:BuzzStream

BuzzStream是比较适合企业的外链工具。您可以为您的团队分配任务,更适合专业的网络营销团队使用。并且还有挖掘目标公司邮箱的能力。整理并找到相关的外部链接。发现您所在行业的热点

十六:忍者外展

软件的优势主要在于内容营销,可以轻松找到行业热点。庞大的数据库

十七:组高

该工具的主要内容是内容营销,它可以帮助您快速找到与您的行业相关的优质内容生产者并与之取得联系。

十八:URL Profiler

链接建设、内容营销、社交数据。你可以在这个平台上得到它。

十九:Scrapebox

Scrapebox 是一个强大的工具,我第一次接触谷歌 seo 时就知道这个工具。但应用最广的还是在黑帽SEO领域。事实上,牛B的一些白帽seo工作者也在使用这个工具。价格不是很贵。主要是自动博客采集,以及博客评论。

二十:断链生成器

只要输入你的关键词,你就可以找到几十个Broken Links,我们可以用得到的数据来构建外链

21:白火花

Whitespark主要是用来做地理排名的,如果要做地理排名的话。推荐你使用,他会根据你选择的地区提供最好的外链机会。使用免费版本,您可以每天免费搜索 3 次。

22:谷歌网站管理员工具

Google 网站管理员工具可用于监控指向您的 网站 的链接。如果有垃圾外链,我们可以用它去除对网站影响比较差的外链。

二十四:Followerwonk

Followerwonk 是 MOZ 的一个工具,主要用于跟踪和分析您的 Twitter 关注者。您可以在您的粉丝中找到合适的人来帮助您建立链接。

二十五:链接矿工

Link Miner 与 Majestic SEO 和 Point Blank SEO 的 Chrome 扩展程序集成,可以为您节省大量构建外部链接的精力。

二十六:渣滓架

Muck Rack 是业内用于查找和联系相关博主和记者的最佳工具之一。此工具将帮助您发现并联系与您的产品相关的主题的最佳博主和记者。

二十七:投球箱

Pitch Box是一个网红推广和内容营销的综合平台。使用他,你可以在第一时间找到出版商、博主和营销人员,然后发邮件联系合作。

28:链接助手

一个主要用于外链建设的软件,一个比较长期的软件。主要用于Windows系统环境操作。

二十九:BuzzSumo

这个工具在谷歌目录中经常使用,可以注册7天免费试用。我觉得主要作用是挖掘行业热点,国外新媒体运营,然后做传播性比较强的内容,这样外链才能自己成长。

三十:SEOQuake

SEOQuak 是一款简单、免费且易于使用的浏览器插件,可在 Firefox 和 Google 浏览器中使用。使用此工具快速检查您的网站 内部链接和外部链接。

31:搜索引擎优化望远镜

国内几位长期做谷歌优化的朋友都在用这个工具。主要用于分析外部链接和比较外部链接。然后根据获得的数据建立外部链接。

三十二:链接排毒

随着谷歌算法的更新,你永远不会知道。你的链接建设策略正确吗?会不会有一天突然被谷歌惩罚?Link Detox 将帮助您完美处理这个问题,他会不断审查您的外部链接。确保算法更新外部链接对页面的负面影响。

三十三:WhoLinkstoMe

WhoLinksToMe 是一款简单易用的工具,可为您提供全面的链接数据、详尽的报告和竞争对手报告。

三十四:高级链接管理器

Advanced Link Manager 被索尼、微软、英伟达等大品牌采用,是目前市场上最好的管理和外链建设工具之一。

三十五:Fresh Link Finder

Fresh Link Finder 是一款出色的工具,可以将所有相关的反向链接数据聚合到一个易于访问的位置。该工具可以帮助您在出现反向链接时对其进行标记,并允许您根据您当前的链接配置文件快速找到新的外部链接机会。这将允许您根据过去的工作创建更智能、更详细的链接构建策略。Fresh Link Finder 为您提供一个月的免费试用,计划起价为每月 49 美元。

36:LinkOdy

LinkOdy 消除了手动跟踪反向链接的需要,并为您提供了一种简单且自动的方式来监控您的链接配置文件。

37:Linkstant

如果您想立即找到新链接的数据,那么您可以选择Linkstant。尽管您可以使用更传统的服务(例如搜索引擎报告和分析日志)在几天或几个月内轻松跟踪反向链接的数据,但 Linkstant 提供了市场上唯一的即时链接报告软件之一。

使用Linkstant,您将能够立即联系链接网站 以更正信息,确定哪些内容对社交媒体有影响,并在用户评论(正面或负面)出现时做出回应。 查看全部

seo文章采集工具(站长网志挑选出来了几十个谷歌SEO优化工具(组图))

站长博客精选了几十款谷歌SEO&SEM优质外链建设工具与大家分享。不管你要研究什么竞争对手,掌握内容营销,删除网站的死链。我保证新手和有经验的数字营销人员都能找到您想要的工具。现在的外链建设已经不再像以前那样做一些低质量的垃圾外链。我们需要建立高质量的外部链接。所以学习和使用这些外链工具

谷歌搜索引擎优化工具

一:灵芝

Linkio 是一款功能强大的外链自动化工具,用于反向链接规划,可以在设置链接构建活动时执行重复和繁琐的工作。

除了简化品牌和代理商的流程外,该工具还不同于复杂的分析引擎,该引擎主动推荐您需要排名最高的下一个链接。

您可以在系统中输入 URL 和一些关键字,软件会分析您现有的反向链接以计算理想的锚文本百分比。然后,它将为您的个人资料建模,而不是从排名靠前的 网站 开始,并告诉您接下来应该建立哪种类型的链接。

例如,如果您建立反向链接以节省时间,并希望该软件提供有效的建议——Linkio 可能就是您一直在寻找的。

二:Linkio 的锚文本生成器

Linkio 的锚文本生成器工具是一款免费工具,可以为您提供目标关键词的锚文本写作。

Linkio 研究了排名靠前的 网站 的反向链接配置文件,以识别锚文本模式,并使用这些数据创建一种算法来提供锚文本推荐。

无论您是要为主页、产品页面还是博客 文章 构建链接,它们都有自然的锚文本建议,可以帮助您更快地构建更自然的链接。

谷歌目录的经验认为,为了避免谷歌的算法惩罚,需要不同的锚文本配置文件,所以在你的工具包中使用锚文本生成器这样的工具对于任何有上进心的外链专家来说都是成功的第一步。

三:SE排名

SE Ranking目前是semrush的主要竞争对手之一。看看他们的网站,不难知道这是一个比较强大的工具。89美元的价格比较亲民。但是,对 Google SEO 工作者的帮助非常全面。可以提供全面的链接跟踪和排名跟踪。

四:SEMRUSH

SEMrush 可以定位为您的“一体化”SEO 工具包。无论是关键词挖矿,排名监控,竞争对手付费流量分析。这是外链分析的好工具

五:Ahrefs

目前我认为最强的外链分析工具比较贵。这也是谷歌目录中经常使用的工具。我个人认为ahrefs在外链分析中比任何其他工具都更完美。但是与 semrush 相比,排名跟踪感觉不是很准确。

六:雄伟

这个工具是帮我徒弟买的,他是做国内百度seo的,价格不贵。不过外链数据库已经足够强大了。更新速度也比较快,这个工具的优势主要在外链的分析上。当然,你也可以利用他来规划你的网站内容,了解用户更喜欢什么样的内容。

七:打开站点浏览器

以目前的外部数据平台,没有一家公司可以做到完美的数据。如果你没有Open Site Explorer,你得到的外链数据就不会完美。在国外SEO圈的调查中,Open Site Explorer排名第三。

八:乌鸦工具

Raven Tools 可以提供全面的竞争对手分析,并且可以发现你的网站 链接配置的缺点,让你纠正他。

九:MozPro

Moz Pro 为我们提供了证明我们的项目和策略所需的数据。它帮助我们跟踪我们工作的投资回报,并为我们的行业带来显着的透明度。

十:MozBar

MozBar 拥有近 500,000 次安装,是市场上领先的 SEO 工具之一,为您提供与所有主要浏览器兼容的完整 SEO 工具栏。

基本上任何与您相关的 SEO 相关数据点都需要点击两次。页面元素、HTTP 状态代码、链接指示器、结构标签、关键字难度……只需单击两次!MozBar 是我工具箱中最有用的项目之一,而且它一直在变得越来越好。不要浪费你的时间,下载 MozBar!~Beacon Ray,数字营销专家

与 Mozbar Google 目录相比,我更喜欢 SEOquake。

十一:Ontolo

如果你想挖掘数据,没有什么比 Ontolo 更强大的了。Ontolo 的定制软件可以帮助查找潜在客户难以获取的信息。包括联系方式、页面和页面的出站链接。并且可以根据数据进行分类。

十二:链接浏览器

在外链建设方面,获取链接的方式有很多种。不管你做什么行业,为了排名好,稳定。Link Prospector 可以通过研究分析大量数据,列出更多潜在的链接伙伴,大大缩短您的搜索时间。

十三:罗莫夫

如果您想尽快删除您的网站垃圾链接,即对您的网站Google排名有不良影响的链接,那么Rmoov会帮您处理这一切。

十四:认知SEO

它是一个权威工具,可以帮助您快速轻松地找到反向链接活动中的弱点和漏洞。

它会分析您的链接配置文件以查找可能导致处罚的不自然链接,并为您提供快速解决问题所需的工具。

十五:BuzzStream

BuzzStream是比较适合企业的外链工具。您可以为您的团队分配任务,更适合专业的网络营销团队使用。并且还有挖掘目标公司邮箱的能力。整理并找到相关的外部链接。发现您所在行业的热点

十六:忍者外展

软件的优势主要在于内容营销,可以轻松找到行业热点。庞大的数据库

十七:组高

该工具的主要内容是内容营销,它可以帮助您快速找到与您的行业相关的优质内容生产者并与之取得联系。

十八:URL Profiler

链接建设、内容营销、社交数据。你可以在这个平台上得到它。

十九:Scrapebox

Scrapebox 是一个强大的工具,我第一次接触谷歌 seo 时就知道这个工具。但应用最广的还是在黑帽SEO领域。事实上,牛B的一些白帽seo工作者也在使用这个工具。价格不是很贵。主要是自动博客采集,以及博客评论。

二十:断链生成器

只要输入你的关键词,你就可以找到几十个Broken Links,我们可以用得到的数据来构建外链

21:白火花

Whitespark主要是用来做地理排名的,如果要做地理排名的话。推荐你使用,他会根据你选择的地区提供最好的外链机会。使用免费版本,您可以每天免费搜索 3 次。

22:谷歌网站管理员工具

Google 网站管理员工具可用于监控指向您的 网站 的链接。如果有垃圾外链,我们可以用它去除对网站影响比较差的外链。

二十四:Followerwonk

Followerwonk 是 MOZ 的一个工具,主要用于跟踪和分析您的 Twitter 关注者。您可以在您的粉丝中找到合适的人来帮助您建立链接。

二十五:链接矿工

Link Miner 与 Majestic SEO 和 Point Blank SEO 的 Chrome 扩展程序集成,可以为您节省大量构建外部链接的精力。

二十六:渣滓架

Muck Rack 是业内用于查找和联系相关博主和记者的最佳工具之一。此工具将帮助您发现并联系与您的产品相关的主题的最佳博主和记者。

二十七:投球箱

Pitch Box是一个网红推广和内容营销的综合平台。使用他,你可以在第一时间找到出版商、博主和营销人员,然后发邮件联系合作。

28:链接助手

一个主要用于外链建设的软件,一个比较长期的软件。主要用于Windows系统环境操作。

二十九:BuzzSumo

这个工具在谷歌目录中经常使用,可以注册7天免费试用。我觉得主要作用是挖掘行业热点,国外新媒体运营,然后做传播性比较强的内容,这样外链才能自己成长。

三十:SEOQuake

SEOQuak 是一款简单、免费且易于使用的浏览器插件,可在 Firefox 和 Google 浏览器中使用。使用此工具快速检查您的网站 内部链接和外部链接。

31:搜索引擎优化望远镜

国内几位长期做谷歌优化的朋友都在用这个工具。主要用于分析外部链接和比较外部链接。然后根据获得的数据建立外部链接。

三十二:链接排毒

随着谷歌算法的更新,你永远不会知道。你的链接建设策略正确吗?会不会有一天突然被谷歌惩罚?Link Detox 将帮助您完美处理这个问题,他会不断审查您的外部链接。确保算法更新外部链接对页面的负面影响。

三十三:WhoLinkstoMe

WhoLinksToMe 是一款简单易用的工具,可为您提供全面的链接数据、详尽的报告和竞争对手报告。

三十四:高级链接管理器

Advanced Link Manager 被索尼、微软、英伟达等大品牌采用,是目前市场上最好的管理和外链建设工具之一。

三十五:Fresh Link Finder

Fresh Link Finder 是一款出色的工具,可以将所有相关的反向链接数据聚合到一个易于访问的位置。该工具可以帮助您在出现反向链接时对其进行标记,并允许您根据您当前的链接配置文件快速找到新的外部链接机会。这将允许您根据过去的工作创建更智能、更详细的链接构建策略。Fresh Link Finder 为您提供一个月的免费试用,计划起价为每月 49 美元。

36:LinkOdy

LinkOdy 消除了手动跟踪反向链接的需要,并为您提供了一种简单且自动的方式来监控您的链接配置文件。

37:Linkstant

如果您想立即找到新链接的数据,那么您可以选择Linkstant。尽管您可以使用更传统的服务(例如搜索引擎报告和分析日志)在几天或几个月内轻松跟踪反向链接的数据,但 Linkstant 提供了市场上唯一的即时链接报告软件之一。

使用Linkstant,您将能够立即联系链接网站 以更正信息,确定哪些内容对社交媒体有影响,并在用户评论(正面或负面)出现时做出回应。

seo文章采集工具(乐速优化王SEO软件的功能介绍及功能详解)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-10-21 02:16

乐速优化王SEO软件是通过多年对搜索引擎算法的跟踪研究,采用全新智能云优化技术,有效跟踪企业SEO状态网站,分析企业网站@ > 各大搜索引擎排名变化,分析竞争对手在搜索引擎中的表现,智能诊断网站 SEO问题,根据相关诊断报告提升网站在SEO各方面的质量,从而实现其网站关键词在搜索引擎中的良好排名效果。

功能介绍

1、SEO诊断:快速发现网站SEO状态,自动给出合理建议,及时调整。

2、关键词深度挖掘,关键词变化跟踪,快速增加关键词所在页面的权重。

3、强大的SEO预警功能,让网站维护者第一时间发现网站SEO状态。

4、竞争对手分析,竞争对手智能对比分析网站SEO状态5、快速有效提升网站关键词在搜索引擎中的自然排名。

6、智能优化网站的搜索引擎关注度和友好度。

7、智能优化网站搜索引擎收录量;和更新频率。

8、 真正有效增加网站访问量;即增加访问IP和PV。

9、 搜索引擎相关搜索智能优化(显示底层相关搜索中优化的关键词)。

10、 智能优化搜索引擎下拉框,快速占领十大最热门、最抢眼的搜索下拉位置。

11、向各大搜索引擎快速提交网站。同时管理多个网站,减少重复时间。

软件功能

1、简单易用,操作简单,自动升级。

2、 高安全性基于超链接分析原理,不改变网站的任何内容,快速增加关键词所在页面的权重,从而增加权重整个网站。

3、真实有效。基于智能云优化技术,利用网络节点的地域差异和用户的随机性,使访问效果真实有效。

4、通过将网站权重数据包反馈给搜索引擎的优化原则和技巧,合理分配网站的权重,提升网站的关注度和友好度,从而达到快速提升网站关键词排名的效果。 查看全部

seo文章采集工具(乐速优化王SEO软件的功能介绍及功能详解)

乐速优化王SEO软件是通过多年对搜索引擎算法的跟踪研究,采用全新智能云优化技术,有效跟踪企业SEO状态网站,分析企业网站@ > 各大搜索引擎排名变化,分析竞争对手在搜索引擎中的表现,智能诊断网站 SEO问题,根据相关诊断报告提升网站在SEO各方面的质量,从而实现其网站关键词在搜索引擎中的良好排名效果。

功能介绍

1、SEO诊断:快速发现网站SEO状态,自动给出合理建议,及时调整。

2、关键词深度挖掘,关键词变化跟踪,快速增加关键词所在页面的权重。

3、强大的SEO预警功能,让网站维护者第一时间发现网站SEO状态。

4、竞争对手分析,竞争对手智能对比分析网站SEO状态5、快速有效提升网站关键词在搜索引擎中的自然排名。

6、智能优化网站的搜索引擎关注度和友好度。

7、智能优化网站搜索引擎收录量;和更新频率。

8、 真正有效增加网站访问量;即增加访问IP和PV。

9、 搜索引擎相关搜索智能优化(显示底层相关搜索中优化的关键词)。

10、 智能优化搜索引擎下拉框,快速占领十大最热门、最抢眼的搜索下拉位置。

11、向各大搜索引擎快速提交网站。同时管理多个网站,减少重复时间。

软件功能

1、简单易用,操作简单,自动升级。

2、 高安全性基于超链接分析原理,不改变网站的任何内容,快速增加关键词所在页面的权重,从而增加权重整个网站。

3、真实有效。基于智能云优化技术,利用网络节点的地域差异和用户的随机性,使访问效果真实有效。

4、通过将网站权重数据包反馈给搜索引擎的优化原则和技巧,合理分配网站的权重,提升网站的关注度和友好度,从而达到快速提升网站关键词排名的效果。

seo文章采集工具( 小编想解释一下优采云收藏家的收藏原则和过程和收藏过程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-10-20 14:01

小编想解释一下优采云收藏家的收藏原则和过程和收藏过程)

编者:写文章很无聊文章,但是百度的优化排名离不开文章的积累,所以各种文章采集器遍地都是,今天小编就是

写文章很无聊,但百度的优化排名离不开文章的积累,所以市面上各种文章采集器。今天小编就为大家讲解一下优采云采集器的采集原理和流程。什么是数据采集?我们可以理解,我们打开了一个网站,看起来很不错,所以我们复制了文章的标题和内容,然后

写文章很无聊,但百度的优化排名离不开文章的积累,所以市面上各种文章采集器。今天小编就为大家讲解一下优采云采集器的采集原理和流程。

什么是数据采集?我们可以理解,我们打开了一个网站,看到一篇文章的文章很好,所以我们复制了文章的标题和内容,把这个文章移到了我们的网站。我们的过程可以称为获取,它将您网站 上的其他人的有用信息传输到您自己的网站。

采集器是这样做的,但整个过程是由软件完成的。可以理解为我们复制了文章的标题和内容。我们可以知道内容是什么,标题是什么,但是软件不知道,所以我们必须告诉软件如何选择它。这是编写规则的过程。复制后我们打开我们的网站,比如论坛发帖的地方,然后发布。对于软件来说,就是模仿我们的帖子,发布文章,怎么发布,这就是数据发布的过程。

列车采集器是用于采集数据的软件。它是网络上最强大的采集器。它几乎可以捕获您看到的任何 Web 内容。

列车采集器数据采集原理:

火车采集器如何捕获数据取决于您的规则。要获取网页的所有内容,首先需要获取该网页的网址。这是网址。程序根据规则抓取列表页面,分析URL,然后抓取该URL的网页内容。根据你的采集规则分析下载的网页,将标题内容和其他信息分开保存。如果选择下载图片等网络资源,程序会分析采集到的数据,找到图片的下载地址、资源等,下载到本地。

列车采集器数据发布原则:

数据采集完成后,默认保存在本地。我们可以使用以下方法来处理数据。

1. 什么都不做。因为数据本身存储在数据库中(access、db3、mysql、sqlserver),如果只查看数据,可以使用相关软件打开。

2.网站 发布到 网站。程序会模仿浏览器向你的网站发送数据,可以达到手动发布的效果。

3.直接进入数据库。你只需要写一些SQL语句,程序就会根据你的SQL语句将数据导入到数据库中。

4.另存为本地文件。程序会读取数据库中的数据,并按一定格式保存为本地sql或文本文件。

火车采集工作流程

列车采集器分两步采集数据,一是采集数据,二是分发数据。这两个过程可以分开。

1.采集数据,包括采集URL和采集内容。这个过程就是获取数据的过程。我们制定规则并处理挖矿过程的内容。

2. 发布内容是将数据发布到自己的论坛cms的过程,同时也是将数据作为一个已有的过程来执行。您可以使用WEB、数据库存储在线发布或保存为本地文件。

不过,在这里要提醒广大网站管理员,百度飓风算法2.0的引入,进一步加大了百度对采集这一现象的处罚力度。在这个用户体验不断提升的时代,你想用吗?文章采集器,就看管理员的想法了网站!

当前网址:搜狗游花/644.html 查看全部

seo文章采集工具(

小编想解释一下优采云收藏家的收藏原则和过程和收藏过程)

编者:写文章很无聊文章,但是百度的优化排名离不开文章的积累,所以各种文章采集器遍地都是,今天小编就是

写文章很无聊,但百度的优化排名离不开文章的积累,所以市面上各种文章采集器。今天小编就为大家讲解一下优采云采集器的采集原理和流程。什么是数据采集?我们可以理解,我们打开了一个网站,看起来很不错,所以我们复制了文章的标题和内容,然后

写文章很无聊,但百度的优化排名离不开文章的积累,所以市面上各种文章采集器。今天小编就为大家讲解一下优采云采集器的采集原理和流程。

什么是数据采集?我们可以理解,我们打开了一个网站,看到一篇文章的文章很好,所以我们复制了文章的标题和内容,把这个文章移到了我们的网站。我们的过程可以称为获取,它将您网站 上的其他人的有用信息传输到您自己的网站。

采集器是这样做的,但整个过程是由软件完成的。可以理解为我们复制了文章的标题和内容。我们可以知道内容是什么,标题是什么,但是软件不知道,所以我们必须告诉软件如何选择它。这是编写规则的过程。复制后我们打开我们的网站,比如论坛发帖的地方,然后发布。对于软件来说,就是模仿我们的帖子,发布文章,怎么发布,这就是数据发布的过程。

列车采集器是用于采集数据的软件。它是网络上最强大的采集器。它几乎可以捕获您看到的任何 Web 内容。

列车采集器数据采集原理:

火车采集器如何捕获数据取决于您的规则。要获取网页的所有内容,首先需要获取该网页的网址。这是网址。程序根据规则抓取列表页面,分析URL,然后抓取该URL的网页内容。根据你的采集规则分析下载的网页,将标题内容和其他信息分开保存。如果选择下载图片等网络资源,程序会分析采集到的数据,找到图片的下载地址、资源等,下载到本地。

列车采集器数据发布原则:

数据采集完成后,默认保存在本地。我们可以使用以下方法来处理数据。

1. 什么都不做。因为数据本身存储在数据库中(access、db3、mysql、sqlserver),如果只查看数据,可以使用相关软件打开。

2.网站 发布到 网站。程序会模仿浏览器向你的网站发送数据,可以达到手动发布的效果。

3.直接进入数据库。你只需要写一些SQL语句,程序就会根据你的SQL语句将数据导入到数据库中。

4.另存为本地文件。程序会读取数据库中的数据,并按一定格式保存为本地sql或文本文件。

火车采集工作流程

列车采集器分两步采集数据,一是采集数据,二是分发数据。这两个过程可以分开。

1.采集数据,包括采集URL和采集内容。这个过程就是获取数据的过程。我们制定规则并处理挖矿过程的内容。

2. 发布内容是将数据发布到自己的论坛cms的过程,同时也是将数据作为一个已有的过程来执行。您可以使用WEB、数据库存储在线发布或保存为本地文件。

不过,在这里要提醒广大网站管理员,百度飓风算法2.0的引入,进一步加大了百度对采集这一现象的处罚力度。在这个用户体验不断提升的时代,你想用吗?文章采集器,就看管理员的想法了网站!

当前网址:搜狗游花/644.html